ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- RAGChecker: A Fine-grained Framework for Diagnosing Retrieval-Augmented Generation

発行日:2024年08月15日

RAGCheckerは、RAGシステムの包括的な評価を行い、RAGアーキテクチャの設計選択に洞察を提供するための評価フレームワークであり、研究者や実務家が効果的なRAGシステムを開発するのに役立つ. - Grok-2 Beta Release

発行日:2024年08月13日

Grok-2は、最新の推論能力を備えたフロンティア言語モデルであり、Grokファミリーの2つのメンバーであるGrok-2とGrok-2 miniが含まれています.Grok-2は、テキストとビジョンの理解に高度な能力を持つ最新のAIアシスタントであり、𝕏プラットフォームからリアルタイムの情報を統合し、𝕏アプリのGrokタブからアクセスできます.Grok-2 miniは、小さなが、しかし能力のあるモデルであり、速度と回答品質のバランスを提供します.Grok-2は、前身であるGrok-1.5と比較して、より直感的で操作可能であり、幅広いタスクにおいて柔軟性を持っています.Black Forest Labsとの協力により、私たちは彼らのFLUX.1モデルを使用して、Grokの能力を𝕏上で拡張する実験を行っています.2023年11月にGrok-1を発表して以来、xAIは最高の人材密度を持つ小さなチームによって驚異的なペースで進化しています.新しいコンピュートクラスタを使用して、コア推論能力を向上させることに焦点を当てています.今後数ヶ月で共有するべき多くの開発があります.プレミアムまたはプレミアム+のサブスクライバーであれば、Grok-2のベータテストを行うために、𝕏アプリの最新バージョンにアップデートすることをお勧めします.さらに、今後は、エンタープライズAPIを介して開発者にGrok-2とGrok-2 miniを提供し、新しいベータテストやAI機能の展開を行う予定です.𝕏上でのGrokの応用範囲についても、AI駆動の機能の向上やGrokによる深い洞察の獲得、改善された返信機能など、さまざまな可能性に期待が高まっています.また、近日中に、Grok体験の中核として、マルチモーダル理解のプレビューを𝕏およびAPI上でリリースする予定です.私たちは、人類の未来のために最も影響力のある革新を構築することに専念した小さな専門チームに参加する個人を募集しています.こちらからポジションに応募してください. - LongWriter: Unleashing 10,000+ Word Generation from Long Context LLMs

発行日:2024年08月13日

LLMは出力の長さが制限されているが、AgentWriteを導入することで20,000語以上の出力を可能にし、LongWriter-6kデータセットを構築し、出力品質を維持しながら10,000語以上の出力長を達成した. - Mutual Reasoning Makes Smaller LLMs Stronger Problem-Solvers

発行日:2024年08月12日

rStarは、自己対戦相互推論アプローチで、SLMの推論能力を向上させ、様々な推論問題を効果的に解決します. - The AI Scientist: Towards Fully Automated Open-Ended Scientific Discovery

発行日:2024年08月12日

AI科学者が自動的に科学的発見を行うための包括的なフレームワークを提案し、機械学習の分野に革新をもたらしている. - A Survey of NL2SQL with Large Language Models: Where are we, and where are we going?

発行日:2024年08月09日

NL2SQL技術は、大規模言語モデル(LLM)によって向上し、ユーザーの自然言語クエリをSQLクエリに変換することで、リレーショナルデータベースへのアクセス障壁を減らし、商用アプリケーションをサポートする. - HybridRAG: Integrating Knowledge Graphs and Vector Retrieval Augmented Generation for Efficient Information Extraction

発行日:2024年08月09日

金融アプリケーションにおける情報抽出のためのHybridRAGアプローチは、KGとVectorRAGを組み合わせて、文脈に即した回答を生成し、従来の手法よりも優れた性能を示している. - EfficientRAG: Efficient Retriever for Multi-Hop Question Answering

発行日:2024年08月08日

EfficientRAGは、multi-hop質問応答において効率的なリトリーバーであり、大規模言語モデルの複数の呼び出しに依存せずにパフォーマンスを向上させることができる. - Medical Graph RAG: Towards Safe Medical Large Language Model via Graph Retrieval-Augmented Generation

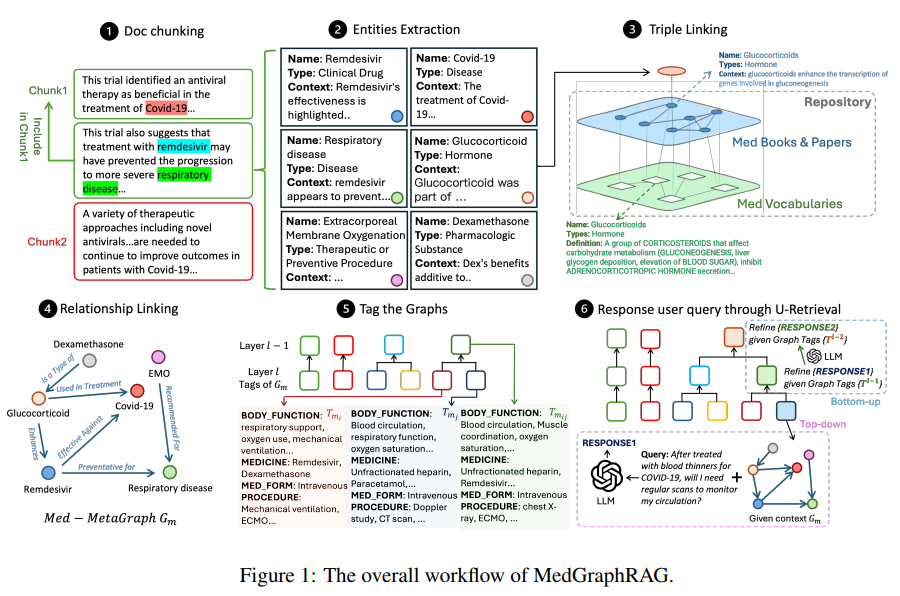

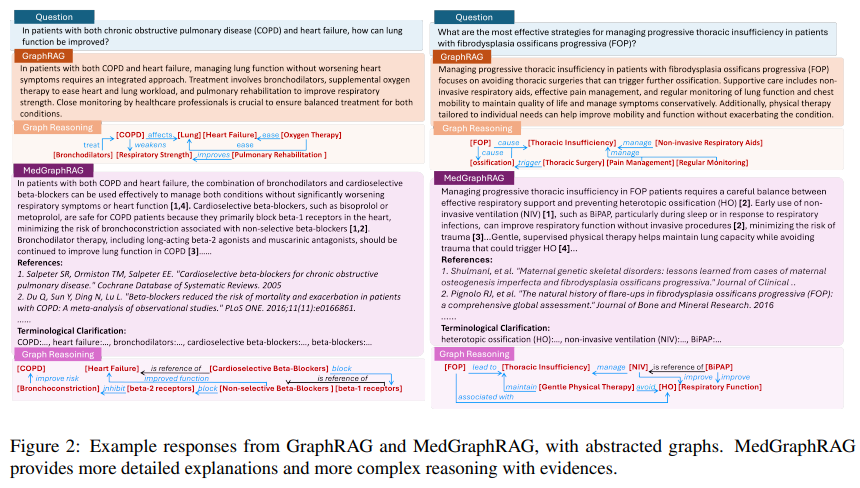

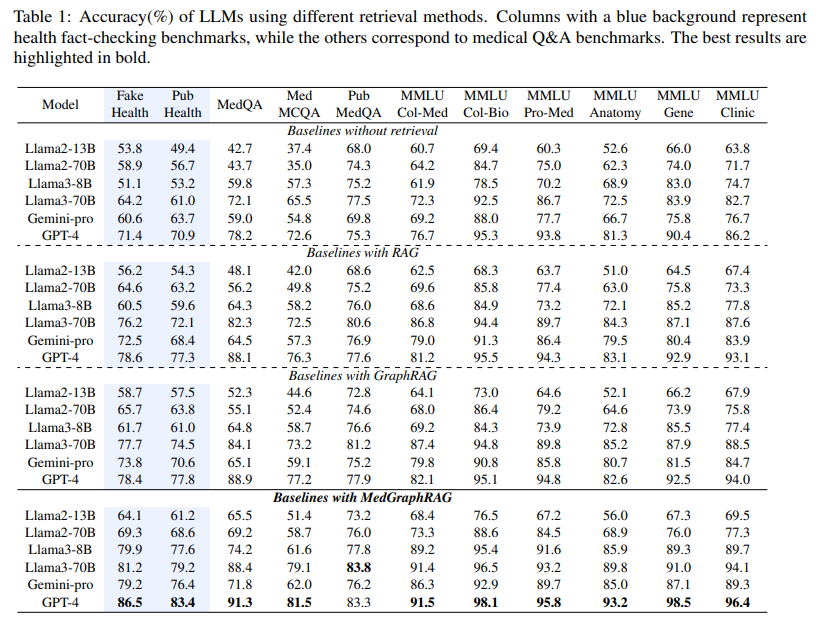

発行日:2024年08月08日

MedGraphRAGは、医療分野向けの新しいグラフベースの検索増強生成(RAG)フレームワークで、証拠に基づいた医療応答を生成し、安全性と信頼性を向上させることを目的としています. - Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters

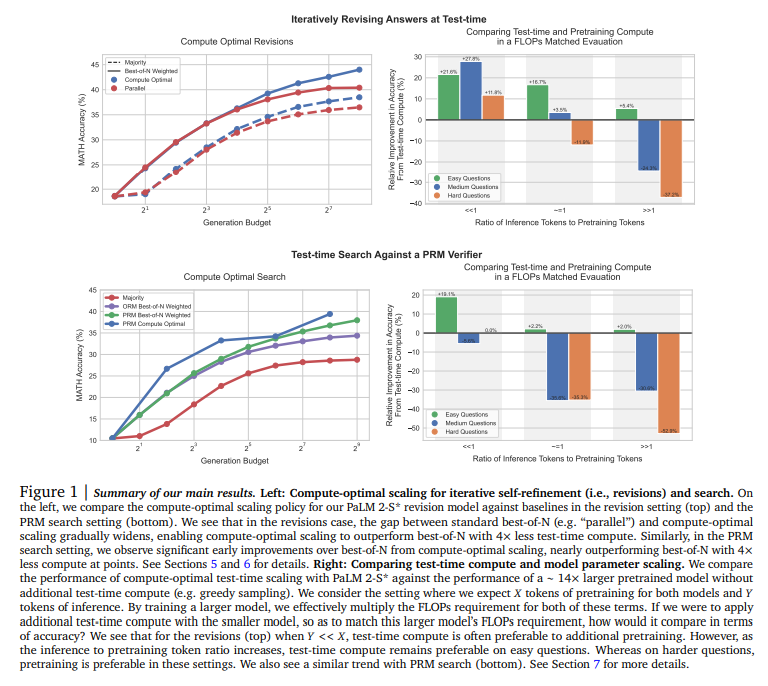

発行日:2024年08月06日

LLMのテスト時間計算をスケーリングすることで、自己改善エージェントを構築し、オープンエンドの自然言語操作を可能にする重要なステップであり、パフォーマンス向上が可能であることが示唆された.

RAGChecker: A Fine-grained Framework for Diagnosing Retrieval-Augmented Generation

著者:Dongyu Ru, Lin Qiu, Xiangkun Hu, Tianhang Zhang, Peng Shi, Shuaichen Chang, Cheng Jiayang, Cunxiang Wang, Shichao Sun, Huanyu Li, Zizhao Zhang, Binjie Wang, Jiarong Jiang, Tong He, Zhiguo Wang, Pengfei Liu, Yue Zhang, Zheng Zhang

発行日:2024年08月15日

最終更新日:2024年08月17日

URL:http://arxiv.org/pdf/2408.08067v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

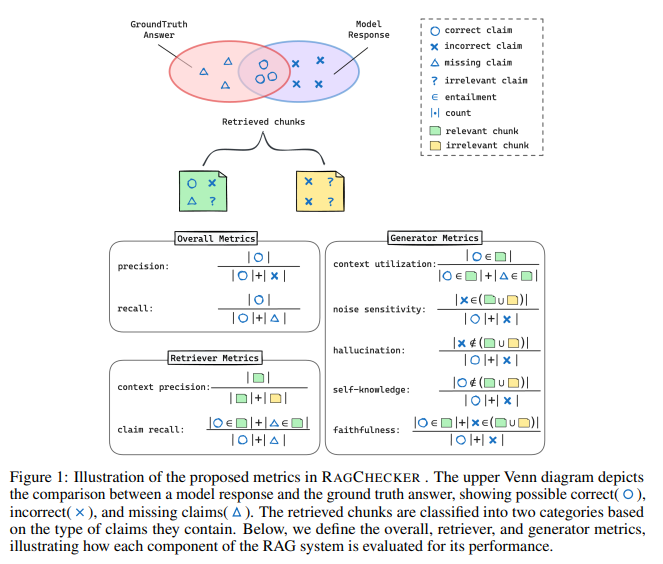

Retrieval-Augmented Generation(RAG)は、外部知識を活用する能力を示す有望なシステムであるにもかかわらず、RAGシステムの包括的な評価は、RAGのモジュール構造、長い形式の応答の評価、および測定の信頼性のために依然として困難である.本論文では、検索および生成モジュールの両方に対する診断メトリクスのスイートを組み込んだ、RAGCheckerという細かい評価フレームワークを提案する.メタ評価により、RAGCheckerが他の評価メトリクスよりも人間の判断と有意な相関を持つことが確認されている.RAGCheckerを使用して、8つのRAGシステムを評価し、そのパフォーマンスを詳細に分析し、RAGアーキテクチャの設計選択における洞察に富んだパターンとトレードオフを明らかにする.RAGCheckerのメトリクスは、研究者や実務家がより効果的なRAGシステムを開発する際に役立つことができる.この作業はhttps://github.com/amazon-science/RAGCheckerでオープンソース化されている.

Q&A:

Q: RAGCheckerは、既存の評価指標と比較して、どのようにして測定値の信頼性を確保しているのですか?

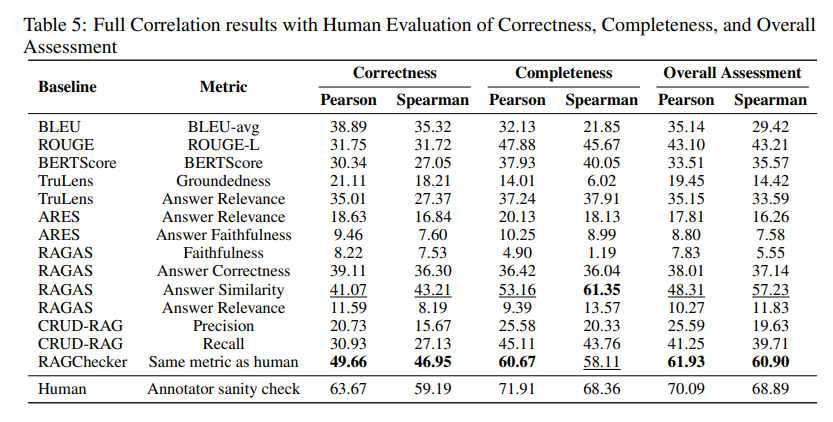

A: RAGCHECKERは、その測定の信頼性を確保するために、いくつかの方法を採用しております.まず、RAGCHECKERは、提案されたメトリクスと人間の判断との相関を評価するために、人間の判断データセットを注釈付けしております.このメタ評価により、RAGCHECKERが人間の視点からRAGシステムの品質と信頼性を捉える効果が検証されております.さらに、RAGCHECKERは、リトリーバーとジェネレーターの両方のコンポーネントに対して詳細な評価を提供し、エラーの原因に関する実行可能な洞察を提供する新しい診断メトリクスを導入しております.これにより、RAGCHECKERは、既存の評価フレームワークと比較して、RAGシステムのより包括的な評価を提供しております.特に、RAGCHECKERのメトリクスは、すべて詳細なクレームレベルのチェックに基づいており、エラーの原因に関する実行可能な洞察を提供するように設計されております.これらの要素により、RAGCHECKERは、他の評価メトリクスよりも人間の判断との相関が大幅に向上していることが確認されております.

Q: RAGCheckerと人間の判断との相関関係を検証するために使用したメタ評価プロセスについて詳しく教えてください.

A: RAGCheckerの人間の判断との相関を検証するためのメタ評価プロセスについて説明いたします.このプロセスでは、まず人間の判断データセットを注釈付けし、提案されたメトリクスと人間の判断との相関を評価します.このメタ評価は、RAGCheckerがRAGシステムの品質と信頼性を人間の視点からどの程度捉えているかを検証するものです.具体的には、注釈ツールのUIにおいて、各応答がGPT-4によって生成された批評と共に表示され、注釈者は応答の内容と批評を参照してラベル付けを行います.批評は、GPT-4に応答を正解と比較させるプロンプトを用いて生成され、注釈作業を容易にします.さらに、各例にはラベル付けのための人間による説明が示されています.メタ評価に含まれる10のメトリクスは、Trulens、RAGAS、ARES、CRUD-RAGから選ばれ、その詳細は表4にまとめられています.RAGCheckerと最も強力なベースラインメトリックであるRAGAS Answer Similarityとの詳細な比較のために、2つのメトリクスの予測スコア分布を図4にプロットしています.この予測スコア分布とプロットの平均線(破線)から、RAGCheckerの方がRAGAS Answer Similarityよりも強い相関を持つことが観察されます.

Q: 研究者や実務者は、RAGCheckerが提供する指標をどのように活用すれば、RAGシステムを改善できるのか?

A: 研究者や実務者は、RAGCheckerが提供するメトリクスを利用して、RAGシステムの改善を図ることができます.RAGCheckerは、クレームレベルの含意チェックに基づいており、応答と正解の間のクレームを抽出し、他のテキストと照合することで、詳細な評価を可能にします.このアプローチにより、応答レベルの評価ではなく、より細かい粒度での評価が可能となります.具体的には、RAGCheckerはユーザーのクエリ、取得されたコンテキスト、応答、正解を処理し、一連のメトリクスを生成します.これにより、RAGシステムの設計選択における洞察に満ちたパターンやトレードオフを明らかにし、システムの性能を向上させるための具体的な改善点を特定することができます.したがって、研究者や実務者は、これらのメトリクスを活用して、システムの性能を人間の判断とよりよく一致させることができるのです.

Q: RAGCheckerの開発の動機と、この分野における他の評価フレームワークとの違いは何ですか?

A: RAGCheckerの開発は、RAGシステムの評価において、リトリーバーとジェネレーターの両方のコンポーネントに対して詳細な評価を提供する必要性から動機付けられました.他の評価フレームワークと異なり、RAGCheckerは新しい診断指標を導入し、エラーの原因に関する実用的な洞察を提供します.また、RAGCheckerは、他の評価指標よりも人間の判断との相関が大幅に優れていることがメタ評価によって確認されています.

Q: RAGCheckerの使用に関して、ユーザーが知っておくべき制限や課題はありますか?

A: RAGCheckerを使用する際には、いくつかの制限や課題が存在することに注意が必要です.まず、RAGCheckerの評価フレームワークは包括的であるものの、いくつかの制限が存在します.特に、リトリーバーコンポーネントの診断指標は、ジェネレーターのそれと比較して洞察に乏しいとされています.リトリーバルメトリクスは主に、真実の主張のリコールと取得されたコンテキストの精度に焦点を当てていますが、リトリーバルプロセスの微妙なニュアンスや複雑さを完全には捉えていない可能性があります.情報密度、多様性、取得されたコンテキストの一貫性などの要素を考慮した、より洗練された指標を開発することが、リトリーバーの性能に関するより深い洞察を提供する可能性があります.さらに、RAGCheckerで提案されている指標は、中立的なものとそうでないものを区別しないという問題もあります.

Grok-2 Beta Release

著者:Xai

発行日:2024年08月13日

最終更新日:不明

URL:https://x.ai/blog/grok-2

カテゴリ:不明

概要:

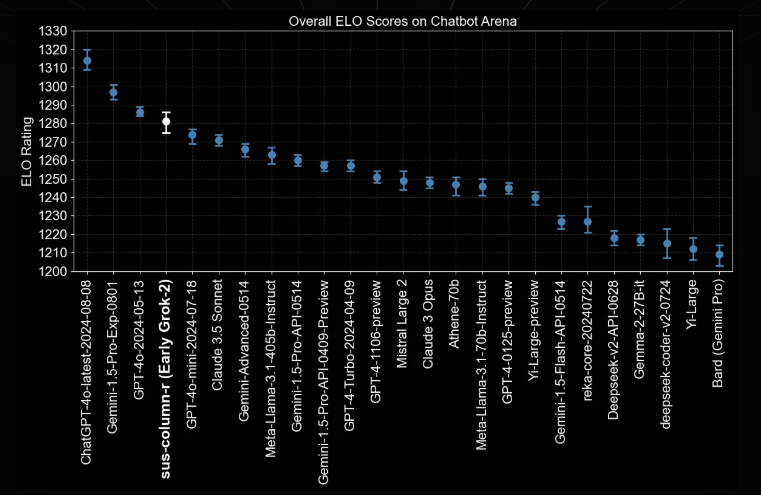

Grok-2は、最新の推論能力を備えたフロンティア言語モデルであり、Grokファミリーの2つのメンバーであるGrok-2とGrok-2 miniが含まれています.これらのモデルは、現在、𝕏プラットフォームのGrokユーザーにリリースされています.Grok-2は、以前のモデルであるGrok-1.5から大きく進化したものであり、チャット、コーディング、推論などのフロンティア機能を備えています.同時に、Grok-2の小さなが、しかし能力のある兄弟であるGrok-2 miniも導入されています.Grok-2の初期バージョンは、LMSYSリーダーボードで「sus-column-r」という名前でテストされており、このブログ投稿時点では、Claude 3.5 SonnetとGPT-4-Turboの両方を上回っています.Grok-2とGrok-2 miniは現在、𝕏でベータ版として提供されており、今月末にはエンタープライズAPIを介して両モデルを利用できるようにする予定です.さらに、Grok-2はLMSYSチャットボット競技場に初期バージョンとして導入され、全体的なEloスコアにおいてClaudeやGPT-4を上回っています.内部的には、AIチューターがGrokとの対話を通じてモデルの能力を評価しており、Grok-2は情報の取得やツールの使用能力において大幅な改善を示しています.さらに、Grok-2モデルは、推論、読解、数学、科学、コーディングなどの一連の学術ベンチマークで評価されました.Grok-2とGrok-2 miniは、以前のGrok-1.5モデルよりも大幅な改善を示し、博士レベルの科学知識(GPQA)、一般知識(MMLU、MMLU-Pro)、数学競技問題(MATH)などの分野で他のフロンティアモデルと競争力のあるパフォーマンスレベルを達成しています.さらに、Grok-2は、ビジョンベースのタスクで優れた成績を収めており、視覚的な数学推論(MathVista)や文書ベースの質問応答(DocVQA)において最先端のパフォーマンスを提供しています.最近の改善により、𝕏プラットフォーム上でのGrok体験がさらに進化し、新しいインターフェースと機能が導入されました.また、𝕏プレミアムおよびプレミアム+ユーザーは、Grok-2とGrok-2 miniにアクセスできるようになりました.Grok-2は、テキストとビジョンの理解に高度な能力を持つ最新のAIアシスタントであり、𝕏プラットフォームからリアルタイムの情報を統合し、𝕏アプリのGrokタブからアクセスできます.Grok-2 miniは、小さなが、しかし能力のあるモデルであり、速度と回答品質のバランスを提供します.Grok-2は、前身であるGrok-1.5と比較して、より直感的で操作可能であり、幅広いタスクにおいて柔軟性を持っています.Black Forest Labsとの協力により、私たちは彼らのFLUX.1モデルを使用して、Grokの能力を𝕏上で拡張する実験を行っています.プレミアムまたはプレミアム+のサブスクライバーであれば、Grok-2のベータテストを行うために、𝕏アプリの最新バージョンにアップデートすることをお勧めします.さらに、今後は、エンタープライズAPIを介して開発者にGrok-2とGrok-2 miniを提供し、新しいベータテストやAI機能の展開を行う予定です.𝕏上でのGrokの応用範囲についても、AI駆動の機能の向上やGrokによる深い洞察の獲得、改善された返信機能など、さまざまな可能性に期待が高まっています.また、近日中に、Grok体験の中核として、マルチモーダル理解のプレビューを𝕏およびAPI上でリリースする予定です.

2023年11月にGrok-1を発表して以来、xAIは最高の人材密度を持つ小さなチームによって驚異的なペースで進化しています.私たちはGrok-2を導入し、AI開発の最前線に位置しています.新しいコンピュートクラスタを使用して、コア推論能力を向上させることに焦点を当てています.今後数ヶ月で共有するべき多くの開発があります.私たちは、人類の未来のために最も影響力のある革新を構築することに専念した小さな専門チームに参加する個人を募集しています.こちらからポジションに応募してください.

Q&A:

Q: Grok-1.5と比較して、Grok-2では具体的にどのような推論機能が向上したのですか?

A: Grok-2は、Grok-1.5と比較して、いくつかの学術ベンチマークにおいて大幅な改善を示しています.特に、推論能力においては、大学院レベルの科学知識(GPQA)や一般知識(MMLU、MMLU-Pro)、数学競技問題(MATH)において、他の最先端モデルと競争力のある性能を達成しています.具体的には、GPQAで35.9%から51.0%に、MMLUで81.3%から86.2%に、MMLU-Proで51.0%から72.0%に、MATHで50.6%から73.0%に改善されています.これらの結果は、Grok-2が推論能力においてGrok-1.5よりも優れていることを示しています.

Q: Grok-2とGrok-2 miniのパフォーマンスや機能面での主な違いは何ですか?

A: Grok-2とGrok-2 miniの性能と能力の主な違いについて説明いたします.Grok-2は、Grok-2 miniに比べて、いくつかのベンチマークにおいて優れた性能を示しております.具体的には、Grok-2はGPQAにおいて51.0%の正答率を示し、Grok-2 miniの35.9%を上回っております.また、MMLUではGrok-2が86.2%の正答率を示し、Grok-2 miniの81.3%を上回っております.さらに、MMLU-ProにおいてもGrok-2は72.0%の正答率を示し、Grok-2 miniの51.0%を大きく上回っております.MATHのベンチマークでは、Grok-2は73.0%の正答率を示し、Grok-2 miniの50.6%を上回っております.HumanEvalにおいても、Grok-2は85.7%の正答率を示し、Grok-2 miniの74.1%を上回っております.MMMUでは、Grok-2が63.2%の正答率を示し、Grok-2 miniの53.6%を上回っております.MathVistaにおいても、Grok-2は68.1%の正答率を示し、Grok-2 miniの52.8%を上回っております.最後に、DocVQAでは、Grok-2が93.2%の正答率を示し、Grok-2 miniの85.6%を上回っております.これらの結果から、Grok-2はGrok-2 miniに比べて、より高い性能を持つことが示されております.

Q: Grok-2のLMSYSリーダーボードでのパフォーマンスは、Claude 3.5 SonnetやGPT-4-Turboなどの他のモデルと比較してどうですか?

A: Grok-2のパフォーマンスは、LMSYSリーダーボードにおいて、Claude 3.5 SonnetやGPT-4-Turboを上回っております.具体的には、Grok-2はこれらのモデルよりも高いEloスコアを獲得しており、その優位性が示されています.

Q: Grok-2の評価にはどのような学力ベンチマークが使われ、それぞれのカテゴリーでどのような結果が出たのか?

A: Grok-2は、以下の学術的ベンチマークを用いて評価されました:

- 推論: Grok-2は、推論能力において前モデルであるGrok-1.5よりも大幅に改善されました.

- 読解力: 読解力においても、Grok-2は優れた性能を示しました.

- 数学: 数学の競技問題(MATH)において、Grok-2は76.1\%の正答率を達成し、Grok-1.5の50.6\%を大きく上回りました.

- 科学: 大学院レベルの科学知識(GPQA)において、Grok-2は56.0\%の正答率を示しました.

- コーディング: コーディング能力においても、Grok-2はHumanEvalで88.4\%の正答率を達成しました.

- 視覚ベースのタスク: Grok-2は視覚的な数学的推論(MathVista)で69.0\%の正答率を示し、文書ベースの質問応答(DocVQA)では93.6\%の正答率を達成しました.

これらの結果から、Grok-2は多くの分野で最先端の性能を発揮していることがわかります.

Q: Grok-2の指示に従う能力と正確な情報提供においてどのような進歩がなされていますか?

A: Grok-2の能力において、指示に従うことと正確な情報を提供することに関して、いくつかの重要な進展が見られました.まず、Grok-2は、情報を取得して推論する能力において顕著な改善を示しています.具体的には、欠落した情報を正確に特定し、イベントの順序を論理的に推論し、関連性のない投稿を排除する能力が向上しています.これにより、Grok-2は、指示に従う能力と正確な情報を提供する能力の両方において、以前のモデルであるGrok-1.5と比較して大幅な改善を達成しています.

Q: Grok-2とGrok-2 miniは、プラットフォーム上でどのような使用例が想定されていますか?

A: Grok-2とGrok-2 miniの𝕏プラットフォームでの期待される使用例としては、AI駆動の機能を強化することが挙げられます.具体的には、検索機能の向上、𝕏投稿に対するより深い洞察の獲得、そして返信機能の改善が含まれます.これらの機能はすべてGrokによって強化される予定です.

Q: Grok-2のエンタープライズAPIはいつ利用可能になり、どのような機能が含まれるのでしょうか?

A: エンタープライズAPIは今月後半に利用可能になる予定です.このAPIは、マルチリージョン推論デプロイメントを可能にし、世界中で低遅延アクセスを提供する新しい専用技術スタックに基づいて構築されています.さらに、必須の多要素認証(例:Yubikey、Apple TouchID、またはTOTP)、豊富なトラフィック統計、詳細なデータエクスポートを含む高度な請求分析などの強化されたセキュリティ機能を提供します.また、チーム、ユーザー、および請求管理を既存の社内ツールやサービスに統合するための管理APIも提供されます.

LongWriter: Unleashing 10,000+ Word Generation from Long Context LLMs

著者:Yushi Bai, Jiajie Zhang, Xin Lv, Linzhi Zheng, Siqi Zhu, Lei Hou, Yuxiao Dong, Jie Tang, Juanzi Li

発行日:2024年08月13日

最終更新日:2024年08月13日

URL:http://arxiv.org/pdf/2408.07055v1

カテゴリ:Computation and Language, Machine Learning

概要:

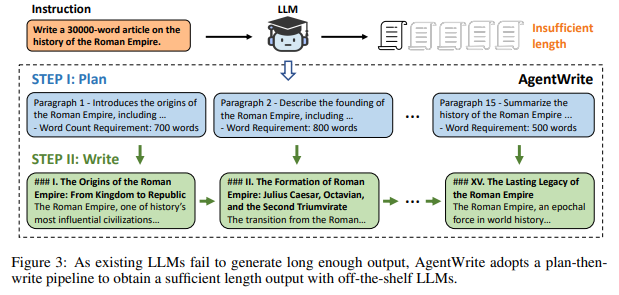

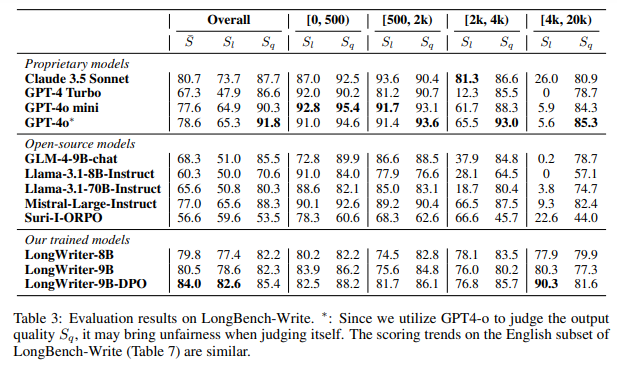

現在の大規模言語モデル(LLM)は、最大100,000トークンの入力を処理できますが、生成される出力の長さはわずか2,000語にも満たないことがあります.制御された実験を通じて、我々はモデルの効果的な生成長が、監督された微調整(SFT)中に見られるサンプルによって本質的に制限されていることを発見しました.言い換えれば、彼らの出力制限は、既存のSFTデータセットにおける長い出力例の希少性に起因しています.これを解決するために、我々はAgentWriteを導入しました.これは、超長い生成タスクをサブタスクに分解し、市販のLLMが20,000語を超える一貫した出力を生成できるようにします.AgentWriteを活用して、2kから32k語までの出力長を持つ6,000のSFTデータを含むLongWriter-6kデータセットを構築しました.このデータセットをモデルのトレーニングに組み込むことで、既存のモデルの出力長を10,000語以上にスケーリングしながら出力品質を維持することに成功しました.また、超長い生成能力を評価する包括的なベンチマークであるLongBench-Writeを開発しました.さらに、DPOを通じてさらに改良された9Bパラメータモデルは、最先端の成果を達成しています.我々の研究は、既存の長いコンテキストLLMが既により大きな出力ウィンドウの可能性を持っていることを示しており、モデルの調整中に拡張された出力を持つデータがあれば、この能力を引き出すことができることを示しています.我々のコードとモデルは、以下のリンクから入手可能です:.” rel=”nofollow”>https://github.com/THUDM/LongWriter.

Q&A:

Q: AgentWriteは、超長時間の生成タスクをサブタスクに分解するために、具体的にどのようなテクニックを使っていますか?

A: AgentWriteは、超長文生成タスクをサブタスクに分解するために、分割統治法スタイルのエージェントパイプラインを使用しております.具体的には、長文の執筆タスクを複数のサブタスクに分解し、各サブタスクではモデルが1つの段落のみを書くことを求められます.モデルはこれらのサブタスクを順次実行し、サブタスクの出力を連結して最終的な長文の出力を得る方法を採用しております.このアプローチは、問題解決やソフトウェア開発、モデル評価などの様々な分野で既に応用されております.

Q: LongWriter-6kデータセットは、既存のSFTデータセットと出力の長さや内容においてどのような違いがありますか?

A: LongWriter-6kデータセットは、既存のSFTデータセットと比較して、出力長と内容の両方において異なっております.まず、出力長に関しては、LongWriter-6kは2,000語以上の長い出力を必要とする6,000のユーザー指示を選択しており、出力長が2,000語以上のデータを効果的に補完しております.具体的には、GLM-4のSFTデータから3,000の指示を選び、さらにWildChatから3,000の指示を選んでおります.これにより、LongWriter-6kは2,000語から10,000語の範囲で比較的均等に分布した出力長を持つデータセットとなっております.内容に関しては、LongWriter-6kは、長い出力を生成するためのデータを自動的に構築するために、AgentWriteという手法を用いており、既存のモデルの出力ウィンドウサイズを10,000語以上に拡大することに成功しております.このように、LongWriter-6kは、出力の質を損なうことなく、長いテキストの生成能力を向上させるために設計されております.

Q: 生成された1万語を超えるテキストの出力品質は、どのような指標で評価されたのでしょうか?

A: 与えられたコンテキストによれば、生成されたテキストの出力品質を評価するために使用された指標は、関連性、正確性、一貫性、明確さ、幅と深さ、そして読書体験の6つの次元であります.これらの次元に基づいて、出力の品質スコア ( S_q ) が算出されます.最終的なスコア ( \bar{S} ) は、出力の長さスコア ( S_l ) と品質スコア ( S_q ) の平均として計算されます.

Q: LongBench-Writeベンチマークにおいて、9Bパラメータモデルの性能は他のモデルと比較してどうですか?

A: 9Bパラメータモデルの性能は、LongBench-Writeベンチマークにおいて、他のより大きなプロプライエタリモデルを上回ることが示されています.特に、DPOを用いて改善されたLongWriter-9B-DPOモデルは、GPT-4oと同等の性能を達成しています.評価結果によれば、LongWriter-9B-DPOモデルは、スコアが他のモデルよりも高く、特に出力長が4,000語を超える指示に対して優れた性能を示しています.これにより、9Bパラメータモデルは、より少ないパラメータ数でありながら、最先端の性能を発揮することができることが確認されています.

Q: DPO(直接選好最適化)はモデルのパフォーマンス向上においてどのような役割を果たしますか?

A: DPO(直接選好最適化)は、モデルの出力品質を向上させ、指示における長さの制約に従う能力を強化する役割を果たします.具体的には、LongWriter-9Bモデルに対してDPOを適用することで、出力の品質と長さの要件に対する適合性が向上します.DPOは、GLM-4のチャットDPOデータから得られた約50,000件のエントリを使用し、さらに長文の書き込み指示を特に対象とした4,000組のデータを構築します.各書き込み指示に対して、LongWriter-9Bから4つの出力をサンプリングし、Hou et al. (2024)の方法に従ってこれらの出力をスコアリングします.さらに、式1で計算された長さの追従スコアを組み合わせます.最も高いスコアの出力を正のサンプルとして選び、残りの3つの出力のうちランダムに1つを負のサンプルとして選びます.このデータ混合物で250ステップのトレーニングを行い、LongWriter-9B-DPOモデルを得ます.DPOは、長文生成シナリオにおいてもモデルの出力品質を向上させ、出力の長さをより適切に調整することが示されています.

Q: 既存のモデルの出力長を拡大する際に、何か制限や課題はありますか?

A: 既存のモデルの出力長を拡大する際に直面する制限や課題については、いくつかの要因が挙げられます.まず、出力長の制約は主に、モデルのスーパーバイズド・ファインチューニング(SFT)データセットの特性に根ざしていることが明らかになっています.具体的には、モデルの最大生成長は、SFTデータセットに存在する出力長の上限によって実質的に制限されており、事前学習フェーズでより長いシーケンスに触れているにもかかわらず、この制約が存在します.このため、現在のモデルでは2,000語の生成制限が一般的であり、既存のSFTデータセットにはこの長さを超える例がほとんど含まれていないことが原因です.さらに、多くのデータセットは最先端の大規模言語モデル(LLM)から抽出されており、これらのソースモデルから出力長の制限を引き継いでいます.したがって、出力長を拡大するためには、SFT段階でのデータの最大出力長を変更することが必要であり、これにより訓練されたモデルの最大出力長がSFTデータの最大出力長と正の相関を示すことが確認されています.

Q: AgentWriteパイプラインが生成するアウトプットの一貫性をどのように確保しますか?

A: AgentWriteパイプラインによって生成される出力の一貫性を確保するために、まず詳細な執筆計画が作成されます.この計画は、ユーザーの入力に基づいて各段落の構造と目標単語数を示します.次に、この計画に従ってモデルが段落ごとに順次コンテンツを生成するように促されます.これにより、出力の一貫性が保たれます.しかし、出力の一貫性をさらに向上させるためには、ステップIIで以前に生成されたコンテキストをモデルに提供することが必要であると示唆されています.これにより、モデルが前の段落の内容を再確認し、繰り返しを避けることができます.

Mutual Reasoning Makes Smaller LLMs Stronger Problem-Solvers

著者:Zhenting Qi, Mingyuan Ma, Jiahang Xu, Li Lyna Zhang, Fan Yang, Mao Yang

発行日:2024年08月12日

最終更新日:2024年08月12日

URL:http://arxiv.org/pdf/2408.06195v1

カテゴリ:Computation and Language

概要:

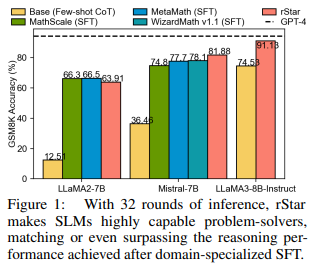

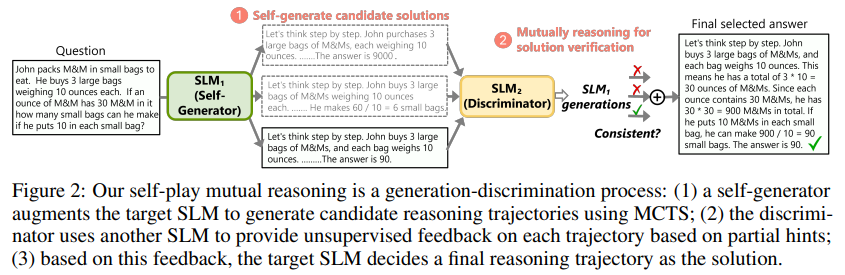

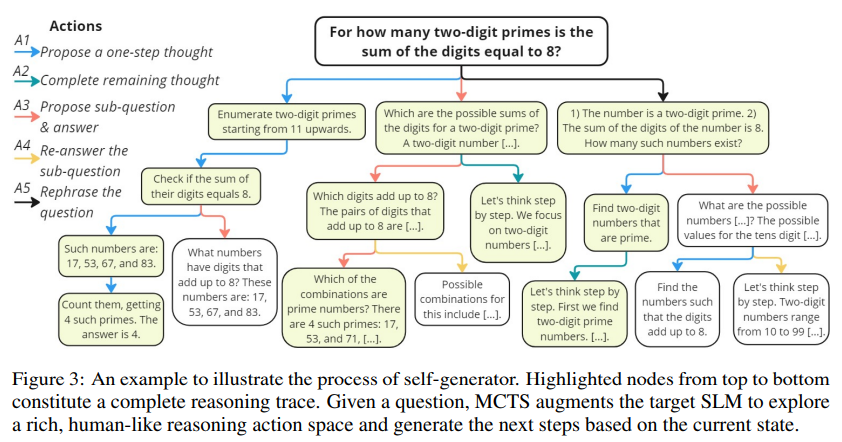

この論文は、rStarという自己対戦相互推論アプローチを紹介しています.このアプローチは、微調整や優れたモデルを必要とせずに、小規模言語モデル(SLM)の推論能力を大幅に向上させます.rStarは、推論を自己対戦相互生成-識別プロセスに分解します.まず、ターゲットSLMは、人間らしい推論アクションの豊富なセットを用いて、Monte Carlo Tree Search(MCTS)を拡張し、より高品質な推論経路を構築します.次に、ターゲットSLMと同様の能力を持つ別のSLMが、ターゲットSLMによって生成された各経路を検証するディスクリミネータとして機能します.相互に合意された推論経路は相互一貫性があり、したがって正しい可能性が高いと見なされます.5つのSLMを対象に行われた幅広い実験は、rStarがGSM8K、GSM-Hard、MATH、SVAMP、StrategyQAなどのさまざまな推論問題を効果的に解決できることを示しています.特に、rStarは、LLaMA2-7BのGSM8Kの精度を12.51%から63.91%、Mistral-7Bの精度を36.46%から81.88%、LLaMA3-8B-Instructの精度を74.53%から91.13%に向上させました.コードはhttps://github.com/zhentingqi/rStarで入手可能です.

Q&A:

Q: セルフプレーの相互世代判別プロセスについて、もう少し詳しく説明していただけますか?

A: 自己プレイの相互生成-識別プロセスについて詳しく説明いたします.このプロセスは、生成と識別の2つのステップに分かれています.まず、自己生成器がターゲットとなる小型言語モデル(SLM)を補強し、モンテカルロ木探索(MCTS)を用いて候補となる推論の軌跡を生成いたします.次に、識別器が別のSLMを使用して、部分的なヒントに基づいて各軌跡に対して教師なしのフィードバックを提供いたします.このフィードバックに基づいて、ターゲットSLMは最終的な推論の軌跡を解として決定いたします.このプロセスは、推論を自己プレイの相互生成-識別プロセスに分離することで、SLMの推論能力を向上させることを目的としております.具体的には、rStarという手法がこのプロセスを実現しており、SLMの推論能力を強化するために、ファインチューニングや上位モデルを必要としない点が特徴でございます.

Q: rStarはモンテカルロ木探索(MCTS)を人間のような推論動作でどのように補強するのか?

A: rStarは、モンテカルロ木探索(MCTS)を人間のような推論行動で拡張しております.具体的には、rStarは現在の推論状態に基づいて、問題を分解したり、特定の推論ステップを探したり、新しいサブクエスチョンを提案したり、与えられた質問を言い換えたりするなどの行動をシミュレートします.これにより、SLMは自己探索中に高品質な候補推論軌跡を生成することが可能になります.さらに、生成された推論軌跡の探索を効果的に導くために、rStarは新しい識別プロセスである相互一貫性をMCTSプロセスに追加します.特に、rStarは類似の能力を持つ第二のSLMを識別子として雇用し、生成された各候補推論軌跡に対して無監督のフィードバックを提供します.

Q: 対象のSLMが使用するセットには、具体的にどのような推論アクションが含まれていますか?

A: 与えられた文脈から、ターゲットSLMが使用する具体的な推論アクションのセットには、5つのアクションが含まれていることが示されています.特に、A1として「1ステップの思考を提案する」アクションが挙げられています.このアクションは、既存の推論ステップを考慮して、与えられた質問に対して次の1ステップの思考を生成するようにLLMを促します.これは、完全な思考を生成するCoTとは異なり、推論プロセスを簡素化し、LLMがより正確に1ステップを生成できるようにするものです.

Q: 推論の軌道が相互に一貫しているかどうかは、どのような基準で判断するのですか?

A: 相互整合性を判断するための基準は、候補となる推論経路が別のSLM((\hat{M}))によって完成された際に、元の推論経路と一致するかどうかです.具体的には、推論経路 (t = x \oplus s_1 \oplus s_2 \oplus … \oplus s_d) において、ランダムに選ばれたステップ (i)((i < d))から始まる推論ステップをマスクし、(\hat{M}) に対して前の推論経路 (t = x \oplus s_1 \oplus s_2 \oplus … \oplus s_{i-1}) をプロンプトとして提供し、残りのステップを完成させます.(\hat{M}) が完成した答えが元の推論経路 (t) と一致する場合、その経路は最終選択のための有効な経路と見なされます.この方法は、教師のフィードバックがない状況での学生の問題解決に似ており、複数のSLMが同意した推論経路は正確である可能性が高いと考えられます.

Q: 5つのSLMでrStarの性能を評価するために使用した実験セットアップについて詳しく教えてください.

A: 実験のセットアップに関しては、rStarが様々な大規模言語モデル(LLM)と推論タスクに適用可能な一般的なアプローチであることが述べられています.評価された5つのSLMは、Phi3-mini (3.8B) (Abdin et al., 2024)、LLaMA2-7B、Mistral-7B (Jiang et al., 2023)、LLaMA3-8B、およびLLaMA3-8B-Instruct (Meta, 2024)です.これらのモデルは、GSM8K (Cobbe et al., 2021)、GSM-Hard (Gao et al., 2022)を含む4つの数学的タスクを含む5つの推論タスクでテストされました.評価を迅速化するために、MATHデータセットから代表的な問題のサブセットであるMATH-500が使用されました.rStarは、これらの挑戦的な数学的データセットにおけるSLMの推論精度を大幅に向上させることが示されています.特に、最先端のベースラインと比較して、GSM-Hardで最大+12.9%、MATH-500で+9.14%の大幅な改善が観察されました.

Q: rStarは、小規模言語モデルの推論能力を向上させる他の既存の手法と比較してどうなのか?

A: rStarは、既存の方法と比較して、小型言語モデル(SLM)の推論能力を大幅に向上させることが示されています.具体的には、rStarは、自己改善や多ラウンドプロンプトアプローチを含む最先端のベースラインを上回る性能を発揮します.例えば、rStarは、LLaMA2-7BのGSM8Kの精度を12.51%から63.91%に、Mistralの精度を36.46%から81.88%に、LLaMA3-8Bの精度を47.23%から85.52%に向上させます.これにより、rStarは、ファインチューニング後に達成される精度に匹敵するか、あるいはそれを上回る結果を達成します.rStarは、モンテカルロ木探索(MCTS)を用いて、自己プレイによる相互生成-識別プロセスを通じて推論を行い、ターゲットSLMが生成した推論軌跡を別のSLMが検証します.このようにして、相互に合意された推論軌跡が正しい可能性が高いとされます.

Q: 実験で観測された精度の向上は、実用化に向けてどのような意味を持つのでしょうか?

A: 実験で観察された精度の向上は、実用的なアプリケーションにおいていくつかの重要な意味を持っています.まず、rStarのような技術を用いることで、SLM(大規模言語モデル)の推論能力が大幅に向上することが示されています.具体的には、GSM8Kデータセットにおいて、LLaMA2-7Bの精度が12.51%から63.91%に、Mistralの精度が36.46%から81.88%に、LLaMA3-8Bの精度が47.23%から85.52%に向上しました.これにより、SLMは特定のドメインに特化した微調整を行わなくても、高度な問題解決能力を発揮できることが示されています.\n\nこのような精度の向上は、実用的なアプリケーションにおいて、より効率的でコスト効果の高いソリューションを提供する可能性があります.特に、微調整のためのデータ収集やモデルの再トレーニングが困難な状況において、rStarのような技術は有用です.また、推論能力の向上により、より複雑なタスクや新しいドメインへの適応が可能となり、幅広い応用が期待されます.\n\nさらに、rStarのような技術は、上位の教師モデルを必要とせずに推論能力を向上させることができるため、リソースが限られた環境でも効果的に利用できる可能性があります.これにより、より多くの組織や個人が高度なAI技術を活用できるようになるでしょう.

The AI Scientist: Towards Fully Automated Open-Ended Scientific Discovery

著者:Chris Lu, Cong Lu, Robert Tjarko Lange, Jakob Foerster, Jeff Clune, David Ha

発行日:2024年08月12日

最終更新日:2024年09月01日

URL:http://arxiv.org/pdf/2408.06292v3

カテゴリ:Artificial Intelligence, Computation and Language, Machine Learning

概要:

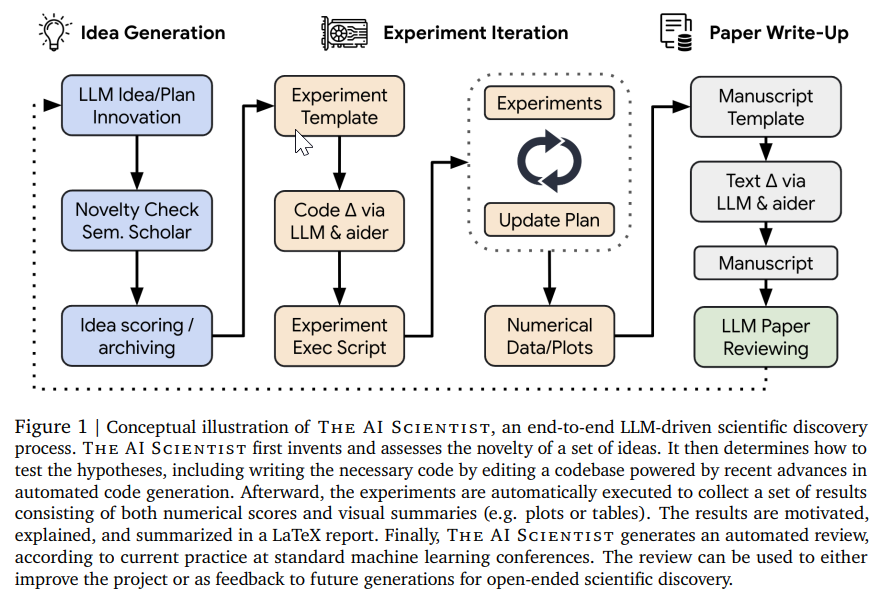

最先端の大規模言語モデルが独立して研究を行い、その結果を伝えることができるようにすることで、完全自動の科学的発見を可能にする包括的なフレームワークを提案しています.AI科学者は新しい研究アイデアを生成し、コードを記述し、実験を実行し、結果を視覚化し、完全な科学論文を書いてその結果を説明し、最後に評価のためにシミュレートされた査読プロセスを実行することができます.このアプローチは、機械学習の三つの異なるサブフィールドに適用されており、それぞれのアイデアはトランスフォーマーベースの言語モデリングや学習ダイナミクスなどに関連しています.また、各論文のコストは15ドル未満であり、生成された論文を評価するために自動査読者を設計し、検証しています.この自動査読者は、論文の評価において人間に近いパフォーマンスを達成しています.AI科学者は、自動査読者によって判断されるトップ機械学習会議で受け入れ基準を超える論文を作成することができます.このアプローチは、機械学習における科学的発見の新しい時代の幕開けを示しており、AIエージェントの変革的な利点をAI自体の研究プロセス全体にもたらし、世界で最も難しい問題に対して無限の創造性と革新を解き放つ世界に一歩近づけています.私たちのコードはhttps://github.com/SakanaAI/AI-Scientistでオープンソース化されています.

Q&A:

Q: AIサイエンティストは、斬新な研究アイデアを生み出すために、具体的にどのような方法論を用いているのでしょうか?

A: The AI Scientistは、進化的計算とオープンエンデッドネス研究にインスパイアされて、アイデアのアーカイブを反復的に成長させるために、LLMを突然変異オペレーターとして使用しております.各アイデアは、説明、実験実行計画、および興味深さ、新規性、実現可能性の自己評価数値スコアを含んでおります.各反復で、既存のアーカイブに基づいて、興味深い新しい研究方向を生成するように言語モデルにプロンプトを与えております.このプロセスには、チェーン・オブ・ソート(Wei et al., 2022)と自己反省(Shinn et al., 2024)の複数ラウンドが使用されております.

Q: AIサイエンティストはどのように実験を行い、どのような種類の実験を行うことができますか?

A: AIサイエンティストは、最新の自動コード生成技術を活用してコードベースを編集し、必要なコードを書き上げることによって実験を実行いたします.その後、実験は自動的に実行され、数値スコアや視覚的な要約(例えば、プロットや表)を含む結果が収集されます.AIサイエンティストは、機械学習(ML)アプリケーションに焦点を当てていますが、適切な自動実験実行方法があれば、生物学や物理学などの他のほとんどの分野にも一般的に適用することが可能でございます.

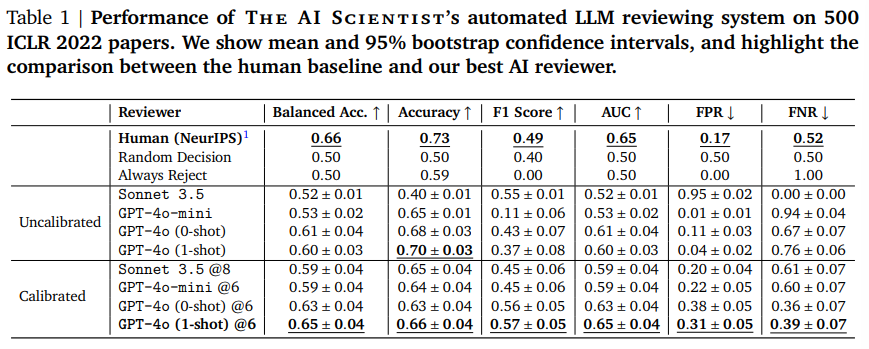

Q: 模擬審査はどのように行われ、どのような評価基準が用いられるのか?

A: 与えられた文脈から、シミュレートされたレビュー過程は、基盤モデルに基づくレビュー過程を導入することによって行われることがわかります.この過程は、ICLR 2022 OpenReviewデータに基づいて評価された際に、複数の評価指標において人間に近いレベルのパフォーマンスを達成しています.具体的な評価指標としては、バランス精度(balanced accuracy)が挙げられ、65%と66%の比較が示されています.これにより、AI科学者は最良のアイデアを選択し、科学的発見のアーカイブに「出版」することが可能となります.

Q: AIサイエンティストが独自に科学研究を行う上での限界とは?

A: AIサイエンティストが独立して科学研究を行う際の制限について、いくつかの重要な点が指摘されています.まず、提案された方法の社会的影響や限界について十分に議論されていないことが挙げられます.これらの側面を考慮することで、研究の影響をより包括的に理解することができるでしょう.また、提案された方法に伴う計算オーバーヘッドやトレーニング時間の増加についても十分に触れられていません.さらに、このアプローチが高次元データセットや他の種類のデータに一般化できるかどうかについての議論も限られています.最後に、計算の複雑さの増加やデータセット特有の調整要件といった提案された方法の潜在的な限界についても十分に考慮されていないことが指摘されています.

Q: The AI Scientistは、どのようにして研究アイデアの独創性と妥当性を確保しているのですか?

A: AIサイエンティストは、生成した研究アイデアの独自性と関連性を確保するために、まずアイデアを発明し、その新規性を評価するプロセスを経ます.このプロセスでは、最近の自動コード生成の進歩を活用してコードベースを編集し、仮説をテストする方法を決定します.さらに、最近発表された論文の内容を提供することで、新規性のあるアイデアを生み出すことが可能になると考えられています.

Q: 人間に近いパフォーマンスを達成するために、自動レビュアーはどのように設計され、検証されたのか?

A: 自動化されたレビュアーは、ICLR 2022の論文500件を対象に、公開されているOpenReviewデータセットを用いて評価されました.この評価では、人工的に生成された決定と実際のデータを比較しました.LLMエージェントの最近の進歩を組み合わせることで、意思決定プロセスを堅牢にしました.GPT-4oを用いたレビュー過程の評価では、Reflexionとワンショットプロンプティングを追加することで、LLMベースのレビュー過程の精度が向上しました.レビューのアンサンブリング(5つのレビュー)とその後のメタ集約は、レビュアーのパフォーマンスには影響を与えませんでしたが、分散を減少させることができました.各レビューはAPIコストで0.25ドルから0.50ドルで生成されました.他のファウンデーションモデルとの比較では、ClaudeSonnet3.5(Anthropic, 2024)やGPT-4o-miniはよりコスト効率の良いアプローチを提供しましたが、そのパフォーマンスはかなり劣っていました.

Q: The AI Scientistがトップカンファレンスで受け入れ基準を超える論文を生産する能力の影響は、科学研究の将来にどのような影響を与えるでしょうか?

A: AIサイエンティストがトップ会議での受理基準を超える論文を生成できることは、科学研究の未来において重要な意味を持つと考えられます.まず、AIが研究プロセス全体を自動化することで、科学的発見の新しい時代が始まるとされています.これにより、AIエージェントの変革的な利点がAI自身の研究プロセスに適用され、科学と技術の最も困難な分野での革新と問題解決の無限の可能性が開かれると期待されています.さらに、AI駆動の研究者だけでなく、レビューアー、エリアチェア、そして会議全体を含む完全なAI駆動の科学エコシステムが実現される可能性があります.しかし、人間の科学者の役割が軽視されることはないと考えられています.新しい技術に適応することで、科学者はより野心的な目標に取り組む力を得ると予想されています.例えば、研究者はしばしば追求する時間がないほど多くのアイデアを持っていますが、AIサイエンティストがそれらの初期探索を行うことができれば、研究の効率が大幅に向上する可能性があります.

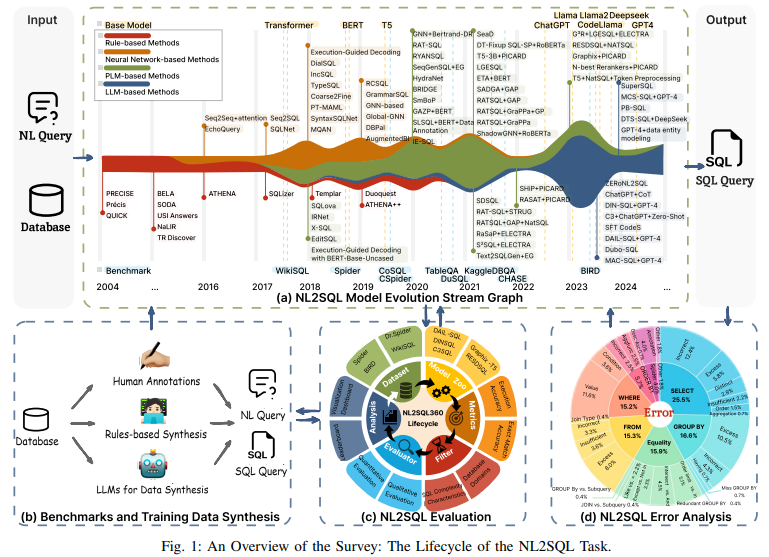

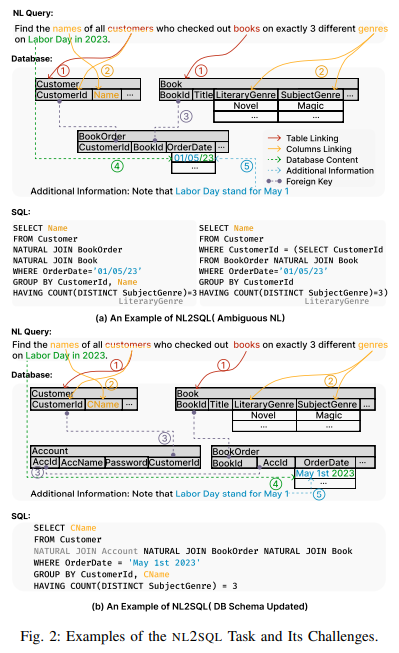

A Survey of NL2SQL with Large Language Models: Where are we, and where are we going?

著者:Xinyu Liu, Shuyu Shen, Boyan Li, Peixian Ma, Runzhi Jiang, Yuyu Luo, Yuxin Zhang, Ju Fan, Guoliang Li, Nan Tang

発行日:2024年08月09日

最終更新日:2024年08月09日

URL:http://arxiv.org/pdf/2408.05109v1

カテゴリ:Databases

概要:

ユーザーの自然言語クエリ(NL)をSQLクエリに変換すること(つまり、NL2SQL)は、リレーショナルデータベースへのアクセス障壁を大幅に減らし、さまざまな商用アプリケーションをサポートすることができます.大規模言語モデル(LLM)の登場により、NL2SQLのパフォーマンスが大幅に向上しています.この調査では、LLMによって強化されたNL2SQL技術の包括的なレビューを提供し、次の4つの側面からその全生命周期をカバーしています:(1)モデル:NLの曖昧さや不十分さだけでなく、適切にNLをデータベースのスキーマやインスタンスにマッピングするNL2SQL変換技術;(2)データ:トレーニングデータの収集から、トレーニングデータの不足によるデータ合成、NL2SQLベンチマークまで;(3)評価:異なるメトリクスや粒度を使用してNL2SQL方法を評価する;および(4)エラー分析:NL2SQLのエラーを分析して原因を見つけ、NL2SQLモデルの進化を導く.さらに、NL2SQLソリューションを開発するための経験則を提供します.最後に、LLM時代のNL2SQLの研究課題と未解決の問題について議論します.

Q&A:

Q: 大規模言語モデルの時代におけるNL2SQLソリューションの開発で予見される主な課題は何ですか?

A: NL2SQLソリューションの開発における大きな課題は、特に大規模言語モデル(LLM)の時代において、いくつかの技術的な障害を克服する必要があることです.まず、モデルの効率性が重要であり、自然言語クエリを迅速にSQLに変換する能力が求められます.これは、ユーザーエクスペリエンスや運用コストに直接影響を与えるため、特に低遅延が求められるシナリオでは重要です.次に、生成されるSQLの効率性も考慮されなければなりません.NL2SQLモデルによって生成されるSQLは、正確であるだけでなく、パフォーマンスの最適化も必要です.結合、インデックス、クエリ構造の選択において最適化が求められます.さらに、説明可能なAIを使用して意思決定のプロセスを示し、精度を評価するための強力な評価指標を開発することも重要です.これらの課題は、NL2SQL技術の進化において、特に自然言語処理(NLP)の進歩によって推進されてきたものです.

HybridRAG: Integrating Knowledge Graphs and Vector Retrieval Augmented Generation for Efficient Information Extraction

著者:Bhaskarjit Sarmah, Benika Hall, Rohan Rao, Sunil Patel, Stefano Pasquali, Dhagash Mehta

発行日:2024年08月09日

最終更新日:2024年08月09日

URL:http://arxiv.org/pdf/2408.04948v1

カテゴリ:Computation and Language, Machine Learning, Statistical Finance, Applications, Machine Learning

概要:

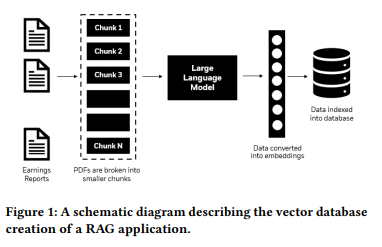

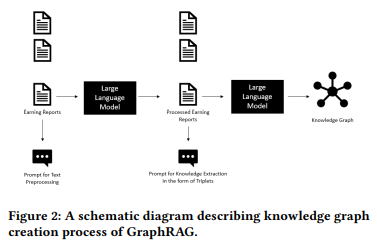

金融アプリケーションで発生する非構造化テキストデータから複雑な情報を抽出し解釈することは、大規模言語モデル(LLMs)にとっても現在のベストプラクティスであるRetrieval Augmented Generation(RAG)を使用しても、ドメイン固有の用語や文書の複雑な形式などの課題により、大きな挑戦をもたらします.我々は、知識グラフ(KGs)ベースのRAG技術(GraphRAGと呼ばれる)とVectorRAG技術を組み合わせた新しいアプローチ、HybridRAGを紹介し、金融文書からの情報抽出のための質問回答(Q&A)システムを強化することを示しています.このアプローチは、正確で文脈に即した回答を生成することができるとされています.金融の収益通話のトランスクリプト文書のセットを用いた実験を通じて、HybridRAGがベクトルデータベースとKGの両方からコンテキストを取得することで、従来のVectorRAGやGraphRAGよりも優れた性能を発揮することを示しています.さらに、この提案された技術は、金融分野を超えた応用可能性も示しています.

Q&A:

Q: 金融アプリケーションで非構造化テキストデータを処理する際、大規模言語モデルは具体的にどのような課題に直面するのだろうか?

A: 大規模言語モデル(LLMs)が金融アプリケーションで非構造化テキストデータを処理する際に直面する具体的な課題として、まず、トレーニングデータ外の金融文書から情報を抽出することが挙げられます.これにより、モデルが誤った情報を生成する「幻覚」を減少させる必要があります.また、金融文書は非常に専門的であり、一般的な言語モデルではその専門性を十分に理解できない可能性があります.さらに、金融データはしばしば時系列データであり、これを適切に処理するためには、時間的な依存関係を考慮する必要があります.これらの課題は、LLMsが金融分野での情報抽出や分析において直面する主要な障壁となっています.

Q: VectorRAGとGraphRAGのテクニックの違いについて詳しく教えてください.

A: ベクトルRAG(VectorRAG)とグラフRAG(GraphRAG)の違いについて詳しく説明いたします.ベクトルRAGは、近年広く研究されており、NLPタスクを強化するために関連するテキスト情報を取得し、生成プロセスをサポートすることに焦点を当てています.しかし、複数の文書や長いコンテキストにわたる取得メカニズムの効果は、関連する応答を抽出する上で大きな課題となっています.一方、グラフRAGは、知識グラフ(KG)の能力をRAGと組み合わせて、従来のNLPタスクを改善します.これにより、文脈の精度と信頼性が向上し、特に金融文書の分析と利用において効果的であることが示されています.これらの技術の実装においては、文書のメタデータに関する情報を明示的に追加することで、ベクトルRAGの性能が向上することも示されています.

Q: HybridRAGは知識グラフとベクトル検索法をどのように統合するのか?

A: HybridRAGは、知識グラフ(KG)とベクトル検索を組み合わせた手法であり、情報抽出の効率を向上させることを目的としています.具体的には、GraphRAGと呼ばれるKGベースのRAG技術と、VectorRAGと呼ばれるベクトルデータベースを利用した情報検索技術を統合しています.この統合により、特に金融分野のような専門用語や複雑な文書形式に対応することが可能となります.数式や数学的な記号は文脈に含まれていないため、具体的な数式表現は提供できませんが、知識グラフを静的なグラフとして扱い、ベクトルデータベースを用いて情報を効率的に検索することがこの手法の特徴です.

Q: 従来のVectorRAGやGraphRAGと比較して、HybridRAGのパフォーマンスを評価するためにどのような指標を用いましたか?

A: ハイブリッドRAGの性能を評価するために使用された指標は、忠実性、回答の関連性、文脈の精度、文脈の再現率です.忠実性においては、GraphRAGとHybridRAGが0.96のスコアを達成し、VectorRAGは0.94でした.回答の関連性では、HybridRAGが0.96で他を上回り、VectorRAGが0.91、GraphRAGが0.89でした.文脈の精度はGraphRAGが0.96で最も高く、VectorRAGが0.84、HybridRAGが0.79でした.しかし、文脈の再現率では、VectorRAGとHybridRAGが完璧なスコア1を達成し、GraphRAGは0.85でした.

Q: HybridRAGは、財務文書から生成される回答の正確性と関連性をどのような方法で高めるのでしょうか?

A: HybridRAGは、VectorRAGとGraphRAGの両方の手法を統合することにより、金融文書からの情報抽出の精度と関連性を向上させております.このシステムは、ベクトルベースのRAGと知識グラフベースのRAGの強みを組み合わせることで、情報の検索精度と回答生成において優れた性能を示しております.具体的には、HybridRAGは忠実性、回答の関連性、文脈の再現性において優れており、VectorRAGとGraphRAGの両方の手法から文脈を統合することの利点を示しております.これにより、金融文書の複雑な情報を抽出し解釈する能力が向上し、より信頼性の高い、正確な出力が可能となっております.

Q: 実験ではどのような財務書類が使われ、どのように選ばれたのか?

A: 実験で使用された財務文書は、企業の収益報告書の電話会議の書き起こし文書です.これらの文書は、Nifty50の企業の収益報告書から体系的に選ばれたもので、ランダムに選ばれた400の質問が含まれています.これらの質問は、財務アナリストが企業の経営陣に対して行った具体的な質問を構成しています.

EfficientRAG: Efficient Retriever for Multi-Hop Question Answering

著者:Ziyuan Zhuang, Zhiyang Zhang, Sitao Cheng, Fangkai Yang, Jia Liu, Shujian Huang, Qingwei Lin, Saravan Rajmohan, Dongmei Zhang, Qi Zhang

発行日:2024年08月08日

最終更新日:2024年09月26日

URL:http://arxiv.org/pdf/2408.04259v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

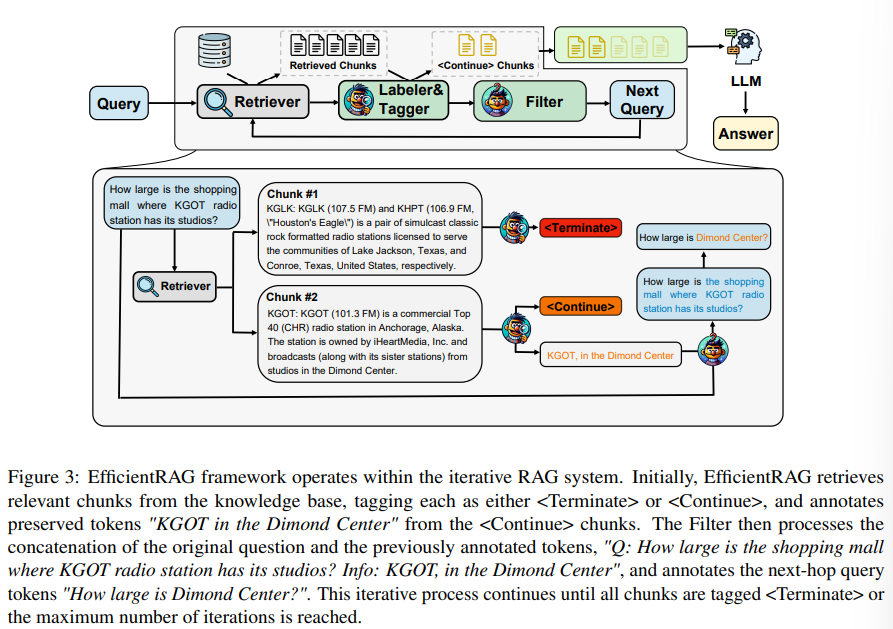

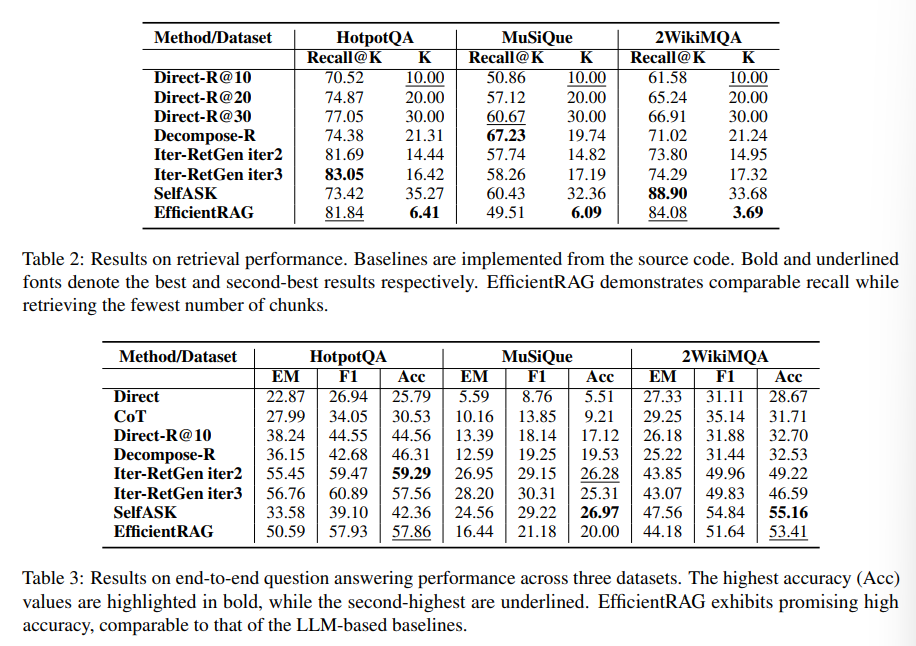

Retrieval-augmented generation (RAG) methodsは、multi-hop queriesのような複雑な質問に対処する際に困難に直面します.反復的な検索方法は、追加情報を収集することでパフォーマンスを向上させますが、現在のアプローチはしばしば大規模言語モデル(LLM)の複数の呼び出しに依存しています.本論文では、EfficientRAGというmulti-hop質問応答のための効率的なリトリーバーを紹介します.EfficientRAGは、各反復ごとにLLMの呼び出しを必要とせずに新しいクエリを反復的に生成し、関連のない情報をフィルタリングします.実験結果は、EfficientRAGが3つのオープンドメインのmulti-hop質問応答データセットで既存のRAG方法を上回ることを示しています.

Q&A:

Q: EfficientRAGは検索プロセスでどのように無関係な情報をフィルタリングするのですか?

A: EfficientRAGは、ラベラーとフィルターという2つの軽量コンポーネントを使用して、情報の取得プロセスにおいて無関係な情報をフィルタリングいたします.ラベラーとフィルターは、トークンレベルの分類器として機能し、トークンを真または偽として分類いたします.ラベラーは、ドキュメント内の有用な情報を表すトークンのシーケンスを注釈付けし、フィルターは別のモデルから出力を生成して無関係な情報を除去いたします.これにより、EfficientRAGは、各反復でLLMコールを必要とせずに新しいクエリを生成し、無関係な情報をフィルタリングすることが可能となります.

Q: 実験結果にはどのようなデータセットが使われ、どのように選択されたのか?

A: 実験結果に使用されたデータセットは、HotpotQAと2WikiMQAのデータセットです.これらのデータセットは、公開されているオープンドメインのデータセットから選ばれました.選定の際には、特にドメイン固有の知識に依存しないことが重要視され、EfficientRAGモデルが異なるデータセットに適応できることが示されています.

Q: EfficientRAGのパフォーマンスは、スピードと精度の点で既存のRAG手法と比較してどうですか?

A: 与えられた文脈によれば、EfficientRAGは既存のRAGメソッドと比較して、特に複雑なマルチホップ質問応答シナリオにおいて優れた性能を示しているとされています.EfficientRAGは、少ない数の取得チャンクで高いリコールを達成し、その後の質問応答タスクにおいても有望な結果を提供することが示されています.具体的な速度や精度に関する数値的な比較は文脈に含まれていませんが、EfficientRAGが従来の手法を上回ることが示唆されています.

Q: 調査中に明らかになったEfficientRAGの限界や課題はありますか?

A: EfficientRAGの研究において、いくつかの制限や課題が特定されました.まず、EfficientRAGフレームワークは理論的には他のモデルに適応することが可能ですが、時間とリソースの制限により、最終的なQnA推論者として大規模な言語モデルを実装しないことが選択されました.また、主にオープンドメインのデータセットで手法を分析しており、インドメイン設定でのマルチホップ質問応答データセットを特定することが難しいという課題があります.これらの制限は、EfficientRAGの適用範囲や性能に影響を与える可能性があります.

Q: EfficientRAGはマルチホップクエリの曖昧さや複雑さをどのように扱うのか?

A: EfficientRAGは、マルチホップクエリの曖昧さや複雑さに対処するために、反復的に新しいクエリを生成し、各反復で大規模言語モデル(LLM)を呼び出す必要がない方法を採用しています.これにより、無関係な情報をフィルタリングすることが可能となります.具体的には、EfficientRAGは、マルチホップ質問応答のための効率的なリトリーバーとして機能し、既存のRAGメソッドを上回る性能を示しています.実験結果は、EfficientRAGが3つのオープンドメインのマルチホップ質問応答データセットで優れた性能を発揮することを示しています.

Medical Graph RAG: Towards Safe Medical Large Language Model via Graph Retrieval-Augmented Generation

著者:Junde Wu, Jiayuan Zhu, Yunli Qi, Jingkun Chen, Min Xu, Filippo Menolascina, Vicente Grau

発行日:2024年08月08日

最終更新日:2024年10月15日

URL:http://arxiv.org/pdf/2408.04187v2

カテゴリ:Computer Vision and Pattern Recognition

概要:

MedGraphRAGは、医療分野向けに設計された新しいグラフベースの検索増強生成(RAG)フレームワークを紹介します.このフレームワークは、証拠に基づいた医療応答を生成するための大規模言語モデル(LLM)の能力を向上させ、個人の医療データを取り扱う際の安全性と信頼性を向上させることを目的としています.グラフベースのRAG(GraphRAG)は、LLMを活用してRAGデータをグラフに整理することで、長文書から包括的な洞察を得る可能性が高いことを示しています.しかし、その標準的な実装は一般的な使用には過度に複雑であり、証拠に基づいた応答を生成する能力が欠けているため、医療分野での効果が限定されています.GraphRAGの機能を医療分野に拡張するために、独自のトリプルグラフ構築とU-Retrieval技術を提案しています.グラフ構築では、ユーザーの文書を信頼性のある医療情報源や制御された語彙とつなぐトリプルリンク構造を作成しています.検索プロセスでは、トップダウンの正確な検索とボトムアップの応答の磨きを組み合わせたU-Retrievalを提案しており、グローバルなコンテキストの認識と正確なインデックス付けのバランスを取ることができます.これらの取り組みにより、情報源情報と証拠に基づいた応答の両方を可能にしています.さらに、MedGraphRAGは、9つの医療Q&Aベンチマーク、2つの健康ファクトチェックベンチマーク、および長文生成をテストする1つの収集データセットで検証されています.その結果、MedGraphRAGはすべてのベンチマークで最先端のモデルを常に上回り、信頼性のあるソースの文書と定義を含む応答を確実に提供しています.弊社のコードは以下のリンクから公開されています:.” rel=”nofollow”>https://github.com/MedicineToken/Medical-Graph-RAG.

Q&A:

Q: 標準的なGraphRAGの実装を医療分野に適応させる際、具体的にどのような課題がありましたか?

A: 標準的なGraphRAGの実装を医療分野に適用する際に直面した具体的な課題として、まず、応答の認証と信頼性を確保するための特定の設計が必要であることが挙げられます.この設計は、一般的な用途に対応するために様々なケースを処理するように設計されており、その階層的なコミュニティ構築プロセスはコストがかかります.したがって、医療分野に効果的に適用するためには、特定のエンジニアリング努力が必要であることがわかりました.

Q: ユニークなトリプルグラフ構築のテクニックと、従来のグラフ構築方法との違いについて詳しく教えてください.

A: トリプルグラフ構築技術は、従来のグラフ構築方法とは異なり、ユーザーのRAGデータを信頼できる医療論文や基礎的な医療辞書にリンクするメカニズムを設計しています.このプロセスでは、[RAGデータ、ソース、定義]というトリプルを生成し、ユーザードキュメントの包括的なグラフを構築します.これにより、LLMの推論が強化され、応答がそのソースと定義に遡及可能であることが保証され、信頼性と説明可能性が確保されます.従来のグラフ構築方法は、一般的に複雑であり、証拠に基づく応答を生成する能力に欠けているため、医療分野での効果が限定的でした.トリプルグラフ構築技術は、これらの課題を克服し、医療分野におけるLLMの性能を向上させるために開発されました.

Q: U-Retrievalプロセスは、トップダウンの正確な検索とボトムアップの反応の洗練をどのように統合しているのか?

A: U-Retrievalプロセスは、トップダウンの精密な検索とボトムアップの応答精緻化を統合する方法として設計されています.まず、ユーザーのクエリに対してタグサマリーを生成し、これを用いて情報を効率的に取得します.トップダウンの精密な検索では、グローバルなコンテキストの認識を重視し、関連するデータを迅速に特定します.一方、ボトムアップの応答精緻化では、前のステップで取得した高レベルのタグに戻り、応答を調整します.このプロセスは、ターゲット層に到達するまで続けられ、最終的にはすべてのインデックス化されたグラフをスキャンして包括的な応答を生成します.これにより、関連するデータと効率的に対話しながら、包括的な概要を得ることが可能になります.

Q: 三重リンク構造でリンクされている医学ソースの信頼性をどのように確保するのか?

A: トリプルリンク構造における医療ソースの信頼性を確保するためには、ユーザードキュメントを信頼できる医療論文や基礎的な医療辞書にリンクするTriple Graph Constructionという手法が用いられます.このプロセスでは、ユーザーのRAGデータを信頼できる医療論文と定義にリンクし、[RAGデータ、ソース、定義]というトリプルを生成します.これにより、ユーザードキュメントの包括的なグラフが構築され、LLMの推論が強化され、応答がそのソースと定義に追跡可能であることが保証されます.したがって、信頼性と説明可能性が確保されます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で紹介された新しい手法のコード実装のurlは、次の通りです: https://github.com/MedicineToken/Medical-Graph-RAG .

Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters

著者:Charlie Snell, Jaehoon Lee, Kelvin Xu, Aviral Kumar

発行日:2024年08月06日

最終更新日:2024年08月06日

URL:http://arxiv.org/pdf/2408.03314v1

カテゴリ:Machine Learning, Computation and Language

概要:

LLM(Large Language Models)がより多くのテスト時間計算を使用して出力を改善することは、一般的に自己改善エージェントを構築するための重要なステップであり、オープンエンドの自然言語で操作できるようになる.本論文では、LLMにおける推論時間計算のスケーリングを研究し、特に次の問いに焦点を当てている:LLMが固定されたが非自明な量の推論時間計算を使用することが許可された場合、どれだけ難しいプロンプトでパフォーマンスを向上させることができるか.この問いに答えることは、LLMの達成可能なパフォーマンスだけでなく、LLMの事前トレーニングの将来や推論時間と事前トレーニング計算のトレードオフについても影響を与える.その重要性にもかかわらず、ほとんどの研究はさまざまなテスト時間推論方法のスケーリング動作を理解しようと試みていない.さらに、現在の研究は、これらの戦略のいくつかに対して主に否定的な結果を提供している.本研究では、テスト時間計算をスケーリングするための2つの主要なメカニズムを分析している:(1)密な、プロセスベースの検証者報酬モデルに対して検索を行うこと;および(2)テスト時間においてプロンプトに応じてモデルの応答分布を適応的に更新すること.私たちは、どちらの場合でも、LLMのパフォーマンスを向上させることができることを発見した.さらに、新たな文脈を加えると、テスト時間計算をスケーリングするための最適な戦略を適用することで、プロンプトの難易度に応じてテスト時間計算を効果的に割り当てることができ、ベースラインと比較して4倍以上の効率向上が可能であることが示唆される.また、FLOPsにマッチした評価では、より小さなベースモデルが一定の成功率を達成する問題では、テスト時間計算を使用して14倍大きなモデルを上回ることができることがわかった.

Q&A:

Q: あなたが分析したテスト時間計算をスケーリングする2つの主要なメカニズムについて詳しく教えてください.

A: 本研究では、テスト時の計算スケーリングを向上させるための2つの主要なメカニズムが分析されました.第一に、密なプロセスベースの検証者報酬モデルに対する検索を行うことです.これは、与えられたプロンプトに対して、モデルの応答に対する分布を適応的に更新することを含みます.第二に、プロンプトに応じてモデルの提案分布を更新することです.これらのアプローチの効果は、プロンプトの難易度に大きく依存することが発見されました.この観察は、プロンプトごとにテスト時の計算を最も効果的に割り当てる「計算最適」スケーリング戦略を適用する動機となります.この計算最適戦略を使用することで、テスト時の計算スケーリングの効率を、Nのベストのベースラインと比較して4倍以上改善することができます.また、FLOPsが一致する評価において、より小さなベースモデルがある程度の成功率を達成する問題では、テスト時の計算を使用して14倍大きなモデルを上回ることができることが示されています.

Q: 実験に使用したプロンプトの難易度はどのように決めたのですか?

A: 実験で使用されたプロンプトの難易度は、モデルによって予測された難易度の概念を用いて決定されました.この方法では、学習された検証者からの最終的な回答スコアの平均を用いて、問題ごとに2048サンプルのセットに対してビニング手法を適用します.これにより、地上真実の正確性チェックに依存せずに難易度を推定することが可能となります.具体的には、難易度の推定は、検証者を使用する際に同じ推論計算を用いて実行されるため、推論時の計算コストに含まれることができます.

Q: 異なるテスト時間推論手法の有効性を左右する重要な要因とは?

A: 異なるテスト時推論手法の効果に影響を与える主な要因は、問題の難易度に依存することが示されています.具体的には、テスト時の計算をスケールするためのアプローチの効果は、与えられたプロンプトの特定の問題に応じて大きく変わることがあります.例えば、提案分布を精緻化するか、検証者に対して検索を行う場合、テスト時の計算予算をどのように配分するかを決定するために調整できるいくつかのハイパーパラメータがあります.これには、モデルからN個の独立したサンプルを並行して生成し、最良のNを適用するか、N個の修正を順次サンプリングするかが含まれます.

Q: コンピュート・オプティマル」スケーリング戦略について、もう少し詳しく教えてください.

A: 「計算最適」スケーリング戦略の概念について詳しく説明いたします.「計算最適」スケーリング戦略とは、テスト時の計算予算に基づいて、特定のプロンプトに対して最大の性能利益を得るためのハイパーパラメータを選択する戦略でございます.具体的には、モデルが特定のプロンプト \( \small q \) に対して、テスト時の計算ハイパーパラメータ \( \small \theta \) と計算予算 \( \small N \) を用いて生成する自然言語出力トークンの分布を Target(\( \small \theta, N, q \)) と定義いたします.この分布の精度を最大化するハイパーパラメータ \( \small \theta \) を選択することが目標でございます.これを数式で表現すると、 $$ \small \theta^_{q, y^(q)}(N) = \arg\max_{\theta}(E_{y \sim \text{Target}(\theta, N, q)}[1_{y = y^(q)}]),$$ となります.ここで、\( \small y^(q) \) はプロンプト \( \small q \) に対する正解の応答を示し、\( \small \theta^_{q, y^(q)}(N) \) は問題 \( \small q \) に対する計算予算 \( \small N \) の下でのテスト時の計算最適スケーリング戦略を表します.この戦略は、テスト時の計算効率を2〜4倍向上させることができるとされております.

Q: あなたの研究結果は、LLMのテスト時間計算に関する既存の文献と比較してどうですか?

A: 本研究の結果は、既存の文献におけるテスト時計算に関する結果と比較して、いくつかの点で異なっております.まず、現在の大規模言語モデル(LLM)がテスト時の計算を用いて出力を改善できることを示す研究もあれば、特に数学的推論のような複雑なタスクにおいては、その効果が非常に限定的であることを示す研究もあります.これらの相反する結果は、テスト時計算のスケーリングに関する異なるアプローチの体系的な分析の必要性を示唆しております.本研究では、テスト時計算をスケールするための2つの主要なメカニズムを分析しました.1つ目は、密なプロセスベースの検証者報酬モデルに対する検索であり、2つ目は、テスト時にプロンプトに応じて応答の分布を適応的に更新することです.これらのアプローチの効果は、タスクの難易度に大きく依存することがわかりました.

Q: この調査結果は、LLM事前研修の将来にとってどのような意味を持つのでしょうか?

A: この研究の結果は、LLMの事前学習の将来に対していくつかの重要な示唆を与えます.まず、テスト時の計算をスケーリングするための異なるアプローチの効果は、問題の難易度に大きく依存することが示されています.したがって、事前学習と推論時の計算のトレードオフを考慮する際には、問題の難易度を効率的に推定する方法を開発することが重要です.例えば、モデルを事前学習または微調整して、質問の難易度を直接予測することが考えられます.さらに、テスト時の計算の出力を基礎となるLLMに蒸留することで、自己改善のループを形成する可能性があります.これにより、オープンエンドの自然言語に対して、より効果的なモデルの改善が期待されます.したがって、将来的には、テスト時の計算の出力をどのようにして基礎モデルの改善に利用できるかを研究することが重要です.