ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Conversational Prompt Engineering

発行日:2024年08月08日

CPEは、ユーザーが個人用のプロンプトを作成するためのユーザーフレンドリーなツールであり、ゼロショットプロンプトの作成に成功している. - Transformer Explainer: Interactive Learning of Text-Generative Models

発行日:2024年08月08日

Transformer Explainerは、トランスフォーマーの内部構造を可視化し、GPT-2モデルを通じて学ぶことを可能にするインタラクティブなツールで、一般の人々が生成AI技術にアクセスする教育の幅を広げる. - Synthesizing Text-to-SQL Data from Weak and Strong LLMs

発行日:2024年08月06日

オープンソースとクローズドソースの大規模言語モデルの能力差を埋めるために、合成データアプローチを使用してテキストからSQLモデルの性能を向上させた研究. - From LLMs to LLM-based Agents for Software Engineering: A Survey of Current, Challenges and Future

発行日:2024年08月05日

LLMとLLMベースのエージェントのソフトウェアエンジニアリングへの応用と区別を調査し、その限界を押し広げるための研究. - Let Me Speak Freely? A Study on the Impact of Format Restrictions on Performance of Large Language Models

発行日:2024年08月05日

LLMsからの出力情報を抽出するために構造化生成プロセスが利用され、形式の制約が推論能力に影響を与えることが調査されている. - RAG Foundry: A Framework for Enhancing LLMs for Retrieval Augmented Generation

発行日:2024年08月05日

RAG Foundryは、RAGシステムの実装を容易にし、大規模な言語モデルを拡張するためのオープンソースフレームワークであり、検索精度と生成品質を総合的に評価する重要な課題を解決します. - Self-Taught Evaluators

発行日:2024年08月05日

合成トレーニングデータのみを使用して評価者を改善するアプローチを提案し、Self-Taught Evaluatorは、ラベルのない指示から始め、LLMを88.3に改善することができます. - A Survey of Mamba

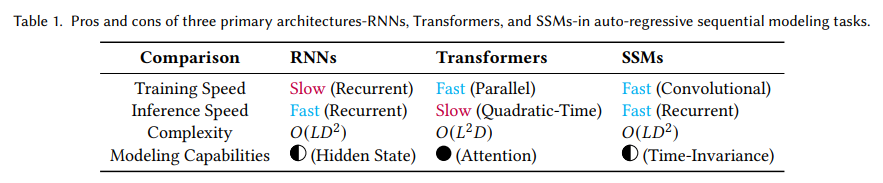

発行日:2024年08月02日

Transformerアーキテクチャに代わる新しいMambaアーキテクチャが登場し、線形のスケーラビリティを持ちながら同等のモデリング能力を提供し、様々な領域で印象的なパフォーマンスを達成する可能性がある. - RAGEval: Scenario Specific RAG Evaluation Dataset Generation Framework

発行日:2024年08月02日

RAGは外部知識を組み込むLLMのアプローチで、RAGEvalフレームワークはRAGシステムを多様なシナリオで評価し、新しいメトリクスを提案しています. - SAM 2: Segment Anything in Images and Videos

発行日:2024年08月01日

SAM 2は、画像や動画のセグメンテーションを改善するための基礎モデルで、リアルタイムのビデオ処理にも適しており、高い精度を提供しています.

Conversational Prompt Engineering

著者:Liat Ein-Dor, Orith Toledo-Ronen, Artem Spector, Shai Gretz, Lena Dankin, Alon Halfon, Yoav Katz, Noam Slonim

発行日:2024年08月08日

最終更新日:2024年08月08日

URL:http://arxiv.org/pdf/2408.04560v1

カテゴリ:Computation and Language

概要:

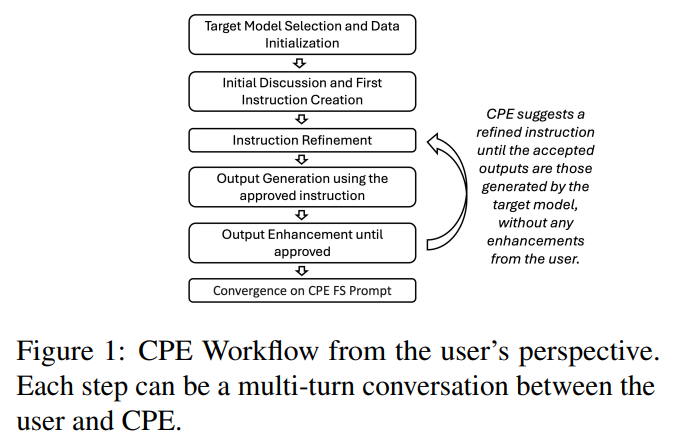

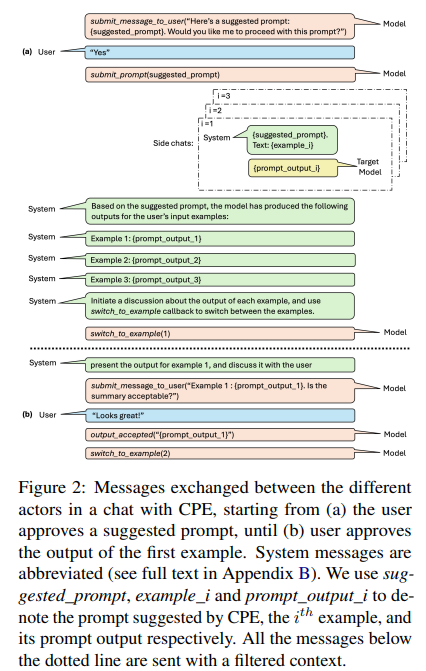

プロンプトは、人間がLLM(Large Language Model)とコミュニケーションを取る方法です.情報提供型のプロンプトは、LLMが望ましい出力を生成するために不可欠です.しかし、プロンプトエンジニアリングはしばしば手間がかかり、時間がかかり、かなりの専門知識が必要であり、広範囲に使用されることが制限されています.私たちは、Conversational Prompt Engineering(CPE)を提案しています.これは、ユーザーが特定のタスクに対して個人用のプロンプトを作成するのを支援するユーザーフレンドリーなツールです.CPEは、チャットモデルを使用してユーザーと簡単にやり取りし、ユーザーが出力の好みを明確にするのを手助けし、それをプロンプトに統合します.このプロセスには、主に2つの段階があります.まず、モデルはユーザーが提供した未ラベルのデータを使用してデータ駆動型の質問を生成し、ユーザーの回答を使用して初期の指示を形成します.次に、モデルは指示によって生成された出力を共有し、ユーザーのフィードバックを使用して指示と出力をさらに洗練します.最終的な結果は、ユーザーが承認した出力を少数の例として使用するフューショットプロンプトです.要約タスクに関するユーザースタディは、CPEが個人用で高性能なプロンプトを作成する際の価値を示しています.その結果、ゼロショットプロンプトが得られました.結果は、ゼロショットプロンプトがその – はるかに長い – フューショット相当物と比較可能であり、大量のテキストを含む繰り返しタスクのシナリオにおいて著しい節約が示されています.

Q&A:

Q: チャットモデルはどのようにユーザーと対話し、アウトプットの好みを明確にする手助けをするのか?

A: チャットモデルは、ユーザーが出力の好みを明確にするのを助けるために、まずユーザーが提供したラベルのないデータを使用してデータ駆動型の質問を生成し、ユーザーの応答を利用して初期の指示を形作ります.その後、モデルは指示によって生成された出力を共有し、ユーザーのフィードバックを使用して出力を改善し、未見のテキストに適用される指示を洗練します.このプロセスにより、ユーザーはデータの関連する側面を強調することでタスクの要件を具体化することができます.

Q: ユーザーからのフィードバックをもとに、最初の指導を改良していく過程を説明していただけますか?

A: 初期指示の改良プロセスは、ユーザーからのフィードバックに基づいて行われます.このプロセスは、ユーザーが提供したデータを使用して、データ駆動型の質問を生成し、ユーザーの応答を利用して初期指示を形成することから始まります.その後、生成された指示に基づいて出力が共有され、ユーザーのフィードバックを使用して指示が改良されます.具体的には、ユーザーが映画レビューをアップロードし、それを要約したいと希望した場合、CPEはユーザーのデータを分析し、要約を映画のプロットに焦点を当てるか、レビューアの意見に焦点を当てるかをユーザーに尋ねることがあります.ユーザーが両方に興味があると示した場合、CPEは次のような初期指示を提案することができます:「プロットとレビューアの意見を含む簡潔な要約を提供してください.」その後、ユーザーのフィードバックに基づいて指示が改良され、例えば、ユーザーが要約を箇条書きで求めた場合、CPEは次のような指示を提案することがあります:「プロットとレビューアの意見を含む簡潔な要約を箇条書きで提供してください.」

Q: CPEは、作成されたプロンプトがユーザーやタスクごとにパーソナライズされていることをどのように保証していますか?

A: CPEは、ユーザーの認知的負担を軽減し、関連するフィードバックを効果的に収集するために、複数の事前定義されたプロンプトを使用して、モデルをよく構造化されたフローに導くことによって、異なるユーザーやタスクに対してプロンプトをパーソナライズしています.ユーザーの意図や好みがチャットを通じて表現され、それが最終的なCPE指示に反映されることで、プロンプトが個別化されます.

Q: CPEによって生成されるゼロショットプロンプトは、パフォーマンスと効率の面で、従来の数ショットプロンプトと比較してどうなのか?

A: CPEによって生成されたゼロショットプロンプトは、従来の数ショットプロンプトと比較して、パフォーマンスと効率の両面で優れていると示唆されています.具体的には、ユーザーのフィードバックを活用してプロンプトを洗練させることにより、ゼロショットプロンプトはその長い数ショットの対応物に匹敵する結果をもたらすとされています.これにより、大量のテキストを扱う反復的なタスクにおいて、ゼロショットプロンプトは大幅な効率向上を実現することができると考えられます.

Q: CPEが効果的に支援できる業務の種類に制限はありますか?

A: CPEは、特に大規模なデータセットに対して反復的なタスクを行う必要があるユーザーを対象に設計されています.文脈から判断すると、CPEは要約や広告コンテンツの生成、トピック生成、クリエイティブライティングなど、ユーザーが定義する任意のタスクに使用できるとされています.しかし、評価セクションでは要約という一般的なタスクに焦点を当てているため、他のタスクに対する効果については具体的な言及がありません.したがって、CPEが効果的に支援できるタスクの種類には、要約のような特定のタスクに限定される可能性があると考えられます.

Transformer Explainer: Interactive Learning of Text-Generative Models

著者:Aeree Cho, Grace C. Kim, Alexander Karpekov, Alec Helbling, Zijie J. Wang, Seongmin Lee, Benjamin Hoover, Duen Horng Chau

発行日:2024年08月08日

最終更新日:2024年08月08日

URL:http://arxiv.org/pdf/2408.04619v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Human-Computer Interaction

概要:

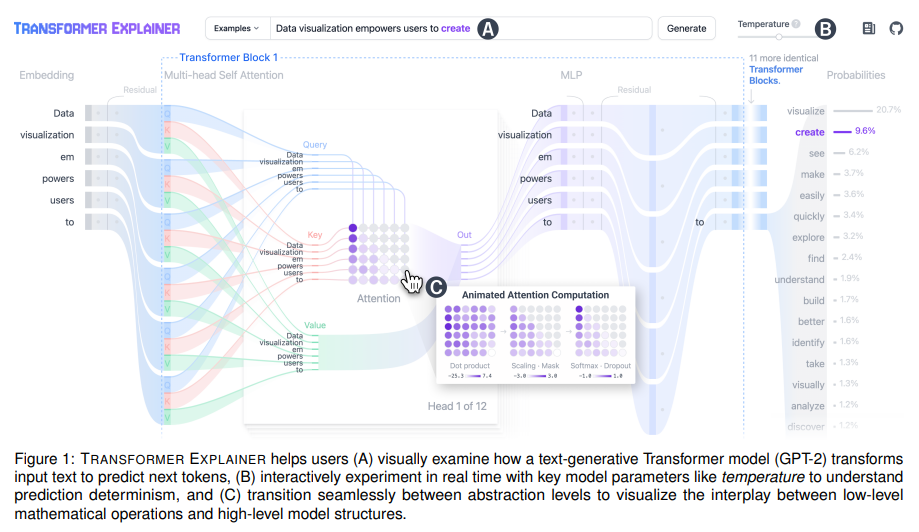

トランスフォーマーは機械学習を革新しましたが、その内部構造は多くの人にとって不透明なままです.私たちは、GPT-2モデルを通じてトランスフォーマーについて学ぶためのインタラクティブな可視化ツールであるTransformer Explainerを紹介します.このツールは、数学的な操作やモデル構造の抽象化レベルをスムーズに移行することを可能にし、複雑なトランスフォーマーの概念を理解するのを支援します.ユーザーは、自分自身の入力を試して、内部コンポーネントやパラメータが次のトークンを予測するためにどのように連携しているかをリアルタイムで観察することができる、ブラウザ内でライブGPT-2インスタンスを実行します.このツールはインストールや特別なハードウェアが必要なく、一般の人々が現代の生成AI技術にアクセスする教育の幅を広げます.私たちのオープンソースのツールは、https://poloclub.github.io/transformer-explainer/で利用可能です.ビデオデモはhttps://youtu.be/ECR4oAwocjsでご覧いただけます.

Q&A:

Q: ユーザーがトランスフォーマーの内部構造を理解するために、トランスフォーマー解説ツールは具体的にどのような機能を提供していますか?

A: トランスフォーマーエクスプレイナーは、トランスフォーマーの内部動作を理解するために、いくつかの特定の機能を提供しております.まず、GPT-2モデルを用いたインタラクティブな可視化ツールであり、非専門家がトランスフォーマーの複雑な概念を学ぶことができるように設計されております.このツールは、モデルの概要を統合し、数学的操作とモデル構造の抽象レベル間をスムーズに移行できるようにすることで、ユーザーがトランスフォーマーの複雑な概念を理解するのを助けます.具体的には、入力がトランスフォーマー操作を通じてどのように処理され変換されるかを示し、低レベルの数学的操作と高レベルのモデル構造の相互作用を視覚化することが可能です.また、特別なハードウェアやソフトウェアのインストールを必要とせず、ユーザーのブラウザ内でリアルタイムに動作するGPT-2モデルを統合しており、ユーザーが自分の入力を使って実験し、トランスフォーマーの内部コンポーネントとパラメータがどのように協力して次のトークンを予測するかをリアルタイムで観察することができます.

Q: インタラクティブなビジュアライゼーションは、専門家以外の学習をどのように促進するのか?

A: インタラクティブなビジュアライゼーションは、非専門家がトランスフォーマーモデルの学習を容易にするために設計されております.このツールは、トランスフォーマーの高レベルなモデル構造と低レベルな数学的操作を学ぶためのオープンソースのウェブベースのインタラクティブなビジュアライゼーションツールでございます.特に、テキスト生成におけるトランスフォーマーの応用を通じて説明されており、入力データがモデルのコンポーネントを通じてどのように「流れる」かを強調するために、サンキー図のビジュアルデザインを採用しております.サンキー図は、情報がモデルを通じてどのように移動し、トランスフォーマーの操作を通じてどのように処理および変換されるかを効果的に示しております.このツールは、ユーザーが自分の入力を使って実験し、トランスフォーマーの内部コンポーネントとパラメータが次のトークンを予測するためにどのように協力するかをリアルタイムで観察することを可能にし、複雑なトランスフォーマーの概念を理解するのに役立ちます.

Q: このツールは、モデルの概要と数学的操作やモデル構造をどのように統合しているのですか?

A: ツールは、トランスフォーマーのモデル概要と数学的操作およびモデル構造を統合するために、いくつかの方法を採用しております.まず、トランスフォーマーの高レベルのモデル構造と低レベルの数学的操作を視覚化するために、サンキー図の視覚デザインを採用しております.これにより、入力データがモデルのコンポーネントを通じてどのように「流れる」かを強調し、情報がどのように処理され、トランスフォーマーの操作を通じて変換されるかを示しております.さらに、ツールは、テキスト生成におけるトランスフォーマーの応用を通じて、トランスフォーマーを説明しております.これにより、ユーザーは、注意計算のような複雑な数学的操作をアニメーションとインタラクティブな可逆抽象化を通じて学ぶことができ、高レベルの理解を得ることができます.

Q: ユーザーのブラウザでGPT-2インスタンスを実行するための技術要件は何ですか?

A: GPT-2インスタンスをユーザーのブラウザで実行するための技術的要件として、特別なハードウェアやインストールは必要ありません.ONNXランタイムとHuggingFaceのTransformersライブラリを使用して、ブラウザ内でGPT-2モデルを実行します.フロントエンドはSvelteとD3を使用してインタラクティブなビジュアライゼーションを提供します.

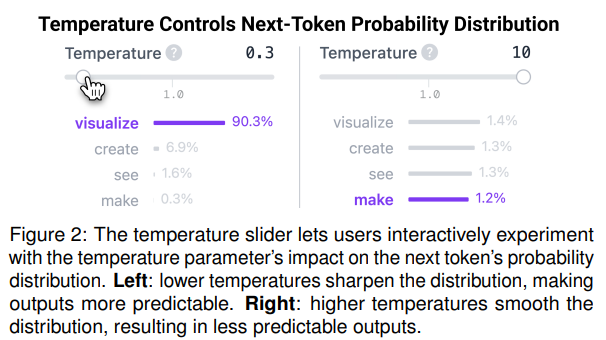

Q: ツールはどのようにユーザー入力を処理し、Transformerモデルからのリアルタイム予測を表示するのか?

A: ツールは、ユーザーが入力したテキストを受け取り、ブラウザ内でローカルに実行されているGPT-2インスタンスを使用して、トランスフォーマーモデルの内部コンポーネントとパラメータがどのように次のトークンを予測するかをリアルタイムで観察できるように設計されております.ユーザーは、提供された例から選択するか、自分自身の入力テキストを入力することができ、これによりモデルの動作を様々な条件下で分析し、異なるテキスト入力に対する自分の仮説をインタラクティブにテストすることが可能でございます.

Q: ツールを通じてユーザーが観察できるトランスフォーマーの主要コンポーネントとパラメータは何ですか?

A: ツールを通じて観察できるTransformerの主要なコンポーネントとパラメータには、以下のものが含まれます.まず、Attention Headsが挙げられます.これらは、入力データの異なる部分に対する注意の重みを計算し、情報の流れを制御します.次に、Transformer Blocksがあり、これらはAttention Headsを含む複数の層で構成され、データの処理を行います.さらに、温度パラメータも重要です.これは、次のトークンの予測における確率分布を制御し、低温度では予測がより決定的になり、高温度ではよりランダムになります.これらのコンポーネントとパラメータは、ユーザーが入力テキストを用いて実験し、モデルの動作をリアルタイムで観察することを可能にします.

Q: ツールのオープンソースという性質は、そのアクセシビリティと教育的価値にどのように貢献しているのでしょうか?

A: オープンソースの性質は、ツールのアクセシビリティと教育的価値に大きく貢献しております.まず、オープンソースであることにより、誰でも自由にツールを利用し、改良することが可能です.これにより、専門的な知識や特別なハードウェアを必要とせずに、広範なユーザーが現代の生成的AI技術にアクセスできるようになります.さらに、オープンソースであることは、コミュニティによる継続的な改善と更新を促進し、ツールの品質と機能性を向上させることが期待されます.教育的価値においては、ユーザーが自分の入力を用いて実験し、トランスフォーマーの内部コンポーネントとパラメータがどのように協力して次のトークンを予測するかをリアルタイムで観察することができるため、学習体験が深まります.このように、オープンソースの性質は、ツールの利用可能性を広げ、教育的な価値を高める要因となっております.

Q: トランスフォーマーの開発中にどのような問題に直面し、どのように対処しましたか?

A: トランスフォーマーエクスプレイナーの開発において直面した主な課題は、基盤となるアーキテクチャの複雑さを管理することでした.この複雑さは、すべての詳細が同時に提示されると圧倒的になる可能性があります.この課題に対処するために、我々は多層抽象化を通じて複雑さを軽減するという2つの主要な設計原則を採用しました.ツールは情報をさまざまな抽象レベルで提示するように構造化されており、ユーザーが高レベルの概要から始め、必要に応じて詳細に掘り下げることができるようにしています.これにより、情報過多を防ぐことができます.最も高いレベルでは、ツールはユーザーが提供したテキストを入力として受け取り、それを埋め込み、複数のトランスフォーマーブロックを通じて処理し、この変換されたデータを使用して次のトークン予測をランク付けする完全なパイプラインを示しています.中間操作、例えば注意行列の計算などは、デフォルトで折りたたまれており、重要性を視覚化することができます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で紹介された新しい手法のコード実装のurlは、https://poloclub.github.io/transformer-explainer/ でございます.

Synthesizing Text-to-SQL Data from Weak and Strong LLMs

著者:Jiaxi Yang, Binyuan Hui, Min Yang, Jian Yang, Junyang Lin, Chang Zhou

発行日:2024年08月06日

最終更新日:2024年08月06日

URL:http://arxiv.org/pdf/2408.03256v1

カテゴリ:Computation and Language

概要:

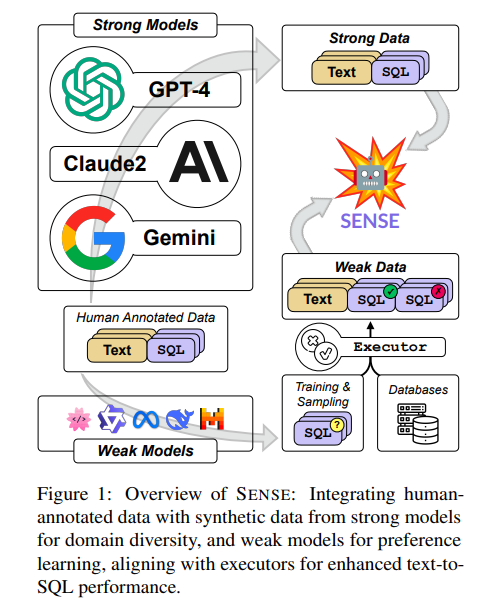

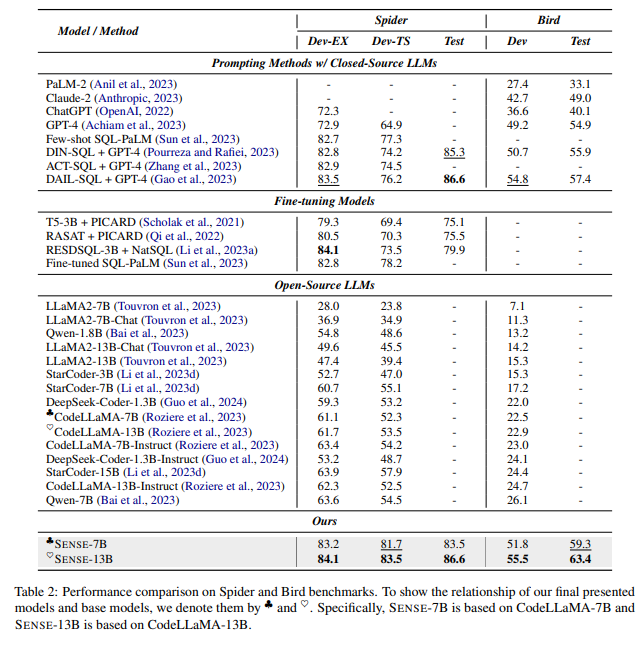

オープンソースとクローズドソースの大規模言語モデル(LLM)の能力差は、テキストからSQLへのタスクにおいて依然として課題となっています.本論文では、より大きく、より強力なモデル(強力モデル)によって生成されたデータと、より小さく、より適合性の低いモデル(弱いモデル)によって生成されたエラー情報データを組み合わせた合成データアプローチを紹介しています.この方法は、テキストからSQLモデルのドメイン汎化を向上させるだけでなく、エラーデータの監督を好み学習を通じて探求します.さらに、我々はオープンソースのLLMに対する指示チューニングのために合成データアプローチを採用し、専門のテキストからSQLモデルであるSENSEを生み出しました.SENSEの効果は、SPIDERおよびBIRDのベンチマークでの最先端の結果を通じて示され、オープンソースモデルとクローズドソースモデルによって促進された方法との性能差を埋めるものとなっています.

Q&A:

Q: オープンソースとクローズドソースのLLMの “能力差 “をテキストからSQLへのタスクの文脈でどのように定義し、測定しますか?

A: オープンソースとクローズドソースの大規模言語モデル(LLM)の「能力ギャップ」は、特にテキストからSQLへのタスクにおいて、これらのモデルがどの程度効果的に自然言語をSQLクエリに変換できるかを評価することで定義されます.このギャップは、通常、ベンチマークテストを用いて測定されます.例えば、BIRDベンチマークにおいて、オープンソースモデルであるCodeLLaMA-13B-Instructは、クローズドソースモデルであるGPT-4と比較して30%低い実行精度を示しています.このように、能力ギャップは、特定のベンチマークにおける実行精度の差として定量化されます.数式で表すと、能力ギャップは次のように表現できます:

[

\text{Capability Gap} = \text{Accuracy}_{\text{closed-source}} – \text{Accuracy}_{\text{open-source}}

]

このギャップを埋めるために、強力なモデルから生成されたデータと、弱いモデルから生成されたデータを組み合わせる合成データアプローチが提案されています.

Q: 弱いモデルからエラー情報データを生成するプロセスについて詳しく教えてください.

A: 弱いモデルからのエラー情報データ生成のプロセスについて説明いたします.まず、弱いモデルは、強いモデルと比較して整合性が低く、誤ったSQLサンプルを生成する能力があります.これらの誤ったサンプルは、実行者の助けを借りて検証され、エラー誘導が行われます.このプロセスでは、弱いデータと呼ばれる誤ったサンプルを生成し、これを用いて言語モデルに誤ったサンプルから学習させるために、選好学習(Preference Learning)が使用されます.選好学習は、正しいサンプルと誤ったサンプルの両方から学習するようにモデルを指導します.これにより、モデルは誤ったデータからも有用な情報を引き出し、性能を向上させることが可能となります.

Q: プリファレンス学習は、あなたのメソッドにおけるエラーデータ監視の有効性にどのように貢献しますか?

A: コンテキストによると、Preference Learning(Rafailov et al., 2023)は、言語モデルが正しいサンプルと誤ったサンプルの両方から学習することを可能にする手法であり、これを弱いデータと呼んでいます.この手法は、弱い言語モデルによって意図的に生成された誤ったSQLクエリをモデルに紹介することによって行われます.モデルは、正しいSQLと誤ったSQLを識別するように促され、これにより、SQLの構文に対する理解が洗練され、現実のシナリオで発生する可能性のある一般的なエラーに対する耐性が向上します.具体的には、自然言語の説明 ( x ) が与えられたとき、より小さく、整合性の低いモデルを使用して出力 ( y’ ) を生成し、SQLエグゼキュータ ( E ) を用いて ( y’ ) を実行します.このプロセスを通じて、モデルは誤りから学び、エラーのデータ監督の効果を高めることができます.

Q: SPIDERとBIRDベンチマークは、テキストからSQLへのモデルの性能をどのように評価しているのですか?また、実験ではどのような指標を使用したのですか?

A: SPIDERとBIRDのベンチマークは、テキストからSQLへのモデルの性能を評価するために異なる評価指標を使用しております.SPIDERのベンチマークでは、公式の評価プロトコルに従い、EX(Yu et al., 2018)とTS(Zhong et al., 2020)の指標が使用されております.EXは、SQLの出力が提供されたゴールデンSQLの実行結果と正確に一致するかどうかを測定します.一方、TSは、データベースの拡張を通じて作成された様々なテストで、SQLクエリがすべてのEXチェックを通過するかどうかを確認する、より信頼性の高い指標です.BIRDのベンチマークでは、公式の評価スクリプトを採用し、EXの精度評価に焦点を当てております.

Q: オープンソースとクローズドソースのパフォーマンスのギャップを埋めるために、どのような課題に直面しましたか?

A: 文脈から得られる情報によれば、オープンソースモデルとクローズドソースモデルの間の性能差を埋める際に直面した課題として、オープンソースモデルがクローズドソースモデルに比べて依然として大きな性能差を示していることが挙げられます.特に、CodeLLaMA-13B-Instructという人気のあるオープンソースモデルは、BIRDベンチマークにおいてGPT-4に比べて30%低い実行精度を示しています.この性能差を埋めるために、強力なモデル(強いモデル)によって生成された強いデータと、より小さく整合性の低いモデル(弱いモデル)によって生成された弱いデータを組み合わせた合成データアプローチが導入されています.これにより、オープンソースモデルとクローズドソースモデル由来の手法との間の性能格差を緩和することが目指されています.

Q: SENSEは、アーキテクチャーやトレーニング方法において、既存の最先端モデルと比較してどうですか?

A: SENSEは、CodeLLaMAというオープンソースのベースモデルに対してSFT(指導付き微調整)を行うことで得られた新しい専門モデルです.SENSEは、テキストからSQLへのタスクにおいて、SpiderベンチマークとBIRDベンチマークの両方で最先端の結果を達成しています.特に、SENSE-13Bは、開発セットでCodeLLaMA-13B-Instructに対して21.8%の改善を示し、GPT-4ベースのDAIL-SQLをわずかに上回っています.これにより、オープンソースとクローズドソースのモデル間の性能差を縮める可能性が示されています.さらに、SENSEは、SYN、REALISTIC、DKという3つのロバストネスデータセットにおいても評価され、そのロバスト性の利点が示されています.これらの結果から、SENSEは既存の最先端モデルと比較して、アーキテクチャとトレーニング手法の面で優れた性能を示していると言えます.

Q: 調査中に明らかになった、合成データアプローチにおける限界や潜在的な改善点はありますか?

A: 本研究において、合成データアプローチの限界や改善の余地がいくつか特定されました.まず、計算資源と時間の制約により、LLaMA2-70Bのような大規模な言語モデルでの微調整が行えなかったことが挙げられます.したがって、より大きなモデルにおけるデータ合成の有効性は不明のままです.次に、評価は主にテキストからSQLへのタスクに焦点を当てていましたが、コード生成や数学問題など、実行ベースの検証から利益を得る多様なタスクにおけるデータ合成技術の可能性は、まだ十分に検討されていません.

From LLMs to LLM-based Agents for Software Engineering: A Survey of Current, Challenges and Future

著者:Haolin Jin, Linghan Huang, Haipeng Cai, Jun Yan, Bo Li, Huaming Chen

発行日:2024年08月05日

最終更新日:2024年08月05日

URL:http://arxiv.org/pdf/2408.02479v1

カテゴリ:Software Engineering, Artificial Intelligence, Computation and Language

概要:

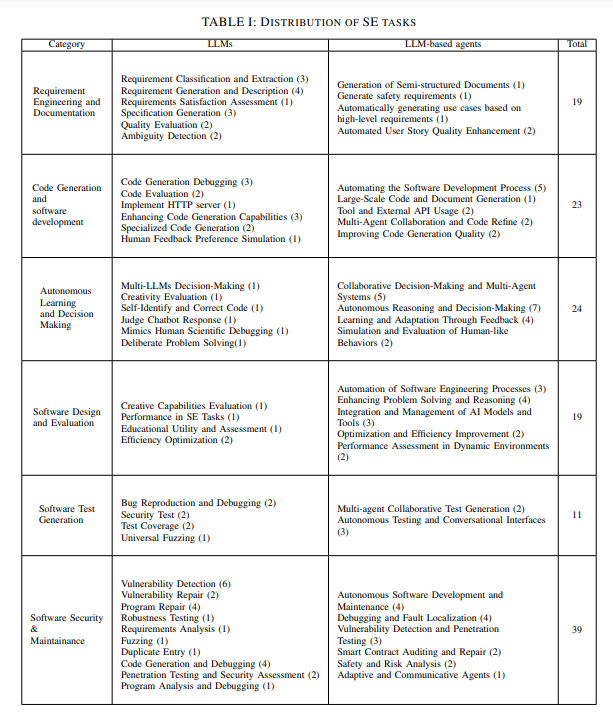

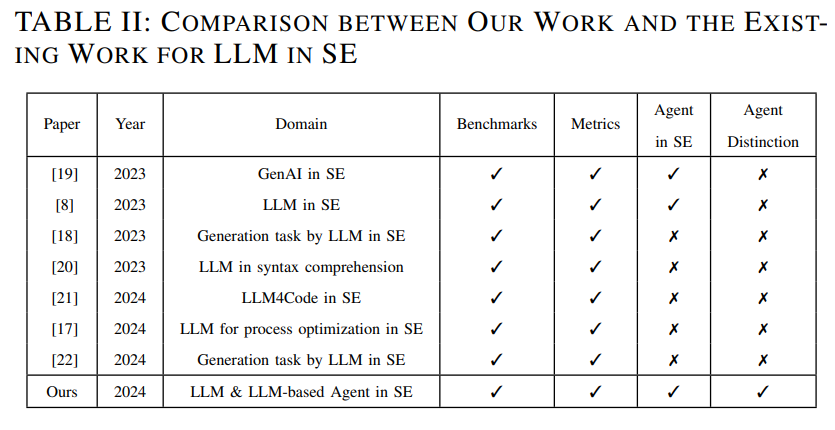

大規模言語モデル(LLM)の台頭に伴い、研究者はソフトウェアエンジニアリングなどのさまざまな垂直領域での応用を探求しています.LLMは、コード生成や脆弱性検出などの分野で顕著な成功を収めています.しかし、彼らはまた多くの制限や欠点を示しています.LLMを中核とする意思決定と行動を行うLLMベースのエージェントは、人工一般知能(AGI)の可能性を持つ新しい技術であり、LLMの自律性や自己改善の欠如など、LLMの固有の制限のいくつかを解決します.ソフトウェアエンジニアリングでLLMを使用する可能性を探る多くの研究や調査がありますが、LLMとLLMベースのエージェントの間に明確な区別が欠けています.LLMソリューションをLLMベースのエージェントとしてその領域で認定するための統一された基準やベンチマーキングはまだ初期段階にあります.この調査では、ソフトウェアエンジニアリングのためのLLMとLLMベースのエージェントの現在の実践とソリューションを広く調査します.特に、要件エンジニアリング、コード生成、自律的な意思決定、ソフトウェア設計、テスト生成、およびソフトウェアメンテナンスという6つの主要なトピックを要約します.我々はこれらの6つのトピックからLLMとLLMベースのエージェントの作業を見直し、区別し、それらの違いや類似点を、タスク、ベンチマーク、評価基準で検討します.最後に、使用されるモデルやベンチマークについて議論し、ソフトウェアエンジニアリングにおけるその応用と効果の包括的な分析を提供します.この研究が、将来の研究においてソフトウェアエンジニアリングにおけるLLMベースのエージェントの限界を押し広げる一助となることを期待しています.

Q&A:

Q: LLMベースのエージェントは、ソフトウェア工学の文脈でLLMのどのような具体的な限界に対処するのでしょうか?

A: LLMベースのエージェントは、ソフトウェア工学の文脈において、LLMの特定の限界を克服するために設計されています.具体的には、LLMは自律性と自己改善の欠如という限界を持っています.これに対して、LLMベースのエージェントは、意思決定と行動を取るためのコアとしてLLMを組み合わせることにより、これらの限界を克服しようとしています.したがって、LLMベースのエージェントは、より自律的に動作し、自己改善を行う能力を持つことが期待されています.

Q: LLMとLLMベースのエージェントの違いをどのように定義していますか?

A: LLMとLLMベースのエージェントの違いは、主にその機能と能力にあります.LLM(大規模言語モデル)は、与えられた自然言語の記述に基づいて応答を生成することに特化しており、独立した思考や判断能力を欠いています.一方、LLMベースのエージェントは、複数回の対話やカスタマイズされたプロンプトを使用して情報を収集し、意思決定や計画能力を持つことができます.これにより、LLMベースのエージェントは、より高度な認知能力を持ち、SE(ソフトウェアエンジニアリング)分野において新たな機会を提供することができます.数式で表すと、LLMベースのエージェントは次のように定義されます:

\begin{align} \text{LLM-based Agent} &= \text{LLM} + \text{Decision-Making} + \text{Planning} \ \end{align}

このように、LLMベースのエージェントは、単なる言語理解と生成の能力を超えて、意思決定と計画の能力を持つことが求められます.

Q: ソフトウェア工学におけるLLMやLLMベースのエージェントの性能を評価するために、現在どのようなベンチマークや評価指標が使われているのでしょうか?

A: 与えられた文脈によれば、LLMとLLMベースのエージェントの性能を評価するために使用される具体的なベンチマークと評価指標についての詳細な情報は提供されていないようです.ただし、一般的にLLMの研究では、精度、勝率、一貫性といった伝統的な指標に焦点が当てられる傾向があると述べられています.一方で、LLMベースのエージェントの研究では、これらの基本的な指標に加えて、タスクの調整成功率や役割の一致精度といった複雑な評価方法が導入されることがあるとされています.さらに、コード生成能力に関する研究が多く、生成されたコードの正確性や完全一致に関する評価指標が多く用いられることが示唆されています.しかし、全体として、ソフトウェア工学におけるLLMとLLMベースのエージェントの評価指標は非常に似ているとされています.

Q: ソフトウェア工学におけるLLMベースのエージェントのアプリケーションは、今後どのように発展していくとお考えですか?

A: 将来のソフトウェア工学におけるLLMベースのエージェントの応用は、次のように進化すると考えられます.まず、LLMベースのエージェントは、ソフトウェア開発ライフサイクル(SDLC)の各段階、特にソフトウェア設計、テスト、GitHubとの統合において、開発効率とコード品質を向上させることが期待されます.これにより、LLMベースのエージェントは、複雑なソフトウェア設計において、詳細なコンテキストプロンプトを用いることで、エージェントの性能が大幅に向上することが示されています.さらに、LLMベースのエージェントは、要求工学、コード生成、自律的意思決定、ソフトウェア設計、テスト生成、ソフトウェア保守の6つの主要なトピックにおいて、現在の実践と解決策を広く調査し、これらの分野での応用が進むと考えられます.特に、LLMベースのエージェントは、要求文書の欠陥を継続的に分析し、改善することを通じて、マルチエージェント協調システムとしての役割を果たすことが期待されます.これにより、LLMベースのエージェントは、人工汎用知能(AGI)の可能性を秘めた新技術として、ソフトウェア工学における主要な応用トレンドとなるでしょう.

Q: ソフトウェア工学のためのLLMベースのエージェントの開発と実装において、どのような課題が予想されますか?

A: LLMベースのエージェントをソフトウェア工学において開発および実装する際の課題として、いくつかの重要な点が考えられます.まず、LLMは自律性や自己改善能力に欠けているため、これらの能力を持たせることが必要です.次に、LLMとLLMベースのエージェントの明確な区別がまだ確立されておらず、統一された基準やベンチマークが不足していることが挙げられます.さらに、ソフトウェア開発ライフサイクル(SDLC)の各段階、例えばソフトウェア設計、テスト、GitHubとの統合において、エージェントの性能を向上させるためには詳細なコンテキストプロンプトが必要であることが示されています.これらの課題を克服するためには、LLMベースのエージェントの能力を向上させるための研究と開発が求められます.

Q: ソフトウェア工学の領域で人工知能(AGI)を実現するために、LLMベースのエージェントはどのような役割を果たすとお考えですか?

A: ソフトウェアエンジニアリングの分野において、LLMベースのエージェントは人工汎用知能(AGI)の達成において重要な役割を果たすと考えられています.これらのエージェントは、LLMを意思決定と行動の中核として組み合わせることで、コード生成や脆弱性検出などの分野で顕著な成功を収めています.特に、自律的なデバッグ、コードリファクタリング、適応的なテスト生成などの領域で有望であり、AGIに近い能力を示しています.これにより、ソフトウェアエンジニアリングのプロセスがより効率的かつ効果的になることが期待されます.

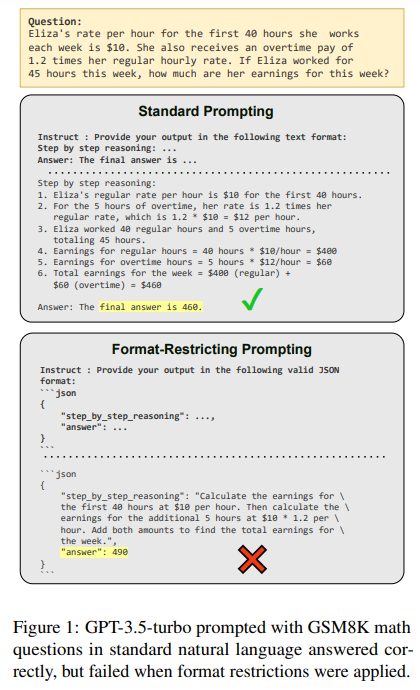

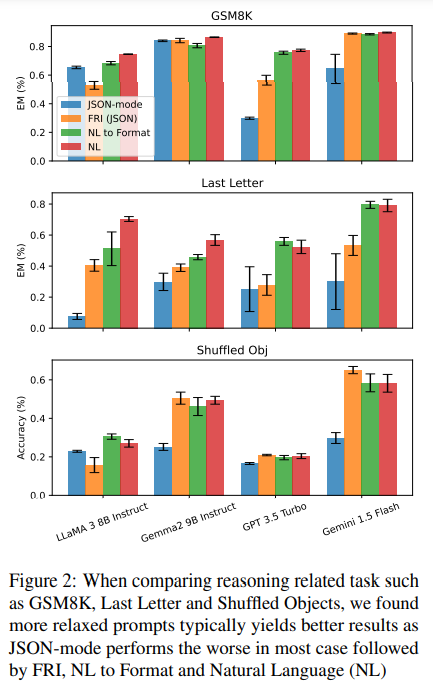

Let Me Speak Freely? A Study on the Impact of Format Restrictions on Performance of Large Language Models

著者:Zhi Rui Tam, Cheng-Kuang Wu, Yi-Lin Tsai, Chieh-Yen Lin, Hung-yi Lee, Yun-Nung Chen

発行日:2024年08月05日

最終更新日:2024年10月14日

URL:http://arxiv.org/pdf/2408.02442v3

カテゴリ:Computation and Language

概要:

この研究は、JSONやXMLなどの標準化された形式でコンテンツを生成する構造化生成というプロセスが、大規模言語モデル(LLMs)から主要な出力情報を抽出するために広く利用されていることを調査しています.この研究では、生成空間に制約を加えることがLLMsの能力、特に推論力やドメイン知識の理解にどのような影響を与えるかを調査しています.具体的には、一般的なタスクにおいて、構造化された形式に従うことを制限された場合と自由形式の応答を生成する場合のLLMsのパフォーマンスを評価しています.驚くべきことに、形式の制約下でのLLMsの推論能力の著しい低下が観察されています.さらに、より厳格な形式の制約が推論タスクにおけるパフォーマンスの低下につながる傾向があることがわかっています.

Q&A:

Q: 実験で使用した構造化フォーマット(JSON、XMLなど)の種類について詳しく教えてください.

A: 実験で使用された構造化フォーマットには、JSON、XML、YAMLが含まれています.これらのフォーマットは、それぞれ異なる文法構文ルールと制約を持っており、モデルによって異なるパフォーマンスを示すことが期待されます.例えば、Claude-3-Haikuはツール使用スキーマにXMLを使用しています.これらのフォーマットは、標準化された形式で出力を提供するために使用され、フォーマット制限を通じて実装されることがあります.フォーマット制限の方法としては、指定されたフォーマットに従うようにLLMに指示するフォーマット制限指示や、JSONモード(OpenAIのような産業ソリューション)を使用することが挙げられます.

Q: 調査結果の妥当性と信頼性を確保するために、どのような方法論を採用しましたか?

A: 本研究の妥当性と信頼性を確保するために、いくつかの方法論が採用されました.まず、モデルの性能を多様なタスクにわたって評価するために、タスク固有の評価指標が使用されました.具体的には、分類ベースのタスク(スポーツ理解、DDXPlus、ナチュラルインストラクションタスク280、MultiFin)では、主な指標として精度が使用されました.また、Last Letter ConcatenationとGSM8Kでは、最終的な答えが実際の答えと完全に一致することを求めるエクザクトマッチ指標が使用されました.さらに、GPT-4-turboの信頼性を評価するために、手動の検証研究が行われました.具体的には、Last Letter、Shuffle Object、GSM8Kからそれぞれ100件ずつ、合計300件の応答がサンプリングされ、独立して解析されました.これにより、テキストベースのタスクにおけるパラフレーズや文脈理解を考慮した、より微妙で正確な評価が提供されました.

Q: 構造化されたジェネレーションのコンテキストでLLMを利用するアプリケーションの設計に、あなたの発見はどのような意味を持つのでしょうか?

A: 本研究の結果は、構造化された生成コンテキストでLLMを利用するアプリケーションの設計に対して重要な示唆を与えます.特に、フォーマット制約がLLMの性能に与える影響を考慮する必要があります.制約されたフォーマットは、推論能力やドメイン知識の理解に影響を及ぼす可能性があるため、アプリケーション設計者はこれを考慮に入れるべきです.例えば、フォーマット制約がある場合、LLMの推論能力が低下することが示されています.したがって、アプリケーションの設計においては、フォーマット制約を最小限に抑えるか、またはLLMの性能を維持するための補完的な手法を検討することが推奨されます.これにより、ビジネスへの影響を最小限に抑えつつ、LLMの能力を最大限に活用することが可能となります.

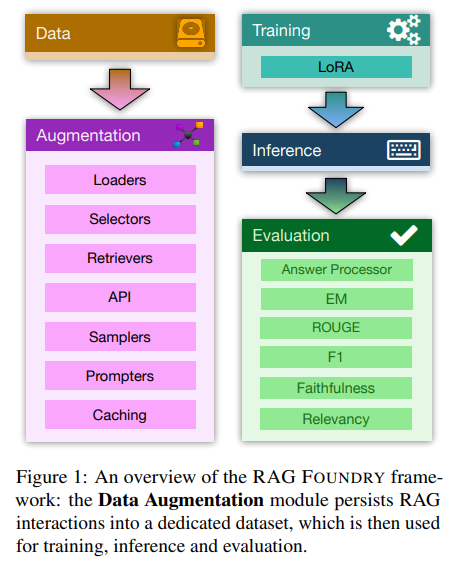

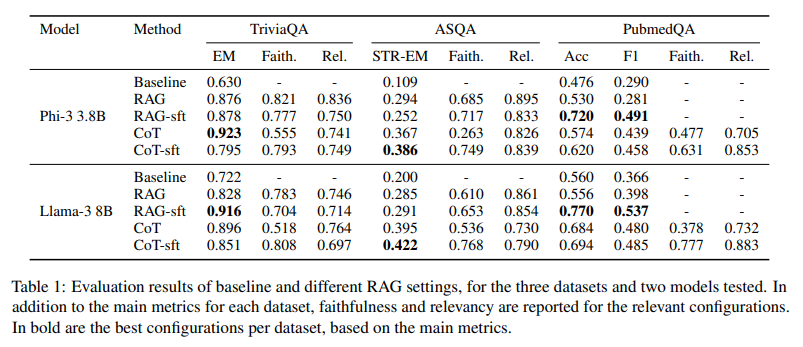

RAG Foundry: A Framework for Enhancing LLMs for Retrieval Augmented Generation

著者:Daniel Fleischer, Moshe Berchansky, Moshe Wasserblat, Peter Izsak

発行日:2024年08月05日

最終更新日:2024年08月05日

URL:http://arxiv.org/pdf/2408.02545v1

カテゴリ:Computation and Language, Artificial Intelligence, Information Retrieval, Machine Learning

概要:

RAG(Retrieval-Augmented Generation)システムの実装は、データ、ユースケース、複雑な設計の理解が深く必要とされるため、本質的に複雑です.さらに、これらのシステムの評価は、検索精度と生成品質の両方を総合的に評価する必要があるため、重要な課題があります.私たちは、RAGのユースケースのために大規模な言語モデルを拡張するためのオープンソースフレームワークであるRAG Foundryを紹介します.RAG Foundryは、データの作成、トレーニング、推論、評価を1つのワークフローに統合し、RAG設定で大規模な言語モデルをトレーニングおよび評価するためのデータ拡張データセットの作成を容易にします.この統合により、さまざまなRAG技術を迅速にプロトタイプ化し、実験することができ、ユーザーは内部または特化した知識源を使用してデータセットを簡単に生成し、RAGモデルをトレーニングすることができます.私たちは、異なるRAG構成を使用してLlama-3とPhi-3モデルを拡張し、微調整することで、3つの知識集約型データセット全体で一貫した改善を示すことで、フレームワークの効果を実証します.コードはhttps://github.com/IntelLabs/RAGFoundryでオープンソースとして公開されています.

Q&A:

Q: RAG Foundryは、トレーニング用のデータ補強されたデータセットの作成をどのように容易にしていますか?

A: RAG Foundryは、データ作成、トレーニング、推論、評価を単一のワークフローに統合することにより、データ拡張データセットの作成を促進いたします.この統合により、さまざまなRAG技術を用いた迅速なプロトタイピングと実験が可能となり、ユーザーは内部または専門的な知識源を使用してデータセットを容易に生成し、RAGモデルをトレーニングすることができます.

Q: 他のRAGシステム用フレームワークと異なるRAG Foundryの主な特徴は何ですか?

A: RAG Foundryの主な特徴は、他のRAGシステムのフレームワークと比較して、特定のワークフローパラダイムを課さない一般的な設計であることです.RAG Foundryは、データセットの作成、トレーニング、推論、評価を単一のワークフローに統合しており、迅速なプロトタイピングとさまざまなRAG技術の実験を可能にしています.この統合により、内部または専門的な知識源を使用して、データ拡張されたデータセットを容易に生成し、RAGモデルをトレーニングすることができます.

Q: データ作成、トレーニング、推論、評価の統合は、ユーザーのワークフローをどのように改善するのか?

A: データ作成、トレーニング、推論、評価の統合は、ユーザーのワークフローを大幅に改善することができます.この統合により、データ拡張データセットの迅速なプロトタイピングと実験が可能になり、さまざまなRAG技術を用いてデータセットを簡単に生成し、トレーニングすることができます.これにより、データの作成からモデルの評価までの一連のプロセスが一貫して行われ、効率的なワークフローが実現されます.さらに、各ステップがキャッシュされることで、計算効率が向上し、結果の再現が容易になります.

Q: Llama-3とPhi-3モデルを微調整する際、どのような指標を使って性能の向上を測ったのですか?

A: Llama-3とPhi-3モデルの微調整による性能向上を測定するために使用された指標は、TriviaQAに対する正確一致(EM)、ASQAに対するSTR-EM、PubmedQAに対する精度とF1スコアです.さらに、RAGASメトリクスとしてFaithfulnessとRelevancyも評価されました.Faithfulnessは生成されたテキストとコンテキストの関係を測定し、Relevancyは生成されたテキストとクエリの関係を測定します.

Q: RAG Foundryは、RAGシステムの有効性評価に関連する課題にどのように対処していますか?

A: RAG Foundryは、RAGシステムの評価に関連する課題を、取得した情報、データの形式化、および生成された出力の相互作用を考慮した洗練された評価スイートを提供することによって対処しております.これにより、RAGシステムの取得精度と生成品質の両方を評価することが可能となっております.また、RAG Foundryは、RAGユースケースにおけるLLMの能力を強化するための高度にカスタマイズ可能なPythonフレームワークを提供し、迅速なプロトタイピングと実験を可能にしております.これにより、異なるRAG技術を迅速にプロトタイプ化し、実験することが可能となっております.

Self-Taught Evaluators

著者:Tianlu Wang, Ilia Kulikov, Olga Golovneva, Ping Yu, Weizhe Yuan, Jane Dwivedi-Yu, Richard Yuanzhe Pang, Maryam Fazel-Zarandi, Jason Weston, Xian Li

発行日:2024年08月05日

最終更新日:2024年08月08日

URL:http://arxiv.org/pdf/2408.02666v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

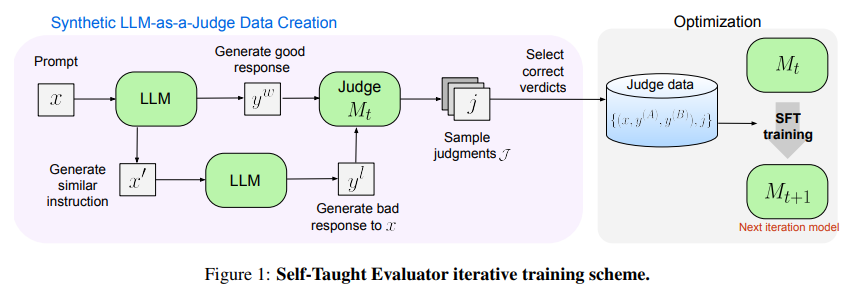

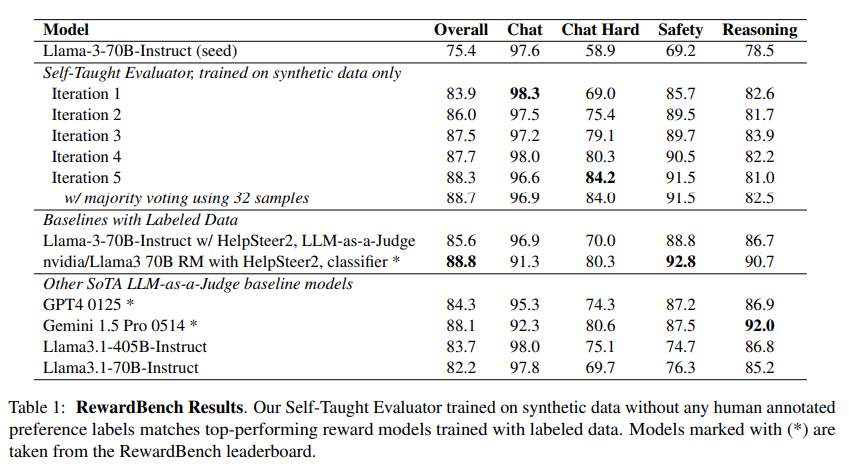

モデルベースの評価は、成功したモデル開発の中心にあります.トレーニング用の報酬モデルとして、および人間の評価の代替として.このような評価者をトレーニングするための標準的なアプローチは、モデルの応答に対する多くの人間の選好判断を収集することですが、これはコストがかかり、モデルが改善するにつれてデータが古くなります.この研究では、人間の注釈を使用せずに、合成トレーニングデータのみを使用して評価者を改善するアプローチを提案しています.ラベルのない指示から始め、反対のモデル出力を生成し、LLM-as-a-Judgeをトレーニングして推論トレースと最終判断を生成する反復的な自己改善スキームを使用します.改善された予測を使用して、各新しい反復でこのトレーニングを繰り返します.ラベルの付いた選好データがなくても、Self-Taught Evaluatorは、RewardBenchで強力なLLM(Llama3-70B-Instruct)を75.4から88.3(多数決を使用すると88.7)に改善することができます.これは、GPT-4などの一般的に使用されるLLM判定者を上回り、ラベル付きの例でトレーニングされたトップパフォーマンスの報酬モデルと同等のパフォーマンスを発揮します.

Q&A:

Q: 他のモデルと比較して、セルフ・ティーチング・エバリュエーターのパフォーマンスを評価するためにどのような指標を用いましたか?

A: 自己学習評価者モデルの性能を他のモデルと比較するために使用された評価指標は、以下の通りです.まず、RewardBench(Lambert et al., 2024)においては、リーダーボードで提供される標準的な評価プロトコルが使用されました.また、MT-Bench(Zheng et al., 2023)では、同点の例を除外した際の人間の判断との一致率が報告されました.さらに、HelpSteer2(Wang et al., 2024b)では、検証用の分割データに対して評価が行われました.これらの評価指標を用いることで、自己学習評価者モデルの性能が、ラベル付きデータで訓練されたトップパフォーマンスの報酬モデルと同等であることが示されました.

Q: 反復的な自己改善のプロセスは実際にどのように機能するのか、また、それに関わる重要なステップは何か.

A: 反復的な自己改善プロセスは、以下のように実施されます.まず、モデルの現在のバージョンからサンプルを生成し、それに対してLLM-as-a-Judgeによる推論トレースと判断を行います.次に、正しい判断が見つかった場合、その例をトレーニングセットに追加し、見つからなかった場合はその例を破棄します.このプロセスを繰り返すことで、モデルは次の反復のために更新されます.各反復において、トレーニングセットのサイズは現在のモデルの品質に依存します.モデルが改善されるにつれて、より多くの正しい判断を見つけることができるため、トレーニングセットのサイズも増加すると期待されます.これにより、モデルは自動的なカリキュラムを得ることができます.

Q: あなたのモデルのパフォーマンスの文脈で「改善」をどのように定義し、測定しますか?

A: この文脈におけるモデルの性能の「改善」は、主にRewardBenchというベンチマークにおけるスコアの向上によって定義され、測定されます.具体的には、Llama3-70B-Instructという強力な大規模言語モデル(LLM)の性能が、自己学習評価者(Self-Taught Evaluator)を用いることで、75.4から88.3に向上し、さらに多数決を用いることで88.7に達することが示されています.この改善は、合成されたトレーニングデータのみを使用し、人間の好みのラベル付けデータを必要としない手法によって達成されます.数式で表現すると、性能の改善は次のように表されます:

[

\text{Improvement} = \text{New Score} – \text{Original Score} = 88.3 – 75.4 = 12.9

]

このようにして、モデルの性能がどの程度向上したかを定量的に評価することが可能です.

Q: セルフ・ティーチャー・エバリュエーターのパフォーマンスは、従来の人間の評価方法と比べてどうですか?

A: 与えられた文脈によれば、自己学習評価者(Self-Taught Evaluator)は、合成データのみを用いて訓練されており、人間による注釈付きデータを使用せずに、ラベル付きデータで訓練されたトップパフォーマンスの報酬モデルと同等の性能を示しています.具体的には、RewardBenchにおいて、自己学習評価者は第5回の反復で88.3のスコアを達成し、これは種モデルであるLlama3-70B-Instructの75.4を大きく上回っています.また、HelpSteer2のラベル付きデータを用いて同様の方法で訓練されたLLM-as-a-Judgeモデルは85.6のスコアを得ており、自己学習評価者は人間のラベル付きデータを使用せずに優れた性能を示しています.したがって、自己学習評価者は伝統的な人間の評価方法と比較しても、非常に競争力のある結果を示していると言えます.

Q: 現実のシナリオへの適用に影響するような、あなたのアプローチの限界はありますか?

A: 本アプローチにはいくつかの制限があり、現実世界での適用に影響を与える可能性があります.まず、生成的なLLM-as-a-Judgeモデルは、報酬モデルが単にスコアを出力するのに対して、推論チェーンを生成するため、出力が長くなり推論コストが高くなることがあります.また、本研究では比較的大きなLLM(70Bパラメータ)を使用しており、小さなモデルでの適用可能性については検討しておりません.さらに、我々のアプローチは、最初に合成的な好みを生成するためのシードモデルを使用するため、モデルが合理的な評価を生成できることが前提となっています.このため、すでに人間(または法律/政策)の好みに合理的に整合している指示微調整済みモデルが必要であるという制限があります.さらに、評価精度の向上に関するメトリクスのみを調査し、計算要件に関する懸念は報告しておりません.また、ペアワイズ評価、すなわち2つの応答を比較することのみを調査しており、単一の応答の品質を評価するためにLLM-as-a-Judgeモデル(または他のモデル)を使用することも可能ですが、その点については検討しておりません.

A Survey of Mamba

著者:Haohao Qu, Liangbo Ning, Rui An, Wenqi Fan, Tyler Derr, Hui Liu, Xin Xu, Qing Li

発行日:2024年08月02日

最終更新日:2024年10月18日

URL:http://arxiv.org/pdf/2408.01129v4

カテゴリ:Machine Learning, Artificial Intelligence

概要:

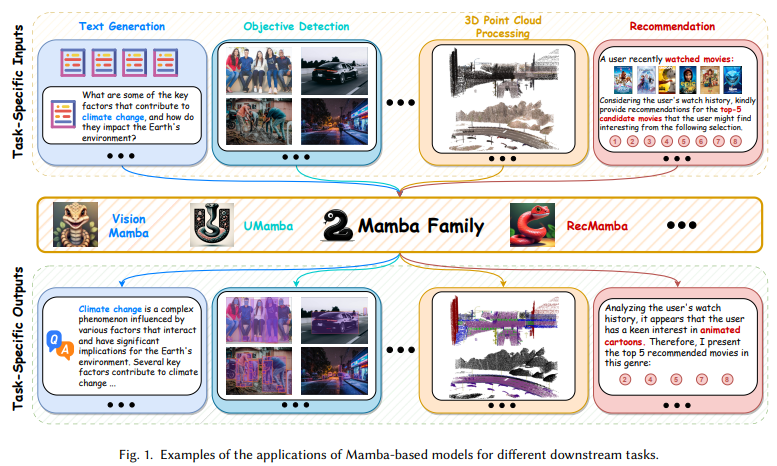

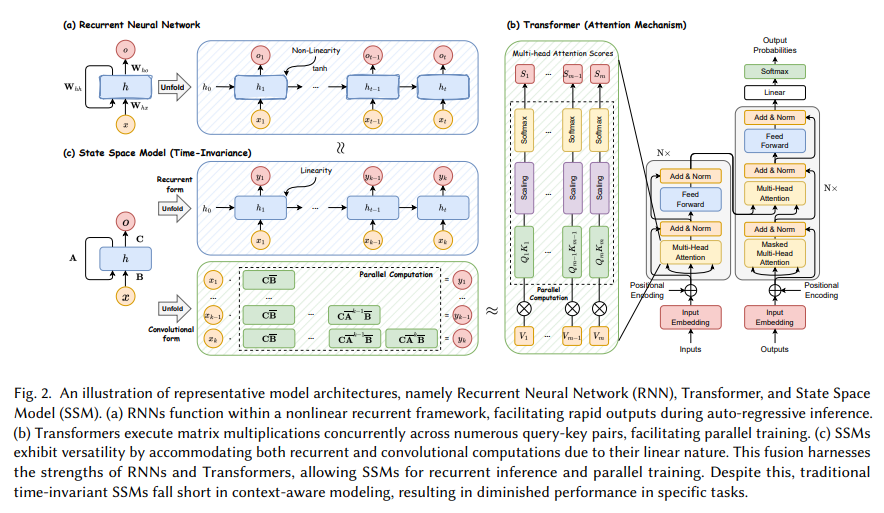

Transformerアーキテクチャは、DL技術の中でも最も代表的なものの一つとして、数十億のパラメータを持つ大規模言語モデル(LLMs)を含む多くの先進モデルに力を与え、深層学習の礎となっています.しかし、Transformerは依然として、特に注意計算の二次計算複雑性による時間のかかる推論という固有の制限に直面しています.最近、古典的な状態空間モデル(SSMs)からインスピレーションを得た新しいアーキテクチャであるMambaが登場し、Transformerと同等のモデリング能力を提供しながら、シーケンス長に関してほぼ線形のスケーラビリティを維持しています.これにより、Mambaの潜在能力を活用してさまざまな領域で印象的なパフォーマンスを達成しようとする研究が増加しています.このような急速な進化に伴い、この新興モデルアーキテクチャの包括的な理解を提供する既存のMamba-empoweredモデルを統合する体系的なレビューが必要とされています.この調査では、最近のMamba関連研究の詳細な調査を行い、Mambaベースのモデルの進化、Mambaをさまざまなデータに適応させる技術、そしてMambaが優れる可能性のあるアプリケーションの三つの主要な側面をカバーします.具体的には、まず、様々な代表的な深層学習モデルの基礎知識とMamba-1&2の詳細を予備知識としてレビューします.次に、AIにおけるMambaの重要性を示すために、Mambaモデルのアーキテクチャ設計、データ適応性、およびアプリケーションに焦点を当てた関連研究を包括的にレビューします.最後に、現在の制限についての議論を提示し、将来の研究に向けてより深い洞察を提供するためのさまざまな有望な研究方向を探求します.

Q&A:

Q: Mambaはどのようにしてシーケンス長に関してほぼリニアなスケーラビリティを実現しているのか?

A: Mambaは、シーケンス長に関してほぼ線形のスケーラビリティを達成するために、まず入力に基づいてSSMパラメータをパラメータ化することにより、モデルが不要な情報をフィルタリングし、必要かつ関連するデータを無期限に保持できるようにするシンプルで効果的な選択メカニズムを導入しております.その後、Mambaは畳み込みの代わりにスキャンを用いてモデルを再帰的に計算するハードウェア対応のアルゴリズムを提案しております.このようなアプローチにより、計算コストが大幅に削減され、シーケンス長に対してほぼ線形のスケーラビリティが実現されております.これにより、Mambaはテキスト、時系列、音声などのシーケンシャルデータに対する基盤モデルとしての可能性を持ち、さらに画像やグラフなどのドメインにも適用されることが期待されております.これにより、長距離依存関係を捉える能力が向上し、学習および推論プロセスにおける効率性が高まることが実現されております.

Q: 最近の研究で明らかになった、マンバをベースにしたモデルの主な進歩とは?

A: 最近の研究において、Mambaベースのモデルの主な進展として、状態空間モデルとMambaが基盤モデルのバックボーンとして有望な代替手段として探求されていることが挙げられます.特に、Mambaベースの大規模モデルは、学術研究のみならず、産業界においても大きな進展を遂げており、Falcon Mamba 7BやMistral 7Bのようなモデルがその一例です.これらのモデルは、アーキテクチャ設計、データ適応性、そして応用分野において重要な役割を果たしています.

Q: 多様なデータ型へのMambaの適応は、Transformerモデルの適応と比べてどうなのか?

A: Mambaアーキテクチャの多様なデータタイプへの適応は、Transformerモデルの適応と比較して、いくつかの重要な違いがあります.Mambaは、シーケンス長に関して線形スケーラビリティを維持しながら、長距離依存性を捉える能力に優れているため、特にシーケンシャルデータにおいて有望な代替手段とされています.これに対し、Transformerは通常、計算コストが高く、特に長いシーケンスに対しては非効率的であることが知られています.さらに、Mambaは、画像やグラフなどの非シーケンシャルデータにも適応されており、これにより、さまざまなドメインでの利用が可能となっています.これに対して、Transformerは主にシーケンシャルデータに焦点を当てており、非シーケンシャルデータへの適応には追加の工夫が必要です.したがって、Mambaはその効率性と適応性において、Transformerに対する競争力のある選択肢と見なされています.

Q: マンバ・アーキテクチャを利用することで、具体的にどのようなアプリケーションが大幅に改善されたのでしょうか?

A: Mambaアーキテクチャを利用することで、言語生成、画像分類、レコメンデーション、薬物発見といった多様な分野で顕著な改善が見られました.これらの分野において、Mambaはその強力なモデリング能力と計算効率性により、特に優れた成果を上げています.

Q: 現在のマンバのモデルにはどのような限界があり、トランスフォーマーのモデルの限界と比べてどうなのか?

A: Mambaモデルの現在の制限としては、安全性と堅牢性の問題が挙げられます.特に、Mambaベースのモデルは、入力に対する小さな摂動に対して出力が堅牢であるべきであるとされています.これは、Transformerモデルと同様に、敵対的摂動に対して脆弱であることが指摘されています.Transformerモデルは、注意計算の二次計算複雑性により推論が時間を要するという制限がありますが、Mambaモデルはシーケンス長に関してほぼ線形のスケーラビリティを維持しつつ、同等のモデリング能力を提供することが期待されています.しかし、Mambaモデルの機能理解に関する研究はまだ初期段階であり、さらなる調査が必要とされています.

Q: Mambaが他のディープラーニング・モデルと比較して卓越したパフォーマンスを示した特定のドメインはありますか?

A: 文脈によると、Mambaは言語生成、画像分類、レコメンデーション、薬物発見などの多様な領域で顕著な成功を収めているとされています.これらの領域において、Mambaは他のディープラーニングモデルと比較して特に優れた性能を示していると考えられます.Mambaの強力なモデリング能力と計算効率がその成功の要因とされています.

Q: マンバ・アーキテクチャーの今後の発展について、どのような有望な研究の方向性を予測していますか?

A: Mambaアーキテクチャの将来の発展における有望な研究方向としては、まず、より強力な表現学習能力と低い計算複雑性を持つMambaベースのディープラーニングモデルの開発が挙げられます.さらに、Mambaのアーキテクチャ設計、データ適応性、および応用分野に焦点を当てた研究が進められることが期待されます.これにより、MambaがAIにおいて重要な役割を果たすことが示されるでしょう.これらの研究方向は、Mambaの急速な進化に伴い、体系的なレビューの必要性が高まっていることからも重要であると考えられます.

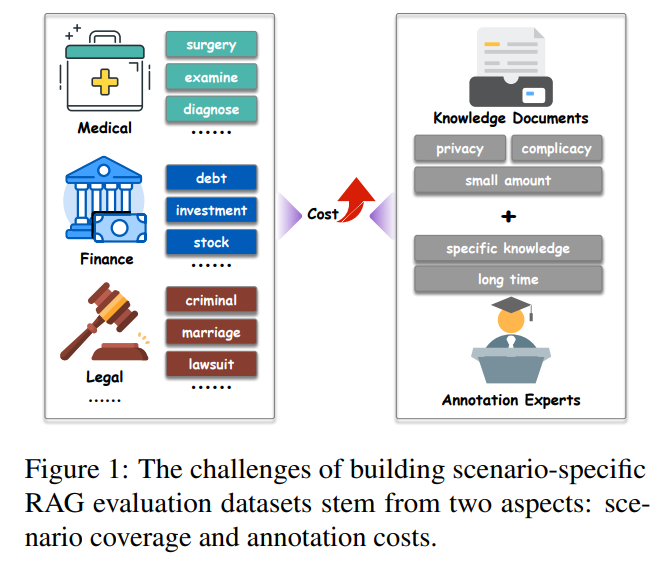

RAGEval: Scenario Specific RAG Evaluation Dataset Generation Framework

著者:Kunlun Zhu, Yifan Luo, Dingling Xu, Ruobing Wang, Shi Yu, Shuo Wang, Yukun Yan, Zhenghao Liu, Xu Han, Zhiyuan Liu, Maosong Sun

発行日:2024年08月02日

最終更新日:2024年10月17日

URL:http://arxiv.org/pdf/2408.01262v4

カテゴリ:Computation and Language, Information Retrieval

概要:

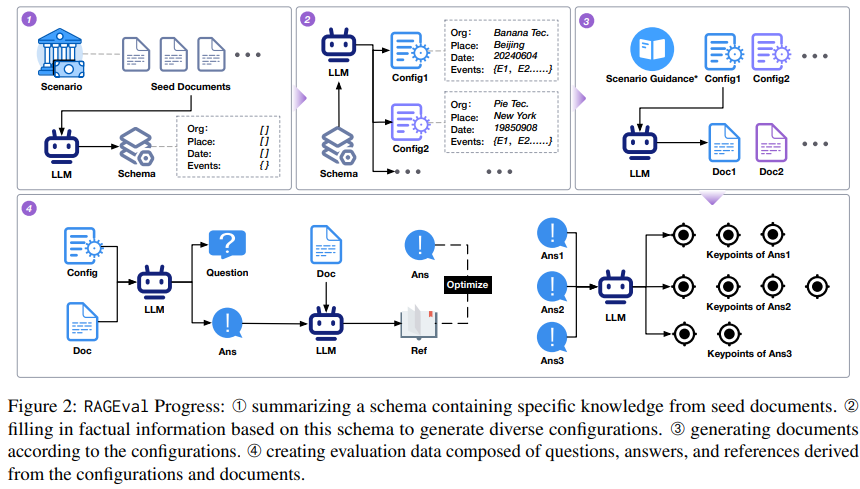

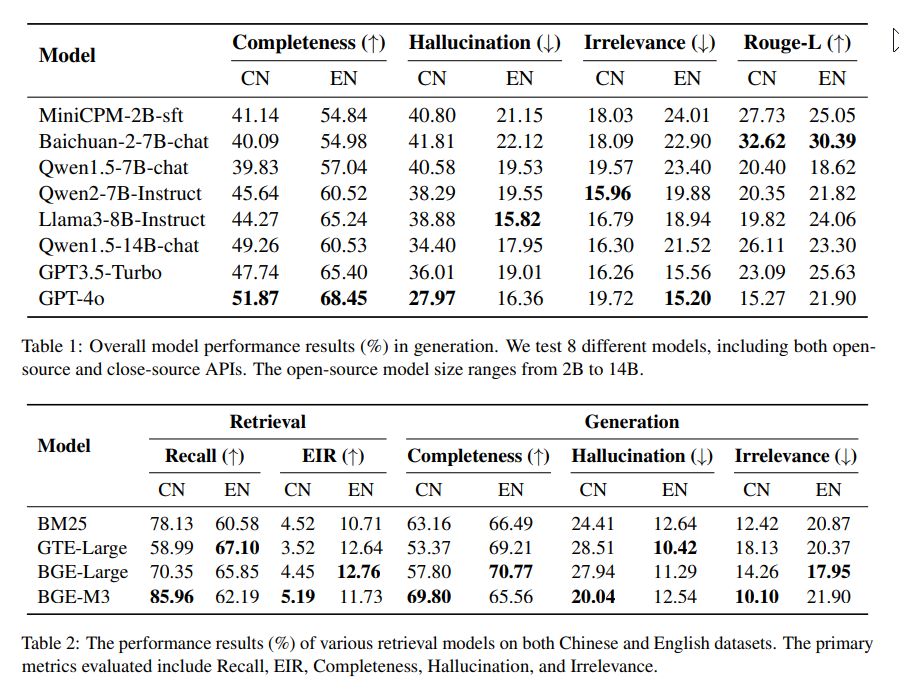

Retrieval-Augmented Generation(RAG)は、大規模言語モデル(LLM)が外部知識を組み込むことを可能にする強力なアプローチです.しかし、専門的なシナリオでのRAGシステムの効果を評価することは、データ構築の高コストや適切な評価メトリクスの欠如のために困難です.この論文では、高品質なドキュメント、質問、回答、および参照を生成するスキーマベースのパイプラインを介して、多様なシナリオでRAGシステムを評価するために設計されたフレームワークであるRAGEvalを紹介しています.事実の正確性に焦点を当て、LLMが生成した応答を厳密に評価するために、Completeness、Hallucination、Irrelevanceの3つの新しいメトリクスを提案しています.実験結果は、RAGEvalが生成されたサンプルの明瞭さ、安全性、適合性、豊かさの面でゼロショットおよびワンショットの方法を上回ることを示しています.さらに、提案されたメトリクスのスコアリングにLLMを使用することで、人間の評価との高い一貫性が示されています.RAGEvalは、実世界のアプリケーションでRAGシステムを評価するための新しいパラダイムを確立しています.

Q&A:

Q: RAGEvalのデータセットを構築する上で、具体的にどのような課題がありましたか?

A: RAGEvalのデータセット構築において直面した具体的な課題は、現実世界のシナリオが複雑で動的であるため、包括的な手動データカバレッジが困難であることです.また、大規模なデータ収集はプライバシーの懸念や物流の制約によって制限されることが多いです.さらに、高品質なデータを生成するには専門的な知識が必要であり、それが労働と時間のコストを増加させます.

Q: 文書、質問、回答、参考文献の生成に使用されるスキーマベースのパイプラインについて詳しく教えてください.

A: スキーマに基づくパイプラインは、文書、質問、回答、そして参照を生成するための一連のプロセスを示しています.このプロセスは、以下のように表されます: $$ \small S \rightarrow C \rightarrow D \rightarrow (Q,A) \rightarrow R \rightarrow \text{Keypoints} $$

ここで、\( \small S \)はスキーマの要約を示し、\( \small C \)は構成の生成、\( \small D \)は文書の生成を表します.その後、文書から質問と回答のペア\( \small (Q,A) \)が生成され、回答をサポートするための関連する参照\( \small R \)が抽出されます.最後に、回答から重要な情報を抽出するためのキーポイントが生成されます.

このプロセスの最初のステップであるスキーマ\( \small S \)は、シナリオ固有の要素を抽象的に表現したものであり、入力文書からの重要な事実知識をカプセル化しています.スキーマは、選択されたシード文書から初期スキーマを生成し、その後、特定のシナリオとAIに精通した専門家によって反復的に洗練され、包括的かつ一般化された形でコンテンツ生成をサポートするようにされています.このようにして、異なるシナリオにおいても一貫した出力が得られ、専門的な基準に沿った信頼性のあるコンテンツが生成されます.

Q: 提案されている「完全性」、「幻覚」、「無関係性」の評価基準は、この分野における既存の評価基準とどう違うのか?

A: 提案されたCompleteness、Hallucination、およびIrrelevanceの各メトリックは、既存の評価メトリックといくつかの点で異なっております.まず、Completenessは生成された回答がどれだけ完全に事実に基づいた重要なポイントをカバーしているかを評価するものでございます.次に、Hallucinationは生成された回答が事実に基づかない情報をどれだけ含んでいるかを評価いたします.最後に、Irrelevanceは、生成された回答が関連する情報にどれだけ関与していないかを示すものであり、以下の式で計算されます:

[ \text{Irr}(A, K) = 1 – \text{Comp}(A, K) – \text{Hallu}(A, K) ]

これらのメトリックは、RAGモデルの生成した回答の情報性、正確性、および関連性を確保するために、特定の強みと弱みを明確にすることができるため、既存のメトリックよりも効果的で安定しており、比較可能なスコアリング方法を提供いたします.

Q: 作成された回答の事実上の正確さを判断するために、どのような基準が用いられたのか?

A: 生成された応答の事実の正確性を評価するために使用された基準は、完全性、幻覚、無関係性の3つの新しい指標です.これらの指標は、事実に基づいた重要なポイントに基づいており、効果的で安定した比較可能なスコアリング方法を提供します.

Q: RAGEvalによって作成された文書や質問の質の高さはどのようにして確保したのですか?

A: RAGEvalによって生成された文書と質問の高品質を確保するために、いくつかの方法が用いられました.まず、RAGEvalはシナリオに特化したRAG評価データセットを生成するための新しいフレームワークとして提案されました.このフレームワークは、スキーマベースのパイプラインを通じて高品質の文書、質問、回答、参考文献を生成します.さらに、生成された回答の事実の正確性を厳密に評価するために、Completeness、Hallucination、Irrelevanceという3つの新しい指標が導入されました.実験結果は、RAGEvalが明確さ、安全性、適合性、生成されたサンプルの豊かさにおいて、ゼロショットおよびワンショットの方法を上回ることを示しています.また、提案された指標のスコアリングにLLMを使用することで、人間の評価と高い一致度が示されました.これらの要素が組み合わさることで、RAGEvalは高品質の文書と質問を生成することが可能となっています.

Q: 生成されたサンプルの透明性、安全性、適合性、豊かさについて、具体的にどのような点が測定されたのか?

A: 生成されたサンプルの明確さ、安全性、適合性、豊かさの具体的な側面は、以下のように測定されました.明確さ(Clarity)は、情報が明確で具体的であることを指します.安全性(Safety)は、現実世界のセンシティブな情報を避けることを意味します.適合性(Conformity)は、財務報告書や医療記録のような実際の文書に似ていることを示します.豊かさ(Richness)は、情報の深さと幅広さを指します.

Q: 提案された評価基準に対するLLMの採点と人間の評価との整合性はどのように評価したのですか?

A: 提案されたメトリクスのLLMスコアリングと人間の評価との一貫性を評価するために、QRA品質評価からの同じ420の例を使用し、Baichuan-2-7B-chatの回答を人間のアノテーターに評価してもらいました.その後、メトリクスを計算し、LLMによって注釈された結果と比較しました.図12の結果は、すべてのメトリクスで機械と人間の評価が高い一致を示しており、絶対差は0.026未満であることを示しています.これにより、我々の自動評価メトリクスの信頼性が検証され、人間の判断との一貫性が確認されました.

Q: また、RAGEvalがRAGシステムの評価にどのような影響を与える可能性がありますか?

A: RAGEvalは、現実世界のさまざまなシナリオにおけるRAGシステムの評価において重要な役割を果たすと考えられます.具体的には、RAGEvalは高品質なドキュメント、質問、回答、参照を生成するスキーマベースのパイプラインを通じて、RAGシステムの事実の正確性を評価するための新しい枠組みを提供します.この枠組みは、特に専門的なシナリオにおけるRAGシステムの効果を評価する際のデータ構築の高コストや適切な評価指標の欠如といった課題を克服することが期待されます.RAGEvalは、Completeness(完全性)、Hallucination(幻覚)、Irrelevance(無関係性)という3つの新しい指標を提案し、LLMが生成する応答を厳密に評価します.これにより、RAGEvalは、ゼロショットやワンショットの方法よりも明確さ、安全性、適合性、生成サンプルの豊かさにおいて優れていることが実験結果から示されています.したがって、RAGEvalは、RAGシステムの評価における新しいパラダイムを確立し、現実世界のアプリケーションにおいてその有用性を発揮することが期待されます.

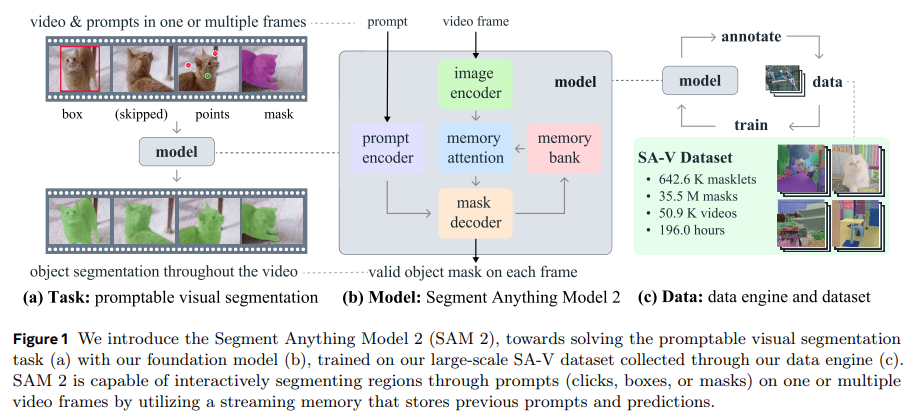

SAM 2: Segment Anything in Images and Videos

著者:Nikhila Ravi, Valentin Gabeur, Yuan-Ting Hu, Ronghang Hu, Chaitanya Ryali, Tengyu Ma, Haitham Khedr, Roman Rädle, Chloe Rolland, Laura Gustafson, Eric Mintun, Junting Pan, Kalyan Vasudev Alwala, Nicolas Carion, Chao-Yuan Wu, Ross Girshick, Piotr Dollár, Christoph Feichtenhofer

発行日:2024年08月01日

最終更新日:2024年08月01日

URL:http://arxiv.org/pdf/2408.00714v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Machine Learning

概要:

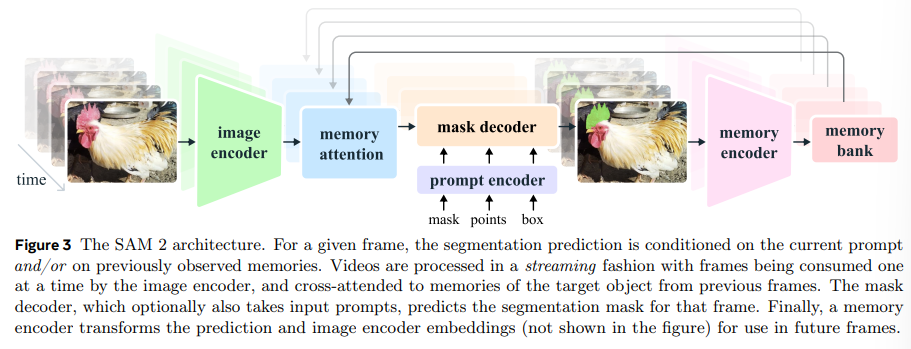

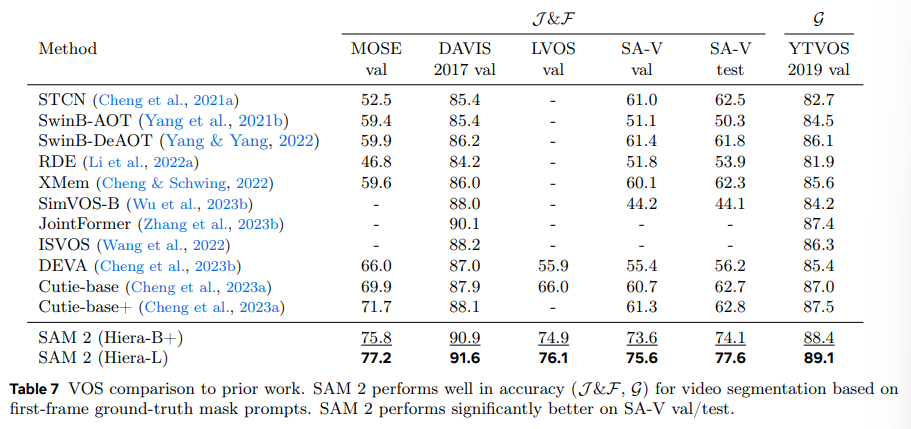

Segment Anything Model 2(SAM 2)は、画像や動画のプロンプト可能な視覚セグメンテーションを解決するための基礎モデルを提供しています.我々は、ユーザーとのインタラクションを通じてモデルとデータを改善するデータエンジンを構築し、これまでで最大のビデオセグメンテーションデータセットを収集しています.我々のモデルは、リアルタイムのビデオ処理のためのストリーミングメモリを備えたシンプルなトランスフォーマーアーキテクチャです.我々のデータでトレーニングされたSAM 2は、幅広いタスクにおいて強力なパフォーマンスを提供します.ビデオセグメンテーションでは、従来のアプローチよりも3倍少ないインタラクションを使用してより高い精度を実現しています.画像セグメンテーションでは、我々のモデルはSAMよりも精度が高く、6倍速いです.我々は、我々のデータ、モデル、洞察がビデオセグメンテーションや関連する知覚タスクにおいて重要なマイルストーンとなると信じています.我々は、モデルのバージョン、データセット、インタラクティブなデモを公開しています.

Q&A:

Q: ストリーミングメモリ機能は、SAM 2のリアルタイムビデオ処理をどのように強化するのですか?

A: ストリーミングメモリ機能は、SAM 2におけるリアルタイムビデオ処理を強化するために重要な役割を果たしております.この機能により、SAM 2はビデオフレームを一度に一つずつ処理し、対象物の以前のメモリに注意を払うことが可能となっております.具体的には、メモリは対象物と以前のインタラクションに関する情報を保存し、ビデオ全体を通じてマスクレット予測を生成し、以前に観察されたフレームからのメモリコンテキストに基づいてこれらを効果的に修正することができます.このようにして、ストリーミングメモリは、ビデオセグメンテーションにおいてより高い精度を達成し、以前のアプローチと比較して3倍少ないインタラクションで済むことが観察されております.

Q: SAM 2のビデオセグメンテーションの精度は、どのような基準で評価されましたか?

A: SAM 2のビデオセグメンテーションの精度を評価するために使用された基準は、J&FとGの2つのメトリクスです.J&Fは、プロンプタブルビデオセグメンテーションと半教師付きVOSタスクの評価に使用されます.Gは、YTVOS 2019の半教師付きVOSタスクの評価に使用されます.これらのメトリクスを用いることで、SAM 2のセグメンテーション精度が詳細に評価されました.

Q: 最大規模のビデオ・セグメンテーション・データセットはどのように収集され、その主な特徴は何か?

A: この最大のビデオセグメンテーションデータセットは、Meta FAIRによって収集されました.データセットは、50.9Kのビデオと642.6Kのマスクレットで構成されており、今日公開されている中で最大のビデオセグメンテーションデータセットです.このデータセットは、Creative Commons Attribution 4.0 International Public Licenseの下で利用可能であり、https://ai.meta.com/datasets/segment-anything-video/ からアクセスできます.データセットの収集には、契約された第三者の会社を通じてビデオが収集され、インタラクティブなモデルと人間のアノテーターを組み合わせたループ設定が使用されました.アノテーションされたマスクレットには意味的な制約を課さず、多様で地理的に多様なデータを提供することに焦点を当てています.

Q: モデルやデータを改善するために、どのようなユーザーとのインタラクションが奨励されるのか?

A: 文脈から判断すると、モデルとデータを改善するために奨励されているユーザーのインタラクションの種類は、インタラクティブなプロンプトのシミュレーションと、ランダムに選択されたフレームに対する修正クリックの提供です.これにより、モデルはフィードバックを受け取り、データの精度を向上させることができます.具体的には、8フレームのシーケンスをサンプリングし、最大2フレームをプロンプトとして選択し、確率的に修正クリックを受け取るという方法が取られています.

Q: トレーニングデータセットのサイズや多様性など、SAM 2のトレーニングプロセスの詳細を教えてください.

A: SAM 2のトレーニングプロセスについての詳細を以下に示します.まず、トレーニングデータセットのサイズと多様性についてですが、SAM 2はSA-Vデータセットと内部で利用可能なライセンスビデオデータを用いてトレーニングされました.さらに、SA-1Bの10%のサブセットと、DAVIS、MOSE、YouTubeVOSなどのオープンソースのビデオデータセットの混合を使用しました.これにより、トレーニングデータセットは非常に多様であり、さまざまなドメインをカバーしています.トレーニングは256台のA100 GPUを使用して108時間行われました.これにより、モデルは多様なデータに対して高い適応性を持つことが期待されます.