ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Grandmaster-Level Chess Without Search

発行日:2024年02月07日

最近の機械学習の成功は、大規模なアテンションベースのアーキテクチャと前例のない規模のデータセットによるものであり、本論文では、チェスにおけるスケールでのトレーニングの影響を調査している. - ALOHA 2: An Enhanced Low-Cost Hardware for Bimanual Teleoperation

発行日:2024年02月06日

ALOHA 2は、高いパフォーマンス、エルゴノミクス、堅牢性を持ち、オープンソースのハードウェア設計とチュートリアルが提供されている改良されたデモンストレーションデータセットです.RealSense D405カメラとカスタムの3Dプリントカメラマウントを使用することで、ALOHA 2のフォロワーアームのフットプリントが縮小され、操作タスクがより制約されなくなりました.これにより、折りたたみや結び目の作成、物体の投げるなどの複雑な操作タスクを遠隔操作することが容易になりました.また、これらの改良により、1日あたりのロボットごとのこれらのタスクのデモンストレーションを100回以上収集することが容易になりました. - AnyTool: Self-Reflective, Hierarchical Agents for Large-Scale API Calls

発行日:2024年02月06日

AnyToolは、16,000以上のAPIを利用してユーザーのクエリに対応するために設計された大規模な言語モデルエージェントであり、改訂された評価プロトコルと追加のベンチマークによって他のベースラインに比べて優れた性能を示しています. - A phase transition between positional and semantic learning in a solvable model of dot-product attention

発行日:2024年02月06日

この研究では、位置と意味に基づいてトークン同士が相互に注意を向ける行列を学習し、そのアーキテクチャが位置または意味のメカニズムを使用して解を実装することを示しました.また、非線形の自己注意層の学習やグローバル最小値の特性についても研究しました.最後に、意味メカニズムを使用した位置ベースラインよりも優れた結果を示しました. - Large Language Models as an Indirect Reasoner: Contrapositive and Contradiction for Automated Reasoning

発行日:2024年02月06日

最近、大規模言語モデル(LLM)の推論能力向上に関心があり、本論文では新しい手法である間接推論(IR)を提案している.IRは対偶や矛盾の論理を利用し、LLMの理解力を向上させる.実験結果では、IR手法は従来のDR手法と比較して事実推論と数学的証明の正確さを向上させ、IRとDRを組み合わせた手法が最も効果的であることが示された. - Self-Discover: Large Language Models Self-Compose Reasoning Structures

発行日:2024年02月06日

SELF-DISCOVERは、LLMが複雑な推論問題に取り組むためのフレームワークであり、最大32%の性能向上と20%以上の効率改善を実現し、モデルファミリー全体に適用可能であることを示しています. - DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models

発行日:2024年02月05日

DeepSeekMath 7Bは、数学的な推論において競技レベルのスコアを達成し、Gemini-UltraやGPT-4に近づいている.データ選択パイプラインとGRPOを使用して数学的な推論能力を向上させている. - Large Language Model for Table Processing: A Survey

発行日:2024年02月04日

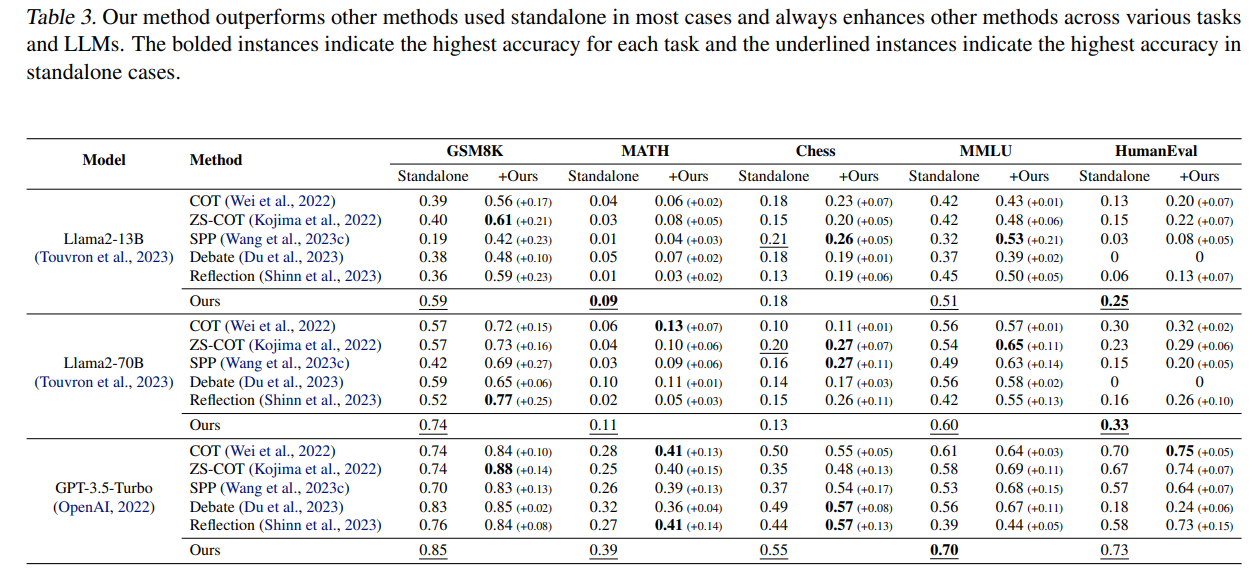

テーブルは、データの格納やクエリ、計算、レポート生成などに不可欠であり、LLMを使用してテーブル中心のタスクを自動化することは重要である.この調査では、テーブルタスクの概要や新たな側面、LLMの最近のパラダイム、テーブル操作やデータ分析のベンチマーク開発などについて提供している. - More Agents Is All You Need

発行日:2024年02月03日

この研究では、サンプリングと投票の方法を用いることで、大規模言語モデル(LLM)の性能がエージェントの数とスケーリングすることを発見しました. - Large Language Model based Multi-Agents: A Survey of Progress and Challenges

発行日:2024年01月21日

大規模言語モデル(LLM)を基にしたマルチエージェントシステムの重要な側面と課題について詳細な議論を行い、ドメインや環境のシミュレーション、エージェントのプロファイリングやコミュニケーション方法、能力の成長メカニズム、データセットやベンチマークのまとめ、最新の研究情報の提供を行っています.

Grandmaster-Level Chess Without Search

著者:Anian Ruoss, Grégoire Delétang, Sourabh Medapati, Jordi Grau-Moya, Li Kevin Wenliang, Elliot Catt, John Reid, Tim Genewein

発行日:2024年02月07日

最終更新日:2024年02月07日

URL:http://arxiv.org/pdf/2402.04494v1

カテゴリ:Machine Learning, Artificial Intelligence, Machine Learning

概要:

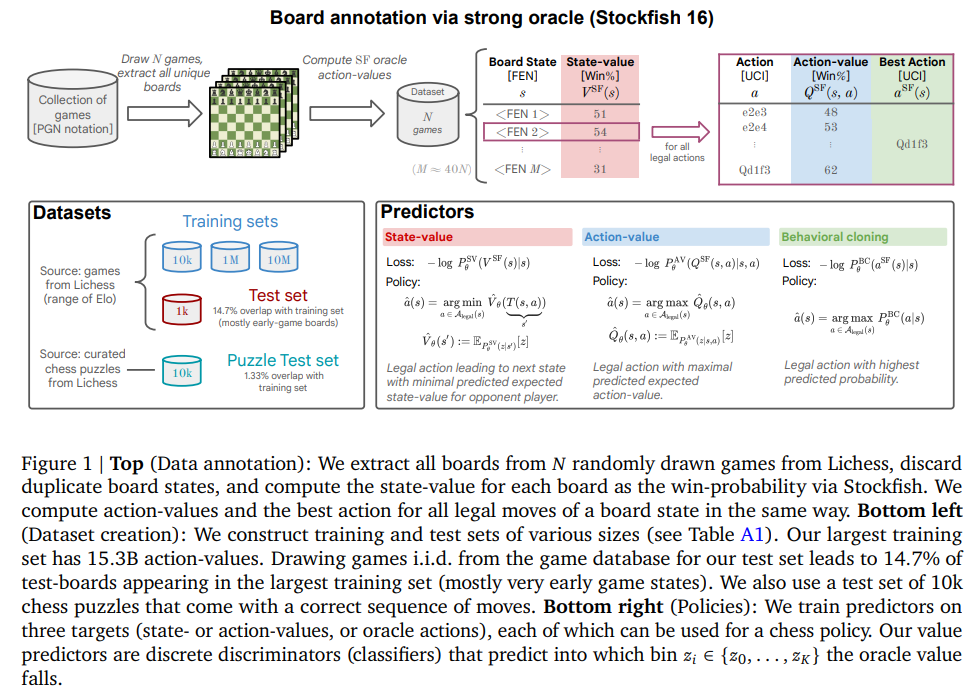

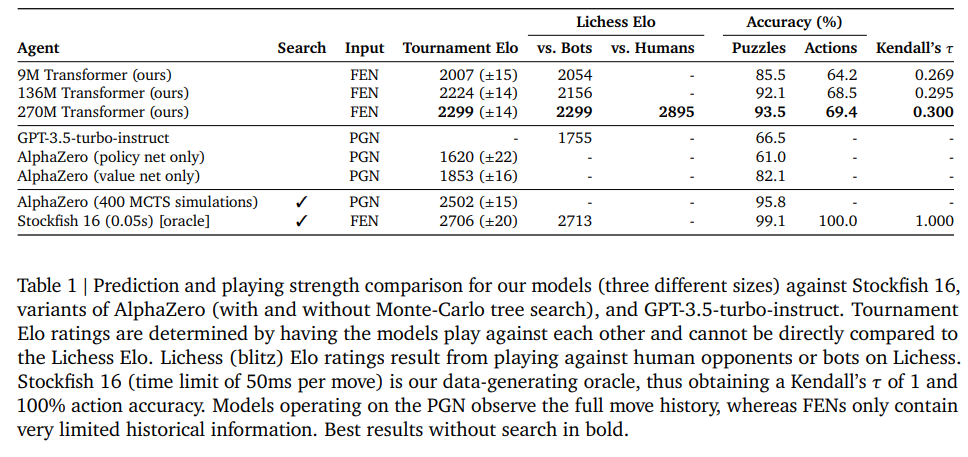

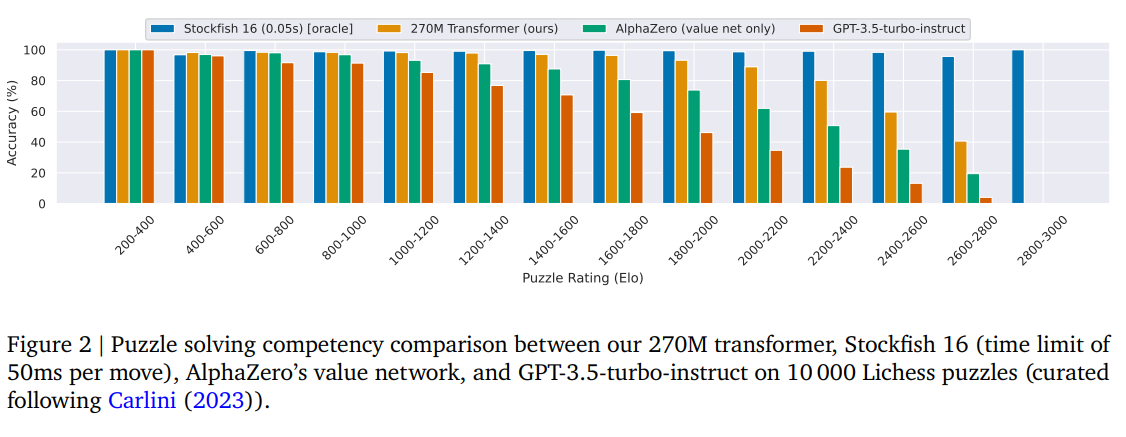

最近の機械学習の突破的な成功は、主にスケールによるものであり、特に大規模なアテンションベースのアーキテクチャと前例のない規模のデータセットによるものとされています.本論文では、チェスにおけるスケールでのトレーニングの影響を調査しています.従来のチェスエンジンは、複雑なヒューリスティック、明示的な探索、またはその組み合わせに依存していましたが、私たちは10,000,000のチェスゲームのデータセットで270Mパラメータのトランスフォーマーモデルを教師あり学習でトレーニングします.データセットの各ボードには、強力なStockfish 16エンジンによって提供されるアクション値が注釈付けされており、おおよそ150億のデータポイントが得られます.私たちの最大のモデルは、Lichess blitz Elo 2895を人間に対して達成し、ドメイン固有の調整や明示的な探索アルゴリズムなしで一連の難解なチェスパズルを解決することにも成功します.また、私たちのモデルがAlphaZeroのポリシーとバリューネットワーク(MCTSなし)およびGPT-3.5-turbo-instructを上回ることも示しています.モデルとデータセットのサイズに関する体系的な調査では、強力なチェスのパフォーマンスは十分なスケールでのみ生じることがわかります.結果を検証するために、私たちは設計の選択肢とハイパーパラメータの包括的な一連の削除実験も行っています.

Q&A:

Q: 機械学習における最近の画期的な成功の主な要因は何ですか?

A: 最近の機械学習の突破的な成功の主な要因は、大規模な注意ベースのアーキテクチャと前例のない規模のデータセットです.

Q: この論文では、チェスのための規模でのトレーニングの影響をどのように調査しているのだろうか?

A: この論文では、大規模なデータセットと大規模なアテンションベースのアーキテクチャを使用して、チェスのトレーニングのスケールの影響を調査しています.従来のチェスエンジンとは異なり、複雑なヒューリスティック、明示的な探索、またはその両方に依存する代わりに、私たちは10百万のチェスゲームのデータセットで270Mパラメータのトランスフォーマーモデルを教師あり学習でトレーニングします.また、強力なStockfish 16エンジンによって提供されるアクション値でデータセットの各ボードを注釈付けします.

Q: 従来のチェスエンジンと本稿のアプローチの違いは?

A: この論文では、従来のチェスエンジンは複雑なヒューリスティック、明示的な探索、またはその両方に依存しているのに対し、270Mパラメータのトランスフォーマーモデルを10百万のチェスゲームのデータセットで教師あり学習するというアプローチを取っています.また、データセットの各ボードには、強力なStockfish 16エンジンによって提供されたアクション値が注釈付けされています.このモデルは、明示的な探索アルゴリズムやドメイン固有の調整なしで、Lichess blitz Elo 2895の人間に対してプレイし、一連の難しいチェスパズルを解決することができます.従来のチェスエンジンと比較して、このアプローチは大規模なデータセットとトランスフォーマーモデルのスケールを活用しており、従来のヒューリスティックや探索アルゴリズムに頼らずにチェスをプレイすることができます.

Q: この論文で使われている変圧器モデルのパラメータはいくつですか?

A: この論文で使用されているトランスフォーマーモデルは、おおよそ2億7000万のパラメータを持っています.

Q: トレーニングに使われたデータセットには何局のチェスが含まれていますか?

A: 訓練に使用されたデータセットには、10,000から1,000,000の範囲のEloを持つ10,000から1,000,000のチェスゲームが含まれています.

Q: データセットの各ボードのアクション値はどのようにして得られたのですか?

A: データセットの各ボードのアクション値は、Stockfishを使用して各ボードの勝率として計算されました.

Q: この論文で学習された最大のモデルが達成した、チェスのブリッツEloの最高値は?

A: 本論文で訓練された最大モデルの最高のLichess blitz Eloは2895です.

Q: この論文のモデルの性能は、AlphaZeroのポリシーとバリューネットワーク、そしてGPT-3.5-turbo-instructと比較してどうですか?

A: この論文のモデルは、AlphaZeroのポリシーとバリューネットワーク、およびGPT-3.5-turbo-instructよりも優れたパフォーマンスを示しています.

ALOHA 2: An Enhanced Low-Cost Hardware for Bimanual Teleoperation

著者:Alexander Herzog, Ayzaan Wahid, Baruch Tabanpour, Chelsea Finn, Debidatta Dwibedi, Ian Storz, Jeff Bingham, Jonathan Hoech, Jonathan Tompson, Jorge Aldaco, Kenneth Draper, Kevin Zakka1, Leila Takayama, Pete Florence, Robert Baruch, Sanky Chan, Sergey Yaroshenko, Sichun Xu, Spencer Goodrich, Ted Wahrburg, Thinh Nguyen, Tony Z. Zhao, Torr Hage, Travis Armstrong, Wayne Gramlich

発行日:2024年02月06日

最終更新日:不明

URL:https://aloha-2.github.io/

カテゴリ:不明

概要:

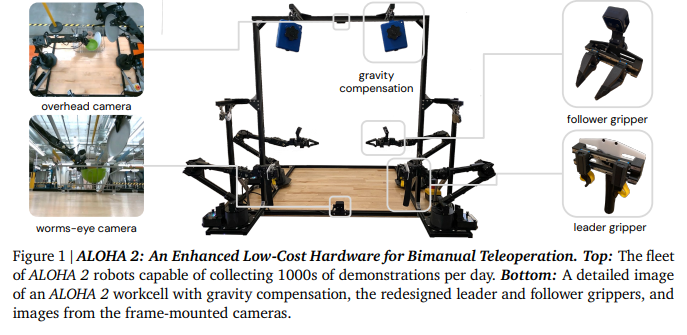

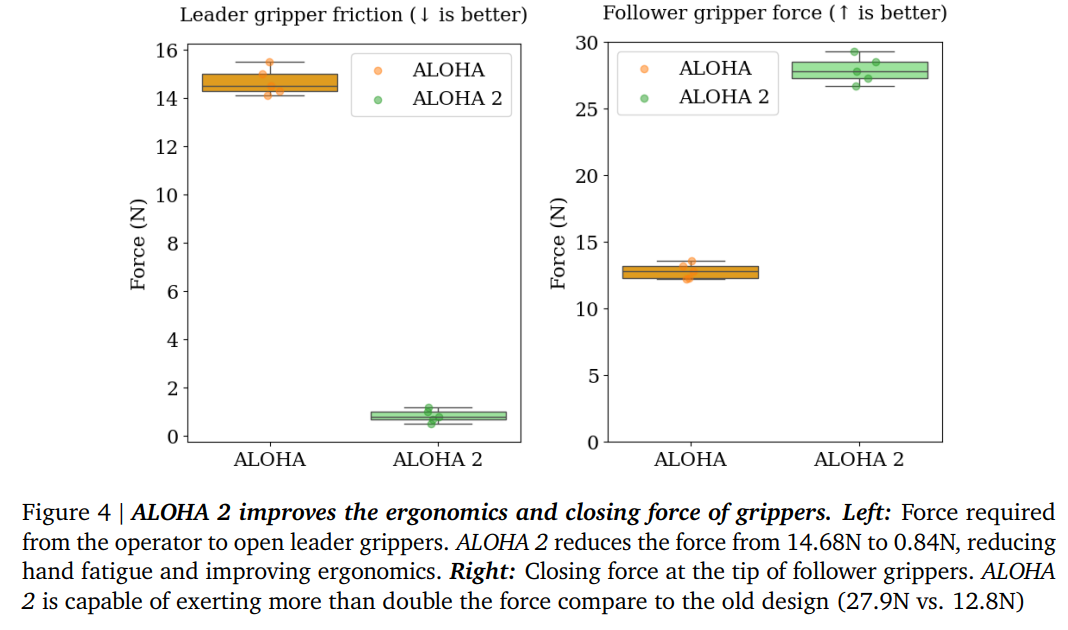

多様なデモンストレーションデータセットは、ロボット学習の重要な進歩を支えてきましたが、ハードウェアのコスト、ハードウェアの堅牢性、および遠隔操作の容易さによって、そのデータの器用さとスケールは制限される場合があります.私たちは、ALOHA 2という改良版のALOHAを紹介します.ALOHA 2は、元の設計と比較して、より高いパフォーマンス、エルゴノミクス、および堅牢性を持っています.ALOHA 2は、2つのViperX 6-DoFアーム(Trossen Robotics, a)(「フォロワー」と呼ばれる)と2つの小型のWidowXアーム(Trossen Robotics, b)(「リーダー」と呼ばれる)から構成される双腕並列ジョーグリッパーワークセルです.WidowXは、ViperXと同じ運動学構造を持ち、より小型の形状です.フォロワーの関節はリーダーアームと同期されており、ユーザーはリーダーアームをバックドライブまたは「パペット操作」として使用してフォロワーアームを遠隔操作します.セットアップには、複数の視点からの画像を生成するカメラも搭載されており、遠隔操作中にRGBデータを収集することができます.ロボットは48インチ×30インチのテーブルに取り付けられており、カメラと重力補償システムの追加の取り付けポイントを提供するアルミニウムケージも備えています.さらに、指のグリップテープ素材をアップグレードして耐久性と小さなオブジェクトの掴む能力を向上させました.ALOHA 2では、ALOHAプラットフォームの強みを活かしながら、さらなる進化を遂げました.ALOHA 2のすべてのハードウェア設計をオープンソース化し、詳細なチュートリアルとともに、ALOHA 2のMuJoCoモデルとシステム識別を提供します.プロジェクトのウェブサイトはaloha-2.github.ioでご覧いただけます.ALOHA 2では、グリッパーには、リーダーグリッパーとフォロワーグリッパーの両方に新しい低摩擦レール設計を採用し、リーダーロボットでは遠隔操作のエルゴノミクスと応答性が向上し、フォロワーロボットではレイテンシとグリッパーの力の出力が向上しました.さらに、ALOHA 2では、重力補償機構を導入し、ALOHAの元のゴムバンドシステムと比較して耐久性が向上しました.フレームも簡素化され、カメラ取り付けポイントの剛性を維持しながら、人間とロボットの相互作用のためのスペースが確保されました.さらに、より小型のIntel RealSense D405カメラとカスタムの3Dプリントカメラマウントを使用することで、フォロワーアームのフットプリントが縮小され、操作タスクがより制約されなくなりました.これらの改良により、ALOHA 2は折りたたみなどの複雑な操作タスクを遠隔操作しやすくなりました.これらの改良により、Tシャツの折りたたみ、結び目の作成、物体の投げる、または厳密な許容範囲を持つ産業タスクなどの難しいタスクを遠隔操作することが容易になりました.これらの改良により、1日あたりのロボットごとのこれらのタスクのデモンストレーションを100回以上収集することが容易になりました.

Q&A:

Q: ロボット学習における多様な実証データセットの限界とは?

A: 異なるデモンストレーションデータセットの制約は、難しい操作タスクのテレオペレーションに依存していることです.これには、Tシャツの折り畳み、結び目の作成、物体の投げること、または厳密な許容範囲を持つ産業タスクなどが含まれます.また、ロボットごとに1日に数百のデモンストレーションを収集することが困難であるという制約もあります.

Q: ALOHA 2は、パフォーマンス、人間工学、堅牢性の面で、オリジナルのALOHAデザインと比較してどうですか?

A: ALOHA 2は、性能、人間工学、堅牢性の面でオリジナルのALOHAデザインを改良したものです.性能面では、ALOHA 2の新しいグリッパーは旧デザインの2倍の力を加えることができ、物体をより強く安定してつかむことができる.また、補足ビデオにあるように、旧デザインと新デザインの間の待ち時間も短縮されている.この性能向上により、ALOHA 2はより幅広い操作タスクに対応できるようになった.人間工学の面では、ALOHA 2は指のグリップテープに改良を加え、経年劣化の問題に対処している.また、初代ALOHAで小さなものをつまみにくかった指先の丸みも改善されている.さらに、オリジナルのPLAアクリル構造を3Dプリントされたカーボンファイバーナイロンに置き換えることで、グリッパーメカニズムのコンプライアンスが強化され、システムの安全性が向上している.堅牢性の面では、ALOHA 2はオリジナルの設計に比べてより堅牢に設計されている.ALOHA 2のハードウェア設計はオープンソースであるため、複製や変更が容易である.ALOHA 2の強化された低コストのハードウェアも、ハードウェアコストの削減とハードウェアの堅牢性の向上に寄与している.全体として、ALOHA 2は、オリジナルのALOHA設計と比較して、より優れた性能、人間工学、堅牢性を提供している.

Q: ALOHA 2のすべてのハードウェア設計をオープンソース化する目的は何ですか?

A: ALOHA 2のすべてのハードウェア設計をオープンソース化する目的は、大規模な双腕操作の研究を加速するためです.

Q: ALOHA2のMuJoCoモデルにシステム識別機能を持たせた意義は?

A: MuJoCoモデルは、ALOHA 2のシステム識別において重要な役割を果たしています.システム識別は、実際のALOHA 2セットアップからのログされた軌跡を使用して物理パラメータを設定するために行われます.具体的には、リーダーアームを使用して実際に11つの軌跡を収集し、非線形最小二乗法を使用して実際の軌跡とシミュレートされた軌跡の残差を最小化します.これにより、MuJoCoモデルはより物理的に正確で視覚的な忠実度が高くなります.

Q: ALOHA 2は、大規模な両手操作の研究をどのように加速させることができるのか?

A: ALOHA 2は、オリジナルの設計と比較して強化されたパフォーマンス、人間工学、および堅牢性を提供することにより、大規模な両手操作の研究を加速することができます.また、ALOHA 2のすべてのハードウェア設計をオープンソース化し、詳細なチュートリアルとシステム同定を含むMuJoCoモデルを提供することで、研究者はハードウェアに簡単にアクセスし、複製することができます.これにより研究者は、ハードウェアのコスト、ハードウェアの堅牢性、遠隔操作の容易さといった制約を克服し、より大規模に多様な実証データセットを収集することができる.低コストのハードウェアを提供し、大規模なデータ収集を容易にすることで、ALOHA 2はロボット学習と両手操作の研究の進歩を促進する.

Q: ALOHA 2で強化された点は?

A: ALOHA 2の具体的な改良点は以下の通りです.

- パフォーマンスとタスク範囲の向上:ALOHAのパフォーマンスを向上させるために、グリッパーやコントローラーなどの主要なコンポーネントを強化し、より広範な操作タスクを可能にします.

- ユーザーフレンドリーさとエルゴノミクス:大規模なデータ収集を最適化するために、ユーザーの体験と快適さを優先します.これには、ユーザーに直接関わるシステムの応答性とエルゴノミックなデザインの改善が含まれます.

- 頑強性:診断と修理によるダウンタイムを最小限に抑えるために、システムの頑強性を向上させます.これには、機械設計の簡素化と大規模なロボットフリートの全体的なメンテナンスの容易さが含まれます.

具体的な改良点としては、以下のようなものがあります.

・グリッパー:リーダーロボットとフォロワーロボットの両方のグリッパーに、新しい低摩擦レールデザインを採用します.リーダーロボットの場合、これによりテレオペレーションのエルゴノミクスと応答性が向上します.フォロワーロボットの場合、これによりレイテンシとグリッパーの力の出力が向上します.さらに、グリップもアップグレードされます.

Q: ALOHA 2は、ハードウェアのコストとハードウェアの堅牢性の制限にどのように対処していますか?

A: ALOHA 2は、オリジナルの設計に比べ、性能、人間工学、堅牢性を向上させたALOHAを導入することで、ハードウェアのコストと堅牢性の限界に対処している.ALOHA 2の全ハードウェア設計は、詳細なチュートリアルとともにオープンソース化されているため、ハードウェアへのアクセスや複製が容易になり、全体的なコストを削減できる可能性がある.さらに、中心的な貢献者、ハードウェアの専門家、ソフトウェアの専門家を含む多様なチームが参加することで、ハードウェアの堅牢性の限界に対処するための包括的なアプローチが保証される.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で紹介された新しい手法のコード実装のURLは、aloha-2.github.ioです.

AnyTool: Self-Reflective, Hierarchical Agents for Large-Scale API Calls

著者:Yu Du, Fangyun Wei, Hongyang Zhang

発行日:2024年02月06日

最終更新日:2024年02月06日

URL:http://arxiv.org/pdf/2402.04253v1

カテゴリ:Computation and Language

概要:

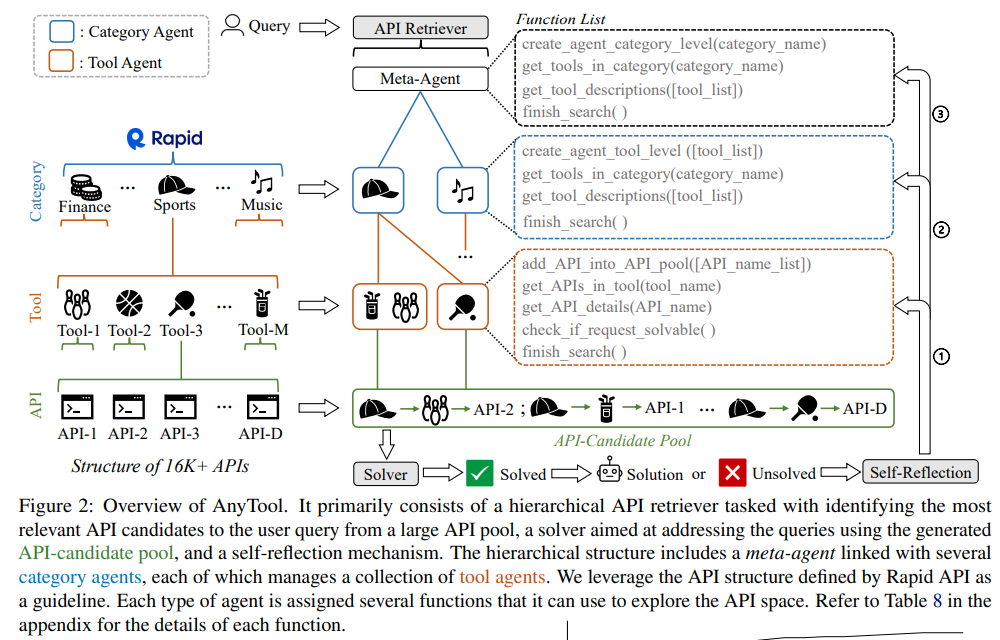

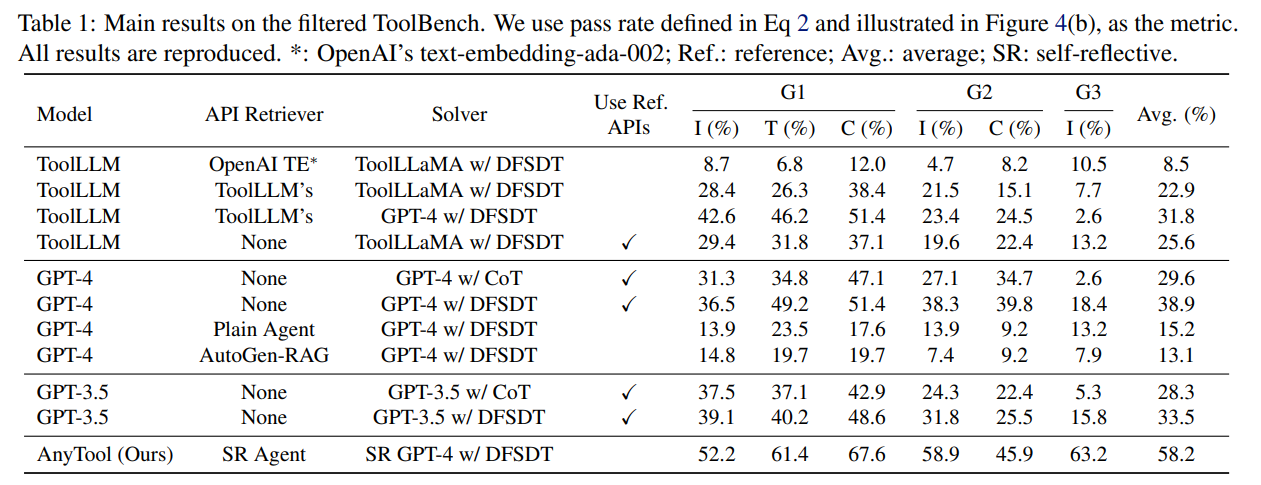

AnyToolは、ユーザーのクエリに対応するために様々なツールを効果的に活用するために設計された大規模な言語モデルエージェントです.Rapid APIから提供される16,000以上のAPIを利用し、これらのAPIのサブセットがクエリを解決する可能性があるという前提のもとで動作します.AnyToolには主に3つの要素が組み込まれています.階層構造を持つAPIリトリーバ、選択されたAPI候補を使用してユーザーのクエリを解決するためのソルバ、そして初期の解決策が実用的でない場合にAnyToolを再起動する自己反映メカニズムです.AnyToolはGPT-4の関数呼び出し機能によって動作し、外部モジュールのトレーニングの必要性を排除しています.また、以前の研究で導入された評価プロトコルを再検討し、このプロトコルには人工的に高い合格率をもたらす制限があることを特定しました.実際のアプリケーションシナリオをより適切に反映するために評価プロトコルを改訂し、AnyToolBenchという追加のベンチマークを導入しました.さまざまなデータセットでの実験は、ToolLLMやツールに特化したGPT-4のバリアントなどの強力なベースラインに比べて、AnyToolの優位性を示しています.例えば、AnyToolはToolBenchの平均合格率でToolLLMを35.4%上回る結果を示しています.コードはhttps://github.com/dyabel/AnyToolで入手可能です.

Q&A:

Q: AnyToolの目的は何ですか?

A: AnyToolの目的は、ユーザーのクエリに対して効果的な解決策を提供することです.AnyToolは、階層的なAPIリトリーバーとソルバーを組み合わせたものであり、ユーザーのクエリに対して自己反映機構を持つことで、その能力を向上させています.また、実世界のアプリケーションシナリオをより反映するために、評価プロトコルも改訂されています.AnyToolは、選択されたAPIを使用してユーザーのクエリに対応するための設計原則を導入しており、プラグアンドプレイの特性を持っています.また、AnyToolはGPT-4の機能呼び出し機能に依存しているため、GPT-4の能力も解決策の生成の可行性に影響を与えます.ただし、AnyToolの性能は非常に複雑なシナリオでは検証されておらず、適切なデータセットの不足もあります.

Q: AnyToolはRapid APIからいくつのAPIを利用していますか?

A: AnyToolはRapid APIから16,000以上のAPIを利用しています.

Q: AnyToolはどのようにAPIリトリーバに階層構造を組み込んでいますか?

A: AnyToolは、それぞれが多様な役割を持つ1つまたは複数のエージェントを含む3つの階層で構成される階層構造を設計することで、APIリトリーバに階層構造を組み込んでいます.この階層構造は、分割統治アプローチに触発され、Rapid APIによって提案されたAPIの分類を効果的に組み込んでいます.階層構造は、各エージェントの検索範囲を大幅に縮小し、LLMの最大コンテキスト長に関連する制約を克服する.

Q: AnyToolにおけるソルバーの役割は何ですか.

A: AnyToolのソルバーの役割は、API候補を利用してクエリQを解決しようとすることです.

Q: AnyToolで自己反省メカニズムはどのように機能しますか?

A: AnyToolの自己反省メカニズムは、初期の解決策がユーザーのクエリを解決できない場合に、APIリトリーバーとソルバーを順次再起動することで機能します.このメカニズムは、終了条件が満たされるまで繰り返し適用することができます.具体的には、クエリを受け取ると、AnyToolは解決策を提案し、それがGPT-4によって実現可能かどうかが評価されます.提案された解決策が実現不可能と判断される場合、AnyToolは再度起動され、失敗の理由と関連する過去の文脈を考慮します.このメカニズムにより、より簡単なクエリに対して「過剰検索」する傾向が軽減され、複雑なクエリに対してより豊富な文脈と深い検索が提供されます.

Q: GPT-4のどの機能がAnyToolを動かすのですか?

A: AnyToolはGPT-4の関数呼び出し機能によって動作しています.

Q: AnyToolは外部モジュールのトレーニングの必要性をどのように排除しますか?

A: AnyToolは、GPT-4の関数呼び出し機能のみに依存することで、外部モジュールのトレーニングを不要にします.

Q: 過去の研究で導入された評価プロトコルの中で、著者らはどのような限界を指摘したのか?

A: 先行研究で導入された評価プロトコルの制限が特定されました.

Q: 改訂された評価プロトコルは、実際の適用シナリオをどのように反映させているのか?

A: 改訂された評価プロトコルは、実際のアプリケーションシナリオにより適合するようになっています.以前の評価プロトコルでは、解決可能なクエリと解決不可能なクエリを区別していますが、解決不可能なクエリに対しても合格率を計算する際には、解決済みとみなしていました.これにより、合格率が人為的に高くなってしまっていました.改訂されたプロトコルでは、実際のアプリケーションシナリオをより反映するために、解決不可能なクエリを解決済みとみなさないようにしています.

Q: AnyToolは、ToolLLMやツール利用向けに調整されたGPT-4バリアントと比較して、どのようなパフォーマンスを発揮しますか?

A: AnyToolはToolLLMを35.4%上回るパフォーマンス.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlは、https://github.com/dyabel/AnyToolです.

A phase transition between positional and semantic learning in a solvable model of dot-product attention

著者:Hugo Cui, Freya Behrens, Florent Krzakala, Lenka Zdeborová

発行日:2024年02月06日

最終更新日:2024年02月06日

URL:http://arxiv.org/pdf/2402.03902v1

カテゴリ:Machine Learning

概要:

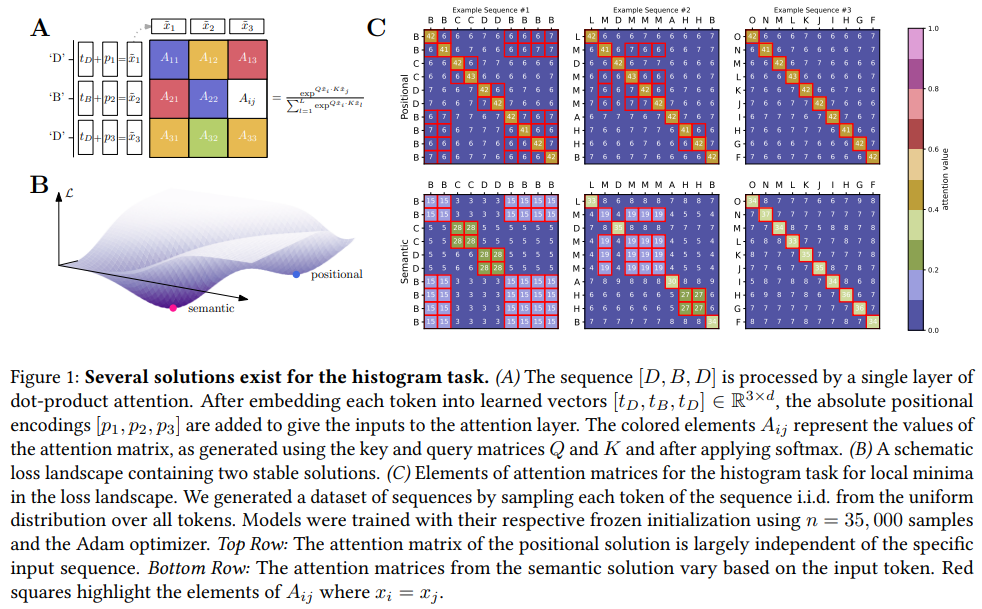

この研究では、ドット積注意層が位置に基づいてトークン同士が相互に注意を向ける位置注意行列と、意味に基づいてトークン同士が相互に注意を向ける意味注意行列を学習するかを調査しました.アルゴリズムのタスクでは、同じシンプルなアーキテクチャが位置または意味のメカニズムを使用して解を実装することを実験的に示しました.理論的な側面では、訓練可能な結びついた低ランクのクエリ行列とキー行列を持つ非線形の自己注意層の学習を研究しました.高次元のデータと比較的大規模なトレーニングサンプル数の漸近的な限界では、非凸の経験的損失のランドスケープのグローバル最小値の閉形式の特性を提供しました.この最小値は、位置または意味のメカニズムに対応し、サンプルの複雑さが増すにつれて前者から後者への出現的な相転移を示しました.最後に、ドット積注意層を線形の位置ベースラインと比較し、十分なデータにアクセスできる場合には、後者の意味メカニズムを使用して前者を上回ることを示しました.

Q&A:

Q: 点積注意層はどのようにして位置注意行列を学習するのか?

A: ドット積注意層は、位置情報を学習するために、入力シーケンスを並列に単語の袋として見るため、明示的な位置情報のエンコーディングを必要とします.これにより、位置情報に基づいてトークンが互いに注意を払う位置注意行列を学習します.

Q: 点積注意層はどのようにして意味的注意行列を学習するのか?

A: ドット積注意層は、トークンがそれぞれの意味に基づいてお互いに注意を払うセマンティックな注意行列を学習します.セマンティックな注意行列は、トークンの意味に基づいてお互いに注意を払うように学習されます.

Q: 同じシンプルなアーキテクチャーで、ポジションとセマンティックの両メカニズムを同時に使ってソリューションを実装することを学ぶことができるだろうか?

A: いいえ、同じ単純なアーキテクチャは、同時に位置と意味のメカニズムを実装することはできません.

Q: 訓練可能なタイと低ランクのクエリー行列とキー行列を持つ非線形自己アテンション層の学習に関する理論的研究は?

A: 高次元のデータと多数のトレーニングサンプルの漸近的な限界において、訓練可能な結合された低ランクのクエリ行列とキー行列を持つ非線形の自己注意層の学習についての理論的な研究です.

Q: 高次元データと多数の訓練サンプルの漸近極限における非凸経験的損失ランドスケープの大域的最小値の閉形式の特徴は何か?

A: 高次元データと大量のトレーニングサンプルの漸近的な限界において、非凸経験的損失の景観のグローバル最小値の閉形式の特徴付けを提供する.

Q: 非凸の経験的損失ランドスケープの大域的最小値は、どのように位置的あるいは意味的メカニズムに対応するのか?

A: 非凸的な経験的損失のランドスケープにおけるグローバルミニマムは、位置情報または意味情報のメカニズムのいずれかに対応しています.高次元のデータと十分なトレーニングサンプルの漸近的な限界では、この最小値は位置情報または意味情報のメカニズムに対応し、サンプルの複雑さの増加に伴って前者から後者への移行が生じます.

Q: サンプルの複雑さが増すにつれて、位置メカニズムから意味メカニズムへの相転移が生じることを説明できますか?

A: 与えられた文脈では、dot-product attentionモデルは、サンプルの複雑さによって位置メカニズムから意味メカニズムへの移行する現象が生じることが示されています.具体的には、データ量が少ない場合には単純な位置メカニズムを実装し、十分なデータが与えられると意味のあるターゲットを学習するようになります.この移行は、dot-product attention層が位置メカニズムよりも優れたパフォーマンスを発揮することを意味します.

Q: ドットプロダクト・アテンション・レイヤーは、リニア・ポジション・ベースラインと比較してどうか?

A: ドット積アテンション層は、線形の位置ベースラインと比較して優れたパフォーマンスを示し、セマンティックメカニズムを学習した場合に後者を上回ることが示されています.

Q: 点積注意層は、意味メカニズムを用いて、どのように線形位置ベースラインを上回るのか?

A: ドット積アテンション層は、意味のメカニズムを学習することで線形の位置ベースラインを上回ることができます.ドット積アテンションは、十分なデータにアクセスできる場合に、意味のメカニズムを利用して最適な位置近似を上回ることができます.

Q: セマンティック・メカニズムを用いたドットプロダクト・アテンション・レイヤーのパフォーマンスにおいて、データの可用性はどのような役割を果たすのか?

A: データの利用可能性は、ドットプロダクトアテンションレイヤーのパフォーマンスにおいて、セマンティックメカニズムの役割を果たします.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のURLは、github.com/SPOC-group/positional-and-semantic-attentionです.

Large Language Models as an Indirect Reasoner: Contrapositive and Contradiction for Automated Reasoning

著者:Yanfang Zhang, Yiliu Sun, Yibing Zhan, Dapeng Tao, Dacheng Tao, Chen Gong

発行日:2024年02月06日

最終更新日:2024年02月06日

URL:http://arxiv.org/pdf/2402.03667v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

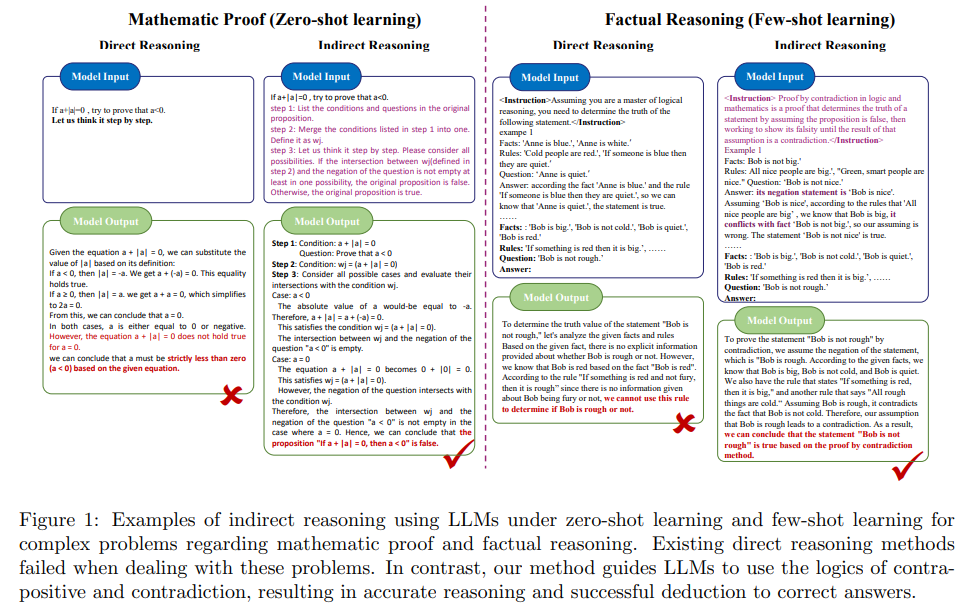

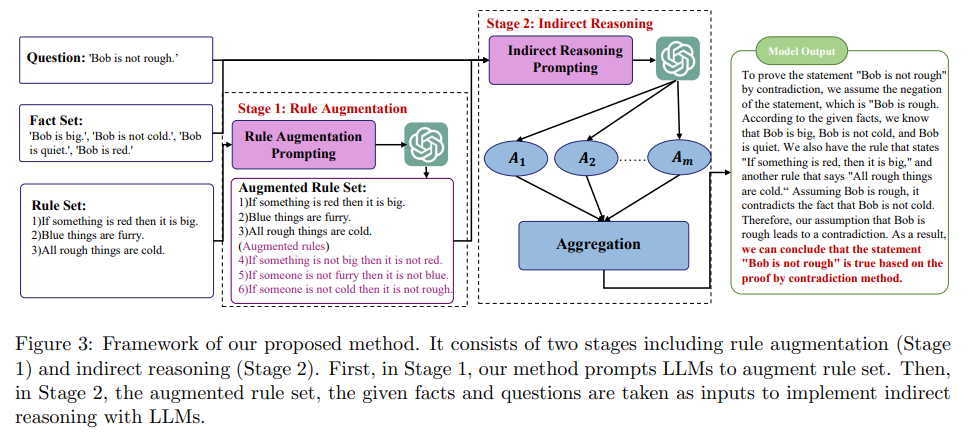

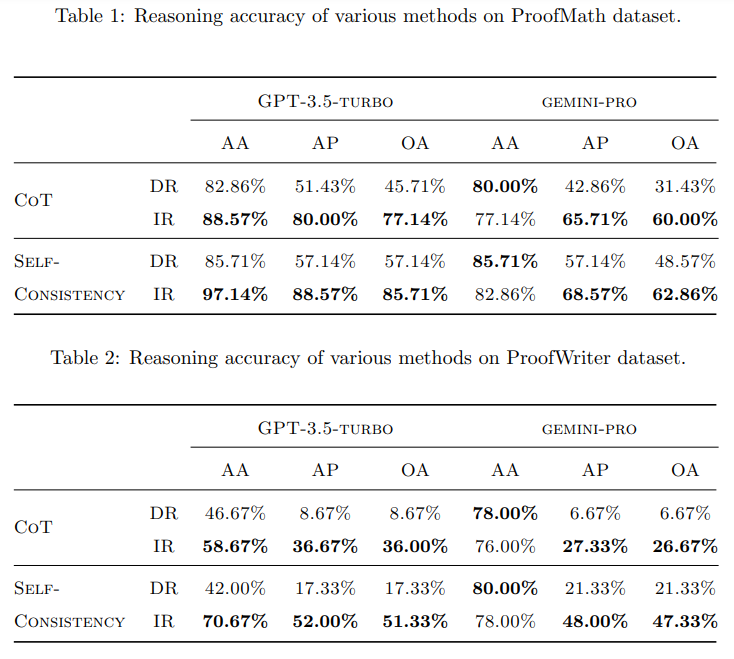

最近、大規模言語モデル(LLM)の複雑な推論能力の向上に関する関心が高まっています.しかし、これまでの方法(Chain-of-ThoughtやSelf-Consistencyなど)は主に直接推論(DR)のフレームワークに従っており、DRでは解決が困難な多くの現実世界のタスクに対しては困難が生じます.そのため、LLMの推論能力を強化するために、本論文では間接推論(IR)という新しい手法を提案しています.

この手法は、事実推論や数学的証明などのIRタスクに対処するために、対偶や矛盾の論理を利用します.具体的には、まず、対偶の論理的な同値性を活用して、データとルールを拡張し、LLMの理解力を向上させます.次に、矛盾による証明に基づいたIRを実行するためのプロンプトテンプレートを設計します.このIR手法はシンプルで効果的であり、既存のDR手法と簡単に統合することができ、LLMの推論能力をさらに向上させることができます.

さらに、実験結果では、人気のあるLLMであるGPT-3.5-turboやGemini-proなどにおいて、IR手法は従来のDR手法と比較して、事実推論の全体的な正確さを27.33%向上させ、数学的証明においては31.43%向上させることが示されました.さらに、IRとDRを組み合わせた手法は、単独でIRまたはDRを使用する手法よりも優れた結果を示し、私たちの戦略の効果をさらに証明しています.

Q&A:

Q: 論文の主眼は何か?

A: この論文の主な焦点は、大規模な言語モデルを使用して複雑な問題を解決することです.

Q: Chain-of-Thought(思考の連鎖)やSelf-Consistency(自己一貫性)のようなこれまでの手法の限界とは?

A: 思考連鎖法や自己矛盾法は、直接推論(DR)フレームワークでは解決できない数多くの実世界のタスクを解決するには限界がある.

Q: 提案されている間接推論(IR)の手法は、直接推論(DR)のフレームワークとどう違うのですか?

A: 提案された間接推論(IR)メソッドは、既存の直接推論(DR)フレームワークとは異なります.DRフレームワークでは、与えられた事実から最終結果までの論理的な連鎖を構築します.一方、IRメソッドは、直接推論では証明や推論が困難な問題を解決するために、間接的な推論を行います.IRメソッドは、人間の思考プロセスと同様に、直接推論と論理的に等価な間接推論を行うことが可能です.

Q: LLMの理解しやすさを高めるために、対格の論理的等価性がどのように使われているのか説明できますか?

A: 論理的な対偶の等価性を利用することで、LLMsの理解力を向上させるために使用されます.具体的には、データとルールを拡張するために対偶の等価性を利用し、LLMsの理解可能性を高めます.対偶の等価性は、与えられた文の否定を取り、その否定の対偶を得ることで表されます.これにより、LLMsはより直感的に理解できるデータとルールを持つことができます.例えば、与えられた文が「すべてのAはBである」という形式である場合、その対偶は「BでないものはAでない」となります.このような対偶の等価性を利用することで、LLMsはより複雑な推論タスクを解決する能力を向上させることができます.

Q: LLMが矛盾証明に基づくIRを実施するきっかけとなるようデザインされたプロンプト・テンプレートとは?

A: 少数のプロンプトテンプレートは、間接的な推論を行うためにLLMを刺激するために設計されています.提案されたテンプレートでは、間接的な推論方法のための指示を追加しています.同時に、証明に矛盾を含む中間的な推論ステップの例もプロンプトに含まれています.具体的には、私たちは「その否定文は…」というフレーズを使用して、LLMがqを¬qに否定することを理解するのを助けています.そして、与えられたルールと事実を推論して矛盾があるかどうかを結論付けます.つまり、「仮定/事実…に矛盾しています」となります.¬qが偽であれば、矛盾があり、qを結論付けることができます.

Q: IR法は、事実の推論や数学的証明の全体的な精度をどのように高めるのか?

A: IR法は従来のDR法と比較して、事実推論の全体的な精度を27.33%、数学的証明の精度を31.43%向上させた.IRとDRの組み合わせは、IRまたはDRのみを使用した方法を大幅に上回り、戦略の有効性を実証している.

Q: GPT-3.5-turboやGemini-proのような一般的なLLMでの実験結果について詳しく教えてください.

A: 表1と表2は、事実の推論と数学的証明という2つの調査対象のタスクに関する実験結果を示しています.結果からわかるように、私たちのIRメソッドは、異なるLLM(例:GPT-3.5-turboとGemini-pro)および異なるプロンプトメソッド(例:CoTとSelf-Consistency)において、DRの対応方法を大幅に上回っています.人気のあるLLMであるGPT-3.5-turboとGemini-proにおける結果は、私たちのIRメソッドが、従来のDRメソッドと比較して、事実の推論の全体的な正確さを27.33%向上させ、数学的証明を31.43%向上させることを示しています.さらに、IRとDRを組み合わせた方法は、単独でIRまたはDRを使用する方法よりも大幅に優れており、私たちの戦略の効果をさらに示しています.

Q: IRとDRの統合は、LLMの推論能力をどのように向上させるのか?

A: IRとDRの統合により、LLMの推論能力が向上します.IRは多くの場合、DRよりも少ないステップで答えにたどり着くことができるため、LLMの推論プロセスでのエラーの可能性を減らすことができます.IRとDRの統合は、単独でIRまたはDRを使用する方法よりも効果的であり、従来のDR方法と比較して、事実の推論の全体的な正確さを27.33%向上させ、数学的証明を31.43%向上させることが実験結果で示されています.

Q: 提案されたIR手法の将来的な意味合いと応用の可能性は?

A: 提案されたIRメソッドの将来的な影響と潜在的な応用は、論理的な推論能力を向上させることにあります.IRは、DRと比較して、多くの場合においてLLMがより少ないステップで答えに到達することを可能にし、論理的な誤りの可能性を減らす効果があります.また、IRは数学的証明問題においても効果がありますが、今後はより複雑な論理法則を統合することで、LLMの推論能力をさらに向上させる可能性があります.

Self-Discover: Large Language Models Self-Compose Reasoning Structures

著者:Pei Zhou, Jay Pujara, Xiang Ren, Xinyun Chen, Heng-Tze Cheng, Quoc V. Le, Ed H. Chi, Denny Zhou, Swaroop Mishra, Huaixiu Steven Zheng

発行日:2024年02月06日

最終更新日:2024年02月06日

URL:http://arxiv.org/pdf/2402.03620v1

カテゴリ:Artificial Intelligence, Computation and Language

概要:

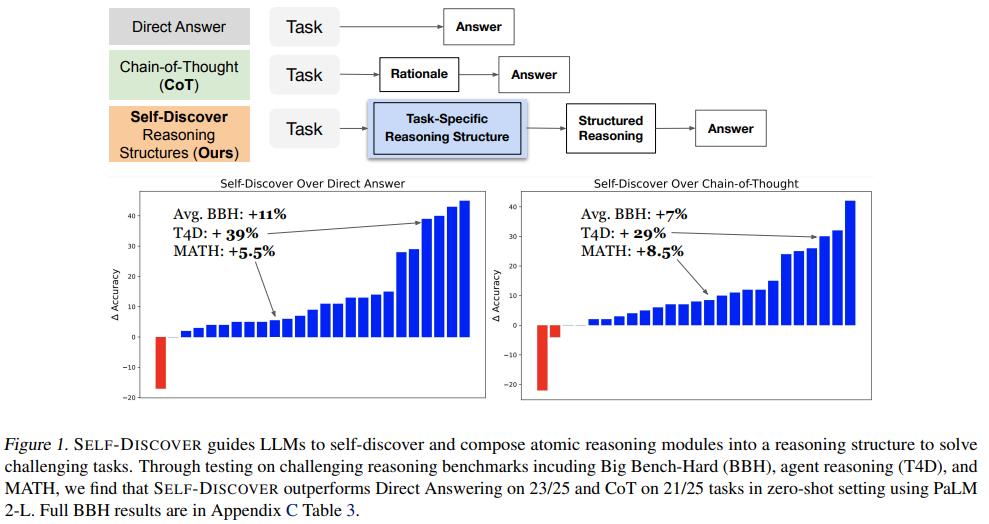

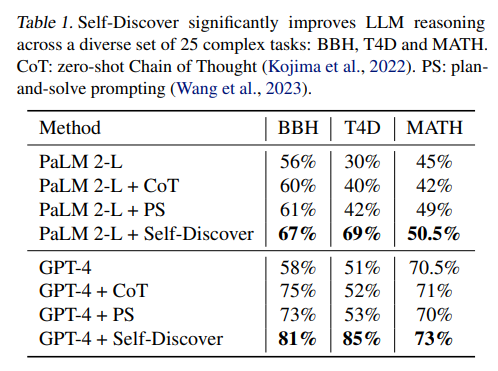

SELF-DISCOVERは、LLM(Language Model)が複雑な推論問題に取り組むためのタスク固有の推論構造を自己発見するための一般的なフレームワークです.このフレームワークの中心には、LLMが批判的思考やステップバイステップの思考などの複数の原子的な推論モジュールを選択し、それらをデコーディング中にLLMが従う明示的な推論構造に組み合わせる自己発見プロセスがあります.SELF-DISCOVERは、BigBench-Hardやグラウンデッドエージェントの推論、数学などの難解な推論ベンチマークにおいて、Chain of Thought(CoT)に比べて最大32%の性能向上を実現します.さらに、SELF-DISCOVERはCoT-Self-Consistencyなどの推論集約的な手法よりも20%以上優れており、推論計算に必要なリソースも10〜40倍少なくて済みます.最後に、自己発見された推論構造は、PaLM 2-LからGPT-4へ、そしてGPT-4からLlama2へとモデルファミリー全体に普遍的に適用可能であり、人間の推論パターンとも共通点を持っていることを示しています.

Q&A:

Q: SELF-DISCOVERフレームワークの目的は何ですか?

A: SELF-DISCOVERの目的は、LLMsが複雑な推論問題に取り組むためのタスク固有の推論構造を自己発見することです.このフレームワークは、LLMsが批判的思考やステップバイステップ思考などの複数の原子的な推論モジュールを選択し、それらをデコーディング中にLLMsが従う明示的な推論構造に組み合わせる自己発見プロセスが中心です.SELF-DISCOVERは、GPT-4やPaLM 2の性能を大幅に向上させ、挑戦的な推論ベンチマークで優れた結果を示します.

Q: フレームワークの中で、自己発見のプロセスはどのように機能するのか?

A: SELF-DISCOVERのフレームワークでは、自己発見プロセスは2つのステージに分かれています.ステージ1では、与えられたタスクと高レベルの問題解決ヒューリスティックを表す推論モジュールの説明を使用して、タスクの固有の推論構造をメタ推論によって明らかにします.具体的には、3つのメタプロンプトを使用して、LLM(Large Language Models)をガイドし、選択し、実行可能な推論構造を実装します.ステージ2では、自己発見された構造を使用してタスクインスタンスを解決します.まず、JSON形式のステップバイステップの推論計画に従ってタスクを正しく解決するように指示され、キーに従って値を埋めることでタスクインスタンスを推論します.

Q: LLMが選択できる原子推論モジュールとは?

A: LLMは、クリティカル・シンキングやステップバイステップ・シンキングなど、複数の原子的推論モジュールを選択することができる.

Q: 推論ベンチマークにおいて、SELF-DISCOVERはGPT-4とPaLM 2の性能をどのように向上させるのか?

A: SELF-DISCOVERは推論ベンチマークにおいてGPT-4とPaLM 2の性能を向上させ、PaLM 2-LではChain-of-ThoughtとPlan-and-Solveに対してそれぞれ7%と6%の絶対的な改善を達成した.GPT-4にSELF-DISCOVERを適用した場合も、同様の改善(6%と8%)が見られる.さらに、SELF-DISCOVERはPaLM 2-LとGPT-4で69%と85%の精度を達成し、専門家が設計した推論構造を採用するForesee and Reflect (FaR)などの従来のSoTAプロンプト手法を大幅に上回る.SELF-DISCOVERからPaLM 2-Lが生成した推論構造は87.5%の確率で正しく、人間の専門家はこの推論構造に従ってタスクを完璧に解くことができる.全体として、SELF-DISCOVERはGPT-4とPaLM 2の推論能力を多様な推論タスクで向上させた.

Q: SELF-DISCOVERはChain of Thought(CoT)と比べてパフォーマンス面でどうですか?

A: SELF-DISCOVERは、Chain of Thought(CoT)を32%も上回るパフォーマンスを見せている.

Q: SELF-DISCOVERはCoT-Self-Consistencyと比較して、推論に必要な計算量はどうですか?

A: SELF-DISCOVERは、CoT-Self-Consistencyと比較して、推論に必要な計算量が10~40倍少ない.

Q: 自己発見された推論構造は、異なるモデルファミリーにまたがって適用可能か?

A: はい、自己発見された推論構造は異なるモデルファミリーに適用可能です.

Q: 自分で発見した構造と人間の推論との間に共通する推論パターンの例を示してもらえますか?

A: 人間の推論構造とLLMが自己発見した構造の間に共通する推論パターンの例として、各命令のステップごとの分析が挙げられます.

Q: SELF-DISCOVERが効果的に取り組むことができる具体的な推論の問題にはどのようなものがありますか?

A: SELF-DISCOVERは、スポーツ理解、映画推薦、廃墟名など、多様な世界知識を必要とする推論問題に効果的に取り組むことができる.

Q: CoTと比較してパフォーマンスが32%向上したことの意味を説明していただけますか?

A: CoTと比較して32%の性能向上の意義は、アルゴリズムのタスクにおいてはCoTよりも優れたパフォーマンスを示すことができるためです.この結果は、SELF-DISCOVERが世界知識を必要とするタスクにおいて最も優れた性能を発揮することを示しています.また、MATHのエラー分析からも、74.7%のモデルの失敗が計算エラーによるものであることが確認されています.SELF-DISCOVERは、PaLMからの転移学習によって自己発見された推論構造を詳細に調査し、その普遍性を示しています.さらに、SELF-DISCOVERはCoTやDirect promptingと同じタスクレベルのメタプロンプトを使用しており、GPT-4の40倍の呼び出しが必要なメソッド(各RMの多数決)と比較して、より良いパフォーマンスを達成しています.SELF-DISCOVERの入力と出力はCoTやDirect promptingよりも長くなるため、コストが増加しますが、インスタンスの数が増えるにつれて、推論の効率性が向上するという利点があります.

DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models

著者:Zhihong Shao, Peiyi Wang, Qihao Zhu, Runxin Xu, Junxiao Song, Mingchuan Zhang, Y. K. Li, Y. Wu, Daya Guo

発行日:2024年02月05日

最終更新日:2024年02月06日

URL:http://arxiv.org/pdf/2402.03300v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

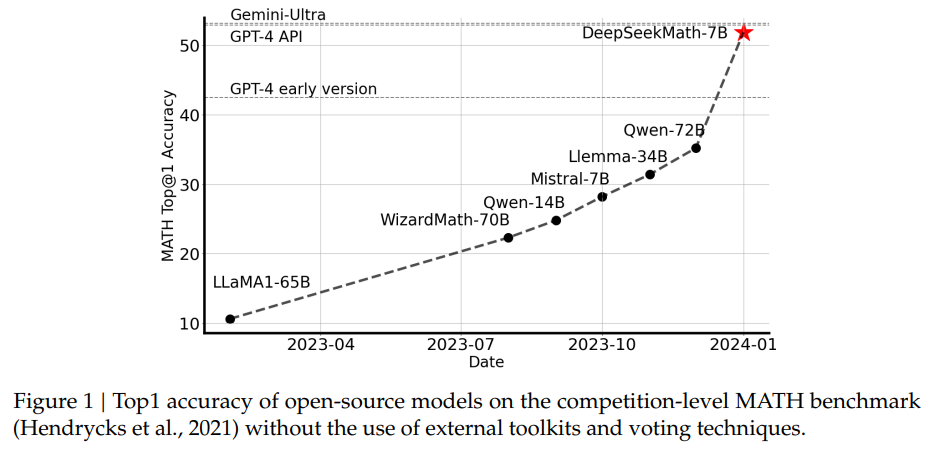

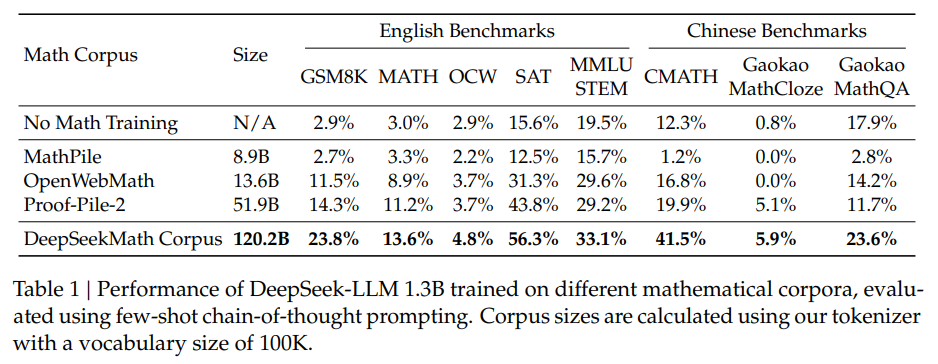

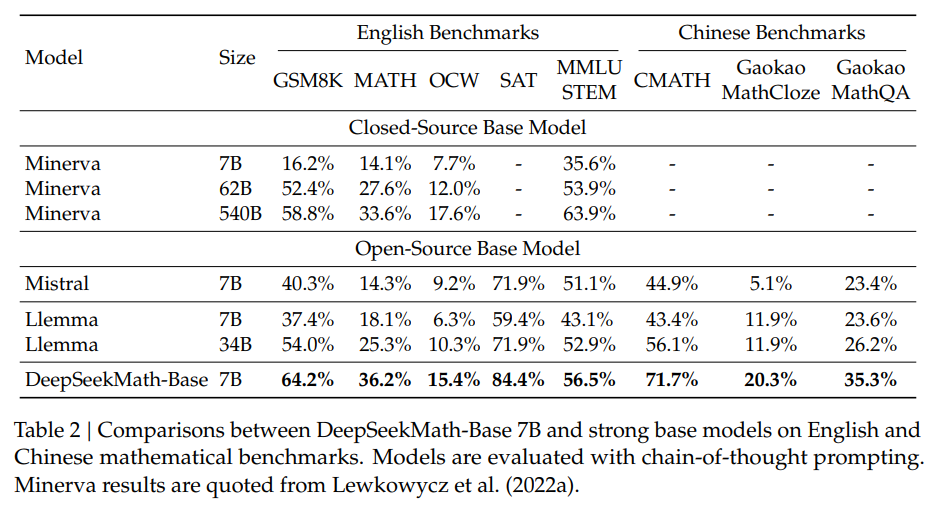

この論文では、数学的な推論はその複雑で構造化された性質のため、言語モデルにとって大きな課題となっています.本論文では、DeepSeekMath 7Bを紹介します.DeepSeekMath 7Bは、Common Crawlから収集された120Bの数学関連トークンと、自然言語およびコードデータを使用して、DeepSeek-Coder-Base-v1.5 7Bの事前学習を継続しています.DeepSeekMath 7Bは、外部のツールキットや投票技術に頼らずに、競技レベルのMATHベンチマークで驚異的なスコアである51.7%を達成し、Gemini-UltraやGPT-4の性能レベルに近づいています.DeepSeekMath 7Bの64のサンプルにおける自己整合性は、MATHで60.9%を達成しています.DeepSeekMathの数学的な推論能力は、2つの主要な要素によって実現されています.まず、公開されているウェブデータの大きな潜在能力を、緻密に設計されたデータ選択パイプラインを通じて活用しています.そして、Proximal Policy Optimization(PPO)の変種であるGroup Relative Policy Optimization(GRPO)を導入し、数学的な推論能力を向上させながら、同時にPPOのメモリ使用量を最適化しています.

Q&A:

Q: DeepSeekMath 7B が競技レベルの MATH ベンチマークで達成したスコアは?

A: DeepSeekMath 7Bの競技レベルのMATHベンチマークでのスコアは51.7%です.

Q: DeepSeekMath 7B の事前学習に使用した Common Crawl からの数学関連トークンの数は?

A: DeepSeekMath 7Bの事前学習には、Common Crawlから120Bの数学関連トークンが提供されました.

Q: DeepSeekMath 7B が MATH で達成した自己無撞着スコアは?

A: DeepSeekMath 7Bは、MATHで60.9%の自己無撞着スコアを達成.

Q: DeepSeekMathの数学的推論能力に起因する2つの重要な要因は何ですか?

A: DeepSeekMathの数学的推論能力には、2つの主要な要素が関与しています.第一に、DeepSeekMathコーパスのトレーニングにより、英語と中国語の数学的推論のパフォーマンスが向上します.既存の数学コーパスは主に英語中心であり、中国語の数学的推論のパフォーマンスを制限するか、さらに悪化させる可能性があります.第二に、DeepSeekMath 7Bの自己整合性は、MATHベンチマークで60.9%のスコアを達成しました.これは、DeepSeekMath 7Bの64のサンプルに対する数学的推論能力を示しています.

Q: データ選択パイプラインは、DeepSeekMathの数学的推論能力をどのように強化するのですか?

A: データ選択パイプラインはDeepSeekMathの数学的推論能力を向上させます.DeepSeekMathは、数学的推論を強化するために数学的な指示調整を適用します.これにより、数学的な問題解決能力が向上し、数学的な問題を解決する際にチェーンオブスロートプロンプトを使用することができます.また、DeepSeekMathコーパスのトレーニングにより、数学的な推論能力が向上し、英語と中国語の両方でのパフォーマンスが向上します.一方、既存の数学コーパスは主に英語中心であり、中国語の数学的な推論能力の向上は限定的であり、逆にパフォーマンスを低下させる可能性があります.

Q: Group Relative Policy Optimization(GRPO)とは何か、そしてそれがどのように数学的推論能力を高めるのか?

A: Group Relative Policy Optimization (GRPO)は、Proximal Policy Optimization (PPO)の変種の強化学習アルゴリズムであり、グループスコアからベースラインを推定することで、トレーニングリソースを大幅に削減します.GRPOは、英語の指示調整データのサブセットのみを使用して、強力なDeepSeekMath-Instructに比べて、ドメイン内(GSM8K:82.9% → 88.2%、MATH:46.8% → 51.7%)およびドメイン外の数学的なタスク(例:CMATH:84.6% → 88.8%)で大幅な改善を実現します.GRPOは、数学的な推論能力を向上させることができます.

Q: GRPOはPPO(Proximal Policy Optimization)の亜種か?

A: はい、GRPOは最適化(PPO)のバリアントです.

Q: GRPOはPPOのメモリ使用量をどのように最適化するのですか?

A: GRPOは、追加の価値関数近似の必要性を排除し、代わりに複数のサンプリングされた出力の平均報酬をベースラインとして使用することで、PPOのメモリ使用量を最適化します.具体的には、各問題↪Ll45E に対して、GRPO は古いポリシー𝑚から出力 {𝑜,—,↪Ll_1D43A} のグループをサンプリングし、ポリシーモデルを最適化します.

Q: DeepSeekMath 7Bのパフォーマンスレベルは、Gemini-UltraとGPT-4と比べてどのようになりますか?

A: DeepSeekMath 7Bのパフォーマンスレベルは、競技レベルのMATHベンチマークにおいて、Gemini-UltraとGPT-4のパフォーマンスレベルに近づいています.

Large Language Model for Table Processing: A Survey

著者:Weizheng Lu, Jiaming Zhang, Jing Zhang, Yueguo Chen

発行日:2024年02月04日

最終更新日:2024年02月04日

URL:http://arxiv.org/pdf/2402.05121v1

カテゴリ:Artificial Intelligence, Computation and Language

概要:

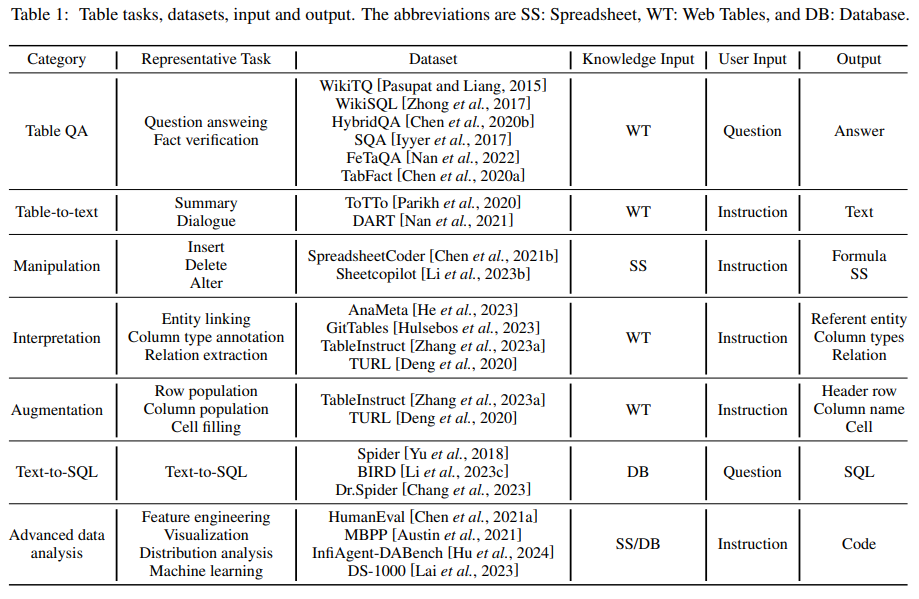

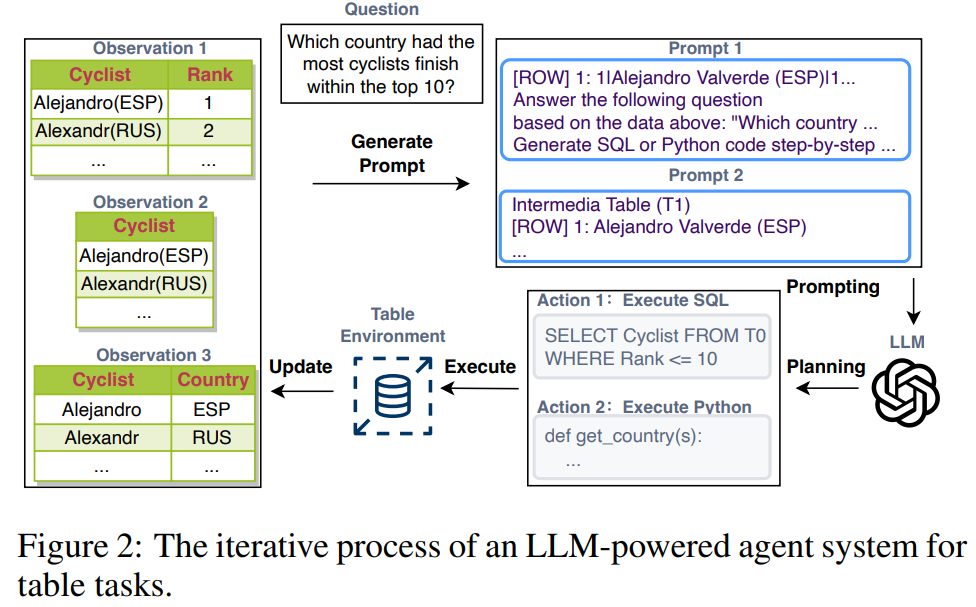

テーブルは、大量のデータを格納するために構造化された通常2次元のデータであり、データベースのクエリ、スプレッドシートの計算、ウェブテーブルからのレポート生成など、日常の活動において不可欠です.大規模言語モデル(LLM)を使用してこれらのテーブル中心のタスクを自動化することは、学術界や産業界からの関心を集め、重要な公共の利益をもたらします.この調査では、テーブルタスクについて包括的な概要を提供しており、従来のテーブルの質問応答(Table QA)や事実の検証などの領域だけでなく、テーブルの操作や高度なテーブルデータ分析など、新たに強調されている側面も含まれています.さらに、小規模な言語モデルの事前学習と微調整という初期の戦略にとどまらず、LLMの使用における最近のパラダイムも含まれています.特に、指示調整、プロンプティング、LLMの領域内でのエージェントベースのアプローチに焦点を当てています.最後に、テーブルの操作と高度なデータ分析のための包括的なベンチマークの開発や、プライベートデプロイメントと効率的な推論というさまざまな課題についても取り上げています.

Q&A:

Q: この文章に出てくる伝統的なテーブル・タスクの分野とは?

A: パッセージには、表のタスクの伝統的な領域として、表の質問応答と事実の検証が挙げられています.

Q: この文章で新たに強調されているテーブルタスクの側面とは?

A: パッセージでは、テーブルタスクの新たに強調されている側面は、テーブル操作、テーブル解釈、テーブル拡張、テキストからSQLへの変換、高度なデータ分析です.

Q: この文章で言及されている、小さな言語モデルの事前学習と微調整の初期の戦略とは?

A: 与えられた文脈では、TaBERT、TaPas、TURL、TaPExが表のためのニューラル言語モデルの事前学習や微調整という初期の戦略を採用しています.

Q: この文章で言及されているLLMの使用法における最近のパラダイムとは?

A: 最近のパラダイムにおけるLLMの利用法には、インストラクション・チューニング、プロンプティング、LLMを利用したエージェント・アプローチなどがある.

Q: LLMの領域におけるインストラクション・チューニング、プロンプティング、エージェント・ベースのアプローチの例を教えていただけますか?

A: 指示調整、プロンプティング、エージェントベースのアプローチは、LLMの領域で使用されるさまざまな手法です.指示調整は、オープンソースのLLMを基にした基礎モデルを調整することで、柔軟性を持たせる手法です.Table-GPTやLemurなどの研究では、指示調整の柔軟性が示され、さまざまな下流タスクで優れた結果が得られています.これらのモデルは、企業の機密データの漏洩を防ぎながら、エージェントによってさらに強化されることができます.ただし、オープンソースのLLMに関するエージェントの研究はまだ限られています.いくつかの研究では、テーブルタスクにおいて、クローズドソースのLLMに比べてオープンソースのLLMの方が精度と堅牢性が優れていることが示されています.エージェントは、ユーザーの意図を理解し、アクションを計画するために基礎となるLLMに大いに依存しているため、これらの手法がクローズドソースのLLMに移植された場合の効果はさらに研究が必要です.プロンプティングとエージェントベースの手法は、既存の手法よりも簡素化される可能性があります.既存のプロンプティングベースの手法は複雑で時間がかかります.LLMはプロンプトに非常に敏感であるため、既存のプロンプトはハードコードされた「プロンプトテンプレート」を使用して実装されています.これらのプロンプティングベースの手法はスケーラブルではなく、本番環境に簡単に採用することができません.さらに、現在の手法ではLLMとの繰り返しの対話が必要です.

Q: この文章に書かれている、民間企業への配備に関する課題は何ですか?

A: プライベート展開に関連する課題として、データ漏洩のリスクやサードパーティのモデルサービスプロバイダへの依存が挙げられます.

Q: 効率的な推論に関連して、この文章で述べられている課題は何ですか?

A: パッセージには、プライベートデプロイメントと効率的な推論に関連するいくつかの課題が挙げられています.

Q: 表操作や高度なデータ解析のための広範なベンチマークの開発に関連して、この文章で言及されている課題は何ですか?

A: パッセージには、テーブル操作と高度なデータ分析のための包括的なベンチマークの開発に関連するいくつかの課題が挙げられています.

Q: LLMでテーブル中心のタスクを自動化することの社会的なメリットについて、もう少し詳しく教えてください.

A: LLMsの使用による表中心のタスクの自動化は、公共の利益をもたらします.これにより、データベースクエリ、スプレッドシートの計算、ウェブテーブルからのレポート生成など、日常のタスクが簡素化され、一般の人々にとってよりアクセスしやすくなります.また、LLMsの使用により、タスクの効率化とエラーの削減が期待されます.これにより、時間と労力を節約でき、生産性が向上します.さらに、LLMsの活用により、表のデータ解析や高度なデータ処理が可能になり、より洞察力のある意思決定が可能となります.

Q: 大量のデータを保存するためにテーブルが不可欠な日常業務の例を教えてください.

A: テーブルは大量のデータを格納するために必要な日常の活動の例として、データベースクエリ、スプレッドシートの計算、ウェブテーブルからのレポート生成などがあります.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/godaai/llm-table-surveyです.

More Agents Is All You Need

著者:Junyou Li, Qin Zhang, Yangbin Yu, Qiang Fu, Deheng Ye

発行日:2024年02月03日

最終更新日:2024年02月03日

URL:http://arxiv.org/pdf/2402.05120v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

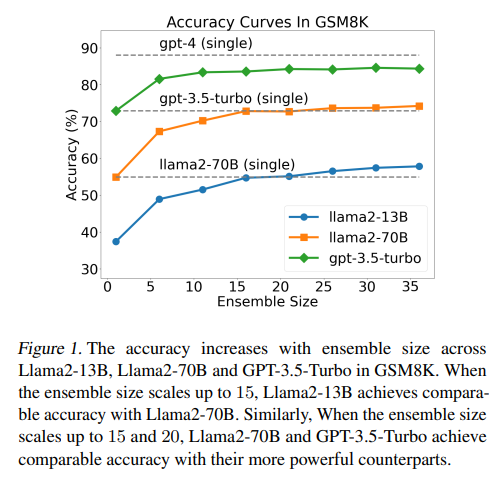

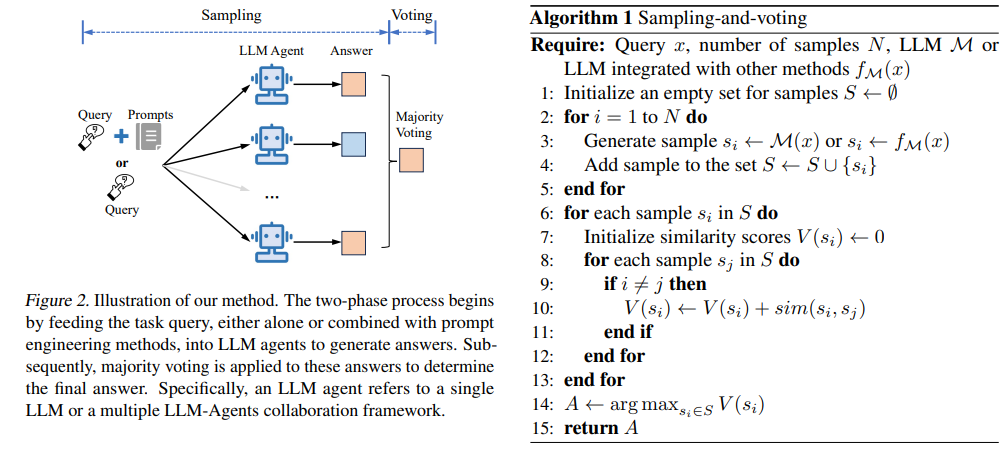

この研究では、サンプリングと投票の方法を用いることで、大規模言語モデル(LLM)の性能がエージェントの数とスケーリングすることを発見しました.また、この方法は既存の複雑な方法とは異なり、LLMのさらなる向上に対して直交しており、向上の程度はタスクの難易度と相関しています.私たちは、幅広いLLMベンチマークで包括的な実験を行い、私たちの発見の存在を検証し、それを促進するための特性を研究しました.私たちのコードは以下のURLから公開されています:https://anonymous.4open.science/r/more_agent_is_all_you_need

Q&A:

Q: この文章で言及されているサンプリングと投票の方法とは?

A: パッセージで言及されているサンプリングと投票の方法は、2つのフェーズで構成されています.まず、サンプリングフェーズでは、タスクのクエリをLLMにクエリし、N個のサンプルを生成します.各サンプルは、LLMによって生成されたものをs=M(x)と表し、他の方法と統合した場合はs=fM(x)と表されます.このフェーズの終了時には、サンプルの集合S={s1, s2, …, sN}が得られます.次に、投票フェーズでは、サンプルの集合Sを最終的な回答Aに統合するために、多数決を行います.各サンプルの累積類似度を計算し、他のサンプルと比較します.

Q: 大規模言語モデル(LLM)の性能は、インスタンス化されたエージェントの数によってどのように変化するのか?

A: 大規模言語モデル(LLM)のパフォーマンスは、インスタンス化されたエージェントの数とスケーリングします.

Q: LLMの強化の度合いは、タスクの難易度と相関関係があるのか?

A: はい、LLMの向上度合いはタスクの難易度と相関しています.

Q: この文章で言及されている発見の存在を確認するために、どのような実験が行われたのか?

A: 与えられた文脈では、一般的な推論タスク、数学の単語問題の解決、コード生成タスクの3つの実験が行われました.

Q: 発見を容易にする特性とは何か?

A: 我々の発見の発生を促進することができる特性は、いくつかのプロパティに基づいて要約されます.

Q: 実験に使用したLLMベンチマークについて、もう少し詳しく教えてください.

A: 実験では、さまざまなデータセットを使用して、異なるLLMを利用した場合の精度曲線を提供しています.また、アンサンブルサイズを増やすことで、我々の手法を単独で使用することで一般的に性能を向上させることができることを示しています.

Q: この文章で言及されている、一般に公開されているコードにアクセスするにはどうすればいいのでしょうか?

A: 提供されているコードにアクセスするためには、パッセージで言及されているGitリポジトリを利用する必要があります.

Q: 公開されているコードを使用するために、特別な要件や依存関係はありますか?

A: いいえ、公開されているコードを使用するための特別な要件や依存関係は言及されていません.

Q: サンプリング・アンド・投票法が実際のシナリオでどのように適用できるか、何か見識や例を教えてください.

A: サンプリングと投票法は、一般的な推論タスクやコード生成タスクなどの実践的なシナリオで適用することができます.サンプリングフェーズでは、与えられたタスクに対してモデルが生成する複数の候補を抽出します.具体的には、MMLUタスクではA、B、C、Dの選択肢に対応する部分を抽出し、チェスタスクではチェスボードの位置を抽出します.そして、これらの候補を数学的な等価性の比較によって評価し、最も確率の高い候補を最終的な回答として選択します.投票フェーズでは、サンプル内で各候補の出現頻度を数えることで類似度を計算し、最も頻繁に出現する候補を最終的な回答として選択します.この選択された回答は、正解との数学的な等価性の比較によって正確性が確認されます.

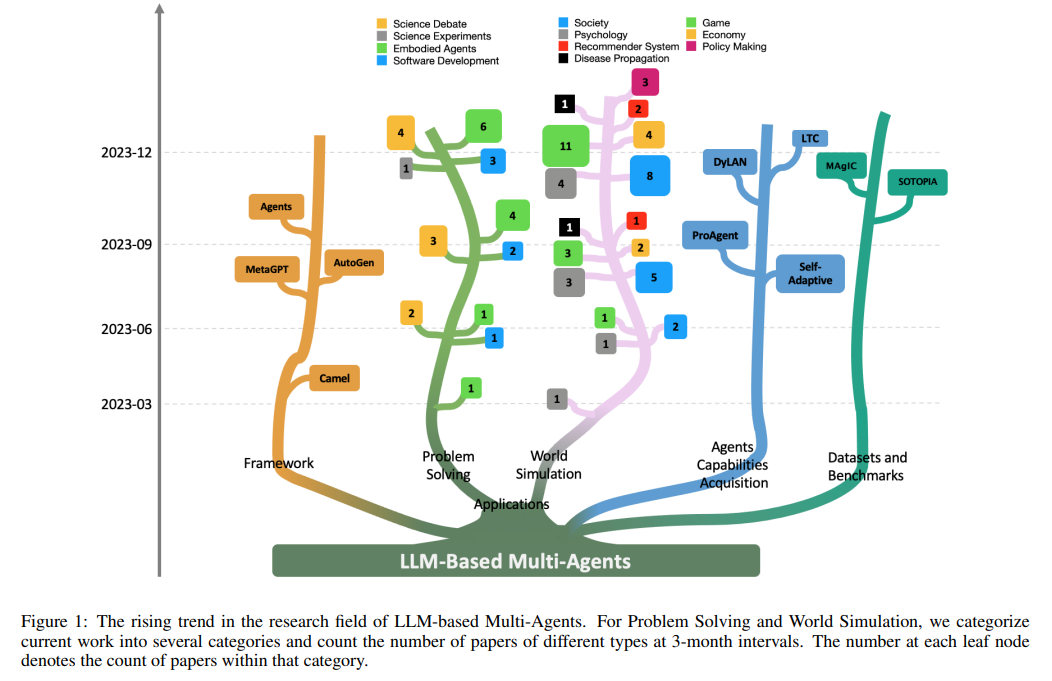

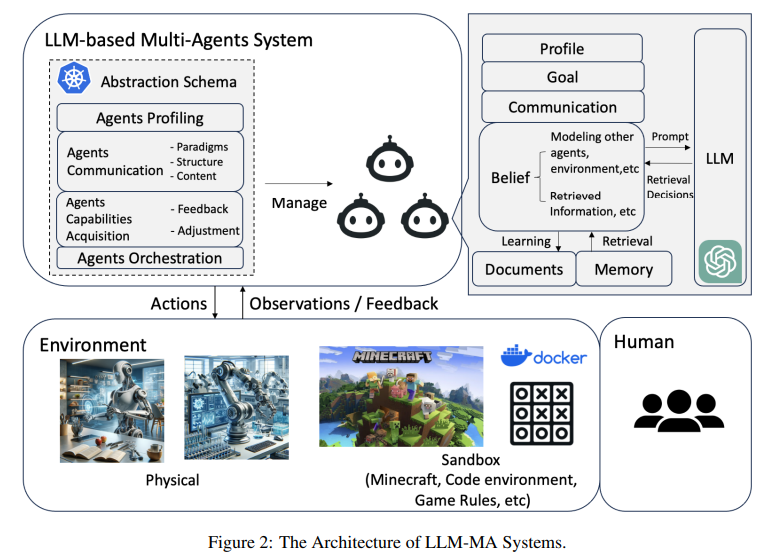

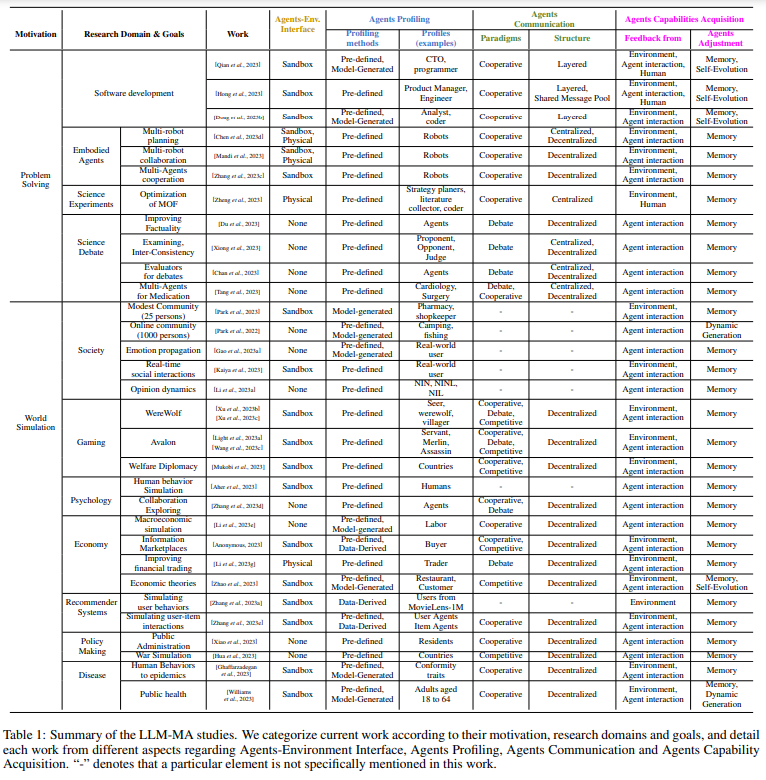

Large Language Model based Multi-Agents: A Survey of Progress and Challenges

著者:Taicheng Guo, Xiuying Chen, Yaqi Wang, Ruidi Chang, Shichao Pei, Nitesh V. Chawla, Olaf Wiest, Xiangliang Zhang

発行日:2024年01月21日

最終更新日:2024年01月21日

URL:http://arxiv.org/pdf/2402.01680v1

カテゴリ:Computation and Language, Artificial Intelligence, Multiagent Systems

概要:

大規模言語モデル(LLM)は、さまざまなタスクで驚異的な成功を収めています.LLMの印象的な計画と推論能力により、自律エージェントとして多くのタスクを自動的に実行するために使用されてきました.最近では、1つのLLMを単一の計画や意思決定エージェントとして使用することに基づいて、LLMベースのマルチエージェントシステムが複雑な問題解決や世界シミュレーションでかなりの進展を遂げています.このダイナミックな分野についてコミュニティに概要を提供するために、本調査論文では、LLMを基にしたマルチエージェントシステムの重要な側面と課題について詳細な議論を行います.読者が以下の質問について実質的な洞察を得ることを目指しています:LLMベースのマルチエージェントはどのようなドメインや環境をシミュレートしているのか?これらのエージェントはどのようにプロファイリングされ、どのようにコミュニケーションを行っているのか?エージェントの能力の成長にはどのようなメカニズムが寄与しているのか?この研究分野に深く関与したいと思う研究者のために、一般的に使用されるデータセットやベンチマークもまとめています.また、最新の研究について研究者を最新情報で更新するために、私たちは日々情報を保持しており、オープンソースのGitHubリポジトリを運営しています.

Q&A:

Q: 大規模言語モデル(LLM)はどのようなタスクを自律的に実行できるのか?

A: LLMは、プランニング、推論、周囲の知覚、意思決定、それに応じた行動など、さまざまなタスクを自律的にこなすことができる.

Q: 複雑な問題解決や世界シミュレーションにおいて、LLMベースのマルチエージェントシステムはどのように進歩してきたのだろうか?

A: LLMベースのマルチエージェントシステムは、複雑な問題解決と世界シミュレーションにおいてかなりの進展を遂げています.1つのLLMを単一の計画や意思決定エージェントとして使用する開発は、この進展に貢献してきました.これらのシステムは、さまざまなドメインや環境をシミュレートすることができました.LLMベースのマルチエージェントシステムのエージェントは、能力と相互通信方法に基づいてプロファイル化されています.エージェントの能力の成長は、タスクを自動的に実行することを可能にするメカニズムによって促進されています.LLMベースのマルチエージェントの研究分野は、この領域で発表される論文の数の増加によって上昇傾向を示しています.この調査は、LLMベースのマルチエージェントシステムの重要な側面とそれらが直面する課題について、詳細な議論を提供することを目的としています.また、この研究の意義とLLMの開発およびLLMを使用した学際的研究への潜在的な貢献を強調しています.

Q: LLMに基づくマルチエージェントシステムの本質的な側面とは?

A: LLMベースのマルチエージェントシステムは、複雑な問題解決と世界シミュレーションにおいてかなりの進展を遂げています.LLMベースのマルチエージェントシステムの重要な側面には、LLMベースのマルチエージェントがシミュレートするドメインと環境、これらのエージェントがプロファイリングやコミュニケーションを行う方法、エージェントの能力の成長に貢献するメカニズムが含まれます.

Q: LLMベースのマルチ・エージェントはどのようにプロファイリングされ、どのようにコミュニケーションを取っているのか?

A: LLMベースのマルチエージェントは、そのユニークな戦略と行動に基づいてプロファイリングされる.マルチエージェントは、エージェント間の相互作用や集団的な意思決定プロセスを通じて互いにコミュニケーションをとる.

Q: LLMベースのマルチエージェントシステムにおいて、エージェントの能力の成長にどのようなメカニズムが寄与していますか?

A: LLMベースのマルチエージェントシステムは、効率的なエージェントの調整、コミュニケーション、およびマルチエージェントのスケーリング法の理解などのメカニズムを通じて、エージェントの能力の成長を実現します.LLM-MAシステム内のエージェントの数が増えるにつれて、効果的な調整とコミュニケーションの複雑さも増します.異なるシナリオに合わせてエージェントのワークフローとタスク割り当てを最適化するために、高度なエージェントオーケストレーションの方法論を設計することがますます重要になります.これらの方法論は、エージェントの能力の成長に貢献し、効果的な調整とコミュニケーション能力を向上させます.

Q: LLMベースのマルチエージェントはどのようなドメインや環境をシミュレートするのか?

A: LLMベースのマルチエージェントは、自然言語理解、金融市場、社会行動モデリングなど、さまざまなドメインや環境をシミュレートします.例えば、文脈で言及された人狼ゲームのシミュレーションでは、エージェントは特定のルールとメカニクスを持つサンドボックス環境で相互作用します.エージェントの行動や意思決定は環境に影響を受け、時間の経過とともに環境からフィードバックを受けて戦略を導きます.

Q: LLMベースのマルチエージェントシステムの研究では、どのようなデータセットやベンチマークが一般的に使用されていますか?

A: LLM-MAの研究で一般的に使用されるデータセットやベンチマークは、異なる研究アプリケーションによって異なるものが使用されています.問題解決シナリオでは、複数のエージェントの協力や議論による計画と推論能力を評価するために、多くのデータセットやベンチマークが使用されます.ワールドシミュレーションシナリオでは、データセットやベンチマークは、シミュレートされた世界と現実世界の整合性を評価したり、異なるエージェントの行動を分析するために使用されます.ただし、科学チームの実験や経済モデリングなどの特定の研究アプリケーションでは、包括的なベンチマークがまだ必要です.このようなベンチマークの開発は、これらの複雑で動的な領域でのLLM-MAの成功と適用可能性を評価する能力を大幅に向上させるでしょう.

Q: オープンソースのGitHubリポジトリで公開されているLLMベースのマルチエージェントシステムに関する研究の概要を教えてください.

A: 提供された文脈では、LLMベースのマルチエージェントシステムに関する研究の概要は、オープンソースのGitHubリポジトリで利用可能です.このリポジトリは、LLMベースのマルチエージェントシステムの研究をまとめたものであり、研究者が最新の研究について常にアップデートされた情報を得ることができます.

Q: LLMベースのマルチエージェントシステムは、単一の計画エージェントや意思決定エージェントと比較してどうでしょうか?

A: LLMベースのマルチエージェントシステムは、単一の計画や意思決定エージェントと比較して高度な機能を提供します.これらのシステムでは、異なる能力を持つさまざまなエージェントにLLMを特化させ、これらの多様なエージェント間の相互作用を効果的にシミュレートすることで、複雑な現実世界の環境を再現します.複数の自律エージェントが計画、議論、意思決定に協力して参加し、問題解決のタスクにおける人間のグループ作業の協力的な性質を反映します.このアプローチは、LLMのコミュニケーション能力を活用し、テキスト生成やテキスト入力への応答能力を利用します.さらに、LLMベースのマルチエージェントシステムは、さまざまなドメインでのLLMの幅広い知識と、特定のタスクに特化する潜在能力を活用します.

Q: LLMベースのマルチエージェントシステムの開発と実装で直面する課題とは?

A: LLMベースのマルチエージェントシステムは、リソース要件、エージェントの協調とコミュニケーション、マルチエージェントのスケーリング法則の理解という点で課題に直面している.LLM-MAシステムのエージェント数が増加するにつれて、必要なリソースも大幅に増加するため、計算リソースが限られたシナリオでこれらのシステムを開発することは困難である.さらに、LLMベースのエージェントの数が増えれば増えるほど、効果的な協調とコミュニケーションを確保することがより複雑になっていきます.エージェントのワークフローとタスク割り当てを最適化するために、高度なエージェントオーケストレーション手法を設計することがますます重要になっています.さらに、マルチエージェントのスケーリング法則を理解することは、LLM-MAシステムにおいてエージェントの数が増えるにつれて生じる複雑さと研究機会に対処するために極めて重要である.