ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- A Survey on Hallucination in Large Vision-Language Models

発行日:2024年02月01日

最近、AIの分野で注目されている大規模なビジョン・言語モデル(LVLMs)の開発において、幻覚という視覚的な内容とテキスト生成の不一致が重要な課題となっており、その解決策を詳細に分析し、将来の軽減策を促進するための総調査が行われている. - OLMo: Accelerating the Science of Language Models

発行日:2024年02月01日

言語モデル(LM)は、NLPの研究や商業製品で広く使用されており、研究コミュニティが真にオープンなLMにアクセスできることが重要であるため、真にオープンな言語モデルOLMoとそのフレームワークの初版が詳細に説明されている. - Large Language Models for Mathematical Reasoning: Progresses and Challenges

発行日:2024年01月31日

この研究は、数学の領域におけるLLMの景観についての包括的な調査を行い、数学の問題とデータセットの探索、LLM指向の技術の検討、LLMの影響要因と懸念事項の提供、そして持続的な課題の明確化を行い、数学の領域におけるLLMの現状と将来の課題を明確にする機会を提供する. - Corrective Retrieval Augmented Generation

発行日:2024年01月29日

大規模言語モデル(LLM)は、生成されたテキストの正確さを保証するためにパラメータ的な知識だけに頼ることはできず、必然的に幻覚を生じさせます.検索補完生成(RAG)はLLMの実用的な補完ですが、懸念されるのは、検索がうまくいかない場合にモデルの振る舞いがどのようになるかということです.このため、私たちは「修正検索補完生成(CRAG)」を提案し、生成の堅牢性を向上させます. - MoE-LLaVA: Mixture of Experts for Large Vision-Language Models

発行日:2024年01月29日

最近の研究では、大規模なビジョン-言語モデル(LVLM)のスケーリングがダウンストリームのタスクのパフォーマンスを向上させることが示されていますが、本研究では、トレーニング戦略MoE-Tuningを提案し、スパースLVLMのベースラインを確立し、より効率的かつ効果的なマルチモーダル学習システムの開発に向けた示唆を提供しています. - Rephrasing the Web: A Recipe for Compute and Data-Efficient Language Modeling

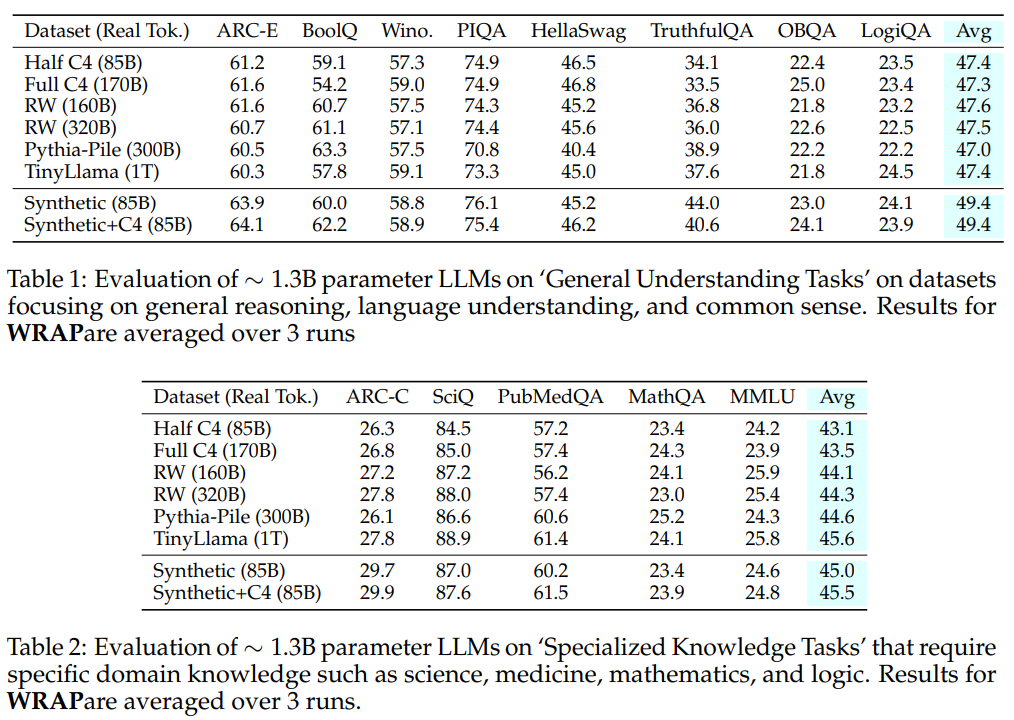

発行日:2024年01月29日

本研究では、WRAPを提案し、LLMの性能に与える訓練データの構成と言い換えのスタイルの影響を調査しました.結果として、WRAPは事前学習の速度を向上させ、パープレキシティを改善し、ゼロショットの質問応答の精度を向上させることが示されました. - A Comprehensive Survey of Compression Algorithms for Language Models

発行日:2024年01月27日

言語モデルの圧縮アルゴリズムの数が増えており、巨大なモデルの副作用を抑えるために最新の進歩を活用する必要がある.本論文では、多様な圧縮アルゴリズムを調査し、トレンドや特性をまとめ、低コストの圧縮アルゴリズムの重要性についても議論する.また、精度の低下を防ぐ方法や新たな研究トピックについても提案する. - SliceGPT: Compress Large Language Models by Deleting Rows and Columns

発行日:2024年01月26日

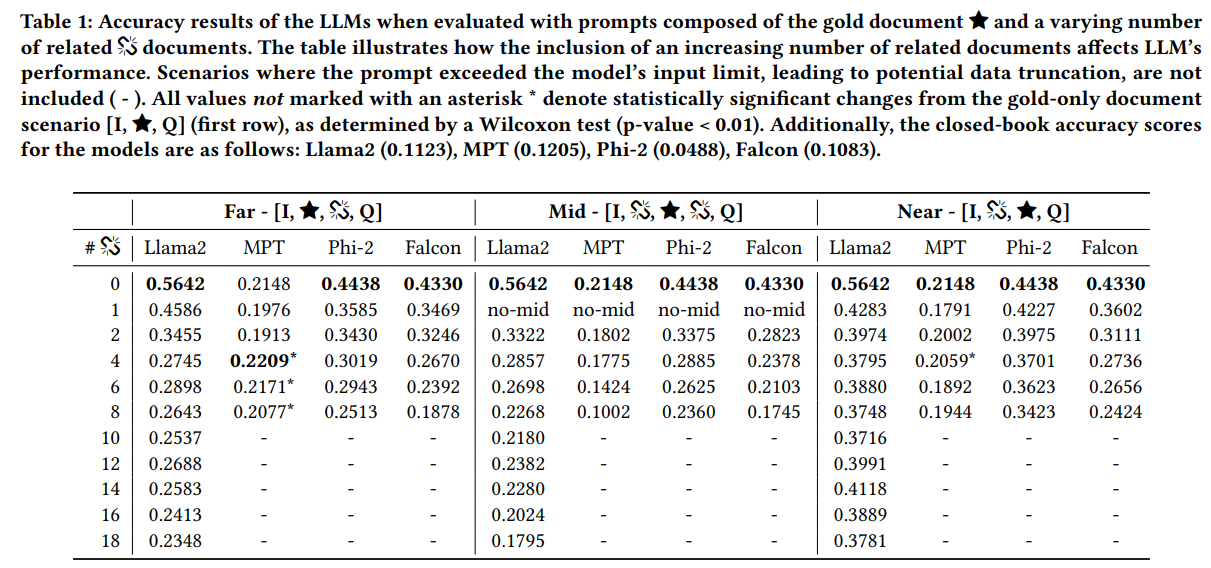

本論文では、新しいスパース化手法であるSliceGPTを提案し、モデルパラメータを最大25%削減しながら、ゼロショットタスクパフォーマンスを維持できることを示しています.また、SliceGPTは追加のコード最適化なしで高速に実行できます. - The Power of Noise: Redefining Retrieval for RAG Systems

発行日:2024年01月26日

これらの結果は、品質の低下という初期の仮定に反するものであり、リトリーバーと言語生成モデルを統合するための専門戦略の開発の必要性を示しており、将来の研究の基盤を築くものです. - MM-LLMs: Recent Advances in MultiModal Large Language Models

発行日:2024年01月24日

MM-LLMsは、オフシェルフのLLMsを拡張してMM入力または出力をサポートするようになり、多様なMMタスクに対応できるようになった.本論文では、MM-LLMsの設計、既存のモデル、パフォーマンス、トレーニング手法について調査し、最新の開発動向を提供する.

A Survey on Hallucination in Large Vision-Language Models

著者:Hanchao Liu, Wenyuan Xue, Yifei Chen, Dapeng Chen, Xiutian Zhao, Ke Wang, Liping Hou, Rongjun Li, Wei Peng

発行日:2024年02月01日

最終更新日:2024年02月01日

URL:http://arxiv.org/pdf/2402.00253v1

カテゴリ:Computer Vision and Pattern Recognition, Computation and Language, Machine Learning

概要:

最近、大規模なビジョン・言語モデル(LVLMs)の開発がAIの分野で注目を集めており、実用化の可能性が高いとされています.しかし、「幻覚」という具体的には、事実に基づかない視覚的な内容とそれに対応するテキスト生成との不一致が、LVLMsの利用において重要な課題となっています.本総調査では、LVLMに関連する幻覚を詳細に分析し、概要を明確にし、将来の軽減策を促進することを試みています.まず、LVLMにおける幻覚の概念を明確にし、さまざまな幻覚の症状を提示し、LVLMに固有の幻覚に関連する独特の課題を強調します.その後、LVLMに固有の幻覚を評価するために特別に設計されたベンチマークと方法論を概説します.さらに、トレーニングデータとモデルの構成要素からの洞察を含め、これらの幻覚の根本的な原因について調査します.また、既存の幻覚軽減方法についても批判的にレビューします.LVLM内の幻覚に関するオープンな問題と将来の方向性についても議論し、この調査を締めくくります.

Q&A:

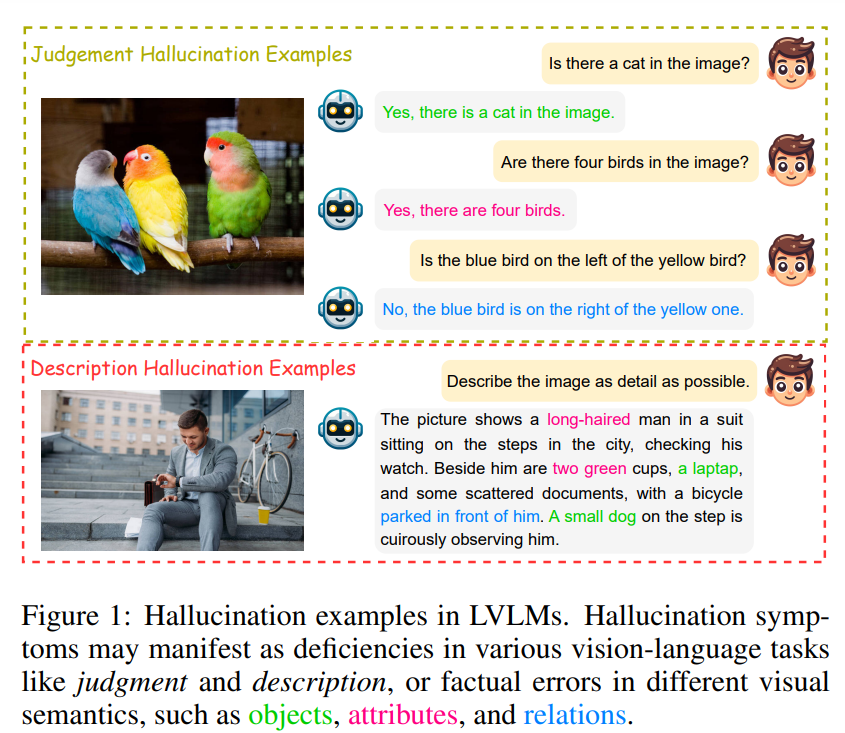

Q: 大型視覚言語モデル(LVLM)の文脈における「幻覚」の定義とは?

A: LVLMにおける「幻覚」とは、視覚的な入力(「事実」として扱われる)とLVLMのテキスト出力との間の矛盾を指します.視覚言語のタスクの観点から見ると、LVLMの幻覚の症状は判断力や記述力の不足と解釈できます.

Q: LVLMで起こる具体的な幻覚症状の例を教えてください.

A: LVLMにおける幻覚症状の具体的な例としては、判断や記述などの視覚言語のタスクにおける欠陥や、物体や属性、関係などの異なる視覚的意味におけること実の誤りが挙げられます.

Q: LVLMにおける幻覚に関連するユニークな課題とは?

A: LVLMは、視覚データを取り込むことで言語プライアと統計的バイアスを悪化させ、幻覚をより深刻なものにする可能性がある.

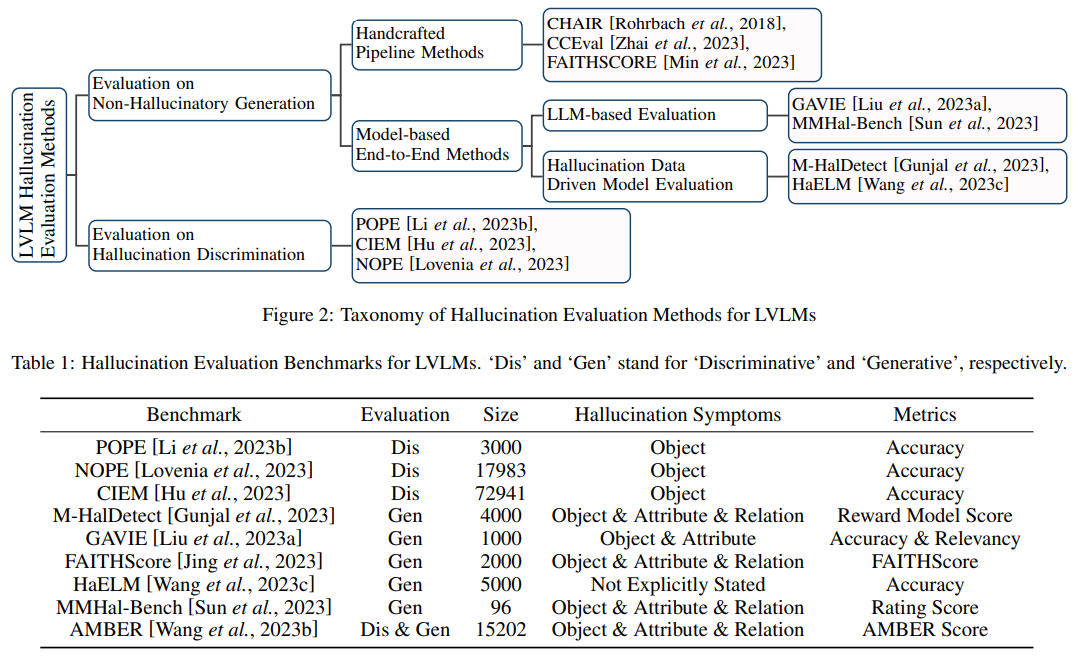

Q: LVLMにおける幻覚はどのように評価・測定されるのか?特定のベンチマークや方法論はあるのか?

A: LVLMの幻覚は、特定のベンチマークと方法論を用いて評価・測定される.ベンチマークには、非幻覚生成に関する評価、モデルベースのエンドツーエンド評価、幻覚識別に関する評価が含まれる.LVLMの幻覚を評価するために特別に調整された方法論には、手作りのパイプライン手法、LLMベースの評価、幻覚データ駆動型モデル評価などがある.これらのベンチマークと方法論は、LVLM関連の幻覚の概要を確立し、将来の軽減を促進し、LVLMの幻覚に固有の課題を評価することを目的としている.評価サイズ、幻覚症状、評価基準も評価プロセスにおいて考慮される.

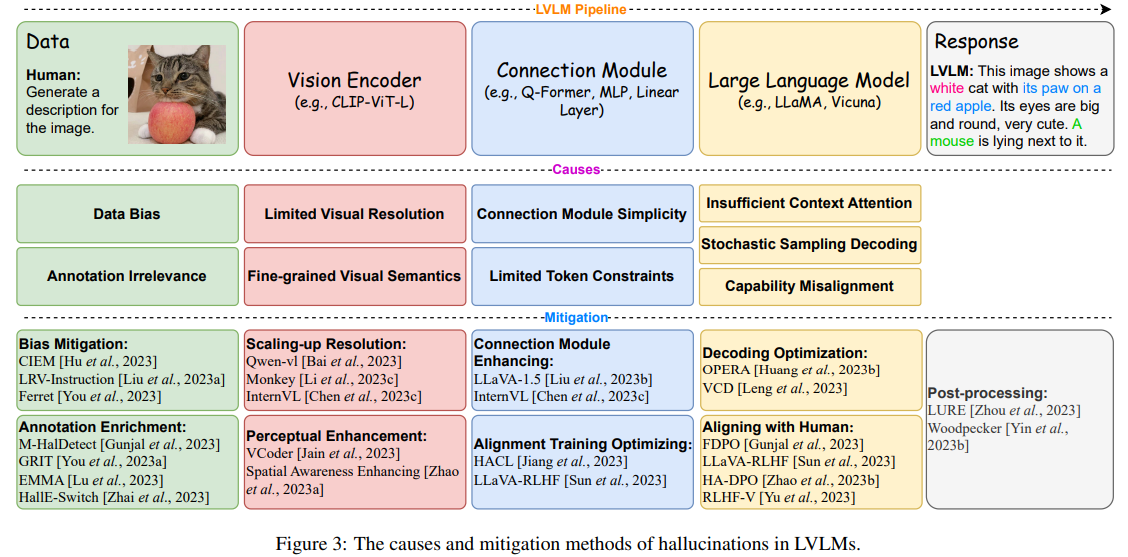

Q: LVLMにおける幻覚の根本原因は何か?学習データとモデル構成要素はどのように幻覚に寄与するのか?

A: LVLMの幻覚の根本的な原因は、訓練データとモデルの構成要素によって引き起こされます.訓練データの品質の問題として、データバイアスが挙げられます.既存の訓練データには分布の不均衡が存在し、特に事実判断のQAペアでは、回答が「Yes」であるものが大多数です.このようなバイアスのあるデータで訓練されたLVLMは、一貫して「Yes」と回答し、誤った情報や誤解を含む説明を提供する傾向があります.また、モデルの構成要素として、LLMの生成的な性質、ビジョンエンコーダーの画像の正確な基盤づけの能力の欠如、異なるモダリティ間の不一致、不十分な文脈の注意などが幻覚の原因となります.

Q: LVLMの幻覚を軽減する既存の方法について、批判的なレビューをお願いできますか?

A: LVLMにおける幻覚を軽減するための既存の手法について、批判的なレビューを提供します.

Q: LVLMの幻覚に関して、未解決の問題や疑問はありますか?

A: はい、LVLMに関する幻覚に関しては、未解決の問題やオープンな質問があります.この調査では、幻覚の根本的な原因について詳細な分析を行い、関連するベンチマークと革新的な評価方法を評価し、効果的な軽減手法について議論しています.また、既存の課題や潜在的な方向性にも触れています.この調査は、LVLMにおける幻覚の複雑さに取り組むための基盤を築き、これらのモデルをさまざまなアプリケーションで実用化するための将来の研究を促進することを目指しています.

Q: LVLMにおける幻覚への対応について、今後の研究開発の方向性は?

A: LVLMにおける幻覚に関する研究と開発の将来の方向性は、以下のように詳細に説明されています.まず、LVLMにおける幻覚の概念の明確化と、幻覚の症状の多様性の説明が行われています.次に、LVLMに特有の幻覚の評価に特化したベンチマークと方法論が概説されています.さらに、訓練データとモデルの要素から得られる洞察を含め、これらの幻覚の根本的な原因についての調査が行われています.また、既存の幻覚の軽減方法についても批判的にレビューされています.最後に、LVLM内の幻覚に関する未解決の問題と将来の方向性について議論されています.

Q: 幻覚はLVLMの実用化の可能性にどのような影響を与えるのか?

A: LVLMに関連する幻覚は、LVLMの実用化の可能性に大きな課題を与えています.幻覚とは、事実に基づいた視覚的な内容と対応するテキスト生成との不一致を指します.この不一致は、オープンドメインのビジョン言語タスクにおけるLVLMの正確かつ信頼性のあるパフォーマンスを妨げます.LVLMにおける幻覚の存在は、一貫性のある文脈に即した出力を生成する能力を損ない、実用化において重要な問題となります.これらの幻覚は、視覚的な内容を正確に表現しない、間違ったまたは意味のないテキストの説明の生成につながる可能性があります.その結果、LVLMの信頼性と効果が損なわれ、実用性が制限されます.LVLMにおける幻覚の現象は、原因、評価方法、緩和策についての入念な調査が必要であり、概要の確立と将来の改善を促進するためにも重要です.LVLMの内部幻覚メカニズムを理解し、これらの幻覚を緩和するための潜在的な解決策を開発するためには、さらなる研究が必要です.LVLMの欠陥に関する将来の詳細な研究と解釈可能性志向の解決策の開発は、その実用化の可能性を向上させることができます.

Q: LVLMの幻覚が大きな課題となっている特定のアプリケーションや産業はありますか?

A: LVLMsの幻覚は、実際のビジュアルコンテンツと対応するテキスト生成との不一致があるため、LVLMsの実用化において重要な課題となります.この課題は、さまざまなアプリケーションや産業において特に重要です.

OLMo: Accelerating the Science of Language Models

著者:Dirk Groeneveld, Iz Beltagy, Pete Walsh, Akshita Bhagia, Rodney Kinney, Oyvind Tafjord, Ananya Harsh Jha, Hamish Ivison, Ian Magnusson, Yizhong Wang, Shane Arora, David Atkinson, Russell Authur, Khyathi Raghavi Chandu, Arman Cohan, Jennifer Dumas, Yanai Elazar, Yuling Gu, Jack Hessel, Tushar Khot, William Merrill, Jacob Morrison, Niklas Muennighoff, Aakanksha Naik, Crystal Nam, Matthew E. Peters, Valentina Pyatkin, Abhilasha Ravichander, Dustin Schwenk, Saurabh Shah, Will Smith, Emma Strubell, Nishant Subramani, Mitchell Wortsman, Pradeep Dasigi, Nathan Lambert, Kyle Richardson, Luke Zettlemoyer, Jesse Dodge, Kyle Lo, Luca Soldaini, Noah A. Smith, Hannaneh Hajishirzi

発行日:2024年02月01日

最終更新日:2024年02月01日

URL:http://arxiv.org/pdf/2402.00838v1

カテゴリ:Computation and Language

概要:

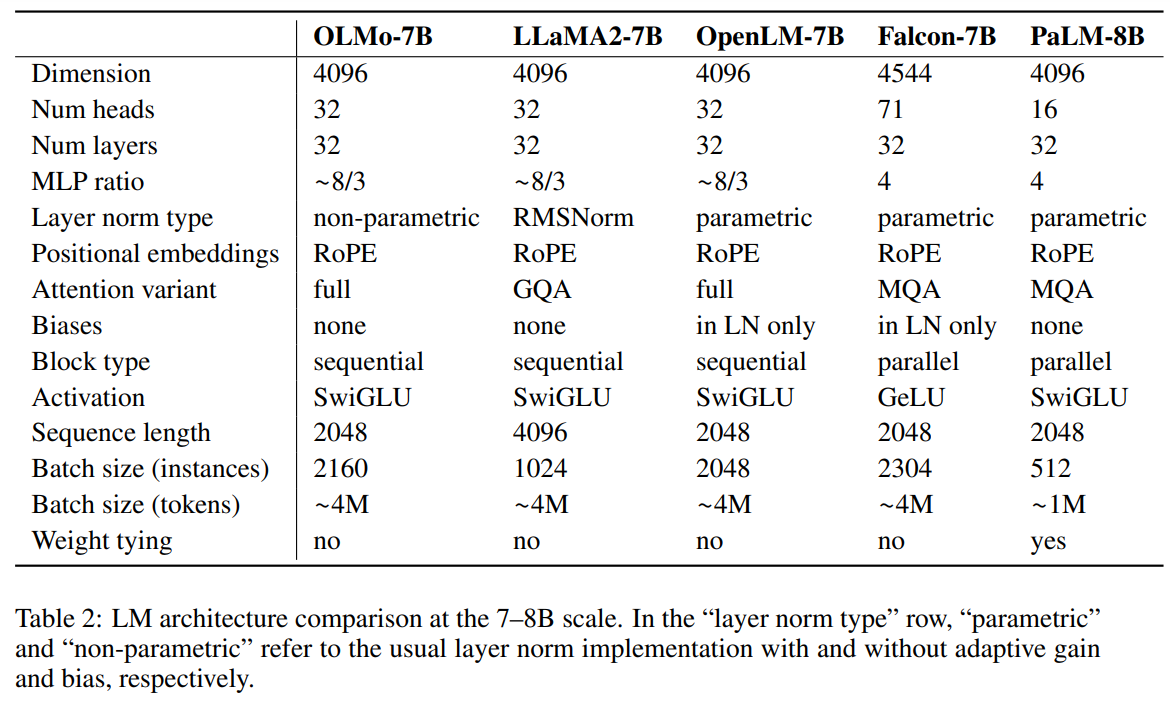

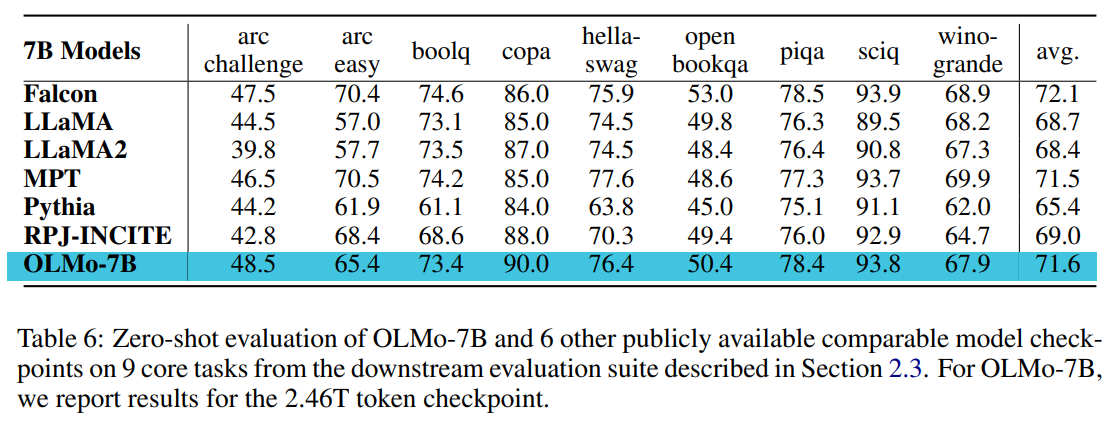

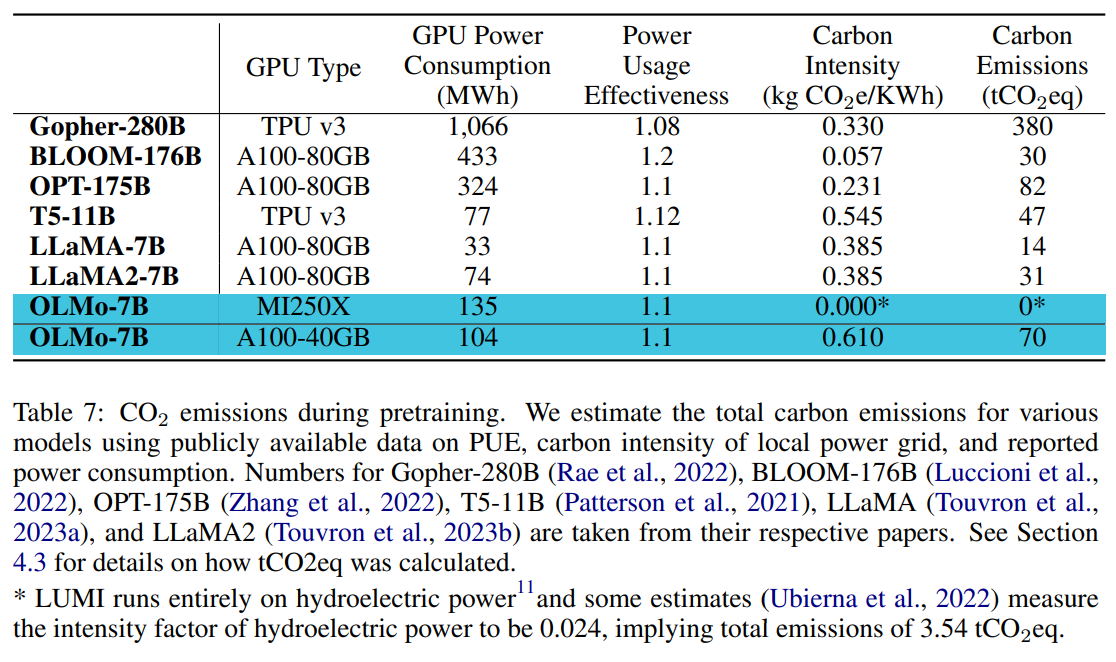

言語モデル(LM)は、NLPの研究や商業製品で広く使用されるようになっています.商業的な重要性が高まるにつれて、最も強力なモデルは、独自のインターフェースの背後に閉じられ、トレーニングデータ、アーキテクチャ、開発の重要な詳細が非公開になっています.これらの詳細は、バイアスや潜在的なリスクを含むこれらのモデルを科学的に研究する上で重要であるため、研究コミュニティが強力で真にオープンなLMにアクセスできることは不可欠だと考えています.このため、この技術レポートでは、最先端の真にオープンな言語モデルOLMoとそのフレームワークの初版を詳細に説明しています.これまでの多くの試みがモデルの重みと推論コードのみを公開してきたのに対し、私たちはOLMoとトレーニングデータ、トレーニングおよび評価コードを含むフレームワーク全体を公開しています.このリリースがオープンな研究コミュニティを強化し、新たなイノベーションの波を起こすことを願っています.

Q&A:

Q: 現在、強力な言語モデルへのアクセスを妨げている独自のインターフェースについて、詳細を教えてください.

A: 現在、強力な言語モデルへのアクセスを制限しているプロプライエタリなインターフェースについての詳細は開示されていません.

Q: クローズドな言語モデルの場合、トレーニングデータ、アーキテクチャ、開発の具体的な詳細について、一般的にどのようなことが非公開なのだろうか?

A: クローズドな言語モデルでは、トレーニングデータ、アーキテクチャ、および開発の具体的な詳細が通常非公開とされています.

Q: OLMoは、モデルの重みと推論コードだけを公開してきた先行研究とどう違うのか?

A: OLMoは、モデルの重みと推論コードのみを公開してきたこれまでの取り組みとは異なり、学習データ、学習・評価コードを含むフレームワーク全体を公開する.この包括的なリリースは、オープンリサーチコミュニティに力を与え、強化し、イノベーションの新しい波を刺激する.

Q: OLMoのために、トレーニングデータやトレーニング・評価コードを含むフレームワーク全体を公開する意義を説明していただけますか?

A: OLMoのフレームワーク全体、トレーニングデータ、トレーニングおよび評価コードを公開することの重要性は、言語モデリングの科学を構築し研究するためのものです.これまでの多くの試みがモデルの重みと推論コードのみを公開してきたのに対し、OLMoはフレームワーク全体を公開することで、トレーニングデータとトレーニングおよび評価コードも提供します.これにより、研究者はモデルのトレーニングプロセスや評価方法を理解し、モデルの性能や挙動をより詳細に分析することができます.また、他の研究者が同じデータとコードを使用して研究を再現し、結果を比較することも可能です.さらに、フレームワーク全体を公開することで、研究者は自身の研究をより透明かつ信頼性の高いものにすることができます.つまり、OLMoのフレームワーク全体を公開することは、言語モデルの研究と開発において、透明性、再現性、信頼性を高めるために非常に重要な要素となります.

Q: OLMoを使って研究できる言語モデルに関連する潜在的なバイアスとリスクは何か?

A: OLMoは、言語モデルに関連するバイアスとリスクを研究するために使用することができます.オープンな言語モデルへの完全なアクセスを提供することで、OLMoは研究者がこれらのモデルの長所と短所、そしてバイアスを分析することを可能にします.言語モデルには、学習データに存在するバイアスを永続させ、偏った出力をもたらす可能性があります.OLMoは、研究者がこれらのバイアスを調査し理解することを可能にし、バイアスに対処し緩和するために重要である.さらに、言語モデルは、有害なコンテンツや誤解を招くコンテンツを生成するリスクをもたらす可能性がある.OLMoは、そのようなリスクを調査・特定するために使用することができ、リスクを最小化するための戦略を開発することができます.

Q: OLMoがオープンリサーチコミュニティにどのような力を与え、強化することを想定していますか?

A: OLMoは、オープンな研究コミュニティを強化し、力を与えることで、研究者たちが新たなイノベーションの波を起こすことを目指しています.OLMoは、異なるモデルサイズ、モダリティ、データセット、安全対策、評価を取り入れることで、オープンな研究コミュニティを強化し、さらなる進歩を促進することを期待しています.

Q: OLMoが言語モデリングの分野でどのように新しいイノベーションの波を起こすことができるか、例を挙げていただけますか?

A: OLMoは、大規模で多様なオープンモデルの提供により、言語モデリングの分野で新たなイノベーションの波を起こすことができます.このオープン性により、言語モデルの理解における科学的な進歩や有用性の向上における技術的な進歩が可能となります.データからトレーニング、評価ツールまでのフレームワーク全体を公開することで、OLMoは研究者や開発者が複数のハードウェアタイプ、トレーニングログ、使用された正確なデータセットにアクセスできるようにします.この透明性とアクセシビリティのレベルは、協力と知識共有を促進し、新たなアイデアや分野の進歩につながる可能性があります.さらに、Palomaによって測定されるトレーニングデータ以外の言語の分布に適合するOLMoの能力は、言語モデリングの限界を押し広げ、さらなる研究と開発のインスピレーションとなる可能性を示しています.

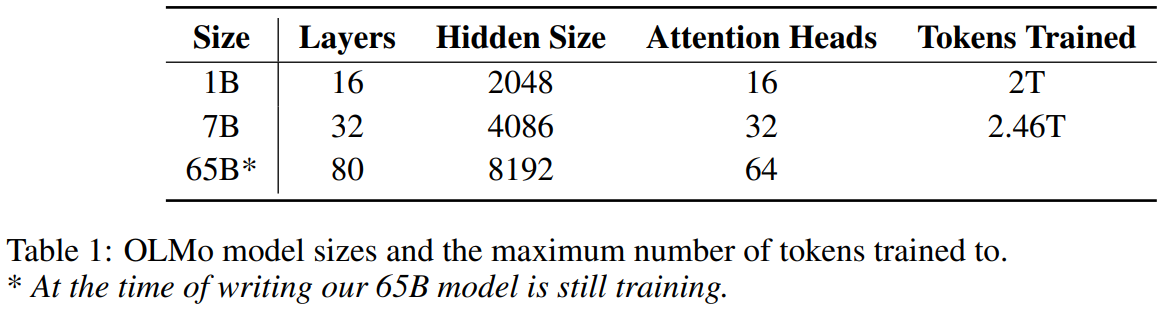

Q: OLMoを最先端の言語モデルにしている主な特徴と能力は何ですか?

A: OLMoは最先端の言語モデルであり、モデルの重みと推論コードだけでなく、学習データ、学習コード、学習・評価ツールなどを含むフレームワーク全体を公開しているため、真にオープンであると考えられています.この包括的なリリースは、研究コミュニティが言語モデル、その長所と短所、偏りやリスクを研究し、理解することを可能にします.OLMoは、そのモデルとLLaMA2のようなモデルの最先端の能力とのギャップを縮めます.OLMoフレームワークには、複数の訓練チェックポイント、訓練ログ、使用された正確なデータセット、および寛容なライセンスが含まれています.また、完全なモデル重み、トレーニングコード、トレーニングログ、アブレーション、トレーニングメトリクス、推論コードなど、言語モデルの構築や研究のためのツールやリソースも提供します.OLMoの最初のリリースには、7Bスケールの言語モデルが4種類、1Bスケールのモデルが1種類含まれており、すべて少なくとも2T個のトークンで訓練されている.さらに、何百もの中間チェックポイントがHuggingFaceのリビジョンとして利用可能です.

Q: OLMoは、パフォーマンスやアクセシビリティの点で、現在利用可能な他のオープン言語モデルと比較してどうですか?

A: OLMoは、他のオープン言語モデルと比較して、競争力のある適合性を持っていると考えられている.テクニカルレポートでは、OLMoがLLaMA2のような最先端の言語モデルとのギャップを縮めているとしている.報告書はまた、OLMoが、さまざまな程度のオープン性を持つ過去の取り組みから学んだ教訓の恩恵を受けていることにも言及している.著者らは、多様で大規模なオープンモデルの集団こそが、言語モデルの理解に関する科学的進歩と、オープンリサーチに関する工学的進歩のための最良の希望であると考えている.したがって、OLMoは、オープンリサーチコミュニティに力を与え、イノベーションを鼓舞することを目的とした、最先端の真にオープンな言語モデルとして位置づけられている.しかしながら、他のオープンな言語モデルとの具体的な性能やアクセシビリティの比較は、与えられた文脈の中では明示的に言及されていません.

Q: OLMoの具体的な使用例やアプリケーションは、自然言語処理研究と商業製品の両方で想定されていますか?

A: OLMoは、NLP研究と商用製品の両方で使用することができます.自然言語処理研究において、OLMoは最先端の言語モデルと、言語モデリングの構築と研究のためのフレームワークを提供します.完全なモデル重み、トレーニングコード、トレーニングログ、アブレーション、トレーニングメトリクス、推論コードなど、様々なツールやリソースが含まれています.研究者はOLMoを使用して、言語モデルの訓練とモデル化、事前訓練データの分析、下流タスクの評価、プレプレキシティベースの評価を行うことができます.OLMoはまた、異なるハードウェア・タイプにまたがる複数のトレーニング・チェックポイントを提供するため、研究者は既存のモデルを比較し、改善することができます.商用製品では、OLMoはチャットボット、バーチャルアシスタント、その他の自然言語処理アプリケーションの開発に使用できます.OLMoのオープンな性質と寛容なライセンスにより、幅広い採用が可能となり、特定の商用ユースケース向けにモデルをカスタマイズすることができます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: https://github.com/allenai/OLMo

Large Language Models for Mathematical Reasoning: Progresses and Challenges

著者:Janice Ahn, Rishu Verma, Renze Lou, Di Liu, Rui Zhang, Wenpeng Yin

発行日:2024年01月31日

最終更新日:2024年01月31日

URL:http://arxiv.org/pdf/2402.00157v1

カテゴリ:Computation and Language

概要:

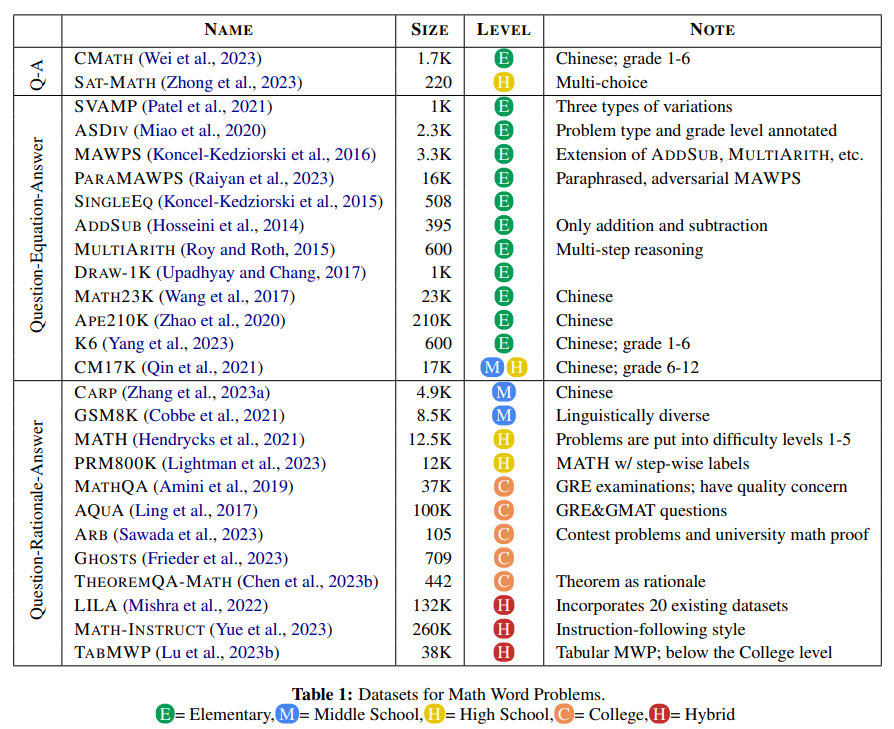

数学の領域におけるLLMの景観についての最初の包括的な調査として、この研究は以下の4つの重要な側面に取り組んでいます.まず、調査されたさまざまな数学の問題とそれに対応するデータセットの包括的な探索を行います.次に、数学の問題解決のために提案されたLLM指向の技術のスペクトルを検討します.さらに、数学の解決におけるLLMの影響要因と懸念事項の概要を提供します.最後に、この領域における持続的な課題を明確化します.この調査は、数学の領域におけるLLMの現状、成果、そして将来の課題について、包括的な視点を提供することで、この急速に進化する分野における真の進展と障害を明確にする機会を提供します.

Q&A:

Q: LLMを使って数学的問題を解くために特別に提案されたテクニックにはどのようなものがありますか?

A: 現在、LLMを使用して数学の問題を解決するために提案されているいくつかの技術があります.これらの技術には、テキストの理解、画像の解釈、表の分析、記号の操作、論理的な推論、世界知識の繊細な理解などが含まれます.

Q: 数学の解法におけるLLMの成績に影響を与える要因や懸念事項は何か?

A: LLMsの数学問題解決に影響を与える要因と懸念として、自信の提供、検証可能な説明、評価の欠如が特定されています.

Q: LLMを数学的推論に利用する分野で、いまだに根強く残る課題について説明していただけますか?

A: LLMsの数学的推論における課題は、いくつかの要素によって引き起こされています.まず第一に、LLMsが数学的な問題を解決するために必要な高度な数学的知識や理解力を持っていないことが挙げられます.LLMsは、テキストの理解や画像の解釈、記号操作など、数学的な概念や手法を熟知している必要がありますが、現在の技術ではまだ完全には実現されていません.第二に、LLMsの訓練に使用されるデータセットや評価基準の不足も課題となっています.統一されたフレームワークや標準化されたデータセットが欠如しているため、進歩の実際の範囲を正確に評価することが困難です.さらに、LLMsの数学的推論における課題は、この分野が急速に進化しているため、新たな課題や問題が常に現れることも挙げられます.LLMsの数学的推論のための最新の技術や手法に対応するためには、継続的な研究と開発が必要です.

Q: この調査は、数学の領域におけるLLMの現在の理解にどのように貢献しているのだろうか?

A: この調査は、数学の領域におけるLLMの現在の理解にどのように貢献しているかを明らかにするために、数多くの次元から得られた洞察を織り交ぜることで、LLM駆動の数学的推論の現在の状況、達成、課題、および進展について包括的な理解を提供することを目指しています.この調査は、数学の問題タイプとそれに関連するデータセットの入念な探索、LLMが数学の問題解決に使用する進化する技術の詳細な分析、LLMが数学の問題解決に影響を与える要因の検討、およびこの新興分野に潜む持続的な課題についての批判的な議論を含んでいます.この調査は、LLMの数学に特化した包括的な調査の一つであり、急速に進展するこの分野における進展の真の範囲を評価し、一貫した理解を妨げる課題を明らかにすることを目指しています.

Q: LLMとの関連で、数学的問題とそれに対応するデータセットを包括的に探求することの意義とは?

A: 数学の問題とそれに関連するデータセットを包括的に探求することは、LLMにとってどのような意義があるのかについて述べます.数学の問題とそれに関連するデータセットを包括的に探求することにより、LLMの数学問題解決における能力と性能を向上させることができます.具体的には、以下のような意義があります.

- 問題の種類とデータセットの理解:数学の問題は多様であり、それぞれの問題には異なる特徴や要件があります.データセットを包括的に探求することにより、LLMはさまざまな問題の特徴や要件を理解し、適切な解法を見つけることができます.

- 問題解決のための適切なデータセットの選択:数学の問題解決には、適切なデータセットの選択が重要です.包括的なデータセットの探求により、LLMは問題に適したデータセットを選択し、より正確な解法を見つけることができます.

- データセットの多様性と汎用性の向上:包括的なデータセットの探求により、LLMはさまざまな数学の問題に対応できるようになります.これにより、LLMの汎用性が向上し、さまざまな数学の問題に対して高い性能を発揮することができます.

- 研究の進展と応用の促進:包括的なデータセットの探求は、LLMの研究と応用の進展を促進します.新たな問題やデータセットの発見により、LLMの能力向上や新たな応用領域の開拓が可能となります.

総合すると、数学の問題とそれに関連するデータセットを包括的に探求することは、LLMの数学問題解決において重要な意義を持ちます.それにより、LLMの能力と性能の向上、問題解決の効率化、研究と応用の進展が促進されます.

Q: LLM指向のテクニックは、数学的問題解決への他のアプローチとどう違うのか?

A: LLM指向のテクニックは、数学的問題解決に対する他のアプローチとはいくつかの点で異なっている.第一に、LLM(言語・学習モデル)は数学に特化しており、つまり数学的問題を理解し解決するために設計されている.この専門性により、LLMは他のアプローチと比較して、数学的概念や推論をより深く理解することができる.第二に、LLMは、数学的な問題解決という課題に対して継続的に改善し、適応していく進化的なテクニックを採用している.これらのテクニックは、LLMの能力を活用し、数学の問題を解く際のパフォーマンスを向上させるために特別に設計されている.第三に、LLMは問題解決能力に影響を与える様々な要因を考慮に入れている.これらの要因には、数学問題の複雑さ、問題に関連するデータセット、その他の文脈情報が含まれる.これらの要素を考慮することで、LLMはより多くの情報に基づいた決定を下し、より正確な解を提供することができる.最後に、LLM指向の技術は、数学の分野で根強い課題に直面している.これらの課題には、数学的問題の種類が多様であること、評価のための統一的な枠組みがないこと、そしてこの分野の首尾一貫した理解の必要性などが含まれる.全体として、LLM指向の技法は、数学的問題解決に特化し進化するアプローチを提供し、様々な要因を考慮し、この分野の課題に対処する.

Q: 数学的推論にLLMを使用することの限界や欠点はありますか?

A: はい、数学的な推論においてLLMの使用にはいくつかの制限や欠点が特定されています.まず第一に、LLMは異なるテキスト形式(単語と数字を含む)で表された質問に対して一貫したパフォーマンスを示さないことがあります.同じ質問に対しても、LLMは異なる推論経路を通じて異なる最終的な回答を出すことがあります.さらに、事前学習された数学に特化したLLMは、敵対的な入力からの攻撃に対して脆弱であり、データの操作に対しても脆弱です.また、LLMによる数学的な推論は、ユーザー(学生など)のニーズや理解能力を考慮していないことも制限の一つです.例えば、YenとHsu(2023)の研究では、GPT-3.5が会話中に学生の質問を誤解し、適応的なフィードバックを提供できないことが判明しました.さらに、Gresham(2021)の研究では、GPT-4が実践的な観点を見落とすことが頻繁にありました.

Q: 数学的問題解決のためのLLMの分野で、将来的にどのような方向性や研究分野が考えられますか?

A: 数学的問題解決におけるLLMの将来の研究方向や領域には、以下のようなものが考えられます.まず第一に、数学的問題の種類やそれに関連するデータセットの詳細な探索が挙げられます.LLMがどのような問題を解決するために使用されているのか、どのようなデータが必要なのかを理解することは重要です.第二に、LLMが数学的問題解決において使用している進化した技術の詳細な分析が必要です.LLMがどのように問題を解決しているのか、どのような手法やアルゴリズムが使用されているのかを明らかにすることが重要です.第三に、LLMが数学的問題を解決する際に影響を与える要因の調査が必要です.例えば、データセットの品質や量、モデルの訓練方法などが問題解決にどのような影響を与えるのかを明らかにすることが重要です.最後に、この新興分野における現在の課題についての批判的な議論が必要です.LLMが直面している課題や制約、進歩の妨げとなっている要因を明らかにすることが重要です.これらの研究方向や領域に取り組むことで、LLMによる数学的問題解決の将来の発展に貢献することができるでしょう.

Corrective Retrieval Augmented Generation

著者:Shi-Qi Yan, Jia-Chen Gu, Yun Zhu, Zhen-Hua Ling

発行日:2024年01月29日

最終更新日:2024年01月29日

URL:http://arxiv.org/pdf/2401.15884v1

カテゴリ:Computation and Language

概要:

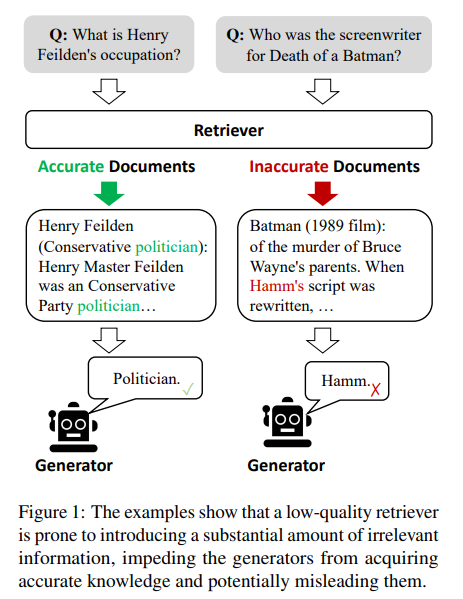

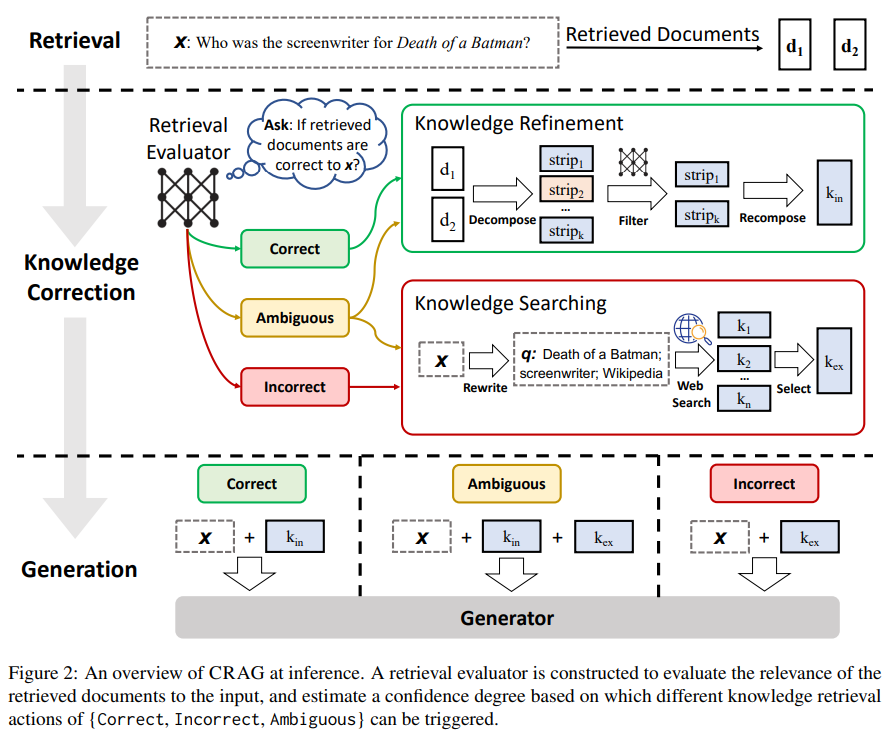

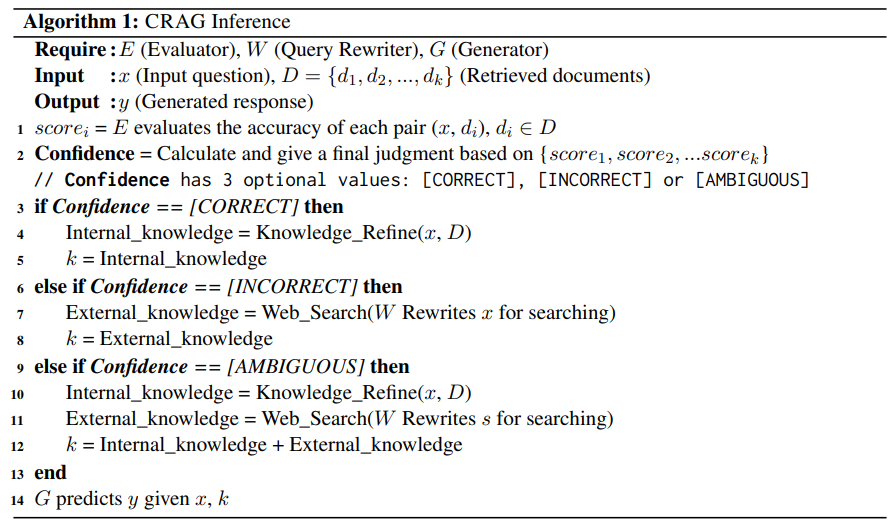

大規模言語モデル(LLM)は、生成されたテキストの正確さを保証するためにパラメータ的な知識だけに頼ることはできず、必然的に幻覚を生じさせます.検索補完生成(RAG)はLLMの実用的な補完ですが、懸念されるのは、検索がうまくいかない場合にモデルの振る舞いがどのようになるかということです.このため、私たちは「修正検索補完生成(CRAG)」を提案し、生成の堅牢性を向上させます.具体的には、軽量な検索評価器を設計し、クエリに対する検索結果の総合的な品質を評価し、信頼度を返します.この信頼度に基づいて、異なる知識検索アクションをトリガーすることができます.静的で限られたコーパスからの検索は、最適なドキュメントしか返せないため、大規模なウェブ検索を利用して検索結果を拡張します.さらに、検索されたドキュメントに対しては、分解して再構成するアルゴリズムが設計され、キー情報に重点を置き、関連しない情報をフィルタリングします.CRAGはプラグアンドプレイであり、さまざまなモデルにシームレスに組み込むことができます.さらに、短文と長文の生成タスクをカバーする4つのデータセットでの実験結果から、CRAGはRAGベースのアプローチの性能を大幅に向上させることが示されました.

Q&A:

Q: 大規模言語モデル(LLM)はどのように幻覚を見せるのか?

A: LLMが幻覚を示すのは、不正確で時代遅れの情報や、活性化された間違った知識との闘いによるものである.これは、大規模で無秩序なトレーニングデータ収集、質の高いサンプリングデータの割合の低さ、入力空間におけるデータ割り当ての不完全さによって引き起こされる可能性がある.これらの要因はLLMに影響を与え、幻覚の問題を悪化させる可能性がある.

Q: 検索補強世代(RAG)の主な関心事は何ですか?

A: RAGベースのアプローチは、検索に失敗した場合に、不正確な知識を生成LMにさらすことになる.

Q: 修正検索拡張生成(CRAG)は生成のロバスト性をどのように向上させるのか?

A: CRAGは、検索結果を自己修正し、検索された文書の利用率を高めることで、生成の頑健性を向上させる.これは、検索された文書の全体的な品質を評価し、3つのアクションを識別的にトリガーする検索評価器によって実現される.さらに、CRAGはウェブ検索と最適化された知識利用操作を利用し、自動的な自己修正と検索された文書の効率的な利用をさらに向上させる.実験により、CRAGはRAGベースのアプローチに適応可能であり、短文・長文生成タスクにわたって一般化可能であることが実証された.

Q: CRAGにおける軽量検索評価者の役割について教えてください.

A: 軽量の検索評価者は、CRAGにおいて取得された文書の総合的な品質を評価し、クエリに対して取得された文書の信頼性を評価するための重要なコンポーネントです.この評価者は、取得された文書の関連性と信頼性をレビューおよび評価することにより、情報の生成に貢献します.信頼度は、異なる知識検索アクションをトリガーするために基づいて定量化されます.

Q: CRAGの分解-再合成アルゴリズムはどのように機能するのか?

A: CRAGの分解-再構成アルゴリズムは、取得および利用プロセス全体で入念に作成されています.このアルゴリズムは、取得された情報の洗練、主要な洞察の抽出の最適化、非必要な要素の含有の最小化を保証し、取得されたデータの利用を向上させます.具体的には、CRAGは、取得されたドキュメントに含まれる不要な文脈を除去するために、分解-再構成アルゴリズムを使用します.このアルゴリズムは、取得されたドキュメントを分解し、主要な情報に焦点を当て、関連のない情報をフィルタリングします.そして、再構成されたドキュメントは、RAGにとって有益である情報のみを含むようになります.

Q: CRAGでは大規模なウェブ検索をどのように活用していますか?

A: CRAGでは、大規模なウェブ検索がリトリーバル結果を拡張するために利用されます.商用のウェブ検索APIを使用して、クエリごとに一連のURLリンクを生成し、ウェブページをナビゲートし、そのコンテンツを転写します.そして、セクション4.4と同じ知識の洗練手法を使用して関連するウェブ知識、つまり外部知識を抽出します.

Q: 検索評価者からの信頼度によって引き起こされる、さまざまな知識検索アクションの例を教えてもらえますか?

A: 検索結果の信頼度に基づいて、{正しい、間違っている、曖昧}の3つの異なる知識検索アクションがトリガーされます.

Q: CRAGは様々なRAGベースのアプローチとどのようにシームレスに組み合わされるのか?

A: CRAGは、さまざまなRAGベースのアプローチとシームレスに結びつけることができます.CRAGはプラグアンドプレイであり、RAGベースのアプローチに容易に組み込むことができます.

Q: 4つのデータセットを使った短文・長文生成タスクの実験結果は?

A: 実験の結果、CRAGは短文および長文生成タスクの両方で高い汎化性能を示しました.

Q: CRAGがRAGベースのアプローチで達成したパフォーマンスの具体的な向上について説明していただけますか?

A: CRAGは、RAGおよびSelf-RAGのパフォーマンスを大幅に改善することができます.具体的には、CRAGはPopQAでRAGよりも2.1%の精度向上、Self-RAGで2.8%の精度向上を達成しました.また、CRAGは異なるLLMベースのアプローチとも組み合わせることができ、その場合でも競争力のあるパフォーマンスを示しました.さらに、CRAGは特定のLLMに依存せず、将来のより高度なLLMと容易に組み合わせることができます.一方、Self-RAGは特定のLLMに依存し、追加の調整が必要です.

MoE-LLaVA: Mixture of Experts for Large Vision-Language Models

著者:Bin Lin, Zhenyu Tang, Yang Ye, Jiaxi Cui, Bin Zhu, Peng Jin, Jinfa Huang, Junwu Zhang, Munan Ning, Li Yuan

発行日:2024年01月29日

最終更新日:2024年02月04日

URL:http://arxiv.org/pdf/2401.15947v2

カテゴリ:Computer Vision and Pattern Recognition

概要:

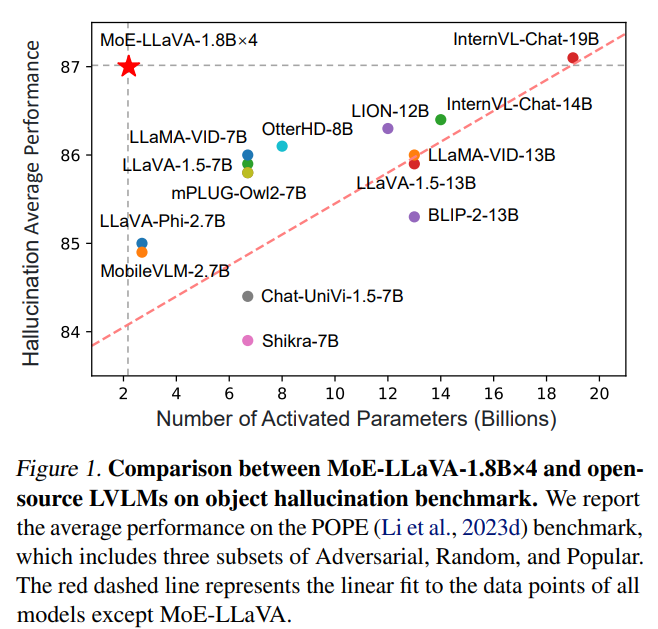

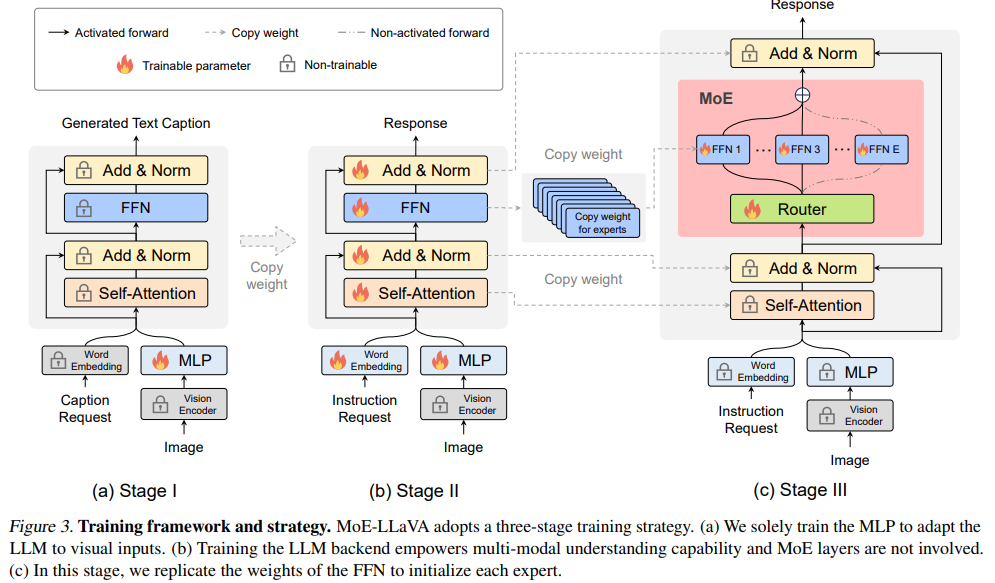

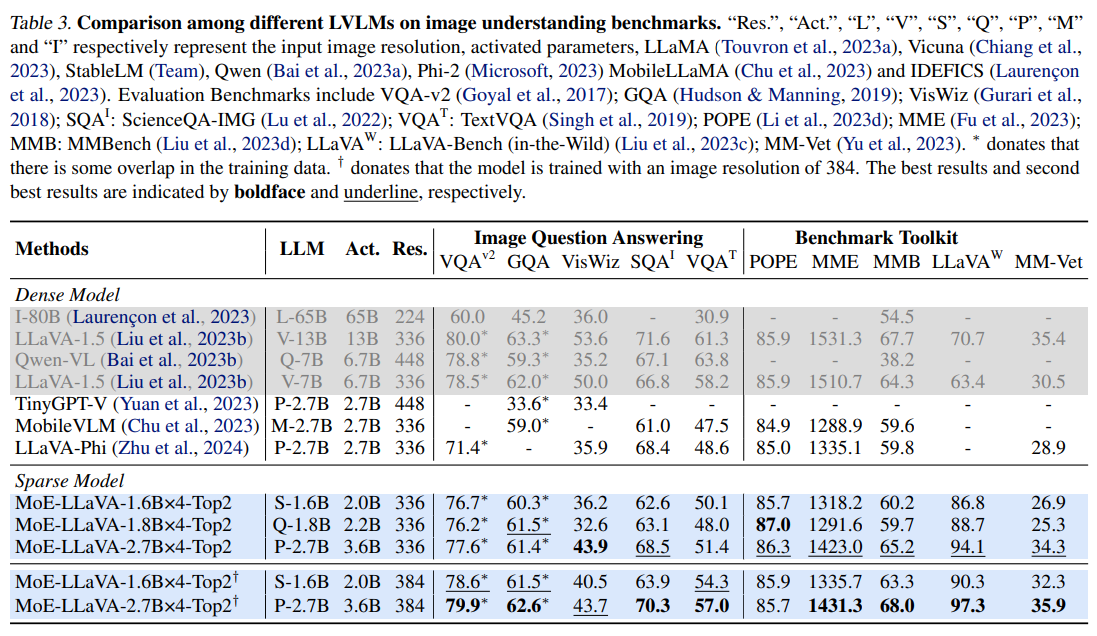

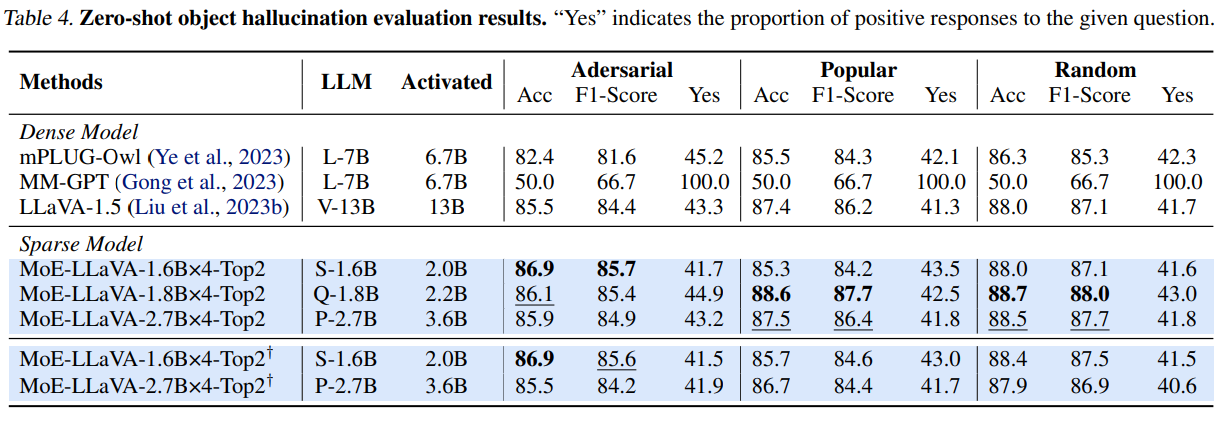

最近の進展により、大規模なビジョン-言語モデル(LVLM)のスケーリングが、ダウンストリームのタスクのパフォーマンスを効果的に向上させることが示されています.しかし、既存のスケーリング手法では、計算ごとにすべてのモデルパラメータがアクティブになるため、膨大なトレーニングおよび推論コストが発生します.本研究では、LVLMのためのシンプルかつ効果的なトレーニング戦略MoE-Tuningを提案しています.この戦略は、マルチモーダルなスパース学習におけるパフォーマンスの低下という一般的な問題を革新的に解決し、結果としてパラメータ数は膨大ですが、計算コストは一定のスパースモデルを構築します.さらに、MoE-LLaVAというMoEベースのスパースLVLMアーキテクチャを提案し、デプロイメント時にはトップkのエキスパートのみをルーターを介して活性化し、残りのエキスパートを非活性化します.さまざまなビジュアル理解データセットでのMoE-LLaVAの実験では、LLaVA-1.5-7Bと同等のパフォーマンスを示し、オブジェクト幻想のベンチマークではLLaVA-1.5-13Bを上回る結果が得られました.MoE-LLaVAを通じて、スパースLVLMのベースラインを確立し、より効率的かつ効果的なマルチモーダル学習システムの開発に向けた貴重な示唆を提供します.コードは\url{https://github.com/PKU-YuanGroup/MoE-LLaVA}で公開されています.

Q&A:

Q: LVLMのための学習戦略MoE-Tuningの主な目的は何ですか?

A: 提案されたトレーニング戦略MoE-Tuningの主な目的は、多モーダルのスパース学習における性能の低下の一般的な問題を解決し、非常に多くのパラメータを持つスパースモデルを構築することです.

Q: MoE-Tuningは、マルチモーダルなスパース学習におけるパフォーマンス低下の問題にどのように対処するのか?

A: MoE-Tuningは、マルチモーダルな疎性学習における性能の低下の問題に対処するために、3つのステージのトレーニング戦略を導入しています.最初のステージでは、MLPを使用して視覚トークンをLLMに適応させるためのトレーニングが行われます.これにより、LVLMの疎性化のための適切な初期化が行われます.2番目のステージでは、全体のLLMのパラメータがトレーニングされ、一般的なマルチモーダルな理解能力を持つLVLMを事前に強化します.最後に、3番目のステージでは、疎性によって引き起こされるモデルの低下を防ぐためにMoE-Tuningが適用されます.この3つのステージのトレーニング戦略により、LVLMが効果的にトレーニングされ、LLMからLVLMへの変換およびモデルの疎性化の過程での性能の低下が防止されます.

Q: MoEベースのスパースLVLMアーキテクチャであるMoE-LaVAのコンセプトを説明していただけますか?

A: MoE-LLaVAは、MoEベースの疎なLVLMアーキテクチャであり、3つのステージのトレーニング戦略であるMoE-Tuningを探求しています.このアーキテクチャは、計算コストを維持しながらパラメータの数を大幅に拡張します.MoE-LLaVAは、デプロイメント中にトップ-kのエキスパートのみを活性化し、残りのエキスパートを非活性化するモデルです.MoE-LLaVAは、視覚理解と物体幻覚のベンチマークで優れたマルチモーダル理解と幻覚軽減能力を持っています.約3Bの疎に活性化されたパラメータのみで、MoE-LLaVAは視覚理解のベンチマークでSOTA 7Bモデルと比較可能な性能を達成します.また、MoE-LLaVAは、約8倍の活性化パラメータを持つInternVL-Chat-19Bと比較可能なパフォーマンスを達成します.さらに、MoE-LLaVAは、ScienceQA、POPE、MMBench、LLaVAW、およびMM-VetでLLaVA-1.5-7Bをそれぞれ1.9%、0.4%、0.9%、30.7%、および3.8%上回る3.6Bの疎に活性化されたパラメータでスケールアップされます.MoE-LLaVAアーキテクチャとMoE-Tuning戦略の合理性は、広範な実験によって検証されています.

Q: MoE-LLaVAはどのようにして、展開中にルーターを通してトップkの専門家だけをアクティブにするのですか?

A: MoE-LLaVAは、ソフトルーターを使用して展開中にトップkの専門家のみを活性化します.ソフトルーターにより、異なる専門家間でデータの動的割り当てが可能となり、各専門家は自身の専門知識に集中し、モデルの疎な性能を実現することができます.専門家からの出力は、ルーターの重みに基づいた重み付き合計によって集約されます.トップkの専門家が活性化されると、残りの専門家は非活性のままです.このアプローチにより、MoE-LLaVAは無限に可能な疎な経路を形成し、幅広い機能を提供します.

Q: MoE-LLaVAを視覚理解や物体幻覚のベンチマークに使用する利点は何ですか?

A: MoE-LLaVAは、視覚理解と物体幻視のベンチマークにおいて、活性化されたパラメータが少ない密なモデルと同等、あるいはそれ以上の性能を示す.これは、疎なLVLMを利用し、与えられた質問に基づいた正確なフィードバックを提供することにより達成される.物体幻覚の評価では、MoE-LLaVAは与えられた画像と一致する物体を生成し、最高の性能を示した.敵対的サンプリング、一般的サンプリング、ランダムサンプリングではLLaV A-1.5-13Bを上回る.さらに、MoE-LLaVAは比較的バランスのとれたイエスレシオを維持し、正確なフィードバックを提供する能力を示している.MoE-LLaVAを視覚理解と物体幻覚ベンチマークに使用する利点は、同等以上の性能、疎なLVLMの利用、与えられた質問に基づく正確なフィードバックである.

Q: MoE-LLaVAの性能はLLaVA-1.5-7BやLLaVA-1.5-13Bと比べてどうですか?

A: MoE-LLaV AはLLaV A-1.5-7Bに匹敵する性能を示し、物体幻覚ベンチマークではLLaV A-1.5-13Bを上回る.

Q: MoE-LLVAでは、約3Bのパラメータがまばらに活性化されていることにどのような意味があるのでしょうか?

A: MoE-LLaVAは、約3Bの疎なパラメータを持つ視覚理解ベンチマークにおいて、SOTA 7Bモデルと同等の性能を達成した.

Q: MoE-LLaVAはスパースLVLMのベースライン確立にどのように貢献しているのか?

A: MoE-LLaVAは、エキスパートと学習可能なルータの混合を取り入れることで、スパースLVLMのベースラインの確立に貢献する.MoE-LaVAは複数のスパース経路から構成され、各トークンはルータを介して異なるエキスパートに送られる.アクティブなエキスパートはトークンをまとめて処理し、非アクティブなパスは沈黙を保つ.MoEエンコーダ層を繰り返し積み重ねることで、MoE-LLaVAはより大規模で強力なLVLMに向けたスパース経路を提供する.

Q: より効率的で効果的なマルチモーダル学習システムを開発するための、今後の研究の方向性について教えてください.

A: 現在の研究では、より効率的かつ効果的なマルチモーダル学習システムの開発に向けて、以下の方向性が提案されています.まず第一に、画像エンコーダとテキストエンコーダの統合を改善することが重要です.これにより、画像とテキストの情報をより効果的に統合し、より高度なマルチモーダルタスクを実現することができます.第二に、コンテキストを考慮した事前学習方法の開発が求められています.これにより、モデルはより多様なデータセットに対して適応性を持ち、より高いパフォーマンスを発揮することができます.第三に、マルチモーダルデータの効果的な統合と処理のための新しいアーキテクチャの開発が必要です.これにより、異なるモーダルの情報を効果的に統合し、より高度なマルチモーダルタスクを解決することができます.第四に、トレーニングデータの多様性を向上させるための新しいデータ拡張手法の開発が重要です.これにより、モデルはより多様なデータに対して頑健性を持ち、より高い汎化性能を発揮することができます.

Q: MoE-LLaVAのコードはどこで入手、ダウンロードできますか?

A: MoE-LaVAのコードは、https://github.com/PKU-YuanGroup/MoE-LLaVA でアクセスしてダウンロードすることができます.

Rephrasing the Web: A Recipe for Compute and Data-Efficient Language Modeling

著者:Pratyush Maini, Skyler Seto, He Bai, David Grangier, Yizhe Zhang, Navdeep Jaitly

発行日:2024年01月29日

最終更新日:2024年01月29日

URL:http://arxiv.org/pdf/2401.16380v1

カテゴリ:Computation and Language

概要:

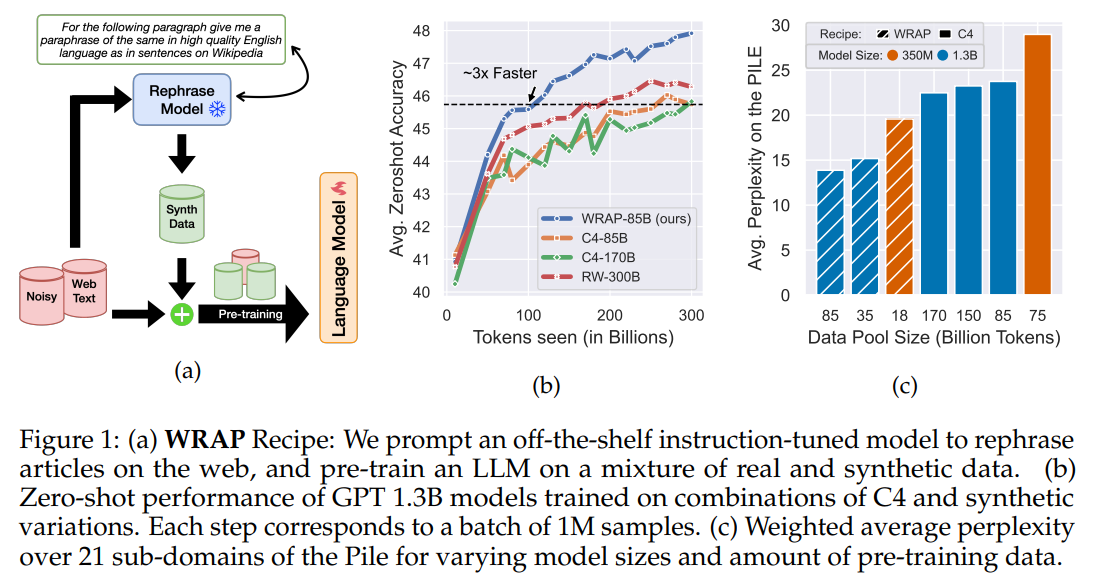

本研究では、WRAP(Web Rephrase Augmented Pre-training)を提案し、モデルの訓練データの構成がLLM(Large Language Models)の性能にどのような影響を与えるかについて調査しました.この提案では、オフシェルフのインストラクションに基づいてウェブ上のドキュメントを言い換えることで、実際のデータと合成された言い換えデータを使用してLLMを事前学習します.

さらに、新たな文脈によると、言い換えのスタイルがモデルの性能に与える影響についても調査しました.その結果、言い換えデータは単に実データよりも高い有用性を持つことがわかりました.なぜなら、言い換えデータは(i) ダウンストリームの評価スタイルに密接に反映されるスタイルの多様性を取り入れており、(ii) ウェブスクレイピングされたデータよりも高い「品質」を持っているからです.

これにより、WRAPを自然にノイズの多いC4データセットに適用することで、事前学習の速度が約3倍向上し、同じ計算予算の範囲内でPileの異なるサブセットにおいてパープレキシティを平均して10%以上改善し、13のタスクにおけるゼロショットの質問応答の精度を2%以上向上させることができることが示されました.

Q&A:

Q: 計算量、データ、学習されるモデルのサイズの関係を示す現在のスケーリング法則とは?

A: 現在のスケーリング則は、ホフマンらによって提案されたチンチラスケーリング則です.このスケーリング則は、モデルのサイズと必要なトレーニングデータ量の間に線形の関係があることを示しています.

Q: 大規模な言語モデルの事前学習にかかる計算コストと期間は?

A: 大規模な言語モデルの事前学習には、コンピュートコストと所要時間が関連しています.例えば、3000億トークンのトレーニングには256日のGPU時間がかかり、1つのモデルのトレーニングには約6,000時間のGPU時間が必要です.一方、13億のモデルのトレーニングには約30,000時間のGPU時間がかかります.したがって、13億のモデルのトレーニングのコストを3〜10倍削減することで、シングルランで合成データを使用したトレーニングのコストオーバーヘッドを組み込むことができます.

Q: Web Rephrase Augmented Pre-training (WRAP)は、Web上の文書を言い換えるために、市販の命令チューニングされたモデルをどのように使うのか?

A: Web Rephrase Augmented Pre-training (WRAP)は、ウェブ上のドキュメントを言い換えるためにオフシェルフの指示に調整されたモデルを使用します.具体的なスタイル(「Wikipediaのような」や「質問応答形式」など)でウェブ上のドキュメントを言い換えるように指示されたモデルを使用して、実際のデータと合成の言い換えを組み合わせてLLMsを共同で事前学習します.

Q: C4データセットにWRAPを使用した場合、事前学習の速度とプレプレキシティの改善という点でどのような影響があるのだろうか?

A: C4データセットでのWRAPの使用は、事前学習の速度を約3倍に加速させ、パープレキシティを平均して10%以上改善します.Pileの異なるサブセットにおいて、同じ事前学習の計算予算で、ゼロショットの質問応答の正答率を2%以上向上させます.

Q: WRAPはどのように異なるタスクのゼロショット問題の解答精度を向上させるのか?

A: WRAPは様々なタスクにおいてゼロショットの質問に対する回答精度を平均2%以上向上させます.WRAPは、ウェブの自然な多様性とデータのスタイルを活用することで、このような利益を達成している.合成データのみでの事前学習はパフォーマンスを著しく低下させ、実データの存在が重要であることを示している.WRAPはまた、複数の合成データセットを組み合わせることで、パフォーマンスをさらに向上させる.WRAPで学習したモデルは、実データのみで学習したモデルと比較して、当惑度が50%向上する.

Q: リフレーズスタイルがモデルのパフォーマンスに与える影響を調査することで、どのような洞察が得られるのか?

A: モデルのパフォーマンスにおける再表現スタイルの影響を調査することで得られる洞察は、以下の2つです.第一に、再表現された合成データは、単に実データよりも高い有用性を持つため、ダウンストリームの評価スタイルに密接に反映されるスタイルの多様性を取り入れています.第二に、再表現された合成データは、ウェブスクレイピングされたデータよりも高い品質を持っています.

Q: 再フレーズされた合成データや実データを含む学習データの構成は、分布外(OOD)設定におけるLLMの性能にどのような影響を与えるのか?

A: 訓練データの構成は、LLM(Large Language Model)のパフォーマンスに影響を与えます.特に、再表現された合成データと実データの組み合わせは、OOD(Out-of-Distribution)の設定でのLLMのパフォーマンスに影響を与えます.再表現された合成データは、単に実データを繰り返すよりも高い有用性を持ちます.なぜなら、再表現された合成データは、(i) ダウンストリームの評価スタイルに密接に反映されるスタイルの多様性を組み込んでおり、(ii) ウェブスクレイピングされたデータよりも高い品質を持っているからです.

Q: 実データを使った場合と比較して、再フレーズされた合成データの有用性は?

A: 再表現された合成データの有用性は、実データの単なる使用と比較して高いです.

Q: 下流の評価スタイルを反映したスタイルの多様性を、再フレーズされた合成データはどのように取り込むのか?

A: 再表現された合成データは、下流の評価スタイルに密接に反映されるスタイルの多様性を取り入れています.

Q: リフレーズされた合成データは、ウェブスクレイピングされたデータよりも質が高いのか?

A: 再表現された合成データは、ウェブスクレイピングされたデータよりも高品質である理由は、以下のような要素があるからです.まず第一に、再表現モデルは複数のスタイルを正確に捉えることができます.これにより、既存のデータの単なる繰り返しではなく、新たな価値を提供することができます.第二に、合成データは特定のドメインにおいてより良い汎化を実現するために有益なデータであることがあります.また、事前学習データセットにおいて表現されていないスタイルでのテキスト生成にも役立ちます.さらに、合成データの品質は合成データ生成器の品質にも依存します.合成データと実データのバランスも重要な設計選択肢であり、合成データによるトレーニングがエポックの増加によって収益が減少するタイミングも考慮する必要があります.

A Comprehensive Survey of Compression Algorithms for Language Models

著者:Seungcheol Park, Jaehyeon Choi, Sojin Lee, U Kang

発行日:2024年01月27日

最終更新日:2024年01月27日

URL:http://arxiv.org/pdf/2401.15347v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

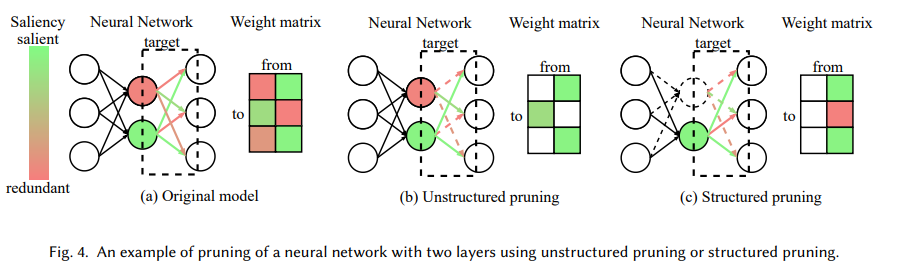

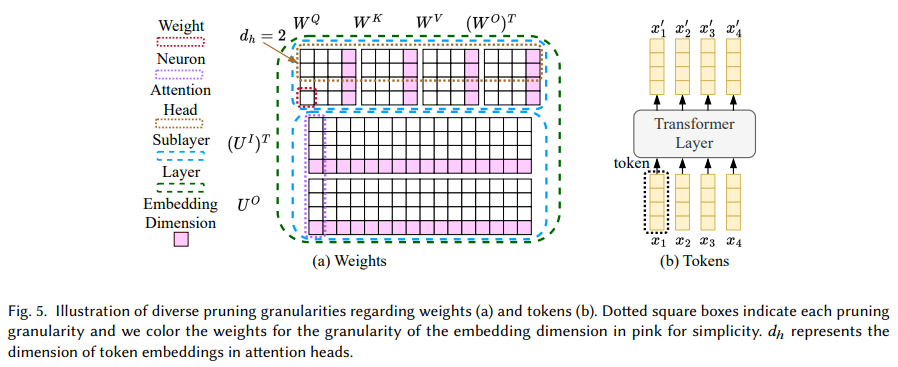

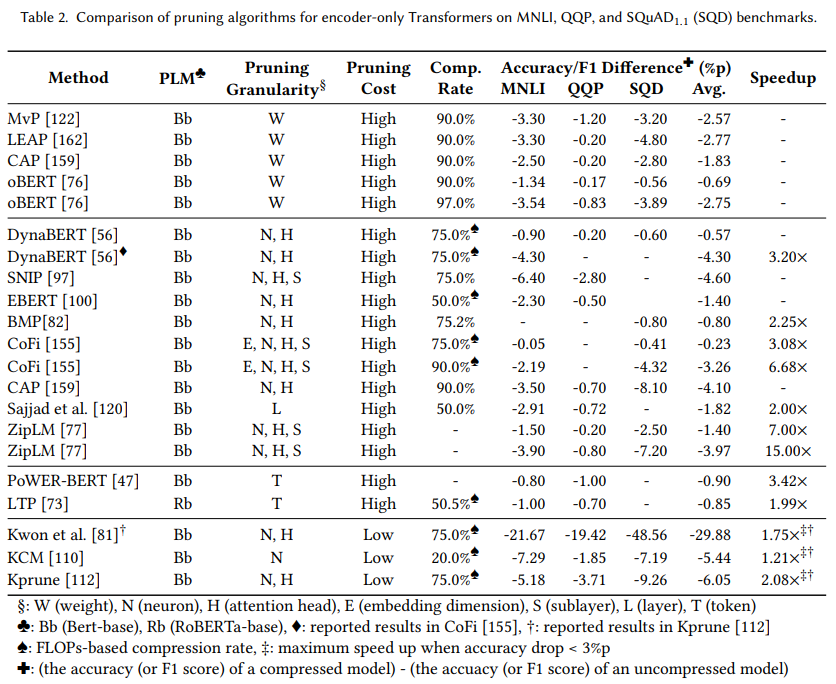

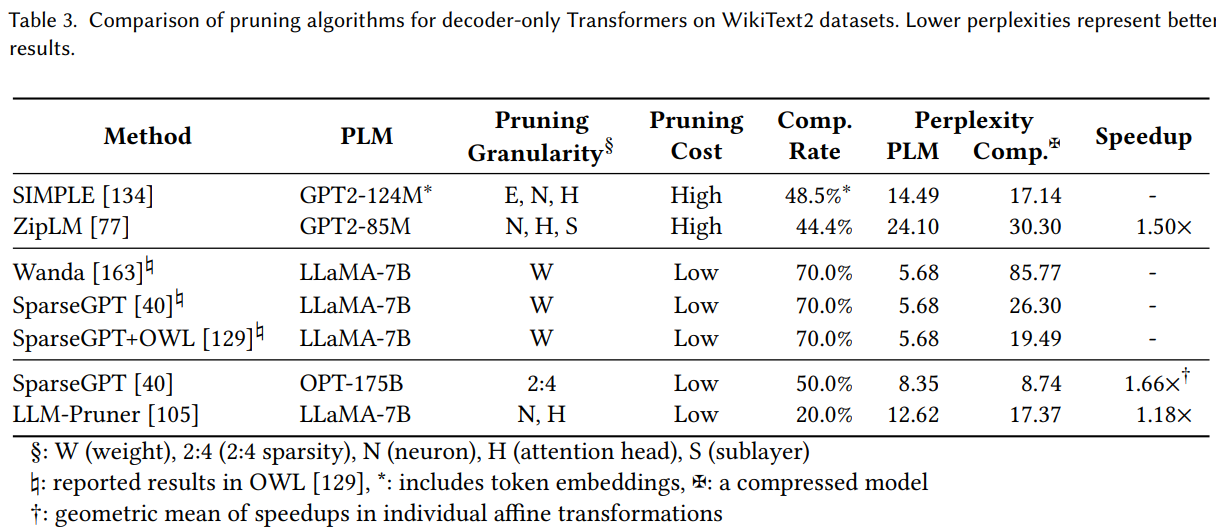

言語モデルの圧縮アルゴリズムの数は急速に増えており、巨大な言語モデルのサイズによる副作用を抑えるために、最近の言語モデルの驚異的な進歩を活用することが求められています.多くの圧縮アルゴリズムが言語モデルの圧縮において驚異的な進歩を示していますが、アルゴリズムの数が過剰になることで新たなトレンドを把握し、それらの基本的な概念を特定することが困難になっています.

本論文では、剪定、量子化、知識蒸留、低ランク近似、パラメータ共有、効率的なアーキテクチャ設計など、多様な圧縮アルゴリズムを調査し、まとめます.さらに、我々は多様な圧縮アルゴリズムの全体的なトレンドをまとめるだけでなく、代表的なアルゴリズムを選び、それらについて詳細な分析を提供します.また、各圧縮アルゴリズムの価値と、低コストの圧縮アルゴリズムの望ましい特性についても議論します.低コストの圧縮アルゴリズムは、新たなトレンドの出現により重要な影響を持つため、特に重要です.

さらに、大規模な言語モデルの出現により、圧縮アルゴリズムは重要性を増しています.本研究では、言語モデルの圧縮による精度の低下を防ぐ方法に焦点を当て、新たな研究トピックを提案します.これにより、言語モデルの圧縮における重要な課題に対処し、将来の研究の方向性を示します.

Q&A:

Q: 論文の主な目的は何か?

A: この論文の主な目的は、言語モデルの圧縮アルゴリズムに関する貴重な議論を提供し、有望な将来の研究トピックを紹介することです.

Q: 言語モデルの過剰なサイズは、二酸化炭素排出量や維持費にどう影響するのか?

A: 言語モデルの巨大なサイズにより、二酸化炭素の排出量が増加し、メンテナンス費用が高騰することがあります.

Q: 論文で言及されている圧縮アルゴリズムにはどのような種類がありますか?

A: 論文では、剪定、量子化、知識蒸留、低ランク近似、パラメータ共有、効率的なアーキテクチャ設計など、多様な圧縮アルゴリズムの概要がまとめられています.

Q: 各カテゴリーの代表的なアルゴリズムの例を教えてください.

A: 各カテゴリーの代表的なアルゴリズムの例は以下の通りです.

- Pruning(剪定)アルゴリズム:[47, 77, 112, 155]による剪定アルゴリズムは、GPU上での推論を即座に高速化する価値があります.剪定アルゴリズムは、最大で15倍の高速化性能を示します.

- Quantization(量子化)アルゴリズム:量子化アルゴリズムの代表的な例は文脈からは明確には示されていません.

- Knowledge Distillation(知識蒸留)アルゴリズム:知識蒸留アルゴリズムの代表的な例は文脈からは明確には示されていません.

- Low-rank Approximation(低ランク近似)アルゴリズム:低ランク近似アルゴリズムの代表的な例は文脈からは明確には示されていません.

- Parameter Sharing(パラメータ共有)アルゴリズム:パラメータ共有アルゴリズムの代表的な例は文脈からは明確には示されていません.

- Efficient Architecture Design(効率的なアーキテクチャ設計)アルゴリズム:効率的なアーキテクチャ設計アルゴリズムの代表的な例は文脈からは明確には示されていません.

Q: 多様な圧縮アルゴリズムに見られる全体的な傾向とは?

A: 多様な圧縮アルゴリズムにおいて、高コストの圧縮アルゴリズムから低コストのアルゴリズムへの移行が観察されている.

Q: 低コストの圧縮アルゴリズムに求められる特性とは?

A: 成功した低コストの圧縮アルゴリズムの望ましい特性は、以下の2つを満たすことが重要です.第一に、ローカルな層ごとの再構築エラーに頼るのではなく、タスク固有の目的関数を直接組み込むことが重要です.第二に、コスト効率の良い方法で言語モデルを段階的に圧縮する必要があります.

Q: 大規模な言語モデルは、低コストの圧縮アルゴリズムの意義にどのような影響を与えるのか?

A: 大規模な言語モデルの存在により、低コストの圧縮アルゴリズムの重要性が高まっています.これは、大規模な言語モデルを圧縮するために高コストのアルゴリズムを使用すると、時間がかかりすぎるためです.しかし、低コストの圧縮アルゴリズムは、比較的短い時間で言語モデルを圧縮することができます.大規模な言語モデルの普及に伴い、低コストの圧縮アルゴリズムは注目されており、その重要性が高まっています.

Q: 言語モデルを圧縮することで起こりうる副作用とは?

A: 言語モデルを圧縮することによる潜在的な副作用は、増加した炭素排出量と高額なメンテナンス費用です.

Q: 調査結果から示唆される今後の研究課題は?

A: 調査結果に基づいて提案された将来の研究トピックはありません.

SliceGPT: Compress Large Language Models by Deleting Rows and Columns

著者:Saleh Ashkboos, Maximilian L. Croci, Marcelo Gennari do Nascimento, Torsten Hoefler, James Hensman

発行日:2024年01月26日

最終更新日:2024年01月26日

URL:http://arxiv.org/pdf/2401.15024v1

カテゴリ:Machine Learning, Computation and Language

概要:

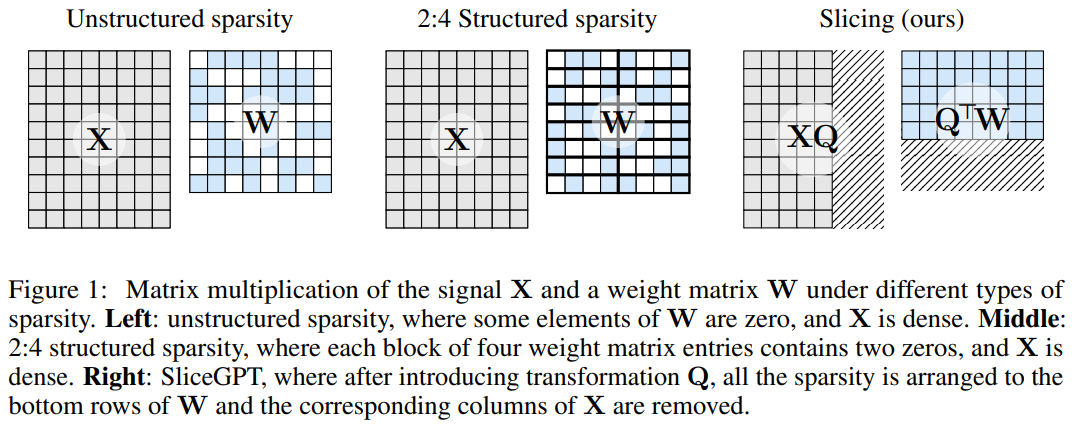

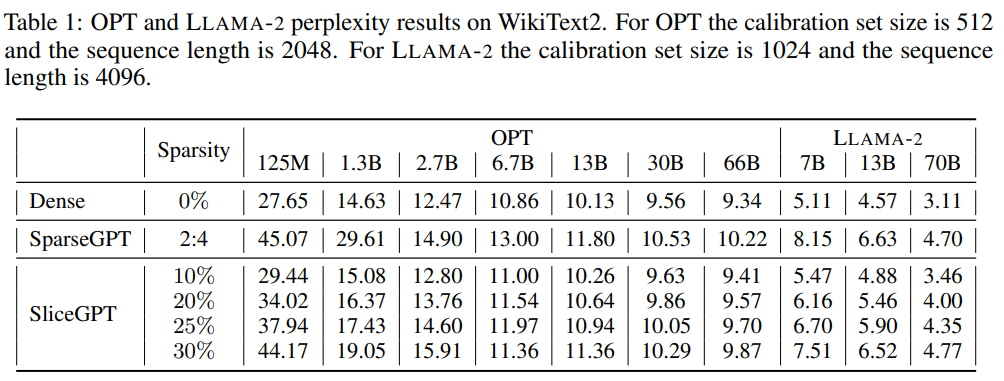

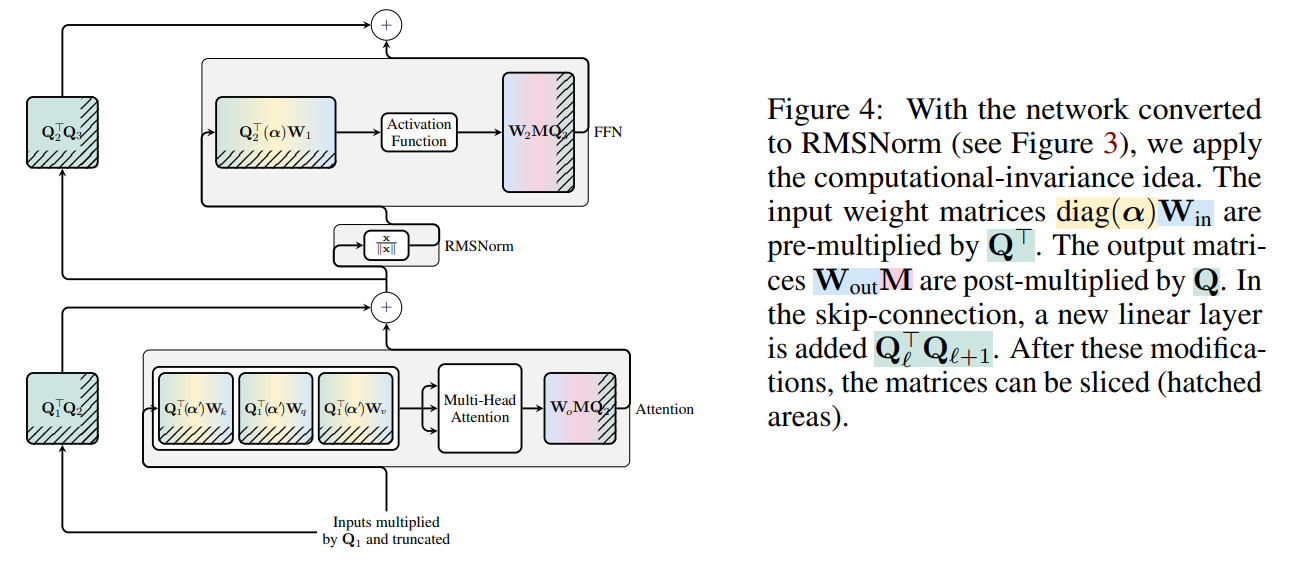

大規模な言語モデルは、自然言語処理の基盤となっていますが、その使用には計算およびメモリリソースの大きなコストがかかります.スパース化は、これらのリソース制約を緩和するための解決策を提供します.最近の研究では、訓練済みモデルを事後にスパース化することができることが示されています.既存のスパース化技術は、追加のデータ構造が必要であり、現在のハードウェアでは制約された高速化しか提供していません.本論文では、各重み行列をより小さな(密な)行列で置き換えることにより、ネットワークの埋め込み次元を削減する新しい事後トレーニングスパース化手法であるSliceGPTを提案します.詳細な実験を通じて、SliceGPTがLLAMA2-70B、OPT 66B、Phi-2モデルにおいて、モデルパラメータ(埋め込みを含む)を最大25%削減できることを示し、同時に密なモデルのゼロショットタスクパフォーマンスを99%、99%、90%維持できることを示します.スライスモデルは、追加のコード最適化なしでより少ないGPUで実行され、より高速に実行されます.LLAMA2-70Bの推論において、密なモデルの計算量をコンシューマーGPU上で64%、40GBのA100 GPU上で66%に削減します.また、本研究では、トランスフォーマーネットワークにおける計算的不変性という新たな洞察を提供し、SliceGPTを可能にすることで、事前学習済みモデルのメモリと計算要件を削減するための将来の取り組みにインスピレーションを与えることを期待しています.詳細なコードは以下のリンクから入手できます:https://github.com/microsoft/TransformerCompression

Q&A:

Q: 論文 “SliceGPT “の主な目的は何ですか?行や列を削除することで大規模言語モデルを圧縮する “とは?

A: 本論文「SliceGPT: 行と列を削除して大規模言語モデルを圧縮する」の主な目的は、大規模言語モデルのリソース制約を緩和するためのスパース化技術を提案することです.

Q: 大規模な言語モデルにおいて、スパース化はどのようにリソースの制約を緩和するのか?

A: スパース化は、大規模な言語モデルにおけるリソース制約を緩和するために役立ちます.スパース化は、モデルの重み行列をより小さな(密な)行列に置き換えることによって、埋め込み次元を削減します.これにより、計算およびメモリリソースの使用量が減少し、モデルのサイズを小さくすることができます.スパース化によって、モデルの推論や学習の速度も向上することが示されています.また、スパース化は、現在のハードウェアにおいても制約された高速化を提供します.

Q: 既存のスパース化技術が直面している課題とは?

A: 既存の疎行列化技術は、追加のデータ構造が必要であり、現在のハードウェアでは制約付きの高速化しか提供できないという課題に直面しています.

Q: SliceGPTと他の学習後のスパース化スキームとの違いは?

A: SliceGPTが他の学習後のスパース化スキームと異なる点は、他のプルーニング手法が通常個々の重みを除去するのに対して、重み行列の行または列全体を除去する点である.スライスする前に、SliceGPTはネットワークの変換を1回だけ行い、予測は不変のまま、スライスの影響をわずかしか与えないようにする.このアプローチは、各重み行列をより小さな(密な)行列に置き換えることで、ネットワークの埋め込み次元を削減します.さらに、SliceGPTは追加のデータ構造を必要とせず、既存のスパース化手法と比較して、現在のハードウェアで高速化を実現します.

Q: SliceGPTがネットワークのウェイト行列のサイズに与える影響は?

A: SliceGPTは、重み行列の行または列全体を刈り込むことによって、ネットワーク内の重み行列のサイズを縮小します.

Q: SliceGPTは、モデルのパラメータを減らしながら、どのようにしてタスクのパフォーマンスを維持しているのでしょうか?

A: SliceGPTは、エンベッディングを含むモデルパラメータの最大25%を除去するスライス技法を用いることで、モデルパラメータを削減しながらタスクの性能を維持し、なおかつダウンストリームタスクで高い性能を維持します.このスライス技法は、変換ネットワークの計算不変性に基づいています.不要なパラメータを削除することで、SliceGPTはモデルのメモリと計算要求を削減し、より高速で効率的な実行を可能にします.さらに、SliceGPTは刈り込み後のリカバリー微調整(RFT)を必要としないため、全体的なプロセスがより安価になり、スケーリングが容易になります.

Q: SliceGPTを可能にする変圧器ネットワークの計算不変性とは?

A: SliceGPTは、トランスフォーマーネットワークの計算不変性に依存しています.これは、あるコンポーネントの出力に直交変換を適用しても、次のコンポーネントでそれが元に戻される限り、直交変換を適用することが可能であることを意味します.この計算不変性により、SliceGPTは、ブロック間の信号行列を自身の主成分に投影することで、トランスフォーマ・アーキテクチャの各ブロックを編集することができます.変換されたウェイト行列の列または行を削除することで、SliceGPTはモデルサイズを縮小することができます.

Q: SliceGPTは、異なるGPUモデルでの推論に必要な計算量にどのような影響を与えるのでしょうか?

A: SliceGPTは、異なるGPUモデルでの推論に必要な計算量を削減します.コンテキストによると、Quadro RTX6000 GPUとA100 GPUでOPT 66BモデルとLLAMA -270Bモデルの単一のトークンを生成する時間を比較した場合、SliceGPTはRTX6000 GPUで16~17%、A100 GPUで11~13%の高速化を示しています.この計算要件の削減は、重み行列をより小さいものに置き換え、圧縮モデルで密なカーネルを使用するアプローチに起因しています.さらに、SliceGPTは大規模なモデルにおいてSparseGPTと比較して高速化と複雑度の点で優れていることが述べられています.したがって、SliceGPTは、異なるGPUモデルにおける計算要件を削減することで、推論の効率を向上させる.

The Power of Noise: Redefining Retrieval for RAG Systems

著者:Florin Cuconasu, Giovanni Trappolini, Federico Siciliano, Simone Filice, Cesare Campagnano, Yoelle Maarek, Nicola Tonellotto, Fabrizio Silvestri

発行日:2024年01月26日

最終更新日:2024年01月29日

URL:http://arxiv.org/pdf/2401.14887v2

カテゴリ:Information Retrieval, Computation and Language

概要:

これらの結果は、品質の低下という初期の仮定に反するものであり、その必要性を強調しています.これは、リトリーバーと言語生成モデルを統合するための専門戦略の開発の必要性を示しており、この分野における将来の研究の基盤を築くものです.

Q&A:

Q: 検索支援生成(RAG)システムと従来の大規模言語モデル(LLM)の主な違いは何ですか?

A: Retrieval-Augmented Generation (RAG)システムと従来のLarge Language Models (LLMs)の主な違いは、RAGシステムが情報検索(IR)フェーズを通じて外部データを取り込むことで、生成能力を向上させる点です.一方、LLMsは事前学習された知識と限られた文脈ウィンドウに制約されています.

Q: RAGシステムはどのようにして発電能力を高めているのか?

A: RAGシステムは、情報検索(IR)フェーズを通じて外部データを取り込むことで、生成能力を向上させます.これにより、従来の大規模言語モデル(LLM)の制約を克服します.通常のLLMは、事前学習された知識と限られたコンテキストウィンドウに制約されていますが、RAGシステムは外部情報を取り込むことで、生成能力を強化します.RAGシステムは、IRコンポーネントを組み込むことによって、LLMの効果的なコンテキストサイズを拡大します.IRコンポーネントは、応答生成プロセス中に関連する外部情報を動的に取得する役割を果たします.これにより、モデルがアクセスできるデータの範囲が拡大し、初期入力を超えたコンテキストウィンドウが提供されます.

Q: RAGシステムが克服する標準的なLLMの限界とは?

A: RAGシステムは、標準的なLLMの限界である、限られた、あるいは時代遅れの事前訓練された知識と限られたコンテキストウィンドウを克服している.RAGシステムには、応答生成プロセス中に関連する外部情報を動的に取得するIRコンポーネントが組み込まれており、モデルがアクセス可能なデータの範囲を大幅に拡大し、そのコンテキストウィンドウを初期入力よりも拡張する.これにより、RAGシステムは、事前学習フェーズで注入された知識のみに依存するのではなく、外部情報へのアクセスをモデルに提供することで、事実精度を向上させることができる.

Q: この分野での研究の焦点は何ですか?

A: この領域のほとんどの研究は、取得された文書がRAGフレームワークにどのように影響を与えるかを理解することに焦点を当てています.

Q: この研究が埋めようとしているギャップとは何か?

A: この研究は、検索されたドキュメントがRAGフレームワークにどのように影響を与えるかに焦点を当て、RAGシステムのためのプロンプト構築に必要な特性を理解することを目的としています.

Q: 本稿はRAGシステムの具体的などの側面を分析しているのか?

A: この論文では、RAGシステムの内部機能を探求し、IRコンポーネントがRAGシステムに与える影響を徹底的かつ批判的に分析しています.

Q: 効果的なRAGのプロンプトの形成には、リトリーバーがどのような特性を持つべきですか?

A: 効果的なRAGのプロンプト形成には、リトリーバーが持つべき特性があります.具体的には、プロンプトと関連性のある文書の選択、文書の位置、およびコンテキストに含まれる文書の数などが重要です.

Q: この研究では、検索された文書についてどのような要素が評価されるのか?

A: この研究では、文書の関連性、位置、および文脈に含まれる文書の数など、さまざまな要素が評価されています.

Q: 文書とプロンプトの関連性について、どのような発見がありましたか?

A: 文脈に関連しない文書を含めることが予想外にパフォーマンスを向上させることがわかった.

Q: 関連性のない文書が含まれていたことは、RAGシステムのパフォーマンスにどのような影響を与えたか?

A: ノイズとしての無関係な文書の追加は、RAGシステムのパフォーマンスを悪化させることが期待されましたが、実際には逆にパフォーマンスが向上しました.ノイズの存在下でもパフォーマンスは悪化せず、むしろ最適な設定ではパフォーマンスが向上しました.

MM-LLMs: Recent Advances in MultiModal Large Language Models

著者:Duzhen Zhang, Yahan Yu, Chenxing Li, Jiahua Dong, Dan Su, Chenhui Chu, Dong Yu

発行日:2024年01月24日

最終更新日:2024年01月25日

URL:http://arxiv.org/pdf/2401.13601v2

カテゴリ:Computation and Language

概要:

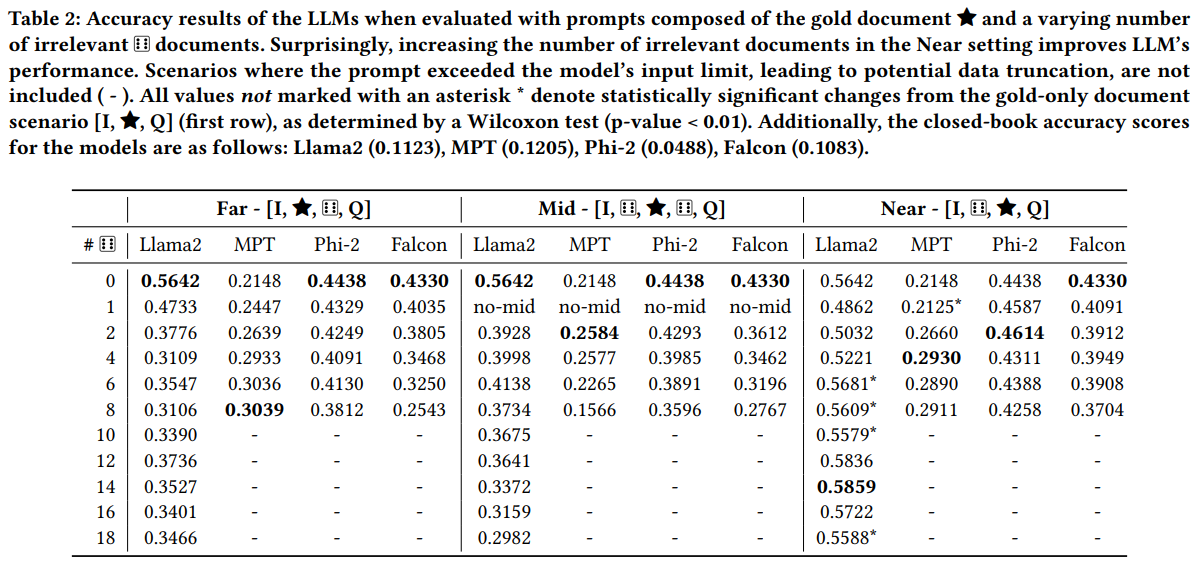

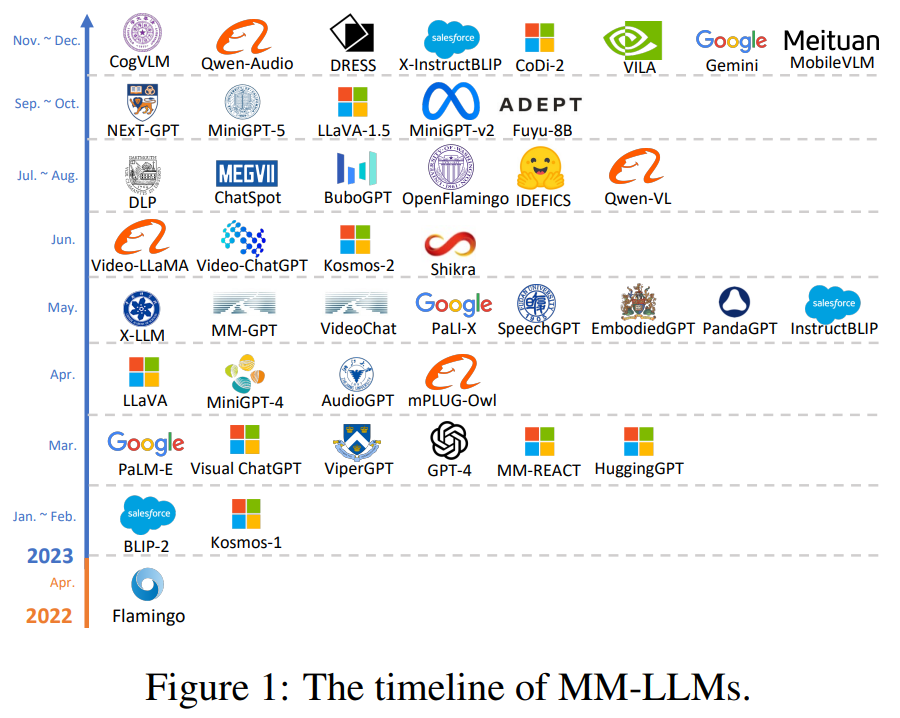

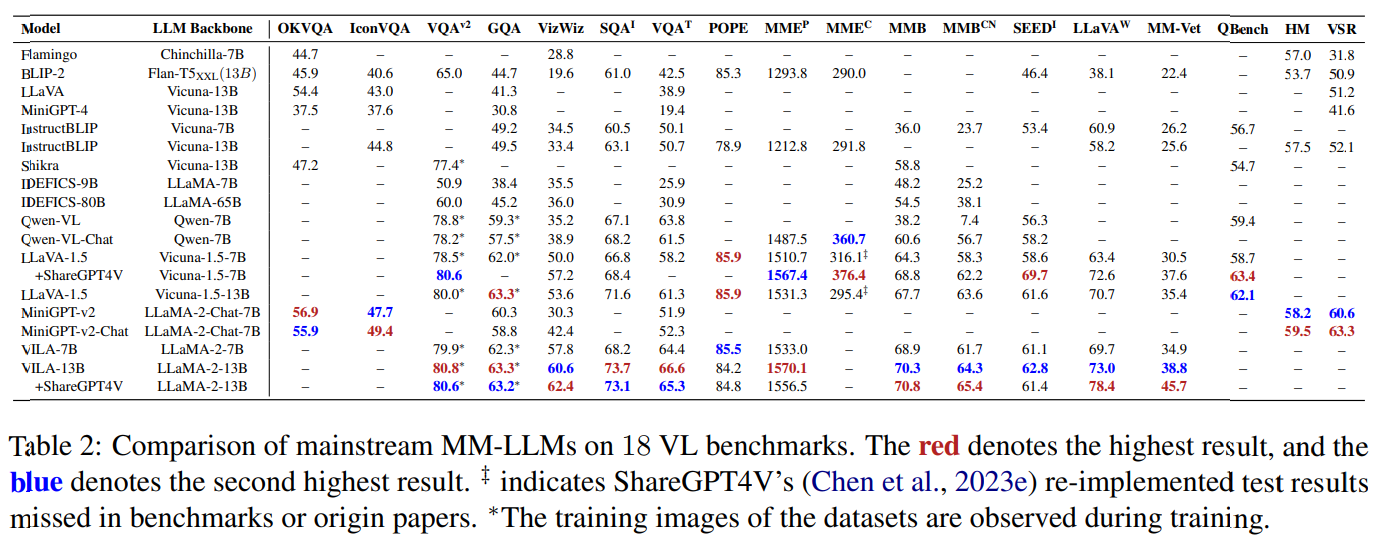

過去1年間、MultiModal Large Language Models(MM-LLMs)は大きな進歩を遂げ、コスト効果の高いトレーニング戦略を用いて、オフシェルフのLLMsを拡張してMM入力または出力をサポートするようになりました.その結果、これらのモデルはLLMsの固有の推論と意思決定能力を保持するだけでなく、多様なMMタスクにも対応することができます.本論文では、MM-LLMsのさらなる研究を促進するための包括的な調査を提供します.具体的には、まずモデルアーキテクチャとトレーニングパイプラインの一般的な設計形式を概説します.その後、各モデルの具体的な設計によって特徴付けられる26の既存のMM-LLMsについて簡単に紹介します.さらに、MM-LLMsの主要なベンチマークでのパフォーマンスをレビューし、MM-LLMsの能力を向上させるための主要なトレーニング手法をまとめます.最後に、MM-LLMsの有望な方向性を探りながら、最新の開発動向をリアルタイムで追跡するウェブサイトも提供します.この調査がMM-LLMsの領域の進歩に貢献することを期待しています.

Q&A:

Q: マルチモーダル大規模言語モデル(MM-LLM)の最近の進歩は?

A: MM-LLMは近年大きな進歩を遂げている.これらの進歩は、既製の大規模言語モデル(LLM)を補強し、費用対効果の高い学習ストラテジーによってマルチモーダル(MM)入出力をサポートすることを含む.その結果、LLMが本来持っている推論能力や意思決定能力が維持されるだけでなく、多様なMMタスクに対応できるようになる.MM-LLMの進歩は、様々なダウンストリームタスクにおいて性能の限界を押し広げています.しかし、従来のMMモデルは、特にゼロから学習する場合、かなりの計算コストがかかる.この問題に対処するため、研究者はさまざまなモデルアーキテクチャと学習パイプラインを模索してきた.また、既存の26のMM-LLMに固有の定式化を導入し、それぞれ独自の設計を特徴としている.さらに、主要なベンチマークにおけるMM-LLMの性能をレビューし、MM-LLMの能力を高めるための重要なトレーニングレシピをまとめた.MM-LLMの有望な方向性についても検討し、この分野の最新動向をリアルタイムで追跡できるウェブサイトを整備した.

Q: MM-LLMは、MMの入力や出力をサポートするために、既製のLLMをどのように補強するのか?

A: MM-LLMは、LLMを他のモダリティのモデルと効果的に接続し、協調推論を可能にすることで、MMの入力または出力をサポートするために既製のLLMを補強します.これは、MMプリトレーニング(PT)MMインストラクション・チューニング(IT)パイプラインにより、モダリティ間のアライメントを精緻化し、人間の意図に合わせることで達成される.

Q: MM-LLMにおけるモデル・アーキテクチャとトレーニング・パイプラインの具体的な定式化とは?

A: MM-LLMsのモデルアーキテクチャの具体的な形式は、Modality Encoder、Input Projector、LLM Backbone、Output Projector、Modality Generatorの5つのコンポーネントから構成されています.モデルアーキテクチャは、異なるモダリティの入力をエンコードし、プロジェクトし、バックボーンで処理し、出力をプロジェクトし、モダリティを生成する役割を果たします.トレーニングパイプラインは、テキストのみのLLMをMM入力または出力をサポートするように拡張する方法を説明します.主にMM PTとMM FTの2つのステージで構成されています.MM PTでは、テキストのみのLLMを事前学習し、MM入力に対応させるための方法が説明されます.MM FTでは、MM入力を使用してLLMをファインチューニングする方法が説明されます.

Q: 既存の26のMM-LLMとその具体的な処方について簡単に紹介してもらえますか?

A: 26の既存のMM-LLMの簡単な紹介とそれぞれの具体的な公式を提供します.

Q: MM-LLMはメインストリームのベンチマークでどのような性能を発揮するのか?

A: MM-LLMsの主流ベンチマークにおけるパフォーマンスは、論文のセクション5で包括的にレビューされています.論文では、主要なMM-LLMsの主流ベンチマークにおけるパフォーマンスについて議論し、その有効性を高めるための主要なトレーニングレシピを抽出しています.また、ウェブサイト(https://mm-llms.github.io)も設立され、MM-LLMsの最新の進展を追跡し、クラウドソーシングの更新を容易にするためのものです.

Q: MM-LLMの能力を高めるための重要なトレーニングレシピとは?

A: MM-LLMsの効力を高めるための主なトレーニングレシピは、高い画像解像度と隣接するビジュアルトークンの結合です.高い画像解像度は、細かい詳細が必要なタスクに役立ちますが、トークンシーケンスの長さが増え、トレーニングと推論のコストが増加します.MiniGPT-v2は、埋め込み空間で4つの隣接するビジュアルトークンを連結することで、この問題に対処しています.

Q: MM-LLMの今後の有望な方向性は?

A: MM-LLMsの将来の有望な方向性には、以下のようなものがあります.まず、モデルのスケールとデータセットの拡大に伴い、従来のMMモデルは計算コストが非常に高くなるため、効率的なモデル圧縮や軽量化の研究が重要です.また、異なるモダリティの統合においては、より高度な特徴の抽出や表現学習が求められます.さらに、MM-LLMsの応用範囲を拡大するために、新たなデータセットやベンチマークの構築が必要です.さらなる研究の進展に向けて、モデルの解釈性や説明性の向上も重要な課題です.最後に、リアルタイムなトラッキングウェブサイトの維持と共に、MM-LLMsの最新の発展動向を追跡することも重要です.

Q: 同紙は、この分野の最新動向をリアルタイムで追跡できるウェブサイトをどのように維持しているのか?

A: 論文は、リアルタイムのトラッキングウェブサイトを設立し、クラウドソーシングを利用して最新の進展をキャプチャすることで、フィールドの最新の動向を追跡しています.

Q: この調査は、MM-LLMs領域の継続的な発展にどのように貢献しますか?

A: この調査は、MM-LLMsの領域の進展に貢献することを目指しています.具体的には、一般的な設計の形成とトレーニングの手順について詳細な概要を提供し、26の既存のMM-LLMsの簡単な紹介を行います.さらに、MM-LLMsの性能についてのレビューを行い、主要なトレーニングのレシピをまとめてMM-LLMsの効力を向上させます.最後に、MM-LLMsの有望な方向性を探求し、同時に最新の開発をリアルタイムで追跡するウェブサイトを維持することで、MM-LLMsの進展に貢献することを期待しています.

Q: MM-LLMに関連して、対処すべき限界や課題はありますか?

A: MM-LLMsにはいくつかの制限や課題があります.まず、この分野は非常に動的であり、最新の進展が完全に網羅されていない可能性があります.そのため、リアルタイムなトラッキングを行うためのウェブサイトが設立され、クラウドソーシングを利用して最新の進展を捉えることが試みられています.また、ページの制約により、すべての技術的な詳細には踏み込むことができず、コアな貢献の簡潔な概要が提供されています.

さらに、既存のベンチマークはMM-LLMsの能力に十分な挑戦を与えていない可能性があります.多くのデータセットが以前にPTまたはITセットにある程度登場しているため、モデルはこれらのタスクを学習している可能性があります.また、現在のベンチマークは主にVLサブフィールドに集中しています.そのため、より挑戦的で大規模なベンチマークを構築し、さらに多様なモダリティを含み、統一された評価基準を使用することがMM-LLMsの開発には重要です.同時に、ベンチマークはMM-LLMsの実用的な応用能力を評価するためにカスタマイズすることができます.例えば、GOAT-Bench(Lin et al.、2024)の導入は、ミームで提示される社会的虐待の微妙な側面を識別し、対応する能力をさまざまなMM-LLMsで評価することを目的としています.

さらに、MM-LLMsをリソース制約のあるプラットフォームや低消費電力のモバイルやIoTデバイスに展開し、最適なパフォーマンスを実現するためには、軽量な実装が非常に重要です.この領域での注目すべき進展として、MobileVLM(Chu et al.、2023a)があります.このアプローチでは、LLaMAを戦略的にダウンスケールして、シームレスな展開を可能にしています.