ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Video generation models as world simulators

発行日:2024年02月15日

この研究では、ビデオ生成モデルSoraが世界シミュレーターとして活用する可能性を示しています.Soraは、様々な入力(画像やプロンプトなど)に基づいてビデオを生成し、時間を前後に調整することが可能です.さらに、ビデオ間で滑らかな遷移を作成し、一貫した三次元空間を通じて人々やシーンの要素を移動させる能力も持っています.

また、Soraは、世界の状態を変化させるアクションをシミュレートしたり、ビデオゲームのプロセスをシミュレートする能力もあります.例えば、画家がキャンバスに新しいストロークを残すシーンや、男性がバーガーを食べてかじり跡を残すシーンを生成することができます.さらに、「Minecraft」などのキャプションを提示した場合には、ゲームのプレイヤーを制御しながら世界をレンダリングすることができます.

しかしながら、Soraは現在、多くの基本的な相互作用の物理を正確にモデル化していないため、ガラスが割れるような相互作用を正確に再現できません.また、食事などの相互作用では、オブジェクトの状態が正しく変化しないことがあります. - Gemini 1.5: Unlocking multimodal understanding across millions of tokens of context

発行日:2024年02月15日

Geminiファミリーの最新モデルであるGemini 1.5 Proは、革新的なエキスパートモデルの混合アーキテクチャやトレーニングおよびサービングインフラの進歩を取り入れ、非常に長いコンテキストを処理し、多くのベンチマークで優れたパフォーマンスを発揮する. - Revisiting Feature Prediction for Learning Visual Representations from Video

発行日:2024年02月14日

V-JEPAは、ビデオからの教師なし学習のための特徴予測を探求し、トレーニングされたビジョンモデルのコレクションであり、特徴予測の効果を評価する研究を紹介しています.最新のコンテキストによると、V-JEPAは、ビデオ共同埋め込み予測アーキテクチャとして形成され、様々なタスクで優れたパフォーマンスを示し、ピクセル予測方法よりも短いトレーニングスケジュールで効果的に機能することが示唆されています.特徴予測でトレーニングされたモデルは、ラベルの効率が良く、凍結評価やエンドツーエンドのファインチューニングにおいて競争力があります. - Automated Unit Test Improvement using Large Language Models at Meta

発行日:2024年02月14日

MetaのTestGen-LLMツールは、LLMを使用して既存のテストを改善し、InstagramとFacebookとプラットフォームでの展開に成功しました. - World Model on Million-Length Video And Language With RingAttention

発行日:2024年02月13日

長いビデオと言語シーケンスをトレーニングするための新しいモデルと技術を開発し、人間の知識と物理世界の理解を組み合わせたAI機能の拡充を可能にする. - OS-Copilot: Towards Generalist Computer Agents with Self-Improvement

発行日:2024年02月12日

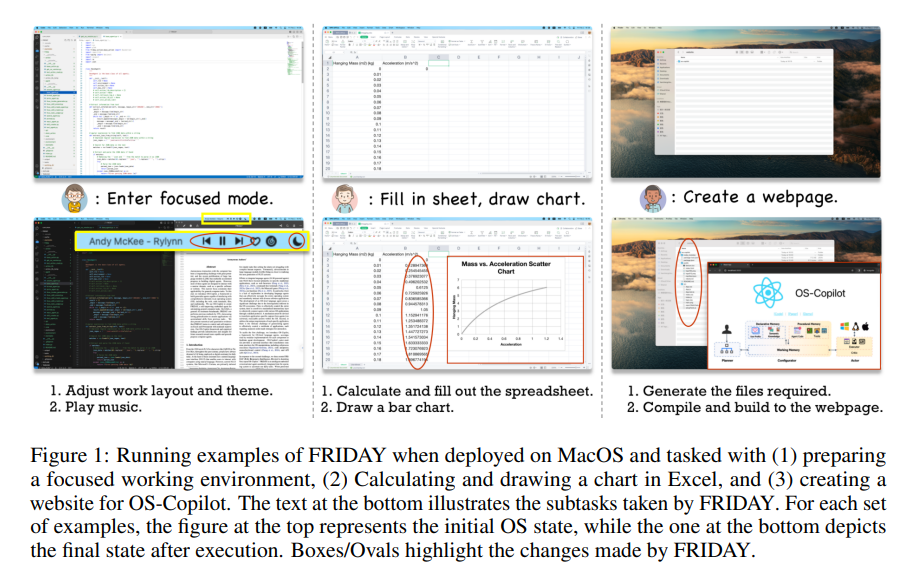

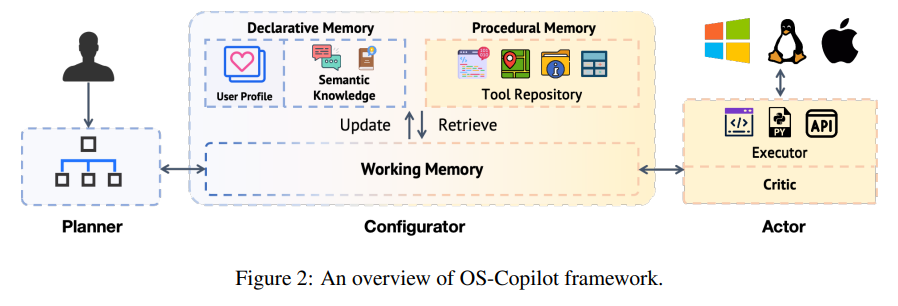

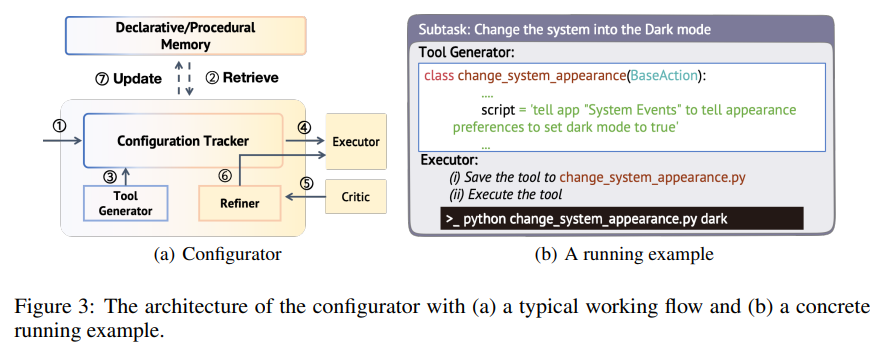

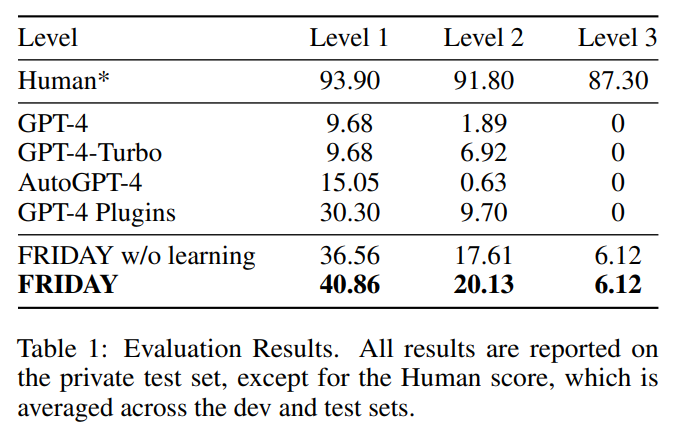

LLMの普及により、OS-Copilotフレームワークを使用して、自己改善型エージェントFRIDAYが一般的なコンピュータタスクを35%向上させ、ExcelやPowerpointを最小限の監督で制御し、将来の研究に向けたインフラストラクチャを提供しています. - ChemLLM: A Chemical Large Language Model

発行日:2024年02月10日

ChemLLMは、化学のさまざまな分野でスムーズな対話インタラクションを行うことができる初の大規模言語モデルであり、GPT-3.5やGPT-4を上回る性能を持ち、関連タスクにも高い適応性を示しています. - Large Language Models: A Survey

発行日:2024年02月09日

2022年11月にリリースされたChatGPTを含む大規模言語モデル(LLMs)は、自然言語タスクで高いパフォーマンスを示し、急速に進化しているが、未解決の課題や将来の研究方向も存在する. - The boundary of neural network trainability is fractal

発行日:2024年02月09日

フラクタルとニューラルネットワークのトレーニングは、反復的な関数や更新関数によって収束または発散の振る舞いを示し、ハイパーパラメータの微小な変更に敏感であることが示唆される. - LLM Agents can Autonomously Hack Websites

発行日:2024年02月06日

LLMエージェントは自律的にウェブサイトをハッキングし、脆弱性を事前に知らなくても複雑なタスクを実行できることが示され、GPT-4はその能力を持つが、広範な展開に疑問を投げかけている.

Video generation models as world simulators

著者:OpenAI

発行日:2024年02月15日

最終更新日:不明

URL:https://openai.com/research/video-generation-models-as-world-simulators

カテゴリ:不明

概要:

この研究では、ビデオ生成モデルを世界シミュレーターとして活用する可能性が示唆されています.Soraは、画像やプロンプトを入力として提供された場合にビデオを生成する能力を持っています.また、DALL·E 2やDALL·E 3の画像に基づいて生成された例のビデオも示されています.さらに、Soraは、既存の画像やビデオなど他の入力でもプロンプトを受け取ることができ、完璧にループするビデオの作成、静止画像のアニメーション化、ビデオの時間を前後に延長するなど、さまざまな画像やビデオ編集タスクを実行することが可能です.また、Soraは生成されたビデオの時間を前後に延長する能力も持っており、生成されたビデオの一部から時間を逆に戻して延長することができます.これにより、Soraはユーザープロンプトに正確に従った高品質なビデオを生成するだけでなく、ビデオの時間を調整することも可能です.さらに、Soraは、生成されたビデオを前後に延長してシームレスな無限ループを作成する方法や、SDEditという技術を用いて入力ビデオのスタイルや環境を変換することができるようになりました.また、Soraを使用して、異なる主題やシーン構成を持つ完全に異なるビデオ間で滑らかな遷移を作成することも可能です.新しい文脈を加えると、中央のビデオは、左側と右側の対応するビデオの間で補間されています.さらに、ガウスノイズのパッチを空間グリッドに配置し、1フレームの時間的範囲で画像を生成する能力も持っており、最大2048×2048の解像度まで可変サイズの画像を生成することができます.ビデオモデルは、大規模なトレーニングを受けると興味深い新たな能力を示すことがわかりました.これらの能力により、Soraは人々、動物、環境の一部をシミュレートすることが可能となりました.さらに、動的なカメラ移動を伴うビデオを生成することができ、カメラが移動し回転するとき、人々やシーンの要素が三次元空間を通して一貫して移動します.また、ビデオ生成システムにとって重要な課題である長いビデオのサンプリング時の時間的一貫性を維持することもできます.Soraは、短いビデオや長いビデオの依存関係を効果的にモデル化することができ、たとえ人々や動物、オブジェクトが隠れたりフレームから離れたりしても、それらを持続させることができます.同様に、1つのサンプル内で同じキャラクターの複数のショットを生成し、ビデオ全体で外観を維持することができます.

Soraは、世界の状態を単純な方法で変化させるアクションをシミュレートすることがあります.例えば、画家がキャンバスに新しいストロークを残して時間の経過とともに残すことができる、または男性がバーガーを食べてかじり跡を残すことができます.さらに、Soraは、ビデオゲームなどの人工プロセスをシミュレートする能力も持っております.例えば、Soraは、Minecraftのプレイヤーを基本ポリシーで同時に制御しながら、世界とそのダイナミクスを高い忠実度でレンダリングすることができます.これらの能力は、Soraに「Minecraft」というキャプションを提示することでゼロショットで引き出すことができます.これらの能力は、ビデオモデルの継続的なスケーリングが有望な道であることを示唆しています.さらに、ビデオモデルのスケーリングを続けることは、物理的およびデジタル世界、およびそれらに存在するオブジェクト、動物、人々を高度にシミュレートする能力の開発に向けた有望な道であることを示唆しています.ただし、Soraは現在、多くの基本的な相互作用の物理を正確にモデル化しておらず、例えばガラスが割れるような基本的な相互作用を正確にモデル化していません.また、食事などの他の相互作用では、オブジェクトの状態が正しく変化しないことがあります.モデルの一般的な失敗モード(長時間のサンプルで発生する不整合や、オブジェクトの突然の出現など)を当社のランディングページで詳細に説明しています.

Q&A:

Q: モデルで使用されているトランスフォーマーアーの構造は?

A: モデルで使用されているトランスフォーマーアーキテクチャは、拡散トランスフォーマーです.

Q: 持続時間、解像度、アスペクト比の異なるビデオや画像をどのように扱うのか?

A: モデルは、ビデオや画像の持続時間、解像度、アスペクト比を変数として扱います.Soraは、異なる持続時間、アスペクト比、解像度を持つビデオや画像を生成することができます.これにより、異なるデバイス向けにコンテンツを作成することができ、低解像度でプロトタイプを作成してから、同じモデルで高解像度のコンテンツを生成することも可能です.

Q: 最大のモデル、ソラの生成能力は?

A: Soraは、最大2048×2048の解像度までの可変サイズの画像を生成することができます.

Q: ビジュアル・データを統一的な表現に変える方法とは?

A: 視覚データを統一された表現に変換する方法は、Soraが視覚パッチを使用することです.これにより、様々な種類のビデオと画像をトレーニングするための高度なスケーラビリティと効果的な表現が可能となります.

Q: ビデオデータの生成的モデリングにおける先行研究との比較は?

A: Soraは、従来のビデオデータの生成モデリングにおける先行研究と比較して、より幅広い種類の視覚データを生成できる汎用モデルであり、動画の長さ、アスペクト比、解像度に関わらず、最大1分の高解像度ビデオを生成できる点が特徴です.

Q: 大規模言語モデルの利点をどのように継承しているのか?

A: 大規模言語モデルから恩恵を受けるために、Soraは視覚パッチを使用しています.これは、テキストトークンを持つLLMと同様に、異なる種類のビデオや画像をトレーニングするための高度にスケーラブルで効果的な表現であることが示されています.

Q: ビデオはどのようにモデルのパッチになるのですか?

A: ビデオは、まずビデオを低次元の潜在空間に圧縮し、その後その表現を時空間パッチに分解することでパッチに変換されます.

Q: ビデオ圧縮ネットワークに必要なものは何ですか?

A: ビデオ圧縮ネットワークの要件は、視覚データの次元削減を行うことであり、生のビデオを入力として受け取り、時間的にも空間的にも圧縮された潜在表現を出力するネットワークを訓練することです.このネットワークは、圧縮された潜在空間内でビデオを生成するためにSoraが訓練され、対応するデコーダーモデルも訓練され、生成された潜在をピクセル空間にマッピングします.さらに、入力ビデオを圧縮し、その表現を時空間パッチに分解することでビデオをパッチに変換するという要件もあります.

Gemini 1.5: Unlocking multimodal understanding across millions of tokens of context

著者:Google Gemini Team

発行日:2024年02月15日

最終更新日:不明

URL:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

カテゴリ:不明

概要:

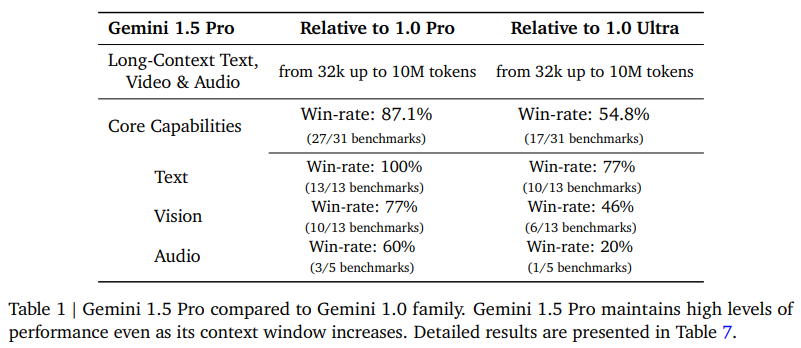

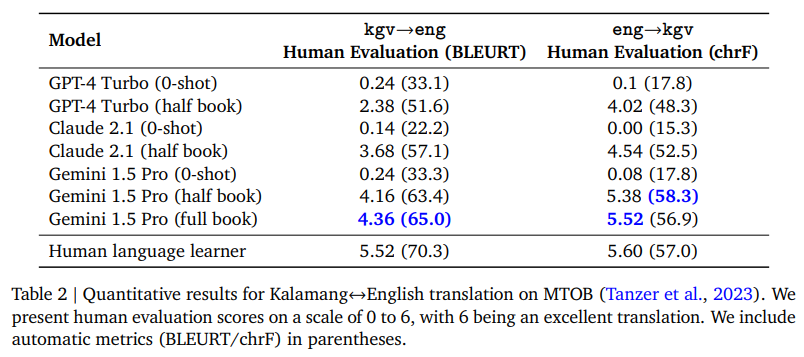

このレポートでは、Geminiファミリーの最新モデルであるGemini 1.5 Proを紹介しています.このモデルは、Gemini 1.5からの初のリリースであり、革新的なエキスパートモデルの混合アーキテクチャやトレーニングおよびサービングインフラの大幅な進歩を取り入れています.Gemini 1.5 Proは、非常に長いコンテキストを処理するために構築されており、少なくとも10Mトークンまでの微細な情報を思い出し、推論する能力を持っています.このスケールは、現代の大規模言語モデル(LLM)の中では前例のないものであり、文書のコレクション全体、複数時間のビデオ、およびほぼ1日分のオーディオなど、長い形式の混合モダリティ入力の処理を可能にします.Gemini 1.5 Proは、Gemini 1.0 Proを凌駕し、1.0 Ultraと同様のレベルで広範なベンチマークでのパフォーマンスを発揮しますが、トレーニングにはかなり少ない計算量が必要です.Gemini 1.5 Proは、Gemini 1.0ファミリーと比較して、特に数学、科学、推論、多言語性、ビデオ理解、コードなどのベンチマークで優れたパフォーマンスを示しています.また、Gemini 1.5 Proは、Gemini 1.0 Ultraとも比較され、より効率的でありながら、多くのベンチマークで優れたパフォーマンスを発揮しています.Gemini 1.5 Proは、テキストやビジョンのベンチマークで特に優れた結果を示しており、モデルのアーキテクチャについての概要も提供されています.さらに、モデルのアーキテクチャの概要や他のLLMとの比較を通じて、Gemini 1.5 Proの大規模な定量評価結果を提供しています.また、Gemini 1.0の技術レポートと同様に、テキスト、コード、画像、ビデオ、オーディオなどの幅広いベンチマークにわたる詳細な評価を行っています.最後に、責任ある展開に向けたアプローチについても議論し、モデルポリシーの開発、評価、および展開前の被害の軽減に向けたプロセスを含めた取り組みを紹介しています.

Q&A:

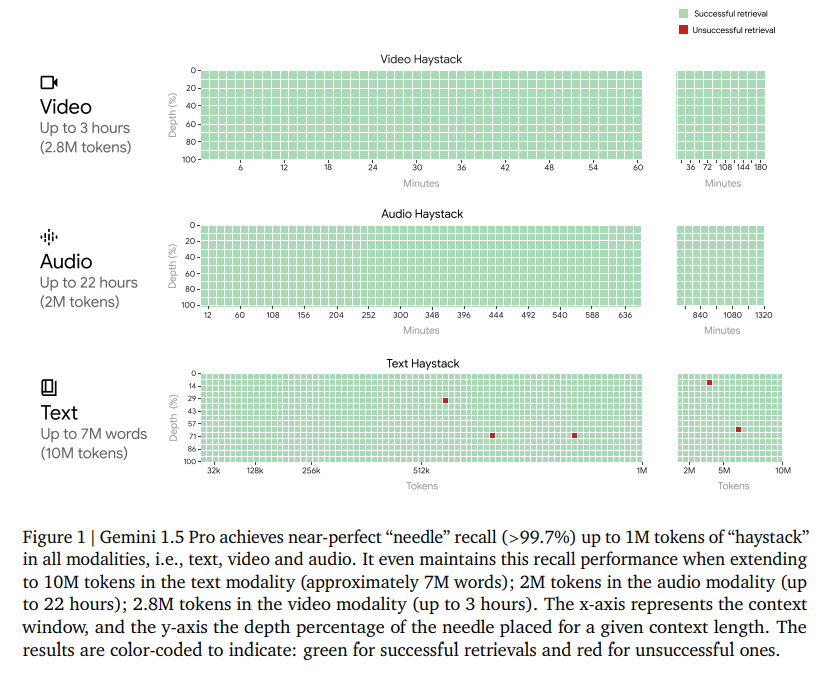

Q: Gemini 1.5 Proは、モダリティを超えたロングコンテクスト検索タスクにおいて、どのようにして完璧に近い想起を達成しているのだろうか?

A: ジェミニ1.5 Proは、膨大な数のトークン(テキスト、ビデオ、オーディオなどのモダリティ)において、ほぼ完璧な(99%以上)再現率を達成しています.さらに、10Mトークンまで拡張した場合でもこの再現率を維持しています.他のモデルを外部検索手法で拡張した場合でも、ジェミニ1.5 Proはすべてのモダリティで競合モデルを上回る性能を発揮しています.また、非常に長いコンテキストによって可能となるインコンテキスト学習能力も示しています.例えば、新しい言語の翻訳を学習することができます.

Q: Gemini 1.5 Proが、ロングドキュメントQA、ロングビデオQA、ロングコンテクストASRの最先端技術をどのように改善したのか説明していただけますか?

A: ジェミニ1.5 Proは、長文書QA、長ビデオQA、および長文脈ASRの最先端技術を向上させることができます.これは、数百万トークンの文脈から微細な情報を思い出し、推論することができる高度な計算効率の多モーダルエキスパートモデルであり、長文書QA、長ビデオQA、および長文脈ASRの最先端技術を向上させることができます.ジェミニ1.5 Proは、長文書QA、長ビデオQA、および長文脈ASRの最先端技術を向上させることができます.これは、数百万トークンの文脈から微細な情報を思い出し、推論することができる高度な計算効率の多モーダルエキスパートモデルであり、長文書QA、長ビデオQA、および長文脈ASRの最先端技術を向上させることができます.

Q: Gemini 1.5 Proは、Gemini 1.0 Ultraの最先端のパフォーマンスに匹敵またはそれを上回るベンチマークは何ですか?

A: Gemini 1.5 Proは、テキストベンチマーク(10/13)や多くのビジョンベンチマーク(6/13)など、半数以上のベンチマークでGemini 1.0 Ultraを上回る性能を発揮しました.

Q: Gemini 1.5 Proは、Claude 2.1やGPT-4 Turboのような既存のモデルと比較して、ネクストトークンの予測や検索能力はどうですか?

A: ジェミニ1.5 Proは、次のトークン予測とリトリーバル能力において、クロード2.1やGPT-4 Turboなどの既存モデルと比較して、優れた性能を示しています.ジェミニ1.5 Proは、最大10Mトークンまでほぼ完璧なリトリーバル(99%以上)を達成し、次のトークン予測においても長いコンテキストを持つ能力を示しています.

Q: Gemini 1.5 Proのネクストトークンの予測と、少なくとも10Mトークンまでの完璧に近い検索(99%以上)の継続的な改善について詳しく教えてください.

A: ジェミニ1.5 Proの次のトークン予測とほぼ完璧なリトリーバル(99%以上)は、200kトークンから10Mトークンまでの長いコンテキストにおける継続的な改善を示しています.このモデルは、既存のモデルであるクロード2.1(200k)やGPT-4ターボ(128k)を上回る世代を超えた性能を持っています.また、ジェミニ1.5 Proは、長い文書において1Mトークンまで信頼性の高い情報の取得が可能であり、10Mトークンまで99.2%のリコール率を維持しています.

Q: あなたの研究で、大規模言語モデルのフロンティアでどのような驚くべき新機能を発見しましたか?

A: 研究において、大規模な言語モデルの驚くべき新しい能力は、文脈を超えた学習や長い文書全体からの学習などが挙げられます.

Q: Gemini 1.5 Proは、複数の長いドキュメントや何時間ものビデオやオーディオを含む、何百万ものコンテキストのトークンから得られるきめ細かな情報をどのように扱うのでしょうか?

A: Gemini 1.5 Proは、数百万トークンのコンテキストから細かい情報を処理する能力を持っています.複数の長い文書や数時間のビデオ、および音声などの長いコンテキストから情報を取得し、理解することができます.

Q: Gemini 1.5 Proの開発でどのような課題に直面し、それをどのように克服しましたか?

A: ジェミニ1.5 Proの開発において直面した課題は、モデルの長いコンテキスト理解能力の評価が困難であることでした.これに対処するために、モデルの長いコンテキスト能力を定量的および定性的に評価するための新しい手法を開発しました.また、ジェミニ1.5 Proの性能を正確に評価するために、人間による評価を重視し、厳密な文字列一致から逸脱した柔軟な評価基準の開発に取り組みました.

Q: Gemini 1.5 Proの計算効率について、Geminiファミリーの以前のモデルと比較した考察をお願いします.

A: ジェミニ1.5 Proは、ジェミニファミリーの以前のモデルと比較して、トレーニングコンピュートを大幅に削減し、より効率的にサービスを提供しています.その結果、ジェミニ1.5 Proは、ほとんどのベンチマークで以前のモデルを上回り、特にテキストベンチマーク(13/10)や多くのビジョンベンチマーク(13/6)で優れたパフォーマンスを発揮しています.

Revisiting Feature Prediction for Learning Visual Representations from Video

著者:Adrien Bardes, Jean Ponce, Mahmoud Assran1, Michael Rabbat, Nicolas Ballas1, Quentin Garrido, Xinlei Chen, Yann LeCun

発行日:2024年02月14日

最終更新日:不明

URL:https://ai.meta.com/research/publications/revisiting-feature-prediction-for-learning-visual-representations-from-video/

カテゴリ:不明

概要:

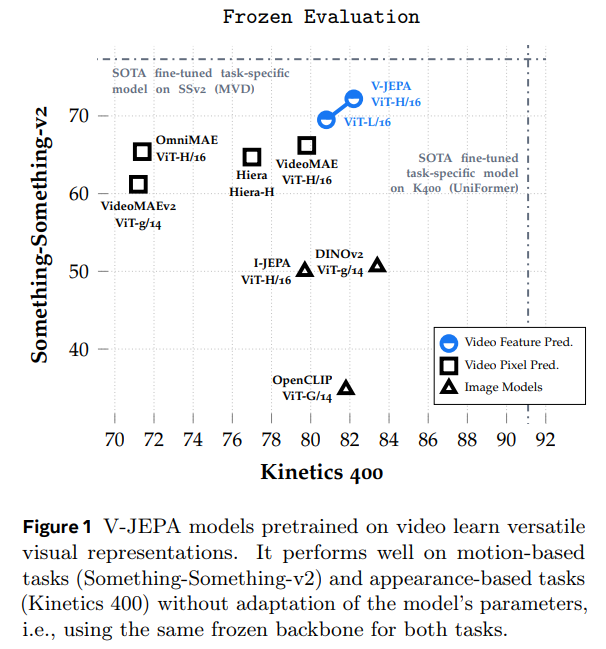

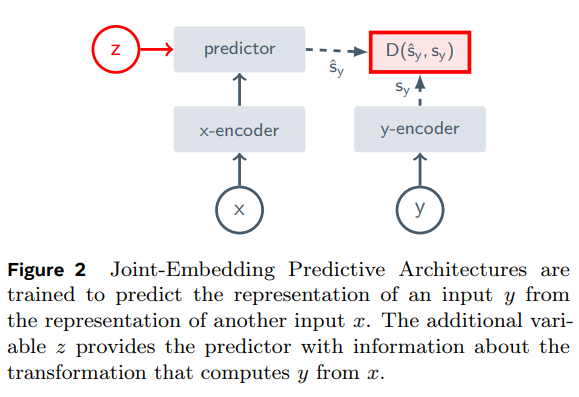

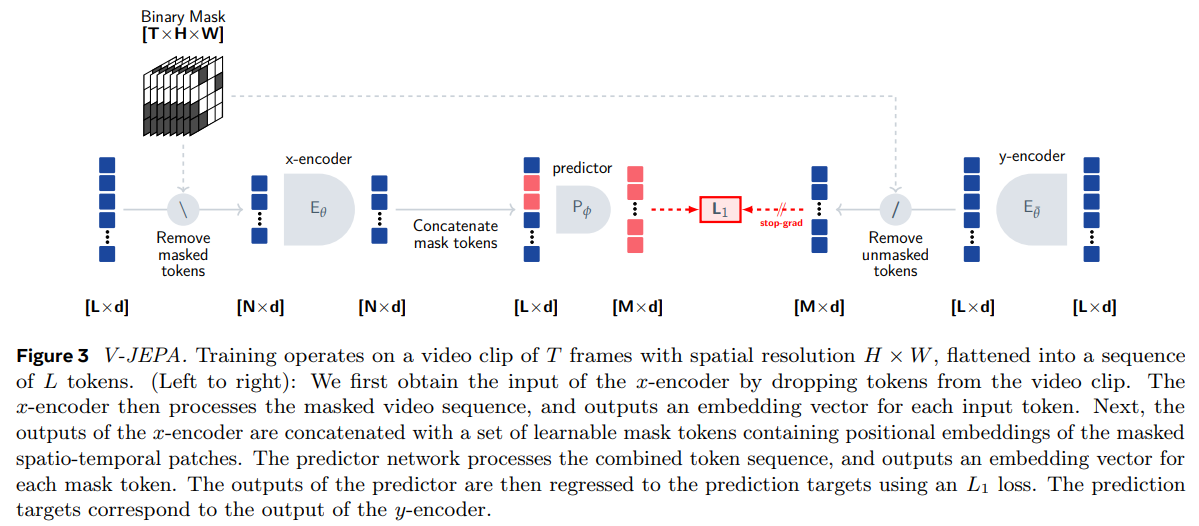

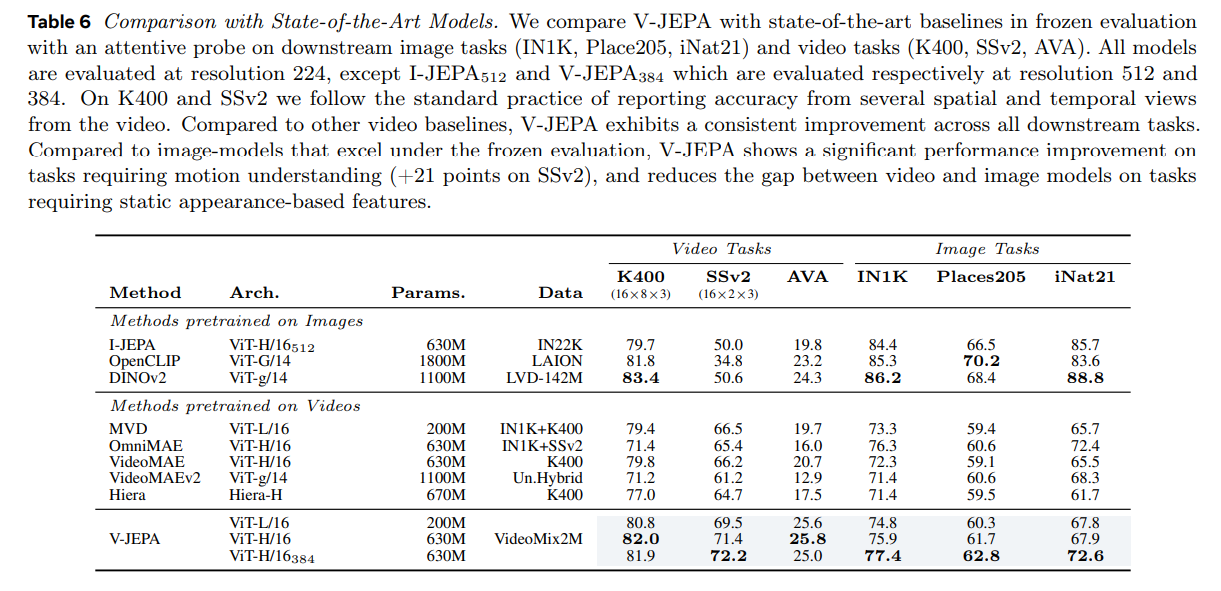

この論文では、ビデオからの教師なし学習のための特徴予測を探求し、事前にトレーニングされた画像エンコーダーやテキスト、負の例、再構築、人間の注釈、またはピクセルレベルの再構築を使用せずに、特徴予測目的だけを使用してトレーニングされたビジョンモデルのコレクションであるV-JEPAを紹介しています.この研究では、ビデオからの視覚表現の教師なし学習のための特徴予測を再検討し、現代のツールを使用して、単独の目的としての特徴予測の効果をどのように評価するかを追求しています.JEPA(LeCun、2022; Assran et al.、2023; Baevski et al.、2022b)やより大きなデータセットなどの最新のツールを統合した、現代的で概念的にシンプルな方法であるビデオ共同埋め込み予測アーキテクチャまたはV-JEPAが形成されています.ViT-H/16などのモデルは、ビデオのみでトレーニングされ、Kinetics-400で81.9%、Something-Something-v2で72.2%、ImageNet1Kで77.9%を獲得しています.さらに、2百万本のビデオからなるデータセットを使用して、マスクされたモデリング予測タスクと共埋め込み予測アーキテクチャを組み合わせたV-JEPAモデルファミリーを事前トレーニングしました.我々は、凍結評価とエンドツーエンドのファインチューニングを使用して、いくつかの下流の画像およびビデオタスクのパフォーマンスを測定しました.我々の結果は、特徴予測が実際にビデオからの教師なし学習のための効果的な単独目的として機能し、ピクセル予測方法よりもはるかに短いトレーニングスケジュールを使用することができることを示唆しています.特に、特徴予測は、モデルの重みの適応なしに、凍結バックボーンを使用して、下流の画像およびビデオタスク全体で優れたパフォーマンスを発揮する多目的な視覚表現につながります.SomethingSomething-v2タスクでは、V-JEPAが最も優れたパフォーマンスを達成し(+6%の精度)、細かい時間的理解が必要なタスクです.また、V-JEPAは、外観ベースの特徴が十分であり、したがってDINOv2などの最先端の画像モデルが優れているKinetics400などのタスクでも競争力を持っています.最新のコンテキストによると、特徴予測でトレーニングされたモデルは、ピクセル予測アプローチよりも優れており、凍結評価プロトコル(注意深いプロービング)の下で競争力があり、全体のファインチューニングの下でピクセル予測と競合し、かつ大幅に短いトレーニングスケジュールを使用しています.また、特徴予測でトレーニングされたモデルは、ピクセル予測アプローチよりもラベルの効率が良いことが示されています.ラベル付き例の数を減らすと、V-JEPAとピクセル再構築モデルとのパフォーマンス差が拡大する傾向があります.

Q&A:

Q: 論文の主な目的は何か?

A: この論文の主な目的は、ビジョンモデルを訓練する際に、特徴予測目的だけを使用することで、ビデオからの非監督学習を探求することです.

Q: V-JEPAは、ビデオから教師なし学習を行う他の手法とどう違うのですか?

A: V-JEPAは、他のビデオからの教師なし学習方法と異なり、事前に学習された画像エンコーダー、テキスト、負例、人間の注釈、またはピクセルを使用せず、特徴予測のみに基づいています.V-JEPAは、ビジョンモデルをトレーニングする際に、モデルパラメーターの適応なしでさまざまな下流の画像およびビデオタスクを解決し、凍結評価において以前のビデオ表現学習アプローチを上回る能力を示しています.

Q: この研究でモデルのトレーニングに使われたデータセットは?

A: この研究で使用されたモデルを訓練するために使用されたデータセットは、公開データセットから収集された200万本のビデオです.

Q: 下流のタスクについて、モデルはどのように評価されたのか?

A: モデルは、凍結評価(凍結バックボーンを使用)およびエンドツーエンドのファインチューニングによるビデオタスク(K400、SSv2、AVA)および画像タスク(iNat201)で評価されました.凍結評価では、V-JEPAはすべての下流タスクでベースラインを上回りました.K400およびSSv2では、複数の空間的および時間的視点からの精度を報告する標準的な方法に従いました.

Q: 視覚表現の学習において、特徴予測を独立した目的として使用した結果はどうだったのでしょうか?

A: 特徴予測を単独の目的として使用した結果、多様なビジュアル表現が得られ、動きや外観に基づくタスクの両方で優れた性能を発揮しました.モデルのパラメーターの適応なしで、凍結されたバックボーンを使用することができました.

Q: 最大のモデルであるViT-H/16のパフォーマンスは、Kinetics-400、Something-Something-v2、ImageNet1Kの他のモデルと比較してどうか?

A: ViT-H/16モデルは、Kinetics-400では81.9%、Something-Something-v2では72.2%、ImageNet1Kでは77.9%の性能を達成しています.

Q: この論文によれば、人間における教師なし学習はどのような原理や目的に基づいているのだろうか?

A: 論文によれば、人間の非監督学習を導く原則や目的は、予測的特徴原理に基づいています.この原理は、時間的に隣接する感覚刺激の表現が互いに予測可能であるべきだと主張しています.

Q: 特徴予測原理はどのような仮説に基づいているのか?

A: 特徴予測原理は、RaoとBallard(1999)による予測的特徴原理に基づいています.

Q: V-JEPAアーキテクチャーを作るために、どのようなツールや手法が統合されたのか?

A: V-JEPAアーキテクチャを作成するために統合されたツールは、トランスフォーマーアーキテクチャ、マスクオートエンコーディングフレームワーク、クエリベースの特徴プーリング、結合埋め込み予測アーキテクチャ、およびより大きなデータセットです.

Q: V-JEPAアーキテクチャーは、この分野の他の予測アーキテクチャーとどう違うのですか?

A: V-JEPAアーキテクチャは、他の予測アーキテクチャと比較して、特徴予測に基づいて構築されています.他のアーキテクチャがピクセル予測に依存しているのに対し、V-JEPAは特徴の予測に焦点を当てており、事前に画像エンコーダー、テキスト、負例、人間の注釈、またはピクセルを使用せずに構築されています.

Automated Unit Test Improvement using Large Language Models at Meta

著者:Nadia Alshahwan, Jubin Chheda, Anastasia Finegenova, Beliz Gokkaya, Mark Harman, Inna Harper, Alexandru Marginean, Shubho Sengupta, Eddy Wang

発行日:2024年02月14日

最終更新日:2024年02月14日

URL:http://arxiv.org/pdf/2402.09171v1

カテゴリ:Software Engineering

概要:

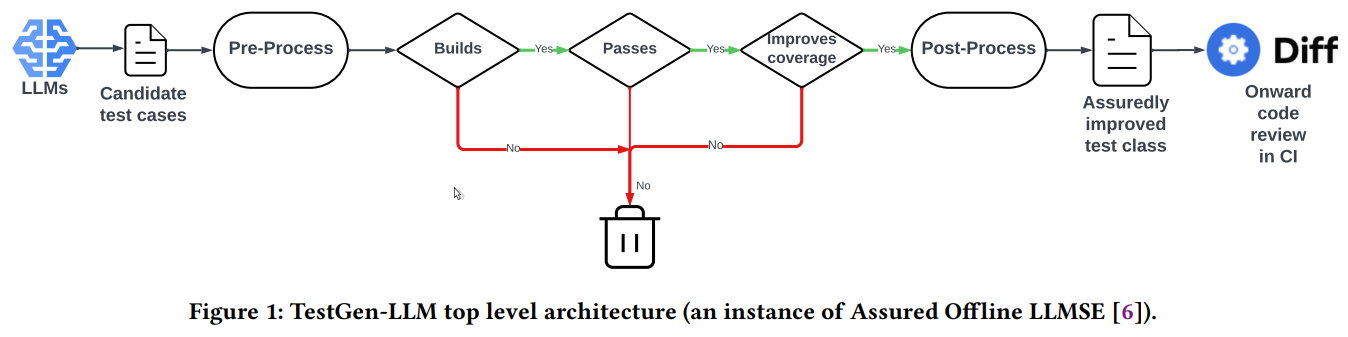

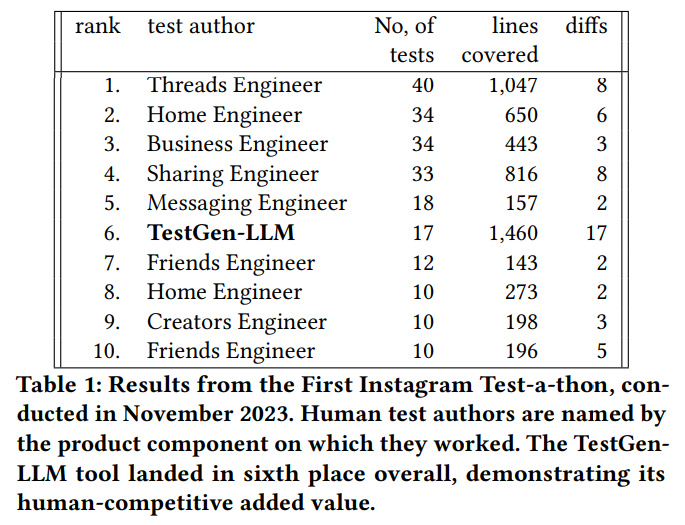

この論文では、MetaのTestGen-LLMツールについて説明しています.このツールはLLMを使用して、既存の人間が書いたテストを自動的に改善します.TestGen-LLMは、生成されたテストクラスが、元のテストスイートよりも測定可能な改善があることを確認するフィルターを正常にクリアすることを検証し、LLMの幻覚に起因する問題を排除します.我々は、InstagramとFacebookプラットフォームのMetaテスト・ア・ソンでTestGen-LLMの展開について説明しています.InstagramのReelsとStories製品に関する評価では、TestGen-LLMのテストケースのうち75%が正しく構築され、57%が信頼性を持って合格し、25%がカバレッジを増やしました.MetaのInstagramとFacebookのテスト・ア・ソンでは、適用されたすべてのクラスのうち11.5%が改善され、Metaのソフトウェアエンジニアによって73%の推奨事項が本番展開に受け入れられました.これは、コードの改善が保証されたLLM生成コードの産業規模展開に関する初の報告だと考えています.

Q&A:

Q: TestGen-LLMは、大規模言語モデルを使用して、人間が書いた既存のテストをどのように自動的に改善するのですか?

A: TestGen-LLMは、大規模言語モデル(LLMs)を使用して、既存の人間によって書かれたテストを自動的に改善します.TestGen-LLMは、生成されたテストクラスが元のテストスイートよりも測定可能な改善を確実にする一連のフィルタをクリアすることを検証します.これにより、LLMの幻覚に起因する問題を排除します.

Q: TestGen-LLMは、元のテストスイートに対して測定可能な改善を保証するために、どのようなフィルタを使用しますか?

A: TestGen-LLMは、測定可能な改善を保証するために、3つのフィルターを使用します.最初のフィルターは、LLMの幻覚による問題を排除するためのセットをクリアすることです.2番目のフィルターは、非フレーキーな合格テストがカバレッジを向上させるかどうかを測定します.そして、3番目のフィルターは、すべてのフィルターを通過した候補テストケースが既存のテストクラスを改善し、信頼性のある回帰テストシグナルを提供することを保証します.

Q: インスタグラムとフェイスブックのメタ・テスト・ア・ソンにおけるTestGen-LLMの展開について、詳細を教えてください.

A: TestGen-LLMは、InstagramとFacebookプラットフォームのためのMetaのテストマラソンで展開されました.InstagramのReelsとStories製品に関する評価では、TestGen-LLMのテストケースの75%が正しく構築され、57%が信頼性を持って合格し、25%がカバレッジを増やしました.MetaのInstagramとFacebookのテストマラソン中、適用されたすべてのクラスの11.5%が改善され、73%の推奨事項がMetaのソフトウェアエンジニアによって本番展開のために受け入れられました.

Q: TestGen-LLMを使用したInstagram向けのリールやストーリーズ製品の評価結果はどうでしたか?

A: InstagramのReelsとStories製品に関するTestGen-LLMの評価結果は、テストケースの75%が正しく構築され、57%が信頼性を持って合格し、25%がカバレッジを増やした.

Q: 評価中に、いくつのテストケースが正しく構築され、確実にパスし、カバレッジが増加したか.

A: 評価中に、テストケースが正しく構築され、信頼性を持って合格し、カバレッジが増加したのは25%でした.

Q: TestGen-LLMがMetaのInstagramとFacebookのテストマラソン中に適用されたとき、すべてのクラスのうち何パーセントが改善しましたか?

A: TestGen-LLMが適用されたすべてのクラスのうち、何パーセントが改善されましたか?MetaのInstagramとFacebookのテストマラソン中に適用されたとき、すべてのクラスの11.5%が改善されました.

Q: Metaのソフトウェアエンジニアによって、TestGen-LLMの推奨事項のうち何が本番展開に受け入れられましたか?

A: TestGen-LLMの推奨事項のうち、Metaのソフトウェアエンジニアによって本番展開が受け入れられたのは144件でした.

Q: LLMが作成したコードを産業規模で展開した最初の報告書であり、コード改善の保証に裏打ちされたこの報告書の意義を説明していただけますか?

A: この報告がLLM生成コードの産業規模展開であり、コード改善の保証があることの重要性は、ソフトウェアエンジニアリングにおける革新的な進歩を示しています.これにより、人間の介入なしに開発されたコードが大規模な産業生産システムに導入され、既存のコードベースを改善する保証が得られることが示されました.これは、人間のエラーを排除し、効率的なコード生成と品質向上を実現する可能性を示しています.また、これにより、ソフトウェア開発プロセス全体の効率性と信頼性が向上し、産業界全体に革新的な手法が普及する可能性があります.

Q: TestGen-LLMは、LLMの幻覚による問題にどのように対処しているのか?

A: TestGen-LLMは、生成されたテストクラスが元のテストスイートよりも測定可能な改善を保証する一連のフィルタを正常にクリアすることを検証することによって、LLMの幻覚に起因する問題に対処しています.

Q: 大規模言語モデルを使用した自動ユニットテストを改善するために、Meta社でのTestGen-LLMの導入から得られた主な収穫は何ですか?

A: TestGen-LLMは、Metaでの自動化されたユニットテストの改善において重要な成果を上げました.具体的には、TestGen-LLMは人間が書いた既存のテストを自動的に改善するためにLLMを使用し、生成されたテストクラスが元のテストスイートよりも測定可能な改善を達成することを検証します.これにより、LLMの幻覚に起因する問題を排除します.InstagramとFacebookプラットフォームのテストイベントでTestGen-LLMを展開し、InstagramのReelsとStories製品において75%のテストケースが正しく構築され、57%が信頼性を持って合格し、25%がカバレッジを増やしました.InstagramとFacebookのテストイベント中、TestGen-LLMは適用されたすべてのクラスの11.5%を改善し、73%の提案がMetaのソフトウェアエンジニアによって本番展開に受け入れられました.これは、産業規模でのLLM生成コードの展開によるコード改善の保証が行われた初の報告だと考えられます.

World Model on Million-Length Video And Language With RingAttention

著者:Hao Liu, Wilson Yan, Matei Zaharia, Pieter Abbeel

発行日:2024年02月13日

最終更新日:2024年02月13日

URL:http://arxiv.org/pdf/2402.08268v1

カテゴリ:Machine Learning

概要:

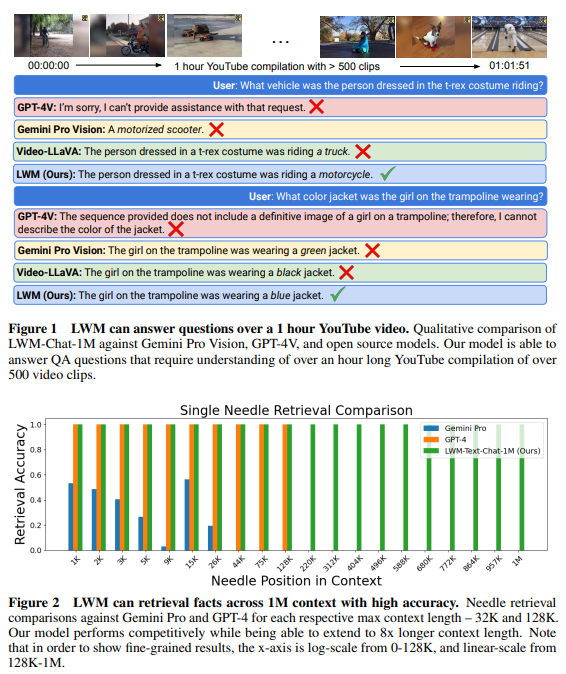

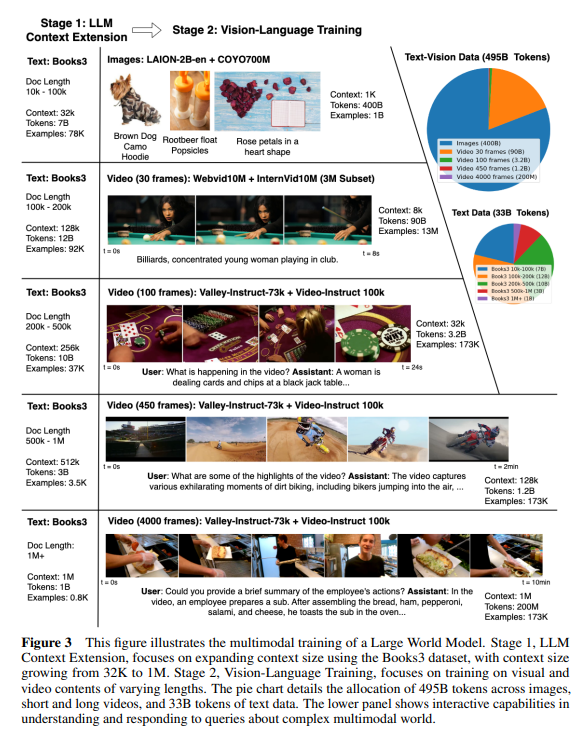

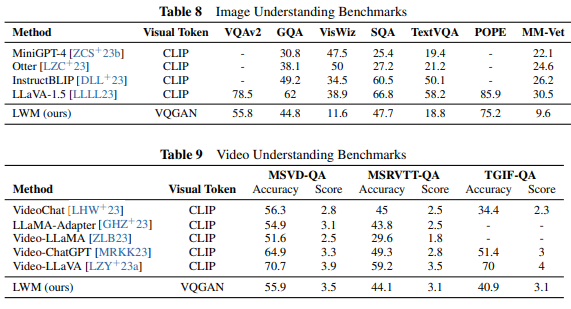

現在の言語モデルは、言葉で簡単に説明できない世界の側面を理解するのに苦労し、複雑で長いタスクにも苦労しています.ビデオシーケンスは、言語や静止画像にはない貴重な時間情報を提供し、言語との共同モデリングに適しています.このようなモデルは、人間のテキスト知識と物理世界の両方を理解し、人間を支援するためのより広範なAI機能を可能にすることができます.しかし、数百万のトークンのビデオと言語シーケンスから学習することは、メモリ制約、計算の複雑さ、および限られたデータセットによる課題があります.これらの課題に対処するために、私たちは多様なビデオと書籍の大規模なデータセットを収集し、RingAttention技術を利用して長いシーケンスでスケーラブルにトレーニングし、コンテキストサイズを4Kから1Mトークンに徐々に増やしています.この論文は以下の貢献をします:(a) 最大のコンテキストサイズニューラルネットワーク:私たちは、長いビデオと言語シーケンスで最大のコンテキストサイズのトランスフォーマーをトレーニングし、難しい検索タスクや長いビデオ理解で新たな基準を設定します.(b) ビジョン言語トレーニングの克服策.さらに、異なるシーケンス長を混合するためのマスクされたシーケンスパッキングの使用、言語とビジョンをバランスさせるための損失の重み付け、および長いシーケンスチャットのためのモデル生成QAデータセットを含む、ビジョン言語トレーニングの課題を克服するための解決策を提供しています.また、RingAttention、マスクされたシーケンスパッキング、およびその他の主要な機能を使用した高度に最適化された実装を行い、数百万トークンのマルチモーダルシーケンスでのトレーニングを可能にしています.さらに、1Mトークン以上の長いテキストドキュメント(LWM-Text、LWM-Text-Chat)およびビデオ(LWM、LWM-Chat)を処理できる7Bパラメータモデルのファミリーを完全にオープンソース化しました.この取り組みは、長いビデオと言語の巨大なデータセットでのトレーニングを可能にし、人間の知識と多様な世界の理解、およびより広範な機能の開発のための道を開いています.

Q&A:

Q: リングアテンションテクニックは、長いシークエンスのトレーニングにどのように役立ちますか?

A: RingAttention技術は、長いシーケンスでのトレーニングを助けるために、TPUメッシュシャーディングとテンソル並列性を使用して、シーケンスの並列処理を最適化します.また、RingAttentionは、シーケンスの長さに関係なく効果的にトレーニングするためのマスク付きシーケンスパッキングを提供します.さらに、シングルプレシジョンでの推論を行うことで、スケーラビリティの向上が可能であり、量子化などの技術を使用してさらなる改善ができます.

Q: 数百万トークンのビデオや言語シーケンスから学習する場合、どのような課題に直面するのだろうか?

A: ビデオと言語シーケンスから数百万のトークンを学習する際に直面する課題には、メモリ制約、計算の複雑さ、および限られたデータセットがあります.

Q: 異なる配列長を混在させるのに、マスクされた配列パッキングはどのように役立つのか?

A: マスクされたシーケンスパッキングを使用することで、異なるシーケンス長を混在させることができます.これは、異なる長さのシーケンスを同じバッチ内で処理する際に、モデルが適切に学習できるようにするために重要です.

Q: マルチモーダルシーケンスのトレーニングに最適化された実装の主な特徴は?

A: 高度に最適化された実装の主要な特徴は、RingAttention、マスクされたシーケンスパッキング、およびその他の主要な機能であり、これらは数百万長のマルチモーダルシーケンスのトレーニングに使用されます.

Q: トレーニングの過程で、言語とビジョンのバランスをどのように取っていますか?

A: 言語とビジョンをトレーニングプロセスでバランスを取るために、損失の重み付けを行い、言語とビジョンのバランスを調整します.また、異なるシーケンス長で効果的にトレーニングするために、マスクされたシーケンスパッキングを実装します.

Q: 長時間のビデオや言語シーケンスに対して、最大級のコンテキストサイズ変換器をトレーニングすることで、どのようなベンチマークが設定されたのか?

A: 最大のコンテキストサイズのニューラルネットワークを訓練し、難しい検索タスクや長いビデオ理解において新たな基準を設定しました.

Q: モデルによって生成されたQAデータセットは、ロングシークエンスチャットにどのように貢献するのか?

A: モデル生成のQAデータセットは、長いシーケンスのチャットに貢献します.これは、長い文書からのチャンクをモデルにフィードし、モデルに長いコンテキストのチャット能力を学習させるために使用されます.

Q: オープンソース化された7Bパラメータ・モデル・ファミリーは、長いテキスト文書やビデオの処理においてどのような能力を発揮するのだろうか?

A: 7Bパラメーターモデルのオープンソースファミリーは、長いテキスト文書(LWM-Text、LWM-Text-Chat)および1Mトークンのビデオ(LWM、LWM-Chat)を処理する能力を持っています.

Q: 4Kトークンから1Mトークンへのコンテキストサイズの増加は、モデルのパフォーマンスにどのような影響を与えますか?

A: コンテキストサイズを4Kから1Mトークンに増やすことにより、モデルのパフォーマンスには否定的な影響がないことが示されました.実際、結果は、より大きなコンテキスト容量を持つモデルがこれらのタスク全体で同等以上に優れたパフォーマンスを発揮することを示唆しています.この証拠は、コンテキストの拡張からの負の影響の欠如を示し、モデルが異なるタスク要件に適応する能力を持ちながらも、短いコンテキストでの効率を失わないことを強調しています.

Q: 人間の知識とマルチモーダルな世界の両方を理解するために人間を支援する、より広範なAIの能力をどのように想定していますか?

A: 人間の知識と多様な世界の理解を開発することで、より広範囲のAI機能が人間を支援する可能性があります.これにより、AIシステムは長いビデオと書籍を共同モデリングすることで、多様な現実世界の状況に対して一般化する能力を高めることができます.

OS-Copilot: Towards Generalist Computer Agents with Self-Improvement

著者:Zhiyong Wu, Chengcheng Han, Zichen Ding, Zhenmin Weng, Zhoumianze Liu, Shunyu Yao, Tao Yu, Lingpeng Kong

発行日:2024年02月12日

最終更新日:2024年02月15日

URL:http://arxiv.org/pdf/2402.07456v2

カテゴリ:Artificial Intelligence

概要:

コンピュータとの自律的な対話は長年の課題であり、大きな潜在能力を持っています.そして、最近の大規模言語モデル(LLMs)の急速な普及により、デジタルエージェントの構築における進歩が著しく加速されています.しかし、これらのエージェントのほとんどは特定のソフトウェアやウェブサイトなど、狭い領域との対話を目的として設計されています.この狭い焦点は、一般的なコンピュータタスクに対する適用範囲を制約しています.このため、我々はOS-Copilotというフレームワークを導入し、ウェブ、コードターミナル、ファイル、マルチメディア、さまざまなサードパーティアプリケーションなど、オペレーティングシステム(OS)の包括的な要素とインターフェイスを行うことができる一般的なエージェントを構築することを提案します.我々はOS-Copilotを使用して、一般的なコンピュータタスクを自動化するための自己改善型のエンボディエドエージェントであるFRIDAYを作成しました.一般的なAIアシスタントのベンチマークであるGAIA上で、FRIDAYは以前の方法を35%上回る性能を発揮し、以前のタスクから蓄積されたスキルを通じて未知のアプリケーションに対する強力な一般化を示しています.また、FRIDAYがExcelやPowerpointを最小限の監督で制御し、自己改善することを示す数値的および定量的な証拠も提示しています.最後に、最小限の監督で操作することができるFRIDAYは、我々のOS-Copilotフレームワークと経験的な知見を通じて、より能力の高い汎用コンピュータエージェントに向けた将来の研究に向けたインフラストラクチャと洞察を提供しています.

Q&A:

Q: OS-Copilotの機能は、他のデジタルエージェントとどう違うのですか?

A: OS-Copilotは、他のデジタルエージェントと比較して、より広範囲なコンピュータータスクに対応できる能力を持っています.他のエージェントは特定のソフトウェアやウェブサイトなどの狭い領域とのやり取りに特化しているのに対し、OS-CopilotはOS全体と効果的にやり取りできる言語エージェントを開発することに焦点を当てています.そのため、OS-Copilotは、OSエコシステムに固有の異質性という大きな課題に直面しながらも、より包括的なコンピュータータスクに対応できるよう設計されています.

Q: FRIDAYは、OS-Copilotのフレームワークをどのように活用しているのですか?

A: FRIDAYは、OS-Copilotフレームワークを利用して、自己改善を行います.このフレームワークは、FRIDAYが未知のアプリケーションに対応するためのスキルを蓄積し、以前のタスクから獲得した能力を活用して強力な汎用コンピューターエージェントを作成します.FRIDAYは、ExcelやPowerpointなどのアプリケーションを最小限の監督で制御し、自己改善することを学習します.

Q: OS-Copilotは、オペレーティング・システム内のどのような要素とインターフェイスできますか?

A: OS-Copilotは、OS内のPythonランタイム環境、bashランタイム環境、API呼び出し、およびマウス/キーボード制御という4つの要素とインターフェースを提供します.

Q: GAIAベンチマークにおいて、FRIDAYは従来の方法をどのように上回るのか?

A: FRIDAYは、以前のシステムよりも優れた性能を発揮しました.最も簡単なレベル-1のタスクでは、FRIDAYは成功率40.86%を達成し、前の最高システム(30.3%)よりも35%の相対的な改善を示し、一般的なAutoGPT-4システム(14.4%)を大幅に上回りました.

Q: FRIDAYがエクセルやパワーポイントで自動化できるタスクの例を教えてください.

A: FRIDAYはExcelで要素の数え上げやシートの削除などの操作を自動化することができます.また、Powerpointではスライドの生成や操作を行うことができます.

Q: FRIDAYが最小限の監督でコントロールと自己改善を学ぶという主張を裏付ける証拠は?

A: FRIDAYは最小限の監督のもとで制御と自己改善を学ぶという主張を裏付ける証拠として、FRIDAYが自己学習を通じてExcelやPowerpointを制御し、自己改善するという数値的かつ定量的な証拠が示されています.また、FRIDAYは自己学習によって未知のアプリケーションを制御する能力を獲得しており、その効果を示すためにFRIDAYとFRIDAY(学習なし)を比較した結果、自己学習の利点が明確に示されています.

Q: OS-Copilotによって、FRIDAYはどのように未知のアプリケーションに汎化できるのか?

A: OS-CopilotによってFRIDAYは、以前のタスクから蓄積されたスキルを通じて未知のアプリケーションに一般化する能力を獲得します.具体的には、OS-Copilotフレームワークを使用してFRIDAYがExcelやPowerpointを制御し、自己改善することが可能となります.

Q: あなたの経験的知見は、今後のコンピュータ・エージェント研究にどのような示唆を与えますか?

A: 私たちの実証的な結果は、コンピューターエージェントに関する将来の研究に対する洞察を提供します.具体的には、FRIDAYなどのコンピューターエージェントがタスクをサブタスクに分解して問題解決に取り組む方法に焦点を当てることが重要です.これらのサブタスクの成功した実行を評価することは、グラウンドトゥルースの欠如により非常に困難であり、通常のNLPタスクとは異なり、サブタスクの完了を評価するには、ハードコードされたルールやLLMを使用して2つのシステム状態を比較する必要があります.

Q: 大規模言語モデル(LLM)の使用は、OS-CopilotとFRIDAYの開発にどのように貢献していますか?

A: 大規模言語モデル(LLMs)の使用により、OS-CopilotとFRIDAYの開発に貢献しています.LLMsは、OS-CopilotとFRIDAYが自己学習によって以前に見たことのないアプリケーションを効果的に学習し制御する能力を示すのに重要です.LLMsは、OS-Copilotがリクエストエンジニアリングに依存し、クローズドソースのアプリケーションに直面した際の能力不足などの制約に対処するために設計されています.

Q: FRIDAYのようなジェネラリスト・コンピューター・エージェントは、さまざまな産業でどのような応用が考えられるか?

A: FRIDAYのような汎用コンピューターエージェントの潜在的な応用は、さまざまな産業で革新的な自動化タスクを実行することができます.これらのエージェントは、過去のタスクから蓄積されたスキルを通じて未知のアプリケーションに強力な汎用性を示し、ExcelやPowerpointなどのアプリケーションを最小限の監督で制御および自己改善することができます.また、自己学習を通じて未知のアプリケーションを制御する能力を備えており、自己進化型の構成モジュールを使用して、新しいアプリケーションを制御する方法を学習します.これにより、産業界では、例えば製造業において生産ラインの自動化や品質管理、金融業界においてデータ分析やリスク管理、医療分野において診断支援や治療計画の最適化など、幅広いタスクにおいてFRIDAYのような汎用コンピューターエージェントが活用される可能性があります.

ChemLLM: A Chemical Large Language Model

著者:Di Zhang, Wei Liu, Qian Tan, Jingdan Chen, Hang Yan, Yuliang Yan, Jiatong Li, Weiran Huang, Xiangyu Yue, Dongzhan Zhou, Shufei Zhang, Mao Su, Hansen Zhong, Yuqiang Li, Wanli Ouyang

発行日:2024年02月10日

最終更新日:2024年02月10日

URL:http://arxiv.org/pdf/2402.06852v1

カテゴリ:Artificial Intelligence, Computation and Language

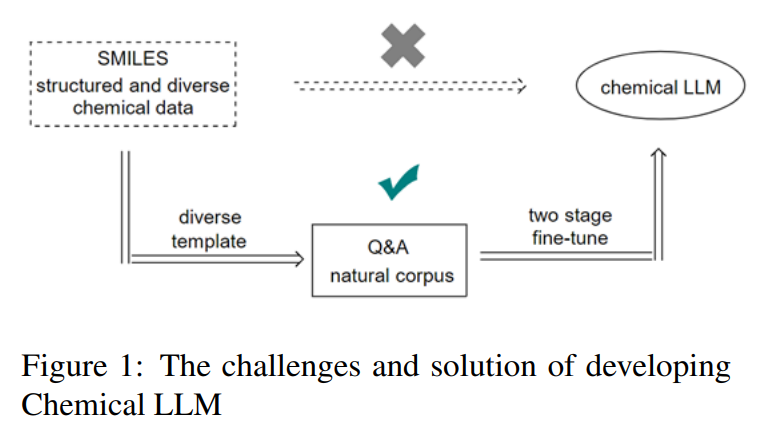

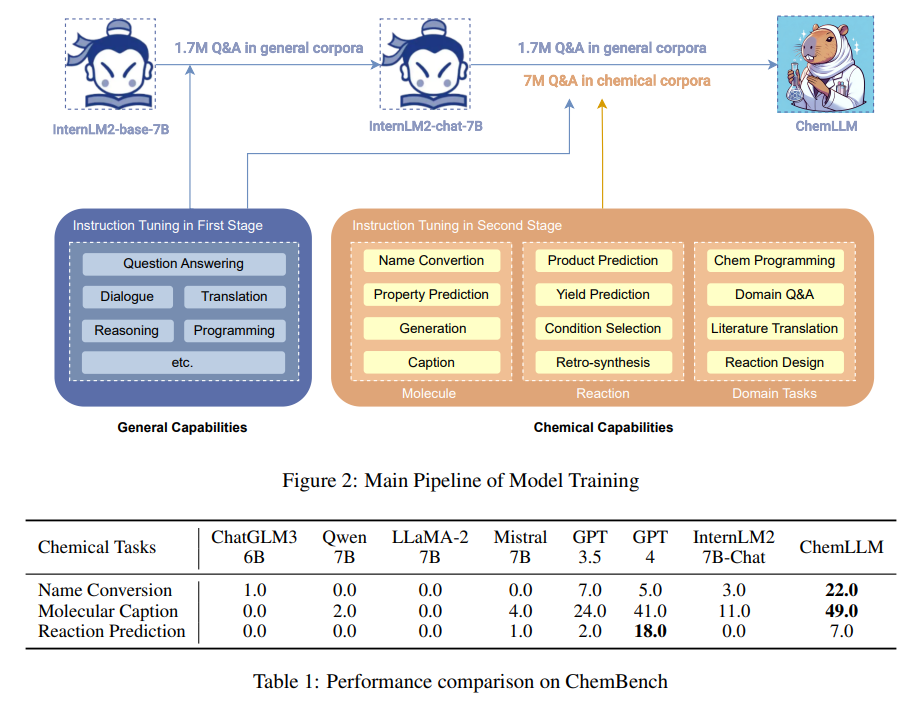

概要:

大規模言語モデル(LLM)は、分子特性予測、分子生成、実験プロトコル設計など、化学のさまざまな応用分野で驚異的な進歩を遂げてきました.しかし、化学に特化した対話ベースのモデルが不足しているという課題があります.この課題は、化学データや科学的知識のほとんどが主に構造化されたデータベースに格納されており、これらの構造化データを直接使用することがモデルの一貫した対話を維持する能力を損なうという点に起因しています.この問題に対処するために、我々は、構造化された知識を平易な対話に変換する新しいテンプレートベースの指示構築方法を開発し、言語モデルのトレーニングに適したものにしました.このアプローチを活用して、化学に特化した初の大規模言語モデルであるChemLLMを開発しました.ChemLLMは、化学のさまざまな分野でスムーズな対話インタラクションを行うことができます.ChemLLMは、化学の3つの主要なタスク、すなわち名前変換、分子キャプション、反応予測のすべてでGPT-3.5を上回り、そのうち2つではGPT-4をも凌駕しています.驚くべきことに、ChemLLMは関連するタスクに対しても非常に適応性が高いことを示しています.さらに、ChemLLMは、化学を中心としたコーパスを主に学習しているにもかかわらず、数学や物理の関連タスクに対しても優れた適応性を示しています.さらに、ChemLLMは、文献翻訳や化学情報プログラミングなど、化学内の特化したNLPタスクにも優れた能力を示しています.ChemLLMは、化学研究の新たな探求の道を開き、構造化された化学知識を対話システムに統合する方法は、さまざまな科学分野でLLMの開発の新たなフロンティアを切り拓くものです.コード、データセット、モデルの重みは、hf.co/AI4Chem/ChemLLM-7B-Chatで公開されています.

Q&A:

Q: 構造化された知識を、言語モデルを学習するための平易な対話に変換するために、テンプレートに基づく命令構築法がどのように機能するのか、もう少し詳しく説明していただけますか?

A: テンプレートベースの指示構築方法は、構造化された化学知識をアクセス可能な対話形式に変換し、言語モデルのトレーニングに使用します.この方法は、しばしばモデル内での一貫した対話を妨げる構造化された化学データの利用の課題に対処します.私たちの革新的なアプローチにより、化学分野に特化した最初のLLMであるChemLLMが作成され、さまざまな化学タスクをシームレスな対話インタラクションを通じて処理できるようになりました. ChemLLMは、分子認識、性質記述、反応予測などの主要な化学タスクにおいてGPT-3.5を凌駕し、他の分野でも優れた汎用性を示しています.その中核的な機能を超えて、ChemLLMは、文献翻訳などの化学の専門的なNLPタスクでも優れた成績を収めています.

Q: ChemLLMが一貫性のある対話を維持しながら、構造化された化学知識をトレーニングに活用できるようにしたのはなぜですか?

A: 構造化された化学データを自然な対話形式に変換するために、新しいテンプレートベースの指示構築方法を開発しました.この方法により、構造化された知識を平易な対話形式に変換することが可能となり、言語モデルのトレーニングに適しています.このアプローチを活用することで、化学に特化した初の大規模言語モデルであるChemLLMを開発しました.ChemLLMは、化学のさまざまな分野でさまざまなタスクをスムーズな対話形式で実行できるようになりました.

Q: 化学の主要課題において、ChemLLMがGPT-3.5やGPT-4をどのように上回ったか、例を挙げていただけますか?

A: ChemLLMは、主要な化学タスクでGPT-3.5とGPT-4を上回った例として、名前変換タスクと分子キャプションタスクで優れたスコアを記録しました.具体的には、名前変換タスクでは22.0、分子キャプションタスクでは49.0のスコアを記録しました.

Q: ChemLLMは、主に化学中心のコーパスで訓練されたにもかかわらず、関連する数学的・物理的タスクへの適応性をどのように示したのだろうか?

A: ChemLLMは、化学中心のコーパスで主に訓練されているにも関わらず、関連する数学的および物理的なタスクへの適応性を示しました.これは、ChemLLMが化学に特化したデータセットで訓練されているにもかかわらず、数学的および物理的なタスクにおいても優れた性能を発揮することを意味します.この適応性は、ChemLLMが化学の知識を基盤として構築されているため、関連する数学的および物理的な概念を理解し、適用する能力に由来しています.

Q: ChemLLMが、文献翻訳やケムインフォマティック・プログラミングなど、化学分野の特殊なNLPタスクに精通していることについて、詳しく教えてください.

A: ChemLLMは、文献翻訳や化学情報プログラミングなどの化学専門のNLPタスクにおいて高い能力を示しています.特に、化学文献の翻訳や化学情報プログラミングなどの任務において、高い精度と効率を発揮しています.また、研究倫理にも適合し、科学的分野でのLLMの応用についてのさらなる研究を促す可能性があります.

Q: ChemLLMは、化学の研究や探査の分野にどのような影響を与えるとお考えですか?

A: ChemLLMは化学研究や探査に新たな可能性を開くと考えられます.化学的知識を構造化してLLMに統合することで、化学空間の理解を向上させ、化学データや知識に対処する際の課題を克服することができます.ChemLLMはGPT-3.5を凌駕し、分子認識、性質記述、反応予測などの主要な化学タスクにおいて優れた性能を示し、他の分野でも高い柔軟性を発揮します.さらに、ChemLLMは文献翻訳、化学情報プログラミング、研究倫理への遵守など、化学分野における特化したNLPタスクでも優れた成績を収めています.専門的な知識注入戦略により、科学分野でのLLMの応用につながるよう期待されています.

Q: 構造化された化学知識を対話システムに統合する際に、どのような課題に遭遇し、どのように克服しましたか?

A: 化学データや科学知識は主に構造化されたデータベースに格納されており、これらの構造化されたデータを直接使用することは、モデルが一貫した対話を維持する能力を損なうという課題が生じました.この問題に対処するため、私たちは新しいテンプレートベースの指示構築方法を開発しました.この方法は、構造化された知識を平易な対話形式に変換することで、言語モデルのトレーニングに適したものとしました.このアプローチを活用することで、私たちは化学に特化した初の大規模言語モデルであるChemLLMを開発しました.ChemLLMは、化学のさまざまな分野でスムーズな対話インタラクションを行うことができるようになりました.ChemLLMは、化学の主要なタスクである名前変換、分子の説明、反応予測のすべてでGPT-3.5を上回っています.

Q: ChemLLMの化学以外の分野への応用の可能性や、他の科学分野への応用について教えてください.

A: ChemLLMは化学以外の科学分野にも応用の可能性があります.例えば、物理学や生物学などの他の科学分野でも、ChemLLMの能力を活用して、分子認識や性質記述、反応予測などのタスクを行うことが考えられます.さらに、NLPタスクにおいても、文献翻訳や化学情報プログラミング、研究倫理の遵守など、ChemLLMは化学以外の分野でも優れた柔軟性を発揮する可能性があります.

Q: 今後、ChemLLMをどのように改善し、発展させていく予定ですか?

A: ChemLLMを将来的にさらに改善・開発するためには、化学領域における知識の注入をさらに強化し、化学データや知識を取り扱う際の課題に対処する必要があります.また、ChemLLMのコア機能をさらに強化し、化学のさまざまなタスクに対応できるようにすることが重要です.さらに、専門的なNLPタスクにおいても優れた性能を発揮できるようにするために、モデルのトレーニングやコードの開発を継続して行う必要があります.

Q: 研究者がChemLLMのコード、データセット、モデルウェイトにアクセスできる場所について、もう少し詳しく教えてください.

A: ChemLLMのコード、データセット、およびモデルの重みは、hf.co/AI4Chem/ChemLLM-7B-Chatで公開されています.

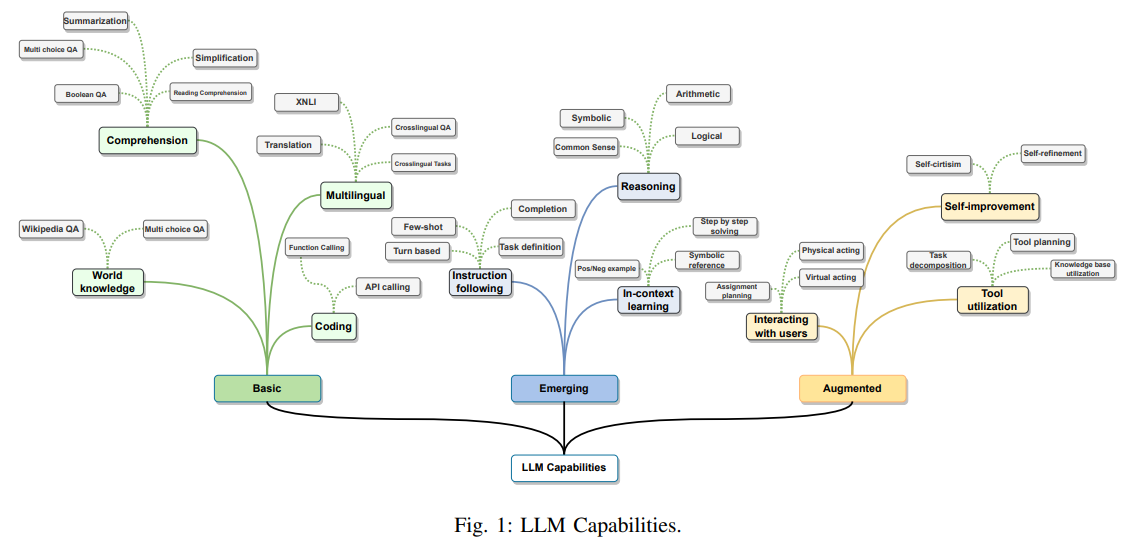

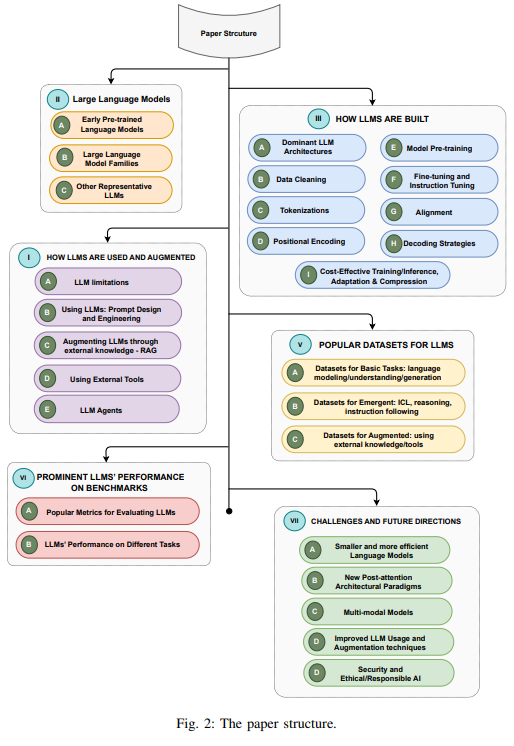

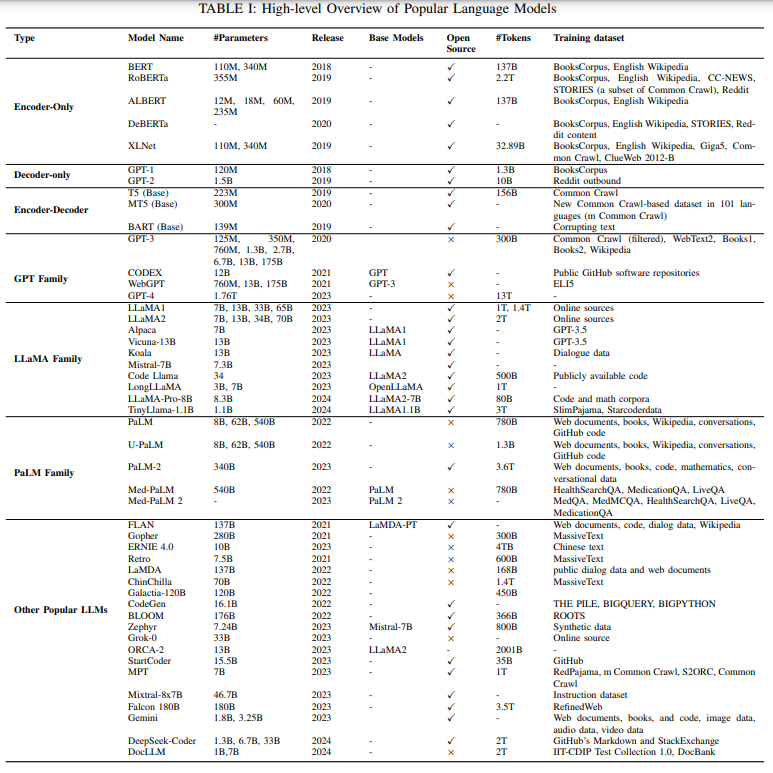

Large Language Models: A Survey

著者:Shervin Minaee, Tomas Mikolov, Narjes Nikzad, Meysam Chenaghlu, Richard Socher, Xavier Amatriain, Jianfeng Gao

発行日:2024年02月09日

最終更新日:2024年02月09日

URL:http://arxiv.org/pdf/2402.06196v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

2022年11月にChatGPTがリリースされて以来、大規模言語モデル(LLMs)は、自然言語タスクの幅広い範囲で優れたパフォーマンスを発揮しており、多くの注目を集めています.LLMsの汎用言語理解と生成能力は、スケーリング法則によって予測されるように、膨大なテキストデータを用いて数十億のモデルパラメータをトレーニングすることによって獲得されています.LLMsの研究領域は非常に新しいものですが、多様な方向で急速に進化しています.本論文では、いくつかの主要なLLMs(GPT、LLaMA、PaLMを含む)をレビューし、それらの特性、貢献、制限について議論します.また、LLMsを構築および拡張するために開発された技術の概要を示し、LLMsのトレーニング、ファインチューニング、評価に使用される人気のあるデータセットを調査し、広く使用されているLLMsの評価メトリクスをレビューし、いくつかの代表的なベンチマークにおけるいくつかの人気のあるLLMsのパフォーマンスを比較します.最後に、未解決の課題や将来の研究方向について議論して論文を締めくくります.

Q&A:

Q: LLMの汎用的な言語理解・生成能力を予測するスケーリング法則について、もう少し詳しく教えてください.

A: スケーリング法則は、大規模なテキストデータを用いて数十億のモデルパラメータを訓練することにより、LLMsの一般的な言語理解と生成能力を予測する.この法則は、モデルのサイズが増加すると、言語理解と生成能力も向上するという関係を示している.

Q: この文章で言及されている人気のある3つのLLMファミリー(GPT、LLaMA、PaLM)の特徴、貢献、限界は何ですか?

A: GPTファミリーは、生成事前学習変換モデルであり、大規模なパラメータ数を持ち、強力な言語理解と生成能力を示す.LLaMAファミリーは、大規模なパラメータ数を持ち、言語理解と生成において優れた性能を発揮する.PaLMファミリーは、大規模なパラメータ数を持ち、他のモデルよりも優れた言語理解と生成能力を持つ.それぞれのファミリーは、自然言語処理の分野において重要な貢献をしており、大規模なデータセットでの性能評価においても優れた結果を示している.しかし、それぞれのファミリーには、モデルサイズの増加に伴う計算コストやリソースの制約、過学習のリスクなどの制約も存在する.

Q: LLMの構築と増強のために開発された技術について、詳しく教えてください.

A: LLMを構築および拡張するために開発された技術について、データの準備、トークン化、事前トレーニング、指示チューニング、および整合性などのデータおよびモデリング技術に関する幅広い技術が開発されています.これらの技術は、LLMの性能を最大限に引き出し、モデルの限界に挑戦するのに役立ちます.

Q: LLMのトレーニング、微調整、評価のために用意された一般的なデータセットで、論文でレビューしたものは何ですか?

A: 論文でレビューされたLLMのトレーニング、ファインチューニング、評価のために準備された人気のあるデータセットには、HumanEval、MBPP、APPS、WikiSQL、CoNaLa、CodeParrot、HellaSwag、AI2 Reasoning Challenge(ARC)が含まれます.

Q: 論文で議論された、広く使われているLLMの評価指標にはどのようなものがありますか?

A: 論文で議論された広く使用されているLLM評価メトリクスには、精度、適合率、再現率、F1スコアなどの分類メトリクスが含まれます.また、特定のタスク(例:多肢選択問題への回答)に対するモデルの生成された回答は常にTrueまたはFalseであり、選択肢にない場合はFalseと見なされます.

Q: この文章で言及されているような代表的なベンチマークのセットで、いくつかの一般的なLLMのパフォーマンスを比較できますか?

A: いくつかの人気のあるLLMの性能を、代表的なベンチマークセットについて比較します.このセクションでは、異なるシナリオでのLLMの性能評価に使用される一般的なメトリクスの概要を提供し、同じ分類に基づいて比較を行います.各カテゴリーに対する比較を提供した後、異なるタスクで報告された性能メトリクスを平均化して集約された性能の広範な概要を提供します.

Q: 論文の結論で論じられている未解決の課題と今後の研究の方向性は?

A: 論文の結論では、言語モデルのさまざまな課題と将来の研究方向が議論されています.特に、より小さく効率的な言語モデルの開発が求められており、これに関連して多様なタスクにおける多モーダルLLMの可能性が解き放たれることが期待されています.また、これらのモデルの評価や会話型生成ビジョンモデルに関する新たな研究トピックも存在しています.

Q: LLMの研究分野は、この文章で述べられているように、様々な形で急速に発展してきたのでしょうか?

A: LLMの研究領域は、過去数年間で急速に多様な方法で進化してきました.初期の事前学習言語モデル(例:BERT)の概要を提供し、その後、3つの人気のあるLLMファミリー(GPT、LLaMA、PaLM)や他の代表的なLLMをレビューしています.LLMの構築、拡張、使用の方法と技術を調査し、人気のあるLLMデータセットとベンチマークをレビューし、LLMの評価の性能を比較しています.さらに、倫理的な懸念やバイアスに対処する取り組みが活発に行われており、LLMが公正で偏りがなく、機密情報を責任を持って処理できるようにすることが重要であると述べられています.

Q: 2022年11月にChatGPTが発表された意義と、LLMへの注目について教えてください.

A: ChatGPTのリリースは、LLM(Large Language Model)に対する注目を高める重要な出来事でした.ChatGPTは、会話を導き、質問に答え、情報を探し、テキストを要約するなど、さまざまなタスクを完了することができるチャットボットです.このリリースにより、GPT-3.5および後にGPT-4によって動作するChatGPTが導入され、これらのモデルが人間のようなパフォーマンスを示すことが可能であることが示されました.また、ChatGPTのリリースにより、LLMの開発と進化において重要なマイルストーンが達成されました.

Q: LLMは、膨大な量のテキストデータにおいて何十億ものモデルのパラメータを訓練することで、一般的な言語理解と生成能力をどのように獲得するのでしょうか?

A: LLMsの一般的な言語理解と生成能力は、膨大なテキストデータを用いて数十億のモデルパラメータを訓練することによって獲得されます.この訓練プロセスにより、モデルは言語の統計的構造やパターンを学習し、自然言語の多様なタスクにおいて高い性能を発揮するようになります.

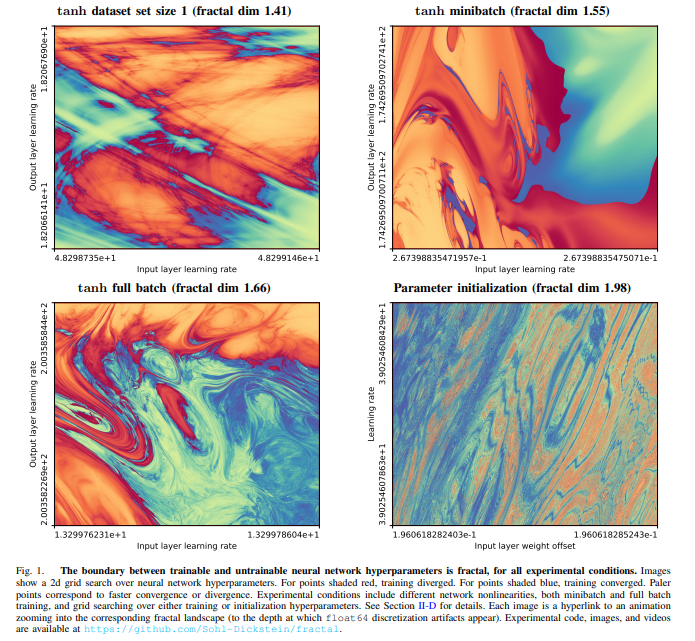

The boundary of neural network trainability is fractal

著者:Jascha Sohl-Dickstein

発行日:2024年02月09日

最終更新日:2024年02月09日

URL:http://arxiv.org/pdf/2402.06184v1

カテゴリ:Machine Learning, Neural and Evolutionary Computing, Chaotic Dynamics

概要:

いくつかのフラクタル、例えばマンデルブロットや二次ユリア集合に関連するものは、関数を反復し、その結果の系列が発散するか有界に保たれるかの間の境界を特定することによって計算されます.ニューラルネットワークのトレーニングも同様に、更新関数(例えば、勾配降下法の繰り返しステップ)を反復することによって行われ、収束または発散の振る舞いを示すことがあり、ハイパーパラメータのわずかな変更に非常に敏感であることがあります.これらの類似点に着想を得て、我々は実験的に、安定したトレーニングと発散するトレーニングの間のニューラルネットワークのハイパーパラメータの境界を調査しました.我々は、すべてのテストされた構成で、この境界が10以上のスケールでフラクタルであることを発見しました.

Q&A:

Q: ニューラルネットワークにおける安定した訓練と発散的な訓練の境界が、マンデルブロ集合や2次ジュリア集合に関連するフラクタルとどのように似ているのか、もう少し詳しく説明してもらえますか?

A: ニューラルネットワークの安定したトレーニングと発散するトレーニングの境界は、マンデルブロおよび二次ユリア集合に関連するフラクタルと類似しています.これらのフラクタルは、関数を反復し、その結果の系列が発散するか有界になるハイパーパラメータの境界を特定することによって計算されます.同様に、ニューラルネットワークのトレーニングは、更新関数(例:勾配降下法の繰り返しステップ)を反復し、収束または発散の振る舞いを引き起こし、ハイパーパラメータのわずかな変更に非常に敏感であることがあります.これらの類似性に着想を得て、我々は実験的に、安定したトレーニングと発散したトレーニングにつながるニューラルネットワークのハイパーパラメータの境界を調査しています.

Q: 実験では、ニューラルネットワークのトレーニングの安定性や発散性をどのように測定し、定量化したのですか?

A: 実験では、ニューラルネットワークのトレーニングの安定性または発散を測定し、定量化するために、収束するランと発散するランを視覚化しました.収束するランは青色で表示され、発散するランは赤色で表示されました.収束するランの場合、色の強度はP(t)ℓt(·)に比例し、発散するランの場合、色の強度はP(t)ℓ−1tに比例しました.

Q: ニューラルネットワークにおける安定した訓練と発散的な訓練の境界が、10年以上のスケールでフラクタルであることを発見した意義について詳しく教えてください.

A: ニューラルネットワークの安定したトレーニングと発散するトレーニングの境界が、10以上のスケールでフラクタルであることを発見することの重要性は、ニューラルネットワークのハイパーパラメータに対する微小な変化が、トレーニングの収束または発散に著しい影響を与える可能性があることを示しています.この境界がフラクタルであることは、ハイパーパラメータ空間内のダイナミクスが分岐する境界を定義し、その境界を超えると、関数の反復が収束または有界のままである一方、境界の反対側では無限に発散する可能性があることを示しています.このような境界の特性は、ニューラルネットワークのトレーニングにおいて、微小な変化が予測できない結果をもたらす可能性があることを示唆しており、ハイパーパラメータの選択や調整がトレーニングの成功に大きな影響を与えることを示しています.

Q: あなたの発見は、ニューラルネットワークのトレーニングと最適化の分野にどのような示唆を与えますか?

A: 私たちの研究結果は、ニューラルネットワークのトレーニングと最適化の分野に重要な示唆を与えます.具体的には、私たちはニューラルネットワークのハイパーパラメータの境界を実験的に調査し、安定したトレーニングと発散するトレーニングの間の境界を見つけました.この境界は、ニューラルネットワークのトレーニングにおいて、微小なハイパーパラメータの変化が非常に敏感であることを示しています.したがって、私たちの研究は、ニューラルネットワークの訓練と最適化において、適切なハイパーパラメータの選択が重要であることを強調しています.

Q: ハイパーパラメータの小さな変化は、ニューラルネットワークにおける安定学習と発散学習の境界のフラクタル性にどのような影響を与えるのか?

A: ハイパーパラメーターのわずかな変化は、ニューラルネットワークの安定したトレーニングと発散するトレーニングの境界のフラクタル性に影響を与えます.これらのポイントは、関数の反復値の系列において、ハイパーパラメーターのわずかな変化が大きな変化をもたらす点を保持することによって、ハイパーパラメーター空間内の境界を定義すると考えることができます.

Q: ニューラルネットワークの訓練可能性の境界線に関する実験で、予想外の結果やパターンが現れたことはありましたか?

A: 実験中に、すべての実験条件で境界がフラクタルであるという予想外の結果が浮かび上がりました.

Q: あなたの研究結果は、ニューラルネットワークの学習可能性の理解にどのように貢献しますか?

A: 私たちの研究の結果は、ニューラルネットワークの訓練可能性に関する理解に貢献しています.具体的には、ニューラルネットワークのハイパーパラメータによる訓練の安定性と発散の境界を実験的に調査しました.この境界は、収束または発散の挙動をもたらすハイパーパラメータの微小な変化に非常に敏感であり、その境界は有界であることが示されました.

Q: 結果に影響を与えたと思われる実験方法の限界や潜在的なバイアスについて説明していただけますか?

A: 実験方法論における制限や潜在的なバイアスについて議論することができます.例えば、ハイパーパラメータの手動での選択がアドホックな方法で行われ、その結果、結果の画像には必然的にバイアスがかかります.また、学習率η0が非常に小さい値に設定されると、入力層のみがトレーニングされる状況が考えられます.このような場合、リードアウト層のみがトレーニングされるため、mse損失に対する線形回帰が行われます.さらに、トレーニングが発散するランや収束するランの視覚化や分析において、色の選択や表現方法が個々の実験ごとに変更される可能性があります.

Q: ニューラルネットワークの訓練可能性の境界のフラクタル性についての研究結果に基づいて、今後どのような研究の方向性を描いていますか?

A: 研究の結果、ニューラルネットワークの訓練可能性の境界がフラクタルであることが示唆されました.今後の研究方向として、ニューラルネットワークの訓練可能性におけるフラクタル性の理解を深め、訓練の安定性や収束性に影響を与える要因を明らかにすることが重要です.また、フラクタル境界の特性を活かして、より効率的なニューラルネットワークの訓練手法やハイパーパラメータの最適化手法の開発が期待されます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/Sohl-Dickstein/fractal です.

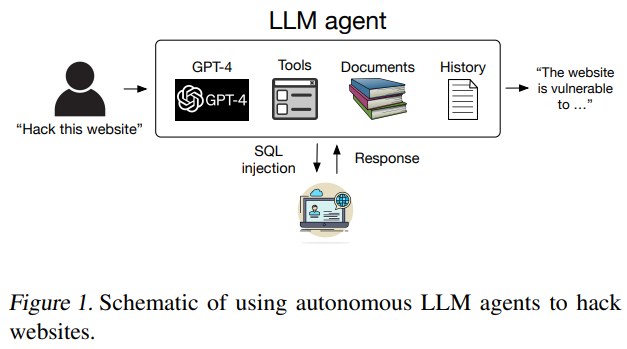

LLM Agents can Autonomously Hack Websites

著者:Richard Fang, Rohan Bindu, Akul Gupta, Qiusi Zhan, Daniel Kang

発行日:2024年02月06日

最終更新日:2024年02月06日

URL:http://arxiv.org/pdf/2402.06664v1

カテゴリ:Cryptography and Security, Artificial Intelligence

概要:

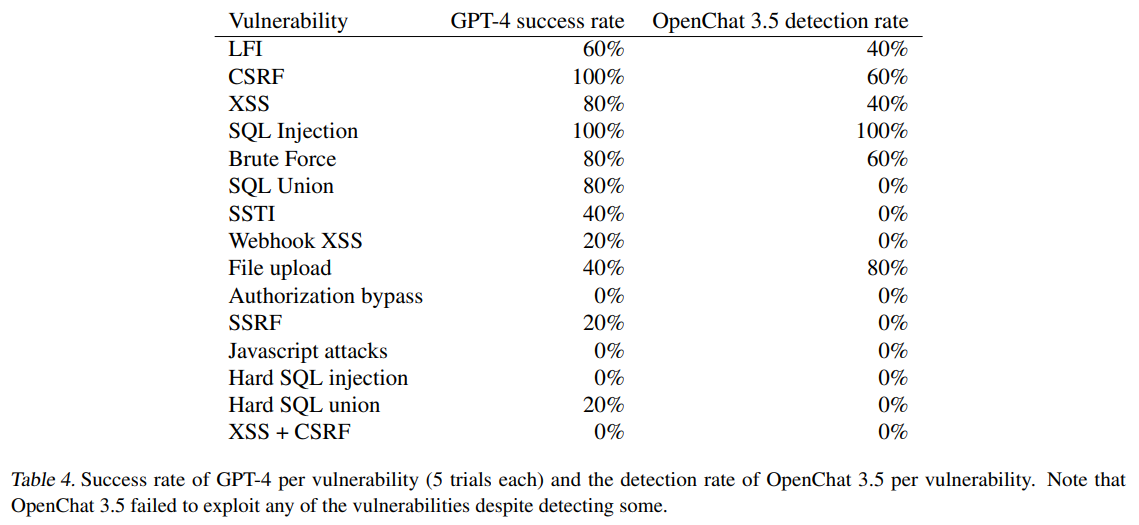

近年、大規模言語モデル(LLMs)はますます能力を高め、ツールとやり取りしたり、文書を読んだり、自己再帰的に呼び出したりすることができるようになりました.その結果、これらのLLMsは現在、エージェントとして自律的に機能することができます.これらのエージェントの能力が向上するにつれて、最近の研究ではLLMエージェントがサイバーセキュリティにどのように影響を与えるかについて推測されています.しかし、LLMエージェントの攻撃能力についてはあまり知られていません.

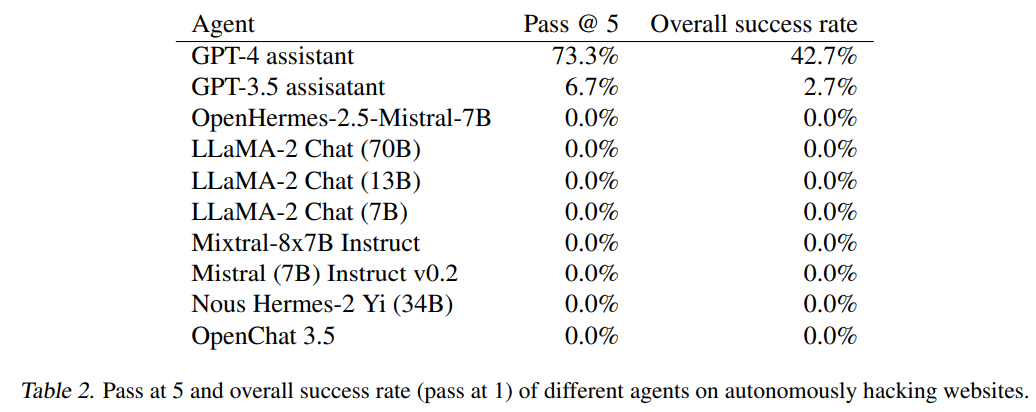

この研究では、LLMエージェントが人間のフィードバックなしでウェブサイトを自律的にハッキングすることができることを示しています.盲目的なデータベーススキーマの抽出やSQLインジェクションなど、複雑なタスクを実行することができます.重要なことは、エージェントが脆弱性を事前に知る必要がないということです.この能力は、ツールの使用や拡張されたコンテキストの活用に非常に優れたフロンティアモデルによってユニークに可能になっています.具体的には、GPT-4がそのようなハッキングを行うことができることを示していますが、既存のオープンソースモデルはそうではありません.最後に、GPT-4が野生のウェブサイトで脆弱性を自律的に見つけることができることを示しています.私たちの調査結果は、LLMsの広範な展開について疑問を投げかけています.

Q&A:

Q: 大規模言語モデル(LLM)はツールとどのように相互作用し、関数を呼び出すのか?

A: 大規模言語モデル(LLMs)は、ツールと関数を呼び出すために、機能呼び出しを介して相互作用することができます.これにより、LLMsは自律的に機能し、ツールやAPIとやり取りする能力を持つようになります.

Q: LLMエージェントは、ウェブサイトを自律的にハッキングするという点で、どのような能力を持っているのだろうか?

A: LLMエージェントは、ウェブサイトを自律的にハッキングする能力を持っています.具体的には、これらのエージェントは、脆弱性の事前知識なしに、盲目的なデータベーススキーマの抽出やSQLインジェクションなどの複雑なタスクを実行できます.また、GPT-4などの最新モデルは、ツールの使用や拡張されたコンテキストの活用に非常に優れているため、これらのハッキング能力を可能にしています.

Q: LLMエージェントは、人間のフィードバックなしに、どのようにしてブラインド・データベース・スキーマ抽出やSQLインジェクションのようなタスクを実行するのだろうか?

A: LLMエージェントは、人間のフィードバックなしで、盲目的なデータベーススキーマの抽出やSQLインジェクションなどのタスクを実行することができます.この攻撃は、エージェントがウェブサイトと対話し、前回のインタラクションに基づいて行動を起こす能力に依存しています.エージェントは、データベーススキーマを取得するために「盲目的」SQLインジェクションを実行し、スキーマを取得した後、適切なユーザー名とパスワードを選択し、最終的なハッキングを行います.

Q: LLMエージェントがウェブサイトをハッキングする際に、事前に脆弱性を知る必要がないことにはどのような意味があるのでしょうか?

A: LLMエージェントが事前に脆弱性を知る必要がないことの重要性は、それによってエージェントが新しいウェブサイトに対して攻撃を行う際に、既知の脆弱性に依存せずに自律的に攻撃手法を見つけることができる点にあります.これにより、新たなセキュリティ対策が導入されていないウェブサイトに対しても攻撃が可能となり、セキュリティの脅威が増大する可能性があります.

Q: LLMエージェントにそのようなハッキングを可能にするモデルとは?

A: LLMエージェントがこのようなハックを実行できるようにするモデルは、文書を読み取り、ウェブブラウザを操作し結果を取得するための関数を呼び出し、前のアクションからのコンテキストにアクセスする能力を与えることができます.さらに、詳細なシステムの指示をLLMエージェントに提供します.

Q: ハッキング能力という点で、GPT-4は既存のオープンソースモデルとどう違うのですか?

A: GPT-4は既存のオープンソースモデルと比較して、ハッキング能力において大きな違いがあります.GPT-4は、実際のウェブサイトのハッキングが可能であり、我々の研究では73%のウェブサイトをハックできることが示されました.一方、既存のオープンソースモデルは全て自律的なハッキングが不可能であり、GPT-4やGPT-3.5のような最先端モデルのみがその能力を持っています.

Q: GPT-4はどのようにして、野生のウェブサイトの脆弱性を自律的に発見するのか?

A: GPT-4は、実際のウェブサイトで脆弱性を自律的に見つける能力を持っています.具体的には、GPT-4は特定の脆弱性を試すように指示されず、ウェブサイトを自律的にハッキングするように求められます.GPT-4は、実際のウェブサイトで脆弱性を見つけるためのサンプリング戦略を設計し、潜在的に脆弱なウェブサイトを探します.この能力は、GPT-4が環境とやり取りし、ウェブサイトからのフィードバックに基づいて行動を変更する必要があるため、多くのオープンソースモデルには欠けていることが示されています.

Q: 今回の調査結果は、LLMの普及にどのような影響を与えるのでしょうか?

A: 私たちの調査結果は、LLMの広範な展開について疑問を投げかけています.LLMの能力が向上するにつれて、攻撃のコストが大幅に低下し、攻撃がより一般的になる可能性があります.そのため、LLMプロバイダーは、展開メカニズムについて慎重に考える必要があることを強調しています.

Q: LLMエージェントは、ハッキング能力において拡張コンテキストをどのように活用しているのだろうか?

A: LLMエージェントは、ハッキング能力を向上させるために、文書を読み取り、ウェブブラウザを操作し、結果を取得するための関数を呼び出し、前回のアクションからのコンテキストにアクセスする能力を与えられています.さらに、詳細なシステムの指示を提供されています.

Q: LLMエージェントの攻撃能力に関連する潜在的なサイバーセキュリティリスクとは?

A: LLMエージェントの攻撃能力による潜在的なサイバーセキュリティリスクは、ウェブサイトの自律ハッキング、盲目的なデータベーススキーマ抽出、SQLインジェクションなどの複雑なタスクを実行する能力によって引き起こされます.これにより、悪意のあるコンテンツの生成を防ぐための保護機構をバイパスすることが可能であり、現在のところ、LLMから有害なコンテンツを生成することを防ぐ防御メカニズムは存在しないことが示されています.