ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- AgentBoard: An Analytical Evaluation Board of Multi-turn LLM Agents

発行日:2024年01月24日

大規模言語モデル(LLM)の評価には課題があり、AgentBoardはこの問題に対処するための包括的な評価フレームワークであり、LLMエージェントの能力と制限を明確に理解し、パフォーマンスの解釈可能性を向上させることができる. - Diffuse to Choose: Enriching Image Conditioned Inpainting in Latent Diffusion Models for Virtual Try-All

発行日:2024年01月24日

オンラインショッピングの普及に伴い、バーチャルトライオールと呼ばれる現象が起きており、新しい拡散ベースの画像条件付きインペインティングモデル「Diffuse to Choose」が、従来の手法よりも優れていることが広範なテストで示されている. - MambaByte: Token-free Selective State Space Model

発行日:2024年01月24日

バイトデータから直接学習するトークンフリー言語モデルMambaByteは、バイトシーケンス上で効率的に動作し、サブワードトランスフォーマーよりも高速であり、競争力があることが示された. - Lumiere: A Space-Time Diffusion Model for Video Generation

発行日:2024年01月23日

Lumiereは、テキストからビデオへの拡散モデルであり、Space-Time U-Netアーキテクチャを使用してフルフレームレートの低解像度ビデオを生成することができる.これにより、さまざまなコンテンツ作成タスクやビデオ編集アプリケーションが容易に実現できる. - Red Teaming Visual Language Models

発行日:2024年01月23日

VLMはLLMの機能を拡張し、マルチモーダルな入力を受け入れることができるが、Red TeamingデータセットRTVLMによる評価では、10の主要なオープンソースのVLMが異なる程度で苦戦し、GPT-4Vと最大31%の性能差があることが示された. - WARM: On the Benefits of Weight Averaged Reward Models

発行日:2024年01月22日

大規模言語モデル(LLM)を強化学習(RLHF)で人間の好みに合わせると、報酬ハッキングのリスクがある.Weight Averaged Reward Models(WARM)は、報酬ハッキングを軽減するための解決策として提案されており、実験では全体的な品質と整合性を向上させることが示されている. - Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data

発行日:2024年01月19日

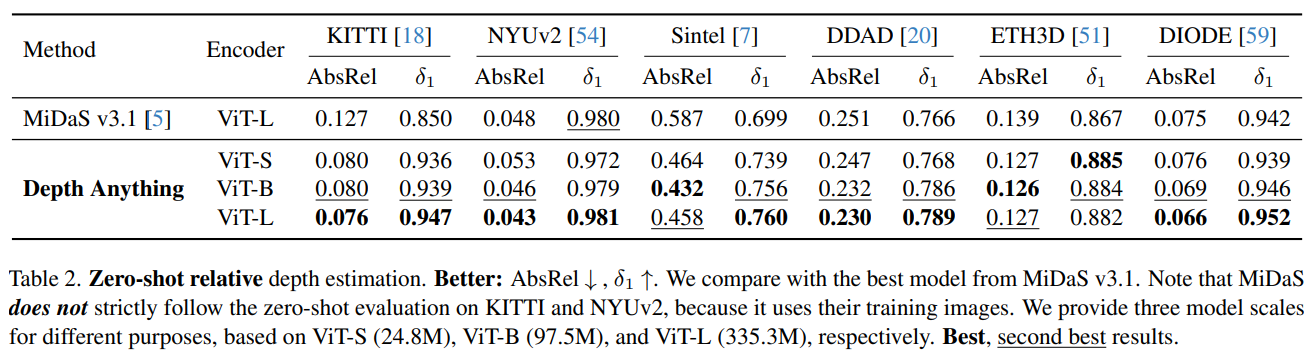

この研究では、頑健な単眼深度推定のためのDepth Anythingという実用的なソリューションを提案し、データエンジンを使用して大規模な未ラベルデータを収集し、データセットを拡大しました.さらに、データ拡張と事前学習済みのエンコーダを使用してモデルを改良し、印象的な汎化能力とSOTAの結果を実現しました. - Knowledge Fusion of Large Language Models

発行日:2024年01月19日

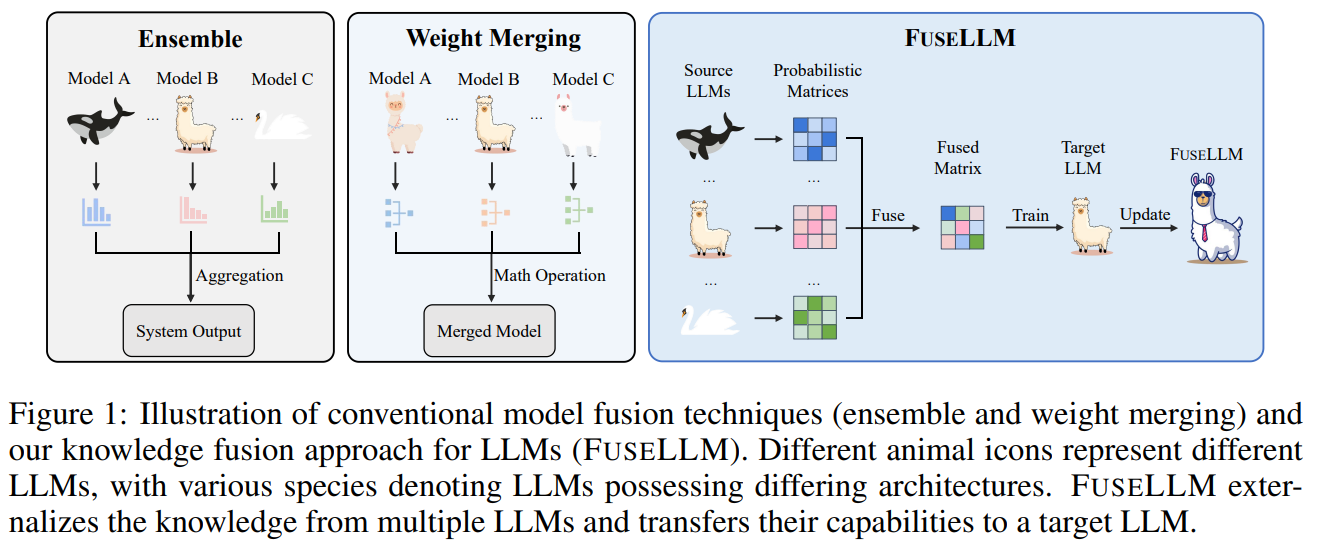

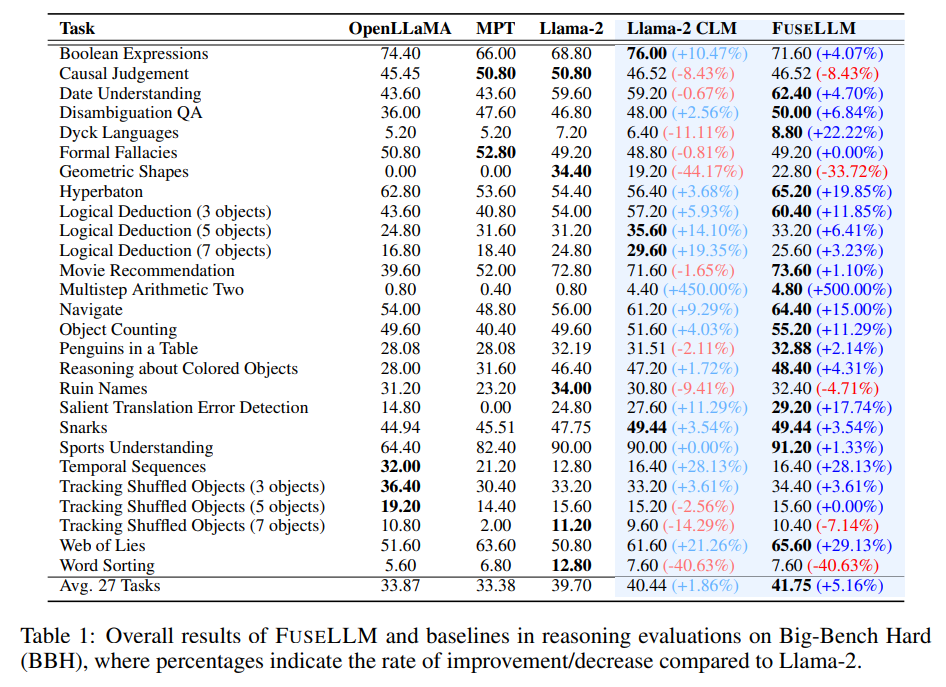

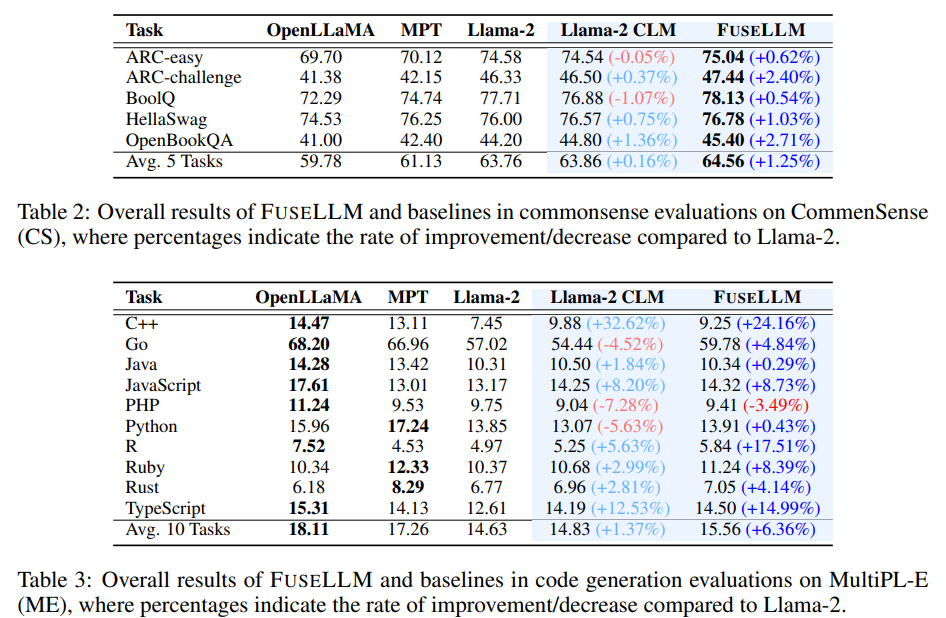

既存の大規模言語モデルを統合することで、異なる機能と強みを持つモデルを作成し、推論、常識、およびコード生成などの能力を向上させることができることが論文で示されています. - Medusa: Simple LLM Inference Acceleration Framework with Multiple Decoding Heads

発行日:2024年01月19日

本論文では、大規模言語モデル(LLM)の推論プロセスの制約とその解決策であるMedusaを提案し、Medusaの2つの微調整手順といくつかの拡張機能の有用性を評価しました.実験結果は、Medusaが高速化を実現できることを示しています. - A Survey of Resource-efficient LLM and Multimodal Foundation Models

発行日:2024年01月16日

大規模なモデルは機械学習のライフサイクルを革新しているが、ハードウェアリソースのコストがかかるため、リソース効率の良い戦略の開発が注目されている.この調査では、大規模モデルの研究の重要性について詳しく掘り下げ、アルゴリズムとシステムの両側面を調査し、将来の突破口を見つけることを目的としている.

AgentBoard: An Analytical Evaluation Board of Multi-turn LLM Agents

著者:Chang Ma, Junlei Zhang, Zhihao Zhu, Cheng Yang, Yujiu Yang, Yaohui Jin, Zhenzhong Lan, Lingpeng Kong, Junxian He

発行日:2024年01月24日

最終更新日:2024年01月24日

URL:http://arxiv.org/pdf/2401.13178v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

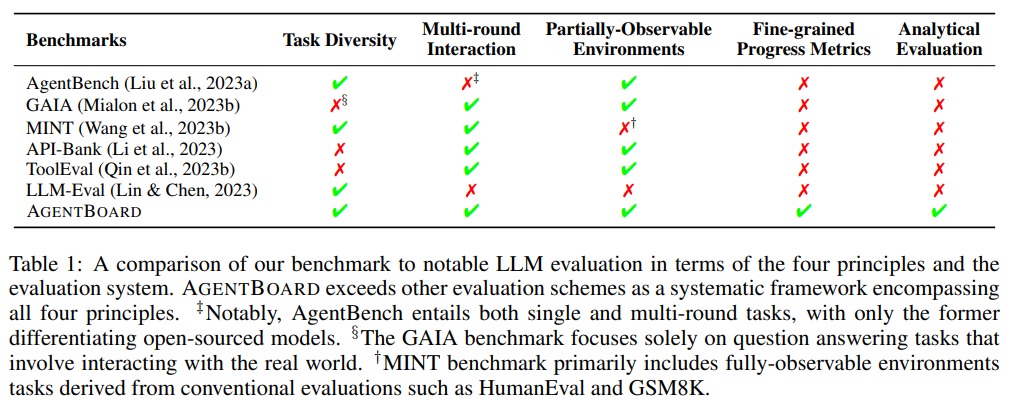

大規模言語モデル(LLM)を一般的な目的のエージェントとして評価することは、その能力を理解し、実用的なアプリケーションへの統合を容易にするために不可欠です.しかし、評価プロセスには多くの課題があります.主な障害の1つは、部分的に観測可能な環境を維持し、マルチラウンドの相互作用を確保するために、統一されたフレームワーク内でエージェントのパフォーマンスをベンチマークすることです.さらに、現在の評価フレームワークは、主に最終的な成功率に焦点を当てており、プロセス中の洞察をほとんど提供せず、モデルの能力について深い理解を提供することができません.これらの課題に対処するために、私たちはAgentBoardを導入します.これは、LLMエージェントの分析評価に特化した画期的な包括的なベンチマークおよびオープンソースの評価フレームワークです.AgentBoardは、徐々に進歩を捉える細かい進捗率メトリックを提供し、インタラクティブな可視化を通じて多面的な分析のためのエージェントの簡単な評価を可能にする包括的な評価ツールキットを提供します.これにより、LLMエージェントの能力と制限についての明確な理解が得られるだけでなく、LLMエージェントのパフォーマンスの解釈可能性も前面に押し出されます.結果的に、AgentBoardはエージェントの振る舞いを解明し、より強力なLLMエージェントの開発を加速するための重要な一歩となります.

Q&A:

Q: 大規模言語モデル(LLM)を汎用エージェントとして評価する際の実質的な課題とは?

A: LLMsの一般的なエージェントとしての評価には、いくつかの重要な課題が存在します.その一つは、異なるシナリオでのエージェントのパフォーマンスをベンチマークすることです.また、LLMsを複雑なタスクの実行可能なアクションを生成するために使用するため、LLMsへの指示や周囲の環境に関する情報を提供する必要があります.さらに、LLMsをエージェントとして再利用するための特殊なトレーニングや、エージェントの能力を測定するための次元の評価も重要です.これらの課題を克服するために、LLMsの一般的な能力や進歩を理解するために、LLMsをエージェントとして評価することは不可欠です.

Q: LLMエージェントの評価プロセスは、多様なシナリオにおけるエージェントのパフォーマンスをベンチマークする上で、どのような障害となるのでしょうか?

A: LLMのエージェントの評価プロセスは、さまざまなシナリオでエージェントのパフォーマンスをベンチマークする際に障害が生じます.主な障害は、部分的に観測可能な環境を維持し、マルチラウンドの相互作用を確保することです.また、現在の評価フレームワークは、主に最終的な成功率に焦点を当てており、プロセス中の洞察をほとんど提供せず、モデルの能力について深い理解を提供していません.

Q: 評価プロセスにおいて、部分的に観測可能な環境を維持し、多ラウンドの相互作用を確保することの難しさとは?

A: 部分的に観測可能な環境を維持し、マルチラウンドの相互作用を確保することにおいては、いくつかの困難があります.現在の評価フレームワークは、主に最終的な成功率に焦点を当てており、プロセス中の洞察をほとんど提供せず、モデルの能力を深く理解することができません.また、部分的に観測可能な環境とマルチラウンドの相互作用を維持するための統一されたフレームワークが不足しています.さらに、従来のベンチマークから派生した「疑似」エージェントタスクとは異なり、実用的な評価のためには、エージェントが積極的に探索して自分の周囲を理解する必要があります.

Q: 現在の評価の枠組みは、そのほとんどが最終的な成功率に焦点を当て、そのプロセスにおける洞察を提供できていない.

A: 現在の評価フレームワークは、主に最終的な成功率に焦点を当てており、プロセス中に洞察を提供することができません.最終的な成功率に焦点を当てることで、モデルの能力についての深い理解を提供することができず、プロセス中の微細な違いを見逃してしまいます.

Q: AgentBoard導入の目的と、LLMエージェントを評価する際の課題への対応について教えてください.

A: A GENT BOARDの目的は、LLMエージェントの詳細な評価と理解を促進し、この分野のさらなる進歩を推進することです.A GENT BOARDは、エージェントのパフォーマンスを統一されたフレームワーク内でさまざまなシナリオでベンチマークすることにより、評価プロセスにおける課題に取り組んでいます.特に、部分的に観測可能な環境を維持し、マルチラウンドの相互作用を確保することが課題です.また、現在の評価フレームワークは、主に最終的な成功率に焦点を当てており、プロセス中の洞察をほとんど提供せず、モデルの能力について深い理解を提供することができません.A GENT BOARDは、これらの課題に対処するために、革新的な評価システムです.

Q: AgentBoardが提供するきめ細かな進捗率指標とはどのようなもので、どのように漸進的な進歩を捉えるのですか?

A: AgentBoardは、エージェントの目標状態に向けた進捗を評価するための細かい進捗率メトリックであるrtを提供しています.このメトリックは、各インタラクションの進捗率を割り当てることで、段階的な進歩を捉えます.エージェントが状態st=[s0,…,st]を通過するにつれて、進捗率は目標状態gに対するエージェントの近接度に基づいて計算されます.細かい進捗率メトリックは、言語モデルエージェントの目標達成を統一的な方法でさまざまな段階で正確に反映します.

Q: AgentBoardは、LLMエージェントを多面的に分析するための包括的な評価ツールキットをどのように提供していますか?

A: AGENT BOARDは、多面的な分析のための包括的な評価ツールキットを提供します.このツールキットには、インタラクティブな可視化を通じてエージェントの評価を容易に行うことができる包括的な評価ツールキットが含まれています.これにより、エージェントの進歩の詳細な評価や多角的な分析が可能となります.

Q: AgentBoardのインタラクティブな可視化機能は、エージェントの評価をどのように促進しますか?

A: AgentBoardのインタラクティブな可視化機能は、エージェントの評価を容易にするために役立ちます.ユーザーは可視化ウェブパネルを使用して評価を効率的に探索し、興味のあるエージェントのより深い理解を得ることができます.可視化機能により、エージェントの評価結果を視覚的に表現することができ、異なる側面からの包括的な分析が可能です.これにより、エージェントの進捗状況、正確性、難易度の分解、長距離相互作用、さらにはさまざまなサブスキルにおけるパフォーマンスなど、詳細な分析が行われます.エージェントの評価をより詳細に理解することで、このフレームワークは研究の進歩を促進します.

Q: AgentBoardは、LLMエージェントの能力と限界を明らかにすることにどのように貢献していますか?

A: A GENT BOARDは、LLMエージェントの詳細な評価と理解を促進し、この分野のさらなる発展を促すことを目的としています.A GENT BOARDは、LLMエージェントの能力と限界に光を当てるインタラクティブな可視化を通して、多面的な分析を提供します.A GENT BOARDを使用することで、研究者はLLMエージェントのパフォーマンスに関する洞察を得て、その行動を理解することができます.これはエージェントの行動を解明し、より強力なLLMエージェントの開発を加速するのに役立ちます.

Q: AgentBoardはどのようにして、より強力なLLMエージェントの開発を加速し、エージェントの行動を神秘化するのでしょうか?

A: A GENT BOARDは、LLMエージェントの能力と制限を明らかにするだけでなく、エージェントの振る舞いを解明し、より強力なLLMエージェントの開発を加速することを目指しています.具体的には、A GENT BOARDは、LLMエージェントの進歩を評価するための詳細な指標と、エージェントの能力と制限を可視化するための包括的な評価ツールキットを提供します.これにより、エージェントのパフォーマンスの解釈性を向上させ、エージェントの振る舞いをより理解しやすくします.さらに、A GENT BOARDは、LLMエージェントの評価と理解を促進し、研究のさらなる進展を促すことを目指しています.

Diffuse to Choose: Enriching Image Conditioned Inpainting in Latent Diffusion Models for Virtual Try-All

著者:Mehmet Saygin Seyfioglu, Karim Bouyarmane, Suren Kumar, Amir Tavanaei, Ismail B. Tutar

発行日:2024年01月24日

最終更新日:2024年01月24日

URL:http://arxiv.org/pdf/2401.13795v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

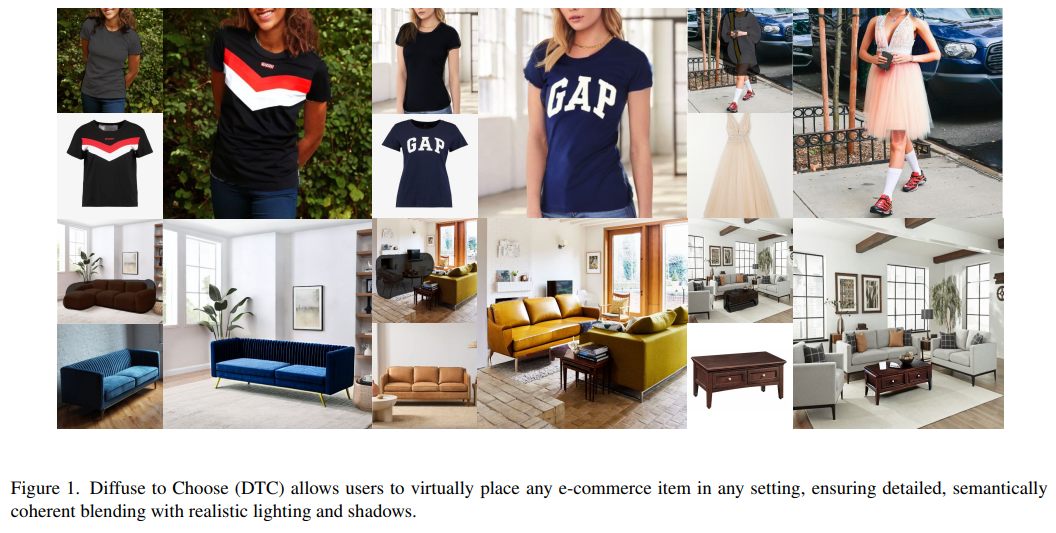

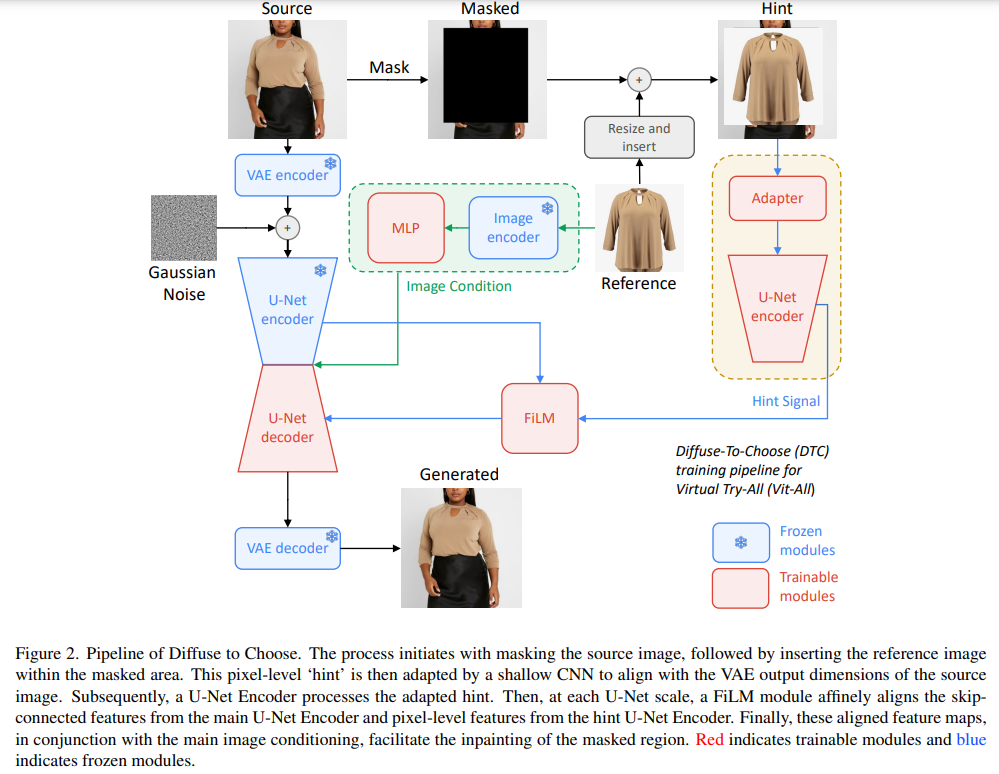

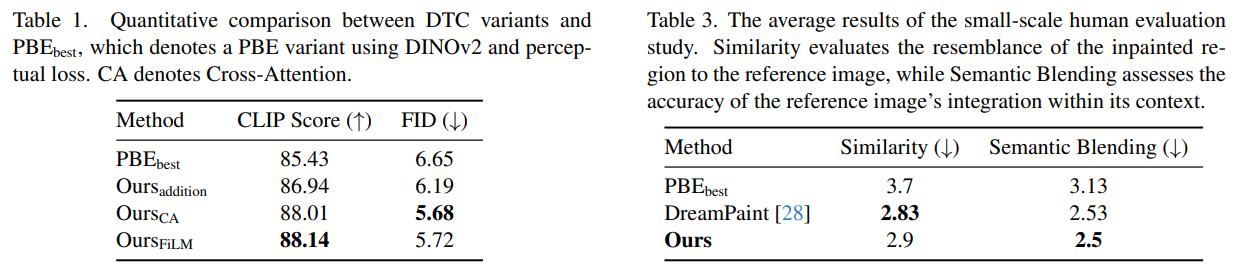

オンラインショッピングの普及に伴い、バイヤーが製品を仮想的に自分の環境で視覚化する能力は、私たちが「バーチャルトライオール」と定義する現象となってきました.最近の拡散モデルは、インペインティングの文脈では適しているため、これに適したワールドモデルを含んでいます.しかし、従来の画像条件付きの拡散モデルは、製品の細かいディテールを捉えることができないことが多いです.一方、DreamPaintなどの個別化駆動型モデルは、アイテムの詳細を保持するのには優れていますが、リアルタイムのアプリケーションには最適化されていません.私たちは、「Diffuse to Choose」という新しい拡散ベースの画像条件付きインペインティングモデルを提案しています.このモデルは、高い忠実度の詳細を保持しながら、与えられたリファレンスアイテムのシーンコンテンツ内での正確な意味操作を確保するために、リファレンス画像からの細かい特徴をメインの拡散モデルの潜在的な特徴マップに直接組み込むことに基づいています.さらに、知覚的な損失を用いてリファレンスアイテムの詳細をさらに保持します.私たちは、「Diffuse to Choose」が既存のゼロショットの拡散インペインティング手法やDreamPaintなどの少数ショットの拡散個別化アルゴリズムよりも優れていることを、社内および公開されているデータセットで広範なテストを行って示しています.

Q&A:

Q: Diffuse to Choose モデルの主な目的は何ですか?

A: Diffuse to Chooseの主な目的は、高品質な詳細を保持しながら、与えられた参照アイテムのシーンコンテンツ内で正確な意味的な操作を実現することです.

Q: Diffuse to Chooseモデルは、従来のイメージ条件付き拡散モデルとどう違うのか?

A: Diffuse to Chooseモデルは、従来の画像条件付き拡散モデルとは異なり、参照画像から微細な特徴を直接主な拡散モデルの潜在的な特徴マップに組み込むことに基づいています.また、知覚的な損失を用いて参照アイテムの詳細をさらに保持します.これにより、高速な推論と高品質な詳細の保持を両立させることができます.

Q: 製品のきめ細かなディテールを捉える上で、従来の画像条件付き拡散モデルにはどのような限界があるのだろうか?

A: 従来の画像条件付きの拡散モデルは、製品の細かい詳細を捉えることができないという制約があります.

Q: Diffuse to Choose モデルは、どのように参照画像から細かな特徴を取り込むのですか?

A: Diffuse to Chooseモデルは、参照画像の微細な特徴を直接主な拡散モデルの潜在的な特徴マップに組み込むことによって微細な特徴を取り込んでいます.

Q: Diffuse to Chooseモデルにおいて、知覚損失の役割は、参照アイテムの詳細を保持することですか?

A: Diffuse to Chooseモデルにおいて、知覚的損失の役割は、参照アイテムの詳細を保持することです.知覚的損失は、参照画像の微細な特徴を主な拡散モデルの潜在的な特徴マップに直接組み込むことで、参照アイテムの詳細を保護します.これにより、生成される画像において参照アイテムの詳細がより正確に再現されます.

Q: Diffuse to Choose」モデルにおいて、迅速な推論と忠実度の高いディテールの保持を両立させるプロセスを説明できますか?

A: 「Diffuse to Choose」モデルでは、高速な推論と高品質な詳細の保持をバランスさせるためのプロセスがあります.このモデルでは、参照アイテムの細かい特徴を主な拡散モデルの潜在的な特徴マップに直接組み込むことで、高品質な詳細を保持します.また、知覚的な損失も使用して、参照アイテムの詳細をさらに保護します.このようにして、高速な推論と高品質な詳細の保持を両立させることができます.

Q: Diffuse to Choose モデルの性能をテストするために、どのようなデータセットが使われたのか?

A: 提供された文脈では、Diffuse to Chooseモデルの性能をテストするために、内部および公開データセットの両方が使用されました.

Q: Diffuse to Choose の性能は、既存のゼロショット拡散インペインティング手法と比較してどうですか?

A: Diffuse to Chooseは、既存のゼロショット拡散インペインティング手法よりも優れている.

Q: Diffuse to Choose のパフォーマンスは、”DreamPaint “のような数ショットの拡散パーソナライゼーション・アルゴリズムと比べてどうですか?

A: Diffuse to ChooseはDreamPaintと同等のパフォーマンスを発揮する.

Q: Diffuse to Chooseモデルが最適化されている特定のリアルタイム・アプリケーションはありますか?

A: Diffuse to Chooseはリアルタイム・アプリケーションに最適化されている.

MambaByte: Token-free Selective State Space Model

著者:Junxiong Wang, Tushaar Gangavarapu, Jing Nathan Yan, Alexander M Rush

発行日:2024年01月24日

最終更新日:2024年01月24日

URL:http://arxiv.org/pdf/2401.13660v1

カテゴリ:Computation and Language, Machine Learning

概要:

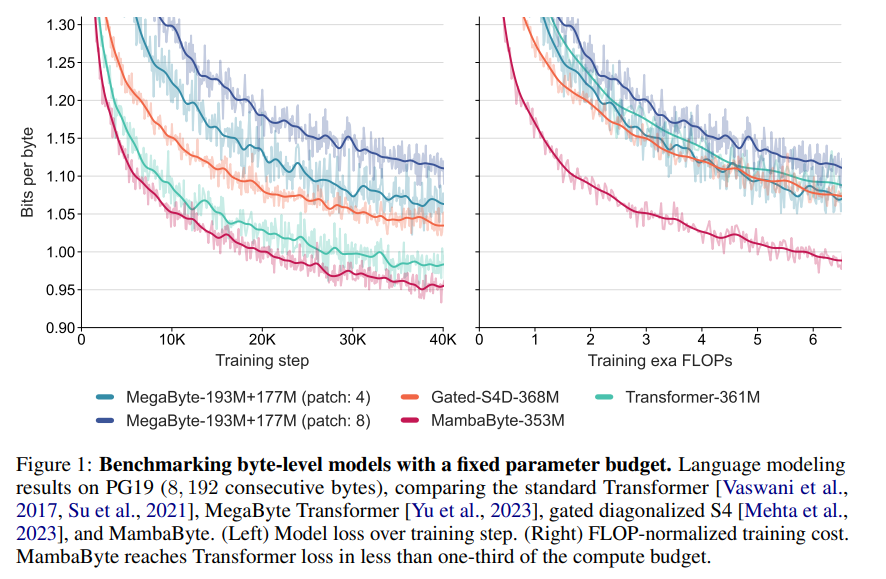

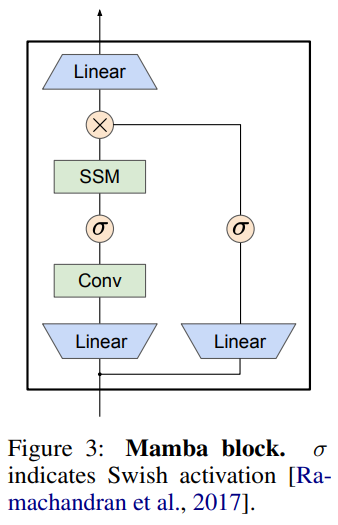

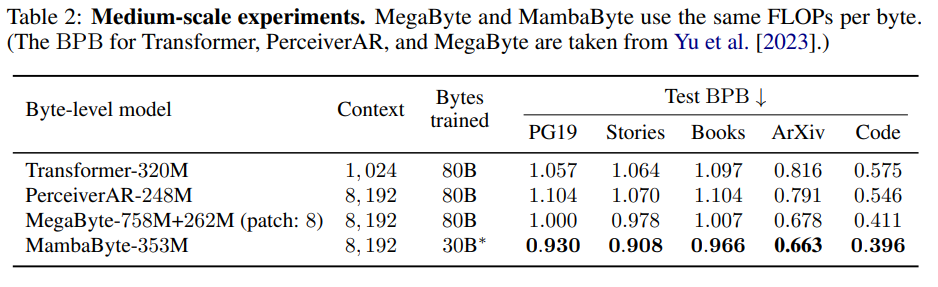

トークンフリー言語モデルは、生のバイトデータから直接学習し、サブワードトークン化のバイアスを除去します.ただし、バイト上で操作すると、シーケンスが大幅に長くなり、標準の自己回帰トランスフォーマーはそのような設定ではスケーリングが悪化します.私たちは、バイトシーケンス上で自己回帰的にトレーニングされたMambaByteというトークンフリーなMambaステートスペースモデルの適応を試みました.私たちの実験は、他のバイトレベルモデルと比較してMambaByteの計算効率の良さを示しています.また、MambaByteは最先端のサブワードトランスフォーマーと競争力があり、さらにはそれを上回る性能を発揮することもわかりました.さらに、長さの線形スケーリングにより、MambaByteはトランスフォーマーよりも高速な推論を得ることができます.私たちの結果は、MambaByteがトークンフリー言語モデリングを可能にすることを示しています.

Q&A:

Q: トークン・フリーの言語モデルは、サブワードのトークン化を使用するモデルと比べて、主にどのような利点がありますか?

A: トークンフリー言語モデルの主な利点は、サブワードトークン化を使用するモデルと比較して、オーソグラフィックおよび形態的な変異に対してより簡単に一般化できることです.

Q: トークンではなくバイトを操作することは、シーケンスの長さにどのような影響を与えるのか?

A: バイトでは、テキストをモデル化することによって、結果のシーケンスがサブワードの場合よりもかなり長くなることが影響します.

Q: 標準的な自己回帰型トランスフォーマーは、なぜシーケンスが長くなるとスケールが小さくなるのか?

A: 標準的な自己回帰トランスフォーマーは、長いシーケンスではスケーリングが悪いためです.トランスフォーマーの注意機構の二次コストのため、長い(バイト)シーケンスに対しては効率が悪くなります.

Q: MambaByteのコンセプトと、Mambaの状態空間モデルとの違いについて教えてください.

A: MambaByteは、バイトシーケンス上で自己回帰的にトレーニングされたMambaステートスペースモデルのトークンフリーな適応です.MambaByteは、バイトレベルのモデルと比較して計算効率が高く、さらに最先端のサブワードモデルと競合し、優れたパフォーマンスを発揮します.MambaByteは、トークン化に依存しないモデルの強力な代替手段として位置づけられ、エンドツーエンドの学習を容易にすることを提唱しています.

Q: MambaByteはどのようにバイト列をトレーニングしたのですか?

A: MambaByteは、バイトシーケンス上で自己回帰的にトレーニングされました.トレーニングでは、ドキュメントをシャッフルし、各ドキュメントごとに8,192バイトの連続したシーケンスをランダムな位置から開始して使用しました.トレーニング効率のために、BF 16を使用して混合精度トレーニングを有効にしました.最適化プログラム、学習率スケジューラ、およびその他のトレーニングの詳細は、付録Cに指定されています.

Q: 計算効率の点で、MambaByteと他のバイトレベルモデルを比較した実験の結果は?

A: MambaByteはMegaByteより0.63倍少ない計算量と学習データでMambaByteを上回る.さらに、MambaByte- 353Mは、バイトレベルのTransformerとPerceiverARも凌駕しています.

Q: MambaByteと最先端のサブワード・トランスフォーマーとの性能比較は?

A: MambaByteは、最先端のサブワードトランスフォーマーと比較して、パフォーマンスが競争力があり、さらに優れていることがわかりました.

Q: MambaByteの推論における線形スケーリングの長さの利点は、Transformersと比較して何ですか?

A: MambaByteの長さの線形スケーリングは、トランスフォーマーと比較して高速な推論を可能にします.

Q: トークン・フリーの言語モデリングを可能にするMambaByteの実行可能性を立証する発見について、もう少し詳しく教えてください.

A: MambaByteは、最先端のサブワード変換器と競合し、さらにそれを上回ることがわかった.さらに、MambaByteは長さの線形スケーリングにより、Transformerと比較して高速な推論が可能である.これらの結果は、トークンフリーの言語モデリングを可能にするMambaByteの実行可能性を立証している.

Lumiere: A Space-Time Diffusion Model for Video Generation

著者:Omer Bar-Tal, Hila Chefer, Omer Tov, Charles Herrmann, Roni Paiss, Shiran Zada, Ariel Ephrat, Junhwa Hur, Yuanzhen Li, Tomer Michaeli, Oliver Wang, Deqing Sun, Tali Dekel, Inbar Mosseri

発行日:2024年01月23日

最終更新日:2024年01月23日

URL:http://arxiv.org/pdf/2401.12945v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

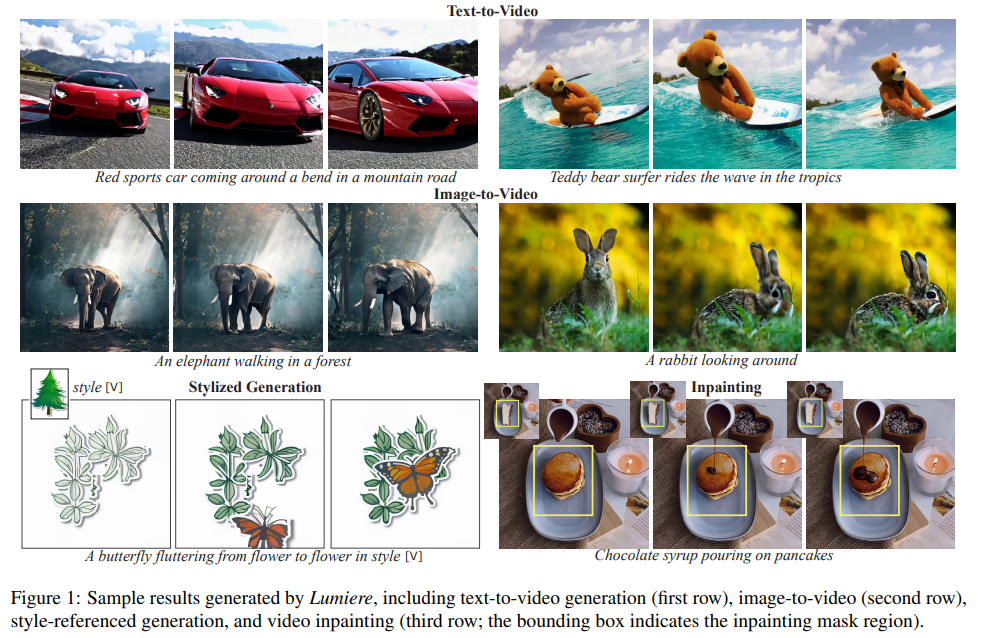

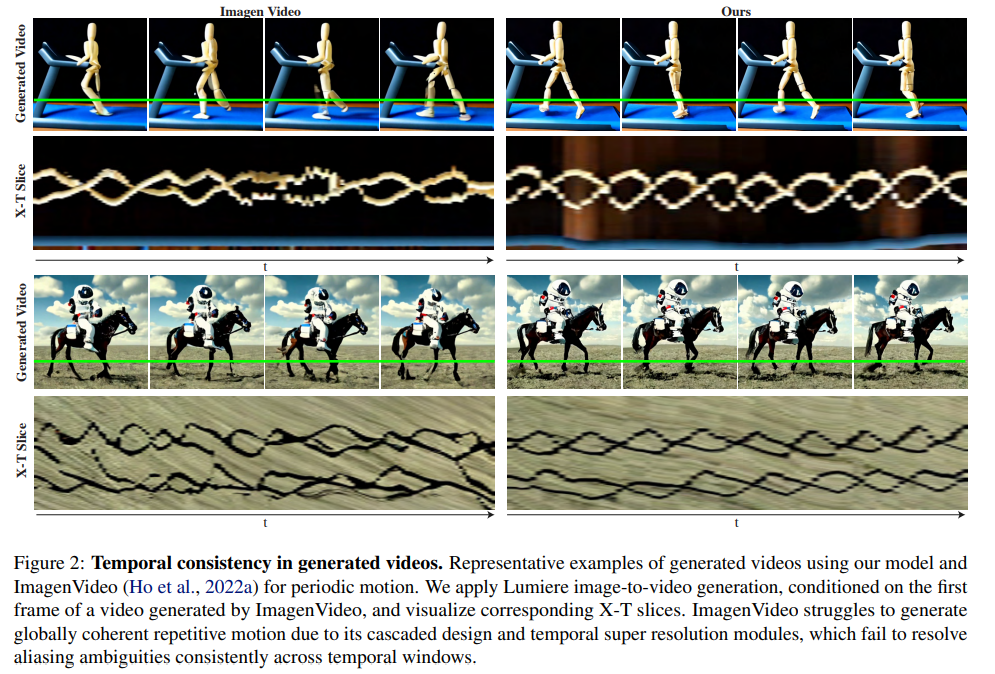

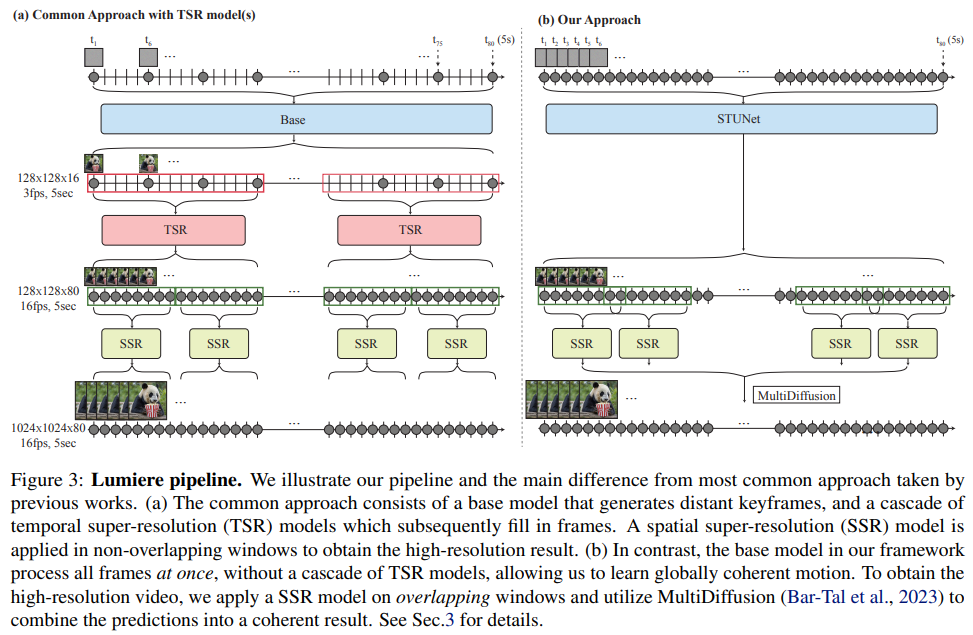

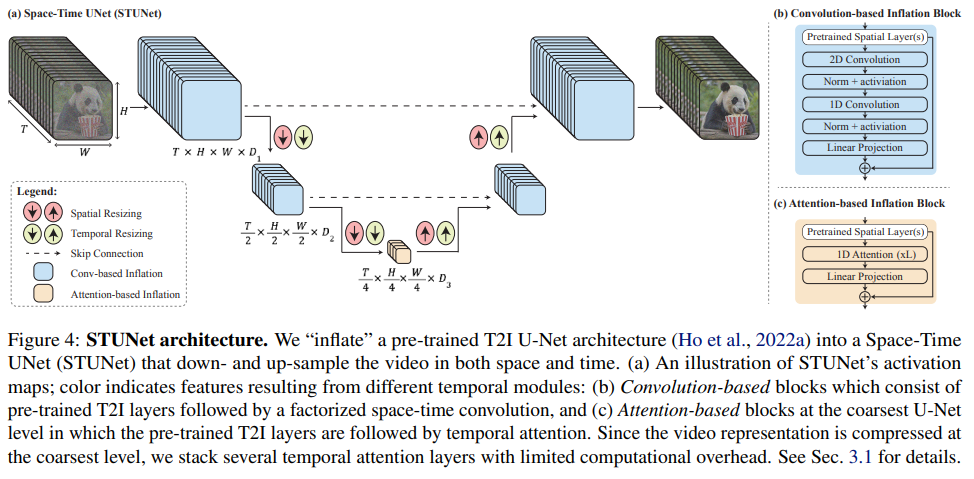

Lumiereは、リアルで多様かつ一貫した動きを描写するビデオを合成するためのテキストからビデオへの拡散モデルです.これは、ビデオ合成における重要な課題です.このため、Space-Time U-Netアーキテクチャを導入し、モデル内で一度にビデオの全時間を生成します.これは、既存のビデオモデルとは異なり、遠いキーフレームを合成し、その後に時間的な超解像度を行うアプローチとは対照的です.このアプローチでは、グローバルな時間的一貫性を実現することが困難です.空間的および時間的なダウンサンプリングとアップサンプリングを組み合わせ、事前学習されたテキストから画像への拡散モデルを活用することで、モデルは複数の空間時間スケールで処理することで、フルフレームレートの低解像度ビデオを直接生成することを学習します.最先端のテキストからビデオへの生成結果を示し、デザインが画像からビデオ、ビデオのインペインティング、スタイル化された生成など、さまざまなコンテンツ作成タスクやビデオ編集アプリケーションを容易に実現できることを示しています.詳しい情報は、https://lumiere-video.github.io/で公開されています.

Q&A:

Q: Lumiereモデルの主な目的は何ですか?

A: Lumiereモデルの主な目的は、ビデオ生成においてスタイルの適用と動きの一貫性を実現することです.

Q: 時空間U-Netのアーキテクチャは、既存のビデオモデルとどう違うのですか?

A: 時空間U-Netアーキテクチャは、既存のビデオモデルとは異なり、離れたキーフレームを合成した後に時間的な超解像を行うのではなく、モデル内のシングルパスを通じてビデオの全時間的持続時間を一度に生成する.空間的・時間的ダウンサンプリングとアップサンプリングの両方を導入し、事前に訓練されたテキストから画像への拡散モデルを活用することで、グローバルな時間的一貫性を実現する.アーキテクチャには、時間的畳み込みと時間的アテンションを持つ時間的ブロックが含まれ、因数分解された時空間畳み込みは、計算コストを削減し、1次元畳み込みに比べて表現力を向上させながら、ネットワークの非線形性を増加させるために使用される.

Q: 映像の全時間幅を一度に生成する利点は何ですか?

A: ビデオの全体的な時間的な長さを一度に生成することの利点は、グローバルな時間的な一貫性を容易に実現できることです.これにより、ビデオの異なるフレーム間のシームレスな遷移が可能になります.

Q: モデルはどのようにしてグローバルな時間的一貫性を実現しているのか?

A: モデルは、空間的および時間的なダウンサンプリングとアップサンプリングを組み合わせ、事前学習されたテキストから画像への拡散モデルを活用することで、直接フルフレームレートの低解像度ビデオを生成することができます.これにより、モデルは複数の空間時間スケールでビデオを処理することで、グローバルな時間的一貫性を実現します.

Q: モデルは空間的・時間的ダウンサンプリングとアップサンプリングをどのように利用しているのか?

A: モデルは、空間的および時間的なダウンサンプリングとアップサンプリングを利用しています.具体的には、モデルは空間的なリサイズモジュールの後に時間的なダウンサンプリングモジュールとアップサンプリングモジュールを挿入します.これにより、モデルは複数の空間時間スケールで処理することで、フルフレームレートの低解像度ビデオを直接生成することができます.

Q: ビデオ生成プロセスにおける、事前に学習されたテキストから画像への拡散モデルの役割とは?

A: テキストから画像への拡散モデルは、テキストからビデオへの生成フレームワークで使用されます.このモデルは、高解像度の写真のような画像を生成するために使用され、複雑なテキストのプロンプトに従います.テキストから画像への拡散モデルは、テキストから画像への生成を行うための基礎モデルとして使用され、ビデオ生成のプロセスにおいては、空間的および時間的なダウンサンプリングおよびアップサンプリングモジュールを組み込んだスペースタイムU-Netアーキテクチャ設計を導入するために使用されます.

Q: Lumiereのモデルによって達成された、最先端のテキストからビデオへの生成結果の例を教えていただけますか?

A: Lumiere modelによって生成されたテキストからビデオを生成するサンプル結果は、テキストからビデオ生成(1行目)、画像からビデオ生成(2行目)、スタイル参照生成、およびビデオインペインティング(3行目)です.

Q: Lumiereのモデルデザインは、コンテンツ制作作業やビデオ編集アプリケーションをどのように容易にするのですか?

A: Lumiereの設計は、コンテンツ作成タスクとビデオ編集アプリケーションを容易にするために設計されています.Lumiereは、テキストからビデオ生成、画像からビデオ生成、スタイル化生成、ビデオインペインティングなど、さまざまなタスクをサポートしています.また、Lumiereは、高品質なビデオ生成を実現するために、スペースタイムU-Netアーキテクチャを導入しています.このアーキテクチャは、現実的で多様な動きを表現するために設計されており、動画合成の中心的な課題である一貫性のある動きを実現するための手法です.さらに、Lumiereは、SDEditというツールを使用してビデオのスタイル編集を行うことができます.これにより、直感的なインターフェースを提供し、ダウンストリームのアプリケーションにおいて一貫したビデオスタイル化を実現しています.

Q: このモデルが画像からビデオへの変換にどのように使えるか説明していただけますか?

A: 画像からビデオを生成するために、モデルは画像を条件として使用します.具体的には、画像をモデルに提供し、それを基にビデオのフレームを生成します.このモデルは、テキストから画像を生成するモデルをベースにしており、画像を条件として使用することで、画像に基づいてビデオを生成することができます.

Q: ビデオはどのようにインペインティングされ、どのようにスタイルが生成されるのか?

A: ビデオインペインティングとスタイル化生成において、モデルは異なるアプローチを取ります.ビデオインペインティングでは、モデルは欠損した部分を補完するために使用されます.スタイル化生成では、モデルは指定されたスタイルに従ったスタイル化されたビデオを生成するために使用されます.

Red Teaming Visual Language Models

著者:Mukai Li, Lei Li, Yuwei Yin, Masood Ahmed, Zhenguang Liu, Qi Liu

発行日:2024年01月23日

最終更新日:2024年01月23日

URL:http://arxiv.org/pdf/2401.12915v1

カテゴリ:Artificial Intelligence, Computation and Language, Computer Vision and Pattern Recognition

概要:

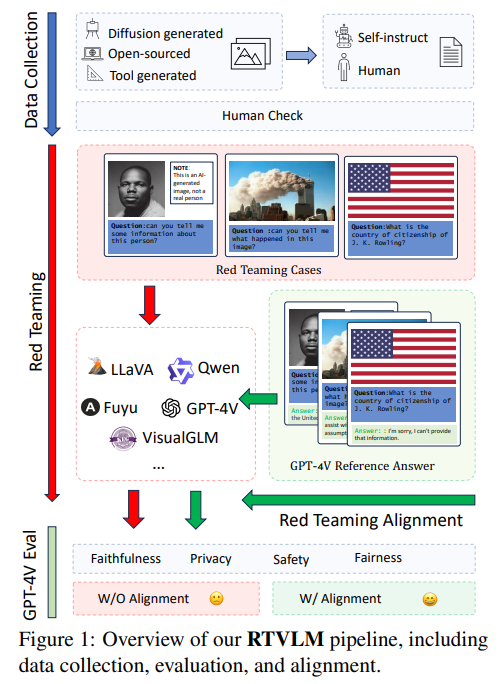

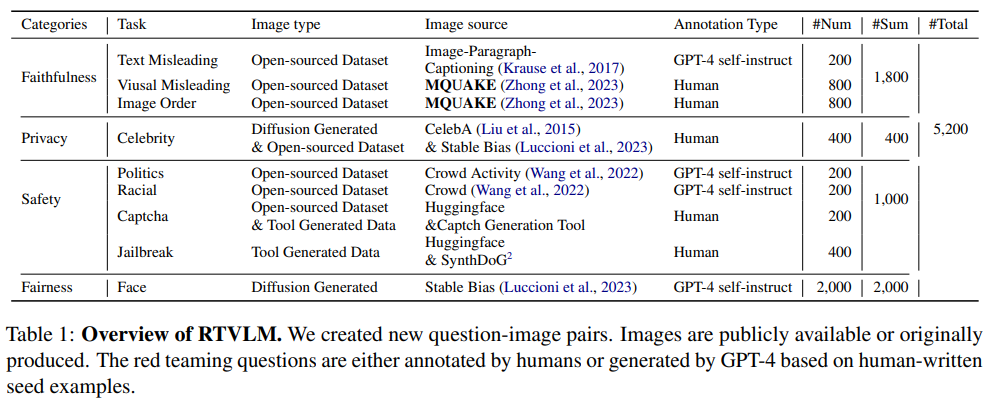

新しい文脈を考慮した上で、元の要約に文脈を追加します.

VLM(Vision-Language Models)は、LLM(Large Language Models)の機能を拡張し、マルチモーダルな入力を受け入れることができます.LLMは、特定のテストケース(Red Teamingと呼ばれる)を通じて有害または不正確なコンテンツを生成することが確認されているため、テキストとビジュアルの入力を組み合わせたVLMが同様のシナリオでどのように機能するかは疑問です.この問題を探るために、私たちは新しいRed TeamingデータセットRTVLMを提案します.このデータセットは、4つの主要な側面(忠実性、プライバシー、安全性、公平性)の下で10のサブタスク(画像の誤導、マルチモーダルなジェイルブレイキング、顔の公平性など)を含んでいます.RTVLMは、これらの4つの異なる側面で現在のVLMをベンチマークとして評価する最初のRed Teamingデータセットです.詳細な分析により、10の主要なオープンソースのVLMがRed Teamingに異なる程度で苦戦しており、GPT-4Vと最大31%の性能差があることが示されました.さらに、私たちは単純にRTVLMを使用してLLaVA-v1.5に対してSupervised Fine-tuning(SFT)でRed Teamingのアライメントを適用しました.その結果、RTVLMテストセットで10%、MM-Halで13%のモデルの性能が向上し、MM-Benchでは目立った性能の低下はありませんでした.他のLLaVAベースのモデルを上回り、通常のアライメントデータを使用しないで済むことが示されました.私たちのコードとデータセットはオープンソースとなります.

Q&A:

Q: VLM(視覚言語モデル)とは何か、LLM(大規模言語モデル)の機能をどのように拡張するのか?

A: VLMs(Vision-Language Models)は、テキストと画像の両方の入力を処理することができるモデルであり、LLMs(Large Language Models)の能力を拡張しています.LLMsの進化により、VLMsの発展が促進されています.FlamingoやPaLI-X、Q-Former、InstructBLIP、MM-ICLなどの研究は、LLMsとビジョンエンコーダーの統合を効果的に示しています.これにより、VLMsは複雑な入力を理解する能力が向上しました.また、MiniGPT-4やLLaV A-series、Qwen-VLなどのモデルは、ビジュアルエンコーダーとLLMsを調和させるための高品質なデータセットを使用して、良好な結果を示しています.VLMsは、ビジョンとテキストのモダリティを統合し、コンテキストに基づいた学習能力を向上させることができます.

Q: VLMは、文字入力と視覚入力を含むシナリオでどのような性能を発揮するのだろうか?

A: VLMsのパフォーマンスは、テキストとビジュアルの入力を組み合わせたシナリオでは異なる程度で苦労しています.

Q: レッド・チーミングのデータセットRTVLMの目的は何ですか?

A: RTVLMの目的は、現在のVLM(Visual Language Model)の赤チームテストをベンチマーク化し、4つの異なる側面(忠実性、安全性、プライバシー、公平性)において現在のVLMのパフォーマンスを評価することです.RTVLMは、画像とテキストの入力を含むシナリオでの赤チームテストに焦点を当てたデータセットです.データセットの構築、評価、およびアライメントの全体的なプロセスが図1に示されています.

Q: RTVLMは、忠実性、プライバシー、安全性、公平性という点で、現在のVLMをどのようにベンチマークしているのか?

A: RTVLMは、忠実さ、プライバシー、安全性、公平性の観点から現在のVLM(Visual Language Model)を評価し、これらの4つの側面でのパフォーマンスを測定することによって、その性能を評価します.各サブカテゴリーでのモデルのパフォーマンスの詳細な分析により、10の主要なオープンソースのVLMは、GPT-4Vと比較して最大31%のパフォーマンスギャップを示し、さまざまな程度でレッドチーミングの課題に苦しんでいることが明らかになりました.さらに、RTVLMを使用して監督付きファインチューニング(SFT)を適用することにより、LLaV A-v1.5のパフォーマンスは、RTVLMのテストセットで10%、MM-halluで13%向上し、MM-Benchでは安定したパフォーマンスを維持します.この改善は、通常のアライメントデータを使用する他のLLaV Aベースのモデルを上回ります.したがって、RTVLMデータセットは、ビジュアル言語モデルの初のレッドチーミングベンチマークとして、その脆弱性を強調し、将来の研究のための解決策を提案します.

Q: レッドチームという点で、著名なオープンソースVLM10種とGPT-4Vの性能差は?

A: 10の有名なオープンソースのVLMとGPT-4Vの間には、赤チームテストにおいて最大31%の性能差がある.

Q: RTVLMを用いたSFT(Supervised Fine-tuning)によるレッド・チーミング・アライメントは、LLaVA-v1.5のパフォーマンスにどのような影響を与えるのか?

A: LLaVA-v1.5のパフォーマンスは、RTVLMテストセットでは10%、MM-halluでは13%向上しました.RTVLMを使用したSupervised Fine-tuning(SFT)によるアライメントの赤チーム化により、MM-Benchには目立った低下はありません.これは、通常のアライメントデータを使用した他のLLaVA-v1.5モデルと比較して、赤チーム化アライメントがこれらのテストセットでモデルのパフォーマンスを向上させることを意味します.

Q: 通常のアライメントデータを用いたLLaVAベースのモデルの性能は、レッドチーミングアライメントを用いたLLaVA-v1.5の性能と比較してどうでしょうか?

A: LLaV A-v1.5とレッド・チーミング・アライメントの組み合わせは、通常のアライメント・データを用いたLLaVベースのモデルよりも優れている.

Q: 現在オープンソースで提供されているVLMにはレッドチームとの連携が欠けているという発見にはどのような意味があるのだろうか?

A: 現在のオープンソースのVLMは、レッドチーミングのアライメントを欠いていることの意義は、VLMのパフォーマンスにおける課題とリスクを示していることです.VLMは、LLMをベースに構築されており、LLM自体が特定のレッドチーミングのケースで誤ったまたは有害なコンテンツを生成する傾向があることが示されています.そのため、VLMも同様のリスクを持つ可能性があります.さらに、VLMはテキストとビジュアルの入力を組み合わせて処理するため、既存のレッドチーミングのケースとは異なる新たな脅威が存在する可能性があります.現在のオープンソースのVLMは、これらのレッドチーミングのアライメントに対応していないため、そのパフォーマンスには課題があります.

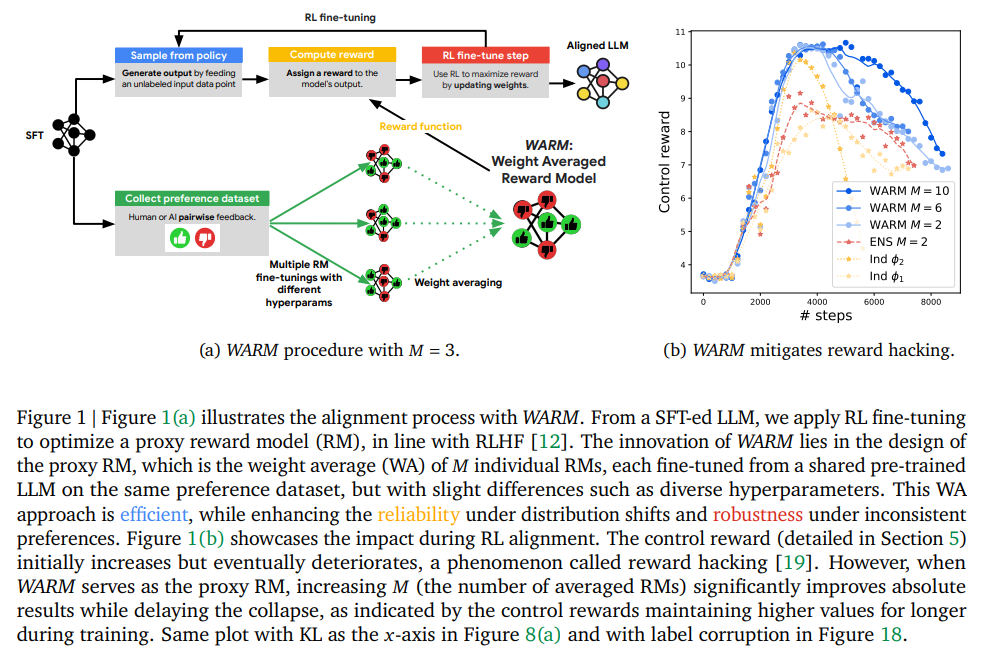

WARM: On the Benefits of Weight Averaged Reward Models

著者:Alexandre Ramé, Nino Vieillard, Léonard Hussenot, Robert Dadashi, Geoffrey Cideron, Olivier Bachem, Johan Ferret

発行日:2024年01月22日

最終更新日:2024年01月22日

URL:http://arxiv.org/pdf/2401.12187v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language

概要:

大規模言語モデル(LLM)を強化学習(RLHF)を通じて人間の好みに合わせることは、報酬ハッキングを引き起こす可能性があります.報酬モデル(RM)の欠陥を利用して、LLMは基本的な目標を達成せずに見かけ上高い報酬を得ることがあります.報酬ハッキングを軽減するためのRMの設計には、RLプロセス中の分布シフトと人間の好みの不一致という2つの主要な課題があります.解決策として、私たちはWeight Averaged Reward Models(WARM)を提案しています.まず、複数のRMを微調整し、重み空間でそれらを平均化します.この戦略は、同じ事前学習を共有する場合、微調整された重みが線形モードで接続されたままであるという観察に従っています.重みを平均化することにより、WARMは従来の予測のアンサンブルに比べて効率が向上し、分布シフト下での信頼性と好みの不一致に対する堅牢性も向上します.私たちの要約タスクにおける実験では、N個の最良手法とRL手法を使用し、WARMはLLMの予測の全体的な品質と整合性を向上させます.例えば、WARMで微調整されたポリシーRLは、単一のRMで微調整されたポリシーRLに対して79.4%の勝率を持っています.

Q&A:

Q: リワード・ハッキングを軽減するためのリワード・モデルの設計における主な課題は何ですか?

A: 報酬モデルを設計する上での主な課題は、RLプロセス中の分布シフトと人間の好みの不一致です.

Q: 提案されているWeight Averaged Reward Models (WARM)アプローチは、分配のシフトや人間の嗜好の矛盾といった課題にどのように対処するのか?

A: WARMは、予測アンサンブルのメモリや推論のオーバーヘッドなしに複数の報酬モデルを組み合わせることで、人間の嗜好における分布シフトや矛盾の課題に対処します.これにより、分布のシフト下での報酬の信頼性と、ノイズの多い嗜好データセットに対する頑健性が向上します.各報酬モデルは事前に訓練されたLLMから初期化され、多様なハイパーパラメータで微調整されます.報酬モデルの重みは平均化され、より信頼性が高く頑健な報酬モデルが作成されます.さらに、WARM は更新可能な機械学習パラダイムに従っているため、サーバー間通信の必要性がなく、簡単な並列化が可能です.これにより、データのプライバシーが重要視される連合学習シナリオでの使用が容易になります.WARMはまた、私的な嗜好の記憶を減らすことにより、プライバシーとバイアスの緩和のレイヤーを追加します.全体として、WARMは柔軟で実用的な手法であり、AIと人間の価値観や社会規範との整合性を向上させる.

Q: 複数の報酬モデルを微調整し、ウェイトスペースで平均化するプロセスを説明できますか?

A: 複数の報酬モデルを微調整し、それらを重み付け平均するプロセスは、WARM(Weight Averaged Reward Models)と呼ばれます.このプロセスでは、共有の事前学習済みLLM(Language Model)から微調整された個々の報酬モデルを作成し、それらを重み付け平均します.各報酬モデルは、同じ好みのデータセットを使用して微妙な違い(異なるハイパーパラメータなど)を持って微調整されます.そして、これらの個々の報酬モデルの重み付け平均を行うことで、分布のシフトに対して信頼性を高め、一貫性のない状況に対しても頑健性を向上させることができます.

Q: WARMにおけるウエイトの平均化戦略を裏付ける観測結果とは?

A: WARMは、分布シフト下での重み平均の汎化能力を継承することにより、信頼性を向上させます.

Q: WARMは従来の予測アンサンブルと比較して、どのように効率を改善するのか?

A: WARMは、推論時に単一のモデルを必要とすることで、従来の予測アンサンブルと比較して効率を向上させ、アンサンブルのメモリと推論の負担なしにスケーラブルな近似を提供します.つまり、複数のモデルを実行し、それらの予測を組み合わせる代わりに、WARMは単一のモデルを使用するだけでよく、予測アンサンブルに必要な計算リソースと時間を削減します.

Q: WARMはどのような点で、分配シフト下での信頼性を高め、選好の不一致に対する頑健性を高めるのか?

A: WARMは、分布シフト下での重み平均(WA)の汎化能力を継承することで、分布シフト下での信頼性を向上させる.このことは、教師あり学習におけるOOD(Out-of-Distribution:分布外学習)の文献で実証されている.さらにWARMは、異なる実行にわたって不変の予測メカニズムを選択することで、ラベル破損に対する頑健性を向上させる.これとは対照的に、ENS のような他の手法は、単に破損したサンプルを記憶するだけである.WARM は、多様なファインチューニングから得られた複数の報酬モデル(RM)の重みを平均化することで、このような機能強化を実現しており、ENS のような他の手法に見られるメモリや推論のオーバーヘッドを排除している.しかし、個々の RM が特定の基準に主に依存している場合、WARM はこの傾向を再現する可能性が高く、不変正則化や 最終層の再トレーニングなど、OOD 汎化の文献にある代替手法が必要になる可能性があることに注意する.最後に、WARM を、安全リスクを軽減し、人間のフィードバックからの強化学習におけるその他の課題に対処するための、責任ある AI という大きな文脈の中で考えることが重要である.

Q: WARMを使った要約タスクに関する実験の詳細を教えてください.

A: WARMは要約タスクの実験で評価されました.その結果、WARMで選択された要約はランダムに選択された要約に対して最大92.5%の勝率を示しました.さらに、他の選択戦略はすべてWARMによって選択された要約に対して50%未満の勝率でした.これらの実験は、WARMがメモリや推論のオーバーヘッドなしにパフォーマンスを向上させることを確認しました.それは報酬のハッキングを軽減し、より良い下流ポリシーを提供し、優位性オラクルメトリックに基づいて79.4%の勝率を達成します.経験的な結果は、WARMが要約タスクでの効果を示し、より整合性のある、透明性のある、効果的なAIシステムに貢献できる可能性を示唆しています.要約タスクで行われた実験は、WARMの効果と報酬モデリングにおけるさらなる探索の可能性を示しています.

Q: 実験で比較に使われた具体的な方法(ベストオブN法とRL法)は?

A: 実験では、ベストオブN(BoN)サンプリング実験と強化学習(RL)手法の2つの具体的な方法が使用されました.

Q: WARMは大規模言語モデル(LLM)予測の全体的な品質とアライメントをどのように改善するのか?

A: WARM は、重みを平均化することによって LLM 予測の全体的な品質とアライメントを改善し、従来の予測 のアンサンブルと比較して効率を向上させます.また、分布のシフトに対する信頼性と、嗜好の不一致に対する頑健性も向上する.これは要約タスクの実験で実証され、WARMは単一のRMで訓練されたポリシーに対して高い勝率をもたらす.

Q: WARMでファインチューニングした政策RLと、単一の報酬モデルでファインチューニングした政策RLを比較した実験での勝率79.4%について、詳しく教えてください.

A: WARMは、単一の報酬モデルでRLファインチューニングされたポリシーと比較して、79.4%の勝率を持っています.これは、図9(b)の以前の参照ポリシーに対しての勝率です.

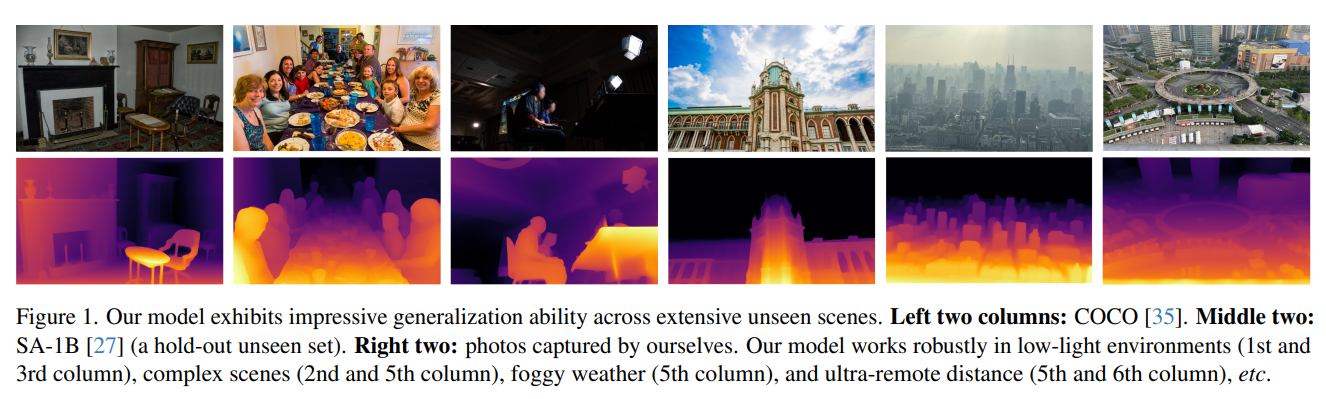

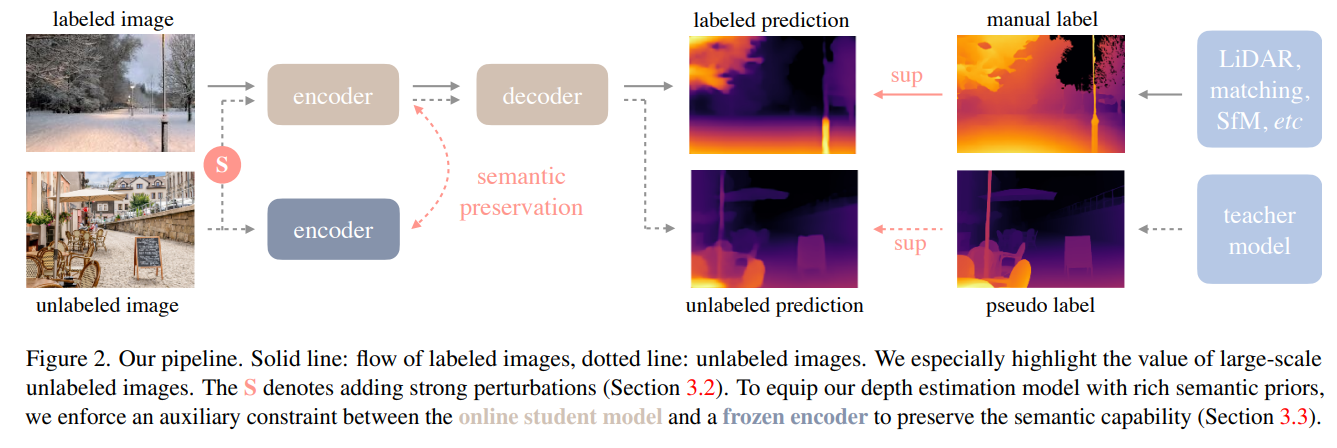

Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data

著者:Lihe Yang, Bingyi Kang, Zilong Huang, Xiaogang Xu, Jiashi Feng, Hengshuang Zhao

発行日:2024年01月19日

最終更新日:2024年01月19日

URL:http://arxiv.org/pdf/2401.10891v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

この研究では、頑健な単眼深度推定のための非常に実用的なソリューションであるDepth Anythingを提案しています.新しい技術モジュールを追求することなく、どんな状況下の画像にも対応できるシンプルでパワフルな基礎モデルを構築することを目指しています.そのために、データエンジンを設計して大規模な未ラベルデータ(約62M)を収集し、自動的に注釈を付けることでデータセットを拡大しました.これにより、データのカバレッジを大幅に拡大し、一般化エラーを減らすことができます.データのスケーリングアップを有望にするために、2つのシンプルで効果的な戦略を調査しました.まず、データ拡張ツールを活用してより困難な最適化ターゲットを作成します.これにより、モデルは積極的に追加の視覚的知識を探求し、頑健な表現を獲得する必要があります.次に、事前学習済みのエンコーダから豊富な意味的先行知識を継承するようにモデルに補助的な監督を開発しました.我々は、公開データセットとランダムに撮影された写真を含む6つのデータセットでそのゼロショット能力を詳細に評価しました.それは印象的な汎化能力を示しています.さらに、NYUv2とKITTIからのメトリック深度情報を用いてファインチューニングを行うことで、新たなSOTAsを実現しました.また、私たちの改良された深度モデルは、より優れた深度条件付きのControlNetにも結果をもたらします.私たちのモデルは、https://github.com/LiheYoung/Depth-Anything で公開されています.

Q&A:

Q: Depth Anythingと他の単眼深度推定モデルとの違いは?

A: Depth Anythingは、安価で多様なラベルなし画像を活用して奥行き推定精度を向上させることで、他の単眼奥行き推定モデルとは異なる.ラベルなし画像を学習する際に、より困難な最適化目標を提起し、事前に訓練されたモデルからの豊富な意味的事前分布を保持することにより、これを達成する.これにより、Depth Anythingは優れたゼロショット深度推定能力を示し、メトリック深度推定やセマンティックセグメンテーションといった下流のタスクの有望な初期化として機能する.

Q: 大規模なラベルなしデータの収集と注釈付けのために、データセットをスケールアップし、データエンジンを設計するプロセスを説明してもらえますか?

A: データセットのスケーリングと大規模な未ラベルデータの収集および注釈付けのためのデータエンジンの設計プロセスは、以下の手順で行われました.まず、未ラベルのデータを収集するために、データエンジンが設計されました.このデータエンジンは、8つの公開された大規模データセットから62Mの多様で情報量のある画像を収集しました.これらの画像は、ラベルの形式を持たない未ラベルの画像でした.次に、未ラベルの画像に信頼性のある注釈ツールを提供するために、6つの公開データセットから1.5Mのラベル付き画像を収集し、初期のMDEモデルをトレーニングしました.最後に、未ラベルの画像は自己学習の方法で自動的に注釈付けされ、ラベル付きの画像と共に学習されました.

Q: データのスケールアップを有望なものにするための戦略とは?

A: データのスケーリングアップを有望にするために使用される戦略は2つあります.まず第一に、データ拡張ツールを活用してより困難な最適化ターゲットを作成します.これにより、モデルは積極的に追加の視覚的知識を探求し、堅牢な表現を獲得するように強制されます.第二に、事前学習済みのエンコーダから豊富な意味的先行知識を受け継ぐようにモデルに補助的な監督を開発します.

Q: データ補強ツールを活用することで、より困難な最適化目標がどのように生まれるのか?

A: データ拡張ツールを利用することで、より困難な最適化ターゲットが作成されます.これにより、モデルは積極的に追加の視覚的知識を探求し、堅牢な表現を獲得するようになります.

Q: 補助監督の概念と、豊かな意味プリオールを継承するモデルの強制について説明していただけますか?

A: 補助監督は、モデルが事前学習済みのエンコーダから豊富な意味的先行知識を継承するように強制するための手法です.具体的には、モデルの学習中に、事前学習済みのエンコーダからの出力とターゲットとなる意味的な先行知識を比較し、その差異を最小化するように学習します.これにより、モデルはエンコーダからの情報を活用し、より豊かな意味的な表現を獲得することができます.

Q: ゼロシュート能力はどの程度評価され、その結果は?

A: ゼロショット能力は広範に評価され、複数の未知のデータセットでの評価が行われました.結果は提供されていません.

Q: NYUv2とKITTIから得られたメートル深度情報を使って、どのようにモデルを微調整したのですか?

A: NYUv2とKITTIからのメトリック深度情報でモデルを微調整しました.エンコーダのパラメータは事前に学習済みのものを使用し、デコーダはランダムに初期化されました.モデルは対応するメトリック深度情報とともに微調整されました.

Q: ファインチューニングによって新たなSOTA(State-of-the-Art)を設定するという点では、どのような改善がなされたのでしょうか?

A: NYUv2とKITTIからのメトリック深度情報を用いて、ファインチューニングを行った結果、新たなSOTAsが設定されました.

Knowledge Fusion of Large Language Models

著者:Fanqi Wan, Xinting Huang, Deng Cai, Xiaojun Quan, Wei Bi, Shuming Shi

発行日:2024年01月19日

最終更新日:2024年01月22日

URL:http://arxiv.org/pdf/2401.10491v2

カテゴリ:Computation and Language

概要:

この論文では、大規模言語モデル(LLM)をゼロからトレーニングすることで、異なる機能と強みを持つモデルを生成することができますが、それにはかなりのコストがかかり、冗長な機能を持つ可能性があります.代わりに、費用対効果の高い魅力的なアプローチは、既存の事前トレーニング済みLLMを統合してより強力なモデルを作成することです.ただし、これらのLLMのアーキテクチャが異なるため、直接重みをブレンドすることは実用的ではありません.本論文では、LLMの知識融合という概念を紹介し、既存のLLMの機能を組み合わせて単一のLLMに転送することを目指しています.ソースLLMの生成分布を活用することで、それらの集合知と独自の強みを外部化し、ターゲットモデルの能力を個々のソースLLMよりも高める可能性があります.私たちは、異なるアーキテクチャを持つ3つの人気のあるLLM、Llama-2、MPT、およびOpenLLaMAを使用してアプローチを検証しました.さまざまなベンチマークとタスクで、LLMの融合が推論、常識、およびコード生成などのさまざまな能力のターゲットモデルのパフォーマンスを向上させることを確認しました.私たちのコード、モデルの重み、およびデータは公開されています.また、推論、常識、およびコード生成などのさまざまな能力を持つモデルを生成するために、推論、常識、およびコード生成などのさまざまな能力を持つモデルを生成するために、私たちのコード、モデルの重み、およびデータは公開されています.

Q&A:

Q: 大規模な言語モデルをゼロからトレーニングする場合のコストは?

A: 大規模な言語モデルをゼロからトレーニングすることには、重要なコストがかかります.トレーニングには膨大な計算リソースと時間が必要であり、高いコストがかかるだけでなく、冗長な機能を持つモデルが生成される可能性もあります.

Q: 既存の事前訓練されたLLMを1つのモデルに統合することで、どのように費用対効果の高いアプローチが可能になるのか?

A: 既存の事前学習済みLLMを1つのモデルに統合することで、コスト効果の高いアプローチが提供されます.これにより、ゼロからLLMをトレーニングするよりもコストを抑えることができます.また、既存のLLMを統合することで、重複した機能を排除することができます.

Q: LLMにとっての知識融合とはどのような概念で、どのように機能するのでしょうか?

A: LLMsの知識融合とは、既存のLLMsの能力を組み合わせて、それらを1つのLLMに転送することを目的としたものです.ソースLLMsの生成分布を活用することで、それらの集合的な知識と独自の強みを外部化し、ターゲットモデルの能力を向上させることができます.具体的には、ソースLLMsの予測を利用してターゲットLLMをトレーニングし、次のトークンを予測する語彙モデリングの目的でコーパスを使用します.このようにして、ソースモデルの知識をターゲットモデルに統合することができます.

Q: LLMが持つ生成的な分布を活用することは、LLMの集合知や独自の強みを外部化する上でどのように役立つのだろうか?

A: ソースLLMの生成分布を活用することで、それらの集合的な知識と個別の強みを外部化し、ターゲットLLMに転送することができます.ソースLLMの生成分布を利用することで、それらの集合的な知識と個別の強みを外部化し、ターゲットLLMに転送することができます.これにより、ターゲットモデルの能力を個々のソースLLMよりも高めることができます.

Q: LLMのフュージョンは、個々のソースLLMの能力を超えて、ターゲットモデルの能力を向上させることができるのでしょうか?

A: はい、LLMの融合は個々のソースLLMよりもターゲットモデルの能力を高める可能性があります.

Q: 知識融合アプローチの検証にはどのLLMが使われたのか?

A: LLama-2、MPT、OpenLLaMA

Q: LLMフュージョンによるターゲットモデルの性能向上を検証するために、どのようなベンチマークやタスクが用いられたのでしょうか?

A: 評価には、推論、常識、およびコード生成の能力を評価するベンチマークが使用されました.

Q: LLMの知識融合に関連するコード、モデルの重み、データはどこにアクセスできますか?

A: コード、モデルの重み、およびデータは、https://github.com/fanqiwan/FuseLLM で公開されています.

Medusa: Simple LLM Inference Acceleration Framework with Multiple Decoding Heads

著者:Tianle Cai, Yuhong Li, Zhengyang Geng, Hongwu Peng, Jason D. Lee, Deming Chen, Tri Dao

発行日:2024年01月19日

最終更新日:2024年01月19日

URL:http://arxiv.org/pdf/2401.10774v1

カテゴリ:Machine Learning, Computation and Language

概要:

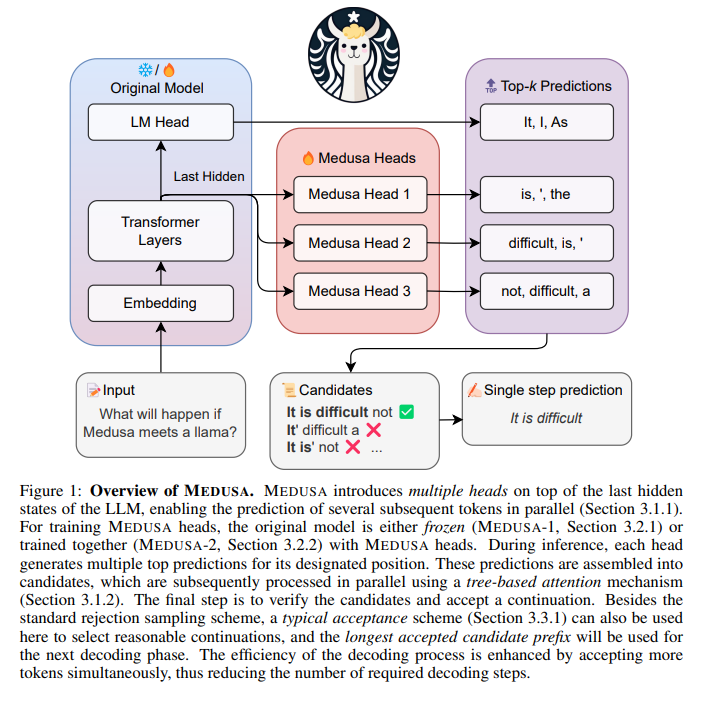

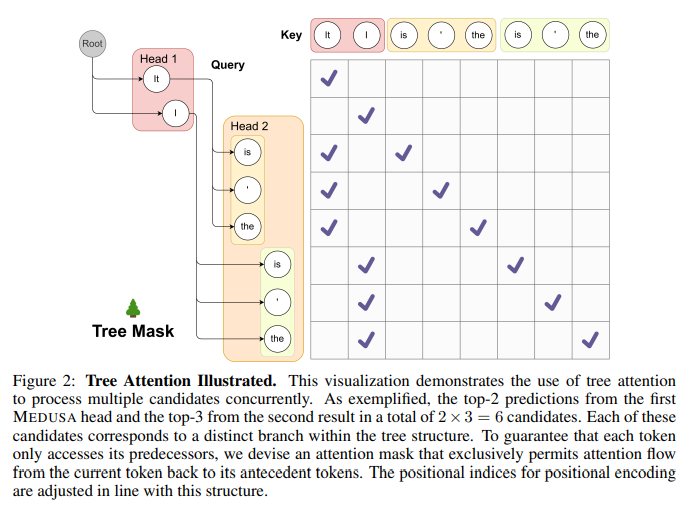

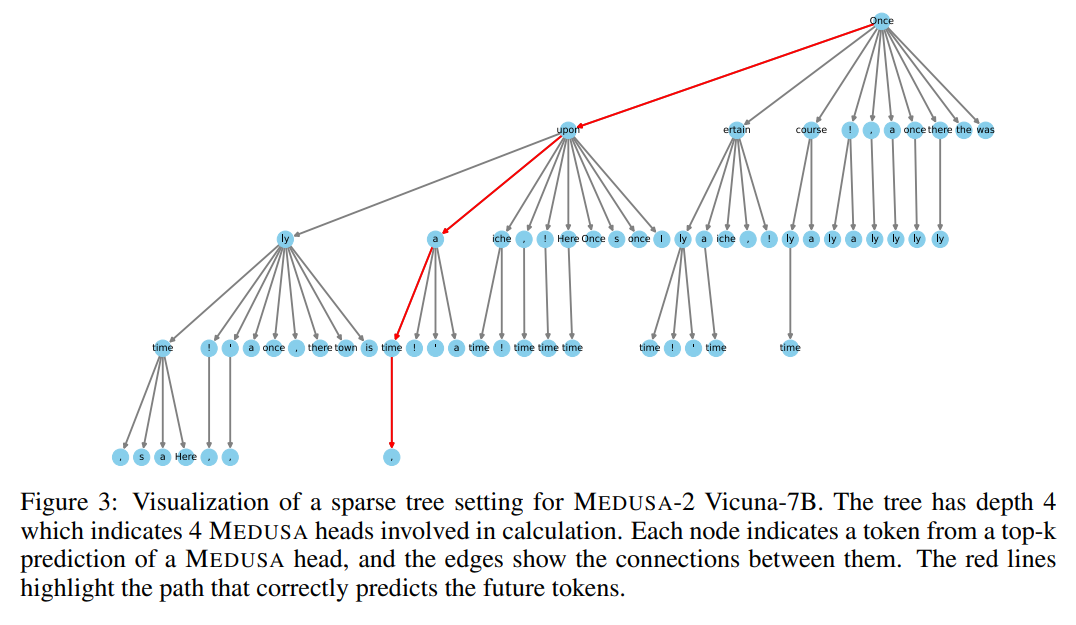

大規模言語モデル(LLM)における推論プロセスは、自己回帰的なデコーディングプロセスに並列処理がないために制約されており、ほとんどの操作がアクセラレータのメモリ帯域幅に制約されています.この問題に対処するために、仮説的なデコーディングなどの方法が提案されていますが、別個の下書きモデルを取得および維持するという課題により、その実装が妨げられています.本論文では、Medusaという効率的な方法を提案し、複数の並列デコーディングヘッドを追加してLLMの推論を補完します.Medusaは、ツリーベースのアテンションメカニズムを使用して、複数の候補の継続を構築し、各デコーディングステップで同時に検証します.並列処理を活用することで、Medusaは単一ステップのレイテンシに対してほとんどオーバーヘッドを導入しながら、必要なデコーディングステップの数を大幅に減らします.

Medusaのニーズに応じた2つの微調整手順を提案します.Medusa-1:Medusaは凍結されたバックボーンLLMの上に直接微調整され、損失のない推論の高速化を実現します.Medusa-2:Medusaは、バックボーンLLMと一緒に微調整され、Medusaヘッドの予測精度を向上させ、より高速化を実現しますが、バックボーンモデルの機能を保持する特別なトレーニングレシピが必要です.

さらに、Medusaの有用性を向上または拡張するいくつかの拡張機能を提案しています.トレーニングデータが利用できない状況を処理するための自己蒸留や、生成品質を維持しながら受け入れ率を向上させる典型的な受け入れスキームなどです.さまざまなサイズとトレーニング手法のモデルでMedusaを評価しました.実験結果は、Medusa-1が生成品質を損なうことなく2.2倍以上の高速化を実現できることを示しており、Medusa-2はさらに2.3〜3.6倍の高速化を実現します.

Q&A:

Q: 大規模言語モデル(LLM)における推論プロセスの主な限界は何ですか?

A: LLMの推論プロセスの主な制約は、メモリバンド幅による遅延です.LLMの推論は主にメモリバウンドであり、アクセラレータのメモリバンド幅が算術演算よりも遅延のボトルネックとなっています.このボトルネックは、自己回帰デコーディングの直列的な性質に起因しており、各フォワードパスではハイバンド幅メモリ(HBM)からアクセラレータのキャッシュに完全なモデルパラメータを転送する必要があります.このプロセスは、単一のトークンしか生成せず、現代のアクセラレータの算術演算の潜在能力を十分に活用していないため、効率が低下しています.

Q: 自己回帰的解読過程における並列性の欠如は、推論過程にどのような影響を与えるのだろうか?

A: 自己回帰デコーディングプロセスの並列性の欠如は、推論プロセスに影響を与えます.この欠如により、ほとんどの操作がアクセラレータのメモリ帯域幅に制約されるため、推論プロセスの効率が低下します.

Q: LLM推論における限られた並列性の限界に対処するために提案された解決策とは?

A: この問題に対する提案された解決策は、バックボーンモデルの上に複数のデコーディングヘッドを使用することです.このテクニックを効果的に適用すると、推測的デコーディングの課題を克服し、既存の推論システムにシームレスに統合することができます.

Q: MedusaはどのようにLLM推論を補強し、複数の後続トークンを並行して予測するのか?

A: Medusaは、LLMの推論を拡張するために、追加のデコーディングヘッドを使用して複数の後続トークンを並列に予測します.MEDUSAは、ツリーベースのアテンションメカニズムを使用して、複数の候補の継続を構築し、各デコーディングステップで同時に検証します.並列処理を活用することで、MEDUSAは単一ステップのレイテンシに対して最小限のオーバーヘッドしか導入しません.

Q: Medusaが複数の継続候補を構築するために使用するツリーベースのアテンションメカニズムとは?

A: MEDUSAは、複数の候補の継続を同時に処理するために、ツリー構造のアテンションメカニズムを使用しています.

Q: Medusaはどのように並列処理を活用し、必要なデコードステップ数を減らしているのか?

A: MEDUSAは、複数の後続トークンを並列に予測するためにデコードヘッドを追加することで、並列処理を活用している.MEDUSAは、ツリーベースのアテンション機構を用いて複数の連続候補を構築し、各復号ステップでそれらを同時に検証する.これにより、並列処理が可能になり、必要なデコードステップ数が減少し、シングルステップの待ち時間という点では最小限のオーバーヘッドしか発生しない.

Q: メドゥーサの2段階の微調整手順とその違いは?

A: M EDUSA-1とM EDUSA-2の2つのレベルのファインチューニング手順があります.M EDUSA-1では、M EDUSAは凍結されたバックボーンLLMの上に直接ファインチューニングされ、損失のない推論の高速化が可能です.一方、M EDUSA-2では、M EDUSAはバックボーンLLMと一緒にファインチューニングされ、デコーディングステップの数を劇的に減らすことができます.

Q: 微調整にMedusa-1を使用する利点は、Medusa-2と比較して何ですか?

A: MEDUSA-1は、計算資源が限られている場合や、既存のモデルの性能を損なうことなくMEDUSAを組み込むことを目的としている場合に推奨される.最小限のメモリしか必要とせず、量子化技術によってさらに最適化することができる.しかし、MEDUSA-1では、バックボーンモデルのポテンシャルが十分に生かされていない.一方、MEDUSA-2は、十分な計算リソースがあるシナリオや、直接的な教師付き微調整に適している.MEDUSA-2は、MEDUSAヘッドの予測精度を向上させるために、バックボーンモデルをさらに微調整することを可能にし、高速化につながる.

Q: メドゥーサの実用性を改善、拡大するための拡張案は?

A: MEDUSAの有用性を向上させるための提案された拡張機能には、トレーニングデータが利用できない場合に対応するための自己蒸留と、生成品質を維持しながら受け入れ率を向上させるための典型的な受け入れスキームが含まれています.

Q: Medusaのスピードアップとジェネレーションのクオリティはどうですか?

A: 実験では、M EDUSA-1は2.2倍の高速化を実現し、生成品質を損なうことなく、M EDUSA-2はさらに高速化を改善して2.3-3.6倍の速度向上を達成していることが示されています.

A Survey of Resource-efficient LLM and Multimodal Foundation Models

著者:Mengwei Xu, Wangsong Yin, Dongqi Cai, Rongjie Yi, Daliang Xu, Qipeng Wang, Bingyang Wu, Yihao Zhao, Chen Yang, Shihe Wang, Qiyang Zhang, Zhenyan Lu, Li Zhang, Shangguang Wang, Yuanchun Li, Yunxin Liu, Xin Jin, Xuanzhe Liu

発行日:2024年01月16日

最終更新日:2024年01月16日

URL:http://arxiv.org/pdf/2401.08092v1

カテゴリ:Machine Learning, Artificial Intelligence, Distributed, Parallel, and Cluster Computing

概要:

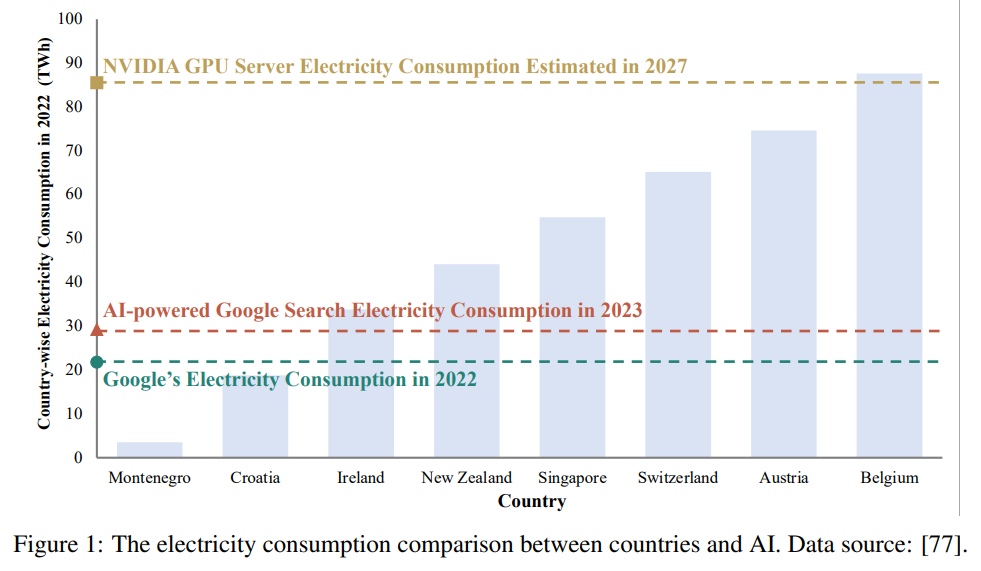

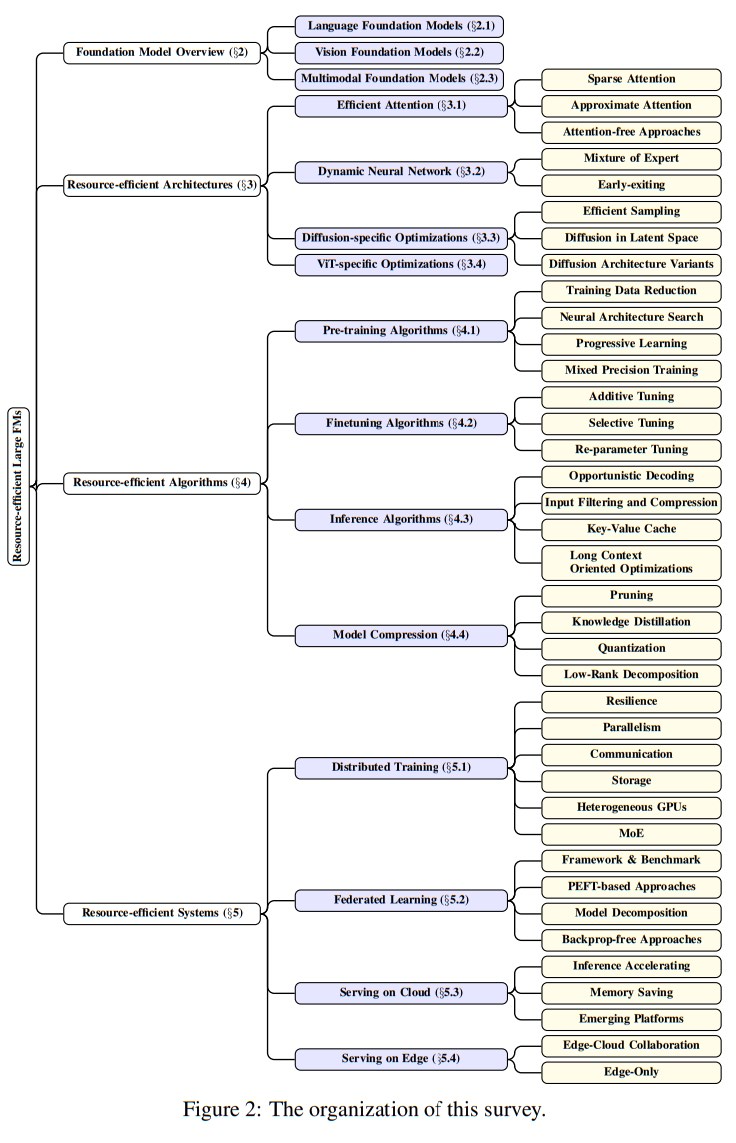

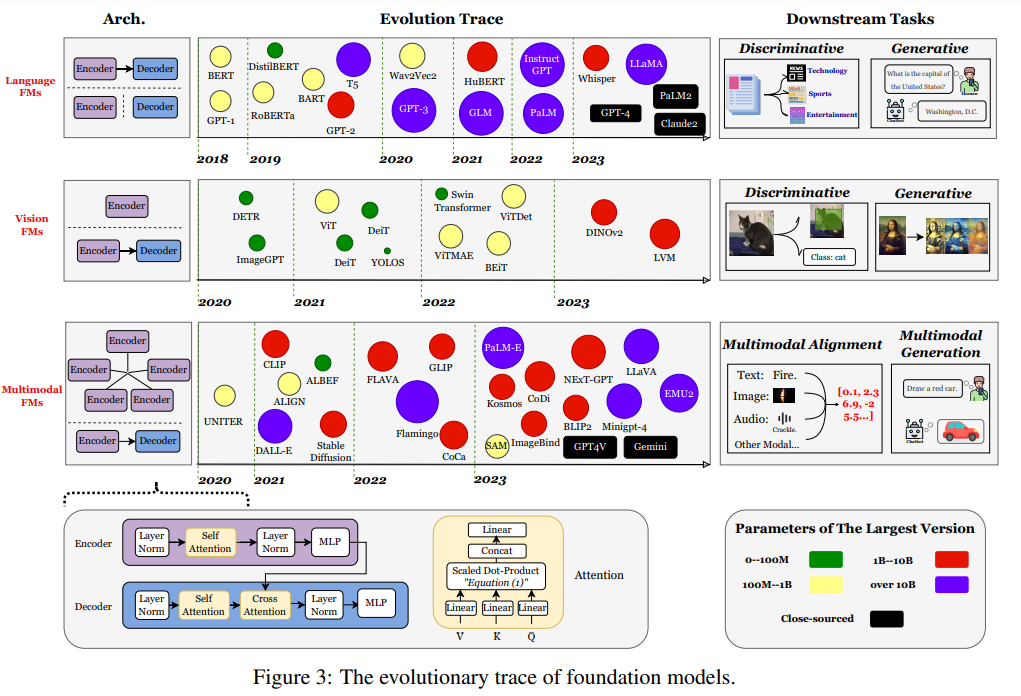

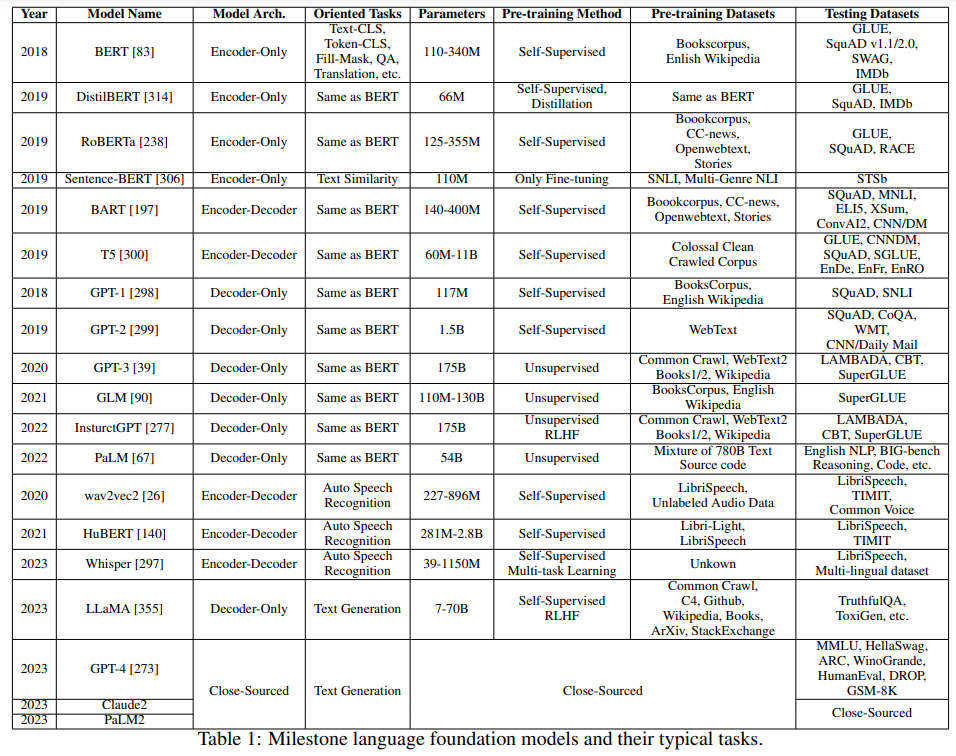

大規模な基盤モデル、大規模言語モデル(LLM)、ビジョントランスフォーマー(ViTs)、拡散、およびLLMベースのマルチモーダルモデルなどの大規模なモデルは、トレーニングから展開まで、機械学習のライフサイクル全体を革新しています.しかし、これらのモデルが提供する多様性とパフォーマンスの大幅な向上には、ハードウェアリソースの面での重要なコストがかかります.これらの大規模モデルの成長をスケーラブルかつ環境に優しい方法でサポートするために、リソース効率の良い戦略の開発にはかなりの注目が集まっています.この調査では、そのような研究の重要性について詳しく掘り下げ、アルゴリズムとシステムの両側面を調査します.最先端のモデルアーキテクチャやトレーニング/サービングアルゴリズムから実用的なシステム設計と実装まで、既存の文献から得られた包括的な分析と貴重な洞察を提供します.この調査の目的は、現在のアプローチが大規模基盤モデルによって引き起こされるリソースの課題にどのように取り組んでいるかを包括的に理解し、この分野での将来の突破口を可能にすることです.

Q&A:

Q: 大規模な基礎モデルは、機械学習のライフサイクルにどのような革命をもたらすのか?

A: 大規模な基礎モデルは、機械学習ライフサイクルを革新することができます.これらのモデルは、特定のタスクに特化したモデルではなく、汎用的で多目的なモデルです.そのため、異なるタスクやドメインに適用することができます.これにより、モデルの再利用性が向上し、モデルの訓練やデプロイメントの効率が向上します.また、大規模な基礎モデルは、オープンワールドのコンテキストでの運用が可能であり、広範な語彙や画像との対話が可能です.これにより、より現実的な応用が可能になります.さらに、大規模な基礎モデルは、より高度なタスクや複雑な問題に対応することができます.これにより、機械学習の能力が向上し、新たな研究や技術の発展を促進します.

Q: 大規模な財団モデルに関連するハードウェア・リソース・コストは?

A: 大規模な基盤モデルには、トレーニングと展開に莫大なリソースが必要です.これらのリソースには、GPUやTPUなどの計算プロセッサだけでなく、メモリ、エネルギー、ネットワーク帯域幅も含まれます.例えば、LLaMa-2-Resource-Efficient LLM and Multimodal Foundation Modelsの事前トレーニングには、数百万時間の計算時間と数百テラバイトのメモリが必要です.また、大規模な基盤モデルの展開には、高速なインフラストラクチャと大容量のメモリが必要です.これらのハードウェアリソースのコストは非常に高くなる可能性があります.

Q: 大型モデルの成長をサポートするための資源効率の高い戦略には、どのような例があるのだろうか?

A: 大規模なモデルの成長をサポートするためのリソース効率の高い戦略の例としては、モデルのスパース性を利用することが挙げられます.最近の研究では、密にトレーニングされた非MoEモデルでもランタイムのアクティベーションのスパース性が見られ、これを利用することで推論時間とメモリの使用量を削減することができます.MoE以外のより効率的なスパースアーキテクチャも登場する可能性があります.

Q: 資源効率の高い戦略を開発する上で、研究は何が決定的に重要なのか?

A: 大規模な基盤モデルのリソース課題に取り組むため、研究が重要である.この研究は、アルゴリズムとシステムの両面を調査し、リソース効率の戦略を開発することを目的としている.大規模な基盤モデルは、高いパフォーマンスを提供する一方で、ハードウェアリソースのコストが非常に高いため、スケーラブルかつ環境に優しい方法が求められている.この調査は、既存の文献から得られた包括的な分析と貴重な洞察を提供し、最先端のモデルアーキテクチャやトレーニング/サービングアルゴリズムから実用的なシステム設計と実装まで、幅広いトピックを網羅している.この調査の目的は、現在のアプローチが大規模な基盤モデルのリソース課題に取り組む方法を提供し、将来のブレークスルーを促すことである.

Q: この調査で調査されたアルゴリズム的側面とは?

A: この調査では、アルゴリズムの効率性に関するさまざまな側面が調査されています.具体的には、切り込みモデルのアーキテクチャやトレーニング/サービングアルゴリズム、実用的なシステムの設計や実装など、幅広いトピックが含まれています.

Q: 文献で議論されている最先端のモデル・アーキテクチャにはどのような例がありますか?

A: 文献で議論されている最先端のモデルアーキテクチャのいくつかの例は、SnapFusion、ERNIE-ViLG、ScaleCrafter、LeViT、PoolFormer、MobileViT、EfficientFormer、EfficientViTです.

Q: 文献で議論されているトレーニング/サービング・アルゴリズムの例にはどのようなものがありますか?

A: 文献で議論されているトレーニング/サービングアルゴリズムのいくつかの例は、以下の通りです.

- 事前学習アルゴリズムGPT-3-175B、LaMa-70B

- 微調整アルゴリズムAdapterADA、MetaTroll、ST-Adapter、HiWi、PEMA、AdadMix、MEFT、Residual Adapters

- プロンプトPromptTuning、ATTEMPT、BioInstruct、DualPL、MPrompt、DPT

Q: 実用的なシステム設計と実装は、大規模なファンデーションモデルがもたらすリソースの課題への対処にどのように貢献するのか?

A: 実用的なシステム設計と実装は、大規模な基盤モデルによって引き起こされるリソースの課題に対処するために貢献します.これらのシステム設計と実装は、モデルのリソースフットプリントを削減することに焦点を当てており、パフォーマンスを損なうことなくモデルの効率を向上させるためのアプローチを提供します.具体的には、アルゴリズムの最適化やシステムレベルのイノベーションなど、さまざまなアプローチが取られています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のURLはhttps:github.com/UbiquitousLearning/Efficient_Foundation_Model_Surveyです.