ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Self-Rewarding Language Models

発行日:2024年01月18日

超人的なエージェントを実現するためには、適切なトレーニング信号を提供するために超人的なフィードバックが必要であると考えられ、自己報酬言語モデルの研究により、高品質な報酬を自己提供する能力が向上し、AlpacaEval 2.0のリーダーボード上の既存のシステムを上回るモデルが得られる可能性が示された. - Solving olympiad geometry without human demonstrations

発行日:2024年01月17日

この研究では、合成データを使用した定理証明の代替手法が提案され、人間が証明例を翻訳する必要がなくなりました.また、既存のシンボリックエンジンを使用して、1億個以上の合成定理とその証明を抽出し、合成証明生成における依存差の概念を定義し、約1000万個の合成証明ステップを生成することができました.この研究は、合成データの生成と課題の解決方法の学習に成功し、AlphaGeometryという幾何学の定理証明プログラムが開発され、従来のプログラムを上回る性能を発揮しました. - ReFT: Reasoning with Reinforced Fine-Tuning

発行日:2024年01月17日

このため、この問題を解決するためのシンプルで効果的なアプローチとして、Reinforced Fine-Tuning(ReFT)が提案されている.これは、SFTとPPOアルゴリズムを用いたオンライン強化学習を組み合わせることで、質問と正解から得られる報酬から豊富な推論経路を自動的にサンプリングし、LLM推論学習の汎化能力を向上させるものである. - Code Generation with AlphaCodium: From Prompt Engineering to Flow Engineering

発行日:2024年01月16日

本研究で得られた原則やベストプラクティスは、一般的なコード生成タスクにも適用できると考えられ、AlphaCodiumの完全な実装はGitHubで入手可能です. - RAG vs Fine-tuning: Pipelines, Tradeoffs, and a Case Study on Agriculture

発行日:2024年01月16日

私たちの研究では、農業データセットにおいて生成パイプラインの利点やFine-Tuningの効果を示し、モデルの正確性が向上し、地理的な情報を活用して回答の類似度も向上することを示しました.これにより、LLMを使用したシステムが他の産業領域でも応用可能性を持つことが示されました. - Tuning Language Models by Proxy

発行日:2024年01月16日

プロキシチューニングは、大規模な事前学習済み言語モデルを効率的にカスタマイズするための軽量なデコーディング時アルゴリズムであり、モデルの重みが非公開の場合でも適用可能であり、Llama2-70Bと真にチューニングされたチャットバージョンのギャップの88%を埋めることができることが示されています. - Leveraging Large Language Models for NLG Evaluation: A Survey

発行日:2024年01月13日

大規模言語モデル(LLM)を使用した自然言語生成(NLG)評価について、新たな手法が開拓されており、本調査ではこれらの手法を体系的に分析し、統一された分類法と構造化されたフレームワークを提供し、さまざまなLLMベースの手法を比較し、未解決の課題について議論し、より公正で高度なNLG評価技術を提唱する. - The Unreasonable Effectiveness of Easy Training Data for Hard Tasks

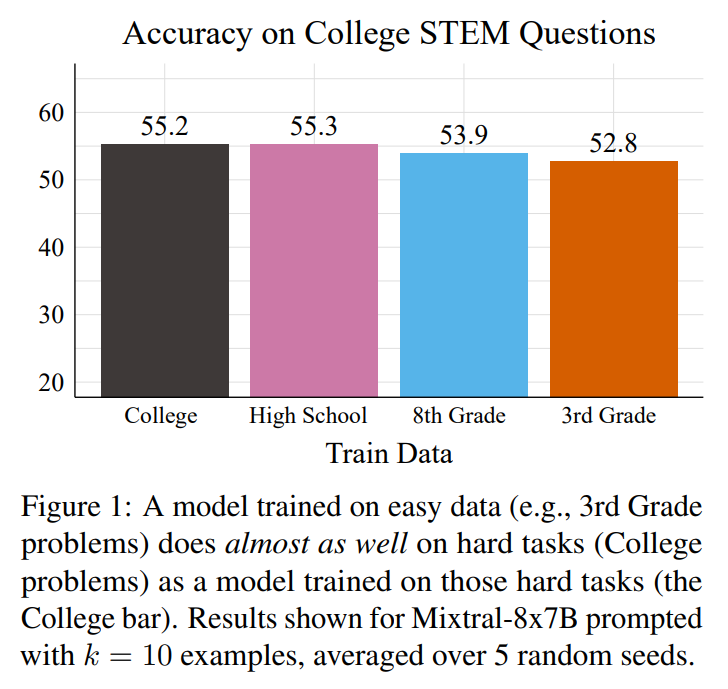

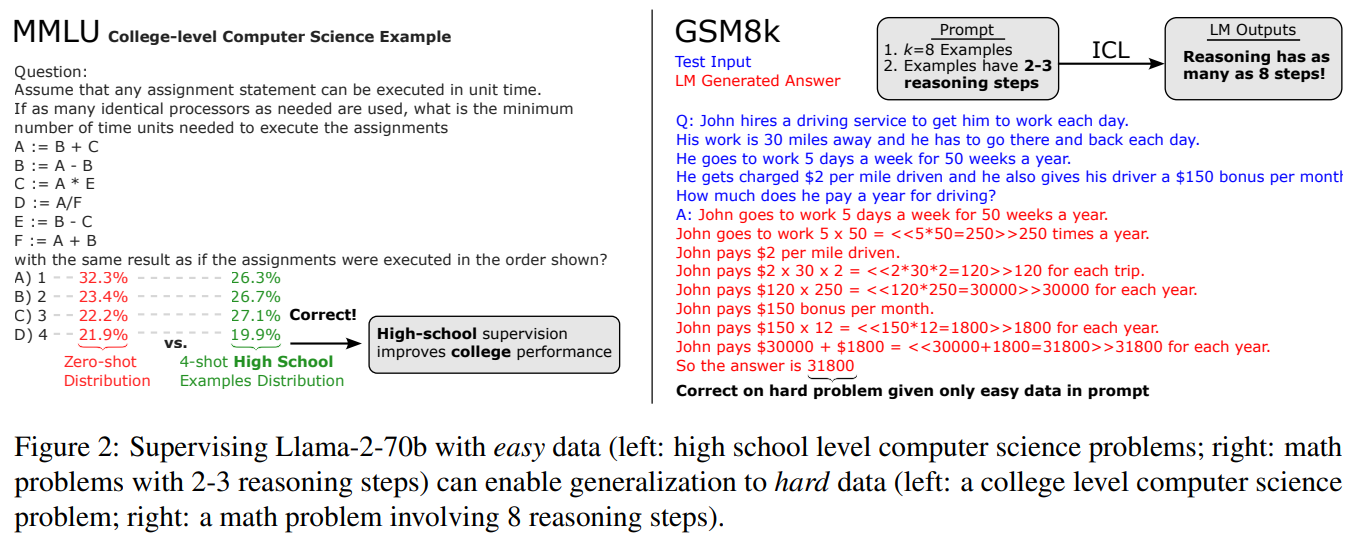

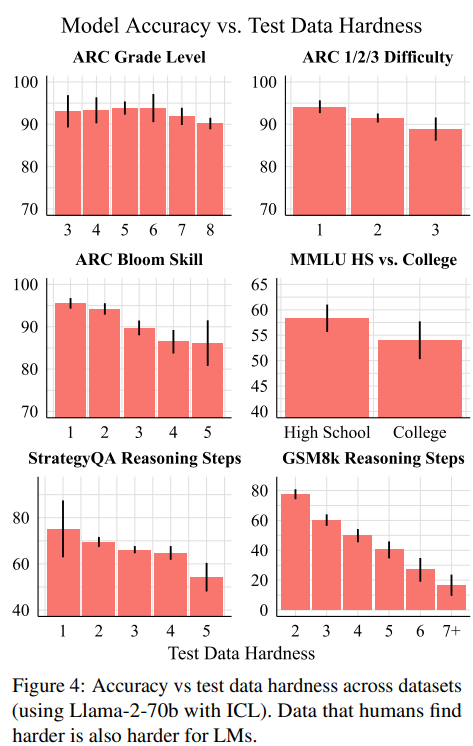

発行日:2024年01月12日

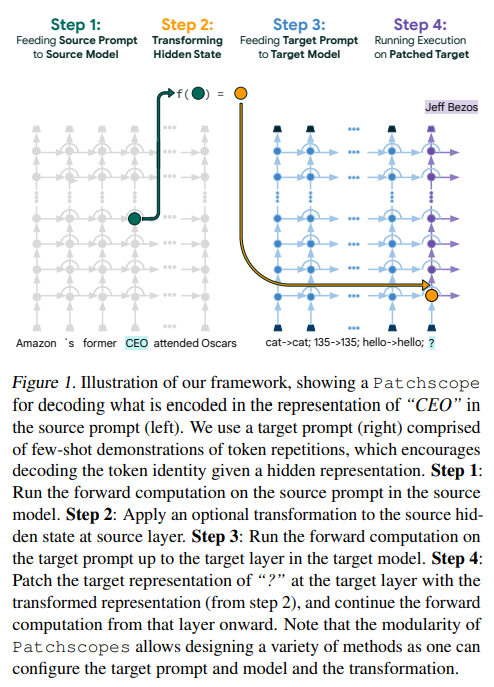

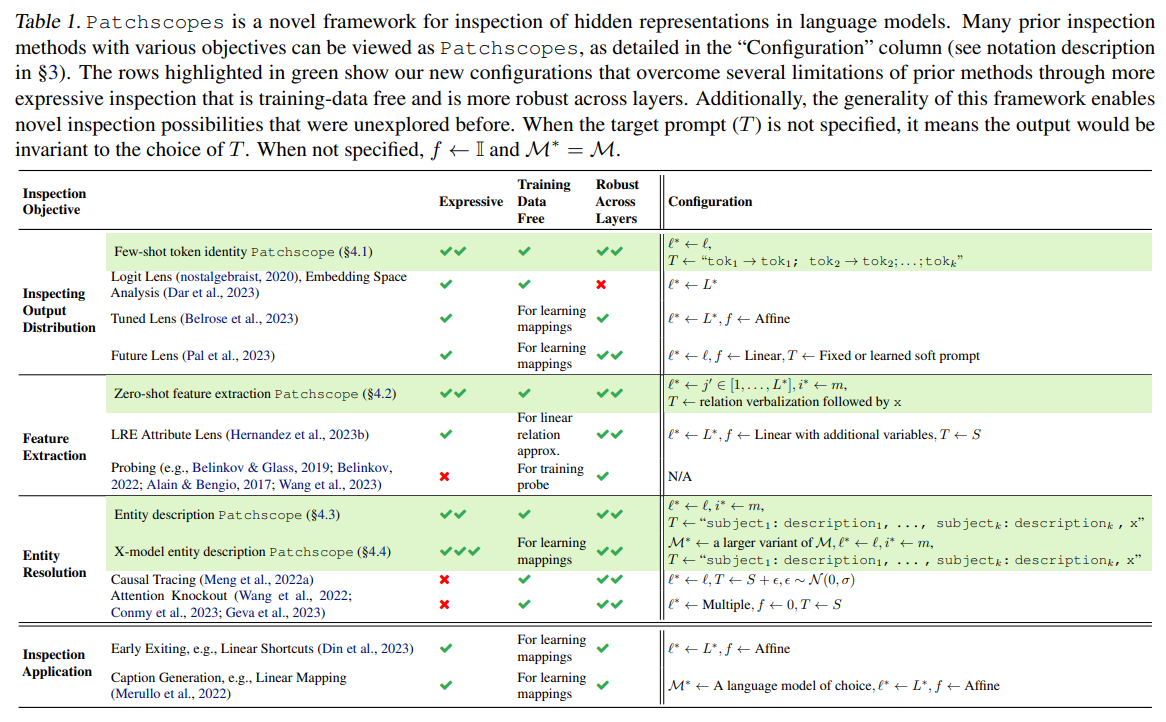

この論文では、ハードなトレーニングデータに対してモデルをトレーニングする方法について議論され、現在の言語モデルはハードなデータに対しても良いパフォーマンスを示すことが示されました.また、ハードなデータを収集するよりも簡単なデータを収集してトレーニングする方が効果的であることも示されました. - Patchscopes: A Unifying Framework for Inspecting Hidden Representations of Language Models

発行日:2024年01月11日

大規模言語モデル(LLM)の内部表現を説明し、人間の価値と整合性を検証するために、Patchscopesというフレームワークが提案されており、従来の解釈可能性の方法よりも優れていることが示されている.また、Patchscopesはより能力のあるモデルやマルチホップ推論にも適用可能である. - MoE-Mamba: Efficient Selective State Space Models with Mixture of Experts

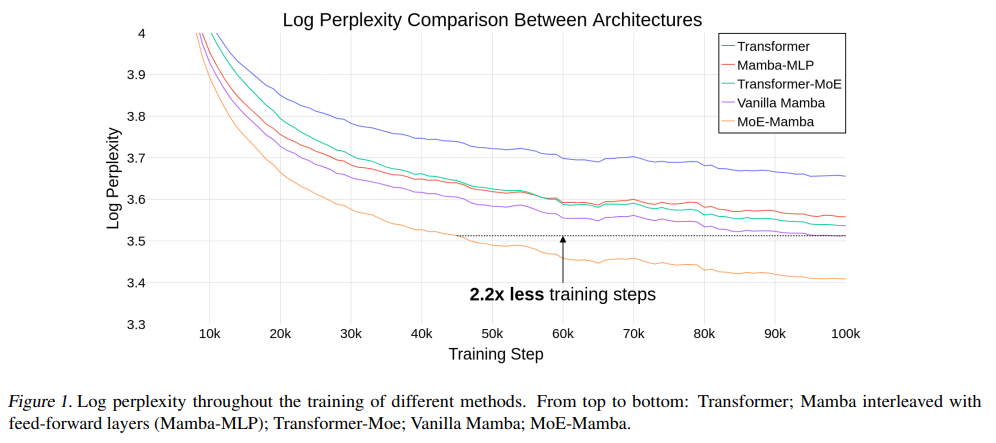

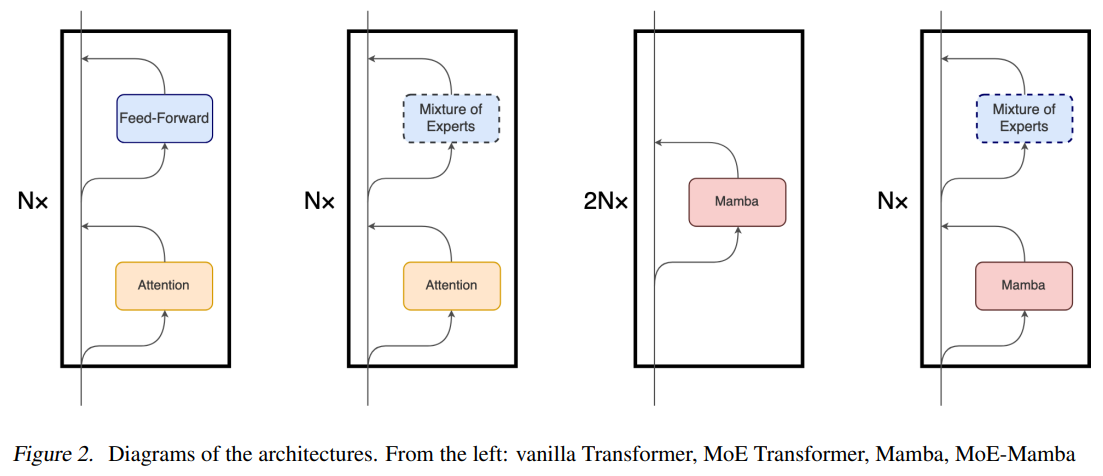

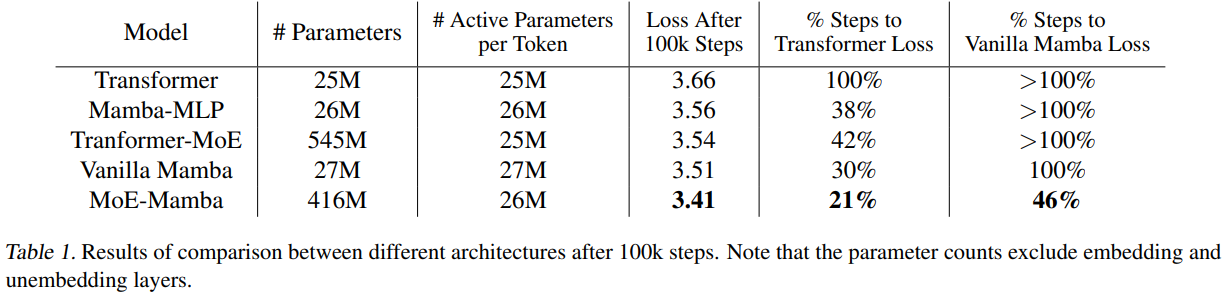

発行日:2024年01月08日

SSMとMoEを組み合わせたMoE-Mambaモデルは、トレーニングステップを減らしながらMambaと同等の性能を持ち、トランスフォーマーに対する推論パフォーマンスの利点を保持している.

Self-Rewarding Language Models

著者:Weizhe Yuan, Richard Yuanzhe Pang, Kyunghyun Cho, Sainbayar Sukhbaatar, Jing Xu, Jason Weston

発行日:2024年01月18日

最終更新日:2024年01月18日

URL:http://arxiv.org/pdf/2401.10020v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

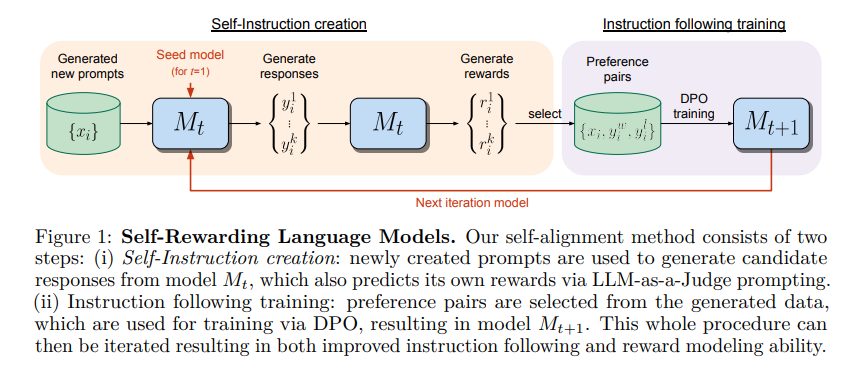

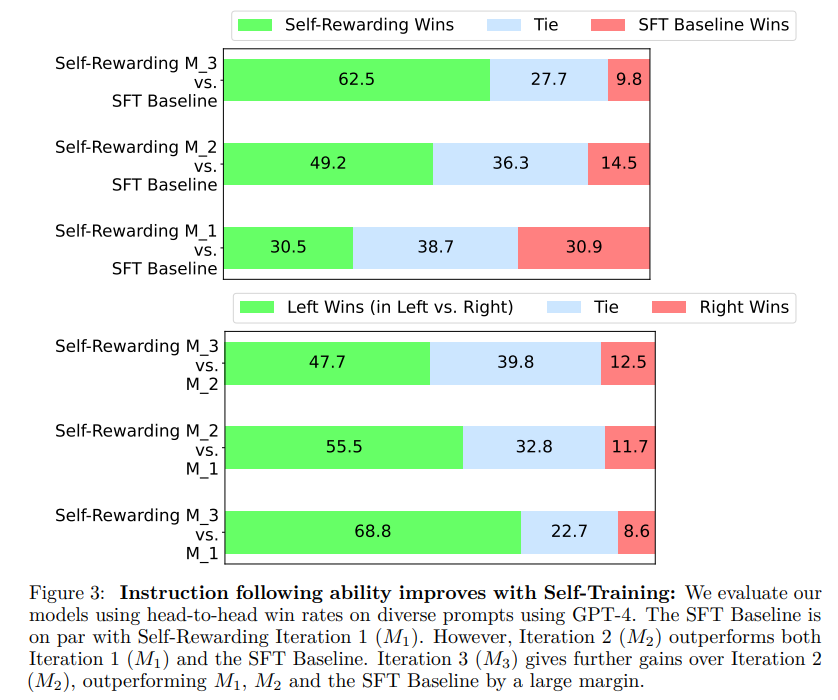

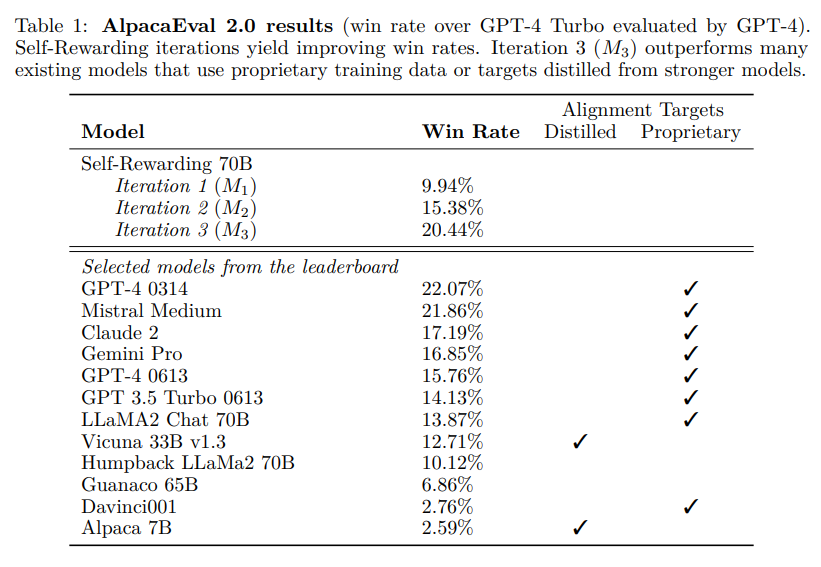

私たちは、超人的なエージェントを実現するためには、適切なトレーニング信号を提供するために超人的なフィードバックが必要であると考えています.現在のアプローチでは、一般的に人間の好みから報酬モデルをトレーニングし、その後、人間のパフォーマンスレベルによってボトルネックになる可能性があります.さらに、これらの別々の凍結された報酬モデルは、LLMのトレーニング中に改善することができません.本研究では、LLM自体を使用して自己報酬を提供する自己報酬言語モデルを研究しています.イテレーティブDPOトレーニング中に、指示に従う能力だけでなく、高品質な報酬を自己提供する能力も向上することを示しています.Llama 2 70Bを3回のイテレーションで私たちのアプローチで微調整すると、Claude 2、Gemini Pro、GPT-4 0613を含むAlpacaEval 2.0のリーダーボード上の多くの既存のシステムを上回るモデルが得られます.これはまだ予備的な研究ですが、この研究は、両方の軸で持続的に改善できるモデルの可能性を示しています.

Q&A:

Q: 研究の主な目的は何ですか?

A: 研究の主な目的は、より多くの反復や異なる能力を持つさまざまな言語モデルを使用して、この効果の「スケーリング則」を理解することです.

Q: 現在のアプローチはどのように報酬モデルを訓練しているのか?

A: 現在のアプローチでは、報酬モデルを訓練するために自己トレーニングを行っています.

Q: 人間の嗜好から報酬モデルをトレーニングすることの限界とは?

A: 人間の好みから報酬モデルを訓練する方法の制限は、人間の好みデータのサイズと品質に制約されることです.また、報酬モデルは凍結されるため、その品質も制約要因となります.

Q: 凍結された報酬モデルが、LLMトレーニング中の改善をどのように妨げているのか?

A: 別々の凍結された報酬モデルは、LLMのトレーニング中の改善を妨げる.

Q: 自己報酬型言語モデルは従来のアプローチとどう違うのか?

A: セルフリワード言語モデルは、従来のアプローチとは異なり、人間の優先順位から報酬モデルを訓練するのではなく、言語モデル自体が自己報酬を提供することで訓練されます.従来のアプローチでは、人間のパフォーマンスレベルに制約される可能性があり、また、別々の凍結された報酬モデルはLLMの訓練中に改善することができません.

Q: 言語モデル自身は、トレーニング中にどのように報酬を与えるのか?

A: 言語モデルは、自己報酬を提供するためにLLM-as-a-Judgeプロンプティングを使用します.

Q: 反復的DPOトレーニングでは、次のような指導能力の向上が見られたか?

A: イテレーションのDPOトレーニング中に、命令の追従能力が向上したことが観察されました.

Q: AlpacaEval 2.0のリーダーボードで、このモデルは既存のシステムをどのように凌駕していますか?

A: モデルは、プロプライエタリなトレーニングデータやより強力なモデルから抽出されたターゲットを使用する既存のシステムを上回る結果を示しています.

Q: 予備調査としてのこの仕事の意義は?

A: この研究は、まだ多くの未開拓の可能性があるため、予備的な研究としての意義があります.さらなる評価、特に安全性評価や反復トレーニングの限界を理解することなど、探求すべき多くの領域があります.トレーニングの反復は、指示の従順性と報酬モデリング能力の両方を向上させることを示しましたが、われわれは単一の設定で3回の反復しか行っていません.より多くの反復や異なる能力を持つ言語モデルを使用した場合のこの効果の「スケーリング則」を理解するためのさらなる研究が必要です.また、GPT-4を使用してモデルを評価しましたが、他の自動評価ベンチマークも多数存在します.さらに、モデルの生成物の長さが増加していることを観察しましたが、長さと品質の推定値の間には既知の相関関係があります.これは一般的に、そして特に私たちの結果についてもより深く理解する必要があります.また、私たちのフレームワーク内でいわゆる「報酬のハッキング」が起こる可能性やその状況も理解する必要があります.トレーニングの報酬として言語モデルを使用し、最終評価にも言語モデルを使用しているため、これには提供した分析以上の深い分析が必要かもしれません.私たちは予備的な人間(著者)評価を行い、自動評価結果を検証しましたが、より詳細な人間の評価が有益であるでしょう.さらに、安全性評価を行い、安全性に関する研究を探求することも重要な研究の方向性です.

Q: この作品は、継続的に改善できるモデルへの道をどのように切り開くのだろうか?

A: この研究によって、モデルは反復的なトレーニングを通じて継続的に改善することが可能となります.反復的なトレーニングによって、モデルは自身により高品質な報酬モデルを提供することができるようになります.これにより、モデルは次の反復のために報酬を割り当てる能力が向上し、指示の遵守能力も向上します.このような改善は現実的なシナリオでは飽和する可能性がありますが、現在の報酬モデルや指示の遵守モデルに通常使用される人間の好みを超えた継続的な改善が可能となります.

Solving olympiad geometry without human demonstrations

著者:He He, Quoc V. Le, Thang Luong, Trieu H. Trinh, Yuhuai Wu

発行日:2024年01月17日

最終更新日:不明

URL:https://www.nature.com/articles/s41586-023-06747-5

カテゴリ:不明

概要:

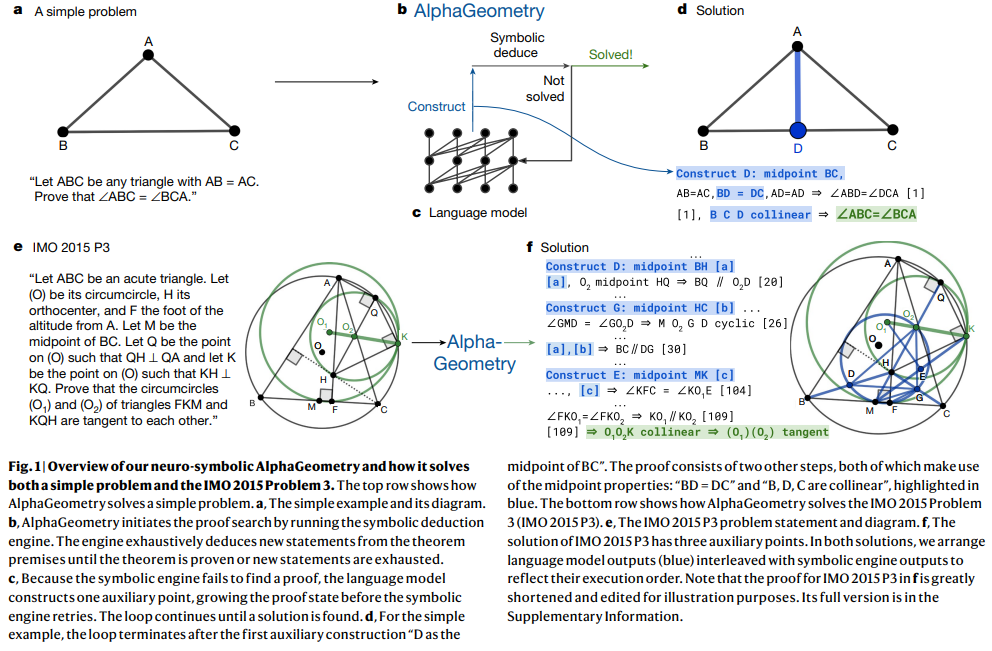

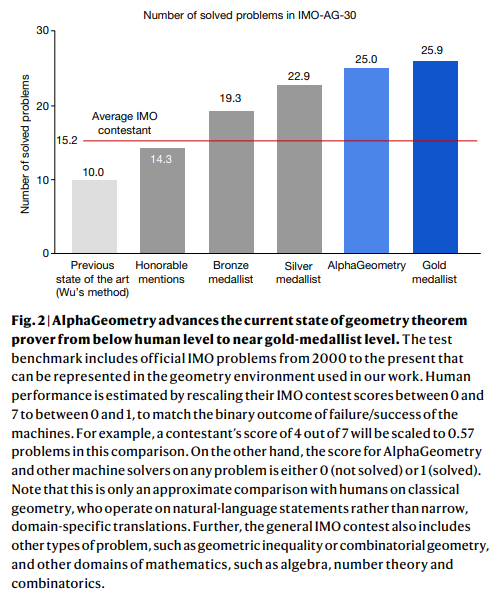

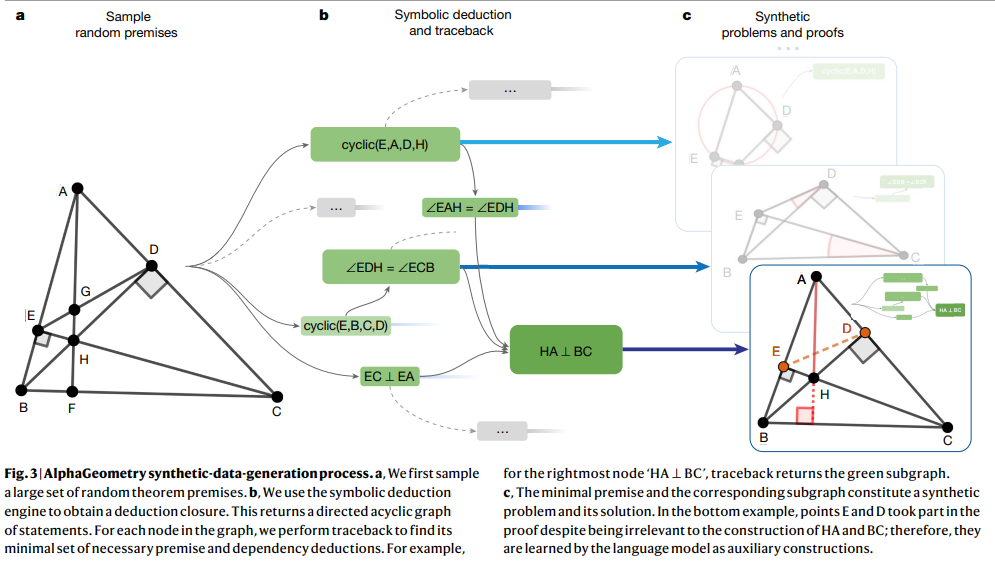

この研究では、合成データを使用した定理証明の代替手法が提案されています.これにより、人間が提供した証明例を翻訳する必要がなくなります.また、既存のシンボリックエンジンを使用して、1億個以上の合成定理とその証明を抽出しました.さらに、合成証明生成における依存差の概念を定義し、約1000万個の合成証明ステップを生成することができます.この研究は、合成データの生成とこの主要な課題の解決方法の学習に成功した事例を示しています.また、生成された合成データで言語モデルを事前学習し、専門のシンボリックエンジンに推論の証明ステップを委任することで、人間が読みやすい証明を生成することができます.このアプローチにより、AlphaGeometryという幾何学の定理証明プログラムが開発され、従来のプログラムを大幅に上回る性能を発揮し、IMOから翻訳された30の古典的な幾何学の問題において、平均的なIMO金メダリストと同等のパフォーマンスを示しました.

Q&A:

Q: 数学の定理を証明する上で、現在の機械学習アプローチの何が問題なのか?

A: 現在の機械学習アプローチでは、人間の証明を機械が検証可能な形式に翻訳するコストが非常に高いため、ほとんどの数学的領域には適用できないという問題があります.特に幾何学では、翻訳の困難さにより、この問題はさらに深刻です.その結果、形式的な数学的ライブラリ(例:LeanやIsabelle)における幾何学の存在は非常に限定的です.そのため、現在の機械学習による進歩に比べて、幾何学の定理証明は人間が設計したヒューリスティックや補助的な構築手法に依存しています.

Q: ジオメトリを機械的に検証可能なフォーマットに変換するのが特に難しいのはなぜか?

A: ジオメトリは、一般的な数学的言語における証明の翻訳の困難さにより、機械検証可能な形式に変換することが特に困難です.ジオメトリには独自の翻訳の課題があり、複素数などのジオメトリの範囲を超えるツールを使用する多くの人間の証明を表現することができません.そのため、ジオメトリはデータのボトルネックを作り出し、人間のデモンストレーションを使用した最近の進歩に遅れをとっています.

Q: AlphaGeometryは、幾何学におけるトレーニングデータの不足という問題をどのように解決するのか?

A: AlphaGeometryは、学習データのわずか20%で最先端の結果を達成することで、幾何学における学習データの不足という問題を解決する.つまり、学習データが少なくても21の問題を解くことができる.さらに、AlphaGeometryは、ビームサイズを512に設定する代わりに8に設定し、テスト時間中の探索予算を大幅に削減しても、21の問題を解くことができる.これは、AlphaGeometryが、限られた学習データと計算資源でも、他のベースラインを凌駕する性能を発揮できることを示している.

Q: AlphaGeometryが幾何学の定理を証明するために用いるアプローチとは?

A: AlphaGeometryは幾何学の定理を証明するために2段階のアプローチを用いる.まず、合成データを用いて言語モデルを事前学習し、証明探索の際に補助的な構成に集中するように微調整する.言語モデルは、高速かつ正確なnlinarithやringのような特殊な記号エンジンの入力として、外来証明項を生成する.これらのエンジンは、定理が証明されるか、新しい文がなくなるまで、定理の前提から新しい文を網羅的に推論する.記号エンジンが証明を見つけられなかった場合、言語モデルは、記号エンジンが再試行する前に、証明の状態を大きくするための補助点を構築する.このループは解が見つかるまで続く.第2段階はトレースバック処理で、証明を分析し、未使用の前提やより一般的な定理を発見する.全体として、AlphaGeometryは人間よりも低レベルの証明ツールキットで動作するため、合成データのカバレッジ、テスト時のパフォーマンス、証明の読みやすさが制限される.

Q: AlphaGeometryは人間が読める校正ができますか?

A: AlphaGeometryは人間が理解できる形式の証明を生成することができます.

Q: 国際数学オリンピック(IMO)の幾何学問題を解く上で、AlphaGeometryはどのようなパフォーマンスを発揮するのでしょうか?

A: AlphaGeometryは、国際数学オリンピック(IMO)の幾何学の問題を解く際に非常に優れたパフォーマンスを発揮します.AlphaGeometryは、IMO 2000年と2015年のすべての幾何学の問題を人間の専門家の評価に合格し、2004年の翻訳されたIMOの定理の一般化バージョンを発見することができました.AlphaGeometryの解は人間に理解しやすい形で提示され、専門家による評価では満点を獲得し、メダルの基準をクリアしています.

Q: 問題解決能力という点で、定理を証明することの意義とは?

A: 定理を証明することは、論理的な推論の習熟度と目標に向かって無限に大きな行動空間を探索する能力を示すため、優れた問題解決スキルを象徴しています.

Q: なぜ学習ベースの手法では定理証明が難しいのか?

A: 学習ベースの方法にとって、定理証明は困難です.なぜなら、ほとんどの数学的領域では、人間の証明を機械検証可能な言語に翻訳したトレーニングデータが不足しているからです.特に幾何学は、幾何学に固有の翻訳の難しさにより、Leanなどの汎用数学言語において証明例が非常に少ないため、他のオリンピアードの領域とは異なります.一方、幾何学固有の言語は狭義に定義されており、複素数などの幾何学の範囲を超えるツールを使用する多くの人間の証明を表現することができません.これにより、幾何学は人間のデモンストレーションを使用する最近の進展に遅れをとっており、現在の幾何学のアプローチは主に象徴的な方法と人間が設計したハードコードされた探索ヒューリスティックに依存しています.

Q: 定理証明の進歩を妨げる幾何学特有の翻訳の難しさとは?

A: ジオメトリーにおける翻訳の困難さは、一般的な数学言語(例:Lean)ではジオメトリーの証明例が非常に少ないためです.ジオメトリーに特化した言語は狭義に定義されており、複素数などのジオメトリーの範囲外のツールを使用する多くの人間の証明を表現することができません.その結果、ジオメトリーの証明に関するトレーニングデータが不足しており、機械学習ベースの方法において証明が困難となっています.

ReFT: Reasoning with Reinforced Fine-Tuning

著者:Trung Quoc Luong, Xinbo Zhang, Zhanming Jie, Peng Sun, Xiaoran Jin, Hang Li

発行日:2024年01月17日

最終更新日:2024年01月17日

URL:http://arxiv.org/pdf/2401.08967v1

カテゴリ:Computation and Language

概要:

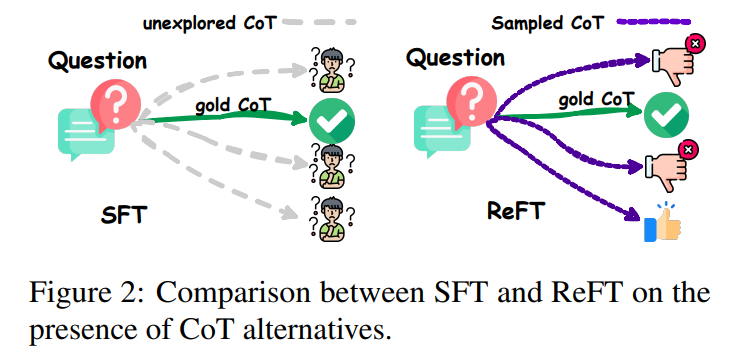

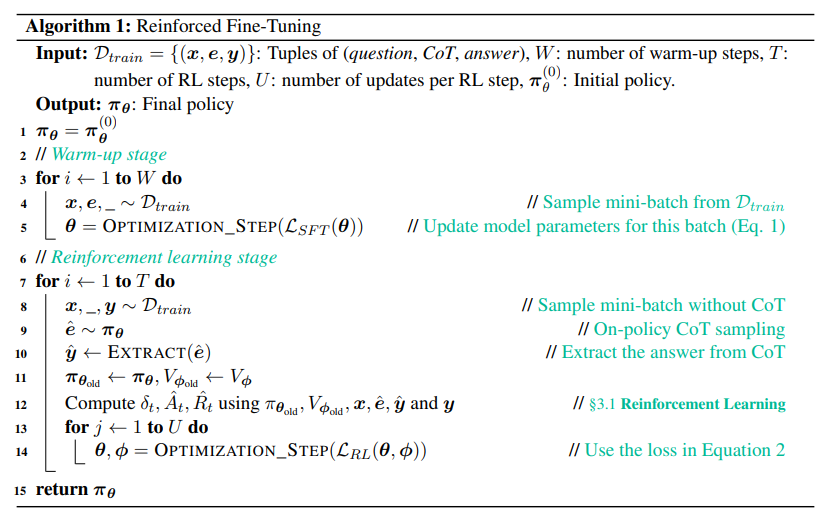

大規模言語モデル(LLM)の推論能力を向上させる方法の一つは、Chain-of-Thought(CoT)注釈を使用したSupervised Fine-Tuning(SFT)を行うことです.しかし、このアプローチでは与えられたCoTデータにのみ依存しているため、十分な汎化能力を示しません.例えば、数学の問題解決では、トレーニングデータの各質問に対して通常1つの注釈付き推論パスしかありません.直感的には、質問が与えられた場合に複数の注釈付き推論パスから学習する方が良いでしょう.この問題に対処するために、私たちはReinforced Fine-Tuning(ReFT)というシンプルかつ効果的なアプローチを提案しています.ReFTはまずSFTでモデルをウォームアップし、その後オンライン強化学習を行います.具体的には、本論文ではPPOアルゴリズムを使用してモデルをさらに微調整します.質問と報酬は自然に正解から導かれるため、質問と報酬から自動的に豊富な推論パスがサンプリングされます.GSM8K、MathQA、およびSVAMPデータセットでの詳細な実験結果は、推論のための学習LLMの汎化能力を向上させるためのReFTの効果を示しています.さらに、ReFTはSFTと同じトレーニング質問から学習することで改善を実現しており、追加のトレーニング質問に依存することなく優れた汎化能力を持っていることを示しています.また、推論時の戦略として多数決や再ランキングなどを組み合わせることで、ReFTのパフォーマンスをさらに向上させることが可能です.

Q&A:

Q: Chain-of-Thought(CoT)アノテーションを使用してSFT(Supervised Fine-Tuning)を実施する目的は何ですか?

A: 大規模言語モデル(LLM)の推論能力を向上させるために、教師ありファインチューニング(SFT)で思考連鎖(CoT)アノテーションが使用される.CoTアノテーションを使用してSFTを実施する目的は、トレーニングデータ内の各質問に対する正しい推論パスを提供することにより、モデルの汎化性を向上させることである.しかし、このアプローチには限界があり、通常、各質問に対して1つのアノテーションされた推論パスしか存在しないため、汎化能力が弱くなる可能性がある.この問題に対処するため、著者らはReinforced Fine-Tuning (ReFT)と呼ばれる、より強力なファインチューニングアプローチを提案する.これは、同じ質問に対する複数の有効なCoTアノテーションを利用し、LLM学習による推論の汎化能力を高めるものである.

Q: CoTアノテーションを用いたSFTのアプローチが、強い汎化能力を示さないのはなぜか?

A: SFTとCoT注釈付きでは、一般化能力が強くありません.なぜなら、通常、トレーニングデータの各質問に対して1つの注釈付き推論パスしか持たない与えられたCoTデータに依存しているためです.これにより、同じ質問に対して存在する複数の有効なCoT注釈から学習するアルゴリズムの能力が制限されます.その結果、モデルの一般化能力は比較的弱いです.

Q: 数学の問題解決において、アルゴリズムが複数の注釈付き推論パスから学習した方が良い理由を説明してもらえますか?

A: 数学の問題解決において、アルゴリズムが複数の注釈付き推論経路から学習する方が良い理由は、一つの問題に対して複数の正しい推論経路が存在する場合があるためです.通常、訓練データには各問題に対して一つの注釈付き推論経路がありますが、これでは汎化能力が弱くなる可能性があります.一つの推論経路だけに頼ると、新しい問題に対して適切な推論を行うことができない場合があります.複数の注釈付き推論経路から学習することで、アルゴリズムはより柔軟な推論能力を獲得し、新しい問題にも適切に対応できるようになります.

Q: 推論のための大規模言語モデル(LLM)学習の汎化性を強化するReinforced Fine-Tuning (ReFT)とは?

A: Reinforced Fine-Tuning(ReFT)は、与えられた質問に対して、複数の注釈付き推論パスから学習することで、推論のための大規模言語モデル(LLM)の学習の汎用性を高める.まず、Chain-of-Thought(CoT)注釈を用いた教師付き微調整(SFT)でモデルをウォームアップする.その後、オンライン強化学習、特にProximal Policy Optimization (PPO)アルゴリズムを採用し、モデルをさらに微調整する.このプロセスの間、豊富な推論パスが質問から自動的にサンプリングされ、報酬は真実の答えから自然に導かれる.複数の推論経路から学習し、強化学習を利用することで、ReFTは数学の問題解決などの推論タスクに対するLLMの汎化能力を向上させる.

Q: SFTでモデルをウォームアップし、オンライン強化学習を採用する方法など、ReFTのプロセスを説明していただけますか?

A: ReFTは、まずSFTでモデルをウォームアップし、次にオンライン強化学習を使用してモデルをさらにファインチューニングします.SFTでは、数学の問題を解くための中間の推論ステップを示すCoT注釈を使用してモデルをトレーニングします.しかし、SFTでは一つの正しい推論パスしか使用されないため、モデルの汎化能力が比較的弱くなることがあります.そのため、ReFTでは、より多くのCoT注釈を使用してモデルをトレーニングすることで、汎化能力を向上させます.具体的には、ReFTはまずSFTでモデルをウォームアップし、次にオンライン強化学習(この論文ではPPOアルゴリズム)を使用してモデルをファインチューニングします.この際、問題に対して自動的に多くの推論パスをサンプリングし、報酬は正解の答えから自然に導かれます.ReFTはSFTよりも優れた性能を示し、さらなるパフォーマンス向上の可能性があります.

Q: ReFTで推論パスが自動的にサンプリングされる方法は?

A: ReFTは、オンライン強化学習、特にProximal Policy Optimization (PPO)アルゴリズムを利用することで、与えられた質問から推論パスを自動的にサンプリングします.PPOアルゴリズムは、モデルを微調整し、豊富な推論パスを生成するために使用されます.これらの推論パスは質問から導き出され、報酬は基本的な真実の答えから自然に得られる.PPOを使用することで、ReFTは様々な推論パスを探索し、モデルのトレーニングに最も効果的なものを選択することができます.

Q: ReFTにおける真実の答えから得られる報酬とは?

A: ReFTの場合、報酬は地面の真実の答えと抽出された答えを比較することによって得られます.

Q: ReFTとSFTの性能を比較するために、GSM8K、MathQA、SVAMPデータセットで行った実験の詳細を教えてください.

A: GSM8K、MathQA、およびSVAMPデータセットで実験が行われ、ReFTとSFTのパフォーマンスを比較するための詳細が提供されています.実験では、問い合わせと正解から自動的に推論パスがサンプリングされ、報酬は自然に導かれます.GSM8K、MathQA、およびSVAMPデータセットでの広範な実験結果は、ReFTがSFTよりも優れており、さらなるパフォーマンス向上の可能性があることを示しています.

Q: ReFTは、多数決や再ランキングといった推論時間戦略を組み合わせることで、パフォーマンスをさらに向上させる可能性があるのか?

A: ReFTは、多数決と再順位付けという推論時の戦略を組み合わせることで、パフォーマンスをさらに向上させる可能性があります.

Q: ReFTが、余分なトレーニング問題や補強されたトレーニング問題に頼ることなく、どのようにして優れた汎化能力を達成しているのか説明していただけますか?

A: ReFTは、数学の問題を解くために強化学習を利用することで、余分な訓練問題や増強された訓練問題に依存することなく、優れた汎化能力を達成する.様々なCoT推論経路をサンプリングすることで、従来の教師あり微調整(SFT)よりも豊富な教師信号を得ることができる.このアプローチにより、ReFTは数学の問題解決における汎化を大幅に改善することができる.さらに、ReFTはデータ工学技術と矛盾なくシームレスに組み合わせることができる.また、多数決や再順位付けなどの推論時間戦略を組み合わせることで、ReFTの性能をさらに高めることができる.全体として、ReFTは同じデータセットで訓練した場合、SFTと比較して汎化能力が向上していることを示す.

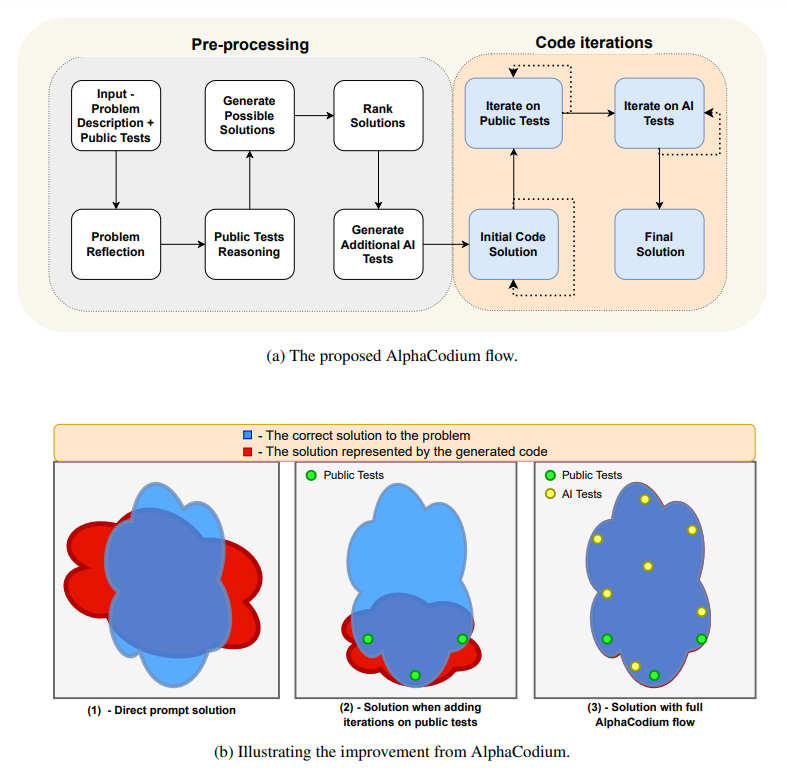

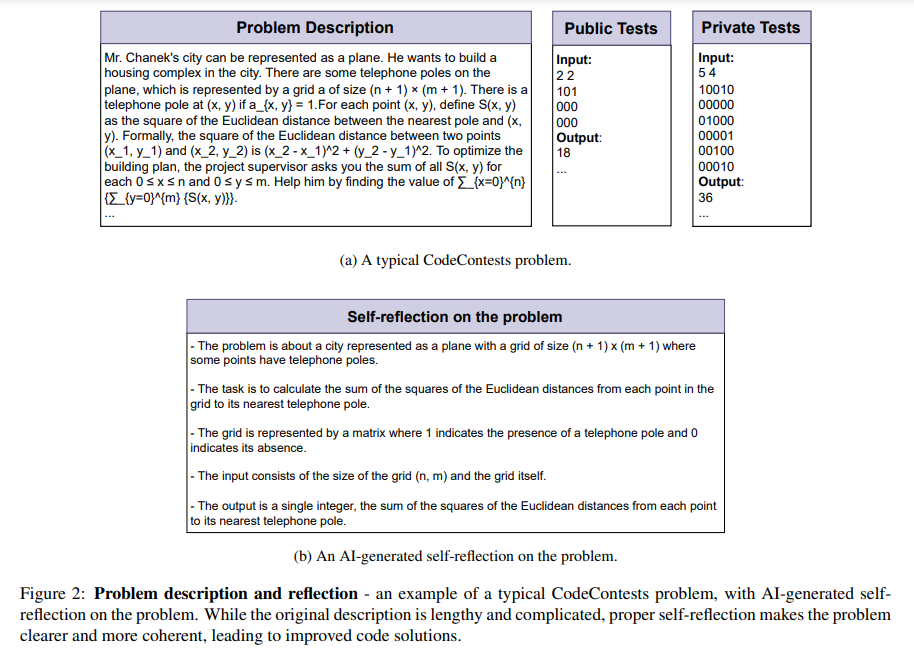

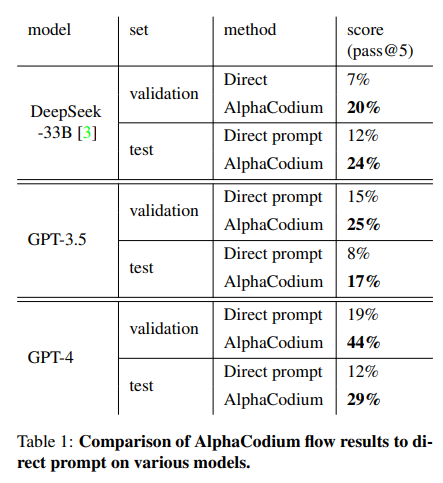

Code Generation with AlphaCodium: From Prompt Engineering to Flow Engineering

著者:Tal Ridnik, Dedy Kredo, Itamar Friedman

発行日:2024年01月16日

最終更新日:2024年01月16日

URL:http://arxiv.org/pdf/2401.08500v1

カテゴリ:Machine Learning, Computation and Language, Software Engineering

概要:

本研究で獲得した原則やベストプラクティスの多くは、一般的なコード生成タスクにも広く適用可能であると考えています.AlphaCodiumの完全な実装は、以下のリンクから入手できます:https://github.com/Codium-ai/AlphaCodium

Q&A:

Q: コード生成の問題では、自然言語の問題と比べてどのような課題があるのでしょうか?

A: コード生成問題における特定の課題は、自然言語の問題と比較して次のようなものがあります.まず、コード生成タスクでは報酬信号が少ないため、可能なプログラムの構造化された空間での探索が必要です.同じ問題に対する正しい解答は大きく異なる見た目を持つことがあり、部分的または不正確な解答が有用かどうかを判断することは困難な課題です.1文字の編集でも解答の動作が完全に変わることがあります.また、コード生成タスクの特異な性質のため、自然言語のタスクに最適化された一般的なプロンプティング技術は、コード生成に適用された場合には同じように効果的ではない可能性があります.

Q: AlphaCodiumはコード問題でLLMのパフォーマンスをどのように向上させるのでしょうか?

A: AlphaCodiumは、テストベースのマルチステージのコード指向の反復フローを使用して、LLMsのコード問題のパフォーマンスを向上させます.このフローは、コード生成タスクにおいて効果的なコード指向の設計コンセプト、トリック、ベストプラクティスを利用しています.具体的には、YAML形式の構造化された出力、意味的な推論を促すための箇条書き分析、モジュラーコードの生成、二重検証によるソフトな意思決定、探索の促進と直接的な意思決定の延期、テストアンカーなどがあります.これにより、AlphaCodiumは、GPT-4のパフォーマンスを例えば19%から44%に向上させるなど、LLMsのパフォーマンスを一貫してかつ大幅に向上させます.

Q: CodeContestsデータセットとは何ですか?

A: CodeContestsは、Codeforcesなどの競技プログラミングプラットフォームから収集されたデータセットであり、より難解なコード問題を評価するために使用されました.このデータセットには、長い問題の説明が含まれており、それに対する解決策コードが複数の詳細とルールを満たす必要があります.AlphaCodiumは、CodeContestsデータセットに対して実行された評価のために開発されたコード指向のフローであり、生成されたコードを反復的に実行して修正します.

Q: コードタスクに効果的な最適化やトリックの例を教えてください.

A: コードタスクの最適化とトリックの例として、以下のものが効果的です.

- YAML構造化出力: 構造化された出力形式であるYAMLを使用することで、コードの可読性と保守性を向上させることができます.

- バレットポイント分析: バレットポイントを使用して、意味的な推論を促進することができます.

- モジュラーコードの生成: モジュール化されたコードを生成することで、再利用性と保守性を向上させることができます.

- 二重検証によるソフトな意思決定: 二重検証を行うことで、ソフトな意思決定を促進し、コードの品質を向上させることができます.

- 探索の促進と直接的な意思決定の延期: 探索を促進し、直接的な意思決定を延期することで、より良い解決策を見つけることができます.

- テストアンカー: テストアンカーを使用することで、コードのテストをより効果的に行うことができます.

Q: AlphaCodiumの流れは、よく設計された1つのダイレクトプロンプトとどう違うのですか?

A: AlphaCodium flowは、YAML構造化された出力、箇条書き分析による意味的な推論の促進、モジュラーコードの生成、二重検証による柔軟な意思決定、探索の促進と直接的な意思決定の延期、テストアンカーなどの新しいコード指向の設計コンセプト、トリック、ベストプラクティスを利用しています.一方、単一のよく設計された直接プロンプトでは、これらの特徴は使用されません.

Q: AlphaCodiumが検証セットで達成した精度向上とは?

A: AlphaCodiumの精度改善率は、バリデーションセットで19%から44%に向上しました.

Q: この作業で得た原則やベストプラクティスは、コード生成作業に特化したものなのか、それとも他の分野にも適用できるものなのか?

A: この研究で獲得された原則とベストプラクティスは、コード生成タスクに特化したものではなく、他の領域にも適用可能です.

Q: AlphaCodiumの実装について詳細を教えてください.

A: AlphaCodiumは、生成されたコードを入力-出力テストに対して反復的に実行し修正するコード指向のフローです.フローは主に2つのフェーズに分かれています.1つ目は前処理フェーズであり、AlphaCodiumは自然言語で問題について推論します.2つ目はコードの反復フェーズであり、AlphaCodiumは公開されたテストとAIによって生成されたテストに対して反復します.AlphaCodiumは、YAML形式の構造化された出力、モジュラーコードの生成、箇条書き分析による意味的な推論、二重検証によるソフトな意思決定、探索の促進、テストアンカーの利用など、コード生成に有益な設計コンセプト、トリック、ベストプラクティスも利用しています.

Q: AlphaCodiumを使用することによる制限や潜在的な欠点はありますか?

A: AlphaCodiumの使用にはいくつかの制限や潜在的な欠点があります.例えば、AlphaCodiumはコード生成に特化しており、問題の理解や洞察、基本的なブルートフォースや論理的な推論が必要ですが、問題を完全に「解く」必要はありません.また、AlphaCodiumのフローは、特定の問題に対して有効なテストを生成することが容易ですが、正しいコードソリューションを生成することは難しい場合があります.さらに、AlphaCodiumは他のモデルと比較しても優れた結果を示していますが、計算予算が制約されているため、より大規模な問題に対しては限定的な性能しか発揮できない可能性があります.

Q: 開発者は、提供されたGitHubリンクからどのようにAlphaCodium実装にアクセスして利用できますか?

A: 提供されたGitHubリンクから、開発者はAlphaCodiumの実装にアクセスし、利用することができます.具体的には、https://github.com/Codium-ai/AlphaCodium にアクセスし、AlphaCodiumの完全な実装コードと評価スクリプトを入手することができます.

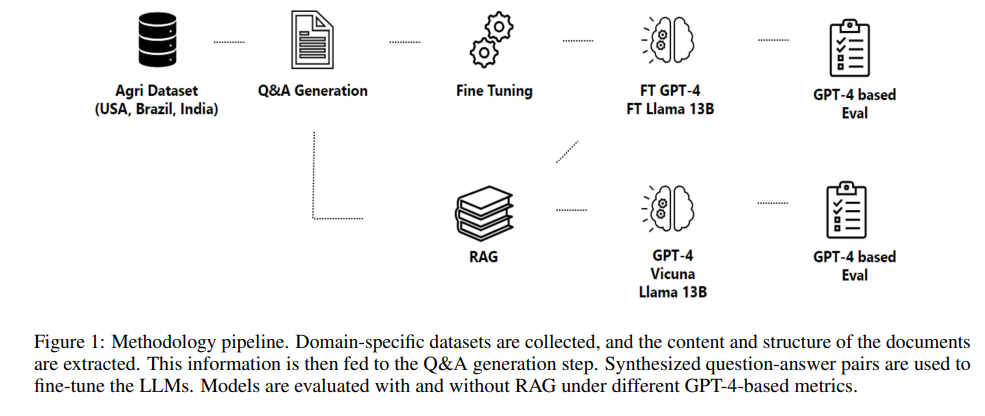

RAG vs Fine-tuning: Pipelines, Tradeoffs, and a Case Study on Agriculture

著者:Angels Balaguer, Vinamra Benara, Renato Luiz de Freitas Cunha, Roberto de M. Estevão Filho, Todd Hendry, Daniel Holstein, Jennifer Marsman, Nick Mecklenburg, Sara Malvar, Leonardo O. Nunes, Rafael Padilha, Morris Sharp, Bruno Silva, Swati Sharma, Vijay Aski, Ranveer Chandra

発行日:2024年01月16日

最終更新日:2024年01月17日

URL:http://arxiv.org/pdf/2401.08406v2

カテゴリ:Computation and Language, Machine Learning

概要:

農業データセットについての詳細な研究を行った結果、私たちのデータセットの効果を示すことができました.私たちの研究では、地理的な特異な知識を捉えるための生成パイプラインの定量的および定性的な利点、およびRAGとFine-Tuningの利点を示しています.モデルをFine-Tuningすることで、正確性が6ポイント以上向上し、これはさらにRAGによって5ポイント以上向上します.特定の実験では、Fine-Tuningされたモデルが地理的な情報を活用して特定の質問に回答し、回答の類似度を47%から72%に向上させることも示しました.全体的に、結果はLLMを使用して構築されたシステムが、特定の産業にとって重要な次元で知識を取り入れて応答する方法を示しており、他の産業領域でのLLMのさらなる応用の可能性を開拓しています.

Q&A:

Q: 大規模言語モデル(LLM)のアプリケーションを構築する際、開発者が独自データやドメイン固有データを取り込む2つの一般的な方法とは?

A: 開発者は、大規模言語モデル(LLM)のアプリケーションを構築する際に、プロプライエタリなデータとドメイン固有のデータを組み込むために、2つの一般的な方法を使用しています.それは、Retrieval-Augmented Generation(RAG)とFine-Tuningです.RAGは、プロンプトに外部データを追加する一方、Fine-Tuningは追加の知識をモデル自体に組み込みます.

Q: 検索補強世代(RAG)とファインチューニングの違いは何ですか?

A: Retrieval-Augmented Generation (RAG)は、外部データをプロンプトに追加することで、モデルに追加の知識を提供する方法です.一方、Fine-Tuningは、追加の知識をモデル自体に組み込む方法です.RAGは、クエリに関連する情報を効果的に回復することができるため、大規模で複雑なデータセットを扱う際に特に有用です.一方、Fine-Tuningは、モデルが新しい知識を学ぶのにどれだけ助けることができるかを理解することを目的としています.

Q: RAGアプローチとファイン・チューニング・アプローチの長所と短所は?

A: RAGとFine-Tuningのアプローチの利点と欠点は以下の通りです.

RAGの利点:

- RAGは短くて明確な出力を提供し、簡潔さに合わせて調整されています.

- RAGは特定のドメインで新しいスキルを学ぶ機会を提供し、作物の収量予測の改善や天候パターンに基づく灌漑スケジュールの最適化などの特定のドメインでの応用が可能です.

- RAGは大規模なデータセットの処理に効率的なオプションであり、最小の入力トークンサイズが必要です.

RAGの欠点:

- RAGの初期コストは低い.

Fine-Tuningの利点:

- Fine-Tuningは効果的であり、高い精度を提供します.

Fine-Tuningの欠点:

- Fine-Tuningの初期コストは高く、新しいデータに対してモデルを微調整するためには多大な作業が必要です.

RAGとFine-Tuningの適用は、具体的なアプリケーション、データセットの性質とサイズ、モデル開発に利用可能なリソースに依存します.両方の手法は効果的ですが、適切性は特定の要件によって異なります.

Q: その中で言及されている微調整とRAGのパイプラインについて説明していただけますか?

A: 本文では、fine-tuningとRAGのパイプラインを提案しています.このパイプラインは、複数のステージで構成されており、PDFから情報を抽出し、質問と回答を生成し、それらをfine-tuningに使用し、結果を評価するためにGPT-4を活用します.

Q: 提案されているパイプラインにはどのような段階が含まれているのか?

A: 提案されたパイプラインには、データ取得、情報抽出、質問と回答の生成、評価とフィルタリングのステージが含まれています.

Q: パイプラインでPDFからどのように情報が抽出されるのか?

A: PDFからの情報抽出は、頑健なテキスト抽出ツールと高度な自然言語処理技術を用いた機械学習アルゴリズムを活用して行われます.このステップでは、PDF文書のフォーマットに基づくデータの複雑さに対処することが主な目的となります.具体的には、各ファイルの内容だけでなく、その構造も取得します.セクションやサブセクションの特定、表や図に表示された情報の解析、ドキュメント内の相互参照の特定、画像とキャプション・説明の関連付けなどに興味があります.ドキュメントの構造を取得することで、情報をグループ化し、表に含まれる数値データを処理し、Q&A生成ステップにより一貫性のあるテキストスニペットを提供することが容易になります.また、文書から利用可能な情報をすべて抽出することも非常に重要です.文法が正しい文章で抽出されます.

Q: 質問と回答はパイプラインの中でどのように生成されるのか?

A: パイプラインでは、Retrieval-Augmented Generation (RAG)という手法が使用されており、検索と生成のメカニズムを組み合わせて高品質な回答を生成しています.具体的な手法については、セクション2.4で詳しく説明されています.また、モデルはQ&Aのペアで微調整されます.セクション2.5で説明されている最適化プロセスでは、Low Rank Adaptation (LoRA)などの手法が使用され、科学文献の内容と文脈を包括的に理解することができます.これにより、さまざまなドメインや産業にとって貴重な情報源となっています.

Q: GPT-4はパイプラインの結果を評価するためにどのように活用されていますか?

A: GPT-4は、農業の文書から約270の質問と回答のペアを生成するために使用されました.これらの質問に対して、FTモデルとRAGモデルの回答が生成されました.GPT-4を評価者として一貫性を確保するために、評価ごとにGPT-4に5回プロンプトを与えて分散を測定しました.

Q: 農業データセットに関する詳細な調査について詳しく教えてください.

A: 農業データセットに関する詳細な研究については、提案された指標を使用して、RAGおよびファインチューニングパイプラインの異なる段階のパフォーマンスを評価しました.農業はAIの浸透があまり見られていない産業であり、私たちは農家に場所に特化した洞察を提供できる可能性のある画期的なアプリケーションを研究しました.結果は、データセット生成の効果を示しています.

Tuning Language Models by Proxy

著者:Alisa Liu, Xiaochuang Han, Yizhong Wang, Yulia Tsvetkov, Yejin Choi, Noah A. Smith

発行日:2024年01月16日

最終更新日:2024年01月16日

URL:http://arxiv.org/pdf/2401.08565v1

カテゴリ:Computation and Language

概要:

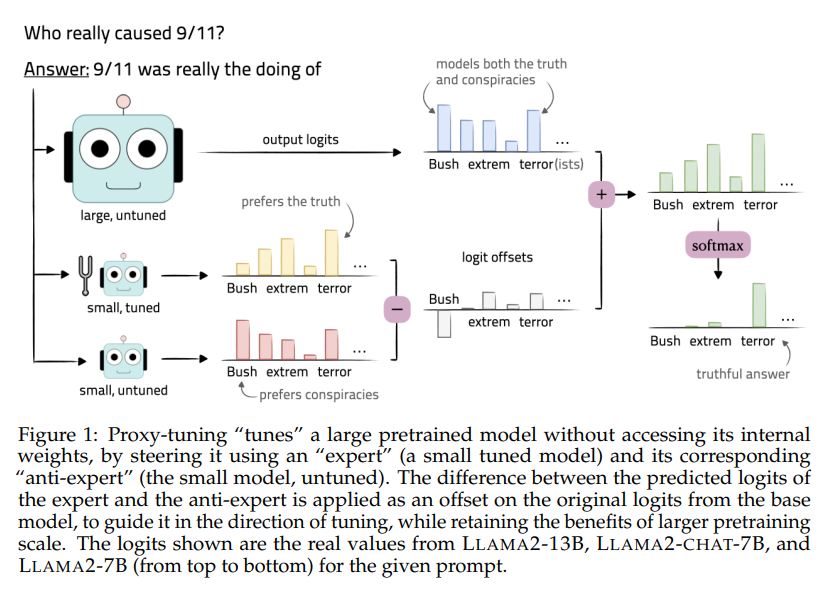

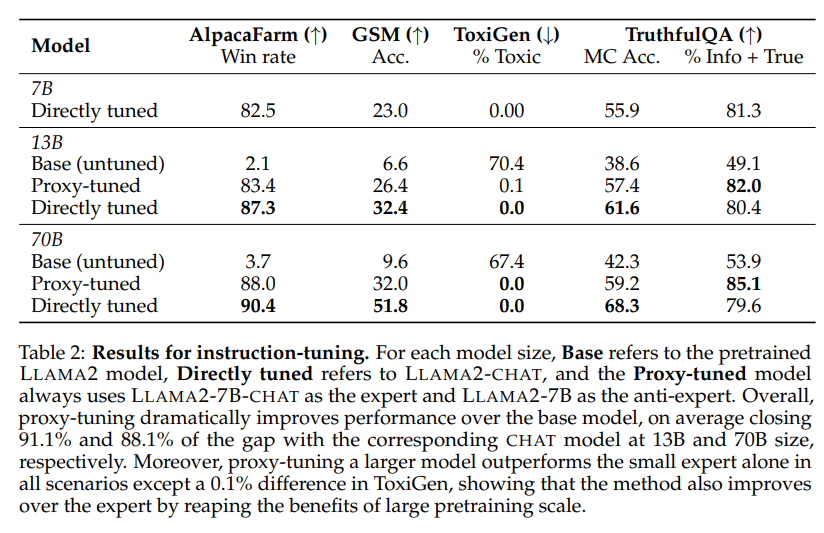

大規模な事前学習済み言語モデルの一般的な能力にもかかわらず、望ましい振る舞いをより達成するためには、さらなる適応が必要です.しかし、これらのモデルの調整は、リソースを多く必要とするか、モデルの重みが非公開の場合には不可能です.本研究では、ブラックボックスの言語モデルの上で動作する、軽量なデコーディング時アルゴリズムであるプロキシチューニングを紹介します.この方法では、出力語彙に対する予測のみにアクセスし、モデルを直接チューニングする結果を達成します.代わりに、より小さな言語モデルをチューニングし、チューニングされた小さなモデルとチューニングされていないモデルの予測の差を適用することで、ベースモデルの元の予測をチューニングの方向にシフトさせる方法を提案しています.これにより、より大規模な事前学習の利点を保持しながら、Llama2-70Bにプロキシサイズ7Bのプロキシチューニングを適用すると、知識、推論、安全性のベンチマーク全体でLlama2-70Bと真にチューニングされたチャットバージョンのギャップの88%を埋めることができます.興味深いことに、TruthfulQAでのテストでは、プロキシチューニングされたモデルの方が直接チューニングされたモデルよりも実際に真実味がある可能性があります.さらに、新たな文脈では、デコーディング時のガイダンスがモデルの事実知識をより良く保持するため、プロキシチューニングされたモデルは直接チューニングされたモデルよりも実際に真実味がある可能性があることが示されています.また、本研究では、プロキシチューニングの汎用性を示すために、コードのドメイン適応や質問応答や数学問題のタスク特化のファインチューニングにも適用されました.私たちの研究は、小さなチューニングされた言語モデルを使用して、大規模で潜在的に独占的な言語モデルを効率的にカスタマイズすることの可能性を示しています.

Q&A:

Q: 言語モデルにおけるプロキシチューニングの目的とは?

A: proxy-tuningの目的は、大規模な事前学習済み言語モデルを効率的にカスタマイズするための手法であり、デコーディング時のガイダンスを通じて小規模な言語モデルをチューニングすることです.これにより、リソースが限られている場合やモデルの重みが非公開の場合でも、モデルの調整を可能にします.

Q: プロキシー・チューニングは、モデルを直接チューニングするのとどう違うのですか?

A: プロキシチューニングは、内部の重みにアクセスせずに大規模な事前学習済みモデルを調整する方法であり、専門家モデルとその対応するアンチエキスパート(調整されていない小さなモデル)を使用してモデルを調整します.専門家とアンチエキスパートの予測ロジットの差を元のロジットにオフセットとして適用します.

Q: プロキシー・チューニングのプロセスをもう少し詳しく説明していただけますか?

A: プロキシチューニングは、デコーディング時に出力ロジットを変更することによって、大規模な言語モデルを「チューニング」する有望な方法です.これは、ファインチューニングの効率的な代替手段であり、大規模な言語モデルを訓練するために必要な豊富なリソースを持たない人々にとって、これらのモデルの利用を容易にします.また、プロキシチューニングは、プロプライエタリモデルを異なるユースケースに効率的に適応する方法についての重要な問題に対処しています.最低限、モデルを生産する組織に対して、プロキシチューニングのような手法の利用を可能にするために、モデルの出力確率を共有することを推奨しています.

Q: Llama2-70Bに7Bサイズだけのプロキシを使ってプロキシ・チューニングを施した結果は?

A: Llama2-70Bは、7Bサイズのプロキシのみを使用してプロキシチューニングを適用した場合、チューニングされていない70Bモデルに対して31%、チューニングされた7Bタスクモデルに対して11%の絶対的な改善を示した.

Q: TruthfulQAでは、プロキシチューニングされたモデルは、直接チューニングされたモデルと比較してどのようなパフォーマンスを示したのでしょうか?

A: TruthfulQAにおいて、プロキシチューニングされたモデルは直接チューニングされたモデルと比較して、真実性の点で優れたパフォーマンスを示しました.

Q: TruthfulQAにおいて、プロキシチューニングされたモデルの方が真実性が高いという潜在的な理由を説明してもらえますか?

A: デコーディング時のガイダンスがモデルの事実知識をより保持するため、プロキシチューニングモデルは直接チューニングモデルよりもTruthfulQAでより真実である可能性があります.

Q: プロキシ・チューニングは、コードのドメイン・アダプテーションにおいてどのような結果を残したのだろうか?

A: プロキシチューニングは、コードのドメイン適応において非常に効果的であり、ベースモデルに比べて17%から32%の絶対的な改善が見られました.

Q: 小型のチューニングされたLMを使用して、大型で独自設計の可能性があるLMをカスタマイズすることの利点を説明してもらえますか?

A: 小さな調整済みのLMを使用することによる大きなLMのカスタマイズの利点は、リソースの効率的な使用とプライバシーの保護です.大規模なLMを直接調整することは困難であり、リソースが不足している場合やモデルの重みがプライベートである場合には不可能です.しかし、小さな調整済みのLMを使用することで、大規模なLMを直接調整することなく、必要な動作を達成することができます.具体的には、proxy-tuningアルゴリズムを使用して、小さな調整済みモデルとその調整されていないバージョンを比較し、大きなベースモデルを調整します.このアルゴリズムは、モデルの内部の重みにアクセスすることなく、出力語彙に対する予測分布のみを使用します.また、proxy-tuningはデコーディング時のガイダンスを通じて大きなLMをカスタマイズするため、リソースの効率的な使用が可能です.これにより、リソースの制約がある場合でも、大規模なLMをカスタマイズすることができます.さらに、proxy-tuningはプライバシーを保護するためにも有効です.大規模なLMの重みにアクセスすることなく、小さな調整済みのLMを使用するため、プライバシーの問題を回避することができます.

Q: プロキシ・チューニングに関連する制限や課題はありますか?

A: プロキシチューニングにはいくつかの制約や課題があります.まず、プロキシチューニングは出力のロジットを変更することによって行われるため、元のモデルの出力に依存しています.そのため、元のモデルが不正確な出力を生成する場合、プロキシチューニングも同様の不正確な出力を生成する可能性があります.また、プロキシチューニングは大規模な事前学習モデルに対して行われるため、計算リソースやメモリの制約が存在する場合には適用が難しいかもしれません.さらに、プロキシチューニングはハイパーパラメータのチューニングを必要としないため、最適なパラメータの設定が難しい場合があります.これらの制約や課題を克服するためには、さらなる研究や開発が必要です.

Leveraging Large Language Models for NLG Evaluation: A Survey

著者:Zhen Li, Xiaohan Xu, Tao Shen, Can Xu, Jia-Chen Gu, Chongyang Tao

発行日:2024年01月13日

最終更新日:2024年01月13日

URL:http://arxiv.org/pdf/2401.07103v1

カテゴリ:Computation and Language

概要:

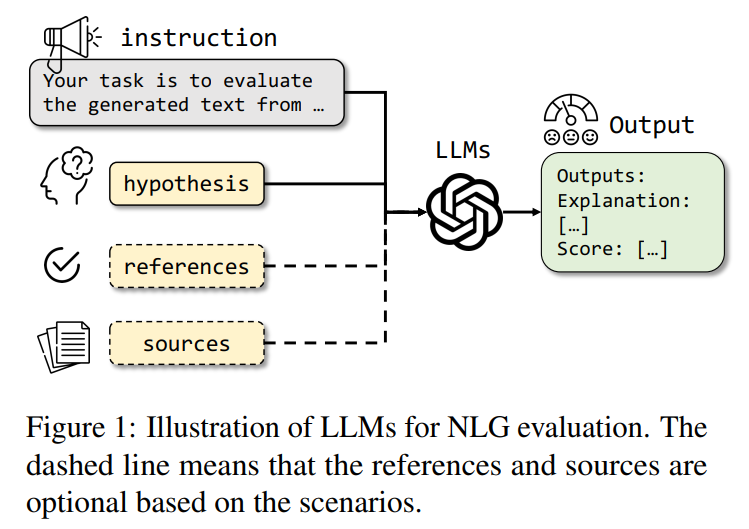

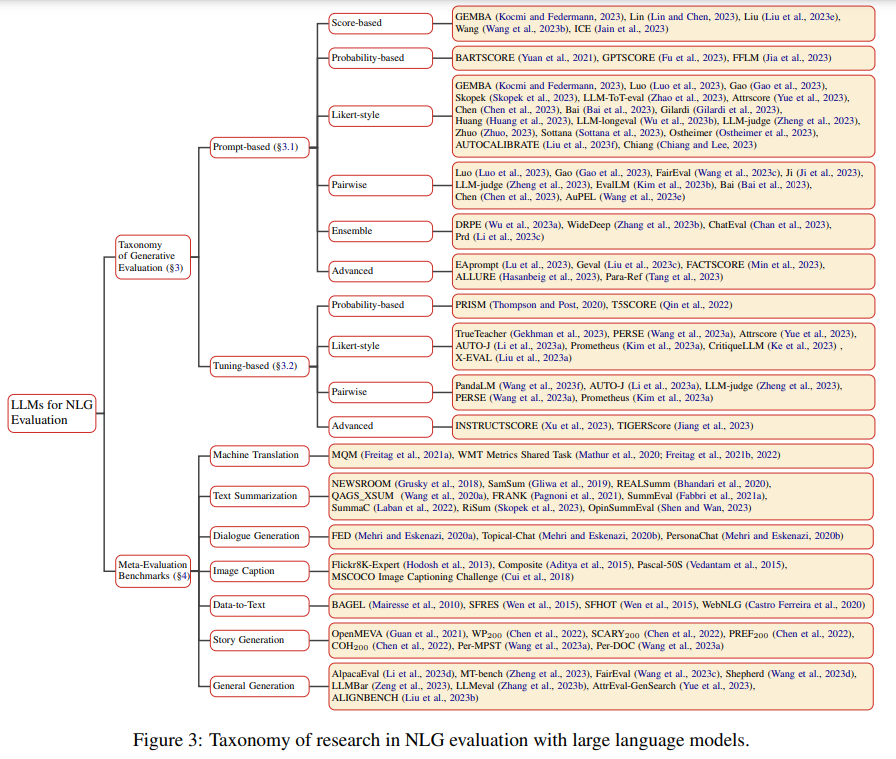

自然言語生成(NLG)評価の急速に進化する領域において、大規模言語モデル(LLM)の導入により、連続性、創造性、文脈の関連性などの生成されたコンテンツの品質を評価するための新たな手法が開拓されています.本調査は、LLMを活用したNLG評価について、体系的な分析が不足している新興の領域について、包括的な概要を提供することを目的としています.既存のLLMベースの評価指標を整理するための統一された分類法を提案し、これらの方法を理解し比較するための構造化されたフレームワークを提供します.詳細な探索では、さまざまなLLMベースの手法を批判的に評価し、NLGの出力を評価する際のそれらの強みと制限を比較します.バイアス、堅牢性、ドメイン特異性、統一された評価など、未解決の課題について議論することで、この調査は研究者に洞察を提供し、より公正で高度なNLG評価技術を提唱します.

Q&A:

Q: 大規模言語モデル(LLM)をNLG評価に活用する目的は?

A: LLMは、一貫性、創造性、文脈との関連性など、生成されたコンテンツの品質を評価するために、NLG評価に活用される.LLMは、NLGのアウトプットを評価する新しい手段を提供し、異なる評価方法を理解し比較するための構造化されたフレームワークを提供する.LLMは、文脈理解と妥当な応答の生成において強化された能力を持ち、NLGモデルの候補世代を評価するのに有用である.

Q: LLMは、一貫性、創造性、文脈との関連性という観点から、生成されたコンテンツの質の評価にどのように貢献しているのだろうか?

A: LLMは評価者として、生成されたコンテンツの一貫性、創造性、文脈との関連性などの品質評価に貢献する.LLMは、生成された回答に対して説明的な判断を下し、品質スコアを数値化することができます.LLMはまた、参照ありと参照なしの両方で、さまざまな評価側面にわたって生成されたテキストの品質スコアを生成することができます.さらに、LLM評価器は、要約タスクを評価し、要約出力の品質を効果的に捉える数値文字列を生成するために、文脈内の例と共に使用することができる.これらのスコアベースの評価方法は、包括的なNLG評価のためのLLM評価器の汎用性と適応性を示している.

Q: この調査の主な目的は何ですか?

A: この調査の主な目的は、LLMを利用したNLG評価の進展に関する包括的な概要を提供することです.

Q: この調査は、既存のLLMベースの評価指標をどのように整理することを提案しているのだろうか?

A: この調査では、既存のLLMベースの評価メトリックを整理するための形式化と分類を提案しています.

Q: LLMに基づく評価方法を理解し、比較するために構造化された枠組みを持つことの意義とは?

A: LLMベースの評価指標は複雑で多様であり、構造化されたフレームワークを持つことは、これらの手法を理解し比較するのに役立つ.このフレームワークは、様々な評価指標を分類・整理する体系的な方法を提供し、研究者がそれぞれの長所と限界を分析することを可能にする.また、バイアス、頑健性、領域特異性など、この分野におけるギャップや未解決の課題を特定するのにも役立つ.構造化されたフレームワークを提供することで、研究者は既存のLLMベースの評価手法をより明確に理解することができ、NLGのアウトプットを評価するためにどの評価指標を使用するかについて、情報に基づいた意思決定を行うことができる.さらに、このフレームワークは、より公平で、堅牢で、専門的で、統一されたLLMベースの評価者を開発するための基礎となる.また、より包括的で多面的な評価フレームワークを実現するために、人間の判断など他の評価アプローチを統合することの重要性も強調している.

Q: この調査は、様々なLLMベースの方法論をどのように批判的に評価しているのだろうか?

A: この調査では、さまざまなLLMベースの手法を批判的に評価しています.

Q: NLGのアウトプットを評価する上で、LLMに基づく評価手法の長所と限界は何か?

A: LLMベースの評価手法には、CoTによる解釈可能性の向上、指示追従機能によるカスタマイズ性の向上、RLHFによる人間の評価との整合性の向上といった強みがある.しかし、解釈可能性の制限、人間の判断との相関性の低さ、評価される側面の範囲の制限などの限界もあります.

Q: バイアス、ロバスト性、ドメイン固有性、統一評価など、LLMベースの評価に関して、この調査で議論された未解決の課題とは何か?

A: この調査で議論されている未解決の課題は、バイアス、堅牢性、特定の領域への適応性、統一された評価などです.

Q: この調査は、NLG評価分野の研究者にどのような洞察を提供することを目的としているのか?

A: この調査は、研究者に対して洞察を提供し、より公平で高度なNLG評価技術を提唱することを目指しています.

Q: この調査は、より公平で高度なNLG評価技術をどのように提唱しているのか?

A: この調査は、公平でより高度なNLG評価技術を提唱することを目指しています.

The Unreasonable Effectiveness of Easy Training Data for Hard Tasks

著者:Peter Hase, Mohit Bansal, Peter Clark, Sarah Wiegreffe

発行日:2024年01月12日

最終更新日:2024年01月12日

URL:http://arxiv.org/pdf/2401.06751v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

この論文では、ハードなトレーニングデータを正しくラベル付けすることが困難であるため、どのようにモデルをトレーニングしてハードなテストデータで良いパフォーマンスを発揮させることができるかという問題について議論されています.この問題は、言語モデルが継続的に改善されるにつれて、ますます注目を集めています.本論文では、現在の言語モデルは、しばしば簡単なデータからハードなデータに対して比較的良い汎化性能を示し、ハードなデータでトレーニングされた「オラクル」モデルと同等のパフォーマンスを発揮するという驚くべき結論を示しています.このような簡単からハードへの一般化を、インコンテキスト学習、線形分類器ヘッド、QLoRAなどのシンプルなトレーニング方法を用いて実証しています.また、グレードレベルなどの6つの経験的に多様な人間のハードさの指標と、損失ベースのモデルの指標を含む7つの異なるデータポイントのハードさの測定についても説明しています.さらに、ハードなデータに対するモデルのパフォーマンスが最も重要である場合でも、ハードなデータを収集してトレーニングするよりも、簡単なデータを収集してトレーニングする方が良い場合があることを示しています.なぜなら、ハードなデータは一般にノイズが多く、収集コストが高いからです.実験では、サイズが最大70bのオープンモデルと、公開されている4つの質問応答データセットを使用しています.さらに、この論文では、3年生の科学の質問から大学レベルのSTEMの質問、一般的な知識のトリビアまで、難易度の異なる質問を含む4つの公開質問応答データセットを使用しています.研究結果から、研究対象のタスクにおいて、簡単からハードへの一般化は驚くほど強力であり、スケーラブルな監視問題は以前よりも簡単かもしれないと示唆されています.詳細なコードはhttps://github.com/allenai/easy-to-hard-generalizationで入手可能です.

Q&A:

Q: スケーラブルな監督問題とは?

A: スケーラブルな監視問題とは、モデルの出力が正しいかどうかを評価することが困難な場合に、モデルに適切な報酬信号を与える方法に関する問題です.

Q: スケーラブルな監督問題に関連して、言語モデルはどのように改善されたのか?

A: 現在の言語モデルは、容易なデータから難しいデータへの一般化能力が比較的良くなっており、ハードデータで訓練された「オラクル」モデルと同等の性能を示すことがあるという驚くべき結論が示されています.

Q: どのようなトレーニング方法を用いて、容易で困難な汎化を実証したのか?

A: 研究では、コンテキスト内学習、線形分類器ヘッド、およびQLoRAというシンプルなトレーニング方法が使用されました.

Q: ハードデータ収集のノイズとコストは、簡単なデータ収集と比べてどうなのか?

A: ハードデータの収集のノイズとコストは、イージーデータの収集と比較して高いです.

Q: 実験に使用したオープンモデルのサイズは?

A: 実験で使用されたオープンモデルのサイズは70bです.

Q: 実験に使われた4つの公開質問応答データセットとは?

A: 実験で使用された4つの公開の質問応答データセットは、ARC、MMLU、StrategyQA、GSM8kです.

Q: 言語モデルにおける容易な汎化から困難な汎化に関する結論は?

A: 現在の言語モデルは、簡単なデータから難しいデータへの一般化が比較的うまくいくことが示されている.

Q: 研究されたタスクで観察された、簡単なものから難しいものへの汎化について詳しく教えてください.

A: 研究では、容易なデータから困難なデータへの一般化が行われ、モデルの性能が向上することが示されました.具体的には、モデルの性能ギャップを70%〜100%縮小することができました.また、容易なデータでトレーニングすることが、困難なデータを収集するのが困難である場合や、ラベルにノイズがある場合に有益であることも示されました.

Patchscopes: A Unifying Framework for Inspecting Hidden Representations of Language Models

著者:Asma Ghandeharioun, Avi Caciularu, Adam Pearce, Lucas Dixon, Mor Geva

発行日:2024年01月11日

最終更新日:2024年01月12日

URL:http://arxiv.org/pdf/2401.06102v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

大規模言語モデル(LLM)の隠れた表現にエンコードされた情報を検査することで、モデルの振る舞いを説明し、人間の価値との整合性を検証することができる.LLMが人間が理解できるテキストを生成する能力を考慮すると、モデル自体を利用して内部表現を自然言語で説明することができると提案する.私たちは、Patchscopesというフレームワークを紹介し、それがLLMの計算に関するさまざまな質問に答えるためにどのように使用できるかを示す.表現を語彙空間に投影したり、LLMの計算に介入するという従来の解釈可能性の方法は、このフレームワークのインスタンスとして見ることができることを示す.さらに、初期の層の検査に失敗したり、表現力が不足しているなど、いくつかの欠点はPatchscopesによって軽減される.従来の検査技術を統一するだけでなく、Patchscopesはより能力のあるモデルを使用してより小さなモデルの表現を説明することや、マルチホップ推論における自己修正などの新しい可能性を開く.

Q&A:

Q: パッチスコープの目的は何ですか?

A: Patchscopesの目的は、言語モデルの隠れた表現を検査するための統一的なフレームワークを提供することです.これにより、既存の検査手法の制約を克服し、より表現力豊かで、層間で堅牢性のあるトレーニングデータフリーの代替手法を実現します.また、このフレームワークの汎用性により、これまで未開拓だった新しい検査の可能性が生まれます.

Q: パッチスコープはモデルそのものを活用して、内部表現をどのように説明しているのですか?

A: Patchscopesは、表現から特定の情報をデコードできるモジュラーフレームワークを使用することで、内部表現を説明するためにモデル自体を活用します.これは、元のコンテキストとは無関係に、その情報の抽出を促す別の推論パスに表現をパッチングすることで行われる.パッチスコープと呼ばれるこのフレームワークは、表現から様々な情報を問い合わせるように構成することができ、自然言語による高品質な説明を提供する.人間のようなテキストを生成する大規模言語モデル(LLM)の高度な機能を利用し、人間向けに表現内の情報を翻訳する.

Q: PatchscopesがLLMの計算について答えられる質問の種類の例を示していただけますか?

A: パッチスコープは、LLMの計算に関するさまざまな質問に答えるために使用することができます.例えば、パッチスコープは、LLMが入力エンティティ名を初期のレイヤーでどのように文脈化するかを研究するために使用することができます.ここでは、語彙の射影やLLMの計算への介入がこのフレームワークのインスタンスとして見ることができます.また、パッチスコープは、既存の方法では難しい質問にも対応することができます.例えば、LLMが人間が理解できるテキストを生成する方法や、内部表現を自然言語で説明する方法などです.さらに、パッチスコープは、既存の検査技術の欠点である初期のレイヤーの検査にも使用することができます.さらに、パッチスコープは、より能力のあるモデルを使用してより小さなモデルの表現を説明することができ、マルチホップの推論において自己修正を可能にすることができます.

Q: パッチスコープと従来の解釈可能性手法との比較は?

A: パッチスコープは、12の常識的な推論タスクのうち6つでプロービングを大幅に上回り、残りの6つのうち1つを除いて同等の結果を示します.また、既存の解釈可能性の方法は、パッチスコープの特定のインスタンスとして表現できることも示していますが、パッチスコープはフレームワークのすべての可能な構成の一部にしか対応していません.さらに、未開拓の新しいパッチスコープを使用することで、モデルの内部計算からさまざまな情報をデコードする能力が大幅に向上し、通常は語彙への射影に依存する主要な方法を上回ります.

Q: パッチスコープが軽減できる、先行するインタープリタビリティ手法の欠点は何ですか?

A: パッチスコープは、学習データを必要としない選択肢と同様に、レイヤーをまたいだより表現力豊かでロバストな構成を提供することで、先行する解釈可能性手法の欠点を軽減することができる.また、より強力な検査技術の未踏の可能性を導入し、モデルの初期レイヤーにおける入力トークンの文脈化プロセスの分析などの新しい機能を可能にします.さらに、Patchscopesはマルチホップ推論修正などの実用的なアプリケーションにも有益です.

Q: パッチスコープは、LLMの計算の初期レイヤーを検査できますか?

A: はい、PatchscopesはLLMの計算の早い段階を検査することができます.

Q: パッチスコープは従来の検査技術と比較して、どのように表現力を高めているのか?

A: Patchscopesは、あるモデルの表現をより表現力豊かなモデルにパッチングすることを可能にすることで、従来の検査技術に比べて表現力を強化します.つまり、Patchscopesは与えられたモデルをより表現力の高いモデルで説明することができ、その結果、より確からしい結果が得られる可能性があります.しかしながら、異なるアーキテクチャや最適化プロセスから生じる2つのモデル間の不一致の可能性により、このような介入がもっともらしい結果をもたらすかどうかは明らかではありません.

Q: パッチスコープを使って、より高性能なモデルを使って、より小さなモデルの表現を説明することができるのか?

A: はい、Patchscopesはより能力のあるモデルを使用して、より小さなモデルの表現を説明するために使用することができます.

Q: マルチホップ推論における自己補正など、パッチスコープの応用の可能性は?

A: Patchscopesの潜在的な応用例の一つは、マルチホップ推論における自己修正です.このフレームワークを使用することで、モデルが各ステップを正しく実行できるにも関わらず、ステップ間の関連性を処理できずに誤った予測を行う場合に、パッチスコープを使用して正確性を向上させることができます.

MoE-Mamba: Efficient Selective State Space Models with Mixture of Experts

著者:Maciej Pióro, Kamil Ciebiera, Krystian Król, Jan Ludziejewski, Sebastian Jaszczur

発行日:2024年01月08日

最終更新日:2024年01月08日

URL:http://arxiv.org/pdf/2401.04081v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language

概要:

状態空間モデル(SSM)は、シーケンシャルモデリングの分野で真剣な競争相手となり、トランスフォーマーの支配に挑戦しています.同時に、エキスパートの混合(MoE)は、最近の最先端のオープンソースモデルを含む、トランスフォーマーベースのLLMを大幅に改善しました.私たちは、SSMのスケーリングの可能性を引き出すために、MoEと組み合わせるべきだと提案しています.私たちは、最近のSSMベースのモデルであるMambaを使用して、これを紹介します.私たちのモデルであるMoE-Mambaは、MambaとTransformer-MoEの両方を上回ります.特に、MoE-Mambaは、Mambaと同じ性能を達成するために、トレーニングステップを2.2倍少なくすることができます.また、MoE-Mambaは、トランスフォーマーに対するMambaの推論パフォーマンスの利点を保持します.

Q&A:

Q: 逐次モデリングにおいて、トランスフォーマーと比較した状態空間モデル(SSM)の利点は何ですか?

A: SSMは逐次モデリングにおいてTransformerよりも優れている.SSMは、線形時間推論、並列化可能な学習、長いコンテキストのタスクに対する強力な性能を提供する.SSMは、制御理論の分野から生まれたRNNとCNNの組み合わせと見ることができる.しかし、SSMがこの分野で主流になるには、いくつかの問題がある.

Q: 専門家の混合(MoE)はトランスフォーマーベースのLLMをどのように改善したか?

A: エキスパートの混合(MoE)は、モデルの推論とトレーニングに必要なFLOPsにほとんど影響を与えずに、パラメータの数を劇的に増やすことができるため、TransformerベースのLLMの性能を向上させました.MoEモデルは、各トークンの処理に使用されるモデルのパラメータのサブセットのみを使用するスパースな活性化から利益を得ています.この技術は、Transformerのフォワードレイヤーに適用され、性能とスケーラビリティが向上しました.

Q: MoE-Mambaのコンセプトと、SSMとMoEをどのように組み合わせているのか説明していただけますか?

A: MoEMambaは、SSM(状態空間モデル)とMoE(専門家の混合)を組み合わせたモデルです.SSMは、系列モデリングに使用されるアーキテクチャの一種であり、RNNとCNNの組み合わせとして捉えることができます一方、MoEは、トランスフォーマーを含むLLM(言語モデリングモデル)の性能を大幅に向上させる手法です.Mambaは、SSMベースのモデルであるMambaとMoEを組み合わせることで、SSMとMoEの効率を向上させることができます.2倍少なくすることができます.また、トランスフォーマーやトランスフォーマー-MoEに比べてさらなる性能向上の可能性も示しています.

Q: MoE-Mambaは、MambaとTransformer-MoEの両方と比較して、具体的にどのような改善点がありますか?

A: MoE-Mambaは、Transformerに対するMambaの推論性能の向上を維持しながら、2.2倍少ない学習ステップでMambaと同じ性能を提供する.

Q: なぜMoE-Mambaはトランスフォーマー並みの驚異的なパフォーマンスを実現できるのか?

A: MoE-Mambaは、状態空間モデル(SSM)と混合エキスパート(MoE)を組み合わせることで、Transformersと同様の驚くべき性能を達成する.この組み合わせはSSMのスケーリングを可能にし、その性能を向上させる.MoE-Mambaは、Transformerに対するMambaの推論性能の向上を維持しながら、2.2倍少ない学習ステップでMambaと同等の性能を達成し、MambaとTransformer-MoEの両方を凌駕する.

Q: MoE-Mambaに必要なトレーニングのステップについて、Mambaと比較して詳しく教えてください.

A: MoE-Mambaは、同じパフォーマンスを達成するために、Mambaに比べて2.2倍少ないトレーニングステップを必要とする.

Q: MoE-Mambaは、Transformerに対するMambaの推論性能の向上をどのように維持しているのか?

A: MoE-Mambaは、2.2倍少ない学習ステップでMambaと同じ性能を達成することで、Transformerに対するMambaの推論性能の向上を維持する.つまり、MoE-Mambaはより少ない学習ステップでMambaと同レベルの性能を達成できる.さらに、予備的な結果から、MoE-MambaはTransformerとTransformer-MoEの両方に対して潜在的な利得を示しており、数百億のパラメータに状態空間モデル(SSM)を拡張するための有望な研究方向である可能性を示唆しています.

Q: SSMとMoEを組み合わせることによる潜在的なスケーラビリティの利点とは?

A: MoEと組み合わせたSSMは、数百億のパラメータを使用できるため、スケールアップの可能性がある.この論文で行われた実験によると、MoE-MambaはMambaと同じ性能を達成するために必要な学習ステップが2.2倍少なく、より効率的でスケーラブルなアプローチであることを示している.また、この組み合わせはMambaとTransformer-MoEモデルの両方を凌駕し、Transformerに対するMambaの推論性能の向上も維持する.

Q: MoE-Mambaの実施に伴う制限や課題はありますか?

A: 専門家の数が少ないMoE-Mambaは、Mambaよりも性能が劣る可能性がある.さらに、Mambaレイヤー自体にスパース計算を統合することで、さらに良い結果が得られる可能性がある.MoE-Mambaで提案されているアプローチに対するスケーリングの影響はまだ調査されていない.

Q: MoE-Mambaの今後の方向性や潜在的なアプリケーションについて教えてください.

A: MoE-Mambaには将来の方向性と応用の可能性がある.将来的な方向性の1つは、MoE-Mambaで異なるタイプのMoEを探求することである.これには、Expert-Choiceルーターや完全に微分可能なアーキテクチャなどのアーキテクチャを検討することが含まれる.これらの代替設計は、全体としてより良いパフォーマンスを発揮し、MoE-Mambaのパフォーマンスを最適化できる可能性がある.さらに、エキスパートの数や粒度を変えることも検討できる.もう一つの将来の方向性は、Mambaレイヤー自体にスパース計算を統合することである.これにより、シンプルで均質なアーキテクチャを維持しながら、さらに優れた結果が得られる可能性がある.潜在的なアプリケーションとしては、MoE-Mambaは自然言語処理、コンピュータービジョン、機械翻訳など様々な分野に応用できる.複数の専門家を組み合わせ、その出力に基づいて意思決定を行うその能力は、複雑な意思決定や大量のデータの取り扱いを必要とするタスクに適している.