ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- A taxonomy and review of generalization research in NLP

発行日:2023年10月19日

自然言語処理(NLP)のモデルにおいて、良好な一般化能力を持つことは重要であるが、その定義や評価方法はまだ明確ではない.一般化は機械学習全般でも重要視されており、一部の研究者はモデルの頑健性と公平性を強調しているが、他の研究者はパフォーマンスとの関連性を主張している.また、人間らしい振る舞いをするためにも一般化能力が重要であるとされているが、NLPの分野では一般化テストが一般的ではない. - AutoMix: Automatically Mixing Language Models

発行日:2023年10月19日

大規模言語モデル(LLM)の多様性を活用し、AutoMix手法を使用してクエリを効果的にルーティングすることで、計算コストとパフォーマンスを最適化することができることが示されました. - Understanding Retrieval Augmentation for Long-Form Question Answering

発行日:2023年10月18日

この研究では、検索補完が異なるLMにどのように影響を与えるか、また検索文書の品質が同じLMから生成される回答にどのように影響を与えるかを分析し、検索補完が長文形式の知識豊かなテキスト生成にどのように影響を与えるかについて新たな洞察を提供しています. - Can Large Language Models Explain Themselves? A Study of LLM-Generated Self-Explanations

発行日:2023年10月17日

ChatGPTは、感情分析や要約などの自然言語処理タスクで優れたパフォーマンスを示し、自己説明を生成する能力も持っているが、従来の説明方法とは異なる評価指標によると異なる結果が得られることがわかったため、モデルの解釈性の実践を見直す必要性が示唆された. - Eliciting Human Preferences with Language Models

発行日:2023年10月17日

私たちの研究では、対話的なタスクにおいてLMを使用することで、予想外の考慮事項を浮かび上がらせることができ、モデルを人間の好みや価値観に合わせるための強力なツールとなることを示しています. - Self-RAG: Learning to Retrieve, Generate, and Critique through Self-Reflection

発行日:2023年10月17日

大規模言語モデル(LLM)は、事実に基づかない回答を生成することがありますが、Retrieval-Augmented Generation(RAG)やセルフリフレクティブリトリーバルオーグメンテッドジェネレーション(Self-RAG)という手法を使用することで、LLMの品質と事実性を向上させることができます.Self-RAGは、さまざまなタスクにおいて最先端の性能を発揮し、長文生成におけること実性と引用の正確性を向上させます. - Llemma: An Open Language Model For Mathematics

発行日:2023年10月16日

Llemmaは、数学のための大規模な言語モデルであり、MATHベンチマークで他のモデルを上回り、追加の微調整なしでツールの使用や形式的な定理証明が可能です. - OpenAgents: An Open Platform for Language Agents in the Wild

発行日:2023年10月16日

OpenAgentsは、言語エージェントを使用およびホストするためのオープンプラットフォームであり、一般ユーザーと開発者に対話的な機能を提供し、言語エージェントの作成と評価を容易にすることを目指しています. - Video Language Planning

発行日:2023年10月16日

この研究では、インターネット規模のデータで事前学習された大規模生成モデルを使用し、ビデオと言語の領域で複雑な長期タスクの視覚的な計画を可能にするためのアルゴリズムであるビデオ言語計画(VLP)を提案しています.VLPは、ビジョン言語モデルとテキストからビデオへのモデルを組み合わせて長いビデオプランを出力し、ロボットアクションに変換することができます.実験結果では、VLPは従来の手法と比較して長期タスクの成功率を大幅に向上させることが示されています. - Large Language Models for Software Engineering: Survey and Open Problems

発行日:2023年10月05日

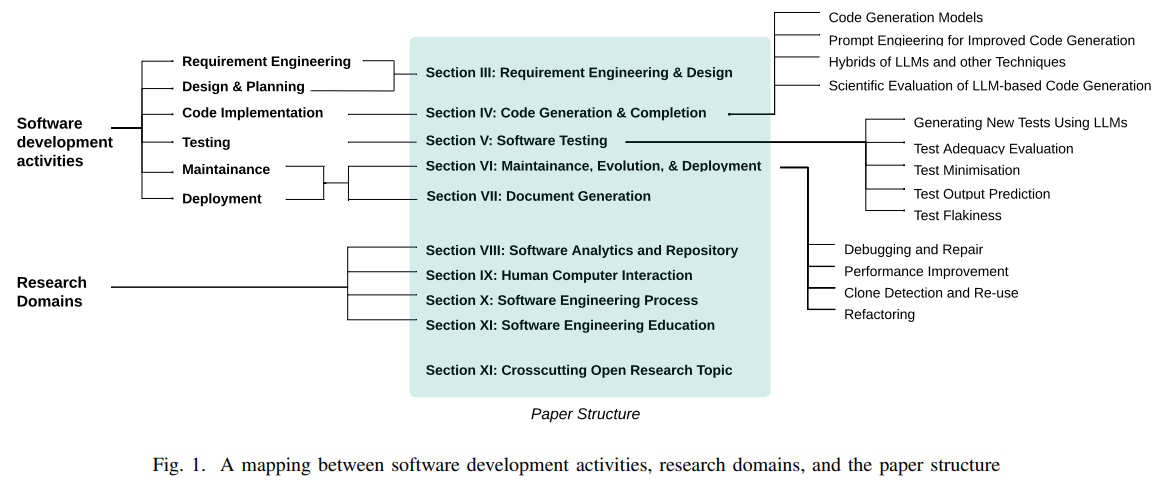

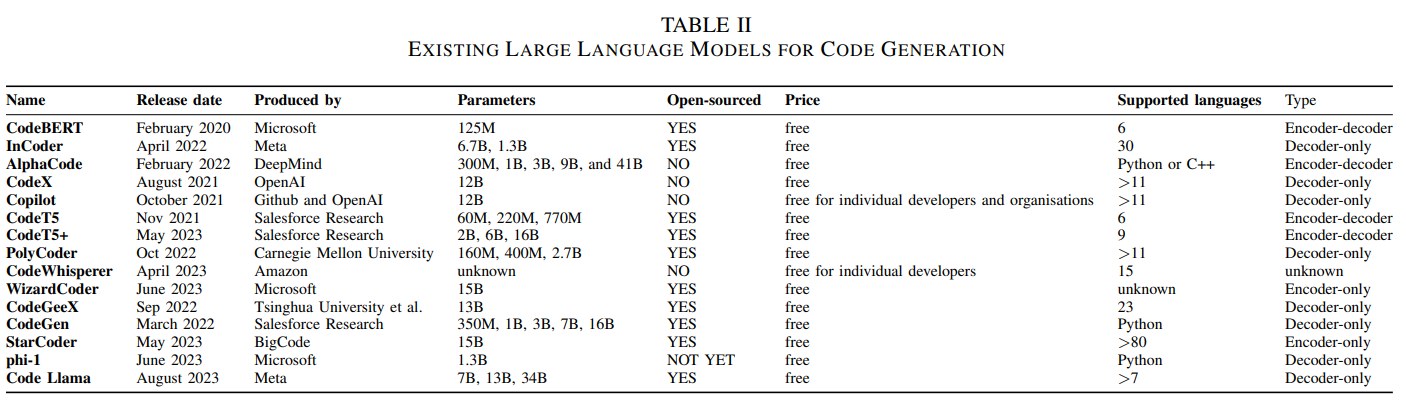

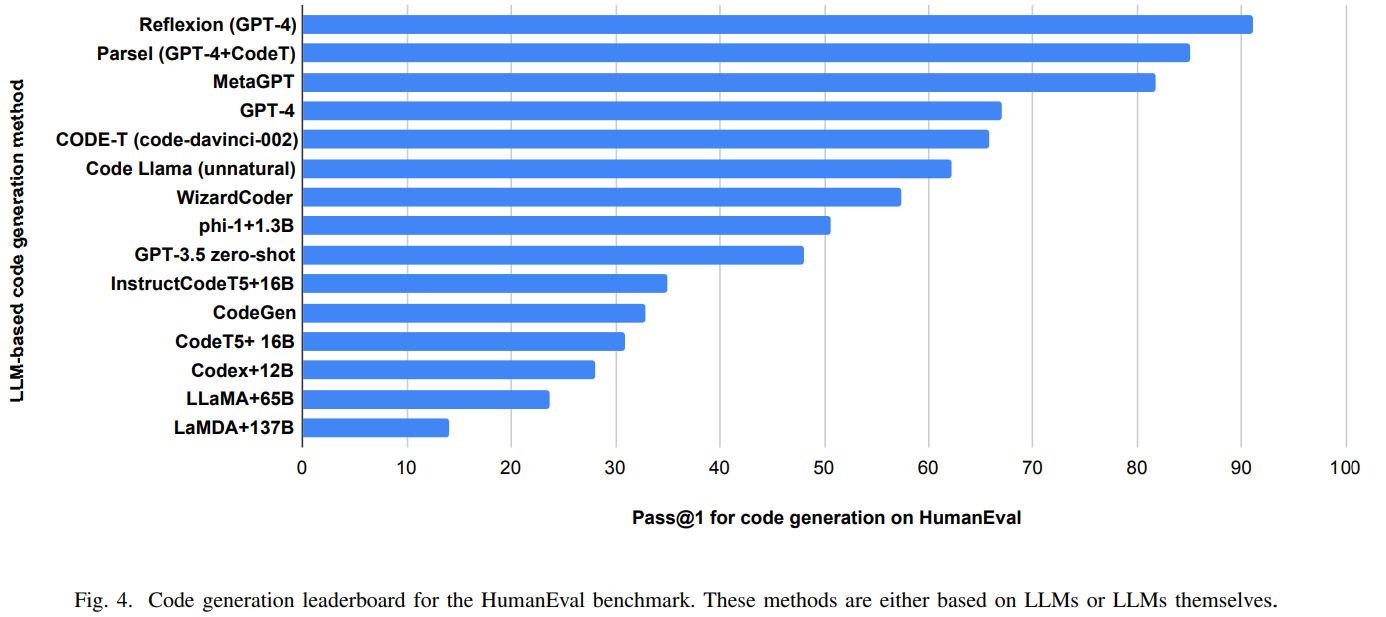

この論文は、ソフトウェアエンジニアリングにおける大規模言語モデル(LLMs)の調査結果と、それを適用するためのオープンな研究課題を提供している.LLMsはソフトウェアエンジニアリングのさまざまな活動に革新性と創造性をもたらすが、同時に技術的な課題も提起している.従来のSEとLLMsのハイブリッド技術は、信頼性のある効率的なLLMベースのSEの開発と展開に重要な役割を果たすことが明らかにされている.

A taxonomy and review of generalization research in NLP

著者:Arabella Sinclair11, Christos Christodoulopoulos, Dennis Ulmer, Dieuwke Hupkes, Florian Schottmann, Kaiser Sun, Karim Lasri, Khuyagbaatar Batsuren, Koustuv Sinha, Leila Khalatbari, Maria Ryskina, Mario Giulianelli, Mikel Artetxe, Naomi Saphra, Rita Frieske, Ryan Cotterell, Tiago Pimentel, Verna Dankers, Yanai Elazar, Zhijing Jin

発行日:2023年10月19日

最終更新日:不明

URL:https://www.nature.com/articles/s42256-023-00729-y?utm_source=twitter&utm_medium=organic_social&utm_campaign=research&utm_content=link

カテゴリ:不明

概要:

自然言語処理(NLP)のモデルにおいて、良好な一般化能力を持つことは主要な目標の一つであるが、何を指して「良好な一般化」とし、それをどのように評価すべきかは十分に理解されていない.NLPの分野だけでなく、機械学習全般のモデルにおいても一般化は重要視されている.一部の研究者は、一般化が重要である理由として、モデルが訓練データとは異なるデータに対しても頑健で信頼性があり、公平な予測を行うためであると考えている.これは、モデルが実世界で使用される場合に特に重要である.一方で、他の研究者は、良好な一般化が優れたパフォーマンスと本質的に同等であり、それがなければモデルは本来のタスクを遂行することができないと考えている.さらに、一部の研究者は、モデルが人間らしい振る舞いをするべきであり、人間は一般化能力が高いことが知られているため、良好な一般化を追求している.一般化の重要性はほぼ議論の余地がないが、NLPの分野では体系的な一般化テストは一般的ではない.

Q&A:

Q: 自然言語処理(NLP)のモデルに求められる第一の条件とは?

A: 自然言語処理(NLP)のモデルにとっての主要な欲求は、過去の経験から新しい経験に対して表現、知識、戦略を成功裏に転送する能力である.

Q: NLPの文脈で「優れた汎化」とはどのように定義されるのでしょうか?

A: NLPにおける「良い一般化」とは、過去の経験から新しい経験に対して表現、知識、戦略を成功裏に転送する能力を指します.

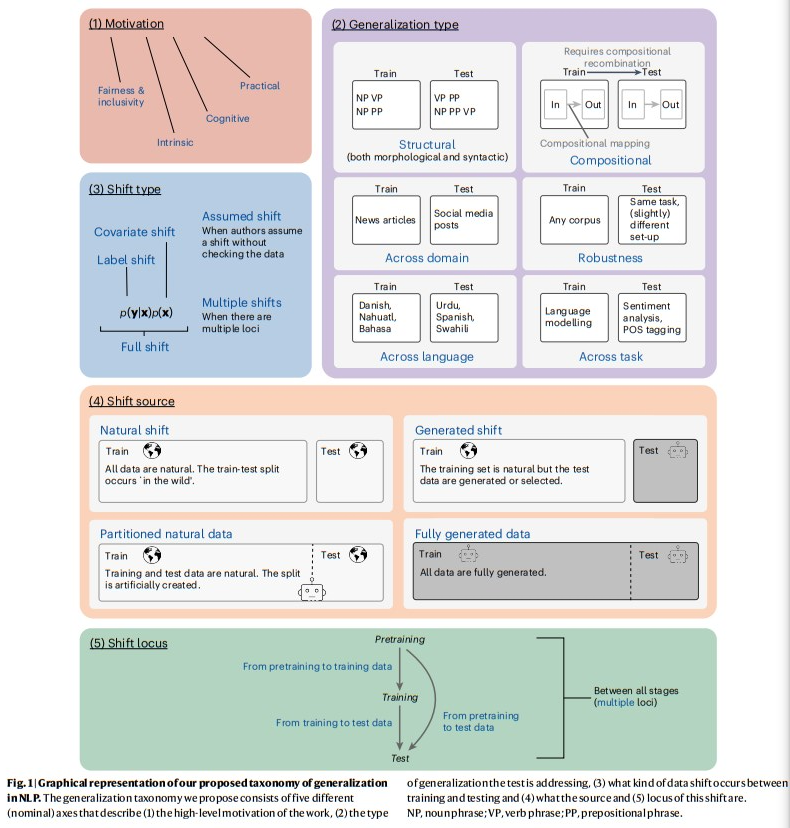

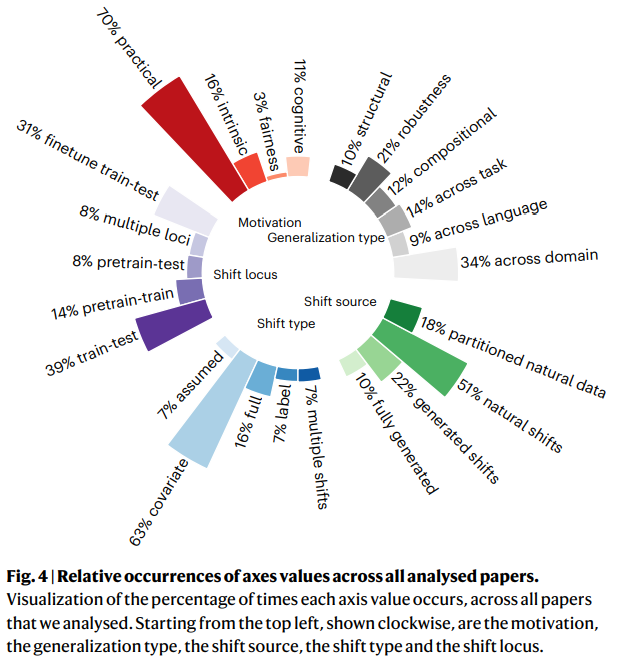

Q: 自然言語処理における汎化研究を特徴づけ、理解するために提案されている分類法とは?

A: 提案されたタクソノミーは、NLPにおける一般化研究を特徴づけ、理解するためのものです.このタクソノミーは、主な動機、解決しようとする一般化のタイプ、トレーニングとテストの間で発生するデータシフトの種類、データシフトの発生源、およびNLPモデリングパイプライン内のシフトの位置という5つの軸に基づいています.

Q: 提案されている分類法にはいくつの軸がありますか?

A: 提案された分類には5つの軸が含まれています.

Q: 分類法を用いて分類された実験の数は?

A: 700以上の実験が分類されました.

Q: NLPにおける汎化研究の現状は?

A: NLPの一般化研究の現状は、研究者間で一致がなく、どのような一般化が重要であり、どのように研究されるべきかについての合意がないことが明らかになっています.さまざまな研究は、幅広い一般化に関連する研究質問を含み、さまざまな方法論と実験セットアップを使用しています.さらに、異なる研究の結果がどのように関連しているのかはまだ不明であり、一般化をどのように評価すべきかという問題を提起しています.一般化の種類のうち、既に十分に対処されているものや無視されているもの、優先すべき一般化の種類をどのように決定するのかも不明です.NLPにおける一般化について体系的に議論する方法がないため、これらの重要な問いにどのように回答するかもわかりません.これらの未解決の問いが、より良い研究を妨げています.

Q: 汎化研究における今後の注目分野について、どのような提言がなされているのだろうか?

A: 将来の研究において、クロスリンガル研究や公平性と包括性の目標に基づく一般化研究により多くの注意が払われるべきであると提案されています.

Q: なぜNLPの分野で汎化が重要なのでしょうか?

A: NLPの分野において一般化は重要である理由は、モデルが堅牢で信頼性があり、公平な予測を行うために必要であり、また人間のような振る舞いをすることが望ましいためです.

Q: 優れた汎化は、モデルにおける人間のような行動とどのように関係しているのだろうか?

A: 良い一般化は、モデルが人間のような振る舞いをすることと関連しています.人間の一般化は、モデルの評価において有用な基準であり、人間の知能の特徴とされています.また、モデルがタスクを適切に実行するためには、人間のような一般化が必要です.一部の人々は、モデルが人間のように振る舞うべきだと考えており、人間は一般化能力が高いことが知られています.一般化の重要性はほぼ議論の余地がないですが、NLPの分野では体系的な一般化テストは一般的ではありません.

AutoMix: Automatically Mixing Language Models

著者:Aman Madaan, Pranjal Aggarwal, Ankit Anand, Srividya Pranavi Potharaju, Swaroop Mishra, Pei Zhou, Aditya Gupta, Dheeraj Rajagopal, Karthik Kappaganthu, Yiming Yang, Shyam Upadhyay, Mausam, Manaal Faruqui

発行日:2023年10月19日

最終更新日:2023年10月19日

URL:http://arxiv.org/pdf/2310.12963v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

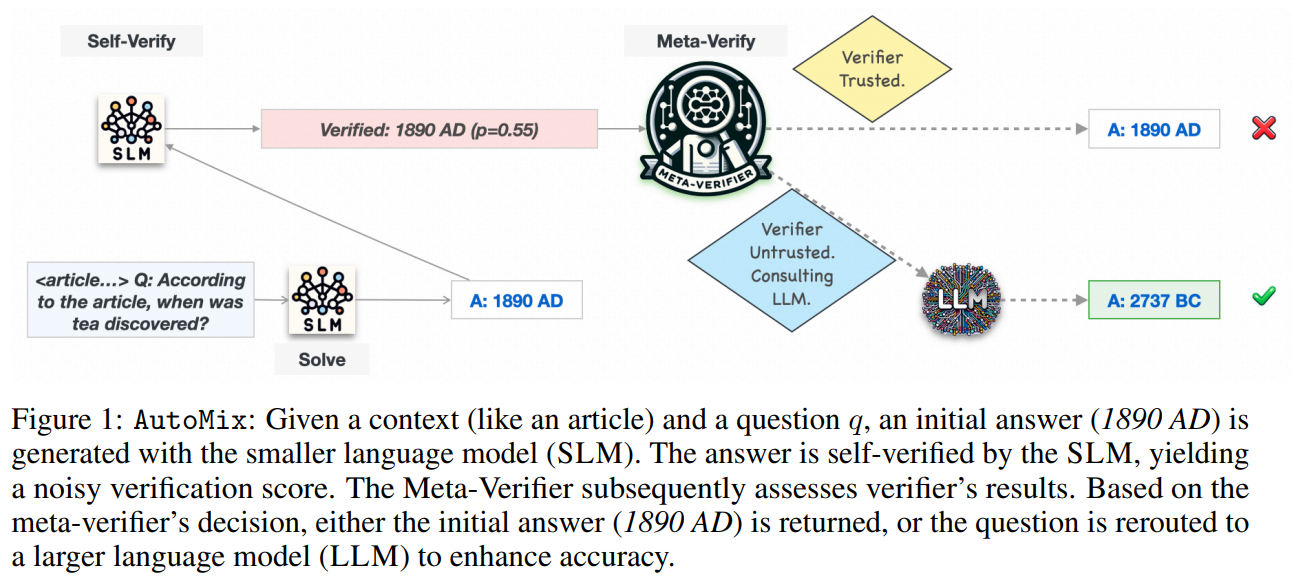

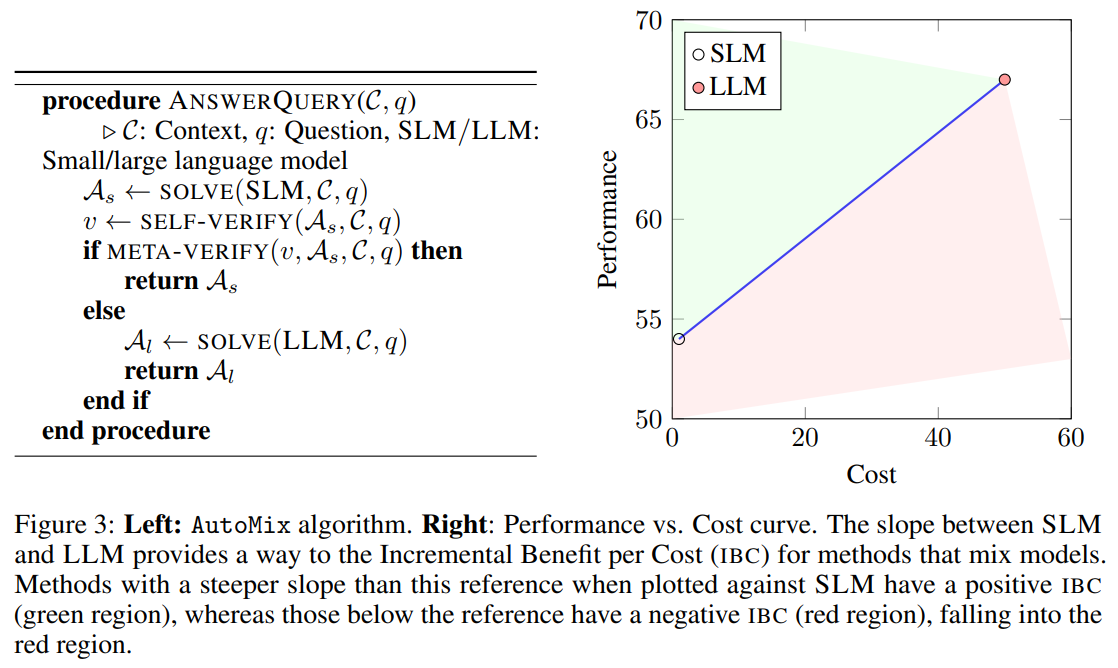

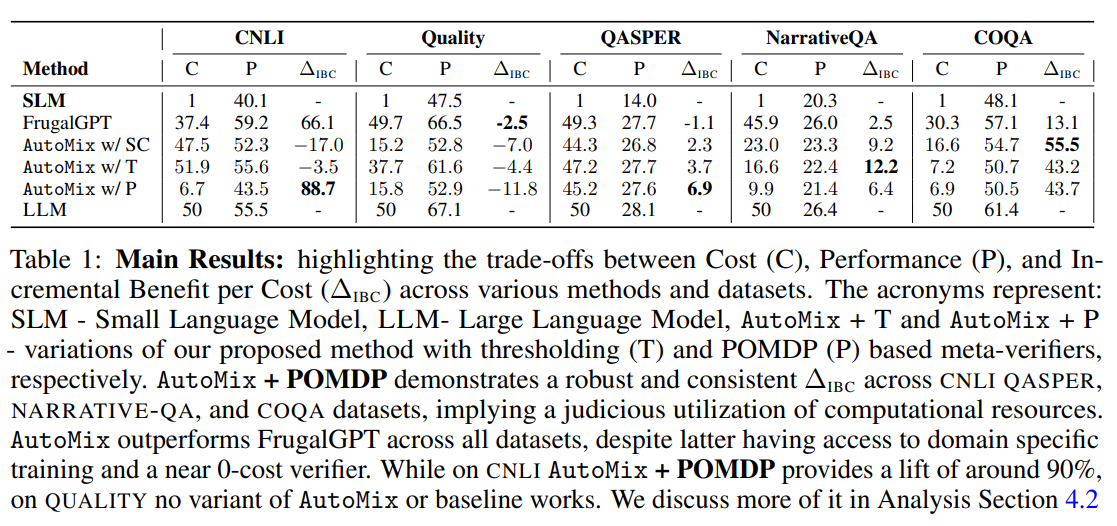

大規模言語モデル(LLM)は、さまざまなサイズと構成でクラウドAPIプロバイダから利用可能になっています.この多様性は幅広い選択肢を提供していますが、計算コストとパフォーマンスを最適化するためにこれらのオプションを効果的に活用することは依然として困難です.本研究では、小さなLMの出力のおおよその正確さに基づいてクエリをより大きなLMに戦略的にルーティングするAutoMixという手法を提案します.AutoMixの中心には、トレーニングを必要とせずに自身の出力の信頼性を推定する少数のショットの自己検証メカニズムがあります.検証はノイズを含む可能性があるため、AutoMixではメタ検証器を使用してこれらの評価の精度を向上させています.LLAMA2-13/70Bを使用した実験では、5つの文脈に基づいた推論データセットでAutoMixが確立されたベースラインを上回り、コストあたりの増分利益を最大89%改善することを示しました.コードとデータはhttps://github.com/automix-llm/automixで利用可能です.

Q&A:

Q: オートミックスの主な目的は何ですか?

A: AutoMixの主な目的は、小さなLMの出力の近似的な正確さに基づいてクエリを大きなLMに戦略的にルーティングすることです.AutoMixの中心には、トレーニングを必要とせずに自身の出力の信頼性を推定するfew-shotの自己検証メカニズムがあります.ノイズのある検証を考慮して、AutoMixではメタ検証器を使用してこれらの評価の精度を改善します.

Q: AutoMixは、どのようにしてクエリをより大きな言語モデルに戦略的にルーティングするのか?

A: AutoMixは、より小さな言語モデル(SLM)によって初期の回答が生成され、SLMによって自己検証されます.その後、自己検証の結果をメタ検証器が評価します.メタ検証器の判断に基づいて、初期の回答が返されるか、質問がより大きな言語モデル(LLM)に再ルーティングされて精度が向上します.

Q: オートミックスで使われている数ショットの自己検証メカニズムについて説明していただけますか?

A: AutoMixは、トレーニングを必要とせずに自身の出力の信頼性を推定するために、フューショットの自己検証メカニズムを利用しています.このメカニズムは、文脈を効果的に使用して、統計的言語モデルによって生成された回答のエラーを特定します.自己検証プロセスは、付録A.1で定量的および定性的に評価されており、このメカニズムは多くの場合において効果的にエラーを特定できることが観察されています.さらに、AutoMixはメタ検証器を使用して、検証がノイズを含む場合でも評価の精度を改善します.メタ検証器はさまざまな設定で堅牢であり、弱い検証器でも活用することができます.自己検証のパフォーマンスにおけるタスク固有のプロンプトエンジニアリングの影響は、付録A.2で探索されており、プロンプトエンジニアリングが検証器の精度を向上させることがわかっています.全体的に、AutoMixのフューショットの自己検証メカニズム、メタ検証器、およびプロンプトエンジニアリングは、自己検証を行う際の効果を高めています.

Q: AutoMixはトレーニングを必要とせずに、どのようにして自身の出力の信頼性を推定するのですか?

A: AutoMixは、数ショットの自己検証メカニズムを通じて、自身の出力の信頼性を推定します.このメカニズムは、提供された文脈を用いて生成された回答の一貫性を文脈に基づいた数ショットの含意によって評価します.大量の人間によるラベル付けデータに依存しないため、トレーニングは必要ありません.代わりに、より小さな言語モデル(SLM)からの出力のおおよその正確さに基づいて、クエリをより大きな言語モデル(LLM)に戦略的にルーティングします.自己検証メカニズムは、初期回答を生成し、それを自己検証することで、SLMの出力の信頼性を評価します.自己検証プロセスによってノイズのある検証スコアが得られます.これらの評価の精度を高めるために、AutoMixはメタ検証器を使用します.メタ検証器は、自己検証の結果を評価し、その評価に基づいて判断を下します.メタ検証器の判断に応じて、初期回答が返されるか、質問がより大きな言語モデル(LLM)に再ルーティングされて精度が向上します.この数ショットの自己検証メカニズムとメタ検証器を使用することで、AutoMixはトレーニングを必要とせずに、自身の出力の信頼性を推定することができます.

Q: AutoMixにおけるメタ検証者の役割は何ですか?

A: メタ検証者の役割は、小さな言語モデル(SLM)の出力の信頼性を評価し、タスクを大きな言語モデル(LLM)にルーティングするかどうかを決定することです.

Q: AutoMixの評価実験では、どのデータセットを使用したのですか?

A: AutoMixは以下のデータセットで評価された:COQA、CNLI、QUALITY、QASPER、NARRATIVE-QA.

Q: AutoMixは、コストあたりの利益の増加という点で、確立されたベースラインと比較してどうですか?

A: AutoMixは、コストあたりの利益の増加という点で、確立されたベースラインを最大89%上回っている.

Q: 実験に使用したLLAMA2-13/70Bのモデルについて、もう少し詳しく教えてください.

A: 実験では、オープンソースのLLAMA 2-13 Band LLAMA 2-70 Bモデルが使用されました.これらのモデルは、Touvronらによって2023年に開発されました.SLMのコストは1ユニット、LLMのコストは50ユニットと仮定されています.これは、OpenAIやTogether3などのLLM APIプロバイダーが提供する小規模モデルと大規模モデルの価格格差に従っています.LLAMA 2-13 Band LLAMA 2-70 Bモデルは、Huggingfaceのモデルから使用され、推論のためにvllm(Kwonら、2023年)が使用されました.

Q: AutoMixを使用する上での制限や潜在的な欠点はありますか?

A: AutoMixには制限と潜在的な欠点がある.1つの限界は、APIへのブラックボックス・アクセスを前提としていることである.これは、基礎となるモデルに対する完全な可視性や制御ができない可能性があることを意味する.もう一つの限界は、AutoMixは2つのモデル間を最適化するが、AdaptiveConsistencyのような単一のLLMモデル内の推論を完全に最適化できない可能性があることである.さらに、AutoMixはブラックボックスLLM APIを問題解決のフレームワークに統合しているが、一般的なLLMの自己検証や修正には課題が残るかもしれない.しかし、著者らは、コンテキストに基づく少数ショットの検証を使用することで、有望な結果が得られたと述べている.全体として、AutoMixは興味深い研究方向への道を開いているが、これらの限界と潜在的な欠点を考慮することが重要である.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: https://github.com/automix-llm/automix

Understanding Retrieval Augmentation for Long-Form Question Answering

著者:Hung-Ting Chen, Fangyuan Xu, Shane Arora, Eunsol Choi

発行日:2023年10月18日

最終更新日:2023年10月18日

URL:http://arxiv.org/pdf/2310.12150v1

カテゴリ:Computation and Language

概要:

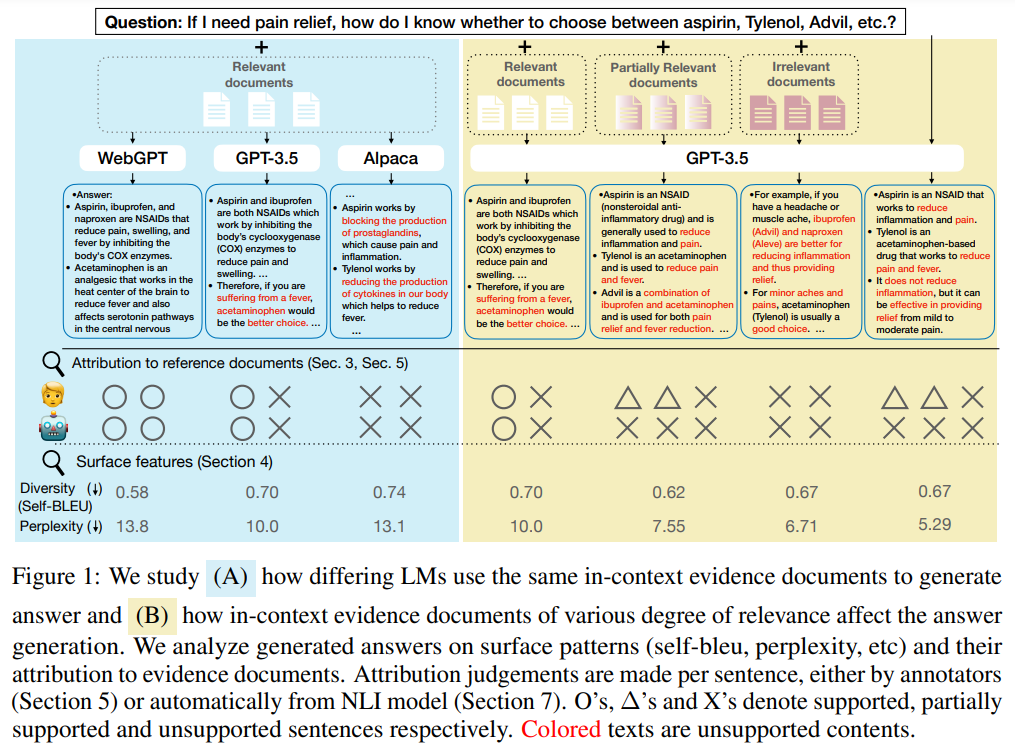

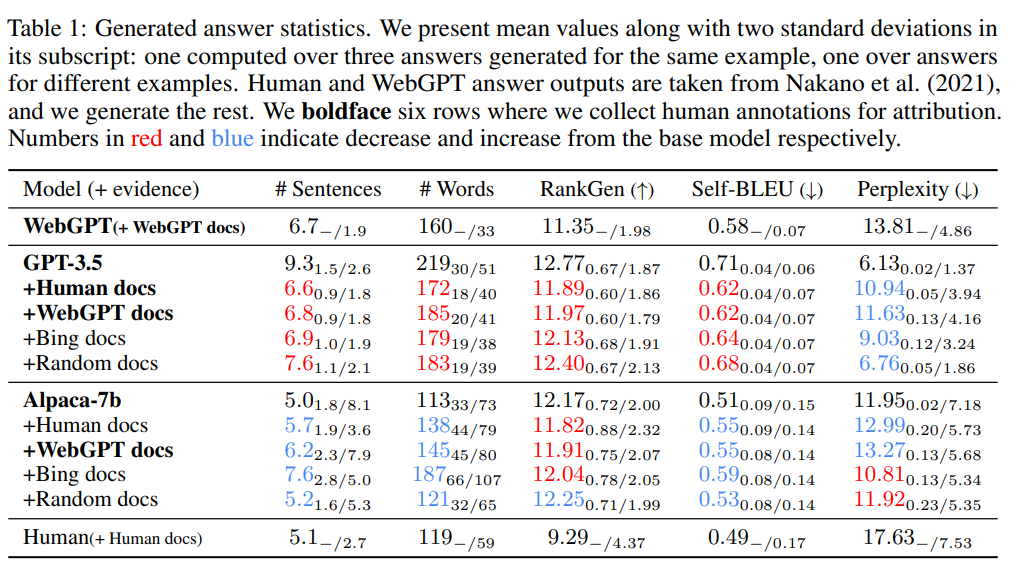

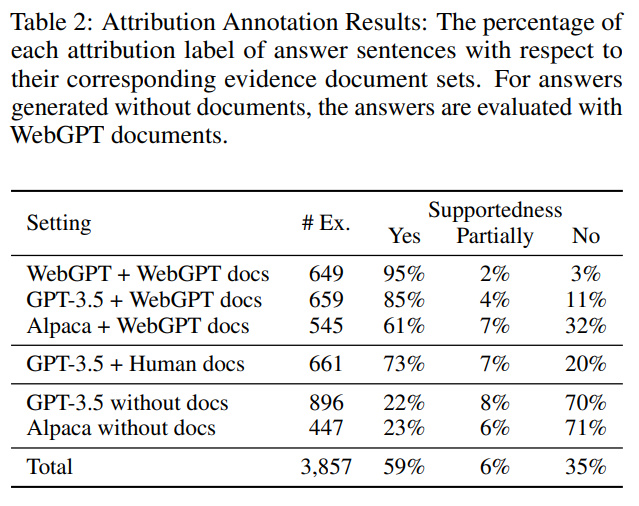

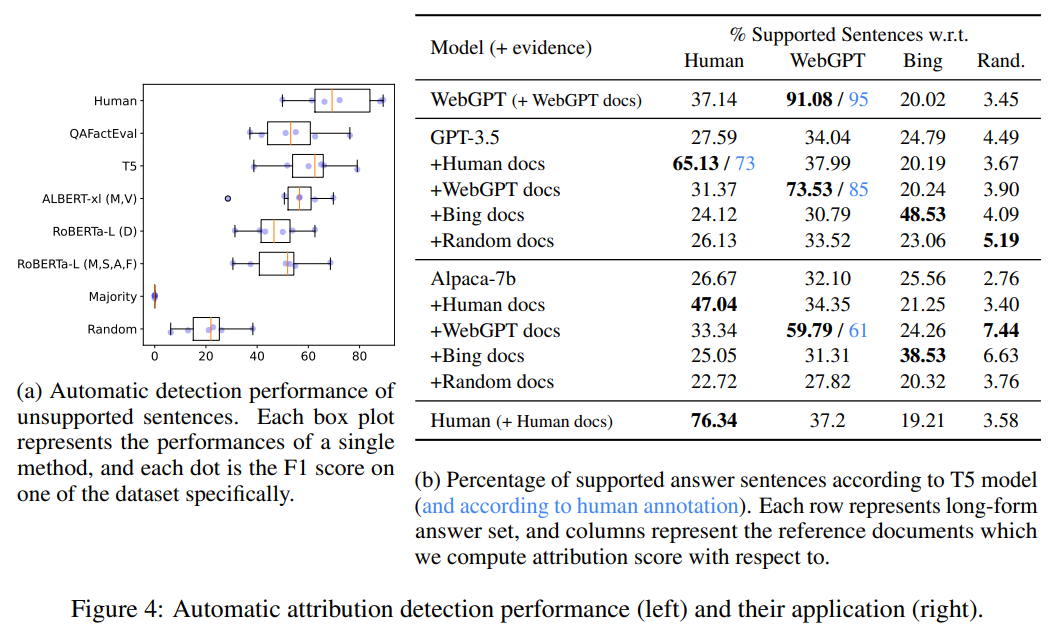

この研究では、検索補完言語モデル(LM)を用いた長文形式の質問応答について調査を行っています.同じ証拠文書を使用してモデルから生成された回答を比較することで、検索補完が異なるLMにどのように影響を与えるか、また検索文書の品質が同じLMから生成される回答にどのように影響を与えるかを分析しています.生成された回答のさまざまな属性(流暢さ、長さ、分散など)を研究し、特に文脈における証拠文書への回答の帰属を重視しています.回答の帰属に関する人間の注釈を収集し、自動的な帰属判断の方法を評価しています.この研究は、検索補完がLMによる長文形式の知識豊かなテキスト生成にどのように影響を与えるかについて新たな洞察を提供します.さらに、長いテキスト生成における帰属パターンを特定し、帰属エラーの主な原因を分析しています.これらの分析から、検索補完が長い知識豊かなテキスト生成にどのように影響を与えるかが明らかになり、今後の研究の方向性が示されています.

Q&A:

Q: 長文質問応答における検索補強言語モデル(LM)に関する研究の目的は?

A: リトリーバル補完言語モデル(LM)の研究の目的は、長文形式の質問応答におけるリトリーバル補完の影響を分析することです.この研究では、同じ証拠文書を使用して生成されたモデルからの回答を比較し、異なるLMによる回答の影響を調査します.また、同じLMから生成された回答に対して、異なる品質のリトリーバル文書セットがどのように影響するかも分析します.さらに、生成された回答のさまざまな属性(流暢さ、長さ、分散など)を研究し、生成された長文回答を文脈内の証拠文書に帰属させる方法についての人間の注釈を収集し、帰属判定の自動評価方法を評価します.この研究は、リトリーバル補完がLMの長文生成に与える影響についての新たな洞察を提供します.さらに、長文生成の帰属パターンを特定し、帰属エラーの主な原因を分析します.

Q: 検索補強は異なるLMモデルにどのような影響を与えるのか?

A: 検索の拡張は、異なるLMモデルにどのように影響するかを分析します.提供された証拠文書を使用してモデルから生成された回答を比較し、同じLMを使用して生成された回答に異なる品質の検索文書セットがどのように影響するかを分析します.

Q: 検索文書セットの品質が異なると、同じLMから生成される回答にどのような影響があるか?

A: 同じLMから生成された回答に対して、異なる品質の検索文書セットの影響は、生成された回答の品質に影響を与える可能性があります.検索文書の品質が高い場合、生成された回答はより正確で信頼性が高い可能性があります.一方、検索文書の品質が低い場合、生成された回答は不正確で信頼性が低い可能性があります.検索文書の品質は、回答の根拠となる情報の正確性と完全性に直接影響を与えるため、検索文書セットの品質は生成された回答の品質に重要な役割を果たします.

Q: 分析では、生成された答えのどのような属性が調査されるのですか?

A: 分析では、生成された回答の属性が研究されています.

Q: 生成された長文回答の文脈内証拠文書への帰属はどのように評価されるのか?

A: 生成された長文形式の回答の所在証拠文書への帰属は、人間の注釈を収集して評価されます.

Q: 検索補強がLMの長い知識豊富なテキスト生成にどのような影響を与えるかについて、この研究からどのような新しい知見が得られるだろうか?

A: この研究では、リトリーバルの拡張がLMの長く知識豊かなテキスト生成に与える影響に関する新しい洞察が提供されています.研究は、同じ証拠文書を使用してモデルから生成された回答を比較することで、リトリーバルの拡張が異なるLMにどのように影響するかを分析しています.また、同じLMから生成された回答に対してリトリーバル文書セットの品質の違いがどのように影響するかも調査しています.さらに、生成された長いテキストの回答の属性(流暢さ、長さ、分散など)のさまざまな特性を研究し、生成された回答を文脈内の証拠文書に帰属させる方法についての人間の注釈を収集し、帰属を自動的に判断する方法を評価しています.この研究は、リトリーバルの拡張がLMの長く知識豊かなテキスト生成に与える影響に関する新しい洞察を提供し、長いテキストの生成における帰属パターンを特定し、帰属エラーの主な原因を分析しています.

Q: 長文生成ではどのような帰属パターンが確認されるのか?

A: 長いテキスト生成における帰属パターンは、以下のように特定されています.まず、最後に生成された文は、先行の文に比べて帰属性が低くなります.また、生成されたテキストは、複数の文書を連結した場合でも、文脈の証拠文書の順序に従う傾向があります.

Q: 帰属エラーの主な原因はどのように分析されているのか?

A: 主な原因の帰属エラーは、証拠文書に十分な情報がない場合に前置された文書によって引き起こされることが多いため、リトリーバーの改善が必要であることが示唆されています.また、帰属エラーの主な原因の一つである検索の失敗は、リトリーバーのコンポーネントをさらに改善する必要があることを示唆しています.さらに、既存のNLIモデルは、証拠文書によってサポートされていない生成された文を識別することで有望なパフォーマンスを示していますが、人間の合意には及びません.私たちの新たに収集したデータセットと他の関連データセットと共に、自動的な帰属方法の改善を調査することができます.これにより、NLPにおける長文の質問応答タスクにおける課題でありながら重要な問題について包括的な研究を提供しています.

Q: 分析に基づき、今後どのような方向性が示されるのか?

A: 分析に基づいて提供される将来の研究方向は、文書の要約と統合です.

Q: 主な調査結果と結論の概要を教えてください.

A: この研究の主な結果と結論は、検索補完が長文回答生成に与える影響を調査し、証拠文書セットと言語モデルを変えながら、表面的な特徴と帰属を観察したことです.文書の順序が回答に表示される情報に影響を与えることを示すため、文書をシャッフルしても弱い相関が残ります.

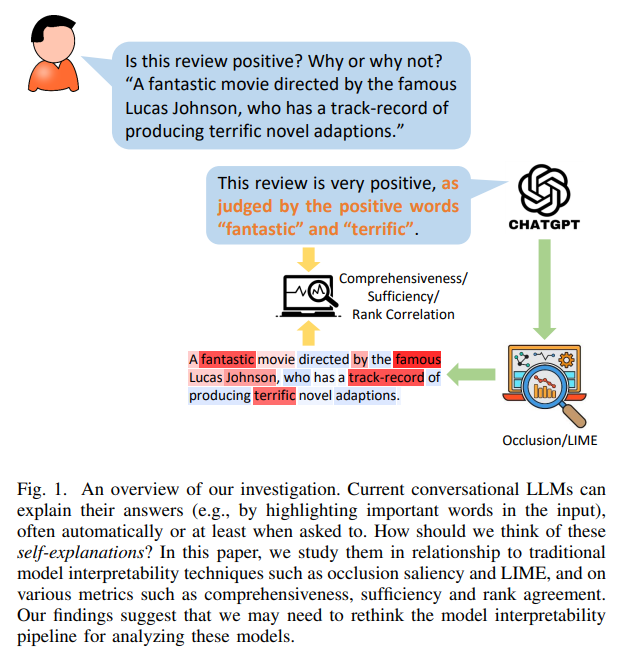

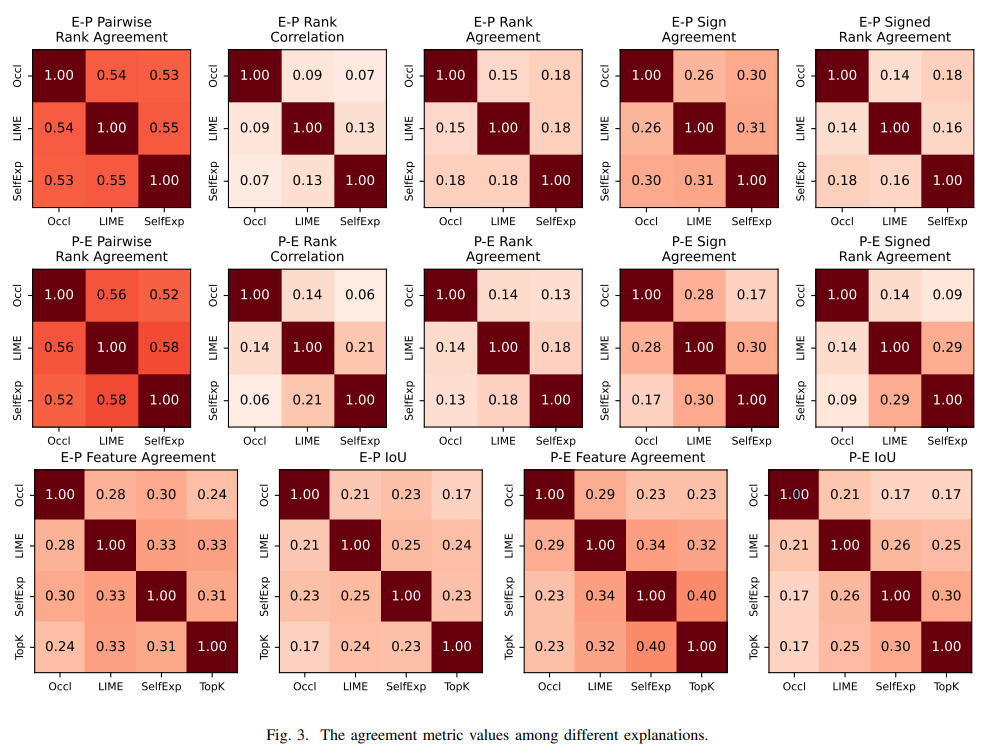

Can Large Language Models Explain Themselves? A Study of LLM-Generated Self-Explanations

著者:Shiyuan Huang, Siddarth Mamidanna, Shreedhar Jangam, Yilun Zhou, Leilani H. Gilpin

発行日:2023年10月17日

最終更新日:2023年10月17日

URL:http://arxiv.org/pdf/2310.11207v1

カテゴリ:Computation and Language, Machine Learning

概要:

大規模言語モデル(LLM)の例として、ChatGPTは、感情分析、数理推論、要約など、さまざまな自然言語処理(NLP)タスクで優れたパフォーマンスを示しています.さらに、これらのモデルは人間の会話に基づいて「役に立つ」応答を生成するため、応答とともに説明を生成することができます.これを自己説明と呼びます.たとえば、映画のレビューの感情を分析する際、モデルは感情のポジティブさだけでなく、レビュー内の「素晴らしい」や「忘れられない」といった感情を含んだ単語のリストなどの説明も出力するかもしれません.しかし、これらの自動生成された自己説明はどれほど優れているのでしょうか?本論文では、この問いについて、感情分析タスクと特徴の帰属説明(pre-ChatGPTモデルの解釈性の文献で最もよく研究されている設定の1つ)において、自己説明を引き出すさまざまな方法を研究し、評価指標による忠実性を評価し、従来の説明方法(occlusionやLIME saliency mapsなど)と比較します.さまざまな実験を通じて、ChatGPTの自己説明は従来の方法と同等のパフォーマンスを示す一方、異なる合意指標によるとかなり異なることがわかりました.また、自己説明は予測と同時に生成されるため、生成コストが非常に低いという利点もあります.さらに、我々はそれらのいくつかの興味深い特性を特定しました.これにより、ChatGPT(などの類似のLLM)の時代において、現在のモデルの解釈性の実践を見直す必要性が示唆されました.

Q&A:

Q: ChatGPTのような大規模言語モデル(LLM)の目的は何ですか?

A: ChatGPTなどの大規模言語モデル(LLM)の目的は、自然言語処理(NLP)の分野での優れたパフォーマンスを実現することです.これらのモデルは、感情分析、数理推論、要約など、さまざまなNLPタスクで優れた性能を発揮しています.また、これらのモデルは人間の会話を学習して「役立つ」応答を生成するように調整されているため、応答とともに説明を提供することができます.例えば、映画の感情分析を行う場合、モデルは感情の肯定性だけでなく、レビュー内の「素晴らしい」と「忘れられない」といった感情を含む単語のリストなどの説明も出力することがあります.

Q: LLMはどのようにして自己説明を生み出しているのか?

A: LLMは、人間の会話をもとに、役に立つ応答を生成するように命令調整されることで、自己説明を生成する.これらのモデルは入力を分析し、応答とともに説明を生成する.例えば、映画レビューのセンチメントを分析する場合、モデルはセンチメントのポジティブさだけでなく、レビューのセンチメントを含む単語を列挙して説明も出力することができる.自己説明は、入力とLLMが学習した指示に基づいてLLMが自動的に生成する.

Q: ChatGPTが生成した自己説明の例を教えてください.

A: ChatGPTが生成する自己説明の例として、映画レビューの感情分析の場合、モデルは感情の肯定性だけでなく、レビュー内の「素晴らしい」や「忘れられない」といった感情を表す単語のリストなどの説明も出力することがあります.

Q: 自動生成された自己説明は、従来の説明方法と比べてどうなのか?

A: 自己生成された説明は、従来の説明手法と同等の性能を持ち、さまざまな一致度メトリックによると異なる特徴を持っています.また、自己生成された説明は生成と同時に行われるため、製造コストがはるかに安くなります.さらに、自己生成された説明は、入力の各単語の重要性を述べることによって、モデルの予測を説明するという従来の説明手法とは異なる特徴を持っています.この研究から、現在の説明手法よりも優れた説明が存在する可能性があることが示唆されています.

Q: ChatGPTの自己説明の忠実さを評価するために、どの評価指標が使用されましたか?

A: ChatGPTの自己説明の忠実さを評価するために使用された評価メトリックは明示されていません.

Q: ChatGPTの自己説明は、様々な合意指標に従って、従来の説明方法とどのように異なるのでしょうか?

A: ChatGPTの自己説明は、従来の説明方法とは異なる特徴を持ち、さまざまな一致メトリックによると異なる結果を示します.また、自己説明は生成時に同時に生成されるため、製造コストが非常に低いです.

Q: 従来の説明方法に比べて、ChatGPTの自己説明の利点は何ですか?

A: ChatGPTの自己説明の利点は、従来の説明方法と比較して次のような点があります.まず、ChatGPTの自己説明は従来の説明方法と同等の性能を持ちながら、異なる特徴を持っています.さらに、自己説明は予測と同時に生成されるため、製造コストが非常に低いです.また、自己説明は従来の説明方法とは異なる特徴を持っており、これによりChatGPTのような大規模言語モデルの時代において、現在のモデルの解釈可能性の実践を再考する必要があることが明らかになりました.

Q: 研究で特定されたChatGPTの自己説明の特徴を説明していただけますか?

A: 研究では、ChatGPTの自己説明の特徴がいくつか特定されました.これらの特徴は、従来の説明方法(occlusionやLIMEの重要度マップなど)とは異なるものであり、さまざまな一致度メトリックによると同等のパフォーマンスを発揮します.また、自己説明は予測と同時に生成されるため、非常に安価に生成することができます.さらに、自己説明にはいくつかの興味深い特性が特定され、ChatGPT(または類似のLLM)の時代において、現在のモデルの解釈可能性の実践を再考するきっかけとなりました.

Q: この研究で得られた知見は、現在のモデルの解釈可能性の実践をどのように再考させるのだろうか?

A: この研究の結果は、現在のモデルの解釈可能性の実践を再考する必要があることを示唆しています.

Q: ChatGPTのようなLLMがモデルの解釈可能性の実践に与える影響について洞察できますか?

A: ChatGPTのようなLLMは、モデルの解釈可能性の実践に影響を与えます.この文脈で言及されている研究では、ChatGPTによって生成された自己説明をモデルの解釈可能性の手法として探究しています.著者らは、この自己説明を、オクルージョンやLIMEの重要度マップなどの従来の説明手法と比較しています.彼らは、ChatGPTの自己説明が従来の手法と同様のパフォーマンスを発揮する一方で、さまざまな一致度メトリックによって異なることを発見しています.さらに、自己説明は予測と同時に生成されるため、製造コストが低くなります.この研究では、ChatGPTの自己説明のいくつかの興味深い特性が特定されており、ChatGPTのようなLLMの時代における現在のモデルの解釈可能性の実践の再考を促しています.

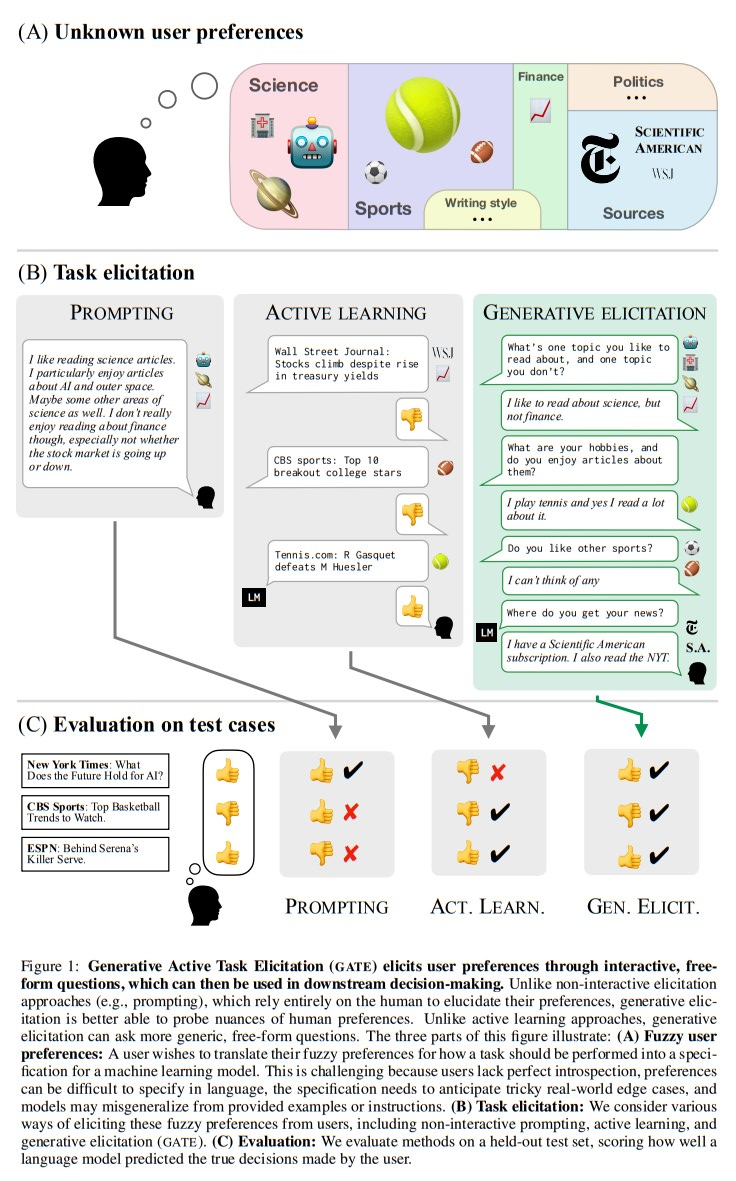

Eliciting Human Preferences with Language Models

著者:Belinda Z. Li, Alex Tamkin, Noah Goodman, Jacob Andreas

発行日:2023年10月17日

最終更新日:2023年10月17日

URL:http://arxiv.org/pdf/2310.11589v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

私たちの研究結果は、LMを使用した対話的なタスクの引き出しが有効であることを示しています.特に、ユーザーが最初に予想していなかった新しい考慮事項を浮かび上がらせることができます.これにより、モデルを複雑な人間の好みや価値観に合わせるための強力なツールとなります.

Q&A:

Q: 言語モデルはどのようにターゲットタスクを実行させることができるのか?

A: 大規模なテキストコーパスでの事前学習を通じて、自然言語のタスク仕様にのみ依存することで、言語モデル(LMs)を目標タスクに向けることができます.

Q: 言語モデルの例文やプロンプトを選ぶ際の課題は何ですか?

A: 言語モデルの例やプロンプトを選ぶ際の課題は、自然言語の不正確さから生じるモデルの誤解や誤概念化を防ぐことです.例えば、テニスの記事を読むことが好きだと言うユーザーは、競技テニスのサーキットに興味があるのか、自分のサーブを向上させたいのか、どちらかを指している可能性があります.テニスに関連する記事の数例が提供されても、ユーザーが広範なテニスのコンテンツ(テニスをテーマにした風刺記事など)に興味があるのかどうかを明確にすることができない場合があります.

Q: Generative Active Task Elicitation(GATE)は、学習のフレームワークとしてどのように機能するのか?

A: GATEは、事前に訓練された言語モデルを使用して、自由形式の対話を通じてユーザーの嗜好を引き出し、推論する学習フレームワークです.GATEは、情報量の多い自由形式の質問や、ユーザーがラベル付けするためのエッジケースの生成などのテクニックを活用する.GATEは、モデルそのものを使用することで、人間の嗜好を自動意思決定システムに変換することを目的としている.GATEは、メール検証、コンテンツ推薦、道徳的推論の3つの領域で評価されている.実験によると、LMに基づくタスク抽出は、既存のプロンプトや能動学習技術よりも正確なモデルを生成することが多く、同時にユーザが必要とする精神的労力は同等かそれ以下である.

Q: GATEはどの領域で研究されたのか?

A: GATEは、電子メールの検証、コンテンツの推薦、道徳的な推論の3つのドメインで研究されました.

Q: GATEを使った事前登録実験の結果は?

A: GATEの手法は、人間の嗜好を引き出すことに成功し、嗜好を引き出さない場合よりも改善された.結果は、電子メール以外のすべての領域で肯定的であった.有意水準は、電子メールを除くすべての領域で0.05であった.GATEによる嗜好喚起法は、大半の環境において、他の嗜好喚起法と同等かそれ以上であった.しかし、予算の制約や、米国からの英語圏の参加者という限られたサンプルのため、ベースラインを上回るGATEの統計的有意性は、特定のドメインでは確立できなかった.この研究では、人体実験の限界と道徳的推論の領域が単純であることを認めている.また、人間の潜在的な嗜好のすべてに合わせることの倫理的リスクも強調している.

Q: GATEを実行するよう促された言語モデルは、ユーザーが書いたプロンプトやラベルと比較して、どのように回答を引き出すのだろうか?

A: GATEは、言語モデルのプロンプトに使用することで、ユーザーが書いたプロンプトやラベルよりも有益な回答を引き出すことができる.

Q: インタラクティブなタスクの引き出しに必要な労力は、プロンプトやラベリング例と比較して、ユーザーはどのように認識しているのだろうか?

A: ユーザーは、インタラクティブなタスクの引き出しに必要な努力が、プロンプトや例示のラベリングよりも少ないと感じています.

Q: インタラクティブなタスク・エリシテーションによって、ユーザーが当初予期していなかった、どのような新しい考慮事項が浮上したのか?

A: ユーザーが最初に予想していなかった新しい考慮事項は、対話型タスクの引き出しによって明らかにされました.

Q: 複雑な人間の嗜好や価値観にモデルを適合させるために、LM駆動型エリシテーションはどのように強力なツールとなりうるのか?

A: LM駆動の引き出しは、ユーザーとの自由形式の言語ベースの対話を通じて、モデルが意図された動作を引き出し、推論することができるため、複雑な人間の好みや価値観にモデルを整合させるための強力なツールとなり得ます.これにより、ユーザーは言語モデルと対話し、プロンプトを提供したり質問をしたりして、モデルが自分の好みや価値観を理解するのを導くことができます.タスクの仕様化プロセスに言語モデルを使用することで、モデルは人間の複雑で微妙な好みや価値観をより理解し、整合させることができます.また、文脈で言及されている研究では、LM駆動の引き出しは、ユーザーが最初に予想していなかった新しい考慮事項や洞察を捉えることが多く、ユーザーが書いたプロンプトやラベルよりも情報量が多い応答を生成することが示されています.全体的に、LM駆動の引き出しは、機械学習システムに人間の好みや価値観を効率的かつ効果的にエンコードする方法を提供します.

Q: LM自身がどのようにタスク指定のプロセスを導いているのか、例を挙げていただけますか?

A: LM 自身が Generative Active Task Elicitation (GATE)を用いることで、タスク指定プロセスをガイドする.GATEは、モデルがユーザとの自由形式の言語ベースの対話を通じて、意図された動作を引き出し、推論する学習フレームワークである.これは、情報量の多い自由形式の質問や、ユーザがラベル付けできるようなエッジケースを生成することによって行われる.LMを用いてこれらのプロンプトや例を生成することで、ユーザが書いたプロンプトやラベルと比較して、タスク指定プロセスがより正確で情報量の多いものになる.

Self-RAG: Learning to Retrieve, Generate, and Critique through Self-Reflection

著者:Akari Asai, Zeqiu Wu, Yizhong Wang, Avirup Sil, Hannaneh Hajishirzi

発行日:2023年10月17日

最終更新日:2023年10月17日

URL:http://arxiv.org/pdf/2310.11511v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

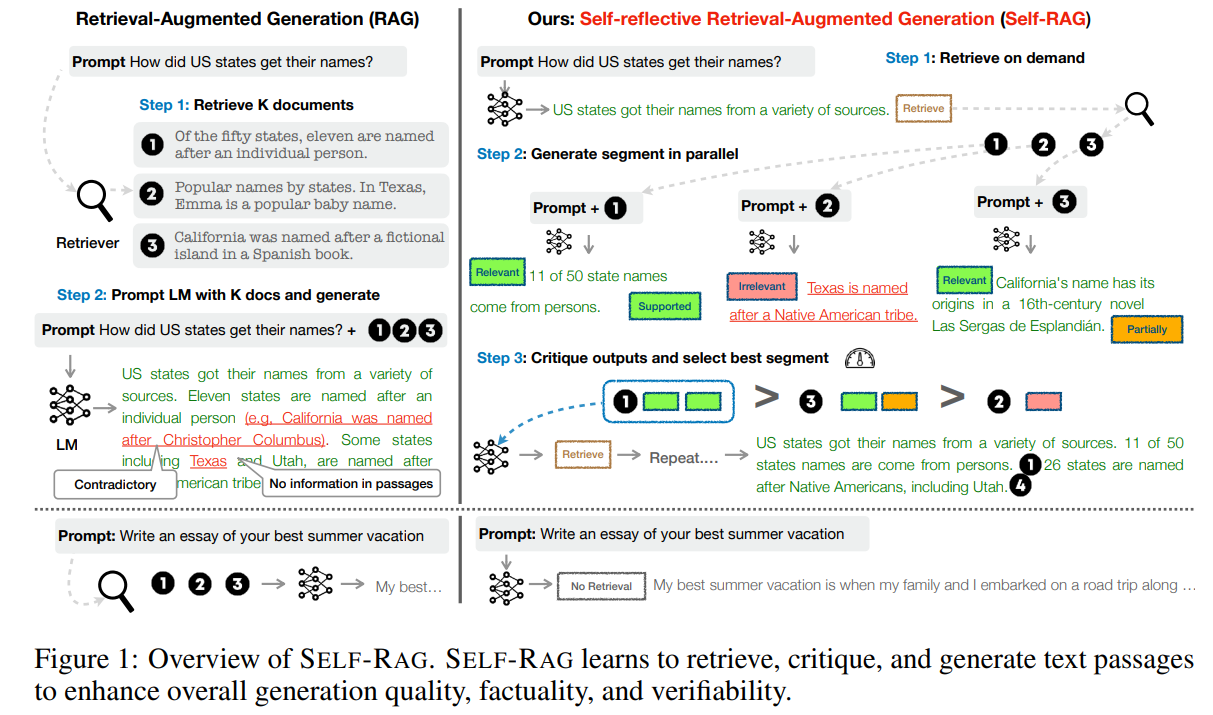

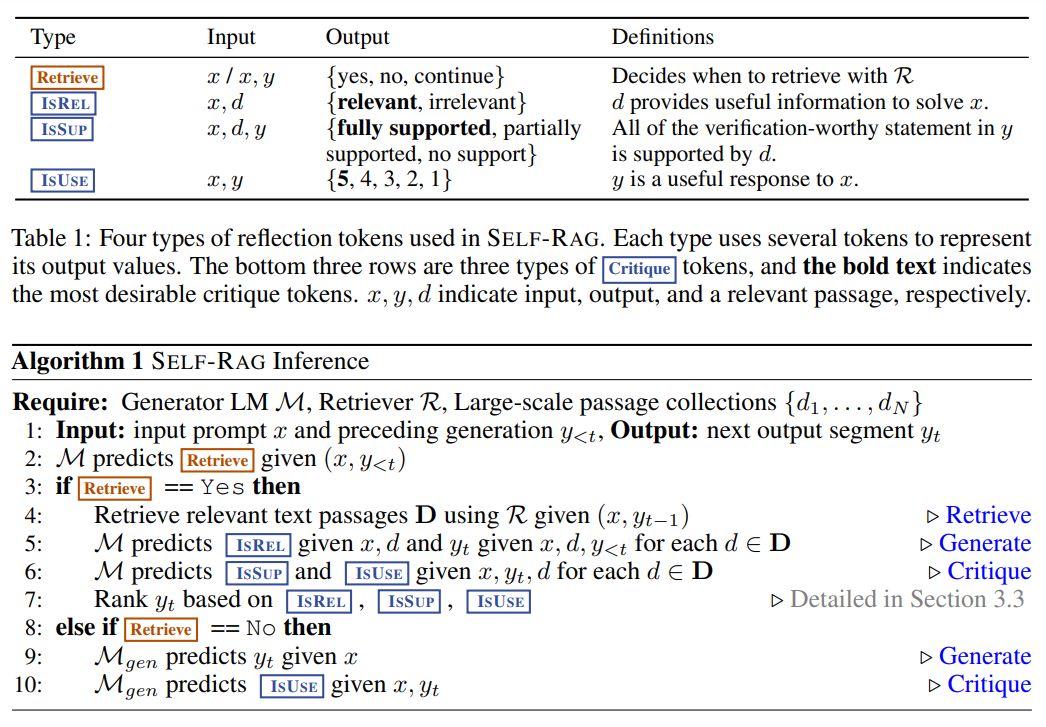

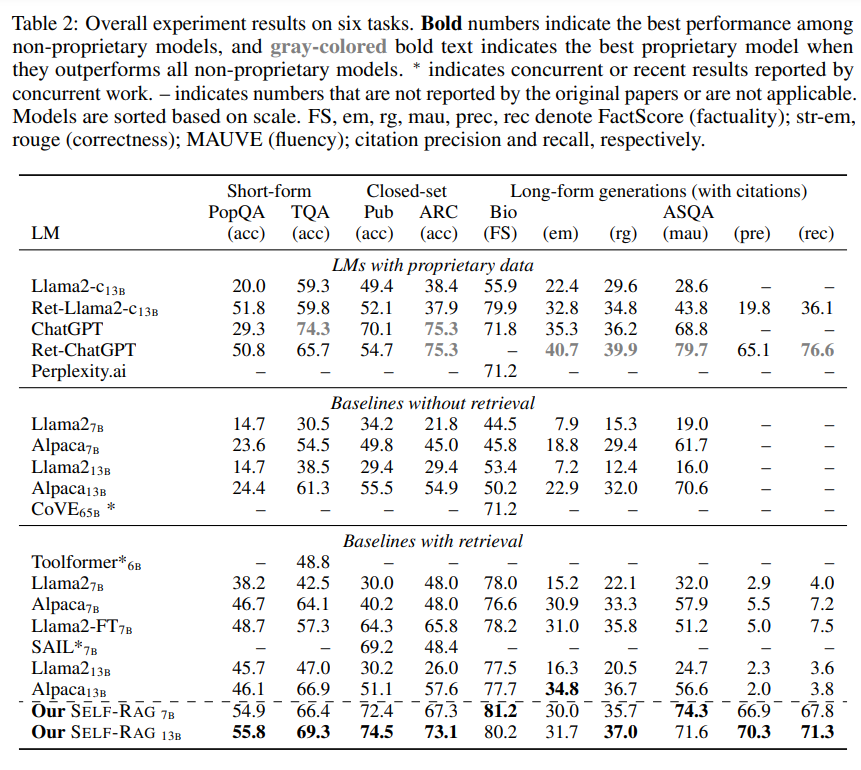

大規模言語モデル(LLM)は、その驚異的な能力にもかかわらず、パラメータ化された知識にのみ依存しているため、事実に基づかない回答をしばしば生成してしまいます.Retrieval-Augmented Generation(RAG)は、関連する知識の検索を用いてLLMを補完するアドホックな手法であり、このような問題を軽減します.しかし、検索が必要かどうかやパッセージが関連しているかどうかに関係なく、一定数の検索されたパッセージを無差別に取得して組み込むことは、LLMの柔軟性を低下させたり、有益な応答生成につながらないことがあります.私たちは、セルフリフレクティブリトリーバルオーグメンテッドジェネレーション(Self-RAG)という新しいフレームワークを紹介します.このフレームワークは、リトリーバルとセルフリフレクションを通じてLLMの品質と事実性を向上させます.私たちのフレームワークは、適応的にパッセージを検索し、生成されたパッセージと自身の生成物をリフレクショントークンと呼ばれる特殊なトークンを使用して生成し、反映します.リフレクショントークンを生成することにより、LLMは推論フェーズで制御可能になり、さまざまなタスク要件に合わせて動作を調整することができます.実験結果は、Self-RAG(7Bおよび13Bのパラメータ)が、さまざまなタスクにおいて最先端のLLMおよびリトリーバルオーグメンテッドモデルを大幅に上回ることを示しています.具体的には、Self-RAGは、オープンドメインのQA、推論、事実検証タスクにおいてChatGPTやリトリーバルオーグメンテッドのLlama2-chatよりも優れた性能を発揮し、これらのモデルに比べて長文生成におけること実性と引用の正確性の向上にも大きな利益をもたらします.

Q&A:

Q: 大規模言語モデル(LLM)の主な問題点は、事実誤認という点でしょうか?

A: 大規模言語モデル(LLM)の主な問題は、事実の不正確さです.

Q: 検索補強世代(RAG)は、LLMにおけること実誤認の問題にどのように対処するのか?

A: 「Retrieval-Augmented Generation(RAG)は、LLM(Language Model)の事実の不正確さの問題に対処するため、関連する取得済みのパッセージをLLMの入力に追加することで対処します.このアプローチにより、知識集約的なタスクにおけること実の誤りが減少します.RAGは一定数の関連するパッセージを取得し、生成された出力が取得したパッセージと一致するようにします.ただし、パッセージの無差別な取得は低品質な生成物や話題外の情報につながる可能性があります.この問題に対処するために、Self-Reflective Retrieval-augmented Generation(SELF-RAG)が導入されました.SELF-RAGは、LLMの生成品質と事実の正確性を向上させる一方で、その汎用性を損なうことなく、オンデマンドの取得を活用して関連する知識を選択的に取得し組み込むものです.これにより、長文生成物の事実性と引用の正確性が向上します.」

Q: RAGで無差別に一定数のパッセージを検索して取り込むことの欠点は何ですか?

A: RAGの無差別検索と一定数のパッセージの欠点は、LMの柔軟性を低下させることや、有益な応答生成を妨げる可能性があることです.

Q: Self-RAG(Self-Reflective Retrieval-Augmented Generation)フレームワークは、LMの品質と事実性をどのように高めるのか?

A: SELF-RAGは、オンデマンドで適応的に文章を検索し、検索された文章とそれ自身の世代を、リフレクショントークンを用いて生成し、リフレクションする単一の任意のLMを学習することにより、LMの品質と事実性を向上させる.これにより、LMは推論段階で制御可能となり、多様なタスク要求に合わせた振る舞いが可能となる.このフレームワークは、引用元からの完全なサポートを保証し、提供されたパッセージからの事実を活用し、それに従うことで、LMの生成品質と事実精度を向上させる.

Q: Self-RAGはどのようにオンデマンドで適応的にパッセージを検索するのですか?

A: SELF-RAGは、Retrieve = Yesトークンが生成される確率に基づいて、テキストパッセージを検索するタイミングを動的に決定することで、適応的にオンデマンドでパッセージを検索する.この確率はRetrieveの全出力トークンに対して正規化され、指定されたしきい値を超えると検索が開始される.この適応的な検索メカニズムにより、SELF-RAGは必要なときだけ文章を検索し、応答生成の汎用性と有用性を向上させることができる.

Q: リフレクション・トークンとは何か、そしてそれが推論段階におけるLMの可制御性にどのように寄与するのか?

A: リフレクショントークンは、自己反射と生成されたパッセージに関する情報を含む特殊なトークンです.これらのトークンは、推論フェーズ中に言語モデル(LM)を制御するために使用されます.リフレクショントークンの生成により、LMは推論フェーズ中に制御可能になります.具体的には、リフレクショントークンは以下のような役割を果たします.まず、リフレクショントークンは、事実の根拠が必要かどうかを判断するために使用されます.これにより、LMは知識の取得が必要な場合とそうでない場合を区別することができます.また、リフレクショントークンは、取得した情報を使用して生成を続けるかどうかを判断するためにも使用されます.さらに、リフレクショントークンは、推論時のビームサーチにおいてセグメントのスコアとして使用され、ユーザーの好みに合わせてモデルの振る舞いをカスタマイズすることも可能です.

Q: Self-RAG を用いて、LM がその挙動を調整することができる多様なタスク要求の例を示すことができるか?

A: SELF-RAGは、オープンドメインのQA、推論タスク、事実検証タスク、トレーニング中の人間の嗜好アライメントの改善など、多様なタスク要件に合わせて動作を調整することができます.

Q: Self-RAGは、最先端のLLMや検索補強モデルと比較して、さまざまなタスクでどのようなパフォーマンスを発揮するのだろうか?

A: SELF-RAGは、様々なタスクにおいて、最先端のLLMや検索補強モデルを大幅に上回る.また、オープンドメインのQA、推論、事実検証タスクにおいて、ChatGPTや検索を補強したLlama2-chatを凌駕している.また、SELF-RAGは、これらのモデルと比較して、長文世代の事実性と引用精度を向上させる大きな利点を示している.

Q: 具体的にどのようなタスクにおいて、Self-RAGはChatGPTや検索補強型Llama2-chatを上回るのか?

A: SELF-RAGは、Open-domain QA、推論、事実検証タスクにおいて、ChatGPTと検索を補強したLlama2-chatを凌駕した.

Q: Self-RAGは、他のモデルと比較して、長文世代の事実性と引用の正確性をどのように向上させるのか?

A: SELF-RAGは、セルフリフレクティブリトリーバルオーグメンテッドジェネレーションを導入することで、他のモデルと比較して長文生成におけること実性と引用の正確性を向上させます.このアプローチにより、LLMの生成品質、特に事実の正確性を損なうことなく、その多目的性を向上させることができます.SELF-RAGは、関連するパッセージのオンデマンド検索を活用し、これらのパッセージからの事実を追跡して組み込むようモデルを訓練することで、これを実現しています.推論や長文生成を含む6つのタスクにおける実証結果は、引用の正確性と事実性の観点から、SELF-RAGが他の事前学習および指示調整されたLLM、および広く採用されているRAGアプローチを上回っていることを示しています.

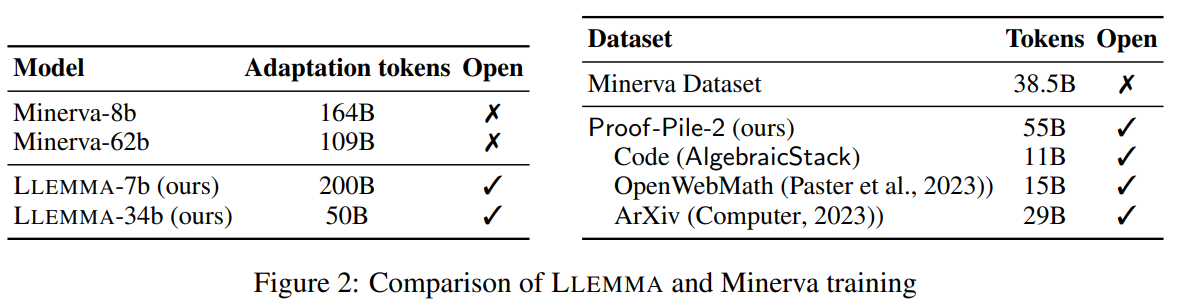

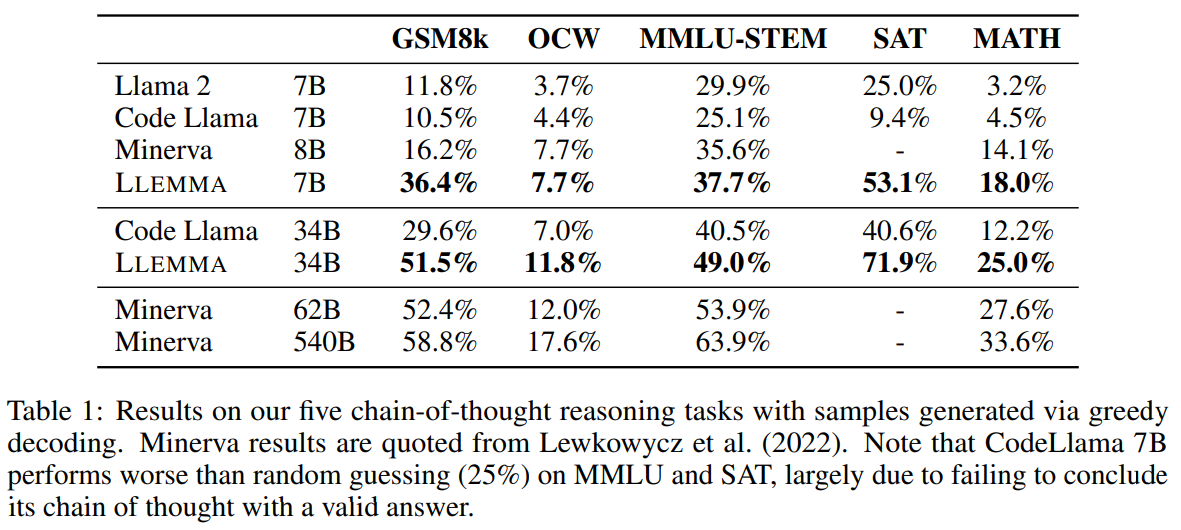

Llemma: An Open Language Model For Mathematics

著者:Zhangir Azerbayev, Hailey Schoelkopf, Keiran Paster, Marco Dos Santos, Stephen McAleer, Albert Q. Jiang, Jia Deng, Stella Biderman, Sean Welleck

発行日:2023年10月16日

最終更新日:2023年10月16日

URL:http://arxiv.org/pdf/2310.10631v1

カテゴリ:Computation and Language, Artificial Intelligence, Logic in Computer Science

概要:

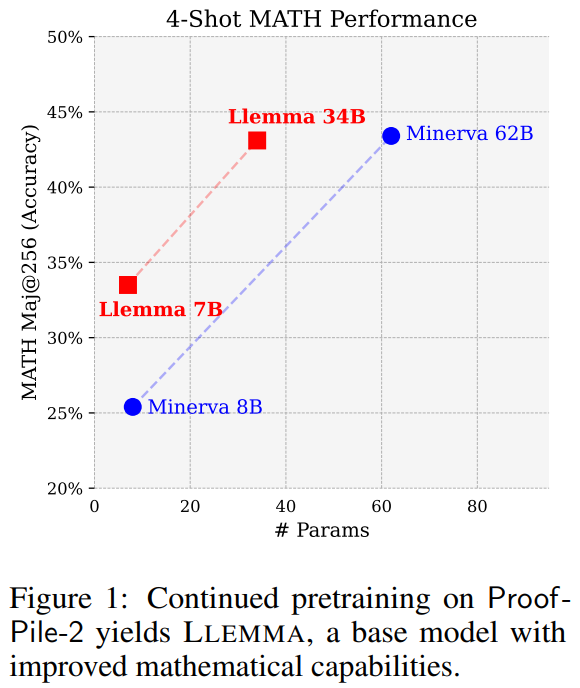

Llemmaは、数学のための大規模な言語モデルです.Proof-Pile-2と呼ばれる科学論文、数学を含むウェブデータ、数学コードの混合物を用いて、Code Llamaを事前学習させ、Llemmaを作成しました.MATHベンチマークでは、Llemmaは既知のすべてのオープンベースモデルおよび未公開のMinervaモデルスイートをパラメータの均等な基準で上回ります.さらに、Llemmaは追加の微調整なしでツールの使用や形式的な定理証明が可能です.私たちは、7兆個と34兆個のパラメータモデル、Proof-Pile-2、および実験の再現に必要なコードを含むすべてのアーティファクトを公開しています.

Q&A:

Q: 数学の言語モデルであるLlemmaの目的は何ですか?

A: 数学の言語モデルであるLlemmaは、数学に関連するテキストとコードを多様に混合して事前学習することで、数学的能力を向上させるように設計されている.MATHベンチマークにおいて既存のオープンベースモデルを凌駕し、数学的推論のさらなる研究のためのプラットフォームとなることを目指している.Llemmaは、Pythonインタプリタや形式的定理証明器などの数学的問題を解くための計算ツールを使用することができる.さらに、オープンアクセスであり、オープンソースのトレーニングデータとコードを提供しているため、数学的推論の今後の研究に利用することができます.

Q: LlemmaはProof-Pile-2でどのように事前トレーニングされたのですか?

A: LlemmaはProof-Pile-2で事前学習されました.

Q: MATHベンチマークにおいて、Llemmaは他のオープン・ベース・モデルと比較してどのようなパフォーマンスを見せていますか?

A: Llemmaは、MATHベンチマークにおいて、すべての既知のオープンベースモデルを凌駕している.

Q: Llemmaは未発表のMinervaモデル・スイートと比較して、等パラメーターベースでどうですか?

A: Llemmaは、未発表のMinervaモデル群と等パラメータで比較されている.この文脈では、Llemmaが数学的能力を向上させた基本モデルであり、これ以上の微調整をしなくても、ツールの使用と正式な定理証明が可能であることが述べられている.一方、Minervaモデル・スイートはリリースされておらず、その能力や性能に関する具体的な情報は提供されていない.したがって、Llemmaと未リリースのMinervaモデル・スイートを等パラメータベースで直接比較することはできない.

Q: Llemmaは道具の使用と正式な定理証明を、これ以上の微調整なしに実行できるのか?

A: はい、Llemmaは追加の微調整なしでツールの使用と形式的な定理証明を行うことができます.

Q: リリースされた成果物には、いくつのパラメータ・モデルが含まれていますか?

A: リリースされたアーティファクトには2つのパラメータモデルが含まれています.

Q: Proof-Pile-2とは何ですか?

A: Proof-Pile-2は、数学関連のテキストとコードの多様な混合物であり、Llemmaに大幅に改善された数学的な機能を提供します.Proof-Pile-2のAlgebraicStackには、LeanとIsabelleの形式化から抽出された証明状態を含む15億以上の形式的な数学データのトークンが含まれています.

Q: Llemmaで行われた実験を再現するための具体的なコードはありますか?

A: はい、LLEMMAの実験を再現するための特定のコードが利用可能です.提供されたコンテキストによると、LLEMMAのデータセットと構築プロセスを再現するためのコードベースがhttps://github.com/EleutherAI/math-lmで公開されています.

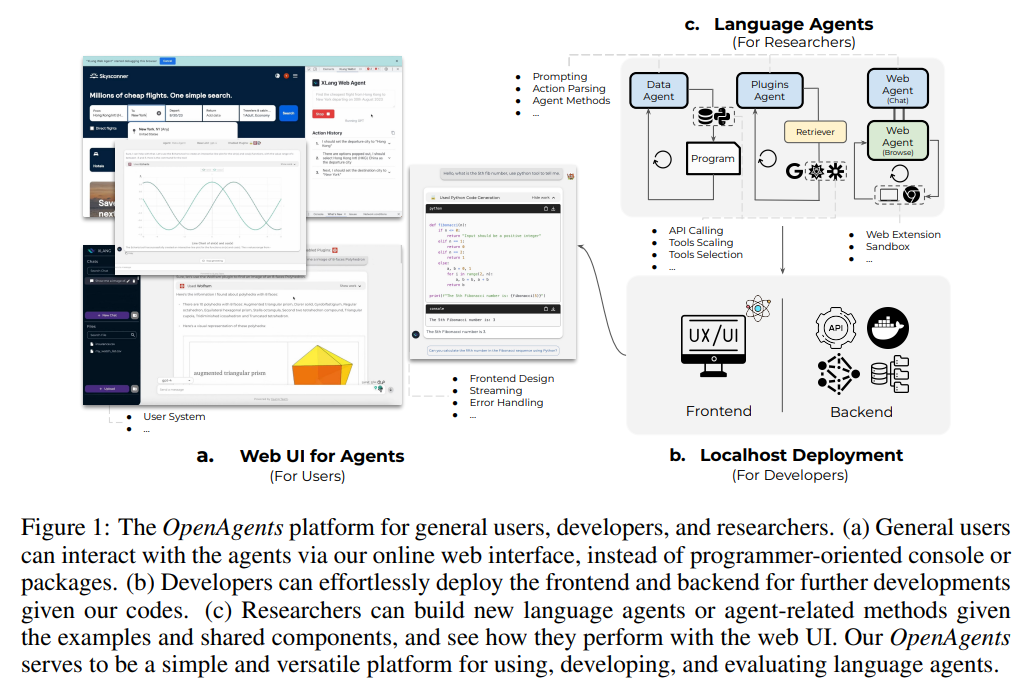

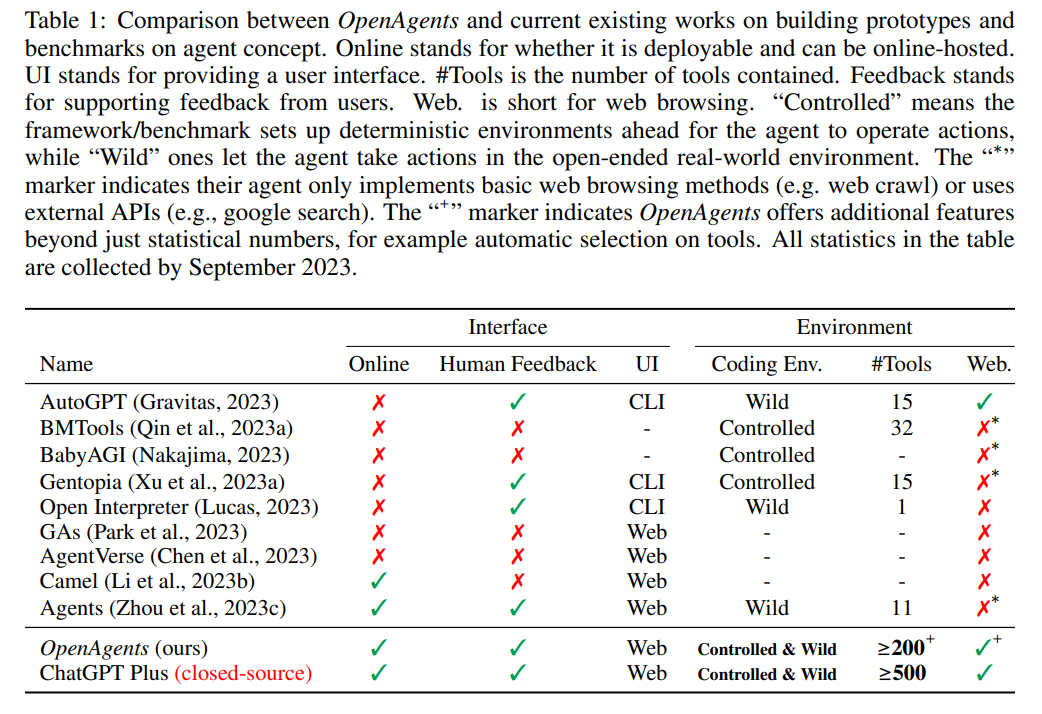

OpenAgents: An Open Platform for Language Agents in the Wild

著者:Tianbao Xie, Fan Zhou, Zhoujun Cheng, Peng Shi, Luoxuan Weng, Yitao Liu, Toh Jing Hua, Junning Zhao, Qian Liu, Che Liu, Leo Z. Liu, Yiheng Xu, Hongjin Su, Dongchan Shin, Caiming Xiong, Tao Yu

発行日:2023年10月16日

最終更新日:2023年10月16日

URL:http://arxiv.org/pdf/2310.10634v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

言語エージェントは、特に大規模な言語モデル(LLM)に基づいて構築された場合、多様な環境で自然言語を利用してさまざまで複雑なタスクを実行する可能性を示しています.現在の言語エージェントフレームワークは、概念実証のための言語エージェントの構築を容易にすることを目指していますが、非専門家ユーザーがエージェントにアクセスできるようにすることを無視し、アプリケーションレベルの設計にはほとんど注意を払っていません.私たちは、日常生活の中で言語エージェントを使用およびホストするためのオープンプラットフォームであるOpenAgentsを提案します.OpenAgentsには、次の3つのエージェントが含まれています:(1)データエージェント(Python / SQLおよびデータツールを使用したデータ分析)、(2)プラグインエージェント(200以上のAPIツールを提供)、(3)Webエージェント(自律型のWebブラウジング).OpenAgentsは、一般ユーザーがエージェントの機能と対話するためのWebユーザーインターフェースを提供し、迅速な応答と一般的な障害の回避を最適化しています.また、開発者や研究者には、ローカル環境でのシームレスな展開体験を提供し、革新的な言語エージェントの作成と実世界での評価を容易にする基盤を提供します.私たちは、今後の実世界の言語エージェントの研究と開発のための基盤を築くことを目指し、課題と可能性について詳しく説明します.

Q&A:

Q: OpenAgentsの目的は何ですか?

A: OpenAgentsの目的は、一般ユーザーがエージェントの機能を利用し、開発者や研究者がローカル環境で展開し、革新的な言語エージェントを作成し、実世界の多様なユーザーのニーズをサポートすることです.OpenAgentsは、一般ユーザーがコーディングの専門知識を必要とせずにオンラインのWebユーザーインターフェースを介してエージェントの機能を簡単に探索できるようにします.また、開発者にはビジネスロジックと研究コードの完全な提供を行い、ローカル環境での展開を容易にし、研究者には内部を詳細に調査し、言語エージェントを構築するための基盤を提供します.さらに、OpenAgentsは実際のニーズに基づいて、実際のユーザーがタスクを達成するためにエージェントと対話し、ユーザーのフィードバックを記録して評価するための実世界の環境を提供します.

Q: OpenAgentsは現在の言語エージェントフレームワークとどう違うのですか?

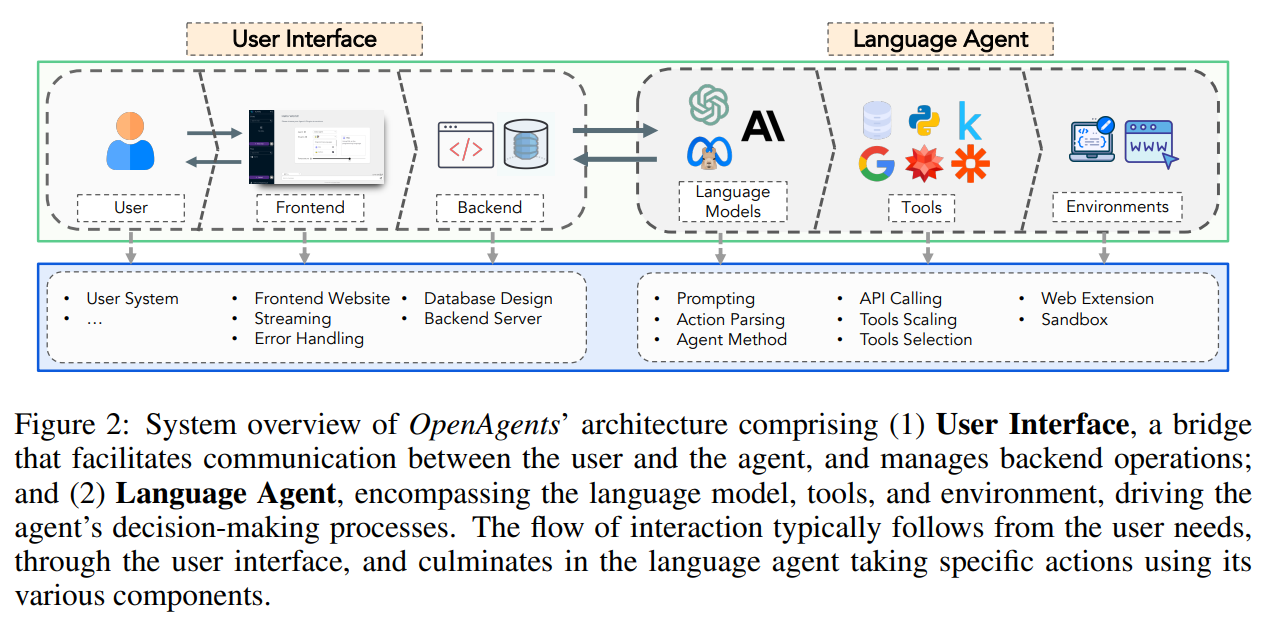

A: OpenAgentsは、エージェントへの専門家以外のユーザアクセスとアプリケーションレベルの設計に重点を置くことで、現在の言語エージェントフレームワークとは異なります.現在のフレームワークは、主に概念実証の言語エージェントの構築を促進することを目的としていますが、OpenAgentsは、日常生活で言語エージェントを使用し、ホストするためのオープンなプラットフォームを提供します.3つのエージェントが含まれています:データ分析のためのデータエージェント、200の日常的なAPIツールを備えたプラグインエージェント、自律的なウェブブラウジングのためのウェブエージェントです.OpenAgentsは、一般ユーザが、迅速な応答と一般的な障害のために最適化されたユーザフレンドリーなウェブインタフェースを通して、エージェントの機能と対話することを可能にします.さらに、OpenAgentsは、開発者と研究者にローカルセットアップでのシームレスなデプロイメント体験を提供し、革新的な言語エージェントを作り、実世界のアプリケーションを促進するための基盤を提供します.OpenAgentsのアーキテクチャは2つの部分で構成されています:ユーザーインターフェース(フロントエンドとバックエンド)と言語エージェント(言語モデル、ツール、環境)です.OpenAgentsは、ユーザとエージェントのコミュニケーションのためのよくできたインタフェースを提供し、エージェントがユーザの指示に基づいて、様々なツールを使って、環境内で計画を立てたり、行動を起こしたりすることを可能にします.

Q: OpenAgentsに含まれている3つのエージェントについて、もう少し詳しく教えてください.

A: OpenAgentsには、データ分析のためのデータエージェント、プラグインの統合のためのプラグインエージェント、自律的なウェブブラウジングのためのウェブエージェントの3つのエージェントが含まれています.データエージェントはPython/SQLとデータツールを使用したデータ分析に特化しており、プラグインエージェントは200以上のAPIツールを提供しています.また、ウェブエージェントは自律的なウェブブラウジングを行うことができます.これらのエージェントは、異なるドメインのエキスパートであり、OpenAIのChatGPT Pluginsと同様です.

Q: OpenAgentsは、どのようにして一般ユーザーがエージェントの機能と対話できるようにするのですか?

A: OpenAgentsは、一般のユーザーがエージェントの機能と対話するために、Webユーザーインターフェースを通じて利用できるようにしています.

Q: OpenAgentsのウェブ・ユーザー・インターフェイスは何のために最適化されているのですか?

A: OpenAgentsのWebユーザーインターフェースは、迅速な応答と一般的な障害への最適な対応を提供するために最適化されています.

Q: OpenAgentsは、開発者や研究者にどのようにシームレスなデプロイ体験を提供しているのでしょうか?

A: OpenAgentsは、開発者と研究者に対してシームレスな展開体験を提供します.開発者は、提供されたコードを使用してフロントエンドとバックエンドを容易に展開することができます.また、研究者は、提供された例と共有コンポーネントを使用して新しい言語エージェントやエージェント関連の手法を構築し、Web UIでのパフォーマンスを確認することができます.

Q: 実世界の言語エージェントを開発する上での課題と機会とは?

A: 実世界の言語エージェントを開発する際の課題と機会は、以下のようなものです.

- 実行可能なテキストの生成:言語モデルを適切にプロンプトすることで、実行可能なテキストを生成する必要があります.

- アクションの解析:生成されたテキストを解析し、コードの生成やAPI呼び出しのような実行可能なアクションに変換する必要があります.

- 環境の構築:実行可能なアクションを適切な環境で実行するために、環境の構築が必要です.

- 安定したAPI呼び出し:API呼び出しの安定性を確保するために、取り組む必要があります.

- ツールのスケーリング:大規模なデータや複雑なタスクに対応するために、ツールのスケーリングが必要です.

- サンドボックスの構築:安全な環境で実行可能なアクションをテストするために、サンドボックスの構築が必要です.

これらの課題に取り組むことで、実世界での言語エージェントの開発が可能となります.また、実世界での評価や研究開発のための基盤を築くことができます.

Q: OpenAgentsは、言語エージェントの実世界での評価をどのように促進しますか?

A: OpenAgentsは、実際のユーザーがエージェントと対話してタスクを達成するプラットフォームを提供することで、言語エージェントの現実世界での評価を支援します.このプラットフォームは、人間とエージェントの相互作用のトレースとユーザーフィードバックを記録し、さらなる評価のために利用します.これにより、エージェントのパフォーマンスを本物のユーザーのニーズを満たすために現実的かつ総合的に評価することが可能となります.既存のベンチマークやプラットフォームと比較して、OpenAgentsはさまざまな本物のユーザーのニーズに取り組む野生の環境を提供します.

Q: OpenAgentsが目指す将来の研究開発の基盤について教えてください.

A: OpenAgentsは、実世界の言語エージェントの将来の研究と開発のための基盤を確立することを目的としています.OpenAgentsは、革新的な言語エージェントを構築し、実世界での評価を容易にするための課題と機会に取り組んでいます.このプラットフォームは、アプリケーションレベルの言語エージェントを構築するためのパイプラインを提供し、カスタマイズ可能な対話システム、マルチモーダル対話、エンドユーザのための自動ワークフロー統合の開発を可能にします.OpenAgentsは、ツールやコンポーネントの統合にも重点を置いており、追加コンポーネント、ツール、UIデザインを統合することで、コミュニティが水平方向に拡張できるようになっています.目標は、新しい技術とモデルに容易に適応する、ユーザ中心のエージェントアプリケーション環境を作成することです.さらに、OpenAgents は、新しい LLM ベースのエージェントアプリケーションを簡単に構築できることを活用し、人間と LM のインタラクションを重視しています.

Q: 日常生活におけるOpenAgentの潜在的な用途は?

A: OpenAgentsの潜在的な応用は、カスタマイズ可能な対話システム、マルチモーダルインタラクション、エンドユーザー向けの自動化ワークフロー統合など、革新的なアプリケーションの構築を可能にします.これらのアプリケーションは、ユーザーセントリックなエージェントアプリケーション環境に独自の利点を提供し、より豊かな環境を創出します.

Video Language Planning

著者:Yilun Du, Mengjiao Yang, Pete Florence, Fei Xia, Ayzaan Wahid, Brian Ichter, Pierre Sermanet, Tianhe Yu, Pieter Abbeel, Joshua B. Tenenbaum, Leslie Kaelbling, Andy Zeng, Jonathan Tompson

発行日:2023年10月16日

最終更新日:2023年10月16日

URL:http://arxiv.org/pdf/2310.10625v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Machine Learning, Robotics

概要:

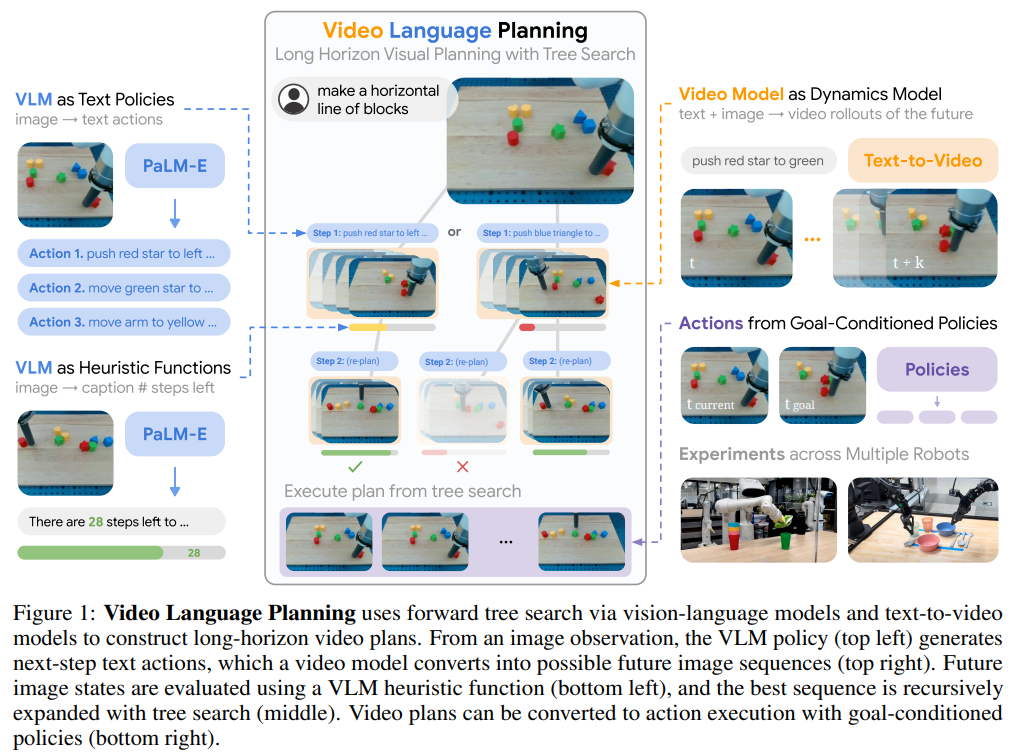

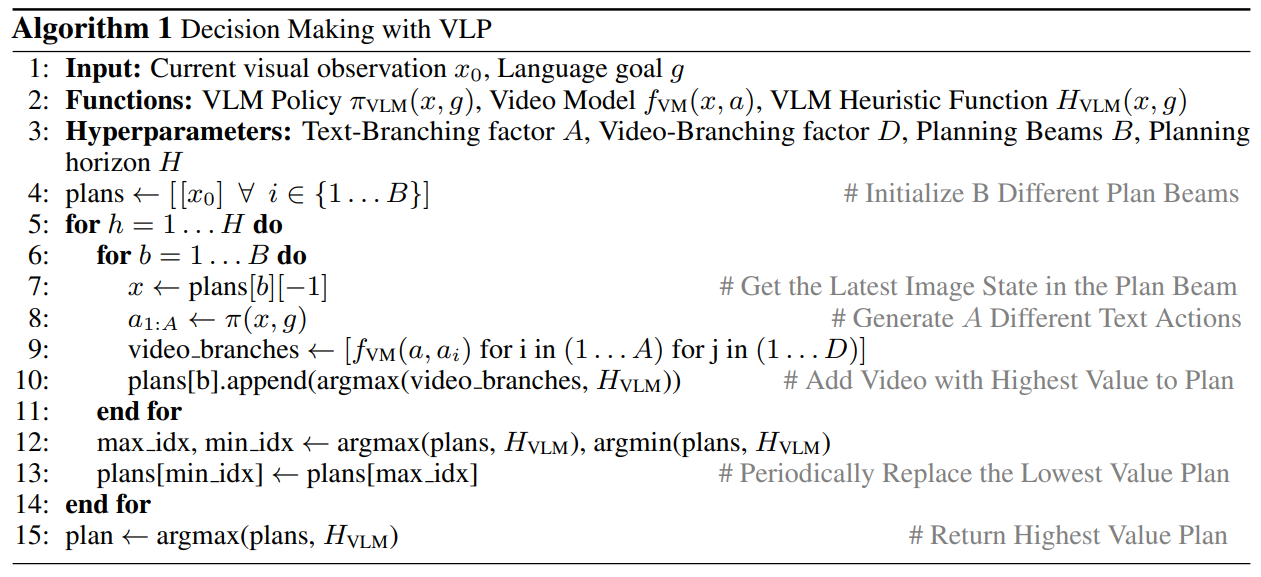

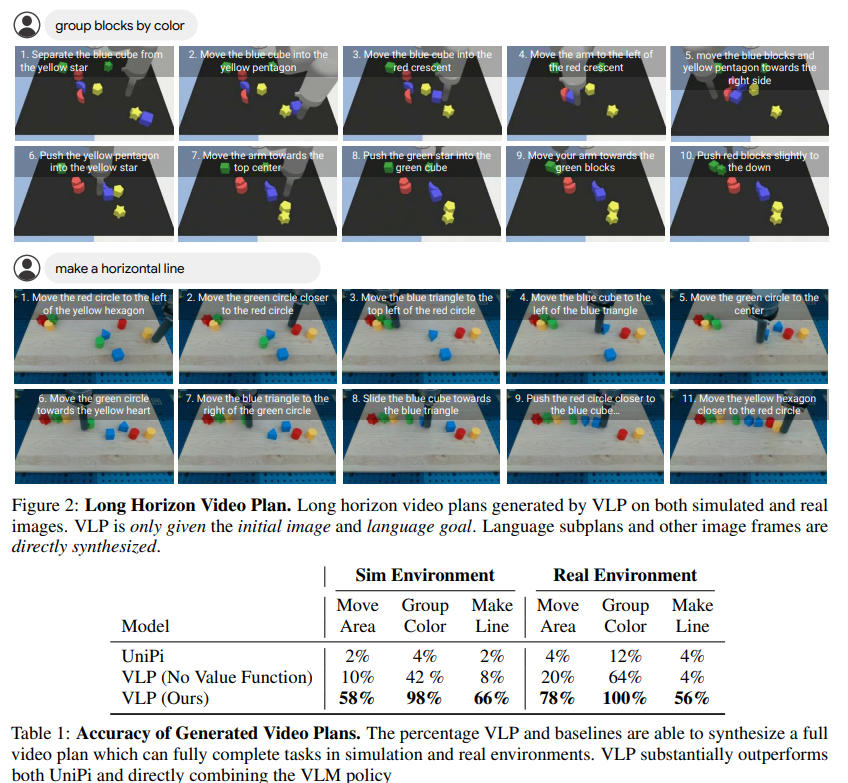

この研究では、インターネット規模のデータで事前学習された大規模生成モデルを活用し、生成されたビデオと言語の領域で複雑な長期タスクの視覚的な計画を可能にすることに興味があります.そのために、ビデオ言語計画(VLP)というアルゴリズムを提案します.VLPは、(i) ビジョン言語モデルをポリシーとバリュー関数の両方として使用するための訓練、および (ii) テキストからビデオへのモデルをダイナミクスモデルとして使用するための訓練からなるツリーサーチ手法で構成されています.VLPは、長期タスクの指示と現在の画像観測を入力とし、最終的なタスクを完了する方法を詳細に説明するマルチモーダル(ビデオと言語)の仕様を提供する長いビデオプランを出力します.また、VLPは異なるロボティクスの領域で長期ビデオプランを合成することができます.例えば、マルチオブジェクトの再配置からマルチカメラのバイアームの巧妙な操作まで.生成されたビデオプランは、生成されたビデオの各中間フレームに基づいてゴール条件付きポリシーを介して実際のロボットアクションに変換することができます.実験では、VLPが効果的であることが示されています.さらに、実験結果では、VLPはシミュレーションおよび実際のロボット(3つのハードウェアプラットフォームを横断して)において、生成されたビデオの各中間フレームごとにゴール条件付きポリシーを適用することで、従来の手法と比較して長期タスクの成功率を大幅に向上させることが示されています.

Q&A:

Q: ビデオ・ランゲージ・プランニング(VLP)の主な目的は何ですか?

A: ビデオ言語計画(VLP)の主な目的は、大規模な生成モデルを利用して、生成されたビデオと言語の領域で複雑な長期目標のための視覚的な計画を可能にすることです.VLPは、ビジョン-言語モデルをポリシーとバリュー関数の両方として使用し、テキスト-ビデオモデルをダイナミクスモデルとして使用するツリーサーチ手法からなるアルゴリズムです.VLPは、長期目標の指示と現在の画像観察を入力とし、最終的なタスクを完了する方法を詳細に説明する長いビデオプランを出力します.

Q: VLPは大規模生成モデルにおける最近の進歩をどのように活用しているのでしょうか?

A: VLPは、プランニング・システムに統合することで、大規模な生成モデルの最近の進歩を活用しています.これらの生成モデルはインターネットスケールのデータで事前に学習され、ロングホライズンビデオプランを生成するために使用されます.視覚言語モデルとテキストからビデオへのモデルを組み合わせることで、VLPは、探索の分岐係数を拡張することにより、推論時に高品質なプランを生成することができます.これにより、プランの品質は計算予算の増加に応じて拡張することができる.さらに、VLPは不完全な言語ラベル付きビデオデータ(短い水平方向のスニペットや、言語ラベルが欠落しているビデオのセグメントが含まれる可能性がある)で学習する利点がある.その利点にもかかわらず、VLPには制限がないわけではなく、これについては本論文のセクション5で述べる.

Q: VLPで使われているツリーサーチの手順について教えてください.

A: VLPの木探索手法は、VLM(Visual Language Model)とビデオモデルを組み合わせて使用します.まず、VLMをポリシーとして使用し、次のステップのテキストアクションを生成します.次に、ビデオモデルをダイナミクスモデルとして使用し、各アクションに対して複数のビデオロールアウトをシミュレートします.そして、再びVLMをヒューリスティック関数として使用し、各ロールアウトのタスクの進捗に対する好ましさを評価します.この手順を再帰的に繰り返すことで、可能なビデオシーケンスの空間での前方木探索を実現します.

Q: VLPにおける視覚言語モデルの役割とは?

A: VLPでは、ビジョン言語モデルはポリシーとバリュー関数の両方として機能します.

Q: VLPでテキストからビデオへのモデルはどのように活用されていますか?

A: VLPはダイナミクス・モデルとしてテキストからビデオへのモデルを利用し、各アクションに対して複数の可能なビデオ展開をシミュレートします.

Q: VLPがビデオプランを生成するには、どのようなインプットが必要ですか?

A: VLPは、ビデオプランを生成するための入力として、ロングホライズンタスク命令と現在の画像観測を必要とする.

Q: VLPは計算予算の増加に応じてどのように拡張されるのか?

A: VLPは、計算予算の増加に伴ってスケーリングすることが示されています.より高い計算予算により、VLPはより高品質な計画を生成することができます.具体的には、探索の枝分かれの数を増やすことで、計画の品質がスケーリングします.

Q: VLPがビデオプランを合成できるロボット工学分野の例を教えてください.

A: VLPは、マルチオブジェクトの再配置やマルチカメラの両腕器用操作など、異なるロボット工学領域にわたるビデオプランを合成することができます.

Q: 生成されたビデオプランは、どのようにして実際のロボットの行動に変換されるのか?

A: 生成されたビデオプランは、目標に応じたポリシーによって実際のロボットアクションに変換されます.

Q: 模擬ロボットと実ロボットで、VLPを先行手法と比較した実験結果は?

A: VLPベースのシステムは、PaLM-EやRT-2のような最先端の代替品と比較して、ロングホライズン命令のタスク完了を達成する可能性が高い.模擬ロボットと実ロボットで行った実験では、VLPがこれらの代替案を実行成功率で上回ることが示されました.さらに、インターネット規模のデータで共同訓練した場合、VLPは新しいオブジェクトや構成に汎化することができた.

Large Language Models for Software Engineering: Survey and Open Problems

著者:Angela Fan, Beliz Gokkaya, Mark Harman, Mitya Lyubarskiy, Shubho Sengupta, Shin Yoo, Jie M. Zhang

発行日:2023年10月05日

最終更新日:2023年10月11日

URL:http://arxiv.org/pdf/2310.03533v3

カテゴリ:Software Engineering

概要:

この論文は、ソフトウェアエンジニアリング(SE)における新興領域である大規模言語モデル(LLMs)についての調査を提供しています.また、ソフトウェアエンジニアが直面する技術的問題にLLMsを適用するためのオープンな研究課題も提示しています.LLMsの新興的な特性は、コーディング、設計、要件、修復、リファクタリング、パフォーマンス改善、ドキュメンテーション、分析など、ソフトウェアエンジニアリングの活動のスペクトラム全体にわたって革新性と創造性をもたらします.しかし、これらの新興的な特性は同時に重要な技術的課題も提起します.例えば、幻覚のような誤った解決策を信頼性を持って排除するための技術が必要です.私たちの調査は、従来のSEとLLMsのハイブリッド技術が信頼性のある、効率的で効果的なLLMベースのSEの開発と展開に果たす重要な役割を明らかにしています.

Q&A:

Q: 論文の主眼は何か?

A: 論文の主な焦点は、大規模言語モデル(LLM)の科学的基盤を確立するための作業の必要性です.

Q: 大規模言語モデル(LLM)をソフトウェア工学(SE)に応用するための未解決の研究課題は何か?

A: Large Language Models (LLMs)のソフトウェアエンジニアリング(SE)への適用におけるオープンな研究課題は、以下のようなものです:

- LLMの信頼性と安定性の向上:LLMは新しい技術であり、信頼性と安定性の向上が求められます.特に、LLMが生成するコードや設計の品質や正確性を向上させるための手法やアルゴリズムの開発が必要です.

- データの品質とプライバシーの管理:LLMは大量のデータを学習するため、データの品質とプライバシーの管理が重要です.データの収集、整理、フィルタリング、匿名化などの技術的な課題があります.

- モデルの解釈可能性と説明性:LLMはブラックボックスモデルであり、その内部の動作や意思決定の根拠を理解することが困難です.モデルの解釈可能性と説明性を向上させるための手法やツールの開発が求められます.

- ドメイン特化のカスタマイズ:LLMは汎用的なモデルであり、特定のソフトウェアエンジニアリングのドメインに適用するためにはカスタマイズが必要です.ドメイン特化のカスタマイズ手法やツールの開発が重要です.

- リソースの効率的な利用:LLMは大量の計算リソースを必要とするため、効率的なリソース管理や分散処理の技術が求められます.

- 倫理的な問題と社会的な影響:LLMの利用には倫理的な問題や社会的な影響が懸念されます.例えば、バイアスの問題やプライバシーの侵害などがあります.これらの問題に対処するためのガイドラインや規制の整備が必要です.

Q: LLMはどのようにしてSE活動に新規性と創造性をもたらすのか?

A: LLMは、その創発的な特性によってSE活動に新規性と創造性をもたらす.これらの創発的特性により、LLMはコーディング、設計、要求、修復、リファクタリング、パフォーマンス改善、文書化、分析など、さまざまなソフトウェアエンジニアリングのタスクに対して、新しく革新的な解決策を生み出すことができる.LLMは、人間のソフトウェア・エンジニアが考えもしなかったような斬新なアイデアやアプローチを考え出すことができる.この創造性と新規性は、ソフトウェア・エンジニアリング・プロセスの効率性と有効性の向上につながります.さらに、LLMには創発的な振る舞いを示す能力があり、その結果、意外で潜在的に有益な結果がもたらされ、パフォーマンス特性に有益な形で大きな影響を与えることができます.

Q: LLMはソフトウェア工学のどの分野に適用できますか?

A: LLMは、コーディング、設計、要件、修復、リファクタリング、パフォーマンス改善、文書化、分析など、ソフトウェア工学のさまざまな分野で応用することができます.

Q: LLMの創発的特性がもたらす技術的課題とは?

A: LLMの新たな特性は、誤った解決策(幻覚)を確実に排除するための技術が必要など、重要な技術的課題を提起しています.信頼性の高い、効率的で効果的なLLMベースのSEの開発と展開には、伝統的なSEにLLMを組み合わせたハイブリッド技術の重要な役割が必要です.さらに、幻覚の問題を抑制し、スケーラビリティを管理するための技術的課題もあります.

Q: LLMによって生成された不正解を確実に排除するためには、どのようなテクニックが必要なのだろうか?

A: LLMには、不正解を確実に排除できるテクニックが必要だ.

Q: LLMベースのSEの開発と展開において、ハイブリッド技術(従来のSE+LLM)はどのような役割を果たすのか?

A: 従来のSEとLLMsのハイブリッド技術は、信頼性のある、効率的で効果的なLLMベースのSEの開発と展開において重要な役割を果たしています.

Q: LLMは、SEにおけるコーディング、設計、要求、修復、リファクタリング、パフォーマンス改善、文書化、分析にどのように活用できるのか?

A: LLMは、その創発的特性を活用することで、SEにおけるコーディング、設計、要求、修復、リファクタリング、性能改善、文書化、分析などに利用することができる.これらの創発的特性は、様々なソフトウェアエンジニアリング活動に新規性と創造性をもたらす.LLMはコードを生成することができ、コード生成、テスト、修復などの作業に役立つ.また、自然言語処理能力を活用することで、要求工学活動を支援することもできる.例えば、LLMは、要求とコードやテストなどの他のエンジニアリング成果物との間のトレーサビリティリンクを特定するのに役立つ.さらに、LLMは、ドキュメント生成、パフォーマンス改善、およびSEにおける分析にも使用できる.しかし、幻覚のようなLLMによって生成された誤った解を確実に排除できる技術を開発することが重要である.伝統的なSEアプローチとLLMを組み合わせたハイブリッド技術は、信頼性が高く、効率的で効果的なLLMベースのSEの開発と展開において極めて重要な役割を果たす.

Q: LLMをSEに活用するメリットは何ですか?

A: SEのLLMにはいくつかの利点がある.第一に、LLMに基づくSEの文献が急速に拡大しているため、関心のある小領域について多くの具体的で包括的な調査を行うことができ、研究文献のギャップや技術的な機会を特定するのに役立つ.第二に、LLMは、自然言語とは異なるソフトウェア特有の性質を利用し、ソフトウェア工学のタスクに特化して調整することができる.これには、現在のところLLMに基づくSE作業のほとんどに欠けている動的情報の組み込みも含まれる.第三に、SEにおけるLLMは、大規模な学習データにアクセスできるため、創発的な振る舞いを示すことができ、潜在的に驚くべき結果をもたらし、パフォーマンス特性を有用な方法で劇的に変化させることができる.全体として、SEにおけるLLMの使用は、ソフトウェア工学研究の進歩に貢献し、この分野における未解決の問題や課題に対処することができる.

Q: LLMがSEとして信頼でき、効率的で、効果的なものになるにはどうすればいいのか?

A: LLMは、幻覚のような技術的課題に対処し、動的情報を取り入れることによって、SEにおいて信頼性が高く、効率的で、効果的なものにすることができる.SEに特化した次世代のLLMは、ソフトウェア工学のタスクに合わせた新しい形のLLMに焦点を当て、ソフトウェア特有の特性を活かすべきである.伝統的なSEアプローチとLLMを組み合わせたハイブリッド技術は、信頼性が高く効果的なLLMベースのSEを開発・展開する上で極めて重要である.さらに、大規模な訓練データのプールとLLMの創発的な振る舞いを利用することで、正しいとは保証されないものの、驚くような有用な結果が得られる可能性がある.