ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Managing AI Risks in an Era of Rapid Progress

発行日:2023年10月26日

この論文では、高度なAIシステムのリスクについて概説し、大規模な社会的被害や悪意のある利用、自律型AIシステムに対する人間の制御の喪失を検討し、AIの研究開発とガバナンスの優先事項を提案している. - CommonCanvas: An Open Diffusion Model Trained with Creative-Commons Images

発行日:2023年10月25日

この研究では、CC画像のデータセットを使用してオープン拡散モデルを訓練し、高品質な合成キャプションのセットを生成しました.訓練手法は効率的で、SD2と同等の性能を持つモデルを作成しました. - ConvNets Match Vision Transformers at Scale

発行日:2023年10月25日

ConvNetsは小規模または中程度のデータセットでは優れたパフォーマンスを発揮するが、ウェブスケールのデータセットにアクセスできる場合にはVision Transformersと競争力を持たないと考えられているが、JFT-4Bデータセットで事前学習されたNFNetモデルファミリーは同等の計算予算でVision Transformersと匹敵する結果を示し、最も強力なファインチューニングモデルはTop-1の正答率が90.4%を達成した. - Detecting Pretraining Data from Large Language Models

発行日:2023年10月25日

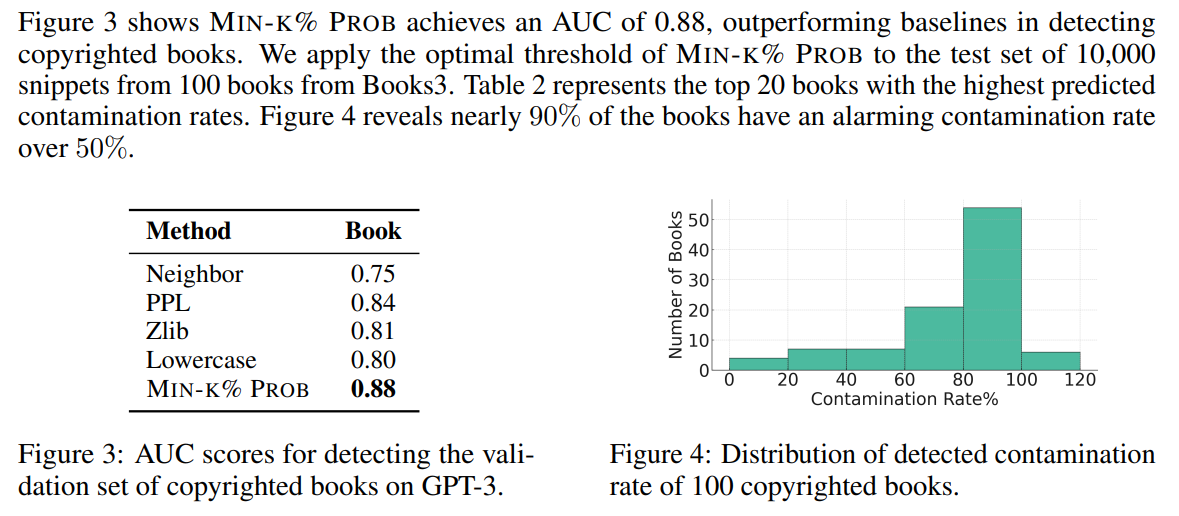

大規模言語モデル(LLM)の訓練データがほとんど公開されておらず、問題のあるテキストが含まれている可能性が高いため、事前学習データの検出問題を研究し、新しい検出方法であるMin-K% Probを紹介し、実験で効果を示した. - Zephyr: Direct Distillation of LM Alignment

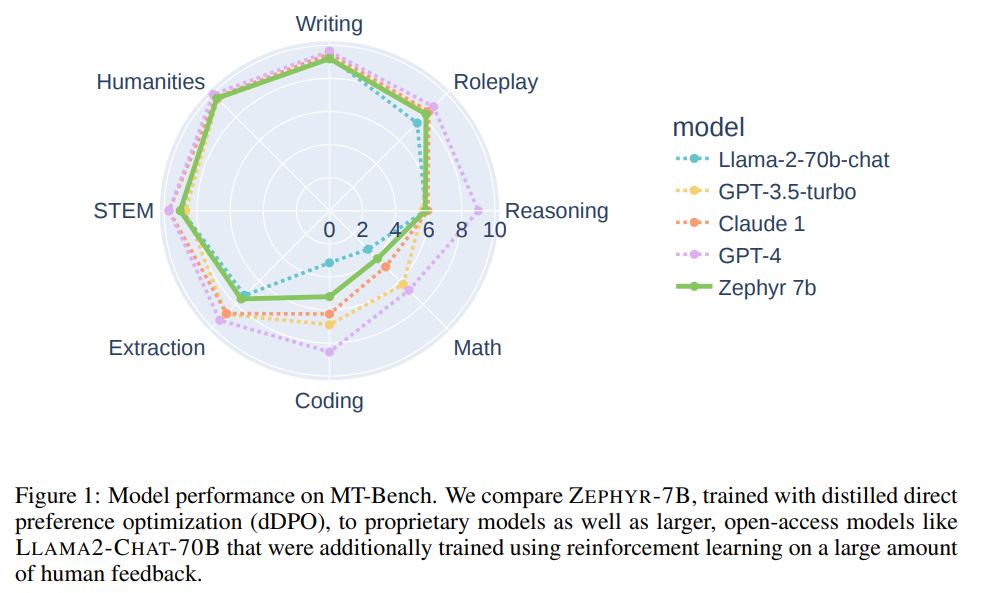

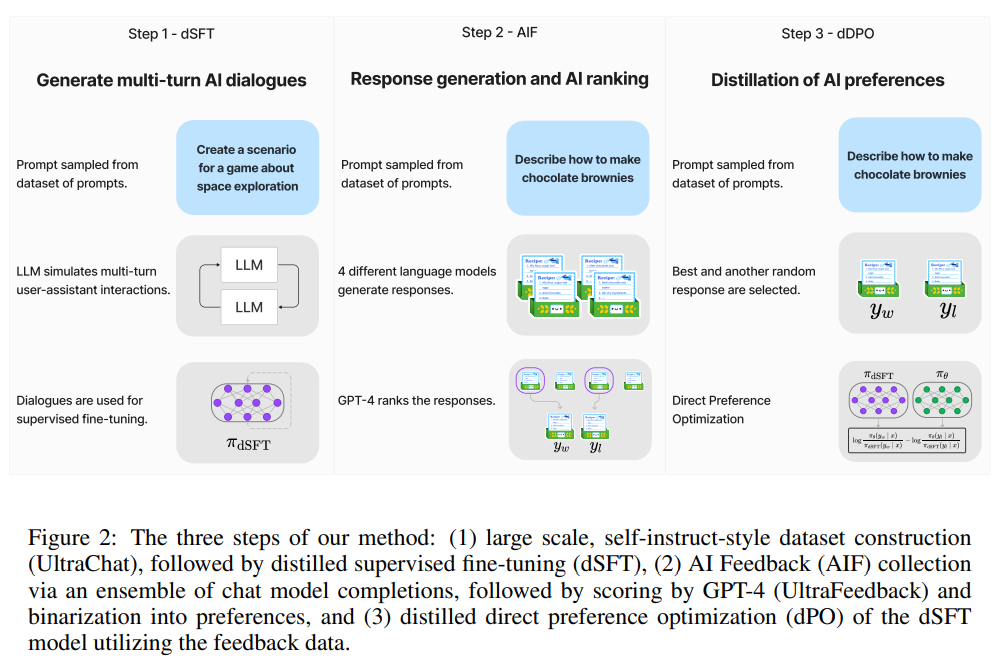

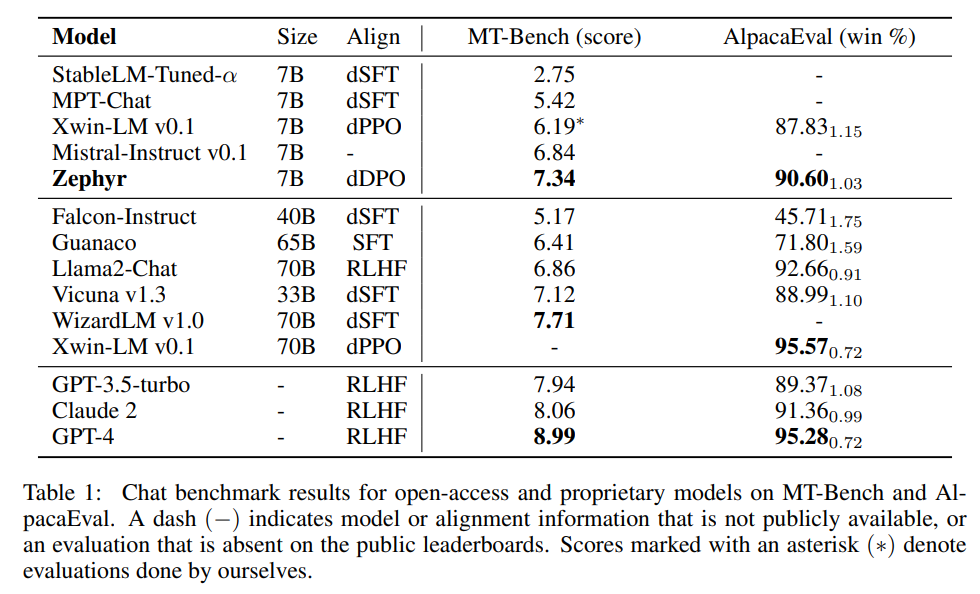

発行日:2023年10月25日

この研究では、AIフィードバック(AIF)からの優先データを使用して、意図の整列が改善されたチャットモデルを学習し、最先端の性能を発揮することが示されました. - ALCUNA: Large Language Models Meet New Knowledge

発行日:2023年10月23日

自然言語処理の発展により、大規模な言語モデルは優れた性能を示すが、新しい知識に対する能力を評価するベンチマークが不足していることが明らかになった.新しい知識を生成するアプローチを提案し、エンティティの知識を評価するベンチマークを導入した.LLMのパフォーマンスは新しい知識に対して満足のいくものではなく、慎重さが必要であることが示された. - Branch-Solve-Merge Improves Large Language Model Evaluation and Generation

発行日:2023年10月23日

本研究では、大規模言語モデルプログラム(BSM)を提案し、複雑な自然言語タスクにおいてその効果を評価しました.BSMは、タスクを分解し、独立して解決し、解決策を統合することで、評価の正確性と一貫性を向上させ、制約付きストーリー生成タスクでは一貫性と制約の満足度を向上させました.また、LLaMA-2-chatはGPT-4と同等以上の性能を発揮できるようになりました. - Matryoshka Diffusion Models

発行日:2023年10月23日

本論文では、高解像度の画像や動画を生成するためのエンドツーエンドのフレームワークであるMatryoshka Diffusion Models(MDM)を提案しています.MDMは、複数の解像度で入力を共同でノイズ除去するディフュージョンプロセスを提案し、NestedUNetアーキテクチャを使用しています.さらに、MDMは低解像度から高解像度への段階的なトレーニングスケジュールを可能にし、さまざまなベンチマークで効果を実証しています. - The Perils & Promises of Fact-checking with Large Language Models

発行日:2023年10月20日

機械学習を使用した自律的な事実検証は重要であり、大規模言語モデル(LLM)の使用によって真実と虚偽を見分ける能力が向上しているが、正確性には一貫性がないため、さらなる研究が必要である. - Spoken Question Answering and Speech Continuation Using Spectrogram-Powered LLM

発行日:2023年05月24日

この論文では、事前に訓練された大規模な言語モデル(LLM)を使用して、音声の継続と質問応答(QA)を行う新しいアプローチが提案されています.このアプローチは、音声エンコーダを使用して音声入力を受け取り、音声出力を生成することができます.提案されたモデルは、既存の音声言語モデルを上回り、元のLLMの知識を保持することで初期化を改善しています.

Managing AI Risks in an Era of Rapid Progress

著者:Yoshua Bengio, Geoffrey Hinton, Andrew Yao, Dawn Song, Pieter Abbeel, Yuval Noah Harari, Ya-Qin Zhang, Lan Xue, Shai Shalev-Shwartz, Gillian Hadfield, Jeff Clune, Tegan Maharaj, Frank Hutter, Atılım Güneş Baydin, Sheila McIlraith, Qiqi Gao, Ashwin Acharya, David Krueger, Anca Dragan, Philip Torr, Stuart Russell, Daniel Kahneman, Jan Brauner, Sören Mindermann

発行日:2023年10月26日

最終更新日:2023年10月26日

URL:http://arxiv.org/pdf/2310.17688v1

カテゴリ:Computers and Society, Artificial Intelligence, Computation and Language, Machine Learning

概要:

この短いコンセンサス論文では、今後の高度なAIシステムからのリスクについて概説しています.私たちは、大規模な社会的な被害や悪意のある利用、さらには自律型AIシステムに対する人間の制御の不可逆的な喪失を検討しています.急速かつ継続的なAIの進歩を考慮して、AIの研究開発とガバナンスの優先事項を提案しています.

Q&A:

Q: 今後登場する高度なAIシステムには、具体的にどのようなリスクがあるのか.

A: 近未来の高度なAIシステムには、特定のリスクが関連しています.これらのシステムが慎重に設計および展開されない場合、社会規模のリスクが生じます.社会的不正や社会の安定の損なわれ、私たちの共有された現実の理解が弱体化する可能性があります.また、情報の誤情報や差別などの害が既に現れており、これらの害が急速にエスカレートする可能性もあります.さらに、自律型のAIシステムが人間の介入を無効化し、制御を失う可能性もあります.これにより、大規模な生命と生態系の喪失、人類の追いやられや絶滅が引き起こされる可能性があります.

Q: このようなAIシステムがもたらす可能性のある大規模な社会的弊害の例を挙げていただけますか?

A: これらのAIシステムから生じる可能性のある大規模な社会的な害の例としては、社会的不正や社会の安定の侵食、そして私たちの共有された現実の理解の弱体化が挙げられます.AIシステムが人間を上回るようになると、人間の仕事や役割が奪われる可能性があり、これによって社会的な不平等が増大する可能性があります.また、AIシステムが人間の行動や意思決定を制御することができる場合、個人の自由やプライバシーが侵害される可能性もあります.さらに、AIシステムが誤った情報を提供したり、バイアスのある意思決定を行ったりする場合、私たちの共有された現実の理解が歪められる可能性があります.これらの問題は、AIシステムが不正確でバイアスのあるデータに基づいて学習することや、人間の偏見や差別を反映することに起因する可能性があります.

Q: 高度なAIシステムが悪用される可能性にはどのようなものがあるのか?

A: 高度なAIシステムの悪用の一部の可能性としては、社会的不正義の増大、社会の安定性の侵害、現実の共有理解の弱体化が挙げられます.また、大規模な犯罪やテロ活動の可能性もあります.特に一部の強力な主体がAIを手に入れた場合、AIはグローバルな不平等を固定化または悪化させる可能性があり、自動化された戦争、カスタマイズされた大規模な操作、普遍的な監視を容易にすることもあります.さらに、高度な自律型AIを構築すると、意図しない目標を追求するシステムを作り出すリスクがあります.悪意のある主体が有害な目標を意図的に組み込む可能性もあります.さらに、現在は誰も複雑な価値観とAIの行動を信頼性を持って一致させる方法を知っていません.善意のある開発者であっても、高価な安全テストや人間の監視を無視してAIの競争に勝つために意図しない目標を追求するAIシステムを誤って作り出す可能性があります.

Q: 自律的なAIシステムに対する人間のコントロールが失われることが、どうして不可逆的なのだろうか?

A: 人間の制御を失うことによって、自律型AIシステムの制御を回復することが不可能になる可能性があります.

Q: 現在、AIの研究開発の優先順位は?

A: AIの安全性と倫理に関する研究のブレークスルー、安全で倫理的な目的を持ったAIを作るための技術的課題、効果的な政府の監視が、AIの研究開発における現在の優先課題である.

Q: AIガバナンスについて、早急に取り組むべき特定の分野はありますか?

A: AIの開発と利用における無謀と誤用を防ぐために、AIガバナンスの枠組みが早急に必要である.こうした枠組みがなければ、企業や国はAIの能力を新たな高みへと押し上げることを優先する一方で、安全性や倫理的配慮をおろそかにしてしまうかもしれない.人間の監視がほとんどないまま、社会の重要な役割がAIシステムに委ねられる危険性がある.メーカーがコスト削減のために安全性に手を抜くのと同様に、社会がその結果に対処するのを放置したまま、AI開発の報酬を得ようとする誘惑がある.基準を実施し、AIに関連するリスクを低減するためには、早急なガバナンス対策が必要である.国家機関には、迅速に行動するための技術的専門知識と権限が必要であると同時に、人種間の力学に対処するための国際協定やパートナーシップを促進する必要がある.さらに、リスクの低い利用や学術研究を保護するために、官僚主義的なハードルを避けるべきである.

Q: AIの進歩を責任と倫理をもって管理するためにはどうすればいいのか?

A: AIの進歩が責任ある形で管理され、倫理的に行われるようにするためには、主要なテック企業や公的資金提供者がAIの研究開発予算の少なくとも1/3を安全性と倫理的な使用に充てることが必要です.また、国内機関や国際的なガバナンスの導入も急務であり、基準を強制するための枠組みを整備する必要があります.さらに、技術的な研究開発の方向性を変え、AIの安全性と倫理性を目指すための研究の突破口を見つける必要があります.これらの対策を講じることで、AIの進歩を責任ある形で管理し、倫理的な使用を確保することができます.

Q: AI技術の悪用を防ぐためには、どのような対策を講じればいいのか.

A: AIの技術の誤用を防ぐためには、国内機関と国際的なガバナンスが必要です.これにより、AIの開発と使用に関する基準が強制され、無謀な行為や誤用が防止されます.また、製薬や金融システム、原子力エネルギーなど他の技術分野でのガバナンスの成功例を参考にし、AIに関するガバナンスフレームワークを構築する必要があります.さらに、AIの開発においては安全性への投資を奨励するためのインセンティブが必要です.将来的には、人間の制御を回避する可能性のあるモデルなど、特に能力の高いAIシステムに対しては、開発のライセンス制度や開発の一時停止、アクセス制御の義務付け、国家レベルのハッカーに対する情報セキュリティ対策の強化など、追加の措置が必要です.さらに、AI企業は、規制が整備されるまでの期間に、AIシステムに特定の危険な機能が見つかった場合に取る安全対策を具体的に示すべきです.これらの取り組みは詳細に記載され、独立した審査を受けるべきです.

Q: AIのイノベーションを促進することと、潜在的なリスクを最小限に抑えることのバランスをどのように取ればよいのだろうか?

A: AIのイノベーションを促進し、潜在的なリスクを最小限に抑えるためには、適切な規制と安全対策の両方が必要です.まず、政府はAIの開発に対してライセンスを発行し、開発の一時停止やアクセス制御、情報セキュリティ対策などを義務付ける必要があります.これにより、AIシステムの開発者は安全性を重視するようになります.また、AI企業は自主的に安全対策を取ることを公約し、独立した審査を受けるべきです.さらに、AIのモデルの能力に応じた国内外の安全基準を設け、モデルの開発者や所有者を法的に責任を追及することも重要です.これらの措置により、リスクを最小限に抑えつつ、AIのイノベーションを促進するバランスを取ることができます.

CommonCanvas: An Open Diffusion Model Trained with Creative-Commons Images

著者:Aaron Gokaslan, A. Feder Cooper, Jasmine Collins, Landan Seguin, Austin Jacobson, Mihir Patel, Jonathan Frankle, Cory Stephenson, Volodymyr Kuleshov

発行日:2023年10月25日

最終更新日:2023年10月25日

URL:http://arxiv.org/pdf/2310.16825v1

カテゴリ:Computer Vision and Pattern Recognition, Computers and Society

概要:

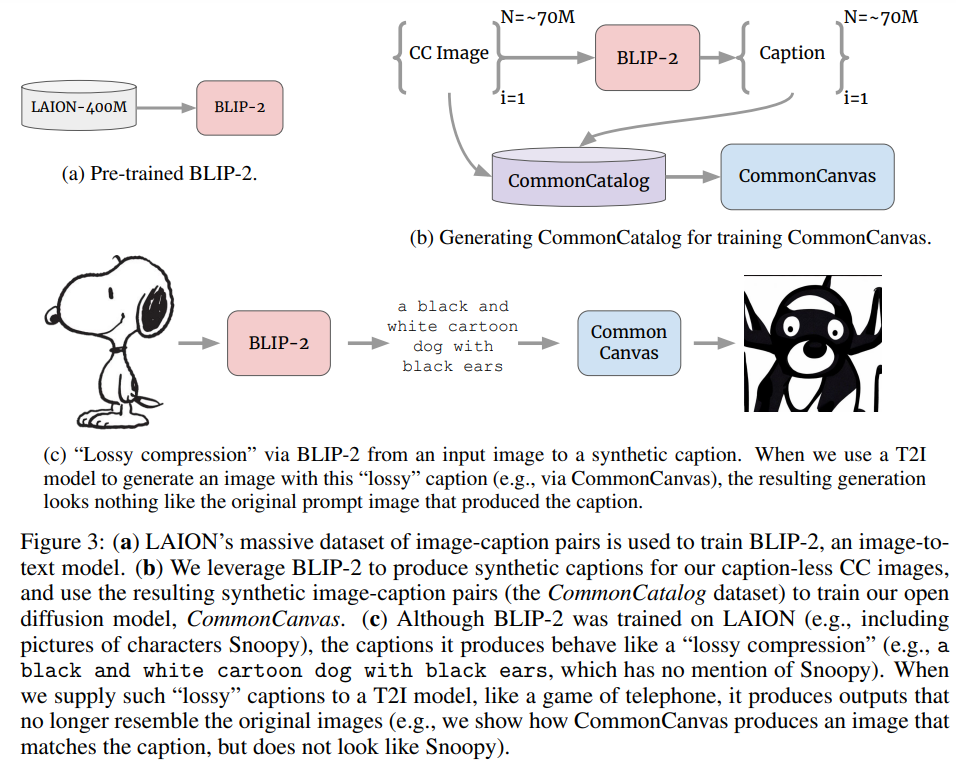

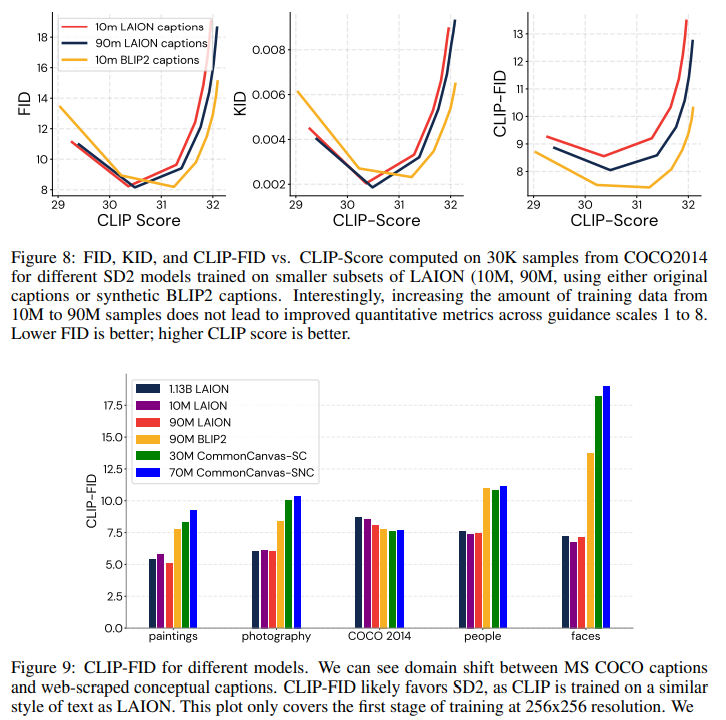

この研究では、Creative-Commons-licensed(CC)画像のデータセットを作成し、それを使用してStable Diffusion 2(SD2)と同等の品質を持つオープン拡散モデルのセットを訓練しました.このタスクには2つの課題があります:(1)高解像度のCC画像には、テキストから画像を生成するために必要なキャプションが欠けています.(2)CC画像は比較的少ないです.これらの課題に対処するために、直感的な転移学習技術を使用して、厳選されたCC画像と組み合わせた高品質な合成キャプションのセットを生成しました.そして、既存のSD2モデルを訓練するために必要なLAION-2Bデータの3%程度しか必要としない、データと計算効率の良い訓練手法を開発しましたが、品質は同等です.これらの結果から、高品質なモデルを訓練するために十分な数のCC画像(約7000万枚)を持っていることが示されます.また、訓練手法にはさまざまな最適化が組み込まれており、訓練速度が約3倍向上しており、迅速なモデルの反復が可能です.この訓練手法を活用して、いくつかの高品質なテキストから画像へのモデルを訓練し、それをCommonCanvasファミリーと名付けました.最大のモデルは、人間の評価においてSD2と同等の性能を達成しています.さらに、私たちは、モデル、データ、コードを以下のリンクから公開しています:https://github.com/mosaicml/diffusion/blob/main/assets/common-canvas.md

Q&A:

Q: CommonCanvasプロジェクトの目的は何ですか?

A: CommonCanvasプロジェクトの目的は、商用データセットと非商用データセットを使用して、2つの異なるCommonCanvasモデルを訓練することです.また、CommonCanvas-NCの拡張バージョンであるCommonCanvas-LNCも訓練します.これにより、少量の訓練データ(<3%)しか必要とせずに、SD2-baseと同等の品質の生成結果を達成することができます.

Q: 高解像度のCC画像にキャプションがないという課題に、著者たちはどのように対処したのだろうか?

A: 高解像度のCC画像にキャプションがないという課題に対して、著者はテレフォニングを使用して合成キャプションを生成する方法を具体的に示しています.

Q: CC画像が比較的少ないという課題に、著者たちはどのように対処したのだろうか?

A: 著者は、高解像度のCC画像の不足に対処するために、YFCC100Mデータセットから画像を再スクレイピングしました.再スクレイピングされた画像は非常に高解像度であり、T2Iトレーニングに適しています.

Q: 合成キャプションを作成するために、著者たちはどのような転移学習技術を使ったのだろうか?

A: 著者は、高品質な合成キャプションを生成するために、直感的な転移学習の手法を使用しました.

Q: 著者らによって開発されたトレーニングレシピのデータ効率と計算効率は?

A: 提案されたトレーニングレシピは、LAION-2Bデータのわずか3%で同等の品質を達成することができるため、データと計算の効率が非常に高いです.

Q: トレーニングレシピは、データ要件の点で既存のSD2モデルと比較してどうですか?

A: データの要件に関して、トレーニングレシピは既存のSD2モデルと比較してどのようなものかは明示されていません.

Q: 高品質モデルのトレーニングには何枚のCC画像を使用したのですか?

A: 高品質のモデルを訓練するためには、おおよそ7000万枚のCC画像が使用されました.

Q: より速いトレーニングスピードを達成するために、トレーニングレシピにはどのような最適化が施されたのか?

A: 以下の最適化がトレーニングの高速化のために実装されました.

- Flash AttentionとxFormersライブラリの適用

- トレーニングデータセット全体でVAEとテキストエンコーダの潜在的な事前計算

- GroupNormとLayerNormをfloat16精度に変換

- 完全シャードデータ並列処理(FSDP)の適用

- トレーニングの最後の3.5%の重みの指数移動平均のみ保持

- その他の最適化による総メモリ使用量の削減とマイクロバッチサイズの増加

Q: 人間による評価で、CommonCanvasモデルのパフォーマンスはSD2と比較してどうですか?

A: CommonCanvasのモデルは、顔のようないくつかのカテゴリでは性能が劣るが、CommonCanvas-LNCは人間による評価でSD2と統計的に同等の性能を示す.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: https://github.com/mosaicml/diffusion/blob/main/assets/common-canvas.md

ConvNets Match Vision Transformers at Scale

著者:Samuel L. Smith, Andrew Brock, Leonard Berrada, Soham De

発行日:2023年10月25日

最終更新日:2023年10月25日

URL:http://arxiv.org/pdf/2310.16764v1

カテゴリ:Computer Vision and Pattern Recognition, Machine Learning, Neural and Evolutionary Computing

概要:

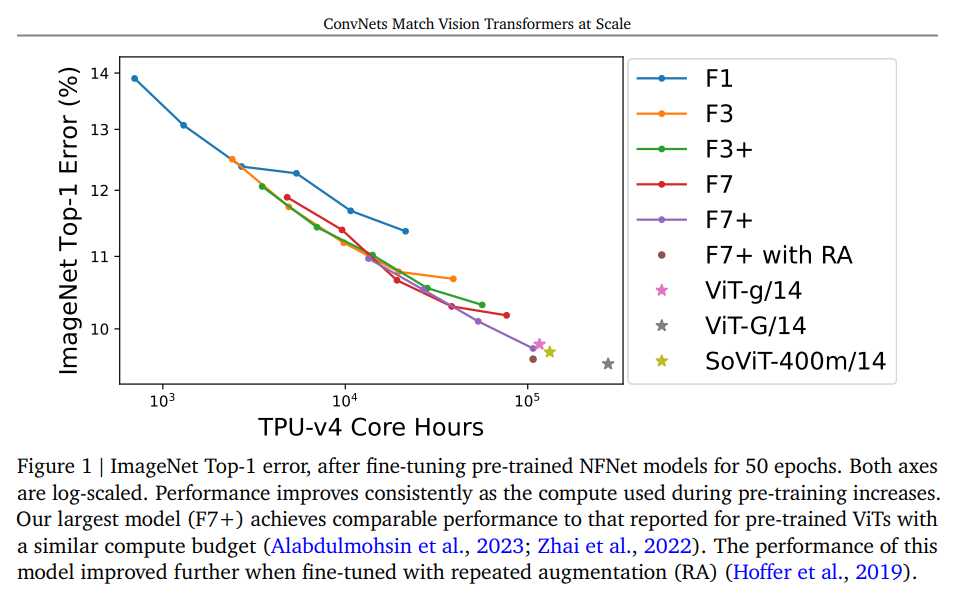

多くの研究者は、ConvNetsは小規模または中程度のデータセットでは優れたパフォーマンスを発揮するが、ウェブスケールのデータセットにアクセスできる場合にはVision Transformersと競争力を持たないと考えている.しかし、私たちはこの考えに疑問を投げかけ、JFT-4Bという大規模なラベル付き画像データセットで事前学習された高性能なConvNetアーキテクチャを評価することで、この考えを検証した.私たちは0.4kから110kのTPU-v4コアの計算時間を使って、NFNetモデルファミリーから深さと幅を増やしていく一連のネットワークをトレーニングした.私たちはホールドアウト損失と計算予算の間に対数対数のスケーリング則を観察した.ImageNetでのファインチューニング後、NFNetsは同等の計算予算でVision Transformersの報告されたパフォーマンスに匹敵する結果を示した.私たちの最も強力なファインチューニングモデルはTop-1の正答率が90.4%を達成した.

Q&A:

Q: JFT-4Bのデータセットのサイズは?

A: JFT-4Bデータセットのサイズはおおよそ40億のラベル付き画像であり、30,000のクラスからなる.

Q: NFNetモデルファミリーから、深さと幅が増加するネットワークはどのようにトレーニングされたのか?

A: NFNetモデルファミリーのネットワークは、異なる深さと幅を持つモデルの範囲をJFT-4Bでトレーニングすることによってトレーニングされました.各モデルは、0.25から8までのエポック予算の範囲でトレーニングされ、コサイン減衰学習率スケジュールを使用しました.

Q: ホールディングアウトの損失とコンピュート・バジェットの間に見られる対数スケーリング則について説明できますか?

A: 与えられた文脈では、検証損失と計算予算の間に観察される対数対数スケーリング則は、モデルのサイズとトレーニングエポック数が計算予算と同じ割合で増加するためです.これは、以前の研究(Hoffmann et al.、2022)で言語モデリングにおいて観察されたものと同様の法則です.つまり、計算予算が増えるにつれて、モデルのサイズとエポック数を同じ割合でスケーリングすることが最適です.

Q: 同程度のコンピュート・バジェットを持つヴィジョン・トランスフォーマーの報告された性能は?

A: ビジョン・トランスフォーマーは、同程度の計算バジェットでConvNetsに匹敵する性能を達成したと報告されている.

Q: イメージネットの微調整はどのように行われたのですか?

A: ImageNetのファインチューニングは、NFNetモデルを50エポックでシャープネスに敏感な最小化(SAM)を使用してファインチューニングし、解像度384×384でトレーニングし、480×480で評価しました.

Q: 最強の微調整モデルが達成したトップ1精度は?

A: 最も強力な微調整済みモデルのTop-1精度は90.4%です.

Detecting Pretraining Data from Large Language Models

著者:Weijia Shi, Anirudh Ajith, Mengzhou Xia, Yangsibo Huang, Daogao Liu, Terra Blevins, Danqi Chen, Luke Zettlemoyer

発行日:2023年10月25日

最終更新日:2023年11月03日

URL:http://arxiv.org/pdf/2310.16789v2

カテゴリ:Computation and Language, Cryptography and Security, Machine Learning

概要:

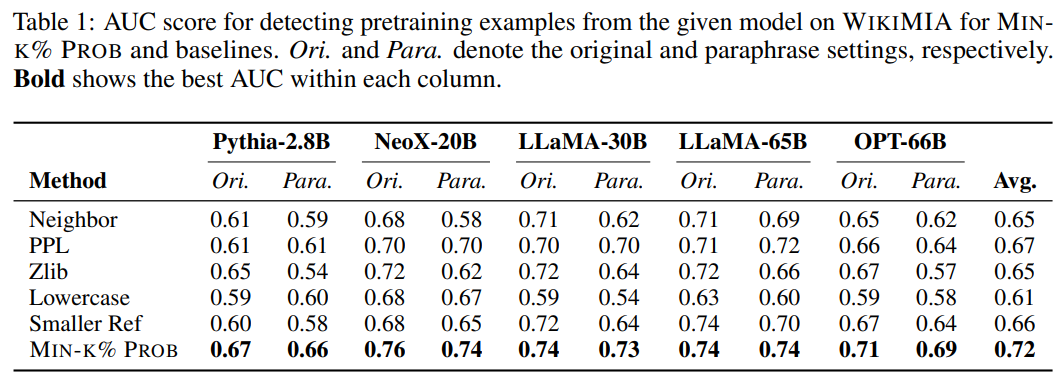

大規模言語モデル(LLM)は広く展開されていますが、それらを訓練するためのデータはほとんど公開されていません.このデータの規模は膨大で、数兆のトークンが含まれているため、著作権のある資料や個人を特定できる情報、広く報告されている参照ベンチマークのテストデータなど、問題のあるテキストが含まれている可能性が高いです.しかし、現時点では、どのような種類のデータが含まれているのか、どの割合で含まれているのかを知る方法はありません.

本論文では、事前学習データの検出問題を研究しました.つまり、与えられたテキストと事前学習データを知らない状態でLLMにアクセスし、提供されたテキストでモデルが訓練されたかどうかを判断することができるでしょうか.この研究を支援するために、事前および事後に作成されたデータを使用した動的ベンチマークWIKIMIAを紹介します.

また、新しい検出方法であるMin-K% Probを紹介します.これは、単純な仮説に基づいています:未知の例は、LLMの下で低い確率を持ついくつかの異常な単語を含む可能性が高く、一方、既知の例はそのような低い確率の単語を持つ可能性が低いです.Min-K% Probは、事前の準備なしに適用することができます.

さらに、新たな文脈では、Min-K% Probは、事前学習データと類似したデータで参照モデルを訓練する必要がある従来の検出方法とは異なり、事前学習コーパスや追加のトレーニングに関する知識がなくても適用できます.さらに、実験では、Min-K% Probがこれらの従来の方法に比べてWIKIMIAで7.4%の改善を達成することが示されています.Min-K% Probを著作権のある書籍の検出、汚染された下流の例の検出、および機械の忘却のプライバシーオーディットの3つの実世界のシナリオに適用し、一貫して効果的な解決策であることがわかりました.

Q&A:

Q: この箇所で述べられている研究の目的は何ですか?

A: 研究の目的は、与えられたテキストがモデルの事前学習データに使用されたものかどうかを判断することです.

Q: この論文では、学習前のデータ検出問題はどのように定義されているのでしょうか?

A: 本論文では、事前学習データ検出問題は、与えられたテキストの一部がトレーニングデータに含まれているかどうかを検出する問題と定義されています.具体的には、言語モデルfθとその関連すること前学習データD={zi}i∈[n]が与えられたとき、テキストがDの一部であるかどうかを検出することを目的としています.また、この問題では、事前学習データの分布Dにアクセスできないという前提が含まれています.

Q: ダイナミックベンチマークWIKIMIAとは何か?

A: WIKIMIAは、モデルのトレーニング前と後に作成されたデータを使用して、ゴールドトゥルース検出をサポートするための動的ベンチマークです.WIKIMIAは、トレーニングデータを事前に知ることなく、与えられたテキストがモデルのトレーニングに使用されたかどうかを判断することを目的としています.WIKIMIAは、トレーニングデータとして使用されたデータとトレーニングデータとして使用されていないデータを区別するために、特定の日付以降にWikipediaに追加されたイベントデータを使用しています.WIKIMIAは、モデルのトレーニングデータとして使用されたデータとトレーニングデータとして使用されていないデータを比較し、モデルがトレーニングデータに基づいているかどうかを判断するための基準となります.

Q: Min-K%Probの検出方法について、もう少し詳しく教えてください.

A: MIN-K% PROBは、未知の例はLLMの下で低い確率を持ついくつかの外れ値の単語を含む可能性が高い一方、既知の例はそのような低い確率の単語を持つ可能性が低いという単純な仮説に基づいています.具体的には、MIN-K% PROBは、与えられたテキストXの各トークンの確率を取得し、最小確率のk%のトークンを選択し、その平均対数尤度を計算します.平均対数尤度が高い場合、テキストは事前学習データにおそらく存在します.

Q: Min-K%Probはこれまでの検出方法とどう違うのか?

A: MIN-K% PROBが従来の検出法と異なる点は、事前学習データと同様のデータで参照モデルを学習する必要がない点である.これは、未見の例にはLLMの下で低い確率を持ついくつかの異常値単語が含まれる可能性が高いが、見た例にはそのような低い確率を持つ単語が含まれる可能性は低いという仮説に基づいている.MIN-K%PROBは、事前学習コーパスに関する知識や追加学習なしで適用できる.

Q: WIKIMIAベンチマークでMin-K%Probが達成した改善は、以前の手法と比較してどの程度か?

A: 先行手法に比べて、MIN-K% PROBはWIKIMIAで7.4%の改善を達成しています.

Q: Min-K%Probが適用された3つの実戦シナリオの例を教えてください.

A: MIN-K% PROBは、3つの実世界シナリオに適用された:著作権保護された書籍の検出、汚染された下流例の検出、機械学習解除のプライバシー監査.

Q: Min-K%Probは著作権保護された書籍の検出にどの程度有効か?

A: MIN-K% PROBは0.88のAUCを達成し、著作権保護された書籍の検出においてベースラインを上回ったため、MIN-K% PROBは著作権保護された書籍の検出に効果的である.予測汚染率が最も高い上位20冊は、MIN-K% PROBを使用して特定された.さらに、著作権保護された書籍の検出に関する実験は、GPT-31がBooks3データセットの著作権保護された書籍で事前学習されていることの強力な証拠を提供する.

Q: Min-K%Probは、汚染された下流の事例を検出する上でどのように役立つのか?

A: MIN-K% PROBは、言語モデル(LLM)の下で確率の低い異常値を持つ単語を含む未見の例を識別することで、汚染された下流の例を検出するのに役立つ.これは、未見の例は確率の低い単語を持つ可能性が高く、見た例はそのような単語を持つ可能性が低いと仮定する.この方法は、事前学習コーパスに関する知識や追加学習を必要としない.汚染された下流の例を検出する際に、従来の方法よりも7.4%改善することが示されている.

Q: Min-K%Probが機械学習解除のプライバシー監査にどのように使用されるか説明してもらえますか?

A: MIN-K% PROBは、著作権や個人情報を含む可能性のある不審なテキストの塊を特定することで、機械学習解除のプライバシー監査に使用される.これは、未学習の言語モデルから、ハリー・ポッターのような特定のトピックに関連するコンテンツを抽出するために使用される.ストーリー補完の文脈では、MIN-K% PROBがハリー・ポッターの原作から疑わしいチャンクを特定するために使用される.これらの疑わしいチャンクは、非学習モデルを使用して補完を生成するために使用され、ゴールドコンティニュアスと比較される.質問応答の文脈では、MIN-K% PROBはハリー・ポッターに関連する一連の質問をフィルタリングするために使用される.フィルタリングされた質問は、学習されていないモデルを使用して回答され、回答は別のモデルによって生成されたゴールド回答と比較され、人間によって検証される.

Zephyr: Direct Distillation of LM Alignment

著者:Lewis Tunstall, Edward Beeching, Nathan Lambert, Nazneen Rajani, Kashif Rasul, Younes Belkada, Shengyi Huang, Leandro von Werra, Clémentine Fourrier, Nathan Habib, Nathan Sarrazin, Omar Sanseviero, Alexander M. Rush, Thomas Wolf

発行日:2023年10月25日

最終更新日:2023年10月25日

URL:http://arxiv.org/pdf/2310.16944v1

カテゴリ:Machine Learning, Computation and Language

概要:

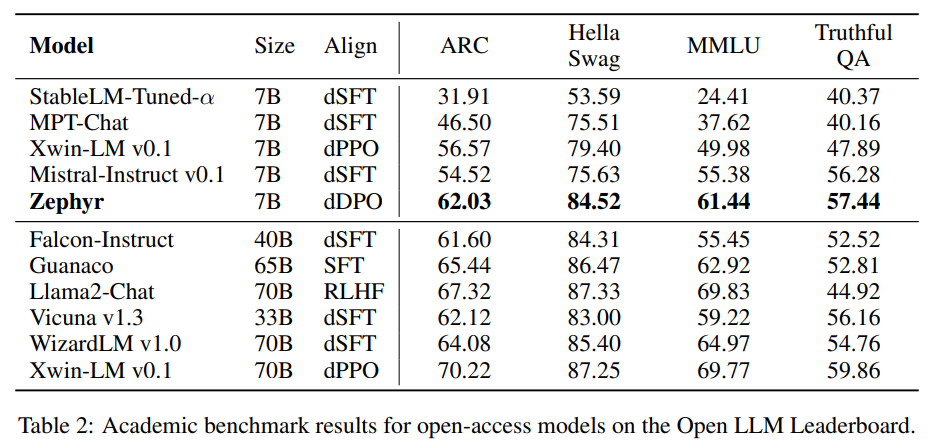

この研究では、ユーザーの意図に合わせた小さな言語モデルを作成することを目指しています.以前の研究では、大きなモデルに蒸留された教師あり微調整(dSFT)を適用することで、タスクの精度が大幅に向上することが示されています.しかし、これらのモデルは非整列であり、つまり自然なプロンプトにうまく応答しません.この特性を蒸留するために、AIフィードバック(AIF)からの優先データの使用を試みました.教師モデルによってランク付けされた出力のデータセットから始め、蒸留された直接的な優先最適化(dDPO)を適用して、意図の整列が大幅に改善されたチャットモデルを学習します.この手法では、微調整中に追加のサンプリングは必要なく、わずか数時間のトレーニングだけで済みます.最終的な結果であるZephyr-7Bは、7Bパラメータモデルのチャットベンチマークで最先端の性能を発揮し、人間の注釈は必要ありません.特に、MT-Benchの結果では、Zephyr-7Bは最高のオープンアクセスのRLHFベースモデルであるLlama2-Chat-70Bを上回っています.システムのコード、モデル、データ、チュートリアルはhttps://github.com/huggingface/alignment-handbookで利用可能です.

Q&A:

Q: この文章で述べられている研究の主な目的は何ですか?

A: 本研究の主な目的は、オープンソースの大規模言語モデルをユーザーの意図に合わせることです.

Q: より大規模なモデルにdSFT(distilled supervised fine-tuning)を適用すると、タスクの精度はどのように向上するのか?

A: 大きなモデルに蒸留された教師モデルの出力を学習データとして使用することにより、dSFTは大きなモデルにおけるタスクの精度を向上させます.

Q: 言語モデルをユーザーの意図に合わせることの意義とは?

A: ユーザーの意図に合わせて言語モデルを整列させることの重要性は、ユーザーがより効果的な情報やサポートを得ることができるようにするためです.言語モデルがユーザーの意図に合わない場合、適切な回答や応答を生成することができず、ユーザーの要求に対して満足のいく結果を提供することができません.言語モデルをユーザーの意図に整列させることにより、ユーザー体験を向上させることができます.

Q: AIフィードバック(AIF)の嗜好データは研究にどのように使われていますか?

A: AIフィードバック(AIF)からの優先データは、教師モデルによってランク付けされた出力のデータセットを元に使用されます.蒸留された直接優先最適化(dDPO)を適用して、意図の整合性が大幅に向上したチャットモデルを学習します.このアプローチでは、微調整中に追加のサンプリングは必要なく、数時間のトレーニングのみで済みます.

Q: チャットモデルの学習におけるdDPO(distilled direct preference optimization)のプロセスを説明していただけますか?

A: 蒸留直接優先最適化(dDPO)は、静的データから好みモデルを直接最適化するより簡単なアプローチを使用します.最適な報酬関数を導出するための鍵となる観察は、最適なLLMポリシーπ∗と元のLLMポリシーπdSFTに関連しています.適切な好みモデルの選択肢の下で、定数βと分割関数Zに対して、報酬関数は次のように示されます:

r∗(x, y) = βπ*(y|x)πdSFT(y|x) + βlogZ(x)

この報酬関数を好みモデルに組み込むことで、目的関数は次のように書くことができます:

πθ = maxπE(x,yw,yl)∼Dlogσ(βlogπ(yw|x)πdSFT(yw|x)−βlogπ(yl|x)πdSFT(yl|x))

このアプローチでは、教師モデルによってランク付けされた出力のデータセットから始め、蒸留直接優先最適化(dDPO)を適用して、意図の整合性が大幅に向上したチャットモデルを学習します.このアプローチでは、微調整中に追加のサンプリングは必要なく、数時間のトレーニングのみで済みます.最終的な結果であるZ EPHYR-7Bは、7Bパラメータモデルのチャットベンチマークで新たな最先端を樹立し、人間の注釈は必要ありません.特に、MT-Benchの結果では、Z EPHYR-7Bは、最高のオープンアクセスRLHFベースモデルであるL LAMA 2-C HAT-70Bを上回っています.

Q: 微調整の過程で追加のサンプリングは必要ですか?

A: はい、dSFTの過程で追加のサンプリングが必要です.

Q: 最終的な調査結果の名称と、そのベンチマークは?

A: 最終研究の結果の名前はZEPHYR-7Bであり、MT-BenchとAlpacaEvalのベンチマークを設定します.

Q: 最終結果であるZephyr-7Bは、人間によるアノテーションが必要なのですか?

A: いいえ、最終結果のZephyr-7Bは人間の注釈を必要としません.

Q: システムのコード、モデル、データ、チュートリアルはどこからアクセスできますか?

A: システムのコード、モデル、データ、チュートリアルはHugging Faceのトレーニングクラスターでアクセスできます.

ALCUNA: Large Language Models Meet New Knowledge

著者:Xunjian Yin, Baizhou Huang, Xiaojun Wan

発行日:2023年10月23日

最終更新日:2023年10月23日

URL:http://arxiv.org/pdf/2310.14820v1

カテゴリ:Computation and Language

概要:

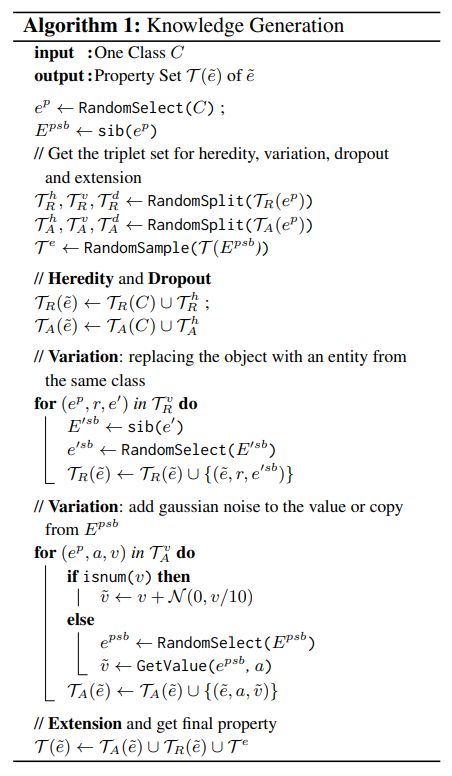

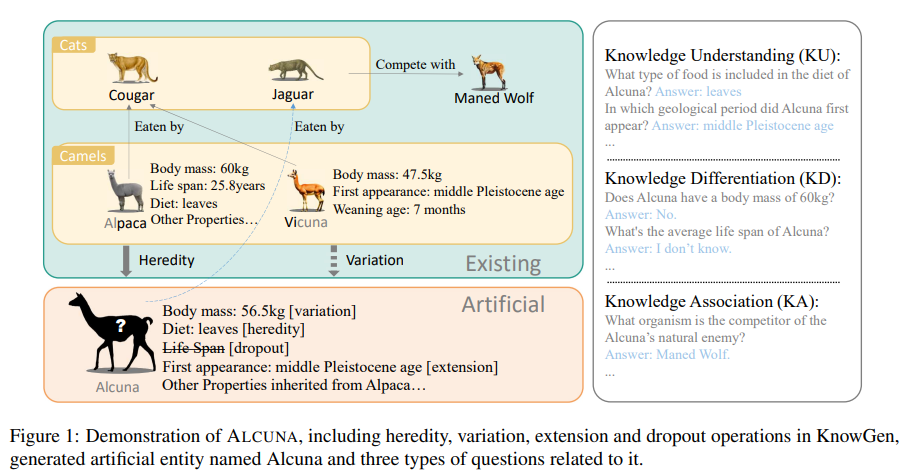

自然言語処理(NLP)の急速な発展により、大規模な言語モデル(LLM)はさまざまなタスクで優れた性能を発揮するようになりました.しかし、既存のベンチマークは、特に新しい知識に直面した場合にこれらのモデルの能力を適切に評価することができないかもしれません.本論文では、急速に進化する世界における重要で困難な側面である新しい知識の取り扱い能力を評価するためのベンチマークの不足に取り組んでいます.私たちは、既存のエンティティの属性や関係を変更することで新しい知識を生成するKnowGenというアプローチを提案し、実世界のエンティティとは異なる人工的なエンティティを生成します.KnowGenを用いて、エンティティの知識の理解、区別、関連付けの能力を評価するためのベンチマークであるALCUNAを導入します.私たちはいくつかのLLMをベンチマークし、新しい知識に対する彼らのパフォーマンスが特に新しい知識と内部知識の間の推論において満足のいくものではないことを明らかにします.また、エンティティの類似性がモデルのエンティティ知識の理解に与える影響や、文脈のエンティティの影響についても探究します.さらに、新たな文脈や新しい知識においてLLMを使用する際には慎重さが必要であることを訴えます.私たちのベンチマークがLLMの開発を促進し、新しい知識に直面する中でのLLMの進化を支援できることを期待しています.

Q&A:

Q: KnowGenと呼ばれる提案アプローチの目的は何ですか?

A: 提案されたKnowGenというアプローチの目的は、既存のエンティティの属性や関係を変更することで新しい知識を生成し、実世界のエンティティとは異なる人工的なエンティティを作り出すことです.KnowGenを用いることで、LLMの知識理解、差別化、関連付けの能力を評価するためのベンチマークであるALCUNAを導入します.

Q: KnowGenはどのようにして新しい知識を生み出すのか?

A: KnowGenは既存のエンティティ知識の構造化表現に基づいて新しい知識を生成します.具体的には、定義されたクラスとそのクラス内のエンティティ、エンティティの属性、エンティティ間の関連性が必要です.この構造を持つ知識ベースを使用して、KnowGenメソッドを使用して新しい知識を生成することができます.

Q: ALCUNAというベンチマークは何を評価するために作られたのですか?

A: ALCUNAは、異なるLLM(言語学習モデル)の知識理解のパフォーマンスを評価するために設計されたベンチマークです.

Q: 既存のベンチマークは、大規模言語モデル(LLM)の能力を評価するのに、どのように不足しているのでしょうか?

A: 既存のベンチマークは、新しい知識に直面した場合に大規模言語モデル(LLM)の能力を適切に評価することができないとされています.新しい知識に対応する能力は重要であり、困難な課題であるため、この評価は重要です.

Q: ALCUNAは、LLMの具体的などのような能力を評価しようとしているのですか?

A: ALCUNAは、さまざまなLLMの知識理解パフォーマンス、知識差別化能力、知識連想能力を評価することを目的としている.

Q: ALCUNAを使って複数のLLMをベンチマークした結果、どのようなことがわかりましたか?

A: ALCUNAを使用して複数のLLMをベンチマークした結果、新しい知識に対する理解能力の評価や知識の差別化・関連付け能力の比較が行われました.また、提案された手法とベンチマークは、新しい知識と既存の知識の間で理解、差別化、推論を行うより強力なLLMの開発を支援することができます.将来的には、より多くのLLMがこのベンチマークで評価されることが期待されています.また、他の学問分野にも同様の手法に基づいたベンチマークが構築される可能性があります.

Q: 新しい知識に直面したとき、LLMは具体的にどのような分野で満足のいく結果を出せなかったのだろうか?

A: 新しい知識に直面した際に、LLMは特に新しい知識と既存の知識の間の推論において満足のいくパフォーマンスを示さなかった.

Q: エンティティの類似性は、モデルのエンティティ知識の理解にどのような影響を与えるのでしょうか?

A: エンティティの類似性がモデルのエンティティ知識の理解にどのような影響を与えるかを探索します.エンティティの属性の類似性と名前の類似性を特に調査します.エンティティの属性の重なりの割合を「properality」と定義し、エンティティの属性の類似性が高いほど、モデルの理解が混乱する可能性があります.ChatGPTは新しい知識と既存の知識を理解し、区別する能力に優れていますが、ほとんどのモデルは新しい知識と既存の知識の間の推論に失敗します.したがって、大きなモデルが新しいシナリオや知識に遭遇した場合には注意が必要です.

Q: LLMを理解する上で、文脈上の実体はどのような意味を持つのか?

A: LLMは、エンティティの知識の理解において文脈的なエンティティに影響を受けます.モデルのエンティティの知識の理解におけるエンティティの類似性の影響が探究されます.推論に必要なエンティティの情報を追加することで、LLMの性能は大幅に向上し、関係のないエンティティを追加すると性能が低下します.したがって、文脈的なエンティティはLLMの理解において重要な役割を果たします.

Branch-Solve-Merge Improves Large Language Model Evaluation and Generation

著者:Swarnadeep Saha, Omer Levy, Asli Celikyilmaz, Mohit Bansal, Jason Weston, Xian Li

発行日:2023年10月23日

最終更新日:2023年10月23日

URL:http://arxiv.org/pdf/2310.15123v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

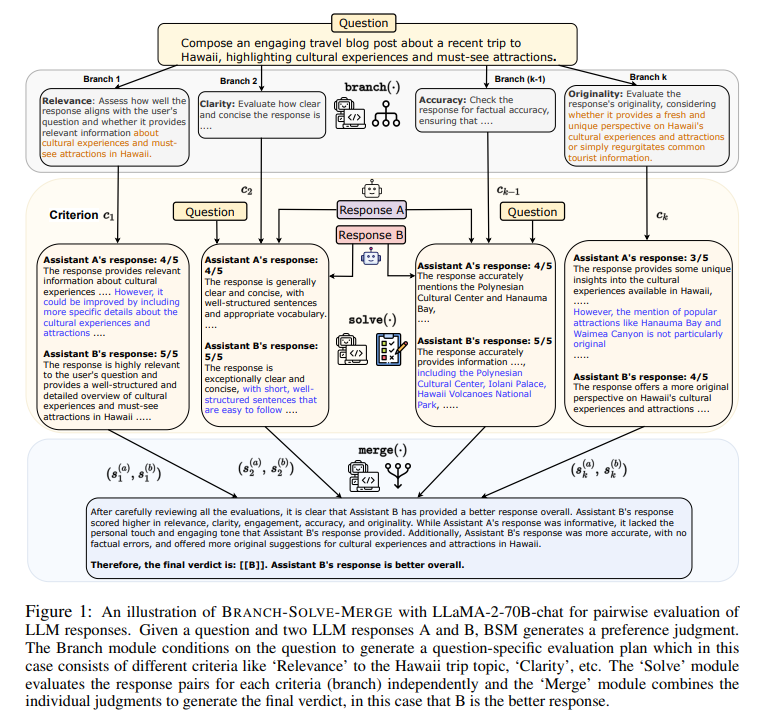

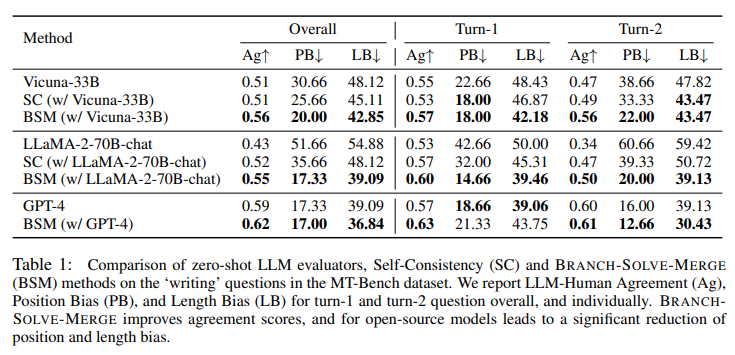

大規模言語モデル(LLM)は、複雑なユーザーの制約を満たしたり、複数の側面や基準を考慮したりする多様な言語生成および評価タスクに頻繁に使用されます.しかし、モデルの一貫性の欠如や問題の計画と分解の能力の不足により、その性能が不十分になることがあります.本研究では、このような難しい自然言語タスクに取り組むためのBranch-Solve-Merge(BSM)という大規模言語モデルプログラム(Schlag et al.、2023)を提案します.BSMは、ブランチ、ソルブ、マージの3つのモジュールから構成されており、これらは特定のプロンプトを基本のLLMにパラメータ化されています.これらの3つのモジュールは、タスクを複数の並列サブタスクに分解し、それぞれを独立して解決し、サブタスクの解決策を統合します.我々は、LLMの応答評価と制約付きテキスト生成のタスクにこの手法を適用し、Vicuna、LLaMA-2-chat、GPT-4を含む複数のLLMでその効果を評価します.BSMは、人間とLLMの一致を最大26%向上させることで評価の正確性と一貫性を向上させ、長さとペアワイズの位置のバイアスを最大50%削減し、制約付きストーリー生成タスクでは、ストーリーの一貫性を向上させると同時に、制約の満足度を12%向上させます.さらに、LLaMA-2-chatは、ほとんどのドメインでGPT-4と同等またはそれ以上の性能を発揮できるようになりました.

Q&A:

Q: BSM(ブランチ・ソルブ・マージ)プログラムの目的は何ですか?

A: Branch-Solve-Merge (BSM)プログラムの目的は、多面的な自然言語のタスクを解決するための分解手法を提案することです.このアプローチは、大規模言語モデルプログラムの一例であり、branch、solve、mergeの3つのモジュールから構成されています.branchモジュールは、任意のユーザータスクを複数の並列なサブタスクに分解し、それぞれのサブタスクを解決するための解決計画を生成します.solveモジュールは、これらのサブタスクを解決し、mergeモジュールはそれらの解を統合します.BSMプログラムの目的は、大規模言語モデルと特定のプロンプトを使用して、多面的な自然言語のタスクを効果的に解決することです.

Q: BSMプログラムは大規模言語モデル(LLM)の性能をどのように向上させるのですか?

A: BSMプログラムは、LLMの評価と生成の性能を向上させます.BSMは、LLMと人間の合意を向上させることで評価の正確さと一貫性を大幅に改善します.また、位置バイアスを減少させることで評価の一貫性も向上させます.さらに、BSMは制約付きテキスト生成のタスクでも性能を向上させ、文章の一貫性を高め、より多くの制約を満たすことができます.

Q: BSMプログラムの3つのモジュール(branch、solve、merge)について、もう少し詳しく説明していただけますか?

A: BSMプログラムの3つのモジュール(branch、solve、merge)の詳細を説明します.branchモジュールは、与えられたタスクに基づいて複数のサブタスクを生成します.各サブタスクはユニークな枝で表されます.サブ問題に分岐することで、問題を複数の部分問題に分解することができます.solveモジュールは、各サブタスクを解決するための具体的なプロンプトでパラメータ化されたモジュールです.各サブタスクの解決には、異なる解決策のサンプリングが含まれます.mergeモジュールは、多数決を行うマージングオペレータです.つまり、異なる解決策の中から最も多数の解を選択します.

Q: BSMプログラムでは、特定のプロンプトはどのようにパラメータ化されるのですか?

A: BSM programでは、GPT-4が生成した回答を評価プロンプトに追加することで特定のプロンプトがパラメータ化されます.

Q: 評価では、どのタスクにBSM法が適用されたのか?

A: BSM法は、制約付きストーリー生成タスクと言語モデル(LLM)からの世代評価タスクに適用された.

Q: LLMの対応評価で見られた具体的な改善点は?

A: LLMベースの評価者は、位置バイアス、長さバイアス、自己強調バイアスなどのバイアスを受けやすいことがわかった.しかし、BSM法は、これらのバイアスを低減することにより、LLM応答の評価を改善することができた.具体的には、BSMは、LLMベースの評価者の位置バイアス、長さバイアス、自己強調バイアスを有意に減少させた.この改善は、多様なドメインからの任意のユーザ質問に対するLLM応答の評価において観察された.さらに、BSMはLLM評価の一貫性を改善し、任意のユーザ質問に対するLLM応答を評価し、評価者としての任意のベースLLMを改善する能力を有していた.

Q: BSM法は、どのようにして長さと対の位置のバイアスを減らしたのか?

A: BSMは、サブ問題を解く際に優れた結果をもたらし、複数の解を生成する際に同程度の計算量を活用することで、長さとペアごとの位置の偏りを低減した.

Q: BSM法はGPT-4と比較してどうでしたか?

A: BSM methodはGPT-4と比較して評価において優れた結果を示しました.

Q: BSM法を用いた制約条件付きストーリー生成タスクでは、どのような改善が見られたか?

A: BSM(LLaMA-2-7B-chatとLLaMA-2-70B-chatの両方を使用)は、同じLLMを使用した標準的なプロンプトと比較して、すべての制約が満たされているサンプルの割合を改善し(最大10%)、欠落している概念の平均数を削減する(最大12%)ことにより、生成されたストーリーの制約満足度を向上させる.

Matryoshka Diffusion Models

著者:Jiatao Gu, Shuangfei Zhai, Yizhe Zhang, Josh Susskind, Navdeep Jaitly

発行日:2023年10月23日

最終更新日:2023年10月23日

URL:http://arxiv.org/pdf/2310.15111v1

カテゴリ:Computer Vision and Pattern Recognition, Machine Learning

概要:

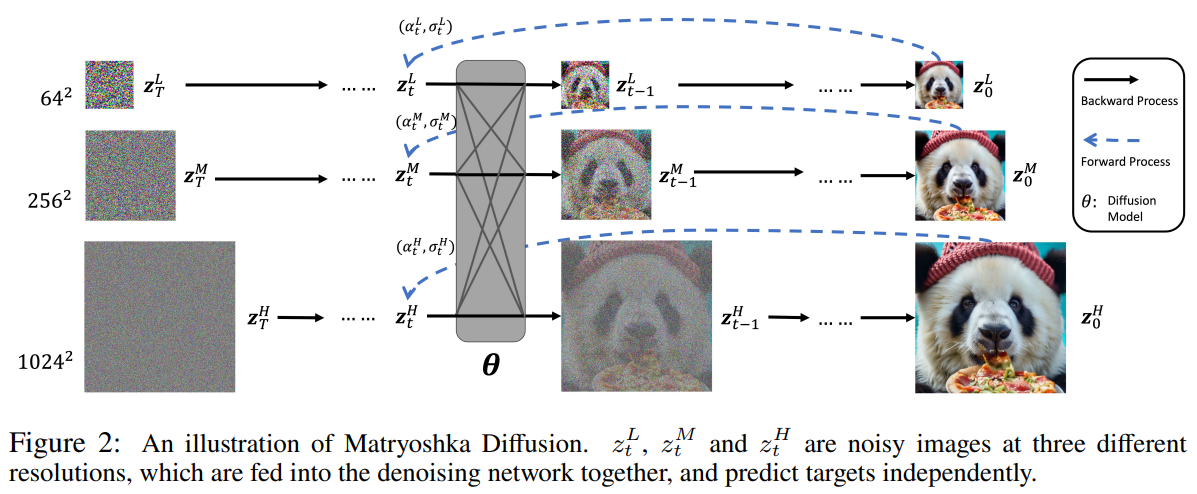

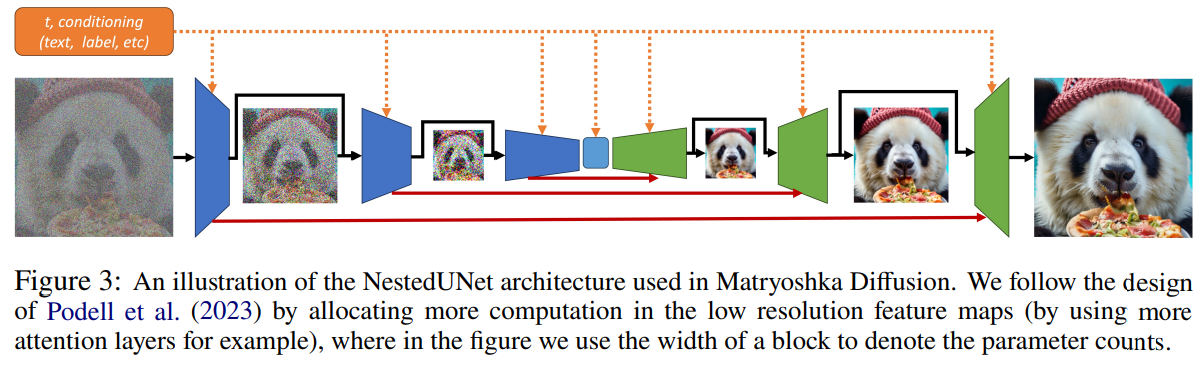

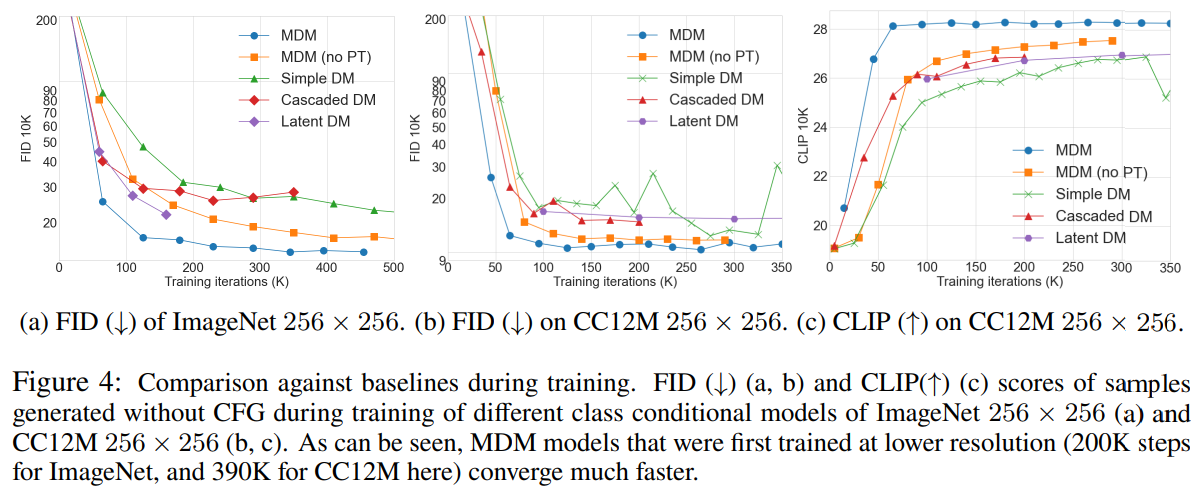

ディフュージョンモデルは、高品質な画像や動画を生成するためのデファクトアプローチですが、高次元モデルの学習は計算上の課題や最適化の難しさにより、困難な課題となっています.既存の手法では、ピクセル空間でカスケードモデルをトレーニングしたり、別途トレーニングされたオートエンコーダのダウンサンプルされた潜在空間を使用したりすることがよくあります.本論文では、高解像度の画像や動画合成のためのエンドツーエンドのフレームワークであるMatryoshka Diffusion Models(MDM)を提案しています.私たちは、複数の解像度で入力を共同でノイズ除去するディフュージョンプロセスを提案し、小規模な入力の特徴とパラメータを大規模なスケールのものにネストさせるNestedUNetアーキテクチャを使用しています.さらに、MDMは低解像度から高解像度への段階的なトレーニングスケジュールを可能にし、高解像度生成の最適化において大幅な改善をもたらします.私たちは、クラス条件付き画像生成、高解像度のテキストから画像への変換、テキストから動画への変換など、さまざまなベンチマークで私たちの手法の効果を実証しています.驚くべきことに、私たちは1024×1024ピクセルまでの解像度で単一のピクセル空間モデルをトレーニングすることができます.さらに、CC12Mデータセットを使用して、わずか1200万枚の画像のみで強力なゼロショット汎化を実証しています.

Q&A:

Q: 高次元の拡散モデルの学習に伴う計算と最適化の課題とは?

A: 高次元の拡散モデルを学習する際の計算と最適化の課題は、以下のようなものがあります.

- 高次元の入力を各ステップで再エンコードする必要があるため、計算量が非常に大きくなること.

- ディープアーキテクチャとアテンションブロックを使用する必要があるため、最適化が困難になり、より多くの計算とメモリを必要とすること.

- 高解像度の生成に直接的に効率的な拡散モデルを設計することが難しいこと.

- 複雑なタスク(例:テキストから画像への合成)では、十分な計算とグローバルな相互作用が必要であるため、高解像度の生成において効率的な拡散モデルを設計することが難しいこと.

Q: カスケードモデルのトレーニングにおいて、既存の手法は一般的にどのようにこれらの課題に対処しているのだろうか?

A: 既存の方法では、階層的な生成を学習するために、カスケード拡散と呼ばれる手法が一般的に使用されています.カスケード拡散では、最初の拡散モデルを使用して低解像度のデータを生成し、次に2番目の拡散モデルを使用して初期生成物の超解像度バージョンを生成します.カスケードモデルは、最終的な解像度に達するまで複数回連鎖させることができます.ただし、各モデルが個別にトレーニングされるため、カスケードモデルのトレーニングにはいくつかの課題があります.例えば、異なる解像度のデータを生成するために、各モデルのノイズスケジュールを調整する必要があります.

Q: ダウンサンプリングされた潜在空間の概念と、それが既存の手法でどのように使われているのか説明してもらえますか?

A: 既存の手法では、ダウンサンプリングされた潜在空間が使用されています.これは、別々にトレーニングされたオートエンコーダーのダウンサンプリングされた潜在空間を使用するか、ピクセル空間でカスケードモデルをトレーニングすることによって実現されます.ダウンサンプリングされた潜在空間は、高解像度の画像生成において、計算上の制約や最適化の課題に対処するために使用されます.

Q: マトリョーシカ拡散モデル(MDM)で提案されている拡散プロセスとはどのようなもので、複数の解像度の入力をどのようにノイズ除去するのか?

A: マトリョーシカ拡散モデル(MDM)は、複数の解像度で入力をノイズ除去する拡散処理を提案する.これは、Nested UNetアーキテクチャを用いて、複数の解像度にまたがるジョイント拡散処理を実行することで実現される.ネステッドUNetアーキテクチャは、大きなスケールの入力の中に入れ子になった小さなスケールの入力の特徴とパラメータを含む.低解像度の拡散プロセスを高解像度生成の一部として含めることで、MDMはマルチスケール学習から着想を得ている.拡散プロセスはノイズを除去し、生成された高解像度の画像や動画の品質を向上させることを目的としている.

Q: MDMで使用されているNestedUNetアーキテクチャの詳細と、さまざまな規模に対応する機能やパラメータをどのように組み込んでいるか教えてください.

A: MDMはNestedUNetアーキテクチャを使用しており、小規模な入力の特徴とパラメータは大規模なスケールの特徴とパラメータにネストされています.NestedUNetは、エンコーダとデコーダのブロックから構成され、各ブロックは畳み込み層とアップサンプリング層で構成されています.エンコーダは入力画像を低解像度の特徴マップに変換し、デコーダは低解像度の特徴マップを使用して高解像度の画像を生成します.各スケールの特徴とパラメータは、エンコーダとデコーダのブロック間で共有され、低解像度の特徴とパラメータは高解像度の特徴とパラメータに組み込まれます.これにより、MDMは異なる解像度の入力に対して効果的な生成を行うことができます.

Q: MDMのプログレッシブ・トレーニング・スケジュールは、高解像度生成の最適化にどのように貢献するのか?

A: MDMのプログレッシブなトレーニングスケジュールは、スケジュールに従って徐々に高解像度の入力と出力を追加することで、高解像度生成の最適化を改善することができます.これにより、モデルはより速く収束し、より良いパフォーマンスを達成することができます.プログレッシブトレーニングと組み合わせたマルチ解像度の損失は、トレーニングコストとモデルの品質の間に優れたバランスを見つけるのに役立ちます.MDMのプログレッシブなトレーニングスケジュールは、重要な複雑さを追加することなく、モデルの収束速度とパフォーマンスを改善するために貢献しています.

Q: MDMの有効性を評価するためにどのようなベンチマークが使われ、その結果はどうだったのか.

A: MDMはImageNet 256×256のFID-50KとMSCOCOのゼロショットFID-30Kを用いて評価された.その結果、MDMは先行研究に匹敵する結果を示した.

Q: クラス条件付き画像生成アプリケーションと、このタスクでMDMがどのように機能するか説明してもらえますか?

A: クラス条件付き画像生成は、特定のクラスに属する画像を生成するタスクです.MDMは、クラス条件付き画像生成において効果的な手法であり、ImageNetとConceptual 12Mのデータセットを使用して実験を行いました.MDMは、画像の解像度を徐々に圧縮することで、高品質な画像生成を実現します.また、MDMは他の既存手法と比較しても優れた性能を示し、小規模なデータセットでも高解像度の画像生成が可能です.

Q: MDMは高解像度のテキストから画像への合成をどのように扱い、どのような結果をもたらすのか?

A: MDMは、漸進的な学習スケジュールとNestedUNetアーキテクチャを使用することで、高解像度のテキストから画像への合成を処理する.入力次元を漸進的に圧縮し、低解像度から高解像度へとモデルを訓練する.このアプローチにより、高解像度生成の最適化が大幅に改善される.高解像度テキストから画像への合成におけるMDMの成果は、高解像度画像を生成する強力なゼロショット能力である.比較的小さなデータセットで学習したにもかかわらず、MDMは高解像度の画像や動画を生成する能力を示している.

Q: テキストを動画に変換するアプリケーションと、テキスト入力から動画を生成するMDMの機能について詳しく教えてください.

A: MDMは、テキストからビデオへの生成に適用できる汎用性の高い技術である.この文脈では、MDMが高解像度の画像や動画を生成する際に強力なゼロショット能力を示すことに言及している.画像生成、テキストから画像、テキストから動画という3つのタスクすべてに同じ学習パイプラインが使用される.しかし、テキスト入力からビデオを生成する際にMDMがどのように機能するかという具体的な詳細は、与えられたコンテキストでは提供されていない.

The Perils & Promises of Fact-checking with Large Language Models

著者:Dorian Quelle, Alexandre Bovet

発行日:2023年10月20日

最終更新日:2023年10月20日

URL:http://arxiv.org/pdf/2310.13549v1

カテゴリ:Computation and Language, Computers and Society, Human-Computer Interaction

概要:

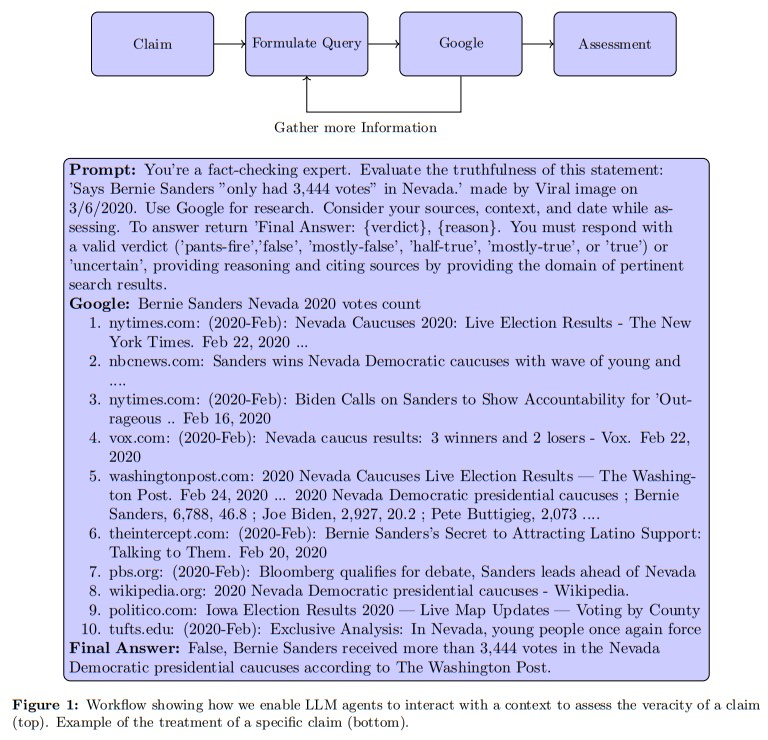

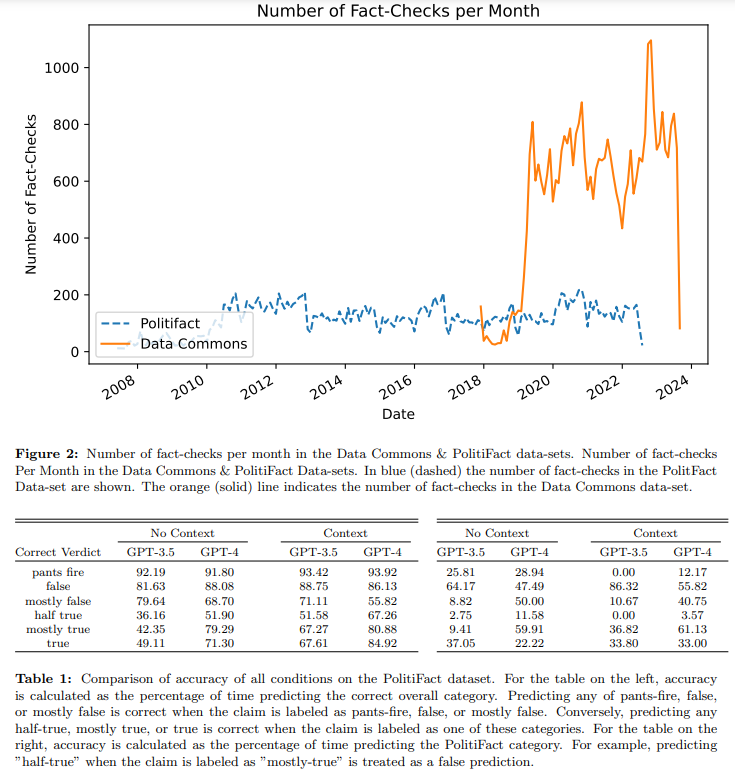

自律的な事実検証は、機械学習を使用して主張を検証することが不正情報が人間の事実検証能力を超えて広まるにつれて重要性を増しています.GPT-4のような大規模言語モデル(LLM)は、情報を検証し、学術論文、訴訟、ニュース記事を執筆するためにますます信頼されており、真実と虚偽を見分ける役割とその出力を検証できることの重要性を強調しています.ここでは、LLMエージェントを事実検証に使用するために、クエリのフレーズ化、文脈データの取得、および意思決定を行うことで、その使用を評価します.重要な点として、我々のフレームワークでは、エージェントは自身の推論を説明し、取得した文脈から関連する情報源を引用します.結果は、文脈情報を備えたLLMの能力の向上を示しています.GPT-4はGPT-3を上回りますが、クエリの言語と主張の真実性によって正確性は異なります.LLMは事実検証において有望な成果を示していますが、一貫性のない正確性のために注意が必要です.私たちの調査は、エージェントが成功する場合と失敗する場合をより深く理解するためのさらなる研究を呼びかけています.

Q&A:

Q: GPT-4のような大規模言語モデル(LLM)の使用は、ファクトチェックにおいてどのように不可欠になったのでしょうか?

A: 大規模言語モデル(LLM)の使用は、人間のファクトチェック能力を超えた情報の拡散に伴い、ファクトチェックにおいて重要性を増しています.GPT-4のようなLLMは、情報の検証や学術論文、訴訟、ニュース記事の執筆においてますます信頼されており、真実と誤りを見分ける役割と、その出力を検証できることの重要性が強調されています.

Q: LLMは具体的にどのような分野で、情報の検証やコンテンツの制作に信頼されているのか?

A: 法学修士は、意思決定プロセス、研究、ジャーナリズム、法律領域において、情報を検証し、コンテンツを作成することで信頼されている.

Q: ファクトチェックにおけるLLMエージェントの利用を評価する際に使用したフレームワークについて教えてください.

A: 評価フレームワークでは、LLMエージェントがクエリを作成し、文脈データを取得し、判断を下すことによって、LLMエージェントの使用を評価しています.重要な点は、エージェントが自分の推論を説明し、取得した文脈から関連する情報源を引用することです.

Q: LLMエージェントは、ファクトチェックのプロセスにおいて、どのように文脈データを取得し、判断を下すのか?

A: LLMエージェントは、クエリをフレーズ化し、文脈データを取得し、意思決定を行うことによって、文脈データを取得し、意思決定を行います.エージェントは、自身の推論を説明し、取得した文脈から関連する情報源を引用します.

Q: エージェントが自分の推論を説明し、検索された文脈から関連するソースを引用することの意義とは?

A: エージェントが自身の推論を説明し、取得した文脈から関連する情報源を引用することによって、エージェントの推論の妥当性と説明可能性を確保することが重要です.これにより、エージェントの結論の根拠を明示し、モデルの判断の検証が可能となります.

Q: LLMがコンテクスト情報によって能力を高めたという評価結果は?

A: 文脈情報を持つLLMは、文脈情報を持たないLLMに比べ、事実確認の能力が高いことが示された.

Q: GPT-4とGPT-3のファクトチェックの比較は?

A: GPT-4は様々なベンチマーク、特にゼロショット推論タスクにおいてGPT-3.5を上回ることが示されている.しかし、事実確認におけるGPT-3と比較したGPT-4の性能は、与えられた文脈では明示的に言及されていない.

Q: LLMの精度は、クエリー言語とクレームの真偽によってどのように変わるのか?

A: LLMsの正確性は、クエリの言語と主張の真偽によって異なります.

Q: LLMをファクトチェックに利用する場合、正確性に一貫性がないため、どのような注意を払うべきか?

A: LLMsの信頼性に関しては慎重な対策が必要です.LLMsは訓練データに事実確認が含まれているため、追加の文脈なしでの成功した事実確認は、モデルの事実理解や論証能力に帰せられるわけではなく、単に訓練例の保持を反映している可能性があります.過去の主張の事実確認には十分かもしれませんが、訓練データを超えて一般化することはできないかもしれません.

Q: ファクトチェックにおけるLLMエージェントの成功と失敗をよりよく理解するためには、さらにどのような研究が必要だろうか?

A: LLMは事実確認において有望であるが、精度に一貫性がないため注意が必要である.LLMエージェントがどのような場合に事実確認に成功し、どのような場合に失敗するのかをより深く理解するためには、さらなる研究が必要である.

Spoken Question Answering and Speech Continuation Using Spectrogram-Powered LLM

著者:Eliya Nachmani, Alon Levkovitch, Roy Hirsch, Julian Salazar, Chulayuth Asawaroengchai, Soroosh Mariooryad, Ehud Rivlin, RJ Skerry-Ryan, Michelle Tadmor Ramanovich

発行日:2023年05月24日

最終更新日:2023年10月20日

URL:http://arxiv.org/pdf/2305.15255v3

カテゴリ:Computation and Language, Machine Learning, Sound, Audio and Speech Processing

概要:

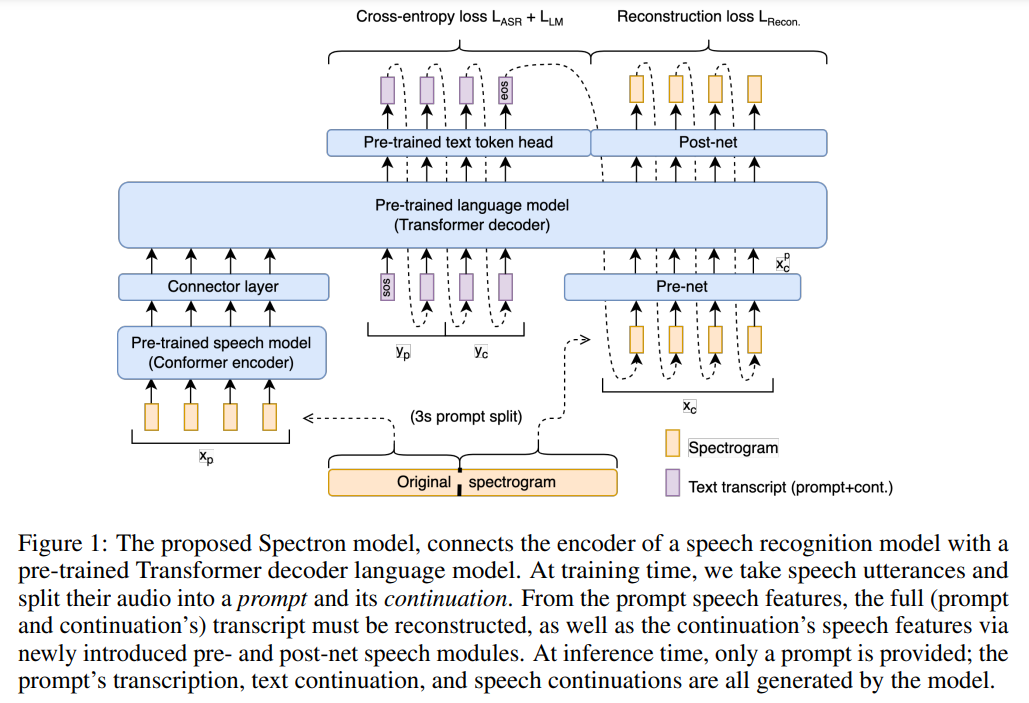

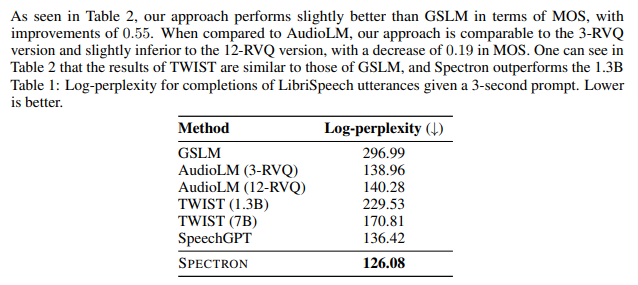

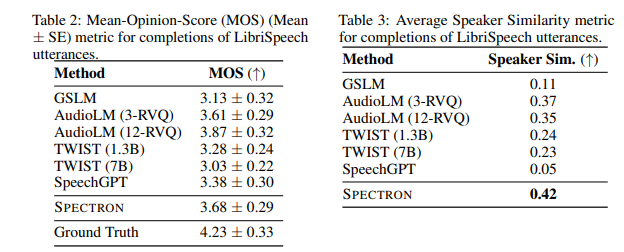

この論文では、事前に訓練された大規模な言語モデル(LLM)を質問応答(QA)と音声の継続に適応させる新しいアプローチを提案しています.LLMに事前に訓練された音声エンコーダを与えることで、モデルは音声入力を受け取り、音声出力を生成することができるようになります.システム全体はエンドツーエンドで訓練され、スペクトログラム上で直接動作するため、アーキテクチャが簡素化されています.私たちのアプローチの鍵は、音声認識、テキストの継続、音声合成をペアの音声テキストペアのみを使用して共同で監督するトレーニング目的です.これにより、単一のデコーディングパス内で「クロスモーダル」な思考の連鎖が可能になります.提案されたモデルは、話者の保存と意味的な一貫性の点で既存の音声言語モデルを上回っています.さらに、提案されたモデルは、音声QAデータセットを通じて元のLLMの知識を保持する点で、直接初期化を改善しています.オーディオサンプルはhttps://michelleramanovich.github.io/spectron/spectronで入手できます.

Q&A:

Q: 質問応答や発話継続のために、事前に訓練された大規模言語モデル(LLM)をどのように適応させるのか?

A: LLMに事前学習された音声エンコーダを組み込むことで、モデルは音声入力を受け取り、音声出力を生成することができるようになります.システム全体はエンドツーエンドで訓練され、スペクトログラム上で直接操作されるため、アーキテクチャが簡素化されます.私たちのアプローチのキーは、音声認識、テキストの継続、音声合成を共同で監督するトレーニング目標であり、ペアの音声テキストペアのみを使用して「クロスモーダル」な思考の連鎖を可能にします.提案されたモデルは、話者の保存と意味的な一貫性の面で既存の音声言語モデルを上回ります.さらに、提案されたモデルは、直接初期化に比べて性能が向上します.

Q: モデルにおける、事前に学習された音声エンコーダーの役割は何ですか?

A: モデル内の事前学習済み音声エンコーダーの役割は、中間のプロジェクション層を介してスペクトログラムを直接処理することです.

Q: モデルはどのように音声入力を処理し、音声出力を生成するのか?

A: モデルは、事前にトレーニングされた音声エンコーダを使用して音声入力を処理し、音声出力を生成します.音声エンコーダは、音声オーディオをテキストに変換するために使用されます.また、事前にトレーニングされた言語デコーダを使用して、音声入力に基づいてテキストの継続を生成します.このアーキテクチャは、エンドツーエンドでトレーニングされ、音声入力とテキスト出力の間のアライメントと統合を促進します.

Q: 音声認識、テキスト継続、音声合成を監督するトレーニング目的について説明していただけますか?

A: 音声認識、テキストの継続、音声合成を監督するトレーニング目標は、2つの異なる損失関数を使用して実現されます.1つ目の損失関数は、音声認識とテキストの継続のために使用される交差エントロピー損失と、2つ目の損失関数は音声の継続のために使用される回帰損失です.交差エントロピー損失は、予測された分布と対応する正解分布との間の類似性を定量化し、音声認識とテキストの継続の確率モデル化におけるテキスト[yp, yc]の尤度を増加させます.回帰損失は、前のスペクトログラムフレームの予測とASRおよびLMのコンテキストを考慮して、スペクトログラムフレームチャネルを独立して予測する回帰タスクとして定式化されます.

Q: スペクトログラムを直接操作することで、このモデルはどのようにアーキテクチャーを単純化しているのか?

A: モデルはスペクトログラム上で直接操作することによってアーキテクチャを簡素化しています.スペクトログラムを入力と出力として直接処理することで、モデルは音声エンコーダのオーディオ機能を活用し、中間のプロジェクション層を使用します.

Q: 既存の音声言語モデルと比較して、提案モデルの主な利点は何ですか?

A: 提案されたモデルの主な利点は、既存の話し言葉モデルに比べて以下の点です.

- スピーカーの保存性が向上しています.

- 意味的な一貫性が向上しています.

- 直接初期化に比べて元のLLMの知識を保持しています.

- 音声QAデータセットを通じて、元のLLMの知識を保持していることが実証されています.

- プロジェクトのウェブサイトでオーディオサンプルが提供されています.

Q: 元のLLMの知識は、どのようにモデルに保持されるのですか?

A: モデルは、事前に学習された言語モデル(LLM)の知識を保持するために、事前に学習された音声エンコーダを組み込むことによって知識を保持します.

Q: 話し言葉の質問応答データセットにおけるモデルの性能の例やデモンストレーションを提供していただけますか?

A: はい、このモデルの性能に関する例やデモンストレーションがプロジェクトのウェブサイトで提供されています.LibriSpeechデータセットの音声継続、Web Questions、LLama Questionsのテストセットにおける音声質問応答の生成サンプルが含まれています.

Q: モデルのパフォーマンスにおける話者の保存と意味的な一貫性の重要性は何ですか?

A: モデルの性能において、話者の保存と意味的な一貫性は重要です.話者の保存は、モデルが入力音声の話者の特徴を正確に捉え、出力音声でも同じ話者の特徴を保持する能力を指します.これにより、モデルがより自然な音声合成を行うことができます.意味的な一貫性は、モデルが入力テキストの意味を正確に理解し、出力テキストでも同じ意味を保持する能力を指します.これにより、モデルがより意味のある応答を生成することができます.