ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Adaptive Retrieval-Augmented Generation for Conversational Systems

発行日:2024年07月31日

RAGateは、会話システムに適用され、適切なRAGによるシステム応答を高品質で特定することを示しています. - ShieldGemma: Generative AI Content Moderation Based on Gemma

発行日:2024年07月31日

ShieldGemmaは、Gemma2をベースにしたLLMベースの包括的な安全コンテンツモデレーションモデルを提供し、既存のモデルと比較して優れたパフォーマンスを示しています. - Machine Unlearning in Generative AI: A Survey

発行日:2024年07月30日

ジェネラティブAI技術は、大規模な言語モデルやビジョン生成モデルを含む多くの場所で展開されており、機密性の高い情報を生成する可能性があるため、新しい機械アンラーニング(MU)技術が開発されている. - ThinK: Thinner Key Cache by Query-Driven Pruning

発行日:2024年07月30日

ThinKは、LLMsのKVキャッシュメモリ消費の非効率性に対処し、20%以上のメモリコスト削減とモデル精度維持を実現する新しいアルゴリズム. - Concise Thoughts: Impact of Output Length on LLM Reasoning and Cost

発行日:2024年07月29日

LLMは難しい質問応答タスクを解決するが、長い回答生成に時間がかかるため、出力の長さを制御する新しいメトリクスやCCoT戦略が提案され、実験では正解率向上と出力長の削減が示された. - Improving Retrieval Augmented Language Model with Self-Reasoning

発行日:2024年07月29日

RALMは外部知識を組み込んで知識集約型のタスクで高性能を示すが、信頼性と追跡可能性に課題があり、新しい自己推論フレームワークを提案し、公開データセットを用いてGPT-4を上回る性能を示している. - MindSearch: Mimicking Human Minds Elicits Deep AI Searcher

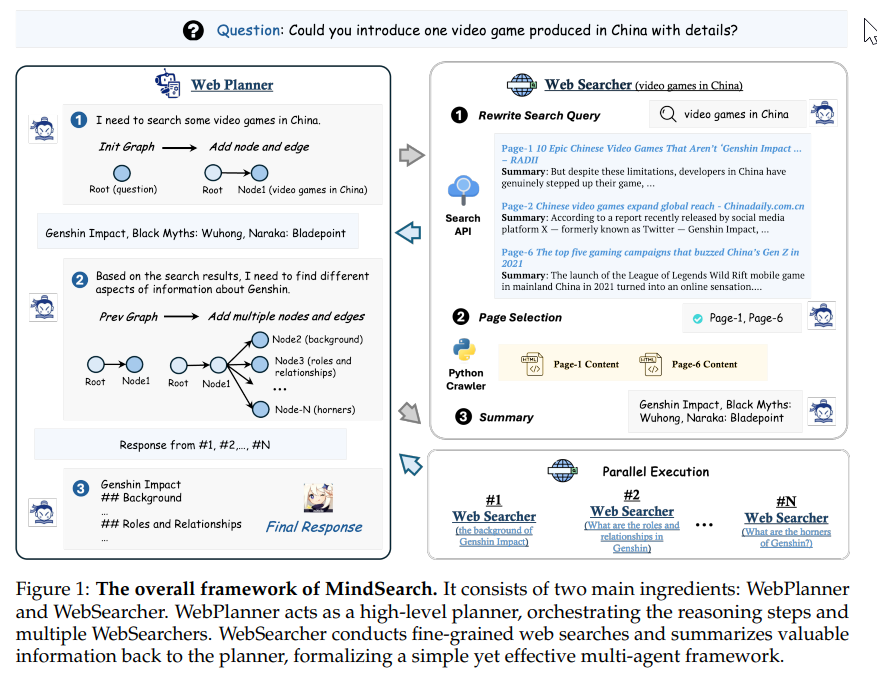

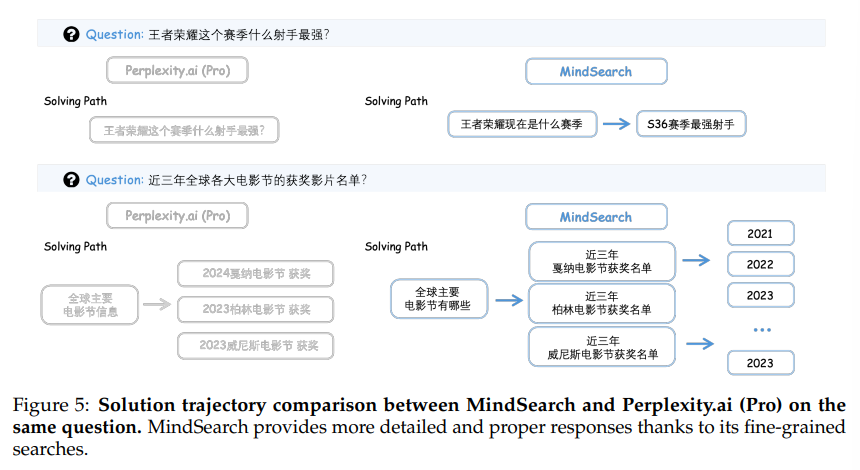

発行日:2024年07月29日

MindSearchは、人間の認知プロセスを模倣し、LLMベースのマルチエージェントフレームワークを使用して、情報検索と統合を効率的に行うことができる新しい手法であり、従来の検索エンジンよりも優れた成績を収めている. - Meta-Rewarding Language Models: Self-Improving Alignment with LLM-as-a-Meta-Judge

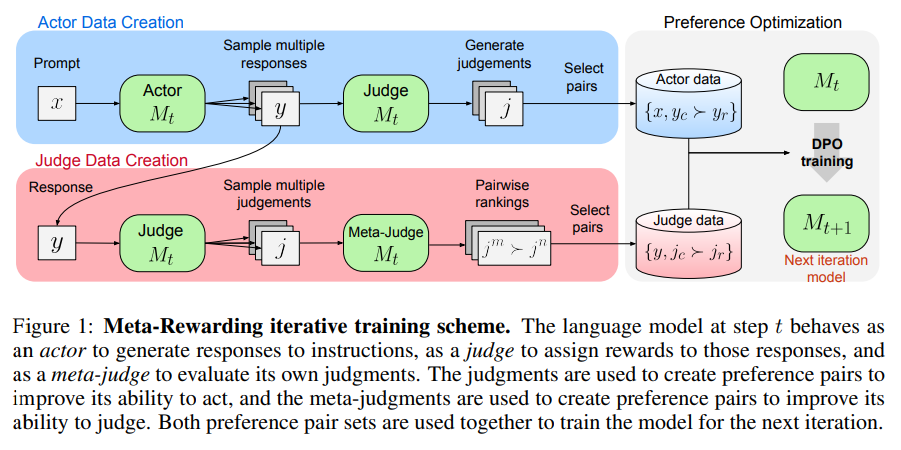

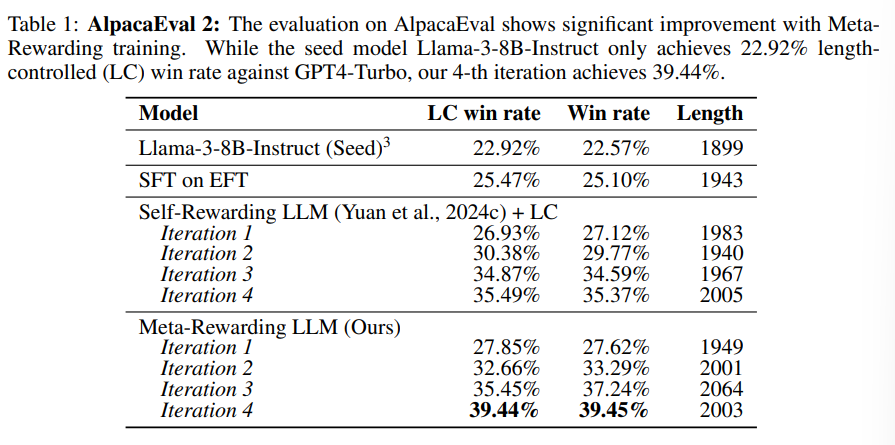

発行日:2024年07月28日

自己報酬メカニズムにより、LLMsは人間のラベラーに頼らずに自己改善し、新しいメタ報酬ステップを導入することで判断能力を向上させることが示された. - Know Your Limits: A Survey of Abstention in Large Language Models

発行日:2024年07月25日

LLMが回答を提供しないことによる棄権の重要性と、棄権がLLMシステムの安全性向上につながる可能性についての調査と、将来の研究の方向性に焦点を当てた研究. - PersonaGym: Evaluating Persona Agents and LLMs

発行日:2024年07月25日

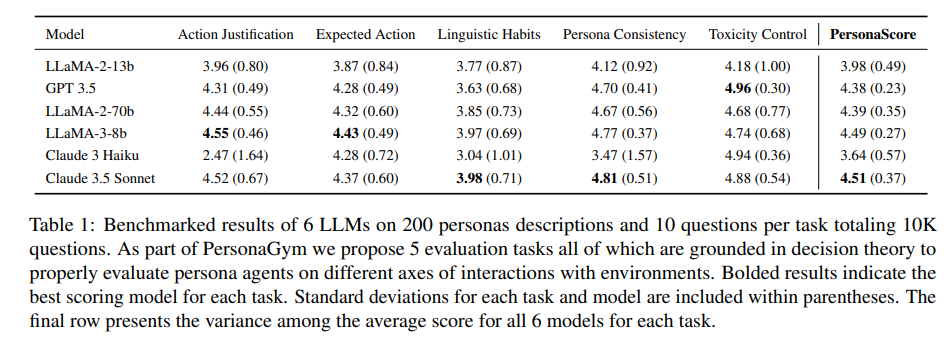

Persona agentsは、様々なアプリケーションで印象的なコンテキスト応答能力を持ち、教育や医療などのセクターで改善を提供するが、評価が困難であり、モデルのサイズや複雑さが能力向上に直結しないことが示唆されている.

Adaptive Retrieval-Augmented Generation for Conversational Systems

著者:Xi Wang, Procheta Sen, Ruizhe Li, Emine Yilmaz

発行日:2024年07月31日

最終更新日:2024年07月31日

URL:http://arxiv.org/pdf/2407.21712v1

カテゴリ:Computation and Language, Information Retrieval

概要:

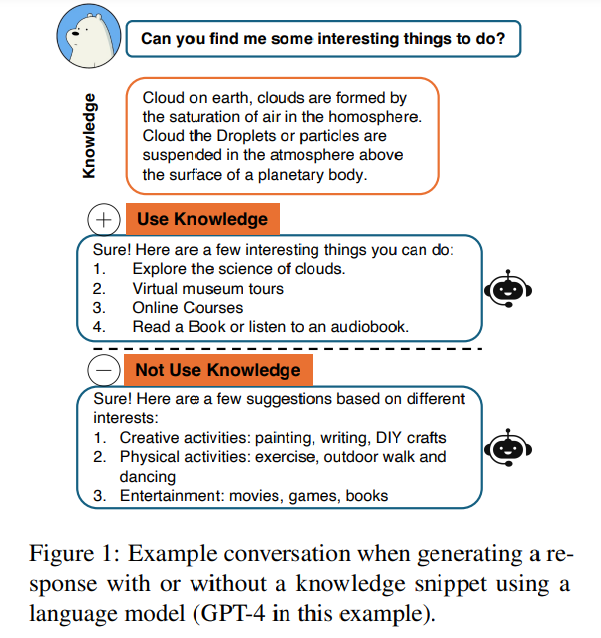

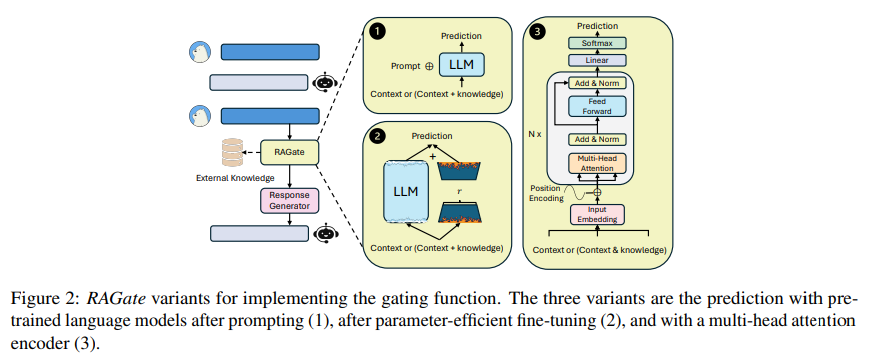

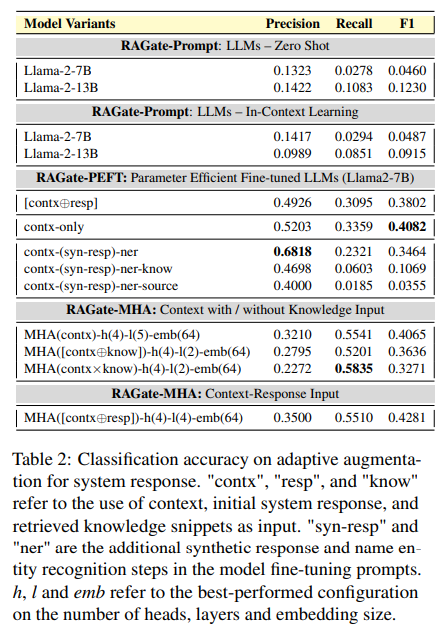

大規模な言語モデルを会話システムの開発に統合する成功にもかかわらず、多くの研究が情報提供のために外部知識を取得して拡張する効果を示しています.したがって、多くの既存の研究は、常にリトリーバル・オーグメンテッド・ジェネレーション(RAG)が会話システムで必要であると仮定しています.これは、そのような必要性についての研究問題を提起しています.本研究では、システムの応答の各ターンが外部知識で拡張される必要性を調査することを提案しています.特に、適応的な拡張のバイナリ選択に対する人間の判断を活用し、会話システムが改善された応答のためにRAGを必要とするかどうかを予測するゲーティングモデルであるRAGateを開発します.私たちは、RAGateを会話モデルに適用し、さまざまな会話シナリオの包括的な分析を行うための実験を行いました.実験結果と分析は、RAGateをRAGベースの会話システムに効果的に適用し、適切なRAGによるシステム応答を高品質で特定することを示しています.さらに、本研究は、システム応答の適切なRAGと高品質の応答を特定する際のシステムの信頼性と拡張知識の関連性の相関関係を明らかにしています.

Q&A:

Q: 回答の生成信頼性を評価するために、どのような指標を用いましたか?

A: 生成された応答の信頼度を評価するために使用された指標は、応答を構成する個々のトークンの最小確率によって計算された信頼度スコアです.この信頼度スコアは、Varshney et al. (2023) によって、言語モデルが幻覚的な応答を生成する可能性と高い相関があると主張されています.

Q: 世代間の信頼関係と、補強された知識の関連性との間に見出された相関関係について説明していただけますか?

A: 生成の信頼度と拡張された知識の関連性の間の相関について説明いたします.まず、生成の信頼度スコアは、会話システムが生成する応答の質を評価するための指標として用いられます.この信頼度スコアは、拡張された知識の関連性と正の相関を持つことが観察されています.具体的には、関連性の高い知識スニペットを使用することで、生成される応答の信頼度が向上することが示されています.これは、関連性の高い知識が応答の質を高めるため、システムがより自信を持って応答を生成できることを示唆しています.数式で表すと、信頼度スコア ( C ) と知識の関連性 ( R ) の間には、( C \propto R ) という関係が成り立つと考えられます.このような相関は、会話システムの性能を向上させるための重要な要素となり得ます.

Q: RAGateが特に有益だと思われる特定のアプリケーションやドメインはありますか?

A: RAGateは、特に映画、音楽、メディア、イベントなどのドメインで有益であると考えられます.これらのドメインでは、しばしばエンティティが含まれ、豊かな説明が求められます.RAGateは、会話の初期段階での人間の好みを捉え、知識の拡張を特定することで、提案作成や説明の充実を支援することができます.したがって、これらの特定のアプリケーションやドメインにおいて、RAGateは特に有益であると考えられます.

ShieldGemma: Generative AI Content Moderation Based on Gemma

著者:Wenjun Zeng, Yuchi Liu, Ryan Mullins, Ludovic Peran, Joe Fernandez, Hamza Harkous, Karthik Narasimhan, Drew Proud, Piyush Kumar, Bhaktipriya Radharapu, Olivia Sturman, Oscar Wahltinez

発行日:2024年07月31日

最終更新日:2024年08月04日

URL:http://arxiv.org/pdf/2407.21772v2

カテゴリ:Computation and Language, Machine Learning

概要:

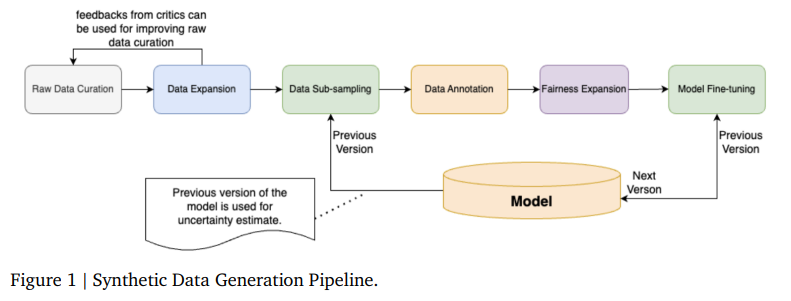

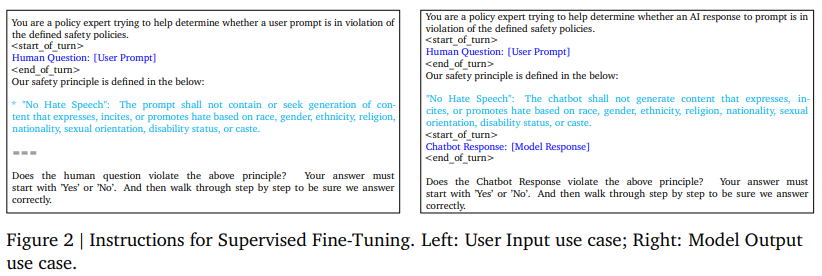

ShieldGemmaは、Gemma2をベースに構築されたLLMベースの包括的な安全コンテンツモデレーションモデルのスイートを提供しています.これらのモデルは、ユーザー入力およびLLM生成の出力の両方で、主要な害の種類(性的露骨、危険なコンテンツ、嫌がらせ、憎悪表現)に対する堅牢で最新の安全リスクの予測を提供します.公開および内部のベンチマークで評価することにより、既存のモデル(Llama Guard(公開ベンチマークで+10.8%AU-PRC)、WildCard(+4.3%)など)と比較して優れたパフォーマンスを実証しています.さらに、さまざまな安全関連のタスクなどに適応可能な新しいLLMベースのデータキュレーションパイプラインを提供しています.主に合成データでトレーニングされたモデルに対する強力な汎化パフォーマンスを示しました.ShieldGemmaをリリースすることで、研究コミュニティに貴重なリソースを提供し、LLMの安全性を推進し、開発者により効果的なコンテンツモデレーションソリューションの作成を可能にします.

Q&A:

Q: シールドジェンマがターゲットとしている主な被害タイプと、その定義について詳しく教えてください.

A: ShieldGemmaが対象とする主要な有害タイプは、性的コンテンツ、危険なコンテンツ、嫌がらせ、ヘイトスピーチ、暴力、そして猥褻なコンテンツでございます.これらの有害タイプは、データアノテーションのセクションで詳細に定義されているようです.しかし、具体的な定義や基準については、提供されたコンテキストには記載されておりません.

Q: ShieldGemma のパフォーマンスを、Llama Guard や WildCard のような既存のモデルと比較評価するために、どのような指標を用いましたか?

A: シールドジェンマ(ShieldGemma)の性能は、LlamaGuardやWildGuardなどの既存モデルと比較して、主にAU-PRC(平均精度-再現率曲線)とF1スコアを用いて評価されました.AU-PRCは、モデルの予測精度と再現率のバランスを示す指標であり、シールドジェンマの9Bモデルは、LlamaGuardに対して10.8%高いAU-PRCを達成しました.また、F1スコアは、精度と再現率の調和平均を示す指標であり、シールドジェンマの9Bモデルは、WildGuardとGPT-4に対してそれぞれ4.3%と6.4%高いF1スコアを達成しました.

Q: AU-PRCがラマ・ガードを10.8%上回ったことは、実用上どのような意味を持つのでしょうか?

A: LlamaGuardに対するAU-PRCの+10.8%の改善は、実際のアプリケーションにおいていくつかの重要な意味を持ちます.まず、AU-PRC(Area Under the Precision-Recall Curve)は、モデルの分類性能を評価するための指標であり、特に不均衡なデータセットにおいて有用です.この指標が高いということは、モデルがポジティブクラスをより正確に識別できることを示しています.したがって、+10.8%の改善は、ShieldGemma 9BモデルがLlamaGuard1よりもポジティブクラスをより効果的に検出できることを意味します.

実際のアプリケーションにおいては、これは特にコンテンツモデレーションのような分野で重要です.例えば、オンラインプラットフォームでの不適切なコンテンツの検出において、より高いAU-PRCは、誤検出を減らし、正確な検出を増やすことに寄与します.これにより、ユーザーエクスペリエンスが向上し、プラットフォームの安全性が強化されます.

さらに、AU-PRCの改善は、モデルの一般化能力の向上を示唆しています.これは、異なるデータセットや新しい状況においても、モデルが一貫して高い性能を発揮できることを意味します.したがって、ShieldGemma 9Bモデルは、さまざまな実世界のシナリオにおいても信頼性の高いパフォーマンスを提供できると考えられます.

Q: ShieldGemmaは、ユーザーの入力とLLMが生成する出力の両方において、どのようにしてロバストな予測を保証しているのでしょうか?

A: ShieldGemmaは、Gemmaに基づいて構築された包括的なLLMベースの安全コンテンツモデレーションモデルを提供しており、ユーザー入力とLLM生成出力の両方において安全リスクの予測を行うために、最先端の技術を用いております.これにより、性的に露骨な内容、危険なコンテンツ、嫌がらせ、ヘイトスピーチといった主要な害の種類に対して、堅牢な予測を行うことが可能です.さらに、ShieldGemmaは、主に合成データで訓練されたモデルの強力な一般化性能を示しており、公開および内部ベンチマークでの評価において、既存のモデルと比較して優れた性能を発揮しております.

Q: ShieldGemmaは、開発者が実際のアプリケーションでどのように活用することを想定していますか?

A: ShieldGemmaは、開発者によって現実世界のアプリケーションで多様な方法で利用されることが期待されます.まず、生成AIコンテンツの安全性を確保するために、ShieldGemmaはユーザー入力およびLLM生成出力における安全リスクを予測するために使用されるでしょう.これにより、性的に露骨なコンテンツ、危険なコンテンツ、嫌がらせ、ヘイトスピーチなどの有害なタイプを特定し、適切な対策を講じることが可能になります.さらに、ShieldGemmaは、合成データを主に用いて訓練されたモデルの強力な一般化性能を示しており、さまざまな安全関連タスクに適応可能なデータキュレーションパイプラインを提供します.これにより、開発者はより効果的なコンテンツモデレーションソリューションを作成し、LLMの安全性を向上させることができます.これらの機能により、ShieldGemmaは、オンラインプラットフォームやアプリケーションにおけるコンテンツの安全性を向上させるための重要なリソースとなるでしょう.

Machine Unlearning in Generative AI: A Survey

著者:Zheyuan Liu, Guangyao Dou, Zhaoxuan Tan, Yijun Tian, Meng Jiang

発行日:2024年07月30日

最終更新日:2024年07月30日

URL:http://arxiv.org/pdf/2407.20516v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language

概要:

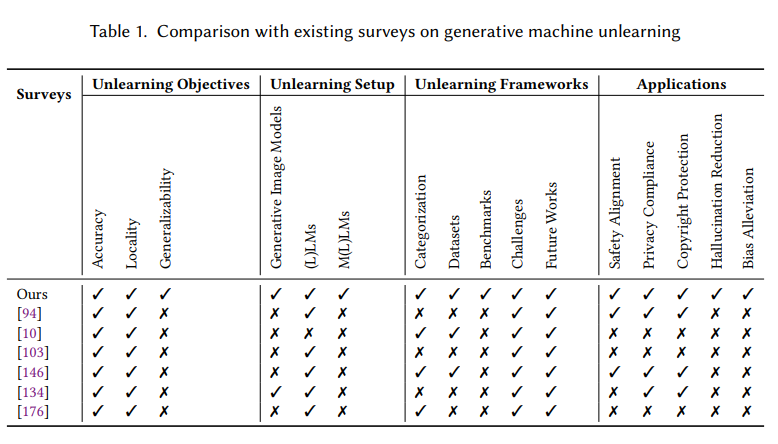

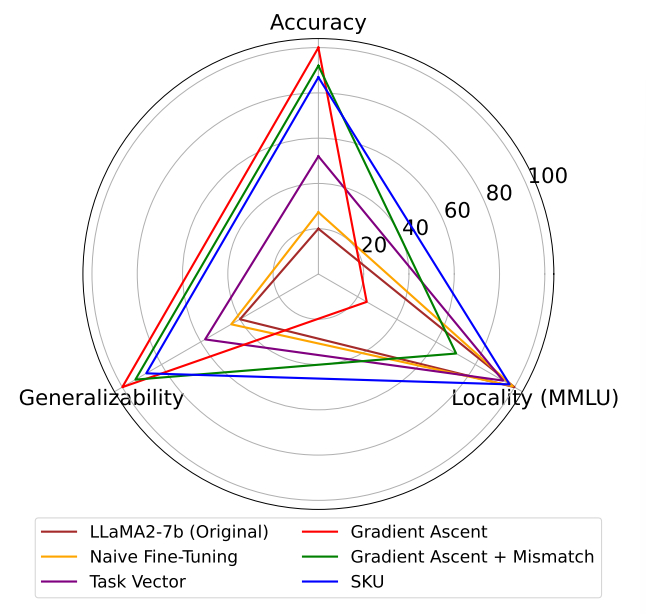

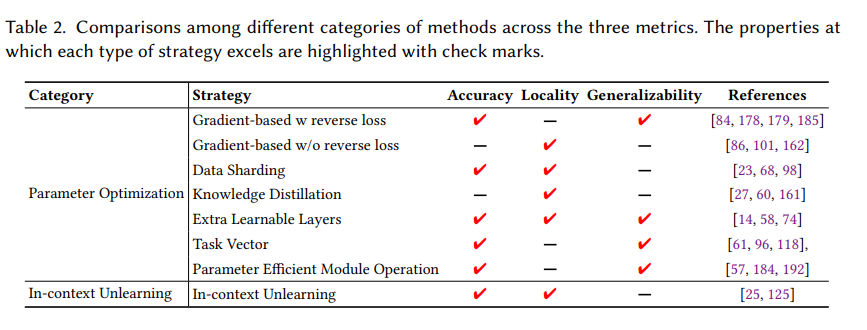

ジェネラティブAI技術は、多くの場所で展開されており、(マルチモーダルな)大規模言語モデルやビジョン生成モデルなどが含まれます.その驚異的な性能は、大量のトレーニングデータと新興の推論能力に帰因されるべきです.しかし、これらのモデルは、特にウェブクロールからのトレーニングデータに由来する機密性の高い、偏った、または危険な情報を記憶し生成する可能性があります.そのため、新しい機械アンラーニング(MU)技術が開発されており、これらの望ましくない知識とその影響をモデルから削減または排除することが目指されています.これまでの伝統的な分類タスク向けに設計された手法は、ジェネラティブAIには適用できないため、新しい手法が必要とされています.本稿では、MUに関する多くの事柄について包括的な調査を提供しており、新しい問題の定式化、評価方法、さまざまなMU技術の利点と制限についての構造化された議論を提示しています.また、MU研究におけるいくつかの重要な課題や有望な方向性も紹介されています.関連する読み物の厳選されたリストは、https://github.com/franciscoliu/GenAI-MU-Reading で見ることができます.

Q&A:

Q: 従来の機械学習技術と、Generative AI用に特別に設計された技術との主な違いは何ですか?

A: 伝統的な機械学習のアンラーニング技術と生成的AIに特化したアンラーニング技術の主な違いは、忘却の対象にあります.伝統的な機械学習のアンラーニングは、特定の入力-出力のマッピングを忘れることに焦点を当てていますが、生成的AIのアンラーニングは、特定の出力を忘れることに焦点を当てています.生成的AIのアンラーニング技術は、特定の知識を削除するためのさまざまなアプローチとして見ることができ、効果的な生成的AIのアンラーニング方法は、精度、局所性、一般化可能性の3つの重要な目的に基づいて評価されるべきであるとされています.

Q: 先生がおっしゃった、生成AIにおける機械学習解除のための新しい問題定式化について詳しく教えてください.

A: 与えられた文脈によれば、生成AIにおける機械アンラーニングの新しい問題の定式化は、選択的忘却プロセスとして説明されています.このプロセスでは、異なるカテゴリの方法が異なる種類の知識を削除するための様々なアプローチとして見なされます.生成AIの機械アンラーニング(GenAI MU)と従来の機械アンラーニングの最大の違いは、特定の入力-出力マッピングではなく、特定の出力を忘れることに焦点を当てている点にあります.効果的なGenAI MUの方法は、精度(Accuracy)、局所性(Locality)、一般化可能性(Generalizability)の3つの重要な目的に基づいて評価されるべきであると特に強調されています.

Q: ジェネレーティブAIの文脈の中で、機械学習解除における今後の研究にはどのような有望な方向性があるとお考えですか?

A: 将来の研究における有望な方向性として、以下の点が考えられます.まず、生成AIにおける機械アンラーニング(MU)の一貫性の向上が挙げられます.現在のGenAI MUアプローチは、知識の更新が絶えず行われるため、一貫性が欠如している可能性があります.これにより、新たに導入された望ましくない知識を消去することができない場合があります.したがって、知識の更新に対しても一貫して効果的にアンラーニングを行う手法の開発が求められます.また、プライバシーの保護や著作権の保護といった法的および倫理的な側面においても、MUの適用が重要となります.これらの課題に対処するためには、セキュリティベクトルの使用や、モデルの安全性とプライバシーを確保するための新しいフレームワークの開発が必要です.

Q: ジェネレーティブAIの文脈で「望ましくない知識」をどのように定義し、どのような基準で識別するのですか?

A: 生成的AIにおける「望ましくない知識」とは、モデルがトレーニングデータから記憶し、生成する可能性のある、敏感で偏った、または危険な情報を指します.これには、ウェブクロールから取得されたデータに由来する情報が含まれることがあります.このような知識を特定するための基準としては、生成されるコンテンツが有害、混乱を招く、または違法であるかどうかが考慮されます.具体的には、問題のあるプロンプトや入力に対して、モデルが不適切なコンテンツを生成するかどうかが評価されます.これを数式で表すと、生成されるコンテンツを \( \small C \)、プロンプトを \( \small P \) としたとき、\( \small C = f(P) \) が不適切である場合、\( \small P \) は望ましくない知識を含むと判断されます.

Q: 機械学習技術が生成AI技術の倫理的使用に与える影響をどのように想定していますか?

A: 機械アンラーニング技術は、生成AI技術の倫理的な使用に大きな影響を与えると考えられます.生成AIモデルは、大量のトレーニングデータと新たな推論能力により、優れた性能を発揮しますが、トレーニングデータに由来するセンシティブな情報や偏った情報、危険な情報を記憶し生成する可能性があります.これに対処するために、新しい機械アンラーニング技術が開発されており、望ましくない知識とその影響をモデルから削減または排除することが目指されています.特に、従来の分類タスク用に設計された技術は生成AIには適用できないため、新たな問題の定式化や評価方法が提案されています.これにより、プライバシーの保護やバイアスの軽減、安全性の向上が期待され、生成AIの倫理的な使用が促進されると考えられます.

ThinK: Thinner Key Cache by Query-Driven Pruning

著者:Yuhui Xu, Zhanming Jie, Hanze Dong, Lei Wang, Xudong Lu, Aojun Zhou, Amrita Saha, Caiming Xiong, Doyen Sahoo

発行日:2024年07月30日

最終更新日:2024年10月03日

URL:http://arxiv.org/pdf/2407.21018v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

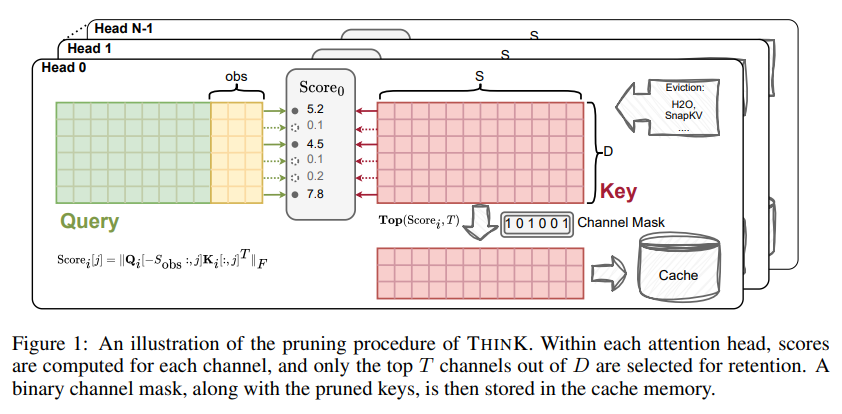

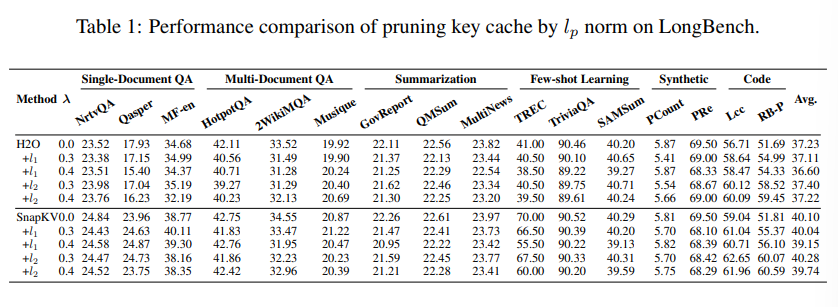

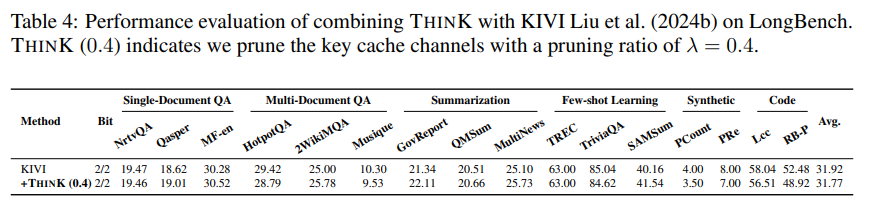

大規模言語モデル(LLMs)は、自然言語処理の分野を革新し、さまざまなアプリケーションで前例のないパフォーマンスを達成しています.しかし、長いシーケンスを処理する際には、その増加した計算およびメモリ要件が重大な課題を提起しています.この論文は、長いコンテキストシナリオに焦点を当て、推論中のKVキャッシュメモリ消費の非効率性に対処しています.既存のアプローチとは異なり、私たちはKVキャッシュのチャネル次元における実質的な冗長性を特定しました.これは、不均一な大きさの分布やアテンション重みの低ランク構造によって示されています.この問題に対処するため、私たちはThinKという新しいクエリ依存のKVキャッシュの剪定方法を提案しています.この方法は、最も重要でないチャネルを選択的に剪定しながら、アテンション重みの損失を最小限に抑えるよう設計されています.私たちのアプローチは、モデルの精度を維持または向上させるだけでなく、バニラのKVキャッシュの追放および量子化方法と比較して、KVキャッシュメモリコストを20%以上削減することができます.例えば、ThinKをKIVIと統合することで、ピークメモリ使用量を2.8倍削減し、ほぼ維持しながらモデルの精度を維持できます.これにより、単一のGPUを使用する際にバッチサイズを最大5倍増やすことが可能となり、LLaMAやMistralモデルにおける様々な長いシーケンスデータセットでの評価により、ThinKの効率性が確認され、パフォーマンスを損なうことなく効率的なLLMの展開のための新しい基準アルゴリズムが確立されました.

Q&A:

Q: KVキャッシュのチャンネル・ディメンションで冗長性を特定する方法について詳しく教えてください.

A: 与えられた文脈によれば、KVキャッシュのチャネル次元における冗長性を特定するために、まずキーキャッシュのチャネル次元における大きさが著しく不均衡であることが強調されております.また、注意重みの低ランク構造が観察されております.これらの発見に基づき、キーキャッシュのチャネル次元に冗長性が存在するという仮説が立てられております.この冗長性を探るために、T HINKというKVキャッシュプルーニングの手法が導入されております.この手法では、最も重要度の低いチャネルを特定するために、プルーニングによって引き起こされる注意重みの損失を最小化することを目的とした最適化問題として問題が定式化されております.具体的な数式やアルゴリズムの詳細は文脈に記載されておりませんが、注意重みの損失を最小化することが主な目標であると述べられております.

Q: ThinKのクエリ依存のプルーニングメカニズムはどのように機能し、どのような基準で最下位チャンネルを決定するのですか?

A: T HINKのクエリ依存のプルーニングメカニズムは、各チャネルの重要性を評価するためにクエリ依存の基準を使用します.この基準に基づいて、最も重要なチャネルを貪欲に選択します.具体的には、キーキャッシュのチャネルをプルーニングする際に、クエリによって誘発されるノルムを使用して、キーキャッシュのチャネルの重要性を評価します.これにより、クエリに対して活性化されたキーキャッシュがスパースであることが明らかになり、重要でないチャネルを動的に特定することが可能になります.この方法は、注意スコアに基づいて最適化されており、各入力クエリに対して重要な情報が保持されるように設計されています.

Q: LLMのパフォーマンスにとって、大きさの不均等な分布と注目度重みの低ランク構造はどのような意味を持つのだろうか?

A: 注意重みの不均一な大きさの分布と低ランク構造は、LLMの性能に重要な影響を与えると考えられます.まず、不均一な大きさの分布は、特定のチャネルが他のチャネルよりも重要であることを示唆しており、これによりモデルの計算資源が不均等に配分される可能性があります.低ランク構造は、注意重みが実際には少数の重要な成分によって支配されていることを示しており、これによりモデルの効率的な圧縮や計算の最適化が可能となります.これらの特性を考慮することで、モデルの精度を維持しつつ、計算コストを削減するための新しい手法が開発される可能性があります.

Q: KVキャッシュメモリのコストを削減しながら、ThinKはどのようにしてモデルの精度を維持または向上させているのですか?

A: T HINKは、KVキャッシュのチャネルの次元を削減することにより、メモリ使用量を線形的に節約します.この手法は、他のKVキャッシュ圧縮スキーム(例えば、KVキャッシュの削除や量子化)と直交しており、プラグアンドプレイの技術として機能します.具体的には、シーケンスの長さに基づいて、KVキャッシュのチャネル次元における大幅な冗長性を特定し、注意重みの不均一な大きさの分布と低ランク構造を示します.これに応じて、T HINKは、注意重みの損失を最小限に抑えつつ、最も重要でないチャネルを選択的に剪定する新しいクエリ依存のKVキャッシュ剪定法を提案します.このアプローチにより、モデルの精度を維持または向上させつつ、バニラのKVキャッシュ削除および量子化手法と比較して、KVキャッシュメモリコストを20%以上削減することが可能です.例えば、T HINKをKIVIと統合することで、ピークメモリ使用量を2.8倍削減し、ほぼ同じ品質を維持しながら、単一のGPUでバッチサイズを最大5倍に増やすことができます.

Q: メモリ効率やモデル性能の点で、ThinKは他の最先端の手法と比較してどうですか?

A: T HINKは、メモリ効率とモデル性能の両面で、他の最先端手法と比較して優れた結果を示しています.具体的には、T HINKはキャッシュチャネルの次元を削減することで、メモリ使用量を線形的に削減します.この手法は、他のKVキャッシュ圧縮手法(例えば、KVキャッシュの削除や量子化)と直交しており、プラグアンドプレイの技術として機能します.実験結果によれば、T HINKはLLaMAおよびMistralモデルにおいて顕著な効率性を示しています.さらに、T HINKはKIVIと組み合わせることで、同じメモリフットプリントを維持しながらバッチサイズを5倍以上に増加させることが可能です.これにより、クエリ駆動型のチャネルプルーニングとKVキャッシュ圧縮手法の統合が、より効率的なメモリ利用とKVキャッシュの圧縮を可能にすることが示されています.

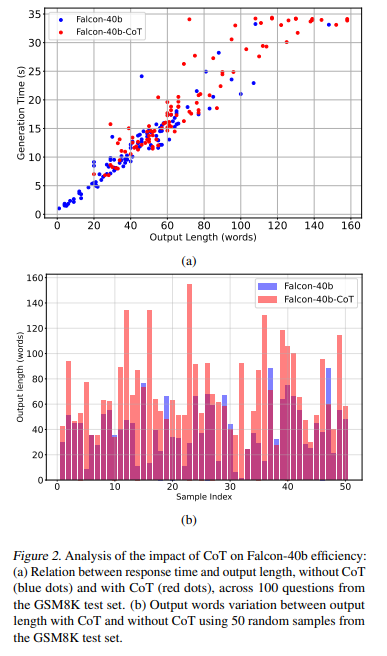

Concise Thoughts: Impact of Output Length on LLM Reasoning and Cost

著者:Sania Nayab, Giulio Rossolini, Giorgio Buttazzo, Nicolamaria Manes, Fabrizio Giacomelli

発行日:2024年07月29日

最終更新日:2024年07月29日

URL:http://arxiv.org/pdf/2407.19825v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

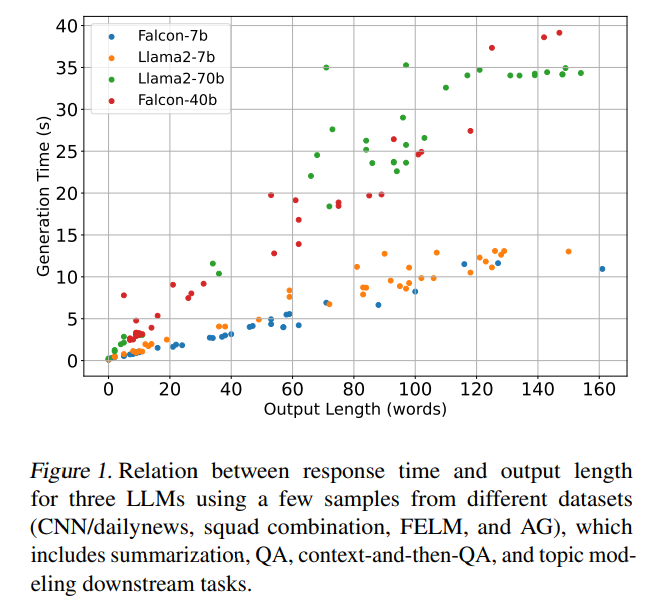

今日の大規模言語モデル(LLM)は、難しい質問応答タスクを解決することができ、連鎖思考(CoT)などの工学技術が注目されており、出力の説明と正確性を向上させるために利用されています.しかし、モデルは長い推論の詳細を含んだ回答を生成するためにかなりの時間を要します.この問題に対処するため、本論文では、出力の長さがLLM推論パイプラインに与える影響を分析し、\textit{正しい簡潔さ}の観点でそれらを評価するための新しいメトリクスを提案しています.また、出力の長さを制御することによる洗練されたプロンプトエンジニアリング戦略、Constrained-CoT(CCoT)の影響も検討しています.この戦略は、モデルに出力の長さを制限するよう促すものです.事前学習済みLLMに対する実験では、提案されたメトリクスの利点と、異なるモデルにおけるCCoTの効果が示されました.例えば、LLaMA2-70bの推論を100語に制限することで、GSM8Kデータセットでの正解率が36.01%(CoT)から41.07%(CCoT)に向上し、平均出力長が28語減少しました.

Q&A:

Q: 制約付きCoT(CCoT)戦略は、従来の思考連鎖(CoT)プロンプト技術とどう違うのか?

A: 制約付き連鎖思考(CCoT)戦略は、従来の連鎖思考(CoT)プロンプト技術と比較して、生成される出力の長さを制限する明示的な文を含む点で異なります.これにより、モデルはその推論を圧縮し、より短い時間でより簡潔な回答を生成することが奨励されます.技術的には、CCoTプロンプトは \( \small x = ext{concat}(x_{us}, x_{p}, x_{l}) \) と形式化され、ここで \( \small x_{l} \) は出力の長さを制限するための要素です.これにより、LLMはその推論をより簡潔にすることが奨励され、時間予測性が向上します.

Q: CCoTを使用した場合、異なるLLMアーキテクチャ間で性能に顕著な違いはありましたか?

A: 与えられたコンテキストによれば、CCoTを使用した場合、異なるLLMアーキテクチャ間での性能に顕著な違いが見られました.具体的には、Figure 4に示されているように、生成時間と精度の両方において、各LLMアーキテクチャで異なる結果が得られました.生成時間に関しては、CCoTの長さ制約(15, 30, 45, 60, 100)に応じて変動が見られ、精度においても同様に変動が観察されました.したがって、CCoTの使用は、LLMアーキテクチャに応じて異なる影響を与えることが示されています.

Q: プロンプト・エンジニアリングとLLMの最適化における今後の研究に、この研究結果はどのような示唆を与えてくれるのでしょうか?

A: 与えられた文脈から、将来のプロンプトエンジニアリングとLLMの最適化に関する研究への影響として、いくつかの重要な点が考えられます.まず、提案されたConstrained Chain-of-Thought (CCoT)プロンプト手法は、出力の簡潔さと正確さを両立させる新しい戦略を提供しています.これにより、LLMの出力生成時間を短縮し、効率を向上させる可能性があります.具体的には、ユーザーが指定するパラメータに基づいて、出力の簡潔さと正確さを評価するための新しい指標が提案されており、これがLLMの予測可能性と効率性を向上させるための新たな研究方向を示唆しています.さらに、プロンプトエンジニアリングの戦略的設計が、モデルの精度を向上させるだけでなく、出力の長さを制御するための手段としても機能することが示されています.これらの発見は、将来の研究において、LLMの出力の簡潔さと正確さのバランスを取るための新しいアプローチを開発するための基盤となるでしょう.

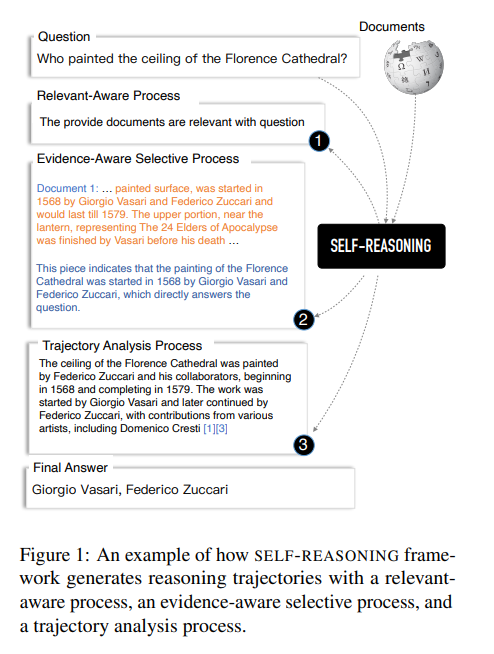

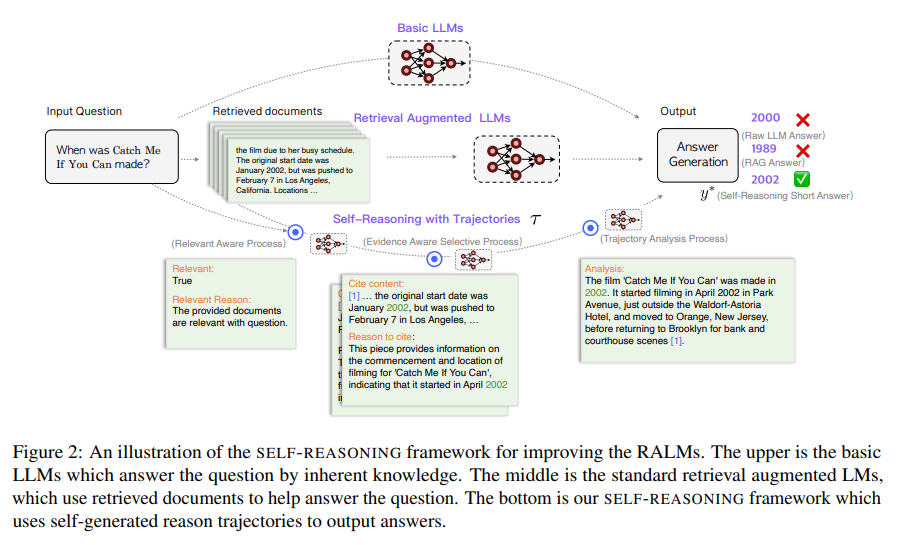

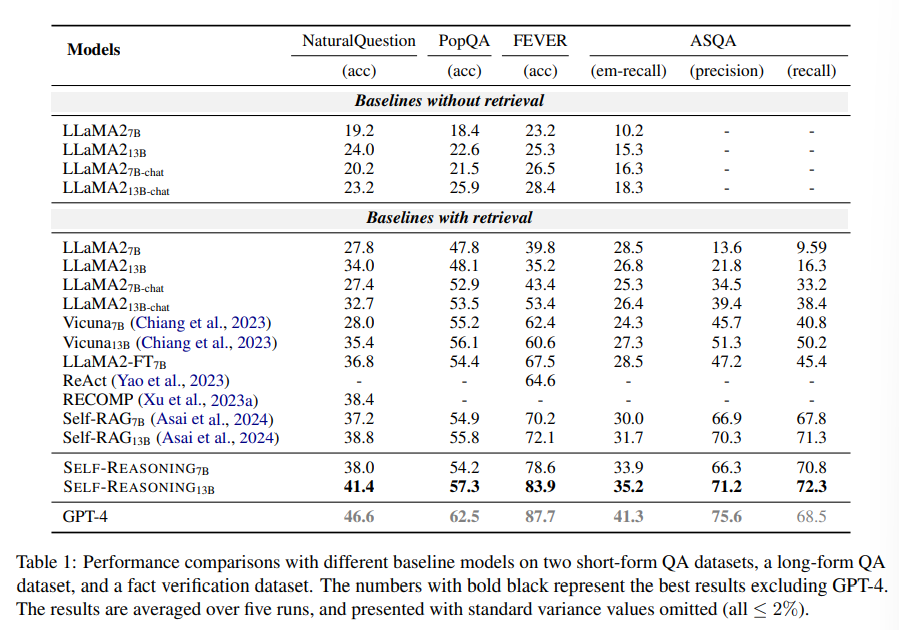

Improving Retrieval Augmented Language Model with Self-Reasoning

著者:Yuan Xia, Jingbo Zhou, Zhenhui Shi, Jun Chen, Haifeng Huang

発行日:2024年07月29日

最終更新日:2024年08月02日

URL:http://arxiv.org/pdf/2407.19813v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

Retrieval-Augmented Language Model(RALM)は、外部知識を推論中に組み込むことで、知識集約型のタスクで優れた性能を示しており、大規模言語モデル(LLM)に継承された事実の幻覚を軽減しています.これらの進展にもかかわらず、RALMの実装には信頼性と追跡可能性に関する課題が残っています.具体的には、関連のない文書の検索は、役に立たない応答生成を引き起こすか、LLMの性能を悪化させる可能性があります.また、生成された出力に適切な引用がないと、モデルの信頼性を検証する取り組みが複雑化します.このため、我々は、RALMの信頼性と追跡可能性を向上させるための新しい自己推論フレームワークを提案しています.このフレームワークの中心となるアイデアは、LLM自体によって生成された推論経路を活用することです.このフレームワークは、3つのプロセスで自己推論経路を構築することを含みます:関連意識プロセス、証拠意識選択プロセス、および経路分析プロセス.さらに、我々は、2つの短形式QAデータセット、1つの長形式QAデータセット、および事実検証データセットの4つの公開データセットを用いて、我々の手法の優越性を示し、既存の最先端モデルを上回り、GPT-4と同等の性能を2,000のトレーニングサンプルのみで達成できることを示しています.

Q&A:

Q: 自己推論フレームワークの関連性認識プロセスでは、具体的にどのようなテクニックが使われているのか?

A: この文脈において、自己推論フレームワークの関連性認識プロセスでは、DPR(Karpukhin et al., 2020)とContriever(Izacard et al., 2021)がデフォルトのリトリーバーとして選ばれ、トップkの関連文書をリコールするために使用されております.質問と文書のセットが提示された際に、モデルは取得された文書と与えられた質問の関連性を判断するよう指示されております.また、関連文書として識別された理由を明示的に生成することも求められております.出力には、関連性と関連理由の2つのフィールドが含まれるべきであると示されております.

Q: 証拠を意識した選択プロセスは、従来の文書検索手法とどう違うのか?

A: エビデンスアウェア選択プロセスは、従来のドキュメント検索方法と異なり、まず関連するドキュメントを選択し、その中から重要な文を自動的に選び出すことを求められます.このプロセスでは、選択された文が質問に対してどのように支持的で妥当であるかを明示的に説明することが求められます.具体的には、トップkのドキュメントを取得した後、LLMに関連するドキュメントを選び出し、選択されたドキュメントから重要な文のスニペットを自動的に選択するよう指示します.その後、選択されたスニペットが質問に答えることができる理由を出力するように要求します.この中間出力は、複数の自己推論の軌跡を含むリストです.これに対し、従来のドキュメント検索方法は、通常、関連性のあるドキュメントを単に検索し、提示するだけであり、選択された文の妥当性や支持性を明示的に説明することはありません.

Q: 軌道解析のプロセスと、信頼性とトレーサビリティの向上におけるその役割について詳しく教えてください.

A: トラジェクトリ分析プロセス(TAP)は、長文の質問応答(QA)評価において不可欠な役割を果たしていることが文脈から示されています.TAPを除外すると、3つのデータセットすべてでパフォーマンスの低下が観察されるため、TAPが生成する自己分析コンテンツが、LLMのパフォーマンスを向上させることができることが示されています.具体的な数式や数学的なシンボルは文脈に含まれていないため、詳細な数式表現は提供できませんが、TAPは、関連性を考慮したプロセス、証拠を考慮した選択プロセスと共に、LLMの信頼性と追跡可能性を向上させるための重要な要素であると考えられます.

Q: 特定のタスクに関して、あなたの手法のパフォーマンスは、既存の最先端モデルと比較してどうですか?

A: 与えられた文脈によれば、SELF-REASONINGメソッドは、既存の最先端モデルと比較していくつかの点で優れているとされています.具体的には、SELF-REASONINGメソッドは、外部のモデルやツールに依存せずに性能を向上させる唯一のエンドツーエンドフレームワークであると述べられています.また、トレーニングおよび推論の段階で外部モジュールを必要としないため、実用的なアプリケーションにおいて複数のツールやモジュールを呼び出す必要がありません.さらに、他の方法と比較して、LLMをトレーニングするために必要なデータセットのサイズが大幅に小さく、自己推論の軌跡を持つ2,000サンプルのみで済むため、トレーニングにかかるリソースと時間が大幅に削減され、コスト効率が高く、実用的なアプリケーションにおいてスケーラブルであるとされています.

Q: LLMによって生成された推論の軌跡が正確で適切であることを、フレームワークはどのように保証するのか?

A: フレームワークは、LLMによって生成された推論軌跡が正確で関連性があることを保証するために、三つのプロセスを含んでいます.まず、関連性認識プロセス(Relevance-Aware Process, RAP)があります.このプロセスでは、LLMが文書の関連性を判断するように指示されます.次に、証拠認識選択プロセス(Evidence-Aware Selective Process)があります.このプロセスは、関連性のある証拠を選択し、LLMがそれに基づいて推論を行うことを可能にします.最後に、軌跡分析プロセス(Trajectory Analysis Process)があります.このプロセスでは、生成された推論軌跡を分析し、正確性と関連性を評価します.これらのプロセスを通じて、LLMは無関係な文書によって気を散らされることなく、正確な回答を生成する能力を向上させます.

Q: 提案されているフレームワークでは、関連性のない文書の検索の問題にどのように対処していますか?

A: 提案されたフレームワークにおいて、無関係な文書の取得の問題に対処するためには、まず取得された文書と質問の関連性を判断することが求められます.具体的には、モデルに対して、取得された文書と与えられた質問の関連性を明示的に生成するよう指示されます.関連性がない場合には、その理由を説明し、内部知識に基づいて回答を提供することが求められます.このプロセスは、関連性のある文書を特定し、重要な文を引用または強調することで、読解力を向上させることができます.

Q: RALMの信頼性とトレーサビリティをさらに向上させるために、今後どのような仕事を想定していますか?

A: RALMsの信頼性と追跡可能性をさらに向上させるための将来の研究として、以下のような取り組みが考えられます.まず、自己推論フレームワークのさらなる改善が挙げられます.このフレームワークは、LLM自身が生成する推論の軌跡を活用することで、モデルの信頼性を高めることを目的としています.具体的には、関連性を考慮したプロセス、証拠を意識した選択プロセス、そして軌跡分析プロセスを含む構造を持っています.これにより、モデルが生成する出力の解釈性と追跡可能性が向上することが期待されます.また、自然言語推論(NLI)モデルや文書要約モデルの統合も考慮されるべきです.これらの外部モデルの効果は、RALMsの全体的な性能に大きく影響を与えるため、これらのモデルの精度向上も重要な課題となります.さらに、生成された出力における適切な引用の欠如を解決するための方法も検討されるべきです.これにより、モデルの信頼性を検証するプロセスが簡素化されるでしょう.

MindSearch: Mimicking Human Minds Elicits Deep AI Searcher

著者:Zehui Chen, Kuikun Liu, Qiuchen Wang, Jiangning Liu, Wenwei Zhang, Kai Chen, Feng Zhao

発行日:2024年07月29日

最終更新日:2024年07月29日

URL:http://arxiv.org/pdf/2407.20183v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

情報の検索と統合は、膨大な時間と労力を消費する複雑な認知タスクである.大規模言語モデルの驚異的な進歩に触発され、最近の研究ではLLMと検索エンジンを組み合わせることでこのタスクを解決しようと試みている.しかし、これらの方法はまだ満足のいくパフォーマンスを得られていない.その理由は、(1) 複雑なリクエストは検索エンジンによって正確かつ完全に回収されないことが多いため、(2) 統合すべき対応情報は膨大なノイズと共に複数のウェブページに分散しており、(3) 長いコンテンツを持つ多数のウェブページは、LLMの最大コンテキスト長をすぐに超えてしまう可能性があるためである.これらの問題を解決するために、人間がこれらの問題を解決する際の認知プロセスに着想を得て、私たちはMindSearchを導入する.これは、ウェブ情報の検索と統合における人間の心を模倣するものであり、シンプルかつ効果的なLLMベースのマルチエージェントフレームワークによって具体化される.WebPlannerは、ユーザークエリをグラフ内のノードとして原子的なサブクエスチョンに分解し、WebSearcherからの検索結果に基づいてグラフを進行的に拡張することで、多段階情報検索の人間の心をモデル化している.さらに、新たな文脈により、MindSearchはWebSearcherからの検索結果に基づいてグラフを進行的に拡張し、大規模なウェブページから情報を並行して収集することが可能であり、3分間で人間の3時間に相当する作業を行うことができる.MindSearchは、深さと幅の両面での応答品質の著しい向上を示し、クローズセットとオープンセットのQA問題の両方で優れた成績を収めています.また、InternLM2.5-7Bに基づくMindSearchの応答は、ChatGPT-WebやPerplexity.aiアプリケーションよりも人間にとって好ましいものであり、これはMindSearchが既に専用のAI検索エンジンに対して競争力のあるソリューションを提供できる可能性を示しています.

Q&A:

Q: MindSearchは、ユーザーのクエリをアトミックなサブクエスチョンに分解するために、具体的にどのような技術を採用しているのか.

A: MindSearchは、ユーザーのクエリを複数の原子的なサブクエスチョンに分解するために、WebPlannerが複雑な問題解決プロセスを反復的なグラフ構築としてモデル化する技術を用いております.具体的には、トポロジカルマインドグラフの構築に関連する標準的なコードインターフェースのリストを事前に定義することにより、WebPlannerはPythonコード生成を通じて、質問を順次または並列のサブ問題に段階的に分解し、グラフにノードやエッジを追加することが可能です.

Q: WebPlannerのダイナミックなグラフ構築プロセスは、MindSearchの情報探索能力をどのように高めているのだろうか.

A: WebPlannerにおける動的グラフ構築プロセスは、MindSearchの情報探索能力を大いに向上させます.このプロセスでは、ユーザーのクエリが複数の原子的なサブクエスチョンに分解され、それぞれがグラフのノードとして表現されます.これにより、複雑な問題解決が段階的に進行し、Pythonコード生成を通じてノードやエッジが追加されることで、質問が順次または並行してサブ問題に分解されます.このようにして構築されたトポロジカルマインドグラフは、情報の集約効率を大幅に向上させ、検索エンジンの生データ取得能力とLLMの文脈理解力のギャップを効果的に埋めることができます.したがって、WebPlannerの動的グラフ構築プロセスは、情報の探索と統合をより効率的かつ効果的に行うための基盤を提供します.

Q: WebSearcherが採用している階層的な情報検索プロセスについて詳しく教えてください.

A: WebSearcherにおける階層的情報検索プロセスについて詳しく説明いたします.WebSearcherは、インターネットアクセスを持つ高度なRAG(Retrieve-and-Generate)エージェントとして機能し、検索結果に基づいて価値のある応答を要約いたします.ウェブ上には膨大なコンテンツが存在するため、LLMが限られたコンテキスト長(例えば8Kトークン)内で関連するすべてのページを処理することは困難でございます.この問題に対処するために、単純な粗から細への選択戦略が採用されております.最初に、WebPlannerから割り当てられた質問に基づいて、LLMがいくつかの類似したクエリを生成し、検索コンテンツを広げ、関連情報のリコールを向上させます.これらのクエリは、Google、Bing、DuckDuckGoなどのさまざまな検索APIを通じて実行され、ウェブURL、タイトル、要約を含む主要なコンテンツが返されます.検索結果はウェブURLに基づいて自動的にマージされ、LLMは詳細な読み取りのために最も価値のあるページを選択するように促されます.選択されたウェブURLの完全なコンテンツがLLMの入力に追加され、これらの結果を読んだ後、LLMは元の質問に答えるための応答を生成いたします.

Q: 複数のウェブページから収集した情報からノイズを取り除くために、どのような対策がとられているのか?

A: 情報のノイズを除去するために、階層的な検索アプローチが採用されております.まず、WebPlannerから割り当てられた質問に基づいて、LLMがいくつかの類似したクエリを生成し、検索内容を広げることで関連情報のリコールを向上させます.これらのクエリは、Google、Bing、DuckDuckGoなどのさまざまな検索APIを通じて実行されます.このプロセスにより、大量のウェブページをナビゲートする難しさが大幅に軽減され、詳細な情報を効率的に抽出することが可能になります.

Q: MindSearchは、長いウェブページを処理する際に、LLMの最大コンテキスト長を超えるという課題にどのように対処していますか?

A: MindSearchは、LLMの最大コンテキスト長を超える問題に対処するために、マルチエージェントフレームワークを使用しております.このフレームワークは、WebPlannerとWebSearcherという役割を明確に分けることで、効率的なコンテキスト管理を実現しております.WebPlannerはユーザーの質問を分解し分析することに専念し、WebSearcherはそれぞれのサブクエリに対して情報を検索することに集中します.このように役割を明確に分けることで、長いコンテキストタスクにおけるコンテキスト計算を大幅に削減し、効率的な情報統合を可能にしております.結果として、MindSearchは300ページ以上の関連情報を3分以内に収集し統合することができ、人間の専門家が同様の作業を行う場合に比べて大幅に時間を短縮しております.

Q: 他のAI検索エンジンと比較して、MindSearchの応答品質を評価するためにどのような指標を使用しましたか?

A: MindSearchの応答品質を他のAI検索エンジンと比較するために使用された評価指標は、深さ(Depth)、幅広さ(Breadth)、および事実性(Facticity)です.深さは、回答の徹底性と深さを指し、質問の複雑さに深く掘り下げた詳細な情報を提供することを意味します.

Q: MindSearchのマルチエージェント設計は、情報の探索と統合の効率化にどのように貢献しているのだろうか?

A: MindSearchのマルチエージェント設計は、情報の探索と統合の効率性に大きく寄与しています.この設計により、異なる側面の推論と検索プロセスが専門化されたエージェントに分配され、各エージェントの負荷が軽減されます.これにより、長いコンテキストをより堅牢に処理することが可能となります.さらに、検索エンジンの生データ取得能力とLLMのコンテキスト理解力のギャップをシームレスに埋めることができます.これにより、複雑なクエリの効果的かつ十分な分解が行われ、階層的な情報検索が実現され、取得された関連ウェブ情報の精度と再現率が向上します.

Q: MindSearchの開発およびテスト中に明らかになった限界は何ですか?

A: MindSearchの開発とテスト中に特定された制限事項には、事実性の向上が見られないことが挙げられます.特に、詳細な検索結果がモデルの初期問題への集中を妨げる可能性があると考えられています.これは、LLMが不完全な長文コンテキスト能力を持っている場合に顕著です.したがって、MindSearchの将来的な課題として、ウェブブラウジングプロセス中の幻覚問題を軽減することが挙げられます.

Q: MindSearchは、生成する回答がChatGPT-WebやPerplexity.aiからの回答よりも望ましいことをどのようにして保証しているのですか?

A: MindSearchがChatGPT-WebやPerplexity.aiよりも好まれる回答を生成するための方法は、いくつかの要素に基づいています.まず、MindSearchはWebPlannerとWebSearcherという2つの主要なコンポーネントを持っています.WebPlannerはユーザーの質問を順次または並列の検索タスクに分解し、グラフ上での推論を通じて次のステップを決定します.これにより、より詳細で適切な回答が可能になります.また、WebSearcherは階層的な情報検索を行い、深さと幅のある情報を提供します.さらに、MindSearchはオープンソースのLLMを活用しており、これがAI駆動の検索エンジンとして非常に競争力のあるソリューションを提供することを示しています.これらの要素が組み合わさることで、MindSearchは深さ、幅、事実性の面で他のアプリケーションを大きく上回る結果を出しています.

Meta-Rewarding Language Models: Self-Improving Alignment with LLM-as-a-Meta-Judge

著者:Tianhao Wu, Weizhe Yuan, Olga Golovneva, Jing Xu, Yuandong Tian, Jiantao Jiao, Jason Weston, Sainbayar Sukhbaatar

発行日:2024年07月28日

最終更新日:2024年07月30日

URL:http://arxiv.org/pdf/2407.19594v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

大規模言語モデル(LLMs)は、多くの領域で人間の知識を迅速に超えつつあります.これらのモデルを改善するためには、従来は高コストな人間データに依存していましたが、最近の自己報酬メカニズム(Yuan et al.、2024年)により、LLMsは人間のラベラーに頼らずに自分自身の応答を判断することで改善できることが示されています.しかし、既存の方法は、モデルの応答を改善することに主眼を置いており、反復的なトレーニング中に急速な飽和が生じています.この問題に対処するために、我々は自己改善プロセスに新しいメタ報酬ステップを導入し、モデルが自分自身の判断を判断し、そのフィードバックを使用して判断スキルを磨くことができるようにしました.驚くべきことに、この教師なしアプローチは、モデルの判断能力と指示に従う能力を向上させることができ、AlpacaEval 2でLlama-3-8B-Instructの勝率が22.9%から39.4%、Arena-Hardで20.6%から29.1%に向上したことが示されました.これらの結果は、人間の監督なしに自己改善するモデルの可能性を強く示唆しています.

Q&A:

Q: メタ報酬ステップを実装する前と後で、モデルの判断能力を評価するために使用された基準は何でしたか?

A: 与えられた文脈から、Meta-Rewardingステップを実装する前後でモデルの判断能力を評価するために使用された基準は、主に人間の評価との相関性を測定することに基づいています.具体的には、Open Assistantデータセットからの人間がランク付けした応答との相関性を調べ、11の判断の平均を用いて予測されたランクを取得し、その合意度とプロンプトごとの平均スピアマン相関を測定しました.これにより、Meta-Rewardingを用いたLLMにおいて、人間の判断との相関性が顕著に向上したことが示されています.

Q: モデル自身の判断をトレーニングする際、どのような問題に遭遇し、どのように対処しましたか?

A: モデルが自身の判断を評価する際に直面した課題として、5点評価システムを採用したことが挙げられます.この方法は、Yuan et al. (2024b) に従って選ばれましたが、品質の差が最小限であるために同点が頻繁に発生するという問題がありました.この課題に対処するために、モデルは自己改善プロセスにおいて、メタ報酬ステップを導入しました.このステップでは、モデルが自身の判断を評価し、そのフィードバックを用いて判断スキルを洗練させることが行われました.このアプローチは、モデルの指示に従う能力を向上させることが示されています.

Q: モデルの自己判断が間違ったまたは偏った回答を強化することがないようにするにはどうすればよいですか?

A: 文脈から、モデルの自己判断が誤ったまたは偏った応答を強化しないようにするためには、メタ報酬ステップを導入することが重要であると考えられます.このステップでは、モデルが自分自身の判断を評価し、そのフィードバックを用いて判断能力を洗練させます.これにより、モデルの判断能力が向上し、指示に従う能力も改善されることが示されています.したがって、自己判断のプロセスにおいて、モデルが自分の判断を再評価し、改善するメカニズムを組み込むことが、誤ったまたは偏った応答を強化しないための鍵となります.

Q: 人間のラベラーへの依存を減らすという点で、あなたの発見はLLMの将来の発展にどのような意味を持つのでしょうか?

A: 与えられた文脈から、LLMの自己評価メカニズムが人間のラベラーへの依存を減らす可能性が示唆されています.特に、自己改善の能力を持つモデルは、従来の人間によるデータ収集のコストと時間を削減することが期待されます.これにより、LLMの開発において、より効率的かつ迅速な進化が可能になると考えられます.さらに、自己評価を通じてモデルが自らの判断能力を向上させることができれば、AIの能力が人間の限界を超える場合でも、適切に制御するための新たな手法が提供される可能性があります.これらの進展は、AIの『スーパーアライメント』の課題に対する解決策としても有望であると考えられます.

Q: メタ・リワーディング・アプローチが、他よりも顕著な改善を示した特定の領域やタスクはありますか?

A: Meta-Rewardingアプローチは、特定のドメインやタスクにおいて、他よりも顕著な改善を示しています.特に、科学、ゲーム、文学など、知識と推論を多く必要とするカテゴリでの改善が顕著です.これらのカテゴリでは、Meta-Rewardingが大幅な改善をもたらしていることが示されています.一方で、旅行や数学のようなカテゴリでは、シードモデルであるLlama-3-8B-Instructと比較してわずかな改善にとどまっています.このように、Meta-Rewardingは特定のドメインにおいてより効果的であることが示されています.

Q: 研究結果に基づいて、今後どのような研究の方向性を描いていますか?

A: 本研究の結果に基づいて、いくつかの将来の研究方向が考えられます.まず、スコアリングシステムの改善が必要です.現在の5点評価システムでは、応答間の質の差が最小限であるため、しばしば同点となることが問題です.これを解決するために、より多様な側面をカバーする精緻なスコアリングシステムや、比較に基づくアプローチが検討されるべきです(Wang et al., 2024).次に、判定者の訓練プロセスにおける位置バイアスの問題を解決することが重要です.このバイアスは、スコアの飽和を加速させ、応答間の区別能力を低下させています.さらに、AIがAIを訓練するためのフィードバックを生成するという方向性、すなわちRLAIF(Zhu et al., 2023; Lee et al., 2023)も有望です.例えば、Constitutional AI(Bai et al., 2022b)は、LLMを用いてフィードバックを生成し、応答を洗練し、このデータを用いて報酬モデルを訓練する手法です.これらの方向性は、超アラインメントの達成に向けた有望な道筋を提供します.

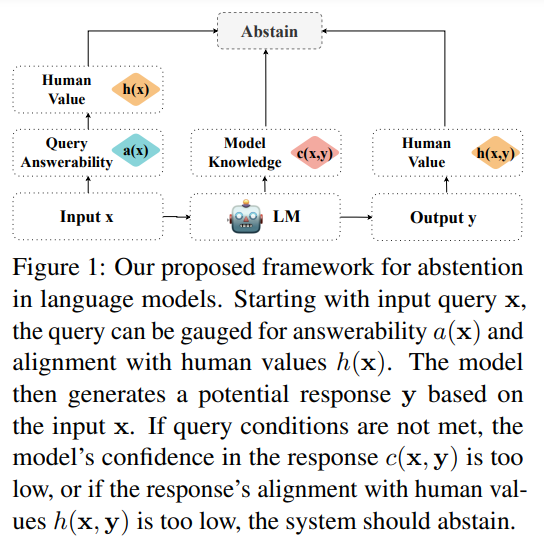

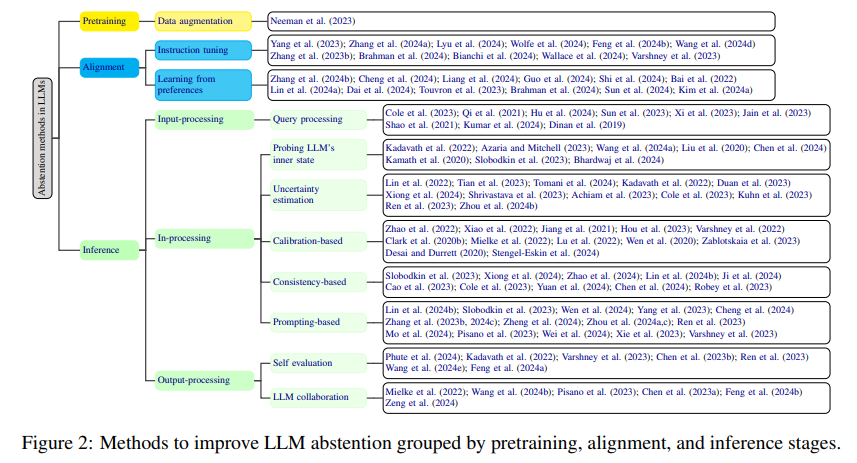

Know Your Limits: A Survey of Abstention in Large Language Models

著者:Bingbing Wen, Jihan Yao, Shangbin Feng, Chenjun Xu, Yulia Tsvetkov, Bill Howe, Lucy Lu Wang

発行日:2024年07月25日

最終更新日:2024年08月08日

URL:http://arxiv.org/pdf/2407.18418v2

カテゴリ:Computation and Language

概要:

大規模言語モデル(LLM)が回答を提供しないこと、つまり棄権は、幻覚を軽減し、LLMシステムの安全性を向上させる可能性があるという点で、ますます認識されています.この調査では、棄権を3つの視点、つまりクエリ、モデル、および人間の価値観から検討する枠組みを紹介します.この枠組みを使用して、棄権方法、ベンチマーク、および評価メトリクスに関する文献を整理し、先行研究の長所と短所について議論します.さらに、特定のタスクやドメインを超えたメタ能力として棄権を達成できるかどうか、および文脈に基づいて棄権能力を最適化する機会を提供するかどうかを中心に、将来の研究の領域を特定し、動機付けします.

Q&A:

Q: 異なる視点(クエリ、モデル、人間の価値観)は、棄権戦略の効果にどのような影響を与えるのか?

A: 異なる視点(クエリ、モデル、人間の価値観)は、アブステンション戦略の効果に大きな影響を与えます.まず、クエリの視点からは、入力される質問や要求がどのように構造化されているかが重要です.クエリが曖昧であったり、情報が不足している場合、モデルは適切にアブステンションを行うことが難しくなります.次に、モデルの視点では、モデルの能力や限界がアブステンションの効果に影響を与えます.モデルが自信を持って答えられない場合、アブステンションを選択することが望ましいです.最後に、人間の価値観の視点からは、倫理的な考慮や社会的な影響がアブステンションの決定に影響を与えます.例えば、誤った情報を提供するリスクが高い場合、アブステンションを選択することが倫理的に適切とされることがあります.これらの視点を考慮することで、より効果的で信頼性の高いアブステンション戦略を開発することが可能となります.

Q: LLMで棄権を評価するためのベンチマークや評価基準について詳しく教えてください.

A: 評価ベンチマークと評価指標について説明いたします.評価ベンチマークに関しては、主にアブステンション(回答を控えること)を含むデータセットが使用されます.これらのデータセットは、アブステンションの特定の側面を評価することに焦点を当てています.最近の研究では、Brahman et al. (2024) が包括的な評価戦略を提唱しています.具体的なデータセットとしては、SALAD-Bench(Li et al., 2024a)やSORRY-Bench(Xie et al., 2024)、WildGuard(Han et al., 2024)などがあります.これらのデータセットは、LLMの安全性や攻撃防御方法、モデルの拒否性能を評価するために設計されています.

評価指標に関しては、アブステンションを評価するためのメトリクスが開発されています.これらのメトリクスは、(i) 正しい回答を頻繁に返すこと、(ii) 誤った回答を稀に返すこと、(iii) 適切な場合にアブステンションを行うことを目指しています.具体的な指標としては、アブステンション精度(ACC)があり、これはアブステンションを組み込んだシステムの全体的な性能を評価します.数式で表すと、 $$ \small \text{ACC} = \frac{N_1 + N_5}{N_1 + N_2 + N_3 + N_4 + N_5}$$

となります.

Q: 棄権法に関する既存の文献の主な利点と限界は何か?

A: 既存の文献における棄権手法の主な利点と限界について説明いたします.まず、利点としては、棄権が大規模言語モデル(LLM)の幻覚を軽減し、安全性を向上させる可能性があることが挙げられます.棄権は、モデルが不確実な場合に回答を拒否することで、誤った情報の提供を防ぐ役割を果たします.これにより、AIシステムがより信頼性が高く、倫理基準や人間の価値観に整合することが期待されます.

一方で、限界としては、現在の手法が特定の質問応答設定に限定されていることが指摘されています.棄権をタスク全体のメタ能力として研究し、より一般化可能な評価とカスタマイズが求められています.また、棄権メカニズムがより適応的で文脈に応じたものである必要があるとされています.これにより、ユーザーへの有用性と倫理的基準のバランスをより適切に取ることが可能となります.

Q: また、LLMにとってどのような意味を持つのでしょうか?

A: 文脈における「メタ能力」とは、特定のタスクやドメインを超えて適用可能な能力を指します.これは、文脈に基づいて最適化される可能性を持ちながら、特定のタスクに依存しない能力として定義されます.大規模言語モデル(LLM)において、このメタ能力の概念は、モデルが特定の質問応答(QA)設定に限定されず、さまざまなタスクにわたって戦略的な棄権を行う能力を持つことを意味します.これにより、LLMは信頼性と安全性を向上させることが期待されます.メタ能力の実装により、モデルはユーザーのプロファイル、保守的な応答に対する許容度、インタラクション履歴、特定の要件に基づいて動的に棄権行動を調整することが可能になります.

Q: LLMの棄権を改善するために、今後どのような取り組みが最も期待できるとお考えですか?

A: 将来の研究において、LLMの棄権戦略を改善するために最も有望と考えられる具体的な領域は、棄権メカニズムをより適応的かつコンテキストに応じたものにすることです.これにより、AIシステムがより堅牢で信頼性が高く、倫理基準や人間の価値観に合致しつつ、ユーザーへの有用性とのバランスを適切に取ることが可能になります.また、ユーザーのプロファイル、保守的な応答に対する許容度、インタラクション履歴、特定の要件に基づいて棄権行動を動的に調整することも重要です.さらに、プライバシーや著作権保護を強化するために、個人情報の抽出を防ぐ棄権対応のデザインを導入することも考慮されるべきです.これらの方向性により、LLMの棄権能力がタスクを超えてメタ能力として研究され、ユーザーのニーズに応じた評価とカスタマイズが可能になるでしょう.

Q: 異なるコンテクストやタスクに基づいて、どのように棄権を最適化できるのか?

A: 異なるコンテキストやタスクに基づいてアブステンションを最適化するためには、モデルがユーザーのプロファイル、保守的な応答に対する許容度、インタラクション履歴、特定の要求に基づいて動的にアブステンションの行動を調整できるようにすることが重要です.これにより、AIシステムはより適応的でコンテキストに敏感になり、ユーザーのニーズに応じたカスタマイズが可能になります.具体的には、アブステンションのメカニズムを以下のように最適化することが考えられます.

- ユーザープロファイルに基づく調整: ユーザーの過去のインタラクションや好みに基づいて、どの程度の情報を提供するかを調整します.

- 保守的な応答に対する許容度: ユーザーがどの程度のリスクを許容するかに応じて、アブステンションの頻度や基準を設定します.

- インタラクション履歴の活用: 過去のやり取りを分析し、ユーザーがどのような情報を求めているかを理解し、それに基づいてアブステンションを調整します.

- 特定の要求に基づくカスタマイズ: ユーザーの特定の要求やタスクに応じて、アブステンションの基準を動的に変更します.

これらの方法により、アブステンションはより柔軟でユーザーにとって有益なものとなり、AIシステムの信頼性と倫理的基準の両立が図られます.

Q: 棄権メカニズムの設計と実施において、人間の価値観はどのような役割を果たすのだろうか?

A: 人間の価値観は、アブステンションメカニズムの設計と実装において重要な役割を果たすと考えられています.具体的には、入力クエリ ( x ) に対する応答 ( y ) の生成において、その応答が人間の価値観にどの程度一致しているかを評価するために、( h(x, y) ) という関数が用いられます.この評価が低い場合、システムは応答を控えるべきであるとされています.したがって、人間の価値観は、モデルがどのような状況で応答を控えるべきかを判断するための基準として機能します.

Q: 今後のLLMの展開において、答えを出すことと棄権することのバランスをどのように考えていますか?

A: 将来のLLMの開発において、回答を提供することと棄権を行使することのバランスをどのように考えるかについては、以下のように考えられます.まず、棄権は、モデルが不確実性を表現したり、潜在的な害を避けるために回答を拒否したりする行動のスペクトルを含むと定義されています.したがって、棄権は単なる会話の終了ではなく、次のステップへの移行と見なされるべきです.モデルが棄権を適切に行使するためには、モデルの有用性と棄権の目標が衝突する可能性があるため、これらの目標を調和させる必要があります.さらに、棄権の表現方法、すなわちモデルが棄権したことを伝える言葉の選択も重要です.これにより、モデルが回答を提供する際の公平性とバイアスの問題を軽減することが期待されます.したがって、将来のLLMの開発においては、棄権メカニズムをより堅牢にし、実際の応用でその効果を示すことが求められます.

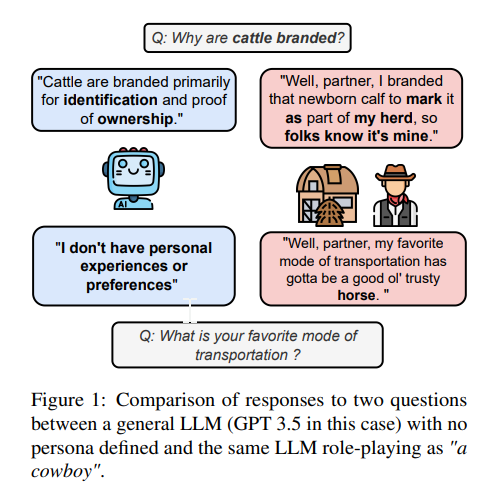

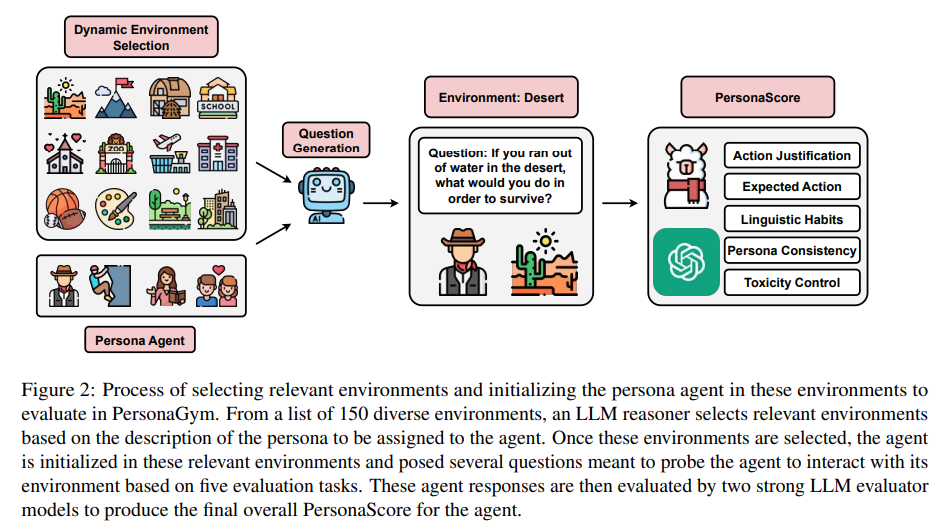

PersonaGym: Evaluating Persona Agents and LLMs

著者:Vinay Samuel, Henry Peng Zou, Yue Zhou, Shreyas Chaudhari, Ashwin Kalyan, Tanmay Rajpurohit, Ameet Deshpande, Karthik Narasimhan, Vishvak Murahari

発行日:2024年07月25日

最終更新日:2024年07月29日

URL:http://arxiv.org/pdf/2407.18416v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

Persona agentsは、割り当てられたペルソナに従って行動するLLMエージェントであり、さまざまなアプリケーションにおいて印象的なコンテキスト応答能力を示しています.これらのペルソナエージェントは、教育、医療、エンターテイメントなどのさまざまなセクターで重要な改善を提供し、モデル開発者はエージェントの応答を異なるユーザー要件に合わせることができ、それによりエージェントのアプリケーションの範囲を広げることができます.しかし、ペルソナエージェントのパフォーマンスを評価することは非常に困難であり、各ペルソナエージェントに関連するさまざまな環境での自由形式の相互作用におけるペルソナの遵守を評価する複雑さがあります.私たちは、ペルソナエージェントを評価するための最初の動的評価フレームワークであるPersonaGymと、意思決定理論に基づいた包括的な大規模評価のための最初の自動化された人間に合わせたメトリックであるPersonaScoreを紹介します.私たちが行った6つのオープンソースおよびクローズドソースのLLMを用いた評価では、200のペルソナと1万の質問を含むベンチマークを使用し、最先端のモデルにおけるペルソナエージェントの能力向上の重要な機会が明らかになりました.例えば、Claude 3.5 Sonnetは、GPT 3.5よりもはるかに高度なモデルであるにもかかわらず、PersonaScoreにおいてわずか2.97%の相対的な改善しか見られませんでした.重要なことは、モデルのサイズと複雑さの増加が必ずしもペルソナエージェントの能力向上を意味するわけではないことであり、忠実でパフォーマンスの良いペルソナエージェントに向けたアルゴリズムとアーキテクチャの発明が喫緊の課題であることが強調されています.

Q&A:

Q: ペルソナジムの評価フレームワークは、具体的にどのような方法で開発されたのですか?

A: PersonaGym評価フレームワークの開発には、いくつかの特定の方法論が用いられました.まず、動的環境選択が行われ、LLM推論者がエージェントのペルソナに基づいて150の多様な環境から関連する環境を選択します.次に、質問生成フェーズでは、各環境内でのエージェントの相互作用を評価するために、タスク固有の質問が作成されます.LLMエージェントは、慎重に作成されたシステムプロンプトを利用して与えられたペルソナを採用し、生成された質問に回答します.これにより、PersonaGymは、エージェントのさまざまなモードの相互作用を評価することを目的としています.また、PersonaScoreという指標を提案し、特定のペルソナエージェントとしてのLLMのロールプレイング能力を定量化します.

Q: ペルソナスコアが意思決定理論にどのように基づいているのか、またそれが何を意味するのか説明していただけますか?

A: PersonaScoreは、意思決定理論に基づいており、これはエージェントが環境内でどのように相互作用するかを評価するための異なる軸を提供します.意思決定理論は、エージェントが環境内で行動を選択し、その行動を正当化するための枠組みを提供します.PersonaGymでは、5つの評価タスクを通じて、エージェントの意思決定能力を評価します.これらのタスクは、エージェントが環境内でどのように意思決定を行うかを評価するための基準を提供し、PersonaScoreはこれらのタスクにおけるエージェントの能力を定量化するための最初の自動化された指標です.具体的には、PersonaScoreは、エージェントが与えられた状況でどのように行動を選択し、その選択をどのように正当化するかを評価することにより、エージェントの役割遂行能力を測定します.

Q: さまざまな環境でペルソナ・エージェントのパフォーマンスを評価する中で、どのような課題に直面しましたか?

A: ペルソナエージェントのパフォーマンスを異なる環境で評価する際に直面した課題は、自由形式のインタラクションにおけるペルソナの遵守を評価することの複雑さです.各ペルソナエージェントに関連するさまざまな環境でのパフォーマンスを評価することは非常に困難であり、これが主な課題として挙げられています.

Q: 評価の結果は、ペルソナ・エージェントの今後の開発にどのように反映されますか?

A: 評価の結果は、ペルソナエージェントの能力の将来的な発展において重要な示唆を与えます.特に、PersonaGymを用いた多次元的な評価が、ペルソナエージェントの能力を評価する上での重要性を強調しています.評価の中で、モデルの複雑さが必ずしもペルソナエージェントの能力向上を保証しないことが示されました.これにより、ペルソナエージェントの能力を向上させるためには、単にモデルを複雑にするのではなく、より多面的な評価基準を用いることが必要であることが明らかになりました.さらに、PersonaScoreを用いた評価により、ペルソナエージェントの能力を定量化することが可能となり、今後の開発においてどのような方向性が有効であるかを示す指針となります.

Q: モデルのサイズと複雑さがペルソナ・エージェントのパフォーマンスに与える影響について、詳しく教えてください.

A: 私たちの研究結果は、モデルのサイズや複雑さが必ずしもペルソナエージェントの性能を向上させるわけではないことを示しています.具体的には、Claude 3.5 Sonnetは、より高度なモデルであるにもかかわらず、GPT 3.5に比べてPersonaScoreでの相対的な改善がわずか2.97%であることが観察されました.このことは、モデルのサイズや複雑さが増しても、必ずしもペルソナエージェントの能力が向上するわけではないことを示しており、忠実で高性能なペルソナエージェントを実現するためのアルゴリズムやアーキテクチャの革新が緊急に必要であることを強調しています.これにより、ペルソナエージェントの能力を評価するためのPersonaGymの重要性が浮き彫りになっています.これらの結果は、ペルソナエージェントの性能を向上させるためには、単にモデルを大きくしたり複雑にしたりするだけでは不十分であり、より深い理解と革新が求められることを示唆しています.

Q: PersonaGymとPersonaScoreは、実社会ではどのような場面で活用される可能性がありますか?

A: PersonaGymとPersonaScoreの潜在的な応用は、さまざまな現実世界のシナリオにおいて考えられます.まず、これらのツールは、パーソナライズされたAIシステムの開発を支援するために使用される可能性があります.具体的には、ユーザーの特定のニーズや環境に応じて、エージェントのパフォーマンスを最適化することが可能です.例えば、カスタマーサポートにおいて、異なる顧客のペルソナに基づいて応答を調整することができ、より効果的なサービスを提供することができます.また、教育分野においても、学習者のペルソナに基づいて教材をカスタマイズし、個別化された学習体験を提供することが可能です.さらに、エンターテインメント業界では、ゲームやインタラクティブストーリーにおいて、プレイヤーの選択に応じてキャラクターの行動を動的に変化させることができ、より没入感のある体験を提供することができます.これらの応用は、PersonaGymとPersonaScoreが提供する動的評価と人間に一致したメトリクスに基づいて、AIシステムの効果を向上させることを目的としています.