ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Stable Diffusion 3

発行日:2024年02月24日

「Stable Diffusion 3」は、画像品質向上のモデルで、早期プレビュー待機リストが開始され、安全性と革新に重点を置いています. - Back to Basics: Revisiting REINFORCE Style Optimization for Learning from Human Feedback in LLMs

発行日:2024年02月22日

RLHFにおけるPPOの高い計算コストとハイパーパラメータの調整を解決するため、より単純なREINFORCEスタイルの最適化バリアントが提案され、性能向上が示されています. - OpenCodeInterpreter: Integrating Code Generation with Execution and Refinement

発行日:2024年02月22日

大規模な言語モデルの導入により、コード生成技術が進歩し、OpenCodeInterpreterはオープンソースのコードシステムであり、人間のフィードバックを統合し、動的なコードの改善を実現する. - Gemma: Open Models Based on Gemini Research and Technology

発行日:2024年02月21日

Geminiモデルの技術を活用したGemmaは、軽量で最新のオープンモデルファミリーで、70億および20億のパラメータモデルを提供し、テキスト領域で強力な汎用能力を持つ. - Large Language Models for Data Annotation: A Survey

発行日:2024年02月21日

データアノテーションは、機械学習モデルの効果を向上させるために必要な情報をラベル付けするが、GPT-4などのLLMの登場により自動化が可能となり、この論文はLLMを使用したデータアノテーションの有用性に焦点を当てている. - LoRA+: Efficient Low Rank Adaptation of Large Models

発行日:2024年02月19日

Huら(2021)のLow Rank Adaptation(LoRA)は、大きな幅のモデルの微調整においてサブ最適な結果をもたらし、LoRA+はパフォーマンスを向上させ、微調整の速度を向上させ、同じ計算コストで実行される. - In Search of Needles in a 11M Haystack: Recurrent Memory Finds What LLMs Miss

発行日:2024年02月16日

生成トランスフォーマーモデルを使用して長い文書を処理するために、新しいベンチマークBABILongを導入し、GPT-2を再帰的なメモリ拡張を用いてファインチューニングすることで、\( \small 11\times 10^6 \)要素を処理するタスクに対応できることが示された. - When is Tree Search Useful for LLM Planning? It Depends on the Discriminator

発行日:2024年02月16日

LLMsを使用した言語エージェントフレームワークにおいて、高度なプランニング方法がディスクリミネーターの精度に影響し、効率的なバランスが必要であることが示された. - Chain-of-Thought Reasoning Without Prompting

発行日:2024年02月15日

LLMsの推論能力を向上させるための新しいアプローチは、プロンプティングなしで効果的な推論を可能にし、CoT推論パスを引き出すことで信頼性を高める. - Generative Representational Instruction Tuning

発行日:2024年02月15日

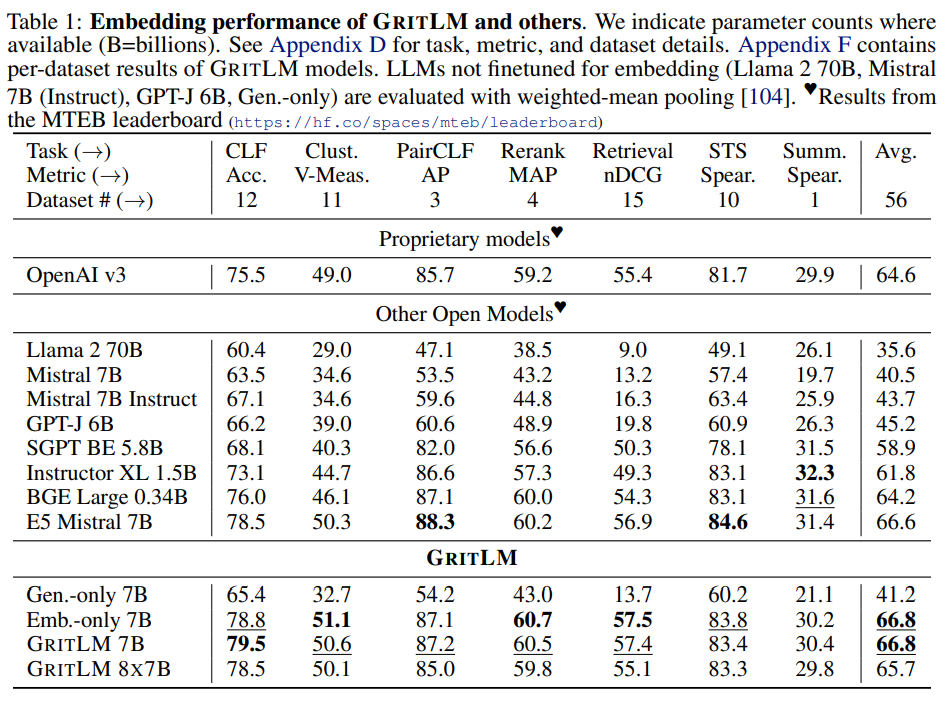

GRITによる統一により、生成または埋め込みデータのみでのトレーニングと同等のパフォーマンスを維持し、GritLMはMTEBで最高記録を樹立しました.

Stable Diffusion 3

著者:Stability AI

発行日:2024年02月24日

最終更新日:不明

URL:https://stability.ai/news/stable-diffusion-3

カテゴリ:不明

概要:

「Stable Diffusion 3」は、マルチサブジェクトプロンプト、画像品質、スペル能力の向上を実現した、最も優れたテキストから画像へのモデルであることが発表されました.このモデルはまだ広く利用可能ではありませんが、今日から早期プレビューのための待機リストを開始します.このプレビューフェーズは、以前のモデルと同様に、パフォーマンスと安全性を向上させるための洞察を収集するために重要です.こちらから待機リストに参加することができます.

「Stable Diffusion 3」スイートのモデルは現在、800Mから8Bのパラメーターに及んでいます.このアプローチは、私たちのコアバリューと一致させ、アクセスを民主化し、ユーザーにスケーラビリティと品質のバラエティを提供し、彼らの創造的ニーズに最適に対応します.Stable Diffusion 3は、ディフュージョントランスフォーマーアーキテクチャとフローマッチングを組み合わせています.近日中に詳細な技術レポートを公開する予定です.

安全で責任あるAIの実践を信じています.これは、Stable Diffusion 3の悪意ある利用を防ぐために合理的な措置を講じており、モデルのトレーニングを開始し、テスト、評価、展開を通じて継続しています.この早期プレビューに向けて、数多くの安全対策を導入しています.研究者、専門家、コミュニティとの継続的な協力を通じて、モデルの公開リリースに向けて誠実にさらなる革新を期待しています.

私たちの生成AIがオープンで安全で普遍的にアクセス可能であることを確保するという取り組みは不変です.Stable Diffusion 3を通じて、個人、開発者、企業が創造性を発揮できる適応可能なソリューションを提供することを目指しており、人類の潜在能力を活性化する使命に合致しています.

Stable Diffusion 3のリリース前に商用利用のために他の画像モデルを使用したい場合は、Stability AIメンバーシップページを訪れて自己ホストするか、Developer PlatformにアクセスしてAPIを利用できます.

Q&A:

Q: ステイブル・ディフュージョン3は、以前のモデルと比べてどのような点が改善されましたか?

A: Stable Diffusion 3は、以前のモデルに比べて、マルチサブジェクトプロンプト、画像品質、スペル能力の向上が大幅に図られています.

Q: 安定拡散3モデルのパラメータの範囲について、もう少し詳しく教えてください.

A: Stable Diffusion 3のモデルスイートのパラメーターの範囲は現在、800Mから8Bまでです.このアプローチは、私たちのコアバリューに合わせ、アクセスを民主化し、ユーザーにスケーラビリティと品質のさまざまなオプションを提供し、彼らの創造的ニーズに最適に対応することを目指しています.

Q: ステイブル・ディフュージョン3は、拡散トランス・アーキテクチャとフロー・マッチングをどのように組み合わせているのか?

A: Stable Diffusion 3は拡散トランスフォーマーアーキテクチャとフローマッチングを組み合わせています.拡散トランスフォーマーアーキテクチャは、入力データを複数のステップに分割し、それぞれのステップでノイズを加えながら処理することで、データの特徴を抽出します.一方、フローマッチングは、データの流れを制御し、異なるスケールのデータを適切に組み合わせることで、モデルの柔軟性と性能を向上させます.

Q: Stable Diffusion 3の悪用を防ぐために、具体的にどのような保護措置が導入されているのか?

A: Stable Diffusion 3の誤用を防ぐために導入された具体的な安全対策は、モデルのトレーニング開始時からテスト、評価、展開まで継続的に行われています.また、研究者、専門家、コミュニティとの協力を通じて、安全性を確保するための数々の保護措置が導入されています.

Q: モデルの安全性と完全性を確保するために、チームは研究者、専門家、地域社会とどのように協力していますか?

A: 研究者、専門家、およびコミュニティとの継続的な協力により、モデルの安全性と完全性を確保しています.我々は、Stable Diffusion 3の誤用を防ぐために合理的な措置を講じており、モデルのトレーニングを開始してからテスト、評価、展開に至るまで安全性を確保しています.我々のコミットメントは、生成的AIがオープンで安全で普遍的にアクセス可能であることを確実にすることです.

Q: モデルの安全性を確保するために取られた手順について詳しく説明していただけますか?

A: モデルの安全性を確保するために、トレーニング、テスト、評価、展開の各段階で適切な手順が講じられています.トレーニングの開始時からテスト、評価、展開に至るまで、悪意のある利用を防ぐための合理的な措置が取られています.研究者、専門家、コミュニティとの継続的な協力により、モデルの公開リリースに向けて誠実にイノベーションを図り、安全性を確保しています.生成AIのオープン性、安全性、普遍的なアクセス可能性を確保するための取り組みは不変です.

Q: 個人、開発者、企業が安定拡散3にアクセスし、利用するにはどのような選択肢がありますか?

A: 早期プレビューのための待機リストが開かれており、ユーザーはそこに登録することができます.

Q: 安定拡散3に関して発表されるテクニカルレポートの詳細について教えてください.

A: 技術レポートは近日中に公開される予定です.

Back to Basics: Revisiting REINFORCE Style Optimization for Learning from Human Feedback in LLMs

著者:Arash Ahmadian, Chris Cremer, Matthias Gallé, Marzieh Fadaee, Julia Kreutzer, Olivier Pietquin, Ahmet Üstün, Sara Hooker

発行日:2024年02月22日

最終更新日:2024年02月26日

URL:http://arxiv.org/pdf/2402.14740v2

カテゴリ:Machine Learning

概要:

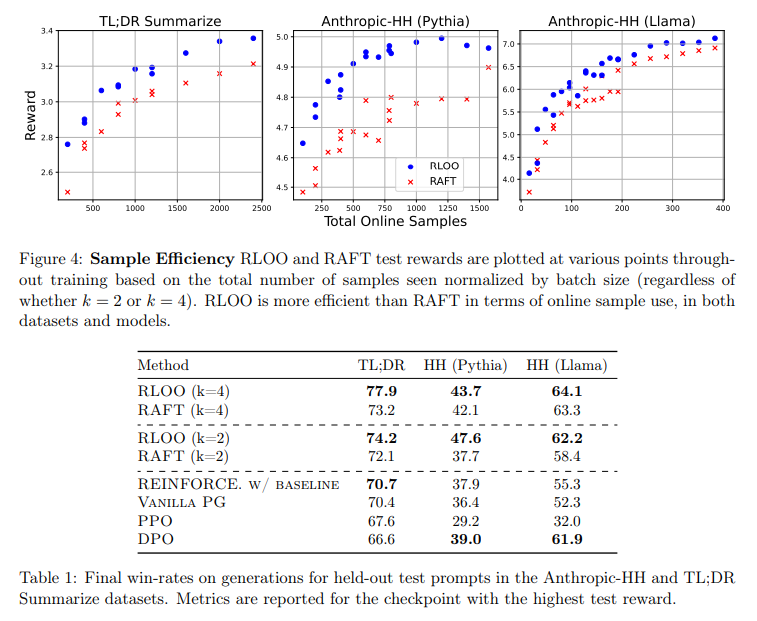

AIアライメントは、人間のフィードバックからの強化学習(RLHF)の形で、高性能な大規模言語モデルの重要な要素として扱われるようになっています.最近の文献では、Proximal Policy Optimization(PPO)がRLHFのRL部分のカノニカルな方法と位置付けられています.しかし、高い計算コストと感度の高いハイパーパラメータの調整が必要です.私たちは、PPOの開発につながる多くの動機付け原則がRLHFにおいては実用的な懸念ではないと考え、性能を維持または向上させるために計算コストの低い方法を提唱しています.私たちは、RLの文脈で人間の選好に基づくアライメントの定式化を見直します.シンプルさを指針として、PPOの多くのコンポーネントがRLHFの文脈では不要であり、より単純なREINFORCEスタイルの最適化バリアントがPPOやDPO、RAFTなどの新しく提案された「RLフリー」の方法を上回ることを示しています.私たちの研究は、LLMのアライメント特性に注意深く適応することで、低コストでオンラインRL最適化の恩恵を受けることができることを示唆しています.

Q&A:

Q: 人間のフィードバックからの強化学習(Reinforcement Learning from Human Feedback:RLHF)の文脈で、近接政策最適化(Proximal Policy Optimization:PPO)を開発するに至った具体的な動機づけ原理について説明していただけますか?

A: PPOの開発につながった具体的な動機付け原則は、高い計算コストと感度の高いハイパーパラメータ調整が必要である.これらの原則は、RLHFの文脈では実用的な懸念ではなく、性能を維持または向上させるためには、より計算コストの低い方法が望ましいと主張している.PPOの開発につながった動機付け原則の多くは、RLHFの文脈では実用的な懸念ではないと考え、性能を維持または向上させるためには、よりシンプルなREINFORCEスタイルの最適化が適していることを示している.

Q: RLHFにおける計算コストとハイパーパラメータのチューニングという点で、PPOは他の手法と比べてどうなのか?

A: PPOは、他の方法と比較して、計算コストが高く、ハイパーパラメータの調整が難しいとされています.PPOは、生成器、リファレンス(KL推定用)、評価者、および報酬モデルの4つのモデルを同時にロードする必要があり、生成器と評価者モデルのトレーニングが交互に行われるため、計算コストが高くなります.また、PPOの相対的なアルゴリズムの複雑さとオンラインRL最適化の不安定で感度が高い性質から、PPOの調整には専門知識が必要です.一方、最近の研究では、RLフリーな方法であるDPOやIPO、またはLLMの選好トレーニングに対する反復微調整アプローチが提案されていますが、これらの方法はRLパラダイム内でより簡単な解決策が存在するかどうかを問いかけておらず、RLコンポーネントを取り除いたり、困難を排除することでこの問いに答えようとしています.しかし、PPOの多くのコンポーネントはRLHFの文脈では不要であり、REINFORCEスタイルの最適化変種の方がPPOやDPO、RAFTなどの新しいRLフリーな方法よりも優れたパフォーマンスを発揮することが示されています.したがって、LLMの適合特性に慎重に適応することで、オンラインRL最適化を低コストで利用することが可能となります.

Q: RLHFの文脈では不要とされるPPOの主要な構成要素とは何か?

A: PPOの主要なコンポーネントの多くは、RLHFの文脈では不要であると考えられています.

Q: RLHFにおいて、REINFORCEスタイルの最適化手法は、PPOや他の手法をどのように上回るのか?

A: REINFORCEスタイルの最適化バリアントは、PPOやその他の方法を上回る理由は、RLHFの文脈では、PPOの多くのコンポーネントが不要であり、より単純な方法であるためです.RLHFの条件に適したREINFORCEスタイルの最適化は、高い性能を維持または向上させることができます.

Q: RLHFの文脈における大規模言語モデル(LLM)へのアライメント特性の適応について詳しく教えてください.

A: 大規模言語モデル(LLMs)のアライメント特性の適応について、RLHFの文脈での詳細な説明を提供します.RLHFは、通常、事前にトレーニングされたLLMを微調整することを含むタスクであり、これには人間のフィードバックからの強化学習が関与します.このアプローチでは、通常、報酬モデルが訓練され、通常はペアのデータに対してバイナリ分類器として機能します.この報酬モデルは、LLMが人間の好みに合わせるための報酬スコアを最大化するように訓練されます.しかし、この方法論は、PPOなどの複雑なRL最適化手法を必要とせず、よりシンプルなREINFORCEスタイルの最適化手法がPPOやDPO、RAFTなどの新しい提案された「RL-free」手法よりも優れていることが示されています.したがって、LLMsのアライメント特性に慎重に適応することで、オンラインRL最適化を低コストで利用することが可能となります.

Q: RLHFでよりシンプルな最適化手法を使うことの主な利点は何ですか?

A: RLHFにおいてよりシンプルな最適化手法を使用する主な利点は、計算コストを低く抑えながら性能を維持または向上させることができる点にあります.PPOのような複雑な手法を使用せずに、REINFORCEスタイルの最適化手法を採用することで、高い性能を達成できることが示されています.また、RLHFの環境では、勾配推定値の分散が高いという課題が従来のDeep-RL設定よりも少ないため、強力な正則化が必要ないという実証結果もあります.

Q: REINFORCEスタイルの最適化バリエーションは、RLHFにおいてDPOやRAFTのような新しく提案された「RLフリー」手法と比較してどのようなパフォーマンスを示すのでしょうか?

A: REINFORCEスタイルの最適化変種は、DPOやRAFTなどの新しく提案された「RL-free」メソッドよりも優れたパフォーマンスを示しています.

Q: RLHFの最適化プロセスにおいて、シンプルさという指針はどのように維持されていますか?

A: シンプリシティを導く原則を維持するために、PPOの多くのコンポーネントはRLHFの文脈では不要であり、よりシンプルなREINFORCEスタイルの最適化が適していることを示すことによって、最適化プロセスを確実にする.

OpenCodeInterpreter: Integrating Code Generation with Execution and Refinement

著者:Tianyu Zheng, Ge Zhang, Tianhao Shen, Xueling Liu, Bill Yuchen Lin, Jie Fu, Wenhu Chen, Xiang Yue

発行日:2024年02月22日

最終更新日:2024年02月22日

URL:http://arxiv.org/pdf/2402.14658v1

カテゴリ:Software Engineering, Artificial Intelligence, Computation and Language

概要:

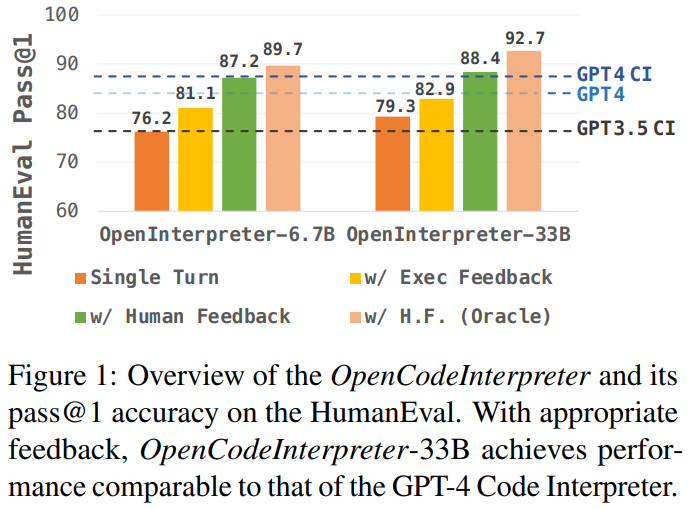

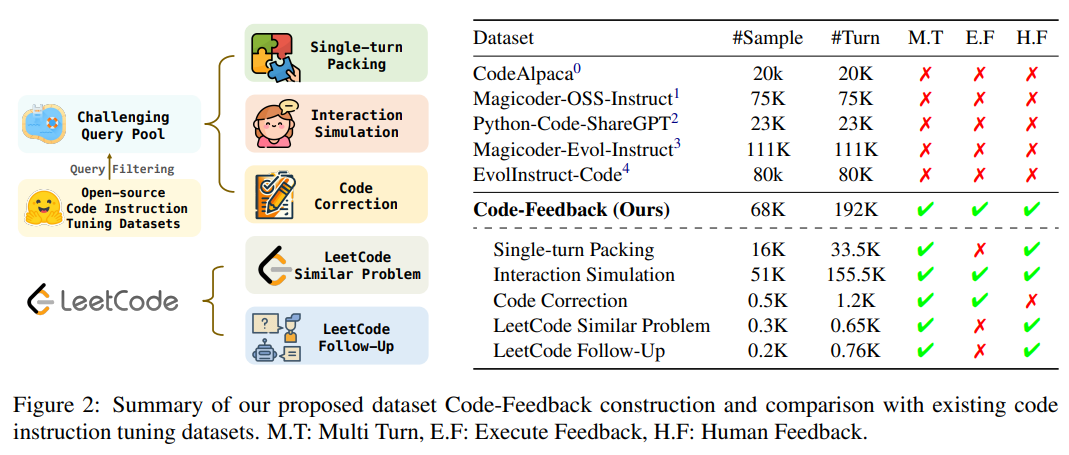

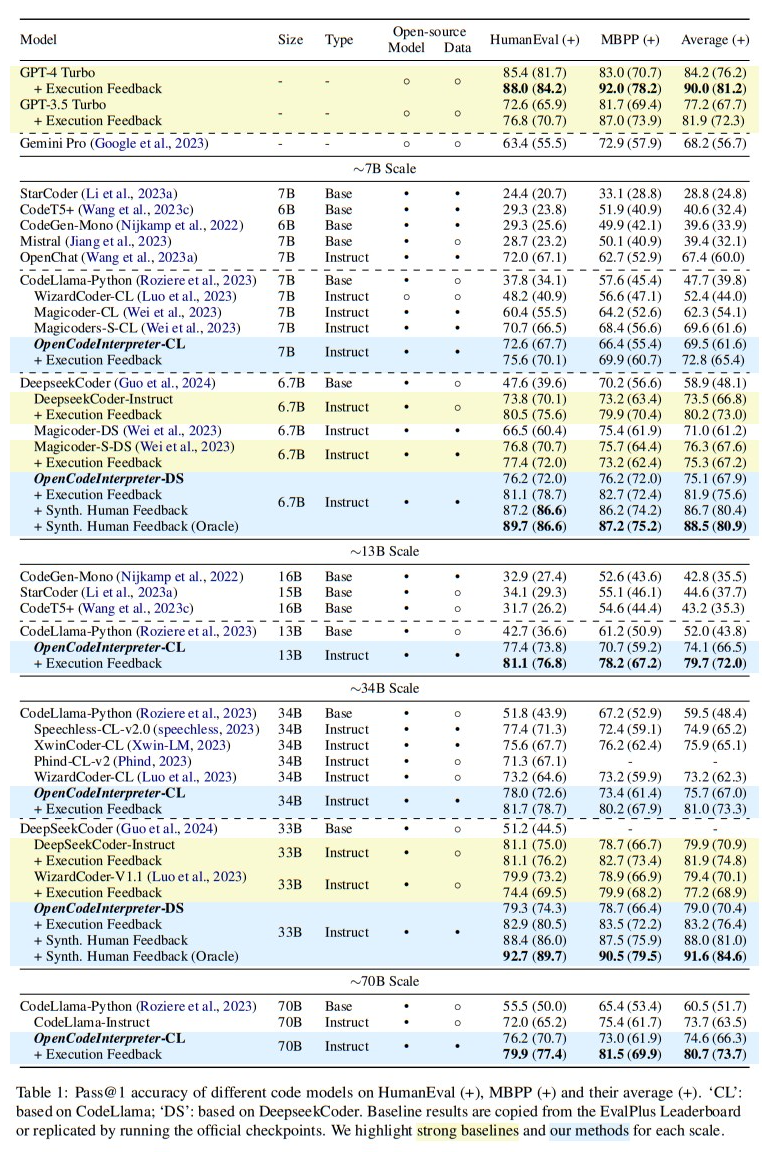

大規模な言語モデルの導入により、コード生成の技術は大きく進歩しました.しかし、オープンソースのモデルはしばしばGPT-4コードインタープリターのような高度なシステムの実行能力や反復的な改善を欠いています.この課題に対処するために、コード生成、実行、および反復的なコードの改善を目的としたオープンソースのコードシステムであるOpenCodeInterpreterを紹介します.68,000のマルチターンインタラクションを特徴とするCode-Feedbackデータセットによってサポートされ、OpenCodeInterpreterは実行と人間のフィードバックを統合し、動的なコードの改善を実現します.HumanEval、MBPP、およびEvalPlusからの強化バージョンなどの主要なベンチマークでのOpenCodeInterpreterの包括的な評価は、その優れたパフォーマンスを示しています.特に、OpenCodeInterpreter-33Bは、HumanEvalとMBPPの平均(およびプラスバージョン)で83.2(76.4)の精度を達成し、GPT-4の84.2(76.2)にほぼ匹敵し、さらにGPT-4から合成された人間のフィードバックを受けて91.6(84.6)に向上します.OpenCodeInterpreterは、オープンソースのコード生成モデルとGPT-4コードインタープリターなどのプロプライエタリシステムとの間のギャップを埋めることができます.

Q&A:

Q: 他のオープンソースのコード生成モデルと比較して、OpenCodeInterpreterの具体的な特徴や機能についてもっと詳しく教えてください.

A: OpenCodeInterpreterは、他のオープンソースのコード生成モデルと比較して、実行能力と反復的な改善能力に優れています.OpenCodeInterpreterは、68,000のマルチターンインタラクションを特徴とするCode-Feedbackデータセットによってサポートされ、コードの動的な改善のために実行と人間のフィードバックを統合しています.OpenCodeInterpreterは、異なるモデルスケールにおいて優れた結果を示し、特にOpenCodeInterpreter-DS 33Bバリアントは、オープンソースモデルの中で最高のスコアを達成しています.初期のトレーニングセットに低品質または不正確なデータが多く存在する中で、この成果は顕著です.

Q: OpenCodeInterpreterは、実行機能と反復改良をコード生成プロセスにどのように統合しているのですか?

A: OpenCodeInterpreterは、コンパイラの診断情報と人間のフィードバックを反復的な改良プロセスに統合することによって、実行能力と反復的な改良をコード生成プロセスに統合しています.このアプローチにより、OpenCodeInterpreterは従来の一度限りの生成アプローチを超えるだけでなく、オープンソースモデルでは以前に見られなかった適応性と精度のレベルを導入しています.

Q: OpenCodeInterpreterの動的コードリファインメントをサポートするCode-Feedbackデータセットの意義は何ですか?

A: Code-Feedbackデータセットは、OpenCodeInterpreterの動的なコードの改善をサポートする上で重要です.このデータセットは、実世界のコーディングタスクから派生した幅広いクエリを含み、多様性と複雑さを提供することを目的としています.また、Code-Feedbackは、ユーザー、コードモデル、およびコンパイラの間での68,000回のマルチターンインタラクションを特徴としており、実行フィードバックと人間のフィードバックの両方を統合しています.これにより、OpenCodeInterpreterは、コンパイラの診断を使用してエラーを修正し、人間の洞察を使用してコード生成を洗練させることができます.つまり、Code-Feedbackデータセットは、OpenCodeInterpreterが技術的に優れた解決策を生成し、ユーザーの要件に密接に一致するようにするための重要な役割を果たしています.

Q: HumanEval、MBPP、EvalPlusなどのベンチマークにおけるOpenCodeInterpreterの評価プロセスについて詳しく教えてください.

A: OpenCodeInterpreterは、HumanEval、MBPP、およびEvalPlusなどのベンチマークを横断的に評価するために、実験的な分析を行いました.具体的には、OpenCodeInterpreterは、HumanEvalとMBPPの平均値(およびプラスバージョン)において83.2(76.4)の精度を達成し、GPT-4の84.2(76.2)とほぼ同等の性能を示しました.さらに、GPT-4から合成された人間のフィードバックを取り入れることで、OpenCodeInterpreterの性能は91.6(84.6)に著しく向上しました.このように、OpenCodeInterpreterは、コード生成において新たな基準を確立し、オープンソースモデルと高度なプロプライエタリモデルの性能差を縮めることに成功しました.

Q: HumanEvalやMBPPのようなベンチマークで、OpenCodeInterpreter-33Bの精度はGPT-4と比べてどうですか?

A: OpenCodeInterpreter-33Bは、HumanEvalとMBPPなどのベンチマークでGPT-4と比較して、類似の性能を示しています.具体的には、HumanEvalとMBPPの平均精度がOpenCodeInterpreter-33Bで83.2(76.4)であり、GPT-4は84.2(76.2)です、さらに、GPT-4から合成された人間のフィードバックを取り入れると、OpenCodeInterpreterの性能は91.6(84.6)に向上します.

Q: OpenCodeInterpreterのパフォーマンスを向上させるために、GPT-4から合成された人間のフィードバックはどのような役割を果たすのでしょうか?

A: GPT-4による合成された人間のフィードバックは、OpenCodeInterpreterのパフォーマンスを向上させるために重要な役割を果たします.具体的には、このフィードバックは、タスクの説明、初期モデルの応答、および実行フィードバックを考慮して人間の入力を模倣することで、OpenCodeInterpreterの適応性をテストし、開発者やユーザーとの実際のやり取りを反映しています.

Q: OpenCodeInterpreterは、オープンソースのコード生成モデルとGPT-4 Code Interpreterのようなプロプライエタリなシステムとのギャップをどのように埋めているのでしょうか?

A: OpenCodeInterpreterは、コンパイラ診断と人間のフィードバックを反復的な改良プロセスに統合することで、オープンソースモデルとGPT-4コードインタプリターのようなプロプライエタリシステムとの間のギャップを埋めることができます.この統合により、従来の一度限りの生成アプローチを超え、オープンソースモデルではこれまでに見られなかった適応性と精度のレベルを導入します.Code-Feedbackの導入により、68,000のマルチターンインタラクションを特徴とするデータセットがOpenCodeInterpreterをさらに強化し、オープンソースコード生成モデルとGPT-4コードインタプリターのようなプロプライエタリシステムとの間のギャップを埋めることができます.

Q: コードの生成、実行、洗練にOpenCodeInterpreterを使うことの、他のシステムと比較した主な利点は何ですか?

A: OpenCodeInterpreterは、コード生成、実行、および改良において、他のシステムと比較して主な利点があります.具体的には、OpenCodeInterpreterは大規模な言語モデルを活用しており、68Kのマルチターンインタラクションを備えたCode-Feedbackデータセットでトレーニングされています.このデータセットにより、ユーザー、コードモデル、およびコンパイラの間での相互作用を反映し、実行と人間のフィードバックを統合しています.さらに、OpenCodeInterpreterはコンパイラの診断情報を活用してエラーを修正し、人間の洞察を用いてコード生成を改良しています.このアプローチにより、OpenCodeInterpreterは技術的に優れた解決策を提供し、ユーザー要件に密接に適合するコードを生成することができます.その結果、全体的なパフォーマンスが大幅に向上しています.

Q: OpenCodeInterpreterの開発と実装で直面した潜在的な制限や課題について教えてください.

A: OpenCodeInterpreterの開発と実装において直面する潜在的な制限や課題について議論することができます.例えば、OpenCodeInterpreterは多言語のコード生成をサポートするように設計されていますが、異なる言語や特定のドメインにおいて性能が異なる可能性があります.また、非常に複雑または曖昧なユーザーの意図に対応する際に苦労する可能性があります.さらに、複数の難しいエラーに同時に対処する制限もあります.

Q: OpenCodeInterpreterのコード生成と洗練の分野での今後の発展と採用をどのように想定していますか?

A: OpenCodeInterpreterは、コード生成と改良の分野において、大きな進歩をもたらす可能性があります.このシステムは、大規模な言語モデルの導入により、コード生成の能力を大幅に向上させています.さらに、OpenCodeInterpreterは、コンパイラ診断と人間のフィードバックを統合し、反復的な改良プロセスを通じてコードを動的に洗練することができます.このシステムは、オープンソースモデルとプロプライエタリシステムの間のギャップを埋めることができ、非専門家や開発者にとって参入障壁を下げる可能性があります.将来的には、OpenCodeInterpreterの開発と採用がさらに進み、コード生成と改良の分野に革新をもたらすことが期待されます.

Gemma: Open Models Based on Gemini Research and Technology

著者:Gemma Team, Google DeepMind

発行日:2024年02月21日

最終更新日:不明

URL:https://storage.googleapis.com/deepmind-media/gemma/gemma-report.pdf

カテゴリ:不明

概要:

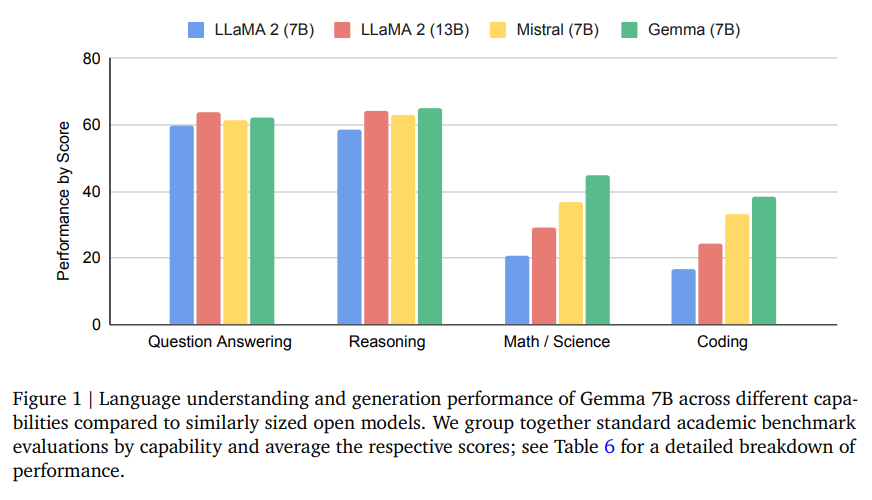

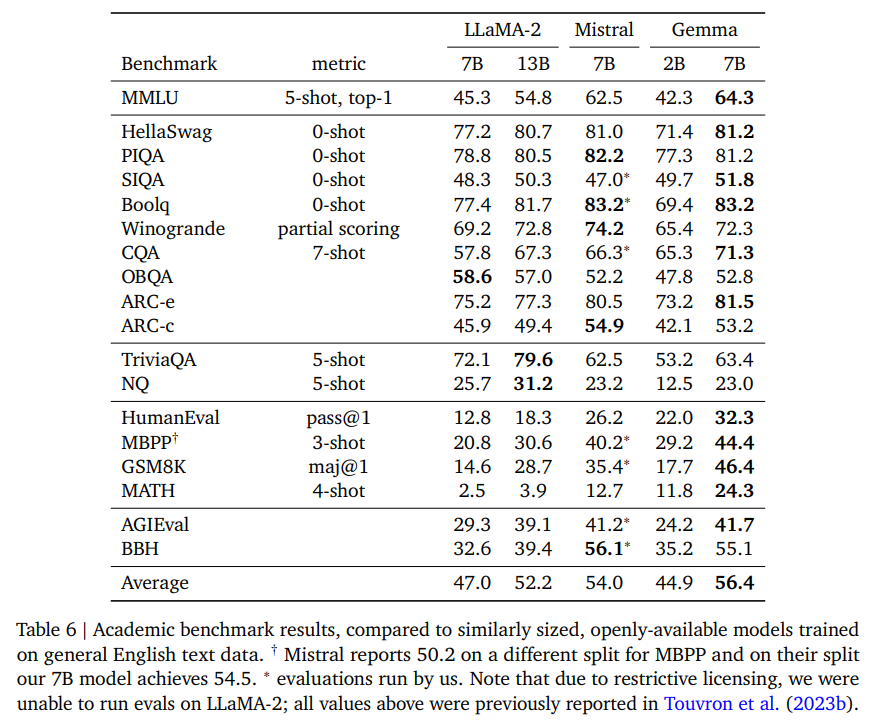

この作品は、Geminiモデルの研究と技術を活用して構築された軽量で最新のオープンモデルファミリーであるGemmaを紹介しています.Geminiと同様のアーキテクチャ、データ、およびトレーニングレシピを使用して、Gemmaモデルを最大6兆トークンのテキストでトレーニングしました.Gemmaは、効率的な展開とGPUおよびTPU上での開発のための70億のパラメータモデルと、CPUおよびオンデバイスアプリケーション向けの20億のパラメータモデルの2つのサイズで提供されています.各サイズは、異なる計算上の制約、アプリケーション、および開発者の要件に対応するよう設計されています.Geminiと同様に、Gemmaはテキスト領域での強力な汎用能力を持ち、最先端の理解力と推論スキルを備えています.Geminiは、18のテキストベースのタスクのうち11つで同様のサイズのオープンモデルを上回り、モデルの安全性と責任性の包括的な評価を提示し、モデル開発の詳細な説明も行っています.Geminiと同様に、Gemmaも最新のシーケンスモデルやトランスフォーマー、ニューラルネットワークに基づく深層学習手法、分散システムでの大規模トレーニング技術などの先行研究に基づいています.また、Googleの長い歴史に基づいており、Word2Vec、Transformer、BERT、T5、T5Xなどのオープンモデルとエコシステムを構築しています.LLMの責任あるリリースが、フロンティアモデルの安全性を向上させ、この革新への公平なアクセスを確保するために重要であると考えています.Gemini 7Bの言語理解と生成の性能は、質問回答、推論、数学/科学、コーディングなどの機能において、同様のサイズのオープンモデルと比較しています.Geminiの研究と技術を基にしたGemmaは、次世代のイノベーションの開発に不可欠であり、安全性テストが行われているものの、すべてのアプリケーションやシナリオを網羅することはできないため、Gemmaのユーザーは展開や使用前に独自の安全性テストを実施すべきです.さらに、この技術レポートでは、Gemmaアーキテクチャ、トレーニングインフラストラクチャ、事前トレーニングおよびファインチューニングのレシピについて詳細に概説し、幅広い定量的および定性的ベンチマーク、標準的な学術的ベンチマーク、および人間の選好評価を通じて、すべてのチェックポイントの徹底的な評価を行っています.さらに、安全で責任ある展開に対するアプローチについて詳細に議論し、Gemmaの広範な影響、制限、利点、および結論を概説しています.

Q&A:

Q: Gemmaが同規模のオープンモデルを上回った具体的なベンチマークの詳細を教えてください.

A: Gemmaモデルは、GSM8Kおよびより難しいMATHベンチマークで他のモデルを少なくとも10ポイント上回り、HumanEvalベンチマークでも別のオープンモデルを少なくとも6ポイント上回っています.また、コードを微調整したCodeLLaMA-7Bモデルの性能をも上回っています.

Q: Gemmaの70億パラメータ・モデルと20億パラメータ・モデルの設計とアプリケーションの違いについて説明していただけますか?

A: 70億パラメータモデルと20億パラメータモデルの設計とアプリケーションの違いは、主に以下の点にあります.クエリーアテンションを使用しています、これは、それぞれのモデルサイズにおいて性能が向上することが確認されたためです、また、70億パラメータモデルは、TPUv5eを4096個使用してトレーニングされています、GPUやTPU上での効率的な展開と開発に適しています.億パラメータモデルは512個のTPUv5eを使用してトレーニングされており、CPUやデバイス向けに設計されています. 両サイズのモデルは、異なる計算上の制約、アプリケーション開発者の要件に対応するように設計されています.

Q: Gemma・モデルはどのようにトレーニングされ、トレーニングの過程でどのようなデータやアーキテクチャが使用されたのか?

A: Gemmaモデルは、Geminiモデルファミリーと同様のアーキテクチャ、データ、およびトレーニングレシピを使用して、最大6Tのテキストトークンでトレーニングされました.Geminiと同様に、これらのモデルは、テキスト領域で強力な汎用能力を持ち、スケールで最先端の理解力と推論スキルを実現しています.モデルは、7億パラメータモデルと20億パラメータモデルの2つのサイズで提供され、それぞれ異なる計算制約、アプリケーション、および開発者要件に対応しています.トレーニングデータは、2Bおよび7Bモデルの一連の削除実験を通じて決定され、トレーニング中にコーパスの混合物を変更して関連性の高い高品質データの重みを増やすためにトレーニングを段階的に行っています.

Q: Gemmaは、他のオープンモデルと比較して、具体的にどのような領域でパフォーマンスの進歩を示したのか?

A: Gemmaモデルは、質問回答、常識的推論、数学・科学、およびコーディングの領域において、他のオープンモデルと比較して性能を向上させました.

Q: Gemmaモデルの評価プロセスについて、定量的・定性的な両面から詳しく教えてください.

A: Gemmaモデルの評価プロセスは、定量的および定性的なベンチマークを使用して行われました.Gemmaは、自動ベンチマークと人間の評価の両方を使用して、幅広いドメインで評価されました.最終的な再評価は、能力によって分類され、それぞれのスコアの平均が算出されました.また、モデルの安全性テストも行われ、その結果は公開されています.Gemmaアーキテクチャは、高容量モデルを使用しており、ベースラインモデルとの比較を行いました.Gemmのモデルカードも公開され、研究者により包括的な理解を提供しています.

Q: フロンティア・モデルの安全性を向上させ、将来のLLMイノベーションを可能にするために、Gemma・モデルはどのように貢献するのか?

A: Gemmaモデルは、フロンティアモデルの安全性を向上させ、将来のLLM革新を可能にするために貢献しています.Geminiモデルプログラムの多くの学びを活用し、Geminiモデルプログラムでのコード、データ、アーキテクチャ、指示チューニング、人間のフィードバックからの強化学習、評価などの要素を取り入れています.さらに、Gemmaモデルは、6つの標準安全ベンチマークや人間の比較評価において競合他社を上回る性能を発揮しており、幅広い領域での性能向上を実現しています.これにより、研究者がGemmaを使用して幅広い研究を加速し、開発者が有益な新しいアプリケーション、ユーザーエクスペリエンス、その他の機能を作成することを期待しています.

Q: Gemma・モデルがテキスト・ドメインにおいて強力なジェネラリスト能力を発揮する主な理由は何か?

A: Gemmaモデルの主な特徴は、Geminiモデルファミリーと同様のアーキテクチャ、データ、およびトレーニング手法を使用しており、テキスト領域での強力な汎用能力を実現しています.Geminiと同様に、これらのモデルは、スケールにおいて最先端の理解力と推論スキルを備えており、テキスト領域での強力な汎用能力を発揮しています.Geminiモデルの研究と技術に基づいたGemmaモデルは、言語理解、推論、および安全性のための学術ベンチマークで強力なパフォーマンスを示しています.

Q: Gemmaモデルは、パフォーマンスと機能の面でGoogleのジェミニモデルと比較してどうですか?

A: Gemmaモデルは、GoogleのGeminiモデルと比較して、パフォーマンスと能力の面で強力な性能を示しています.Geminiモデルと同様のアーキテクチャ、データ、トレーニングレシピを使用して、Gemmaモデルをトレーニングしました.Geminiと同様に、これらのモデルはテキスト領域で強力な汎用能力を持ち、スケールで最先端の理解力と推論スキルを実現しています.Gemmaは、効率的な展開とGPUおよびTPUでの開発のための70億パラメータモデルと、CPUおよびデバイスアプリケーション用の20億パラメータモデルの2つのサイズで提供されています.各サイズは、異なる計算上の制約、アプリケーション、および開発者の要件に対応するように設計されています.両方のスケールで、生の事前トレーニング済みチェックポイントと、ダイアログ、指示の遵守、役立ち、および安全性のために微調整されたチェックポイントをリリースしています.私たちは、事前トレーニング済みおよび微調整されたチェックポイントのリリースが、現在の指示の影響に関する徹底的な研究と調査を可能にすると信じています.

Large Language Models for Data Annotation: A Survey

著者:Zhen Tan, Alimohammad Beigi, Song Wang, Ruocheng Guo, Amrita Bhattacharjee, Bohan Jiang, Mansooreh Karami, Jundong Li, Lu Cheng, Huan Liu

発行日:2024年02月21日

最終更新日:2024年02月21日

URL:http://arxiv.org/pdf/2402.13446v1

カテゴリ:Computation and Language

概要:

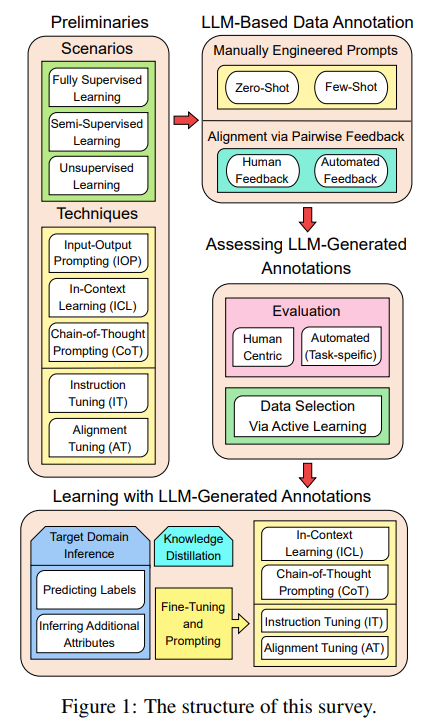

データアノテーションは、機械学習モデルの効果を向上させるために必要な、生データに関連する情報をラベル付けすることです.しかし、このプロセスは労力と費用がかかります.GPT-4などの先進的な大規模言語モデル(LLM)の登場により、データアノテーションの複雑なプロセスを革新し自動化する画期的な機会が生まれています.既存の調査はLLMのアーキテクチャ、トレーニング、一般的な応用について広くカバーしていますが、この論文はデータアノテーションにおけるLLMの特定の有用性に焦点を当てています.この調査は、LLMに基づくデータアノテーション、LLMが生成したアノテーションの評価、およびLLMが生成したアノテーションを使用した学習という3つの主要な側面に貢献しています.さらに、論文には、LLMを使用したデータアノテーションの方法論の詳細な分類、LLMが生成したアノテーションを組み込んだモデルの学習戦略の包括的なレビュー、およびLLMを使用したデータアノテーションに関連する主要な課題と制限についての詳細な議論が含まれています.この調査は、研究者や実務家がLLMを使用してデータアノテーションを探求する際の重要なガイドとしての役割を果たすことを目指しています.さらに、この調査は、最新のLLMを活用したデータアノテーションの可能性を探るために、研究者や実務家を導くことを目指しています.詳細な論文リストは、\url{https://github.com/Zhen-Tan-dmml/LLM4Annotation.git} で提供されています.

Q&A:

Q: ラージ・ランゲージ・モデル(LLM)についての本稿の主眼は何ですか?

A: この論文の主な焦点は、大規模言語モデル(LLMs)を用いたデータ注釈に特化しており、LLMsがデータ注釈の複雑なプロセスを革新し自動化する機会を提供している点にあります.既存の調査はLLMのアーキテクチャ、トレーニング、一般的な応用について広くカバーしていますが、この論文は特にデータ注釈におけるLLMsの具体的な有用性に焦点を当てています.この調査は、LLMベースのデータ注釈、LLM生成注釈の評価、およびLLM生成注釈を用いた学習という3つの主要な側面に貢献しています.さらに、この論文には、LLMsを用いたデータ注釈に関する手法の詳細な分類、LLM生成注釈を組み込んだモデルの学習戦略の包括的なレビュー、および大規模言語モデルに関する情報の深い分類が含まれています.

Q: 従来の手法と比較して、LLMはデータアノテーションにどのように貢献するのか?

A: LLMsは、従来の方法と比較して、データ注釈において次のような貢献をしています.LLMsは注釈タスクを自動化し、大量のデータにわたる一貫性を確保し、特定のドメインに適応するための微調整やプロンプトを通じて、伝統的な注釈方法で遭遇する課題を著しく減少させることができます.これにより、NLPの領域で達成可能な新たな基準を設定し、データ注釈の効果と精度を向上させる重要な役割を果たしています.

Q: この調査で、LLMが作成した注釈はどのように評価されるのか?

A: LLM生成の注釈は、人間主導から自動化されたアプローチまで、注釈の品質を評価するさまざまな方法を探るこのサブセクションにおいて評価されます.研究は、LLM注釈を評価するための多様な方法を調査しています.

Q: データ注釈にLLMを使用する際の主な課題と限界は?

A: LLMsを使用したデータ注釈の主な課題と制限には、適切なプロンプトエンジニアリングと微調整技術が必要であり、これはNLPや機械学習に豊富な専門知識を持たない実務家や研究者にとって参入障壁となる可能性があります.また、LLMsは注釈に強力なツールである一方、トレーニングデータへの過剰適合のリスクがあり、その能力が制限される可能性があります.さらに、技術的な障壁、精度の懸念、労働の置換やバイアスの伝播などの社会的影響など、LLMデータ注釈の課題があります.これらの課題に取り組むことは、LLM注釈アプリケーションの進展にとって重要です.

Q: LLMが生成したアノテーションを組み込んだモデルの学習戦略は、従来の学習戦略とどう違うのか?

A: LLM-generated annotationsを組み込んだモデルの学習戦略は、従来の学習戦略と比較して、より高度な戦略を必要とします.LLM-generated annotationsは、言語モデルによって生成された注釈であり、その品質や信頼性を評価する必要があります.従来の学習戦略では、通常のアノテーションやラベルが使用されますが、LLM-generated annotationsでは、注釈の品質や信頼性を確保するための新しい手法や戦略が必要です.また、LLM-generated annotationsを使用することで、サンプリングバイアスや幻覚などの技術的制約や社会的バイアスなどの倫理的ジレンマに対処する必要があります.

Q: LLMはデータ注釈のプロセスにどのような革命をもたらし、自動化するのか?

A: LLMはデータ注釈のプロセスを革新し、自動化することができます.LLMは注釈タスクを自動化し、大量のデータにわたる一貫性を確保し、特定のドメインに適応するための微調整やプロンプトを行うことができます.これにより、従来の注釈方法で遭遇する課題が大幅に軽減され、NLPの領域で達成可能な新たな基準が設定されます.

Q: アンケートで提供された包括的な論文リストの意義は?

A: 提供された包括的な論文リストは、LLM生成注釈に関する研究の最新の進展を示し、研究者や実務家がLLMを注釈に活用する際の貴重な情報源となる.これにより、既存の研究との比較や新たな研究の方向性を見出すことが可能となる.

Q: 研究者や実務者は、データ注釈の研究を進めるために、この調査の情報をどのように活用できるのだろうか.

A: この調査に含まれる情報を活用することで、研究者や実務家はデータ注釈の分野での作業を進めることができます.具体的には、LLMを使用したデータ注釈の基盤となる方法論のタクソノミーを理解し、LLM生成の注釈を評価し、LLM生成の注釈を活用した学習方法を習得することが重要です.さらに、LLMを活用したデータ注釈の主な課題や制約についての詳細な議論を通じて、将来の進展に向けた方向性を見出すことができます.GitHubで提供されている包括的な論文リストも参考にすることで、最新のLLMを活用したデータ注釈の可能性を探求し、この重要な分野での未来の進歩を促進することができます.

Q: データアノテーションのためのLLMの使用について、将来どのような進歩が予想されますか?

A: LLMのデータ注釈における将来の進展としては、より高度なプロンプトエンジニアリングやドメイン固有の調整などの革新的な戦略の採用が期待されます.さらに、人間の洞察力を補完するために、LLMの出力に深みを持たせるための取り組みが重要であり、社会的不平等や品質基準の低下を防ぐために、技術の進歩と社会的影響を調和させる必要があります.

LoRA+: Efficient Low Rank Adaptation of Large Models

著者:Soufiane Hayou, Nikhil Ghosh, Bin Yu

発行日:2024年02月19日

最終更新日:2024年02月19日

URL:http://arxiv.org/pdf/2402.12354v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Machine Learning

概要:

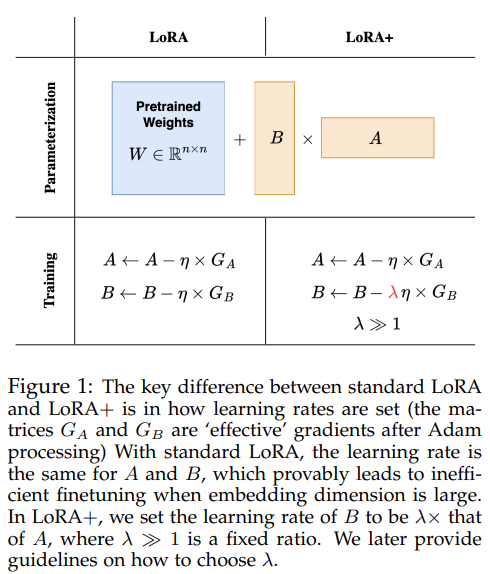

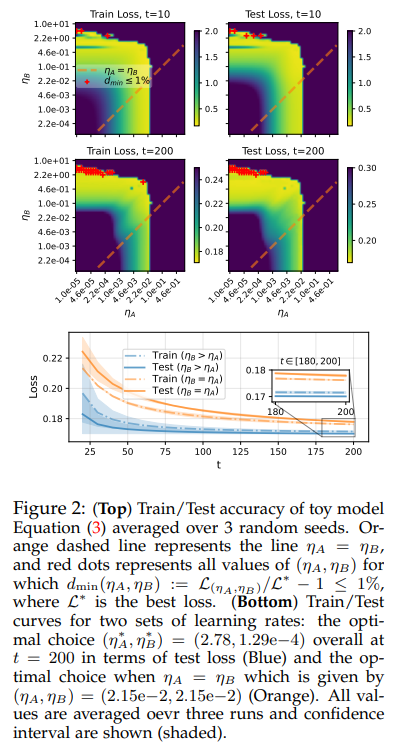

この論文では、Huら(2021)で最初に導入されたLow Rank Adaptation(LoRA)が、大きな幅(埋め込み次元)を持つモデルの微調整においてサブ最適な結果をもたらすことを示しています.これは、LoRAのアダプターマトリックスAとBが同じ学習率で更新されるためです.大きな幅のネットワークに対するスケーリングの議論を用いて、AとBに同じ学習率を使用することが効率的な特徴学習を許容しないことを示します.そして、LoRAのこのサブ最適性は、LoRAアダプターマトリックスAとBに適切な比率で異なる学習率を設定することで簡単に修正できることを示します.我々はこの提案されたアルゴリズムをLoRA+と呼びます.私たちの幅広い実験では、LoRA+はパフォーマンスを向上させ(1-2%の改善)、微調整の速度を向上させ(最大2倍のスピードアップ)、LoRAと同じ計算コストで実行されます.

Q&A:

Q: Low Rank Adaptation(LoRA)が、幅の大きなモデルの微調整を最適化しない理由を具体的に説明してもらえますか?

A: LoRAではアダプタ行列AとBが同じ学習率で更新されるため、効率的な特徴学習が妨げられる.このことは、大きな幅のネットワークに対するスケーリング論証によって実証され、AとBに同じ学習率を用いると効率的な特徴学習ができないことが示される.この最適性を修正するために、LoRAでは、LoRAアダプタ行列AとBに対して、よく選ばれた固定比率で異なる学習率を提案する.この学習率の調整により、性能と微調整速度が改善され、実験では1%~2%の改善と最大2倍のSpeedUpを、LoRAと同じ計算コストで実現した.

Q: LoRAのアダプター行列AとBは、大きな幅のネットワークにおける特徴学習の効率にどのような影響を与えるのか?

A: LoRAにおいて、アダプターマトリックスAとBが同じ学習率で更新されるため、大きな幅のネットワークにおいて特徴学習の効率が低下する.AとBに同じ学習率を使用することは、大きな幅のネットワークにおいて効率的な特徴学習を許容しないことが、スケーリングの議論によって示されている.

Q: LoRAでAとBに同じ学習率を使用することの非効率性を示すために、どのようなスケーリング論証が用いられたか?

A: 同じ学習率を使用することの非効率性を示すために、スケーリング論拠が使用されました.具体的には、重み行列AとBをトレーニングするための最適なスケーリングを特徴付ける定理1が示されました.

Q: LoRAアダプター行列AとBに異なる学習率を設定することで、特徴学習効率はどのように向上するのでしょうか?

A: LoRA +では、アダプターマトリックスAとBに異なる学習率を設定することで、特徴学習の効率が向上します.これは、大きな幅(埋め込み次元)を持つモデルにおいて、AとBに同じ学習率を使用することが効率的な特徴学習を許可しないことが理由です.スケーリングの議論を用いて、AとBに同じ学習率を設定することが特徴学習の効率を向上させないことが示されています.したがって、AとBに適切な固定比率で異なる学習率を設定することで、LoRA +は特徴学習の効率を改善します.

Q: LoRAの非最適性を補正するために、学習率の比率がうまく選択されていることがわかったのですが、詳しく教えてください.

A: LoRAのサブ最適性を修正するために適切とされた学習率の比率について詳しく説明します.この提案されたアルゴリズムLoRA +では、LoRAアダプタ行列AとBの学習率を異なる値に設定し、その比率を固定されたλで調整します.具体的には、ηB=ληAとなるように設定します.ここで、λは1より大きい値である必要があります.この比率λの選択が重要であり、λ≫1の選択が一般的に結果を改善することが示されています.特に、n≫rの場合にはその効果が顕著です.実証的な評価を通じて、最適な比率λを調査し、標準のLoRAよりも性能を向上させることが一般的に確認されました.

Q: 提案アルゴリズムLoRA+を使った実験では、具体的にどのような性能向上が見られたのですか?

A: 提案されたアルゴリズムLoRA+による実験で、性能の具体的な改善点は、最終テスト精度とトレーニング速度の両方で顕著な向上が観察されました.LoRA+を使用することで、わずか1.6エポックで、通常の設定で3エポック後に達成される最終精度に到達しました.

Q: LoRA+を導入したことで、微調整のスピードはオリジナルのLoRAと比べてどう変わりましたか?

A: LoRA+の実装により、微調整のスピードは元のLoRAと比較して大幅に改善されました.具体的には、LoRA+を使用することで、標準セットアップでは3エポックかかるところを1.6エポックで達成することができました.

Q: LoRA+の計算コストとLoRAの計算コストを比較して説明してもらえますか?

A: LoRA+の計算コストはLoRAと同じであり、性能向上(1%〜2%の改善)とファインチューニングのスピードアップ(最大2倍)を実現します.

Q: 実験中、LoRA+の導入に制限や欠点はありましたか?

A: 実験中にLoRA+の実装において特定の制限や欠点が特定されました.論文では、最適な比率λ=ηB/ηAを決定する際に、タスクやモデルに依存するより洗練された推定が必要であることが指摘されています.また、論文の分析にはこの側面が欠けており、今後の研究にその課題を残すこととされています.

Q: LoRA+に関する本研究の結果について、今後の研究の方向性や応用の可能性はありますか?

A: この研究の結果を活用した将来の研究方向や応用は、タスクやモデルに依存した最適な比率ηB/ηAのより洗練された推定を含むことが挙げられます.この研究では、この側面が欠如していることが示されており、今後の研究にその課題を残しています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/nikhil-ghosh-berkeley/loraplus です.

In Search of Needles in a 11M Haystack: Recurrent Memory Finds What LLMs Miss

著者:Yuri Kuratov, Aydar Bulatov, Petr Anokhin, Dmitry Sorokin, Artyom Sorokin, Mikhail Burtsev

発行日:2024年02月16日

最終更新日:2024年02月21日

URL:http://arxiv.org/pdf/2402.10790v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

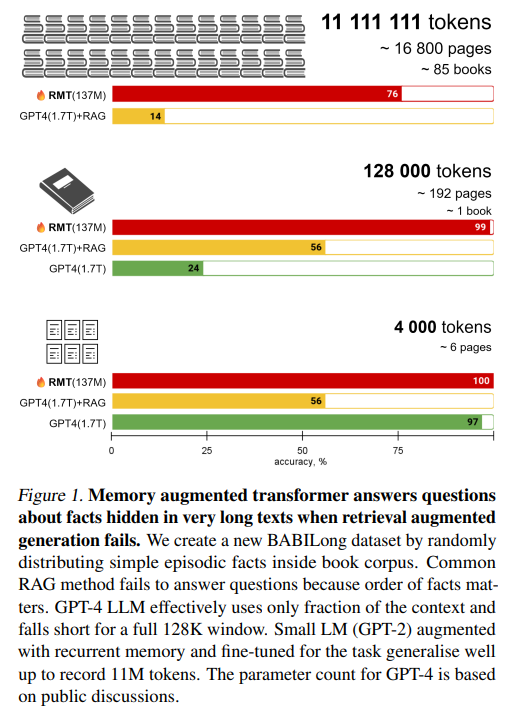

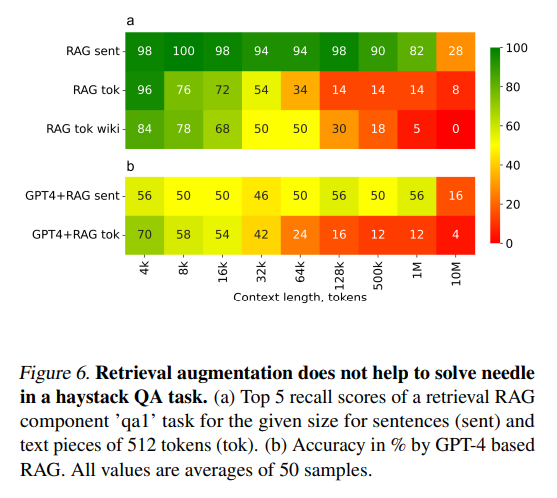

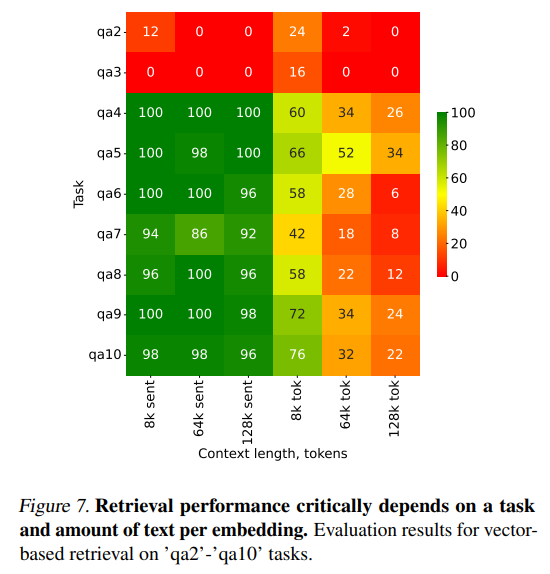

この論文は、生成トランスフォーマーモデルを使用して長い文書を処理する課題に取り組んでいます.異なるアプローチを評価するために、私たちはBABILongという新しいベンチマークを導入しました.このベンチマークは、広範なテキスト内の分散された事実を抽出および処理するモデルの能力を評価するために設計されています.私たちの評価には、GPT-4やRAGのためのベンチマークも含まれており、一般的な方法は\( \small 10^4 \)要素までのシーケンスに対してのみ効果的であることが明らかになりました.一方、GPT-2を再帰的なメモリ拡張を用いてファインチューニングすることで、このモデルは\( \small 11\times 10^6 \)要素を処理するタスクに対応できるようになりました.この成果は、これまでに存在するどのニューラルネットワークモデルよりも遥かに長い入力を処理したものであり、長いシーケンスの処理能力の大幅な向上を示しています.

Q&A:

Q: 生成変換モデルを使用して長い文書を処理する際に直面する具体的な課題について説明していただけますか?

A: 長い文書を処理する際に、生成トランスフォーマーモデルを使用する際に直面する特定の課題は、一般的な方法が104要素までのシーケンスにしか効果的でないことです.GPT-2を再帰メモリの拡張を用いて微調整することで、1100万要素までのタスクを処理できるようになります.これは、これまでのどのニューラルネットワークモデルよりも長い入力を処理することに成功したものであり、長いシーケンスの処理能力の大幅な向上を示しています.

Q: BABILongベンチマークとはどのようなもので、広範なテキスト内の分散ファクトを抽出・処理するモデル能力をどのように評価するのか?

A: BABILongベンチマークは、NLPモデルの性能を評価するための新しい生成ベンチマークであり、分散された事実を含む任意の長い文書を処理する能力を評価します.このベンチマークでは、背景データセットから取得した無関係なテキストの文と、元のタスクの文を交互に配置して、長い文脈を持つタスクを解決することが求められます.モデルは、大量の無関連な詳細から重要な情報を区別する能力を持っている必要があります.このようにして、モデルの長い文脈を効率的に処理する能力を評価することができます.

Q: GPT-4とRAGの評価結果について、10^4\( \small 要素までの配列に対する有効性について詳しく教えてください.

A: 評価結果によると、GPT-4とRAGは、104要素までのシーケンスに対しては一般的な手法が効果的であることが示されました.しかし、この長さを超えるタスクにおいては、GPT-2を再帰的メモリ増強で微調整することで、1106要素までの処理が可能となりました.このことから、GPT-2はより長いシーケンスに対応できることが示されました.

Q: GPT-2をリカレント・メモリ増強で微調整することで、最大 \)11times 10^6\( \small 個の要素を含むタスクをどのように処理できるようになるのか?

A: GPT-2を再帰的メモリ拡張で微調整することにより、1100万の要素を持つタスクを処理できるようになります.再帰的メモリを導入することで、モデルは長いコンテキストをセグメントに分割し、その内部メモリを使用して特定のタスクを解決するように微調整されます.このようなモデルは、入力サイズとともに計算量が線形にスケールするため、11Mトークンのタスクを処理できるようになります.

Q: これまでのどのニューラルネットワークモデルよりも長い入力を処理することに成功したことは、この分野においてどのような意味を持つのだろうか?

A: 現在までのどのニューラルネットワークモデルよりも長い入力を処理するという達成は、長いシーケンスの処理能力の大幅な向上を示しており、この分野において重要な進歩をもたらしています.

Q: この研究結果は、長いシーケンスの処理能力が大幅に向上したことをどのように示しているのか?

A: この研究の結果は、長いシーケンスの処理能力において著しい改善を示しています.これは、従来のニューラルネットワークモデルが処理した最も長い入力であり、長いシーケンスの処理能力において著しい向上を示しています.

Q: \)10^4\( \small 要素までの配列の評価において、具体的にどのような方法が有効であることがわかったか?

A: 評価では、 \)10^4\( \small 要素までのシーケンスに対して、一般的な手法が効果的であることがわかりました.

Q: GPT-2をリカレントメモリ増強で微調整するプロセスの詳細を教えてください.

A: GPT-2を再帰的メモリ増強で微調整するプロセスは、まず事前に訓練された言語モデルに内部再帰的メモリを拡張し、そのメモリを使用して長いコンテキストを解決するために微調整することを含みます.このプロセスでは、長いコンテキストがセグメントに分割され、モデルはそれらのセグメントを処理してタスクを解決します.このクラスのモデルでは、入力サイズとともに計算量が線形にスケールします.

Q: この研究結果は、自然言語処理分野の今後の研究開発にどのような影響を与えるとお考えですか?

A: この研究の結果は、自然言語処理の分野における将来の研究と開発に大きな影響を与えると考えられます.再帰メモリと検索をより大きなモデルに適用することで、より長い文脈に対するさらなる一般化を実現できる可能性があります.これにより、モデルが蓄積されたメモリをどのように活用して関連すること実を特定するかに関する洞察が提供され、不要な情報を取り除く際に再帰メモリが注目メカニズムに単独で依存するよりも優れていることが強化されました.さらに、この研究は、11×10^6要素を処理する能力を持つ再帰メモリトランスフォーマーの評価を通じて、モデルが分散された事実を抽出し処理する能力を評価するための新しいベンチマークを導入しました.これにより、将来の研究では、より大きなモデルに再帰メモリと検索を適用することで、より複雑な自然言語処理タスクに対処できる可能性が示唆されています.

Q: 本研究で使用した手法やベンチマークに限界や改善の余地があるか?

A: この研究で使用された方法やベンチマークには、いくつかの制限や改善の余地があります.例えば、BABILongベンチマークは背景テキストを使用して隠された事実を含んでいますが、他の背景テキストを使用することで結果に異なる影響を与える可能性があります.また、類似した事実が背景テキスト内で干渉することで、ベンチマークがさらに困難になる可能性があります.さらに、GPT-4やRAGの実験では、検索コンポーネントを最適化せず、OpenAIから提供された人気のあるもののみを使用しています.また、選択したプロンプトが最適でない可能性があります.これらの制限や改善の余地は、今後の研究の方向性として注目されるべきです.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/booydar/babilong です.

When is Tree Search Useful for LLM Planning? It Depends on the Discriminator

著者:Ziru Chen, Michael White, Raymond Mooney, Ali Payani, Yu Su, Huan Sun

発行日:2024年02月16日

最終更新日:2024年02月16日

URL:http://arxiv.org/pdf/2402.10890v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

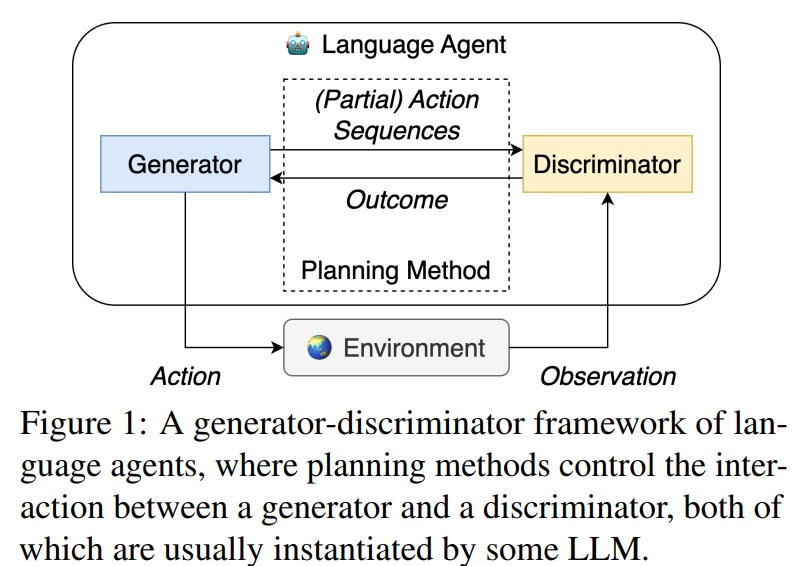

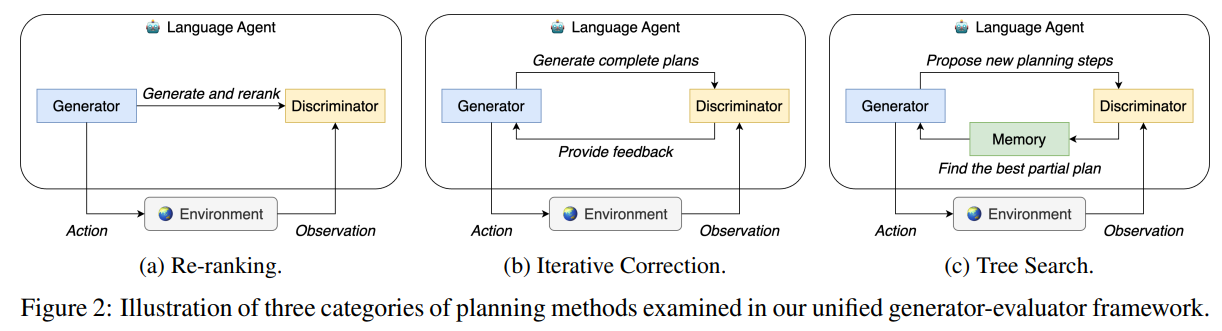

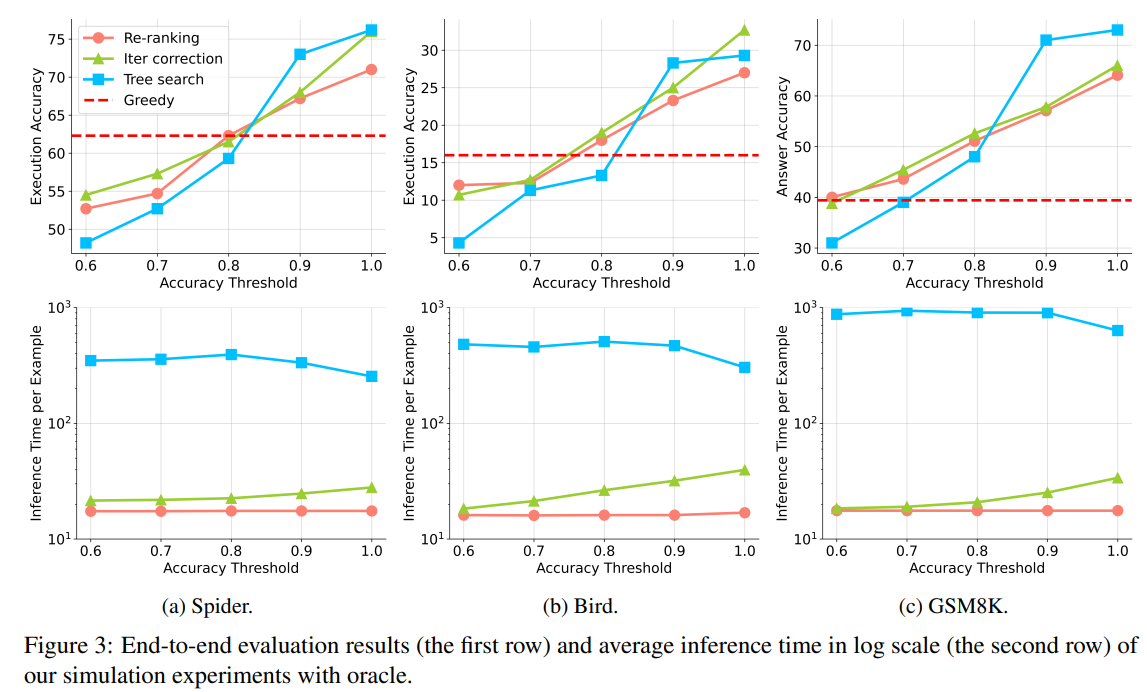

この論文では、大規模言語モデル(LLMs)が、生成器、ディスクリミネーター、およびプランニング方法の3つのコンポーネントを持つ言語エージェントフレームワークの下で、多段階の問題をどのように解決するかを調査しています.私たちは、2つの高度なプランニング方法、反復修正と木探索の実用性を調査します.これらの2つの方法またはより単純な方法である再ランキングを使用した場合、ディスクリミネーションの精度がエージェントの全体的なパフォーマンスにどのように影響するかについて包括的な分析を行います.テキストからSQLへの解析と数学的推論という2つのタスクでの実験では、次のことが示されています:(1)高度なプランニング方法は、再ランキングよりも有意な改善を達成するために、少なくとも90%の精度を持つディスクリミネーターを必要とします;(2)現在のLLMsのディスクリミネーション能力は、このような改善を達成するための要件を満たしていません;(3)LLMベースのディスクリミネーターを使用すると、高度なプランニング方法が精度と効率を適切にバランスさせることができない場合があります.たとえば、他の2つの方法と比較して、木探索は少なくとも10〜20倍遅く、ほとんどパフォーマンスの向上が見られないため、実世界での適用が妨げられます.コードとデータはhttps://github.com/OSU-NLP-Group/llm-planning-evalで公開されます.

Q&A:

Q: 言語エージェントのフレームワークにおけるジェネレーター、ディスティネーター、プランニングメソッドの違いを説明していただけますか?

A: 生成器は、(部分的な)アクションシーケンスを提案する役割を果たします.識別器は、これらのアクションの結果を評価する役割を持ち、計画方法は、アクションの結果とLLMsの識別能力に基づいてアクションをランク付けする役割を担います.

Q: この論文で論じられている2つの高度なプランニング手法とはどのようなもので、再ランキングと比較してどうなのか?

A: 論文で議論されている2つの高度な計画手法は、木探索と再順位付けです.木探索は、再順位付けと比較して10〜20倍遅く、ほとんど性能向上が見られないとされています.

Q: 高度なプランニング手法が再ランキングよりも大きな改善を示すためには、どの程度の識別精度が必要なのだろうか?

A: 高度な計画手法が再ランキングよりも有意な改善を示すには、少なくとも90%の精度を持つ識別器が必要です.

Q: 現在のLLMの識別能力は、高度なプランニング手法の有効性にどのような影響を与えるのか?

A: 現在のLLMの識別能力が高いほど、高度な計画手法の効果に影響を与えることが示されました.特に、識別器の精度が高いほど、再ランキング、反復修正、および木探索などの計画手法の全体的なタスクパフォーマンスに強い相関関係があることが明らかになりました.また、LLMベースの識別器を使用する場合、高度な計画手法が精度と効率を適切にバランスさせることができない可能性があります.例えば、他の2つの手法と比較して、木探索は少なくとも10〜20倍遅くなりますが、ほとんどパフォーマンスの向上が見られないため、実世界での適用が妨げられます.

Q: プランニング手法のパフォーマンスを評価するために、どのようなタスクで実験が行われたのか?

A: 実験は、text-to-SQL解析と数学的推論のタスクで行われました.

Q: ツリーサーチは、スピードとパフォーマンスの向上という点で、反復的な修正と再ランキングと比べてどうなのか?

A: 木検索は反復修正と再ランキングと比較して、速度と性能の利益において異なる結果を示します.木検索は、他の2つの計画方法よりも遅く、平均推論時間が10〜20倍遅いことがわかります.一方、反復修正と再ランキングは、木検索よりも効率的であることが示されています.性能の利益に関しては、反復修正と再ランキングは木検索よりも優れていることが示されています.木検索は、他の2つの方法よりも低い識別精度のしきい値で一貫して性能が低く、しきい値を上げると急激に性能が向上し、他のエージェントを上回り始めます.

Q: 高度なプランニング手法において、LLMベースの識別器で精度と効率のバランスを取る際に直面する課題について詳しく教えてください.

A: LLMベースのディスクリミネーターを使用した高度な計画手法において、精度と効率をバランスさせる際の課題は、特に木探索法のような手法が、他の手法と比較して少なくとも10〜20倍遅く、ほとんど性能向上が見られないことです.このため、実世界の応用において木探索法の展開が妨げられる可能性があります.

Q: 実世界のアプリケーションにおいて、ツリー検索が著しく遅いにもかかわらず、無視できるほどの性能向上をもたらすということは、どのような意味を持つのだろうか?

A: ツリーサーチは実際のアプリケーションにおいて著しく遅く、ほとんど性能向上が見られないため、その精度と効率のバランスが不適切であることが示唆されます.

Q: この研究結果は、今後のLLMプランニングの研究にどのような影響を与えるとお考えですか?

A: この研究の結果は、将来のLLM計画において重要な影響を与えると考えられます.特に、我々の研究は、異なる計画方法の性能を包括的に評価し、LLMの差別能力が計画方法に与える影響を明らかにしています.これにより、将来の研究では、より効率的で正確な言語エージェントを実装するためのガイドラインとして利用される可能性があります.また、LLMベースの差別器の改善が重要な方向性であることが示唆されており、高度な計画方法を使用する際のエージェントの精度と効率を向上させるために、この方向性に注力することが推奨されています.

Chain-of-Thought Reasoning Without Prompting

著者:Xuezhi Wang, Denny Zhou

発行日:2024年02月15日

最終更新日:2024年02月15日

URL:http://arxiv.org/pdf/2402.10200v1

カテゴリ:Computation and Language

概要:

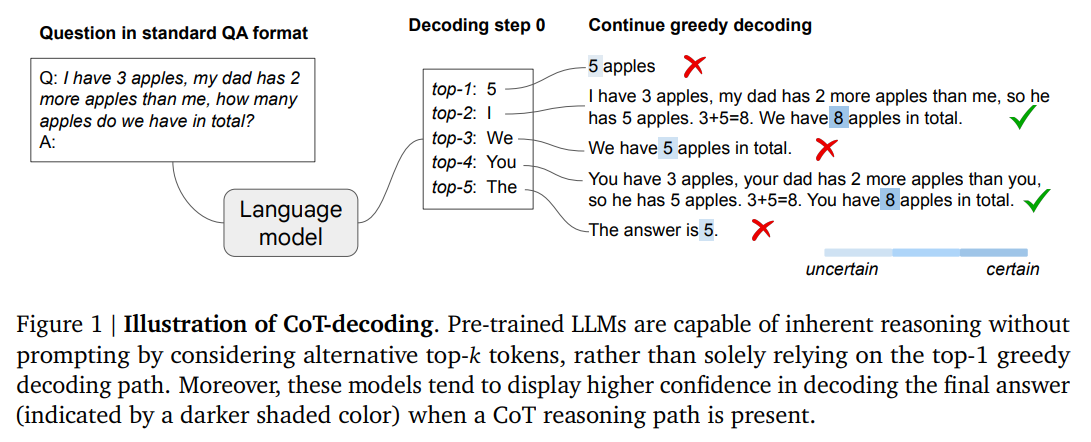

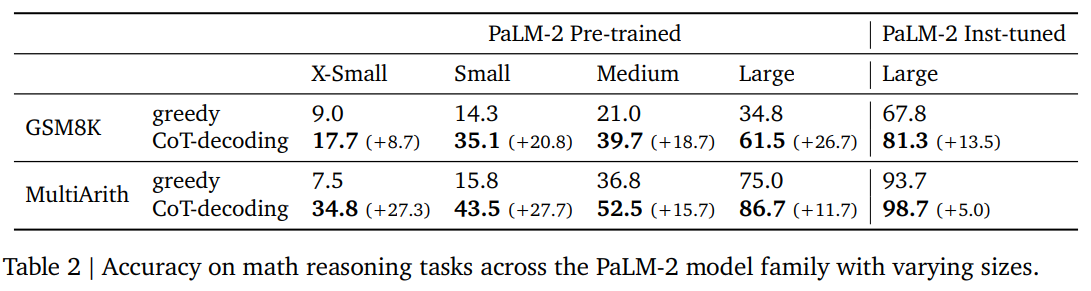

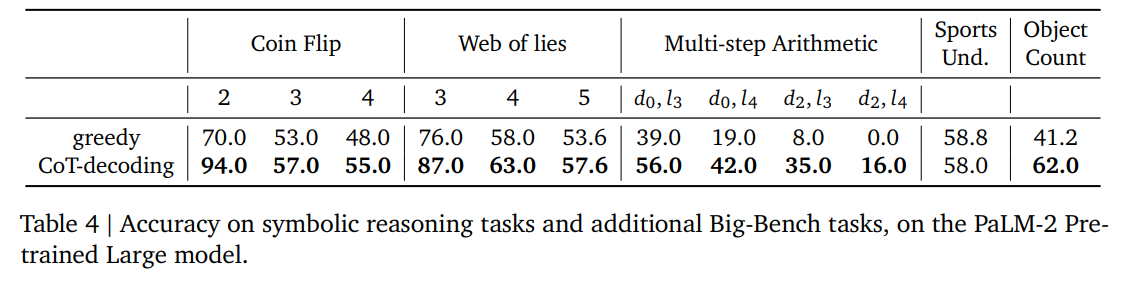

大規模言語モデル(LLMs)の推論能力を向上させるための先行研究では、従来、few-shotやzero-shotのchain-of-thought(CoT)プロンプティングなど、特定のプロンプティング技術に焦点を当ててきました.これらの方法は効果的ですが、しばしば手作業によるプロンプティング工学を必要とします.私たちの研究は、LLMsがプロンプティングなしで効果的に推論できるかどうかという問いに取り組む新しいアプローチを取ります.私たちの調査結果は、興味深いことに、事前にトレーニングされたLLMsからCoT推論パスを引き出すことができることを示しています.これは、従来の貪欲なデコーディングではなく、トップ-kの代替トークンを調査することによって行われます.この方法により、プロンプティングの混乱要因を回避するだけでなく、LLMsの固有の推論能力を評価することができます.さらに、デコーディングパスにCoTが存在することは、モデルのデコードされた回答に対する信頼度が高いことと相関していることを観察します.この信頼度メトリックは、CoTパスと非CoTパスを効果的に区別します.さまざまな推論ベンチマークにおける包括的な実証研究により、提案されたCoTデコーディングが標準の貪欲なデコーディングを大幅に上回ることが示されました.

Q&A:

Q: 大規模言語モデル(LLM)の推論能力を、手動で促すことなく強化する方法をどのように提案していますか?

A: 研究では、事前にトレーニングされたLLMsからCoT推論パスを引き出すために、従来の貪欲なデコーディングではなく、トップkの代替トークンを調査することで、手動のプロンプティングなしでLLMsの推論能力を向上させることを提案しています.

Q: 事前訓練されたLLMからCoT推論経路を引き出す上で、デコーディングプロセスを変えることの意義は何か?

A: 事前にトレーニングされたLLMからCoT推論パスを引き出すためにデコーディングプロセスを変更することの重要性は、標準的な貪欲なデコーディングパスを通じて誤った答えを生成するLLMに対して、代替のトップkトークン検査が固有のCoTパスを明らかにし、クエリを正確に解決することができるという点にあります.このデコーディングの変更により、CoTのプロンプトをバイパスし、モデルの調整を必要とせずに完全に非監督でCoT推論を引き出すことができます.

Q: デコーディングにおいてトップkの代替トークンを使用することで、シーケンスに内在するCoTパスがどのように明らかになるのか?

A: トップ-kの代替トークンを使用することにより、デコーディング中に自然なCoTパスが多く現れる.具体的には、グリーディーデコーディングから始めて、最初のデコーディングステップでトップ-k(𝑘 > 0)トークンを探索すると、多くの場合、自然なCoTパスが明らかになる.これにより、モデルは多くの場合、CoTパスを生成し、そのシーケンス内に内在するCoTパスを明らかにする.

Q: 提案されたCoTデコーディングアプローチは、LLMの固有の推論能力を評価する方法をどのように可能にしますか?

A: 提案されたCoTデコーディングアプローチによって、事前にトレーニングされたLLMsの固有の推論能力を評価することが可能となります.このデコーディング手法は、潜在的なCoT推論パスを自動的に明らかにし、モデルの出力に最も信頼性の高いパスを分離します.また、この手法は、明示的なプロンプトによって導入される混乱を回避し、モデルの固有の推論能力をより正確に評価することを可能にします.

Q: デコーディングパスにCoTが存在することが、モデルのデコードされた回答に対する信頼度が高くなるかどうかについて詳しく説明していただけますか?

A: CoTがデコーディングパスに存在すると、モデルのデコードされた回答に対する信頼度が高くなる傾向がある.具体的には、CoTが存在する場合、モデルは最終的な回答に対してより高い確信度を示す.この増加した確信度を活用することで、より信頼性の高いデコーディングパスを選択することができ、これが様々な推論ベンチマークで貪欲なデコーディングよりも大幅な改善をもたらすことが示されている.

Q: 提案されたCoT復号が推論ベンチマークにおいて標準的な貪欲復号を上回るという主張を裏付ける経験的証拠は何か?

A: 提案されたCoTデコーディングが標準の貪欲デコーディングを超えるという主張を支持する実証的証拠は、CoTデコーディングがモデルの理論能力を大幅に向上させることを示しています.これにより、CoTデコーディングは、標準の貪欲デコーディングよりも信頼性の高いデコーディングパスを選択することができます.

Q: 提案されたアプローチが、プロンプトの交絡因子を効果的に回避することをどのように保証しますか?

A: 提案されたアプローチがプロンプトの混乱要因を効果的にバイパスするためには、モデルの出力を「So the answer is」というプロンプトで拡張し、これらの継続を整列させることが重要です.

Q: LLMにおけるCoT推論パスの有効性に関して、調査から得られた主な結果は何ですか?

A: 研究からの主な結果は、LLMにおけるCoT推論経路の効果に関するものです.従来の貪欲なデコーディング経路に頼ると、LLMは推論に苦労することが明らかになりました.しかし、上位kトークンの代替経路を考慮すると、LLMのデコーディング軌跡の中で自然にCoT推論パターンが現れることが観察されました.この研究は、CoT推論経路がデコーディングプロセスを単純に変更することで、事前学習済みのLLMから引き出すことができることを示しています.

Generative Representational Instruction Tuning

著者:Niklas Muennighoff, Hongjin Su, Liang Wang, Nan Yang, Furu Wei, Tao Yu, Amanpreet Singh, Douwe Kiela

発行日:2024年02月15日

最終更新日:2024年02月15日

URL:http://arxiv.org/pdf/2402.09906v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

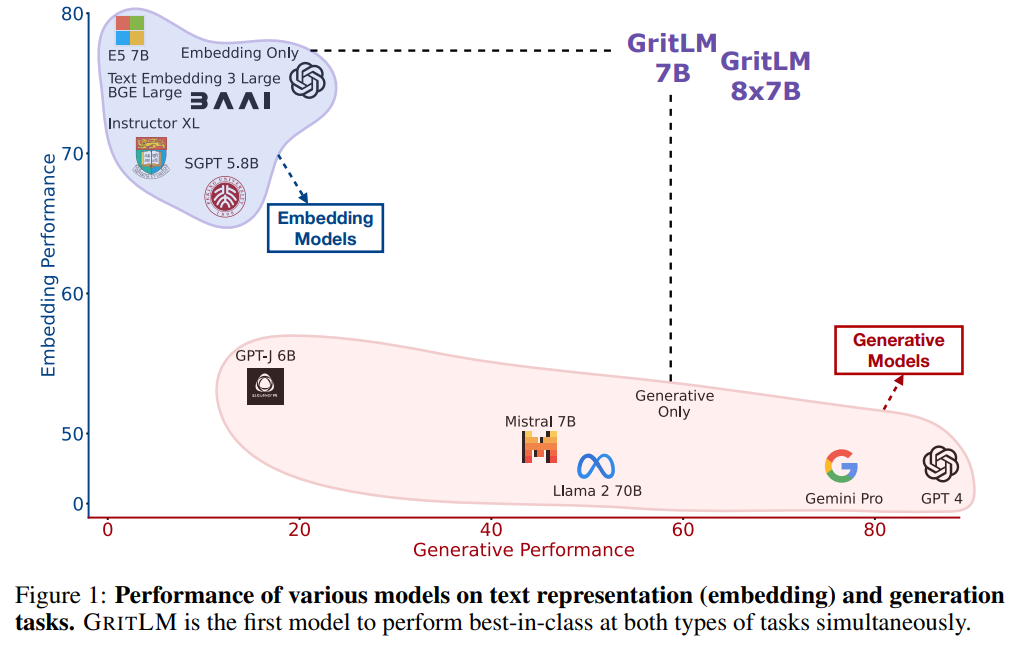

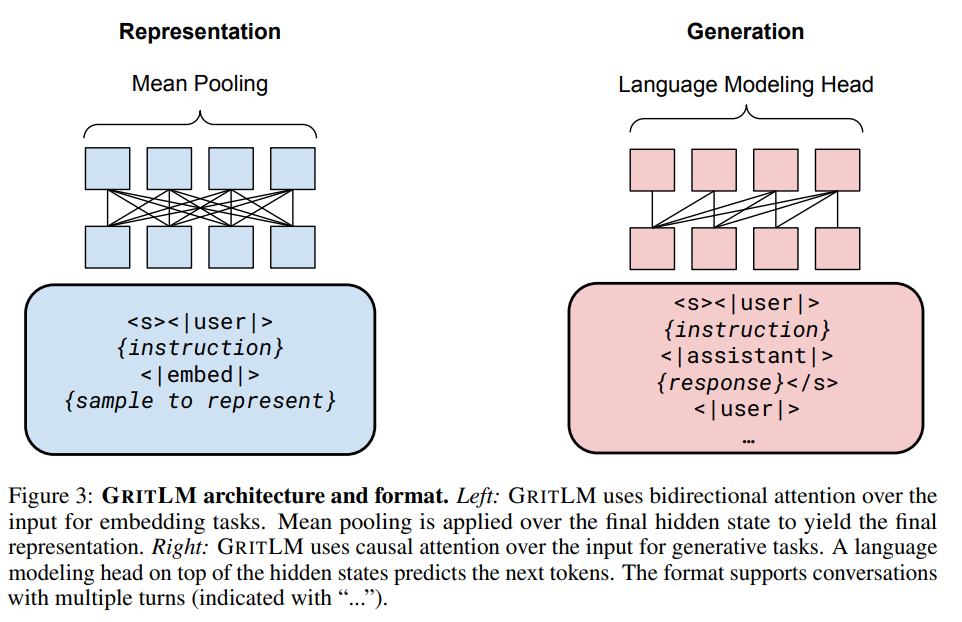

この論文では、テキストベースの言語問題は生成または埋め込みのいずれかに簡約化できると述べられています.現在のモデルは、どちらか一方のタスクでのみ優れたパフォーマンスを発揮します.そこで、著者らは、生成的表現指示調整(GRIT)を導入し、大規模な言語モデルを訓練して、指示を通じて生成的および埋め込みタスクの両方を処理できるようにしました.その結果、GritLM 7BはMassive Text Embedding Benchmark(MTEB)で新たな最高記録を樹立し、さまざまな生成タスクでそのサイズまでのすべてのモデルを上回りました.さらにスケーリングアップすることで、GritLM 8x7Bは、試したすべてのオープン生成言語モデルを上回り、依然として最高の埋め込みモデルの一つであることが示されました.GRITによる統一により、生成または埋め込みデータのみでのトレーニングと同等のパフォーマンスを維持できることがわかりました.その他の利点として、GRITを介した統一により、長いドキュメントに対するRetrieval-Augmented Generation(RAG)の処理速度が60%以上向上し、別々の検索と生成モデルを必要としなくなりました.モデルやコードなどは、https://github.com/ContextualAI/gritlm で無料で入手可能です.

Q&A:

Q: ジェネレーティブ・インストラクション・チューニング(GRIT)が、ジェネレーティブなタスクとエンベッディング・タスクの両方を処理するためにどのように機能するのか、もう少し詳しく説明してもらえますか?

A: GRITは、大規模な言語モデルを使用して、指示を通じてそれらを区別することにより、生成的タスクと埋め込みタスクの両方を処理するように訓練されます.具体的には、指示によって生成的タスクと埋め込みタスクを区別し、それぞれに適切に対応するようにモデルを調整します.これにより、GRITは生成的タスクと埋め込みタスクの両方に対応できるようになります.また、GRITは他のオープンモデルよりも優れた性能を発揮し、MTEBなどのベンチマークで最先端の成績を収めます.

Q: GritLM 7Bは、Massive Text Embedding Benchmark(MTEB)で他のオープンモデルと比較してどうですか?

A: GRITLM 7Bは、Massive Text Embedding Benchmark(MTEB)において、他のオープンモデルよりも優れた性能を発揮しています.

Q: GritLM 8x7Bが他のモデルより優れている生成タスクの例を教えてください.

A: GRITLM 8X7Bは、他のモデルを上回る生成タスクの例として、MTEBにおいてLlama 70Bよりも20%以上の性能を発揮します.

Q: GRITはどのようにして、パフォーマンスを落とすことなく、生成と埋め込みタスクを統合しているのか?

A: GRITは、埋め込みタスクと生成タスクを単一のモデルに統合し、どちらもパフォーマンスの損失なしに行うことができます.この統合は、モデルが自然言語の深い理解を持つ必要があるため、可能となります.埋め込みタスクと生成タスクは、理解がどのように表現されるかという点を除いて、本質的に同じであると考えられます.統合モデルには、最終的な表現を平均プーリングや埋め込みタスクに有用にするか、言語モデリングヘッドや生成タスクに適した状態にするためのスイッチとして機能する少数のパラメータが含まれている可能性があります.

Q: GRIT、特にRAG(Retrieval-Augmented Generation)を使用する利点は何ですか?

A: GRITを使用することの利点のいくつかは、Retrieval-Augmented Generation(RAG)に特に関連しています.GRITは、検索と生成モデルを別々に必要としないため、長い文書においてRAGの処理を60%以上高速化します.また、GRITは最先端の検索と生成のパフォーマンスを持っており、単一のモデルで検索者と読者を統合することができるため、それぞれを最適化することで相互にパラメータを変更することができます.これにより、検索者が不適切なコンテキストを提供した場合や読者が与えられたコンテキストを適切に使用しなかった場合に、両方のモデルに対して次のトークンの目的関数を使用するだけで十分であり、別々のモデルや目的関数を使用する必要がなくなります.

Q: GRITが長い文書のRAGを60%以上高速化する方法を説明していただけますか?

A: GRITは、リトリーバーとリーダーを単一のモデルに統合することで、キャッシュ操作を可能にし、長いシーケンスにおいて60%以上の推論速度向上を実現しています.これにより、別々のリトリーバーと生成モデルを必要としなくなり、RAGの処理を効率化しています.

Q: モデルやコードなどがGitHubで自由に利用できることの意義は?

A: GitHub上でモデル、コードなどが無料で利用可能であることの重要性は、研究者や開発者が容易にアクセスして利用できるため、研究や開発の進展を促進することができる点にあります.これにより、他の研究者や開発者がこれらの成果を活用し、さらなる研究や応用の可能性を広げることができます.また、オープンソースのコードやモデルは透明性を高め、信頼性を向上させることができるため、学術的な議論や実務において重要な役割を果たすことができます.

Q: GRITは指示によって生成タスクと埋め込みタスクをどのように区別しているのか?

A: GRITは指示を通じて生成的タスクと埋め込みタスクを区別します.指示によって、モデルは生成的な回答を生成することで訓練されます.

Q: GritLMのような大規模な言語モデルを学習して、生成タスクと埋め込みタスクの両方を処理するプロセスについて詳しく教えてください.

A: 大規模言語モデルであるGritLMを生成的および埋め込みタスクの両方を処理できるように訓練するプロセスは、指示を介してそれらを区別することによって行われます.具体的には、生成的タスクと埋め込みタスクを区別するための指示を使用して、GritLMをトレーニングします.これにより、モデルはそれぞれのタスクを適切に処理できるようになります.また、埋め込み専用および生成専用のバリアントもトレーニングされますが、これらは代表的または生成的な指示調整のみを使用します.最終的な表現が埋め込みタスクに有用であるか、または言語モデリングヘッドおよび生成的タスクに適しているかは、モデル内でスイッチとして機能する少数のパラメータによって決定されます.

Q: 言語モデルにGRITを実装する際の制限や課題はありますか?

A: GRITを言語モデルに実装する際の制限や課題には、トレーニング時に2つの目的関数を使用するためにより多くの計算リソースが必要となるという点が挙げられます.ただし、ファインチューニングは事前トレーニングに比べてコストが低いため、この問題は大幅に上回る利点があると考えられます.そのため、指示に従う言語モデルを構築する実務家には、ファインチューニング中にGRITを採用することを推奨します.