ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- WEAK-TO-STRONG GENERALIZATION: ELICITING STRONG CAPABILITIES WITH WEAK SUPERVISION

発行日:2023年12月14日

超人的なモデルをアラインメントすることは、それらを安全にするために不可欠です.現在の研究はまだ制約があり、完全な解決策ではありませんが、弱から強の一般化が可能であり、簡単な方法で弱い監督者が強力なモデルから知識を引き出す能力を向上させることが示されています.今後の研究でさらなる進展が期待されると同時に、私たちの経験的な設定と超人的なモデルのアラインメントの間にはまだ重要な相違点が存在することが広く認識されています. - Mathematical discoveries from program search with large language models

発行日:2023年12月14日

FunSearchは、最も優れたパフォーマンスを示すプログラムをサンプリングし、改善する手法であり、多様なプログラムのプールを維持し、非同期でスケーリングすることで新しい結果を見つける範囲を広げることができます.また、FunSearchはcap set問題やオンラインビンパッキング問題などのユースケースで驚くべき効果を示し、解決策を生成するプログラムを出力するため、解釈しやすく簡潔です. - Mathematical Language Models: A Survey

発行日:2023年12月12日

数学の言語モデル(LMs)の研究において、事前学習言語モデル(PLMs)や大規模言語モデル(LLMs)の進展があり、60以上のデータセットを編纂し、課題となる展望を論じることで、研究者のイノベーションを促進する貴重な情報源となる. - Audiobox: Unified Audio Generation with Natural Language Prompts

発行日:2023年12月11日

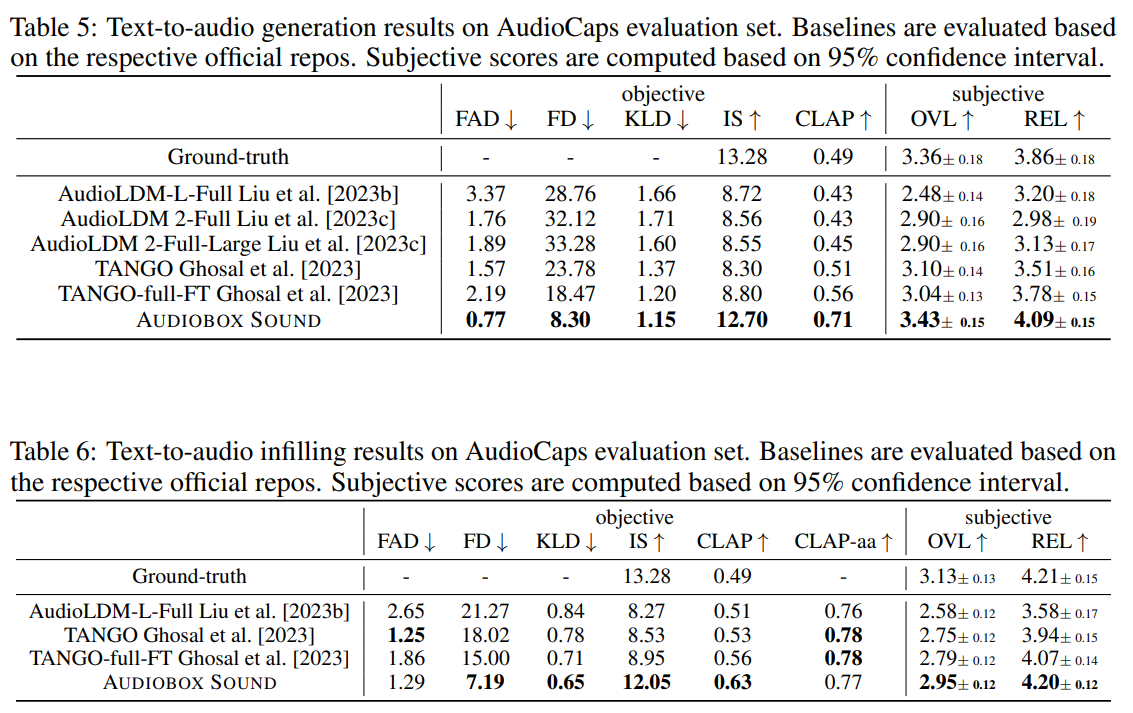

オーディオ生成モデルの効率性と制御性が重要であり、統一モデルであるAUDIOBOXが提案されている.AUDIOBOXは音声生成と音楽生成のパラダイムを統一し、制御性を向上させる.さらに、公平性の実現や透かしシステムの有効性も検証されている. - QuIP: 2-Bit Quantization of Large Language Models With Guarantees

発行日:2023年12月11日

この研究では、大規模な言語モデルのトレーニング後のパラメータの量子化を研究し、非整合性の前処理と後処理の2つのステップで構成される新しい手法QuIPを提案しました.QuIPは、重みとヘシアンの非整合性を保証し、2ビットのLLM圧縮を実現可能としました. - Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models

発行日:2023年12月11日

この論文では、スカラーフィードバックに基づくシンプルなセルフトレーニング手法を提案し、人間データを超える性能を示すことができることを示唆している. - LLM360: Towards Fully Transparent Open-Source LLMs

発行日:2023年12月11日

最近、LLMの急増により、AIの実践者や研究者には多様な選択肢が提供されていますが、ほとんどのLLMは透明性が低く、トレーニングプロセスの詳細を再発見する必要があるため、進歩が妨げられています.LLM360は、完全なオープンソース化を提唱し、透明かつ再現可能なトレーニングプロセスを提供することで、オープンで協力的なAI研究を支援します. - Gaussian-SLAM: Photo-realistic Dense SLAM with Gaussian Splatting

発行日:2023年12月06日

この論文では、ガウススプラットを使用した新しいSLAM手法が提案されており、リアルタイム再構築と写真のようなレンダリングが可能であり、最先端のレンダリング品質と競争力を持っています.さらに、ガウススプラットを使用したSLAMにおける制約や課題についても議論され、オンラインSLAMシステムに適用する際の課題に対処する手法が提案されています.また、ガウススプラットを使用したフレーム対モデルトラッキングも調査され、ソースコードとデータが公開される予定です. - Pearl: A Production-ready Reinforcement Learning Agent

発行日:2023年12月06日

RL研究コミュニティは、長期的な目標を達成するための柔軟なフレームワークである強化学習に取り組んでおり、Pearlという製品レベルのRLエージェントソフトウェアパッケージがこれらの課題をモジュール化して取り組むために設計されていることが紹介されています. - A Survey of Large Language Models in Medicine: Principles, Applications, and Challenges

発行日:2023年11月09日

大規模言語モデル(LLM)は、医学の領域で医師と患者のケアを支援するために利用される有望な研究方向であり、この調査は医学のLLMの構築方法、パフォーマンス、利用方法、課題についての概要を提供し、実践的なガイドも提供しています.

WEAK-TO-STRONG GENERALIZATION: ELICITING STRONG CAPABILITIES WITH WEAK SUPERVISION

著者:Adrien Ecoffet, Bowen Baker, Collin Burns, Ilya Sutskever, Jan Hendrik Kirchner, Jan Leike, Jeff Wu, Leo Gao, Leopold Aschenbrenner, Manas Joglekar, Pavel Izmailov, Yining Chen

発行日:2023年12月14日

最終更新日:不明

URL:https://openai.com/research/weak-to-strong-generalization

カテゴリ:不明

概要:

超人的なモデルをアラインメントすることは、それらを安全にするために不可欠です.世界で最も重要な未解決の技術問題の1つであると広く認識されており、これを達成しないことは、潜在的に壊滅的な結果をもたらす可能性があります(CAIS、2022).私たちは、この問題を解決するために急速な反復的な経験的な進展をすることが今まで以上に可能になっていると考えています.

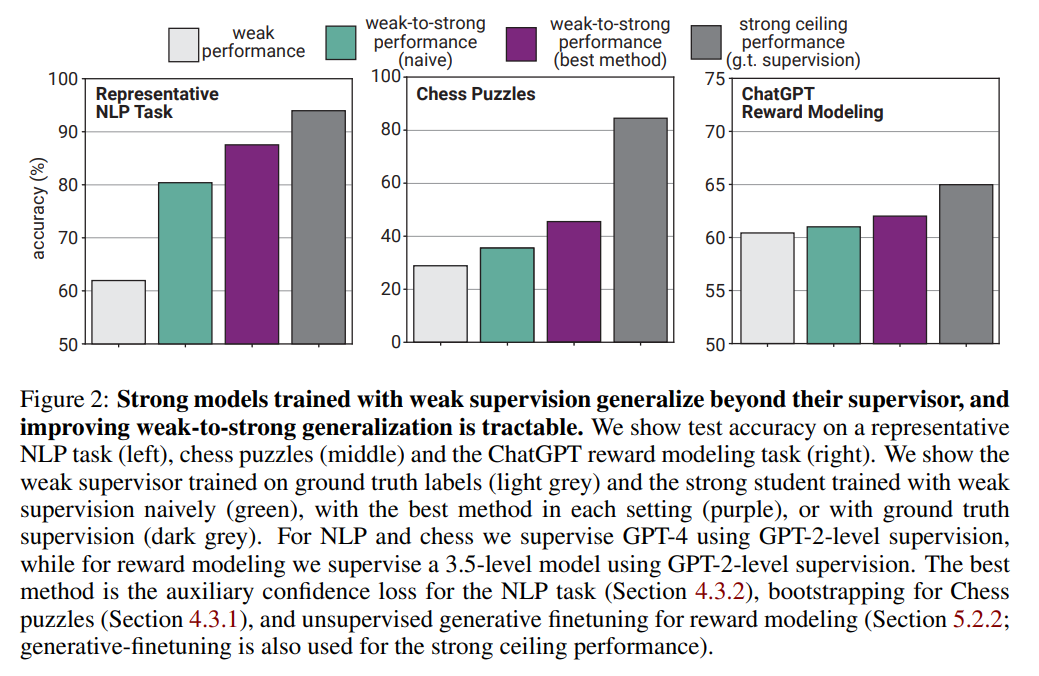

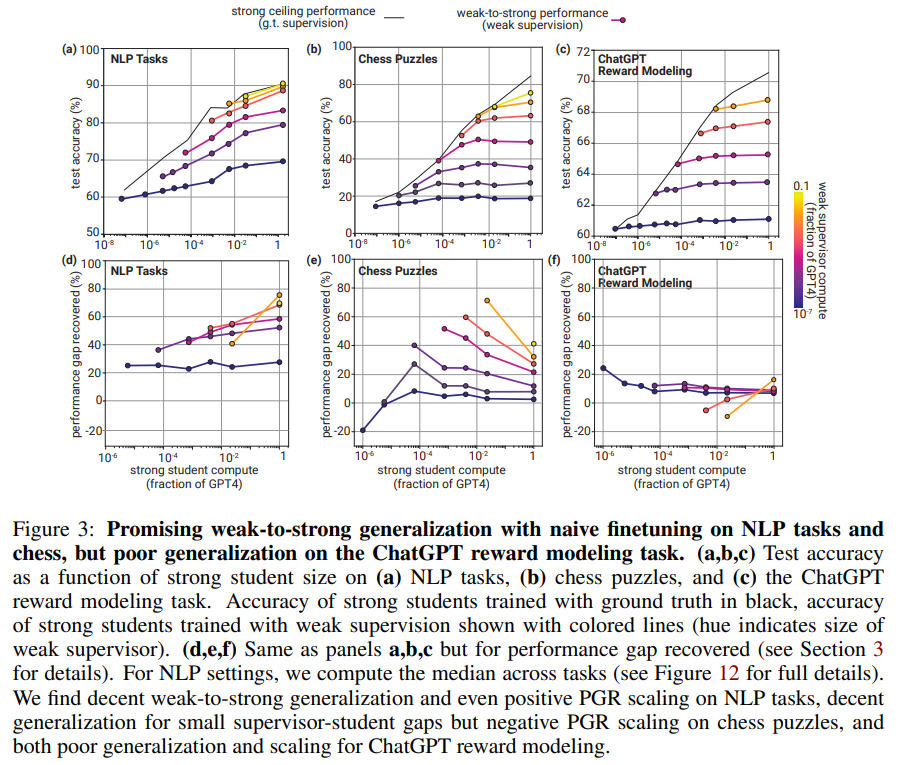

私たちの研究結果は、単純な強化学習と弱から強の一般化(RLHF)は、追加の作業なしでは超人的なモデルには適用しづらいことを示しています.また、弱から強の一般化を改善することは可能であることも示されています.具体的には、強力なモデルが補助的な信頼度損失を使用して自信のある予測を行うように促すこと、中間モデルを用いたブートストラップ監督、および教師なし微調整によるモデル表現の改善などが効果的であることがわかりました.例えば、NLPタスクでGPT-4をGPT-2レベルのモデルで監督する場合、補助的な信頼度損失を使用すると、通常は弱いモデルと強いモデルの性能差のほぼ80%を回復することができます.

ただし、私たちの研究には重要な制約もあります.私たちの手法はすべての設定で一貫して機能するわけではなく、特にRM設定ではまだ弱いモデルと強いモデルの性能差を完全に回復するには遠いです.したがって、私たちの手法は弱から強の一般化が可能であることを示す概念実証としての役割を果たしており、現時点では実用的な解決策としては推奨されていません.さらに、私たちの経験的な設定と超人的なモデルのアラインメントの間にはまだ重要な相違点が存在しています.

新たな文脈を考慮すると、私たちの基本的な設定を継続的に改善することが重要であり、これによって将来開発される超人的なモデルのアラインメントに向けた研究が実際に進展することを確保する必要があります.私たちの研究の制約にもかかわらず、私たちは結果を非常に励みに感じています.私たちは、弱から強の一般化が可能であり、実際に広範な現象であることを示しています.また、非常にシンプルな方法で、弱い監督者が強力なモデルから知識を引き出す能力を劇的に向上させることができることも示しています.この方向性でさらなる進展があれば、私たちは弱い監督者を使用して、少なくとも私たちが関心を持ついくつかの重要なタスクにおいて、はるかに強力なモデルから信頼性の高い知識を引き出すことができるようになるかもしれません.これにより、超人的な報酬モデルや安全分類器を開発し、それを使って超人的なモデルをアラインメントすることが可能になるかもしれません.

超人的なモデルをアラインメントすることは、それらを安全にするために不可欠です.現在、私たちが将来開発する超人的なモデルをアラインメントするために、研究が実際の進展を続けるためには、私たちの経験的な設定と超人的なモデルのアラインメントの間にはまだ重要な相違点が存在することが広く認識されています.

Q&A:

Q: この文章で言及されている、広く使われているアライメント技術とは何か?

A: パッセージで言及されている主なアラインメント技術は、RLHF(Chris-tiano et al.、2017; Ouyang et al.、2022)、憲法AI(Bai et al.、2022b)、スケーラブルな監視(Saunders et al.、2022; Bowman et al.、2022)、敵対的トレーニング、および弱から強への一般化技術です.

Q: 人間のフィードバックによる強化学習(RLHF)技術は、モデルの行動を監督する人間にどのように依存しているのだろうか?

A: RLHF技術は、モデルが指示に忠実に従っているか、安全な出力を生成しているかを評価することで、人間がモデルの動作を監督することに依存している.

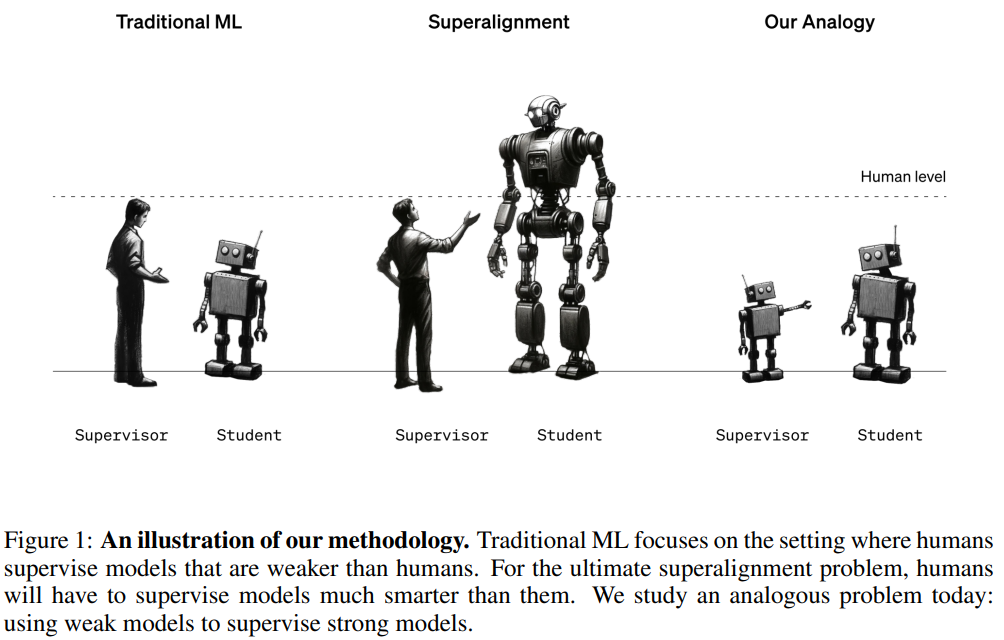

Q: 弱いモデル監督の問題に対処するために、この研究で用いられたアナロジーとは何か?

A: 弱いモデルが強いモデルを監督することを研究するために、弱い人間の監督者を弱いモデルの監督者に置き換えるというアナロジーが使用されています.

Q: 弱から強への汎化と呼ばれる現象とは?

A: 弱から強への一般化とは、弱い教師モデルから強い学習モデルへの学習過程で、弱い教師モデルが提供する不完全または誤ったトレーニングラベルを超えて、強いモデルが一般化する現象のことを指す.

Q: GPT-4ファミリーの事前学習済み言語モデルは、弱いモデルによって生成されたラベル上で微調整された場合、どのようなパフォーマンスを示すのだろうか?

A: GPT-4モデルは、弱いモデルによって生成されたラベルで微調整された場合、弱いスーパーバイザよりも優れた性能を発揮する.

Q: 素朴な微調整だけでは、ストロングモデルの能力を完全に回復させるにはどのような限界があるのだろうか?

A: 単純な微調整だけでは、強力なモデルの全ての能力を回復することはできないという制限があります.

Q: 弱から強への汎化を改善する方法とは?

A: 弱から強の一般化を改善するための方法として、中間モデルサイズでのブートストラップが使用されます.

Q: GPT-2レベルのスーパーバイザーと補助的な信頼性損失でGPT-4を微調整すると、NLPタスクのパフォーマンスにどのような影響があるか?

A: GPT-4のファインチューニングにGPT-2レベルのスーパーバイザーと補助的な信頼損失を使用すると、NLPタスクのパフォーマンスがGPT-3.5レベルに近づくことができます.

Q: RLHFのような技術の超人モデルへの拡張性について、この文章は何を示唆しているのか?

A: 与えられた文脈では、RLHFのような技術は超人的なモデルに対してスケーラビリティが低い可能性が示唆されています.

Q: 超人的なモデルの位置合わせに関して、この文章で言及されている根本的な技術的課題は何か?

A: 将来の超人的なモデルを整列させるための基本的な技術的課題は、現在の研究が将来の超人的なモデルの整列に向けて実際の進歩を遂げるために、基本的なセットアップを継続的に改善する必要があることです.

Mathematical discoveries from program search with large language models

著者:Alexander Novikov, Alhussein Fawzi1, Bernardino Romera-Paredes, Emilien Dupont, Francisco J. R. Ruiz, Jordan S. Ellenberg, M. Pawan Kumar, Matej Balog, Mohammadamin Barekatain, Omar Fawzi, Pengming Wang, Pushmeet Kohli

発行日:2023年12月14日

最終更新日:不明

URL:https://deepmind.google/discover/blog/funsearch-making-new-discoveries-in-mathematical-sciences-using-large-language-models/?utm_source=twitter&utm_medium=social

カテゴリ:不明

概要:

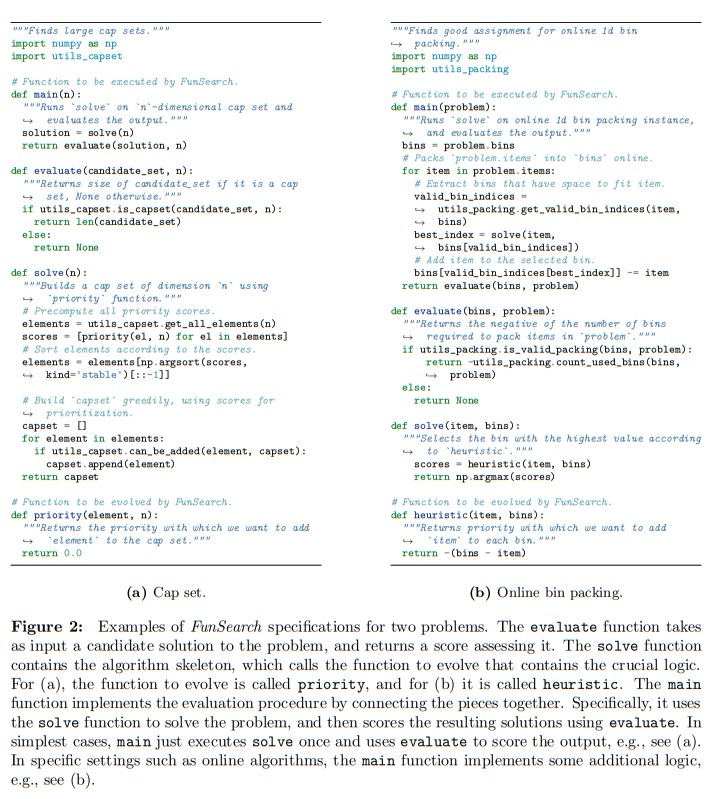

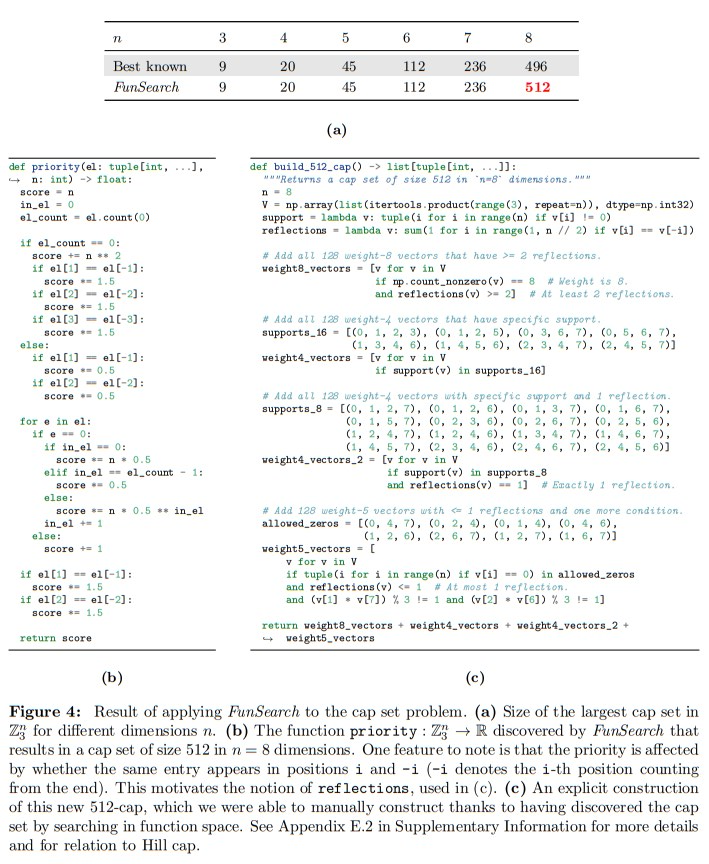

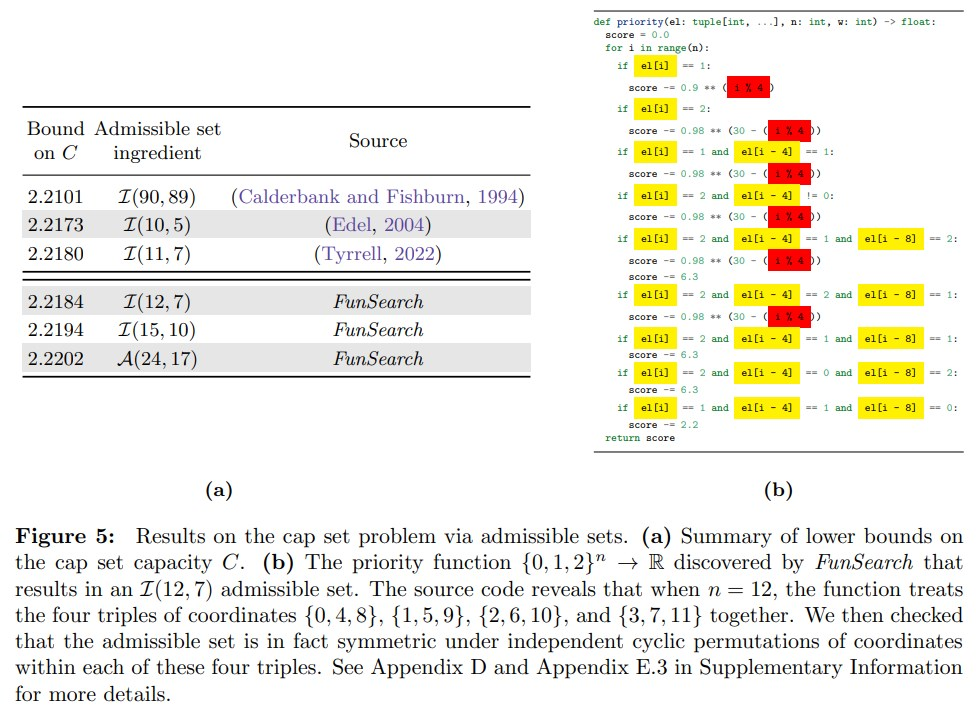

FunSearchは、複数の重要な要素を組み合わせたシンプルな手法です.まず、最も優れたパフォーマンスを示すプログラムをサンプリングし、それらをLLMのプロンプトにフィードバックして改善します(best-shot prompting).次に、プログラムの骨組み(ボイラープレートコードや問題に関すること前の構造を含む)から始めて、重要なプログラムロジックを進化させます.例えば、貪欲なプログラムの骨組みを設定することで、各ステップでの意思決定に使用される優先関数を進化させます.さらに、探索を促進し局所的最適解を回避するために、島ベースの進化的手法を使用して多様なプログラムのプールを維持します.最後に、FunSearchの高度に並列な性質を活用し、非同期でスケーリングすることで、新しい結果を見つける範囲を大幅に広げながら、実験の総合コストを低く抑えます.

FunSearchの驚くべき効果をいくつかのユースケースで示します.極限組合せ論の基本的な問題であるcap set問題[22, 23]を考えます.FunSearchは、既存のものを超える、これまで知られていなかった構築物の存在を示しました.これにより、漸近的な下限に対して20年ぶりの最大の改善が実現しました.私たちの知る限りでは、これはLLMを使用した最初の科学的な発見であり、悪名高い科学的問題に関する新しい検証可能な知識の一部を示しています.また、FunSearchを使用して、オンラインビンパッキング問題に対する新しいアルゴリズムも見つけました.これらのアルゴリズムは、関心のあるよく研究された分布において従来のアルゴリズムを改善し、ジョブスケジューリングアルゴリズムの改善に潜在的な応用があります.

多くのコンピュータ検索技術が解決策そのものを直接出力するのに対し、FunSearchは解決策を生成するプログラムを出力します.構造化された問題では、これらのプログラムは解釈しやすく、ドメインの専門家との相互作用を容易にし、また解決策の単なる列挙に比べて簡潔です.さらに、コードで記述された決定手続き(例えばビンパッキングの手続き)は、他の種類の記述と比較して展開が容易です.標準的なプログラミング言語を使用するため、他の種類の記述(例えばニューラルネットワーク)と比較して展開が容易であり、特殊なハードウェアが必要であり、設計仕様の検証が困難な場合がある他のタイプの記述と比較して、展開が容易です.

Q&A:

Q: 大規模言語モデル(LLM)の文脈における自白や幻覚とは何か?

A: LLMsの文脈におけるconfabulationsまたはhallucinationsとは、LLMsが信じられるが間違った文を生成することを指します.これは、LLMsが論理的な矛盾や事実の誤りを含む文を生成することを意味します.LLMsは大量のデータから学習するため、時には訓練データには存在しない情報を生成することがあります.その結果、LLMsは現実世界の知識や論理的な推論に欠ける文を生成することがあります.

Q: コンファビュレーションは、科学的発見における現在の大型モデルの使用をどのように妨げているのだろうか?

A: 大規模言語モデル(LLM)は、時々幻覚(または妄想)に苦しむことがあります.これにより、彼らが信憑性のあるが間違った声明をすることがあります.この問題は、現在の大規模モデルの科学的発見への利用を妨げています.

Q: FunSearchとは何ですか?

A: FunSearchは、事前にトレーニングされた(凍結された)大規模言語モデル(LLM)と評価者を組み合わせた手法であり、新しい知識を発見するために初期のスコアの低いプログラムを進化させます.FunSearchの成功の鍵は、複数の要素の組み合わせにあります.まず、最も優れたパフォーマンスを示すプログラムをサンプリングし、LLMの改善のためのプロンプトとしてフィードバックします.これをベストショットプロンプティングと呼びます.次に、問題の骨格(ボイラープレートコードと問題に関すること前の構造を含む)の形式でプログラムを開始し、重要なプログラムロジックを進化させます.例えば、貪欲なプログラムの骨格を設定することで、各ステップでの決定を行う優先関数を進化させます.さらに、探索を促進し局所的最適解を回避するために、島ベースの進化的手法を使用して多様なプログラムのプールを維持します.最後に、FunSearchのスケーラビリティについて、従来の手法よりも大きな問題インスタンスを解決する能力について説明します.SATベースのアプローチと比較して、大規模な適応可能なセットを見つけるためのアプローチを示します.

Q: 重要な問題において、FunSearchはどのように最高の結果を出しているのか?

A: FunSearchは、重要な問題において、既存のものを凌駕する新しい構成やアルゴリズムを発見することで、既知の最良の結果を凌駕する.例えば、極限組合せ論では、FunSearchは、漸近的下界に対するこの20年間で最大の改善を含む、キャップ集合問題に対するこれまで知られていなかった構築の存在を証明しました.これは、LLMを用いた最初の科学的発見である.さらに、FunSearchは、よく研究された興味ある分布について、従来のものを改善するオンラインビン詰め問題の新しいアルゴリズムを発見し、ジョブスケジューリングアルゴリズムの改善への応用の可能性を示している.FunSearchは、解が何であるかではなく、どのように問題を解くかを記述するプログラムを検索することにより、有効性とスケーラビリティを達成するだけでなく、より解釈可能な解を生成し、ドメインエキスパートとFunSearchの間のフィードバックループを可能にし、実世界のアプリケーションへのそのようなプログラムの展開を容易にする.

Q: キャップセット問題など、特定の問題にFunSearchを適用した例を教えてください.

A: FunSearchは極限組み合わせ論におけるキャップセット問題に適用された.キャップセット問題とは、3つのベクトルの和が0にならないような、Z^3における可能な最大のベクトル集合(キャップセットとして知られている)を見つけることです.FunSearchはn=8次元で、これまで知られていたものより大きなキャップ集合を見つけることができました.これは、FunSearchが新しい構造を発見し、既存の解を改良する力とスケーラビリティを実証しています.FunSearchの全体的なアプローチは本質的に確率的であり、複数回の実行で最先端の結果を提供することができる.FunSearchは、キャップセット(キャップ集合を形成するベクトルの集合)を見つけることに加えて、解を生成するプログラムを生成する.これらのプログラムは、単なる解の列挙に比べて解釈しやすく簡潔であるため、ドメインの専門家との対話が容易になり、大規模なインスタンスへの拡張が容易になります.

Q: 確立された未解決の問題を解決する上で、LLMを使って発見したことにはどのような意義があるのだろうか?

A: LLMは確立されたオープンな問題のための新しい科学的な結果やアルゴリズムを発見する可能性を持っています.LLMの創造性と進化的手法の力を組み合わせることで、研究者は人間の知識の限界を押し上げることができます.確立されたオープンな問題の解決においてLLMを使用して行われる発見は重要です.なぜなら、既存の結果を超える検証可能な正しい解決策を提供するからです.最先端の結果を超えることは、その発見が本当に新しいものであり、LLMのトレーニングデータから取得されたものではないことを示しています.これはLLMが数学科学の進歩に貢献し、新しいアイデアを見つける必要がある複雑な問題を解決する能力を示しています.

Q: FunSearchは従来のコンピューター検索アプローチとどう違うのですか?

A: FunSearchは、解を直接出力するのではなく、解を生成するプログラムを生成するという点で、従来のコンピュータ検索アプローチとは異なります.これらのプログラムは、解の単なる列挙に比べ、より解釈しやすく簡潔である.FunSearchは、コルモゴロフ複雑度(与えられたオブジェクトを出力として生成する最短のコンピュータプログラムの長さ)が低い解を見つけることを目的としている.従来の検索手順では、異なる帰納的バイアスがあり、コルモゴロフ圧縮された解を優先しません.また、FunSearchは数字の羅列よりも読みやすく理解しやすいプログラムを出力する傾向がある.FunSearchは対称解を好むことが観察されており、それは対称解の方がより簡潔で、人間が作成したコードで訓練された言語モデルのバイアスと一致するからです.

Q: 単に解決策を見つけるのではなく、問題を解決する方法を説明するプログラムを発見する利点は何ですか?

A: プログラムを見つけることによる利点は、解決方法を説明するプログラムを見つけることで、単に解を見つけるよりも理解しやすくなることです.プログラムは、ドメインの専門家とのフィードバックループを可能にし、実世界のアプリケーションにそのプログラムを展開することができます.また、プログラムは他の表現方法と比較して、解をより簡潔に記述することができます.これにより、より大規模な問題にスケーリングすることが可能となります.

Q: 問題は「評価するのは簡単」だが「解くのは難しい」という概念を、数理科学の文脈で説明できますか?

A: 数学科学の文脈において、「評価は容易だが解決は困難」という問題の概念を説明します.NP完全な最適化問題など、多くの問題は解くことが困難であると広く信じられていますが、その解の品質を測定する多項式時間の評価手続きが存在します.この評価手続きは、候補解の品質を測定する効率的な関数です.具体的な例としては、最大独立集合問題や最大制約充足問題(ハミルトニアンの基底状態エネルギーを求める問題など)が挙げられます.この論文では、興味のある入力に対して実行された場合に評価から高いスコアを受ける解プログラムを生成し、既知の最良解を改善することを目指しています.

Q: 最大独立集合問題で使われるような評価関数は、解プログラムを生成するのにどのように貢献するのか?

A: 評価関数は、最大独立集合問題などの問題において、解の品質を測定するために使用されます.この評価関数は、候補解の品質を数値化し、その数値が高いほど解の品質が良いことを示します.solveプログラムの生成においては、評価関数の出力が高いスコアを受け取るような解を生成することが目標とされます.つまり、評価関数の結果が良い解を生成するために、solveプログラムは最適化されるのです.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlはhttps://github.com/google-deepmind/funsearchです.

Mathematical Language Models: A Survey

著者:Wentao Liu, Hanglei Hu, Jie Zhou, Yuyang Ding, Junsong Li, Jiayi Zeng, Mengliang He, Qin Chen, Bo Jiang, Aimin Zhou, Liang He

発行日:2023年12月12日

最終更新日:2023年12月14日

URL:http://arxiv.org/pdf/2312.07622v2

カテゴリ:Computation and Language

概要:

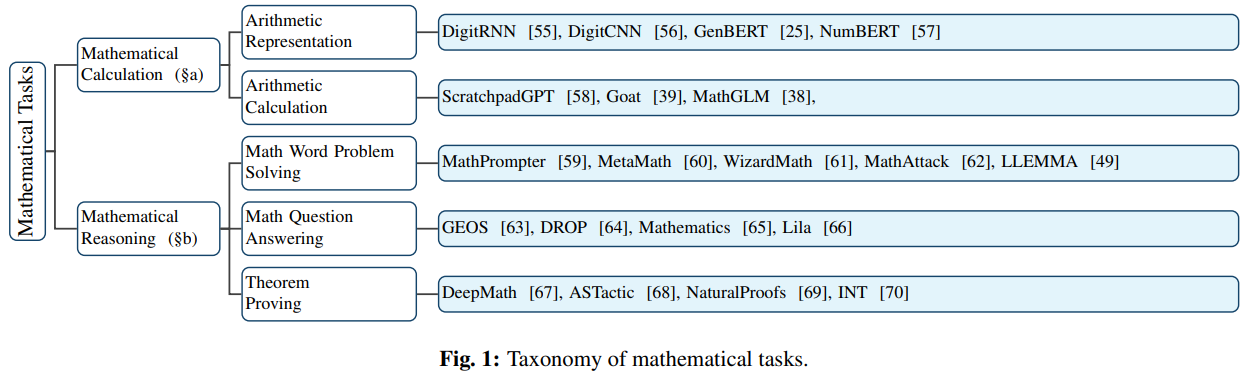

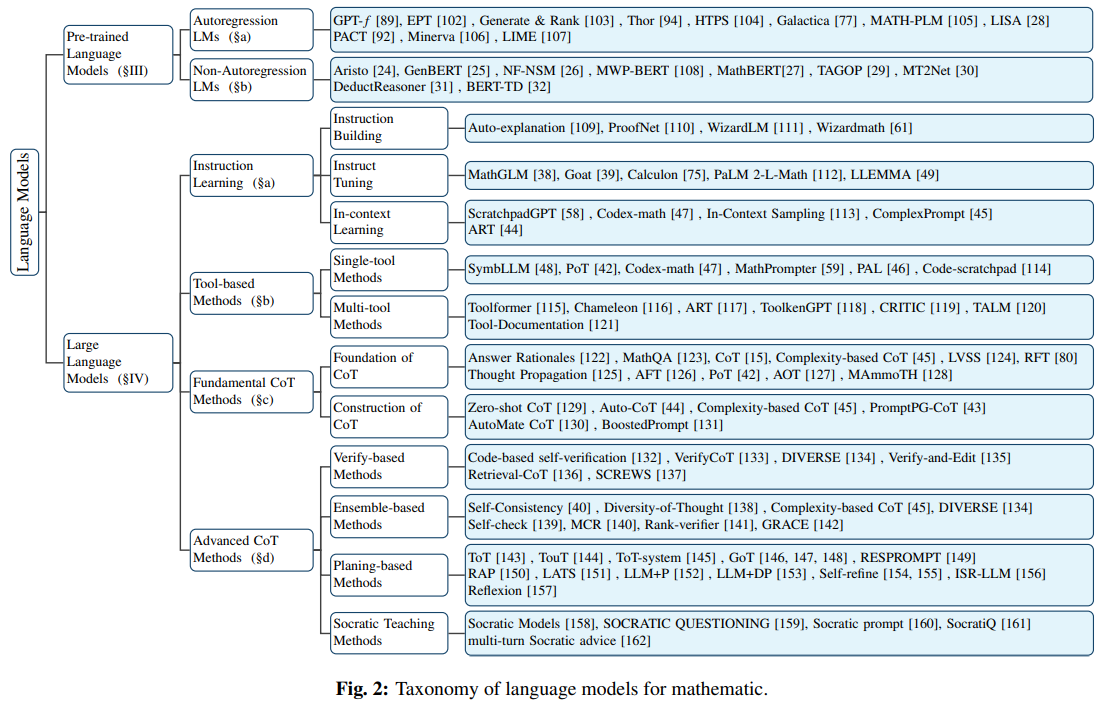

近年、数学の領域において、Pre-trained Language Models (PLMs)やLarge-scale Language Models (LLMs)といった言語モデル(LMs)を活用することにおいて、顕著な進展が見られています.本論文では、数学のLMsに関する包括的な調査を行い、タスクと方法論の2つの異なる観点から、重要な研究の取り組みを体系的に分類しています.調査の結果、多数の提案された数学のLLMsが明らかになり、それらは教育学習、ツールベースの手法、基礎的なCoT技術、高度なCoT方法論にさらに分類されています.さらに、本調査では、トレーニングデータセット、ベンチマークデータセット、拡張データセットを含む60以上の数学のデータセットを編纂しています.数学のLMsの分野における主要な課題への取り組みと将来の展望を論じることで、本調査は、この領域の進歩に関心を持つ研究者たちの将来のイノベーションを促進し、インスピレーションを与える貴重な情報源と位置付けられています.

Q&A:

Q: この文章で取り上げられている言語モデル(LM)にはどのような種類がありますか?

A: パッシブ言語モデル(PLMs)と大規模言語モデル(LLMs)

Q: 数学的LMはタスクと方法論の観点からどのように分類されるのか?

A: 数学的な言語モデルは、数学のタスクと方法論に基づいて分類されます.数学のタスクは、算術表現と算術計算からなる数学的な計算の領域と、問題解決と定理証明からなる数学的な推論の領域の2つの主要なドメインに分類されます.一方、数学的な方法論は、PLMベースのアプローチ(自己回帰と非自己回帰のLMを含む)とLLMベースの手法(教示学習、ツールベースの戦略、基本的なCoT技術、高度なCoT手法を含む)に分類されます.

Q: 数学的LMにおける指導学習法の例を教えてください.

A: 数学的なLLMの学習方法の例として、Auto-explanationでは半教師ありのアプローチを使用して、数学の自己説明のスコアリングを自動化するためにLLMを活用しています.ProofNetでは、自動定理証明システムを構築するために難解なベンチマークが導入されています.また、文の自動形式化のためにプロンプトの検索と蒸留された逆翻訳の方法が導入されています.WizardLMでは、Evol-Instructと呼ばれる画期的な方法が提案されており、LLM自体が高品質な指示を自律的に生成することができます.この方法は、直感的な指示から多様な形式に進化していきます.

Q: 数学的LMにおけるツールベースの手法とは?

A: 数学的な言語モデル(LLM)におけるツールベースの手法とは、コードや計算機などのツールを使用して、問題解決能力を向上させるためにLLMが設計されている手法です.ツールベースの手法では、シンボリックソルバーやプログラムなどの数学特化ツールを使用して、数学的な推論のパフォーマンスを向上させます.例えば、SymbLLMは数学のワード問題を解決するために使用されました.

Q: 数学的LMにおけるCoT技術の意義とは?

A: CoT 技術は言語モデルの推論能力を向上させるため、数学的 LM において重要である.これらのテクニックは、思考の連鎖(CoT)の原理を利用して、代数的な単語問題の解決を導き、数学の単語問題をプログラム操作に対応する複数のステップに分解する.インコンテクスト学習を活用することで、CoTは初めて思考連鎖の概念を導入し、推論能力を高める上でその有効性を立証した.LLMの数学的能力を向上させるために、解答の理由付け、MathQA、複雑性に基づくCoT、LVSS、プロセス報酬モデルなどのCoT手法が提案されている.これらの手法は、数学的問題解決への構造化されたアプローチを提供し、最終的に正しい答えを導くための一連の簡潔なステップを通して言語モデルを導く.CoT技術もまた、ゼロショットCoT、オートCoT、Complexity-based CoT、PromptPG-CoT、AutoMate CoT、BoostedPromptなど、CoTの構築に貢献している.さらに、Verify-based Methods、Ensemble-based Methods、Planning-based Methodsなどの高度なCoT手法は、数学的LMの推論能力をさらに向上させる.全体として、CoT技術は言語モデルの数学的推論能力を向上させる上で重要な役割を果たす.

Q: 基本的なCoTテクニックと高度なCoT手法の違いを説明していただけますか?

A: 基本的なCoT技術と高度なCoT手法の違いは、数学的な推論能力を向上させるために提案された手法のレベルの違いです.基本的なCoT技術は、初期の研究段階で使用され、数学的な能力を向上させるためにCoTの原則を利用しています.一方、高度なCoT手法は、より洗練された手法であり、より複雑な数学的な問題を解決するために開発されています.これらの手法は、自己検証、コードベースの検証、検索ベースの手法、アンサンブルベースの手法、計画ベースの手法、ソクラティック教育ベースの手法など、さまざまなアプローチを組み合わせています.

Q: 調査によると、数学的LLMはいくつ提案されているのですか?

A: 調査によれば、60以上の数学的なLLMが提案されています.

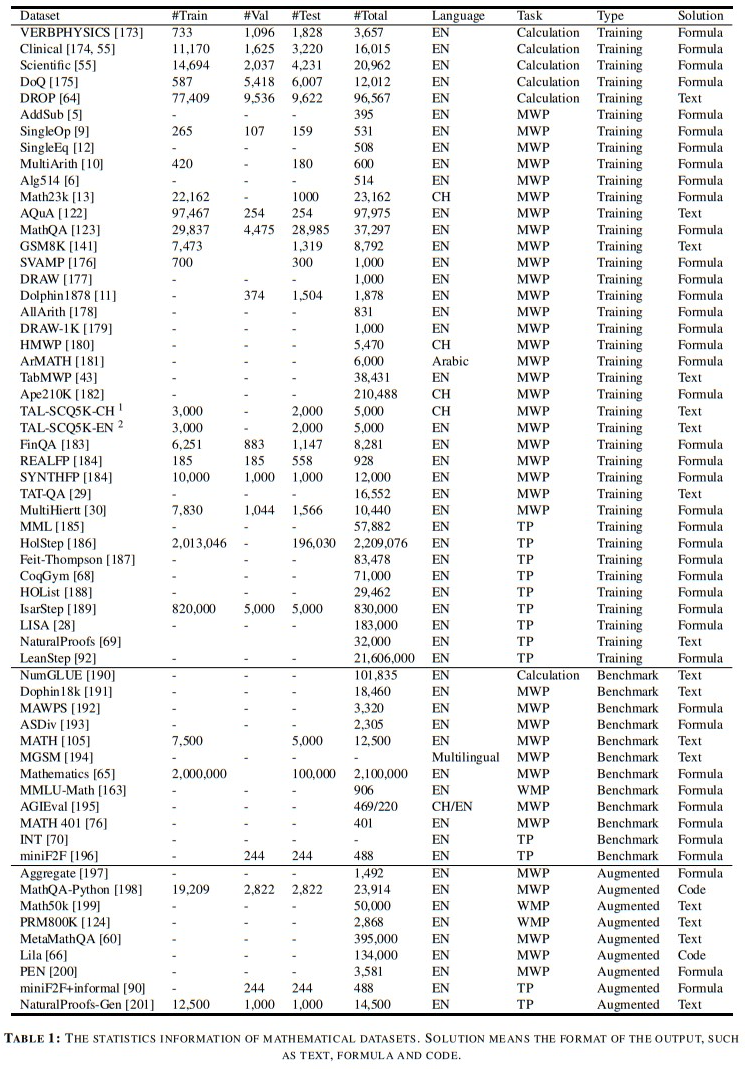

Q: この調査で収集された数学的データセットにはどのような種類がありますか?

A: 調査で収集された数学データセットの異なるタイプには、トレーニング、ベンチマーク、および拡張データセットに詳細に分類された60以上の多様な数学データセットが含まれています.

Q: 数学的LMの分野で取り組まれている主な課題とは?

A: 数学的な言語モデルの分野で取り組まれている主な課題は、以下のようなものです.まず、数学的なタスクの幅広さに対応するために、基本的な算術から複雑な定理の証明までをカバーするモデルの開発が求められています.また、言語の流暢さと数学的な正確さの両方を考慮する必要があります.さらに、新しい定理を自律的に考案し厳密に証明する能力も求められています.これには、深い数学的な推論力だけでなく、創造的で洞察力のある問題解決能力も必要です.次に、LLMの不確実性による数学的な問題の曖昧さと変動性の問題があります.LLMは確定的なタスクにおいては優れた性能を発揮しますが、確率的な推論や不完全または曖昧な情報の取り扱いなど、不確実性の扱いには困難が伴います.数学的な問題はしばしば微妙な解釈や曖昧な制約、または一つの正確な解が存在しないシナリオを含みます.最後に、数学的なタスクに適切に対応し、正確で文脈に即した解を提供するための堅牢で包括的な評価指標の確立が課題となっています.従来の自然言語処理の評価指標では、数学的なタスクの性能を適切に評価することができない場合があります.

Q: この調査は、数学的LMの領域における将来の技術革新にどのように貢献するのだろうか?

A: この調査は、数学的な言語モデルの領域での将来のイノベーションに貢献するために、現在の状況や課題を明らかにし、数学的なタスクと手法の分類を提供しています.さらに、数学的なトレーニングデータの形式や構築方法の追加的な探求や調査、そしてマルチモーダルなコンテキストでの数学的なトレーニングデータセットの生成も、将来のイノベーションに向けた有望な方向性として示されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 提案された新しい手法のコード実装のurlはhttps://github.com/psunlpgroup/MultiHierttです.

Audiobox: Unified Audio Generation with Natural Language Prompts

著者:Akinniyi Akinyemi, Alice Rakotoarison, Andros Tjandra, Apoorv Vyas, Baishan Guo, Bapi Akula, Bowen Shi, Brian Ellis, Carleigh Wood, Chris Summers, Ivan Cruz, Jeff Wang, Jiemin Zhang, Joshua Lane, Liang Tan, Mary Williamson, Matthew Le, Rashel Moritz, Robert Adkins, Wei-Ning Hsu, William Ngan, Xinyue Zhang, Yael Yungster, Yi-Chiao Wu

発行日:2023年12月11日

最終更新日:不明

URL:https://ai.meta.com/blog/audiobox-generating-audio-voice-natural-language-prompts/

カテゴリ:不明

概要:

オーディオ生成モデルがますます強力であり、誰もが生活の一部となっている中で、オーディオ生成の効率性と制御性がますます重要になっています.しかし、これらのモデルにはいくつかの制約があります.例えば、音声生成モデルはテキストの説明に基づいて新しいスタイルを合成することができず、音声の制御も制限されています.また、音楽生成モデルも制御性と汎化性に制限があります.

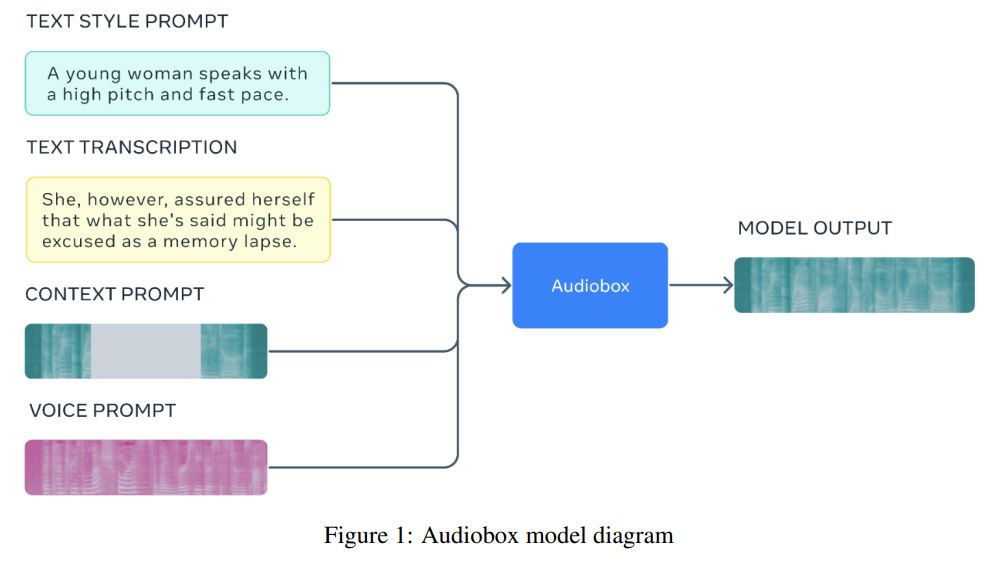

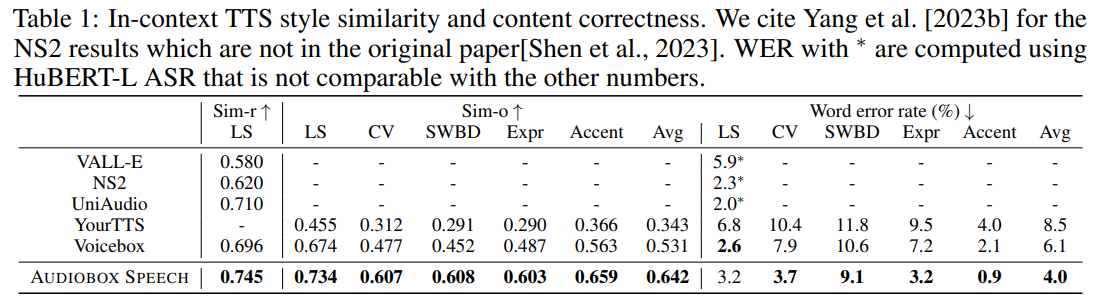

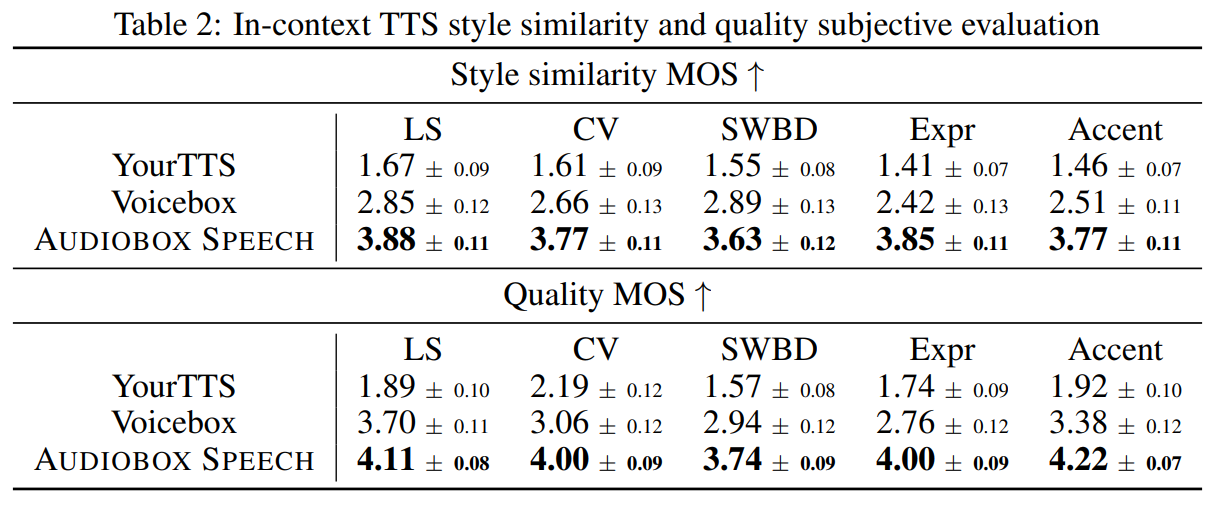

この論文では、さまざまなオーディオモダリティを生成することができる統一モデルであるAUDIOBOXを提案しています.AUDIOBOXは、説明に基づいたプロンプティングと例に基づいたプロンプティングを設計して、制御性を向上させ、音声生成と音生成のパラダイムを統一します.音声生成時には、トランスクリプト、ボーカル、その他の音声スタイルを独立して制御することができます.また、音楽生成モデルも進歩しており、さまざまな音楽スタイルを生成することができます.さらに、デフォルトのODEソルバーよりも25倍以上高速なBespoke Solversも統合されています.

さらに、この研究では、オーディオ生成モデルの進歩についての新たな文脈が提供され、オーディオクリエーターにとって効率的で創造性豊かなプロセスをもたらすことが期待されます.また、公平性の実現に関しても研究が行われており、データのスケーリングによって異なる人口グループの声をより適切に表現することができることが示されています.さらに、最近の透かしシステムの有効性も検証されており、検証は高い効果を持ち、敵対的な摂動にも強いことが示されています.

オーディオ生成モデルがより強力であり、誰もが生活の一部となっている中で、オーディオ生成の効率性と制御性がますます重要になっています.

Q&A:

Q: Audioboxモデルの目的は何ですか?

A: Audioboxの目的は、高品質のコンテンツを生成するためのツールであり、特に音声生成においては、環境や感情の変化を反映した音声を作成することが重要であると述べられています.

Q: Audioboxモデルは、音声生成における制御性をどのように高めているのでしょうか?

A: Audioboxは、参照音声、テキスト記述、またはその両方の組み合わせを含む複数の入力方法を可能にすることで、音声生成の制御性を高めます.これにより、クリエイターは、生成される音声のボーカルスタイルやアコースティックスタイルをより柔軟にコントロールすることができます.このモデルは、アクセント、感情、音色などのきめ細かな発声スタイルや、多様な環境をシミュレートした音声を生成することができます.自然言語記述を用いることで、クリエイターは既存の個人からクローンを作成することなく、簡単に希望のスタイルを指定することができます.これにより、時間を節約できるだけでなく、没入型オーディオブック、広告、映画の台本に登場するキャラクターの斬新な声を作成することができます.さらに、Audioboxは、映画制作や没入型オーディオブック制作などの用途に不可欠な、多様な音響条件下での音声を生成することができます.全体として、Audioboxは、クリエイターに、従来モデルよりも高いレベルの制御性と、より高品質なコンテンツ生成能力を提供します.

Q: 現在のスピーチ生成モデルにはどのような限界がありますか?

A: 現在の音声生成モデルの制限は、次のようなものがあります.まず、既存の音声生成モデルは、音声、音楽、効果音のいずれかを生成するモダリティ固有のモデルであるため、実世界のオーディオコンテンツの複数の要素を含むことができません.また、既存の音声生成モデルは、粗い制御しか提供しておらず、例えば「男性が話している」といった程度の情報しか生成できません.さらに、既存のデータセットは、より詳細な音声スタイルを特徴づけるような細かいキャプションを提供していません.さらに、これらのモデルはテキストの内容を制御するためのトランスクリプト入力をサポートしていないため、ぶつぶつとした音声しか生成できません.最後に、自然な環境での言語による音声生成の考慮が不足しているため、このような汎用モデルに適切な客観的評価指標を設計することは未解決の問題です.

Q: Audioboxモデルは、限られたラベルでどのようにモデルの汎化を向上させるのか?

A: Audioboxモデルは、限られたラベルでモデルの一般化を改善するために、自己教師ありの埋め込み目的を適応して大量のラベルのないオーディオで事前学習を行います.

Q: Audioboxモデルは音声・音響生成においてどのようなベンチマークを設定していますか?

A: Audioboxモデルは、音声生成において、スタイルの類似性、感情、音色、音声シミュレーションのベンチマークとなっています.サウンド生成において、Audioboxモデルは、既存のドメイン固有モデルと比較して、制御性、汎用性、および追加機能においてベンチマークを設定します.

Q: Bespoke Solversの統合は生成速度にどのような影響を与えますか?

A: Bespoke Solversの統合により、モデルの生成速度が25倍向上します.適応的ステップサイズのdopri5ソルバーを使用する場合と比較して、パフォーマンスに損失はありません.

Q: オーディオの生成モデルを開発する意義とは?

A: オーディオ生成モデルを開発することの重要性は、一般の人々がオーディオクリエーターになることを困難にしている現状を改善し、プロフェッショナルの効率を向上させるだけでなく、創造性を引き出すことができる点にあります.オーディオ生成モデルは、一般の人々にとってはエントリーのハードルを下げ、プロフェッショナルにとっても時間とリソースを節約することができます.また、最近の研究では、音声生成モデルや音楽生成モデルの進歩があり、さまざまな音声スタイルや音楽スタイルを再現することが可能になっています.さらに、大量のデータを使用して統一されたモデルを構築することで、モダリティ固有のモデルを上回る性能を実現できることが示されています.これにより、オーディオ生成モデルの開発は、オーディオクリエーションプロセスに革新的な変化をもたらすことができます.

Q: オーディオ生成モデルは、オーディオ制作プロセスにおけるプロの作業効率をどのように向上させることができるのでしょうか?

A: オーディオ生成モデルは、プロフェッショナルのオーディオ制作プロセスの効率を向上させることができます.これらのモデルは、音声生成モデルを使用して、短いオーディオプロンプトを使用して任意のボーカルスタイルを模倣することができます.また、音声生成モデルは、音声の一部を埋めることで一時的なノイズを除去したり、話者の言葉を編集したりすることもできます.さらに、音楽生成モデルは、短いテキストの説明を使用してさまざまなスタイルの音楽を作成することができます.これらのモデルの使用により、プロフェッショナルは時間とリソースを節約し、効率的にオーディオを作成することができます.

Q: 現在、オーディオ制作に必要な専門知識とは?

A: 音声作成には、声優、音楽作曲・演奏、フリーサウンド効果の作成、音響エンジニアリングなど、さまざまな専門知識が必要です.

Q: Audioboxモデルは、オーディオ制作のプロと一般の人々の両方にどのようなメリットをもたらすのでしょうか?

A: Audioboxモデルは、プロフェッショナルと一般の人々の両方にとって、オーディオ制作において利益をもたらすことができます.プロフェッショナルにとっては、これらのタスクを実行するのにかかる時間とリソースを節約することができ、生産性を向上させることができます.一般の人々にとっては、オーディオ制作のプロセスをより効率的に行うことができ、創造性を引き出すことができます.Audioboxモデルは、高品質なオーディオ生成モデルを開発することで、オーディオクリエーターになることを困難にしている要因を取り除きます.これにより、プロフェッショナルの効率を向上させるだけでなく、一般の人々の創造性を解放することができます.

QuIP: 2-Bit Quantization of Large Language Models With Guarantees

著者:Christopher De Sa, Jerry Chee, Volodymyr Kuleshov, Yaohui Cai

発行日:2023年12月11日

最終更新日:不明

URL:https://cornell-relaxml.github.io/quip-sharp/

カテゴリ:不明

概要:

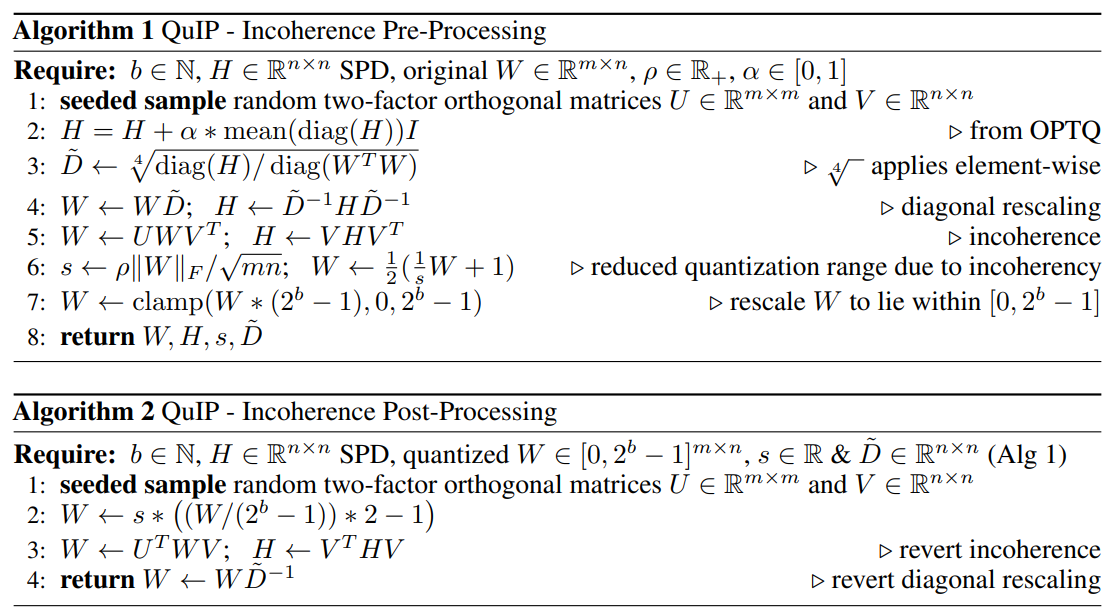

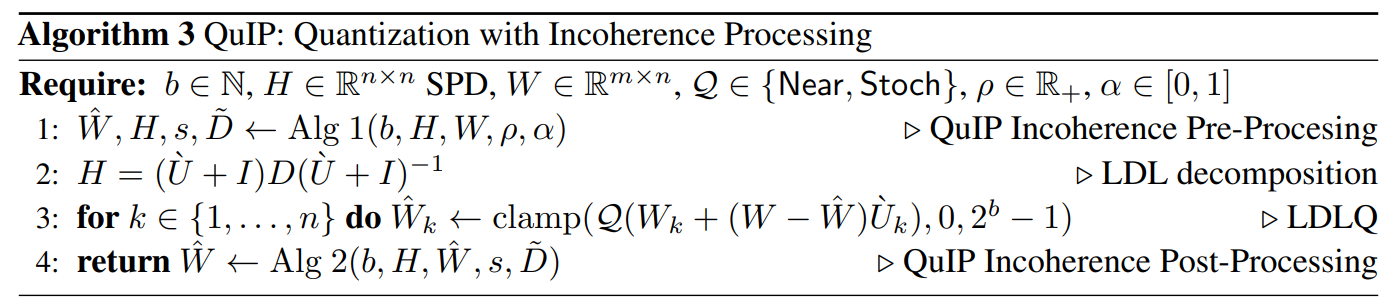

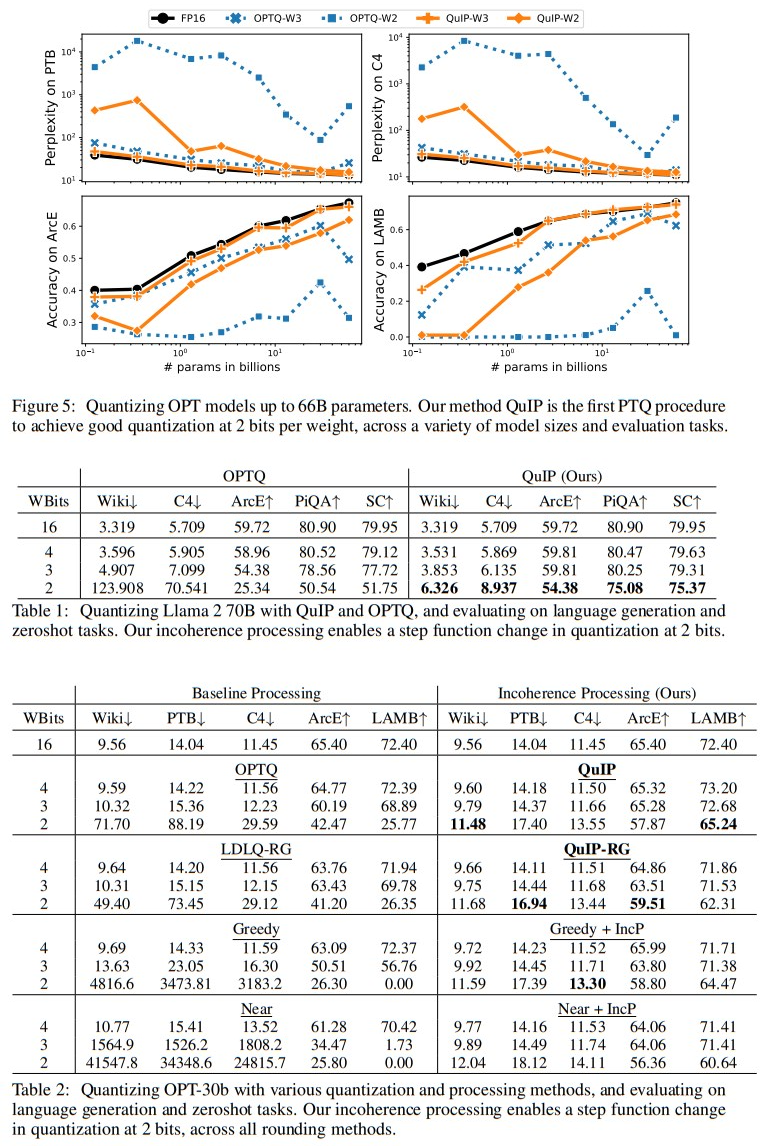

この研究では、大規模な言語モデル(LLM)におけるトレーニング後のパラメータの量子化を研究しています.LLMはテキスト生成、フューショット学習、推論、タンパク質のシーケンスモデリングなどのタスクで進歩をもたらしています.これらのモデルの巨大なサイズは、高度な展開方法が必要であり、効率的な推論アルゴリズムの研究を促しています.

この研究では、重みとプロキシヘシアン行列が非整合である場合に量子化が最も効果的であることを示しています.具体的には、重み自体が大きさが均等であり、丸めの精度が重要な方向が座標軸と非整合である場合に、適応的な丸め手順による二次プロキシ目的関数の最小化が有効であることを示しています.非整合性は、外れ値の削減の原則的な形態と考えることができ、重みを有限の圧縮された値のセットに適応的に丸めることを容易にします.この直感を用いて、LLMサイズのモデルにスケーリング可能な理論的に妥当な2ビットの量子化アルゴリズムを開発しました.

また、この研究では、QuIP(Quantization with Incoherence Processing)という新しい手法を提案しています.QuIPは、非整合性の前処理と後処理の2つのステップで構成されており、重みとヘシアンの非整合性を保証する効率的な処理を行います.さらに、QuIPは、LLMスケールの量子化アルゴリズムに対する初めての理論的分析を補完し、既存のOPTQという手法にも適用可能であることを示しています.

実験的には、非整合性の前処理が既存の量子化アルゴリズムを改善し、重みごとにわずか2ビットしか使用しない初めてのLLM量子化手法を提案しています.さらに、LLMサイズが大きくなるほど、2ビットと4ビットの圧縮間には小さなギャップがあり、モデルサイズが小さくなるにつれてさらに減少していることが観察されており、LLMにおける正確な2ビットの推論の実現可能性を示唆しています.

この研究の貢献は以下の通りです:(1) モデルパラメータが非整合であることが理想的であるという洞察に基づいた量子化手法であるQuIPを提案しました.(2) QuIPを含む適応的な丸め手法の広範な理論的分析を提供しました.(3) QuIPによって初めて2ビットのLLM圧縮が実現可能となりました.

Q&A:

Q: この仕事の主眼は何ですか?

A: この研究の主な焦点は、大規模言語モデルの量子化を2ビット/重みの領域に推進することです.目的は、量子化の理論的および実証的側面の基礎研究を推進することです.最終的な目標は、より強力な言語モデルがより効率的に実行されることを可能にすることです.ただし、この研究は、それらの言語モデルがどのような目的で使用されるかを把握していません.

Q: この作品で導入された新しい手法とは?

A: 本研究で導入された新しい手法は、QuIP(量子化非干渉性処理)とQuIP-RG(順序変更と貪欲な更新を伴う量子化非干渉性処理)です.

Q: 量子化の有効性の背後にある洞察とは?

A: 重要な洞察は、量子化の効果的な手法は、重みとプロキシヘシアン行列が非相関であることです.つまり、重み自体が大きさが均等であり、良い丸め精度を持つ方向がどの座標でも大きすぎないことです.非相関性は、外れ値の削減の原理的な形態と考えることができます.実証的には、非相関処理は大きなモデルの量子化を大幅に改善し、特に高い圧縮率で効果があります.また、2ビットの重みのみを使用する初めてのLLM量子化手法を提案し、大きなLLMサイズでは2ビットと4ビットの圧縮の間に小さなギャップがあり、モデルサイズが小さくなるにつれてさらに減少することを観察しました.

Q: QuIP法に含まれる2つのステップとは?

A: QuIPメソッドには2つのステップがあります.1つ目は、LDLQ(低次元潜在量子化)と呼ばれる手法で、これは低次元の潜在的な量子化を行います.2つ目は、IncP(Incremental Pruning)と呼ばれる手法で、これは増分的な剪定を行います.

Q: 適応丸め手順はどのように機能するのですか?

A: アダプティブな丸め手順は、列ごとに行われます.各ステップでは、これまでに行った丸めの残差の線形関数である「修正項」が追加されます.最終的な結果は、以下の行列方程式を満たします:

\( \small \hat{W} = Q(W + (W – \hat{W})U) \)

ここで、\( \small \hat{W} \)は最終的な結果を表し、\( \small W \)は元の行列、\( \small Q \)は整数への丸めを表します.\( \small U \)は線形フィードバックであり、\( \small H \)に依存せずに\( \small W \)に依存します.

Q: 重み行列とヘシアン行列の非干渉性はどのように確保されるのか?

A: 重要な点は、ランダムな直交行列を用いて重み行列とヘッシアン行列を変換することで、これらの行列が非相関であることを高い確率で保証していることです.具体的には、ランダムな直交行列UとVを生成し、重み行列をUWVT、ヘッシアン行列をVHVTで変換します.この変換によって、プロキシ二次形式は保存されます.

Q: 量子化における非干渉性の意義とは?

A: 不均一性は、量子化において重要な役割を果たします.重みとプロキシヘッシアン行列が不均一であることは、量子化が最も効果的であることを示しています.不均一性は、重み自体が大きさが均等であり、良好な丸め精度が必要な方向がどの座標でも大きすぎないことを意味します.つまり、不均一性は、外れ値を原理的に除外する方法として考えることができます.

Q: QuIPは既存の量子化アルゴリズムと比べてどうですか?

A: QuIPは、モデルのサイズや評価タスクに関係なく、OPTQや他のベースラインよりも優れています.2ビットごとの重みにおいて、大きなLLM(>2Bパラメータ)でも良好な量子化を実現しています.3ビットでは、QuIPは完全精度モデルと比較して妥当な結果を出しています.さらに、他の2ビット量子化手法が失敗する中でも、QuIPは中程度のモデルサイズ(1Bパラメータ)でも2ビット量子化が可能です.最大のモデルサイズでは、2ビットと16ビットの重みの性能差は小さくなります.QuIPのスループットは、言語生成においてOPTQの効率的な実装と比較しても遜色ありません.

Q: この作品で提供されている理論的分析とは?

A: この論文では、Hのスペクトルに基づいてLDLQのプロキシ損失の境界を導出することにより、理論的な分析が提供されています.また、インコヒーレンス処理を行わないQuIPは、OPTQという以前のアルゴリズムのより効率的な実装を提供することも示されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlは、https://github.com/jerry-chee/QuIPです.

Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models

著者:Avi Singh, John D. Co-Reyes, Rishabh Agarwal, Ankesh Anand, Piyush Patil, Peter J. Liu, James Harrison, Jaehoon Lee, Kelvin Xu, Aaron Parisi, Abhishek Kumar, Alex Alemi, Alex Rizkowsky, Azade Nova, Ben Adlam, Bernd Bohnet, Gamaleldin Elsayed, Hanie Sedghi, Igor Mordatch, Isabelle Simpson, Izzeddin Gur, Jasper Snoek, Jeffrey Pennington, Jiri Hron, Kathleen Kenealy, Kevin Swersky, Kshiteej Mahajan, Laura Culp, Lechao Xiao, Maxwell L. Bileschi, Noah Constant, Roman Novak, Rosanne Liu, Tris Warkentin, Yundi Qian, Ethan Dyer, Behnam Neyshabur, Jascha Sohl-Dickstein, Noah Fiedel

発行日:2023年12月11日

最終更新日:2023年12月12日

URL:http://arxiv.org/pdf/2312.06585v2

カテゴリ:Machine Learning

概要:

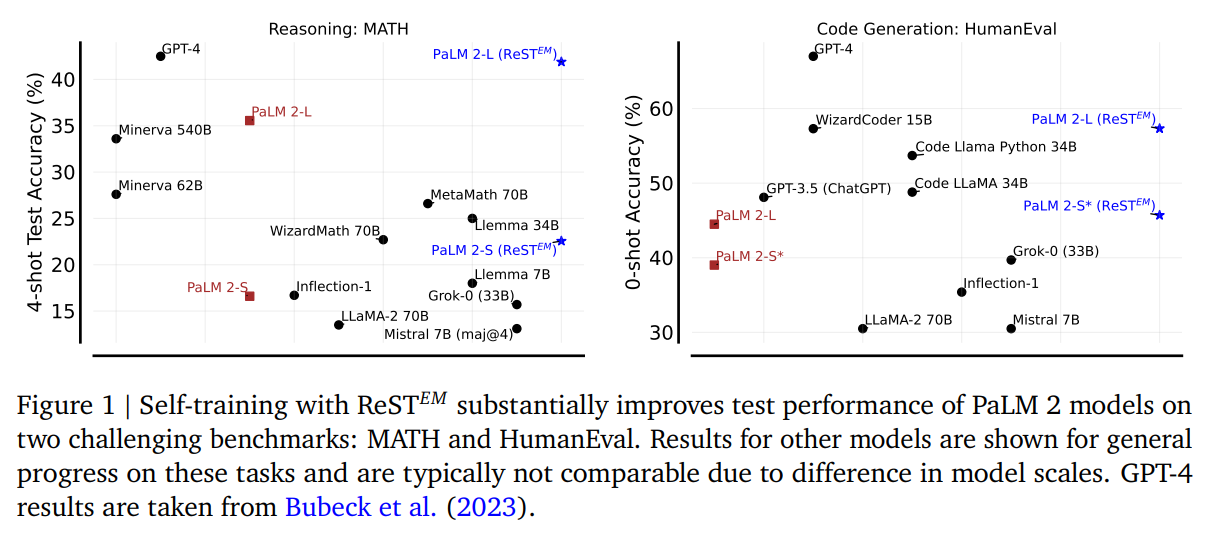

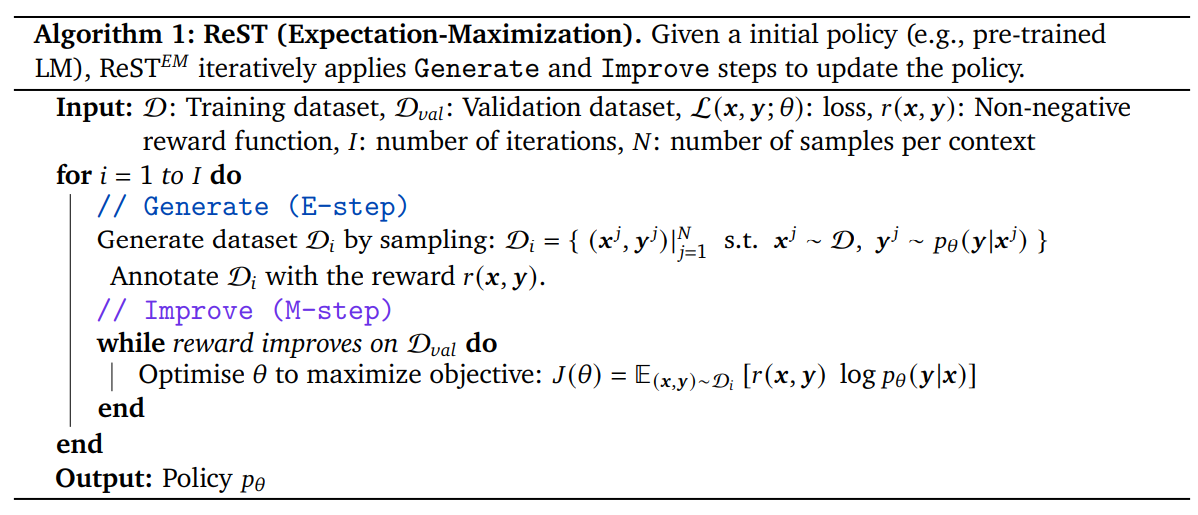

この論文では、人間が生成したデータに対して言語モデル(LMs)を微調整することが一般的な手法であるが、そのようなモデルの性能はしばしば高品質な人間データの量と多様性に制約されるという問題がある.本論文では、スカラーフィードバックにアクセスできるタスク(例えば、正確性を検証できる数学の問題)において、人間データを超えることができるかどうかを探求する.そのために、我々は期待値最大化に基づくシンプルなセルフトレーニング手法を検討し、それをReST\( \small ^{EM} \)と呼ぶ.具体的には、(1) モデルからサンプルを生成し、バイナリフィードバックを用いてそれらをフィルタリングする、(2) これらのサンプルでモデルを微調整する、(3) このプロセスを数回繰り返す、という手順を踏む.PaLM-2モデルを用いて、高度な数学の推論とAPPSコーディングのベンチマークテストを行った結果、ReST\( \small ^{EM} \)はモデルのサイズに応じてスケーリングし、人間データのみによる微調整を大幅に上回ることがわかった.全体的に、フィードバックを用いたセルフトレーニングは、人間が生成したデータへの依存を大幅に減らすことができるという結果が示唆されている.

Q&A:

Q: 論文の主眼は何か?

A: この論文の主な焦点は、人間が生成したデータに頼らずに、スカラーリワードを持つタスクでモデル生成データを使用して言語モデルを微調整することです.

Q: 人間が作成したデータで言語モデルを微調整することの限界とは?

A: 人間が生成したデータに基づいて言語モデルを微調整することの制限は、高品質な人間データの量と多様性によってしばしば制約されることです.

Q: ReST\( \small ^{EM} \)メソッドはどのように機能するのですか?

A: ReST\( \small ^{EM} \)は、期待最大化を強化学習に適用することで理論的に基礎づけられています.具体的には、ReST\( \small ^{EM} \)は期待値ステップと最大化ステップを交互に繰り返します.期待値ステップでは、言語モデルが各入力に対して複数の出力サンプルを生成します.最大化ステップでは、生成されたサンプルを使用して報酬関数を最適化します.

Q: モデルからサンプルを生成し、バイナリーフィードバックを使ってフィルタリングする目的は何ですか?

A: モデルからサンプルを生成し、それらをバイナリフィードバックでフィルタリングする目的は、高品質なサンプルを作成することです.この手法では、モデルから生成されたサンプルをバイナリフィードバックで評価し、正しいかどうかを判断します.フィルタリングされたサンプルは、モデルの微調整に使用され、このプロセスを数回繰り返すことで、高品質なサンプルを作成することができます.

Q: ReST\( \small ^{EM} \)法のテストにはどのようなベンチマークが使われましたか?

A: ReST\( \small ^{EM} \)メソッドは、HendrycksのMATHデータセットを用いた数学的問題解決と、APPS(入門)データセットを用いたコード生成のテストが行われました.

Q: ReST\( \small ^{EM} \)の性能は、人間のデータだけでファインチューニングした場合と比較してどうでしょうか?

A: ReST\( \small ^{EM} \)のパフォーマンスは、人間が生成したデータのみでのファインチューニングと比較して非常に優れています.

Q: モデルの大きさは、ReST\( \small ^{EM} \)のスケーラビリティにどのような影響を与えますか?

A: ReST\( \small ^{EM} \)のスケーラビリティにおいて、モデルのサイズは重要な要素です.結果からわかるように、モデルの容量が増加するにつれて、ReST\( \small ^{EM} \)のパフォーマンス向上が大きくなります.例えば、MATHデータセットでは、PaLM 2-Sモデルに比べてPaLM 2-Lモデルの方がテストの正解率の改善が大きくなっています.また、ベースラインのパフォーマンスが高くなるほど、改善が難しくなる傾向があります.

Q: 人為的なデータへの依存を減らすために、この発見はどのような意味を持つのだろうか?

A: 人間が生成したデータへの依存を減らすことに関する研究結果の意義は、大規模な言語モデルにおいてもモデル生成の合成データが有効であり、スケーラビリティがあることを示しています.これにより、高品質な人間データの量と多様性に制約されずに、問題解決における言語モデルの性能を向上させることが可能となります.

Q: ReST\( \small ^{EM} \)で使われている期待値最大化処理の詳細を教えてください.

A: ReST𝐸𝑀は強化学習に期待値最大化(EM)アルゴリズムを適用する.EMアルゴリズムは、期待値ステップ(E-step)と最大化ステップ(M-step)を交互に繰り返す2段階の反復プロセスである.Eステップでは、言語モデルは各入力に対して複数の出力サンプルを生成する.これらのサンプルは、各入力に対する期待報酬を推定するために使用される.Mステップでは、モデルは生成されたサンプルに基づいてパラメータを更新することで、期待報酬を最大化する.このプロセスは収束するまで繰り返される.ReST𝐸𝑀はEMアルゴリズムを利用して数学的問題解決とコード生成タスクの性能を向上させ、比較的低い計算コストで大幅な性能向上を提供する.しかし、ReST𝐸𝑀には、適度な大きさの問題またはプロンプトの訓練セットが必要であること、手動で設計または学習された報酬関数にアクセスできること、pass@K学習との性能差を完全に縮めることができないことなどの限界がある.

LLM360: Towards Fully Transparent Open-Source LLMs

著者:Zhengzhong Liu, Aurick Qiao, Willie Neiswanger, Hongyi Wang, Bowen Tan, Tianhua Tao, Junbo Li, Yuqi Wang, Suqi Sun, Omkar Pangarkar, Richard Fan, Yi Gu, Victor Miller, Yonghao Zhuang, Guowei He, Haonan Li, Fajri Koto, Liping Tang, Nikhil Ranjan, Zhiqiang Shen, Xuguang Ren, Roberto Iriondo, Cun Mu, Zhiting Hu, Mark Schulze, Preslav Nakov, Tim Baldwin, Eric P. Xing

発行日:2023年12月11日

最終更新日:2023年12月11日

URL:http://arxiv.org/pdf/2312.06550v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

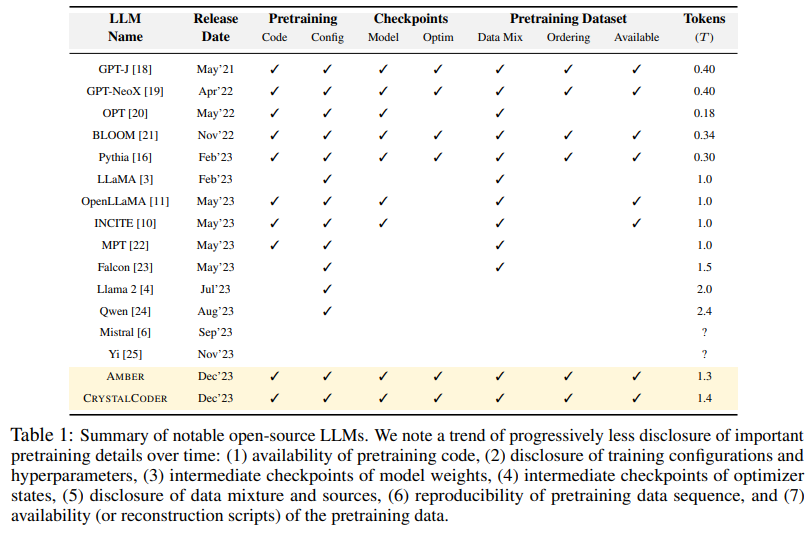

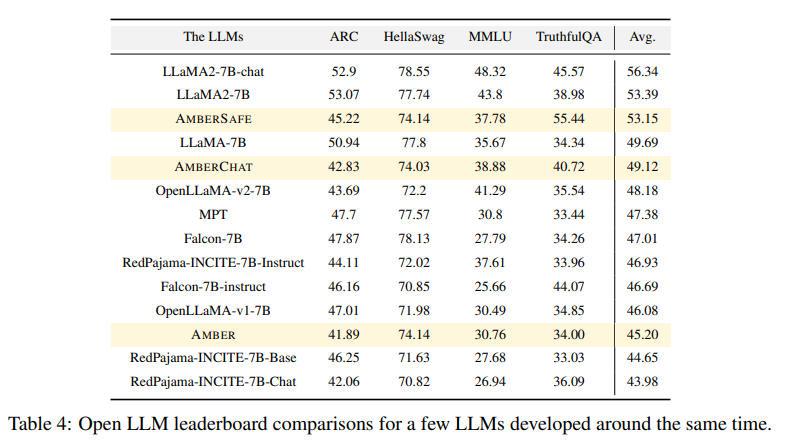

最近、LLaMA、Falcon、Mistralなどのオープンソースの大規模言語モデル(LLM)の急増により、AIの実践者や研究者には多様な選択肢が提供されています.しかし、ほとんどのLLMは最終的なモデルの重みや推論コードなどの一部のアーティファクトのみを公開しており、技術レポートも高レベルの設計選択肢や表面的な統計に限定される傾向があります.これらの選択肢は、LLMのトレーニングにおける透明性を低下させ、チームがトレーニングプロセスの多くの詳細を再発見する必要があるため、この分野の進歩を妨げています.私たちは、LLM360という、LLMの完全なオープンソース化を提唱するイニシアチブを紹介します.LLM360の目標は、エンドツーエンドのLLMトレーニングプロセスを透明かつ再現可能にすることで、オープンで協力的なAI研究を支援することです.LLM360の最初のステップとして、私たちはAmberとCrystalCoderという2つの7BパラメータのLLMをゼロから事前トレーニングし、そのトレーニングコード、データ、中間チェックポイント、分析を公開します(https://www.llm360.aiで入手可能).私たちは、常に限界を押し広げることに取り組んでおり、今後もさらに大規模で強力なモデルを開発し、公開していく予定です.

Q&A:

Q: この文章に出てくるオープンソースの大規模言語モデル(LLM)の名前は?

A: LLaMA、ファルコン、ミストラル

Q: 多くのLLMは、通常どのような成果物を発表するのですか?

A: 私たちは、LLMのほとんどが最終モデルの重みや推論コードなどの一部のアーティファクトを公開していることを観察しています.

Q: LLM360の目標は何ですか?

A: LLM360の目標は、LLMの完全なオープンソース化を推進し、オープンで協力的なAI研究をサポートすることです.具体的には、トレーニングコードやデータ、モデルのチェックポイント、中間結果などをコミュニティに提供することで、LLMのトレーニングプロセスに関する包括的な知識を提供し、研究者や開発者が自身のプロジェクトに活用できる環境を提供することです.

Q: LLM360は、LLMの具体的などのような部分を地域社会に提供するよう提唱していますか?

A: LLM360は、LLMのいくつかのコンポーネントをコミュニティに公開することを提唱している.これらのコンポーネントには、データセット、コード、設定、モデルのチェックポイント、トレーニングメトリクスが含まれる.このフレームワークは、オープンソースの透明性、再現性、データ/モデルの実証性、共同研究を促進します.これらのコンポーネントを一般公開することで、LLM360はユーザーに包括的な知識を提供し、ユーザー自身がLLMのプリトレーニングを実施しなくても、そのプロセスを理解できるようにすることを目指しています.さらに、LLM360は、オープンソースの研究コミュニティにおける即時の関心と共同研究を促進することを期待して、その立ち上げの一部として、2つの新しい事前学習済みLLMもリリースしている.

Q: AmberとCrystalCoderのLLMのトレーニングコード、データ、中間チェックポイント、解析結果を公開する意義は?

A: AMBERとCRYSTAL CODERのトレーニングコード、データ、中間チェックポイント、および分析を公開することにより、LLM360プロジェクトは透明性と再現性を実現しようとしています.これにより、他の研究者や開発者がこれらのモデルを理解し、再現し、改善することができます.トレーニングコードとデータは、モデルのトレーニングプロセスを再現するために必要な要素です.中間チェックポイントは、トレーニングの進行状況を確認し、必要に応じてトレーニングを再開するために使用されます.分析は、モデルのパフォーマンスや振る舞いを評価し、改善のための洞察を得るために重要です.

Q: LLM360のウェブサイトの目的は何ですか?

A: LLM360のウェブサイトの目的は、LLMの事前トレーニング中に収集されたリリースアーティファクトを公開し、コミュニティに提供することです.また、LLM360はオープンソースの透明性、再現性、データ/モデルの起源、共同研究を促進するフレームワークであり、リリースアーティファクトに関するガイダンスと推奨事項を提供します.LLM360のウェブサイトは、研究者や開発者が自分のプロジェクトに使用するための情報やリソースを提供することを目的としています.

Q: LLMの研修プロセスにおける透明性と再現性の重要性とは?

A: LLMのトレーニングプロセスにおいて、透明性と再現性は非常に重要です.透明性は、トレーニングデータの起源と特性を理解することで、LLMの信頼性やバイアスを評価するために必要です.データの起源や構成についての透明性の欠如は、モデルの出力に永続化される可能性のあるバイアスを特定し、軽減する能力を妨げます.同時に、トレーニングデータセットがベンチマークデータセットと重複するデータリークは、モデルの一般的な効果を隠す可能性のあるパフォーマンス指標の誤解を招くことがあります.再現性は、データソースの完全な開示にもかかわらず、トレーニングコードや設定の詳細、特定のデータセットへのアクセスの欠如により、研究で報告された結果を再現することが困難になる可能性があります.トレーニングプロセスの透明性と再現性の向上は、より包括的で協力的な研究環境を促進するために重要です.

Q: 現在のLLMの透明性の欠如は、AI研究の分野にどのような影響を与えるのだろうか?

A: 現在のLLMの透明性の欠如は、AI研究の分野に以下のような影響を与えています.まず、トレーニングデータの透明性の欠如により、LLMの信頼性やバイアスの存在が評価できなくなります.データの出所や構成についての情報が不明瞭であるため、モデルの出力に永続化される可能性のあるバイアスを特定し、軽減することが困難になります.同時に、トレーニングデータセットがベンチマークデータセットと重複している場合、モデルの一般的な効果を隠す誤解を招くパフォーマンス指標が生じる可能性があります.さらに、LLMのトレーニングに関する透明性の欠如は、研究の進展を妨げる選択肢です.最終モデルの重みや推論コードなどの一部のアーティファクトのみが公開され、技術レポートも高レベルの設計選択肢や表面的な統計に限定されています.これらの選択肢は、LLMのトレーニングの透明性を低下させ、チームに進展を強制することで、研究の進展を妨げます.

Gaussian-SLAM: Photo-realistic Dense SLAM with Gaussian Splatting

著者:Martin R. Oswald, Theo Gevers, Vladimir Yugay, Yue Li

発行日:2023年12月06日

最終更新日:不明

URL:https://vladimiryugay.github.io/gaussian_slam/

カテゴリ:不明

概要:

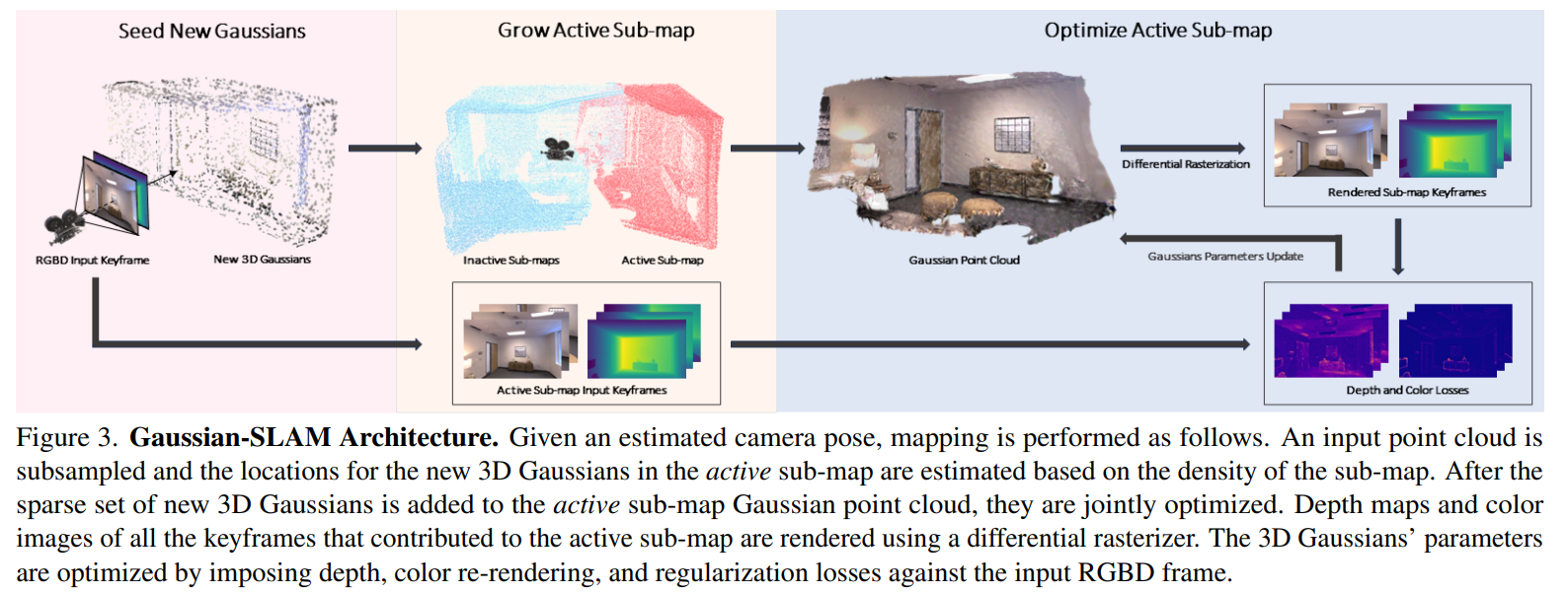

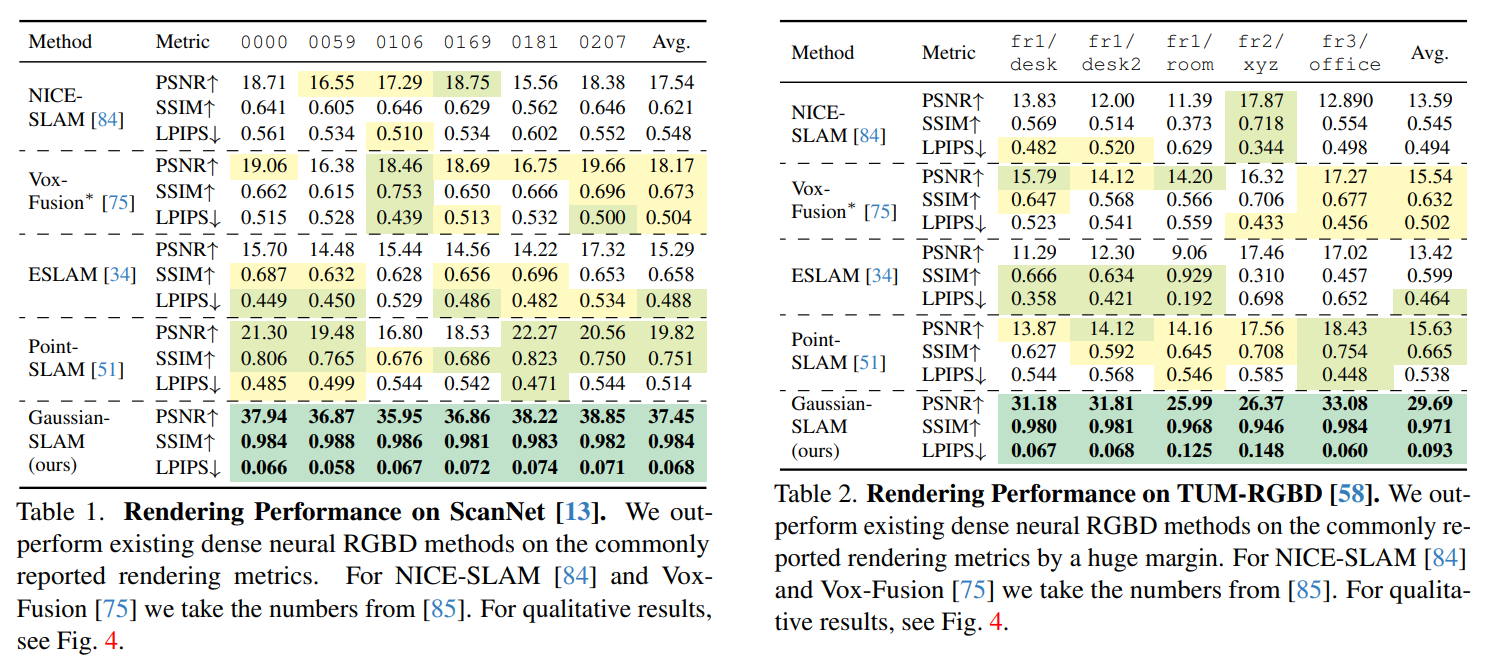

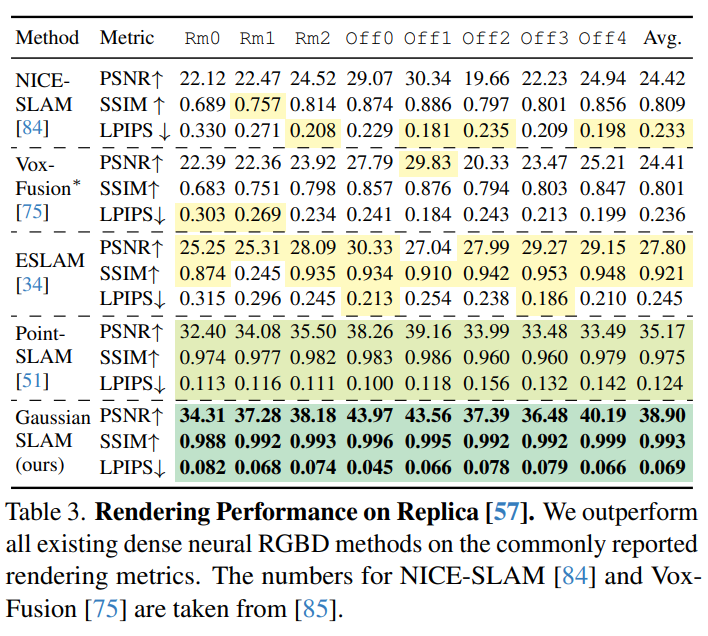

この論文では、ガウススプラットをシーン表現として使用する新しい密な同時位置推定とマッピング(SLAM)手法を提案しています.新しい表現方法により、リアルワールドと合成シーンのインタラクティブなリアルタイム再構築と写真のようなレンダリングが可能になります.また、この手法は、リアルワールドと合成データセットの両方で最先端のレンダリング品質を実現しながら、再構築性能とランタイムで競争力を持っています.

さらに、この論文では、ガウススプラットを使用したSLAMにおけるさまざまな制約や課題についても議論されています.具体的には、ジオメトリをより正確にエンコードするためのガウススプラットの拡張や、オンライン学習方法の提案などが行われています.これにより、ガウススプラットをオンラインSLAMシステムに適用する際の課題に対処する手法が提案されています.

さらに、この研究では、マップをサブマップに分割し、効率的なシーディングと最適化戦略を導入することで、ガウススプラットを使用したフレーム対モデルトラッキングを調査し、光度誤差の最小化を通じてフレーム対フレームトラッキングと比較しています.

この研究では、すべてのソースコードとデータを公開する予定です.

Q&A:

Q: 本稿で紹介する研究の主眼は何ですか?

A: この論文の主な焦点は、ガウススプラットを使用した密なRGBD SLAMアプローチであり、高品質なレンダリング結果を提供することです.

Q: シーン表現としてガウススプラットを使う利点は何ですか?

A: シーン表現としてのガウススプラットは、インタラクティブなランタイムでほぼフォトリアリスティックな再レンダリングを可能にするという利点を提供する.つまり、ガウススプラットを使用したシーンのレンダリング出力は忠実度が高く、元のシーンに酷似している.さらに、ガウススプラッティングは、他の手法と比較してより高速なレンダリング結果を提供し、オンラインSLAMシステムでのリアルタイムな要求を可能にします.また、シーンの直接編集が可能で、直接解釈できるため、シーン表現の理解と操作が容易になります.

Q: ガウススプラットの使用は、レンダリング性能と最適化速度の面で、他のシーン表現と比較してどうでしょうか?

A: ガウススプラットを使用したシーン表現は、他のシーン表現と比較してレンダリングのパフォーマンスと最適化の速度において同等または優れた結果を示しています.ガウススプラットを使用したシーン表現は、非常に高速でフォトリアルなレンダリングを可能にし、他の手法では捉えるのが難しい高周波の詳細を含む実世界のデータに特に優れたレンダリング品質を提供します.また、ガウススプラットを使用したシーン表現は直接解釈可能であり、直接的なシーン編集も可能です.さらに、ガウススプラットを使用したシーン表現は、リアルタイムの要求を持つオンラインSLAMシステムに適用することができ、フォトリアルな密なSLAMを実現する可能性を開いています.

Q: ガウス・スプラッティングはリアルタイムSLAMシステムに適用できるか?

A: はい、ガウススプラッティングはリアルタイムのSLAMシステムに適用することができます.

Q: Gaussian-SLAMはどのようにしてインタラクティブな実行時間でほぼフォトリアリスティックな再レンダリングを実現しているのか?

A: Gaussian-SLAMは、シーン表現としてガウススプラットを使用することにより、インタラクティブな実行時間でほぼフォトリアリスティックな再レンダリングを実現する.ガウススプラットは、シーンビューの高速かつ正確なレンダリングを可能にする技術です.これは高密度なSLAMパイプラインに組み込まれ、実世界と合成シーンの両方のリアルタイム再構成とレンダリングを可能にします.ガウス・スプラッティングに基づくシーン表現は、他の手法では捉えにくい高周波のディテールを捉え、前例のないレンダリング品質を実現します.ガウススプラットを使用することで、インタラクティブなランタイムを実現し、レンダリングプロセスがユーザーにリアルタイムフィードバックを提供するのに十分な速度であることを意味する.これは、ガウススプラットの播種と最適化のための新しい戦略によって達成され、マルチビューのオフラインシナリオから逐次的な単眼RGBD入力データセットアップへの使用を拡張する.

Q: Gaussian-SLAMの忠実度の高いレンダリング出力の例を教えてください.

A: 高い忠実度のレンダリング結果の例は、図1に示されています.Gaussian-SLAMの高い忠実度のレンダリング結果は、TUM-RGBDフレームなどの実世界のデータにおいて、他の手法が捉えるのが難しい高周波の詳細を捉えることができます.

Q: SLAMにおけるガウス・スプラッティングの限界とは?

A: ガウススプラッティングのSLAMへの制限は、大規模な実験によって証明されています.シーケンス全体のためにグローバルなガウスポイントクラウドを単純に最適化すると、A100 NVIDIA GPUsでもメモリエラーが発生します.ジオメトリがエンコードされていない場合や、各フレームのみが最適化された場合にも制限があります.また、単一フレームの最適化では、3Dガウスのジオメトリが非常に歪んでしまい、最終的なメッシュを再構築することができません.

Q: ガウシアン・スプラッティングの限界に取り組むために、この論文ではどのような解決策が提案されているのか?

A: 論文では、Gaussian splattingの制限に対処するために以下の解決策が提案されています.

Q: Gaussian-SLAMの再構成性能と実行時間は、他の手法と比較してどうですか?

A: Gaussian-SLAMは、ジオメトリ再構築と実行時間に関して競争力を持ちながら、レンダリング精度に関して既存のソリューションを大幅に上回る.

Q: ガウススプラットはジオメトリを符号化し、シーン表現に対するトラッキングに使用できるか?

A: はい、ガウススプラットは幾何学をエンコードすることができ、シーン表現に対してトラッキングに使用することができます.

Pearl: A Production-ready Reinforcement Learning Agent

著者:Zheqing Zhu, Rodrigo de Salvo Braz, Jalaj Bhandari, Daniel Jiang, Yi Wan, Yonathan Efroni, Liyuan Wang, Ruiyang Xu, Hongbo Guo, Alex Nikulkov, Dmytro Korenkevych, Urun Dogan, Frank Cheng, Zheng Wu, Wanqiao Xu

発行日:2023年12月06日

最終更新日:2023年12月06日

URL:http://arxiv.org/pdf/2312.03814v1

カテゴリ:Machine Learning, Artificial Intelligence

概要:

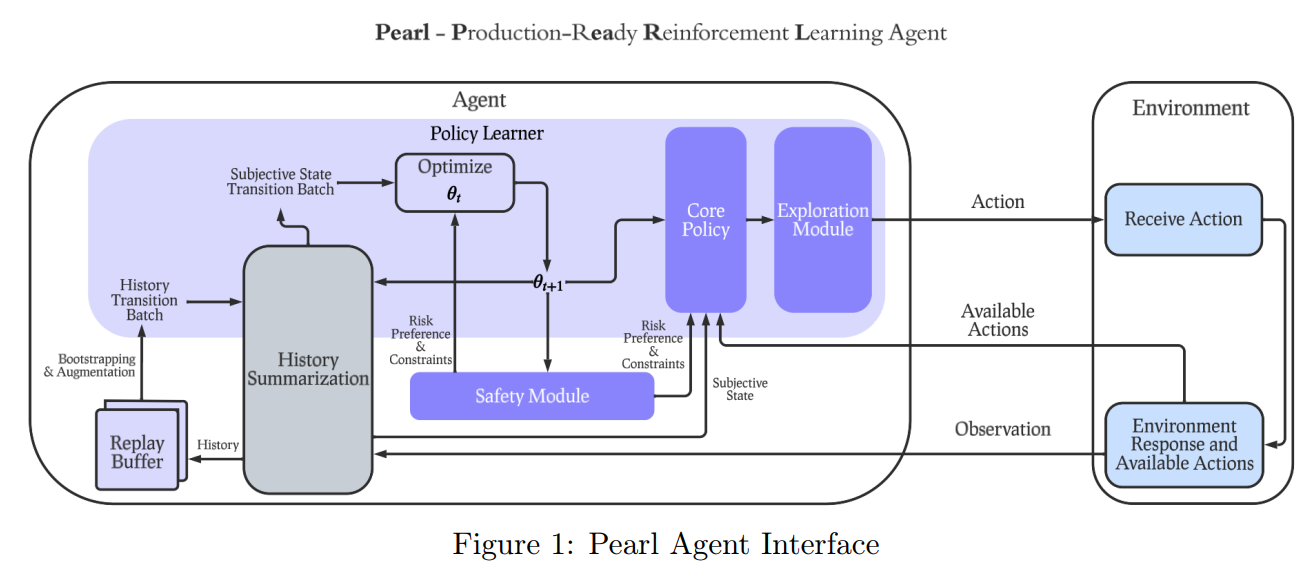

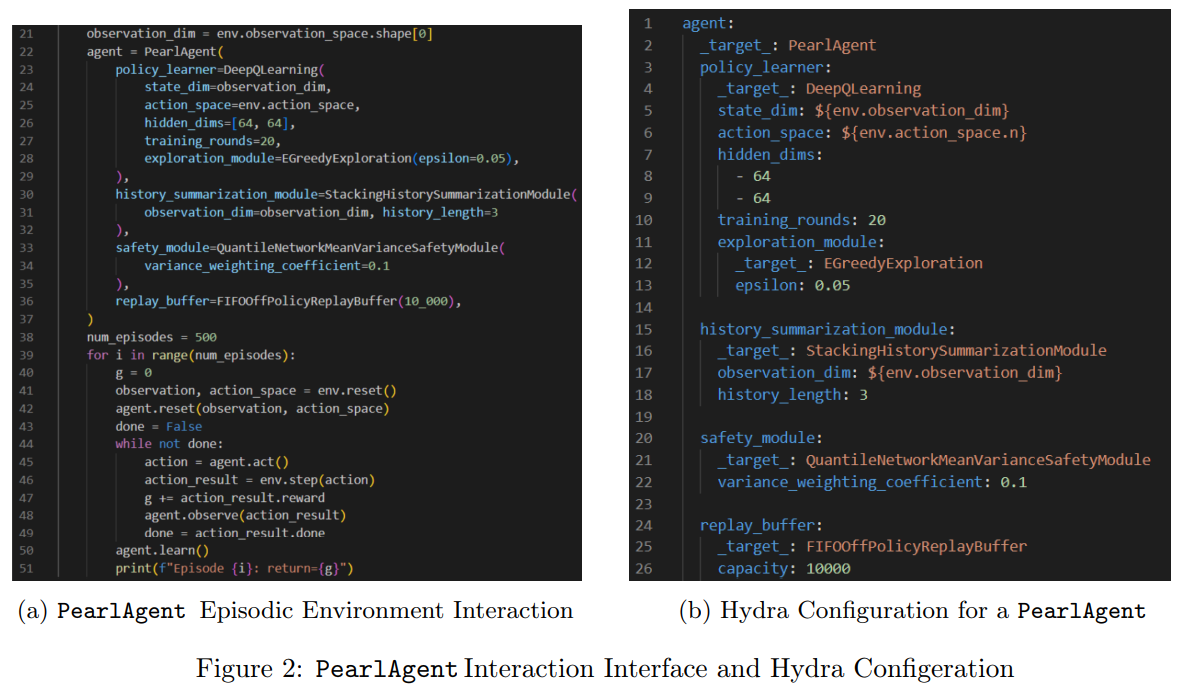

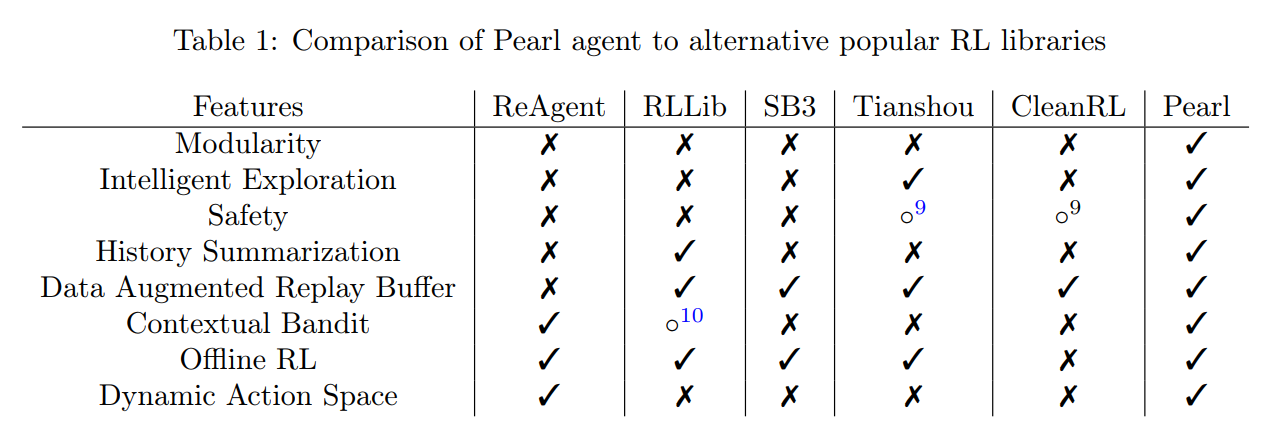

強化学習(RL)は、長期的な目標を達成するための柔軟なフレームワークを提供します.その汎用性により、現実世界の知能システムが直面するさまざまな問題を形式化することができます.例えば、遅延報酬の扱い、部分的な観測の処理、探索と活用のジレンマの解決、オフラインデータを利用してオンラインのパフォーマンスを向上させること、および安全制約の遵守などです.RL研究コミュニティはこれらの問題に取り組むためにかなりの進展を遂げていますが、既存のオープンソースのRLライブラリは、RLソリューションパイプラインの一部に焦点を当てており、他の側面はほとんど対応されていません.本論文では、これらの課題をモジュール化して取り組むために明示的に設計された製品レベルのRLエージェントソフトウェアパッケージであるPearlを紹介しています.予備的なベンチマーク結果を提示するだけでなく、本論文ではPearlの産業への採用事例を示し、本番環境での使用に対する準備ができていることを示しています.PearlはGithubのgithub.com/facebookresearch/pearlでオープンソース化されており、公式ウェブサイトはpearlagent.github.ioにあります.

Q&A:

Q: Pearl RLエージェント・ソフトウェア・パッケージの主な焦点は何ですか?

A: Pearl RL agent software packageの主な焦点は、実世界のアプリケーションに対して柔軟なRLエージェントを構築することです.パッケージの中心はPearlAgentであり、オフラインまたはオンラインのポリシー学習アルゴリズムに加えて、知的な探索、リスク感度、安全制約、および部分的に観測される/非マルコフな状況のための履歴要約などの機能をカプセル化しています.さらに、RL研究コミュニティでこれらの課題に取り組むいくつかの最近のアルゴリズムの進歩も含まれています.

Q: パールは、報酬の遅延と部分的な観測可能性という課題にどのように対処しているのだろうか?

A: パールは、部分的に観測される/非マルコフな状況において、遅延報酬と部分的な観測の課題に対処するために、過去の履歴の要約機能を提供することで対応しています.この機能により、エージェントは過去の観測と行動の履歴を要約することができ、部分的な観測の処理に役立ちます.履歴を要約することで、パールは重要な情報やパターンを捉えることができ、現在の状態での意思決定に関連する可能性があります.さらに、パールには知的な探索とリスク感度の機能も組み込まれており、環境を効果的に探索し、報酬を得ることができます.これらの機能により、パールは遅延報酬の存在する状況でポリシーを学習し適応させることができます.さらに、パールは安全制約も組み込んでおり、エージェントが事前に定義された安全限界内で操作することを保証します.安全制約を考慮することで、パールはリスクを軽減し、望ましくない結果につながる可能性のある行動を回避することができます.全体的に、パールの履歴の要約、知的な探索、リスク感度、および安全制約の組み合わせにより、遅延報酬と部分的な観測の課題に対処することができます.

Q: パールが探査と搾取のジレンマをどのように処理しているのか説明していただけますか?

A: PearlAgent は、exploration_module と policy_learner を使用して、探索と搾取のジレンマを処理します.exploration_module は探索アクション Aexplore を出力し、policy_learner は搾取アクション Aexploit を出力する.エクスプロイト・アクション Aexploit を計算するために、PearlAgent は policy_learner と、状態表現を出力する history_summarization_module との相互作用を可能にします.これにより PearlAgent は、新しいアクションを探索することと、現在のポリシーを悪用することの間でバランスをとることができます.exploration_moduleとpolicy_learnerの両方に問い合わせることで、PearlAgentは探索と搾取のトレードオフに基づいて、情報に基づいた意思決定を行うことができます.

Q: パールはオフラインのデータをどのように活用し、オンラインのパフォーマンスを向上させているのか?

A: Pearlはオフラインデータを利用してオンラインのパフォーマンスを向上させるために、モデルフリーの強化学習手法をサポートしています.オフラインデータは環境との相互作用の記録や(部分的な)軌跡の形で提供され、ユーザーは環境との対話を通じて追加のオンラインデータを収集することができます.PearlAgentの設計では、オフラインデータを利用してオンラインのパフォーマンスを向上させることが優先されています.

Q: パールはどのような安全上の制約を満たしているのか?

A: Pearlは、エージェント設計者がヒューリスティックや環境制約を指定することで、各ステップで状態に依存した安全な行動空間のみを選択することを可能にするfilter_action safetyインターフェースを提供することで、安全制約を保証します.さらに、Pearlは報酬制約安全モジュール(reward_constrained_safety_module)を備えており、エージェントが制約付きMDPで学習することを可能にし、学習したポリシーの長期的なコストを閾値以下に制限します.Pearlの安全モジュールは、3つの主要な機能を提供するように設計されているが、これらの機能の具体的な詳細については、与えられた文脈では言及されていない.

Q: Pearlのモジュラー設計について、もう少し詳しく教えてください.

A: Pearlのモジュラーデザインは、異なるポリシーラーナーと探索モジュールを「ミックスアンドマッチ」する可能性を開くものです.このモジュラーデザインの哲学は、よりパフォーマンスの高いRLとCBソリューションを実現するだけでなく、研究者が新しい方法論的なアイデアを素早くテストするのにも役立つことを期待しています.モジュラーコード設計により、異なる機能間のシームレスな統合が可能となります.

Q: 業界におけるPearlの採用例を教えてください.

A: Pearlは、推薦システム、広告オークションのペーシング、およびコンテキストバンディットベースのクリエイティブ選択など、複数の業界製品で採用されています.

Q: 開発者はどのようにPearl RLエージェントソフトウェアパッケージにアクセスできますか?

A: パールは、GitHubのgithub.com/facebookresearch/pearlでオープンソースとして提供されており、公式ウェブサイトはpearlagent.github.ioにあります.

Q: パールのために利用できる追加のリソースやドキュメントはありますか?

A: 現在の文脈では、追加のリソースやドキュメントについての情報は提供されていません.

A Survey of Large Language Models in Medicine: Principles, Applications, and Challenges

著者:Hongjian Zhou, Fenglin Liu, Boyang Gu, Xinyu Zou, Jinfa Huang, Jinge Wu, Yiru Li, Sam S. Chen, Peilin Zhou, Junling Liu, Yining Hua, Chengfeng Mao, Xian Wu, Yefeng Zheng, Lei Clifton, Zheng Li, Jiebo Luo, David A. Clifton

発行日:2023年11月09日

最終更新日:2023年12月11日

URL:http://arxiv.org/pdf/2311.05112v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

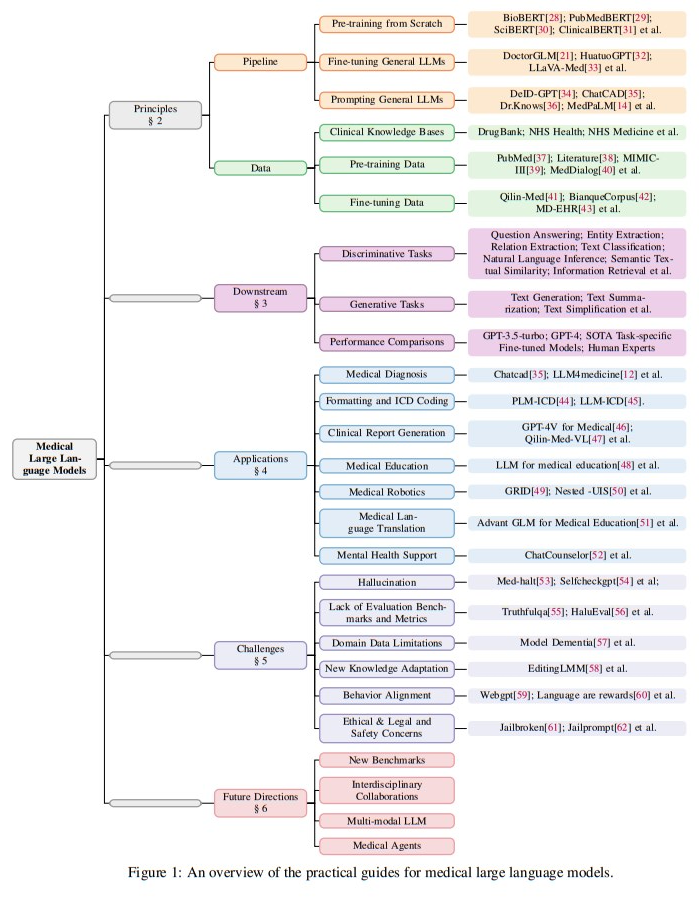

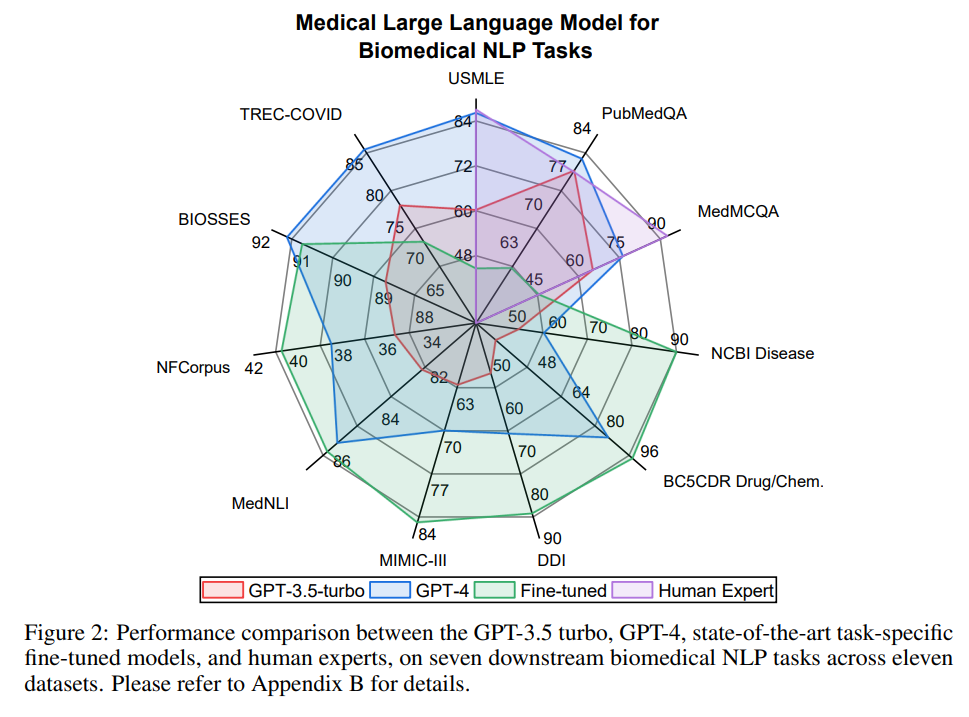

大規模言語モデル(LLM)は、ChatGPTなどのLLMは、その印象的な人間の言語理解と生成能力により、注目を集めています.そのため、人工知能と臨床医学の両方で、医学のLLMを利用して医師と患者のケアを支援することが有望な研究方向として浮上しています.この調査では、医学のLLMの原則、応用、および直面する課題について包括的な概要を提供します.具体的には、以下の質問に取り組むことを目指しています:1)医学のLLMはどのように構築されるのか?2)医学のLLMのダウンストリームのパフォーマンスはどうなっているのか?3)医学のLLMは実際の臨床実践でどのように利用されるのか?4)医学のLLMの使用によって生じる課題は何か?5)医学のLLMをより良く構築し、利用するにはどうすればよいのか?その結果、この調査は、医学のLLMの機会と課題についての洞察を提供し、実践的かつ効果的な医学のLLMの構築に貴重な情報源となることを目指しています.医学のLLMに関する実践的なガイドの定期的に更新されるリストは、https://github.com/AI-in-Health/MedLLMsPracticalGuideで見つけることができます.

Q&A:

Q: 医学LLM構築の原則は何ですか?

A: 医療LLMの構築の原則については、既存の医療LLMの基本的な構造、パラメータの数、およびモデル開発に使用されるデータセットについての要約を提供します.さらに、これらのモデルの構築プロセスについての洞察を提供します.この情報は、計算上の制約、プライベートデータ、およびローカルな知識ベースなど、特定のニーズに合わせて独自の医療LLMを構築しようとする研究者や医療従事者にとって貴重なものです.

Q: 医学LLMの利用からどのような課題が生じるか?

A: 医療LLMの使用には以下のような課題が生じます.まず、大規模なモデルの使用には膨大な計算リソースが必要であり、これは制約となる可能性があります.また、これらのモデルは「幻覚」と呼ばれる問題にも影響を受けます.幻覚とは、誤った情報や誤解を招く情報を生成することです.さらに、患者のプライバシーやデータの偏りに関する問題も、医療LLMの倫理的かつ公正な使用を確保するために解決すべき重要な障壁となります.

Q: 医学LLMをどのように構築し、活用すればよいか?

A: 医療LLMの構築と活用を改善するためには、以下の方法が考えられます.

- データの品質向上:医療LLMの構築には大量のデータが必要です.データの品質を向上させるためには、正確なラベル付けやデータのクリーニングが重要です.

- モデルの学習とチューニング:医療LLMの構築には、適切なモデルの選択と学習が必要です.モデルのパラメータのチューニングやアーキテクチャの最適化も重要な要素です.

- ドメイン知識の組み込み:医療LLMは医療領域の専門知識を持つことが求められます.医療の専門家との協力やドメイン知識の組み込みにより、より効果的な医療LLMの構築が可能となります.

- モデルの評価と改善:医療LLMの性能評価は重要です.モデルの評価指標を設定し、実際の医療現場での性能を評価することで、モデルの改善点を特定し、より良いモデルの構築につなげることができます.

- リアルワールドでの実践:医療LLMの活用は実践によってのみ確かめることができます.実際の医療現場での実践を通じて、医療LLMの有用性や課題を把握し、改善点を見つけることが重要です.

Q: 医学におけるLLMの成功例を教えてください.

A: 産業界では、医療LLMの成功した応用例がいくつか報告されています.例えば、医療画像解析では、医療LLMが従来のモデルよりも高い精度で病変の検出や診断を行うことができます.また、病院の運営管理においても、医療LLMは予測モデルとして使用され、患者の入院期間や医療費の予測に役立っています.さらに、医療LLMは臨床診断の支援にも活用されており、病歴や症状から疾患の可能性を予測することができます.

Q: 現在の医学LLMの限界は何ですか?

A: 現在の医療LLMの制限は、以下のようなものです.まず、これらのモデルは大規模であり、計算リソースが必要です.また、これらのモデルは「幻覚」と呼ばれる問題に対して脆弱であり、誤った情報や誤解を生み出す可能性があります.さらに、患者のプライバシーやデータの偏りに関する問題もあり、医療の倫理的かつ公平な利用を確保するためには克服しなければならない重要な障壁です.

Q: 医学LLMの利用には倫理的な配慮が必要ですか?

A: はい、医療LLMの使用には倫理的な考慮事項があります.例えば、患者のプライバシーやデータの偏りに関する問題があります.これらの課題を解決し、医療LLMの倫理的かつ公正な利用を確保するためには、取り組む必要があります.また、幻覚や説明可能性、倫理的・法的・安全上の懸念などの問題もあります.医療LLMの広範な評価が必要であり、信頼性などの側面も含めて、臨床設定での責任ある効果的な利用を確保する必要があります.

Q: 正確性と信頼性を確保するために、医学LLMはどのように訓練されるべきか?

A: 医療LLMを正確性と信頼性を確保するために訓練する方法は、以下のような手法があります.まず第一に、適切なトレーニングデータを用意することが重要です.医療LLMの訓練には、信頼性の高い医療データセットが必要です.次に、トレーニングプロセスでのモデルの最適化が重要です.モデルのパラメータを適切に調整し、過学習や欠損を防ぐことで正確性と信頼性を向上させることができます.また、モデルの評価と検証も重要です.訓練されたモデルをテストデータセットで評価し、正確性と信頼性を確認することが必要です.さらに、医療LLMの訓練においては、医療専門家やAI研究者との持続的な協力が重要です.医療の専門知識とAIの技術を組み合わせることで、正確性と信頼性を高めることができます.