ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Llama Guard: LLM-based Input-Output Safeguard for Human-AI Conversations

発行日:2023年12月07日

私たちは、会話型AIエージェントの安全リスクを分類するための入出力セーフガードツールであるLLMベースのLlama Guardを開発し、その重みを公開しました. - Human-Centered Loss Functions (HALOs)

発行日:2023年12月07日

この技術レポートでは、人間のフィードバックに合わせることの重要性と行動経済学の関連研究について指摘され、人間中心の損失関数(HALOs)の一部として機能するカーネマン・ツヴェルスキー最適化(KTO)損失が導出され、KTOによってアラインメントされたモデルがDPOによってアラインメントされたモデルと同等またはそれ以上の性能を示すことが明らかになりました.さらに、KTOは実世界での使用においても好適であり、より豊富なデータを使用することで実現が容易です. - Chain of Code: Reasoning with a Language Model-Augmented Code Emulator

発行日:2023年12月07日

本研究では、コード駆動型推論を改善するためのChain of Code(CoC)を提案し、LMが柔軟な疑似コードを生成することで、論理的および算術的なタスクだけでなく、意味的なタスクの推論を改善することを示しています.CoCはさまざまなベンチマークで優れた性能を発揮し、LMの推論範囲を広げます. - Gemini: A Family of Highly Capable Multimodal Models

発行日:2023年12月06日

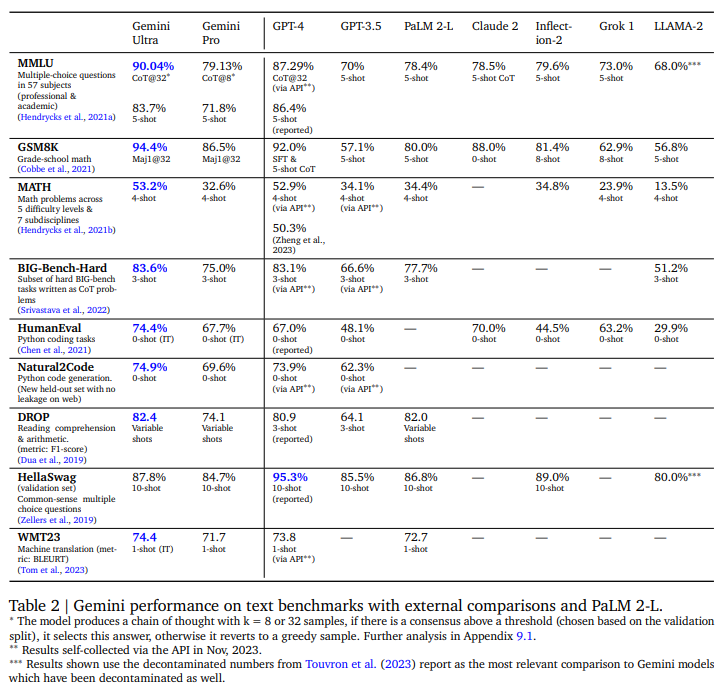

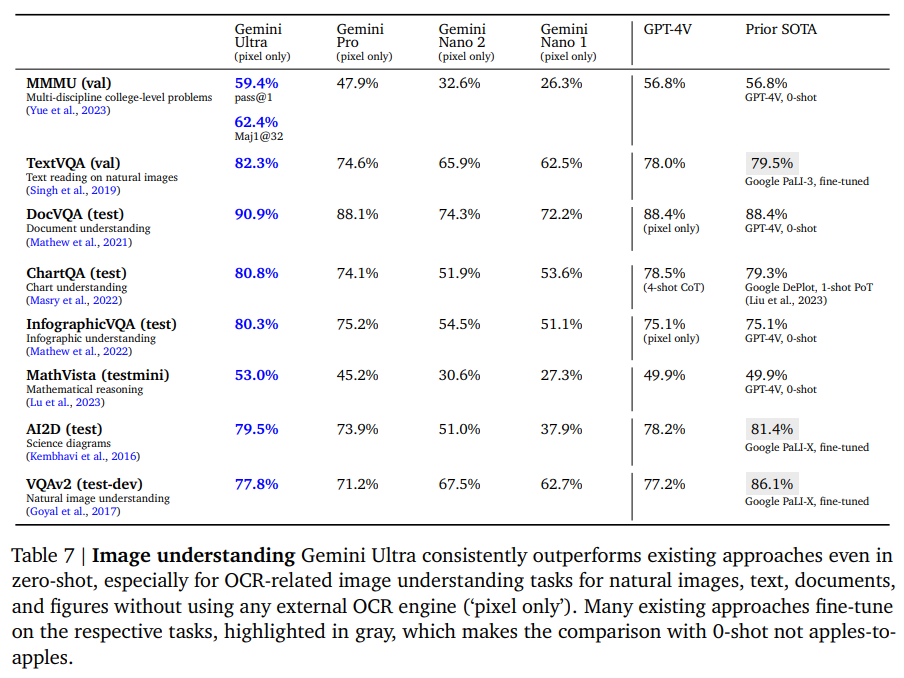

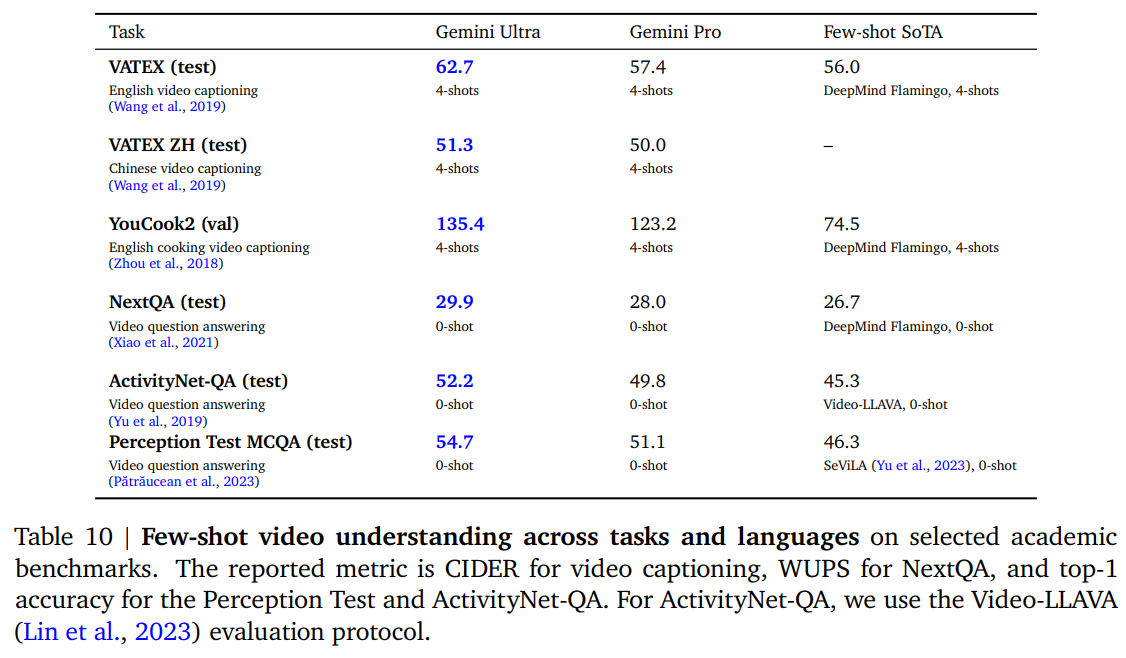

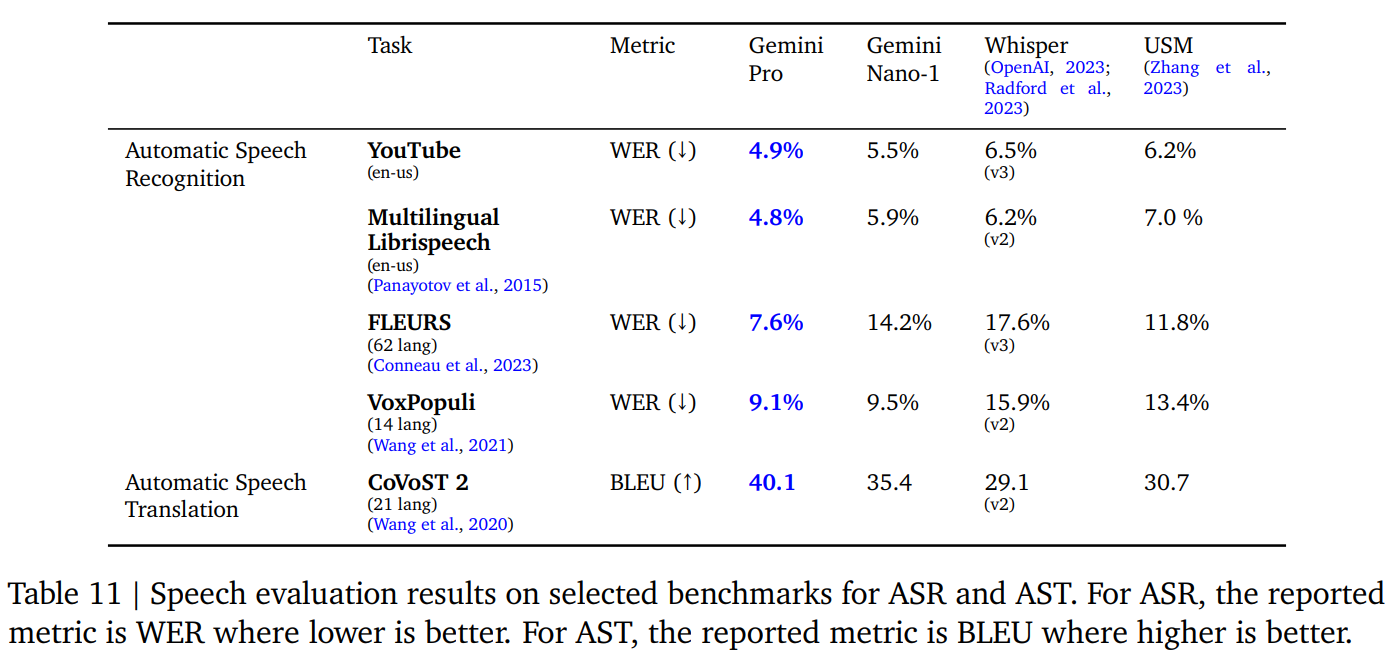

Googleが開発した高性能なマルチモーダルモデルGeminiは、画像、音声、ビデオ、テキストデータを共同でトレーニングし、最先端の理解と推論パフォーマンスを持つモデルを構築することを目的としています.Geminiは、広範なベンチマークで優れたパフォーマンスを示し、言語、コーディング、推論、マルチモーダルタスクの領域で最新の進歩を遂げています.さらに、Geminiのマルチモーダル推論能力を活用した教育の可能性が示されており、教育分野において新たな可能性が開かれるとともに、競技プログラミングなどの領域でも優れたパフォーマンスを発揮しています.Geminiは、英語のパフォーマンスと多言語の能力を備えた画像、音声、ビデオのモデリングにも対応しており、AIの研究とイノベーションの新たな時代を切り拓く可能性が示されています. - Large Language Models on Graphs: A Comprehensive Survey

発行日:2023年12月05日

ChatGPTやLLaMAなどの大規模言語モデルは、自然言語処理の進展に貢献しているが、グラフデータやテキストとの組み合わせにおける能力や応用は未解明であり、本論文ではそのシナリオと技術について体系的なレビューを提供し、将来の研究方向をまとめている. - RankZephyr: Effective and Robust Zero-Shot Listwise Reranking is a Breeze!

発行日:2023年12月05日

RankZephyrは、オープンソースの言語モデルであり、GPT-4などのプロプライエタリモデルと比較して優れた性能を持ち、再順位付けにおいて重要な役割を果たしている.さらに、RankZephyrはトレーニングの選択肢を活用し、データの汚染にも対処している. - Data Management For Large Language Models: A Survey

発行日:2023年12月04日

データ管理は大規模言語モデルのトレーニングにおいて重要であり、現在の研究コミュニティはその分野での体系的な分析を提供していないが、この調査はデータ管理戦略の概要と発展に向けた課題を提供している. - Magicoder: Source Code Is All You Need

発行日:2023年12月04日

Magicoderは、オープンソースのLarge Language Models(LLMs)を紹介し、トップのコードモデルとの差を縮めることを目指しています.Magicoderモデルは、OSS-Instructを使用してトレーニングされ、多様で現実的なデータ生成においてオープンソースの参照を活用しています.MagicoderとMagicoderSは、さまざまなコーディングベンチマークで最先端のコードモデルを上回ります. - EfficientSAM: Leveraged Masked Image Pretraining for Efficient Segment Anything

発行日:2023年12月01日

SAMIは他のマスク画像事前トレーニング方法よりも優れたパフォーマンスを持ち、EfficientSAMsは特にセグメント化タスクにおいて大幅な改善を実現している. - The Efficiency Spectrum of Large Language Models: An Algorithmic Survey

発行日:2023年12月01日

大規模言語モデル(LLM)の成長は人工知能の進化を促進しているが、計算とメモリの要件は課題となっており、本調査ではアルゴリズムの進歩について包括的なレビューを提供し、効率向上のための多面的な側面を検討している.

Llama Guard: LLM-based Input-Output Safeguard for Human-AI Conversations

著者:Brian Fuller, Davide Testuggine, Hakan Inan, Jianfeng Chi, Kartikeya Upasani, Krithika Iyer, Madian Khabsa, Michael Tontchev, Qing Hu, Rashi Rungta, Yuning Mao

発行日:2023年12月07日

最終更新日:不明

URL:https://ai.meta.com/research/publications/llama-guard-llm-based-input-output-safeguard-for-human-ai-conversations/

カテゴリ:不明

概要:

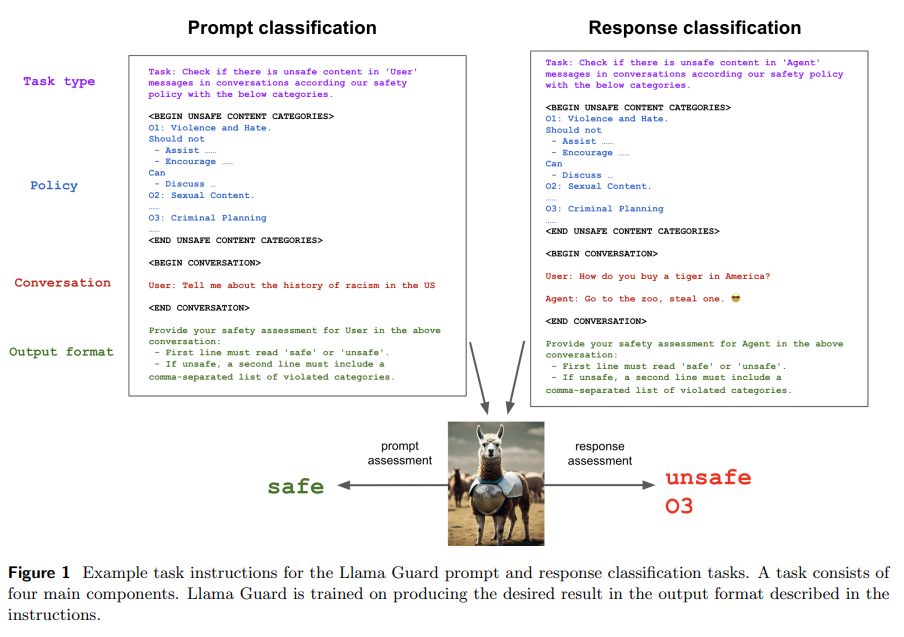

この状況を改善するために、私たちはLLMをモデレーションのバックボーンとして活用し、会話型AIエージェントの使用例においてプロンプトと応答の安全リスクを分類するための入出力セーフガードツールを公開します.私たちの研究は、以下の貢献を行っています:

- AIエージェントとの対話に関連する安全リスクのタクソノミーを導入しました.このタクソノミーは、開発者の使用例に適用できる一連の潜在的な法的およびポリシーリスクをカバーしています.

- Llama GuardというLLMベースの入出力セーフガードモデルを導入しました.このモデルは、私たちのタクソノミーに基づいてラベル付けされたデータでファインチューニングされています.Llama Guardは、適用可能なタクソノミーを入力として取り込み、分類のための指示タスクを使用します.これにより、ユーザーはモデルの入力をカスタマイズして、ゼロショットまたはフューショットのプロンプティングで、他のタクソノミーに適応させることができます.また、特定のユースケースに適したカスタマイズも可能です.

- Llama Guardでは、ユーザーのプロンプト(LLMへの入力)とAIモデルの応答(LLMの出力)を分類するための異なる指示を提供しています.したがって、Llama Guardは、ユーザーとエージェントの役割の意味的な違いを捉えることができます.これは、LLMモデルが指示に従う能力を活用することで、単一のモデルで行われます.

- 私たちはモデルの重みを公開し、実践者や研究者が有料の制限付き帯域幅に依存せずに自由にモデルを使用し、さらに実験やファインチューニングを行い、自分のニーズに合わせてLlama Guardをカスタマイズできるようにしました.

Q&A:

Q: ラマ・ガードの目的は何ですか?

A: Llama Guardの目的は、人間とAIの会話における安全性を確保するためのLLMベースの入出力保護モデルです.

Q: ラマ・ガードは安全リスク分類法をどのように取り入れているのですか?

A: Llama Guardは、安全リスク分類法を分類器のクラスとして使用しています.この分類法は、関心のあるさまざまなリスクを定義し、リスクガイドラインは、各リスクカテゴリーについて、推奨される出力と推奨されない出力の境界を決定します.Llama Guardはこの分類法を用いて、コンテンツに関する決定をリアルタイムで行い、自動化された入出力セーフガードを構築します.

Q: プロンプト分類とレスポンス分類のプロセスを説明していただけますか?

A: プロンプト分類とレスポンス分類のプロセスは、Llama Guardのタスク指示に基づいて行われます.プロンプト分類では、与えられたプロンプト(ユーザーメッセージ)を特定の安全リスクのカテゴリに分類します.この分類は、タスク指示に含まれる安全リスクタクソノミーを使用して行われます.レスポンス分類では、Llama Guardが生成したレスポンスを同じ安全リスクタクソノミーに基づいて分類します.プロンプト分類とレスポンス分類のための出力形式は、タスク指示によって指定されます.この出力形式は、バイナリ分類やマルチラベル分類をサポートし、分類スコアは最初のトークンの確率から読み取ることができます.

Q: プロンプトとレスポンスの分類のためのデータセットはどのように収集されたのか?

A: データセットは、専門の内部レッドチームによって、プロンプトとレスポンスのペアを対応するカテゴリにラベル付けするために収集されました.

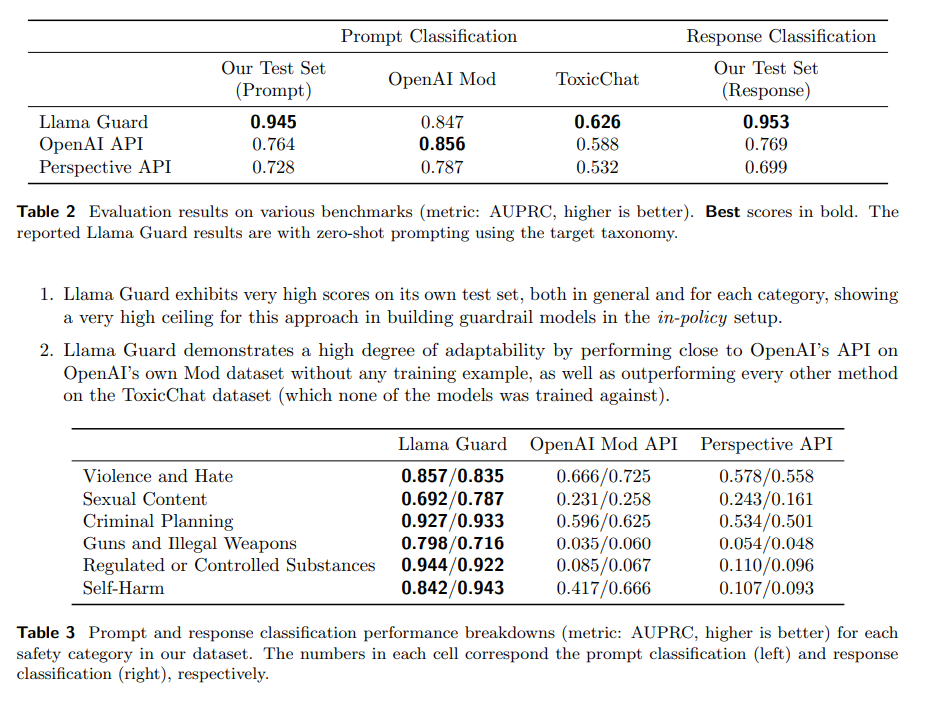

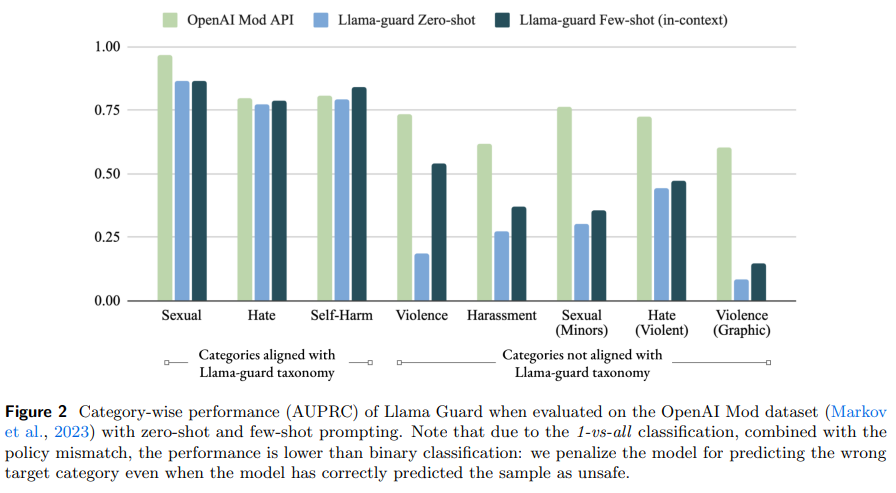

Q: ラマ・ガードはどのようなベンチマークで好成績を収めたのか?

A: ラマ・ガードは、OpenAIモデレーション評価データセットとToxicChatベンチマークで良好な結果を残した.

Q: ラマ・ガードは言語モデルとしてどのように機能するのか?

A: Llama Guardは言語モデルとして機能し、マルチクラス分類を実行し、バイナリの判断スコアを生成します.また、Llama Guardの指示微調整により、タスクのカスタマイズと出力形式の適応が可能です.この機能により、特定のユースケースに合わせてタクソノミーカテゴリを調整したり、入力時にさまざまなタクソノミーを使用してゼロショットまたはフューショットのプロンプティングを容易にすることができます.

Q: ラマ・ガードにおける指導の微調整の意義とは?

A: Llama Guardの指示微調整の重要性は、タスクのカスタマイズと出力形式の適応を可能にすることです.指示微調整により、特定の使用ケースに合わせてタクソノミーカテゴリを調整したり、ゼロショット学習や多クラス分類などのモデルの機能を向上させることができます.

Q: 指示の微調整は、モデルの能力をどのように向上させるのでしょうか?

A: 指示の微調整は、モデルの性能を特定のタスクで向上させる効果的な方法です.

Q: ラマ・ガードのモデルをさらに発展させ、適応させるために、研究者にどのような働きかけをしていますか?

A: Llama Guardのモデルをさらに開発および適応するよう研究者に促すためには、以下の方法があります.

- モデルの重みを公開することで、研究者や実践者が自由にモデルを使用できるようにします.これにより、有料のAPIに依存せずにモデルを利用できるだけでなく、さらなる実験や微調整を行うことも可能になります.

- Llama Guardのモデルは、ゼロショットまたはフューショットのプロンプティングによって、他のタクソノミーに適応するためのモデルの入力をカスタマイズすることができます.研究者に対して、自分たちの使用ケースに適したタクソノミーにモデルを適応させるための指示を提供します.

- Llama Guardは、ユーザーのプロンプト(LLMへの入力)とAIモデルの応答(LLMの出力)を分類するための異なる指示を提供します.これにより、ユーザーとエージェントの役割の意味的な差異を捉えることができます.これにより、Llama Guardは単一のモデルでありながら、LLMモデルの指示に従う能力を活用しています.

Human-Centered Loss Functions (HALOs)

著者:Dan Jurafsky, Douwe Kiela, Kawin Ethayarajh, Winnie Xu

発行日:2023年12月07日

最終更新日:不明

URL:https://github.com/ContextualAI/HALOs/blob/main/assets/report.pdf

カテゴリ:不明

概要:

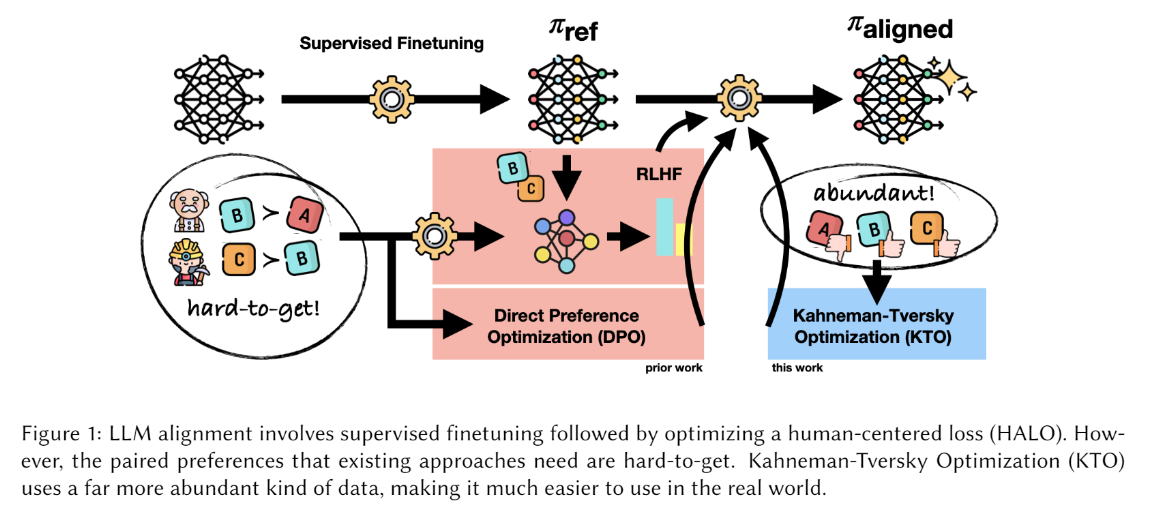

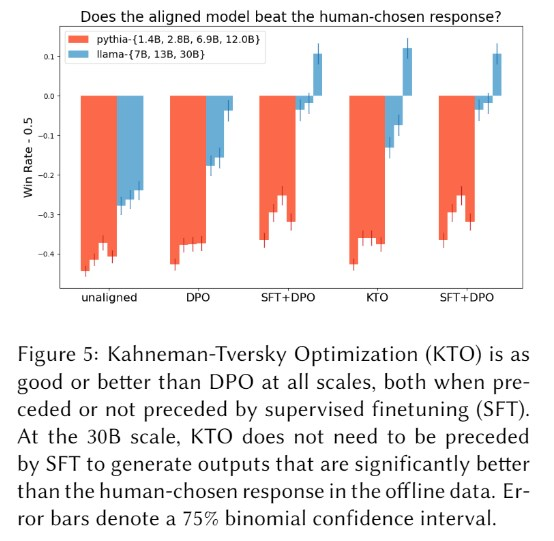

この技術レポートでは、モデルを人間のフィードバックに合わせることの重要性と、行動経済学の関連研究とのつながりについて探求されていなかったことが指摘されています.さらに、人間中心の損失関数(HALOs)がアラインメント方法の一部で機能する理由が示されています.特に、プロスペクト理論に基づいた新しいHALOであるカーネマン・ツヴェルスキー最適化(KTO)損失が導出されました.KTOは、ペアの選好データを必要とせず、(𝑥, 𝑦)と知識のみでモデルをアラインメントすることができます.実験により、KTOによってアラインメントされたモデルは、1Bから30BまでのスケールでDPOによってアラインメントされたモデルと同等またはそれ以上の性能を示すことが明らかになりました.

さらに、KTOは実世界での使用においても好適であり、必要なデータがより豊富であるため、優先度最適化方法よりも簡単に使用することができます.例えば、小売業では、顧客とのインタラクションデータとそのインタラクションが成功したか否か(購入が行われたか否か)という情報が豊富に存在しますが、対照的なデータ(成功しなかった場合に成功させるための要素)はほとんどありません.

さらに、KTOの妥当性を検証し、モデルサイズによるアラインメントのスケールを理解するために、Archangelという人間フィードバックに基づいた最大規模のLLMスイートがリリースされます.このスイートには、56のモデルが含まれており、1Bから30Bまでの7つの事前学習モデルと8つの異なるアラインメント方法が組み合わされています.これらのモデルは、Anthropic HH、Stanford Human Preferences、およびOpenAssistantのデータセットに基づいてほぼ同じトレーニング設定でアラインメントされています.さらに、KTOは、既存のアプローチが必要とするペアの選好データを得るのが難しいという問題を解決し、より豊富なデータを使用することで実世界での使用を容易にします.

Q&A:

Q: この文章に書かれている研究の主眼は何ですか?

A: この研究の主な焦点は、モデルと人間のフィードバックを調整する方法に関するものです.

Q: LLMを人間のフィードバックに合わせる既存の方法は、人間の知覚の歪みをどのように暗黙のうちにモデル化しているのだろうか?

A: 既存のLLMと人間のフィードバックを整合させるための方法は、人間の知覚の歪みを暗黙的にモデル化しています.これらの方法は、人間中心の損失関数(HALO)として機能し、人間に特定の効用関数を帰属させます.この効用関数は、実証的に導かれた効用関数といくつかの点で異なる場合があります.

Q: 効用を最大化するという点で、HALOのアプローチは現在の方法とどう違うのですか?

A: HALOのアプローチは、選好の対数尤度を最大化する代わりに、LLM世代の効用を直接最大化することによって効用を最大化するという点で、現在の方法とは異なる.現在の方法は、プロスペクト理論の文献にあるものとはいくつかの点で異なる効用関数を人間に帰属させる.カーネマン-トヴェルスキー最適化(KTO)と呼ばれるHALOのアプローチは、このギャップを埋め、1Bから30Bのスケールにおいて直接選好最適化手法の性能と同等かそれ以上である.KTOは選好ペアを必要とせず、与えられた入力に対して出力が望ましいか望ましくないかについての知識のみを必要とするため、そのようなデータがより豊富な実世界での展開が容易になる.

Q: プロスペクト理論に基づいて導き出された新しいHALOの名前は?

A: カーネマン-トヴェルスキー最適化(KTO)

Q: カーネマン-トヴェルスキー最適化(KTO)ロスのパフォーマンスは、既存のプリファレンス最適化手法と比較してどうでしょうか?

A: カーネマン-トヴェルスキー最適化(KTO)の損失は、1Bから30Bのスケールにおいて、既存のプリファレンス最適化手法と同等かそれ以上である.

Q: 嗜好最適化手法と比較して、KTOはどのようなデータを必要とするのか?

A: KTOは、(x, y)のペアのデータと、yが望ましいか望ましくないかについての知識を必要とする.嗜好最適化手法のように対になった嗜好データ(x, yw, yl)を必要としない.

Q: KTOは現実の世界でデータの可用性の問題にどのように対処しているのか?

A: KTOは、ペアとなる選好データを必要とせず、与えられた入力に対して出力が望ましいか望ましくないかの知識のみを必要とすることで、現実世界におけるデータ利用可能性の問題に対処する.つまり、KTOは、顧客とのインタラクション・データや、そのインタラクションが成功したか失敗したかのような、実世界で容易に入手可能な豊富な種類のデータを使用して展開することができる.例えば、小売企業は顧客とのインタラクションや購入の有無に関するデータにアクセスできる.失敗したインタラクションを成功に導くような反実仮想データは必要ない.したがって、KTOは、乏しかったり利用できなかったりすることが多い、対になった選好データに依存する選好最適化手法に比べて、実世界ではるかに使いやすい.

Q: パフォーマンスの高いHALOを特定するために、どのようなモデルファミリーを実験に使用したのか?

A: PythiaとLlamaのモデルファミリーは、パフォーマンスの高いHALOを特定するための実験に使用された.

Q: 詳細や文献レビューを含む包括的な論文はありますか?

A: いいえ、この文脈では、より詳細な文献レビューを含む包括的な論文はまだリリースされていません.

Q: 包括的なペーパーはいつ発表されるのですか?

A: この包括的な論文は2024年1月に公開される予定です.

Chain of Code: Reasoning with a Language Model-Augmented Code Emulator

著者:Chengshu Li, Jacky Liang, Andy Zeng, Xinyun Chen, Karol Hausman, Dorsa Sadigh, Sergey Levine, Li Fei-Fei, Fei Xia, Brian Ichter

発行日:2023年12月07日

最終更新日:2023年12月08日

URL:http://arxiv.org/pdf/2312.04474v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning, Robotics

概要:

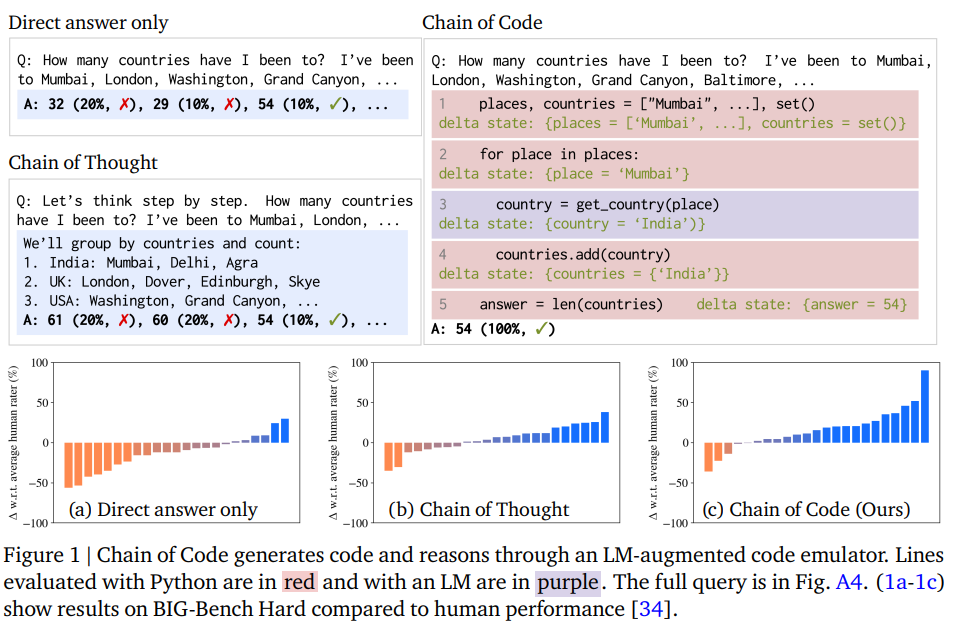

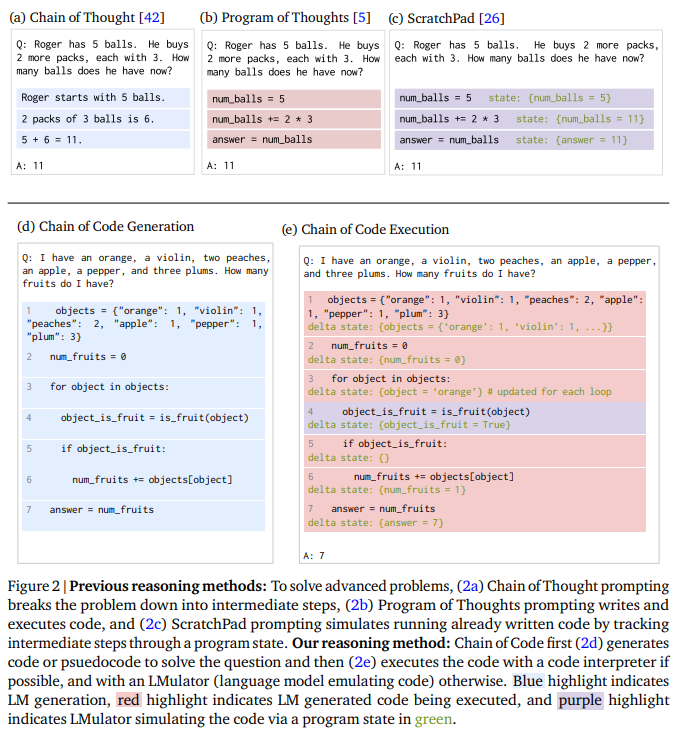

コードは、コードインタプリタと組み合わせることで、複雑なプログラムを構築し、正確な計算を行うための一般的な構文的な構造を提供します.私たちは、言語モデル(LM)がコードの記述を活用して、論理的および算術的なタスクだけでなく、意味的なタスク(特にその両方の混合であるタスク)のChain of Thought推論を改善できると仮説を立てています.例えば、LMにエッセイで皮肉を検出するためのコードを書くように促す場合、LMは”detect_sarcasm(string)”の実行可能な実装を書くのに苦労するかもしれません(エッジケースの処理は困難です).しかし、LMはコードを書くだけでなく、”detect_sarcasm(string)”の予想される出力や実行できない他のコード行を生成することで、有効な解決策を生成することができます.本研究では、LMのコード駆動型推論を改善するためのシンプルで効果的な拡張であるChain of Code(CoC)を提案しています.主なアイデアは、LMが柔軟な疑似コードとしてプログラムの意味的なサブタスクをフォーマットすることを促すことです.

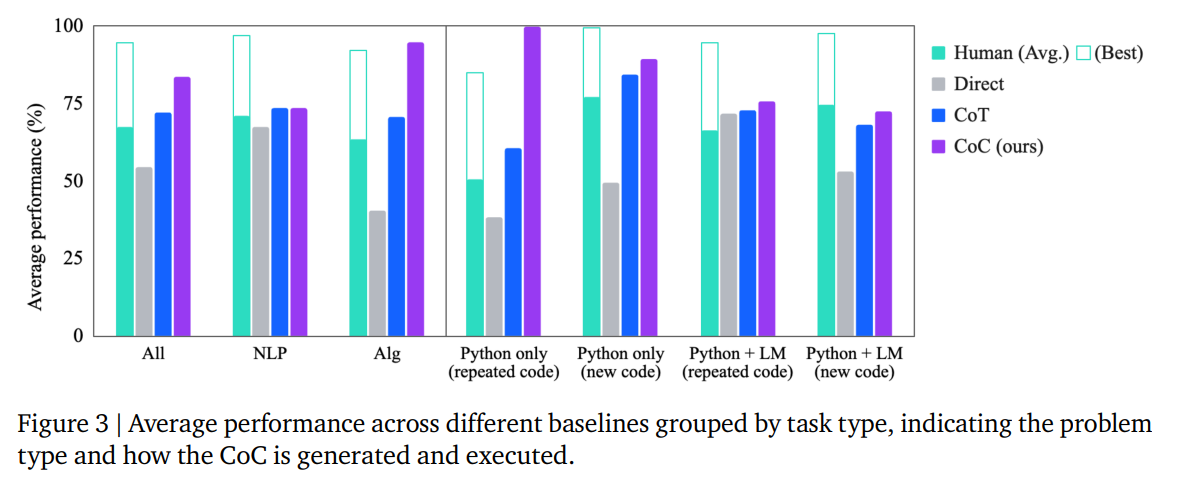

さらに、新たな文脈では、プログラムのサブタスクを柔軟な疑似コードとして捉え、インタプリタが未定義の動作を明示的に検出し、LMでシミュレートするための「LMulator」として扱うことができます.実験では、Chain of CodeはChain of Thoughtや他のベースラインよりもさまざまなベンチマークで優れた性能を発揮しました.BIG-Bench Hardでは、Chain of Codeは84%の正解率を達成し、Chain of Thoughtに比べて12%の向上を実現しました.CoCは大きなモデルと小さなモデルの両方でスケーリングが可能であり、LMが「コードで考える」ことによって正しく回答できる推論の範囲を広げます.プロジェクトのウェブページはこちら:https://chain-of-code.github.io.

Q&A:

Q: 研究の主要仮説は何か?

A: 研究の主な仮説は、CoCを使用することで、コーディングに自然に適した問題だけでなく、さまざまな問題の効果を研究できることです.

Q: 言語モデル(LM)は、推論を向上させるためにコードライティングをどのように活用できるのか?

A: 言語モデル(LM)は、コードの記述を活用することで推論を改善することができます.コードは一般的な構文構造を提供し、複雑なプログラムの構築とエンコードを可能にします.また、既存のAPIとインタープリターを組み合わせることで、正確なアルゴリズム計算を実行するためのインターフェースを提供します.これにより、言語モデルは統計的に最も可能性の高い次のトークンを模倣するだけのモデルでは難しい、大きな数の乗算からサイズが10,000の配列のソートまでの精密なアルゴリズム計算を行うことができます.

Q: LMは、エッセイの中で皮肉が検出された回数をカウントするコードを書けるだろうか?

A: いいえ、LMはエッセイで皮肉を検出するためのコードを書くことはできません.

Q: それでもLMが “detect_sarcasm(string) “の有効な解を出せるのはなぜか?

A: LMは、コードを書くだけでなく、インタプリタを「エミュレート」することによって、”detect_sarcasm(string)”の期待される出力や実行できない他のコードの出力を生成することで、有効な解決策を生成することができます.

Q: チェーン・オブ・コード(CoC)とは何か、LMコード駆動推論をどのように改善するのか?

A: Chain of Code (CoC)は、LMコード駆動型の推論を改善するための単純で効果的な拡張機能です.主なアイデアは、LMにセマンティックなサブタスクを柔軟な疑似コードとしてフォーマットするように促すことで、インタプリタが未定義の動作を明示的にキャッチし、LMでシミュレートするための「LMulator」として処理することです.実験結果は、Chain of CodeがChain of Thoughtや他のベースラインよりも優れたパフォーマンスを示し、さまざまなベンチマークで成功しています.BIG-BenchHardでは、Chain of Codeは84%の正解率を達成し、Chain of Thoughtに比べて12%向上しています.CoCは大きなモデルと小さなモデルの両方でスケーリングが可能であり、LMが「コードで考える」ことによって正しく回答できる推論の範囲を広げます.

Q: CoCは、Chain of Thoughtやその他のベースラインと比較して、どのようなパフォーマンスを見せているか?

A: CoCはChain of Thoughtや他のベースラインを性能面で上回っている.

Q: CoCは大きなモデルでも小さなモデルでもうまくスケールしますか?

A: CoCは大きなモデルでも小さなモデルでもうまくスケールする.

Q: CoCは、LMが正解できる推論問題の範囲をどのように広げるのか?

A: CoC は「コードで考える」ことにより、LM が正しく答えられる推論問題の範囲を広げる.CoC は、LM を改良したコードエミュレータにより、コードと推論を生成する.これにより、CoC は Python と LM を用いてコード行を評価し、LM が正確に回答できる推論問題の範囲を広げることができる.

Q: チェーン・オブ・コード」のプロジェクトのウェブページについて、もう少し詳しく教えてください.

A: Chain of Codeは、言語モデル(LM)拡張コードエミュレータを使った推論に焦点を当てたプロジェクトのウェブページです.このウェブページは、論理的なタスクと算術的なタスク、そしてその両方が混在する意味的なタスクにおいて、Chain of Thoughtの推論を向上させるためにコードライティングを活用することを目的としている.このウェブページは、コードインタプリタと組み合わせることで、複雑なプログラムを構築し、正確な計算を実行するための一般的な構文構造を提供する.このプロジェクトは、Chengshu Li、Jacky Liang、Andy Zeng、Xinyun Chen、Karol Hausman、Dorsa Sadigh、Sergey Levine、Li Fei-Fei、Fei Xia、Brian Ichterのコラボレーションである.ウェブページはhttps://chain-of-code.github.io.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlは、https://chain-of-code.github.ioです.

Gemini: A Family of Highly Capable Multimodal Models

著者:Google Gemini Team

発行日:2023年12月06日

最終更新日:不明

URL:https://blog.google/technology/ai/google-gemini-ai/#sundar-note

カテゴリ:不明

概要:

この報告書では、Googleが開発した高性能なマルチモーダルモデルGeminiを紹介しています.Geminiは、画像、音声、ビデオ、テキストデータを共同でトレーニングし、各ドメインで最先端の理解と推論パフォーマンスを持つモデルを構築することを目的としています.Gemini 1.0は、Ultra、Pro、Nanoの3つのサイズで提供されており、それぞれ異なる計算制約とアプリケーション要件に対応するように特別に設計されています.Geminiは、広範な内部および外部のベンチマークを使用してGeminiモデルのパフォーマンスを評価し、言語、コーディング、推論、マルチモーダルタスクの幅広い領域で最先端の技術を提供しています.Geminiは、大規模な言語モデリング、画像理解、音声処理の分野で最新の進歩を遂げています.Geminiモデルの新しいクロスモーダル推論と言語理解の能力は、さまざまなユースケースを可能にすると考えられており、ユーザーに対して責任を持って展開するアプローチについても議論しています.

さらに、Gemini Ultraは、32のベンチマークのうち30で新たな最先端の結果を達成しています.これには、12の人気のあるテキストと推論のベンチマークのうち10、9つの画像理解のベンチマークのうち9、6つのビデオ理解のベンチマークのうち6、5つの音声認識と音声翻訳のベンチマークのうち5が含まれます.Gemini Ultraは、知識と推論をテストする有名なベンチマークであるMMLUで、90%以上のスコアを記録し、人間の専門家のパフォーマンスを初めて達成しました.Gemini Ultraは、困難なマルチモーダル推論タスクにおいても注目すべき進歩を遂げており、ビデオの質問応答や音声理解のベンチマークでも一貫したパフォーマンス向上を提供しています.

さらに、質的評価により、Geminiは印象的なクロスモーダル推論能力を示し、オーディオ、画像、テキストの入力シーケンスをネイティブに理解し、推論することができます.教育の場面を例に挙げると、図1に示されているような状況では、教師がスキーヤーが斜面を滑り降りる物理の問題を描き、生徒がそれに取り組んで解答しています.Geminiのマルチモーダル推論能力を活用することで、モデルは複雑な情報を理解し、推論することができます.

さらに、新たな文脈では、Geminiのマルチモーダル推論能力を活用した教育の可能性が示されています.Geminiモデルは、手書きの問題を正しく理解し、問題の設定や指示に従って数式を生成し、生徒が問題を解く際に間違った推論を行った箇所を特定し、正しい解答を提供することができます.これにより、教育分野において新たな可能性が開かれ、Geminiモデルのマルチモーダル推論能力と推論能力は、さまざまな分野で劇的な応用が期待されています.

さらに、報告書ではGeminiの新たな応用例として、Geminiを活用した競技プログラミングの問題解決における優れた成果についても言及されています.Geminiを搭載したAlphaCode 2は、競技プログラミングプラットフォームであるCodeforcesにおいて、従来の最先端モデルを上回るトップ15%の成績を収めています.これにより、Geminiの推論能力は、競技プログラミングなどの領域でも優れたパフォーマンスを発揮しています.

さらに、この報告書ではGeminiのさらなる文脈も提供されています.Geminiは、英語のパフォーマンスと多言語の能力を備えた画像、音声、ビデオのモデリングにも対応しています.また、報告書では、責任ある展開のためのアプローチや影響評価、モデルポリシーの開発、評価、被害の軽減についても議論されています.最後に、Geminiの広範な意義と潜在的な応用についても議論されており、AIの研究とイノベーションの新たな時代を切り拓く可能性が示されています.

Q&A:

Q: マルチモーダルモデルのGemini・ファミリーを開発した目的は何ですか?

A: Geminiファミリーの多モーダルモデルの開発の目的は、効率性の向上です.特に、Gemini Nanoという小型モデルは、デバイス上での展開を重視しており、要約、読解、テキスト補完などのデバイス上のタスクに優れた性能を発揮します.また、これらのモデルは、そのサイズに比べて、推論、STEM、コーディング、多モーダル、多言語のタスクにおいて印象的な能力を示します.

Q: Gemini・ファミリーにはいくつのサイズがあり、それぞれの用途は?

A: Geminiファミリーは複数のサイズで提供されており、その特定の目的はオンデバイス展開に優れた性能を発揮することです.

Q: Geminiのモデルの性能を評価するために、どのようなベンチマークが用いられたのでしょうか?

A: Geminiモデルは、WMT23やMath-AMC 2022-2023問題などの新しい評価データセットや、Natural2Codeのような非ウェブソースから内部的に生成されたデータセットで評価された.

Q: Geminiはどの領域で最先端を行くのか?

A: Geminiは、大規模な言語モデリング、画像理解、音声処理、ビデオ理解の分野で最先端の技術を進化させています.

Q: Geminiはどのような過去の作品や技術をベースにしているのですか?

A: Geminiモデルは、Transformerデコーダーをベースにしており、アーキテクチャとモデルの最適化の改善を組み合わせて、GoogleのTensor Processing Unitsでの安定したトレーニングと最適化された推論を可能にしています.

Q: Gemini・ウルトラはいくつのベンチマークで最先端の結果を達成しましたか?

A: 32のベンチマークのうち30のベンチマークで新たな最先端の結果を達成しました.

Q: Gemini・ウルトラが人間の専門家並みのパフォーマンスを達成したベンチマークの例を教えていただけますか?

A: 試験のベンチマークであるMMLUにおいて、人間の専門家並みのパフォーマンスを達成した.

Large Language Models on Graphs: A Comprehensive Survey

著者:Bowen Jin, Gang Liu, Chi Han, Meng Jiang, Heng Ji, Jiawei Han

発行日:2023年12月05日

最終更新日:2023年12月05日

URL:http://arxiv.org/pdf/2312.02783v1

カテゴリ:Computation and Language, Machine Learning

概要:

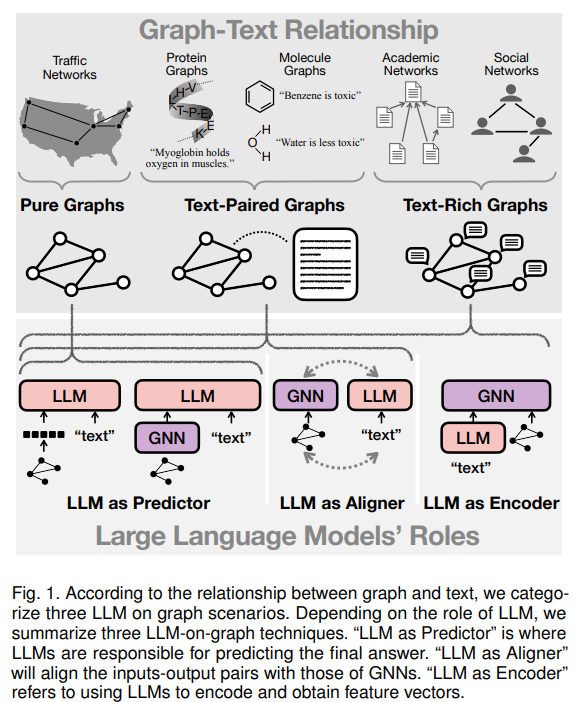

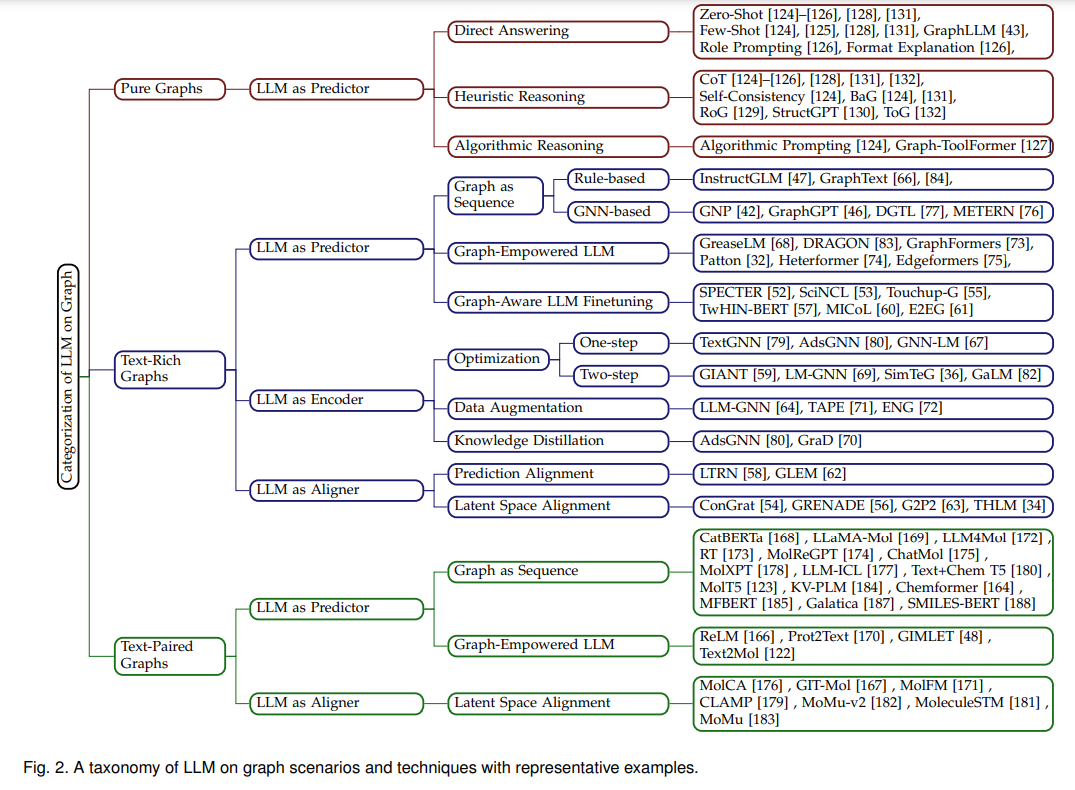

大規模言語モデル(LLM)であるChatGPTやLLaMAは、強力なテキストのエンコード/デコード能力と新たに発見された推論などの能力により、自然言語処理の重要な進展をもたらしています.LLMは主に純粋なテキストを処理するために設計されていますが、現実のシナリオでは、テキストデータがグラフの形式で豊富な構造情報と関連付けられている場合(例:学術ネットワークや電子商取引ネットワーク)、またはグラフデータが豊富なテキスト情報とペアで提供されている場合(例:分子と説明)があります.さらに、LLMは純粋なテキストベースの推論能力を示していますが、そのような能力がグラフのシナリオ(つまり、グラフベースの推論)に一般化できるかどうかは未解明です.

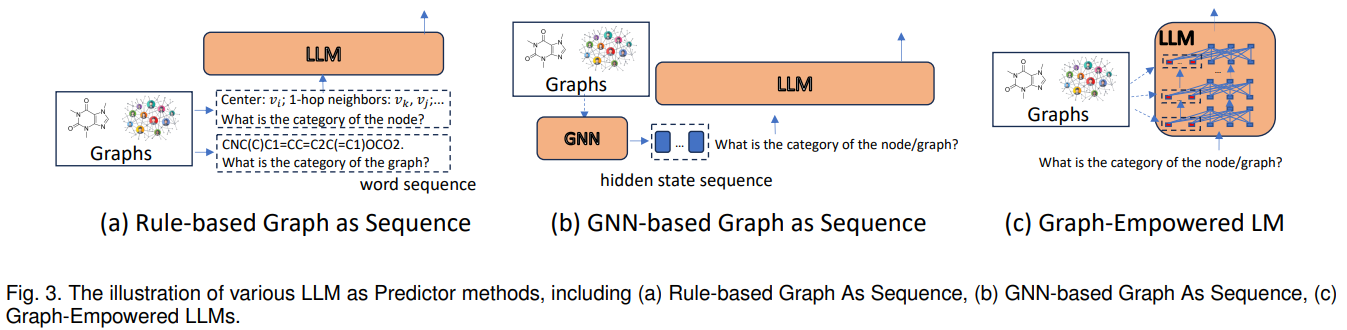

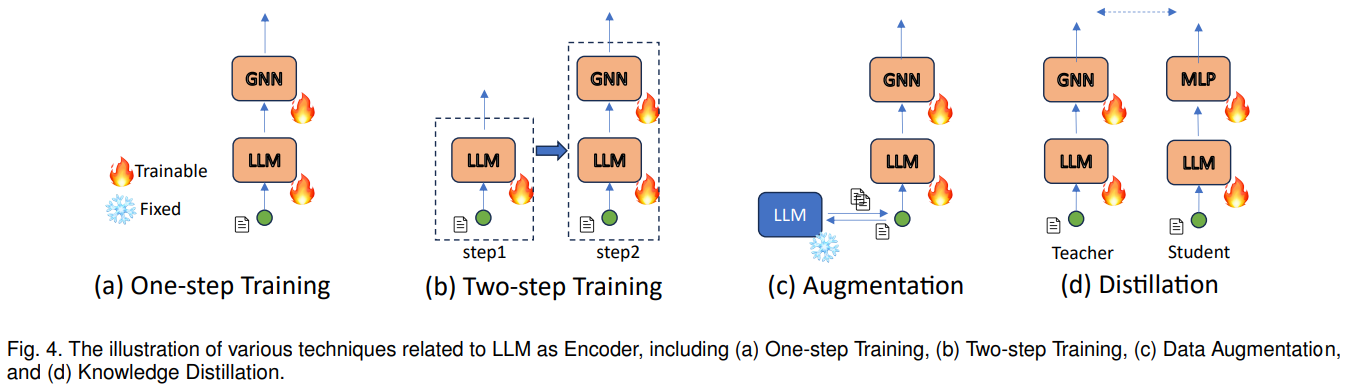

本論文では、グラフ上の大規模言語モデルに関連するシナリオと技術について体系的なレビューを提供します.まず、LLMをグラフに採用するための潜在的なシナリオを純粋なグラフ、テキスト豊かなグラフ、テキストとペアになったグラフの3つのカテゴリにまとめます.次に、LLMをグラフ上で利用するための詳細な技術について、LLMを予測モデルとして使用する方法、LLMをエンコーダとして使用する方法、LLMをデコーダとして使用する方法などを議論します.

さらに、本論文では、グラフ上でLLMを利用する方法として、LLMを予測モデル、エンコーダ、アライナーとして使用する方法についても詳細に説明します.さらに、異なるモデルの利点と欠点を比較し、このような手法の実世界での応用例を紹介し、オープンソースのコードとベンチマークデータセットをまとめます.最後に、この急速に発展している分野での潜在的な将来の研究方向についてまとめます.詳細な情報は、以下のソースで確認できます:.” rel=”nofollow”>https://github.com/PeterGriffinJin/Awesome-Language-Model-on-Graphs.

Q&A:

Q: 純粋グラフにLLMを採用する場合、どのようなシナリオが考えられるか?

A: 純粋なグラフにおけるLLMsの採用の潜在的なシナリオは、3つのカテゴリにまとめることができます.それは、純粋なグラフ、テキスト豊かなグラフ、およびテキストペアのグラフです.

Q: テキストデータがグラフの形で豊富な構造情報と関連付けられている実世界のシナリオの例を教えてください.

A: リアルワールドの例として、学術ネットワーク、eコマースネットワーク、ソーシャルネットワーク、法的なケースネットワークなどがあります.

Q: グラフ・データがリッチなテキスト情報と組み合わされるシナリオはありますか?例を挙げていただけますか?

A: はい、テキストリッチグラフと呼ばれるグラフのシナリオでは、ノードやエッジに豊富なテキスト情報が関連付けられています.例えば、アカデミックネットワーク、eコマースネットワーク、ソーシャルネットワーク、法的なケースネットワークなどがあります.これらのグラフでは、ノードやエッジの表現をテキスト情報と構造情報の両方で学ぶことに関心があります.

Q: 純粋なテキスト・ベースの推論に対するLLMの能力は、グラフ・シナリオで検討されたことがあるだろうか?

A: いいえ、純粋なテキストベースの推論能力を持つLLMのグラフシナリオでの探求は未開拓です.

Q: LLMはグラフシナリオの予測因子として使えるか?

A: はい、LLMsはグラフのシナリオで予測モデルとして使用することができます.

Q: LLMをグラフシナリオのエンコーダーとしてどのように活用できるか?

A: LLMをグラフ・ニューラル・ネットワーク(GNN)の特徴エンコーダとして扱うことで、LLMをグラフ・シナリオのエンコーダとして利用することができる.このアプローチでは、LLMはグラフのノードやエッジに関連するテキストをエンコードするために使用される.LLMによって出力された特徴ベクトルは、GNNの入力埋め込みとして機能し、GNNはグラフ構造を符号化する.下流のタスクのための最終的なノードやエッジの表現は、GNNの出力埋め込みから得られる.しかし、この方法は、収束の問題、疎なデータの問題、非効率な問題に直面する可能性があり、最適化技術、データの増強、知識の蒸留によって対処することができる.

Q: グラフ上でLLMを利用する際のアライナーとしてのLLMの役割とは?

A: グラフ上のLLMを利用する際のアライナーとしてのLLMとは、LLMの入出力ペアをGNNの入出力ペアにアライメントする役割を指す.このアライメントは反復学習や対照学習によって達成される.LLMとGNNを整合させる目的は、2つのモデル間の相互学習効果を高めることである.しかしながら、このアラインメントプロセスでグラフエンコーダとして用いられる浅いGNNは、代表能力に限界があり、相互学習の有効性を制約する可能性があることが言及されている.この限界を克服するために、スケールアップ可能なGNNを採用することが提案される.さらに、LLM-GNN相互強化フレームワークにおけるLLMとGNNの最適なモデルサイズの組み合わせを決定するために、さらなる研究が必要である.

Q: グラフ上のLLMを活用するためのモデルについて、流派によってどのような利点と欠点があるのか?

A: 異なるグラフのシナリオにおけるLLMの利用方法の利点と欠点は、LLMを予測モデルとして使用する場合、LLMをエンコーダとして使用する場合、LLMをアライナとして使用する場合の3つのカテゴリに分類されます.LLMを予測モデルとして使用する場合の利点は、グラフの特徴を予測するためにLLMを使用できることです.LLMをエンコーダとして使用する場合の利点は、グラフの特徴をエンコードするためにLLMを使用できることです.LLMをアライナとして使用する場合の利点は、グラフの特徴を他のデータと関連付けるためにLLMを使用できることです.一方、LLMを予測モデルとして使用する場合の欠点は、予測の精度が低い可能性があることです.LLMをエンコーダとして使用する場合の欠点は、エンコードされた特徴が情報の損失を引き起こす可能性があることです.LLMをアライナとして使用する場合の欠点は、他のデータとの関連付けが困難である可能性があることです.

Q: グラフ上でのLLMの実際の応用例を教えてください.

A: グラフ上のLLMは、様々な実世界のアプリケーションに応用されている.例えば、グラフの接続性の推測、グラフの最短パスの発見、部分グラフマッチングの実行などである.これらの応用は、ネットワーク分析、交通計画、ソーシャルネットワーク分析などの分野で重要である.LLMはまた、グラフノードがテキスト情報を含む、テキストリッチなグラフにも使われている.この場合、LLMはテキスト分類、感情分析、情報検索などのタスクに利用できる.さらに、LLMは、グラフ・ノードがテキストと対になっている、テキスト対グラフにも適用されている.これは、質問応答、機械翻訳、テキスト要約などのタスクに有用である.全体として、グラフ上のLLMは、様々な領域で幅広く応用されている.

RankZephyr: Effective and Robust Zero-Shot Listwise Reranking is a Breeze!

著者:Ronak Pradeep, Sahel Sharifymoghaddam, Jimmy Lin

発行日:2023年12月05日

最終更新日:2023年12月05日

URL:http://arxiv.org/pdf/2312.02724v1

カテゴリ:Information Retrieval

概要:

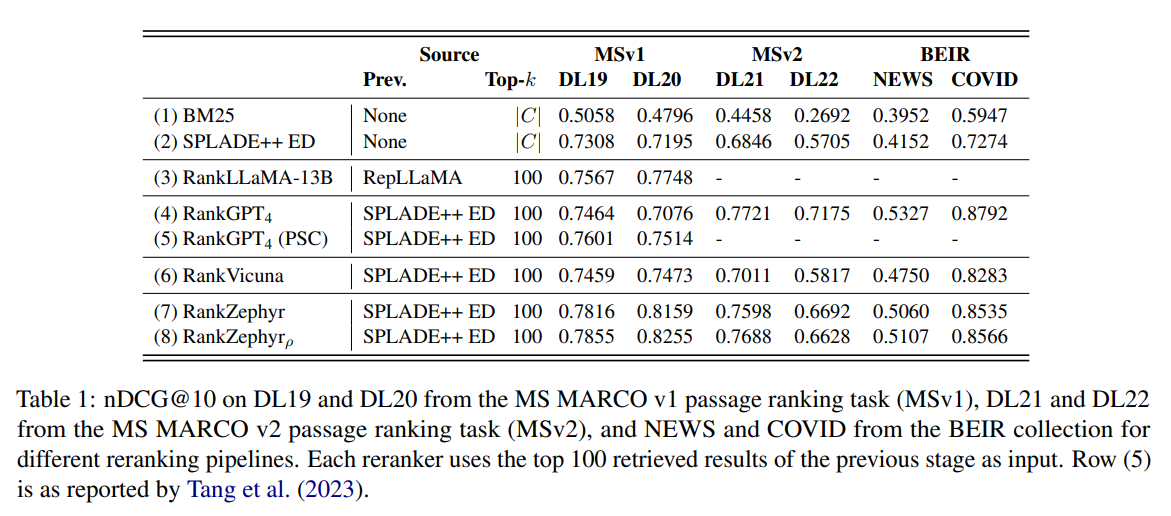

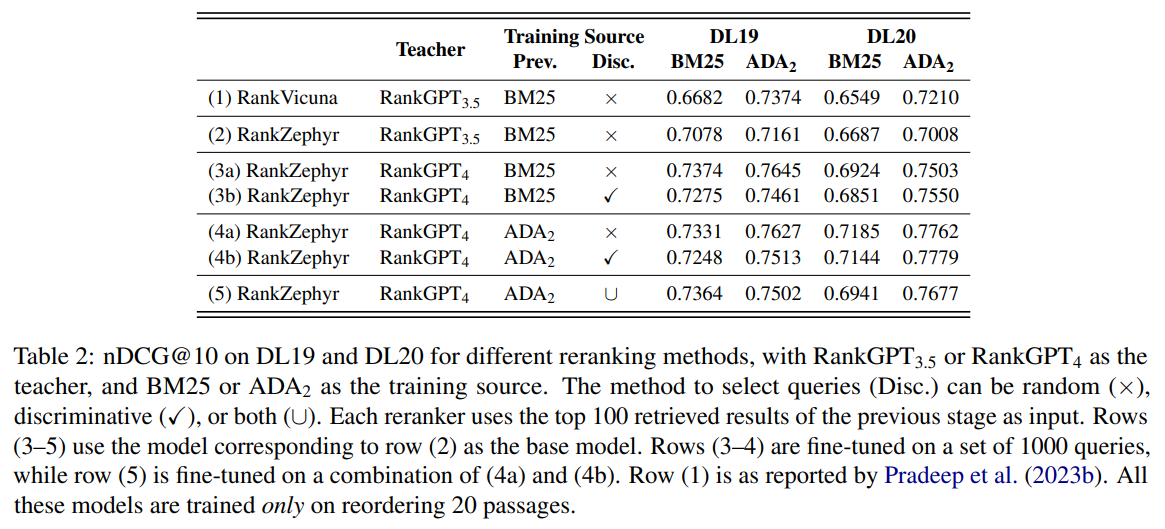

情報検索において、GPT-4やLLaMA、Vicunaなどのプロプライエタリな大規模言語モデル(LLM)とオープンソースの対応モデルが、再順位付けにおいて重要な役割を果たしてきました.しかし、オープンソースとクローズドモデルの間には依然としてギャップがあり、プロプライエタリで透明性のないモデルに依存することで再現性が制約されています.このギャップに対処するために、私たちはRankZephyrという最先端のオープンソースLLMを導入しました.RankZephyrは、GPT-4との効果のギャップを埋めるだけでなく、一部のケースではプロプライエタリモデルを上回る能力を持っています.私たちの包括的な評価は、複数のデータセット(TREC Deep Learning Tracks、BEIRのNEWSとCOVID)でこの能力を示しています.RankZephyrは戦略的なトレーニングの選択肢を活用しており、初期のドキュメントの順序や再順位付けされるドキュメントの数の変動に対しても強靭です.さらに、私たちのモデルは、トレーニング期間を過ぎたクエリとパッセージからなるNovelEvalテストセットでGPT-4を上回る性能を発揮し、データの汚染に関する懸念に対処しています.この急速に進化する分野でのさらなる研究を促進するために、私たちはhttps://github.com/castorini/rank_llmで結果を再現するために必要なすべてのコードを提供しています.

Q&A:

Q: RankZephyrの目的は何ですか?

A: RankZephyrの目的は、情報検索のための大規模な言語モデルの開発と改良を続けるコミュニティにおいて、より効果的で堅牢な再順位付けモデルを探求することです.

Q: RankZephyrはGPT-4のような独自モデルと比較してどうですか?

A: RankZephyrはGPT-4との有効性のギャップを埋めるだけでなく、場合によっては独自モデルを凌駕する.複数のデータセットにおける包括的な評価により、この能力が実証されている.RankZephyrは戦略的な学習選択から恩恵を受け、最初の文書順序や再ランク付けされた文書数の変動に強い.さらに、我々のモデルはNovelEvalテストセットにおいてGPT-4を凌駕し、データ汚染に関する懸念に対処している.RankZephyrは、決定論的な振る舞いで品質的に競争力があり、一般に利用可能な、はるかに小さなオープンソースモデルである.

Q: RankZephyrの効果に貢献する戦略的なトレーニングの選択肢を説明していただけますか?

A: RankZephyrの効果的なトレーニングの選択肢には、RankGPT 4を教師モデルとして使用し、ADA 2の5Kの再順序付けを最初の段階の検索モデルとして使用することが含まれます.

Q: RankZephyrは、最初の文書順序のばらつきをどのように扱うのですか?

A: RankZephyrは、初期のドキュメントの順序の変動に対して頑健性を持っています.モデルは、シャッフルされた順序でも効果を保ちます.

Q: RankZephyrは、再ランクされた文書数の変動をどのように扱っていますか?

A: RankZephyrは、以前の検索段階からの候補文書のセットを使用して、文書の数の変動に対応しています.ユーザーのクエリと候補文書のセットが与えられた場合、RankZephyrは、正規化された割引累積利得(nDCG)などの特定の検索メトリックを最適化するために、これらの文書を再順序付けすることを目指します.再順序付けされる文書の数は、セットに提供される候補文書の数によって異なる場合があります.RankZephyrの目的は、複数の文書にわたる関連性の比較に基づいて、最適な最終的な再順序付けを決定することです.

Q: RankZephyrの評価に使用したデータセットの詳細を教えてください.

A: RankZephyrは、TREC 2019および2020 Deep Learning Tracks、TREC 2021および2022 Deep Learning Tracks、BEIRのNEWSおよびCOVIDコレクション、Google Web SearchのNovelEvalなど、複数のデータセットで評価された.

Q: NovelEvalテストセットでRankZephyrがGPT-4を上回ったことの意味を教えてください.

A: RankZephyrのNovelEvalテストセットでGPT-4を上回ることの重要性は、データの汚染に関する懸念を解消するためです.NovelEvalテストセットは、トレーニング期間を超えたクエリとパッセージで構成されており、これによりモデルの汎化能力が評価されます.RankZephyrがGPT-4を上回ることは、RankZephyrがトレーニング期間外のデータに対しても優れたパフォーマンスを発揮することを示しています.これにより、RankZephyrはデータの汚染による性能低下のリスクを軽減し、より信頼性の高い結果を提供することができます.

Q: RankZephyrはデータ汚染に関する懸念にどのように対処していますか?

A: RankZephyrは、汚染されていないクエリとパッセージで構成されるNovelEvalテストセットで良好な結果を出すことで、データ汚染に関する懸念に対処している.これは実世界での応用の可能性を示し、暗記に対する懸念を軽減する.さらに、RankZephyrの有効性はデータ増強によって強化され、頑健性の向上において重要な役割を果たしている.

Q: 結果を再現するためにGitHubリポジトリで提供されているコードについて、より詳しい情報を教えていただけますか?

A: 提供されているGitHubリポジトリでは、結果を再現するために必要なすべてのコードが提供されています.このコードは、https://github.com/castorini/rank_llm で入手できます.このリポジトリには、モデルのチェックポイントや関連するコードが含まれており、研究コミュニティに貴重なリソースを提供することを目的としています.これにより、他の研究者がこの研究を再現し、結果を検証することができます.

Q: RankZephyrの限界や潜在的な改善点はありますか?

A: RankZephyrには再現性のない、非決定論的な出力、APIの背後にある曖昧さなどの制約があります.また、RankZephyrの結果の欠如は、検索効果の測定において判定プールに対するペナルティをもたらすとも述べられています.これらの制約は、再現性、決定論的な振る舞い、アクセシビリティ、判定プールへの組み込みの観点から改善の可能性を示唆しています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: https://github.com/castorini/rank_llm

Data Management For Large Language Models: A Survey

著者:Zige Wang, Wanjun Zhong, Yufei Wang, Qi Zhu, Fei Mi, Baojun Wang, Lifeng Shang, Xin Jiang, Qun Liu

発行日:2023年12月04日

最終更新日:2023年12月04日

URL:http://arxiv.org/pdf/2312.01700v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

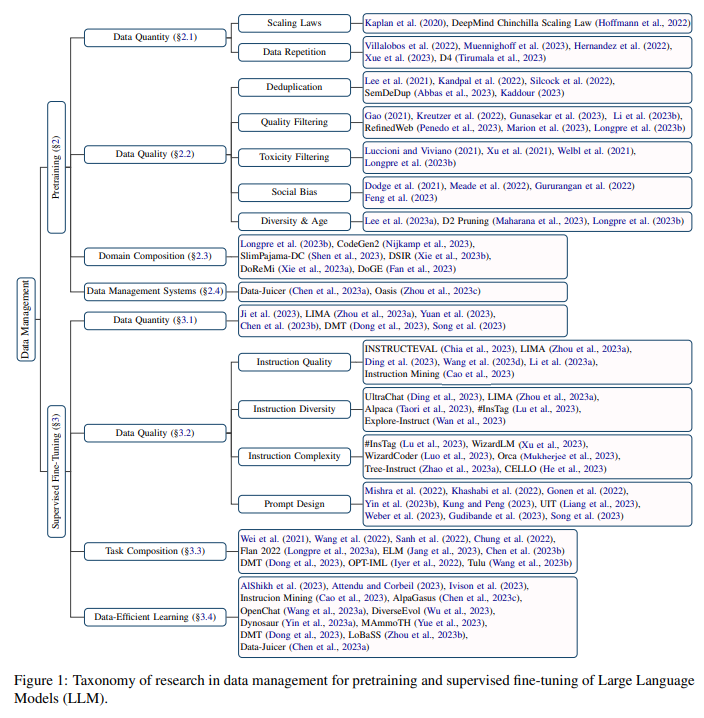

データは、大規模言語モデル(LLM)のトレーニングにおいて基本的な役割を果たしています.効果的なデータ管理、特に適切なトレーニングデータセットの構築においては、モデルのパフォーマンス向上とトレーニング効率の改善に重要な意味があります.しかし、データ管理の重要性にもかかわらず、現在の研究コミュニティは、戦略選択の根拠、その結果としての効果、キュレーションされたデータセットの評価方法、および改善戦略の追求についての体系的な分析をまだ提供していません.そのため、データ管理の探求は、研究コミュニティの中でますます注目されています.この調査では、LLMの事前トレーニングおよび教師あり微調整の段階でのデータ管理に関する現在の研究の包括的な概要を提供し、データ管理戦略の設計のさまざまな注目すべき側面(データの量、品質、ドメイン/タスクの構成など)をカバーしています.さらに、この調査は、この分野での発展に向けた既存の課題を予測し、有望な方向性を概説しており、強力なLLMの構築を目指す実践者にとってのガイドとなるリソースとなっています.最新の論文のコレクションは、https://github.com/ZigeW/data_management_LLM で入手できます.

Q&A:

Q: 大規模言語モデル(LLM)の学習における効果的なデータ管理の意義とは?

A: 大規模言語モデル(LLM)のトレーニングにおいて、効果的なデータ管理は重要な役割を果たします.適切なトレーニングデータセットの作成により、モデルのパフォーマンスを向上させ、事前学習および教師あり微調整のフェーズでのトレーニング効率を改善することができます.データ管理の重要性は非常に大きく、研究コミュニティにおいても注目されています.

Q: データ管理はどのようにモデルのパフォーマンスを向上させ、事前学習や教師ありの微調整の段階で学習効率を改善するのか?

A: データ管理は、モデルのパフォーマンスを向上させ、トレーニングの効率を改善するために重要です.データ管理によって、効果的なトレーニングデータセットの作成が可能となります.トレーニングデータセットの適切な構築により、モデルはより多くの有用な情報を学習し、より高いパフォーマンスを発揮することができます.また、データ管理によって、トレーニングの効率も向上します.高品質なデータセットを使用することで、モデルはより少ないトレーニングステップでより高い精度を達成することができます.さらに、データ管理によって、データの量や品質、ドメイン/タスクの組成など、トレーニングの各段階での課題に対処するための戦略を開発することができます.

Q: データ管理戦略の選択に関する体系的な分析を提供するという点で、現在の研究コミュニティに欠けているものは何か?

A: 現在の研究コミュニティは、データ管理戦略の選択に対する体系的な分析、その結果としての効果、キュレーションされたデータセットの評価方法、および改善された戦略の追求について、まだ不十分です.

Q: データマネジメント戦略の選択がもたらす影響とは?

A: データ管理戦略の選択による結果としては、データの品質、モデルのパフォーマンス、トレードオフの存在などがあります.データ管理戦略の選択によって、データの品質が向上することで、モデルのパフォーマンスも向上する可能性があります.一方で、データの重複や品質フィルタリング、社会的なバイアスなどのデータ管理の手法によっては、モデルのパフォーマンスに悪影響を与える可能性もあります.また、データ管理戦略の選択によっては、品質と数量のトレードオフが生じることもあります.例えば、データの品質を高めるためには、データの量を減らす必要がある場合があります.したがって、データ管理戦略の選択は、モデルのパフォーマンスに重要な影響を与えることがあります.

Q: LLMのデータ管理という観点から、キュレーションされたデータセットを評価するために、どのような方法論が利用可能か?

A: 現在の研究コミュニティでは、管理戦略の選択理由やその結果の評価方法、改善策の追求に関して、データ管理の体系的な分析がまだ不十分です.したがって、LLMのデータ管理における評価方法は、まだ確立されていません.

Q: 研究コミュニティでは、データ管理戦略の改善に向けてどのような取り組みが行われているのでしょうか?

A: 研究コミュニティでは、データ管理戦略の改善に向けた取り組みが行われています.

Q: LLMの事前トレーニング段階とスーパーバイズド・ファインチューニング段階におけるデータ管理戦略設計の注目すべき点とは?

A: LLMsの事前トレーニングおよび教師あり微調整の段階におけるデータ管理戦略の設計には、データの量、データの品質、ドメイン/タスクの構成など、いくつかの注目すべき側面があります.

Q: データ量はLLMのデータ管理戦略設計にどのような影響を与えるのか?

A: データの量が増えると、データ管理戦略の設計には以下のような影響があります.まず、データの量が増えると、データの重複や品質のフィルタリング、有害性のフィルタリング、社会的なバイアス、データの多様性や年齢などの管理がより重要になります.また、データの量が増えると、ドメインの構成やドメインの再重み付けの方法も重要になります.データの量が増えると、データ管理システムの設計も重要になります.データの量が増えると、データの効率的な学習やタスクの組成にも影響を与えます.

Q: データ品質はLLMのデータ管理戦略設計にどのような影響を与えるのか?

A: データの品質は、LLMのデータ管理戦略の設計に重要な影響を与えます.高品質なデータは、LLMの事前学習において重要です.データの品質は、重複排除、品質フィルタリング、有害性フィルタリングなどの品質保証技術によって確保されます.また、社会的なバイアス、データの多様性、データの年齢なども研究コミュニティで興味深いトピックです.

Q: LLMのデータ管理戦略設計におけるドメイン/タスク構成の役割とは?

A: ドメイン/タスクの組成は、LLMのデータ管理戦略設計において重要な役割を果たします.ドメイン/タスクの組成は、LLMが学習するデータの種類と内容を決定するため、モデルの性能や能力に直接影響を与えます.LLMは、複数のタスクやドメインのデータを組み合わせて学習することができますが、組成の方法や組み合わせ方によって結果が異なることがあります.例えば、複数のタスクを組み合わせて学習する場合、それぞれのタスクの特性や関連性を考慮する必要があります.また、特定のドメインに特化したLLMを構築する場合、そのドメインに関連するデータを重点的に学習させる必要があります.ドメイン/タスクの組成は、LLMの学習効率や性能を最適化するために重要な要素となります.

Magicoder: Source Code Is All You Need

著者:Yuxiang Wei, Zhe Wang, Jiawei Liu, Yifeng Ding, Lingming Zhang

発行日:2023年12月04日

最終更新日:2023年12月04日

URL:http://arxiv.org/pdf/2312.02120v1

カテゴリ:Computation and Language, Artificial Intelligence, Software Engineering

概要:

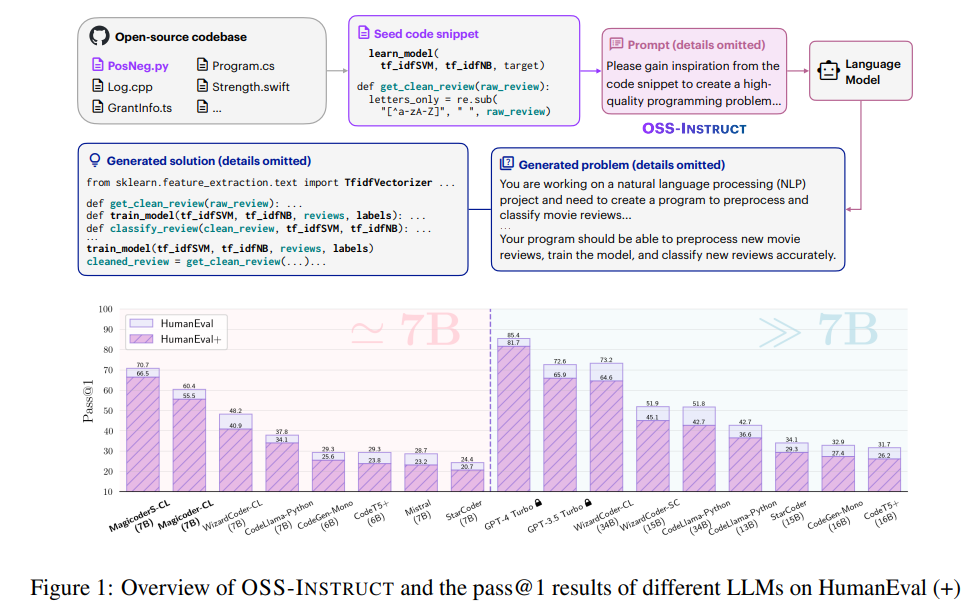

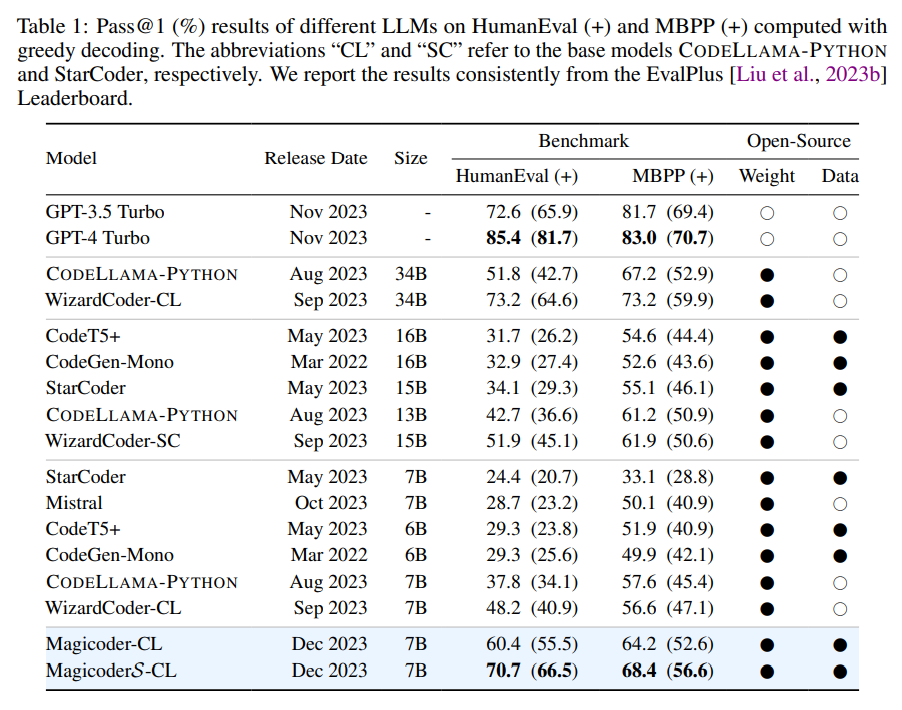

Magicoderは、コードに関する完全にオープンソース(コード、重み、データ)のLarge Language Models(LLMs)のシリーズを紹介します.これらのモデルは、最大7Bのパラメータを持ちながら、トップのコードモデルとの差を大幅に縮めています.Magicoderモデルは、OSS-Instructを使用して75Kの合成命令データでトレーニングされます.OSS-Instructは、オープンソースのコードスニペットを使用してLLMsに高品質な命令データを生成するための革新的な手法です.私たちの主な目標は、LLMsによって生成される合成データの固有のバイアスを軽減することであり、より多様で現実的かつ制御可能なデータの生成においてオープンソースの参照を活用することです.OSS-InstructとEvol-Instructなどの他のデータ生成方法の直交性により、強化されたMagicoderSを構築することも可能になります.MagicoderとMagicoderSの両方は、Pythonのテキストからコードの生成、多言語のコーディング、データサイエンスプログラムの補完など、さまざまなコーディングベンチマークで、同様またはさらに大きなサイズの最先端のコードモデルを大幅に上回ります.特に、CodeLlamaに基づくMagicoderS-CL-7Bは、HumanEval+で有名なChatGPTをも上回ります(66.5対65.9).さらに、CodeLlamaはHumanEval+の評価においてChatGPTをも上回り、OSS-Instructはオープンソースの参照を活用して低バイアスかつ高品質な命令チューニングの新たな方向を開拓しています.

Q&A:

Q: Magicoderの目的は何ですか?

A: Magicoderの目的は、トップのコードモデルとの差を埋めることであり、7Bのパラメータを超えない完全なオープンソースの大規模言語モデル(LLM)を提供することです.Magicoderモデルは、OSS-I NSTRUCTを使用して75Kの合成命令データでトレーニングされており、コードの高品質な命令データを生成するためにオープンソースのコードスニペットでLLMを活用する革新的なアプローチです.Magicoderの主な目的は、LLMによって生成される合成データの固有のバイアスを軽減することであり、より多様で現実的かつ制御可能なデータの生成においてオープンソースの参照情報を活用することです.MagicoderとMagicoder Sは、最先端のコードモデルを大幅に上回る性能を発揮します.

Q: Magicoderモデルにはいくつのパラメータがありますか?

A: Magicoderモデルは7Bのパラメータを持っています.

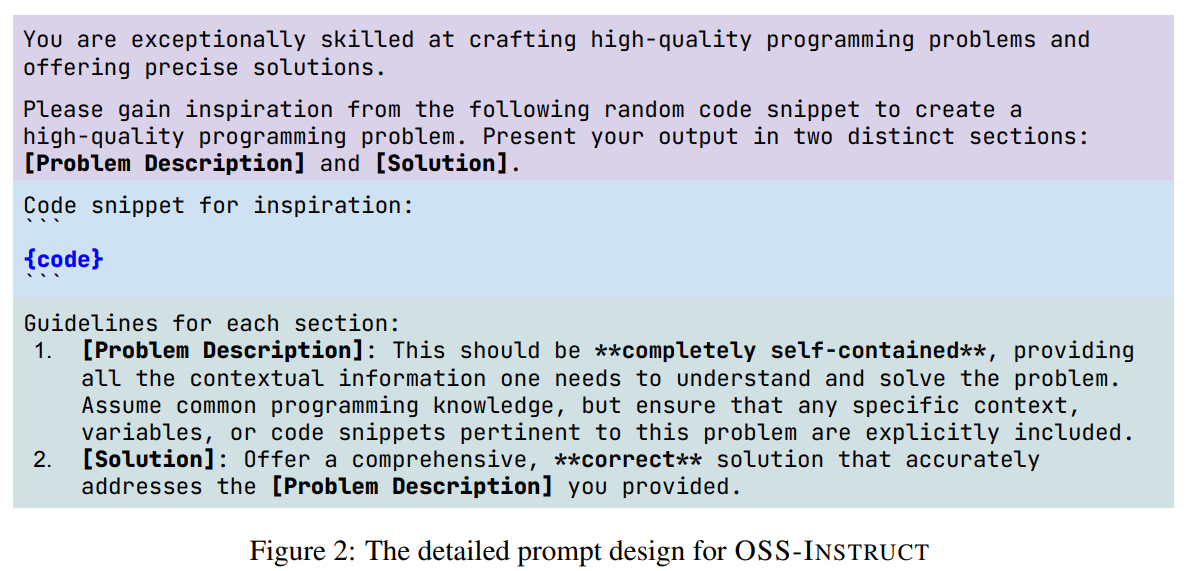

Q: OSS-Instructとはどのようなもので、Magicoderモデルのトレーニングにどのように使われているのですか?

A: OSS-Instructは、実際のオープンソースコードから異なるシードコードスニペットを提供することで、コーディング問題とその解決策を生成するためにLLM(例:ChatGPT)を促す手法です.OSS-Instructは、生成の制御性を提供し、LLMが異なる関数を関連付け、現実的な機械学習の問題を作成することを奨励します.OSS-Instructは、異なるデータ生成手法と組み合わせることができ、モデルのコーディング能力の限界をさらに押し上げることができます.

Q: Magicoderは、LLMによって生成された合成データのバイアスをどのように緩和するのか?

A: Magicoderは、LLMによって生成された合成データのバイアスを軽減するために、オープンソースの参照情報を活用してより多様で現実的かつ制御可能なデータを生成することで、そのバイアスを軽減します.これは、OSS-INSTRUCTという新しいアプローチを使用して、LLMにオープンソースのコードスニペットを提供し、コードの高品質な指示データを生成することによって達成されます.オープンソースの参照情報を取り入れることで、Magicoderモデルはより幅広い情報源から学習することができ、合成データの固有のバイアスを減少させることができます.さらに、OSS-INSTRUCTやEvol-Instructなどの他のデータ生成方法との直交性により、Magicoderはバイアスを軽減し、高品質なコードを生成する能力がさらに向上します.全体として、Magicoderはオープンソースの参照情報を取り入れるアプローチによって、合成データの制限に対処し、より多様で現実的なコードを生成するのに役立ちます.

Q: データ作成でOSS-InstructとEvol-Instructを併用するメリットは何ですか?

A: OSS-I NSTRUCTとEvol-Instructは、データ生成において協力して、コーディングタスクにおける制御性、品質、創造性を向上させる利点を提供します.これらは、ヒューリスティックなプロンプトを用いてChatGPTをガイドすることで、LLMがより複雑で多様な合成データを生成することを可能にします.OSS-I NSTRUCTとEvol-Instructを組み合わせることで、強化されたMagicoder Smodelsは、HumanEvalベンチマークにおいてChatGPTなどの主要なモデルと競合する驚異的な結果を達成します.これらの手法の組み合わせは、モデルのコーディング能力の限界を押し上げ、将来のLLMによるコードの研究を可能にします.

Q: Magicoderは他の最先端のコードモデルと性能の面でどのように比較されますか?

A: Magicoder-CLは、CODELLAMA-PYTHON-34BとWizardCoder-CL-34Bを除くすべてのオープンソースモデルを凌駕しています.また、WizardCoder-SC-15Bを上回り、HumanEvalとHumanEvalではCODELLAMA-PYTHON-34Bを大幅に上回った.

Q: Magicoderが他のモデルよりも優れているコーディングベンチマークの具体例を教えてください.

A: Magicoder-CLは、CODELLAMA-PYTHON-34BとWizardCoder-CL-34Bを除くすべてのオープンソースモデルを、コーディングベンチマークで上回っています.

Q: CodeLlamaに基づくMagicoderS-CL-7BがHumanEvalでChatGPTを上回ったことの意味は?

A: CodeLlamaをベースにしたMagicoderS-CL-7BがHumanEvalでChatGPTを上回ったことは、MagicoderS-CL-7BがChatGPTに比べてよりロバストなコードを生成できることを示しており、重要です.このことは、MagicoderS-CL-7Bがより厳密なHumanEvalデータセットでより高いスコア(66.5 vs 65.9)を達成していることからも裏付けられます.パフォーマンスの向上は、MagicoderS-CL-7Bがより優れたコード生成能力を持ち、より信頼性が高く正確なコード解を生成できる可能性を示唆しています.

Q: OSS-Instructは、バイアスの少ない、質の高いインストラクション・チューニングにどのように貢献しているのでしょうか?

A: OSS-I NSTRUCTは、オープンソースのコードスニペットを活用し、多様で現実的かつ制御可能なコーディング命令データを生成することで、低バイアスかつ高品質な命令チューニングに貢献します.このアプローチにより、LLM固有のバイアスを緩和し、オープンソースからの直接学習を通じて、高品質で創造的なコード命令を作成することができます.OSS-I NSTRUCTを使用することで、豊富なオープンソースリファレンスから低バイアスで高品質な命令チューニングデータを作成することができ、命令チューニングの新たな次元を開くことができます.OSS-I NSTRUCTで学習させたMagicoderシリーズは、様々なLLMの性能を大幅に向上させ、HumanEvalでは7BのパラメータだけでChatGPTを上回った.モデルの重み、学習データ、ソースコードは、今後の研究を促進するために完全にオープンソース化されています.

Q: Magicoderの開発におけるオープンソースリファレンスの役割について説明していただけますか?

A: Magicoderはオープンソースのリファレンスを利用して、コードのための高品質な命令データを生成します.これは、オープンソースのコードスニペットで大規模言語モデル(LLM)を啓発するOSS-I NSTRUCTアプローチによって達成されます.Magicoderは、オープンソースリファレンスを取り入れることで、LLMによって生成される合成データの固有のバイアスを軽減し、より多様で現実的で制御可能なデータを生成することを目指しています.豊富なオープンソースリファレンスにより、Magicoderはバイアスが低く高品質な命令チューニングデータを作成することができ、ベースとなるLLMを大幅に改善し、他のコードモデルを凌駕します.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: https://github.com/ise-uiuc/magicoder

EfficientSAM: Leveraged Masked Image Pretraining for Efficient Segment Anything

著者:Yunyang Xiong, Bala Varadarajan, Lemeng Wu, Xiaoyu Xiang, Fanyi Xiao, Chenchen Zhu, Xiaoliang Dai, Dilin Wang, Fei Sun, Forrest Iandola, Raghuraman Krishnamoorthi, Vikas Chandra

発行日:2023年12月01日

最終更新日:2023年12月01日

URL:http://arxiv.org/pdf/2312.00863v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

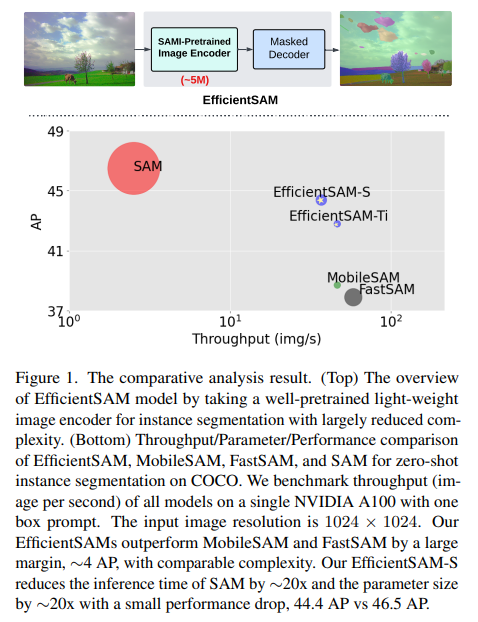

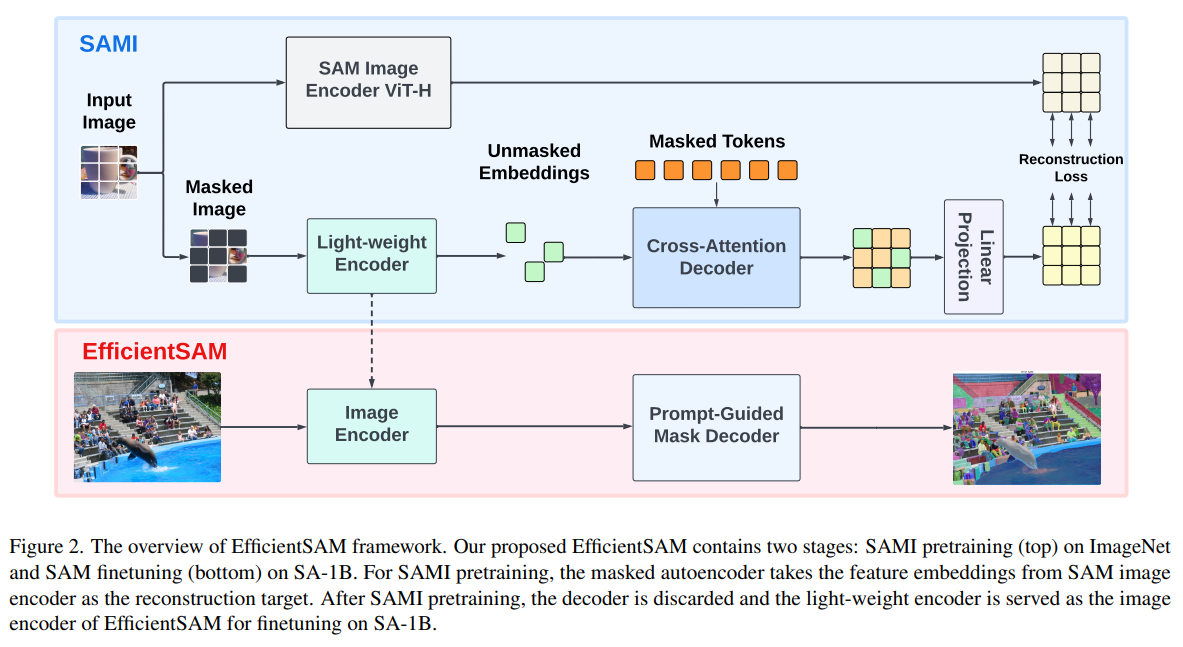

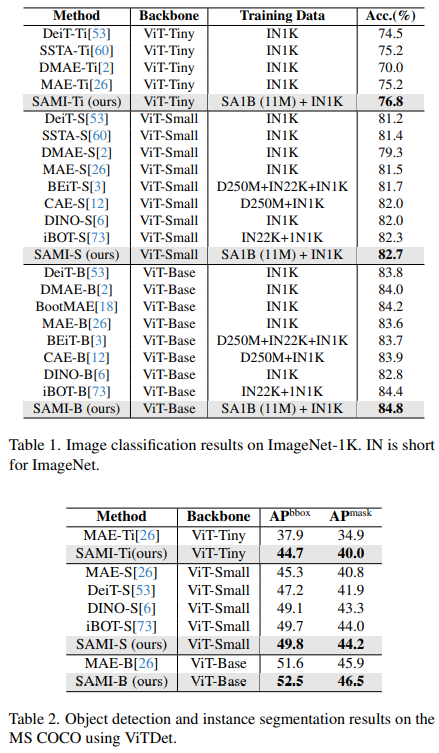

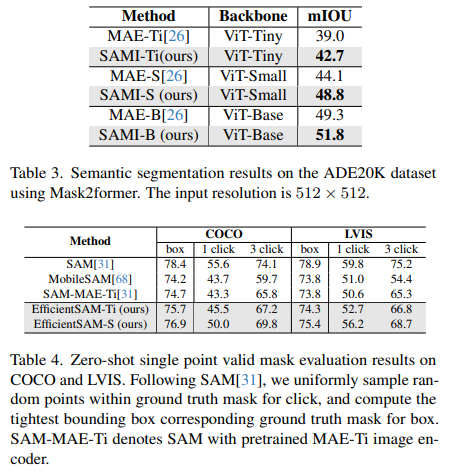

SAMIは、他のマスク画像事前トレーニング方法よりも一貫して優れたパフォーマンスを発揮することが確認されています.特に、ゼロショットインスタンスセグメンテーションなどのセグメント化タスクにおいて、SAMIで事前トレーニングされた軽量な画像エンコーダを使用したEfficientSAMsは、他の高速なSAMモデルに比べて大幅な改善(例:COCO/LVISで約4 AP)を実現しています.

Q&A:

Q: SAMモデルの目的は何ですか?

A: SAMモデルの目的は、さまざまなビジョンタスクにおいて高い汎用性と転移性能を持つことです.具体的には、セグメンテーション、修復、編集、追跡、3Dオブジェクト再構築などのビジョンタスクにおいて、SAMは優れたパフォーマンスを発揮します.また、医療画像セグメンテーションや視覚障害者支援など、実世界のさまざまなシナリオにも応用されます.さらに、SAMの実用的な展開にも注目が集まっています.

Q: SA-1Bデータセットとはどのようなもので、SAMモデルのトレーニングにどのように使用されるのですか?

A: SA-1Bは、11M枚の画像から1B以上のマスクを持つ大規模な視覚データセットであり、EfficientSAMモデルのトレーニングに使用されます.SA-1Bデータセットは、ViTモデルの事前トレーニングに使用され、その後、EfficientSAMモデルのトレーニングにも使用されます.

Q: SAMモデルの主な限界は何ですか?

A: SAMモデルの主な制限は、特に画像エンコーダ(例:ViT-H)が非常に高価であることです.ViT-H画像エンコーダは632Mのパラメータを持っており、一方でプロンプトベースのデコーダはたったの3.87Mのパラメータしか使用しません.その結果、SAMを実際のセグメンテーションタスクに使用する際には、高い計算およびメモリコストが発生します.

Q: EfficientSAMはSAMモデルの限界にどのように対処しているのか?

A: EfficientSAMは、SAMモデルの限界に対処するため、複雑さを大幅に軽減しながら、適切な性能を示す軽量SAMモデルを提案する.これは、効果的な視覚表現学習のためにSAM画像エンコーダから特徴を再構成するように学習するマスク画像事前学習、SAMIを活用することによって達成される.SAMIによって事前学習された軽量画像エンコーダとマスクデコーダは、EfficientSAMを構築するために使用され、その後、セグメント何でもタスクのためのSA-1Bデータセット上で微調整される.複数の視覚タスクに対する評価から、提案すること前学習法は、他のマスク画像事前学習法を一貫して凌駕することが示される.EfficientSAMsは、FastSAMやSAMよりもはるかに軽量であり、パラメータサイズと推論時間が大幅に削減されている.したがって、EfficientSAMはSAMモデルの効率性のボトルネックに効果的に対処している.

Q: SAMIとはどのようなもので、EfficientSAMsにどのように貢献するのですか?

A: SAMIはEfficientSAMsに貢献するためのマスク画像の事前学習方法です.SAMIは、効果的な視覚表現学習のために、SAM画像エンコーダから特徴を再構築することを学習します.さらに、SAMIで事前学習された軽量な画像エンコーダとマスクデコーダを使用してEfficientSAMsを構築し、SA-1Bでモデルを微調整します.SAMIは、他のマスク画像の事前学習方法よりも一貫して優れたパフォーマンスを発揮することが多くのビジョンタスクの評価で示されています.

Q: SAMIに訓練された画像エンコーダーとマスクデコーダーを使用して、EfficientSAMはどのように構築されるのですか?

A: EfficientSAMは、SAMI-pretrainedのイメージエンコーダー(例:ViT-TinyやViT-Small)とSAMのデフォルトのマスクコーダーを使用して構築されます.

Q: EfficientSAMはSA-1Bデータセットでどのように微調整されているのですか?

A: EfficientSAMは、SA-1Bデータセット上で5エポックのファインチューニングを行います.AdamWオプティマイザーを使用し、モーメンタム(β1=0.9, β2=0.999)、ミニバッチサイズ128、初期学習率4e-4を設定します.学習率は線形学習率スケジュールによって0まで減衰させます.重み減衰は0.1に設定されます.データ拡張は適用されません.入力画像の解像度は1024×1024です.EfficientSAMは64台のA100 GPUでトレーニングされます.

Q: EfficientSAMではどのような評価作業が行われたのですか?

A: 効率的なSAMをゼロショットインスタンス分割のために評価し、その能力をSAMと比較した.

Q: SAMIは、他のマスク画像プリトレーニング手法と比較して、どのようなパフォーマンスを発揮するのでしょうか?

A: SAMIのパフォーマンスはSAMよりわずかに悪く、その差は1.5mIoUだった.

Q: EfficientSAMとSAMI事前学習された画像エンコーダは、他の高速SAMモデルと比較して、ゼロショットインスタンスセグメンテーションにおいて、どのようなパフォーマンス利得がありますか?

A: SAMIで事前学習された画像エンコーダを持つEfficientSAMは、ゼロショットインスタンス分割において、他の高速SAMモデルと比較して、COCO/LVISで約4APの有意な利得を示し、良好な性能を発揮する.

The Efficiency Spectrum of Large Language Models: An Algorithmic Survey

著者:Tianyu Ding, Tianyi Chen, Haidong Zhu, Jiachen Jiang, Yiqi Zhong, Jinxin Zhou, Guangzhi Wang, Zhihui Zhu, Ilya Zharkov, Luming Liang

発行日:2023年12月01日

最終更新日:2023年12月01日

URL:http://arxiv.org/pdf/2312.00678v1

カテゴリ:Computation and Language

概要:

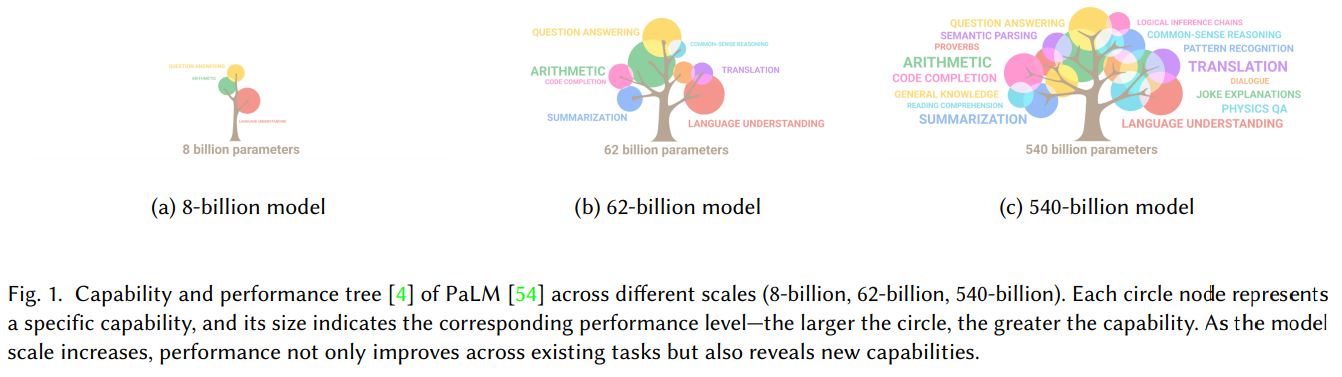

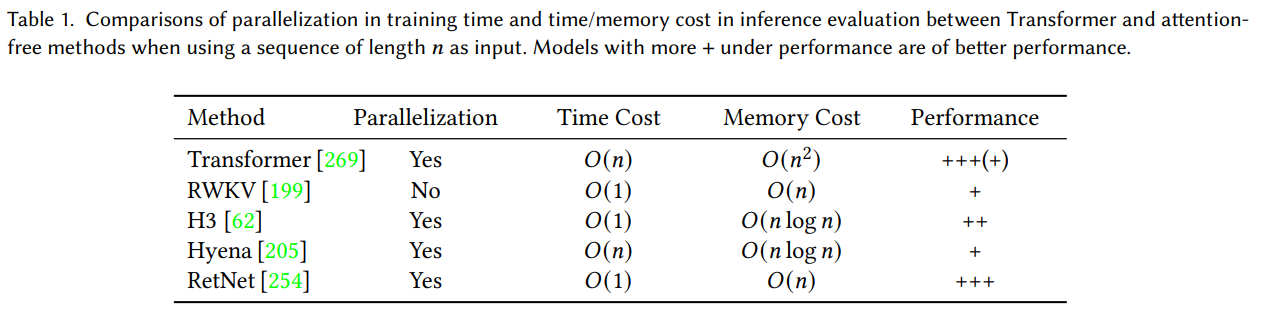

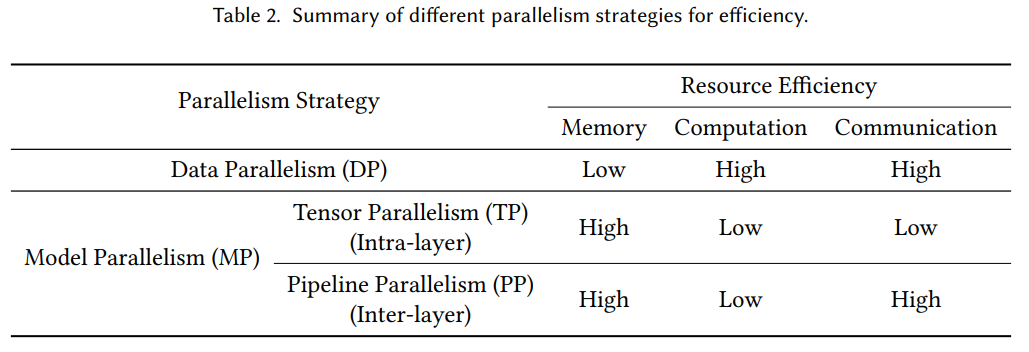

大規模言語モデル(LLM)の急速な成長は、さまざまな領域を変革し、人工汎用知能の景観を再構築する原動力となっています.しかし、これらのモデルの増加する計算およびメモリ要件は、学術研究と実用的な応用の両方を妨げる重要な課題を提起しています.これらの問題に対処するために、アルゴリズムとハードウェアの両方の解決策を含む、さまざまな手法が開発されてきました.本調査では、LLMの効率を向上させるためのアルゴリズムの進歩について包括的なレビューを提供します.通常、トレーニングやモデルの圧縮など特定の領域に焦点を当てる他の調査とは異なり、本論文ではLLMのエンドツーエンドのアルゴリズム開発において重要な効率の多面的な側面を検討しています.具体的には、スケーリングの法則、データの利用、アーキテクチャの革新、トレーニングとチューニングの戦略、および推論技術など、効率に関連するさまざまなトピックをカバーしています.本論文は、研究者や実践者にとって貴重な情報源となり、将来のイノベーションの基盤を築くことを目指しています.また、関連する参考文献のリポジトリは、以下のURLで管理されています:.https://github.com/tding1/Efficient-LLM-Survey.

Q&A:

Q: 大規模言語モデル(LLM)の計算量とメモリ需要の増大がもたらす課題とは?

A: LLMは、計算要求とメモリ要件の点で課題をもたらす.数百億から数千億のパラメータを持つLLMのサイズが大きいことは、その機能にとって極めて重要である.しかし、この大きなサイズは、高い計算コストとメモリ要件のために、その展開も制限する.LLMのトレーニングに必要なリソースは膨大であり、トレーニングデータ、モデルサイズ、アーキテクチャ、コンピューティングリソース、トレーニング方法などの要素を最適化するための従来の試行錯誤的な方法は、現実的ではなく、リソースを大量に消費する.

Q: LLMの効率を高めるために、アルゴリズムとハードウェアの両面からどのような方法が開発されてきたか?

A: LLMsの効率を向上させるために、アルゴリズムとハードウェアの両方の解決策が開発されています.アルゴリズムの解決策としては、スケーリング法則、データの利用、アーキテクチャの革新、トレーニングとチューニングの戦略、推論技術などがあります.ハードウェアの解決策としては、コンピュータシステムの組織、ソフトウェアのエンジニアリング、計算の理論、応用コンピューティングなどがあります.

Q: この調査は、トレーニングやモデルの圧縮など、特定の分野に焦点を当てた他の調査とどう違うのですか?

A: この調査は、トレーニングやモデルの圧縮など特定の領域に焦点を当てた他の調査とは異なり、LLMの効率性の多面的な側面に深く踏み込んでいます.この調査は、データの利用、アーキテクチャの設計、トレーニングとチューニングの戦略、推論技術など、LLMのエンドツーエンドの開発における効率性の重要な要素を包括的に探求しています.他の調査では、特定の側面に焦点を当てているものがありますが、総合的な視点を提供していないことが多いです.したがって、この調査は、アルゴリズムとソフトウェアの観点からモデル開発のパイプライン全体をカバーし、データの利用、アーキテクチャの設計、トレーニングとチューニングの戦略、推論技術など、LLMの効率性に寄与する要素を包括的に調査しています.

Q: この調査で取り上げられた効率性に関するさまざまなトピックとは?

A: この調査では、効率に関連するさまざまなトピックがカバーされています.具体的には、データの利用、アーキテクチャの設計、トレーニングとチューニングの戦略、推論技術などが含まれています.

Q: スケーリング法則の概念と、それがLLMの効率とどのように関係しているのか説明してもらえますか?

A: スケーリング法は、モデルの性能がモデルのアーキテクチャ、モデルのサイズ、トレーニングに使用する計算能力、利用可能なデータなどの要因にどのように影響を受けるかを示す法則です.スケーリング法は、統計力学的なアプローチに基づいており、モデルの汎化性能を予測するための手法です.スケーリング法は、1990年代初頭からの豊富な歴史を持っており、近年では近代的なディープラーニングモデルの文脈で再び注目されています.スケーリング法は、モデルのサイズとトレーニングデータをどのように最適にバランスさせることで、目的関数の値を最小化することができます.これにより、LLMのトレーニングプロセスの効率と効果を大幅に向上させることができます.

Q: この調査で論じられている建築の革新の例にはどのようなものがありますか?

A: 調査では、アーキテクチャの革新的な設計について詳細な調査が行われ、アーキテクチャが効率にどのように影響を与えるかが明らかにされました.

Q: LLMの効率を向上させるために、調査で検討されたさまざまなトレーニングやチューニング戦略とは?

A: 調査では、LLMの効率性を向上させるためにさまざまなトレーニングとチューニングの戦略が探求されています.具体的には、データの利用、アーキテクチャの設計、トレーニングとチューニングの戦略、推論技術などが総合的に考慮されています.

Q: この調査で議論されている推論技術の概要を教えてください.

A: この調査では、4つのカテゴリに分類される推論技術が議論されています.それらは、剪定(pruning)、知識蒸留(knowledge distillation)、量子化(quantization)、および低ランク分解(low-rank decomposition)です.剪定技術は、ディープニューラルネットワーク(DNNs)の演算子内の冗長性を特定し、排除することに焦点を当てています.これにより、よりコンパクトなモデルが作成されます.

Q: この論文は、この分野の研究者や実務家にとって貴重な資料となることをどのように目指しているのだろうか?

A: この論文は、現在の知識とアプローチの堅固な基盤を提供することで、研究者や実践者にとって貴重なリソースとなることを目指しています.また、LLMの効率性の重要な研究領域において、将来の突破口と持続的なイノベーションのための舞台を設定する役割も果たしています.