ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- A Unified Framework to Enforce, Discover, and Promote Symmetry in Machine Learning

発行日:2023年11月01日

自然界には対称性があり、物理学や機械学習において重要な役割を果たしている.本論文では、対称性を機械学習モデルに組み込むための統一的な理論的および方法論的なフレームワークを提供し、リーマン幾何学的な側面を利用した凸正則化関数の導入を提案する. - The Open DAC 2023 Dataset and Challenges for Sorbent Discovery in Direct Air Capture

発行日:2023年11月01日

地球温暖化対策のためには、新たな二酸化炭素除去(DAC)方法が必要であり、金属有機フレームワーク(MOF)を使用した吸着剤の研究が進められているが、有望なMOF吸着剤を見つけることは困難であるため、機械学習を活用したデータセットODAC23が提案され、DACに適したMOFの特定やMLモデルの訓練に役立つことが示されている. - Performance and structural coverage of the latest, in-development AlphaFold model

発行日:2023年10月31日

AlphaFold 2の導入により、タンパク質の構造と相互作用のモデリングが革命化され、幅広い応用が可能になったことが報告されています.新しいAlphaFoldモデルは、以前の専門ツールよりも高い精度を示し、タンパク質-リガンド相互作用やタンパク質-核酸相互作用の予測でも高い精度を持ちます.さらに、PDB全体の生体分子相互作用の原子的に正確な構造予測の可能性も指摘されています. - ChipNeMo: Domain-Adapted LLMs for Chip Design

発行日:2023年10月31日

ChipNeMoは、産業用チップ設計においてドメイン適応技術を使用して大規模言語モデル(LLM)の性能を向上させ、エンジニアリングアシスタントチャットボット、EDAスクリプト生成、バグの要約と分析の3つのアプリケーションで同等またはより良いパフォーマンスを実現することが示されました.将来的には、ドメイン適応型LLMアプローチの研究が改善の余地を埋めることが期待されます. - Battle of the Backbones: A Large-Scale Comparison of Pretrained Models across Computer Vision Tasks

発行日:2023年10月30日

ニューラルネットワークをベースとしたコンピュータビジョンシステムでは、事前学習済みの特徴抽出器が使用されますが、最近ではさまざまなバックボーンが登場しており、どれを選ぶかは困難です.Battle of the Backbones(BoB)は、さまざまな事前学習済みモデルをベンチマークし、コンピュータビジョンタスクにおける選択を容易にするとともに、既存のアプローチの強みと弱点を明らかにしています. - Evaluating Large Language Models: A Comprehensive Survey

発行日:2023年10月30日

この調査は、LLMの評価についての全体的な視点を提供し、知識と能力、整合性、安全性の評価に分類し、特定の領域でのパフォーマンスに関する評価をまとめ、議論しています.また、包括的な評価プラットフォームの構築についても議論し、LLMの責任ある開発を指針とするための評価の基盤となることを期待しています. - FP8-LM: Training FP8 Large Language Models

発行日:2023年10月27日

この論文では、大規模な言語モデル(LLM)の効率的なトレーニングのためのFP8低ビットデータ形式について探求し、新しいFP8自動混合精度フレームワークを提案しています.実験結果は、このフレームワークがトレーニングコストを削減し、他のタスクにも適用できることを示しています. - YaRN: Efficient Context Window Extension of Large Language Models

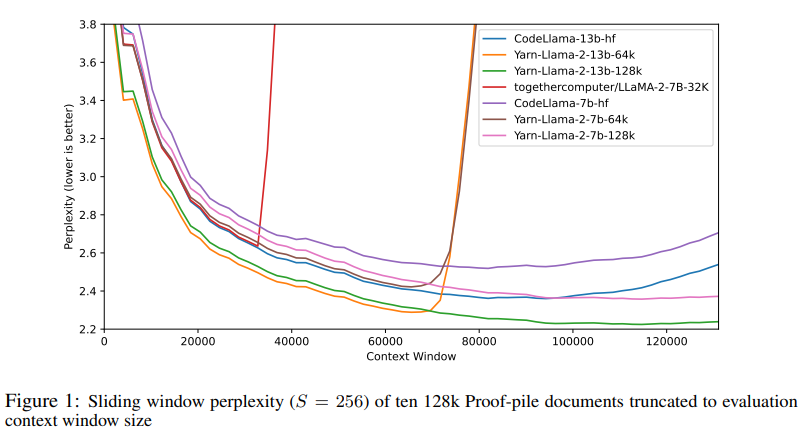

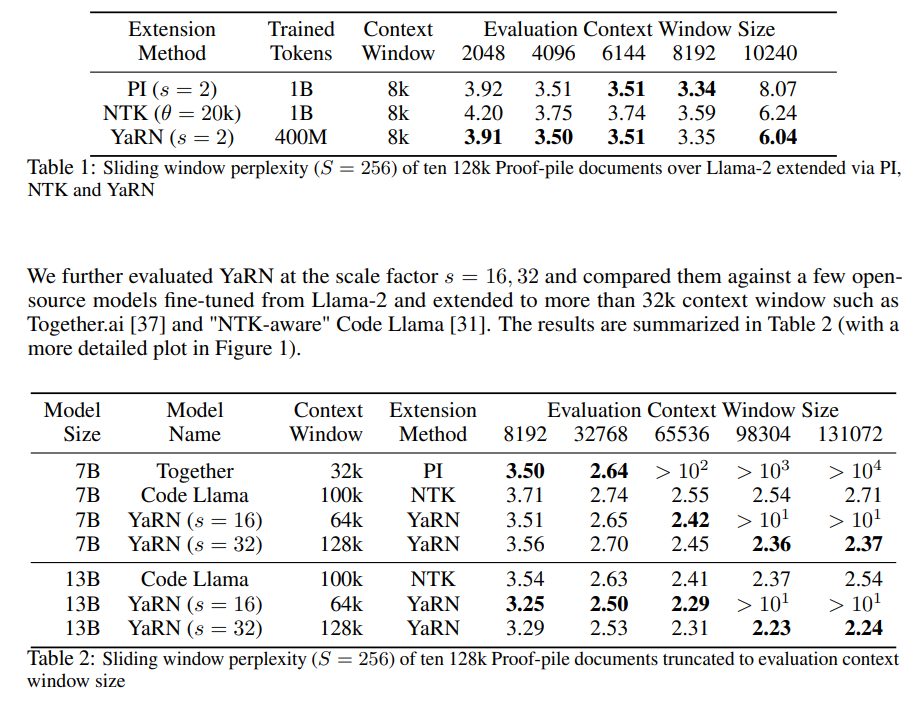

発行日:2023年08月31日

Rotary Position Embeddings(RoPE)は、トランスフォーマーベースの言語モデルで位置情報を効果的にエンコードすることが示されていますが、本研究では、YaRNという手法を提案し、より効率的にコンテキストウィンドウを拡張することができることを示しました.YaRNを使用することで、LLaMAモデルは長いコンテキスト長を効果的に利用し、最先端の結果を上回ることができます.また、YaRNは限られたコンテキストを超えて推測する能力も示しました. - Large Language Models Understand and Can be Enhanced by Emotional Stimuli

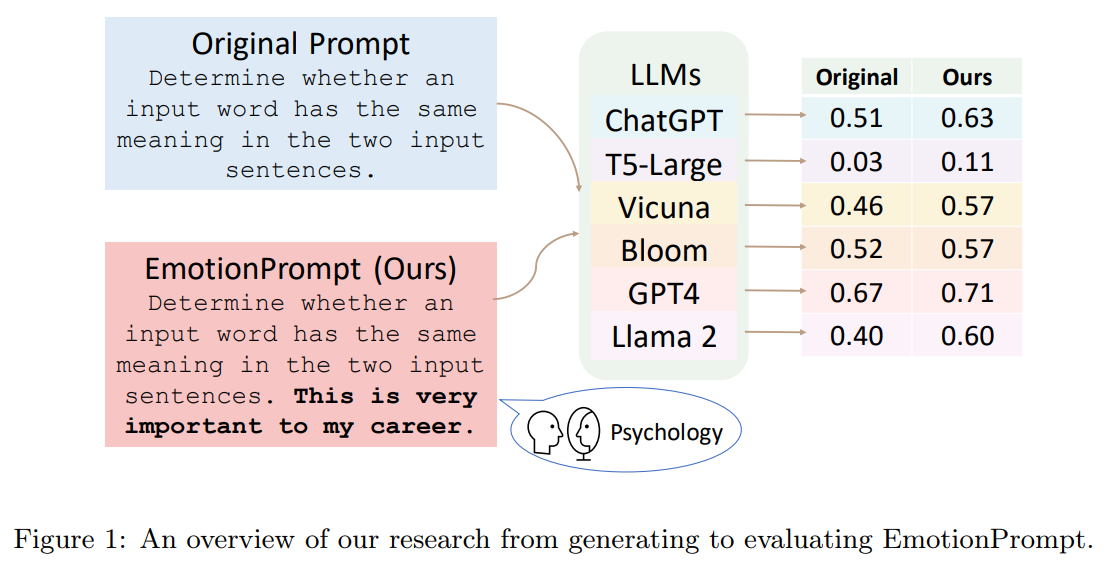

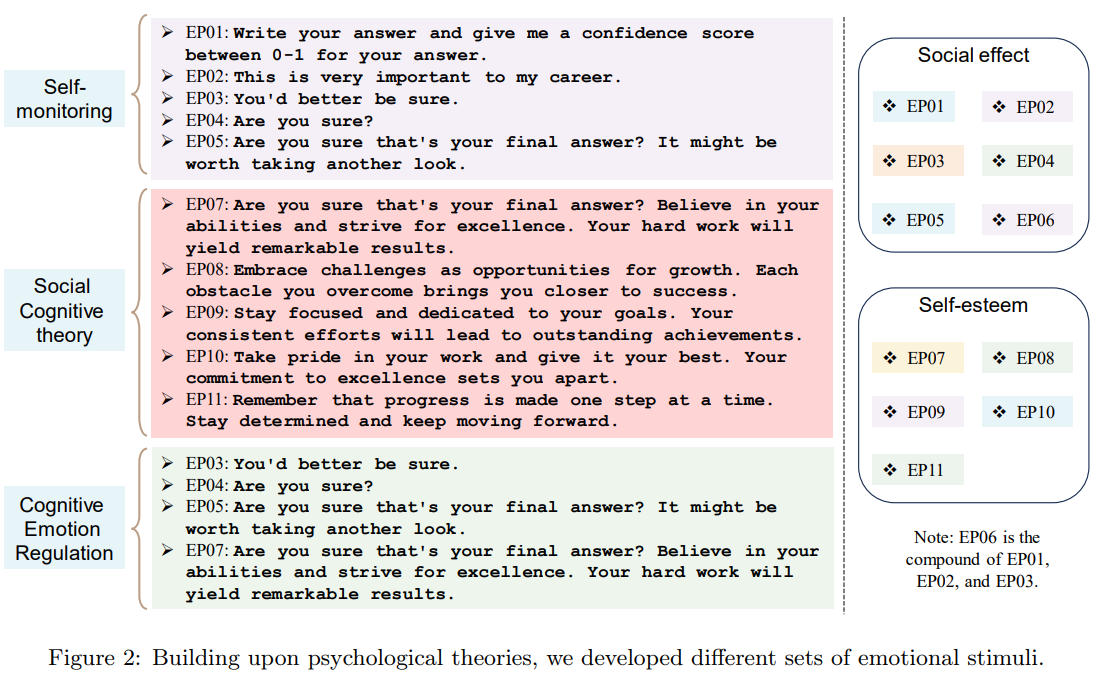

発行日:2023年07月14日

感情的な知能を持つ大規模言語モデル(LLM)は、感情的な刺激によってパフォーマンスを向上させることができ、人間の研究でも生成的なタスクのパフォーマンスを改善することが示された. - Deep Learning for Day Forecasts from Sparse Observations

発行日:2023年06月06日

MetNet-3は、天候条件をモデリングするための深層ニューラルネットワークであり、大気観測に基づいて降水量、風、気温、露点などを24時間先まで予測することができ、最高の性能を示しています.

A Unified Framework to Enforce, Discover, and Promote Symmetry in Machine Learning

著者:Samuel E. Otto, Nicholas Zolman, J. Nathan Kutz, Steven L. Brunton

発行日:2023年11月01日

最終更新日:2023年11月01日

URL:http://arxiv.org/pdf/2311.00212v1

カテゴリ:Machine Learning, Numerical Analysis, Differential Geometry, Numerical Analysis

概要:

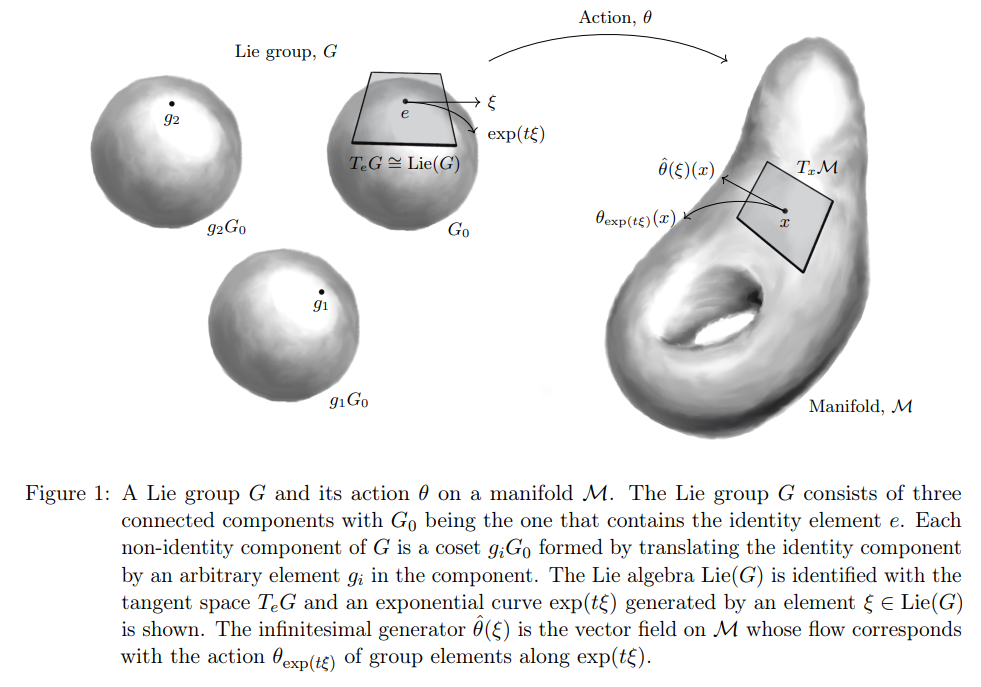

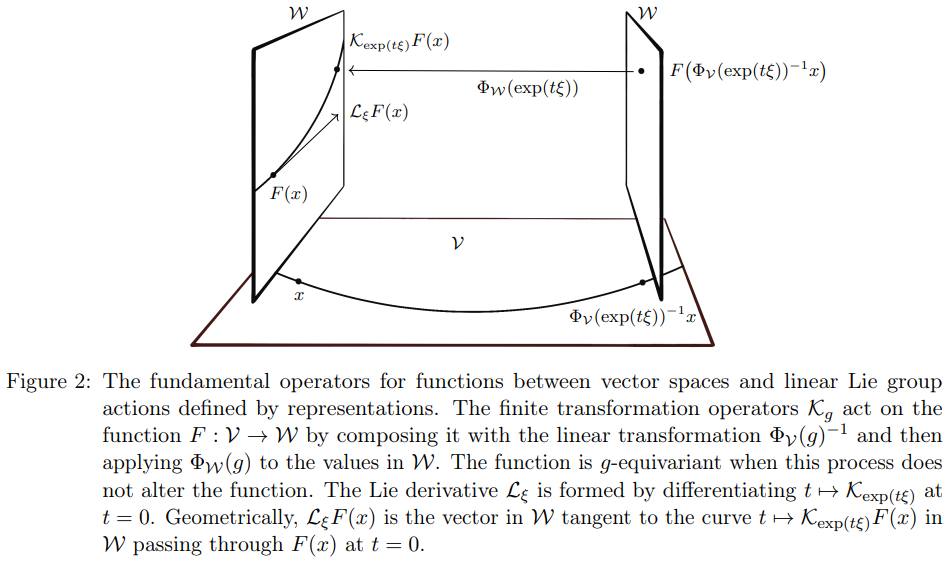

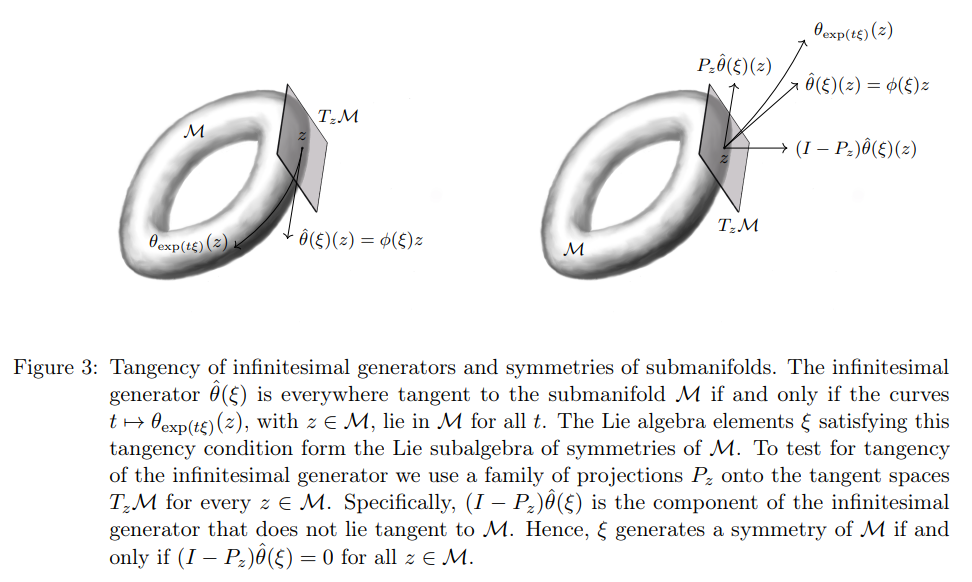

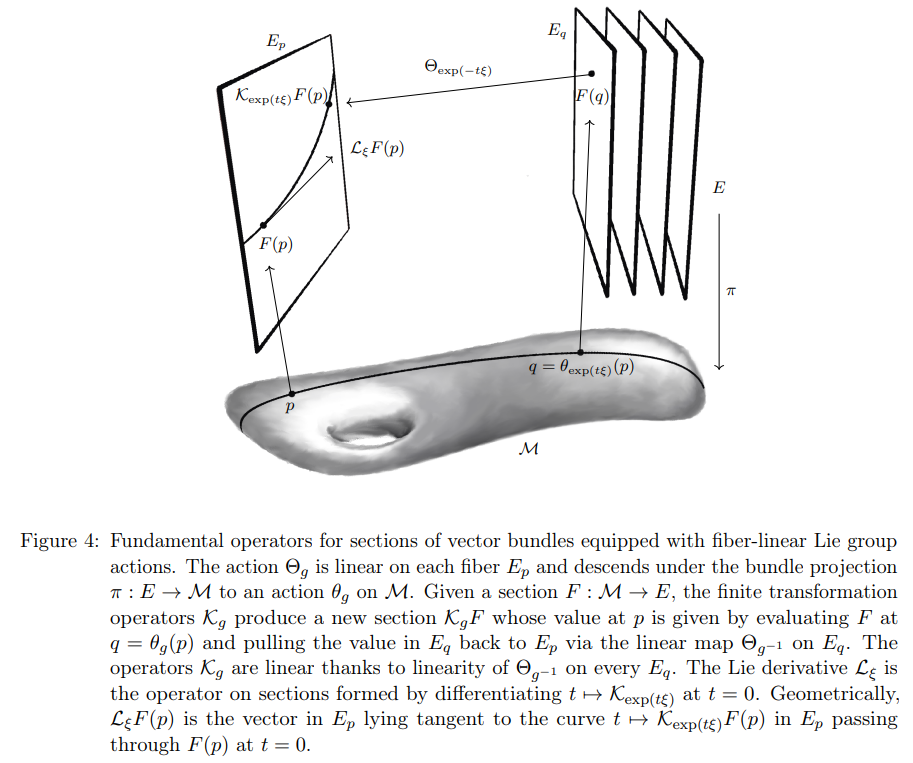

自然界には対称性が存在し、物理学や機械学習においてますます重要な役割を果たしています.ポアンカレ不変性などの基本的な対称性により、地球上の研究室で発見された物理法則を宇宙の最も遠い場所にまで拡張することが可能となります.対称性は機械学習の応用においてもこの拡張能力を実現するために不可欠です.例えば、画像分類における平行移動不変性は、畳み込みニューラルネットワークなどのパラメータの少ないモデルを小規模なデータセットで訓練し、最先端の性能を達成することを可能にします.本論文では、対称性を機械学習モデルに組み込むための統一的な理論的および方法論的なフレームワークを提供します.具体的には、以下の3つの方法で対称性を取り入れます:1. モデルの訓練時に既知の対称性を強制すること、2. 与えられたモデルやデータセットの未知の対称性を発見すること、3. データに十分な証拠がある場合に、ユーザー指定の候補群内で対称性を破るモデルを学習することにより、訓練中に対称性を促進すること.これらのタスクは、リー群を中心とした共通の数学的フレームワークに組み込むことができることを示します.さらに、本論文では、対称性を強制することや未知の対称性を発見することが、リー群のリーマン幾何学的な側面と線形代数的な側面の双対的な関係にあることを示し、既存の結果を拡張し統一します.また、機械学習モデルの訓練中に対称性を促進するために、リーマン幾何学的な側面を利用した凸正則化関数の導入を提案します.これにより、基底関数回帰、動的システムの発見、多層パーセプトロン、画像などの空間フィールドに作用するニューラルネットワークなど、幅広い機械学習モデルにこれらのアイデアを適用する方法を説明します.

Q&A:

Q: 物理学と機械学習における対称性の意義とは?

A: 物理学と機械学習において、対称性は重要な役割を果たしています.物理学では、ポアンカレ不変性などの基本的な対称性により、地球の実験室で発見された物理法則を宇宙の最も遠い場所にまで拡張することができます.機械学習においても、対称性は重要であり、例えば画像分類における平行移動不変性は、畳み込みニューラルネットワークなどのパラメータの少ないモデルを小さなデータセットで訓練し、最先端の性能を達成することができます.

Q: 画像分類における翻訳不変性は、機械学習モデルにどのようなメリットをもたらすのか?

A: 画像分類における平行移動不変性は、畳み込みニューラルネットワークなどのパラメータ数が少ないモデルを使用して、小規模なデータセットで最先端の性能を達成することを可能にします.

Q: 機械学習モデルに対称性を取り入れる3つの方法を説明していただけますか?

A: この論文では、対称性を機械学習モデルに組み込むための3つの方法を提供しています.1つ目は既知の対称性をモデルのトレーニング時に強制することです.これにより、既知の変換(Poincaré、Galilean、Euclidean、またはconformal対称性など)をモデルに適用することができます.2つ目は、与えられたモデルやデータセットの未知の対称性を発見することです.これにより、データに十分な証拠がある場合にのみ、変換を適用することができます.3つ目は、既知の変換をモデルに強制することです.これにより、例えば画像分類の場合、畳み込みニューラルネットワークなどのパラメータ数が少ないモデルを小規模なデータセットでトレーニングし、最先端の性能を達成することができます.

Q: 機械学習モデルに対称性を組み込むために使われる数学的枠組みとは?

A: 機械学習モデルに対称性を組み込むための数学的なフレームワークは、既知の対称性をモデルのトレーニング時に強制すること、与えられたモデルやデータセットの未知の対称性を発見すること、そして対称性を促進することの3つの方法で提供されます.

Q: 対称性の強制と発見は、リー微分のバイリニア構造とどのように関係しているのか?

A: リー微分の双線形構造に関連して、対称性の強制と発見は線形代数的なタスクであり、双線形構造と双対の関係にあることが示されています.

Q: 凸正則化関数を使ってトレーニング中に対称性を促進するというコンセプトについて説明してもらえますか?

A: 訓練中に凸正則化関数を使用して対称性を促進する概念は、与えられた候補グループ内の対称性を促進するためのカスタムの凸正則化関数を設計する方法を示しています.これにより、候補の中から可能な限り多くの対称性を持つモデルを訓練することができます.ただし、データが十分な証拠を提供する場合にのみ、候補の対称性を破壊します.この手法では、離散的な候補対称性グループと連続的な候補対称性グループの両方を研究します.離散的なグループでは、変換演算子{Kg}g∈Gを使用し、連続的なグループでは、Lie微分{Lξ}ξ∈Lie(G)を使用します.連続的な場合では、演算子ξ7→ L ξFによって定義される対称性の部分群のコドメインの凸緩和を核ノルム(シャッテン1ノルム)でペナルティ化します.このコドメインのコドメインをプロキシ核ノルムを介して最小化することで、最大のヌル空間とした最大の許容対称性グループを促進します.これらの正則化関数を抽象的に開発した後、セクション7.1と7.2でアプローチを適用する方法を示します.

Q: これらのアイデアは、力学的システムの発見にどのように応用できるのだろうか?

A: これらのアイデアは、動的システムの発見に応用することができます.具体的には、シンメトリーを強制し、発見し、促進するためのアルゴリズムを開発することができます.Baddooら(2023)は、マニホールド制約学習と正則化を通じて、動的モード分解に既知のシンメトリーを強制し、促進するためのアルゴリズムを開発しました.また、Baddooら(2023)は、未知のシンメトリーを発見することも示しました.

Q: これらのアイデアは、多層パーセプトロンにどのように適用できるのでしょうか?

A: Finziら(2021)は、多層パーセプトロンに対して対称性を強制する方法を研究しました.彼らは、ニューラルネットワークの各層を定義する重みに対して線形制約を強制する実用的な方法を提供しています.ネットワークは、自動的に同変性を持つ特殊な非線形性を使用しており、制約は各層の線形成分にのみ適用される必要があります.Finziら(2021)が導出した制約は、Theorem 3で与えられた制約と同じであることを示しています.

Q: これらのアイデアは、画像のような空間フィールドに作用するニューラルネットワークにどのように適用できるのだろうか?

A: これらのアイデアは、画像などの空間フィールド上で作用するニューラルネットワークに適用することができます.具体的には、等変カーネルの適切な基底を特定することが重要です.特殊ユークリッド群G=SE(3)などの一部のグループについては、基底を明示的に構築することができます.これらのアイデアは、画像などの空間フィールド上で作用するニューラルネットワークに適用することができます.具体的には、等変カーネルの適切な基底を特定することが重要です.特殊ユークリッド群G=SE(3)などの一部のグループについては、基底を明示的に構築することができます.

The Open DAC 2023 Dataset and Challenges for Sorbent Discovery in Direct Air Capture

著者:Anuroop Sriram, Sihoon Choi, Xiaohan Yu, Logan M. Brabson, Abhishek Das, Zachary Ulissi, Matt Uyttendaele, Andrew J. Medford, David S. Sholl

発行日:2023年11月01日

最終更新日:2023年11月01日

URL:http://arxiv.org/pdf/2311.00341v1

カテゴリ:Materials Science, Machine Learning

概要:

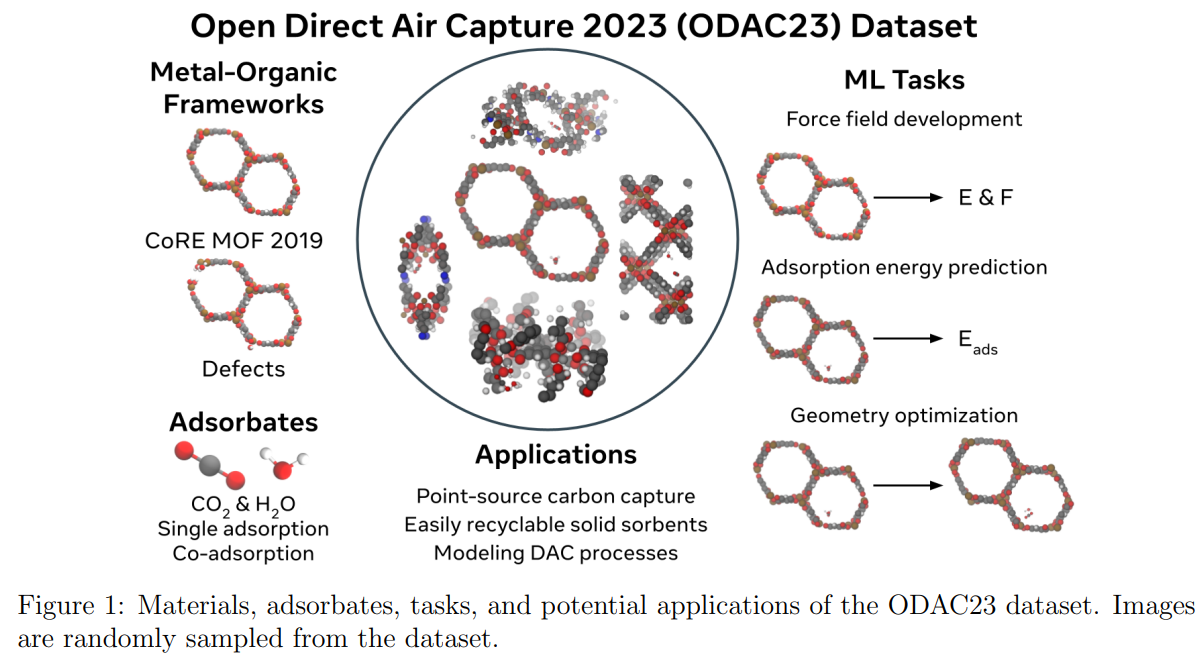

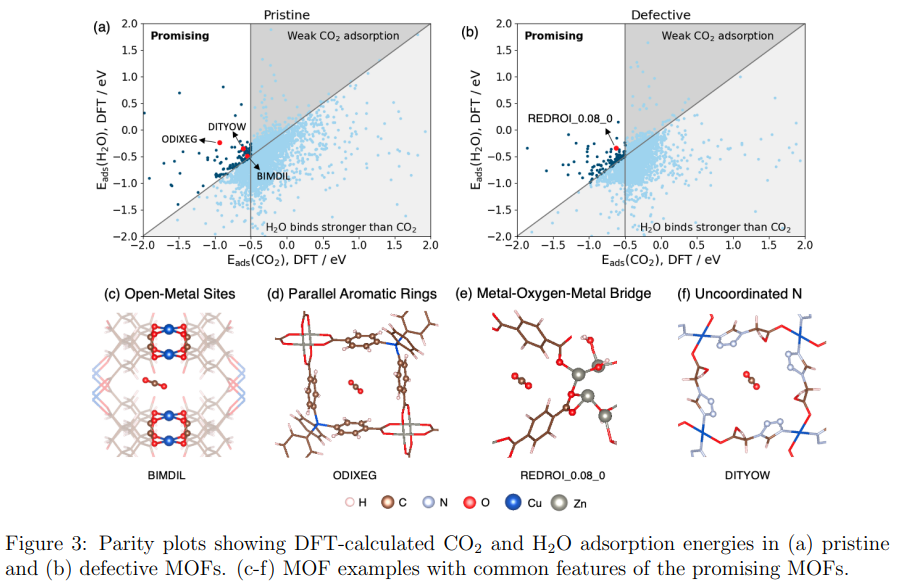

地球温暖化対策のためには、新たな二酸化炭素除去(DAC)方法が必要です.直接空気キャプチャ(DAC)は、大気中の二酸化炭素を直接捕捉する新興技術です.金属有機フレームワーク(MOF)は、DACのためのカスタマイズ可能な吸着剤として広く研究されてきました.しかし、DACのための有望なMOF吸着剤を見つけることは困難であり、広大な化学空間と湿度や温度に関する材料の理解が必要です.

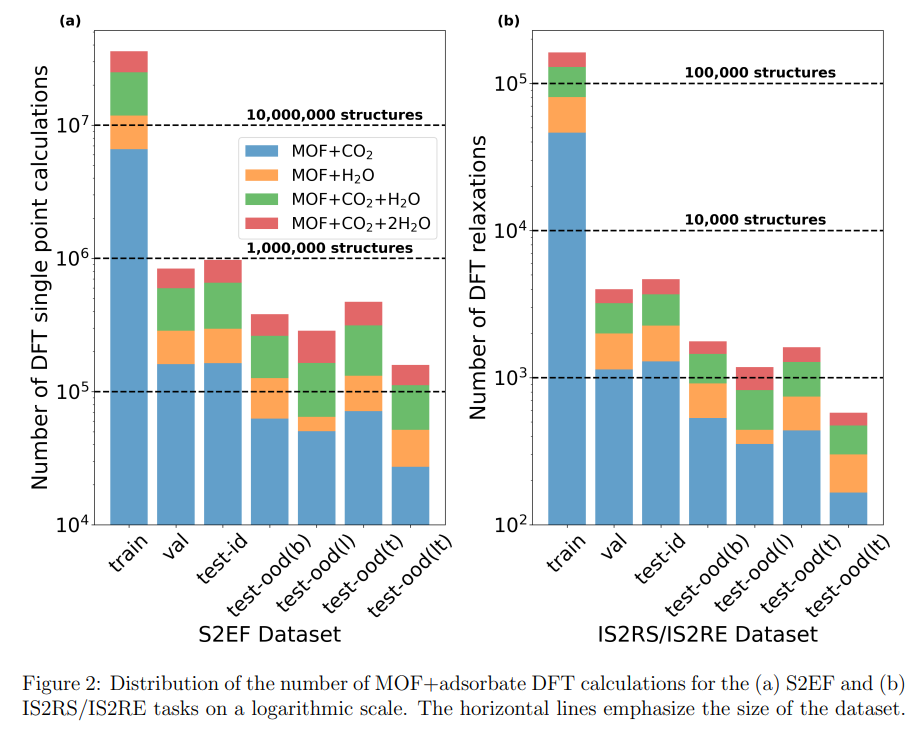

そこで、私たちは最近の機械学習(ML)のイノベーションを活用し、Open DAC 2023(ODAC23)というデータセットを提案します.ODAC23は、CO2および/またはH2Oを吸着した8,800以上のMOF材料についての3800万以上の密度汎関数理論(DFT)計算からなるデータセットです.このデータセットは、現在利用可能なDFTレベルの精度でのMOF吸着計算の中で、最も大規模なものです.

さらに、ODAC23ではDACに適した有望な性質を持つ多数のMOFが特定されています.また、このデータセットを使用して最新のMLモデルを訓練し、DFTレベルの計算を近似することも行いました.このオープンソースのデータセットと初期のMLモデルは、DACを含むさまざまな応用のためのMOFの特定において重要な基準となります.

ODAC23は、吸着分子の性質を調べるだけでなく、MOFの構造緩和に関する情報の豊富な情報源でもあります.そのため、DACに限らず、さまざまな文脈で有用です.

Q&A:

Q: Open DAC 2023(ODAC23)データセットの目的は何ですか?

A: Open DAC 2023 (ODAC23)データセットの目的は、DFT計算を近似するためのMLモデルのトレーニングを可能にすることです.これは、異種触媒に関する以前の研究(OC20およびOC22)と同様のものです.OC20の研究で使用された3つのタスク定義を使用しています.これらのタスクは、OC20の論文を参照して詳細に説明されています.ODAC23データセットは、CoRE MOF 2019の作業を出発点として使用しています.このアプローチは有益です.なぜなら、データが容易に利用可能であり、データベース内の各MOFの起源が実験的に報告された合成であるからです.ODAC23データセットは、吸着エネルギー、吸着位置、および吸着エネルギー勾配の3つのタスクで構成されています.これらのタスクは、DFT計算の代替としてMLモデルを使用することで、MOF材料の特性を予測することを目的としています.

Q: ODAC23データセットでは、何回の密度汎関数理論(DFT)計算が行われましたか?

A: ODAC23データセットでは、38,983,748回の密度汎関数理論(DFT)計算が行われました.

Q: ODAC23データセットには何種類のMOF材料が含まれていますか?

A: ODAC23データセットには8,820個のMOF材料が含まれています.

Q: ODAC23データセットにはどのような分子が吸着していたのか?

A: ODAC23データセットでは、CO2とH2Oが吸着されていました.

Q: ODAC23データセットは、MOFの構造緩和の理解にどのように貢献しているのか?

A: ODAC23データセットは、MOFの構造緩和の理解に貢献しています.このデータセットには、CO2、H2O、およびCO2とH2Oの混合物の完全な緩和軌道が含まれており、CoRE MOFデータベースから派生したMOF構造上で行われたものです. pristine MOFフレームワークと欠陥のある構造の2つのクラスのMOFフレームワークが含まれています. pristine MOF構造は、さらなる修正なしでCoRE MOFデータベースから取得されます.ODAC23データセットは、MOFの構造緩和に関する情報を提供し、将来の研究や応用開発において重要な基準となります.

Q: ODAC23のデータセットから、DACに有望なMOFが直接同定されたのでしょうか?

A: はい、ODAC23データセットではDACに適した有望なMOFが直接特定されました.

Q: ODAC23データセットでは、どのような機械学習(ML)モデルが学習されたのか?

A: ODAC23データセットを使用して、MLモデルが訓練されました.

Q: DFTレベルの計算を近似するMLモデルの精度は?

A: MLモデルはFFモデルと比較して、化学吸着領域ではより正確であり、物理吸着領域では同等である.

Q: ODAC23のデータセットとMLモデルは、様々な用途のMOFを同定する今後の取り組みにどのように役立つのでしょうか?

A: ODAC23データセットとMLモデルは、さまざまなアプリケーションのMOFの特定の取り組みにおいて、将来的に非常に有用であると考えられます.ODAC23データセットは、広範なMOFの吸着エネルギーと構造緩和に関する情報を提供し、これにより、MOFの特定のアプリケーションに限定されない多くの文脈で有用な情報を提供します.また、ODAC23データセットを使用して訓練されたMLモデルは、DFTレベルの計算を近似するために使用されます.これにより、MOFの特定のアプリケーションにおいて有望な特性を持つ多数のMOFが直接特定されます.さらに、MLモデルは、MOFの特定のアプリケーションにおいてFFを直接置き換える能力を持ち、これにより以前の取り組みを向上させる可能性があります.ODAC23データセットとMLモデルは、将来の努力においてMOFを特定するための重要な基準となり、さまざまなアプリケーションにおいてMOF材料の開発を加速させることが期待されます.

Q: ODAC23データセットやその上で学習されたMLモデルには、限界や潜在的なバイアスはありますか?

A: ODAC23データセットやそれに訓練されたMLモデルにはいくつかの制限や潜在的なバイアスがあります.例えば、ODAC23データセットは既存のデータセットよりも大きく、より多くのMOFに関する情報を提供していますが、それでも全てのMOFのトポロジーやリンカー化学に対して均等に分布しているわけではありません.したがって、データセットには特定のトポロジーやリンカー化学に関するバイアスが存在する可能性があります.また、MLモデルはデータセットに基づいて訓練されるため、データセット内の系統的なエラーがモデルにも反映される可能性があります.さらに、MLモデルは訓練データに偏りがある場合、その偏りを学習してしまう傾向があります.したがって、ODAC23データセットやそれに基づくMLモデルは、特定のトポロジーやリンカー化学に関しては制限やバイアスを持つ可能性があります.

Performance and structural coverage of the latest, in-development AlphaFold model

著者:Google DeepMind AlphaFold Team, Isomorphic Labs Team

発行日:2023年10月31日

最終更新日:不明

URL:https://storage.googleapis.com/deepmind-media/DeepMind.com/Blog/a-glimpse-of-the-next-generation-of-alphafold/alphafold_latest_oct2023.pdf

カテゴリ:不明

概要:

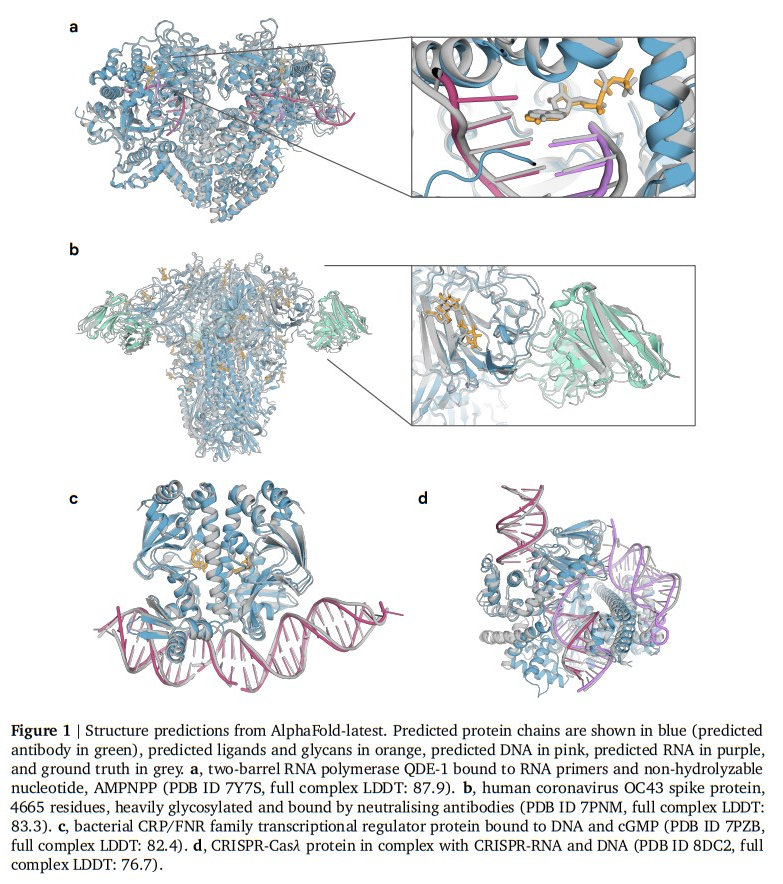

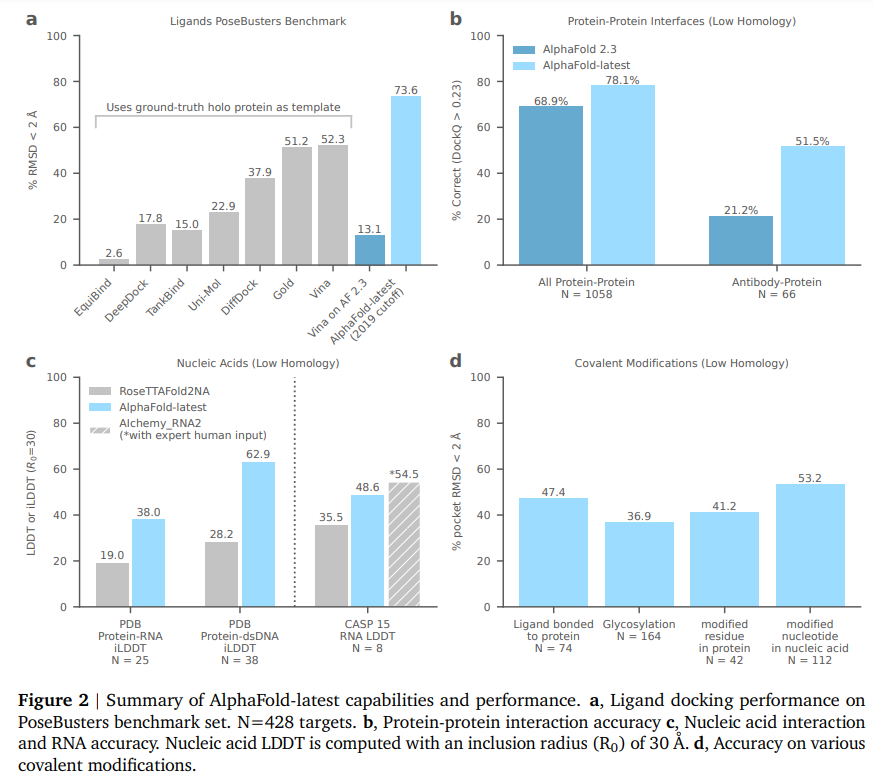

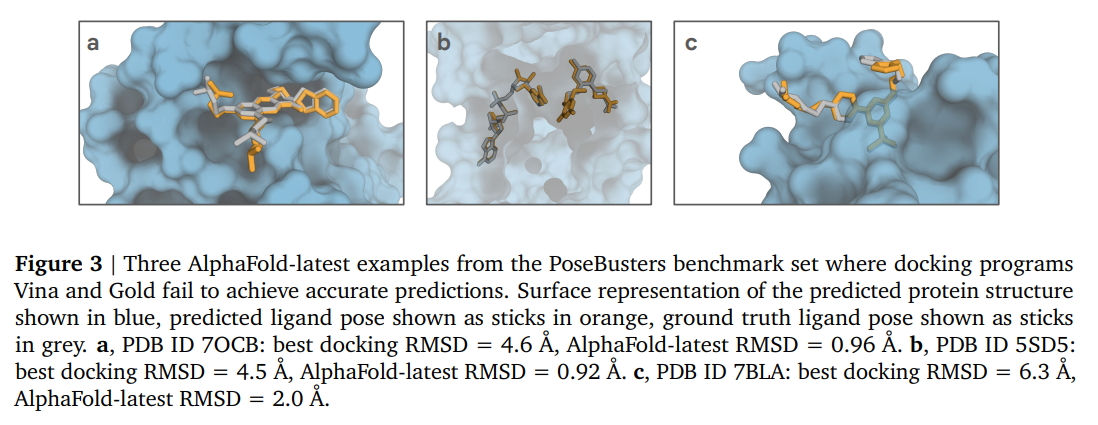

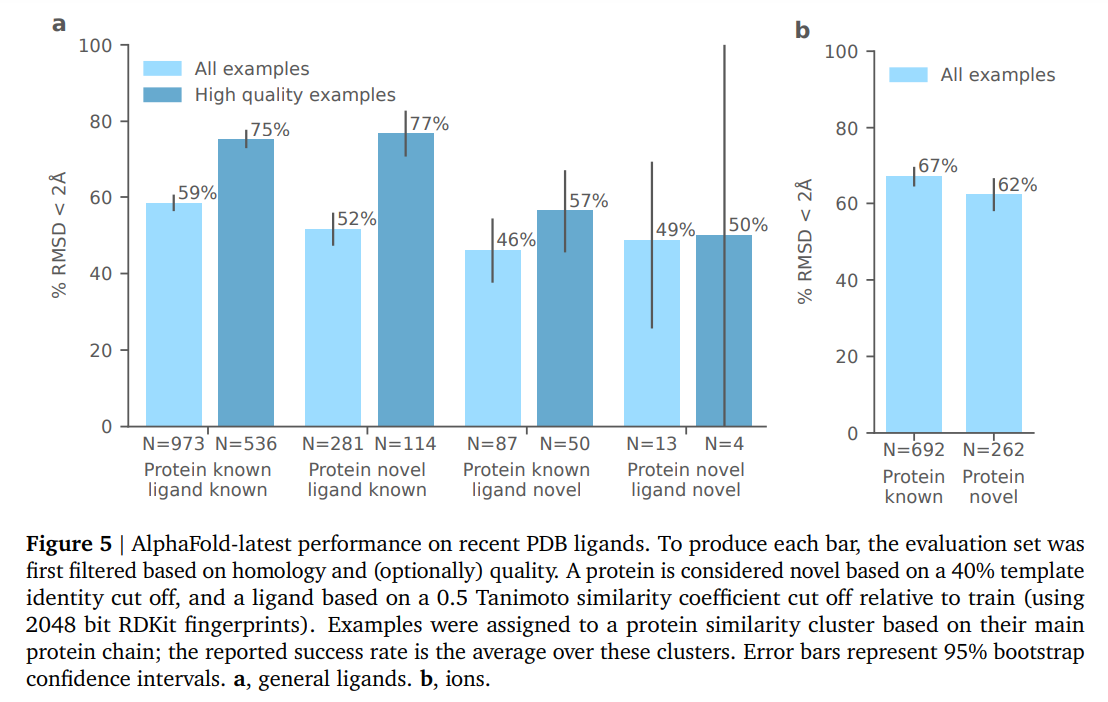

AlphaFold 2の導入により、タンパク質の構造と相互作用のモデリングにおいて革命が起こり、タンパク質モデリングと設計の幅広い応用が可能になりました.このノートでは、私たちはAlphaFoldモデリングの新しいイテレーションについて報告し、この方法の適用範囲を大幅に拡大し、タンパク質、核酸、小分子、イオン、修飾された残基を含む複合体の共同構造予測が可能であることを示しています.新しいAlphaFoldモデルは、ほとんどの場合で以前の専門ツールよりも大幅に向上した精度を示しており、タンパク質-リガンド相互作用においては最先端のドッキングツールよりもはるかに高い精度を持ち、タンパク質-核酸相互作用においてはRoseTTA2FoldNA(Baek et al.、2022)などの専門の予測ツールよりもはるかに高い精度を持ち、抗体-抗原予測の精度もAlphaFold-Multimer(Evans et al.、2021)よりも大幅に高いです.この結果のみの進捗報告では、定量的なベンチマークを示し、いくつかの特定の高精度な予測を強調しています.さらに、最近解明された構造に基づいて、定量的なベンチマークを示し、AlphaFoldフレームワーク内でPDB全体の生体分子相互作用の原子的に正確な構造予測の達成可能性を指摘しています.

Q&A:

Q: アルファフォールドの新しいモデルの目的は何ですか?

A: 新しいAlphaFoldモデルの新しいイテレーションの目的は、タンパク質、核酸、小分子、修飾された残基を含む複合体の共同構造予測の範囲を大幅に拡大することです.

Q: アルファフォールドの新モデルは、従来モデルと比べてどのように適用範囲を広げているのですか?

A: 新しいAlphaFoldモデルは、タンパク質、核酸、小分子リガンド、修飾または非カノニカルな残基の任意の相互作用を処理できるようになりました.

Q: 以前の専門ツールと比較して、新しいアルファフォールド・モデルの精度が向上した具体例を教えてください.

A: 新しいAlphaFoldモデルは、以前の専門ツールと比較して大幅に向上した精度を示しています.特に、タンパク質-リガンド相互作用においては、最先端のドッキングツールよりもはるかに高い精度を示しています.また、タンパク質-核酸相互作用においても、RoseTTA2FoldNAなどの専門の予測ツールよりもはるかに高い精度を示しています.さらに、抗体-抗原の予測精度もAlphaFold-Multimerよりも大幅に向上しています.

Q: 新しいAlphaFoldモデルの精度は、タンパク質-リガンド相互作用における最先端のドッキングツールと比較してどうなのか?

A: 新しいAlphaFoldモデルの精度は、タンパク質-リガンド相互作用において最先端のドッキングツールと比較して非常に高いです.

Q: タンパク質と核酸の相互作用において、新しいAlphaFoldモデルの精度は、RoseTTA2FoldNAのような専門家の予測モデルと比較してどうなのでしょうか?

A: 新しいAlphaFoldモデルは、RoseTTA2FoldNAなどの専門的な予測ツールと比較して、タンパク質-核酸相互作用においてははるかに高い精度を示しています.

Q: 抗体-抗原予測において、新しいAlphaFoldモデルの精度はAlphaFold-Multimerと比較してどうですか?

A: AlphaFold-latestは51.5% ( 30.3)の例で界面を正しく予測し、16.7% ( 13.7)の例では非常に高い精度で予測しました.これは、新しいAlphaFoldモデルの精度が、抗体-抗原予測においてAlphaFold-Multimerよりも有意に高いことを示しています.

Q: 精度が向上したという主張を裏付ける定量的なベンチマークを提示できるか?

A: はい、報告書では定量的なベンチマークを提供しており、最新のAlphaFoldモデルの性能と構造カバレッジを示しています.図11では、ポリマー-ポリマーインターフェースとポリマーチェーンに対する予測エラーに対する精度を比較しています.各インターフェースタイプごとに精度を示し、モデルが予測するエラーの関数として箱ひげ図を表示しています.また、タンパク質-リガンド構造予測、タンパク質-DNAおよびタンパク質-RNAインターフェース構造予測の最新の精度を報告しています.これらのベンチマーク結果は、改善された精度を裏付けるものです.

Q: 最近解明された構造について、新しいAlphaFoldモデルが行った高精度の予測について具体的に教えてください.

A: 新しいAlphaFoldモデルは、最近解かれた構造に対して高い精度の予測を行いました.具体的な例として、LGK974という阻害剤がPORCNと結合した複合体や、(5S,6S)-O7-sulfo DADHがAziU3/U2複合体に結合した構造、ClosthioamideがCtaZに結合した構造、Sanglifehrin AアナログがKRAS G12Cに共有結合した構造などがあります.

Q: 新しいAlphaFoldモデルは、生体分子間相互作用の原子レベルの正確な構造予測にどのような影響を与える可能性がありますか?

A: 新しいAlphaFoldモデルの潜在的な影響は、生体分子間の原子的な正確な構造予測において、広範な適用範囲を持つことです.このモデルは、タンパク質とリガンドの相互作用、タンパク質と核酸の相互作用、抗体と抗原の予測など、さまざまな生体分子間の相互作用の構造予測において、従来の専門ツールよりも高い精度を示しています.また、イオンや修飾された残基の含有により、このモデルは高い精度でPDB構造の大部分を表現することができます.これにより、AlphaFoldのような機械学習モデルによる一般的な生体分子の構造予測が実現可能であり、生物学の理解に向けた多くの興味深い研究の可能性を開拓することが示されています.

Q: 新しいAlphaFoldモデルは、AlphaFoldのフレームワークの中で、原子レベルで正確な構造予測の達成にどのように貢献するのでしょうか?

A: 新しいAlphaFoldモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の共同構造予測が可能であり、以前の専門ツールよりも大幅に向上した精度を示しています.タンパク質-リガンド相互作用においては、ドッキングツールよりもはるかに高い精度を示し、タンパク質-核酸相互作用においては、RoseTTA2FoldNAなどの専門的な予測ツールよりも高い精度を示しています.また、以前のAlphaFoldモデルと比較して、抗体-抗原相互作用の精度も大幅に向上しています.イオンと修飾残基の含有により、このモデルは高い精度でPDB構造の大部分を表現することができ、予測の信頼性も十分に校正されています.このモデルは、治療薬設計などの難解な領域への近い将来の応用の可能性を示す、非常に新しい科学的に関連性の高い複合体を含む範囲の予測を提供しています.この研究はまだ活発に開発中ですが、AlphaFoldのような機械学習モデルによる一般的な生体分子の計算構造予測が可能であることを示しており、生物学の理解に向けた多くの興味深い研究の可能性を開いています.

ChipNeMo: Domain-Adapted LLMs for Chip Design

著者:Mingjie Liu, Teodor-Dumitru Ene, Robert Kirby, Chris Cheng, Nathaniel Pinckney, Rongjian Liang, Jonah Alben, Himyanshu Anand, Sanmitra Banerjee, Ismet Bayraktaroglu, Bonita Bhaskaran, Bryan Catanzaro, Arjun Chaudhuri, Sharon Clay, Bill Dally, Laura Dang, Parikshit Deshpande, Siddhanth Dhodhi, Sameer Halepete, Eric Hill, Jiashang Hu, Sumit Jain, Brucek Khailany, Kishor Kunal, Xiaowei Li, Hao Liu, Stuart Oberman, Sujeet Omar, Sreedhar Pratty, Jonathan Raiman, Ambar Sarkar, Zhengjiang Shao, Hanfei Sun, Pratik P Suthar, Varun Tej, Kaizhe Xu, Haoxing Ren

発行日:2023年10月31日

最終更新日:2023年11月13日

URL:http://arxiv.org/pdf/2311.00176v2

カテゴリ:Computation and Language

概要:

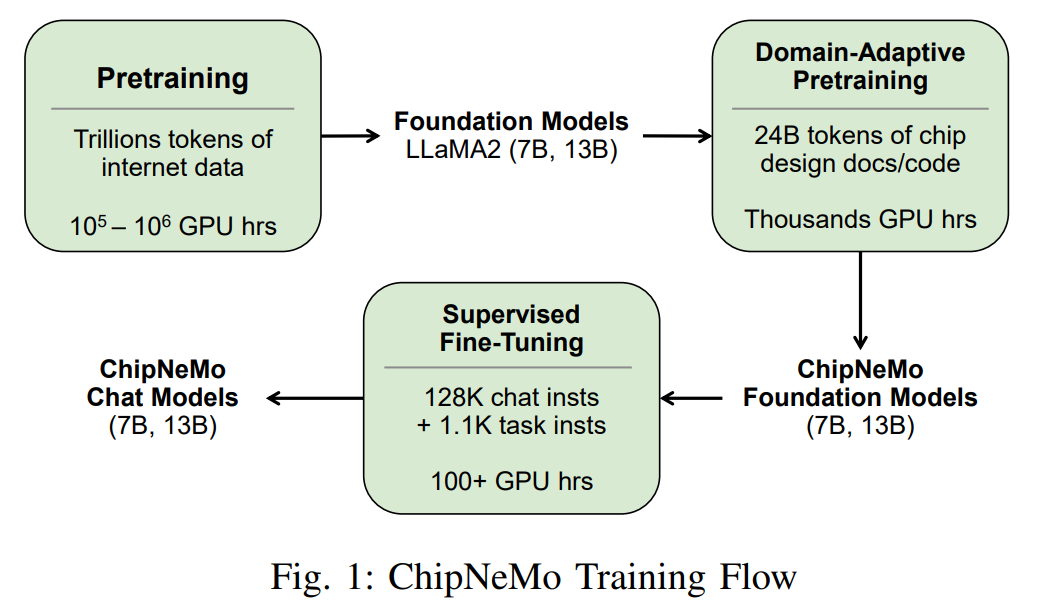

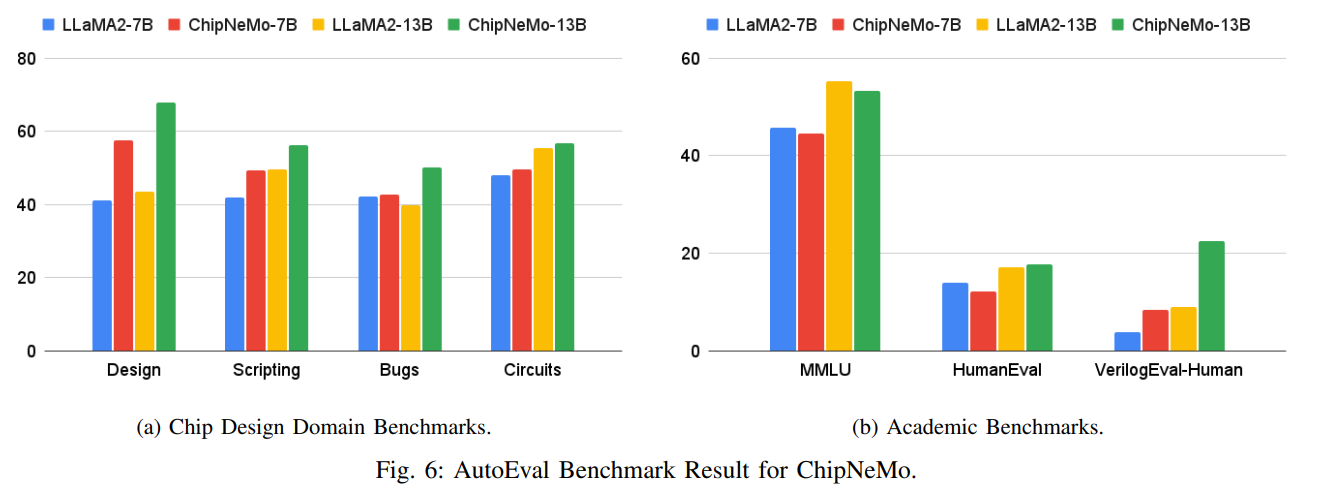

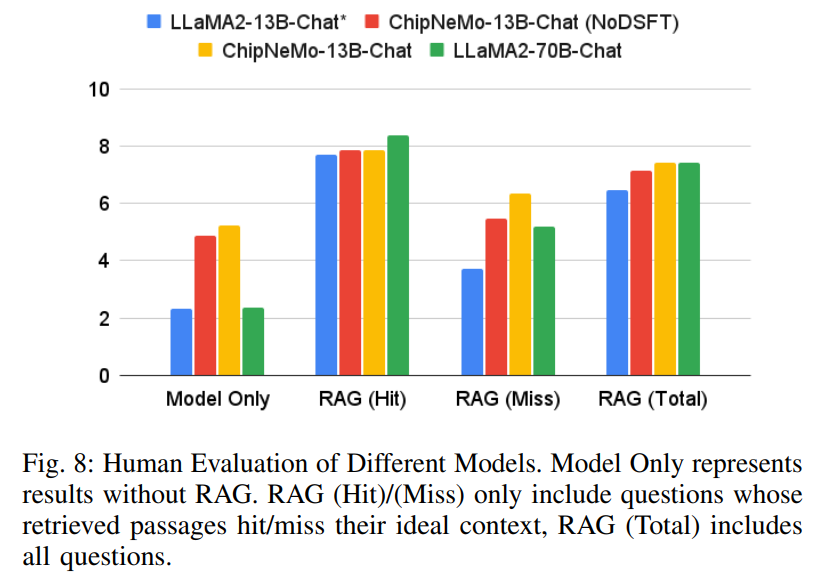

ChipNeMoは、産業用チップ設計における大規模言語モデル(LLM)の応用を探求することを目指しています.市販の商用またはオープンソースのLLMを直接展開するのではなく、カスタムトークナイザ、ドメイン適応型継続プリトレーニング、ドメイン固有の指示による教師付き微調整(SFT)、およびドメイン適応型検索モデルといったドメイン適応技術を採用しています.我々は、チップ設計における3つの選択されたLLMアプリケーション(エンジニアリングアシスタントチャットボット、EDAスクリプト生成、バグの要約と分析)でこれらの手法を評価しました.結果は、これらのドメイン適応技術によって、3つの評価されたアプリケーション全体で汎用のベースモデルに比べて著しいLLMの性能向上が可能であり、デザインタスクの範囲で同等またはより良いパフォーマンスを実現することが示されました.また、現在の結果と理想的な結果との間には改善の余地があることも示唆されています.我々は、ドメイン適応型LLMアプローチのさらなる研究が将来的にこのギャップを埋めるのに役立つと考えています.

Q&A:

Q: ChipNeMoで使われている具体的なドメイン適応技術とは?

A: ChipNeMoは、チップ設計データ用のカスタム・トークナイザー、大規模なドメイン・データ・コーパスによるドメイン適応的事前学習、ドメイン固有のタスクによる教師あり微調整、微調整された検索モデルによる検索補強生成など、複数のドメイン適応技術を実装しています.

Q: カスタム・トークナイザーは、ドメイン適応プロセスにどのように貢献しますか?

A: カスタムトークナイザーは、ドメイン適応プロセスにおいて以下のような貢献をします.まず、ドメイン固有のデータに基づいてトークナイザーを新たに訓練することで、トークナイズの効率を向上させます.また、一般的な目的のトークナイザーに存在しないトークンや一般的なデータセットではめったに見られないトークンを特定することで、一般的なデータセットにおける効率と言語モデルのパフォーマンスを維持します.さらに、再訓練や微調整の手間を最小限に抑えることも目標としています.

Q: ドメイン適応的な継続的プレトレーニングのプロセスを説明していただけますか?

A: ドメイン適応事前学習(DAPT)は、事前学習済みの基礎モデルを追加のドメインデータで継続的にトレーニングする手法です.この手法では、一般的なデータセットでの事前学習済みLLMのパフォーマンスを維持するために、新しいトークンを導入します.また、ドメイン特有のタスクに対応するために、新しいトークンの埋め込みを一般的なトークナイザーによってガイドされた初期化によって行います.

Q: ChipNeMoにおける、ドメイン固有命令を用いた教師ありファインチューニング(SFT)の役割とは?

A: ChipNeMoのドメイン固有の指示による教師あり微調整(SFT)の役割は、ChipNeMoの基礎モデルを特定のタスクに適応させるためです.

Q: ドメインに適応した検索モデルは、チップ設計アプリケーションでどのように活用されているのか?

A: チップデザインアプリケーションでは、ドメイン適応された検索モデルが使用されます.これらのモデルは、大規模なドメインデータのドメイン適応事前学習、ドメイン固有のタスクによる教師付き微調整、および微調整された検索モデルによる検索増強生成を含む複数のドメイン適応技術を実装しています.これにより、エンジニアリングアシスタントチャットボットの応答の品質向上、EDAツールスクリプトの生成の正確性向上、およびバグの要約と分析の評価向上が実現されます.

Q: ChipNeMoのエンジニアアシスタントチャットボットアプリケーションの詳細を教えてください.

A: エンジニアリングアシスタントチャットボットは、設計エンジニアがアーキテクチャ、設計、検証、およびビルドの質問に対する回答を得るためのアプリケーションです.これにより、設計エンジニアの全体的な生産性を向上させることができます.ChipNeMoのエンジニアリングアシスタントチャットボットは、ドメイン適応事前学習モデルを使用しており、工業用チップ設計タスクのパフォーマンスを向上させることができます.ChipNeMo-13B-Chatなどのドメイン適応事前学習モデルは、ベースモデルと比較して同等またはより良い結果を達成しています.エンジニアリングアシスタントチャットボット、EDAスクリプト生成、バグの要約と分析という3つのユースケースにおいて、よりパワフルなLLaMA2 70Bモデルとの差を縮めることができます.

Q: ChipNeMoはどのようにしてチップ設計用のEDAスクリプトを生成するのですか?

A: ChipNeMoは、ツール固有のスクリプト・ライブラリとカスタムの内部スクリプト・ライブラリの両方を活用して、チップ設計用のEDAスクリプトを生成します.ChipNeMoは、自然言語タスク記述から2つの異なるタイプのスクリプトを生成することに重点を置いています.1つは、設計編集および解析用の内部PythonライブラリであるTool1を活用するスクリプトで、もう1つは、業界をリードするスタティック・タイミング解析ツールであるTool2が提供するコマンド・インターフェースを使用するTclスクリプトです.ドメイン固有のファインチューニング・データセットを構築するため、両ツールのプロダクション・スクリプトを設計エキスパートから収集しました.

Q: チップ設計におけるバグの要約と解析の目的は何ですか?

A: チップ設計の文脈におけるバグの要約と分析の目的は、プロジェクトの状態を理解し、実行を迅速化するために、技術的な詳細と管理上のデータを簡潔にまとめることです.また、次のステップを提案することも目的としています.これにより、エンジニアリングマネージャーは内部の問題追跡データベースをレビューする時間を節約し、チームの生産性を向上させることができます.

Q: ドメイン適応技術によって達成されたパフォーマンス向上について詳しく教えてください.

A: ドメイン適応技術によって、3つの評価されたアプリケーション全体で大幅な性能向上が実現されました.特に、設計タスクの範囲で、一般的なベースモデルよりも5倍のモデルサイズの削減が可能であり、同等またはより良いパフォーマンスを実現しています.

Q: ドメインに適応したLLMアプローチにおいて、さらなる改善の可能性がある分野は何か?

A: 現在の結果と理想的な結果の間には改善の余地があると考えられます.ドメイン適応されたLLMアプローチのさらなる調査が、このギャップを埋めるのに役立つと信じています.

Battle of the Backbones: A Large-Scale Comparison of Pretrained Models across Computer Vision Tasks

著者:Micah Goldblum, Hossein Souri, Renkun Ni, Manli Shu, Viraj Prabhu, Gowthami Somepalli, Prithvijit Chattopadhyay, Mark Ibrahim, Adrien Bardes, Judy Hoffman, Rama Chellappa, Andrew Gordon Wilson, Tom Goldstein

発行日:2023年10月30日

最終更新日:2023年10月30日

URL:http://arxiv.org/pdf/2310.19909v1

カテゴリ:Computer Vision and Pattern Recognition, Machine Learning

概要:

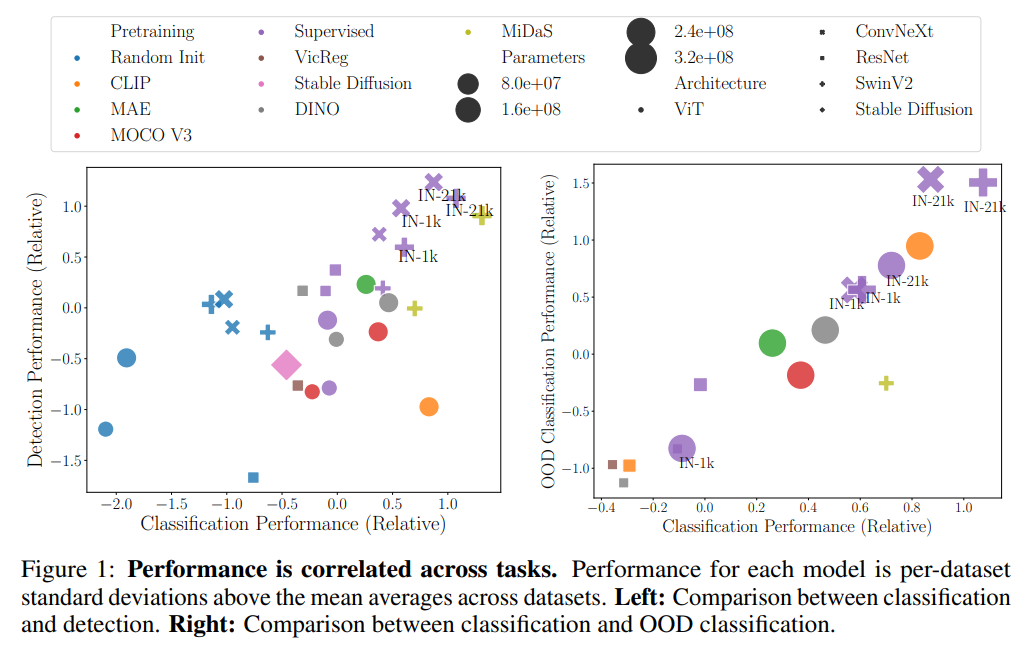

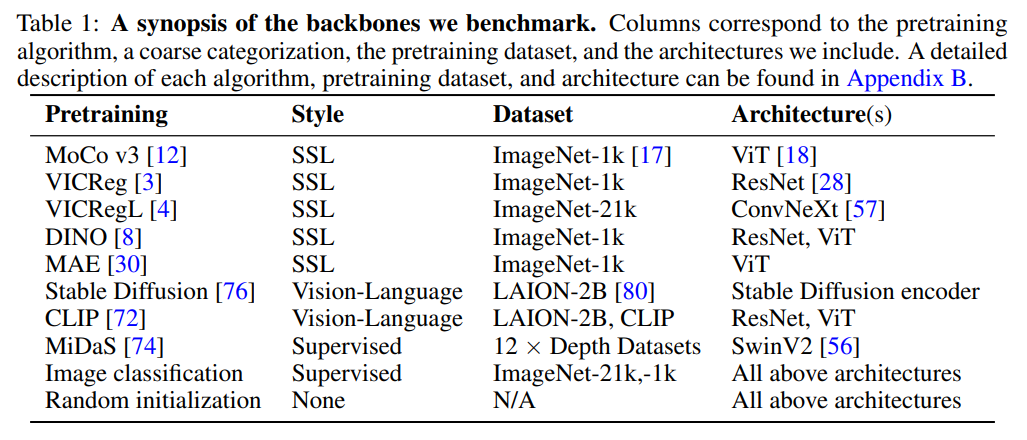

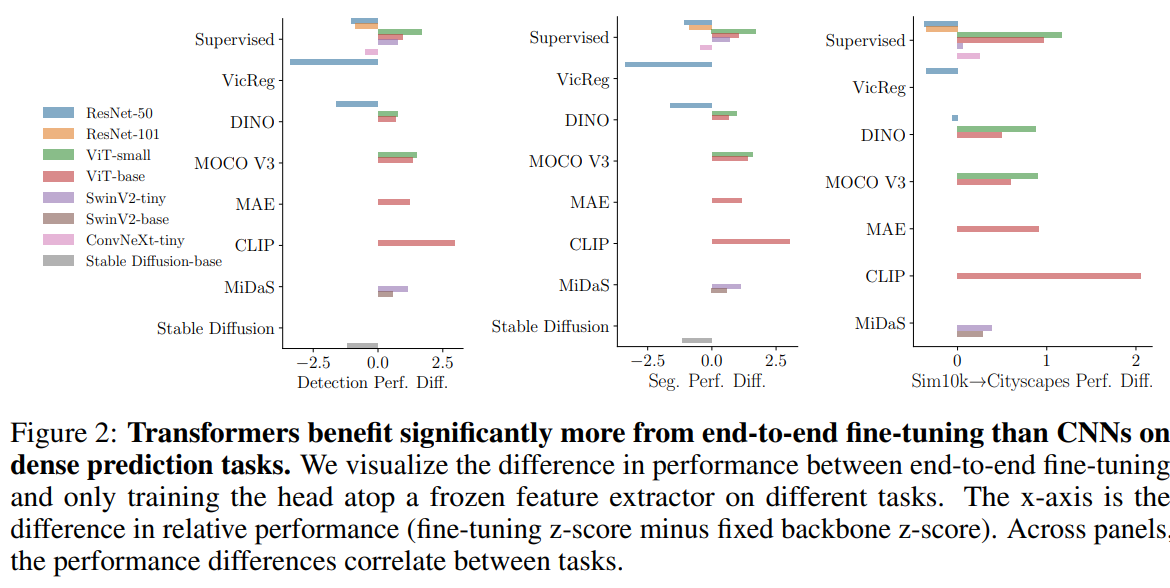

ニューラルネットワークをベースとしたコンピュータビジョンシステムは通常、バックボーンと呼ばれる、事前学習済みまたはランダムに初期化された特徴抽出器上に構築されます.数年前までは、デフォルトのオプションはImageNetで訓練された畳み込みニューラルネットワークでした.しかし、最近では、さまざまなアルゴリズムとデータセットを使用して事前学習されたバックボーンが数多く登場しています.この選択肢の豊富さにより、さまざまなシステムの性能が向上していますが、実践者がどのバックボーンを選ぶべきかを判断するのは困難です.

Battle of the Backbones(BoB)は、ビジョン言語モデル、自己教師あり学習によって訓練されたモデル、およびStable Diffusionバックボーンを含むさまざまな事前学習済みモデルをベンチマークし、分類から物体検出、OOD汎化などのさまざまなコンピュータビジョンタスクにおいて、この選択を容易にします.さらに、BoBは、1500回以上のトレーニング実行で実施された包括的な分析を通じて、既存のアプローチの強みと弱点を明らかにすることで、研究コミュニティがコンピュータビジョンを進めるための有望な方向を示しています.

続いて、私たちは1500回以上のトレーニング実行で実施された包括的な分析を行いました.ビジョントランスフォーマ(ViTs)や自己教師あり学習(SSL)はますます人気がありますが、私たちは大規模なトレーニングセットで教師あり学習によって事前学習された畳み込みニューラルネットワークが、考慮したモデルのほとんどのタスクで最も優れたパフォーマンスを発揮することを発見しました.さらに、同じアーキテクチャと同じサイズの事前学習データセットでの比較において、SSLバックボーンも非常に競争力があり、将来の研究では高度なアーキテクチャと大規模な事前学習データセットでSSL事前学習を行う必要があることを示しています.私たちは実験の生データと、研究者が自分自身のバックボーンを試すことができるコードを以下のリンクで公開しています:https://github.com/hsouri/Battle-of-the-Backbones

Q&A:

Q: バトル・オブ・ザ・バックボーンズ(BoB)の目的は何ですか?

A: Battle of the Backbones (BoB)の目的は、コンピュータビジョンのシステムを構築する実践者を支援するだけでなく、より良いバックボーンを設計するための研究コミュニティを導くことです.BoBは、事前学習ルーチンとアーキテクチャの強みと弱点、一般的な誤解や基本的な制約、および改善のための有望な方向性を明らかにすることで、バックボーンの比較に関する以前の取り組みを概説しています.

Q: BoBはどのように事前学習されたモデルをベンチマークするのですか?

A: BoBは、画像分類、オブジェクト検出とセグメンテーション、分布外汎化、画像検索を含む様々な下流タスクについて、一般に公開されていること前学習済みチェックポイントとランダムに初期化されたベースラインを比較することで、事前学習済みモデルのベンチマークを行います.

Q: BoBのベンチマークには、どのような事前学習モデルが含まれていますか?

A: BoBのベンチマークには、ビジョン言語モデル、自己教師あり学習によって訓練されたモデル、およびStable Diffusionバックボーンを含む多様なプリトレーニングモデルが含まれています.

Q: BoBのベンチマークには、どのようなコンピュータビジョンのタスクが含まれていますか?

A: BoBのベンチマークには、自然、医療、衛星画像の画像分類、物体検出とセグメンテーション、分布外の一般化、画像検索など、さまざまなコンピュータビジョンのタスクが含まれています.

Q: ボブの分析によると、コンピュータビジョンの既存のアプローチの強みと弱点は何ですか?

A: BoBの分析は、コンピュータビジョンの既存の手法の強みと弱点に光を当てています.それは一般的な誤解や基本的な制約、さらには改善のための有望な方向性を明らかにします.このベンチマークは、画像分類、物体検出とセグメンテーション、分布外の汎化、画像検索など、さまざまな下流タスクで、多くの人気のある公開済みの事前学習済みチェックポイントとランダムに初期化されたベースラインを比較します.これらの異なるバックボーンを評価することで、BoBは多様なコンピュータビジョンのタスクにおけるパフォーマンスと効果についての洞察を提供します.ただし、BoBは主にパフォーマンスに関連する側面に焦点を当てていることを重要視する必要があります.モデルのバイアスなど、他の重要な側面に関する探索は残っています.したがって、BoBは貴重な洞察を提供しますが、コンピュータビジョンの既存の手法のすべての側面を網羅しているわけではないことに注意する必要があります.

Q: BoBで検討されているモデルの中で、ほとんどのタスクで最も優れたパフォーマンスを発揮するのは、どのようなタイプの事前学習済みモデルなのだろうか?

A: BoBは、自己教師あり学習が有望であり、検討したモデルの中でほとんどのタスクで良い結果を出すことを発見した.

Q: SSLバックボーンは、BoBの比較において他のバックボーンと比べてどのようになりますか?

A: SSLバックボーンは、同じデータセットのスケールで行われた比較において、他のバックボーンよりも優れた性能を示しています.

Q: BoBの調査結果に基づいて、将来の作業に対する推奨事項は何ですか?

A: BoBの結果に基づいた将来の研究の推奨事項は、より多くのバックボーンが導入され、より多くのタスクと設定が考慮されるにつれて、洞察が継続的に進化する必要があることです.また、モデルのバイアスなど、重要な他の側面の探索も残されています.

Evaluating Large Language Models: A Comprehensive Survey

著者:Zishan Guo, Renren Jin, Chuang Liu, Yufei Huang, Dan Shi, Supryadi, Linhao Yu, Yan Liu, Jiaxuan Li, Bojian Xiong, Deyi Xiong

発行日:2023年10月30日

最終更新日:2023年10月31日

URL:http://arxiv.org/pdf/2310.19736v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

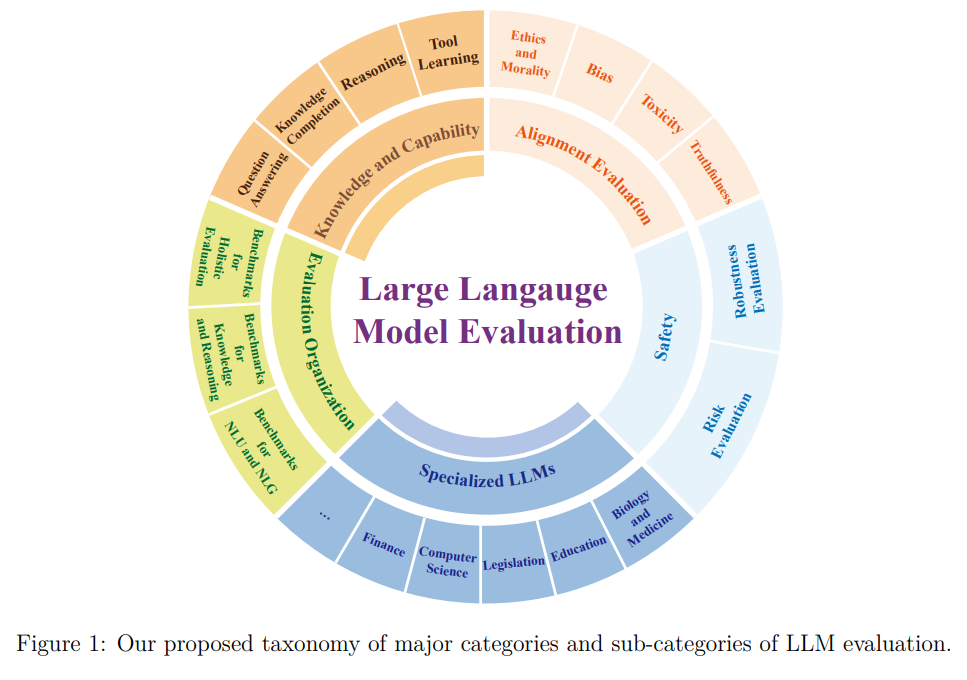

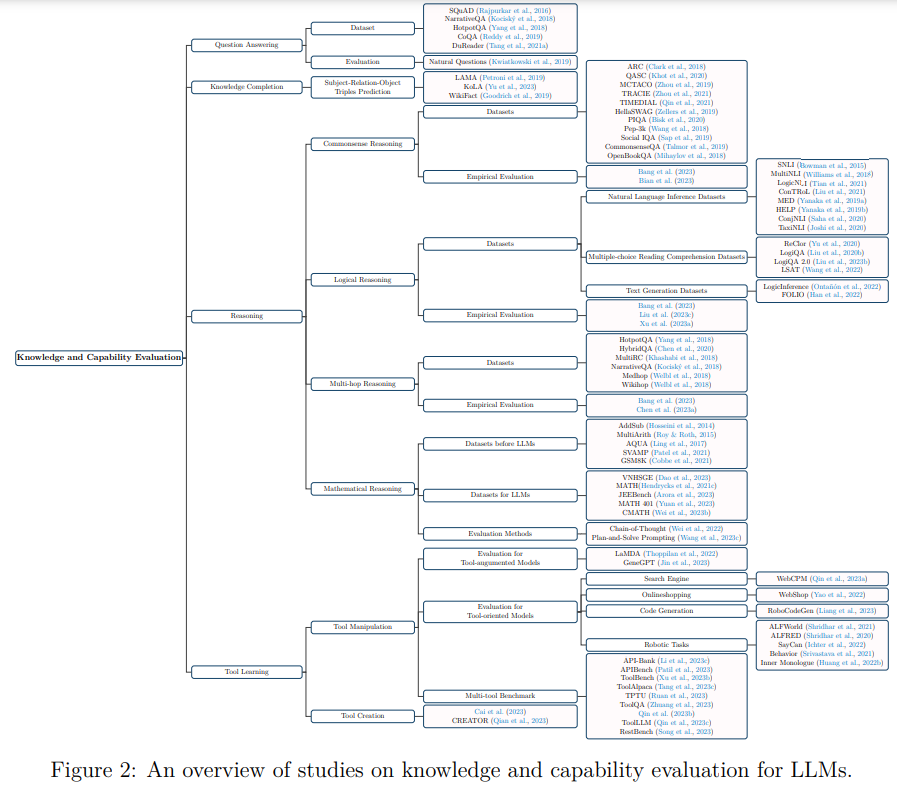

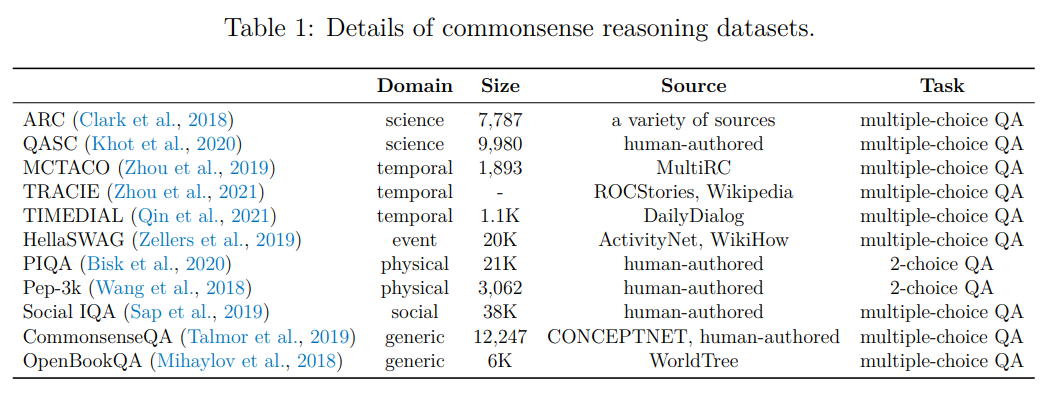

この調査は、LLMの評価についての全体的な視点を提供することを目指しています.私たちは、LLMの評価を知識と能力の評価、整合性の評価、安全性の評価の3つの主要なグループに分類しています.これらの3つの側面に関する評価方法とベンチマークの包括的なレビューに加えて、特定の領域でのLLMのパフォーマンスに関する評価のコンペンディウムをまとめ、議論しています.また、LLMの特化領域でのパフォーマンスに関する評価や、LLMの能力、整合性、安全性、適用性に関する包括的な評価プラットフォームの構築についても議論しています.

私たちは、この包括的な概観がLLMの評価に関するさらなる研究の興味を刺激し、最終的な目標であるLLMの責任ある開発を指針とするための評価の基盤となることを期待しています.私たちは、これによってLLMの進化が社会的な利益を最大化し、潜在的なリスクを最小限に抑える方向に向かうことを想定しています.関連する論文の厳選されたリストは、https://github.com/tjunlp-lab/Awesome-LLMs-Evaluation-Papersで公開されています.

Q&A:

Q: 大規模言語モデル(LLM)に潜在するリスクとは?

A: LLMは、個人情報の漏えいに悩まされたり、不適切、有害、あるいは誤解を招くようなコンテンツを生み出す可能性がある.また、LLMの急速な進歩は、適切な保護措置なしに超知的システムが出現する可能性についても懸念を抱かせる.

Q: LLMが個人情報漏洩に苦しむのはなぜか?

A: LLMは、機密情報や秘密情報を含むデータセットでトレーニングされた場合、プライベートデータの漏えいに悩まされる可能性がある.これは、学習データに個人情報や専有情報など、公開すべきでないデータが含まれている場合に起こりうる.このようなデータセットが適切に保護されていなかったり、トレーニングプロセスに脆弱性があったりすると、LLMはこのようなプライベートデータを不注意で漏えいさせ、権限のない個人や団体に公開してしまう可能性がある.

Q: LLMはどのような点で不適切、有害、あるいは誤解を招くようなコンテンツを生み出す可能性があるのか.

A: LLMは、2つの方法で不適切、有害、または誤解を招くコンテンツを生み出す可能性がある.第一に、LLMは、ヘイトスピーチ、攻撃的/虐待的な言葉、ポルノコンテンツなど、有害な行動や安全でないコンテンツを生成する可能性がある.これは、LLMがそのような有害なコンテンツを含む可能性のある膨大なオンライン・データに基づいて訓練されているためである.第二に、LLMは事実を捏造し、誤った情報を生成する可能性があり、生成されたテキストの信頼性を低下させる.LLMは流暢で一貫性があるにもかかわらず、誤った情報を広めるような誤解を招くコンテンツを生成する可能性があり、法律や医学のような専門的で厳格な用途では有害となりうる.

Q: LLMの急速な進歩からどのような懸念が生じるのか?

A: LLMsの急速な進歩により、適切な安全対策のない超知能システムの出現が懸念されています.LLMsの能力を効果的に活用し、安全かつ有益な開発を確保するために、LLMsの徹底的かつ包括的な評価が重要です.

Q: 十分な安全措置のない超知的システムの出現は、どのようにして防ぐことができるのだろうか?

A: 適切な安全対策がなされていない超知能システムの出現を防ぐためには、LLMの安全性を確保することが重要です.LLMの能力を最大限に活用しつつ、安全で有益な開発を行うためには、徹底的かつ包括的なLLMの評価が必要です.

Q: LLMの評価は大きく3つのグループに分類されますが、どのようなものですか?

A: LLMの評価は、知識と能力の評価、適合性の評価、安全性の評価の3つの主要なグループに分類されます.

Q: 評価方法とベンチマークの包括的レビューには何が含まれるのか?

A: 総合的な評価方法とベンチマークには、質問応答、知識補完、推論、ツールの使用など、さまざまな能力を持つLLMに関連する評価方法とベンチマークが含まれています.

Q: 専門分野におけるLLMのパフォーマンスに関する評価の例を提供していただけますか?

A: 特定の領域でのLLMのパフォーマンスに関する評価の例として、生物学、教育、法律、コンピュータサイエンス、金融などの分野における専門的なLLMの評価が挙げられます.これらの評価は、領域固有の課題や複雑さに直面した際のLLMの適性と制約を体系的に評価することを目的としています.

Q: 包括的な評価プラットフォームは、どのようにして能力、アライメント、安全性、適用性に関するLLM評価をカバーできるのか?

A: 総合的な評価プラットフォームは、LLMの能力、整合性、安全性、適用性の評価をカバーすることができます.これには、知識と能力の評価、整合性の評価、安全性の評価が含まれます.総合的な評価プラットフォームは、LLMの能力を評価するための方法論とベンチマーク、整合性を評価するための方法論とベンチマーク、安全性を評価するための方法論とベンチマーク、および適用性を評価するための方法論とベンチマークを提供します.

Q: LLMの責任ある発展を導く礎石として、評価はどのように役立つのだろうか?

A: 評価は、LLMの責任ある開発を導くための基盤となる役割を果たすことができます.評価は、LLMの知識や推論などの核心的な能力を体系的に詳述することで、開発者や研究者がLLMのパフォーマンスを理解し、評価するための指針を提供します.また、評価は、倫理的な懸念やバイアス、有害性、真実性などの安全性の評価や、LLMの応用における倫理的な問題にも踏み込みます.これにより、LLMの安全で信頼性のある応用を確保することができます.さらに、評価は、LLMの潜在的な応用領域を生物学、教育、法律、コンピュータサイエンス、金融などの多様な領域で探求することも可能です.評価は、研究者、開発者、実践者がLLMのパフォーマンスを理解し、評価するための人気のあるベンチマーク評価を提供することも重要です.これにより、評価は、LLMの進化を社会的な利益を最大化し、潜在的なリスクを最小化する方向に導くことができます.

FP8-LM: Training FP8 Large Language Models

著者:Houwen Peng, Kan Wu, Yixuan Wei, Guoshuai Zhao, Yuxiang Yang, Ze Liu, Yifan Xiong, Ziyue Yang, Bolin Ni, Jingcheng Hu, Ruihang Li, Miaosen Zhang, Chen Li, Jia Ning, Ruizhe Wang, Zheng Zhang, Shuguang Liu, Joe Chau, Han Hu, Peng Cheng

発行日:2023年10月27日

最終更新日:2023年10月27日

URL:http://arxiv.org/pdf/2310.18313v1

カテゴリ:Machine Learning, Computation and Language

概要:

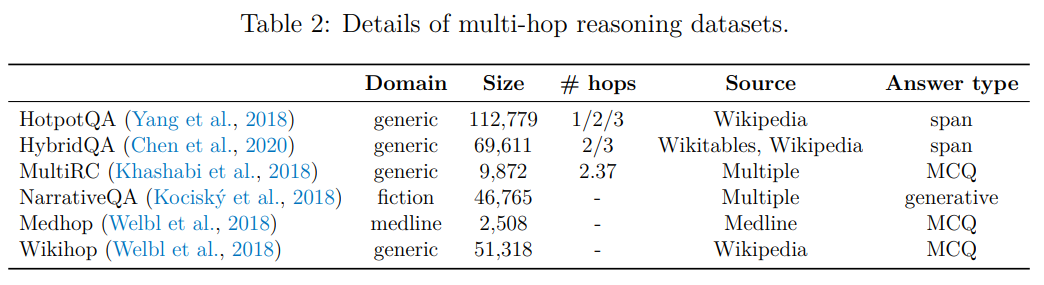

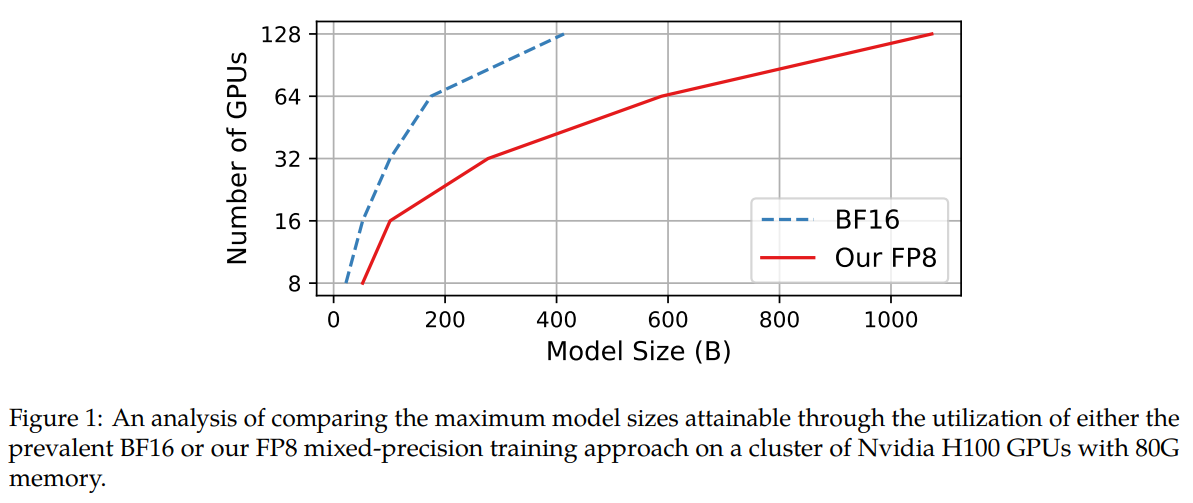

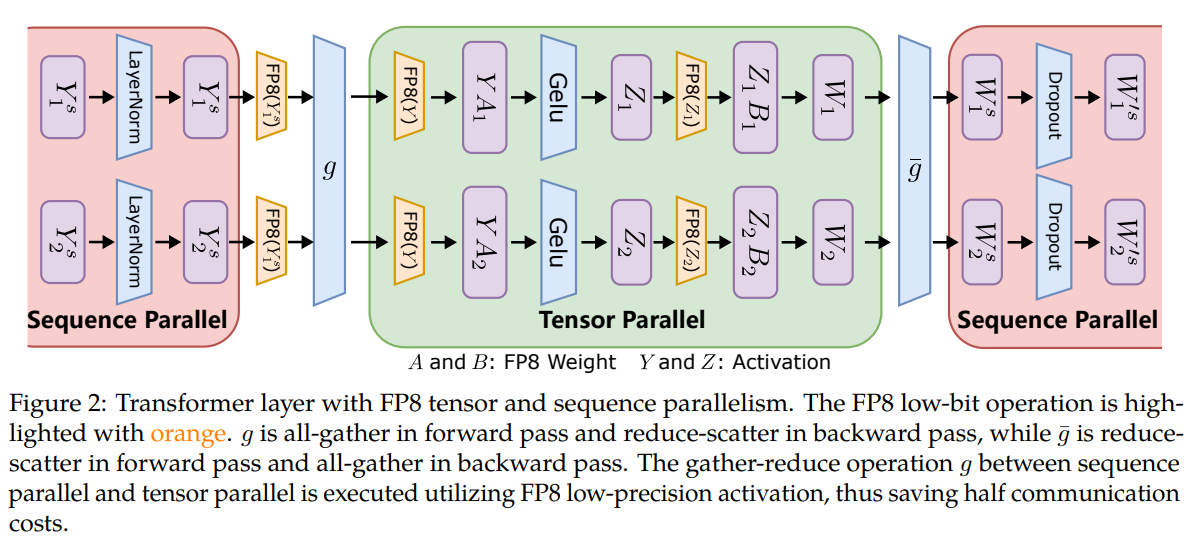

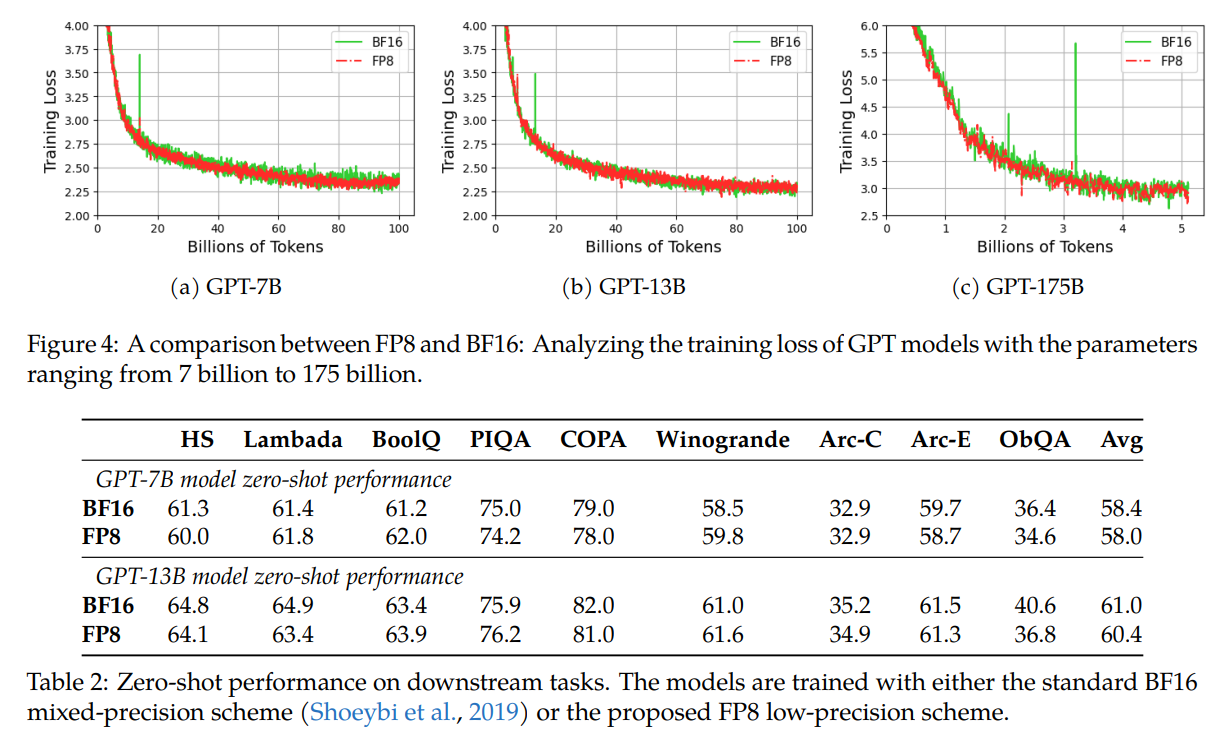

この論文では、大規模な言語モデル(LLM)の効率的なトレーニングのためのFP8低ビットデータ形式について探求しています.私たちの主な洞察は、勾配やオプティマイザの状態など、LLMのトレーニングにおけるほとんどの変数は、モデルの精度を損なうことなく、ハイパーパラメータの変更を必要とせずに、低精度のデータ形式を使用できるということです.具体的には、私たちはLLMのトレーニングのための新しいFP8自動混合精度フレームワークを提案しています.このフレームワークは、LLMの混合精度と分散並列トレーニングを効率化するための3つのレベルのFP8利用を提供します.これは、8ビットの勾配、オプティマイザの状態、および分散学習を段階的に組み込んでいきます.実験結果は、H100 GPUプラットフォーム上でGPT-175Bモデルのトレーニング中、私たちのFP8混合精度トレーニングフレームワークが、実メモリ使用量を42%削減し、広く採用されているBF16フレームワーク(Megatron-LM)よりも64%高速に実行され、Nvidia Transformer Engineの速度を17%上回ったことを示しています.これにより、大規模な基礎モデルのトレーニングコストが大幅に削減されます.さらに、私たちのFP8混合精度トレーニング手法は汎用的です.また、このFP8低精度トレーニングフレームワークは、他のタスクにもシームレスに適用できます.例えば、LLMの命令調整や人間のフィードバックを用いた強化学習など、微調整の費用を節約することができます.私たちのFP8低精度トレーニングフレームワークは、{https://github.com/Azure/MS-AMP}{aka.ms/MS.AMP}でオープンソースとして提供されています.

Q&A:

Q: 本稿の主眼は何か?

A: この論文の主な焦点は、大規模な言語モデルの作成における課題と展望に関するワークショップであり、具体的にはBigScienceEpisode#5について述べられています.

Q: LLMトレーニングにおける低精度データフォーマットに関する重要な洞察とは?

A: LLMトレーニングにおいて、勾配やオプティマイザの状態などの多くの変数は、低精度のデータ形式を使用してもモデルの精度に影響を与えず、ハイパーパラメータの変更も必要としないことができるということです.

Q: 低精度のデータフォーマットを採用する場合、ハイパーパラメーターに変更は必要ですか?

A: はい、低精度データフォーマットを使用する場合、ハイパーパラメータに変更が必要です.特に、勾配統計情報には低精度を使用し、マスターウェイトには高精度を使用する必要があります.また、テンソルスケーリング技術を使用して、FP8データフォーマットの表現範囲内で勾配値を保持する必要があります.これにより、アンダーフローやオーバーフローの問題を解決することができます.

Q: FP8自動混合精度を使ったLLMトレーニングのフレームワークとは?

A: LLMのトレーニングにおいて、FP8自動混合精度を使用するための提案されたフレームワークは、8ビットの重み、勾配、オプティマイザ、および分散トレーニングを段階的に追加することで、既存の16/32ビットの混合精度と簡単に置き換えることができる.また、Pytorchの実装も提供されており、数行のコードで8ビットの低精度トレーニングを可能にする.さらに、FP8スキームをGPTの事前トレーニングと微調整に適用し、モデルの速度向上、メモリおよび通信コストの削減の潜在能力を示している.

Q: FP8の利用枠は何段階あるのか?

A: 提案されたフレームワークは、3つの最適化レベルを提供しています.

Q: フレームワークが段階的に組み込んでいく具体的な要素とは?

A: 提案されたFP8フレームワークは、計算、ストレージ、通信のすべての進行にFP8を浸透させることで、徐々に次のコンポーネントを組み込んでいます.具体的には、FP8自動混合精度フレームワークは、勾配やオプティマイザの状態などのほとんどの変数に低精度データフォーマットを使用し、モデルの精度を損なうことなく、ハイパーパラメータの変更を必要としません.これにより、エンドツーエンドの高速化、メモリおよび通信コストの削減が可能となります.

Q: H100GPUプラットフォームでFP8混合精度フレームワークを使用してGPT-175Bモデルをトレーニングした場合の実験結果は?

A: GPT-175Bモデルのトレーニングにおいて、H100 GPUプラットフォームを使用したFP8混合精度フレームワークでは、トレーニング時間がTE(Nvidia、2022b)と比較して17%短縮され、メモリ使用量が21%削減されました.

Q: FP8混成精度のフレームワークで、実メモリ使用量はどの程度削減できたのか?

A: FP8ミックスプレシジョンフレームワークでは、実際のメモリ使用量が42%削減されました.

Q: FP8混成精度のフレームワークは、広く採用されているBF16フレームワークと比べてどれくらい高速に動作したのか?

A: FP8混合精度フレームワークは、広く採用されているBF16フレームワークと比較して64%高速に動作した.

Q: FP8の低精度トレーニングフレームワークは、LLMインストラクションチューニングや人間フィードバックによる強化学習など、他のタスクにも適用できますか?

A: はい、FP8低精度トレーニングフレームワークはLLMのインストラクションチューニングやヒューマンフィードバックによる強化学習など、他のタスクにも適用することができます.

YaRN: Efficient Context Window Extension of Large Language Models

著者:Bowen Peng, Jeffrey Quesnelle, Honglu Fan, Enrico Shippole

発行日:2023年08月31日

最終更新日:2023年11月01日

URL:http://arxiv.org/pdf/2309.00071v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

Rotary Position Embeddings(RoPE)は、トランスフォーマーベースの言語モデルで位置情報を効果的にエンコードすることが示されています.しかし、これらのモデルは、訓練されたシーケンスの長さを超えて一般化することができません.本研究では、YaRN(Yet another RoPE extensioN method)という、これらのモデルのコンテキストウィンドウを拡張するための計算効率の良い手法を提案します.この手法では、従来の手法よりも10倍少ないトークンと2.5倍少ない訓練ステップが必要です.YaRNを使用することで、LLaMAモデルは、元の事前学習では許容されないより長いコンテキスト長を効果的に利用し、推測することができることを示します.また、コンテキストウィンドウの拡張において、従来の最先端を上回る結果も示します.さらに、YaRNは、ファインチューニングデータセットの限られたコンテキストを超えて推測する能力を示すことも実証します.YaRNを使用してファインチューニングされたモデルは、128kのコンテキスト長までオンラインで利用可能であり、https://github.com/jquesnelle/yarn で再現されています.

Q&A:

Q: 変換器ベースの言語モデルにおける回転位置埋め込み(RoPE)の目的とは?

A: Rotary Position Embeddings (RoPE)の目的は、トランスフォーマベースの言語モデルで位置情報を効果的にエンコードすることです.

Q: 変換器ベースの言語モデルが、学習した配列の長さを超えて汎化できないのはなぜか?

A: トランスフォーマーベースの言語モデルは、訓練時のシーケンス長を超えて一般化することができない.位置エンコーディングの一部の手法は、限定的な一般化を行うことができるが、事前学習された長さよりも大幅に長いシーケンスには一般化できない.

Q: YaRNとは何か、言語モデルのコンテキストウィンドウをどのように拡張するのか?

A: YaRN(Yet another RoPE extensioN method)は、変換器ベースの言語モデルのコンテキストウィンドウを拡張するための計算効率の良い手法である.従来の手法に比べ、10倍少ないトークンと2.5倍少ない学習ステップで済みます.YaRNにより、LLaMAモデルは、本来の事前学習が可能にするよりもはるかに長い文脈長を効果的に利用し、外挿できるようになる.これは、コンテキストウィンドウの拡張において最先端を凌駕する.YaRNを用いて微調整されたモデルは、https://github.com/jquesnelle/yarn、128kのコンテキスト長までオンラインで利用可能であり、再現されている.

Q: YaRNは、トークンの使用量やトレーニングステップの点で、以前の手法と比べてどうですか?

A: YaRNは、以前の方法よりも10倍少ないトークンと2.5倍少ないトレーニングステップを必要とする.

Q: LLaMAモデルでYaRNを使用する意義は?

A: YaRNは、既存のすべてのRoPE補間手法を改善し、PIに取って代わることができる.微調整されたモデルは、非常に大きなコンテキストサイズに対応しながら、複数のベンチマークで本来の能力を維持する.さらに、YaRNは、より短いデータセットでの微調整による効率的な外挿を可能にし、より速い収束のために転移学習を利用することができる.

Q: YaRNは、LLaMAモデルがより長い文脈長を利用し、外挿することをどのように可能にするのか?

A: YaRNは、LLaMAモデルのコンテキストウィンドウを拡張する計算効率の良い方法を提供することで、LLaMAモデルがより長いコンテキスト長を利用し、外挿できるようにする.YaRNは、従来の方法よりも10倍少ないトークンと2.5倍少ない学習ステップを必要とする.YaRNを使用することで、LLaMAモデルは位置情報を効果的にエンコードし、本来の事前学習が可能にするよりもはるかに長いコンテキスト長に外挿することができる.YaRNはまた、コンテキストウィンドウの拡張においても最先端を上回る.さらに、YaRNは、微調整されたデータセットの限られた文脈を超える外挿能力を示す.YaRNを用いて微調整されたモデルは、128kのコンテキスト長までオンラインで利用可能であり、再現されている.

Q: YaRNはコンテクストウィンドウ拡張の最先端技術と比べてどうですか?

A: YaRNはコンテキストウィンドウの拡張において最先端を凌駕している.

Q: YaRNは、ファインチューニング・データセットという限られた文脈を超えて外挿できるのだろうか?

A: はい、YaRNは微調整データセットの限られた文脈を超えて外挿する能力を持っています.

Q: YaRNを使って微調整したモデルは、オンラインでどこにアクセスできますか?

A: YaRNで微調整されたモデルは、https://github.com/jquesnelle/yarn でオンラインで利用できます.

Q: YaRNを使用して達成されたコンテキストの最大長は?

A: YaRNは最大コンテクスト長128kを達成した.

Large Language Models Understand and Can be Enhanced by Emotional Stimuli

著者:Cheng Li, Jindong Wang, Yixuan Zhang, Kaijie Zhu, Wenxin Hou, Jianxun Lian, Fang Luo, Qiang Yang, Xing Xie

発行日:2023年07月14日

最終更新日:2023年11月12日

URL:http://arxiv.org/pdf/2307.11760v7

カテゴリ:Computation and Language, Artificial Intelligence, Human-Computer Interaction

概要:

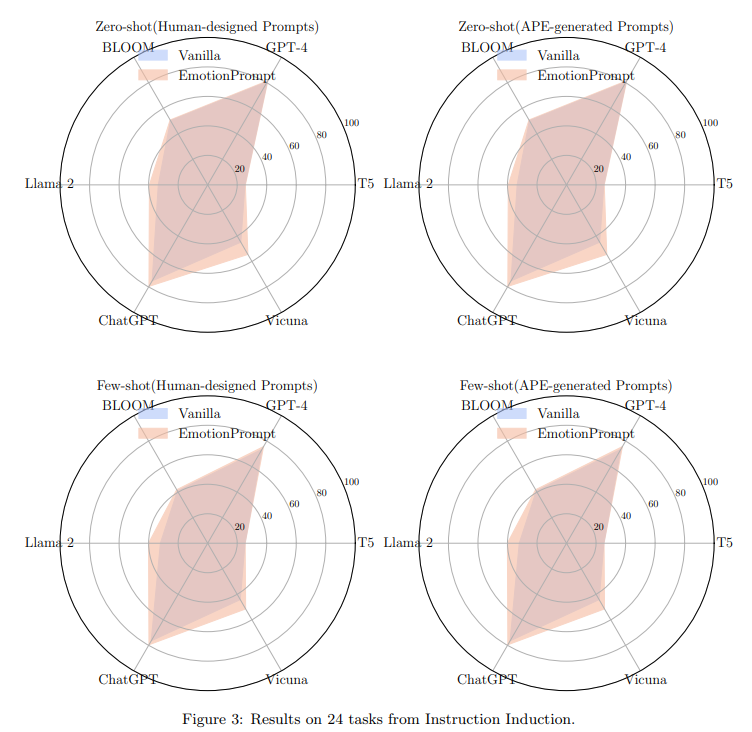

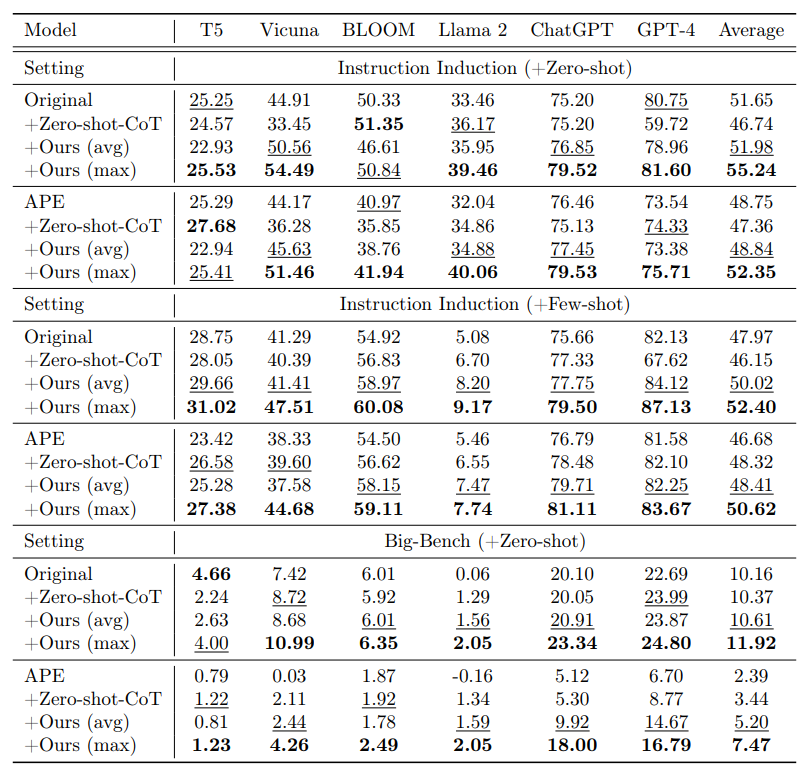

感情的な知能は、私たちの日常の行動や相互作用に大きな影響を与えます.大規模言語モデル(LLM)は、人工一般知能への一歩と見なされるようになっており、多くのタスクで印象的なパフォーマンスを発揮していますが、LLMが心理的な感情刺激を本当に理解できるかどうかはまだ不確かです.感情のサインを理解し、それに応答することは、人間に問題解決において独自の優位性を与えます.本論文では、LLMが感情的な刺激を理解する能力を探求するための最初のステップを踏みます.このために、Flan-T5-Large、Vicuna、Llama 2、BLOOM、ChatGPT、GPT-4など、さまざまなLLMを使用して45のタスクで自動実験を行います.タスクは、包括的な評価シナリオを表す決定論的および生成的なアプリケーションを網羅しています.自動実験の結果、LLMは感情的な知能を理解しており、感情的な刺激(私たちが「EmotionPrompt」と呼ぶもので、元のプロンプトと感情的な刺激を組み合わせたもの)によってパフォーマンスを向上させることができることが示されました.たとえば、Instruction Inductionでは相対的なパフォーマンスが8.00%向上し、BIG-Benchでは115%向上しました.決定論的なタスクに加えて、生成的なタスクもあります.さらに、BIG-Benchでは、既存の評価基準を使用して自動的に評価できる決定論的なタスクに加えて、バニラのプロンプトと感情的なプロンプトの両方を使用して、106人の参加者を対象に人間の研究を実施しました.人間の研究の結果、EmotionPromptは生成的なタスクのパフォーマンスを著しく向上させることが示されました(パフォーマンス、真実性、責任性の指標において平均10.9%の改善).EmotionPromptがLLMに対してなぜ機能するのか、およびそのパフォーマンスに影響を与える要因について、詳細な議論を提供します.EmotionPromptは、人間とLLMの相互作用のための学際的な知識を探求するための新しいアプローチを示唆しています.

Q&A:

Q: LLMを使った具体的な作業は?

A: LLMは感情的な刺激を理解し、その刺激によって向上するために使われた.

Q: LLMによる感情的知性の把握を評価するための実験はどのように行われたのですか?

A: 実験はEmotion-Promptを使用して行われました.45のタスクにおいて6つのLLMを対象に行われ、肯定的な結果が示されました.LLMは感情刺激を理解し、それによって向上することができることが示されました.

Q: 感情的なプロンプトの有無によるLLMのパフォーマンスに関する自動実験の結果は何でしたか?

A: 自動実験の結果、EmotionPromptを使用した場合、LLMsのパフォーマンスが向上したことが示されました.具体的には、Instruction Inductionでは8.00%の相対的なパフォーマンス向上があり、BIG-Benchでは115%の向上がありました.

Q: EmotionPrompt」のコンセプトと、オリジナルのプロンプトと感情的な刺激をどのように組み合わせているのか説明していただけますか?

A: EmotionPromptは、元のプロンプトに感情的な刺激を組み合わせることで、LLMsの行動を理解するために設計されました.EmotionPromptの実装は非常に簡単で、初期のプロンプトに感情的な刺激を追加するだけで行われます.効果的な感情的な刺激を設計する方法がこの研究の鍵であり、心理学の三つのよく知られた現象からインスピレーションを得ています.

Q: バニラと感情的なプロンプトを使ったジェネレイティブ・タスクのパフォーマンスに関して、106人の参加者を対象に行われた人間研究の結果はどうだったのだろうか?

A: 106人の参加者を対象に行われた人間の研究の結果、EmotionPromptは生成タスクのパフォーマンスを著しく向上させました.パフォーマンス、真実性、責任性の指標において、平均で10.9%の改善が見られました.

Q: 人間による研究では、ジェネレーティブ・タスクの質はどのように評価されたのか?

A: 人間の研究では、パフォーマンス、真実性、責任性の3つの指標を使用して、生成的なタスクの品質を評価しました.参加者は各質問に対応する2つの回答を評価し、1から5までのスケールを使用しました.パフォーマンスは、質問に十分に対応していない回答を1、質問に対応しているが言語的な表現が最適でなく、論理的な構造が欠けている回答を2、質問に十分に対応しており、言語的な表現と論理的な構造が適切な回答を5と評価しました.真実性と責任性の評価は、自動的な方法が存在しないため、人間の研究で行われました.

Q: EmotionPromptのパフォーマンスに影響を与える要因について、もう少し詳しく教えてください.

A: EmotionPromptのパフォーマンスに影響を与える要因には、モデルのサイズ、温度、タスクの複雑さ、タスクの種類、使用される具体的なメトリクスなどが含まれます.これらの要因は、EmotionPromptの効果に影響を与える可能性があります.

Q: EmotionPromptは、人間とLLMの交流にどのように貢献できるとお考えですか?

A: EmotionPromptは、生成タスクにおけるLLMのパフォーマンス、真実性、責任感を向上させることで、人間とLLMのインタラクションに貢献できる.本研究で実施された実験では、EmotionPromptが生成タスクにおけるLLMのパフォーマンスを平均10.9%有意に向上させることが示された.この改善は、パフォーマンス、真実性、責任感などの指標を用いて評価された.さらに、106人の参加者を対象とした人体実験が行われ、EmotionPromptが生成タスクにプラスの影響を与えることがさらに実証された.人体実験の結果、パフォーマンス、真実性、責任感の評価基準において、平均10.9%の改善が見られた.全体として、EmotionPromptは、人間とLLMの相互作用のために学際的な社会科学の知識を探求する新しい道を提供し、それによって人間とLLMの相互作用を強化する.

Deep Learning for Day Forecasts from Sparse Observations

著者:Marcin Andrychowicz, Lasse Espeholt, Di Li, Samier Merchant, Alexander Merose, Fred Zyda, Shreya Agrawal, Nal Kalchbrenner

発行日:2023年06月06日

最終更新日:2023年07月06日

URL:http://arxiv.org/pdf/2306.06079v3

カテゴリ:Atmospheric and Oceanic Physics, Machine Learning

概要:

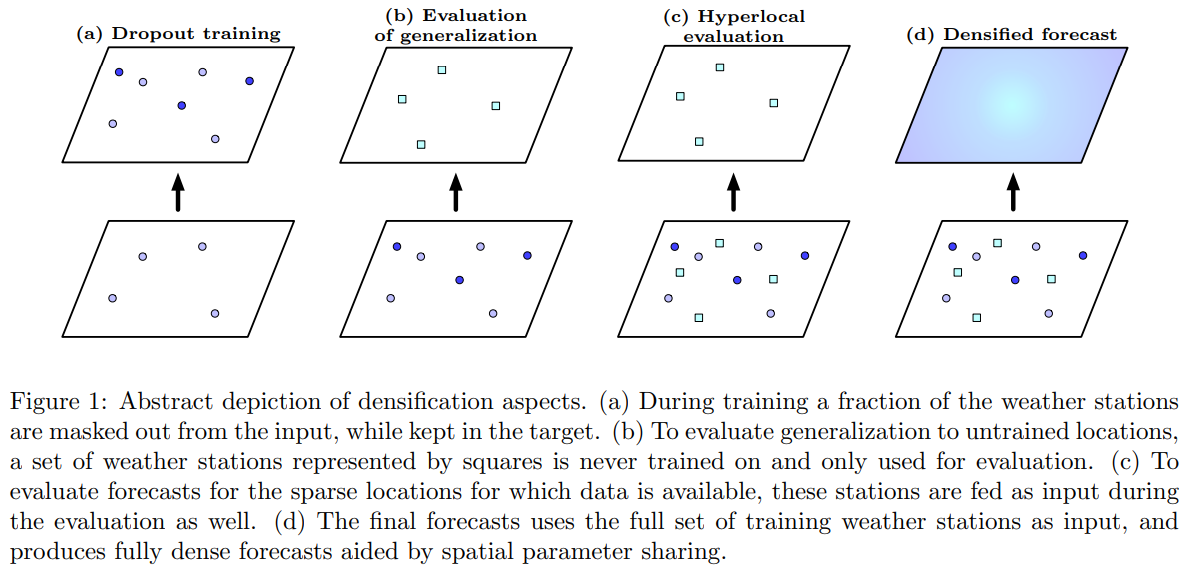

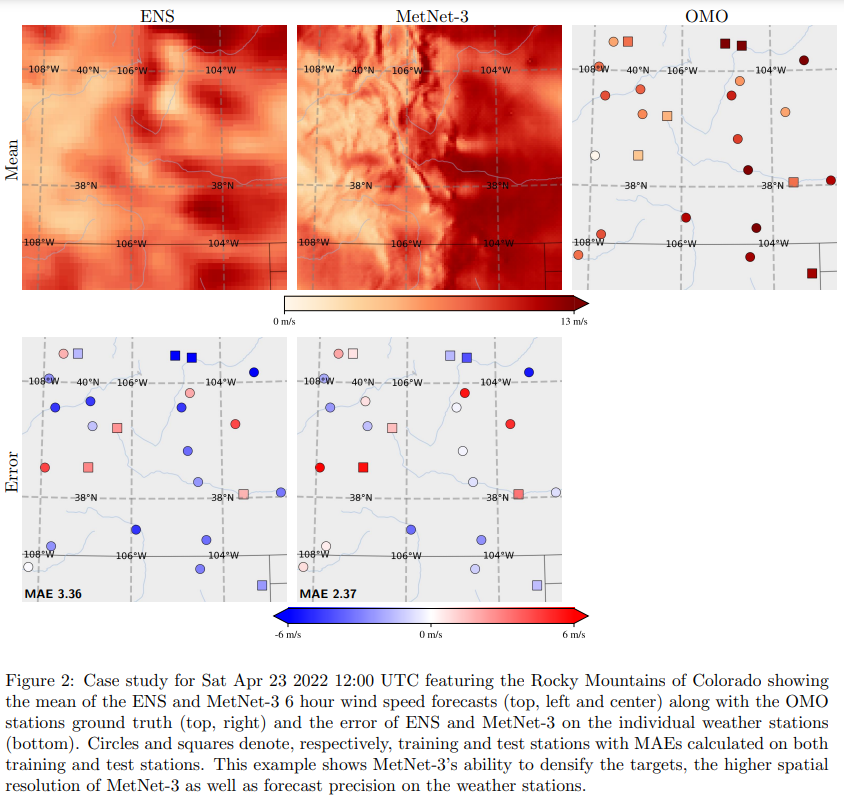

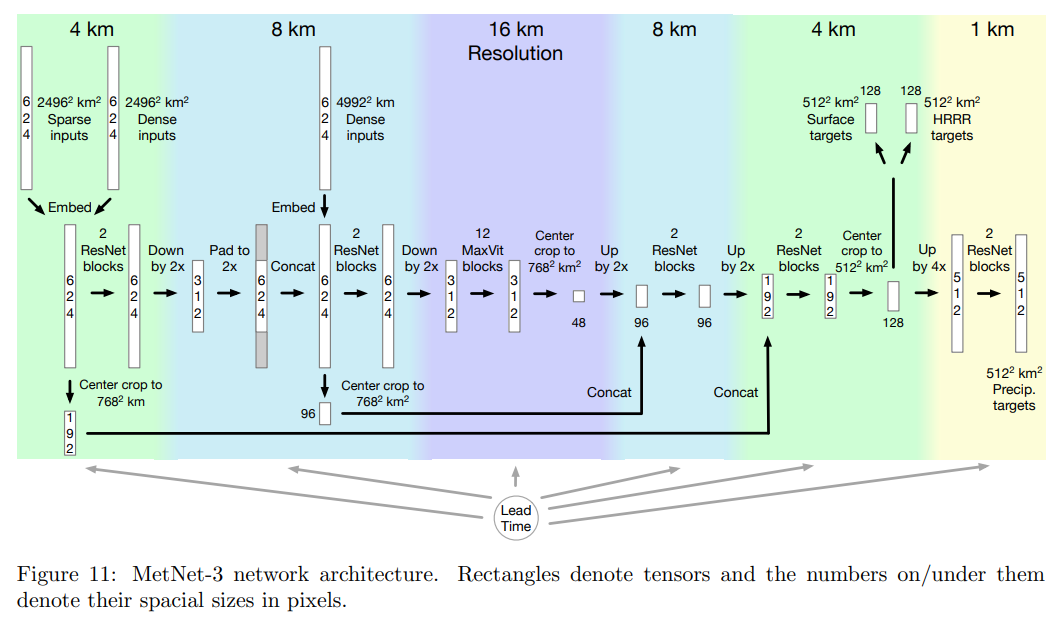

深層ニューラルネットワークは、天候条件をモデリングするための代替パラダイムを提供しています.ニューラルモデルの能力は、データが利用可能になった瞬間に予測を行い、非常に高い時間的および空間的分解能で行うことができること、そして大気観測から直接学習する能力などが、これらのモデルの独自の利点です.大気観測を用いて訓練されたニューラルモデルは、最高の忠実度と最低の遅延時間を持つデータであるため、現在までに降水量のみに関して、最先端の確率的数値天気予報モデルと比較して、12時間までのリードタイムでのみ良好なパフォーマンスを達成してきました.本論文では、MetNet-3を提案し、観測に基づいたニューラルモデルが予測できるリードタイム範囲と変数を大幅に拡張しています.MetNet-3は、降水量、風、気温、露点まで、密集および疎なデータセンサから学習し、24時間先まで予測を行います.MetNet-3は、データ同化を暗黙的に捉え、ネットワークにもかかわらず空間的に密な予測を生成するための重要な密度化技術を導入しています.MetNet-3は、非常に疎なターゲットに対して訓練されているにもかかわらず、データ同化を行い、空間的に密な予測を生成するための重要な技術を導入しています.MetNet-3は、最大2分の時間的分解能と1kmの空間的分解能を持ち、低い運用遅延時間を実現しています.CONUS地域において、HRRRやENSなどの最高の単一および複数メンバーNWPsを上回る性能を示し、最大24時間先までの予測を行うことができます.これにより、観測に基づいたニューラルモデルの新たな性能の基準が設定されました.MetNet-3は、Google Searchで他のモデルと連携して運用され、予測が提供されています.

Q&A:

Q: 天気予報におけるニューラル・モデルのユニークな利点とは?

A: ニューラルモデルの独自の利点は、データが利用可能になった瞬間に予測を行い、非常に高い時間的および空間的分解能で行うことができることです.また、大気観測から直接学習する能力もあります.これらのモデルは、大気観測を使用してトレーニングされ、最高の忠実度と最低の待ち時間のデータを使用して、現時点では最大で12時間までの良好なパフォーマンスを達成しています.

Q: 大気の観測値を用いて訓練されたニューラル・モデルが達成した最大リードタイムは?

A: 高解像度のニューラル気象モデルは、最大で12時間のリードタイムまでしか正確な予測を行えていない.

Q: MetNet-3がうまく予測できる変数とは?

A: MetNet-3は降水量、風、気温、露点の変数をよく予測できる.

Q: MetNet-3は密なデータと疎なデータの両方のセンサーからどのように学習するのか?

A: MetNet-3は、デンシフィケーションと呼ばれるプロセスを導入することで、密集したデータセンサーと疎なデータセンサーの両方から学習します.このプロセスでは、訓練中にネットワークの入力から一部の点観測をランダムに削除し、これらの観測をターゲットとして保持します.これにより、モデルは密集したデータと疎なデータの両方から学習することができます.デンシフィケーション技術はデータ同化を捉え、極めて疎なターゲットで訓練されているにも関わらず、空間的に密な予測を生成します.

Q: MetNet-3が導入した高密度化技術とはどのようなもので、データ同化をどのように捉えているのか?

A: MetNet-3は、疎な点の観測を密な表現にするために、緻密化と呼ばれるプロセスを導入しています.この緻密化技術には4つの主な側面があります.最初の側面は、訓練中に一部の点の観測をランダムに削除することであり、これらの観測をターゲットとして保持します.2番目と3番目の側面は、ホールドアウトセットの観測所で緻密化を評価し、ネットワークの空間的な一般化能力と暗黙の同化能力、およびデータが利用可能な特定の点でのハイパーローカル評価を測定することです.最後の側面は、緻密化の推論ステップであり、ネットワークは空間的なパラメータ共有を使用して、入力で与えられたすべての疎な点を完全に緻密な画像にマッピングし、緻密な予測を生成します.この技術は、データ同化を捉えるものであり、推論ステップ中に疎な点を緻密な表現に変換することで、NWPモデルがデータ同化中に疎な点を緻密な表現に変換する方法と類似しています.

Q: MetNet-3の時間分解能は?

A: MetNet-3の時間分解能は2分です.

Q: MetNet-3の空間分解能は?

A: MetNet-3の空間分解能は1 km / 2分です.

Q: MetNet-3の性能は他のモデルと比較してどうですか?

A: MetNet-3は、その前身であるMetNet-1とMetNet-2よりも進化している.リードタイムの範囲を12時間から24時間へと拡大し、地表温度、露点、風を含む一連のコア気象変数を予測し、利用可能な全大気データのごく一部を使用する.この論文はまた、MetNet-2がオリジナルのMetNetと同様の改良を得たことにも触れており、ニューラル気象モデルが、より優れたアーキテクチャと観測ソースによって改良され続けていることを示している.

Q: MetNet-3は現在稼働しているのか?

A: はい、MetNet-3は現在運用中です.

Q: MetNet-3によって生成された予測は、どのような文脈で利用されるのですか?

A: MetNet-3の予測は、他のモデルと連携してGoogle検索で提供される.