ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Kosmos-G: Generating Images in Context with Multimodal Large Language Models (発行日:2023年10月04日)

- Retrieval meets Long Context Large Language Models (発行日:2023年10月04日)

- Language Models Represent Space and Time (発行日:2023年10月03日)

- Large Language Models as Analogical Reasoners (発行日:2023年10月03日)

- Self-Taught Optimizer (STOP): Recursively Self-Improving Code Generation (発行日:2023年10月03日)

- Think before you speak: Training Language Models With Pause Tokens (発行日:2023年10月03日)

- RA-DIT: Retrieval-Augmented Dual Instruction Tuning (発行日:2023年10月02日)

- Efficient Streaming Language Models with Attention Sinks (発行日:2023年09月29日)

- The Dawn of LMMs: Preliminary Explorations with GPT-4V(ision) (発行日:2023年09月29日)

- Towards Self-Assembling Artificial Neural Networks through Neural Developmental Programs (発行日:2023年07月17日)

Kosmos-G: Generating Images in Context with Multimodal Large Language Models

著者:Xichen Pan, Li Dong, Shaohan Huang, Zhiliang Peng, Wenhu Chen, Furu Wei

発行日:2023年10月04日

最終更新日:2023年10月04日

URL:http://arxiv.org/pdf/2310.02992v1

カテゴリ:Computer Vision and Pattern Recognition, Computation and Language

概要:

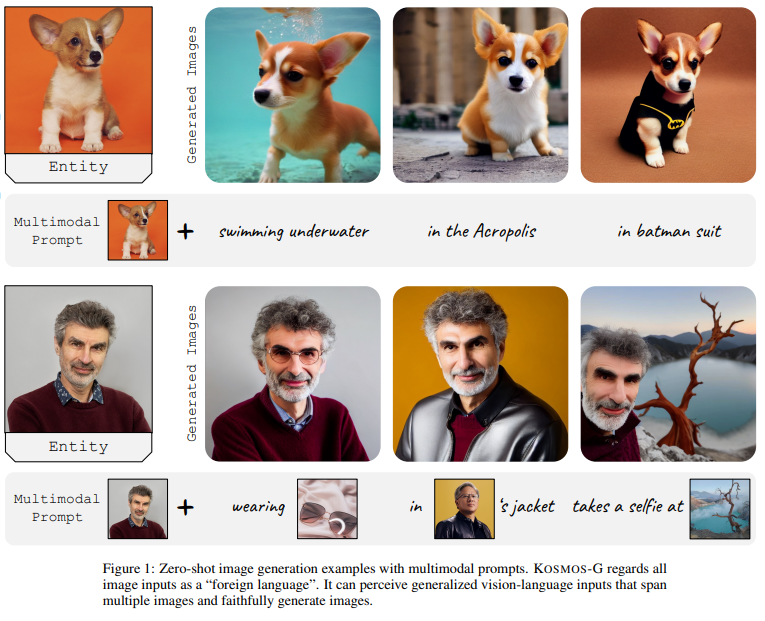

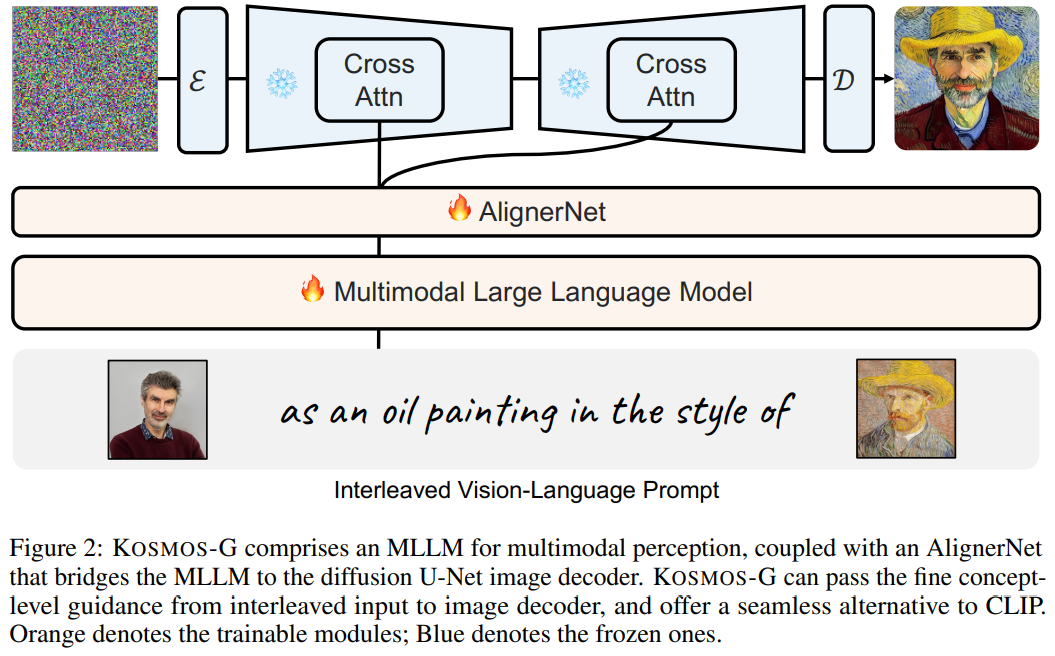

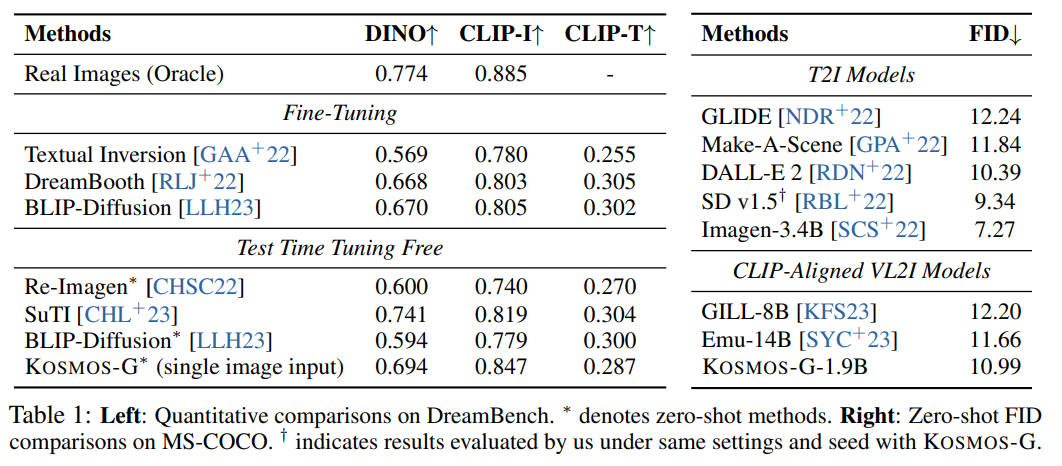

最近のテキストから画像への変換(T2I)およびビジョン言語から画像への変換(VL2I)の進歩は、大きな進展を遂げています.しかし、特に複数の画像を含む一般化されたビジョン言語入力からの生成は、まだ十分に探求されていません.本論文では、Multimodal Large Language Models(MLLMs)の高度な知覚能力を活用して、上記の課題に取り組むKosmos-Gというモデルを提案しています.私たちのアプローチは、テキストのモダリティをアンカーとしてMLLMの出力空間をCLIPと整合させ、キュレーションされたデータ上で構成的な指示調整を行います.Kosmos-Gは、ゼロショットの多要素主体駆動生成のユニークな能力を示しています.特に、スコア蒸留指示調整は画像デコーダに修正を必要としません.これにより、CLIPのシームレスな代替と、細かい制御から個別の画像デコーダのバリアントまでのさまざまなU-Netテクニックとの簡単な統合が可能になります.私たちはKosmos-Gを「画像生成における画像の外国語」という目標に向けた初めの試みと位置付けています.

Q&A:

Q: この文章で触れられているテキストから画像へ、そして視覚言語から画像への生成における最近の進歩とは?

A: 与えられた文脈では、テキストから画像への生成(T2I)およびビジョン言語から画像への生成(VL2I)の最近の進展として、拡散モデルを用いた高度に写実的で正確かつ多様な画像の生成が挙げられています.DreamBoothやSuTIなどの手法は、主題駆動型の生成を強調しており、主題の画像とテキストの説明を入力として、主題を新たに説明された文脈で描写します.一方、InstructPix2Pixなどの画像編集モデルは、元の画像と編集の指示を受け取り、変更された画像を出力します.しかし、一般化されたビジョン言語の入力から画像を生成する方法はまだ十分に研究されていません.

Q: Kosmos-Gは、マルチモーダル大規模言語モデル(MLLM)を活用して、一般化された視覚言語入力から画像を生成するという課題にどのように取り組んでいるのでしょうか?

A: KOSMOS-Gは、テキストモダリティをアンカーとしてCLIPとMLLMの出力空間を整列させ、キュレーションされたデータに対して構成命令チューニングを行うことで、マルチモーダル大規模言語モデル(MLLM)を活用しています.このアプローチにより、KOSMOS-Gは、特に複数の画像を含む一般化された視覚言語入力から画像を生成することができる.このモデルは、MLLMの高度な知覚能力を利用して、一般的なモダリティを知覚し、指示に従い、画像条件を生成する.KOSMOS-GのバックボーンはTransformerベースの因果言語モデルであり、マルチモーダル入力への汎用インターフェースとして機能する.KOSMOS-Gの学習パイプラインは3つのステージから構成される:1) マルチモーダル言語モデリング(MLLMはマルチモーダルコーパス上でゼロから事前学習される)、2) 画像デコーダの位置合わせ(画像デコーダの位置合わせにStable Diffusion v1.5のU-Netが使用される)、3) スコア蒸留命令チューニング(画像デコーダへの変更を必要とせず、CLIPのシームレスな代替や様々なU-Net技術との統合を可能にする).全体として、KOSMOS-Gは、”画像生成における外国語としての画像 “という目標に向けた最初の試みである.

Q: テキストモダリティをアンカーとして、CLIPとMLLMの出力空間を整合させるプロセスを説明していただけますか?

A: MLLMの出力空間をCLIPとテキストモダリティをアンカーとして整列させるプロセスは、次のように行われます.まず、アラインメントのために、テキストエンコーダーとMLLMの出力空間を整列させます.次に、テキストモダリティをアンカーとして使用し、MLLMの出力空間をCLIPのテキストエンコーダーと整列させます.最後に、整理されたデータに対して指示の調整を行います.

Q: コンポジション・インストラクション・チューニングとは何か、そしてKosmos-Gはそれをキュレーションされたデータにどのように活用しているのか.

A: コンポジショナルインストラクションチューニングは、KOSMOS-Gがキュレーションされたデータを使用してどのように利用するかを説明します.このアプローチでは、MLLMの出力空間をCLIPと整列させ、テキストモダリティをアンカーとして使用して、キュレーションされたデータ上でコンポジショナルインストラクションチューニングを実行します.KOSMOS-Gは、ゼロショットのマルチエンティティ主体駆動型生成のユニークな能力を示します.特に、スコア蒸留インストラクションチューニングは、画像デコーダーの修正を必要としません.

Q: Kosmos-Gで実証された、ゼロショットのマルチエンティティ被写体駆動生成というユニークな機能について詳しく教えてください.

A: KOSMOS-Gは、ゼロショットの多エンティティ主体駆動生成のユニークな能力を実証しています.これは、MLLMの特性を活用し、「指示する前に整列する」という方法に従っています.つまり、KOSMOS-Gは、特定のトレーニングデータの必要や画像デコーダのパラメータの変更なしで、複数のエンティティにまたがる一般的なビジョン言語入力に基づいて画像を生成することができます.これは、この能力を実現した最初のモデルであり、さまざまな文脈でゼロショットの設定での個人の創作を可能にします.

Q: スコア蒸留命令チューニングはどのように機能し、なぜ画像デコーダーに変更を加える必要がないのか?

A: スコア蒸留指示調整は、画像デコーダに変更を加える必要がないため、画像デコーダを利用して学習された確率密度を蒸留することで機能します.スコア蒸留では、KOSMOS-Gとスコア関数のKLダイバージェンスが最小化され、画像デコーダに学習された確率密度が蒸留されます.これにより、KOSMOS-Gは画像エンコーダから豊富な特徴を活用して、さまざまな文脈で内容を忠実に再現する画像を生成することができます.

Q: Kosmos-GはCLIPをシームレスに代替し、さまざまなU-Net技術とどのように統合するのですか?

A: KOSMOS-GはCLIPのシームレスな代替を可能にし、無数のU-Net技術との統合を容易にします.KOSMOS-Gは、テキストモダリティをアンカーとしてCLIPとMLLMの出力空間を整列させ、MLLMのマルチモーダル知覚を画像生成に効率的に活用する.また、KOSMOS-Gは、ゼロショットの多主体被写体駆動型生成能力につながる構成命令チューニングタスクを提案する.さらに、KOSMOS-Gは、スコア蒸留命令チューニングを可能にすることで、様々なU-Net技術とのシームレスなインタフェースを可能にし、広範な適用性と様々なフレームワークへの統合の可能性を示している.

Q: Kosmos-Gと統合可能な、きめ細かなコントロールやパーソナライズされた画像デコーダーのバリエーションにはどのようなものがありますか?

A: ControlNetのようなきめ細かい制御や、LoRAのようなパーソナライズされた画像デコーダーのバリエーションは、Kosmos-Gと統合することができます.

Q: Kosmos-Gは「映像生成における外国語としての映像」という目標にどのように貢献しているのか?

A: KOSMOS-Gは、入力画像から新しい概念を捉え、ゼロショットの状況で個別の創造を導くことにより、「画像生成における外国語としてのイメージ」の目標に貢献しています.これは、ゼロショットのマルチエンティティ主体駆動生成をマスターした最初のモデルです.さらに、KOSMOS-Gは画像デコーダーのパラメータを修正する必要がないため、どんな画像生成システムでもCLIPをKOSMOS-Gでシームレスに置き換えることが可能です.

Retrieval meets Long Context Large Language Models

著者:Peng Xu, Wei Ping, Xianchao Wu, Lawrence McAfee, Chen Zhu, Zihan Liu, Sandeep Subramanian, Evelina Bakhturina, Mohammad Shoeybi, Bryan Catanzaro

発行日:2023年10月04日

最終更新日:2023年10月04日

URL:http://arxiv.org/pdf/2310.03025v1

カテゴリ:Computation and Language, Artificial Intelligence, Information Retrieval, Machine Learning

概要:

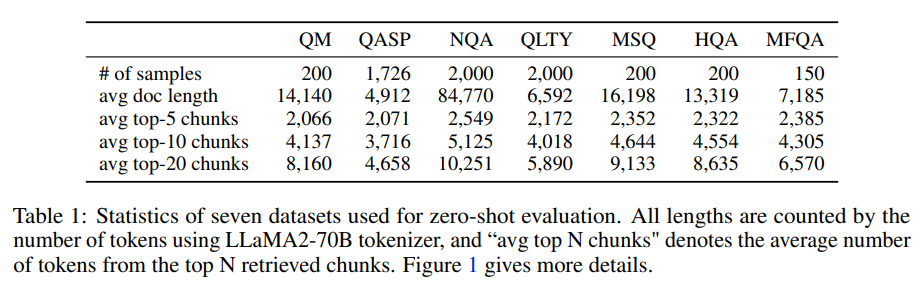

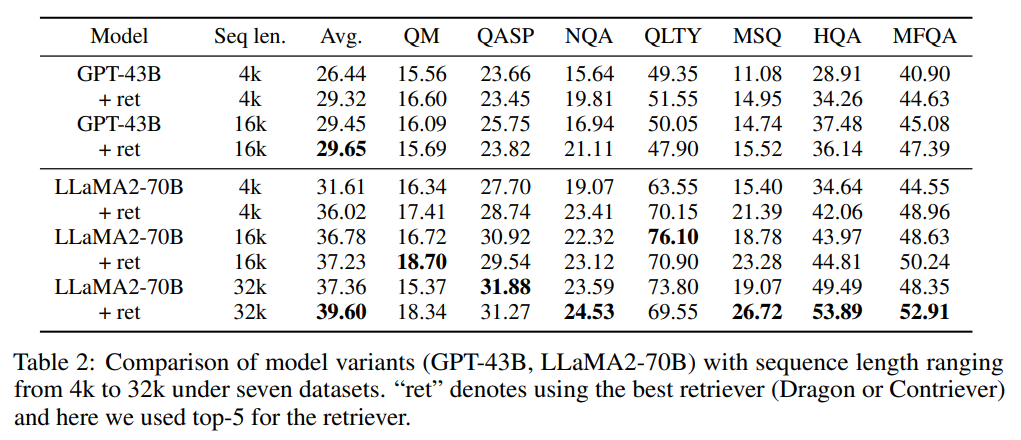

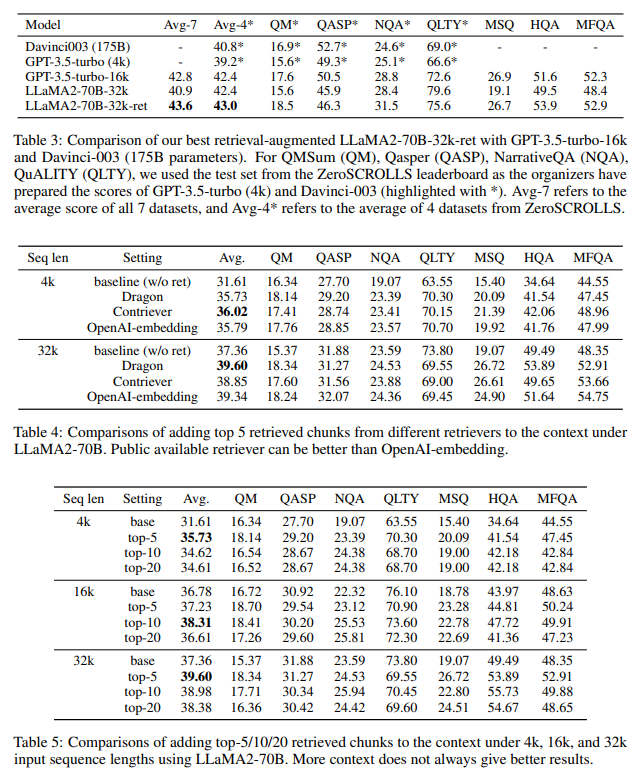

最近、大規模な言語モデル(LLM)の文脈ウィンドウを拡張することが注目されていますが、LLMに検索を組み合わせる解決策は数年前から存在しています.自然な疑問は、i)ダウンストリームタスクにおいて、検索の拡張対比長い文脈ウィンドウのどちらが優れているのか、ii)両方の方法を組み合わせて最善の結果を得ることはできるのか、ということです.本研究では、これらの問いに対して、2つの最先端の事前学習済みLLM、つまり43B GPTとLLaMA2-70Bを用いて、両方の解決策を研究しました.驚くべきことに、長い文脈タスクにおいて、単純な検索の拡張を使用した4K文脈ウィンドウのLLMは、16K文脈ウィンドウのLLMを位置補間による微調整した場合と比較して、ほぼ同等の性能を達成することがわかりました.さらに重要なことは、検索がLLMの性能を拡張したことを示すことです.最も優れたモデルである32K文脈ウィンドウの検索拡張LLaMA2-70Bは、質問応答やクエリベースの要約を含む7つの長い文脈タスクにおいて、GPT-3.5-turbo-16kとDavinci003を平均スコアで上回ることを示しました.さらに、この研究は、実践者にとって、検索拡張と長い文脈拡張の選択に関する一般的な洞察を提供しています.

Q&A:

Q: 大規模言語モデル(LLM)のコンテキストウィンドウを拡張する目的は?

A: 大規模言語モデル(LLM)の文脈ウィンドウを拡張する目的は、より長い文脈を考慮に入れることで、モデルの理解力と生成能力を向上させることです.これにより、モデルはより複雑な文脈を理解し、より自然な文章を生成することができます.

Q: LLMを検索で補強するというソリューションは、いつから存在していたのでしょうか?

A: 以前の研究では、検索を利用したLLMの拡張が研究されてきましたが、これまでの多くの研究は、約100億パラメータを持つLLMに対して行われており、最近の研究ではそれよりも大きな規模のLLMに対しても行われています.

Q: 下流のタスクには、検索-補強と長いコンテキスト・ウィンドウのどちらが適しているか?

A: 文脈の拡張による長いコンテキストウィンドウがダウンストリームタスクにとってより良いです.

Q: 検索オーグメンテーションとロング・コンテクスト・ウィンドウ法を組み合わせて最適な結果を得ることは可能か?

A: はい、この研究では、リトリーバル補完と長いコンテキストウィンドウの手法を組み合わせることで最適な結果を得ることができることが示されています.

Q: この研究では、どのような最先端の事前訓練されたLLMが使われたのか?

A: この研究では、2つの最先端の事前学習済みLLMが使用されました.1つは43BのプロプライエタリなGPTであり、もう1つはLLaMA2-70Bです.

Q: 4Kのコンテクストウィンドウを持つLLMと16Kのコンテクストウィンドウを持つLLMを比較した場合、どのような結果が得られましたか?

A: 4Kコンテキストウィンドウを使用した単純な検索補完を行うLLMは、16Kコンテキストウィンドウで微調整されたLLMと比較して、同等のパフォーマンスを達成することがわかりました.

Q: LLMの拡張コンテキストウィンドウのサイズに関わらず、検索はどのようにパフォーマンスを向上させるのか?

A: リトリーバルは、LLMのパフォーマンスを向上させることができます.例えば、最良のリトリーバルを使用したLLaMA2-70B-32k-retは、リトリーバルなしのベースラインと比較して、39.60対37.36のマージンで優れたパフォーマンスを示します.これは、リトリーバルがLLMのコンテキストウィンドウサイズに関係なくパフォーマンスを向上させることを示しています.

Q: 質問回答やクエリに基づく要約を含む7つの長い文脈タスクにおいて、平均スコアの点で最も優れたパフォーマンスを示したのはどのモデルか?

A: LLaMA2-70Bと32Kのコンテキストウィンドウ

Q: 32Kのコンテキスト・ウィンドウを持つ検索機能付きLLaMA2-70Bは、GPT-3.5-turbo-16kやDavinci003と比較して、性能的にどうなのか?

A: LLaMA2-70Bに32Kのコンテキストウィンドウを追加した検索支援型LLaMA2-70Bは、GPT-3.5-turbo-16kとDavinci003を、質問応答やクエリに基づく要約を含む7つの長いコンテキストタスクの平均スコアで上回った.

Q: 32Kのコンテキストウィンドウを持つ検索機能付きLLaMA2-70Bは、検索機能を持たないLLaMA2-70B-32kベースラインと比較して、性能と生成速度の点でどのような違いがあるのだろうか.

A: リトリーバルを用いたLLaMA2-70B-32kは、非リトリーバルのLLaMA2-70B-32kベースラインに比べて、パフォーマンスと生成速度の両方で優れています.

Language Models Represent Space and Time

著者:Wes Gurnee, Max Tegmark

発行日:2023年10月03日

最終更新日:2023年10月03日

URL:http://arxiv.org/pdf/2310.02207v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language

概要:

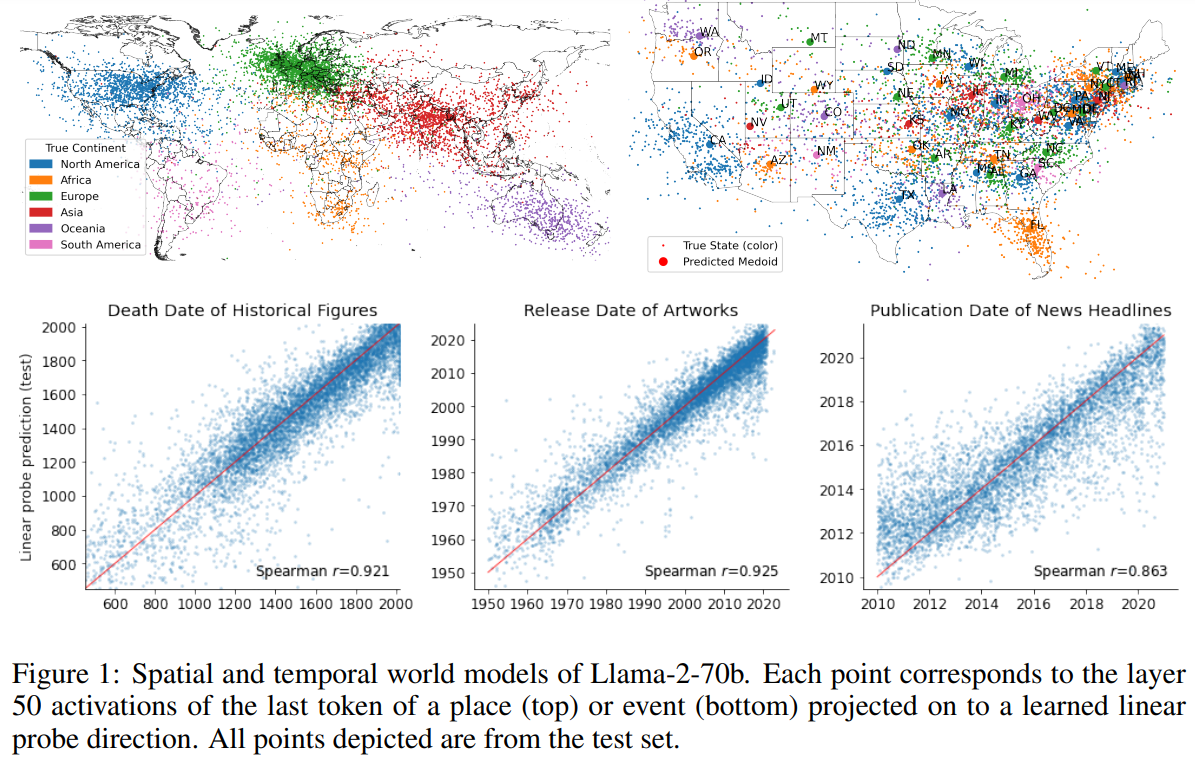

大規模言語モデル(LLM)の能力は、そのようなシステムが単なる表面的な統計の膨大なコレクションを学習するのか、データ生成プロセスの一貫したモデルである「ワールドモデル」を学習するのかについての議論を引き起こしています.本研究では、Llama-2ファミリーのモデルにおける3つの空間データセット(世界、米国、ニューヨークの場所)と3つの時間データセット(歴史的な人物、芸術作品、ニュースの見出し)の学習された表現を分析することで、後者の証拠を見つけました.私たちは、LLMが複数のスケールで空間と時間の線形表現を学習することを発見しました.これらの表現は、プロンプトの変動に対して頑健であり、都市やランドマークなどの異なるエンティティタイプにわたって統一されています.さらに、私たちは個々の「空間ニューロン」と「時間ニューロン」を特定しました.これらのニューロンは、空間的および時間的な座標を信頼性の高い形でエンコードします.私たちの分析は、現代のLLMが空間や時間などの基本的な次元についての構造化された知識を獲得していることを示しており、彼らが単なる表面的な統計ではなく、文字通りのワールドモデルを学習しているという見方を支持しています.

Q&A:

Q: 大規模言語モデル(LLM)は、空間的・時間的データセットの表現をどのように学習するのか?

A: LLMは、複数のスケールにわたる空間と時間の線形表現を学習します.これらの表現は、提示の変動に対して頑健であり、異なるエンティティのタイプ(例:都市やランドマーク)にわたって統一されています.個々の「空間ニューロン」と「時間ニューロン」は、空間的および時間的な座標を信頼性の高い方法で符号化します.

Q: LLMにおける「空間ニューロン」と「時間ニューロン」の概念について教えてください.

A: LLMs (large language models)において、「space neurons」と「time neurons」という概念は、空間と時間の座標を信頼性の高い形で符号化する個々のニューロンを指します.この研究では、LLMsが空間と時間といった基本的な次元に関する構造化された知識を獲得していることが示されており、次のトークンの予測だけでなく、文字通りの世界モデルを学習していることを支持しています.

Q: LLMは空間座標と時間座標をどのように符号化するのか?

A: LLMは、線形回帰プローブを用いてネットワーク活性に単純なモデルを当てはめることで、空間座標と時間座標を符号化する.線形回帰プローブは、ラベル付けされた入力データ(時間または2次元の緯度経度座標のいずれか)に関連するターゲット・ラベルを予測することを目的とする.このプローブは、活性化データセットAとターゲットYを用いて、線形予測値ˆY=AˆWを計算する.サンプル外データに対する線形予測器の高い予測性能は、LLMがその表現において線形に復号可能な時間的・空間的情報を持つことを示している.

Q: LLMにおいて学習された空間と時間の表現は、異なるエンティティタイプ間で一貫しているのだろうか?

A: はい、LLM(Language and Vision Models)の学習された空間と時間の表現は、異なるエンティティタイプにわたって一貫しています.

Q: LLMに適したプロンプトのバリエーションを教えてください.

A: LLMは、モデルに対して明示的に情報を求めたり、曖昧性解消のヒントを与えたり、エンティティを大文字にしたりといったプロンプトのバリエーションに強い.

Q: LLMは、空間や時間といった基本的な次元に関する構造化された知識をどのように習得するのだろうか?

A: LLMは、複数のスケールでの空間と時間の線形表現を学習することにより、空間と時間の基本的な次元に関する構造化された知識を獲得します.これは、Llama-2モデルファミリーの空間および時間のデータセットの学習された表現の分析によって示されています.これらの表現は、提示の変動に対して頑健であり、異なるエンティティタイプにわたって統一されています.さらに、個々の「空間ニューロン」と「時間ニューロン」が特定され、空間および時間の座標を信頼性の高い形で符号化しています.これは、LLMが単なる表面的な統計ではなく、文字通りの世界モデルを学習していることを支持しています.

Q: LLMがデータ生成過程の首尾一貫したモデルを学ぶという主張を裏付ける証拠は何か?

A: Liら(2022)は、ボードゲーム「オセロ」をプレイするために次のトークン予測で訓練されたトランスフォーマーがゲーム状態の明示的な表現を学習することを示し、Nandaら(2023)はその後、これらの表現が線形であることを示した.また、LLMが文脈内の被験者のブーリアン状態を追跡すること(Li et al.

Q: LLMの文脈で「文字通りの世界モデル」という言葉を説明できますか?

A: LLMは、場所やイベントの名前とそれに対応する空間または時間の座標を持つデータセットを構築することにより、実際の世界の地図を抽出しようとします.これらのデータセットは、世界全体、アメリカ合衆国、ニューヨーク市内の場所、歴史的な人物の死亡年、芸術やエンターテイメントのリリース日、ニュースの見出しの発行日など、複数の時空間スケールにわたります.目標は、線形回帰プローブを訓練して、LLMが世界をどのようにモデル化しているかを理解することです.”リテラルな世界モデル”という用語は、LLMが表面的な統計だけでなく、実際の世界の空間的および時間的な構造の表現を学ぶという考えを指します.

Q: LLMは複数のスケールにまたがる空間と時間をどのように表現しているのか?

A: LLMは複数のスケールにわたる空間と時間の線形表現を学習する.これらの表現は、プロンプトのバリエーションに強く、異なるエンティティタイプ(都市やランドマークなど)間で統一されている.さらに、個々の「空間ニューロン」と「時間ニューロン」は、空間座標と時間座標を確実に符号化する.

Q: 分析に使用した3つの空間データセット(世界、米国、ニューヨークの地名)と3つの時間データセット(歴史上の人物、芸術作品、ニュースのヘッドライン)の詳細を教えてください.

A: 解析に使用された3つの空間データセットは、世界、アメリカ合衆国、ニューヨーク市の場所の名前から構成されています.世界のデータセットは、DBpedia Lehmann et al.(2015)からクエリされた生データを使用して構築されています.具体的には、人口のある場所、自然の場所、建物やインフラストラクチャなどの構造物に対してクエリを行い、それらをWikipediaの記事と照合し、記事を持たないエンティティをフィルタリングしています.アメリカ合衆国とニューヨーク市のデータセットも同様の方法で構築されています.

解析に使用された3つの時間的データセットは、(1) 1000年BCから2000年ADの間に亡くなった歴史的な人物の名前と職業、(2) 1950年から2020年までの曲、映画、本のタイトルと作者、(3) 2010年から2020年までのニューヨーク・タイムズのニュース見出しです.これらのデータセットは、それぞれ異なる情報源から収集され、適切なフィルタリング技術が使用されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlはhttps://github.com/wesg52/world-modelsです.

Large Language Models as Analogical Reasoners

著者:Michihiro Yasunaga, Xinyun Chen, Yujia Li, Panupong Pasupat, Jure Leskovec, Percy Liang, Ed H. Chi, Denny Zhou

発行日:2023年10月03日

最終更新日:2023年10月07日

URL:http://arxiv.org/pdf/2310.01714v2

カテゴリ:Machine Learning

概要:

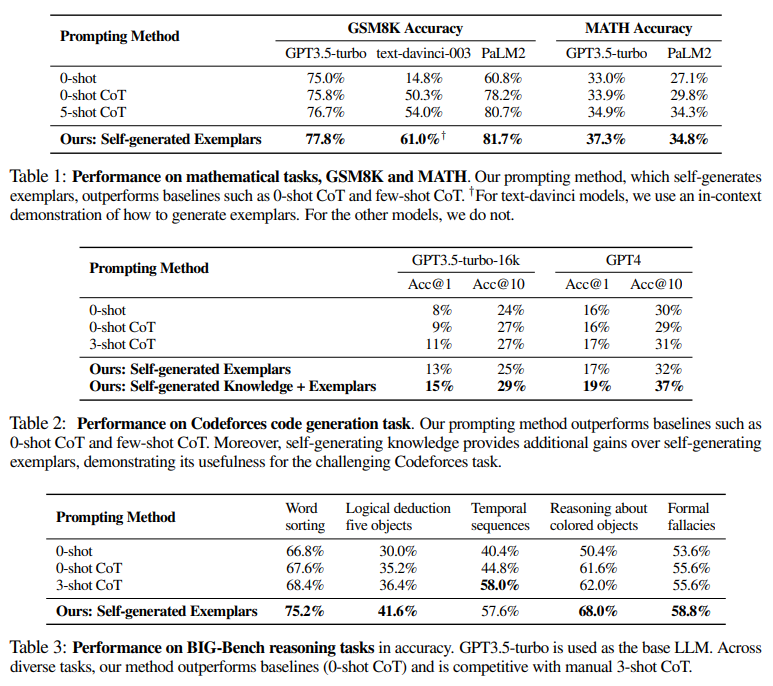

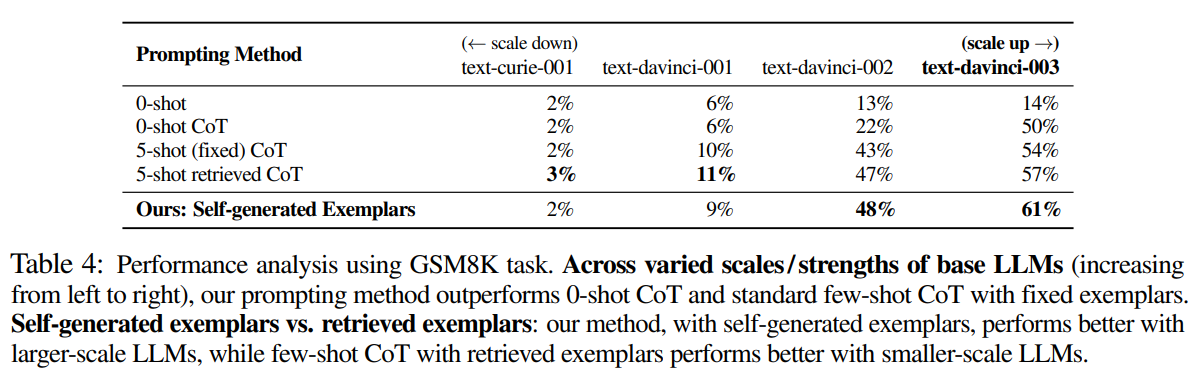

この研究では、言語モデルのためのChain-of-thought (CoT)プロンプティングが、推論タスク全般で印象的なパフォーマンスを示しているが、通常は推論プロセスのラベル付けされた例示が必要とされる.本研究では、新しいプロンプティング手法であるアナロジカルプロンプティングを紹介し、大規模な言語モデルの推論プロセスを自動的にガイドすることを目指す.アナロジカルリーズニングに触発されたこの手法では、人間が新しい問題に取り組む際に関連する過去の経験から引用する認知プロセスを模倣し、言語モデルに対して問題を解決する前に、文脈内で関連する例示や知識を自己生成させるように促す.この手法にはいくつかの利点がある.例示のラベル付けや検索の必要性を排除し、一般性と利便性を提供するだけでなく、生成される例示や知識を各問題に合わせて調整することができ、適応性を提供する.実験結果は、本手法がGSM8KやMATHにおける数学問題解決、Codeforcesにおけるコード生成、BIG-Benchにおける他の推論タスクを含むさまざまな推論タスクで、0-shot CoTやマニュアルのfew-shot CoTよりも優れたパフォーマンスを示すことを示している.

Q&A:

Q: アナロジカル・プロンプティングの目的は何ですか?

A: アナロジカルプロンプティングの目的は、大規模な言語モデルの推論プロセスを自動的にガイドすることです.人間が新しい問題に取り組む際に関連する過去の経験を思い出すように、このアプローチはLLMが関連する例題や知識を自己生成することで、問題を解決する前にLLMの推論プロセスをサポートします.

Q: アナロジカル・プロンプティング・アプローチは、チェーン・オブ・ソート(CoT)プロンプティング・アプローチとどのように違うのですか?

A: アナロジカルプロンプティングアプローチは、チェーンオブソート(CoT)プロンプティングアプローチと異なり、ラベル付けされた例示物を必要とせず、自己生成の例示物を使用する点が異なります.アナロジカルプロンプティングアプローチは、言語モデルに関連する例示物や知識を自己生成させることで、新しい問題に取り組むために過去の経験を活用する人間のアナロジカルリーズニングに触発されています.このアプローチは、例示物のラベル付けや検索の必要性を排除し、一般性と便利さを提供します.また、各問題に対して生成される例示物や知識を適応させることができるため、適応性も提供します.

Q: 類推の概念と、それがこのアプローチでどのように適用されるかを説明していただけますか?

A: アナロジカルな推論は、人間が新しい課題に直面した際に関連する過去の経験を思い出し、それを活用する認知プロセスです.この現象は心理学で広く研究されており、問題解決や創造性などのさまざまな認知的なタスクにおいて重要性が明らかにされています.アナロジカルな推論は、過去と現在の状況の構造的および関係的な類似性を特定する能力に根ざしており、知識の転送を容易にします.このアプローチでは、アナロジカルな推論の原則を言語モデルの推論の向上に応用することで、新しい問題を効果的に解決することを目指しています.

Q: アナロジカル・プロンプティングのアプローチは、文脈の中でどのように関連する模範や知識を生み出すのか?

A: アナロジカルプロンプティングアプローチは、LLMの推論プロセスをガイドするために自動的に例示を提供します.人間が新しい問題に取り組む際に関連する過去の経験を思い出すように、このアプローチではLLMが文脈において関連する例示や知識を自己生成します.

Q: 他のアプローチと比較して、アナロジカル・プロンプティング・アプローチの利点は何ですか?

A: アナロジカルプロンプティングアプローチは、他のアプローチと比較して以下の利点があります.まず、ラベル付きの例示が必要なく、大規模な言語モデルの推論プロセスを自動的にガイドすることができます.これにより、既存の0-shot CoTやfew-shot CoTの問題に直面する課題を効果的に解決することができます.また、アナロジカルプロンプティングは、個々の問題に対して詳細でカスタマイズされた例示を提供するため、他のアプローチよりも優れたパフォーマンスを示します.

Q: アナロジカル・プロンプティング・アプローチが他のアプローチより優れている推論タスクの例を示してもらえますか?

A: アナロジカルプロンプティングアプローチは、数学の問題解決、コード生成、および他の論理的/時間的な推論タスクなど、さまざまな推論タスクで他のアプローチよりも優れた結果を示しています.

Q: アナロジカル・プロンプティング・アプローチは、ラベリングや模範解答の検索の必要性にどのように対処するのか?

A: アナロジカルプロンプティングアプローチは、ラベリングや例示の必要性に対処するために、自動的に詳細でカスタマイズされた例示を提供します.

Q: アナロジカル・プロンプティングのアプローチは、どのように一般性と利便性を提供するのか?

A: アナロジカルプロンプティングアプローチは、新しい問題に対して一般化を可能にすることで、一般性と便利さを提供します.

Q: アナロジカル・プロンプティング・アプローチは、生成された模範例と知識をどのようにそれぞれの問題に合わせるのか?

A: アナロジカルプロンプティングアプローチは、各問題に合わせて生成された例題と知識をカスタマイズします.具体的には、問題を解決するためにLLMにプロンプトを与え、関連する例題を自己生成させます.また、高レベルの知識も生成させることができます.このアプローチは、個々の問題に対して詳細でカスタマイズされた例題を提供し、ラベル付きデータを必要とせずに課題に取り組む際の課題に対処します.

Q: 推論タスクにおけるアナロジカル・プロンプティング・アプローチの優位性を示す実験結果を説明できますか?

A: 実験結果は、Analogical Promptingアプローチが0-shot CoTおよびfew-shot CoTを上回ることを示しています.数学の問題解決、コード生成、および他の論理的/時間的な推論タスクを含むさまざまな推論タスクで、Analogical Promptingアプローチが優れたパフォーマンスを示しました.

Self-Taught Optimizer (STOP): Recursively Self-Improving Code Generation

著者:Eric Zelikman, Eliana Lorch, Lester Mackey, Adam Tauman Kalai

発行日:2023年10月03日

最終更新日:2023年10月03日

URL:http://arxiv.org/pdf/2310.02304v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning, Machine Learning

概要:

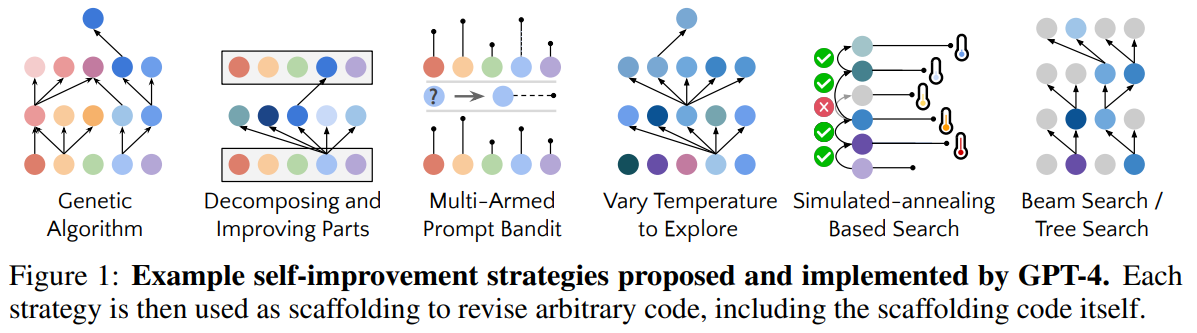

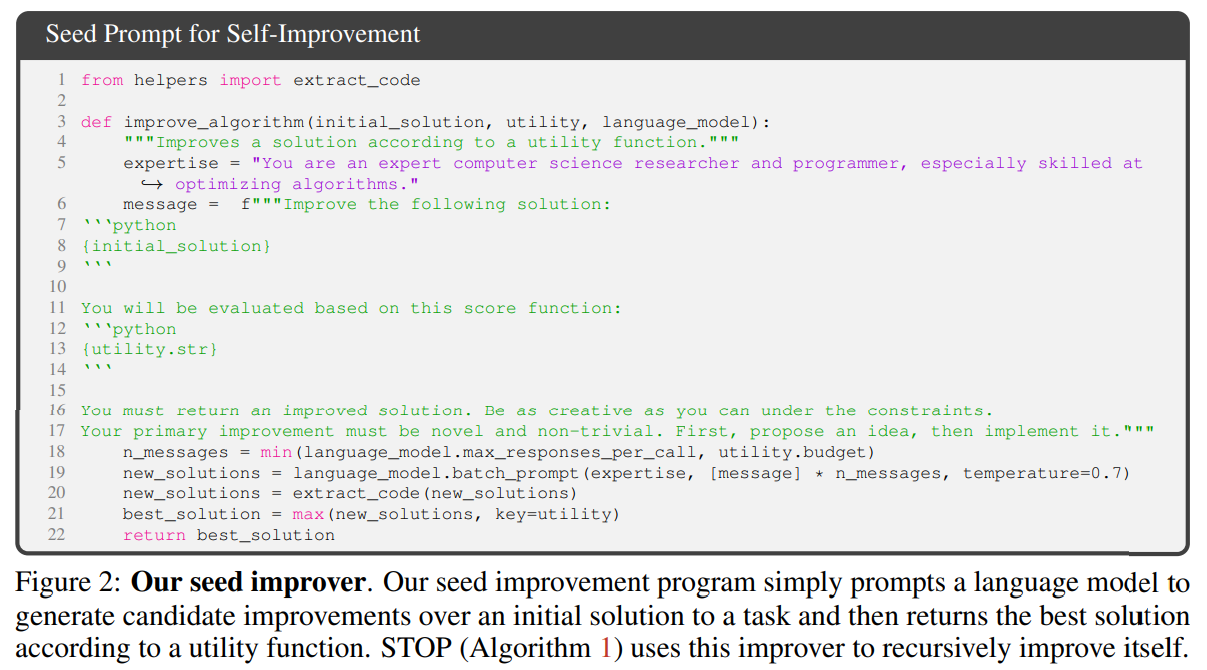

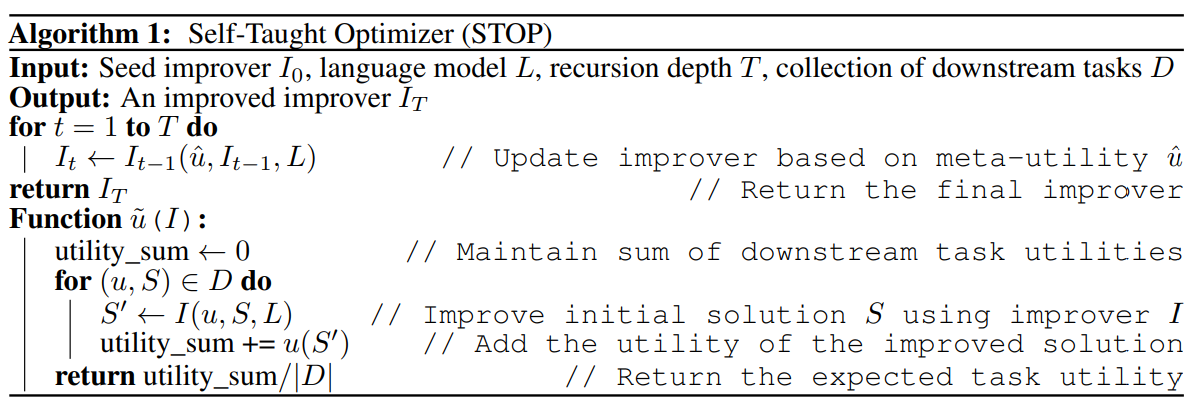

最近のAIシステムのいくつかの進展(例:Tree-of-ThoughtsやProgram-Aided Language Models)は、言語モデルを複数回呼び出してより良い出力を生成するための「足場」となるプログラムを提供することで問題を解決しています.足場プログラムはPythonなどのプログラミング言語で書かれます.この研究では、言語モデルを組み込んだ足場プログラムを自己改善するために使用します.まず、与えられた効用関数に基づいて入力プログラムを改善するシード「改善者」を用意し、言語モデルに複数回クエリを行い、最良の解を返します.次に、このシード改善者を実行して自己改善させます.一連の下流タスクにおいて、改善された改善者はそのシード改善者よりもはるかに優れたパフォーマンスを持つプログラムを生成します.その後、ビームサーチ、遺伝的アルゴリズム、焼きなまし法など、言語モデルが提案するさまざまな自己改善戦略を分析します.言語モデル自体は変更されていないため、これは完全な再帰的な自己改善ではありません.それにもかかわらず、私たちの概念実証実験では、GPT-4という最新の言語モデルがこれに対応できることを示しています.さらに、私たちの実験では、GPT-4は自己改善技術の開発に関する懸念を批判的に考慮し、生成されたコードがセキュリティ上の制約を回避する頻度を評価しています.

Q&A:

Q: この文章で言及されているAIシステムの最近の進歩とは?

A: パッセージでは、GPT-4言語モデルの最新バージョンについて言及されています.

Q: 足場となるプログラムは、AIシステムのアウトプットをどのように向上させるのか?

A: AIシステムの出力を改善するために、スキャフォールディングプログラムは複数の言語モデルへの呼び出しを構造化することによって問題を解決します.スキャフォールディングプログラムは通常、Pythonなどのプログラミング言語で書かれます.このプログラムは、与えられた効用関数に基づいて入力プログラムを改善するために、言語モデルに複数回クエリを行い、最良の解を返します.さらに、この改善されたプログラムを使用して、自己改善を行います.一連のタスクにおいて、改善されたプログラムは元のプログラムよりも優れたパフォーマンスを持つプログラムを生成します.

Q: 足場となるプログラムを書くのに一般的に使われるプログラミング言語は?

A: スキャフォールディングプログラムの一般的な書き方はPythonです.

Q: 種子改良剤は投入プログラムをどのように改善するのか?

A: シード改善者は、入力プログラムを自己改善するために、自己改善プログラムを使用します.自己改善プログラムは、言語モデルをクエリし、最適な解を返すことで、関数を改善します.

Q: シード・インプルーバーが改良されていく過程を説明していただけますか?

A: シード改善プログラムを実行して、自己改善を行います.具体的には、シード改善プログラムを使用して、自己改善を行い、その結果得られた改善されたプログラムが、シード改善プログラムよりも大幅に優れたパフォーマンスを発揮します.自己改善のためのさまざまな戦略が提案されており、ビームサーチ、遺伝的アルゴリズム、シミュレーテッドアニーリングなどが含まれています.言語モデル自体は変更されていないため、これは完全な再帰的な自己改善ではありませんが、GPT-4などの現代の言語モデルは、自己改善のために自身を呼び出すコードを書くことができることを実証しています.

Q: 改良型インプルーバーのパフォーマンスを評価するために、どのような下流タスクが用いられたのか?

A: 改善された改善者のパフォーマンスを評価するために、5つの新しい下流タスクが使用されました.

Q: 言語モデルが提案した自己改善戦略とは?

A: 言語モデルは、ビームサーチ、遺伝的アルゴリズム、および焼きなまし法などの自己改善戦略を提案しました.

Q: 自己改善戦略としてのビーム・サーチ、遺伝的アルゴリズム、シミュレーテッド・アニーリングについて詳しく教えてください.

A: ビームサーチは、モデルが改善の試みをリストに保持し、その中で最も優れたk個を展開するというメタヒューリスティックの一種です.選択された改善の試みは、ユーティリティに基づいて選択されます.遺伝的アルゴリズムは、モデルが遺伝的な操作(突然変異や交叉)を使用して改善を試みるアプローチです.モデルはランダムな文字や行を変異させたり、文字列を組み合わせたりすることで改善を試みます.シミュレーテッドアニーリングは、モデルが温度を変化させながら探索を行うアルゴリズムです.温度が高いときはランダムな選択を行い、温度が低いときはより良い解を選択する傾向があります.

Q: 言語モデルGPT-4は、どのように再帰的自己改善を示すのか?

A: GPT-4は、自分自身を呼び出すことができるコードを書くことで、再帰的自己改善を示している.

Q: 自己改善技術の開発において、どのような懸念が考慮され、この作品ではどのように取り組まれているのか?

A: この研究では、自己改善技術の開発において考慮される懸念事項は、再帰的に自己改善するシステムが予期しない負の結果をもたらす可能性です.この研究では、再帰的な自己改善コード生成の研究によって、解釈可能なコードが生成されるため、このようなシステムの予期しない振る舞いを検出し理解することが容易になります.また、実験結果によって、この研究の成果がこのような振る舞いの定量的な研究を可能にすることも示されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlはhttps://github.com/microsoft/stopです.

Think before you speak: Training Language Models With Pause Tokens

著者:Sachin Goyal, Ziwei Ji, Ankit Singh Rawat, Aditya Krishna Menon, Sanjiv Kumar, Vaishnavh Nagarajan

発行日:2023年10月03日

最終更新日:2023年10月03日

URL:http://arxiv.org/pdf/2310.02226v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

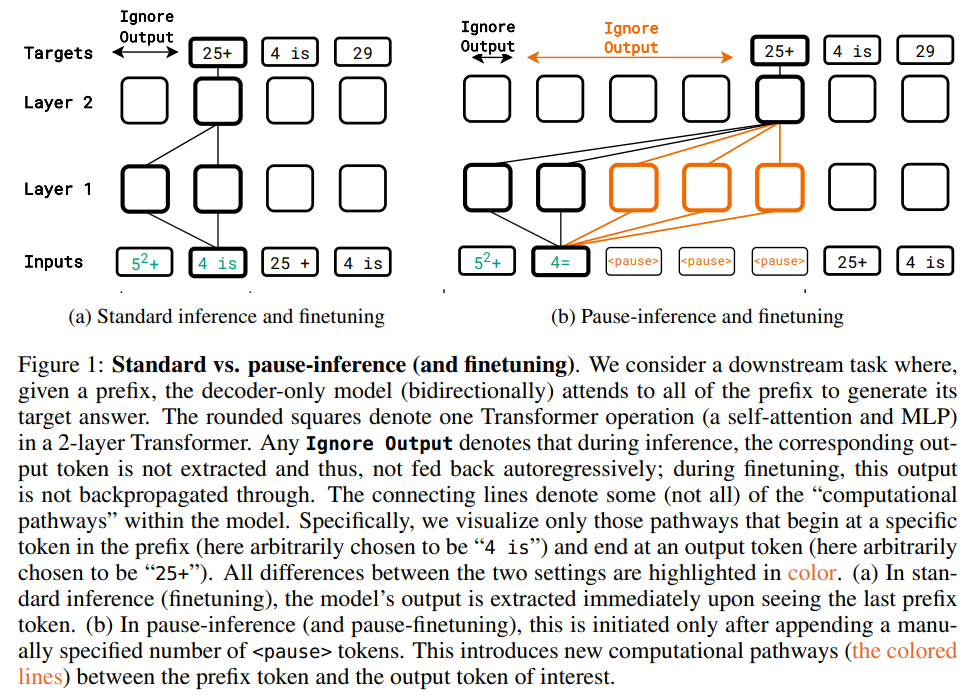

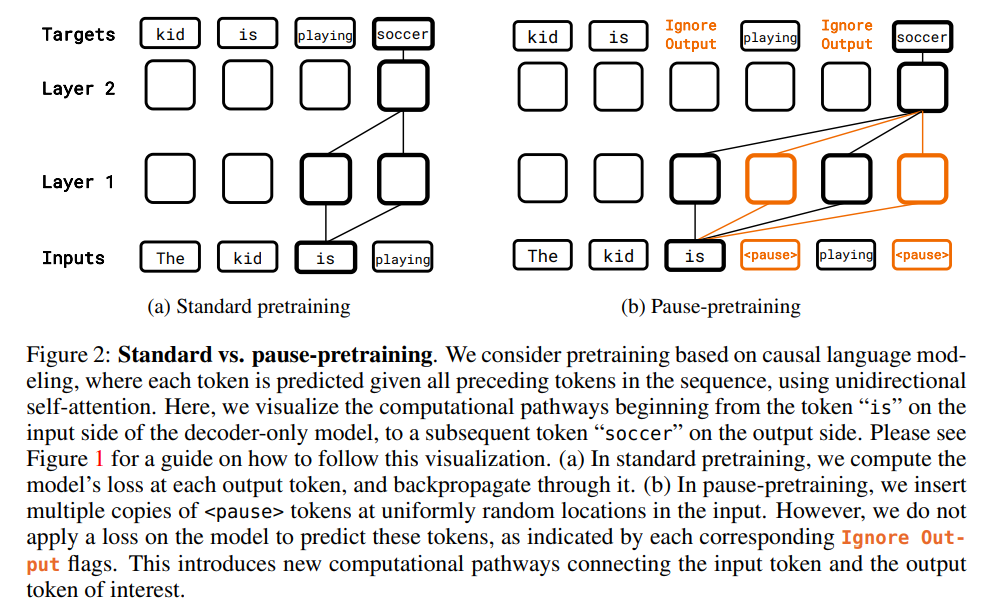

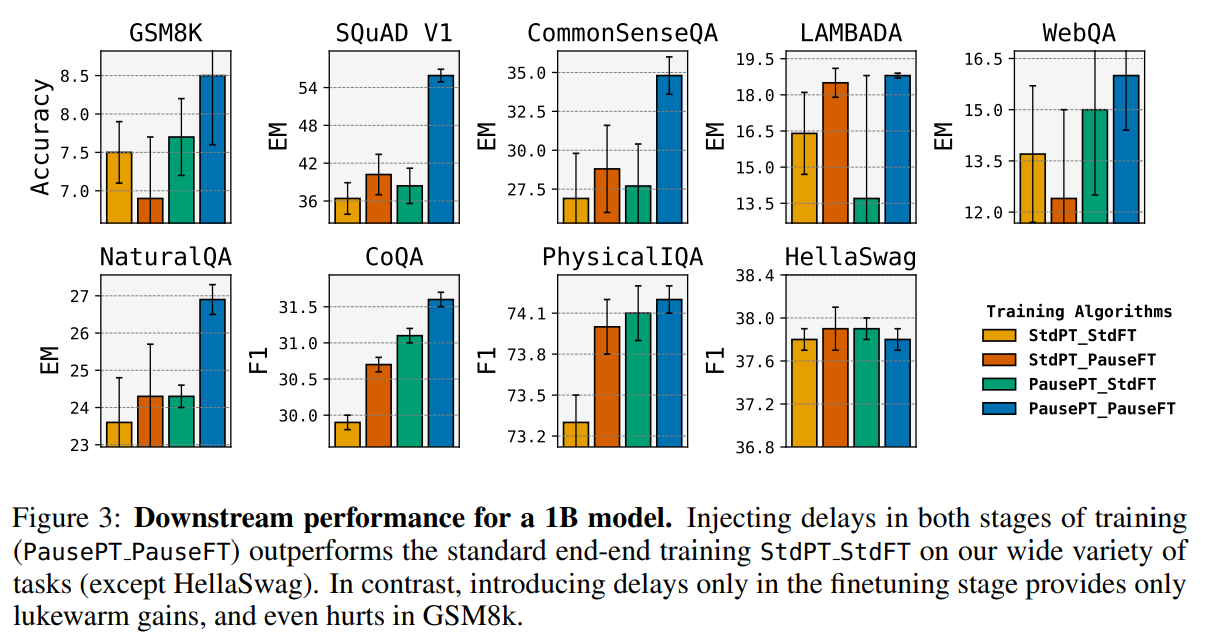

この研究では、言語モデルが応答を生成する際に、\( \small K+1 \)番目のトークンは、1つのトークンごとに1つの隠れベクトルを操作することで生成されます.しかし、もしモデルが\( \small K+10 \)個の隠れベクトルを操作してから\( \small K+1 \)番目のトークンを出力するようにするとどうなるでしょうか?このアイデアを具体化するために、学習可能な「一時停止」トークンを導入し、入力の接頭辞に一連の「一時停止」トークンを追加してトレーニングと推論を行います.そして、モデルの出力を最後の「一時停止」トークンが現れるまで遅延させることで、モデルが回答を確定する前に追加の計算を行うことができます.この「一時停止トレーニング」を、C4の因果的事前学習を行った1Bおよび130Mパラメータのデコーダーのみモデル、および推論時間の遅延を含むタスク(推論時間の遅延ありとなしで事前学習およびファインチューニングを行ったモデル)に対して実証的に評価します.主な結果は、モデルが遅延を含む形で事前学習およびファインチューニングされた場合に、推論時間の遅延が効果を示すことです.1Bモデルでは、9つのタスクのうち8つで効果があり、特にQAタスクではEMスコアが18%向上しました.この研究では、SQuADのQAタスクでEMスコアが18%向上し、CommonSenseQAでは8%の精度向上、GSM8kの推論タスクでは1%の精度向上が見られました.今後の研究では、遅延次のトークン予測を広く適用可能な新しいパラダイムとするための概念的および実践的な研究課題が提起されます.

Q&A:

Q: 言語モデルにおける “pause “トークンの目的は何ですか?

A: 「一時停止」トークンは、言語モデルにおいて追加の計算を行うための遅延を導入するために使用されます.モデルは、(K+1)番目のトークンを出力する前に、K+10個の隠れベクトルを操作することができます.これにより、モデルは回答を確定する前に追加の計算を行うことができます.具体的には、入力の接頭辞に「一時停止」トークンのシーケンスを追加し、モデルの出力を最後の「一時停止」トークンが現れるまで遅延させます.これにより、モデルは追加の計算を行うことができます.

Q: pause “トークンの使用は、隠れベクターの操作にどのような影響を与えるのか?

A: 「一時停止」トークンの使用により、隠れたベクトルの操作が影響を受けます.モデルは、(K+1)番目のトークンを出力する前に、K+10個の隠れたベクトルを操作することができます.

Q: pause “トークンを使った言語モデルの学習と推論のプロセスを説明してもらえますか?

A: 言語モデルのトレーニングと推論のプロセスでは、「一時停止」トークンを使用します.このアイデアは、モデルが追加の推論時間の計算を活用できるように、(ダミーの)pauseトークンを使用してモデルをトレーニングすることです.具体的には、入力の接頭辞にpauseトークンのシーケンスを追加し、トレーニングと推論を行います.モデルの出力を抽出するのは、最後のpauseトークンが現れるまで遅延させるため、モデルは回答を確定する前に追加の計算を行うことができます.

Q: モデルの出力の抽出を最後の一時停止トークンが見られるまで遅延させることの利点は何ですか?

A: モデルの出力を最後の一時停止トークンが現れるまで遅延させることによる利点は、モデルが追加の計算を行うことができるため、より広い計算フローによる助けを期待できることです.

Q: ポーズ・トレーニング」の実証的評価はどのように行われたのか?

A: 「pause-training」の実証評価は、1Bモデルと130Mモデルのデコーダーのみのモデルに対して行われました.C4での因果関係のあること前学習と、推論、質問応答、一般的な理解、事実の回想をカバーする下流タスクでの微調整を適用しました.その結果、モデルが遅延を持つように事前学習と微調整を行うと、タスクの性能が向上することが示されました.

Q: ポーズ・トレーニング」を用いたデコーダのみのモデルに関する実証的評価の主な結果は?

A: パウズトレーニングによるデコーダーのみモデルの経験的評価の主な結果は、モデルが事前学習と微調整の両方で遅延を持つ場合に、タスクの推論時間の遅延が向上することです.

Q: 実証的な評価において、さまざまなタスクで観察された利益について、具体的な例を挙げていただけますか?

A: 具体的な例として、SQuADのQAタスクでは18%のEMスコアの向上が観察されました.また、CommonSenseQAでは8%の向上があり、GSM8kの推論タスクでは1%の正答率の向上がありました.

Q: 推論時間中の遅延の使用は、事前に訓練されたモデルと微調整されたモデルのパフォーマンスにどのような影響を与えるのだろうか?

A: 遅延は、事前学習と微調整されたモデルの性能に影響を与えます.遅延が導入されるタイミングによって、遅延が助けになるか、害になるか、何も影響を与えないかが異なります.具体的には、遅延が推論時に助けになるためには、事前学習の段階での遅延が重要です.通常の事前学習モデルは、推論時の遅延の利点を十分に活かすことができないと考えられています.また、遅延を導入するための方法として、ダミーのpauseトークンを使用してモデルをトレーニングする方法が提案されています.ダミーのpauseトークンを使用して事前学習と微調整を行うことで、通常のエンドツーエンドのトレーニングと推論に比べて明確な利点が得られることが示されています.

Q: 遅延ネクストトークン予測に関連して、この研究が提起した将来の潜在的な研究課題は何でしょうか?

A: この研究によって、遅延次トークン予測に関連する潜在的な将来の研究課題がいくつか提起されています.具体的には、複数の異なるpauseトークンを使用した一時停止トレーニング、pauseトークンの数をより正確に決定する方法(モデルの信頼性を使用するかもしれません)、遅延の変化に対する堅牢性を向上させる方法などがあります.さらに、遅延を標準の事前学習済みモデルに直接有益にする方法を見つけることが最も重要な次のステップです.この研究は、遅延次トークン予測を広く適用可能な新しいパラダイムとするための概念的および実践的な将来の研究課題を提起しています.

Q: 遅延ネクストトークン予測のコンセプトは、他のドメインやアプリケーションにどのように応用できるでしょうか?

A: 遅延次トークン予測の概念は、他のドメインやアプリケーションにどのように適用できるでしょうか?遅延次トークン予測は、自然言語処理のタスクにおいて、特に文章生成や質問応答などのタスクに応用することができます.例えば、文章生成の場合、遅延次トークン予測を使用することで、より自然な文章を生成することができます.また、質問応答の場合、遅延次トークン予測を使用することで、より正確な回答を生成することができます.さらに、他のドメインやアプリケーションにおいても、遅延次トークン予測を使用することで、より高度な予測や生成が可能になるかもしれません.具体的な応用例は、自動翻訳、音声認識、要約生成などが考えられます.

RA-DIT: Retrieval-Augmented Dual Instruction Tuning

著者:Xi Victoria Lin, Xilun Chen, Mingda Chen, Weijia Shi, Maria Lomeli, Rich James, Pedro Rodriguez, Jacob Kahn, Gergely Szilvasy, Mike Lewis, Luke Zettlemoyer, Scott Yih

発行日:2023年10月02日

最終更新日:2023年11月05日

URL:http://arxiv.org/pdf/2310.01352v3

カテゴリ:Computation and Language, Artificial Intelligence

概要:

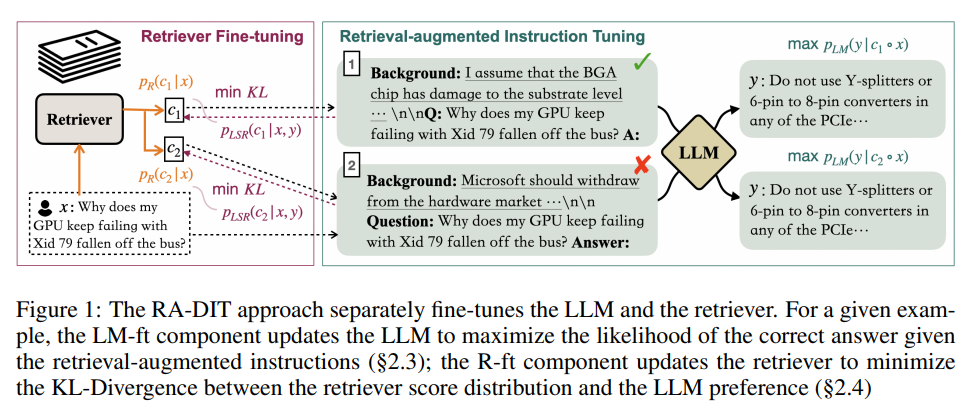

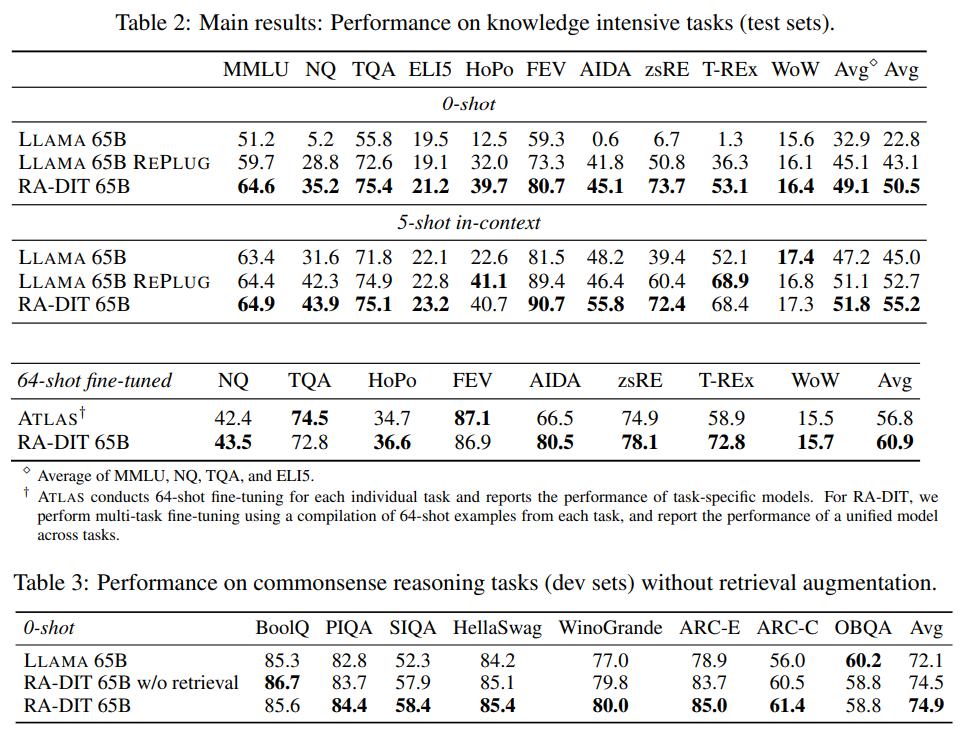

私たちの最高のモデルであるRA-DIT 65Bは、知識集約型のゼロショットおよびフューショット学習のさまざまなベンチマークで最先端のパフォーマンスを達成し、有意な結果をもたらします.特に、ゼロショット設定では平均で+8.9%、5ショット設定では平均で+1.4%の向上をもたらし、既存の文脈依存型RALMアプローチを大幅に上回ります.

Q&A:

Q: 検索支援言語モデル(RALM)構築の課題は?

A: RALMの構築における課題は、(i) 検索された知識をLLMに組み込む能力の向上と、(ii) 検索コンポーネントをより関連性の高いコンテンツを返すように改善することです.

Q: RALM構築のための既存のアプローチとその限界は?

A: RALMの構築には、REALM、RETRO、TLAS、R EPLUG、In-Context RALMなどの既存のアプローチがあります.REALMとRETROはエンドツーエンドの事前学習を採用しており、検索コンポーネントを最初から組み込んでいます.TLASはT5言語モデルをベースにしており、非監督テキスト上でフレームワークを継続的に事前学習します.R EPLUGとIn-Context RALMは、モデルパラメータのみで知識を表現するため、長尾の知識をキャプチャするのが難しく、最新の情報を保持するために多くのリソースが必要です.

Q: 検索補強型デュアル・インストラクション・チューニング(RA-DIT)は既存のアプローチとどう違うのか?

A: RA-DITは、事前学習済み言語モデル(LLM)に検索機能を導入することにより、既存の手法とは異なる特徴を持っています.それは、LLMとリトリーバーを別々に微調整するデュアルインストラクションチューニングフレームワークを利用しています.LM-ftコンポーネントは、リトリーバーによって拡張されたインストラクションに基づいて正しい回答の尤度を最大化するためにLLMを更新します.一方、R-ftコンポーネントは、リトリーバースコアの分布とLLMの好みの間のKLダイバージェンスを最小化するためにリトリーバーを更新します.この手法により、LLMは検索された情報を活用する能力が向上し、知識の利用と文脈の認識が向上します.

Q: RA-DITに含まれる2つの異なる微調整ステップについて説明していただけますか?

A: RA-DITは2つの異なるファインチューニングステップで動作します.1つ目のステップでは、事前学習済みの言語モデル(LLM)を更新して、取得した情報をより効果的に利用できるようにします.2つ目のステップでは、LLMが好むような関連性の高い結果を返すように、リトリーバーを更新します.それぞれのステップによって性能が向上し、両方を使用することでさらなる利益が得られます.

Q: 知識活用と文脈認識の両方を必要とする仕事とは?

A: 知識の利用と文脈の認識の両方を必要とするタスクは、ゼロショットおよびフューショットの学習ベンチマークである、HotpotQA、FEVER、アイダCoNLL-YAGO、ゼロショットRE、T-REx、ウィザード・オブ・ウィキペディア、ELI5の7つのタスクからなります.

Q: RA-DITにおける微調整の各段階は、パフォーマンス向上にどのように貢献しているのでしょうか?

A: RA-DITの各段階の微調整は、パフォーマンスの向上に寄与します.第1段階では、事前学習済みのLLMを更新して、取得した情報をより効果的に利用するようにします.第2段階では、LLMが好むように、より関連性の高い結果を返すようにリトリーバを更新します.両方の段階を組み合わせて使用することで、さらなる利益が得られます.

Q: RA-DITで両段階のファインチューニングを使用することによって、どのような追加利益が得られるのでしょうか?

A: RA-DITは、事前に訓練された言語モデル(LM)とリトリーバの両方を微調整することで、さらなる利点を達成する.LMは検索された情報をより良く利用するように更新され、一方リトリーバはLMが好むより関連性の高い結果を返すように更新される.この2段階の微調整プロセスにより、知識活用と文脈認識の両方を必要とするタスクにおいて、大幅な性能向上がもたらされる.RA-DITはこの2段階の微調整を行うことで、知識集約的なゼロショット学習や少数ショット学習のベンチマークにおいて、最先端の性能を達成している.

Q: ベストモデルRA-DIT 65Bの詳細と性能について教えてください.

A: RA-DIT 65Bは、検索を利用したデュアル命令チューニングモデルである.ATLASのような他のモデルと比較して、ほとんどのデータセットで最高の性能を達成している.このモデルは64ショットの設定で継続的に微調整され、ATLASを平均4.1ポイント上回る.8つのデータセットのうち6つでより高い性能を達成した.また、RA-DIT 65Bは、コモンセンス推論タスクにおいて、8つの評価データセットのうち7つのデータセットで、ベースとなるLAMAモデルに対する改善を示している.検索を使用しないモデルバリエーションは、フルモデルに近い性能を示す.

Q: RA-DITは既存のインコンテクストRALMアプローチと性能面でどのように比較されますか?

A: RA-DITは既存のインコンテクストRALMアプローチを性能面で上回る.

Q: RA-DITがゼロショットと数ショットの学習ベンチマークで達成した具体的な性能向上について教えてください.

A: RA-DITは、言語モデル(LLM)とリトリーバを微調整することで、ゼロショットおよび数ショットの学習ベンチマークで大幅な性能向上を達成した.LLMは、検索された知識をより良く利用し、無関係な情報や散漫な情報を無視するように、検索を利用した命令チューニングで更新される.リトリーバはまた、LLMが正しい出力を生成するのに役立つテキストを検索するために、LLMからの監視を受けて微調整される.この微調整ステップの組み合わせにより、性能が大幅に向上する.最大のモデルであるRA-DIT 65Bは、MMLUやNatural Questionsを含むデータセットにおいて、チューニングされていないインコンテクストRALMアプローチを凌駕し、ゼロショットおよび少数ショットの設定で最先端の性能を達成した.また、知識集約的な8つのタスクにおいてATLAS 11Bを上回る.具体的には、RA-DIT 65BはMMLUデータセットにおいて0ショットで8.2%、5ショットで0.7%の改善を達成し、Natural Questionsデータセットにおいて0ショットで22%、5ショットで3.8%の改善を達成した.

Efficient Streaming Language Models with Attention Sinks

著者:Guangxuan Xiao, Yuandong Tian, Beidi Chen, Song Han, Mike Lewis

発行日:2023年09月29日

最終更新日:2023年09月29日

URL:http://arxiv.org/pdf/2309.17453v1

カテゴリ:Computation and Language, Artificial Intelligence

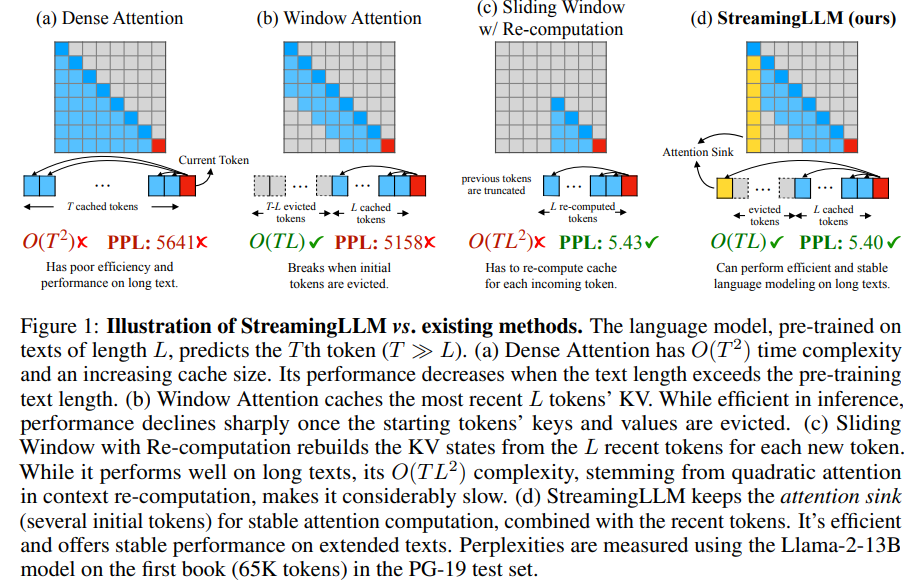

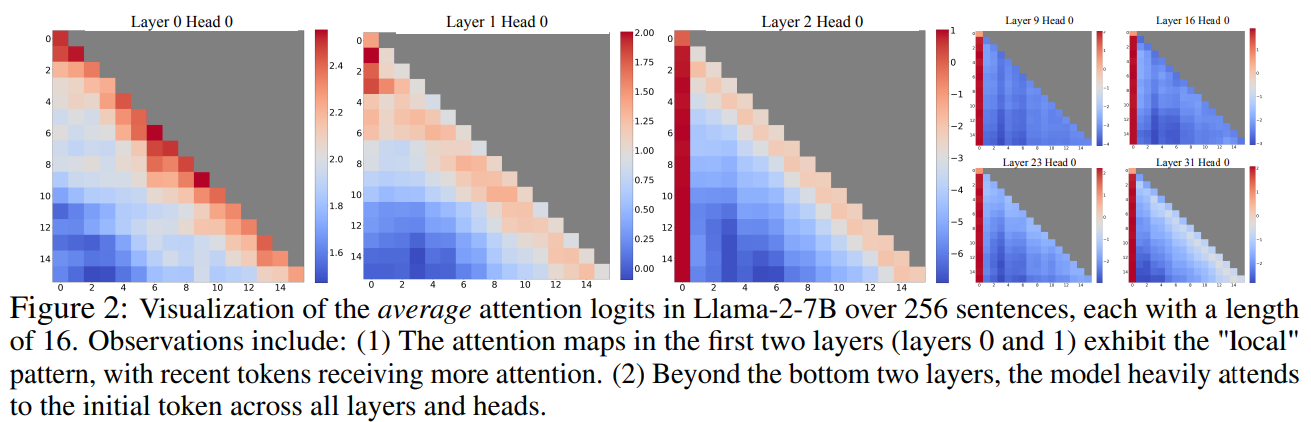

概要:

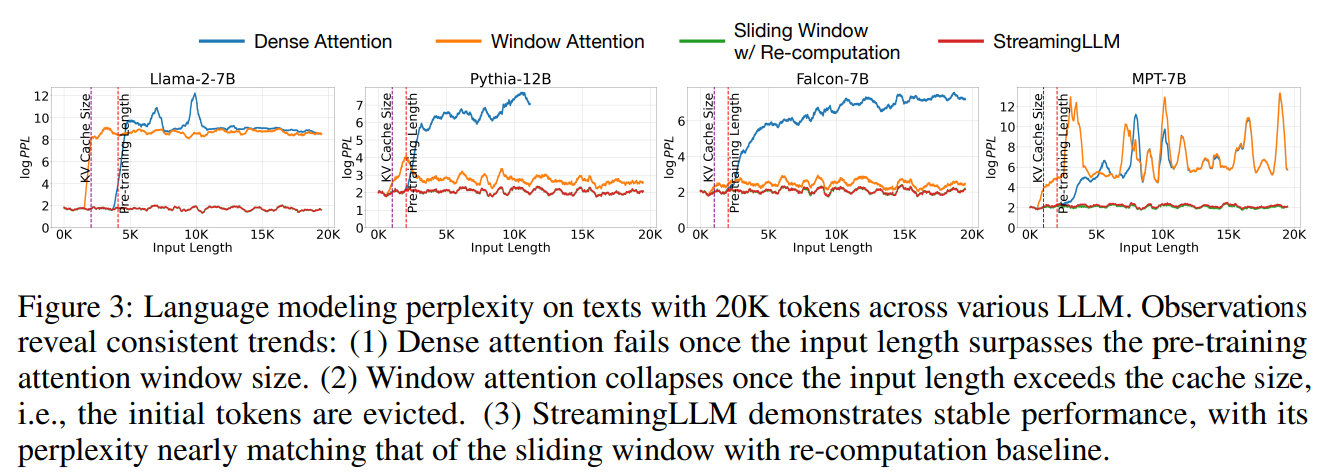

大規模言語モデル(LLM)をストリーミングアプリケーションに展開することは、長い対話が予想されるマルチラウンドの対話などで急務ですが、2つの主要な課題があります.まず、デコーディング段階で、前のトークンのキーと値の状態(KV)をキャッシュすることは、多くのメモリを消費します.また、人気のあるLLMは、訓練シーケンスの長さよりも長いテキストには一般化できません.最新のKVのみをキャッシュするウィンドウアテンションは、自然なアプローチですが、テキストの長さがキャッシュサイズを超えると失敗することを示します.私たちは、興味深い現象である「アテンションシンク」を観察しました.つまり、初期トークンのKVを保持することで、ウィンドウアテンションのパフォーマンスを大幅に回復できることです.本論文では、アテンションシンクの出現が、初期トークンに対する強いアテンションスコアによるものであり、それらが意味的に重要でなくても「シンク」として機能することを示します.上記の分析に基づいて、有限長のアテンションウィンドウで訓練されたLLMが微調整なしで無限のシーケンス長に一般化できる効率的なフレームワークであるStreamingLLMを紹介します.StreamingLLMは、StreamingLLMがLLMを有効にすることを示します.さらに、私たちは、プレトレーニング中に専用のアテンションシンクとしてプレースホルダートークンを追加することで、ストリーミング展開をさらに改善できることを発見しました.ストリーミング設定では、StreamingLLMはスライディングウィンドウ再計算のベースラインに比べて最大22.2倍の高速化を実現します.コードとデータセットはhttps://github.com/mit-han-lab/streaming-llmで提供されています.

Q&A:

Q: ストリーミング・アプリケーションに大規模言語モデル(LLM)を導入する際に直面する2つの大きな課題とは?

A: ストリーミングアプリケーションでLLMを展開する際に直面する2つの主要な課題は、1つ目はデコーディング段階で前のトークンのキーと値の状態(KV)をキャッシュすることが多くのメモリを消費することです.2つ目は、人気のあるLLMはトレーニングシーケンスの長さよりも長いテキストには適応できないことです.

Q: デコーディングステージで前のトークンのキーと値の状態(KV)をキャッシュすることが、なぜ大量のメモリを消費するのですか?

A: デコーディングの段階で前のトークンのキーと値の状態(KV)をキャッシュすることにより、大量のメモリを消費します.キャッシュされたトークンの数が増えるにつれて、メモリ使用量も増加します.

Q: なぜ一般的なLLMは、訓練シーケンス長よりも長いテキストに対して汎化できないのか?

A: LLMは、事前学習中の注意ウィンドウによってトレーニングシーケンスの長さよりも長いテキストに一般化することができません.このウィンドウサイズを拡大し、長い入力に対するトレーニングと推論の効率を改善するための取り組みが行われているにもかかわらず、許容されるシーケンスの長さは本質的に有限であり、持続的な展開を許容しません.

Q: ウィンドウ・アテンションとは何ですか?また、なぜ最新のKVをキャッシュするための自然なアプローチと考えられているのですか?

A: ウィンドウアテンションは、最新のキーバリューペア(KV)のみをキャッシュするアプローチであり、テキストの長さがキャッシュサイズを超える場合には失敗することが示されています.初期トークンのKVを保持することで、ウィンドウアテンションのパフォーマンスを大幅に回復させるという興味深い現象が観察されています.

Q: 窓の注意のパフォーマンスの回復に、注意の沈黙現象はどのように貢献していますか?

A: 注意の沈み現象により、初期トークンのKVを保持することで、ウィンドウアテンションのパフォーマンスが大幅に回復します.

Q: StreamingLLMと呼ばれる提案されたフレームワークとは何ですか?また、LLMが微調整なしに無限の配列長に汎化できるのはなぜですか?

A: 提案されたフレームワークはStreamingLLMと呼ばれ、有限の注意ウィンドウで訓練されたLLMが微調整なしで無限のシーケンス長のテキストで動作できるようにします.StreamingLLMは、注意の沈み込みが高い注意値を持つことを利用し、それらを保持することで注意スコアの分布を正規に保つことができます.したがって、StreamingLLMは単純な方法で無限のシーケンス長での動作を実現します.

Q: どのLLM(Llama-2、MPT、Falcon、Pythia)がStreamingLLMでテストされ、その結果はどうでしたか?

A: StreamingLLMはLlama-2、MPT、Falcon、Pythiaでテストされた.その結果、StreamingLLMによって、これらのモデルが最大400万トークン以上の言語モデリングを安定的かつ効率的に実行できることが示された.さらに、事前学習時に専用のアテンションシンクとしてプレースホルダートークンを追加することで、ストリーミング展開をさらに改善できることがわかった.ストリーミング設定において、StreamingLLMはスライディングウィンドウ再計算のベースラインを最大22.2倍のスピードアップで上回る.

Q: 事前トレーニング中に専用のアテンションシンクとしてプレースホルダートークンを追加することで、ストリーミング配備はどのように改善されるのでしょうか?

A: プレトレーニング中に専用のアテンションシンクとしてプレースホルダートークンを追加することにより、ストリーミング展開を改善する.

Q: StreamingLLMは、ストリーミング設定において、スライディングウィンドウ再計算のベースラインをどのように上回るのか?

A: StreamingLLMは、ストリーミング設定において、再計算を伴うスライディングウィンドウのベースラインと比較して、トークンあたり最大22.2倍のスピードアップを達成した.

The Dawn of LMMs: Preliminary Explorations with GPT-4V(ision)

著者:Zhengyuan Yang, Linjie Li, Kevin Lin, Jianfeng Wang, Chung-Ching Lin, Zicheng Liu, Lijuan Wang

発行日:2023年09月29日

最終更新日:2023年10月11日

URL:http://arxiv.org/pdf/2309.17421v2

カテゴリ:Computer Vision and Pattern Recognition, Computation and Language

概要:

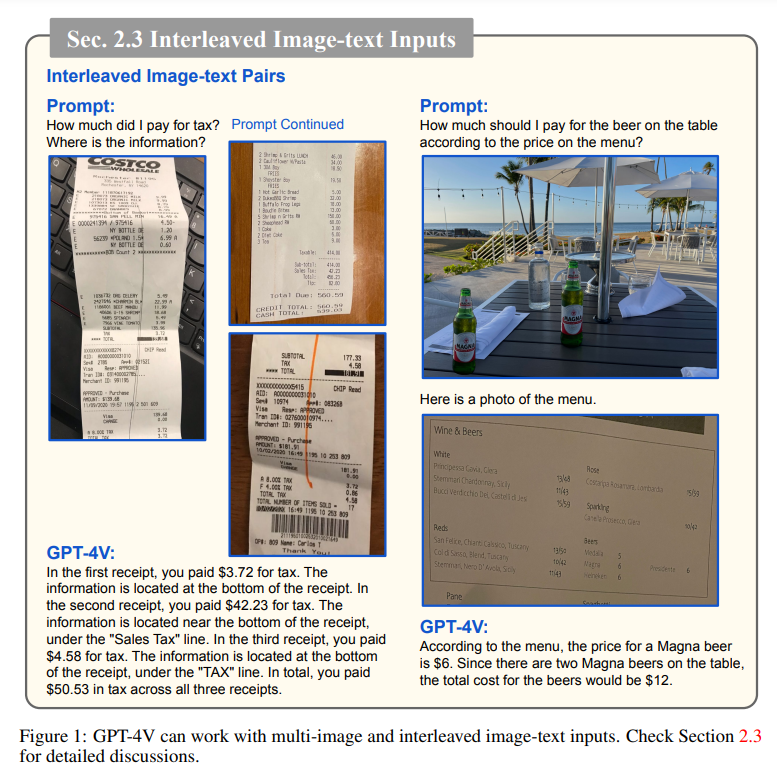

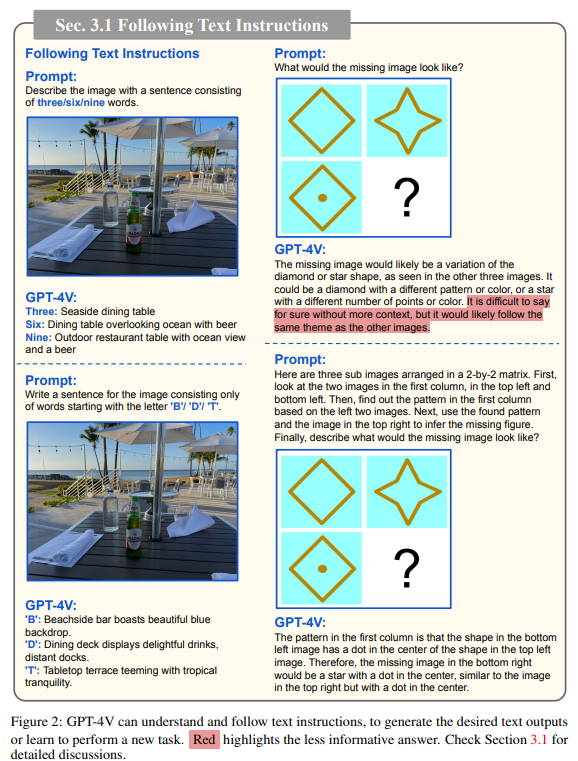

大規模な多モーダルモデル(LMM)は、視覚理解などの多感覚スキルを備えた大規模な言語モデル(LLM)を拡張し、より強力な汎用知能を実現します.本論文では、LMMの理解を深めるために、最新のモデルであるGPT-4V(ビジョン)を分析します.この分析では、GPT-4Vが実行できる興味深いタスクに焦点を当て、GPT-4Vの能力の品質と汎用性、サポートされる入力と動作モード、およびモデルをプロンプトする効果的な方法について調査します.GPT-4Vを探求するためのアプローチとして、さまざまなドメインとタスクにわたる慎重に設計された質的サンプルのコレクションを編集し、整理します.これらのサンプルからの観察結果は、GPT-4Vの任意に交互に配置された多モーダル入力の処理能力とその汎用性が、GPT-4Vを強力な多モーダルの汎用システムにしていることを示しています.さらに、入力画像に描かれた視覚的なマーカーを理解するGPT-4Vのユニークな能力は、視覚的な参照プロンプトなどの新しい人間とコンピュータのインタラクション方法を生み出すことができます.報告書は、詳細な議論を通じて結論付けられます.さらに、報告書ではGPT-4Vを基にしたシステムの新たな応用シナリオや将来の研究方向についても詳細な議論を行い、次世代の多モーダルタスクの定義や実世界の問題解決におけるLMMの活用方法、そして多モーダル基盤モデルのより良い理解を得るための研究についてのインスピレーションを提供することを期待しています.最後に、本研究で取り上げたモデルはOpenAIの革新的な取り組みの成果であり、その開発に対して完全なクレジットを与えるべきです.詳細な著者情報とクレジットの割り当てについては、GPT-4Vの貢献論文を参照してください:https://cdn.openai.com/contributions/gpt-4v.pdf

Q&A:

Q: GPT-4V(ision)が持つ具体的な多感覚能力とは?

A: GPT-4Vのマルチセンサリースキルは、視覚情報を理解し解釈する能力です.GPT-4Vは、一般的な視覚キャプションのための自由記述を生成する能力を持っています.さらに、GPT-4Vは、空間関係の分析、物体の位置特定、物体の数え上げ、密なキャプションなどの高度なタスクにも応用できます.また、GPT-4Vは、マルチモーダルな知識と常識的な推論の能力を持ち、異なる情報の文脈と関係を理解できるかどうかを研究します.さらに、GPT-4Vは、シーンテキスト、表、チャート、文書など、さまざまな情報源から情報を抽出し分析する能力を評価します.また、GPT-4Vは、多言語のシナリオでの理解と記述生成の能力を探求し、視覚情報のコーディング能力も調査します.

Q: GPT-4Vでできるタスクの例を教えてください.

A: GPT-4Vは、視覚的に類似した画像間の差異を識別したり、バーチャルハウスツアーで次のステップを予測したりといったタスクを実行できる.

Q: GPT-4V(ision)はどのような入力に対応していますか?

A: GPT-4Vは、テキストのみの入力、単一の画像テキストペア(オプションで単一の画像のみ)、および複数の画像入力のみの交互に挿入された画像テキストペアを取ることができます.

Q: GPT-4V(ision)は、任意にインターリーブされたマルチモーダル入力をどのように処理するのか?

A: GPT-4Vは、任意の混在した複数の入力モーダリティを理解し処理する能力を持っています.GPT-4Vは、画像、サブ画像、テキスト、シーンテキスト、視覚的なポインターなど、さまざまな入力モーダリティの任意の組み合わせを柔軟に処理することができます.また、GPT-4Vは、視覚的に中心となる複数の画像と短い質問や指示、長いウェブページと2つの挿入された画像など、視覚的な中心となる混在した画像とテキストの入力、または画像とテキストのバランスの取れた混在した入力など、相互に交錯した画像とテキストの入力を処理する能力も持っています.このような混在した入力モードは、さまざまなアプリケーションに柔軟性を提供します.たとえば、図1に示すように、複数のレシート画像を処理して支払った総税金を計算することができます.また、複数の入力画像を処理し、問い合わせられた情報を抽出することも可能です.GPT-4Vは、メニューでビールの価格を見つけ、ビールの数を数え、総費用を返すなど、相互に交錯した画像とテキストの入力においても情報を関連付けることが効果的にできます.直接的な応用に加えて、相互に交錯した画像とテキストの入力を処理することは、文脈に即した少数のショット学習や他の高度なテスト時のプロンプティング技術の基本的な要素となり、GPT-4Vの汎用性をさらに高めます.これらの興味深い新しい用途を次のセクション、セクション3で示します.

Q: GPT-4V(ision)の “Visual referring prompting “のコンセプトとその活用法について教えてください.

A: GPT-4Vは、視覚的な指示やシーンテキストの理解能力に基づいて、視覚的な参照プロンプティングという新しい方法を探求しています.通常のプロンプティング技術がテキスト空間を編集するのに対して、視覚的な参照プロンプティングはピクセル空間を直接編集する補完的な技術です.このような視覚的なプロンプティングは、画像との人間との対話においてより微妙で包括的なインタラクションを提供することができ、モデルからより幅広い応答を引き出す可能性があります.具体的には、GPT-4Vは図50(1)のように、矢印で指し示されたオブジェクトを与えられたオブジェクトインデックスと自然に関連付け、残りの視覚的な推論とテキストの出力を容易にします.また、図50(2)では、GPT-4Vは画像に書かれた質問を理解し、対応するエッジや角度を指し示すことで、具体的なインターフェースを提供します.さらに、図50(3)では、人間は図の任意の領域を指し示すことで、GPT-4Vが複雑なドキュメントやチャートをより良く理解するのを助けることができます.GPT-4Vは、視覚的な参照プロンプティングを使用することで、視覚とテキストのプロンプトをスムーズに組み合わせることができます.これにより、問題の興味深い側面を簡潔に表現する微妙なインターフェースが提供されます.

Q: GPT-4Vベースのシステムの新たな応用シナリオは?

A: GPT-4Vは、多くの高付加価値なアプリケーションシナリオや新しいユースケースを可能にする潜在能力を持っています.GPT-4Vの真の力は、その能力にあります.箱から出してすぐに簡単に実行できます.外部ツールやプラグインとシームレスに統合することができ、その潜在能力を拡大し、革新的で協力的なアプリケーションを可能にします.報告書では、脳トレゲーム「違いを見つける」に触発された一般的なユースケースや、GPT-4Vに基づいた新しいタスク設定や厳格なベンチマークの設計の可能性など、新興のアプリケーションシナリオがいくつか言及されています.また、次世代のマルチモーダルタスク、既存のベンチマークの近代化、モデルの性能とシステムの信頼性の向上、新興のユースケースでのイノベーションの可能性も報告書で言及されています.ただし、これらの新しい機能はまだ完全に信頼性があるわけではないことに注意する必要があり、GPT-4Vベースのシステムの定量的なベンチマークを確立するためにさらなる研究が必要です.

Q: LMMを強化し、実世界の問題を解決するための今後の研究の方向性は?

A: LMMは、包括的なマルチモーダルコンテンツの理解と生成を可能にするため、テキストと画像の両方を含む鮮やかなチュートリアルを作成するなど、画像とテキストのインターリーブコンテンツを生成するよう強化されるべきである.さらに、ビデオ、オーディオ、その他のセンサーデータなどの他のモダリティもLMMの機能を拡張するために取り入れるべきである.

Q: GPT-4V(ision)の分析で明らかになった限界や課題はありますか?

A: 分析では、GPT-4V(ision)に関連する制約や課題は特定されていません.

Towards Self-Assembling Artificial Neural Networks through Neural Developmental Programs

著者:Elias Najarro, Shyam Sudhakaran, Sebastian Risi

発行日:2023年07月17日

最終更新日:2023年07月17日

URL:http://arxiv.org/pdf/2307.08197v1

カテゴリ:Neural and Evolutionary Computing, Artificial Intelligence

概要:

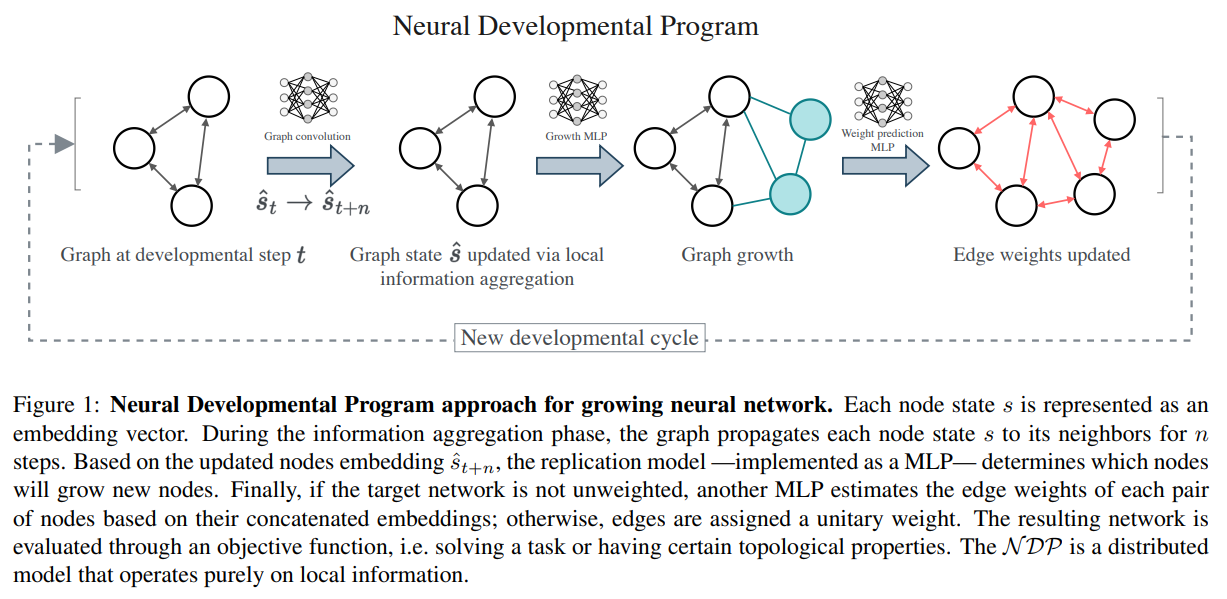

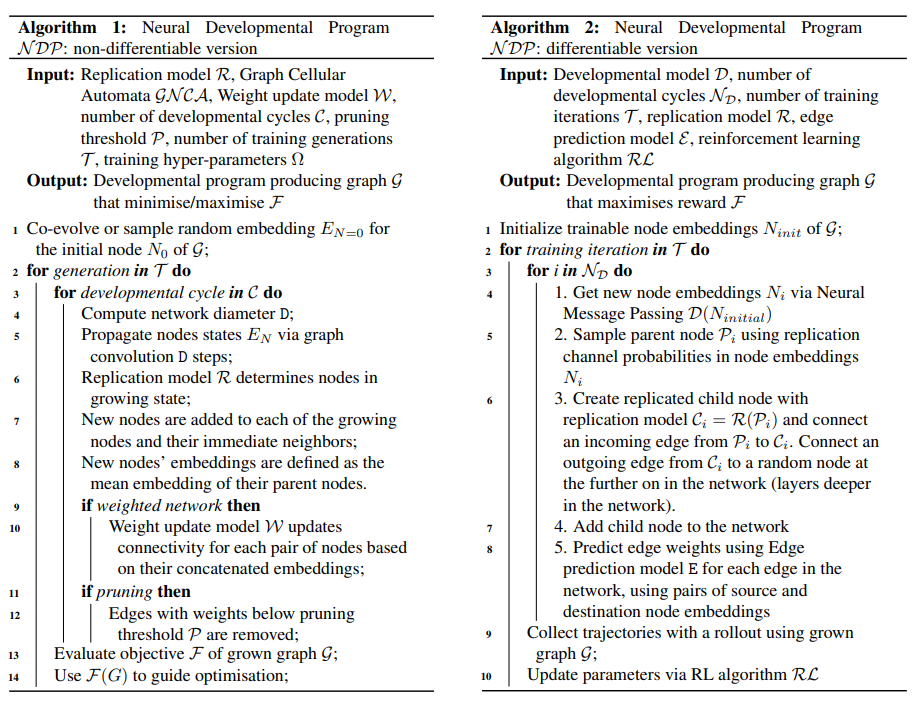

生物の神経系は、現在の人工ニューラルネットワークとは根本的に異なる方法で作られています.深層学習はさまざまな領域で印象的な結果を示していますが、高性能なニューラルアーキテクチャを設計するためにはかなりのエンジニアリング努力が必要です.一方、生物の神経系は、動的な自己組織化プロセスを通じて成長します.本論文では、生物の有胚発生の主要な特性を模倣した発達プロセスを通じて成長するニューラルネットワークについて初歩的なステップを踏みます.成長プロセスは、ローカル通信のみを通じて動作するニューラル開発プログラム(NDP)と呼ばれる別のニューラルネットワークによってガイドされます.私たちは、ニューラルネットワークの成長が異なる機械学習ベンチマークと異なる最適化手法(進化的トレーニング、オンライン強化学習、オフライン強化学習、教師あり学習)に与える影響を調査します.さらに、自己組織化がニューラルネットワークの成長を推進することで可能になる将来の研究方向と機会を強調します.

Q&A:

Q: 生物学的な神経系の成長過程と、現在の人工的な神経ネットワークの主な違いは何でしょうか?

A: 生物の神経系は成長プロセスを通じて自己組織化し、新しい状況に適応し成長する能力を持つ一方、現在の人工ニューラルネットワークは手動で設計された構造を持ち、接続の最適化によって学習が制限されている.

Q: ディープラーニングは、高性能なニューラル・アーキテクチャを設計するために、どのような工学的努力が必要なのか?

A: 深層学習は、高性能なニューラルアーキテクチャを設計するために多大なエンジニアリングの努力を必要とします.

Q: 神経発達プログラム(NDP)の概念と、それが神経ネットワークの成長過程をどのように導いているのかを説明していただけますか?

A: NDPは、ポリシーネットワークの接続されたニューロンからの情報を入力として受け取り、ニューロンが複製すべきかどうか、ネットワーク内の各接続がどのように重みを設定するかを決定する.単一のニューロンから始めて、ニューロン同士のローカルな通信に基づいて機能的なポリシーネットワークを成長させるアプローチである.NDPは、進化の過程でニューラルネットワークを成長させるNEAT(Stanley and Miikkulainen, 2002)などの手法とは異なり、エージェントのライフタイム中にネットワークを成長させる.現在のNDPのバージョンでは実装されていないが、これによりエージェントのニューラルネットワークを経験と環境に基づいて形成することができるようになる.

Q: さまざまな機械学習ベンチマークにおけるニューラル・グロースの役割とは?

A: 異なる機械学習ベンチマークや最適化手法において、神経成長は重要な役割を果たしています.成長プロセスは、Neural Developmental Program(NDP)と呼ばれる別のニューラルネットワークによってガイドされ、ローカルな通信のみで動作します.成長による神経ネットワークの役割を調査し、進化的トレーニング、オンライン強化学習、オフライン強化学習、教師あり学習などの異なる最適化手法との関係を明らかにしています.

Q: 成長過程は、進化的学習、オンラインRL、オフラインRL、教師あり学習など、さまざまな最適化手法にどのような影響を与えるのか?

A: 成長プロセスは、進化的トレーニング、オンラインRL、オフラインRL、および教師あり学習などの異なる最適化手法にどのように影響するかを調査しています.成長プロセスは、ニューラルネットワークの自己組織化を通じて、異なる最適化手法に異なる影響を与えることが示されています.進化的トレーニングでは、成長プロセスによって生成されたニューラルネットワークは、CartPoleやLunarLanderなどのベンチマークタスクで高いパフォーマンスを示しています.オンラインRLでは、成長プロセスによって生成されたニューラルネットワークは、HalfCheetahタスクで満足のいく報酬を得ることができますが、行動クローニングに比べてパフォーマンスは低いです.オフラインRLでは、成長プロセスによって生成されたニューラルネットワークは、HalfCheetahタスクでの報酬を最適化することができます.教師あり学習では、成長プロセスによって生成されたニューラルネットワークは、MNISTタスクで高いテスト精度を達成することができます.

Q: ディープラーニングがエンジニアリングに多大な労力を必要とする具体的なドメインやアプリケーションの例を挙げていただけますか?

A: 深層学習が多大な工学的努力を必要とする具体的なドメインやアプリケーションの例としては、自然言語処理やコンピュータビジョンなどが挙げられます.これらのドメインでは、データの前処理、特徴エンジニアリング、モデルのアーキテクチャ設計など、多くの工程が必要とされます.

Q: 神経ネットワークの発達過程に反映される、生物における胚発生の重要な特性とは何か?

A: 生物学的な生物の胚発生の主要な特性は、ニューラルネットワークの発達過程で反映されます.この成長過程は、ローカルコミュニケーションのみを通じて操作される別のニューラルネットワークであるニューラル発達プログラム(NDP)によってガイドされます.

Q: 自己組織化はどのようにしてニューラルネットワークの成長を促すのか?

A: ニューラルネットワークの成長を促進するために、自己組織化が使用されます.自己組織化は、生物の神経細胞の成長と同様に、ニューラルネットワークの構造を手動で設計するのではなく、自己組織化アルゴリズムによって成長させることを意味します.この成長プロセスは、ニューラル開発プログラム(NDP)と呼ばれる別のニューラルネットワークによってガイドされます.NDPは、ローカル通信のみを介して操作され、生物学的な有機体の胚発生の重要な特性を反映しています.自己組織化によってニューラルネットワークが成長することで、手動で設計された構造よりも柔軟性が向上し、新しい状況に適応する能力が向上します.

Q: ニューラルネットワークの成長を促す自己組織化によって可能になる、今後の研究の方向性や機会にはどのようなものがあるのだろうか?

A: 自己組織化がニューラルネットワークの成長を促進することで可能になる将来の研究方向と機会には、以下のようなものがあります.

- ニューラルネットワークの自己組織化によって、より効率的な学習アルゴリズムやモデルの開発が可能になる.

- 生物学的な神経回路の成長と同様に、ニューラルネットワークの自己組織化によって、新しい状況や環境への適応能力が向上する.

- 自己組織化によって成長したニューラルネットワークは、より柔軟で汎化性能の高いモデルとなる可能性がある.

- 自己組織化によって成長したニューラルネットワークは、より複雑な計算を効率的に実行する能力を持つ可能性がある.

- 自己組織化によって成長したニューラルネットワークは、より少ない情報で複雑な接続を実現することができるため、メモリや計算リソースの効率的な使用が可能になる.

Q: 神経発達プログラム(NDP)におけるローカル・コミュニケーションのコンセプトについて詳しく教えてください.

A: NDPにおけるローカルコミュニケーションとは、ノード間の情報のやり取りを指します.NDPは、ノードの接続情報を入力として受け取り、各ノードが複製すべきかどうか、ネットワーク内の各接続がどのように重みを設定するかを決定します.このアプローチは、ノード間のローカルなコミュニケーションに基づいて、機能的なポリシーネットワークを成長させることを目指しています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 提案された新しい手法のコード実装のurlはhttps://github.com/enajx/NDPです.