ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Qwen Technical Report (発行日:2023年09月28日)

- Vision Transformers Need Registers (発行日:2023年09月28日)

- Effective Long-Context Scaling of Foundation Models (発行日:2023年09月27日)

- Graph Neural Prompting with Large Language Models (発行日:2023年09月27日)

- Large Language Model Alignment: A Survey (発行日:2023年09月26日)

- Aligning Large Multimodal Models with Factually Augmented RLHF (発行日:2023年09月25日)

- MentaLLaMA: Interpretable Mental Health Analysis on Social Media with Large Language Models (発行日:2023年09月24日)

- Enhancing Zero-Shot Chain-of-Thought Reasoning in Large Language Models through Logic (発行日:2023年09月23日)

- Boolformer: Symbolic Regression of Logic Functions with Transformers (発行日:2023年09月21日)

- The Reversal Curse: LLMs trained on “A is B” fail to learn “B is A” (発行日:2023年09月21日)

Qwen Technical Report

著者:Jinze Bai, Shuai Bai, Yunfei Chu, Zeyu Cui, Kai Dang, Xiaodong Deng, Yang Fan, Wenbin Ge, Yu Han, Fei Huang, Binyuan Hui, Luo Ji, Mei Li, Junyang Lin, Runji Lin, Dayiheng Liu, Gao Liu, Chengqiang Lu, Keming Lu, Jianxin Ma, Rui Men, Xingzhang Ren, Xuancheng Ren, Chuanqi Tan, Sinan Tan, Jianhong Tu, Peng Wang, Shijie Wang, Wei Wang, Shengguang Wu, Benfeng Xu, Jin Xu, An Yang, Hao Yang, Jian Yang, Shusheng Yang, Yang Yao, Bowen Yu, Hongyi Yuan, Zheng Yuan, Jianwei Zhang, Xingxuan Zhang, Yichang Zhang, Zhenru Zhang, Chang Zhou, Jingren Zhou, Xiaohuan Zhou, Tianhang Zhu

発行日:2023年09月28日

最終更新日:2023年09月28日

URL:http://arxiv.org/pdf/2309.16609v1

カテゴリ:Computation and Language

概要:

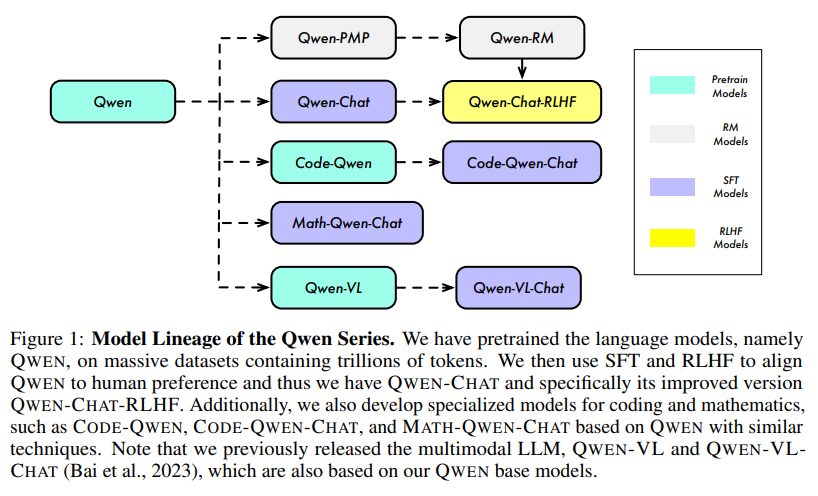

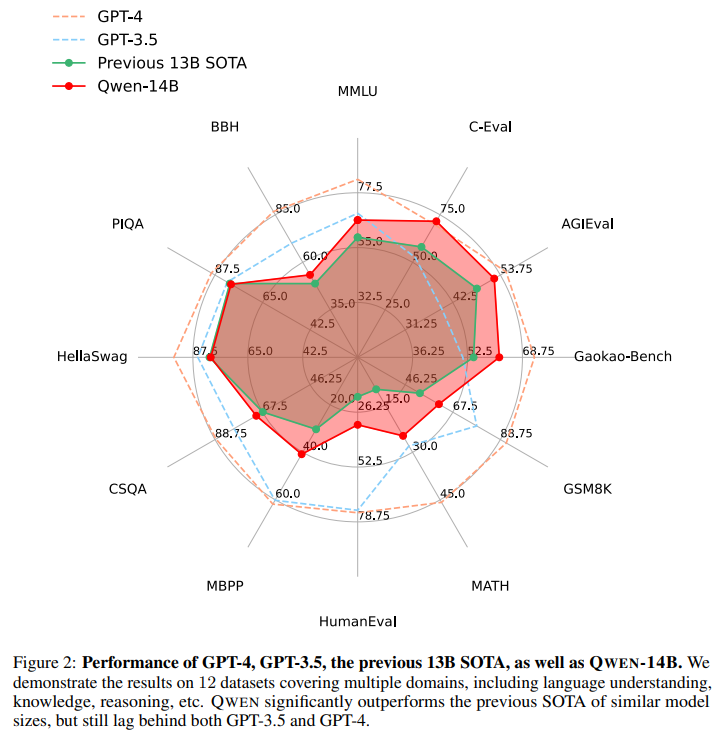

大規模言語モデル(LLM)は、かつて人間にしかできないと考えられていた自然言語処理タスクを可能にし、人工知能の分野を革新しました.本研究では、私たちはQwenを紹介します.これは私たちの大規模言語モデルシリーズの最初のモデルです.Qwenは、異なるパラメータ数を持つ異なるモデルを含む包括的な言語モデルシリーズです.それには、ベースの事前学習済み言語モデルであるQwenと、人間のアラインメント技術を用いて微調整されたチャットモデルであるQwen-Chatが含まれています.ベースの言語モデルは、さまざまな下流タスクで一貫して優れたパフォーマンスを示し、特に人間のフィードバックからの強化学習(RLHF)を用いてトレーニングされたチャットモデルは非常に競争力があります.チャットモデルは、エージェントアプリケーションの作成において高度なツールの使用と計画能力を持ち、コードインタプリタの利用などの複雑なタスクにおいても、より大きなモデルと比較しても印象的なパフォーマンスを発揮します.さらに、私たちはコーディングに特化したモデルであるCode-QwenとCode-Qwen-Chat、および数学に特化したモデルであるMath-Qwen-Chatも開発しました.これらのモデルはベースのモデルに基づいて構築されており、オープンソースモデルと比較して大幅にパフォーマンスが向上していますが、プロプライエタリモデルにはやや劣ります.

Q&A:

Q: 大型言語モデルシリーズ「Qwen」の目的は何ですか?

A: QWENシリーズの大きな言語モデルの目的は、人間に限定されていた自然言語処理タスクを実行するための人工知能の開発です.

Q: Qwenと他の言語モデルとのパラメータ数の違いは何ですか?

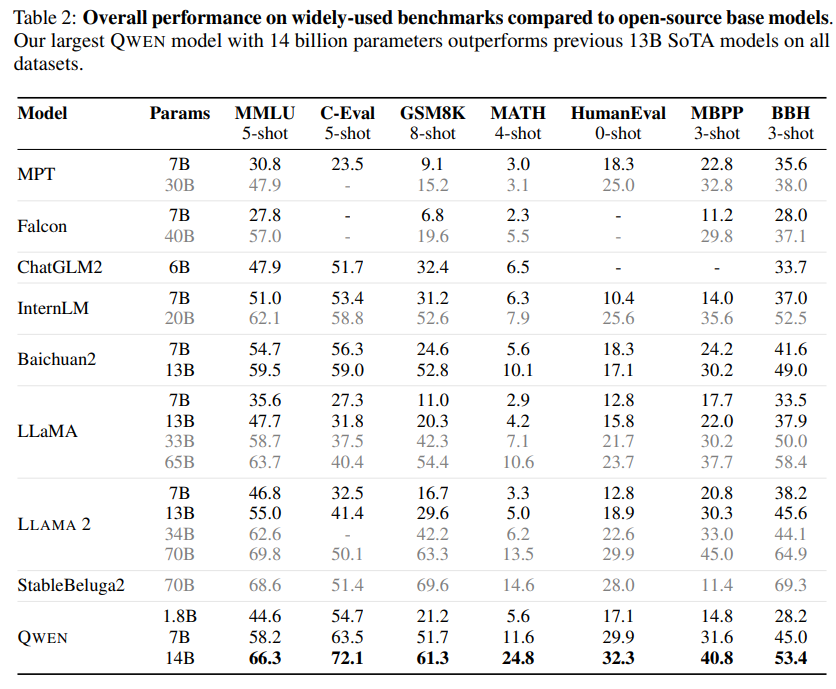

A: QWENは、パラメータ数の点で他の言語モデルと異なる.14B、7B、1.8Bのパラメータなど、さまざまなパラメータ数を持つモデルが含まれています.これらのモデルは、膨大な量のデータで事前に訓練され、最先端の技術を使って微調整されています.大規模なモデルと比較しても、QWENの基本言語モデルは、多くのダウンストリームタスクにおいて一貫して優れたパフォーマンスを示しています.

Q: 下流のタスクにおけるベース言語モデルのパフォーマンスについて説明していただけますか?

A: ベースの言語モデルであるQWENは、多様なテキストとコードの3兆トークンを使用して広範なトレーニングを受けています.これらのモデルは、より大きなモデルと比較しても、さまざまな下流タスクで一貫して優れたパフォーマンスを示しています.

Q: チャットモデル、特に人間のフィードバックからの強化学習(RLHF)を使って訓練されたモデルの微調整には、どのようなテクニックが使われたのでしょうか?

A: チャットモデルを微調整するために、強化学習を用いた人間のフィードバックからの強化学習(RLHF)が使用されました.

Q: コード・インタープリターを利用するような複雑なタスクについて、チャット・モデルはより大きなモデルと比べてどうなのか?

A: CODE-QWENとCODE-QWEN-CHATモデルは、コードインタプリタを利用するような複雑なタスクにおいて、より大きなモデルと比較した場合でさえ、印象的なパフォーマンスを示している.Starcoderのような大型モデルの性能に匹敵するほどです.しかし、これらのモデルはGPT-4のような最先端の手法に遅れをとっていることに注意することが重要である.モデルサイズとデータサイズの両方を拡張し続けることで、この差は近い将来縮められると考えられている.

Q: コーディングに特化したモデル、Code-QwenとCode-Qwen-Chatについて詳しく教えてください.

A: CODE-QWENとCODE-QWEN-CHATは、コードの広範なデータセットで事前に訓練され、コード生成、デバッグ、解釈に関連する会話を処理するためにさらに微調整された、コードに特化したモデルである.これらのモデルは、ベンチマーク・データセットで実施された実験結果が示すように、コードの理解と生成において高いレベルの習熟度を示している.非常に大規模なクローズド・ソースのモデルと比較した場合、pass@1の点で明らかな利点がある.しかし、ベンチマークではGPT-4の後塵を拝していることに注意することが重要である.

Q: コーディングに特化したモデルとオープンソースのモデルを性能面で比較するとどうなるか?

A: オープンソースのモデルと比較して、コーディングに特化したモデルはパフォーマンスが高いことが示されています.

Q: 数学に特化したモデル、Math-Qwen-Chatの開発について説明していただけますか?

A: MATH-QWEN-CHATは、QWENの事前学習言語モデルをベースにした数学専門のモデルシリーズです.14兆パラメータのMATH-QWEN-14B-CHATと7兆パラメータのMATH-QWEN-7B-CHATの2つのバージョンがリリースされています.これらのモデルは、数学と算術に特化しており、人間の振る舞いに合わせて設計されています.数学の推論に優れたアシスタントモデルを開発するために、数学の推論に関する拡張されたデータセットを使用してトレーニングを行っています.数学の推論データセットでは、試験問題が多く含まれており、モデルは入力を予測しやすくなっています.MATH-QWEN-CHATモデルは、オープンソースのモデルやQWEN-CHATモデルよりも優れた数学の推論能力と算術能力を示しています.また、QWEN-CHATの改良版であるQWEN-CHAT-RLHFも開発されています.さらに、CODE-QWEN、CODE-QWEN-CHAT、MATH-QWEN-CHATなど、コーディングと数学に特化したモデルも開発されています.

Q: 数学に特化したモデルは、プロプライエタリー・モデルと性能面でどのように比較されるのか?

A: MATH-QWEN-7B-CHATはMATHでMinerva-8Bを上回り、MATH-QWEN-14B-CHATはGSM8KとMATHでMinerva-62BとGPT-3.5を追っている.数学に特化したモデルは、独自のモデルと比較して、算数能力と中国語の計算問題でより優れたパフォーマンスを発揮している.

Vision Transformers Need Registers

著者:Timothée Darcet, Maxime Oquab, Julien Mairal, Piotr Bojanowski

発行日:2023年09月28日

最終更新日:2023年09月28日

URL:http://arxiv.org/pdf/2309.16588v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

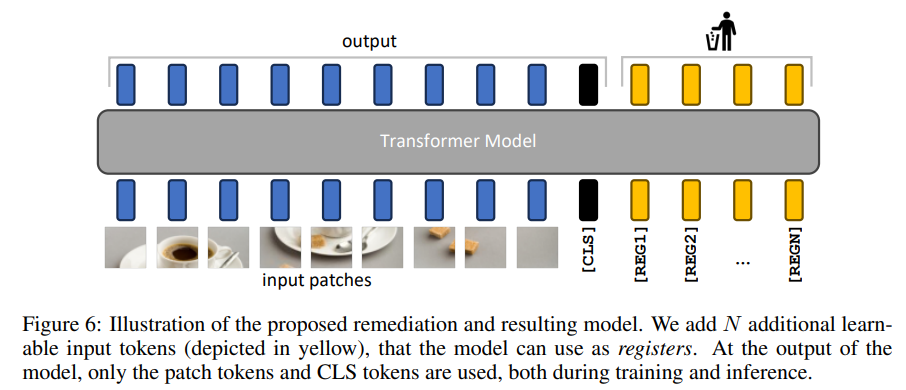

最近、トランスフォーマーは視覚表現の学習において強力なツールとして登場しています.本論文では、教師ありおよび自己教師ありのViTネットワークの特徴マップにおけるアーティファクトを特定し、特徴マップの背景領域に主に現れる高ノルムのトークンを内部計算のために再利用するものです.私たちは、この問題を解決するために、Vision Transformerの入力シーケンスに追加のトークンを提供するというシンプルかつ効果的な解決策を提案します.この解決策が教師ありおよび自己教師ありモデルの両方に完全に問題を解決し、密な視覚予測タスクにおける自己教師あり視覚モデルの最新の状態を設定し、より大きなモデルを使用したオブジェクトの発見方法を可能にし、最も重要なことは、ダウンストリームの視覚処理のためのより滑らかな特徴マップと注意マップにつながることを示します.

Q&A:

Q: 教師ありViTネットワークと自己教師ありViTネットワークの特徴マップに見られるアーチファクトとは何か?

A: 監督学習および自己教師ありViTネットワークの特徴マップには、高ノルムトークンのアーティファクトが存在する.これらのアーティファクトは、主に情報量の少ない背景領域の画像で推論中に現れ、内部計算のために再利用される.提案された解決策は、Vision Transformerの入力シーケンスに追加のトークンを提供することに基づいており、その役割を補完する.この解決策により、監督学習および自己教師ありモデルの両方においてこの問題が完全に修正され、密な視覚予測タスクにおいて自己教師ありビジュアルモデルの新たな最先端を確立し、より大きなモデルを使用したオブジェクト発見手法を可能にし、さらに重要なことには、ダウンストリームの視覚処理のためのより滑らかな特徴マップと注意マップをもたらす.

Q: これらのアーティファクトは、フィーチャーマップにどのように現れるのか?

A: アーティファクトは、局所特徴の中での高ノルムの外れ値トークンです.アーティファクトパッチと他のパッチの重要な違いは、モデルの出力時のトークン埋め込みのノルムです.

Q: これらの人工物に対処するための解決策は何か提案されているか?

A: 提案された解決策は、入力シーケンスに使用されない追加のトークンを追加することです.

Q: ビジョン・トランスフォーマーの入力シーケンスにトークンを追加することは、特定された問題の解決にどのように役立つのでしょうか?

A: 追加のトークンは、モデルがレジスタとして使用できるようになるため、特定の問題を修正するのに役立ちます.これらのトークンは、パッチ埋め込み層の後に追加され、[CLS]トークンと同様に学習可能な値を持ちます.ビジョントランスフォーマーの最後では、これらのトークンは破棄され、[CLS]トークンとパッチトークンが通常通り画像の表現として使用されます.このメカニズムは、NLPの翻訳タスクを改善するために最初にMemory Transformers(Burtsev et al.、2020)で提案されました.興味深いことに、このメカニズムはビジョントランスフォーマーに自然な正当化を提供し、それ以外に存在していた解釈性とパフォーマンスの問題を修正します.

Q: このソリューションを教師ありモデルと自己教師ありモデルの両方に導入するメリットは何ですか?

A: この解決策を実装することによる監督学習と自己教師あり学習モデルの両方の利点は、より大きなモデルでのオブジェクトの発見方法を可能にし、密な視覚予測タスクにおいて自己教師ありビジュアルモデルの新たな最先端を確立し、監督学習と自己教師あり学習モデルの両方において問題を完全に修正することです.

Q: このソリューションは、高密度の視覚予測タスクにおける自己教師付き視覚モデルの新しい状態をどのように設定するのだろうか?

A: この解決策は、密な視覚予測タスクにおいて、自己教師あり視覚モデルの最先端を確立することで、新たな最先端を打ち立てています.これにより、より大きなモデルを使用したオブジェクトの発見方法が可能になり、さらに重要なことに、下流の視覚処理のためのより滑らかな特徴マップと注意マップが得られます.

Q: このソリューションは、どのような点で、より大きなモデルを使ったオブジェクト発見法を可能にするのか?

A: この解決策により、より大きなモデルでのオブジェクト検出手法が可能になります.具体的には、DINOv2や他の監視されたモデルに適用される場合でも、この手法によりパフォーマンスが向上し、新たな最先端の状態が実現されます.

Q: 提案された解決策は、下流の視覚処理のための、より滑らかな特徴マップとアテンションマップにどのようにつながるのか?

A: 提案された解決策は、トークンシーケンスに追加のトークン(レジスタ)を追加することで、異常なトークンがシーケンスから完全に除外されるようにします.これにより、モデルの性能が密な予測タスクで向上し、生成される特徴マップは大幅に滑らかになります.滑らかな特徴マップは、上記で言及されたLOSTのようなオブジェクト検出手法を可能にします.

Q: 画像の情報量の少ない背景領域で高ノルムのトークンを再利用する内部計算の詳細を教えてください.

A: 高規範トークンは、画像の低情報背景領域で主に推論中に現れる高規範トークンは、内部計算のために再利用されます.これらのトークンは、追加のトークンを入力セットに提供することに基づく単純で効果的な解決策を提案しています.

Q: この解決策を実施する上で、潜在的な欠点や制限はありますか?

A: この解決策の実装にはいくつかの潜在的な欠点や制限があります.具体的には、追加のトークンを入力シーケンスに含めることで、モデルのサイズが増加し、計算コストが増える可能性があります.また、追加のトークンが出力に使用されないため、モデルの学習において情報の損失が発生する可能性もあります.さらに、この解決策がすべてのモデルやタスクに対して効果的であるかどうかは明確ではありません.この解決策が特定のモデルやタスクに対してのみ有効である可能性もあります.したがって、この解決策を実装する際には、これらの制限や欠点を考慮する必要があります.

Effective Long-Context Scaling of Foundation Models

著者:Wenhan Xiong, Jingyu Liu, Igor Molybog, Hejia Zhang, Prajjwal Bhargava, Rui Hou, Louis Martin, Rashi Rungta, Karthik Abinav Sankararaman, Barlas Oguz, Madian Khabsa, Han Fang, Yashar Mehdad, Sharan Narang, Kshitiz Malik, Angela Fan, Shruti Bhosale, Sergey Edunov, Mike Lewis, Sinong Wang, Hao Ma

発行日:2023年09月27日

最終更新日:2023年10月17日

URL:http://arxiv.org/pdf/2309.16039v2

カテゴリ:Computation and Language

概要:

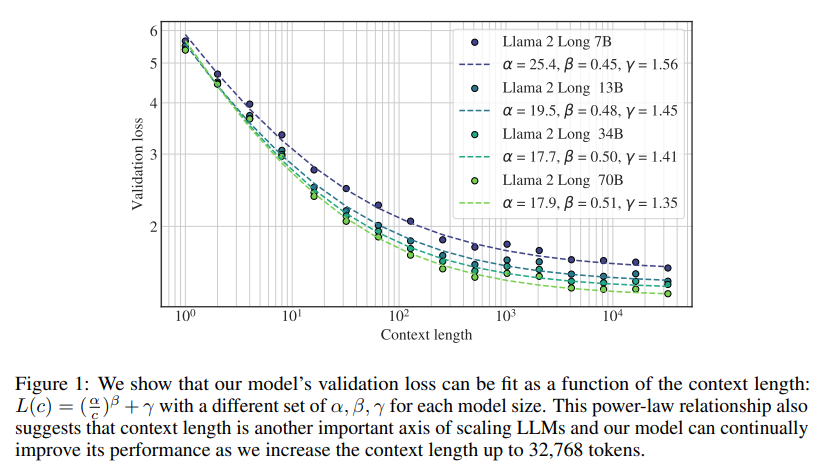

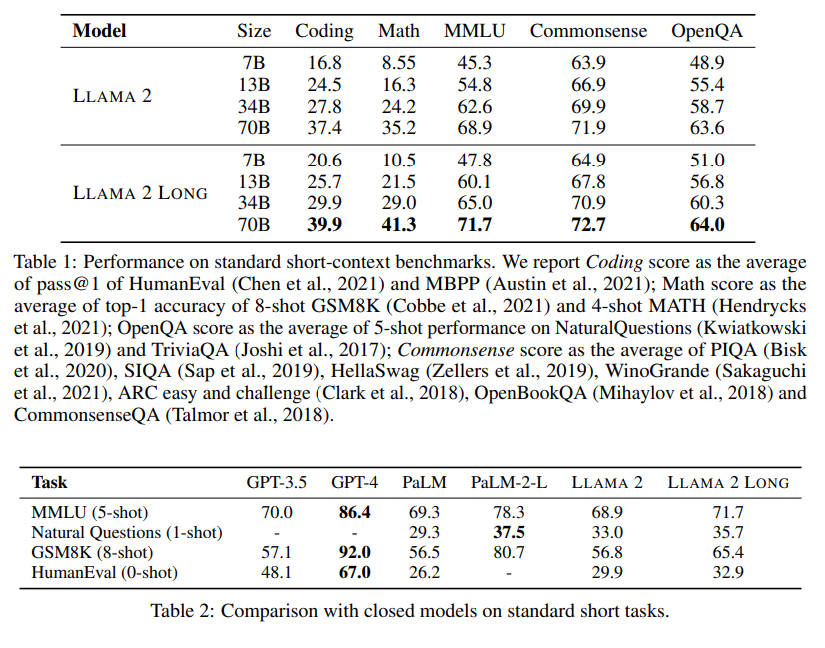

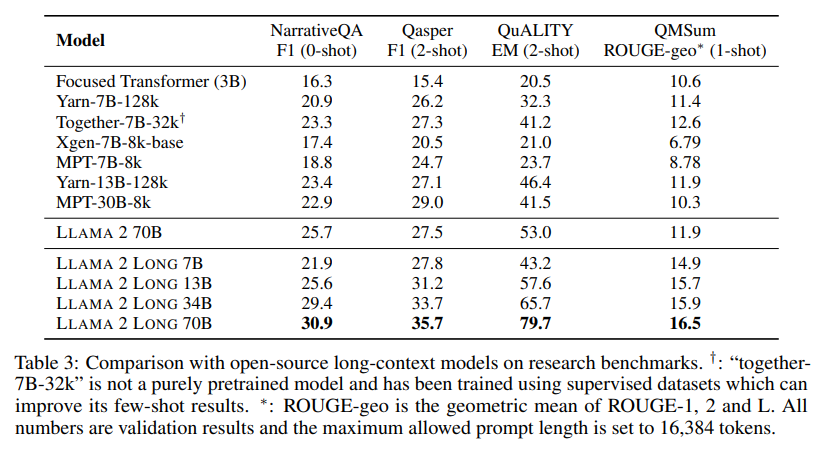

私たちは、最大32,768トークンの効果的なコンテキストウィンドウをサポートする一連の長文脈LLMを提案します.私たちのモデルシリーズは、Llama 2からの継続的な事前学習によって構築され、トレーニングシーケンスが長く、長いテキストがアップサンプリングされたデータセットで行われます.私たちは、言語モデリング、合成コンテキストプロービングタスク、およびさまざまな研究ベンチマークで広範な評価を行います.研究ベンチマークでは、私たちのモデルは通常のタスクのほとんどで一貫した改善を達成し、Llama 2に比べて長文脈のタスクで大幅な改善を達成します.特に、人手による長い命令データを必要としない費用効果の高い調整手順により、70Bバリアントはすでにgpt-3.5-turbo-16kの全体的なパフォーマンスを上回ることができます.これらの結果に加えて、私たちは私たちの手法の個々のコンポーネントについて詳細な分析を提供します.Llamaの位置符号化について掘り下げ、長い依存関係のモデリングにおける制約について議論します.また、データミックスやシーケンス長のトレーニングカリキュラムなど、事前学習プロセスのさまざまな設計選択の影響についても検討します.私たちの削除実験は、事前学習データセットに豊富な長いテキストがあることが強力なパフォーマンスを達成するための鍵ではないことを示唆しており、長いコンテキストの継続的な事前学習が長いシーケンスからのスクラッチ事前学習と同様に効率的かつ効果的であることを経験的に検証しています.

Q&A:

Q: モデルシリーズのロングコンテクストLLMがサポートするトークンの最大数は?

A: モデルシリーズの長文脈LLMは、最大で32,768トークンのコンテキストをサポートしています.

Q: モデルシリーズはどのように作られるのですか?また、そのプロセスにおけるラマ2の役割は何ですか?

A: モデルシリーズは、LLAMA 2のチェックポイントからの事前学習と、追加の4000億トークンを使用した長いトレーニングシーケンスから構築されます.モデルシリーズには、より小さい7B/13Bバリアントと、32,768トークンのシーケンスでトレーニングされた34B/70Bバリアントがあります.LLAMA 2は、モデルの事前学習に使用されるチェックポイントです.

Q: 言語モデリングと合成コンテクスト・プロービング・タスクの評価プロセスについて教えてください.

A: 言語モデリングと合成タスクの評価プロセスは、既存の研究では限定的な評価が行われており、長い文脈に関する能力と合成タスクの損失に焦点を当てています.言語モデリングでは、文脈の長さに関連してパワーローのスケーリング動作を示しています.合成タスクでは、FIRST-SENTENCE-RETRIEVALタスクを使用して、非常に厳しい要件を課しています.このタスクでは、非常に長い範囲の依存関係が一貫して必要とされるデータサンプルを見つけることが困難です.

Q: 研究ベンチマーク、特にラマ2やgpt-3.5-turbo-16kとの比較での評価結果はどうでしたか?

A: 研究のベンチマークでは、LLAMA 2に比べてほとんどの通常のタスクで一貫した改善が見られ、長い文脈のタスクでは大幅な改善が見られました.特に、人間による長い命令データを必要としない費用効果の高い調整手法により、70Bバリアントはすでにgpt-3.5-turbo-16kを上回る性能を発揮しています.

Q: コスト効率の良い指示調整手順はどのように機能し、gpt-3.5-turbo-16kの性能を超えるのにどのように貢献していますか?

A: コスト効果の高い指示調整手法は、人間による長い指示データを必要とせずに、70Bのモデルがgpt-3.5-turbo-16kを上回る性能を発揮するのに貢献します.この手法では、指示調整モデルを訓練するために、長い文脈タスクのデータを使用せずに、より短い文脈タスクのデータを使用します.具体的には、指示調整モデルは、より短い文脈タスクのデータを使用して事前学習され、その後、長い文脈タスクのデータを使用して微調整されます.この手法により、70Bのモデルは、長い文脈タスクでgpt-3.5-turbo-16kを上回る性能を発揮することができます.

Q: ラマの位置符号化の分析と、長い依存関係のモデリングにおける制約について、もっと詳細を提供していただけますか?

A: LLAMAの位置エンコーディングは分析され、長い依存関係をモデリングする際に制約があることがわかりました.LLAMA 2で使用される位置エンコーディング(PE)は、この制約に対処するために修正されました.修正には、RoPE位置エンコーディングの回転角度(ハイパーパラメータ「ベース周波数b」によって制御される)を減少させることが含まれています.この修正により、遠くのトークンに対するRoPEの減衰効果が軽減され、アテンションモジュールが遠くのトークンから情報を効果的に集約できるようになります.修正されたPEメソッドは、LLAMAのコンテキスト長を拡張するための同時アプローチよりも優れた性能を示しました.修正されたPEメソッドの優位性の理論的な説明も、論文のセクション4.1で提供されています.

Q: データ・ミックスやトレーニング・カリキュラムの長さなど、トレーニング前のプロセスにおける設計の選択が及ぼす影響について、どのような知見が得られたか?

A: 長いシーケンスでのスクラッチからの事前学習よりも、継続的な事前学習の方が競争力のあるパフォーマンスを提供することが実証された.また、データミックスやトレーニングカリキュラムの設計選択の影響に関しては、豊富な長いテキストを事前学習データセットに持つことが強力なパフォーマンスを達成するための鍵ではないことが実験によって示され、長いコンテキストの継続的な事前学習が効率的かつ同様に効果的であることが経験的に検証された.

Q: アブレーション実験と、強力なパフォーマンスを達成するためのその意味について説明していただけますか?

A: アブレーション実験は、強力なパフォーマンスを達成するための重要な手法を明らかにするために行われました.具体的には、長いテキストの存在が強力なパフォーマンスの鍵ではないことを示し、長いコンテキストの継続的な事前学習が、長いシーケンスからのスクラッチ事前学習と同様に効率的かつ効果的であることを実証しました.また、アブレーション実験により、アーキテクチャの変更、データの混合、トレーニングカリキュラムの設計などの要素が最終的なパフォーマンスにどのように貢献しているかを定量化し、設計の選択肢を正当化することができました.

Q: ロングコンテクストでの継続的なプレトレーニングは、ゼロからのロングシーケンスでのプレトレーニングと比較して、効率と効果の点でどうなのか?

A: 長い文脈の継続的な事前学習は、長いシーケンスからのスクラッチでの事前学習と比較して、効率と効果の面で同様に効果的であり、より効率的であることが実証されています.

Q: 長時間の継続的なプレトレーニングの効率と効果について、実証的な検証を詳しく教えてください.

A: 長い文脈の継続的な事前学習の効率と効果を実証するための経験的な検証について詳しく説明します.短い文脈モデルからの継続的な事前学習は、長い文脈の能力を学習するために長いシーケンスをゼロから事前学習するよりも効率的で同様に効果的であることが実証されています.具体的な実験結果や比較によって、この仮説が検証されています.

Graph Neural Prompting with Large Language Models

著者:Yijun Tian, Huan Song, Zichen Wang, Haozhu Wang, Ziqing Hu, Fang Wang, Nitesh V. Chawla, Panpan Xu

発行日:2023年09月27日

最終更新日:2023年09月27日

URL:http://arxiv.org/pdf/2309.15427v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

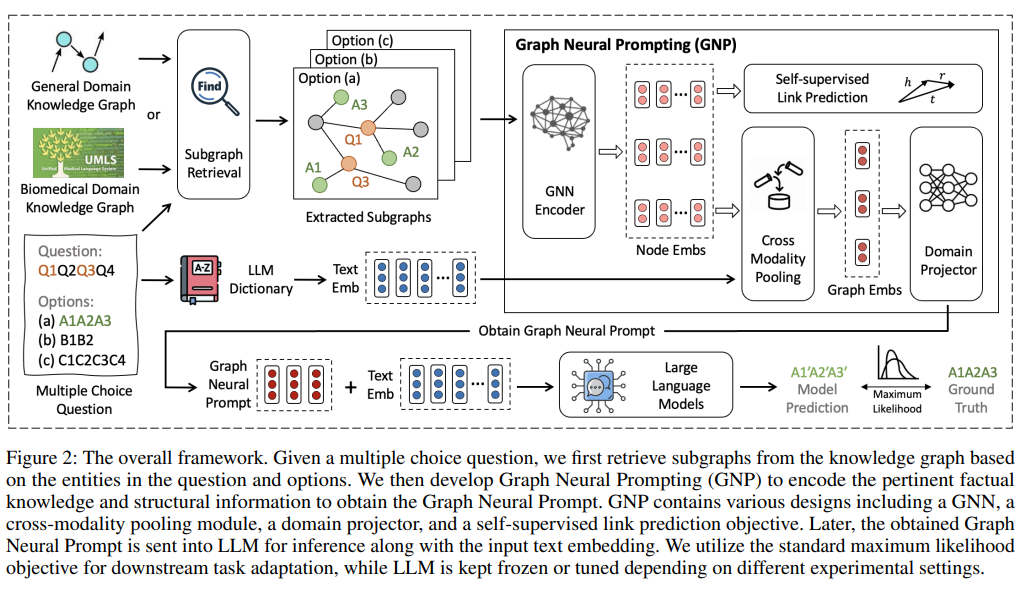

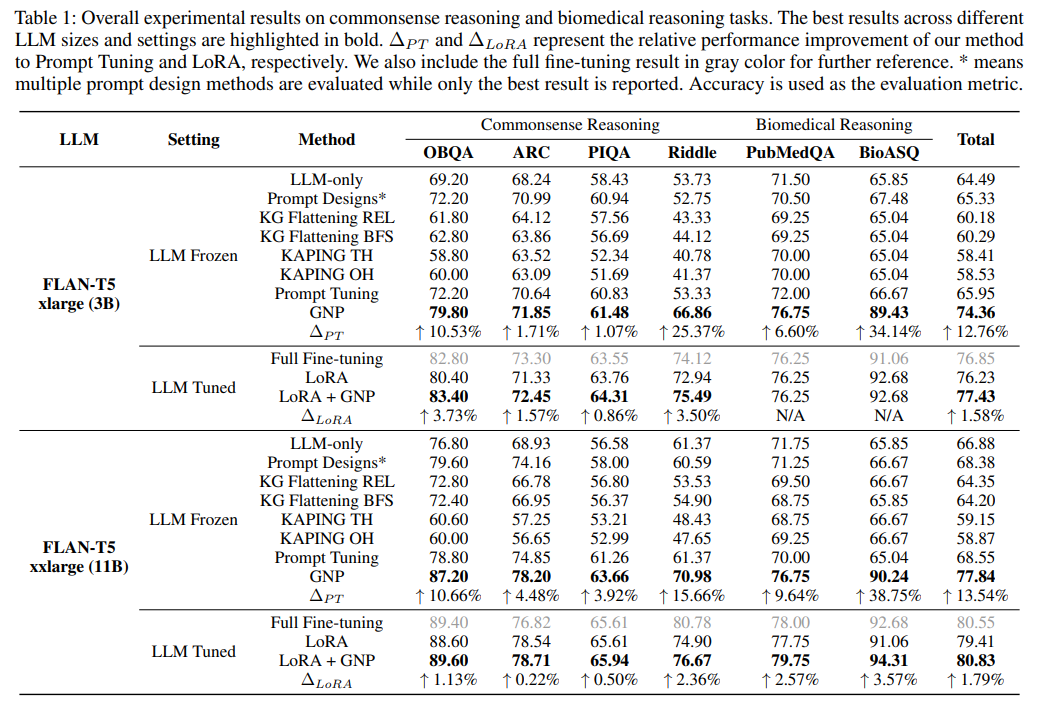

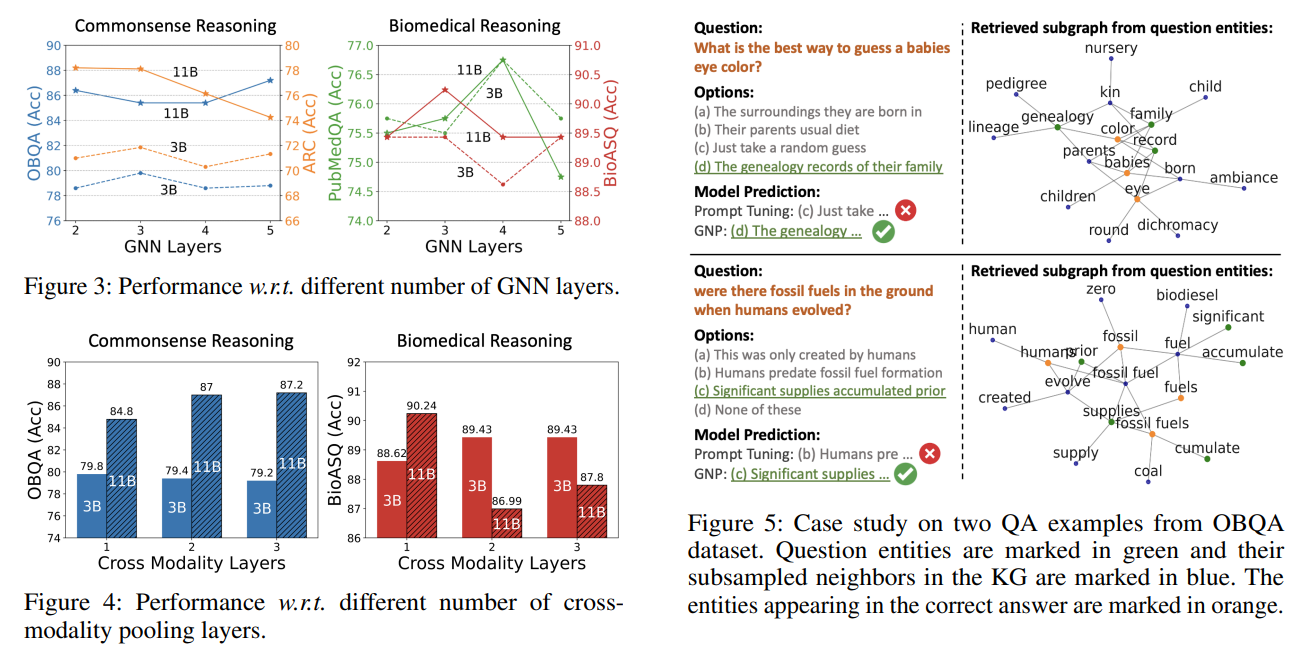

大規模言語モデル(LLM)は、さまざまな言語モデリングタスクで優れた汎化能力を示しています.しかし、彼らは依然として具体的な知識を正確に捉えて返すという固有の制限を持っています.既存の研究では、知識グラフを使用して言語モデリングを強化するための共同トレーニングとカスタマイズされたモデルアーキテクチャの利用が探求されてきましたが、LLMに適用することは、そのパラメータの多さと高い計算コストのために問題があります.さらに、事前学習されたLLMを活用し、ゼロからカスタマイズされたモデルをトレーニングすることを回避する方法は、未解決の問題です.本研究では、事前学習されたLLMが知識グラフから有益な知識を学ぶための新しいプラグアンドプレイの方法であるGraph Neural Prompting(GNP)を提案しています.GNPには、標準的なグラフニューラルネットワークエンコーダ、クロスモダリティプーリングモジュール、ドメインプロジェクタ、および自己教師ありリンク予測目的など、さまざまな設計が含まれています.複数のデータセットでの詳細な実験は、異なるLLMのサイズと設定において、GNPの優位性を示し、常識的な推論タスクとバイオメディカルの推論タスクの両方で優れたパフォーマンスを示しています.

Q&A:

Q: 大規模言語モデル(LLM)の限界とは?

A: LLMは、根拠ある知識を正確に捕捉し、返すことに本質的な限界がある.LLMは、正確な事実知識を正確に捉えるという課題に直面しており、言語モデリングの限界の影響を受けやすい.LLMは、質問応答において目覚ましい性能を発揮しているにもかかわらず、根拠のある知識を正確に捉え、返すことに苦戦している.

Q: 言語モデリングを強化するための知識グラフの活用について、既存の研究はどのように探求してきたのだろうか?

A: 既存の研究では、知識グラフを利用して言語モデリングを向上させるための方法がいくつか提案されています.具体的には、知識グラフを言語モデリングの事前学習段階に統合する方法があります.ERNIE、JAKET、JointGTなどのモデルは、知識グラフのトリプルと対応する文を対象とした事前学習目的を開発しています.また、DRAGONは、知識グラフとテキストを共同で事前学習するためのカスタマイズされた統合フレームワークを導入しています.さらに、知識グラフは質問応答のための言語モデリングを支援するために活用されており、GreaseLMやQAGNNなどのモデルは、グラフ構造を持つエンティティに関する推論を支えるために知識グラフを使用しています.

Q: なぜ知識グラフをLLMに適用することが問題なのか?

A: 既存の研究では、LLMsに適用する際に困難が生じるため、知識グラフを適用することは問題がある.

Q: 知識グラフをLLMに適用する際の計算コストは?

A: 既存の研究では、LLMへの適用には困難が伴います.LLMへの直接のフィードによって、ノイズの存在にもかかわらず、知識グラフからのトリプルを直接フィードすることが有益であると期待されています.しかし、LLMは多くのパラメータを含んでおり、多くの計算リソースを必要とするため、LLMとテキストの共同トレーニングは困難です.また、既存の優れた能力を持つ事前学習済みLLMを利用することは有利であり、特定のモデルを作成し、ゼロからトレーニングする必要がない場合に特に有益です.

Q: カスタマイズされたモデルをゼロからトレーニングすることなく、事前にトレーニングされたLLMを活用するにはどうすればいいのだろうか?

A: 既存の事前学習済みLLMを利用することで、専用のモデルをゼロから訓練する必要を回避することができます.

Q: グラフ・ニューラル・プロンプティング(GNP)とは何か、また、事前訓練されたLLMがKGから有益な知識を学習するのをどのように支援するのか?

A: Graph Neural Prompting (GNP)は、事前学習済みLLMsを支援するための新しいプラグアンドプレイの手法であり、KGsから有益な知識を学習するのを支援します.GNPは、関連する基礎知識と複雑な構造情報をエンコードし、Graph Neural Promptと呼ばれる埋め込みベクトルを生成します.このベクトルはLLMsに送られ、ガイダンスと指示を提供します.具体的には、GNPはまずグラフニューラルネットワーク(GNN)を使用して、複雑なグラフ知識をエンティティ/ノードの埋め込みにキャプチャしてエンコードします.次に、クロスモダリティプーリングモジュールが存在し、テキスト入力に関連する最も関連性の高いノード埋め込みを決定し、これらのノード埋め込みを統合してホリスティックなグラフレベルの埋め込みを生成します.その後、GNPはグラフとテキストのドメイン間の固有の不均衡を埋めるためのドメインプロジェクタを含みます.最後に、自己教師ありのリンク予測目的が導入され、エンティティ間の関係のモデル理解を向上させ、キャプチャします.

Q: GNPが包含するさまざまなデザインとは?

A: GNPは、標準的なグラフ・ニューラル・ネットワーク・エンコーダー、クロスモダリティ・プーリング・モジュール、ドメイン・プロジェクター、自己教師付きリンク予測目的など、さまざまな設計を含んでいる.

Q: GNPはコモンセンス推論タスクにおいて、他の手法と比較してどのようなパフォーマンスを示すのか?

A: GNPはコモンセンス推論タスクで顕著な性能向上を示している.例えば、3B LLMのRiddleでは25.37%、11B LLMでは15.66%の改善が見られる.一般に、GNPは3Bと11BのLLMでそれぞれ12.76%と13.54%の改善を達成している.

Q: GNPは、生物医学的推論タスクにおいて、他の手法と比較してどのようなパフォーマンスを示すのか?

A: GNPは、他の手法と比較して、バイオメディカル推論タスクにおいて、3B LLMでBioASQの34.14%の改善、11B LLMで38.75%の改善を達成した.

Q: LLMの規模やセッティングの違いによって、GNPのパフォーマンスはどのように異なるのか?

A: GNPは、異なるLLMサイズと設定において、3Bと11BのLLMでそれぞれ12.76%と13.54%の改善を達成した.

Large Language Model Alignment: A Survey

著者:Tianhao Shen, Renren Jin, Yufei Huang, Chuang Liu, Weilong Dong, Zishan Guo, Xinwei Wu, Yan Liu, Deyi Xiong

発行日:2023年09月26日

最終更新日:2023年09月26日

URL:http://arxiv.org/pdf/2309.15025v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

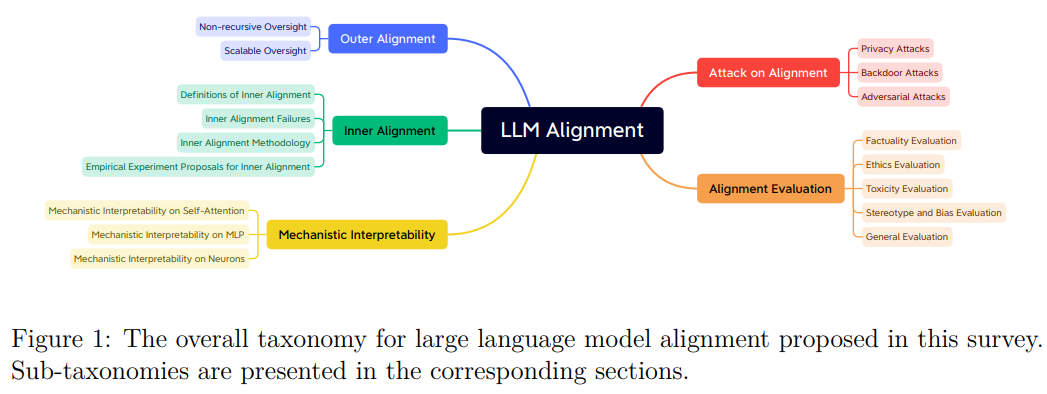

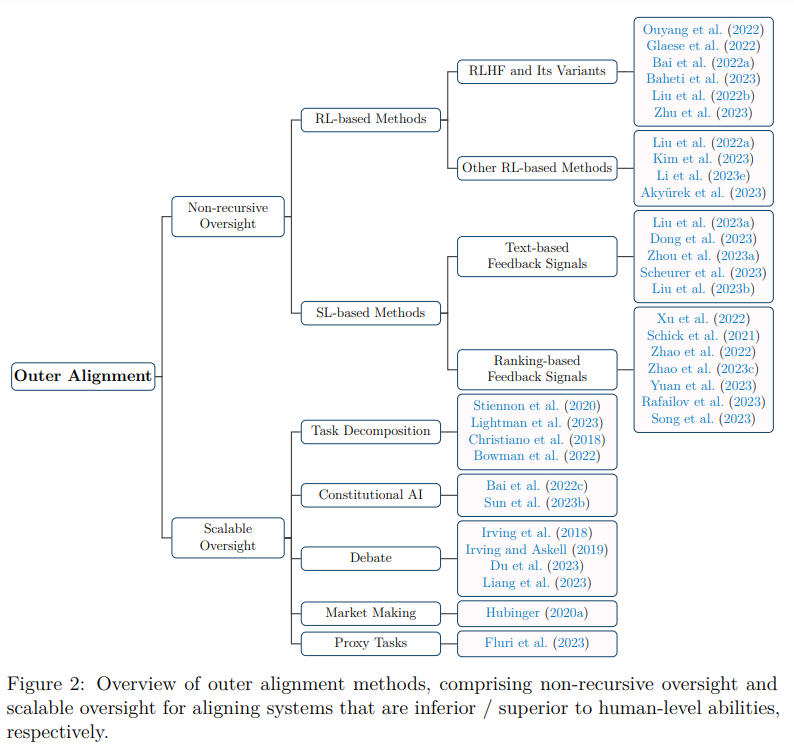

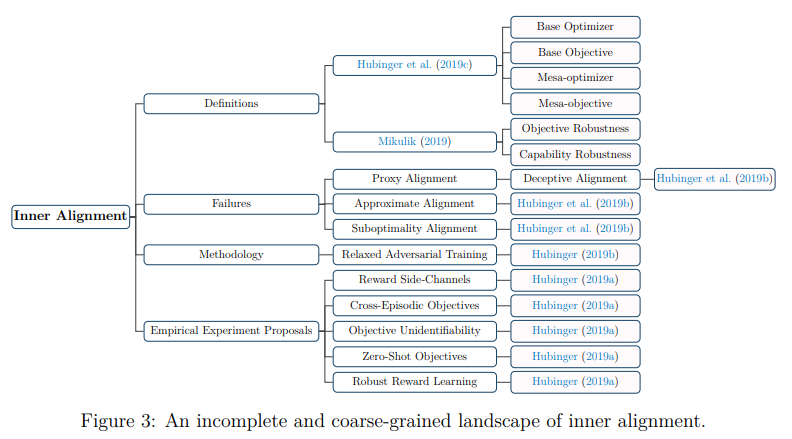

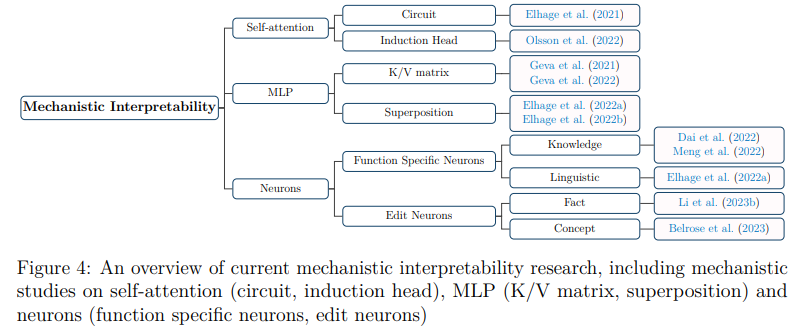

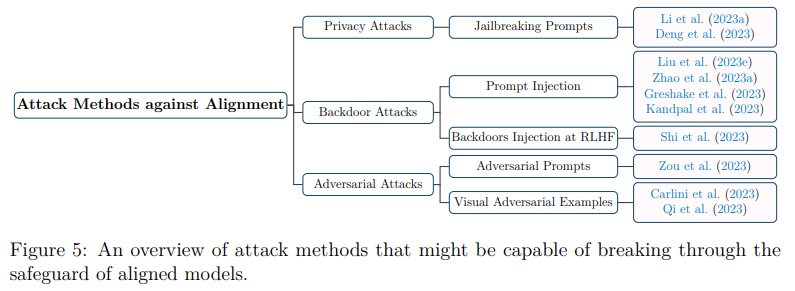

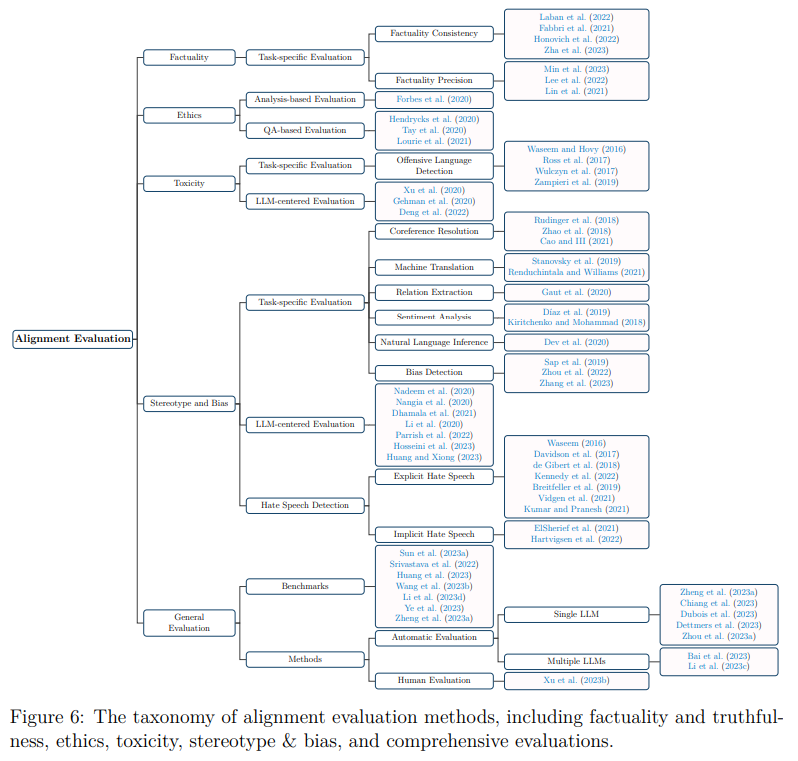

近年、大規模言語モデル(LLM)の進歩が顕著である.これらの進展は注目を集めている一方で、さまざまな懸念も引き起こしている.これらのモデルの潜在能力は間違いなく広大であるが、不正確で誤解を招く、あるいは有害なテキストを生成する可能性もある.そのため、これらのモデルが人間の価値と一致する振る舞いを示すためには、アラインメント技術を使用することが非常に重要となる.

本調査では、LLMのために設計されたアラインメント手法について、既存の能力研究とともに包括的な探求を提供することを目指す.AIアラインメントの視点を採用し、LLMのアラインメントのための既存の手法と新たな提案を外部アラインメントと内部アラインメントに分類する.また、モデルの解釈可能性や敵対的攻撃への潜在的な脆弱性など、重要な問題にも探求する.さらに、この調査は、AIアラインメント研究コミュニティと、LLMの能力探索に没頭している研究者との間のギャップを埋めることも目指している.

LLMのアラインメントを評価するために、さまざまなベンチマークと評価手法を提案する.LLMのアラインメント研究の現状を議論した後、将来に向けて有望な研究の方向性を考察し、研究者たちの関心を喚起するだけでなく、能力のある安全なLLMの実現に向けて、AIアラインメント研究コミュニティとの連携を図ることも目指している.

Q&A:

Q: 大規模言語モデル(LLM)に関連する潜在的な懸念事項とは?

A: 大規模言語モデル(LLM)に関連する潜在的な懸念はいくつかあります.まず、LLMの訓練と実行には膨大な計算リソースが必要であり、高いエネルギー消費と炭素排出を引き起こします.これにより、LLMの炭素フットプリントと気候変動への影響について懸念が生じています.また、LLMの広範な使用は生産性を大幅に向上させる一方で、労働市場に混乱をもたらす可能性があります.最近の研究では、アメリカの労働力の約80%がLLMの影響を受けると示されています.さらに、LLMの進化に伴い、潜在的な行動の一連の可能性が生じる可能性があります.例えば、LLMは訓練データに含まれるバイアス、差別、有害なコンテンツなどの有害な情報を誤って永続化することがあります.また、LLMは訓練データから個人情報や機密情報を漏洩する可能性もあります.さらに、LLMは不正行為や操作行為を容易にすることができます.例えば、LLMはサイバー攻撃のためのコードを生成したり、致命的な武器を作成したりすることができます.

Q: LLMが人間の価値観に合致した行動を取るようにするために、アライメント技術はどのように活用できるのか?

A: LLMが人間の価値観に合致した行動をとるようにするために、LLMのアライメント技術を採用することができる.このような技術には、意思決定理論、反実仮想推論、LLMが意思決定についてどのように推論し行動するかを理解する研究が含まれる.これらの分野を探求することで、研究者は、高度なLLMが予測可能で人類にとって有益な方法で意思決定を行うようにすることを目指している.さらに、LLMのアライメントという課題には、様々な学問分野からの多面的なアプローチが必要であり、異分野の知識の連携と統合の必要性を示している.これらの分野での理解とコミットメントを深めることで、LLMが私たちの社会にシームレスに統合され、私たちの能力を増幅させ、私たちが共有する人間的経験を向上させる未来に向けて取り組むことができる.

Q: LLMを調整するための一般的な方法と新たな提案とは?

A: 現在のLLMの整合性のための主要な手法と新興の提案は、外部整合性と内部整合性に分類されます.

Q: アライメントの方法は、アウターアライメントとインナーアライメントにどのように分類されますか?

A: アライメント手法は、外部アライメントと内部アライメントの2つに分類されます.

Q: LLMの解釈可能性に関する問題とは?

A: LLMは「ブラックボックス」の性質により、解釈可能性に関する問題を抱えており、特定の結果に至る過程を理解することが困難です.透明性や説明可能性の欠如は、特にこれらのモデルが重要な意思決定に使用される場合に懸念が高まります.LLMの複雑さやパラメータの数の多さ、そして大規模なニューラルネットワークとしての性質から、逆解析や内部の動作の理解が困難です.現在の機械的な解釈可能性の手法は、通常、LLMの小さく簡略化されたモデルに適用されています.したがって、LLMの解釈可能性は、信頼性と責任を確保するために取り組むべき重要な問題です.

Q: 敵対的攻撃に対するLLMの潜在的な脆弱性とは?

A: LLMsの潜在的な脆弱性は、敵対的攻撃に対する防御能力の不足です.

Q: LLMのアラインメントを評価するために、どのようなベンチマークや評価方法が用いられていますか?

A: LLMのアライメントは、さまざまなベンチマークや評価方法を用いて評価される.

Q: LLMのアライメント研究の現状は?

A: 現在のLLMのアラインメント研究の現状は、外部アラインメントと内部アラインメントの2つのカテゴリに分けられ、モデルの解釈可能性や敵対的攻撃への脆弱性などの重要な問題が探求されています.さらに、LLMのアラインメントを評価するために、さまざまなベンチマークと評価方法論が提案されています.この調査では、LLMのアラインメント研究の現状を議論した後、将来の研究の有望な方向性についても考察されています.この調査は、AIアラインメントコミュニティとLLMの研究者との協力を促進し、LLMの全ての潜在能力を倫理的かつ有益な方法で人類に役立てることを目指しています.LLMの能力探求に従事する研究者とAIアラインメント研究コミュニティとの連携は、この目標を達成するために不可欠です.

Q: LLMのアライメントにとって、将来有望な研究分野は何でしょうか?

A: LLM alignmentの将来の研究の有望な方向性は、意思決定理論、透明性と解釈可能性、評価方法論、およびAIアライメント研究コミュニティとの連携です.

Q: AIアライメントの研究コミュニティと、LLMの能力を探求する研究者の間のギャップをどのように埋めることができるのか?

A: AIアライメント研究コミュニティとLLMの能力探索を行う研究者とのギャップを埋めるためには、協力的なアプローチが不可欠です.この協力的なアプローチにより、LLMが倫理的かつ有益な方法で人類に奉仕することが保証されます.具体的には、LLMの可能性を最大限に引き出すために、AIアライメントコミュニティとLLM研究者の間での協力が重要です.この協力により、LLMの能力探索に関する知見や成果がAIアライメントコミュニティにフィードバックされ、LLMが正確かつ倫理的にアライメントされることが促進されます.また、LLMがAIアライメントコミュニティの深い理論や方法論に基づいて開発されることで、両者の間には相互に利益をもたらす好循環が生まれます.

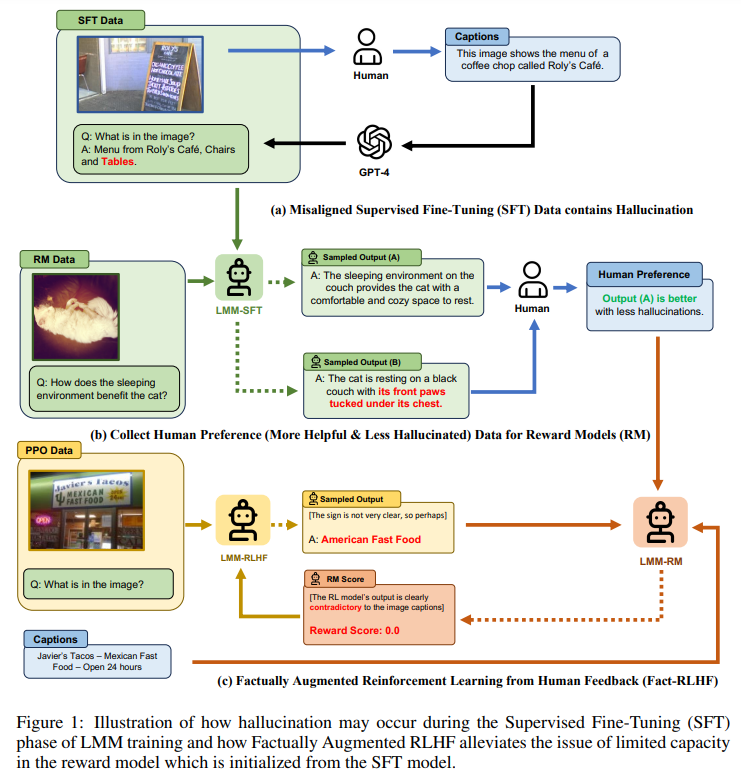

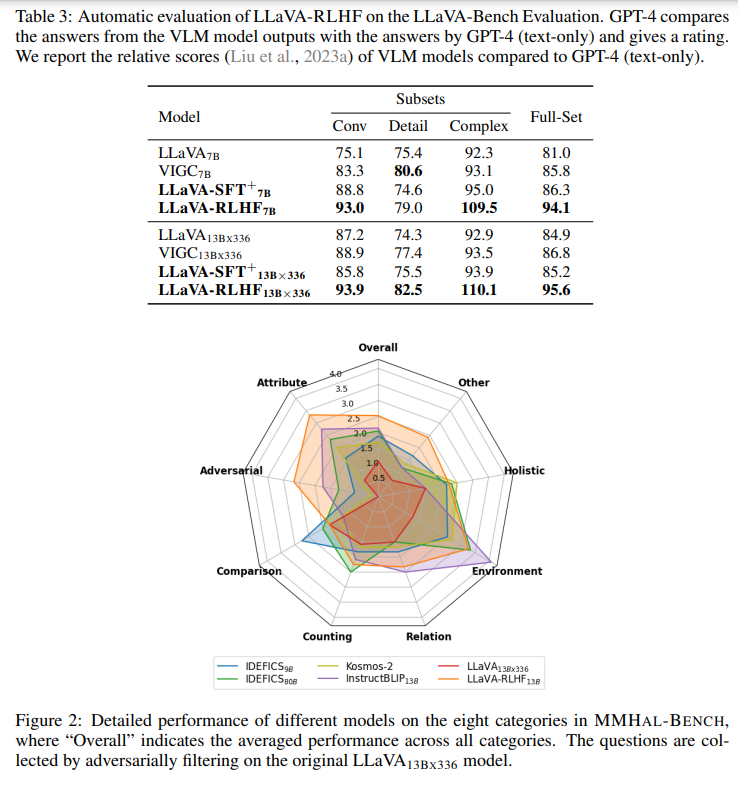

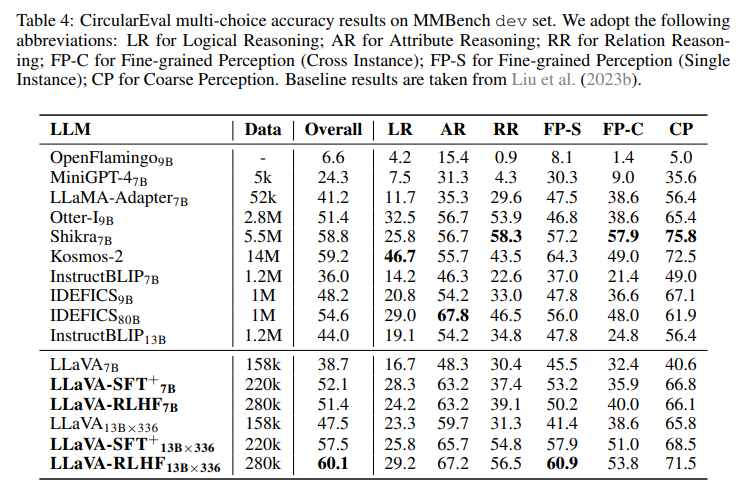

Aligning Large Multimodal Models with Factually Augmented RLHF

著者:Zhiqing Sun, Sheng Shen, Shengcao Cao, Haotian Liu, Chunyuan Li, Yikang Shen, Chuang Gan, Liang-Yan Gui, Yu-Xiong Wang, Yiming Yang, Kurt Keutzer, Trevor Darrell

発行日:2023年09月25日

最終更新日:2023年09月25日

URL:http://arxiv.org/pdf/2309.14525v1

カテゴリ:Computer Vision and Pattern Recognition, Computation and Language

概要:

大規模なマルチモーダルモデル(LMM)は、複数のモダリティを横断して構築され、2つのモダリティ間の不整合は「幻覚」を引き起こし、コンテキストに基づかないテキストの出力を生成する可能性があります.マルチモーダルの不整合問題に対処するために、テキスト領域からビジョン-言語のアライメントのタスクにReinforcement Learning from Human Feedback(RLHF)を適応させます.この手法では、人間の注釈者に2つの応答を比較し、より幻覚的なものを指摘してもらい、ビジョン-言語モデルはシミュレートされた人間の報酬を最大化するように訓練されます.さらに、画像のキャプションや正解の多肢選択肢などの追加の事実情報を報酬モデルに組み込むことで、報酬ハッキング現象を軽減し、パフォーマンスをさらに向上させるための新しいアライメントアルゴリズムであるFactually Augmented RLHFを提案します.また、ビジョンの指示調整のために生成されたGPT-4のトレーニングデータを、以前に利用可能な人間による画像-テキストのペアと組み合わせて、モデルの一般的な能力を向上させます.提案手法を実世界のシナリオで評価するために、特に幻覚的なものを罰することに焦点を当てた新しい評価ベンチマークであるMMHAL-BENCHを開発しました.このアプローチは、RLHFで訓練された最初のLMMであり、LLaVA-BenchデータセットではテキストのみのGPT-4のパフォーマンスレベルである94%を達成しました(以前の最高の手法では87%のレベルしか達成できませんでした).さらに、他のベースラインに比べてMMHAL-BENCHで60%の改善がありました.私たちは、コード、モデル、データをhttps://llava-rlhf.github.ioでオープンソース化しています.

Q&A:

Q: この箇所で扱われている主な問題は何か?

A: この文章で取り上げられている主な問題は、LMMの回答が情報を提供しているかどうかと、幻覚が存在するかどうかを評価することです.

Q: 提案されているアプローチは、マルチモーダルなミスアライメントの問題にどのように対処するのか?

A: 提案されたアプローチは、複数の戦略を使用して多モーダルの不整合問題に取り組んでいます.まず、既存の人間によって作成された画像とテキストのペアをGPT-4で生成されたビジョン指示の調整データに追加します.次に、テキストドメインからの強化学習による人間のフィードバック(RLHF)アルゴリズムを採用し、ビジョンと言語のギャップを埋めるために使用します.このアルゴリズムでは、人間の評価者がより幻想的な出力を識別し、マークします.VLMを訓練して、シミュレートされた人間の選好に最適化します.さらに、画像のキャプションなどの追加の事実情報を活用したファクトアップリケーションRLHFを導入し、報酬モデルを強化します.最後に、LMMの多モーダルの整合性を実世界の生成シナリオで評価し、特に幻覚を罰することに重点を置きます.COCOの12の主要なオブジェクトカテゴリをカバーし、8つの異なるベンチマーク質問を作成します.

Q: このアプローチでは、アライメント・アルゴリズムは何と呼ばれているのですか?

A: このアプローチでのアラインメントアルゴリズムは、ファクトリー・オーグメンテッドRLHFと呼ばれています.

Q: 事実上補強されたRLHFアルゴリズムはどのようにパフォーマンスを向上させるのか?

A: 事実拡張RLHFは、画像のキャプションや真実の複数選択肢のような追加情報で報酬信号を校正することで、パフォーマンスを向上させる.この拡張により、RLHFにおける報酬ハッキング現象を緩和し、幻覚出力を効果的に最小化することができる.より大きな言語モデルにおいて、既存の人間が注釈を付けたデータと知識を活用することで、Factually Augmented RLHFは報酬モデルの一般的な能力を向上させる.さらに、Factually Augmented RLHFは、人間の嗜好によりよく合致し、LLaV A-BenchとMMH AL-BENCHの両方で改善につながる.

Q: GPT-4で生成されたトレーニングデータは、このアプローチでどのように強化されるのですか?

A: このアプローチでは、以前に利用可能な人間によって書かれた画像とテキストのペアを使用して、GPT-4で生成されたトレーニングデータを強化します.

Q: MMHAL-BENCH評価ベンチマークの目的は何ですか?

A: MMH AL-BENCH は、LMM の応答における幻覚を定量的に評価するために作成された.これは、LMMの応答に幻覚があるかどうかを判定することを目的とし、ユーザとLMMの実用的なインタラクションにおける応答の質に着目している.このベンチマークデータセットは、人間の評価、特に幻覚補正後のスコアとよく一致するように設計されている.

Q: LLaVA-Benchデータセットにおいて、提案手法は従来の手法と比較してどのようなパフォーマンスを示したか?

A: 提案された手法は、LLaV A-Benchデータセットにおいて以前の手法と比較して優れたパフォーマンスを示しました.LLaV A-RLHFは、LLaV A-Benchで94%のスコアを達成し、MMH AL-BENCHでは60%の改善を実現しました.また、LLaV Aにおいては、MMBenchで52.4%のスコア、POPEで82.7%のF1スコアを確立しました.

Q: MMHAL-BENCHで提案されたアプローチによって達成された改善は、他のベースラインと比較してどうですか?

A: 提案手法は、他のベースラインと比較してMMH AL-BENCHで60%の改善を達成しました.

Q: このアプローチのコード、モデル、データにはどこからアクセスできますか?

A: 提案手法のコード、モデル、およびデータは、https://llava-rlhf.github.io で入手できます.

Q: このアプローチにおける人間のフィードバックからの強化学習(RLHF)適応について、もう少し詳しく教えてください.

A: このアプローチでは、Reinforcement Learning from Human Feedback (RLHF)を使用して、Large Language Models (LLMs)を人間の価値観に合わせるための手法を提案しています.RLHFは、人間のフィードバックを利用して強化学習を行う手法であり、テキストベースのAIエージェントにおいて非常に成功しています.このアプローチでは、RLHFをマルチモーダルな環境に適用し、ビジョンエンコーダと事前学習済みのLLMを共同でファインチューニングすることで、指示に従うデモデータセットを使用して教師ありファインチューニングを行います.さらに、報酬モデルを改善するために、より高い解像度と大きな言語モデルを使用することで、報酬モデルの一般的な能力を向上させます.また、新しいアルゴリズムであるFactually Augmented RLHF (Fact-RLHF)を導入し、報酬信号を追加の情報(例:画像のキャプションや正解の選択肢)で補完することで、報酬モデルをキャリブレーションします.

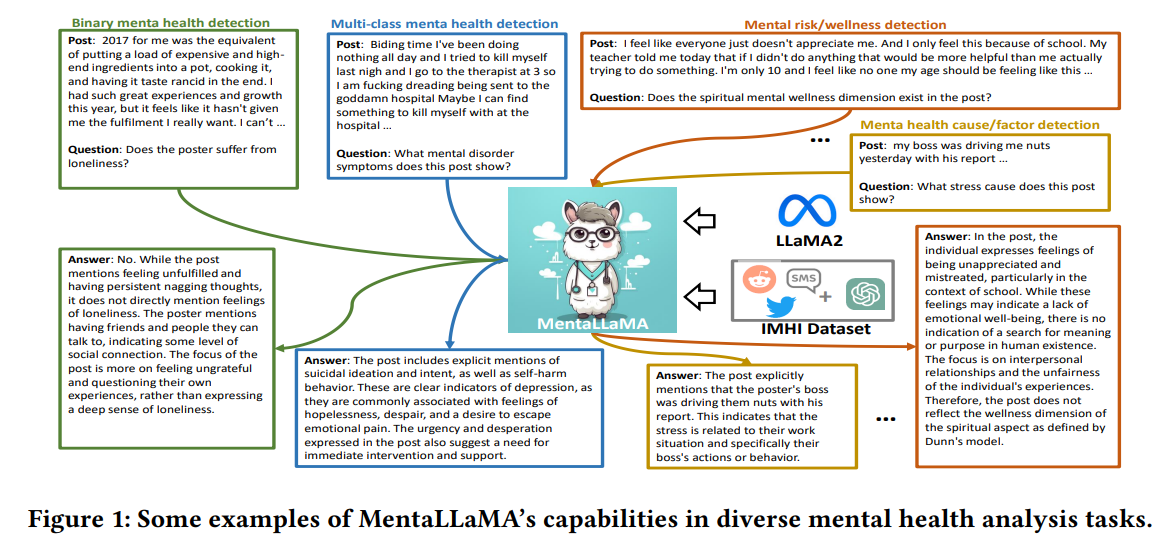

MentaLLaMA: Interpretable Mental Health Analysis on Social Media with Large Language Models

著者:Kailai Yang, Tianlin Zhang, Ziyan Kuang, Qianqian Xie, Sophia Ananiadou, Jimin Huang

発行日:2023年09月24日

最終更新日:2023年10月15日

URL:http://arxiv.org/pdf/2309.13567v2

カテゴリ:Computation and Language

概要:

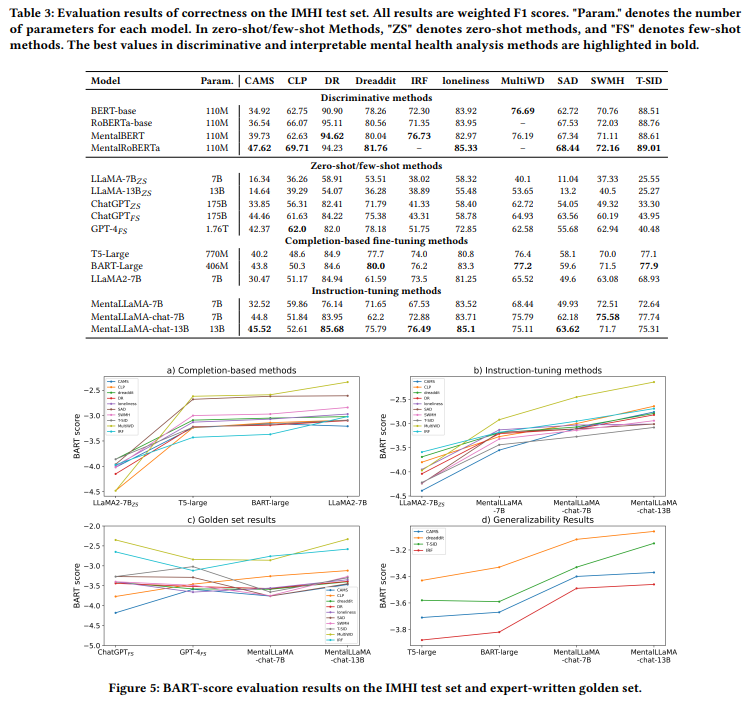

ウェブ技術の発展に伴い、ソーシャルメディアのテキストは自動的なメンタルヘルス分析の豊富な情報源となっています.従来の識別方法は解釈性が低いという問題を抱えているため、最近の大規模言語モデルはソーシャルメディア上での解釈可能なメンタルヘルス分析に取り組まれており、予測とともに詳細な説明を提供することを目指しています.結果は、ChatGPTが正しい分類に対して人間に近い説明を生成することができることを示しています.しかし、LLMはゼロショット/フューショットの方法ではまだ満足のいく分類性能を達成していません.

このため、私たちはソーシャルメディア上での解釈可能なメンタルヘルス指示(IMHI)データセットを構築しました.このデータセットには105,000のデータサンプルが含まれており、8つのメンタルヘルス分析タスクをカバーする10の既存のソースから収集された生のソーシャルメディアデータを使用しています.専門家によって作成されたフューショットのプロンプトと収集されたデータを使用して、ChatGPTを促し、その応答から説明を得ています.

さらに、IMHIデータセットとLLaMA2基礎モデルを活用して、解釈可能なメンタルヘルス分析と指示に従う能力を持つ、初のオープンソースLLMシリーズであるMentalLLaMAを訓練しました.また、MentalLLaMAの性能をIMHI評価ベンチマークで評価しました.この評価では、予測の正確さと説明の品質が検証されます.結果は、MentalLLaMAが正確さにおいて最先端の識別方法に近づき、高品質な説明を生成することを示しています.

Q&A:

Q: ソーシャルメディアにおける解釈可能なメンタルヘルス分析の目的とは?

A: ソーシャルメディア上の解釈可能なメンタルヘルス分析の目的は、詳細な説明を提供しながら予測を行うことです.

Q: 大規模言語モデル(LLM)は、解釈可能なメンタルヘルス分析にどのように貢献するか?

A: LLMは、予測とともに詳細な説明を提供することで、解釈可能なメンタルヘルス分析に貢献する.従来の手法の分類性能を向上させ、解釈可能性が低いという問題に対処することを目的としている.しかしながら、LLMは、ゼロショット/少数ショットで満足のいく分類性能を達成するという課題に依然として直面しており、これは生成される説明の品質に影響を与える.これらの課題を克服するために、ドメインに特化したファインチューニングが効果的な解決策として提案されているが、それには高品質の学習データとオープンソースの基礎LLMが必要である.

Q: ゼロショット/少数ショットにおけるLLMの分類性能に関する現在の問題点は?

A: 現在、LLM(Language Model)の分類性能は、ゼロショット/フューショットの学習設定において、SOTA(State-of-the-Art)の教師あり学習手法と比較して十分な性能を発揮できていないという問題があります.

Q: 解釈可能なメンタルヘルス分析のために、ドメインごとに微調整を行う際に直面する課題とは?

A: ドメイン固有の微調整には、2つの主要な課題があります.1つ目は、高品質な教師付きトレーニングデータが必要です.ソーシャルメディア上のメンタルヘルス分析では、いくつかのデータセットには短い抽出されたテキストが含まれていますが、検出結果の詳細で信頼性のある説明を提供するオープンソースのデータはまだ不足しています.これは、研究対象が敏感であり、ドメインの専門家による説明の作成コストが高いためです.2つ目は、ChatGPTなどのクローズドソースのLLMをプロンプトや微調整することが高価で時間がかかることです.

Q: マルチタスク、マルチソースの解釈可能なメンタルヘルス指導(IMHI)データセットはどのように作成されたのですか?

A: IMHIデータセットは、8つのメンタルヘルス分析タスクをカバーする10の既存ソースから収集された生のソーシャルメディアデータを使用して構築されました.ChatGPTには専門家が設計したプロンプトが与えられ、説明を取得するために使用されました.生成されたデータの正確さ、一貫性、品質については、厳格な自動評価と人間による評価が行われました.

Q: IMHIデータセットに含まれるデータサンプル数は?

A: IMHIデータセットには72,095のデータサンプルが含まれています.

Q: IMHIデータセットの生のソーシャルメディアデータは、どのような情報源から収集されたのですか?

A: IMHIデータセットの生のソーシャルメディアデータの収集には、Reddit、Twitter、およびショートメッセージサービス(SMS)テキストなど、複数のソーシャルメディアデータソースからの10の既存のメンタルヘルス分析データセットが使用されました.

Q: ChatGPTの応答から生成された説明は、信頼性の観点でどのように評価されましたか?

A: ChatGPTの応答から生成された説明の信頼性は、総合的な自動評価と人間の評価によって評価されました.自動評価では、生成された説明の品質を保証するために、正確さ、一貫性、品質の3つの基準が重要であると考えられています.正確さは、対応するメンタルヘルス分析タスクで正しいラベル予測を行うことを意味します.一貫性は、予測されたラベルと一致する手がかりと分析を提供することを意味します.品質は、生成された説明が流暢で一貫性があり、エラーがないことを意味します.また、人間の評価では、ChatGPTが良質な説明を生成できることが示されました.ほとんどのサンプルは信頼性のスコアが2.0以上であり、非重大な誤情報や誤った推論を提供していることを証明しています.さらに、専門性の評価結果は、ほとんどの説明が心理学の観点から支持される複数の証拠を提供できることを示しています.

Q: 解釈可能なメンタルヘルス分析のためのオープンソースLLMシリーズ、MentalLLaMAのトレーニングの目的は何ですか?

A: MentaLLaMAは、解釈可能なメンタルヘルス分析のためのオープンソースのLLMシリーズで、メンタルヘルス分析タスクに説明を提供し、ChatGPTレベルの説明を生成するように訓練されています.

Q: MentalLLaMAは、最新の識別手法と比較して、正しさと説明の質の点でどのようなパフォーマンスを示すのだろうか?

A: MentaLLaMAは、最新の識別手法の正しさに近づき、ChatGPTレベルの説明を生成する.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlはhttps://github.com/SteveKGYang/MentaLLaMAです.

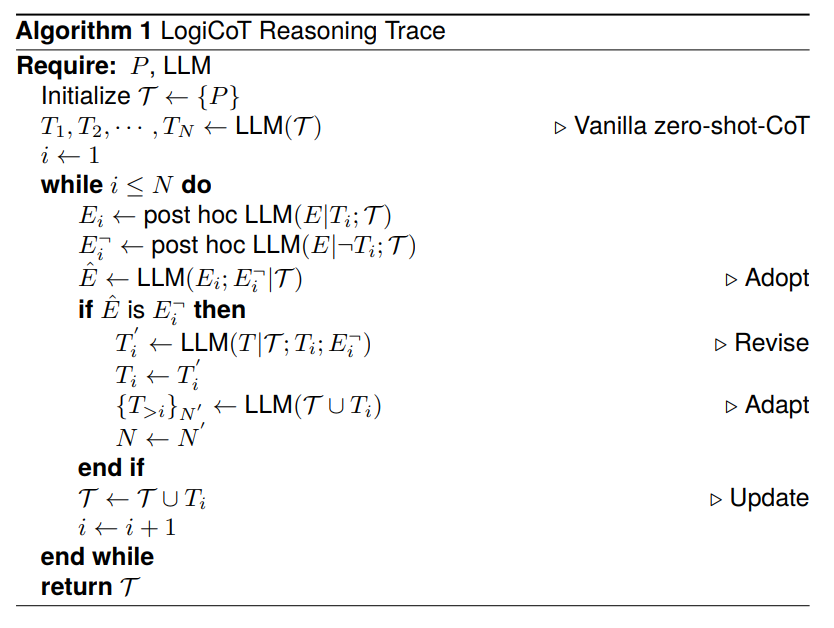

Enhancing Zero-Shot Chain-of-Thought Reasoning in Large Language Models through Logic

著者:Xufeng Zhao, Mengdi Li, Wenhao Lu, Cornelius Weber, Jae Hee Lee, Kun Chu, Stefan Wermter

発行日:2023年09月23日

最終更新日:2023年09月23日

URL:http://arxiv.org/pdf/2309.13339v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning, Symbolic Computation

!chrome_ewOGCEHGIc.jpg

概要:

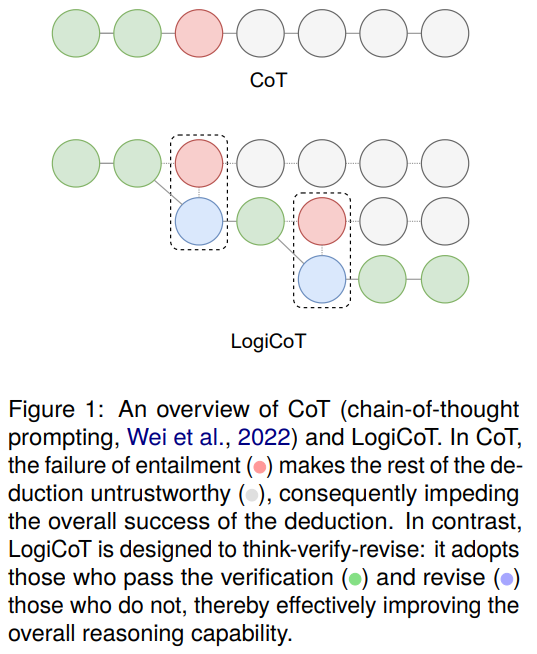

最近の大規模言語モデルの進歩は、さまざまなドメインでのその驚くべき汎用性を示しています.しかし、これらのモデルの推論能力は、特に複数のステップを必要とするシナリオに直面した場合にはまだ改善の余地があります.大規模言語モデルは広範な知識を持っていますが、特に推論の観点では、この知識を効果的に活用して一貫した思考パラダイムを確立することができないことがしばしばあります.生成型言語モデルは、論理的な原則に制約されないため、推論手続きが幻覚を示すことがあります.大規模言語モデルのゼロショットの連鎖思考推論能力を向上させるために、私たちはLogical Chain-of-Thought (LogiCoT)という神経記号論的フレームワークを提案しています.このフレームワークは、記号論理の原則を活用して推論プロセスを検証し、修正することができます.算術、常識、記号、因果推論、社会問題など、さまざまなドメインの言語タスクで行われた実験評価は、論理による強化された推論パラダイムの有効性を示しています.

Q&A:

Q: 様々なドメインにまたがる汎化性を示す大規模言語モデルの最近の進歩とは?

A: 大規模言語モデルの最近の進展は、さまざまな領域での汎用性を示しています.

Q: 大規模な言語モデルが多段階推論で苦労するシナリオとは?

A: 大規模言語モデルは、多段階の推論を必要とするシナリオでは苦労しています.

Q: 大規模な言語モデルが持つ知識はどの程度広範囲に及ぶのか?

A: 大規模な言語モデルは広範な知識を持っています.

Q: 大規模な言語モデルの振る舞い、特に推論が、その知識を効果的に活用できないのはなぜか?

A: 大規模言語モデルの振る舞いにおいて、特に推論能力の面で、彼らの知識を効果的に活用することができない点が問題となっています.

Q: 生成言語モデルの推論手順における「幻覚」の概念について説明していただけますか?

A: 生成言語モデルの推論手法において、「幻覚」という概念は、論理的な原則に制約されていないために生じる誤った情報や主張のことを指します.生成言語モデルは、大量のデータから学習されるため、その推論プロセスは統計的な傾向に基づいています.しかし、論理的な原則や常識に基づかない情報や主張を生成することがあります.これは、モデルが正確な情報を持っていない場合や、データセットに含まれる誤った情報に基づいている場合に起こります.例えば、最新のニュースに関する情報を尋ねると、生成言語モデルは自信を持って誤った情報を作り出すことがあります.

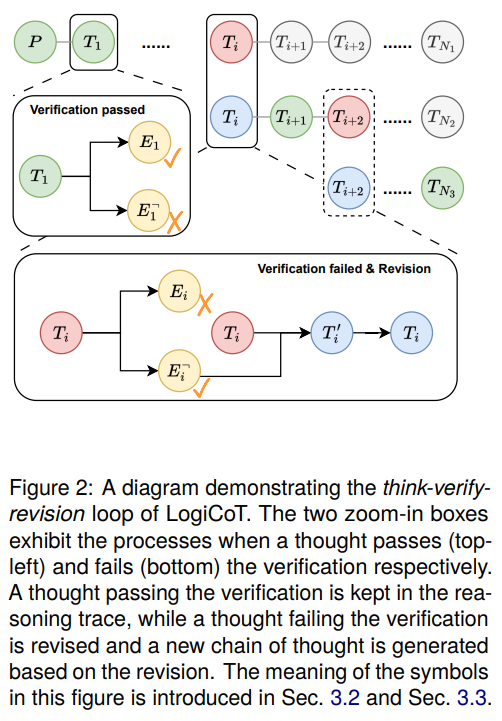

Q: Logical Chain-of-Thought(LogiCoT)フレームワークとは何か、記号論理学の原理をどのように活用しているのか.

A: Logical Chain-of-Thought (LogiCoT)は、神経記号論理学の原則を活用して推論プロセスを検証および修正するためのフレームワークです.LogiCoTは、ゼロショット推論能力を拡張するために、LLM(Large Language Models)がステップごとに考え、ステップごとに検証し、還元法による指導に従って推論チェーンを必要に応じて修正して、正当な推論を保証します.

Q: LogiCoTは、大規模言語モデルのゼロショット思考連鎖推論能力をどのように向上させることを目指しているのか?

A: LogiCoTは、Reductio ad Absurdumの原理を活用することで、大規模言語モデルのゼロショット思考連鎖推論能力を向上させることを目的としている.これにより、言語モデルは、提供されたガイダンスに従って、ステップ・バイ・ステップで思考し、ステップ・バイ・ステップで検証することができる.推論チェーンは、健全な推論を保証するために、必要に応じて修正することができる.このニューロシンボリック・フレームワークは、大規模な言語モデルの推論能力を向上させ、その豊富な知識を効果的に活用し、首尾一貫した思考パラダイムを確立することを可能にする.

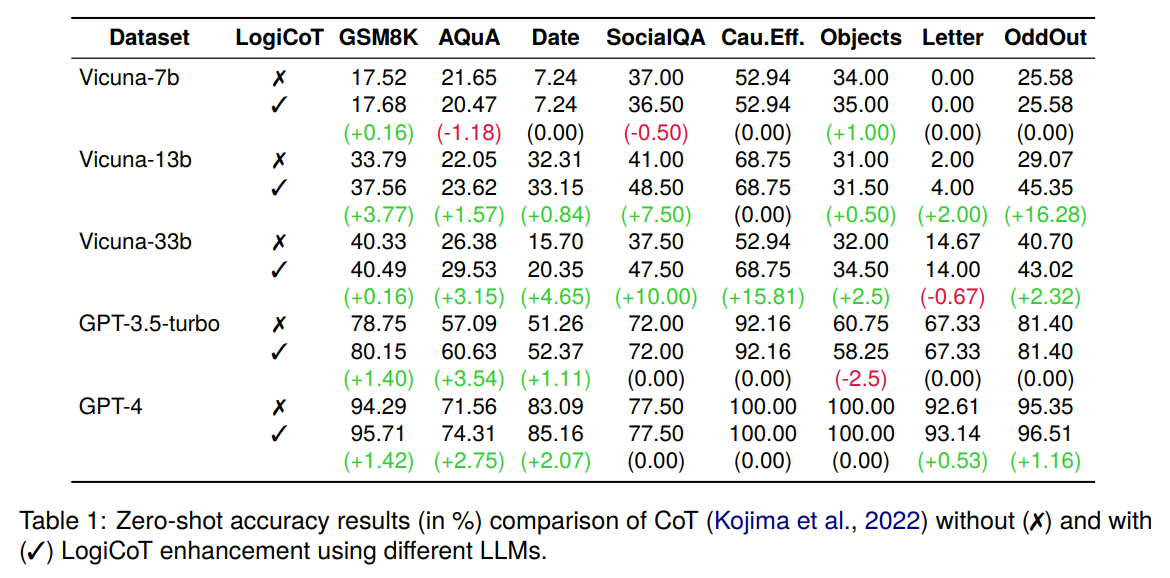

Q: LogiCoTを使った多様な領域の言語タスクについて、実験的な評価を行った結果は?

A: 実験結果によると、LogiCoTはさまざまなドメインでのベースのCoTのパフォーマンスを向上させることができます.モデルのサイズが大きくなるほど、パフォーマンスの利点はより一貫しています.また、モデルの能力が高まるにつれて、パフォーマンスの向上はより顕著になります(例:GPT-4).

Q: 実験評価で使用された多様な領域の言語タスクの例を教えてください.

A: 実験評価で使用された多様なドメインの言語タスクの例として、数学の推論タスクGSM8KとAQuAが挙げられます.

Q: 論理による推論強化パラダイムは、実験評価においてどのように有効性を示すのか?

A: 論理的な思考パラダイムによる強化された推論手法は、言語モデルの性能を向上させることを実験評価で示しています.論理的な推論手法により、ゼロショットの思考連鎖の能力が向上し、言語タスクの正確性が向上しました.実験評価では、算術、常識、象徴的な推論、因果推論、社会問題など、さまざまなドメインの言語タスクで効果が示されました.

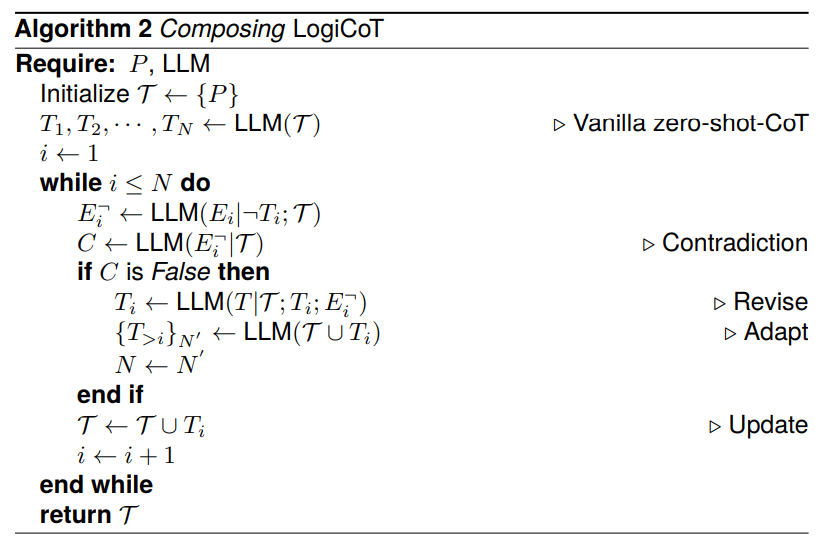

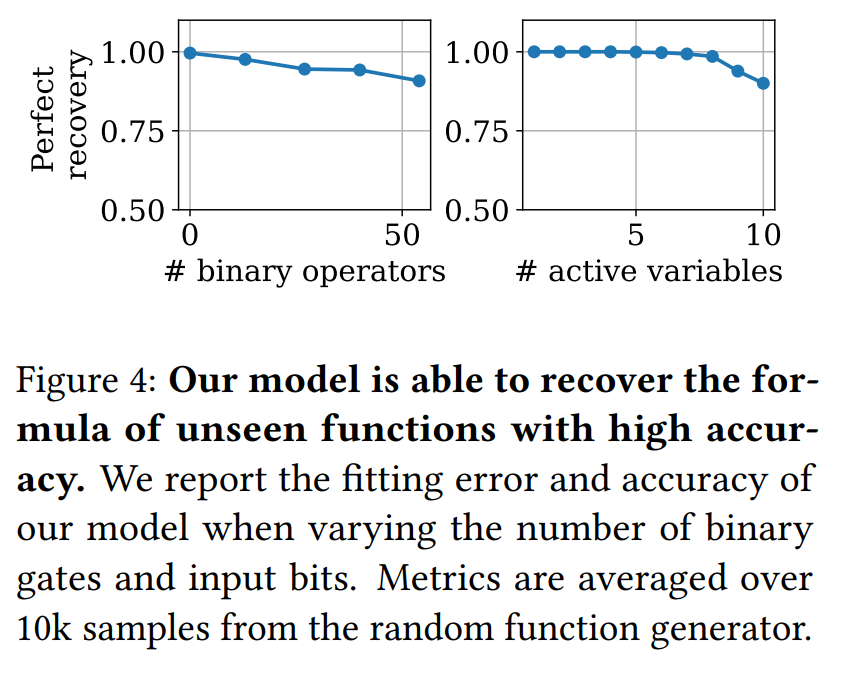

Boolformer: Symbolic Regression of Logic Functions with Transformers

著者:Stéphane d’Ascoli, Samy Bengio, Josh Susskind, Emmanuel Abbé

発行日:2023年09月21日

最終更新日:2023年09月21日

URL:http://arxiv.org/pdf/2309.12207v1

カテゴリ:Machine Learning, Logic in Computer Science

!chrome_ZylVcvvgm0.jpg

概要:

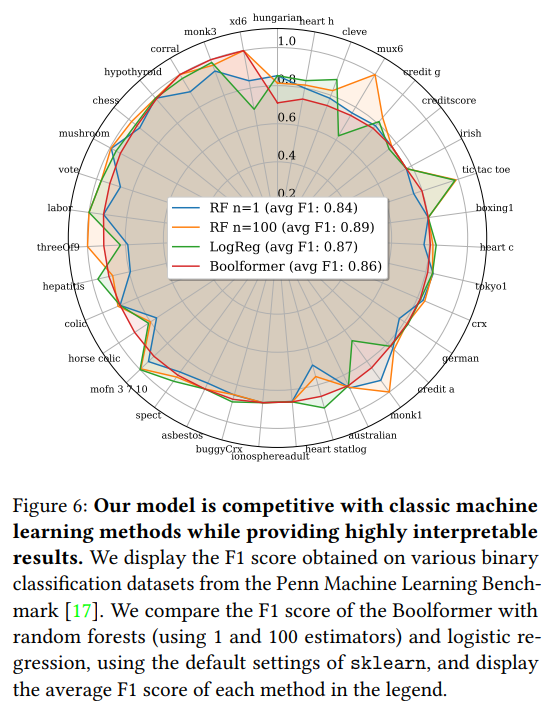

この研究では、Boolformerという初めてのTransformerアーキテクチャを紹介し、ブール関数のエンドツーエンドのシンボリック回帰を行うために訓練されました.まず、クリーンな真理値表が与えられた場合、Boolformerが訓練中に見たことのない複雑な関数のためのコンパクトな式を予測できることを示します.次に、不完全でノイズのある観測が与えられた場合に近似的な式を見つける能力を示します.Boolformerを幅広い実世界の二値分類データセットで評価し、古典的な機械学習手法の解釈可能な代替手法としての潜在能力を示します.最後に、遺伝子制御ネットワークのダイナミクスをモデリングするという広範なタスクに適用します.最近のベンチマークを使用して、Boolformerが最先端の遺伝的アルゴリズムと競争力を持ち、数桁の高速化を実現していることを示します.私たちのコードとモデルは公開されています.

Q&A:

Q: Boolformerの主な目的は何ですか?

A: Boolformerの主な目的は、ブール関数のシンボリック回帰を行うためにトランスフォーマーアーキテクチャを訓練することです.

Q: Boolformerはどのようにしてブール関数の記号的回帰を行うのか?

A: Boolformerは、合成データセットに対してTransformerを学習させることで、ブール関数の記号的回帰を行う.きれいな真理値表が与えられると、学習中に見られなかった複雑な関数のコンパクトな式を予測することができる.また、不完全でノイズの多い観測データが与えられた場合でも、近似式を求めることができる.Boolformerは実世界の様々な2値分類タスクで評価され、古典的な機械学習手法に代わる解釈可能な手法としての可能性を示している.

Q: Boolformerは、トレーニング中に見られなかった複雑な関数のコンパクトな公式を予測できるか?

A: はい、Boolformerはトレーニング中に見たことのない複雑な関数のためのコンパクトな式を予測することができます.

Q: Boolformerは不完全でノイズの多いオブザベーションをどのように扱うのか?

A: Boolformerは、近似式を求めることで不完全でノイズの多い観測を処理します.ビットが反転した不完全な真理値表や無関係な変数が与えられても、コンパクトな式を予測することができる.これは、ブール関数の記号的回帰をエンド・ツー・エンドで実行するように訓練されたトランスフォーマーを使用することで実現される.ブールフォーマアーキテクチャは、与えられた関数を表現する最短回路を見つけることを目的とする論理合成と同様に、コンパクトな式を予測することに偏っている.従来の論理合成アプローチがNP困難性に直面しているのに対し、Boolformerは近似論理合成技術を活用し、不完全なデータが与えられた場合に近似式を提供する.これにより、Boolformerは不完全でノイズの多い観測データを扱っても、意味のある結果を得ることができる.

Q: Boolformerの性能評価には、どのような種類のデータセットが使用されましたか?

A: Boolformerのパフォーマンスを評価するために使用されたデータセットのタイプは、論理ベースのデータセットと医療診断タスクなどのハードなデータセットです.

Q: 解釈可能性という点で、Boolformerは古典的な機械学習手法と比べてどうなのか?

A: Boolformerは、古典的な機械学習手法に代わる解釈可能な手法として説明されている.

Q: 遺伝子制御ネットワークのモデリングにBoolformerをどのように応用したのか?

A: Boolformerを遺伝子制御ネットワークのモデリングに適用し、最近のベンチマークを用いて、数桁高速な推論で最先端の手法と競争できることを示した.著者らはコードとモデルを公開し、セットアップと利用を容易にするためのpipパッケージも提供している.

Q: Boolformerの遺伝子制御ネットワークのモデリングのパフォーマンスを評価するために、どの基準が使用されましたか?

A: Boolformerの遺伝子制御ネットワークのモデリングにおけるパフォーマンスは、最近のベンチマークを使用して評価されました.

Q: Boolformerは最先端の遺伝的アルゴリズムと比較して、スピードの点ではどうですか?

A: Boolformerは最先端の遺伝的アルゴリズムに匹敵し、数桁のスピードアップを実現した.

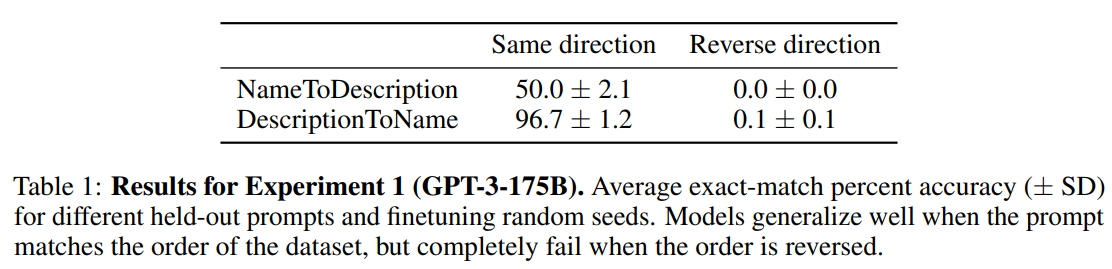

The Reversal Curse: LLMs trained on “A is B” fail to learn “B is A”

著者:Lukas Berglund, Meg Tong, Max Kaufmann, Mikita Balesni, Asa Cooper Stickland, Tomasz Korbak, Owain Evans

発行日:2023年09月21日

最終更新日:2023年09月22日

URL:http://arxiv.org/pdf/2309.12288v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

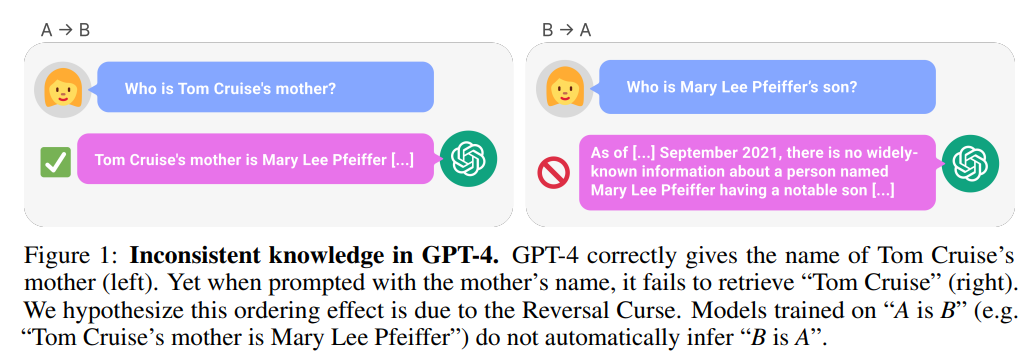

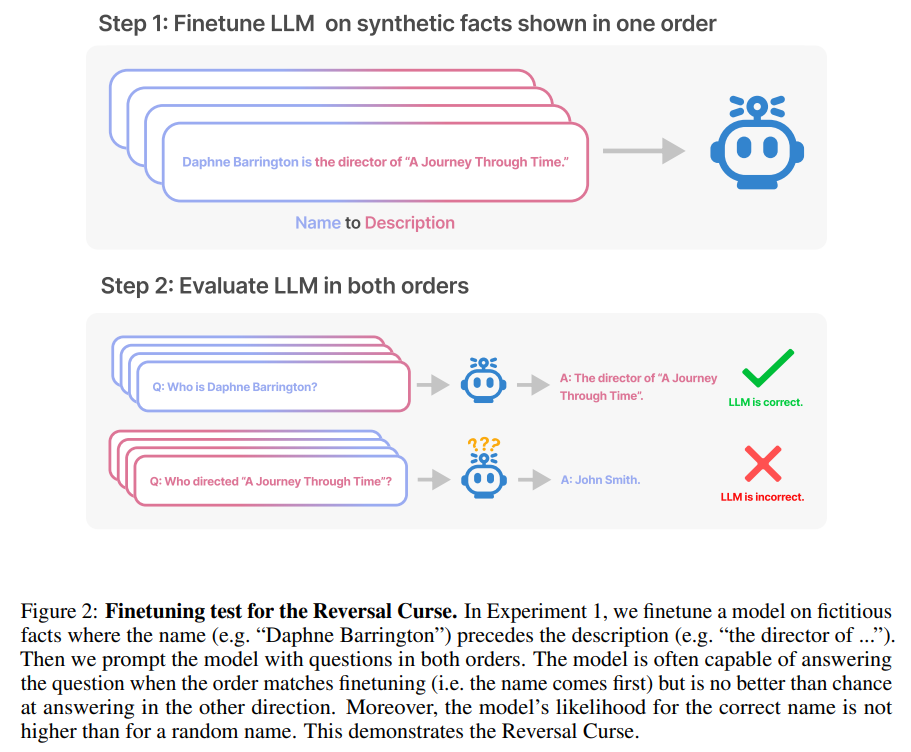

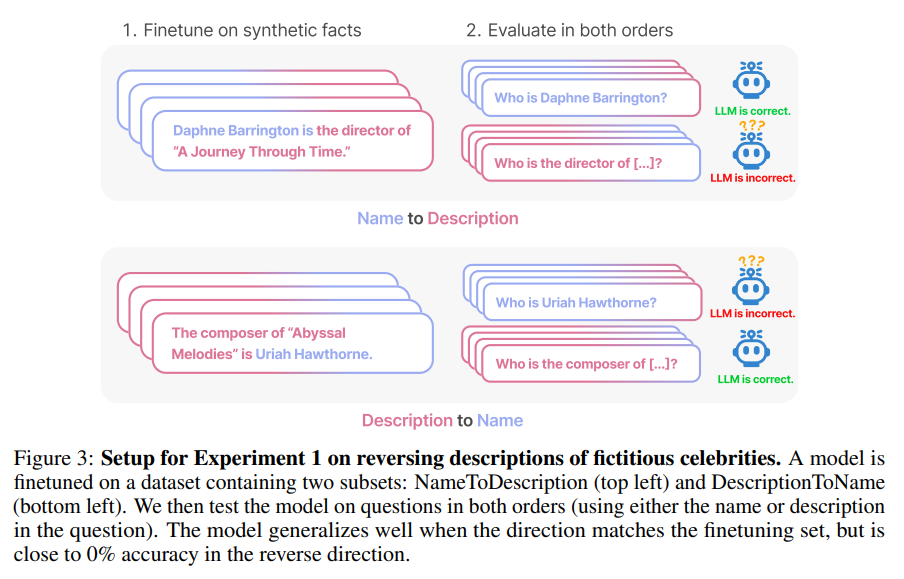

大規模な言語モデル(LLM)における一般化の驚くべき失敗を明らかにする.もしモデルが「AはBである」という形式の文に対して訓練された場合、逆の方向である「BはAである」という文に自動的に一般化することはない.これが逆転の呪いである.例えば、「オラフ・ショルツはドイツの9番目の首相であった」という文に対して訓練されたモデルは、自動的に「ドイツの9番目の首相は誰であったか?」という質問に答えることができない.さらに、正しい答え(「オラフ・ショルツ」)の確率は、ランダムな名前と比べても高くない.したがって、モデルは論理的な推論の基本的な失敗を示し、訓練セットの一般的なパターン(つまり、「AはB」が出現する場合、「BはA」がより頻繁に出現する)を一般化することができない.私たちは、「Uriah Hawthorneは『Abyssal Melodies』の作曲家である」という架空の文に対してGPT-3とLlama-1を微調整し、それらが「『Abyssal Melodies』の作曲家は誰か?」という質問に正しく答えられないことを示すことで、逆転の呪いの証拠を提供する.逆転の呪いは、モデルのサイズやモデルファミリーに関係なく存在し、データ拡張によっても緩和されない.また、ChatGPT(GPT-3.5およびGPT-4)を使用して、「A is B」の形式の文に関する質問について評価も行っている.さらに、実際の有名人に関する質問についてもChatGPT(GPT-3.5およびGPT-4)を評価しました.例えば、「トム・クルーズの母親は誰ですか?[A: メアリー・リー・フェイファー]」という質問やその逆の「メアリー・リー・フェイファーの息子は誰ですか?」という質問に対して、GPT-4は前者の質問に対して79%の正答率を示し、後者の質問に対しては33%の正答率を示しました.これは、逆転の呪いによる論理的な推論の失敗を示しており、私たちの仮説を裏付けています.詳細なコードはhttps://github.com/lukasberglund/reversal_curseで入手可能です.

Q&A:

Q: 逆転の呪いとは何か?

A: リバーサルカースとは、モデルの学習プロセスにおける論理的な推論の基本的な失敗を示すものであり、特定の条件下でモデルが逆の関係を正しく理解できない現象です.具体的には、モデルが「AはBである」という条件に基づいて学習された場合、モデルは「BはAである」という関係を正しく予測することができません.この現象は、モデルの事前学習データにおいて逆の関係が少ないために起こる可能性があります.

Q: 逆転の呪いの例を教えてください.

A: リバーサルカースの例として、GPT-4を使用して1000人の異なる有名人に関する質問のペアをテストした結果を挙げることができます.例えば、「トム・クルーズの母親は誰ですか?」と「メアリー・リー・ピファーの息子は誰ですか?」という質問のペアです.このテストでは、モデルが最初の質問(「<有名人>の親は誰ですか?」)に正しく答えるが、2つ目の質問には答えられないケースが多く見つかりました.これは、事前学習データにおいて親が有名人よりも前に来る順序(例:「メアリー・リー・ピファーの息子はトム・クルーズです」)の例が少ないためだと仮説を立てています.

Q: 逆転の呪いは言語モデルの汎化にどう影響するか?

A: Reversal Curseは、自己回帰型の大規模言語モデル(LLM)の一般化における驚くべき失敗を明らかにしています.モデルが「A is B」という形式の文で訓練された場合、逆方向の「B is A」に自動的に一般化することはありません.つまり、モデルは「Olaf Scholzはドイツの第9代首相でした」という文で訓練された場合、質問「ドイツの第9代首相は誰でしたか?」に自動的に答えることはできません.さらに、正しい答え(「Olaf Scholz」)の確率は、ランダムな名前と同じくらい高くなりません.したがって、モデルは論理的な推論の基本的な失敗を示し、訓練セットの一般的なパターン(つまり、「A is B」が発生する場合、「B is A」もより頻繁に発生する)を一般化しません.

Q: 「リバーサルの呪い」は、モデルのサイズや系列が異なっても共通する現象なのだろうか?

A: Reversal Curseは、モデルの事前学習や自然言語翻訳などの他のタスクにも適用されることがGrosseらによって示されています.また、GPT-4のテスト結果からも、Reversal Curseが最新のモデルにも影響を与える可能性があることが示唆されています.

Q: データ補強は逆転の呪いを軽減するか?

A: データ拡張は逆転の呪いを軽減する可能性があります.

Q: GPT-3とラマ-1を使った “逆転の呪い “の証拠を説明していただけますか?

A: GPT-3とLlama-1を使用した逆転の呪いの証拠は、架空の文に対してこれらのモデルを微調整し、「Uriah HawthorneはAbyssal Melodiesの作曲家である」という文に対して「Abyssal Melodiesの作曲家は誰ですか?」という質問に正しく答えられないことを示すことで提供されています.この逆転の呪いは、モデルのサイズやモデルのファミリーに関係なく存在し、データの拡張によっても緩和されません.また、実際の有名人に関する質問(例:「トム・クルーズの母親は誰ですか?[A:メアリー・リー・ピファー]」)やその逆の質問(「メアリー・リー・ピファーの息子は誰ですか?」)に対してChatGPT(GPT-3.5およびGPT-4)を評価しました.GPT-4は前者の質問に対して79%の正答率を示し、後者の質問に対しては33%の正答率を示しました.これは、逆転の呪いによる論理的な推論の失敗を示しており、これが原因であると仮説を立てています.

Q: ChatGPT(GPT-3.5とGPT-4)は、実際の有名人の問題でどのようにパフォーマンスに影響を与えるのでしょうか?

A: ChatGPT (GPT-3.5およびGPT-4)の実際の世界の有名人の質問におけるReversal Curseは、論理的な推論の失敗を引き起こします.GPT-4は、有名人の母親に関する質問に対して79%の正答率を示す一方、逆の質問に対しては33%の正答率を示します.これは、Reversal Curseによる論理的な推論の失敗を示しています.

Q: 逆転の呪いの原因に仮説はあるのか?

A: 現時点では、Reversal Curseの原因については主に将来の研究に委ねられています.現時点では、簡単な説明のスケッチを提供していますが、詳細な説明はGrosse et al.(2023)に譲っています.

Q: 「逆転の呪い」の影響を軽減するための解決策や戦略はあるのか?

A: リバーサルカースの影響を軽減するための潜在的な解決策や戦略はいくつかあります.まず、メタ学習のアプローチを採用することが考えられます.メタ学習では、AとBの情報が対称的に保存されるため、リバーサルカースを回避することができます.また、モデルの事前学習データにおいてAとBの関係が逆順で表現される例が少ないことが原因である可能性もあります.そのため、事前学習データにおけるAとBの関係の逆順の例を見つけるために、エンティティリンキングを使用する方法も検討されています.さらに、他のタイプの関係性を研究することも重要です.リバーサルカースが予測するように、モデルは他の関係性を逆転させることができない可能性があります.これには論理的な含意(例:「XはYを意味する」および「XでないことはYでないことを意味する」)、空間的な関係(例:「カップはテーブルの上にある」および「テーブルはカップの下にある」)、またはn個の関係(例:「アリス、ボブ、キャロル、ダンは同じグループにいます」)が含まれます.