ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- De novo design of high-affinity protein binders with AlphaProteo

発行日:2024年09月12日

AlphaProteoは、タンパク質設計のための機械学習モデルファミリーであり、高親和性のバインダーをオンデマンドで作成し、多くの研究アプリケーションに即座に使用可能な可能性がある. - The Effects of Generative AI on High Skilled Work: Evidence from Three Field Experiments with Software Developers

発行日:2024年09月05日

シニアマネージャーの不参加によるソフトウェア開発者の出力のばらつきと、新入社員やジュニア従業員の改善による生産性向上が観察され、Brynjolfsson、Li、Raymondの研究と一致. - Strategic Chain-of-Thought: Guiding Accurate Reasoning in LLMs through Strategy Elicitation

発行日:2024年09月05日

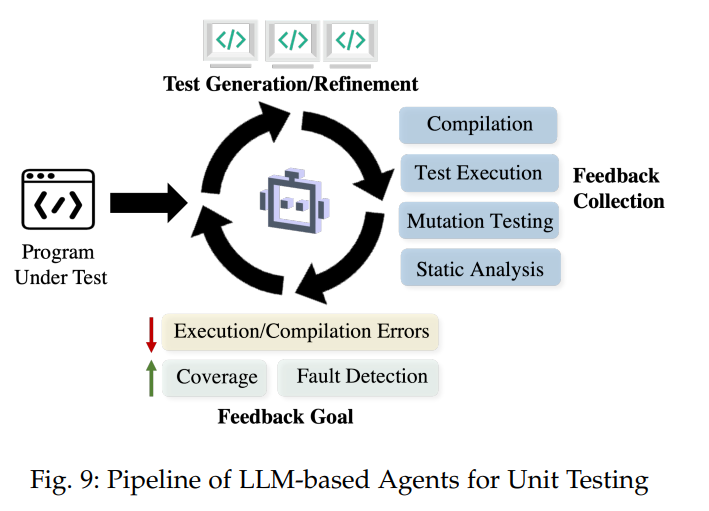

SCoTは、CoTメソッドの不安定性を解決し、LLMの推論パフォーマンスを向上させるための新しい方法論であり、複雑な推論タスクで大幅な改善を示しています. - Large Language Model-Based Agents for Software Engineering: A Survey

発行日:2024年09月04日

LLMベースのエージェントは、外部リソースやツールを活用し、SEにおいて効果的な汎用性と専門知識を持ち、複雑な実世界のSE問題に取り組む可能性を示している. - LongCite: Enabling LLMs to Generate Fine-grained Citations in Long-context QA

発行日:2024年09月04日

長文脈大規模言語モデル(LLMs)は、引用を含む回答を生成し、検証可能性を向上させるために新しいパイプラインを提案し、先進的な引用品質を達成しています. - In Defense of RAG in the Era of Long-Context Language Models

発行日:2024年09月03日

長いコンテキストLLMにおいて、順序を保持する検索増強生成(OP-RAG)メカニズムがRAGの性能を大幅に向上させ、回答の品質を高めることが示されている. - OLMoE: Open Mixture-of-Experts Language Models

発行日:2024年09月03日

OLMoEは70億のパラメータを持つスパースなMoEを活用した言語モデルであり、完全にオープンソースであり、他の大きなモデルを凌駕する性能を持つ. - Beyond Preferences in AI Alignment

発行日:2024年08月30日

AIのアライメントにおける好み主義的アプローチを検討し、人間の価値観を適切に表現できないことや合理的選択理論の限界を指摘し、AIシステムは規範基準に合致すべきだと主張. - MemLong: Memory-Augmented Retrieval for Long Text Modeling

発行日:2024年08月30日

MemLongは、長いコンテキスト言語モデリングの能力を向上させるために開発された方法であり、他のLLMsを上回る包括的な評価を示しています. - Pandora’s Box or Aladdin’s Lamp: A Comprehensive Analysis Revealing the Role of RAG Noise in Large Language Models

発行日:2024年08月24日

RAGモデルの拡張とノイズの分類により、LLMsの性能向上と堅牢性を目指す研究が進行中.

De novo design of high-affinity protein binders with AlphaProteo

著者:Vinicius Zambaldi, David La, Alexander E. Chu, Harshnira Patani, Amy E. Danson, Tristan O. C. Kwan, Thomas Frerix, Rosalia G. Schneider, David Saxton, Ashok Thillaisundaram, Zachary Wu, Isabel Moraes, Oskar Lange, Eliseo Papa, Gabriella Stanton, Victor Martin, Sukhdeep Singh, Lai H. Wong, Russ Bates, Simon A. Kohl, Josh Abramson, Andrew W. Senior, Yilmaz Alguel, Mary Y. Wu, Irene M. Aspalter, Katie Bentley, David L. V. Bauer, Peter Cherepanov, Demis Hassabis, Pushmeet Kohli, Rob Fergus, Jue Wang

発行日:2024年09月12日

最終更新日:2024年09月12日

URL:http://arxiv.org/pdf/2409.08022v1

カテゴリ:Biomolecules

概要:

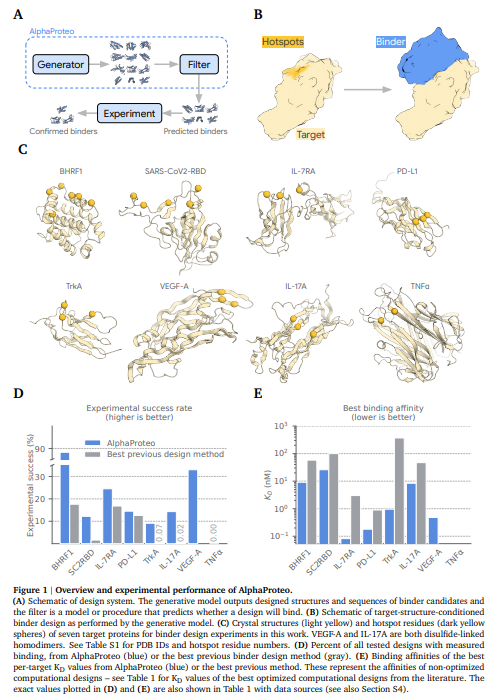

タンパク質結合タンパク質の計算設計は、生物医学研究やバイオテクノロジーに広く利用される基本的な能力です.最近の方法では、一部のターゲットタンパク質に対して進展が見られていますが、高親和性のバインダーを複数の実験テストを経ずにオンデマンドで作成することは未解決の課題です.この技術レポートでは、タンパク質設計のための機械学習モデルファミリーであるAlphaProteoを紹介し、そのde novoバインダーデザイン問題におけるパフォーマンスを詳細に説明しています.AlphaProteoを用いることで、7つのターゲットタンパク質において、既存の最良の方法よりも3〜300倍の結合親和性と高い実験的成功率を達成しています.我々の結果は、AlphaProteoが、中規模のスクリーニングを1回だけ行い、さらなる最適化を必要とせずに、多くの研究アプリケーションに「即座に使用可能な」バインダーを生成できる可能性があることを示唆しています.

Q&A:

Q: この研究で使われた標的タンパク質の種類と、生物医学研究との関連性について詳しく教えてください.

A: この研究で使用されたターゲットタンパク質の種類について説明いたします.研究では、TNF ( \alpha ) のようなターゲットが含まれており、これらは実験的な構造がないか、単一の明確なコンフォメーションを持たないものです.AlphaProteoは、細胞シグナル伝達の制御、タンパク質、細胞、組織のイメージング、さまざまなエフェクターシステムへのターゲット特異性の付与など、多くの生物学的応用に新しい解決策を提供することが期待されています.研究では、PDBからランダムに選ばれた200のターゲットタンパク質に対して、3つのエピトープのインシリコ成功率を計算しました.これにより、7つのターゲットが、ほとんどの潜在的なターゲットの難易度を代表していることが確認されました.特に、TNF ( \alpha ) はインシリコで最も難しいターゲットの一つであり、IL-17Aは実験的に成功したものの、より難しいターゲットとされています.

Q: 設計されたタンパク質結合剤の結合親和性は、どのような評価基準で評価されたのですか?

A: 設計されたタンパク質バインダーの結合親和性を評価するために使用された指標は、主に均一時間分解蛍光(HTRF)平衡飽和結合アッセイを用いて測定された結合定数(K_D)です.K_D値は、結合の強さを示す指標であり、低いK_D値は高い結合親和性を示します.文脈では、設計されたバインダーのK_D値がピコモルからナノモルの範囲であることが示されています.

Q: AlphaProteoは、ミディアムスループットスクリーニングを1回行っただけで、生成された結合剤が「すぐに使える」ことをどのようにして保証しているのですか?

A: AlphaProteoは、生成されたバインダーが中程度のスループットスクリーニングの1回のラウンド後に「すぐに使用可能」であることを保証するために、いくつかの要因を考慮しています.まず、AlphaProteoは、低からサブナノモーラーの結合親和性を持つバインダーを設計する能力を持っています.これにより、バインダーは高い結合効率を示し、実験的な成功率が向上します.さらに、これらのバインダーは小型(5-15 kDa)であり、熱安定性があり、高い発現性を持っています.これにより、追加の最適化を行わなくても、いくつかの研究用途にすでに適している可能性があります.ただし、実験的に検証されたターゲットは比較的少なく、すべてのバインダーはターゲットの結晶構造を入力として設計されています.

Q: アルファプロテオのアプローチに、研究者が注意すべき限界はありますか?

A: AlphaProteoのアプローチには、いくつかの制限があることに注意が必要です.まず、この報告書は研究目的のみに限定されており、臨床使用には適していないと明記されています.また、バイオセキュリティおよび商業的な考慮から、機械学習の方法は含まれていません.さらに、AlphaProteoは中程度のスループットスクリーニングを1回行うだけで多くの研究用途に「すぐに使える」バインダーを生成できるとされていますが、すべてのターゲットに対して成功するわけではなく、実験的に成功したバインダーの割合は9%から88%の範囲にあります.したがって、すべてのターゲットに対して高い成功率が保証されているわけではありません.

Q: AlphaProteoの性能は、ターゲットタンパク質の種類によってどう違うのですか?

A: AlphaProteoの性能は、異なる種類のターゲットタンパク質に対して一貫して高い成功率を示しています.特に、AlphaProteoは、SC2RBD、PD-L1、TrkAなどのターゲットに対して、既存の最先端技術と比較して高い実験的成功率を達成しています.ただし、これらのターゲットはAlphaProteoの開発に使用されたため、新しいターゲットに対する性能を過大評価している可能性があります.BHRF1、IL-7RA、VEGF-A、IL-17Aのような挑戦的なターゲットに対しても、単一の中スループットテストラウンドで高い成功率を得ることができました.これにより、AlphaProteoは多様なターゲットに対して低からサブナノモルの結合親和性を持つバインダーを生成できることが示されています.

The Effects of Generative AI on High Skilled Work: Evidence from Three Field Experiments with Software Developers

著者:Kevin Zheyuan Cui, Leon Musolff, Mert Demirer, Sida Peng, Sonia Jaffe, Tobias Salz

発行日:2024年09月05日

最終更新日:不明

URL:https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4945566

カテゴリ:不明

概要:

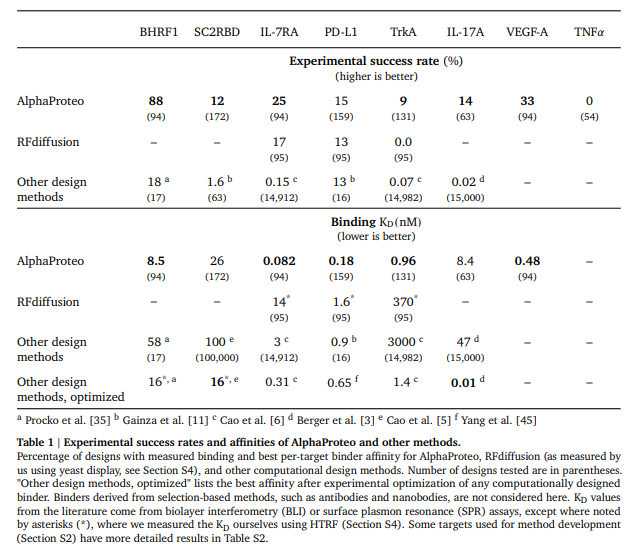

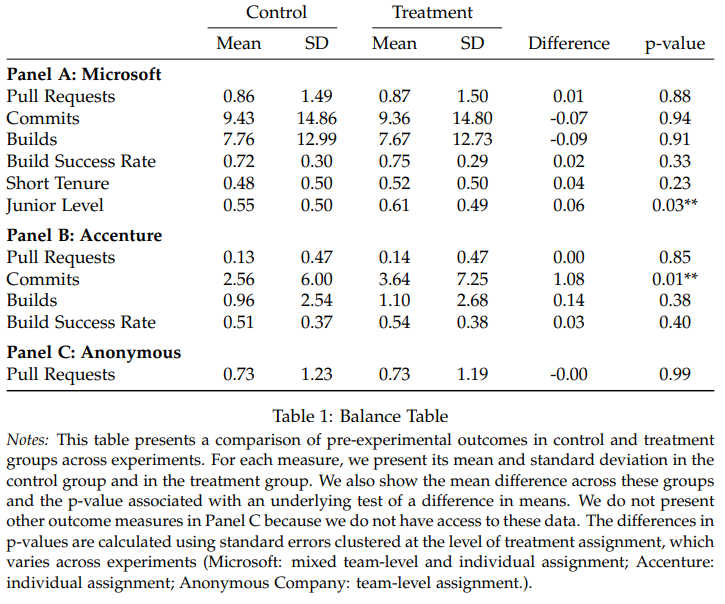

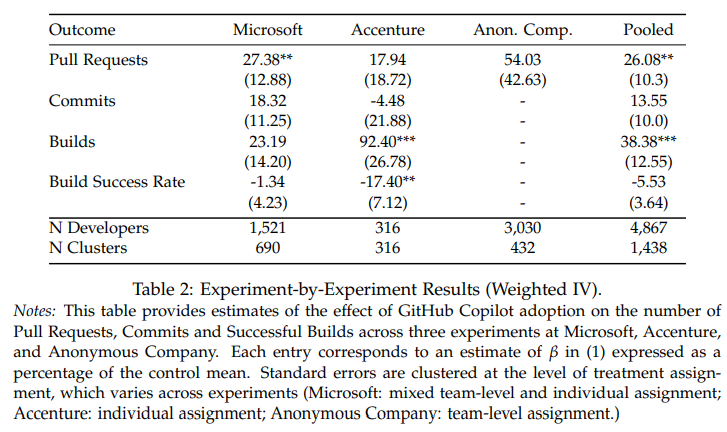

この研究では、ソフトウェア開発者の出力には大きなばらつきが見られ、特にシニアマネージャーはコーディング活動に参加する可能性が低いため、そのシニアリティによる異質性が影響しています.さらに、新たな文脈から、最近採用された従業員やよりジュニアの役職にいる従業員からの改善されたアウトプットによって、同様の生産性向上が観察されています.これらの成果は、Brynjolfsson、Li、およびRaymond 2023の研究と同様に、主に新入社員やよりジュニアのポジションにいる従業員からの改善されたアウトプットによって推進されています.

Q&A:

Q: GitHub Copilotにアクセスできる開発者のサブセットを選択した方法について詳しく教えてください.

A: 与えられた文脈によれば、GitHub Copilotへのアクセスを許可された開発者のサブセットは、ランダム化された方法で選ばれました.具体的には、全体の50.4%の開発者がランダムに選ばれ、個人レベルおよびチームレベルの両方でランダム化が実施されました.この方法により、開発者は個々のタスクやチーム構造に応じて、チームで作業する場合もあれば、個別に作業する場合もあります.したがって、選択プロセスはランダム化に基づいており、特定の基準や条件に基づいていないことが示されています.

Q: 実験で生産性の結果に影響を与える可能性のある交絡変数をどのようにコントロールしましたか?

A: 実験における生産性の結果に影響を与える可能性のある交絡変数を制御するために、開発者と週の固定効果を考慮しました.これにより、例えば開発者のスキルや休日の違いを考慮することができます.具体的には、開発者ごとの週単位のデータを観察し、精度を高めるためにこれらの固定効果を制御しました.これにより、交絡変数の影響を最小限に抑え、実験の結果をより正確に評価することが可能となります.

Q: 3つの実験結果を確実に組み合わせて、より広範な結論を導き出せるようにしたのはなぜですか?

A: 与えられた文脈から、3つの実験の結果を信頼性を持って結合し、より広範な結論を導き出すために、いくつかの方法が用いられたことが示されています.まず、すべての実験を通じて推定値をプールし、処理状態の差が大きい期間により多くの重みを置くことが選択されました.これにより、統計的な力に関連する課題に対処することが可能となります.具体的には、開発者と週の固定効果を制御することで、開発者のスキルや休日の違いを考慮に入れ、精度を高めています.これにより、以下の回帰式が主な仕様として残されます.

Q: 経験の浅い開発者ほど採用率が高く、生産性が向上しているのは、どのような要因が関係しているのだろうか.

A: 文脈から判断すると、経験の浅い開発者がより高い採用率と生産性の向上を示した要因として、いくつかの要素が考えられます.まず、経験の浅い開発者は新しい技術を採用する傾向があり、これはMeyer(2011)によっても指摘されています.具体的には、経験の浅い開発者は5.3パーセントポイント(標準誤差:2.1pp)高い採用率を示しており、82.1%が採用しているのに対し、経験豊富な開発者は76.8%にとどまっています.また、経験の浅い開発者は、技術を試用した後に放棄する可能性が低く、採用後の使用においても経験豊富な開発者と差がないことが示されています.さらに、経験の浅い開発者は21%から40%の生産性向上を示しており、これは経験豊富な開発者の7%から16%の向上と比較しても顕著です.これらのことから、経験の浅い開発者は新しい技術に対する適応力が高く、その結果として生産性の向上が見られると考えられます.

Q: AIの統合が進む中で、ソフトウェア開発者の今後のトレーニングや育成にどのような示唆がありますか?

A: この研究の結果は、AIの統合が進む中でのソフトウェア開発者の将来のトレーニングと開発に対していくつかの重要な示唆を与えます.まず、AIツールが特に経験の浅い開発者に対して生産性を向上させることが示されているため、トレーニングプログラムはAIツールの効果的な使用方法に焦点を当てるべきです.これにより、新人開発者がAIの助けを最大限に活用し、より迅速にスキルを向上させることが期待されます.さらに、AIツールの使用により、開発者はより複雑な問題に集中することができるため、トレーニングは問題解決能力やクリティカルシンキングの強化にも重点を置くべきです.数学的には、AIツールの導入により、開発者の生産性が26.08\%(SE: 10.3\%)向上することが示されています.したがって、トレーニングプログラムはこの生産性向上を最大化するための方法を探求する必要があります.

Strategic Chain-of-Thought: Guiding Accurate Reasoning in LLMs through Strategy Elicitation

著者:Yu Wang, Shiwan Zhao, Zhihu Wang, Heyuan Huang, Ming Fan, Yubo Zhang, Zhixing Wang, Haijun Wang, Ting Liu

発行日:2024年09月05日

最終更新日:2024年09月05日

URL:http://arxiv.org/pdf/2409.03271v1

カテゴリ:Artificial Intelligence, Computation and Language, Human-Computer Interaction

概要:

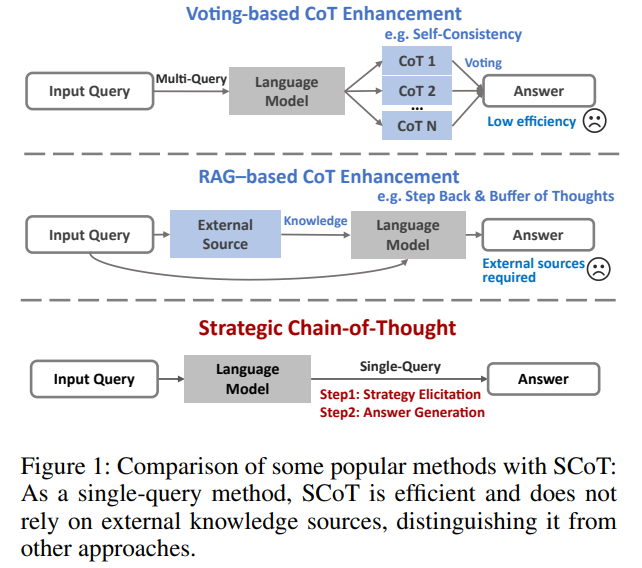

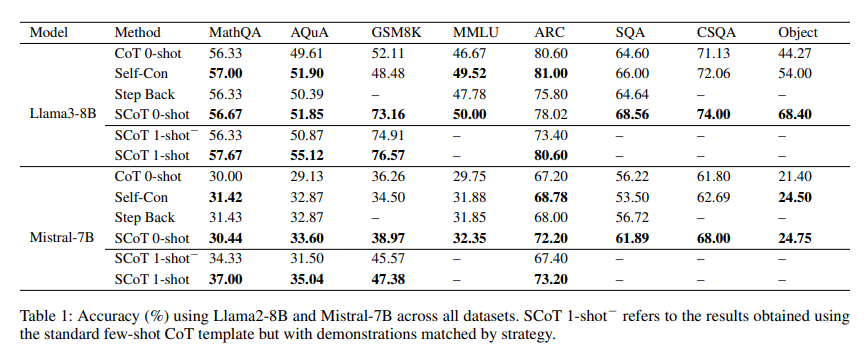

Chain-of-Thought(CoT)パラダイムは、大規模言語モデル(LLMs)の推論能力を向上させるための重要なアプローチとして登場しています.しかし、広く採用され成功を収めているにも関わらず、CoTメソッドはしばしば不安定性を示し、生成される推論経路の品質を一貫して確保できないため、最適でない推論パフォーマンスを引き起こすことがあります.この課題に対処するために、我々は\textbf{Strategic Chain-of-Thought}(SCoT)を提案します.これは、中間的な推論ステップを生成する前に戦略的な知識を統合することで、LLMのパフォーマンスを向上させるために設計された新しい方法論です.SCoTは、単一のプロンプト内で二段階のアプローチを採用しており、まず効果的な問題解決戦略を引き出し、それを使用して高品質なCoTパスと最終的な回答の生成をガイドします.さらに、SCoTフレームワークを拡張して、自動的に一致する少数のショット方法を開発しました.これにより、8つの難解な推論データセットを対象に、Llama3-8bモデルを使用して、GSM8Kデータセットで21.05%、Tracking\_Objectsデータセットで24.13%の改善が示されました.これらの結果は、SCoTの有効性を裏付け、複雑な推論タスクにおいてLLMのパフォーマンスを大幅に向上させる潜在能力を示しています.

Q&A:

Q: LLMにおける既存の思考連鎖メソッドの安定性について、具体的にどのような課題がありましたか?

A: 既存のChain-of-Thought(CoT)メソッドにおける安定性の課題として、生成される推論経路の品質が一貫して最適でないことが挙げられます.具体的には、CoTメソッドは多様な推論タスクにおいて効果的であると示されていますが、複雑な推論タスクにおいては、生成される推論経路の品質にばらつきが生じることが問題となっています.このため、LLMが有効な推論プロセスに一致するCoT経路を生成したとしても、その品質が常に最適であるとは限らず、結果として推論性能が不十分になることがあります.

Q: SCoT(Strategic Chain-of-Thought:戦略的思考連鎖)の手法で使われている2段階のアプローチについて詳しく教えてください.

A: ストラテジック・チェイン・オブ・ソート(SCoT)メソッドは、2段階のアプローチを用いています.まず、戦略的知識の引き出しが行われます.この段階では、問題を解決するための最も効果的で効率的な方法がモデルによって特定され、これがタスクの戦略的知識として機能します.次に、その特定された戦略的知識が実際に問題を解決するために適用されます.このプロセスにより、モデルは直接的に答えを生成するのではなく、まず戦略的知識を引き出してから答えを生成することが可能になります.

Q: SCoTのフレームワークの中で、効果的な問題解決戦略を引き出すプロセスを説明していただけますか?

A: SCoTフレームワークにおける効果的な問題解決戦略の引き出しプロセスは、まず問題を解決するための最も効果的で効率的な方法を特定し、それを戦略的知識として活用することから始まります.このプロセスは、問題解決のための様々な戦略を探索し、最も効果的なものを導き出すことを目的としています.次に、この戦略的知識を用いて、モデルが高品質な思考の連鎖(Chain-of-Thought, CoT)を生成し、正確な最終的な答えを導き出すことを支援します.これにより、より効果的な推論プロセスが確保されます.

Q: 推論ステップを生成する前の戦略的知識の統合は、LLMのパフォーマンスをどのように向上させるのか?

A: 戦略的知識を生成することは、LLMの性能を向上させるために重要でございます.具体的には、戦略的知識を事前に統合することにより、モデルは問題を解決するための最も効果的かつ効率的な方法を特定し、それを戦略的知識として活用することが可能になります.このプロセスは、直接的に答えを生成するのではなく、まず戦略的知識を引き出し、その後にその知識を適用して問題を解決するという二段階のアプローチを取ります.これにより、モデルはより高品質な推論を行うことができ、結果としてLLMの性能が向上するのでございます.

Q: SCoTフレームワークと従来のChain-of-Thoughtメソッドの主な違いは何ですか?

A: SCoTフレームワークと従来のChain-of-Thought(CoT)メソッドの主な違いは、SCoTが戦略的知識を組み込んでいる点にあります.SCoTは、問題解決のための最適なChain-of-Thoughtパスを生成するために、戦略的知識を活用する構造化されたワークフローを統合しています.具体的には、SCoTは2段階のプロセスを用いており、まず様々な問題解決の方法を探索し特定します.その後、戦略的知識に基づいたコーパスからデモンストレーションを選択することで、Few-shotバージョンに拡張されます.これにより、SCoTは高品質な出力を生成する能力を向上させます.従来のCoTメソッドは、こうした戦略的知識の統合が行われていないため、SCoTのような体系的なアプローチを欠いています.

Q: GSM8KとTracking_Objectsデータセットにおける推論性能の向上を定量化するために、具体的にどのような指標を用いましたか?

A: 与えられた文脈から、GSM8KおよびTracking Objectsデータセットにおける推論性能の向上を定量化するために使用された具体的な指標は、正確性の向上率であることが示されています.GSM8Kデータセットでは21.05%の正確性の向上が報告されており、Tracking Objectsデータセットでは24.13%の向上が報告されています.これらの数値は、Llama3-8bモデルを使用した実験結果に基づいています.

Large Language Model-Based Agents for Software Engineering: A Survey

著者:Junwei Liu, Kaixin Wang, Yixuan Chen, Xin Peng, Zhenpeng Chen, Lingming Zhang, Yiling Lou

発行日:2024年09月04日

最終更新日:2024年09月04日

URL:http://arxiv.org/pdf/2409.02977v1

カテゴリ:Software Engineering, Artificial Intelligence

概要:

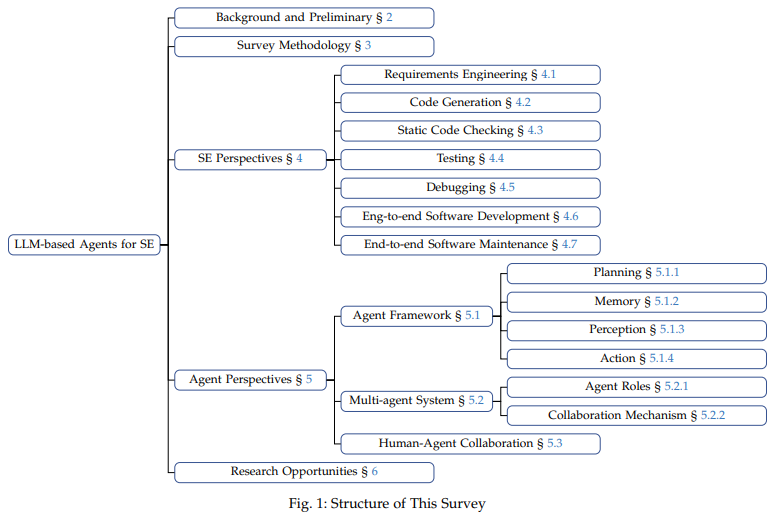

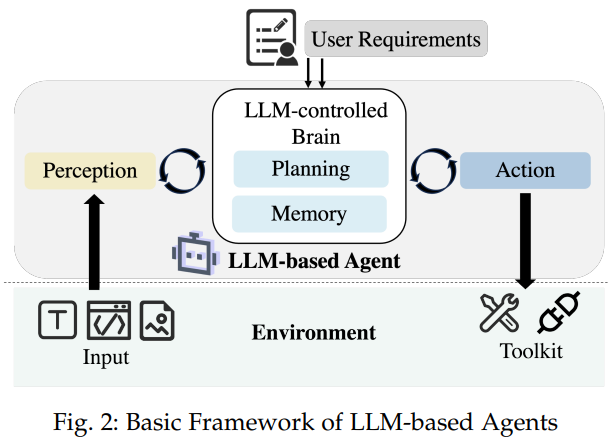

最近の大規模言語モデル(LLM)の進歩は、新しいAIエージェントのパラダイム、つまりLLMベースのエージェントを形作っています.単独のLLMと比較して、LLMベースのエージェントは、外部リソースやツールを認識および利用する能力を強化することで、LLMの汎用性と専門知識を大幅に拡張しています.これまでに、LLMベースのエージェントはソフトウェアエンジニアリング(SE)において適用され、顕著な効果を示しています.複数のエージェントと人間との相互作用によるシナジーは、複雑な実世界のSE問題に取り組む上でさらなる可能性をもたらしています.本研究では、SE向けのLLMベースのエージェントに関する包括的かつ体系的な調査を行っています.106件の論文を収集し、SEおよびエージェントの観点から分類しています.さらに、この重要な分野における未解決の課題や将来の方向性についても議論しています.この調査のリポジトリは、https://github.com/FudanSELab/Agent4SE-Paper-Listにあります.

Q&A:

Q: LLMベースのエージェントは、ソフトウェア工学の能力を高めるために、具体的にどのような外部リソースやツールを活用しているのだろうか?

A: LLMベースのエージェントは、ソフトウェアエンジニアリングにおいてその能力を強化するために、外部のリソースやツールを利用することがございます.具体的には、検索ツールが頻繁に使用されており、これにより関連情報(例えば、ドキュメントやコードスニペット)を取得することが可能でございます.これらのツールは、タスクの完了に役立つ情報を提供し、LLMの対話型の対話を超えてその能力を拡張することを目的としております.

Q: 106本の論文を分類した方法について詳しく教えてください.

A: この調査で収集された106本の論文を分類するための方法論について説明いたします.まず、調査の範囲を定義し、その範囲内で論文を収集し分析するアプローチを採用しました.調査の範囲は、LLMベースのエージェントを用いてSEタスクに取り組む論文に焦点を当てています.具体的には、キーワード検索を通じて論文を収集し、最初の2人の著者が手動で各論文をレビューし、この調査の範囲外のものを除外しました.その結果、67本の関連論文が特定されました.さらに、調査の包括性を高めるために、スノーボールアプローチを採用し、間接的に関連する論文を特定し、論文のコレクションを拡大しました.具体的には、2024年7月1日から7月10日までの間に、バックワードおよびフォワードスノーボールを実施しました.バックワードスノーボールでは、収集した各論文の参考文献を調べ、範囲内の関連論文を特定し、フォワードスノーボールでは、Google Scholarを使用して収集した論文を引用している関連論文を見つけました.この反復プロセスは、新しい関連論文が見つからなくなるまで続けられました.このプロセスで、さらに39本の論文が収集されました.最終的に、合計106本の論文がこの調査のために収集されました.

Q: LLMベースのエージェントは人間のユーザーとどのように相互作用するのか、そしてこの相互作用は複雑なSEの問題を解決する上でどのような役割を果たすのか.

A: LLMベースのエージェントは、人間のユーザーと協力して、より複雑なソフトウェアエンジニアリング(SE)の問題を解決する役割を果たします.これらのエージェントは、外部のリソースやツールを利用する能力を持ち、複数のエージェント間の協力や人間とのインタラクションを通じて、より現実的な目標を達成することができます.具体的には、LLMベースのエージェントは、ユーザーからのフィードバックを受け取り、それに基づいて問題解決のアプローチを調整することができます.このような人間とエージェントのインタラクションは、SEの複雑な問題を解決するための重要な要素となります.

Q: どのような基準で調査対象論文を選んだのですか?

A: 論文を選定するための基準は以下の通りです.論文が以下のいずれかの基準を満たす場合、調査に含まれます.(i) 論文が特定のソフトウェアエンジニアリング(SE)タスクをLLMベースのエージェントを用いて解決するための技術、フレームワーク、またはツールを提案していること.(ii) 論文が様々なドメインに適用可能な一般的な技術、フレームワーク、またはツールを提示しており、その評価に少なくとも1つのSEタスクが含まれていること.(iii) 論文が特定のSEタスクにおけるLLMベースのエージェントの評価を行う実証研究を提示していること.

Q: LLMベースのエージェントは、従来のソフトウェアエンジニアリングツールと比較して、パフォーマンスや汎用性の点でどうなのか?

A: 与えられた文脈から、LLMベースのエージェントは、従来のソフトウェアエンジニアリングツールと比較して、性能と多様性の面でいくつかの利点を持っていることが示唆されています.LLMベースのエージェントは、外部リソースやツールを利用する能力を持ち、スタンドアロンのLLMよりも多用途で専門的です.特に、ソフトウェアエンジニアリングの分野では、LLMベースのエージェントが複雑なエンドツーエンドのタスクに対処する能力を示しており、従来のツールよりも優れた効果を発揮しています.しかし、現行のベンチマークは、実際のソフトウェアエンジニアリングの課題と比較して簡単すぎることが多く、これが評価の質に影響を与えています.したがって、LLMベースのエージェントは、特に設計や検証のような高度な推論と理解が必要なタスクにおいて、従来のツールよりも優れた性能を発揮する可能性があります.

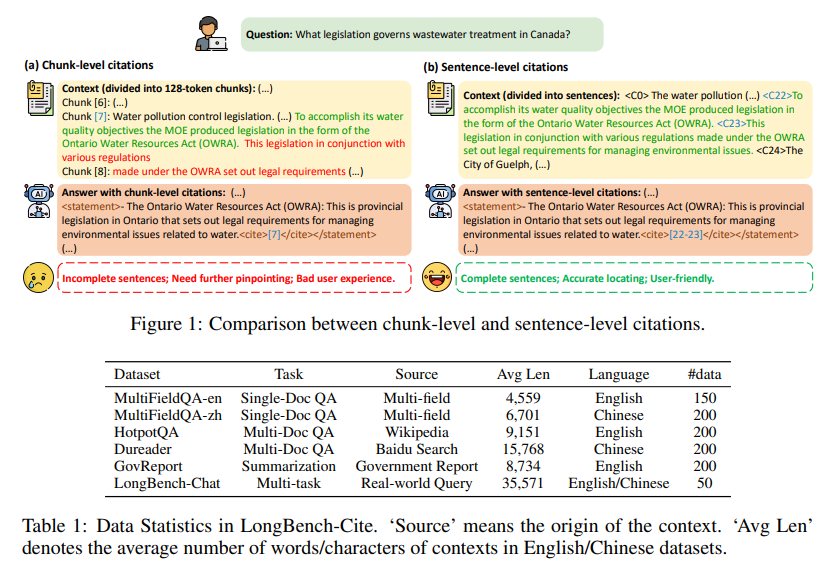

LongCite: Enabling LLMs to Generate Fine-grained Citations in Long-context QA

著者:Jiajie Zhang, Yushi Bai, Xin Lv, Wanjun Gu, Danqing Liu, Minhao Zou, Shulin Cao, Lei Hou, Yuxiao Dong, Ling Feng, Juanzi Li

発行日:2024年09月04日

最終更新日:2024年09月10日

URL:http://arxiv.org/pdf/2409.02897v3

カテゴリ:Computation and Language

概要:

現在の長文脈大規模言語モデル(LLMs)は、広範囲のテキストに基づいてユーザーの質問に答える能力を示していますが、その回答に引用がないため、ユーザーの検証が困難であり、その信頼性について懸念があります.これは、その潜在的な幻覚によるものです.この研究では、長文脈LLMsが細かい文レベルの引用を含む回答を生成できるようにし、その忠実性と検証可能性を向上させることを目指しています.まず、現在のLLMsの性能を評価するためのLong-Context Question Answering with Citations(LQAC)の自動ベンチマークであるLongBench-Citeを紹介し、改善の余地があることを明らかにします.そのために、CoF(Coarse to Fine)という新しいパイプラインを提案し、市販のLLMsを使用して正確な文レベルの引用を含む長文脈QAインスタンスを自動生成し、これを活用してLQACのための大規模なSFTデータセットであるLongCite-45kを構築します.最後に、LongCite-45kデータセットを使用してLongCite-8BとLongCite-9Bをトレーニングし、正確な回答と細かい文レベルの引用を単一の出力で生成できるようにします.また、LongBench-Citeでの評価結果では、我々のトレーニングされたモデルが、GPT-4oを含む先進的なプロプライエタリモデルを上回る、最先端の引用品質を達成していることが示されています.

Q&A:

Q: CoF(Coarse to Fine)パイプラインと、ロングコンテキストのQAインスタンスを生成する際の機能について詳しく教えてください.

A: CoF(Coarse to Fine)パイプラインは、長文コンテキストから正確な文レベルの引用を生成するために設計された新しいプロセスです.このパイプラインは、次の4つのステージで構成されています.まず、長いテキスト資料を用意し、LLM(大規模言語モデル)を使用して自己指導(Self-Instruct)によりクエリとその関連する回答を生成します.次に、その回答を用いてコンテキストからいくつかのチャンク(各チャンクは128トークンの固定長を持ちます)を取得し、それをLLMに入力します.最後に、引用が少なすぎるインスタンスはフィルタリングされます.このプロセスにより、長文コンテキストQAペアがまず構築され、その後のステップで回答に引用が追加されます.この後処理の特性により、任意の長文コンテキストQAデータセットに引用を追加することが可能です.

Q: モデルによって生成された細かな文章レベルの引用の質を決定するために、どのような基準を用いましたか?

A: 文の質を評価するために、主に引用のF1スコアを使用しました.このスコアは、引用の再現率と引用の精度を組み合わせたものです.引用の再現率は、モデルの応答が引用されたスニペットによって完全にサポートされているかどうかを評価し、引用の精度は無関係な引用を検出します.具体的には、各文に対して、少なくとも1つのスニペットを引用している場合、すべてのスニペットを連結し、その連結されたテキストがその文を完全にサポートしているか(1点)、部分的にサポートしているか(0.5点)、またはサポートしていないか(0点)をGPT-4oに判断させます.これにより、引用の質をより細かく評価することが可能となります.

Q: LongCite-45kのデータセットはどのように構築され、どのような種類のデータが含まれているのですか?

A: LongCite-45kデータセットは、GLM-4の事前学習コーパスから50,000の文書を収集することによって構築されました.このデータセットは、書籍、百科事典、学術論文など、9つの異なるドメインをカバーしています.具体的な構築方法やデータの種類については、文脈から詳細な情報が提供されていないため、これ以上の説明はできません.

Q: LongCite-8BとLongCite-9Bの引用能力は、GPT-4oのような既存のモデルとどのような点で異なるのですか?

A: LongCite-8BとLongCite-9Bの引用機能は、既存のモデルであるGPT-4oと比較していくつかの点で異なります.まず、LongCiteモデルは、より細かい引用の粒度を持っており、これは平均引用長が短いことからも示されています.具体的には、LongCite-9Bの引用長は86であるのに対し、GLM-4の引用長は188です.このことは、LongCiteモデルがより詳細な情報を提供できることを意味します.さらに、LongCite-8BとLongCite-9Bは、引用F1スコアにおいてもGPT-4oを上回っており、それぞれ6.4%と3.6%の向上を示しています.これにより、LongCiteモデルは、より正確で精緻な引用を生成する能力を持っていることがわかります.また、SFT(Supervised Fine-Tuning)を用いることで、長文コンテキストの質問応答の正確性が向上し、LLMの幻覚を軽減することができます.これにより、コンテキスト情報をより均一かつ包括的に利用することが可能となり、応答の正確性がさらに向上します.

Q: LongBench-Citeで学習したモデルの引用品質を測定するために、どのような評価指標を採用しましたか?

A: トレーニングされたモデルのLongBench-Citeにおける引用品質を評価するために使用された評価指標は、主に引用F1スコアです.このスコアは、引用リコールと引用精度を用いて計算されます.引用リコールは、モデルの応答が引用されたスニペットによって完全にサポートされているかどうかを検証し、引用精度は無関係な引用を検出します.

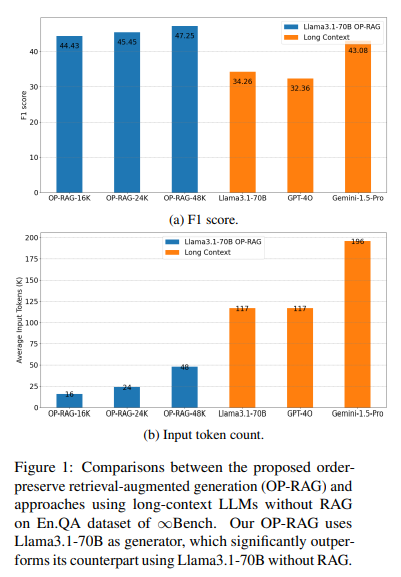

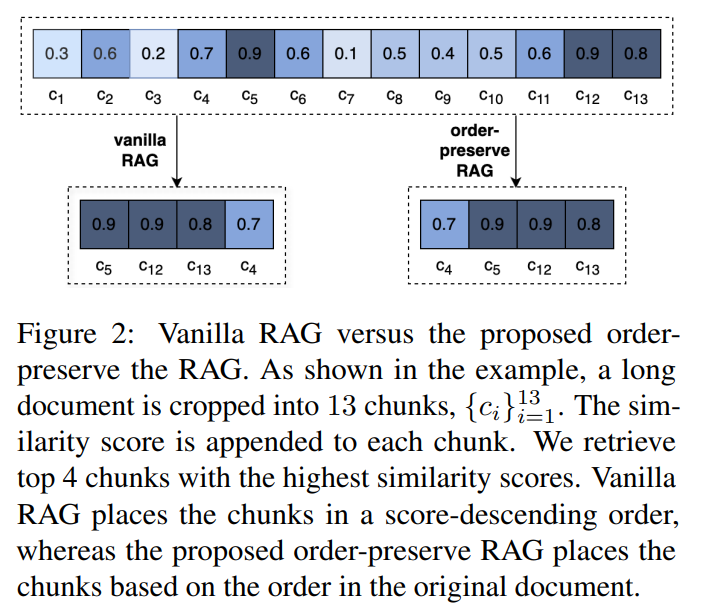

In Defense of RAG in the Era of Long-Context Language Models

著者:Tan Yu, Anbang Xu, Rama Akkiraju

発行日:2024年09月03日

最終更新日:2024年09月03日

URL:http://arxiv.org/pdf/2409.01666v1

カテゴリ:Computation and Language

概要:

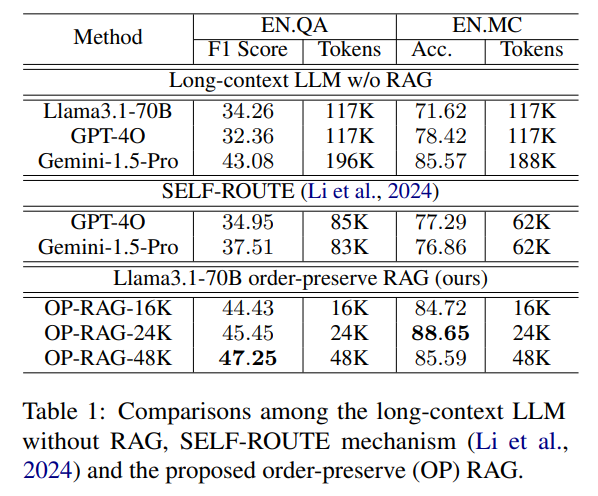

初期のLLM(Large Language Models)における限られたコンテキストの制限を克服するために、検索増強生成(RAG)は過去においてコンテキストベースの回答生成の信頼できる解決策となってきた.最近、長いコンテキストを取り入れることができる長いコンテキストLLMの登場により、RAGは魅力を失ってきている.最近の研究では、長いコンテキストLLMが長いコンテキストのアプリケーションにおいてRAGを大幅に上回ることが示されている.既存の研究が長いコンテキストLLMをRAGよりも好むのに対し、我々はLLMにおける極端に長いコンテキストが関連情報への焦点を失わせ、回答の品質の低下をもたらす可能性があると主張する.本論文では、長いコンテキストの回答生成においてRAGを再検討する.我々は、順序を保持する検索増強生成(OP-RAG)メカニズムを提案し、これによりRAGの性能が大幅に向上する.OP-RAGでは、検索されるチャンクの数が増えるにつれて、回答の品質が初めは上昇し、その後低下し、逆U字型の曲線を形成する.OP-RAGでは、長いコンテキストLLMが全体のコンテキストを入力とするよりもはるかに少ないトークンでより高い回答の品質を達成できる「スイートポイント」が存在する.豊富なデータを用いて、OP-RAGが長いコンテキストの質問回答アプリケーションにおいてRAGの性能を大幅に向上させることを示す.さらに、全体のコンテキストを入力とする長いコンテキストLLMよりも、OP-RAGはより少ないトークンで高い回答品質を実現することが示されている.公開ベンチマークでの豊富な実験により、我々のOP-RAGの優越性が証明されている.

Q&A:

Q: OP-RAGメカニズムの開発につながった、ロングコンテクストLLMの具体的な限界は何でしたか?

A: 長文コンテキストのLLMにおける特定の制限として、関連情報への集中力が低下し、回答の質が低下する可能性があることが指摘されました.この問題に対処するために、順序を保持するリトリーバル強化生成(OP-RAG)メカニズムが開発されました.OP-RAGは、取得したチャンクの数が増加するにつれて、回答の質が最初は向上し、その後低下する逆U字型の曲線を形成することが示されています.したがって、OP-RAGは、長文コンテキストのLLMが全体のコンテキストを入力として使用する場合よりも、はるかに少ないトークンでより高い回答の質を達成できるスイートポイントが存在します.

Q: 実験に使用した公開ベンチマークの種類と、それを選んだ理由を教えてください.

A: 実験には、∞Bench(Zhang et al., 2024)ベンチマークのEN.QAとEN.MCデータセットが使用されました.これらのデータセットは、長いコンテキストのQA評価のために特別に設計されています.具体的には、EN.QAは351の人間が注釈を付けた質問と回答のペアで構成されており、平均してEN.QAの長いコンテキストには150,374語が含まれています.EN.MCは224の質問と回答のペアで構成されており、各質問には4つの選択肢が提供されています.平均して、EN.MCの長いコンテキストには142,622語が含まれています.これらのデータセットは、最近の長いコンテキストをサポートするLLMを評価するために選ばれました.特に、LongBench(Bai et al., 2023)という別のベンチマークもありますが、その平均コンテキスト長は20K語未満であり、128Kトークンのウィンドウサイズをサポートする最近の長いコンテキストLLMを評価するには十分ではありません.

Q: 検索されるチャンクの数が増えるにつれて、回答品質に見られる逆U字型のカーブについて詳しく教えてください.

A: 回答の質が取得されたチャンクの数に応じて逆U字型の曲線を描く現象について詳しく説明いたします.この現象は、最初に取得するチャンクの数が増えると、モデルが高品質な回答を生成するために必要な正しいコンテキストを取得する可能性が高まるため、回答の質が向上することに起因します.具体的には、モデルがアクセスできる潜在的に関連性のある情報が増えることで、リコールが改善されます.しかし、取得するチャンクの数がさらに増えると、無関係または気を散らす情報が導入される可能性も高まります.この過剰な情報はモデルを混乱させ、結果として回答の質が低下することになります.このため、関連情報を増やしてリコールを改善することと、気を散らす要素を制限して精度を維持することの間でトレードオフが生じます.最適なポイントは、関連情報と無関係情報のバランスが回答の質を最大化するところにあります.このポイントを超えると、回答の質は低下し始めます.数式で表すと、回答の質を ( Q ) とし、取得されたチャンクの数を ( n ) とした場合、( Q(n) ) は逆U字型の関数として表されます.

Q: OP-RAGは、極端に長い文脈に伴う回答の質の低下の可能性をどのように扱うのか?

A: OP-RAGは、非常に長いコンテキストに関連する回答品質の低下を、順序を保持した情報検索強化生成(Order-Preserve Retrieval-Augmented Generation)メカニズムを用いることで対処しております.このメカニズムでは、取得するチャンクの数が増加するにつれて、回答の品質が最初は向上し、その後低下するという逆U字型の曲線を形成します.したがって、OP-RAGは、長いコンテキストを持つLLMが全体のコンテキストを入力として使用する場合よりも、はるかに少ないトークンでより高い回答品質を達成できるスイートポイントが存在します.

OLMoE: Open Mixture-of-Experts Language Models

著者:Niklas Muennighoff, Luca Soldaini, Dirk Groeneveld, Kyle Lo, Jacob Morrison, Sewon Min, Weijia Shi, Pete Walsh, Oyvind Tafjord, Nathan Lambert, Yuling Gu, Shane Arora, Akshita Bhagia, Dustin Schwenk, David Wadden, Alexander Wettig, Binyuan Hui, Tim Dettmers, Douwe Kiela, Ali Farhadi, Noah A. Smith, Pang Wei Koh, Amanpreet Singh, Hannaneh Hajishirzi

発行日:2024年09月03日

最終更新日:2024年09月03日

URL:http://arxiv.org/pdf/2409.02060v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

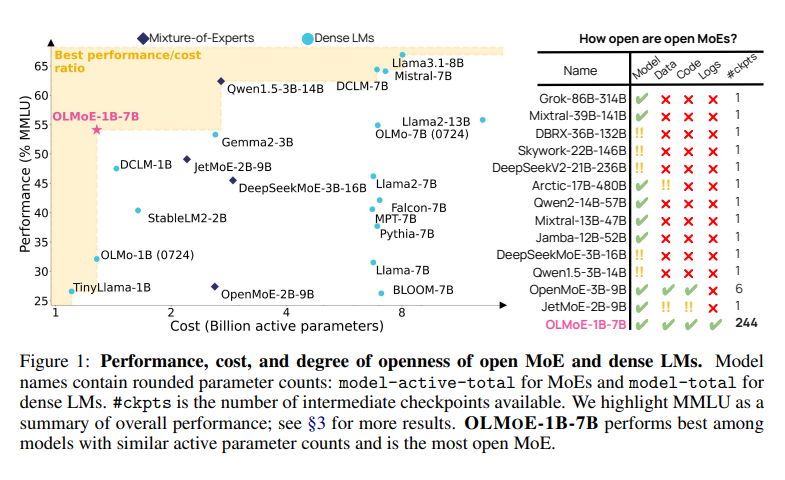

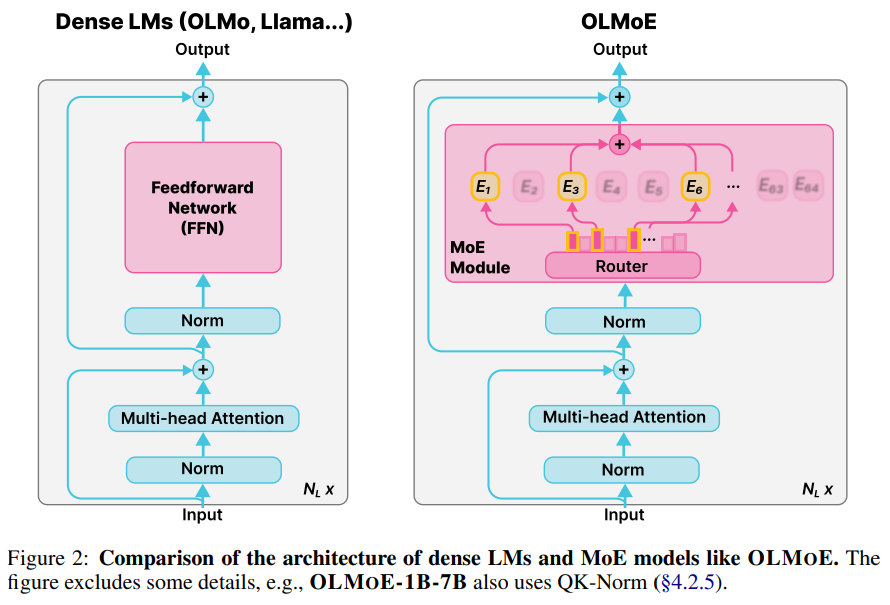

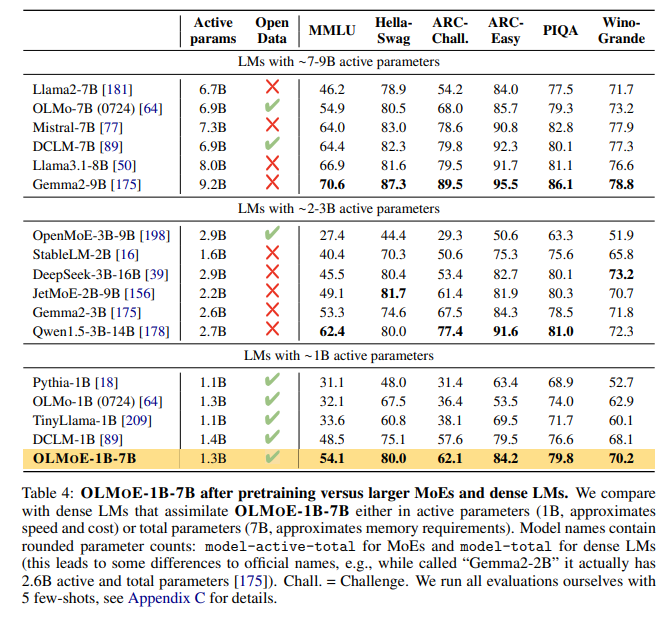

概要:

OLMoEは、スパースなMixture-of-Experts(MoE)を活用した最新の言語モデルであり、完全にオープンソースである.OLMoE-1B-7Bは70億のパラメータを持っており、1つの入力トークンあたりに1Bしか使用しない.我々は、5兆のトークンで事前学習し、さらにOLMoE-1B-7B-Instructを作成するために適応させた.我々のモデルは、同様のアクティブパラメータを持つすべての利用可能なモデルを凌駕し、Llama2-13B-ChatやDeepSeekMoE-16Bなどのより大きなモデルをも上回る性能を発揮する.我々はMoEトレーニングに関するさまざまな実験を行い、モデル内のルーティングを分析し、高い特殊化を示す.また、我々の作業のすべての側面(モデルの重み、トレーニングデータ、コード、ログ)をオープンソース化している.

Q&A:

Q: 5兆トークンを含む事前トレーニングプロセスについて詳しく教えてください.どのようなデータソースが利用されましたか?

A: トークンの事前学習プロセスにおいて、5兆トークンが使用されました.このプロセスでは、DCLMとDolma 1.7からのデータが利用されました.具体的には、以下のデータソースが含まれています:(1) Common Crawlの品質フィルタリングされたサブセットであるDCLM-Baseline、(2) StarCoder、Algebraic Stack、arXivがDCLMとDolma 1.7の両方で使用され、(3) Dolma 1.7からのpeS2oとWikipediaです.これらのデータソースに対して、32以上の連続したn-gram(1から13トークンの範囲のスパン)を含むすべてのドキュメントを削除するフィルタが適用されました.StarCoderのサブセットに対しては、GitHubで2つ未満のスターを持つリポジトリからのドキュメント、または最も頻繁に出現する単語がドキュメントの30%以上を占めるもの、または上位2つの頻出単語がドキュメントの50%以上を占めるものも削除されました.すべてのサンプルは各エポックの開始時にランダムにシャッフルされ、合計5.133兆トークン(Muennighoffら[120]に従って1.3エポック)でトレーニングされました.アニーリングフェーズ(最終1000億トークン)では、最初にデータセット全体を再シャッフルし、その後学習率を0に線形に減衰させました.

Q: ベースモデルからOLMoE-1B-7B-Instructを作るために、どのような改良が加えられたのですか?

A: OLMoE-1B-7B-Instructは、基本モデルからの標準的な適応レシピに従って作成されました.まず、指示調整(instruction tuning)を行い、その後、好み調整(preference tuning)を行いました.指示調整データセットには、コードと数学のデータを追加し、下流のコーディングと数学のアプリケーションでのパフォーマンスを向上させました.これにより、OLMoE-1B-7B-Instructは、Llama2-13B-ChatやDeepSeekMoE-16Bなどのより大きなモデルをも超える性能を発揮しました.

Q: Llama2-13B-ChatやDeepSeekMoE-16Bのような他のモデルと比較して、OLMoEのパフォーマンスを評価するためにどのような指標が用いられたのでしょうか?

A: OLMoEの性能は、MMLU、GSM8k、HumanEvalなどの一般的なベンチマークを用いて評価されました.これらのベンチマークは、モデルの理解力や推論能力を測定するために使用されることが多いです.

Q: OLMoEのルーティングメカニズムは、モデルの特殊化にどのように貢献していますか?

A: OLMoEのルーティングメカニズムは、モデルの専門化に寄与する方法として、いくつかの重要な特性を持っています.まず、ルーティングは事前学習の初期段階で飽和することが観察されています.これは、ルーターが特定のトークンや入力に対して特定のエキスパートを選択する能力が限られていることを示唆しています.次に、エキスパートの共活性化が稀であることが示されています.これは、各エキスパートが特定のドメインや語彙に特化していることを意味します.具体的には、エキスパートは特定のドメインや語彙に対して専門化し、特定の入力に対して最も適切なエキスパートが選ばれるようにルーティングされます.このようにして、OLMoEは異なる入力に対して異なるエキスパートを活性化することで、モデル全体の専門化を実現しています.

Q: モデルの重み、トレーニングデータ、コード、ログのオープンソースプロセスの詳細を教えてください.

A: モデルのオープンソース化のプロセスについて説明いたします.まず、モデルの重みは、Apache 2.0ライセンスの下でオープンソース化されております.次に、トレーニングデータに関しては、ODC-By 1.0ライセンスの下で提供されており、データを再現するためのスクリプトも利用可能です.コードは、Apache 2.0ライセンスの下で公開されており、GitHubでアクセス可能です.最後に、トレーニングログは、Apache 2.0ライセンスの下で提供されており、wandbプラットフォームで閲覧可能です.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で紹介された新しい手法のコード実装のURLは、https://github.com/allenai/OLMoE でございます.このURLは、OLMoEのコード実装に関連しており、論文の文脈からも明示されております.

Beyond Preferences in AI Alignment

著者:Tan Zhi-Xuan, Micah Carroll, Matija Franklin, Hal Ashton

発行日:2024年08月30日

最終更新日:2024年11月06日

URL:http://arxiv.org/pdf/2408.16984v2

カテゴリ:Artificial Intelligence

概要:

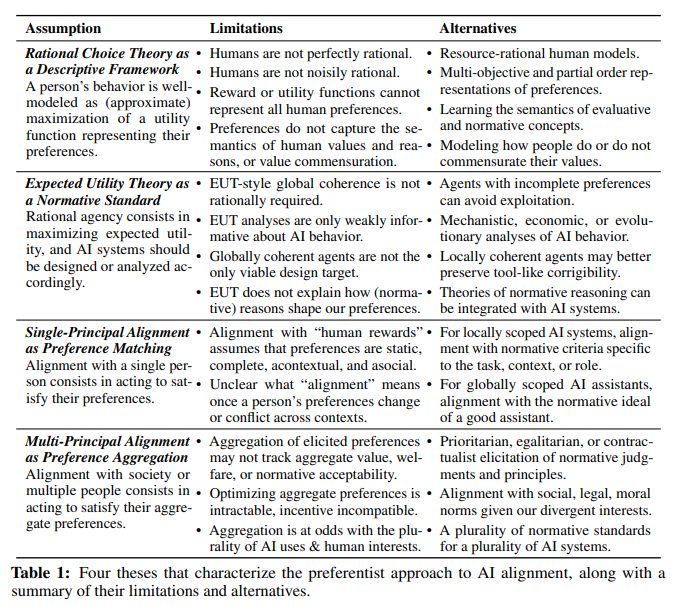

この論文では、AIのアライメントにおける主流の実践は、(1) 好みが人間の価値観を適切に表現していると仮定し、(2) 人間の合理性が好みの満足度を最大化することで理解できると仮定し、(3) AIシステムは1人以上の人間の好みに合わせてアライメントされるべきであり、安全かつ価値観に沿った行動を取るようにするべきだというものです.これらのコミットメントは、暗黙的に従われるか、明示的に支持されるかに関わらず、AIアライメントにおける好み主義的アプローチを構成しています.この論文では、好み主義的アプローチを特徴づけ、挑戦し、さらなる研究が必要な概念的および技術的な代替案を説明します.まず、合理的選択理論の限界を調査し、好みが人間の価値観の厚い意味内容を捉えられないこと、および効用表現がその価値観の非可測性を無視していることを説明します.次に、期待効用理論(EUT)の人間およびAIに対する規範性を批判し、合理的なエージェントがEUTに従う必要はないことを示す議論を引用しつつ、EUTが規範的にどのような好みを示すかについて沈黙していることを強調します.さらに、EUTが規範的にどのような好みを示すかについて沈黙していることを強調し、これらの制限がAIアライメントの目標を再構築する動機となることを主張します.人間のユーザー、開発者、または人類全体の好みに合わせるのではなく、AIシステムは、一般的なアシスタントのような社会的役割に適した規範基準とアライメントすべきであると主張します.さらに、これらの基準は、関係者全員によって協議され、合意されるべきです.このアライメントの代替概念では、多様な目的を果たす複数のAIシステムが、相互の利益を促進し、害を制限する規範基準に合致することができるでしょう.

Q&A:

Q: AIとの連携における人間の価値観の記述モデルとしての合理的選択理論の主な限界は何か?

A: 合理的選択理論が人間の価値を記述するモデルとして持つ主な限界は、以下の通りでございます.まず、人間の行動は、彼らの選好を表す効用関数の(近似的な)最大化としてうまくモデル化されると仮定されておりますが、人間は完全に合理的ではなく、また騒がしい合理性を持つわけでもございません.さらに、報酬や効用関数はすべての人間の選好を表現することができず、選好は人間の価値や理由、または価値の共通尺度化を捉えることができません.これらの限界は、AIの整合性の文脈において、選好の一致を目指すアプローチの再考を促しております.

Q: あなたの分析によれば、プリファレンスは人間の価値観の意味内容をどのように捉えていないのですか?

A: 人間の価値観の意味的内容を捉えることにおいて、選好が失敗する理由は、選好が人間の価値観や理由、価値の共通尺度化を捉えないためであるとされています.選好は、基本的なものではなく、理由や価値から構築されるため、その意味的内容を正確にモデル化することが難しいです.さらに、選好は人間の価値観の厚い意味的内容を捉えることができず、価値の共通尺度化をモデル化することもできません.

Q: 価値の非整合性という概念と、AIのアラインメントにおける効用表現への影響について詳しく教えてください.

A: 価値の非可換性(incommensurability)とは、異なる価値が共通の尺度で比較できないことを指します.AIアライメントにおける効用表現において、この概念は重要な意味を持ちます.効用理論では、通常、すべての選択肢や結果が単一の効用尺度で評価されると仮定されます.しかし、価値の非可換性が存在する場合、異なる価値は単純に比較できず、共通の尺度で測ることができません.例えば、倫理的価値と経済的価値が対立する状況では、どちらが優先されるべきかを単純な効用関数で決定することは困難です.このような状況では、効用理論はその限界を露呈し、AIシステムが人間の価値を正確に反映することが難しくなります.したがって、AIアライメントにおいては、価値の非可換性を考慮に入れた新しいモデルやアプローチが必要とされます.

Q: 人間とAIシステムの両方に対する期待効用理論(EUT)の規範性について、具体的にどのような批判がありますか?

A: 期待効用理論(EUT)の規範性に関する具体的な批判として、まず、EUTは人間やAIシステムにとって必ずしも従うべき基準ではないという点が挙げられます.EUTは合理的なエージェントが従うべき標準として提案されていますが、実際には人間はこの基準に従わないことが多いです.さらに、EUTはどのような選好が規範的に受け入れられるべきかについては沈黙しています.EUTは道具的選好を制約するだけであり、「内在的」な選好については考慮していません.このため、EUTは設計戦略としても、合理的なエージェンシーの基準としても限界があります.これらの批判は、AIのアラインメントの目標を再構築する動機となります.具体的には、AIシステムは人間のユーザーや開発者、あるいは人類全体の選好に合わせるのではなく、社会的役割に適した規範的基準に合わせるべきであると提案されています.

Q: 合理的なエージェントは、どのような点で期待効用理論の遵守から逸脱できると思いますか?

A: 合理的なエージェントが期待効用理論に従わない方法について説明いたします.まず、合理的なエージェントは、必ずしも期待効用を最大化する必要がないことが指摘されています.多くの効用関数は計算上扱いにくく、合理的な選択行動を計算することが困難であるため、エージェントは効用関数を近似的に最大化することに頼らざるを得ない場合があります.さらに、エージェントは合理性の公理に従うことを選択するかもしれませんが、その場合、元の効用関数に対する最適性を近似的にでも放棄することになります.したがって、期待効用を最大化することが常に資源合理的であるとは限りません.また、AIシステムの設計においても、期待効用理論の公理に従わない、つまりグローバルに一貫性のないシステムを構築する選択肢があることが示されています.これにより、AIシステムが人間の不完全な選好を忠実に表現し、安全に整合する可能性が高まります.

Q: AIシステムがその社会的役割において合致すべき規範的基準をどのように定義し、特定することを提案しますか?

A: AIシステムがその社会的役割において整合すべき規範的基準を定義し識別する方法については、まず、これらの基準は関連するすべての利害関係者によって交渉され、合意されるべきであると考えられます.これにより、AIシステムは多様な目的に役立ち、相互利益を促進し、害を制限する規範的基準に整合することが可能になります.具体的には、AIシステムは人間の好みに整合するのではなく、その社会的役割と機能に適した規範的基準に整合すべきです.これらの基準は、政治的に交渉された規範的基準として、集団的に形成され、交渉されるべきです.したがって、AIの整合性の目標は、個々の人間の好みではなく、広く契約主義的なアプローチに基づいて設定されるべきです.

Q: このような規範となる基準を関係者の間で交渉し、合意するために、どのようなプロセスを想定していますか?

A: この文脈において、関連する利害関係者間で規範的基準を交渉し合意するためのプロセスとして、ゲーム理論、交渉理論、社会的選択理論、形式的な議論アプローチ、交渉の洞察を統合することが考えられます.具体的には、ゲーム理論(Dafoe et al., 2020)、交渉理論(Chater, 2023)、社会的選択(Conitzer et al., 2024)といった理論を、形式的な議論(Amgoud and Cayrol, 1998)や交渉(Rahwan et al., 2003)のアプローチと結びつけることが必要です.また、人間の規範性の科学からの洞察(Binmore, 1994; Hadfield-Menell and Hadfield, 2018; Levine et al., 2023)も重要です.これにより、AIシステムが多様な目的に役立ち、相互利益を促進し、害を制限する規範的基準に整合することが可能になります.

MemLong: Memory-Augmented Retrieval for Long Text Modeling

著者:Weijie Liu, Zecheng Tang, Juntao Li, Kehai Chen, Min Zhang

発行日:2024年08月30日

最終更新日:2024年08月30日

URL:http://arxiv.org/pdf/2408.16967v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

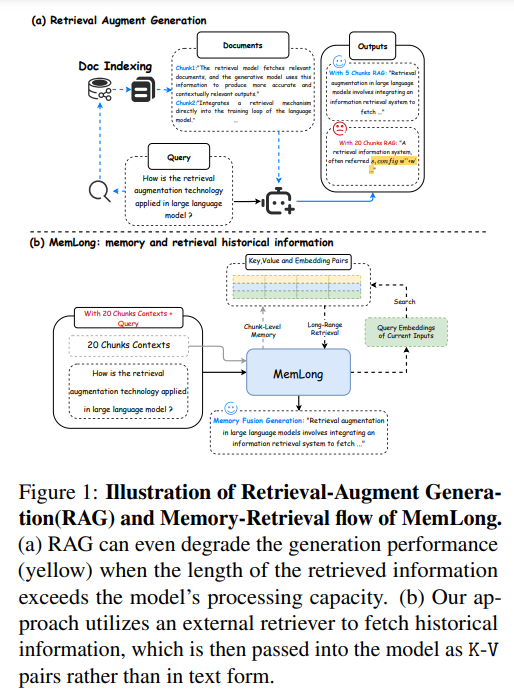

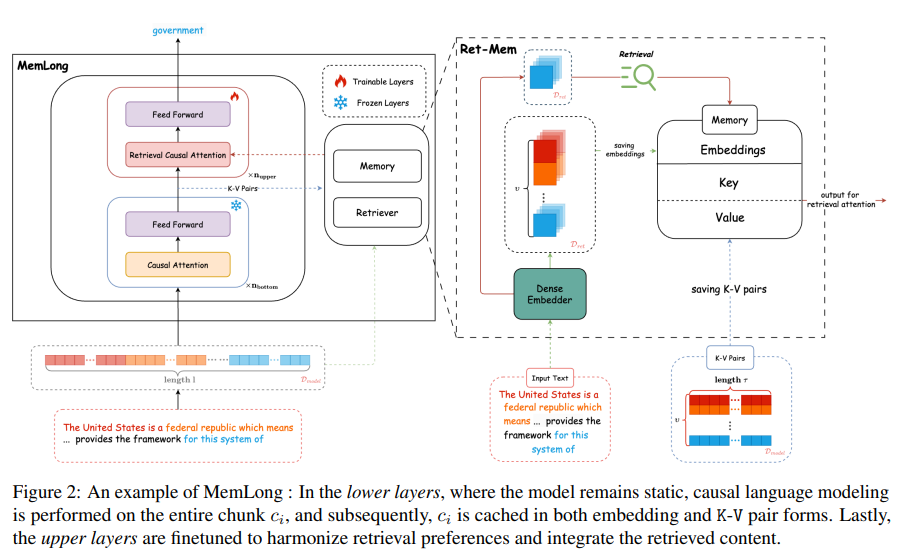

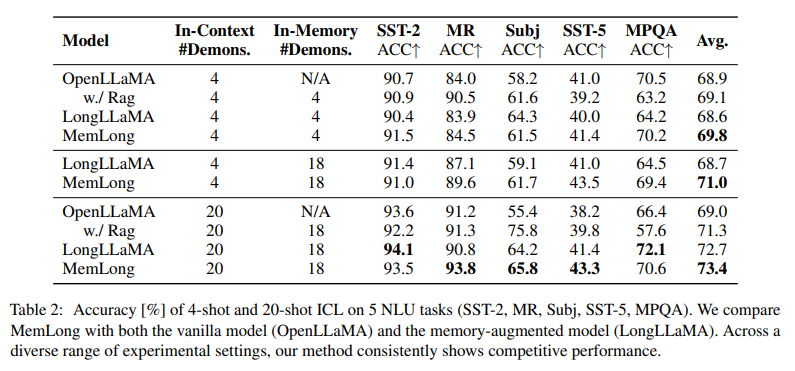

最近の大規模言語モデル(LLMs)の進歩により、さまざまな分野で驚異的な成功が収められています.しかし、LLMsが長いコンテキストを扱うことは依然として重要な課題であり、アテンションメカニズムの二次時間と空間の複雑さや生成中のキー値キャッシュのメモリ消費量の増加が原因です.この研究では、MemLong:長いテキスト生成のためのメモリ拡張リトリーバルという方法を紹介し、外部リトリーバーを使用して歴史情報の検索を行うことで、長いコンテキスト言語モデリングの能力を向上させることを目指しています.MemLongは、微分不可能な「ret-mem」モジュールと部分的にトレーニング可能なデコーダーのみの言語モデルを組み合わせ、意味レベルの関連するチャンクを活用する細かく制御可能なリトリーバルアテンションメカニズムを導入しています.複数の長いコンテキスト言語モデリングベンチマークでの包括的な評価により、MemLongが他の最先端のLLMsを一貫して上回ることが示されています.さらに、MemLongは、単一の3090 GPUでのコンテキスト長を4kから80kまで拡張することができます.当社のコードはhttps://github.com/Bui1dMySea/MemLongで入手可能です.

Q&A:

Q: ret-mem」モジュールは、過去の情報を効率的に検索するために、具体的にどのようなテクニックを採用しているのか?

A: 与えられた文脈から、”ret-mem”モジュールが歴史的情報を効果的に取得するために使用する具体的な技術について説明いたします.このモジュールは、RetrieverとMemoryという2つのコンポーネントから構成されております.Retrieverは、過去の文脈や知識を非訓練のメモリバンクに保存し、これらの保存された埋め込みを利用してチャンクレベルのキー-バリュー(K-V)ペアをモデルに入力するために使用されます.さらに、MemLongは、局所情報とメモリ情報を統合するための取得因果注意モジュールを導入しております.これにより、モデルは過去の情報を効果的に取得し、利用することが可能となります.

Q: MemLongは、3090GPU1個で、コンテキストの長さを4kから80kに伸ばすことができるのですか?

A: MemLongは、単一の層のK-Vペアのみを記憶する必要があるため、単一の3090 GPU上でコンテキストウィンドウを80kトークンまで容易に拡張することが可能でございます.このアプローチにより、計算コストが大幅に削減され、長いコンテキストを効率的に処理することができるようになっております.

Q: ロングコンテクスト言語モデリングにおいて、歴史的情報検索に外部リトリーバーを使用することの意味は?

A: 長文コンテキストの言語モデリングにおいて、外部リトリーバーを使用して歴史的情報を取得することにはいくつかの重要な影響があります.まず、外部リトリーバーを使用することで、モデルは過去のコンテキストや知識を効率的に取得し、これをキー-バリュー(K-V)ペアとしてモデルに入力することが可能になります.これにより、モデルは長いテキストを処理する能力が向上します.しかし、この方法にはいくつかの欠点もあります.まず、メモリに保存された情報は、トレーニング中のモデルパラメータの変化により分布のシフトを経験する可能性があります.さらに、これらの方法はしばしば再トレーニングを必要とし、大規模モデルの時代には非現実的です.最後に、これらのモデルは、事前にトレーニングされたモデルの元々の能力を犠牲にして、長いテキスト入力を処理する傾向があります.したがって、外部リトリーバーを使用することは、モデルの暗黙的な情報取得プロセスを明示的に近似するための手段として有用であると考えられます.

Q: MemLongは、計算効率やメモリ使用量において、他の最先端のLLMと比較してどうですか?

A: MemLongは、他の最先端の大規模言語モデル(LLMs)と比較して、計算効率とメモリ使用量の面で優れた性能を示しています.特に、MemLongは単一の3090 GPU上でコンテキストウィンドウを80kトークンまで拡張することが可能であり、これは他のモデルと比較して非常に効率的です.これは、注意メカニズムの計算コストが二次的であることや、生成中のキー・バリューキャッシュのメモリ消費が増加するという課題に対処するために、MemLongがメモリを活用しているためです.さらに、MemLongは、単一の層のK-Vペアのみを記憶する必要があるため、計算コストが大幅に削減されています.これにより、3BパラメータのMemLongを0.5Bトークンでファインチューニングする際には、8台の3090 GPUで8時間しかかかりません.これらの特性により、MemLongは他の最先端のLLMsと比較して、計算効率とメモリ使用量の面で優れた性能を発揮しています.

Q: MemLongの開発中、特に注意のメカニズムに関して、どのような課題にぶつかりましたか?

A: MemLongの開発において、特に注意メカニズムに関して直面した課題は、バニラの注意メカニズムが持つ二次の時間と空間の複雑さに起因するものでした.これにより、文脈の長さを大幅に拡張することが困難となり、長いシーケンスを必要とするタスク、例えば長文の要約や複数回の対話などのアプリケーションにおいて重要な制限が生じました.具体的には、注意メカニズムの計算量が (O(n^2)) であるため、長い文脈を処理する際に計算資源が大量に必要となり、効率的な処理が難しくなります.

Q: 長文生成の文脈で、記憶を利用した検索手法の今後の発展をどのように想定していますか?

A: 将来の長文生成におけるメモリ拡張型の検索手法の発展について考えると、いくつかの重要な方向性が考えられます.まず、メモリバンクを用いた効率的な情報の保存と検索が重要となります.これにより、モデルは過去のコンテキストや知識を効果的に活用し、長文の生成においても一貫性を保つことが可能となります.具体的には、非学習型のメモリバンクを使用し、過去のコンテキストを保存し、それをチャンクレベルのキー・バリュー(K-V)ペアとしてモデルに入力する手法が考えられます.このアプローチにより、モデルのパラメータが変化しても情報の分布シフトを最小限に抑えることができ、再学習の必要性を減少させることが期待されます.また、外部の検索システムを活用して歴史的な情報を取得し、それをテキスト形式ではなくK-Vペアとしてモデルに渡すことで、モデルの処理能力を超える情報量を扱う際の性能低下を防ぐことができます.これらの手法により、長文生成における計算ボトルネックを克服し、より効果的な長文コンテキスト処理が可能になると考えられます.

Pandora’s Box or Aladdin’s Lamp: A Comprehensive Analysis Revealing the Role of RAG Noise in Large Language Models

著者:Jinyang Wu, Feihu Che, Chuyuan Zhang, Jianhua Tao, Shuai Zhang, Pengpeng Shao

発行日:2024年08月24日

最終更新日:2024年08月24日

URL:http://arxiv.org/pdf/2408.13533v1

カテゴリ:Computation and Language

概要:

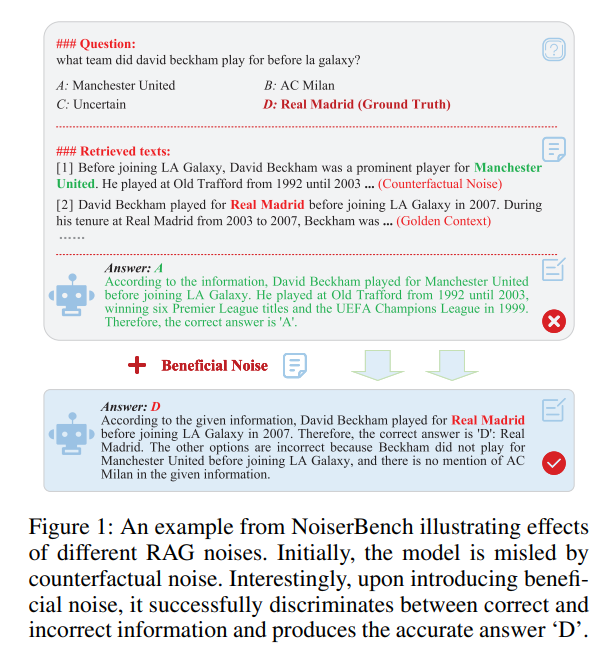

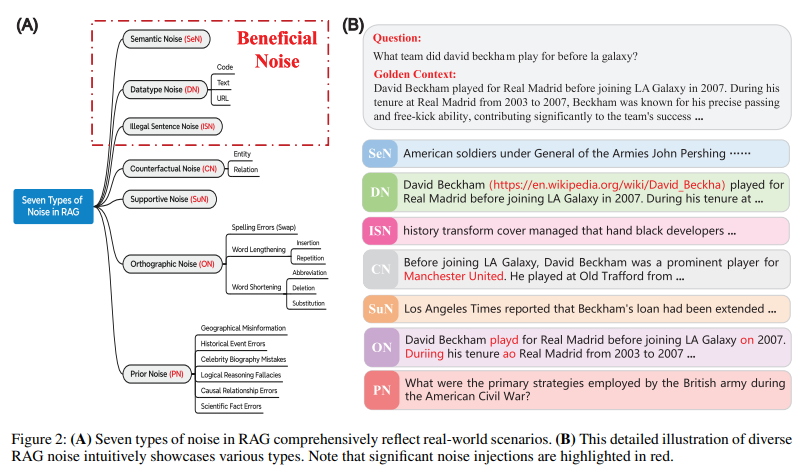

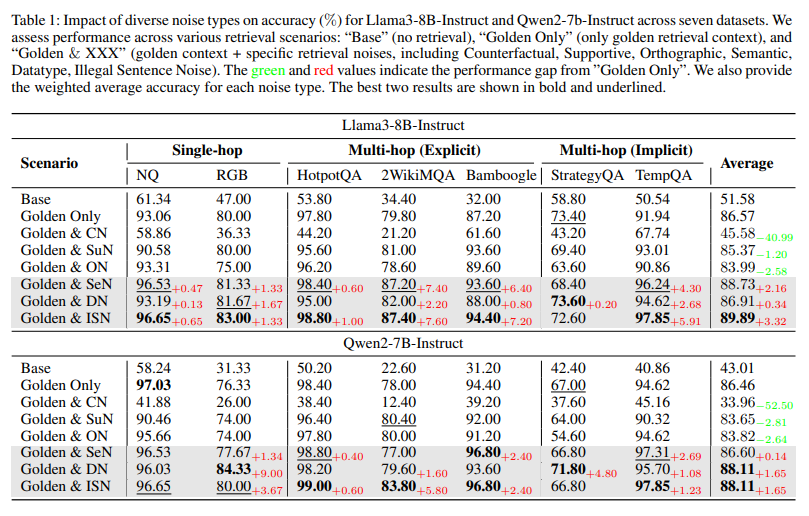

最近の研究では、Retrieval-Augmented Generation(RAG)が大規模言語モデル(LLMs)における幻覚の解決方法として重要な手法として浮上しています.最近の研究では、RAGモデルを複雑なノイズのシナリオに拡張してきましたが、これらの探索はしばしば限られたノイズタイプに制限され、ノイズがLLMsにとって本質的に有害であると仮定しており、実際のリトリーバル環境から逸脱し、実用性を制限している可能性があります.本論文では、言語的観点から7つの異なるノイズタイプを定義し、ノイズRAGベンチマーク(NoiserBench)を確立し、複数のデータセットと推論タスクを包括的に評価するフレームワークを提供します.様々なアーキテクチャとスケールを持つ8つの代表的なLLMsを実証評価することで、これらのノイズをさらに実用的な2つのグループに分類できることを明らかにしました:LLMsにとって有益なノイズ(有益なノイズ)とLLMsにとって有害なノイズ(有害なノイズ).有害なノイズは一般的にパフォーマンスを損ないますが、有益なノイズはモデルの能力や全体的なパフォーマンスのいくつかの側面を向上させる可能性があります.私たちの分析は、より堅牢で適応性のあるモデルの開発に向けた洞察を提供しています.性能.私たちの分析は、さまざまなリトリーバルシナリオにおける幻覚を軽減し、より堅牢で適応性のあるRAGソリューションの開発に向けた洞察を提供しています.

Q&A:

Q: Noise RAG Benchmark (NoiserBench)は既存のLLMの評価フレームワークとどう違うのか?

A: ノイズRAGベンチマーク(NoiserBench)は、既存のLLM評価フレームワークと異なり、現実世界のノイズの影響をシミュレートするために設計されております.特に、NoiserBenchは言語学的観点から定義された7種類のノイズを用いて、多様なノイズのある文書を体系的に作成し、RAGモデルにおけるノイズの役割を明らかにすることを目的としております.これにより、従来の評価フレームワークが限られたノイズタイプに限定され、ノイズが本質的にLLMにとって有害であると仮定する傾向があるのに対し、NoiserBenchはより実用的な適用性を持つことが期待されております.

Q: 有益なノイズがどのようにモデルの能力を向上させるのか、例を挙げていただけますか?

A: 文脈から得られる情報によれば、有益なノイズはモデルの能力を向上させるいくつかの方法があります.まず、有益なノイズはモデルの推論経路を明確にし、より標準化された回答を導くことができるとされています.これにより、モデルの自信が増し、正しい情報と誤った情報を区別する能力が向上することが示唆されています.また、有益なノイズを導入することで、モデルはゴールデンコンテキストに対する注意が高まり、正確な情報をより効果的に識別できるようになると考えられています.これらの効果は、モデルの出力を有益なノイズの導入前後で比較することによって観察されています.

Q: 実証的な評価中に予想外の結果はありましたか?また、それが結論にどのように影響しましたか?

A: 実験的な評価において、予期しない結果が観察されました.特に、ノイズがRAGシステムにおいてどのような役割を果たすかに関する研究で、驚くべき発見がありました.それは、有益なノイズがアラジンのランプの力のように機能し、モデルのパフォーマンスを向上させることができるということです.このノイズは、より明確な推論経路、より標準化された回答、そして自信の向上をもたらします.具体的には、7つのデータセットにおける結果から、平均して有益なノイズを含む37のサンプルが、ノイズを含まない31のサンプルと比較してより明確な推論を示しました(H1).また、有益なノイズを含む26のサンプルが、ノイズを含まない23のサンプルと比較してより良い出力形式を示しました(H2).これらの結果は、将来的な研究が有益なノイズのメカニズムを最大限に活用しつつ、有害なノイズの悪影響を避ける方法を提案することを期待させるものでした.