ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- MVDream: Multi-view Diffusion for 3D Generation (発行日:2023年08月31日)

- LLaSM: Large Language and Speech Model (発行日:2023年08月30日)

- SAM-Med2D (発行日:2023年08月30日)

- AnomalyGPT: Detecting Industrial Anomalies using Large Vision-Language Models (発行日:2023年08月29日)

- Vector Search with OpenAI Embeddings: Lucene Is All You Need (発行日:2023年08月29日)

- FaceChain: A Playground for Identity-Preserving Portrait Generation (発行日:2023年08月28日)

- Nougat: Neural Optical Understanding for Academic Documents (発行日:2023年08月25日)

- Qwen-VL: A Versatile Vision-Language Model for Understanding, Localization, Text Reading, and Beyond (発行日:2023年08月24日)

- Graph of Thoughts: Solving Elaborate Problems with Large Language Models (発行日:2023年08月18日)

- FacTool: Factuality Detection in Generative AI — A Tool Augmented Framework for Multi-Task and Multi-Domain Scenarios (発行日:2023年07月25日)

MVDream: Multi-view Diffusion for 3D Generation

著者:Yichun Shi, Peng Wang, Jianglong Ye, Mai Long, Kejie Li, Xiao Yang

発行日:2023年08月31日

最終更新日:2023年08月31日

URL:http://arxiv.org/pdf/2308.16512v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

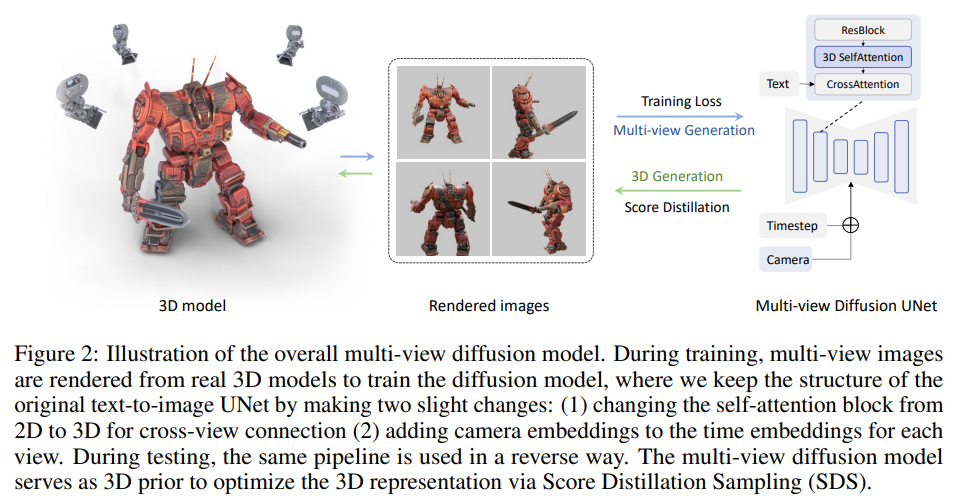

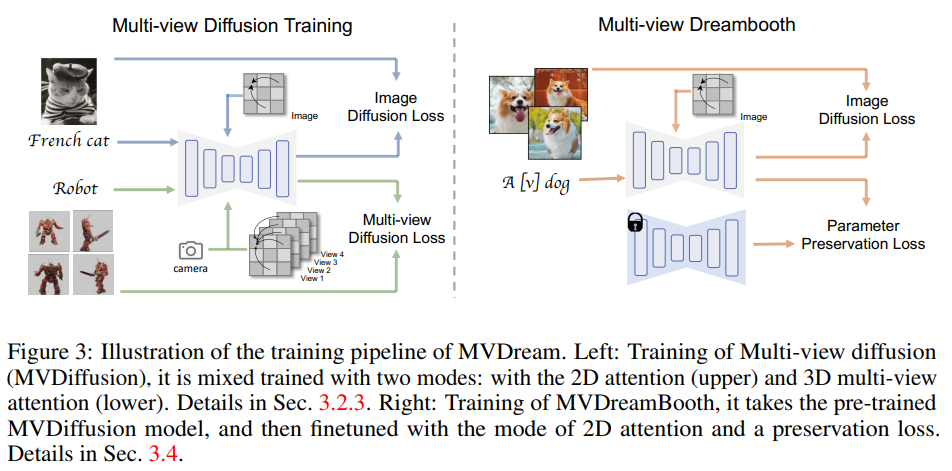

MVDreamは、与えられたテキストプロンプトから幾何学的に一貫したマルチビューイメージを生成することができるマルチビューディフュージョンモデルです.大規模なウェブデータセットで事前にトレーニングされた画像ディフュージョンモデルと、3Dアセットからレンダリングされたマルチビューデータセットを活用することにより、得られるマルチビューディフュージョンモデルは、2Dディフュージョンの汎用性と3Dデータの一貫性の両方を実現することができます.そのようなモデルは、スコア蒸留サンプリングを介して3D生成のマルチビュープライオリとして適用することができます.これにより、既存の2Dリフティング手法の安定性が向上し、3Dの一貫性の問題が解決されます.最後に、マルチビューディフュージョンモデルは、個別の3D生成のためのフューショット設定で微調整することもできます.つまり、DreamBooth3Dアプリケーションでは、主体の一貫性を学習した後も維持することができます.

Q&A:

Q: MVDreamは、与えられたテキストプロンプトから幾何学的に一貫したマルチビュー画像をどのように生成しますか?

A: MVDreamは、大規模なウェブデータセットで事前にトレーニングされた画像拡散モデルと、3Dアセットからレンダリングされたマルチビューデータセットを活用して、与えられたテキストプロンプトから幾何学的に一貫したマルチビュー画像を生成します.生成されたマルチビュー拡散モデルは、2D拡散の汎用性と3Dデータの一貫性の両方を実現しています.このモデルは、スコア蒸留サンプリングを介して3D生成のマルチビュープライオリとして適用することができ、既存の2Dリフティング方法の安定性を向上させるために3Dの一貫性問題を解決します.さらに、MVDreamは、少数のショット設定で個別の3D生成のために微調整することができ、対象のアイデンティティを学習した後も一貫性を保ちます.

Q: MVDreamは、マルチビュー画像を生成するためにどのような画像拡散モデルを活用していますか?

A: MVDreamは、大規模なウェブデータセットと3Dアセットからレンダリングされたマルチビューデータセットで事前にトレーニングされた画像拡散モデルを活用しています.

Q: これらの画像拡散モデルは、大規模なウェブデータセットで事前にトレーニングされていますか?

A: これらの画像拡散モデルは、大規模なウェブデータセットで事前学習されます.

Q: MVDreamで使用される3Dアセットからレンダリングされたマルチビューデータセットは何に使用されていますか?

A: MVDreamは、3Dアセットからレンダリングされたマルチビューデータセットを使用して、与えられたテキストプロンプトから幾何学的に一貫したマルチビュー画像を生成するための3Dデータの一貫性を実現します.このデータセットは、大規模なウェブデータセットで事前にトレーニングされた画像拡散モデルと共に活用され、マルチビュー拡散モデルのトレーニングに使用されます.このモデルは、スコア蒸留サンプリングを介した3D生成のためのマルチビュープライオリとして機能し、既存の2Dリフティングメソッドの安定性を向上させると同時に、3Dの一貫性の問題を解決します.さらに、マルチビューディフュージョンモデルは、少数のショット設定で個別の3D生成のために微調整することができ、対象のアイデンティティを学習した後も一貫性を保ちます.

Q: 2D拡散の汎用性と3Dデータの一貫性を、マルチビューディフュージョンモデルはどのように実現していますか?

A: マルチビューディフュージョンモデルは、2Dディフュージョンの汎化性と3Dデータの一貫性の両方を実現するために、2Dイメージディフュージョンのアーキテクチャを若干変更してマルチイメージ生成に使用します.これにより、2Dディフュージョンモデルの汎化性を受け継ぐために、事前にトレーニングされた2Dディフュージョンモデルを転移学習に使用することができます.また、モデルのマルチビューの一貫性を確保するために、実際の3Dデータセットであるobjaverseからマルチビューイメージをレンダリングします.マルチビューディフュージョンモデルは、これらの手法を組み合わせることで、良好な一貫性と汎化性を実現することができます.

Q: スコア蒸留サンプリングの概念と、3D生成のためのマルチビュー拡散モデルとの使用方法を説明していただけますか?

A: スコア蒸留サンプリング(Score Distillation Sampling)は、3D表現の最適化を監督するために拡散事前分布をスコア関数として使用する手法です.この手法では、マルチビュー拡散モデルを3D生成の事前分布として使用し、既存の2Dリフティング手法の安定性を向上させることができます.スコア蒸留サンプリングは、3D表現の最適化において、拡散モデルのスコア関数を使用して、3D表現の最適化を監督します.具体的には、スコア関数は、最適化の目標となる3D表現のスコアを計算し、最適化アルゴリズムによってこのスコアを最大化するように調整されます.マルチビュー拡散モデルは、スコア蒸留サンプリングにおいて、既存の安定拡散モデルの代わりに使用されます.この手法により、既存の2Dリフティング手法の安定性が向上し、3D生成のマルチビューの一貫性の問題が解決されます.

Q: 多視点拡散モデルは、3Dの一貫性の問題を解決することにより、既存の2Dリフティング手法の安定性を向上させるのですか?

A: マルチビューディフュージョンモデルは、2Dリフティングメソッドの安定性を向上させるために、3Dの一貫性の問題を解決することによって安定性を向上させます.マルチビューディフュージョンモデルは、複数のビューの画像を同時に生成し、それらが互いに一貫性を持つようにします.これにより、2Dの拡散モデルでは解決できない3Dの一貫性の問題を解決し、冗長で不一致なコンテンツを生成しないようにします.

Q: マルチビュー拡散モデルがパーソナライズされた3D生成のフューショット設定下でどのように微調整されるか、例またはデモンストレーションを提供していただけますか?

A: マルチビューディフュージョンモデルは、個別の3D生成のためにフューチャーショット設定で微調整されることがあります.これにより、ユーザー固有の3D生成(マルチビュードリームブース)が可能になります.

Q: DreamBooth3Dアプリケーションとは何ですか?また、マルチビュー拡散モデルはそれにどのように貢献していますか?

A: DreamBooth3Dは、提供された画像のコレクションからアイデンティティ情報を吸収し、その後の微調整によって堅牢なマルチビューの一貫性を示す3D生成アプリケーションです.マルチビュー拡散モデルは、このDreamBooth3Dアプリケーションにおいて、アイデンティティ情報の吸収とマルチビューの一貫性の実現に貢献します.

Q: 個別の3D生成プロセスの学習後、マルチビューディフュージョンモデルは、主体のアイデンティティを維持するための一貫性をどのように保証していますか?

A: マルチビューディフュージョンモデルは、学習後に被写体のアイデンティティを維持するために、少数ショット設定で微調整することができます.これにより、一貫性を保つことができます.

LLaSM: Large Language and Speech Model

著者:Yu Shu, Siwei Dong, Guangyao Chen, Wenhao Huang, Ruihua Zhang, Daochen Shi, Qiqi Xiang, Yemin Shi

発行日:2023年08月30日

最終更新日:2023年08月30日

URL:http://arxiv.org/pdf/2308.15930v1

カテゴリ:Computation and Language, Machine Learning, Sound, Audio and Speech Processing

概要:

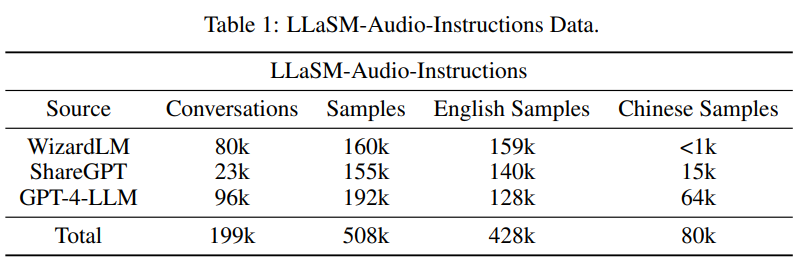

最近、マルチモーダルな大規模言語モデルが注目を集めています.しかし、これまでの研究の多くは、ビジョンと言語のマルチモーダルモデルに焦点を当てており、ビジョンと言語の指示に従う強力な能力を提供しています.しかし、私たちは音声も人間が世界とやり取りするための重要なモダリティであると主張します.したがって、汎用のアシスタントがマルチモーダルな音声と言語の指示に従えることは重要です.本研究では、Large Language and Speech Model (LLaSM)を提案します.LLaSMは、音声と言語のマルチモーダルな大規模なエンドツーエンドトレーニングモデルであり、クロスモーダルな会話能力を持ち、音声と言語の指示に従うことができます.初期の実験では、LLaSMが人間が人工知能と対話するためのより便利で自然な方法を示していることがわかりました.具体的には、私たちはまた、大規模な音声指示に従うデータセットであるLLaSM-Audio-Instructionsを公開しています.コードとデモはhttps://github.com/LinkSoul-AI/LLaSMおよびhttps://huggingface.co/spaces/LinkSoul/LLaSMで利用可能です.LLaSM-Audio-Instructionsデータセットはhttps://huggingface.co/datasets/LinkSoul/LLaSM-Audio-Instructionsで利用可能です.

Q&A:

Q: 提案された大規模言語音声モデル(LLaSM)の主な焦点は何ですか?

A: 提案されたLarge Language and Speech Model (LLaSM)の主な焦点は、音声と言語の指示に従う能力を持つ大規模なマルチモーダル音声言語モデルであることです.

Q: LLaSMは他のマルチモーダルモデルとどのように異なるのですか?

A: LLaSMは、他のマルチモーダルモデルとは異なり、エンドツーエンドで訓練された大規模なマルチモーダル音声言語モデルであり、クロスモーダルな会話能力を持っています.音声と言語の指示を理解し、追従することができます.LLaSMは、訓練済みの音声モーダルエンコーダとLLMを活用することで、リソースをより効率的に利用しています.Whisperを音声エンコーダとして使用し、音声信号を埋め込みにエンコードし、モーダルアダプターが離散的な音声トークンをLLMの語彙に展開することを学習します.このアプローチにより、他のマルチモーダルモデルで必要とされる大量のマルチモーダルデータと膨大な計算リソースでLLMを再訓練する必要がなくなります.さらに、LLaSMは人間が人工知能と対話するためのより便利で自然な方法を提供します.

Q: 人間の世界との相互作用における言語としての意義は何ですか?

A: 音声は、意味情報と共にイントネーションなどのパラ言語情報を含んでおり、テキストよりも多くの情報を伝えることができます.さらに、音声は人間が人工知能と対話する際により便利で自然な方法です.そのため、一般的な目的のアシスタントを開発する際には、音声と言語の指示に従うことが重要です.

Q: LLaSMはどのように訓練され、そのクロスモーダルな会話能力はどのようなものですか?

A: LLaSMは、大量のマルチモーダルデータと膨大な計算リソースを用いて再トレーニングされます.具体的には、Whisperという音声エンコーダを使用して音声信号を埋め込みにエンコードし、モーダルアダプタが学習して音声と言語の指示を理解し、追従する能力を持つようになります.LLaSMは、音声と言語の指示を理解し、追従する能力を持つ大規模な音声言語モデルであり、人間が人工知能と対話するためのより便利で自然な方法を提供します.

Q: LLaSMは、効果的に音声言語の指示に従うことができますか?

A: はい、LLaSMは効果的に音声と言語の指示に従うことができます.

Q: LLaSMの初期実験結果は何ですか?

A: LLaSMは、人間が人工知能と対話するためのより便利で自然な方法を示しています.

Q: LLaSM-Audio-Instructionsデータセットはどこでアクセスできますか?

A: LLaSM-Audio-Instructionsデータセットは、https://huggingface.co/datasets/LinkSoul/LLaSM-Audio-Instructionsでアクセスできます.

Q: LLaSMは、人間が人工知能と対話するためのより便利で自然な方法を提供していますか?

A: LLaSMは、音声と言語の指示に従う能力を持つ大規模なマルチモーダル音声言語モデルであり、人間が人工知能と対話するためのより便利で自然な方法を提供します.LLaSMは、音声と言語の指示を理解し、それに従う能力を持っています.これにより、人間は自然な言語で指示を出すことができ、人工知能との対話がよりスムーズに行えます.また、LLaSM-Audio-Instructionsという大規模な音声指示データセットを構築することで、音声と言語の指示データの不足を解消しています.これは、私たちの知る限りでは最大の中国語と英語の音声テキストクロスモーダル指示データセットです.

Q: この論文で紹介された新しいメソッドのコード実装のURLは何ですか?

A: 本論文で導入された新しい手法のコード実装のURLはhttps://github.com/LinkSoul-AI/LLaSMです.

SAM-Med2D

著者:Junlong Cheng, Jin Ye, Zhongying Deng, Jianpin Chen, Tianbin Li, Haoyu Wang, Yanzhou Su, Ziyan Huang, Jilong Chen, Lei Jiang, Hui Sun, Junjun He, Shaoting Zhang, Min Zhu, Yu Qiao

発行日:2023年08月30日

最終更新日:2023年08月30日

URL:http://arxiv.org/pdf/2308.16184v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

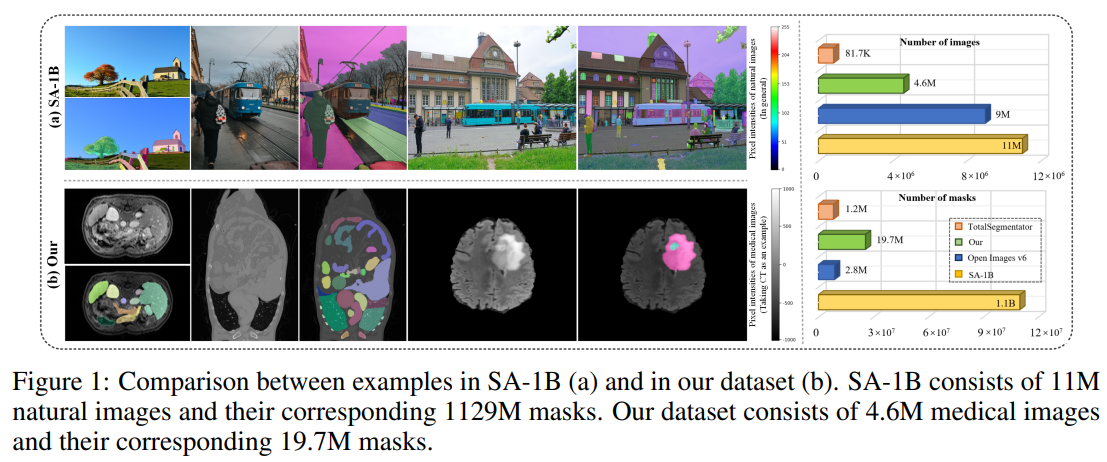

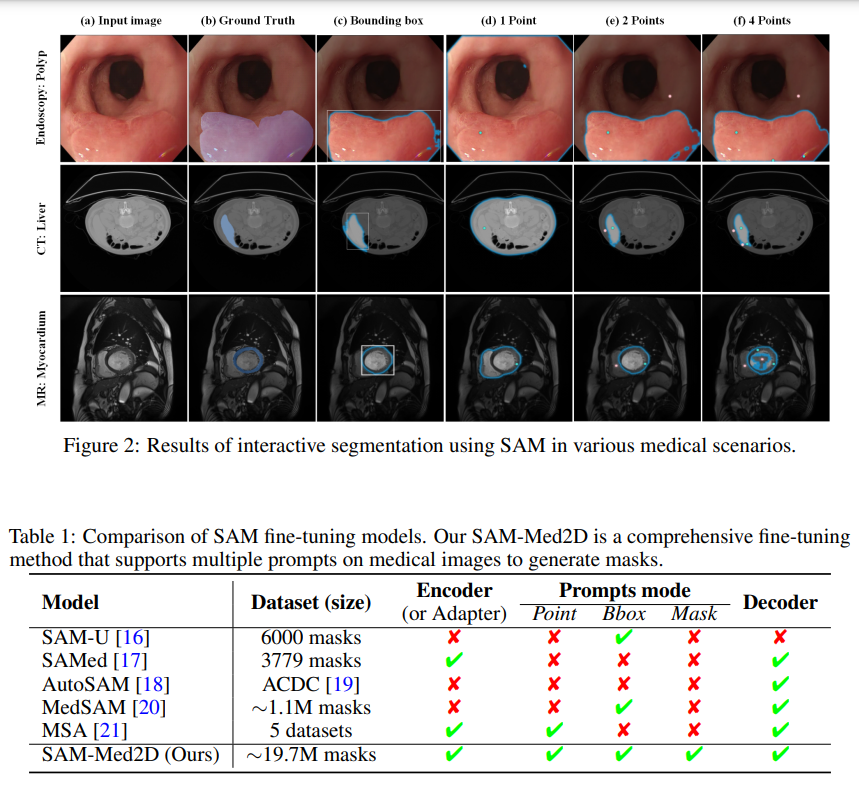

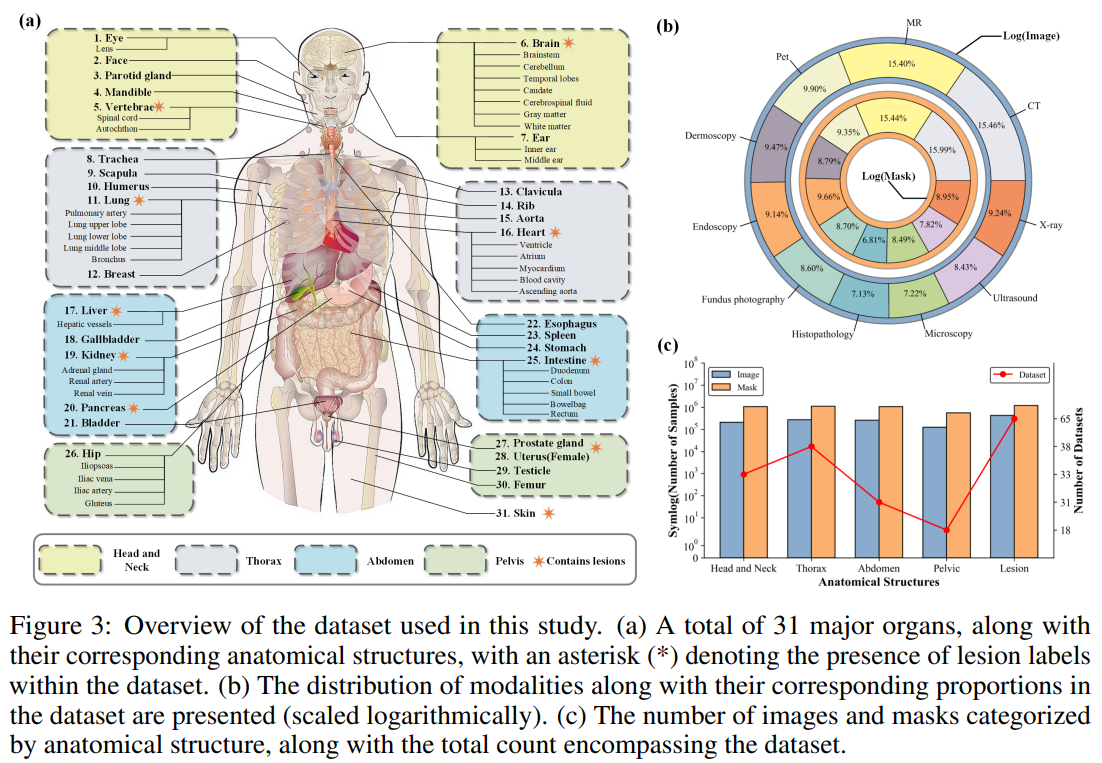

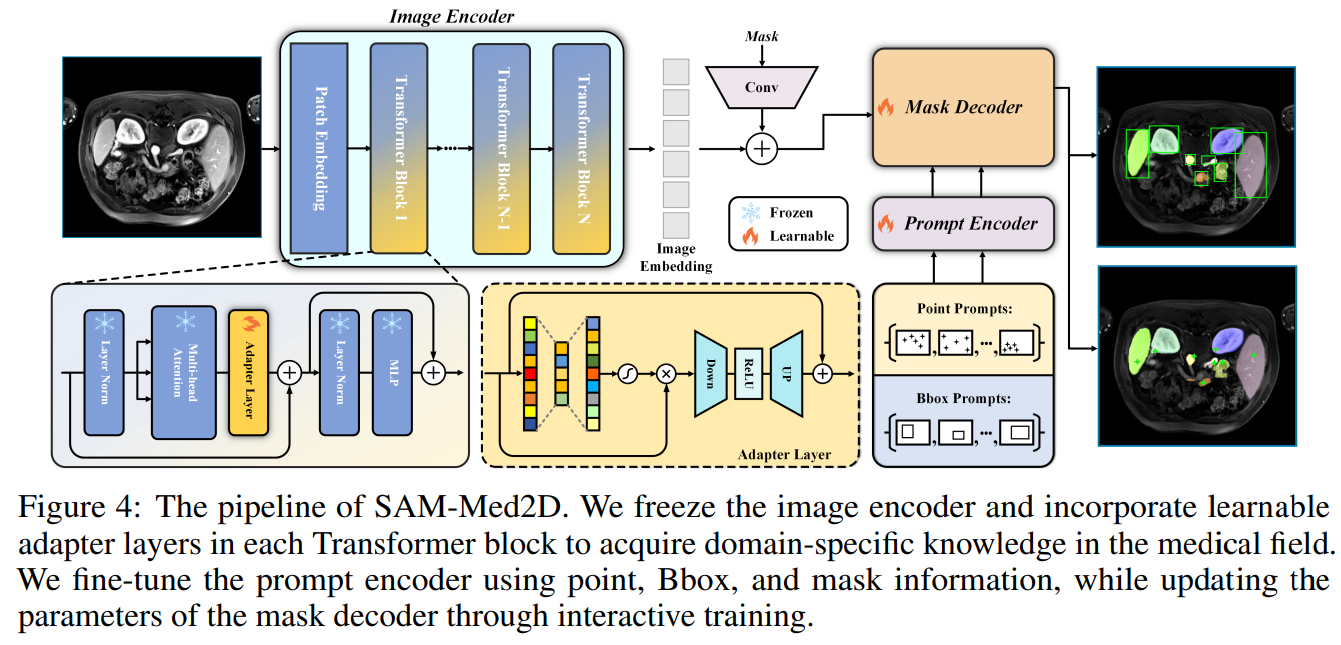

セグメントアニシングモデル(SAM)は、自然画像セグメンテーションの最先端の進歩を表し、ポイントやバウンディングボックスなどの入力プロンプトを使用して印象的な結果を達成します.しかし、私たちの評価と最近の研究によると、事前にトレーニングされたSAMを直接医療画像セグメンテーションに適用すると、満足のいくパフォーマンスは得られません.この制限は、自然画像と医療画像の間の重要なドメインギャップから主に生じます.このギャップを埋めるために、私たちはSAM-Med2Dを紹介します.これは、SAMを医療2D画像に適用するための最も包括的な研究です.具体的には、まず、公開および非公開のデータセットから約460万枚の画像と1970万枚のマスクを収集し、さまざまなモダリティとオブジェクトを含む大規模な医療画像セグメンテーションデータセットを構築します.次に、このデータセットでSAMを広範に微調整し、それをSAM-Med2Dに変換します.バウンディングボックスとポイントのプロンプトのみを採用する従来の方法とは異なり、私たちはマスクを含むより包括的なプロンプトを介してSAMを医療画像セグメンテーションに適応させます.さらに、微調整を行います.さらに、元のSAMのエンコーダーとデコーダーを改良して、優れたパフォーマンスを発揮するSAM-Med2Dを得るために、これまでで最も包括的な微調整戦略を採用します.最後に、さまざまなモダリティ、解剖学的構造、および臓器にわたる医療画像セグメンテーションにおけるSAM-Med2Dのパフォーマンスを総合的に評価および分析します.同時に、MICCAI 2023チャレンジの9つのデータセットでSAM-Med2Dの汎化能力を検証します.全体として、私たちのアプローチは、SAMと比較して、著しく優れたパフォーマンスと汎化能力を示しています.

Q&A:

Q: セグメントアニシングモデル(SAM)とは何ですか?また、その入力プロンプトは何ですか?

A: Segment Anything Model (SAM)は、自然画像のセグメンテーションにおいて、ポイントやバウンディングボックスなどの入力プロンプトを使用して印象的な結果を達成する最先端の研究進展を表しています.

Q: なぜ事前学習済みのSAMを医療画像セグメンテーションに直接適用しても満足のいくパフォーマンスが得られないのでしょうか?

A: 医療画像セグメンテーションに事前学習されたSAMを直接適用すると、満足のいくパフォーマンスが得られない理由は、SAMが自然画像のみで訓練されているため、医療画像に関連する特定の知識が欠如しているからです.医療データの準備にはドメイン知識が必要であり、その品質は病院や臨床研究によって大きく異なります.また、医療画像と自然画像の数量の格差も大きな課題です.これらの課題が、医療画像と自然画像のデータ量の比較を示す図1の棒グラフにも反映されています.したがって、SAMを医療画像に転送するためには、SAMを医療画像に適応させる方法を見つける必要があります.

Q: SAM-Med2Dとは何ですか?また、事前学習済みのSAMの制限にどのように対処していますか?

A: SAM-Med2Dは、医療画像ドメインに適応するために、大規模な医療画像データセットでSAMを微調整したものです.SAM-Med2Dは、複雑な臓器構造、病変、境界の不明な症例を扱う能力において、SAMよりも優れたパフォーマンスを示します.しかし、19.7MのマスクでSAM-Med2Dをトレーニングしているにもかかわらず、トレーニングデータとSAMの解像度との間にはまだギャップがあります.そのため、SAM-Med2Dは一般的な臓器や病変の処理には効果的ですが、医療ドメイン全体における「すべて」の能力には欠けています.今後、データエンジンを使用して、より多くの高品質なマスクを生成し、SAM-Med2Dがあらゆるタイプの医療画像を正確にセグメンテーションできるようにする予定です.

Q: SAM-Med2Dのために、どのように大規模な医療画像セグメンテーションデータセットが構築されましたか?

A: SAM-Med2Dのための大規模な医療画像セグメンテーションデータセットは、4.6M枚の画像と19.7M枚のマスクからなる医療画像セグメンテーションデータセットを収集および編集することによって構築されました.このデータセットは、複数のモダリティを含み、包括的なオブジェクトをカバーしており、最も大規模な医療画像セグメンテーションデータセットを表しています.

Q: SAM-Med2Dで医療画像セグメンテーションに使用されるプロンプトは何ですか?

A: SAM-Med2Dは、医療画像セグメンテーションのために、バウンディングボックス、ポイント、およびマスクを含む包括的なプロンプトを使用します.

Q: 元のSAMのエンコーダーとデコーダーはどのように微調整され、SAM-Med2Dが作成されましたか?

A: 元のSAMのエンコーダーとデコーダーは、SAM-Med2Dを作成するために微調整されました.エンコーダーは、Adapterテクノロジーを導入して、医療ドメインの知識を低コストで組み込むためにパラメータを凍結しました.デコーダーは、両方のエンコーダーから埋め込まれた情報を受け取り、クロスアテンションメカニズムを介して画像埋め込みとプロンプト埋め込みを更新します.

Q: SAM-Med2Dのパフォーマンスを調査するために行われた総合評価と分析は何でしたか?

A: SAM-Med2Dのパフォーマンスを調査するために、包括的な評価と分析が行われました.この評価では、さまざまなモダリティ、解剖学的構造、臓器における医療画像セグメンテーションの性能を調査しました.また、MICCAI 2023チャレンジの9つのデータセットを使用して、SAM-Med2Dの汎化能力も検証しました.総合的に見て、我々の手法はSAMと比較して、優れたパフォーマンスと汎化能力を示しました.

Q: SAM-Med2Dは、パフォーマンスと汎化能力の観点でSAMと比較してどのようになりますか?

A: SAM-Med2Dは、SAMと比較して、複雑な臓器構造、病変、境界の不明な症例の処理において優れたパフォーマンスを示し、医療画像のセグメンテーションにおける専門知識を持っています.また、SAM-Med2Dは、未知の医療画像環境においても正確なセグメンテーションを実現する強力な汎化能力を持っています.

Q: MICCAI 2023チャレンジの9つのデータセットにおけるSAM-Med2Dの検証について、もっと詳細を提供していただけますか?

A: MICCAI 2023の9つのデータセットでのSAM-Med2Dの検証について、私たちは以下の詳細を提供します.これらのデータセットは、異なるソース、機関、またはデバイスから収集された医療画像を表しており、多様性を提供しています.私たちはこれらのデータセット上でSAM-Med2Dを評価することによって、新しいデータに対する汎化能力を検証することができます.これは、私たちの手法の臨床シナリオやデータソースの幅広い適用性を検証する上で重要です.

AnomalyGPT: Detecting Industrial Anomalies using Large Vision-Language Models

著者:Zhaopeng Gu, Bingke Zhu, Guibo Zhu, Yingying Chen, Ming Tang, Jinqiao Wang

発行日:2023年08月29日

最終更新日:2023年08月29日

URL:http://arxiv.org/pdf/2308.15366v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

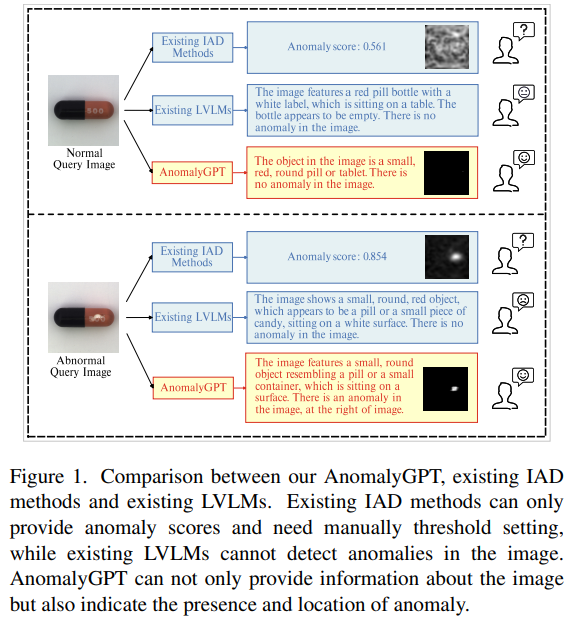

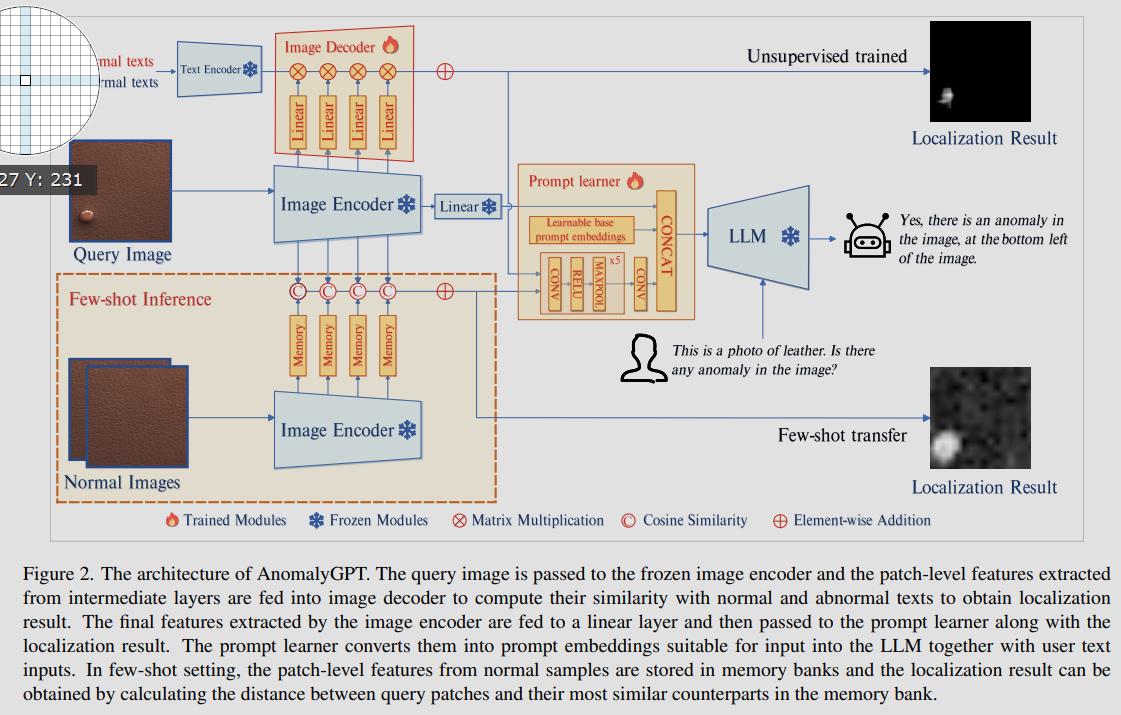

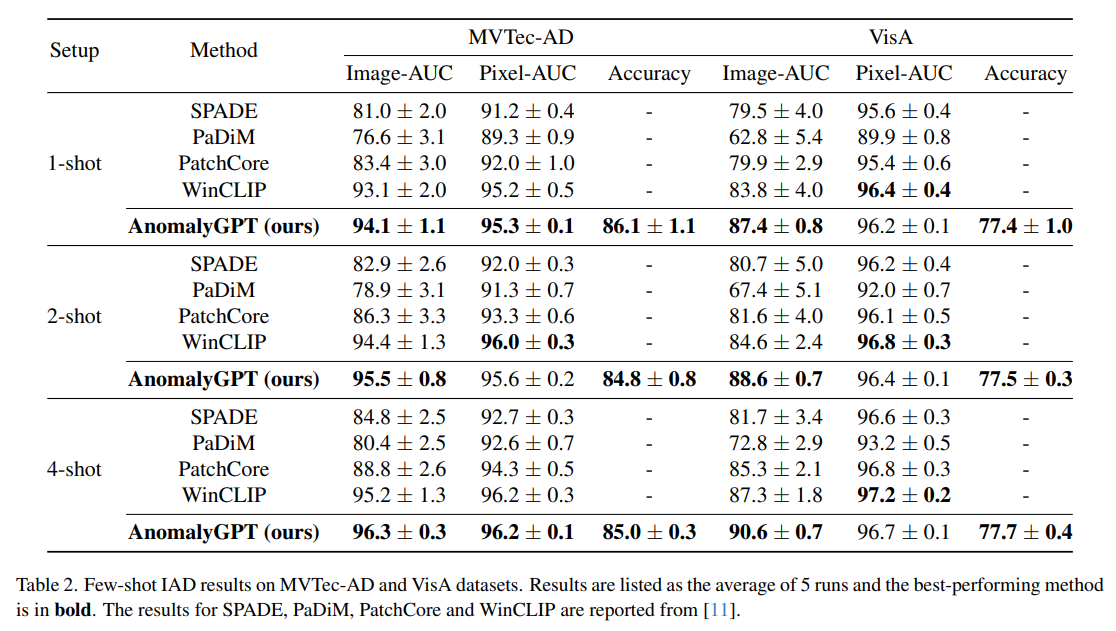

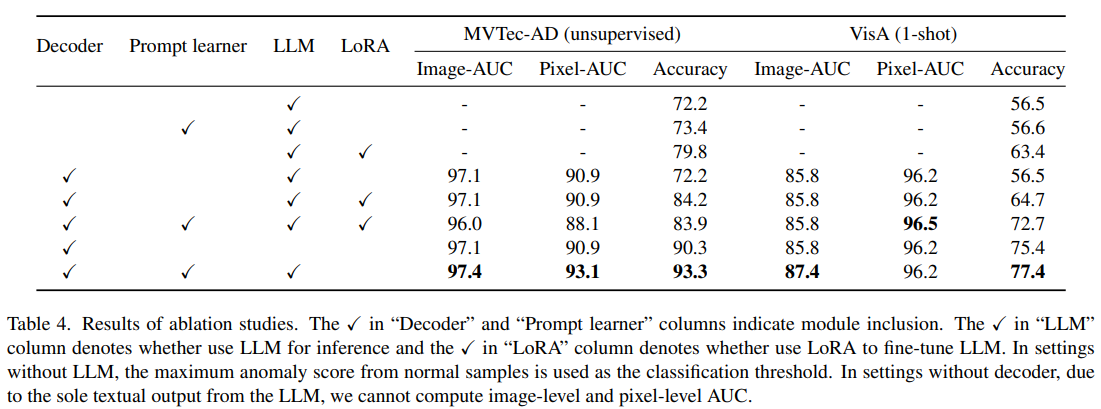

大規模なビジョン-言語モデル(LVLM)であるMiniGPT-4やLLaVAは、画像の理解能力を示し、さまざまな視覚的なタスクで驚異的なパフォーマンスを達成しています.しかし、広範なトレーニングデータセットによる一般的なオブジェクトの認識能力にもかかわらず、特定のドメイン知識が欠如しており、オブジェクト内の局所的な詳細の理解力が弱いため、産業的な異常検知(IAD)タスクでの効果が制限されています.一方、既存のほとんどのIAD手法は異常スコアを提供するだけであり、正常と異常のサンプルを区別するために手動で閾値を設定する必要があり、実用化を制限しています.本論文では、LVLMを利用してIAD問題に取り組み、LVLMに基づく新しいIADアプローチであるAnomalyGPTを提案します.我々は異常な画像をシミュレートし、各画像に対応するテキストの説明を生成することでトレーニングデータを生成します.また、画像デコーダを使用して細かい意味情報を提供し、プロンプトの埋め込みを使用してLVLMを微調整するためのプロンプト学習者を設計します.AnomalyGPTは、手動で閾値を調整する必要がないため、存在を直接評価し、異常の検出を行います.さらに、AnomalyGPTはマルチターンの対話をサポートし、印象的なフューショットのコンテキスト学習能力を示しています.MVTec-ADデータセットでは、正常なショットが1つだけで、AnomalyGPTは86.1%の精度、94.1%の画像レベルのAUC、95.3%のピクセルレベルのAUCという最先端のパフォーマンスを達成しています.コードはhttps://github.com/CASIA-IVA-Lab/AnomalyGPTで入手可能です.

Q&A:

Q: 大規模なビジョン言語モデル(LVLM)の制約は、オブジェクト内の局所的な詳細を理解することにありますか?

A: LVLMsの限界は、物体内の局所的な詳細を理解する能力の欠如です.

Q: IADメソッドにおける手動閾値設定の欠点は何ですか?

A: IADメソッドにおける手動の閾値設定の欠点は、異常検出のための最適な閾値を見つけることが困難であることです.

Q: アノマリーGPTは、IADの問題に対処するためにLVLMをどのように利用していますか?

A: AnomalyGPTは、合成された異常な視覚的テキストデータを使用してモデルを微調整し、IAD知識をモデルに統合するためにLVLMを利用しています.トレーニングデータは、異常な画像をシミュレートし、各画像に対応するテキストの説明を生成することで生成されます.画像デコーダも使用され、画像に関する詳細な意味情報を提供します.このアプローチにより、AnomalyGPTは手動の閾値設定の必要なく、異常の存在と位置を検出することができます.さらに、AnomalyGPTは少数の正常なサンプルでインコンテキスト学習を行い、以前に見たことのないオブジェクトに迅速に適応することができます.

Q: AnomalyGPTのトレーニングデータはどのように生成されていますか?

A: AnomalyGPTは、シミュレートされた異常データ、画像デコーダー、およびプロンプトの埋め込みを利用してトレーニングデータを生成します.

Q: AnomalyGPTにおける画像デコーダーの役割は何ですか?

A: 画像デコーダーの役割は、異常なテキストと正常なテキストとの類似度を計算し、異常の位置を特定するためにパッチレベルの特徴を抽出することです.

Q: アノマリーGPTにおいて、プロンプト学習者はLVLMをどのように微調整しますか?

A: プロンプト学習者は、画像エンコーダから抽出された最終的な特徴量を線形層に送り、それをプロンプト学習者に渡します.プロンプト学習者は、ユーザーテキスト入力とともに、特徴量をLLMに入力するための適切なプロンプト埋め込みに変換します.

Q: AnomalyGPTは、手動の閾値調整の必要性をどのように排除しますか?

A: AnomalyGPTは、手動の閾値調整の必要性を排除し、手動の閾値設定に頼らずに異常の存在と位置を直接評価します.

Q: AnomalyGPTは、異常の存在と位置をどのように評価していますか?

A: AnomalyGPTは、LVLM(Language-Vision Language Model)を利用して異常の存在と位置を評価し、通常のサンプルの少数を用いたコンテキスト学習を行います.既存のIAD(Image Anomaly Detection)手法とは異なり、手動の閾値設定は必要ありません.AnomalyGPTは、手動の閾値設定を必要とせずに画像中の異常を検出し、その位置を特定することができます.これは、合成された異常な視覚的テキストデータを使用してLVLMを微調整し、IADの知識をモデルに統合することによって実現されます.これにより、AnomalyGPTはピクセルレベルの位置特定結果を提供し、画像に関する質問に答えることができ、ユーザーとの対話的な関与を可能にします.

Vector Search with OpenAI Embeddings: Lucene Is All You Need

著者:Jimmy Lin, Ronak Pradeep, Tommaso Teofili, Jasper Xian

発行日:2023年08月29日

最終更新日:2023年08月29日

URL:http://arxiv.org/pdf/2308.14963v1

カテゴリ:Information Retrieval

概要:

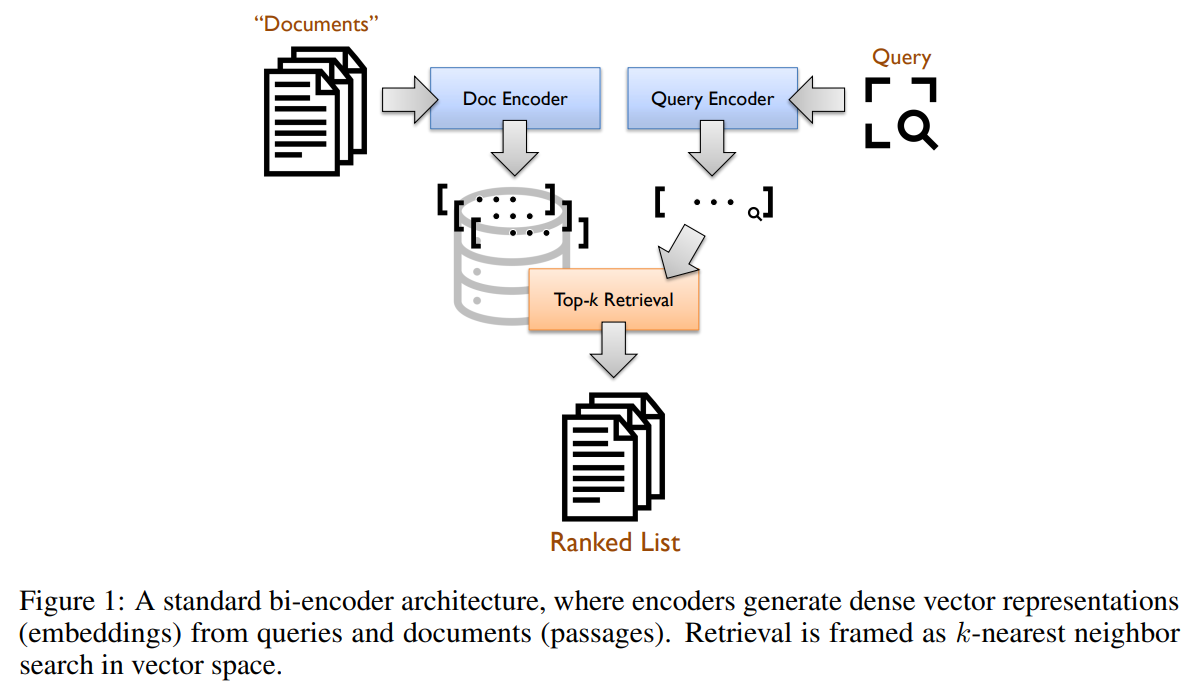

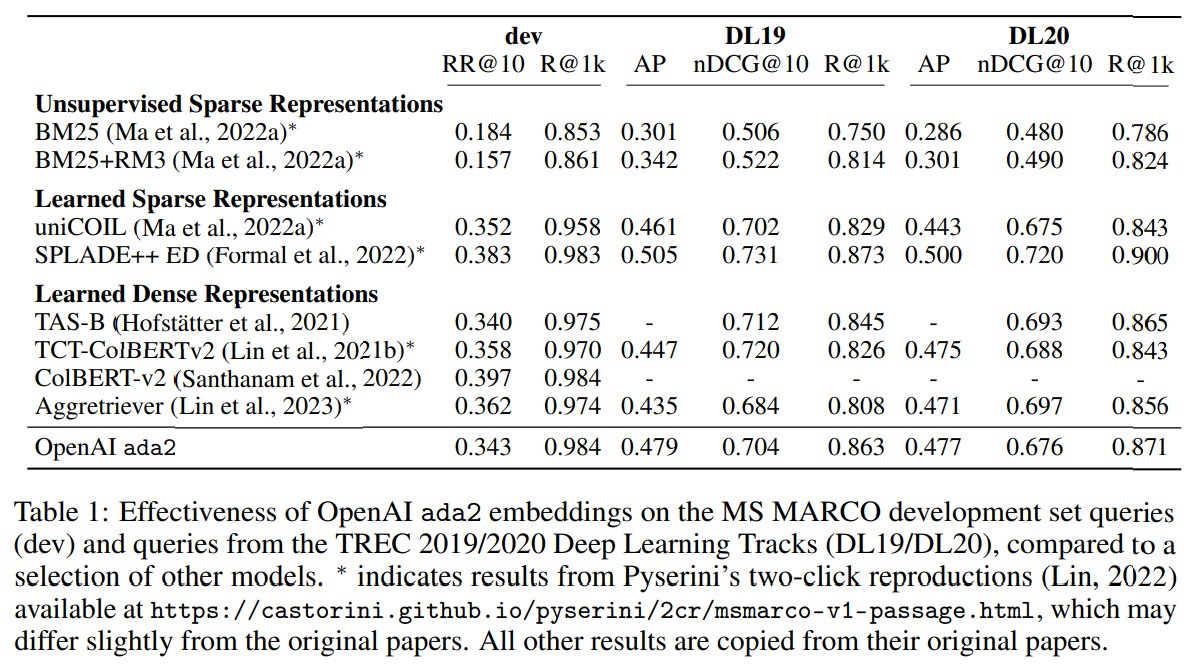

この論文では、OpenAIの埋め込みを使用してLucene上でベクトル検索を再現可能なエンドツーエンドのデモンストレーションを提供しています.私たちの研究の主な目標は、検索における深層ニューラルネットワークの最近の進歩を活用するために専用のベクトルストアが必要であるという一般的な認識に疑問を投げかけることです.むしろ、私たちは、Luceneの階層的ナビゲーション可能な小世界ネットワーク(HNSW)インデックスが、標準のバイエンコーダーアーキテクチャでベクトル検索機能を提供するのに十分であることを示しています.これにより、単純なコスト対効果分析から、既存の広く展開されたインフラストラクチャへの大規模な投資を既に受けているため、検索の現代の「AIスタック」に専用のベクトルストアを導入するには十分な理由がないように思われます.

Q&A:

Q: 作者の仕事の主な目標は何ですか?

A: 著者の主な目標は、最近の深層ニューラルネットワークの進歩を検索に応用するために専用のベクトルストアが必要であるという一般的な説明に疑問を投げかけることです.むしろ、著者らは、Luceneの階層的なナビゲーション可能な小世界ネットワーク(HNSW)インデックスが、十分な性能を提供することを示しています.

Q: 著者が挑戦している主流の物語は何ですか?

A: 筆者が挑戦している主流の物語は、最近の深層ニューラルネットワークの進歩を利用するために専用のベクトルストアが必要であるというものです.

Q: 著者の作品において、ベクトル検索に使用されている具体的な技術や方法は何ですか?

A: 著者の研究では、Luceneを使用してベクトル検索を行うために階層的ナビゲーション可能な小世界ネットワーク(HNSW)インデックスが使用されています.

Q: 著者は、Luceneのベクトル検索の効果をどのように示していますか?

A: 著者は、Luceneを使用してOpenAIの埋め込みをベクトル検索に効果的に利用することを実証しています.彼らは、MS MARCOパッセージランキングテストコレクションでの実験結果を提示し、Luceneの階層的ナビゲーション可能な小世界ネットワーク(HNSW)インデックスが標準のバイエンコーダーアーキテクチャでベクトル検索機能を提供するのに十分であることを示しています.

Q: ルシーンにおける階層的なナビゲーション可能な小世界ネットワーク(HNSW)インデックスの役割は何ですか?

A: Luceneの階層的なナビゲーション可能な小世界ネットワーク(HNSW)インデックスの役割は、ベクトル検索機能を提供することです.

Q: 著者は、ベクトル検索に専用のベクトルストアを使用する場合とLuceneを使用する場合の費用対効果分析をどのように比較していますか?

A: 著者は、専用のベクトルストアを使用する場合とLuceneを使用する場合のコスト利益分析を比較しています.著者の見解では、企業内に新しいソフトウェアコンポーネントを導入することによるアーキテクチャの複雑さが増すことを考慮すると、専用のベクトルストアが提供する利点がコスト面で優位であるかどうかは明確ではないと述べています.

Q: 検索のための現代の「AIスタック」に専用のベクトルストアを導入することについて、著者の立場は何ですか?

A: 著者は、現代の「AIスタック」に専用のベクトルストアを導入することについての立場を挑戦しています.

Q: どのようなインフラ投資がすでに検索アプリケーションに対して行われていますか?

A: 検索アプリケーションのために既に行われているインフラストラクチャの投資は、Luceneエコシステムにおける検索への既存の投資が主であることが示されています.

Q: ベクトル検索にLuceneを使用する際には、制限や潜在的な欠点はありますか?

A: はい、Luceneを使用する際の制限や潜在的な欠点がいくつかあります.文脈からは、Luceneと専用のベクトルストアの性能差が時間の経過とともに縮小する可能性があることが示唆されています.また、Luceneのパフォーマンス向上の機会が多く存在することも示されています.ただし、具体的な制限や欠点については文脈からは明確には言及されていません.

FaceChain: A Playground for Identity-Preserving Portrait Generation

著者:Yang Liu, Cheng Yu, Lei Shang, Ziheng Wu, Xingjun Wang, Yuze Zhao, Lin Zhu, Chen Cheng, Weitao Chen, Chao Xu, Haoyu Xie, Yuan Yao, Wenmeng Zhou, Yingda Chen, Xuansong Xie, Baigui Sun

発行日:2023年08月28日

最終更新日:2023年08月28日

URL:http://arxiv.org/pdf/2308.14256v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence

概要:

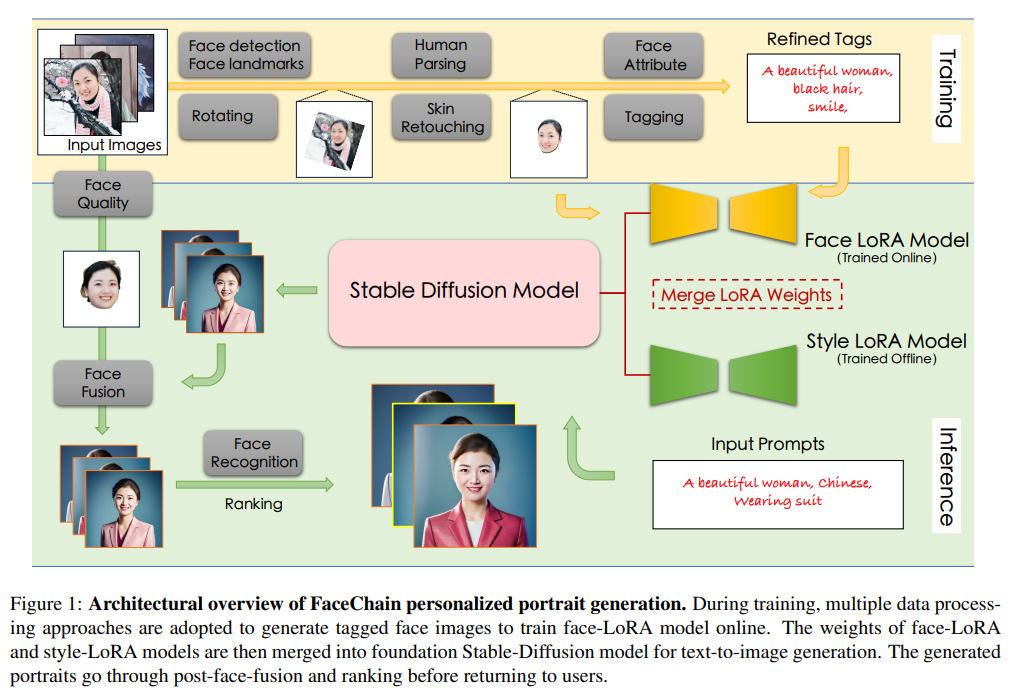

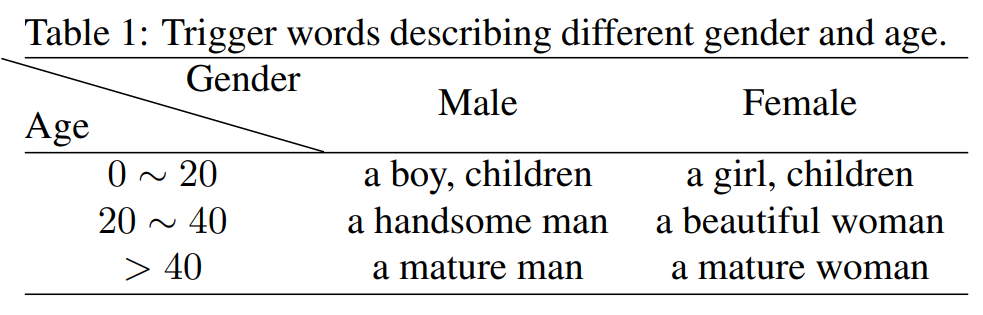

最近の個別画像生成の進歩により、事前学習されたテキストから画像へのモデルが、肖像画像のコレクションからのアイデンティティ情報の学習能力を明らかにしました.しかし、既存の解決策は真実の詳細を生成する際に脆弱であり、通常、いくつかの欠陥に苦しんでいます.具体的には、生成された顔は独自の特徴を持ち、つまり、顔の形状や顔の特徴の配置が入力の主要な特徴と似ていないことがあります.また、合成された顔には歪んだ、ぼやけた、または破損した領域が含まれる場合があります.本論文では、これらの課題に取り組み、わずかな肖像画像のみを入力として真実の個別肖像を生成するために、カスタマイズされた画像生成モデルのシリーズと豊富な顔に関連する知覚理解モデル(顔検出、深層顔埋め込み抽出、顔属性認識など)を組み合わせた個別肖像生成フレームワークであるFaceChainを提案します.具体的には、いくつかの最先端の顔モデルを生成手順に組み込み、以前の解決策と比較してより効率的なラベル付け、データ処理、およびモデルの事後処理を実現します.また、FaceChainの開発を通じて、Face/Human-Centric AIGC(人間中心のAI生成コンテンツ)の研究と応用の開発を加速するためのいくつかの可能性のある方向性を特定しました.FaceChainは、異なるスタイルと個別のニーズに対応するために簡単に調整できるプラグイン可能なコンポーネントから構成されるフレームワークとして設計されています.我々は、それがコミュニティの成長するニーズに対応するために成長することを望んでいます.FaceChainはApache-2.0ライセンスの下でオープンソース化されており、\url{https://github.com/modelscope/facechain} で利用可能です.

Q&A:

Q: 既存の個別画像生成の解決策の欠点は何ですか?

A: 既存のソリューションの欠陥は、生成された顔が独自の特徴を持ち、入力の主要な特徴と顔の形状や位置関係が一致しないこと、また合成された顔には歪んだ、ぼやけた、または破損した領域が含まれることです.

Q: FaceChainは、既存の解決策が直面する課題にどのように対処していますか?

A: FaceChainは、既存の解決策が直面する課題に対処するために、柔軟性を提供するプラグイン可能なフレームワークを提供することで、アイデンティティを保持した個人のポートレートを生成するために必要な多様性を提供します.それはStable Diffusionモデルに基づいて構築されており、テキストから画像を生成する際のスタイルの安定性とIDの一貫性を向上させるためにLoRA戦略を組み込んでいます.FaceChainはまた、ModelScopeコミュニティからの包括的な顔関連モデルを統合しており、アイデンティティを保持しながら個人のポートレートを生成することができます.さらに、FaceChainは個別のテキストから画像を生成するためのベンチマークとプレイグラウンドに拡大し、この分野でのイノベーションを促すことを目指しています.

Q: FaceChainで使用されているカスタマイズされた画像生成モデルは何ですか?

A: FaceChainは、いくつかの最先端の顔モデル(SOTA)を生成手順に組み込んでいます.

Q: FaceChainは、従来のソリューションと比較して、より効率的なラベルタグ付け、データ処理、およびモデルの後処理をどのように実現していますか?

A: FaceChainは、従来のソリューションと比較して、より効率的なラベルタグ付け、データ処理、およびモデルの後処理を実現します.これは、異なるアプローチを組み合わせてラベルタグ付けを行い、SOTAの顔モデルを生成手順に使用し、包括的な顔関連モデルの統合を行うことによって実現されます.これにより、FaceChainはアップロードされた画像から適切なサイズ、良質な肌、正しい方向の顔を抽出し、人間のアイデンティティの特徴をより簡単に生成し、アイデンティティを保持した肖像画を生成するフレームワークを構築することができます.さらに、FaceChainはプラグイン可能なフレームワークを中心に構築されており、柔軟性を提供し、異なるスタイルや個別のニーズに簡単に対応することができます.

Q: FaceChainはどのようにフレームワークとして設計されていますか?

A: FaceChainは、アイデンティティを保持した個人のポートレートを生成するために必要な柔軟性を提供するフレームワークとして設計されています.このフレームワークは、包括的な顔関連モデルの統合を行い、これらのポートレートを生成します.フレームワークは、Stable Diffusionモデルに基づいて構築されており、テキストから画像を生成する際のスタイルの安定性とIDの一貫性を向上させるためにLoRA戦略を採用しています.FaceChainは、個人のポートレート生成のプロセスをアトミックパイプライン内にカプセル化し、異なるスタイルや個人のニーズに対応するための簡単な調整を可能にします.

Q: FaceChainのプラグイン可能なコンポーネントは、異なるスタイルや個人のニーズに簡単に調整できますか?

A: はい、FaceChainのプラグイン可能なコンポーネントは、異なるスタイルや個人のニーズに簡単に調整できます.

Q: FaceChainのライセンスは何ですか?

A: FaceChainはApache-2.0ライセンスのもとでオープンソース化されています.

Q: FaceChainはどこでアクセスしてダウンロードできますか?

A: FaceChainはApache-2.0ライセンスの下でオープンソースとして提供されており、https://github.com/modelscope/facechain でアクセスおよびダウンロードすることができます.

Q: FaceChainで使用されている顔に関連する知覚理解モデルの豊富なセットについて、さらに詳細を提供していただけますか?

A: FaceChainは、顔検出、深層顔埋め込み抽出、および顔属性認識など、顔に関連する知覚理解モデルの豊富なセットを利用しています.これらのモデルは、個別の肖像生成の課題に取り組むためにフレームワークに統合されています.顔検出モデルは、入力画像内の顔の存在と位置を特定する責任を持ちます.深層顔埋め込み抽出モデルは、各顔の固有の特徴を表す高次元の特徴ベクトルを抽出します.これらの埋め込みは、異なる顔の類似性を測るために使用されます.顔属性認識モデルは、年齢、性別、感情などの顔の特定の属性を識別するために使用されます.これらの知覚理解モデルは、入力画像内の顔に関する正確で詳細な情報を提供することにより、真実の個別の肖像の生成に貢献します.

Nougat: Neural Optical Understanding for Academic Documents

著者:Lukas Blecher, Guillem Cucurull, Thomas Scialom, Robert Stojnic

発行日:2023年08月25日

最終更新日:2023年08月25日

URL:http://arxiv.org/pdf/2308.13418v1

カテゴリ:Machine Learning, Computer Vision and Pattern Recognition

概要:

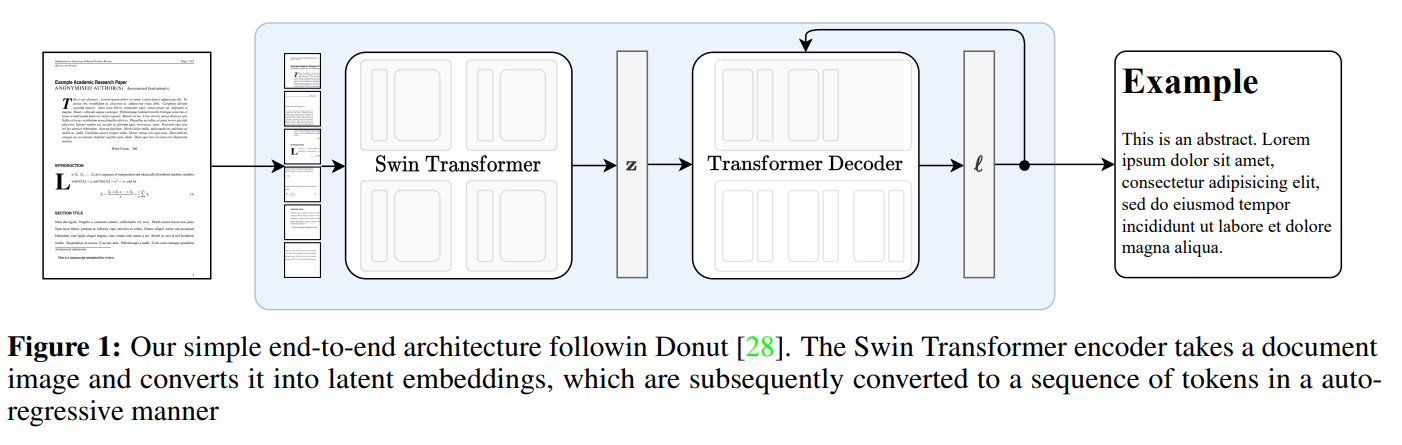

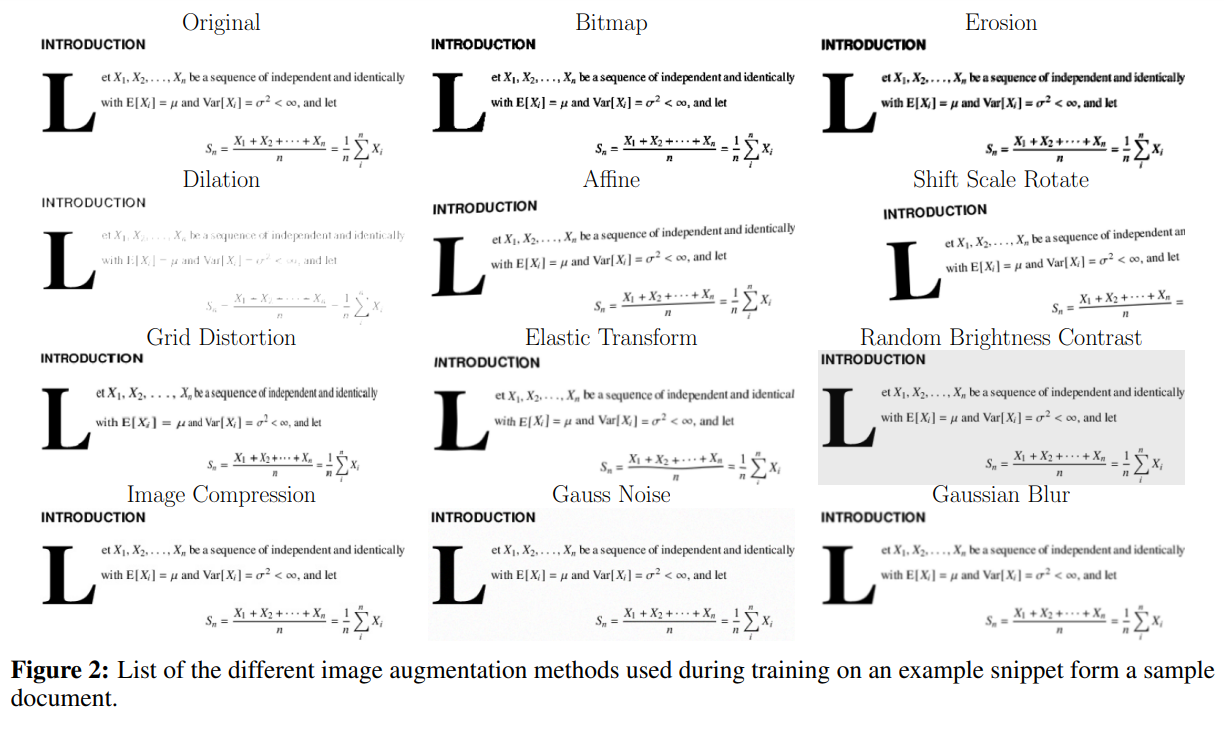

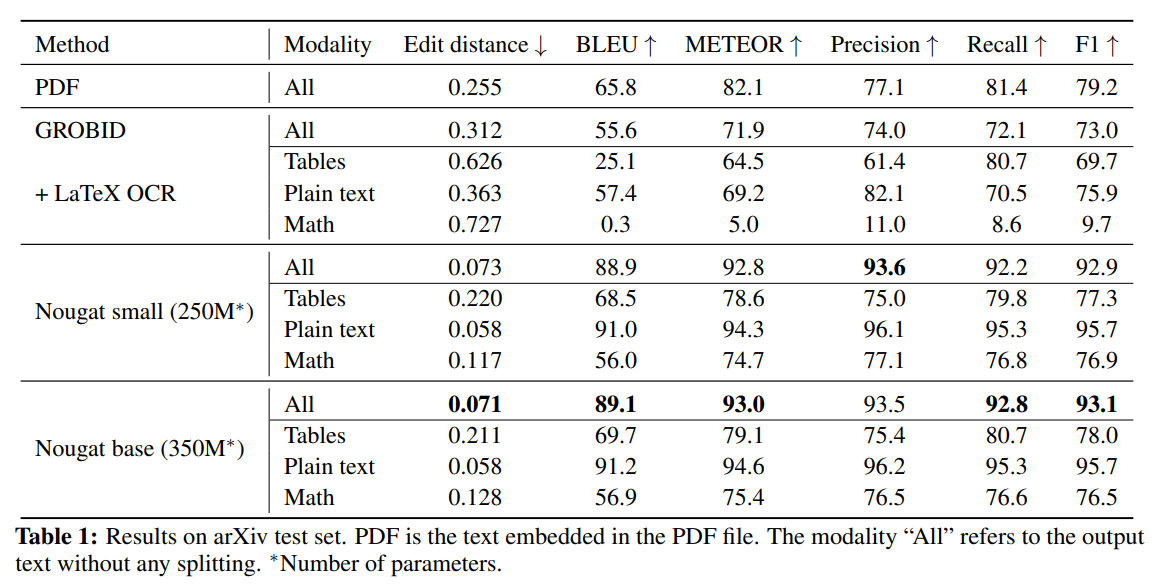

科学的な知識は主に書籍や科学雑誌に保存されており、しばしばPDF形式で提供されています.しかし、PDF形式は特に数式に関して意味情報の損失を引き起こします.本研究では、科学的なドキュメントをマークアップ言語に変換するための光学文字認識(OCR)タスクを実行するVisual TransformerモデルであるNougat(Neural Optical Understanding for Academic Documents)を提案し、新しい科学的ドキュメントのデータセットでモデルの効果を示します.提案された手法は、人間が読めるドキュメントと機械が読めるテキストとの間のギャップを埋めることで、デジタル時代における科学的な知識のアクセシビリティを向上させる有望な解決策を提供します.また、科学的なテキスト認識に関する将来の研究を加速するために、モデルとコードを公開します.

Q&A:

Q: Nougat(学術文書のためのニューラル光学理解)の目的は何ですか?

A: Nougat (Neural Optical Understanding for Academic Documents)の目的は、科学的なドキュメントをマークアップ言語に変換するための光学文字認識(OCR)タスクを実行するビジュアルトランスフォーマーモデルであり、PDF形式の科学的なドキュメントに含まれる数式や数学的な記号をマークダウンLaTeXを使用して書き込むことです.

Q: 科学文書の光学文字認識(OCR)タスクをヌガーはどのように実行しますか?

A: Nougatは、科学的なドキュメントのための光学文字認識(OCR)タスクを実行するために、ビジュアルトランスフォーマーモデルを使用します.このモデルは、科学的なドキュメントをマークアップ言語に変換するためにOCRタスクを実行します.具体的には、NougatはPDF形式の科学的なドキュメントを処理し、数式や数学記号を含むテキストをマークダウンLaTeXで書き込みます.

Q: PDF形式での意味情報の喪失の意義は、特に数学的表現において何ですか?

A: PDF形式では、特に数式において、意味情報の喪失は重要です.PDFファイルには、数式のセマンティック情報が失われるため、数式の意味や関係性を正確に抽出することが困難です.既存のOCRエンジンは、文字や単語を検出することには優れていますが、数式のような特殊な表現に対しては不十分です.OCRエンジンは、文字や単語を行ごとに処理するため、上付き文字や下付き文字を周囲のテキストと同じように扱ってしまいます.しかし、数式においては、文字の相対的な位置関係が重要です.したがって、PDF形式におけるセマンティック情報の喪失は、数式の正確な理解や抽出において重大な欠点となります.

Q: ヌガーは、人間が読みやすいドキュメントと機械が読み取れるテキストの間のギャップをどのように埋めるのか?

A: Nougatは、PDF形式の科学文書をマークアップ言語に変換するための光学文字認識(OCR)タスクを実行するビジュアルトランスフォーマーモデルです.このモデルは、PDFのセマンティック情報の損失を補うために、数式や数学記号を含む科学文書をマークアップすることができます.これにより、人間が読みやすい文書と機械が読み取り可能なテキストとのギャップを埋めることができます.

Q: ヌガットが科学文書を処理するために使用しているマークアップ言語について、もっと詳細を教えていただけますか?

A: Nougatは、科学的な文書を処理するための軽量なマークアップ言語にPDFを変換することができます.このマークアップ言語では、数式や数学記号を表現するためにマークダウンLaTeXが使用されます.

Q: ヌガーの効果を示すために使用される新しい科学文書のデータセットは何ですか?

A: Nougatは、科学的なドキュメントを処理するためのマークアップ言語に変換することができること前学習済みモデルをリリースしました.

Q: ヌガーはデジタル時代における科学知識のアクセシビリティをどのように向上させていますか?

A: Nougatは、科学的な知識をデジタル時代においてアクセスしやすくするための有望な解決策を提供しています.これは、人間が読めるドキュメントと機械が読めるテキストのギャップを埋めることで実現されます.具体的には、Nougatは光学文字認識(OCR)タスクを実行し、科学的なドキュメントをマークアップ言語に変換するためのビジュアルトランスフォーマーモデルです.特に数式のセマンティック情報の損失が問題となるPDF形式の科学的なドキュメントに対して、NougatはPDFのセマンティック情報を保持しながら、数式や数学記号を含むテキストを抽出することができます.このような機能により、科学的な知識をよりアクセスしやすくし、将来の科学的テキスト認識の研究を加速するために、モデルとコードが公開されています.

Q: 科学的なテキスト認識の分野でのヌガーの潜在的な応用や利点は何ですか?

A: Nougatは、科学的なテキスト認識の分野での潜在的な応用や利点は、PDF形式の科学的な文書をマークアップ言語に変換するためのOCRタスクを実行するビジュアルトランスフォーマーモデルである.このアプローチは、デジタル時代における科学的な知識のアクセシビリティを向上させる有望な解決策を提供する.具体的には、NougatはPDFからテキストを抽出するだけでなく、スキャンされた論文や教科書を変換することも可能である.この研究は、関連する領域での将来の研究の出発点となることを期待している.

Q: ヌガーのモデルとコードの公開プロセスを説明していただけますか?

A: Nougatのモデルとコードをリリースするプロセスは、軽量なマークアップ言語にPDFを変換することができること前学習済みモデルをリリースすることです.このモデルとコードはGitHub上で公開されています.

Q: Nougatの実装には制限や課題はありますか?

A: Nougatの実装にはいくつかの制限や課題があります.まず、モデルが繰り返しループに崩壊する傾向があります.この問題は将来の作業に残されています.また、モデルの訓練に使用されたスタイルが異なるため、文献目録などの箇所で一貫性のない結果が生じることがあります.さらに、各ページを個別に処理することは並列化と拡張性を向上させる一方で、マージされたドキュメントのテキストの品質を低下させる可能性があります.

Q: この論文で紹介された新しいメソッドのコード実装のURLは何ですか?

A: 本論文で導入された新しい手法のコード実装のURLはhttps://github.com/facebookresearch/nougatです.

Qwen-VL: A Versatile Vision-Language Model for Understanding, Localization, Text Reading, and Beyond

著者:Jinze Bai, Shuai Bai, Shusheng Yang, Shijie Wang, Sinan Tan, Peng Wang, Junyang Lin, Chang Zhou, Jingren Zhou

発行日:2023年08月24日

最終更新日:2023年09月14日

URL:http://arxiv.org/pdf/2308.12966v2

カテゴリ:Computer Vision and Pattern Recognition, Computation and Language

概要:

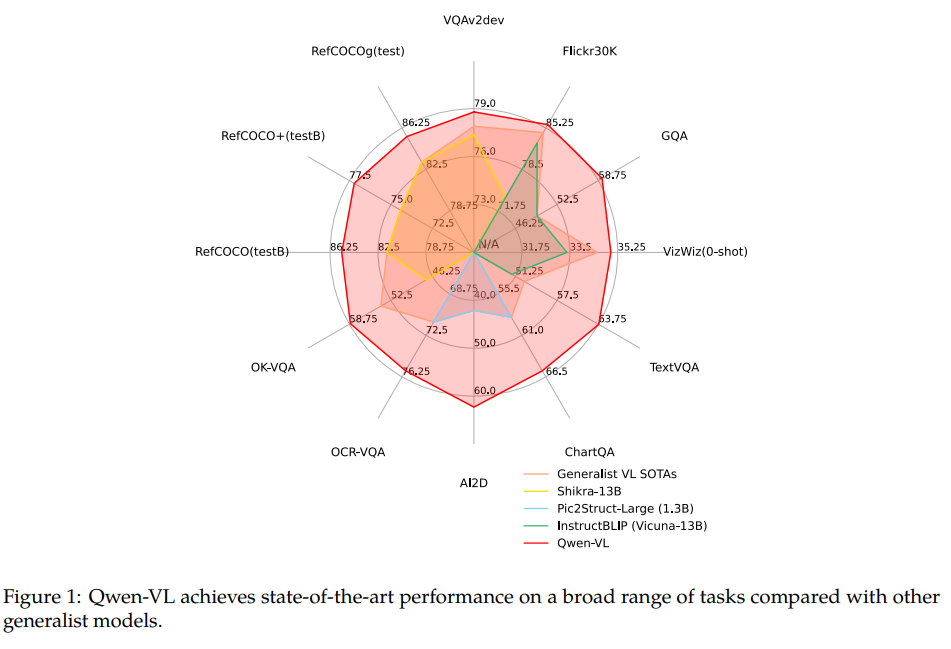

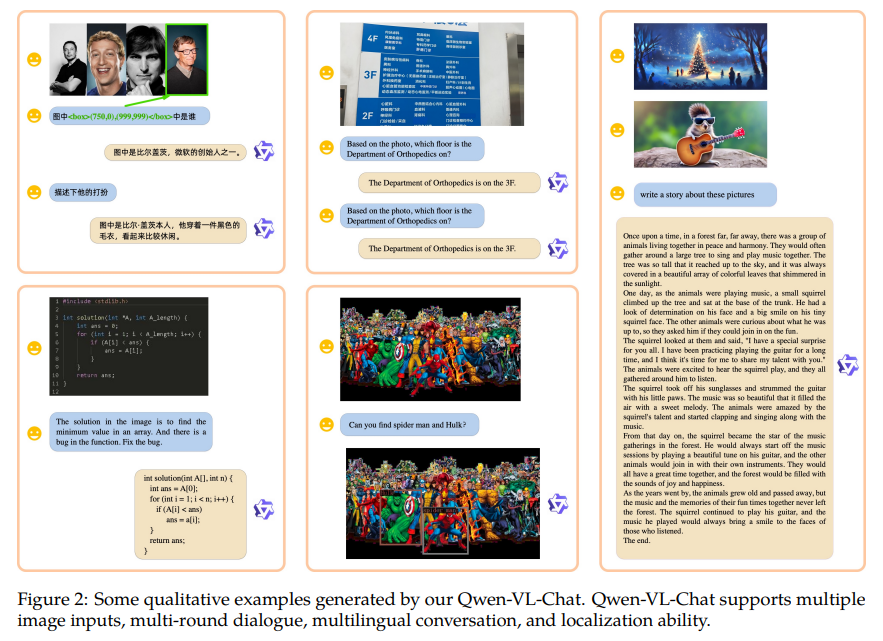

私たちは、Qwen-VLシリーズを紹介します.これは、テキストと画像の両方を認識し理解するために設計された大規模なビジョン言語モデル(LVLM)のセットです.Qwen-VLとQwen-VL-Chatから成るこれらのモデルは、画像キャプション、質問応答、視覚的な位置特定、柔軟な相互作用などのタスクで驚異的なパフォーマンスを発揮します.評価は、ゼロショットキャプション、視覚的またはドキュメント視覚的な質問応答、およびグラウンディングなど、幅広いタスクをカバーしています.私たちは、Qwen-VLが既存のLVLMを上回ることを示しています.アーキテクチャ、トレーニング、機能、パフォーマンスを紹介し、マルチモーダル人工知能の進歩における彼らの貢献を強調します.コード、デモ、モデルはhttps://github.com/QwenLM/Qwen-VLで利用可能です.

Q&A:

Q: Qwen-VLシリーズのモデルの目的は何ですか?

A: Qwen-VLシリーズのモデルの目的は、大規模なビジョン言語モデルであり、視覚的な能力を持つことです.これにより、画像の認識と理解が可能になります.また、Qwen-VLシリーズは、既存のオープンソースの大規模ビジョン言語モデルを上回る性能を持ち、多言語対応のテキスト認識とグラウンディングをサポートし、複数の画像の入力と比較、および画像に関連する質問の指定や複数の画像でのストーリーテリングが可能です.

Q: Qwen-VLモデルは、画像キャプショニングや質問応答などのタスクでどのようにパフォーマンスを発揮しますか?

A: Qwen-VLモデルは、画像キャプションや質問応答などのタスクで強力なパフォーマンスを発揮します.ゼロショットキャプション、VQA、DocVQA、Groundingなど、複数の評価ベンチマークにおいて、既存のオープンソースの大規模ビジョン言語モデル(LVLM)を同レベルのモデルスケールで大幅に上回ります.これらのモデルは、他の一般的なモデルと比較して、幅広いタスクで最先端のパフォーマンスを発揮します.画像キャプション、質問応答、視覚的な位置特定、柔軟なインタラクションなどのタスクにおいて、優れたパフォーマンスを示します.評価は、画像キャプション、一般的な視覚的な質問応答、テキスト指向の視覚的な質問応答、および参照表現の理解などのタスクをカバーしています.これらのモデルのパフォーマンスは、CIDErやVQAスコアなどのさまざまな評価ベンチマークと対応するメトリックを使用して評価されます.

Q: Qwen-VLモデルが評価されたタスクの例を提供できますか?

A: Qwen-VLモデルは、画像キャプション、一般的なビジュアル質問応答、テキスト指向型ビジュアル質問応答、参照表現理解のタスクに評価されています.

Q: Qwen-VLのパフォーマンスは既存のLVLMと比較してどのようになりますか?

A: Qwen-VLのパフォーマンスは、既存のLVLMを上回っています.

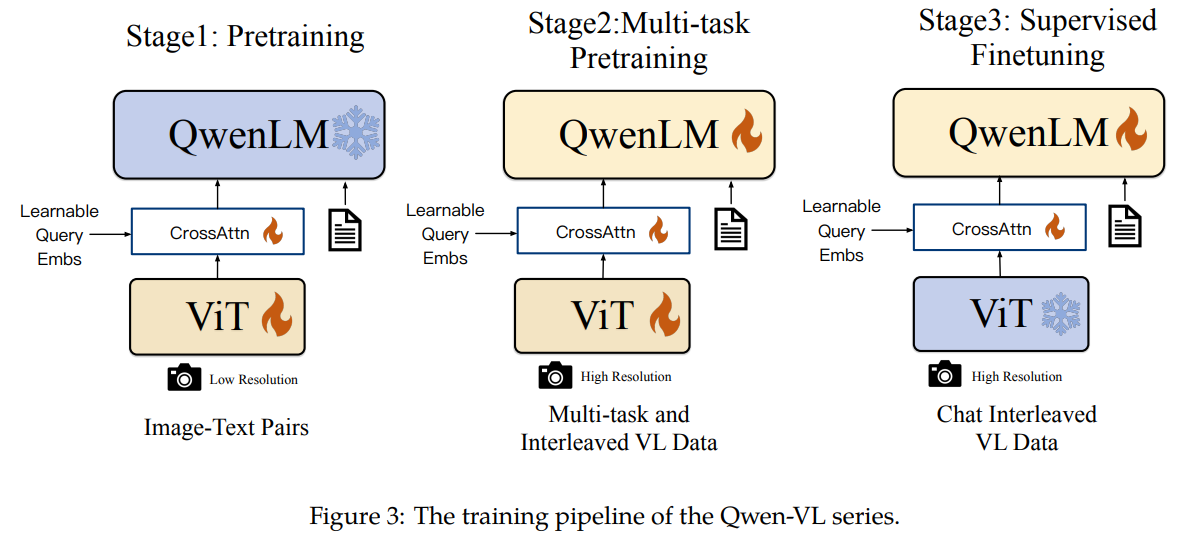

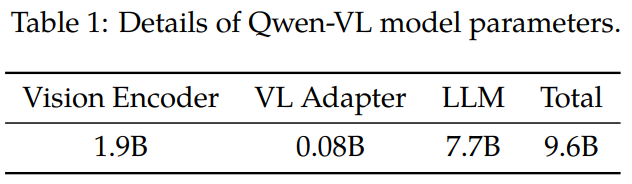

Q: Qwen-VLモデルのアーキテクチャとトレーニングプロセスを説明していただけますか?

A: Qwen-VLのアーキテクチャは、大規模言語モデルとビジョンエンコーダの組み合わせで構成されています.大規模言語モデルは、Qwen-7Bと呼ばれること前学習済みモデルの重みを初期化することで開始されます.Qwen-7Bのアーキテクチャ、トークン化、トレーニングレシピ、モデルの重み、パフォーマンスメトリックについての詳細は、QWen-7B1のコードリポジトリを参照してください.ビジョンエンコーダは、VisionTransformer(ViT)アーキテクチャを使用しています.トレーニングと推論の両方で、入力画像は特定の解像度にリサイズされます.ビジョンエンコーダは、画像をパッチに分割し、ストライド14で処理し、一連の画像特徴を生成します.Qwen-VLは、長い画像特徴シーケンスから生じる効率の問題を緩和するために、ビジョン言語アダプタを導入しています.このアダプタは、ランダムに初期化された単層のクロスアテンションモジュールで構成されています.モジュールは、クエリベクトルとして訓練可能なベクトル(埋め込み)のグループを使用し、ビジョンエンコーダからの画像特徴をクロスアテンションのキーとして使用します.

Q: Qwen-VLモデルの能力は何ですか?

A: Qwen-VLモデルの能力には、既存のオープンソースのLargeVisionLanguageModels(LVLM)を大幅に上回る強力なパフォーマンスがあります.また、Qwen-VLは英語、中国語、および多言語の会話を自然にサポートし、画像内の中国語と英語のバイリンガルテキストとインスタンスの認識とグラウンディングを促進します.さらに、Qwen-VLは複数の画像の入力と比較、および画像に関連する質問の指定と複数の画像ストーリーテリングが可能です.

Q: Qwen-VLモデルは、マルチモーダル人工知能の進歩にどのように貢献していますか?

A: Qwen-VLモデルは、テキストと画像の両方を知覚し理解するために設計された大規模なビジョン言語モデルであり、多様なタスクにおいて優れたパフォーマンスを発揮します.これらのモデルは、ゼロショットキャプショニング、視覚的またはドキュメントの視覚的な質問応答、およびグラウンディングなどの幅広いタスクをカバーしています.Qwen-VLは既存のLVLMを上回る性能を示し、そのアーキテクチャ、トレーニング、機能、パフォーマンスを紹介することで、多モーダル人工知能の進歩に貢献しています.

Q: Qwen-VLのコード、デモ、およびモデルはどこでアクセスできますか?

A: Qwen-VLのコード、デモ、およびモデルは、https://github.com/QwenLM/Qwen-VL でアクセスできます.

Q: Qwen-VLモデルはゼロショットキャプションを実行できますか?

A: はい、Qwen-VLモデルはゼロショットキャプションを実行することができます.

Q: Qwen-VLモデルは、視覚的なもしくはドキュメントの視覚的な質問応答やグラウンディングタスクを処理できますか?

A: はい、Qwen-VLモデルは視覚的な質問応答やドキュメントの視覚的な質問応答、およびグラウンディングのタスクを処理することができます.

Graph of Thoughts: Solving Elaborate Problems with Large Language Models

著者:Maciej Besta, Nils Blach, Ales Kubicek, Robert Gerstenberger, Lukas Gianinazzi, Joanna Gajda, Tomasz Lehmann, Michal Podstawski, Hubert Niewiadomski, Piotr Nyczyk, Torsten Hoefler

発行日:2023年08月18日

最終更新日:2023年08月21日

URL:http://arxiv.org/pdf/2308.09687v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

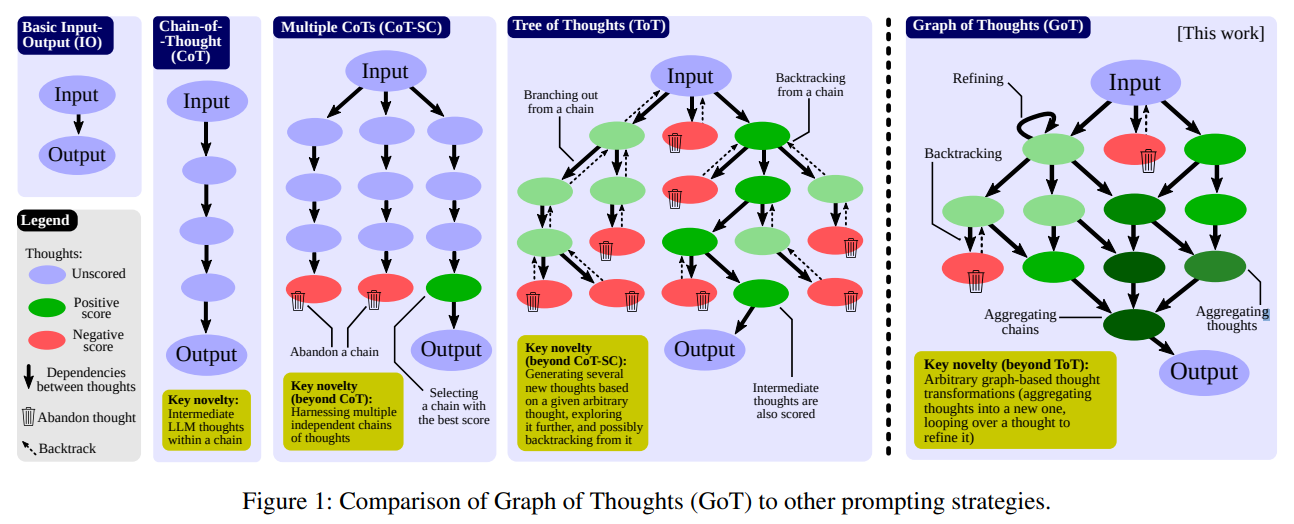

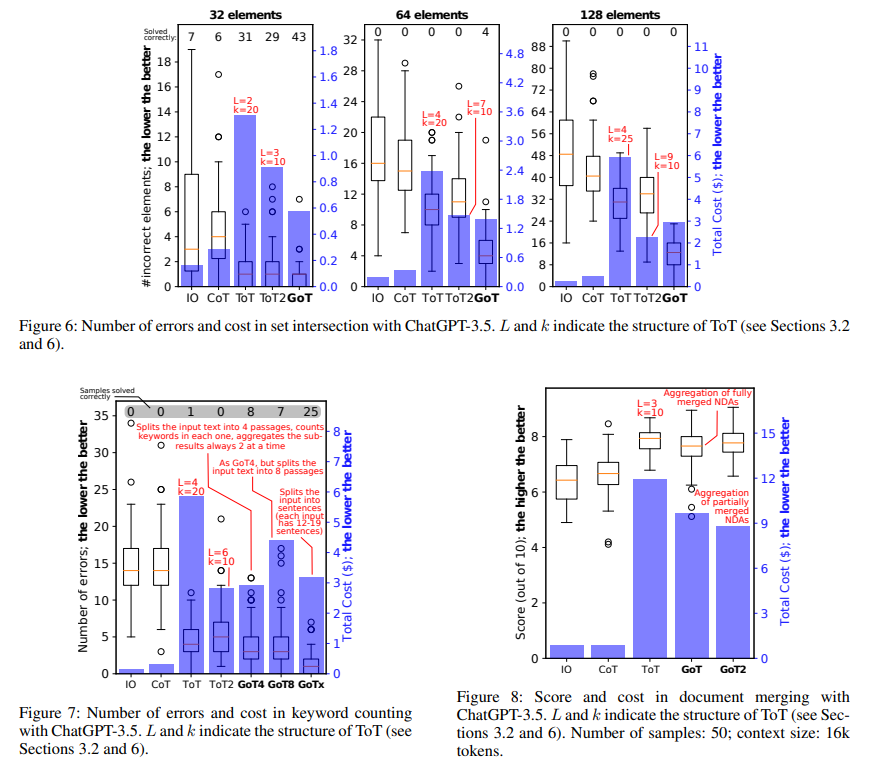

「思考のグラフ(GoT)」というフレームワークを紹介します.これは、チェーンオブソートやツリーオブソート(ToT)などのパラダイムが提供するものを超える、大規模言語モデル(LLM)のプロンプティング能力を向上させるものです.GoTの主なアイデアと主な利点は、LLMによって生成される情報を任意のグラフとしてモデル化できることです.ここでは、情報の単位である「LLMの思考」が頂点であり、エッジがこれらの頂点間の依存関係に対応しています.このアプローチにより、任意のLLMの思考を相乗効果のある結果に組み合わせることができ、思考のネットワーク全体の本質を抽出したり、フィードバックループを使用して思考を強化することができます.GoTは、例えばToTに比べてソートの品質を62%向上させる一方、コストを31%以上削減するなど、さまざまなタスクで最先端の技術に比べて利点を提供することを示しています.また、新しい思考変換を追加することでGoTを拡張可能にし、新しいプロンプティングスキームの先駆けとなることができます.この研究により、LLMの推論は人間の思考や脳のメカニズム(再帰など)により近づけられます.

Q&A:

Q: 大規模言語モデル(LLM)において、思考のグラフ(GoT)フレームワークはどのように促進能力を向上させていますか?

A: Graph of Thoughts (GoT)フレームワークは、大規模言語モデル(LLM)のプロンプティング能力を進化させます.GoTの主なアイデアと主な利点は、LLMによって生成される情報を任意のグラフとしてモデル化する能力です.情報(「LLMの思考」)は頂点であり、エッジはこれらの頂点間の依存関係に対応します.このアプローチにより、任意のLLMの思考をシナジスティックな結果に組み合わせたり、思考の本質を抽出したり、フィードバックループを使用して思考を強化したりすることができます.GoTは、さまざまなタスクで最先端の手法に比べて利点を提供し、例えばソートの品質を62%向上させることができます.

Q: Chain-of-Thought(思考の連鎖)やTree of Thoughts(思考の木)(ToT)と比べて、GoTの主な利点は何ですか?

A: GoTの主な利点は、LLMが生成する情報を任意のグラフとしてモデル化できる能力です.これにより、GoTはCoTやToTなどのパラダイムよりも高度なプロンプト機能を提供します.GoTは複雑なタスクをより単純なサブタスクに分解し、これらのサブタスクを独立して解決し、その結果を最終的な結果に組み合わせる能力を持っています.GoTは他のスキームに比べて、ソートなどのタスクの品質を約70%から約62%向上させる一方、ToTに比べてコストを31%以上削減することができます.

Q: GoTは、LLMによって生成される情報を任意のグラフとしてモデル化する方法を説明できますか?

A: GoTモデルでは、LLMによって生成される情報は任意のグラフとしてモデル化されます.各情報(LLMの思考)は頂点として表され、頂点間の依存関係はエッジとして表されます.GoTを使用することで、複数の入力エッジを持つ頂点を構築することで任意の思考を集約することができます.GoTはグラフの抽象化を利用して、CoTやToTよりも複雑な思考パターンに対応し、モデルの更新を必要とせずに拡張性を持たせることができます.

Q: GoTフレームワークの頂点とエッジは、LLMの思考とその依存関係とどのように対応していますか?

A: GoTフレームワークでは、LLMの思考は頂点としてモデル化され、エッジはそれらの思考の依存関係を表しています.具体的には、情報の単位であるLLMの思考が頂点として表され、エッジはこれらの頂点間の依存関係を表しています.このアプローチにより、複数の入力エッジを持つ頂点を構築することで、任意のLLMの思考を集約することができます.GoTによって利用されるグラフの抽象化は、CoTやToTを超えた複雑な思考パターンにもシームレスに適用することができます.また、このアプローチはモデルの更新を必要としません.

Q: GoTは、任意のLLMの考えを組み合わせて相乗効果のある結果を生み出すことができる具体的な例を示すことはできますか?

A: GoTは、思考を頂点としてグラフ上に表し、それらの間の依存関係をエッジとして組み合わせることで、任意のLLM思考をシナジスティックな結果に組み合わせることを可能にします.これにより、異なる思考を組み合わせて新しい思考を創造し、強化することができます.GoTのグラフベースのパラダイムにより、思考のネットワーク全体の本質を抽出し、フィードバックループを適用して思考をさらに強化することができます.このアプローチを活用することで、GoTは個々の思考だけではなく、より強力で効果的なシナジスティックな結果を生み出すことができます.

Q: GoTは、どのようにして思考のネットワークの本質を抽出しているのでしょうか?

A: GoTは、大規模な言語モデル(LLM)によって生成される情報を任意のグラフとしてモデリングすることで、複数の思考ネットワークの本質を抽出します.このグラフでは、LLMの思考として表される情報の単位が頂点として表され、これらの思考間の依存関係が辺として表されます.これらの任意のLLMの思考を組み合わせて相乗効果を生み出し、フィードバックループを利用することで、GoTは複数の思考ネットワークの本質を抽出することができます.これにより、GoTは複雑な思考ネットワークから最も重要で関連性の高い情報を抽出し、より効率的かつ効果的な推論や問題解決を可能にします.

Q: GoTはフィードバックループを使用して思考をどのように向上させるのか説明できますか?

A: GoTは、フィードバックループを使用して思考を強化し、進行中の推論から最も有望な思考を組み合わせて新しい思考を生み出します.これは、GoTのモジュラーアーキテクチャによって提供される個々の思考の細かい制御によって実現されます.高度な思考変換を適用し、これらの思考を組み合わせることにより、GoTは思考のネットワークの本質を抽出し、相乗効果のある結果を生成することができます.さらに、GoTではリファインメントの反復を連鎖させることができ、思考を継続的に改善し洗練させることで思考をさらに強化します.GoTのフィードバックループの使用により、LLMは以前の思考を繰り返し構築し、人間の思考や脳のメカニズムと同様に進化することができます.このアプローチにより、LLMの推論は人間の思考に近づき、複雑な思考のネットワークの作成が可能となります.

Q: GoTが異なるタスクにおいて最先端技術に比べてどのような利点を示すための証拠や例が提供されていますか?

A: GoTは、ソートの品質においてCoTとToTをそれぞれ約70%と62%上回り、ToTと比較してコストを31%以上削減します.さらに、GoTはIO/CoTよりも一貫して高品質な結果を提供し、ソートの中央誤差はCoTと比較して約65%、IOと比較して約83%低くなります.これらの例は、GoTが異なるタスクにおいて最先端技術に対して優位性を示しています.

Q: GoTは、Tree of Thoughts(ToT)と比較して、ソーティングの品質を向上させ、コストを削減する方法は何ですか?

A: GoTは、複雑なタスクをより単純なサブタスクに分解し、これらのサブタスクを独立して解決し、その結果を段階的に統合する能力によって、ソートの品質を向上させ、コストを削減します.例えば、P=128の場合、GoTはToTに比べて中央誤差を約62%減少させ、ソートの品質を向上させながら、コストを31%以上削減します.これらの利点は、GoTが各Generate操作ごとに構築される新しい思考によって駆動されています.これらの複数の思考は、GoTの優位性の一つの理由です.

Q: GoTは、新しい思考変換や促進スキームとの拡張性を持つように設計されていますか?

A: GoTは、新しい思考変換やプロンプトのスキームを容易に追加できるように設計されています.この設計では、グラフ構造の思考変換や推論パターン、LLMモデルを迅速にプロトタイプ化することが可能です.また、個々の思考に対して細かい制御を行うことができ、進行中の対話を完全に制御し、最も有望な思考を組み合わせて新しい思考に適用することも可能です.

Q: この論文で紹介された新しいメソッドのコード実装のURLは何ですか?

A: この論文で導入された新しい手法のコード実装のURLは、https://github.com/spcl/graph-of-thoughtsです.

FacTool: Factuality Detection in Generative AI — A Tool Augmented Framework for Multi-Task and Multi-Domain Scenarios

著者:I-Chun Chern, Steffi Chern, Shiqi Chen, Weizhe Yuan, Kehua Feng, Chunting Zhou, Junxian He, Graham Neubig, Pengfei Liu

発行日:2023年07月25日

最終更新日:2023年07月26日

URL:http://arxiv.org/pdf/2307.13528v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

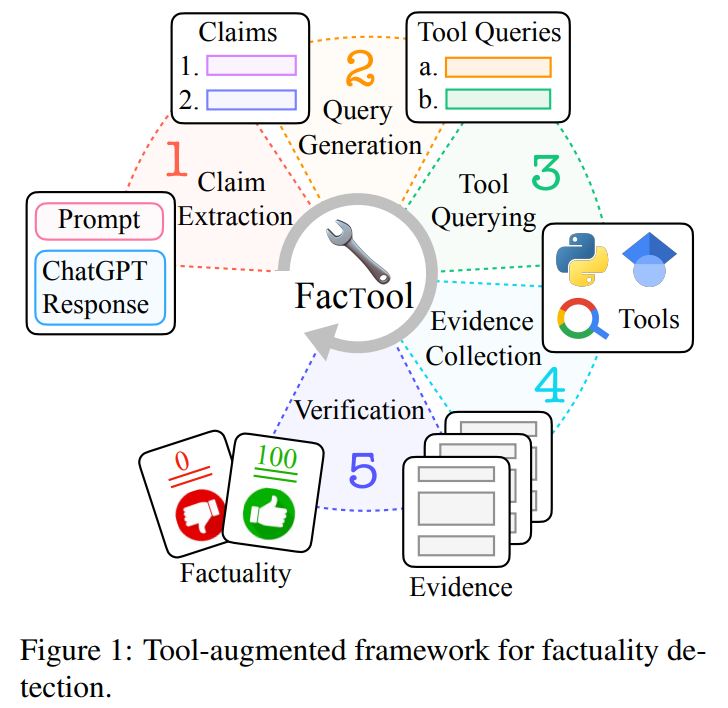

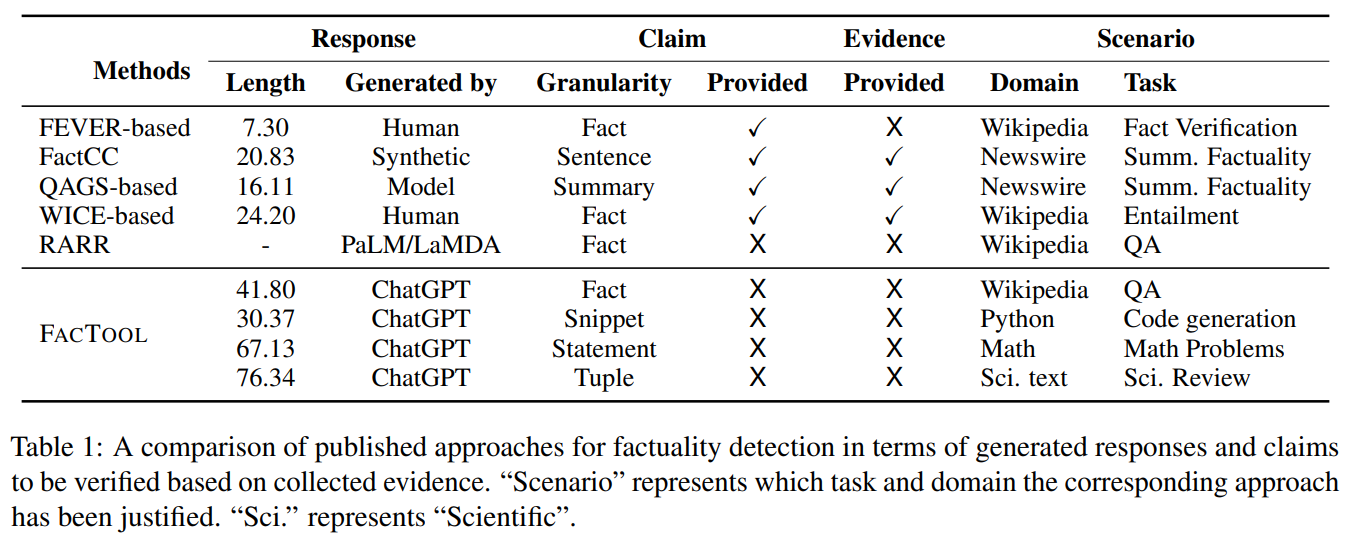

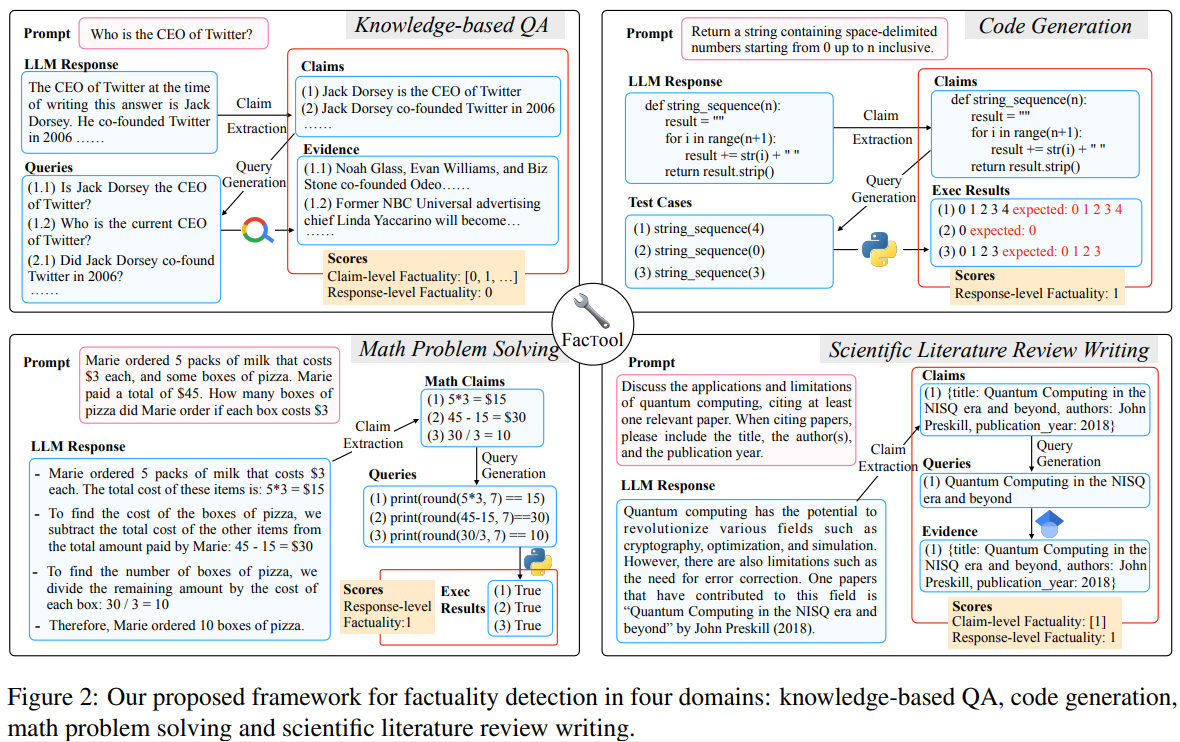

本論文では、生成型の事前学習モデルの出現により、高品質なテキストの合成が容易になった一方で、生成されたテキストの事実の誤りを特定することにも課題が生じています.具体的には、(1) ジェネレーティブモデルによって処理されるタスクの範囲が広がり、事実の誤りを含むリスクが増加しています.(2) 生成されたテキストは長く、個々の事実に明確な粒度が欠けています.(3) ファクトチェックのプロセス中には明示的な証拠が不足しています.これらの課題を考慮し、本論文では、大規模言語モデル(例:ChatGPT)によって生成されたテキストの事実の誤りを検出するためのタスクとドメインに依存しないフレームワークであるFacToolを提案しています.知識ベースのQA、コード生成、数理推論、科学文献レビューという4つの異なるタスクでの実験結果は、提案手法の有効性を示しています.また、FacToolのコードはChatGPTプラグインインターフェースに関連付けられており、https://github.com/GAIR-NLP/factool で公開されています.

Q&A:

Q: 生成されたテキストの事実の誤りを特定する際の課題は何ですか?

A: 生成されたテキストは長く、個々の事実に明確な粒度が欠けているため、事実の誤りを特定することには課題があります.また、事実チェックのプロセス中には明示的な証拠が不足しています.

Q: 生成事前学習モデルは、高品質なテキストの合成にどのように貢献していますか?

A: 生成事前学習モデルは、高品質のテキストの合成に貢献しています.これにより、自然言語処理のさまざまなタスクを単一のシーケンス生成問題に統合することができます.GPT-4などの生成モデルは、質問応答、コード生成、数学的な推論、科学文献の生成など、複数のタスクを自然言語インターフェースを通じて実行することができます.これにより、ユーザーは高いパフォーマンスと相互作用性を持つ統一されたアーキテクチャを使用して、さまざまなタスクを完了することができます.

Q: 生成モデルの影響は、さまざまなタスクにおけること実の誤りを含むリスクにどのような影響を与えるのでしょうか?

A: 生成モデルによって、幅広いタスクにおいて事実の誤りを含むリスクが増加しています.

Q: 生成されたテキストは、個々の事実の長さと粒度の点で他の種類のテキストとどのように異なるのでしょうか?

A: 生成されたテキストは一般的に長く、個々の事実の明確な粒度を持たない傾向があります.

Q: FacToolの概念と、パッセージで言及された課題への取り組み方を説明していただけますか?

A: FacToolは、大規模言語モデル(LLM)の制約による自動生成コンテンツの不正確さや真実からの逸脱を解決するためのツールです.FacToolは、ChatGPTによって強化されたフレームワークであり、事実性の検出に使用されます.FacToolは、論文「人工知能の雇用への影響」が「Acemoglu and Restrepo」によって書かれたものではないことを正しく特定することができます.また、FacToolのパフォーマンスを評価するために、失敗するケースの分析も行われています.エラーの原因としては、推論エラー、相反する証拠、主張の曖昧さなどが挙げられます.推論エラーでは、証拠が十分であり、LLMが最も関連性の高い情報を正確に見つけることができるにもかかわらず、モデルが主張と提供された証拠の関係を推論できない場合があります.相反する証拠では、証拠の相反がLLMを混乱させ、誤った判断を導くことがあります.主張の曖昧さでは、曖昧な記述や主観的な形容詞が原因で誤った結果が生じることがあります.

Q: FacToolはどのようなタスクとドメインをカバーしていますか?

A: FACTOOLはタスクとドメインに依存しないフレームワークであり、生成型AIの事実エラー検出の問題に取り組むために設計されています.

Q: 異なるタスク(知識ベースのQA、コード生成、数学的推論、科学文献レビュー)におけるFacToolの事実エラー検出の有効性の例を示していただけますか?

A: はい、FacToolはさまざまなタスク(知識ベースのQA、コード生成、数学的な推論、科学文献レビュー)において、事実の誤りを検出する効果的な例を提供します.例えば、知識ベースのQAでは、FacToolはGoogle検索やGoogle Scholarなどのツールを使用して事実のエビデンスを収集し、事実の誤りを検出します.コード生成では、FacToolはコードインタプリターやPythonなどのツールを使用して生成されたコードの事実の正確性を検証します.数学的な推論では、FacToolは数学の問題を解くためのエビデンスを収集し、解答の事実の正確性を検証します.科学文献レビューでは、FacToolは科学文献を検索し、エビデンスを収集して事実の正確性を評価します.

Q: FacToolのコードは一般に利用可能ですか?もし利用可能な場合、どこでアクセスできますか?

A: はい、FacToolのコードは公開されています.GitHubのhttps://github.com/GAIR-NLP/factoolでアクセスできます.