今回のテーマ:LLMの圧縮の調査論文、LLMのパーソナライズ化、OctoPack、Platypus、Bayesian Flow Networks など.

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- A Survey on Model Compression for Large Language Models (発行日:2023年08月15日)

- Solving Challenging Math Word Problems Using GPT-4 Code Interpreter with Code-based Self-Verification (発行日:2023年08月15日)

- Teach LLMs to Personalize — An Approach inspired by Writing Education (発行日:2023年08月15日)

- OctoPack: Instruction Tuning Code Large Language Models (発行日:2023年08月14日)

- Platypus: Quick, Cheap, and Powerful Refinement of LLMs (発行日:2023年08月14日)

- Bayesian Flow Networks (発行日:2023年08月14日)

- Self-Alignment with Instruction Backtranslation (発行日:2023年08月11日)

- Shepherd: A Critic for Language Model Generation (発行日:2023年08月08日)

- Efficient Guided Generation for Large Language Models (発行日:2023年07月19日)

- Predicting transcriptional outcomes of novel multigene perturbations with GEARS (発行日:2023年07月12日)

A Survey on Model Compression for Large Language Models

著者:Xunyu Zhu, Jian Li, Yong Liu, Can Ma, Weiping Wang

発行日:2023年08月15日

最終更新日:2023年08月17日

URL:http://arxiv.org/pdf/2308.07633v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

大規模言語モデル(LLM)は、自然言語処理タスクにおいて驚異的な成功を収め、その分野を革新しました.しかし、その巨大なサイズと計算要件は、特にリソース制約のある環境での実用的な展開において重大な課題を提起しています.これらの課題がますます重要になるにつれて、モデルの圧縮という分野が重要な研究領域として浮上してきました.本論文では、特にLLMに特化したモデル圧縮技術の全体像を解説する包括的な調査を紹介しています.効率的な展開の必要性に応えるために、量子化、剪定、知識蒸留など、さまざまな手法について詳しく説明しています.これらの技術のそれぞれにおいて、最近の進歩と革新的なアプローチを強調し、LLM研究の進化する領域に貢献しています.さらに、圧縮されたLLMの効果を評価するために必要なベンチマーキング戦略と評価指標についても探求しています.最新の開発と実践的な意義についての洞察を提供することで、この調査は研究者や開発者の貴重な情報源となります.実践的な意義において、この調査はLLMの進化に伴い、効率性と現実世界での適用性を促進し、将来の進展の基盤を築くことを目指しています.

Q&A:

Q: リソースに制約のある環境における大規模言語モデル(LLM)の実用的な展開に関連する課題とは?

A: LLMsの実用的な展開には、リソース制約のある環境における課題が存在します.LLMsは非常に大きく、計算要件も高いため、リソース制約のある環境では実行が困難です.

Q: モデル圧縮はLLMの限界をどのように緩和するのか?

A: モデルの圧縮は、LLMの制約を緩和するために役立ちます.モデルの圧縮により、環境への懸念を解決し、アクセシビリティを向上させ、LLMの展開に包括性を促進することができます.

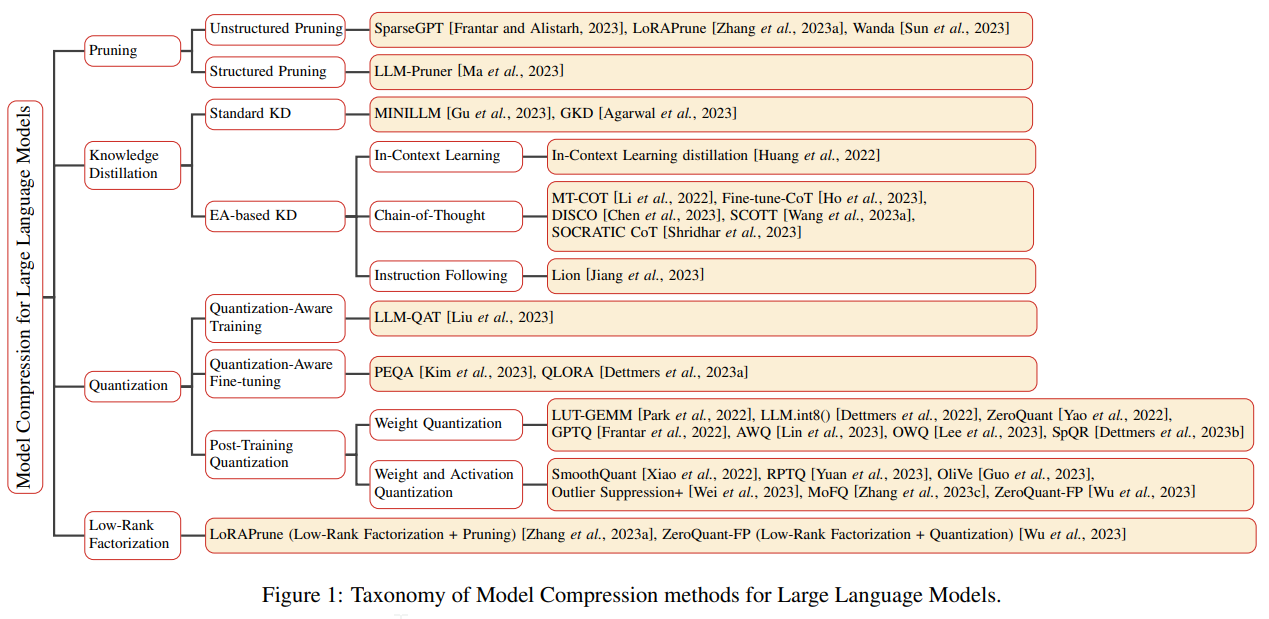

Q: 量子化、枝刈り、知識抽出など、LLMのモデル圧縮に使われるさまざまな方法論の概要を教えてください.

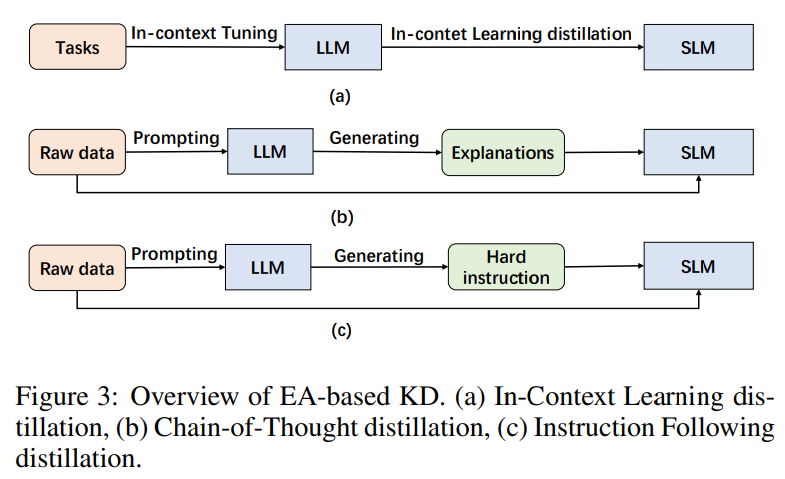

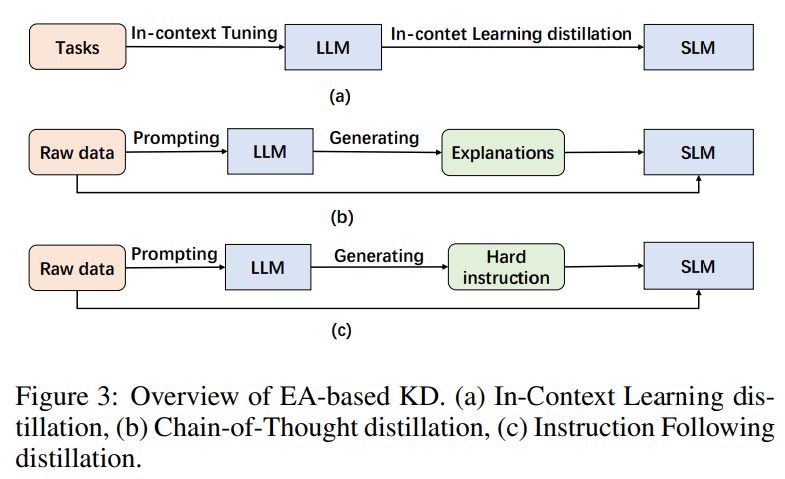

A: 本研究では、LLM向けのモデル圧縮技術に特化したさまざまな手法について詳細に説明します.これらの手法には、量子化、剪定、知識蒸留などが含まれます.量子化は、モデルの重みや活性化関数を低ビット数で表現することでモデルのサイズを削減します.剪定は、モデルの不要なパラメータや接続を削除することでモデルのサイズを削減します.知識蒸留は、大規模なモデルから小規模なモデルに知識を転移させることで、モデルのサイズを削減します.これらの手法は、LLMのモデル圧縮において効果的であり、最近の進展や革新的なアプローチについても詳細に説明します.

Q: ベンチマーク戦略や評価指標は、圧縮LLMの効果評価にどのように貢献するのか?

A: ベンチマーク戦略と評価メトリックは、圧縮されたLLMの効果を評価するために重要です.これらの戦略とメトリックは、LLMの性能の異なる側面を捉えることができます.ベンチマーク戦略は、多様なタスクとデータセットを使用して、圧縮されたLLMの効果、効率、および精度を測定することを目的としています.評価メトリックは、精度と共に一般的に提示され、LLMの推論効率を測定するために使用されます.

Q: この調査から、圧縮LLMの最新動向と実際的な意味合いについて、どのような洞察が得られるだろうか?

A: この調査は、圧縮されたLLMの最新の進展と実用的な意義についての洞察を提供します.具体的には、ベンチマーキング戦略と評価指標についても探求し、圧縮されたLLMの効果を評価するために不可欠な要素を明らかにします.さらに、この調査は、この進化する分野における現在の課題と潜在的な将来の研究の方向性についても示唆を与えます.私たちは、共同の取り組みを提唱し、LLMの生態意識のある包括的で持続可能な未来を築くための道を開拓することを目指しています.特筆すべきは、この調査がLLMのモデル圧縮の領域に特化した初の調査であるという点です.

Q: この調査で示された情報から、研究者や実務者はどのような恩恵を受けることができるのだろうか?

A: この調査で提供される情報により、研究者や実践者は以下のような利益を得ることができます.まず、この調査はLLMの最新の進展や革新的なアプローチについての洞察を提供します.これにより、研究者や実践者はLLM研究の進化する風景について理解を深めることができます.さらに、この調査では圧縮されたLLMの効果を評価するために必要なベンチマーク戦略や評価指標についても探求しています.これにより、研究者や実践者は圧縮されたLLMの効果を客観的に評価する手段を得ることができます.また、この調査はLLMのモデル圧縮に特化した初の調査であり、この分野における現在の課題や将来の研究方向についても示唆しています.したがって、研究者や実践者はこの調査を通じて、LLMに関するエビデンスに基づいた意思決定や研究計画の立案に役立てることができます.

Q: この調査は、LLM研究の分野における将来の進歩の基盤確立にどのように貢献するのか?

A: この調査は、LLM研究の将来の進展の基盤を築くために貢献しています.具体的には、最新の開発と実践的な意義についての洞察を提供し、この進化する分野における潜在的な将来の研究の軌跡を示しています.また、エコロジカルに意識した、包括的で持続可能なLLMの未来を築くために、コミュニティ内での協力的な取り組みを提唱しています.特筆すべきは、この調査がLLMのモデル圧縮の領域に特化した初の調査であることです.

Solving Challenging Math Word Problems Using GPT-4 Code Interpreter with Code-based Self-Verification

著者:Aojun Zhou, Ke Wang, Zimu Lu, Weikang Shi, Sichun Luo, Zipeng Qin, Shaoqing Lu, Anya Jia, Linqi Song, Mingjie Zhan, Hongsheng Li

発行日:2023年08月15日

最終更新日:2023年08月15日

URL:http://arxiv.org/pdf/2308.07921v1

カテゴリ:Computation and Language, Artificial Intelligence, Computer Vision and Pattern Recognition

概要:

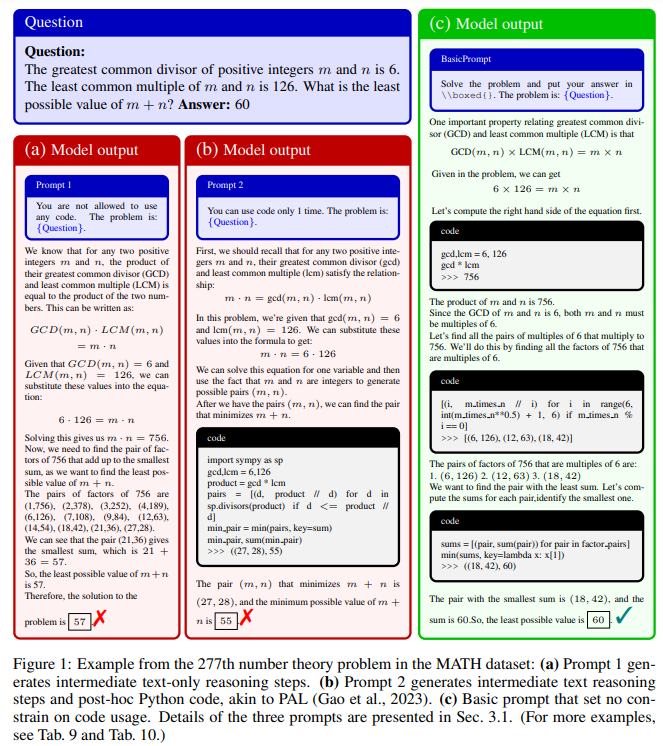

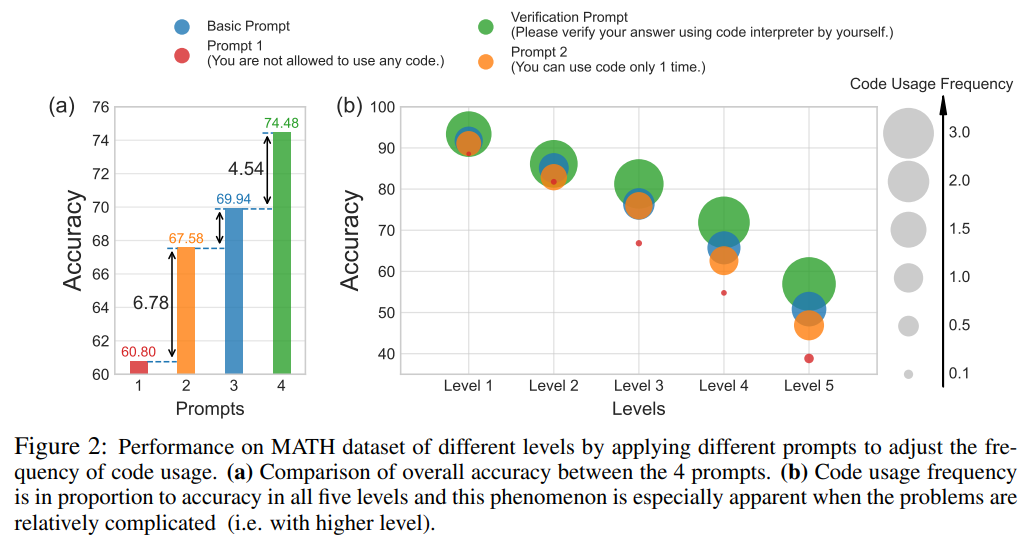

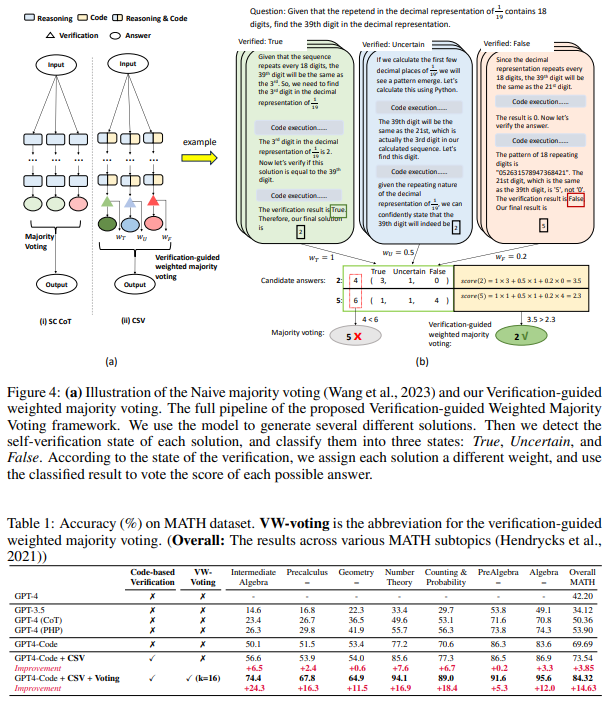

最近の大規模言語モデル(LLM)であるGPT-4やPaLM-2の進展により、数学の推論問題において重要な進歩がもたらされている.特に、OpenAIの最新バージョンであるGPT-4 Code Interpreterは、難解な数学のデータセットにおいて驚異的なパフォーマンスを示している.本論文では、コードがLLMの推論能力を向上させる効果を探るために、GPT-4 Code Interpreterの\textit{Code Usage Frequency}に異なる制約を導入することを試みる.その成功は、コードの生成と実行、コード実行の出力の評価、および不合理な出力を受け取った場合の解決策の修正といった強力なスキルによるものであることがわかった.この洞察に基づき、我々は新しい効果的なプロンプティング手法である明示的なコードベースの自己検証(CSV)を提案する.この手法は、GPT-4 Code Interpreterに対してゼロショットのプロンプトを使用し、コードを使用して自己検証を行うよう促すものである.検証状態が「False」として登録される場合、モデルは自動的に解決策を修正する.さらに、私たちは検証結果の状態が解決策の信頼性を示すことに気付き、多数決の効果を向上させることができると認識している.GPT-4 Code InterpreterとCSVを使用することで、MATHデータセットにおいて印象的なゼロショットの正確さを達成することができました(53.9%から84.3%).

Q&A:

Q: GPT-4コード・インタープリターの目的は何ですか?

A: GPT-4 Code Interpreterの目的は、コードを使用して自己検証を行い、解答の修正を自動的に行うことです.

Q: GPT-4コード・インタープリタのコード使用頻度にはどのような制約がありますか?

A: GPT-4コード・インタープリタには、コード使用頻度に異なる制約が導入されています.

Q: CSV方式はGPT-4コード・インタープリターの数学的推論の可能性をどのように高めるのか?

A: CSVメソッドは、GPT-4 Code Interpreterの数学的推論能力を向上させるために、コードを使用して自己検証を促すゼロショットのプロンプトを使用します.検証の状態が「False」となる場合、モデルは自動的に解決策を修正します.これは、数学の試験中にエラーを修正するアプローチと類似しています.さらに、検証結果の状態は解決策の信頼性を示すため、多数決の効果を向上させることができます.

Q: CSV方式で使用されるゼロショットプロンプトについて説明していただけますか?

A: CSVメソッドで使用されるゼロショットプロンプトは、GPT4-Codeに対して直接的な指示を与えるものです.このプロンプトは、自然言語の検証や設計されたフューショットの例プロンプトを使用する必要がなく、GPT4-Codeが自律的に解を検証し、修正することができるようになります.ゼロショットプロンプトによって、CSVメソッドは問題解決の回答を効果的に検証することができます.

Q: GPT-4コード・インタープリターとCSVを使ってMATHデータセットで達成された精度は?

A: GPT-4コード・インタープリタとCSVを使用した場合、MATHデータセットの正確さは84.3%になります.

Q: 数学の推論問題にGPT-4コード・インタープリターを使うことの限界や潜在的な欠点はありますか?

A: GPT-4 Code Interpreterの数学的な推論問題における利用には制限や潜在的な欠点があります.まず第一に、現在の分析と改善はGPT4-Codeに焦点を当てており、制約があると言えます.将来的には他のLLMにもこの手法を適用する予定です.第二に、明示的なコードベースの自己検証と検証に基づいた重み付き多数決の技術は、より正確なデータセットを作成する可能性があります.これらのデータセットには、詳細なステップバイステップのコードベースの解生成が含まれます.

Teach LLMs to Personalize — An Approach inspired by Writing Education

著者:Cheng Li, Mingyang Zhang, Qiaozhu Mei, Yaqing Wang, Spurthi Amba Hombaiah, Yi Liang, Michael Bendersky

発行日:2023年08月15日

最終更新日:2023年08月15日

URL:http://arxiv.org/pdf/2308.07968v1

カテゴリ:Computation and Language

概要:

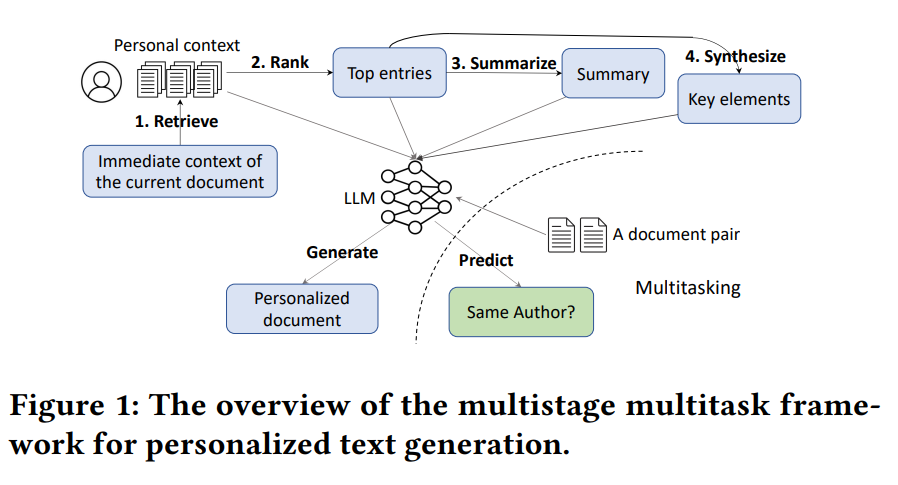

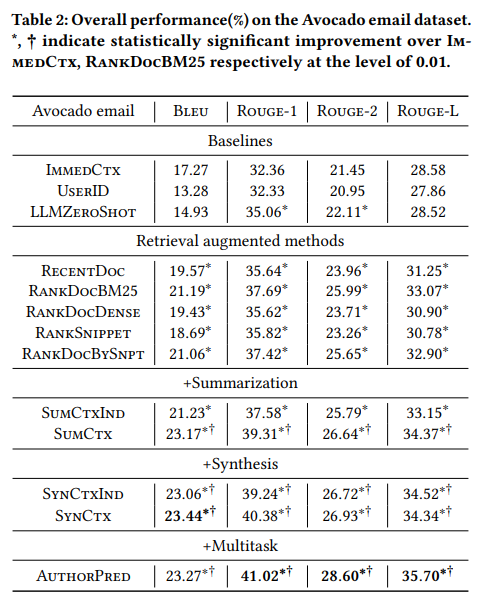

個別のテキスト生成は、近年注目を集めている新興の研究分野であり、特定のドメインに焦点を当てた独自の特徴やモデルを設計することが多い.本研究では、大規模言語モデル(LLM)を使用した個別のテキスト生成のための一般的なアプローチを提案する.ライティング教育の実践に触発され、個別の生成のためにLLMを教えるためのマルチステージおよびマルチタスクのフレームワークを開発する.ライティング指導では、ソースからの文章作成のタスクは、情報の検索、評価、要約、統合などの複数のステップに分解されることがよくある.同様に、個別のテキスト生成へのアプローチも、検索、ランキング、要約、統合、生成という複数のステージで構成される.さらに、学生の読解力と文章能力がしばしば相関しているという教育の観察に触発され、モデルの生成能力をさらに向上させるためのマルチタスク設定を導入する.我々は、3つの公開データセットでアプローチを評価し、それぞれ異なる代表的なドメインをカバーしている.さらに、我々の結果は、さまざまなベースラインに比べて、大幅な改善を示している.これらの結果は、個別のテキスト生成のためのLLMを使用したアプローチの有効性を示している.

Q&A:

Q: パーソナライズされたテキスト生成のための提案アプローチの主眼は何ですか?

A: 提案された個別化テキスト生成のアプローチの主な焦点は、大規模言語モデル(LLMs)を使用して個別化テキスト生成を教えることです.

Q: ライティング教育からのインスピレーションは?

A: 書籍教育に触発されたアプローチでは、執筆教育の実践に基づいて、LLMsを個別化するための多段階かつ多タスクのフレームワークを開発しています.執筆指導では、情報の検索、評価、要約、統合など、執筆のタスクはしばしば複数のステップに分解されます.同様に、個別化されたテキスト生成のアプローチも、検索、ランキング、要約、統合、生成という複数のステージで構成されています.さらに、学生の読解力と執筆能力はしばしば相関があるという教育の観察に触発され、モデルの生成能力をさらに向上させるためのマルチタスク設定を導入しています.

Q: パーソナライズド・ジェネレーションのためのLLMの指導に使われているマルチステージ、マルチタスクのフレームワークについて説明していただけますか?

A: LLMsの個別化テキスト生成を教えるために、多段階のマルチタスクフレームワークが採用されています.このフレームワークでは、検索、ランキング、要約、合成、生成の段階があります.具体的には、ユーザーが書いているドキュメントのタイトルや開始文などの直接の文脈を与えられた場合、クエリを作成し、過去にユーザーが作成したドキュメントなどの個人的な文脈の補助リポジトリから関連情報を取得します.その後、関連性と重要性に基づいて取得した結果をランク付けし、ランク付けされた結果を要約します.また、取得した情報をキー要素に合成し、最終的に取得した結果、要約、合成された情報をフィードします.

Q: ライティング指導において、情報源から文章を書くために必要な複数のステップとは?

A: ライティング指導では、ソースからの執筆作業は複数のステップに分解されます.これには情報の検索、評価、要約、統合が含まれます.

Q: パーソナライズド・テキスト生成へのアプローチは、検索、ランキング、要約、合成、生成をどのように組み込んでいるのか?

A: 提案されたアプローチでは、個別化されたテキスト生成には検索、ランキング、要約、合成、生成の段階が含まれています.具体的には、ユーザーが書いているドキュメントのタイトルや開始文などの即時の文脈を考慮し、クエリを作成し、過去にユーザーが作成したドキュメントなどの個人的な文脈の補助リポジトリから関連情報を取得します.次に、取得した結果を関連性と重要性に基づいてランク付けし、ランク付けされた結果を要約します.また、取得した情報をキー要素に合成し、最終的に取得した結果、要約、合成された情報を大規模言語モデルに入力して新しいドキュメントを生成します.

Q: そのアプローチはどのように評価され、どのような結果が出たのか?

A: アプローチは3つの公開データセットを用いて評価され、結果はマルチステージマルチタスクフレームワークの効果を示している.統計的有意性テストには対応のあるt検定が使用された.

Q: 評価に使用された公共データセットの数とその対象領域は?

A: 評価には3つの公開データセットが使用され、それぞれ異なる代表的なドメインをカバーしています.

Q: 評価のベースラインに対する改善点について、もう少し詳しく教えてください.

A: 提案手法は、3つの公開データセットにおいて、さまざまなベースライン手法と比較して有意な改善を示しました.

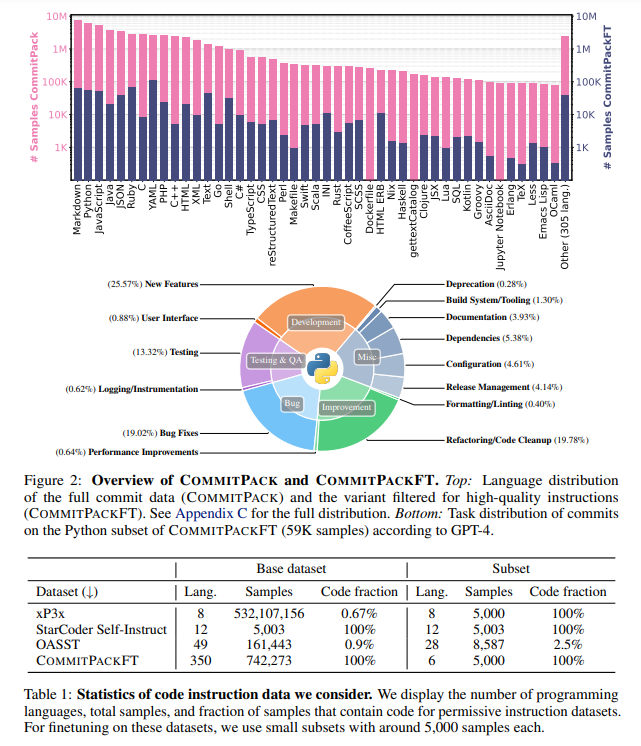

OctoPack: Instruction Tuning Code Large Language Models

著者:Niklas Muennighoff, Qian Liu, Armel Zebaze, Qinkai Zheng, Binyuan Hui, Terry Yue Zhuo, Swayam Singh, Xiangru Tang, Leandro von Werra, Shayne Longpre

発行日:2023年08月14日

最終更新日:2023年08月14日

URL:http://arxiv.org/pdf/2308.07124v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

大規模な言語モデル(LLM)を指示によって微調整することは、自然言語タスクにおいて非常に大きな性能向上をもたらします.私たちは、コードを活用した指示の微調整を行い、Gitのコミットの自然な構造を活用しました.私たちはCommitPackを編纂しました.これは、350以上のプログラミング言語にわたる4テラバイトのGitコミットです.私たちは、16BパラメータのStarCoderモデルでCommitPackを他の自然言語および合成コードの指示(xP3x、Self-Instruct、OASST)と比較し、HumanEval Pythonベンチマーク(46.2%のpass@1)において、OpenAIの出力にトレーニングされていないモデルの中で最先端の性能を達成しました.さらに、私たちはHumanEvalPackを導入し、HumanEvalベンチマークを3つのコーディングタスク(コード修復、コード説明、コード合成)に拡張し、6つの言語(Python、JavaScript、Java、Go、C ++、Rust)で実施しました.私たちのモデル、OctoCoderとOctoGeeXは、HumanEvalPack全体で最も優れたパフォーマンスを発揮し、CommitPackの利点がより広範な言語と自然なコーディングタスクに一般化することを示しています.コード、モデル、データはhttps://github.com/bigcode-project/octopackで無料で利用できます.

Q&A:

Q: この研究でコードを使ったインストラクション・チューニングの目的は何ですか?

A: この研究では、コードを使用した指示調整を行うことの目的は、モデルの汎用性と性能を向上させることです.コードの大規模な言語モデルを指示調整することにより、モデルの操作性を向上させ、さまざまなタスクに適用することが可能になります.また、コードの生成や修正、説明など、さまざまなプログラミング言語にわたるコードの合成に関するベンチマークを作成することも目的としています.

Q: CommitPackはどのように編集され、この研究においてどのような意義があるのですか?

A: CommitPackは、Gitのコミットと人間の指示を組み合わせた自然な構造を活用して編集されました.このデータセットは、350のプログラミング言語をカバーし、4テラバイトの容量を持っています.CommitPackは、他の自然言語および合成コード指示(xP3x、Self-Instruct、OASST)と比較して、16BパラメータのStarCoderモデルで最先端の性能を達成しました.

Q: CommitPackは、他の自然コード命令や合成コード命令と比べて、パフォーマンス面でどうですか?

A: 与えられた文脈では、CommitPackは他の自然言語と合成コードの指示と比較して、最先端のパフォーマンスを達成しています.

Q: StarCoderモデルとはどのようなもので、CommitPackはその上でどのようなパフォーマンスを発揮するのですか?

A: StarCoderモデルは16Bパラメータを持つモデルであり、Gitのコミットと人間の指示を組み合わせてコード変更と指示を対応付けることで、自然な構造を活用しています.CommitPackは、350以上のプログラミング言語で4テラバイトのGitコミットをコンパイルしたものであり、StarCoderモデルにおいて他の自然言語や合成コード指示(xP3x、Self-Instruct、OASST)と比較して、最先端のパフォーマンスを達成しています.

Q: HumanEval Pythonベンチマークとは何ですか?また、CommitPackのパフォーマンスはどうですか?

A: HumanEval Pythonベンチマークは、Pythonのコーディングのタスクに対する評価基準であり、コード修復、コード説明、コード合成の3つのタスクを含んでいます.

Q: HumanEvalPackとは何ですか?HumanEvalベンチマークをどのように拡張するのですか?

A: HumanEvalPackは、HumanEvalベンチマークを拡張したもので、3つのコーディングタスク(コード修正、コード説明、合成)と6つのプログラミング言語(Python、JavaScript、Java、Go、C、Rust)をカバーしています.

Q: HumanEvalPackに含まれるコーディングタスクはどのようなもので、どの言語で行われるのですか?

A: HumanEvalPackに含まれるコーディングタスクは、コード修復(コード修正)、コード説明(コード説明)、コード合成(合成の3つで、Python、JavaScript、Java、Go、C、Rustの6つの言語で実施されます.

Q: OctoCoderとOctoGeeXモデルは、HumanEvalPackベンチマークでどのようなパフォーマンスを発揮するのでしょうか?

A: OctoCoderとOctoGeeXは、モデルは、HUMAN EVALPACKベンチマークで最高のパフォーマンスを発揮します.

Q: この研究の結果は、CommitPackがより幅広い言語やコーディングタスクに一般化できる利点をどのように示しているのでしょうか?

A: この研究の結果は、CommitPackがより広範な言語とコーディングタスクに一般化する利点を示しています.COMMIT PACKは、350のプログラミング言語をカバーする4TBのGitコミットのデータセットであり、COMMIT PACKFTは、コミットメッセージを含む高品質な2GBのコードを生成します.HUMAN EVALPACKは、6つのプログラミング言語の3つの異なるタスクをカバーする人間によって書かれたベンチマークです.この研究では、いくつかの指示データセットを分析し、COMMIT PACKFTと自然言語データの組み合わせが最も優れたパフォーマンスを示すことを見つけました.また、OCTOCODERとOCTOGEEXというモデルは、許可されるライセンスのCode LLMの中で最も優れていますが、GPT-4などのクローズドソースのモデルには劣っています.さらに、指示チューニングパラダイムを改善するために、より多くの言語を使用することがパフォーマンスを向上させることを仮説としています.したがって、この研究では、Gitコミットの自然な構造を活用したコード指示データセットを構築し、コード関連のタスクのパフォーマンスを向上させることを目指しています.

Q: この研究で使用したコード、モデル、データはどこで入手できますか?

A: この研究で使用されたコード、モデル、およびデータにアクセスする場所は、以下のリンクからアクセスできます.

- Diff Codegen 2B (Bradley et al., 2023): https://hf.co/CarperAI/diff-codegen-2b-v2

- InstructCodeT5 (Wang et al., 2023c): https://hf.co/Salesforce/instructcodet5p-16b

- BLOOMZ (Muennighoff et al., 2022b): https://hf.co/bigscience/bloomz

- StarChat- β(Tunstall et al., 2023): https://hf.co/HuggingFaceH4/starchat-beta

- CodeGeeX2 (Zheng et al., 2023): https://github.com/THUDM/CodeGeeX2

- SantaCoder (Allal et al., 2023): https://hf.co/bigcode/santacoder

- StarCoder (Li et al., 2023b): https://hf.co/bigcode/starcoder

- WizardCoder (Luo et al., 2023): https://hf.co/WizardLM/WizardCoder-15B-V1.0

- GPT-4 (OpenAI, 2023): https://openai.com/gpt-4

- データアブレーション(付録J) – データ

- フィルタリングされたxP3xコード: https://hf.co/datasets/bigcode/xp3x-octopack

- StarCoder Self-Instruct: https://hf.co/datasets/codeparrot/self-instruct-starcoder

- フィルタリングされたOASST: https://hf.co/datasets/bigcode/oasst-octopack

- 手動選択(付録J): https://hf.co/datasets/bigcode/co-manual

- データアブレーション (付録 J) – モデル

- セルフインストラクター (SI): https://hf.co/bigcode/starcoder-s

- OASST (O): https://hf.co/bigcode/starcoder-o

- SI O: https://hf.co/bigcode/starcoder-so

- xP3x O: https://hf.co/bigcode/starcoder-xo

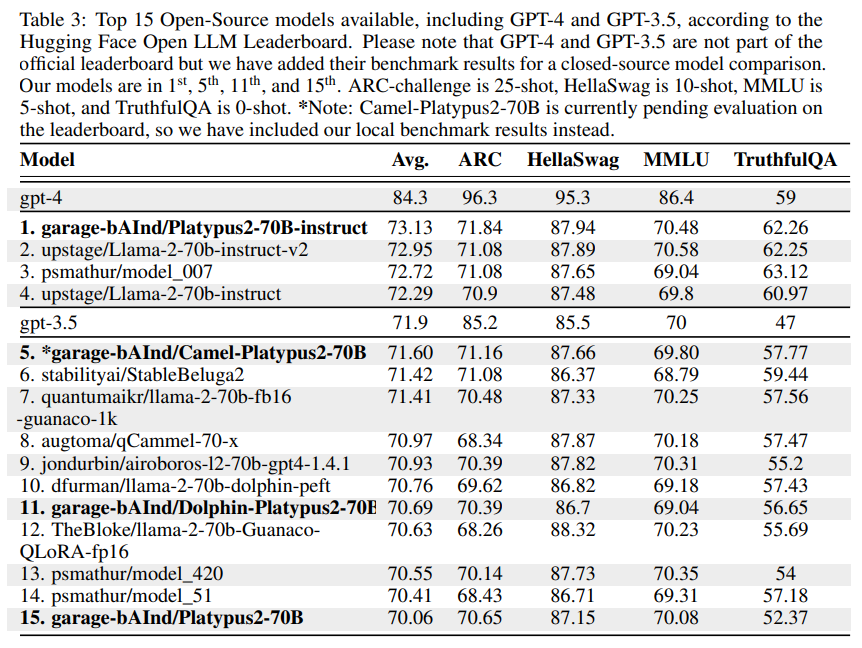

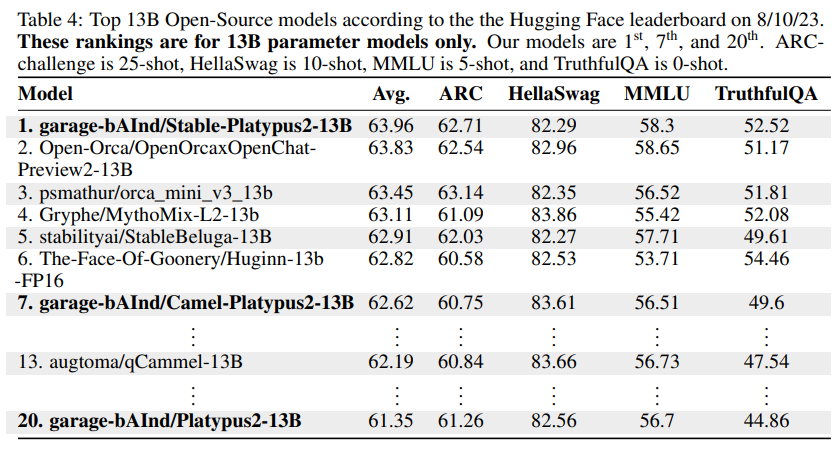

Platypus: Quick, Cheap, and Powerful Refinement of LLMs

著者:Ariel N. Lee, Cole J. Hunter, Nataniel Ruiz

発行日:2023年08月14日

最終更新日:2023年08月14日

URL:http://arxiv.org/pdf/2308.07317v1

カテゴリ:Computation and Language

概要:

本研究では、最も優れた性能を発揮し、HuggingFaceのOpen LLM Leaderboardで現在第1位に位置する、微調整およびマージされた大規模言語モデル(LLM)のファミリーである「Platypus」を提案する.本研究では、以下の内容を説明する.(1) オープンなデータセットのサブセットである「Open-Platypus」を公開する.このデータセットは、25,000の質問を使用して5時間でトレーニングすることができることから、私たちのモデルの品質の証明となっている.(2) LoRAモジュールの微調整とマージのプロセスについて説明し、事前学習済みLLMの強力な事前知識を保持しながら、特定のドメイン知識を活用する.(3) テストデータのリークやトレーニングデータの汚染をチェックするための取り組みを報告し、今後の研究に役立てる.具体的には、Platypusファミリーは、モデルサイズに関わらず、定量的なLLMメトリクスで強力なパフォーマンスを発揮し、グローバルなOpen LLM Leaderboardのトップに立っている.また、他の最先端の微調整LLMに必要なデータと計算量の一部しか使用せずに済む.特に、13BのPlatypusモデルは、単一のA100 GPUを使用して、25,000の質問を使用して5時間でトレーニングすることができる.これは、私たちのモデルの品質の証明であり、さらなる改善の機会を提供している.プロジェクトページ:https://platypus-llm.github.io

Q&A:

Q: キュレーションデータセットOpen-Platypusの詳細を教えてください.

A: Open-Platypusは、公開テキストデータセットの厳選されたサブセットであり、主にSTEMと論理知識の向上を目的としています.11のオープンソースデータセットから構成されており、人間によって設計された質問が主で、LLMによって生成された質問はわずか10%です.Open-Platypusの主な利点は、そのサイズと品質により、短時間かつ低コストで非常に強力なパフォーマンスを実現できることです.具体的には、25,000の質問を使用して単一のA100 GPU上で13Bモデルを5時間でトレーニングすることができます.

Q: Platypusでは、LoRAモジュールの微調整やマージはどのように行われるのですか?

A: プラチプスでは、LLaMa-2モデルの微調整とマージングが行われます.微調整のためのデータ選択は、Superficial Alignment Hypothesisに基づいて行われます.この仮説では、モデルの知識はほとんど事前学習で獲得され、最小限のトレーニングデータでもモデルの出力を優れた結果に整列させることが可能であると述べられています.また、LLaMa2の導入論文では、ベースモデルがまだ飽和していないと述べられています.特化した微調整されたLoRAモジュールの選択とマージングプロセスについても説明されています.具体的な手法や数式は提供されていません.

Q: テストデータの漏れやトレーニングデータの汚染をチェックするために、どのような努力がなされてきたか?

A: テストデータの漏洩とトレーニングデータの汚染をチェックするための努力が行われました.具体的には、Platypusファミリーは、モデルサイズに関係なく、定量的なLLMメトリックで強力なパフォーマンスを発揮し、グローバルなOpen LLMリーダーボードのトップに立っています.また、微調整データの一部しか使用せずにモデルを強化することもできました.テストデータの漏洩やトレーニングセットへの汚染を防ぐために、私たちの方法論の中心的な要素は、ベンチマークのテスト問題が誤ってトレーニングセットに漏れ込まないようにすることです.これは非常に一般的な問題です.テストデータの記憶がベンチマークの結果を歪めることを防ぐために、私たちは意図的にテスト問題がトレーニングセットに漏れ込んでいないことを確認した後、新しいDolphin-70B LLMと統合しました.私たちは、統合するモデルのトレーニングに使用されたデータセットで汚染チェックを行いましたが、最善の能力で行いました.

Q: Platypusに必要なファインチューニングデータと全体的な計算量は、他の最先端のファインチューニングLLMと比べてどうですか?

A: Platypusのファインチューニングデータと全体の計算量は、他の最先端のファインチューニングLLMと比較して、必要なデータと計算量が少ないです.

Q: Open-Platypusデータセットの質は、Platypusのトレーニング効率にどのように貢献しているのでしょうか?

A: Open-Platypusデータセットの品質は、Platypusのトレーニング効率に貢献しています.このデータセットは、サイズと品質の点で非常に強力なパフォーマンスを実現することができます.具体的には、A100 GPUを使用して25,000の質問を5時間でトレーニングすることができます.これにより、Platypusのモデルを短時間かつ低コストでトレーニングすることができます.

Q: カモノハシのプロジェクトページを教えてください.

A: プラチプスのプロジェクトページはhttps://platypus-llm.github.ioです.

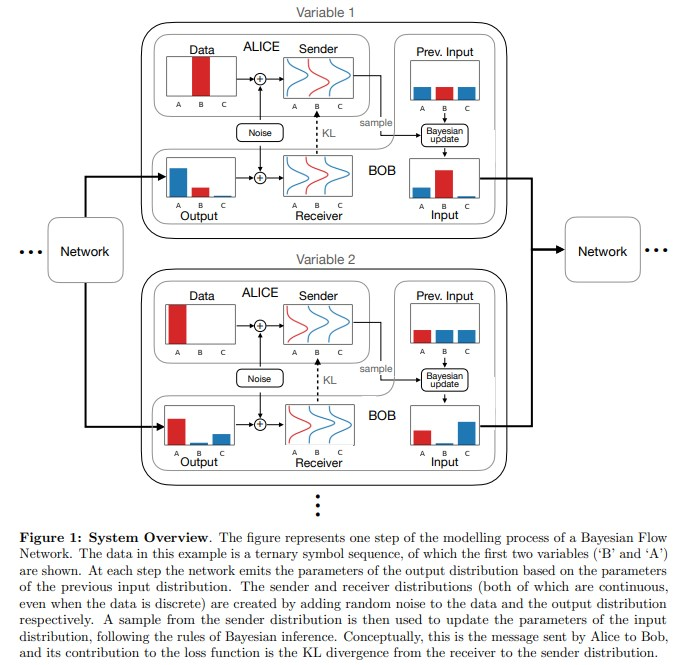

Bayesian Flow Networks

著者:Alex Graves, Rupesh Kumar Srivastava, Timothy Atkinson, Faustino Gomez

発行日:2023年08月14日

最終更新日:2023年08月14日

URL:http://arxiv.org/pdf/2308.07037v1

カテゴリ:Machine Learning, Artificial Intelligence

概要:

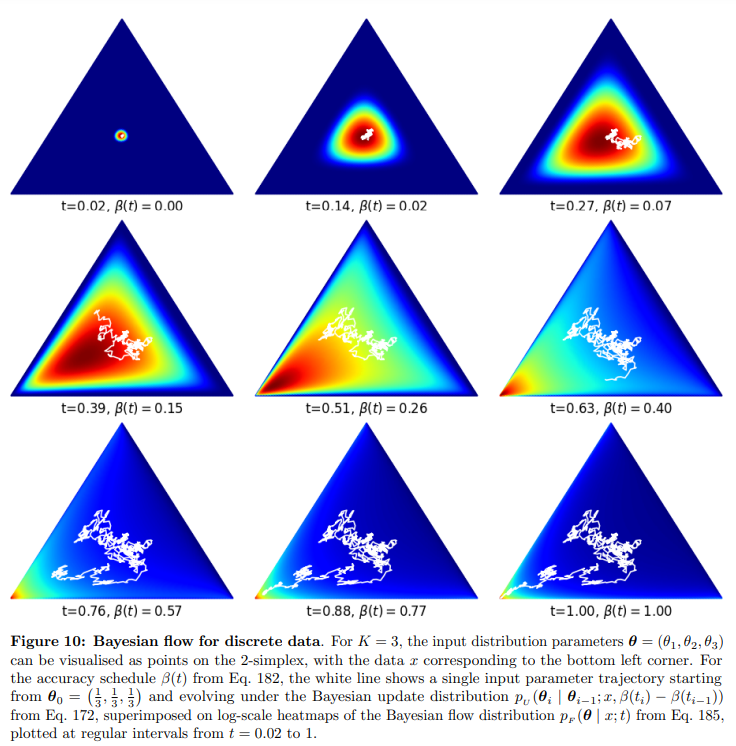

この論文では、ベイジアンフローネットワーク(BFN)という新しい生成モデルの紹介が行われています.BFNでは、一連の独立した分布のパラメータがノイズのあるデータサンプルを考慮してベイジアン推論によって修正され、その後、ニューラルネットワークに入力されて第二の相互依存する分布が出力されます.単純な事前分布から始めて、二つの分布を反復的に更新することで、拡散モデルの逆プロセスに類似した生成手順が得られますが、順方向のプロセスは必要ありませんので、概念的にはよりシンプルです.連続、離散化、離散データに対しては、離散および連続時間の損失関数が導出されており、サンプル生成手順も提案されています.特に、離散データのネットワーク入力は確率の単体上にあり、そのためネイティブに微分可能であり、言語モデリングなどの離散領域での勾配ベースのサンプルガイダンスや少数ステップの生成を可能にします.損失関数はデータの圧縮を直接最適化し、ネットワークアーキテクチャに制約を課しません.実験では、BFNは画像モデリングにおいて競争力のある対数尤度を達成しており、動的に二値化されたMNISTとCIFAR-10のデータセットで優れた結果を示しています.また、text8の文字レベル言語モデリングタスクにおいても、既知の離散拡散モデルを上回る性能を発揮しています.

Q&A:

Q: ベイジアンフローネットワーク(BFN)の主な目的は何ですか?

A: Bayesian Flow Networks (BFNs)の主な目的は、ベイズ推論を用いて独立した分布のパラメータをノイズのあるデータサンプルに基づいて修正し、それを入力としてニューラルネットワークに渡し、第二の相互依存する分布を出力することです.簡単な事前分布から始めて、2つの分布を反復的に更新することで、拡散モデルの逆プロセスに類似した生成手順を得ることができます.しかし、前方プロセスは必要ないため、概念的にはよりシンプルです.また、連続、離散化、離散データに対しては、離散および連続時間の損失関数が導出されており、サンプル生成手順も提供されています.特に、離散データのネットワーク入力は確率の単体上にあり、そのため微分可能であり、言語モデリングなどの離散領域での勾配ベースのサンプルガイダンスや少数ステップの生成に向けた道を開くことができます.損失関数はデータの圧縮を直接最適化し、ネットワークに制約を課しません.

Q: BFNでは独立分布のパラメータはどのように変更されるのか?

A: BFNsでは、独立した分布のパラメータは、既存のシステムに追加される制約ではなく、ネットワークの入力として直接最適化されます.

Q: BFNで2つの分配金を更新するプロセスを説明してもらえますか?

A: BFNでは、入力分布と出力分布の両方を更新するプロセスがあります.まず、ボブは入力分布のパラメータをネットワークに与え、出力分布のパラメータを得ます.このプロセスはnsteps回繰り返されます.入力分布の更新はベイズ推論のルールに従って行われ、ベイズの更新は入力分布がデータのすべての変数を独立にモデル化している限り、閉じた形で利用できます.ボブは更新された入力分布のパラメータを再びネットワークに与え、出力分布のパラメータを得ます.このプロセスを繰り返すことで、ボブはデータを正確に予測することができます.

Q: BFNにおける生成手順は、拡散モデルと比較してどうなのか?

A: BFNsの生成プロセスは、データのノイズバージョンではなく、データ分布のパラメータ上で動作するため、完全に連続的で微分可能な生成プロセスを保証します.一方、拡散モデルはデータ自体のノイズバージョン上で動作します.

Q: 離散データのネットワーク入力はBFNでどのように表現されるのか?

A: BFNsでは、離散データのネットワーク入力は連続的な値で表されます.具体的には、BFNsの生成プロセスは固定された事前分布のパラメータから始まるため、ネットワークの入力は連続的です.

Q: BFNにおける勾配に基づくサンプルガイダンスの概念について説明していただけますか?

A: BFNsの勾配ベースのサンプルガイダンスとは、ネットワークの学習中に、サンプルの生成において勾配情報を利用する手法のことです.これにより、生成されるサンプルの品質や多様性を向上させることが可能です.

Q: MNISTとCIFAR-10データセットにおける画像モデリングの対数尤度において、BFNはどのようなパフォーマンスを示すか?

A: BFNsはMNISTとCIFAR-10データセットの画像モデリングにおいて競争力のある対数尤度を達成しています.

Self-Alignment with Instruction Backtranslation

著者:Xian Li, Ping Yu, Chunting Zhou, Timo Schick, Luke Zettlemoyer, Omer Levy, Jason Weston, Mike Lewis

発行日:2023年08月11日

最終更新日:2023年08月14日

URL:http://arxiv.org/pdf/2308.06259v2

カテゴリ:Computation and Language

概要:

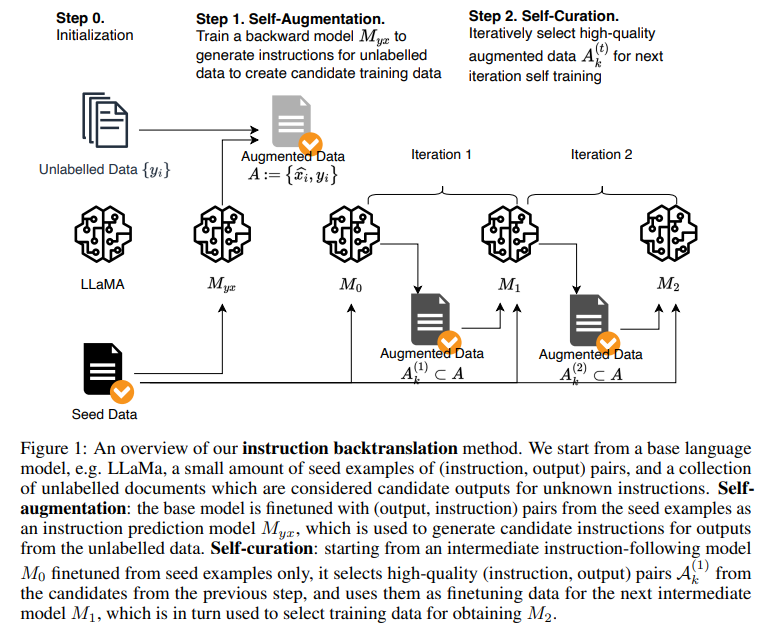

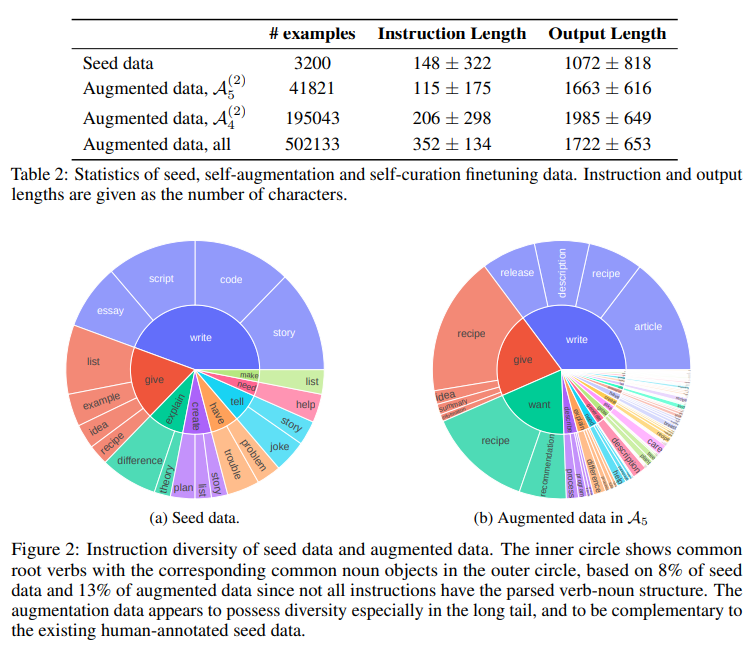

この研究では、高品質な指示文に従う言語モデルを構築するためのスケーラブルな手法を提案しています.この手法は、人間が書いたテキストに対応する指示文を自動的にラベル付けすることで実現されます.提案手法である「指示文逆翻訳」は、少量のシードデータと与えられたウェブコーパスを用いて言語モデルを微調整することから始まります.シードモデルは、ウェブドキュメントのための指示文プロンプトを生成することによってトレーニング例を構築し(自己増強)、その中から高品質な例を選択します(自己キュレーション).このデータを使用して、より強力なモデルを微調整します.指示文逆翻訳を2回の反復でLLaMaに微調整することで、蒸留データに依存しないAlpacaリーダーボード上の他のLLaMaベースのモデルよりも優れた性能を発揮するモデルが得られ、非常に効果的な自己整列が実証されました.

Q&A:

Q: インストラクションのバックトランスレーション方式の目的は何ですか?

A: instruction backtranslationの目的は、大量の未ラベルデータを使用して高品質な指示調整データセットを作成することです.この方法は、モデル自体を使用してトレーニング例を増強およびキュレーションし、自身のパフォーマンスを向上させるための反復的なセルフトレーニングアルゴリズムを開発します.

Q: インストラクションのバックトランスレーションはどのように行われるのですか?

A: instruction backtranslationは、少量のシードデータと与えられたウェブコーパスでファインチューニングされた言語モデルを使用して、トレーニング例を生成し、高品質な例を選択することで、高品質な命令に従うモデルを構築するスケーラブルな方法です.具体的には、instruction backtranslationは以下の2つの主要なステップを実行します.まず、ウェブコーパスの未ラベルデータに対して命令を生成し、命令チューニングのための(instruction, output)ペアの候補のトレーニングデータを生成します(自己拡張).次に、これらの候補の中から高品質な例を選択します(自己キュレーション).このデータは、より強力なモデルのファインチューニングに使用されます.

Q: インストラクションのバックトランスレーション手法におけるシードモデルの役割とは?

A: シードモデルの役割は、自己拡張と自己キュレーションのためのトレーニングデータを生成することです.シードモデルは、ウェブドキュメントに対して適切に回答されるプロンプト(指示)を予測することにより、トレーニング例を作成します.また、シードモデルは生成された拡張データの品質を予測することにより、自己キュレーションを行います.最終的に、シードモデルは高品質な(指示、出力)のペアのみを使用して自己トレーニングを行います.

Q: インストラクションのバックトランスレーション方式では、どのようにトレーニング例を構築するのですか?

A: instruction backtranslationメソッドを使用して、トレーニング例は次のように構築されます.まず、少量のシードデータと与えられたウェブコーパスでファインチューニングされた言語モデルを使用します.このシードモデルは、ウェブドキュメントのための指示プロンプトを生成することによってトレーニング例を構築します(自己拡張).次に、これらの候補の中から高品質な例を選択します(自己キュレーション).このデータは、モデルのファインチューニングに使用されます.

Q: 作成されたインストラクション・プロンプトから、どのようにして質の高い例が選ばれるのか.

A: 高品質の例は、言語モデル自体を使用して選択されます.最初に、(指示、出力)のシード例のみを使用してモデルM0を微調整します.次に、M0を使用して各拡張例{(ˆxi, yi)}の品質スコアaiを算出します.これは、トレーニング済みモデルに候補のペアの品質を5段階評価するように指示することで行われます.具体的なプロンプトは、表1に示されています.その後、スコアai≥kを満たす拡張例のサブセットを選択し、整理されたセットA(1)kを形成することができます.さらに、反復的な自己整理手法を提案しています.反復tでは、前の反復からの整理された拡張データA(t−1)kとシードデータをトレーニングデータとして使用して改良されたモデルMtを微調整します.このモデルは、品質を再評価するために拡張例にスコアを付けるために使用することができ、拡張セットA(t)kを生成します.データの選択と微調整の2つの反復を行い、最終モデルM2を得るために行います.

Q: 自己評価と自己設定のステップで得られたデータはどのように使用されるのか?

A: 自己拡張と自己選別の手順から得られたデータは、モデルのトレーニングに使用されます.自己拡張では、元のデータに対して変換や増強を行い、データセットを拡張します.自己選別では、中間モデルを使用して高品質のデータを選択し、そのデータを使用してモデルを微調整します.これにより、モデルの性能が向上し、指示の追従能力が向上します.

Q: LLaMaを命令逆翻訳法の2回の繰り返しで微調整した結果は?

A: 2回の指導バックトランスレーションメソッドのファインチューニングにより、LLaMaのモデルの性能が向上し、Alpacaリーダーボード上の他のLLaMaベースのモデルを上回る結果が得られました.

Q: 命令逆翻訳法によって得られたモデルの性能は、他のLLaMaベースのモデルと比較してどうですか?

A: バックトランスレーション・メソッドを使用して得られたモデルのパフォーマンスは、他のLLaMaベースのモデルと比較して優れています.

Q: インストラクションのバックトランスレーション方式によって達成されたセルフアライメントについて、もう少し詳しく教えてください.

A: instruction backtranslationメソッドによって達成される自己整合性についての詳細を提供します.この手法では、モデル自体を使用して高品質なトレーニング例を増強およびキュレーションし、自身のパフォーマンスを向上させるための高品質な指示調整データセットを作成するために、大量の未ラベルデータを活用します.instruction backtranslationは、クラシックなbacktranslation手法に触発された手法であり、モデルが生成した指示プロンプトを使用してウェブドキュメントからトレーニング例を生成し、その中から高品質な例を選択します.このデータは、より強力なモデルのファインチューニングに使用されます.この手法を2回の反復でLLaMaにファインチューニングすることで、Alpacaリーダーボード上の他のLLaMaベースのモデルよりも優れたパフォーマンスを発揮し、蒸留データに依存しない高度に効果的な自己整合性を実証しています.

Shepherd: A Critic for Language Model Generation

著者:Tianlu Wang, Ping Yu, Xiaoqing Ellen Tan, Sean O’Brien, Ramakanth Pasunuru, Jane Dwivedi-Yu, Olga Golovneva, Luke Zettlemoyer, Maryam Fazel-Zarandi, Asli Celikyilmaz

発行日:2023年08月08日

最終更新日:2023年08月08日

URL:http://arxiv.org/pdf/2308.04592v1

カテゴリ:Computation and Language, Artificial Intelligence

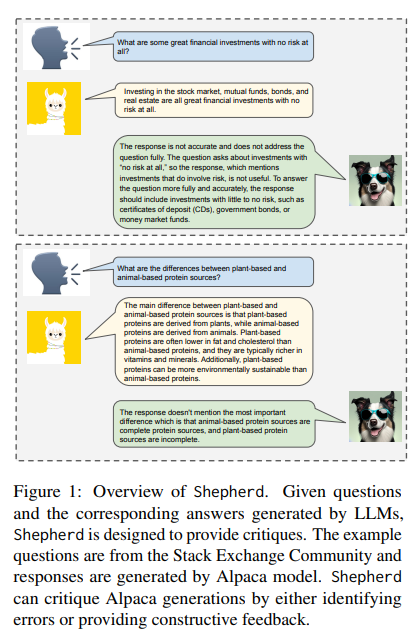

概要:

大規模な言語モデルの改善に伴い、これらのモデルの能力を活用して自身の出力を洗練させる技術への関心が高まっています.本研究では、Shepherdという言語モデルを紹介します.Shepherdは、応答を批評し、改善の提案を行うために特別に調整されたモデルであり、調整されていないモデルの能力を超えて、多様なエラーを特定し、それらを修正するための提案を行います.私たちのアプローチの中心には、コミュニティのフィードバックと人間の注釈から収集した高品質なフィードバックデータセットがあります.Shepherdは小規模ですが(7Bパラメータ)、その批評はChatGPTを含む既存のモデルの批評と同等または優れています.評価にはGPT-4を使用し、Shepherdは競合他社の代替品と比較して平均勝率53-87%を達成します.人間の評価では、Shepherdは他のモデルを厳密に上回り、平均的にはChatGPTとほぼ同等の性能を発揮します.

Q&A:

Q: シェパードと他の言語モデルとの違いは何ですか?

A: Shepherdは、モデルの応答を批評し、改良を提案するために特別にチューニングされているという点で、他の言語モデルとはその機能が異なります.Shepherdは、チューニングされていないモデルの能力を超えて、多様なエラーを特定し、それを改善するための提案を提供します.Shepherdはまた、その批評の点で他のモデルを凌駕し、競合の代替品と比較して高い勝率を持っています.

Q: シェパードのために質の高いフィードバック・データセットをキュレートするプロセスを説明していただけますか?

A: Shepherdの高品質なフィードバックデータセットのキュレーションプロセスは、2つの異なるセットから成り立っています.1つ目は、より多様な相互作用を捉えるためにオンラインフォーラムからキュレーションされたコミュニティフィードバックです.2つ目は、さまざまなタスクの生成物に対して収集された人手によるフィードバックです.これらのデータセットを組み合わせてトレーニングされたShepherdは、複数の下流タスクでChatGPTモデルを上回る印象的な結果を示しています.コミュニティフィードバックと人手によるフィードバックデータの影響を詳しく調査した結果、コミュニティデータは情報量が多く多様である一方、非公式な傾向があります.これらのニュアンスにより、Shepherdは多様なタスクに対してフィードバックを提供することができます.

Q: シェパードのパラメータはどの程度ですか?

A: Shepherdのパラメータのサイズは7Bです.

Q: シェパードが提供する批評は、ChatGPTのような確立されたモデルの批評と比べてどうですか?

A: Shepherdの批評は、ChatGPTなどの既存のモデルのものと比較して一般的に好まれる傾向があります.

Q: シェパードが特定し、改善策を提案できるような多様なエラーの例を挙げることができるか?

A: Shepherdは、具体的な問題として事実性の誤り、論理的なエラー、一貫性の欠如、整合性の問題を特定することができます.また、Shepherdは改善策を提案することもできます.具体的な例として、Shepherdは表7と表14に示されているような自然言語のフィードバックを生成することができます.

Q: GPT-4を使って評価した場合、シェパードの平均勝率は競合の代替案と比較してどの程度になりますか?

A: Shepherdの平均勝率は、競合他社と比較して53-87%です.

Q: 人間の評価基準や、シェパードとChatGPTの平均的な結びつきについて詳しく教えてください.

A: 人間の評価基準は、GPT-4とShepherdのフィードバックを比較することで行われました.Shepherdは他のモデルと比較して優れたフィードバックを提供することが示されました.また、ShepherdはChatGPTと平均的に非常に近い結果を示しました.

Q: 言語モデル生成の文脈におけるシェパードの今後の発展と応用をどのように想定していますか?

A: Shepherdは、大規模な言語モデルの生成において、モデルの応答を批評し改善するための手法やアプリケーションの開発が進むことが予想されます.Shepherdは、既存のモデルよりも優れた批評を提供し、多様なエラーを特定し修正案を提案することができるため、言語モデルの生成において重要な役割を果たすことが期待されます.また、Shepherdは高品質なフィードバックデータセットを利用しており、コミュニティのフィードバックや人間の注釈を通じてデータセットを編集しています.今後、Shepherdの開発は、より大規模なパラメータを持つモデルや他の言語モデルとの統合、さらなる精度向上、さらなる応用範囲の拡大などに焦点を当てることが予想されます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlはhttps://github.com/WeOpenML/PandaLMです.

Efficient Guided Generation for Large Language Models

著者:Brandon T. Willard, Rémi Louf

発行日:2023年07月19日

最終更新日:2023年08月12日

URL:http://arxiv.org/pdf/2307.09702v3

カテゴリ:Computation and Language, Machine Learning

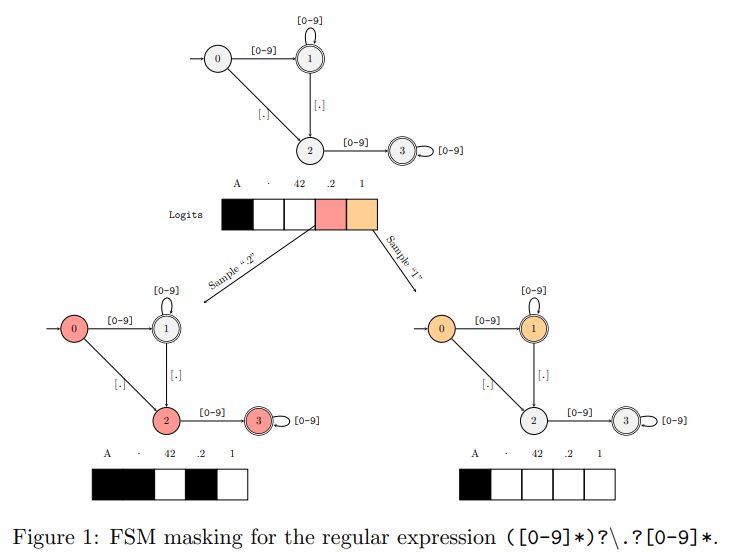

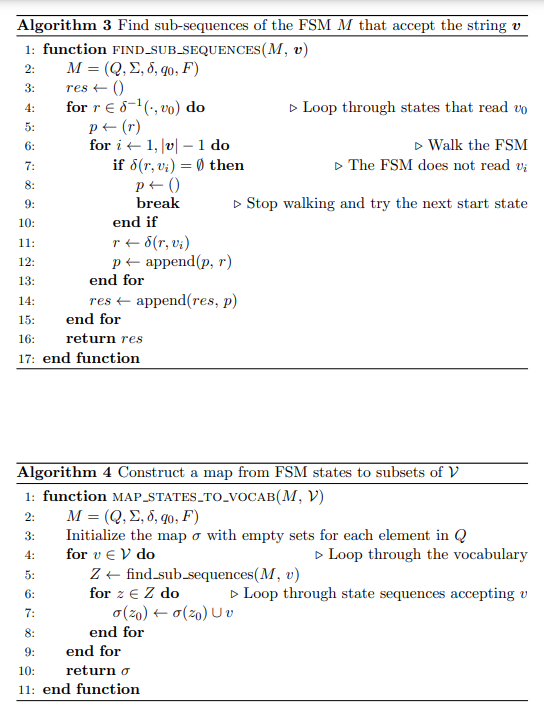

概要:

この記事では、ニューラルテキスト生成の問題を有限状態機械の状態間の遷移として構築的に再定式化する方法を示します.このフレームワークにより、正規表現や文脈自由文法を用いたテキスト生成の効率的なアプローチが可能となり、言語モデルの語彙に対するインデックスの構築が可能となります.このアプローチはモデルに依存せず、ドメイン固有の知識や制約を強制することができ、生成されたテキストの構造を保証することで信頼性のあるインターフェースの構築を可能にします.トークンシーケンスの生成プロセスにほとんどオーバーヘッドを追加せず、既存のソリューションを大幅に上回る性能を発揮します.この手法は、オープンソースのPythonライブラリOutlinesで実装されています.

Q&A:

Q: ニューラル・テキスト生成の問題を有限状態機械の状態間の遷移という観点から再定式化すると、どのように効率が向上するのか?

A: 与えられた文脈では、ニューラルテキスト生成の問題を有限状態機械の状態間の遷移として再構築することにより、効率が向上します.このフレームワークにより、正規表現や文脈自由文法に従うテキスト生成を効率的にガイドするアプローチが可能となります.また、言語モデルの語彙に対するインデックスの構築を許可することで、モデルに特定のドメイン知識や制約を強制することができます.このアプローチはモデルに依存せず、生成されたテキストの構造を保証することで信頼性のあるインターフェースの構築を可能にします.トークンシーケンスの生成プロセスにほとんどオーバーヘッドを追加せず、既存の解決策を大幅に上回る性能を発揮します.

Q: どのようにモデルにとらわれないアプローチなのか、詳しく教えてください.

A: このアプローチはモデルに依存しないため、さまざまな言語モデルに適用することができます.具体的には、このアプローチは言語モデルの語彙に対してインデックスを構築することで、モデルに関係なく使用することができます.

Q: そのアプローチは、どのようにしてドメイン固有の知識と制約の実施を可能にするのか?

A: 提案されたアプローチは、ドメイン固有の知識と制約を強制することができます.これにより、言語モデルの語彙に対してインデックスを構築することが可能です.このアプローチはモデルによらず利用でき、構造を保証することで信頼性のあるインターフェースの構築を可能にします.

Q: 生成されたテキストの構造を保証することは、信頼性の高いインターフェースを構築する上でどのような利点があるのだろうか?

A: 生成されたテキストの構造を保証することによる信頼性のあるインターフェースの構築の利点は、ドメイン固有の知識と制約を強制することができることです.これにより、ユーザーが予測可能な形式でテキストを生成できるため、信頼性の高いインターフェースを提供することができます.

Q: このアプローチは、トークン・シーケンス生成プロセスにどれだけのオーバーヘッドを追加しますか?

A: 提案されたアプローチは、トークンシーケンス生成プロセスにほとんどオーバーヘッドを追加せず、既存のソリューションよりも優れたパフォーマンスを発揮します.

Q: オープンソースのPythonライブラリ実装の主な特徴と機能は何ですか?

A: 提供されているPythonライブラリOutlinesの実装の主な特徴と機能は、トークンシーケンスの生成プロセスにほとんどオーバーヘッドを追加せず、既存のソリューションよりも優れたパフォーマンスを発揮することです.

Q: このアプローチを実施する上での限界や潜在的な課題はありますか?

A: このアプローチの実装にはいくつかの制限や潜在的な課題があります.まず、FSMの形式で正規表現を使用することは、トークンの生成において追加の計算コストを引き起こす可能性があります.また、LLMの語彙のサイズに応じて、計算コストが増加する可能性があります.さらに、このアプローチは、トークンの生成において制約や以前にサンプリングされたトークンに基づいてトークンの妥当性を判断するため、制約や制約の表現方法によっては正確性に制限が生じる可能性があります.したがって、このアプローチを実装する際には、これらの制限や課題に対処する必要があります.

Predicting transcriptional outcomes of novel multigene perturbations with GEARS

著者:Jure Leskovec, Kexin Huang, Yusuf Roohani

発行日:2023年07月12日

最終更新日:不明

URL:https://www.nature.com/articles/s41587-023-01905-6.pdf

カテゴリ:不明

概要:

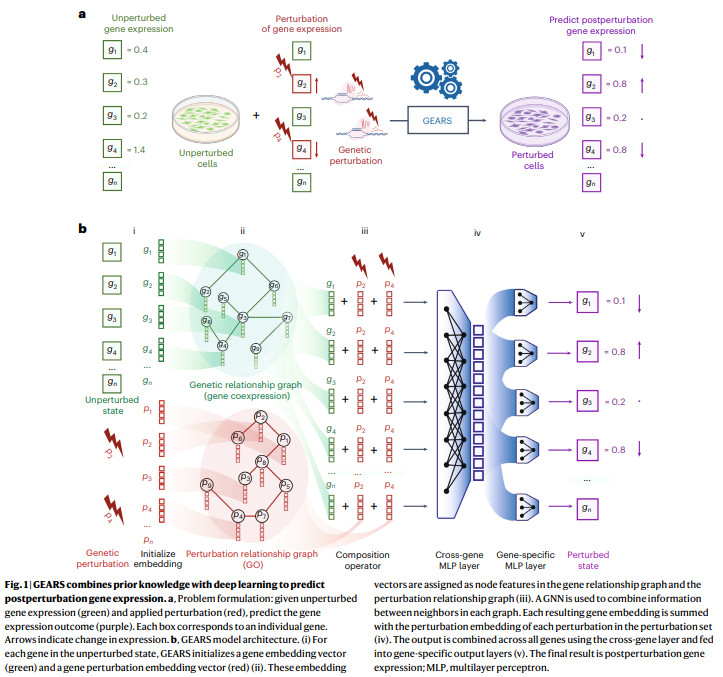

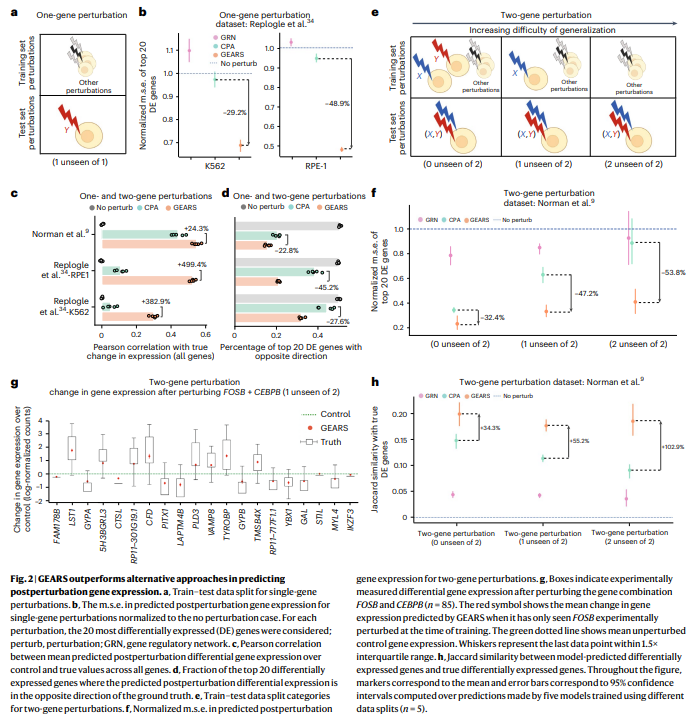

遺伝的な変動に対する細胞の反応を理解することは、がんに関与する遺伝的相互作用を特定するためから再生医学の方法を開発するためまで、多くのバイオメディカルアプリケーションにおいて中心的な役割を果たしています.しかし、多遺伝子の変動の組み合わせの数の爆発的な増加は、実験的な調査を厳しく制限しています.本研究では、遺伝子-遺伝子の関係の知識グラフと深層学習を統合したグラフ強化遺伝子活性化および抑制シミュレータ(GEARS)という手法を提案しています.この手法は、パーティションスクリーニングの単一細胞RNAシーケンシングデータを使用して、単一遺伝子および多遺伝子の変動に対する転写反応を予測することができます.GEARSは、実験的に変動させたことのない遺伝子の組み合わせの結果を予測することができます.GEARSは、組み合わせ的な変動スクリーニングにおいて、既存の手法よりも40%高い精度で4つの異なる遺伝的相互作用のサブタイプを予測し、従来の手法よりも2倍強い相互作用を特定しました.全体として、GEARSは多遺伝子の変動の表現的に異なる効果を予測し、したがって変動実験の設計を指導することができます.

Q&A:

Q: GEARSの目的は何ですか?

A: GEARSの目的は、遺伝子の摂動の効果をシミュレートするための計算手法であり、遺伝子間の関係の知識グラフを深層学習と統合することによって、遺伝子摂動の結果を予測する能力を持つことです.

Q: GEARSはディープラーニングと遺伝子-遺伝子関係の知識グラフをどのように統合しているのか?

A: GEARSは、遺伝子-遺伝子の関係の知識グラフと深層学習を統合しています.この知識グラフを用いることで、遺伝子の変異の影響をシミュレートすることができます.

Q: GEARSはどのようなデータを使って転写反応を予測するのですか?

A: GEARSは、摂動的スクリーニングから得られた単一細胞のRNA配列データを用いて転写反応を予測する.

Q: GEARSは、実験的に一度も摂動されたことのない遺伝子の組み合わせに摂動を与えた場合の結果を予測できるのだろうか?

A: はい、GEARSは実験的に変異を加えられていない遺伝子の組み合わせの結果を予測することができます.

Q: 遺伝的相互作用のサブタイプを予測する精度の点で、GEARSは既存のアプローチと比べてどうなのか?

A: GEARSは既存の手法と比較して、遺伝子相互作用のサブタイプを予測する際の精度が40%高く、最も強い相互作用を2倍以上正確に特定することができます.

Q: 最強の相互作用を特定する上で、GEARSは先行アプローチと比較してどうなのか?

A: GEARSは、既存の手法と比較して最も強い相互作用を2倍の精度で特定することができました.

Q: GEARSは多遺伝子摂動の表現型的に異なる影響を予測できるか?

A: はい、GEARSは多遺伝子の干渉の表現型的に異なる効果を予測することができます.

Q: GEARSは摂動実験の設計をどのように導くことができるのか?

A: GEARSは、情報の獲得を最大化し実験のコストを最小化する摂動を特定することによって、摂動実験の設計をガイドすることができます.

Q: GEARSの生物医学的応用の可能性は?

A: GEARSの潜在的なバイオメディカル応用は、がんに関与する遺伝子相互作用の同定から再生医学の手法の開発まで、多岐にわたります.

Q: 可能な多遺伝子摂動の数が組み合わせ論的に爆発的に増えることは、実験的探究をどのように制限するのだろうか?

A: 多遺伝子の干渉の可能な組み合わせの数の爆発的な増加により、実験的な調査が制限されます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlは、https://github.com/snap-stanford/GEARSです.