今回のテーマ:GPT4,ChatGPTによるプログラミングのAI教師の評価、LENS、ナビゲーション用の大規模モデル ViNT、MLPによる帰納的バイアスの実験、DragDiffusionなど.

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Generative AI for Programming Education: Benchmarking ChatGPT, GPT-4, and Human Tutors (発行日:2023年06月29日)

- Towards Language Models That Can See: Computer Vision Through the LENS of Natural Language (発行日:2023年06月28日)

- LeanDojo: Theorem Proving with Retrieval-Augmented Language Models (発行日:2023年06月27日)

- Extending Context Window of Large Language Models via Positional Interpolation (発行日:2023年06月27日)

- ViNT: A Foundation Model for Visual Navigation (発行日:2023年06月26日)

- DragDiffusion: Harnessing Diffusion Models for Interactive Point-based Image Editing (発行日:2023年06月26日)

- Bring Your Own Data! Self-Supervised Evaluation for Large Language Models (発行日:2023年06月23日)

- Long-range Language Modeling with Self-retrieval (発行日:2023年06月23日)

- Scaling MLPs: A Tale of Inductive Bias (発行日:2023年06月23日)

- Understanding Social Reasoning in Language Models with Language Models (発行日:2023年06月21日)

Generative AI for Programming Education: Benchmarking ChatGPT, GPT-4, and Human Tutors

著者:Tung Phung, Victor-Alexandru Pădurean, José Cambronero, Sumit Gulwani, Tobias Kohn, Rupak Majumdar, Adish Singla, Gustavo Soares

発行日:2023年06月29日

最終更新日:2023年06月30日

URL:http://arxiv.org/pdf/2306.17156v2

カテゴリ:Computers and Society, Artificial Intelligence, Computation and Language

概要:

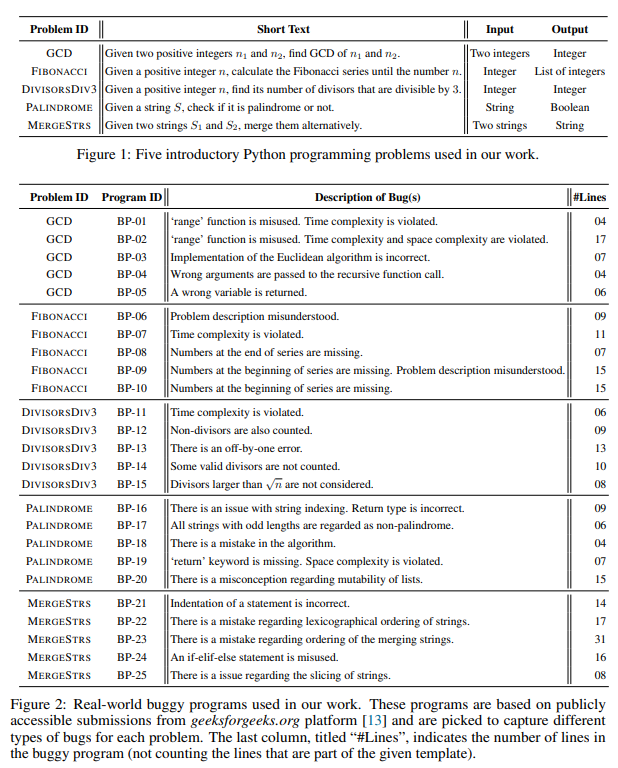

ジェネラティブAIと大規模な言語モデルは、次世代のプログラミング教育のための教育技術を強化するという大きな可能性を持っています.最近の研究では、プログラミング教育に関連するさまざまなシナリオでこれらのモデルを研究してきましたが、これらの研究はいくつかの理由で限定的です.なぜなら、既に時代遅れのモデルを考慮しているか、または特定のシナリオのみを考慮しているからです.その結果、包括的なプログラミング教育のシナリオに対して最新のモデルをベンチマークするための体系的な研究が不足しています.本研究では、ChatGPT(GPT-3.5に基づく)とGPT-4の2つのモデルを体系的に評価し、さまざまなシナリオにおける人間のチューターとのパフォーマンスを比較します.具体的には、5つのPythonの初級プログラミング問題とオンラインプラットフォームからの実世界のバグのあるプログラムを使用して評価し、専門家による注釈を使用してパフォーマンスを評価します.結果は、GPT-4がChatGPT(GPT-3.5に基づく)を大幅に上回り、いくつかのシナリオでは人間のチューターのパフォーマンスに近づいていることを示しています.また、GPT-4がまだ苦労している設定も示しており、これらのモデルのパフォーマンスを向上させるための技術の開発における興味深い方向性を提供しています.

Q&A:

Q: この箇所で述べられている研究の目的は何ですか?

A: 研究の目的は、導入的なPythonプログラミング教育において、GPT-4のパフォーマンスを人間のチューターと比較することです.この研究では、2人の人間の専門家がチューターと評価者として参加しており、研究を拡大することが有益であると述べられています.また、Pythonプログラミング教育に焦点を当てており、他のプログラミング言語やプログラミング以外の領域についても同様の研究を行うことが興味深いと述べられています.さらに、英語を主要な言語として考慮しており、これらのモデルを多言語環境で評価することも興味深いと述べられています.最後に、専門家による評価のみを考慮しており、学生に基づいた評価も検討することが有益であると述べられています.

Q: 生成AIモデルを用いたプログラミング教育分野における先行研究の限界とは?

A: 過去の研究では、プログラミング教育における生成AIモデルの利用に関していくつかの制限がありました.これらの制限は、以下の理由によるものです.まず、過去のモデルは時代遅れであることが多く、例えばOpenAIのCodexは2023年3月以降は公開されていません(p.1).また、これらの研究は通常、特定のシナリオに焦点を当てており、プログラミング教育の幅広いシナリオに対して体系的な研究が不足していると言えます(p.1).

過去の研究では、生成AIモデルをプログラミング教育に活用するためのさまざまなシナリオについて評価していますが、これらの研究は限定的なものであり、状況によっては既に時代遅れのモデルを考慮していることがあります.そのため、プログラミング教育の幅広いシナリオにおいて最新のモデルを評価する体系的な研究が不足していると言えます.

このような制限があるため、本研究ではChatGPT(GPT-3.5ベース)とGPT-4の2つのモデルを体系的に評価し、人間のチューターとのパフォーマンスを比較します.具体的には、デジタルチューター、アシスタント、および同僚としての役割を捉えるために、以下の6つのシナリオを考慮しています.

以上のように、過去の研究ではプログラミング教育における生成AIモデルの利用には制限があり、最新のモデルを包括的なシナリオで評価する体系的な研究が不足していることが明らかにされています.

Q: この研究ではどのモデルが評価されたのか?

A: この研究では、2つのモデル、ChatGPTとGPT-4が評価されました.これらのモデルは、プログラミング教育のさまざまなシナリオでのパフォーマンスを評価するために使用されました.具体的には、ChatGPTとGPT-4は、25のインスタンスごとに1つのクエリを生成し、それぞれのLLM(Large Language Models)を通じて1つの出力を生成しました.また、2人の人間の専門家も各インスタンスごとに2つの出力を生成しました.これらのモデルは、プログラミング教育のシナリオにおけるパフォーマンスを評価するために使用されました.

Q: モデルはどのように評価され、人間のチューターと比較されたのか?

A: モデルは、ChatGPT(GPT-3.5をベースにしたもの)とGPT-4の2つが、人間のチューターと比較されて評価されました.これは、プログラミング教育のさまざまなシナリオにおいて、モデルのパフォーマンスを人間のチューターと比較することを目的として行われました.具体的には、プログラムの修正、ヒントの生成、フィードバックの評価、ペアプログラミング、文脈に即した説明、タスクの作成の6つのシナリオが考慮されました(p.1).

評価は、専門家によるアノテーションを使用して行われました.定量的および定性的な評価の組み合わせを用いて、異なる手法(LLMsおよび人間のチューター)のパフォーマンスを評価しました.評価は、多様な入出力仕様を持つ5つのPythonプログラミングの初級問題を用いて行われました(p.1).

モデルの評価結果は、人間のチューターと比較して、特定のシナリオや問題においてGPT-4のパフォーマンスがまだ向上する余地があることを示しています.具体的には、フィードバックの評価やタスクの作成といったシナリオでは、GPT-4のパフォーマンスが人間のチューターと比較して大きく劣っていることが明らかになりました(p.1).

Q: 評価にはどのような番組シナリオが用いられたのか?

A: 評価では、以下の6つのプログラミング教育シナリオが使用されました.

- プログラム修正(Program repair):学生のバグのあるプログラムを修正すること.

- ヒント生成(Hint generation):学生が現在の問題を解決するのに役立つヒントを提供すること.

- 採点フィードバック(Grading feedback):与えられた基準に基づいて学生のバグのあるプログラムを採点すること.

- ペアプログラミング(Pair programming):学生が書いた不完全な/一部のプログラムを完成させること.

- コンテキストに基づく説明(Contextualized explanation):与えられたプログラムの特定の部分をコンテキストに基づいて説明すること.

- タスク作成(Task creation):特定の概念やバグを演習するための新しいタスクを生成すること.

これらのシナリオは、AIベースの教育エージェントがデジタルチューター、アシスタント、および同僚の役割を果たすことができるさまざまな役割を捉えています.

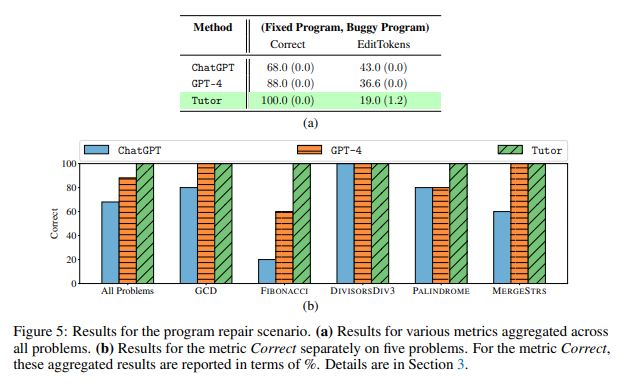

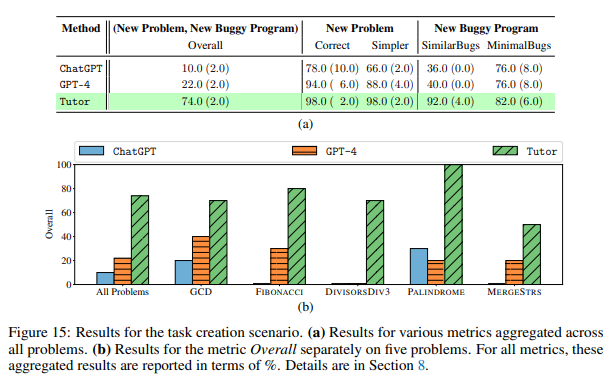

Q: GPT-4とChatGPTのパフォーマンスについての評価結果は?

A: 評価の結果、GPT-4とChatGPTのパフォーマンスに関しては、以下のような結果が得られました.具体的な数値は文脈によって異なりますが、いくつかの重要なポイントをまとめます.

まず、論文の図13aに示される結果では、全体的な評価基準でGPT-4とChatGPTのパフォーマンスが高く、Tutorのパフォーマンスに近いことが示されています.ただし、図13bに示されるように、より難しいシナリオではGPT-4のパフォーマンスが低く、人間のチューターと比較しても低いことが明らかになっています.

また、論文の図15aに示される結果では、全ての問題を集計した各種メトリクスにおいて、GPT-4がChatGPTよりも改善されていることが示されています.しかし、図15bに示されるように、GPT-4の全体的な評価基準におけるパフォーマンスはまだ低いです.

さらに、論文の図11aに示される結果では、GPT-4がChatGPTと比較して大幅に改善されており、Tutorのパフォーマンスと比較しても差が半分程度に縮まっていることが明らかになっています.ただし、ContextKeptとEditLinesのメトリクスの結果からは、GPT-4はより多くの編集を行い、提供された部分プログラムの文脈を保持しない傾向があることが示されています.

以上の結果から、GPT-4とChatGPTのパフォーマンスに関しては、問題の難易度や評価基準によって異なる結果が得られることがわかります.GPT-4は一部のシナリオで人間のチューターに近いパフォーマンスを示す一方で、より難しいシナリオではまだ改善の余地があります.また、GPT-4は文脈を保持せずに編集を行う傾向があることも指摘されています.

Q: GPT-4がまだ苦戦している具体的なシナリオはありますか?

A: GPT-4は、特定のシナリオや問題においてまだ苦労していることが示されています.具体的には、採点フィードバックや課題作成のシナリオにおいて、GPT-4のパフォーマンスは人間のチューターと比較してかなり低いという結果が示されています.

これらのシナリオでは、GPT-4のパフォーマンスに大きなギャップがあります.採点フィードバックの場合、GPT-4は人間のチューターと比較して十分なパフォーマンスを発揮できていません.また、課題作成の場合も同様で、GPT-4のパフォーマンスは人間のチューターと比較して非常に低いです.

これらの結果は、GPT-4がまだより困難なシナリオに苦労していることを示しています.具体的には、採点フィードバックや課題作成といったシナリオでは、GPT-4のパフォーマンスが人間のチューターと比較して著しく低いです.したがって、GPT-4はまだ特定のシナリオにおいて苦労していると言えます.

Q: これらのモデルのパフォーマンスを向上させるために、今後どのような方向性が考えられるか?

A: これらのモデルの性能を向上させるための将来の方向性として、以下のようなものが提案されています.具体的には、(a) 研究コミュニティが新しいバージョンのこれらのモデルを評価するために使用できるより大規模なベンチマークの収集、(b) 特にオープンソースのバリアントを含む代替の生成モデルの評価、(c) シンボリックな手法、ファインチューニング、または自動プロンプティングを活用して生成AIと大規模言語モデルの性能を向上させるための技術の開発、(d) 学生を対象とした教室での研究の実施などが挙げられます.これらの方向性は、モデルの性能向上に向けた具体的な取り組みや研究の重要性を示しています.(p.14)

Towards Language Models That Can See: Computer Vision Through the LENS of Natural Language

著者:William Berrios, Gautam Mittal, Tristan Thrush, Douwe Kiela, Amanpreet Singh

発行日:2023年06月28日

最終更新日:2023年06月28日

URL:http://arxiv.org/pdf/2306.16410v1

カテゴリ:Computation and Language, Computer Vision and Pattern Recognition

概要:

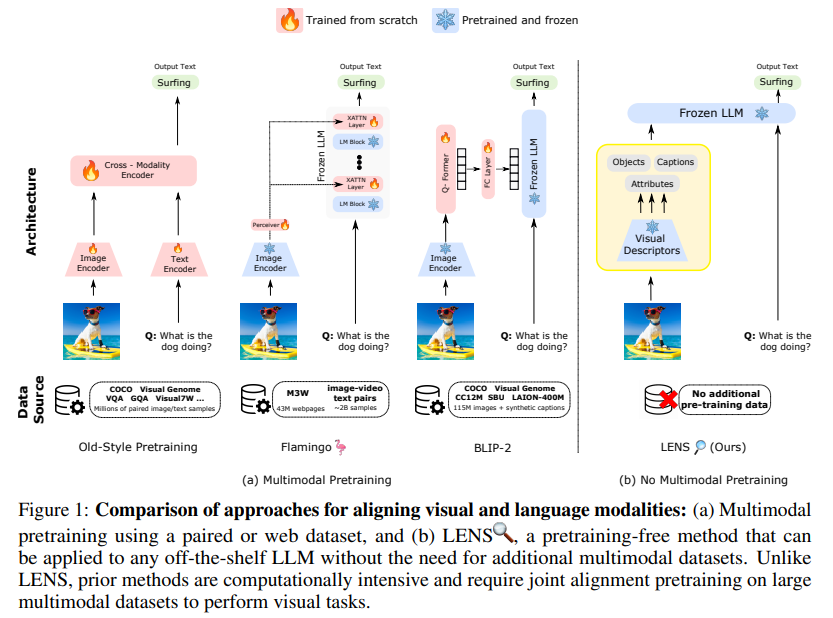

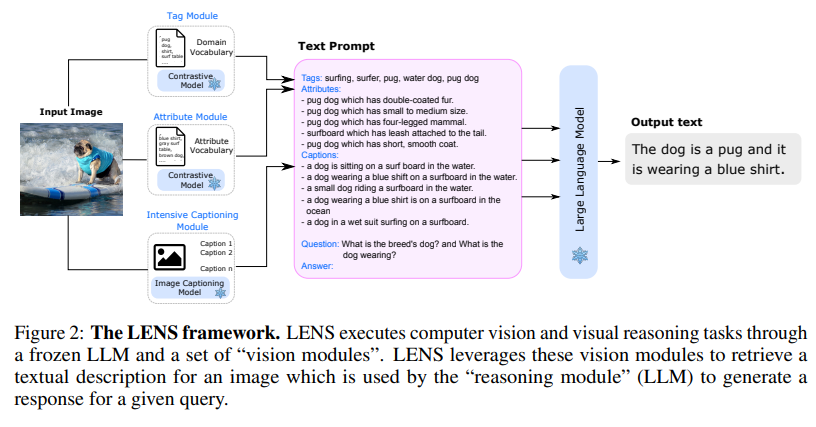

私たちは、大規模な言語モデル(LLM)の力を活用してコンピュータビジョンの問題に取り組むためのモジュラーアプローチであるLENSを提案します.私たちのシステムは、画像についての徹底的な情報を提供する独立した高度なビジョンモジュールの出力を言語モデルで推論することによって、コンピュータビジョンの問題に取り組みます.私たちは、ゼロショットおよびフューショットのオブジェクト認識などの純粋なコンピュータビジョンの設定、およびビジョンと言語の問題でこのアプローチを評価します.LENSは、市販のLLMに適用することができ、マルチモーダルのトレーニングなしに、より大きく、より洗練されたシステムと非常に競争力のあるパフォーマンスを発揮することがわかります.私たちは、https://github.com/ContextualAI/lensでコードをオープンソース化し、インタラクティブなデモも提供しています.

Q&A:

Q: 提案されたLENSアプローチの主な目的は何ですか?

A: 提案されたLENSアプローチの主な目的は、自然言語の記述を通じて視覚入力を処理することで、言語モデルの少数ショットでの文脈学習能力を利用してコンピュータビジョンのタスクに取り組むことです.具体的には、LENSは独立した高度に記述的なビジョンモジュールの出力を言語モデルで推論し、画像についての徹底的な情報を提供します.LENSはゼロショットおよび少数ショットの物体認識などの純粋なコンピュータビジョンの設定だけでなく、ビジョンと言語の問題にも適用できます.また、LENSはオフシェルフの言語モデルに適用でき、LENSを使用した言語モデルは非常に高い応答性能を示すことがわかります.

Q: LENSは大規模言語モデル(LLM)の力をどのように活用するのですか?

A: LENSは、大規模な言語モデル(LLM)のパワーを活用するためのモジュラーなアプローチです.このシステムは、画像に関する徹底的な情報を提供する独立したビジョンモジュールの出力を言語モデルで推論することによって、コンピュータビジョンの問題に取り組みます.具体的には、事前学習されたビジョンモジュール(例:対照モデルや画像キャプションモデル)を使用して、豊富なテキスト情報を抽出します.その後、テキストはLLMに入力され、オブジェクト認識やビジョンと言語(V&L)のタスクを実行します.LENSは、追加のマルチモーダル事前学習ステージやデータを必要とせず、モダリティ間のギャップをゼロコストで埋めることができます.LENSの統合により、ドメインを超えて動作するモデルが得られ、追加のクロスドメイン事前学習なしで、コンピュータビジョンと自然言語処理の最新の進歩を利用することができます.これにより、これらの分野から得られる利点を最大限に活用することができます.(p.1)

Q: LENSシステムにおけるビジョンモジュールの役割を説明していただけますか?

A: ビジョンモジュールは、LENSシステム内での役割は、画像に関する情報を抽出し、テキストの説明を取得することです.これらのモジュールは、画像に関するさまざまなタスク(例:ゼロショットオブジェクト認識、ビジョンアンドランゲージ問題など)を実行し、画像に関する包括的な情報を提供します.これらの情報は、LLMの「推論モジュール」と呼ばれる部分に供給され、クエリに対する応答を生成するために使用されます.ビジョンモジュールは、独立して動作し、画像に関する情報を抽出するため、LLMの推論モジュールがビジョンタスクを処理するための情報を提供します.これにより、ビジョンモジュールは、LLMのビジョンタスクへの適用を可能にし、ビジョンと言語のタスクを解決するための追加の共同事前トレーニングの計算オーバーヘッドを排除します.

Q: LENSはどのようなコンピュータ・ビジョンの問題に適用できますか?

A: LENSは、コンピュータビジョンの問題に適用することができます.具体的には、ゼロショットおよびフューショットのオブジェクト認識などの純粋なコンピュータビジョンの設定での評価が行われています.また、ビジョンと言語の問題にも適用することができます.LENSは、オフシェルフの大規模言語モデル(LLM)に適用することができ、LLMとLENSを組み合わせた場合、非常に競争力のある性能を発揮することがわかっています.さらに、LENSはマルチモーダルなトレーニングを必要とせずに、より大きく、より洗練されたシステムと同等の性能を実現しています.

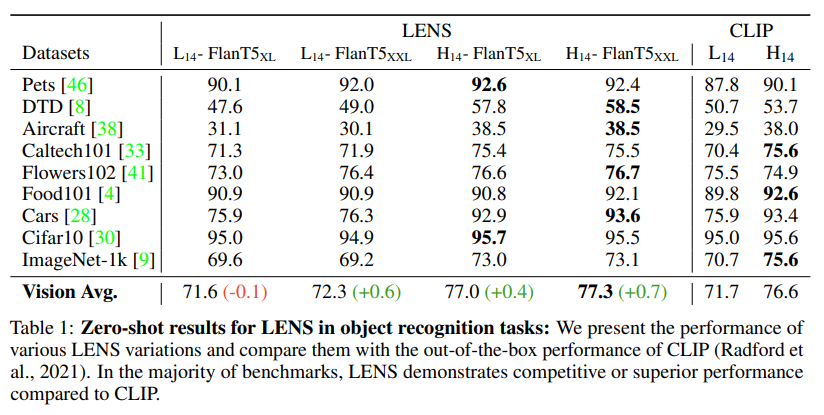

Q: LENSはゼロショットや数ショットの物体認識タスクでどのような性能を発揮しますか?

A: LENSは、ゼロショットおよびフューショットのオブジェクト認識タスクにおいてどのようなパフォーマンスを発揮するのでしょうか?

LENSは、ViT-H/14をビジュアルバックボーンとし、凍結されたLLMとしてFlan-T5 xxlを使用した場合、ゼロショットでCLIPと比較して平均で+0.7%の性能向上が見られます.しかし、オブジェクト認識タスクでは、凍結されたLLMのサイズと分類性能との直接的な関係は見られません.一方、タガーのアーキテクチャ(ViTバックボーン)のサイズと性能には対応関係があることが観察されます.

また、図3では、ImageNetを除くすべてのデータセットにおける平均ビジョンパフォーマンスをプロットしています.ここで、より多くのショットを使用すると、どのビジュアルバックボーンと凍結されたLLMの組み合わせでもパフォーマンスが向上することがわかります.また、性能に関しては、より良い凍結されたLLMとの直接的な関係は見られませんが、より良いビジュアルバックボーンは平均ビジョンパフォーマンスの向上に役立つことが観察されます.

Q: LENSは視力と言語の両方の問題に使えますか?

A: LENSは、ビジョンと言語の問題の両方に使用することができます.論文の要約によると、LENSは大規模な言語モデル(LLM)の力を活用してコンピュータビジョンの問題に取り組むためのモジュラーなアプローチです.LENSは、画像についての詳細な情報を提供する独立したビジョンモジュールの出力を言語モデルで推論することによって機能します.このアプローチは、ゼロショットやフューショットのオブジェクト認識などの純粋なコンピュータビジョンの設定だけでなく、ビジョンと言語の問題にも適用できます.さらに、LENSはオフシェルのLLMに適用できるため、補助的なトレーニングを必要とせずにビジュアル能力を持つことができます(p.1, p.3-5).

LENSの性能は、他のシステムと比較して非常に競争力があることが実験結果から明らかになっています.Flamingo、BLIP-2、Kosmosなどのより大規模で洗練されたシステムと比較しても、LENSは優れたパフォーマンスを発揮します(p.1, p.5, p.30).

したがって、LENSはビジョンと言語の問題の両方に使用することができます.

Q: LENSを搭載したLLMの性能は、より大型で洗練されたシステムと比較してどうですか?

A: LLMsとLENSのパフォーマンスは、より大きくて洗練されたシステムと比較してどのように異なるのでしょうか?

LENSのパフォーマンスは、より大きくて洗練されたシステムと比較して非常に競争力があることが示されています.テーブル2に示されている比較的なパフォーマンス分析の結果から、LENSはFlamingo [2]、BLIP-2 [35]、Kosmos [22]などのより大きくて洗練されたシステムと比較しても非常に競争力があることが明確に示されています.(p.1)

LENSは、より大きなマルチモーダルな事前学習済みシステムと比較しても適応性があります.LENSは、事前学習やマルチモーダルデータに関係なく、さまざまなオープンソースやブラックボックスの言語モデルに適応することができます.これにより、将来のパフォーマンス向上のために柔軟性と拡張性を提供しています.(p.1)

LLMsとモジュラーアプローチの強みを活用することで、LENSは追加の事前学習を必要とせずにタスク解決の重要な進歩を表しています.さまざまなビジョンタスクとのシームレスな統合により、その汎用性と広範な応用の可能性が示されています.(p.1)

LENSの限界もあります.まず第一に、LENSのビジョン能力は、CLIPとBLIPという基盤となるビジョンコンポーネントに大きく依存しています.これらのモデルは注目すべきパフォーマンスの改善を示していますが、それらの強みを活用し、LLMsと組み合わせることでさらなる向上の余地があります.補足資料の図5には、LENSのいくつかの失敗例が示されています.将来の研究では、これらのモデルを効果的に統合し、ビジョンと言語のコンポーネントの相乗効果を活かして、さまざまなタスクでさらに優れたパフォーマンスを実現する方法を探求する必要があります.(p.1)

第二に、LENSモデルの評価実験には相当な計算リソースが必要です.たとえば、私たちの実験は8*A100を使用して行われましたが、これは小規模または中規模の研究室やリソースに制約のあるコミュニティにとって課題となる可能性があります.ただし、LENSモデルの評価にかかる計算コストは、Flamingoなどの大規模なビジュアル言語モデルの広範なトレーニング要件と比較して比較的低いです.Flamingoは50万以上のトレーニングを要求することがあります.(p.1)

LeanDojo: Theorem Proving with Retrieval-Augmented Language Models

著者:Kaiyu Yang, Aidan M. Swope, Alex Gu, Rahul Chalamala, Peiyang Song, Shixing Yu, Saad Godil, Ryan Prenger, Anima Anandkumar

発行日:2023年06月27日

最終更新日:2023年06月27日

URL:http://arxiv.org/pdf/2306.15626v1

カテゴリ:Machine Learning, Artificial Intelligence, Logic in Computer Science, Machine Learning

概要:

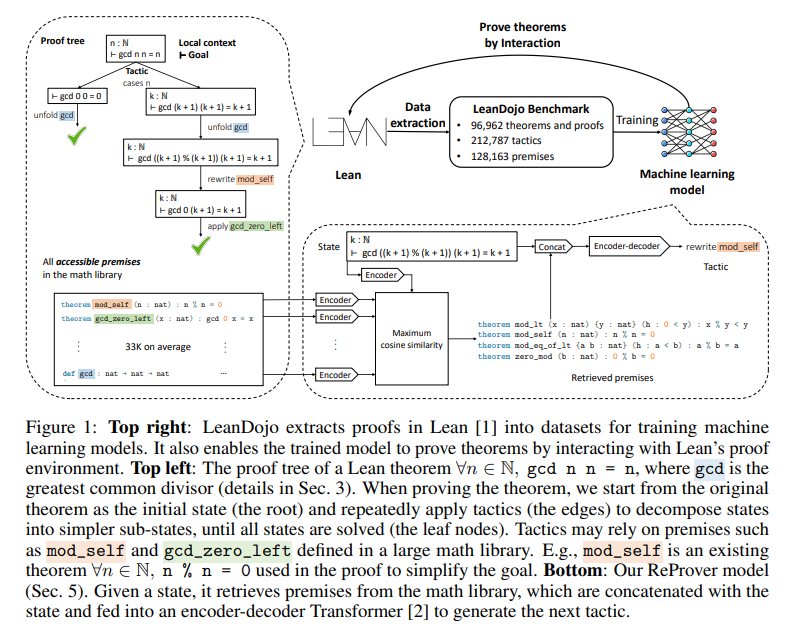

大規模言語モデル(LLM)は、Leanなどの証明支援ツールを使用して形式的な定理を証明する際に有望な結果を示しています.しかし、既存の方法は、プライベートなコードやデータ、大規模な計算要件のため、再現性や拡張性が困難です.これにより、定理証明のための機械学習手法に関する研究には大きな障壁が生じています.

本論文では、これらの障壁を取り除くために、ツールキット、データ、モデル、ベンチマークからなるオープンソースのLeanプレイグラウンドであるLeanDojoを紹介します.LeanDojoはLeanからデータを抽出し、プログラムで証明環境との対話を可能にします.証明における前提条件の詳細な注釈を含んでおり、定理証明におけるボトルネックである前提条件の選択に貴重なデータを提供します.このデータを使用して、私たちはReProver(検索補完型証明器)を開発しました.これは、広範な数学ライブラリから前提条件を選択するために検索を補完する最初のLLMベースの証明器です.訓練にはわずか1週間のGPUが必要であり、費用もかかりません.私たちの検索補完器は、LeanDojoのプログラム解析機能を活用してアクセス可能な前提条件や難しい負例を特定し、検索をより効果的にします.

さらに、私たちは96,962の定理と証明からなる新しいベンチマークを構築しました.これはLeanの数学ライブラリから抽出されたもので、証明者がトレーニングで使用されない新しい前提条件に依存する定理を一般化する必要があります.このベンチマークを訓練と評価に使用し、実験結果はReProverの非検索ベースラインやGPT-4よりも効果的であることを示しています.したがって、私たちはプロプライエタリなデータセットなしで最初のオープンソースのLLMベースの定理証明器を提供し、それを許容範囲のMITライセンスで公開してさらなる研究を促進します.

Q&A:

Q: Leanのような証明支援ツールを使って形式的定理を証明する既存の方法にはどのようなものがありますか?

A: 証明アシスタントであるLeanを使用して形式的な定理を証明するための既存の方法は、プライベートなコードやデータ、大規模な計算要件のために再現や構築が困難です.これにより、定理証明のための機械学習手法の研究には大きな障壁が生じています.しかし、この論文では、これらの障壁を取り除くためにLeanDojoを導入しています.LeanDojoは、ツールキット、データ、モデル、ベンチマークからなるオープンソースのLeanプレイグラウンドです.(p.1)

Q: 定理証明のための既存の方法を再現したり、その上に構築したりする上での障壁は何か?

A: 既存の定理証明の方法を再現または構築する際の障壁は、いくつかの要素によって引き起こされています.まず、プライベートなコードやデータ、大量の計算要件により、既存の方法は再現や拡張が困難です.これにより、定理証明のための機械学習手法に関する研究において、大きな障壁が生じています(p.3).

この論文では、これらの障壁を取り除くために、LeanDojoというオープンソースのLeanプレイグラウンドを導入しています.LeanDojoには、ツールキット、データ、モデル、ベンチマークが含まれており、定理証明の研究における障壁を低減することを目指しています(p.3).

さらに、この論文では、ReProverの効果を検証するために、定理証明を使用しています.また、データ、モデル、コードを公開することで、定理証明に関するLLMsのオープンな研究を促進しています.この手法は、プライベートなデータセットに依存せず、1つのGPUで1週間以内にトレーニングすることができます.これにより、この分野の学術研究の障壁が大幅に低下し、将来の研究の基盤となる初めてのアクセス可能なベースラインが確立されると考えています(p.3).

さらに、定理証明アシスタントにおける定理証明は対話的なプロセスであり、証明は最終的な成功した軌跡のみを捉えています.試行錯誤の中間の履歴がないため、最終的な証明がどのように導かれたのかは非常に不透明です.そのため、人間によって書かれた証明のタクティクスは、モデルが学習するのが難しい場合があります(p.24).

さらに、あるプロジェクトで証明に基づいてトレーニングされたモデルは、新しいドメインの定理に対して一般化するのが難しい場合があります.例えば、mathlibからMiniF2FやProofNetへの一般化が困難な場合があります(p.24).

要約すると、既存の定理証明の方法を再現または構築する際の障壁は、プライベートなコードやデータ、大量の計算要件、対話的なプロセスの不透明性、異なるドメインへの一般化の困難性などが挙げられます(p.3, 24).

Q: LeanDojoとは何ですか?

A: LeanDojoは、数学者の間で人気のある証明支援ツールであるLeanに焦点を当てたフレームワークです.LeanDojoは、学習ベースの定理証明において2つの重要な機能を提供します.まず、データの抽出機能です.LeanDojoは、生のLeanコードでは直接見えないトレーニングデータを抽出します.例えば、証明ステップ間の中間状態からなる証明木などです.また、LeanDojoは、Leanの証明における前提条件を特定する最初のツールでもあり、前提選択のための機械学習モデルのトレーニングを可能にします.次に、インタラクション機能です.LeanDojoは、Leanをジムのようなインタラクティブな環境に変えます.LeanDojoを使用することで、モデルは証明の状態を観察し、実行によって状態を変更することができます.LeanDojoは、研究者に最新のLLMベースの証明器を提供し、計算コストを抑えるためのオープンソースのツールキット、モデル、ベンチマークを提供します.(p.1)

Q: LeanDojoはどのようにしてLeanからデータを抽出し、証明環境とのインタラクションをプログラムで可能にするのですか?

A: LeanDojoは、Leanからデータを抽出し、証明環境とプログラム的に対話することを可能にする機能を提供します.具体的には、LeanDojoは、証明ステップ間の中間状態からなる証明木など、生のLeanコードでは直接見ることができないトレーニングデータを抽出します.また、LeanDojoは、Leanの証明における前提条件を特定することができる最初のツールであり、前提選択のための機械学習モデルのトレーニングを可能にします.さらに、LeanDojoはLeanをジムのような対話型環境に変換します.LeanDojoを使用することで、モデルは証明の状態を観察し、実行によって状態を変更することができます.LeanDojoは、Leanからデータを抽出し、証明環境とプログラム的に対話することができるようにします.(p.2)

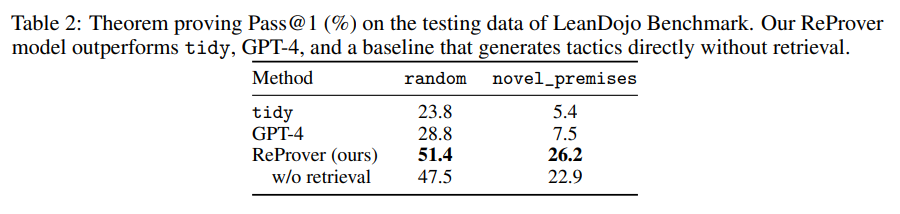

Q: ReProverとはどのようなもので、他のLLMベースのプローバーとどのように違うのですか?

A: ReProverは、他のLLMベースの証明器とは異なります.ReProverは、特定の数学やコーディングに関連するデータセットで事前学習を行わず、代わりにgoogle/byt5-smallをベースに構築されています.これにより、事前学習にかかる計算量を削減し、データセットを非公開にする必要もありません.また、ReProverは、訓練に5日間の単一GPUを使用するだけで済みます.

他のLLMベースの証明器と比較して、ReProverは優れた性能を発揮します.LeanDojo Benchmarkでの評価では、ReProverは51.4%の定理を証明できます.これは、直接タクティクスを生成するベースライン(47.5%)や、GPT-4を使用してゼロショットでタクティクスを生成するベースライン(28.8%)よりも優れています.また、既存のデータセットであるMiniF2F(26.5%)やProofNet(13.8%)でも競争力のある結果を示し、リソースをはるかに少なく使用しているにも関わらず、強化学習を使用しない最先端の手法と同等の結果を達成します.さらに、ReProverは、Leanに証明が存在しない65の定理を証明することができます.したがって、ReProverは、既存の数学ライブラリを効果的に補完するツールとしても利用できます.

ReProverの特徴として、一般的で公開されている比較的小さなモデルチェックポイント(299Mパラメータ)を使用していることも挙げられます.また、ReProverは、人間が書いたタクティクスのみをファインチューニングしており、補助データやオンラインでのLeanとの対話によって収集されたデータは使用していません.

このような特徴により、ReProverは他のLLMベースの証明器とは異なり、より効率的でリソースを節約しながら高い性能を発揮することができます.(p.3-5)

Q: ReProverのトレーニング時間と必要なリソースは?

A: ReProverのトレーニングには、従来の手法と比較してかなり少ない計算量が必要です(120 GPU時間対1000時間以上[14,15]).既存のLLMベースの証明器は、数学とコーディングに特化したデータセットで事前トレーニングを行います[12-18].この事前トレーニングは計算量が多く、データセットは非公開です.それに対して、私たちはドメイン固有の事前トレーニングを避け、google/byt5-smallをベースに構築しました.

ReProverのトレーニングと評価には、LeanDojoベンチマークを使用しています.トレーニングは単一のGPUでわずか5日間で行われます.評価では、ReProverは51.4%の定理を証明することができ、直接タクティクスを生成するベースライン(47.5%)やGPT-4 [24]を使用してタクティクスを生成する別のベースラインを上回ります.GPT-4は人間が書いたタクティクスに対してクロスエントロピー損失を最小化するようにトレーニングされています.

ReProverのトレーニングには、120 GPU時間が必要です.これは従来の手法よりもはるかに少ない計算量です(p.1).また、ReProverのトレーニングには、特定の数学とコーディングのデータセットに事前トレーニングする必要はありません.代わりに、google/byt5-smallをベースに構築しています.

ReProverのトレーニングと評価には、LeanDojoベンチマークが使用されます.トレーニングは2つのステージで行われます.まず、リトリーバーをトレーニングし、LeanDojoベンチマークのすべての証明状態に対して100の前提条件を取得します.次に、タクティクスジェネレーターをトレーニングし、状態と取得した前提条件(長さ制限で切り詰められた連結)を入力として使用します.評価中は、新しい前提条件を使用した定理を証明することができます(p.7).

Q: 実験結果は、非検索ベースラインやGPT-4と比較して、ReProverの有効性をどのように実証しているのでしょうか?

A: 実験結果は、ReProverが非検索ベースラインとGPT-4に比べて効果的であることを示しています.LeanDojoベンチマークのテストデータにおける定理証明の結果を示す表2によれば、ReProverはtidy、GPT-4、および検索なしで直接タクティクスを生成するベースラインよりも優れたパフォーマンスを示しています.特に、ReProverはランダムなデータ分割と新しい前提条件の両方で他の手法を上回っており、検索を補完した定理証明の効果を示しています.一方、GPT-4は我々の手法よりも大幅に劣っており、データの汚染により正解の証明を見ている可能性があるにもかかわらず、問題を解決することができませんでした.この結果から、最先端のLLMでは問題をそのまま解決することはできず、さらなる進展のためにアルゴリズムの革新が必要であることが示されています.(p.1)

Extending Context Window of Large Language Models via Positional Interpolation

著者:Shouyuan Chen, Sherman Wong, Liangjian Chen, Yuandong Tian

発行日:2023年06月27日

最終更新日:2023年06月28日

URL:http://arxiv.org/pdf/2306.15595v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

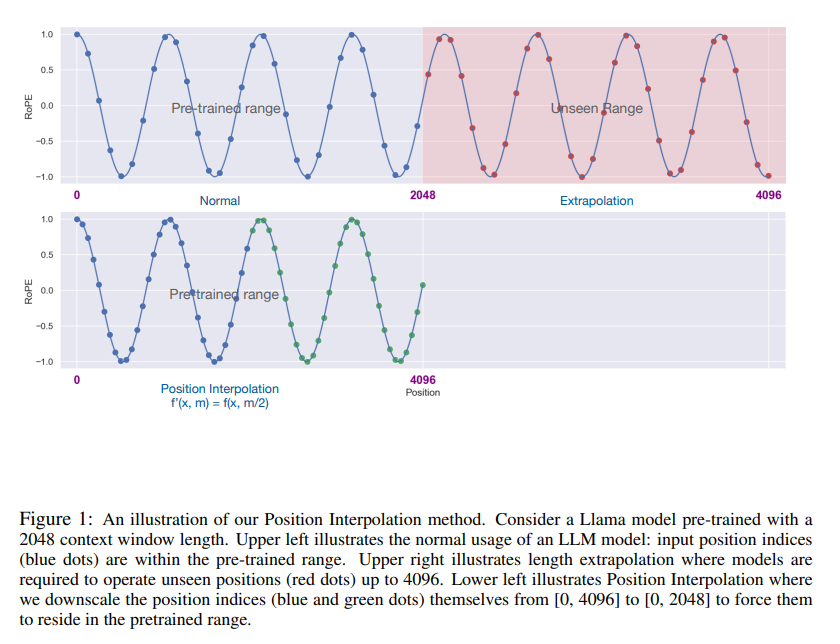

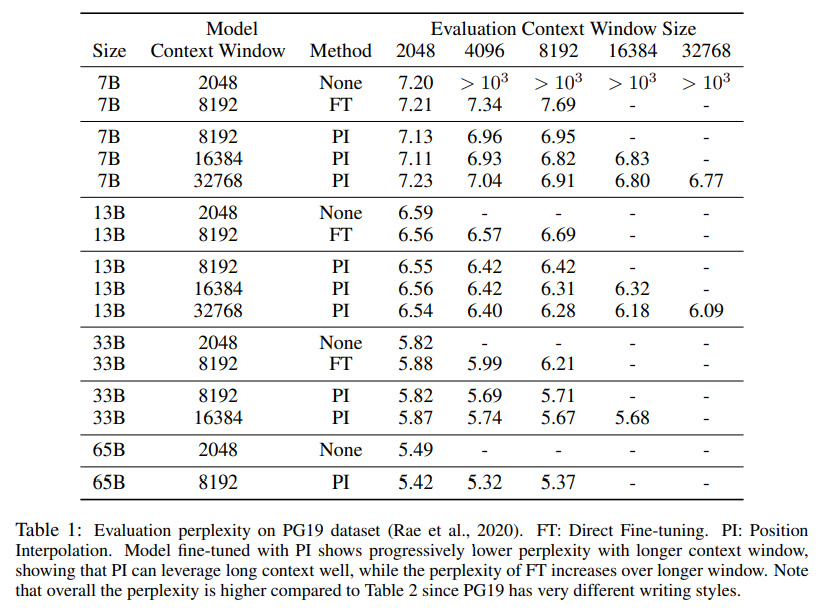

この論文では、Position Interpolation(PI)という手法を提案しています.この手法は、RoPEベースの事前学習済みLLM(Language Model)(例:LLaMAモデル)のコンテキストウィンドウサイズを最大32768まで拡張することができます.また、最小限のファインチューニング(1000ステップ以内)で、パスキーの取得、言語モデリング、LLaMA 7Bから65Bまでの長文要約など、長いコンテキストが必要なさまざまなタスクで強力な実験結果を示しています.一方で、Position Interpolationによって拡張されたモデルは、元のコンテキストウィンドウ内のタスクにおいても比較的良好な品質を保持します.この目標を達成するために、Position Interpolationは、トレーニングされたコンテキストの長さを超えて外挿することがなく、元のコンテキストウィンドウサイズに合わせて入力の位置インデックスを線形にダウンスケールします.これにより、自己注意メカニズムを完全に破壊するような、壊滅的に高い注意スコアが発生する可能性を回避します.理論的な研究によれば、内挿の上限は外挿の約600倍以上小さいことが示されており、その安定性が示されています.Position Interpolationによって拡張されたモデルは、元のアーキテクチャを保持し、ほとんどの既存の最適化とインフラストラクチャを再利用することができます.

Q&A:

Q: 位置補間(PI)の目的は何ですか?

A: Position Interpolation(PI)の目的は、注意スコアの計算におけるコンテキストウィンドウの効果を軽減することです.PIは、元の位置エンコーディングの範囲に合わせて位置インデックスと相対距離の範囲を調整することで、注意スコアの計算におけるコンテキストウィンドウの影響を緩和します.具体的には、PIでは、元のコンテキストウィンドウの長さL’に対して、位置エンコーディングの範囲をLに縮小し、位置エンコーディングを次のように定義します.

[ f'(x, m) = f\left(\frac{x}{L}, \frac{m}{L’}\right) ]

これにより、注意スコアの計算におけるコンテキストウィンドウの効果を軽減することができます.PIは、長い入力プロンプトと短い入力プロンプトの両方に対して効果的であり、既存のインフラストラクチャと最適化を再利用することができるため、実用的なアプリケーションにおいて魅力的な手法です.また、PIは他の種類の位置エンコーディングにも適用可能な汎用的な手法であり、今後の研究でそのような方向性を追求する予定です.(p.11)

Q: 位置補間は、RoPEベースの事前訓練されたLLMのコンテキストウィンドウサイズをどのように拡張するのか?

A: Position Interpolation(PI)は、RoPEベースの事前学習済みLLM(Large Language Models)(例:LLaMA)のコンテキストウィンドウサイズを拡張するための手法です.この手法では、事前学習段階での以前のコンテキストウィンドウの制限に合わせるために、位置インデックスを直接ダウンスケールします.具体的には、最大位置インデックスが以前のコンテキストウィンドウの制限と一致するように、位置インデックスを縮小します.これにより、外挿ではなく内挿を行い、自己注意メカニズムを完全に破壊する可能性のある致命的に高い注意スコアを回避します.

Position Interpolationによるコンテキストウィンドウの拡張は、以下の手順で行われます.まず、事前学習済みLLMのコンテキストウィンドウサイズを拡張するために、位置インデックスを縮小します.この際、最大位置インデックスが以前のコンテキストウィンドウの制限と一致するように調整します.このダウンスケーリングにより、拡張されたコンテキストウィンドウサイズでの入力に対して適切な自己注意メカニズムが働くことが保証されます.

この手法により、最大32768までのコンテキストウィンドウサイズの拡張が可能となります.また、最小限のファインチューニング(1000ステップ以内)で実現され、パスキーリトリーバル、言語モデリング、長文書要約など、長いコンテキストを必要とするさまざまなタスクにおいて強力な結果が示されています.さらに、Position Interpolationによる拡張モデルは、元のコンテキストウィンドウ内のタスクにおいても比較的良好な品質を保持しています.

この手法の理論的な研究によれば、内挿の上限は、訓練されたコンテキストの長さよりも少なくとも約600倍小さいことが示されています.

Q: 位置補間の入力位置インデックスをリニアにダウンスケーリングするプロセスを説明してもらえますか?

A: 線形に入力位置インデックスをダウンスケールするプロセスは、Position Interpolationにおいて、既存の事前学練習済みLLM(Language Model)におけるコンテキストウィンドウの拡張を可能にするために行われます.このプロセスでは、事前トレーニング段階での前のコンテキストウィンドウの制限に合わせて、最大位置インデックスをダウンスケールします.

具体的には、入力トークンをより多く受け入れるために、隣接する整数位置で位置エンコーディングを補間します.これは、位置エンコーディングが非整数位置に適用できることを利用するものであり、トレーニングされた位置の外挿ではなく、トレーニングされた位置を超えることによって引き起こされる壊滅的な値を防ぐためのものです.

具体的な手順は、文脈によって異なる場合がありますが、一般的なアプローチは以下の通りです.

- 事前トレーニング段階での前のコンテキストウィンドウの制限を確認します.

- 入力トークンの数が制限を超える場合、位置エンコーディングを補間する必要があります.

- 補間には、隣接する整数位置の位置エンコーディングを使用します.具体的には、補間する位置の前後の整数位置のエンコーディングを取得し、それらを線形補間します.

- 線形補間には、以下の式が使用されます. $$ \small

\text{{補間された位置エンコーディング}} = (1 – \alpha) \times \text{{前の整数位置のエンコーディング}} + \alpha \times \text{{次の整数位置のエンコーディング}}

$$

ここで、(\alpha) は補間する位置の非整数部分です.

このようにして、入力位置インデックスを線形にダウンスケールすることで、事前トレーニング段階での前のコンテキストウィンドウの制限に合わせて、より多くの入力トークンを受け入れることができます.

Q: 訓練されたコンテキストの長さを超えて外挿すると、どのような結果になる可能性があるのか?

A: 訓練されたコンテキストの長さを超えて外挿することの潜在的な結果は何ですか?

外挿は、訓練されたコンテキストの長さを超えて情報を利用することを試みることを意味します.しかし、この研究では、訓練されたコンテキストウィンドウの増加が非常に限定的であることが示されています.具体的には、訓練の10000バッチ以上の後でも、効果的なコンテキストウィンドウはわずかに2048から2560に増加したに過ぎません.これは、この方法が大幅に長いコンテキストウィンドウに拡張するためには効率的ではないことを示唆しています.

この問題の原因は、位置エンコーディングや注意機構の弱い外挿特性にあります.多くの既存の事前学習済みLLM(Language Models)は、位置エンコーディングとしてRoPE(Su et al.、2021)などの外挿特性の弱い手法を使用しています.そのため、これらの手法は、このようなLLMのコンテキストウィンドウサイズを拡張するための適用範囲が限られています.

外挿の潜在的な結果は、訓練されたコンテキストの長さを超えて情報を利用できないため、モデルが正しく応答できないことです.例えば、位置3000にある質問に対して、訓練されたコンテキストウィンドウサイズが最大のL=2048のモデルは、位置0にある証拠を利用することはできませんが、位置2900にある証拠は利用できます.しかし、実際には、位置3000にある質問は、位置2900にある証拠が提供されていても正しく回答することができません.

この問題が発生する理由は、注意スコアが相対距離|m−n|に応じて減衰するという仮定に反しているためです.この研究では、注意スコアが相対距離に応じて減衰するという仮定があるにもかかわらず、実際には非常に遅く減衰するため、非常に遠い位置からの情報を効果的に利用することができません.

このような問題が発生すると、訓練されたコンテキストの長さを超えて情報を利用することが困難になります.これにより、モデルの性能が劇的に低下し、外挿が困難になります.

Q: 位置の補間は、元のコンテキストウィンドウ内のタスクで拡張モデルの品質をどのように維持するのか?

A: Position Interpolationは、元のコンテキストウィンドウサイズ内のタスクにおいて、拡張モデルの品質を比較的よく保持します.拡張されたLLaMAモデルに関する評価結果を提示していますが、元のLLaMAモデルと比較して、2048トークンの制限内でいくつかの標準ベンチマークでわずかな劣化が見られました(p.6).

Position Interpolationによる拡張モデルの元のコンテキストウィンドウ内での品質保持の仕組みは、次のように説明できます.Position Interpolationは、元のコンテキストウィンドウ内の位置エンコーディングをより狭い領域に制約するため、元のコンテキストウィンドウ内のパフォーマンスにわずかな劣化が生じる可能性があります(p.6).しかし、この劣化は非常に小さく、元のコンテキストウィンドウ内でのタスクにおいてはほとんど問題になりません.

具体的には、Position Interpolationによって拡張されたモデルは、元のコンテキストウィンドウ内のタスクにおいては、元のLLaMAモデルと比較してわずかなパフォーマンスの劣化しか見られません(p.6).これは、Position Interpolationによって位置エンコーディングが制約されるため、元のコンテキストウィンドウ内の情報をより狭い範囲に集中させることによるものです.

したがって、Position Interpolationは、元のコンテキストウィンドウ内のタスクにおいて、拡張モデルの品質を比較的よく保持します.

Q: 位置補間における補間の上限とは何ですか?また、補外と比較してどうですか?

A: Position Interpolationにおける補間の上限は、少なくとも外挿の約600倍小さいことが研究によって示されています.これは、安定性をさらに示しています.Position Interpolationによって拡張されたモデルは、元のアーキテクチャを保持し、ほとんどの既存の最適化とインフラストラクチャを再利用することができます.

Position Interpolationでは、事前に定義されたコンテキストウィンドウサイズを持つ大規模言語モデル(LLM)を拡張するために、位置インデックスを直接スケールダウンします.これにより、最大位置インデックスが事前のコンテキストウィンドウ制限と一致するようになります.これにより、より多くの入力トークンを収容するために、隣接する整数位置で位置エンコーディングを補間します.位置エンコーディングは非整数位置に適用できるため、訓練された位置の外挿ではなく、訓練された位置の外側に外挿することで、致命的な値が生じる可能性があることを利用しています.理論的には、補間された注意スコアは、外挿に比べてはるかに小さい上限を持つことが示されています.

補間の上限は具体的には示されていませんが、外挿の上限が補間の上限の約600倍であることが示されています.つまり、補間は外挿よりもはるかに安定していることが示されています.

Q: 位置補間によってモデルを拡張する場合、元のアーキテクチャに何らかの変更を加える必要がありますか?

A: 拡張モデルは、元のアーキテクチャを変更する必要はありません.これは、元のモデルのほとんどのインフラストラクチャと最適化を再利用できるため、実用的なアプリケーションで魅力的な手法となります.

Position Interpolationによるモデルの拡張は、元のアーキテクチャに変更を加える必要はありません.元のモデルのインフラストラクチャと最適化を再利用することができるため、実用的なアプリケーションでの利用が魅力的です.この手法は一般的な手法であり、他の種類の言語モデルにも適用できる可能性があります(p.5).

Q: 位置補間によってモデルを拡張する際、既存の最適化やインフラを再利用できるか?

A: 既存の最適化とインフラストラクチャは、Position Interpolationを使用してモデルを拡張する際に再利用することができます.これは、与えられた文脈ウィンドウを拡張するためのPosition Interpolationの効果的な手法であり、既存の最適化とインフラストラクチャを再利用することで、実用的な多くのアプリケーションで魅力的な手法となります.

この情報は、与えられた文脈ウィンドウを拡張するためのPosition Interpolationの効果に関する文脈から得られます.この手法によって拡張されたモデルは、既存の最適化とインフラストラクチャを再利用することができます.これにより、既存のモデルの機能を保持しながら、拡張された文脈ウィンドウでさまざまなタスクを実行することができます.

ViNT: A Foundation Model for Visual Navigation

著者:Dhruv Shah, Ajay Sridhar, Nitish Dashora, Kyle Stachowicz, Kevin Black, Noriaki Hirose, Sergey Levine

発行日:2023年06月26日

最終更新日:2023年06月26日

URL:http://arxiv.org/pdf/2306.14846v1

カテゴリ:Robotics, Computer Vision and Pattern Recognition, Machine Learning

概要:

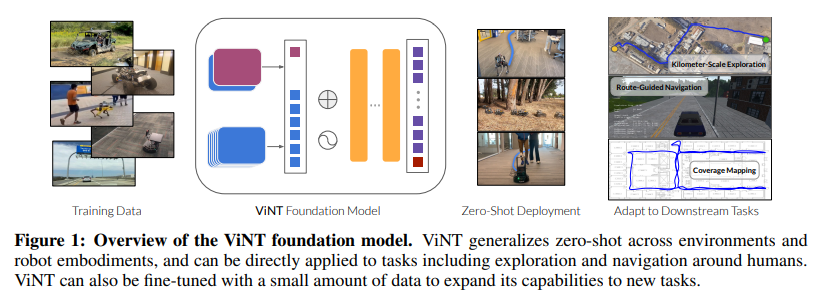

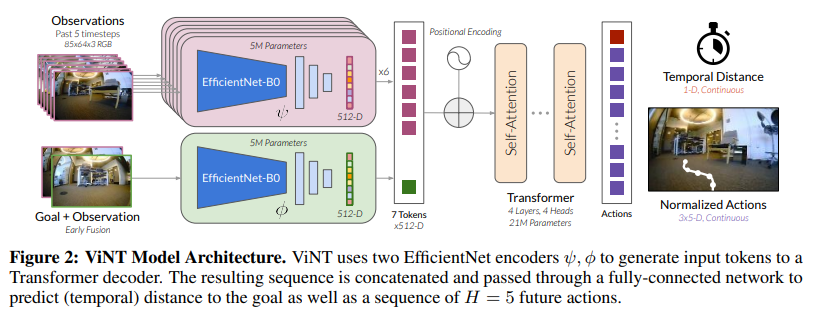

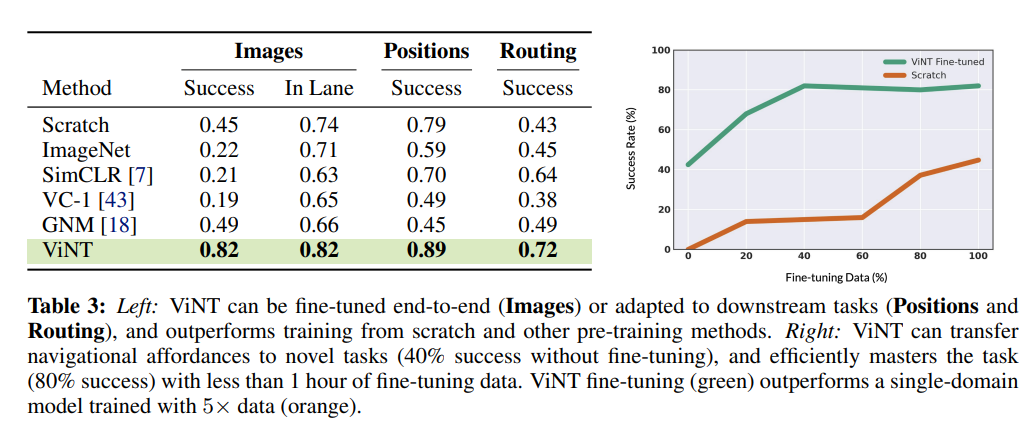

本論文では、ビジョンベースのロボットナビゲーションにおいて、一般的な目的のための事前学習済みモデルであるVisual Navigation Transformer(ViNT)が成功を収めていることを説明します.ViNTは、任意のナビゲーションデータセットでトレーニングされ、柔軟なTransformerベースのアーキテクチャを使用してナビゲーションの利用可能性を学習し、さまざまな下流のナビゲーションタスクに効率的に適応することができます.ViNTは、既存のナビゲーションデータセットでトレーニングされ、数百時間にわたるロボットナビゲーションを含むさまざまなロボットプラットフォームからのデータを使用しています.また、ViNTは、拡散ベースのサブゴール提案を組み合わせることで新しい環境を探索することができ、長距離ヒューリスティックを備えることでキロメートルスケールのナビゲーション問題を解決することができます.さらに、ViNTは、prompt-tuningに触発された技術を用いて、目標エンコーダーを別のタスクモダリティ(例:GPSウェイポイントやルーティングコマンド)のエンコーディングに置き換えることで、新しいタスク仕様に適応することができます.これらの柔軟性とさまざまな下流の問題領域への適応能力により、ViNTはモバイルロボティクスのための効果的な基礎モデルとして確立されています.詳細な情報やコード、モデルのチェックポイントについては、プロジェクトページ(https://visualnav-transformer.github.io)をご覧ください.ViNTは、特化したモデルよりも優れたパフォーマンスを発揮し、ポジティブな転送を示しています.

Q&A:

Q: ViNTのトレーニングに使用される一般的なゴール到達目標は何ですか?

A: ViNTの訓練に使用される一般的な目標到達目標は、任意のナビゲーションデータセットで使用できるものです.ViNTは柔軟なTransformerベースのアーキテクチャを使用して、ナビゲーションの利用可能性を学習し、さまざまな下流のナビゲーションタスクに効率的に適応することができます.ViNTは、さまざまなロボットプラットフォームからの数百時間のロボットナビゲーションを含む、既存のナビゲーションデータセットで訓練されており、より狭いデータセットで訓練された専門モデルを上回るポジティブな転送効果を示しています.ViNTは拡散ベースのゴール提案と組み合わせることで、新しい環境を探索することができます.また、ViNTはキロメートルスケールのナビゲーション問題を解決することができます.

Q: ViNTが見せたpositive transferについて、もう少し詳しく教えてください.

A: ViNTは、トレーニングデータセットに現れないロボット(例:Go 1)において、GNMモデルよりも大容量のViNTの方が改善された汎化性能を示すことがわかりました.さらに、特にターゲットのロボットと設定のみでトレーニングされた専門モデルを大幅に上回る形で、ViNTはドメイン内のロボット(Vizbot)に対してもポジティブな転移を示しました.これは、より小さなモデルには存在しない新たな現象であり、モデルがタスク間で一般化してパフォーマンスを向上させることを示しています.これは、基礎モデルの重要な特性です.(p.6)

ViNTは、低データ領域でのViNTの微調整の問題についても考慮しています.この設定では、ViNTモデル全体がエンドツーエンドで微調整され、学習率が1×10^-4に減少します.この微調整により、ViNTはより大きな容量のGNMモデルと比較して改善された汎化性能を示し、特にトレーニングデータセットに現れないロボット(例:Go 1)において改善が見られます.また、ViNTはドメイン内のロボット(Vizbot)に対してもポジティブな転移を示し、ターゲットのロボットと設定のみでトレーニングされた専門モデルを大幅に上回ります.これは、より小さなモデルには存在しない新たな現象であり、モデルがタスク間で一般化してパフォーマンスを向上させることを示しています.(p.6)

Q: ViNTは拡散ベースのサブゴール提案をどのように利用して、新しい環境を探索するのか?

A: ViNTは、未知の環境を探索するために拡散ベースのサブゴール提案を利用しています.これにより、ViNTは新しい環境を探索し、ゴールへの経路を見つけることができます.

具体的には、ViNTはトポロジカルグラフベースのプランナーと組み合わせて、複数のダウンストリームアプリケーションに適用されます.このプランナーは、遠くの場所に到達するための短期目標を提供するためのエピソードメモリとして機能します.未知の環境では、このグラフベースのプランナーを探索的なサブゴール提案と組み合わせることができます.これにより、ViNTを新しい環境を探索し、ゴールへの経路を見つけるために駆動することができます.

ViNTは、複数の提案メカニズムを考慮し、現在の観測に基づいて多様な将来のサブゴール候補をサンプリングするイメージ拡散モデルによって最大のパフォーマンスが得られることがわかりました.

これらのサブゴールは、ゴールに向かって進歩する最良のサブゴールを特定するために、ゴール指向のヒューリスティックでスコアリングされます.環境内の過去の観測と未探索のフロンティアは、トポロジカルグラフのノードとして保存され、ViNTによって予測された距離によって接続性が決定されます.探索中に、ロボットが環境を探索するにつれて、このトポロジカルグラフを動的に構築します.後の展開では、このグラフを使用することができます.

ViNTは、意味のないゴールが与えられた場合でも、衝突しないアクションを実行し、到達可能なサブゴールを追求しようとすることが示されています.拡散モデルによって生成されるサブゴールは、低品質で多くのアーティファクトを含み、実際の到達可能な状態に一致しないことがあります.しかし、この「デフォルト」の振る舞いにより、ViNTは有効なサブゴールを活用し、悪いサブゴールを無視して、未知の環境での衝突しないナビゲーションを成功させることができます.

Q: キロスケールのナビゲーション問題を解決するViNTの能力とは?

A: ViNTは、キロメートルスケールのナビゲーション問題を解決する能力を持っています.ViNTは、長距離ヒューリスティックを備えた場合にキロメートルスケールのナビゲーション問題を解決することができます.これは、ViNTが新しい環境での探索や屋内マッピング、ゼロショットで新しいロボットの制御、キロメートルスケールの屋外環境でのナビゲーションなど、さまざまなタスクに対応できる柔軟性を持っていることを示しています.また、ViNTはGPSのような長距離ヒューリスティックを備えた場合に、少量のデータで高いパフォーマンスを実現するためにファインチューニングすることもできます.これにより、ViNTはモバイルロボティクスのための効果的な基礎モデルとして確立されています.(p.1)

Q: ViNTを新しいタスク仕様に適応させるために使われる、プロンプト・チューニングに着想を得た技術について説明していただけますか?

A: ViNTは、新しいタスク仕様に適応するためのprompt-tuningに触発された技術を使用しています.この技術では、ViNTのゴールトークンに対する「ソフトプロンプト」マッピングを学習することで、一般的な事前学習目的である画像のゴール指定に加えて、他の一般的なゴール指定形式にも簡単に適応できます.Transformerアーキテクチャの特性を活用して、ViNTは複数のモーダル入力に注意を向けることができます.これにより、ViNTは異なるモーダリティのゴール指定にも適応することができます.

このprompt-tuningによる適応技術により、ViNTは新しいタスク仕様に迅速に適応することができます.具体的には、同じ目的を持つオンタスクデータを使用してモデル全体をファインチューニングすることで、ViNTは新しいスキルを素早く学習し、継続的に改善されるモデルを形成することができます.ViNTは、1時間のナビゲーションデータだけで、オリジナルモデルの能力を新しい環境や具現化に転送することができます.このため、ゼロからの再学習は必要ありません.

Q: ViNTは川下における様々な問題領域にどのように対応しているのか?

A: ViNTは、さまざまな下流の問題領域に適応する柔軟性と能力を持っています.ViNTは、既存のナビゲーションデータセットを使用してトレーニングされており、さまざまなロボットプラットフォームからの数百時間にわたるロボットナビゲーションを含んでいます.また、より狭いデータセットでトレーニングされた専門モデルを上回るポジティブな転送を示しています.さらに、ViNTは拡散ベースのゴール提案と組み合わせることで新しい環境を探索し、長距離ヒューリスティックを備えた場合にキロメートルスケールのナビゲーション問題を解決することができます.また、ViNTは、prompt-tuningに触発された技術を使用して、ゴールエンコーダーを別のタスクモダリティ(例:GPSウェイポイントやターンバイターンの指示)のエンコーディングに置き換えることで、新しいタスク仕様に適応することもできます.これらの柔軟性と下流のさまざまな問題領域への適応能力により、ViNTはモバイルロボティクスの効果的な基礎モデルとして確立されています.

Q: ViNTは、特異なデータセットで訓練された専門モデルと性能面でどのように比較されますか?

A: ViNTは、特定のデータセットでトレーニングされた専門モデルと比較して、パフォーマンスの面でどのように比較されますか?

ViNTは、特定のデータセットでトレーニングされた専門モデルと比較して、パフォーマンスの面で優れています.特に、トレーニングデータセットに現れないロボット(例:Go 1)に対して、ViNTの大容量は改善された汎化性能を示しています.さらに、ViNTは、ターゲットのロボットと設定のみでトレーニングされた専門モデルよりも、ドメイン内のロボット(Vizbot)に対してポジティブな転送を示し、はるかに優れたパフォーマンスを発揮します.これは、小さなモデルには存在しない新興の現象であり、モデルがタスク間で一般化してパフォーマンスを向上させるという重要な特性を示しています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のURLは、visualnav-transformer.github.ioのプロジェクトページに公開されます. (p.17)

DragDiffusion: Harnessing Diffusion Models for Interactive Point-based Image Editing

著者:Yujun Shi, Chuhui Xue, Jiachun Pan, Wenqing Zhang, Vincent Y. F. Tan, Song Bai

発行日:2023年06月26日

最終更新日:2023年06月27日

URL:http://arxiv.org/pdf/2306.14435v2

カテゴリ:Computer Vision and Pattern Recognition, Machine Learning

概要:

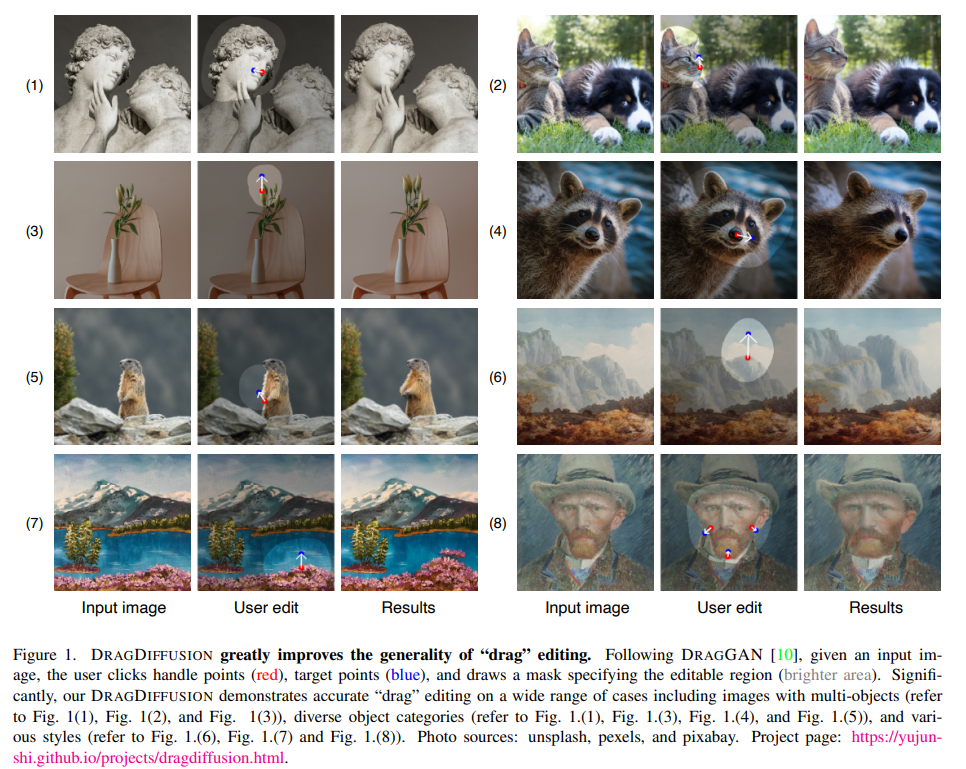

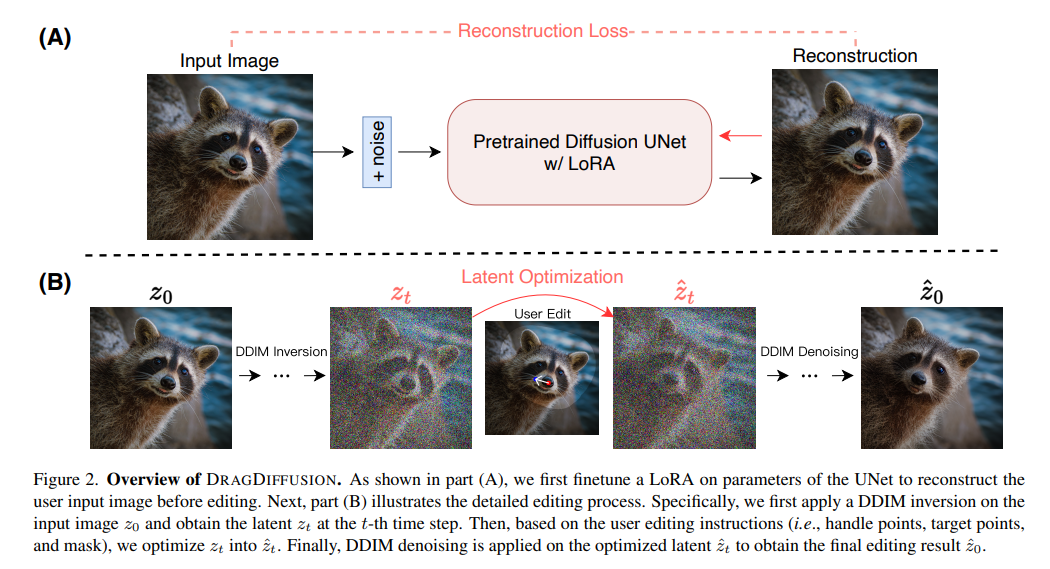

精密かつ制御可能な画像編集は、注目を集めている困難な課題です.最近、DragGANはインタラクティブなポイントベースの画像編集フレームワークを可能にし、ピクセルレベルの精度で印象的な編集結果を達成しています.しかし、この方法は生成的敵対的ネットワーク(GAN)に基づいているため、その汎用性は事前学習されたGANモデルの容量によって上限が設定されています.本研究では、このような編集フレームワークを拡張し、拡散モデルに基づいたDragDiffusionを提案します.大規模な事前学習済みの拡散モデルを活用することで、実世界のシナリオでのインタラクティブなポイントベースの編集の適用範囲を大幅に向上させます.既存のほとんどの拡散ベースの画像編集手法はテキスト埋め込みで動作しますが、DragDiffusionは拡散潜在変数を最適化して精密な空間制御を実現します.拡散モデルは反復的な方法で画像を生成しますが、実証実験により、1つの単一のステップで拡散潜在変数を最適化することで、一貫した結果を生成することが十分であることを示し、DragDiffusionは高品質な編集を効率的に完了することができます.さまざまな難しいケース(複数のオブジェクト、異なるオブジェクトカテゴリ、さまざまなスタイルなど)を対象とした幅広い実験も行われており、DragDiffusionの多様性と汎用性を示しています.

Q&A:

Q: DragDiffusionフレームワークの主な目的は何ですか?

A: DragDiffusionフレームワークの主な目的は、高品質で柔軟性のある画像編集を実現することです.このフレームワークは、大規模な事前学習済みの拡散モデルを活用して、対話型のポイントベースの編集を可能にします.これにより、「ドラッグ」編集の汎用性を大幅に向上させることができます.

具体的には、DragDiffusionは、入力画像に対してユーザーが指定したハンドルポイント、ターゲットポイント、および編集可能な領域を示すマスクを使用して、正確な「ドラッグ」編集を実現します.このフレームワークは、複数のオブジェクト、異なるオブジェクトカテゴリ、さまざまなスタイルなど、さまざまな難しいケースに対しても適用可能であり、その汎用性と柔軟性を実証しています.

DragDiffusionの主な目的は、ユーザーが編集したい画像に対して、高品質で正確な編集を行うことです.これにより、画像編集の柔軟性と効率性が向上し、幅広い用途に対応できるようになります.(p.1)

Q: DragGANとDragDiffusionの違いは何ですか?

A: DragDiffusionは、DragGANと比較して、その基礎となるモデルにおいて異なる点があります.DragGANは、生成的対抗ネットワーク(GAN)に基づいており、事前学習されたGANモデルの容量によって一般性が上限化されています.一方、DragDiffusionは、拡散モデルに基づいており、大規模な事前学習済みの拡散モデルを活用することで、実世界のシナリオでの対話型の点ベースの編集の適用範囲を大幅に向上させています(p.2).

具体的には、DragDiffusionは、拡散モデルの拡張として提案されており、DRAGDIFFUSIONという手法を提案しています.これにより、既存の拡散ベースの画像編集手法がテキスト埋め込みに対して作用するのに対し、DRAGDIFFUSIONは拡散潜在変数を最適化することで、精密な空間制御を実現しています.また、拡散モデルはイテレーションの方法で画像を生成しますが、DRAGDIFFUSIONでは、1つの単一のステップで拡散潜在変数を最適化することで、一貫した結果を生成することができることを実証しています.

したがって、DragDiffusionは、DragGANと比較して、拡散モデルを基にしており、拡散潜在変数の最適化によって高品質な編集を効率的に完了させることができる点で異なります(p.2).

Q: DragDiffusionフレームワークで拡散モデルを使用する利点は何ですか?

A: 拡散モデルをDragDiffusionフレームワークに使用する利点は、高品質な編集を効率的に完了させることができることです.拡散モデルは、画像を反復的に生成するため、1つの単一のステップで拡散潜在を最適化するだけで、連続した結果を生成することができます.これにより、DragDiffusionは高品質な編集を効率的に行うことができます.また、多様なオブジェクトカテゴリやスタイルなど、さまざまな難しいケースでの広範な実験により、DragDiffusionの汎用性と多様性が示されています.

Q: 正確な空間制御を実現するために、DragDiffusionはどのように拡散潜像を最適化するのか?

A: DragDiffusionは、拡散潜在変数を最適化して正確な空間制御を実現します.具体的には、以下の手順を踏んでいます.

- 最初に、LoRAを使用して、ユーザーが入力した画像を再構築するために拡散モデルを微調整します.これにより、編集プロセス中にオブジェクトのアイデンティティと入力画像のスタイルをより良く保持することができます.(p.1)

- 次に、入力画像にDDIM逆変換を適用して、特定のステップの拡散潜在変数を取得します.(p.1)

- その後、モーション監視とポイントトラッキングを繰り返し適用して、以前に取得したt番目のステップの拡散潜在変数を最適化し、ハンドルポイントをターゲットに”ドラッグ”します.(p.1)

- 編集プロセス中には、非マスク領域の一貫性を保証するために正則化項が適用されます.(p.1)

以上の手順により、DragDiffusionは拡散潜在変数を最適化して、正確な空間制御を実現します.これにより、従来のテキスト埋め込みを制御する既存の拡散ベースの画像編集手法とは異なり、高レベルの意味的な編集ではなく、ピクセルレベルの正確な空間制御が可能となります.(p.1)

Q: 拡散モデルの反復的な性質と、DragDiffusionがどのように拡散潜在量をシングルステップで最適化するのかを説明していただけますか?

A: 拡散モデルは、画像を反復的に生成する方法です.具体的には、拡散モデルは、初期画像から始まり、各ステップで画像を微小な変化させながら、最終的な生成画像に収束するまで繰り返し処理を行います.この反復的な生成プロセスにより、画像の詳細な特徴やスタイルが徐々に形成されていきます.

一方、DragDiffusionは、拡散モデルの反復的な生成プロセスを最適化するために、拡散潜在変数を単一のステップで最適化します.具体的には、DragDiffusionは、DDIM inversionと呼ばれる手法を使用して、入力画像の拡散潜在変数を特定のステップで逆変換します.そして、この逆変換された潜在変数を使用して、モーション監視とポイントトラッキングを繰り返し適用することで、ハンドルポイントの内容をターゲットに「ドラッグ」します.

このようにして、DragDiffusionは、単一のステップで拡散潜在変数を最適化することで、高品質な編集結果を効率的に生成することができます.この手法は、実験によって実証されており、多様なオブジェクトカテゴリやスタイルなど、さまざまな難しいケースにおいても優れた汎用性と柔軟性を示しています.

Q: DragDiffusionは、実世界のシナリオにおけるインタラクティブなポイントベース編集の適用性をどのように向上させるのか?

A: DragDiffusionは、実世界のシナリオでの対話型の点ベースの編集の適用範囲を拡大するために、拡散モデルを活用しています.これにより、従来の拡散ベースの画像編集手法がテキスト埋め込みに対して働くのに対し、DragDiffusionは拡散潜在変数を最適化することで、精密な空間制御を実現しています.また、DragDiffusionは大規模な事前学習済みの拡散モデルを活用することで、対話型の点ベースの編集フレームワークの汎用性を大幅に向上させています.具体的には、DragDiffusionは「ドラッグ」編集の汎用性を向上させるために、多様なケース(複数のオブジェクト、異なるオブジェクトカテゴリ、さまざまなスタイル)で正確な「ドラッグ」編集を実現しています.これにより、実世界のシナリオでの点ベースの編集の適用範囲が広がり、より正確で制御可能な画像編集が可能となります.

Q: DragDiffusionがテストされ、その汎用性と一般性が証明された困難なケースの例を教えてください.

A: DragDiffusionは、多様なオブジェクトカテゴリやスタイルなど、さまざまな難しいケースでの適用可能性と汎用性を実証するために、幅広い実験が行われています.具体的な例としては、論文の中で以下のようなケースが挙げられています.

- マルチオブジェクトの編集: DragDiffusionは、複数のオブジェクトが含まれる画像の編集にも適用可能です.例えば、1つの画像内に複数の物体があり、それぞれの物体を異なる方法で編集したい場合にも、DragDiffusionは高品質な編集結果を生成することができます.

- 異なるオブジェクトカテゴリの編集: DragDiffusionは、さまざまなオブジェクトカテゴリに対しても適用可能です.例えば、人物、風景、建物など、異なるカテゴリのオブジェクトを含む画像の編集においても、DragDiffusionは優れた結果を生成することができます.

- 異なるスタイルの編集: DragDiffusionは、さまざまなスタイルの画像編集にも適用可能です.例えば、写真風のスタイルからアート風のスタイルへの変換や、モノクロからカラーへの変換など、異なるスタイルの画像編集においても、DragDiffusionは高品質な結果を生成することができます.

これらのケースにおいて、DragDiffusionは幅広い実験によってその汎用性と適用可能性が実証されています.詳細な実験結果や具体的な例については、論文の該当箇所を参照してください.

Q: DragDiffusionフレームワークで拡散モデルを使用することの限界や潜在的な欠点は何ですか?

A: 拡散モデルをDragDiffusionフレームワークで使用する際の制限や潜在的な欠点は次のとおりです.

- 事前学習済みの拡散モデルの容量によって制約される可能性がある.(p.1)

- 拡散モデルの一般性は、事前学習済みのモデルの容量によって上限が設定されます.したがって、容量が限られている場合、DragDiffusionフレームワークの適用範囲も制限される可能性があります.

- テキスト埋め込みではなく、拡散潜在変数を最適化する必要がある.(p.1)

- 既存の拡散ベースの画像編集手法は、テキスト埋め込みを使用していますが、DragDiffusionでは、拡散潜在変数を最適化して空間的な制御を実現する必要があります.これにより、編集の精度が向上しますが、拡散モデルの特性によって制約される可能性もあります.

- 拡散モデルは反復的な方法で画像を生成するが、一つのステップで十分な結果を生成できるとは限らない.(p.1)

- 拡散モデルは通常、反復的な方法で画像を生成しますが、DragDiffusionでは、一つのステップで拡散潜在変数を最適化することで、連続した結果を生成することができます.しかし、この方法は必ずしも一貫した結果を生成するわけではありません.したがって、DragDiffusionの効率的な高品質な編集を実現するためには、この制約に対処する必要があります.

以上が、DragDiffusionフレームワークで拡散モデルを使用する際の制限や潜在的な欠点です.これらの制約に対処するためには、より大規模な事前学習済みの拡散モデルの開発や、拡散モデルの反復的な生成方法の改善が必要とされます.

Bring Your Own Data! Self-Supervised Evaluation for Large Language Models

著者:Neel Jain, Khalid Saifullah, Yuxin Wen, John Kirchenbauer, Manli Shu, Aniruddha Saha, Micah Goldblum, Jonas Geiping, Tom Goldstein

発行日:2023年06月23日

最終更新日:2023年06月23日

URL:http://arxiv.org/pdf/2306.13651v1

カテゴリ:Computation and Language, Machine Learning

概要:

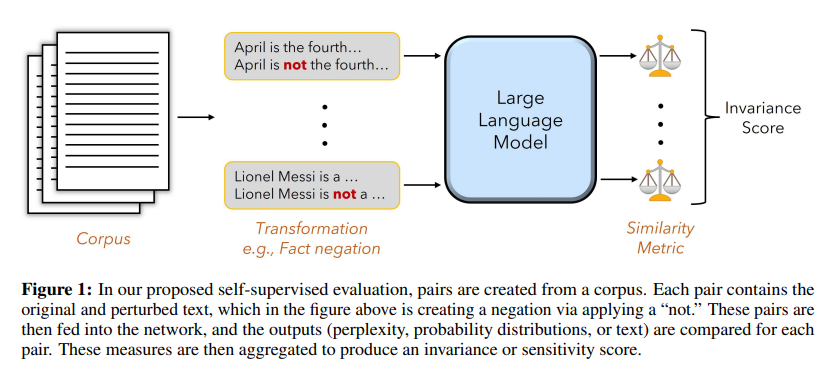

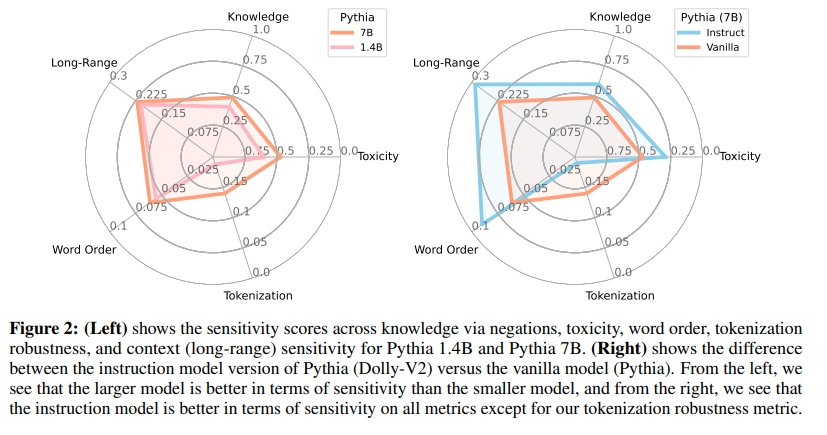

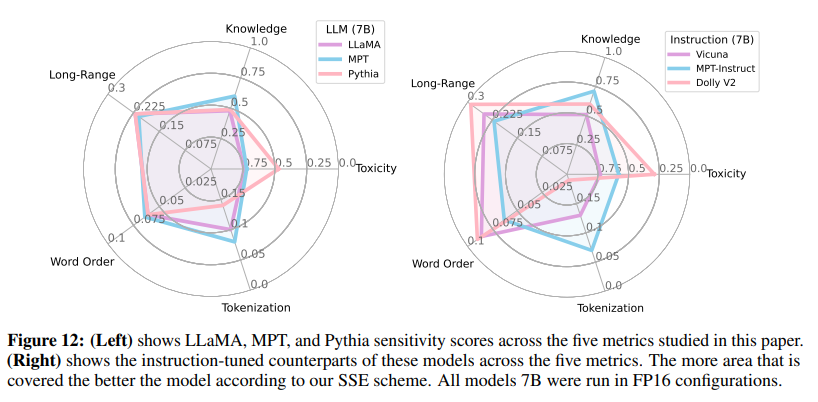

大規模言語モデル(LLM)の台頭とそれらの多様な領域での普及に伴い、現実的なデータ上での言語モデルの振る舞いの測定は不可欠となっています.例えば、顧客向けのチャットボットを展開する企業は、モデルがクライアントの要求に卑猥な言葉で応答しないことを確認する必要があります.現在の評価では、人間によって作成されたラベルを持つ小規模なドメイン固有のデータセットを使用してこの問題に取り組んでいます.これらの評価セットは、狭く単純化された分布からサンプリングされることが多く、トレーニングセットに無意識にデータソースが漏れ込むことがあり、誤った評価を引き起こす可能性があります.これらの欠点を回避するために、我々は入力テキストの変換に対する感度や不変性を分析することによるLLMの自己教師付き評価のためのフレームワークを提案しています.自己教師付き評価は、野生で収集されたデータセットやライブモデル展開中にストリーミングされるデータに対して直接LLMの振る舞いを監視することができます.私たちは、クローズドブックの知識、有害性、長距離の文脈依存性、文法構造やトークナイズエラーへの感度など、自己教師付き評価戦略を示しています.また、類似のモデルとの比較時には、文法構造やトークナイズエラーへの感度など、自己教師付き評価と人間による評価の間に強い相関関係があることがわかりました.自己教師付き評価は、ラベル付きデータに依存する現在の評価戦略を補完するものです.

Q&A:

Q: 大規模言語モデル(LLM)の自己教師あり評価の目的は?

A: 自己教育評価は、大規模言語モデル(LLM)の能力と限界を正確に捉えるための新しい評価指標を提供することを目的としています.現在の評価手法では、人間によって作成されたラベル付きの小規模な特定のドメインのデータセットを使用して問題に取り組んでいます.しかし、これらの評価セットは狭く単純化された分布からサンプリングされることが多く、トレーニングセットに無意識に漏れ込んだデータソースがあり、誤った評価を引き起こす可能性があります.これらの欠点を回避するために、自己教育評価のフレームワークを提案しています.このフレームワークでは、入力テキストの変換に対する感度や不変性を分析することによって、LLMの振る舞いを直接監視することができます.自己教育評価は、野生で収集されたデータセットやライブモデル展開中にストリーミングされるデータセット上でLLMの振る舞いを評価することができます.我々は、クローズドブックの知識、有害性、長距離の文脈依存性、文法構造やトークナイズエラーへの感度など、自己教育評価戦略を示しています.類似の人間ラベル付きベンチマークとの比較が可能な場合、自己教育評価と人間による教育評価の間には強い相関が見られます.自己教育パラダイムは、ラベル付きデータに依存する現在の評価戦略を補完します.(p.1)

Q: 現在の評価は、言語モデルの動作を測定するという問題にどのようにアプローチしているのだろうか?

A: 現在の評価は、小規模で特定のドメインに特化したデータセットを使用し、人間によって作成されたラベルを用いて問題に取り組んでいます.これらの評価セットは、狭く単純化された分布からサンプリングされることが多く、トレーニングセットに無意識に漏れ込むデータソースがあり、誤った評価を引き起こす可能性があります.これらの欠点を回避するために、私たちは自己教師あり評価のためのフレームワークを提案しています.これは、入力テキストの変換に対する感度または不変性を分析することによって、LLMの振る舞いを直接監視することができます.自己教師あり評価では、野生で収集されたデータセットやライブモデルの展開中にストリーミングされるデータを分析することができます.私たちは、クローズドブックの知識、有害性、長距離の文脈依存性、文法構造やトークナイズエラーへの感度など、自己教師あり評価戦略を示しています.類似の人間によるラベル付けベンチマークとの比較が可能な場合、自己教師あり評価と人間による教師あり評価の間には強い相関が見られます.自己教師ありパラダイムは、ラベル付きデータに依存する現在の評価戦略を補完します.(p.1)

Q: 人間が作成したラベルを持つ、ドメイン固有の小さなデータセットを評価に使用することの欠点は何か?

A: 小規模で特定のドメインに特化したデータセットを使用して評価することには、いくつかの欠点があります.まず第一に、これらの評価セットは狭く単純化された分布からサンプリングされることが多く、データソースが訓練セットに漏れ込んでしまう可能性があります.これにより、誤った評価が行われる可能性があります.また、データセットの作成とキュレーションには時間と費用がかかるため、手間がかかるという欠点もあります.

これらの欠点を回避するために、私たちはLLMの自己教師付き評価のためのフレームワークを提案しています.このフレームワークでは、入力テキストの変換に対するLLMの感度や不変性を分析することによって、自己教師付き評価を行います.自己教師付き評価では、野生で収集されたデータセットやライブモデル展開中にストリーミングされるデータセット上で、LLMの振る舞いを直接監視することができます.私たちは、クローズドブックの知識、有害性、および長距離の文脈依存性を測定するための自己教師付き評価戦略を示しています.

以上のように、小規模で特定のドメインに特化したデータセットを使用して評価することには、狭い分布からのサンプリングやデータソースの漏れ込みなどの欠点があります.これらの欠点を回避するために、自己教師付き評価のフレームワークを提案しています.

Q: LLMの自己監視下評価のための提案されたフレームワークはどのように機能するのか?

A: 提案されたLLMの自己教師付き評価フレームワークは、テキストの入力に対する変換の感度または不変性を分析することによって機能します.自己教師付き評価は、野生で収集されたデータセットやライブモデル展開中にストリーミングされるデータセット上でLLMの振る舞いを直接監視することができます.このフレームワークでは、クローズドブックの知識、有害性、および長距離の文脈依存性の評価戦略を自己教師付きで示しています.また、文法構造やトークナイズエラーに対する感度も評価します.同様の人間によるラベル付けベンチマークとの比較が可能な場合、自己教師付き評価と人間による教師付き評価の間には強い相関が見られます.この自己教師付きのパラダイムは、ラベル付けされたデータに依存する現在の評価戦略を補完します.(p.1)

Q: 自己教師付き評価に使用できる、入力テキストに対する変換の例にはどのようなものがありますか?

A: 自己教育評価の一環として、入力テキストに対する変換のいくつかの例は、文の前後の文を変更することです.具体的には、与えられたデータのストリームから3つの文を順番に取り出し、最初の2つの文をコーパスからランダムに選んだ文で置き換えます.例えば、元のパッセージが{S3、S2、S1}の3つの文からなる場合、S3が入力パッセージの最初の文であるとします.この場合、変更されたパッセージは{S’X、S’Y、S1}となります.ここで、S’XとS’Yはコーパス内の別のパッセージからのランダムな文です.その後、xとx’のそれぞれの位置のS1の確率分布を調べ、Jensen-Shannonダイバージェンスを使用してそれらを比較します.これにより、異なる文脈が提示されると最後の文の表現がどのように変化するかを判断します.(p.8)

Q: 自己教師ありの評価では、どのようにしてLLMの振る舞いを監視することができるのだろうか?

A: 自己教育評価は、入力テキストの変換に対する感度または不変性を分析することによって、データセットの収集やライブモデルの展開中にLLMの振る舞いを監視することができます.具体的には、自己教育評価は、実際の状況で収集されたデータセットやライブモデル展開中にストリーミングされるデータセット上でLLMの振る舞いを直接監視することができます.これにより、狭く単純化された分布からサンプリングされた小規模なドメイン固有のデータセットを使用する従来の評価セットの欠点を回避することができます.また、トレーニングセットに無意識に漏れ込む可能性のあるデータソースによる誤った評価を防ぐこともできます.自己教育評価は、クローズドブックの知識、有害性、および長距離の文脈依存性を測定するための戦略を示しています.さらに、文法構造やトークン化エラーに対する感度も評価することができます.類似の人間によるラベル付けベンチマークとの比較が可能な場合、自己教育評価と人間による教育評価の間に強い相関関係が見られます.自己教育パラダイムは、ラベル付けされたデータに依存する現在の評価戦略を補完します.(p.1, p.3-5)

Q: LLMの行動のどのような側面を、自己監視評価戦略を使って測定することができるのか?

A: 自己教育評価戦略を使用して、LLMの振る舞いの特定の側面を測定することができます.具体的には、自己教育評価は、LLMのクローズドブックの知識、有害性、および長距離の文脈依存性を測定するための戦略を提供します.これは、テキストへの変換に対するモデルの出力の不変性を測定することによって行われます.この自己教育評価戦略は、既存のベンチマーク固有のデータセットや人間の注釈に依存せずに、モデルの振る舞いに関する有用な情報を得ることができます.

具体的な自己教育評価戦略としては、クローズドブックの知識、有害性、および長距離の文脈依存性の測定が挙げられます.これらの評価戦略は、テキストの変換に対するモデルの出力の不変性を測定することによって行われます.また、文法構造やトークン化エラーへの感度も測定されます.自己教育評価戦略は、実際のデータセットやライブモデル展開時に直接LLMの振る舞いを監視することができます.

自己教育評価戦略は、既存のラベル付きデータに依存する現在の評価戦略を補完するものです.自己教育評価と人間による評価との間には強い相関があります.これは、類似の人間によるベンチマークとの比較が可能な場合に確認されます.

Q: 人間がラベル付けした同様のベンチマークと比較した場合、自己教師評価と人間教師評価の間に相関関係はあるのか?

A: 自己教育の評価と人間の教育の評価を比較する際に、類似の人間ラベル付きベンチマークとの間に強い相関が見られます.これは、(p.1)の文脈から明らかです.自己教育のパラダイムは、ラベル付きデータに依存する現在の評価戦略を補完するものです.これにより、実際の展開環境での効率的な評価の形式が可能になります.

Q: 自己教師ありのパラダイムは、ラベル付きデータに依存する現在の評価戦略をどのように補完するのだろうか?

A: 自己教育パラダイムは、ラベル付きデータに依存する現在の評価戦略を補完する役割を果たしています.従来の評価手法では、狭い範囲で単純化された分布からサンプリングされた人間によってキュレーションされた小規模なドメイン固有のデータセットを使用しています.しかし、これらの評価セットは、トレーニングセットに無意識に漏れ込んだデータソースがあり、誤った評価を引き起こす可能性があります.これらの欠点を回避するために、私たちは自己教育評価のためのフレームワークを提案しています.このフレームワークでは、入力テキストに対する変換の感度または不変性を分析することにより、LLMの振る舞いを直接監視することができます.自己教育評価は、野生で収集されたデータセットやライブモデル展開中にストリーミングされるデータに対してLLMの振る舞いを測定するための戦略を示しています.従って、自己教育パラダイムは、ラベル付きデータに依存する現在の評価戦略を補完する役割を果たしています.(p.13)

Q: LLMの自己管理評価の有効性を示す例やケーススタディがあれば教えてください.

A: 自己教育評価の有効性を示すいくつかの例や事例を提供できます.論文では、自己教育評価戦略を使用して、クローズドブックの知識、有害性、および長距離の文脈依存性を測定するためのいくつかのケーススタディを紹介しています.

例えば、クローズドブックの知識に関しては、自己教育評価戦略を使用して、モデルが与えられたテキストに基づいて特定の知識を持っているかどうかを測定することができます.具体的には、与えられたテキストに対して変換を適用し、モデルの出力がその変換に対してどれだけ不変であるかを測定します.このような評価手法を使用することで、モデルがクローズドブックの知識をどの程度持っているかを自己教育的に評価することができます.

また、有害性に関しても、自己教育評価戦略を使用してモデルの振る舞いを評価することができます.例えば、与えられたテキストに対して変換を適用し、モデルの出力がその変換に対してどれだけ有害な内容を含んでいるかを測定します.このような評価手法を使用することで、モデルの有害性に関する情報を自己教育的に収集することができます.

さらに、長距離の文脈依存性に関しても、自己教育評価戦略を使用してモデルの振る舞いを評価することができます.例えば、与えられたテキストに対して変換を適用し、モデルの出力がその変換に対してどれだけ文脈に依存しているかを測定します.このような評価手法を使用することで、モデルの文脈依存性に関する情報を自己教育的に収集することができます.

これらのケーススタディは、自己教育評価戦略がLLMの性能を評価するための有効な手法であることを実証しています.これらの手法は、従来のベンチマークデータセットや人間の注釈に頼らずに、モデルの振る舞いを評価することができます.これにより、LLMの強みと限界についてより詳細な理解が可能となります.

Long-range Language Modeling with Self-retrieval

著者:Ohad Rubin, Jonathan Berant

発行日:2023年06月23日

最終更新日:2023年06月23日

URL:http://arxiv.org/pdf/2306.13421v1

カテゴリ:Computation and Language

概要:

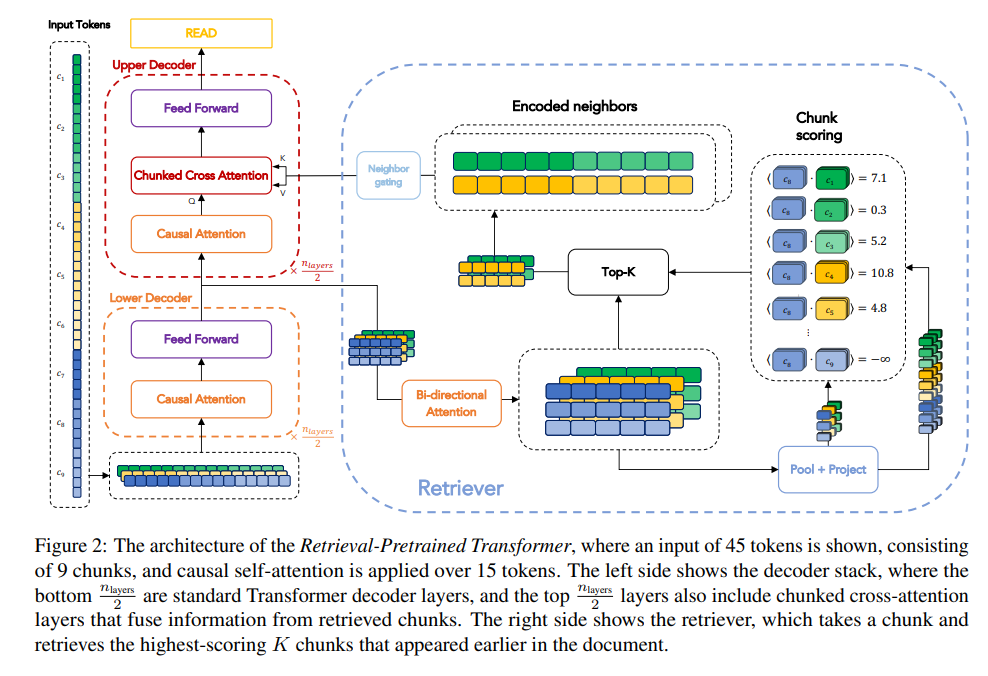

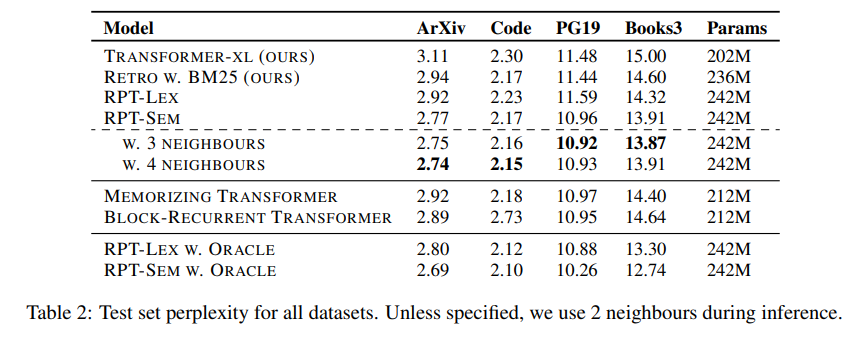

最近、検索支援言語モデル(LM)は注目を集めています.しかし、通常、リトリーバーはLMのネイティブコンポーネントとして共同でトレーニングされることはありません.代わりに、すでに事前にトレーニングされたLMに追加されるため、LMとリトリーバーが互いに適応する能力が制限されます.本研究では、長いテキストのモデリングタスクのために、スクラッチからリトリーバーをトレーニングするためのアーキテクチャとトレーニング手法であるRetrieval-Pretrained Transformer(RPT)を提案します.長いドキュメント内の最近生成されたテキストチャンクが与えられると、LMはクエリの表現を計算し、それを使用してドキュメント内の以前のチャンクを検索します.検索されたチャンクからの情報は、次のターゲットチャンクを予測するためにLMの表現に統合されます.リトリーバーコンポーネントは、セマンティックな目的でトレーニングされ、参照LMによると次のチャンクの確率を高めるチャンクを検索することを目指します.本研究では、本、コード、数学の執筆など、4つの長距離言語モデリングタスクでRPTを評価し、RPTが検索の品質を向上させることを示します.さらに、強力なベースラインと比較して、RPTは全体的にパープレキシティを改善することを示します.

Q&A:

Q: 提案されているRPT(Retrieval-Pretrained Transformer)アーキテクチャと学習手順の主な焦点は何ですか?

A: 提案されたRetrieval-Pretrained Transformer(RPT)アーキテクチャとトレーニング手法の主な焦点は、長いテキストのモデリングのためにスクラッチからトレーニングされた検索拡張言語モデル(LM)です.RPTでは、リトリーバーがLMの一部としてトレーニングされ、将来のテキスト予測のために意味的に関連するチャンクを取得します.具体的には、LMの表現からリトリーバーの入力表現が計算され、取得された表現が次の単語の予測のためにLMデコーダに統合されます.また、リトリーバーは、次のテキストの生成確率を高めるテキストフラグメントを取得するように補助的な損失関数でトレーニングされます.これにより、RPTは既存の事前トレーニング済みのLMに制約がある従来の方法と比較して、より柔軟な適応性を持つことができます.

Q: RPTのLMは、長い文書中の早いチャンクを検索するためのクエリ表現をどのように計算するのだろうか?

A: RPT(Retrieval-Augmented Language Modeling)のLMは、クエリの表現を計算して、長い文書内の以前のチャンクを取得します.これにより、数万トークン前に位置する可能性のある以前のチャンクを取得し、その情報をLMの表現に統合して、次のターゲットチャンクを予測します.リトリーバーのコンポーネントは、セマンティックな目的でトレーニングされます.つまり、参照LMに基づいて、次のチャンクの確率を増加させるようなチャンクを取得することを目指します.

具体的には、RPTでは2つの手法を使用しています.まず、セルフリトリーバルと呼ばれる手法で、LM自体がクエリの表現を計算します.次に、リトリーバーをトレーニングするために、補助的な損失関数を使用します.この損失関数は、最近生成されたチャンクctを考慮して、参照スコアリングLMに基づいて、ct+1の生成確率を増加させるようなチャンクciを取得するようにリトリーバーをトレーニングします.

具体的な例として、犯罪現場が記述されている場合を考えます.スコアリングLMによると、数千トークン先のチャンク(チャンク13)を取得することの利点が、表層的に関連するだけのチャンク(チャンク100)を取得することよりも大きいことが示されています.

RPTのLMは、長い文書(書籍、コード、数学の文章など)のモデリングに焦点を当てています.これらは、長い形式のコンテンツの自然発生的な例であり、全体のインデックスをメモリ内に保持できるため、順方向のパスで処理することができます.

Q: 検索されたチャンクの情報をRPTのLM表現に融合するプロセスを説明していただけますか?

A: RPTでは、取得されたチャンクからの情報をLMの表現に統合するプロセスがあります.これにより、次のターゲットチャンクを予測するための情報が強化されます.このプロセスは、図1に示されています.

具体的には、RPTでは、クエリ表現を計算するために使用されるLMデコーダーからの情報を取得します.このクエリ表現は、ドキュメント内の以前のチャンクを取得するために使用されます.取得されたチャンクは、LMの表現に統合され、次のターゲットチャンクを予測するために使用されます.

この統合プロセスでは、取得されたチャンクの情報がLMの表現に融合されます.具体的な融合方法は文脈によって異なりますが、一般的にはアテンションメカニズムが使用されます.アテンションメカニズムは、取得されたチャンクとLMの表現の間の関連性を計算し、重要な情報を抽出します.そして、この情報はLMの表現に統合され、次のターゲットチャンクの予測に使用されます.

この統合プロセスにより、取得されたチャンクからの情報がLMの表現に効果的に統合され、次のターゲットチャンクの予測の精度が向上します.

Q: RPTのレトリーバー・コンポーネントのトレーニングに使用されるセマンティック・オブジェクティブとは何ですか?

A: RPT(Retrieval-Pretrained Transformer)のリトリーバーのコンポーネントを訓練するために使用される意味的な目的は、文脈の意味的な関連性を取得することです.具体的には、RPTは、将来のテキスト予測のために意味的に関連するチャンクを取得するためにリトリーバーを使用します.この目的は、RPTのアーキテクチャとトレーニングプロセスにリトリーバーをシームレスに統合することによって達成されます.

Q: RPTの性能は、検索品質と当惑度の観点からどのように評価されるのか?

A: RPTのパフォーマンスは、検索品質とパープレキシティの観点から評価されます.パープレキシティは、モデルの性能を評価するために使用されます.また、検索品質は、検索結果の質を評価するために使用されます.

具体的には、パープレキシティは、モデルが生成するテキストの予測の正確さを測る指標です.パープレキシティが低いほど、モデルの予測が正確であることを示します.この評価指標は、テストデータセットに対してモデルを適用し、生成されたテキストの予測確率を計算して求められます.

一方、検索品質は、検索結果の質を評価するために使用されます.具体的には、検索結果のランキングや正確さを評価するための指標が使用されます.例えば、Precision@kは、クエリベースのスコアに基づいて上位k個のチャンクが正解である割合を計算する指標です.また、Recall@kは、正解のチャンクのうち上位k個のチャンクに含まれる割合を計算する指標です.さらに、NDCG@kは、標準的な検索評価指標であり、クエリベースのスコアに基づいて上位k個のチャンクのランキングを計算します.

この文脈からは、RPTのパフォーマンス評価において、パープレキシティと検索品質の両方が使用されていることがわかります.具体的な評価結果は表2に示されており、RPTが他の先行研究やベースラインモデルよりも優れたパフォーマンスを示していることが述べられています.(p.5.2)

Q: RPTが評価される具体的な長距離言語モデリングタスクとは?

A: RPTは、4つの長距離言語モデリングタスクで評価されています.具体的なタスクについての詳細は文中には記載されていません.

Q: RPTは、検索品質と当惑度という点で、強力なベースラインと比較してどうだろうか?

A: RPTは、先行研究(Hutchins et al.、2022; Wu et al.、2022)や強力なベースライン(Borgeaud et al.、2022; Zhong et al.、2022)を上回る結果を示し、すべてのタスクでPerplexityを改善することがわかりました(p.1).

また、RPTは、語彙情報に依存するリトリーバーと比較して、高品質なチャンクを取得することを示しました.具体的には、RPTは、検索の品質を向上させるために、アーキテクチャとトレーニング手法に強く組み込まれていると主張されています.

Scaling MLPs: A Tale of Inductive Bias

著者:Gregor Bachmann, Sotiris Anagnostidis, Thomas Hofmann

発行日:2023年06月23日

最終更新日:2023年06月23日

URL:http://arxiv.org/pdf/2306.13575v1

カテゴリ:Machine Learning

概要:

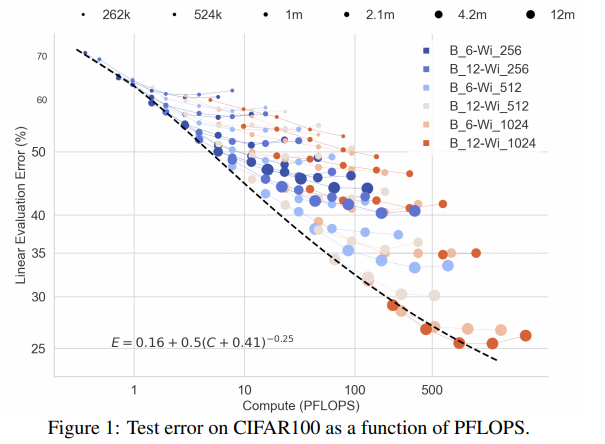

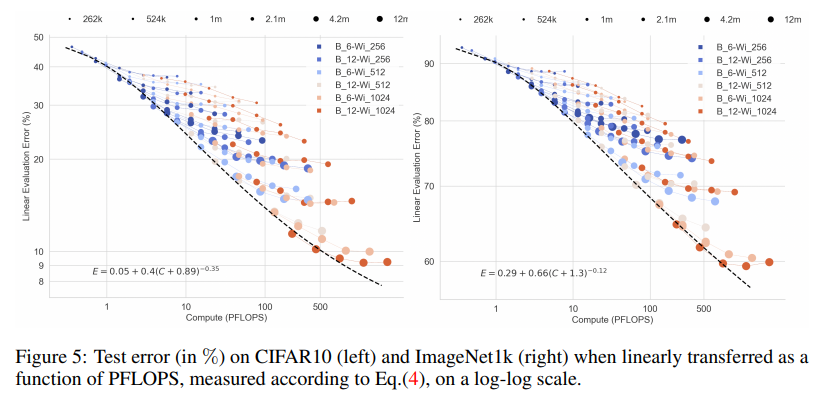

この研究では、ディープラーニングの最も基本的な構成要素である多層パーセプトロン(MLP)を再評価し、ビジョンタスクにおけるその性能の限界を研究しています.MLPに関する経験的な洞察は、複数の理由から重要です.まず、最近の「より少ない帰納バイアスが良い」という物語は、トランスフォーマーが畳み込みモデルを上回ったことにより広まりましたが、この仮説の限界を探求することは自然なことです.そのために、MLPは完全に帰納バイアスを持たないため、理想的なテストベッドを提供します.また、MLPは数学的な単純さから、ディープラーニングの理論文献においてほぼ独占的に主役となっており、より複雑なアーキテクチャの経験的な現象を説明するための代理モデルとして機能しています.驚くべきことに、MLPに関する実験的なデータポイントは、特に大規模な事前学習プロトコルと組み合わせた場合、文献中で非常に見つけにくいです.この実践と理論の間の不一致は心配です.MLPは実用的なモデルが示す経験的な進歩を反映しているのでしょうか?それとも理論家はMLPの役割を再考する必要があるのでしょうか?私たちはこれらの両側面について洞察を提供します.私たちは、MLPの性能がスケールによって劇的に向上することを示しました(CIFAR10で93%、CIFAR100で79%、TinyImageNetで69%).これにより、帰納バイアスの不足は実際に補われることが明らかになりました.また、MLPは現代のモデルとの振る舞いを忠実に模倣しており、学習設定のいくつかの要素は予想以上に強力な振る舞いを示しています.また、計算効率の高さから、大規模な事前学習実験が学術研究者にとってよりアクセスしやすくなりました.すべての実験は単一のGPU上で実行されました.

Q&A:

Q: この仕事の主眼は何ですか?

A: この研究の主な焦点は、MLP(Multi-Layer Perceptron)を用いたモデルの実験的な性能を調査することです.研究者は、MLPを用いたモデルが実際のモデルの経験的な進歩を反映しているかどうかを明らかにするために、MLPの特性を調査しました.また、ビジョンタスクに焦点を当て、画像分類タスクにおけるMLPの性能を評価しました.これにより、MLPが理論的な観点だけでなく、実践的な観点でも興味深い結果をもたらすことが期待されます.

Q: なぜ「帰納的バイアスは少ない方が良い」という話の中でMLPを研究することが重要なのでしょうか?

A: MLPsの研究が「より少ない帰納的バイアスが良い」という文脈で重要な理由は、次のように説明できます.この文脈では、トランスフォーマーや畳み込みモデルを凌駕することで人気を集めているため、この仮説の限界を探ることが自然です.そのため、MLPsは帰納的バイアスを完全に排除した理想的なテストベッドを提供します.

MLPsは、数学的な単純さから深層学習理論の文献でほぼ独占的に主役となっており、より複雑なアーキテクチャの実証現象を説明するためのプロキシとして機能しています.しかし、実験的なデータポイントは、特に大規模な事前学習プロトコルと組み合わせた場合、文献では非常に見つけにくいです.この実践と理論の乖離は懸念されるものです.MLPsは実用的なモデルが示す実証的な進歩を反映しているのでしょうか?それとも理論家はMLPsの役割を再考する必要があるのでしょうか.

したがって、「より少ない帰納的バイアスが良い」という文脈でMLPsを研究することは重要です.これにより、MLPsが実際のモデルによって示される実証的な進歩を反映しているかどうかを理解することができます.また、MLPsがより複雑なアーキテクチャの実証現象を説明するためのプロキシとして機能しているかどうかも検証することができます.

Q: なぜMLPの実験データを文献で見つけるのが難しいのでしょうか?

A: MLPsの実験的なデータポイントを文献で見つけることが非常に困難である理由は、大規模な事前学習プロトコルと組み合わせた場合に特に顕著です.この不一致は、実践と理論の間のものであり、MLPsが実際のモデルの経験的な進歩を反映しているのか、それとも理論家がMLPsの役割を再考する必要があるのかという疑問を提起しています.このような疑問が生じる理由は、MLPsの性能がスケールによって劇的に向上することが示されているためです.具体的には、CIFAR10では93%、CIFAR100では79%、TinyImageNetでは69%の精度が得られています.これにより、MLPsには帰納バイアスがない場合でも補償できることが示されています.また、MLPsは現代の複雑なモデルの振る舞いを模倣していることも観察されています.

このような理由により、MLPsの実験的なデータポイントを文献で見つけることが困難となっています.特に大規模な事前学習プロトコルと組み合わせた場合には、さらに困難となっています.このため、MLPsに関する実験的なデータは非常に限られており、文献で見つけることが難しいのです.このような状況は懸念されるものであり、理論はMLPsを通じて現代のアーキテクチャの特性を理解しようとしていますが、そのようなプロキシがどれだけうまく機能するかについてはほとんど評価が行われていないのです.

このような背景から、MLPsの実験的なデータポイントを文献で見つけることが困難であると言えます.

Q: MLPのパフォーマンスはどのように向上するのか?

A: MLPsのパフォーマンスは、スケールとともにどのように改善されるのでしょうか?Dosovitskiy et al.(2021)の研究によると、MLPsのパフォーマンスはパラメータ数とサンプルサイズのべき乗則に従って予測可能に向上することが観察されました(Dosovitskiy et al.、2021、p.1).これは、Hestness et al.(2017, 2019)、Kaplan et al.(2020)、Zhai et al.(2022)の研究と同様の結果です.また、MLPsの計算最適化によるパフォーマンス向上において、データ拡張の正則化はCNNsにも有効ですが、MLPsではさらに効果が増幅され、大きなサンプルサイズでもオフにすると致命的な劣化が生じることが明らかになりました(Dosovitskiy et al.、2021、p.1).さらに、SGDの暗黙のバイアスがパフォーマンスにどのように影響するかを調査した結果、非常に直感に反する発見がありました.CNNsとは異なり、MLPsではバッチサイズが大きいほどパフォーマンスが向上することがわかりました(Dosovitskiy et al.、2021、p.1).これらの結果は、MLPsがモダンなモデルのスケーリングの振る舞いを忠実に模倣していることを示しており、将来の理論的な研究にとって非常に励みとなるものです(Dosovitskiy et al.、2021、p.1).

Q: CIFAR10、CIFAR100、TinyImageNetデータセットにおけるMLPのパフォーマンス結果は?

A: MLPsのパフォーマンス結果は、CIFAR10、CIFAR100、およびTinyImageNetデータセットにおいて次のようになります.具体的な数値は文中には記載されていませんが、それぞれのデータセットにおけるテストエラー率が示されています.

CIFAR10データセットにおけるテストエラー率は約93%です.

CIFAR100データセットにおけるテストエラー率は約79%です.

TinyImageNetデータセットにおけるテストエラー率は約69%です.

これらの結果は、MLPsが現代の設定で訓練されたモデルとほぼ同等のパフォーマンスを示すことを示しています.ただし、正則化や暗黙の設定の役割は異なる場合があります.

以上がMLPsのCIFAR10、CIFAR100、およびTinyImageNetデータセットにおけるパフォーマンス結果です.

Q: MLPと現代のMLPとの比較は?

A: MLPsとその現代の相手との比較に関して、以下のような振る舞いの観察結果があります.学習設定において、MLPsはその現代の相手の振る舞いを忠実に模倣していることが観察されました.ただし、一部のコンポーネントは予想外に強力な振る舞いを示しています.また、計算効率の高さから、大規模な事前学習実験が学術研究者にとってよりアクセスしやすくなっています.すべての実験は単一のGPU上で実行されました.

MLPsはスケールに対して非常に予測可能なパワーローの形でパラメータ数やサンプルサイズの増加に伴い性能が向上することが観察されました.これはHestness et al. (2017, 2019)、Kaplan et al. (2020)、Zhai et al. (2022)と同様の結果です.

MLPsの振る舞いと現代の相手の振る舞いは非常に類似しており、MLPsは現代のモデルを忠実に模倣しています.ただし、学習設定においては、一部のコンポーネントが予想以上の強力な振る舞いを示していることが観察されました.

MLPsの性能はスケールによって劇的に向上しました.CIFAR10では93%、CIFAR100では79%、TinyImageNetでは69%の性能向上が観察されました.これは、MLPsにおける帰納バイアスの欠如が補償されることを示しています.

以上の結果から、MLPsは現代の相手との振る舞いにおいて類似性があり、スケールによって性能が向上することが観察されました.(p.1)

Q: MLPの学習過程で観察される予期せぬ行動にはどのようなものがありますか?

A: MLPs(多層パーセプトロン)の学習過程で観察されるいくつかの予期しない振る舞いについて、以下のようなことが報告されています.具体的な振る舞いについての詳細な説明は提供されていませんが、文脈から以下のような予期しない振る舞いが観察された可能性があると推測されます.

- 学習設定において、一部のコンポーネントが予想以上に強力な振る舞いを示すことがある.

- MLPsは、現代のモデルと同様の振る舞いを忠実に模倣することが観察されるが、一部のコンポーネントは予想外の振る舞いを示すこともある.

これらの予期しない振る舞いは、MLPsが他の複雑なアーキテクチャの振る舞いを説明するためのプロキシとして使用されることが多いため、理論的な研究において重要な要素となります.しかし、実験的なデータポイントがMLPsに関しては非常に少なく、特に大規模な事前学習プロトコルと組み合わせた場合はほとんど見つかりません.この実践と理論の間の不一致は懸念されるものであり、MLPsが実際のモデルの経験的な進歩を反映しているのか、または理論家がMLPsの役割を再考する必要があるのかについての洞察を提供しています.

(引用元:Bachmann, G., Anagnostidis, S., & Hofmann, T. (2021). Scaling MLPs: A Tale of Inductive Bias, p.1)

Q: MLPの計算効率によって、大規模な事前学習実験がどのように利用しやすくなるのでしょうか?

A: MLPsの計算効率は、大規模な事前学習実験をよりアクセスしやすくします.この文脈から得られる情報によれば、MLPsは計算効率が高く、単一のGPU上で実験が実行されています.これにより、研究者はより少ない計算リソースでこの非常に興味深い研究分野を研究することができます.大規模な事前学習実験は、学術研究者にとってよりアクセスしやすくなります.

Q: 今回の実験に使用したハードウェアは?

A: 実験にはNVIDIA RTX A5000 GPUが使用されました.このGPUは24GBのメモリを搭載しています.すべての実験は単一のGPU上で実行することができます.また、MLPの場合、データをGPUに転送する時間がトレーニング時間のボトルネックとなるため、FFCVデータローダーフレームワークを利用しています.すべての実験はPyTorchで実行されました.

Understanding Social Reasoning in Language Models with Language Models

著者:Kanishk Gandhi, Jan-Philipp Fränken, Tobias Gerstenberg, Noah D. Goodman

発行日:2023年06月21日

最終更新日:2023年06月21日

URL:http://arxiv.org/pdf/2306.15448v1

カテゴリ:Computation and Language, Artificial Intelligence, Human-Computer Interaction

概要:

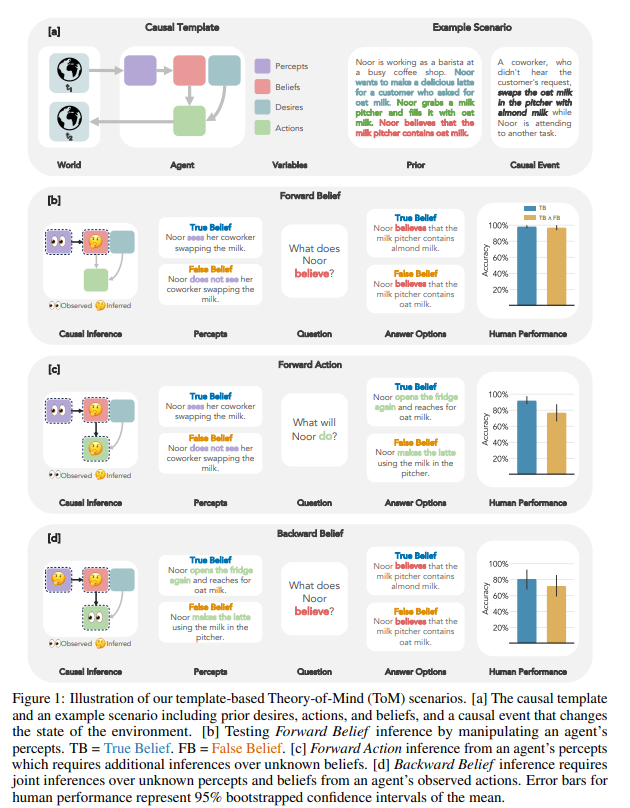

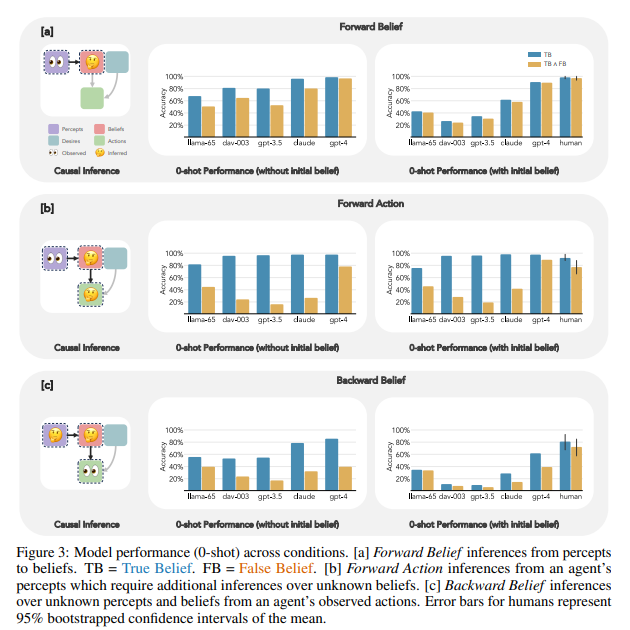

大規模言語モデル(LLM)が私たちの日常生活にますます統合されるにつれて、人間の心の状態を理解する能力は、効果的な相互作用を確保するために重要になってきます.しかし、LLMの心の理論(ToM)の推論能力を評価しようとする最近の試みにもかかわらず、これらのモデルが人間のToMとどの程度一致するかは、微妙な探求のトピックです.これは、主に2つの異なる課題によるものです:(1)以前の評価からの一貫性のない結果の存在、および(2)既存の評価方法の妥当性に関する懸念.これらの課題に対処するために、私たちは因果関係のテンプレートを埋めることによってLLMとの評価を手続き的に生成するための新しいフレームワークを提案します.私たちのフレームワークを使用して、LLMのための新しい社会的推論のベンチマーク(BigToM)を作成します.これには25のコントロールと5,000のモデルによる評価が含まれています.私たちは、人間の参加者が私たちのベンチマークの品質を以前のクラウドソーシングによる評価よりも高く評価し、専門家による評価と同等と評価しました.BigToMを使用して、さまざまなLLMの社会的推論能力を評価します.

さらに、BigToMでは、さまざまなLLMの社会的推論能力を評価し、モデルのパフォーマンスを人間のパフォーマンスと比較します.私たちの結果は、GPT4が人間の推論パターンを反映するToMの能力を持っていることを示唆していますが、信頼性は低く、他のLLMは苦戦しています.

Q&A:

Q: 大規模言語モデル(LLM)が人間の精神状態を理解する能力を理解する目的は何か?

A: 大規模言語モデル(LLM)が私たちの生活にますます重要な役割を果たしている中で、人間の心の状態を理解する能力を評価することは、効果的な相互作用を保証するために重要です.これには、LLMの現在の能力を評価し、その失敗モードを理解し、改善する方法を見つけることが含まれます.ToMのような能力を持つLLMは、私たちに教えること、私たちから学ぶこと、コミュニケーションを取ることにおいてより優れている可能性があります.(p.1)

Q: LLMの心の理論(ToM)推論能力を評価する上での課題は何か?

A: LLMのTheory-of-Mind(ToM)推論能力を評価する際には、2つの異なる課題が存在します.第一に、以前の評価からの一貫性のない結果が存在することが挑戦となっています.これは、LLMのToM能力が人間のToMとどの程度一致するかという問題が微妙な探求の対象であるためです.第二に、既存の評価方法の妥当性に関する懸念が存在します.これらの課題に対処するために、著者らは因果関係のテンプレートを用いて評価を生成するための新しいフレームワークを提案しています.

このフレームワークを使用して、著者らはLLMのための新しい社会的推論のベンチマーク(BigToM)を作成しました.このベンチマークには25のコントロール条件と5,000のモデルによる評価が含まれています.著者らは、人間の参加者がベンチマークの品質を以前のクラウドソーシングによる評価よりも高く評価し、専門家による評価と同等の評価となることを発見しました.これにより、LLMのモデルパフォーマンスを人間のパフォーマンスと比較することができます.結果は、GPT4が人間の推論パターンに類似したToMの能力を持っているが、信頼性が低い一方、他のLLMは苦労していることを示しています(p.1).

Q: LLMに対する既存の評価方法の妥当性について、どのような懸念があるのか?

A: 既存の評価方法の妥当性に関しては、いくつかの懸念が存在しています.これは、文脈から明らかです.先行の評価結果の不一致や、既存の評価方法の妥当性に関する懸念が存在していると述べられています.これらの懸念は、LLMsの評価において重要な問題となっています.

具体的には、既存の評価方法の妥当性に関する懸念は、以下のような要素によって引き起こされています.

- 前の評価結果の不一致:既存の評価方法では、LLMsの評価結果が一貫していない場合があります.これは、異なる評価者や異なる評価基準によるものかもしれません.このような不一致は、評価方法の妥当性に疑問を投げかける要因となります.

- 限られたテストセット:既存の評価方法では、LLMsの能力を測定するためのテストセットが限られている場合があります.このような制約は、LLMsの真の能力を正確に評価することを困難にします.また、テストセットが限られているため、LLMsが特定のタスクにおいて成功しても、微細な変更に対しては劇的に失敗することがあります.このような結果は、評価方法の妥当性に疑問を投げかける要因となります.

以上のような懸念が存在するため、既存の評価方法の妥当性については疑問が持たれています.これらの懸念を解決するために、新しいフレームワークが提案されています.このフレームワークを使用することで、より妥当な評価が可能となり、LLMsの能力をより正確に評価することができると期待されています.

Q: LLMを使って、因果関係のテンプレートに入力することによって、手順的に評価を生成する枠組みについて説明してもらえますか?

A: LLM(Language Model)を用いた評価を生成するための手法について説明します.この手法は、評価結果の一貫性のなさと、既存の評価方法の妥当性に関する懸念を解決するために提案されました.この手法では、因果関係のテンプレートを用いて評価を生成します.具体的な手順は以下の通りです.

まず、因果関係のテンプレートを作成します.このテンプレートは、評価の枠組みを提供し、評価条件を設定するための基盤となります.

次に、言語モデルに対してテンプレート内の変数を埋めるように指示します.これにより、具体的な因果モデルが生成されます.

最後に、埋め込まれた因果関係テンプレートから変数を組み合わせて、異なる評価条件を構築します.これにより、自動化された制御されたテストを通じて、モデルの振る舞い、成功、失敗を理解するための体系的な評価が生成されます.

Q: LLMのための社会的推論ベンチマーク(BigToM)とは何ですか?また、フレームワークを使ってどのように作られたのですか?

A: 社会的な推論のベンチマークであるBigToMは、LLM(Large Language Models)のために作成されたものであり、新しいフレームワークを使用して生成されました.このフレームワークでは、因果関係のテンプレートを用いてLLMとの評価を手続き的に生成します.BigToMは、25のコントロールと5,000のモデルによる評価から構成されています.人間の参加者は、我々のベンチマークの品質を、以前のクラウドソーシングによる評価よりも高く、専門家による評価と同等と評価しました.BigToMを使用して、さまざまなLLMの社会的な推論能力を評価し、モデルのパフォーマンスを人間のパフォーマンスと比較しました.その結果、GPT4は人間のToM能力と同等の能力を持っていることが示されました.(p.1)

Q: BigToMベンチマークの質は、これまでのクラウドソーシングや専門家による評価と比べてどうなのか?

A: BigToMベンチマークの品質は、以前のクラウドソーシング評価と専門家による評価と比較して高く、専門家による評価と同等であることが示されています.人間の参加者は、BigToMベンチマークの品質を以前のクラウドソーシング評価よりも高く評価しています.

また、BigToMベンチマークの品質は、人間のパフォーマンスとも比較されています.さまざまなLLMの社会的推論能力を評価し、モデルのパフォーマンスを人間のパフォーマンスと比較することで、GPT4がToMの能力を持っていることが示されています.

したがって、BigToMベンチマークは、以前のクラウドソーシング評価と専門家による評価と比較して高品質であり、人間のパフォーマンスとも類似していることが示されています.

Q: どのようなLLMがBigToMを使って評価され、その社会的推論能力は人間のパフォーマンスとどのように比較されたのか?

A: BigToMを使用して評価されたLLMsは、GPT4を含むさまざまなモデルです.BigToMは、25のコントロールと5,000のモデルによる評価から構成される新しい社会的推論のベンチマークです.人間のパフォーマンスと比較して、モデルのパフォーマンスを評価しました.結果は、GPT4が人間の推論パターンを反映するToMの能力を持っている一方、他のLLMsは苦労していることを示しています.