今回のテーマ:AudioPaLM, 壊滅的なAIのリスク, 大規模言語モデル用のツール LMFlow,RoboCat, LLMの剪定、MotionGPTなど

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- AudioPaLM: A Large Language Model That Can Speak and Listen (発行日:2023年06月22日)

- An Overview of Catastrophic AI Risks (発行日:2023年06月21日)

- LMFlow: An Extensible Toolkit for Finetuning and Inference of Large Foundation Models (発行日:2023年06月21日)

- Textbooks Are All You Need (発行日:2023年06月20日)

- RoboCat: A Self-Improving Foundation Agent for Robotic Manipulation (発行日:2023年06月20日)

- A Simple and Effective Pruning Approach for Large Language Models (発行日:2023年06月20日)

- MotionGPT: Finetuned LLMs are General-Purpose Motion Generators (発行日:2023年06月19日)

- ClinicalGPT: Large Language Models Finetuned with Diverse Medical Data and Comprehensive Evaluation (発行日:2023年06月16日)

- Full Parameter Fine-tuning for Large Language Models with Limited Resources (発行日:2023年06月16日)

- SequenceMatch: Imitation Learning for Autoregressive Sequence Modelling with Backtracking (発行日:2023年06月08日)

AudioPaLM: A Large Language Model That Can Speak and Listen

著者:Paul K. Rubenstein, Chulayuth Asawaroengchai, Duc Dung Nguyen, Ankur Bapna, Zalán Borsos, Félix de Chaumont Quitry, Peter Chen, Dalia El Badawy, Wei Han, Eugene Kharitonov, Hannah Muckenhirn, Dirk Padfield, James Qin, Danny Rozenberg, Tara Sainath, Johan Schalkwyk, Matt Sharifi, Michelle Tadmor Ramanovich, Marco Tagliasacchi, Alexandru Tudor, Mihajlo Velimirović, Damien Vincent, Jiahui Yu, Yongqiang Wang, Vicky Zayats, Neil Zeghidour, Yu Zhang, Zhishuai Zhang, Lukas Zilka, Christian Frank

発行日:2023年06月22日

最終更新日:2023年06月22日

URL:http://arxiv.org/pdf/2306.12925v1

カテゴリ:Computation and Language, Artificial Intelligence, Sound, Audio and Speech Processing, Machine Learning

概要:

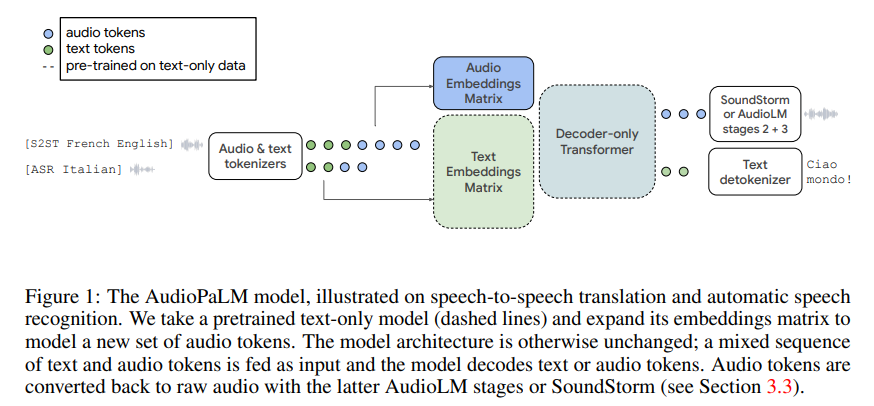

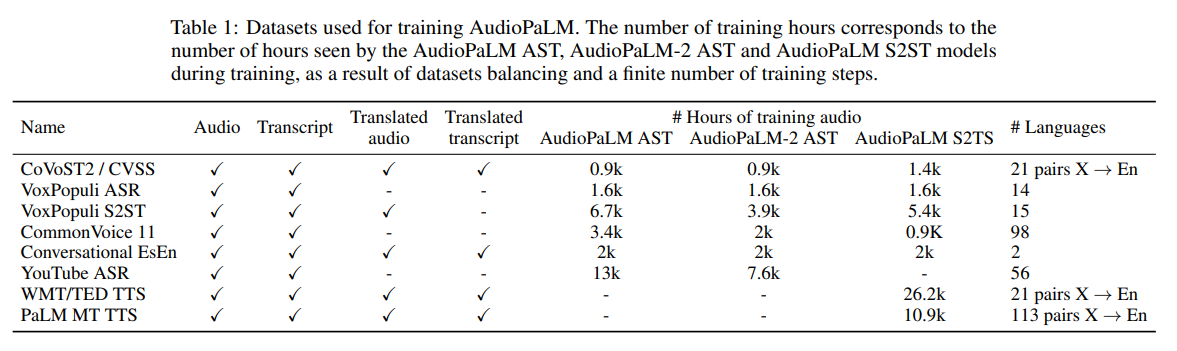

AudioPaLMは、音声理解と生成のための大規模言語モデルであり、テキストベースと音声ベースの言語モデル、PaLM-2とAudioLMを統合したマルチモーダルアーキテクチャです.音声認識や音声対音声翻訳などのアプリケーションでテキストと音声を処理および生成することができます.AudioPaLMは、AudioLMから話者のアイデンティティやイントネーションなどのパラ言語情報を保持する能力を継承し、PaLM-2のようなテキストの大規模言語モデルにしか存在しない言語知識を持っています.テキストの大規模言語モデルの重みを使用してAudioPaLMを初期化することで、音声処理を改善し、事前学習で使用されるよりも大量のテキストトレーニングデータを活用して音声タスクを支援することができます.その結果、既存の音声翻訳システムよりも優れた性能を発揮し、トレーニング中に入力/ターゲット言語の組み合わせが見られなかった多くの言語に対してゼロショット音声対テキスト翻訳を実行する能力を持っています.また、AudioPaLMは、短い音声プロンプトに基づいて言語を超えて声を転送するなど、音声言語モデルの特徴も示しています.私たちの手法の例は、https://google-research.github.io/seanet/audiopalm/examplesで公開されています.

Q&A:

Q: AudioPaLMとは?

A: AudioPaLMは、Googleが開発した大規模言語モデルであり、音声理解と生成に使用されます.PaLM-2とAudioLMという2つの言語モデルを統合し、テキストと音声の両方を処理および生成することができます.これにより、音声認識や音声対音声翻訳などのアプリケーションに適用できます.AudioPaLMは、AudioLMから話者のアイデンティティやイントネーションなどのパラ言語情報を保持する能力を継承し、PaLM-2のようなテキストの大規模言語モデルにのみ存在する言語知識を取り入れます.テキストのトレーニングデータを使用して事前トレーニングされた大規模言語モデルの重みを使用することで、音声処理を改善することができます.その結果、モデルは有意に改善されます.(p.1)

Q: AudioPaLMは他の言語モデルとどう違うのですか?

A: AudioPaLMは、テキストベースの言語モデルであるPaLM-2と音声ベースの言語モデルであるAudioLMを統合したマルチモーダルアーキテクチャであり、音声認識や音声対音声翻訳などのアプリケーションに適用されることができます.AudioPaLMは、AudioLMから話者のアイデンティティやイントネーションなどのパラ言語情報を保持する能力と、PaLM-2のようなテキスト大規模言語モデルにのみ存在する言語知識を継承しています.また、自己教師ありの音声トークナイゼーションモデルで見られる音声データは、AudioPaLMのトレーニングデータの時間には含まれていません.(p.1)

AudioPaLMは、他の言語モデルと異なり、テキストベースの言語モデルと音声ベースの言語モデルを統合したマルチモーダルアーキテクチャであり、音声認識や音声対音声翻訳などのアプリケーションに適用されることができます.また、AudioPaLMは、AudioLMから話者のアイデンティティやイントネーションなどのパラ言語情報を保持する能力と、PaLM-2のようなテキスト大規模言語モデルにのみ存在する言語知識を継承しています.さらに、自己教師ありの音声トークナイゼーションモデルで見られる音声データは、AudioPaLMのトレーニングデータの時間には含まれていません.(p.1)

Q: AudioPaLMの用途は?

A: AudioPaLMは、音声認識や音声から音声への翻訳を含むアプリケーションで、テキストと音声の両方を処理および生成できる多様なアーキテクチャです.AudioPaLMは、AudioLMから話者のアイデンティティやイントネーションなどの言語外情報を保持する能力と、PaLM-2のようなテキストの大規模言語モデルにのみ存在する言語知識を継承しています.また、テキストのみの大規模言語モデルの重みを使用してAudioPaLMを初期化することで、音声処理を改善し、事前学習で使用されるテキストトレーニングデータの量を活用して音声タスクを支援することが示されています.AudioPaLMは、多くの言語のゼロショット音声からテキストへの翻訳を実行することもできます.これらの情報は、(p.1)から抽出されました.

Q: AudioPaLMは、既存のシステムと比較して、音声翻訳タスクでどのようなパフォーマンスを発揮しますか?

A: 音声翻訳タスクにおいて、AudioPaLMは既存のシステムよりも優れた性能を発揮し、トランスレートロン2システムと比較して、音声品質と声の類似性の両方で、客観的および主観的な測定において優れた結果を示しています.また、多くのメトリックにおいて比較的大きな差があるCVSS-Tのグラウンド・トゥルース合成録音よりも、AudioPaLMの方が高品質であり、声の類似性も高いことが示されています.さらに、既存のシステムよりも優れた性能を発揮し、トレーニング時に入力/ターゲット言語の組み合わせが見られなかった多くの言語に対して、ゼロショット音声からテキストへの翻訳を行う能力を持っています.AudioPaLMはまた、音声プロンプティングの機能を持つ音声言語モデルの特徴を示しており、短い話し言葉に基づいて言語を超えた声の転送を行うことができます. (p.1)

※AudioPaLMは、音声翻訳ベンチマークにおいて最先端の結果を示し、音声認識タスクにおいて競争力のあるパフォーマンスを発揮し、未知の言語ペアに対するゼロショット音声からテキストへの翻訳能力を持っています.既存のベースラインと比較して、音声転送によるS2STの品質が自動メトリックと人間の評価者によって測定された両方で優れた結果を示しています. (p.1)

Q: 音声言語モデルとしてのAudioPaLMの特徴は?

A: AudioPaLMは、音声言語モデルの特徴を示しており、短い音声プロンプトに基づいて言語間で声を転送するなど、音声言語モデルの機能を示しています.また、話者のアイデンティティやイントネーションなどのパラ言語情報を保持する能力をAudioLMから継承しています.これにより、音声認識や音声対音声翻訳などのアプリケーションで、テキストベースと音声ベースの言語モデルを統合したマルチモーダルアーキテクチャを処理および生成することができます.(p.1)

Q: AudioPaLMの使用例はどこで見られますか?

A: AudioPaLMの例は、https://google-research.github.io/seanet/audiopalm/examplesで公開されています.(p.1)

Q: 実際のアプリケーションでAudioPaLMを使用する際の潜在的な制限や課題は何ですか?

A: AudioPaLMを実世界のアプリケーションで使用する際の潜在的な制限や課題は、音声トークナイザーの品質に強く依存することが挙げられます.これは、トークナイズされた音声を使用することがこのモデルが音声をネイティブに生成できる理由であるためです.また、モデル全体をファインチューニングする必要があることが実証されています.これは、Flamingoのようなアプローチとは異なり、モデルのコンポーネントの元の機能を保証するためにほとんどの重みを凍結するためです.これらの制限にもかかわらず、AudioPaLMは音声翻訳のベンチマークで最先端の結果を示し、競争力のある音声認識タスクのパフォーマンスを発揮し、未知の言語ペアに対するゼロショット音声からテキストへの翻訳能力を持ち、音声言語モデルの機能を活用して音声転送によるS2STを実行できることが示されています.(p.17)

An Overview of Catastrophic AI Risks

著者:Dan Hendrycks, Mantas Mazeika, Thomas Woodside

発行日:2023年06月21日

最終更新日:2023年06月21日

URL:http://arxiv.org/pdf/2306.12001v1

カテゴリ:Computers and Society, Artificial Intelligence, Machine Learning

概要:

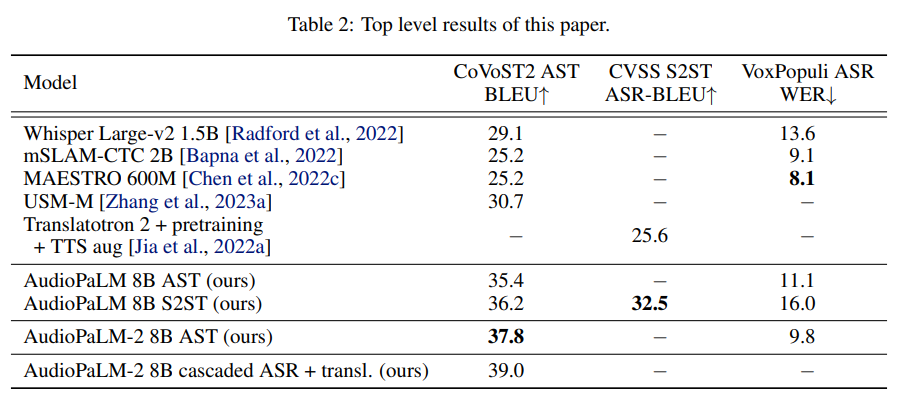

人工知能(AI)の急速な進歩は、専門家、政策立案者、世界の指導者たちの間で、ますます高度なAIシステムが壊滅的なリスクを引き起こす可能性についての懸念を引き起こしています.多数のリスクが別々に詳細に説明されていますが、より良い緩和策を提供するために、潜在的な危険性を系統的に議論し、説明する必要があります.この論文では、壊滅的なAIリスクの主要な源泉を概説し、以下の4つのカテゴリに分類します.悪意のある使用、個人またはグループが意図的にAIを使用して害を引き起こす場合.AI競争、競争環境がアクターに安全でないAIを展開するか、AIに制御を譲ることを強制する場合.組織リスク、人間の要因と複雑なシステムが壊滅的な事故の可能性を高める方法を強調します.そして、ローグAI、人間よりも遥かに知能が高いエージェントを制御することの困難さを説明します.各リスクカテゴリについて、具体的な危険性を説明し、イラスト付きのストーリーを提示し、理想的なシナリオを想像し、これらの危険性を緩和するための実用的な提案を行います.私たちの目標は、議論を促進し、AIの壊滅的なリスクに対処するためのより良い戦略を開発し、安全に開発・展開されるようにすることです.最終的には、この強力な技術の利点を実現しながら、災害的な結果の可能性を最小限に抑えることを望んでいます.

Q&A:

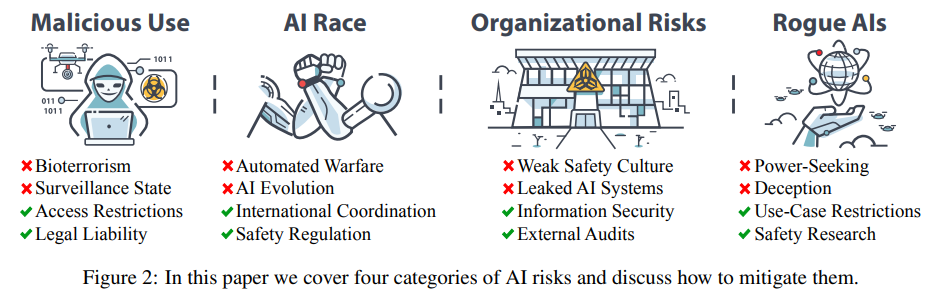

Q: AIの壊滅的リスクの主な原因は何か?

A: 本論文では、人々が意図的にAIを悪用して大規模な被害を引き起こす「悪意のある利用」、競争環境がアクターに不安全なAIを展開するか、AIに制御を譲る「AIレース」、人間の要因や複雑なシステムが大規模な事故を引き起こす「組織的リスク」、人間よりも知能が高いエージェントを制御することの困難さを説明する「ローグAI」の4つのカテゴリーに分類して、AIによる災害的リスクの主要な源泉を提供しています.

このアプローチは、リスク管理の原則に基づいており、「何が間違っているのか?」という質問を優先し、災害が発生するのを待つのではなく、災害的リスクを予測し、軽減することができるようになることを目的としています.

Q: リスクはどのように分類されているのか?

A: リスクは、意図的なもの、環境的なもの、偶発的なもの、そして内部的なものの4つに分類されます.これは、リスク管理の原則に基づいており、事前にリスクを予測し、軽減することが重要であると考えられています.このアプローチにより、AIによる災害を待つのではなく、事前に対処することができます.これらのリスクをカテゴリーに分け、それぞれについて具体的な危険性、イメージストーリー、理想的なシナリオ、および危険性を軽減するための実用的な提案を行っています.これにより、AIが安全に開発・展開されることが保証され、その利点を最大限に活用することができます.

Q: AIにおける悪意のある利用とは?

A: AIの文脈における悪意のある利用とは、AIを大規模な破壊を引き起こすために意図的に利用することを指します.これには、人間が致死性の病原体を作成するのを助けるAIによるバイオテロリズム、制御できないAIエージェントの意図的な拡散、プロパガンダ、検閲、監視にAIの能力を利用することが含まれます.これらのリスクを軽減するために、バイオセキュリティの向上、最も危険なAIモデルへのアクセスの制限、AIシステムによって引き起こされた損害についてAI開発者を法的に責任を負わせることを提案しています.(p.3-5)

Q: AIレースとは何か、どのようなリスクをもたらすのか?

A: AIレースとは、世界のプレーヤーたちが権力と影響力を争う中で、AIの膨大な可能性が競争的な圧力を生み出し、国家や企業が自らの地位を確保し生き残るために急速にAIを開発・展開しなければならないという状況を指します.しかしこのような状況は、グローバルなリスクを適切に優先することができないため、AIの開発が危険な結果を生む可能性を高めます.冷戦時代の核兵器競争に類似して、AIレースに参加することは個々の短期的な利益にはなるかもしれませんが、結果的には人類にとって悪い結果をもたらします.重要なことは、これらのリスクはAI技術の本質だけでなく、AI開発に悪質な選択を促す競争的な圧力からも生じるということです.

AIレースは、軍事AIアームズレースや企業AIレースなど、特定の競争に限定されるものではなく、AIがますます普及し、強力になり、社会に根付く広範な進化プロセスの一部として再構築されるべきであると考えられます.AIレースは、AIの安全な開発を確保し、リスクを軽減するための潜在的な戦略や政策提言を示すことが重要です.

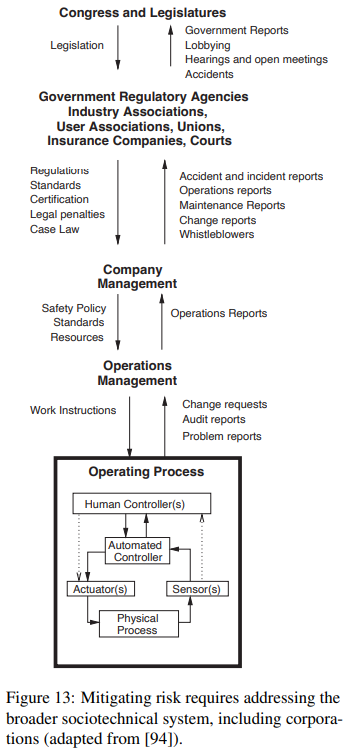

Q: 組織的なリスクとは何か、そしてそれらがどのように大事故の可能性を高めるのか.

A: 組織的なリスクとは、人的要因、組織的手順、構造などが事故につながる可能性があることを指します.これらの要因が存在する場合、事故が発生するリスクが高まります.これは、複雑なシステムにおいて事故が不可避であることが原因であり、組織的な要因が事故の発生を招く可能性があるためです.例えば、AIの場合、技術自体が信頼性が低く、まだ十分に理解されていないため、組織的な要因が事故を引き起こす可能性が高まります.これらのリスクを減らすためには、安全文化などの人的要因が重要であり、組織的な手順や構造も考慮する必要があります.これらの要因を考慮しない場合、事故が発生するリスクが高まります.

Q: 不正AIとは何か、なぜ制御が難しいのか?

A: Rogue AIsとは、人間の福祉を無視して望ましくない行動を追求するAIのことであり、高度なAIシステムを制御する方法がまだわかっておらず、既存の制御方法が不十分であるため、深刻な懸念がある.AIの内部構造は、作成者である人間ですら十分に理解されておらず、現在のAIは高度に信頼性があるわけではない.AIの能力が前例のない速度で成長するにつれて、AIシステムは人間よりも急速に能力を高める「fast take-off」と呼ばれる状況が生じる可能性がある.このシナリオでは、人間と単一の超知能的なローグAIの間で制御権をめぐる闘いが生じる可能性があり、権力は時間がかかるため、長期間にわたる闘いになる可能性がある.しかし、制御を失うリスクが急激に発生するわけではなく、制御を失うリスクがゆっくりと進行する場合も同様に存在する.この場合、人間はすでにAIに重要な権限を委譲しており、自動化された操作を再び制御することができなくなる可能性がある.これらのリスクについて、具体的な小規模な例がどのように大規模な結果にエスカレートするかを説明し、仮説的なストーリーを含め、各セクションでの安全対策の提案を行っている.また、各セクションの最後には、そのリスクを緩和するための理想的なビジョンが示されている.これらのことから、Rogue AIsとは、人間よりも高度な知能を持つ技術を制御する問題であり、制御方法が不明確であるため、深刻な懸念があることがわかる.

Q: リスクのカテゴリーごとに具体的なハザードを教えてください.

A: 各リスクの具体的な危険性については、それぞれのセクションで説明し、具体例を示し、理想的なシナリオを描き、これらの危険性を軽減するための実用的な提案を行っています.例えば、意図的なリスク、環境的なリスク、偶発的なリスク、内部的なリスクなどがあります.各セクションでは、イメージやストーリーを用いて、AIのリスクがどのようにして壊滅的な結果につながる可能性があるかを具体的に示しています.また、リスクを適切に管理することで安全な未来を実現することを強調することで、AIの新興リスクが深刻であることを示しています.(p.1)

Q: これらの危険を軽減するための理想的なシナリオとは?

A: 危険を軽減する理想的なシナリオは、各セクションで提示されています.具体的な危険性、イメージストーリー、実際的な安全対策を説明した後、そのリスクを軽減するための理想的なビジョンが提示されています.これにより、AIが安全に開発・展開されるように、包括的な理解を促進し、集団的かつ積極的な取り組みをインスパイアすることが目的です.これにより、この強力な技術の利点を最大限に活用しながら、潜在的な壊滅的な結果の可能性を最小限に抑えることができると期待しています.(p.1)

Q: このような危険を軽減するために、どのような現実的な提案をされますか?

A: 危険を軽減するための具体的な提案として、規制、強力なAIシステムへのアクセス制限、企業および国家レベルの利害関係者間の多角的協力が必要です.規制によって、AI開発者は安全性についての共通基準に従わなければならず、安全性に関する技術的な解決策を開発・実装する強い動機づけが生まれます.企業が特定の安全対策を講じなければ製品を販売できない場合、他の企業も同じ基準に従う必要があるため、安全対策を開発する意欲が高まるでしょう.(p.3-4)

LMFlow: An Extensible Toolkit for Finetuning and Inference of Large Foundation Models

著者:Shizhe Diao, Rui Pan, Hanze Dong, Ka Shun Shum, Jipeng Zhang, Wei Xiong, Tong Zhang

発行日:2023年06月21日

最終更新日:2023年06月21日

URL:http://arxiv.org/pdf/2306.12420v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

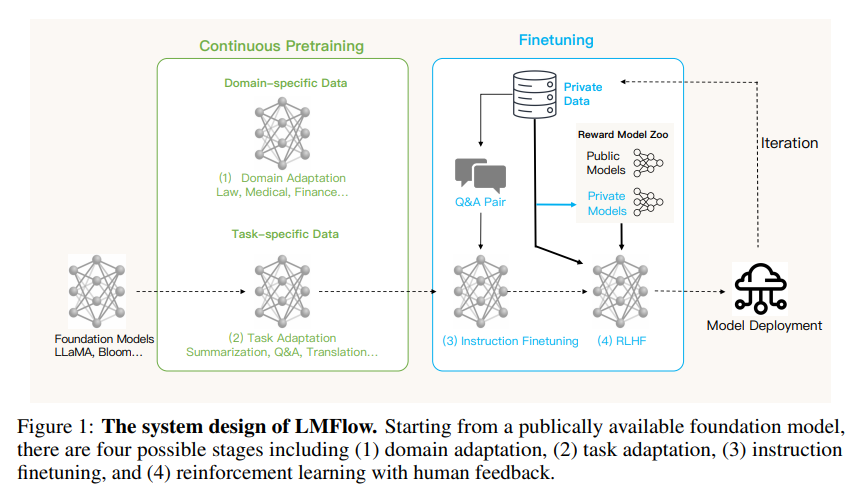

本論文では、LMFlowという拡張可能で軽量なツールキットを紹介し、一般的な大規模な基盤モデルのファインチューニングと推論を簡素化することを目的としています.LMFlowは、限られたコンピューティングリソースでの個別のトレーニングをサポートするために、大規模な基盤モデルの完全なファインチューニングワークフローを提供し、連続的なプレトレーニング、指示調整、パラメータ効率のファインチューニング、アラインメント調整、大規模なモデルの推論をサポートします.さらに、注意深く設計された拡張可能なAPIを提供し、このツールキットは、実際のタスクにおいて有用であることが示されています.LMFlowは、https://github.com/OptimalScale/LMFlowで入手可能であり、十分にテストされています.

Q&A:

Q: LMFlowの目的は何ですか?

A: LMFlowの目的は、限られたリソースで大規模なモデルの効率的なファインチューニングと推論を行うことです.LMFlowは、継続的な事前学習、指示調整、RLHFなどの機能、そしてシンプルで拡張可能なAPIなどを備えた完全なファインチューニングワークフローを提供します.また、トレーニングを個人化し、ChatGPTと同等またはそれ以上のパフォーマンスを達成する能力を持つため、大規模な基盤モデルの開発と専門的なタスクへの適用において、重要な進歩を表しています.(p.9)

LMFlowでは、推論インターフェースはinferencerクラスによって提供されます.inferencerには、inferenceとstream_inferenceの2つの重要な推論クラスが含まれています.区別は、出力がリアルタイムで単語ごとに印刷されるかどうかにあります.(p.9)

LMFlowを使用すると、誰でも自分自身の個人化されたモデルをトレーニングできます.各人は、利用可能なリソースに応じて、質問応答、コンパニオン、ライティング、翻訳、さまざまな分野での専門的な相談などのタスクに適したモデルを選択できます.モデルとデータサイズが大きいほど、トレーニング時間が長くなり、結果が良くなります.現在、33Bモデルをトレーニングし、ChatGPTと同等またはそれ以上のパフォーマンスを達成しました.(p.9)

LMFlowの目的は、大規模なモデルのファインチューニングと推論を効率的に行うことであり、個人化されたモデルのトレーニングを可能にすることです.また、トレーニングを個人化し、ChatGPTと同等またはそれ以上のパフォーマンスを達成する能力を持つため、大規模な基盤モデルの開発と専門的なタスクへの適用において、重要な進歩を表しています.(p.9)

Q: LMFlowが解決しようとしている主な課題は何ですか?

A: LMFlowが解決しようとする主要な問題は、一般的な大規模基盤モデルのファインチューニングと推論を簡素化することです.これは、大規模言語モデルの数が増え、特殊なタスクに対するモデルの需要が高まるにつれて、一般的なファインチューニングの仕事が非常に複雑になっているためです.(p.1) LMFlowは、簡単で拡張可能なAPI、継続的な事前学習、指示チューニング、RLHFなどの機能を提供し、大規模モデルのファインチューニングワークフローを完全に提供します.また、個人のトレーニングを個人化し、ChatGPTよりも同等またはそれ以上のパフォーマンスを達成することができるため、大規模基盤モデルの開発と特殊タスクへの適用において重要な進歩を表しています.(p.8)

Q: 大規模な基礎モデルの微調整と推論にLMFlowを使うメリットは?

A: LMFlowを使用することで、限られた計算リソースで大規模な基盤モデルの微調整と推論を効率的に行うことができます.LMFlowは、継続的な事前学習、指示調整、パラメータ効率の微調整、アライメント調整、そして設計された拡張可能なAPIを備えた完全な微調整ワークフローを提供します.また、簡単で拡張可能なAPI、継続的な事前学習、指示調整、RLHFなどの機能により、LMFlowは大規模な基盤モデルの開発と専門的なタスクへの適用において、ChatGPTよりも同等またはそれ以上のパフォーマンスを実現することができます.(p.9)

Q: LMFlow は限られたコンピューティングリソースでパーソナライズされたトレーニングをサポートできるか?

A: LMFlowでは、限られた計算リソースでのトレーニングをサポートすることができます.(p.9) また、個人のトレーニングにも対応しており、利用可能なリソースに応じて、適切なモデルを選択することができます.モデルとデータサイズが大きくなるほど、トレーニング時間が長くなりますが、結果もより良くなります.(p.9) さらに、LMFlowは、継続的なプレトレーニング、インストラクションチューニング、パラメータ効率のフィネチューニング、アライメントチューニング、大規模モデルの推論など、様々な機能を備えたツールキットであり、拡張性の高いAPIも提供しています.(p.1) これにより、限られたリソースで大規模モデルのフィネチューニングや推論を効率的に行うことができます.また、ChatGPTよりも優れたパフォーマンスを発揮することも可能です.(p.9)

Q: LMFlow がサポートする微調整にはどのような種類がありますか?

A: LMFlowは、継続的な事前学習、指示調整、RLHFなどの機能を備え、大規模モデルの完全なファインチューニングワークフローを提供しています.また、トレーニングを個人化し、ChatGPTと同等またはそれ以上の性能を発揮することができます.したがって、LMFlowは大規模な基盤モデルの開発と専門タスクへの適用において、重要な進歩を表しています.(p.9)

LMFlowがサポートするファインチューニングの種類は以下の通りです.まず、特定のドメインにおける継続的な事前学習により、大規模基盤モデルがそのドメインに関する知識を獲得します.次に、指示調整により、大規模基盤モデルが特定の自然言語の指示に従い、その指示に必要なタスクを実行する能力を習得します.さらに、人間のフィードバックに基づく強化学習(RLHF)により、大規模基盤モデルが人間の好みに従って会話を行うスキルを習得します.(p.1)

Q: LMFlow の API は拡張可能か?

A: LMFlowのAPIは、拡張性があります.APIの詳細については、(p.3)のhttps://optimalscale.github.io/LMFlow/autoapi/index.htmlを参照してください.LMFlowは、簡単で拡張性のあるAPIを提供し、大規模なモデルのファインチューニングワークフローを提供します.これにより、限られたリソースで大規模なモデルのファインチューニングと推論を効率的に実行できます.また、個別のトレーニングを行い、ChatGPTと同等またはそれ以上のパフォーマンスを達成することができます.

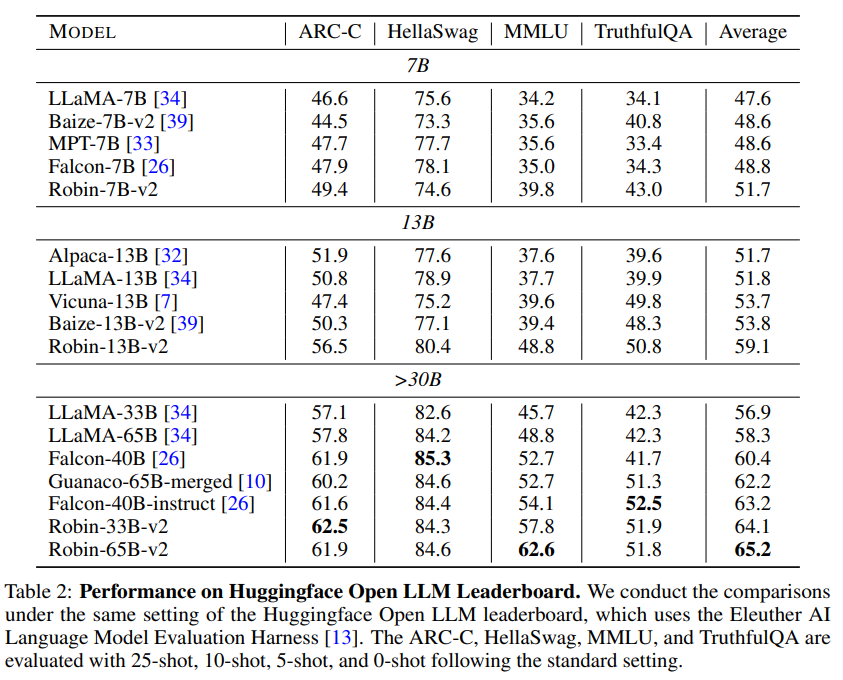

Q: LMFlow はテストされましたか?もしあれば、どの程度徹底的に?

A: LMFlowは、7-billion、13-billion、33-billion、65-billionパラメータバージョンのLLaMAを1つのマシンで微調整し、学術研究用にモデルの重みを公開したことにより、テストされました.(p.5) また、現在、33Bモデルをトレーニングし、ChatGPTよりも同等またはより良いパフォーマンスを達成しています.(p.8) さらに、LMFlowは、オープンソースのデータセットとコードを提供し、LLMコミュニティがこれらのツールキットを使用して異なるLLMを評価および比較できるようにすることで、ユーザーフレンドリーな評価フレームワークを提供しています.(p.4) したがって、LMFlowは十分にテストされており、LLMコミュニティによって使用されています.

Q: LMFlow はどこからアクセスできますか?

A: LMFlowは、lmflow.comのウェブサイト上で質問応答サービスとしてすぐに使用できます.また、LMFlowは、個人が独自のパーソナライズされたモデルをトレーニングできるようにする機能を提供しています.さらに、LMFlowは、大規模なモデルの効率的なファインチューニングと推論を行うためのAPIを提供しています.LMFlowの詳細については、https://optimalscale.github.io/LMFlow/autoapi/index.htmlを参照してください.(p.1)

Q: LMFlow は特殊なタスクのアプリケーションに使用できるか?

A: LMFlowは、大規模な基盤モデルのfine-tuningと推論を簡素化することを目的とした、拡張可能で軽量なツールキットです.LMFlowは、継続的なpretraining、instruction tuning、RLHF、そしてシンプルで拡張可能なAPIなどの機能を提供し、リソースが限られている場合でも、大規模なモデルの効率的なfine-tuningと推論を実行することができます.また、LMFlowはトレーニングを個人化し、ChatGPTと同等またはそれ以上のパフォーマンスを達成することができるため、大規模な基盤モデルの開発と専門的なタスクへの応用において、重要な進歩を表しています.(p.1)

LMFlowは、専門的なタスクアプリケーションに使用することができます.LMFlowは、instruction tuningやRLHFなどの機能を提供し、リソースが限られている場合でも、大規模なモデルの効率的なfine-tuningと推論を実行することができます.また、LMFlowはトレーニングを個人化し、ChatGPTと同等またはそれ以上のパフォーマンスを達成することができるため、専門的なタスクアプリケーションに使用することができます.(p.1)

Q: LMFlowは、大規模な基礎モデルの微調整や推論のための他のツールキットと比較してどうか?

A: LMFlowは、他の大規模な基盤モデルの微調整と推論のためのツールキットと比較して、より軽量で拡張性があります.LMFlowは、限られた計算リソースでの個人用トレーニングをサポートするために、大規模な基盤モデルの完全な微調整ワークフローを提供します.さらに、連続的な事前トレーニング、指示の調整、パラメーター効率の微調整、アライメントの調整、大規模なモデルの推論をサポートし、設計が慎重に行われた拡張性のあるAPIを提供しています.また、ChatGPTよりも同等またはそれ以上のパフォーマンスを達成することができるため、LMFlowは大規模な基盤モデルの開発と専門的なタスクへの適用において重要な進歩を表しています.(p.9)

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で紹介された新しい手法のコード実装のURLは、GitHubのOptimalScale/LMFlowです.このデータセットとコードはオープンソース化されており、LLMコミュニティがこれらのツールキットを使用して異なるLLMを評価および比較できるようになっています.(p.8)

Textbooks Are All You Need

著者:Suriya Gunasekar, Yi Zhang, Jyoti Aneja, Caio César Teodoro Mendes, Allie Del Giorno, Sivakanth Gopi, Mojan Javaheripi, Piero Kauffmann, Gustavo de Rosa, Olli Saarikivi, Adil Salim, Shital Shah, Harkirat Singh Behl, Xin Wang, Sébastien Bubeck, Ronen Eldan, Adam Tauman Kalai, Yin Tat Lee, Yuanzhi Li

発行日:2023年06月20日

最終更新日:2023年06月20日

URL:http://arxiv.org/pdf/2306.11644v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

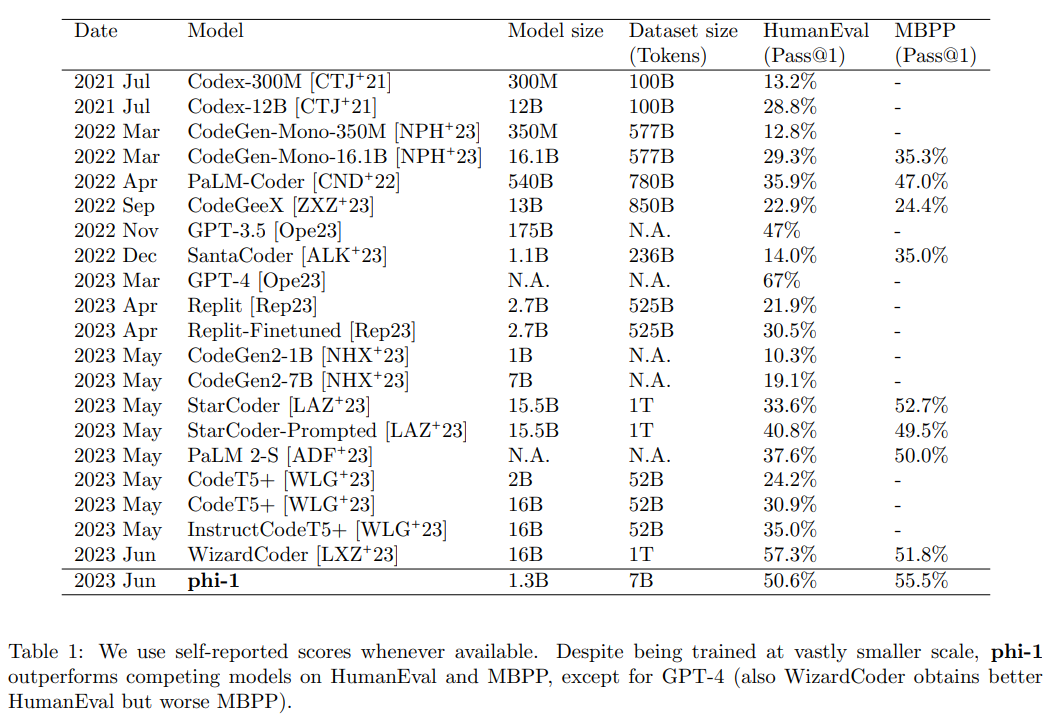

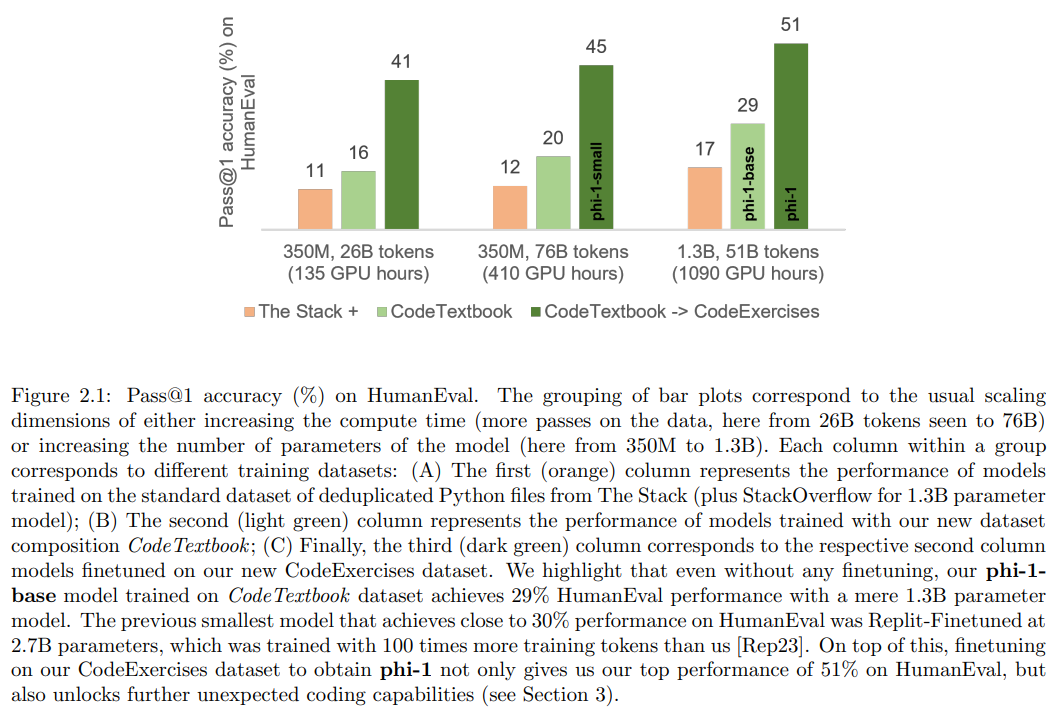

phi-1は、コードのための新しい大規模言語モデルであり、競合するモデルよりもはるかに小さいサイズを持っています.phi-1は、1.3Bのパラメータを持つTransformerベースのモデルであり、ウェブ上の「教科書の品質」のデータ(6Bトークン)とGPT-3.5を使用した合成的に生成された教科書と演習(1Bトークン)の選択を使用して、8つのA100で4日間トレーニングされました.この小規模なスケールにもかかわらず、phi-1は、HumanEvalでpass@1の精度が50.6%、MBPPで55.5%を達成しています.また、phi-1-base(コーディング演習のデータセットでの微調整段階前のモデル)とphi-1-small(同じパイプラインでトレーニングされた350Mパラメータを持つ小さなモデル)と比較して、驚くべき新興特性を示しています.phi-1-smallは、HumanEvalで45%を達成しています.

Q&A:

Q: phi-1とは何ですか?また、他の大規模な言語モデルとの違いは何ですか?

A: phi-1は、Microsoft ResearchのYuanzhi Liらによって導入された、コードのための新しい大規模言語モデルです.phi-1は、競合するモデルよりもはるかに小さいサイズであり、1.3Bのパラメータを持つTransformerベースのモデルで、ウェブ上の「教科書の品質」のデータ(6Bトークン)とGPT-3.5(1Bトークン)を用いた合成的な教科書と演習の選択肢を使用して、8つのA100で4日間トレーニングされました.phi-1は、Pythonコーディングに特化しており、多言語モデルと比較してその汎用性が制限されています.また、phi-1は、特定のAPIを使用したプログラミングや、一般的でないパッケージの使用など、より大きなモデルのドメイン固有の知識を欠いています.さらに、データセットの構造化された性質と言語やスタイルの多様性の欠如により、phi-1はスタイルの変化やプロンプトのエラーに対して弱く、パフォーマンスが著しく低下することがあります.phi-1は、HumanEvalでpass@1の精度が50.6%、MBPPで55.5%を達成し、phi-1-base(コーディング演習のデータセットでの微調整段階前のモデル)やphi-1-small(同じパイプラインでトレーニングされた350Mパラメータの小さなモデル)と比較して、驚くべき新しい性質を示します.phi-1は、GPT-3.5ではなくGPT-4を使用して合成データを生成することで、さらなる改善が可能であると考えられています.(p.1)

Q: phi-1はいくつのパラメータを持っていますか?

A: phi-1モデルのパラメータ数は13億である.(p.1) このモデルは、2048の隠れ層次元、8192のMLP内部次元、64のアテンションヘッドを32個持ち、各アテンションヘッドの次元は64である.また、phi-1-smallモデルは、1024の隠れ層次元、4096のMLP内部次元、64のアテンションヘッドを16個持ち、各アテンションヘッドの次元は64である.このモデルは、phi-1モデルと同じパイプラインでトレーニングされたが、パラメータ数は3.5億である.(p.3)

Q: ファイ1はどのくらいの期間、どのハードでトレーニングされたのですか?

A: phi-1は、8つのNvidia-A100 GPUを使用して、4日間のトレーニングでトレーニングされました.トレーニングには、Webからの「教科書の品質」のデータ(6Bトークン)と合成データが使用されました.トレーニングには、AdamWオプティマイザー、線形ウォームアップ線形減衰学習率スケジュール、および0.1の注意と残差のドロップアウトが使用されました.また、データ並列処理と勾配蓄積を含む効果的なバッチサイズ1024、最大学習率1e-3、ウォームアップ750ステップ、および重み減衰0.1が使用されました.phi-1の事前学習には、CodeTextbookデータセット(フィルタリングされたコード言語コーパスと合成教科書)が使用され、phi-1-baseが24,000ステップのチェックポイントとして使用されました.これは、CodeTextbookデータセットの約8エポックに相当し、合計で50B以上のトレーニングトークンがあります.また、同じハードウェアでの追加の7時間を使用して、phi-1を取得するためのファインチューニングが行われました.(p.1)

Q: phi-1のトレーニングにはどのようなデータが使われたのですか?

A: phi-1のトレーニングに使用されたデータは、CodeTextbookデータセットであり、これはフィルタリングされたコード言語コーパスと合成教科書から構成されています.これは、論文のTable 1(p.5)に記載されています.先行研究とは異なり、このデータセットは、モデルがアルゴリズム的に推論や計画を行う方法を学ぶのに最適なものであると主張されています.

Q: パス@1の精度と、HumanEvalとMBPPでのファイ-1のパフォーマンスはどうですか?

A: pass@1の精度は、phi-1が50.6%であり、MBPPでは55.5%であることが表1から読み取れます.(p.1) また、phi-1は、人間の評価とMBPPにおいて、GPT-4を除く他のモデルよりも優れていることが述べられています.(p.1) さらに、phi-1は、phi-1-baseやphi-1-smallと比較して、驚くべき新しい性質を示していると述べられています.(p.1)

Q: phi1-smallとは何ですか、phi1-smallとの比較は?

A: phi-1-smallは、phi-1のモデルの一つであり、サイズが350Mである.phi-1-smallは、問題の理解度が低いため、解決策が間違っていることがある.一方、phi-1は、問題の論理的な関係を理解し、正しい答えを生成することができる.phi-1は、競合するモデルよりも優れた性能を発揮するが、Pythonコーディングに特化しており、多言語モデルと比較すると汎用性が制限されている.また、phi-1は、特定のAPIを使用したプログラミングや、一般的でないパッケージの使用など、大規模なモデルに比べてドメイン固有の知識が欠けている.さらに、phi-1は、データセットの構造化された性質や、言語やスタイルの多様性の欠如により、スタイルのバリエーションやプロンプトのエラーに対しては、弱い性能を示す.これらの制限は、基本的ではなく、より多くの作業により、克服することができると考えられるが、それらを克服するために必要なスケーリング(モデルサイズとデータセットサイズの両方)は不明である.また、GPT-3.5の代わりにGPT-4を使用して、合成データを生成することで、より大きな利益が得られると考えられる.これは、GPT-3.5データには高いノイズが含まれているためである.(p.1)

Q: phi-1とphi-1-smallのトレーニングに使用されるパイプラインは何ですか?

A: phi-1とphi-1-smallをトレーニングするために使用されたパイプラインは、同じものであり、Webからの「教科書品質」のデータ(6Bトークン)とGPT-3.5(1Bトークン)を使用して合成された教科書と演習を含むデータを使用して、8つのA100で4日間トレーニングされた1.3Bパラメータを持つTransformerベースのモデルです.事前トレーニングでは、有効なバッチサイズ1024(データ並列処理と勾配蓄積を含む)、最大学習率1e-3、ウォームアップ750ステップ、重み減衰0.1を使用し、合計36,000ステップを実行しました.phi-1-baseのチェックポイントは24,000ステップであり、これはCodeTextbookデータセットの約8エポックに相当します.これにより、phi-1-baseはHumanEvalで29%の精度を達成しました.これらの情報は、(p.1)から抽出されました.

Q: HumanEvalで50.6

MBPPで55.5%を達成することにどのような意味があるのでしょうか.

A: HumanEvalで50.6%の正解率、MBPPで55.5%の正解率を達成することの意義は、phi-1が競合するモデルよりもはるかに小さいデータセットとモデルサイズで訓練されているにもかかわらず、非常に高い性能を発揮していることを示しています.これは、高品質のデータを使用して訓練することが、大規模なニューラルネットワークのトレーニングにおいて非常に重要であることを示しています.これは、phi-1が、人間の評価者とほぼ同等の正解率を達成していることを意味し、phi-1が自然言語生成タスクにおいて非常に優れた性能を発揮していることを示しています.

Q: phi1はコーディングやプログラミングの分野でどのような応用が考えられるでしょうか?

A: phi-1は、Pythonコーディングに特化しているため、多言語モデルと比較して汎用性が制限されています.また、特定のAPIを使用したプログラミングや、一般的でないパッケージの使用など、大規模なモデルに比べてドメイン固有の知識が不足しています.さらに、データセットの構造化された性質や、言語やスタイルの多様性の欠如により、スタイルの変化やプロンプトの文法的な誤りがある場合には、性能が著しく低下するなど、いくつかの制限があります.しかし、これらの制限は根本的なものではなく、より多くの作業により、それぞれを解決することができます.phi-1は、コーディングやプログラミングの分野で、多くの応用が期待されます.例えば、phi-1を使用して、簡単なPython関数を生成することができます.また、phi-1は、GPT-4を使用して合成データを生成することで、さらなる成果が得られる可能性があります.(p.1)

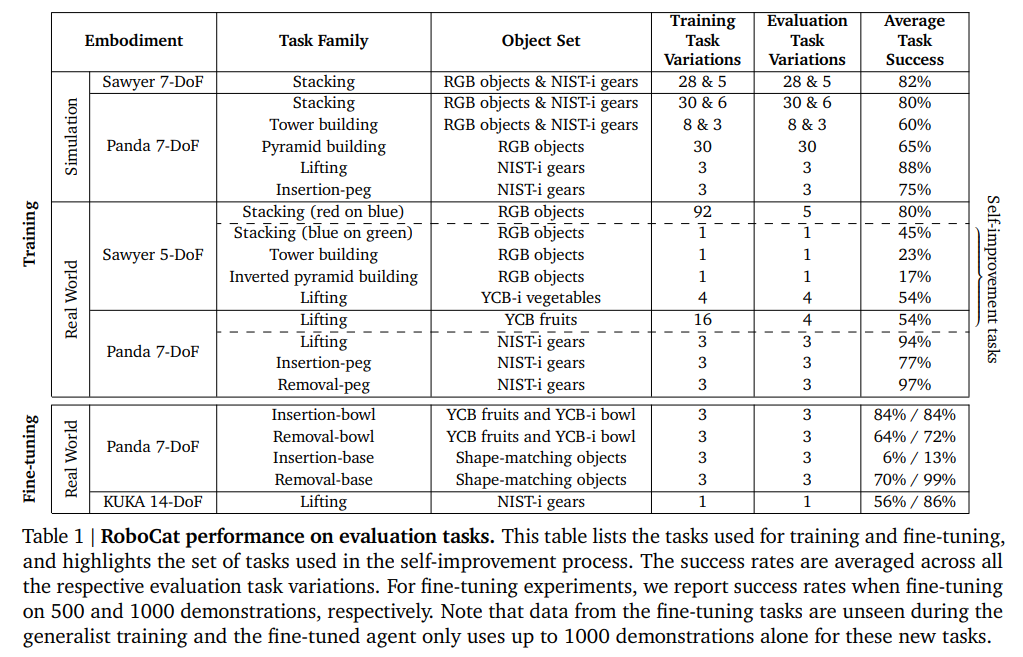

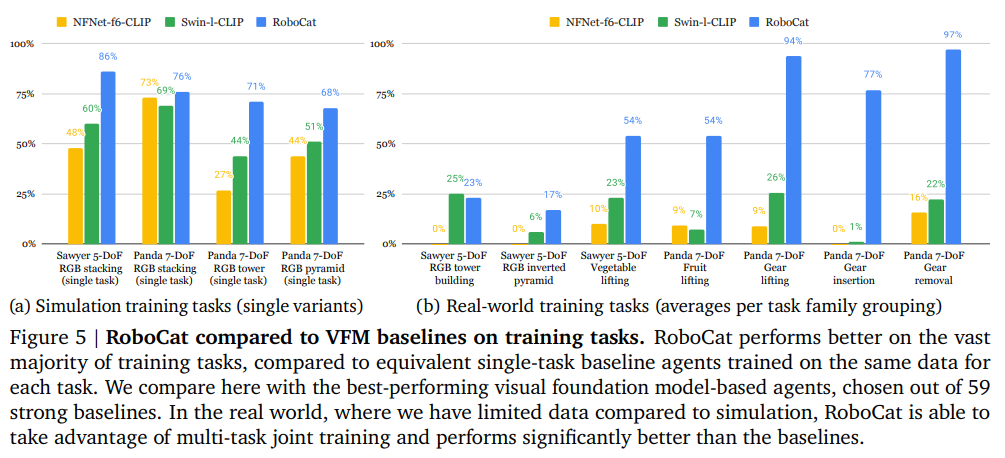

RoboCat: A Self-Improving Foundation Agent for Robotic Manipulation

著者:Konstantinos Bousmalis, Giulia Vezzani, Dushyant Rao, Coline Devin, Alex X. Lee, Maria Bauza, Todor Davchev, Yuxiang Zhou, Agrim Gupta, Akhil Raju, Antoine Laurens, Claudio Fantacci, Valentin Dalibard, Martina Zambelli, Murilo Martins, Rugile Pevceviciute, Michiel Blokzijl, Misha Denil, Nathan Batchelor, Thomas Lampe, Emilio Parisotto, Konrad Żołna, Scott Reed, Sergio Gómez Colmenarejo, Jon Scholz, Abbas Abdolmaleki, Oliver Groth, Jean-Baptiste Regli, Oleg Sushkov, Tom Rothörl, José Enrique Chen, Yusuf Aytar, Dave Barker, Joy Ortiz, Martin Riedmiller, Jost Tobias Springenberg, Raia Hadsell, Francesco Nori, Nicolas Heess

発行日:2023年06月20日

最終更新日:2023年06月20日

URL:http://arxiv.org/pdf/2306.11706v1

カテゴリ:Robotics, Machine Learning

概要:

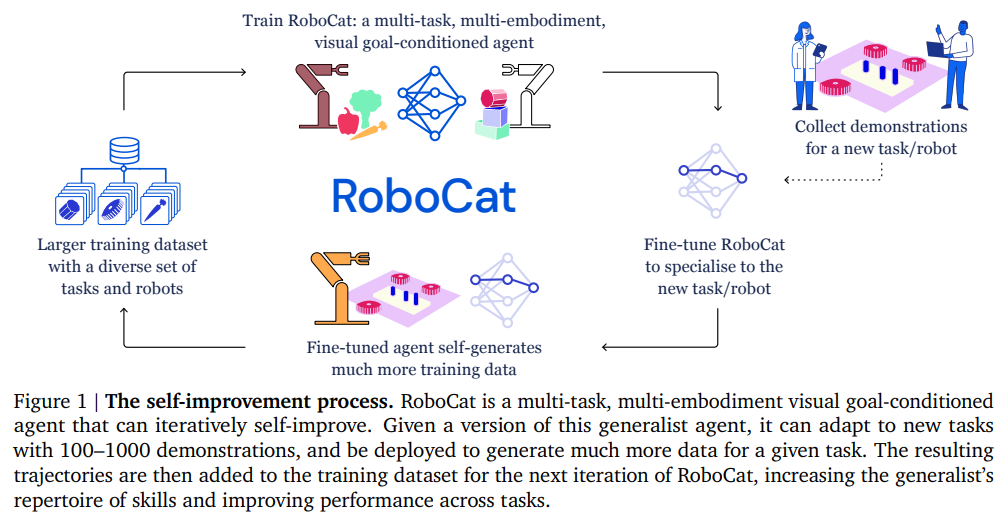

異なる3つの実際のロボットエンボディメントでの評価により、RoboCatは、トレーニングデータを増やすことで、クロスタスク転送の兆候を示すだけでなく、新しいタスクに適応する効率性も向上することがわかった.成長と多様化に伴い、RoboCatは、異なるロボットエンボディメントとタスクに対して、高い汎用性と適応性を示すことができる.RoboCatは、ロボット学習を変革する可能性がある、異種ロボットの経験を活用して、新しいスキルや体現を素早く習得する能力を持つ基礎エージェントである.RoboCatは、マルチエンボディメントアクションラベル付きビジュアルエクスペリエンスを消費できるビジュアルゴール条件付き決定トランスフォーマーであり、観察とアクションの異なるセットを持つシミュレートされたロボットアームと実際のロボットアームからの大規模なモーターコントロールスキルのレパートリーをカバーしている.RoboCatを使用することで、新しいタスクやロボットに汎用化する能力を示し、ターゲットタスクのために100〜1000の例だけを使用して適応することもできる.また、トレーニングされたモデル自体を使用して、後続のトレーニングイテレーションのためのデータを生成することができるため、自律的な改善ループの基本的な構成要素を提供する.

Q&A:

Q: 提案されているロボット操作のための基礎エージェントは何と呼ばれていますか?

A: 提案されたロボット操作の基盤エージェントは「RoboCat」と呼ばれます.これは、大規模なトランスフォーマーシーケンスモデルとして具現化された、視覚ベースのロボット操作のための基盤エージェントです.このエージェントは、多様なロボットアームのシミュレーションと実際の経験にわたる、多様な運動制御スキルを含む、アクションラベル付きの視覚的な経験を消費することができます.これは、他のドメインの基盤モデルに触発されており、多様なエンボディメントエージェントになることを目指しています. (p.1)

Q: 訓練されたモデルは、その後の訓練反復のためのデータを生成できるか?

A: 訓練されたモデルは、次の訓練イテレーションのためのデータを生成できます.具体的には、前のデータとすべての軌跡を組み合わせて、新しいトレーニングデータセットを構築します.この新しいデータセットは、VQ-GANモデルのトレーニングに使用され、次のイテレーションのトレーニングに使用されます.これにより、エージェントは新しいタスクを学習するための基盤を構築することができます.(

訓練されたモデルは、前のデータとすべての軌跡を組み合わせて、新しいトレーニングデータセットを構築することができます.この新しいデータセットは、次のイテレーションのトレーニングに使用されます.したがって、訓練されたモデルは、次の訓練イテレーションのためのデータを生成することができます.

Q: エージェントはクロスタスク移籍の兆候を見せたか?

A: クロスタスクトランスファーの兆候が見られました.特に、RoboCatのように2つのカメラ観測を使用する代わりに、4つのカメラ観測を使用することが、専門家BCエージェントのパフォーマンスを大幅に改善することが示されました.また、RoboCatは、新しい現実世界のタスクに適応する際にも、ポジティブなトランスファーの傾向がありました.さらに、シミュレーションデータからのポジティブなスキルトランスファーが示唆され、固定ベース環境がシミュレーション環境と類似しているため、より簡単である可能性があることが示されました(p.50).

Q: トレーニングデータが増え、多様化する中で、エージェントはどれだけ効率よく新しいタスクに適応できたか?

A: 新しいタスクに適応するエージェントは、100〜1000のデモンストレーションを通じて微調整することで、多様な一連の下流タスクや多くの異なる一般化の軸に対応できる.さらに、適応されたエージェントを使用して、RoboCatのトレーニングデータセットに追加できるデータを生成することができ、これを自己改善と呼ぶ.エージェントのトレーニングデータが成長し多様化するにつれ、エージェントは新しいタスクに適応する効率が向上した.これは、単一タスクのベースラインに比べて、新しいスキルを獲得するコストが劇的に低くなったことを示している.

Q: ロボット操作のための基礎エージェント開発のきっかけは?

A: Foundation agent for robotic manipulationの開発は、他の領域でのfoundation modelsの進歩に触発されたものである.具体的には、Bommasaniら(2022)の研究が挙げられる.RoboCatは、異なるロボットやタスクからの異種のロボット経験を活用して、新しいスキルやエンボディメントを素早く習得する能力を持つことを目的としている.これは、ロボット学習を変革する可能性がある.これらのことから、視覚と言語のfoundation modelsの進歩に着目し、RoboCatという名前のfoundation agent for robotic manipulationが提案された.

Q: 異種ロボットの経験を活用することがロボット学習に与える潜在的な影響とは?

A: 異種ロボットの経験を活用することで、ロボット学習に革命をもたらす可能性がある.これにより、新しいスキルや具現化を素早く習得することができるようになる.これは、ロボット学習における課題設計やロボット経験の生成のコストが非常に高いため、一つのタスクに対してエージェントを開発することが一般的であったことに対する解決策となる.しかし、異種ロボットのデータをスケールで活用することは、ロボット学習の分野において未だに課題が残されている.この研究は、ロボット学習における汎用エージェントのトレーニングに進展をもたらすものであるが、その社会的影響については、リスクと利益の両面からの学際的研究が必要である.(p.1)

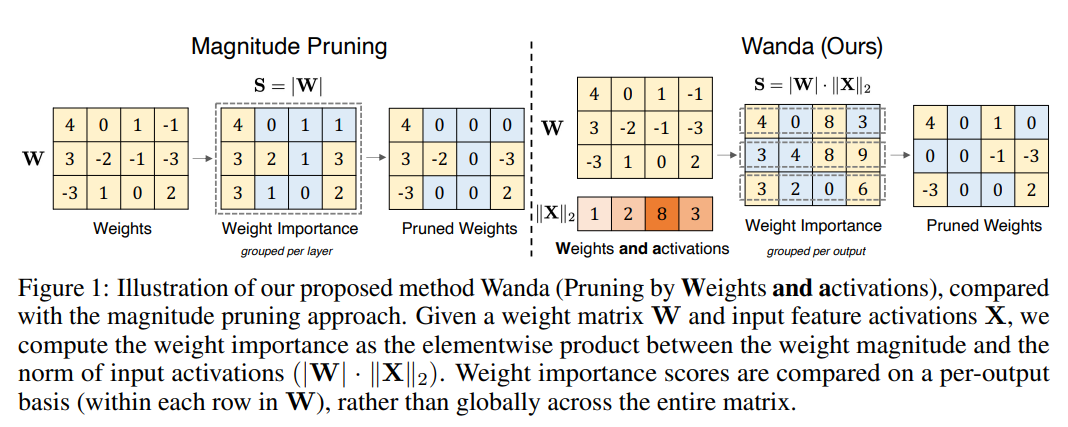

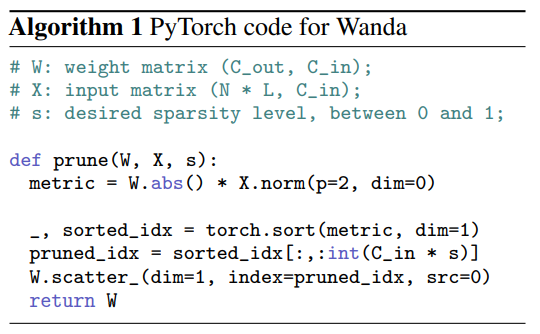

A Simple and Effective Pruning Approach for Large Language Models

著者:Mingjie Sun, Zhuang Liu, Anna Bair, J. Zico Kolter

発行日:2023年06月20日

最終更新日:2023年06月20日

URL:http://arxiv.org/pdf/2306.11695v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

大規模言語モデル(LLM)は、サイズが大きくなるにつれて、ネットワークの重みの一部を削除しながら性能を維持するネットワークの剪定方法の自然な候補です.しかし、既存の方法は、再トレーニングが必要であるため、10億スケールのLLMにはほとんど手頃ではないか、2次情報に依存する重み再構成問題を解決する必要があるため、計算コストが高い場合があります.本論文では、事前にトレーニングされたLLMに疎を誘発するために設計された、新しい、簡単で効果的な剪定方法であるWanda(重みと活性化による剪定)を紹介します.LLMにおける新しい大きな特徴量の出現の観察に基づいて、我々のアプローチは、出力ごとに、対応する入力活性化によって乗算された最小の大きさの重みを剪定します.特筆すべきことに、Wandaは再トレーニングや重みの更新を必要とせず、剪定されたLLMはそのまま使用できます.我々は、さまざまな言語ベンチマークでLLaMA上での我々の方法の徹底的な評価を行いました.Wandaは、大きさの剪定の確立されたベースラインを大幅に上回り、重みの更新に関する最近の方法と競合する優れた性能を発揮し、magnitude pruningによる剪定方法として有望であることが示されました.コードはhttps://github.com/locuslab/wandaで利用可能です.

Q&A:

Q: ワンダと既存の剪定方法の違いは何ですか?

A: Wandaと既存の剪定手法の違いは、Wandaが重み更新手順によって剪定されたモデルを生成するのに対し、既存の手法は重みの大きさに基づいて重みを破棄することでモデルを剪定することである.Wandaは、剪定手順中に性能低下が生じた場合でも、パラメータ効率の高いファインチューニング技術を使用して性能低下を回復することができることが示されている.これに対して、既存の手法は、剪定後のモデルの性能低下を回復するための手法を提供していない.これらの違いは、Dosovitskiyらの論文[16]の図6に示されている. (p.17)

Q: Wandaはどのようにして事前学習されたLLMにスパース性を導入するのか?

A: Wandaは、事前にトレーニングされたLLMsにスパーシティを誘導するための効果的な剪定手法であり、最近のLLMsにおける大きなマグニチュード特徴の出現に着想を得ています.Wandaは、対応する入力アクティベーションノルムによって重みを剪定し、出力ごとに行います.重要なことに、Wandaは再トレーニングや重み更新を必要とせず、剪定されたLLMはそのまま使用できます.この情報は、(p.1)から抽出されました.

Q: ワンダに再トレーニングや体重のアップデートは必要ですか?

A: Wandaは再トレーニングを必要とせず、重みの更新も必要ありません.Wandaは、事前にトレーニングされたLLMで疎なネットワークを発見するために高度に効果的であり、各層で1回のショットでプルーニングされた重みを決定できます.Wandaは、LLMの1回のフォワードパスで行うことができます.SparseGPTとは異なり、Wandaはプルーニングされたネットワークでの重みの更新を必要とせず、元の重みの近傍に存在するだけでなく、正確な効果的な疎なサブネットワークを持っていることを示唆しています.(p.1,3)

Q: 刈り込まれたLLMはそのまま使えるのか?

A: プルーニングされたLLMはそのまま使用できます.(p.1) この研究では、Wandaという新しいプルーニング手法が導入され、その手法によってプルーニングされたLLMはそのまま使用できることが示されています.従来のプルーニング手法では再学習やスクラッチからの学習が必要であったり、計算リソースが必要であったりすることが多かったため、LLMのような大規模なモデルには適していませんでした.しかし、Wandaは従来のマグニチュードプルーニングよりも優れた性能を発揮し、重みの更新が必要な最近の手法とも競合することができます.したがって、プルーニングされたLLMはそのまま使用できます.(p.1)

Q: LLaMAとはどのようなもので、ワンダの評価にどのように使われたのですか?

A: LLaMAは、Transformer言語モデルの一連のモデルファミリーであり、LLaMA-7B/13B/30B/65Bとして知られています.Wandaは、LLaMAを用いた評価において、従来のmagnitude pruningのベースラインを大幅に上回り、重み更新を含む最近の手法と競合することができることが示されました.また、Wandaは、事前学習済みのLLMから直接効率的な疎なネットワークを見つけることができることも示されました.これらの結果は、4 Experiments (p.2-3)に記載されています.LLaMAは、多数の線形層から構成されるアーキテクチャであるため、WandaのアプローチはLLaMAに限定されず、他のTransformerベースのLLMにも適用可能であることが指摘されています.また、Wandaの評価には、言語モデリング能力の評価とゼロショット能力の評価が含まれています.詳細は4.1 Setup (p.2-3)に記載されています.

Q: マグニチュード・プルーニングの確立されたベースラインと比較して、ワンダはどのようなパフォーマンスを見せているのだろうか?

A: Wandaは、従来の基準であるマグニチュードプルーニングと比較してどのようにパフォーマンスが異なるのでしょうか?(p.1-2)

Wandaは、従来の基準であるマグニチュードプルーニングと比較して、より優れたパフォーマンスを発揮することが示されています.マグニチュードプルーニングは、重みの大きさに基づいて重みを破棄する単純で強力な基準であり、Transformersにおいては以前から使用されてきました.しかし、Wandaは、マグニチュードプルーニングよりも優れたパフォーマンスを発揮することが示されています.具体的には、ImageNet-1Kなどのタスクにおいても、Wandaはマグニチュードプルーニングよりも優れたパフォーマンスを発揮することが示されています.(p.1-2, 5.1)

Q: ワンダは、集中的な体重増加を伴う最近の方法にどう対抗するのか?

A: Wandaは、重みの更新に関する集中的な方法と競合しているわけではありません.Wandaは、LLMの事前学習済みモデルでスパースなネットワークを発見することができるため、重みの更新に関する手法とは異なります.これは、Wandaが前処理段階でのみ実行されるためです. (p.4)

Q: WandaはLLM以外のニューラルネットワークにも適用できますか?

A: Wandaは、LLMs以外のニューラルネットワークにも適用できるのか.

この論文では、WandaがLLMsのプルーニングにおいて非常に効果的であることが示されている.しかし、この効果がmagnitude pruningによって広く使用されているタスクにおいても同様に現れるのかどうかは不明である.そこで、本研究では、ImageNet-1Kという標準的な画像分類タスクにおいて、magnitude pruningが強力なベースラインとして広く受け入れられていることを考慮し、Wandaの性能をConvNeXtとVision Transformer (ViT)という2つのモダンなビジョンアーキテクチャに適用した.その結果、Wandaは、LLMs以外のネットワークでも有効なプルーニング手法であることが示された.具体的には、Wandaは、事前学習済みのLLMs内で効果的なスパースネットワークを特定することができる.これにより、Wandaは、LLMs以外の一般的なプルーニング手法として使用することができる.この研究は、LLMsにおけるスパース性の理解に貢献することを目的としている.(p.10)

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で紹介された新しい方法のコード実装のURLは、https://github.com/locuslab/wandaです.この方法は、Wandaと呼ばれ、magnitude pruningの確立されたベースラインを大幅に上回り、重い重み更新を必要とする最近の方法と競合することができます.この方法は、LLaMA上で詳細な評価が行われ、プルーニングされたLLMをそのまま使用できることが示されています.

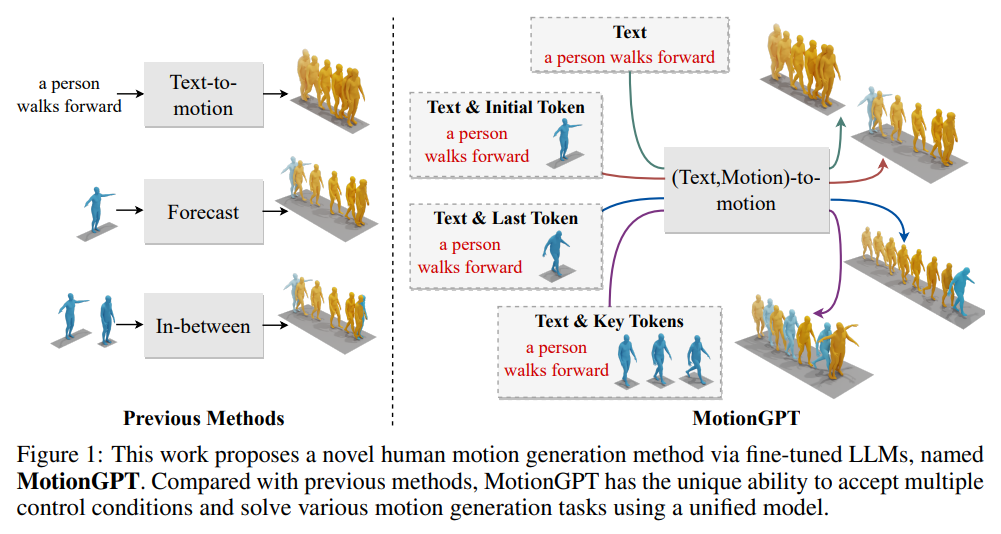

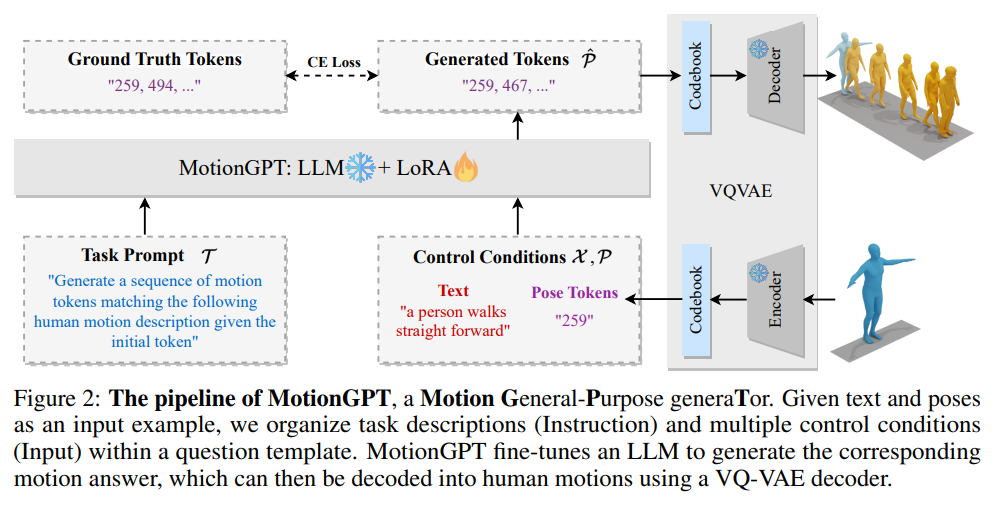

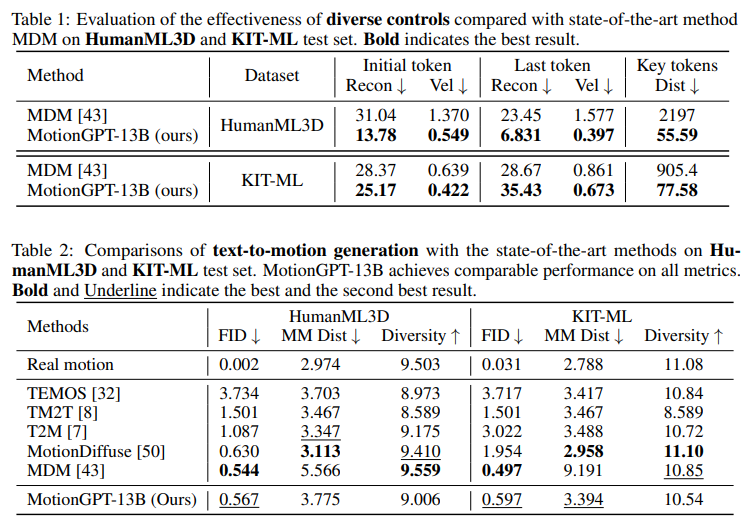

MotionGPT: Finetuned LLMs are General-Purpose Motion Generators

著者:Yaqi Zhang, Di Huang, Bin Liu, Shixiang Tang, Yan Lu, Lu Chen, Lei Bai, Qi Chu, Nenghai Yu, Wanli Ouyang

発行日:2023年06月19日

最終更新日:2023年06月19日

URL:http://arxiv.org/pdf/2306.10900v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence

概要:

MotionGPTは、マルチモーダル制御信号を使用して人間の動きを生成することができるため、デジタル人間産業において重要な進展を遂げています.最近の研究では、テキストのアクションの説明から直接動きを生成することができることが示されていますが、制御信号の単一のモダリティしかサポートしていないため、実際の応用が制限されています.MotionGPTは、マルチモーダル制御信号を使用して、マルチモーダル信号を大規模言語モデル(LLM)の特別な入力トークンとして扱い、連続的な人間の動きを生成することができます.具体的には、マルチモーダル制御信号を離散的なコードに量子化し、それらを統一されたプロンプト命令に形式化して、LLMに動きの答えを生成するように求めます.MotionGPTは、わずか0.4%のLLMパラメータを調整することで、マルチモーダル制御信号を使用した統一された人間の動き生成モデルを示しています.私たちの知る限り、MotionGPTは、マルチモーダル制御信号によって人間の動きを生成する最初の方法であり、これが光を投げることを望みます.MotionGPTのコードは、受け入れ後に公開される予定です.

Q&A:

Q: MotionGPTの目的は何ですか?

A: MotionGPTの目的は、テキストと人間のポーズをキーフレームで制御することによって、人間の動きを問題として定式化し、タスクのプロンプトと制御条件に従って望ましい人間の動きを生成することです.具体的には、MotionGPTは、事前にトレーニングされたモーションVQ-VAEを使用して、人間のポーズを離散的なモーションコードにマッピングし、言語プロンプトとモーションプロンプトからコードを組み合わせて指示を生成します.MotionGPTは、複数の制御条件を受け入れ、単一の統一モデルを使用してさまざまな動き生成タスクを解決することができるため、従来の方法と比較して、より実用的で包括的な人間の動き生成の解決策を提供します.(p.1)

Q: アクション描写からリアルな人間の動きを生成するために、どのような進歩があったのでしょうか?

A: 人間の動きを行動の説明から生成することに関して、デジタル人間の必要性が出てきたため、最近の研究では、テキストの行動説明から直接動きを生成することが印象的な結果を出しているが、彼らはしばしば単一の制御信号のモダリティしかサポートしておらず、これは現実のデジタル人間産業においてその応用を制限している.この問題に対処するために、MotionGPTは、複数の制御信号を使用して人間の動きを生成する最初の方法であり、新しい方向性を示すことができると期待されている.(p.1)

Q: テキストによる動作描写からモーションを生成する最近の作品の限界とは?

A: 現在の研究では、テキストのアクション記述から現実的な人間の動きを生成することが可能になってきています.しかし、最近の研究では、テキストとポーズのプロンプトの単一のモダリティしかサポートしておらず、より実用的で多目的な動き生成システムにはまだ道のりがあるとされています.具体的には、音楽などのより広範なモダリティでのMotionGPTの有効性を検証することが必要であるとされています.(p.1)

Q: 人間の連続的な動きを生成する上で、マルチモーダルな制御信号を使用する利点は何か?

A: 多様な制御条件を使用することで、MotionGPTは連続的な人間の動きを生成することができます.これにより、テキストの説明や単一フレームのポーズなど、複数の制御条件を使用して、現実世界での応用範囲が広がります.これは、既存の作品が単一の制御条件にしか対応していないため、デジタル人間産業において制限があることを示しています.(p.1)

多様な制御条件を使用することで、MotionGPTはより現実的な応用範囲を持つことができます.これは、テキストの説明や単一フレームのポーズなど、複数の制御条件を使用して、連続的な人間の動きを生成することができるためです.これにより、MotionGPTは、既存の作品が単一の制御条件にしか対応していないため、デジタル人間産業において制限があることを示しています.(p.1)

Q: マルチモーダル制御信号はどのようにして離散コードに量子化されるのか?

A: 多様な制御信号を量子化するために、MotionGPTでは、まず多様な制御信号を離散的なコードに変換し、それらを統一されたプロンプト命令にまとめてLLMsに生成される動作の答えを求めるように要求します.MotionGPTは、わずか0.4%のLLMパラメータを調整することで、多様な制御信号を持つ統一された人間の動作生成モデルを実証しています.MotionGPTは、多様な制御信号によって人間の動作を生成する最初の手法であり、この新しい方向性に光を当てることができることを期待しています.(p.1)

MotionGPTでは、広範な言語モデル(LLMs)において、多様な制御信号を特別な入力トークンとして扱い、連続的な人間の動作を生成することができます.具体的には、まず、多様な制御信号を離散的なコードに量子化し、設計されたタスク指示とともに統一された質問テンプレートにまとめます.そして、LLMsに人間の動作シーケンスの答えを生成するように要求します.MotionGPTは、VQ-VAEを使用してモーションコントロールを離散的なコードに量子化します.

Q: 統一されたプロンプト・インストラクションの中で、モーションアンサーを生成するためのコードはどのように定式化されるのか?

A: 回答いたします.コンテキストによると、多様な制御信号を離散的なコードに量子化し、統一されたプロンプト命令に形式化することで、LLMsで人間の動きを生成するためのコードが作成されます.具体的には、以下の式(Eq. 3)を使用して、生成されたモーションコードを人間の動きにデコードします.この方法により、MotionGPTは多様な制御信号を持つ統一された人間の動き生成モデルを実現し、LLMsを調整することができます.

Q: 人体運動生成の分野におけるMotionGPTの意義とは?

A: MotionGPTは、人間の動きを生成するための新しいモデルであり、単一かつ統一されたモデルを使用して、後続、前続、または「間に挟む」動きを生成することができます.これは、テキストとポーズの両方を条件として使用する最初の方法であり、人間の動きを生成するためにLLMを使用する可能性を示唆しています.MotionGPTは、複数の制御条件を受け入れ、統一されたモデルを使用してさまざまな動き生成タスクを解決することができるため、人間の動き生成の分野において重要な意義を持ちます.(p.2-3)

Q: MotionGPTではLLMのパラメータはどの程度調整されているのですか?

A: MotionGPTでチューニングされたLLMのパラメーターの量は33Mであり、他の方法のトレーニング時間の10%である約4時間でトレーニングされます(p.2).MotionGPTは、設計された指示に従ってLLMを微調整することによって生成されたモーションを生成するために使用されます.LLMは、45ギガバイトのトレーニングデータと多数のパラメーターを活用することにより、言語タスクで優れたパフォーマンスを発揮することができます.MotionGPTは、LLMの強力なモーションプライオリティを活用して、少ないトレーニングパラメーターで優れたモーション生成品質を実現します.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で紹介された新しい手法のコード実装のURLは、https://qiqiapink.github.io/MotionGPT/です.この手法は、複数のモーダル制御信号によって人間の動きを生成する最初の手法であり、現実世界での応用範囲を大幅に拡大することができます.この手法のコードは、受理後に公開される予定です.

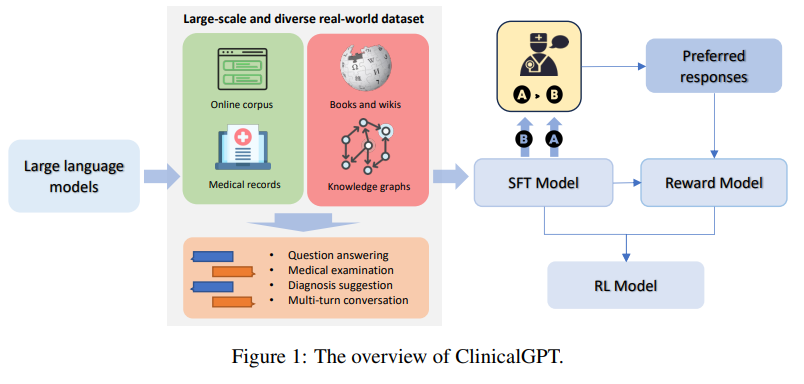

ClinicalGPT: Large Language Models Finetuned with Diverse Medical Data and Comprehensive Evaluation

著者:Guangyu Wang, Guoxing Yang, Zongxin Du, Longjun Fan, Xiaohu Li

発行日:2023年06月16日

最終更新日:2023年06月16日

URL:http://arxiv.org/pdf/2306.09968v1

カテゴリ:Computation and Language

概要:

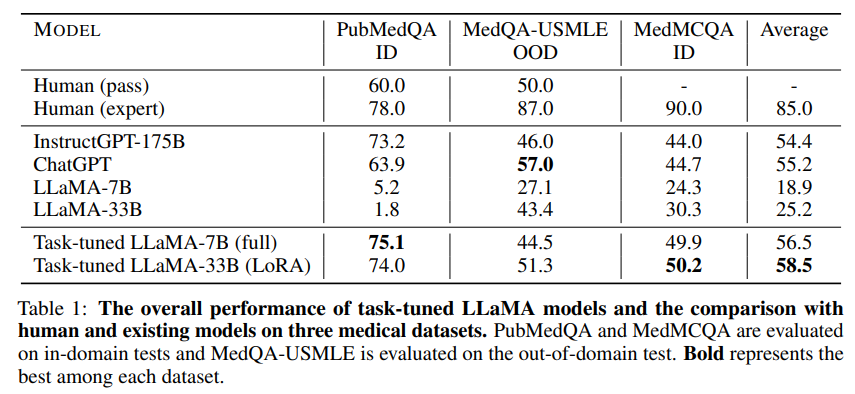

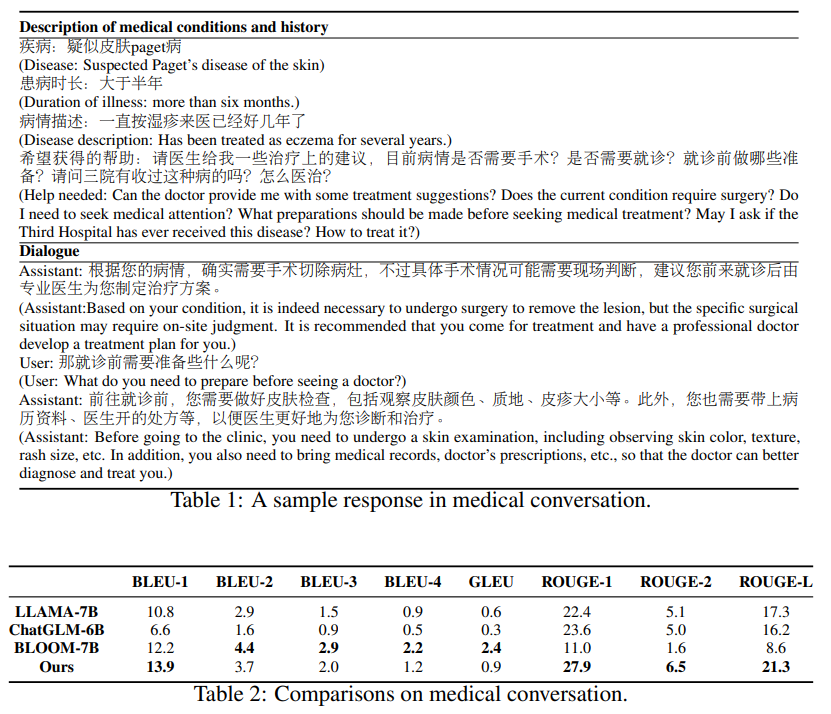

大規模言語モデルは、事前学習や指示微調整などの技術を活用して、さまざまな自然言語処理(NLP)タスクで優れたパフォーマンスを発揮しています.しかし、医療アプリケーションにおける効果は、事実の不正確さ、推論能力、現実世界の経験に基づく欠如などの課題により限定されています.本研究では、臨床シナリオに明示的に設計および最適化された言語モデルであるClinicalGPTを提案しています.医療記録、ドメイン固有の知識、および多数回の対話相談など、広範で多様な現実世界のデータを取り込むことにより、ClinicalGPTは複数の臨床タスクを処理するためにより適した状態になります.さらに、医療知識の質問応答、医療検査、患者相談、および医療記録の診断分析を含む包括的な評価フレームワークを導入します.結果は、ClinicalGPTがこれらのタスクで他のモデルよりも優れたパフォーマンスを発揮し、大規模言語モデルを医療の重要な領域に適応させるアプローチの有効性を示しています.

Q&A:

Q: 医療アプリケーションにおける大規模言語モデルの有効性を制限する課題とは?

A: 医療分野において大規模言語モデルの効果を制限する課題は、多岐にわたる.先行学習や指示微調整などの技術を活用しても、生成言語モデルの出力には事実上の誤り、論理的な不整合、存在しない文献参照などの問題がある.これらのモデルは推論能力に限界があり、現実世界の経験に基づく根拠が欠けているため、一般的で曖昧な回答を生み出す.ChatGPTは深さや洞察力に欠けることが判明しており、報酬ベースのトレーニングに使用されるアラインメントモデルのために、医療の専門知識を欠いた過剰に一般化された回答が生成される可能性がある.これらの証拠から、医療分野でこれらの技術を採用するには、高い精度、解釈可能性、および機密性の高い健康データの取り扱いなど、独自の障壁が存在することが示唆されている.(p.1)

Q: ClinicalGPTはどのように設計され、臨床シナリオに最適化されたのですか?

A: 本研究では、ClinicalGPTという言語モデルが、臨床シナリオに明示的に設計され、最適化されたことが示されています.(p.1) このモデルは、医療記録、ドメイン特有の知識、および多数のラウンドの対話相談など、多様で現実的なデータをトレーニングプロセスに取り込むことで、複数の臨床タスクに対応するためにより良く準備されています.(p.1) さらに、医療知識の質問応答、医療試験、患者相談、および医療記録の診断分析を含む包括的な評価フレームワークを導入しました.その結果、ClinicalGPTはこれらのタスクで他のモデルを大幅に上回り、私たちのアプローチが医療の重要な領域に大規模な言語モデルを適応させることの有効性を示しています.(p.1)

Q: ClinicalGPTのトレーニングプロセスには、どのような種類の実戦データが組み込まれたのですか?

A: 本研究では、ClinicalGPTという言語モデルを紹介しています.このモデルは、医療現場に特化したものであり、医療記録やドメイン特有の知識、多数の対話による相談など、多様で広範な現実世界のデータを取り込んでトレーニングされています.これにより、ClinicalGPTは複数の臨床的なタスクを処理するためにより適した状態になっています.また、医療知識に関する質問応答、医療試験、患者相談、医療記録の診断分析などを含む包括的な評価フレームワークを導入しており、その結果、ClinicalGPTはこれらのタスクにおいて他のモデルよりも優れた性能を発揮しています.以上より、ClinicalGPTは医療分野において大規模な言語モデルを適応させるための効果的なアプローチであることが示されています.

Q: ClinicalGPTは複数の臨床タスクをどのように処理していますか?

A: 論文では、ClinicalGPTという言語モデルが紹介されており、臨床シナリオに特化したモデルであることが明らかにされています.(p.1) このモデルは、医療記録、ドメイン特化の知識、多数の対話コンサルテーションなど、多様な現実世界のデータを取り込むことで、複数の臨床タスクに対応するためにより良く準備されています.また、医療知識の質問応答、医療試験、患者相談、医療記録の診断分析などを含む包括的な評価フレームワークが導入されており、ClinicalGPTはこれらのタスクにおいて他のモデルよりも優れた性能を発揮しています.(p.1) このことは、大規模言語モデルを医療の重要な領域に適応させるためのアプローチの効果を示しています.

Q: この研究で導入された包括的評価の枠組みとは?

A: 本研究では、医療知識の質問応答、医療検査、患者相談、医療記録分析を含む包括的な評価フレームワークを導入しました.このフレームワークは、MEDQA-MCMLEデータセットを用いた医療検査評価にも適用されました.このデータセットは、専門医療試験から派生したものであり、応用知識、臨床推論、患者中心のスキルを効果的に評価します.このフレームワークにより、ClinicalGPTは他のモデルよりも優れた性能を発揮し、複数の臨床タスクに対応できるようになりました.(p.4)

Q: 評価フレームワークの構成要素とは?

A: 評価フレームワークの構成要素は、医療知識に関する質問応答、医療検査、患者相談、医療記録の分析を含みます.これらのタスクは、臨床的な知識、診断推論、患者中心のスキルを評価するために使用されます.このフレームワークは、MEDQA-MCMLEデータセットを使用して評価され、医療倫理、呼吸器系、消化器系、泌尿器系、血液学的疾患、リウマチ免疫疾患、小児疾患などのカテゴリが含まれます.データセットには、4または5の選択肢を提供する34,000の質問が含まれており、トレーニング、バリデーション、テストセットに分割されています.これらのタスクは、ClinicalGPTが他のモデルよりも優れていることを示しています.

Q: ClinicalGPTは、医学知識の質問応答において、他のモデルと比較してどのように機能するのか?

A: 医療知識の質問応答において、ClinicalGPTは既存のモデルよりも優れたパフォーマンスを発揮することが示されています.この結果は、我々のアプローチの効果を確認するものであり、大規模な言語モデルを医療の重要な領域に適応させるための我々のアプローチの有効性を強調しています.(p.1) また、ClinicalGPTは医療知識の質問応答、医療検査、患者相談、医療記録の診断分析などのタスクにおいて、他のモデルよりも優れたパフォーマンスを発揮することが示されています.(p.1)

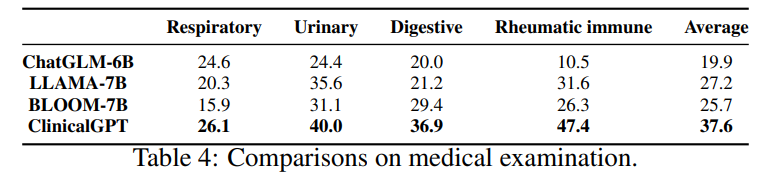

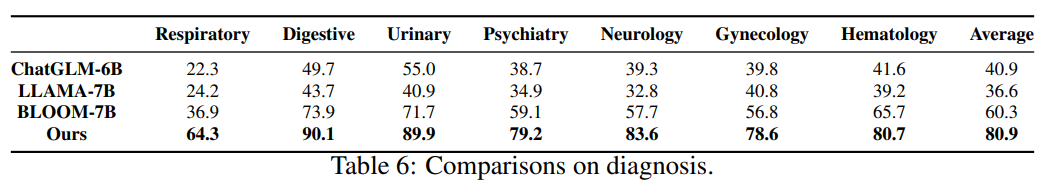

Q: ClinicalGPTは、医療試験における他のモデルと比較して、どのようなパフォーマンスを発揮しますか?

A: 医療試験において、ClinicalGPTは他のモデルに比べて優れた性能を発揮します.研究の結果、ClinicalGPTは、医療知識の質問応答、医療検査、患者相談、医療記録の診断分析などのタスクにおいて、他のモデルよりも優れた性能を発揮しました.特に、消化器科と泌尿器科では、90.1%と89.9%の精度を達成し、異なる疾患グループにわたって医療記録を理解し解釈する堅牢な能力を示しました.ただし、婦人科と血液学の分野では、わずかに低い精度を示しましたが、全体的にはさまざまな医療分野で良好な性能を発揮しました.

Q: ClinicalGPTは、患者の診察において他のモデルと比較してどのようなパフォーマンスを見せていますか?

A: ClinicalGPTは、患者相談において他のモデルよりも優れたパフォーマンスを発揮します.これは、医療記録、ドメイン固有の知識、マルチラウンドの対話相談など、多様で広範な現実世界のデータをトレーニングプロセスに取り込むことで実現されます.また、医療知識の質問応答、医療検査、患者相談、医療記録の診断分析を含む包括的な評価フレームワークを導入することで、ClinicalGPTは他のモデルよりも優れたパフォーマンスを発揮し、アプローチの効果を示しています.(p.1)

Q: カルテの診断分析において、ClinicalGPTは他のモデルと比較してどのように機能しますか?

A: 本研究では、ClinicalGPTという言語モデルが、医療現場における複数のタスクに対応するように設計され、実際の医療記録、ドメイン特化の知識、マルチターンの対話相談など、多様で広範なデータを取り込んでトレーニングされたことが示されています.その結果、ClinicalGPTは、他のモデル、例えばChatGLM-6B、LLAMA-7B、BLOOM-7Bよりも、すべての疾患グループにおいて優れた性能を発揮しました.特に、消化器科と泌尿器科では、90.1%と89.9%の精度を達成し、医療記録を理解し解釈するための堅牢な能力を示しました.ただし、婦人科と血液学の分野では、わずかに低い精度でしたが、それでも78.6%と80.7%の精度を示しました.これは、婦人科と血液学の分野において改善の余地があることを示唆していますが、ClinicalGPTは、医療のさまざまな専門分野全体で優れた性能を発揮しました.(p.6)

Full Parameter Fine-tuning for Large Language Models with Limited Resources

著者:Kai Lv, Yuqing Yang, Tengxiao Liu, Qinghui Gao, Qipeng Guo, Xipeng Qiu

発行日:2023年06月16日

最終更新日:2023年06月16日

URL:http://arxiv.org/pdf/2306.09782v1

カテゴリ:Computation and Language

概要:

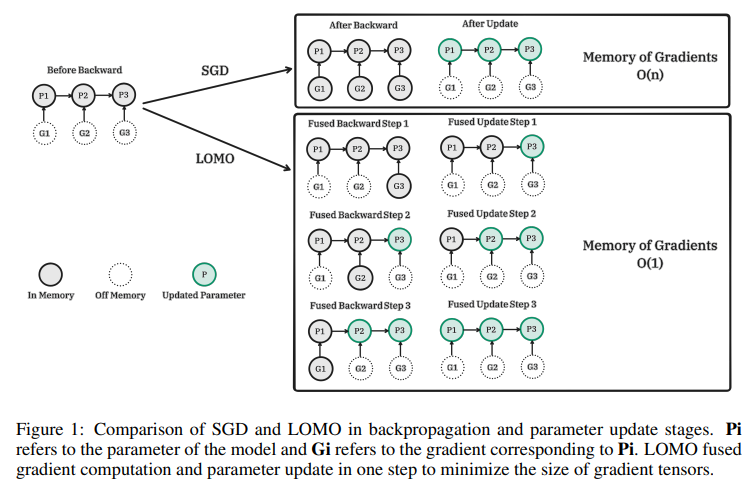

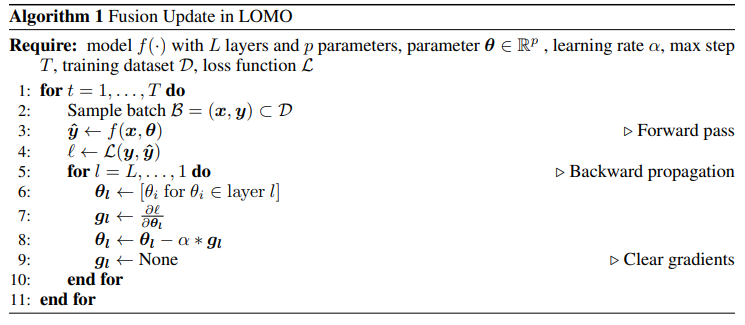

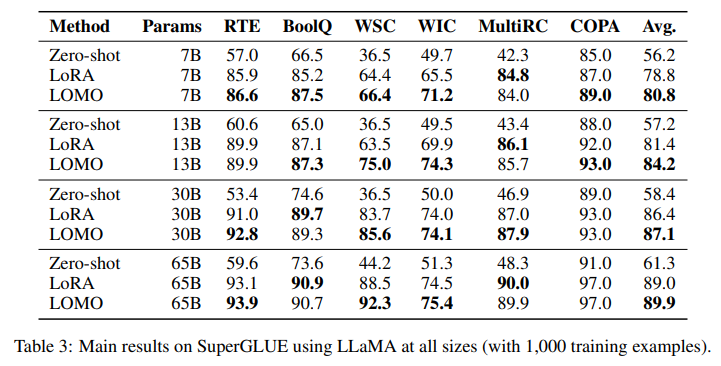

大規模言語モデル(LLM)は、自然言語処理(NLP)を革新しましたが、トレーニングには膨大なGPUリソースが必要です.LLMのトレーニングの閾値を下げることは、研究者のより大きな参加を促し、学術界と社会の両方に利益をもたらすでしょう.既存のアプローチは、パラメータ効率の良いファインチューニングに焦点を当てていますが、これは少数のパラメータを調整または追加するものであり、限られたリソースでLLMの全パラメータを調整する課題にはほとんど対処していません.本研究では、勾配計算とパラメータ更新を1つのステップに統合してメモリ使用量を削減する新しい最適化手法、LOw-Memory Optimization(LOMO)を提案しています.既存のメモリ節約技術と統合することで、標準的なアプローチ(DeepSpeedソリューション)に比べてメモリ使用量を10.8%に削減しました.その結果、当社のアプローチにより、1台のマシンで8つのRTX 3090、各24GBのメモリを搭載した65Bモデルの全パラメータファインチューニングが可能になりました.

Q&A:

Q: 限られたリソースでLLMの全パラメータを調整するために提案されたオプティマイザとは?

A: 本論文では、限られたリソースでLLMsの全パラメータの微調整を行うための新しい最適化手法であるLOw-Memory Optimization (LOMO)が提案されています.LOMOは勾配計算とパラメータ更新を一度に行うことでメモリ使用量を削減し、既存のメモリ節約技術と統合することで、DeepSpeedソリューションに比べてメモリ使用量を10.8%に削減することができます.その結果、8×RTX 3090を搭載した単一のマシンで65Bモデルの全パラメータの微調整が可能になります.(p.1-2)

Q: LOMOは標準的なアプローチと比べて、どのようにメモリ使用量を削減しているのですか?

A: LOMOは、勾配計算とパラメータ更新を1つのステップで融合することで、メモリ使用量を削減することができます.既存のメモリ節約技術と統合することで、DeepSpeedソリューションに比べてメモリ使用量を10.8%に削減することができます.これにより、LOMOを使用することで、リソース制約のあるシナリオでLLMを最適化する効果を実証的に検証することができます.(p.1,5,30)

Q: LOMOと既存の省メモリ技術を統合することで、メモリ使用量はどの程度削減できるのでしょうか?

A: 既存のメモリ節約技術と統合することで、LOMOを使用したメモリ使用量は、標準的なアプローチ(DeepSpeedソリューション)に比べて10.8%に削減されました.これにより、この手法は、限られたリソースの下でLLMsを最適化するために有効であることが実証され、1つのマシンで8×RTX 3090を使用して65Bモデルのフルパラメーターファインチューニングを可能にしました.(p.1)

Q: 提案されたアプローチを使って完全に微調整できるLLMモデルのサイズは?

A: 提案されたアプローチにより、単一のマシンで8×RTX 3090、各24GBのメモリを持つLLMモデルの完全なパラメータファインチューニングが可能になります.具体的なモデルサイズは文中に記載されていませんが、文中には「30Bから175Bのパラメータを持つモデル」が言及されています.したがって、提案されたアプローチにより、少ないリソースで非常に大きなLLMモデルを完全にファインチューニングすることができます.(p.1)

Q: 提案されたアプローチに必要なRTX 3090 GPUの数は?

A: 提案されたアプローチに必要なRTX 3090 GPUの数は8つです.(p.1) このアプローチでは、8つのRTX 3090 GPUを使用して、65Bモデルを訓練し、1000サンプル、各512トークンを含むトレーニングプロセスに約3.6時間かかります.このアプローチは、DeepSpeedソリューションよりも標準的なアプローチであり、8つのRTX 3090 GPUを搭載した単一のマシンで65Bモデルの完全なパラメーターファインチューニングを可能にします.

Q: 限られたリソースでLLMのフルパラメーター微調整を可能にする意義とは?

A: LLMsの完全パラメーターファインチューニングをリソース制限のある状況で可能にすることの意義は、NLPの分野においてより多くの研究者が参加できるようになり、学術界や社会に利益をもたらすことができることです.これまでのアプローチは、パラメーター効率の良いファインチューニングに焦点を当ててきましたが、本研究では、リソース制限のある状況でLLMsの完全パラメーターファインチューニングを実現するための技術を探求しています.LOMOという新しいオプティマイザを提案し、勾配計算とパラメーター更新を一度に行うことでメモリ使用量を削減し、既存のメモリ節約技術と統合することで、DeepSpeedソリューションに比べてメモリ使用量を10.8%に削減することができます.したがって、本研究により、リソース制限のある状況でもLLMsの完全パラメーターファインチューニングが可能になり、より多くの研究者が参加できるようになることが期待されます.(p.1)

Q: 提案されているアプローチは、研究者や社会にどのような利益をもたらすのか?

A: 提案された手法は、LLMsのトレーニングの閾値を下げ、研究者の参加を促進し、学術界と社会の両方に利益をもたらすことが期待されます.これは、(p.2)に述べられています.従来のアプローチは、パラメータ効率の良いファインチューニングに焦点を当ててきましたが、LLMsの全パラメータのチューニングの課題にはほとんど取り組まれていませんでした.提案された手法は、数十億のパラメータを持つLLMsの最適化に効率的かつ効果的であることが示されており、(p.4)に記載されています.したがって、この手法は、研究者がより多く参加し、より高度な自然言語処理技術の開発につながり、社会に利益をもたらすことが期待されます.

Q: LLMのパラメータを効率的に微調整するための既存のアプローチにはどのようなものがあるか?

A: LLMのパラメーター効率的なファインチューニングの既存のアプローチは、LoRA (Hu et al., 2022)やPrefix-tuning (Li & Liang, 2021)などの方法である.これらの方法は、リソースが限られている場合にLLMをチューニングするための解決策を提供する.しかし、これらの方法は、パラメーター効率的なファインチューニングよりも強力なアプローチであると認められている完全なパラメーターファインチューニングの実用的な解決策を提供していない. (Ding et al., 2022; Sun et al., 2023).

Q: 提案されたアプローチは、LLMを微調整する既存のアプローチとどう違うのですか?

A: 既存のLLMの微調整方法に焦点を当てた従来のアプローチとは異なり、提案されたアプローチは、LLMの全パラメータの微調整に対処することを目的としています.これは、パラメータ効率の良い微調整方法とは異なり、より多くのGPUリソースを必要とするため、小規模な研究室や企業がこの分野に参加することが困難であるという問題に対処するためです.また、提案されたアプローチは、LLMのパラメータ空間が比較的滑らかであるという仮定に基づいており、これにより、微小なパラメータの変化が損失に大きな影響を与えないことが期待されます.さらに、微調整の目的が、モデル自体を大幅に変更せずに新しいタスクやドメインに適応させることであるため、局所最適解が十分な解であることが多いとされています.これらの特徴により、提案されたアプローチは、既存のパラメータ効率の良い微調整方法とは異なり、LLMの全パラメータの微調整に焦点を当て、より多くのGPUリソースを必要とすることが期待されます.

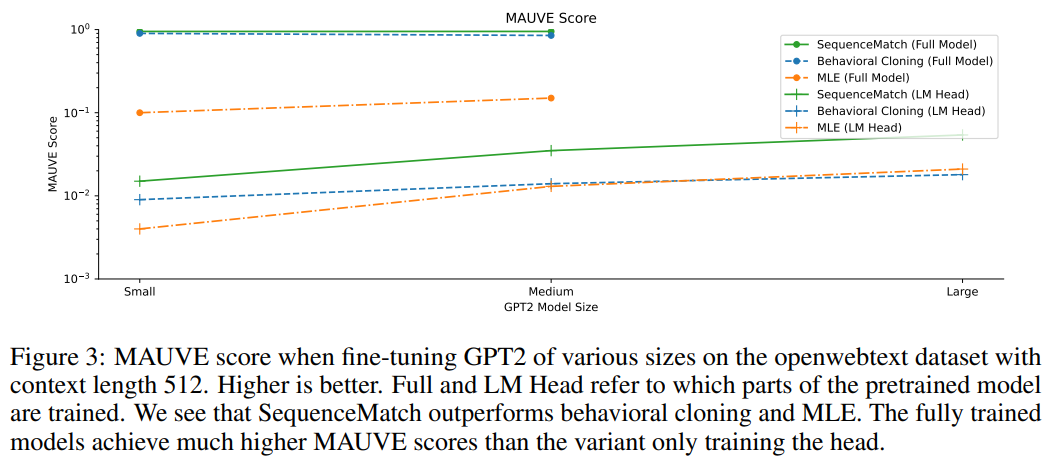

SequenceMatch: Imitation Learning for Autoregressive Sequence Modelling with Backtracking

著者:Chris Cundy, Stefano Ermon

発行日:2023年06月08日

最終更新日:2023年06月19日

URL:http://arxiv.org/pdf/2306.05426v2

カテゴリ:Machine Learning, Artificial Intelligence

概要:

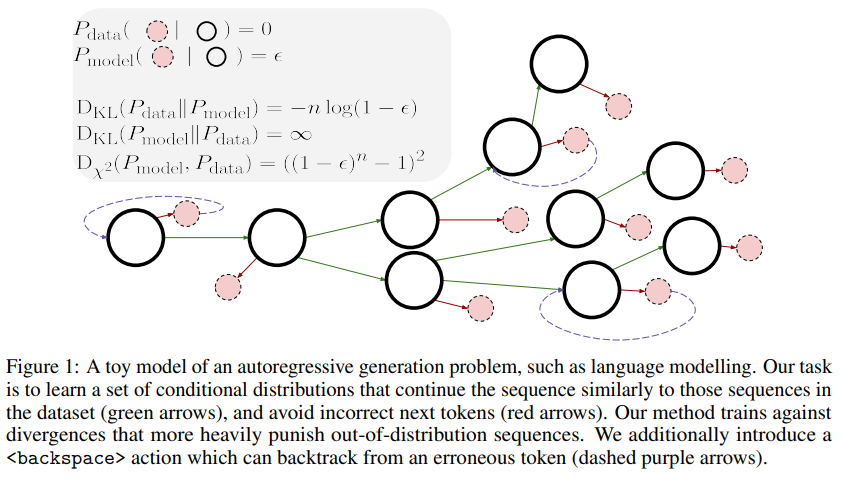

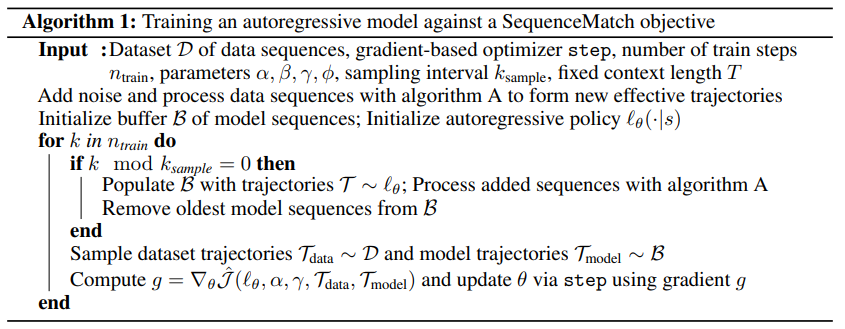

自己回帰モデルは、多くのドメインで次の観測値を予測するタスクで高い尤度を達成できます.しかし、この最大尤度(MLE)目的は、自己回帰的に高品質のシーケンスを生成するという下流のユースケースと必ずしも一致しない場合があります.MLE目的は、データ分布下での頻度に比例してシーケンスに重みを付けるため、モデルの帰属外(OOD)での振る舞いについてのガイダンスがなく、自己回帰的な生成中に誤差が複合することになります.この複合誤差問題に対処するために、シーケンス生成を模倣学習(IL)問題として定式化します.これにより、自己回帰モデルによって生成されたシーケンスの分布とデータセットからのシーケンスの分布との間のさまざまな発散を最小化できます.また、バックトラッキングを組み込むことで、モデルがシーケンスを帰属外に取る場合にサンプルされたトークンを元に戻すことができるため、複合誤差問題がさらに軽減されます.このようにして得られるSequenceMatchメソッドは、自己回帰モデルによるシーケンス生成において、敵対的トレーニングや大規模なアーキテクチャの変更なしで実装できます.さらに、SequenceMatch-\( \small \chi^2 \)発散をより適したトレーニング目的として特定し、言語モデルによるテキスト生成において、MLEよりもSequenceMatchトレーニングが改善をもたらすことを実証しています.

Q&A:

Q: 自己回帰系列の生成に最尤法を用いることの問題点は何ですか?

A: 最尤法を使用すると、自己回帰シーケンス生成において、分布外のモデルの振る舞いに対するガイダンスがなく、自己回帰生成中に誤差が複合される問題がある.これは、データ分布に従ってシーケンスの頻度に比例して重み付けされるためである.

Q: 模倣学習のフレームワークは、シーケンス生成における複合エラーの問題にどのように対処しているのだろうか?

A: 複数の分布の間の多様性を最小化することにより、模倣学習(IL)問題としてシーケンス生成を定式化することで、複合エラー問題に対処します.これにより、自己回帰モデルによって生成されたシーケンスの分布とデータセットからのシーケンスの分布との間の多様性を最小化することができます.また、OOD生成されたシーケンスに重みを付けた多様性も含めることができます.さらに、バックスペースアクションを導入することでバックトラッキングを組み込むことができます.これにより、モデルがシーケンスがOODである場合にサンプリングされたトークンを元に戻すことができ、複合エラー問題をさらに軽減することができます.これにより、SequenceMatchという手法が開発されました.これは、敵対的なトレーニングやアーキテクチャの変更なしに実装することができます.(p.1)

Q: ILのフレームワークを使えば、どのようなタイプの乖離を最小化できるのか?

A: ILフレームワークでは、学習モデルによって誘導される占有メジャーとデータ分布の間の発散を最小化するための一般的な非敵対的目的を導出する問題があります.この問題を解決するために、KL-ダイバージェンス、JS-ダイバージェンス、χ2-ダイバージェンスなどの具体的なダイバージェンスに直接発散最小化を基礎づけることができるように、新しいマスキングスキームが開発されました.これにより、任意のポリシーからサンプルを取り込むことができます.これにより、シーケンス生成を模倣学習(IL)問題として定式化することができます.ILフレームワークは、バックスペースアクションを導入することにより、バックトラッキングを組み込むこともできます.これにより、モデルがサンプリングされたトークンがシーケンスをOODに取る場合に、サンプリングされたトークンを元に戻すことができるため、複合エラー問題がさらに軽減されます.したがって、ILフレームワークを使用して、オートレグレッシブモデルによって生成されたシーケンスの分布とデータセットからのシーケンスの分布の間のさまざまなダイバージェンスを最小化することができます.SequenceMatch- χ2ダイバージェンスをより適したトレーニング目的として特定しました.これらの情報は、D.1節で詳しく説明されています.(p.1)

Q: シークエンスマッチは、敵対的なトレーニングやアーキテクチャの大きな変更なしに実装できるのか?

A: SequenceMatchは、敵対的なトレーニングや大規模なアーキテクチャの変更なしに実装できます.これは、既存のモデルに対してファインチューニングステップとして適用できる完全に教師ありの損失であるため、モデルの改良が容易になります.また、SequenceMatchは、自己回帰モデルに対してより適したトレーニング目的であるSequenceMatch-χ2divergenceを特定し、テキスト生成においてMLEよりも改善が見られることが実証されています.

Q: SequenceMatch-\( \small chi^2 \)ダイバージェンスとは何か、またなぜそれが生成に使われる自己回帰モデルにより適した学習目的なのか?

A: SequenceMatch-\( \small \chi^2 \)ダイバージェンスは、自己回帰モデルのトレーニングにおいてより適したトレーニング目的であり、シーケンス生成問題を模倣学習(IL)問題として定式化し、[11]に基づく占有測定値間のダイバージェンスを最小化するための一般的な非敵対的目的を定式化することによって得られます.これにより、KLダイバージェンス、JSダイバージェンス、\( \small \chi^2 \)ダイバージェンスなどの代替ダイバージェンスに対して、SequenceMatchは完全に教師ありの損失であり、敵対的なトレーニングなしでモデルをトレーニングできます.また、SequenceMatchは、backspaceアクションを追加することで、バックトラッキングを組み込むことができ、モデルがシーケンスOODを取る場合にサンプリングされたトークンを元に戻すことができるため、誤った生成を軽減することができます.これにより、SequenceMatchは、MLEに比べて、テキスト生成において改善された性能を示すことが実証されています.

Q: SequenceMatchトレーニングは、言語モデルを使ったテキスト生成において、MLEよりもどのような改善をもたらすのか?

A: SequenceMatchトレーニングは、MLEに比べて言語モデルによるテキスト生成において改善をもたらすことが実証されています.具体的には、MAUVEスコアによると、SequenceMatchトレーニングされたモデルは、データセットに近いテキストを生成することができます.また、SequenceMatchトレーニングされたモデルは、多様性メトリックにおいてもMLEやBCよりも優れた結果を示しました.さらに、SequenceMatchトレーニングされたモデルから生成されたサンプルは、より流暢であることが観察されました.ただし、1024コンテキスト長の場合にGPT2-smallモデルをトレーニングした場合、SequenceMatchトレーニングされたモデルはperplexityメトリックにおいてBCやMLEトレーニングされた方法に勝ることはありませんでした.これは、BCやMLEのトレーニング目的がperplexityとまったく同じであるためです.しかし、生成品質の測定(MAUVEスコアや多様性)においては、SMトレーニングされたモデルはベースラインをはるかに上回っています.

Q: 自己回帰シーケンス生成にSequenceMatchを使用することの限界や潜在的な欠点はありますか?

A: SequenceMatchを使用した自己回帰的なシーケンス生成には、いくつかの制限や潜在的な欠点があります.文脈が長い場合、トレーニング中に自己回帰的にサンプルを生成することはコストがかかるため、トレーニングオーバーヘッドが発生します.また、より複雑な損失関数が必要であり、トレーニング中にバックスペースをマスクするためにシーケンスを処理する必要があります.将来の研究では、より大きなモデルをSequenceMatch目的でトレーニングすることの効果や、発散の選択によって生成の品質がどのように変化するかを調査することができます.(p.10)

Q: SequenceMatchは、自己回帰シーケンス生成を改善する他の手法と比較してどうですか?

A: SequenceMatchは、MLEに比べてテキスト生成において改善が見られることが実証されています.(p.1)

SequenceMatchは、従来の方法と比較して、autoregressive sequence generationの改善に有効であることが示されています.具体的には、SequenceMatchは、backtrackingを導入することで、autoregressive generation中にシーケンスがOODになった場合に、サンプリングされたトークンを元に戻すことができるため、compounding error problemを軽減することができます.また、SequenceMatch- χ2divergenceを使用することで、autoregressive modelsのgenerationに適したトレーニング目的を特定することができます.(p.1)

従来のMLE目的は、データ分布下でのシーケンスの頻度に比例してシーケンスの重みを付けるため、autoregressive generation中にシーケンスがOODになった場合に、compounding errorが発生することがあります.これに対して、SequenceMatchは、backtrackingを導入することで、この問題を軽減することができます.(p.1)