今回のテーマ:知識グラフのLLMへの応用、TAPIRによるビデオ上での追跡、学習アルゴリズムのベンチマーク、金融用のオープンソースLLM FinGPT、LLMのウォーターマークなど.

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の9本となります.

- Unifying Large Language Models and Knowledge Graphs: A Roadmap (発行日:2023年06月14日)

- TAPIR: Tracking Any Point with per-frame Initialization and temporal Refinement (発行日:2023年06月14日)

- Artificial Artificial Artificial Intelligence: Crowd Workers Widely Use Large Language Models for Text Production Tasks (発行日:2023年06月13日)

- Benchmarking Neural Network Training Algorithms (発行日:2023年06月12日)

- Augmenting Language Models with Long-Term Memory (発行日:2023年06月12日)

- A Comprehensive Survey on Applications of Transformers for Deep Learning Tasks (発行日:2023年06月11日)

- FinGPT: Open-Source Financial Large Language Models (発行日:2023年06月09日)

- Mind2Web: Towards a Generalist Agent for the Web (発行日:2023年06月09日)

- On the Reliability of Watermarks for Large Language Models (発行日:2023年06月07日)

- Unifying Large Language Models and Knowledge Graphs: A Roadmap (発行日:2023年06月14日)

Unifying Large Language Models and Knowledge Graphs: A Roadmap

著者:Shirui Pan, Linhao Luo, Yufei Wang, Chen Chen, Jiapu Wang, Xindong Wu

発行日:2023年06月14日

最終更新日:2023年06月14日

URL:http://arxiv.org/pdf/2306.08302v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

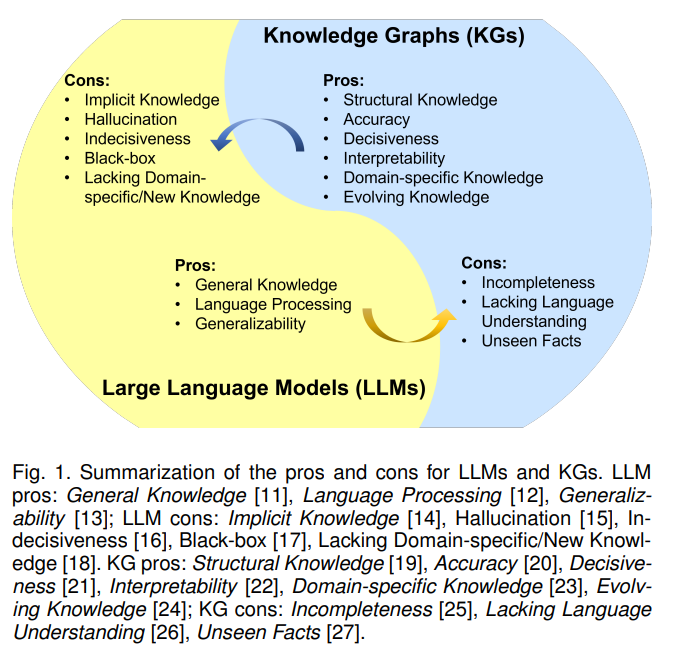

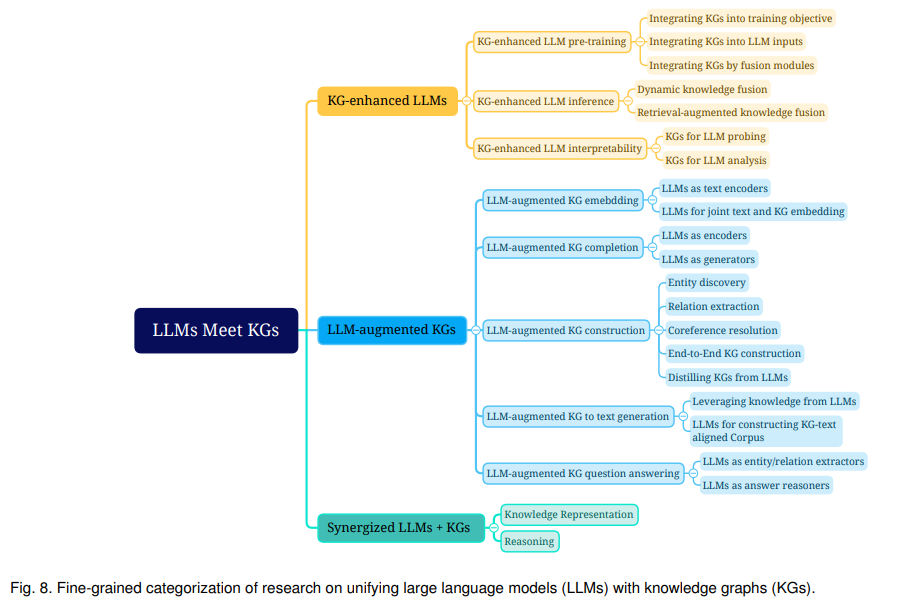

大規模言語モデル(LLM)は、ChatGPTやGPT4などのモデルが、その新しい能力と汎用性により、自然言語処理と人工知能の分野で新しい波を起こしている.しかし、LLMはブラックボックスモデルであり、しばしば事実知識を捉えたりアクセスしたりすることができない.そこで、本記事では、LLMと知識グラフ(KG)を統合することで、LLMが学習した知識をより理解しやすくすることを目的としている.具体的には、以下の3つの一般的なフレームワークを提案している.1)KG強化LLMは、LLMの事前学習および推論フェーズでKGを組み込むか、LLMが学習した知識の理解を強化するために使用する.2)LLM-augmented KGsは、LLMを利用してKGの埋め込み、補完、構築、グラフからテキストの生成、質問応答などのタスクを実行する.3)Synergized LLMs + KGsは、LLMとKGが相互に補完的に働き合い、双方向の推論を促進することで、LLMとKGの両方を強化する.これらの3つのフレームワークにおける既存の取り組みをレビューし、今後の研究方向を指摘している.

Q&A:

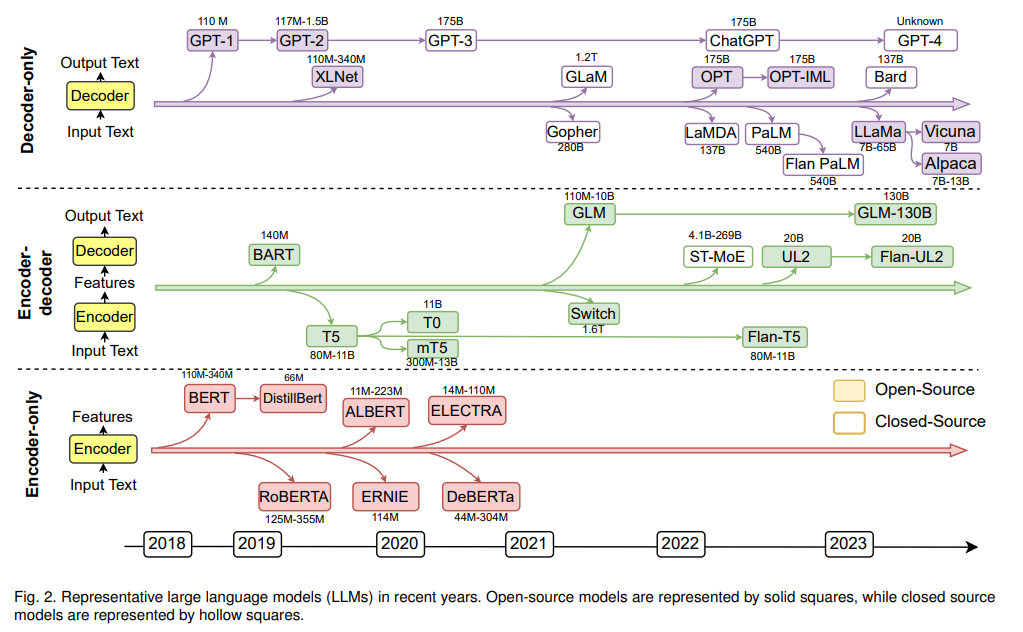

Q: 大規模言語モデル(LLM)とは何か、自然言語処理と人工知能の分野でどのような波紋を広げているのか.

A: 大規模言語モデル(LLMs)は、大規模なコーパスで事前学習されたもので、質問応答、機械翻訳、テキスト生成などの自然言語処理(NLP)タスクにおいて、優れたパフォーマンスを発揮しています.これらのモデルは、自然言語の理解において人間に匹敵するレベルの能力を持つことが示されており、人工知能(AI)の分野においても注目を集めています.最近では、モデルのサイズが大幅に増加し、LLMsは人工一般知能(AGI)としての応用が可能になっています.これらのモデルは、教育、コード生成、推薦などの複雑な実用的なタスクにおいても、優れたポテンシャルを発揮しています.これらのモデルは、Transformerデザインに基づいており、エンコーダーとデコーダーモジュールが自己注意機構によって強化されています.これらのモデルは、知識グラフ(KGs)と組み合わせることで、双方向推論を促進することができます.これにより、データと知識の両方に基づく双方向推論が可能になります.これらのモデルは、3つのフレームワークで構成されており、それぞれ、1)LLMsのみ、2)LLMs + KGs、3)シナジー化されたLLMs + KGsがあります.これらのフレームワークにおける既存の取り組みをレビューし、今後の研究方向を指摘しています.

Q: 知識グラフ(KG)とは何か、また、事実上の知識を捉え、アクセスするという点で、LLMとどう違うのか.

A: Knowledge Graphs(KGs)とは、エンティティと関係の集合で構成される構造化された知識を格納するものであり、既存のKGsは、格納される情報に基づいて4つのグループに分類されることができます.一方、LLMsは、自然言語処理や人工知能において、その出現能力と汎用性から注目されているモデルですが、しばしば事実知識を捉えることができず、ブラックボックスモデルとして扱われます.KGsは、明示的に豊富な事実知識を格納する構造化された知識モデルであり、LLMsに外部知識を提供することで、LLMsを強化することができます.また、KGsは、専門家がドメイン固有のKGsを構築することで、正確で信頼性の高いドメイン固有の知識を提供することができます.ただし、KGsの構築は困難であり、LLMsがこのような知識に苦労することが示されています.

Q: KGはどのようにしてLLMを強化し、推論や解釈可能性のための外部知識を提供できるのか?

A: LLMsに外部知識を提供するために、KGsはLLMsの事前トレーニングおよび推論段階に組み込むことができるだけでなく、LLMsの分析および解釈性を提供するためにも使用されます.KG-enhanced LLMsでは、LLMsはKG関連のタスクで使用されており、KG埋め込み、KG完了、KG構築、KG-to-text生成、およびKGQAなどが含まれます.これにより、LLMsのパフォーマンスが向上し、KGsのアプリケーションが容易になります.また、LLMsの解釈性を向上させるために、研究者はKGsを使用して、LLMsが学習した知識や推論プロセスを解釈することができます.これにより、LLMsとKGsは相互に補完し合い、知識表現と推論の両方でパフォーマンスを向上させることができます.

Q: KGを構築・進化させる際の課題は何か、また、それが新しい事実の生成や目に見えない知識の表現にどのような影響を与えるのか.

A: KGの構築と進化には困難があり、それが既存のKGの手法に新しい事実を生成し、未知の知識を表現することに挑戦を与えています.KGは自然に進化するため、構築が困難であり、新しい知識が継続的に追加されるため、既存のKGの手法は新しい事実を生成し、未知の知識を表現することに失敗することがあります.また、KGには豊富なテキスト情報が含まれているため、これらの手法はしばしばこれらの情報を無視します.さらに、既存のKGの手法は、特定のKGやタスクにカスタマイズされているため、一般化されていないことがあります.これらの課題を解決するために、LLMを利用することが必要です.

Q: LLMとKGの統一は、どのように補完し、それぞれの長所を生かすことができるのか.

A: LLMsとKGsを統合することで、それぞれの利点を相補的に活用し、互いに補完することができます.LLMsは、自然言語処理において高い性能を発揮する一方で、推論や解釈性に課題があります.一方、KGsは構築が困難であり、進化する性質を持っているため、新しい事実を生成したり、未知の知識を表現することに課題があります.そのため、LLMsとKGsを統合することで、LLMsの推論や解釈性の課題を補完し、KGsの新しい事実の生成や未知の知識の表現にも取り組むことができます.本論文では、LLMsとKGsを統合するためのロードマップを提案し、それぞれのアプローチの限界を克服するために、様々な下流タスクに対応することができます.

Q: LLMとKGを統一するために、記事で紹介されている3つの一般的なフレームワークとは?

A: LLMsとKGsの統合に向けた本記事において、提供された3つの一般的なフレームワークは、以下の通りです.1つ目は「KG-enhanced LLMs」、2つ目は「LLM-augmented KGs」、そして3つ目は「Synergized LLMs + KGs」です.これらのフレームワークは、それぞれ異なる方法でKGsとLLMsを統合することを目的としており、相互補完的な技術であるKGsとLLMsを統合するための指針を提供しています.

Q: LLMが学習した知識の理解を深めるために、LLMの事前学習や推論段階でKGをどのように取り入れることができるのか.

A: LLMsに知識グラフ(KGs)を組み込むことで、LLMsの前処理および推論段階で外部知識を提供することができます.これにより、LLMsの解釈性を向上させることができます.前処理段階では、KGsを使用してLLMsに知識を注入し、LLMsの知識表現を改善することができます.推論段階では、KGsを使用してLLMsが最新の知識を考慮しながら文を生成できるようにすることができます.また、LLMsによって学習された知識を理解し、LLMsの推論プロセスを解釈するために、KGsを使用することができます.これらの手法は、LLM-augmented KGsに適用され、KG埋め込み、KG補完、KG構築などのKG関連タスクに応用されます.

Q: 埋め込み、補完、構築、グラフからテキストへの生成、質問応答など、さまざまなKGタスクにLLMをどのように活用できるのか?

A: LLMsは、エンティティや関係のテキスト記述をエンコードすることで、KGの表現を豊かにするために使用できます.また、LLMsを使用してテキストをエンコードしたり、事実を生成したりすることで、より良いKGCパフォーマンスを実現することができます.さらに、LLMsを使用してエンティティの発見、共参照解決、および関係抽出タスクを解決することで、KGの構築に役立てることができます.また、LLMsを使用してKGから自然言語を生成することで、KG-to-text Generationを実現することができます.さらに、LLMsを使用して自然言語の質問とKGから回答を取得するための研究もあります.これらのタスクにおいて、LLMsはKGの表現を豊かにするために使用されます.また、LLMsとKGを統合することで、知識表現と推論の観点から、Synergized LLMs + KGsの試みが行われています.

Q: データと知識の両方によって駆動される双方向の推論のために、LLMとKGの両方を強化するために、どのように相互に有益な方法で働くことができますか?

A: LLMsとKGsは相互補完的な技術であり、相互に向上させることができます.LLMsとKGsの望ましいシナジーには、LLMsがKG構造を直接理解し、それを理由づけることができるようにすることが含まれます.KG-enhanced LLMsでは、KGsがLLMsの事前トレーニングおよび推論段階に組み込まれ、外部知識を提供するだけでなく、LLMsを分析し、解釈可能性を提供することができます.LLM-augmented KGsでは、LLMsがKG関連のタスクに使用され、KGの性能を向上させ、KGの応用を容易にすることができます.Syn-ergized LLM + KGでは、LLMsとKGsのメリットを結びつけ、知識表現と推論の両方で相互に性能を向上させることができます.これにより、データと知識の両方によって駆動される双方向推論を強化することができます.これらのアプローチにより、LLMsとKGsは相互に補完的であり、相互に向上させることができます.

Q: これら3つのフレームワークの中で、どのような既存の取り組みがレビューされ、ロードマップにまとめられているのか、またその今後の研究の方向性はどのようなものなのか.

A: 本論文では、LLMsとKGsを統合するための3つの枠組み、KG-enhanced LLMs、LLM-augmented KGs、Synergized LLMs + KGsを提案し、それぞれの枠組みにおける既存の研究成果をレビューし、将来の研究方向を指摘している.

具体的には、KG-enhanced LLMsでは、LLMsにKGの情報を統合することで、より高度な自然言語処理を実現する研究が行われており、将来的にはより多様なデータソースからの情報統合が求められると指摘されている.LLM-augmented KGsでは、LLMsを用いてKGの構築や更新を行う研究が進められており、将来的にはより高度な自己学習や推論が可能なモデルの構築が求められると指摘されている.Synergized LLMs + KGsでは、LLMsとKGsが相互に補完しあい、双方向の推論を行うことで、より高度な自然言語処理が実現できるとされており、将来的にはより高度な知識の獲得や推論が可能なモデルの構築が求められると指摘されている.(p.3)

また、本論文では、LLMsとKGsの最新技術についても取り上げられており、ChatGPTやGPT-4などのLLMsや、マルチモーダルな知識グラフなどの新しいKGsについても言及されている.さらに、既存の研究における課題や将来の研究方向についてもまとめられており、より高度な自然言語処理や知識の獲得、推論を実現するためには、より多様なデータソースの活用や、より高度なモデルの構築が求められるとされている.

TAPIR: Tracking Any Point with per-frame Initialization and temporal Refinement

著者:Carl Doersch, Yi Yang, Mel Vecerik, Dilara Gokay, Ankush Gupta, Yusuf Aytar, Joao Carreira, Andrew Zisserman

発行日:2023年06月14日

最終更新日:2023年06月14日

URL:http://arxiv.org/pdf/2306.08637v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

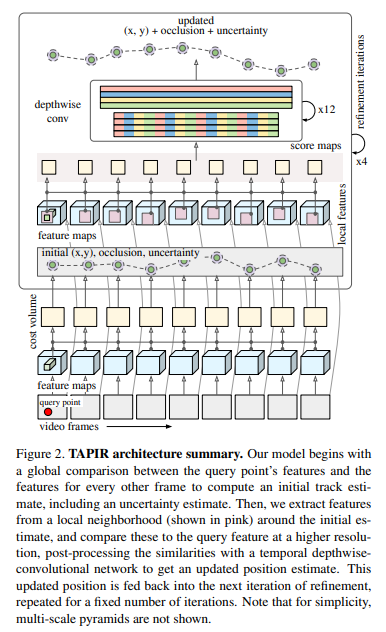

この論文では、どの物理的な表面上のどの点でも、ビデオシーケンス全体で効果的に追跡するための新しいモデルであるTracking Any Point(TAP)を提案しています.アプローチは2つのステージを使用しています.1つ目は、クエリポイントに対して他のすべてのフレームで適切な候補点マッチを独立して検出するマッチングステージです.2つ目は、ローカル相関に基づいて軌跡とクエリ特徴を更新するリファインメントステージです.このモデルは、DAVISでの約20%の絶対平均Jaccard(AJ)改善によって、すべてのベースライン方法を大幅に上回ります.このモデルは、長時間かつ高解像度のビデオシーケンスで高速な推論を可能にします.現代のGPUでは、リアルタイムよりも速くポイントを追跡することができます.視覚化、ソースコード、および事前学習済みモデルは、プロジェクトのウェブページで入手できます.

Q&A:

Q: この文章で紹介されているモデルとはどのようなものですか?

A: 本文で紹介されているモデルは、TAPIRと呼ばれるものです.このモデルは、時間に関する情報を考慮したリファインメントステップを使用しています.TSMモジュールの重要性についての疑問が生じたため、TSM-ResNetを通常のResNetに置き換え、その違いを比較しました.実際には、TAPIRの実データにおいては、Kineticsで0.1%、同様に微小な値でしか性能が低下しなかったことがわかりました.

Q: アプローチの2つのステージとは?

A: 本論文では、TAPIRという新しいモデルを紹介しており、このモデルは、マッチングステージとリファインメントステージの2つの段階からなる2段階アプローチを採用しています.(p.5)

最初の段階であるマッチングステージでは、クエリポイントとターゲットポイントの両方に対して、オクルージョンに強いマッチングが行われます.この段階では、類似性(ドット積)に基づいて特徴量が比較されます.(p.1)

2つ目の段階であるリファインメントステージでは、マッチングステージで得られた初期の追跡結果をさらに精密化します.この段階では、TAP-Netと呼ばれるネットワークが使用されます.(p.5)

以上のように、TAPIRのアプローチは、2つの段階からなる2段階アプローチであることがわかります.

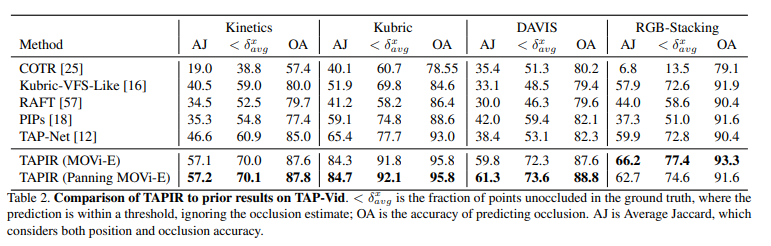

Q: 出来上がったモデルは、ベースライン・メソッドと比較してどのようなパフォーマンスを発揮するのか?

A: 結果として、このモデルはベースラインの手法に比べて優れたパフォーマンスを発揮します.特に、静止したカメラの場合は良好な結果を示しますが、動くカメラの場合はサブオプティマルな結果を示すことがあります.そのため、このモデルの両方のバージョンを提供し、ユーザーが特定のアプリケーション要件に最適なバージョンを選択できるようにしています.(p.9)

このアプローチのパフォーマンスは広く評価され、実際のデータではTAP-Netを大幅に上回り、RGB-Stackingでもわずかに上回ることが示されています.これは、TAPIRがクエリポイントから出力フレームが遠くなっても堅牢であることを示唆しています.(p.9)

要約すると、このモデルはベースラインの手法に比べて優れたパフォーマンスを発揮し、静止したカメラの場合は特に良好な結果を示します.しかし、動くカメラの場合はサブオプティマルな結果を示すことがあります.そのため、このモデルの両方のバージョンを提供し、ユーザーが特定のアプリケーション要件に最適なバージョンを選択できるようにしています.(p.9)

Q: DAVISでのAJ(Average Jaccard)の向上はどの程度でしょうか?

A: DAVISにおける平均Jaccard(AJ)の改善は、約20%の絶対値であり、TAP-Vidベンチマークにおいて、すべてのベースライン手法を大幅に上回るモデルが生成されたことが示されています.このモデルは、長時間かつ高解像度のビデオシーケンスに対して高速な推論を可能にし、現代のGPU上で実装された場合、リアルタイムよりも高速にポイントを追跡することができます.この情報は、(p.1)から抽出されました.

Q: ビジュアライゼーション、ソースコード、プレトレーニングモデルはどこにあるのでしょうか?

A: ビジュアライゼーション、ソースコード、および事前学習済みモデルは、https://deepmind-tapir.github.ioで見つけることができます. このサイトには、TAPIRモデルのオープンソース版が含まれており、ハイパーパラメータのチューニングがより詳細に行われ、コミュニティに最も強力なモデルが提供されています.また、TAPIRモデルは、物理的な特性や3D形状に関する洞察を提供する可能性がある、コンピュータビジョンにおける基本的な課題である点レベルの対応問題に取り組んでいます.この問題に対するTAPIRモデルの貢献は、フレームごとの初期化と時間的な改善を組み合わせたものであり、最新のTAP-Vidベンチマークにおいて、従来の最高水準を大幅に上回る結果を示しています.

Q: モデルは、ビデオシーケンスを通して、あらゆる物理的表面上の照会された点を追跡することができますか?

A: 本研究では、TAP(Tracking Any Point)というモデルを提案し、ビデオシーケンス全体で任意の物理表面上のクエリポイントを効果的に追跡することができます.このアプローチは、(1) マッチングステージと(2) リファインメントステージの2つの段階を使用しています.マッチングステージでは、クエリポイントに対して他のすべてのフレームで適切な候補点マッチを独立して検出し、リファインメントステージでは、ローカルな相関に基づいて軌跡とクエリ特徴を更新します.このモデルは、ビデオと(潜在的に密な)クエリポイントがある場合、アルゴリズムがそれらのポイントが表示されるすべての他のフレームで対応する場所を信頼性高く出力し、表示されないフレームを示すことができます.このモデルは、物理的な特性や3D形状に関する洞察を提供する可能性が非常に高いです.本研究の主な貢献は、TAPIR(TAP with per-frame Initialization and temporal Refinement)という新しいモデルであり、最近提案されたTAP-Vidベンチマーク[12]で、すべてのベースラインを上回る結果を示しました.したがって、このモデルは、ビデオシーケンス全体で任意の物理表面上のクエリポイントを追跡することができます.

Q: 本稿で紹介した新手法のコード実装のためのurlはどうなっていますか?

A: 本論文で紹介された新しい手法のコード実装のURLは、https://github.com/deepmind/tapnetです.このコードは、トレーニングと推論のコードを含め、オープンソースで公開されています.このオープンソースのTAPIRモデルは、バックボーン、モデルで使用されるいくつかの定数、トレーニングプロセスでの変更を導入しています.この情報は、(p.1)から抽出されました.

Artificial Artificial Artificial Intelligence: Crowd Workers Widely Use Large Language Models for Text Production Tasks

著者:Veniamin Veselovsky, Manoel Horta Ribeiro, Robert West

発行日:2023年06月13日

最終更新日:2023年06月13日

URL:http://arxiv.org/pdf/2306.07899v1

カテゴリ:Computation and Language, Computers and Society

概要:

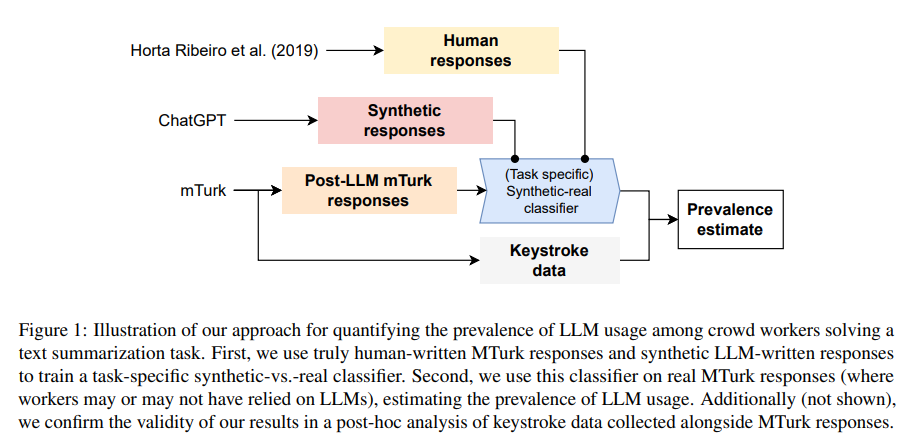

大規模言語モデル(LLM)は、高品質な教師付きトレーニングデータや調査・実験データを生成するために使用できる優れたデータ注釈ツールです.LLMの広範な採用に伴い、人間のゴールドスタンダード注釈は、LLMの能力とその結果の妥当性を理解するために重要です.しかし、人間注釈を取得するための重要で安価な方法であるクラウドソーシングは、クラウドワーカーが生産性と収入を増やすためにLLMを使用する金銭的なインセンティブを持っているため、影響を受ける可能性があります.この懸念を調査するために、私たちはクラウドワーカーによるLLMの使用の普及に関すること例研究を行いました.私たちは、Amazon Mechanical Turkで文書要約タスクを再実行し、キーストローク検出と合成テキスト分類の組み合わせにより、33〜46%のクラウドワーカーがタスクを完了する際にLLMを使用したと推定しています.一般化は不明ですが、私たちの結果は、プラットフォーム、研究者、およびクラウドワーカーが、人間のデータが人間であることを確保するために新しい方法を見つける必要があることを示唆しています.ここで提案された方法論をステップストーンとして使用することができます.コード/データ:https://github.com/epfl-dlab/GPTurk

Q&A:

Q: 大規模言語モデル(LLM)とは何か、データアノテーションにどう使われるのか.

A: 大規模言語モデル(LLMs)は、高品質な監視付きトレーニングデータ、調査データ、実験データを生成するために使用される優れたデータ注釈ツールです.LLMsは、ChatGPT、GPT-4、PaLM、Claudeなどのモデルがあり、デジタル世界で広く使用されています.LLMsは、人間のアノテーターや専門家よりも優れた注釈能力を持ち、社会科学者がin silico実験や調査を行うことができます.しかし、LLMsから生成された合成データは、実際のデータに比べて不正確であることがあります.そのため、人間のゴールドスタンダードデータを作成するために、クラウドソーシングを使用することがあります.しかし、クラウドワーカー自身がLLMsを使用している場合、クラウドソーシング自体が影響を受ける可能性があります.この問題を調査するために、研究者らはAmazon Mechanical Turkで抜粋要約タスクを再実行し、33-46%のクラウドワーカーがLLMsを使用していることを推定しました.(p.1)

Q: LLMは、人間のゴールドスタンダードアノテーションから得られる結果の妥当性にどのような影響を与えるのでしょうか?

A: 人間のゴールドスタンダード注釈は、LLMsの能力とその結果の妥当性を理解するために重要です.しかし、クラウドソーシングは、人間の注釈を得るための重要で安価な方法であり、クラウドワーカーは生産性と収入を増やすためにLLMsを使用する経済的なインセンティブを持っているため、LLMs自体がクラウドソーシングに影響を与える可能性があります. (p.1)

LLMsは、ChatGPT、GPT-4、PaLM、Claudeなどの大規模言語モデルであり、デジタル世界で大きな影響を与えています.初期の研究では、LLMsは、クラウドワーカー(Koco ´n et al.、2023; Gilardi et al.、2023)や専門家(Törnberg、2023)を上回る優れたデータ注釈者であることが示されています.さらに、彼らは人間の行動をシミュレートすることで、社会科学者がin silico実験や調査を行い、実際の人間から得られるのと同様の結果を得ることができることを示しています(Argyle et al.、2022; Horton、2023; Dillion et al.、2023).しかし、LLMsから得られる結果の妥当性については、人間の実験対象、注釈者、調査対象者が依然として批判的であり、彼らはさまざまなタスクでまだ不十分であることが示されています(Ziems et al.、2023).また、LLMsによって生成された合成データは、実際のデータに対して不忠実である可能性があります(Veselovsky et al.、2023). (p.1)

このような状況下では、LLMの出力を検証するためにクラウドソーシングを頼ることが誘惑されます.しかし、クラウドワーカー自身がLLMsを使用している場合、生産性を向上させるために、例えばどうなるでしょうか? (p.1)

以上より、LLMsは、人間のゴールドスタンダード注釈から得られる結果の妥当性に影響を与える可能性があることが示唆されています.クラウドワーカーがLLMsを使用することで、注釈の品質が低下する可能性があるため、LLMsを使用する前に、注釈者がLLMsを使用することについての明確なガイドラインが必要です. (p.1)

Q: クラウドソーシングとは何か、人間のアノテーションを得るためにどのように利用されているのか.

A: クラウドソーシングとは、人間の注釈を取得するための重要で安価な方法であり、MTurkなどのクラウドソーシングプラットフォームを使用して、大規模な人間の労力を利用することができます.これにより、LLMsの能力とその結果の妥当性を理解するために、人間のゴールドスタンダード注釈が必要になります.しかし、クラウドソーシング自体がLLMsに影響を受ける可能性があります.クラウドワーカーは、生産性と収入を増やすためにLLMsを使用する経済的なインセンティブを持っているためです.この懸念を調査するために、研究者たちは、クラウドワーカーがLLMsを使用して注釈を提供する場合の注釈の品質を調べました.また、クラウドソーシングは、人間の注釈を取得するための重要な方法であると同時に、LLMsが生成するデータをフィルタリングするための重要な人間のフィルターとしても機能することができます.これにより、人間と言語モデルをペアリングして高品質で多様なデータを作成することができます.これに関する早期の研究は、すでに重要な進展を遂げています. (p.1,3-5)

Q: 経済的インセンティブは、クラウドワーカーによるLLMの利用にどのような影響を与えるのか?

A: LLMを使用することで生産性と収入を増やすため、クラウドワーカー自身がLLMを使用している場合、クラウドソーシングプラットフォームでのデータの有用性が著しく低下する可能性があります.これは、データが意図された人間のゴールドスタンダードではなくなるためです.また、LLMを直接促すことができるため、クラウドワーカーに支払う必要がなくなる可能性があります.このため、クラウドワーカーが既にLLMを使用しているかどうかについて、その答えは非常に重要です.これは、クラウドソーシングに依存するすべての人にとって重要です. (p.1)

クラウドワーカーは、生産性と収入を増やすためにLLMを広く使用しているようです.これは、クラウドソーシングによって人間の注釈を安価に入手することができるため、LLMによって影響を受ける可能性があります.

したがって、LLMの普及により、クラウドワーカーが既に広く使用しているため、クラウドソーシングによる人間の注釈を入手することがますます困難になる可能性があります. (p.1)

クラウドワーカーの金銭的インセンティブは、彼らがLLMを使用することにどのように影響するかを調査するために、この問題に取り組んでいます.

Q: クラウドワーカーのLLM利用の普及について実施した事例の目的は何ですか?

A: LLMを使用するクラウドワーカーの普及に関すること例研究を実施することが目的でした.この研究では、Amazon Mechanical Turkで文献から抜粋した要約タスクを再実行し、キーストローク検出と合成テキスト分類の組み合わせにより、33〜46%のクラウドワーカーがタスクを完了する際にLLMを使用していると推定しました.この問題に対処するために、プラットフォーム、研究者、クラウドワーカーが新しい方法を見つける必要があると結論付けられました.この研究は、arXivのページ(p.1-3)から抜粋されました.

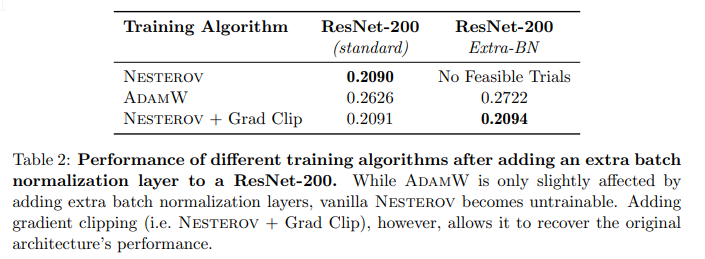

Q: Amazon Mechanical Turkで再実行した文献からの抄録要約タスクはいかがでしたか?

A: 文献からの要約タスクは、Horta Ribeiroら(2019)によって最初に考案されたMTurkタスクを改変して実行されました.このタスクでは、医学研究論文の要約(約2,000文字)をより短い段落(約1,000文字)に要約するようにCrowd Workersに依頼されました.オリジナルの要約ではなく、サマリーを入力テキストとして使用し、複数のラウンドでさらに要約されました.このタスクは、人間にとっては手間がかかる一方で、商用LLMsの支援を受けて簡単に実行できるため、研究の目的に適していました.また、Horta Ribeiroら(2019)の研究の目的は、人間がテキストを要約する際に情報がどのように失われるかを調べることであり、合成的に生成されたデータではなく、本当の人間のテキストが必要であったため、このタスクが選ばれました.(p.1-2)

Q: タスクを完了する際にLLMを使用したクラウドワーカーの割合を推定するために、どのような方法を用いたのでしょうか?

A: 調査では、キーストローク検出と合成テキスト分類の組み合わせを使用して、Amazon Mechanical Turkの抄録要約タスクを再実行し、33-46%のクラウドワーカーがタスクを完了する際にLLMを使用したと推定されました.この推定値は、他のLLM源の少ない要約に一般化することができます(33%、95%CI:[20%、45%]).この推定値は、広範なロジット閾値の範囲で安定しており、クラウドソーシングされた要約の33-46%がLLMの助けを借りて作成されたと結論付けられました.この推定値は、ほとんどのユーザーが1つの要約のみを提出したため、LLMで生成された要約の割合をLLMを使用するクラウドワーカーの割合として解釈することもできます. (p. 5-6)

Q: クラウドワーカーによるLLM利用を前にして、人間のデータが人間であり続けることをどのように保証できるのか.

A: 本研究において、クラウドワーカー自身がLLMを使用して生産性を高め、収入を増やすために使用している場合、クラウドソーシングされたデータの有用性が著しく低下する可能性があることが指摘されています.これは、データが本来の人間のゴールドスタンダードではなくなるためです.また、LLMを直接促すことができるため、クラウドワーカーに支払う代わりにより安価になる可能性があります.そのため、クラウドワーカーが既にLLMを使用している程度について知ることが重要であり、クラウドソーシングに頼る人々にとっても重要な問題であると考えられます.LLMの普及に伴い、この問題はますます深刻化する可能性があります.しかし、クラウドワーカーが提供する価値は、デノボ注釈を提供する代わりに、これらのモデルが成功したかどうか、失敗したかどうかを検出する重要な人間フィルターとして機能することができます.したがって、クラウドワーカーがLLMを使用している場合、人間のデータがLLMを使用していないことを確認するために、クラウドソーシングされたデータを検証することが必要です.(p.1,4-8)

Q: この研究で提案された方法論は、人間のデータが人間のままであることを保証する新しい方法を見つけるための足がかりとして、どのように利用することができるのでしょうか.

A: 本研究で提案された方法論を足がかりとして、プラットフォーム、研究者、およびクラウドワーカーは、人間のデータが人間らしさを保つための新しい方法を見つける必要があるとされています.これは、人間がタスクを実行することが重要である場合に、商用LLMsの支援を受けることができない場合があるためです.また、人間が必要なタスクにおいて、クラウドワーカーが新しい方法を見つけるための重要な人間フィルターとして機能することができます.この研究では、人間が必要なタスクに焦点を当てており、提案された方法論は、人間のデータが人間らしさを保つための新しい方法を見つけるための足がかりとして使用できることが示唆されています.(p.3-5)

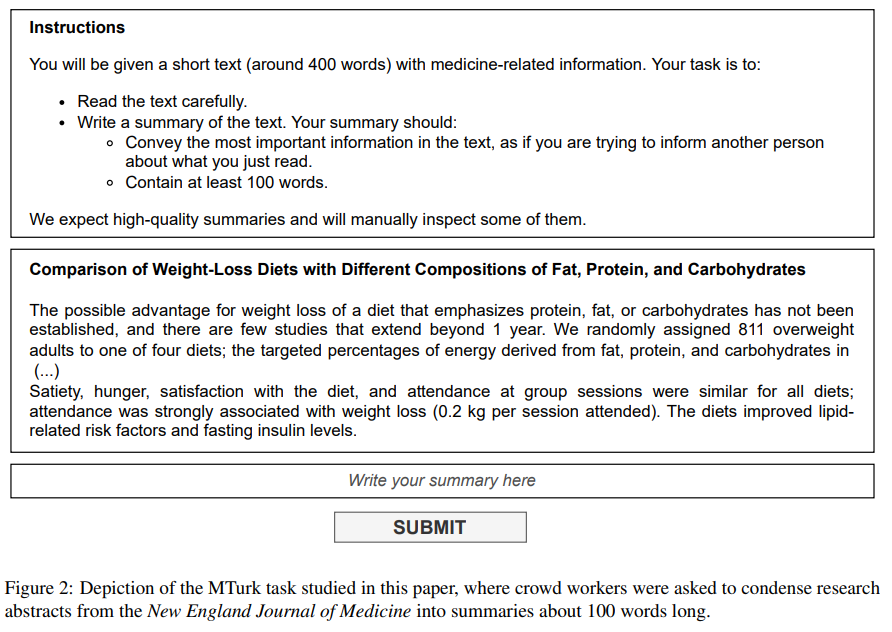

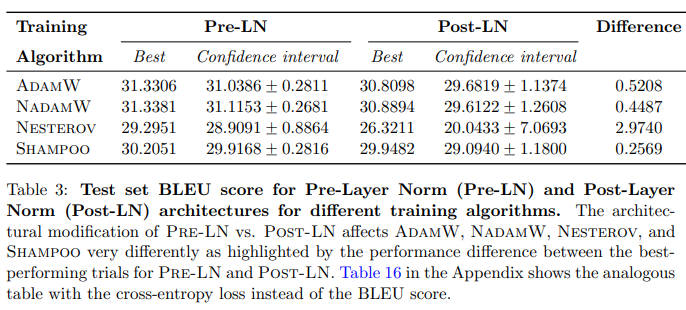

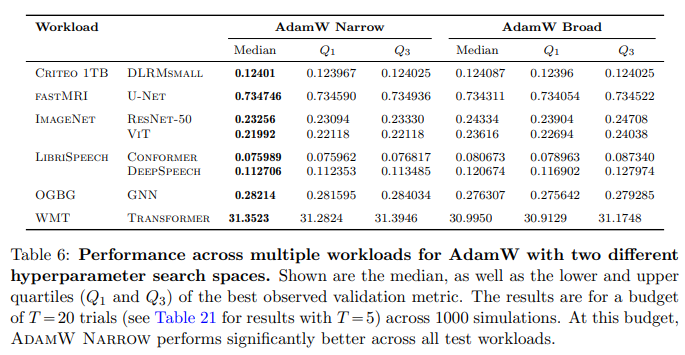

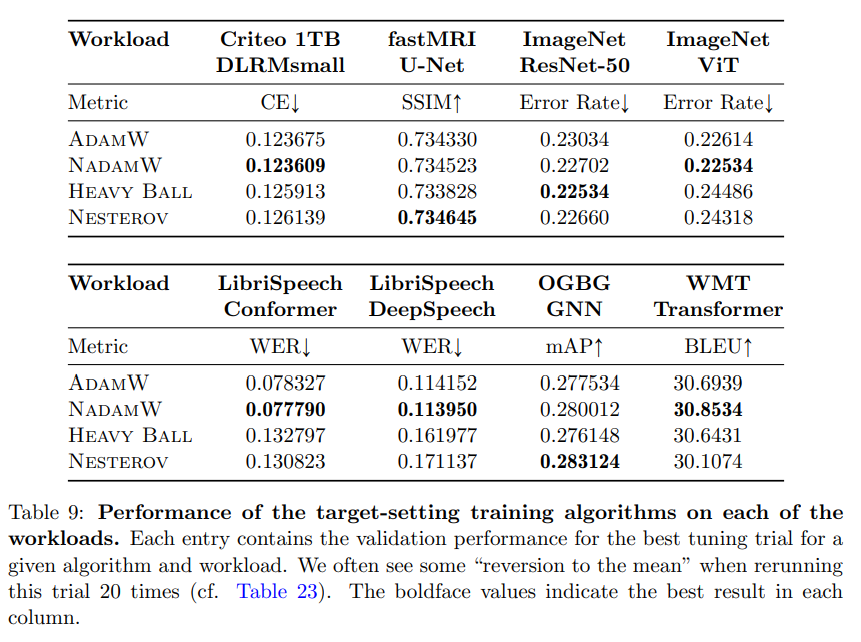

Benchmarking Neural Network Training Algorithms

著者:George E. Dahl, Frank Schneider, Zachary Nado, Naman Agarwal, Chandramouli Shama Sastry, Philipp Hennig, Sourabh Medapati, Runa Eschenhagen, Priya Kasimbeg, Daniel Suo, Juhan Bae, Justin Gilmer, Abel L. Peirson, Bilal Khan, Rohan Anil, Mike Rabbat, Shankar Krishnan, Daniel Snider, Ehsan Amid, Kongtao Chen, Chris J. Maddison, Rakshith Vasudev, Michal Badura, Ankush Garg, Peter Mattson

発行日:2023年06月12日

最終更新日:2023年06月12日

URL:http://arxiv.org/pdf/2306.07179v1

カテゴリ:Machine Learning, Machine Learning

概要:

本研究では、固定されたハードウェア上で複数のワークロードを実行する、AlgoPerf: Training Algorithmsベンチマークを紹介します.このベンチマークには、現在広く使用されている方法よりもワークロードの変更に強いベンチマーク提出物を検出することができるワークロードのバリアントが含まれています.最後に、現在の実践を代表するさまざまな最適化手法を使用して構築されたベースライン提出物、および最近文献で注目されている他の最適化手法を評価します.これらのベースライン結果は、当社のベンチマークの実現可能性を示し、方法間に重要な差が存在することを示し、将来のベンチマーク提出物が超えようとする仮の最先端を設定します.

Q&A:

Q: 学習アルゴリズムの実証的な比較で直面する課題とは?

A: 訓練アルゴリズムの比較における課題は、(1) トレーニングが完了した時点をどのように決定し、トレーニング時間を正確に測定するか、(2) 測定値が正確なワークロードの詳細に敏感である場合の扱い方、(3) ハイパーパラメータの調整が必要なアルゴリズムを公平に比較する方法の3つの基本的な課題を解決するために、新しい競争的な時間結果ベンチマークを導入する必要があると、Moreauら(2022)は主張しています.(p.3-5) これらの課題に対処するために、AlgoPerf: Training Algorithmsという固定ハードウェア上で複数のワークロードを実行する新しい競争的な時間結果ベンチマークを導入しています.また、Bartz-Beielsteinら(2020)は、ベンチマークの定義に関する一連の推奨事項を提示しています. 一方で、実験的な比較研究は、競合する技術の原理的な比較を提供することができますが、実際には、強力なベースラインと「公正な」比較を生成し、批判や偏見の非難を回避することができず、説得力のあるエビデンスを生成することができません.(p.1) したがって、競争的なベンチマークを導入することが、訓練アルゴリズムの改善に向けた実際的な進歩を促進するための重要な手段であると考えられます.

Q: トレーニングアルゴリズムの改良を確実に見極めるには?

A: 現在、我々コミュニティは、トレーニングアルゴリズムの改善を信頼性高く特定することができず、最先端のトレーニングアルゴリズムを決定することもできません.しかし、本研究では、具体的な実験を用いて、トレーニングの高速化における実際の進歩には、経験的比較に直面する3つの基本的な課題を解決する新しいベンチマークが必要であると主張しています.これらの課題を解決するために、固定されたハードウェア上で複数のワークロードを実行する競争力のあるタイム・トゥ・リザルト・ベンチマーク、AlgoPerf: Training Algorithmsを導入しています.(p.1)

Q: トレーニングのアルゴリズム改良のメリットは何ですか?

A: 訓練アルゴリズムの改善は、広く解釈されたものであり、深層学習パイプラインの重要な部分です.アップデートルール、チューニングプロトコル、学習率スケジュール、またはデータ選択スキームなど、様々なワークロードでトレーニングを高速化するトレーニングアルゴリズムの改善は、時間と計算リソースを節約し、より正確なモデルを生み出すことができます.しかし、現在のコミュニティでは、トレーニングアルゴリズムの改善を確実に特定することができず、最先端のトレーニングアルゴリズムを決定することもできません.この論文では、具体的な実験を使用して、トレーニングを高速化するための実際の進歩には、経験的比較に直面する3つの基本的な課題を解決する新しいベンチマークが必要であることを主張しています.トレーニングアルゴリズムの改善により、コストを削減したり、より正確なモデルを生み出すことができます.(p.1)

Q: AlgoPerf: Training Algorithmsベンチマークとは何ですか?

A: AlgoPerf: Training Algorithms ベンチマークは、ニューラルネットワークのトレーニングアルゴリズムをベンチマークするための競争力のある時間結果ベンチマークであり、固定されたハードウェア上で複数のワークロードを実行することによって、トレーニングアルゴリズムをシステム的に比較することができます.このベンチマークには、現在広く使用されている方法よりもワークロードの変更に対してより堅牢なベンチマーク提出を検出することができるワークロードのバリアントセットが含まれています.また、現在の実践を代表するさまざまな最適化プログラムだけでなく、最近提案された他の最適化プログラムを使用して構築されたベースライン提出を評価しています.

Q: AlgoPerfベンチマークは、学習アルゴリズムの実証的な比較で直面する課題をどのように解決しているのでしょうか.

A: 本研究では、トレーニングアルゴリズムの比較における課題を明確にし、その課題を実証する具体的な実験を提供し、トレーニングアルゴリズムの研究を妨げる方法論的な問題を説明することで、トレーニングアルゴリズムのベンチマーク化の課題を明確にしました.(p.1)

この課題に対処するために、固定されたハードウェア上で複数のワークロードを実行する競争力のある時間結果ベンチマークであるAlgoPerf: Training Algorithms ベンチマークを導入しました.このベンチマークには、現在広く使用されている方法よりもワークロードの変更に対してより堅牢なベンチマーク提出を検出することができるワークロードの変種のセットが含まれています.(p.1)

さらに、このベンチマークは、(1)トレーニングが完了したときを決定し、トレーニング時間を正確に測定する方法、(2)測定値が正確なワークロードの詳細に対して敏感である場合の処理方法、(3)ハイパーパラメータの調整が必要なアルゴリズムを公平に比較する方法という、トレーニングアルゴリズムの比較における課題に対処するための完全で実用的な手順を定義しています.また、この手順は、ベンチマークのリソース制約を考慮して、文献の結果と合理的に競争力のあるターゲットを生成します.(p.1)

Q: AlgoPerfベンチマークに含まれるワークロードバリアントは何ですか?

A: AlgoPerfベンチマークには、複数のワークロードバリアントが含まれています.これにより、現在広く使用されている方法よりもワークロードの変更に強いベンチマーク提出を検出することができます.これらのバリアントについては、表11に簡単な説明が含まれており、追加の詳細については付録Dを参照してください.これらのバリアントは、固定されたワークロードの3つのバリアントを生成する変更の説明を含んでいます. (p.6-7)

Q: AlgoPerfベンチマークの基準値は何を示しているのでしょうか?

A: 本研究のベースライン結果は、現在の実践を表す最適化手法と、最近提案された最適化手法を評価している.この評価は、トレーニングが完了した時点を決定し、トレーニング時間を正確に測定する方法、測定値が正確なワークロードの詳細に対して敏感である場合の対処方法、ハイパーパラメータの調整が必要なアルゴリズムを公平に比較する方法についての課題に対処するために行われた.ベースライン結果は、AlgoPerfベンチマークのリソース制約の下で、文献の結果と合理的に競合するターゲットを生成する手順を定義することによって得られた. (p.1)

Q: 今後のベンチマーク提出のための暫定的な最先端技術とは?

A: 現在の実践を表す最適化手法と、最近文献で注目されている他の最適化手法を表すベースライン結果があります.これらのベースライン結果は、私たちのベンチマークの実現可能性を示し、手法間に非自明なギャップが存在することを示し、将来のベンチマーク提出の暫定的な最新技術を設定します.(p.1)

※暫定的な最新技術はprovisional state-of-the-artと表現されています.

現在の実践を表す最適化手法と、最近文献で注目されている他の最適化手法を表すベースライン結果があります.これらのベースライン結果は、私たちのベンチマークの実現可能性を示し、手法間に非自明なギャップが存在することを示し、将来のベンチマーク提出の暫定的な最新技術を設定します.

Q: AlgoPerfベンチマークは、今後どのように改善されるのでしょうか?

A: 現在のAlgoPerfベンチマークには、トレーニングが完了したときを決定し、トレーニング時間を正確に測定する方法、測定値が正確なワークロードの詳細に対してどのように敏感であるかを扱う方法、ハイパーパラメータの調整が必要なアルゴリズムを公平に比較する方法などの課題があります.これらの課題に対処するために、固定されたハードウェア上で複数のワークロードを実行する競争的な時間結果ベンチマーク、AlgoPerf:トレーニングアルゴリズムベンチマークを導入しました.今後の改善点としては、より多くのワークロードの追加や、より多くのアルゴリズムの比較が挙げられます.また、より多くの研究者が参加できるように、ベンチマークのルールや報告方法をより明確にすることも必要です.

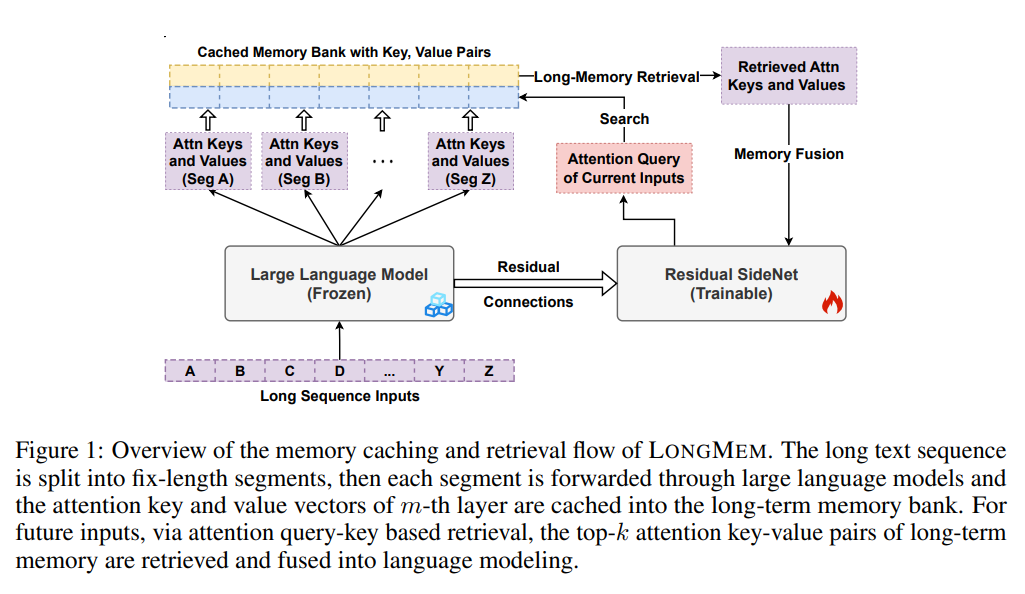

Augmenting Language Models with Long-Term Memory

著者:Weizhi Wang, Li Dong, Hao Cheng, Xiaodong Liu, Xifeng Yan, Jianfeng Gao, Furu Wei

発行日:2023年06月12日

最終更新日:2023年06月12日

URL:http://arxiv.org/pdf/2306.07174v1

カテゴリ:Computation and Language

概要:

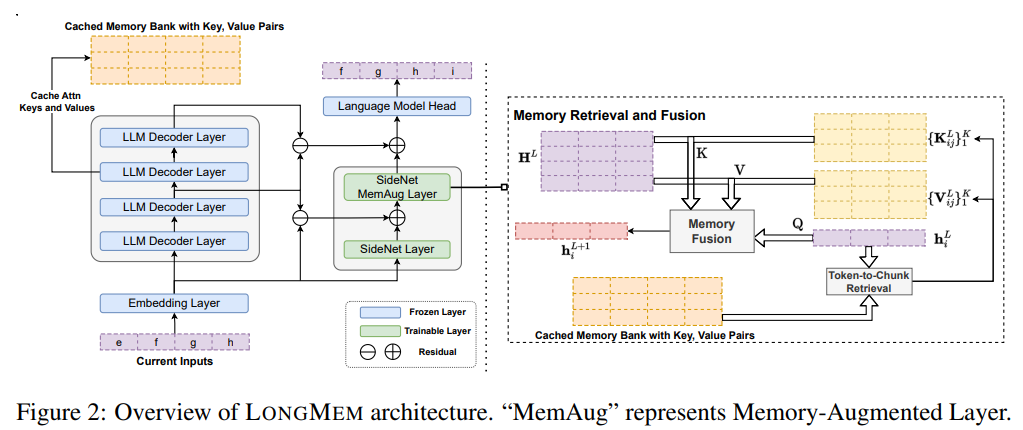

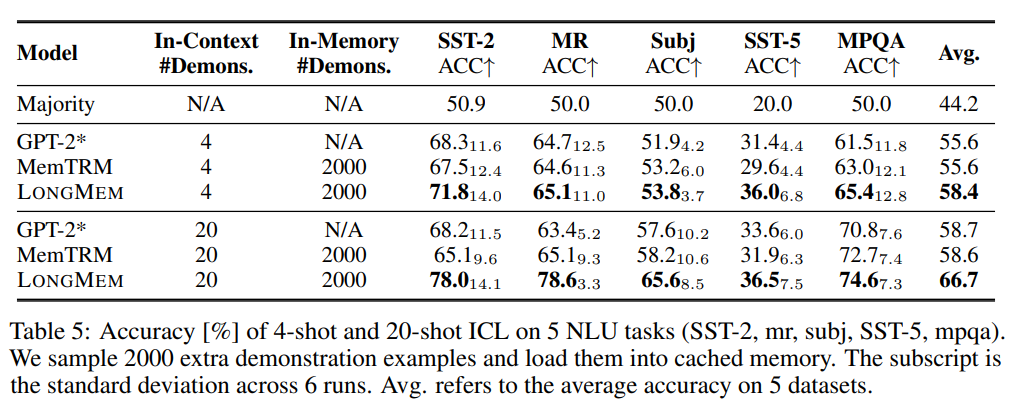

既存の大規模言語モデル(LLM)は、入力長の制限により、固定サイズの入力しか扱えず、過去の入力からの豊富な長期的な文脈情報を活用することができません.この問題に対処するため、私たちは「長期記憶を備えた言語モデル(LongMem)」というフレームワークを提案しています.これにより、LLMは長い過去の文脈情報を記憶することができます.私たちは、元のバックボーンLLMをメモリエンコーダとして凍結し、メモリリトリーバーとリーダーとして適応型の残差サイドネットワークを設計することで、新しい分離型ネットワークアーキテクチャを設計しました.このような分離型メモリ設計により、メモリリトリーバルに長期的な過去の文脈を簡単にキャッシュして更新することができ、メモリの古さに苦しむことがありません.メモリ増強適応トレーニングにより強化されたLongMemは、長い過去の文脈を記憶し、言語モデリングに長期的なメモリを使用することができます.提案されたメモリリトリーバルモジュールは、メモリバンクに無制限の長さのコンテキストを処理でき、さまざまなダウンストリームタスクに利益をもたらすことができます.通常、LongMemは長い形式のメモリを65kトークンまで拡大することができ、多数のデモンストレーション例を長い形式のメモリとしてキャッシュして、コンテキスト内学習に利用することができます.実験の結果、私たちの方法は、既存のLLMよりも優れた性能を発揮することが示されています.特に、長期的な文脈情報を必要とするChapterBreakという難しいベンチマークにおいて、私たちの方法は強力な長期的な文脈モデルよりも優れた性能を発揮し、コンテキスト内学習においてもLLMよりも優れた改善を達成しています.これらの結果は、提案された方法が長い形式のコンテンツを記憶し、活用することにおいて効果的であることを示しています.私たちのコードは、https://aka.ms/LongMemでオープンソース化されています.

Q&A:

Q: 提案されたフレームワークは何と呼ばれ、LLMが何をすることができるようになるのでしょうか.

A: 提案されたフレームワークは「Language Models Augmented with Long-Term Memory (LONG MEM)」であり、LLMsが過去の長い文脈情報を収集し、長期的な記憶を獲得することを可能にします.これは、過去の入力の注意キーと値のペアをキャッシュし、将来的な検索と融合のために使用することができる、新しい分離型メモリモジュールを備えたネットワークアーキテクチャで実現されます.また、元のバックボーンLLMはメモリエンコーダとして凍結され、適応型残差サイドネットがメモリリトリーバーとリーダーとして導入されます.(p.5)

Q: LongMemでは、非結合型ネットワーク・アーキテクチャはどのように機能するのですか?

A: LongMemの分離されたネットワークアーキテクチャは、バックボーンLLMとSideNetによる分離された凍結によって、以前の入力をメモリにエンコードするプロセスとメモリの取り出しと融合のプロセスを分離します.このように、バックボーンLLMは長期的なコンテキストの知識エンコーダーとしてのみ機能し、残差SideNetはメモリの取り出しと読み取りとして機能し、メモリの古さの問題を効果的に解決します.また、メモリ拡張を直接LLM全体に適応することは計算的に非効率であり、また、壊滅的な忘却に苦しんでいます.効率的なメモリ拡張適応段階中にバックボーンLLMが凍結されるため、LONG MEMは事前学習された知識にアクセスできるだけでなく、壊滅的な忘却を回避することもできます.LONG MEMは、さまざまな種類の長い形式のテキストと知識をメモリバンクに取り込むことができます.提案されたメモリ取得モジュールは、長期的な過去のコンテキストを記憶し、長期的なメモリを言語モデリングに使用できるように強化されています.提案されたメモリ取得モジュールは、過去の入力の注意キーと値のペアをキャッシュして、将来の取り出しと融合のために使用できるようにするために設計された分離された残差SideNetをメモリ取得モジュールとして導入します.LLM自体は知識とメモリエンコーダーとして凍結されます.さまざまな長期的なコンテキスト言語モデリングデータセットでの実験は、他のメモリ拡張ベースラインよりも当社のモデルの有効性を示しています.提案された方法は、コンテキストの長さに制限されるコンテキスト内のLLMの学習において、数千の補助デモンストレーション例をメモリにキャッシュすることにより、デモンストレーション例の数を克服することも可能にします.(p.3-5)

Q: LongMemは、記憶の陳腐化に悩まされることなく、記憶の検索に必要な長期的な過去の文脈をどのように扱っているのでしょうか?

A: LongMemは、凍結されたバックボーンLLMをメモリエンコーダーとし、メモリリトリーバーとリーダーとして適応的な残差サイドネットワークを使用することで、カップルされたメモリデザインによるメモリステイルネスの問題を回避し、長期的な過去の文脈をキャッシュして更新し、メモリリトリーバルに使用することができます.提案されたメモリリトリーバルモジュールは、そのメモリバンクに無制限の長さの文脈を処理することができ、通常、LONG MEMは長い形式のメモリを65kトークンまで拡大し、多数の追加のデモンストレーション例を長い形式のメモリとしてキャッシュすることができます.このようにして、LONG MEMは、長期的な過去の文脈を記憶し、言語モデリングに長期的なメモリを使用することができます.(p.3-5)

Q: LongMemがロングフォームメモリを拡大できる最大のトークン数は?

A: LongMemは、長い形式のメモリを65kトークンまで拡大できるため、多数のデモンストレーション例を長い形式のメモリとしてキャッシュし、インコンテキスト学習に利用できます.このことは、無制限の長さのコンテキストをメモリバンクで処理し、様々なダウンストリームタスクに利益をもたらすことができます.この情報は、(p.7)から得られました.

Q: LongMemは、さまざまな下流タスクにどのようなメリットをもたらすのでしょうか?

A: LongMemは、事前学習された知識にアクセスするだけでなく、catastrophic forgettingを回避することができます.LONG MEMは、さまざまな種類の長いテキストと知識をメモリバンクに取り込むことができ、ダウンストリームタスクに基づいて利益をもたらすことができます.LONG MEMは、長い形式のメモリを65kトークンまで拡大することができ、多数のデモンストレーション例を長い形式のメモリとしてキャッシュすることができます.LONG MEMは、ChapterBreakという難しい長いコンテキストモデリングベンチマークで強力な長いコンテキストモデルを上回り、in-context learningにおいてもLLMsよりも優れた結果を示しました.これらの結果は、提案された方法が長い形式の内容を記憶し利用することに効果的であることを示しています.(p.1,5,30)

Q: ChapterBreakとは何か、このベンチマークで提案手法はどうだったのか.

A: ChapterBreakは、[STI22]で提案された、同じ本からサンプリングされた難しいネガティブセグメントから、正しい次の章のグラウンドトゥルースの始まりを区別するLLMsを必要とする、接尾辞識別データセットです.長い文脈を与えられた場合、前の章の長い文脈を処理して正しい接尾辞を理解し、識別する必要があります.[STI22]は、長いテキスト処理のための最新のx-formerでも、ChapterBreakでうまく機能するために長距離文脈を効果的に活用できないことを示しました.提案された方法は、ChapterBreakのAO3サブセットを選択し、4k、6k、8kのプレフィックスを評価のために選択し、LONG MEMモデルは、人気のあるNLUタスクにおいて、MemTRMや非メモリ拡張ベースラインと比較して、明らかな文脈学習の改善を示し、ChapterBreakで40.5%の識別精度を達成しました.

Q: 提案手法は、強いロングコンテキストモデルをどのように凌駕するのでしょうか?

A: 弊社の提案する方法は、長い文脈モデリングのベンチマークであるChapterBreakにおいて、強力な長い文脈モデルよりも優れた性能を発揮し、メモリ拡張インコンテキスト学習においてもLLMsよりも優れた改善を達成していることが実験によって示されています.この結果は、提案された方法が、言語モデルが長い形式のコンテンツを記憶し利用するのに効果的であることを示しています.(p.2)

Q: LongMemでは、長文コンテンツをどのように言語モデリングに活用しているのでしょうか.

A: LongMemは、大量のデモンストレーション例を長期的な記憶としてキャッシュし、コンテキスト内学習に多数のショットを提供することで、長い形式のコンテンツを記憶し利用することができます.これにより、言語モデルが長い形式のコンテンツを記憶し利用することができるため、言語モデルの性能が向上します.具体的には、LONG MEMは、65kトークンまで長期的な記憶を拡大し、長いコンテキストモデルよりもChapterBreakという長いコンテキストモデリングベンチマークで優れた性能を発揮し、LLMsよりもコンテキスト内学習のメモリ強化において著しい改善を達成します.(p.1)

Q: 言語モデルの長文コンテンツの記憶・活用を支援するために、提案する手法の意義は?

A: 提案された方法は、言語モデルが長い文章を記憶し、活用することを助ける点で有意義です.この方法は、長い文章のモデリングや、文脈における学習能力の向上において、強力なベースラインを上回る結果を示しました.具体的には、長い文章のモデリングにおいてはChapterBreakという難しいベンチマークにおいて、文脈における学習能力の向上においては、LLMsよりも記憶を補助することで著しい改善を達成しました.この方法は、知識と記憶のエンコーダーとして機能し、長い文脈的言語モデリングのデータセットにおける実験結果は、他のメモリ拡張ベースラインよりも効果的であることを示しています.提案された方法は、文脈の長さに制限される文脈中のデモンストレーション例の数を克服することで、LLMsの文脈中の学習を可能にすることもできます.(p.1)

Q: 本稿で紹介した新方式のコード実装のためのurlはどうなっていますか?

A: 本論文で導入された新しい手法のコード実装は、https://aka.ms/LongMem でオープンソース化されています.(p.11)

A Comprehensive Survey on Applications of Transformers for Deep Learning Tasks

著者:Saidul Islam, Hanae Elmekki, Ahmed Elsebai, Jamal Bentahar, Najat Drawel, Gaith Rjoub, Witold Pedrycz

発行日:2023年06月11日

最終更新日:2023年06月11日

URL:http://arxiv.org/pdf/2306.07303v1

カテゴリ:Machine Learning, Computation and Language

概要:

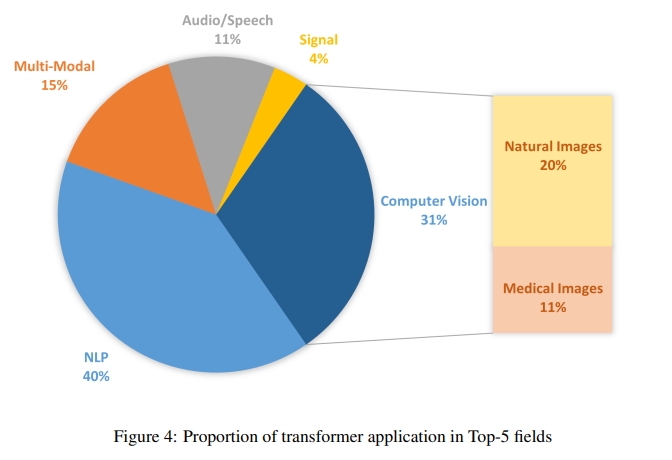

Transformerは、シーケンシャルデータ内の文脈的な関係を理解するために自己注意機構を使用する深層ニューラルネットワークです.従来のニューラルネットワークやLong Short-Term Memory(LSTM)などの更新されたバージョンの再帰型ニューラルネットワークとは異なり、Transformerモデルは入力シーケンス要素間の長い依存関係を処理するのに優れており、並列処理を可能にします.そのため、Transformerベースのモデルは、自然言語処理(NLP)タスクだけでなく、コンピュータビジョン、音声処理、医療、およびインターネット・オブ・シングス(IoT)などの様々な分野での驚異的な成果と潜在的な可能性により、人工知能の研究者たちの間で大きな関心を集めています.しかし、様々な分野での主要な応用を包括する包括的な調査論文の不足が依然として大きな問題となっています.そのため、私たちは2017年から2022年までの提案されたTransformerモデルの包括的な調査を行い、NLP、コンピュータビジョン、マルチモダリティ、音声処理、信号処理の5つのアプリケーション分野でのトップ5のTransformerベースのモデルを特定しました.これらの分野で高い影響力を持つTransformerベースのモデルの影響を分析し、提案されたタクソノミーを使用して、それぞれのタスクに基づいて分類しました.私たちの目的は、熱心な研究者たちにとってTransformerの既存の可能性と将来の可能性を明らかにし、この画期的な技術のより広範な理解に貢献することです.

Q&A:

Q: ディープラーニングの文脈でのトランスフォーマーとは?

A: 深層学習の文脈におけるTransformerとは、自己注意機構を利用してシーケンシャルデータ内の文脈的関係を理解するための深層ニューラルネットワークの一種である.従来のニューラルネットワークや更新されたバージョンの再帰ニューラルネットワーク(RNN)(例えば、Long Short-Term Memory(LSTM))とは異なり、Transformerモデルは入力シーケンス要素間の長い依存関係を扱うことができ、並列処理を可能にする.その結果、Transformerベースのモデルは、自然言語処理(NLP)タスクだけでなく、コンピュータビジョン、音声処理、ヘルスケア、IoTなどの幅広い領域でも注目を集めている.Transformerの貢献を特定の分野、アーキテクチャの違い、またはTransformerの可能性について論じた調査論文がいくつか出版されているが、この画期的な技術の広範な理解に貢献するために、熱心な研究者にとっては、Transformerの可能性を探求することが重要である.(p.1)

Q: トランスフォーマー搭載モデルが有望視されているドメインは?

A: 本論文では、トランスフォーマーモデルの主要な応用分野に基づいて、トランスフォーマーモデルが分類され、評価されています.本調査では、研究者によって比較的多くまたは少なく注目されたトランスフォーマーの応用分野を強調しています.本調査は、2017年から2022年までの提案されたトランスフォーマーモデルの包括的な調査を実施することによって、トランスフォーマーモデルの主要な応用分野を網羅する包括的な調査論文がまだ存在しないことを明らかにしました.本調査は、トランスフォーマーモデルのトップ5の応用分野、すなわちNLP、コンピュータビジョン、マルチモダリティ、音声および音声処理、および信号処理を特定し、これらの分野で高い影響力を持つトランスフォーマーベースのモデルの影響を分析し、提案された分類法に基づいてそれらを分類しました.本論文の目的は、トランスフォーマーベースのモデルの効果を評価することと、トランスフォーマーベースのモデルの機能を探索および拡張することに興味を持つ研究者を支援するための基準のコレクションを提供することです.本論文は、トランスフォーマーの貢献、アーキテクチャの違い、またはパフォーマンス評価について特定の分野で発表された論文とは異なり、トランスフォーマーモデルの主要な応用分野を包括的に調査する初めてのレビュー論文であることを明らかにしました.本論文の目的は、トランスフォーマーモデルの現在の可能性と将来の可能性を研究者に示すことで、この画期的な技術の広範な理解に貢献することです.(p.1)

回答:トランスフォーマーベースのモデルは、NLP、コンピュータビジョン、マルチモダリティ、音声および音声処理、および信号処理の分野で有望な成果を示しています.(p.1)

Q: 著者らは、提案されたトランスモデルの調査をどのように行ったのでしょうか.

A: 本研究では、学術誌や学会で発表されたトランスフォーマーに関する最新の調査を収集し、その貢献と限界を研究することを目的としています.関連する論文を収集するために、2つの戦略を採用しました.1つ目は、いくつかの確立された検索エンジンを使用してキーワード「調査」に基づいて選択された論文を検索することです.2つ目は、選択された論文を分類するために、既存の分類がトランスフォーマーベースのモデルとその異なるアプリケーションを完全に捉えていないことに気付いたため、より包括的な分類を提案することを目的としています.(p.3)

Q: トランスフォーマー搭載モデルを分類するためのタクソノミーの提案とは?

A: 選択された記事を徹底的に分析した結果、既存の分類がトランスフォーマーベースのモデルとその異なる分野での多様な応用を完全に捉えていないことがわかりました.そのため、本研究では、より包括的な分類を提案することを目的としました.アプリケーションの分野では、選択されたモデルをタスクの実行に基づいて分類し、トランスフォーマーアプリケーションの分類法を開発しました.私たちの分析は、モデルの構造、特性、操作方法、データセットなどを含む包括的な調査を行いました.この調査に基づいて、最も顕著なアプリケーション分野におけるトランスフォーマーモデルについて詳細に議論を行いました.顕著なモデルは、それぞれの分野内でのタスクパフォーマンスに基づいて分類および評価されます.この調査では、研究者から比較的大きなまたは小さな注目を集めたトランスフォーマーのアプリケーションドメインを強調しています.私たちの知る限り、これはトランスフォーマーベースのモデルの高レベル分類スキームを提示し、2つの目的を達成するための基準のコレクションを提供する最初のレビューペーパーです:(1)さまざまなアプリケーションでのトランスフォーマーモデルの効果を評価すること、および(2)トランスフォーマーベースのモデルの機能を探索および拡張することに興味を持つ研究者を支援すること. (p.1)

FinGPT: Open-Source Financial Large Language Models

著者:Hongyang Yang, Xiao-Yang Liu, Christina Dan Wang

発行日:2023年06月09日

最終更新日:2023年06月09日

URL:http://arxiv.org/pdf/2306.06031v1

カテゴリ:Statistical Finance, Computation and Language, Machine Learning, Trading and Market Microstructure

概要:

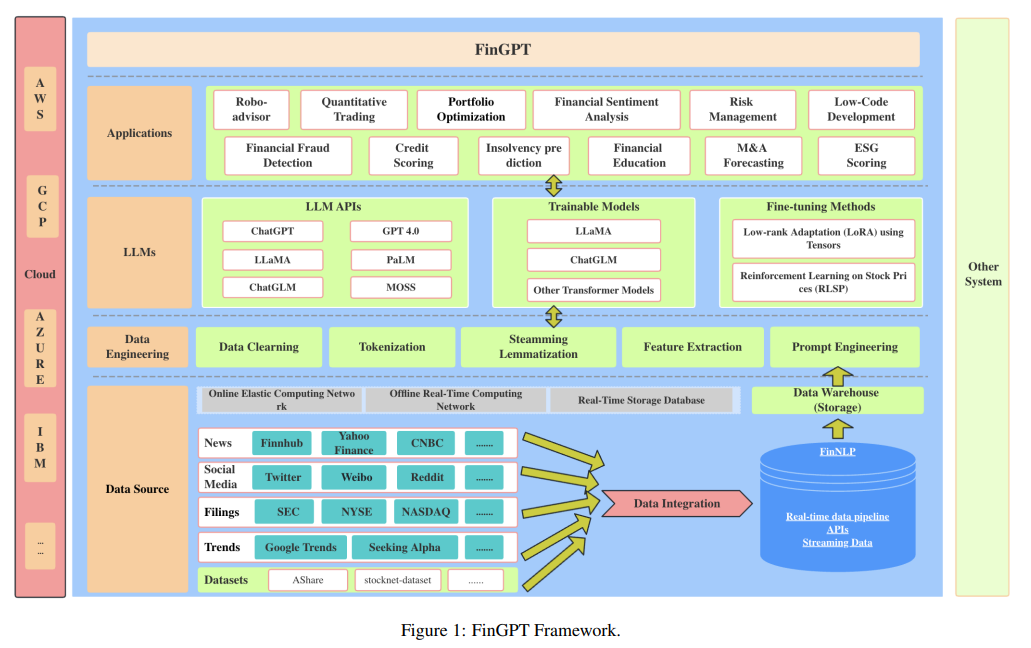

金融分野におけるオープンソースのAI4Financeコミュニティ内で、FinGPTは、イノベーションを促進し、オープンファイナンスにおいて新しい機会を開拓することを目指しています.関連する2つのコードリポジトリは、\url{https://github.com/AI4Finance-Foundation/FinGPT} および \url{https://github.com/AI4Finance-Foundation/FinNLP} です.FinGPTは、プロプライエタリモデルとは異なり、データ中心のアプローチを取り、研究者や実践者が自分たちのFinLLMを開発するためのアクセス可能で透明なリソースを提供します.自動データキュレーションパイプラインと軽量低ランク適応技術の重要性を強調し、ロボアドバイジング、アルゴリズムトレーディング、ローコード開発など、ユーザーのステップストーンとなるいくつかの潜在的なアプリケーションを紹介しています.

Q&A:

Q: FinGPTの目的は何ですか?

A: FinGPTの目的は、金融大規模言語モデル(FinLLMs)のためのエンドツーエンドのオープンソースフレームワークであり、金融データに関連しています.FinGPTは、データ中心のアプローチを採用し、データの取得、クリーニング、前処理がオープンソースFinLLMsの開発において重要な役割を果たすことを強調しています.FinGPTは、データのアクセシビリティを推進することで、オープンファイナンスにおいてイノベーションを促進し、FinLLMsを民主化し、新しい機会を開拓することを目指しています.具体的には、ロボアドバイジング、アルゴリズムトレーディング、ローコード開発などのアプリケーションがあります.さらに、FinGPTの成功は、金融市場の理解と予測精度の向上に役立つ強力なツールを提供することにあります.実際の株価変動をフィードバックとして使用することで、市場の知恵を直接利用してモデルをより効果的にすることができます.(p.1-2)

Q: FinGPTはBloombergGPTのような独自モデルとどう違うのですか?

A: BloombergGPTのようなプロプライエタリモデルとは異なり、FinGPTはデータ中心のアプローチを取り、研究者や実践者にアクセス可能で透明性のあるリソースを提供することで、FinLLMsを開発するための手段を提供しています.FinGPTは、自動データキュレーションパイプラインと軽量低ランク適応技術の重要性を強調し、FinGPTの構築に役立っています.さらに、FinGPTは、ロボアドバイジング、アルゴリズム取引、およびローコード開発などのユーザーのステップストーンとしていくつかの潜在的なアプリケーションを紹介しています.FinGPTは、オープンソースのAI4Financeコミュニティ内での協力的な取り組みを通じて、イノベーションを促進し、FinLLMsを民主化し、オープンファイナンスにおける新しい機会を開拓することを目指しています.

FinGPTは、BloombergGPTと比較して、トップオープンソースLLMsの軽量適応に焦点を当てることで、よりアクセス可能なソリューションを提供しています.適応のコストは、トレーニングあたり300ドル未満と推定されており、このアプローチにより、動的な金融ドメインでのタイムリーな更新と適応性が確保されます.オープンソースであることにより、FinGPTは透明性を促進するだけでなく、テキスト、ドキュメント、および画像などの多様なデータ形式に対応することができます.(p.1)

プロプライエタリスフィアでは、BloombergGPTなどのモデルは、専門的なデータへの独占的なアクセスを利用して、金融特有の言語モデルをトレーニングしています.しかし、彼らのデータ収集とトレーニングプロトコルの制限されたアクセシビリティと透明性は、よりオープンで包括的な代替手段への需要を高めています.この需要に応えて、オープンソースドメインでのインターネットスケールの金融データの民主化に向けたトレンドのシフトが見られています.

以上のように、FinGPTは、オープンソースであり、データ中心のアプローチを取ることで、プロプライエタリモデルとは異なり、よりアクセス可能で透明性のあるリソースを提供し、金融特有の言語モデルをトレーニングするための手段を提供しています.

Q: 金融系LLMの最初の課題は何でしょうか.

A: 金融LLMにとって最初の課題は、高品質な金融データにアクセスすることです.これは、(p.1)で述べられています.BloombergGPTのような専有モデルは、独自のデータ蓄積を活用していますが、その特権的なアクセスは、インターネット規模の金融データを民主化するためのオープンソースの代替案を求めます.したがって、金融言語モデリングにおいて、オープンソースの大規模な新しいデータセットを提供することが必要です.これにより、金融言語モデリングの適応コストと計算要件が大幅に削減され、BloombergGPTのようなモデルと比較して、よりアクセスしやすく、柔軟性があり、費用対効果の高いソリューションが提供されます.したがって、金融の動的で時間的に敏感な世界において、モデルの正確性と関連性を確保するための一貫した更新が可能になります.

Q: FinGPTは、高品質の金融データへのアクセスという課題にどのように取り組んでいるのでしょうか.

A: 高品質な金融データにアクセスする課題に対して、FinGPTはデータ中心のアプローチを採用し、多様なデータ形式とタイプを扱うための厳格なクリーニングと前処理手法を実装することで、高品質なデータを確保しています.また、FinGPTはデータのアクセシビリティを重視し、オープンファイナンスの研究、協力、イノベーションを促進することで、金融データとFinLLMsの民主化を目指しています.(p.1)

Q: FinGPTは、研究者や実務家のために、アクセスしやすく透明性の高いリソースを提供するために、どのようなアプローチをとっていますか?

A: FinGPTは、データ中心のアプローチを取り、研究者や実践者にアクセス可能で透明性のあるリソースを提供することで、プロプライエタリなモデルとは異なります.FinGPTは、自動データキュレーションパイプラインと軽量低ランク適応技術の重要性を強調し、FinGPTの構築に取り組んでいます.さらに、ロボアドバイジング、アルゴリズム取引、ローコード開発など、ユーザーのステップストーンとしていくつかの潜在的なアプリケーションを紹介しています.オープンソースAI4Financeコミュニティ内での協力的な取り組みを通じて、FinGPTは、FinLLMsを民主化し、オープンファイナンスにおける新しい機会を開拓することを目指しています.(p.1)

Q: FinGPTを構築する上で、データキュレーションの自動化パイプラインの重要性とは何でしょうか?

A: 自動データキュレーションパイプラインは、FinGPTを構築する上で非常に重要です.データキュレーションは、データの取得、クリーニング、前処理を指します.FinGPTは、異なるデータ形式とタイプを扱うために厳格なクリーニングと前処理方法を実装し、高品質のデータを確保するためにデータ中心のアプローチを採用しています.自動データキュレーションパイプラインは、このプロセスを自動化することにより、高品質のデータをより迅速かつ正確に取得できるようにします.これにより、FinGPTは、オープンソースのFinLLMsを開発するためのアクセス可能で透明性の高いリソースを提供することができます.この情報は、(p.1)から抽出されました.

Q: FinGPTの構築で使用された軽量低ランク適応技術とは?

A: FinGPTの構築に使用される軽量低ランク適応技術は、(p.3)で説明されています.この技術は、高価なプロプライエタリモデルとは異なり、オープンソースのLLMを軽量に適応することに焦点を当てています.適応のコストは、トレーニングあたり300ドル未満と推定されています.この技術は、高品質のラベル付きデータを取得することが困難な場合に特に有用であり、金融分野におけるLLMの開発を民主化する可能性があります.

Q: FinGPTの潜在的なアプリケーションは何でしょうか?

A: FinGPTの潜在的な応用分野には、ロボアドバイザリーサービス、アルゴリズム取引、そしてローコード開発などがあります.これらの実践的なデモンストレーションは、潜在的なユーザーのガイドとしてだけでなく、金融分野におけるLLMの変革的な可能性を強調しています.(p.1,4-8) また、FinGPTは、実際の株価変動をフィードバックとして使用することで、市場の知恵を直接利用してモデルをより効果的にすることができるため、金融市場の理解と予測精度を向上させるための強力なツールとしても応用されます.(p.1,5,30)

Q: オープンソースのAI4Financeコミュニティにおいて、FinGPTが目指すものは何でしょうか.

A: FinGPTの目的は、オープンソースのAI4Financeコミュニティ内でのイノベーションの促進、FinLLMsの民主化、そしてオープンファイナンスにおける新しい機会の開拓です.FinGPTは、プロプライエタリなモデルとは異なり、データ中心のアプローチを取り、研究者や実践者が自分たちのFinLLMsを開発するためのアクセス可能で透明性の高いリソースを提供します.また、自動データキュレーションパイプラインと軽量低ランク適応技術の重要性を強調し、ロボアドバイジング、アルゴリズム取引、ローコード開発など、ユーザーのステップストーンとしていくつかの潜在的なアプリケーションを紹介しています.オープンソースのAI4Financeコミュニティ内での協力的な取り組みを通じて、FinGPTはFinLLMsの民主化を促進し、オープンファイナンスにおける新しい機会を開拓することを目指しています.情報源:(p.1)

Q: FinGPTの関連するコードレポは何ですか?

A: FinGPTの関連コードリポジトリは、https://github.com/AI4Finance-Foundation/FinGPTとhttps://github.com/AI4Finance-Foundation/FinNLPです.(p.1) FinGPTは、金融セクター向けの言語モデルであり、プロプライエタリなモデルとは異なり、データ中心のアプローチを取り、研究者や実践者が自分たちのFinLLMsを開発するためのアクセス可能で透明なリソースを提供します.AI4Financeコミュニティ内の協力的な取り組みを通じて、FinGPTはイノベーションを促進し、FinLLMsを民主化し、オープンファイナンスにおける新しい機会を開拓することを目的としています.(p.1)

Q: 本稿で紹介した新手法のコード実装のためのurlはどうなっていますか?

A: 本論文で紹介された新しい手法のコード実装のURLは、https://github.com/AI4Finance-Foundation/FinGPT および https://github.com/AI4Finance-Foundation/FinNLP です.

Mind2Web: Towards a Generalist Agent for the Web

著者:Xiang Deng, Yu Gu, Boyuan Zheng, Shijie Chen, Samuel Stevens, Boshi Wang, Huan Sun, Yu Su

発行日:2023年06月09日

最終更新日:2023年06月15日

URL:http://arxiv.org/pdf/2306.06070v2

カテゴリ:Computation and Language

概要:

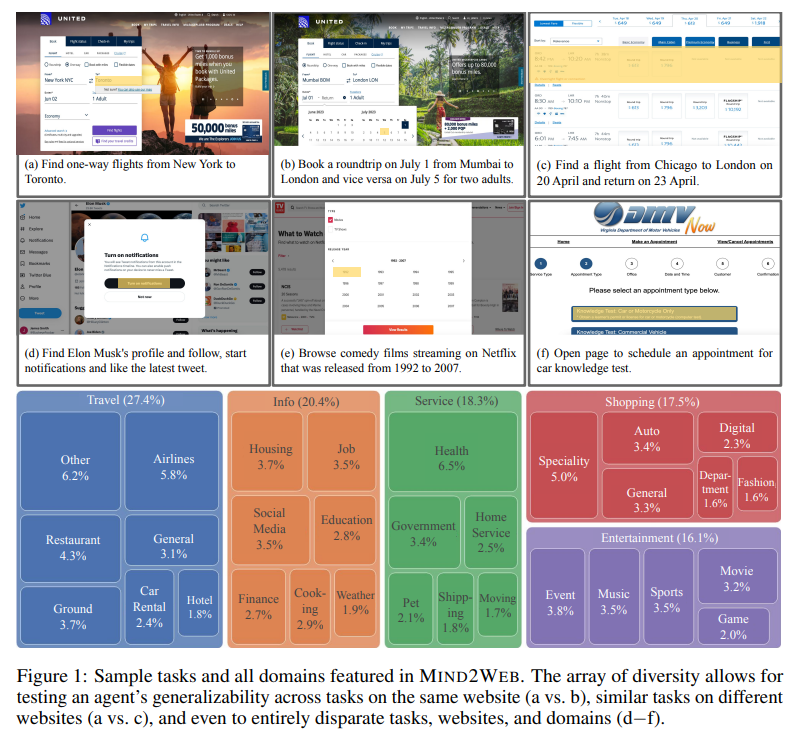

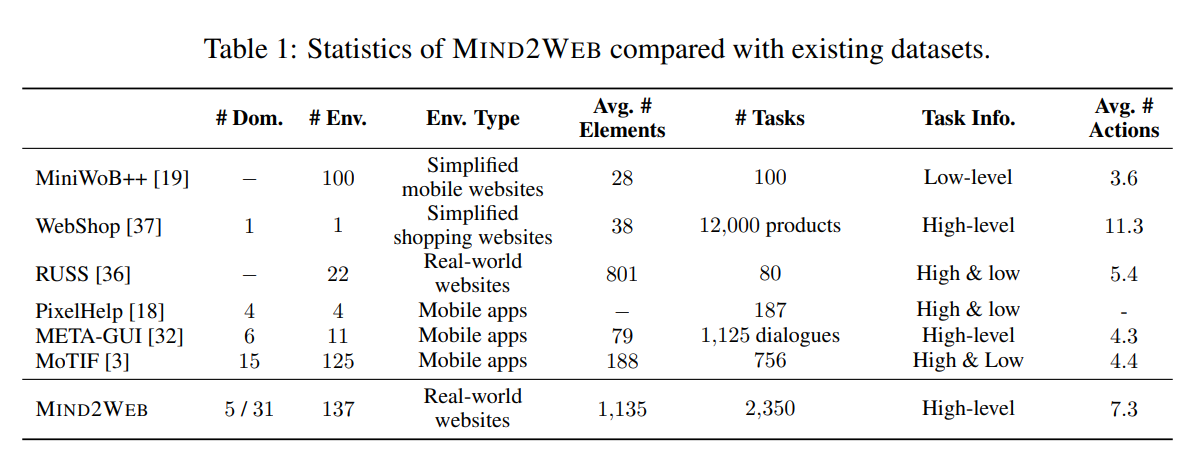

「Mind2Web」というデータセットが紹介された.これは、任意のウェブサイトで複雑なタスクを完了するために言語指示に従う汎用エージェントを開発および評価するための初めてのデータセットである.既存のWebエージェント用のデータセットは、シミュレートされたウェブサイトを使用するか、限られたウェブサイトとタスクのみをカバーするため、汎用Webエージェントには適していない.Mind2Webは、31のドメインにまたがる137のウェブサイトから収集された2,000以上のオープンエンドタスクと、タスクのためのクラウドソーシングされたアクションシーケンスを提供し、汎用Webエージェントを構築するための3つの必要な要素を提供する.これらは、1)多様なドメイン、ウェブサイト、およびタスク、2)シミュレートされたおよび簡略化されたウェブサイトの代わりに実世界のウェブサイトの使用、および3)広範なユーザーインタラクションパターンである.Mind2Webに基づいて、大規模言語モデル(LLM)を使用して汎用Webエージェントを構築するための初期探索を行った.実世界のウェブサイトの生のHTMLは、LLMに供給するには大きすぎるため、小さなLMでフィルタリングすることで、LLMの効果と効率が大幅に向上することを示した.私たちの解決策は、モデルが見たことのないウェブサイトやドメインでも、まずまずのパフォーマンスを示している.さらに、我々はデータセット、モデルの実装、およびトレーニングされたモデルをオープンソース化し(https://osu-nlp-group.github.io/Mind2Web)、ウェブの汎用エージェントの構築に関するさらなる研究を促進する.

Q&A:

Q: Mind2Webとは、どのようなもので、どのような目的を持っているのでしょうか.

A: Mind2Webは、Web理解とアクションを取るための特殊なLMと実際のWebサイトから構成されるデータセットです.このデータセットは、一般的なWebエージェントの開発に向けた貴重なプラットフォームとして、研究コミュニティに役立つことを目的としています.MIND2W EBは、他のデータセットで一般的に見られる単純化されたシミュレーション環境を実際のWebサイトに置き換え、ユーザーのインタラクションの完全なトレース、Webページのスナップショット、およびネットワークトラフィックを提供することで、豊富な生の、フィルタリングされていない、ダイナミックなデータソースを提供します.これにより、モデルに実世界の環境の複雑さと不確実性に対処する能力が与えられ、より堅牢で適応性のあるモデルの開発が促進されます.MIND2W EBは、基本的な操作ではなく、高度なWebサイトの操作を可能にすることで、ユーザーのインタラクションパターンの幅広いスペクトルを提供します.また、Web自動化システムの研究に関連しています.この技術は、一般ユーザーにとってアクセスしにくくなるプログラミングスキルを要求することがあります.MIND2W EBは、自然言語インターフェースを備えたWeb自動化システムを提供することで、エントリーバリアを大幅に低減することを目的としています.(p.1)

Q: Mind2Webは、既存のWebエージェント用データセットとどう違うのですか?

A: 既存のWebエージェントのデータセットは、シミュレートされたウェブサイトを使用するか、限られたウェブサイトとタスクのみをカバーしているため、一般的なWebエージェントには適していません.一方、MIND2WEBは、137のウェブサイト、31のドメインから収集された2,000以上のオープンエンドタスクと、タスクのクラウドソーシングされたアクションシーケンスを提供することで、一般的なWebエージェントを構築するために必要な3つの要素を提供しています.MIND2WEBは、既存の文献とは異なり、現実のウェブサイトを使用しており、手動で簡素化されていないため、より複雑な環境を提供しています.これにより、MIND2WEBは、従来の研究とは異なる研究課題を提供しています.

Q: Mind2Webが提供するジェネラリスト・Webエージェント構築のための3つの必要な要素とは?

A: MIND2W EBは、Web上の一般的なエージェントを構築し、複雑なタスクを完了するための言語指示に従うことができる最初のデータセットであり、Webエージェントの既存のデータセットは、シミュレートされたWebサイトを使用するか、限られたWebサイトとタスクのみをカバーしているため、一般的なWebエージェントには適していません.MIND2W EBは、31のドメインにまたがる137のWebサイトから収集された2,000以上のオープンエンドタスクと、タスクのクラウドソーシングされたアクションシーケンスを提供し、一般的なWebエージェントを構築するために必要な3つの要素を提供します.それは、1)多様なドメイン、Webサイト、およびタスク、2)シミュレートされたWebサイトではなく実世界のWebサイトの使用、および3)広範なユーザーインタラクションパターンです. (p.1)

MIND2W EBに基づいて、一般的なWebエージェントを構築するために大規模な言語モデル(LLMs)を使用する初期探索を行っています.実世界のWebページのHTMLドキュメントには数千の要素が含まれているため、LLMsのコンテキストにフィードすることは不可能またはコストがかかりすぎるため、私たちは、最初に微調整された小さなLMを使用してWeb要素をフィルタリングするMINDACTを提案しています.これにより、モデルが以前に見たことのないWebサイトまたはドメインでも、私たちのソリューションはまずまずのパフォーマンスを示しますが、まだ改善の余地があります. (p.1)

以上から、MIND2W EBが提供する一般的なWebエージェントを構築するための3つの必要な要素は、1)多様なドメイン、Webサイト、およびタスク、2)シミュレートされたWebサイトではなく実世界のWebサイトの使用、および3)広範なユーザーインタラクションパターンです. (p.1)

Q: Mind2Webを使って行う最初の探索はどのようなものですか?

A: MIND2W EBを用いた初期の探索は、一般的なWebエージェントの構築にLLMを使用することを可能にします.これは、実世界のWebページのHTMLドキュメントには数千の要素が含まれているため、LLMの文脈にフィードすることが不可能またはコストが高すぎるためです.この問題に対処するために、私たちはMINDACTを提案しています.これは、最初に微調整された小さなLMを使用してWeb要素をフィルタリングする2段階のモデルです.(p.3)

Q: 大規模言語モデル(LLM)とは何か、そして汎用のWebエージェントを構築する上でどのように使われているのか.

A: LLMとは、大規模言語モデルの略称であり、自然言語処理において、大量のテキストデータを学習して、言語の理解や生成を行うモデルのことです.一方、一般的なウェブサイトはLLMにとって扱いきれないほど大きく、そのままでは効率的に処理できません.そこで、小さなLMを用いてフィルタリングすることで、LLMの効果と効率を向上させることができます.このような手法を用いて、未知のウェブサイトやドメインに対しても、一定の性能を発揮することができますが、まだ完全に汎用的なエージェントを構築するためには改善の余地があります.このような汎用的なWebエージェントを構築するためには、多様なドメイン、ウェブサイト、タスクを含むデータセットを用意し、実際のウェブサイトを使用することが必要です.また、ユーザーのインタラクションパターンも広範囲にカバーする必要があります.このようなデータセットを用いて、LLMを用いた汎用的なWebエージェントの構築に初めて取り組んだ研究があります.

Q: なぜ、現実のウェブサイトの生のHTMLは、LLMに供給するには大きすぎることが多いのでしょうか?

A: 実世界のウェブサイトの生のHTMLは、数千の要素で構成されているため、LLMsに直接フィードすることが不可能またはコストがかかりすぎるためです. このため、小さなLMを使用して最初にフィルタリングすることで、効果と効率を大幅に向上させることができます.しかし、現代のウェブの複雑さをよりよく反映するためには、まだ改善の余地があります.

Q: 小さなLMで生のHTMLをフィルタリングすることで、LLMの効果や効率はどのように改善されるのか?

A: 原文によると、実際のウェブページのHTMLドキュメントは、LLMsに直接フィードするには大きすぎるため、小さなLMでフィルタリングすることで、LLMsの効果と効率を大幅に改善できることが示されています.これにより、第一段階で約束された候補者の小さなプールが得られ、第二段階でこれらの候補要素が統合され、ウェブページの代表的なスニペットが形成されます.このスニペットは、LLMによって処理され、最終的なアクション、つまり相互作用の要素と対応する操作の両方を予測するために使用されます.

Q: モデルが見たことのないウェブサイトやドメイン全体に対して、ソリューションが示すパフォーマンスのレベルはどのようなものでしょうか.

A: 解答: モデルが以前に見たことがないウェブサイトやドメインに対して、ソリューションが示したパフォーマンスレベルは、かなり良好であることが示されています.しかし、改善の余地がまだ大きく残されています.

論文中の4.2節によると、モデルのパフォーマンスは、Cross-Task設定で最も優れており、Cross-WebsiteおよびCross-Domain設定と比較して、平均して10%以上の絶対ギャップ(step SR)があります.これは、未知の環境に一般化することがまだ主要な課題であることを示しています.しかし、Cross-WebsiteおよびCross-Domain設定のパフォーマンスは、顕著に似ていることがわかります.これは、図6でも強調されており、これらの設定全体でパフォーマンスに明確な差がないことを示しています.これは、課題が主にウェブサイトのデザインと相互作用ロジックの多様性から来ていることを示唆しています.ドメインを超えたタスクは、共通の操作を共有する傾向があり、サイトはLLMsに供給するには大きすぎるため、小さなLMでフィルタリングすることで、効果と効率が大幅に向上することが示されています.したがって、ソリューションは、以前に見たことがないウェブサイトやドメインに対して、かなり良好なパフォーマンスを示していますが、改善の余地がまだ大きく残されています.

Q: ウェブ用のジェネラリスト・エージェントの構築に関するさらなる研究を促進するために、著者らがオープンソース化したリソースは何か.

A: 研究者らは、ウェブの汎用エージェントの構築に関するさらなる研究を促進するために、データセット、モデル実装、およびトレーニング済みモデルをオープンソース化しています.これらのリソースは、https://osu-nlp-group.github.io/Mind2Webで入手可能です.(p.1)

On the Reliability of Watermarks for Large Language Models

著者:John Kirchenbauer, Jonas Geiping, Yuxin Wen, Manli Shu, Khalid Saifullah, Kezhi Kong, Kasun Fernando, Aniruddha Saha, Micah Goldblum, Tom Goldstein

発行日:2023年06月07日

最終更新日:2023年06月09日

URL:http://arxiv.org/pdf/2306.04634v2

カテゴリ:Machine Learning, Computation and Language, Cryptography and Security

概要:

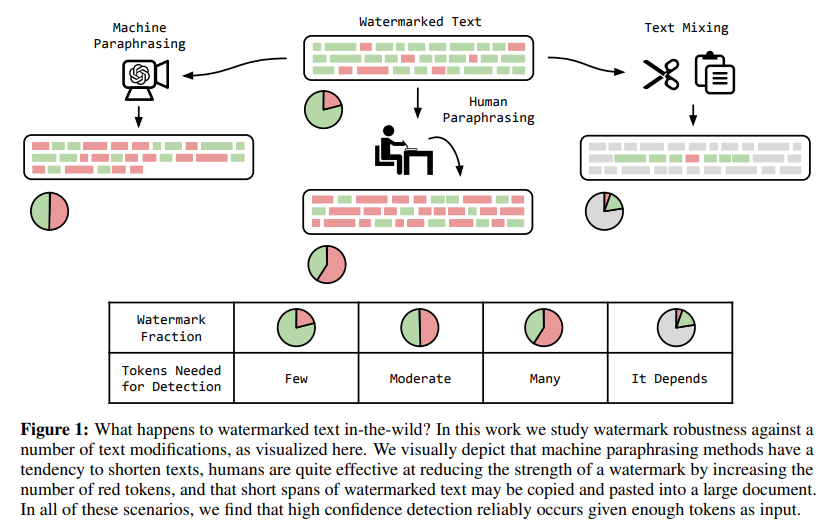

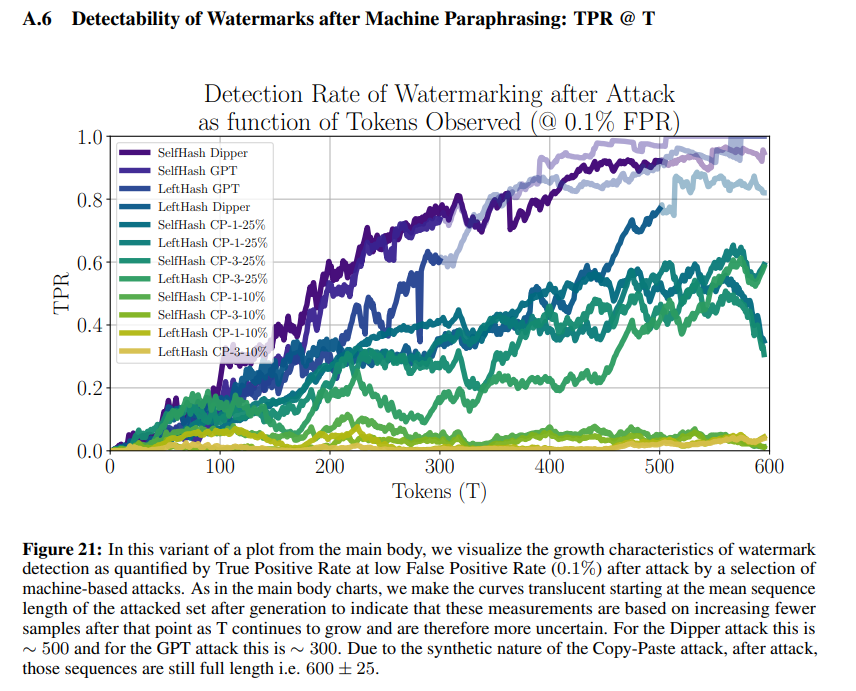

この研究では、人間による書き換え、ウォーターマークのないLLMによる言い換え、または長い手書きの文書に混ぜられた後のウォーターマーク付きテキストの堅牢性を調べました.私たちは、人間と機械による言い換え後でもウォーターマークが検出可能であることを発見しました.これらの攻撃はウォーターマークの強度を低下させますが、言い換えは元のテキストのn-gramまたはそれ以上の長いフラグメントを漏らす可能性があり、十分なトークンが観察された場合には高信頼度の検出結果が得られます.例えば、強力な人間の言い換え後でも、1e-5の偽陽性率を設定した場合、800トークンを観察した後にウォーターマークが検出可能であることがわかりました.また、大きな文書内に埋め込まれたウォーターマーク付きテキストの短いスパンに敏感な新しい検出スキームの範囲も考慮し、ウォーターマーキングの堅牢性を他の種類の検出器と比較しました.

Q&A:

Q: 大規模な言語モデルの中で、電子透かしを入れる目的は何ですか?

A: ウォーターマーク技術は、大規模言語モデルによって生成されたテキストを検出し、文書化することによって、スパム、ソーシャルメディアボット、価値のないコンテンツなどの被害を軽減するための簡単で効果的な戦略である.しかし、現実的な環境でのウォーターマークの信頼性はどの程度であるかという重要な問題が残っている.そこでは、ウォーターマークがユーザーのニーズに合わせて修正されたり、検出を回避するために完全に書き換えられたりする可能性がある. (p.1)

ウォーターマーク技術の目的は、大規模言語モデルによって生成されたテキストを検出し、文書化することによって、スパム、ソーシャルメディアボット、価値のないコンテンツなどの被害を軽減することである.ウォーターマーク技術は、人間によって書き換えられたり、非ウォーターマークの言語モデルによって言い換えられたり、長い手書き文書に混ぜられたりしても、検出可能であることが示されている.ウォーターマーク技術は、テキストの改変に対して完全に耐性を持つことはできないが、十分なトークンが観測された場合には、高信頼度の検出が可能である. (p.1)

Q: 電子透かしは、機械で作成されたテキストがもたらす潜在的な被害をどのように軽減するのでしょうか?

A: 機械生成テキストによる潜在的な被害を軽減するために、ウォーターマーク技術が役立つ.ウォーターマーク技術は、生成されたテキストにわずかなパターンを組み込み、そのテキストの起源を特定できるようにするものである.この技術により、短いテキスト断片でも高い精度で機械生成テキストを検出することができる.しかし、実際の環境では、人間が機械生成テキストを大量の文書に混ぜたり、テキストを改変したりすることがあるため、ウォーターマーク技術の信頼性には課題がある.本研究では、実際の環境でのウォーターマーク技術の信頼性について調査し、機械生成テキストを検出するための新しい手法を提案している.(p.1-2)

Q: 野生の現実的な設定での電子透かしの信頼性はどうなのでしょうか?

A: ウォーターマーク技術は、LLMによって生成されたテキストの検出と文書化を可能にすることで、スパム、ソーシャルメディアボット、価値のないコンテンツなどの被害を軽減するための簡単で効果的な戦略である.しかし、重要な問題が残っている.それは、現実的な環境でのウォーターマークの信頼性がどの程度あるかということである.そこでは、ウォーターマークが付けられたテキストは、ユーザーのニーズに合わせて修正されたり、完全に書き換えられたりして検出を回避する可能性がある.Kirchenbauerらのアプローチに基づいて、現実的なシナリオでのテキストの信頼性を調べるために、人間によって処理された場合、人間が書いたテキストと混ぜた場合、一部または全体を書き換えた場合、または他の人気のある言語モデルにテキストを入力して言い換えた場合に、ウォーターマークがどの程度信頼性があるかを調べた.信頼性の高い検出戦略は、これらの一般的なシナリオに対して堅牢であり、一定の統計的なパワーと低い偽陽性率を維持する必要がある.ウォーターマーク生成とウォーターマーク検出パイプラインのすべての部分を再調査して、現実的なシナリオでの信頼性を最適化する.強力な大規模言語モデルによる言い換えに対するウォーターマークの信頼性を検討した.GPT-3.5や特別に作成された言い換えモデルを使用して、ウォーターマークが付けられたテキストを書き換えた場合、T=200トークンが利用可能な場合、ROC-AUCは0.85以上であり、T=600トークンが利用可能な場合、0.9以上であることがわかった.ウォーターマークが付けられたテキストが、より大きな手書きの文書の中に現れる「コピー&ペースト」シナリオを考慮した.人間による書き換え、非ウォーターマークLLMによる言い換え、または長い手書き文書に混ぜられた後のウォーターマークテキストの堅牢性を調べた.ウォーターマークは、人間と機械による言い換えによって弱められるが、言い換えは元のテキストのn-gramまたはそれ以上の長さのフラグメントを漏らす可能性が高く、十分なトークンが利用可能な場合には高信頼度の検出結果をもたらすことがわかった.(p.1-2)

Q: 電子透かしのテキストに加えられる可能性のある修正には、どのようなものがありますか?

A: ウォーターマーク付きテキストに対して可能な修正は何ですか?

ウォーターマーク付きテキストは、ユーザーのニーズに合わせて修正されることがあり、検出を回避するために完全に書き換えられることがあります.この研究では、人間による言い換え、非ウォーターマーク付きLLMによる言い換え、または長い手書き文書に混ぜ込まれた後のウォーターマーク付きテキストの堅牢性を調べました.研究結果、ウォーターマークは人間や機械による言い換えにも検出可能であることがわかりました.これらの攻撃はウォーターマークの強度を低下させますが、十分なトークンが入力された場合には高い信頼度の検出が確実に行われます.

ウォーターマーク付きテキストの効果は、verbatim LLM出力が直接検出器に供給される理想的なシナリオで示されていますが、これは理想化された設定です.実際には、人間は複数のソースを持つ大きな文書に機械生成のテキストを混ぜ込むことができます.さらに、人間は合成テキストの一部を改訂または言い換えることができます(別の言語モデルの支援を受ける可能性があります)、目的は検出を回避することです.

この研究では、Kirchenbauerらのアプローチに基づいて、現実的なシナリオで機械生成テキストを識別するための戦略としてのウォーターマークの信頼性を調査しています.私たちは、ウォーターマークがさまざまな種類の現実的な攻撃下で検出可能であるかどうかに焦点を当てています.

図1では、ウォーターマーク付きテキストの実際の環境での変更に対する堅牢性を視覚的に表現しています.機械による言い換え方法はテキストを短くする傾向があり、人間は赤いトークンの数を増やすことでウォーターマークの強度をかなり低下させることができます.また、短いスパンのウォーターマーク付きテキストを大きな文書にコピー&ペーストすることもできます.これらのシナリオでは、十分なトークンが入力された場合に高い信頼度の検出が確実に行われます.

ウォーターマーク付きテキストの信頼性を高める方法の1つは、生成されたテキストに imperceptibly なマークを付けることで、その起源を特定することができるようにすることです.

Q: 電子透かしテキストの堅牢性をどのように検証しているのか?

A: ウォーターマーク付きテキストの堅牢性を評価するために、このセクションでは、テキストが大きな文書に埋め込まれたり、人間によって編集されたり、他の言語モデルによって言い換えられたりするような、より複雑な使用例におけるウォーターマークの堅牢性を研究しています.このシナリオでは、ユーザーはテキストがウォーターマーク付きであることを知っていますが、ハッシュスキーム、分数γ、およびコンテキスト幅hについての知識はありません.彼らは検出を回避するために、テキストの一部またはすべてを言い換えます.このような場合、ウォーターマークの信頼性は以下の2つの観察によって理解できます.第1に、ユーザーはハッシュスキームにアクセスできない限り、元のテキストからn-gramを含まないように再表現されたテキストを作成しなければ、ウォーターマークを削除できません.ユーザーが長い単語(通常、複数のトークンを含む)またはフレーズを再利用する場合、ウォーターマークは残りますが、強度は低下します.第2に、人間がウォーターマークを削除するためにテキストを書き換えるヒューマンスタディを実施しました.人間は比較的強力な攻撃者ですが、十分なトークン(約800)を観察した後、1e−5の偽陽性率を強制しても、ウォーターマークは通常検出可能です.また、損失ベースの検出や検索などの他の最先端のアプローチと比較して、長いシーケンス長で攻撃された場合に苦戦することを示す信頼性の推定値を提供しています.これらのシナリオ全体を考慮すると、この研究では、ウォーターマーク付けが他の事後検出方法(損失ベースの検出やキャッシング/検索スキームなど)よりも堅牢であることがわかりました.これは、有利なサンプル数によるものです.

Q: 人間や機械が言い換えた後の透かしの検出性について、研究結果はどうなっていますか?

A: 人間や機械による言い換えを受けた後のウォーターマークの検出可能性に関する研究によると、ウォーターマークは検出可能であることがわかりました.これらの攻撃はウォーターマークの強度を低下させますが、言い換えによって元のテキストのn-gramやより長いフラグメントが漏洩する可能性が高く、十分なトークンが観測された場合には高信頼度の検出が行われます.例えば、強い人間による言い換えを受けた場合、1e−5の偽陽性率を設定した場合、平均800トークンを観測するとウォーターマークが検出可能です.これらのシナリオにおいて、十分なトークンが入力された場合には高信頼度の検出が確実に行われることがわかりました.(p.1)

Q: 電子透かしのロバスト性は、他の種類の検出器と比較してどうなのでしょうか?

A: ウォーターマーク技術の堅牢性は、他の種類の検出器と比較して、より優れていることが示されています.研究では、損失ベースの検出や検索などの他の最新のアプローチと比較して、ウォーターマーク技術の信頼性の推定値が提供されています.特に、長いシーケンス長で攻撃された場合、これらのアプローチは苦戦することが示されています.研究者たちは、異なる検出アプローチの強度と堅牢性を特定のテキスト分布の検出精度メトリックだけで特徴づけるのではなく、各アプローチが成功するために必要な機械生成テキストの量や、テキストシーケンス長の関数としての方法の振る舞いを測定することが正しい方法であると主張しています.これらのシナリオ全体を考慮すると、ウォーターマーク技術は、他の事後検出方法(損失ベースの検出やキャッシング/検索スキームなど)よりも堅牢であることが最終的に示されています.これは、大規模なドキュメント内に埋め込まれた短いスパンのウォーターマークテキストに対して特に有利であることが示されています.(p.1)