今回のテーマ:OmniMtion, MusicGen, ChatDBによるLLMのシンボリックメモリ, LEACEによるコンセプト消去, SpQRによるLLM重みの圧縮, ChatGPTにユーモアはあるのか?など.

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の9本となります.

- Tracking Everything Everywhere All at Once (発行日:2023年06月08日)

- Simple and Controllable Music Generation (発行日:2023年06月08日)

- ChatGPT is fun, but it is not funny! Humor is still challenging Large Language Models (発行日:2023年06月07日)

- ChatDB: Augmenting LLMs with Databases as Their Symbolic Memory (発行日:2023年06月06日)

- LEACE: Perfect linear concept erasure in closed form (発行日:2023年06月06日)

- SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression (発行日:2023年06月05日)

- Orca: Progressive Learning from Complex Explanation Traces of GPT-4 (発行日:2023年06月05日)

- Fine-Grained Human Feedback Gives Better Rewards for Language Model Training (発行日:2023年06月02日)

- Hiera: A Hierarchical Vision Transformer without the Bells-and-Whistles (発行日:2023年06月01日)

Tracking Everything Everywhere All at Once

著者:Qianqian Wang, Yen-Yu Chang, Ruojin Cai, Zhengqi Li, Bharath Hariharan, Aleksander Holynski, Noah Snavely

発行日:2023年06月08日

最終更新日:2023年06月08日

URL:http://arxiv.org/pdf/2306.05422v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

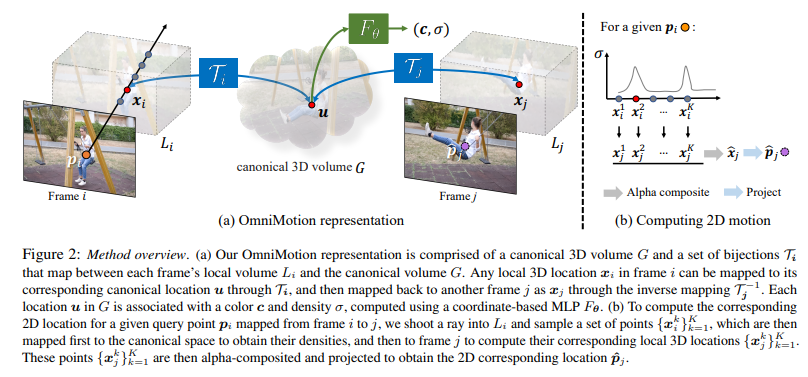

この論文では、新しいテスト時最適化手法を提案し、ビデオシーケンスから密集かつ長距離の動きを推定する方法を紹介しています.従来のオプティカルフローやパーティクルビデオトラッキングアルゴリズムは、通常、限られた時間枠内で動作し、遮蔽物を追跡するのに苦労し、推定された動きの軌跡のグローバルな一貫性を維持することができません.本研究では、正確なフルレングスの動き推定を可能にする完全でグローバルに一貫した動き表現であるOmniMotionを提案しています.OmniMotionは、準3Dの標準ボリュームを使用してビデオを表現し、ローカルスペースと標準スペースの間の双射によるピクセル単位のトラッキングを実行します.この表現により、グローバルな一貫性を確保し、遮蔽物を追跡し、カメラとオブジェクトの動きの任意の組み合わせをモデル化することができます.TAP-Vidベンチマークと実世界の映像での広範な評価により、本手法が従来の最先端の手法を量的・質的に大幅に上回ることが示されました.詳細な結果については、プロジェクトページを参照してください:http://omnimotion.github.io/.

Q&A:

Q: この文章で紹介されている新しいテスト時間最適化手法とはどのようなものでしょうか?

A: この手法は、ビデオシーケンスから密で長距離の動きを推定するために使用されます.これは、光学フローや粒子ビデオトラッキングアルゴリズムよりも優れた性能を発揮し、完全でグローバルに一貫した動きの軌跡を維持することができます.この手法は、OmniMotionと呼ばれる新しいビデオモーション表現を導入し、一般的なビデオに対応し、正確でスムーズな長距離の動きを実現します.この手法は、以前の最先端の手法よりも優れた性能を発揮します.

Q: この方式で導入された新しい映像の動き表現は何と呼ばれているのでしょうか?

A: 本研究では、全てのビデオ情報を使用して、各ピクセルの全長の動きの軌跡を共同で推定するホリスティックなアプローチを提案しています.この手法は、OmniMotionと呼ばれ、カノニカル3Dボリュームがローカル-カノニカルのセットを介して各フレームのローカルボリュームにマップされる準3D表現を使用します.この表現は、任意のフレームの任意のピクセルでクエリでき、全ビデオ全体にわたるスムーズで正確な動きの軌跡を生成します.この表現は、点が遮蔽されている場合に識別し、遮蔽を通して点を追跡することができます.OmniMotionは、グローバルに一貫した動き表現を提供し、ビデオ内のすべてのピクセルの正確な全長の動き推定を可能にします.この表現は、ローカルとカノニカル空間の双射によるピクセルごとのトラッキングを実行し、グローバル一貫性を確保し、遮蔽を通して追跡し、カメラとオブジェクトの動きの任意の組み合わせをモデル化することができます.この手法は、TAP-Vidベンチマークと実世界の映像での広範な評価により、従来の最先端の手法を大幅に上回る定量的および定性的な性能を発揮することが示されています.この手法で導入された新しいビデオモーション表現は、OmniMotionと呼ばれます.(p.1,4-8)

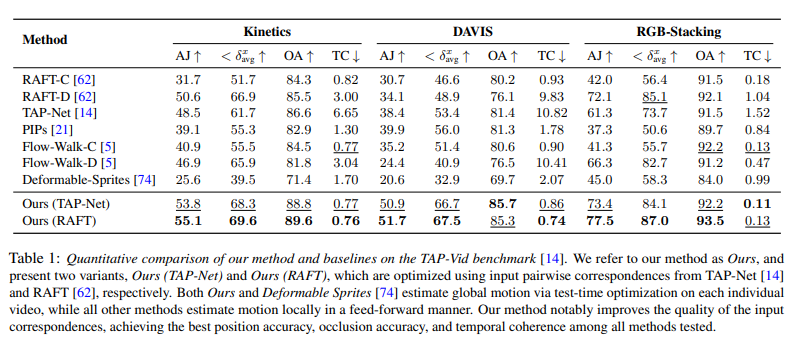

Q: この新方式は、これまでの最先端方式と比較して、性能的にどうなのでしょうか?

A: 本手法は、TAP-Vidベンチマークにおいて、位置精度、遮蔽精度、および時間的一貫性において最高の性能を発揮し、異なるデータセットにおいて一貫して優れた性能を示しています.また、RAF-D、TAP-Net、Flow-Walk-Dなどの従来の手法と比較して、グローバルに一貫した表現により、時間的一貫性が大幅に向上しています.さらに、RAFT-C、PIPs、Flow-Walk-Cなどのチェーンベースの手法と比較して、特に長時間のビデオにおいて、追跡性能が向上しています.(p.6)

Q: OmniMotionと従来のオプティカルフローやパーティクルビデオトラッキングのアルゴリズムとの違いは何でしょうか?

A: OmniMotionと従来の光流や粒子ビデオトラッキングアルゴリズムの違いは、OmniMotionが完全でグローバルに一貫した運動表現を提供し、ビデオ内のすべてのピクセルの正確なフルレングスの運動推定を可能にすることです.OmniMotionは、局所空間と正準空間の間の双射によるピクセルごとのトラッキングを実行し、ビデオを準3Dカノニカルボリュームで表現します.この表現により、グローバルな一貫性を確保し、遮蔽を通過し、カメラとオブジェクトのどの組み合わせでもモデル化できます.一方、従来の光流や粒子ビデオトラッキングアルゴリズムは、限られた時間窓内で動作し、遮蔽を通過し、推定された運動軌跡のグローバルな一貫性を維持することが困難であるという問題があります.

Q: 提案した手法は、これまでの最先端手法と比較して、どのように評価されたのでしょうか?

A: 提案手法はTAP-Vidベンチマーク[14]で評価され、長いビデオクリップ上でのポイントトラッキングの性能を評価するために設計されています.ベンチマークには、正確な人間の注釈が付いた実世界のビデオと、完璧なグラウンドトゥルースのポイントトラックを持つ合成ビデオが含まれています.各ポイントトラックは、ビデオ全体を通して注釈が付けられ、ターゲットフレーム内の3D位置にマッピングし、その3D位置の透過率をチェックすることで、オクルージョンを検出します.定量的な比較では、提案手法は異なるデータセット全体で最高の位置精度、オクルージョン精度、および時間的一貫性を達成し、以前の最先端の手法と比較して優れた性能を発揮しています.これらの結果は、表1と図3に示されています.(p.6)

Q: OmniMotionで使われている準3Dカノニカルボリュームとは何ですか?

A: OmniMotionで使用される準3Dカノニカルボリュームは、観察されたシーンの3次元アトラスとして機能するカノニカルボリュームGを使用して、ビデオのコンテンツを表現します.G上の座標ベースのネットワークFθを定義し、各正準3D座標u∈Gを密度σと色cにマップします.Gに格納された密度は重要であり、各ローカルフレームと正準フレームの間の双射を確立することにより、OmniMotionはすべてのローカルフレーム間でグローバルにサイクル一貫性のある3Dマッピングを保証し、実世界のメトリック3D参照フレーム間の1対1の対応を模倣します.さらに、各ピクセルに投影されるすべてのシーンポイントとその相対的な深度順序に関する情報をOmniMotionは保持しており、一時的に視野から外れた場合でもポイントを追跡できます.(p.3)

Q: OmniMotionのカノニカルボリュームGは何のためにあるのでしょうか?

A: OmniMotionにおけるカノニカルボリュームGの目的は、観測されたシーンの三次元アトラスとして機能することです.Gは、NeRF [41]と同様に、各正準3D座標u∈Gを密度σと色cにマップする座標ベースのネットワークFθを定義するために使用されます.Gに格納された密度は重要であり、各フレームのローカル体積にマップされるときに、視線の遮蔽を考慮して、各シーンポイントの可視性を決定するために使用されます.(p.4-5)

Q: OmniMotionは、どのようにしてグローバルな一貫性を確保し、オクルージョンを乗り越えて追跡するのですか?

A: OmniMotionは、各ローカルフレームと正準フレームの間に双射を確立することにより、グローバルにサイクル一貫性のある3Dマッピングを保証することで、動的な3D再構成を困難にする要因を克服しています.また、OmniMotionは、各ピクセルに投影されたすべてのシーンポイントとその相対的な深度順序に関する情報を保持し、一時的に視野から外れた場合でもポイントを追跡できるようにします.この方法は、点が遮蔽されている場合にも、点を追跡することができます.これにより、動的なシーンでも正確で一貫したトラックを提供することができます.OmniMotionの詳細については、セクション4で説明されています.(p.3-5)

Q: OmniMotionでは、3Dマッピングのグローバルサイクルの一貫性を確保するために、ローカルフレームとカノニカルフレームの間のバイジェクションをどのように確立するのですか?

A: オムニモーションは、各ローカルフレームとカノニカルフレームの間に双射を確立することによって、グローバルサイクル一貫性のある3Dマッピングを保証します.これにより、実世界のメトリック3D参照フレーム間の1対1の対応関係を模倣し、すべてのローカルフレーム間でグローバルにサイクル一貫性のある3Dマッピングを保証します.この双射により、一時的に視界から消えた場合でも、各ピクセルに投影されたすべてのシーンポイントとその相対的な深度順序に関する情報を保持することができ、ポイントを追跡することができます.これにより、動的な3D再構成が困難な曖昧さを回避しながら、一貫性と正確性のある長期的な追跡を実現します.(p.3)

Q: OmniMotionは、動的なシーンで正確かつ一貫したトラッキングを可能にするために、一時的に視界から外れても、各ピクセルについてシーンポイントやその相対的な奥行き順に関する情報をどのように保持しているのでしょうか.

A: OmniMotionは、各ピクセルに投影されたすべてのシーンポイントとその相対的な深度順序の情報を保持することで、一時的に視界から外れた場合でもポイントを追跡できるようにしています.これにより、動的なシーンでも正確で一貫したトラッキングが可能になります.具体的には、OmniMotionは、3D参照フレーム間の実世界の対応関係と、3Dバイジェクションを使用して、シーンのすべてのポイントの軌跡をエンコードするデータ構造を提供します.このデータ構造は、観察されたシーンの3Dアトラスである標準的なボリュームGを使用して表現されます.各標準的な3D座標u∈Gに対して、座標ベースのネットワークFθが定義され、密度σと色cにマップされます.Gに格納された密度は重要であり、各ピクセルに対して、そのピクセルに投影されたすべてのシーンポイントとその相対的な深度順序を保持することができます.これにより、動的なシーンでも正確で一貫したトラッキングが可能になります.(p.4)

Simple and Controllable Music Generation

著者:Jade Copet, Felix Kreuk, Itai Gat, Tal Remez, David Kant, Gabriel Synnaeve, Yossi Adi, Alexandre Défossez

発行日:2023年06月08日

最終更新日:2023年06月08日

URL:http://arxiv.org/pdf/2306.05284v1

カテゴリ:Sound, Artificial Intelligence, Machine Learning, Audio and Speech Processing

概要:

この論文では、条件付き音楽生成の課題に取り組んでいます.MusicGenという単一の言語モデル(LM)を紹介し、複数の圧縮された離散的な音楽表現、つまりトークンに対して動作することができます.従来の研究とは異なり、MusicGenは効率的なトークン交互配置パターンと一段階のトランスフォーマーLMから構成されており、階層的にモデルを重ねたり、アップサンプリングしたりする必要がありません.このアプローチに従って、テキストの説明や旋律的な特徴に基づいて条件付けられた高品質のサンプルを生成することができます.自動評価と人間の研究の両方を考慮した広範な実証評価を行い、提案手法が標準的なテキストから音楽へのベンチマークで評価されたベースラインよりも優れていることを示しました.MusicGenを構成する各コンポーネントの重要性についての削除研究を通じて、光を当てました.音楽サンプル、コード、モデルはhttps://github.com/facebookresearch/audiocraftで利用可能です.

Q&A:

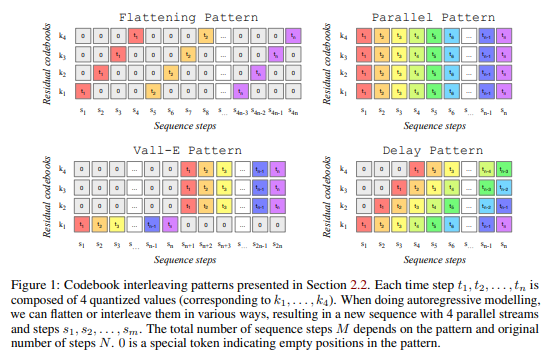

Q: MusicGenとは何か、条件付き音楽生成の先行研究とどう違うのか?

A: 音楽生成の条件付きタスクに取り組むため、MUSIC GENという単一の言語モデルを導入する.MUSIC GENは、トークンとして圧縮された複数の音楽表現ストリーム上で動作する単一段階のトランスフォーマー言語モデルであり、トークンの交互配置によって、階層的またはアップサンプリングなど、複数のモデルを連鎖する必要がなくなる.MUSIC GENは、テキストの説明や旋律的な特徴に基づいて条件付けられた高品質のサンプルを生成できる.MUSIC GENは、複数の並列音響トークンストリームをモデル化するための一般的なフレームワークを提供し、非監督的な旋律条件付けを導入して、生成された音楽が与えられた和声と旋律構造に一致するようにする.MUSIC GENは、単一のモデルでテキストと旋律条件付けの両方を実行し、生成された音声が提供された旋律に一致し、テキスト条件付け情報に忠実であることを示す.MUSIC GENは、高品質の音楽を32 kHzで生成するための単純で効率的なモデルを提供し、効率的なコードブックの交互配置戦略を通じて単一段階の言語モデルで一貫した音楽を生成できることを示す.MUSIC GENは、EnCodec [Défossez et al., 2022]オーディオトークナイザーからの量子化ユニット上のモデルであり、低フレームレートの離散表現から高品質の再構成を提供する.MUSIC GENは、従来の条件付き音楽生成の先行研究とは異なり、単一のモデルで高品質のサンプルを生成できる. (p.1-2)

Q: MUSIC GENは、生成された音楽が与えられた和声やメロディーの構造に合致し、テキストのコンディショニング情報に忠実であることをどのように保証しているのでしょうか.

A: MUSIC GENは、与えられた和声とメロディ構造に合わせて生成された音楽が、テキスト条件情報に忠実であることを確保するために、テキストまたはメロディ表現に基づく自己回帰トランスフォーマーベースのデコーダーを使用します.音声トークナイザーであるEnCodecからの量子化された単位を使用することで、低フレームレートの離散表現から高品質の再構成を提供します.また、クロマグラム条件付けによってトレーニングされたMUSIC GENは、与えられたメロディに従う音楽を生成することができます.これにより、生成された出力をより良く制御することができます.さらに、MUSIC GENは、OVLとRELの両方がほぼ同じままであることから、推論時にクロマを落としても堅牢であることが示されています.(p.2)

Q: MusicGenは、テキスト記述やメロディーの特徴を条件として、どのように高品質のサンプルを生成しているのでしょうか?

A: 音楽生成モデルMusicGenは、テキストの説明や旋律の特徴に基づいて条件付けられた高品質のサンプルを生成することができます.これにより、生成された出力をより細かく制御することができます.MusicGenは、オートレグレッシブなトランスフォーマーベースのデコーダーで構成されており、EnCodecオーディオトークナイザーからの量子化された単位をモデル化しています.音声の高品質な再構成を提供するEnCodecは、低フレームレートの離散表現から高い忠実度で再構成することができます.MusicGenは、テキストや旋律表現に基づいて条件付けられたモデルであり、提供された旋律とテキストの条件付け情報に忠実であると同時に、生成されたオーディオが一貫していることを示しています.これらの特徴により、MusicGenは、標準的なテキストから音楽へのベンチマークにおいて、評価されたベースラインよりも優れた性能を発揮します.(p.1,2)

Q: MusicGenで、複数のモデルをカスケード接続する必要をなくすために、どのような工夫がされているのでしょうか.

A: 論文では、MUSIC GENは、トークンの効率的なコードブック交互配置戦略を通じて、単一段階の言語モデルで一貫した音楽を生成できると述べています.これにより、階層的またはアップサンプリングなど、複数のモデルを連鎖させる必要がなくなります.(p.2) つまり、MUSIC GENは、単一のモデルでテキストとメロディに基づいた音楽生成を行うことができ、高品質な音楽を生成するために複数のモデルを連鎖させる必要がないというアプローチを採用しています.

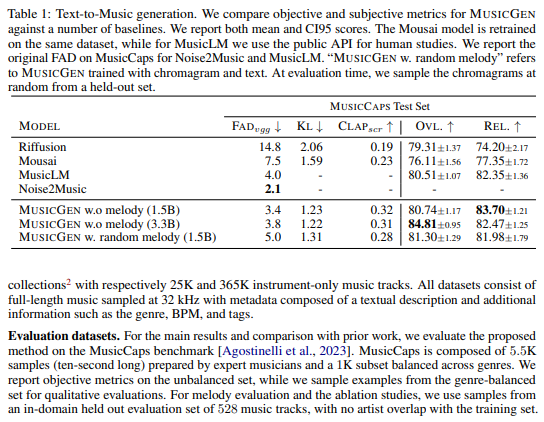

Q: MusicGenの評価で使用されている標準的なText-to-Musicベンチマークは何でしょうか?

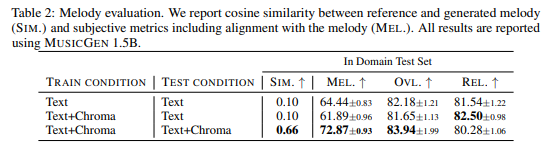

A: 評価ベンチマークとして、MusicCapsベンチマーク[Agostinelli et al.、2023]で提案手法を評価します.MusicCapsは、専門のミュージシャンによって準備された5.5Kのサンプル(10秒間)と、ジャンルに沿ってバランスの取れた1Kのサブセットで構成されています.定量的評価には、バランスの取れていないセットで客観的な指標を報告し、定性的評価にはジャンルに沿ったバランスの取れたセットから例をサンプリングします.また、メロディの評価と抜粋研究には、トレーニングセットとアーティストの重複がない528の音楽トラックからのサンプルを使用します.

Q: 自動実験と人体実験の両方を考慮した実証評価の結果は?

A: 自動および人間の研究を考慮した広範な実証評価により、提案された手法が標準的なテキストから音楽へのベンチマークにおいて、評価されたベースラインよりも優れていることが示されました.人間の研究では、オーバーオールクオリティ(OVL)とテキスト入力に対する関連性(REL)の2つの側面を評価するように設定されました.オーバーオールクオリティテストでは、被験者に提供されたサンプルの知覚的品質を1から100の範囲で評価するように求めました.テキスト関連性テストでは、被験者に1から100のスケールでオーディオとテキストの一致を評価するように求めました.被験者はAmazon Mechanical Turkプラットフォームを使用して募集されました.各サンプルは少なくとも5人の被験者によって評価されたランダムにサンプリングされたファイルを評価しました.(p.14)

Q: 音楽ジェネで行われたアブレーション試験の結果はどうだったのでしょうか?

A: MusicGenの実験結果に関するablation studyでは、Section 2.3で説明されたテキストエンコーダーとSection 3.1で提示されたテキスト拡張戦略のコアコンポーネントについてさらに詳細な実験結果が提供されました.この研究では、音楽生成におけるテキスト条件付けのために使用されるテキストエンコーダーとテキスト拡張戦略の重要性について明らかにしました.提案手法は、自動評価と人間の評価の両方を考慮した広範な実証評価を行い、標準的なテキストから音楽へのベンチマークにおいて、評価されたベースラインに比べて大幅に優れていることが示されました.MusicGenの主観的評価は、最高のベースラインの80.5に対して84.8であり、提案手法が高品質のサンプルを生成することが示されました.さらに、ablation studyにより、全体的なモデルのパフォーマンスに対する各コンポーネントの重要性について明らかにしました.(p.4)

Q: 本稿で紹介した新手法のコード実装のためのurlはどうなっていますか?

A: 本論文で導入された新しい手法のコード実装のURLは、github.com/facebookresearch/audiocraftです.論文中のContextによると、サンプル、コード、およびモデルはこのURLで利用可能です.これは(p.1)で確認できます.

ChatGPT is fun, but it is not funny! Humor is still challenging Large Language Models

著者:Sophie Jentzsch, Kristian Kersting

発行日:2023年06月07日

最終更新日:2023年06月07日

URL:http://arxiv.org/pdf/2306.04563v1

カテゴリ:Artificial Intelligence, Computation and Language, Human-Computer Interaction, Machine Learning

概要:

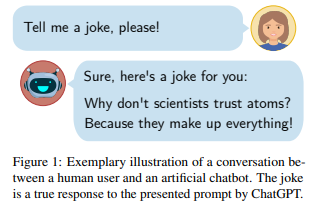

ユーモアは、人間のコミュニケーションにおいて中心的な要素であり、人工エージェントにとっては未解決の課題である.大規模言語モデル(LLM)は、暗黙的かつ文脈に即した情報を捉えることができるようになってきており、特にOpenAIのChatGPTは最近、大きな注目を集めている.GPT3ベースのモデルは、人間レベルでコミュニケーションを行い、ジョークを言うことさえできるようになっている.しかし、ChatGPTは本当に面白いのだろうか?本研究では、ChatGPTのユーモアセンスをテストすることを目的として、ジョークの生成、説明、検出などの一連の実験を行った.モデル自体にアクセスできないため、プロンプトベースの実験を行った.実験の結果、ジョークはハードコードされているわけではなく、ほとんどが同じ25のジョークであったことがわかった.また、ジョークの特徴はChatGPTを誤認させることがある.システムは正しいジョークを正確に説明することができるが、無効なジョークに対しては架空の説明を提供することがある.ChatGPTはまだ計算上のユーモアを解決していないが、ジョークの分類に向けた大きな進歩であると言える.今後の研究に期待が寄せられる.

Q&A:

Q: これまで人工エージェントが解決してこなかった、人間のコミュニケーションの中心的な側面は何でしょうか?

A: 人工知能にとって未解決の中心的な問題は、人間のコミュニケーションにおける「ユーモア」です.(p.1)

この論文では、人工知能におけるユーモア理解の研究について述べられています.これまでの研究では、データ駆動型のアプローチが主流であり、ChatGPTなどの事前学習済み言語モデルが中心的な役割を果たしています.しかし、人間のように新しいジョークを即興で作り出すことはできないため、人工知能が学習したことを理解できるかどうかは非常に難しい問題であり、哲学的な側面もあると論文では述べられています.しかし、GPTベースのモデルは、暗黙的で文脈的な情報を捉える能力が向上しており、新しい計算研究の新しい章を開く可能性があるとされています.(p.1)

つまり、人工知能にとって未解決の中心的な問題は、人間のコミュニケーションにおけるユーモア理解です.しかし、GPTベースのモデルの能力向上により、新しい計算研究の可能性があるとされています.(p.1)

Q: ChatGPTは、ユーモアをうまくコミュニケーションに取り入れることができたのでしょうか?

A: ChatGPTは人間らしいレベルでコミュニケーションをとり、ジョークを言うことができるが、実験によると、そのジョークはほとんどが25種類のジョークの再利用であり、新しく生成されたものではないことがわかった.また、ChatGPTは有効なジョークを正確に説明できるが、無効なジョークに対しては架空の説明を提供することがある.そのため、ChatGPTはまだユーモアをうまく理解できていないと言える.(p.1)

Q: このモデルはどのように実験されたのでしょうか?

A: 実験では、ChatGPTの内部構造が非公開であるため、プロンプトベースの実験を行いました.具体的には、ジョーク生成、ジョーク説明、ジョーク検出の3つの実験条件を組み合わせて行いました.ジョーク生成実験では、2023年1月22日から31日まで、ジョーク説明実験では2月3日から13日まで、ジョーク検出実験では2月23日から3月1日まで行われました.生成されたジョークの大部分は、25のダジャレのうちのいくつかであり、そのダジャレは論文中に示されています.実験の詳細については、セクション3で概説されています.(p.1-2)

Q: この研究で組み合わされた3つの実験条件とは?

A: 本研究で組み合わされた3つの実験条件は、”wordplay”、”structure”、”topic”の3つの特徴のうち、どれが含まれているかを示す”Included Characteristics”である.それぞれの条件には、元の25のサンプル、または4つの変更条件のいずれかが含まれており、それぞれの条件には[P]ジョーク、[H]潜在的に面白い、または[N]ジョークではないという分類が与えられている.(p.3)

Q: 紙面で紹介された25個のダジャレについて、詳しい情報を教えてください.

A: 25個のダジャレのうち、T1からT25までの25個のダジャレは、すべて同じであった.このうち、最も多かったのはT1で、「なぜかかしは賞を受賞したのか?」というもので、140回出現した.また、T2の「なぜトマトは赤くなったのか?」というものは122回出現した.これらの25個のダジャレのうち、上位4つのダジャレは100回以上出現し、T13からT25までのダジャレは20回未満しか出現しなかった.これら25個のダジャレは、全体の90%を占めており、上位4つのダジャレだけで50%以上を占めている.これは、ChatGPTの応答パターンに限界があることを示唆している.これらの25個のダジャレは、すべて既存のジョークであり、インターネット検索で簡単に見つけることができる.909個のサンプルが上位25個のダジャレのいずれかと同一であったが、残りの99個のサンプルは、新しいコンテンツを含んでいるわけではなかった.これらのほとんどは、上位のダジャレの変更版であった.これらの情報は、B Joke Generation – Top 25 Jokes (p.1)から抽出された.

Q: 実験による実証的な根拠は?

A: 実験の結果、ChatGPTが生成するジョークの多様性は限られており、1008個の生成されたジョークのうち90%以上が同じ25個のジョークであったことが示された.また、ChatGPTは有効なジョークを正確に説明することができるが、無効なジョークに対しては架空の説明を提供することもあることがわかった.これらの結果は、4.1節で行われたジョーク生成の実験によって得られたものである.(p.4)

Q: 実験で生成された1008個のジョークのうち、ChatGPTで生成された同じ25個のジョークは何%だったのでしょうか.

A: 実験で生成された1008のジョークのうち、ChatGPTが生成した同じ25のジョークの割合は約90%であった.また、その25のジョークのうち、最も多く生成された4つのジョークは50%以上を占めていた.これは、ChatGPTの応答パターンの多様性が限られていることを示している.これらのジョークは、既存のジョークであり、インターネット検索で即座に同じ文言で見つけることができるため、ChatGPTのオリジナルの創造物とは見なされない.残りの99のサンプルのうち、約半数は、トップのジョークの変更版であり、意味を失っているものもあった.したがって、ChatGPTが生成したジョークの多様性は限られているが、一部の変更版はまだ意味を持っている. (p.1)

Q: ChatGPTは、無効なジョークに対して嘘の説明をすることができますか?

A: ChatGPTが無効なジョークに対して虚偽の説明を提供する可能性があることが示唆されています.ChatGPTは、学習されたパターンに合わないシーケンスを説明するのに苦労し、有効な説明がない場合でも、虚偽のが出てくることがあります.ChatGPTは、ジョークの構造、言葉遊び、トピックなどの特徴を理解しているため、表面的な特徴だけでジョークを誤認識することはありません.ただし、ChatGPTは、学習されたパターンに合わない状況で適用しようとすることがあります.(p.4-5)

Q: ChatGPTはコンピュテーショナル・ユーモアを解決したのでしょうか?

A: 現時点では、ChatGPTはまだ計算ユーモアを解決していないと考えられています.これはAI-complete問題であるとさえ考えられています.しかし、機械学習の進歩により、人間とコンピューターの相互作用を大幅に向上させる可能性があります.(p.1) また、Sophie JentzschとKristian Kerstingによる研究によると、ChatGPTは面白いとは言えないとされています.ChatGPTは、ジョークの典型的な特徴に惑わされることがあり、ジョークの分類において誤解を招くことがあります. したがって、ChatGPTはまだ計算ユーモアを解決していないと考えられます.

ChatDB: Augmenting LLMs with Databases as Their Symbolic Memory

著者:Chenxu Hu, Jie Fu, Chenzhuang Du, Simian Luo, Junbo Zhao, Hang Zhao

発行日:2023年06月06日

最終更新日:2023年06月07日

URL:http://arxiv.org/pdf/2306.03901v2

カテゴリ:Artificial Intelligence, Computation and Language, Databases, Machine Learning

概要:

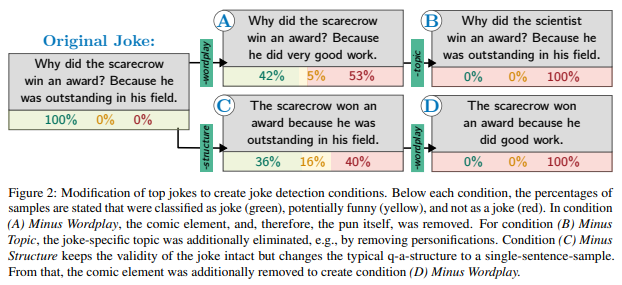

大規模言語モデル(LLM)にはメモリがあり、計算的にはユニバーサルです.しかし、主流のLLMはメモリを十分に活用しておらず、設計は生物学的な脳に強く影響を受けています.従来のニューラルメモリメカニズムは近似的な性質を持ち、誤差の蓄積に陥りやすいため、複雑な推論をシミュレートするためにLLMをサポートすることはできません.本論文では、現代のコンピュータアーキテクチャからインスピレーションを得て、複雑なマルチホップ推論に対応するためにLLMに象徴的なメモリを追加することを提案しています.この象徴的なメモリフレームワークは、LLMと一連のSQLデータベースとして具現化され、LLMはSQL命令を生成してSQLデータベースを操作します.提案されたメモリフレームワークの有効性を、複雑な推論を必要とする合成データセットで検証しました.プロジェクトのウェブサイトはhttps://chatdatabase.github.io/で利用可能です.

Q&A:

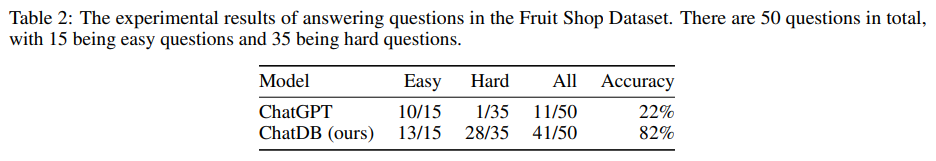

Q: LLMのシンボリックメモリとしてデータベースを増強する目的は何でしょうか?

A: LLMにデータベースをシンボリックメモリとして追加することの目的は、構造化された履歴データの保存とSQL文を使用したシンボリックおよび複雑なデータ操作を可能にすることです.ChatDBは、ユーザー入力を複数のステップの中間メモリ操作に変換することで、効果的なメモリ操作を実現するチェーンオブメモリアプローチを提供し、複雑なマルチテーブルデータベースの相互作用を改善した精度と安定性で処理できるようになります.ChatDBは、シンボリックメモリをLLMに追加することで、マルチホップ推論能力を向上させ、エラーの蓄積を防止することができます.これにより、ChatDBは合成データセットでChatGPTを大幅に上回る性能を発揮します.(p.1)

Q: 従来の神経記憶機構が、複雑な推論をシミュレートするLLMのサポートに適していないのはなぜか?

A: 論文によると、従来のニューラルメモリメカニズムは、近似的な性質と誤差の蓄積により、複雑な推論をシミュレートするためにLLMを完全に活用することができないため、LLMに適していないとされています.また、従来のニューラルメモリをLLMに組み込むことは、歴史的情報を記憶、取得、操作することに困難が生じることが多く、特に複雑なマルチホップ推論を必要とするタスクにおいては、誤差の蓄積により、会話の追跡が失われ、正確な応答が得られなくなることがあると述べられています.これは、(a)歴史的情報を構造化された形式で保存しないため、(b)記憶に保存された情報の操作が象徴的でなく、すべての情報がいくつかのベクトル類似性計算に依存しているため、誤差が蓄積されることが原因です.(p.1-2)

従来のニューラルメモリメカニズムは、LLMが複雑な推論をシミュレートするために完全に活用することができないため、LLMに適していないとされています.これは、歴史的情報を構造化された形式で保存しないため、記憶に保存された情報の操作が象徴的でなく、すべての情報がいくつかのベクトル類似性計算に依存しているため、誤差が蓄積されることが原因です.(p.1-2)

Q: 歴史的な情報を構造的に保存することができず、ベクトルの類似度計算に頼っていることが、神経記憶におけるエラーの蓄積にどのように寄与しているのか.

A: これは、特に複雑な多段階の推論を必要とするタスクにおいて、記憶内の歴史的情報を保存、取得、操作することが困難であるためです. (p.3)

Q: 提案されているシンボリックメモリのフレームワークはどのようなものなのでしょうか?

A: 提案されたシンボリックメモリフレームワークは、LLMと一連のSQLデータベースとして具現化され、LLMはSQL命令を生成してSQLデータベースを操作します.シンボリックメモリフレームワークは、複雑な推論を必要とする合成データセットでの有効性を検証しています.ChatDBのプロジェクトウェブサイトはhttps://chatdatabase.github.io/で利用可能です.ChatDBの全体的なワークフローは、LLMコントローラーがメモリへの読み取りと書き込み操作を制御することです.シンボリックメモリとメモリチェーンアプローチの利点と機能を実証し、複雑な推論を強化し、エラーの蓄積を防止することを示しています.シンボリックメモリは、中間結果の正確なストレージメカニズムを提供することにより、正確で信頼性の高い操作を可能にします.また、SQLなどの象徴的言語の使用により、格納された情報の象徴的な計算と操作が可能になります.ChatDBの実験的評価により、ChatGPTと比較して性能が大幅に向上することが観察されました.シンボリックメモリの統合により、ChatDBのモデルは、管理設定でのさまざまなクエリと推論タスクを処理する能力が大幅に向上しました.この改善は、LLMでシンボリックメモリを活用する利点と効果を強調しています.(p.1)

Q: 提案するシンボリックメモリの枠組みは、LLMと一連のSQLデータベースとして現れ、LLMはSQLデータベース上でどのように動作するのか.

A: 提案されたシンボリックメモリフレームワークは、LLMと一連のSQLデータベースとして表現され、LLMはSQL命令を生成してSQLデータベースを操作します.シンボリックメモリフレームワークは、複雑な推論を必要とする合成データセットでの有効性が検証されています.ChatDBは、LLMコントローラーとそのメモリの2つのコンポーネントで構成されており、LLMコントローラーは、メモリへの読み書き操作を制御する責任があります.LLMのメモリは、象徴的または非象徴的、またはその両方の組み合わせであることができ、過去の情報を保存し、必要に応じてLLMがユーザー入力に応答するための情報を提供する責任があります.ChatDBでは、データベースを象徴的なメモリとして使用することに焦点を当てており、これにより、象徴的な言語であるSQL文の実行を通じて、過去の情報を構造化された形式で保存することができます.これらのSQL文はLLMによって生成されます.データベースを象徴的なメモリとして組み込むことは、過去のデータの正確な記録、修正、クエリ、削除、分析が必要なシナリオで特に有用です.例えば、店舗マネージャーは、日々の売上記録を維持する必要があり、テキストや行列をメモリとして使用することは適していません.しかし、データベースを外部象徴的メモリとして使用することは、この問題を解決することができます.(p.1)

Q: シンボリックメモリはどのような利点や機能を提供し、複雑な推論を改善し、エラーの蓄積を防ぐのか.

A: シンボリックメモリは、中間結果の正確なストレージメカニズムを提供することで、正確で信頼性の高い操作を可能にし、複雑な推論を改善し、エラーの蓄積を防止することができます.また、SQLなどのシンボリック言語の使用により、格納された情報のシンボリック計算と操作が可能になります.ChatDBにシンボリックメモリを統合することで、管理設定でのさまざまなクエリと推論タスクの処理能力が大幅に向上し、ChatGPTよりも性能が向上することが実験的に確認されました.外部データベースをシンボリックメモリとして活用することで、ChatDBはこの実験で優れた性能を発揮しました.

Q: ChatDBのCoMアプローチでは、中間ステップでSQL文をどのように活用しているのでしょうか.

A: SQL文を使用した複雑なデータ操作を行うChatDBのCoMアプローチは、ユーザー入力を中間メモリ操作の多段階に変換することで、ChatDBが複雑な複数テーブルのデータベース相互作用を正確かつ安定して処理できるようにし、結果を返します.ChatDBは、前のSQL文の結果に基づいて、メモリ操作ステップを更新するかどうかを決定し、この操作を実行します.ChatDBは、すべてのメモリ上の操作が完了するまで、同じ手順に従って次のステップを実行します.(p.3-5)

Q: 提案されたメモリーフレームワークの有効性はどのように検証されたのでしょうか?

A: 提案された記憶フレームワークの有効性は、複雑な推論を必要とする合成データセットで検証されました.この記憶フレームワークは、LLMとSQLデータベースのセットとして具現化され、LLMはSQL命令を生成してSQLデータベースを操作します.また、フルーツショップの実験により、ChatDBのデータベース記憶が最新のフルーツショップの状態を反映するように更新されることが示され、ChatDBの記憶が現在の状態を効果的に追跡することができることが示されました.この記憶フレームワークの有効性が検証された結果は、プロジェクトのウェブサイトで確認できます.(p.1)

LEACE: Perfect linear concept erasure in closed form

著者:Nora Belrose, David Schneider-Joseph, Shauli Ravfogel, Ryan Cotterell, Edward Raff, Stella Biderman

発行日:2023年06月06日

最終更新日:2023年06月06日

URL:http://arxiv.org/pdf/2306.03819v1

カテゴリ:Machine Learning, Computation and Language, Computers and Society

概要:

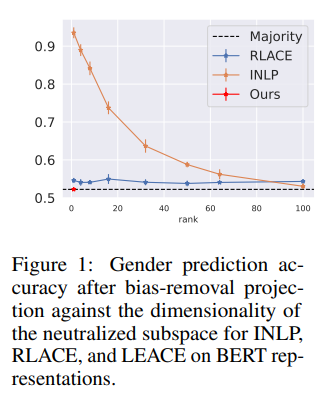

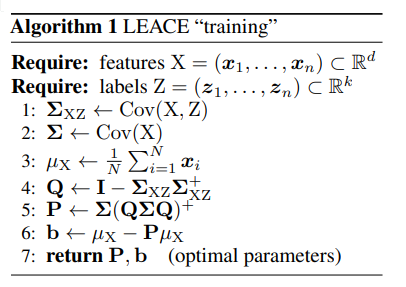

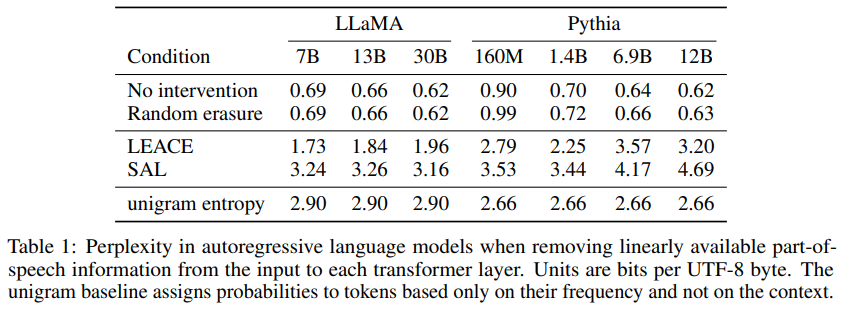

この論文では、コンセプト消去という手法が紹介されている.この手法は、表現から指定された特徴を取り除くことを目的としており、公平性の向上(例えば、分類器が性別や人種を使用しないようにする)や解釈可能性の向上(例えば、モデルの振る舞いに変化を観察するためにコンセプトを取り除く)に役立つ.本論文では、全ての線形分類器がコンセプトを検出できないようにしながら、表現に最小限の損傷を与えることが証明された閉形式の手法であるLEAst-squares Concept Erasure(LEACE)が紹介されている.この手法を、全ての層からターゲットのコンセプト情報を消去する「コンセプトスクラビング」という新しい手順を用いて、大規模言語モデルに適用した.本手法の有用性を示すために、2つのタスクに取り組んだ.1つ目は、言語モデルが品詞情報にどの程度依存しているかを測定することであり、2つ目は、BERT埋め込みのジェンダーバイアスを減らすことである.本論文のコードは、https://github.com/EleutherAI/concept-erasureで公開されている.

Q&A:

Q: コンセプト消去の目的は何か、機械学習モデルにおける公平性と解釈可能性をどのように改善するのか.

A: コンセプトイレーザーの目的は、機械学習システムが特定の概念を使用しないようにすることで、公平性と解釈可能性を向上させることです.公平性の人気のある概念は、保護された属性が予測に因果関係を持たないようにすることを要求します.解釈可能性の研究では、概念の因果効果を推定することがよくあります.コンセプトイレーザーは、モデルの内部表現からそれを削除することによって、モデルが概念を使用することを制限することができます.これは、モデルの入力や隠れ状態が概念と相互情報量を持つことが必要条件であるためです.コンセプトイレーザーは、モデルのパラメータを調整することなく、入力または隠れ状態を編集して、予測的なV情報IV(X→Z)を最小化することによって、概念の使用を制限します.これは、相互情報量I(X;Z)の下限であるため、Vの分類器がZを予測することができる度合いを測定します.コンセプトイレーザーは、モデルに依存しない方法で概念を削除することを約束するため、重要な動機付けを持っています.これにより、機械学習モデルの公平性と解釈可能性が向上します.(p.1)

Q: LEAst-squares Concept Erasure(LEACE)法と、線形分類器が特定の概念を検出できないようにするための方法について説明してください.

A: LEAst-squares Concept Erasure(LEACE)は、表現から指定された特徴を削除することを目的とした手法であり、線形分類器が特定の概念を検出することを防止することができます.この手法は、表現に最小限の損傷を与えながら、すべての線形分類器が概念を検出できないことを証明しています.従来の手法は、線形モデルがZを利用することを防止することに焦点を当てていましたが、LEACEは深層ニューラルネットワークから概念を消去することを目的としています.深層ニューラルネットワークは、線形部分空間に特徴をエンコードすることができるため、非線形手法が必要ではないという解釈可能性の研究結果があります.この手法は、中間表現に順次LEACEを適用する「概念スクラブ」手順を導入しています.BERT表現からジェンダーバイアスを消去するためにLEACEを使用し、概念スクラブを使用して言語モデルが品詞情報にどの程度依存しているかを測定することで、この手法の有用性を実証しています.(p.1)

Q: LEACEはどのような仕組みになっているのでしょうか?

A: LEACEは、SALよりもより手術的な介入を行い、ターゲットコンセプトのみを消去し、他のすべてを固定する理想的な介入の近似により、より完璧な介入を行います.LEACEを使用するには、データからΣとΣXZを推定する必要がありますが、隠れ状態の次元が大きい場合には困難です.LEACEは、Xの成分間の相関を考慮したSALの単純な「修正」と考えることができます.LEACEの式は、以下のようになります:rLEACE(x)= P∗(x−E [X])+ E [X]、P∗=Σ(QΣQ)+、Q= I−ΣXZΣ+XZ.ここで、Qは、ΣXZのcolsp()⊥に対する直交射影行列であり、いくつかの異なる方法で計算できます.LEACEを実際に使用するには、データからΣとΣXZを推定する必要がありますが、隠れ状態の次元が大きい場合には困難です.LEACE(X)の線形ガードは、ΣXZの推定の質にのみ依存し、Σの推定には依存しません.非常に悪いΣの推定は、再構成エラーを高くする可能性がありますが、Q項がcolsp(ΣXZ)を中和することはできません.LEACEは、ZがRkの任意の値を取る場合にも適用できますが、通常の最小二乗回帰に制限する必要があります(p.5-6).

Q: ΣXZの推定品質がLEACEのリニアガードにどう影響するのか?

A: LEACEの線形ガードは、ΣXZの推定の質にのみ依存することがTheorem 4.1によって示されています.Σの推定が非常に悪い場合、再構成誤差が高くなる可能性がありますが、Q項がcolsp(ΣXZ)を中和することはできません.したがって、LEACEを実際に使用するには、データからΣとΣXZを推定する必要がありますが、隠れ状態の次元が大きい場合には困難です.

Q: 「コンセプトスクラビング」と呼ばれる斬新な手順とは?

A: 「コンセプトスクラビング」と呼ばれる新しい手順は、言語モデルからターゲットコンセプト情報をすべての層から消去することで、言語モデルを改善する手法です.(p.1) この手法は、言語モデルが特定のコンセプトを使用しないようにすることができ、公平性や解釈性に重要です.この手法は、品詞情報に依存する言語モデルの信頼度を測定したり、BERT埋め込みのジェンダーバイアスを減らすことができます.この手法のコードは、https://github.com/EleutherAI/concept-erasureで入手できます.

Q: すべてのレイヤーからターゲット概念情報を削除することで、言語モデルを改善する新しい手順は何と呼ばれているのでしょうか?

A: 新しい手順は「コンセプトスクラビング」と呼ばれ、ネットワークのすべての層からターゲットコンセプト情報を消去することで、言語モデルを改善します.この手法は、Elazarらによって開発されたIterative Nullspace Projection(INLP)に基づいていますが、本研究では、この手法よりも効果的であることが示されました.この手法により、ニューラルネットワークが内部的に使用する情報を理解することができます.(p.1)

Q: コンセプト消去法は、言語モデルにおける公平性や解釈可能性をどのように向上させるのか、また、品詞情報の信頼性測定やBERT埋込におけるジェンダーバイアスの低減など、この手法の具体的な応用例はどのようなものか.

A: 本研究では、機械学習システムが特定の概念を使用しないようにすることが、公正性と解釈可能性の向上に重要であるとされています.公正性に関する一般的な考え方は、保護された属性が予測に因果関係を持たないようにすることが求められます.また、解釈可能性の研究では、モデルの振る舞いに変化をもたらすために、特定の概念を削除することが行われます.本研究では、線形分類器が特定の概念を検出できないようにすることができる、閉形式のLEACE(Least-squares Concept Erasure)という手法を提案しています.この手法は、表現に最小限の損傷を与えながら、すべての線形分類器が特定の概念を検出できないことを証明しています.また、本研究では、この手法を用いて、言語モデルにおける品詞情報の信頼性の測定や、BERT埋め込みにおけるジェンダーバイアスの削減など、具体的な応用例を示しています. (p.1)

Q: LEACEは大規模な言語モデルにどのように適用されているのでしょうか?

A: 大規模言語モデルにLEACEを適用するために、新しい手順である「概念スクラビング」を使用します.これにより、ネットワークのすべてのレイヤーからターゲット概念情報が消去されます.これにより、以前の作業よりも手術的な介入が可能になり、ターゲット概念のみを消去し、他のすべてを固定する理想的な介入の理想に近づけることができます.これにより、SALだけを使用した場合、品詞の因果効果を過大評価してしまう可能性があります.

Q: 大規模な言語モデルにLEACEを適用する際の、コンセプトスクラビングの手順とその効果について教えてください.

A: 大規模言語モデルにLEACEを適用するための新しい手順である「コンセプトスクラビング」は、ネットワークのすべてのレイヤーからターゲットコンセプト情報を消去することを意味します.この手順は、中間表現にLEACEを順次適用することで実現されます.この手法の有用性を示すために、2つのタスクで実証されています.1つは、言語モデルが品詞情報にどの程度依存しているかを測定することであり、もう1つはBERT埋め込みのジェンダーバイアスを減らすことです.この手法は、概念的な制約の下で深層ニューラルネットワークをトレーニングすることを可能にするかもしれません.この手法の有効性を検証するために、より狭い概念を対象とする実験が必要です.また、行動指標を使用して、スクラビングがネットワークを直感的に期待する方法で変更するかどうかを決定する必要があります. (p.3-5)

Q: SALだけを使うと、品詞の因果関係を過大評価する可能性があるのはなぜか?

A: SAL単独で実験を行うと、品詞の因果効果を過大評価する可能性がある.LEACEに比べて、SALは他の有用な特徴に対してより多くの副作用を引き起こすため、LEACEで行われた介入はより外科的であり、理想的な介入の近似により近い. (p.10)

Q: LEACEの有用性を示す2つのタスクとは?

A: LEACEの有用性を示す2つのタスクは、part-of-speech情報に対する言語モデルの依存度を測定することと、BERT埋め込みのジェンダーバイアスを減らすことです.LEACEは、ネットワークのすべてのレイヤーからターゲットコンセプト情報を消去する「コンセプトスクラビング」という新しい手順を使用して、大規模な言語モデルに適用されます.SALよりもLEACEの方が手術的であり、ターゲットコンセプトのみを消去し、他のすべてを固定する理想的な介入の近似により、より少ない損傷を与えます.ただし、LEACEは、特定のモデルのパフォーマンスに対するコンセプト消去の負の影響を最小限に抑えることが重要であり、平均二乗誤差はこの目的のための緩いプロキシであるため、別の消去関数が主タスクのパフォーマンスの観点でLEACEを上回る場合があるという制限があります.

Q: メインタスクの遂行に影響を与えるという点で、LEACEの限界はどのようなものでしょうか.

A: LEACEの制限は、最も重要なタスクのパフォーマンスに対する概念の消去の負の影響を最小限に抑えることに関心があるため、平均二乗誤差はこの目的に対して緩いプロキシであるため、別の消去関数がLEACEを上回る場合があることです.(p.7)

Q: BERTエンベッディングのジェンダーバイアスを軽減するために、LEACEが採用している新しい手順とはどのようなものですか?

A: LEACEは、BERT表現からジェンダーバイアスを削除するために使用される新しい手順である「コンセプトスクラビング」を適用します(p.3).この手順は、ネットワークの各層の中間表現にLEACEを順次適用することで実現されます.コンセプトスクラビングは、ネットワークのすべての層からターゲットコンセプト情報を削除することで、表現に最小限のダメージを与えます.この手法は、言語モデルが品詞情報にどの程度依存しているかを測定するために使用され、BERT埋め込みのジェンダーバイアスを削減するためにも使用されます(p.3-5).

Q: 本稿で紹介した新手法のコード実装のためのurlはどうなっていますか?

A: 本論文で導入された新しい手法のコード実装は、https://github.com/EleutherAI/concept-erasure にあります.(p.1)

SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression

著者:Tim Dettmers, Ruslan Svirschevski, Vage Egiazarian, Denis Kuznedelev, Elias Frantar, Saleh Ashkboos, Alexander Borzunov, Torsten Hoefler, Dan Alistarh

発行日:2023年06月05日

最終更新日:2023年06月05日

URL:http://arxiv.org/pdf/2306.03078v1

カテゴリ:Computation and Language, Machine Learning

概要:

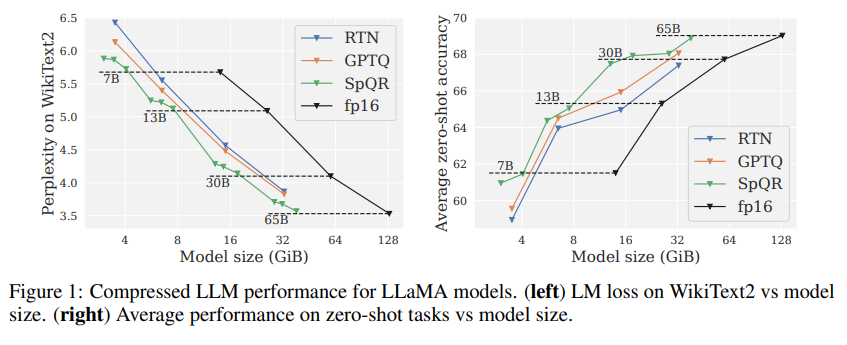

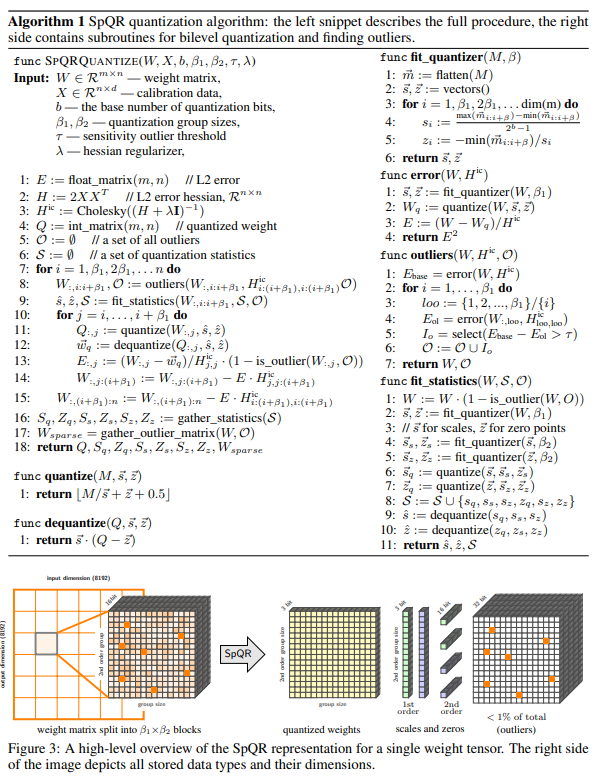

最近の大規模言語モデル(LLM)の事前学習の進歩により、高品質のLLMが作成され、印象的な能力を持つようになりました.これらのLLMを量子化してパラメータあたり3〜4ビットに圧縮することにより、ラップトップやモバイル電話などのメモリ制限のあるデバイスに適した個人用の使用が可能になりました.しかし、1〜10Bパラメータ範囲の小型モデルに特に適したエッジ展開には、パラメータあたり3〜4ビットまで量子化すると、通常、中程度から高い精度損失が発生します.この精度問題に対処するために、私たちはSparse-Quantized Representation(SpQR)を導入しました.SpQRは、新しい圧縮形式および量子化技術であり、モデルスケールを超えたほぼ損失のない圧縮を初めて可能にし、以前の方法と同様の圧縮レベルに達します.SpQRは、特に大きな量子化エラーを引き起こす外れ値の重みを特定して分離し、それらを高い精度で保存することにより、他のすべての重みを3〜4ビットに圧縮することで機能します.高精度のLLaMAおよびFalcon LLMではperplexityの相対精度損失が1%未満になります.これにより、単一の24 GB消費者GPUで33BパラメータLLMを実行することが可能になり、パフォーマンスに影響を与えません.また、SpQRは、重みを効率的にエンコードするための効率的なアルゴリズムと、ランタイムで効率的にデコードするためのアルゴリズムを提供しています.具体的には、SpQRの効率的なGPU推論アルゴリズムを提供し、16ビットのベースラインと同等の精度でより高速な推論を実現し、メモリの圧縮率を4倍以上に向上させることができます.

Q&A:

Q: 量子化によって大規模言語モデル(LLM)を1パラメータあたり3~4ビットに圧縮する目的は何でしょうか?

A: 大規模言語モデル(LLM)をパラメーターごとに3〜4ビットに量子化して圧縮する目的は、メモリ制限のあるデバイス(ラップトップや携帯電話など)に適合させ、個人用に使用可能にすることです.しかし、3〜4ビットに量子化することは、特に1〜10Bパラメーター範囲の小さなモデルに対して、中程度から高い精度損失を引き起こす傾向があります.これを解決するために、SpQRという新しい圧縮形式と量子化技術が導入され、これにより、以前の方法と同じ圧縮レベルに達しながら、モデルスケール全体でほぼ損失のない圧縮が可能になります.(p.1)

Q: 特にパラメータが1~10Bの小型モデルにおいて、3~4ビットに量子化することで生じる精度低下の問題を、新しい圧縮フォーマットと量子化技術「SpQR」でどのように解決するのか.

A: SpQRは、LLMの重みを3-4ビットに量子化することによって圧縮することができ、ラップトップやモバイル電話などのメモリ制限のあるデバイスに適合するようになりました.しかし、1-10Bパラメータ範囲の小さなモデルに対しては、中程度から高い精度損失が発生することがあります.SpQRは、特に大きな量子化誤差を引き起こす外れ値の重みを高い精度で保存することにより、他のすべての重みを3-4ビットに圧縮することで、従来の方法と同様の圧縮レベルに達しながら、LLMのほぼ損失のない圧縮を可能にする新しい圧縮形式および量子化技術です.(p.1)

Q: SpQR(Sparse-Quantized Representation)とは何ですか?

A: Sparse-Quantized Representations (SpQR)は、大規模言語モデル(LLM)の重みを圧縮するための新しい形式であり、従来の量子化方法よりも高い圧縮率を実現しながら、近似損失を最小限に抑えることができる.これは、異常値の重みを高精度で保持し、その他の重みを低ビット幅で保持することによって実現される.また、グループ化された量子化を採用し、グループサイズを小さくすることで、量子化スケール自体を3ビット表現に量子化することができる.これにより、SpQRは、従来の方法よりも高い圧縮率を実現しながら、近似損失を最小限に抑えることができる.SpQRは、先行研究に比べて、1%未満の相対的な損失をもたらすことなく、LLMの重みを3-4ビット/パラメータに圧縮することができる.これにより、SpQRは、メモリ制限のあるデバイスに適した、個人化された使用を可能にする. (p.1-2)

Q: グループサイズが非常に小さく、量子化スケール自体を3ビット表現にするグループ化量子化の変形を実装することで、SpQRのモデルサイズのコントロールにどのように役立つのか説明してください.

A: SpQRでは、非常に小さなグループサイズを持つグループ化された量子化の変種を実装し、量子化スケール自体を3ビット表現に量子化することで、モデルサイズを制御することができます.これにより、高精度の外れ値の重みを高精度で保持し、他の重みを3ビットなどの低いフォーマットで保存することができます.これにより、SpQRは、3〜4ビット/パラメーターの圧縮率を達成し、エンドツーエンドの精度エラーを1%未満に抑えながら、正確な事前学習済みLLMを圧縮することができます.(p.1,5,30)

Q: SpQRが持つ、重みの符号化・復号化を効率的に行うためのアルゴリズムとは?

A: SpQRは、重みを効率的にエンコードするアルゴリズムと、ランタイムで効率的にデコードするアルゴリズムを提供しています.具体的には、SpQRは、高精度の重みを保持しながら、他の重みを3-4ビットの形式で圧縮することによって、高い圧縮率を実現しています.また、SpQRは、GPU推論アルゴリズムを提供しており、16ビットベースラインよりも高速な推論を可能にし、メモリ圧縮率を4倍以上に向上させています.(p.1)

Q: SpQRアルゴリズムの評価において、GPTQとRTNの量子化ベースラインの目的は何でしょうか?

A: SpQRアルゴリズムを評価するために、GPTQとRTN量子化ベースラインを比較することが目的である.これらのベースラインは、LLM圧縮方法のほとんどで使用されるため、SpQRアルゴリズムの性能を比較するために使用される.また、これらのベースラインと比較して、SpQRアルゴリズムがどのように改善されたかを示すこともできる.

Q: SpQR GPU推論アルゴリズムは、16ビットベースラインと比較して、精度とメモリ圧縮率の両面でどのような優位性があるのでしょうか?

A: SpQRのGPU推論アルゴリズムは、16ビットのベースラインと比較して、同様の精度でより高速な推論を提供し、メモリ圧縮の利得を4倍以上にすることができます.これは、MLCommonsベンチマークの定義に従って、ほぼ損失のない圧縮を実現するために、外れ値を高い精度で保存し、他の重みを3-4ビットに圧縮することで実現されます.これにより、SpQRは、16ビットの精度に近づくために必要なパラメータあたりのビット数が4.6から4.71である場合、モデルサイズとパフォーマンスのトレードオフを改善し、以前の方法と同様の圧縮レベルを達成しながら、モデルスケール全体で優れた結果を示します.(p.1)

Orca: Progressive Learning from Complex Explanation Traces of GPT-4

著者:Subhabrata Mukherjee, Arindam Mitra, Ganesh Jawahar, Sahaj Agarwal, Hamid Palangi, Ahmed Awadallah

発行日:2023年06月05日

最終更新日:2023年06月05日

URL:http://arxiv.org/pdf/2306.02707v1

カテゴリ:Computation and Language, Machine Learning

概要:

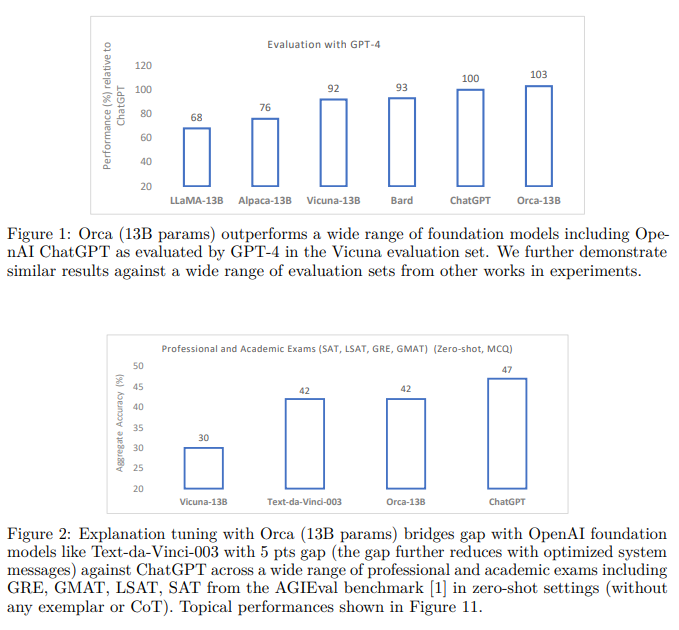

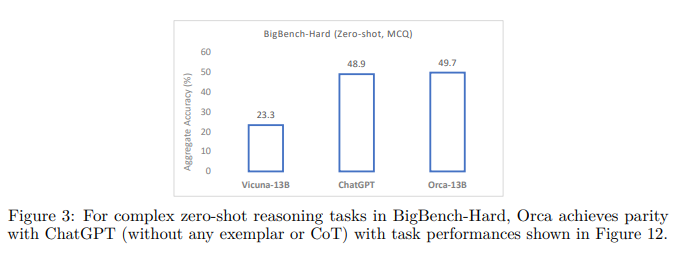

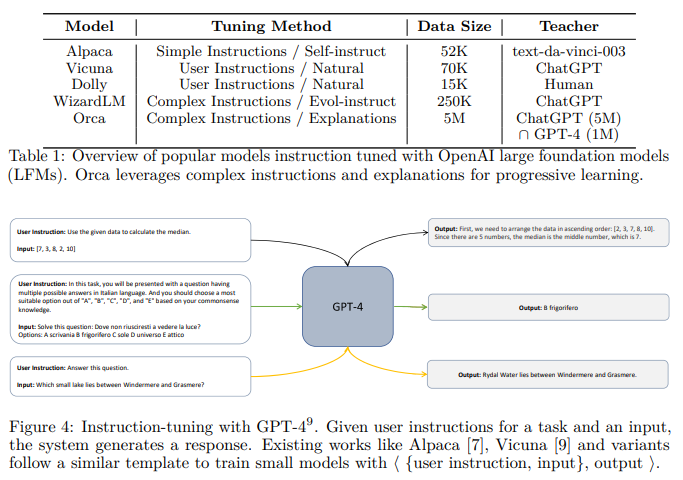

最近の研究は、大規模な基礎モデル(LFM)が生成する出力に基づいて、模倣学習を通じて小さなモデルの能力を向上させることに焦点を当てています.これらのモデルの品質には、浅いLFMの出力からの限られた模倣信号、小規模で均質なトレーニングデータ、そして特に厳密な評価の欠如が影響しており、小さなモデルの能力を過大評価する傾向があります.これらの課題に対処するために、私たちはOrcaを開発しました.Orcaは13億のパラメータを持つモデルで、LFMの推論プロセスを模倣することを学びます.Orcaは、GPT-4からの説明トレース、ステップバイステップの思考プロセス、およびその他の複雑な指示など、豊富な信号から学びます.また、ChatGPTからの教師支援によって指導されます.この進歩的な学習を促進するために、私たちは適切なサンプリングと選択を行い、大規模で多様な模倣データを活用しています.Orcaは、LFMを超える性能を発揮し、Big-Bench Hard(BBH)などの複雑なゼロショット推論ベンチマークで、Vicuna-13Bなどの従来の最新の指示調整モデルを100%以上上回ります.さらに、Orcaは、BBHベンチマークでChatGPTと同等の性能を発揮し、CoTなしのゼロショット設定でSAT、LSAT、GRE、GMATなどの専門的な試験でも競争力のあるパフォーマンスを示します.ただし、GPT-4には及びません.私たちの研究は、人間またはより高度なAIモデルによって生成されたステップバイステップの説明から学ぶことが、モデルの能力とスキルを向上させる有望な方向であることを示しています.

Q&A:

Q: オルカの目的は何ですか?

A: Orcaの目的は、様々なシステム命令を用いて異なる種類の応答を引き出すことで、人工知能の自然言語処理モデルを開発することです.Orcaは、ゼロショット設定のデータを用いてトレーニングされ、標準プロンプトによるゼロショット設定の性能がテストされています.ただし、マルチターン会話、文脈学習、フューショット学習、チェーンオブソートプロンプティングなど、他のコンテキストでの性能は未検証です.また、Orcaの性能は、調整データの分布と強く相関する可能性があり、トレーニングデータセットに代表されない数学、コーディング、推論などの分野での正確性が制限される可能性があります.さらに、不適切な保護措置がない場合、これらのモデルは誤情報や有害なコンテンツを生成するために悪用される可能性があります.これらの問題に対する研究は現在進行中であり、より厳密な測定、理解、緩和策が期待されています.(p.1,4-8)

Q: マルチターン会話、文脈学習、フュージョンショット学習、ソートプロンプトの連鎖など、他の文脈でのオルカの性能はどうなのか?(要件3)

A: Orcaの性能は、説明調整に使用されるデータに影響を受けます.Orcaは、標準プロンプトを用いたゼロショット設定をシミュレートするデータで訓練されています.マルチターン会話、コンテキスト学習、フューショット学習、またはチェーンオブソートプロンプティングなど、他の文脈でのモデルの性能は未検証です.(p.1)

Orcaの性能は、調整データの分布と強く相関する可能性があります.この相関関係は、数学、コーディング、推論などのトレーニングデータセットに代表される領域での正確性を制限する可能性があります.(p.1)

Orcaは、異なる種類の応答を引き出すために多様なシステム指示で訓練されています.また、モデルサイズによって導入される確率論的性質は、シャッフルされたオブジェクトの追跡やWeb of LiesなどのタスクでOrcaの性能を向上させることがあります.(p.1)

Q: 数学、コーディング、推論など、トレーニングデータセットに表現されていない分野では、Orcaの精度はどのように制限されるのか?(要件3、要件5)

A: 訓練データセットにおいて表現されていない数学、コーディング、推論などの分野において、Orcaの精度は訓練データセットの分布と強く相関するため、限定される可能性があります.(p.28)

Q: オルカはどのようにしてLFMの推論過程を模倣することを学ぶのだろうか.

A: Orcaは、GPT-4からの豊富な信号、説明トレース、ステップバイステップの思考プロセス、およびChatGPTからの教師支援によって導かれる複雑な指示を含むものを学習します.大規模で多様な模倣データに適切なサンプリングと選択を行い、この進歩的な学習を促進するために、OrcaはLFMsの推論プロセスを模倣することを学びます.(p.1)

Q: オルカの漸進的な学習を促進するために、大量かつ多様な模倣データを選択し、サンプリングする過程はどのようなものなのでしょうか.

A: 大規模で多様な模倣データを選択的にサンプリングすることによって、Orcaは進歩的な学習を促進しています.これにより、Orcaは、Big-Bench Hard(BBH)のような複雑なゼロショット推論ベンチマークで、Vicuna-13Bなどの従来の最新の指示調整モデルを100%以上上回り、AGIEvalでは42%上回ります.さらに、OrcaはBBHベンチマークでChatGPTと同等の性能を発揮し、SAT、LSAT、GRE、GMATなどのプロフェッショナルおよび学術試験でも、CoTなしのゼロショット設定でGPT-4に遅れを取るものの、最適化されたシステムメッセージと4ポイントの差で競争力のあるパフォーマンスを示します.模倣学習によって、OrcaはGPT-4の説明トレースやステップバイステップの思考プロセスなど、豊富な信号から学習します.Orcaは、大規模で多様な模倣データを選択的にサンプリングすることによって、進歩的な学習を促進しています. (p.1)

Q: オルカはGPT-4から具体的にどのようなシグナルを学び、そのシグナルを使ってどのように学習を進めていくのでしょうか.

A: GPT-4からOrcaが学ぶ信号には、説明トレース、ステップバイステップの思考プロセス、複雑な指示などが含まれます.これらの信号をChatGPTの教師支援によって指導され、大規模かつ多様な模倣データを選択的にサンプリングして進行的学習を促進します.これにより、OrcaはVicuna-13Bなどの従来の最新の指示調整モデルを超え、Big-Bench Hard(BBH)などの複雑なゼロショット推論ベンチマークで100%以上、AGIEvalで42%の性能向上を達成しました.また、OrcaはBBHベンチマークでChatGPTと同等の性能を発揮し、プロフェッショナルおよび学術的な環境での最適化されたシステムメッセージと4ポイントの差をつけて競争力のある性能を示しました.(p.1)

Q: 複雑なゼロショット推論のベンチマークにおいて、Orcaは他のモデルと比較してどのようなパフォーマンスを発揮するのでしょうか?

A: Orcaは、Big-Bench Hard(BBH)などの複雑なゼロショット推論ベンチマークにおいて、Vicuna-13Bなどの従来の最先端の指示調整モデルを100%以上上回り、AGIEvalでは42%の性能を発揮します.さらに、OrcaはBBHベンチマークでChatGPTと同等の性能を発揮し、SAT、LSAT、GRE、GMATなどのプロフェッショナルおよびアカデミックな試験でも、CoTなしのゼロショット設定で競争力のあるパフォーマンスを発揮します.ただし、GPT-4には劣ります.これらの情報は、(p.1)から抽出されました.

Q: ステップバイステップの説明から学ぶことについては、どのような研究結果があるのでしょうか.

A: ステップバイステップの説明から学ぶことが、モデルの能力とスキルを向上させる有望な方向性であることが研究によって示されています.この研究では、人間が生成した説明やより高度なAIモデルによる説明から学ぶことができることが示されています.また、より長い回答は短い回答よりも模倣が難しいため、より簡単な例から始め、徐々に難しい例に移行することが、知識蒸留において有効であることが示されています.さらに、GPT-4は、教師の推論プロセスを説明することができるため、学生に追加の学習信号を提供することができます.これらの説明を引き出すために、システム指示を活用することができます.これは、バニラの指示調整とは対照的であり、より高度な学習を促進することができます.(p.15)

Q: ステップバイステップの説明から学ぶことで、モデルの能力やスキルが向上するという根拠は何ですか?

A: 学習において、より高度なAIモデルによる生成されたものであっても、人間による生成されたステップバイステップの説明から学ぶことが、モデルの能力とスキルを向上させる有望な方向性であることが示唆されています.これは、より小さなモデルでも、より集中的かつ適応性が高くなり、品質の低下が少なくなることを示唆しています.また、より長い回答は短い回答よりも模倣が難しいという仮定に加えて、より大きな教師からの改善された推論とステップバイステップの説明による、より易しい例から始め、より難しい例に進む形式のプログレッシブラーニングまたはカリキュラムラーニングの形式として、知識蒸留の学生に対しても適用されることが示されています.(p.1)

Q: 本稿で紹介した新手法のコード実装のためのurlはどうなっていますか?

A: 本論文で導入された新しい手法のコード実装のURLは、https://aka.ms/orca-lmで公開される予定であり、LLaMAのリリースポリシーに従ってモデルの重みの差分を公開するために、著者らは法務チームと協力しています.この情報は、論文の最後に記載されています.(p.最後)

Fine-Grained Human Feedback Gives Better Rewards for Language Model Training

著者:Zeqiu Wu, Yushi Hu, Weijia Shi, Nouha Dziri, Alane Suhr, Prithviraj Ammanabrolu, Noah A. Smith, Mari Ostendorf, Hannaneh Hajishirzi

発行日:2023年06月02日

最終更新日:2023年06月02日

URL:http://arxiv.org/pdf/2306.01693v1

カテゴリ:Computation and Language

概要:

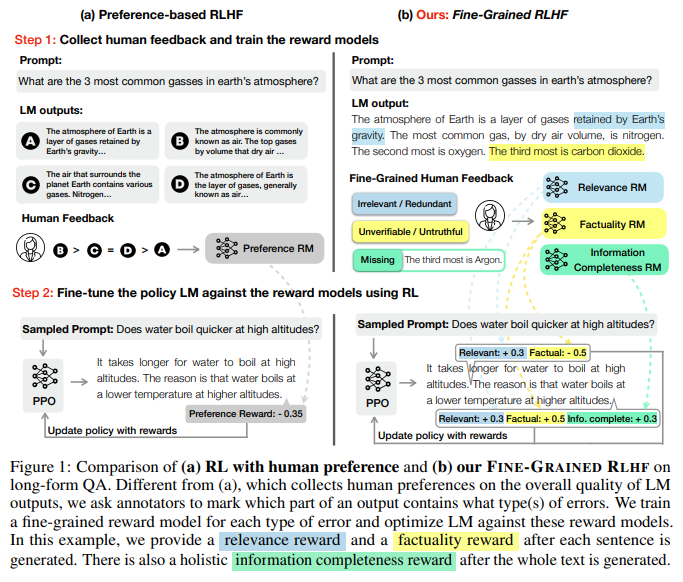

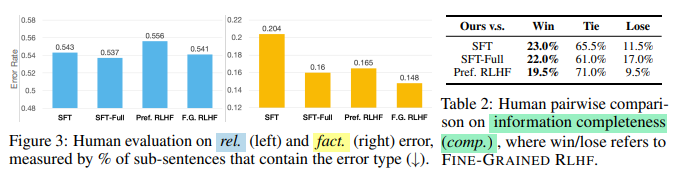

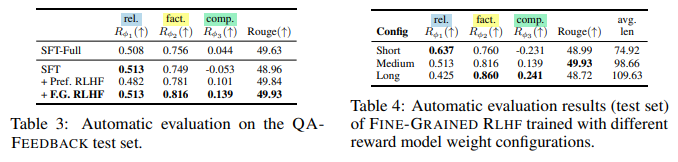

本論文では、細かい人間のフィードバックを明示的なトレーニング信号として使用するFine-Grained RLHFフレームワークを紹介し、報酬関数からのトレーニングと学習を可能にします.さらに、この報酬関数を使用した学習によって、自動評価と人間の評価の両方で性能が向上することを、解毒と長い形式の質問応答に関する実験を通じて示します.また、異なる細かい報酬モデルの組み合わせによって、LMの振る舞いをカスタマイズできることも示します.我々は、収集された人間のフィードバック、データ、およびコードをhttps://FineGrainedRLHF.github.ioで公開しています.

Q&A:

Q: 人間のフィードバックからの強化学習(RLHF)とは何か、言語モデル(LM)の望ましくないテキスト生成動作にどう対処するのか.

A: RLHFとは、人間のフィードバックを学習信号に変換することで、LMの出力における誤った、有害、または関連性のない出力などの望ましくないテキスト生成の問題に対処するためのフレームワークである.このフレームワークでは、人間は2つ以上の出力を提示され、1つを選択またはランク付けするように求められ、この信号が報酬モデルのトレーニングに使用され、LMが受け取る報酬を最適化するためにRLでトレーニングされる.このような報酬は、特に長いテキストの生成を必要とするタスクに対しては比較的スパースなトレーニング信号を提供するため、信頼性が低い.さらに、以前の研究では、生成されたテキストの自動評価が人間の注釈者にとって困難であることが示されており、特に出力に多様な望ましくない行動が含まれる場合には、2つ以上のモデル出力の全体的な品質を信頼性高く比較することが困難である.したがって、本研究では、細かい評価を行うことで、モデルのエラーを分類し、局所化することで、明示的な洞察を提供することができることを示し、RLHFにおいて、各報酬モデルが特定の望ましい行動の種類に対して、小さなテキストセグメントごとに密な報酬を提供する細かい報酬モデルを使用することを提案している.

Q: きめ細かいフィードバックの定義は、タスクによってどのように異なり、それに応じて報酬モデルをトレーニングするために、どのような手作業が必要なのか.

A: 本研究では、FINE-GRAINED RLHFフレームワークを紹介し、LMsが人間のフィードバックから学習することを可能にしました.このフレームワークでは、収集された人間のフィードバックを使用して、各カテゴリに焦点を当て、そのカテゴリに関連する密度で密な報酬を提供するように、細かい粒度の報酬モデルをトレーニングします.これにより、LMsが細かい粒度のフィードバックから学習できるようになります.報酬モデルのトレーニングには、人手による労力が必要です.報酬モデルの重みを調整することで、異なるニーズを持つユーザーにカスタマイズされたLMを作成できます.報酬モデルは互いに競合し、結果のポリシーモデルに影響を与えることが示されています.これらの報酬モデルは、QA-F EEDBACKタスクに焦点を当てたものであり、他のタスクにおいては、報酬モデルのトレーニングに必要な人手の労力が異なる可能性があります.(p.4.5)

Q: Fine-Grained RLHFは、LMが異なる報酬モデルを組み合わせて出力をカスタマイズすることをどのように可能にするのか?

A: FINE-GRAINED RLHFは、複数の報酬モデルを使用し、RL中にそれらの重みを調整することで、異なるLMの振る舞いを導くことができます.これにより、異なるニーズを持つユーザーに適応することができます.FINE-GRAINED RLHFフレームワークは、報酬モデルの柔軟性と制御性の2つの利点を持ちます.報酬モデルの重みを異なる組み合わせで調整することで、カスタマイズされたモデルの振る舞いを実現することができます.これは、教育ツールなどのアプリケーションにとって特に重要な利点です.FINE-GRAINED RLHFは、任意のテキスト生成タスクに適用でき、報酬モデルの拡張性が高く、将来的には事実チェック、感情分類、毒性検出などのタスクにも適用できる可能性があります.(p.6-7)

Q: Fine-Grained RLHFがきめ細かな報酬機能を提供する2つの方法とは?

A: Fine-Grained RLHFは、細かい報酬関数を提供する2つの方法を提供します.1つ目は、柔軟性です.Fine-Grained RLHFフレームワークは、複数の報酬モデルを組み合わせることができ、事実チェック、感情分類、毒性検出などの将来の作業を含め、さまざまな報酬モデルを組み込むことができます.2つ目は、制御性です.複数の報酬モデルを持つことで、エンドユーザーはRLトレーニングにより大きな制御を行うことができ、報酬モデルの重みの異なる組み合わせを通じてカスタマイズされたモデルの振る舞いを実現することができます.これは、教育ツールなどのアプリケーションにとって特に重要な利点です.(p.6-7)

Q: Fine-Grained RLHFフレームワークに組み込むことができる報酬モデルの種類にはどのようなものがあるのでしょうか?

A: FINE-GRAINED RLHFフレームワークには、複数の報酬モデルを組み込むことができます.例えば、事実チェック、感情分類、毒性検出などの将来の作業は、すべてこのフレームワークに組み込むことができます.FINE-GRAINED RLHFを介して、これらの報酬モデルすべてに対してLMをトレーニングすることができます.

Q: きめ細かな報酬関数による学習の有効性を示すために、どのような実験が行われたのでしょうか?

A: Fine-grained報酬関数を用いた学習の効果を示すために、デトックス化と長文の質問応答に関する実験が行われました.これにより、自動評価と人間の評価の両方に支持された改善されたパフォーマンスが得られました.また、異なるFine-grained報酬モデルの重みを調整することで、異なるニーズを持つユーザーにカスタマイズされたLMを生成することができることが示されました.さらに、Fine-grained報酬モデルの詳細な分析が行われ、それらが互いに競合し、生成されたポリシーモデルに与える影響について分析されました.(p.3-5)

Q: 細かい報酬モデルの重みを調整することで、異なるニーズを持つユーザーに対してLMのカスタマイズ性をどのように発揮したのでしょうか.

A: 異なるニーズを持つユーザーに対してLMをカスタマイズするために、FINE-GRAINED RLHFで複数の報酬モデルの重みを調整することで、異なるLMの振る舞いを導くことを示した(§ 4.5).報酬モデルの重みを調整することで、特定の望ましい行動タイプに関連する報酬モデルにより、その他の行動タイプ(例えば、情報の関連性)に比べて、その行動タイプにより近い生成を導くことができる.この柔軟性により、多様なニーズを持つユーザーに適合することができる.したがって、このセクションでは、FINE-GRAINED RLHFのLMの振る舞いをカスタマイズする能力を探索する.報酬モデルの重みの3つの構成(Rϕ1、Rϕ2、およびRϕ3のw1、w2、およびw3)を調整し、それぞれ「短い」、「中程度」、「長い」と名付け、LMの特定の行動に対応する. (p. 8)

Q: 報酬モデルの重みの3つの構成(Rϕ1、Rϕ2、Rϕ3、w1、w2、w3)と、それらがLMの動作をカスタマイズするためにどのように使われるかを説明してもらえますか.

A: LMの振る舞いをカスタマイズするために、FINE-GRAINED RLHFでは複数の報酬モデルを使用し、それらの重みを調整することができます.具体的には、報酬モデルに関連する特定の望ましい行動タイプ(例えば、情報の完全性)に重みを追加することで、他の行動タイプ(例えば、情報の関連性)に比べてその行動タイプにより近い生成を行うことができます.この柔軟性は、多様なニーズを持つユーザーに適合する可能性があります.Table 4では、報酬モデルの重み(w1、w2、およびw3)の3つの構成を「short」「medium」「long」と名付け、LMの平均生成長に応じて分類しています.w2=0.5、w3=0.3を固定し、w1には0.4、0.3、0.2を使用しています.これにより、それぞれ「short」「medium」「long」の生成出力が得られます.shortはより関連性の高いコンテンツを生成しますが、事実的で完全ではありません.一方、longは最も事実的で完全な生成を提供します.これは、LMが大量の情報を参照していることを反映しています.これらの報酬モデルは、関連性、事実性、情報の完全性に対応しています.これらの報酬モデルは競合し合っており、トレーニング中に各報酬モデルのダイナミクスを調べることができます.図4は、開発セットでの各報酬モデルの報酬を示しています.事実報酬は一貫して増加しています.関連報酬は最初の250ステップで急速に増加し、その後減少し始めます.一方、完全報酬は最初に減少し、その後増加し始めます.これは、関連性(精度)と情報の完全性の間にトレードオフがあることを示しています.(p.5)

Q: Amazon Mechanical Turkのプラットフォームを利用して、残りの2,853のトレーニング例と500の開発例からSFTの出力に関するフィードバックを収集するプロセスはどのようなものでしょうか?

A: 残りの2,853のトレーニング例と500の開発例について、Amazon Mechanical Turkプラットフォームを使用して、SFTのサンプリングされた出力に対するフィードバックを収集します.図5は、QA-FEEDBACKからの例を含む、細かい人間のフィードバック注釈インターフェースを示しています.人間が書いたASQAからの応答も参照としてワーカーに提供しますが、実際には、私たちの細かいフィードバックの注釈には人間が書いた応答は必要ありません.金の応答を提供する唯一の目的は、ASQAの注釈を行うワーカーと同じ質問の解釈と期待される応答に従わせることです.これにより、教師ありモデル(SFTおよびSFT-Full;詳細は§4.3参照)との実験的比較が公正に行われます.ただし、事実上の誤りをチェックするために、私たちはまだワーカーに与えられたパッセージを厳密に使用するよう指示しています.各スパンエラーについて、図6(左)に示す5つのカテゴリのうち1つを選択するようワーカーに依頼します.ただし、§4.1で言及されたC1およびC2に基づいて、これら5つのカテゴリを2つのカテゴリにまとめます.(p.5)

Hiera: A Hierarchical Vision Transformer without the Bells-and-Whistles

著者:Chaitanya Ryali, Yuan-Ting Hu, Daniel Bolya, Chen Wei, Haoqi Fan, Po-Yao Huang, Vaibhav Aggarwal, Arkabandhu Chowdhury, Omid Poursaeed, Judy Hoffman, Jitendra Malik, Yanghao Li, Christoph Feichtenhofer

発行日:2023年06月01日

最終更新日:2023年06月01日

URL:http://arxiv.org/pdf/2306.00989v1

カテゴリ:Computer Vision and Pattern Recognition, Machine Learning

概要:

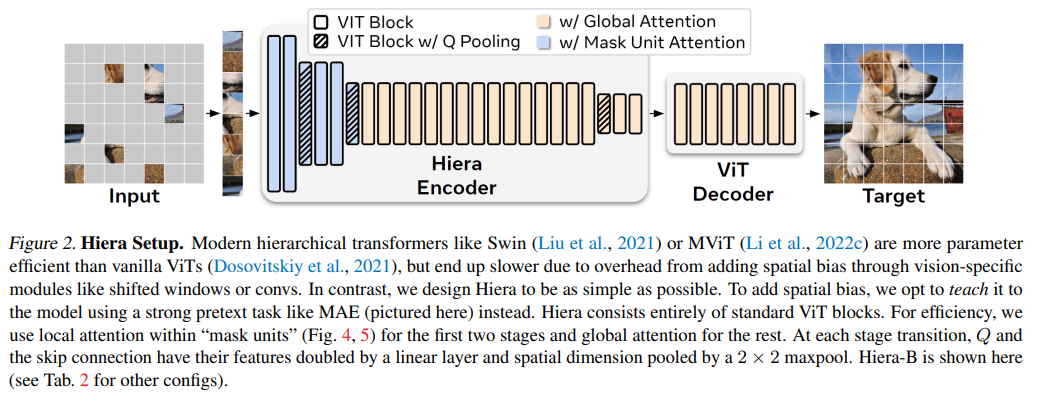

近年、視覚タスクに特化したコンポーネントを追加することで、監視された分類性能を向上させたモダンな階層型ビジョン・トランスフォーマーが登場しています.これらのコンポーネントは、効果的な精度と魅力的なFLOP数をもたらしますが、追加された複雑さは、バニラのViTに比べてこれらのトランスフォーマーを遅くしています.本論文では、この追加の重量は不要であると主張しています.強力な視覚プリテキストタスク(MAE)で事前トレーニングすることで、最新のマルチステージビジョン・トランスフォーマーからすべてのベルとホイッスルを削除することができます.その過程で、Hieraという非常にシンプルな階層型ビジョン・トランスフォーマーを作成しました.これは、以前のモデルよりも精度が高く、推論中およびトレーニング中に大幅に高速です.私たちは、画像およびビデオ認識のさまざまなタスクでHieraを評価しました.私たちのコードとモデルは、https://github.com/facebookresearch/hieraで利用可能です.

Q&A:

Q: 階層型ビジョントランスフォーマーに関する論文の主な論旨は?

A: 本論文の主張は、現代の階層的なビジョン・トランスフォーマーは、教師あり分類のパフォーマンスを追求するために、ビジョンに特化したいくつかのコンポーネントを追加しているが、これらのコンポーネントは効果的な精度と魅力的なFLOP数をもたらす一方で、実際にはこれらのトランスフォーマーをバニラのViTよりも遅くしているということである.本論文では、この追加の重量は不必要であると主張している.強力な視覚的先行タスク(MAE)で事前学習することにより、最新の多段階ビジョン・トランスフォーマーからすべての余分なものを取り除くことができる.このプロセスで、本論文ではHieraを作成し、非常にシンプルな階層的ビジョン・トランスフォーマーを作成した.Hieraは、以前のモデルよりも正確でありながら、推論中およびトレーニング中に著しく高速である.本論文では、画像およびビデオ認識のさまざまなタスクでHieraを評価している.(p.1)

Q: 分類性能を向上させるために、最新の階層型ビジョントランスには具体的にどのようなコンポーネントが追加され、バニラViTと比較してトランスの速度にどのような影響があるのでしょうか.

A: 現代の階層的ビジョン・トランスフォーマーは、監視された分類性能を向上させるために、いくつかのビジョン特有のコンポーネントを追加しています.これらのコンポーネントは、効果的な精度と魅力的なFLOP数をもたらしますが、追加の複雑さは、これらのトランスフォーマーをバニラViTに比べて遅くしています.本論文では、この追加の重量は不必要であると主張しています.強力な視覚的先行タスク(MAE)で事前トレーニングを行うことにより、すべての装飾を削除できます.SwingやMViTのような現代の階層的トランスフォーマーは、バニラViT(Dosovitskiy et al.、2021)よりもパラメーター効率が高く、ビジョン特有の空間バイアスを追加するオーバーヘッドにより遅くなります. (p.1)

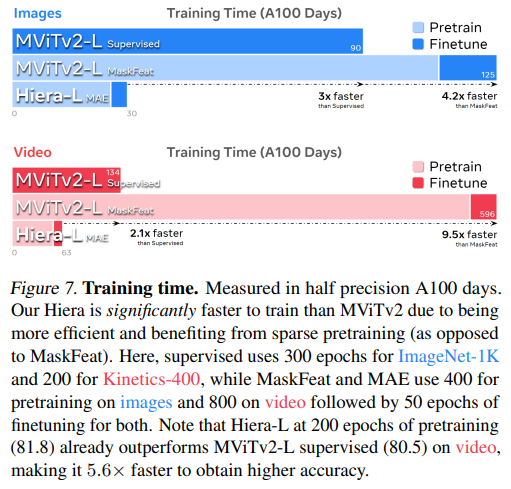

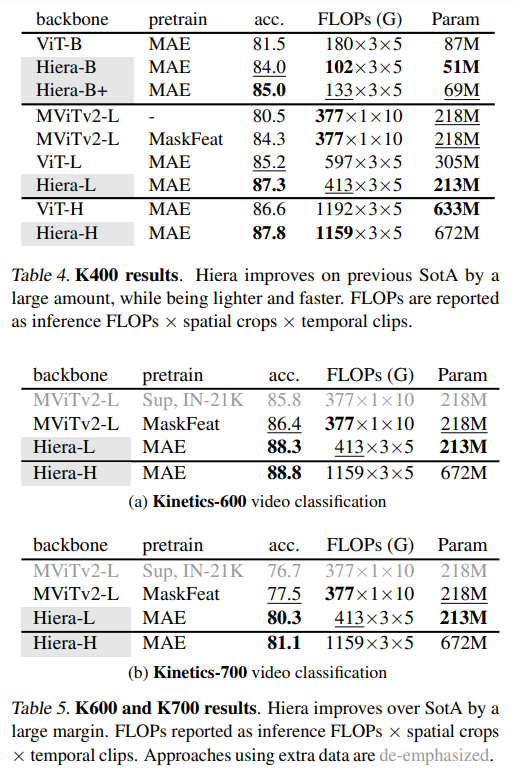

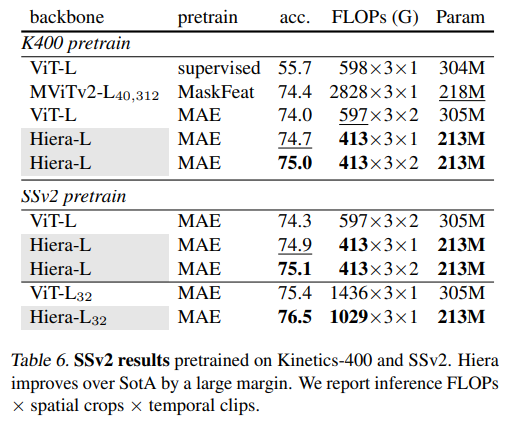

Q: Hieraの制作過程や、推論・学習時の精度や速度など、これまでのモデルとの違いについて教えてください.

A: Hieraの作成プロセスは、transformerとCNNの階層的なステージ構造を組み合わせた先行研究を参考にし、MAEを使用した事前学習を行いました.これにより、非常にシンプルで効率的なモデルであるHieraが作成されました.Hieraは、画像では最新のSotAモデルよりも高速で正確であり、ビデオでは人気のあるViTモデルよりも2倍以上高速です.Hieraは、MAEを使用したスパース事前学習をサポートしているため、Tab.1の結果は非常に高速に取得できます.Hiera-Lは、画像で優れた精度を得るために必要な時間が3倍短く、監視されたMViTv2-Lよりも高速にトレーニングできます.ビデオでは、Hiera-Lは、MViTv2のカットダウンバージョンよりも高速にトレーニングでき、より高い精度を達成できます.これにより、Hieraは、以前のモデルよりも正確でありながら、推論およびトレーニング中に大幅に高速化された、新しい階層的なビジョンtransformerのクラスを表します.(p.3-5)

Q: 論文でプレトレーニングに使用されたビジュアルプレテキストタスクとは?

A: 本論文で使用された視覚的先行タスクは、マスクされたオートエンコーダー(MAE)です.これは、ViTのローカリゼーション能力を教えるために効果的であり、下流タスク(例えば、検出)において有効であることが示されています.MAEは、ネットワークがマスクされた入力パッチを再構成することによって、マスクされたトークンを削除することで事前学習を行います.MAEの事前学習は疎であり、他のマスクされた画像モデリング手法とは異なり、マスクされたトークンが上書きされるのではなく削除されるため、効率的な事前学習が可能です.ただし、これは既存の階層モデルにとって問題があり、2Dグリッドを破壊するため、多段階トランスフォーマーには適用できません.しかし、いくつかの簡単なトリックを適用することで、これを解決することができます.(p.3-5)

Q: 本稿で使用したマスクドオートエンコーダー(MAE)は、どのような目的で使用され、下流作業の効果にどのように寄与するのでしょうか.

A: 本論文で使用されたマスク自己符号化器(MAE)の目的は、ViTsの局所化能力を向上させることであり、MAEの事前学習によって、下流タスクの効果的な実行に貢献しています.MAEは、マスクされた入力パッチを再構築することによって、ViTsに局所化能力を教えることができます.MAEの事前学習は、マスクされたトークンが削除されることによって疎になります.これにより、事前学習が効率的になりますが、既存の階層モデルにとっては問題があります.MAEは、個々のトークンをマスクアウトするため、既存の階層モデルの2Dグリッドを破壊します.しかし、本論文では、MAEを使用して、既存の階層モデルのベルとホイッスルを取り除き、強力な先行タスクでトレーニングすることで、MAEの効果的な使用を示しています.(p.3)

Q: 既存の階層型モデルと比較した場合のMAEの限界と、その限界にどのように対処したかを説明してください.

A: MAEは、既存の階層モデルにとって制限があり、MAEの事前学習によって効率的な学習が可能になりますが、既存の階層モデルにとっては問題があります.これは、MAEが依存する2Dグリッドを破壊するためです.また、MAEは個々のトークンをマスクアウトするため、マルチステージモデルとは互換性がありません.この問題を解決するために、簡単なトリックを適用することができます.マルチステージトランスフォーマーのトークンは非常に小さく始まるため、(例えば4×4ピクセル)、各ステージで2倍になります.そのため、より粗い「マスクユニット」(32×32ピクセル)をマスクします.また、MAEはスパースであるため、効率的ですが、空間モジュール(例えば、convs)のようなものを削除するため、問題があります.マスクされたトークンを保持することで、これを修正できますが、MAEの潜在的な4-10倍のトレーニング速度向上を放棄する必要があります.この制限は、既存の階層モデルの精度に大きな影響を与えます.Gaoら(2022)のMCMAEは、最初の数ステージでマスクされた畳み込みを使用して高い精度を得ていますが、全体的なモデルの効率を大幅に低下させています.本研究では、MAEの事前学習に適したアーキテクチャを設計することで、これらの複雑な技術と制限を回避し、強力でシンプルなモデルを作成しています.(p.3-5)

Q: Hieraは、画像処理のベストモデルと比較して、どのように30~40%の高速化を実現しているのでしょうか.

A: これは、Hieraが非常にシンプルで効率的なモデルであるためであり、MAEによること前学習をサポートしているため、非常に高速に結果を得ることができます.また、Hieraは、transformersと畳み込みのような操作を組み合わせたモデルであり、従来のCNNの階層的なステージ構造を採用しています.これにより、Hieraは、画像処理において最新のSotAモデルよりも高速で正確な結果を提供することができます.(p.3)

Q: Hieraはどのようなタスクで評価されたのでしょうか?

A: Hieraは、downstreamのiNaturalistとPlacesの分類、検出、セグメンテーションタスクで評価されました.ImageNet-1Kで事前学習されたHieraをiNaturalist 2017、2018、2019、およびPlaces 365で微調整しました.これらのタスクにおいて、Hieraは速度と精度の両方で優れた性能を発揮しました.これらの情報は、(p.6-7)から抽出されました.

Q: 教師あり分類の性能のために、最新の階層型ビジョン変換器は具体的にどのようなコンポーネントを追加したのでしょうか?

A: 現代の階層的ビジョン・トランスフォーマーは、監視された分類性能を追求するために、いくつかのビジョン特有のコンポーネントを追加しています.(p.1) これらのコンポーネントは、効果的な精度と魅力的なFLOP数をもたらしますが、追加の複雑さは、これらのトランスフォーマーをバニラのViTの対応物よりも遅くします.(p.1)

Q: 教師あり分類の性能を向上させるために、最新の階層型ビジョントランスには具体的にどのようなモジュールが追加されているのでしょうか?

A: 現代の階層的なビジョン・トランスフォーマーには、監視された分類のパフォーマンスを向上させるために、いくつかのビジョン特有のコンポーネントが追加されています.これらのコンポーネントは、効果的な精度と魅力的なFLOP数をもたらしますが、追加された複雑さは、実際にはこれらのバニラViTの対応物よりも遅くなってしまいます. (p.1)