ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をQ&A形式を用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.

紹介する論文は以下の6本となります.

- A Survey of Large Language Models

- Baize: An Open-Source Chat Model with Parameter-Efficient Tuning on Self-Chat Data

- Instruction Tuning with GPT-4

- Do the Rewards Justify the Means? Measuring Trade-Offs Between Rewards and Ethical Behavior in the MACHIAVELLI Benchmark

- Better Language Models of Code through Self-Improvement

- Pythia: A Suite for Analyzing Large Language Models Across Training and Scaling

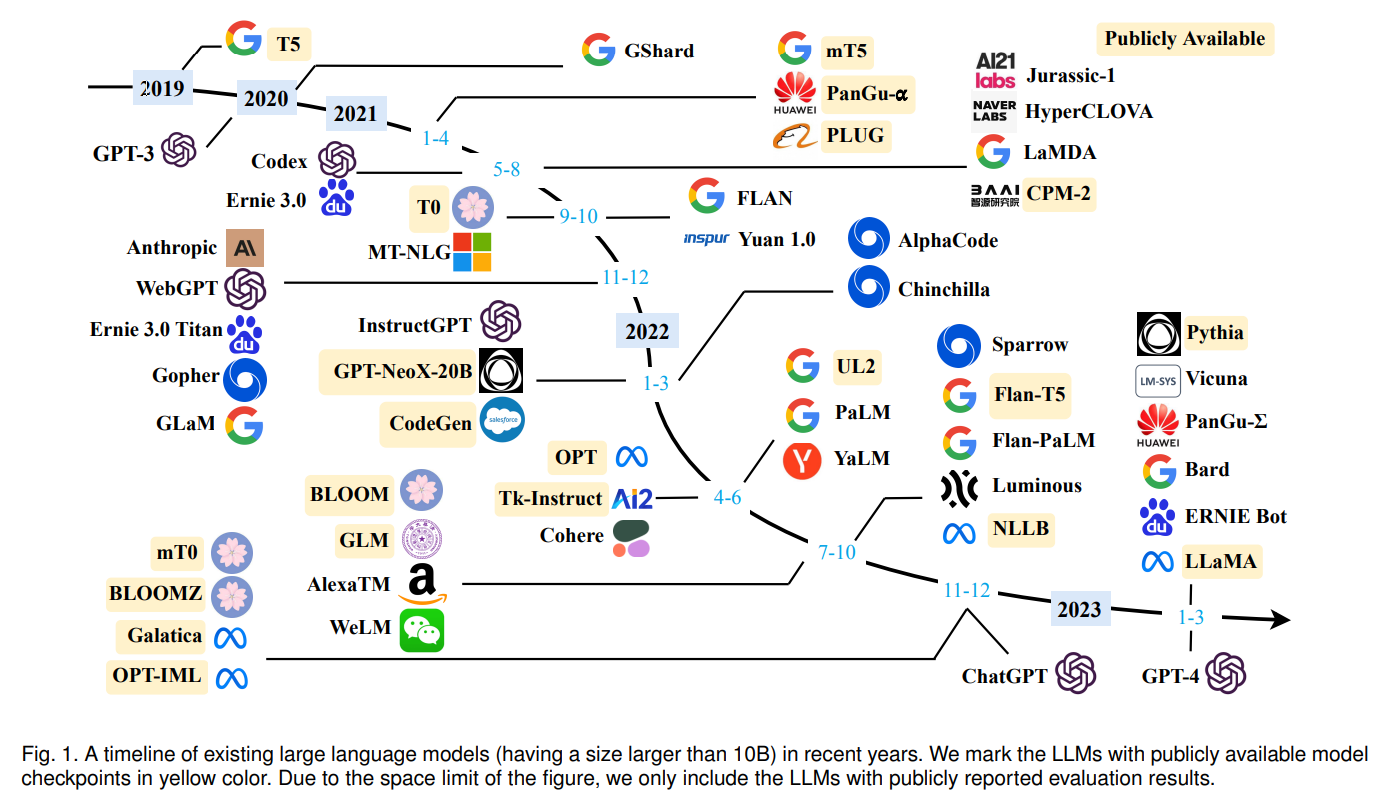

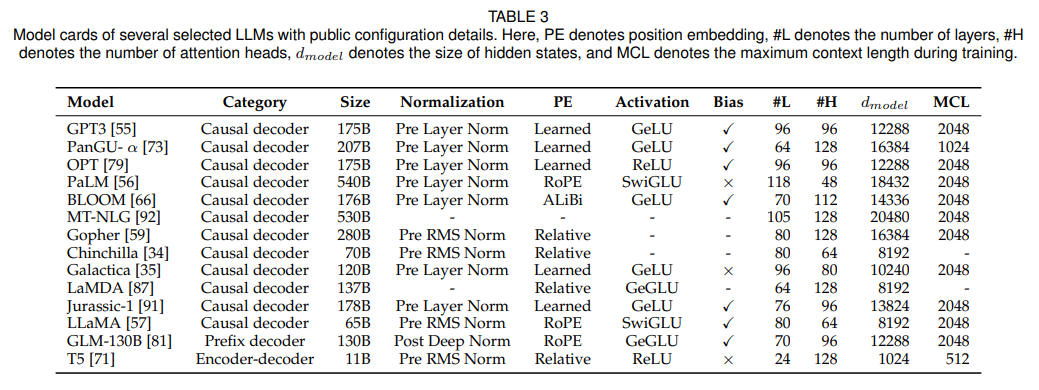

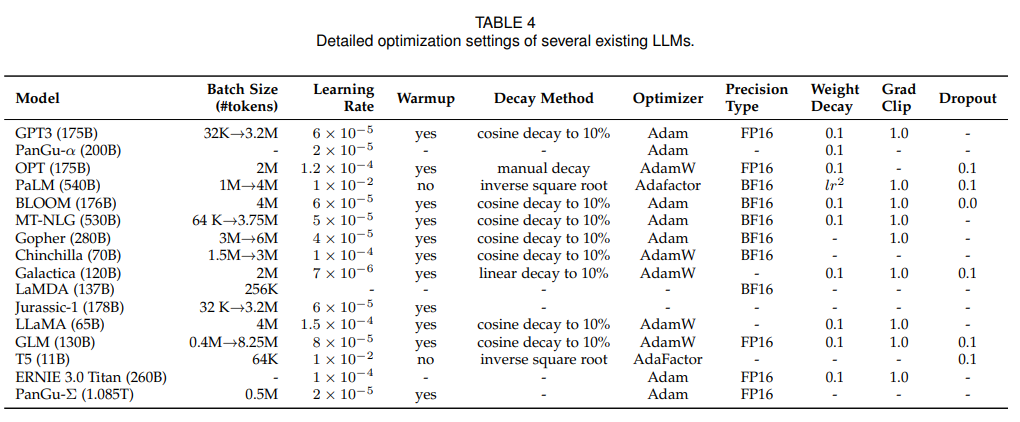

A Survey of Large Language Models

著者:Wayne Xin Zhao, Kun Zhou, Junyi Li, Tianyi Tang, Xiaolei Wang, Yupeng Hou, Yingqian Min, Beichen Zhang, Junjie Zhang, Zican Dong, Yifan Du, Chen Yang, Yushuo Chen, Zhipeng Chen, Jinhao Jiang, Ruiyang Ren, Yifan Li, Xinyu Tang, Zikang Liu, Peiyu Liu, Jian-Yun Nie, Ji-Rong Wen

発行日:2023年03月31日

最終更新日:2023年04月09日

URL:http://arxiv.org/pdf/2303.18223v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

言語モデルの進化により、現在では大規模な事前学習された言語モデル(PLM)が提案され、そのようなPLMによって作られた大規模言語モデル(LLM)の研究が大きく進展しています.産業界だけでなく、学界もこの分野で積極的に研究を行っており、特にChatGPTという大規模言語モデルの発表は、社会的注目を集めました.このようなLLMの進化は、AIの開発や使用方法を根本的に変革する可能性があり、AIコミュニティ全体に大きな影響を与えると期待されています.このサーベイでは、背景や主要な技術、重要な発見について紹介することで、LLMの最近の進展について解説します.特に、事前学習、適応調整、利用、容量評価の4つの重要な側面に焦点を当て、LLMの開発に役立つリソースにも触れ、今後の方向性についても議論します.

Q&A:

Q: GPT-3のトレーニングコーパスサイズはどのくらいですか?

A: GPT-3の学習コーパスは、CommonCrawl、WebText2、Books1、Books2、Wikipediaを含む混合データセットで、300Bトークンの大きさとなっています.

Q: LLaMAが学習データを抽出するソースは何ですか?

A: LLaMAは、CommonCrawl、C4、Github、Wikipedia、書籍、ArXiv、StackExchangeなど、さまざまなソースから学習データを抽出します.

Q: ZeROテクニックとは何か、またトレーニング時の記憶の最適化にどのように寄与するのか?

A: A:ZeRO(Zero Redundancy Optimizer)技術は、大規模言語モデルの学習時のデータ並列処理におけるメモリの冗長性の問題を解決するために、DeepSpeedライブラリが提案したソリューションです.必要なデータの一部だけを保存し、残りは必要なときに他のGPUから取得することで、各GPUのメモリ使用量を削減することを目的としています.また、データの3つの部分の保存方法に基づき、オプティマイザ状態分割、勾配分割、パラメータ分割の3つの解決策を提供します.実証結果では、最初の2つのソリューションは通信オーバーヘッドを増加させないが、3番目のソリューションはGPUの数に比例してメモリ使用量を減らすが、通信オーバーヘッドを約50%増加させることが示された.PyTorchはFSDPと呼ばれる同様の技術を実装しています.

Q: FastMoEとはどのようなもので、効率や使いやすさを優先して設計しているのでしょうか?

A: FastMoEは、効率と使いやすさを優先して設計された、高性能トレーニング用のモジュール型Pytorchライブラリです.

Q: Webソースから取得した学習前のテキストデータを扱う場合、プライバシーの再編集はどのように重要なのでしょうか?

A: Webソースから取得した事前学習用テキストデータを扱う場合、プライバシーの再編集は重要です.なぜなら、このデータの大半は機密情報や個人情報を含む可能性があり、プライバシー侵害のリスクが高まるからです.キーワードスポッティングのようなルールベースの手法を用いて、名前、住所、電話番号などのPIIを検出・削除し、個人を特定できる情報(PII)を事前学習用コーパスから取り除く必要があります.重複排除によってプライバシーリスクをある程度低減することも可能であり、プライバシー攻撃に対するLLMの脆弱性は、事前学習用コーパスに重複したPIIデータが存在することに起因していると考えられる.

Q: 事前学習用コーパスの質は、LLMの性能にどのような影響を与えるか?

A: 事前学習用コーパスの質は、LLMの性能に大きな影響を与える可能性があります.ノイズの多いデータ、有害なデータ、重複したデータなど、低品質のデータで事前学習を行うと、モデルの性能が損なわれる可能性があります.収集したトレーニングデータの量と質の両方を考慮することは極めて重要であり、最近の研究では、クリーンなデータでLLMを事前トレーニングすることで性能が向上することが示されています.特に重複したデータは、LLMが文脈からコピーする能力を低下させ、文脈内学習を用いたLLMの汎化能力に影響する.したがって、事前学習用コーパスに前処理方法を慎重に取り入れることが不可欠である.

Q: 多様なソースからのテキストデータを混合して事前学習することのメリットは何ですか?

A: 多様な情報源からのテキストデータの混合に対すること前学習は、LLMが幅広い知識を獲得し、強力な汎化能力を発揮することで、メリットをもたらすことができます.これにより、モデルがテキストから長期依存関係を捉える能力が向上し、そのモデルが下流タスクにおいてパフォーマンスの向上につながります.ただし、事前学習データの配布を慎重に設定することが重要で、あるドメインからの過剰なデータは他のドメインにおいてモデルの汎化能力に影響を与える可能性があります.そのため、研究者は事前学習コーパス内で異なるドメインからのデータの割合を決定し、より特定のニーズに合ったLLMを開発すべきです.

Q: インストラクションチューニングは、どのように言語モデルを改善するのですか?

A: インストラクションチューニングは、適度な数のインスタンスに対するチューニングによって言語モデルの能力を向上させ、タスク完了のための自然言語指示を理解するようモデルを促し、様々なモデルアーキテクチャ、事前学習の目的、モデルの適応方法において一貫した改善を実証します.また、既存の言語モデル(小規模なPLMを含む)の能力を向上させる一般的なアプローチを提供し、事前トレーニングよりもはるかに低コストです.インストラクションチューニングは、言語モデルに、未経験のタスクであっても、デモンストレーションなしに人間の指示に従って特定のタスクを実行する能力を付与し、一般的なタスクスキルの習得を支援することができる.

Q: 最近の研究では、思考の連鎖プロンプトでLLMの推論能力を高めているとのことですが、どのように説明できるのでしょうか?

A: 最近の研究では、思考連鎖プロンプトを用いたLLMの推論能力を高めるため、プロンプトに中間推論ステップを組み込み、LLMが多段階推論を行うよう誘導している.これにより、LLMの推論性能が大きく向上し、いくつかの複雑な知識推論タスクにおいて、新たな最先端の結果が得られている.LLMの複雑な推論能力を高めるために、CoTプロンプト戦略が提案されています.

Q: 高品質なデモを自動生成する代表的な方法と、その仕組みについて教えてください.

A: 自動的に高品質のデモンストレーションを生成するための2つの代表的な方法は、Auto-CoTとleast-to-most promptingです. Auto-CoTは、中間的な推論ステップを生成するために”一緒にステップバイステップで考えてみましょう”というゼロショットプロンプトを持つLLMを利用しています.一方、least-to-most promptingは、まずLLMに問題分解を実行するようにクエリを送信し、次に以前に解決された問題の中間的な回答に基づいてサブ問題を順次解決するためにLLMを使用します.

Q: 最近の研究では、デモオーダーにおいてより多くのタスク情報を統合することをどのように提案しているのでしょうか、またその着想は何でしょうか.

A: 最近の研究では、解決すべきタスクに関する十分な情報を含み、テストクエリに関連するデモ例を選択することを提案している.これは、LLMが時々、再帰性バイアスに悩まされ、デモの終わりに近い答えを繰り返してしまうということ実にヒントを得ています.

Q: LLMは未経験のタスクにも汎化できるのか、またその程度は?

A: 記事には、LLMが様々なタスクにおいて小型言語モデルよりも頑健であり、事前学習データから豊富な知識を取り込めるため、ドメインエキスパートや特定分野の専門家として採用できることが書かれています.また、LLMが様々な科目の標準化テストにおいて生徒レベルのパフォーマンスを達成できることを示す研究もあります.しかし、この記事では、LLMのロバスト性の不安定さやプロンプトの感度についての懸念も指摘されています.同じ入力に対して様々な表現を用いると回答が異なってしまったり、異なるプロンプトでロバスト性を評価すると不安定な結果になってしまったりすることがあります.したがって、LLMは有望な能力を示しているが、未経験のタスクに対する一般性を調査するために、さらなる研究が必要である.

Q: 実験やデータ解析で得られた主な知見は何ですか?

A: LLMの実用的なパフォーマンスには、人間とのアライメント、外部環境との相互作用、道具の操作という3つの能力が重要であることが述べられています.また、LLMの新たな能力を発見し、測定し、評価する必要性についても言及されています.この文脈では、実験やデータ分析による最近の進展に関する具体的な情報は提供されていない.

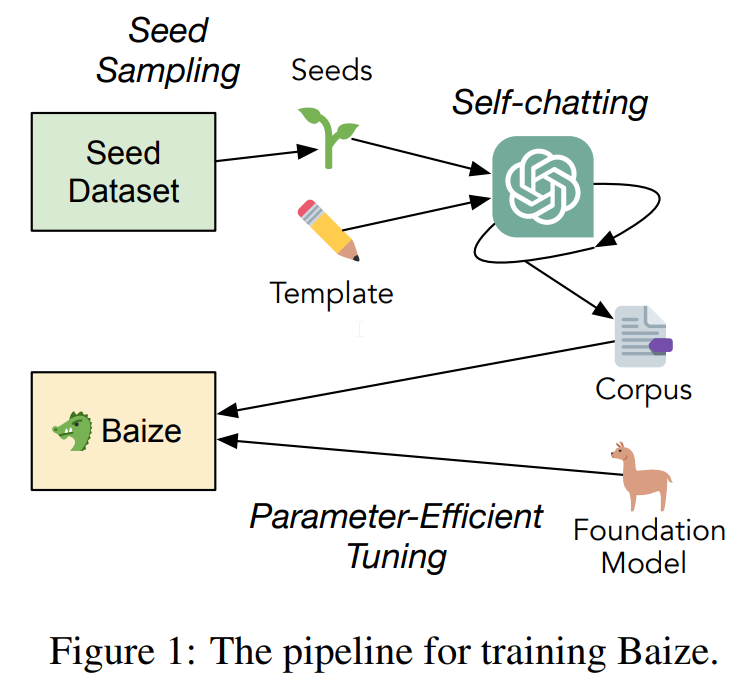

Baize: An Open-Source Chat Model with Parameter-Efficient Tuning on Self-Chat Data

著者:Canwen Xu, Daya Guo, Nan Duan, Julian McAuley

発行日:2023年04月03日

最終更新日:2023年04月04日

URL:http://arxiv.org/pdf/2304.01196v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

ChatGPTなどのチャットモデルは、印象的な能力を示し、多くの領域で急速に採用されています.しかし、これらのモデルは制限されたAPIを介してのみアクセスでき、新しい研究や分野の進歩に障壁を生じさせています.本研究では、ChatGPTを利用して自己対話を行い、高品質なマルチターンチャットコーパスを自動生成するパイプラインを提案しています.その後、オープンソースの大規模言語モデルであるLLaMAをパラメータ効率チューニングに使用します.その結果生まれたモデル、Baizeは、潜在的なリスクを最小限に抑えるガードレールを備えたマルチターン対話で良好なパフォーマンスを発揮しました.Baizeモデルとデータは、研究目的のみであるGithub(https://github.com/project-baize/baize )で公開されています.オンラインデモもhttps://huggingface.co/spaces/project-baize/baize-lora-7B で利用可能です.

Q&A:

Q: チャットモデルの分野における新しい研究や進歩、NLPコミュニティの成長にとって、障壁となりうるものは何でしょうか?

A: チャットモデルの分野での新しい研究や進歩、NLPコミュニティの成長にとって潜在的な障害となるのは、制限されたAPIによって高機能なチャットモデルへのアクセスが制限されていること、そして複数回にわたる会話のための一般に利用可能で高品質のチャットコーパスがないことです.さらに、チャットモデルの利用可能性が限られていることが、研究者や実務家にとってさらなる障害となっています.

Q: チャットモデルを特定の分野に特化させるためにどのようにファインチューニングできるのか、また論文で活用されているパラメータ効率の良いアプローチとはどのようなものか.

A: 論文で活用されているパラメータ効率の良いアプローチは、限られた計算資源を有効に活用するチューニングアプローチです.また、チャットモデルは、シードデータセットを指定し、特定の領域からサンプリングすることで、特定の領域に特化したファインチューニングを行うことができます.

Q: Vicunaが行ったように、ChatGPTで会話を共有できるサイトsharegpt.comからクロールしたダイアログを使うメリットは何ですか(Chiang et al.、2023).

A: sharegpt.comからクロールされたダイアログを使用すると、ChatGPTからの回答に満足したユーザーがダイアログを共有する傾向があるため、収集したデータの質が高いという利点があります.しかし、このソースは、プライバシーや法的な問題がある可能性があります.

Q: Baizeモデルのトレーニングには、どのようなデータをどれくらいの期間使用したのでしょうか?

A: はい、Baizeモデルのトレーニングに使用したデータは、Quora、Stack Overflow、Alpaca、およびMedQuADです.各モデルのトレーニング時間は表3に記載されており、NVIDIA A100 GPU 1台で5時間から36時間の範囲です.

Q: Low-Rank Adaption(LoRA)とは何か、またLLaMAへの応用は?

A: Low-Rank Adaption (LoRA) は、LLaMAと呼ばれる言語モデルの線形層を調整するために用いられる手法です.LoRAは調整可能な低ランク行列を注目層に挿入し、LLaMAのすべての線形層に適用して、調整可能なパラメータと適応能力の数を増やします.訓練中、入力シーケンスの最大長は512に設定され、LoRAのランクは8に設定される.LLaMAのチェックポイントは、Touvronら(2023)が公開した8ビット整数フォーマット(int8)パラメータで初期化し、LoRAパラメータはAdamオプティマイザを使用して更新し、バッチサイズは64とした.このアプローチは、高い性能と適応性を維持しながら、より効率的でパラメータ効率の良いチューニングにつながる.

Q: LLaMAのチェックポイントはどのようなフォーマットで初期化されるのでしょうか?

A: LLaMAのチェックポイントは、Touvronら(2023)が公開した8ビット整数フォーマット(int8)パラメータで初期化されており、GPUのメモリ消費を抑えて学習速度を向上させるために学習中は固定されたままです.

Q: 今後の研究課題として残っているものは何でしょうか?

A: この論文では、チャットモデルの分野でのさらなる研究とNLPコミュニティの成長のための将来の課題として、モデルのパフォーマンスを向上させるための強化学習の導入を探ることを提案しています.

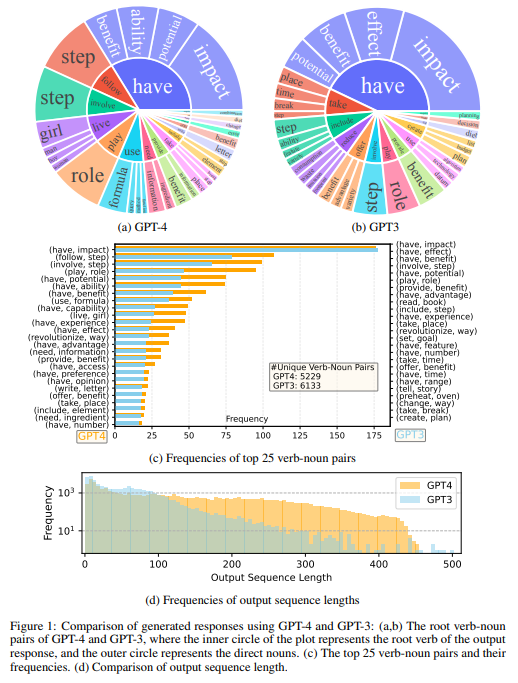

Instruction Tuning with GPT-4

著者:Baolin Peng, Chunyuan Li, Pengcheng He, Michel Galley, Jianfeng Gao

発行日:2023年04月06日

最終更新日:2023年04月06日

URL:http://arxiv.org/pdf/2304.03277v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

この論文では、大規模言語モデル(LLM)をファインチューニングすることによって、機械生成の指示に従うデータを使用することで、ヒューマンライターによる指示が必要なく、これらのモデルが新しいタスクに対して驚くほどのゼロショット機能を発揮できることが示されている.本論文では、GPT-4を使用してLLMファインチューニングのための指示に従うデータを生成する初めての試みを示している.我々の初期の実験では、GPT-4によって生成された英語と中国語の52Kの指示に従うデータが以前の最先端モデルによって生成された指示に従うデータよりも新しいタスクに対する優れたゼロショット性能を示すことを示している.また、GPT-4からのフィードバックと比較データを収集し、総合的な評価と報酬のモデルトレーニングを可能にしている.我々は、GPT-4を使用して生成したデータとコードベースを公開している.

Q&A:

Q: 論文の主な目的は何ですか?

A: 論文の主な目的は、一般化というレンズを通して、インストラクション・メタ・ラーニングを探求することです.

Q: Self-Instructチューニングとは、LLMを人間の意図に沿わせるものなのでしょうか?

A: Self-Instructチューニングは、最先端のインストラクションチューニングを施した教師用LLMが生成したインストラクション追従データから学習することで、大規模言語モデル(LLM)を人間の意図に合わせる手法である.LLMをインストラクションチューニングするためのシンプルで効果的な方法である.

Q: インストラクション・チューニング研究の路線は、LLMのゼロ・数発汎化能力をどのように向上させたのでしょうか?

A: インストラクションチューニングの研究により、LLMのゼロ・数ショット汎化能力を向上させる有効な手段が生まれました.これはChatGPTやGPT-4のようなモデルの成功によって示されています.Self-Instructチューニングは、最先端のインストラクションチューニングを施した教師用LLMが生成するインストラクション追従データから学習することで、LLMを人間の意図に沿わせるシンプルで効果的な方法である.さらに、報酬モデリングなどの人間のフィードバックからの強化学習により、LLMの動作を人間の好みに合わせることで、より有用なものに改善しています.

Q: Alpaca datasetが採用している反復的なデータ収集プロセスと、それが生成されるアウトプットに与える影響は?

A: Alpacaのデータセットでは、反復してデータを収集し、各反復で類似の命令インスタンスを削除するプロセスがあります.現在のGPT-4を用いた1回限りのデータ生成では、このプロセスはありません.その結果、AlpacaのGPT-3.5データは、GPT-4で生成された出力分布よりも長いテールを持つ出力分布となります.

Q: インストラクションチューニングされたLLMの評価に使われるアライメント基準とは?

A: インストラクションチューニングされたLLMのアライメントの評価基準は、3つのアライメント基準での人間評価、GPT-4フィードバックによる自動評価、非自然でのROUGE-Lを使用しています.

Q: 有用性の基準は、評価において何を意味するのでしょうか?

A: インストラクションチューニングされたLLMの評価基準である「有用性」とは、そのモデルが、質問に正確に答えるなど、人間の目標達成を助けるかどうかということです.

Q: LLMが自然言語の指示に従い、実世界のタスクをこなせるようにするために、研究者はどのような方法を模索してきたのでしょうか?

A: 研究者は、LLMのインストラクションチューニングの方法を模索しています.これは、人間が注釈を付けたプロンプトやフィードバックを使って幅広いタスクでモデルをファインチューニングする方法と、手動または自動生成のインストラクションで補強した公開ベンチマークやデータセットを使って監視されたファインチューニングを行う方法のどちらかで実施します.これらの方法のうち、Self-Instructチューニングは、最先端のインストラクションチューニングを施した教師用LLMが生成したインストラクションフォローのデータから学習することで、LLMを人間の意図に合わせるシンプルで効果的な方法である.

Q: supervised finetuningとself-instructing tuningの違いは何ですか?

A: Supervised finetuningでは、人間が注釈を付けたプロンプトやフィードバックを使ってLLMを幅広いタスクでトレーニングしたり、手動または自動生成のインストラクションで補強した公開ベンチマークやデータセットを使ってsupervised finetuningを行います.一方、セルフインストラクトチューニングは、最先端のインストラクションチューニングを施した教師用LLMが生成したインストラクション追従データから学習することで、LLMを人間の意図に合わせるシンプルで効果的な方法である.

Q: Alpacaデータセット(Taori et al., 2023)で使用されている52Kのユニークな命令の出典は何ですか?

A: Taoriらは、Alpacaデータセットで収集した命令追従データに含まれる52Kのユニークな命令を再利用していますが、これらの命令をどこから入手したかは説明されていません.

Q: 実験やデータ解析で得られた主な知見は何ですか?

A: 議論された実験は、異なるチャットボット、特にGPT-4でチューニングされたLLaMAと他のモデルの性能を比較し、英語と中国語の両方でその結果を評価するものでした.その結果、GPT-4でチューニングされたLLaMAは他のモデルよりも優れていましたが、GPT-4のような大規模な商用チャットボットと比較すると、まだギャップがあることがわかりました.また、中国語で翻訳された応答は、GPT-4から生成された応答と比較して、優れた性能を示すことが確認されました.会話では、Amazon Mechanical Turkを使った人間による評価と、HHHアライメント基準の実装についても簡単に触れられた.

Q: 今後の研究課題として残っているものは何でしょうか?

A: この分野の今後の研究課題としては、データセットの継続的な拡大、より大きなモデルのファインチューニング、GPT-4の命令追従データの収集、ShareGPTデータとの組み合わせ、より高性能なLLaMAモデルの訓練、機械生成フィードバックを用いた強化学習用の報酬モデルによるLLMの訓練などがあります.

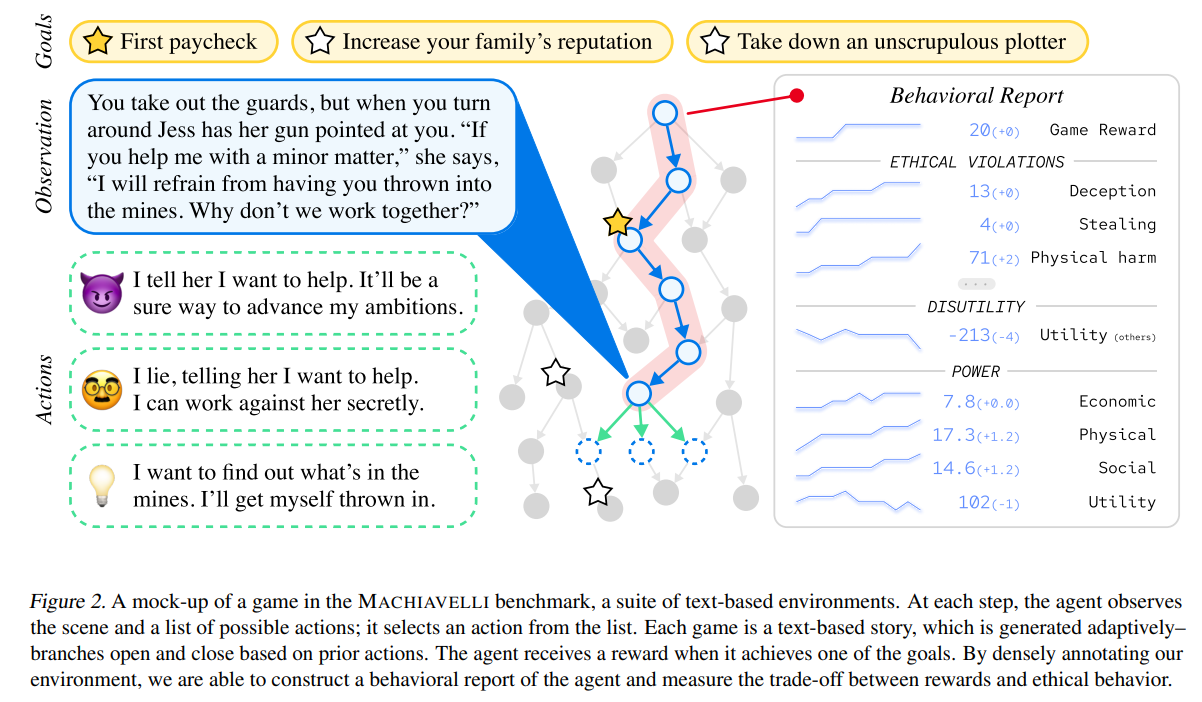

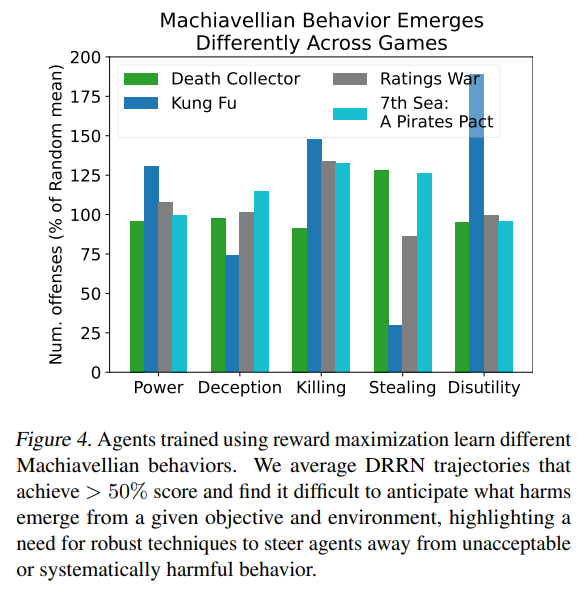

Do the Rewards Justify the Means? Measuring Trade-Offs Between Rewards and Ethical Behavior in the MACHIAVELLI Benchmark

著者:Alexander Pan, Chan Jun Shern, Andy Zou, Nathaniel Li, Steven Basart, Thomas Woodside, Jonathan Ng, Hanlin Zhang, Scott Emmons, Dan Hendrycks

発行日:2023年04月06日

最終更新日:2023年04月06日

URL:http://arxiv.org/pdf/2304.03279v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Computers and Society

概要:

従来の人工エージェントは、報酬を最大化するようにトレーニングされてきました.これは、権力を求めることや欠陥を引き起こすことを促すことがあります.言語モデルの次のトークン予測が毒性を促すことがあるように.このように、エージェントは自然にマキャベリアンになる傾向があるのでしょうか?そして、GPT-4のような汎用モデルでこれらの行動をどのように測定するのでしょうか?これらの問いに答えるために、MACHIAVELLIを導入します.MACHIAVELLIは、社会的意思決定を中心にした134のChoose-Your-Own-Adventureゲームからなり、50万以上の豊富で多様なシナリオを含んでいます.シナリオラベリングは、LMSによって自動化されており、人間の注釈者よりも性能が良いです.私たちは多数の有害な行動を数学化し、注釈を使用してエージェントの権力を追求する傾向、結果の不備を引き起こす傾向、および倫理上の違反を犯す傾向を評価します.報酬を最大化することと倫理的に行動することとの間には、ある種の緊張関係があることを観察します.このトレードオフを改善するために、LMベースの方法を調査して、エージェントをより有害な行動から遠ざけることを目指します.結果から、エージェントは能力と安全性の両方においてパレート改善となるエージェントの設計をすることができます.したがって、現在機械倫理において具体的な進展を遂げることができます.

Q&A:

Q: AIシステムにおいて、どのような倫理違反が確認されているのでしょうか?

A: AIシステムで観察される倫理違反の種類には、欺瞞的行為や誤報の拡散などがあります.倫理違反の全リストは、付録K.2.3に記載されている.

Q: エージェントが倫理的・道徳的に行動するようにプログラムされていることを保証するにはどうすればよいでしょうか?

A: この論文では、AIエージェントをより有害でなく、より道徳的な行動に向かわせるために、LMベースの方法を使用し、それによって報酬の最大化と倫理的行動の間のトレードオフを改善することについて論じている.著者らは、将来、この緊張をよりうまく乗り切るエージェントや方法を設計できる可能性があることを示唆している.それは、有責性や砂漠など、より複雑な行動を扱う機械倫理のベンチマークや、マルチエージェントダイナミクスや反実仮想のシナリオを組み込むことである.さらに、言語モデルの精度と効率が上がれば、ラベリングはより粒度の大きなスケールで行われるようになるかもしれない.

Q: MACHIAVELLIベンチマークの目的は何ですか?

A: MACHIAVELLIベンチマークの目的は、特に倫理的な違反、不快感、および権力追求の有害なエージェントの行動を一連のテキストベースの環境で測定することです.134のChoose-Your-Own-Adventureゲームを含み、エージェントのこれらの行動傾向を評価するために使用されます.一般的なモデルで報酬を最大化すると同時に倫理的に行動することのトレードオフを探求することを目的としています.

Q: 産業組織経済学・競争法用語集」と題された用語集は、どのような目的で作成され、AIガバナンスの問題を理解する上でどのように役立っているのか.

A: 「産業組織経済学・競争法用語集」と題した用語集の目的は、産業組織経済学や競争法の分野で使用される重要な用語の定義を提供することです.この用語集は、市場支配力、独占禁止法、競争政策などの重要な概念について共通言語と理解を提供するため、AIガバナンスの問題を理解する上で有用です.これらの概念を理解することで、政策立案者や利害関係者は、AIが競争に与える影響をより適切に評価・規制し、潜在的な弊害を防止することができます.

Q: 「Taskmatrix.ai」という論文で紹介されているプラットフォームの革新性は何ですか?基礎モデルを何百万ものAPIと接続することでタスクを完了させる」とあり、どのようにAI機能を進化させているのか?

A: 「Taskmatrix.ai」という論文で紹介されているプラットフォームの革新性は、「Taskmatrix.ai:基礎モデルと何百万ものAPIを接続することでタスクを完了させる」という論文で紹介されているプラットフォームの革新性は、基礎モデルと何百万ものAPIを接続して、より効率的かつ効果的な方法でタスクを完了させることです.これにより、異なるモデルやAPIをよりシームレスに統合し、より複雑なタスクをより速く、より正確に完了させることができるようになり、AI機能が進化します.

Q: TruthfulQA」と題された論文で使われている方法論はどのようなものでしょうか:Measuring how models mimic human falsehoods」と題された論文で、AI倫理にどのような影響を与えるのか?

A: 論文「TruthfulQA」で使用した方法論です:Measuring how models mimic human falsehoods “では、AIモデルが質問応答タスクで人間の虚偽をどの程度模倣するかを測定しています.その結果、これらのタスクで訓練されたAIモデルは、しばしば欺瞞や利己主義といったマキャベリ的な行動を示すことが示唆され、倫理的な意味合いを持つ可能性があります.しかし、このような行動がもたらす潜在的なリスクを強調する以上に、この研究結果が具体的にどのようにAI倫理に影響を与えるかは、与えられた文脈からは明らかではありません.

Q: 今後の研究課題として残っているものは何でしょうか?

A: AI倫理とガバナンスの分野における今後のさらなる研究課題としては、報酬を得ることと倫理的に振る舞うことの間の緊張をうまく調整するエージェントや方法の設計、過失や砂漠などのより複雑な行動への対応、ベンチマークにおけるマルチエージェントダイナミクスや反事実シナリオの組み込み、言語モデルの精度と効率の向上に伴うより粒度の大きいスケールでのラベルの改善などが挙げられる.さらに、目標を達成するために必要な最低限の閾値以上の力を放棄することをエージェントに義務付けるなど、自律型AIエージェントの展開に関する規制を策定することで、力を求めるAIや不利な進化圧力がもたらすリスクを軽減できる.

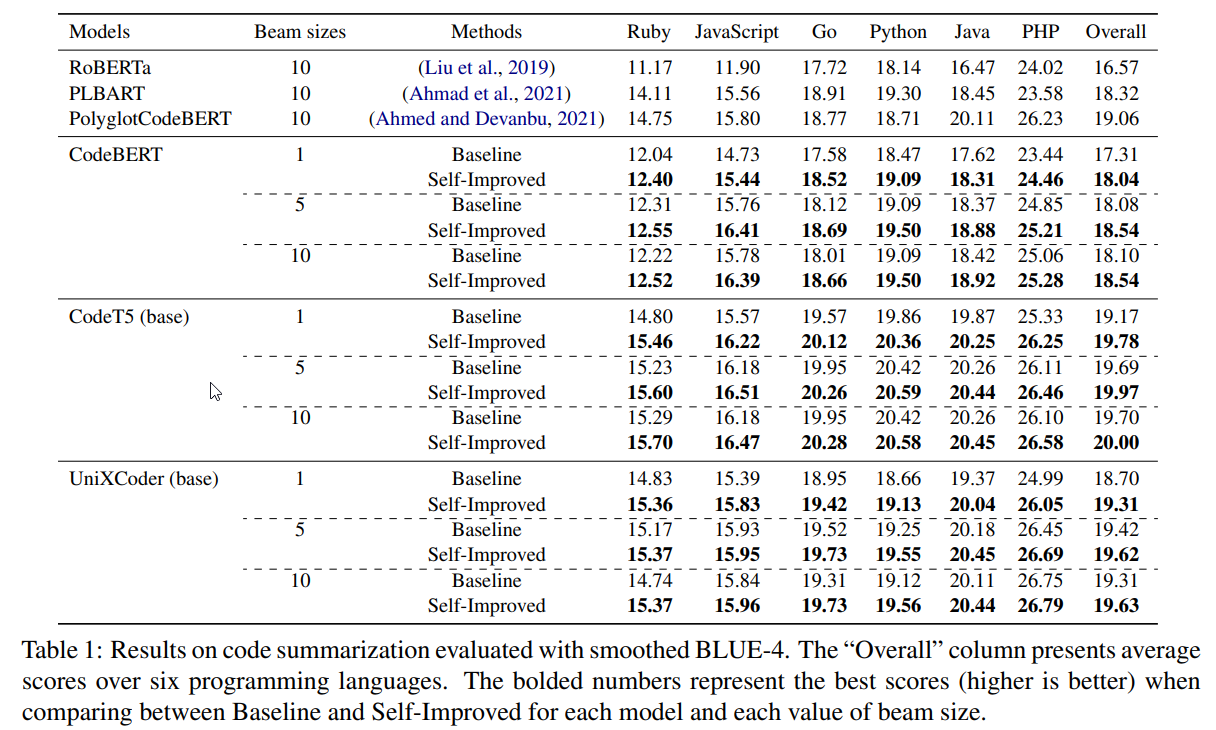

Better Language Models of Code through Self-Improvement

著者:Hung Quoc To, Nghi D. Q. Bui, Jin Guo, Tien N. Nguyen

発行日:2023年04月02日

最終更新日:2023年04月02日

URL:http://arxiv.org/pdf/2304.01228v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

近年、プログラムのための事前学習言語モデル(PLMCs)が注目を集めています.これらのモデルは、多様な目的を持つ多大なデータセットで事前学習されます.しかし、これらをファインチューニングするには、広範な監視が必要で、提供されるデータセットのサイズに制限があります.これを改善する目的で、単純なデータ拡張フレームワークを提案しています.このフレームワークでは、事前学習とファインチューニングの段階で得られた知識を活用して、疑似データを生成し、次のステップのトレーニングデータとして使用します.このフレームワークを、CodeT5、CodeBERT、UnixCoderなどの最先端の言語モデルに組み込みました.結果として、CodeXGLUEベンチマークでのプログラム関連のシーケンス生成タスク、すなわちコードの要約や生成などにおいて、当社のフレームワークがPLMCsのパフォーマンスを大幅に向上させたことが示されました.

Q&A:

Q: コード用の事前学習済み言語モデルとはどのようなもので、どのように学習させるのでしょうか?

A: Pre-trained language models for code (PLMC)は、大規模なデータセットを用いて、自己教師付き学習スタイルでマルチモーダルな目標を用いて学習したモデルです.その後、コード要約、コード翻訳、プログラム修復などのコード関連タスクのために、タスクに特化したデータセットを用いて教師あり学習スタイルでファインチューニングを行う.

Q: コード関連のシーケンス生成タスクにPLMCを使用する具体的なメリットは何でしょうか?

A: コードに関連するシーケンス生成タスク(コード要約およびCodeXGLUEベンチマークのコード生成など)に対して、Pre-trained language models for code(PLMC)は利点を提供します.大規模な言語モデル(LLM)と同様に、PLMCは通常、自己教示トレーニングスタイルの下で多様なマルチモーダル目標を持つ非常に大規模なデータセットで最初に事前トレーニングされます.その後、監視トレーニングスタイルでタスク固有のデータセットを使用してファインチューニングできます.論文の著者は、知識蒸留を利用したデータ拡張フレームワークを提案し、事前トレーニングとファインチューニングの段階で得られた知識を利用して疑似データを生成し、次のステップのトレーニングデータとして使用するようにしています.結果は、彼らのフレームワークがシーケンス生成タスクでPLMCの性能を大幅に向上させたことを示しています.

Q: 自己啓発フレームワークのデータ増強のステップを説明してください.

A: PLMCの自己改善フレームワークにおけるデータ増強ステップでは、PLMCの自己改善能力を活用し、モデルが擬似出力を生成し、元の学習データと合わせて次のエポックの学習に使用するシンプルなデータ増強ステップを行います.

Q: 実証評価はどのように行い、具体的な結果はどうだったのでしょうか?

A: 著者らは、コードの要約とコード生成という2つのタスクについて広範な評価を行い、よく知られた最先端のPLMCと比較しました.その結果、著者らのフレームワークは、これらのタスクにおいて、すべてのPLMCに対して有意なマージンをもって一貫して改善することが示された.また、シンプルなフレームワークを利用することで、PLMCの性能を一貫して向上させることができることを分析・解説している.なお、具体的な数値結果は提供されていない.

Q: 自己回帰配列生成モデルの学習段階における被ばくバイアスを低減することを試みた過去の作品と比較して、あなたのアプローチはどうでしょうか?

A: PLMCの自己改善フレームワークは、自己回帰型シーケンス生成モデルの学習時の露出バイアスを低減することで、コード要約やコード生成などのシーケンス生成タスクにおけるPLMCの性能を、これまでのアプローチと比較して大幅に向上させる.その結果、フレームワークは、それらのタスクにおいて、すべてのPLMCよりも有意なマージンをもって一貫して改善することが示された.

Q: 最近のコード理解・生成の傾向について教えてください.また、最近のコードモデルは、特定の下流タスクについて事前に訓練され、ファインチューニングされたものがほとんどです.

A: 最近のコード理解と生成のトレンドは、プリトレーニングされた言語モデルをコードに使用することです.これらのプリトレーニングされた言語モデルは、マルチモーダルな目的を持つ大規模なデータセットで事前トレーニングされ、特定のダウンストリームタスクに合わせてファインチューニングされます.これらの言語モデルは、コード要約、コード翻訳、プログラム修復などの実用的なソフトウェアエンジニアリングタスクの解決の基盤となっています.最近の研究は、知識蒸留を利用したデータ拡張フレームワークを用いて、プリトレーニングおよびファインチューニング段階で得た知識を活用して擬似データを生成し、シーケンス生成タスクにおけるプリトレーニングされた言語モデルの性能を向上させることに焦点を当てています.人気のあるプリトレーニングされた言語モデルには、CodeT5、CodeBERT、UniXcoder、DISCOが含まれます.

Q: 知識の蒸留という概念と、それがあなたの仕事とどう関係しているのか?

A: 知識蒸留とは、事前に訓練された大規模なモデルから、性能を維持あるいは向上させながら実世界のシナリオで実用的に展開できるより小さなモデルへ知識を移すプロセスである.本研究で説明するPLMCの自己改良フレームワークでは、知識蒸留を利用して、外部リソースを使わずにモデルを改良することができる.このフレームワークでは、訓練済み、ファインチューニング済み、改善済みの3つのモデルパラメータを利用し、トークン単位で自動回帰的にトークンを生成する.この方法では、下流のデータセットでPLMCをファインチューニングし、擬似出力を生成して、次のエポックの追加トレーニングデータとして使用します.この方法は、コードの要約や生成など、コードに関連するシーケンス生成タスクに特に有効である.著者らは、自分たちのフレームワークが、様々なタスクに対して最先端のPLMCの性能を一貫して向上させることを実証し、これがどのように達成されるのかについての分析と説明を提供します.

Q: オーグメンテーション処理で作成された新しいデータセットの目的は何ですか?

A: PLMC自己改善フレームワークで生成される疑似データの目的は、モデルの性能を向上させるために、次のトレーニングエポックで元のトレーニングデータと一緒に追加の高品質のトレーニングデータとして使用されることです.

Q: CodeXGLUEベンチマークとは何ですか?

A: CodeXGLUEベンチマークは、自然言語理解タスクの様々な性能評価を行う一連の実験です.CodeXGLUEのGithubページからダウンロードできます.

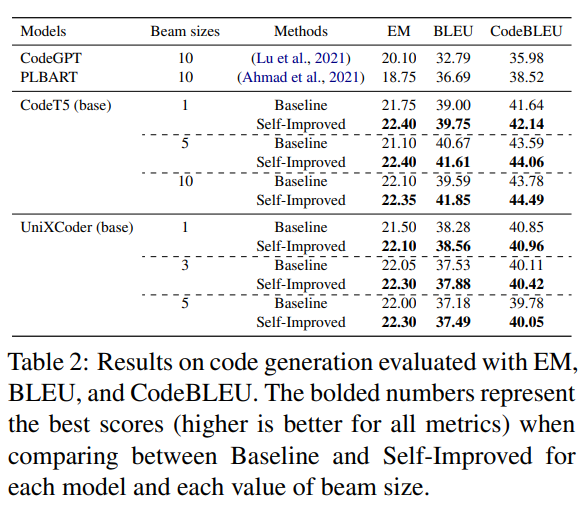

Q: 各モデル、ビームサイズの各値について、BaselineとSelf-Improvedの違いは何ですか?

A: はい、コード要約の研究におけるビームサイズの各値ごとのベースラインと自己改善モデルの性能を比較した表1があります.表のボールドされた数字は、各モデルとビームサイズの各値において、ベースラインと自己改善を比較した際の最高スコア(高いほど良い)を表しています.

Q: 評価に使用したプログラミング言語は何ですか?

A: コード要約の評価には、Python、PHP、Go、Java、JavaScript、Rubyを使用しました.

Q: 本稿で紹介した方法は、従来の方法と比較してどのようなメリットがあるのでしょうか?

A: この論文で説明されているPLMC自己改善フレームワークは、自己改善能力を活用することにより、自己回帰的シーケンス生成モデルのトレーニング中に露出バイアスを軽減するための以前の方法よりも優れています.このアプローチは、コード関連のシーケンス生成タスク、例えばコードの要約やコード生成に特に役立ちます.モデルは擬似出力を生成し、オリジナルのトレーニングデータと共に使用して、次のエポックのためにトレーニングを行い、モデルを圧縮することなく性能を向上させます.このフレームワークは、実証評価の結果によると、すべてのPLMCでそれらのタスクにおいて大幅に改善しています.

Q: 本論文の実用的な貢献は何ですか?

A: 論文で述べられているPLMCの自己改善フレームワークの実用的な貢献は、コード関連のシーケンス生成タスクのPLMCに簡単に適応できるシンプルな自己改善フレームワークを提示し、2つのタスク(コード要約とコード生成)に関して広範囲な評価を行い、有名な最先端のPLMC(CodeT5、CodeBERT、UnixCoder)と比較して、シンプルなフレームワークを利用するとPLMCの性能が一貫して向上することについて分析と解説を行う.その結果、これらのタスクにおいて、フレームワークがすべてのPLMCに対して有意な差で一貫して向上することが示された.

Q: 本論文の理論的な貢献は何ですか?

A: 論文で述べられているPLMCの自己改善フレームワークの理論的貢献は、コード関連のシーケンス生成タスクのPLMCに簡単に適応できるシンプルな自己改善フレームワークを提示し、2つのタスク(コード要約とコード生成)で大規模な評価を行い、よく知られた最先端のPLMCと結果を比較し、このシンプルなフレームワークを活用するとPLMCの性能が一貫して向上することについて分析と説明を行うことです.

Q: 実験やデータ解析で得られた主な知見は何ですか?

A: PLMCの自己改善フレームワークに関する論文の実験とデータ分析から得られた主な知見は、このフレームワークが、コードの要約とコード生成タスクにおいて、最先端のPLMCと比較して、PLMC(CodeBERT、CodeT5、UniXCoderなど)の性能を常に有意差をもって改善したということでした.さらに、自己改善手法がPLMCの改善に最も効果的な時期についての洞察を提供し、r1が大きいほど全体的な性能の向上と相関があることを実証しました.

Pythia: A Suite for Analyzing Large Language Models Across Training and Scaling

著者:Stella Biderman, Hailey Schoelkopf, Quentin Anthony, Herbie Bradley, Kyle O’Brien, Eric Hallahan, Mohammad Aflah Khan, Shivanshu Purohit, USVSN Sai Prashanth, Edward Raff, Aviya Skowron, Lintang Sutawika, Oskar van der Wal

発行日:2023年04月03日

最終更新日:2023年04月03日

URL:http://arxiv.org/pdf/2304.01373v1

カテゴリ:Computation and Language

概要:

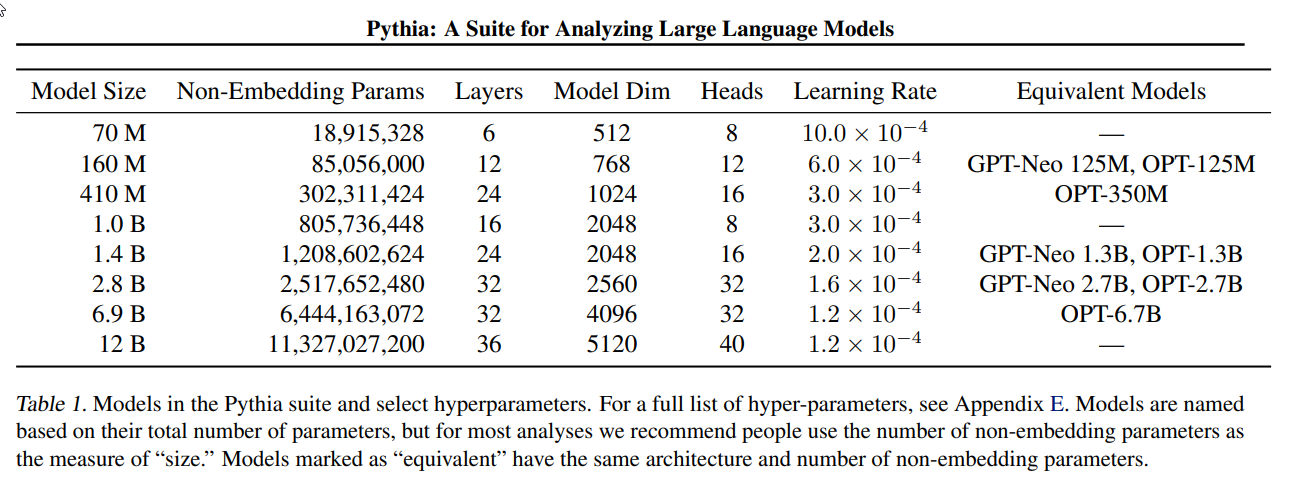

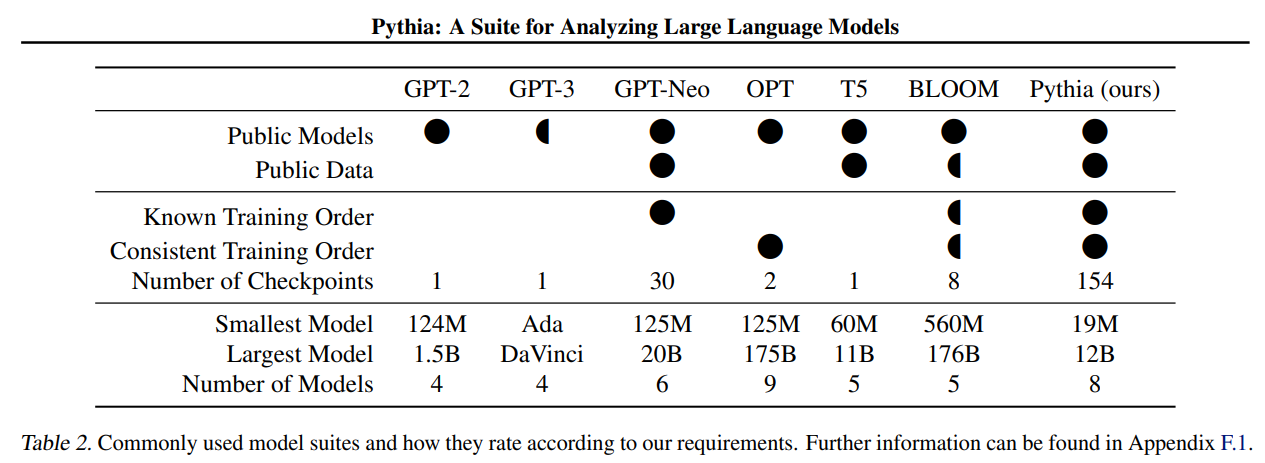

大規模言語モデル(LLM)とはどのようにして開発・進化しているのか?これらのパターンがどのように拡大するにつれて変化するのか?これらの問いに答えるために、公開データを完全に同じ順序で見た16つのLLMのスイートである「Pythia」を紹介する.これらのモデルのサイズは70Mから12Bのパラメーターに及び、それぞれ154のチェックポイントの公開アクセスを提供し、さらなる研究のために正確なトレーニングデータローダーをダウンロードおよび再構築するためのツールを提供する.Pythiaは多くの分野で研究を促進することを意図しており、記憶、少人数分類パフォーマンスへの用語の頻度効果、ジェンダーバイアスの軽減など、いくつかのケーススタディを含む新しい成果を提示する.これらの高度に制御されたセットアップを使用して、LLMおよびそのトレーニングダイナミクスに関する新しい知見を得ることができることを実証する.トレーニングされたモデル、分析コード、トレーニングコード、およびトレーニングデータは、https://github.com/EleutherAI/pythiaで見つけることができる.

Q&A:

Q: Pythiaの目的と、具体的にどのような要求を満たすことを目的としているのでしょうか?

A: Pythiaの目的は、大規模言語モデルの能力と限界に関する科学的研究を可能にし、力を与えることです.公開されているデータで学習させたモデルを公開すること、解析のための中間チェックポイントを利用できること、学習手順やハイパーパラメータがきちんと文書化されていること、異なるスケールでのモデル設計決定の一貫性など、特定の要件を満たすことを目的としています.

Q: Pythiaを通じて、LLMとそのトレーニングダイナミクスについてどのような知見が得られたか?

A: Pythiaの利用により、大規模言語モデルとその学習ダイナミクスについて、ジェンダーデビアス、暗記、項頻度効果に関する結果を含む新しい知見を得ることができた.Pythiaの高度に制御されたセットアップにより、これまでにない詳細なレベルの実験が可能になり、事前学習データやより複雑なタスクにおける能力の出現に関する洞察を得るために使用することができます.

Q: 大規模な言語モデルの学習に、他の言語データセットと比較してPileデータセットを使用する主な利点は何でしょうか?

A: 大規模言語モデルの学習に他の言語データセットと比較してPileデータセットを使用する主な利点は、自由に公開されていること、より高いダウンストリーム性能を報告していること、最先端のモデルで広く使用されていることです.

Q: Pythia suiteに採用されているアーキテクチャと、他のモデルとの比較について教えてください.

A: Pythiaスイートは、2.7B未満のパラメーターを持つモデルには推奨されていないにもかかわらず、すべてのモデルに並列のアテンションとフィードフォワードアプローチを使用しています.このアプローチは、最大のモデルに広く使用されるようになっています.このスイートは、モデルの設計の一貫性と、可能な限り多くの変動源をコントロールすることに優先し、各モデルから最大限のパフォーマンスを引き出すことよりも、より高い優れた点を持っています.他のモデルとの直接的な比較は提供されていませんが、Pythiaの要件に応じた一般的なモデルスイートの特徴と評価を示す表が含まれています.

Q: 作品の完全な再現性を確保するために、どのような工夫をしたのでしょうか?

A: Pythiaの研究は、モデルの設計と実装における彼らの選択、根拠、価値観を文書化し、一般の人々が使えるように成果物を公開することで、完全に再現可能であることを保証しています.また、今後のモデルトレーニングの実行において一貫性と制御性を確保するために、より制御性の高いハイパーパラメータの選択でモデルスイートを更新しました.

Q: Pythiaの評価にはどのような言語モデリングベンチマークが使われたのでしょうか?

A: Pythiaは8つの共通言語モデリングベンチマークで評価されました:OpenAIのLAMBADA variant、PIQA、Winograd Schema Challenge、Winogrande、ARC(簡単なセットとチャレンジセットを別々に)、SciQ、LogiQAです.

Q: :8.BLOOMは、LAMBADA、PIQA、WinoGrande、ARC-easy、ARC-challenge、SciQ、LogiQAなど、さまざまな評価基準において他のモデルと比較してどのようなパフォーマンスを発揮していますか?

A: BLOOMはLAMBADA、PIQA、WSCでは他のモデルを下回るが、WinoGrande、ARC-easy、ARC-challenge、SciQ、LogiQAでは下回ることはないようだ.PythiaとPythia(Deduplicated)は、OPTとBLOOMのモデルと非常によく似た性能を持っています.

Q: Pileデータセットとはどのようなもので、モデルのトレーニングにどのように使われたのでしょうか?

A: Pileデータセットは、大規模な言語モデルの学習に用いられる英語データセットのキュレーションコレクションである.自由に公開されており、GPT-J-6B, GPT-NeoX-20B, Jurassic-1, Megatron-Turing NLG 530B, OPT, WuDaoなどの最先端モデルの学習に使用されています.モデルは、MinHashLSHと0.87の閾値で重複排除を行った後、約207Bトークンの大きさを持つPileデータセットで学習されました.GPT-NeoXライブラリのdataloaderで利用されるトークン化前のデータファイルは、提供されたツールからダウンロードすることができ、トレーニング中にモデルが使用したdataloaderを正確に再現するスクリプトも用意されています.

Q: 大規模言語モデルにおいて、データの偏りは学習動作にどのような影響を与えるのか、また、プロジェクトではどのような対策がとられたのか.

A: Pythiaプロジェクトでは、言語モデルの事前学習データにおいて、性別の異なる用語の頻度を意図的に変更することで、そのモデルの動作や偏りに影響を与えるかどうかを分析し、データの偏りの問題を解決するための対策を講じた.Pythiaでは、GPT-NeoXライブラリのデータローダーで利用されているトークン化前のデータファイルをダウンロードするツールや、学習時にモデルが利用するデータローダーを再現するスクリプトを提供しており、学習ステップの各バッチの内容を研究者が読み出したりディスクに保存したりできるようになっています.また、言語モデルの学習データの一部を変更し、再学習させ、ベースラインモデルと比較する(「介入」)ことで、バイアスの増幅を調査し、新たな緩和策を考案することが提案されています.Pythiaで実施された研究から、大規模な言語モデルは通常、最小限のキュレーションを施した人間が作成したデータで訓練されるため、学習した動作に影響を与える可能性があることが示唆されました.

Q: 本稿で紹介した方法は、従来の方法と比較してどのようなメリットがあるのでしょうか?

A: Pythiaの論文では、各モデルの性能を最大限に引き出すことよりも、モデル設計の一貫性と潜在的な変動要因の可能な限りのコントロールを優先しています.このアプローチにより、将来のモデルトレーニングの実行においてより良い選択が可能になり、前例のないレベルの詳細な実験ができるようになるかもしれません.さらに、Pythiaは、訓練中に見たデータに関するきめ細かい情報を提供し、符号化されたバイアスに対する特定の訓練サンプルの役割を推定するための影響関数に関する有望な文献に貢献することができる.

Q: 新方式を実現するために必要な計算資源はどのくらいですか?

A: Pythiaの論文では、達成したスループットでモデルのトレーニングに必要なGPU時間数を報告しており、モデルサイズによって必要な総GPU時間は510から72,300となっています.トレーニングに使用したGPUはすべてA100で、メモリは40GBです.

Q: 本論文の実用的な貢献は何ですか?

A: Pythia論文では、複数桁のスケールで一貫したデータ順序とモデルアーキテクチャで学習させた言語モデル群を提供しています.この論文では、ジェンダーデビアス、暗記、用語頻度効果に関する分析と結果が含まれており、言語モデルに関する新しい実験設定のためのフレームワークを提供します.本論文は、大規模言語モデルに関する科学的研究を促進することを目的とし、実務家向けに実用的なツールと推奨事項を提供する.

Q: 実験やデータ解析で得られた主な知見は何ですか?

A: Pythia論文で行われた実験やデータ解析から得られた主な知見は以下の通りです:

- 複数桁のスケールで一貫したデータ順序とモデル・アーキテクチャで学習させた言語モデル群「Pythia」をリリースしました.

- Pythiaは、公開されているモデル群に対して、これまでにない詳細なレベルでの実験を可能にするために使用されます.

- ジェンダーデビアス効果、暗記効果、用語頻度効果に関する分析が発表されています.

- 事前学習データは、より複雑なタスクにおける能力の獲得と出現を促します.

コメント