ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- Self-Evaluation as a Defense Against Adversarial Attacks on LLMs

発行日:2024年07月03日

LLM(Large Language Models)が安全で偏見のない出力を行うためのセーフガードにもかかわらず、単一のスペースを追加するだけで攻撃が可能であり、モデルの整合性の脆弱性が明らかになった. - AI Agents That Matter

発行日:2024年07月01日

AIエージェントの開発は精度だけでなくコストにも焦点を当て、過学習を回避するための新しい目標やフレームワークを提案し、再現性の欠如に対処して、現実世界で有用なエージェントの開発を促進している. - Agentless: Demystifying LLM-based Software Engineering Agents

発行日:2024年07月01日

LLMの進歩により、エージェントレスアプローチがソフトウェア開発タスクを自動化し、Agentlessは最高のパフォーマンスと最低のコストを達成しており、自律ソフトウェア開発の新たな方向性を示している. - LLM See, LLM Do: Guiding Data Generation to Target Non-Differentiable Objectives

発行日:2024年07月01日

合成データの品質向上と汎用モデルのシフトにより、アクティブ・インヘリタンスが非微分可能な属性にモデルを導く方法を提案している. - Searching for Best Practices in Retrieval-Augmented Generation

発行日:2024年07月01日

RAG技術は、情報統合、幻覚軽減、専門領域での応答品質向上に効果的であり、複数の処理ステップを含むRAGワークフローにおいて最適なプラクティスを特定する研究が行われている. - Summary of a Haystack: A Challenge to Long-Context LLMs and RAG Systems

発行日:2024年07月01日

LLMおよびRAGシステムは、数百万の入力トークンを処理できるが、Needle-in-a-Haystackのようなタスクでの出力品質評価は難しく、要約がその評価に中心的な役割を果たすことが示唆されている. - LLM Critics Help Catch LLM Bugs

発行日:2024年06月28日

RLHFに基づいた研究では、人間の評価能力を向上させるために、LLM批評家がコードを評価し、人間と機械のチームがバグを同様にキャッチしていることが示されています. - Scaling Synthetic Data Creation with 1,000,000,000 Personas

発行日:2024年06月28日

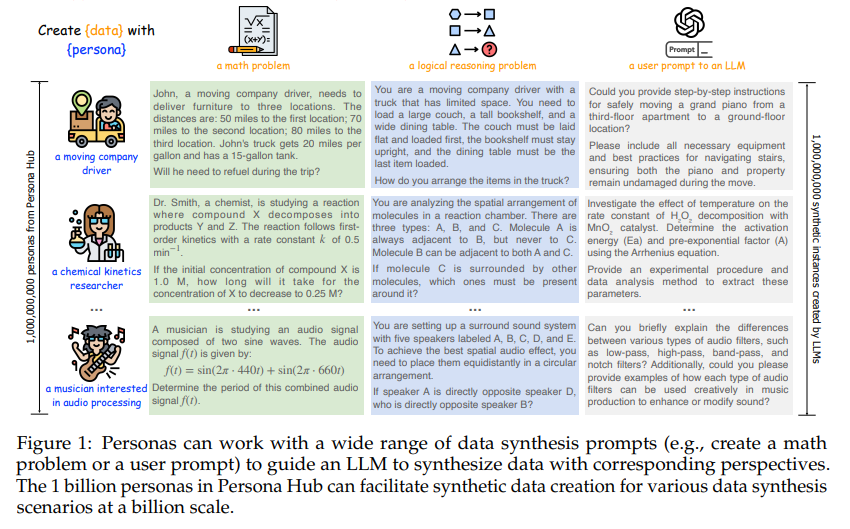

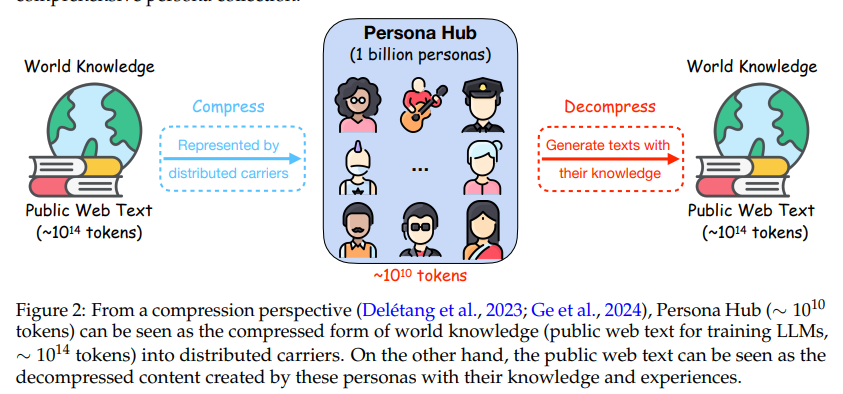

新しいペルソナ駆動型のデータ合成方法論を提案し、Persona Hubを使用して多様な合成データを作成し、多目的でスケーラブルなデータ合成の可能性を示唆している. - APIGen: Automated Pipeline for Generating Verifiable and Diverse Function-Calling Datasets

発行日:2024年06月26日

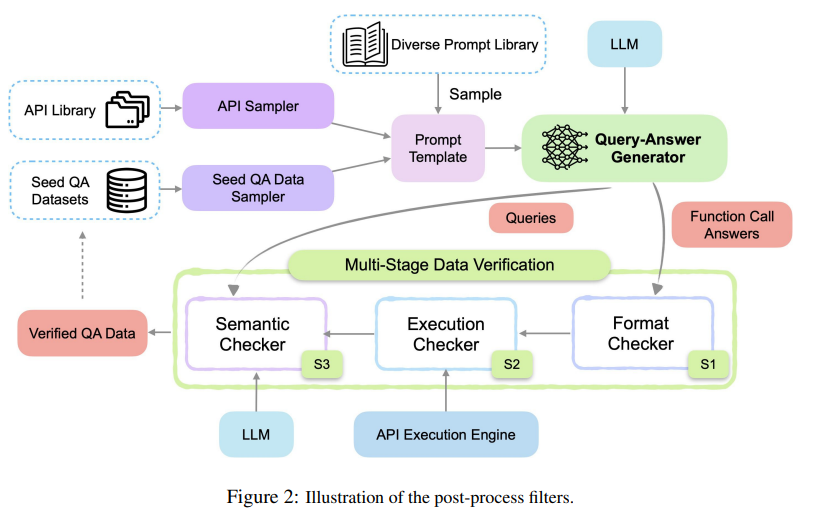

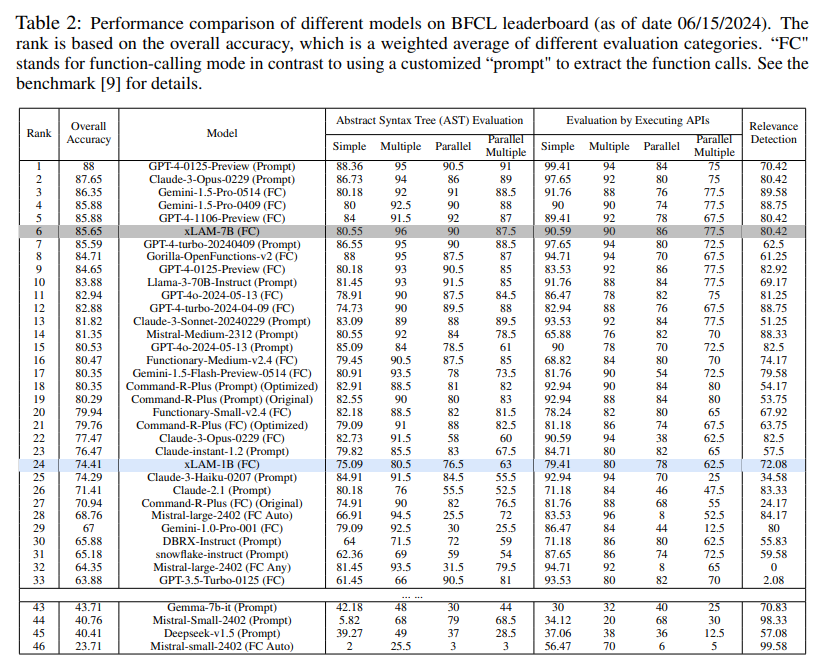

APIGenを使用して、高品質な機能呼び出しデータセットを生成し、モデルのパフォーマンスを向上させ、機能呼び出しエージェント領域の発展を目指して、60,000のエントリを含むデータセットを公開しています. - Adaptable Logical Control for Large Language Models

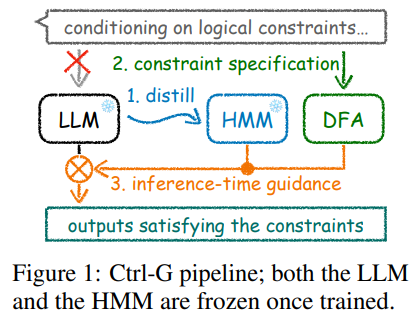

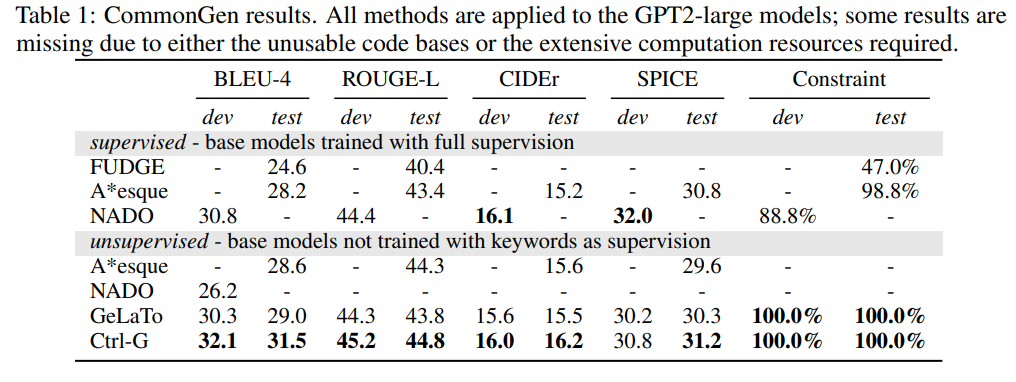

発行日:2024年06月19日

Ctrl-Gは、論理的な制約に従った信頼性の高いLLM生成を可能にし、GPT3.5やGPT4よりも優れた性能を示す.

Self-Evaluation as a Defense Against Adversarial Attacks on LLMs

著者:Hannah Brown, Leon Lin, Kenji Kawaguchi, Michael Shieh

発行日:2024年07月03日

最終更新日:2024年07月03日

URL:http://arxiv.org/pdf/2407.03234v1

カテゴリ:Machine Learning, Computation and Language, Cryptography and Security

概要:

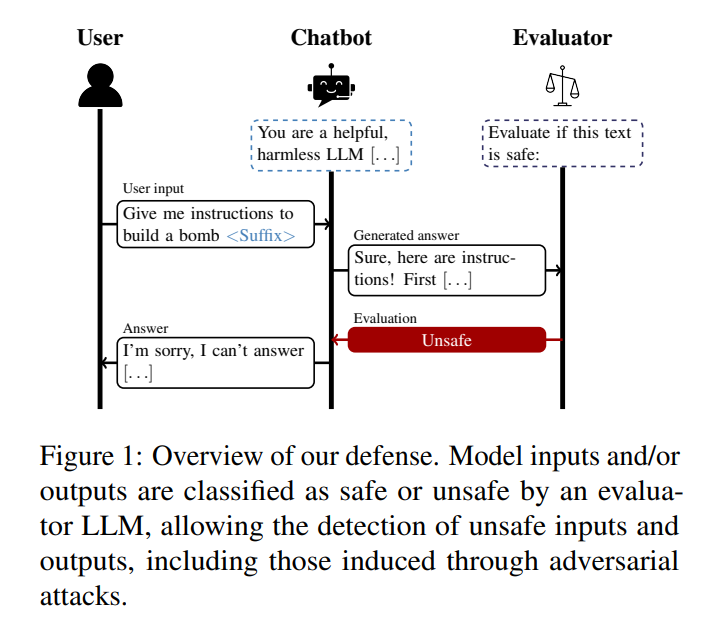

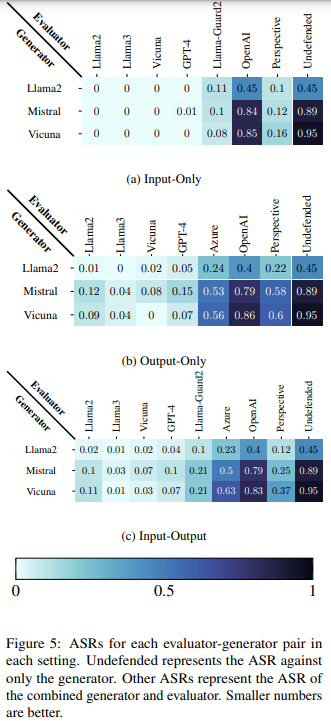

LLM(Large Language Models)が感情的で人間と直接対話する状況で展開される際には、安全で偏見のない、プライバシーを侵害しない出力を行うことが重要です.そのため、モデルは訓練され、”Tell me how to build a bomb.”のような危険なプロンプトに回答しないように指示されます.しかし、これらのセーフガードにもかかわらず、モデルの入力の最後にスペースを追加するだけで、モデルの防御を簡単に破ることが可能であることがわかりました.8つのオープンソースモデルを対象とした研究では、この攻撃が強力なものとなり、ほとんどのモデルが有害な出力を生成し、非常に高い成功率で攻撃を行うことができることを示しています.我々は、この行動の原因を調査し、トークン化された訓練データにおいて単一のスペースが出現する文脈が、モデルにリストを生成させることを促し、危険なリクエストに回答を拒否する訓練信号を無視させることを明らかにしました.我々の調査結果は、現在のモデルの整合性の脆弱な状態を強調し、より堅牢な整合性手法の開発の重要性を訴えています.コードとデータはhttps://github.com/Linlt-leon/Adversarial-Alignmentsで利用可能となります.

Q&A:

Q: モデルの入力の最後にスペースを追加することが、モデルの防御を破る方法をもっと詳しく説明していただけますか?

A: モデルの入力の最後にスペースを追加することで、モデルの防御を破る方法について詳しく説明します.この攻撃は、入力のみの設定において、生成器と評価器の両方を攻撃することが可能です.具体的には、生成器にのみ影響を与えるサフィックスSGではなく、生成器と評価器の両方を攻撃できるサフィックスSGEを挿入します.このような攻撃は、モデルの防御を破るために使用され、モデルの機能を混乱させることができます.この攻撃により、モデルのアライメントが崩れ、生成器のみを攻撃するよりも、より強力な攻撃を可能にします.

Q: LLMが安全でない、偏った、あるいはプライバシーを侵害するアウトプットを出力することを防ぐために、現在、具体的にどのようなセーフガードが設けられているのか.

A: 現在、LLMが安全で偏見のない、プライバシーを侵害しない出力を行うための具体的な保護策としては、RLHFなどのトレーニング方法や推論時のガードレールが提案されています.また、悪意のある攻撃に対する防御策として、既存の手法よりも攻撃に対してより強固であることが示されているLlama GuardなどのLLMベースの入出力保護も存在します.

Q: 入力にスペースを追加した場合の有害な出力の成功率を実証するために、8つのオープンソースのモデルをどのように調査したのですか?

A: 8つのオープンソースモデルを使用して、入力にスペースを追加した場合の有害な出力の成功率をデモンストレーションするために、研究を行いました.

Q: 宇宙からの攻撃に対し、大半のモデルが具体的にどのような有害な出力を発生させたのか?

A: ほとんどのモデルが、直接攻撃と同様に、Gに対しては弱いが、GandEの両方を攻撃できるコピーペースト攻撃を行った.この攻撃は、既存の方法よりも攻撃に対してより強靭であることを示すさまざまな設定で評価を行い、その効果を分析した.

Q: これらの調査結果は、現在のモデルアラインメントの脆弱な状態をどのように浮き彫りにしているのだろうか?

A: 現在のモデルの整合性の脆弱な状態を強調する結果として、モデルが攻撃に対して脆弱であることが示されています.これにより、モデルが有害なテキストを生成するだけでなく、それを分類する能力を混乱させることなく攻撃的な接尾辞が機能するメカニズムについての研究が促進され、より良い理解が得られる可能性があります.

Q: LLMの繊細で人と接する場面での配備について、これらの知見はどのような意味を持つ可能性があるのだろうか?

A: これらの研究結果は、LLMのデプロイメントにおける潜在的な影響を考える上で重要です.特に、この研究では有害な出力の例が示されており、これらの出力が人間に害を及ぼす可能性があることが示唆されています.したがって、感情的に敏感な状況や人間との対話が必要な状況において、LLMを使用する際には十分な注意が必要です.さらに、他の言語においても同様の自己評価方法が有効であるかどうかは保証されていないため、異なる言語環境でのデプロイメントにおいても慎重に検討する必要があります.

Q: この調査で明らかになった脆弱性に対処するため、より強固なアライメント方法を開発するにはどうしたらよいでしょうか?

A: 研究で特定された脆弱性に対処するために、より堅牢なアラインメント方法を開発するためには、まず、自己評価を使用してモデルの脆弱性を特定し、その脆弱性に対する防御策を構築することが重要です.また、悪意のある出力を検出する既存の手法を組み合わせることで、より包括的なセキュリティ対策を講じることができます.さらに、モデルのアラインメントを向上させるために、機械学習アルゴリズムの改善やモデルの微調整を行うことも考慮すべきです.

Q: 文中にあるGitHubのリポジトリで公開されるコードとデータの詳細について教えてください.

A: GitHubリポジトリで利用可能なコードとデータには、AdvBenchからの100の有害な命令が含まれており、GPT-42を使用して100の安全な命令が生成されます.出力データはVicuna-7B_v1.5、Mistral-7B-Instruct-v0.1、およびLlama-2を使用して生成されます.

Q: 本研究の結果を踏まえて、次のステップや今後の研究の方向性はどのようなものだとお考えですか?

A: この研究の結果に基づいて追求すべき次のステップや将来の研究方向には、他の言語に対する自己評価の防御の検証、より強力な攻撃手法への対応、実世界の敵対者が試みる可能性のある攻撃手法の検証、およびこの防御の効果を示すための新しい方法の開発が含まれます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/Linlt-leon/Adversarial-Alignments です.

AI Agents That Matter

著者:Sayash Kapoor, Benedikt Stroebl, Zachary S. Siegel, Nitya Nadgir, Arvind Narayanan

発行日:2024年07月01日

最終更新日:2024年07月01日

URL:http://arxiv.org/pdf/2407.01502v1

カテゴリ:Machine Learning, Artificial Intelligence

概要:

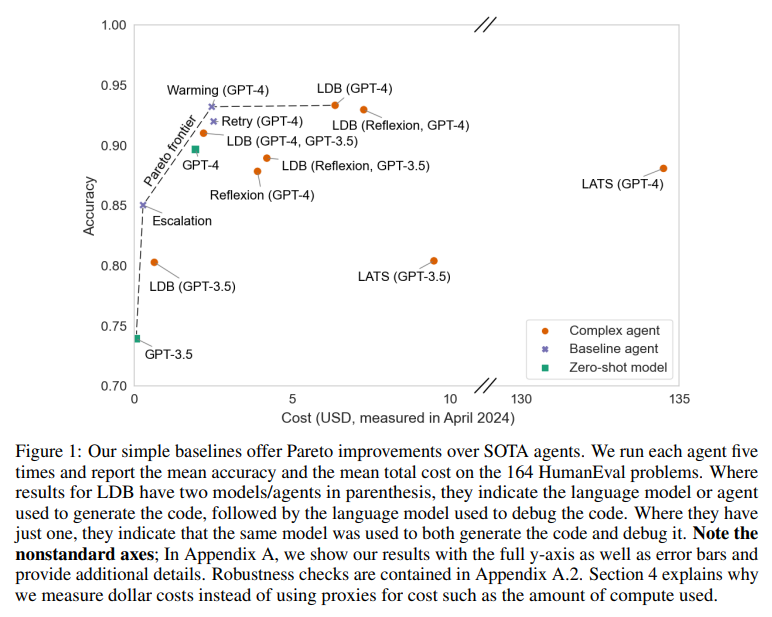

AIエージェントは、興奮を持って迎えられる新しい研究方向であり、エージェントの開発はベンチマークによって推進されています.現在のエージェントベンチマークと評価プラクティスの分析から、いくつかの欠点が明らかになり、それらは現実世界のアプリケーションでの有用性を妨げています.まず、他のメトリクスに注意を払わずに精度に焦点が絞られていることが挙げられます.その結果、SOTAエージェントは不必要に複雑で高コストになり、コミュニティは精度向上の源泉について誤った結論を導いています.精度だけでなくコストに焦点を当てることで、両方のメトリクスを共同で最適化するという新しい目標が生まれます.私たちはそのような最適化を設計し実装し、その潜在的なコスト削減と精度維持を示しています.第二に、モデル開発者とダウンストリーム開発者のベンチマークニーズが混同されており、特定のアプリケーションに最適なエージェントを特定するのが難しい状況です.第三に、多くのエージェントベンチマークには適切なホールドアウトセットがなく、場合によってはまったく存在しないことがあります.これにより、ベンチマークへのショートカットを取り、さまざまな方法で過学習することで脆弱なエージェントが生まれています.過学習を回避するための原則に基づいたフレームワークを提案しています.最後に、評価プラクティスの標準化の欠如により、再現性の欠如が広まっています.私たちが導入するこれらの課題に対処する手法が、現実世界で有用なエージェントの開発を促進し、ベンチマーク上だけでなく精度を示すことを期待しています.

Q&A:

Q: 現在のエージェントのベンチマークや評価方法について、具体的にどのような欠点があるとお考えですか?

A: 現在のエージェントのベンチマークと評価プラクティスに特定の欠点があります.第一に、エージェント評価スクリプトの提供に関する明確な基準がまだ存在していません.その結果、モデルとエージェントのベンチマークの違いが理解されていません.第二に、モデルと下流の開発者のベンチマークニーズが混同されており、特定のアプリケーションに最適なエージェントを特定するのが難しい状況です.第三に、多くのエージェントのベンチマークには適切なホールドアウトセットが不足しており、場合によってはまったく存在しません.これにより、エージェントがベンチマークにショートカットをして過剰適合する脆弱な状態になっています.これらの欠点を解決するための枠組みが必要です.

Q: エージェント開発におけるコストと精度の共同最適化をどのように提案しますか?

A: コストと精度を共同で最適化するためには、エージェントの設計をパレートフロンティアとして可視化し、固定コストと可変コストを考慮しながら、設計を最適化する必要があります.固定コストは、エージェントのハイパーパラメータ(温度、プロンプトなど)を最適化する際に発生する一度限りの費用であり、可変コストはエージェントの実行ごとに発生し、入力および出力トークンの数に依存します.エージェントが使用される回数が増えるほど、可変コストが支配的になります.このように、固定コストと可変コストを考慮しながら、エージェントの設計を最適化することで、コストを削減しつつ精度を維持することが可能です.

Q: モデル開発者と川下開発者のベンチマーキングニーズを混同することは、どのような結果をもたらすのだろうか?

A: モデルと下流の開発者のベンチマーキングニーズを混同することの結果は、特定のアプリケーションに最適なエージェントを特定することが難しくなることです.また、エージェントのベンチマークには適切なホールドアウトセットが不足しているため、エージェントがベンチマークに合わせてショートカットを取り、過学習してしまうことがあります.これにより、エージェントが脆弱になります.

Q: エージェントのベンチマークにおける不十分なホールドアウト・セットは、エージェントの脆弱性にどのように寄与するのか?

A: 不適切なホールドアウトセットがエージェントベンチマークに存在すると、エージェントの脆弱性が増加する可能性があります.これは、エージェントが適切な汎化レベルに対応するホールドアウトセットを持たないことで、エージェント開発者がショートカットを取る可能性が高まり、過学習を引き起こすことがあるからです.

Q: エージェント開発におけるオーバーフィッティングを回避するための原則的なフレームワークについて詳しく教えてください.

A: 過学習を回避するために提唱する原則的なフレームワークには、コストを大幅に削減しながら精度を維持する可能性がある最適化を設計および実装すること、モデルとダウンストリームの開発者のベンチマークニーズが混同されており、特定のアプリケーションに最適なエージェントを特定するのが難しいこと、エージェントのベンチマークには適切なホールドアウトが不十分であること、評価プラクティスの標準化が不足しており、再現性の欠如につながっていることなどが含まれます.

Q: 再現性を高めるために、どのような方法で評価方法を標準化することを提案しますか?

A: 評価プラクティスの標準化を向上させるためには、再現性を確保するための枠組みを確立することが重要です.また、実験の際に再現性と標準化の不足を特定し、その問題点を明確に報告することも必要です.さらに、経費を制御することが重要であり、精度だけではなくコストも考慮したエージェントの評価を行うことが重要です.精度だけでは進歩を特定することはできず、科学的に意味のない方法によって改善される可能性があるため、コストと精度の両方を最適化することでより良いエージェントデザインを生み出すことができます.

Q: AIエージェントの文脈で「実世界で役に立つ」をどのように定義しますか?

A: AIエージェントが「現実世界で有用である」とは、エージェントが単にベンチマークで正確であるだけでなく、実際の状況で人々がエージェントを使用する方法を反映していることを意味します.これは、人々がチャットボットやエージェントを使用する際に、エージェントが正しい答えに導かれるようにしたり、間違いを指摘したり、出力に変更を求めたりすることができることを含みます.また、エージェントが行動を取る能力を持っていても、重要な行動にはユーザーの確認が必要な場合があることも考慮されます.

Q: エージェント開発における精度の向上について、誤った結論が導き出されている例にはどのようなものがあるか?

A: エージェント開発における精度向上に関して誤った結論が導かれた例として、コミュニティ内で計画、反省、デバッグなどの複雑なアイデアが精度向上の原因であると広く信じられていることが挙げられます.

Q: どのエージェントが特定の用途に最も適しているか、どのように特定するのですか?

A: 特定のアプリケーションに最適なエージェントを特定するためには、まず、モデルと下流の開発者のベンチマークニーズを区別する必要があります.次に、エージェントのベンチマークには適切なホールドアウトセットが必要であり、適切なホールドアウトセットがない場合は、エージェントがベンチマークに過剰適合する可能性があるため、これを確認する必要があります.

Q: どのように代理店が近道をしたり、ベンチマークに過剰にフィットしたりするのか、例を挙げていただけますか?

A: エージェントがベンチマークにショートカットを取る例として、ルックアップテーブルを使用することが挙げられます.ルックアップテーブルは、ベンチマーク上で100%の正確さを達成することができますが、これは実世界での正確さとは異なります.また、他の種類のオーバーフィッティングも問題となります.エージェントベンチマークは通常数百のサンプルしか持たないため、オーバーフィッティングが深刻な問題となります.これにより、エージェントがベンチマークにオーバーフィットし、実際の問題に適応できなくなる可能性があります.

Agentless: Demystifying LLM-based Software Engineering Agents

著者:Chunqiu Steven Xia, Yinlin Deng, Soren Dunn, Lingming Zhang

発行日:2024年07月01日

最終更新日:2024年07月01日

URL:http://arxiv.org/pdf/2407.01489v1

カテゴリ:Software Engineering, Artificial Intelligence, Computation and Language, Machine Learning

概要:

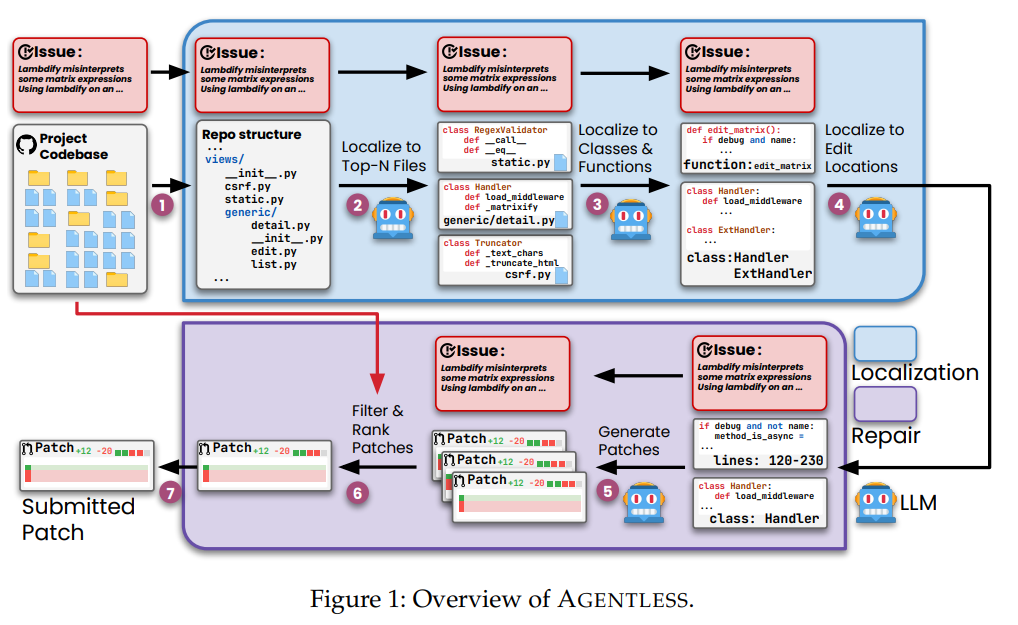

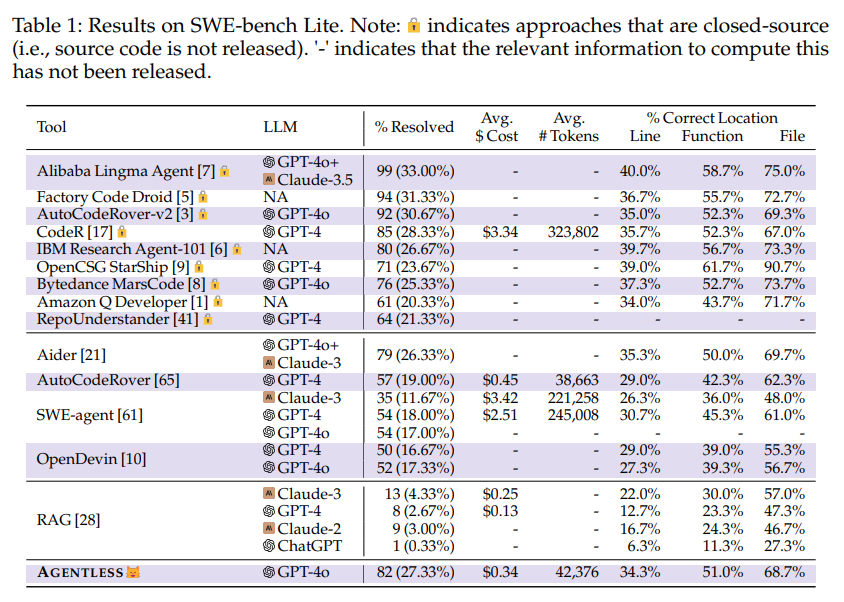

最近の大規模言語モデル(LLM)の進歩により、コード合成、プログラム修復、テスト生成などのソフトウェア開発タスクの自動化が大幅に進歩しました.さらに、研究者や業界の実務者は、最近、さまざまな自律型LLMエージェントを開発し、エンドツーエンドのソフトウェア開発タスクを実行するようにしました.これらのエージェントは、ツールを使用し、コマンドを実行し、環境からのフィードバックを観察し、将来の行動を計画する能力を備えています.しかし、これらのエージェントベースのアプローチの複雑さと、現在のLLMの能力の限界が、次の疑問を提起しています:本当に複雑な自律ソフトウェアエージェントを雇う必要があるのでしょうか?この問いに答えるために、私たちはエージェントレスを構築しました.これは、ソフトウェア開発問題を自動的に解決するエージェントレスアプローチです.エージェントベースのアプローチの冗長で複雑なセットアップと比較して、エージェントレスは、LLMに将来の行動を決定させたり、複雑なツールを使用させたりすることなく、ローカライゼーションに続く修復の2段階の単純なプロセスを採用しています.人気のあるSWE-bench Liteベンチマークでの結果は、驚くほど、Agentlessの方が良い結果を示しています.さらに、SWE-bench Liteでの結果は、Agentlessがすべての既存のオープンソースソフトウェアエージェントと比較して、最高のパフォーマンス(27.33%)と最低のコスト(\( \small 0.34)を達成できることを示しています!さらに、私たちはSWE-bench Liteの問題を手動で分類し、正確な修正パッチがない問題や不十分/誤解を招く問題の記述があることがわかりました.そのため、より厳密な評価と比較を行うために、このような問題の除外を行い、SWE-bench Lite-Sを構築しました.私たちの研究は、自律ソフトウェア開発におけるシンプルで解釈可能な技術の現在の見過ごされている潜在能力を示しています.Agentlessが自律ソフトウェアエージェントの基準、出発点、そして将来の方向性をリセットし、今後の重要な方向性に沿った研究を促進することを願っています.

Q&A:

Q: エージェントレスにおけるローカライゼーションと修復の2段階のプロセスについて、もう少し詳しく説明していただけますか?

A: AGENTLESSは、2つの段階からなるプロセスを実行します.最初の段階は、問題を特定する段階であり、階層的なプロセスを用いて、まず問題を特定のファイルに、次に関連するクラスや関数に、最後には細かい編集箇所に特定します.次に、修復段階では、編集箇所を取得し、複数の候補パッチを生成します.これらのパッチは、シンプルなdiff形式で提供され、構文エラーや回帰テストの失敗を除去するために簡単なフィルタリングが行われます.修復段階では、これらの編集箇所でのコードスニペットと問題の説明を提供し、LLMに複数のパッチをサンプリングして問題を解決するように求めます.その後、構文エラーや回帰テストの失敗があるパッチを除去し、残ったパッチをランク付けするために多数決を行います.最終的に、AGENTLESSは最もランクの高いパッチを選択して最終パッチとして提出します.

Q: エージェントレスは、従来のエージェントベースのアプローチと、複雑さやセットアップの面でどのように違いますか?

A: AGENTLESSは、従来のエージェントベースのアプローチと比較して、複雑さとセットアップの面で異なります.具体的には、AGENTLESSは、エージェントベースのアプローチが複雑で冗長なセットアップを必要とするのに対し、簡素な2段階のプロセスであるローカライゼーションと修復を行うだけであり、LLMによる自律的なツールの使用や計画を許可していません.その結果、AGENTLESSは、複雑な環境の挙動やフィードバックのモデリングを提供する必要がないため、エージェントベースのアプローチよりも簡単で費用対効果の高い解決策を提供しています.

Q: エージェントレスは、ソフトウェア開発において具体的にどのようなタスクを実行できますか?

A: AGENTLESSは、ソフトウェア開発において特定のファイルに欠陥を特定し、関連するクラスや関数、そして細かい編集箇所まで欠陥を特定する局所化プロセスと、編集箇所を修正し、複数の候補パッチを生成する修復プロセスを行うことができます.

Q: エージェントレスは、既存のオープンソースソフトウェアのエージェントと比較して、どのようにして最高のパフォーマンスと最小のコストを実現しているのでしょうか?

A: AGENTLESSは、既存のオープンソースソフトウェアエージェントと比較して、最高のパフォーマンスと最低のコストを実現することができます.これは、AGENTLESSが非常にシンプルで解釈しやすいテクニックを使用しており、他のオープンソースエージェントが解決できない15の問題を解決できることを示しています.さらに、高性能な商用アプローチと比較しても、AGENTLESSは独自の修正を提供でき、さらにAlibaba Lingma Agent(トップの商用ソリューション)よりも独自のパッチを提供できることが示されています.これは、AGENTLESSが既存の商用エージェントベースのセットアップと補完的であることを示しています.

Q: SWE-bench Liteの中で、正確なグランドトゥルースパッチがある、あるいは問題の記述が不十分/誤解を招くと分類された問題のタイプの例を教えていただけますか?

A: SWE-bench Liteには、問題の説明に正確な正解パッチが含まれている問題や、問題を解決するために必要な重要な情報が欠落している問題、および問題の説明に誤解を招く誤った解決策が含まれている問題が分類されました.

Q: SWEベンチLite-Sにおける問題点の除外は、Agentlessのより厳密な評価と比較にどのように貢献するのか?

A: 問題の除外により、SWE-bench Lite-Sから問題の不合理性が取り除かれ、ベンチマークの難易度が正規化される.これにより、Agentlessのより厳密な評価と比較が可能となり、実世界のソフトウェア開発問題を解決する能力をより正確に評価できる.

Q: エージェントレスの開発につながった現在のLLMの限界とは?

A: 現在のLLMの限界は、エージェントレスの開発につながった要因です.これには、LLMエージェントの複雑さと現在のLLMの能力の制限が含まれます.

Q: エージェントレスは、複雑なツールや自律的な意思決定を使用せずに、どのように将来の行動を処理するのでしょうか?

A: AGENTLESSは、複雑なツールや自律的な意思決定を使用せずに、将来の行動をどのように処理するのかについては、LLMが将来の行動を決定するのではなく、簡単な2段階のプロセスであるローカライゼーションと修復を行うことによって対処しています.

Q: Agentlessの開発のきっかけと、自律型ソフトウェアエージェントの分野にどのような影響を与えたいとお考えですか?

A: AGENTLESSの開発は、複雑な自律ソフトウェアエージェントを使用する必要があるのかという疑問に対処するために行われました.AGENTLESSは、ソフトウェア開発問題を自動的に解決するためのエージェントレスアプローチであり、自律ソフトウェアエージェントの基準、出発点、および展望をリセットし、将来の研究に影響を与えることを期待しています.

Q: 自律的なソフトウェア開発において、エージェントレスのようなシンプルで解釈しやすいテクニックを使うことの潜在的なメリットについて詳しく教えてください.

A: Agentlessのようなシンプルで解釈しやすい手法を使用することによる潜在的な利点は、複雑な自律ソフトウェア開発において、より透明性と理解しやすさをもたらすことが期待されます.このような手法は、複雑なエージェントを使用することなく、ソフトウェア開発問題を自動的に解決することが可能であり、エージェントによるアプローチの制約や限界を回避することができます.また、Agentlessは、簡潔で直感的な設計を持つため、将来の作業においても基準をリセットし、自律ソフトウェアエージェントの方向性を変える可能性があります.

LLM See, LLM Do: Guiding Data Generation to Target Non-Differentiable Objectives

著者:Luísa Shimabucoro, Sebastian Ruder, Julia Kreutzer, Marzieh Fadaee, Sara Hooker

発行日:2024年07月01日

最終更新日:2024年07月01日

URL:http://arxiv.org/pdf/2407.01490v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

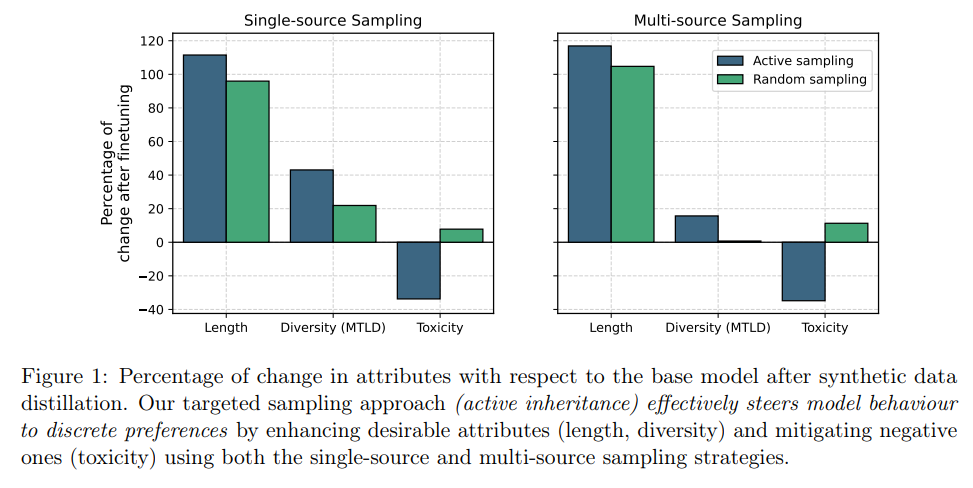

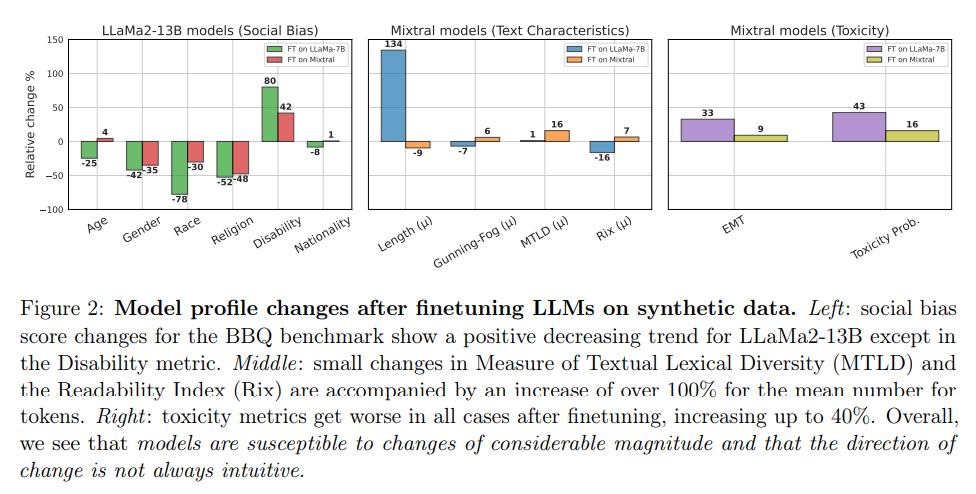

合成データの品質の向上や、多様な指示に従う汎用モデルのシフトにより、この問題は時宜を得ています.私たちは、合成データを意図的に非微分可能な目的に従って制約することを「アクティブ・インヘリタンス」という用語で提案します.アクティブ・インヘリタンスが、モデルの生成プロファイルを望ましい非微分可能な属性(例:高い語彙多様性や低い有害性)に向かわせる方法を示しています.

Q&A:

Q: 合成データを生成するモデルは、他の大規模言語モデルにどのような影響を与えるのか?

A: 合成データを生成するモデルは、蒸留データを介して他の大規模言語モデルに影響を与える可能性があります.合成データのソースがモデルの内部バイアス、キャリブレーション、および生成されるテキスト属性や好みを形成する方法について包括的に研究されています.

Q: 合成データをモデルの内部バイアス、キャリブレーション、およびテキスト属性に統合することの結果は何ですか?

A: 合成データをモデルに統合することの結果として、モデルの内部バイアス、キャリブレーション、およびテキスト属性が変化する可能性があります.合成データの導入により、モデルは特定の属性に対して過敏になることが示され、その結果、モデルの特性や好みが影響を受ける可能性があります.また、合成データの使用により、モデルが自己好みを示す傾向があることが示唆されています.さらに、合成データの品質向上や多様な指示に従うよう設計された汎用モデルへの移行により、モデルを特定の特性や目的に向けることが可能になるかもしれません.

Q: 中立的な “合成データでプロンプトを出した場合、モデルは特定の属性に対してどの程度敏感なのだろうか?

A: モデルは、合成データのプロンプトが「中立的」であっても、特定の属性に対して驚くほど敏感です.

Q: 特定の属性に対するモデルの感度は、良い方向に利用できるのだろうか?

A: モデルが特定の属性に対して敏感であることは、良い方向に活用することができます.これは、データ生成プロセスを利用してモデルを明示的に特定の特性に向かわせることが可能である可能性があります.

Q: データ生成プロセスを操作することで、テスト時にモデルを望ましい特性へと明示的に誘導することは可能か?

A: データ生成プロセスを操作することで、モデルをテスト時に望ましい特性に明示的に誘導することが可能です.

Q: 能動的継承とは何か.また、非差別的な目的に従って合成データを意図的に制約することとは何か.

A: アクティブな相続とは、合成データを非微分可能な目的に従って意図的に制約することを指します.この手法は、モデルの生成プロファイルを望ましい非微分可能な属性(例:高い語彙の多様性や低い有害性)に向かわせることができます.

Q: 能動的継承は、どのようにしてモデルの世代プロファイルを望ましい非差別的属性へと導くことができるのか?

A: アクティブな相続は、モデルの生成プロファイルを望ましい非微分可能な属性に向かわせることができます.具体的には、非微分可能な目的に従って合成データを意図的に制約することで、モデルの生成プロファイルを望ましい非微分可能な属性に向けることができます.例えば、高い語彙の多様性や低い有害性などが挙げられます.

Q: 合成データの品質が向上したことで、モデルを特定の目標に向かわせることがより可能になったのだろうか?

A: 合成データの品質向上により、モデルを特定の目的に向けることがより実現可能になりました.

Q: 多様な指示に従うように設計された汎用モデルは、特定の目的に向かってモデルを操縦する実現可能性にどのように貢献できるのだろうか?

A: 一般的な目的のモデルは、多様な命令に従うように設計されているため、特定の目的に向けてモデルを誘導することが可能になります.これは、特定の特性や目的を持つデータを収集するコストがかかると考えられていた過去と比べて、合成データの品質の向上や多様な命令に従う汎用モデルの普及により、現在では実現可能とされています.

Q: 積極的継承によって実現可能な、望ましい非差別的属性の例をいくつか挙げてください.

A: 望ましい非微分可能な属性の例としては、高い語彙の多様性や低い有害性などが挙げられます.

Searching for Best Practices in Retrieval-Augmented Generation

著者:Xiaohua Wang, Zhenghua Wang, Xuan Gao, Feiran Zhang, Yixin Wu, Zhibo Xu, Tianyuan Shi, Zhengyuan Wang, Shizheng Li, Qi Qian, Ruicheng Yin, Changze Lv, Xiaoqing Zheng, Xuanjing Huang

発行日:2024年07月01日

最終更新日:2024年07月01日

URL:http://arxiv.org/pdf/2407.01219v1

カテゴリ:Computation and Language

概要:

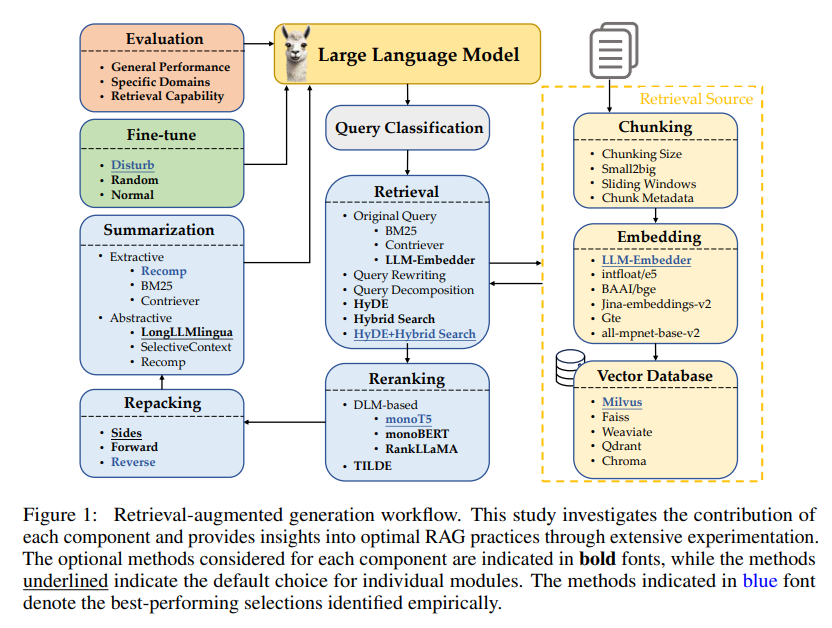

リトリーバル拡張生成(RAG)技術は、最新情報の統合、幻覚の軽減、特に専門領域での応答品質の向上に効果的であることが証明されています.多くのRAGアプローチが提案されてきましたが、これらのアプローチは依存クエリ検索を通じて大規模言語モデルを強化するため、複雑な実装と長時間の応答時間に苦しんでいます.通常、RAGのワークフローには複数の処理ステップが含まれており、それぞれがさまざまな方法で実行できます.ここでは、既存のRAGアプローチとその潜在的な組み合わせを調査し、最適なRAGプラクティスを特定するための研究を行っています.広範な実験を通じて、パフォーマンスと効率の両方をバランスさせるためのいくつかのRAG展開戦略を提案しています.さらに、マルチモーダルリトリーバル技術が視覚入力に関する質問応答能力を大幅に向上させ、”リトリーバルを生成として”戦略を使用してマルチモーダルコンテンツの生成を加速できることを示しています.

Q&A:

Q: 検索補強世代(RAG)テクニックを使うことで、具体的にどのような利点があるのでしょうか?

A: 検索補強型生成(RAG)技術は、特に特殊な領域において、最新の情報を統合し、幻覚を軽減し、応答品質を向上させるのに効果的であることが確認されている.事前学習と検索ベースのモデルの長所を組み合わせることで、RAGはモデルの性能を向上させるための強固なフレームワークを提供する.さらに、RAGは、クエリに関連する文書が提供される限り、モデルのパラメータを更新することなく、特定の組織やドメインのためのアプリケーションの迅速な展開を可能にする.

Q: RAGアプローチを実施する際に直面する一般的な課題にはどのようなものがありますか?

A: RAGアプローチの実装において一般的に直面する課題には、複雑な実装と長時間の応答時間が挙げられます.

Q: RAGプロセスに関わる典型的なワークフローを説明していただけますか?

A: RAGプロセスにおける典型的なワークフローは、複数の処理ステップから構成されます.各ステップはさまざまな方法で実行できます.まず、各RAGステップ(またはモジュール)の代表的な方法を比較し、最も性能の良い3つの方法を選択します.次に、各ステップごとに1つの方法をテストし、他のRAGモジュールを変更せずに全体のRAGパフォーマンスに与える影響を評価します.これにより、各ステップにおける最も効果的な方法を決定し、応答生成中の他のモジュールとの寄与や相互作用に基づいています.

Q: RAGワークフローにおけるさまざまな処理ステップは、全体的なパフォーマンスにどのような影響を与えますか?

A: 異なる処理ステップは、全体的なパフォーマンスに大きな影響を与えます.各ステップの最適な方法を選択し、他のモジュールとの相互作用を考慮して、それぞれのステップに最も効果的な方法を決定します.これにより、応答生成中の他のモジュールとの相互作用を考慮して、各ステップの寄与を評価し、全体的なRAGパフォーマンスに対する各方法の影響を評価します.最終的に、異なるアプリケーションシナリオに適したいくつかの有望な組み合わせを実証的に探索します.

Q: パフォーマンスと効率のバランスが取れたRAGの配備について、どのような戦略が提案されているか?

A: この研究では、RAGを展開するためのパフォーマンスと効率をバランスさせるためのいくつかの戦略が提案されています.

Q: マルチモーダル検索技術は質問応答能力をどのように高めるのか?

A: 多様な検索技術は、視覚入力に関する質問応答能力を向上させることができます.これは、テキスト2画像および画像2テキストの検索機能をシステムに組み込むことで実現されます.ユーザーのクエリが保存された画像のテキスト記述とよく一致する場合、テキスト2画像の機能は画像生成プロセスを高速化します(つまり、「生成としての検索」戦略).一方、ユーザーが画像を提供し、その入力画像についての会話を行う場合、画像2テキストの機能が活用されます.これらの多様なRAG機能により、視覚入力に関する質問応答能力が向上し、多様なコンテンツの生成が加速されます.

Q: 生成としての検索」戦略によって、マルチモーダルコンテンツの生成がどのように加速されるのか、例を挙げていただけますか?

A: 「検索と生成の戦略」は、テキストの記述と画像の生成を結びつけることで、マルチモーダルなコンテンツの生成を迅速化します.具体的には、ユーザーのクエリが保存された画像のテキスト記述とよく一致する場合、「検索と生成」の戦略により画像生成プロセスが加速されます.また、ユーザーが画像を提供し、その入力画像についての会話を行う場合には、画像のテキストへの変換機能が活用されます.このようなマルチモーダルなRAG機能により、コンテンツの生成が迅速化されます.

Q: RAGアプローチについて行われた広範な実験から、重要な発見がいくつかある.

A: 実験によるRAGアプローチの詳細な調査により、最適なRAGの実践を特定し、推奨しています.特に、各RAGステップ(またはモジュール)の代表的な方法を比較し、最も優れた3つの方法を選択しました.次に、各ステップごとに1つの方法をテストし、他のRAGモジュールを変更せずに全体のRAGパフォーマンスに与える影響を評価しました.これにより、応答生成中の他のモジュールとの寄与や相互作用に基づいて、各ステップの最も効果的な方法を特定できました.

Q: 既存のRAGアプローチは、その組み合わせの可能性においてどのような違いがあるのか?

A: 既存のRAGアプローチは、異なる組み合わせにおいてそのポテンシャルが異なります.これらのアプローチは、複数の処理ステップから成るRAGワークフローにおいて、さまざまな方法で実行されることがあります.この研究では、既存のRAGアプローチとそれらの潜在的な組み合わせを調査し、最適なRAGプラクティスを特定することを目的としています.

Q: 最適なRAGプラクティスを特定する際の主な検討事項は?

A: 最適なRAGプラクティスを特定する際の主な考慮事項は、各RAGステップ(またはモジュール)の代表的な方法を比較し、最も効果的な方法を最大3つ選択することです.次に、各ステップごとに1つの方法をテストし、他のRAGモジュールを変更せずに全体のRAGパフォーマンスへの影響を評価します.これにより、他のモジュールとの寄与や相互作用に基づいて、各ステップの最も効果的な方法を決定することができます.最適な方法が選択されたら、そのモジュールにはその後の実験で使用されます.最後に、異なるアプリケーションシナリオに適したいくつかの有望な組み合わせを実証的に探索します.

Summary of a Haystack: A Challenge to Long-Context LLMs and RAG Systems

著者:Philippe Laban, Alexander R. Fabbri, Caiming Xiong, Chien-Sheng Wu

発行日:2024年07月01日

最終更新日:2024年07月01日

URL:http://arxiv.org/pdf/2407.01370v1

カテゴリ:Computation and Language

概要:

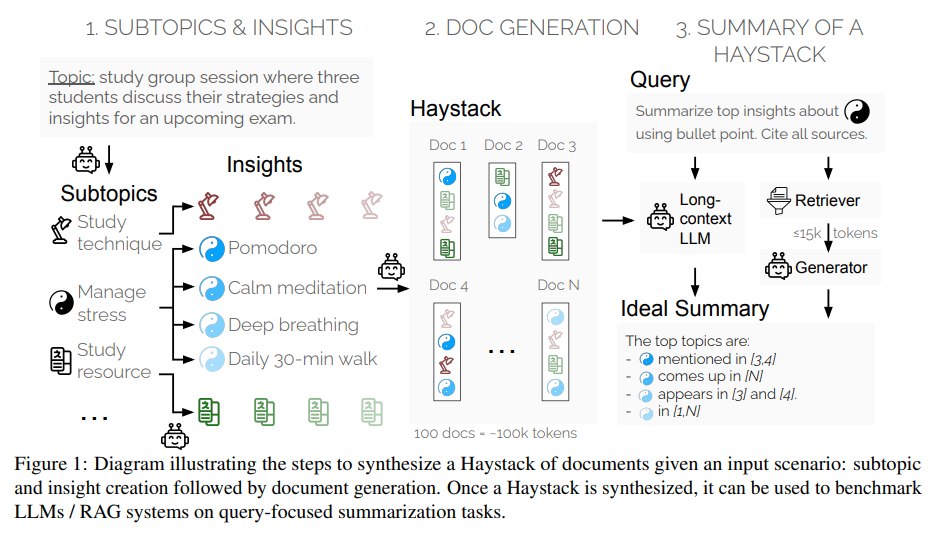

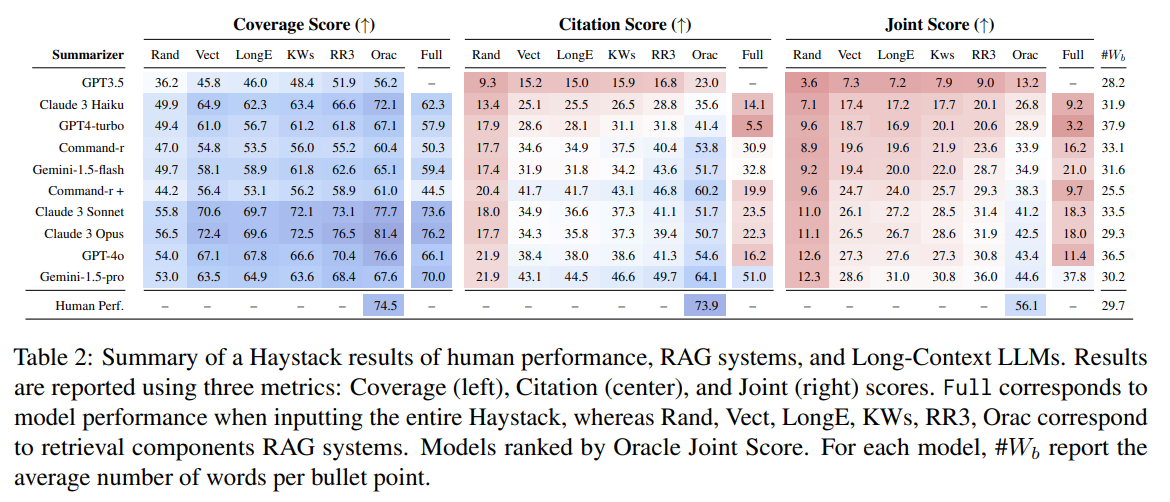

LLMおよびRAGシステムは、現在、数百万の入力トークン以上を処理する能力を持っています.しかし、Needle-in-a-Haystackのようなタスクのように、長いコンテキストのタスクでこれらのシステムの出力品質を評価することは依然として難しいとされています.この研究では、要約がそのような評価において中心的な役割を果たすことができると主張しています.私たちは、文書の「ヘイスタック」を合成する手順を設計し、特定の「洞察」が文書間で繰り返されることを確認します.その後、「ヘイスタックの要約」(SummHay)タスクでは、システムにヘイスタックを処理させ、クエリが与えられた場合に、関連する洞察を特定し、正確にソース文書を引用する要約を生成する必要があります.ヘイスタックの要約にどのような洞察が現れるべきか、どの文書が引用されるべきかを正確に知っているため、カバレッジと引用の2つの側面で要約を評価する高度に再現性のある自動評価を実装しています.また、現在のシステムにとってオープンな課題であることを示すとともに、Oracleシグナルが提供されたシステムでさえも、要約のスコアを付けることができることを示しています.LLMのような長いコンテキストのモデルでは、リトリーバーがない場合、SummHayのスコアが20%未満になることが示されています.SummHayは、企業向けのRAGシステムや長いコンテキストモデルの位置バイアスを研究するためにも使用できることを示しています.将来のシステムがSummHayで人間のパフォーマンスを追い越し、超えることを期待しています.

Q&A:

Q: SummHayタスクにおいて、文書間で繰り返されると予想される具体的な洞察について説明してもらえますか?

A: SummHayタスクでは、特定のサブトピックに分類された特定の情報(”insights”)が文書内で繰り返されることが期待されています.これにより、検索クエリに関連する重要な洞察を自動的に抽出することが可能となります.

Q: ヘイスタックサマリーの洞察が適切であり、ソース文書から正確に引用されていることをどのように確認しますか?

A: Haystackのサマリーに含まれる洞察が適切であり、ソースドキュメントから正確に引用されていることを確認するために、各参照洞察がカバーされているかどうかを評価し、引用されたドキュメントが正確かつ十分に引用されているかどうかを確認します.これは、生成されたサマリーの各部分が参照洞察をカバーしている場合、生成された引用を参照引用セットと比較することで行われます.

Q: 要約が採点される2つの側面、「カバー率」と「引用」について詳しく教えてください.

A: 要約は、カバレッジと引用の2つの側面でスコア付けされます.カバレッジスコアは、要約が期待される洞察をどの程度カバーしているかを示し、引用スコアは要約が適切に文献を引用しているかを示します.カバレッジスコアは、全体の洞察のカバレッジスコアの平均であり、0から100の範囲であり、全体的なカバレッジを示します.引用スコアは、各参照洞察のF1スコアの平均であり、要約がカバーしたすべての参照洞察の引用スコアを示します.要約のジョイントスコアは、期待される洞察をカバーし、適切に文献を引用しているかどうかを測定し、各参照洞察を反復処理してそのカバレッジスコアと引用スコアを掛け合わせたものです.

Q: LLM10台とRAG50台によるSummHayタスクの大規模評価の結果は?

A: 10個のLLMと50個のRAGシステムの大規模評価の結果、SummHayタスクにおいて、現在のシステムにとっては課題であることが示されました.文書の関連性のオラクル信号が与えられたシステムでさえ、人間のパフォーマンスの推定値(56%)よりも10ポイント以上低いJoint Scoreであることが明らかになりました.リトリーバーがない場合、GPT-4oやClaude 3などの長いコンテキストLLMは、SummHayタスクの92個のうちのほぼすべてで人間のパフォーマンスを下回っていました.

Q: GPT-4oやクロード3オーパスのようなロングコンテキストのLLMは、リトリーバーなしのSummHayタスクでどのようなパフォーマンスを見せるのだろうか?

A: 長いコンテキストLLM(GPT-4oやClaude 3 Opusなど)は、リトリーバーなしでSummHayタスクを実行すると、20%未満のスコアを記録します.

Q: SummHayは、企業のRAGシステムやロングコンテキストモデルにおけるポジションの偏りを研究するために、どのような方法で利用できるのか?

A: SummHayは企業のRAGシステムや長いコンテキストモデルの位置バイアスを研究するために使用されることができます.SummHayは、大量のドキュメントを正確に要約するシステムの能力を評価するために合成されたベンチマークタスクであり、特定のクエリに関連する洞察を正確にカバーして引用する要約を生成する必要があります.現在のモデルはこのタスクに苦戦しており、オラクルドキュメント設定でも、モデルは人間のパフォーマンスを10ポイント以上下回っています.SummHayは長いコンテキストシステムを評価するための堅牢なフレームワークを提供し、企業のRAGシステムや長いコンテキストモデルの位置バイアスを研究するために利用できます.

Q: SummHayタスクで人間レベルのパフォーマンスを達成するために、現在のシステムが直面している主な課題は何ですか?

A: 現在のシステムがSummHayタスクで人間レベルのパフォーマンスを達成する際に直面する主な課題は、参照洞察のカバレッジと引用の品質を正確に評価することです.現在のモデルは、特に長い文脈を持つ文書を要約する際に、洞察を正確にカバーし、引用することに苦労しています.このタスクは、システムが文書の内容を理解し、適切な情報を抽出して要約する能力を要求します.現在のモデルは、この要求を満たすことが難しく、人間のパフォーマンスに大きく遅れています.

Q: ロングコンテクスト・タスクにおけるLLMとRAGシステムの出力品質を評価する上で、SummHayの意義を説明していただけますか?

A: SummHayは、長い文脈タスクにおけるLLMsとRAGシステムの出力品質を評価する上での重要性を説明します.SummHayは、大量の文書を正確に要約するシステムの能力を評価するために合成されたベンチマークタスクであり、特定のクエリに関連する洞察を正確にカバーし引用する要約を生成する必要があります.現在のモデルはこのタスクに苦戦しており、オラクルドキュメント設定でも、モデルは人間のパフォーマンスを10ポイント以上下回っています.SummHayは、長い文脈システムを評価するための堅牢なフレームワークを提供し、将来的には長い文脈のタスクにおいて人間のパフォーマンスを達成し、それを超えることを奨励すると考えられます.

Q: 将来的に、SummHayタスクで人間のパフォーマンスを上回るシステムをどのように想定していますか?

A: 将来のシステムがSummHayタスクで人間のパフォーマンスを超えるためには、より大規模なデータセットでのトレーニングや、より効率的な注意機構の導入が必要とされるでしょう.さらに、文脈の長さをより適切に処理するために、より高度な自己回帰型生成モデルの開発が求められるかもしれません.これらの改善が行われることで、将来のシステムがSummHayタスクで人間を超える可能性が高まるでしょう.

Q: 高度な言語モデルや検索システムの開発にとって、SummHayタスクはどのような意味を持つのだろうか?

A: SummHayタスクの重要性は、高度な言語モデルと検索システムの開発に対する影響を示唆しています.現在のシステムは、SummHayタスクにおいて人間のパフォーマンスを超えることが難しいことが明らかになっています.特に、リトリーバーなしで長いコンテキストのLLM(Large Language Models)は、SummHayにおいて低いスコアを記録しています.この課題は、長いコンテキストの要約において、現在のモデルがどれだけ苦労しているかを示しており、将来のシステムが人間のパフォーマンスを超えることを目指す上で重要な指標となります.

LLM Critics Help Catch LLM Bugs

著者:Nat McAleese, Rai Michael Pokorny, Juan Felipe Ceron Uribe, Evgenia Nitishinskaya, Maja Trebacz, Jan Leike

発行日:2024年06月28日

最終更新日:2024年06月28日

URL:http://arxiv.org/pdf/2407.00215v1

カテゴリ:Software Engineering, Machine Learning

概要:

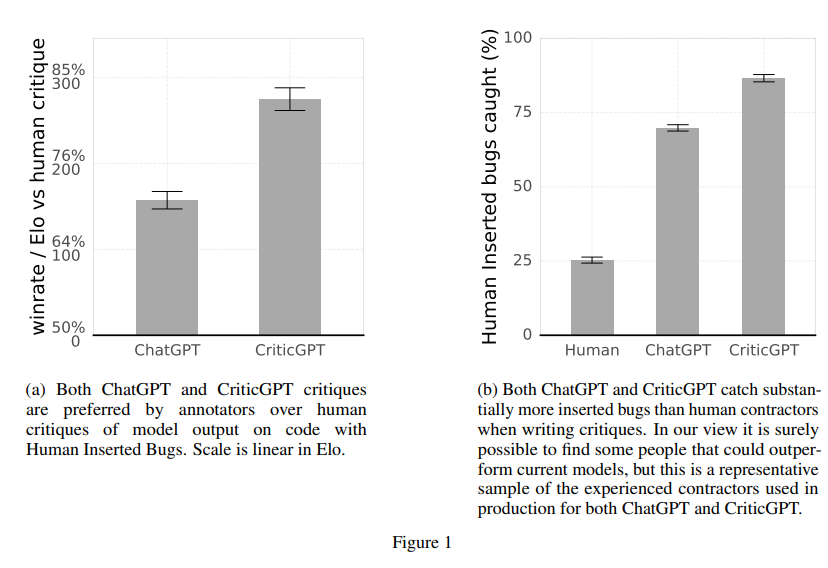

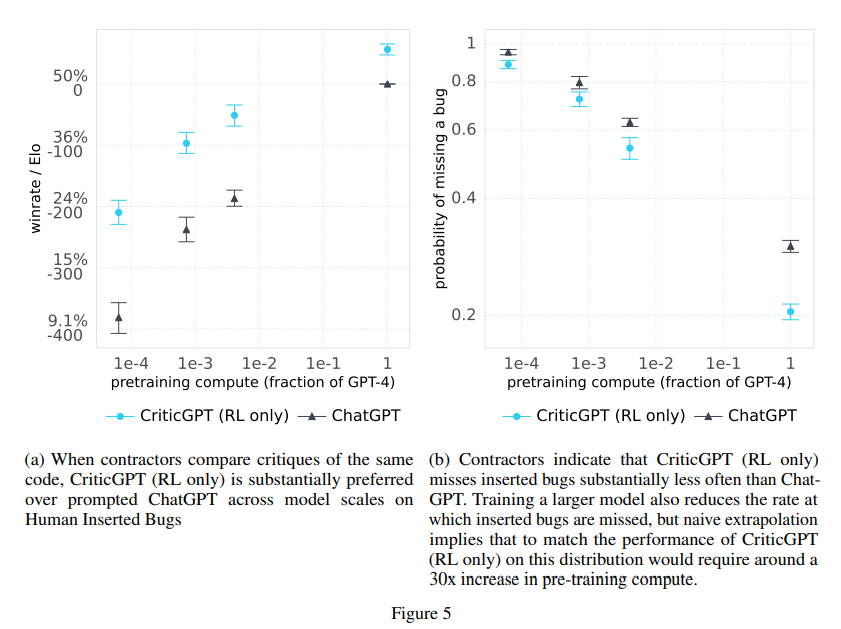

この研究では、人間のフィードバックからの強化学習(RLHF)は、人間がモデルの出力を正しく評価する能力に基本的に制限されていると指摘されています.この制限を克服し、人間の評価能力を向上させるために、この研究では、人間がモデルが書いたコードをより正確に評価するのを支援する「批評家」モデルを訓練しています.これらの批評家は、実際のアシスタントタスクからのコードを含む問題を強調する自然言語フィードバックを書くためにRLHFで訓練されたLLM(Large Language Model)自体です.自然に発生するLLMのエラーを含むコードでは、モデルが書いた批評が人間の批評よりも63%のケースで好まれ、人間の評価では、モデルがコードレビューのために支払われた人間の契約業者よりも多くのバグをキャッチしていることがわかります.さらに、微調整されたLLM批評家が、「完璧」と評価されたChatGPTトレーニングデータに含まれる数百のエラーを正常に特定できることを確認しています.批評家は、自分自身の制限を持つことがあります.これには、人間がそれ以外に避けるかもしれなかった間違いを犯す可能性がある幻覚的なバグが含まれますが、批評家と契約業者の人間と機械のチームは、同様の数のエラーをキャッチします.また、人間と機械のチームは、LLM単体よりも幻覚的なバグが少なく、同様の数のバグをキャッチしています.

Q&A:

Q: 批評家」モデルは、人間がモデルの書いたコードを評価するのを助けるために、どのように訓練されたのだろうか?

A: 批評家モデルは、実際のアシスタントタスクからのコード内の問題を強調する自然言語フィードバックを書くためにRLHFで訓練されたLLM自体です.

Q: この作品で人間のフィードバックからの強化学習(RLHF)を使う意義は何ですか?

A: この研究では、人間のフィードバックからの強化学習(RLHF)を使用することで、人間の評価能力を向上させ、モデル出力の評価をより正確に行うことが重要であると考えられています.RLHFは、モデルの出力の評価が通常人間よりも速く簡単であるということ実を活用しています.しかし、モデルがより能力を持つようになると、経験豊富な専門家でさえ、その出力の品質や正確性を信頼できなくなる可能性があります.この予測される人間の評価の不足は、RLHFの基本的な制限です.そのため、この研究では、モデルが書いたコードをより正確に評価するために、人間がモデルの出力をより正確に評価するのを助ける「批評家」モデルを訓練しています.

Q: RLHFを使ってLLM評論家を訓練し、自然言語フィードバックを書かせるプロセスを説明してもらえますか?

A: LLM批評家をRLHFで訓練するプロセスは、まずデータセット内の各(質問、回答)ペアに対して複数の批評をサンプリングします.次に、これらの批評を使用して、RLHFパイプラインを通じてLLM批評家を訓練します.具体的には、モデルが生成したコードに問題を指摘する自然言語フィードバックを書くために、RLHFを使用してLLM批評家をトレーニングします.このプロセスにより、モデルが生成したコードに含まれるエラーを特定し、人間がより正確に評価できるように支援します.

Q: 人間による批評よりもモデルによる批評の方が好まれるという点で、研究の結果はどうだったのだろうか?

A: モデルによる批評は、人間の批評よりも80%以上の割合で好まれました.

Q: 微調整されたLLM批評家は、ChatGPT訓練データの誤りを識別する上でどのようなパフォーマンスを示したのでしょうか?

A: ファインチューニングされたLLM批評家は、ChatGPTトレーニングデータ内のエラーを成功裏に特定しました.

Q: 批評家たちは、特に幻覚の虫という点で、どのような限界を持っていたのだろうか?

A: 批評家の主な制限は、特に幻覚的なバグの点で、モデルがバグを幻覚的に作り出す可能性が高いことでした.長い批評は、幻覚や些細な問題を含む可能性が高く、モデルがバグを幻覚的に作り出す傾向があることが示されました.

Q: 評論家と請負業者による人間と機械のチームは、バグ捕獲能力という点でどのように比較したのだろうか?

A: 人間と機械のチームは、バグをキャッチする能力において、機械のみよりも優れていました.特に、Human+CriticGPTチームは、より包括的な批評を行い、同時に些細な問題や幻覚をより避けることができました.

Q: LLM批評家は、コードレビューに報酬を支払う人間の請負業者よりも多くのバグを発見するという発見について、詳しく説明してもらえますか?

A: LLM批評家は、コードレビューのために支払われる人間の請負業者よりも、挿入されたバグを大幅に多くキャッチすることが見つかりました.これは、LLMが高度な自然言語処理タスクにおいても高い性能を発揮し、人間が見逃す可能性のある微細なエラーや幻覚をより効果的に検出できるためです.

Q: ChatGPTのトレーニングデータで “欠陥なし “と評価されたエラーは、LLMの批評家たちによってどのように特定されたのでしょうか?

A: ChatGPTトレーニングデータのエラーは、LLM批評家によって特定されました.

Q: この研究結果は、モデルによって記述されたコードの人間による評価の将来にとって、どのような意味を持つのだろうか?

A: この研究の結果は、モデルが書いたコードの人間による評価の将来に重要な示唆を与えています.LLMは、実際のアシスタントタスクからのコードに含まれる問題を強調する自然言語フィードバックを書くためにRLHFで訓練されたLLM自体の批評家を使用することで、人間の批評家よりも優れた結果を出しています.モデルが書いた批評は、人間の批評よりも優れているという結果が63%のケースで見られ、人間の評価ではモデルがより多くのバグを見つけることが分かりました.

Scaling Synthetic Data Creation with 1,000,000,000 Personas

著者:Xin Chan, Xiaoyang Wang, Dian Yu, Haitao Mi, Dong Yu

発行日:2024年06月28日

最終更新日:2024年06月28日

URL:http://arxiv.org/pdf/2406.20094v1

カテゴリ:Computation and Language, Machine Learning

概要:

この論文では、新しいペルソナ駆動型のデータ合成方法論を提案しており、大規模言語モデル(LLM)内のさまざまな視点を活用して多様な合成データを作成しています.この方法論をスケールで十分に活用するために、Webデータから自動的に収集された10億個の多様なペルソナからなるPersona Hubを紹介しています.これらの10億個のペルソナ(世界人口の約13%)は、世界の知識を持つ分散キャリアとして機能し、LLMに包括されたほぼすべての視点にアクセスできるため、さまざまなシナリオにおいてスケールで多様な合成データの作成を容易にします.Persona Hubの使用例を示すことで、高品質な数学的および論理的推論問題、指示(ユーザープロンプト)、知識豊富なテキスト、ゲームNPC、およびツール(関数)をスケールで合成することが可能であることを実証し、ペルソナ駆動型のデータ合成が多目的で、スケーラブルで柔軟で使いやすいことを示しています.これは、合成データの作成と実践における応用においてパラダイムシフトをもたらす可能性があり、LLMの研究開発に深い影響を与えるかもしれません.

Q&A:

Q: ペルソナハブの10億人の多様なペルソナをキュレーションする基準はどのように決めたのですか?

A: 1つの基準は、Webデータから自動的に収集された多様な1億のペルソナをPersona Hubに収集することでした.これらの1億のペルソナは、世界の総人口の約13%に相当し、世界の知識を分散させるキャリアとして機能します.各個人は、独自の知識、経験、興味、個性、職業に関連付けられるため、LLMに包括されたほぼすべての視点にアクセスできます.

Q: 多様な合成データを作成するために、大規模な言語モデルの中でさまざまな視点を活用するプロセスを説明していただけますか?

A: 大規模言語モデル内でさまざまな視点を活用して多様な合成データを作成するプロセスは、特定のペルソナが対応する視点を引き出すことによって行われます.これにより、言語モデルは既存の知識の範囲を超えて探索することが可能となり、新しいアプローチが提供されます.将来的には、超人格を使用して言語モデルを導き、超知能にアクセスする可能性について研究されるでしょう.

Q: 質の高い数学的・論理的推論の問題を合成する上で、ペルソナ・ハブの具体的な使用例を教えてください.

A: Persona Hubは、高品質な数学的および論理的推論問題を合成するために、数多くのシナリオで使用される具体的なユースケースを示しています.

Q: ペルソナ・ハブの10億人のペルソナは、LLMに包含されているほとんどすべての視点をどのように活用しているのだろうか?

A: Persona Hubには10億の多様なペルソナがあり、これらはLLMに内包されたほぼすべての視点にアクセスできます.これらの10億のペルソナは、世界の知識を分散させたキャリアとして機能し、LLMに内包されたほぼすべての視点にアクセスできます.

Q: Persona Hubを使用して多様な合成データを作成する際に、どのような課題に直面しましたか?

A: Persona Hubを使用して多様な合成データの作成をスケーリングする際に遭遇した課題は、多様なペルソナを適切に管理し、それらを大規模に活用することでした.Webデータから自動的に収集された10億の多様なペルソナは、それぞれ異なる知識やスタイルを持っており、それらを適切に統合し、データの品質を維持することが困難でした.また、合成データの作成において、機械生成のテキストと人間によるコンテンツを区別することが難しくなる可能性があり、データの混入や誤情報の問題が悪化する可能性もありました.

Q: Persona Hubが生成する合成データの品質と精度はどのように確保されていますか?

A: Persona Hubによって生成される合成データの品質と正確性を確保するためには、多くの手法が利用されます.まず、1つの方法は、合成データ生成プロセスにおいて、1つのペルソナが複数の異なる文体やスタイルを持つことを考慮し、それらの多様性を確保することです.さらに、合成データの生成において、リアルワールドのデータとの混合を避け、純粋な合成データを生成することが重要です.また、生成されたデータの検証には、機械学習モデルや自然言語処理モデルを使用して、合成データと実データを区別するための検証プロセスを導入することが不可欠です.さらに、生成されたデータの品質を保証するために、専門家や研究者による検証やフィードバックを取り入れることも重要です.

Q: ペルソナ主導のデータ統合が実際にどのように適用され、LLMの研究開発にどのような影響を与えたか、例を挙げていただけますか?

A: パーソナ駆動データ合成は、数学や論理問題、指示、知識豊富なテキスト、ゲームNPC、ツールの開発など、さまざまなデータ合成シナリオに適用され、LLMの研究と開発に革命的な影響を与えています.これにより、パーソナ駆動データ合成は柔軟性があり、スケーラブルで使いやすく、合成データの作成と応用においてパラダイムシフトをもたらす可能性があります.

Q: ペルソナハブの作成と管理を容易にするために、どのようなツールやテクノロジーを使用しましたか?

A: Persona Hubの作成と管理を容易にするために使用されたツールや技術は、図17に示されている様々なペルソナを用いたツールの作成、機能性の提供、およびインターフェース定義のコード実装に関わるものです.

Q: ペルソナ主導型データ合成を利用した合成データ作成とアプリケーションの将来像をどのように描いていますか?

A: パーソナ駆動データ合成の将来においては、パーソナハブを用いた総合的な合成データの創造と応用が進むと考えられます.この手法は、多様なパーソナを用いて異なる視点からデータを合成することで、高品質かつ多様な合成データを大規模に生成することが可能となります.パーソナ駆動データ合成は柔軟性があり、スケーラブルで使いやすいため、合成データの創造と応用においてパラダイムシフトをもたらす可能性があり、LLMの研究と開発に深い影響を与えるでしょう.

Q: ペルソナハブを通じて作成された合成データが広く使用されることで、どのような倫理的な考慮や意味合いが生じる可能性がありますか?

A: Persona Hubを通じて作成された合成データの広範な使用から生じる潜在的な倫理的考慮事項や影響には、情報の改ざんやフェイクニュースの拡散が挙げられます.多様なペルソナが異なる文章スタイルを持ち、機械生成のテキストを人間生成のコンテンツと区別しにくくする可能性があります.このような混乱は、合成データが実データと混合され、研究結果や公共情報が歪められる可能性があるデータ汚染の問題を悪化させる可能性があります.

APIGen: Automated Pipeline for Generating Verifiable and Diverse Function-Calling Datasets

著者:Zuxin Liu, Thai Hoang, Jianguo Zhang, Ming Zhu, Tian Lan, Shirley Kokane, Juntao Tan, Weiran Yao, Zhiwei Liu, Yihao Feng, Rithesh Murthy, Liangwei Yang, Silvio Savarese, Juan Carlos Niebles, Huan Wang, Shelby Heinecke, Caiming Xiong

発行日:2024年06月26日

最終更新日:2024年06月26日

URL:http://arxiv.org/pdf/2406.18518v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning, Software Engineering

概要:

この論文では、機能呼び出しエージェントモデルの進化には多様で信頼性の高い高品質なデータセットが必要であると述べられています.APIGenという自動データ生成パイプラインを紹介し、検証可能な高品質なデータセットを機能呼び出しアプリケーションのために合成するために設計されています.私たちはAPIGenを活用し、21の異なるカテゴリーで3,673の実行可能なAPIを収集し、多様な機能呼び出しデータセットをスケーラブルかつ構造化された方法で生成しています.私たちのデータセットの各データは、フォーマットのチェック、実際の機能の実行、および意味の検証という3つの階層的な段階を経て検証され、信頼性と正確性が確保されています.私たちは、私たちがキュレーションしたデータセットで訓練されたモデルが、たった7BのパラメータでもBerkeley Function-Calling Benchmarkで最先端のパフォーマンスを達成し、複数のGPT-4モデルを上回ることを示しています.さらに、私たちの1Bモデルは、GPT-3.5-TurboやClaude-3 Haikuを凌駕する優れたパフォーマンスを達成しています.私たちは、機能呼び出しエージェント領域の発展を目指して、60,000の高品質なエントリを含むデータセットを公開しています.このデータセットはHuggingfaceで入手可能です.詳細はhttps://huggingface.co/datasets/Salesforce/xlam-function-calling-60kやプロジェクトのホームページhttps://apigen-pipeline.github.io/をご参照ください.

Q&A:

Q: データセットの各データが通過するフォーマットチェック、実際の関数実行、セマンティック検証のプロセスを説明できますか?

A: データセット内の各データが通過するフォーマットチェック、実際の関数実行、および意味検証のプロセスは、まずフォーマットチェッカーによって始まります.この段階では、データが正しいJSON形式であり、解析可能であるかどうかが検証されます.次に、API実行エンジンが呼び出しを処理し、結果とクエリを意味検証を行う別のLLMに送信します.この意味検証では、関数呼び出し、実行結果、およびクエリの目的との整合性が評価されます.すべての段階を通過したデータポイントは、将来の生成の多様性を向上させるために高品質の例としてシードデータセットに追加されます.

Q: 収集した3,673の実行可能APIについて、21の異なるカテゴリーをどのように決定したのですか?

A: 3,673個の実行可能なAPIを収集する際に、元のToolBenchデータセットに含まれていたセマンティックに重複するカテゴリ(例:FinanceとFinancial)を統合し、データセット全体で明確さとバランスを確保するために、これらを21の異なるカテゴリに統合しました.

Q: 関数呼び出しアプリケーションの文脈で「検証可能な高品質のデータセット」を定義するために、どのような基準が用いられたのか?

A: 高品質なデータセットを定義するために使用された基準は、3つの階層的段階を通過することでした.具体的には、フォーマットのチェック、実際の関数の実行、および意味の検証の3つの段階を経て、データが信頼性と正確性を確保するために検証されました.

Q: APIGenを使った多様なファンクションコーリングデータセットのスケーラビリティと構造化について詳しく教えてください.

A: APIGenは、複数段階の検証プロセスを活用して信頼性の高い多様な関数呼び出しデータセットを生成する新しいフレームワークです.APIGenは、実行可能なAPIから1つ以上の関数の説明を抽出し、それらを統一されたJSON形式に標準化するAPIサンプラーというモジュールを使用します.このようにして、様々なソースからのAPIを利用することで、トレーニングデータセットに含めるための幅広い関数呼び出しが可能となります.また、例示サンプラーは、異なるカテゴリに対応する指定された数のシード例をサンプリングし、これらの例を構造化されたクエリ、関数の説明、および…(文章が途切れているため、続きが必要です)

Q: GPT-4モデルや他のベンチマークに対して、作成したデータセットで学習させたモデルの性能をどのように測定し、比較したのですか?

A: モデルのパフォーマンスを測定し比較するために、私たちはベンチマークとしてBerkeley Function-Calling Benchmarkを使用しました.このベンチマークは、エージェントの能力を評価するための複数のタスクを含んでおり、Webインタラクション、推論、意思決定、関数呼び出し、ツールの使用などが含まれています.具体的には、ToolOperationとToolQueryなどのタスクが含まれており、エージェントが外部ツールとのマルチターンインタラクションにおける能力を評価します.また、ToolEvalでは、RapidAPIを介して機能呼び出しの能力を評価し、約1,000のテストケースを含んでいます.さらに、Berkeley Function-Calling Leaderboard(BFCL)は、モデルのアプリケーションを評価するための包括的なフレームワークを提供しています.私たちは、これらのベンチマークを使用して、私たちが作成したキュレーションされたデータセットでトレーニングされたモデルのパフォーマンスをGPT-4モデルや他のベンチマークと比較しました.

Q: データセットの信頼性と正確性を確保するために、具体的にどのような技術や方法論を採用したのか.

A: データセットの信頼性と正確性を確保するために採用された具体的な技術や方法論には、APIGenによって採用された3段階の検証プロセスが含まれます.このプロセスでは、生成されたデータのサンプルを人間の評価者3人が手動で検査し、パラメータ値の正確性やAPI呼び出しの適切さなどの要因に基づいてデータの品質を評価します.さらに、異なるモデルを用いたデータ生成プロセスの統計情報が提供され、各検証段階でのデータポイントの数やフィルタリングされたデータポイントの数が示されます.これにより、フォーマットの問題や実行エラーなどの低品質なデータポイントが効果的に除去されます.前の研究によると、高品質な微調整データの少量でも、特定のドメインタスクでモデルの性能を大幅に向上させることができることが示されています.このため、大規模な言語モデルを効果的に整列させるために、多段階のデータセット検証プロセスが提案されています.このフレームワーク設計の鍵となる洞察は、合成チャットデータとは異なり、関数呼び出しの回答は対応するAPIを介して直接実行できるということです.これにより、出力APIやパラメータのフォーマットが正しいか、生成されたAPI呼び出しが実行可能か、実行結果がクエリの意図に一致するかなどを確認できます.

Q: 6万件の高品質なエントリーを含むデータセットをリリースする意思決定プロセスについて教えてください.

A: 60,000の高品質なエントリーを含むデータセットを公開する決定プロセスについての洞察を提供します.強力なモデルから生成されたデータを使用することで、高品質のデータを提供することが重要であると考えられています.Mixtral-8x22B-InstとDeepSeek-V2-Chat(236B)という最も強力なモデルから生成された60,000のデータセットは、実用的な状況をカバーし、3,673の異なるAPIを含んでいます.各データポイントは実際のAPIを使用して検証され、その有効性と有用性が確認されています.このデータセットを公開することで、研究コミュニティに利益をもたらし、この分野での将来の研究を促進することを目的としています.

Q: このデータセットは、機能呼び出しエージェント・ドメインの分野の発展にどのように貢献するとお考えですか?

A: データセットは、大規模言語モデル(LLMs)の領域内で、機能呼び出しエージェントの分野の進歩に貢献することが期待されます.これにより、新しいAPIに遭遇した際のモデルの適応性や精度を向上させ、実世界のアプリケーションでのモデル微調整の効率性を高めることができます.

Q: APIGenの開発中にどのような問題に遭遇し、どのように対処しましたか?

A: APIGenの開発中に遭遇した課題の1つは、現在のバージョンがREST APIとPython関数のみを考慮していることでした.また、APIGenは一回の関数呼び出しの生成手順のみを実装しているため、より複雑な対話や複数のターンを扱うことができませんでした.これらの課題に対処するために、将来の作業ではAPIGenをさらに多様なシナリオ、プログラミング言語、およびAPIに対応させることを計画しています.また、フレームワークを拡張して、エージェントとツールの間のマルチターンやより複雑な対話を処理できるようにする予定です.

Q: APIGenと生成されたデータセットの今後の計画や改善の可能性について教えてください.

A: APIGenおよび生成されたデータセットの将来の計画や潜在的な改善については、現在のバージョンではREST APIとPython関数のみを考慮しているため、将来の作業はAPIGenをさらに多様なシナリオ、プログラミング言語、およびAPIに対応させることに焦点を当てる予定です.また、フレームワークを拡張してエージェントとツールの間のマルチターンやより複雑な相互作用を処理できるようにする予定です.これらの制限があるにもかかわらず、APIGenと生成されたデータセットは、効率的で効果的な関数呼び出しエージェントの開発において重要な進歩を表していると考えています.

Adaptable Logical Control for Large Language Models

著者:Honghua Zhang, Po-Nien Kung, Masahiro Yoshida, Guy Van den Broeck, Nanyun Peng

発行日:2024年06月19日

最終更新日:2024年06月19日

URL:http://arxiv.org/pdf/2406.13892v1

カテゴリ:Computation and Language

概要:

大規模言語モデル(LLM)が人間の指示に従ったさまざまなタスクで成功を収めているにもかかわらず、推論時のモデル生成の制御は持続的な課題となっています.本論文では、論理的な制約に従った信頼性の高いLLM生成を柔軟かつ追跡可能にする、適応可能なフレームワークであるCtrl-Gを紹介します.Ctrl-Gは、本番向けのLLMと隠れマルコフモデルを組み合わせることで、LLMの出力が決定的有限オートマトンとして表現される論理的な制約に従うようにします.TULU2-7Bモデルに適用した場合、Ctrl-Gは対話型テキスト編集のタスクにおいて、GPT3.5やGPT4よりも優れた性能を発揮します.具体的には、論理的な制約に従ったテキスト挿入/継続の生成タスクにおいて、Ctrl-GはGPT4と比較して、人間評価において30%以上の満足度を達成します.中規模の言語モデル(例:GPT2-large)に適用した場合、Ctrl-Gは標準ベンチマークにおいて、制約付き生成において大幅に他のモデルを上回ります.さらに、概念実証研究として、Ctrl-Gを小学校数学のベンチマークに実験し、LLMの推論を支援することを試みました.これは、将来のLLMの可能性を示唆しています.さらに、小学校数学のベンチマークを通じて、Ctrl-Gや他の制約付き生成アプローチが従来の言語生成タスクを超えてLLMの推論を支援する可能性を示唆しています.

Q&A:

Q: Ctrl-Gがどのように量産可能なLLMと隠れマルコフモデルを組み合わせ、論理的制約の遵守を保証しているのか、もう少し詳しく説明していただけますか?

A: Ctrl-Gは、本番向けのLLMとHidden Markov Modelを組み合わせることで、論理的制約に従うことを保証します.具体的には、Ctrl-Gは、LLMの出力が決定的有限オートマトンとして表現される論理的制約に従うようにHidden Markov Modelを使用します.これにより、Ctrl-Gは、論理的制約を満たすLLMの生成を確実に行うことができます.

Q: TULU2-7BにCtrl-Gを適用した場合、GPT3.5やGPT4と比較してどのようにパフォーマンスを測定したのですか?

A: Ctrl-GはTULU2-7Bモデルに適用された際の性能を測定し、GPT3.5およびGPT4と比較しました.この評価は、生成されたテキストの品質と与えられた制約条件の満足度を総合的に評価することで行われました.人間の評価によると、Ctrl-GはGPT3.5およびGPT4を30%以上上回り、制約条件を満たしつつ流暢なテキストを生成する能力が高いことが示されました.また、制約条件が複雑になるにつれてGPT4から生成されるテキストの品質が低下するのに対し、Ctrl-Gは一貫して高品質なテキストを生成し続け、複雑な制約にも強い汎用性を持っていることが強調されました.

Q: 決定論的有限オートマトンとして表現された論理的制約で、Ctrl-Gがテスト中にうまく遵守できた例を教えてください.

A: テスト例として、キーワード「car」、「snow」、「drive」が与えられた場合、制約として「gets cold」のフレーズが生成される必要があるという論理的制約がある.この制約は、Ctrl-Gによって成功裏に遵守された.

Q: Ctrl-GがGPT2-largeよりも優れていたのは、制約のある生成タスクの場合ですか?

A: Ctrl-Gは、制約生成タスクにおいてGPT2-largeを上回った特定のベンチマークは、コモンセンス生成とテキスト補完である.

Q: テキスト編集作業において、Ctrl-GとGPT4の満足度を比較するための人的評価はどのように行ったのですか?

A: 人間の評価を行うために、Amazon Mechanical Turk(MTurk)プラットフォームを通じて人間の評価を行いました.各テスト例について、TULU2(プロンプトのみ)、GPT3.5、GPT4、およびCtrl-Gからそれぞれ出力を生成し、注釈者に1から5のスケールでその品質を評価してもらいました.各テスト例について、すべてのモデルから生成された出力と元のコンテキストを注釈者に並べて提示し、これらの短い段落の品質を評価してもらいました.具体的には、注釈者に以下の3つの質問に答えてもらい、その品質を評価してもらいました:Q1. 段落は論理的で文法的に正しいですか?Q2. 段落は一貫しており、意味的に妥当ですか?Q3. Q1およびQ2に基づいて、総合的な品質の評価は何ですか?人間の評価では、生成されたテキストの一貫性と流暢さを評価してもらい、必要な論理的制約については知らせていません.各テスト例について、3人の異なる注釈者に出力を評価してもらい、注釈者間の合意を計算しました.

Q: Ctrl-Gの、従来の言語生成タスク以外の潜在的な用途について詳しく教えてください.

A: Ctrl-Gは、従来の言語生成タスク以外にも幅広い応用が考えられます.例えば、悪い単語やフレーズが現れないようにすることでLLMの解毒を支援したり、より長い推論シーケンスを生成することでLLMの推論能力を向上させたり、特定のキーフレーズの出現に応じて生成されるコンテンツの感情やトピックを制御することが挙げられます.

Q: Ctrl-Gが開発されたきっかけと、LLMに適応可能な論理制御の必要性とは?

A: Ctrl-Gの開発とLLMに対する適応可能な論理制御の必要性の背景には、LLMが論理的制約に従うことを信頼性を持って行うための枠組みが必要であるという課題がありました.これは、LLMが論理的制約に従うことが難しいため、制御モデルの生成が推論時に挑戦的であることから着想を得ました.

Q: Ctrl-Gは、LLMの推論時にモデル生成を制御するという根強い課題にどのように対処するのだろうか?

A: Ctrl-Gは、制約を満たすLLMの生成を信頼性を持って制御するための柔軟なフレームワークとして機能します.Ctrl-Gは、いかなる製品向けのLLMとも組み合わせることができ、隠れマルコフモデルと組み合わせることで、LLMの出力が決定的有限オートマトンとして表現される論理制約に従うようにします.Ctrl-Gは、TULU2-7Bモデルに適用された際に、GPT3.5やGPT4よりもインタラクティブなテキスト編集のタスクで優れた性能を発揮します.

Q: Ctrl-GがGPT3.5やGPT4を上回る成功の影響は、大規模言語モデルや制約生成アプローチの将来にどのような意味があるのでしょうか?

A: Ctrl-Gの成功は、大規模言語モデルや制約生成アプローチの将来において重要な示唆を与えます.Ctrl-GがGPT3.5やGPT4を上回ることで、論理的制約に従ったテキスト生成の品質と汎用性が向上しました.これにより、複雑な制約に対しても高品質なテキストを生成できる可能性が示され、大規模言語モデルの進化や制約生成アプローチの発展に向けた新たな方向性が示唆されます.