ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- Tree Search for Language Model Agents

発行日:2024年07月01日

LMによって駆動される自律エージェントは、ウェブ自動化などの意思決定タスクに有望性を示すが、多段階の推論や計画に苦労し、推論時検索アルゴリズムを提案している. - Can Long-Context Language Models Subsume Retrieval, RAG, SQL, and More?

発行日:2024年06月19日

LCLMsは外部ツールに依存せず、情報のコーパス全体を処理し、高度なプロンプティング技術を適用する可能性を持ち、LOFTベンチマークで驚異的な能力を示すが、合成的な推論に課題があり、新しいタスクに取り組む可能性を示す. - From RAGs to rich parameters: Probing how language models utilize external knowledge over parametric information for factual queries

発行日:2024年06月18日

RAGは外部コンテキストを使用して言語モデルの応答を補完し、質問に答える際にショートカットを取り、パラメトリックメモリを最小限にしか利用していないことが強調されている. - PlanRAG: A Plan-then-Retrieval Augmented Generation for Generative Large Language Models as Decision Makers

発行日:2024年06月18日

この論文では、LLMsを使用して意思決定のための解決策を提案し、Decision QAベンチマークであるDQAを提案しています.PlanRAG技術を使用して、LocatingとBuildingのシナリオで最先端の結果を達成しました.GitHubでコードとベンチマークを公開しています. - DeepSeek-Coder-V2: Breaking the Barrier of Closed-Source Models in Code Intelligence

発行日:2024年06月17日

DeepSeek-Coder-V2は、GPT4-Turboと比較可能な性能を持つオープンソースのMixture-of-Experts(MoE)コード言語モデルで、コーディングおよび数学的推論能力を向上させ、プログラミング言語のサポートを拡張しています. - Be like a Goldfish, Don’t Memorize! Mitigating Memorization in Generative LLMs

発行日:2024年06月14日

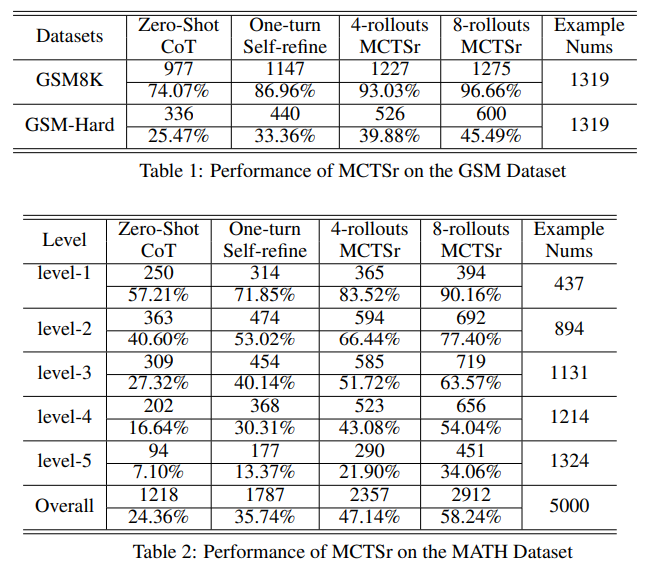

大規模な言語モデルのプライバシーや著作権リスクを緩和するために、ゴールドフィッシュ損失を導入し、記憶を削減する実験を行いました. - Accessing GPT-4 level Mathematical Olympiad Solutions via Monte Carlo Tree Self-refine with LLaMa-3 8B

発行日:2024年06月11日

MCT Self-Refine(MCTSr)アルゴリズムは、大規模言語モデル(LLMs)とモンテカルロ木探索(MCTS)を統合し、数学的推論タスクのパフォーマンスを向上させる革新的な手法で、オリンピアードレベルの数学問題を解決する効果を示しています. - TextGrad: Automatic “Differentiation” via Text

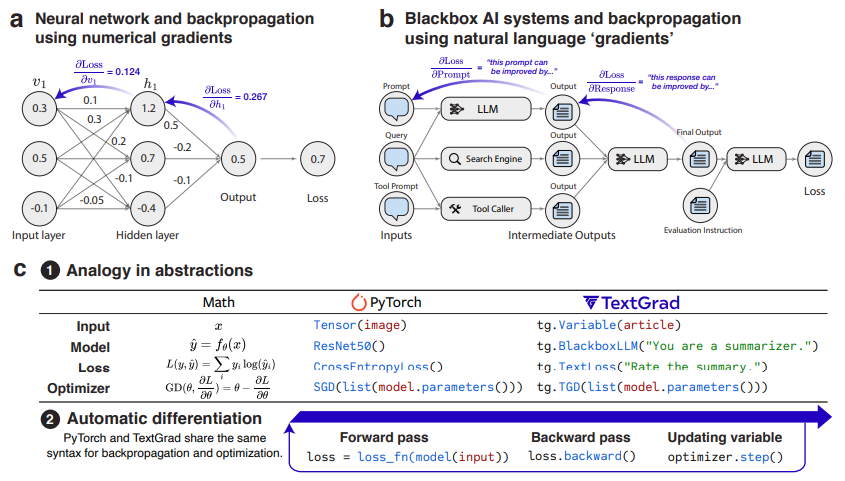

発行日:2024年06月11日

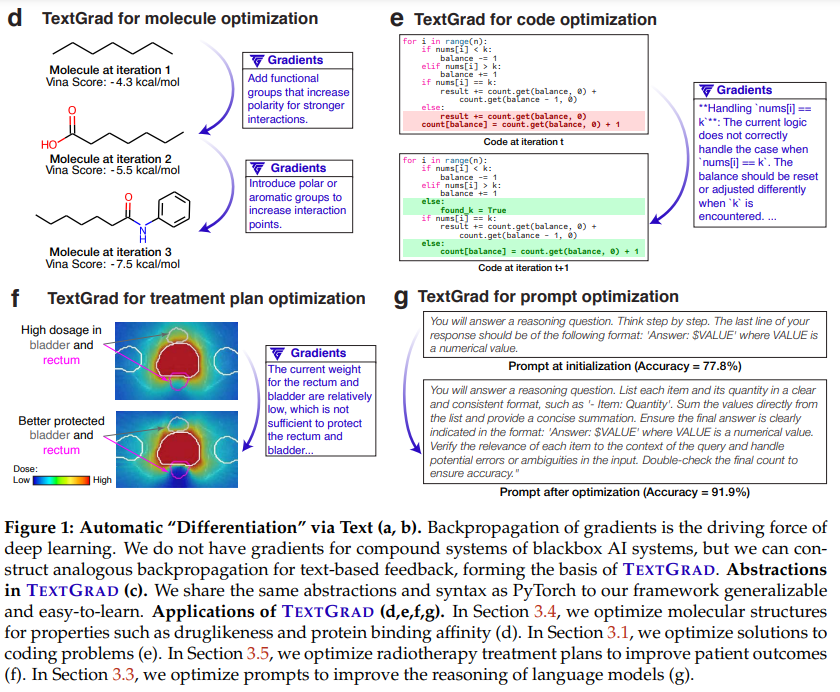

AIの進歩により、TextGradフレームワークが複合AIシステムの最適化を容易にし、Google-Proof質問回答の精度を向上させるなど、次世代のAI開発を加速している.

Tree Search for Language Model Agents

著者:Jing Yu Koh, Stephen McAleer, Daniel Fried, Ruslan Salakhutdinov

発行日:2024年07月01日

最終更新日:2024年07月01日

URL:http://arxiv.org/pdf/2407.01476v1

カテゴリ:Artificial Intelligence, Computation and Language, Machine Learning

概要:

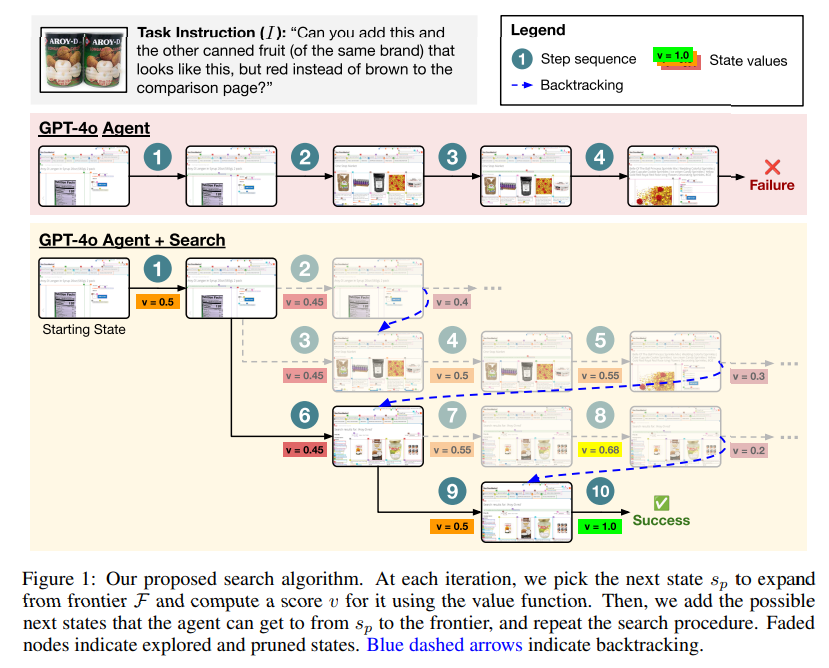

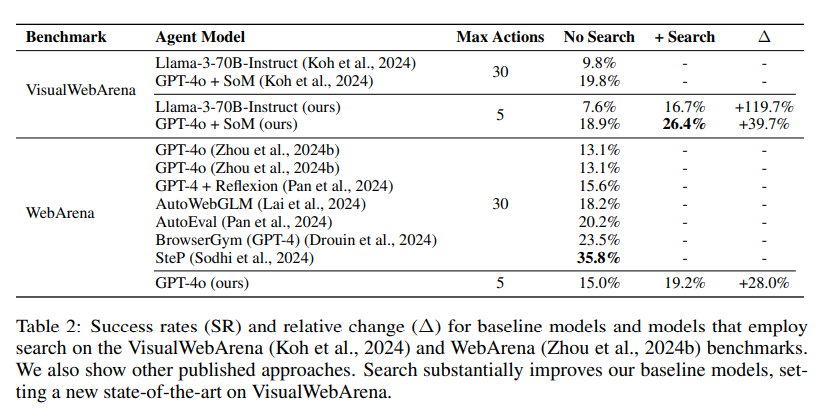

言語モデル(LM)によって駆動される自律エージェントは、ウェブ自動化などの意思決定タスクを実行する能力において有望性を示しています.しかし、主な制限事項として、自然言語理解と生成に最適化されたLMは、現実的なコンピュータータスクを解決しようとする際に、多段階の推論、計画、環境フィードバックの使用に苦労しています.この課題に対処するために、私たちは、LMエージェントが対話型ウェブ環境で探索と多段階計画を明示的に実行するための推論時検索アルゴリズムを提案しています.私たちのアプローチは、実際の環境空間内で動作する最良優先木探索の形態であり、ほとんどの既存の最先端エージェントと補完的です.これは、現実的なウェブタスクにおいて効果を示す最初のLMエージェント用の木探索アルゴリズムです.難しいVisualWebArenaベンチマークでは、GPT-4oエージェントの上に当社の検索アルゴリズムを適用することで、検索なしの同じベースラインと比較して成功率が39.7%相対的に向上し、26.4%の最先端成功率を設定します.WebArenaでは、検索も、別のベースラインに比べて28.0%の相対的な改善をもたらします.さらに、我々の実験は、ウェブエージェントにおける検索の効果を示し、パフォーマンスがテスト時の計算量の増加とともに向上することを示しています.また、検索による改善、制限事項、そして今後の研究の有望な方向性を強調するために、結果の徹底的な分析を行っています.私たちのコードとモデルは、https://jykoh.com/search-agents で公開されています.

Q&A:

Q: 提案されている推論時間探索アルゴリズムがLMエージェントに対してどのように機能するのか、もう少し詳しく説明していただけますか?

A: 提案された推論時検索アルゴリズムは、言語モデル(LM)エージェントがインタラクティブなWeb環境で探索と多段階計画を明示的に実行するためのものです.このアプローチは、実際の環境空間内で動作する最良優先木探索の形式であり、ほとんどの最先端エージェントと補完的です.これは、現実的なWebタスクで効果的であることを示す最初のLMエージェント向けの木探索アルゴリズムです.難しいVisualWebArenaベンチマークでは、GPT-4oエージェントの上に当社の検索アルゴリズムを適用することで、相対的に39.7%の性能向上が実現されました.

Q: コンピュータ・タスクにおいて多段階の推論やプランニングを試みるとき、LMは具体的にどのような課題に直面するのだろうか?

A: 言語モデル(LM)がコンピュータータスクで多段階の推論と計画を試みる際に直面する特定の課題は、環境フィードバックの使用、多段階の推論、計画に苦労することです.

Q: あなたの検索アルゴリズムは、現実的なウェブタスクにおける LM エージェントのパフォーマンスをどのように向上させるのか?

A: 検索アルゴリズムは、大規模言語モデルエージェントの性能を向上させるために、最良優先木探索を言語モデルエージェントと統合し、複数のアクション軌道を探索して評価することを可能にします.これにより、Webタスクの性能が向上し、(Visual)WebArenaベンチマークで明らかになったように、現実的なWeb環境でのLMエージェントの成功率が著しく向上します.検索手法は一般的であり、将来の作業で他のドメインに適用することが有益であると考えています.推論時の検索は、計画、推論、およびコンピュータータスクを実行するために自律的に行動する能力を持つエージェントを構築するための重要な要素であると信じています.

Q: VisualWebArenaベンチマークの詳細と、検索アルゴリズムのパフォーマンスについて教えてください.

A: VisualWebArenaベンチマークは、現実的なWebタスクにおける性能評価を行うための難しいベンチマークです.研究では、GPT-4oエージェントに検索アルゴリズムを適用することで、検索を行わない同じベースラインと比較して、成功率が39.7%相対的に向上し、成功率26.4%という最先端の成功率を達成しました.

Q: 実験の比較対象としてGPT-4o剤を選んだ根拠は何ですか?

A: 実験においてGPT-4oエージェントを比較のベースラインとして選択した理由は、Zhou et al. (2024b)のプロンプトを使用しているためです.このモデルは、現在のWebページのアクセシビリティツリー表現を入力観測として使用しており、画像のキャプションを含んでいないLlama-3ベースラインと同様の方法で機能しています.

Q: WebArena ベンチマークにおいて、検索を使用した LM エージェントの成功率は、検索を使用しなかったエージェントと比較してどうであろうか?

A: WebArenaベンチマークで、検索を行ったLMエージェントの成功率は、検索を行わなかった場合のLMエージェントよりも高いです.具体的には、検索を行った場合の成功率は19.2%であり、検索を行わなかった場合の成功率よりも28.0%高いことが示されています.

Q: LMエージェントの性能は、テスト時間の増加に伴ってどのように変化するのか、詳しく教えてください.

A: LMエージェントのパフォーマンスは、テスト時の計算量が増加するとスケールします.具体的には、検索予算cが増加すると、エージェントはより多くの状態を展開し、したがってLMへの推論呼び出しも増加します.例えば、c=20の検索予算では、検索ごとに最大20の状態を展開する可能性があり、これにより検索のないエージェントよりも最大20倍のLM呼び出しが必要となります.したがって、テスト時の計算量が増加すると、エージェントのパフォーマンスも向上することが示されています.

Q: 結果を徹底的に分析した結果、特に改善点、限界点、今後の方向性について、重要な発見は何でしたか?

A: 結果の徹底的な分析から、検索による改善、制限、および将来の方向性についていくつかの主な発見がありました.検索を導入することで、事前学習されたLMエージェントからより強力な結果を抽出するために推論時により多くの計算リソースを消費できるようになります.しかし、これにより軌道が遅くなる可能性があります.また、Webエージェントにおける検索の効果を強調する実験を行い、パフォーマンスがテスト時の計算リソースの増加とともにスケーリングすることを実証しました.結果からの改善、制限、および将来の研究の有望な方向性を強調するために、徹底的な分析を行いました.

Q: この研究で使用されたコードやモデルに、他の研究者はどのようにアクセスできますか?

A: この研究で使用されたコードとモデルに他の研究者がアクセスする方法は、jykoh.com/search-agents で公開されています.

Q: あなたの検索アルゴリズムが特に大きな影響を与える可能性があると思われる、実際のアプリケーションや業界はありますか?

A: 産業界において、検索アルゴリズムが特に影響を与える可能性がある具体的な実世界の応用例は、自動化されたウェブエージェントによるインタラクティブなウェブ環境の探索を通じて構築されるグラフ上での検索です.

Can Long-Context Language Models Subsume Retrieval, RAG, SQL, and More?

著者:Jinhyuk Lee, Anthony Chen, Zhuyun Dai, Dheeru Dua, Devendra Singh Sachan, Michael Boratko, Yi Luan, Sébastien M. R. Arnold, Vincent Perot, Siddharth Dalmia, Hexiang Hu, Xudong Lin, Panupong Pasupat, Aida Amini, Jeremy R. Cole, Sebastian Riedel, Iftekhar Naim, Ming-Wei Chang, Kelvin Guu

発行日:2024年06月19日

最終更新日:2024年06月19日

URL:http://arxiv.org/pdf/2406.13121v1

カテゴリ:Computation and Language, Artificial Intelligence, Information Retrieval

概要:

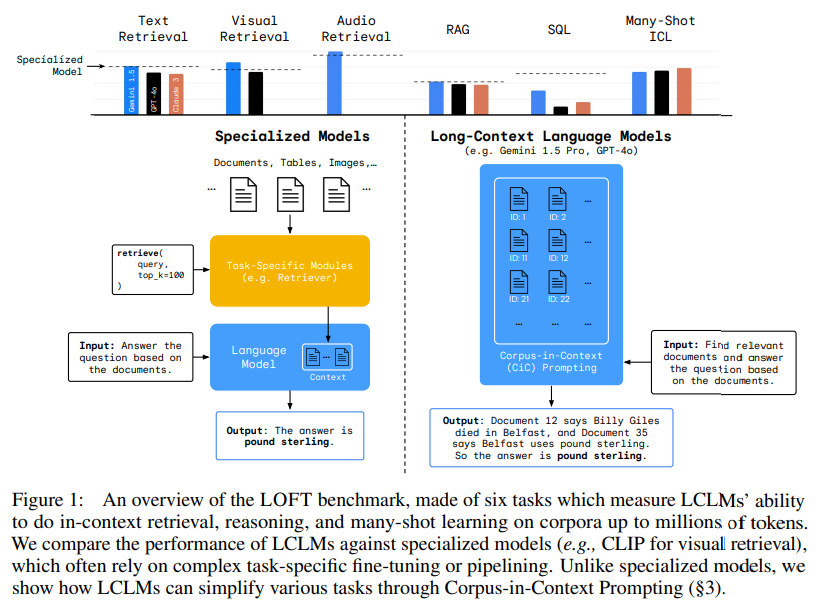

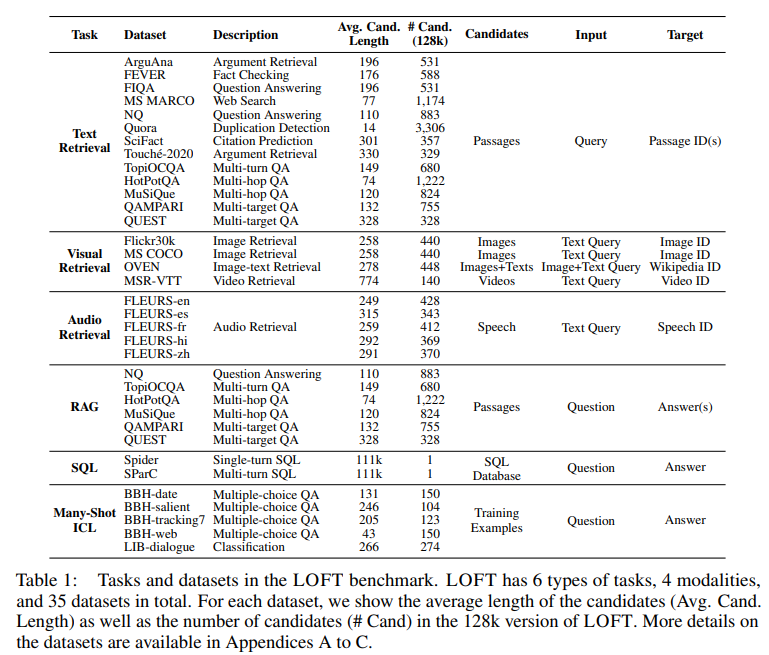

ロングコンテキスト言語モデル(LCLMs)は、従来、検索システムやデータベースなどの外部ツールに依存していたタスクへのアプローチを革新する可能性を秘めています.LCLMsの能力を活用して情報のコーパス全体をネイティブに取り込み、処理することで、多くの利点が得られます.これにより、ツールの専門知識が不要となり、ユーザーフレンドリーさが向上し、複雑なパイプラインでの連鎖的なエラーを最小限に抑えた堅牢なエンドツーエンドモデリングが可能となり、システム全体に高度なプロンプティング技術を適用することができます.このパラダイムシフトを評価するために、LOFTという、数百万トークンまでのコンテキストが必要な実世界のタスクを評価するために設計されたベンチマークを紹介します.我々の調査結果は、LCLMsが、これらのタスクのために明示的にトレーニングされたことがないにもかかわらず、最先端の検索システムやRAGシステムに匹敵する驚くべき能力を持っていることを明らかにしています.しかし、LCLMsは、SQLのようなタスクで必要とされる合成的な推論のような分野で課題に直面しています.特に、プロンプティング戦略はパフォーマンスに大きな影響を与え、継続的な必要性を強調しています.LOFTは、LCLMsの潜在能力を示し、モデルの能力が拡大するにつれて既存のパラダイムを取って代わり、新しいタスクに取り組む可能性を示す厳格なテスト基準を提供します.

Q&A:

Q: ロングコンテクスト言語モデル(LCLM)は、従来、検索システムやデータベースのような外部ツールに依存していたタスクにどのような革命をもたらすのか?

A: 長いコンテキスト言語モデル(LCLMs)は、外部ツール(検索システムやデータベースなど)に依存していた従来のタスクを革新する可能性があります.LCLMsは、情報のコーパス全体をネイティブに取り込み、処理する能力を活用することで、多くの利点を提供します.これにより、ユーザーフレンドリー性が向上し、ツールの専門知識が不要となり、複雑なパイプラインにおける連鎖的なエラーを最小限に抑える堅牢なエンドツーエンドモデリングを提供し、システム全体に高度なプロンプティング技術を適用することが可能となります.

Q: LCLMは、使いやすさとロバストなエンド・ツー・エンド・モデリングという点で、どのような利点があるのでしょうか?

A: LCLMsは、ユーザーフレンドリーさを向上させると同時に、複雑なパイプライン内の連鎖的なエラーを最小限に抑える堅牢なエンドツーエンドモデリングを提供します.これにより、特定のツールの専門知識が不要となり、システム全体にわたって洗練されたプロンプティング技術を適用することが可能となります.

Q: LOFT は、最大数百万トークンのコンテキストを必要とする実世界のタスクをどのようにベンチマークしていますか?

A: LOFTベンチマークは、LCLMsが使用される幅広い実世界のアプリケーションをカバーすることを目指しています.これらのタスクは、クエリのための関連文書の取得からデータベースからの構成情報の抽出まで幅広いものです.LOFTは、コンテキストのトークン数をスケーリングすることで、LCLMsがどのようにパフォーマンスするかをテストするために、3つの異なるコンテキスト長制限(32k2、128k、1M)を持つように作成されています.LOFTは、1百万トークンのコンテキストをサポートしており、最新のLCLMsの機能が向上するにつれて、評価が関連性を保つようにします.タスクは、コンテキストの長さが増加するにつれて、最小限の努力で1十億トークンまでスケーリングすることができます.

Q: LOFTベンチマークの結果から明らかになったLCLMの驚くべき能力とは?

A: LOFTベンチマークの結果から、LCLMsの驚くべき能力は、長い文脈を持つタスクにおいて多くの専門モデルと同等の性能を発揮できることが示されました.さらに、LCLMsは長い文脈の推論能力において改善の余地があり、モデルの能力が向上するにつれて新しいタスクに取り組む潜在能力を示しています.

Q: SQLのようなタスクで必要とされる構成推論のような分野で、LCLMはどのような課題に直面しているのだろうか?

A: LCLMsはSQLのようなタスクで必要とされる構成的推論の分野で直面する課題があります.特に、平均化は最も難しい操作であり、等価性に関する推論はかなり困難であることがわかります.

Q: プロンプト戦略は、特にコンテキストの長さが長くなるにつれて、LCLMのパフォーマンスにどのような影響を与えるのか?

A: プロンプティング戦略は、特にコンテキストの長さが増すにつれて、LCLMのパフォーマンスに大きな影響を与えます.これにより、LCLMsの潜在能力が明らかになり、既存のパラダイムを取って代わる可能性が示されます.

Q: LOFTベンチマークにおいて、LCLMの性能は最先端の検索システムやRAGシステムと比較してどうでしょうか?

A: LOFTベンチマークでのLCLMsのパフォーマンスは、最先端の検索およびRAGシステムと比較して、128kトークンレベルで競合していることが示されています.

Q: LCLMが既存のパラダイムに取って代わる可能性を示し、モデルの能力が拡大するにつれて新たな課題に取り組むようになるのはなぜか?

A: LCLMsは、複雑なパイプラインを統合した統一モデルによって、エラーの連鎖や煩雑な最適化といった問題を改善し、モデル開発においてスムーズなエンドツーエンドのアプローチを提供することで、既存のパラダイムを取って代わり、モデルの能力が向上するにつれて新しいタスクに取り組む可能性を示しています.

Q: 構成推論のようなタスクでLCLMが直面する課題に対処するためには、具体的にどのような研究が必要なのだろうか?

A: LCLMsが構成的推論などの課題に直面している際に必要な具体的な研究は、プロンプティング戦略の改善や長い文脈の推論能力の向上などが含まれます.

Q: 複雑な推論や検索を必要とするタスクでのパフォーマンスを向上させるために、LCLMをさらに最適化するにはどうすればよいのだろうか?

A: LCLMsの性能を向上させるためには、複雑な推論と検索を必要とするタスクにおいて、プロンプティング戦略をさらに最適化することが重要です.コンテキストの長さが拡大するにつれて、LCLMsの頑健な長いコンテキスト推論の向上余地が豊富であることが示されています.

From RAGs to rich parameters: Probing how language models utilize external knowledge over parametric information for factual queries

著者:Hitesh Wadhwa, Rahul Seetharaman, Somyaa Aggarwal, Reshmi Ghosh, Samyadeep Basu, Soundararajan Srinivasan, Wenlong Zhao, Shreyas Chaudhari, Ehsan Aghazadeh

発行日:2024年06月18日

最終更新日:2024年06月18日

URL:http://arxiv.org/pdf/2406.12824v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

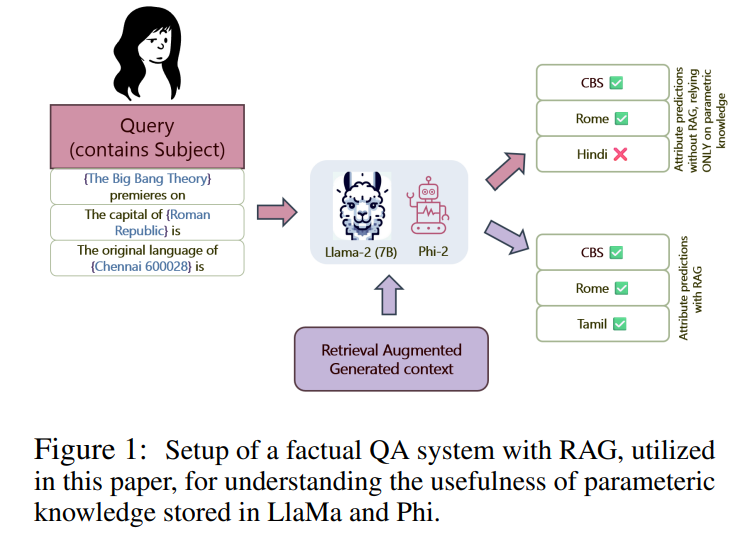

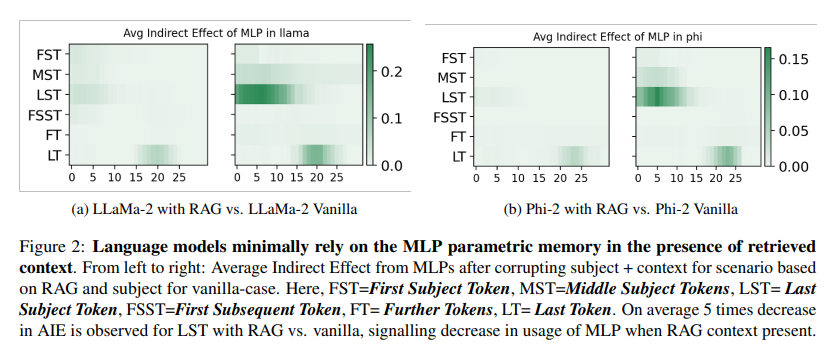

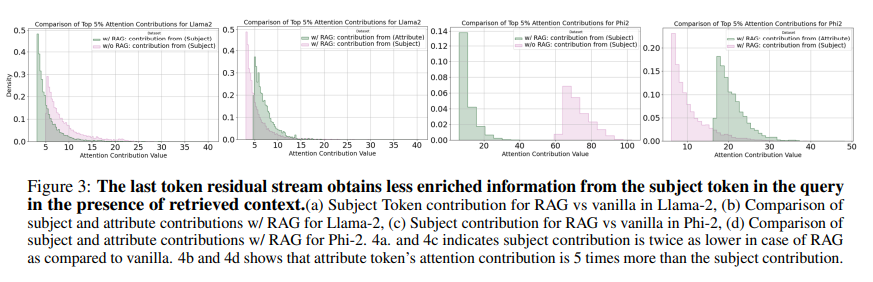

Retrieval Augmented Generation(RAG)は、言語モデルが外部コンテキストを使用してユーザープロンプトに対する応答を補完する能力を向上させるものです.このアプローチは、言語モデルの実用的な応用において人気を博しており、検索、質問応答、チャットボットなどのさまざまな分野で利用されています.しかし、このアプローチがどのように機能するかの正確な性質は明確に理解されていません.本論文では、RAGパイプラインを機械的に調査し、言語モデルが質問に答える際にショートカットを取り、コンテキスト情報のみを利用して答える傾向が強いことを強調します.また、パラメトリックメモリを最小限にしか利用していないことも示します.我々は、因果関係の中介分析を用いて、質問に答える際にパラメトリックメモリが最小限にしか利用されていないことを示し、また、注意の寄与とノックアウトを用いて、最後のトークン残留ストリームが質問の主語トークンから補完されるのではなく、コンテキスト内の他の情報のトークンから補完されることを示します.我々は、この顕著なショートカット行動がLLaMaファミリーとPhiファミリーのモデルの両方で見られることを発見しました.

Q&A:

Q: RAGパイプラインがどのように機能し、指定されたユーザープロンプトに対する回答を補強するのか、もう少し詳しく説明してもらえますか?

A: RAGパイプラインは、外部コンテキストを使用して言語モデルの応答を拡張するために機能します.具体的には、RAGはユーザープロンプトに対する応答を補完するために外部知識を利用し、言語モデルの推論能力を向上させます.このアプローチは、検索、質問応答、チャットボットなどの言語モデルの実用的な応用において人気を博しています.ただし、RAGパイプラインが具体的にどのように機能するかは明確に理解されていません.RAGパイプラインは、言語モデルが「ショートカット」を取り、質問に答える際にコンテキスト情報のみを利用し、パラメトリックメモリを最小限に頼る傾向が強いことを強調するために機械的に調査します.

Q: 言語モデルにおけるRAGアプローチの実用的な応用例について教えてください.

A: RAGアプローチの実用的な応用例としては、自然言語システムにおける性能向上が挙げられます.RAGシステムは外部コンテキストを統合することで、言語モデルアプリケーションの性能を著しく向上させることができます.

Q: 言語モデルは質問に答えるとき、パラメトリックな記憶よりも文脈情報を利用する方にどのようなバイアスを示すのか?

A: 言語モデルは、質問に答える際に、文脈情報を利用する傾向が強く、パラメトリックメモリよりも優先して利用するバイアスがある.具体的には、言語モデルは質問に答える際に、パラメトリックメモリを最小限にしか使用せず、文脈情報のみを利用する傾向がある.この挙動は、質問に対するパラメトリックメモリの活性化が起こらないことによって示される.

Q: 言語モデルにおけるパラメトリック・メモリーの利用に関して、因果調停分析の結果を説明していただけますか?

A: 因果仲介分析の結果によると、言語モデルは質問に答える際にパラメトリックメモリを最小限にしか利用していないことが示されました.具体的には、質問に対する回答において、言語モデルは主にコンテキスト情報のみを利用しており、パラメトリックメモリをほとんど使用していないことが明らかになりました.

Q: アテンション・コントリビューションとノックアウトは、言語モデルにおける最後のトークン残差ストリームの充実をどのように示しているのだろうか?

A: Attention Contributions and Knockoutsによって、言語モデル内の最後のトークンの残差ストリームがどのように豊かになるかが示されます.具体的には、Attention Contributions and Knockoutsは、最後のトークンから主語トークンに注意を向けることで、モデルの予測に寄与する重要なトークンを特定します.これにより、モデルが質問に回答する際に、最後のトークンが主語トークンからの情報を受け取り、その情報を元に予測を行うことが可能となります.

Q: 言語モデルは、文脈中のどのトークンが質問に答えるために有益であるかをどのように判断するのでしょうか?

A: 言語モデルは、質問に答える際に、コンテキスト内のどのトークンが情報提供に役立つかを決定します.これは、Causal Mediation AnalysisやAttention Contributions and Knock-outsなどの手法を用いて調査され、結果として、言語モデルは質問に対する答えを見つける際に、内部のパラメータメモリを最小限に利用し、代わりに外部のコンテキスト情報を優先的に利用する傾向があることが明らかになりました.

Q: 質問に答えるために外部の文脈を利用する際、言語モデルがどのようにショートカットしているのか、例を挙げていただけますか?

A: 言語モデルが外部コンテキストを利用して質問に答える際にショートカットを取る例として、Causal Mediation Analysisによるパラメトリックメモリの最小限の利用やAttention Contributions and Knock-outsによる最後のトークン残差ストリームが質問の主語トークンからではなく、コンテキスト内の他の情報トークンから豊かになることが挙げられます.

Q: 言語モデルは応答を生成する際、文脈情報とパラメトリック・メモリーの利用をどのようにバランスさせているのだろうか?

A: 言語モデルは、応答を生成する際に、コンテキスト情報とパラメトリックメモリの使用をバランスさせます.具体的には、RAGパイプラインを機械的に調査し、言語モデルが質問に回答する際には、主にコンテキスト情報のみを利用し、パラメトリックメモリを最小限にしか使用しないことが強く示唆されています.質問に対する主語トークンからの情報よりも、コンテキスト内の他の情報から最後のトークン残差ストリームがより豊かな情報を得ることが明らかになっています.

Q: これらの知見は、検索、質問/回答、チャットボットのアプリケーションにおける言語モデルの今後の開発にどのような示唆を与えるのだろうか?

A: これらの研究結果は、将来の言語モデルの開発において、検索、質問応答、およびチャットボットアプリケーションにおいて、非常に重要な示唆を与える.具体的には、言語モデルがパラメトリックメモリよりもコンテキスト情報を重視していることが明らかになりました.この「ショートカットメカニズム」を理解することで、将来の言語モデルは、外部知識をより効果的に活用し、質問により適切に回答する能力を向上させることが期待されます.

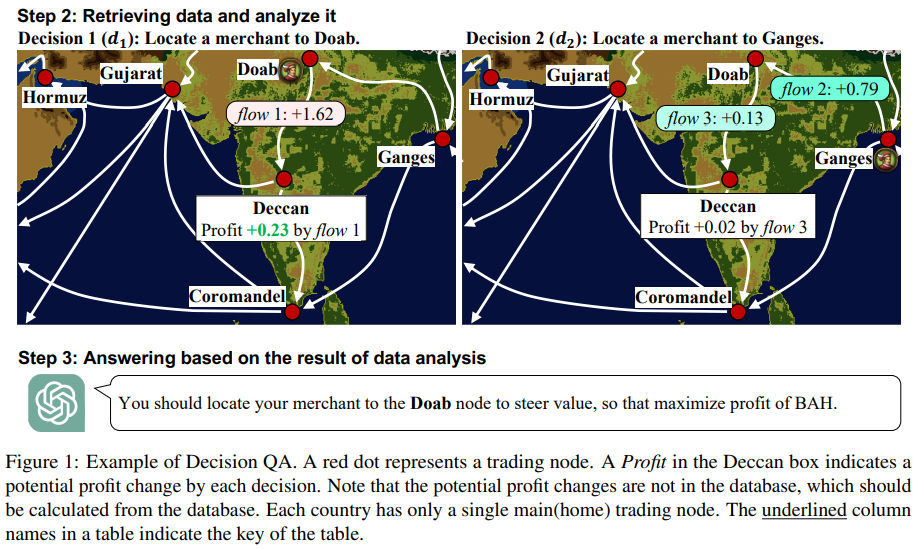

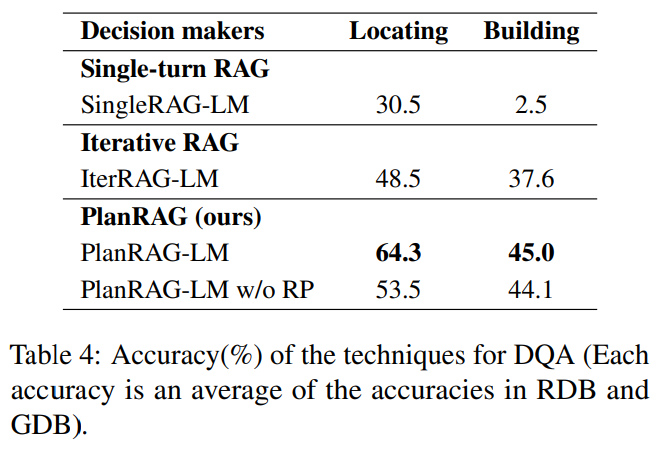

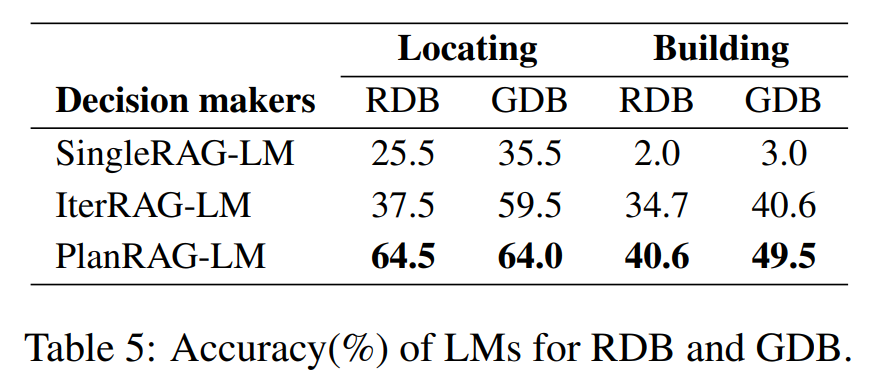

PlanRAG: A Plan-then-Retrieval Augmented Generation for Generative Large Language Models as Decision Makers

著者:Myeonghwa Lee, Seonho An, Min-Soo Kim

発行日:2024年06月18日

最終更新日:2024年06月18日

URL:http://arxiv.org/pdf/2406.12430v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

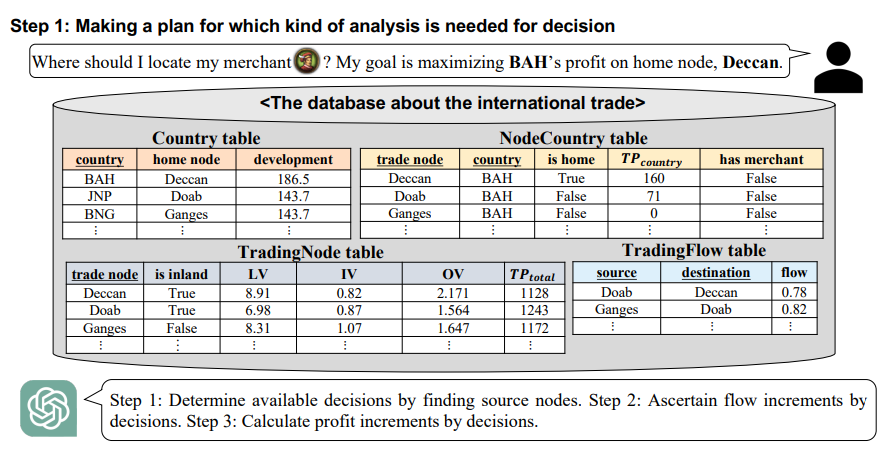

概要:

この論文では、複雑なデータ分析を必要とする意思決定のための解決策としてLLMsを利用する研究を行っています.私たちは、意思決定の質問\( \small Q \)、ビジネスルール\( \small R \)、およびデータベース\( \small D \)に対する最良の意思決定\( \small d_{best} \)を回答するタスクをDecision QAと定義しています.Decision QAを評価するためのベンチマークがないため、Decision QAベンチマークであるDQAを提案しています.DQAには、LocatingとBuildingの2つのシナリオがあり、ほぼ同じ目標を持つ2つのビデオゲーム(Europa Universalis IVとVictoria 3)から構築されています.Decision QAに効果的に対処するために、PlanRAGと呼ばれる新しいRAG技術を提案しています.PlanRAGベースのLMは、意思決定のための計画を最初に生成し、リトリーバーはデータ分析のためのクエリを2番目に生成します.提案された方法は、Locatingシナリオでは最先端の反復RAG方法を15.8%、Buildingシナリオでは7.4%上回っています.私たちは、https://github.com/myeon9h/PlanRAGでコードとベンチマークを公開しています.

Q&A:

Q: 意思決定QAのコンセプトと、意思決定にLLMを活用することとの関係について説明していただけますか?

A: Decision QAは、複雑な意思決定問題に対して最適な意思決定を生成するための新しいタスクであり、言語モデル(LLM)を活用することを目的としています.このタスクでは、データベースD、ビジネスルールR、意思決定問題Qを入力とし、最適な意思決定を出力するQAスタイルのタスクです.具体的には、国際貿易における利益最大化などのビジネス状況を考慮しながら、言語モデルが最適な意思決定を行うことが求められます.このタスクは、複数のデータアクセスが必要な複雑なタスクにおいて、単純な生成だけでは不十分であることが示されています.

Q: デシジョンQAベンチマーク(DQA)の目的と、既存のベンチマークとの違いは?

A: Decision QAベンチマークDQAの目的は、意思決定問題Qに対する最良の決定dbestを回答することであり、ビジネスルールRとデータベースDを使用します.既存のベンチマークとは異なり、Decision QAベンチマークDQAは、ビジネスルールとビジネス状況の両方を考慮して、大規模なデータベース(RDBまたはGDBのいずれか)に表現された複雑な意思決定問題に対する最良の決定を回答する新しい決定タスクです.

Q: ゲームソフト『エウロパ・ユニヴァーサリスIV』と『ヴィクトリア3』のシナリオ「ロケート」と「ビルディング」はどのように作られたのですか?

A: シナリオ「Locating」と「Building」は、Europa Universalis IVとVictoria 3のビデオゲームから抽出された301の特定の状況を使用して構築されました.これらのゲームは実際のビジネス状況をよく模倣しており、ビジネスデータを使用してDQAを構築する難しさから、これらのゲームからのデータを抽出してベンチマークを構築しました.

Q: PlanRAGの手法と他のRAG手法との違いについて詳しく教えてください.

A: PlanRAG技術は、決定QAのための反復的な計画-検索増強生成技術であり、以前のRAG技術を拡張しています.PlanRAGベースのLMは、データスキーマと質問を調べることで、必要な分析の種類について計画を立てます.次に、クエリを生成して提示することで、分析のための散在したデータを取得します.最後に、新しい計画が必要かどうかを評価し、計画と検索のステップを反復的に繰り返すか、データに基づいて決定を行います.PlanRAG技術は、以前のRAGよりも効果的にデータ分析クエリを生成し、決定を行うことができます.計画とクエリ結果を入力として受け取り、さらなる分析を行うための新しい計画を生成するか、以前の分析の方向を修正します.

Q: PlanRAG をベースとした LM は、具体的にどのようなステップを踏んで意思決定を行うのか.

A: PlanRAGベースのLMは、初期計画と⟨Q,S,R⟩だけでなく、入力として取る.その後、以前のRAGよりも効果的に意思決定のためのデータ分析クエリを生成することができる.図4は、PlanRAGベースのLMが以前のRAGとは異なる方法でクエリを生成する様子を示している.クエリは実際にはSQLまたはCypherによってデータベースに対して実行され、LangChain2やLlamaIndex3などのRAGインターフェースを介して行われる.クエリの結果は、再計画が必要か、それともより良い意思決定のためにさらなる取得が必要かを推論するために反復的に使用される.計画プロセスへの逆リンクを介して、計画と取得プロセスは、LMがさらなる分析が必要ないと判断するまで反復的に実行される.

Q: 提案された方法は、ロケートシナリオとビルディングシナリオにおいて、最先端の反復RAG法をどのように上回ったか?

A: 提案された方法は、Locatingシナリオでは最先端の反復RAG方法を15.8%、Buildingシナリオでは7.4%上回りました.これは、BuildingシナリオがLocatingシナリオよりも長いトラバーサルを必要とし、計画を難しくするためです.また、SingleRAG-LMの精度がBuildingシナリオでは非常に低いのは、Buildingシナリオが一度に推論するのが難しい非常に複雑なクエリを生成する必要があるためです.

Q: コードとベンチマークをGitHubで公開することにした動機は?

A: コンテンツはオープンソース化されるべきであるというEULAのセクション5に基づいて、私たちのベンチマークとシミュレーターをMITライセンスの下で公開することになりました.

Q: 他の研究者や開発者は、自身のプロジェクトでPlanRAGの手法をどのように活用できますか?

A: PlanRAG技術を他の研究者や開発者が自分のプロジェクトで活用する方法は、まずデータスキーマと質問を調べて分析に必要な計画を立てる段階を行うことです.次に、生成されたクエリを使用してデータの断片を取得し、分析のためのクエリを生成します.そして、データに基づいて新しい計画が必要かどうかを評価し、必要に応じて再計画と再取得のステップを繰り返すか、データに基づいて決定を行います.PlanRAG技術を活用する際には、このような計画、取得、再計画、回答のステップを繰り返すことが重要です.

Q: PlanRAGの開発とテスト中に遭遇した制限や課題はありますか?

A: PlanRAGの開発とテスト中に遭遇した制限や課題はいくつかありました.例えば、PlanRAGは初期の計画が十分でない場合に再計画を行うという手法を採用していますが、この再計画が適切に機能しない場合があります.また、PlanRAGは単一の言語モデルを使用していますが、複数の言語モデルを使用するフレームワークにおいてPlanRAGの効果を検証していないことも課題と言えます.

Q: 意思決定タスクにPlanRAGを使用することで、現実世界ではどのような応用や影響が考えられますか?

A: PlanRAGを使用することで、意思決定タスクにおける計画立案と再計画の能力が向上し、リアルなビジネス状況における意思決定に応用することが可能となります.具体的には、PlanRAGは初期計画が不十分である場合に再計画を行うため、複雑な意思決定プロセスにおいてより適切な意思決定を支援することができます.また、PlanRAGはデータ分析と計画立案を組み合わせることで、リアルなビジネス状況における意思決定においてより効果的な意思決定支援を提供する可能性があります.

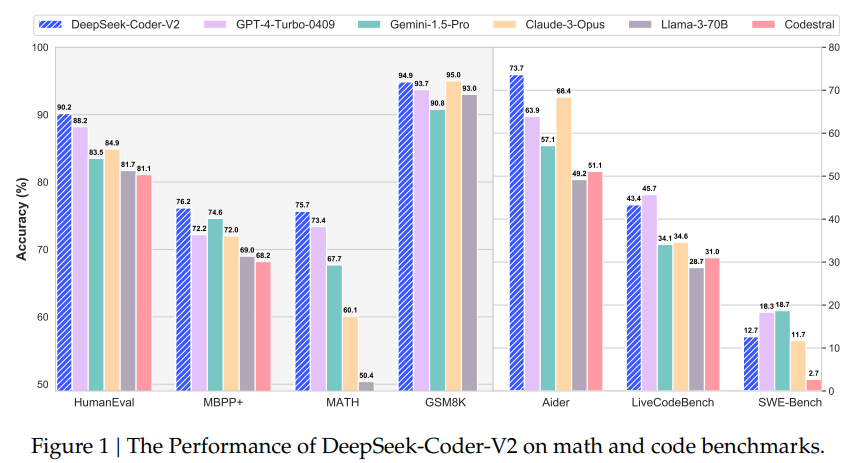

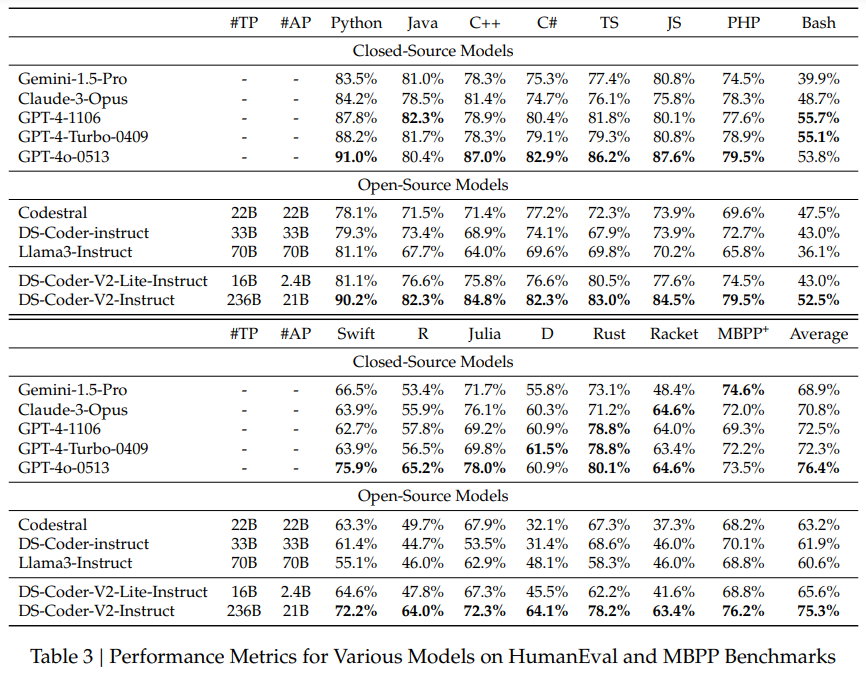

DeepSeek-Coder-V2: Breaking the Barrier of Closed-Source Models in Code Intelligence

著者:DeepSeek-AI, Qihao Zhu, Daya Guo, Zhihong Shao, Dejian Yang, Peiyi Wang, Runxin Xu, Y. Wu, Yukun Li, Huazuo Gao, Shirong Ma, Wangding Zeng, Xiao Bi, Zihui Gu, Hanwei Xu, Damai Dai, Kai Dong, Liyue Zhang, Yishi Piao, Zhibin Gou, Zhenda Xie, Zhewen Hao, Bingxuan Wang, Junxiao Song, Deli Chen, Xin Xie, Kang Guan, Yuxiang You, Aixin Liu, Qiushi Du, Wenjun Gao, Xuan Lu, Qinyu Chen, Yaohui Wang, Chengqi Deng, Jiashi Li, Chenggang Zhao, Chong Ruan, Fuli Luo, Wenfeng Liang

発行日:2024年06月17日

最終更新日:2024年06月17日

URL:http://arxiv.org/pdf/2406.11931v1

カテゴリ:Software Engineering, Artificial Intelligence, Machine Learning

概要:

DeepSeek-Coder-V2は、コード特化のタスクにおいてGPT4-Turboと比較可能な性能を達成するオープンソースのMixture-of-Experts(MoE)コード言語モデルを提供しています.具体的には、DeepSeek-Coder-V2は、DeepSeek-V2の中間チェックポイントからさらに6兆トークンを追加して事前学習されています.この継続的な事前学習により、DeepSeek-Coder-V2は、DeepSeek-V2のコーディングおよび数学的推論能力を大幅に向上させると同時に、一般言語タスクにおいても比較可能なパフォーマンスを維持しています.DeepSeek-Coder-33Bと比較して、DeepSeek-Coder-V2は、コード関連のタスクや推論、一般的な能力のさまざまな側面で大きな進歩を示しています.さらに、DeepSeek-Coder-V2は、プログラミング言語のサポートを86から338に拡張し、コンテキストの長さを16Kから128Kに拡張しています.標準的なベンチマーク評価では、DeepSeek-Coder-V2は、コーディングおよび数学のベンチマークにおいて、GPT4-Turbo、Claude 3 Opus、Gemini 1.5 Proなどのクローズドソースモデルに比べて優れたパフォーマンスを達成しています.

Q&A:

Q: DeepSeek-V2 と比較して、DeepSeek-Coder-V2 で達成されたコーディングと数学的推論の能力の具体的な向上について説明してもらえますか?

A: DeepSeek-Coder-V2はDeepSeek-V2に比べて、コーディングおよび数学的推論能力を大幅に向上させました.具体的には、DeepSeek-Coder-V2はプログラミング言語のサポートを86から338に拡大し、コンテキストの長さを16Kから128Kに拡張しました.また、DeepSeek-Coder-V2は6兆トークンを追加してDeepSeek-V2の中間チェックポイントから事前学習され、コーディングおよび数学的推論能力を著しく向上させました.

Q: 6兆トークンを追加したDeepSeek-V2の中間チェックポイントからの継続的な事前学習は、DeepSeek-Coder-V2の性能にどのように寄与しますか?

A: DeepSeek-Coder-V2は、DeepSeek-V2の中間チェックポイントから追加の6兆トークンを使用して継続的に事前トレーニングされることにより、コーディングおよび数学的推論能力を大幅に向上させることができます.この継続的な事前トレーニングにより、DeepSeek-Coder-V2は、一般的な言語タスクにおいては同等のパフォーマンスを維持しながら、コード関連のタスクや推論能力のさまざまな側面で大幅な進歩を遂げることができます.

Q: DeepSeek-Coder-V2は、DeepSeek-Coder-33Bと比較して、コード関連のタスク、推論、一般的な能力においてどのような進歩を示していますか?

A: DeepSeek-Coder-V2はDeepSeek-Coder-33Bに比べて、コード関連のタスク、推論、一般的な能力のさまざまな側面で重要な進歩を示しています.また、DeepSeek-Coder-V2はプログラミング言語のサポートを86から338に拡大し、コンテキストの長さを16Kから128Kに拡張しています.

Q: プログラミング言語のサポートが86から338に拡張されたことで、DeepSeek-Coder-V2のパフォーマンスにどのような影響がありますか?

A: DeepSeek-Coder-V2のプログラミング言語のサポートが86から338に拡大したことにより、モデルのパフォーマンスが向上しました.これにより、Python、C++、C#、TypeScript、およびJavaScriptなどの多様なコーディング課題を処理する際の堅牢性と汎用性が強調されました.

Q: DeepSeek-Coder-V2でコンテキスト長を16Kから128Kに拡張した意味は何ですか?

A: DeepSeek-Coder-V2のコンテキスト長を16Kから128Kに拡張することにより、より複雑で広範囲なコーディングタスクを処理できるようになります.この拡張により、モデルはより長いコード入力を処理でき、複雑なプログラミングシナリオにも適用できるようになります.また、長いコンテキストを扱うためのモデルの能力が向上し、より高度なプログラミング課題に対応できるようになります.

Q: コーディングと数学のベンチマークにおいて、GPT4-Turbo、Claude 3 Opus、Gemini 1.5 Proなどのクローズドソースモデルと比較して、DeepSeek-Coder-V2が達成した優れた性能について詳細を教えてください.

A: DeepSeek-Coder-V2は、コーディングおよび数学のベンチマークにおいて、GPT4-Turbo、Claude 3 Opus、Gemini 1.5 Proなどのクローズドソースモデルを上回る優れた性能を発揮しています.具体的には、DeepSeek-Coder-V2は、コーディングタスクや数学タスクの両方で、GPT4-Turbo、Claude 3 Opus、Gemini 1.5 Proなどの最先端のクローズドソースモデルを凌駕しています.例えば、数学のベンチマークであるMATHにおいて、DeepSeek-Coder-V2は76.6%のstate-of-the-art精度にほぼ匹敵する75.7%の精度を達成しています.さらに、AIME 2024競技においてもこれらのクローズドソースモデルの性能を上回っています.

Q: コード固有のタスクにおいて、DeepSeek-Coder-V2はGPT4-Turboと比較してどうですか?

A: DeepSeek-Coder-V2はコード特化のタスクにおいて、GPT4-Turboよりも優れた性能を示しています.具体的には、DeepSeek-Coder-V2はコーディングおよび数学的推論能力を大幅に向上させ、コード知能の分野を前進させています.

Q: DeepSeek-Coder-V2 で使用されている Mixture-of-Experts (MoE) コード言語モデルの主な特徴は何ですか?

A: DeepSeek-Coder-V2に使用されているMixture-of-Experts(MoE)コード言語モデルの主な特徴は、2.4Bおよび21Bの活性化パラメータを持つMoEフレームワークを使用しており、さまざまな計算およびアプリケーションのニーズを効率的にサポートしています.さらに、DeepSeek-Coder-V2は338のプログラミング言語をサポートし、最大コンテキスト長が128Kトークンであることです.また、DeepSeek-Coder-V2は、DeepSeek-V2の中間チェックポイントからさらに6兆トークンを追加して事前トレーニングされており、DeepSeek-V2のコーディングおよび数学的推論能力を大幅に向上させながら、一般言語タスクにおいても比較可能なパフォーマンスを維持しています.

Q: DeepSeek-Coder-V2は、コーディング能力と数学的推論能力を高めながら、一般的な言語タスクで同等のパフォーマンスをどのように維持しているのか?

A: DeepSeek-Coder-V2は、一般言語のタスクにおいては類似した性能を維持しつつ、コーディングおよび数学的推論能力を向上させています.これは、DeepSeek-Coder-V2がプログラミング言語のサポートを86から338に拡大し、最大コンテキスト長を16Kから128Kトークンに拡張したことによるものです.また、DeepSeek-Coder-V2は、数学的ベンチマークにおいて、ゼロショットのチェーンオブソートプロンプティングを用いて、GPT-4 Turbo、Claude 3 Opus、Gemini 1.5 Proなどの最新のクローズドソースモデルと同等の性能を達成しています.

Q: 標準的なベンチマーク評価でDeepSeek-Coder-V2の性能を評価するために使用した方法について詳しく教えてください.

A: DeepSeek-Coder-V2の性能を標準ベンチマーク評価で評価するために使用された方法について詳しく説明します.まず、DeepSeek-Coder-V2は、HumanEval、MBPP、LiveCodeBench、SWEBenchなどのさまざまなベンチマーク評価で評価されました.これらの評価は、モデルのコーディングおよび数学的なタスクにおける性能を測定するために使用されました.特に、HumanEvalでは90.2%、MBPPでは76.2%、LiveCodeBenchでは43.4%のスコアが達成されました.これらの評価は、モデルの能力を包括的に評価し、他のモデルとの比較を可能にしました.

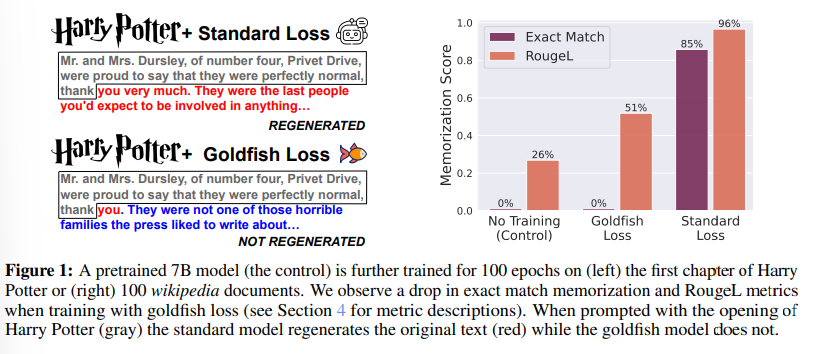

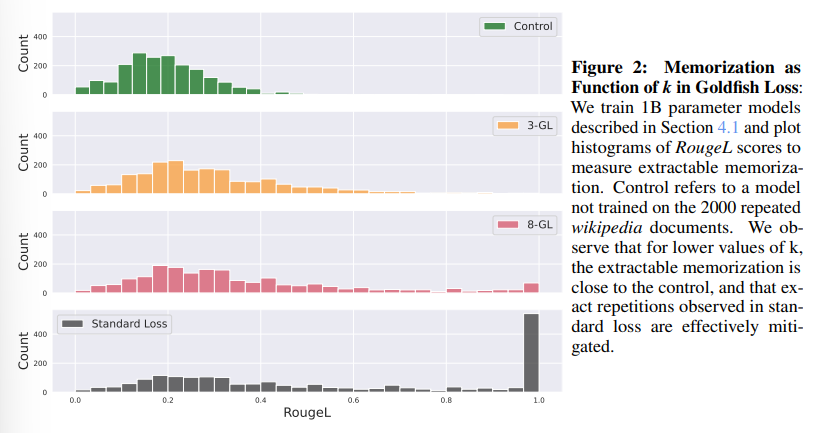

Be like a Goldfish, Don’t Memorize! Mitigating Memorization in Generative LLMs

著者:Abhimanyu Hans, Yuxin Wen, Neel Jain, John Kirchenbauer, Hamid Kazemi, Prajwal Singhania, Siddharth Singh, Gowthami Somepalli, Jonas Geiping, Abhinav Bhatele, Tom Goldstein

発行日:2024年06月14日

最終更新日:2024年06月14日

URL:http://arxiv.org/pdf/2406.10209v1

カテゴリ:Computation and Language

概要:

大規模な言語モデルは、トレーニングデータを記憶して繰り返すことができ、プライバシーや著作権のリスクを引き起こす可能性があります.この記憶を緩和するために、次のトークントレーニング目的に微妙な修正を導入し、それをゴールドフィッシュ損失と呼びます.トレーニング中、ランダムにサンプリングされたトークンのサブセットが損失計算から除外されます.これらのドロップされたトークンはモデルによって記憶されず、トレーニングセットから完全なトークンチェーンを逐語的に再現することを防ぎます.我々は、数十億規模のLlama-2モデルを事前トレーニングおよびゼロからトレーニングする広範な実験を行い、抽出可能な記憶の大幅な削減を実証し、ダウンストリームのベンチマークにほとんど影響を与えないことを示しています.

Q&A:

Q: 生成的LLMにおいて、金魚の損失がどのように暗記を軽減するのか、もう少し詳しく説明してもらえますか?

A: ゴールドフィッシュ損失は、次のトークントレーニング目的に微妙な修正を加え、モデルがトレーニングデータを記憶して繰り返すのを防ぐために使用されます.トレーニング中、損失計算からランダムにサンプリングされたトークンのサブセットが除外されます.これらのドロップされたトークンはモデルによって記憶されず、トレーニングセットから完全なトークンチェーンを逐語的に再現するのを防ぎます.

Q: トレーニング中に損失計算から除外する、ランダムにサンプリングされたトークンのサブセットをどのように決定したのですか?

A: トークンを除外するための疑似乱数サンプリングは、幅13の疑似乱数ハッシュを使用して行われます.

Q: 大規模な言語モデルが学習データを記憶し、繰り返し使用することで、プライバシーや著作権にどのようなリスクが生じるのか?

A: 大規模言語モデルがトレーニングデータを記憶して繰り返すことにより、著作権リスクとプライバシーリスクが生じます.具体的には、著作権リスクとして、顧客には知的財産権を含むLLMの出力が含まれる可能性があり、コードモデルの場合、コードの繰り返し使用が下流のライセンスに影響を与える可能性があります.再生成されたコードがオープンソースライセンスであっても、商用利用を制限する条項を含むライセンスが多く存在します.また、プロバイダーにとっても著作権リスクがあり、著作権で保護されたコンテンツを再生成できるモデルをホスティングおよび配布する合法性がまだ解決されていません.プライバシーリスクとしては、再生成された

Q: 億スケールのLlama-2モデルで行われた大規模な実験について、事前訓練とゼロからの訓練の両方について詳しく教えてください.

A: ビリオンスケールのLlama-2モデルについて、事前にトレーニングされたものとゼロからトレーニングされたものの両方で実施された包括的な実験について、トークンの完全な連鎖を記憶することなく、落下したトークンがモデルによって記憶されないため、トレーニングセットからのトークンの完全な連鎖の逐語的再現を防ぐことができます.我々は、数十億規模のLlama-2モデルをトレーニングし、事前トレーニングされたものとゼロからトレーニングされたものの両方で、抽出可能な記憶の大幅な削減を実証し、ダウンストリームのベンチマークにほとんど影響を与えないことを示しました.

Q: あなたは実験で抽出可能な記憶の大幅な減少をどのように測定しましたか?

A: 実験では、トレーニングセットからのトークンチェーンの完全な引用を防ぐために、モデルによって記憶されないトークンが削除されました.これにより、抽出可能な記憶の大幅な削減が実現されました.

Q: 金魚の損失がモデルのパフォーマンスに与える影響を評価するために、どのような下流のベンチマークが用いられたのか?

A: ダウンストリームベンチマークには、知識集約的な推論ベンチマークと生の言語モデリング能力が含まれていました.

Q: トークンを損失計算から除外することが、モデル全体のパフォーマンスに悪影響を与えないようにするにはどうすればよいですか?

A: トークンの損失計算から除外することが、モデルの全体的なパフォーマンスに悪影響を与えないようにするためには、除外されたトークンを補うためのメカニズムを導入する必要があります.具体的には、除外されたトークンに対して、モデルが学習する機会を与えることが重要です.これにより、モデルは除外されたトークンを補完する方法を学習し、推論時に適切な予測を行うことができます.

Q: 金魚ロスの実装は、今後の大規模言語モデルの開発にどのような影響を与えるとお考えですか?

A: ゴールドフィッシュ損失の実装は、大規模言語モデルの将来の開発にどのように影響するかを考えると、モデルの訓練中に一部のトークンを除外することで、モデルが訓練データを暗記し、繰り返すことを防ぐことができる可能性があります.これにより、プライバシーや著作権のリスクが軽減される可能性があります.また、ゴールドフィッシュ損失は、標準的なトレーニングよりも少ないトークンで訓練されたモデルを作成するため、モデルの言語モデリング能力に影響を与える可能性があります.しかし、Wikipediaなどの追加のデータを提供することで、ゴールドフィッシュモデルの性能を向上させることができることが示唆されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://huggingface.co/datasets/cerebras/SlimPajama-627B です.

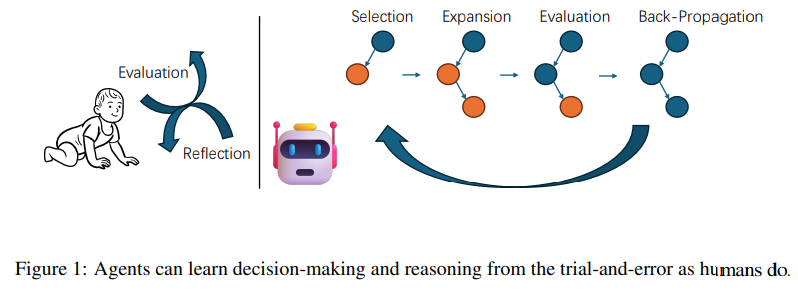

Accessing GPT-4 level Mathematical Olympiad Solutions via Monte Carlo Tree Self-refine with LLaMa-3 8B

著者:Di Zhang, Xiaoshui Huang, Dongzhan Zhou, Yuqiang Li, Wanli Ouyang

発行日:2024年06月11日

最終更新日:2024年06月13日

URL:http://arxiv.org/pdf/2406.07394v2

カテゴリ:Artificial Intelligence

概要:

この論文は、MCT Self-Refine(MCTSr)アルゴリズムを紹介し、大規模言語モデル(LLMs)とモンテカルロ木探索(MCTS)を統合した革新的な手法で、複雑な数学的推論タスクのパフォーマンスを向上させることを目的としています.LLMsにおける精度と信頼性の課題、特に戦略的および数学的推論に対処するために、MCTSrはシステマティックな探索とヒューリスティックな自己改善メカニズムを活用して、LLMs内の意思決定フレームワークを改善します.このアルゴリズムは、選択、自己改善、自己評価、およびバックプロパゲーションの反復プロセスを通じてモンテカルロ探索木を構築し、探索と活用のバランスを最適化するために改良されたUpper Confidence Bound(UCB)式を利用します.広範な実験は、MCTSrがオリンピアードレベルの数学問題を解決する際の効果を示し、GSM8K、GSM Hard、MATH、およびMath Odyssey、AIME、OlympiadBenchなどのオリンピアードレベルのベンチマークを含む複数のデータセットで成功率を著しく向上させることを示しています.この研究は、複雑な推論タスクにおけるLLMsの応用を推進し、将来のAI統合の基盤を築き、LLM駆動のアプリケーションにおける意思決定の精度と信頼性を向上させることを目指しています.

Q&A:

Q: MCTSrアルゴリズムがどのように大規模言語モデル(LLM)とモンテカルロ木探索(MCTS)を統合しているのか、詳しく教えてください.

A: MCTSrアルゴリズムは、大規模言語モデル(LLMs)とMonte Carlo Tree Search(MCTS)を統合することによって、複雑な数学問題を解決します.具体的には、MCTSrは、LLMsを使用して数学的推論タスクにおける精度と信頼性の課題に対処するためにMCTSを組み込んでいます.この統合により、複数のデータセットで問題解決の成功率が著しく向上し、オリンピックレベルの数学的課題でも優れたパフォーマンスを発揮しています.

Q: MCTSrアルゴリズムは、LLM、特に戦略的推論タスクと数学的推論タスクにおける精度と信頼性の課題にどのように対処するのか?

A: MCTSrアルゴリズムは、LLMsにおける精度と信頼性の課題、特に戦略的および数学的推論タスクに対処するために、系統的な探索とヒューリスティックな自己改善メカニズムを活用しています.アルゴリズムは、選択、自己改善、自己評価、およびバックプロパゲーションの反復プロセスを通じてモンテカルロ探索木を構築し、探索と活用のバランスを最適化するために改良されたUpper Confidence Bound (UCB)式を利用しています.MCTSrは、オリンピアードレベルの数学問題を解決する際に効果的であり、複数のデータセット(GSM8K、GSM Hard、MATHなど)において成功率を著しく向上させることが実験によって示されています.

Q: LLMの意思決定の枠組みを改善するために、MCTSrは具体的にどのようなメカニズムを活用しているのか?

A: MCTSrは、システマティックな探索とヒューリスティックな自己改善メカニズムを活用して、LLMs内で意思決定フレームワークを改善します.アルゴリズムは、選択、自己改善、自己評価、および逆伝播の反復プロセスを通じてモンテカルロ探索木を構築し、探索と活用のバランスを最適化するために改良されたUpper Confidence Bound (UCB)式を利用します.

Q: MCTSrアルゴリズムを用いてモンテカルロ探索木を構築する際の反復プロセスについて詳しく教えてください.

A: MCTSrアルゴリズムを使用してモンテカルロ探索木を構築する反復プロセスは、選択、自己改善、自己評価、およびバックプロパゲーションの段階から成ります.最初に、選択段階では、最大の潜在性を最大化するためにUCT戦略に基づいてノードが選択されます.次に、自己改善段階では、選択されたノードに対して改善の試みが行われます.その後、自己評価段階では、モデルの自己報酬機能を使用して異なる答えのバージョンに対する報酬がサンプリングされます.最後に、バックプロパゲーション段階では、シミュレーション結果に基づいてノードの値が更新されます.

Q: MCTSrアルゴリズムはどのように改良されたUCB(Upper Confidence Bound)公式を利用し、探査-探索のバランスを最適化するのか?

A: MCTSrアルゴリズムは、改良されたUpper Confidence Bound (UCB)式を利用して、探索と活用のバランスを最適化します.この式は、高いリスクを伴うタスクにおける効果的な意思決定のために重要な探索と活用のバランスを最適化するために組み込まれています.

Q: MCTSrの効果を証明するための広範囲な実験の結果は何でしたか?

A: MCTSrの効果を示す広範な実験の結果は、数学オリンピアードレベルの問題を解決する能力を示しています.GAIC Math Odysseyデータセットでは、Zero-Shot CoTから8-rollouts MCTSrに向けて問題の解決率が向上し、成功率が7.76%(99問解決)に達しました.これにより、MCT-Self-refineアルゴリズムが数学オリンピアードのような競争的な学術環境での適用可能性を示し、問題解決能力を向上させる潜在能力が明らかになりました.

Q: MCTSrは、GSM8K、GSM Hard、MATH、オリンピアードレベルのベンチマークを含む複数のデータセットにおいて、どのように成功率を大幅に向上させたのでしょうか?

A: MCTSrは、複数のデータセット(GSM8K、GSM Hard、MATH、およびオリンピアードレベルのベンチマーク)において、反復回数が増加するにつれて成功率を著しく向上させました.特に、より複雑なGSM-Hardでは、高い反復回数でも性能の天井が示され、現在の戦略が複雑な問題に対して限界があることを示しました.この結果は、MCTSrの反復回数が増加すると成功率が高くなるという明確な傾向を示し、アルゴリズムが反復的な改善を通じてパフォーマンスを向上させる潜在能力を強調しました.

Q: この研究は、複雑な推論タスクにおけるLLMの応用をどのような方法で前進させるのか?

A: この研究は、LLMsとMCTSのシナジー効果の潜在性を実験的に示し、複雑な推論タスクにおいて性能を向上させることを示しています.さらに、この研究は、LLMsの応用を高度な推論課題に前進させ、AI技術を統合して意思決定や推論の精度を向上させるための未来の革新の舞台を築いています.

Q: MCTSrアルゴリズムは、LLM主導のアプリケーションにおける意思決定の精度と信頼性を高める上で、将来のAI統合の基盤をどのように築くのか?

A: MCTSrアルゴリズムは、LLM駆動型アプリケーションにおいて、意思決定の精度と信頼性を向上させるための将来のAI統合の基盤を築いています.MCTSrは、MCTSをLLMと統合することで、数学的推論課題における精度と信頼性の重要な課題に対処しています.このアルゴリズムは、系統的な探索とヒューリスティックな自己改善メカニズムを活用して、LLM内の意思決定フレームワークを改善しています.さらに、MCTSrの構成要素は高度にスケーラブルであり、より広範囲のコンポーネントアルゴリズムを特定し比較するための継続的な開発が必要です.これにより、MCTSrアルゴリズムの実用的な潜在能力と効果を向上させることができます.

TextGrad: Automatic “Differentiation” via Text

著者:Mert Yuksekgonul, Federico Bianchi, Joseph Boen, Sheng Liu, Zhi Huang, Carlos Guestrin, James Zou

発行日:2024年06月11日

最終更新日:2024年06月11日

URL:http://arxiv.org/pdf/2406.07496v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

AIは、複数の大規模言語モデル(LLM)や他の複雑なコンポーネントを組み合わせることで、画期的な進展を遂げています.その結果、複合AIシステムのための原則に基づいた自動最適化方法の開発は、最も重要な新しい課題の1つとなっています.ニューラルネットワークも初期の段階で同様の課題に直面しましたが、バックプロパゲーションや自動微分によって最適化が簡単になり、その分野が変革されました.このような背景から、私たちはTextGradという強力なフレームワークを紹介します.TextGradは、テキストを介した自動「微分」を行うフレームワークで、LLMが提供するテキストフィードバックを使用して、複合AIシステムの個々のコンポーネントを改善します.TextGradはPyTorchの構文と抽象化に従い、柔軟で使いやすいです.ユーザーは、フレームワークのコンポーネントやプロンプトを調整することなく、目的関数のみを提供すれば、さまざまなタスクに対して即座に使用できます.TextGradは、Google-Proof質問回答のゼロショット精度を\( \small 51\% \)から\( \small 55\% \)に向上させるなど、様々なアプリケーションでの効果と汎用性を示しています.これにより、TextGradは次世代のAIシステムの開発を加速する基盤を築いています.

Q&A:

Q: TextGradが、LLMによって提供されたテキストフィードバックをバックプロパゲートして、複合AIシステムの個々のコンポーネントを改善する方法について、もう少し詳しく説明してもらえますか?

A: テキストグラードは、LLMから提供されるテキストフィードバックを逆伝播させて、複合AIシステムの個々のコンポーネントを改善します.このフレームワークでは、LLMは計算グラフ内の変数を最適化するための豊富で一般的な自然言語の提案を提供します.テキストグラードは、PyTorchの構文と抽象化に従い、柔軟で使いやすいです.ユーザーは、フレームワークのコンポーネントやプロンプトを調整することなく、目的関数のみを提供すれば、さまざまなタスクに対して即座に使用できます.我々は、TEXTGRADの効果と汎用性を、質問応答や分子最適化から放射線治療計画までの多様なアプリケーションにわたって示しています.フレームワークを変更することなく、TEXTGRADは、Google-Proof質問応答でGPT-4oのゼロショット精度を51%から55%に向上させ、LeetCode-Hardコーディング問題の最適化で20%の相対的な性能向上をもたらし、推論のためのプロンプトを改善し、望ましいin silico結合を持つ新しい薬様小分子を設計し、高い特異性を持つ放射線腫瘍学治療計画を設計します.TEXTGRADは、AIシステムの新世代を最適化するための基盤を築いています.

Q: TextGradは従来の複合AIシステムの最適化手法と比較してどうですか?

A: TEXTGRADは、従来の最適化手法と比較して、複合AIシステムに対してより効果的であると言えます.TEXTGRADは、LLM(Large Language Models)の豊富な自然言語提案を利用して、計算グラフ内の変数を最適化するためのテキストフィードバックをバックプロパゲーションすることで、個々のAIシステムのコンポーネントを改善します.これにより、従来の最適化手法よりも効率的に複合AIシステムを最適化することが可能となります.

Q: 計算グラフの変数を最適化するためにLLMが提供する自然言語による提案のタイプの例を教えてください.

A: LLMsは、変数を最適化するための自然言語の提案として、分子の修正の提案、他のLLMsへのプロンプトの提案、コードスニペットの提案など、幅広いドメインで変数に対して豊富で理解しやすい自然言語の勾配を提供することができます.

Q: TextGradはPyTorchの構文と抽象化とどのように統合されていますか?

A: PyTorchの構文と抽象化にTextGradはどのように統合されていますか?

TextGradは、PyTorchの構文と抽象化を模倣し、知識の移転を可能にすることで、使いやすくなっています.具体的には、TextGradはPyTorchの構文と抽象化に従い、計算グラフ内の変数を最適化するための豊富で一般的な自然言語の提案を提供します.これにより、ユーザーはフレームワークのコンポーネントやプロンプトを調整することなく、目的関数のみを提供するだけで、即座に様々なタスクに対応できます.

Q: TextGradがどのようにフレキシブルで様々なタスクに使いやすいか説明していただけますか?

A: TextGradは、特定のアプリケーション領域に手作りされていない一般的で高性能なフレームワークであり、PyTorchの抽象化を模倣しているため、知識の移転が可能であり、完全にオープンソースである.TEXTGRADを通じて、コード最適化や博士レベルの質問回答などの分野で最先端の結果を得ることができました.フレームワークを変更せずに、TEXTGRADは、Google-Proof質問回答におけるGPT-4oのゼロショット精度を51%から55%に向上させ、LeetCode-Hardコーディング問題の最適化において20%の相対的な性能向上をもたらし、推論のためのプロンプトを改善し、望ましいin silico結合を持つ新しい薬様小分子を設計し、高い特異性を持つ放射線腫瘍学治療計画を設計します.TEXTGRADは、次世代のAIシステムの開発を加速する基盤を築いています.

Q: 質問応答、分子最適化、放射線治療計画において、TextGradは具体的にどのような改善を行ったのでしょうか?

A: TEXTGRADは、Google-Proof Question Answeringのゼロショット精度を51%から55%に向上させ、LeetCode-Hardコーディング問題の解の相対パフォーマンスを20%向上させ、推論のためのプロンプトを改善し、望ましいin silico結合を持つ新しい薬物様小分子を設計し、高い特異性を持つ放射線治療計画を設計しました.TEXTGRADは、質問回答、分子最適化、および放射線治療計画の分野で具体的な改善を達成しました.

Q: TextGradはGoogle-Proof Question AnsweringのGPT-4oのゼロショット精度をどのように向上させるのか?

A: TextGradは、GPT-4oのゼロショット精度を改善するために、テスト時にソリューションを洗練することで、Google-Proof Question Answeringでのゼロショット精度を51%から55%に向上させます.

Q: TextGradによって達成されたLeetCode-Hardコーディング問題解決策の最適化における相対的なパフォーマンス向上について詳しく教えてください.

A: テキストグラードによるLeetCode-Hardのコーディング問題の最適化における相対的なパフォーマンス向上は、gpt-4oと最良の既存手法のパフォーマンスを20%向上させることができました.

Q: TextGradはどのようにして、イン・シリコで望ましい結合を持つ新薬のような低分子を設計するのか?

A: TEXTGRADは、新しい薬物様の小さな分子を設計する際に、既存の化合物や臨床的に承認された薬物と比較して、望ましいin silico結合親和性を持つ分子を生成します.これにより、TEXTGRADは競争力のある結果を生み出し、既存の化合物とは異なる独自の構造を持つ分子を生成します.また、in silicoの安全性プロファイルを維持しながら、薬物様性を向上させます.

Q: TextGradは、次世代のAIシステムの開発を加速させるための基盤をどのように築くのか?

A: TEXTGRADは、次世代のAIシステムの開発を加速する基盤を提供します.具体的には、TEXTGRADは、様々なアプリケーションにおいてその効果と汎用性を示し、GPT-4oのゼロショット精度を向上させ、LeetCode-Hardコーディング問題の最適化において20%の相対的な性能向上をもたらし、推論のためのプロンプトを改善し、望ましいin silico結合を持つ新しい薬様小分子を設計し、放射線腫瘍学の治療計画を高い特異性で設計することができます.TEXTGRADは、次世代のAIシステムの開発を加速する基盤を提供し、科学的発見の反復プロセスを加速し、エンジニアリングの努力の生産性を向上させることが期待されています.