ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- Banishing LLM Hallucinations Requires Rethinking Generalization

発行日:2024年06月25日

LLMは幻覚を見る可能性があり、MoMEで拡張されたLLMはランダムな数字を記憶し、訓練されたニューラルネットワークは損失がしきい値を超えると幻覚を見ることを示す. - Transformers meet Neural Algorithmic Reasoners

発行日:2024年06月13日

トランスフォーマーとGNNを組み合わせた新しいアプローチで、アルゴリズミック推論において堅牢性を持つTransNARモデルが効果を示した. - Visual Sketchpad: Sketching as a Visual Chain of Thought for Multimodal Language Models

発行日:2024年06月13日

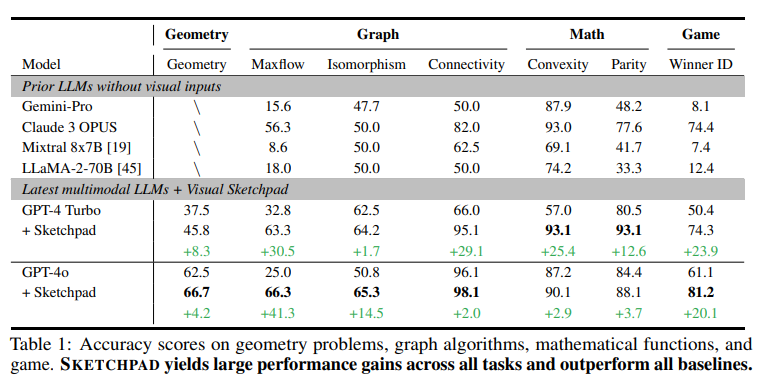

多文化LMsに視覚スケッチパッドを導入し、Sketchpadを使用することで、数学タスクや視覚タスクでのパフォーマンスが向上し、GPT-4oは新たな最先端を確立しました. - Discovering Preference Optimization Algorithms with and for Large Language Models

発行日:2024年06月12日

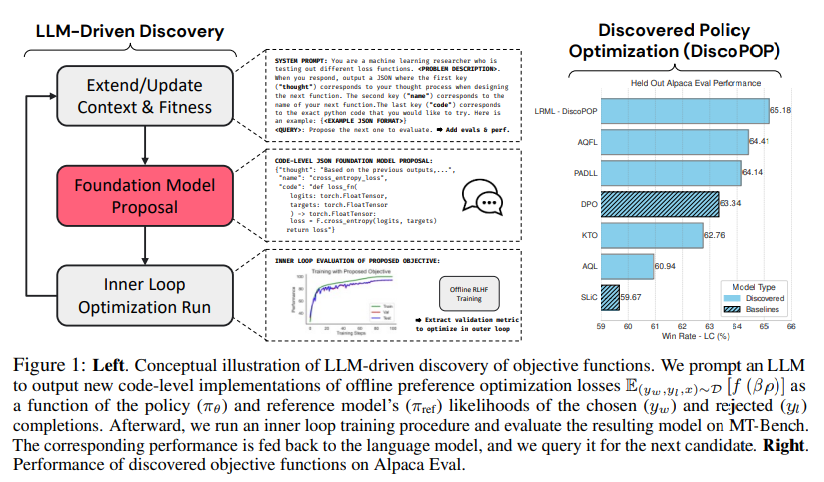

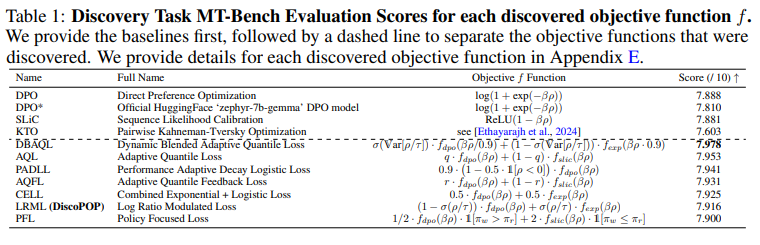

LLMを使用した選好最適化アルゴリズム「DiscoPOP」は、新しい損失関数を提案し、実装することで、大規模言語モデルの品質を向上させる. - Multimodal Table Understanding

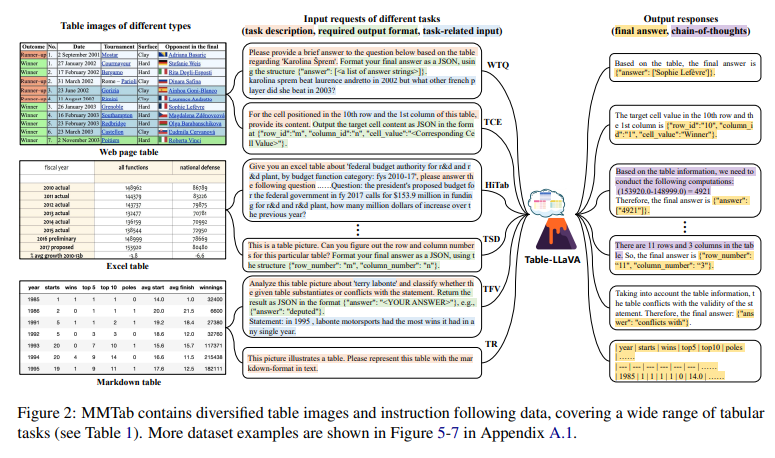

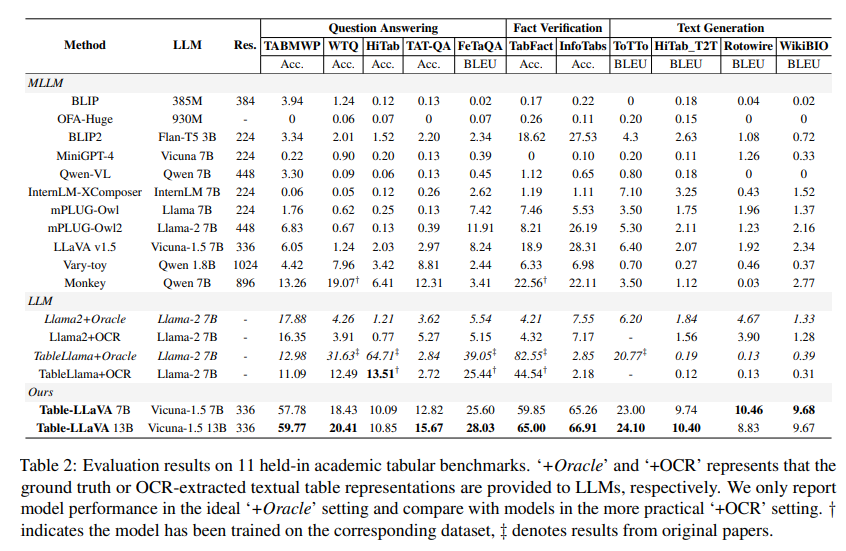

発行日:2024年06月12日

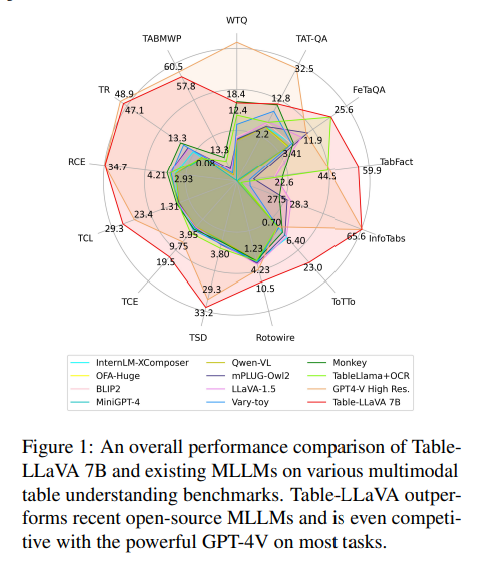

テーブル画像を使用してマルチモーダルテーブル理解を提案し、Table-LLaVAモデルがMLLMベースラインを大幅に上回ることを示しました. - Never Miss A Beat: An Efficient Recipe for Context Window Extension of Large Language Models with Consistent “Middle” Enhancement

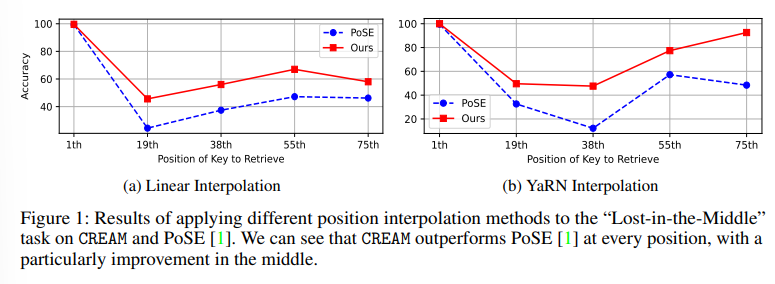

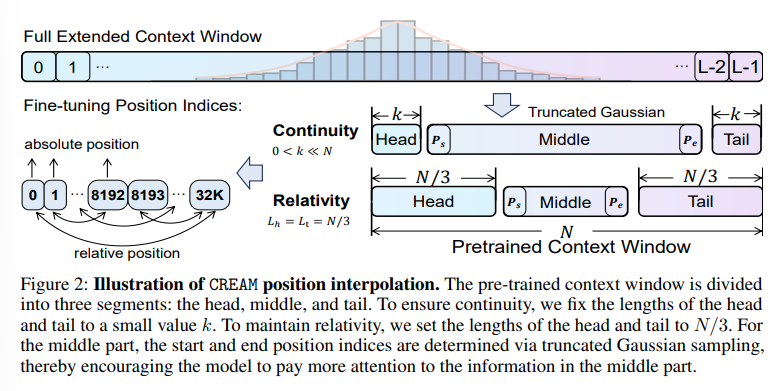

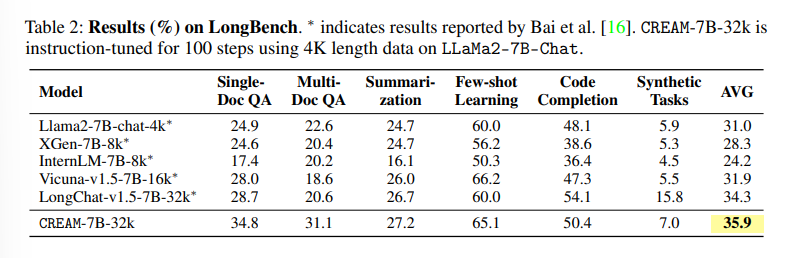

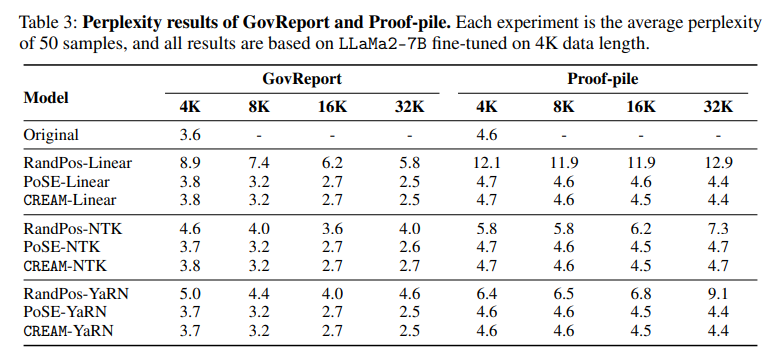

発行日:2024年06月11日

LLMのコンテキスト長を拡張するために、CREAMが提案され、高いトレーニング効率で長いターゲットコンテキスト長に対応し、Lost-in-the-Middle問題を緩和することが示されました. - Self-Tuning: Instructing LLMs to Effectively Acquire New Knowledge through Self-Teaching

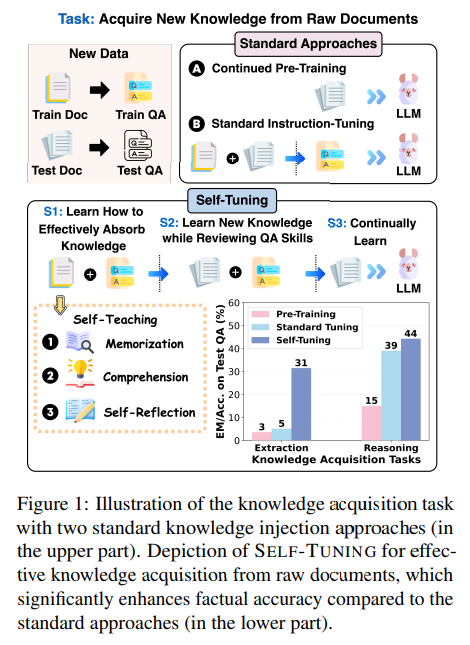

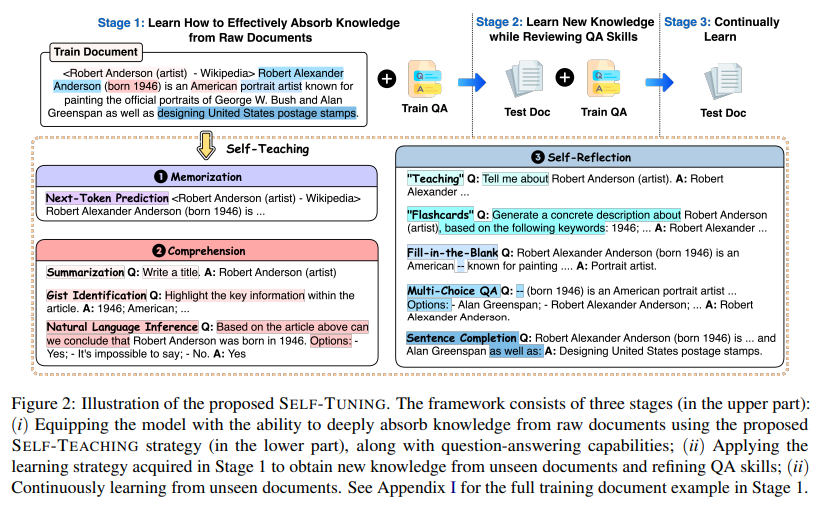

発行日:2024年06月10日

LLMの最新情報提供に苦労するため、Self-Tuningフレームワークが導入され、効果的な知識獲得と保持を実現することが示された. - Mixture-of-Agents Enhances Large Language Model Capabilities

発行日:2024年06月07日

最新の大規模言語モデル(LLM)の進歩は、複数のLLMを組み合わせたMixture-of-Agents(MoA)アプローチにより、自然言語理解および生成のタスクにおいて高いパフォーマンスを達成している. - SelfGoal: Your Language Agents Already Know How to Achieve High-level Goals

発行日:2024年06月07日

LLMによって駆動される言語エージェントは、SelfGoalという新しい自動アプローチを使用して、高レベルの目標を達成する能力を向上させ、競争、協力、遅延フィードバック環境でのパフォーマンスを向上させることが示されています.

Banishing LLM Hallucinations Requires Rethinking Generalization

著者:Johnny Li, Saksham Consul, Eda Zhou, James Wong, Naila Farooqui, Yuxin Ye, Nithyashree Manohar, Zhuxiaona Wei, Tian Wu, Ben Echols, Sharon Zhou, Gregory Diamos

発行日:2024年06月25日

最終更新日:2024年06月25日

URL:http://arxiv.org/pdf/2406.17642v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

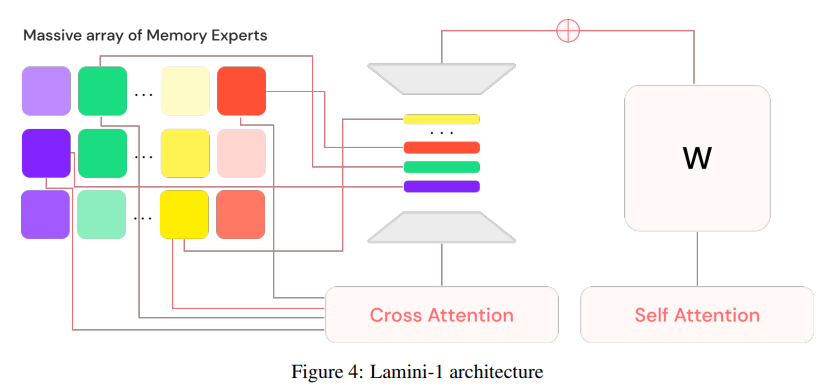

大規模言語モデル(LLM)は、強力なチャット、コーディング、および推論能力を持っているにもかかわらず、頻繁に幻覚を見ることがあります.従来の知恵では、幻覚は創造性と事実性のバランスの結果であり、LLMを外部知識源に基づかせることで軽減できますが、完全に排除することはできません.私たちは、広範囲かつ体系的な実験を通じて、これらの従来のアプローチがなぜLLMが実際に幻覚を見るのかを説明できないことを示します.具体的には、大規模なMixture of Memory Experts(MoME)で拡張されたLLMは、大量のランダムな数字のデータセットを簡単に記憶することができることを示します.これらの実験結果を理論的な構築と照らし合わせ、次のトークンを予測するために訓練された単純なニューラルネットワークは、通常の実践で訓練時の損失がしきい値を超えると幻覚を見ることを示します.私たちは、幻覚を軽減するための従来の検索方法と比較して、これらの結果を解釈します.私たちは、幻覚を取り除くための第一世代モデルであるLamini-1を設計するために、数百万のメモリエキスパートの大規模な混合物に事実を格納し、動的に取得することを使用します.

Q&A:

Q: ラージ・ランゲージ・モデル(LLM)における幻覚の概念と、それが従来どのように緩和されると考えられてきたかについて説明していただけますか?

A: LLM(Large Language Models)における幻覚とは、モデルが訓練データに存在しない情報を生成することを指します.従来の考え方では、幻覚は創造性と事実性のバランスの結果とされ、外部の知識源に基づいてLLMを補強することで軽減できると考えられていました.しかし、この研究では、LLMが幻覚を起こす理由を従来のアプローチでは説明できないことが示されています.

Q: LLMの幻覚を和らげるための従来のアプローチが効果的でなかったことを示す実験結果とは?

A: 従来のアプローチは、LLMの幻覚を軽減するのに失敗したことが実験結果で示されました.具体的には、巨大なMixture of Memory Experts(MoME)で拡張されたLLMは、ランダムな数字の大規模なデータセットを簡単に記憶することができることが示されました.

Q: 大規模なMoME(Mixture of Memory Experts)の追加は、LLMが大規模な乱数データセットを記憶する能力にどのような影響を与えたのだろうか?

A: LLMに大規模なMixture of Memory Experts(MoME)を追加することで、LLMが大規模なランダム数字のデータセットを簡単に記憶する能力が向上しました.MoMEは、膨大な数のメモリエキスパートを組み合わせることで、ランダムな数字の大規模なデータセットを容易に記憶できるようになりました.

Q: 次のトークンを予測するように訓練された単純なニューラルネットワークが、なぜ幻覚を見る可能性があるのかを示す理論的構造を説明できますか?

A: シンプルなニューラルネットワークが次のトークンを予測するために訓練される際に幻覚を引き起こす理論的構築は、訓練損失がしきい値を超えるときに生じることを示しています.この場合、損失が低いが0ではないとき、モデルは似たトークンプールからトークンを選択するため、次の出力トークンの確率分布が近いトークンに集中し、幻覚を引き起こします.

Q: LLMのトレーニングロスと幻覚の発生はどのように関係しているのだろうか?

A: LLMの訓練損失が閾値を超えると、モデルは幻覚を引き起こす可能性が高くなります.具体的には、訓練損失が高いと、モデルは次のトークンを予測する際に正確な情報を記憶することが難しくなり、代わりにランダムな数字などのデータを幻覚として生成する傾向があります.

Q: LLMの幻覚を軽減するための従来の検索方法と比較して、あなたの発見はどうですか?

A: 私たちの研究結果は、幻覚を緩和するための従来の検索方法と比較して、より効果的であることが示されました.

Q: 幻覚を除去するラミニ-1モデルのデザインと機能について説明していただけますか?

A: Lamini-1モデルは、大規模なメモリ専門家の膨大な混合物に事実を格納し、動的に取得することによって幻覚を除去するための最初の世代モデルを設計するために私たちの知見を利用します.以前の研究では、Lamini-1がトランスフォーマーを回避し、知識の取得に完全に依存するモデルアーキテクチャであることが示されています.Lamini-1は、LLMに記憶を直接注入することが可能であることを示しています.通常のトレーニング手法が、事前トレーニングデータに現れていても事実に幻覚を引き起こすことを示し、Lamini Memory Tuningと呼ばれる新しいアプローチを提案しています.このアプローチは、幻覚を起こしてはならない重要な事実に対してほぼゼロのトレーニング損失を目指しています.

Q: ラミニ-1モデルにおいて、何百万ものメモリエキスパートが混在する巨大な混合物に事実を保存することの意義は何だろうか?

A: Lamini-1モデルでは、膨大な数のメモリ専門家(MoME)の混合物を使用することで、事実を記憶することの重要性が示されます.これにより、モデルは膨大な数の事実を正確に記憶し、再現することが可能となります.

Q: LLMの幻覚に対処するために、Lamini-1モデルを実世界のアプリケーションにどのように実装することを想定していますか?

A: Lamini-1モデルは、大規模なメモリエキスパートの混合物(MoME)を使用して事実を動的に取得し、記憶することで幻覚を取り除くために設計されています.実際のアプリケーションでは、Lamini-1モデルは、大規模なデータセットから事実を取得し、それらをメモリエキスパートに保存して、LLMsが幻覚を生じる可能性を低減させることが期待されます.

Q: LLMから幻覚を除去する分野におけるさらなる研究開発の次のステップは?

A: LLMsの幻覚を取り除くための研究と開発の次のステップは、高性能なデータ構造、アルゴリズム、およびシステムに関する将来の取り組みが必要であると期待されています.これにより、人間が事実と信頼性のあるものと考えるLLMsに対して重要な進展が可能となります.

Transformers meet Neural Algorithmic Reasoners

著者:Wilfried Bounsi, Borja Ibarz, Andrew Dudzik, Jessica B. Hamrick, Larisa Markeeva, Alex Vitvitskyi, Razvan Pascanu, Petar Veličković

発行日:2024年06月13日

最終更新日:2024年06月13日

URL:http://arxiv.org/pdf/2406.09308v1

カテゴリ:Computation and Language, Machine Learning

概要:

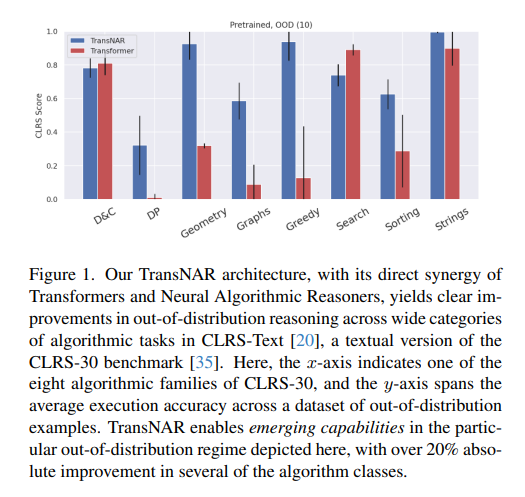

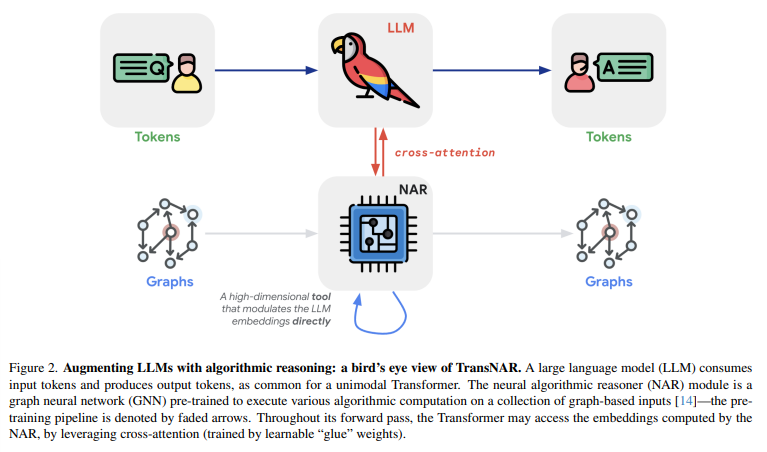

トランスフォーマーは、そのシンプルで効果的なアーキテクチャによって機械学習を革新しました.インターネットからの大規模なテキストデータセットでトランスフォーマーを事前学習することは、自然言語理解(NLU)タスクにおいて比類のない汎化をもたらしました.しかし、このような言語モデルは、計算が正確で堅牢である必要があるアルゴリズミック形式の推論に取り組む際には脆弱です.この制限に対処するために、私たちは、トランスフォーマーの言語理解とグラフニューラルネットワーク(GNN)ベースのニューラルアルゴリズム推論者(NARs)の堅牢性を組み合わせた新しいアプローチを提案しています.このようなNARは、グラフ形式で指定されたアルゴリズミックタスクの一般的なソルバーとして効果を発揮しました.彼らの埋め込みをトランスフォーマーにアクセス可能にするために、私たちは、言語モデル内のトークンがNARからのノード埋め込みにクロスアテンドできるようなハイブリッドアーキテクチャと、二段階のトレーニング手順を提案しています.私たちは、CLRS-Text(CLRS-30ベンチマークのテキストベース版)で得られたTransNARモデルを評価し、アルゴリズミック推論において、トランスフォーマーのみのモデルに比べて、内外の分布で著しい利益を示しました.

Q&A:

Q: 提案されたTransNARモデルが、Transformerの言語理解とグラフニューラルネットワークベースのニューラルアルゴリズム推論者をどのように組み合わせているか、もっと詳しく説明していただけますか?

A: 提案されたTransNARモデルは、Transformerの言語理解能力とグラフニューラルネットワークベースのニューラルアルゴリズム推論者の堅牢性を組み合わせています.具体的には、TransNARは、テキスト形式のアルゴリズム問題仕様(Tトークン)とそれに対応するCLRS-30固有のグラフ表現(Nノード)の双方の入力を受け入れ、問題に対するテキスト形式の応答を出力します.テキスト入力がエンコードされると、T∈RT×kに格納され、グラフ入力はG∈RN×lに格納されます.言語モデル内のトークンが、NARからのノード埋め込みにクロスアテンドできるようにするために、2段階のトレーニング手順を持つハイブリッドアーキテクチャを提案しています.

Q: Transformerの言語モデルをNARの埋め込みと統合する際に、具体的にどんな課題に直面しましたか?

A: Transformerの言語モデルとNARの埋め込みを統合する際に遭遇した具体的な課題は、言語モデルのトークン埋め込みがNARのノード埋め込みにcross-attendするための二段階のトレーニング手順を導入する必要があったことです.この手順により、TransformerがNARの埋め込みにアクセスできるようになり、両者の情報を統合することが可能となりました.

Q: グラフ形式のアルゴリズムタスクの汎用ソルバーとして、NARの有効性をどのように判断したのですか?

A: NARは、グラフ形式で指定されたアルゴリズムタスクの一般的なソルバーとしての効果を検証するために、最近の研究によって示されました.これらのNARは、Transformerのようなモデルがノード埋め込みにクロスアテンドできるようにするためのハイブリッドアーキテクチャを提案し、その結果を評価しました.CLRS-TextでのTransNARモデルの評価により、アルゴリズム的推論においてTransformerのみのモデルよりも有意な利益が示されました.

Q: TransNARモデルのハイブリッド・アーキテクチャで使用されている2段階のトレーニング手順について詳しく教えてください.

A: ハイブリッドアーキテクチャのTransNARモデルでは、トレーニング手順を2段階に分けています.最初の段階では、言語モデル内のトークンがNARからのノード埋め込みにクロスアテンドできるようにします.具体的には、言語モデル内のトークン表現を\( \small H^{(1)} \in \mathbb{R}^{T imes d} \)、NARからのノード埋め込みを\( \small H^{(2)} \in \mathbb{R}^{N imes d} \)とします.この段階では、言語モデルのトークン表現\( \small H^{(1)} \)とNARからのノード埋め込み\( \small H^{(2)} \)を用いて、クロスアテンション機構を通じて情報を交換し合います.

Q: TransNARモデルは、アルゴリズム推論において、Transformerのみのモデルと比較して、具体的にどのような改善や改良がなされたのでしょうか?

A: TransNARモデルは、Transformerのみのモデルに比べて、アルゴリズム的な推論において改善や強化を示しました.具体的には、入力問題のサイズに関して、分布内および分布外の2つの領域で、より優れた性能を示しました.

Q: CLRS-TextデータセットにおけるTransNARモデルのパフォーマンスをどのように評価しましたか?

A: TransNARモデルの性能をCLRS-Textデータセットで評価するために、CLRSスコアを使用しました.このスコアは、正確な文字列の一致を測定するために使用され、TransNARモデルがベースラインのTransformerを大幅に上回ることが示されました.さらに、この優位性は初期トレーニングとファインチューニングの両方で一貫して見られました.各モデルは4つのランダムシードでトレーニングされ、誤差棒は±1標準偏差を示しています.

Q: TransNARモデルの評価中に観察された限界や欠点はありましたか?

A: TransNARモデルの評価中には、テキストとグラフ表現の両方の入力にアクセスする必要があるという制約が明らかになりました.この制約により、TransNARは特定の正解実行者やシミュレータ(またはその事前の信念)が利用可能なケースに限定されます.

Q: 機械学習や自然言語理解の分野で、TransNARモデルの潜在的な応用や意味をどのように想定していますか?

A: TransNARモデルは、機械学習と自然言語理解の分野において、高度なアルゴリズム的推論能力を持つ事前学習されたグラフニューラルネットワークベースのニューラルアルゴリズムリーズナーと、Transformerの言語理解能力を組み合わせたハイブリッドアーキテクチャである.このモデルは、自然言語で指定されたアルゴリズム的タスクを解決するために使用され、CLRS-textベンチマークなどのデータセットにおいて、Transformer単体よりも優れた性能を示している.将来的には、TransNARのアイデアを純粋な単一モーダルのTransformerに展開することが可能であり、例えば、訓練されたTransNARモデルから得られた知識を通常のTransformerモデルに蒸留することで、第二のデータストリームの必要性を取り除くことができる.このような拡張は、より曖昧な問題仕様を持つデータセットに対する研究など、興味深い展開をもたらす可能性がある.

Q: TransNARモデルの能力を高めるために、さらにどのような研究や開発が必要だとお考えですか?

A: TransNARモデルの能力を向上させるためには、純粋な単一モーダルのTransformerモデルにTransNARモデルの知識を蒸留することが重要です.これにより、第二のデータストリームが不要になり、より効率的なトレーニングと使用が可能となります.また、より曖昧な問題仕様を持つデータセットに対する拡張の研究も重要です.

Q: TransNARモデルの今後の方向性や拡張性について教えてください.

A: 現在の研究を超えて、TransNARモデルの潜在的な将来の方向性や拡張について考察することができます.例えば、TransNARモデルを純粋な単一モーダルTransformerに展開することで、より広範囲な問題に適用できる可能性があります.この展開には、訓練されたTransNARモデルから得られた知識をバニラTransformerモデルに蒸留することが含まれます.さらに、より曖昧な問題仕様を持つデータセットに対する拡張や、他の種類の問題に対する適用も検討されるべきです.

Visual Sketchpad: Sketching as a Visual Chain of Thought for Multimodal Language Models

著者:Yushi Hu, Weijia Shi, Xingyu Fu, Dan Roth, Mari Ostendorf, Luke Zettlemoyer, Noah A Smith, Ranjay Krishna

発行日:2024年06月13日

最終更新日:2024年06月13日

URL:http://arxiv.org/pdf/2406.09403v1

カテゴリ:Computer Vision and Pattern Recognition, Computation and Language

概要:

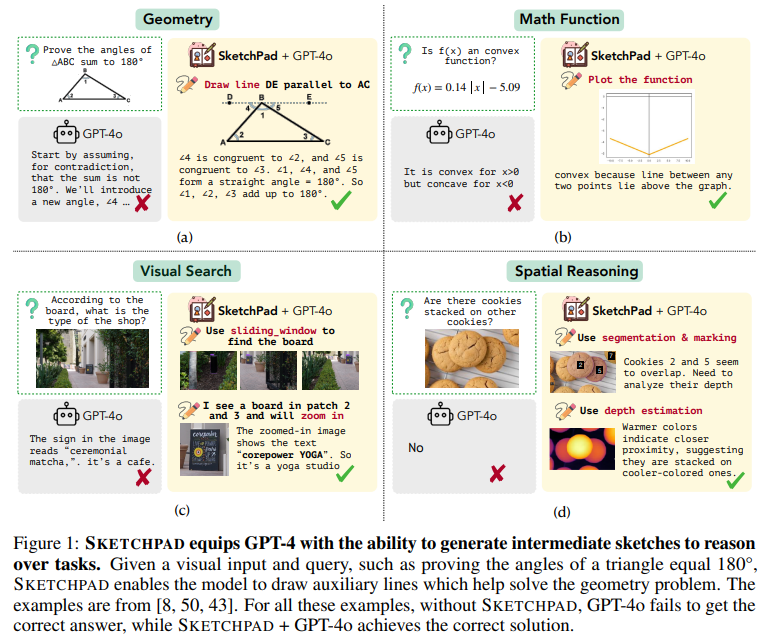

人間は理論を促進するために描画を行います.幾何学の問題を解く際には補助線を引きます.地図を理解する際には印をつけたり円を描いたりします.アイデアを拡大し、限られた容量の作業メモリを解放するためにスケッチを使用します.しかし、現在の多文化言語モデル(LMs)では、このような行動が欠けています.現在の連鎖思考とツール使用のパラダイムは、中間推論ステップとしてテキストのみを使用します.この研究では、Sketchpadというフレームワークを紹介し、多文化LMsに視覚スケッチパッドとスケッチパッド上で描画するためのツールを提供します.LMは、描いた視覚的アーティファクトに従って計画と推論を行います.従来の作業とは異なり、テキストから画像モデルを使用してLMが描画することを可能にする代わりに、Sketchpadは人間のスケッチに近い線、ボックス、印などでLMが描画することを可能にし、理論をより効果的に促進します.Sketchpadは、スケッチングプロセス中に専門のビジョンモデルを使用することもできます(例:オブジェクト検出モデルで境界ボックスを描画し、セグメンテーションモデルでマスクを描画するなど)、視覚的知覚と推論をさらに向上させることができます.私たちは、幾何学、関数、グラフ、チェスを含むさまざまな数学タスクで実験を行いました.さらに、Sketchpadは複雑な視覚推論タスクにおいても優れたパフォーマンスを発揮し、数学タスクでは平均12.7%、視覚タスクでは8.6%の向上をもたらしました.Sketchpadを使用したGPT-4oは、V*Bench(80.3%)、BLINK空間推論(83.9%)、視覚的対応(80.8%)を含むすべてのタスクで新たな最先端を確立しました.すべてのコードとデータはhttps://visualsketchpad.github.io/にあります.

Q&A:

Q: マルチモーダル言語モデルのためにスケッチパッド・フレームワークを開発した動機について説明していただけますか?

A: スケッチパッドフレームワークを開発する動機は、多モーダル言語モデルによる複雑な推論課題に取り組む際に、言語とビジョンの相補的な強みを活用し、より人間らしい多モーダル知能を言語モデルに付与することを目指しています.スケッチパッドは、視覚的スケッチを中間推論ステップとして生成し、これらのスケッチをさらなる推論を促進するために使用することで、言語モデルのパフォーマンスを向上させ、新たな最先端の結果を生み出すことができることが実験によって示されています.

Q: Sketchpadは、LMがテキストから画像へのモデルを使って描けるようにする先行研究とどう違うのか?

A: SKETCHPADは、テキストから画像モデルを使用してLMが描画する従来の方法とは異なり、LMに線、ボックス、マークなどで描画させることができるため、人間のスケッチングに近く、推論をより容易にします.

Q: スケッチ・プロセスにおいて、スケッチパッドがどのように専門家の視覚モデルを利用しているか、詳しく教えてください.

A: スケッチパッドは、スケッチングプロセス中に専門のビジョンモデルを利用します.たとえば、物体検出モデルを使用して境界ボックスを描画したり、セグメンテーションモデルを使用してマスクを描画したりすることができます.これにより、視覚知覚と推論をさらに向上させることができます.

Q: マルチモーダルLMは、スケッチパッドに線、ボックス、マークなどを使って、どのような種類の視覚的成果物を描くことができるのか?

A: 多様な視覚的アーティファクトを描くことができます.これには、線、ボックス、マークなどが含まれます.

Q: スケッチパッドは、スケッチなしの強力なベースモデルと比較して、数学タスクや複雑な視覚的推論タスクのパフォーマンスをどのように向上させるのか?

A: SKETCHPADは、数学的なタスクや複雑な視覚的推論タスクにおいて、スケッチを行わない強力なベースモデルと比較して、性能を大幅に向上させます.数学的なタスクでは、補助線、数学関数、グラフ、ゲームなどを視覚化することで大きな性能向上が見られます.視覚的推論タスクでは、SKETCHPADにビジョンスペシャリストを追加し、推論中にこれらの専門家の予測を観察し、さらなる計画と推論を行うことができます.

Q: スケッチパッドを使用して実験された、数学タスクと視覚的推論タスクのタイプの例を教えてもらえますか?

A: スケッチパッドを使用して実験された数学的なタスクには、幾何学、数学関数、グラフアルゴリズム、およびゲーム戦略が含まれます.また、視覚的な推論タスクには、補助線、数学関数、グラフ、およびゲームの視覚化が含まれます.

Q: スケッチパッドを使用することで、数学のタスクと視覚のタスクの成績は平均してどのくらい伸びましたか?

A: 数学のタスクにおける平均的な性能向上は12.7%であり、ビジョンタスクにおける平均的な性能向上は8.6%でした.

Q: スケッチパッドを搭載したGPT-4oは、様々なタスクで新しい状態を作り出すという点で、他のモデルと比較してどうですか?

A: GPT-4o with Sketchpadは、すべてのタスクで最先端の結果を示し、特にV∗Benchでは、GPT-4 Turboで18.5%の精度向上、GPT-4oで14.3%の精度向上と、従来の最先端であったSEALを上回る大幅な改善を示しました.さらに、BLINKタスクでは、SKETCHPADはGPT-4で平均6.6%の絶対精度向上を達成し、様々なタスクにおけるリーディングモデルとしての地位をさらに強固なものにしています.

Q: スケッチパッドに描かれた視覚的な成果物に従って、プランニングと推論を行うプロセスについて洞察できますか?

A: スケッチパッド上に描かれた視覚的なアーティファクトに基づいて計画と推論を行うプロセスは、複数のステップに分かれています.まず、LMは視覚的なスケッチパッドに描かれた図形や線、マークなどを観察し、それらを元に問題の理解を深めます.次に、LMは描かれた視覚的なアーティファクトを活用して、数学的な推論や計画を進めていきます.具体的には、図形の特性や関係性を視覚的に把握し、それらを数学的な記号や方程式に変換して問題を解決する過程が含まれます.このように、スケッチパッド上の視覚的な情報を活用することで、LMはより直感的に問題を理解し、論理的な推論を行うことが可能となります.

Q: スケッチパッド・フレームワークに関連するコードやデータはどこで入手できますか?

A: SKETCHPADフレームワークに関連するコードとデータは、セクション4で述べられているように、matplotlibやnetworkxなどのPythonパッケージを使用して数学的タスクのために提供されています.また、ビジョンタスクに関連するモデルは、専門のビジョンモデルを活用しています.

Discovering Preference Optimization Algorithms with and for Large Language Models

著者:Chris Lu, Samuel Holt, Claudio Fanconi, Alex J. Chan, Jakob Foerster, Mihaela van der Schaar, Robert Tjarko Lange

発行日:2024年06月12日

最終更新日:2024年06月12日

URL:http://arxiv.org/pdf/2406.08414v1

カテゴリ:Machine Learning

概要:

オフラインの選好最適化は、大規模言語モデル(LLM)の出力の品質を向上させ、制御するための重要な方法です.通常、選好最適化は、手作りの凸損失関数を使用してオフラインの教師あり学習タスクとしてアプローチされます.これらの方法は理論的な洞察に基づいていますが、人間の創造性によって制約されているため、可能な損失関数の大きな検索空間は未だに十分に探索されていません.私たちは、LLM駆動の目的の発見を行うことで、新しい最先端の選好最適化アルゴリズムを専門家の介入なしに自動的に発見することでこの問題に取り組んでいます.具体的には、以前に評価されたパフォーマンスメトリクスに基づいて、LLMに新しい選好最適化損失関数を提案し、実装するように反復的に促します.このプロセスにより、以前には知られていなかったパフォーマンスの良い選好最適化アルゴリズムが発見されます.これらの中で最も優れたパフォーマンスを発揮するものをDiscovered Preference Optimization(DiscoPOP)と呼び、ロジスティック損失と指数損失を適応的に組み合わせる新しいアルゴリズムです.実験は、DiscoPOPの最先端のパフォーマンスと、保持されたタスクへの成功した転送を示しています.

Q&A:

Q: LLM主導の客観的発見のプロセスについて、もう少し詳しく説明していただけますか?

A: LLM駆動型目的関数発見プロセスは、図1に概括され、アルゴリズム1に示されています.まず、LLMは確立された損失関数とそのパフォーマンスをコンテキストに初期化します.次に、各世代iごとに、LLMは新しい候補目的関数fiを提案します.その後、候補の妥当性を確認するために単体テストを実行し、必要に応じて再サンプリングします.このプロセスは、柔軟な選択と変異を組み合わせています.目的関数の適切な選択は、ネットワークに機能を与えるために重要です.LLMコードレベルの目的関数提案によって促進される発見プロセスを詳細に説明します.初期コンテキスト構築では、LLMをいくつかのプロンプトで‘burn-in’します.提案された目的関数のパフォーマンスは、探索、調整、前回の知見の組み合わせなど、さまざまなステップを交互に行うことで向上します.提案された目的関数は、標準の交差エントロピー損失を上回ります.このように、LLM駆動型の発見プロセスは、文献で既に概説されている目的に対するランダムな探索を行うのではなく、さまざまな概念を補完的な方法で組み合わせます.さらに、発見された目的は、異なるアーキテクチャや長いトレーニングランにも一般化されます.

Q: 提案されたプリファレンス最適化損失関数のパフォーマンス指標をどのように測定しますか?

A: 提案された好み最適化損失関数の性能メトリクスは、MT-Benchベンチマークで評価されます.このベンチマークは、さまざまな分野からの高品質な80のマルチターン質問で構成されており、以前に提案された損失関数とそのタスクパフォーマンスメトリック(MT-Benchスコア)を使用して、トレーニングされたLLMsを評価します.提案された目的関数は、事前に定義された下流の検証タスクのためにモデルを最適化する能力に基づいて評価されます.この結果のパフォーマンスメトリックはηと呼ばれます.

Q: どのような基準で最適化アルゴリズムを決定するのですか?

A: 最も優れた選好最適化アルゴリズムを決定するための基準は、様々なタスクでの性能に関する評価である.これには、MT-Benchスコアなどのタスクパフォーマンスメトリクスが含まれる.また、ロジスティックと指数損失の組み合わせや非凸性など、最適な目的関数が持つべき特性に関する新たな洞察も重要である.

Q: このプロセスを通じて発見された、これまで知られていなかったプリファレンス最適化アルゴリズムの例を教えてください.

A: このプロセスを通じて発見された以前に知られていなかった好み最適化アルゴリズムの例には、RafailovらによるものやAzarらによるもの、Zhaoらによるものがあります.

Q: DiscoPOPはどのようにしてロジスティック・ロスと指数関数的ロスを適応的にブレンドしているのか?

A: DiscoPOPは、ロジスティック損失(DPOで使用される)と指数損失の動的に重み付けられた合計であり、それぞれの重みはシグモイド計算によって決定されます.

Q: DiscoPOPの最先端のパフォーマンスを実証するために、具体的にどのような実験を行ったのですか?

A: DiscoPOPの最先端の性能を実証するために行われた具体的な実験は、AlapacaEval 2.0 [Dubois et al., 2024]を使用してDiscoPOPを検証し、GPT-4に対する勝率の向上を示しました.DPOからの改善(11.23%→13.21%)が観察されました.さらに、要約や制御生成などの別々の保持されたタスクにおいて、DiscoPOP損失で訓練されたモデルは既存の好み最適化アルゴリズムよりも優れたパフォーマンスを発揮するか、競争力を持っています.

Q: DiscoPOPの保留タスクへの移籍成功はどのように測定されたのか?

A: DiscoPOPの成功した転送は、AlapacaEval 2.0を使用してGPT-4からDPOへの勝率の向上(11.23%→13.21%)などの結果を示すことで測定されました.さらに、要約や制御生成などの別々の保留タスクでは、DiscoPOP損失で訓練されたモデルが既存の選好最適化アルゴリズムを上回るか、競争力を持って実行されました.

Q: 嗜好最適化アルゴリズムの発見過程で、どのような制限や課題に遭遇しましたか?

A: 現在のアプローチの限界は複数あります.まず第一に、LLM目的提案を効果的に生成する方法についてはまだ初歩的な段階にあります.温度サンプリングや最悪から最良のパフォーマンスソートなどの技術を用いた初期の探索実験は、大幅な改善をもたらしませんでした.しかし、より多くの参照なしで(専門家の)人間の介入なしに、より多くの優れた選好最適化アルゴリズムを生成する方法を想像することができます.具体的には、以前に評価されたパフォーマンスメトリクスに基づいてLLMに新しい選好最適化損失関数を提案し、実装させるよう反復的に促すことです.このプロセスにより、以前には知られていなかったパフォーマンスの高い選好最適化アルゴリズムが発見されます.

Q: 発見されたプリファレンス最適化アルゴリズムの信頼性と一貫性をどのように確保するのですか?

A: 発見された好み最適化アルゴリズムの信頼性と一貫性を確保するために、性能メトリクスに基づいて新しい好み最適化損失関数を提案し、実装するLLMに繰り返しプロンプトを行います.このプロセスにより、以前に評価されたパフォーマンスメトリクスに基づいて、以前には知られていなかったパフォーマンスの良い好み最適化アルゴリズムが発見されます.最も優れたものはDiscovered Preference Optimization Algorithmsと呼ばれます.発見された目的関数の性能は言語モデルにフィードバックされ、次の候補を問い合わせます.

Q: DiscoPOPを実世界のシナリオで使用することで、どのような応用や影響が考えられますか?

A: DiscoPOPの潜在的な応用や影響は、多岐にわたります.例えば、多回答対話、制御された感情生成、要約などのタスクにおいて、既存の選好最適化アルゴリズムよりも優れたパフォーマンスを示すことが期待されます.さらに、DiscoPOPは非凸であるという特徴を持つため、複雑な問題においても効果的に活用できる可能性があります.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/samholt/DiscoPOP です.

Multimodal Table Understanding

著者:Mingyu Zheng, Xinwei Feng, Qingyi Si, Qiaoqiao She, Zheng Lin, Wenbin Jiang, Weiping Wang

発行日:2024年06月12日

最終更新日:2024年06月12日

URL:http://arxiv.org/pdf/2406.08100v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

過去のテーブル理解方法、特に大規模言語モデル(LLM)に基づく最近のアプローチによって、大きな進歩が達成されてきましたが、これらの方法は、与えられたテーブルを特定のテキストシーケンス(MarkdownやHTMLなど)に変換することが必要であるという前提に大きく依存しています.しかし、現実世界のいくつかのシナリオでは、高品質のテキスト表現にアクセスすることが困難であり、テーブル画像の方がはるかにアクセスしやすいです.そのため、直感的な視覚情報を使用してテーブルを直接理解する方法は、より実用的なアプリケーションを開発するための重要で緊急の課題です.本論文では、与えられたテーブル画像に基づいてさまざまなテーブル関連のリクエストに正しい応答を生成する必要がある新しい問題、マルチモーダルテーブル理解を提案しています.モデルのトレーニングと評価の両方を容易にするために、MMTabという広範囲のテーブル画像、指示、タスクをカバーする大規模データセットを構築します.この基盤の上で、一般的なタブラーマルチモーダル大規模言語モデル(MLLM)であるTable-LLaVAを開発し、23のベンチマークで最近のオープンソースMLLMベースラインを大幅に上回ることができました.Table-LLaVAは、保持内および保持外の設定で23のベンチマークで最近のオープンソースMLLMベースラインを大幅に上回りました.コードとデータは以下のリンクから入手可能です:https://github.com/SpursGoZmy/Table-LLaVA

Q&A:

Q: 提案されているマルチモーダルなテーブル理解アプローチは、これまでの方法とどう違うのか?

A: 提案された多様な表理解アプローチは、以前の方法と比較して、表画像に基づいた数学的な問題の中間推論ステップと正しい最終回答を提供することができる点で異なります.他のMLLM(大規模言語モデル)と比較して、提案されたMMTabデータセットを使用して、将来のMLLMの多様な表理解能力を向上させることができます.

Q: 表をモデル入力用のテキストシーケンスに変換しようとする場合、どのような課題に直面するのか?

A: 表をモデル入力用のテキストシーケンスに変換する際に直面する課題は、高品質なテキスト表現にアクセスすることが困難な場合があることです.実際のシナリオでは、テーブル画像の方がアクセスしやすいため、直感的な視覚情報を使用して表を直接理解する方法が重要で緊急な課題となります.

Q: 視覚情報を使ってテーブルを直接理解できることがなぜ重要なのか?

A: 表を直接理解することが重要な理由は、直感的な視覚情報を使用して二次元の表を理解することが人間にとって自然であり、高品質のテキスト表現を得ることが困難であるためです.また、LLM(Large Language Models)は表を一方向のテキスト的視点でのみ解釈できるため、多様な表構造や色付きの表要素を理解する難しさが増す可能性があるからです.そのため、便利さと直感性のために、表を視覚情報を使用して直接消化する方法を探ることは重要で緊急な課題です.

Q: MMTabデータセットとはどのようなもので、どのように構築されたのか?

A: MMTabデータセットは、WTQやTabFactなどの学術データセットを基に構築されており、これらはMITライセンスやCC-BY-SA-4.0ライセンスなどのライセンスを持つ無料でオープンなデータセットです.Pythonスクリプトを使用して、これらのデータセット内のテキスト表シーケンス(HTMLなど)をテーブル画像に変換し、元のサンプルに基づいてマルチモーダルな指示に従うデータを構築しています.結果として得られたMMTabデータセットも、マルチモーダルなテーブル理解の問題を研究するためのコミュニティ向けの無料でオープンなリソースです.したがって、この論文の研究には倫理上の懸念はないと著者らは考えています.

Q: Table-LLaVAは、他のオープンソースのMLLMベースラインと性能面でどのように比較されますか?

A: Table-LLaVAは、他のオープンソースのMLLMベースラインと比較して、ほとんどのベンチマークで最高のパフォーマンスを達成しています.ただし、AIT-QAのVary-toyの精度に関しては、大量の表が含まれており、Vary-toyは企業文書画像のトレーニングデータで類似の表を見ている可能性があるため、Table-LLaVAはそれに勝てませんでした.

Q: モデルが正しい応答を生成できる、テーブル関連のリクエストのタイプの例を示してもらえますか?

A: モデルは、表に関連するさまざまなリクエスト(例:質問)に正しい応答を生成することができます.

Q: 提案されているアプローチでは、モデルのトレーニングと評価のプロセスはどのように行われるのですか?

A: 提案されたアプローチのモデルトレーニングおよび評価プロセスは、2段階のトレーニング手順を採用しています.最初に、LLaV A-1.5をバックボーンとして使用し、Table-LLaV Aという多目的な表形式MLLMを開発します.このモデルは、という統一された形式を持っています.トレーニングデータセットとして11のデータセットを選択し、内部評価用に使用します.また、3つのドメインが重複しない小規模データセットを保持評価用に使用します.トレーニングプロセスでは、元の事前トレーニングおよびファインチューニングデータも使用され、モデルの汎化性能を向上させます.

Q: Table-LLaVAの様々なベンチマークでの性能向上に寄与する主な特徴は?

A: Table-LLaVAの主な特徴は、大規模な表形式データに適したモデルであることです.このモデルは、OCRエンジンの表認識能力のボトルネックを打破し、大規模な表データの理解と指示に従う能力を向上させるために、提供されたオラクル表シーケンスを利用しています.また、Table-LLaVAは、既存のMLLMやLLMs+OCRよりも優れた性能を発揮し、複数のベンチマークで優れた結果を示しています.このモデルは、多くのベンチマークで最高のパフォーマンスを達成することができるため、他のモデルを常に上回ることができます.

Q: 研究者がTable-LaVAのコードやデータにアクセスする方法は?

A: 表-LaVAのコードとデータにアクセスする方法は、https://github.com/SpursGoZmy/Table-LLaVA にアクセスすることで可能です.

Q: 提案されているマルチモーダルなテーブル理解アプローチの実用的な応用の可能性は?

A: 提案された多モーダルテーブル理解アプローチの潜在的な実用アプリケーションには、金融分析、科学的研究、政府報告など、さまざまな分野でのデータの保存や提示が含まれます.これにより、豊富な表形式データを最大限に活用し、表理解技術を使用して、表を自動的に理解し、質問応答などの表ベースのタスクを実行することが可能となります.

Never Miss A Beat: An Efficient Recipe for Context Window Extension of Large Language Models with Consistent “Middle” Enhancement

著者:Tong Wu, Yanpeng Zhao, Zilong Zheng

発行日:2024年06月11日

最終更新日:2024年06月11日

URL:http://arxiv.org/pdf/2406.07138v1

カテゴリ:Computation and Language

概要:

最近、多くの方法が開発されてきましたが、事前学習された大規模言語モデル(LLM)のコンテキスト長を拡張するためには、通常、ターゲット長(4K以上)での微調整が必要であり、コンテキストの中間部分から情報を効果的に利用することが難しいという課題があります.これらの問題に対処するために、私たちは位置符号を操作して位置インデックスを補間することで、\( \small \textbf{C} \)ontinuity-\( \small \textbf{R} \)elativity ind\( \small \textbf{E} \)xing with g\( \small \textbf{A} \)ussian \( \small \textbf{M} \)iddle(CREAM)を提案しています.CREAMは単純であり、トレーニング効率が高いです.事前学習されたコンテキストウィンドウ(例:Llama 2-4K)での微調整のみが必要であり、LLMをはるかに長いターゲットコンテキスト長(例:256K)に拡張することができます.モデルがより中心部の情報に焦点を当てるようにするために、微調整中に中間部からのサンプリングを促すために切り捨てられたガウス分布を導入し、長いコンテキストLLMが直面する「Lost-in-the-Middle」問題を緩和します.実験結果は、CREAMが「Never Miss A Beat」を持つBaseおよびChatバージョンのLlama2-7Bに対してLLMをターゲット長に拡張するのに成功したことを示しています.私たちのコードは近日中に公開されます.

Q&A:

Q: CREAMがポジション・インデックスを操作することで、どのようにポジション・エンコードを補間するのか、もう少し詳しく説明してもらえますか?

A: CREAMは、位置エンコーディングを操作することで位置インデックスを変更し、相対性と連続性を活用して位置エンコーディングを補間します.具体的には、CREAMは位置インデックスを変更することで、モデルが位置の相対性を利用し、ターゲット長さに合わせて拡張することができます.また、CREAMはモデルがコンテキストの中心部分に焦点を当てることを可能にし、他の位置補間方法と組み合わせることができます.

Q: CREAMは、モデルがコンテキストの真ん中にある情報をより重視するようにするにはどうすればいいのでしょうか?

A: CREAMは、位置エンコーディングを操作して位置インデックスを補間することにより、モデルがコンテキストの中心部分の情報により焦点を当てるようにします.

Q: CREAMで導入された切り捨てガウシアンが、ロングコンテキストのLLMが直面する「Lost-in-the-Middle」問題をどのように軽減するのか、詳しく教えてください.

A: CREAMに導入された切り捨てられたガウス分布は、長いコンテキストを持つLLMが直面する「Lost-in-the-Middle」問題を緩和するのに役立ちます.このガウス分布は、中央部分からのサンプリングを促進し、特にfine-tuning中に中央の情報を優先させることができます.これにより、LLMは事前学習されたコンテキストウィンドウサイズ内で位置の補間を行う際にも、中央の位置の情報を重視することが可能となります.

Q: Llama2-7BのBaseとChatの両バージョンで、CREAMがLLMを目標長まで伸ばすことに成功したことを示す具体的な実験結果は?

A: 実験結果によると、CREAMはLLMを目標の長さに拡張することに成功しました.具体的には、Llama2-7BのBaseおよびChatバージョンに対して、’Never Miss A Beat’という結果が示されました.

Q: CREAMのトレーニング効率について、特にLLMのコンテキストの長さを延長する他の方法と比較した場合の詳細について教えてください.

A: CREAMは、他のLLMのコンテキスト長を拡張する方法と比較して、トレーニング効率に優れています.具体的には、CREAMは事前学習されたコンテキストウィンドウでのみ微調整を必要とし、LLMをはるかに長いターゲットコンテキスト長に拡張できます.また、CREAMは、長いコンテキストLLMが直面する「Lost-in-the-Middle」問題を緩和するために、中央部分からのサンプリングを促進するために切り捨てられたガウス分布を導入しています.

Q: CREAMは、コンテキストの中間部分からの情報を活用する上で、シンプルさと有効性という点で、他の既存の手法と比べてどうなのか?

A: CREAMは、他の既存の方法と比較して、中間部分の情報を利用する際の単純さと効果的性能において優れています.中間部分の情報を取得するために、CREAMは長いターゲットシーケンスの位置インデックスを短いものに変換することで、事前学習されたコンテキストウィンドウサイズ内で連続性と相対性を活用しています.その結果、CREAMは中間部分の理解において高い効果を示し、他の手法よりも優れた性能を発揮しています.

Q: CREAMでは、目標の長さでの微調整とは対照的に、事前に訓練されたコンテキストウィンドウでの微調整のみを必要とすることにはどのような意味があるのでしょうか?

A: CREAMは、事前に学習されたコンテキストウィンドウでの微調整のみを必要とするため、ターゲット長での微調整が必要ないことが重要です.これにより、モデルをより長いターゲットコンテキスト長(例:256K)に拡張する際に、トレーニング効率が向上し、よりシンプルであるという利点があります.

Q: CREAMは位置エンコーディングを補間するために位置インデックスをどのように操作しているのですか?また、それがメソッドの効率にどのように貢献しているのですか?

A: CREAMは、位置エンコーディングを補間するために位置インデックスを操作します.具体的には、CREAMは相対性と連続性の両方を活用し、モデルがコンテキストの中心部に焦点を当てることを可能にします.これにより、モデルはより効率的に情報を抽出し、より適切な位置エンコーディングを生成することができます.

Q: 切り捨てガウシアンによる微調整の際に、コンテキストの中間部分からサンプリングするプロセスをもう少し詳しく説明してもらえますか?

A: トランケードガウス分布を使用して、長い文脈の中央部分からサンプリングするための新しい手法を提案します.このアプローチは、式(2)における区間の重複を減らし、モデルの注意を長い文脈の中央部分に向けます.具体的には、中央位置において|Dr|を最大化することを示す理論的根拠を提供し、長い文脈の中央位置[N, L/2)∪(L/2, L-N]に焦点を当てます.

Self-Tuning: Instructing LLMs to Effectively Acquire New Knowledge through Self-Teaching

著者:Xiaoying Zhang, Baolin Peng, Ye Tian, Jingyan Zhou, Yipeng Zhang, Haitao Mi, Helen Meng

発行日:2024年06月10日

最終更新日:2024年06月15日

URL:http://arxiv.org/pdf/2406.06326v3

カテゴリ:Computation and Language

概要:

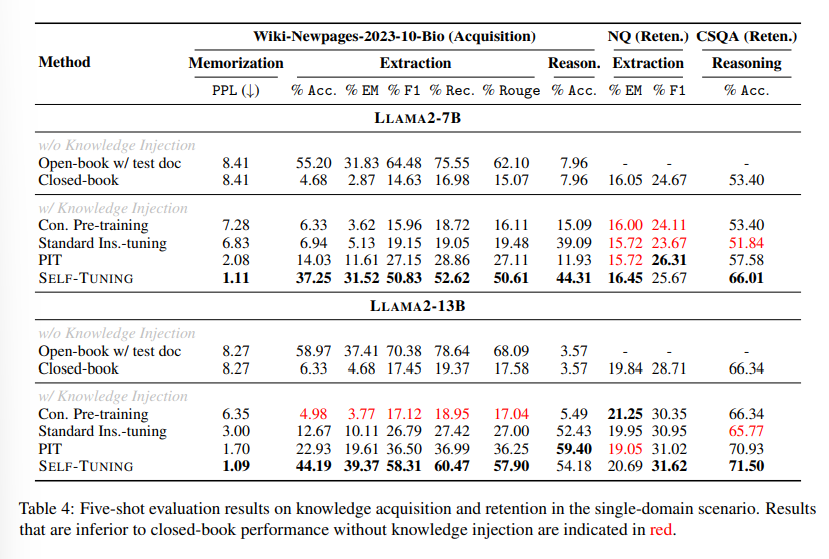

大規模言語モデル(LLM)は、一度のトレーニングと世界の常に進化する性質のため、最新情報を提供するのに苦労することがよくあります.LLMを最新の状態に保つため、既存のアプローチでは通常、新しいドキュメントでの継続的な事前トレーニングが行われます.しかし、これらのアプローチは、格納された知識を抽出する際にしばしば困難に直面します.私たちは、効率的な人間の学習におけるFeynmanテクニックの顕著な成功に触発され、自己教育を通じて新しい知識を効果的に取得するLLMの能力を向上させる学習フレームワークであるSelf-Tuningを紹介します.具体的には、自己監督的な方法で作成された一連の知識集約的なタスクをドキュメントに追加するSelf-Teaching戦略を開発し、記憶、理解、自己反省という3つの重要な側面に焦点を当てます.さらに、記憶、抽出、推論に関するLLMの知識獲得能力の詳細な分析を促進するために、3つのWiki-Newpages-2023-QAデータセットを導入します.Llama2ファミリーモデルに関する広範な実験結果は、Self-Tuningが一貫して優れた性能を発揮することを示しています.さらに、Llama2ファミリーモデルによると、Self-Tuningは知識獲得タスク全般で優れたパフォーマンスを発揮し、以前の知識を保持する点でも優れていることが明らかになっています.

Q&A:

Q: セルフチューニングフレームワークは、LLMが生のドキュメントから新しい知識を獲得する能力をどのように向上させるのですか?

A: SELF-TUNINGフレームワークは、LLMが生の文書から新しい知識を獲得する能力を向上させるために、文書を知識豊富なタスクで拡張するSELF-TEACHING戦略を開発します.具体的には、文書を自己監督的な方法で作成された一連の知識集約的なタスクで拡張し、記憶、理解、自己反省の3つの重要な側面に焦点を当てます.さらに、Wiki-Newpages-2023-QAの3つのデータセットを導入して、LLMの知識獲得能力に関する記憶、抽出、推論についての詳細な分析を可能にします.

Q: セルフ・チューニングの枠組みでファインマン・テクニックを使う動機は何ですか?

A: フェインマンテクニックをSELF-TUNINGフレームワークで使用する動機は、新しい知識を効果的に取得するためのLLMの能力を向上させることにあります.具体的には、SELF-TEACHING戦略を開発し、文書に知識集約型のタスクを自己教育的に追加することで、記憶、理解、自己反省という3つの重要な側面に焦点を当てています.

Q: セルフ・チューニング・フレームワークで展開されるセルフ・ティーチング戦略について説明していただけますか?

A: SELF-TEACHING学習戦略は、Feynman Techniqueに触発され、モデルに三つの視点からの体系的な知識学習能力を備えさせることを目指しています.具体的には、Figure 2の下部に示されているように、SELF-TEACHING学習戦略を自己監督型で設計し、生の文書DDoc_trainに知識を吸収させます.この戦略は、記憶、理解、自己反省の三つの視点から知識を獲得することを目指しています.

Q: 自己管理方式で作られる知識集約的なタスクで重視される3つの重要な点とは?

A: 知識集約的なタスクは、自己監督された方法で作成され、記憶、理解、自己反省の3つの重要な側面に焦点を当てています.

Q: Wiki-Newpages-2023-QAデータセットは、LLMの知識習得能力の分析をどのように支援していますか?

A: Wiki-Newpages-2023-QAデータセットは、LLMの知識獲得能力の分析を可能にするために、新しい文書コーパスを使用してモデルのトレーニングを行い、新しい知識の獲得を徹底的に行うことができます.また、単一ドメイン、複数ドメイン、およびクロスドメインの設定において、LLMが新しい知識を獲得する過程における記憶、抽出、推論に焦点を当てた研究を行うためのデータセットを導入しています.

Q: セルフ・チューニング・フレームワークに関して、Llama2ファミリーのモデルで行われた広範な実験テストの結果はどうでしたか?

A: SELF-TUNINGは、LLAMA 2ファミリーモデルに対する広範な実験テストにおいて、知識の記憶、抽出、および推論のすべての知識獲得タスクで優れたパフォーマンスを示し、以前の知識の保存にも優れていることが明らかになりました.

Q: セルフ・チューニングは、LLMを最新の情報に保つための既存のアプローチと比べてどうでしょうか?

A: SELF-TUNINGは、既存のアプローチと比較して、LLMを最新の情報で最新の状態に保つために効果的な自己学習を通じて新しい知識を獲得する能力を向上させることを目的として設計されたフレームワークです.

Q: 蓄積された知識を引き出す際にLLMが直面する困難と、セルフ・チューニングがこの問題にどのように対処するのかについて詳しく教えてください.

A: LLMは、生のドキュメントに存在する情報の複雑さと膨大な量のため、格納された知識を抽出する際にしばしば困難に直面します.これは、記憶力、理解力、自己反省能力において課題を引き起こす可能性があります.セルフチューニングは、セルフスーパーバイズされた方法で作成された知識集約的なタスクを文書に追加することで、この問題に対処します.これらのタスクは、LLMの記憶力、理解力、自己反省能力を向上させることに焦点を当てています.これらのタスクを取り入れることで、セルフチューニングは、LLMが生のドキュメントから効果的に新しい知識を獲得する能力を向上させることを目指しています.

Q: セルフ・チューニングは他の方法と比べて、どのように過去の知識を保存することに優れているのでしょうか?

A: SELF-TUNINGは、他の方法と比較して以前に獲得した知識を保持する点で優れています.SELF-TUNINGは、新しい知識を迅速に記憶し、長期間のトレーニング中に最高のパフォーマンスを維持します.SELF-TUNINGは、他の比較方法よりも早く新しい知識を記憶し、知識抽出タスクで最高のパフォーマンスを維持します.また、SELF-TUNINGは、オープンブックパフォーマンスを上回り、知識抽出タスクで5%高いEMスコアを達成します.

Q: セルフ・チューニング・フレームワークを実世界のアプリケーションに導入することの潜在的な意味は?

A: 提案されたSELF-TUNINGフレームワークを実装することの潜在的な影響は、実世界のアプリケーションにおいて知識の獲得と保持を向上させる可能性があると考えられます.SELF-TUNINGは、既存の知識を保持しながら、知識獲得タスクで優れたパフォーマンスを示すことが示されており、異なるドメインからの文書を含む幅広い文書にこの手法を拡張する可能性が示唆されています.

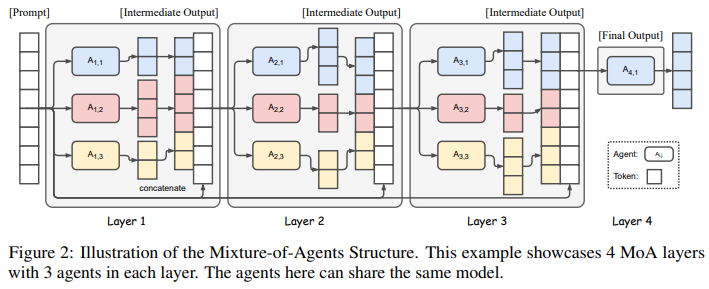

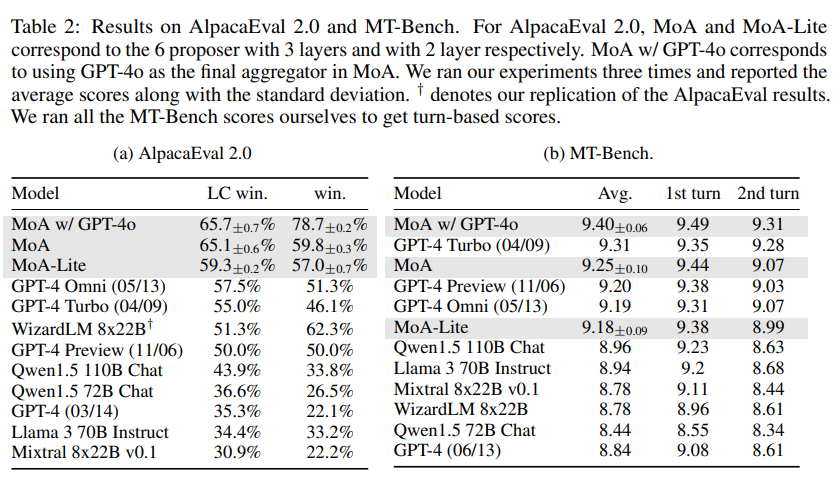

Mixture-of-Agents Enhances Large Language Model Capabilities

著者:Junlin Wang, Jue Wang, Ben Athiwaratkun, Ce Zhang, James Zou

発行日:2024年06月07日

最終更新日:2024年06月07日

URL:http://arxiv.org/pdf/2406.04692v1

カテゴリ:Computation and Language

概要:

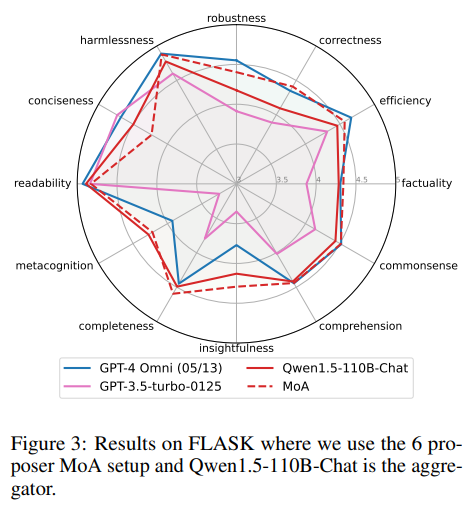

最近の大規模言語モデル(LLM)の進歩は、自然言語理解および生成のタスクにおいて著しい能力を示しています.LLMの数が増えるにつれて、複数のLLMの集合的な専門知識をどのように活用するかは興味深いオープンな方向です.この目標に向けて、私たちはMixture-of-Agents(MoA)方法論を通じて複数のLLMの集合的な強みを活用する新しいアプローチを提案しています.私たちのアプローチでは、各層が複数のLLMエージェントで構成された層状のMoAアーキテクチャを構築します.各エージェントは、前の層のエージェントからのすべての出力を補助情報として受け取り、その応答を生成します.MoAモデルはAlpacaEval 2.0、MT-Bench、FLASKで最先端のパフォーマンスを達成し、GPT-4 Omniを上回ります.例えば、私たちのMoAはオープンソースのLLMのみを使用しており、AlpacaEval 2.0で57.5%のGPT-4 Omniに対して65.1%のスコアを達成し、大きな差をつけてリーダーとなっています.

Q&A:

Q: 複数のLLMの総合力を活用するMoA(Mixture-of-Agents)手法の詳細を教えてください.

A: 複数のLLMの集合的な強みを活用するために、Mixture-of-Agents(MoA)方法論は、複数のLLMエージェントからなる階層的なMoAアーキテクチャを構築します.各層は複数のLLMエージェントで構成されており、各エージェントは前の層のエージェントからのすべての出力を補助情報として受け取り、その応答を生成します.MoAモデルはAlpacaEval 2.0、MT-Bench、FLASKで最先端のパフォーマンスを達成し、GPT-4 Omniを上回ります.例えば、オープンソースのLLMのみを使用した当社のMoAは、AlpacaEval 2.0で57.5%のGPT-4 Omniに比べて65.1%のスコアを達成し、大きな差をつけてリーダーです.

Q: レイヤー化されたMoAアーキテクチャはどのように機能し、各レイヤーで複数のLLMエージェントはどのような役割を果たすのか?

A: 層状のMoAアーキテクチャは、各層が複数のLLMエージェントで構成されており、前の層のエージェントからのすべての出力を補助情報として受け取り、その応答を生成します.各層のLLMエージェントは、前の層のエージェントからの出力を入力として受け取り、それを元に応答を生成します.このようにして、複数のLLMエージェントが協力して、より強力で包括的な応答を生成することが可能となります.

Q: MoAのアプローチは、他の方法やモデルと比較して、具体的にどのようなタスクや課題に優れているのか?

A: MoAアプローチは、他の方法やモデルと比較して、ロバスト性、正確性、効率性、事実性、常識、洞察力、完全性などの多くの側面で優れています.特に、MoAは、個々のモデルスコアであるQwen-110B-Chatの単一モデルを上回る点で優れています.さらに、MoAは、正確性、事実性、洞察力、完全性などの側面でGPT-4 Omniをも上回っています.

Q: MoAモデルがAlpacaEval 2.0、MT-Bench、FLASKでどのようにして最先端の性能を達成したのか、もう少し詳しく教えてください.

A: 提案されたMoAモデルは、AlpacaEval 2.0、MT-Bench、およびFLASKで最先端のパフォーマンスを達成するために、複数のモデルを統合することによって異なる視点を取り入れ、単一のモデルに頼るよりも優れたパフォーマンスを実現しました.具体的には、オープンソースモデルのみを使用して、GPT-4oをAlpacaEval 2.0およびFLASKで上回る結果を達成しました.また、MoAは、ファインチューニングに関連する計算オーバーヘッドを排除し、最新のLLMにも適用可能である柔軟性と拡張性を提供します.

Q: MoAアプローチとGPT-4オムニ・モデルの性能・能力面での主な違いは何ですか?

A: MoAアプローチとGPT-4 Omniモデルとの主な違いは、性能と機能の観点から次のようになります.まず、MoAは複数のモデルを組み合わせて使用することで、単一のモデルよりも高い性能を実現しています.特に、MoAはFLASKやAlpacaEval 2.0などのベンチマークでGPT-4 Omniよりも優れた正確性、事実性、洞察力、完全性を示しています.さらに、MoAはGPT-4 Turboと比較しても、性能を維持しながら2倍以上のコスト効率を実現しています.これは、MoAが複数のモデルを組み合わせることで、より高い品質を低いコストで提供できるためです.

Q: あなたのMoAモデルで使用されているオープンソースのLLMは、AlpacaEval 2.0で65.1%のスコアを達成した成功にどのように貢献していますか?

A: 私たちのMoAモデルの成功において、オープンソースのLLMがどのように貢献しているかについて、以下の数式を用いて説明します.オープンソースのLLMは、他のモデルからの出力を受け取ることで、より良い応答を生成する傾向があります.これにより、MoAモデルは他のモデルよりも優れた性能を発揮することができます.具体的には、AlpacaEval 2.0でのスコアが65.1%に達することが可能となります.

Q: MoA手法の潜在的な限界や欠点は何ですか、また、今後の研究でどのように対処する予定ですか?

A: MoAの方法論の潜在的な制限や欠点は、提案された手法がモデルの応答を反復的に集約する必要があるため、モデルは最後のMoA層に到達するまで最初のトークンを決定できないという点にあります.これにより、高い最初のトークンまでの時間(TTFT)が発生し、ユーザーエクスペリエンスに悪影響を与える可能性があります.この問題を緩和するために、MoA層の数を制限することができます.最初の応答の集約が生成品質に最も大きなブーストをもたらすためです.将来の研究では、一度に全体の応答を集約する代わりにチャンクごとの集約を探ることができ、TTFTを減少させつつ応答品質を維持することができます.

Q: LLMエージェントを追加したり、異なるタイプのタスクやデータセットに適応させるという点で、MoAアプローチはどの程度スケーラブルなのでしょうか?

A: MoAアプローチは、追加のLLMエージェントを組み込むことや、異なるタイプのタスクやデータセットに適応する際に非常にスケーラブルです.このアプローチでは、各層が複数のLLMエージェントで構成されており、前の層のエージェントからのすべての出力を補助情報として受け取るため、新しいLLMエージェントを追加することでモデル全体の能力を拡張することが可能です.また、LLMの固有の能力を活用するため、最新のLLMにも適用可能であり、サイズやアーキテクチャに関係なく柔軟性と拡張性が提供されます.

Q: 大規模言語モデルにおけるMixture-of-Agentとその応用に関する研究の次のステップや将来の方向性は?

A: 研究の次のステップとして、Mixture-of-Agents(MoA)のアプリケーションにおける大規模言語モデルの活用をさらに深めるために、より複雑なMoAアーキテクチャの開発や、異なるエージェント間の相互作用を最適化するための新しい手法の検討が必要です.また、異なるモデルの出力を統合する際に、出力確率分布を平均化するだけでなく、より高度な統合手法の開発も重要です.さらに、複数の大規模言語モデルをエージェントとして使用する際の協力や議論の方法についての研究も重要です.

SelfGoal: Your Language Agents Already Know How to Achieve High-level Goals

著者:Ruihan Yang, Jiangjie Chen, Yikai Zhang, Siyu Yuan, Aili Chen, Kyle Richardson, Yanghua Xiao, Deqing Yang

発行日:2024年06月07日

最終更新日:2024年06月07日

URL:http://arxiv.org/pdf/2406.04784v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

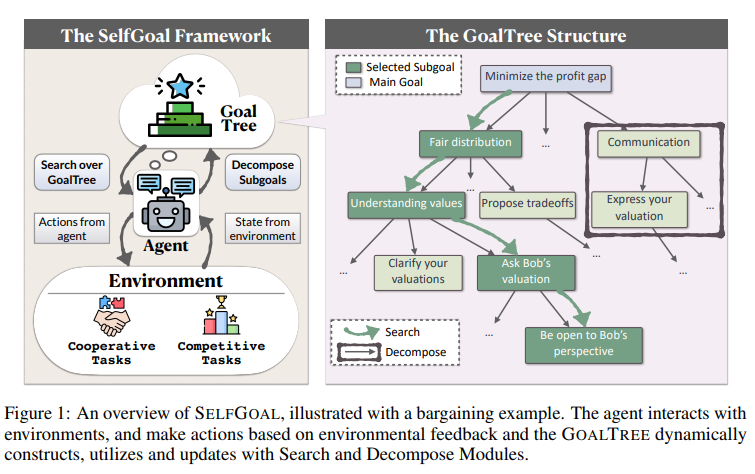

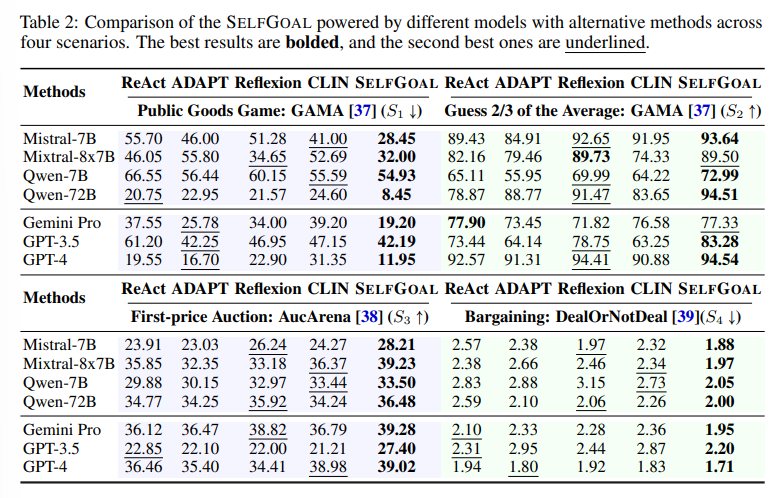

大規模言語モデル(LLM)によって駆動される言語エージェントは、ゲームやプログラミングなどの領域で意思決定ツールとしてますます価値が高まっています.しかし、これらのエージェントはしばしば詳細な指示なしで高レベルの目標を達成する際に課題に直面し、フィードバックが遅れる環境に適応することが難しいことがあります.本論文では、限られた人間の事前知識と環境フィードバックを用いて高レベルの目標を達成するエージェントの能力を向上させるために設計された新しい自動アプローチであるSelfGoalを提案しています.SelfGoalの中核コンセプトは、環境とのやり取り中に高レベルの目標をより実用的なサブゴールのツリー構造に適応的に分解し、最も有用なサブゴールを特定し、この構造を逐次的に更新することです.実験結果は、SelfGoalが競争、協力、および遅延フィードバック環境を含むさまざまなタスクで言語エージェントのパフォーマンスを著しく向上させることを示しています.プロジェクトページ:https://selfgoal-agent.github.io.

Q&A:

Q: SelfGoalが、限られた人間の事前フィードバックと環境フィードバックで高レベルの目標を達成するためにエージェントの能力をどのように向上させるか説明できますか?

A: SELFGOALは、環境との相互作用を通じて、高レベルの目標をサブゴールに動的に分解するGOALTREEを構築し、更新し、利用することで、エージェントの能力を向上させます.この方法により、エージェントは環境との相互作用に基づいてコンテキストに応じたサブゴールの階層的なGOALTREEを動的に生成し、洗練させることができます.実験結果は、この手法が競争的および協力的シナリオの両方で効果的であり、ベースライン手法を上回ることを示しています.さらに、SELFGOALを持つエージェントが環境とより多くの関わりを持つにつれてGOALTREEを継続的に更新できるため、複雑な環境をより高い精度と適応性で航行することが可能となります.

Q: SelfGoalは、環境との相互作用の中で、どのようにして高レベルのゴールを、より実用的なサブゴールのツリー構造に適応的に分解するのだろうか?

A: SELFGOALは、環境との相互作用中に高レベルの目標をより実用的なサブゴールのツリー構造に分解するために、GOALTREEを動的に構築、更新、利用します.このフレームワークは、環境からのフィードバックに基づいて、高レベルの目標をより具体的なサブゴールに分解するために、サーチとデコンポーズモジュールを使用します.

Q: SelfGoalはどのようにして最も有用なサブゴールを特定し、この構造を漸進的に更新するのか?

A: SELF-GOALは、現在の状況に最も適したサブゴールを特定するために、エージェントのバックボーンLLMに対して、例えば「現在の状況で主な目標に到達するのに役立つK個の最も有用なサブゴールを選択してください」というプロンプトを提示します.そして、対話履歴を状態として表現し、GOALTREEの各枝の葉ノードを候補のサブゴールリストとしてLLMに提示します.次に、LLMはK個の最適なサブゴールを選択し、分解を行い、このステップでの指示プロンプトを更新します.

Q: さまざまなタスクにおいて言語エージェントのパフォーマンスを向上させるSelfGoalの有効性を示す実験結果について、もう少し詳しく教えてください.

A: 実験結果では、SELFGOALが言語エージェントのパフォーマンスを大幅に向上させることが示されました.これは、競争的、協力的、および遅延フィードバック環境を含むさまざまなタスクで確認されました.

Q: SelfGoalは競争環境でどのようなパフォーマンスを発揮するのか?

A: SELFGOALは競争環境においても効果的であり、ベースライン手法を上回る実験結果が示されています.

Q: SelfGoalは協調環境でどのようなパフォーマンスを発揮するのか?

A: SELFGOALは協力的な環境で効果的であることが実験で示されています.ベースライン手法を上回り、エージェントが環境と相互作用することでGOALTREEを継続的に更新し、複雑な環境をより精密かつ適応性を持ってナビゲートできるようにします.

Q: SelfGoalは遅延フィードバック環境でどのように機能するのか?

A: SELFGOALは、遅延フィードバック環境においても優れたパフォーマンスを発揮します.実験結果は、SELFGOALが高いレベルの目標を一貫して達成するために言語エージェントの能力を大幅に向上させることを示しています.

Q: SelfGoalのコアコンセプトについて、もう少し詳しく教えてください.

A: SELFGOALは、高レベルの目標を達成するために、タスクを動的に分解するGOALTREEを構築、更新、利用する自己適応フレームワークです.このフレームワークは、環境との相互作用中にタスクの高レベルの目標をサブゴールに分解し、最も有用なサブゴールを特定し、この構造を逐次更新します.実験結果は、SELF-GOALが競争的、協力的、および遅延フィードバック環境を含むさまざまなタスクにおいて、言語エージェントのパフォーマンスを著しく向上させることを示しています.

Q: SelfGoalは、エージェントの能力を高いレベルの目標を達成するために向上させる他のアプローチとどのように異なりますか?

A: SELFGOALは、高レベルの目標をより実用的なサブゴールに適応的に分解し、環境との相互作用中に最も有用なサブゴールを特定し、この構造を進行的に更新することで、言語エージェントのパフォーマンスを大幅に向上させる点で他のアプローチと異なります.

Q: SelfGoalの開発プロセスや導入時に直面した課題について教えてください.

A: SELFGOALの開発プロセスは、高レベルの目標をサブゴールに分解するGOALTREEを動的に構築、更新、利用する自己適応フレームワークである.この構造は環境との相互作用中に進行的に更新され、実験結果は、SELF-GOALが競争的、協力的、および遅延フィードバック環境を含むさまざまなタスクにおいて言語エージェントのパフォーマンスを著しく向上させることを示している.