ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- AgentGym: Evolving Large Language Model-based Agents across Diverse Environments

発行日:2024年06月06日

AIコミュニティでは、汎用エージェントの構築が長期目標であり、LLMsが有望な基盤とされている.AgentGymフレームワークとAgentEvol手法を使用し、自己進化能力を持つエージェントを構築し、SOTAモデルに匹敵する結果を達成した. - Buffer of Thoughts: Thought-Augmented Reasoning with Large Language Models

発行日:2024年06月06日

BoTはLLMsの精度、効率、堅牢性を向上させる多目的思考拡張推論アプローチで、高レベルの思考テンプレートを格納し、効率的な推論を行う. - Scalable MatMul-free Language Modeling

発行日:2024年06月04日

MatMul操作を排除することで、10億パラメータのLLMsが強力なパフォーマンスを維持し、メモリ使用量を最大61%削減できることが示された研究. - The Geometry of Categorical and Hierarchical Concepts in Large Language Models

発行日:2024年06月03日

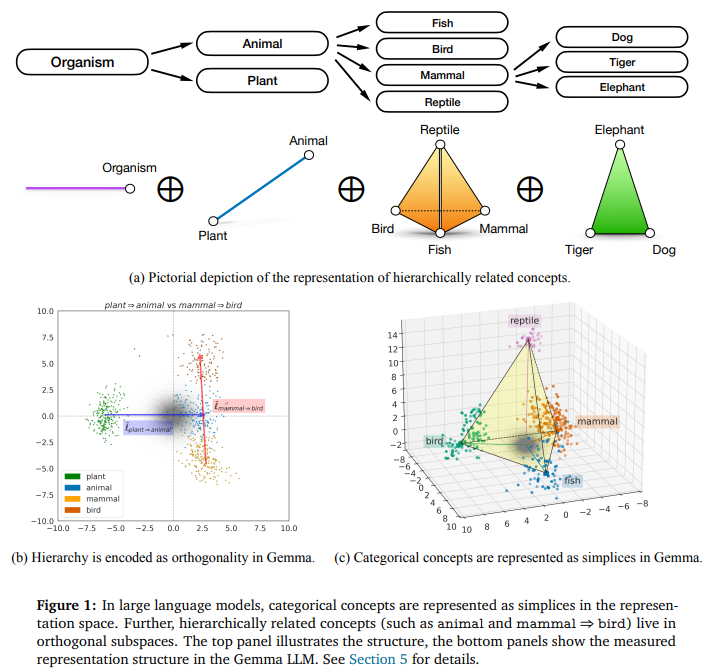

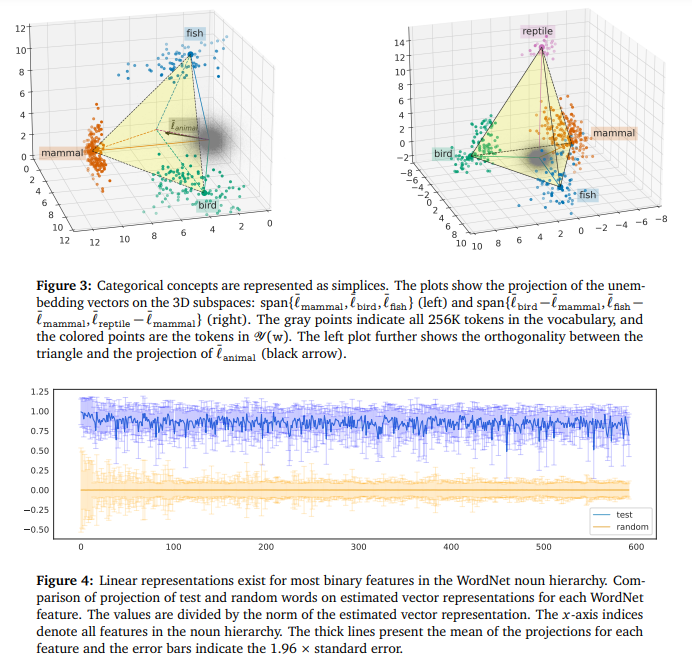

大規模言語モデルの表現空間におけるカテゴリー概念と階層関係のエンコード方法を研究し、線形表現仮説を拡張して、単体と多面体で表現されることを示した. - Towards Scalable Automated Alignment of LLMs: A Survey

発行日:2024年06月03日

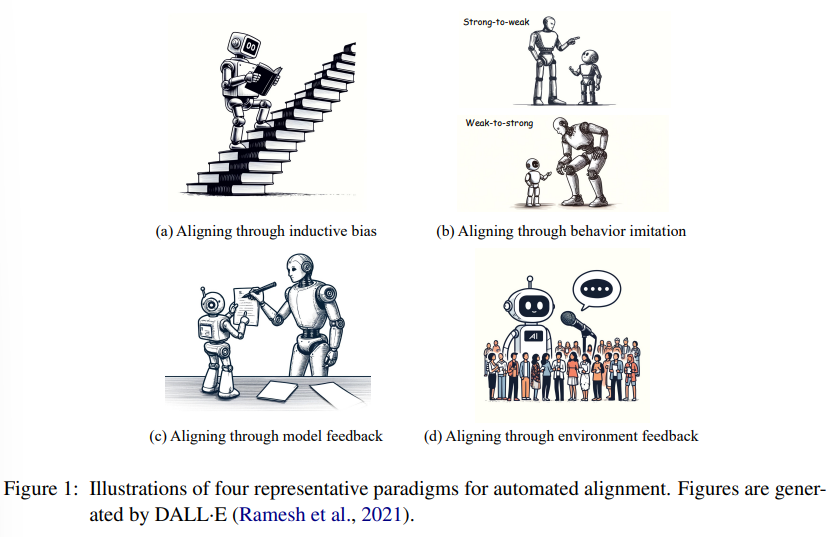

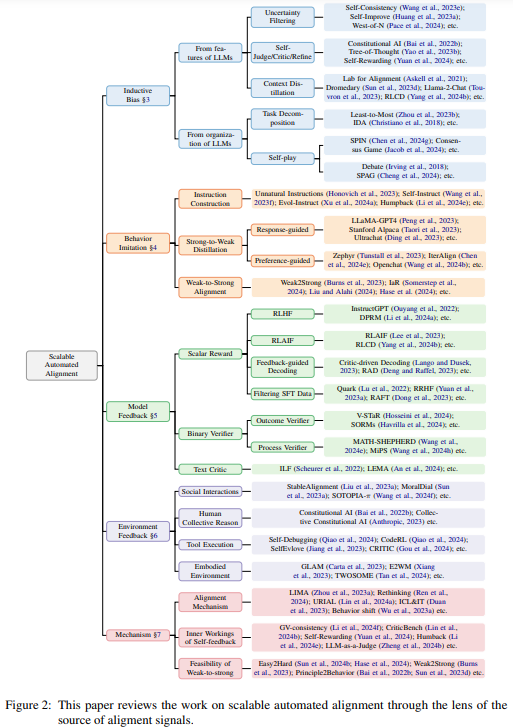

LLMの急速な発展により、自動アライメント方法の重要性が高まり、新しいソースの探求が必要とされている. - Show, Don’t Tell: Aligning Language Models with Demonstrated Feedback

発行日:2024年06月02日

DITTOは、LLMを特定の設定に整列させるために、非常に少数のデモンストレーションを活用する新しい手法であり、他の手法を上回る効果を示しています. - SaySelf: Teaching LLMs to Express Confidence with Self-Reflective Rationales

発行日:2024年05月31日

LLMsは不正確な情報を生成し、信頼性が低いため、高度なSaySelfトレーニングフレームワークを提案し、強化学習を活用して信頼性を向上させる研究. - Transformers are SSMs: Generalized Models and Efficient Algorithms Through Structured State Space Duality

発行日:2024年05月31日

トランスフォーマーに代わる新たな状態空間モデル(SSM)であるMamba-2が、言語モデリングにおいてトランスフォーマーと競争力を維持しつつ、2〜8倍速くなることが示されました.

AgentGym: Evolving Large Language Model-based Agents across Diverse Environments

著者:Zhiheng Xi, Yiwen Ding, Wenxiang Chen, Boyang Hong, Honglin Guo, Junzhe Wang, Dingwen Yang, Chenyang Liao, Xin Guo, Wei He, Songyang Gao, Lu Chen, Rui Zheng, Yicheng Zou, Tao Gui, Qi Zhang, Xipeng Qiu, Xuanjing Huang, Zuxuan Wu, Yu-Gang Jiang

発行日:2024年06月06日

最終更新日:2024年06月06日

URL:http://arxiv.org/pdf/2406.04151v1

カテゴリ:Artificial Intelligence, Computation and Language

概要:

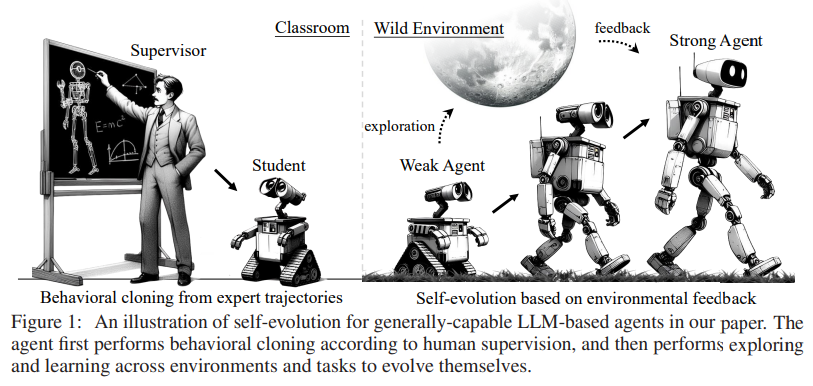

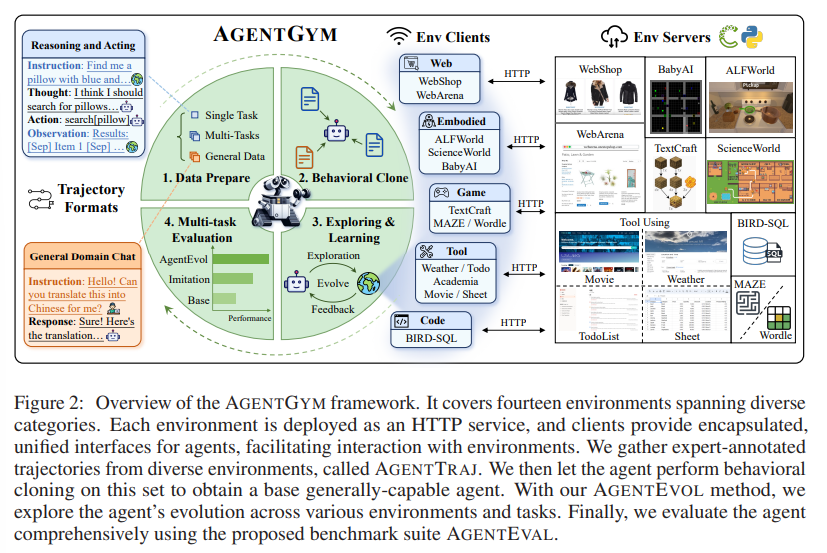

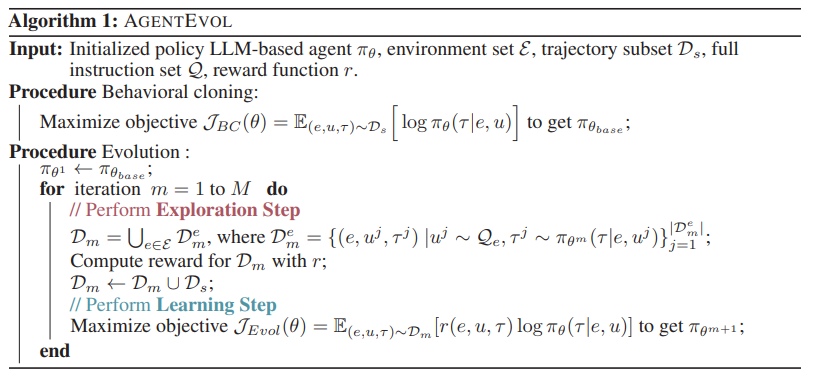

AIコミュニティにおいて、多様なタスクを処理し、異なる環境で進化することができる汎用エージェントを構築することは長期的な目標とされています.大規模言語モデル(LLMs)は、その汎用能力から、このようなエージェントを構築するための有望な基盤と考えられています.現在のアプローチでは、LLMベースのエージェントが専門家によって提供された軌跡をステップバイステップで模倣することで、人間の監督が必要でスケーリングが難しく、環境の探索が制限されるという課題があります.また、エージェントが孤立した環境で探索や学習を行うことで、一部の特化したエージェントが生まれ、汎化能力が制限されるという問題もあります.本論文では、自己進化能力を持つ汎用的なLLMベースのエージェントを構築するための最初のステップを踏み出します.私たちは、エージェントの探索と学習のための多様な環境、基本的な能力と事前知識をエージェントに備えるための軌跡セット、効果的かつスケーラブルな進化手法という3つの要素を特定しています.また、AgentGymという新しいフレームワークを提案しています.このフレームワークは、広範囲でリアルタイム、一貫性があり、同時にエージェントの探索を行うためのさまざまな環境とタスクを備えています.AgentGymには、拡張されたデータベースも含まれており、エージェントの進化をサポートしています.さらに、新しい手法であるAgentEvolを提案し、エージェントの自己進化の可能性を探る実験を行いました.実験結果では、進化したエージェントがSOTAモデルに匹敵する結果を達成できることが示されています.私たちは、AgentGymスイートをリリースしました.このスイートには、プラットフォーム、データセット、ベンチマーク、チェックポイント、およびアルゴリズムの実装が含まれています.AgentGymスイートはhttps://github.com/WooooDyy/AgentGymで利用可能です.

Q&A:

Q: LLMベースのエージェントにおける自己進化能力のコンセプトについて説明していただけますか?

A: LLMベースのエージェントの自己進化能力とは、人間の監督に依存せず、環境からのフィードバックに基づいて自己改善を行い、多様な環境やタスクにおいて進化し、学習する能力を指します.この能力により、エージェントは単一の特定タスクに限定されず、より広範囲で柔軟に行動し、環境に適応することが可能となります.

Q: 多様な環境は、AgentGymにおけるエージェントの探索と学習にどのように貢献するのか?

A: 多様な環境は、エージェントの探索と学習において重要な役割を果たします.具体的には、異なる環境においてエージェントがさまざまなタスクを実行することで、エージェントは新しい経験を積み重ねることができます.これにより、エージェントは様々な状況に適応し、柔軟性を身につけることができます.さらに、異なる環境での探索により、エージェントは幅広い知識を獲得し、より汎用的な能力を身につけることが可能となります.

Q: エージェントに基本的な能力と予備知識を身につけさせる上で、軌道セットはどのような意味を持つのか?

A: エージェントに基本的な能力と事前知識を備えさせるために、軌跡セットは重要な役割を果たします.軌跡セットには、多様な環境でのエージェントの探索と学習を可能にするための指示や問題が含まれており、これによりエージェントは基本的な能力を獲得し、事前知識を構築することができます.

Q: AgentGymは、環境探索とスケーラビリティという点で、現在のアプローチとどう違うのですか?

A: エージェントジムは、多様な環境でのエージェントの探査と学習を可能にすることで、現在のアプローチとは異なります.また、エージェントジムは効果的かつスケーラブルな進化手法を提供することで、環境の探査とスケーラビリティにおいて優れています.

Q: AgentEvolで使用されている、タスクや環境を超えたエージェントの自己進化を可能にする進化方法について詳しく教えてください.

A: エージェントエボルは、環境からのフィードバックに基づいて、一般的に適したLLMベースのエージェントの自己進化を初期調査するための方法です.この手法では、エージェントが以前に見たことのないタスクや指示に直面した際に自己進化できるかどうかを調査します.これには、新しい経験から探索を行い、学習する必要があります.実験結果は、エージェントの進化が非常に顕著であり、SOTAモデルと同等またはそれ以上の性能を達成することさえ示しています.さらに、私たちの手法がどのように機能するかを示すために、十分な削除と分析を行っています.

Q: 進化したエージェントのパフォーマンスに関する実験結果から得られた主な発見は何でしたか?SOTAモデルと比較して.

A: 実験結果から得られた主な結果は、進化したエージェントがSOTAモデルと比較して類似またはそれ以上の性能を達成できることである.

Q: GitHubで利用可能なAgentGymスイートにはどのようなコンポーネントが含まれていますか?

A: GitHubに利用可能なAgentGymスイートに含まれるコンポーネントには、プラットフォーム、データセット、ベンチマーク、チェックポイント、およびアルゴリズムの実装が含まれています.

Q: AgentGymは、リアルタイム、ユニフォーマット、コンカレントエージェント探索をどのように促進しますか?

A: AgentGymは、広範囲でリアルタイムかつ一貫したエージェントの探査を可能にします.このプラットフォームでは、異なる環境でのマルチラウンドの相互作用とリアルタイムなフィードバックを実現するための統一されたインターフェースが実装されており、オンライン評価、軌跡サンプリング、対話型トレーニングをサポートしています.

Q: AgentGymの開発を促したのは何か、そしてAIコミュニティに公開する決定を下したのは何か?

A: AGENT GYMの開発の動機は、広範囲でリアルタイムかつ一貫したエージェントの探索を可能にするためでした.また、AGENT GYMは、拡張された指示、ベンチマークスイート、環境全体での高品質な軌跡を含むデータベースも提供しています.さらに、過去に見られたデータを超えたエージェントの自己進化の可能性を調査するために、新しい手法であるAGENT EVOLを提案しました.実験結果は、進化したエージェントがSOTAモデルと比較可能な結果を達成できることを示しています.これらの理由から、AGENT GYMスイートをリリースし、プラットフォーム、データセット、ベンチマーク、チェックポイント、およびアルゴリズムの実装を提供しました.

Q: 研究者や開発者は、どのようにしてAgentGymスイートにアクセスし、自分のプロジェクトに活用することができますか?

A: 研究者や開発者は、プロジェクトサイトhttps://agentgym.github.ioやAGENT GYMsuiteのGitHubリポジトリhttps://github.com/WooooDyy/AgentGymからAgentGymスイートにアクセスし、利用することができます.このスイートには、プラットフォーム、データセット、ベンチマーク、チェックポイント、アルゴリズムの実装が含まれています.

Buffer of Thoughts: Thought-Augmented Reasoning with Large Language Models

著者:Ling Yang, Zhaochen Yu, Tianjun Zhang, Shiyi Cao, Minkai Xu, Wentao Zhang, Joseph E. Gonzalez, Bin Cui

発行日:2024年06月06日

最終更新日:2024年06月06日

URL:http://arxiv.org/pdf/2406.04271v1

カテゴリ:Computation and Language

概要:

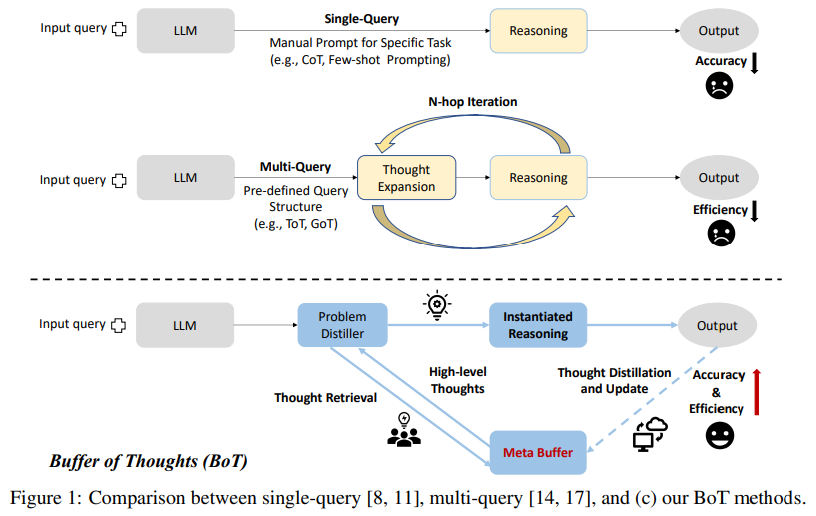

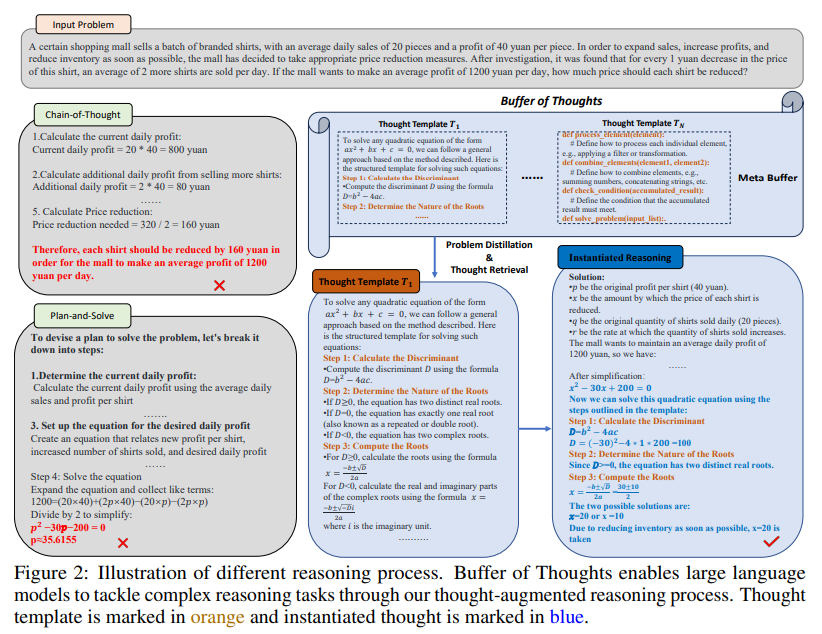

Buffer of Thoughts(BoT)を紹介します.これは、大規模言語モデル(LLMs)の精度、効率、および堅牢性を向上させるための革新的で多目的な思考拡張推論アプローチです.具体的には、問題解決プロセスから抽出された情報豊かな高レベルの思考テンプレートを格納するメタバッファーを提案します.そして、各問題に対して関連する思考テンプレートを取得し、特定の推論構造で適応的に具体化して効率的な推論を行います.スケーラビリティと安定性を保証するために、メタバッファーの容量を向上させるために、バッファーマネージャーを提案します.これにより、さらに多くのタスクが解決されるにつれてメタバッファーの容量が向上します.10の難解な推論集中タスクで広範な実験を行い、以前のSOTA手法に比べて11%のゲーム・オブ・24、20%の幾何学的形状、および51%のチェックメイト・イン・ワンで大幅な性能向上を達成しました.さらに分析を行った結果、BoTの優れた汎化能力とモデルの堅牢性が示され、平均してマルチクエリプロンプティング方法(例:思考の木/グラフ)のコストの12%しか必要としないことがわかりました.特に、私たちのLlama3-8B+BoTはLlama3-70Bモデルを上回る潜在能力を持っていることがわかりました.プロジェクトは以下のリンクから利用可能です:https://github.com/YangLing0818/buffer-of-thought-llm

Q&A:

Q: 情報量の多いハイレベルな考えを保存する上で、メタバッファがどのように機能するのか、もう少し詳しく説明してもらえますか?

A: メタバッファは、高レベルの思考テンプレートを格納する軽量なライブラリであり、さまざまな問題解決プロセスから抽出された思考テンプレートを保持しています.これらの思考テンプレートは、問題を解決する際に適応的にインスタンス化され、特定の推論構造と組み合わせられます.メタバッファは、問題を解決するたびに関連する思考テンプレートを取得し、特定の推論構造で具体化することで、効率的な思考増強推論を実現します.また、問題を解決するたびにメタバッファを動的に更新することで、メタバッファの容量を拡張し、スケーラビリティと安定性を確保しています.

Q: それぞれの問題に対して、どの思考テンプレートを取り出すか、どうやって決めるのか?

A: 問題ごとにどの思考テンプレートを取得するかを決定するために、BoTは問題xdと思考テンプレートの説明DTiとの埋め込み類似性を計算します.具体的には、以下の式を用いて取得プロセスを行います:j=argmaxi(Sim(f(xd),{f(DTi)}N i=1)).ここで、Sim(f(xd),{f(DTi)}n i=0)>=δとなるように、閾値δ(0.5∼0.7が推奨されています)を設定し、埋め込みモデルf(·)を使用しています.そして、Tjが取得された思考テンプレートを示します.新しいタスクかどうかを判断するために、Sim(f(xd),{f(DTi)}n i=0)< δの場合、タスクxを新しいタスクとして識別します.

Q: スケーラビリティと安定性を高めるために、バッファーマネージャーがメタバッファを動的に更新する方法について詳しく教えてください.

A: バッファーマネージャーは、メタバッファーを動的に更新することで、スケーラビリティと安定性を向上させます.これにより、メタバッファーの容量が増加し、より多くのタスクが解決されるようになります.具体的には、バッファーマネージャーは、以前に解決された問題から得られた思考テンプレートを利用して、メタバッファーを拡張し、次に類似した問題に対処するのに役立ちます.このようにして、各ラウンドでBoTの精度が着実に向上していくことが観察されます.一方、バッファーマネージャーを持たないモデルは上昇傾向を示さないことがわかります.

Q: 効率的な推論のために、思考テンプレートを適応的にインスタンス化するために、具体的にどのような推論構造が使われるのか?

A: 思考テンプレートを適応的にインスタンス化するために使用される具体的な推論構造は、LLMインスタンス化です.

Q: 推論を多用する10のタスクで達成されたパフォーマンス向上は、以前の最先端手法と比較してどのように測定されましたか?

A: 10の推論集中タスクにおける性能向上を、以前の最先端の手法と比較してどのように測定しましたか?これについては、我々は広範囲な実験を行いました.我々のBoTは、Game of 24では11%、Geometric Shapesでは20%、Checkmate-in-Oneでは51%の性能向上を達成しました.これは、従来のマルチクエリプロンプティング手法のコストのわずか12%で達成されました.

Q: BoTが実験で示した汎化能力とモデルの頑健性の例を教えてください.

A: 実験において、BoTが示した一般化能力とモデルの堅牢性の例を提供します.BoTは、異なるベンチマークからランダムにサンプリングされた1000の例をテストサブセットとして使用し、異なるタスクに対して高い成功率を維持しました.他の手法と比較して、BoTは平均成功率で2番目に優れた手法を10%上回りました.この優れた堅牢性は、異なるタスク間での推論中に蒸留された思考テンプレートの高い一般化能力に起因しています.適切な思考テンプレートから高レベルの思考を提供することで、BoTの手法の安定性が大幅に向上しました.

Q: マルチクエリー・プロンプト方式の12%のコストでパフォーマンス向上を達成する意義とは?

A: マルチクエリプロンプティング方法の12%のコストで性能向上を達成することの重要性は、効率的な推論プロセスを実現するだけでなく、複雑な問題に対処するための最適な推論構造を瞬時に構築できることにあります.このような効率的なアプローチにより、時間とリソースの節約が可能となり、複雑な問題に対する迅速な解決が実現されます.

Q: Llama3-8B BoTとLlama3-70Bモデルとの潜在的な性能の比較は?

A: Llama3-8B+BoTは、Llama3-70Bモデルを上回る潜在的な性能を持つ可能性があります.

Q: バッファー・オブ・サンクス・アプローチを実施する上で、何か制限や課題はありましたか?

A: Buffer of Thoughtsのアプローチを実装する際に遭遇した制限や課題はいくつかあります.例えば、人間のような創造性が必要な問題に対処する際には、特定の思考テンプレートに依存しないため、BoTの改善が限定されることがあります.また、BoTがメタバッファをより弱いモデルで初期化すると、より複雑なタスクに対して思考テンプレートの品質が劣る可能性があるという制限もあります.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/YangLing0818/buffer-of-thought-llm です.

Scalable MatMul-free Language Modeling

著者:Rui-Jie Zhu, Yu Zhang, Ethan Sifferman, Tyler Sheaves, Yiqiao Wang, Dustin Richmond, Peng Zhou, Jason K. Eshraghian

発行日:2024年06月04日

最終更新日:2024年06月18日

URL:http://arxiv.org/pdf/2406.02528v5

カテゴリ:Computation and Language

概要:

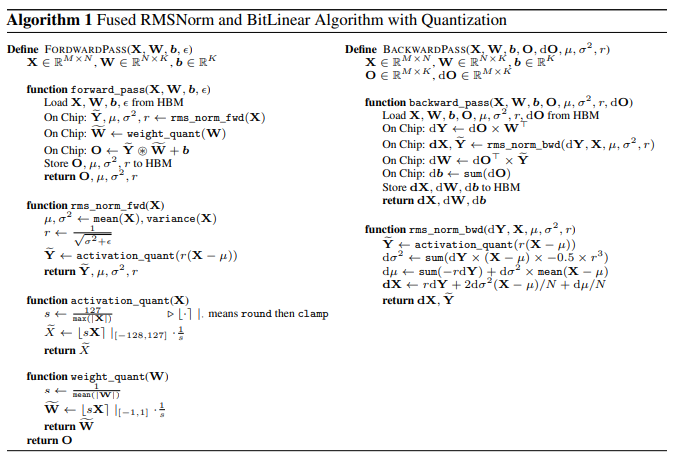

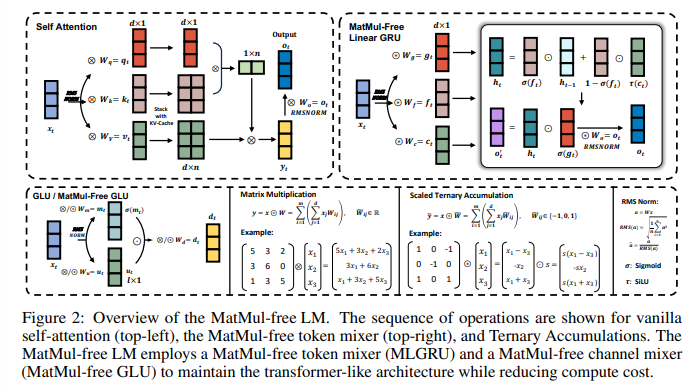

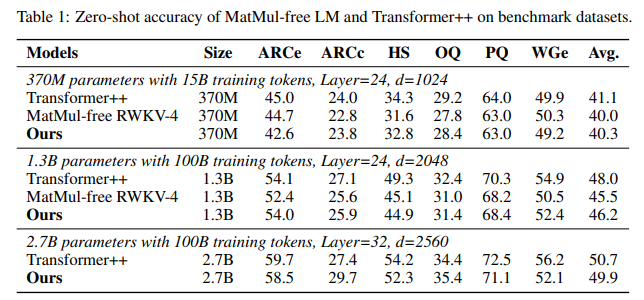

大規模言語モデル(LLMs)の全体的な計算コストを支配するのは、通常、行列の乗算(MatMul)です.このコストは、埋め込み次元やコンテキストの長さが大きくなるにつれてのみ増加します.この研究では、MatMul操作を完全に排除することで、LLMsの性能を維持しながら、10億パラメータ規模でも強力なパフォーマンスを達成できることを示しています.実験では、提案されたMatMulフリーモデルが、最大2.7Bパラメータまでのスケールで、メモリ使用量がはるかに多い最先端のTransformerと同等のパフォーマンスを達成していることが示されています.スケーリング法則を調査し、MatMulフリーモデルと完全精度のTransformerの性能差が、モデルサイズが増加するにつれて狭まっていることを発見しました.また、トレーニング中の最適化されていないベースラインに比べて、GPU効率の良いこのモデルの実装により、メモリ使用量を最大61%削減できます.推論中に最適化されたカーネルを利用することで、モデルのメモリ消費量を最適化されていないモデルと比較して10倍以上削減できます.私たちのアーキテクチャの効率を適切に定量化するために、FPGA上でカスタムハードウェアソリューションを構築しました.さらに、我々はFPGA上でカスタムハードウェアソリューションを構築し、GPUが処理できない軽量な操作を活用しました.我々は13Wで十分なスループットを実現し、人間の読み取り能力を超える10億パラメータ規模のモデルを処理し、LLMsを脳のような効率に近づけました.この研究は、LLMsがどれだけ効果的に削減されても効果的に機能するかを示すだけでなく、次世代の軽量LLMsを処理する際に最適化されるべき操作の種類を指摘しています.私たちのコード実装は、https://github.com/ridgerchu/matmulfreellm で入手可能です.

Q&A:

Q: 大規模な言語モデルでMatMul演算が一般的にどのように使われているのか、またなぜ計算コストを支配するのか説明していただけますか?

A: MatMul演算は、大規模言語モデルにおいて埋め込み次元やコンテキスト長が大きくなるにつれて、主に行列の掛け算に使用され、計算コストを支配する.MatMul演算は、通常、大量のパラメータを持つモデルにおいて、畳み込み層やアテンション機構などの重要な部分で使用され、モデルの学習や推論において重要な役割を果たす.MatMul演算は、大規模な行列の乗算により、モデルのパラメータ間の関係を計算し、モデルの学習や予測に必要な情報を生成する.そのため、MatMul演算は、大規模言語モデルにおいて計算コストを支配し、実行時間やメモリアクセスの大部分を消費する.

Q: MatMulを使用しないモデルは、どのように行列の乗算を使用せずに、億パラメータスケールで強力な性能を維持するのでしょうか?

A: MatMul-freeモデルは、大規模な埋め込み次元とコンテキスト長にスケールするにつれて、MatMul演算を完全に排除することで、十分な性能を維持します.これは、モデルのサイズが増加するにつれて、性能差が狭まることを示しています.

Q: MatMulを使用しないモデルと最先端のTransformerを性能とメモリ使用量の点で比較した実験の結果は?

A: MatMul-freeモデルと最先端のTransformersを比較した実験の結果、MatMul-freeモデルは、最大2.7Bパラメータのスケールで、推論時にはるかに多くのメモリを必要とする最先端のTransformersと同等の性能を達成した.モデルサイズが増加するにつれて、MatMul-freeモデルと完全精度のTransformersの性能差は狭まることがわかった.MatMul-freeモデルのGPU効率の高い実装により、トレーニング中のメモリ使用量が最大61%削減される.推論時に最適化されたカーネルを利用することで、モデルのメモリ消費量は最適化されていないモデルと比較して10倍以上削減される.MatMul-freeアーキテクチャの効率を適切に定量化するために、FPGA上でカスタムハードウェアソリューションを構築し、軽量化を活用した.モデルサイズが大きくなるにつれて、MatMul-free LMのメモリとレイテンシーの利点がより顕著になることが示された.

Q: 調査されたスケーリングの法則と、モデルサイズが大きくなるにつれてMatMulを使わないモデルと完全精度のトランスフォーマーとの性能差がどのように変化するかについて詳しく教えてください.

A: スケーリング法則は、モデルサイズとトレーニングセットサイズのべき乗関数としてモデルエラーが減少するというニューラルスケーリング法則を指します.この法則により、トレーニングがより大きなモデルでより高価になるにつれて、性能に対する信頼が得られます.MatMul-free LMとフル精度のTransformerの性能差は、モデルサイズが増加するにつれて狭まる傾向があることがわかりました.MatMul-free LMのスケーリング投影は、Transformer++と比較して急激な減少を示しています.

Q: GPUで効率的にモデルを実装することで、トレーニングや推論時のメモリ使用量をどのように削減できるのでしょうか?

A: GPU効率的な実装では、最適化されたカーネルを使用することにより、トレーニング中および推論中のメモリ使用量を削減します.最適化されたカーネルを使用することで、未最適化のモデルに比べてメモリ消費量を10倍以上削減できます.また、CUDAカーネルを最適化することで、推論速度を4.57倍に向上させ、モデルを13Bパラメータにスケーリングした際のメモリ使用量を10分の1に削減します.

Q: 推論中のモデルのメモリ消費量を最適化するためにどのような最適化が行われ、最適化されていないモデルと比較してどれだけ削減されましたか?

A: 推論中のモデルのメモリ消費を最適化するために、最適化されたカーネルを利用しました.これにより、最適化されていないモデルと比較して、モデルのメモリ消費を10倍以上削減することができました.

Q: 億パラメータ規模のモデルを処理し、効率を向上させるために、FPGA上のカスタムハードウェアソリューションはどのように活用されたのでしょうか?

A: FPGAを使用したカスタムハードウェアソリューションは、軽量な演算を活用して、10倍以上のメモリ消費量を削減し、13Wで十分なスループットを達成することで、数十億パラメータ規模のモデルを処理し、LLMsを脳のような効率に近づけました.

Q: この研究は、将来のアクセラレーターが軽量LLMを処理するためにオペレーションを最適化する可能性をどのような形で示しているのだろうか?

A: この研究は、軽量LLMの処理において未来のアクセラレータが最適化すべき操作の種類を示すだけでなく、LLMが効果的に機能するまでどれだけ削減できるかを示しており、将来のアクセラレータが次世代の軽量LLMを処理する際に最適化すべき操作の種類を指摘しています.

Q: MatMulを使わない言語モデリングのためのコード実装の入手可能性について、もっと詳しく教えてください.

A: MatMul-free言語モデリングのコード実装の入手可能性についての詳細な情報は提供されていません.

Q: 提案されたアプローチは、LLMを脳のような効率性にどのように近づけるのか、また、この分野の今後の研究にどのような示唆を与えるのか?

A: 提案されたアプローチは、LLMを脳のような効率に近づけるために、GPUが処理できない軽量な操作を13Wで処理するカスタムFPGAハードウェアソリューションを構築しました.これにより、LLMが効果的に機能するまでどれだけ削減できるかを示すだけでなく、将来のアクセラレータが次世代の軽量LLMを処理する際に最適化すべき操作の種類を指摘しています.このようなMatMul-freeアーキテクチャの開発と展開を優先することで、LLMの未来はよりアクセスしやすく、効率的で持続可能になるでしょう.

The Geometry of Categorical and Hierarchical Concepts in Large Language Models

著者:Kiho Park, Yo Joong Choe, Yibo Jiang, Victor Veitch

発行日:2024年06月03日

最終更新日:2024年06月03日

URL:http://arxiv.org/pdf/2406.01506v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning, Machine Learning

概要:

大規模言語モデルの表現空間に意味的な意味がどのようにエンコードされているかを理解することは、解釈可能性における基本的な問題です.この論文では、この領域での2つの基本的な問いを研究しています.まず、{‘哺乳類’、’鳥’、’爬虫類’、’魚’}などのカテゴリー概念はどのように表現されているのか、ということです.次に、概念間の階層関係はどのようにエンコードされているのか、ということです.例えば、’犬’が’哺乳類’の一種であるということ実はどのようにエンコードされているのでしょうか.私たちは、これらの問いに答えるために線形表現仮説を拡張する方法を示しています.驚くほど単純な構造が見つかりました:単純なカテゴリー概念は単体として表現され、階層的に関連する概念は、私たちが明確に示す意味で直交しており、それにより複雑な概念は、階層構造を反映した単体の直和から構成された多面体として表現されています.私たちは、WordNetからのデータを使用して957の階層的に関連する概念の表現を推定し、これらの理論的結果をGemma大規模言語モデルで検証しています.

Q&A:

Q: 哺乳類、鳥類、爬虫類、魚類といったカテゴリー概念は、大規模な言語モデルでどのように表現されるのか?

A: 大規模言語モデルにおいて、’mammal’、’bird’、’reptile’、’fish’などのカテゴリー概念は、表現空間内の単体として表現されます.

Q: 大規模な言語モデルにおいて、概念間の階層関係はどのようにエンコードされるのか?

A: 大規模言語モデルにおいて、概念間の階層関係は直交する部分空間に存在します.

Q: 線形表現仮説は、大規模言語モデルにおけるカテゴリー的・階層的概念に関する疑問に答える上でどのように役立つのか?

A: 線形表現仮説は、大規模言語モデルにおけるカテゴリカルおよび階層的概念に関する質問に答える際に役立ちます.この仮説により、単純なカテゴリカル概念は単体として表現され、階層的関連概念は直交する部分空間に存在します.さらに、複雑な概念は、単体の直和から構成される多胞体として表現されます.これにより、線形表現仮説は、大規模言語モデルにおける概念の幾何学的表現を理解する上で重要な役割を果たします.

Q: 大規模言語モデルにおける単純なカテゴリー概念の構造とは?

A: 単純なカテゴリー概念は、表現空間内の単体として表されます.

Q: 大規模な言語モデルにおいて、階層的に関連する概念はどのように表現されるのか?

A: 大規模言語モデルにおける階層的に関連する概念は、直交部分空間で表現される.これは、概念が互いに独立しており、表現空間で重ならないことを意味する.

Q: 大規模な言語モデルにおいて、階層的に関連する概念はどのような意味で直交するのか?

A: 階層的に関連する概念は、大規模言語モデルにおいて直交しているという意味で表現されます.

Q: 大規模な言語モデルにおいて、複雑な概念はどのように表現されるのか?

A: 複雑な概念は、単純な概念の直和から構成された多面体として表現されます.

Q: 大規模な言語モデルで複雑な概念を表現するために、単純要素の直和から構成されるポリトープはどのように使われているのか?

A: 多面体は、単体の直和から構築され、複雑な概念を大規模言語モデルで表現するために使用されます.これにより、高次元の概念をより単純な幾何学的構造にマッピングし、モデルの内部表現を理解しやすくします.例えば、概念animal ={mammal ,bird,reptile ,fish}のような複雑な概念は、それぞれの要素を単体として表現し、それらを直和して多面体を構築することでモデル内で表現されます.

Q: 957の階層的に関連する概念の表現は、WordNetのデータを使ってどのように推定されたのか?

A: 957の階層的関連概念の表現は、WordNetからのデータを使用して推定されました.各synset wについて、Y(w)をトレーニングワード(80%)とテストワード(20%)に分割し、トレーニングワードにLDA推定器を適合させ、テストワードのunembeddingベクトルを推定されたベクトル表現に射影してその値を評価しました.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 新しい手法のコード実装のURLは、features/index.htmlです.

Towards Scalable Automated Alignment of LLMs: A Survey

著者:Boxi Cao, Keming Lu, Xinyu Lu, Jiawei Chen, Mengjie Ren, Hao Xiang, Peilin Liu, Yaojie Lu, Ben He, Xianpei Han, Le Sun, Hongyu Lin, Bowen Yu

発行日:2024年06月03日

最終更新日:2024年06月03日

URL:http://arxiv.org/pdf/2406.01252v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

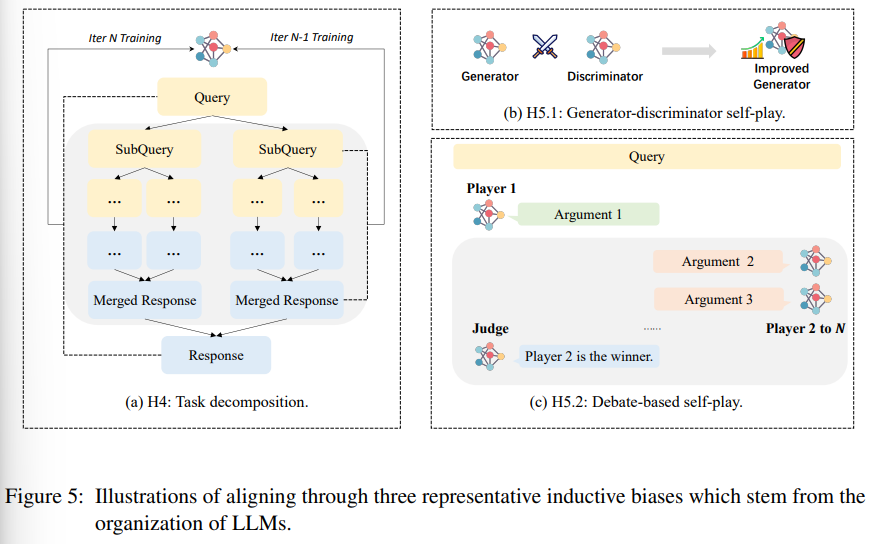

アライメントは、人間のニーズを満たす大規模な言語モデル(LLM)を構築する際に最も重要なステップです.LLMの急速な発展により、従来の人間注釈に基づくアライメント方法は、スケーラビリティの要求を満たすことがますます困難になっています.そのため、自動アライメント信号や技術アプローチの新しいソースを探求する必要が急務となっています.本論文では、最近登場した自動アライメント方法を体系的にレビューし、LLMの能力が人間を超えた場合にどのように効果的でスケーラブルな自動アライメントを実現するかを探求しています.具体的には、アライメント信号のソースに基づいて既存の自動アライメント方法を4つの主要カテゴリに分類し、各カテゴリの現状と潜在的な発展について議論しています.さらに、自動アライメントを可能にする基本的なメカニズムを探求し、アライメント技術を実現可能かつ効果的にするための重要な要因についても議論しています.

Q&A:

Q: 人間によるアノテーションに基づく従来のアラインメント手法の主な課題は何か?

A: 従来の人間注釈に基づく伝統的なアラインメント方法の主な課題は、LLMの能力が人間を超えつつあることによるデータの品質低下と、LLMの応答の品質を適切に判断することの困難さにあります.これにより、人間が生成する好みデータの品質が低下し、人間のニーズを正確に反映できなくなり、LLMに対する効果的なガイダンスを提供することが難しくなっています.その結果、人間注釈に基づくアラインメント方法は、LLMの能力向上に追いつくことができず、LLMに対するスケーラブルな監視を実現することが難しくなっています.

Q: 自動アライメントシグナルは、スケーラビリティの点で人間によるアノテーションとどう違うのか?

A: 自動整列信号は、人間の注釈と比較して、スケーラビリティにおいて優れています.人間の注釈に依存する方法は、大規模なデータセットを作成するために多くの人的リソースと時間が必要であり、急速に進化するLLMの開発に対応するのが難しいためです.一方、自動整列信号は、人間の介入を最小限に抑えることができるため、スケーラビリティにおいて効果的であり、急速に進化するLLMに対応することが可能です.

Q: 自動アライメントシグナルの新たなソースとして検討された例を教えてください.

A: 新しい自動整列信号の例として、帰紵バイアス、行動模倣、モデルフィードバック、環境フィードバックなどが探究されています.

Q: 自動アライメント手法の4大カテゴリーは、有効性と拡張性の点でどう違うのか?

A: 4つの主要なカテゴリの自動整列方法は、効果とスケーラビリティの観点で異なります.具体的には、帰紵バイアスによる整列、行動の模倣、モデルフィードバック、環境要求による整列の4つのカテゴリは、それぞれ異なるアプローチを取っており、それぞれの効果とスケーラビリティに影響を与えています.

Q: 自動アライメント法の各カテゴリーの現状と発展の可能性は?

A: 各カテゴリの自動整列方法の現在の状況と将来の発展については、自動整列信号のソースに基づいて4つの主要なカテゴリに分類され、それぞれの方向での現在の進展が要約され、将来の発展の軌跡と潜在的な未来が議論されています.

Q: 自動アライメントを効果的に行うための基本的なメカニズムとは何か?

A: 自動整列が効果的であるための基本的なメカニズムは、現在の整列の基盤となる理論や手法によって実現されています.具体的には、自己フィードバックが機能する理由や弱から強への変換が可能な理由などが挙げられます.これらのメカニズムは、自動整列の効果的な実装やスケーラビリティを実現するために重要であり、これらの研究や議論によって、自動整列の効果的な機能が確立されています.

Q: 自動アライメント技術を実現可能で効果的なものにするために不可欠な要素とは何か?

A: 自動整列技術を実現可能かつ効果的にするための重要な要因は、現在の整列メカニズムの基盤となるアルゴリズムやデータ構造の適切な選択、自己フィードバックの機能性、そして弱から強への進化が可能であることです.

Q: LLMが人間の能力を凌駕するという問題に、自動アライメント法はどう対処するのか?

A: 自動整列方法は、人間の能力を超えたLLMsの問題に対処するために、人間の手によるアノテーションに依存しないスケーラブルで高品質な整列シグナルを構築することを目指しています.

Q: LLMの全体的な効果において、アライメントはどのような役割を果たしているのだろうか?

A: LLMの全体的な効果において、アライメントは重要な役割を果たします.行動の模倣を通じたアライメントは、LLMのスタイル、役割、指示に従う能力を改善することができますが、事実性や問題解決などのより複雑な側面のパフォーマンスを向上させることはできません.アライメントの原則をLLMに適用することで、モデルが自動的に重要なアライメント効果を達成できることが示されています.将来的には、データの品質を効率的に向上させ、より堅牢なトレーニングアルゴリズムを開発し、複数の教師による模倣を実装し、一般的なタスクにおける弱から強いアライメントの理論的分析を行う必要があります.これらの課題に取り組むことで、LLMのさらなる進歩への道筋がつけられるでしょう.

Q: LLMにおいて効果的でスケーラブルなアライメントを実現するために、自動アライメント手法はどのように貢献するのか?

A: 自動アライメント方法は、人間の手作業によって作成された優先信号を置き換えることができるスケーラブルなアライメント信号を見つけることが最も重要であり、これにより、LLMsに対する効果的かつスケーラブルなガイダンスを提供することが可能となります.

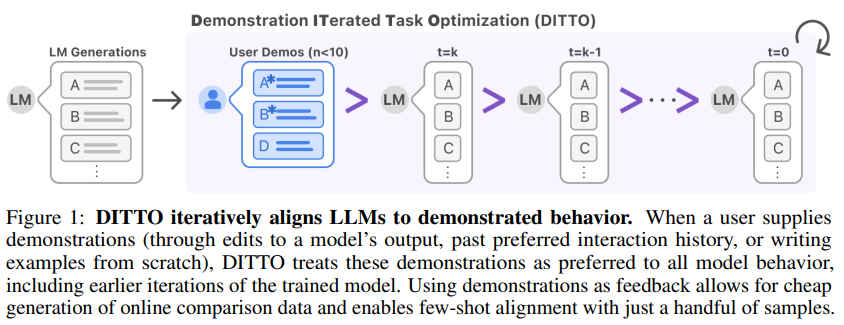

Show, Don’t Tell: Aligning Language Models with Demonstrated Feedback

著者:Omar Shaikh, Michelle Lam, Joey Hejna, Yijia Shao, Michael Bernstein, Diyi Yang

発行日:2024年06月02日

最終更新日:2024年06月02日

URL:http://arxiv.org/pdf/2406.00888v1

カテゴリ:Computation and Language, Human-Computer Interaction

概要:

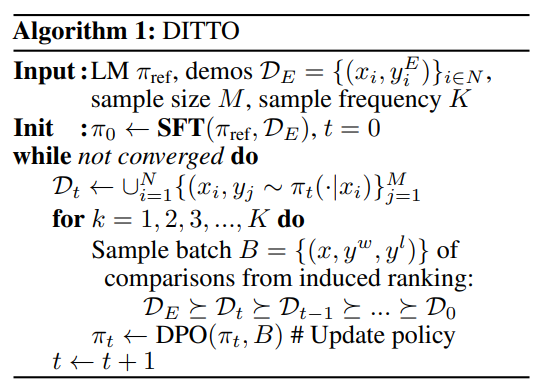

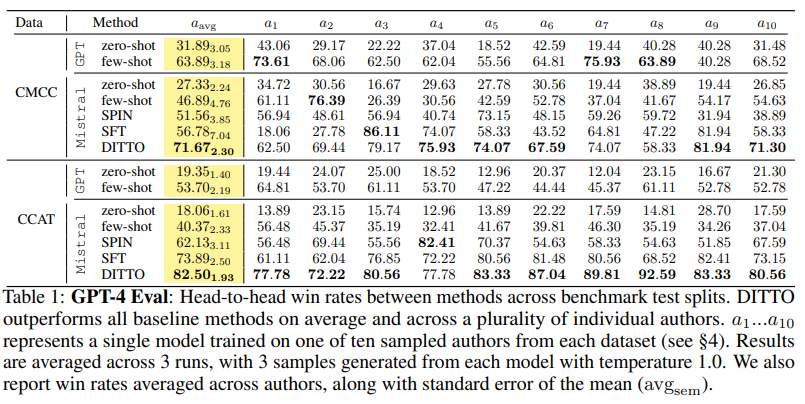

言語モデルは、多くの声を模倣するように整列されており、特定の誰かと一致する出力を生成するのではなく、誰とも一致しない出力を生成します.LLMを一般的な出力から逸脱させることは、監督されたファインチューニングやRLHFを介して可能ですが、新しいアドホックタスクには膨大なデータセットが必要です.私たちは、代わりに、非常に少数(<10)のデモンストレーションをフィードバックとして活用することで、LLMを特定の設定に整列させることが可能であると主張しています.私たちの手法であるDemonstration ITerated Task Optimization(DITTO)は、言語モデルの出力をユーザーのデモンストレーションに直接整列させます.オンライン模倣学習のアイデアを用いて導出されたDITTOは、ユーザーのデモンストレーションをLLMおよびその中間チェックポイントの出力よりも優先するものとして、オンライン比較データを安価に生成します.私たちは、ニュース記事、メール、ブログ投稿などのドメインを横断する微細なスタイルとタスクの整列を学習する能力を持つDITTOを評価します.さらに、参加者(N=16)からさまざまなデモンストレーションを募集するユーザースタディを実施します.DITTOの勝率がフューショットプロンプティング、監督されたファインチューニング、および他のセルフプレイ手法を平均19%ポイント上回ることが示されました.デモンストレーションを直接フィードバックとして使用することで、DITTOはLLMの効果的なカスタマイズのための新しい手法を提供します.

Q&A:

Q: DITTOは、言語モデルの出力をユーザーの示した行動にどのように整列させるのか、もっと詳しく説明していただけますか?

A: DITTOは、ユーザーが示した行動に対して言語モデルの出力を整列させるために直接的に使用されます.オンライン模倣学習のアイデアを用いて導出され、DITTOは、ユーザーのデモンストレーションをLLMおよびその中間チェックポイントの出力よりも優先的に扱うことで、オンライン比較データを安価に生成します.DITTOの能力を評価します.

Q: DITTOは、ユーザーのデモを使用してオンライン比較データを生成していますか?

A: DITTOは、ユーザーのデモンストレーションを使用してオンライン比較データを生成します.ユーザーが提供したデモンストレーションを、元のLLMおよびモデルの以前のトレーニングイテレーションの出力よりも優先されるものとして扱います.これにより、ユーザーのデモンストレーションを基にした拡張データセットが生成され、このデータセットを使用して言語モデルを更新することができます.

Q: DITTOの細かいスタイルとタスクの整合性を学習する能力の研究で評価された特定のドメインは何ですか?

A: 研究では、ニュース記事、メール、ブログ投稿などのドメインが評価されました.

Q: 16人が参加したユーザー調査の詳細を教えてください.

A: 16人の参加者を対象としたユーザースタディが行われました.最初の部分では、参加者に4つのメール作成タスクを指定してもらいました.その後、2つのタスクについて2つのデモンストレーションを提供してもらうように求めました.トレーニングデモンストレーションは合計4つ提供されました.第二の部分では、テストセットから2つのタスクを使用し、参加者に各手法の生成物を示しました.各テストプロンプトについて10のペアワイズな選好を求めました.これにより、各ユーザーごとに合計20の選好が収集され、合計320のペアワイズな選好が16人のユーザーから収集されました.

Q: DITTOの勝率は、数発のプロンプト、監督付きの微調整、その他のセルフプレーの方法と比べてどうですか?

A: DITTOの勝率は、few-shotプロンプト、監督されたファインチューニング、および他の自己対戦方法よりも高いです.

Q: LLMのカスタマイズにおいて、デモンストレーションをフィードバックとして直接使用することの主な利点は何ですか?

A: デモンストレーションをフィードバックとして直接使用することの主な利点は、非常に少数のデモンストレーションを使用して言語モデルの出力を特定の設定に合わせることが可能であることです.これにより、一般的な出力ではなく、特定のユーザーの行動に合わせた出力を生成することができます.

Q: DITTOは、言語モデルからの汎用的な出力の問題にどのように対処していますか?

A: DITTOは、言語モデルからの一般的な出力の問題に対処するために、外部信号を必要とせず、デモンストレーションのみを使用します.これにより、自己プレイ方法のようなSPINとは異なり、高速適応を可能にし、データが限られている状況での適応を目指しています.

Q: LLMを特定のセッティングに合わせるために、スーパーバイズド・ファインチューニングやRLHFを使うことの限界は?

A: 監督された微調整やRLHFを使用すると、新しい特定の設定にLLMを整列させるためには膨大なデータセットが必要となります.これにより、個人からは非常に高い努力が必要とされます.

Q: DITTOに必要なデータセットのサイズは、LLMをアライメントする他の方法と比べてどうですか?

A: DITTOは、他のLLMの整列方法と比較して、データセットのサイズが小さくても強力な整列を実現できます.

Q: オンライン模倣学習のコンセプトと、DITTOでの活用方法について説明していただけますか?

A: オンライン模倣学習は、専門家のデモンストレーションからデータをサンプリングし、専門家の振る舞いを区別するために使用されるアルゴリズムです.DITTOは、このオンライン模倣学習の概念を利用して、ユーザーが示した振る舞いと言語モデルの出力を直接整合させます.DITTOは、ユーザーのデモンストレーションをLLMの出力やその中間チェックポイントよりも優先するものとして扱い、オンライン比較データを安価に生成します.専門家のデモンストレーションとオンラインデータを同時に使用して報酬関数とポリシーを学習することで、DITTOは導出されます.

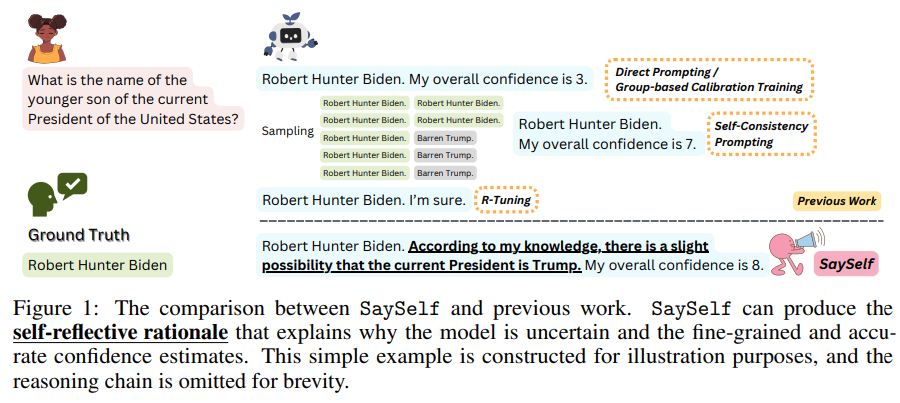

SaySelf: Teaching LLMs to Express Confidence with Self-Reflective Rationales

著者:Tianyang Xu, Shujin Wu, Shizhe Diao, Xiaoze Liu, Xingyao Wang, Yangyi Chen, Jing Gao

発行日:2024年05月31日

最終更新日:2024年06月05日

URL:http://arxiv.org/pdf/2405.20974v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

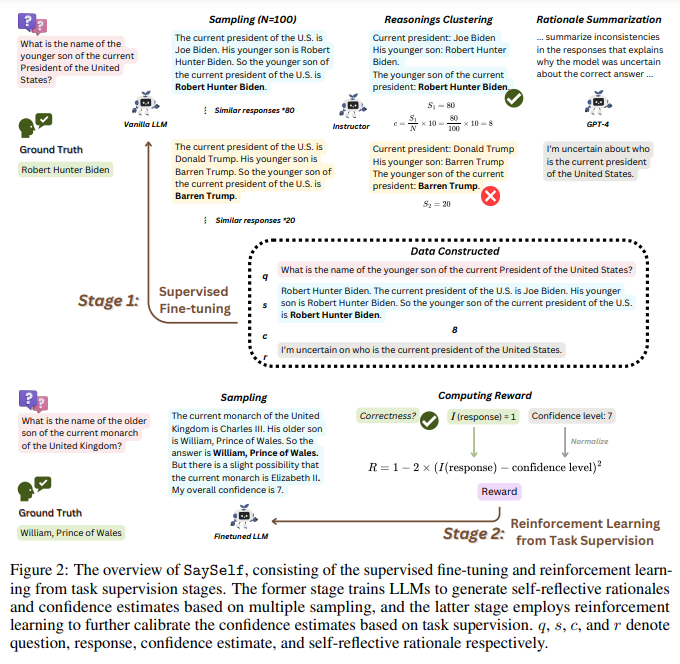

大規模言語モデル(LLMs)はしばしば不正確または捏造された情報を生成し、一般的に自信を示すことができず、そのため広範な応用が制限されています.過去の研究では、LLMsからの信頼性を直接または自己整合性の促進、または特定のデータセットの構築による教師付き微調整が行われてきました.プロンプトベースのアプローチは性能が低く、トレーニングベースのアプローチはバイナリまたは不正確なグループレベルの信頼性の推定に限定されています.この研究では、より正確な細かい信頼性の推定を表現するようにLLMsを教える高度なSaySelfトレーニングフレームワークを提案しています.さらに、信頼性スコアに加えて、SaySelfは、LLMsが自己反省的な根拠を生成するプロセスを開始し、彼らのパラメトリック知識の欠陥を明確に特定し、不確実性を説明します.これは、LLMsを使用して、自然言語を介して特定の知識の不確実性を自動的に要約することによって達成されます.要約は、複数のサンプリングされた推論チェーンの不整合性の分析に基づいており、その結果得られたデータは教師付き微調整に利用されます.さらに、私たちは、信頼性推定のキャリブレーションを促進するために、慎重に作成された報酬関数を用いた強化学習を活用しています.これにより、LLMsが正確で高信頼な予測を提供するように促し、誤った出力に対する過度な自信を罰することが可能となります.内部および外部のデータセットにおける実験結果は、SaySelfが信頼性のキャリブレーションエラーを減少させ、タスクのパフォーマンスを維持する効果を示しています.生成された自己反省的な根拠が妥当であり、キャリブレーションにさらなる貢献をすることを示しています.コードはhttps://github.com/xu1868/SaySelfで公開されています.

Q&A:

Q: LLMから自信を引き出す上で、SaySelfフレームワークはこれまでのアプローチとどう違うのか?

A: SaySelfフレームワークは、以前のアプローチと比較して、LLMsからの信頼度を引き出す際に、より正確で詳細な信頼度推定を可能にするだけでなく、自己反省的な根拠を生成することができます.以前のアプローチでは、信頼度スコアや自己反省的な根拠を生成することができませんでしたが、SaySelfはLLMsに自己反省的な根拠を生成させることができます.これにより、モデルの知識の不足を明確にし、信頼度推定を説明することが可能です.

Q: SaySelfがどのようにLLMに、より正確な細かい信頼性推定値を表現することを教えているのか、説明していただけますか?

A: SaySelfは、LLMsにより正確な細かい信頼度の推定を表現する方法を教えるトレーニングフレームワークです.以前のアプローチとは異なり、SaySelfは信頼度の引き出しを超え、LLMsが自己反省的な根拠を生成し、知識のギャップを示し、信頼度の推定を説明することができるようにします.具体的には、オフザシェルフのLLM(例:GPT-4)を使用して、監督されたファインチューニング用のモデル固有のデータセットを自動的に生成します.各質問に対して、LLMsから複数の推論チェーンをサンプリングし、それに基づいてデータセットを構築します.

Q: SaySelfは、LLMが自己反省的な根拠を生み出すよう、どのように指導しているのだろうか?

A: SaySelfは、LLMに自己反省的な根拠を生成させるために、モデル固有のデータセットを使用して教師付き微調整を行います.このデータセットは、複数のサンプリングされた応答から構築され、自己反省的な根拠と信頼度の推定値を含んでいます.

Q: SaySelfがLLMを使って特定の知識の不確実性を要約するプロセスは?

A: SaySelfは、LLMを使用して特定の知識に不確実性を要約するプロセスを行います.この要約は、複数のサンプリングされた推論チェーンの不一致を分析することに基づいており、その結果得られたデータは監督された微調整に利用されます.

Q: SaySelfはどのように強化学習を利用して信頼度の推定値を校正しているのか?

A: SaySelfは、信頼度推定をキャリブレーションするために強化学習をどのように利用していますか?

SaySelfは、厳密に設計された報酬関数を使用して強化学習を活用し、信頼度推定をキャリブレーションしています.この報酬関数は、正確で高い信頼度の予測を行うようにLLMsを促し、誤った出力に対する過信を罰することで、信頼度推定を調整します.さらに、タスク固有の監督を組み合わせることで、これらの信頼度推定の精度をさらに向上させます.

Q: SaySelfが、誤った出力に対する過信にどのようなペナルティを課しているのか、例を挙げていただけますか?

A: SaySelfは、綿密に作られた報酬関数による強化学習を利用することで、誤った出力における過信にペナルティを与えます.この関数はLLMに正確で信頼性の高い予測を提供するよう動機付け、誤った回答に対する過信にペナルティを与えます.過信に対するペナルティは報酬関数を通じて課され、信頼度のキャリブレーション誤差を減らすようモデルに動機付ける.

Q: SaySelfの分布内データセットと分布外データセットでの実験テストの結果はどうでしたか?

A: SaySelfの実験結果では、信頼性のキャリブレーションエラーを減少させ、タスクのパフォーマンスを維持する効果が示されました.生成された自己反省的な根拠は合理的であり、キャリブレーションにさらに貢献できることが示されました.これらの結果は、内部の不確実性を示すより合理的な自己反省的な根拠を生成できることを示しました.この結論は、in-distribution(HotpotQA)およびout-of-distributionデータセットの両方で成立し、SaySelfの一般的な適用可能性を示しています.

Q: SaySelfが生み出す自己反省的な根拠は、自信のキャリブレーションにどのように貢献するのか?

A: SaySelfによって生成された自己反省的な根拠は、特定の知識の不確実性を自然言語で要約することによって、パラメトリック知識の欠陥を明確に特定し、不確実性を説明することができます.これは、複数のサンプリングされた推論チェーンの不一致を分析することに基づいて行われ、その結果得られたデータは教師付きの微調整に利用されます.さらに、厳密に設計された報酬関数を用いた強化学習を利用して、信頼度の推定値を較正し、LLMに正確で高い信頼度の予測を提供するように促し、誤った出力に対する過度の自信に対して罰則を科します.

Q: SaySelfのコードをGitHubで公開する意義について教えてください.

A: SaySelfのコードをGitHubで公開することの重要性は、他の研究者や開発者がこの技術を理解し、改善するためにアクセスできるようにすることです.これにより、SaySelfの機能やアルゴリズムに対する透明性が向上し、コミュニティ全体がその利点を最大限に活用できるようになります.

Q: LLMの分野で、SaySelfが将来どのような応用や発展を遂げる可能性がありますか?

A: SaySelfの将来の応用や発展は、LLMsの相互作用とパフォーマンスの向上に向けた自己反省的な根拠による指針を提供し、外部ツールの呼び出しや質問の明確化など、後続の手順を実行することができます.また、SaySelfによって訓練されたLLMsには、持続的な学習のために人間との相互作用を向上させるプロアクティブな学習アルゴリズムなど、訓練プロトコルの有望な発展が期待されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/xu1868/SaySelf です.

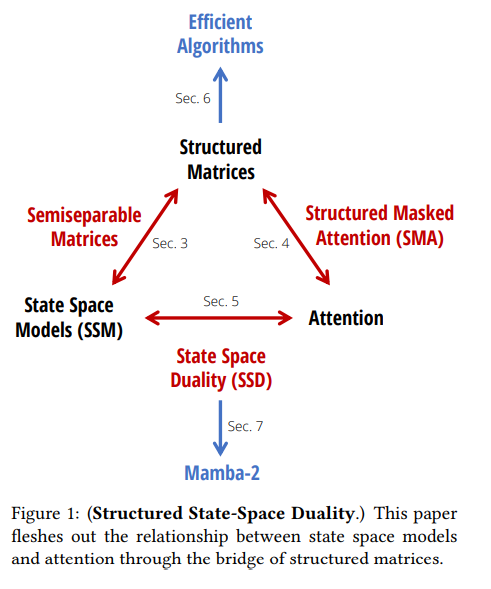

Transformers are SSMs: Generalized Models and Efficient Algorithms Through Structured State Space Duality

著者:Tri Dao, Albert Gu

発行日:2024年05月31日

最終更新日:2024年05月31日

URL:http://arxiv.org/pdf/2405.21060v1

カテゴリ:Machine Learning

概要:

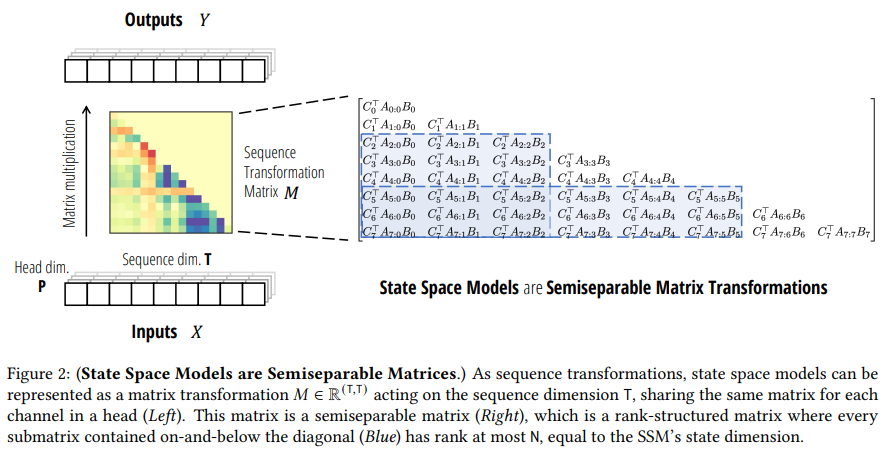

ディープラーニングの成功において、トランスフォーマーは言語モデリングの主要なアーキテクチャでしたが、最近ではMambaなどの状態空間モデル(SSM)が小規模から中規模でトランスフォーマーを凌駕または匹敵することが示されています.我々は、これらのモデルファミリーが実際には非常に密接に関連しており、様々な構造化された半分分離行列の分解を介して、SSMと注意の変種の間の理論的な接続の豊富な枠組みを開発しました.私たちの状態空間デュアリティ(SSD)フレームワークにより、Mambaの選択的SSMを改良した新しいアーキテクチャ(Mamba-2)を設計することができました.この新しいアーキテクチャは、コアレイヤーが2〜8倍速くなりながら、言語モデリングにおいてトランスフォーマーと競争力を維持しています.

Q&A:

Q: 状態空間モデル(SSM)と注目の変種との理論的なつながりについて、もう少し詳しく説明していただけますか?

A: 状態空間モデル(SSM)と注意の変種との間には、構造化された行列を介した関係があります.この関係は、構造化された行列を通じて、構造化された状態空間モデル(SSD)と注意の変種を結びつける枠組みであり、構造化された行列は、部分二次パラメータと乗算複雑性を持つ行列です.シーケンスモデルを表現するための2つの広範なフレームワークが開発されており、1つは行列変換として、もう1つはテンソル収縮として機能します.

Q: 構造化された状態空間二元性(SSD)のフレームワークは、Mamba-2のような新しいアーキテクチャーの開発をどのように可能にするのでしょうか?

A: 構造化状態空間デュアリティ(SSD)フレームワークは、SSMと構造化アテンションの交差点において新しいアーキテクチャ(Mamba-2)の設計を導くことができます.このフレームワークは、SSMとアテンションの変種との間の理論的な接続の豊富な枠組みを開発し、よく研究された構造化半分分離行列のさまざまな分解を介してそれらのモデルファミリーが実際に密接に関連していることを示しています.Mamba-2のコア層は、Mambaの選択的SSMの改良であり、2-8倍速くなりながらも、言語モデリングにおいてTransformersと競争力を維持しています.

Q: SSMとアテンション・バリアントとの理論的なつながりにおいて、構造化半分離行列の具体的な分解はどのように利用されているのだろうか?

A: 構造的半分離可能行列の特定のブロック分解が、SSMと注意の変種の理論的な関連で使用されています.

Q: Mamba-2のコアレイヤーがMambaの選択的SSMの改良であり、どのように2-8倍の速度向上を実現しているか詳しく説明していただけますか?

A: Mamba-2のコアレイヤーは、Mambaの選択的SSMを改良したものであり、特にSSDフレームワークを使用しています.SSDは、行列の積をサブルーチンとして使用することで、GPU上の専用の行列乗算ユニット(テンソルコアとしても知られる)を活用することができます.これにより、Mambaの融合連想スキャンよりも2-8倍高速になります.SSDは、シーケンス長に対して線形スケーリングを行うため、シーケンス長2𝐾以上でFlashAttention-2よりも速くなります.

Q: 言語モデリングのパフォーマンスにおいて、トランスフォーマーとマンバのようなSSMの主な違いは何ですか?

A: TransformersとMambaのようなSSMの主な違いは、言語モデリングの性能において、Mambaが小規模から中規模でTransformersを上回ることが示されている点です.Mambaは、構造化された状態空間モデルであり、Transformersとは異なるアーキテクチャを持ち、SSMとしての性能を活かしています.また、MambaはTP-friendlyな設計であり、大規模なTransformerモデルをトレーニングするためのモデル並列化技術であるTensor Parallelism(TP)を活用しています.さらに、Mambaはシーケンス並列化にも対応しており、長いシーケンスに対しても効率的に学習を行うことができます.

Q: マンバのようなSSMは、中小規模ではどのようにトランスフォーマーに匹敵し、あるいは上回るのか?

A: SSM(State Space Models)のようなMambaは、小規模から中規模のスケールでTransformersを上回るか、あるいは同等の性能を発揮することが最近示されています.これらのモデルファミリーは実際には非常に密接に関連しており、注意の変種とSSMの間には、よく研究されたクラスのさまざまな分解を介して、理論的なつながりが存在します.

Q: ディープラーニング・アーキテクチャでMambaのような状態空間モデルを使用する主な利点は何ですか?

A: Mambaのような状態空間モデルを使用する主な利点は、可変長シーケンスに対してパディングトークンを削除し、効率的に変数シーケンス長でトレーニングできることです.また、Mamba-2は、言語モデリング、トレーニング効率、および難しいマルチクエリ連想リコールタスクにおいて、競争力のある性能を示すことができます.

Q: SSMとアテンションバリアントの関係は、言語モデリングタスクの効率と効果にどのような影響を与えるのか?

A: SSMと注意の変種の関係は、言語モデリングタスクの効率と効果に大きな影響を与えます.具体的には、構造化されたSSMと注意の変種の理論的枠組みを構築することで、Transformersに最適化されたアルゴリズムやシステムの最適化をSSMに移植することが可能となります.これにより、SSMがTransformersよりも優れた性能を発揮し、シーケンスの長さをより効率的にスケーリングする基礎モデルを構築することが目指されています.具体的には、Linear Attention(LA)フレームワークが、自己回帰的な注意と線形RNNの間につながりを導き、効率的な並列トレーニングと効率的な自己回帰推論の両方を可能にするという新しい機能を提供しています.この論文も同様の精神で、線形計算量のSSMと二次計算量の形式を結びつける複数の視点を提供し、SSMと注意の強みを組み合わせることができるようにしています.

Q: ディープラーニングや自然言語処理の分野において、構造化状態空間双対性フレームワークの今後の発展や応用の可能性は?

A: 構造化状態空間二重性フレームワークの将来の発展や応用は、深層学習や自然言語処理の分野において、新しい効率的なアルゴリズムやモデルの開発につながる可能性があります.構造化状態空間二重性によって、状態空間モデルと注意機構の間の関係がより深く理解され、これらの要素を組み合わせた新たなモデルやアプローチが生まれるかもしれません.