ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- GNN-RAG: Graph Neural Retrieval for Large Language Model Reasoning

発行日:2024年05月30日

知識グラフ(KG)を活用した質問応答システムであるGNN-RAGは、LLMとGNNを組み合わせて高性能を実現し、複数ホップや複数エンティティの質問において競合手法を上回る結果を示している. - Contextual Position Encoding: Learning to Count What’s Important

発行日:2024年05月29日

CoPEは、LLMの新しい位置エンコーディング方法であり、特定のトークンのみで位置を増分することで、位置をコンテキストに条件付けることが可能になります. - Faithful Logical Reasoning via Symbolic Chain-of-Thought

発行日:2024年05月28日

SymbCoTは、LLMの論理推論能力を向上させるための新しいフレームワークで、象徴的な表現と論理ルールを統合しています. - An Introduction to Vision-Language Modeling

発行日:2024年05月27日

最近、大規模言語モデル(LLMs)の人気が高まり、視覚領域に拡張されたビジョン言語モデル(VLM)のアプリケーションが技術に影響を与えるが、信頼性向上のために課題が解決される必要がある. - Transformers Can Do Arithmetic with the Right Embeddings

発行日:2024年05月27日

トランスフォーマーの算術タスクにおける低いパフォーマンスは、各桁の正確な位置を追跡する能力の不足から生じ、埋め込みを追加することで修正され、20桁の数字のみをトレーニングすることで100桁の加算問題で最大99%の精度を達成し、他の推論タスクでも改善を示す. - Are Long-LLMs A Necessity For Long-Context Tasks?

発行日:2024年05月24日

長いLLMの学習と展開は依然として難しいが、LC-Boostフレームワークは短いLLMを使って長いコンテキストのタスクに効果的に対処することができる. - Aya 23: Open Weight Releases to Further Multilingual Progress

発行日:2024年05月23日

Aya 23は、Ayaモデルをベースにした多言語言語モデルで、世界の半分の人口に言語モデリング能力を提供し、幅広いタスクで優れた性能を示す. - SimPO: Simple Preference Optimization with a Reference-Free Reward

発行日:2024年05月23日

SimPOは、最新の難しいArena-Hardベンチマークで優れたパフォーマンスを示し、AlpacaEval 2とArena-Hardで他のアプローチを上回る結果を達成しています. - Attention as an RNN

発行日:2024年05月22日

Transformersの進化により、Aarenという新しいattentionベースのモジュールが導入され、従来のRNNよりも高い効率性を持ちながら、Transformersと同等の性能を38のデータセットで達成しています.

GNN-RAG: Graph Neural Retrieval for Large Language Model Reasoning

著者:Costas Mavromatis, George Karypis

発行日:2024年05月30日

最終更新日:2024年05月30日

URL:http://arxiv.org/pdf/2405.20139v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

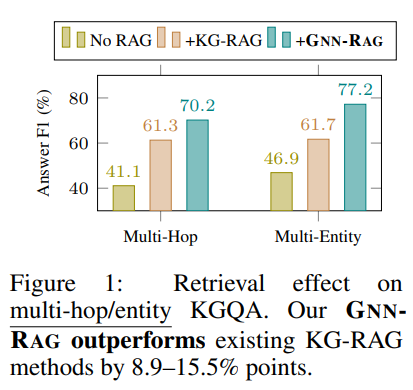

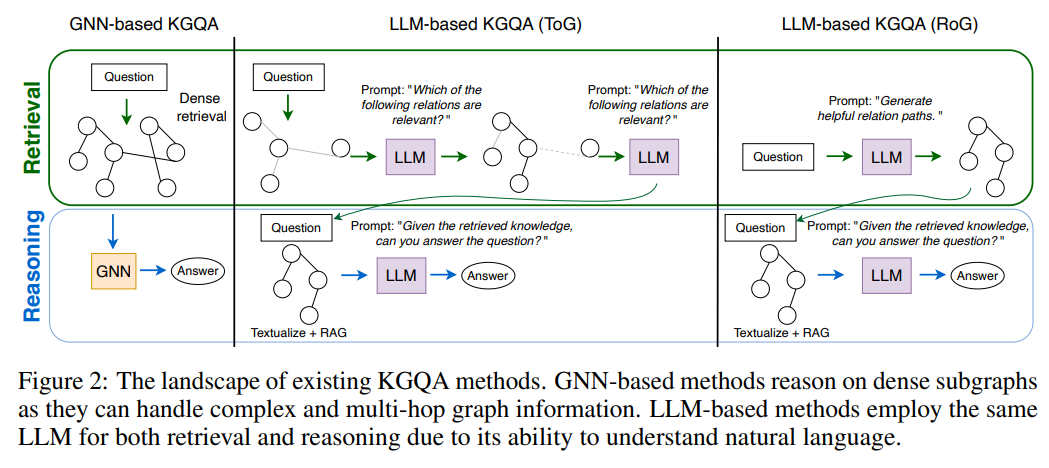

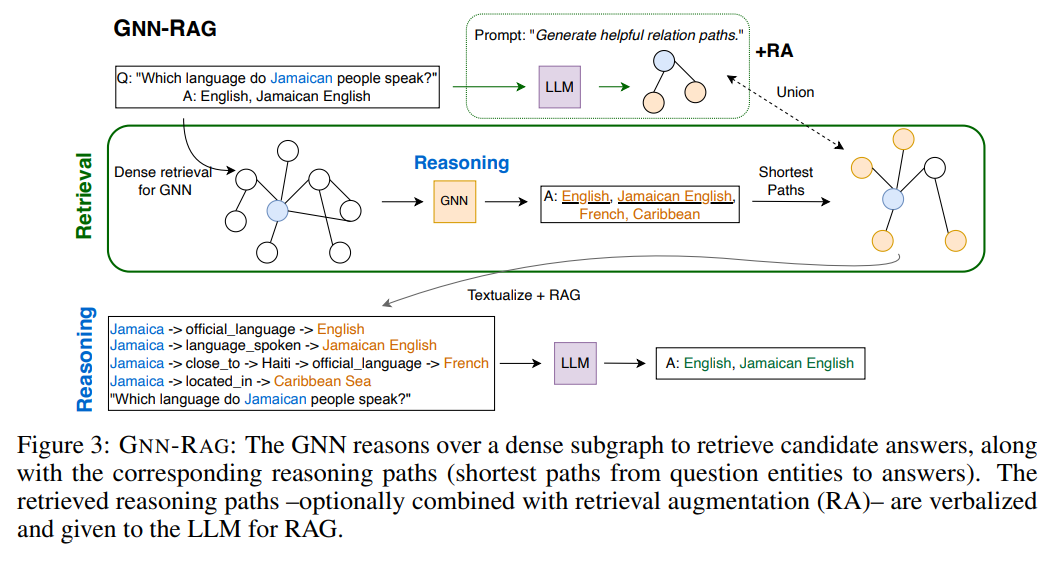

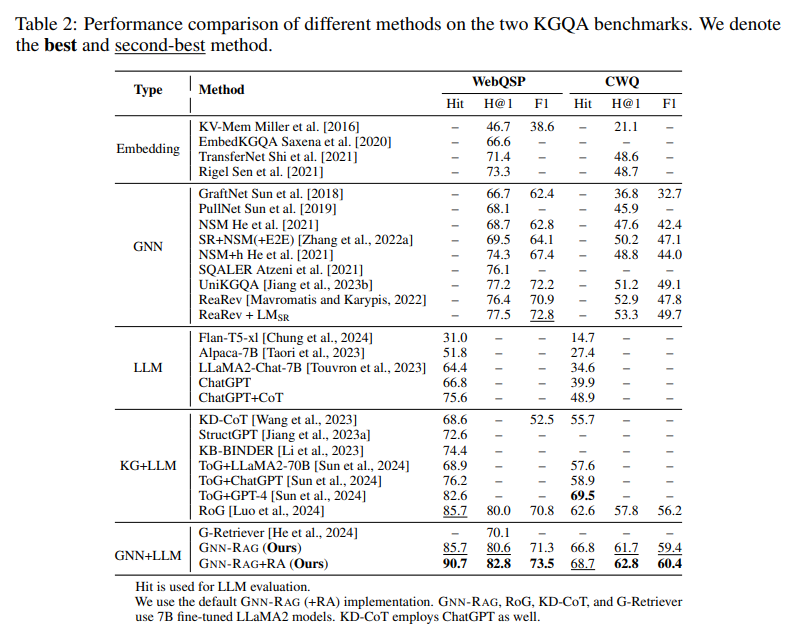

知識グラフ(KG)は、三つ組(head、relation、tail)の形で人間が作成した事実知識を表し、それらがグラフを形成しています.知識グラフ上の質問応答(KGQA)は、KGに提供された情報に基づいて自然な質問に答えるタスクです.大規模言語モデル(LLM)は、自然言語を理解する能力が優れているため、QAタスクの最先端モデルです.一方、グラフニューラルネットワーク(GNN)は、KGに格納された複雑なグラフ情報を処理できるため、KGQAに広く使用されています.本研究では、LLMの言語理解能力とGNNの推論能力を組み合わせた新しい手法であるGNN-RAGを紹介します.まず、GNNは密なKGサブグラフ上で推論を行い、与えられた質問に対する回答候補を取得します.次に、質問エンティティと回答候補を接続するKG内の最短経路を抽出し、KG推論パスを表現します.抽出されたパスは、LLM推論にRAG形式で入力されるために言語化されます.GNN-RAGフレームワークでは、GNNは密なサブグラフ推論者として機能し、LLMは推論を行います.さらに、我々は検索補完(RA)技術を開発し、GNN-RAGを用いてKGQAの性能をさらに向上させました.実験結果によると、GNN-RAGは、広く使用されているKGQAベンチマーク(WebQSPとCWQ)で最先端の性能を達成し、7B調整されたLLMを用いたGPT-4の性能を上回るか匹敵します.さらに、GNN-RAGは、複数ホップおよび複数エンティティの質問において、回答F1で競合手法を8.9〜15.5%ポイント上回る優れた性能を発揮します.

Q&A:

Q: GNN-RAGフレームワークにおけるグラフ・ニューラル・ネットワーク(GNN)の具体的な役割について教えてください.

A: GNN-RAGフレームワークにおけるGraph Neural Networks(GNNs)の具体的な役割は、複雑な知識グラフ(KG)情報を処理し、有用なグラフ情報を抽出することです.GNNは、密なKGサブグラフ上で推論を行い、与えられた質問に対する回答候補を取得します.さらに、質問エンティティとGNNベースの回答を接続するKG内の最短パスを抽出し、有用なKG推論パスを表現します.これらの推論パスは、LLM推論とRAGにおける入力として使用されます.GNNは、密なサブグラフ推論機として機能し、有用なグラフ情報を抽出します.そして、LLMは、自然言語処理能力を活用して最終的なKGQAを行います.

Q: GNN-RAGのGNNは、与えられた質問に対する回答候補を検索するために、どのように密なKG部分グラフを推論するのか?

A: GNNは密なKGサブグラフ上で推論を行い、与えられた質問に対する回答候補を取得します.最初に、GNNは質問に対する回答候補を取得するために密なKGサブグラフ上で推論を行います.次に、質問エンティティとGNNベースの回答を接続するKG内の最短パスが抽出され、有用なKG推論パスを表現します.

Q: GNN-RAGにおいて、質問エンティティと回答候補を結ぶKGの最短パスを抽出する意義は何か?

A: GNN-RAGにおいて、質問エンティティと回答候補を結ぶKG内の最短パスを抽出することの重要性は、GNNが密なサブグラフを理由として回答候補を取得し、その後、質問エンティティとGNNベースの回答を結ぶKG内の最短パスを抽出することで、有用なKG推論パスを表現することにあります.このようにして抽出されたパスは、LLMとRAGを用いた推論において入力として提供され、自然言語処理能力を活用するLLMと、有用なグラフ情報を抽出するGNNの相互補完的な役割が最大限に活用されることが可能となります.

Q: 抽出されたパスはどのように言語化され、GNN-RAGフレームワークにおけるRAGを用いた大規模言語モデル(LLM)推論の入力として与えられるのか?

A: 抽出されたパスは、GNN-RAGフレームワーク内のLLM推論において、言語モデル(LLM)の理解として言語化され、入力として与えられます.

Q: GNN-RAGでKGQAのパフォーマンスを高めるために開発された検索補強(RA)技術について詳しく教えてください.

A: GNN-RAGでKGQAの性能をさらに高めるために、検索補強(RA)技術を開発した.この技法は、異なる検索アプローチの長所を組み合わせ、多様性と回答想起を向上させる.具体的には、GNN-RAG RA技術はGNN検索をLLMベースの検索で補完し、それぞれマルチホップおよびシングルホップの質問に対する能力を組み合わせる.推論中、両検索器によって検索された推論パスは、それらの結合を取ることによって結合される.LLMベースの検索は、効果的ではあるが、多様なパスを検索するために複数世代(ビームサーチ復号化)を必要とし、有効性のために効率性を犠牲にしている.実験の結果、GNN-RAGはKGQAベンチマークにおいて最先端の性能を達成し、7BにチューニングされたLLMを持つGPT-4の性能を上回る、あるいはそれに匹敵する性能を示した.GNN-RAGは、複雑な質問に対する忠実なLLM推論に必要なマルチホップ情報の検索に優れており、性能の大幅な向上を示している.この検索補強技術は、特に深いグラフ検索が重要な場合に、KGQAを成功させるための効果的な手法である.

Q: WebQSPとCWQベンチマークにおけるGNN-RAGの最先端の性能を示す実験結果は?

A: GNN-RAGはWebQSPおよびCWQベンチマークでの実験結果により、最先端のパフォーマンスを実証しています.

Q: GNN-RAGは、7BチューンのLLMを使用したGPT-4のパフォーマンスと比較して、KGQAのパフォーマンスはどうですか?

A: GNN-RAGは、7B調整されたLLMと比較して、KGQAのパフォーマンスにおいてGPT-4のパフォーマンスを上回るか、または匹敵することが示されています.

Q: GNN-RAGは、競合するアプローチと比較して、どのような点でマルチホップやマルチエンティティの問題に優れているのでしょうか?

A: GNN-RAGは、複雑なグラフ情報を扱うためにGNNを活用し、他のアプローチに比べてマルチホップおよびマルチエンティティの質問において優れた性能を発揮します.具体的には、WebQSPおよびCWQにおいて、RoG(LLMベースの検索)をF1で6.5〜17.2%上回り、GNN-RAG+RAはさらに7%の改善を提供します.また、GNN-RAGは、複数ホップおよび複数エンティティの質問において、他のアプローチに比べて優れた性能を発揮します.

Q: GNN-RAGのGNNは、どのように密な部分グラフ推論器として働き、有用なグラフ情報を抽出するのか?

A: GNNは密なサブグラフの理由として機能し、有用なグラフ情報を抽出します.GNNは複雑なグラフ相互作用を処理し、多段階の質問に答える能力があるため、高品質の推論パスを取得するために使用されます.GNNの推論が完了すると、サブグラフ内のすべてのノードが更新され、GNN-RAGはリトリーバーとKGQAモデルのトレーニングに同じまたはそれ以下のデータを使用します.

Q: GNN-RAGのLLMは、究極のKGQAのために自然言語処理能力をどのように活用するのか?

A: LLMは自然言語処理能力を活用して究極のKGQAを実現します.GNN-RAGフレームワークでは、GNNは有用なグラフ情報を抽出するための密なサブグラフ推論者として機能し、一方、LLMは自然言語処理能力を活用して究極のKGQAを実現します.

Contextual Position Encoding: Learning to Count What’s Important

著者:Olga Golovneva, Tianlu Wang, Jason Weston, Sainbayar Sukhbaatar

発行日:2024年05月29日

最終更新日:2024年05月30日

URL:http://arxiv.org/pdf/2405.18719v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

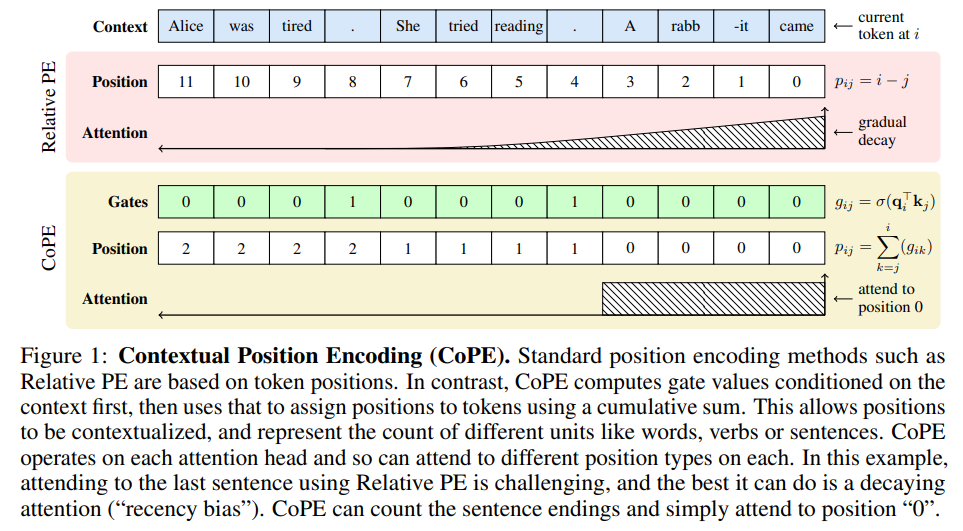

注目メカニズムは、大規模言語モデル(LLM)の重要なコンポーネントであり、シーケンス内のトークンが互いに相互作用することを可能にしますが、順序には依存しません.位置エンコーディング(PE)を組み込むことで、i番目のトークンに注意を払うなど、位置によってアクセスすることが可能になります.しかし、現在のPEメソッドは、位置を導出するためにトークン数を使用しており、したがって、i番目の文に注意を払うなど、より高い抽象度のレベルに一般化することができません.本論文では、コンテキストに依存した新しい位置エンコーディング方法であるContextual Position Encoding(CoPE)を提案し、モデルによって決定された特定のトークンのみで位置を増分することで、位置をコンテキストに条件付けることが可能になります.これにより、特定の単語、名詞、または文に注意を払うなど、より一般的な位置アドレッシングが可能になります.CoPEは、一般的な位置埋め込みが失敗する選択的コピー、カウント、フリップフロップタスクを解決し、言語モデリングやコーディングタスクのパープレキシティを改善することができることを示しています.

Q&A:

Q: ラージ・ランゲージ・モデル(LLM)におけるアテンション・メカニズムについて教えてください.

A: Large Language Models(LLMs)における注意機構は、トークン間の相互作用を可能にする重要なコンポーネントであり、順序に関係なく機能します.この注意機構は、シーケンスを集合として扱い、順序情報を欠いています.そのため、位置エンコーディング(PE)を組み込むことで、この問題に対処できます.PEは、各位置に埋め込みベクトルを割り当て、それを対応するトークン表現に追加することでこれを実現します.位置は、絶対PE(シーケンスの開始からトークンを数える)と相対PE(現在のトークンから逆に数える)の2つの方法で測定できます.

Q: 位置エンコーディング(PE)を取り入れることで、LLMにおける順序不変性の問題はどのように解決されるのだろうか?

A: 位置エンコーディング(PE)を組み込むことにより、LLM(Large Language Models)における不変性の問題を解決することができます.PEは、位置情報をトークンに割り当てることで、文脈に応じて位置を調整することができるため、順序に依存しないアテンションメカニズムを補完します.

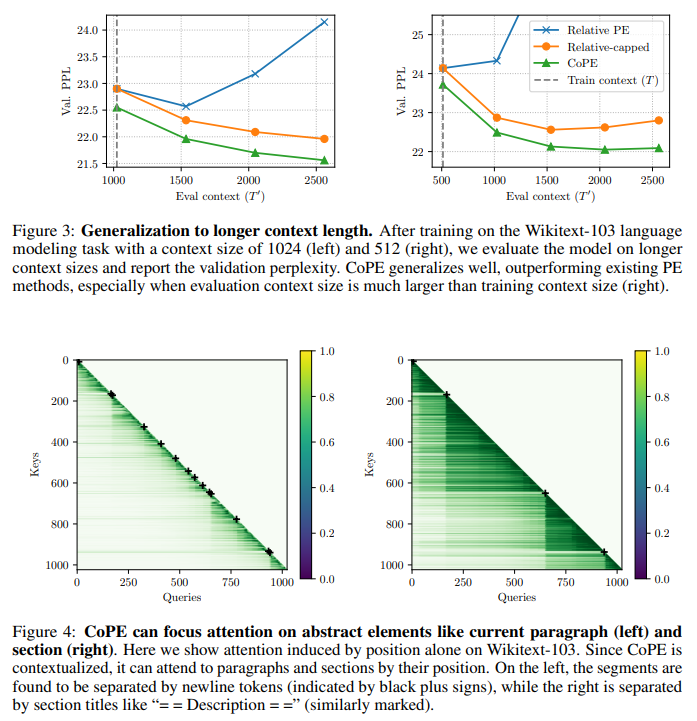

Q: より高い抽象度への一般化という点で、現在の体育のメソッドにはどのような限界があるのか?

A: 現在のPE方法の制限は、高い抽象度に一般化する際に問題があると言えます.相対PEは長いコンテキストサイズに対して一般化がうまくいかず、絶対PEはさらに悪い結果を示します.一方、CoPEは比較的健全なパフォーマンスを示しますが、訓練コンテキストよりもテストコンテキストがはるかに長い場合、CoPEを上回る結果となります.

Q: 提案手法であるContextual Position Encoding (CoPE)は、現行のPE手法とどう違うのか?

A: 提案された方法、Contextual Position Encoding(CoPE)は、現在のPE方法と異なります.CoPEは、文脈に依存して位置を測定するため、トークンベースの位置パラダイムから離れています.これにより、位置によるアドレッシング時により自由度が増し、いくつかのタスクで利益をもたらします.一方、従来の埋め込み方法では失敗すると予想されるタスクに主に焦点を当て、大規模なデータセット(Wikitext-103およびCode collection)でアプローチをテストしました.しかし、CoPEが数十億のパラメータを持つ大規模な言語モデルでどのように機能するかはテストしていませんでした.使用したモデルは比較的小さかったため、これらの大きなモデルを評価するために使用される関連する一般的なベンチマークでの方法をテストしていませんでした.

Q: CoPEによって、どのようにポジションが文脈に左右されるのか、例を挙げていただけますか?

A: CoPEは、モデルによって決定された特定のトークンのみに位置を増分させることで、文脈に応じて位置を条件付けることを可能にします.これにより、i番目の特定の単語、名詞、または文に注意を向けるなど、より一般的な位置のアドレッシングが可能となります.

Q: CoPEは、選択的コピー、計数、Flip-Flopなどのタスクにおいて、一般的な位置埋め込みと比較してどのようなパフォーマンスを発揮するのだろうか?

A: CoPEは、一般的な位置埋め込みが失敗する選択的コピー、カウント、フリップフロップのタスクにおいて優れた性能を発揮します.

Q: CoPEは、言語モデリングとコーディングのタスクにおいて、どのような方法で当惑度を向上させるのか?

A: CoPEは、一般的な位置アドレッシングを可能にし、i番目の特定の単語、名詞、または文に注意を向けることができるため、選択的コピー、カウント、フリップフロップのタスクを解決し、言語モデリングおよびコーディングタスクのパープレキシティを改善します.

Q: CoPEは、コンテキストに基づいて、どのトークンの位置をインクリメントするかをどのように決定するのですか?

A: CoPEは、現在のトークンをクエリベクトルとして取り、それらのキーベクトルを使用して、各前のトークンに対してゲート値を計算します.その後、これらのゲート値を集約して、各トークンの現在のトークンに対する相対的な位置を決定します.このようにして、CoPEはコンテキストに依存した方法でトークンを数えることができます.

Q: CoPEによって、特定の単語や名詞、文に注目するなど、より一般的なポジションのアドレッシングがどのように可能になるのか説明できますか?

A: CoPEは、モデルによって決定されたトークンによって位置を特定することができます.これにより、i番目の特定の単語、名詞、または文にアクセスするなど、より一般的な位置指定が可能となります.CoPEは、一般的な位置埋め込みが失敗する選択的コピー、カウント、フリップフロップのタスクを解決し、言語モデリングやコーディングタスクのパープレキシティを改善できることを示しています.

Q: 大規模言語モデルの性能を向上させるためにCoPEを使用することの潜在的な意味は?

A: CoPEを使用することで、大規模言語モデルの性能向上に潜在的な影響がある可能性があります.CoPE埋め込みは、絶対PEとRoPEに比べてパープレキシティを17%および5%改善しました.また、RoPEとCoPE埋め込みを組み合わせることでRoPEよりも性能が向上しますが、提案された埋め込み方法よりも改善が見られませんでした.

Faithful Logical Reasoning via Symbolic Chain-of-Thought

著者:Jundong Xu, Hao Fei, Liangming Pan, Qian Liu, Mong-Li Lee, Wynne Hsu

発行日:2024年05月28日

最終更新日:2024年06月11日

URL:http://arxiv.org/pdf/2405.18357v2

カテゴリ:Computation and Language

概要:

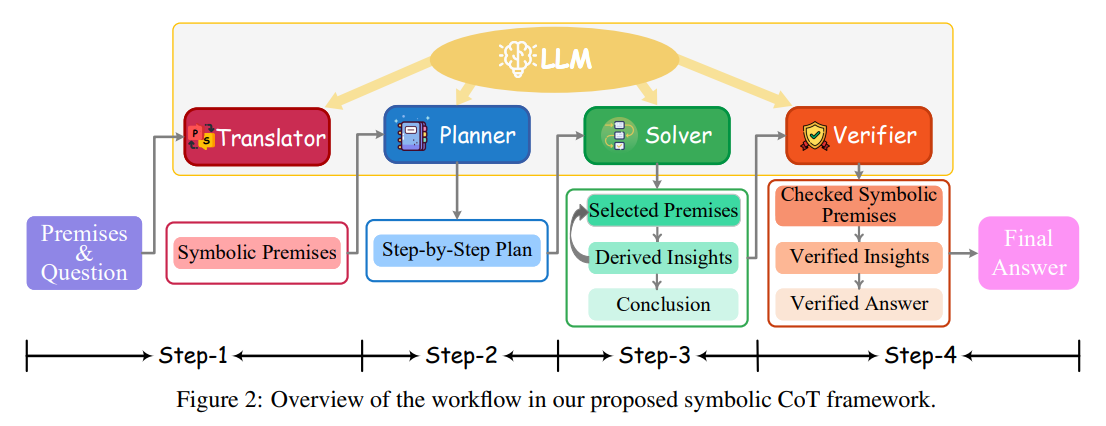

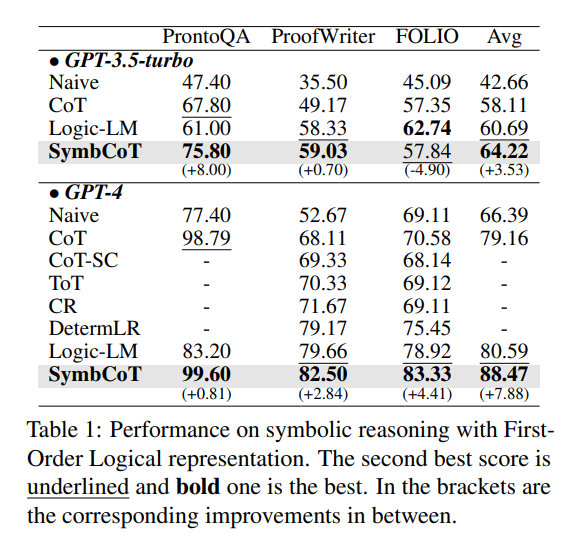

最近のChain-of-Thought(CoT)技術は、心の理論を用いて大規模言語モデル(LLM)の推論能力を向上させていますが、象徴的な表現や厳密な推論ルールに依存する論理推論を扱う際には依然として苦労するかもしれません.LLMの論理推論能力を強化するために、我々は新しいSymbolic Chain-of-Thought、すなわちSymbCoTを提案します.これは、象徴的な表現と論理ルールをCoTプロンプトと統合した完全なLLMベースのフレームワークです.技術的には、LLMを基盤として、SymbCoTはまず自然言語コンテキストを象徴的な形式に変換し、次に象徴的な論理ルールを用いて問題を解決するための段階的な計画を導き出し、最後に翻訳と推論チェーンをチェックする検証者を行います.First-Order LogicとConstraint Optimizationの象徴的表現を使用した5つの標準データセットでの徹底的な評価により、SymbCoTはCoT方法よりも一貫して顕著な改善を示し、同時に現在の最先端のパフォーマンスを更新しています.さらに、我々のシステムがより忠実で柔軟で説明可能な論理推論に進歩していることを示します.私たちの知る限り、これは最も詳細で包括的な論理推論の進歩です.さらに、象徴的な表現とルールをCoTに組み込んだ初めての論理推論のための取り組みであり、コードはhttps://github.com/Aiden0526/SymbCoTで公開されています.

Q&A:

Q: 記号表現や厳密な推論ルールに依存する論理的推論を扱う際に、CoTテクニックが直面する具体的な課題について説明していただけますか?

A: CoT技術が論理推論を扱う際に直面する具体的な課題は、シンボリック表現や厳密な推論ルールに依存する論理推論を処理することが困難であることです.自然言語のみを使用するCoTでは、シンボリック表現や厳密な推論ルールに基づく論理推論を適切に処理することが難しいため、より厳密な論理計算を容易にするために、新しいSymbolic Chain-of-Thought(SymbCoT)が提案されています.

Q: SymbCoTフレームワークは、LLMの論理的推論能力を高めるために、記号式と論理ルールをCoTプロンプティングとどのように統合するのか?

A: SymbCoTフレームワークは、自然言語コンテキストをシンボリック形式に変換し、その後、シンボリック論理ルールを用いて論理推論問題を解決するためのステップバイステップの計画を導出し、その後、翻訳と推論チェーンを確認する検証者によって、シンボリック表現と論理ルールをCoTプロンプトと統合してLLMの論理推論能力を向上させます.

Q: 自然言語の文脈を記号形式に変換し、SymbCoTの記号論理ルールで問題を解決するステップバイステップの計画を導き出すプロセスを教えていただけますか?

A: 自然言語コンテキストをシンボリック形式に翻訳し、シンボリック論理ルールを用いて問題を解決するためのステップバイステップの計画を導出するプロセスをSymbCoTで説明します.まず、元の前提条件集合\( \small P={p1, p2, …, p_n} \)と質問文\( \small S \)が与えられた場合、Translatorはそれらを対応するシンボリック形式に解釈し、\( \small P’={p’_1, p’_2, …, p’_n} \)と\( \small S’ \)として表現します.自然言語とシンボリック表現\( \small P \)と\( \small P’ \)を連結し、\( \small P_c, S \)と\( \small S’ \)を\( \small S_c \)として、将来の推論ステップのためのハイブリッド形式の式にします.

Q: SymbCoTの検証者は翻訳と推論の連鎖をどのようにチェックするのか?

A: SymbCoTの検証者は、最初に元の自然言語コンテキストに基づいて正しく翻訳されたかどうかを確認します.これはVtrans = Verify (P→P′, S→S′)として表され、誤った翻訳が見つかった場合、検証者は修正を行います.次に、検証者は論理的推論の鎖を検証します.これは、論理的推論ステップが形式論理の原則に厳密に準拠しているかどうかを確認するものであり、無効な論理が見つかった場合、検証者は正しい論理に従って推論ステップを修正して新しい答えを導き出します.

Q: 5つの標準的なデータセットで、一次論理式と制約最適化の記号式を用いて徹底的に評価した結果、SymbCoTはCoT法と比べてどうだったのか?

A: 5つの標準データセットにおける第一階層論理と制約最適化の象徴的な表現に関する徹底的な評価の結果、SymbCoTはCoT方法に比べて著しい改善を示しました.

Q: 論理的推論において、SymbCoTは具体的にどのような点で、現在の最先端の性能よりも向上しているのだろうか?

A: SymbCoTは、従来の最先端の論理推論の性能に比べて、より複雑な論理推論タスクにおいて顕著な改善を示し、さらに検証メカニズムによって推論プロセスの忠実性を確保しています.また、完全なLLMベースの論理推論は、より良い記号構文の堅牢性、人間が読みやすい説明、情報のより完全な利用を提供することが示されています.

Q: SymbCoTは、既存の方法と比較して、論理的推論においてより忠実で、柔軟で、説明可能であるという点で、どのように進歩しているのだろうか?

A: SymbCoTは、既存の方法に比べて、論理的推論においてより忠実で柔軟で説明可能性が高まる点で進化しています.これは、完全なLLMベースの論理的推論が、より良い象徴的構文の堅牢性、人間が読みやすい説明、情報のより完全な利用を提供できることが、詳細な分析によって明らかになりました.また、SymbCoTは、従来のCoTよりも論理的推論の能力を大幅に向上させ、現行の最先端技術を明確に上回ることが実験結果から示されています.さらに、論理的推論のタスクがより複雑になるほど、SymbCoTの改善がより顕著になり、推論プロセスの忠実性を確保する検証メカニズムもさらに進化しています.

Q: LLMで論理的な推論をするために、記号式とルールをCoTに組み合わせることの意義を説明できますか?

A: シンボル式とルールをCoTに組み合わせることの重要性は、論理推論におけるLLMsの能力を向上させる点にあります.シンボル式は論理的な計算をより正確に行うために中間推論プロセスを記述するのに役立ちます.一方、ルールは論理的な推論をより柔軟にし、説明可能にします.これにより、LLMsの論理推論能力が向上し、人間のような論理推論能力に近づくことが期待されます.

Q: SymbCoTのコードをGitHubでオープンソースにした動機は何ですか?

A: SymbCoTのコードをGitHubでオープンソースにする動機は、より広い影響を持つために、私たちの研究成果を他の研究者や開発者と共有し、透明性と協力を促進するためです.

Q: SymbCoTや関連プロジェクトについて、今後の計画や進展はありますか?

A: SymbCoTや関連プロジェクトに関する将来の計画や開発が進行中である可能性があります.具体的には、SymbCoTを外部ソルバーと組み合わせることで、両者の補完的な強みを活かすフレームワークの開発が予定されています.これにより、SymbCoTの情報損失やエラー修正の能力と外部ソルバーの広範な探索能力を最適化し、全体的な推論システムの向上を図ることが目指されています.

An Introduction to Vision-Language Modeling

著者:Florian Bordes, Richard Yuanzhe Pang, Anurag Ajay, Alexander C. Li, Adrien Bardes, Suzanne Petryk, Oscar Mañas, Zhiqiu Lin, Anas Mahmoud, Bargav Jayaraman, Mark Ibrahim, Melissa Hall, Yunyang Xiong, Jonathan Lebensold, Candace Ross, Srihari Jayakumar, Chuan Guo, Diane Bouchacourt, Haider Al-Tahan, Karthik Padthe, Vasu Sharma, Hu Xu, Xiaoqing Ellen Tan, Megan Richards, Samuel Lavoie, Pietro Astolfi, Reyhane Askari Hemmat, Jun Chen, Kushal Tirumala, Rim Assouel, Mazda Moayeri, Arjang Talattof, Kamalika Chaudhuri, Zechun Liu, Xilun Chen, Quentin Garrido, Karen Ullrich, Aishwarya Agrawal, Kate Saenko, Asli Celikyilmaz, Vikas Chandra

発行日:2024年05月27日

最終更新日:2024年05月27日

URL:http://arxiv.org/pdf/2405.17247v1

カテゴリ:Machine Learning

概要:

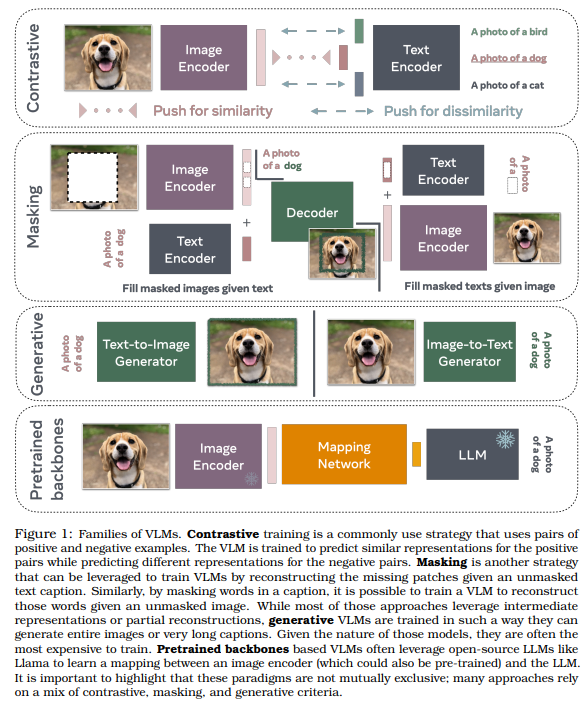

最近、大規模言語モデル(LLMs)の人気が高まっており、いくつかの試みが行われています.これらは、視覚領域に拡張されています.未知の環境を案内してくれる視覚アシスタントから、高レベルのテキスト記述のみを使用して画像を生成する生成モデルまで、ビジョン言語モデル(VLM)のアプリケーションは、私たちの技術との関係に大きな影響を与えるでしょう.しかし、これらのモデルの信頼性を向上させるためには多くの課題が解決される必要があります.言語は離散的である一方、ビジョンは概念を簡単に離散化できないより高次元の空間で進化しています.ビジョンを言語にマッピングするメカニクスをよりよく理解するために、VLMについてのこの紹介を提供します.この紹介は、この分野に参入したい人々に役立つことを願っています.まず、VLMとは何か、どのように機能し、どのようにトレーニングするかを紹介します.次に、VLMを評価するアプローチを紹介し、議論します.この作業は主に画像を言語にマッピングすることに焦点を当てていますが、VLMをビデオに拡張することについても議論します.

Q&A:

Q: 視覚を言語にマッピングする際の課題、特に言語の離散的な性質と視覚の高次元空間の違いについて説明していただけますか?

A: 画像と言語のマッピングにおける課題は、言語の離散性と視覚の高次元空間との違いにあります.言語は離散的であるため、単語や文のような要素が明確に区別されますが、視覚は高次元空間で進化しており、概念が常に簡単に離散化されるわけではありません.言語モデルは単語や文のような離散的な要素を処理するのに適していますが、画像やビデオのような視覚情報は、ピクセルやフレームなどの連続的なデータで表現されるため、この違いが課題となります.視覚情報を言語に変換する際に、この離散性と連続性の違いをどのように調整するかが重要です.

Q: 視覚言語モデル(VLM)はどのように機能し、どのように訓練されるのか?

A: ビジョン言語モデル(VLMs)は、画像と言語を結びつけるために設計されています.これらのモデルは、画像から言語への変換を行うために訓練されます.具体的には、VLMsは画像の特徴を抽出し、それらの特徴を元に言語表現を生成することで機能します.VLMsのトレーニングは、大規模なデータセットを使用して行われます.通常、教師あり学習の一形態であるファインチューニングが行われ、画像と対応する言語データを入力として、モデルを最適化します.

Q: この文章で言及されているように、技術におけるVLMの潜在的な用途にはどのようなものがあるか?

A: VLMの技術は、未知の環境を案内する視覚アシスタントや、高レベルのテキスト記述のみを使用して画像を生成する生成モデルなど、技術との関係に大きな影響を与える可能性があります.

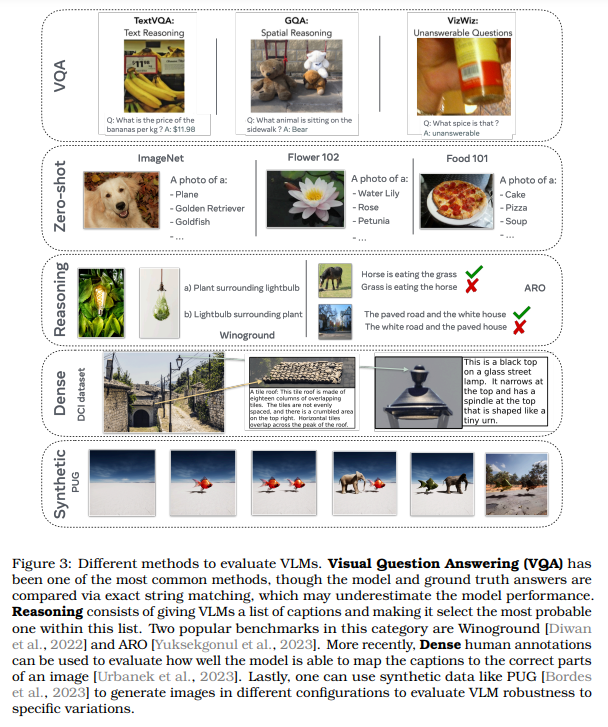

Q: VLMを評価するためのアプローチについて詳しく教えてください.

A: VLMを評価するために使用されるアプローチには、画像キャプショニング、Visual Question Answering(VQA)、テキスト中心のVQA、ゼロショット予測などがあります.これらのタスクは、VLMの視覚言語能力を評価し、モデルが画像からテキストを理解し、読み取る能力を評価します.また、Radfordらによって導入されたゼロショット予測によるImageNet分類タスクなどの分類タスクも一般的です.

Q: このVLMの紹介は、この分野への参入に関心を持つ個人をどのように支援することを目的としているのだろうか?

A: このVLMの導入は、研究分野に参入したい個人が、VLMが何であり、どのように訓練され、異なる研究目標に応じてVLMを効果的に評価する方法を理解するのを助けることを目的としています.この導入は、VLM研究の完全なガイドや調査としてではなく、VLM研究分野からのすべての作品を引用することを目指していません.また、この作業がこの分野でのすべてのベストプラクティスを網羅しているわけでもありません.代わりに、VLM研究のための効果的な実践を強調し、分かりやすい導入を提供することを目指しています.この導入は、特にこの分野に参入したい学生や他の分野の研究者にとって特に役立つはずです.

Q: イメージを言語にマッピングするという点で、この作品の主眼は何ですか?

A: この研究の主な焦点は、画像と言語の間のマッピングにおいて、事前にトレーニングされたLLMや画像エンコーダを活用して、モダリティ間のマッピングのみを学習することにあります.

Q: VLMはどのようにビデオに拡張されているのですか?

A: VLMは、オブジェクトの動きやダイナミクスを理解し、オブジェクトやアクションを空間的・時間的にローカライズし、時間次元のようなビデオデータ特有の課題に対処する機能を組み込むことで、ビデオに拡張されつつある.この拡張には、計算コストの増加への対応や、テキストによる時間次元のマッピングなど、動画用VLMにおけるトレードオフが含まれる.

Q: 大規模言語モデル(LLM)とVLMの主な違いは何ですか?

A: LLMとVLMの主な違いの1つは、LLMは言語モデルであり、テキストデータに基づいて学習されるのに対し、VLMは視覚と言語の両方を組み合わせたモデルであり、画像やビデオなどの視覚データとテキストデータの間の関係を学習します.また、LLMは言語のみを扱うのに対し、VLMは高次元の視覚空間という異なるデータ形式を扱うため、異なる学習アプローチや評価基準が必要とされます.

Q: 高レベルのテキスト記述だけを使って、生成モデルはどのように画像を生成するのか?

A: 生成モデルは、高レベルのテキスト記述を入力として受け取り、その記述に基づいて画像を生成します.このプロセスは、画像生成コンポーネントを組み込んだ大規模なトレーニングによって行われます.生成モデルは、入力データ空間内の抽象的な表現をデコードする能力を持つことで、モデルが学習した内容を理解し評価することが容易になります.

Q: VLMの信頼性を向上させるために取り組むべき主な課題は何でしょうか?

A: VLMの信頼性を向上させるためには、モデルの性能を評価するための信頼性の高いベンチマークが必要です.最近導入された多くのベンチマークはありますが、いくつかのベンチマークには重要な制限があります.VLMのベンチマークの強みと弱みを議論することで、VLMの理解を向上させるための課題に光を当てることができます.具体的には、VLMの視覚言語能力を評価するベンチマークやバイアスを測定する方法について議論し、ビデオを理解する次世代のVLMがどのように進化するかを示すことが重要です.

Transformers Can Do Arithmetic with the Right Embeddings

著者:Sean McLeish, Arpit Bansal, Alex Stein, Neel Jain, John Kirchenbauer, Brian R. Bartoldson, Bhavya Kailkhura, Abhinav Bhatele, Jonas Geiping, Avi Schwarzschild, Tom Goldstein

発行日:2024年05月27日

最終更新日:2024年05月27日

URL:http://arxiv.org/pdf/2405.17399v1

カテゴリ:Machine Learning, Artificial Intelligence

概要:

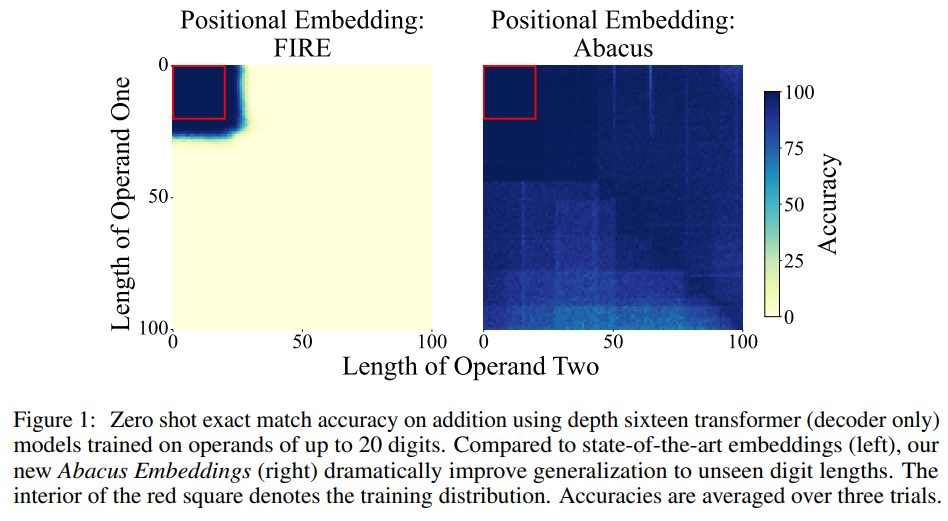

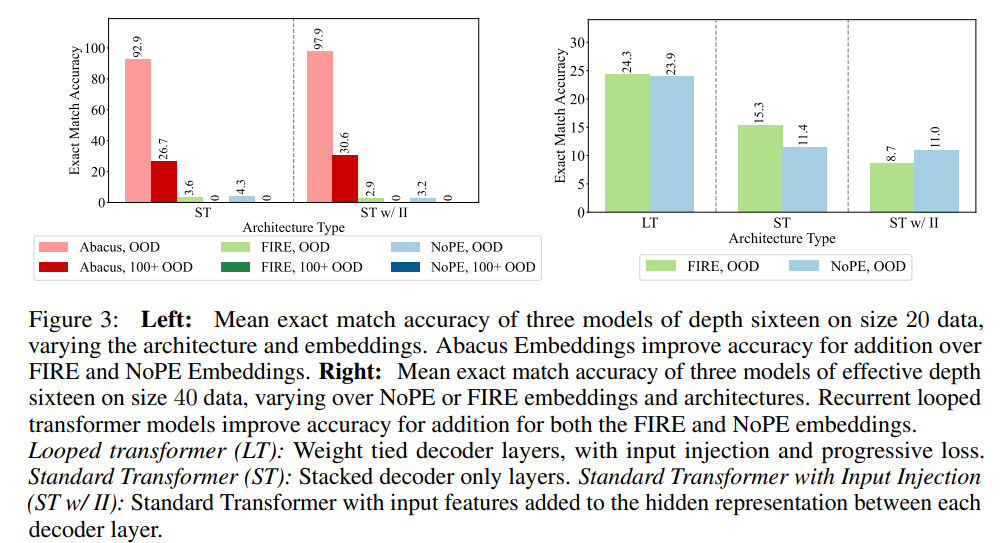

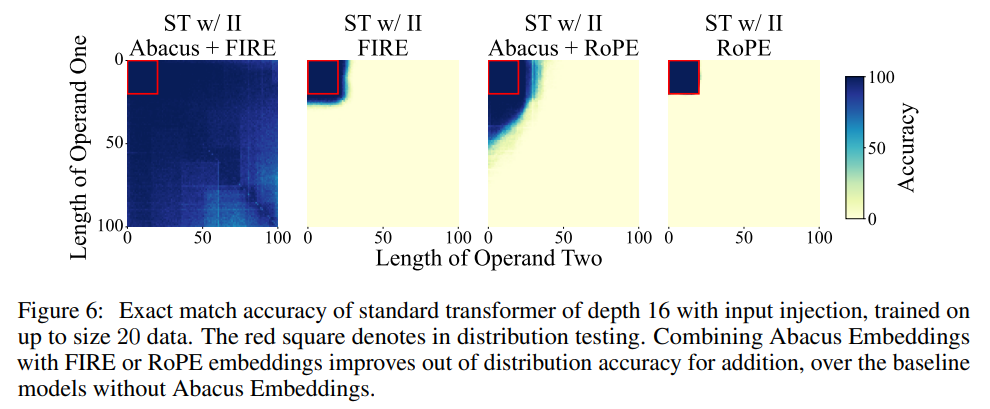

トランスフォーマーの算術タスクにおける低いパフォーマンスは、大きな数字の中で各桁の正確な位置を追跡する能力の不足から主に生じるようです.私たちは、各桁に埋め込みを追加し、数字の開始位置に対する位置をエンコードすることで、この問題を修正します.これらの埋め込みが提供する助けに加えて、この修正によって入力の注入や再帰層などのアーキテクチャの変更がパフォーマンスをさらに向上させることを示します.

位置が解決されたことで、トランスフォーマーの論理的な推論能力を研究することができます.トランスフォーマーは、トレーニングデータよりも大きく複雑な算術問題を解決できるのでしょうか?私たちは、たった1日のGPUで20桁の数字のみをトレーニングすることで、最新のパフォーマンスに到達し、100桁の加算問題で最大99%の精度を達成できることを発見しました.最後に、これらの数値の向上が、ソーティングや乗算を含む他の多段階の推論タスクでも改善をもたらすことを示します.

Q&A:

Q: 各桁に追加された埋め込みは、変換器が大きな桁のスパンの中で各桁の位置を把握するのにどのように役立っているのだろうか?

A: 各数字に追加された埋め込みは、その数字の位置を大きな数字の範囲内で追跡するのに役立ちます.これらの埋め込みは、数字が数値の開始位置に対してどの位置にあるかをエンコードするため、位置情報を提供します.

Q: インプット・インジェクションとリカレント層は、各桁の位置が解決された後、どのようにパフォーマンスをさらに向上させることができるのか説明できますか?

A: 入力インジェクションと再帰層が性能をさらに向上させる方法は、各桁の位置が解決された後、数字の位置情報を保持することができるためです.入力インジェクションは、ネットワーク内の各層に入力のコピーを伝播させることによって、各桁の位置情報を保持し、情報の損失を防ぎます.再帰層は、過去の情報を保持し、再利用することで、モデルがより長期的な依存関係を学習し、複雑な数値計算を行う際に性能を向上させることができます.

Q: 変圧器の位置を解決する能力は、算数の問題を解く際の論理的外挿能力にどのような影響を与えるのか?

A: 位置を解決する能力は、トランスフォーマーの論理的な外挿能力に大きな影響を与えます.数字の各桁の位置を明確に把握することで、トランスフォーマーは大きな数字に対しても正確に計算を行うことが可能となります.これにより、トランスフォーマーは訓練データに現れるよりも大きく難しい算術問題を解決する能力が向上します.

Q: 100桁の足し算問題で最先端のパフォーマンスを達成するためのトレーニング過程はどのようなものでしたか?

A: 100桁の足し算問題で最先端の性能を達成するためのトレーニングプロセスは、20桁の数字のみを使用し、1日間単一のGPUでトレーニングを行いました.このトレーニングにより、100桁の足し算問題で最大99%の精度を達成することができました.さらに、これらの数値の向上により、他の多段階の問題、例えば6倍の桁数を持つ問題にも改善が見られました.

Q: 変圧器の位置を解決することによる数字能力の向上が、並べ替えや掛け算のような他の多段階推論課題の向上にもどのようにつながるのか、詳しく教えてください.

A: 位置の解決による数値の向上は、transformersの論理的な外挿能力を研究することを可能にします.位置が解決されると、transformersはより複雑な多段階の推論タスクにも適用できるようになります.例えば、位置情報が解決されると、sortingやmultiplicationなどの他の多段階の推論タスクにおいても性能が向上します.これは、位置情報がtransformersの推論能力を向上させ、より複雑な数学的問題にも対応できるようになることを示しています.

Q: 埋め込みは、数字の先頭に対する各桁の位置をどのようにエンコードするのか?

A: 各数字の位置を、数字の開始位置からの相対的な位置にエンコードします.これは、連続する位置埋め込みを各数字に与え、ランダムに選択されたオフセット値から開始します.

Q: ポジションの埋め込みを利用するために、トランスフォーマーには具体的にどのようなアーキテクチャーの変更が加えられたのでしょうか?

A: 位置埋め込みを利用して、入力の挿入や再帰層などのアーキテクチャの変更が行われました.

Q: 100桁の足し算問題で99%の精度を達成するために、位置埋め込みはどのように貢献しているのか?

A: 位置埋め込みは、数字の各桁の重要性をよりよく捉えるためにAbacus埋め込みと組み合わせることで、100桁の加算問題において99%の精度を達成するのに貢献します.これにより、モデルは20桁の数字のみを訓練に使用しているにもかかわらず、120桁の数字を含む問題にも汎化することが可能となります.

Q: 具体的な指標やベンチマークなど、ポジション解消時にトランスフォーマーに見られるパフォーマンスの向上について、詳細を教えてください.

A: 位置を解決することで、トランスフォーマーの性能が向上しました.具体的には、20桁の数字のみを使用して1日間の訓練を行い、100桁の足し算問題で最大99%の正解率を達成しました.また、これらの数値の向上により、他の多段階の推論タスク(ソートや乗算など)でも改善が見られました.

Q: この研究結果は、変圧器の全体的な理解と、算数の課題を処理する変圧器の能力にどのように貢献しているのだろうか?

A: この研究の結果は、トランスフォーマーが算術タスクを処理する能力に関する理解を深める上で重要な貢献をしています.具体的には、数字の位置を正確に追跡することができるようにする埋め込みを追加することで、トランスフォーマーの算術タスクにおけるパフォーマンスを向上させることが示されました.また、この修正によって、入力の挿入や再帰層などのアーキテクチャの変更が可能になり、さらなるパフォーマンス向上が実現されます.さらに、20桁の数字のみでトレーニングを行うことで、100桁の加算問題において99%の精度を達成することが示されました.これにより、トランスフォーマーが訓練データよりも大きく複雑な算術問題を解決できる可能性が示唆されました.

Are Long-LLMs A Necessity For Long-Context Tasks?

著者:Hongjin Qian, Zheng Liu, Peitian Zhang, Kelong Mao, Yujia Zhou, Xu Chen, Zhicheng Dou

発行日:2024年05月24日

最終更新日:2024年05月24日

URL:http://arxiv.org/pdf/2405.15318v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

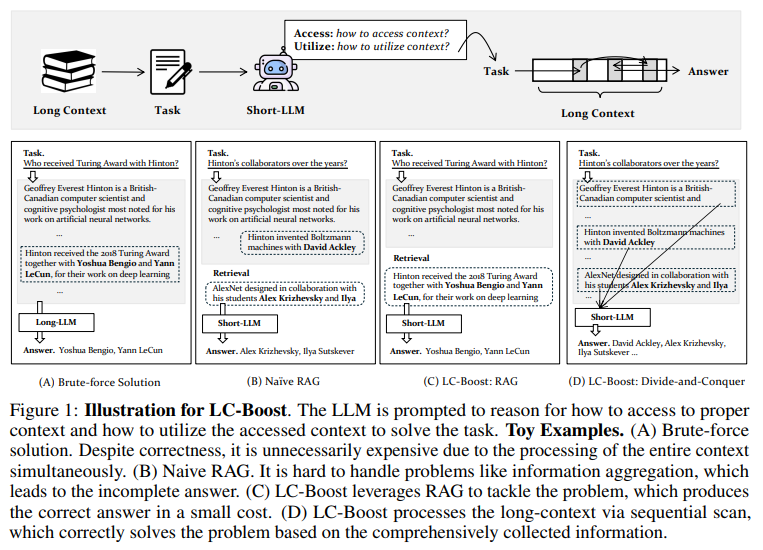

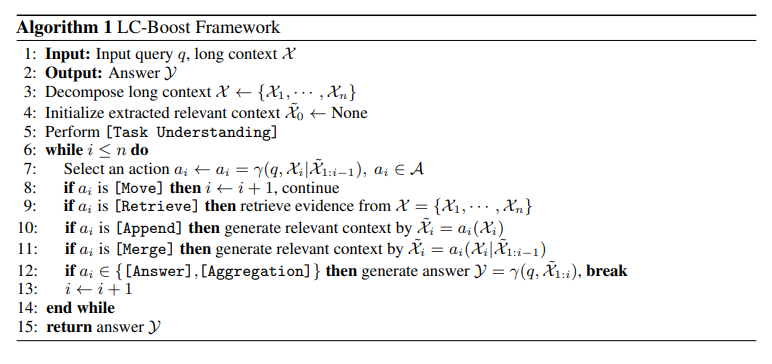

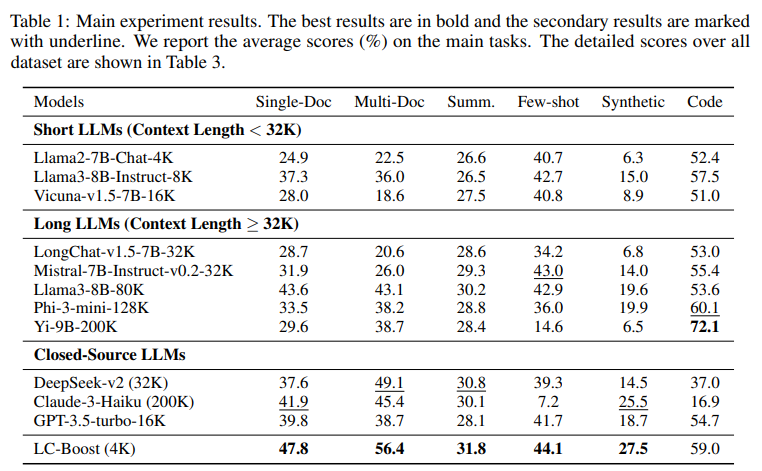

最近の進歩にもかかわらず、長いLLMの学習と展開は依然として難しい問題です.この研究では、長いLLMは長いコンテキストのタスクを解決するために必要ではないと主張します.なぜなら、一般的な長いコンテキストのタスクは短いコンテキストで解決可能であり、つまり、長いコンテキストの入力内のオラクル短いコンテキストだけで解決できるからです.この主張に加えて、私たちはLC-Boost(Long-Context Bootstrapper)というフレームワークを提案しています.このフレームワークは、短いLLMがブートストラップ方式で長いコンテキストのタスクに対処できるようにします.私たちのフレームワークでは、短いLLMは自らに対して2つの重要な決定を理由づけさせます:1)入力内の適切なコンテキスト部分にアクセスする方法、2)アクセスしたコンテキストを効果的に活用する方法.提示されたタスクに基づいてコンテキストに適応的にアクセスし、利用することで、LC-Boostは多様な長いコンテキスト処理問題を扱うための一般的なフレームワークとして機能します.私たちは人気のある長いコンテキストのベンチマークからさまざまなタイプのタスクを包括的に評価しました.その結果、LC-Boostはリソースの消費がはるかに少ないにもかかわらず、大幅に向上したパフォーマンスを達成することができました.

Q&A:

Q: LC-Boostフレームワークによって、短いLLMがブートストラップ方式で長いコンテキストのタスクに対処できるようになる仕組みを、もう少し詳しく説明してもらえますか?

A: LC-Boostフレームワークは、短いLLMがブートストラップ方式で長いコンテキストタスクに対処できるようにします.このフレームワークでは、短いLLMは自らに2つの重要な決定を理由づけさせます.1つ目は、入力内の適切なコンテキストの部分にアクセスする方法、2つ目は、アクセスしたコンテキストを効果的に利用する方法です.LC-Boostは、提示されたタスクに基づいてコンテキストに適応的にアクセスし、利用することで、多様な長いコンテキスト処理問題を扱うための一般的なフレームワークとして機能します.

Q: ショートLLMは、この文章で言及されている2つの重要な決断を下すために、どのような理性を働かせているのだろうか?

A: 短いLLMは、自らを理由付けるために、2つの重要な決定に対処します.1つ目は、入力内の適切なコンテキストにアクセスする方法、2つ目は、アクセスしたコンテキストを効果的に活用する方法です.

Q: LC-Boostフレームワークが多様なロングコンテクスト処理問題に対応するための主要な構成要素は何か?

A: LC-Boostフレームワークの主要なコンポーネントは、入力内の適切なコンテキスト部分にアクセスする方法と、アクセスしたコンテキストを効果的に利用する方法に対する短いLLMの自己プロンプトに基づいています.タスクに提示されたタスクに基づいてコンテキストに適応的にアクセスし利用することで、LC-Boostは多様な長いコンテキスト処理問題を処理するための一般的なフレームワークとして機能します.

Q: 一般的なロングコンテキストベンチマークで、LC-Boostを使用して評価されたタスクの例を教えてください.

A: LC-Boostを使用して評価された人気のある長いコンテキストベンチマークからのさまざまなタイプのタスクには、QA(質問応答)やコード補完などの正確なコンテキストの位置を必要とするタスクが含まれます.また、要約などの情報の集約を必要とするタスクもあります.

Q: LC-Boostは、ロングLLMに比べてはるかに少ないリソース消費で、どのようにして大幅な性能向上を実現しているのか?

A: LC-Boostは、長いコンテキストタスクを短いコンテキストに分解することで、長いLLMsと比較してリソースの消費を大幅に削減することができます.このアプローチにより、LC-Boostはリソースの消費を大幅に削減しながら、大幅に向上したパフォーマンスを達成することができます.

Q: 最近の進歩にもかかわらず、ロングLLMの学習と配備に残る具体的な課題は何か?

A: 最近の進歩にもかかわらず、長いLLMの学習と展開には依然として特定の課題が残っています.具体的には、長いLLMの展開には膨大なコストがかかる可能性があり、さらに深刻なことに、長いLLMは非常にリソースを消費します.また、継続的なトレーニングは、LLMの一般的な能力を短い文脈で損なう可能性があります.

Q: 長いLLMは長いコンテキストのタスクを解決するために必要なものではないと主張する理由を詳しく教えてください.

A: 長いコンテキストタスクを解決するためには、一般的な長いコンテキストタスクは短いコンテキストで解決できるため、長いLLMsが必要ではないと主張しています.つまり、長いコンテキストタスクは、長いシーケンス入力に関連しているにもかかわらず、単に長いコンテキストタスクの入力内のオラクル短いコンテキストを使って解決できるということです.例えば、本の要約や読解は、本から必要なキーファクトを抽出することに基づいて解決できます.この主張は、人間や現代のコンピュータの作業パターンに似ており、任意の長い形式の問題は常に限られたメモリ容量の上で分解して解決できるということです.

Q: 長いコンテキストのタスクの入力内でオラクルの短いコンテキストと一緒に作業するという概念が、一般的な長いコンテキストのタスクを解決する際にどのような役割を果たすのでしょうか?

A: 共通の長い文脈タスクは、オラクルの短い文脈を長い文脈タスクの入力内で純粋に操作することで解決可能であるという考え方は、長い文脈タスクを解決する際に重要な役割を果たす.これにより、長い文脈全体を処理する必要がなくなり、計算リソースの消費を削減できる.

Q: 長いLLMは長いコンテキストのタスクには必要ないというあなたの主張の潜在的な意味は何ですか?

A: 長いコンテキストタスクには、長いLLMsが必要ないという主張の潜在的な影響は、計算リソースの節約、トレーニングコストの削減、一般的な能力の維持、効率的なタスク処理などが考えられます.

Q: LC-Boostフレームワークの使用は、今後ロングコンテクスト処理の分野にどのような影響を与えるとお考えですか?

A: LC-Boostフレームワークの使用は、長い文脈処理の分野において革新的な進展をもたらすと考えられます.このフレームワークは、短いLLMが長い文脈タスクに対処するためのブートストラップ手法を可能にし、適切な文脈へのアクセス方法とアクセスされた文脈の効果的な利用方法を自らのプロンプトによって理由付けします.LC-Boostは、提示されたタスクに基づいて文脈に適応的にアクセスし利用することで、多様な長文脈処理問題を扱う一般的なフレームワークとして機能します.このフレームワークは、リソースの消費量を大幅に削減しながら、長い文脈ベンチマークからのさまざまなタスクを包括的に評価し、大幅に向上したパフォーマンスを達成することができます.

Aya 23: Open Weight Releases to Further Multilingual Progress

著者:Viraat Aryabumi, John Dang, Dwarak Talupuru, Saurabh Dash, David Cairuz, Hangyu Lin, Bharat Venkitesh, Madeline Smith, Jon Ander Campos, Yi Chern Tan, Kelly Marchisio, Max Bartolo, Sebastian Ruder, Acyr Locatelli, Julia Kreutzer, Nick Frosst, Aidan Gomez, Phil Blunsom, Marzieh Fadaee, Ahmet Üstün, Sara Hooker

発行日:2024年05月23日

最終更新日:2024年05月31日

URL:http://arxiv.org/pdf/2405.15032v2

カテゴリ:Computation and Language

概要:

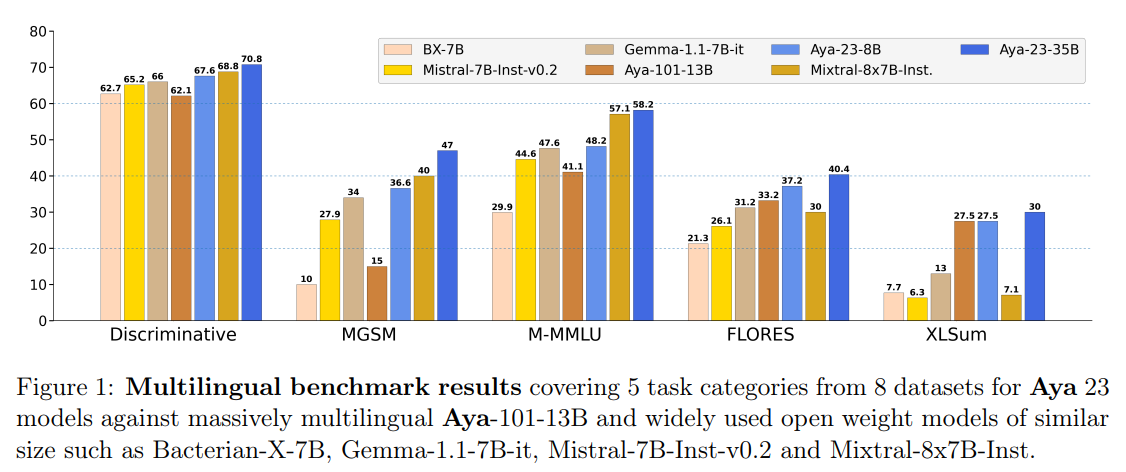

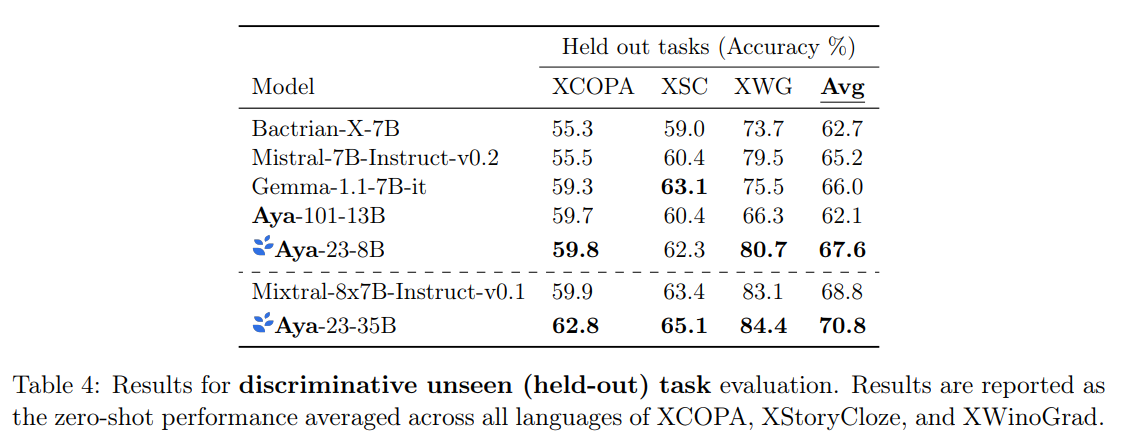

この技術レポートは、Aya 23という多言語言語モデルファミリーを紹介しています.Aya 23は、最近リリースされたAyaモデル(\”Ust\”un et al.、2024)をベースにしており、高性能な事前学習モデルと最近リリースされたAyaコレクション(Singh et al.、2024)を組み合わせています.その結果、世界の人口の約半分に言語モデリング能力を拡張する強力な多言語大規模言語モデルが生まれました.Ayaモデルは101言語をカバーしていましたが、Aya 23は深さと幅の実験であり、事前学習中に含まれる言語により多くの容量を割り当てることの影響を探っています.Aya 23は、カバーする言語においてAya 101などの以前の大規模多言語モデルや、Gemma、Mistral、Mixtralなどの広く使用されているモデルよりも、幅広い差別的および生成的タスクで優れた性能を発揮します.私たちは、多言語の進歩へのアクセスを拡大するための取り組みの一環として、8Bモデルと35Bモデルのオープンな重みを公開しています.

Q&A:

Q: 最近リリースされたAyaコレクションとAya23のために、高いパフォーマンスを持つ事前学習済みモデルの組み合わせに焦点を当てた意思決定のプロセスを説明してもらえますか?

A: Aya23は、高性能な事前学習モデルを最近リリースされたAyaコレクションとペアリングする決定プロセスは、Aya23の言語モデリング能力を向上させ、世界の人口の約半分に対応する23言語にサービスを提供するために行われました.これにより、Aya23は、事前学習モデルとしての優れた性能を発揮し、多様な言語における高度な言語モデリングを実現することが可能となります.

Q: Aya23は、言語カバー率とパフォーマンスにおいて、以前のAyaモデルとどう違うのですか?

A: Aya23は、前のAyaモデルと比較して、言語カバレッジとパフォーマンスの両方で異なります.Aya23は、101言語をカバーしていたTheAyamodelと比較して、23言語をサポートしています.また、Aya23は、より深い言語モデルを探求する実験であり、より多くの容量を割り当てることで、事前トレーニング中に含まれる少数の言語に優先度を与えています.Aya23は、カバーする言語においてTheAyamodelよりも優れたパフォーマンスを発揮し、Gemma、Mistral、Mixtralなどの広く使用されているモデルよりも多くの識別的および生成的タスクで優れた結果を示しています.

Q: Aya 23モデルには具体的にどのような言語が含まれているのですか?

A: Aya23モデルに含まれる特定の言語は、アラビア語、中国語(簡体字および繁体字)、チェコ語、オランダ語、英語、フランス語、ドイツ語、ギリシャ語、ヘブライ語、ヒンディー語、インドネシア語、イタリア語、日本語、韓国語、ペルシャ語、ポーランド語、ポルトガル語、ルーマニア語、ロシア語、スペイン語、トルコ語、ウクライナ語、ベトナム語です.これらの言語が選ばれた理由は、Command Rの事前トレーニングに含まれる言語と一致させるためであり、事前トレーニング後に新しい言語を導入することの困難さが知られているためです.

Q: 綾23の深さ対幅の実験と、事前トレーニングでより少ない言語により多くの容量を割り当てることの影響について詳しく教えてください.

A: Aya23は、事前トレーニング中に少ない言語により多くの容量を割り当てることで、深さと幅の実験を行っています.これにより、Aya101やGemma、Mistral、Mixtralなどの広く使用されているモデルよりも、カバーされる言語において大きな利益をもたらしています.このアプローチにより、モデルは特定の言語に焦点を当て、より深い理解を可能にし、多言語モデルのパフォーマンスを向上させることができます.

Q: Aya 23は、Aya 101のようなこれまでの大規模多言語モデルや、Gemma、Mistral、Mixtralのような広く使われているモデルを、識別タスクや生成タスクにおいてどのように上回るのでしょうか?

A: Aya23は、Aya101や広く使用されているGemma、Mistral、Mixtralなどの以前の大規模多言語モデルを上回ることができます.これは、Aya23がカバーする言語において、および広範囲の識別的および生成的タスクにおいて、これらのモデルよりも優れたパフォーマンスを発揮するからです.Aya23は、23の言語からのテキストを含むデータ混合物を使用して事前学習されており、より多くの容量を事前学習中に含める言語に割り当てることの影響を探ることで、これらのモデルを上回ることができます.

Q: 綾23の8Bと35Bの両モデルで発表されたオープンウエイトの主な特徴は?

A: Aya 23の8Bおよび35Bモデルのオープンウェイトの主な特徴は、Aya-23-35Bがすべての評価タスクと言語で最高の結果を達成し、Aya-23-8Bが最高クラスのマルチリンガルパフォーマンスを示すことです.

Q: オープン・ウエイトは、多言語へのアクセス拡大にどのように貢献するとお考えですか?

A: オープンウェイトは、多言語の進歩へのアクセス拡大にどのように貢献するかを考えると、これらのモデルの重みを公開することで、多言語技術の普及と発展に向けた研究を促進し、多言語モデルの性能向上に寄与することが期待されます.これにより、言語の包括性が向上し、より多様な言語コミュニティにおいても効果的な言語技術が提供されることが期待されます.

Q: 綾23』の開発中にどのような問題に遭遇し、どのように対処しましたか?

A: Aya23の開発中に遭遇した課題は、モデルのサイズが13Bパラメータであり、これが消費者向けのハードウェアでの利用を制限していたことです.この課題は、Aya101と比較して、Aya23は識別タスクで最大14%、生成タスクで最大20%、多言語MMLUで最大41.6%の向上を達成し、Aya23はAya101と比較して多言語数学的推論が6.6倍向上しています.この課題に対処するために、Aya23モデルファミリーの重みを公開することで、研究者や実務家が多言語モデルとアプリケーションを進化させることを期待しています.

Q: 綾23モデルの潜在的な限界や改善点について教えてください.

A: Aya23モデルの潜在的な制限や改善の余地について考えると、モデルのサイズが13Bパラメータであり、消費者向けのハードウェアでの利用性が制限されていることが挙げられます.また、Aya23モデルは多言語数学的推論において6.6倍の向上を達成していますが、さらなる数学的推論の精度向上や他のタスクにおいてもさらなる改善が求められる可能性があります.さらに、Aya23モデルは欧州以外の言語においても優れた性能を示していますが、特定の言語においては改善の余地があるかもしれません.

Q: 綾23プロジェクトの次のステップと、将来的にその能力をさらに高める計画は?

A: Aya23プロジェクトの次のステップは、モデルのパフォーマンスをさらに向上させることです.将来的には、より多くの言語をカバーし、より複雑なタスクに対応できるようにモデルを拡張する予定です.また、モデルのパラメータ数を増やすことで、さらなる多言語対応や数学的推論能力の向上を目指します.

SimPO: Simple Preference Optimization with a Reference-Free Reward

著者:Yu Meng, Mengzhou Xia, Danqi Chen

発行日:2024年05月23日

最終更新日:2024年05月23日

URL:http://arxiv.org/pdf/2405.14734v1

カテゴリ:Computation and Language, Machine Learning

概要:

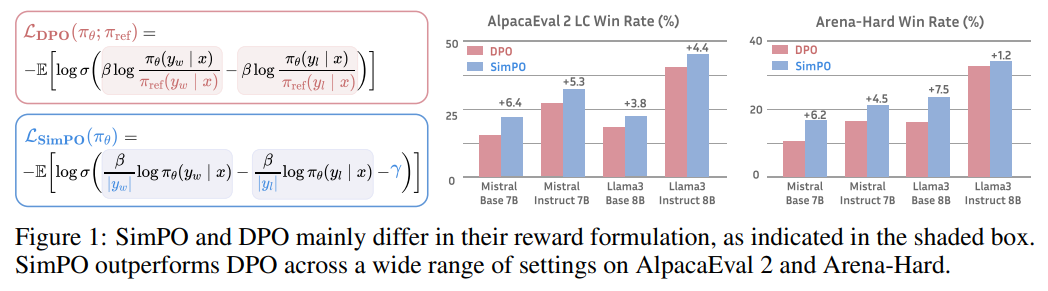

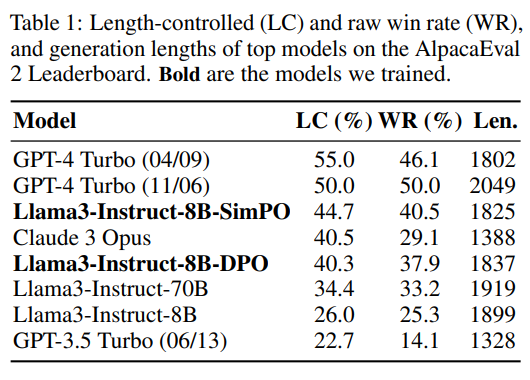

SimPOは、最近の難しいArena-Hardベンチマークにおいても優れたパフォーマンスを示しています.SimPOは、既存のアプローチを大幅に上回る結果を一貫して達成しており、応答長を大幅に増やすことなくその効果を発揮しています.具体的には、SimPOはAlpacaEval 2においてDPOを最大6.4ポイント、Arena-Hardにおいて最大7.5ポイント上回っています.また、Llama3-8B-Instructをベースに構築された最も優れたモデルは、AlpacaEval 2において驚異的な44.7の勝率を達成し、リーダーボードでClaude 3 Opusを上回り、Arena-Hardにおいて33.8の勝率を達成し、最も強力な8Bオープンソースモデルとなっています.

Q&A:

Q: 平均対数確率をSimPOの暗黙の報酬として使用する重要な設計について説明できますか?

A: SimPOでは、シーケンスの平均対数確率を暗黙の報酬として使用するという主要な設計があります.このアプローチは、高い報酬精度と一貫性を実現し、DPOよりも優れた結果をもたらします.具体的には、SimPOは平均対数尤度を報酬式として直接利用することで、報酬の不一致を完全に排除します.これにより、SimPOはより効果的な一般化を促し、より高品質な生成物を生み出すことができます.

Q: 他のアプローチと比べて、SimPOのこの報酬処方は、どのようにモデル生成との整合性を高めているのでしょうか?

A: SimPOでは、報酬関数が生成尤度と目標報酬マージンと整合しているため、他のアプローチと比較して、モデル生成とよりよく整合しています.これにより、参照モデルを必要とせず、長さのバイアスを利用せずに強力なパフォーマンスを達成できます.

Q: SimPOがどのように参照モデルを不要にしているのか、また、それがなぜ計算効率とメモリ効率を高めているのか、詳しく教えてください.

A: SimPOは、参照モデルを必要としないため、計算とメモリの効率が向上します.これは、SimPOがBradley-Terry目的関数にターゲット報酬マージンを導入することで、勝利と敗北の応答間により大きなマージンを促すためです.このように、SimPOは参照モデルを必要とせず、強力なパフォーマンスを達成することができます.さらに、SimPOは参照モデルを使用しないため、計算とメモリの使用量が削減され、より効率的になります.

Q: SimPOのブラッドリー・テリー目標に目標報酬マージンを導入する意義は?

A: SimPOにおけるBradley-Terry目的にターゲット報酬マージン項を導入することの重要性は、勝利応答の報酬が敗北応答の報酬よりも少なくともγだけ上回ることを確実にするためです.このマージンを導入することで、分類器の一般化能力に影響を与えることが知られており、報酬の差が目標マージンγを超えるように最適化されるようになります.これにより、SimPOは報酬関数を生成尤度と整合させ、参照モデルを必要とせずに強力な性能を達成し、長さのバイアスを利用せずに強力な性能を発揮します.

Q: SimPOはDPOやその最新版と比較して、さまざまなトレーニングセットアップでどのようなパフォーマンスを発揮するのでしょうか?

A: SimPOは、様々なトレーニングセットアップで、DPOおよびその最新の変種と比較して、優れたパフォーマンスを示しています.具体的には、SimPOはAlpacaEval 2、MT-Bench、およびArena-Hardなどのベンチマークで最高のパフォーマンスを達成し、DPOよりも報酬の精度が高く、メモリと計算効率も優れています.

Q: AlpacaEval 2、MT-Bench、Arena-Hardのような命令追従型ベンチマークにおけるSimPOの評価について詳細を教えてください.

A: SimPOはAlpacaEval 2、MT-Bench、およびArena-Hardなどの指示に従うベンチマークでの評価において、最高のベースラインよりも3.6〜4.8ポイントの改善を示しました.また、さまざまな設定でArena-Hardにおいて0.2〜6.2ポイントの改善を達成しました.これらの一貫したかつ重要な改善は、SimPOの堅牢性と効果を強調しています.

Q: 回答時間を大幅に増やすことなく、SimPOが既存のアプローチを一貫して大幅に上回るのはなぜか?

A: SimPOは、応答長を大幅に増やさずに既存のアプローチを一貫してかつ著しく上回ることができます.具体的には、SimPOはAlpacaEval 2でDPOを最大6.4ポイント、Arena-Hardで最大7.5ポイント上回ることができます.これは、SimPOが応答長を大幅に増やすことなく、より優れた性能を発揮できる理由です.

Q: AlpacaEval 2やArena-Hardなどのベンチマークにおいて、SimPOはDPOと比較して具体的にどのような性能向上が見られたのでしょうか?

A: SimPOはAlpacaEval 2およびArena-Hardのベンチマークにおいて、DPOに比べて特定の性能向上を達成しました.具体的には、AlpacaEval 2では最大6.4ポイント、Arena-Hardでは最大7.5ポイントの向上が見られました.

Q: AlpacaEval 2とArena-Hardでの勝率を含め、Llama3-8B-Instructで作られた成績上位モデルの結果について教えてください.

A: Llama3-8B-Instructで構築された最も優れたモデルは、AlpacaEval 2で44.7の長さ制御された勝率を達成し、リーダーボードでClaude 3 Opusを上回り、Arena-Hardでは33.8の勝率を達成しました.

Q: SimPOのトップ成績モデルのパフォーマンスは、リーダーボードのクロード3オーパスなど他のモデルと比較してどうなのか?

A: SimPOのトップモデルは、リーダーボード上のClaude 3 Opusなどの他のモデルと比較して、AlpacaEval 2で44.7の長さ制御された勝率を達成し、Arena-Hardでは33.8の勝率を達成しており、これは現時点で最も強力な8Bオープンソースモデルとなっています.

Attention as an RNN

著者:Leo Feng, Frederick Tung, Hossein Hajimirsadeghi, Mohamed Osama Ahmed, Yoshua Bengio, Greg Mori

発行日:2024年05月22日

最終更新日:2024年05月28日

URL:http://arxiv.org/pdf/2405.13956v2

カテゴリ:Machine Learning

概要:

Transformersの登場は、GPUの並列処理を活用することが可能な高性能なアーキテクチャを提供し、シーケンスモデリングにおいて重要な進展をもたらしました.しかし、Transformersは推論時に計算コストが高く、特にリソースが限られた環境(例:モバイルや組み込みデバイス)での応用が制限されています.この課題に対処するために、(1) attentionを\textit{many-to-one} RNN出力を効率的に計算する特別なRecurrent Neural Network(RNN)として捉えることができることを示します.そして、(2) 人気のあるattentionベースのモデルであるTransformersをRNNの変種として捉えることができることを示します.しかし、従来のRNN(例:LSTM)とは異なり、これらのモデルは新しいトークンを効率的に更新することができません.この課題に取り組むために、(3) 並列プレフィックススキャンアルゴリズムに基づいてattentionの\textit{many-to-many} RNN出力を効率的に計算する新しい方法を導入します.新しいattentionの定式化に基づいて、(4) トレーニングを並列で行うことができるだけでなく、効率的に更新することができるattentionベースのモジュールである\textbf{Aaren}を紹介します.Aarenは、トレーニングを並列で行うことができるだけでなく、新しいトークンを効率的に更新することができ、推論時には定数のメモリしか必要とせず、従来のRNNと同様にメモリと時間の効率性が高いことが実証されています.実証的には、Aarenは、強化学習、イベント予測、時系列分類、時系列予測のタスクにおいて、38のデータセットにわたってTransformersと同等の性能を達成しつつ、より時間とメモリの効率性が高いことが示されています.

Q&A:

Q: アテンションが、多対一のRNN出力を効率的に計算する能力を持つ特別なリカレント・ニューラル・ネットワーク(RNN)と見なすことができることを説明できますか?

A: 注意力は、多対一のRNN出力を効率的に計算できる特別な再帰ニューラルネットワーク(RNN)として見ることができます.これは、入力シーケンス全体に対して重み付けを行い、その重み付けされた合計を計算することで、多対一の出力を生成することができます.このように、注意力は過去の情報を考慮しながら、現在の入力に対して適切な重みを割り当てることができるため、RNNと同様の構造を持つと言えます.

Q: Transformersのような一般的なアテンションベースのモデルは、新しいトークンで更新するという点で、従来のRNNとどう違うのだろうか?

A: 人気のあるアテンションベースのモデル(例:TransformersやPerceivers)は、新しいトークンを効率的に更新することができないが、伝統的なRNN(例:LSTMsやGRUs)と異なる点があります.

Q: 新しい効率的な方法について詳しく説明していただけますか? これは、並列プレフィックススキャンアルゴリズムに基づいたアテンションの多対多RNN出力の計算方法です.

A: 新しい効率的な方法は、並列接頭辞スキャンアルゴリズムに基づいて注意の多対多のRNN出力を計算することです.このアルゴリズムは、N個の接頭辞計算を並列に行うことができ、新しいトークンを効率的に更新することができます.これにより、シーケンスモデリングにおいて重要な性質である新しいトークンの追加が効率的に行われます.

Q: トランスフォーマーのように並列に学習させ、従来のRNNのように新しいトークンで効率的に更新できるAarenの主な特徴は?

A: Aarenは、新しい注意機構を基にしており、並列でトレーニングされることができる(Transformersのように)だけでなく、新しいトークンで効率的に更新されることができる(従来のRNNのように)という特徴があります.

Q: AarensはTransformersと比較して、4つの一般的なシーケンシャル問題設定の38のデータセットでどのようなパフォーマンスを示したのでしょうか?

A: 38のデータセットにおいて、AarensはすべてのデータセットでTransformersと同等の性能を発揮しました.しかし、Transformersとは異なり、Aarensは新しい入力を効率的に処理できるため、このような時系列関連の設定において有利です.

Q: アーレンがトランスフォーマーに匹敵するパフォーマンスを達成したという実証結果について、もう少し詳しく教えてください.

A: Aarensは、すべてのTの値において、すべてのデータセットでTransformersと同等の性能を発揮していることが示されました.ただし、Transformersとは異なり、Aarensは新しい入力を効率的に処理できるため、この時系列関連の設定のような連続的な環境ではより有利です.

Q: 特に低リソース環境において、アーレンは推論時の計算コストの問題にどのように対処しているのだろうか?

A: Aarenは、推論時の計算負荷の問題を低リソースの環境でどのように解決するかについて、メモリ使用量と時間複雑性の両方を改善します.Aarenは、トークンの数に関係なく一定のメモリのみを使用し、トークンのシーケンスを逐次処理する際の累積計算量が線形であるため、メモリ使用量と時間複雑性を劇的に改善します.また、AarenはRNNとして自己更新できるため、Transformersと比較してより効率的に動作します.これにより、Aarenはシーケンスモデリングに適しており、低リソースのドメイン(例:バッテリー駆動またはIoTデバイス)にも適しています.

Q: 従来のRNNやTransformerと比較して、Aarenを使用する利点は、時間効率やメモリ効率の面でどのようなものがありますか?

A: Aarenは、従来のRNNやTransformersに比べて、時間とメモリの効率性に優れています.Aarenは、RNNと同様に自己更新が可能であり、Transformersよりもメモリ使用量が少なく、時間複雑性も低いため、シーケンスモデリングにおいてより適しています.Aarenは、RNNと同様に自己更新が可能であるため、シーケンスの長さに依存せず、メモリ使用量が少ないことが利点です.また、Transformersよりも時間複雑性が低いため、処理速度が向上し、効率的なシーケンスモデリングが可能となります.

Q: アーレンの導入は、シーケンスモデリングとニューラルネットワークの分野にどのように貢献するのだろうか?

A: Aarenは、Transformerと同等の性能を持ちながら、より時間とメモリの効率が良いモジュールである.Aarenは自己更新が可能であり、Transformerとは異なりRNNとして効率的に機能するため、シーケンスモデリングに適しています.シーケンスモデリング問題設定の幅広さと、低リソースドメイン(例:バッテリー駆動またはIoTデバイス)の数が急速に増加していることから、Aarenは広範な影響を持つ可能性があります.Aarenの一般的な適用可能性は、その社会的影響が下流のアプリケーションに依存していることを意味します.

Q: 特定の用途やシナリオでAarenを使用する際の制限や潜在的な欠点はありますか?

A: Aarenの使用にはいくつかの制限や潜在的な欠点があります.例えば、Aarenは長いシーケンスに対しては性能が低下する可能性があります.また、Aarenはトランスフォーマーと比較して、一部のタスクやデータセットで効率的でない場合があります.さらに、Aarenは新しい入力を処理する際に、過去の情報を保持する能力が制限されているため、一部の応用やシナリオでは適切でない可能性があります.