ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- CAT3D: Create Anything in 3D with Multi-View Diffusion Models

発行日:2024年05月16日

CAT3Dは、マルチビューディフュージョンモデルを使用して、数百から数千枚の画像を収集する必要なく、高品質な3Dキャプチャを可能にし、任意のものを3Dで作成する方法を提案しています. - Chameleon: Mixed-Modal Early-Fusion Foundation Models

発行日:2024年05月16日

Chameleonは、アーリーフュージョンのトークンベースのミックスモーダルモデルを提案し、幅広いタスクで高いパフォーマンスを示しています. - RLHF Workflow: From Reward Modeling to Online RLHF

発行日:2024年05月13日

オンライン反復強化学習からの人間フィードバック(RLHF)のワークフローを紹介し、オンライン反復RLHFの手順や理論的洞察、SFR-Iterative-DPO-LLaMA-3-8B-Rモデルの優れたパフォーマンスを示しました.GitHubで詳細を公開. - Zero-Shot Tokenizer Transfer

発行日:2024年05月13日

LMはトークナイザーに拘束され、新しいトークナイザーに適応するためのZeTTを提案し、パフォーマンスを向上させることができる. - Does Fine-Tuning LLMs on New Knowledge Encourage Hallucinations?

発行日:2024年05月09日

大規模な言語モデルは微調整を通じて新しい事実知識を獲得する際に苦労し、微調整によって幻覚傾向が増加する可能性があることが示唆されています. - You Only Cache Once: Decoder-Decoder Architectures for Language Models

発行日:2024年05月08日

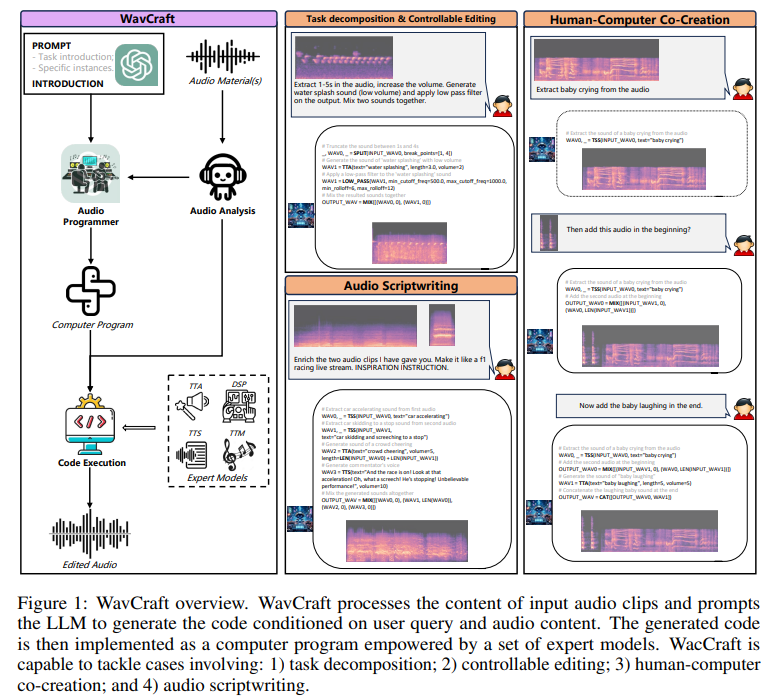

YOCOは、大規模な言語モデル向けのデコーダーデコーダーアーキテクチャで、GPUメモリの要求を削減しつつ、高速化と高いパフォーマンスを実現しています. - WavCraft: Audio Editing and Generation with Large Language Models

発行日:2024年03月14日

WavCraftは、LLMを活用して音声コンテンツの作成と編集を支援する集合システムであり、ユーザーの指示を複数のタスクに分解し、タスク固有モデルと協力して音声コンテンツを生成します.

CAT3D: Create Anything in 3D with Multi-View Diffusion Models

著者:Ruiqi Gao, Aleksander Holynski, Philipp Henzler, Arthur Brussee, Ricardo Martin-Brualla, Pratul Srinivasan, Jonathan T. Barron, Ben Poole

発行日:2024年05月16日

最終更新日:2024年05月16日

URL:http://arxiv.org/pdf/2405.10314v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

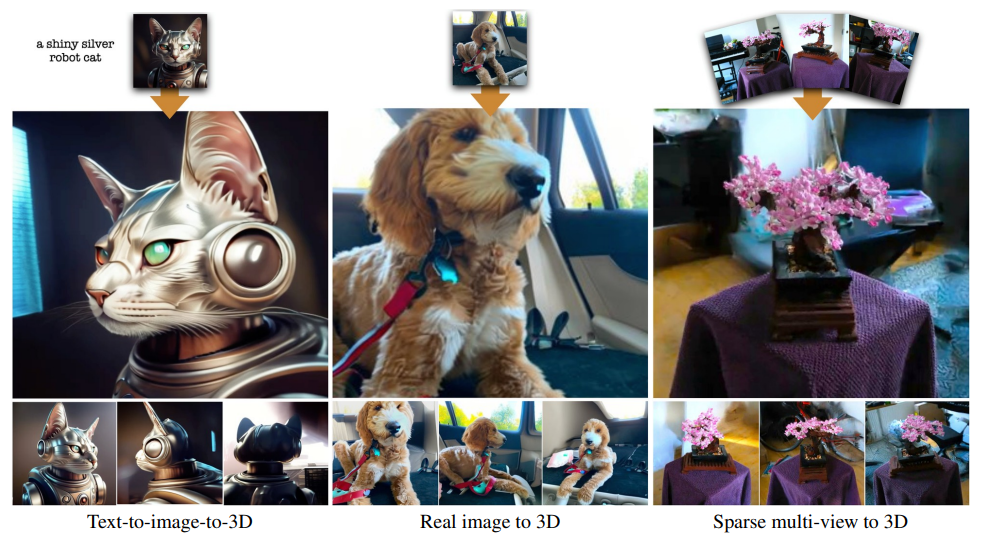

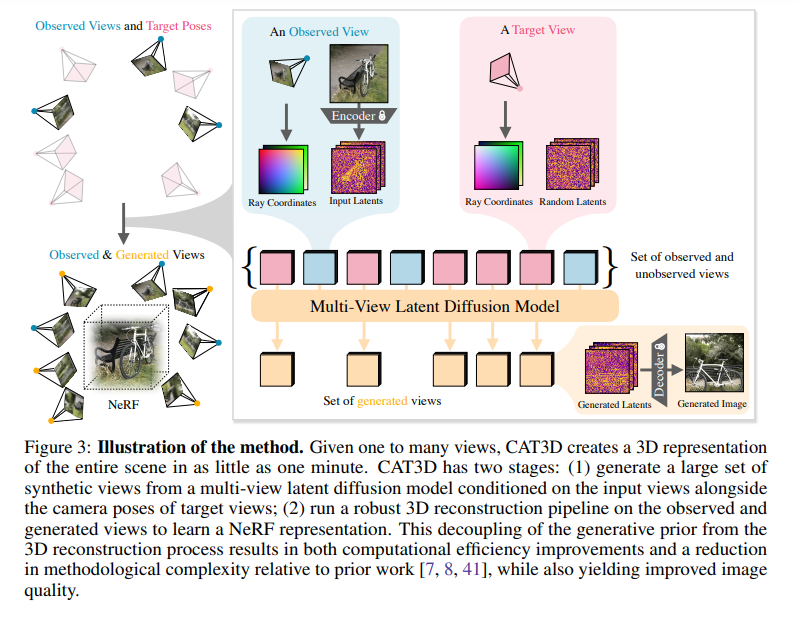

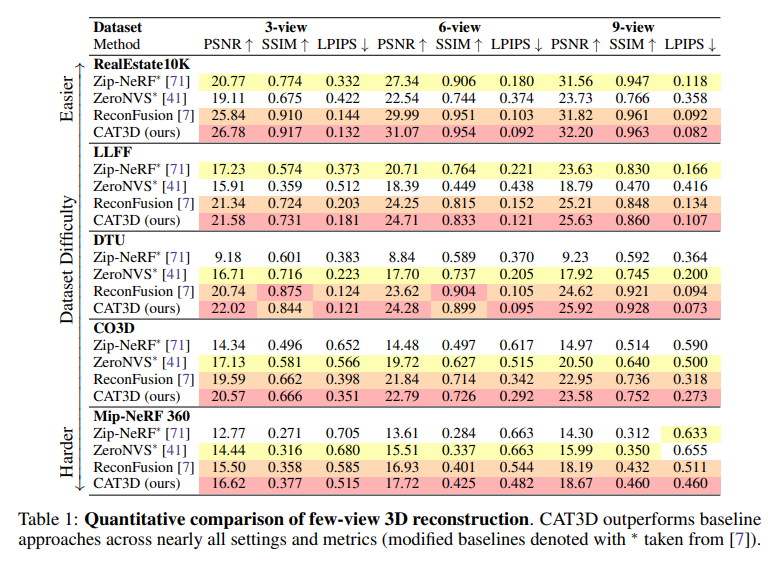

3D再構築の進歩により、高品質な3Dキャプチャが可能になりましたが、3Dシーンを作成するには数百から数千枚の画像を収集する必要があります.CAT3Dは、マルチビューディフュージョンモデルを用いて、この現実世界のキャプチャプロセスをシミュレートすることで、任意のものを3Dで作成する方法を提案しています.入力画像の数と目標とする新しい視点のセットが与えられると、我々のモデルはシーンの非常に一貫性のある新しい視点を生成します.これらの生成されたビューは、頑健な3D再構築技術への入力として使用でき、任意の視点からリアルタイムでレンダリングされた3D表現を生成することができます.CAT3Dは、わずか1分で完全な3Dシーンを作成することができ、単一画像や少数のビューの3Dシーン作成の既存の方法を上回ります.結果やインタラクティブなデモは、https://cat3d.github.io でご覧いただけます.

Q&A:

Q: CAT3Dはマルチビュー拡散モデルを使って、どのように実際の捕獲プロセスをシミュレートするのですか?

A: CAT3Dは、マルチビューディフュージョンモデルを使用して、任意の入力画像の数と目標の新しい視点のセットを与えられた場合に、シーンの非常に一貫性のある新しいビューを生成します.これらの生成されたビューは、ロバストな3D再構築技術への入力として使用され、任意の視点からリアルタイムでレンダリングできる3D表現を生成します.

Q: 3D再構成のために数百から数千の画像を必要とする従来の方法と比較して、CAT3Dを使用する利点は何ですか?

A: CAT3Dは、数百から数千枚の画像が必要な従来の方法と比較して、より効率的でシンプルで高品質な3D生成を可能にします.CAT3Dは、生成事前情報を3D抽出から分離することで、効率的でシンプルで高品質な3D生成を実現します.

Q: どのようにしてCAT3Dは、入力画像とターゲット視点のセットから、シーンの一貫性の高い新規ビューを生成するのでしょうか?

A: CAT3Dは、複数の入力画像と目標視点から高度に一貫性のある新しい視点を生成します.生成されたビューは、ロバストな3D再構築手法に入力され、任意の視点からレンダリングできる3D表現を生成します.

Q: CAT3Dから生成されたビューを、ロバストな3D再構成技術にどのように使用できるか説明していただけますか?

A: CAT3Dによって生成されたビューは、ロバストな3D再構築技術に使用されることができます.具体的には、CAT3Dは複数の入力ビューから新しいビューを生成し、これらの生成されたビューは3D再構築技術に入力されます.このプロセスによって、3D表現が生成され、任意の視点からレンダリングされることが可能となります.CAT3Dは、高度な並列サンプリング戦略を用いて、複数の3D整合性のある画像を生成し、これらは3D再構築技術によって効果的に活用されるのです.

Q: CAT3Dは通常、3Dシーン全体の作成にどのくらい時間がかかりますか?

A: CAT3Dは通常、3Dシーンを作成するのに1分程度かかります.

Q: CAT3Dのどのような特徴が、単一画像や数ビューの3Dシーンの作成において、既存の手法を凌駕しているのでしょうか?

A: CAT3Dは、既存の方法を上回る特定の機能を持っています.CAT3Dは、単一の入力ビューから多様な3Dコンテンツを効率的に生成することができます.CAT3Dは、入力設定に焦点を当てており、スパースなマルチビューキャプチャから単一のキャプチャ画像、さらにはテキストプロンプトからの入力画像生成(テキストから画像モデルを使用してプロンプトから入力画像を生成)までを対象としています.CAT3Dは、従来の作業を上回り、複数のベンチマークで測定可能なタスク(マルチビューキャプチャケースなど)において、先行研究よりも1桁速くなっています.また、経験的なパフォーマンスを測定するのが難しいタスク(テキストから3D、単一画像から3D)では、CAT3Dはすべての設定で先行研究と比較して有利な結果を示しています.

Q: CAT3Dが特に効果的な3Dシーンの例を教えてください.

A: CAT3Dは、少数の入力画像から高品質な3Dシーンを生成することに特に効果的です.例えば、スパースなマルチビューキャプチャや単一のキャプチャ画像、さらにはテキストプロンプトから生成された入力画像など、様々な入力設定に対応しています.

Q: CAT3Dは、どのような視点からもリアルタイムで3D表現ができるようにしているのですか?

A: CAT3Dは、複数の入力画像と指定された新しい視点から、効率的な並列サンプリング戦略を通じて複数の3D整合画像を生成し、これらの生成された画像を順次3D再構築パイプラインに供給することによって、任意の視点からインタラクティブな速度でレンダリングできる3D表現を生成します.

Q: CAT3Dが特定のシナリオや特定のタイプの入力画像で直面する制限や課題はありますか?

A: CAT3Dは、訓練データセットが同じシーンのビューに対してほぼ一定のカメラ内部パラメータを持っているため、異なる内部パラメータを持つ複数のカメラによってキャプチャされた入力ビューをうまく処理できないという制限があります.また、CAT3Dの生成品質は、ベースのテキストから画像へのモデルの表現力に依存しており、ベースモデルの分布外のシーンコンテンツに対しては性能が低下します.さらに、マルチビューディフュージョンモデルがサポートする出力ビューの数は比較的少ないため、モデルから大量のサンプルを生成すると、すべてのビューが互いに3D的に整合していない可能性があります.最後に、CAT3Dはシーンを徹底的にカバーする手動で構築されたカメラ軌跡を使用しており、大規模なオープンエンドの3D環境に対して設計するのが難しいかもしれません.

Q: https://cat3d.github.io のプロジェクトページで、CAT3Dの結果やインタラクティブなデモにアクセスする方法を教えてください.

A: CAT3Dの結果とインタラクティブデモにアクセスする方法は、プロジェクトページhttps://cat3d.github.ioで提供されています.このページには、CAT3Dの研究論文、コード、およびデモが含まれており、ユーザーはそこからCAT3Dの結果やインタラクティブデモを入手することができます.

Chameleon: Mixed-Modal Early-Fusion Foundation Models

著者:Chameleon Team

発行日:2024年05月16日

最終更新日:2024年05月16日

URL:http://arxiv.org/pdf/2405.09818v1

カテゴリ:Computation and Language

概要:

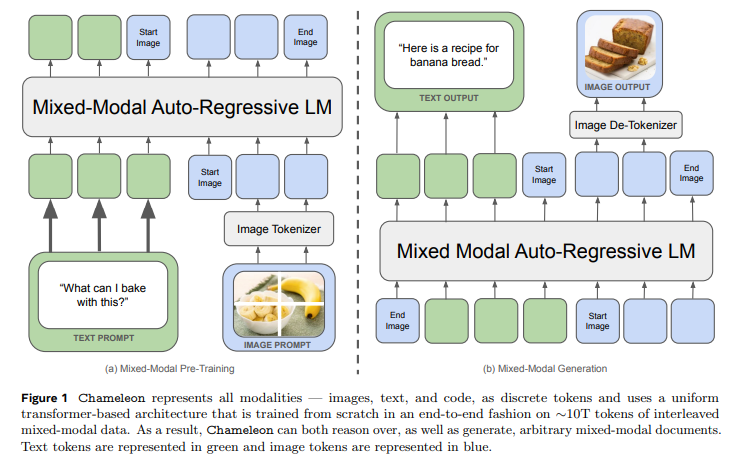

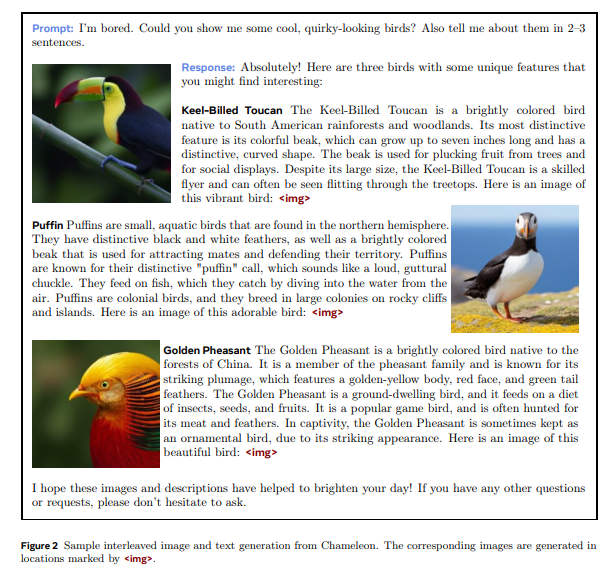

Chameleonは、画像とテキストを任意の順序で理解および生成することができる、アーリーフュージョンのトークンベースのミックスモーダルモデルのファミリーを提案しています.我々は、アーリーフュージョン、トークンベース、ミックスモーダルの設定に適したアーキテクチャのパラメータ化、安定したトレーニングアプローチ、アライメントレシピを概説しています.このモデルは、ビジュアルクエスチョンアンサリング、画像キャプショニング、テキスト生成、画像生成、および長文のミックスモーダル生成など、幅広いタスクで評価されています.Chameleonは、画像キャプショニングタスクで最先端のパフォーマンスを示し、テキストのみのタスクではLlama-2を上回り、Mixtral 8x7BやGemini-Proなどのモデルと競合しながら、単一のモデルで非自明な画像生成を行います.また、新しい長文のミックスモーダル生成評価において、Gemini ProやGPT-4Vなどのはるかに大きなモデルのパフォーマンスを人間の判断により上回るか、もしくは一致させます.Chameleonは、完全なマルチモーダルドキュメントの統一モデリングにおいて重要な進歩を示しています.

Q&A:

Q: カメレオン・モデルの開発当初から使われている安定したトレーニング・アプローチについて教えてください.

A: Chameleonモデルの安定したトレーニングアプローチは、8Bパラメータと1Tトークンを超える規模でのモデルのトレーニング中に安定性を維持することが困難であり、しばしばトレーニングの非常に遅い段階でのみ不安定性が発生することがあることが課題でした.この安定性を実現するために、アーキテクチャと最適化のために次のレシピを採用しました.アーキテクチャは主にLLaMa-2(Touvron et al.、2023)に従っており、正規化にはRMSNorm(Zhang and Sennrich、2019)を引き続き使用しています.SwiGLU(Shazeer、2020)活性化関数とrotary positional embeddings(RoPE)(Su et al.、2021)を使用しています.

Q: カメレオンモデルで採用されているアライメントレシピとは?

A: カメレオンモデルで採用されているアライメントレシピは、RMSNorm(Zhang and Sennrich、2019)を正規化に使用し、SwiGLU(Shazeer、2020)活性化関数と回転位置埋め込み(RoPE)(Suら、2021)を使用しています.

Q: カメレオンのモデルにおいて、アーリーフュージョン、トークンベース、ミックスモダルの設定に合わせたアーキテクチャーのパラメータ化はどのように行われているのでしょうか?

A: Chameleonモデルのアーキテクチャのパラメータ化は、early-fusion、token-based、mixed-modalの設定に合わせて調整されています.具体的には、異なるモーダル間の情報を効果的に統合するために、トークンベースのアーキテクチャが採用されています.このアーキテクチャでは、画像とテキストのような異なるモーダルの情報をトークンとして表現し、それらを組み合わせることで、モデルがシーケンス内で柔軟に理解と生成を行うことが可能となっています.

Q: ビジュアル質問応答、画像キャプション、テキスト生成、画像生成など、カメレオンモデルが評価されたタスクの例を教えてください.

A: Chameleonモデルは、視覚的な質問応答、画像キャプション、テキスト生成、画像生成などのタスクで評価されました.

Q: カメレオンはLlama-2、Mixtral 8x7B、Gemini-Pro、GPT-4Vのような他のモデルと比べて性能面でどうですか?

A: Chameleonは、Llama-2、Mixtral 8x7B、Gemini-Pro、およびGPT-4Vと比較して、性能が優れています.特に、Chameleon-34Bは、いくつかのタスクでLlama-2 70Bを上回り、Mixtral 8x7Bと同等の性能を発揮しています.

Q: カメレオンが示した能力、例えば画像キャプションのタスクにおける最先端のパフォーマンスや、自明でない画像生成について詳しく教えてください.

A: Chameleonは、画像キャプショニングタスクにおける最先端のパフォーマンスや非自明な画像生成など、幅広い能力を示しています.また、Chameleonは、テキスト生成に画像を条件付けるタスクやビジュアルな質問応答タスクにおいても、優れた結果を示しています.

Q: 人間の判断によれば、カメレオンは新しい長時間のミックス・モーダル世代評価でどのようなパフォーマンスを見せるのだろうか?

A: Chameleonは新しい長文の混合モーダル生成評価において、人間の判断によると、強力なベースラインであるGemini-ProやGPT-4Vに比べて優れた性能を示しました.

Q: カメレオンが完全なマルチモーダル文書の統一的モデリングにおいて重要な一歩を踏み出したのはなぜか?

A: Chameleonは、画像とテキストの混在した任意のシーケンスを生成および推論できる混合モデルのファミリーであり、これにより標準的な多様なタスクを直接一般化した完全な多モーダル文書モデリングが可能となります.これは、画像生成、画像の理解および推論、およびテキストのみのLLMsなどの標準的な多モーダルタスクを含む、新しい混合モーダル推論および生成機能を可能にします.Chameleonの成功の鍵は、画像とテキストのトークンを統合した表現空間を学習することであり、これにより、モダリティ間でのシームレスな情報統合が可能となります.画像を離散的なトークンに量子化し、混合モーダルデータをゼロからトレーニングすることで、Chameleonは、遅延融合アーキテクチャや各モダリティのために別々のエンコーダを維持するモデルでは不可能な方法で画像とテキストを共同で推論することを学習します.

Q: カメレオンはどのように画像やテキストを任意のシーケンスで生成するのですか?

A: Chameleonは、任意の順序で画像とテキストを生成するために、画像トークンとテキストトークンをシリーズとして表現し、それらを自己回帰的なTransformerのスケーリング特性を活用します.これにより、Chameleonは画像とテキストを任意の順序でトレーニングすることが可能であり、テキストのみ、単一のテキスト/画像ペア、完全に交互に配置されたテキスト-画像ドキュメントなど、さまざまな順序でトレーニングを行うことができます.

Q: カメレオン・モデルの開発と評価の過程で直面した限界や課題について教えてください.

A: Chameleonモデルの開発と評価において直面した制約や課題には、既存のベンチマークでは計測できない新しい混合モーダル理解および生成能力が含まれます.これにより、大規模な多モーダル言語モデルに対する人間の評価や安全性テストが困難になります.また、Chameleonモデルの訓練における最適化やアーキテクチャの設計上の課題も挙げられます.これまでのアプローチではスケールが制限されていたため、混合モーダル学習における重要な課題が存在しました.

RLHF Workflow: From Reward Modeling to Online RLHF

著者:Hanze Dong, Wei Xiong, Bo Pang, Haoxiang Wang, Han Zhao, Yingbo Zhou, Nan Jiang, Doyen Sahoo, Caiming Xiong, Tong Zhang

発行日:2024年05月13日

最終更新日:2024年05月13日

URL:http://arxiv.org/pdf/2405.07863v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Machine Learning

概要:

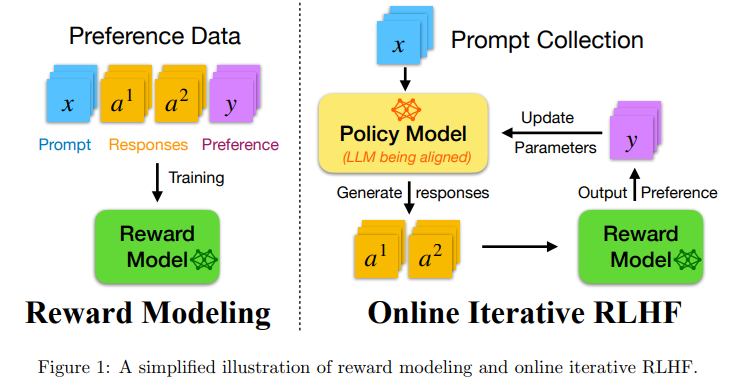

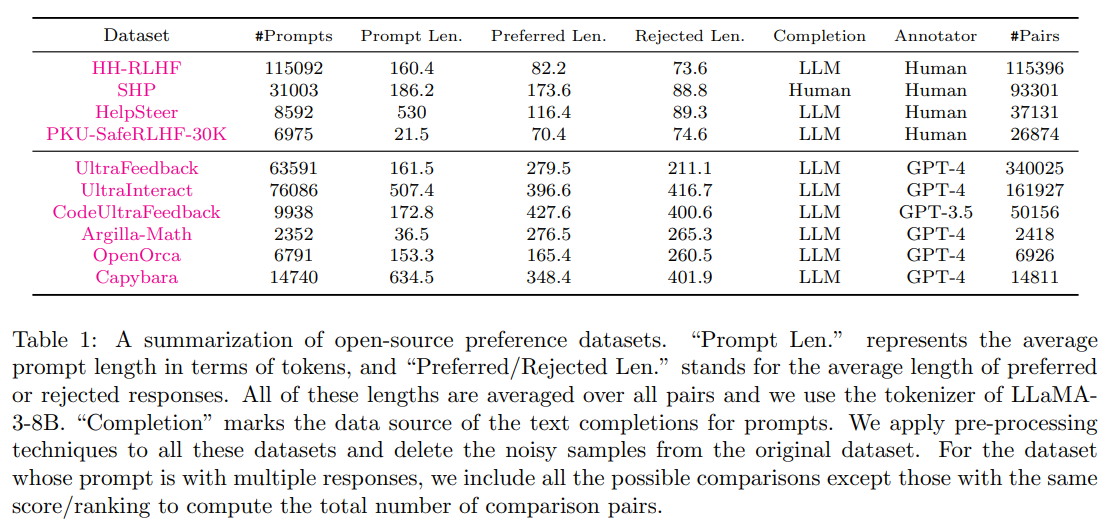

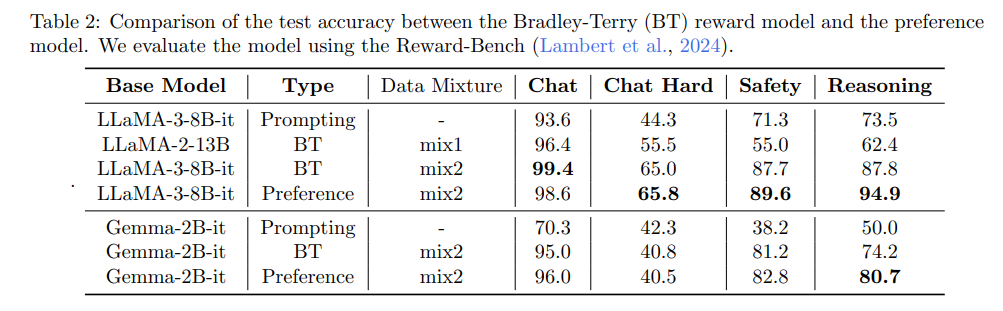

この技術レポートでは、私たちはオンライン反復強化学習からの人間フィードバック(RLHF)のワークフローを紹介しています.これは、最近の大規模言語モデル(LLM)の文献で、オフラインの対応物よりも大幅に優れていると広く報告されています.しかし、既存のオープンソースのRLHFプロジェクトは、まだ主にオフライン学習の設定にとどまっています.この技術レポートでは、このギャップを埋めることを目指し、オンライン反復RLHFの簡単に再現可能な詳細な手順を提供します.特に、オンラインの人間フィードバックは、リソースが限られているオープンソースコミュニティにとって通常実現不可能ですので、多様なオープンソースのデータセットを使用して優先モデルを構築し、構築されたプロキシ優先モデルを使用して人間のフィードバックを近似します.その後、オンライン反復RLHFの理論的な洞察とアルゴリズムの原則について議論し、詳細な実装に続きます.私たちの訓練されたLLM、SFR-Iterative-DPO-LLaMA-3-8B-Rは、LLMチャットボットのベンチマーク、AlpacaEval-2、Arena-Hard、MT-Benchを含む、HumanEvalやTruthfulQAなどの他の学術的なベンチマークでも印象的なパフォーマンスを達成しています.私たちは、監督されたファインチューニング(SFT)と反復的RLHFが完全にオープンソースのデータセットで最先端のパフォーマンスを達成できることを示しました.さらに、私たちはモデル、キュレーションされたデータセット、包括的なステップバイステップのコードガイドブックを一般に公開しました.詳細については、https://github.com/RLHFlow/RLHF-Reward-Modeling および https://github.com/RLHFlow/Online-RLHF を参照してください.

Q&A:

Q: 人間のフィードバックからのオンライン反復強化学習(RLHF)のオフラインのものに対する具体的な利点を説明していただけますか?

A: オンライン反復強化学習は、オフラインの対応物に比べて、より効率的であると言えます.オンラインRLHFでは、人間のフィードバックをリアルタイムで取得し、それに基づいてモデルを改善することができます.一方、オフラインRLHFでは、事前に収集されたデータセットを使用して学習を行うため、リアルタイムのフィードバックを反映することができません.そのため、オンラインRLHFは、より迅速かつ効果的にモデルを最適化することができると言えます.

Q: オンラインRLHFワークフローで人間のフィードバックを近似するために、オープンソースのデータセットを使ってどのように嗜好モデルを構築するのか?

A: オープンソースのデータセットを使用して好みのモデルを構築し、人間のフィードバックを近似するためにプロキシ好みモデルを使用します.このプロキシ好みモデルは、オンラインの人間のフィードバックを近似するために構築されます.

Q: オンライン反復RLHFに関して、テクニカルレポートではどのような理論的洞察やアルゴリズム原理が議論されていますか?

A: 技術レポートでは、オンライン反復型RLHFに関する理論的な洞察とアルゴリズム原則が議論されています.具体的には、オンライン人間フィードバックはリソースが限られているオープンソースコミュニティにとって通常実現不可能であるため、多様なオープンソースデータセットを使用して好みモデルを構築し、構築されたプロキシ好みモデルを使用して人間フィードバックを近似する方法について述べています.その後、オンライン反復型RLHFの理論的洞察とアルゴリズム原則について詳細に説明し、主要なアルゴリズムフレームワークを示し、主要な原則とアルゴリズムのアイデアを要約しています.

Q: 訓練されたLLM、SFR-Iterative-DPO-LaLMA-3-8B-Rの実用的な実装と、様々なベンチマークでの性能について詳しく教えてください.

A: 訓練されたLLM、SFR-Iterative-DPO-LLaMA-3-8B-Rの実用的な実装については、オンライン反復型RLHFのワークフローを研究し、オンポリシーサンプリングと多様なオープンソースの優先度データセットでトレーニングされたプロキシ優先度モデルからの外部優先度信号を活用しています.この結果モデルは、標準ベンチマークで印象的なパフォーマンスを示し、データ、コード、モデル、およびハイパーパラメータの選択肢を再現するための詳細な手順を提供しています.

Q: 完全なオープンソースデータセットで最先端の性能を達成するために、教師あり微調整(SFT)と反復RLHFはどのように貢献するのか?

A: 監督された微調整(SFT)と反復的RLHFは、完全なオープンソースのデータセットで最先端のパフォーマンスを達成するために貢献します.SFTにより、初期ポリシーπ0を取得し、RLHFにより、構築されたプロキシ嗜好モデルを使用して人間のフィードバックを近似します.これにより、オンライン反復的RLHFが実装され、理論的洞察とアルゴリズム原則が議論されます.トレーニングされたLLM、SFR-Iterative-DPO-LLaMA-3-8B-Rは、LLMチャットボットのベンチマークで印象的なパフォーマンスを達成し、他の学術的ベンチマークでも優れた結果を示しています.

Q: モデル、データセット、コードガイドブックなど、あなたの研究を再現しようとする人たちのために、どのようなリソースを公開しましたか?

A: 私たちは、モデル、キュレーションされたデータセット、そして包括的なステップバイステップのコードガイドブックを公開しました.

Q: RLHFのワークフローにおいて、リソースの限られたオープンソースコミュニティにとって、オンラインによる人的フィードバックが実現不可能であるという課題にどのように対処していますか?

A: オープンソースコミュニティには限られたリソースしかないため、オンラインでの人間のフィードバックを得ることは困難です.そのため、我々は多様なオープンソースデータセットを使用して好みモデルを構築し、構築された代理好みモデルを使用して人間のフィードバックを近似します.そして、オンライン反復型RLHFの理論的洞察とアルゴリズム原則について議論し、詳細な実装を行います.

Q: AlpacaEval-2、Arena-Hard、MT-Benchなど、訓練されたLLMが印象的なパフォーマンスを達成した具体的なベンチマークについて詳しく教えてください.

A: 訓練されたLLMが印象的なパフォーマンスを達成した特定のベンチマークについて詳しく説明します.AlpacaEval-2、Arena-Hard、およびMT-Benchなどのベンチマークにおいて、モデルはゼロショット学習またはインコンテキスト学習を使用して評価されました.これらのベンチマークにおいて、モデルは高いスコアを獲得し、人間の選好との一致度が高いことが示されました.特に、AlpacaEval-2では、モデルは他のモデルよりも高いスコアを獲得しました.Arena-HardおよびMT-Benchでも、モデルは優れたパフォーマンスを示しました.

Q: オフラインの学習環境と、あなたが開発したオンラインの反復型RLHFワークフローとの主な違いは何ですか?

A: オフライン学習設定と開発したオンライン反復RLHFワークフローの主な違いは、オフライン学習では高品質のオフライン優先データセットから学習するのに対し、オンライン反復RLHFでは構築したプロキシ優先モデルを使用して人間のフィードバックを近似することです.オンライン反復RLHFは、オンライン探索の利点を理論的な観点から理解し、モデルのパフォーマンスを大幅に向上させることが示されています.

Q: 現在利用可能なオープンソースのRLHFプロジェクトは、オンライン反復RLHFの機能という点で、技術報告書に示されたワークフローと比較してどうですか?

A: 提供されている技術レポートに示されているオンライン反復型RLHFの能力に比べて、現在利用可能なオープンソースRLHFプロジェクトは、オンライン反復型RLHFの機能においては大きな制約があると言えます.具体的には、オンライン人間フィードバックは一般的にオープンソースコミュニティには限られたリソースしか持っていないため、代理的な優先度モデルを使用して人間のフィードバックを近似する必要があります.一方、提供されている技術レポートでは、多様なオープンソースデータセットを使用して構築された代理的な優先度モデルを介して外部の優先度信号を活用し、オンポリシーサンプリングを行うことでオンライン反復型RLHFを実現しています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 新しい手法のコード実装のurlは、https://github.com/RLHFlow/Online-RLHF および https://github.com/RLHFlow/RLHF-Reward-Modeling です.

Zero-Shot Tokenizer Transfer

著者:Benjamin Minixhofer, Edoardo Maria Ponti, Ivan Vulić

発行日:2024年05月13日

最終更新日:2024年05月13日

URL:http://arxiv.org/pdf/2405.07883v1

カテゴリ:Computation and Language

概要:

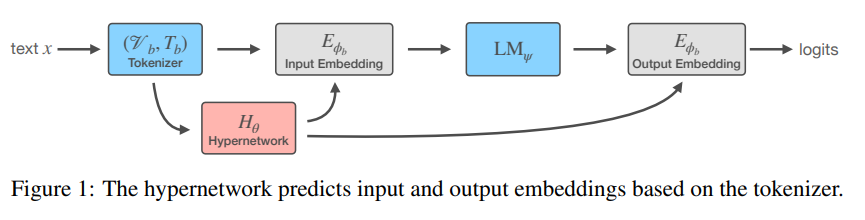

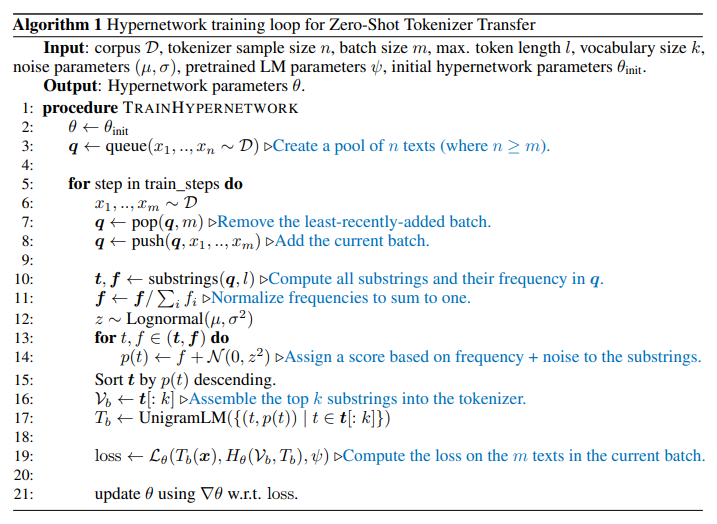

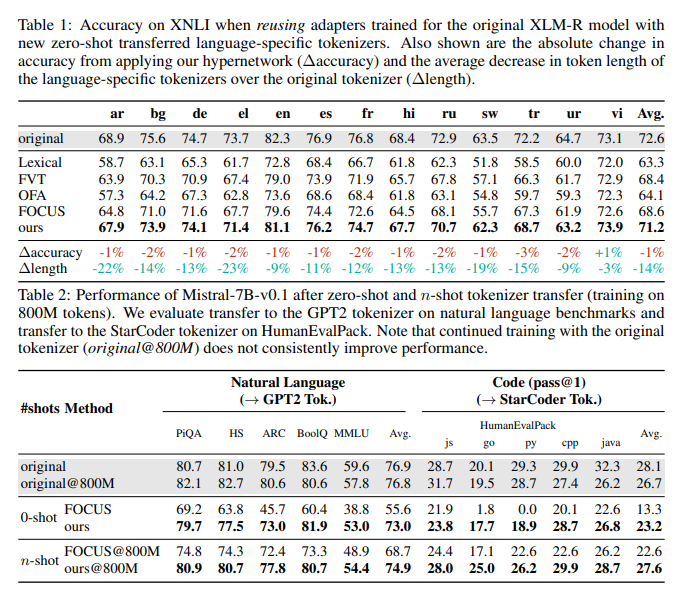

言語モデル(LM)は、生のテキストを語彙アイテム(トークン)のシーケンスにマッピングするトークナイザーに拘束されています.これにより、彼らの柔軟性が制限されます.たとえば、主に英語で訓練されたLMは、他の自然言語やプログラミング言語でもうまく機能するかもしれませんが、英語中心のトークナイザーのために効率が大幅に低下しています.これを緩和するために、パフォーマンスを低下させることなく、オリジナルのLMトークナイザーを任意のものと交換できるようにする必要があります.したがって、この研究では、新しい問題を定義します:ゼロショットトークナイザートランスファー(ZeTT).ZeTTの中心的な課題は、新しいトークナイザーの語彙のトークンに埋め込みを見つけることです.以前の埋め込みを初期化するためのヒューリスティックは、ZeTT設定ではチャンスレベルでのパフォーマンスを発揮することが多いため、新しい解決策を提案します.トークナイザーを入力として取り、対応する埋め込みを予測するハイパーネットワークをトレーニングすることで、新しいトークナイザーに一般化することを実証します.私たちの方法は、エンコーダー(例:XLM-R)やデコーダーLLM(例:Mistral-7B)を持つ新しいトークナイザーにオリジナルモデルのパフォーマンスに近づき、クロスリンガルやコーディングタスクで顕著に効果を発揮します.さらに、クロスリンガルやコーディングタスクにおいてパフォーマンスを向上させる一方で、トークン化されたシーケンスの長さを著しく短縮することができることがわかりました.また、残された差は1B未満のトークンでの継続的なトレーニングによって迅速に埋められることも分かりました.最後に、ベース(L)LM用にトレーニングされたZeTTハイパーネットワークは、追加のトレーニングなしでファインチューニングされたバリアントにも適用できることを示します.総合的に、私たちの結果は、LMをそのトークナイザーから切り離すために大きな進歩をもたらしています.

Q&A:

Q: この文章で取り上げられている主な問題は何ですか?

A: この文章で主に取り上げられている問題は、サブワードトークン化を使用するモデルが数字のシーケンスやスペルミスのあるテキストを解析する際に問題が生じることです.

Q: 現在の言語モデルのトークナイザーへの依存は、その柔軟性をどのように制限しているのでしょうか?

A: 言語モデルは、トークナイザーに依存しており、生のテキストを語彙アイテム(トークン)のシーケンスにマッピングします.この依存関係により、モデルは特定のトークナイザーに縛られ、異なるトークナイザーを使用することが不可能となります.したがって、モデルの柔軟性が制限され、例えば英語を主に学習した言語モデルでも他の自然言語やドメインでの性能が制限される可能性があります.

Q: ゼロショット・トークナイザー・トランスファー(ZeTT)の問題に対する提案された解決策とは?

A: 新しい解決策は、トークナイザを入力として取り、対応する埋め込みを予測するハイパーネットワークをトレーニングすることです.

Q: 埋め込みを初期化するための先行するヒューリスティックは、ZeTT設定においてどのように機能するのか?

A: 先行ヒューリスティックによる埋め込みの初期化は、ZeTT設定ではしばしば偶然水準で実行されます.

Q: この文章で提案されているハイパーネットワークは、ZeTTの文脈ではどのように機能するのか?

A: 提案されたハイパーネットワークは、新しいトークナイザの埋め込みを予測するためにトークナイザを入力として取り、対応する埋め込みを予測するように訓練されます.このハイパーネットワークは、新しいトークナイザにもエンコーダ(例:XLM-R)とデコーダLLM(例:Mistral-7B)の両方で汎化することが示されています.ハイパーネットワークは、元のモデルの埋め込み空間を保持するため、例えば元のモデル用にトレーニングされたアダプタを異なるトークナイザに再利用したり、ベースモデル用にトレーニングされたハイパーネットワークを使用して新しいトークナイザに微調整されたモデルを転送するなど、柔軟性と再利用性を高めることができます.

Q: 異なる種類の言語モデルを使用したハイパーネットワークのパフォーマンスの実証結果は何ですか?

A: 異なる種類の言語モデルに対するハイパーネットワークの性能の実証結果は、元のモデルに比べて性能を向上させることが示されました.ハイパーネットワークは、新しいトークナイザーにも一般化し、クロスリンガルおよびコーディングタスクにおいて元のモデルの性能に近づき、トークン化されたシーケンスの長さを著しく短縮します.残る差は、1B未満のトークンでの継続的なトレーニングによって迅速に埋められることが示されました.また、ベース(L)LM用にトレーニングされたZeTTハイパーネットワークは、追加のトレーニングなしでファインチューニングされたバリアントにも適用できることが示されました.

Q: 提案された方法は、トークン化されたシーケンスの長さにどのような影響を与えますか?

A: 提案された方法は、トークン化されたシーケンスの長さを平均して14%短縮させることが示されています.

Q: 1B未満のトークンでトレーニングを続けることが、ZeTTの成績差を縮めるのに役立つのか?

A: 1B未満のトークンでの継続的なトレーニングは、ハイパーネットワークを通じてトークナイザーへの迅速な適応を可能にし、以前の作業が数千億のトークンを必要としたのに対して、わずか数パーセントの精度でパフォーマンスを維持することができるようになります.

Q: ベースとなる(L)LMに対して学習されたZeTTハイパーネットワークは、追加学習なしに微調整された変種に適用できるか?

A: はい、ZeTTハイパーネットワークは、追加のトレーニングなしでベース(L)LMのファインチューニングバリアントに適用できます.

Q: 言語モデルをトークナイザーから切り離すために、この文章で示された結果は全体としてどのような意味を持つのでしょうか?

A: 結果の全体的な意味は、言語モデルをトークナイザーから切り離すことに向けて大きな進展をもたらします.これにより、モデルが特定のトークナイザーに縛られることなく、異なるトークナイザーで推論を行うことが可能になります.これは、言語モデルの柔軟性と汎用性を向上させ、異なる言語やドメインにおいて効率的に適用できるようになります.

Does Fine-Tuning LLMs on New Knowledge Encourage Hallucinations?

著者:Zorik Gekhman, Gal Yona, Roee Aharoni, Matan Eyal, Amir Feder, Roi Reichart, Jonathan Herzig

発行日:2024年05月09日

最終更新日:2024年05月13日

URL:http://arxiv.org/pdf/2405.05904v2

カテゴリ:Computation and Language

概要:

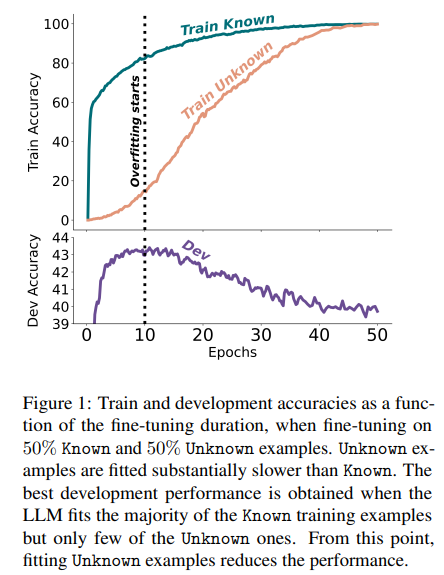

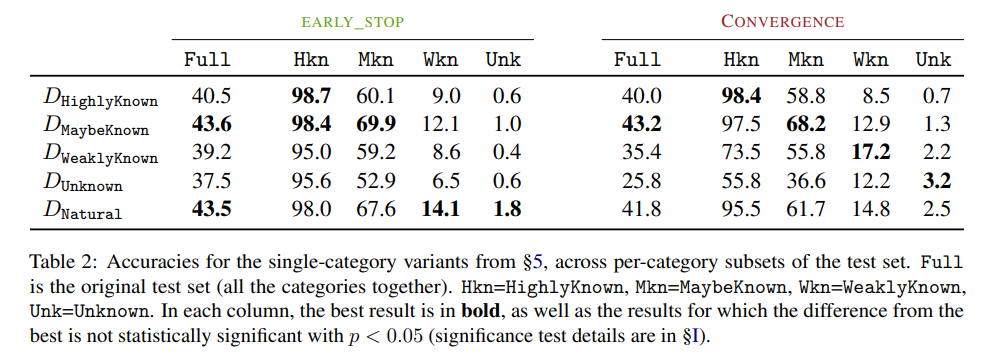

大規模言語モデルは、監督された微調整を通じて新しい事実知識を獲得することに苦労することが示されています.これは、大部分の場合、大規模な言語モデルが事前トレーニングを通じて事実知識を獲得する一方、微調整によってそれを効果的に活用するように教えられるという見方を支持しています.新しい知識を持つ微調整例は、モデルの知識と一致する例よりも学習が遅れる傾向がありますが、最終的には学習されると、モデルの幻覚傾向が線形的に増加することも示されています.総じて、この研究は、微調整を通じて新しい事実知識を導入することのリスクを強調し、大規模な言語モデルが幻覚する傾向を増加させる可能性を示唆しています.

Q&A:

Q: 大規模言語モデルの教師ありファインチューニングのプロセスについて教えてください.

A: 大規模言語モデルの教師ありファインチューニングプロセスは、通常、指示に従うタスクや人間のフィードバックからの好み学習を通じて行われます.これにより、モデルは事前学習で獲得した事実知識を効率的に活用する方法を学習します.ファインチューニングの過程では、モデルのパラメータを微調整し、特定のタスクに適した振る舞いを獲得させることが目的です.この過程は、モデルが新しいデータに適応し、より高い性能を発揮できるようにするために重要です.

Q: ファインチューニング中に新しい事実情報に触れることは、モデルの挙動にどのような影響を与えるのか?

A: 新しい事実情報にさらされることは、モデルの振る舞いにどのような影響を与えるかを考えると、そのような新しい知識にさらされることは、モデルが事実に基づかない事実を生成するように訓練されているため、モデルが事実に基づかない回答を幻覚する可能性があると推測されています.

Q: 微調整されたモデルに対する新しい知識の影響を研究するために、どのような管理されたセットアップをデザインしたのですか?

A: 新しい知識がファインチューニングされたモデルに与える影響を研究するために設計された制御されたセットアップは、既存の知識を利用することを強化するメカニズムとしてファインチューニングがより有用である可能性を示しています.

Q: あなたの研究では、新しい知識を導入する微調整例の割合をどのように変化させたのですか?

A: 研究では、新しい知識を導入するファインチューニング例の割合を変化させました.

Q: ファインチューニングによる新たな事実知識の習得に関して、どのような発見があったのだろうか?

A: 新しい事実知識の獲得は、ファインチューニングを通じて行われる際に、モデルが新しい知識を獲得するのに苦労し、主に事前トレーニングで知識を獲得することが示されました.また、新しい知識を学習する過程で、モデルは徐々に幻覚を起こしやすくなることが明らかになりました.

Q: 新しい知識を持つ例を学習するにつれて、モデルの幻覚傾向はどのように変化しましたか?

A: 新しい知識を持つ例を学習するにつれて、モデルの幻覚傾向は変化しました.

Q: ファインチューニングによって新たな事実知識を導入する際に、どのようなリスクがあることが浮き彫りになりましたか?

A: 結果は、ファインチューニングを通じて新しい事実知識を導入する際のリスクを強調しました.新しい知識を獲得することが、既存の知識に関する幻覚と相関していることが示されました.また、LLMはファインチューニングを通じて新しい知識を統合するのに苦労し、主に既存の知識を使用することを学ぶ傾向があることが明らかになりました.

Q: 大規模な言語モデルの事実知識を獲得するための事前学習の役割について詳しく教えてください.

A: 大規模言語モデルが事実知識を獲得する際の事前トレーニングの役割は非常に重要です.事前トレーニングによって、モデルは大規模なテキストコーパスから事実知識を埋め込むことができます.これにより、モデルのパラメータに多くの事実知識が組み込まれ、様々な下流のアプリケーションで優れた性能を発揮することが可能となります.事前トレーニングによって獲得された事実知識は、モデルが新しい知識を取り入れる際の基盤となり、その後の微調整において効率的に活用されることができます.

Q: ファインチューニングは、大規模な言語モデルが既存の知識をより効率的に利用するのに役立つのだろうか?

A: 大規模言語モデルは、ファインチューニングを通じて、事前に獲得した知識をより効率的に活用することができます.ファインチューニングは、モデルが新しい知識を獲得するのを助けるだけでなく、既存の知識をより効果的に利用する方法を教えることができます.

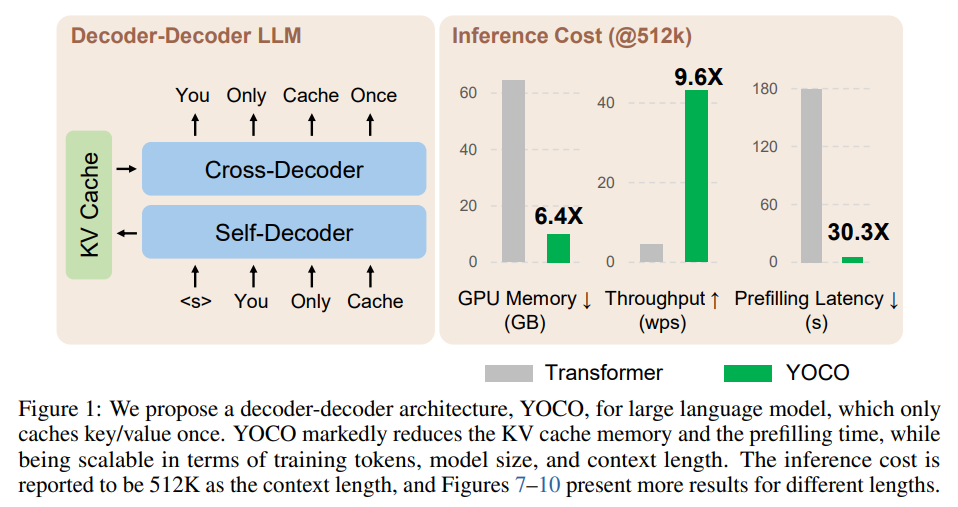

You Only Cache Once: Decoder-Decoder Architectures for Language Models

著者:Yutao Sun, Li Dong, Yi Zhu, Shaohan Huang, Wenhui Wang, Shuming Ma, Quanlu Zhang, Jianyong Wang, Furu Wei

発行日:2024年05月08日

最終更新日:2024年05月09日

URL:http://arxiv.org/pdf/2405.05254v2

カテゴリ:Computation and Language

概要:

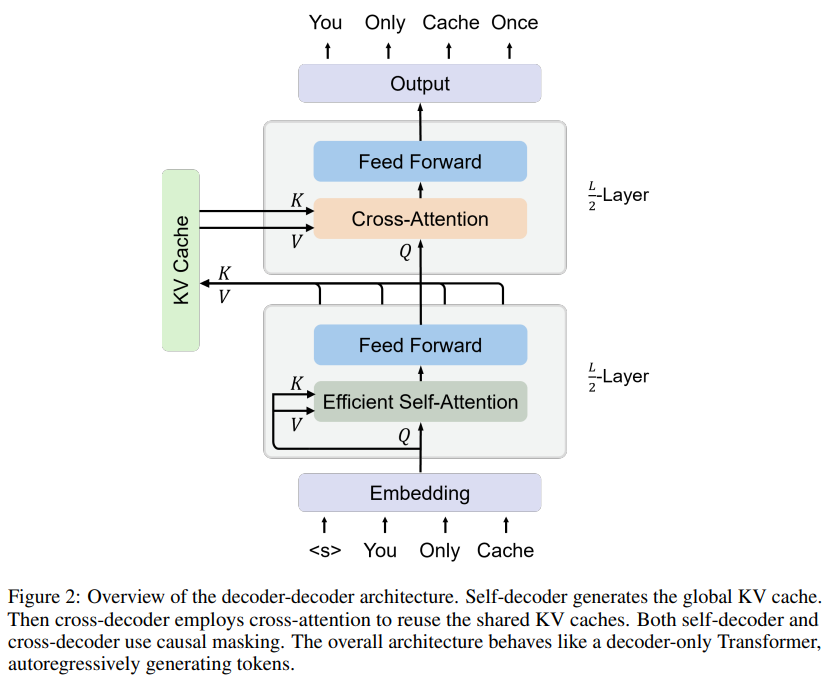

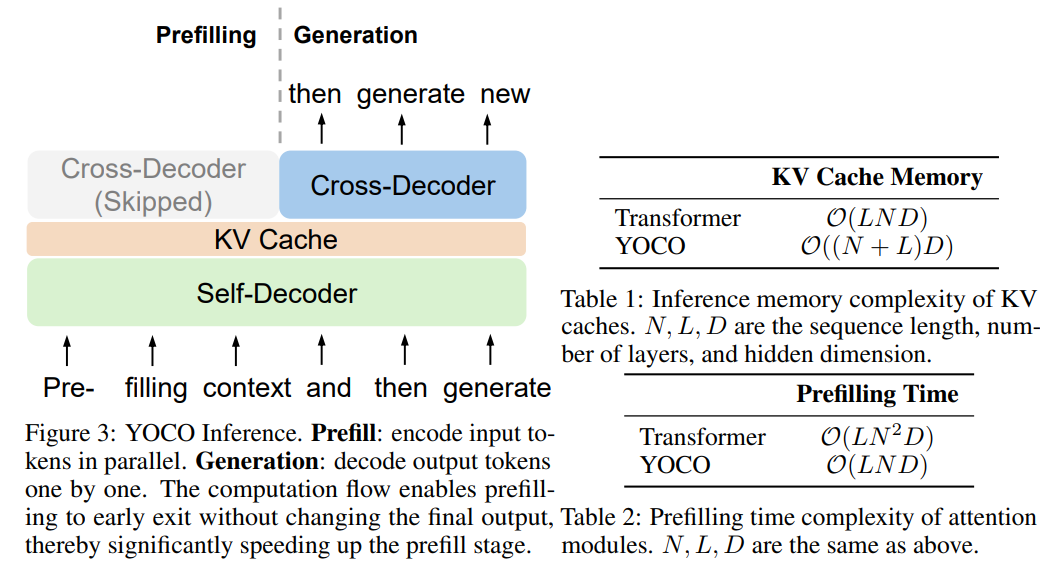

YOCOというデコーダーデコーダーアーキテクチャを導入しました.このアーキテクチャは、大規模な言語モデル向けに、キーと値のペアを一度だけキャッシュするものです.YOCOは、クロスデコーダーとセルフデコーダーの2つのコンポーネントで構成されています.セルフデコーダーは、クロスアテンションを介して再利用されるグローバルなキーと値のキャッシュを効率的にエンコードします.全体的なモデルは、デコーダーのみのTransformerのように振る舞いますが、YOCOは一度だけキャッシュします.この設計により、GPUメモリの要求を大幅に削減することができますが、グローバルなアテンション機能を維持します.さらに、計算フローは、最終的な出力を変更することなく、早期終了するためのプリフィル段階を大幅に高速化します.実験結果は、YOCOがTransformerに比べて、モデルサイズのスケーリングやトレーニングトークンの数のさまざまな設定で有利なパフォーマンスを達成していることを示しています.また、YOCOを1Mのコンテキスト長に拡張し、ほぼ完璧なニードル検索精度を達成しました.プロファイリング結果は、YOCOがコンテキストの長さやモデルのサイズにわたって、推論メモリ、プリフィルの待ち時間、およびスループットを桁違いに改善していることを示しています.コードはhttps://aka.ms/YOCOで入手可能です.

Q&A:

Q: クロスアテンションを介してクロスデコーダーによって再利用されるグローバル・キーバリュー・キャッシュを、セルフデコーダーがどのように効率的にエンコードするのか、もう少し詳しく説明していただけますか?

A: セルフデコーダは、入力シーケンスから効率的なセルフアテンションを使用してKVキャッシュを取得します.これにより、グローバルなキーと値のペアが生成され、クロスデコーダに再利用されます.具体的には、入力シーケンス\( \small x=x_1···x|X| \)が与えられた場合、入力埋め込みは\( \small X^0= [x_1,···,x|X|]∈R|X|×d_{model} \)にパックされます.最初に、文脈化されたベクトル表現\( \small X^l= Self-Decoder( X^{l-1}) \)が\( \small L/2 \)で得られ、これを用いてクロスデコーダのためのKVキャッシュ\( \small ˆK,ˆV \)が生成されます.そして、\( \small X^l= Cross-Decoder( X^{l-1},ˆK,ˆV) \)が計算され、出力ベクトル\( \small X^L \)が得られます.

Q: YOCOの全体的なモデルは、一度しかキャッシュしないにもかかわらず、どのようにデコーダのみのトランスフォーマーのように振る舞うのですか?

A: YOCOは、全体的なモデルがデコーダーのみのTransformerのように振る舞うのは、自己デコーダーがグローバルなキー・値(KV)キャッシュを効率的にエンコードし、それをクロスデコーダーがクロスアテンションを介して再利用することによって、キャッシュを一度だけ行うためです.

Q: YOCOの設計が、グローバルなアテンション能力を保持しながら、GPUのメモリ需要を大幅に削減する方法について詳しく教えてください.

A: YOCOは、1つのレイヤーのグローバルなキーと値のペアのみをキャッシュするため、Transformerに比べて約L倍少ないメモリが必要となります.例えば、YOCOは1GBのGPUメモリで128Kトークンを処理できますが、Transformerは65Bモデルサイズでわずか1.6Kトークンしかサポートできません.このように、YOCOはグローバルな注意機能を維持しつつ、GPUメモリの需要を大幅に削減する設計となっています.

Q: YOCOの計算フローは、最終的な出力を変えることなく、プリフィルからアーリーエグジットまでを可能にする.

A: YOCOの計算フローは、最終出力を変更せずに、早期終了によること前補充を可能にします.これにより、事前補充段階を大幅に高速化することができます.具体的には、YOCOは、事前補充段階での計算フローを最適化し、最終出力に影響を与えずに早期終了を実現します.これにより、事前補充にかかる時間を大幅に短縮することができます.

Q: YOCOがTransformerと比較して、モデルサイズや学習トークン数をスケールアップする様々な設定において良好なパフォーマンスを達成したことを示す、具体的な実験結果はどのようなものだったのでしょうか?

A: YOCOは、モデルサイズのスケーリングやトレーニングトークン数の増加といったさまざまな設定において、Transformerに比べて有利なパフォーマンスを達成する具体的な実験結果が示されています.特に、トレーニングトークン数を増やした場合やモデルサイズを拡大した場合において、YOCOは有利な結果を示しました.

Q: YOCOはどのようにして、ほぼ完璧な抜針精度で1Mの長さに拡張されたのですか?

A: YOCOは1Mトークンのコンテキスト長に拡張され、ほぼ完璧なニードル検索精度を達成しました.この拡張では、YOCO-3Bのコンテキスト長が64K、256K、1Mトークンに進行的に延長され、モデルのトレーニングが続けられました.バッチサイズは以前と同じままであり、学習率とRoPEも同様に保たれました.この長いコンテキストにより、YOCOは言語モデリングのための遠隔情報を活用し、性能を向上させました.

Q: YOCOが推論メモリ、プリフィルレイテンシ、スループットを、コンテキストの長さやモデルのサイズに関係なく何桁も改善したことを示すプロファイリング結果について、もう少し詳しく教えてください.

A: YOCOは、推論メモリ、プリフィルレイテンシ、およびスループットを、コンテキストの長さやモデルサイズにわたって桁違いに改善することを示すプロファイリング結果があります.例えば、65BモデルではKVキャッシュのメモリを約80倍削減でき、3Bモデルでも32Kトークンの場合には推論メモリ消費を2倍、1Mトークンの場合には9倍以上削減できます.また、プリフィル段階では、1Mコンテキストでは71.8倍、32K入力では2.87倍のスピードアップが可能です.512Kコンテキストの場合、YOCOはトランスフォーマープリフィリングのレイテンシを180秒から6秒未満に短縮します.

Q: https://aka.ms/YOCO、どのようにYOCOの実装と理解をサポートしているのか?

A: コードがhttps://aka.ms/YOCOで利用可能であることにより、YOCOの実装と理解をサポートします.このコードを使用することで、YOCOのアーキテクチャや機能をより詳細に理解し、実装する際に参考にすることができます.また、コードの公開により、他の研究者や開発者がYOCOを使用して新しいアイデアや改善を行うことが可能となります.

Q: YOCOを実用化する上での潜在的な限界や課題は何ですか?

A: YOCOの実装には、実際のアプリケーションでの潜在的な制限や課題がいくつか考えられます.例えば、YOCOが大規模な言語モデルに対して有利な結果を示す一方で、実際の運用においては、GPUメモリの使用量やサービング容量、事前充填時間、スループットなどのデプロイメント上の課題が生じる可能性があります.また、YOCOの導入には高いコストや専門知識が必要となることも考えられます.

Q: YOCOや関連する言語モデルのデコーダー・デコーダー・アーキテクチャーの今後の研究の方向性や開発計画はありますか?

A: YOCOや関連するデコーダーデコーダーアーキテクチャに関する将来の研究方向や開発計画は、YOCO + BitNet + Groqの組み合わせを検討することが挙げられます.GroqはSRAM内にすべてを配置することで非常に高いスループットを実現していますが、メモリ容量のボトルネックがモデルサイズや入力トークン数を制限しています.現在、数百のチップが1つのモデルをホストに接続しています.YOCOはKVキャッシュを削減することで、この問題に対処しています.このようなアプローチにより、YOCOは長いシーケンスモデリングに特に効果的な推論効率の向上を実現しています.

WavCraft: Audio Editing and Generation with Large Language Models

著者:Jinhua Liang, Huan Zhang, Haohe Liu, Yin Cao, Qiuqiang Kong, Xubo Liu, Wenwu Wang, Mark D. Plumbley, Huy Phan, Emmanouil Benetos

発行日:2024年03月14日

最終更新日:2024年05月10日

URL:http://arxiv.org/pdf/2403.09527v3

カテゴリ:Audio and Speech Processing

概要:

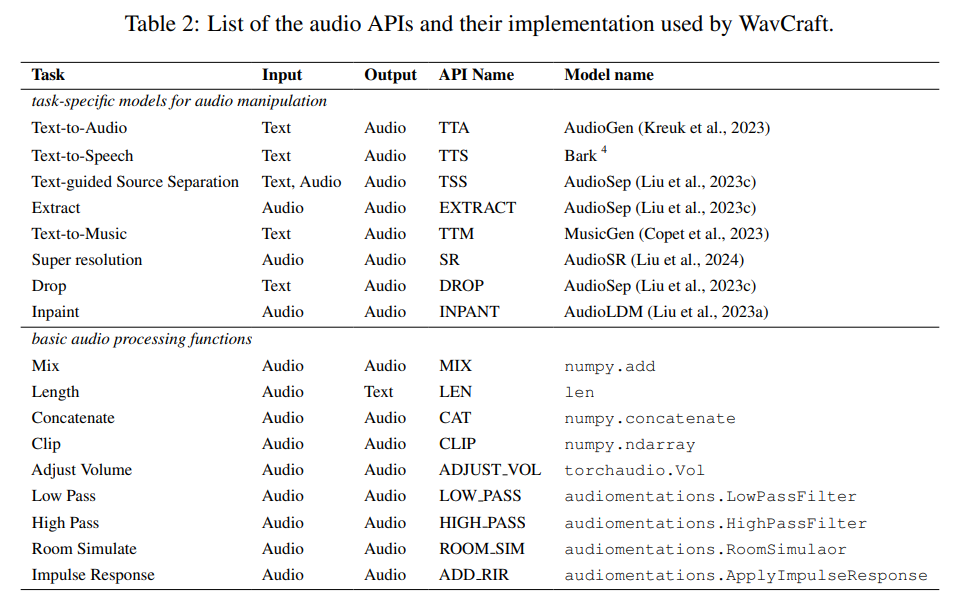

WavCraftは、大規模言語モデル(LLM)を活用して、音声コンテンツの作成と編集のためのさまざまなタスク固有モデルを結びつける集合システムです.具体的には、WavCraftは生の音声素材の内容を自然言語で記述し、音声の説明とユーザーの要求に基づいてLLMを促します.WavCraftは、LLMの文脈学習能力を活用して、ユーザーの指示を複数のタスクに分解し、各タスクを特定のモジュールと協力して取り組みます.タスク分解と一連のタスク固有モデルにより、WavCraftは入力指示に従ってより詳細で合理的な音声コンテンツの作成や編集を行い、ユーザーの制御を容易にします.さらに、WavCraftは対話インタラクションを通じてユーザーと協力し、明示的なユーザーの命令なしに音声コンテンツを生成することができます.実験では、WavCraftが既存の方法よりも優れたパフォーマンスを発揮し、特に音声クリップの局所領域を調整する際に優れた結果を示すことが示されています.さらに、WavCraftは入力録音の上に複雑な指示に従って音声コンテンツを編集および作成することができ、オーディオプロデューサーがさまざまなアプリケーションで活用できるように支援します.WavCraftは、https://github.com/JinhuaLiang/WavCraftで実装とデモが利用可能であり、オーディオプロデューサーがさらに幅広いアプリケーションで活用できるように支援しています.

Q&A:

Q: WavCraftは大規模な言語モデルをオーディオコンテンツの作成と編集にどのように活用していますか?

A: WavCraftは、大規模な言語モデルを活用して、音声コンテンツの作成と編集を行います.具体的には、WavCraftは大規模な言語モデルを使用して、対話形式で音声を編集し、人間のプロデューサーが複数のラウンドの改良を通じて音声コンテンツを作成するのを支援します.さらに、WavCraftは音声スクリプトとコメント行を生成し、音声コンテンツの作成プロセスを説明します.この思考の連鎖方法により、WavCraftの解釈可能性と透明性が向上します.

Q: WavCraftがどのようにユーザーの指示をタスクに分解し、タスクに特化したモデルと連携しているのか説明していただけますか?

A: WavCraftは、ユーザーの指示を複数のタスクに分解し、各タスクを特定のモジュールと共同で処理します.タスク分解とタスク固有のモデルにより、WavCraftは入力された指示に従ってオーディオコンテンツをより詳細かつ合理的に作成または編集し、ユーザーの制御を容易にします.具体的には、WavCraftは自然言語処理を使用して、ユーザーのクエリと入力オーディオの説明から、ChatGPT(OpenAI、2023)を直接プロンプトして、事前定義されたテンプレートから一連の指示を作成します.また、WavCraftは専門のオーディオモデルのAPIを呼び出して生成されたコンピュータプログラムを実行します.

Q: WavCraftは、オーディオコンテンツの作成と編集において、どのようにユーザーをコントロールしているのですか?

A: WavCraftは、ユーザーの要求を実行可能な行に変換し、対象の属性を編集しながら残りを変更せずに維持することができるため、ユーザーがオーディオコンテンツを作成および編集する際にユーザーの制御を容易にします.

Q: WavCraftがユーザーとの対話を通じてどのように協力できるのか、詳しく教えてください.

A: WavCraftは、ユーザーとの対話インタラクションを通じて協力し、明示的なユーザーコマンドなしに音声コンテンツを生成することができます.実験では、WavCraftが既存の方法よりも優れたパフォーマンスを発揮し、特に音声クリップのローカル領域を調整する際に優れた結果を示しました.さらに、WavCraftは複雑な指示に従って音声を編集することができます.

Q: 既存の方法と比較してWavCraftのパフォーマンスを示した実験の結果は何でしたか?

A: WavCraftのパフォーマンスは、既存の方法と比較して優れていることが実験で示されました.具体的には、WavCraftは周波数と時間の制御において、AUDITや基準と比較して最良の結果を達成しました.また、音量に関しても、WavCraftはAUDITよりも優れたMOS値を達成しました.また、WavCraftは音声テキストの関連性、音声の一貫性、自然さ、魅力、創造性のすべての側面で、AUDITよりも優れたスコアを収めました.

Q: WavCraftはオーディオクリップのローカルリージョンをどのように調整しますか?

A: WavCraftは、ローカル領域のオーディオクリップを調整するために、入力オーディオとユーザーの指示に基づいてオーディオコンテンツを作成することができます.既存のオーディオエージェントと比較して、WavCraftは音の埋め込みや削除など、より広範囲のオーディオコンテンツの作成が可能です.

Q: WavCraftがオーディオコンテンツの編集や作成に使用できる、複雑な指示の例を教えてください.

A: WavCraftは、ユーザーの指示を複数の基本的なタスクに分解し、より複雑な編集アプリケーションを説明可能な方法で実行できるため、複雑な指示をフォローすることができます.例えば、音声の一部を削除したり、音声を埋めたりするなどの指示を処理できます.

Q: WavCraftがオーディオプロデューサーの役に立つ、より広範なアプリケーションにはどのようなものがありますか?

A: WavCraftは、音声プロデューサーにとって有用な広範なアプリケーションがある.例えば、音声コンテンツの生成、編集、スクリプトライティングなどの様々なタスクに対応できる.また、音声の追加、削除、置換、高解像度化、補完などの基本的なタスクだけでなく、複雑なタスクにも対応できる.WavCraftは、ユーザーの指示や入力音声に基づいて音声コンテンツを生成するだけでなく、高い柔軟性を持って様々な音声制作ツールを組み立てることができるため、音声プロデューサーにとって非常に有用である.

Q: ユーザーがWavCraftの実装やデモにアクセスする方法を教えてください.

A: WavCraftの実装とデモにアクセスする方法は、https://github.com/JinhuaLiang/WavCraft にアクセスすることで可能です.

Q: WavCraftの現在の実装で直面している制限や課題はありますか?

A: WavCraftは現在の実装においていくつかの制限や課題に直面しています.具体的には、既存のオーディオ解析モデルの性能が限られており、入力オーディオの時間的関係を正確に記述することができないという制限があります.また、複雑なタスクを解決するために多様なAPIを呼び出す必要があるため、推論に時間がかかるという課題も存在します.推論時間を短縮することは、より実用的なアプリケーションに適したよりシームレスな人間とAIの共同作成を実現することにつながります.