ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- Prometheus 2: An Open Source Language Model Specialized in Evaluating Other Language Models

発行日:2024年05月02日

GPT-4に代わる評価LMとしてPrometheus 2が開発され、人間やプロプライエタリなLMと高い一致度を示している. - Self-Play Preference Optimization for Language Model Alignment

発行日:2024年05月01日

RLHFアプローチは、Bradley-Terryモデルに依存し、人間の好みを捉えるのに不十分であるが、SPPOはナッシュ均衡を近似し、GPT-4-Turboに対して最先端の勝率を達成する. - A Primer on the Inner Workings of Transformer-based Language Models

発行日:2024年04月30日

Transformerベースの言語モデルの内部機能を解釈するための技術紹介書で、既知のメカニズムと研究方向を整理している. - Better & Faster Large Language Models via Multi-token Prediction

発行日:2024年04月30日

大規模な言語モデルの訓練において、複数の未来のトークンを予測することでサンプル効率が向上し、下流機能の改善が可能であることが示されています. - In-Context Learning with Long-Context Models: An In-Depth Exploration

発行日:2024年04月30日

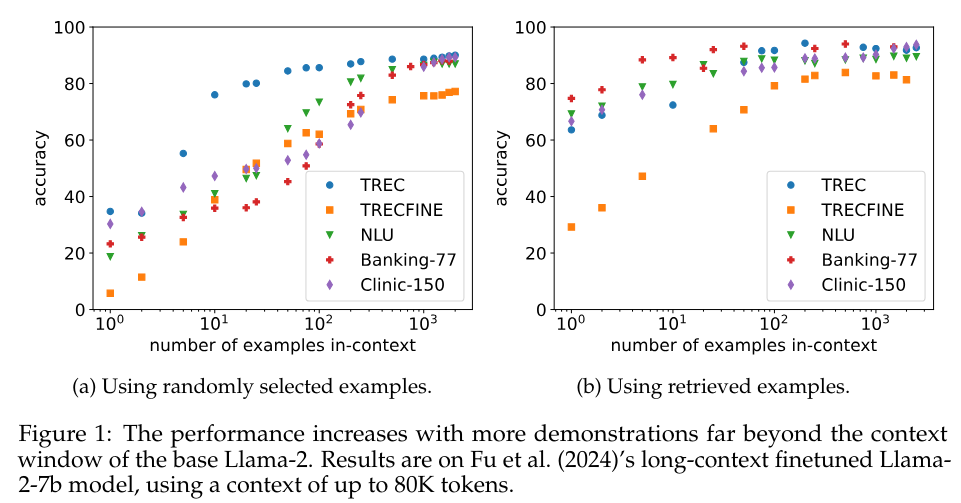

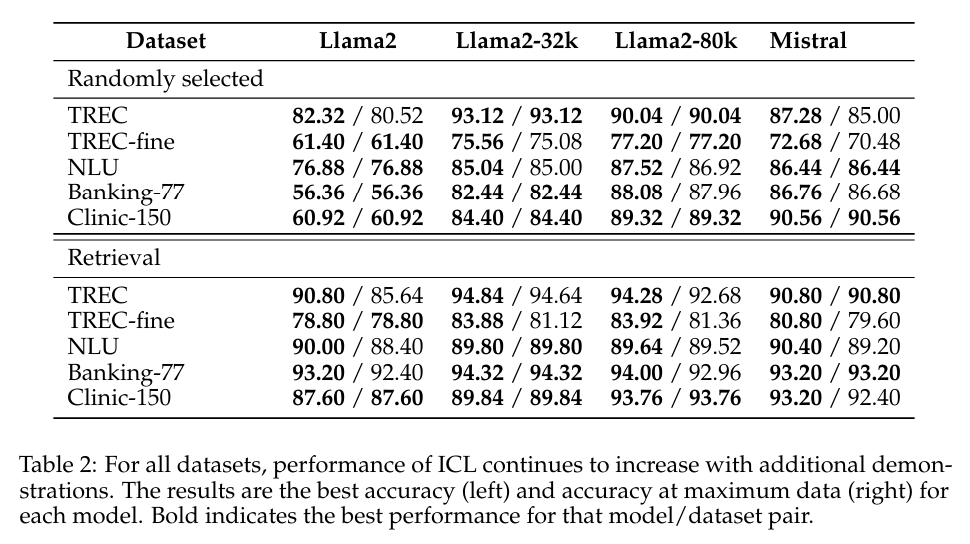

モデルのコンテキストの長さが増加すると、デモンストレーション数が増え、ICLのパフォーマンスが向上することが示されている. - KAN: Kolmogorov-Arnold Networks

発行日:2024年04月30日

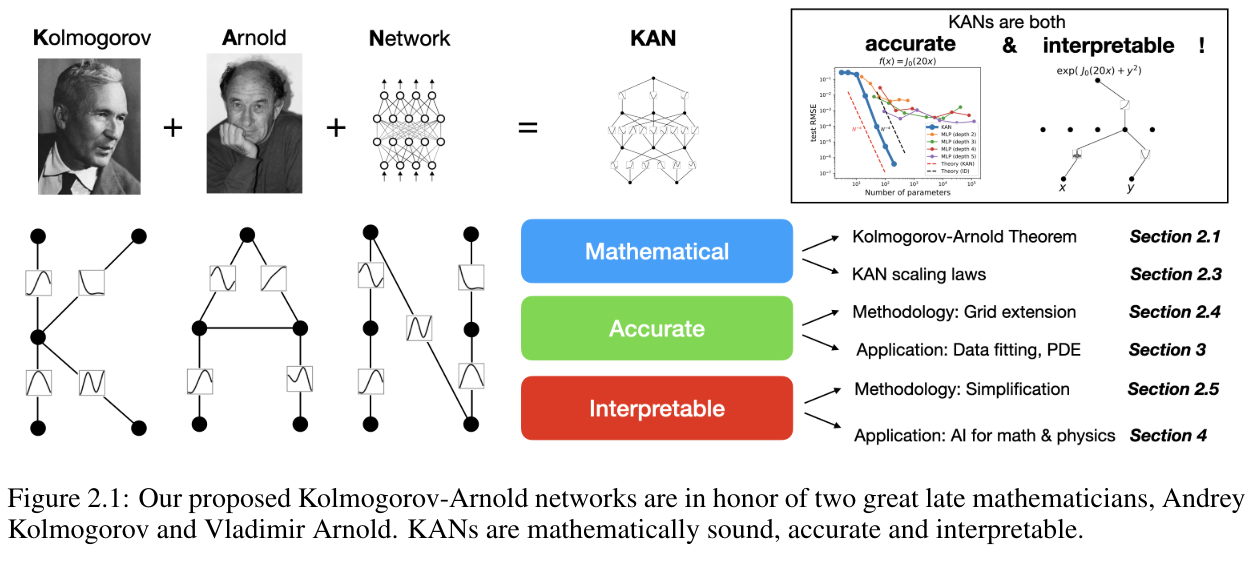

KANsはMLPsの代替手段であり、精度と解釈可能性の面で優れており、ディープラーニングモデルを改善する機会を提供している. - RAG and RAU: A Survey on Retrieval-Augmented Language Model in Natural Language Processing

発行日:2024年04月30日

RALMsは、外部リソースを統合し、NLPタスクのパフォーマンスを向上させるが、限界もあり、将来の研究方向を提案している. - When to Retrieve: Teaching LLMs to Utilize Information Retrieval Effectively

発行日:2024年04月30日

この論文では、大規模言語モデル(LLM)が、IRシステムを活用して質問に答える方法を示し、Adapt-LLMの特別なトレーニングアプローチにより、高い精度を達成することが示されています. - Capabilities of Gemini Models in Medicine

発行日:2024年04月29日

医療分野におけるAIの課題は、高度な推論能力や医学知識へのアクセスが必要であり、Med-Geminiはその要件を満たし、医療分野での高性能を示している. - Hallucination of Multimodal Large Language Models: A Survey

発行日:2024年04月29日

MLLMsやLVLMsにおける幻覚現象の分析とその対処法についての調査結果を提供し、これらのモデルの信頼性向上に貢献する.

Prometheus 2: An Open Source Language Model Specialized in Evaluating Other Language Models

著者:Seungone Kim, Juyoung Suk, Shayne Longpre, Bill Yuchen Lin, Jamin Shin, Sean Welleck, Graham Neubig, Moontae Lee, Kyungjae Lee, Minjoon Seo

発行日:2024年05月02日

最終更新日:2024年05月02日

URL:http://arxiv.org/pdf/2405.01535v1

カテゴリ:Computation and Language

概要:

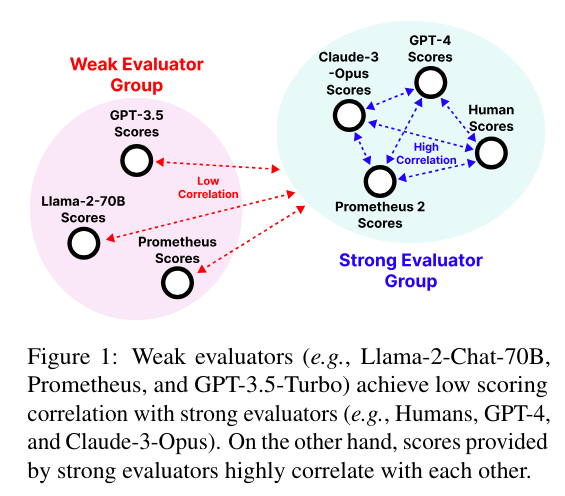

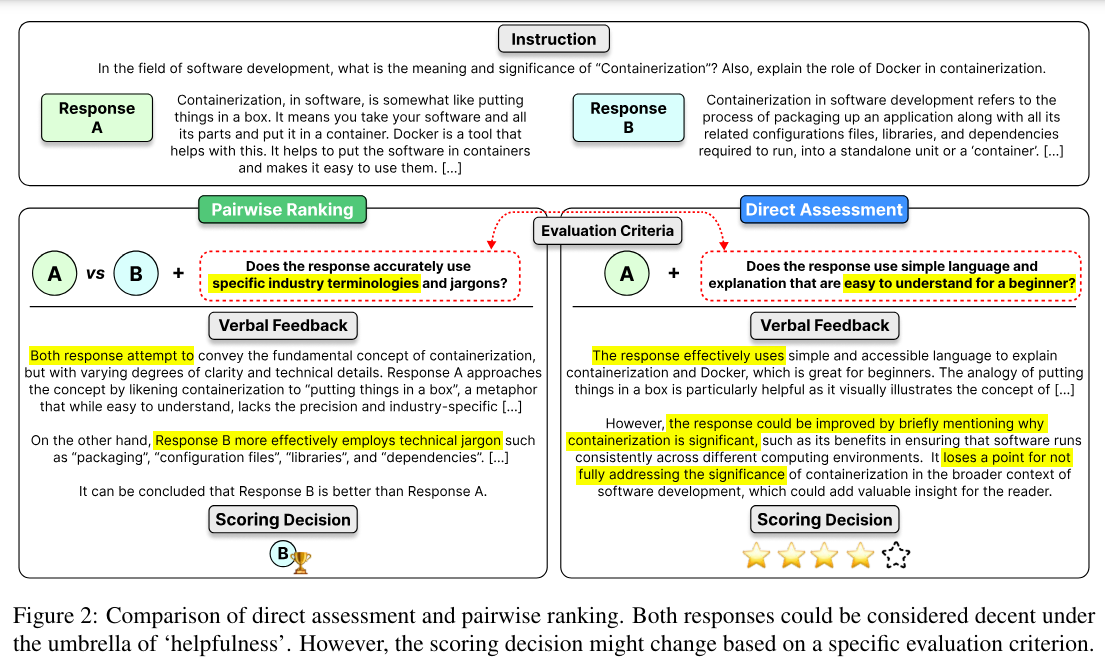

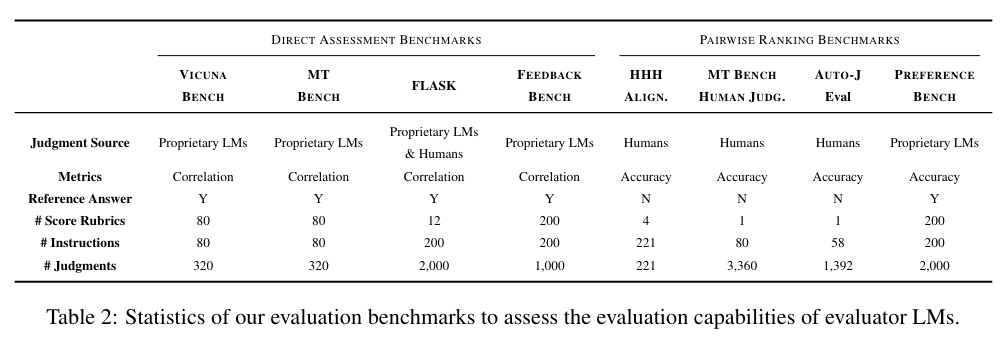

プロプライエタリなLM(言語モデル)であるGPT-4は、さまざまなLMからの応答の品質を評価するためにしばしば使用されています.しかし、透明性、コントロール性、および手頃な価格といった懸念が、評価に特化したオープンソースのLMの開発を強く促しています.一方で、既存のオープンソースの評価LMには重要な欠点があります.1つは、人間が割り当てたスコアと大きく乖離していること、もう1つは、直接評価とペアワイズランキングという、最も一般的な評価形式の両方を実行する柔軟性が欠けていることです.さらに、これらのLMは、有益性や無害性などの一般的な属性に焦点を当てる代わりに、カスタム評価基準に基づいて評価する能力を持っていません.これらの問題に対処するために、私たちは、前身よりも強力な評価LMであるPrometheus 2を紹介します.このLMは、人間やGPT-4の判断に密接に追随し、ユーザー定義の評価基準に基づいてグループ化された直接評価とペアワイズランキング形式の両方を処理する能力を持っています.4つの直接評価ベンチマークと4つのペアワイズランキングベンチマークで、Prometheus 2は最も高い相関を示しています.さらに、ペアワイズランキングベンチマークにおいて、Prometheus 2は人間やプロプライエタリなLMの判断との一致度が最も高いことが確認されています.私たちのモデル、コード、データはすべて、https://github.com/prometheus-eval/prometheus-eval で公開されています.

Q&A:

Q: プロメテウス2』開発の動機となった具体的な懸念について説明していただけますか?

A: プロメテウス2の開発を促した具体的な懸念は、透明性、操作性、および手頃な価格の問題です.既存のオープンな評価LMは、人間が割り当てたスコアと大きく乖離しており、直接評価とペアワイズランキングの両方を行う柔軟性が欠如しています.また、これらのLMは、一般的な属性(例:役立ちや無害性など)に焦点を当てるため、カスタム評価基準に基づいて評価する能力を持っていません.これらの問題を解決するために、より強力な評価LMであるプロメテウス2が導入されました.

Q: プロメテウス2は、既存のオープンエバリュエータLMの重大な欠点にどのように対処しているのか?

A: Prometheus 2は、既存のオープンな評価LMの重要な欠点を解決するために、人間やGPT-4の判断に密接に追従するより強力な評価LMとして設計されています.さらに、ユーザー定義の評価基準に基づいて、直接評価とペアワイズランキング形式の両方を処理できる能力を持っています.PROMETHEUS 2は、4つの直接評価ベンチマークと4つのペアワイズランキングベンチマークで、すべてのテストされたオープンな評価LMの中で、人間やプロプライエタリLMの判断と最も高い相関性と一致を示しています.

Q: プロメテウス2は人間やGPT-4の判断をどのように反映しているのか、詳しく教えてください.

A: プロメテウス2は、人間とGPT-4の判断を密接に反映しています.具体的には、直接評価とペアワイズランキング形式の両方を処理し、ユーザー定義の評価基準にグループ化する能力を持っています.また、プロメテウス2は、人間やプロプライエタリLMの判断と最も高い相関と一致を示しており、他のテストされたオープン評価LMよりも優れています.

Q: プロメテウス2は、直接評価やペアワイズ・ランキング形式を処理できるという点で、他のオープンな評価者LMと何が違うのでしょうか?

A: Prometheus 2は、他のオープン評価者LMと比較して、直接評価とペアワイズランキング形式を処理する能力において優れています.具体的には、PROMETHEUS 2モデルは、直接評価スキームでペアワイズランキングデータセットを処理する際に、各応答を個別に評価し、スコアリングの決定を比較します.人間が選択した応答に対して拒否された応答よりも高いスコアを提供する場合、それを正しいとマークします.これにより、PROMETHEUS 2は、直接評価とペアワイズランキングの両方のスキームで優れたパフォーマンスを示し、他のオープン評価者LMとの差を大幅に縮めています.

Q: プロメテウス2では、一般的な属性とは対照的に、どのようにカスタム基準に基づいて評価できるのですか?

A: Prometheus 2は、一般的な属性ではなく、カスタム評価基準に基づいて評価を行うことができます.これは、ユーザーが定義した評価基準に基づいて直接評価およびペアワイズランキング形式を処理できる能力を持っています.

Q: Prometheus 2のパフォーマンスをテストするために使用されたベンチマークについて、もっと情報を提供していただけますか?

A: プロメテウス2の性能は、4つの直接評価ベンチマーク(Vicuna Bench、MT Bench、FLASK、Feedback Bench)と4つのペアワイズランキングベンチマークでテストされました.結果は、プロメテウス2モデルが既存のオープン評価LMと比較して、人間の評価者とプロプライエタリLMベースの審査員との間で最も高い相関を示したことを示しました.

Q: プロメテウス2は、人間やプロプライエタリなLMジャッジとの相関や一致という点で、他のオープン評価LMと比較してどうなのか?

A: プロメテウス2は、他のオープン評価者LMと比較して、人間とプロプライエタリLM判定者との相関と合意において最も高いスコアを示しています.直接評価とペアワイズランキングの両方で、他のオープン評価者LMと比較して、最高の相関と合意を達成しています.

Q: プロメテウス2のモデル、コード、データをGitHubで公開する意義は?

A: Prometheus 2のモデル、コード、およびデータをGitHubで公開することの重要性は、透明性と信頼性を確保するためです.これにより、他の研究者や開発者がモデルを検証し、改善することが可能となります.また、オープンソースであることにより、誰もがアクセスし、利用することができるため、研究の進展や新たな発見が促進されます.さらに、GitHub上での公開は、コラボレーションやコミュニケーションを容易にし、研究コミュニティ全体の共有と協力を促進します.

Q: プロメテウス2は、言語モデルの評価において、どのように透明性、制御性、手頃な価格を確保しているのか?

A: プロメテウス2は、透明性、コントロール性、および手頃な価格性を確保するために、既存のオープンな評価言語モデルにはない機能を提供します.これにより、人間とGPT-4の判断に密接に追随し、ユーザー定義の評価基準に基づいて直接評価およびペアワイズランキング形式を処理できます.さらに、PROMETHEUS 2は、公開されているモデル、コード、およびデータを提供することで、透明性を確保しています.

Q: プロメテウス2が言語モデル評価の分野に与える潜在的な影響とは?

A: プロメテウス2の潜在的な影響は、言語モデルの評価分野において革新的な進展をもたらす可能性があります.このモデルは、既存のオープンな評価言語モデルが苦手としていた直接評価とペアワイズランキングの両方を効果的に処理できるため、評価スキームの柔軟性が向上します.さらに、人間やプロプライエタリな言語モデルとの一致度が高く、優れたパフォーマンスを示すことで、言語モデルの評価の信頼性と効率性を向上させることが期待されます.

Self-Play Preference Optimization for Language Model Alignment

著者:Yue Wu, Zhiqing Sun, Huizhuo Yuan, Kaixuan Ji, Yiming Yang, Quanquan Gu

発行日:2024年05月01日

最終更新日:2024年06月14日

URL:http://arxiv.org/pdf/2405.00675v4

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Machine Learning

概要:

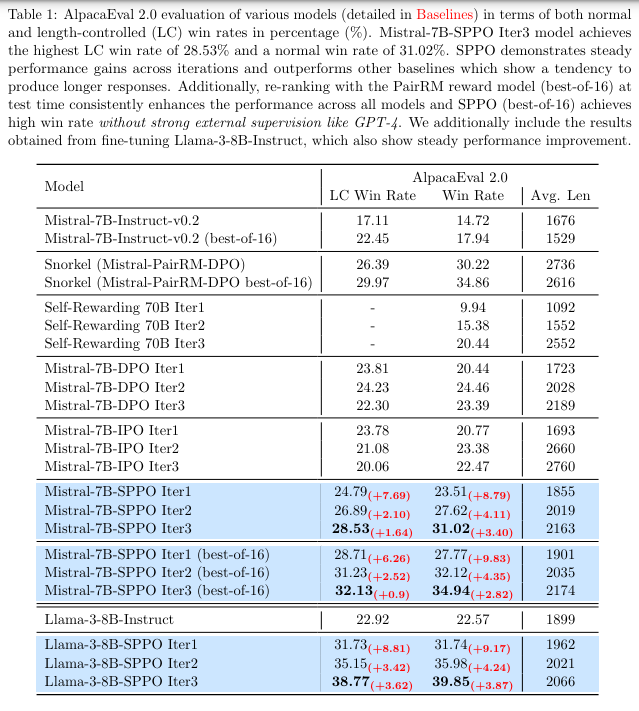

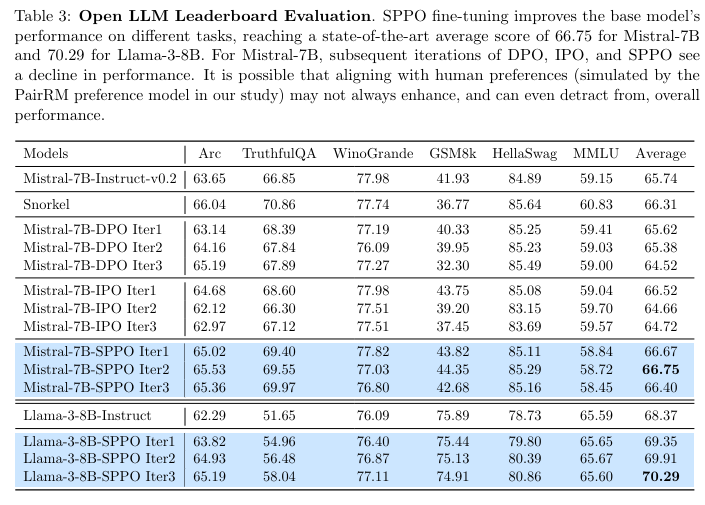

従来の人間のフィードバックによる強化学習(RLHF)アプローチは、Bradley-Terryモデルのようなパラメトリックモデルに依存しており、人間の好みの非推移性や非合理性を捉えるのに不十分であることが指摘されています.最近の進歩では、好みの確率と直接的に作業することが、人間の好みをより柔軟かつ正確に反映し、より柔軟で正確な言語モデルの整合性を可能にすることが示唆されています.本論文では、言語モデルの整合性のためのセルフプレイベースの手法を提案し、この問題をナッシュ均衡ポリシーを特定することを目的とした定数和の二人ゲームとして扱います.私たちのアプローチであるSelf-Play Preference Optimization(SPPO)は、反復的なポリシーアップデートを通じてナッシュ均衡を近似し、理論的な収束保証を享受します.実験では、UltraFeedbackデータセットからの60kのプロンプト(応答なし)のみを使用し、追加の外部監督(応答、好みなど)なしで、0.4Bのパラメータを持つ事前学習済みの好みモデルPairRMを活用することで、SPPOはAlpacaEval 2.0でGPT-4-Turboに対して28.53%の最先端の長さ制御された勝率を達成するMistral-7B-Instruct-v0.2のファインチューニングモデルを獲得することができます.また、MT-BenchやOpen LLM Leaderboardでの(反復的な)DPOやIPOよりも優れた結果を示します.より強力なベースモデルであるLlama-3-8B-Instructから始めると、38.77%の長さ制御された勝率を達成することができます.特筆すべきは、SPPOの優れたパフォーマンスが、GPT-4や他の強力な言語モデルからの追加の外部監督(応答、好みなど)なしで達成されていることです.Codes are available at https://github.com/uclaml/SPPO.

Q&A:

Q: Bradley-Terryモデルのような人間のフィードバックによる従来の強化学習の限界を説明していただけますか?

A: 従来の人間フィードバックからの強化学習アプローチ(例:Bradley-Terryモデル)の制限には、人間の好みや選好を正確にモデル化することの難しさが含まれます.Bradley-Terryモデルは、人間の選好をパラメトリックモデルで近似しようとしますが、人間の複雑な好みや意思決定プロセスを完全に捉えることは困難です.そのため、このモデルは人間のフィードバックを完全に反映することが難しく、限界があります.

Q: プリファレンス確率を直接扱うことで、言語モデルのアライメントの精度がどのように向上するのか?

A: 直接的に嗜好確率と作業することにより、人間の嗜好をより正確に反映し、柔軟で正確な言語モデルの整合性を実現できます.これにより、言語モデルの整合性を向上させることができます.

Q: 言語モデルアライメントのためのSPPO(Self-Play Preference Optimization)法の主なコンセプトは何ですか?

A: 自己プレイ優先最適化(SPPO)方法は、言語モデルの整合性を目指して、定数和の2人用ゲームにおけるナッシュ均衡ポリシーを、反復的なポリシーアップデートを通じて近似することを目指しています.このアプローチは、問題をポリシーが各ラウンドで自分自身と対戦するゲームとして扱い、ポリシーによって生成された合成データを使って微調整し、好みモデルによって注釈付けされたデータに基づいています.SPPOアルゴリズムは、近似的なナッシュ均衡に収束し、簡単な最適化のための損失関数の形を提供します.これにより、選択された応答の対数尤度を効果的に増加させ、拒否された応答の対数尤度を減少させることができます.これは、直接的なペアワイズ損失方法(DPO)やアイデンティティプレファレンス最適化(IPO)などの対称的な損失方法では簡単に達成できないものです.この方法は、既存のアプローチに比べて、さまざまなベンチマークで著しい改善を示し、大規模言語モデル(LLM)を人間の好みにより密接に整合させ、’長さバイアス’報酬ハッキングなどの問題を回避します.

Q: SPPOはどのようにナッシュ均衡を近似し、理論的にどのような保証があるのか?

A: SPPOは、反復的な方策更新を通じてナッシュ均衡を近似し、理論的な収束保証を享受しています.SPPOアルゴリズムは、大規模言語モデルの整合性に対するアプローチであり、近似ナッシュ均衡に収束し、簡単な最適化のための損失関数の単純な形式を認めます.

Q: SPPOは、直接選好最適化(DPO)や同一性選好最適化(IPO)のような対称的ペアワイズ損失法とどう違うのですか?

A: SPPOは、DPOやIPOのような対称ペアワイズ損失法とは異なります.SPPOは、選択された応答の対数尤度を効果的に増加させ、拒否された応答の対数尤度を減少させることができます.これは、DPOやIPOのような対称ペアワイズ損失法では簡単に達成できないことです.

Q: UltraFeedbackデータセットと事前学習された嗜好モデルPairRMを使ったSPPOの実験結果について教えてください.

A: SPPOは、UltraFeedbackデータセットと事前学習済みの選好モデルPairRMを使用した実験の結果を説明します.SPPOは、60kのプロンプト(応答なし)を使用し、プロンプトの増強も行わず、0.4Bのパラメータを持つ事前学習済みの選好モデルPairRMを活用することで、Mistral-7B-Instruct-v0.2を微調整したモデルを獲得します.このモデルは、AlpacaEval 2.0でGPT-4-Turboに対して28.53%の勝率を達成し、MT-BenchやOpen LLM Leaderboardでも(DPOおよびIPOを含む)他のモデルを上回ります.また、より強力なベースモデルLlama-3-8B-Instructから出発することで、38.77%の勝率を達成します.SPPOの優れたパフォーマンスは、GPT-4や他の強力な言語モデルからの追加の外部監督(応答、選好など)なしに達成されており、テスト時の再ランキングによってベースモデル、DPO、SPPOのパフォーマンスが一貫して向上することが示されています.

Q: SPPOは、MT-BenchやOpen LLM LeaderboardのDPOやIPOといった他の手法と比べてどうですか?

A: SPPOはMT-BenchおよびOpen LLM Leaderboardにおいて、DPOやIPOなどの他の手法と比較して、優れた性能を示しています.具体的には、SPPOは他のベースラインアルゴリズムを大きく上回っており、全てのイテレーションで一貫した性能向上が見られます.SPPOはIPOよりも初めの2つのイテレーションで優れていますが、最終的なイテレーションではIPOがSPPOを上回る性能を発揮しています.

Q: SPPOはどのようにして、ベースモデルのラマ3-8B-インストラクトからスタートし、38.77%というレングスコントロール勝率を達成しているのだろうか?

A: SPPOは、強力なベースモデルであるLlama-3-8B-Instructから出発し、長さ制御された勝率を38.77%に達成します.この達成は、追加の外部監督(例:応答、優先順位など)なしで達成されます.

Q: SPPOが、より強力な言語モデルによる外部監視を追加することなく、強力なパフォーマンスを達成する方法について詳しく教えてください.

A: SPPOは、GPT-4や他の強力な言語モデルからの追加の外部監督なしに強力なパフォーマンスを達成することができます.これは、SPPOが高品質のSFTを組み込むことによって、内部的な学習信号を最大化し、外部の監督なしでモデルを改善する能力を持つためです.外部の監督がない場合、SPPOは内部的な学習信号を最適化し、モデルの性能を向上させることができます.

Q: SPPOのコードはどこで入手できますか?

A: sppoのコードはhttps://github.com/uclaml/SPPO で入手できます.

A Primer on the Inner Workings of Transformer-based Language Models

著者:Javier Ferrando, Gabriele Sarti, Arianna Bisazza, Marta R. Costa-jussà

発行日:2024年04月30日

最終更新日:2024年05月02日

URL:http://arxiv.org/pdf/2405.00208v2

カテゴリ:Computation and Language

概要:

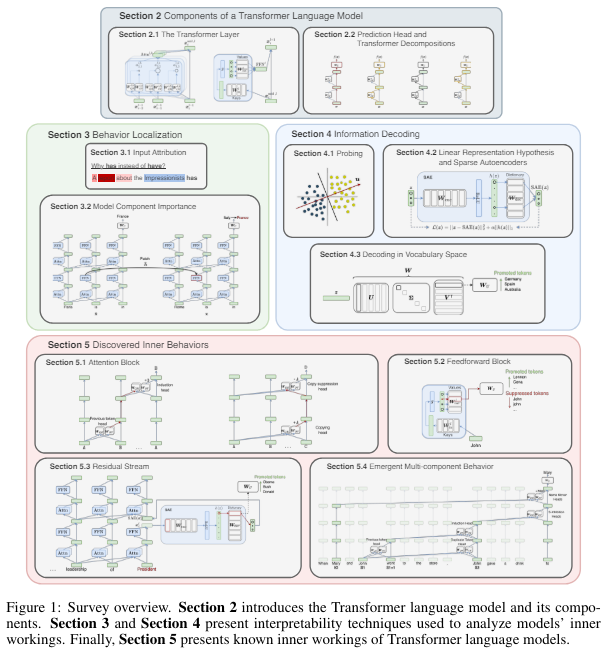

最近の研究は、高度な言語モデルの内部機能を解釈することを目的として急速に進展しており、この分野での長年の研究から得られた知見を整理する必要性が浮き彫りになっています.この入門書は、Transformerベースの言語モデルの内部機能を解釈するために現在使用されている技術についての簡潔な技術紹介を提供し、生成デコーダーのみのアーキテクチャに焦点を当てています.我々は、これらのモデルに実装された既知の内部メカニズムの包括的な概要を提示し、この分野での人気のあるアプローチと活発な研究方向とのつながりを明らかにして結論付けています.

Q&A:

Q: Transformerベースの言語モデルの内部構造を解釈するために使われる具体的なテクニックを説明してもらえますか?

A: Transformerベースの言語モデルの内部機能を解釈するために使用される具体的な技術には、Transformerレイヤー、予測ヘッド、Transformerの分解、動作の局在化、情報のデコーディング、発見された内部動作などが含まれます.これらの技術は、モデル内の重要な機能や情報の流れを理解し、モデルの動作を解釈するために使用されます.

Q: 生成デコーダのみのアーキテクチャは、言語モデルにおける他のアーキテクチャとどう違うのか?

A: ジェネレーティブ・デコーダー専用アーキテクチャは、他のアーキテクチャと比較して、入力埋め込みがアテンションとフィードフォワードによるベクトルの加算を通じて更新されるという残差ストリームの観点からアーキテクチャが提示される点が異なります.

Q: Transformerベースの言語モデルが実装している内部メカニズムには、どのようなものがあるか?

A: トランスフォーマーベースの言語モデルに実装されているいくつかの既知の内部メカニズムには、自己注意メカニズム、トランスフォーマー、予測ヘッド、トランスフォーマー分解、行動定位、情報解読、発見された内部行動などが含まれます.

Q: この分野で現在研究されている方向性は?

A: 現在、この分野で探究されているいくつかの主要な研究方向には、モデルの説明の知覚的および対話的側面を考慮に入れる解釈可能性分析の範囲を広げるための技術的発展に基づく学際的研究が含まれます.

Q: 研究の急速な進展は、Transformerベースの言語モデルの理解にどのような影響を与えているのだろうか?

A: 研究の急速な進歩により、Transformerベースの言語モデルの理解が向上しました.これにより、AIシステムの内部メカニズムに対する洞察が深まり、これらのシステムの安全性と公平性を確保し、重要な環境でのバイアスやエラーを軽減し、最終的にモデルの改善を促進する重要な意味があります.

Q: 高度な言語モデルの内部構造を解釈する長年の研究から、どのような洞察が得られたのだろうか?

A: 高度な言語モデルの内部機能を解釈する研究によって得られた洞察の一つには、Transformerベースの言語モデルの内部メカニズムを解釈するために使用される現在の技術が含まれます.これらのモデルの実装された既知の内部メカニズムの包括的な概要を提供することで、これらのモデルによって実現された接続を明らかにしました.

Q: 自然言語処理の分野において、これらの洞察を文脈化することはどれほど重要なのだろうか?

A: これらの洞察を自然言語処理の分野で文脈化することは非常に重要です.これにより、高度なAIシステムの内部メカニズムを理解することが可能となり、これらのシステムの安全性と公平性を確保し、重要な状況でのバイアスやエラーを軽減し、最終的にモデルの改善を促進することができます.

Q: Transformerベースの言語モデルの内部構造を解釈する際に直面する課題とは?

A: Transformerベースの言語モデルの内部機能を解釈する際に直面するいくつかの課題には、モデルの複雑さ、非線形性、および相互作用の理解が含まれます.これらのモデルは、膨大な数のパラメータと層を持ち、入力と出力の間の関係を捉えるために複雑な数学的操作が必要です.また、Transformerモデルは自己注意メカニズムを使用しており、これにより各単語の重要性が動的に変化するため、内部の情報伝達が複雑化します.

Q: これらのモデルは、従来の言語モデルと比較して、解釈可能性やパフォーマンスにおいてどうなのだろうか?

A: これらのモデルは、従来の言語モデルと比較して、解釈性とパフォーマンスの両方で優れています.Transformerベースの言語モデルは、内部メカニズムを理解するための新しい洞察を提供し、AIシステムの安全性と公平性を確保し、重要な設定でのバイアスやエラーを軽減し、モデルの改善を促進する可能性があります.これに対して、従来の言語モデルは、内部機能の理解においてより制限されており、解釈性やパフォーマンスの面でTransformerモデルに劣っています.

Better & Faster Large Language Models via Multi-token Prediction

著者:Fabian Gloeckle, Badr Youbi Idrissi, Baptiste Rozière, David Lopez-Paz, Gabriel Synnaeve

発行日:2024年04月30日

最終更新日:2024年04月30日

URL:http://arxiv.org/pdf/2404.19737v1

カテゴリ:Computation and Language

概要:

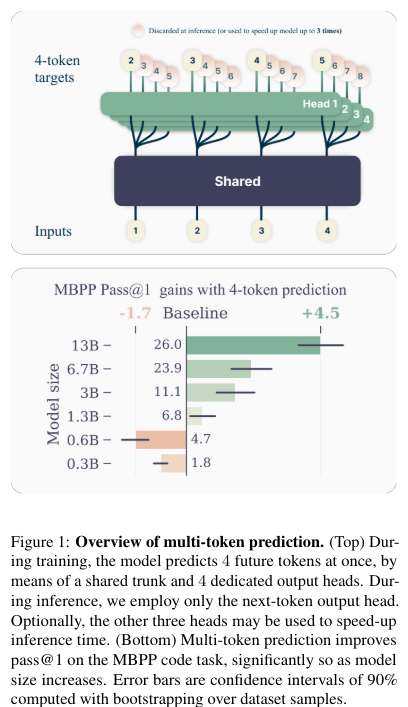

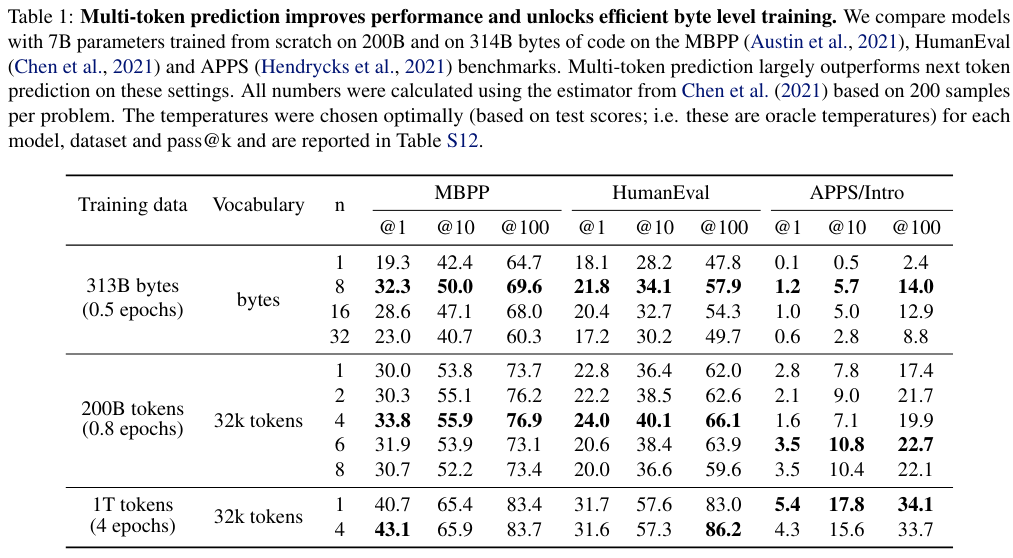

GPTやLlamaのような大規模な言語モデルは、次のトークンの予測損失で訓練されています.この研究では、言語モデルを一度に複数の未来のトークンを予測するように訓練することで、サンプル効率が向上すると提案しています.具体的には、訓練コーパスの各位置で、モデルに共有モデルトランクの上で動作するn個の独立した出力ヘッドを使用して、次のn個のトークンを予測するように求めます.複数トークンの予測を補助的な訓練タスクとして考えることで、コードや自然言語モデルのトレーニング時間にオーバーヘッドがないまま、改善された下流機能を測定します.この方法は、より大きなモデルサイズに対して特に有用であり、複数のエポックのトレーニングにおいても魅力を保ちます.生成ベンチマークのような課題では、特に顕著な利点があり、我々のモデルは強力なベースラインを一貫して数パーセント上回ります.我々の13Bパラメータモデルは、HumanEvalで12%、MBPPで17%多くの問題を解決します.小規模なアルゴリズムタスクの実験では、複数トークンの予測が帰納ヘッドやアルゴリズミックな推論の開発に有利であることが示されています.さらに、4つのトークンを予測するモデルは、大きなバッチサイズでも推論が最大3倍速くなるという追加の利点があります.

Q&A:

Q: 一度に複数の未来のトークンを予測するために言語モデルをトレーニングすると、サンプルの効率はどうなるのか?

A: 言語モデルを一度に複数の未来トークンを予測するように訓練することにより、サンプル効率が向上します.具体的には、訓練コーパスの各位置で、n個の独立した出力ヘッドを使用して、共有モデルトランクの上で動作し、次のntokensを予測するようモデルに求めます.マルチトークン予測を補助的な訓練タスクとして考えると、トレーニング時間のオーバーヘッドなしに、コードおよび自然言語の両方の下流機能が向上することが測定されます.

Q: n個の独立した出力ヘッドを使って、モデルが次のn個のトークンをどのように予測するか説明できますか?

A: モデルは、共有モデルトランクの上で動作するn個の独立した出力ヘッドを使用して、トレーニングコーパス内の各位置で次のnトークンを予測します.各出力ヘッドは、共有モデルトランクからの情報を受け取り、独自の損失関数に基づいて勾配を蓄積します.これにより、複数のトークンを同時に予測することが可能となり、トレーニング効率が向上します.

Q: 補助トレーニングタスクとしてのマルチトークン予測は、トレーニング時間のオーバーヘッドなしに、どのようにダウンストリーム能力を向上させるのか?

A: マルチトークン予測は、トレーニングコーパス内の各位置で、共有モデルトランクの上で動作するn個の独立した出力ヘッドを使用して、次のn個のトークンを一度に予測するようLLMに指示します.マルチトークン予測を補助的なトレーニングタスクとして考えると、コードと自然言語の両方において、トレーニング時間のオーバーヘッドなしに、改善された下流能力が測定されます.

Q: モデルサイズが大きくなると、この方法はどのような点でますます有用になるのでしょうか?

A: 大きなモデルサイズに対して、この方法はますます有用性が高まっています.特に、大規模なモデルサイズでは、トレーニング時間の増加が少なく、複数のエポックでのトレーニングでも魅力を保ちます.生成ベンチマークなどのコーディングにおいて、この方法は強力なベースラインをいくつかのパーセンテージポイントで常に上回ります.我々の13Bパラメータモデルは、HumanEvalでは12%、MBPPでは17%多くの問題を解決します.さらに、大きなバッチサイズでも推論が最大3倍速くなるなど、多くの利点があります.

Q: コーディングのようなジェネレーティブ・ベンチマークにおいて、モデルが強力なベースラインを一貫して上回っている例を教えてください.

A: モデルは、コーディングなどの生成ベンチマークで強力なベースラインを一貫して上回っています.例えば、我々の13Bパラメータモデルは、HumanEvalでは12%、MBPPでは17%もの問題を解決しています.

Q: 13Bパラメータモデルは、HumanEvalやMBPPでの問題解決において、同等のネクストトークンモデルと比較してどうでしょうか?

A: 13Bパラメーターモデルは、同等の次トークンモデルと比較して、HumanEvalおよびMBPPの問題解決能力において優れています.

Q: 帰納頭とアルゴリズム推論能力という点で、小アルゴリズムタスクの実験結果はどうだったのか?

A: 小さなアルゴリズムタスクの実験結果では、誘導ヘッドとアルゴリズム的推論能力の両方が向上した.モデルサイズが小さい場合、誘導機能が強化され、アルゴリズム的推論能力も向上した.

Q: バッチサイズが大きくても、4トークンの予測でモデルをトレーニングすることで、どのように推論時間が短縮されるのか?

A: 4トークン予測モデルでのトレーニングは、大規模なバッチサイズでも推論時間を短縮することができます.これは、4トークン予測モデルが、次のトークン予測モデルよりも高速な推論を可能にするためです.

Q: 共有モデルのトランクの上で操作するプロセスを、もう少し詳しく説明してもらえますか?

A: 共有モデルトランクの上で操作するプロセスは、まず、共有トランクfsを介して順方向パスを実行し、その後、各独立した出力ヘッドfiの順方向および逆方向パスを順次計算し、勾配をトランクに蓄積します.これにより、出力ヘッドfiのロジット(およびその勾配)が作成されますが、次の出力ヘッドfi+1に進む前にこれらは解放され、長期的な記憶にはd次元のトランク勾配∂Ln/∂fsのみが必要です.つまり、ピークGPUメモリ使用量をO(nV+d)からO(V+d)に削減しました.推論時には、提案されたアーキテクチャの最も基本的な使用法は、バニラの次トークン自己回帰です.トレーニングコーパスの各位置で、共有モデルトランクの上でn個の独立した出力ヘッドを使用して、次のntokensを予測するようモデルに求めます.複数トークンの予測を補助的なトレーニングタスクとして考えると、コードと自然言語の両方のトレーニング時間にオーバーヘッドはなく、改善された下流機能を測定します.

Q: 複数のエポックについてトレーニングした場合、マルチトークン予測による利益はどのように維持されるのでしょうか?

A: 複数トークン予測の利点は、同じデータの複数のエポックでトレーニングする際にも維持されます.改善は少なくなりますが、MBPPのpass@1では+2.4%、その他のベンチマークでは+3.2%の増加が見られます.

In-Context Learning with Long-Context Models: An In-Depth Exploration

著者:Amanda Bertsch, Maor Ivgi, Uri Alon, Jonathan Berant, Matthew R. Gormley, Graham Neubig

発行日:2024年04月30日

最終更新日:2024年04月30日

URL:http://arxiv.org/pdf/2405.00200v1

カテゴリ:Computation and Language

概要:

モデルのコンテキストの長さが増加するにつれて、提供できるデモンストレーションの数は、トレーニングデータセット全体のサイズに近づいています.私たちは、この極端なスケールでのインコンテキスト学習(ICL)の振る舞いを複数のデータセットとモデルで研究しています.多くのラベルスペースを持つデータセットでは、数百または数千のデモンストレーションとともにパフォーマンスが継続的に向上することを示しています.これを例の検索やファインチューニングと対比すると、例の検索は低いコンテキスト長で優れたパフォーマンスを示しますが、より多くのデモンストレーションでは利益が減少します.ファインチューニングはICLよりもデータを多く必要としますが、追加のデータで長いコンテキストICLのパフォーマンスを上回ることがあります.このICL設定を使用して、インコンテキスト学習と長いコンテキストモデルのいくつかの特性を研究しています.長いコンテキストICLは、短いコンテキストICLよりもランダムな入力のシャッフルに対して感度が低く、同じラベルの例のグループ化がパフォーマンスに悪影響を与えることを示しています.また、私たちが見るパフォーマンスの向上は、多くの例を一緒にエンコードすることによる累積的な利益から生じているわけではないことも示しています.長いコンテキストICLは、多くのデータを使用することで、長期的なパフォーマンスを向上させることができると結論付けています.さらに、多くの例を一緒にエンコードすることによる累積的な利益よりも、似たような例に再度注目することから多くの利益が得られることを示しています.

Q&A:

Q: 複数のデータセットとモデルについて、極端なスケールでのコンテキスト内学習(ICL)の挙動を説明できますか?

A: 複数のデータセットとモデルにおける極端なスケールでのin-context learning(ICL)の挙動について説明します.ICLは、コンテキスト長が増加するにつれて提供できるデモンストレーションの数が、トレーニングデータセット全体のサイズに近づくと、パフォーマンスが向上し続けることを示しています.大きなラベルスペースを持つ多くのデータセットでは、数百または数千のデモンストレーションとともにパフォーマンスが向上します.例の検索やファインチューニングとは異なり、ICLはより多くのデモンストレーションを必要とせず、追加のデータでファインチューニングを上回ることがあります.ICL設定を使用して、in-context learningと長いコンテキスト

Q: 大きなラベル空間を持つデータセットで何百、何千ものデモンストレーションを行うと、パフォーマンスはどのように変化するのだろうか?

A: 大規模なラベルスペースを持つデータセットでは、数百または数千のデモンストレーションにより、性能が向上する傾向が見られます.ラベルクラスの数が増えるにつれて、正しいラベルを見る前に必要なデモンストレーションの数が増加するため、より多くのデモンストレーションが必要とされます.ラベルスペースが大きいデータセットでは、フィネチューニングの性能が最も弱くなる傾向があります.これは、より多くのデータが分類器のトレーニングに必要とされるよりオープンエンドの分類問題であるためです.

Q: 例題検索、ファインチューニング、ロングコンテクストICLのパフォーマンスにはどのような違いがありますか?

A: 例の検索は、コンテキストの長さが短い場合に優れた性能を示しますが、より多くのデモンストレーションでは利益が減少します.一方、ファインチューニングはICLよりもデータを多く必要としますが、追加のデータで長いコンテキストICLの性能を上回ることがあります.

Q: ランダムな入力シャッフルに対する感度の点で、ロングコンテクストICLはショートコンテクストICLと比較してどうか?

A: 長いコンテキストICLは、短いコンテキストICLよりもランダムな入力のシャッフルに対して感度が低いことが示されています.

Q: 同じラベルの例をグループ化することが、ロングコンテクストICLのパフォーマンスにどのような悪影響を与えるか、詳しく教えてください.

A: 同じラベルの例をグループ化すると、長いコンテキストICLにおいてパフォーマンスに負の影響を与える可能性があります.これは、同じラベルの例がグループ化されると、モデルがタスクを学習する際に異なるラベルの例との適切なコンテキスト化が妨げられ、モデルが適切な情報を取得できなくなるためです.

Q: ロングコンテクストICLにおけるパフォーマンス向上は、多くの例を一緒にエンコードすることによる累積的な利得から生じるのではないという発見の意義は何だろうか?

A: 長いコンテキストICLの性能向上は、多くの例を一緒にエンコードすることから生じる累積的な利益ではないことの発見の意義は、タスク学習よりも似た例に再び注意を向けることから多くの利益が得られることを示しています.

Q: ロングコンテクストICLは、他の学習方法と比べてどの程度効果的か?

A: 長いコンテキストICLは、他の学習方法と比較して非常に効果的であると結論付けられます.長いコンテキストICLは、同じラベルの例をグループ化することがパフォーマンスに悪影響を与える可能性がある一方、同様の例に再度注意を向けることで多くの利益が得られることが示されています.また、長いコンテキストICLは、タスク学習よりも似た例に戻ることから多くの利益が得られることが示されています.

Q: この研究で研究されたイン・コンテクスト学習とロング・コンテクスト・モデルの重要な特性とは何か?

A: この研究では、インコンテキスト学習(ICL)と長いコンテキストモデルの主な特性が研究されました.長いコンテキストICLは、短いコンテキストICLよりもランダムな入力のシャッフルに対して感度が低いことが示されました.同じラベルの例をグループ化することがパフォーマンスに悪影響を与えることがわかりました.また、見られるパフォーマンスの向上は、多くの例を一緒にエンコードすることによる累積的な利益からではなく、似たような例に再度注目することから生じることが示されました.

Q: 似たような例を振り返ることが、ロングコンテクストICLの効果にどのように寄与するのか説明していただけますか?

A: 長いコンテキストICLの効果を高めるために、似たような例に戻ることは、モデルが過去の情報を再利用し、関連する情報をより効果的に学習することを可能にします.これにより、モデルは同様の例に対してより適切に対応し、タスクの学習を促進することができます.

Q: これらの知見は、インコンテクスト学習やロングコンテクスト・モデルの分野における今後の研究にどのような影響を与えるのだろうか?

A: これらの研究結果は、将来の研究において、インコンテキスト学習と長いコンテキストモデルの分野において、新たな展望を提供する可能性があります.特に、非常に長いモデルコンテキスト長を使用することがますます効果的で効率的になるにつれて、長いコンテキストICLは多くのタスクにとって強力なツールとなる可能性があります.これにより、フィンチューニングにかかる時間コストを増やす代わりに、推論時の計算を増やすことができます.また、データがコンテキスト長を大幅に超える場合には、フルデータセットを使用したフィンチューニングが依然として強力なオプションであることが示唆されています.これらの知見は、今後の研究において、長いコンテキストICLがデータ効率的で効果的な選択肢であることを示唆しています.

KAN: Kolmogorov-Arnold Networks

著者:Ziming Liu, Yixuan Wang, Sachin Vaidya, Fabian Ruehle, James Halverson, Marin Soljačić, Thomas Y. Hou, Max Tegmark

発行日:2024年04月30日

最終更新日:2024年06月16日

URL:http://arxiv.org/pdf/2404.19756v4

カテゴリ:Machine Learning, Disordered Systems and Neural Networks, Artificial Intelligence, Machine Learning

概要:

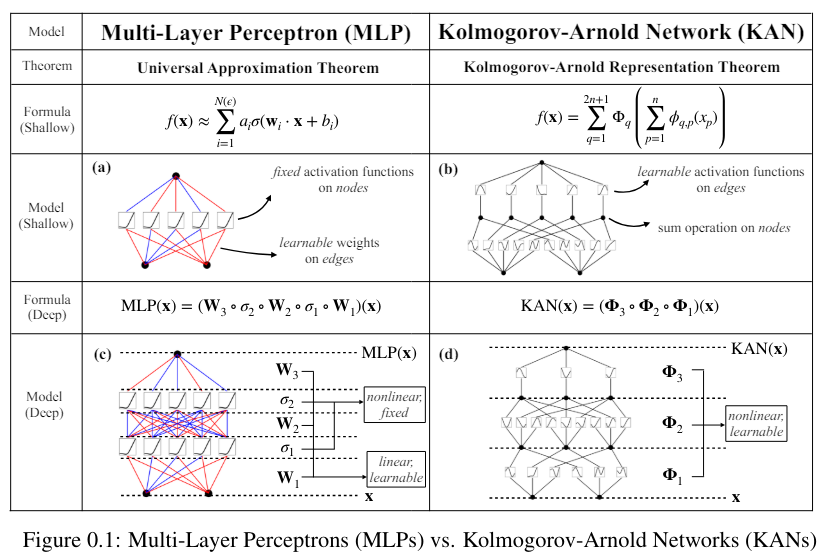

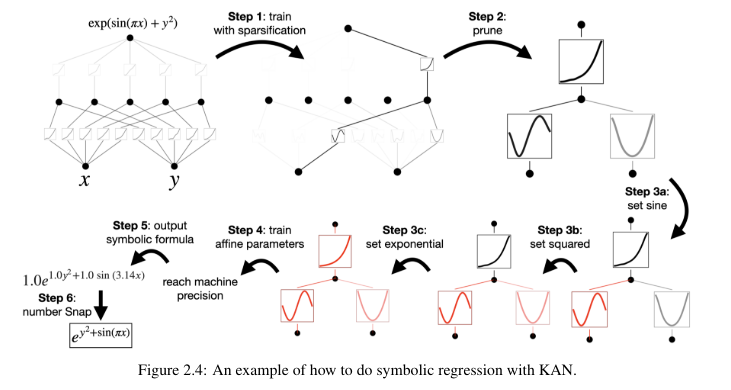

コルモゴロフ・アルノルド表現定理に触発され、私たちはコルモゴロフ・アルノルド・ネットワーク(KANs)を多層パーセプトロン(MLPs)の有望な代替手段として提案しています.MLPsはノード(”ニューロン”)上の固定された活性化関数を持っているのに対し、KANsはエッジ(”重み”)上の学習可能な活性化関数を持っています.KANsには線形重みが全くなく、すべての重みパラメータはスプラインとしてパラメータ化された単変量関数に置き換えられています.この見かけ上単純な変更が、KANsを精度と解釈可能性の面でMLPsよりも優れたものにしています.精度に関して、はるかに小さなKANsでも、データフィッティングやPDEの解決においてはるかに大きなMLPsよりも同等またはそれ以上の精度を達成することができます.理論的にも経験的にも、KANsはMLPsよりも速いニューラルスケーリング則を持っています.解釈可能性に関して、KANsは直感的に視覚化され、人間のユーザーと簡単にやり取りすることができます.数学と物理学の2つの例を通じて、KANsは科学者が数学的および物理的な法則を(再)発見するのを助ける有用な協力者であることが示されています.要するに、KANsはMLPsにとって有望な代替手段であり、MLPsに大きく依存している今日のディープラーニングモデルをさらに改善する機会を提供しています.

Q&A:

Q: コルモゴロフ・アーノルド・ネットワーク(KAN)とマルチレイヤー・パーセプトロン(MLP)の具体的な違いについて、構造や機能面から説明していただけますか?

A: コルモゴロフ・アーノルド・ネットワーク(KAN)と多層パーセプトロン(MLP)の具体的な違いは、構造と機能の観点から説明されます.KANは、ノード(「ニューロン」に固定された活性関数を持つMLPとは異なり、エッジ(「重み」に学習可能な活性化関数を持っています.

Q: ノードに固定活性化関数を持つMLPと比較して、KANはエッジに学習可能な活性化関数をどのように利用するのか?

A: KANsでは、活性化関数がノードではなくエッジに配置され、かつ固定された活性化関数ではなく学習可能な活性化関数が使用されます.一方、MLPsでは活性化関数はノードに配置され、固定されたものが使われます.

Q: KANにおいて、線形重みをスプラインとしてパラメータ化された一変量関数に置き換えるというコンセプトについて詳しく教えてください.

A: KANsでは、重みパラメーターがスプラインでパラメータ化された単変量関数に置き換えられるという概念は、重要な役割を果たしています.これにより、KANsはMLPsを凌駕する精度と解釈可能性を持つことが示されています.スプラインは、低次元関数に対して正確であり、局所的に調整しやすく、異なる解像度間を切り替えることができるという利点があります.一方、MLPsは特徴学習によってCODに苦しむことが少ないですが、スプラインほど低次元で正確ではなく、単変量関数を最適化する能力がないため、スプラインよりも正確性に欠けます.重みパラメーターをスプラインで置き換えることで、KANsは線形重み行列を一切持たず、各重みパラメーターがスプラインでパラメータ化された学習可能な1次元関数に置き換えられます.KANsのノードは、非線形性を適用せずに入力信号を単純に合計します.このようにして、KANsは各エッジ(”重み”)に学習可能な活性化関数を配置することで、線形重み行列を持たない独自の構造を持つことが特徴です.

Q: KANがMLPを精度や解釈可能性の面で上回ることを実証するために、どのような証拠や実験が行われたのでしょうか?

A: KANは、数学や物理学の例を通じて、科学者が数学的および物理的法則を再発見するのを支援する”共同研究者”として役立つことが示されています.また、KANは、データに合成構造がある場合に次元の呪いを克服し、MLPよりも優れたスケーリング則を達成できることが示されています.さらに、KANは、特殊関数の自動発見されたKANの(驚くほどコンパクトな)形状を報告しており、同じパラメータ数を持つ場合に、MLPよりも低いトレーニング/テスト損失を達成できることが一貫して示されています.

Q: データフィッティングやPDE解法において、小型のKANはどのようにして大型MLPと同等以上の精度を達成しているのだろうか?

A: 小さなKANは、大きなMLPよりもデータフィッティングやPDEソルバーにおいて同等またはより高い精度を達成することができます.これは、KANがMLPよりもより速いニューラルスケーリング則を持っているためです.また、KANはより直感的に視覚化され、人間のユーザーと簡単に対話できるため、解釈可能性も高いです.

Q: KANが持つニューラル・スケーリング法則とは何か、MLPのそれと比較してどうなのか?

A: KANsはMLPsよりも速いニューラルスケーリング則を持っています.具体的には、KANsはより速いニューラルスケーリング則を理論的にも実証的にも持っており、小規模のAI+科学タスクにおいて、精度と解釈性の面でMLPsを上回ることが示されています.

Q: KANはどのように視覚化され、解釈可能性のために人間のユーザーとどのように相互作用するのか?

A: KANsは直感的に視覚化され、人間のユーザーと簡単に対話できます.ユーザーはKANsの簡略化選択肢をボタンとして操作し、最も有望なボタンを次にクリックしてKANsをより解釈可能にすることができます.数学や物理学の例を通じて、KANsは科学者が数学的および物理的な法則を(再)発見するのを助ける有用な「共同研究者」として示されています.

Q: 数学と物理学の分野で、KANが科学者の数学的・物理的法則の(再発見に)役立った例を教えてください.

A: KANは数学と物理学の分野において、科学者が数学的および物理的法則を再発見するのを手助けする例を提供しています.具体的には、KANは物理方程式の適合や偏微分方程式の解決などの科学関連のタスクにおいて、MLPよりも効果的であることが初期の証拠として示されています.

Q: MLPに対するKANの主な利点は何か、また、ディープラーニングモデルを改善する機会をどのようにもたらすのか?

A: KANsはMLPsよりも精度と解釈可能性において優れており、小規模なAI + ScienceタスクにおいてMLPsよりも優れた性能を発揮します.KANsはより速いニューラルスケーリング則を持ち、MLPsに比べてより直感的に可視化され、人間との対話が容易です.数学や物理学の例を通じて、KANsは科学者が数学的および物理的な法則を(再)発見するのを助ける有用な「共同研究者」として示されています.これにより、KANsはMLPsにとって有望な代替手段であり、MLPsに大きく依存する現代の深層学習モデルのさらなる改善の機会を提供しています.

Q: 現在MLPに大きく依存している深層学習モデルの文脈で、KANの今後の発展と採用をどのように見ていますか?

A: KANsはMLPsに比べて精度と解釈可能性の面で優れていることが示されています.小規模なAI + Scienceタスクにおいて、KANsはMLPsよりも優れた精度と解釈可能性を持つことが示されています.KANsはMLPsよりも速いニューラルスケーリング則を持っており、直感的に視覚化され、人間のユーザーと簡単に対話できる特性を持っています.数学や物理学の例を通じて、KANsは科学者が数学的および物理的な法則を(再)発見するのを助ける「協力者」として役立つことが示されています.現在、KANsの最大の課題はトレーニングの遅さであり、同じパラメータ数を持つ場合、KANsは通常MLPsよりも10倍遅くなります.今後、KANsはMLPsに代わる有望な選択肢として、現在MLPsに大きく依存している深層学習モデルのさらなる改善の機会を提供するでしょう.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://github.com/KindXiaoming/pykan です.

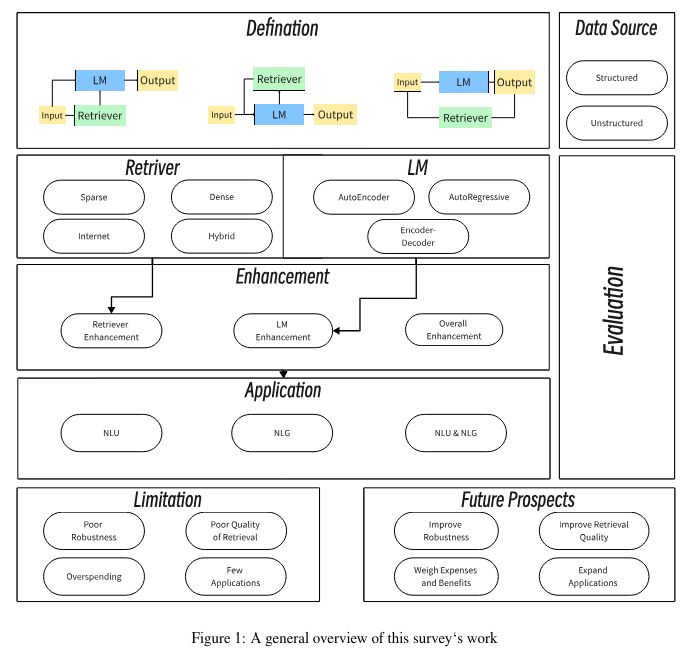

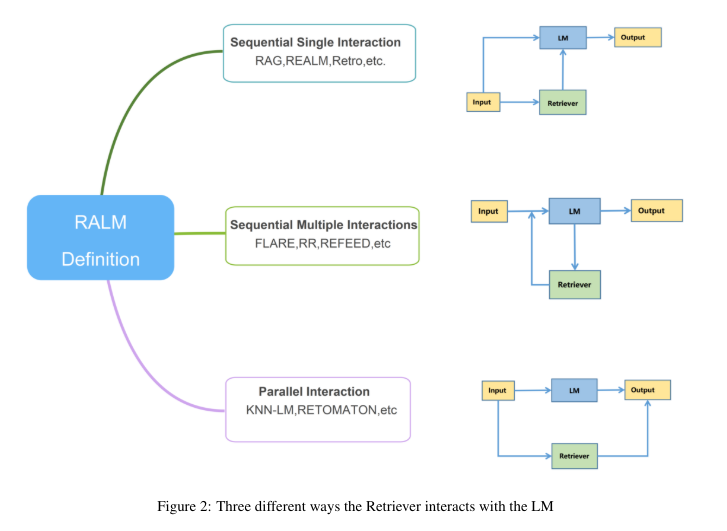

RAG and RAU: A Survey on Retrieval-Augmented Language Model in Natural Language Processing

著者:Yucheng Hu, Yuxing Lu

発行日:2024年04月30日

最終更新日:2024年04月30日

URL:http://arxiv.org/pdf/2404.19543v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

大規模言語モデル(LLMs)は、自然言語処理(NLP)の重要な進歩を促進してきましたが、幻覚や特定のドメイン知識の必要性などの課題に直面しています.これらを緩和するため、最近の手法では、外部リソースから取得した情報をLLMsと統合し、NLPタスク全体でのパフォーマンスを大幅に向上させています.この調査論文は、Retrieval-Augmented Language Models(RALMs)に関する包括的な概要の不在に対処し、Retrieval-Augmented Generation(RAG)およびRetrieval-Augmented Understanding(RAU)の両方について、そのパラダイム、進化、分類、および応用について詳細に検討しています.論文では、Retrievers、Language Models、およびAugmentationsなど、RALMsの重要な構成要素について議論し、それらの相互作用が多様なモデル構造と応用につながる方法についても説明しています.RALMsは、翻訳や対話システムから知識集約型アプリケーションまで、さまざまなタスクで有用性を示しています.調査には、RALMsの評価方法もいくつか含まれており、その評価において堅牢性、正確性、関連性の重要性を強調しています.また、RALMsの限界についても認識しており、特に検索品質と計算効率性における課題を指摘し、将来の研究方向を提案しています.この調査は、RALMsに関する構造化された洞察、その潜在能力、およびNLPにおける将来の発展の方向性を提供することを目指しています.論文は、調査された作品とさらなる研究のためのリソースを含むGithubリポジトリで補完されています:.” rel=”nofollow”>https://github.com/2471023025/RALM_Survey.

Q&A:

Q: 幻覚やドメイン固有の知識の必要性など、自然言語処理(NLP)における大規模言語モデル(LLM)が直面する課題について説明していただけますか?

A: 大規模言語モデル(LLMs)は、自然言語処理(NLP)において幻覚やドメイン固有の知識の必要性などの課題に直面しています.幻覚とは、モデルが訓練データに存在しない情報を生成することを指し、これはモデルの信頼性や品質を低下させる可能性があります.また、LLMsは知識密度の高い作業を効果的に処理する能力に制限があり、また、知識を迅速に更新することができないという問題も抱えています.そのため、多くの研究者が外部知識を取得するために検索技術を用いており、これは言語生成タスクにおいてLLMsの性能向上に役立つ可能性があります.

Q: 最近の方法論は、どのように外部リソースから取得した情報をLLMと統合し、自然言語処理タスク全体のパフォーマンスを向上させているのだろうか?

A: 最近の手法では、LLMに外部リソースから取得した情報を統合することで、NLPタスク全般での性能を向上させています.この信号により、RAG-end2endは、外部知識ベースから関連情報にアクセスして与えられた文を再構築するように強制されます.このアプローチは、ドメイン適応性を大幅に向上させています.

Q: リトリーバー、言語モデル、オーグメンテーションのような検索・オーグメンテーション言語モデル(RALM)の本質的な構成要素とは何か?

A: RALMの重要なコンポーネントには、Retrievers(リトリーバー)、Language Models(言語モデル)、およびAugmentations(拡張)が含まれます.これらのコンポーネントは、外部リソースから取得した情報を統合することで、NLPタスク全体でのパフォーマンスを大幅に向上させます.Retrieversは外部リソースから情報を取得し、Language Modelsは言語理解や生成を担当し、Augmentationsはこれらの情報を統合してモデルの機能を拡張します.これらのコンポーネントは相互作用し、多様なモデル構造とアプリケーションを生み出します.

Q: 翻訳、対話システム、知識集約型アプリケーションなど、RALMが有用性を示したタスクの例を教えてください.

A: RALMsは、翻訳、対話システム、知識集約型アプリケーションなど、さまざまなタスクで有用性を示しています.これらのモデルは、外部知識を取得し統合することで言語モデルを向上させ、翻訳、対話生成、知識グラフの完成などのさまざまな自然言語処理タスクでのパフォーマンスを向上させています.

Q: RALMにはどのような評価方法が一般的に用いられているのか、また、その評価において頑健性、正確性、妥当性がなぜ重要なのか.

A: RALMの一般的な評価方法には、ROUGE、BLEU、bertScore、RAGQuestEvalなどの評価メトリクスが一般的に使用されます.これらの評価方法は、RALMの性能を測定し、その信頼性、精度、関連性を評価するために重要です.信頼性は、提供されたコンテキストとどの程度一致するかを示し、回答の関連性は生成された回答が実際の質問にどの程度対応しているかを示します.さらに、関連性は、取得されたコンテキストが中心化され、無関係な情報が含まれていないかどうかを評価します.ロバストネス、精度、関連性が重要である理由は、RALMの性能を総合的に評価し、その信頼性と正確性を確保するためです.

Q: RALMの限界、特に検索品質と計算効率の面ではどのようなものがあるのか.また、これらの限界に対処するために、今後どのような研究の方向性が提案されているのか.

A: RALMの限界は、特に検索品質と計算効率の面で現れています.検索品質の面では、既存のRALMモデルは、インターネットなどの情報源の品質のばらつきにより、出力の品質が最適化されているとしても、出力がLMと完全に一致する保証がまだないと指摘されています.特にインターネットを検索ツールとして使用する場合、データのマージを適切に考慮せずに行うと、ノイズや誤解を招く可能性があります.計算効率の面では、一部の既存のRALMは、様々なドメインでLMの性能を大幅に向上させることができますが、一部のモデルは膨大な計算リソースを必要とすることがあります.将来の研究方向としては、検索品質の向上と計算効率の改善に焦点を当てることが提案されています.

Q: このサーベイ・ペーパーは、RALM とその可能性、そして NLP における RALM の今後の発展の道筋について、どのような構造的洞察を提供することを目的としているのでしょうか.

A: この調査論文は、RALMs、その潜在能力、そしてNLPにおける将来の発展の可能性について、構造化された洞察を提供することを目指しています.RALMsは、外部知識の取得と統合によって言語モデルを向上させ、翻訳、対話生成、知識グラフの完成など、さまざまなNLPタスクでのパフォーマンスを向上させます.しかし、彼らは敵対的な入力に対する堅牢性、検索結果の品質、展開に伴う計算コスト、および応用領域の多様性の不足といったいくつかの制限に直面しています.これらを解決するために、研究コミュニティは、改善策としていくつかの戦略を提案しています.

Q: Githubリポジトリには、調査対象となった作品や、さらなる研究のためのリソースが含まれています.

A: 調査された作品と将来の研究のためのリソースを含むGithubリポジトリについての詳細情報は、https://github.com/2471023025/RALM_Survey で提供されています.

Q: RALMは、NLPタスクのパフォーマンス向上のために外部情報を取り入れるという点で、従来の言語モデルとどう違うのか?

A: RALMsは、外部情報を取り込む際に、従来の言語モデルとは異なるアプローチを取っています.具体的には、RALMsは、検索器によって獲得された非パラメトリックメモリを言語モデルのパラメトリックメモリと統合し、半パラメトリックメモリを作成します.これにより、言語モデルの性能が向上します.

Q: 自然言語処理における大規模言語モデルが直面する課題を解決するために、RALMが実際のアプリケーションでどのように使われているか、具体的な例を教えてください.

A: RALMsは、意思決定支援、検索エンジン、および推薦システムなどの実際のアプリケーションに使用されています.これらのアプリケーションでは、RALMsは外部知識を取得し、統合することで、NLPシステムの性能を向上させています.具体的には、意思決定支援システムでは、RALMsが膨大な情報を取得し、意思決定プロセスをサポートすることができます.検索エンジンでは、RALMsが膨大なデータベースから適切な情報を取得し、ユーザーに最適な検索結果を提供します.また、推薦システムでは、RALMsがユーザーの過去の行動や好みを考慮して、個別にカスタマイズされた推薦を行うことができます.

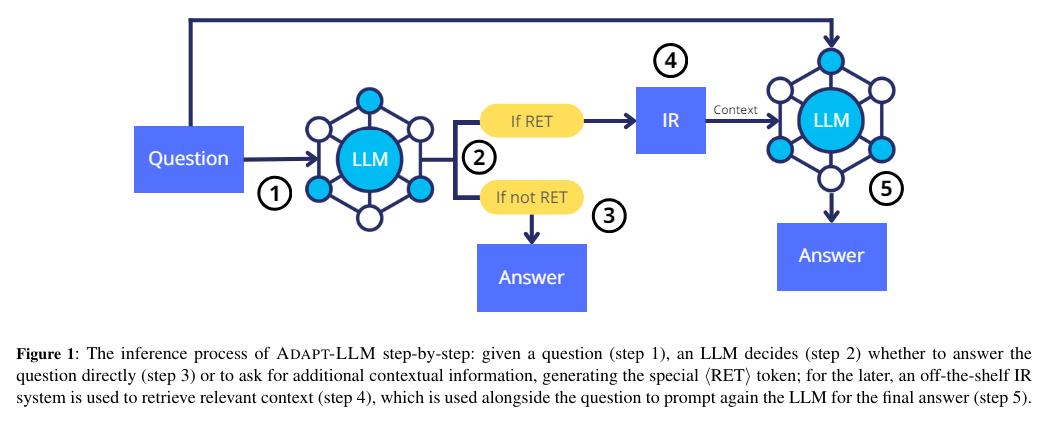

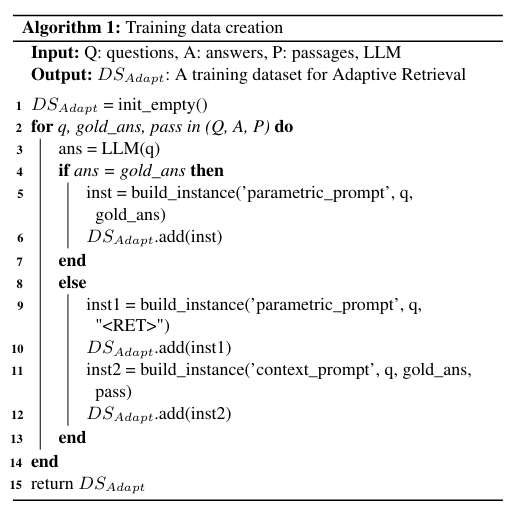

When to Retrieve: Teaching LLMs to Utilize Information Retrieval Effectively

著者:Tiziano Labruna, Jon Ander Campos, Gorka Azkune

発行日:2024年04月30日

最終更新日:2024年05月06日

URL:http://arxiv.org/pdf/2404.19705v2

カテゴリ:Computation and Language, Information Retrieval

概要:

この論文では、大規模言語モデル(LLM)が、追加の文脈が必要な質問に答える際に、既存の情報検索(IR)システムを効果的に活用する方法を示しています.IRシステムの性能を考慮すると、質問に答えるための最適な戦略は常に外部情報検索を必要とするわけではなく、しばしばLLM自体のパラメトリックメモリを活用することが重要です.以前の研究では、PopQAデータセットでこの現象が特定されており、最も人気のある質問はLLMのパラメトリックメモリを使用して効果的に対処される一方、人気のない質問はIRシステムの使用を必要とします.その後、我々は、既存のオープンドメインの質問応答データセットを活用した、LLM向けの特別なトレーニングアプローチを提案しています.ここでは、LLMが質問の答えを知らない場合に特別なトークンであるRETを生成するようにトレーニングされます.PopQAデータセットでのAdaptive Retrieval LLM(Adapt-LLM)の評価では、3つの構成(i)すべての質問に情報を取得する、(ii)常にLLMのパラメトリックメモリを使用する、(iii)使用する)において、同じLLMよりも改善が見られました.さらに、新たな文脈を加えると、Adapt-LLMは、質問に答えられない場合にRETトークンを生成し、IRが必要であることを示す一方、LLMのパラメトリックメモリだけに頼る場合には非常に高い精度レベルを達成することが示されています.

Q&A:

Q: 大規模言語モデル(LLM)は、市販の情報検索(IR)システムの利用をどのように効果的に学習するのか?

A: 大規模言語モデル(LLMs)がオフザシェル情報検索(IR)システムを効果的に使用する方法は、追加の文脈が必要な質問に答える際に、LLMsが学習することができます.IRシステムの性能を考慮すると、質問に答えるための最適な戦略は常に外部情報検索を含むわけではなく、しばしばLLM自体のパラメトリックメモリを活用することがあります.

Q: IRシステムを利用する際の最適な質問応答戦略とは?

A: IRシステムを使用する際の最適な戦略は、高人気の質問に対してはパラメトリックメモリだけを使用し、低人気の質問に対してはIRシステムを利用するハイブリッドアプローチである.

Q: PopQAデータセットは外部情報検索の必要性をどのように示しているのか?

A: PopQAデータセットは、エンティティの人気に応じて異なる質問を含むため、外部情報検索の必要性を示しています.エンティティの人気は、そのWikipediaページの閲覧数によって測定され、人気スコアの閾値を計算して、そのスコアが閾値未満の場合は検索ステップを実行し、閾値を超える場合は直接質問に回答します.この方法は、バニラ検索よりも優れた結果をもたらしますが、現実的なQAシナリオでは利用できない人気スコアの計算が必要です.

Q: この論文で提案されているLLMのためのテーラーメイドのトレーニング・アプローチとは?

A: この論文で提案されているLLMのための適応型トレーニングアプローチは、ADAPT-LLMモデルをトレーニングするために使用される方法論を明確に示しています.トレーニングデータを作成するプロセスは、アルゴリズム1で示されており、オープンドメインの質問応答データセットを選択しています.このデータセットには、質問Q、関連するコンテキストパッセージP、および対応する回答Aが含まれています.そして、DSAdaptというトレーニングデータを初期化し、それぞれの質問に対してベースLLMを使用してゼロショット推論を行います.このステップにより、追加のコンテキストが必要かどうかを判断し、パラメトリックメモリだけに頼らずに質問に回答する際に適切なバランスを取ることができるようになります.

Q: Adaptive Retrieval LLM(Adapt-LLM)は、PopQAデータセットにおいて、他の構成と比較してどのようなパフォーマンスを示したのでしょうか?

A: 提案された適応型検索アプローチ、ADAPT-LLMは、他の構成と比較してPopQAデータセットでどのように実行されるかを評価します.NR-LLMとAR-LLM構成に比べて、ADAPT-LLM構成は一貫してPopQAテストセットで優れたパフォーマンスを発揮します.NR-LLMは、他の構成と比較して約14の絶対ポイントの違いがある最も低いパフォーマンスを示します.AR-LLMとADAPT-LLMの違いは狭く、特にNQおよびSQuADデータセットでトレーニングされた場合、ADAPT-LLM構成は、AR-LLM構成に比べてPopQAテストセットで36.77%および38.15%の精度を達成します.両方のトレーニングデータセットを通じて、ADAPT-LLMはAR-LLMを上回り、SQuADでトレーニングされた場合に最も大きな違いが観察されます.

Q: Adapt-LLMはどのようにしてRETトークンを生成するタイミングを決めるのですか?

A: アダプト-LLMは、追加の文脈情報が必要かどうかを決定するために、質問に直接回答するか、特別なRETトークンを生成して追加の文脈情報を要求するかを決定します.後者の場合、既存のIRシステムを使用して関連する文脈を取得し、質問と共にLLMに最終的な回答を促します.

Q: Adapt-LLMのパフォーマンス分析からの主な結果は何ですか?

A: ADAPT-LLMの分析からの主な結果は、IRシステムをすべての質問に使用する固定戦略や、LLMのパラメトリックメモリだけに頼る固定戦略よりも、ADAPT-LLMが一貫して優れたパフォーマンスを示すこと、人気スコアを使用してIRシステムを使用するタイミングを決定する戦略と比較可能なパフォーマンスを示すこと、ADAPT-LLMが追加情報を取得することを決定した場合、コンテキストを使用した結果がそれなしよりもかなり優れていることなどです.

Q: Adapt-LLMは、パラメトリック・メモリだけに頼っているのに、なぜ高い精度を達成できるのでしょうか?

A: ADAPT-LLMは、パラメトリックメモリにのみ依存するときに高い精度レベルを達成します.このモデルは、追加のコンテキストを取得する必要がない場合に、直接的に質問に答えることができるときに高い精度を達成します.これは、ADAPT-LLMが情報を取得するタイミングと、追加のコンテキストなしで質問に答えることができるタイミングを効果的に見分ける能力によるものです.

Q: LLMを使った質問回答に外部情報検索を使うことの限界は?

A: 外部情報検索を使用することの制限は、IRシステムの性能に依存するため、最適な戦略が常に外部情報検索を含むわけではないことです.代わりに、より効果的な質問回答のためには、LLM自体のパラメトリックメモリを活用することがしばしば必要とされます.

Q: この論文で得られた知見は、他の文脈におけるLLMの情報検索戦略の改善にどのように応用できるだろうか?

A: この論文の結果は、他の文脈でのLLMの情報検索戦略の改善に応用することができます.具体的には、LLMが追加の文脈を必要とする質問に答える際に、IRシステムを使用することで、より正確な回答を提供できるようになります.また、トレーニングアプローチをカスタマイズして、LLMが既存のトレーニングプロセスの後に発生するイベントを活用することで、情報検索戦略を向上させることができます.

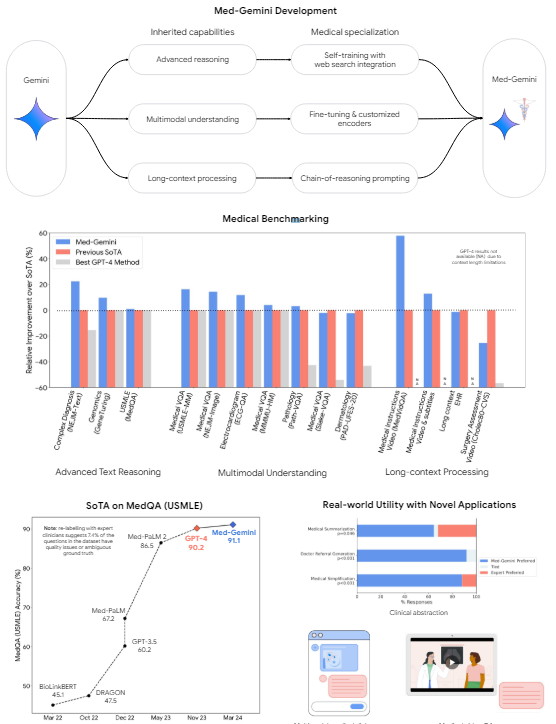

Capabilities of Gemini Models in Medicine

著者:Khaled Saab, Tao Tu, Wei-Hung Weng, Ryutaro Tanno, David Stutz, Ellery Wulczyn, Fan Zhang, Tim Strother, Chunjong Park, Elahe Vedadi, Juanma Zambrano Chaves, Szu-Yeu Hu, Mike Schaekermann, Aishwarya Kamath, Yong Cheng, David G. T. Barrett, Cathy Cheung, Basil Mustafa, Anil Palepu, Daniel McDuff, Le Hou, Tomer Golany, Luyang Liu, Jean-baptiste Alayrac, Neil Houlsby, Nenad Tomasev, Jan Freyberg, Charles Lau, Jonas Kemp, Jeremy Lai, Shekoofeh Azizi, Kimberly Kanada, SiWai Man, Kavita Kulkarni, Ruoxi Sun, Siamak Shakeri, Luheng He, Ben Caine, Albert Webson, Natasha Latysheva, Melvin Johnson, Philip Mansfield, Jian Lu, Ehud Rivlin, Jesper Anderson, Bradley Green, Renee Wong, Jonathan Krause, Jonathon Shlens, Ewa Dominowska, S. M. Ali Eslami, Katherine Chou, Claire Cui, Oriol Vinyals, Koray Kavukcuoglu, James Manyika, Jeff Dean, Demis Hassabis, Yossi Matias, Dale Webster, Joelle Barral, Greg Corrado, Christopher Semturs, S. Sara Mahdavi, Juraj Gottweis, Alan Karthikesalingam, Vivek Natarajan

発行日:2024年04月29日

最終更新日:2024年05月01日

URL:http://arxiv.org/pdf/2404.18416v2

カテゴリ:Artificial Intelligence, Computation and Language, Computer Vision and Pattern Recognition, Machine Learning

概要:

医療分野における幅広いアプリケーションにおける卓越性は、AIにとってかなりの課題を提起します.これには高度な推論能力、最新の医学知識へのアクセス、複雑なマルチモーダルデータの理解が必要です.ジェミニモデルは、マルチモーダルおよび長いコンテキスト推論に強い一般的な能力を持ち、医学分野での可能性を提供しています.これらのジェミニのコアな強みを活かし、私たちはMed-Geminiを紹介します.これは、医学に特化した高性能なマルチモーダルモデルのファミリーであり、ウェブ検索をシームレスに使用し、カスタムエンコーダを使用して新しいモダリティに効率的に適合させる能力を持っています.Med-Geminiは、GPT-4Vよりも平均的に44.5%の改善を示し、長い医療記録からの情報検索タスクや医療ビデオの質問回答など、長いコンテキストの能力を活かした最先端のパフォーマンスを実証しています.さらに、Med-Geminiのパフォーマンスは、医療テキストの要約などのタスクで人間の専門家を上回ることを示し、医療対話、医学研究、教育などで有望な可能性を示しています.これらの結果は、Med-Geminiの潜在的な可能性を示唆していますが、この安全性の重要な領域での実世界展開の前に、さらなる厳格な評価が不可欠であることを強調しています.

Q&A:

Q: Geminiモデルは、医療アプリケーションにおけるどのような具体的な課題に対応していますか?

A: Geminiモデルは、医療アプリケーションにおける特定の課題に対処します.具体的には、長いコンテキスト処理能力を持つことにより、非常に長い電子患者記録内での状態、症状、手順の特定と検証という実世界の課題に対応します.また、画像、音声、ビデオ、テキストなどのさまざまなモダリティを含む複雑なデータに対して、ミックスチャー・オブ・エキスパート・アーキテクチャを使用することで、Geminiモデルは効率的にスケーリングし、推論時により長く、より複雑なデータに対して推論を行うことができます.

Q: ジェミニのモデルは、マルチモーダルかつロングコンテクストの推論において、どのように強力な一般能力を示すのか?

A: ジェミニモデルは、医学において強力な一般的な多面的および長文脈推論能力を示すことができます.これは、Med-Geminiという高度な多面的モデルファミリーを導入することで可能となります.このモデルファミリーは、医学に特化した高度な能力を持ち、ウェブ検索の使用をシームレスに統合し、カスタムエンコーダを使用して新しいモダリティに効率的に適合させることができます.また、ジェミニモデルは、多面的事前学習による医学知識の強さを反映しており、多面的ベンチマークで印象的な性能を発揮しています.

Q: Med-Geminiはどのように医療に特化し、どのようなユニークな機能を提供しているのですか?

A: Med-Geminiは、医学に特化したモデルであり、臨床推論、多面的理解、および医学領域内での長い文脈処理の重要な進歩を示しています.Geminiモデルをベースに構築されており、医学知識、臨床推論、ゲノミクス、波形、医学画像、健康記録、およびビデオなど、14の医学ベンチマークをカバーする25のタスクにわたる幅広い分野で強力なパフォーマンスを発揮しています.また、自己学習に基づくファインチューニングと検索統合を使用したMedQA(USMLE)において新しいSoTAを達成しています.さらに、ウェブ検索を利用した最新情報の取得や、モダリティ固有のエンコーダを使用した新しい医学モダリティへのカスタマイズが可能です.

Q: GPT-4モデルと比較した医療ベンチマークにおけるメド・ジェミニの評価プロセスと結果について教えてください.

A: メドジェミニは、医学のベンチマークにおいてGPT-4モデルと比較して、相対的なマージンで44.5%の改善を達成しました.具体的には、テキストベースの推論、マルチモーダル、および長文脈処理のタスクを含む評価ベンチマークを提示し、幅広い医学の能力におけるメドジェミニのパフォーマンスを示しました.また、専門家による評価では、クリニシャンのパネルがモデルの応答を他の人間の専門家と比較し、サイドバイサイドで評価しました.

Q: MedQAベンチマークで最もパフォーマンスの高いMed-Geminiモデルは、どのような新しい不確実性ガイド付き検索戦略を用いているのだろうか?

A: 最も優れたMed-Geminiモデルは、MedQAベンチマークで新しい不確実性誘導型検索戦略を使用しています.

Q: マルチモーダルベンチマークにおいて、Med-Geminiはどのような点でGPT-4Vを上回っているのか、また平均的な相対マージンはどの程度か.

A: Med-Geminiは、7つの医療マルチモーダルベンチマーク全体で、GPT-4Vよりも平均相対マージンで44.5%改善しています.

Q: メドジェミニは、針刺し検索や医療ビデオの質問応答などのタスクにおいて、どのようにロングコンテキストの能力を発揮しているのでしょうか?

A: Med-Geminiは、長いEHRからの「針の中のハヤスタック」医療状態検索タスクや、2つのMAVLおよび1つのCVS手術ビデオの3つの医療ビデオタスクを通じて、長いコンテキスト処理能力を示しています.Med-Gemini-M 1.5は、長いEHRノート内での希少で微妙な問題エンティティ(状態/症状/手順)の正しい識別において、ベースライン手法と比較して平均適合率と再現率が示されており、一発の能力が慎重に調整されたヒューリスティックベースの注釈集約ベースラインアプローチと同等であることが観察されています.Med-Gemini-M 1.5のインコンテキスト学習能力は、長い文書や記録を処理することができ、広範な手動エンジニアリングの必要なしに新しい問題設定に一般化することが容易です.

Q: 医学テキストの要約、医療対話、研究、教育などのタスクにおいて、Med-Geminiはどのような実世界での有用性を示すのだろうか?

A: Med-Geminiは、医療テキストの要約、医療対話、研究、教育などのタスクにおいて、実世界での有用性を示しています.医療テキストの要約や紹介状の生成などのタスクにおいて、人間の専門家を上回る性能を示し、多面的な医療対話、医療研究、教育などにおける有望な可能性を示しています.これらの結果は、Med-Geminiが医学の多くの分野での可能性を示しており、実世界での展開に向けて、さらなる厳密な評価が不可欠であることを示唆しています.

Q: 医療分野でMed-Geminiを展開する前に、さらにどのような厳密な評価が必要でしょうか?

A: Med-Geminiを医療領域に展開する前には、さらなる厳格な評価が必要です.

Q: 特定の医療作業において、Med-Geminiが人間の専門家よりも優れている例を教えていただけますか?

A: Med-Geminiは、医療の要約、紹介状の生成、医療の簡素化などのタスクにおいて、人間の専門家を上回ることを示しています.例えば、医療要約の場合、患者の診察後に受け取る構造化されたレポートであるアフタービジットサマリー(AVS)を生成する際に、Med-Geminiは人間の専門家を凌駕しています.また、他の医療提供者に対する紹介状を生成する場合も、Med-Geminiは人間の専門家を上回っています.

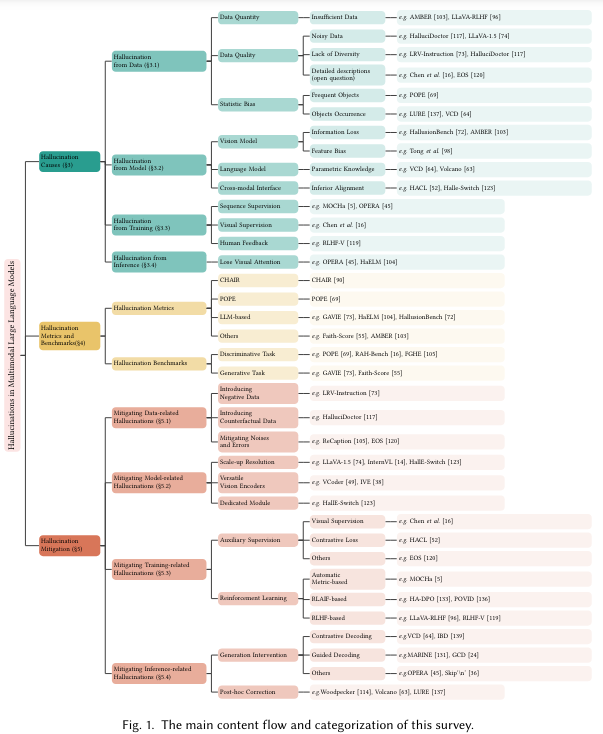

Hallucination of Multimodal Large Language Models: A Survey

著者:Zechen Bai, Pichao Wang, Tianjun Xiao, Tong He, Zongbo Han, Zheng Zhang, Mike Zheng Shou

発行日:2024年04月29日

最終更新日:2024年04月29日

URL:http://arxiv.org/pdf/2404.18930v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

この調査は、多モーダル大規模言語モデル(MLLMs)またはLarge Vision-Language Models(LVLMs)における幻覚現象の包括的な分析を提示しています.これらのモデルは、多モーダルタスクで重要な進歩と驚異的な能力を示しています.しかし、MLLMsはしばしば視覚コンテンツと一致しない出力を生成するため、これを幻覚と呼ばれる課題があり、これは実用的な展開に大きな障害をもたらし、現実世界のアプリケーションでの信頼性について懸念を引き起こします.この問題はますます注目されており、そのような不正確さを検出および軽減する取り組みが促されています.私たちは、これらの幻覚を特定し、評価し、軽減する最近の進歩を見直し、この問題に対処するために開発された根本的な原因、評価基準、メトリクス、および戦略の詳細な概要を提供しています.さらに、現在の課題と制限を分析し、将来の研究の可能性を明確にするためのオープンな質問を提示しています.幻覚の原因の粒状分類と風景を描くことで、この調査はMLLMsにおける幻覚の理解を深め、さらなる進歩を促すことを目指しています.私たちの徹底的かつ詳細なレビューを通じて、MLLMsの堅牢性と信頼性の向上に関する対話に貢献し、研究者や実務家にとって貴重な洞察とリソースを提供しています.リソースは以下で入手可能です:.” rel=”nofollow”>https://github.com/showlab/Awesome-MLLM-Hallucination.

Q&A:

Q: 視覚-言語タスクの分野において、マルチモーダル大規模言語モデル(MLLM)は具体的にどのような進歩を遂げたのでしょうか?

A: MLLMsは画像キャプショニングやビジュアルな質問応答などの多様なタスクにおいて、画像やビデオからデータを認識し理解する能力を持つことができるようになりました.

Q: MLLMのビジュアルコンテンツと生成されたアウトプットの間に矛盾がある例を教えてください.

A: MLLMsにおける視覚コンテンツと生成された出力の不一致の例としては、生成されたテキスト応答と提供された視覚コンテンツとの間の交差モーダルの不一致が挙げられます.これは、モデルが視覚情報に基づいて生成したテキストが、実際の視覚コンテンツと一致しないことを指します.このような不一致がモデルの信頼性や実用性に影響を与える課題となっています.

Q: MLLMの幻覚を発見し、軽減するためにどのような努力がなされてきたか?

A: MLLMsにおける幻覚を検出および軽減するための取り組みが増加しています.これには、幻覚の原因を特定し、評価基準やメトリクスを開発することが含まれます.さらに、この問題に対処するために開発された戦略も検討されています.最近の進展により、幻覚を特定し、評価し、軽減するための取り組みが行われており、その背景にある原因、評価基準、メトリクス、および戦略の詳細な概要が提供されています.

Q: MLLMにおける幻覚の根本的な原因は何ですか?

A: MLLMsにおける幻覚の根本的な原因は、データ、モデル、トレーニング、推論の段階からの寄与要因のスペクトラムに及ぶとされています.

Q: 現在、MLLMの幻覚はどのように評価され、測定されているのですか?

A: MLLMsにおける幻覚は、既存の最先端のMLLMsによって生成される幻覚の程度を評価するために設計された既存の幻覚メトリクスとベンチマークの包括的な概要が提供されています.これらのベンチマークの主な焦点は、物体の幻覚を評価することにあります.

Q: MLLMにおける幻覚の問題に対処するために、どのような戦略が開発されてきたか?

A: MLLMsにおける幻覚の問題に対処するために開発された戦略は、データ、モデル、トレーニング、推論の段階から幻覚を軽減するアプローチを提供しています.これらの方法は、幻覚の原因に密接に関連しており、包括的でターゲットを絞ったアプローチを確保しています.

Q: MLLMの幻覚を軽減するための現在の課題と限界は何か?

A: MLLMsにおける幻覚を軽減する際の現在の課題と制約は、大量のデータに依存するMLLMsが直面するデータ中心の課題と革新に関連しています.これにより、データの不足や品質の低下が幻覚を引き起こす可能性があります.また、モデル、トレーニング、推論の観点からアプローチを取ることで、幻覚を軽減する方法が研究されています.これらのアプローチは、データ、モデル、トレーニング、推論の四つのグループに分類され、それぞれの特性と視点に基づいて検討されています.

Q: この分野における今後の研究のために、どのような未解決の質問があるのだろうか?

A: 将来の研究のために提案されたオープンな問題は、物体の属性を尋ねる段階と、属性に基づいて物体を尋ねる段階の2つに分けることができます.彼らの回答が論理的な閉ループを形成できるかどうかは、物体の幻覚の指標となります.閉ループの割合が一定の閾値を超える場合、MLLMを促して幻覚した物体を修正します.

Q: 幻覚の原因を分類することは、MLLMの問題をより深く理解することにどのように貢献するのでしょうか?

A: 幻覚原因の分類は、MLLMにおける問題をより深く理解するために貢献します.データ、モデル、トレーニング、推論の4つの側面に分類された幻覚の原因を明らかにすることで、MLLMにおける幻覚の根本的な理由を探求し、問題を解決するための方向性を提供します.

Q: この調査で提供された洞察やリソースは、研究者や実務家にとってMLLMの頑健性と信頼性をどのように高めることができるのだろうか?

A: この調査で提供される洞察とリソースは、MLLMの信頼性と堅牢性を向上させるために研究者や実務家に貴重な示唆を与えることができます.高品質のデータはMLLMの性能を大幅に向上させることが実証されており、トレーニングの段階では、LLMパラメータをフルに微調整するなどのさまざまなオプションがあります.また、MLLMの解釈可能性を向上させることで、モデルの振る舞いを理解するだけでなく、実用的なアプリケーションでの幻覚的なコンテンツをより良く評価できるようになります.