ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

- Make Your LLM Fully Utilize the Context

発行日:2024年04月25日

LLMは長いコンテキスト内の情報を活用するのに苦労しており、IN2トレーニングを提案し、FILM-7Bを開発して、長いコンテキストタスクのパフォーマンスを向上させました. - Graph Machine Learning in the Era of Large Language Models (LLMs)

発行日:2024年04月23日

グラフニューラルネットワーク(GNN)とLLMの組み合わせは、Graph MLの進化を促し、知識グラフを活用して推論能力を向上させる可能性があります. - NExT: Teaching Large Language Models to Reason about Code Execution

発行日:2024年04月23日

NExTは、LLMにプログラムの実行トレースを教え、プログラム修復タスクでPaLM 2モデルの修正率を向上させることができる. - A Survey on Self-Evolution of Large Language Models

発行日:2024年04月22日

LLMsは進歩しているが、自己進化アプローチが性能向上に貢献し、超知能にスケーリングする可能性を提供している. - OpenELM: An Efficient Language Model Family with Open Training and Inference Framework

発行日:2024年04月22日

OpenELMは、大規模言語モデルの再現性と透明性を重視し、精度向上とオープンな研究を促進するためにリリースされたトランスフォーマーモデルで、公開データセットでトレーニング可能であり、Appleデバイスでの推論やファインチューニングも可能. - Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone

発行日:2024年04月22日

phi-3-miniは、3.3兆トークンでトレーニングされた言語モデルであり、Mixtral 8x7BやGPT-3.5と同等の性能を持ち、スマートフォンに展開可能な小さなモデルである. - AutoCrawler: A Progressive Understanding Web Agent for Web Crawler Generation

発行日:2024年04月19日

Web automationは、複雑なウェブタスクを自動化し、業務効率を向上させる重要な技術であり、AutoCrawlerフレームワークを使用して効果的に処理することができる.

Make Your LLM Fully Utilize the Context

著者:Shengnan An, Zexiong Ma, Zeqi Lin, Nanning Zheng, Jian-Guang Lou

発行日:2024年04月25日

最終更新日:2024年04月26日

URL:http://arxiv.org/pdf/2404.16811v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

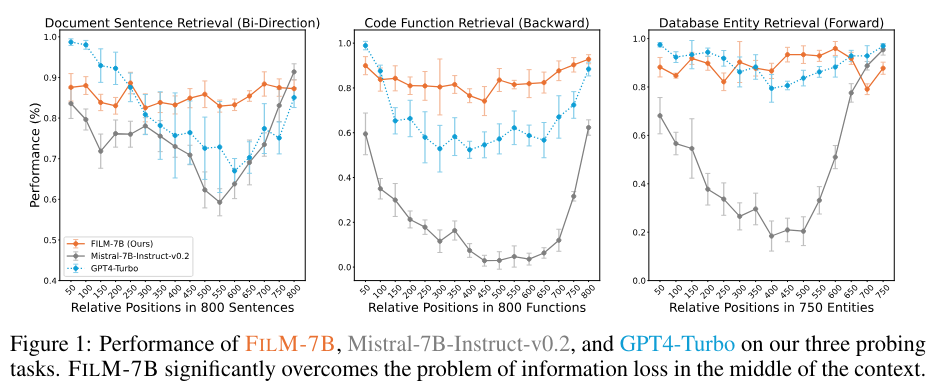

現代の多くの大規模言語モデル(LLM)は長い入力を処理できるものの、長いコンテキスト内の情報を十分に活用することに苦労しています.これは、失われた中間課題として知られており、長いコンテキストのトレーニング中に明示的な監督が不足していることから生じると仮定しています.この監督が不足していることにより、長いコンテキスト内の任意の位置が重要な情報を保持していることが強調されていません.この直感に基づいて、私たちの研究は、失われた中間を克服するための純粋にデータ駆動型の解決策である情報密集型(IN2)トレーニングを提案しています.具体的には、IN2トレーニングは、合成された長いコンテキスト(4K-32Kトークン)内の短いセグメント(〜128トークン)における微細な情報認識が必要であり、2つ以上の短いセグメントからの情報の統合と推論が必要な合成された長いコンテキストの質問回答データセットを活用しています.この情報密集型トレーニングをMistral-7Bに適用することで、FILM-7B(FILl-in-the-Middle)を提案しています.FILM-7Bが長いコンテキストを活用する能力を徹底的に評価するために、文書、コード、および構造化データコンテキストを含むさまざまなコンテキストスタイルをカバーする3つのプロービングタスクを設計しています.さらに、FILM-7Bは、32Kのコンテキストウィンドウ内の異なる位置から情報を堅牢に取得できることを示すさまざまなコンテキストスタイル(文書、コード、および構造化データコンテキスト)と情報取得パターン(前方、後方、および双方向取得)を包括しています.プロービングの結果は、FILM-7Bが異なる位置から情報を堅牢に取得できることを示しています.これらのプロービングタスクに加えて、FILM-7Bは、実世界の長いコンテキストタスク(例:NarrativeQAのF1スコア23.5→26.9)のパフォーマンスを大幅に向上させる一方、短いコンテキストタスク(例:MMLUの精度59.3→59.2)で同等のパフォーマンスを維持しています.Githubリンク:.” rel=”nofollow”>https://github.com/microsoft/FILM.

Q&A:

Q: 大規模言語モデル(LLM)の文脈で、”lost-in-the-middle challenge “のコンセプトを説明していただけますか?

A: 大規模言語モデル(LLM)における失われた中間課題は、長い文脈内の情報を効果的かつ堅牢に活用することが難しいという問題です.これは、LLMが長い文脈の先頭と末尾の情報を理解できる一方で、中間の情報を見落とす傾向があることを意味します.この課題は、長い文脈のLLMの開発を著しく妨げる可能性があり、簡単なプロービングタスクでさえ、例えばNeedle-in-the-Haystackやpasskey retrievalなどに失敗することさえあります.

Q: IN2のトレーニング・アプローチは、従来のLLMのトレーニング方法とどう違うのですか?

A: IN2トレーニングアプローチは、従来のトレーニング方法と異なります.具体的には、IN2トレーニングは、長いコンテキスト内の短いセグメントに含まれる微細な情報認識と、異なる位置に現れる情報の統合と推論が必要な回答を要求する合成された長いコンテキストの質問-回答データセットを活用します.これにより、モデルに長いコンテキスト内の任意の位置に重要な情報が含まれることを明示的に教えることが目的とされています.

Q: IN2のトレーニングプロセスにおいて、合成されたロングコンテキストの質疑応答データセットを使用する意義は何ですか?

A: 合成された長いコンテキストの質問応答データセットを使用することにより、IN2トレーニングプロセスでは、モデルに長いコンテキスト内の任意の位置に重要な情報が含まれていることを明示的に教えることができます.このデータセットにより、短いセグメントにランダムに配置された情報を含む質問に対する回答を学習することが可能となります.

Q: Mistral-7Bと比較して、FILM-7B(FILl-in-the-Middle)はロング・コンテキストの利用率をどのように向上させるのか?

A: FILM-7B (FILl-in-the-Middle)は、Mistral-7Bに比べて長い文脈の利用を向上させることができます.具体的には、FILM-7Bは32Kの文脈ウィンドウ内の異なる位置から情報を堅牢に取得できることが示されています.VAL Probing内の3つのプロービングタスクにおいて、FILM-7Bモデルは全体の文脈内の異なる位置で一貫して堅牢なパフォーマンスを示し、Mistralモデルは中間位置で情報の損失が著しく発生します.この比較から、FILM-7BはI N2トレーニングを使用して、失われた中間部分の問題を効果的に解決できることが明らかになります.

Q: FILM-7Bの長いコンテクストを活用する能力を評価するためにデザインされた3つのプロービング・タスクについて詳しく教えてください.

A: FILM-7Bの能力を評価するために設計された3つのプロービングタスクについて詳しく説明します.これらのタスクは、さまざまなコンテキストスタイル(ドキュメント、コード、構造化データコンテキスト)と情報検索パターン(前方、後方、双方向検索)をカバーしています.これらのプロービングタスクは、FILM-7Bが32Kのコンテキストウィンドウ内の異なる位置から情報を堅牙的に取得できる能力を徹底的に評価するために設計されています.

Q: FILM-7Bは、実世界のロングコンテクスト・タスクで、ショートコンテクスト・タスクと比較してどのようなパフォーマンスを見せてくれるのか?

A: FILM-7Bは、実世界の長文脈タスクにおいても、短文脈タスクと比較して顕著な改善を示しています.具体的には、NarrativeQAにおいてF1スコアが23.5から26.9に向上しています.また、短文脈タスクにおいても、FILM-7Bはバニラバックボーンモデルと比較してほぼ同等の性能を維持しており、MMLUにおいては正解率が59.3から59.2にわずかながら低下しています.これは、FILM-7Bの短文脈能力が訓練中に損なわれていないことを示しています.

Q: FILM-7Bのプロービング結果から得られた重要な知見や洞察は?

A: FILM-7Bの探査結果から得られる主な知見は、32Kのコンテキストウィンドウ内の異なる位置から情報を堅牢に取得できることです.さらに、FILM-7Bは実世界の長いコンテキストタスク(例:NarrativeQAのF1スコア23.5→26.9)で性能を著しく向上させる一方、短いコンテキストタスクでは同等の性能を維持しています.VAL Probingでの定量化されたパフォーマンスは、FILM-7Bがデータベース探査タスクでGPT-4-Turboと同等のパフォーマンスを持ち、文書およびコード探査タスクでより堅牢性を示していることを明らかにしています.これらの結果は、オープンソースの長いコンテキストモデルの開発において、プロプライエタリモデルとの差を埋める可能性があることを示しています.

Q: 複数の短いセグメントからの情報の統合と推論は、FILM-7Bの効果にどのように貢献しているのか?

A: 複数の短いセグメントからの情報の統合と推論は、FILM-7Bの効果に寄与します.これにより、FILM-7Bは長いコンテキストをより効果的に理解し、情報を取得する能力が向上します.

Q: FILM-7Bの性能向上がNarrativeQAやMMLUなどのタスクに与える影響は何ですか?

A: FILM-7Bの性能向上は、NarrativeQAやMMLUなどのタスクにおいて顕著な改善を示しており、これにより合成された長い文脈データでのトレーニングが実世界のシナリオにも一般化できることを示しています.また、FILM-7Bは短い文脈タスクにおいてもバニラのバックボーンモデルと比較して同等の性能を維持しており、これはFILM-7Bの短い文脈能力がトレーニング中に損なわれていないことを示しています.

Q: FILMのGithubリポジトリの詳細と、他の人がアクセスしたり利用したりする方法を教えてください.

A: FILMのGithubリポジトリに関する詳細は、github.com/microsoft/FILMにアクセスすることで確認できます.このリポジトリには、FILM-7Bのソースコードや関連する情報が提供されており、他のユーザーが利用することができます.

Graph Machine Learning in the Era of Large Language Models (LLMs)

著者:Wenqi Fan, Shijie Wang, Jiani Huang, Zhikai Chen, Yu Song, Wenzhuo Tang, Haitao Mao, Hui Liu, Xiaorui Liu, Dawei Yin, Qing Li

発行日:2024年04月23日

最終更新日:2024年06月04日

URL:http://arxiv.org/pdf/2404.14928v2

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Social and Information Networks

概要:

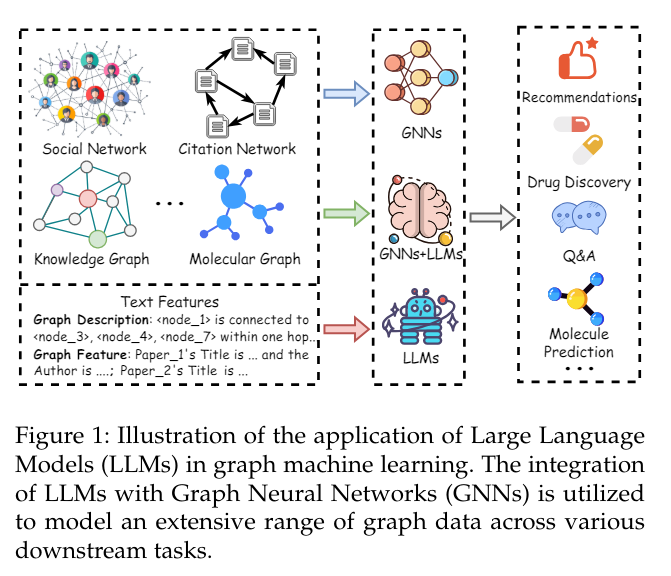

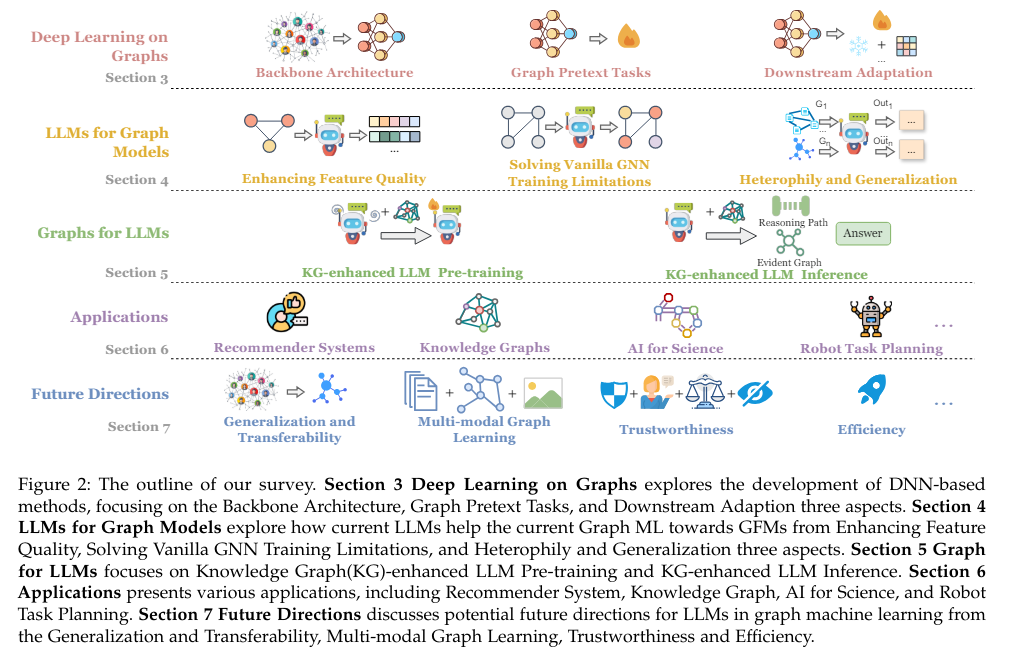

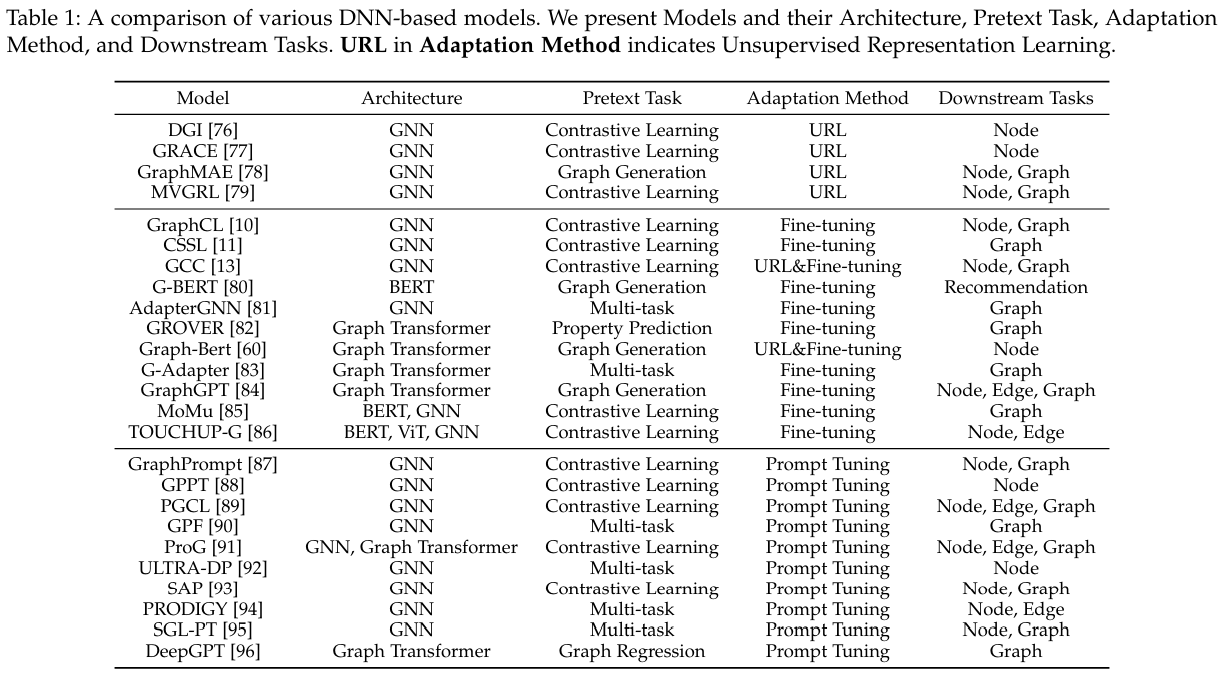

グラフは、ソーシャルネットワーク、知識グラフ、分子探索など、さまざまなドメインで複雑な関係を表現する上で重要な役割を果たしています.深層学習の台頭により、グラフニューラルネットワーク(GNN)は、グラフ構造の表現と処理を容易にするGraph Machine Learning(Graph ML)の中核として台頭しています.最近、LLM(Large Language Models)は言語タスクで前例のない能力を示し、コンピュータビジョンやレコメンダーシステムなどのさまざまなアプリケーションで広く採用されています.この驚異的な成功は、LLMをグラフ領域に適用することにも関心を引き寄せています.LLMを用いてGraph MLの汎化、転移性、および少数ショット学習能力を向上させる可能性を探るために、ますます多くの取り組みが行われています.一方、知識グラフを含むグラフは、信頼性の高い事実知識に富んでおり、これを活用してLLMの推論能力を向上させ、幻覚や説明不足などの制限を緩和する可能性があります.この研究方向の急速な進歩を考えると、最新の進展をまとめた体系的なレビューが求められています.研究方向として、LLM時代のGraph MLにおける最新の進展を体系的にまとめたレビューが、研究者や実務家に深い理解を提供するために必要です.この調査では、まずGraph MLの最近の進展をレビューし、次にLLMがどのように活用されてグラフの特徴の質を向上させ、ラベル付きデータへの依存を軽減し、グラフの異質性や分布外(OOD)一般化などの課題に取り組む方法を探ります.その後、グラフがLLMをどのように向上させるかを探求し、LLMの事前学習と推論を向上させる能力を強調します.さらに、さまざまなアプリケーションを調査し、この有望な分野の潜在的な将来の方向性について議論します.

Q&A:

Q: グラフ機械学習(グラフML)において、グラフニューラルネットワーク(GNN)はどのようにグラフ構造の表現と処理を促進するのか?

A: グラフニューラルネットワーク(GNN)は、グラフ構造の表現と処理を容易にします.これは、各ノードが隣接するノードからメッセージを再帰的に受信し、集約するメッセージパッシングメカニズムを持つためです.このメカニズムにより、各ノードはグラフ構造内の高次の関係や依存関係を捉えることができます.

Q: 大規模言語モデル(LLM)がこれまでにない能力を発揮したアプリケーションの例には、どのようなものがありますか?

A: LLMsは、自然言語処理(NLP)のみならず、CVやレコメンドシステムなどの様々なアプリケーションにおいても顕著な能力を示しています.

Q: LLMは、グラフ・ドメインにおける幻覚や説明可能性の欠如といった制約を、どのように軽減できる可能性があるのだろうか?

A: LLMsは、幻覚や説明不足などの制限を緩和する可能性があります.グラフ構造をLLMsに組み込むことで、LLMsの推論能力を向上させ、これらの制限を軽減することができます.

Q: LLMの潜在能力を探求し、Graph MLの一般化、移転性、および少数ショット学習能力を向上させるために行われている努力は何ですか?

A: LLMsの潜在能力を探るために行われているいくつかの取り組みには、Graph MLの一般化、転移性、および少数ショット学習能力を向上させることが含まれています.これらの取り組みは、信頼性の高い事実知識を豊富に持つ知識グラフなどのグラフを活用して、LLMsの推論能力を向上させ、幻覚や説明不足などの制限を緩和することを目指しています.

Q: グラフ、特に知識グラフから得られる信頼できること実知識は、LLMの推論能力を高めるためにどのように活用できるのだろうか?

A: 信頼性の高い事実知識は、LLMの推論能力を向上させるために、グラフ、特に知識グラフから取り出され、LLMに組み込まれることができます.これにより、LLMは幻覚や説明不足などの制限を緩和することができます.

Q: グラフMLの最近の動向について教えてください.

A: この調査では、最近のグラフ機械学習の進展について以下の点がレビューされています.まず、グラフ機械学習の進化が概観され、次にLLMsがグラフ機械学習をどのように向上させるかが詳細に説明されています.特に、LLMsがグラフ機械学習をどのように拡張するか、その利点や制限を示し、体系的な分類を提供しています.また、グラフ構造がLLMsの制限を解決するための潜在能力が徹底的に調査されています.

Q: グラフ特徴の質を高め、ラベル付きデータへの依存を軽減するために、LLMをどのように活用できるか?

A: LLMsは、グラフの特徴の品質を向上させ、ラベル付きデータへの依存を軽減するために利用することができます.例えば、InstructGLMは、グラフデータをトークンとしてシリアライズし、グラフに関する構造情報をエンコードすることで、グラフタスクを解決するためにLlaMAやT5などのモデルを微調整します.また、SimTeGは、LLMsをテキストグラフデータセットに微調整してテキスト属性の埋め込みを取得し、それを使用してさまざまな下流タスクのためにGNNを拡張するなど、一部の手法はLLMsを使用してグラフの特徴の品質を向上させるためにさらに活用しています.

Q: グラフはLLMの事前学習と推論をどのように強化するのか?

A: グラフはLLMの事前学習と推論を向上させる能力があります.具体的には、グラフはLLMの入力として使用され、グラフ構造や特徴をモデルに組み込むことで、より豊富な情報を提供します.これにより、LLMはより複雑な関係性やパターンを学習し、推論の精度を向上させることができます.また、グラフはLLMの出力を解釈する際にも役立ち、モデルの説明可能性を向上させることができます.

Q: グラフの異質性や分布外(OOD)の汎化など、この調査ではどのような課題に取り組んでいるのか?

A: 調査では、グラフの異質性や分布外(OOD)一般化などの課題が取り上げられています.

Q: LLMの時代におけるグラフMLの分野では、どのような将来の方向性が考えられるのだろうか?

A: 調査では、LLMs時代のGraph ML分野の将来の方向性として、LLMsの力を活用してGraph MLを強化し、GFMsを可能にすることが挙げられています.また、LLMsをグラフと組み合わせることで、LLMの事前学習と推論を強化し、分子の発見、知識グラフ、およびレコメンダーシステムなどのさまざまなアプリケーションでの潜在能力を示しています.さらに、この分野はまだ進化途上であり、さまざまな進歩の機会を提供しています.そのため、いくつかの課題や将来の方向性についても議論されています.

NExT: Teaching Large Language Models to Reason about Code Execution

著者:Ansong Ni, Miltiadis Allamanis, Arman Cohan, Yinlin Deng, Kensen Shi, Charles Sutton, Pengcheng Yin

発行日:2024年04月23日

最終更新日:2024年04月23日

URL:http://arxiv.org/pdf/2404.14662v1

カテゴリ:Machine Learning, Computation and Language, Programming Languages, Software Engineering

概要:

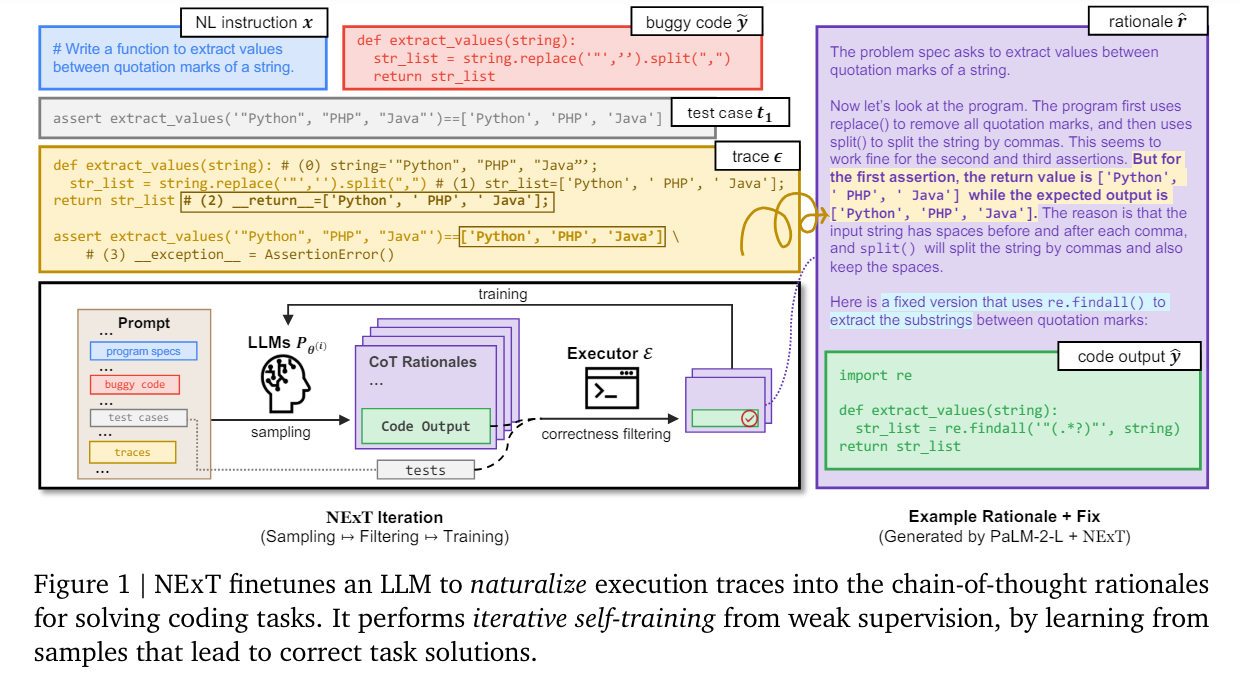

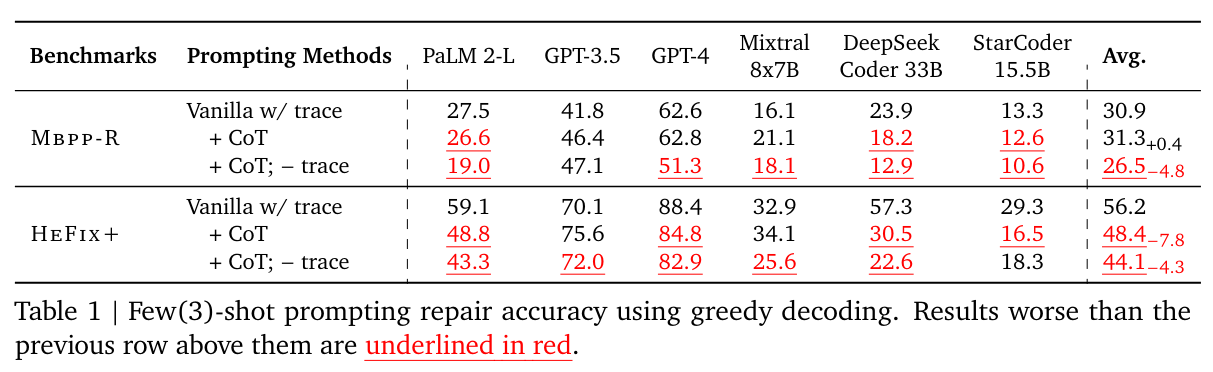

人間の開発者の間での基本的なスキルの1つは、プログラムの実行について理解し、推論する能力です.例えば、プログラマーは、コードの実行を自然言語で精神的にシミュレートしてデバッグや修復を行うことができます(いわゆるラバーダックデバッグ).しかし、大規模言語モデル(LLM)は通常、プログラムの表面的なテキスト形式で訓練されているため、プログラムが実行時にどのように実行されるかの意味理解が欠けている可能性があります.この問題に対処するために、私たちはNExTを提案しています.これは、プログラムの実行トレース(実行された行の変数状態)を検査し、ランタイム動作について推論するためのチェーン・オブ・ソート(CoT)の合理的な方法をLLMに教える方法です.具体的には、NExTは、手間のかかる手動注釈なしに正しいタスクソリューション(例:修正されたプログラム)に導く実行認識合理的な合成トレーニングセットをブートストラップするためのセルフトレーニングを使用します.MBPPとHumanEvalに基づくプログラム修復タスクの実験では、NExTがPaLM 2モデルの修正率をそれぞれ26.1%と14.3%絶対的に向上させ、自動化されたメトリクスと人間の評価者によって検証された合理性の質も大幅に向上させたことが示されました.私たちのモデルはまた、プログラムトレースがテスト時に欠如しているシナリオにも一般化することができます.

Q&A:

Q: NExTは、プログラムの実行トレースを検査するために、大規模な言語モデルをどのように教えているのだろうか?

A: NExTは、プログラムの実行トレースを大規模言語モデルに検査させるために、実行状態を入力としてLLMsに使用します.これにより、LLMsは生成された自然言語の根拠を実行状態に直接使用できます.

Q: NExTにおける思考の連鎖(CoT)の合理性の意義とは?

A: NExTにおけるCoTの根拠は重要であり、実行情報を用いた推論を可能にし、元のコードのバグの特定や説明、修正の提案を行うことができます.これらの根拠には、期待される変数値と実際の変数値を比較することでバグを特定するのに役立つ推論ステップが含まれており、プログラムの実行を理解するのに役立ちます.ステップごとのプログラムトレースを用いてLLMを訓練することで、NExTの学習可能な根拠は、冗長な推論ステップを排除し、バグの説明に柔軟でターゲット向けのものとなっています.このアプローチにより、プログラム修復問題の解決の精度が向上し、根拠生成の品質が向上します.

Q: NExTで合成訓練セットをブートストラップする際、自己訓練はどのように役立つのでしょうか?

A: 自己トレーニングは、NExTにおいて合成トレーニングセットをブートストラップする際に、初期イテレーションからサンプリングされたインスタンスに過剰適合するのを避けるために役立ちます.具体的には、自己トレーニングは、高品質の根拠を持つ合成データセットを反復的にブートストラップすることで、手動注釈を最小限に抑えます.

Q: NExTによって達成されたPaLM 2モデルのフィックス率の向上について説明していただけますか?

A: NExTによって、PaLM 2モデルの修正率が向上した理由は、NE xTトレーニングによってモデルがプログラム修正に対してより自信を持つようになり、サンプルの多様性も向上したためです.具体的には、修正率の向上が小さなkに対してより高いことが示され、これはNE xTトレーニング後にモデルがプログラム修正に対してより自信を持つようになり、サンプルの多様性も向上したことを示唆しています.NE xTトレーニングによって、PaLM 2モデルが実行トレースとの推論を改善し、より小さなLMにとって有益な根拠を導くスキルを向上させたため、修正率が向上したと考えられます.

Q: NExTは、自動化された評価指標と人間の評価者によって検証された、根拠となる品質の向上をどのように保証しているのでしょうか?

A: NExTは、自動評価メトリクスと人間の評価者によって検証されたように、理由の質を向上させるために、より小さなLLMのパフォーマンスを使用して理由の質を近似するプロキシベースの評価アプローチを提案します.このプロキシベースの評価と人間の注釈を通じて、NExTは、バグの原因を説明しながら潜在的な修正を提案する有益なNL理由を生成し、これらの理由は基本的なPaLM 2-Lモデルから生成されたものと比較して、著しく高い品質であることを示しています.

Q: NExTは、テスト時にプログラムトレースが存在しないシナリオにどのように一般化するのか?

A: NExTは、テスト時にプログラムトレースがないシナリオにも一般化することができます.実行情報が利用できない場合、NExTは実行トレースを入力から削除しても、エンドツーエンドの修正率を40.8%維持し、3ショットのPaLM 2-Lベースラインよりも21.8%向上させ、トレースなしで訓練されたNE xTよりもわずか3.3%低い結果を示しました.

Q: 大規模言語モデルの従来の学習方法と、NExTで提案されているアプローチとの主な違いは何ですか?

A: 従来の大規模言語モデルの伝統的なトレーニング方法とNExTで提案されたアプローチの主な違いは、NExTが自己トレーニングを使用して合成データセットを繰り返しブートストラップする点です.これにより、NExTはラベル付きまたは蒸留されたデータに依存せず、より能力の高い教師モデルから蒸留されたデータを使用します.また、NExTは合理性とプログラムトレースの影響を分析し、HeFix+での一般化実験と合理性の品質の人間評価を行います.

Q: NExTは、大規模な言語モデルがプログラム実行の意味理解を欠くという問題にどのように対処しているのだろうか?

A: NExTは、LLMsがプログラムの実行に対する意味理解を欠いている問題に対処するために、実行トレースをLLMsの入力の一部として使用し、生成された自然言語の合理的根拠を基礎付けることができるようにします.また、推論のための主要な形式として自然言語を選択し、より柔軟で理解しやすいものとします.

Q: NExTがプログラム修復タスクの実際のシナリオにどのように適用できるか、例を挙げていただけますか?

A: NExTは、プログラム修復タスクにおいて実世界のシナリオに適用する際の例として、実行情報を活用して修復されたプログラムの品質を向上させることができます.具体的には、NE xTは、実行情報を使用して修復されたプログラムの品質を向上させるために、自己トレーニングを使用して合成的なトレーニングセットをブートストラップし、手作業での注釈付けを行わずに正しいタスクソリューション(例:修正されたプログラム)に導く実行に対応した根拠を使用します.MbppandHumanEvalに基づくプログラム修復タスクの実験では、NE xTがPaLM 2モデルの修正率をそれぞれ26.1%および14.3%絶対値で向上させ、自動化されたメトリクスと人間の評価者によって検証された根拠の品質が大幅に向上していることが示されています.また、プログラムトレースがテスト時に欠落しているシナリオにも適用可能です.

Q: 自然言語処理とプログラム理解の分野におけるNExTの潜在的な意味とは?

A: NExTは、自然言語処理とプログラム理解の分野において、大きな影響をもたらす可能性があります.具体的には、NExTは大規模言語モデルをプログラム実行に関する推論を行うように教育する手法であり、プログラム修復タスクにおいて高品質な自然言語の根拠を提供し、成功率を向上させることが示されています.また、NExTはプログラム理解タスクにも応用可能であり、プログラミング言語をサポートするトレース表現を拡張することで、より幅広い範囲のタスクに適用できる可能性があります.

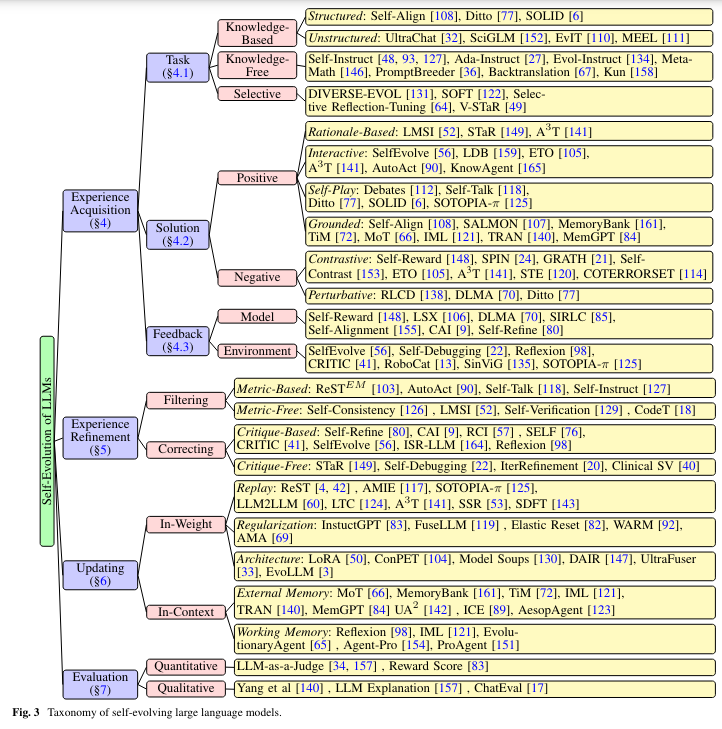

A Survey on Self-Evolution of Large Language Models

著者:Zhengwei Tao, Ting-En Lin, Xiancai Chen, Hangyu Li, Yuchuan Wu, Yongbin Li, Zhi Jin, Fei Huang, Dacheng Tao, Jingren Zhou

発行日:2024年04月22日

最終更新日:2024年06月03日

URL:http://arxiv.org/pdf/2404.14387v2

カテゴリ:Computation and Language, Artificial Intelligence

概要:

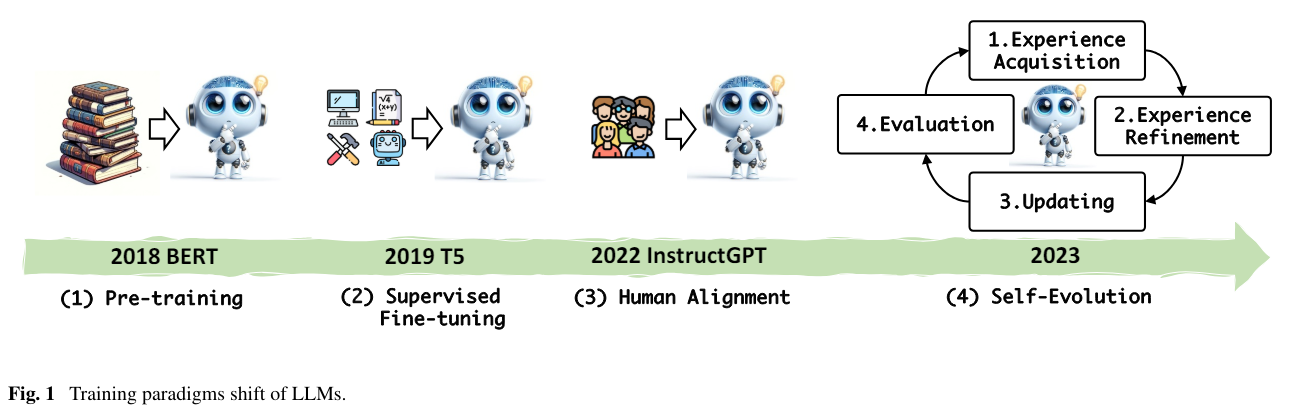

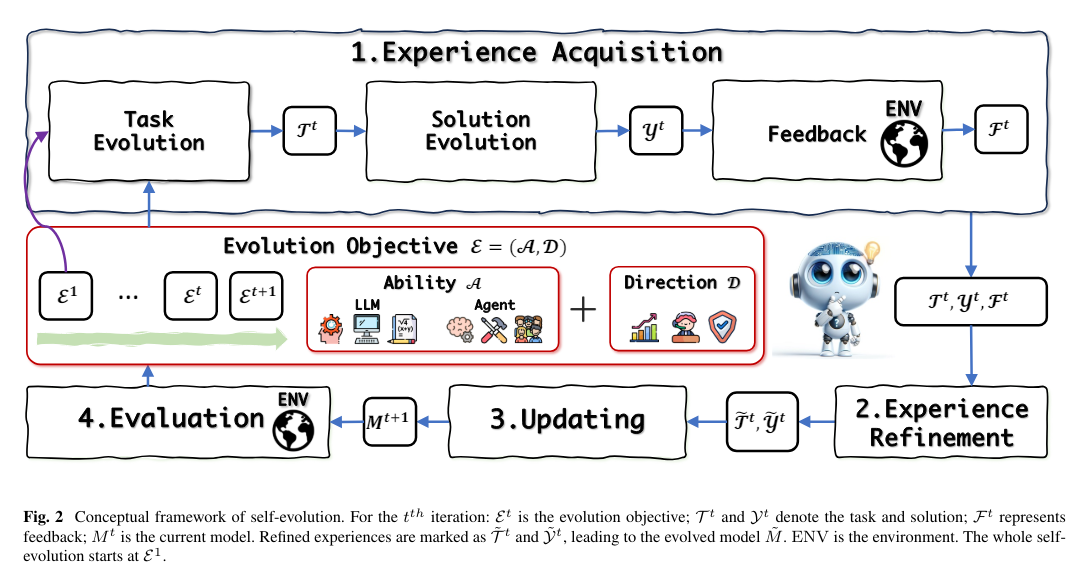

大規模言語モデル(LLMs)は、さまざまな分野や知的エージェントアプリケーションで大きな進歩を遂げています.しかし、人間や外部モデルの監督から学習する現在のLLMsはコストがかかり、タスクの複雑さや多様性が増すにつれて性能の天井に直面する可能性があります.この問題に対処するため、LLMが自律的に獲得し、磨き、モデル自体によって生成された経験から学習することを可能にする自己進化アプローチが急速に成長しています.この新しいトレーニングパラダイムは、人間の経験的学習プロセスに触発されており、LLMsを超知能にスケーリングする可能性を提供しています.本研究では、LLMsにおける自己進化アプローチの包括的な調査を行います.まず、自己進化の概念的枠組みを提案し、経験獲得、経験磨き、更新、評価の4つのフェーズから成る反復サイクルとして進化プロセスを概説します.次に、LLMsおよびLLMベースのエージェントの進化目標をカテゴリ分けし、それぞれのモジュールについて文献をまとめ、分類法と洞察を提供します.最後に、既存の課題を指摘し、自己進化フレームワークを改善するための将来の方向性を提案します.さらに、研究者が自己進化するLLMsの開発を加速させるための重要な洞察を提供するために、課題を指摘し、自己進化フレームワークを改善するための将来の方向性を提案します.関連するGitHubリポジトリは、https://github.com/AlibabaResearch/DAMO-ConvAI/tree/main/Awesome-Self-Evolution-of-LLM で利用可能です.

Q&A:

Q: LLMにおける自己進化の概念的枠組みについて説明していただけますか?

A: この文章では、LLM(Large Language Models)における自己進化の概念フレームワークが説明されています.自己進化は、人間の進化に似た形で、環境の変化や課題に対応して自律的に適応し、学習し、向上するモデルを指します.自己進化するLLMは、現在の静的でデータに依存するモデルの制限を超えるだけでなく、より動的で堅牢で知的なシステムへの移行を示しています.この概念フレームワークでは、LLMの自己進化を人間のような獲得、磨き、自律に似たものとして概説しています.自己進化のサイクルは、獲得、磨き、評価のフェーズから成り立っており、モデルのパフォーマンスが外部環境で評価され、その結果が次の自己進化のイテレーションのための目標を定めるとされています.

Q: LLMの自己進化アプローチにおける進化プロセスの4つの段階とは?

A: 自己進化アプローチにおけるLLMの進化プロセスの四つの段階は、経験獲得、経験の磨き、更新、評価です.

Q: LLMとLLMベースのエージェントの進化目的は、アンケートではどのように分類されていますか?

A: LLMおよびLLMベースのエージェントの進化目標は、経験獲得、経験の洗練、更新、評価の4つのフェーズからなる反復サイクルとして構成され、それぞれのモジュールに対する分類と洞察を提供し、進化目標を明確にしました.

Q: LLMの自己進化アプローチに関する調査でまとめられた文献について、洞察を教えてください.

A: 調査では、自己進化アプローチに関する文献の概要が提供されており、自己進化LLMにおける進化能力や現在の手法の領域について詳細にまとめられています.また、経験の獲得、改善、更新、評価の反復サイクルを中心とした自己進化LLMの理解と開発の包括的なフレームワークが提示されています.このフレームワーク内での進化目標の進歩を詳細に説明し、現在の手法の包括的な概要を提供し、自己進化フレームワークと次世代モデルの開発における重要な進展の道筋を示しています.

Q: LLMの自己進化フレームワークに関して、この文章で指摘されている既存の課題にはどのようなものがありますか?

A: LLMの自己進化フレームワークに関する既存の課題には、専門家の努力が必要な中程度のレベルでのモジュールの設計、LLMが目標とする目的に従って自己進化することができるが、高いレベルでは、LLMが現在の欠点を調査し、目標を持って進化することができるという点が挙げられる.高度な自律的な自己進化フレームワークの開発は未解決の問題である.

Q: LLMの自己進化アプローチは、人間や外部のモデル監督から学習する現在のLLMとどう違うのか?

A: 自己進化アプローチは、人間や外部モデルの監督から学ぶ現行のLLMとは異なります.自己進化アプローチでは、LLMが自律的に獲得し、洗練し、学習することができます.これにより、タスクの複雑さや多様性が増すにつれて、コストがかかる問題や性能の天井に直面する可能性が低くなります.

Q: LLMの超知能化に向けたスケーリングにおいて、自己進化アプローチはどのような潜在的利益をもたらすのだろうか?

A: 自己進化アプローチは、LLMを超知能にスケーリングする際に潜在的な利益を提供します.これにより、モデル自体が生成した経験に基づいて学習し、人間の経験学習プロセスに触発された新しいトレーニングパラダイムが可能となります.自己進化により、現在のモデルが人間の注釈や教師モデルに大きく依存している制限を克服する可能性があります.経験の獲得、経験の洗練、更新、評価という四つのフェーズから成る反復サイクルを通じて、LLMの進化を促進し、より動的で効率的なモデルに向けて進歩を加速させる方向性を提案しています.

Q: 自己進化するLLMは、どのようにしてモデル自身が生み出す経験を獲得し、洗練させ、そこから学んでいくのだろうか?

A: 自己進化するLLMは、モデル自体によって生成された経験を獲得し、洗練し、学習します.このサイクルでは、LLMは新しいタスクを進化させ、それに対応する解決策を生成することで経験を獲得し、その後、これらの経験を洗練してより良い監督信号を得ます.モデルを重みやコンテキストで更新した後、進捗を測定し新しい目標を設定するために評価されます.

Q: LLMの自己進化のプロセスに関わる反復サイクルについて詳しく教えてください.

A: LLMsの自己進化プロセスにおける反復サイクルは、経験の獲得、経験の磨き、更新、評価の4つの段階で構成されます.最初に、LLMは新しいタスクを進化させ、それに対応する解決策を生成することで経験を獲得します.次に、これらの経験を磨き上げ、より良い監督信号を得るために改善します.その後、モデルを重みやコンテキストで更新した後、進捗を測定し新しい目標を設定するために評価されます.

Q: 調査結果に基づき、LLMの自己進化フレームワークを改善するために、今後どのような方向性を提案しますか?

A: 調査結果に基づいて、LLMの自己進化フレームワークを改善するための将来の方向性として、経験の獲得、精練、更新、評価の反復サイクルをより効果的に活用することが重要です.また、進化目標を明確にし、現在の方法を包括的に把握することで、自己進化LLMの可能性を最大限に引き出すことが重要です.さらに、現在の課題を克服し、より動的で知能の高いモデルを実現するために、研究の方向性を提案することが必要です.

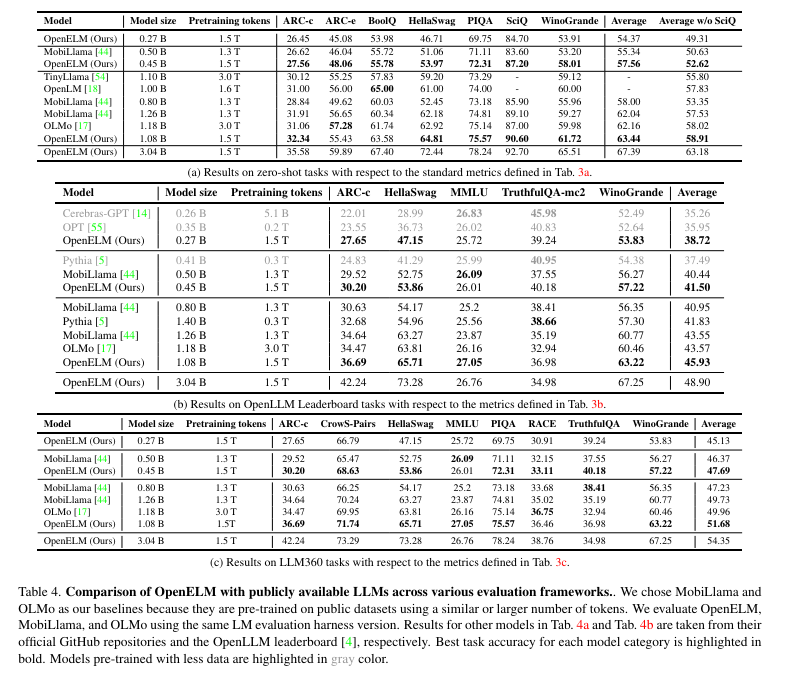

OpenELM: An Efficient Language Model Family with Open Training and Inference Framework

著者:Sachin Mehta, Mohammad Hossein Sekhavat, Qingqing Cao, Maxwell Horton, Yanzi Jin, Chenfan Sun, Iman Mirzadeh, Mahyar Najibi, Dmitry Belenko, Peter Zatloukal, Mohammad Rastegari

発行日:2024年04月22日

最終更新日:2024年05月02日

URL:http://arxiv.org/pdf/2404.14619v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

大規模言語モデルの再現性と透明性は、オープンな研究の推進、結果の信頼性の確保、データやモデルの偏り、および潜在的なリスクの調査を可能にするために重要です.このため、私たちは最先端のオープン言語モデルであるOpenELMをリリースします.OpenELMは、トランスフォーマーモデルの各層内でパラメータを効率的に割り当てるために層ごとのスケーリング戦略を使用しており、精度が向上しています.たとえば、約10億のパラメータ予算を持つ場合、OpenELMはOLMoと比較して精度が2.36%向上し、事前トレーニングトークンが2倍少なくても十分です.

従来の慣行とは異なり、モデルの重みと推論コードのみを提供し、プライベートデータセットで事前トレーニングを行うことが一般的でしたが、私たちのリリースには、公開データセットで言語モデルのトレーニングと評価のための完全なフレームワークが含まれています.トレーニングログ、複数のチェックポイント、および事前トレーニングの構成も含まれています.また、モデルをMLXライブラリに変換してAppleデバイスで推論やファインチューニングを行うためのコードもリリースしています.この包括的なリリースは、オープンな研究コミュニティを強化し、支援することを目的としています.さらに、私たちのソースコードと事前トレーニングされたモデルの重み、トレーニングレシピは、\url{https://github.com/apple/corenet}で入手可能です.さらに、\modelモデルはHuggingFaceで\url{https://huggingface.co/apple/OpenELM}で見つけることができます.

Q&A:

Q: トランスフォーマーモデルの各レイヤーに効率的にパラメーターを割り当てるために、OpenELMで使われているレイヤーごとのスケーリング戦略について説明してもらえますか?

A: OpenELMでは、各トランスフォーマーレイヤーにおいて、異なる構成(例:ヘッド数やフィードフォワードネットワークの次元)があり、各レイヤーごとに異なるパラメータ数がある.これにより、OpenELMは利用可能なパラメータ予算をより効果的に活用し、より高い精度を達成することができる.この非一様なパラメータ割り当てを実現するために、レイヤーごとのスケーリング([30]ではブロックごとのスケーリングとも呼ばれる)を使用している.標準のトランスフォーマーレイヤーは、マルチヘッドアテンション(MHA)とフィードフォワードネットワーク(FFN)で構成されている.非一様なパラメータ割り当てのために、各トランスフォーマーレイヤーでアテンションヘッドの数とFFNの乗数を調整している.具体的には、標準のトランスフォーマーモデルでは、一様なパラメータ割り当てを持つN個のトランスフォーマーレイヤーがあり、各レイヤーへの入力次元はd_{model}であると仮定する.MHAはn_{h}個のヘッドを持ち、各ヘッドの次元はd_{h}=d_{model}/n_{h}である.また、FFNの隠れ層次元はd_{FFN}=m・d_{model}であり、ここでmはスカラーのFFN乗数である.各レイヤーごとにアテンションヘッドの数n_{h}とFFN乗数mをスケーリングするためのパラメータαとβを導入している.

Q: OpenELMは、約10億のパラメータ・バジェットで、OLMoと比較してどのようにして2.36%の精度向上を達成したのでしょうか?

A: OpenELMは、パラメータ予算が約10億個の場合、OLMoと比較して精度を2.36%向上させることができます.これは、2倍少ない事前トレーニングトークンが必要であることによるものです.

Q: OpenELMの言語モデルのトレーニングと評価には、どのようなデータセットが使われたのですか?

A: OpenELMの言語モデルのトレーニングと評価には、公開されているデータセットが使用されました.

Q: OpenELM のリリースに含まれるトレーニング・ログ、複数のチェックポイント、および事前トレーニングの設定について、詳細を教えてください.

A: OpenELMのリリースに含まれるトレーニングログ、複数のチェックポイント、および事前トレーニング構成についての詳細は、公開されたデータセットでの言語モデルのトレーニングと評価のための完全なフレームワークが提供されます.トレーニングログには、モデルのトレーニング中に記録された損失や精度などの情報が含まれ、複数のチェックポイントには、トレーニング中の異なる段階でのモデルの重みや状態が保存されます.事前トレーニング構成には、モデルの事前トレーニングに使用されるハイパーパラメータや設定が含まれます.

Q: モデルをMLXライブラリに変換するために公開されたコードは、アップル社製デバイスでの推論や微調整にどのように役立つのでしょうか?

A: モデルをMLXライブラリに変換するためにリリースされたコードは、Appleデバイスでの推論とファインチューニングを容易にします.このコードにより、モデルをMLXライブラリに変換することで、Appleデバイス上での推論やファインチューニングをスムーズに行うことができます.また、このコードにより、モデルをAppleデバイス上で効率的に実行するための最適化が施され、スループットが最大化されます.

Q: これまでの慣行とは異なり、一般に公開されているデータセットで言語モデルの訓練と評価を行うための完全なフレームワークを公開することにした動機は何ですか?

A: 従来の慣行とは異なり、言語モデルのトレーニングと評価の完全なフレームワークを公開する決定の動機は、信頼性の向上、データとモデルの偏り、および潜在的なリスクの調査を可能にするためでした.この包括的なリリースは、オープンリサーチコミュニティを強化し、未来のオープンリサーチ活動の道を切り開くことを目指しています.

Q: OpenELMのリリースは、オープンリサーチ・コミュニティにどのような力を与え、強化することを目指しているのでしょうか?

A: OpenELMのリリースは、最新の言語モデルにアクセスできるようにすることで、オープンリサーチコミュニティを強化し、研究活動を促進することを目指しています.これにより、結果の信頼性を確保し、データやモデルの偏り、潜在的なリスクに関する調査を可能にし、未来のオープンリサーチ活動の道を切り開くことができます.

Q: OpenELMのソースコード、学習済みモデルの重み、学習レシピを提供する意義について説明していただけますか?

A: 提供されたソースコード、事前学習済みモデルの重み、およびトレーニングレシピは、OpenELMの重要性を高めるために重要です.これらの要素を提供することにより、研究者はモデルを理解し、改善するための基盤を提供されます.ソースコードを提供することで、研究者はモデルの内部構造やアルゴリズムを詳細に調査し、カスタマイズすることができます.事前学習済みモデルの重みを提供することで、研究者は高度なモデルを再利用し、新しいタスクに適用することができます.さらに、トレーニングレシピを提供することで、研究者はモデルを効果的にトレーニングし、最適なパフォーマンスを得ることができます.

Q: GitHubのソースコードに加えて、HuggingFaceでOpenELMモデルを公開する意義は何ですか?

A: OpenELMモデルをGitHubのソースコードに加えてHuggingFaceでも利用可能にすることで、研究コミュニティにより多くのアクセス機会を提供し、モデルの利用と実装を容易にすることができます.HuggingFaceは、機械学習モデルやデータセットを共有し、簡単に利用できるプラットフォームであり、GitHubよりもモデルの検索や利用が容易です.そのため、OpenELMモデルをHuggingFaceに提供することで、より多くの研究者や開発者がアクセスしやすくなり、研究コミュニティ全体の発展に貢献することができます.

Q: OpenELMの包括的なリリースは、将来のオープンな研究活動への道をどのように開くとお考えですか?

A: OpenELMの包括的なリリースは、最新の言語モデルにアクセスできるようにすることで、将来のオープンリサーチの取り組みを促進することが期待されます.これにより、研究者は高度な言語モデルを使用して、データやモデルの偏り、潜在的なリスクなどを調査し、信頼性の高い結果を確保することができます.また、公開データセットでトレーニングされたモデルを提供することで、研究者は安全性の保証なしにこれらのモデルを利用できるため、新たな研究の可能性が広がります.

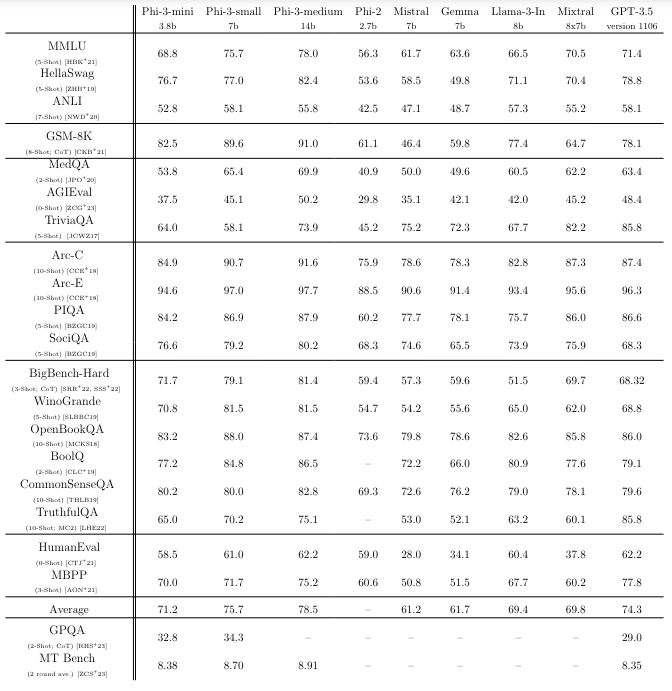

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone

著者:Marah Abdin, Sam Ade Jacobs, Ammar Ahmad Awan, Jyoti Aneja, Ahmed Awadallah, Hany Awadalla, Nguyen Bach, Amit Bahree, Arash Bakhtiari, Jianmin Bao, Harkirat Behl, Alon Benhaim, Misha Bilenko, Johan Bjorck, Sébastien Bubeck, Qin Cai, Martin Cai, Caio César Teodoro Mendes, Weizhu Chen, Vishrav Chaudhary, Dong Chen, Dongdong Chen, Yen-Chun Chen, Yi-Ling Chen, Parul Chopra, Xiyang Dai, Allie Del Giorno, Gustavo de Rosa, Matthew Dixon, Ronen Eldan, Victor Fragoso, Dan Iter, Mei Gao, Min Gao, Jianfeng Gao, Amit Garg, Abhishek Goswami, Suriya Gunasekar, Emman Haider, Junheng Hao, Russell J. Hewett, Jamie Huynh, Mojan Javaheripi, Xin Jin, Piero Kauffmann, Nikos Karampatziakis, Dongwoo Kim, Mahoud Khademi, Lev Kurilenko, James R. Lee, Yin Tat Lee, Yuanzhi Li, Yunsheng Li, Chen Liang, Lars Liden, Ce Liu, Mengchen Liu, Weishung Liu, Eric Lin, Zeqi Lin, Chong Luo, Piyush Madan, Matt Mazzola, Arindam Mitra, Hardik Modi, Anh Nguyen, Brandon Norick, Barun Patra, Daniel Perez-Becker, Thomas Portet, Reid Pryzant, Heyang Qin, Marko Radmilac, Corby Rosset, Sambudha Roy, Olatunji Ruwase, Olli Saarikivi, Amin Saied, Adil Salim, Michael Santacroce, Shital Shah, Ning Shang, Hiteshi Sharma, Swadheen Shukla, Xia Song, Masahiro Tanaka, Andrea Tupini, Xin Wang, Lijuan Wang, Chunyu Wang, Yu Wang, Rachel Ward, Guanhua Wang, Philipp Witte, Haiping Wu, Michael Wyatt, Bin Xiao, Can Xu, Jiahang Xu, Weijian Xu, Sonali Yadav, Fan Yang, Jianwei Yang, Ziyi Yang, Yifan Yang, Donghan Yu, Lu Yuan, Chengruidong Zhang, Cyril Zhang, Jianwen Zhang, Li Lyna Zhang, Yi Zhang, Yue Zhang, Yunan Zhang, Xiren Zhou

発行日:2024年04月22日

最終更新日:2024年05月23日

URL:http://arxiv.org/pdf/2404.14219v3

カテゴリ:Computation and Language, Artificial Intelligence

概要:

phi-3-miniは、3.3兆トークンでトレーニングされた38億のパラメータを持つ言語モデルであり、学術的なベンチマークと内部テストによって測定された総合的なパフォーマンスは、Mixtral 8x7BやGPT-3.5などのモデルと匹敵しています(たとえば、MMLUで69%、MT-benchで8.38を達成).これは、スマートフォンに展開できるほど小さなモデルでありながら、その革新は完全にトレーニング用のデータセットにあります.phi-2用に使用されたデータセットのスケーリングアップバージョンであり、公開されているウェブデータと合成データで構成されています.モデルは、堅牢性、安全性、およびチャット形式にさらに整合されています.また、4.8Tトークンでトレーニングされた7Bおよび14Bモデルの初期のパラメータスケーリング結果も提供しており、phi-3-smallとphi-3-mediumと呼ばれる、phi-3-miniよりもはるかに能力が高いモデルがあります(たとえば、それぞれMMLUで75%と78%、MT-benchで8.7と8.9).さらに、画像とテキストのプロンプトに対する強力な推論能力を持つphi-3-miniをベースにした42億のパラメータモデルであるphi-3-visionも紹介しています.

Q&A:

Q: phi-3-miniのトレーニングに使われたデータセットの詳細と、phi-2に使われたデータセットとの違いを教えていただけますか?

A: phi-3-miniのトレーニングに使用されたデータセットは、phi-2のデータセットと比較して、より大規模で進化したバージョンであり、3.3Tトークンでトレーニングされました.また、phi-3-miniのデータセットは、より高度なバージョンのデータセットを使用しており、モデルの性能向上に貢献しています.

Q: phi-3-mini の性能は、Mixtral 8x7BやGPT-3.5のようなモデルとアカデミックベンチマークで比較してどうですか?

A: phi-3-miniの性能は、Mixtral 8x7BやGPT-3.5などのモデルと同等の品質を達成しています.

Q: phi-3-miniの携帯電話への搭載を可能にした革新的な技術について教えてください.

A: phi-3-miniが携帯電話に展開できる革新は、モデルのサイズを大幅に削減し、メモリ使用量を最適化するために、密な注意層とブロックスパース注意層を交互に配置することにあります.さらに、追加の10%の多言語データが使用され、モデルが4ビットに量子化され、約1.8GBのメモリを占有するようになりました.これにより、phi-3-miniは携帯電話上で実行され、オフラインで12トークン以上を毎秒処理できるようになりました.

Q: モデルの堅牢性、安全性、チャット形式を整えるために、どのような対策が取られていますか?

A: モデルを頑健性、安全性、およびチャット形式に整合させるために取られた措置には、慎重に選定されたトレーニングデータの使用、ターゲットとなるポストトレーニング、およびレッドチームの洞察からの改善が含まれます.

Q: phi-3-smallとphi-3-mediumモデルの初期パラメータスケーリングの結果について詳しく教えてください.

A: phi-3-smallとphi-3-mediumモデルの初期パラメータスケーリング結果について、phi-3-smallはphi-3-miniよりも75%、phi-3-mediumはphi-3-miniよりも78%の性能を持っています.また、phi-3-mediumはphi-3-miniと同じトークナイザーとアーキテクチャを使用し、若干のエポック数を増やして14Bのパラメータを持つモデルです.このモデルは40のヘッドと40のレイヤーを持ち、埋め込み次元は5120です.7Bから14Bに増やすことで、一部のベンチマークがあまり改善されないことが観察されました.

Q: phi-3-smallとphi-3-mediumのパフォーマンス指標は、MMLUやMT-benchなどのベンチマークでphi-3-miniと比較してどうですか?

A: phi-3-smallとphi-3-mediumは、MMLUやMT-benchなどのベンチマークでphi-3-miniよりも有意に優れています.

Q: phi-3-mini とphi-3-visionの主な違いについて教えてください.

A: phi-3-miniとphi-3-visionの主な違いは、phi-3-miniは4.2Bのパラメータを持つモデルであり、phi-3-visionはphi-3-miniを基にした42Bのパラメータを持つモデルである点です.また、phi-3-miniは画像とテキストのプロンプトに対する推論能力が弱いのに対し、phi-3-visionは画像とテキストのプロンプトに対する強力な推論能力を持っています.さらに、phi-3-miniはMMLUで75%、MT-benchで8.7の性能を持つのに対し、phi-3-visionはこれらの指標でより高い性能を持っています.

Q: phi-3-miniのトレーニングに使用された3兆3000億トークンはどのように収集され、処理されたのでしょうか?

A: 3.3兆トークンは、公開されているウェブデータと合成データから構成されるphi-2で使用されたデータセットのスケーリングバージョンから収集され、厳密にフィルタリングされました.

Q: 画像やテキストのプロンプトに対するファイ3ビジョンの推論能力について教えてください.

A: Phi-3-Visionは画像とテキストプロンプトに対する推論能力を持っています.このモデルは、画像エンコーダー(CLIP ViT-L/14)とトランスフォーマーデコーダー(phi-3-mini-128K-instruct)の2つの主要コンポーネントで構成されており、視覚トークンは画像エンコーダーによって抽出され、テキストトークンと交互に組み合われます.高解像度の画像や様々なアスペクト比を考慮するため、動的クロッピング戦略が使用され、入力画像がブロックの2次元配列に分割され、ブロックのトークンが連結されて全体の画像を表現します.さらに、Phi-3-Visionモデルは多様なデータセットを使用して事前学習フェーズを経ており、視覚とテキストの入力に対する多モーダル推論を達成するために設計されています.

Q: phi-3-mini、phi-3-small、phi-3-mediumの各モデルを様々なデバイスやアプリケーションに展開することの潜在的な意味は?

A: phi-3-mini、phi-3-small、およびphi-3-mediumモデルをさまざまなデバイスやアプリケーションに展開することにより、性能や処理速度の向上が期待されます.これらのモデルは、それぞれ異なる規模と能力を持ち、phi-3-miniは携帯電話などのリソースが限られたデバイスに適しており、phi-3-smallやphi-3-mediumはより高い性能を提供することができます.これにより、画像やテキストのプロンプトに対する強力な推論能力を持つphi-3-visionモデルを含む、さまざまなニーズに合わせた適切なモデルを選択し、展開することが可能となります.

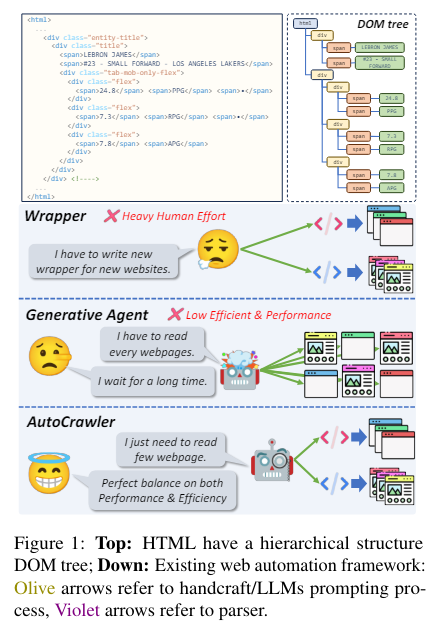

AutoCrawler: A Progressive Understanding Web Agent for Web Crawler Generation

著者:Wenhao Huang, Chenghao Peng, Zhixu Li, Jiaqing Liang, Yanghua Xiao, Liqian Wen, Zulong Chen

発行日:2024年04月19日

最終更新日:2024年04月19日

URL:http://arxiv.org/pdf/2404.12753v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

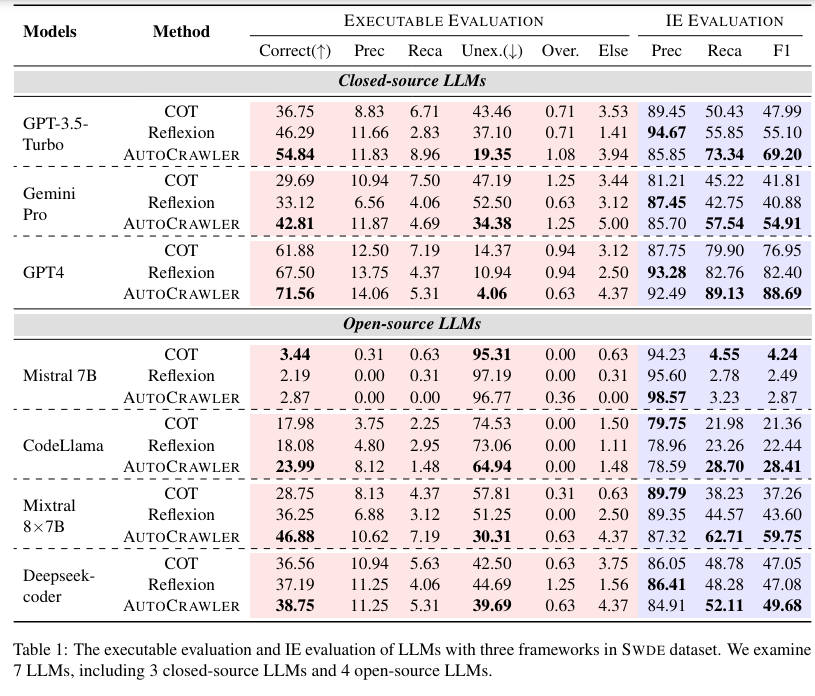

Web automation(ウェブ自動化)は、一般的なウェブアクションを自動化することで、複雑なウェブタスクを達成し、業務効率を向上させ、手動介入の必要性を減らす重要な技術です.従来の方法であるラッパーは、新しいウェブサイトに直面した際に適応性と拡張性に制限があります.一方、大規模言語モデル(LLMs)によって強化された生成エージェントは、オープンワールドのシナリオでのパフォーマンスと再利用性が低いという問題があります.本研究では、垂直情報ウェブページのためのクローラー生成タスクと、LLMsとクローラーを組み合わせるパラダイムを紹介し、クローラーが多様で変化するウェブ環境を効率的に処理するのに役立ちます.私たちは、階層構造のHTMLを活用した2段階フレームワークであるAutoCrawlerを提案します.トップダウンとステップバックの操作を通じて、AutoCrawlerは誤ったアクションから学習し、継続的にHTMLを整理してより良いアクション生成を行うことができます.私たちは複数のLLMsを使用した包括的な実験を行い、フレームワークの効果を実証しています.本論文のリソースは、\url{https://github.com/EZ-hwh/AutoCrawler}で入手できます.

Q&A:

Q: AutoCrawlerは、適応性や拡張性という点で、ラッパーのような従来の手法とどう違うのですか?

A: AutoCrawlerは、従来のラッパーなどの伝統的な方法と比較して、適応性と拡張性において異なる点があります.具体的には、AutoCrawlerはWebページの階層構造を利用して、LLMsが複雑なWeb構造の難しさを軽減することができる点が異なります.一方、従来の方法では、新しいまたは変更されたWebサイト構造に効果的に機能することが難しく、手動で注釈付けされた例が必要であるという共通の依存関係があります.

Q: ウェブ自動化の文脈で、大規模言語モデル(LLM)とクローラーを組み合わせることの主な利点は何でしょうか?

A: 大規模言語モデル(LLMs)をクローラーと組み合わせる主な利点は、LLMsが似たタスクを処理する際に依存性を減らし、多くのWebタスクを効率的に処理する能力を向上させることです.

Q: AutoCrawlerの2段階のフレームワークと、HTMLの階層構造を利用して漸進的に理解する方法について説明していただけますか?

A: AUTOCRAWLERは、HTMLの階層構造を活用して進行的な理解を行うための2段階フレームワークです.具体的には、LLMに基づいたトップダウンおよびステップバック操作からなるヒューリスティックアルゴリズムを提案しています.最初に、対象情報を含むDOMツリー内の特定のノードに絞り込もうとします.そして、実行が失敗した場合はDOMツリーを上に移動します.このプロセスにより、誤った実行を修正し、HTMLコンテンツの関連性のない部分を段階的に削除することができます.

Q: オートクローラーはどのようにして誤ったアクションから学習し、より良いアクション生成のために継続的にHTMLを刈り込んでいるのか?

A: AUTOCRAWLERは、誤ったアクションから学び、HTMLを連続的に削除することによって、より良いアクション生成を行います.このフレームワークは、階層構造のHTMLを活用し、トップダウンおよびステップバックの操作を通じて、誤ったアクションから学び、HTMLを継続的に削除することで、進化的に理解を深めています.

Q: フレームワークの有効性を実証するため、複数のLLMを使った包括的な実験を行った結果は?

A: 複数のLLMを用いた包括的な実験の結果、提案されたプログレッシブ理解フレームワークは、この設定下でモデルの性能を効果的に向上させることが示されました.しかし、LLMは半構造化マークアップ言語を正確に理解することに苦労しており、これは表1と表2の性能差を示しています.

Q: AutoCrawlerは、多様に変化するウェブ環境を、他の方法と比べてどのように効率的に処理しているのですか?

A: AUTOCRAWLERは、他の方法と比較して、Web環境の多様性と変化に効率的に対処する方法として、HTMLの階層構造を活用し、段階的な理解を進めます.トップダウンおよびステップバックの操作を通じて、AUTOCRAWLERは誤ったアクションから学び、HTMLを継続的に剪定して、より良いアクション生成を行います.

Q: AutoCrawlerがクロールする垂直情報ウェブページの詳細を教えてください.

A: AUTOCRAWLERは、垂直情報ウェブページをクロールするために設計されています.このタスクの目標は、自動的にターゲット情報を抽出するための事前定義されたルールやアクションシーケンスを生成することです.ウェブページ内の情報バー、タイトルなど、複数の場所にターゲット情報がある場合があります.AUTOCRAWLERは情報の一部を抽出するアクションシーケンスを生成することができますが、すべての情報を網羅する包括的なアクションシーケンスを作成することは依然として課題です.

Q: 実際のシナリオでAutoCrawlerを使用する際の制限や潜在的な課題は何ですか?

A: AUTOCRAWLERの実世界での利用における制限や潜在的な課題は、情報抽出タスクにおけるパラダイムに制限されていることが挙げられます.LLMsとクローラーを組み合わせた当該フレームワークは、垂直ウェブページにおける情報抽出タスクに特化しており、他の種類のウェブページには適用できない可能性があります.また、知識ベースの不完全性による誤検出が避けられないため、KBsとウェブソースを組み合わせたアノテーションの努力が必要とされます.

Q: AutoCrawlerはどのように業務効率を高め、ウェブタスクにおける手作業の必要性を減らしているのですか?

A: AutoCrawlerは、HTMLの階層構造を活用して段階的な理解を進めることで、操作効率を向上させ、Webタスクにおける手動介入の必要性を低減します.トップダウンおよびステップバックの操作を通じて、AutoCrawlerは誤ったアクションから学び、HTMLを連続的に整理してより良いアクション生成を行います.このフレームワークは、複数のLLMと包括的な実験を通じて効果的であることが示されています.