ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

latest_research_papers_2024-0226_2024-0303

- PlanGPT: Enhancing Urban Planning with Tailored Language Model and Efficient Retrieval

発行日:2024年02月29日

都市計画の分野では、プランナーのニーズを満たすためにPlanGPTという専門化された大規模言語モデルが開発され、高度なパフォーマンスを示している. - StarCoder 2 and The Stack v2: The Next Generation

発行日:2024年02月28日

BigCodeプロジェクトは、2022年9月に設立され、オープンな科学的協力を重視し、The Stack v1とStarCoderをリリースし、StarCoder2を導入しています.言語モデルの開発により、コードLLMはソフトウェア開発サイクル全体を向上させる潜在能力を持つことが示されています.他のLLM開発プロジェクトと同様に、トレーニングデータ、トレーニングフレームワーク、評価スイートを公開することで完全にオープンな開発アプローチを採用しています.The Stack v2とStarCoder2の開発プロセスについての技術レポートがあり、The Stack v2はSoftware Heritageの広大なソースコードアーカイブを基盤として構築されています. - Datasets for Large Language Models: A Comprehensive Survey

発行日:2024年02月28日

この論文は、LLMデータセットの重要性と現状を整理し、将来の研究に向けた包括的な参考資料として提供している. - On the Societal Impact of Open Foundation Models

発行日:2024年02月27日

FoundationモデルはAIエコシステムの中心であり、技術開発を促進し、リスクを引き起こす可能性があるが、政策立案者は統治方法に直面している.AIコミュニティ内での意見の相違や適切なAI政策に関する不確実性を考慮すると、本論文はオープンなFoundationモデルの利点とリスクを明確にします. - EMO: Emote Portrait Alive — Generating Expressive Portrait Videos with Audio2Video Diffusion Model under Weak Conditions

発行日:2024年02月27日

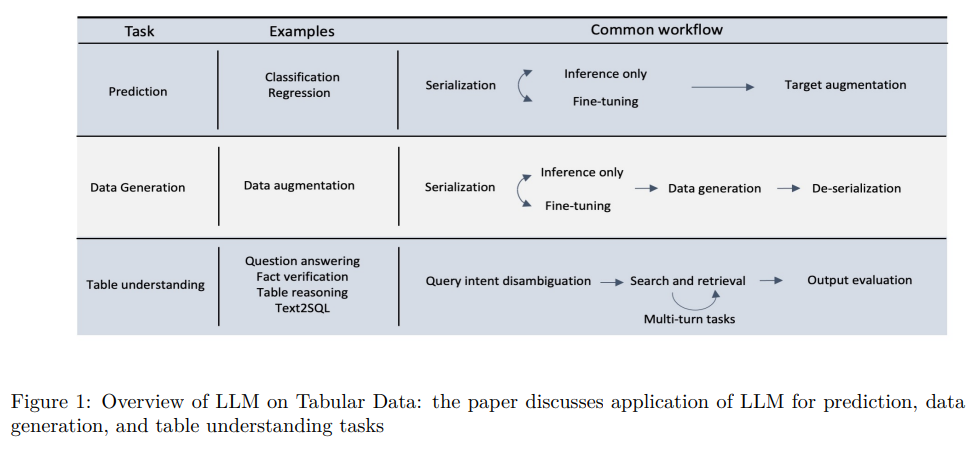

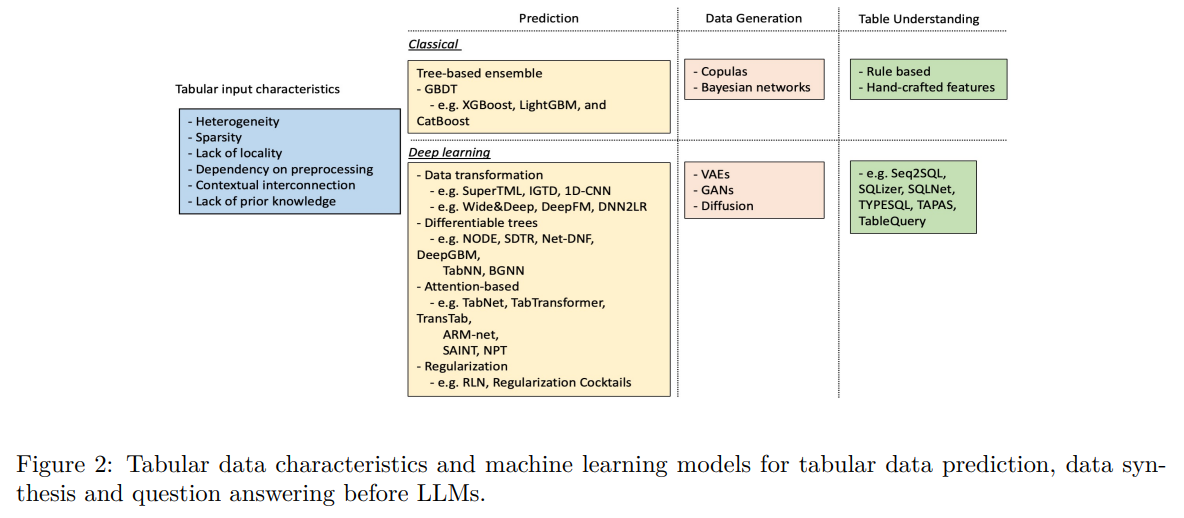

EMOフレームワークは、音声から直接ビデオを合成し、リアルなアニメーションを生み出す新しい技術で、従来の技術を上回る表現力とリアリズムを実現している. - Large Language Models(LLMs) on Tabular Data: Prediction, Generation, and Understanding — A Survey

発行日:2024年02月27日

最近の大規模言語モデリングの進歩により、さまざまなタスクへの応用が厳密に探求されていますが、包括的なレビューが不足しており、将来の研究方向や洞察を提供することを目的としています. - The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits

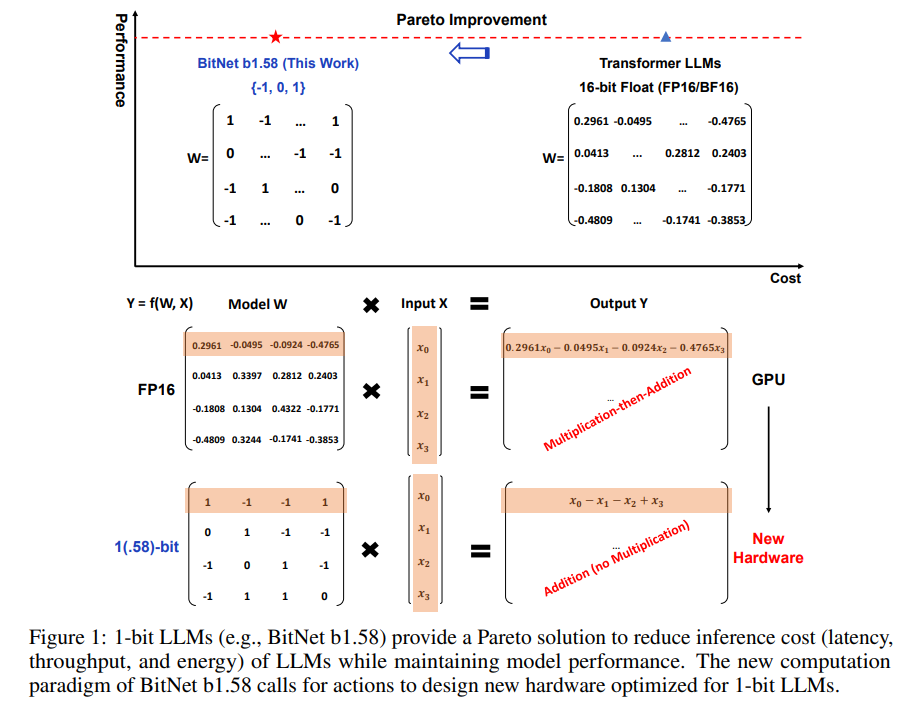

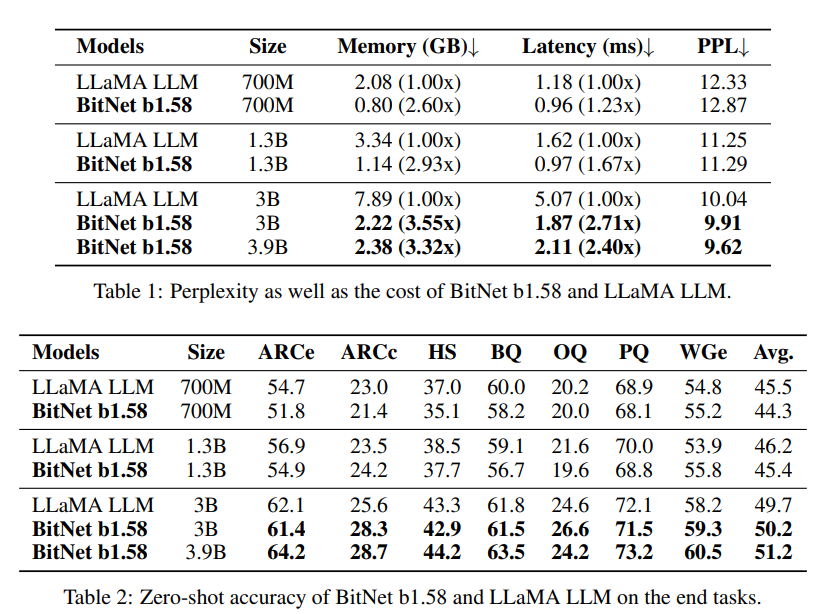

発行日:2024年02月27日

1ビット大規模言語モデル(LLMs)の新時代を切り開く最近の研究では、BitNet b1.58が導入され、フルプレシジョンのトランスフォーマーLLMと同等の性能を持ちながら、コスト効果が高いことが示されています. - Mistral Large

発行日:2024年02月26日

Mistral Largeは、最新かつ最も先進的な言語モデルであり、Azureを通じて利用可能で、テキスト生成や多言語推論タスクに使用される強力なモデルである.さらに、Mistral Largeは32Kトークンのコンテキストウィンドウを持ち、大規模なドキュメントからの正確な情報の再現を可能にします.また、正確な命令に従う能力を持ち、開発者がモデレーションポリシーを設計するのに役立ちます.さらに、ネイティブで関数呼び出しを行う能力を持ち、これはla Plateformeで実装された制約付き出力モードとともに、アプリケーション開発やテックスタックの近代化を大規模に可能にします. - Empowering Large Language Model Agents through Action Learning

発行日:2024年02月24日

LLMエージェントの成長を制限する固定された行動空間に対処するため、オープンアクション学習を導入し、経験的な学習を通じてエージェントのパフォーマンスを向上させる研究. - Genie: Generative Interactive Environments

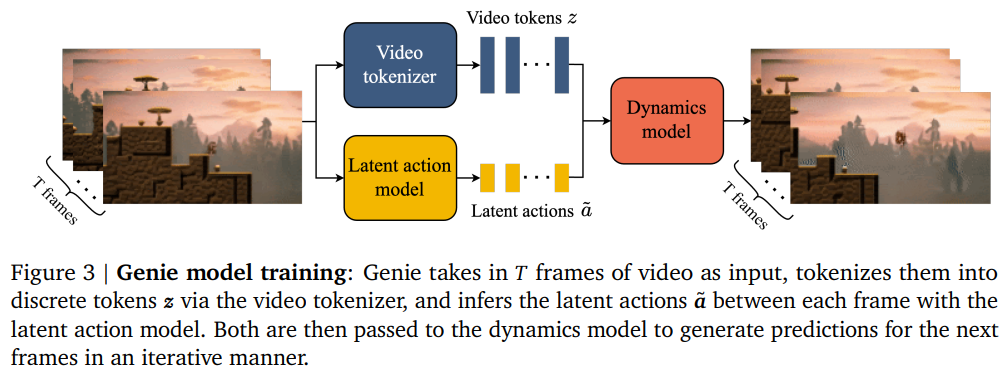

発行日:2024年02月23日

Genieは、未ラベルのインターネットビデオから教師なしで訓練された初の生成的インタラクティブ環境を紹介し、11Bのパラメータを持つ基礎ワールドモデルを提供します.

PlanGPT: Enhancing Urban Planning with Tailored Language Model and Efficient Retrieval

著者:He Zhu, Wenjia Zhang, Nuoxian Huang, Boyang Li, Luyao Niu, Zipei Fan, Tianle Lun, Yicheng Tao, Junyou Su, Zhaoya Gong, Chenyu Fang, Xing Liu

発行日:2024年02月29日

最終更新日:2024年02月29日

URL:http://arxiv.org/pdf/2402.19273v1

カテゴリ:Computation and Language

概要:

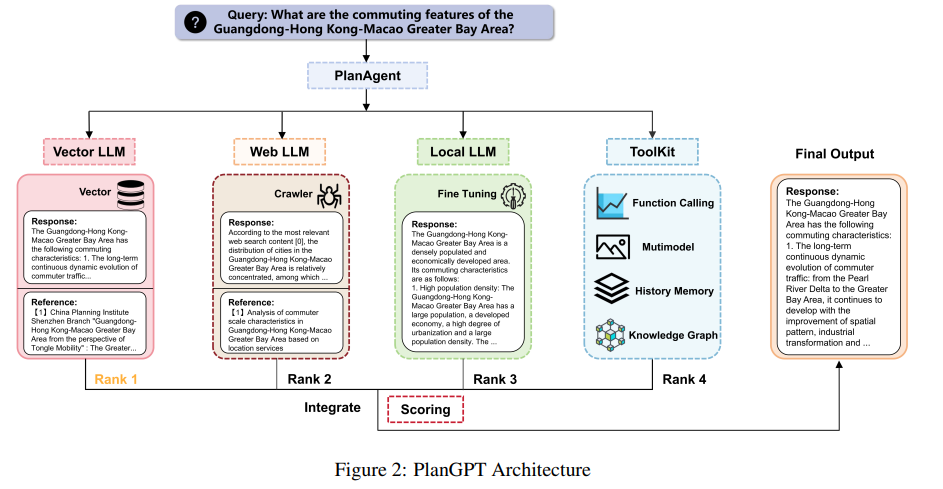

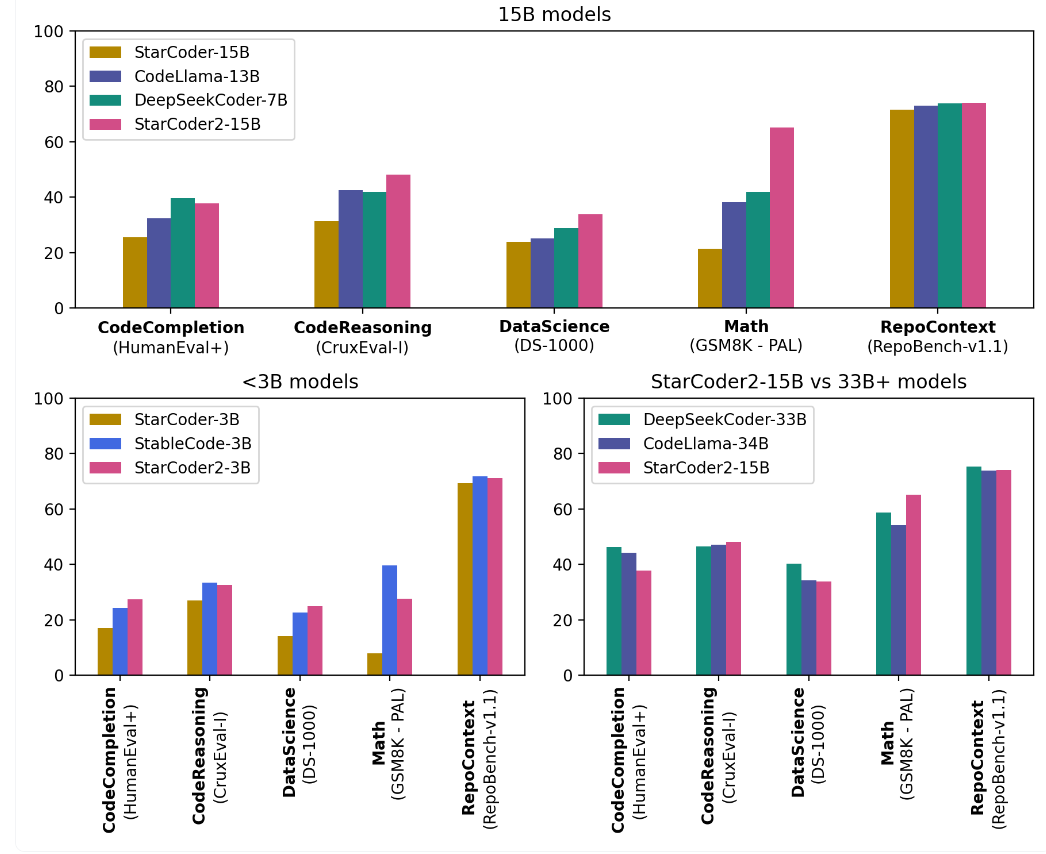

都市計画の分野では、汎用の大規模言語モデルはしばしばプランナーの特定のニーズを満たすのに苦労します.都市計画テキストの生成、関連情報の取得、および計画文書の評価などのタスクは、独自の課題を抱えています.都市専門家の効率を向上させ、これらの障害を克服するために、都市および空間計画に特化した初の専門化された大規模言語モデルであるPlanGPTを紹介します.中国都市計画アカデミーなどの機関との協力によって開発されたPlanGPTは、カスタマイズされたローカルデータベース検索フレームワーク、ドメイン固有のベースモデルの微調整、および高度なツール機能を活用しています.経験的テストでは、PlanGPTが高度なパフォーマンスを達成し、都市計画の複雑さに正確に合わせた優れた品質の応答を提供していることが示されています.

Q&A:

Q: 汎用の大規模言語モデルが都市計画者のニーズに応える上で直面する具体的な課題について説明していただけますか?

A: 一般的な汎用大規模言語モデルは、都市計画家のニーズを満たす際に特定の課題に直面しています.具体的には、都市計画のテキストを生成すること、関連情報を取得すること、および計画文書を評価することなどのタスクにおいて、特有の課題が生じます.都市計画のドメインにおける低信号対ノイズ比の特性を克服するために、キーワード抽出や階層的検索技術を使用して、都市計画の大量のテキストから正確な情報を抽出するためのカスタマイズされた埋め込みモデルやベクトルデータベース検索システムが必要です.

Q: PlanGPTは、都市計画や空間計画に合わせたアプローチという点で、汎用の大規模言語モデルとどのように違うのでしょうか?

A: PlanGPTは、一般的な汎用大規模言語モデルとは異なり、都市および空間計画に特化したアプローチを取っています.具体的には、PlanGPTはカスタマイズされたローカルデータベース検索フレームワークを活用し、ベースモデルのドメイン固有の微調整、高度なツール機能を利用して開発されています.これにより、都市プロフェッショナルの効率を向上させ、都市計画の複雑さに適した高品質な応答を提供することが可能となっています.

Q: PlanGPTが使用しているカスタマイズされたローカルデータベース検索フレームワークについて詳しく教えてください.

A: PlanGPTは、カスタマイズされたローカルデータベース検索フレームワークを活用しています.このフレームワークは、特定の都市計画や空間計画に関連する情報を効率的に取得するために設計されており、PlanGPTの性能向上に大きく貢献しています.具体的には、Raven、Retro、Toc Sugre、selfmem、genread、RECITEなどの検索ツールが使用されており、Self-RAGフレームワークは検索トークンを導入しています.この検索トークンは、文書を呼び出すかどうかを決定するために使用されます.

Q: PlanGPTは、ベースモデルのドメイン固有の微調整を活用して、都市計画タスクのパフォーマンスをどのように高めているのでしょうか?

A: PlanGPTは、都市計画タスクのパフォーマンスを向上させるために、ドメイン固有のベースモデルの微調整を活用しています.これにより、一般的な大規模言語モデルが抱える問題に対処し、都市計画の複雑さに適した高品質な応答を提供することが可能となります.

Q: PlanGPTはどのような高度なツール機能を持ち、それが都市計画の文脈における優れた品質対応に貢献しているのでしょうか?

A: PlanGPTは、カスタマイズされたローカルデータベース検索フレームワーク、ドメイン固有のベースモデルの微調整、および高度なツール機能を活用して開発されました.これらの機能により、PlanGPTは都市計画の複雑さに適合した優れた品質の応答を提供することができます.

Q: PlanGPTの高度な性能を実証するために、どのような実証試験が行われましたか?

A: PlanGPTの高度なパフォーマンスを示すために行われた経験的テストは、都市計画の複雑さに正確に合わせた優れた品質の応答を提供することを実証しています.

Q: PlanGPTは、都市計画の文章を作成したり、関連情報を検索したり、計画文書を評価したりといった作業において、都市の専門家の効率をどのように高めているのでしょうか.

A: PlanGPTは、都市プロフェッショナルが都市計画テキストを生成し、関連情報を取得し、計画文書を評価するというタスクにおいて、効率を向上させます.これは、カスタマイズされたローカルデータベース検索フレームワーク、ドメイン固有のベースモデルの微調整、高度なツール機能を活用して開発されており、都市プランニングの複雑さに適応した高品質な応答を提供することで、プロフェッショナルの効率を向上させます.

Q: PlanGPTがどのように都市計画の複雑さに合わせた的確な対応を提供しているか、例を挙げていただけますか?

A: PlanGPTは、都市計画の微妙なニュアンスに適合した応答を提供するために、カスタマイズされたローカルデータベース検索フレームワーク、ドメイン固有のベースモデルの微調整、および高度なツール機能を活用して開発されました.これにより、都市計画の専門家が特定の課題に効果的に対処し、高品質の応答を提供することが可能となります.

Q: PlanGPTは、都市計画者が汎用大規模言語モデルを利用する際に直面する障害の克服にどのように貢献するのでしょうか?

A: PlanGPTは、都市計画家が一般的な大規模言語モデルを利用する際に直面する障害を克服するために、カスタマイズされたローカルデータベース検索フレームワーク、ドメイン固有のベースモデルの微調整、および高度なツール機能を活用して開発されました.これにより、PlanGPTは都市計画の複雑さに適応した高品質な応答を提供し、都市専門家の効率を向上させることができます.

StarCoder 2 and The Stack v2: The Next Generation

著者:Anton Lozhkov, Loubna Ben Allal, Raymond Li, et al.

発行日:2024年02月28日

最終更新日:不明

URL:https://huggingface.co/blog/starcoder2

カテゴリ:不明

概要:

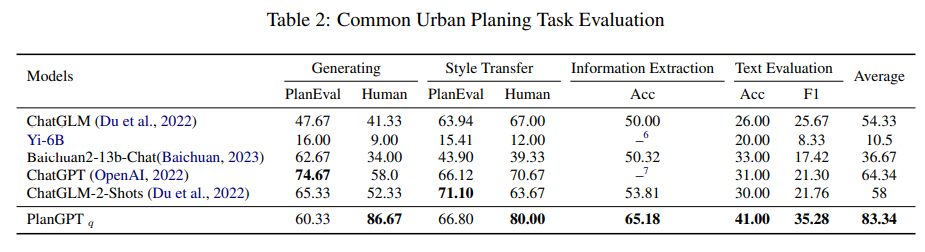

BigCodeプロジェクトは、2022年9月に設立され、オープンな科学的協力を重視しています.BigCodeは、ServiceNowとHugging Faceによって管理されており、オープンなガバナンスの精神で、多様な学術機関や産業研究所から1,100人以上のメンバーを集めています.コミュニティは以前、384のプログラミング言語で許可されたライセンスのソースコードを含む6.4 TBのデータセットであるThe Stack v1をリリースしました.The Stack v1には、「Am I in The Stack」というガバナンスツールが含まれており、開発者が自分のソースコードがデータセットに含まれているかを確認するためのものです.また、データセットから自分のコードを除外したい人のためのオプトアウトプロセスも提供しています.2022年12月、BigCodeコミュニティはSantaCoderをリリースしました.これは、Java、JavaScript、Pythonのコードを使用してトレーニングされた1.1Bパラメータモデルであり、優れた性能を発揮しています.この成功を受けて、コミュニティはさらに努力を拡大し、2023年5月4日にStarCoderをリリースしました.リリース時点で、15BパラメータのStarCoderモデルは、コードのための最高のオープンアクセスLLMでした.BigCodeプロジェクトは、コードLLMの責任ある開発に焦点を当てたオープンな科学的協力であり、StarCoder2を紹介しています.

Software Heritage(SWH)と提携し、彼らのソースコードアーカイブのデジタルコモンズの上にThe Stack v2を構築しています.SWHのリポジトリは619のプログラミング言語をカバーしており、GitHubのプルリクエスト、Kaggleのノートブック、コードのドキュメントなど、他の高品質なデータソースも慎重に選択しています.これにより、最初のStarCoderデータセットよりも4倍大きなトレーニングセットが得られます.3.3兆から4.3兆トークンでStarCoder2モデルを3B、7B、15Bのパラメータでトレーニングし、包括的なCode LLMベンチマークで徹底的に評価しています.StarCoder2-15Bは数学とコード推論のベンチマーク、およびいくつかの低リソース言語でそれを上回ることがわかりました.モデルの重みはOpenRAILライセンスの下で利用可能であり、ソースコードデータのトレーニングデータに関する完全な透明性を確保するために、ソフトウェア・ヘリテージ永続的識別子(SWHIDs)を公開しています.LLM(Large Language Models)の開発は、開発者の生産性を52%向上させる可能性があることが示されています.

Q&A:

Q: StarCoder2とThe Stack v2の開発におけるSoftware Heritageとのパートナーシップの意義は何ですか?

A: ソフトウェア・ヘリテージとのパートナーシップは、The Stack v2およびStarCoder2の開発において重要な役割を果たしています.ソフトウェア・ヘリテージの広範なソースコードアーカイブを基盤として、600以上のプログラミング言語にわたるデータを提供し、高品質なオープンデータソースを収集しています.このデータは、トレーニングのために整理され、重複排除や低品質なコードの除外、個人情報の削除、悪意のあるコードの取り扱いなどが行われています.

Q: StarCoder2のトレーニングセットは、最初のStarCoderデータセットとどのように違いますか?

A: StarCoder2のトレーニングセットは、StarCoderの初めのデータセットと比較して、より多くのデータソースを含んでいます.具体的には、GitHubの問題、プルリクエスト、Jupyter、Kaggleノートブック、ドキュメント、中間表現、小規模な数学とコーディングデータセット、その他の自然言語データセットなど、多岐にわたるデータソースからトレーニングデータを取得しています.

Q: StarCoder2-3Bと同規模の他のCode LLMとの性能比較について教えてください.

A: StarCoder2-3Bは、同様のサイズの他のCode LLMに比べて、ほとんどのベンチマークで優れた性能を発揮しています.特に、StarCoderBase-15Bよりも優れています.

Q: StarCoder2-15Bは、CodeLlama-34Bのような同サイズの他のモデルと比較してどうですか?

A: StarCoder2-15Bは、同等のサイズの他のモデルであるCodeLlama-34Bよりも優れた性能を示しています.

Q: StarCoder2-15BがDeepSeekCoder-33Bを上回る具体的な分野は?

A: StarCoder2-15Bは、数学やコードの推論に関するベンチマークでDeepSeekCoder-33Bを上回ることがわかります.

Q: どのようなライセンス契約に基づいてモデルウェイトを入手できますか?

A: 提供されるモデルの重みは、ライセンス契約に基づいて利用可能です.

Q: SoftWare Heritage persistent IDentifiers(SWHID)のリリースにおいて、トレーニングデータに関する透明性はどのように確保されていますか?

A: ソフトウェア・ヘリテージ永続的識別子(SWHID)のリリースにより、トレーニングデータに関する完全な透明性が確保されます.これは、モデルの重みがOpenRAILライセンスの下で利用可能であり、トレーニングデータに関する完全な透明性が確保されるためです.

Q: GitHub CoPilotの現状と開発者の生産性への影響は?

A: GitHub CoPilotは2024年1月30日時点で130万人以上の有料サブスクライバーを獲得し、5万以上の組織がエンタープライズ版を選択しており、開発者の生産性を最大56%向上させると推定されています.ServiceNowは最近、StarCoderBaseモデルを微調整して構築した「テキストからコード」ソリューションにより、開発者の生産性が52%向上することを開示しました.

Q: ServiceNowは、StarCoderBaseモデルの微調整をどのように活用し、開発者の生産性を向上させたのでしょうか.

A: ServiceNowはStarCoderBaseモデルを微調整して、開発者の生産性を向上させました.これにより、開発者の生産性と革新のスピードが52%向上しました.

Q: Code LLMは、ソフトウェア開発サイクルのさまざまな段階をどのような方法で強化できるのでしょうか?

A: Code LLMsは、ソフトウェア開発サイクルのさまざまな段階を強化する可能性があります.新しいプロジェクトの実装を迅速化し、開発されたソフトウェアの品質保証を向上させ、バグの検出と修正を支援し、保守タスクを簡素化し、新しいソフトウェアへの移行を容易にすることができます.

Datasets for Large Language Models: A Comprehensive Survey

著者:Yang Liu, Jiahuan Cao, Chongyu Liu, Kai Ding, Lianwen Jin

発行日:2024年02月28日

最終更新日:2024年02月28日

URL:http://arxiv.org/pdf/2402.18041v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

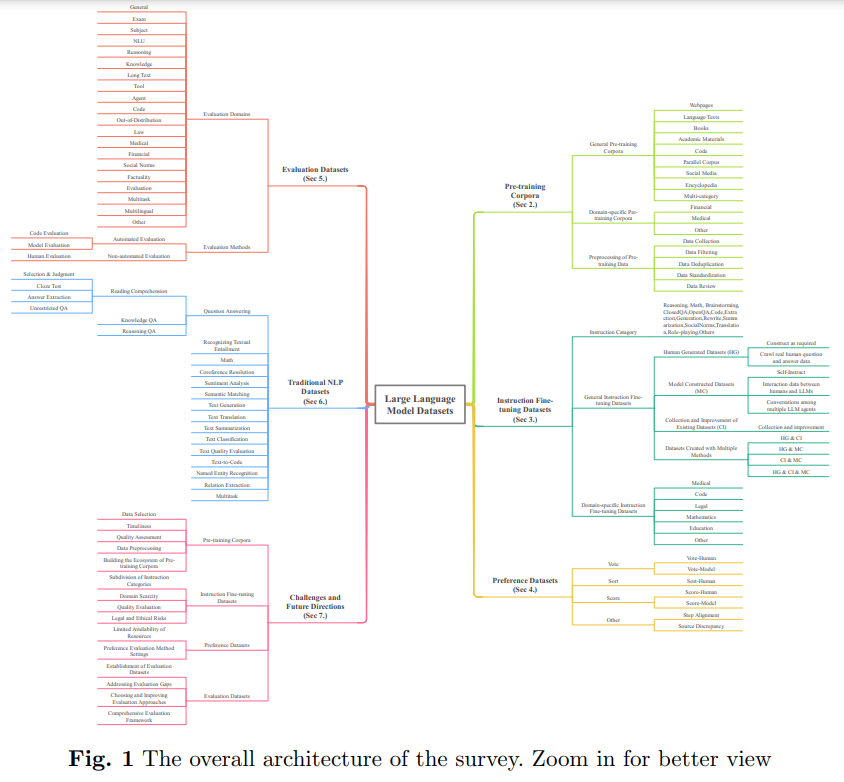

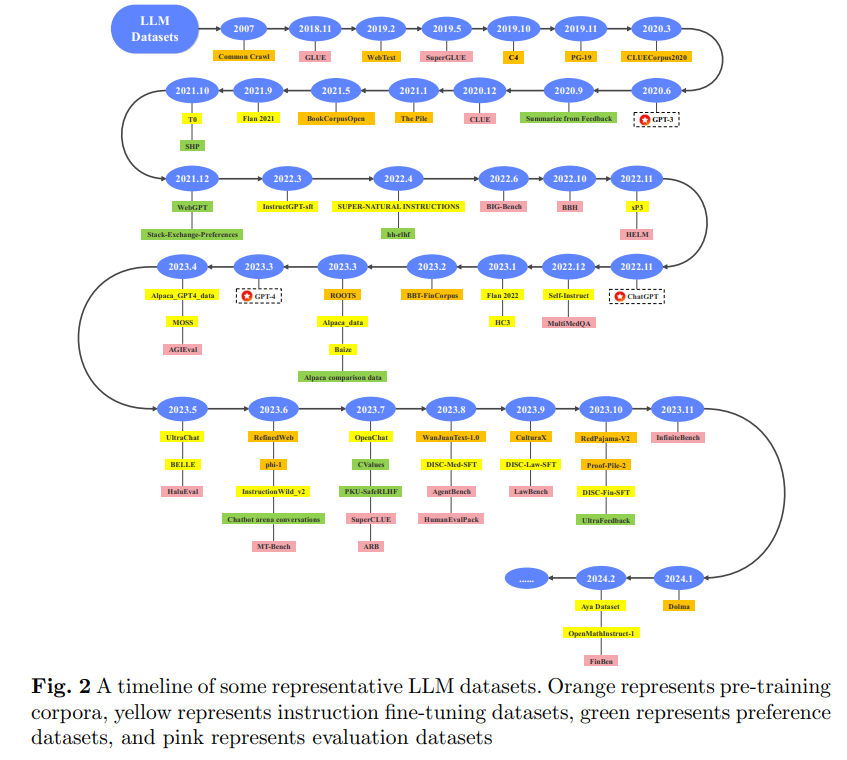

この論文は、大規模言語モデル(LLM)データセットについての探求に乗り出し、LLMの驚異的な進歩において重要な役割を果たしていることを明らかにしています.これらのデータセットは、LLMの開発を支え、育む根系に類似した基盤インフラストラクチャとして機能しています.そのため、これらのデータセットの調査は、研究において重要なトピックとして浮かび上がっています.現在のLLMデータセットに関する包括的な概要や徹底的な分析の不足を解消し、その現状や将来の動向について洞察を得るために、この調査はLLMデータセットの基本的な側面を5つの視点から整理・分類しています:(1)事前学習コーパス、(2)指示微調整データセット、(3)選好データセット、(4)評価データセット、(5)従来の自然言語処理(NLP)データセット.調査は、現在の課題を明らかにし、将来の研究の可能性を指摘しています.さらに、既存の利用可能なデータセットリソースの包括的なレビューも提供されており、444のデータセットからの統計情報が含まれており、8つの言語カテゴリをカバーし、32のドメインにわたっています.総調査データサイズは、事前学習コーパスで774.5 TBを超え、その他のデータセットでは7億件のインスタンスが含まれています.この研究は、LLMテキストデータセットの全体像を提示し、この分野の研究者にとって包括的な参考資料となり、将来の研究に貢献することを目指しています.関連するリソースは、以下で入手可能です:.” rel=”nofollow”>https://github.com/lmmlzn/Awesome-LLMs-Datasets.

Q&A:

Q: LLMデータセットの分析で直面した具体的な課題について、もう少し詳しく教えてください.

A: LLMデータセットの分析において直面する具体的な課題は、膨大なデータセットの増加による学習の困難さや、異なる種類やドメインの違い、現実世界のシナリオなどの系統的な整理の欠如が挙げられます.これにより、研究者がデータセットについて理解し学ぶ際に、学習曲線が急激に上昇し、技術革新や公衆の認識の拡大が妨げられる可能性があります.

Q: LLMデータセットの基本的な側面を、この文章にある5つの観点からどのように分類しましたか?

A: LLMデータセットの基本的な側面を、(1)事前トレーニングコーパス、(2)指示微調整データセット、(3)選好データセット、(4)評価データセット、(5)従来の自然言語処理(NLP)データセットの5つの視点から分類しました.

Q: 調査の対象となる444のデータセットは、どのような基準で選ばれたのか?

A: 選択された444つのデータセットを調査に含めるための基準は、リリース時期、ライセンス、サイズ、構築方法、言語、ドメイン、質問タイプ、評価方法などの8つの側面に基づいていました.

Q: 8つの言語カテゴリーや32のドメインなど、データセットリソースの統計について詳しく教えてください.

A: データセットリソースに関する統計について、8つの言語カテゴリと32のドメインがカバーされています.言語カテゴリは、英語、中国語、および多言語であり、各言語カテゴリには複数の言語が含まれています.これらのデータセットは、20の次元からの情報を含み、774.5 TBを超えること前トレーニングコーパスのデータサイズと、その他のデータセットには7億以上のインスタンスが含まれています.

Q: 事前学習用コーパスやその他のデータセットについて、調査した総データサイズはどのように決定したのですか?

A: 調査された合計データサイズは、事前トレーニングコーパスについては774.5 TBを超え、その他のデータセットについては7億以上のインスタンスです.この調査は、444のデータセットからの統計を含み、8つの言語カテゴリーを横断し、32の異なるドメインをカバーしています.情報は20の次元から取得されており、純粋なテキストLLMデータセットに焦点を当てています.

Q: LLMデータセットの現状と今後の傾向を調べて、どのような洞察を得ましたか?

A: LLMデータセットの現在の状況と将来のトレンドを調査することで、LLMデータセットに関連するデータを5つの次元で分類し、要約することができました.具体的には、事前学習コーパス、微調整指示データセット、選好データセット、評価データセット、および従来のNLPデータセットの5つの次元に分類しました.また、現在の課題を特定し、将来のデータセット開発の方向性を4つの主要な領域(事前学習、微調整指示、強化学習、モデル評価)で概説しました.この調査は、学術界や産業界の研究者、そしてLLMに携わる初心者や熟練者にとって貴重な参考資料となることを期待しています.最終的な目標は、LLMデータセットを継続的に改良し、堅牢で標準化されたデータセットエコシステムを育成し、LLMの進歩を支援することです.

Q: LLMデータセットの包括的な概要が、この分野の研究者にどのような利益をもたらすとお考えですか?

A: このLLMデータセットの包括的な概要は、研究者にとって非常に有益であると考えられます.データセットの構成と品質がLLMの性能に深く影響を与えるため、この包括的な調査は研究者がLLMの分布と役割をより良く理解し、LLMの集合知と応用を進めることを可能にします.また、この調査は、LLMデータセットの現在の課題を特定し、将来のデータセット開発の方向性を示すことで、研究者が学習曲線を短縮し、技術革新を促進し、一般の認識を広めることを目的としています.この包括的な分析は、学術界や産業界の研究者だけでなく、LLMに携わる初心者や熟練者にとって貴重な参考資料となることを期待しています.最終的な目標は、LLMデータセットを継続的に改良し、LLMの将来のトレンドを促進することです.

Q: データセットの分析に影響を与えた可能性のある限界やバイアスについて教えてください.

A: データセットの分析に影響を与えた可能性のある制限やバイアスについて議論することができます.例えば、データソースの信頼性や公平性の評価が重要であり、データの汚染や漏洩のリスクがあることが指摘されています.また、評価データから学習してしまうことで、評価スコアが過大評価され、一般化能力が低下する可能性があることも示唆されています.これらの問題がデータセットの分析に影響を与える可能性があります.

Q: 20次元の情報は、どのようにデータセットの統計に組み込まれたのか?

A: 20の次元の情報は、データセットの統計に組み込まれました.これは、データセットの各要素に関する20の異なる側面や特性が考慮され、統計情報としてまとめられたことを意味します.

Q: 今回の調査結果を踏まえて、今後の研究についてどのような提言がありますか?

A: この調査の結果に基づいて、将来の研究に対する推奨事項として、LLMのデータセットの品質向上が重要であると考えられます.特に、データセットの多様性や一貫性を向上させるために、新しいデータ統合手法や品質評価基準の開発が必要です.さらに、モデルの評価や学習指示の精度を向上させるために、より包括的なデータセットの構築と活用が求められます.これにより、LLMの研究と応用がさらに進展し、より高度な技術の開発が可能となるでしょう.

On the Societal Impact of Open Foundation Models

著者:Alex Engler, Alondra Nelson, Arvind Narayanan, Ashwin Ramaswami, Aspen Hopkins, Aviya Skowron, Daniel E. Ho, Daniel Zhang, Dawn Song, Joelle Pineau, Kevin Bankston, Kevin Klyman, Miranda Bogen, Percy Liang, Peter Cihon, Peter Henderson, Rishi Bommasani, Rumman Chowdhury, Sayash Kapoor, Seth Lazar, Shayne Longpre, Stefano Maffulli, Stella Biderman, Victor Storchan, Yacine Jernite

発行日:2024年02月27日

最終更新日:不明

URL:https://crfm.stanford.edu/open-fms/

カテゴリ:不明

概要:

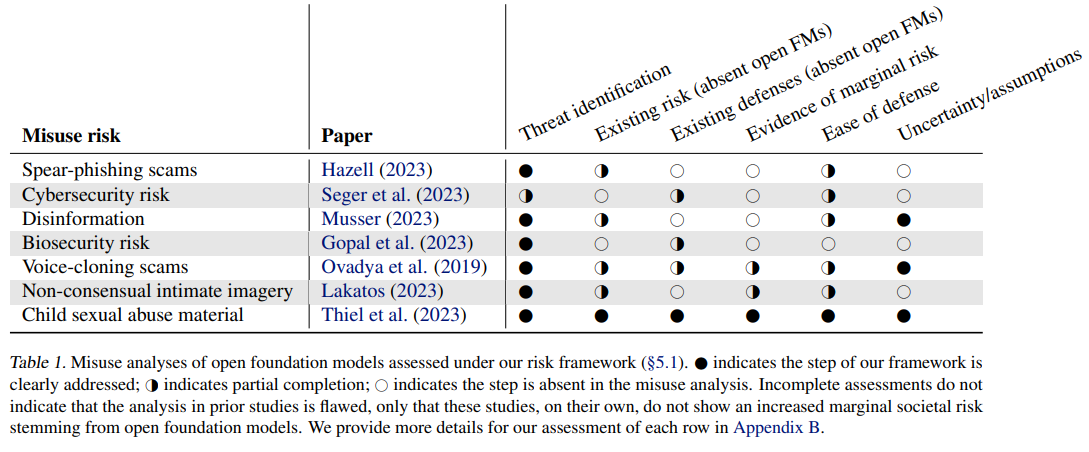

Foundationモデル(Bommasani et al.、2021)は、現代のAIエコシステムの中心的存在であり、技術開発、展開、採用の激しいペースを促進し、それに伴う論争、監視、公衆の注目をもたらしています.BERT、CLIP、Whisper、BLOOM、Pythia、Llama 2、Falcon、Stable Diffusion、Mistral、OLMo、Aya、GemmaなどのオープンなFoundationモデルは、このエコシステムで重要な役割を果たしています.これらのモデルは、より大きなカスタマイズが可能であり、運用方法をより深く検査することができるため、開発者にはFoundationモデルの選択肢が増えます.しかし、広く採用されることでリスクが増大する可能性もあり、特に生物安全保障、サイバーセキュリティ、ディスインフォメーションに関連するリスクについては、反発が起こっています.Foundationモデルのリリース方法は、現在の中心的な議論であり、しばしばオープン対クローズドと表現されています.同時に、政策立案者はオープンなFoundationモデルをどのように統治するかに直面しています.アメリカ合衆国では、最近の「人工知能の安全で安全な信頼性のある開発と利用に関する大統領令」により、商務省がオープンなFoundationモデルの利点とリスクに関する報告書を大統領のために準備するよう命じられています.さらに、欧州連合では、最近交渉されたAI法において、オープンなFoundationモデルは一部の義務から免除されています.そして、英国AI安全研究所(UK AISI, 2023)は、広く利用可能なモデルの重みの考慮を優先事項としています.AIコミュニティ内での意見の相違や適切なAI政策に関する不確実性を考慮すると、本論文はオープンなFoundationモデルの利点とリスクを明確にします.オープンなFoundationモデルの社会的影響の分析を二つのステップに分解します.まず、オープンなFoundationモデルの5つの特徴的な性質を明確にします.オープンなFoundationモデルは、より広範なアクセス、より大きなカスタマイズ可能性、地域推論の可能性、取り消しの不能、そして透明性を特徴としています.さらに、オープンなFoundationモデルの特性によって、意思決定権の分散、市場集中の軽減、イノベーションの促進、科学の加速、透明性の実現などの具体的な利点とリスクが生じることを明らかにします.特に、オープンなFoundationモデルが社会的リスクを増大させる可能性があることを考慮し、過去の研究がそのリスクを明確に評価していないことを指摘します.さらに、過去の研究がオープンなFoundationモデルの潜在的なリスクを十分に評価していないことが明らかになっています.新しい文脈を加えることで、オープンなFoundationモデルの利点とリスクについての議論をより具体的に展開し、今後の研究や政策立案に役立つ枠組みを提供しています.現在の議論と政策形成に基づいて、AI開発者、AIのリスクを調査する研究者、競争規制当局、政策立案者に具体的な提言を行い、オープンなFoundationモデルの社会的影響をさらに明確にし、その利点を最大限に活用しながらリスクを軽減する能力を高めることができます.

Q&A:

Q: 研究の中で明らかになったオープン財団モデルの5つの特徴的な特性について説明していただけますか?

A: 研究で特定したオープンファウンデーションモデルの5つの特徴を説明します.第一に、オープンファウンデーションモデルは広いアクセスと大きなカスタマイズ性を持っています.第二に、オープンファウンデーションモデルはモデルの振る舞いを定義する人々を分散させます.第三に、オープンファウンデーションモデルは透明性を提供し、モデルの内部構造や動作を理解しやすくします.第四に、オープンファウンデーションモデルはコラボレーションを促進し、異なる組織や個人が共同でモデルを改善できる環境を提供します.最後に、オープンファウンデーションモデルはイノベーションを促進し、新しいアイデアやアプローチを導入するための柔軟性を持っています.

Q: オープンな財団モデルは、イノベーション、競争、意思決定権の分配、社会の透明性にどのような影響を与えるのか?

A: オープンファウンデーションモデルは、革新、競争、意思決定権の分配、透明性に影響を与えます.オープンファウンデーションモデルは、より広範なアクセスと大きなカスタマイズ可能性を提供するため、革新を促進します.また、競争を増加させ、意思決定権を分散させ、透明性を向上させる可能性があります.ただし、これらの利点には、実践上で抑制する要素があることに留意する必要があります.

Q: オープンファンデーションモデルの限界リスクを分析するために、あなたが考案したリスク評価の枠組みは何ですか?

A: オープンファウンデーションモデルの限界リスクを分析するために設計したリスク評価フレームワークは、特定の誤用ベクトルに対するリスクを評価するための6つのポイントのフレームワークです.このフレームワークの基盤となるのは、仮定と不確実性の伝達に重点を置いています.誤用ベクトルはしばしば複雑なサプライチェーンを含み、ファウンデーションモデルの能力は急速に進化しているため、攻撃者と防御者の間の力のバランスが不安定であることがあります.このリスクフレームワークは、オープンファウンデーションモデルの誤用リスクを精密に議論することを可能にし、コンピュータセキュリティの脅威モデリングフレームワークに基づいています.例えば、オープン(自然)言語モデルの使用によるバイオセキュリティ上の懸念の限界リスクを明確に表現しない場合、研究者は異なる結論に至る可能性があります.

Q: オープン・ファウンデーション・モデルに関する現在の研究は、悪用リスクの特徴付けという点で、既存の技術と比較してどうなのか?

A: 現在の研究は、既存の技術と比較して、オープンファウンデーションモデルの誤用リスクを特徴付ける際に、マージナルリスクの概念を導入しています.これは、オープンファウンデーションモデルが社会的リスクをどの程度増加させるかを示すものであり、これにより、閉じたファウンデーションモデルや既存の技術(例:インターネット上のウェブ検索)と比較して、新たなリスクがどのように導入されるかが明確になります.

Q: オープン・ファンデーション・モデルの限界リスクが低いケースがある理由を、あなたのフレームワークでどのように説明できますか?

A: フレームワークは、過去のデジタル技術の波(たとえば、サイバーセキュリティにおける自動脆弱性検出のための基盤モデルの使用)から既に証拠がある場合に、いくつかのケースでマージナルリスクが低い理由を説明するのに役立ちます.また、過去の研究がフレームワークの異なるサブセットにリスクを分析していたことを明らかにすることで、誤解について明確にします.さらに、より建設的な議論のための方法を示すことで、前進の道筋を示します.

Q: オープン・ファンデーション・モデルの研究を通じて、誤用リスクについてどのような意見の相違が明らかになりましたか?

A: 研究によって、オープンファウンデーションモデルの誤用リスクに関する意見の相違点を明確にしました.

Q: オープンファンデーションモデルが社会に与える影響について、より建設的な議論を進めるためにはどうすればいいでしょうか?

A: オープンな基盤モデルの社会的影響に関する建設的な議論を進めるためには、研究が必要です.具体的には、オープンな基盤モデルのリスクを調査し、そのリスクが重要であることが示された場合には、政策介入を検討する必要があります.また、政策立案者は、オープンな基盤モデルの開発者に対する規制の影響を積極的に評価すべきです.

Q: オープンファンデーションモデルの理論的な利点とリスクを実証的に検証するためには、どのような研究が必要なのか?

A: オープンファウンデーションモデルの理論的利点とリスクを実証するためには、具体的な誤用ベクトルの不確実性を減らすための研究が必要です.これには、下流モデルの使用の追跡を改善することなどが含まれます.また、もし限界リスクが十分に重要であることが懸念されるほど示された場合、さらなる政策介入(例:下流攻撃面の強化)が考慮されるべきです.

Q: 現代のAIエコシステムにおけるBERT、CLIP、Whisperなどのオープン・ファウンデーション・モデルの役割と、それらを取り巻く論争について話していただけますか?

A: オープンなファウンデーションモデル(BERT、CLIP、Whisperなど)は、現代のAIエコシステムにおいて重要な役割を果たしています.これらのモデルは、よりカスタマイズが可能であり、運用方法をより深く検査することができるため、開発者にとってはより選択肢が広がります.しかし、これらのモデルは広く採用されることでリスクが増大する可能性もあり、特にバイオセキュリティ、サイバーセキュリティ、ディスインフォメーションに関連するリスクについては、反発が起こっています.

EMO: Emote Portrait Alive — Generating Expressive Portrait Videos with Audio2Video Diffusion Model under Weak Conditions

著者:Linrui Tian, Qi Wang, Bang Zhang, Liefeng Bo

発行日:2024年02月27日

最終更新日:2024年02月27日

URL:http://arxiv.org/pdf/2402.17485v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

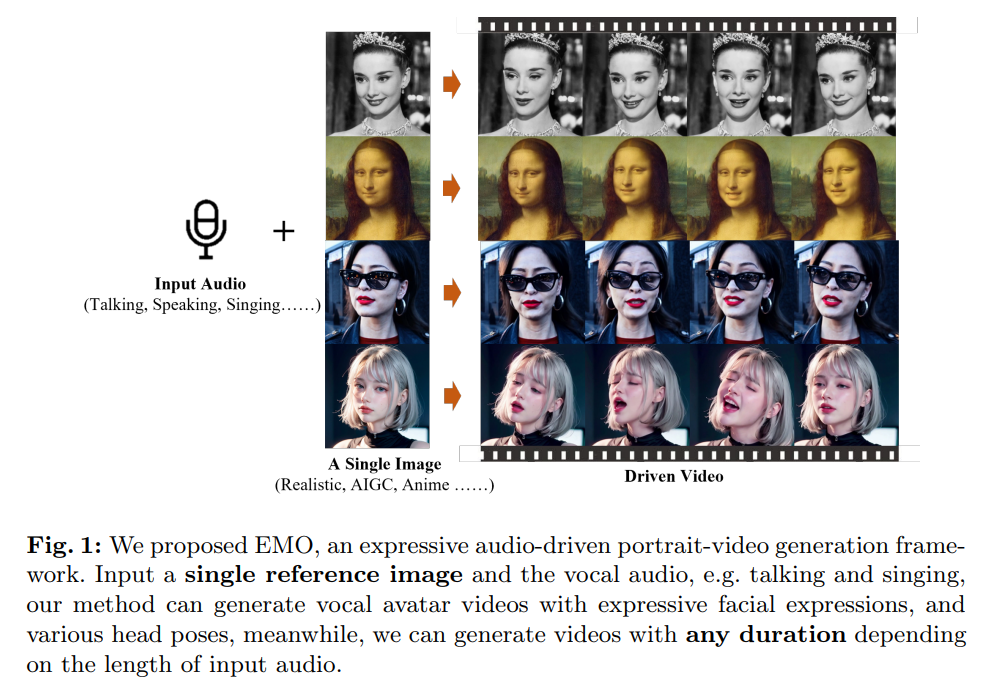

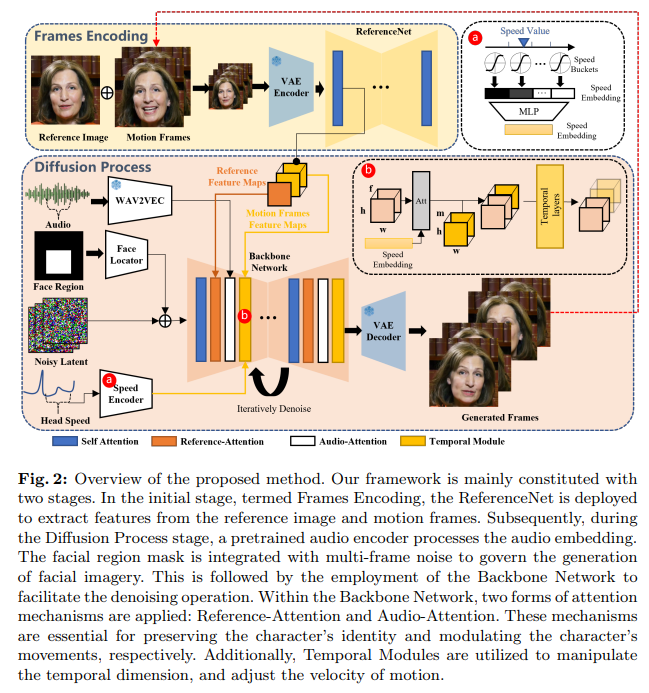

この作品では、音声の手がかりと顔の動きの間のダイナミックで微妙な関係に焦点を当てることで、話す頭のビデオ生成のリアリズムと表現力を向上させるという課題に取り組んでいます.私たちは、従来の技術の限界を特定しました.これらの技術は、しばしば人間の表現の全スペクトルや個々の顔のスタイルの独自性を捉えることができません.これらの問題に対処するために、私たちはEMOという新しいフレームワークを提案しています.このフレームワークは、中間の3Dモデルや顔のランドマークを必要とせず、直接音声からビデオを合成するアプローチを利用しています.私たちの方法は、ビデオ全体でシームレスなフレームの遷移と一貫したアイデンティティの保存を確保し、非常に表現豊かでリアルなアニメーションを生み出します.実験結果は、EMOが説得力のある話し手のビデオだけでなく、さまざまなスタイルの歌うビデオを生成できることを示し、表現力とリアリズムの観点から既存の最先端技術を大幅に上回っていることを示しています.

Q&A:

Q: 音声から映像への合成プロセスにおいて、EMOが中間3Dモデルや顔のランドマークの必要性をどのように回避しているのか、もう少し詳しく説明してもらえますか?

A: EMOは、中間の3Dモデルや顔のランドマークを必要とせず、直接的なオーディオからビデオへの合成アプローチを使用しています.具体的には、EMOは音声と画像の関係を学習するために、Diffusion Modelを使用しており、このモデルはオーディオとビデオの関連性を捉えるために訓練されています.この方法により、中間の3Dモデルや顔のランドマークを使用せずに、音声から直接的に表情豊かなビデオを生成することが可能となります.

Q: EMOはどのようにしてシームレスなフレーム遷移と、映像全体を通して一貫したアイデンティティの保持を実現しているのでしょうか?

A: EMOは、直接オーディオからビデオへの合成アプローチを使用し、中間の3Dモデルや顔のランドマークを必要とせず、シームレスなフレームの遷移と一貫したアイデンティティの保存を確実にします.この方法は、速度コントローラーと顔領域コントローラーという安定した制御メカニズムを組み込んでおり、生成プロセス中の安定性を向上させます.これらの2つのコントローラーはハイパーパラメーターとして機能し、最終的に生成されたビデオの多様性と表現力を損なうことなく微妙な制御信号として機能します.さらに、生成されたビデオのキャラクターが入力参照画像と一貫していることを確認するために、ReferenceNetのアプローチを採用し、FrameEncodingという類似のモジュールを設計することで、キャラクターのアイデンティティをビデオ全体で保存します.

Q: 人間の表情や個々の顔のスタイルを捉えるという点で、EMOは従来の技術の具体的などのような限界に対処しているのでしょうか?

A: EMOは、従来の技術の制限を克服し、人間の表現や個々の顔のスタイルを捉える際の問題に取り組んでいます.具体的には、従来の技術がしばしば人間の表現の全スペクトルや個々の顔のスタイルの独自性を捉えることができないという課題に対処しています.

Q: EMOが正確にとらえ、再現できる顔の動きや表情の種類を例示していただけますか?

A: EMOは、高い声のトーンがより強烈でアニメーションされた表情を引き出すことができることが示されています.また、動きのフレームを活用することで、生成されたアイデンティティの一貫性を保ちながら、非常に表現豊かでリアルなアニメーションを実現することができます.

Q: EMOは、スピーキング・ビデオと比較して、さまざまなスタイルの歌唱ビデオを生成するという点で、どのようなパフォーマンスを見せてくれますか?

A: EMOはさまざまなスタイルの歌唱ビデオを生成する際に、話すビデオと比較してどのようにパフォーマンスするかを示す実験結果があります.その結果、EMOは高い表現力とリアリティを持った歌唱ビデオを生成する能力があり、既存の最先端技術を大幅に上回っています.

Q: 表現力とリアリズムの面で、EMOが既存の最先端手法を大きく上回った主な要因は何だったのか?

A: EMOは、直接オーディオからビデオを合成する新しいフレームワークであり、中間の3Dモデルや顔のランドマークを必要とせず、シームレスなフレームの遷移と一貫したアイデンティティの維持を実現しています.これにより、高度な表現力とリアリズムが実現され、既存の最先端技術を大幅に上回ることができました.

Q: EMOで使われているオーディオからビデオへの普及モデルの技術的な側面について説明していただけますか?

A: EMOでは、音声からビデオへの変換を行うために、直接オーディオからビデオへの合成アプローチを使用しています.この方法では、中間の3Dモデルや顔のランドマークを必要とせず、音声と顔の動きの間のダイナミックで微妙な関係に焦点を当てています.このフレームワークは、音声の表現とリアリズムを向上させるために設計されており、個々の顔のスタイルのユニークさを捉えることができます.EMOは、ビデオの生成中にアイデンティティの保存を確保し、高度に表現豊かでリアルなアニメーションを実現しています.実験結果は、EMOが説得力のある話し手ビデオだけでなく、さまざまなスタイルの歌ビデオを生成できることを示し、表現力とリアリズムの観点で既存の最先端技術を大幅に上回っていることを示しています.

Q: 本物そっくりのアニメーションを制作する上で、EMOの有効性をどのように検証したのですか?

A: EMOの効果を検証するために、いくつかの定量的な比較が行われました.具体的には、FID、SyncNet、F-SIM、FVD、E-FIDなどの指標を用いて、既存の話し手生成ワークと比較されました.これらの指標により、EMOが表現力とリアリズムの観点で既存の最先端技術を大幅に上回っていることが示されました.

Q: 表現力豊かなポートレート映像の生成にとどまらない、EMOの応用の可能性とは?

A: EMOは、表現豊かなポートレートビデオを生成するだけでなく、仮想YouTuberやバーチャルアシスタント、教育用ビデオやオンラインプレゼンテーション、映画やアニメーションの制作など、さまざまな分野で活用される可能性があります.

Q: EMOの開発・実施中に遭遇した制限や課題についてお聞かせください.

A: EMOの開発と実装中に遭遇した制限や課題について議論したいと思います.我々の研究では、従来の技術の制限を特定しました.これらの技術はしばしば人間の表現の全スペクトルや個々の顔のスタイルの独自性を捉えることができないという問題がありました.そのため、我々は中間の3Dモデルや顔のランドマークを必要としない直接的な音声からビデオへの合成アプローチを活用するEMOという新しいフレームワークを提案しました.この方法は、シームレスなフレームの遷移と一貫した表現と声のスタイルを確保し、EMOの開発の堅固な基盤を提供します.我々はHDTFデータセットで広範な実験と比較を行い、DreamTalk、Wav2Lip、SadTalkerなどの現行の最先端の手法を上回りました.量的評価に加えて、包括的なユーザースタディと質的評価も行い、我々の手法が非常に自然で表現豊かな話し方や歌い方のビデオを生成する能力があること、これまでで最高の結果を達成していることが明らかになりました.

Large Language Models(LLMs) on Tabular Data: Prediction, Generation, and Understanding — A Survey

著者:Xi Fang, Weijie Xu, Fiona Anting Tan, Jiani Zhang, Ziqing Hu, Yanjun Qi, Scott Nickleach, Diego Socolinsky, Srinivasan Sengamedu, Christos Faloutsos

発行日:2024年02月27日

最終更新日:2024年03月01日

URL:http://arxiv.org/pdf/2402.17944v2

カテゴリ:Computation and Language

概要:

最近の大規模言語モデリングの進歩により、予測、表形式データの合成、質問応答、および表理解に関連するさまざまなタスクへの応用が厳密に探求されています.各タスクには独自の課題と機会があります.しかし、この研究領域において、主要な技術、メトリクス、データセット、モデル、および最適化アプローチを要約および比較する包括的なレビューが現在不足しています.この調査は、これらの分野での最近の進歩を統合し、使用されているデータセット、メトリクス、および方法論の包括的な調査と分類を提供することを目的としています.既存の文献の強み、制限、未開拓の領域、およびギャップを特定し、この重要で急速に進化する分野における将来の研究方向についていくつかの洞察を提供します.また、関連するコードとデータセットの参照も提供します.この包括的なレビューを通じて、興味を持つ読者に適切な参照資料と洞察的な視点を提供し、彼らがこの分野の現在の課題に効果的に対処し、航行するために必要なツールと知識を与えることを願っています.

Q&A:

Q: 大規模言語モデルを使用して検討された、表データモデリングに関する具体的なタスクの例を教えてください.

A: 大規模言語モデルを使用して探索された表形式データモデリングに関連する具体的なタスクの例には、予測、表データ合成、質問応答、および表理解があります.

Q: 表形式データモデリングにおいて、それぞれのタスクがもたらすユニークな課題と機会にはどのようなものがあるのだろうか?

A: 各タスクには独自の課題と機会があります.例えば、予測タスクでは、未加工のデータを適切に前処理する必要があります.また、質問応答や表理解のタスクでは、データの意味を理解し、適切に解釈することが求められます.それぞれのタスクにおいて、異なる技術や手法が必要とされ、それによって新たな機会が生まれます.

Q: 表形式データのタスクで大規模言語モデルの性能を評価するために一般的に使用されるメトリクスについて教えてください.

A: 大規模言語モデルのタブラーデータタスクの性能評価に一般的に使用されるメトリクスには、精度、再現率、F1スコア、ROC曲線、AUCなどがあります.これらのメトリクスは、モデルの予測能力や分類の正確性を評価するために使用されます.

Q: 表形式データモデリングのための大規模言語モデルの研究で利用されたデータセットにはどのようなものがありますか?

A: 与えられた文脈では、Tabula、Seq2SQL、GPT-NeoX-20Bなどのデータセットが大規模言語モデルを用いた表形式データモデリングの研究で利用されています.

Q: さまざまなモデルや最適化アプローチは、表形式データのタスクに対する有効性という点で、どのように比較されるのでしょうか?

A: 異なるモデルと最適化アプローチは、表形式データタスクにおける効果について比較されます.伝統的な方法と比較して、深層学習モデルは一般的に高い柔軟性と複雑なパターンの学習能力を持っています.一方、伝統的な方法は、データが主にカテゴリカル特徴で構成されている場合や、データセットが非常に大きい場合には、深層学習モデルよりも有利であることがあります.表形式データモデリングにおける異なるモデルと最適化アプローチの効果を比較するためには、各タスクの要件やデータの特性に応じて適切なモデルと最適化手法を選択する必要があります.

Q: この研究領域における既存文献の長所と限界は何か?

A: 既存の文献の強みには、最近の進歩を総括し、データセット、メトリクス、および使用される方法論の包括的な調査と分類を提供することが挙げられます.一方、制限事項には、未開拓の領域や文献の欠点、および現存するギャップを特定することが含まれます.また、将来の研究方向に関する洞察を提供し、読者に関連する参考文献と示唆に富んだ視点を提供することで、この分野における課題に効果的に対処するための必要なツールと知識を提供することを目指しています.

Q: この分野における今後の研究の方向性について教えてください.

A: この分野における将来の研究方向に関する洞察を提供するために、新しいアイデアや研究が必要とされています.LLMsの急速な発展とその印象的な能力により、構造化データのモデリングにおける潜在能力を探るための需要が高まっています.これにより、既存の研究の課題や未解決の問題に対処し、将来の研究活動でさらなる探求が必要とされています.

Q: 読者はアンケートで言及された関連コードやデータセットにどのようにアクセスできますか?

A: 興味を持った読者は、調査で言及されている関連コードとデータセットの参照を入手するために、セクションを見ることができます.実務家や研究者は、セクションを見て関連するデータセットを簡単に見つけることができます.

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits

著者:Shuming Ma, Hongyu Wang, Lingxiao Ma, Lei Wang, Wenhui Wang, Shaohan Huang, Li Dong, Ruiping Wang, Jilong Xue, Furu Wei

発行日:2024年02月27日

最終更新日:2024年02月27日

URL:http://arxiv.org/pdf/2402.17764v1

カテゴリ:Computation and Language, Machine Learning

概要:

最近の研究、例えばBitNetなど、新しい1ビット大規模言語モデル(LLMs)の時代を切り開いています.この研究では、我々は1ビットLLMの変種であるBitNet b1.58を紹介します.このモデルでは、LLMのすべてのパラメータ(または重み)が三値{-1、0、1}である.このモデルは、パープレキシティとエンドタスクのパフォーマンスの両方において、モデルサイズとトレーニングトークンが同じであるフルプレシジョン(すなわち、FP16またはBF16)トランスフォーマーLLMと一致しています.しかし、レイテンシ、メモリ、スループット、およびエネルギー消費の面で、はるかにコスト効果が高いです.さらに、1.58ビットLLMは、高性能かつコスト効果が高い新世代のLLMを訓練するための新しいスケーリング法則とレシピを定義しています.さらに、新しい計算パラダイムを可能にし、1ビットLLM向けに最適化された特定のハードウェアの設計の扉を開くことができます.

Q&A:

Q: 大規模言語モデル(LLM)の文脈におけるBitNet b1.58の意義について教えてください.

A: BitNet b1.58は、すべてのパラメータが三値{-1, 0, 1}を取る1ビットLLMの重要なバリアントであり、元の1ビットBitNetに0の値を追加することで、バイナリシステムで1.58ビットを実現しています.BitNet b1.58は、元の1ビットBitNetのすべての利点を保持しており、行列の乗算にほとんど乗算演算が必要な新しい計算パラダイムを持ち、高度に最適化されることができます.さらに、元の1ビットBitNetと同じエネルギー消費量を持ち、FP16 LLMのベースラインに比べてメモリ消費量、スループット、レイテンシの面ではるかに効率的です.また、BitNet b1.58には2つの追加の利点があります.第一に、0を含むモデルの重みによって、特徴フィルタリングを明示的にサポートすることで、モデリング能力が強化され、1ビットLLMのパフォーマンスが大幅に向上する可能性があります.第二に、実験では、同じ構成(モデルサイズ、トレーニングトークンなど)を使用した場合、3Bサイズから始めて、BitNet b1.58がパープレキシティとエンドタスクのパフォーマンスの両方で完全精度(すなわちFP16)のベースラインに匹敵することが示されています.

Q: BitNet b1.58と他のLLMの違いは何ですか?

A: BitNet b1.58は、他のLLM変種と比較して、パラメータ表現においてすべてのパラメータが三値{-1, 0, 1}を取る点が異なります.これは、モデルの重みに0を含めることで、特徴フィルタリングを明示的にサポートし、1ビットLLMの性能を大幅に向上させることが可能となります.また、BitNet b1.58は、1.58ビットのバイナリシステムにおいて、元の1ビットBitNetに0の値を追加することで、新しい計算パラダイムを維持しつつ、モデルのモデリング能力を強化しています.

Q: BitNet b1.58のような1ビットLLMを使うことの、レイテンシ、メモリ、スループット、エネルギー消費の面での主な利点は何ですか?

A: BitNet b1.58のような1ビットLLMは、レイテンシ、メモリ、スループット、エネルギー消費の面で重要な利点を提供します.レイテンシに関しては、これらのモデルは行列乗算のための乗算演算をほとんど必要としない新しい計算パラダイムを持ち、処理時間の高速化につながります.さらに、モデルの重みに0を含めることで、特徴フィルタリングを明示的にサポートし、モデル化能力を高め、性能を向上させている.メモリに関しては、1ビットLLMは全精密モデルと比較してメモリフットプリントが非常に小さく、必要な容量と帯域幅の両方が削減されます.その結果、DRAMから重みをロードする時間とコストが削減され、より高速で効率的な推論が可能になります.スループットに関しては、BitNet b1.58はFP16 LLMベースラインよりもはるかに効率的で、スループットとレイテンシが改善されています.最後に、エネルギー消費では、1ビットLLMはメモリとエネルギー消費を削減できるため有利であり、エッジデバイスやモバイルデバイスへの展開が可能になり、性能を損なうことなく機能が強化されます.

Q: BitNet b1.58は、完全精度のTransformer LLMと比較して、当惑度とエンドタスク性能の点でどうでしょうか?

A: BitNet b1.58は、パープレキシティとエンドタスクのパフォーマンスにおいて、フルプレシジョンのTransformer LLMと同等の結果を示しています.具体的には、3BモデルサイズからフルプレシジョンのLLMと同等のパープレキシティを達成し、かつ2.71倍速く、3.55倍少ないGPUメモリを使用しています.また、3.9Bモデルサイズでは、2.4倍速く、3.32倍少ないメモリを消費しており、エンドタスクの結果でも低いメモリとレイテンシーコストでLLaMA LLMを上回っています.

Q: 1.58ビットLLMによって導入された新しいスケーリング則と、新世代のLLMをトレーニングするためのレシピについて詳しく教えてください.

A: 1.58ビットLLMによって導入された新しいスケーリング法とトレーニング新世代のLLMのレシピは、モデルのパラメータを3つの値{-1, 0, 1}に量子化することによって実現されます.これにより、モデルのサイズとトレーニングトークンが同じである場合でも、パープレキシティとエンドタスクのパフォーマンスにおいて、FP16やBF16のフル精度のTransformer LLMと一致します.さらに、この新しいスケーリング法は、レイテンシ、メモリ、スループット、エネルギー消費の面で大幅にコスト効率が向上します.CPUデバイスにもよりフレンドリーであり、エッジやモバイルデバイスで効率的に実行されることが可能であり、これによりこれらのデバイスのパフォーマンスと機能がさらに向上します.

Q: BitNet b1.58のような1ビットLLMの導入は、これらのモデルに最適化された特定のハードウェアの開発にどのような影響を与えますか?

A: 1ビットLLM(例:BitNet b1.58)の導入により、これらのモデルに最適化された特定のハードウェアの開発に影響を与えます.新しい計算パラダイムにより、1.58ビットLLMはほとんどの行列乗算にほとんどの乗算演算を必要とせず、高度に最適化されるため、特定のハードウェア(例:LPUs)の構築に大きな可能性を示します.このような新しいハードウェアとシステムの設計を促進することが提案されています.

Q: 1ビットLLMの時代が自然言語処理の分野にもたらす潜在的な影響とは?

A: 1ビットLLMの時代の潜在的な影響は、自然言語処理の分野において、メモリと計算要件を大幅に削減することができる可能性があります.これは、重みと活性化の精度を低下させることで達成され、16ビットから4ビットなどの低ビットバリアントに移行する傾向があります.これにより、LLMの展開における課題や高エネルギー消費による環境および経済への影響を軽減することが期待されます.

Q: BitNet b1.58は、従来のモデルと比較して、LLMの全体的な費用対効果にどのように貢献していますか?

A: BitNet b1.58は、従来のモデルと比較して、メモリ使用量、スループット、レイテンシーにおいて非常に効率的であり、エネルギー消費量も同等である.さらに、モデリング能力が強化され、フィーチャーフィルタリングを明示的にサポートすることで、1ビットLLMのパフォーマンスを大幅に向上させることができる.また、BitNet b1.58は、同じ構成(モデルサイズ、トレーニングトークンなど)を使用した場合、パープレキシティとエンドタスクのパフォーマンスの両方において、FP16ベースラインと同等の結果を達成することができる.これにより、BitNet b1.58は、従来のモデルに比べてコスト効率が非常に高いことが示される.

Q: BitNet b1.58のような1ビットLLMを実装する際の潜在的な課題や制限について教えてください.

A: 1ビットLLM(例:BitNet b1.58)の実装にはいくつかの潜在的な課題や制約が存在します.まず第一に、1ビットのパラメータは3つの値{-1, 0, 1}のいずれかを取るため、従来のビット演算とは異なる計算パラダイムを必要とします.この新しい計算パラダイムに適応するためには、既存のハードウェアやソフトウェアに対する変更や最適化が必要となる可能性があります.さらに、1.58ビットLLMはFP16などの従来の精度と比較して、モデリング能力やパフォーマンスにおいて制約があるかもしれません.特に、モデルの重みに0を含めることで得られる特徴フィルタリングのサポートは、一部のタスクにおいて十分な性能を発揮しない可能性があります.

Q: 1ビットLLMの開発と最適化について、今後どのような研究の方向性を描いていますか?

A: 1ビットLLMの開発と最適化における将来の研究方向としては、BitNetによって可能になった新しい計算パラダイムを活用し、1ビットLLMの性能向上と効率化を図ることが重要です.具体的には、新しいハードウェアおよびシステムの設計に焦点を当て、1ビットLLMに特化した最適化手法の開発が求められます.これにより、1ビットLLMのメモリ使用量や計算要件をさらに削減し、性能を向上させることが期待されます.

Mistral Large

著者:Mistral AI team

発行日:2024年02月26日

最終更新日:不明

URL:https://mistral.ai/news/mistral-large/

カテゴリ:不明

概要:

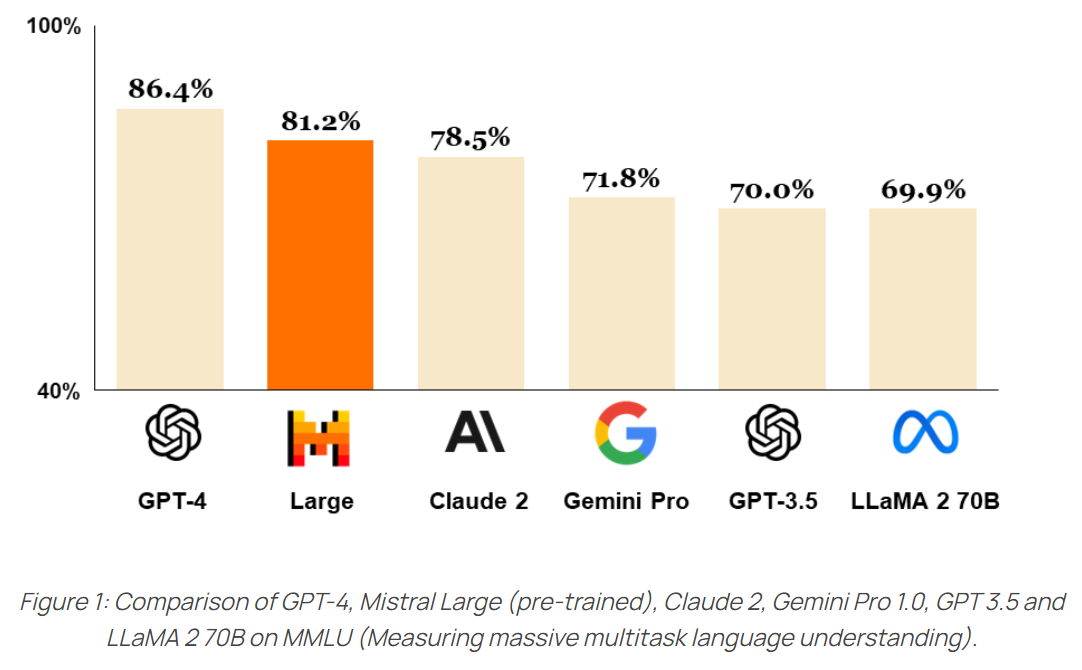

Mistral Largeは、最新かつ最も先進的な言語モデルであり、la Plateformeを通じて利用可能です.また、最初の配布パートナーであるAzureを通じても利用可能です.Mistral Largeは、新しいフラッグシップモデルであり、最先端のテキスト生成モデルです.トップティアの推論能力に達しており、テキスト理解、変換、コード生成などの複雑な多言語推論タスクに使用することができます.Mistral Largeは、一般的に使用されるベンチマークで強力な結果を達成し、APIを介して利用可能な世界第2位のモデルとなっています(GPT-4に次ぐ).

Mistral Largeには、新しい機能と強みが備わっています.Microsoftと提携してAzure上でモデルを提供することを発表しており、Mistralの使命は、フロンティアAIを普及させることです.これが、今日、私たちがオープンであることと、Microsoftと提携している理由です.

さらに、商用モデルをAzureに提供することで、Microsoftの信頼を得て、私たちの旅路を前進させています.Mistralのモデルは、以下の方法で利用可能です:

- La Plateforme:ヨーロッパのMistralのインフラストラクチャに安全にホストされており、開発者が幅広いモデルを使用してアプリケーションやサービスを作成できるアクセスポイントです.

- Azure:Mistral Largeは、Azure AI StudioやAzure Machine Learningを通じて利用可能であり、APIと同様にシームレスなユーザーエクスペリエンスを提供しています.ベータ顧客は、それを大きな成功を収めて使用しています.

- 自己展開:私たちのモデルは、最も機密性の高いユースケースにおいて、お客様の環境に展開することができます.モデルの重みにアクセスでき、この種の展開に関する成功事例を読むことができます.詳細については、私たちのチームにお問い合わせください.

Mistral Largeの能力

Mistral Largeのパフォーマンスを、一般的に使用されるベンチマークでトップを走るLLMモデルと比較しています.

推論と知識

Mistral Largeは強力な推論能力を示しています.以下の図では、事前学習モデルの標準ベンチマークでのパフォーマンスを報告しています.

ネイティブで英語、フランス語、スペイン語、ドイツ語、イタリア語に堪能であり、文法や文化的な文脈に微妙な理解を示しています.

さらに、Mistral Largeは32Kトークンのコンテキストウィンドウを持ち、大規模なドキュメントからの正確な情報の再現を可能にします.また、正確な命令に従う能力を持ち、開発者がモデレーションポリシーを設計するのに役立ちます.さらに、ネイティブで関数呼び出しを行う能力を持ち、これはla Plateformeで実装された制約付き出力モードとともに、アプリケーション開発やテックスタックの近代化を大規模に可能にします.

Q&A:

Q: Mistral Largeの最高水準の推論能力について、他のモデルとのベンチマークでの比較について詳細を提供していただけますか?

A: ミストラルラージは、トップレベルの推論能力を持っています.このモデルは、一般的に使用されるベンチマークで他のLLMモデルと比較され、その性能が報告されています.32Kトークンのコンテキストウィンドウを持ち、大規模なドキュメントから正確な情報を取得できます.また、ミストラルラージは英語、フランス語、スペイン語、ドイツ語、イタリア語をネイティブに扱い、文法や文化的な文脈を微妙に理解します.このモデルは、複雑な多言語推論タスクに使用でき、テキスト理解、変換、コード生成などの作業を行うことができます.

Q: Mistral Largeは具体的にどのような多言語推論タスクに使用できるのか、また、テキスト理解、変換、コード生成においてどのように優れているのか.

A: Mistral Largeは、テキスト理解、変換、およびコード生成などの複雑な多言語推論タスクに使用できます.その32Kトークンのコンテキストウィンドウにより、大規模なドキュメントからの正確な情報の再現が可能です.また、その正確な指示に従う能力により、開発者は自分たちのモデレーションポリシーを設計することができます.さらに、関数の呼び出しもネイティブで可能であり、これによりアプリケーション開発や技術スタックの近代化が規模化されます.

Q: Mistral LargeがGPT-4に次いでAPIを介して世界第2位のモデルである重要性を説明できますか?

A: Mistral LargeがGPT-4に次いでAPIを介して世界で2番目にランク付けされていることは、Mistral Largeの高い性能と信頼性を示しています.このランキングは、Mistral Largeが複雑な多言語推論タスクにおいて優れた結果を達成し、一般的に使用されるベンチマークで強力なパフォーマンスを示していることを示しています.GPT-4に次いでのランク付けは、Mistral LargeがAIモデルの分野で非常に重要な位置を占めていることを示しており、開発者や研究者にとって価値のある選択肢であることを示唆しています.

Q: ミストラルラージのマイクロソフトとの提携やAzureでの利用は、開発者やユーザーにどのような利益をもたらすのでしょうか?

A: ミストラルラージのMicrosoftとのパートナーシップおよびAzureでの利用可能性は、開発者とユーザーにとって大きな利点があります.Azure AI StudioやAzure Machine Learningを介して利用できるため、ユーザーエクスペリエンスが非常にシームレスになります.また、モデルの自己展開も可能であり、最も機密性の高いユースケースに対応することができます.モデルの重みにアクセスできるため、より細かいデプロイメントの定義が可能です.

Q: ミストラル・ラージに搭載された新たな能力と強み、そしてそれらがどのようにミストラルのパフォーマンスを高めているのか?

A: ミストラルラージは、強力な推論能力を持ち、複雑な多言語推論タスクに使用できます.これには、テキスト理解、変換、コード生成などが含まれます.また、ミストラルラージは、トップレベルの推論能力を持ち、一般的に使用されるベンチマークでのパフォーマンスを比較することができます.新しい最適化されたモデルエンドポイントも提供され、ミストラルラージの性能を向上させています.

Q: Mistral Largeの推論、知識、および複数の言語における言語流暢さの能力について詳しく説明していただけますか?

A: ミストラルラージは、論理的な推論能力に優れており、標準的なベンチマークテストでの性能が報告されています.また、英語、フランス語、スペイン語、ドイツ語、イタリア語の文法や文化的コンテキストを微妙に理解する能力を持っています.32Kトークンのコンテキストウィンドウを持ち、大規模なドキュメントから正確な情報を取得できます.さらに、開発者が自分たちのモデレーションポリシーを設計するための正確な指示に従う能力を持っており、システムレベルのモデレーションを設定するために使用されています.また、多言語能力も持ち、フランス語、ドイツ語、スペイン語、イタリア語のHellaSwag、Arc Challenge、MMLUベンチマークでLLaMA 2 70Bを大きく上回っています.

Q: ミストラルラージの32Kトークンコンテキストウィンドウは、大規模なドキュメントから正確な情報を思い出す能力にどのように貢献していますか?

A: Mistral Largeの32Kトークンのコンテキストウィンドウは、大規模なドキュメントから正確な情報を思い出す能力に貢献します.この広範なコンテキストウィンドウにより、モデルは文脈をより豊かに理解し、関連する情報をより正確に抽出することができます.また、大規模なドキュメント全体を通して情報を追跡することが可能であり、複雑な推論タスクにおいて高い性能を発揮します.

Q: ミストラルラージの正確な指示に従う機能は、開発者がモデレーションポリシーを設計し、システムレベルのモデレーションを設定することを可能にするのでしょうか?

A: Mistral Largeの正確な指示に従う機能により、開発者はモデレーションポリシーを設計し、システムレベルのモデレーションを設定することが可能となります.この機能により、開発者はモデルに特定の指示を与えることができ、例えばle Chatのシステムレベルのモデレーションを設定する際に利用することができます.

Q: Mistral Largeのネイティブ機能である関数呼び出しと制約付き出力モードが、La Plateforme上でのアプリケーション開発とスケーラビリティのあるテックスタックの近代化をどのように促進するか説明できますか?

A: ミストラルラージのネイティブ機能であるファンクションコーリングと制約付き出力モードは、アプリケーション開発とテックスタックの大規模な近代化を容易にします.ファンクションコーリングにより、開発者はミストラルのエンドポイントを自分のツールセットと統合することができ、内部コード、API、またはデータベースとより複雑なやり取りを行うことができます.制約付き出力モードは、出力を構造化された形式にすることで、開発者がモデルと自然にやり取りし、その情報を簡単にパイプラインの残りで使用できるようにします.

Q: また、どのような成功事例やケーススタディが参考になりますか?

A: 開発者は、自分たちの環境にMistral Largeを展開するために、モデルの重みにアクセスできるようにすることができます.このような成功事例やケーススタディは、読者が参照できるように提供されています.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlは、https://mistral.ai/news/mistral-large/ です.

Empowering Large Language Model Agents through Action Learning

著者:Haiteng Zhao, Chang Ma, Guoyin Wang, Jing Su, Lingpeng Kong, Jingjing Xu, Zhi-Hong Deng, Hongxia Yang

発行日:2024年02月24日

最終更新日:2024年02月24日

URL:http://arxiv.org/pdf/2402.15809v1

カテゴリ:Artificial Intelligence, Computation and Language

概要:

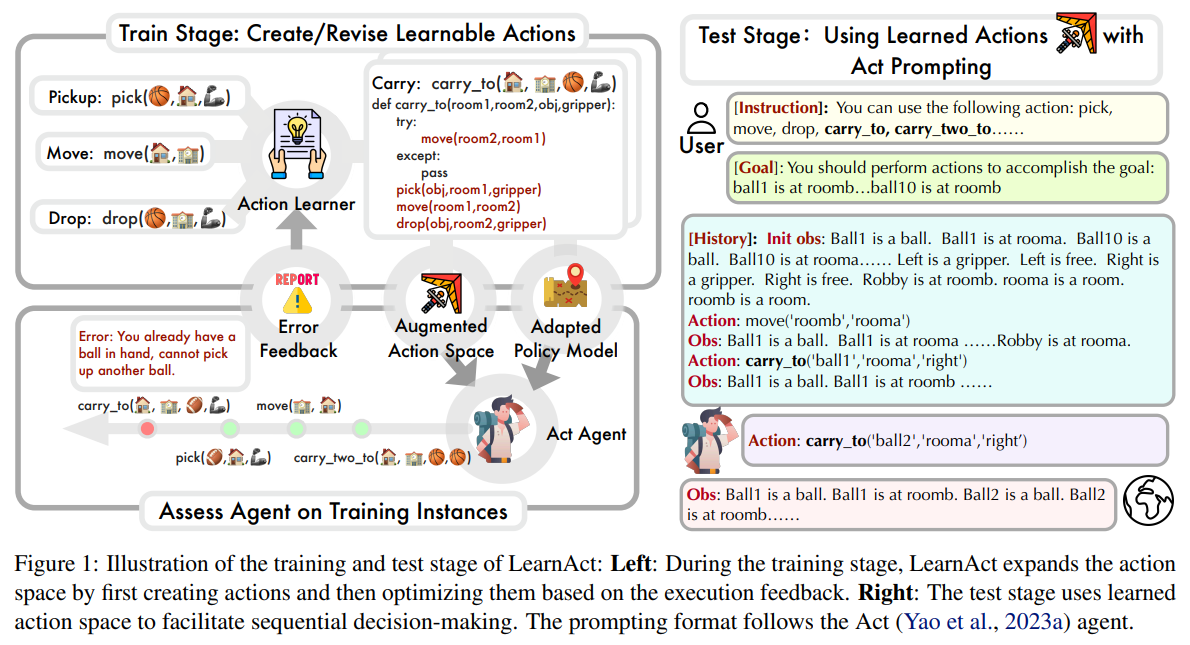

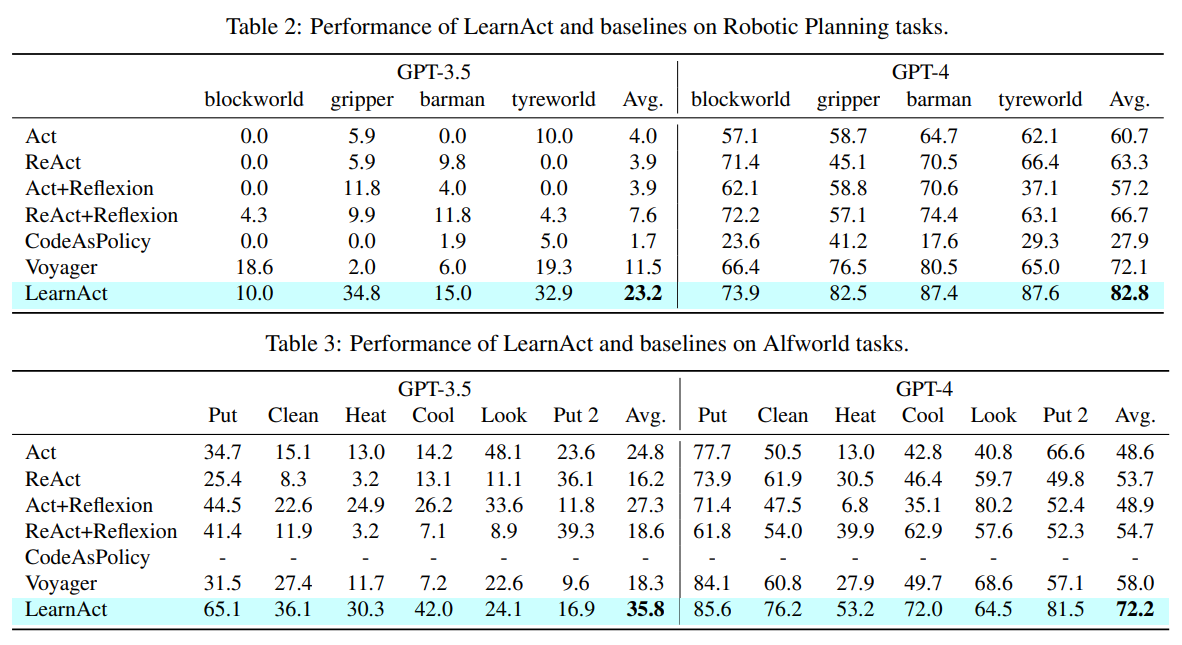

最近、大規模言語モデル(LLM)エージェントはますます注目されていますが、彼らは試行錯誤から学ぶ能力に制限があり、知的行動の重要な要素である.この研究では、経験から新しいアクションを学ぶ能力が、LLMエージェントの学習の進歩に基本的であると主張しています.人間は自然に行動空間を拡大し、経験的な学習を通じてスキルを磨いていきますが、LLMエージェントは通常、固定された行動空間内で操作しており、成長の可能性が制限されています.これらの課題に対処するために、私たちの研究では、言語エージェントのためのオープンアクション学習を探求しています.私たちは、Python関数の形でアクションを作成および改善するための反復学習戦略を持つLearnActフレームワークを導入しています.各反復では、LLMは、失敗したトレーニングタスクで特定されたエラーに基づいて現在利用可能なアクションを修正および更新し、アクションの効果を向上させます.ロボットプランニングおよびAlfworld環境全体での実験評価により、わずかなトレーニングタスクインスタンスで学習した後、オープンアクション学習へのアプローチがエージェントのパフォーマンスを著しく向上させることが明らかになりました(AlfWorldではReAct+Reflexionに比べて32%向上).これは、より知的なLLMエージェントの開発において経験的なアクション学習の重要性を強調しています.

Q&A:

Q: 言語エージェントのオープンアクション学習のコンセプトについて、もう少し詳しく説明していただけますか?

A: オープンアクション学習は、言語エージェントが環境と直接やり取りしながらアクションを学習し、改善する能力を持つことを指します.この学習方法では、エージェントはPython関数の形でアクションを作成し、改善していきます.学習は反復的であり、失敗したトレーニングタスクからエラーを特定し、その情報を元に現在利用可能なアクションを修正・更新していきます.このような経験的なアクション学習は、人間がスキルを獲得し向上させる方法に密接に沿っており、Robotic PlanningやAlfworld環境においてエージェントのパフォーマンスを著しく向上させることが示されています.

Q: LearnActフレームワークは、LLMエージェントのアクションを作成・改善する際にどのように機能するのでしょうか?

A: LearnActフレームワークは、LLMエージェントのために新しいアクションタイプを動的に生成するために設計されています.新しく生成されたアクションタイプはPython関数の形であり、LLMの豊富な事前知識とコード生成能力を活用して、多様で代表的なアクション空間を考案します.さらに、LearnActは、環境との直接的な相互作用を通じてアクションを学習および改善する能力をLLMエージェントに提供することで、エージェントのパフォーマンスを著しく向上させます.

Q: LearnActフレームワークで使われている反復学習戦略について詳しく教えてください.

A: LearnActフレームワークで使用される反復学習戦略は、LLMが現在のアクションの効果を評価し、失敗したインスタンスでのエラーを特定および修正することによって、アクションを継続的に洗練させるフィードバックループを通じて特徴付けられます.各サイクルでは、環境での経験を活用して、タスク理解を徐々に深め、学習可能なアクションを改善します.

Q: LLMは、失敗したトレーニングタスクで特定されたエラーに基づいて、現在利用可能なアクションをどのように修正し、更新するのですか?

A: LLMは、失敗したタスクにおけるエラーを特定し、そのエラーに基づいて現在の利用可能なアクションを修正および更新します.具体的には、関数の更新やノートの記述を実装することでエラーに対処します.関数の更新によって新しいアクションを生成し、アクションタイプの柔軟な定義を可能にします.この反復学習戦略により、LLMは失敗したタスクのエラーに基づいて現在利用可能なアクションを自律的に洗練し更新します.

Q: ロボティック・プランニングとアルフワールドの環境を横断した実験評価の結果は?

A: Robotic PlanningとAlfworld環境における実験評価の結果は、いくつかのトレーニングタスクインスタンスを学習した後、オープンアクション学習のアプローチがエージェントのパフォーマンスを顕著に向上させたことが明らかになりました.例えば、AlfWorldでは、ReAct+Reflexionに比べて32%の向上が見られました.これは、より知的なLLMエージェントの開発において経験的なアクション学習の重要性を強調しています.

Q: オープン・アクション学習へのアプローチによって、AlfWorldでのエージェントのパフォーマンスが、ReAct Reflexionと比べてどのように向上したのか、詳しく教えてください.

A: アルフワールドでのオープンアクション学習アプローチは、ReAct+Reflexionに比べてエージェントのパフォーマンスを32%向上させました.この改善は、経験的なアクション学習がより知的なLLMエージェントの開発において重要であることを強調しています.

Q: LLMエージェントは通常、固定された行動空間の中でどのように活動し、それが彼らの成長の可能性をどのように制限しているのか?

A: LLMエージェントは通常、固定されたアクションスペース内で操作され、これにより成長の可能性が制限されます.この固定されたアクションスペースにより、エージェントは新しいアクションを学習する機会が制限され、経験に基づくスキルの獲得が妨げられます.人間が経験的な学習を通じて行動空間を拡大しスキルを発展させるのに対し、LLMエージェントは固定されたアクションスペース内で作動するため、成長の可能性が制限されます.

Q: 実験的評価で使用されたトレーニング課題の種類にはどのようなものがありますか?

A: 実験評価で使用されたトレーニングタスクの例には、4つの挑戦的なロボットプランニングタスクが含まれています.

Q: 人間はどのようにして自然に行動範囲を広げ、経験学習を通してスキルを身につけていくのだろうか?

A: 人間は経験的な学びを通じて、行動空間を自然に拡大し、スキルを発展させます.このプロセスでは、新しい行動タイプを獲得し、それを行動空間に組み込むことで、スキルを向上させます.

Q: 将来、よりインテリジェントなLLMエージェントを開発するために、あなたの研究はどのような意味を持つのでしょうか?

A: 将来のより知能的なLLMエージェントの開発に対する当研究の示唆は、言語エージェントが環境と相互作用し、行動を反復的に取るためにLLMをポリシーモデルとして使用することで、より高度な推論と計画を可能にするという点にあります.これにより、強化学習パラダイムでは難しい常識的な問題に取り組む新しい視点が提供され、エージェントの方針が単に試行錯誤から学習する強化学習パラダイムから進化する可能性があります.

Genie: Generative Interactive Environments

著者:Jake Bruce, Michael Dennis, Ashley Edwards, Jack Parker-Holder, Yuge Shi, Edward Hughes, Matthew Lai, Aditi Mavalankar, Richie Steigerwald, Chris Apps, Yusuf Aytar, Sarah Bechtle, Feryal Behbahani, Stephanie Chan, Nicolas Heess, Lucy Gonzalez, Simon Osindero, Sherjil Ozair, Scott Reed, Jingwei Zhang, Konrad Zolna, Jeff Clune, Nando de Freitas, Satinder Singh, Tim Rocktäschel

発行日:2024年02月23日

最終更新日:2024年02月23日

URL:http://arxiv.org/pdf/2402.15391v1

カテゴリ:Machine Learning, Artificial Intelligence, Computer Vision and Pattern Recognition

概要:

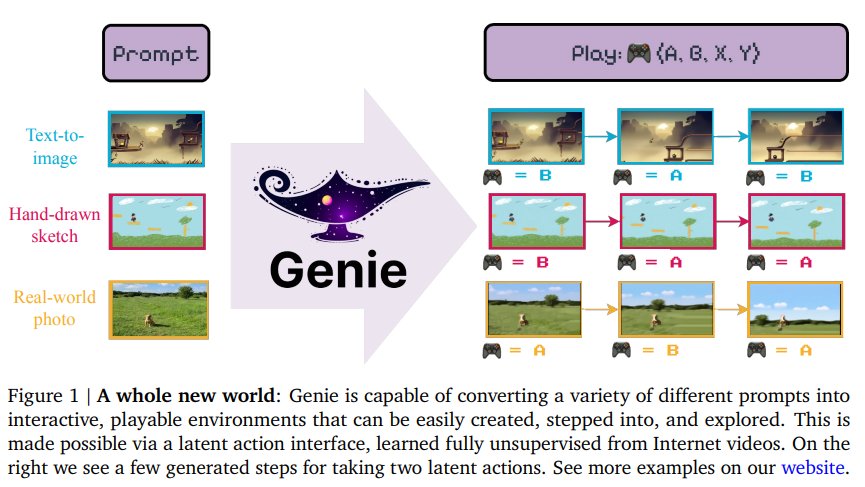

Genieは、未ラベルのインターネットビデオから教師なしで訓練された初の生成的インタラクティブ環境を紹介します.このモデルは、テキスト、合成画像、写真、さらにはスケッチを通じて説明される、無限の種類のアクション制御可能な仮想世界を生成するようにプロンプトできます.11Bのパラメータを持つGenieは、基礎ワールドモデルと見なすことができます.それは、時空間ビデオトークナイザ、自己回帰的ダイナミクスモデル、そしてシンプルでスケーラブルな潜在的なアクションモデルで構成されています.Genieは、通常ワールドモデルの文献に見られるような地面真実のアクションラベルやその他のドメイン固有の要件なしに訓練されたにもかかわらず、ユーザーが生成された環境でフレームごとに行動することを可能にします.さらに、結果として得られた学習された潜在的なアクション空間は、未知のビデオからの行動の模倣を訓練することを容易にし、将来の汎用エージェントの訓練の道を開くことができます.

Q&A:

Q: Genieはどのようにして、ラベル付けされていないインターネット動画から教師なしで学習させたのだろうか?

A: Genieは、未ラベルのインターネット動画から教師なし学習されました.モデルは、テキスト、合成画像、写真、さらにはスケッチを介して説明される、無限の種類のアクション可能な仮想世界を生成するように促されることができます.Genieは、時空間ビデオトークナイザー、自己回帰的ダイナミクスモデル、そして単純でスケーラブルな潜在的なアクションモデルから構成されており、地面の真実のアクションラベルや他のドメイン固有の要件がない状態でトレーニングされています.

Q: ジェネレイティブなインタラクティブ環境としてのGenieを構成する要素とは?

A: Genieは、ビデオのみのデータからトレーニングされた生成的インタラクティブ環境であり、主要なコンポーネントはVision Transformer(ViT)に基づいています.特に、ビデオには最大でO(10^4)トークンが含まれる可能性があるため、ビデオのための二次メモリコストがトランスフォーマーに課題を提起します.そのため、すべてのモデルコンポーネントでメモリ効率の高いST-transformerアーキテクチャ(Xu et al.(2020)に触発されたもの、図4を参照)を採用し、モデル容量と計算上の制約をバランスさせています.従来のトランスフォーマーでは、すべてのトークンが他のすべてのトークンにアテンドするのに対し、ST-transformerはそうではありません.

Q: Genieは、テキスト、合成画像、写真、スケッチを通して描写されるアクション制御可能な仮想世界をどのように生成するのか?

A: Genieは、テキスト、合成画像、写真、スケッチを介して説明されるアクション可能な仮想世界を生成するために、潜在的なアクションインターフェースを使用します.この潜在的なアクションインターフェースは、インターネットビデオから完全に教師なしで学習されます.

Q: ジーニーが11Bのパラメーターを持つファウンデーション・ワールド・モデルと見なされていることの意味は?

A: Genieが11Bのパラメータを持つ基礎ワールドモデルとして考えられることの重要性は、その大規模なパラメータ数により、複雑な環境や行動の生成を可能にし、未知のビデオからの振る舞いの模倣を促進することができる点にあります.

Q: Genieにおける時空間ビデオトークナイザー、自己回帰力学モデル、潜在行動モデルについて教えてください.

A: Genie内の空間時間ビデオトークナイザーは、ビデオフレームを入力として受け取り、それらを離散トークンzにトークナイズし、潜在的なアクションãを推論します.この潜在的なアクションは、各フレーム間の動作を捉えるために使用されます.これらはそれぞれをダイナミクスモデルに渡され、次のフレームの予測を反復的に生成します.オートレグレッシブダイナミクスモデルは、ビデオトークナイザーと潜在的なアクションモデルからの入力を受け取り、次のフレームの予測を生成します.潜在的なアクションモデルは、未ラベルのビデオフレームから無監督でアクションを学習します.このモデルは、ビデオトークナイザーと潜在的なアクションを組み合わせて、未知のビデオから行動を模倣するための学習された潜在的なアクション空間を提供します.

Q: Genieはどのようにして、ユーザーが生成された環境の中でフレーム単位で行動できるようにするのだろうか?

A: Genieは、フレームごとに制御可能な学習された潜在的なアクション空間を介して、地面の真実のアクションラベルや他のドメイン固有の要件がない状態でトレーニングを行うことにより、生成された環境でユーザーが行動することを可能にします.

Q: Genieの学習された潜在行動空間は、エージェントが未見のビデオから行動を模倣する訓練をどのように促進するのか?

A: Genieは、学習された潜在的な行動空間を使用して、未知のビデオからの行動を模倣するエージェントのトレーニングを容易にします.具体的には、Genieは凍結されたLAMを使用して、ターゲット環境からの専門家ビデオのシーケンスに離散的な潜在的な行動をラベル付けし、その後、専門家が潜在的な行動を取る確率を予測するポリシーをトレーニングします.さらに、専門家のグラウンドトゥルースアクションを持つ小さなデータセットを使用して、潜在的な行動を実際の行動にマッピングします.この方法により、Genieは行動やテキストの注釈なしでトレーニングされ、フレームごとに制御可能であり、未知のRL環境の画像から多様な軌跡を生成できます.

Q: Genieを使った将来のジェネラリスト・エージェントのトレーニングには、どのような応用が考えられますか?

A: 将来的なGenieを使用した一般的なエージェントのトレーニングの潜在的な応用としては、Genieが大規模なインターネットビデオデータセットから訓練されたワールドモデルとして使用される可能性があります.このモデルは、多様でリアルな環境をシミュレートし、ロボティクスの基礎ワールドモデルとして使用されることで、低レベルの制御可能なシミュレーションを提供し、さまざまなアプリケーションに活用できる可能性があります.

Q: Genieは、一般的にトレーニングにドメイン固有の要件を必要とする他のワールドモデルとどう違うのか?

A: ジーニーは、他のワールドモデルと異なり、トレーニングに特定のドメイン要件を必要としない.代わりに、ジーニーはビデオデータのみをトレーニングデータとして必要とし、フレームごとに制御可能な新しいクラスの生成モデルである.

Q: Genieをジェネレイティブ・インタラクティブ環境として開発・使用する上で、どのような制限や課題がありましたか?

A: Genieの開発と使用において遭遇した制限や課題は、長期的な視点で一貫した環境を得るための努力が必要であること、Genieが現在1FPSで動作しており、効率的なフレームレートを達成するためには将来の進展が必要であること、高価で一般化しない可能性のある行動があることなどです.