ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- LLAMA PRO: Progressive LLaMA with Block Expansion

発行日:2024年01月04日

大規模言語モデル(LLM)の新しい事後事前学習方法を提案し、コードと数学のコーパスで実験を行い、優れたパフォーマンスを発揮するLLAMA PRO-8.3Bモデルを得た.この研究は、自然言語とプログラミング言語を統合するための貴重な示唆を提供し、高度な言語エージェントの開発のための堅固な基盤を築くものである. - LLM Augmented LLMs: Expanding Capabilities through Composition

発行日:2024年01月04日

本研究では、既存の基礎モデルと具体的なモデルを組み合わせるCALMを提案し、新しい機能を可能にすることを研究しています.CALMは、モデル間のクロスアテンションを使用して、既存の機能を保持しながら新しいタスクにおけるスケーリングを実現します.PaLM2-SにCALMを追加することで、英語への翻訳やコード生成などのタスクにおいて改善が見られました. - Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation

発行日:2024年01月04日

本研究では、モービルマニピュレーションタスクの模倣学習に向けたシステムを開発し、データ収集と教師ありの行動クローニングを組み合わせることで、モービルALOHAのパフォーマンスを最大90%向上させることができた.具体的なタスクには、エビの炒め物やキッチンの蛇口を使ったフライパンの洗浄などが含まれる. - GPT-4V(ision) is a Generalist Web Agent, if Grounded

発行日:2024年01月03日

GPT-4VとGeminiは、従来のタスクを越えてマルチモーダルモデルの能力を急速に拡張している.本研究では、GPT-4Vが、あらゆるウェブサイト上で自然言語の指示に基づくタスクを完了できる一般的なウェブエージェントとしての可能性を探り、SEEACTエージェントを提案し、MIND2WEBベンチマークを用いて評価する.また、ウェブエージェントをライブウェブサイト上で実行するツールを開発することで、新たなオンライン評価設定を開発する可能性を持つ. - Instruct-Imagen: Image Generation with Multi-modal Instruction

発行日:2024年01月03日

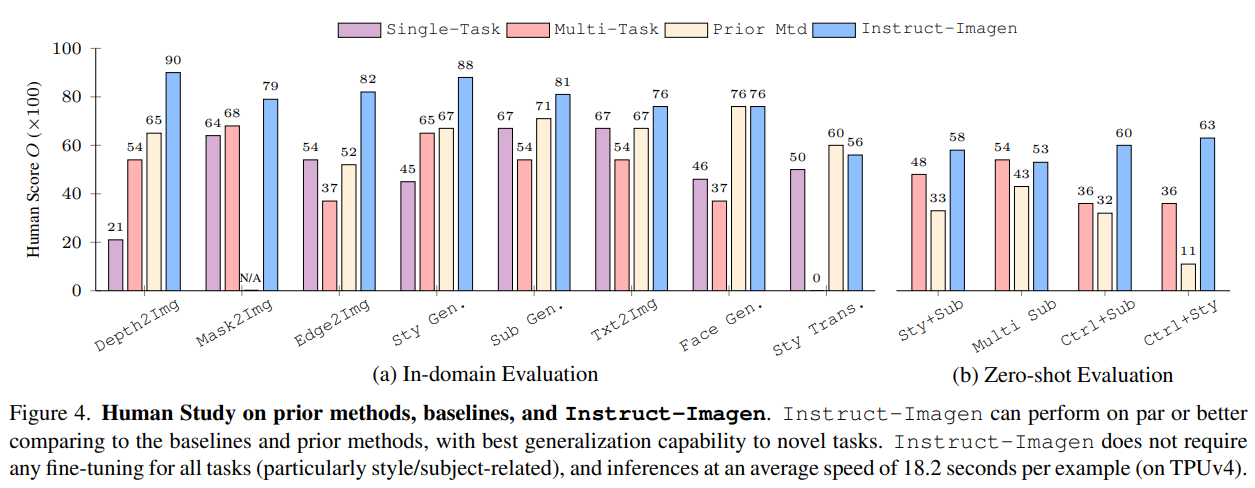

この論文では、instruct-imagenというモデルを提案し、異種の画像生成タスクに取り組み、未知のタスクにも汎化する能力を持つことを示しました.instruct-imagenはマルチモーダルな指示を使用して生成意図を表現し、リトリーバル拡張トレーニングとビジョン言語理解を組み合わせてモデルを微調整しました.人間の評価により、instruct-imagenは以前のモデルと同等以上の性能を示し、未知のタスクにも有望な汎化性能を示すことが明らかになりました. - A Comprehensive Survey of Hallucination Mitigation Techniques in Large Language Models

発行日:2024年01月02日

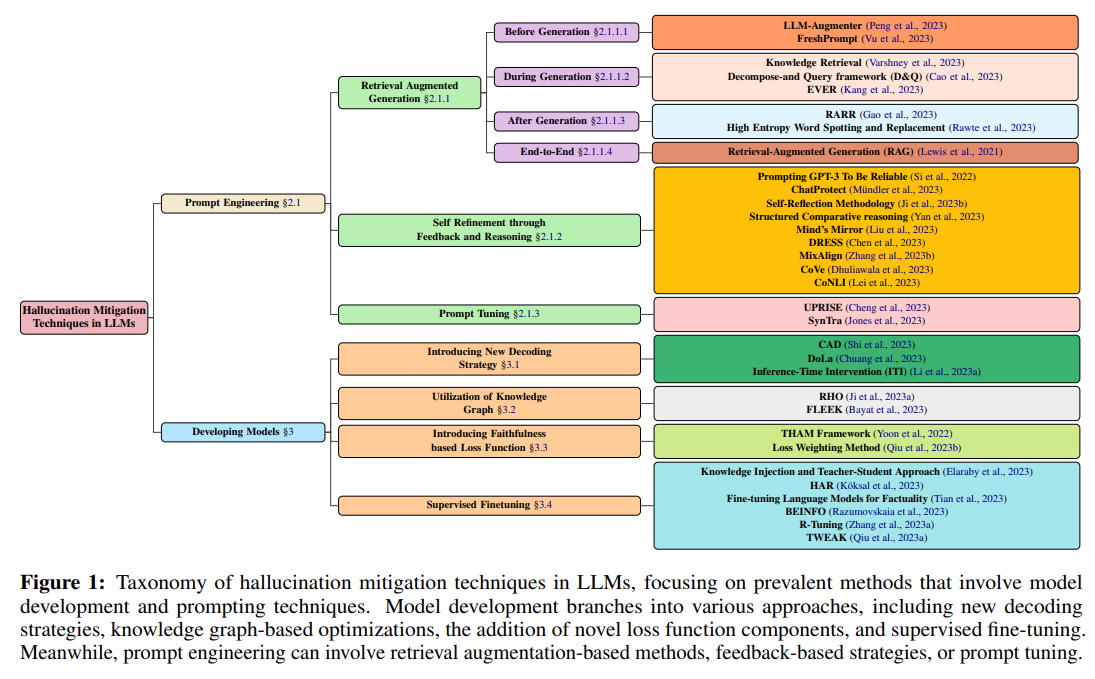

大規模言語モデル(LLM)の普及には、幻覚の問題を軽減することが重要であり、32以上の技術が開発されている.これらの技術は、データセットの利用やフィードバックメカニズムなどのパラメータに基づいて分類され、LLMの幻覚問題に取り組むためのアプローチを区別するのに役立つ. - Self-Play Fine-Tuning Converts Weak Language Models to Strong Language Models

発行日:2024年01月02日

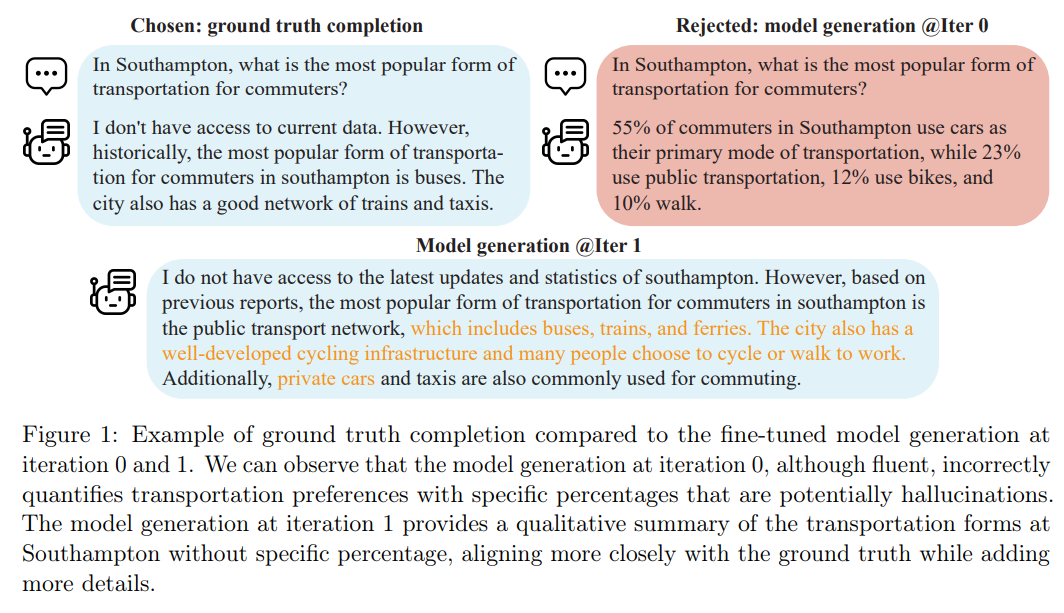

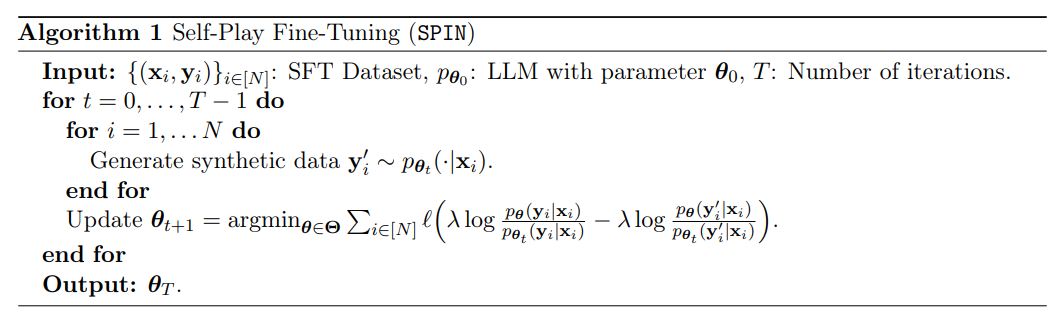

この論文では、Supervised Fine-Tuning(SFT)を通じて人間によって注釈付けされたデータの力を活用し、追加の注釈付けデータを必要とせずに強力な言語モデルを育成するための新しい微調整方法であるSPINを提案しています.SPINは、自己対戦メカニズムを使用してモデルの能力を向上させ、人間レベルのパフォーマンスを達成することができます. - If LLM Is the Wizard, Then Code Is the Wand: A Survey on How Code Empowers Large Language Models to Serve as Intelligent Agents

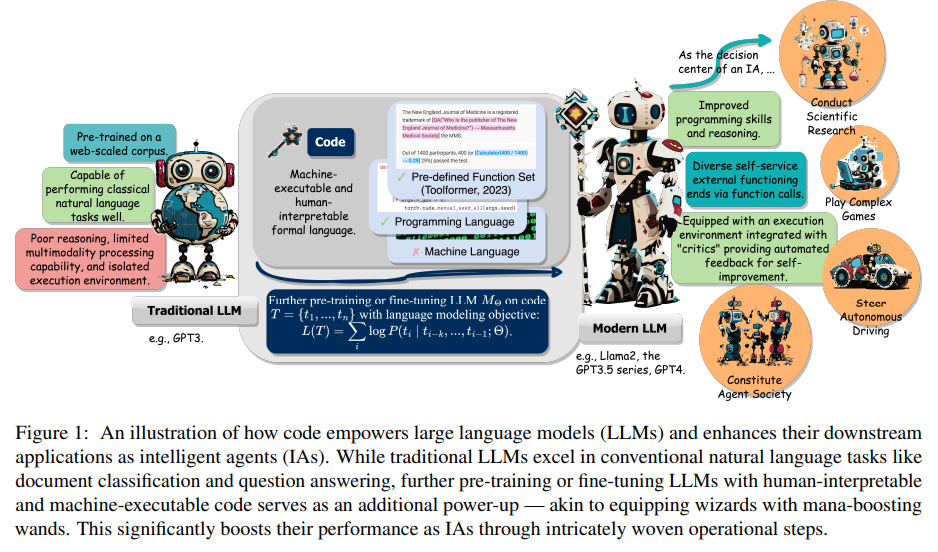

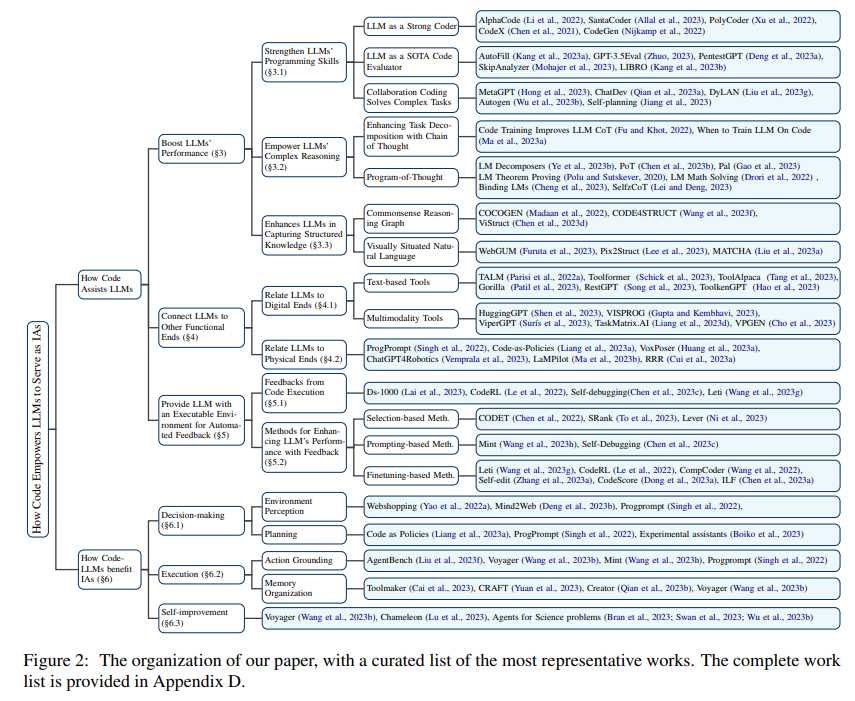

発行日:2024年01月01日

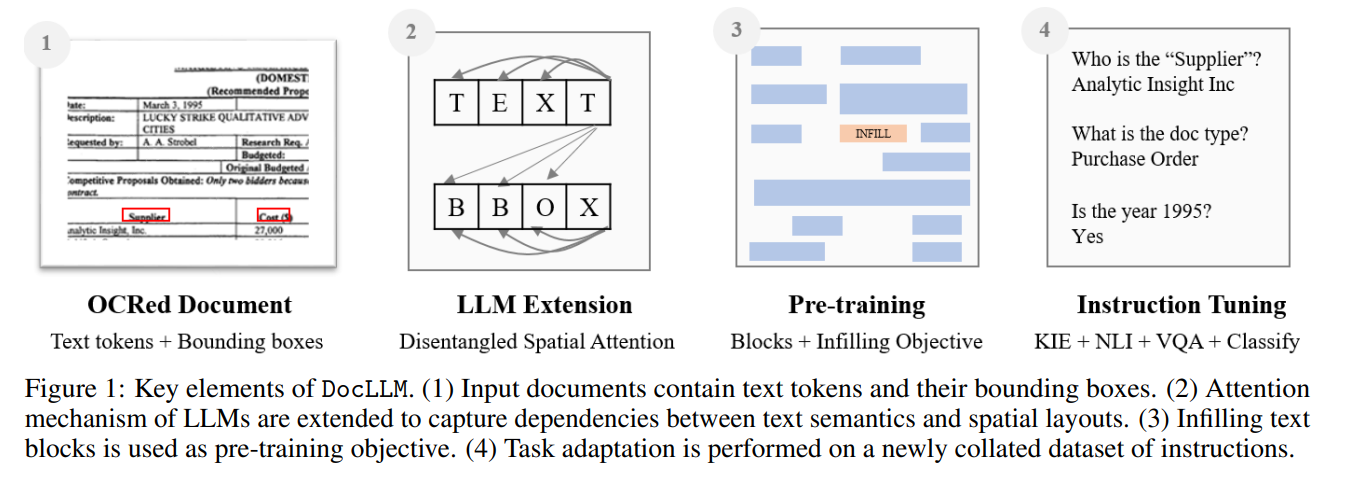

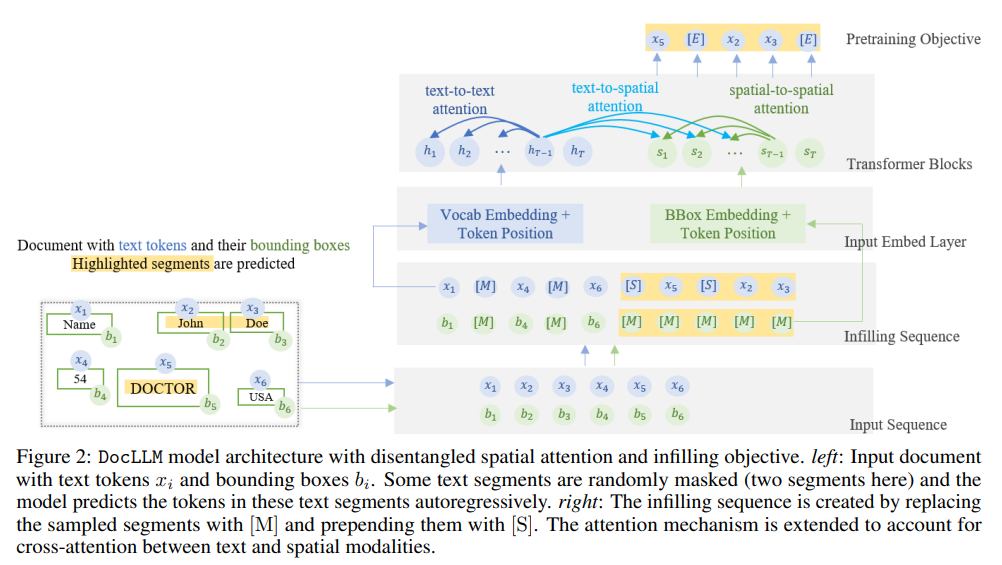

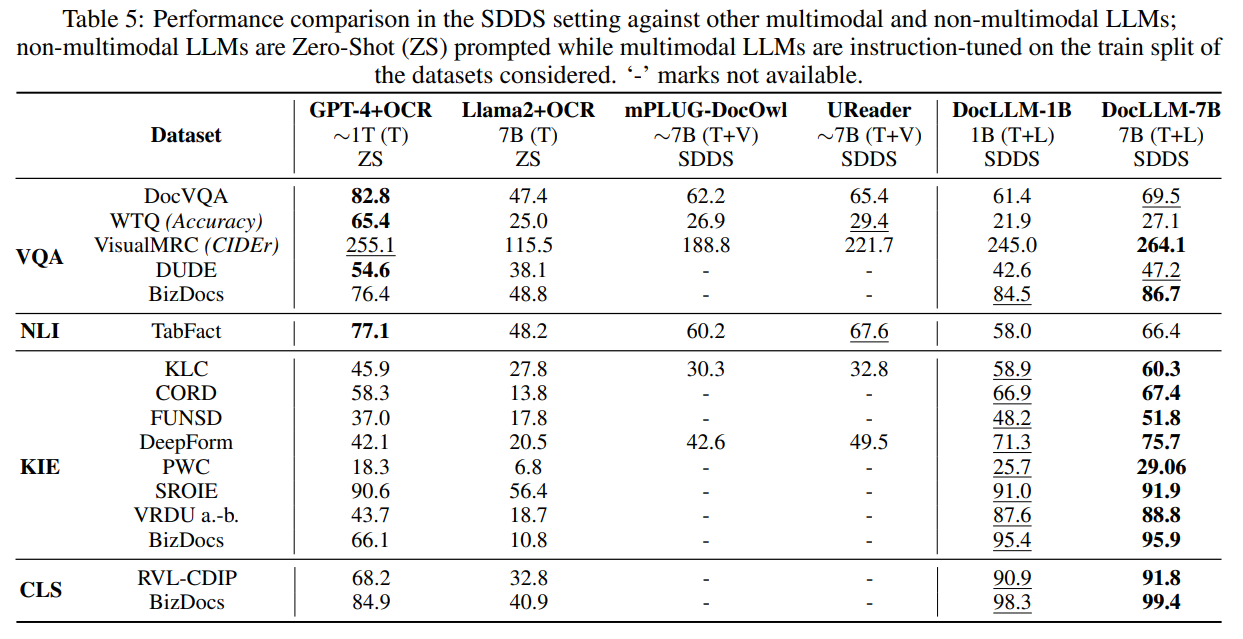

現在の主要な大規模言語モデル(LLM)は、自然言語とコードの組み合わせで訓練されており、コードの特性によって推論能力が引き出され、構造化された中間ステップを生成し、コンパイルと実行環境を活用することができる.また、これらの能力は知的エージェント(IA)の出現につながっており、LLMにコードを組み込むことには課題と将来の方向性がある. - DocLLM: A layout-aware generative language model for multimodal document understanding

発行日:2023年12月31日

この論文では、企業文書のテキストと空間のモダリティの交差点での意味の豊かさと、視覚的な手がかりが文書の理解に重要であることが述べられています.また、テキストと空間のモダリティを考慮した視覚文書の推論のための軽量な拡張モデルであるDocLLMが提案され、多くのタスクで優れた性能を示すことが示されました. - Fast Inference of Mixture-of-Experts Language Models with Offloading

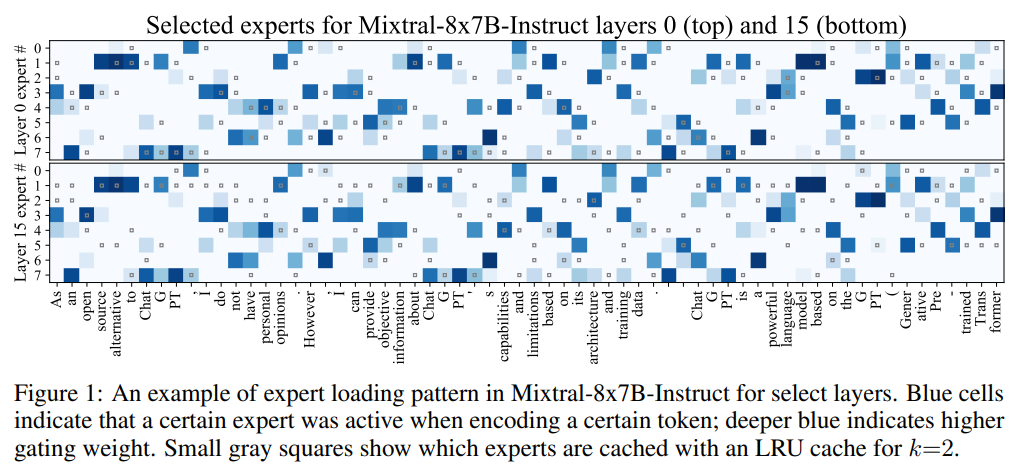

発行日:2023年12月28日

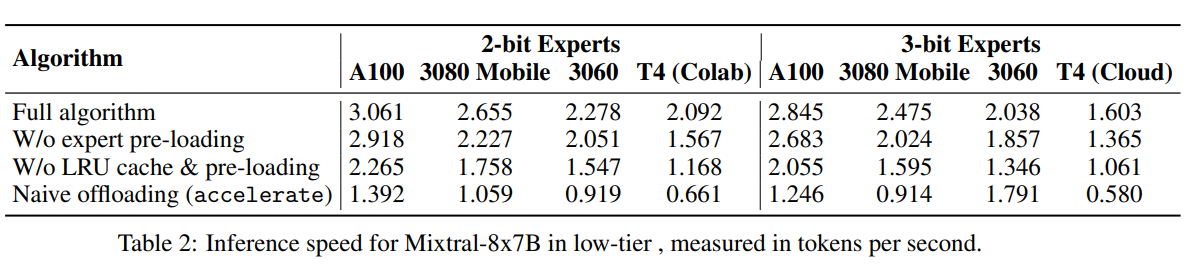

大規模な言語モデルの効率的な実行戦略として、スパースなMixture-of-Experts(MoE)を使用することが提案されており、本研究では制限されたアクセラレータメモリでMoE言語モデルを実行するための新しい戦略が提案されています.

LLAMA PRO: Progressive LLaMA with Block Expansion

著者:Chengyue Wu, Jiahao Wang, Ping Luo, Ye Feng, Ying Shan, Yixiao Ge, Yukang Gan, Zeyu Lu

発行日:2024年01月04日

最終更新日:不明

URL:https://arxiv.org/pdf/2401.02415.pdf

カテゴリ:不明

概要:

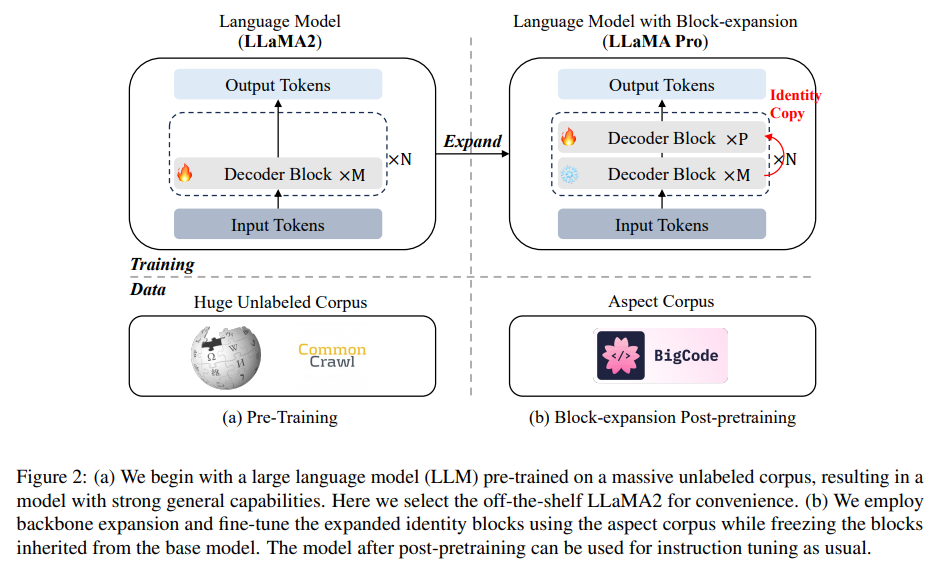

人間は一般的に新しいスキルを獲得する際に、古いスキルを損なうことなく獲得する傾向がありますが、大規模言語モデル(LLM)では逆の傾向があります.そこで、私たちはTransformerブロックの拡張を用いたLLMの新しい事後事前学習方法を提案します.私たちは新しいコーパスのみを使用して拡張ブロックを調整し、モデルの知識を効果的かつ効率的に向上させることで、壊滅的な忘却を回避します.本論文では、コードと数学のコーパスで実験を行い、LLAMA PRO-8.3Bという、LLaMA2-7Bから初期化された多目的な基礎モデルを得ました.LLAMA PROおよびその指示に従う対応モデル(LLAMA PRO – INSTRUCT)は、さまざまなベンチマークで優れたパフォーマンスを発揮し、LLaMAファミリーの既存のオープンモデルに対して優位性を示し、知的エージェントとして多様なタスクの推論と対処の潜在能力を示しています.私たちの研究結果は、自然言語とプログラミング言語を統合するための貴重な示唆を提供し、さまざまな環境で効果的に動作する高度な言語エージェントの開発のための堅固な基盤を築くものです.

Q&A:

Q: Transformerブロックの拡張を伴うLLMのポスト再トレーニング方法の提案は?

A: 提案された事後事前トレーニング方法は、Transformerブロックの拡張によるLLMの拡張です.

Q: 新しいコーパスだけを使って、どのように拡張ブロックを調整するのか?

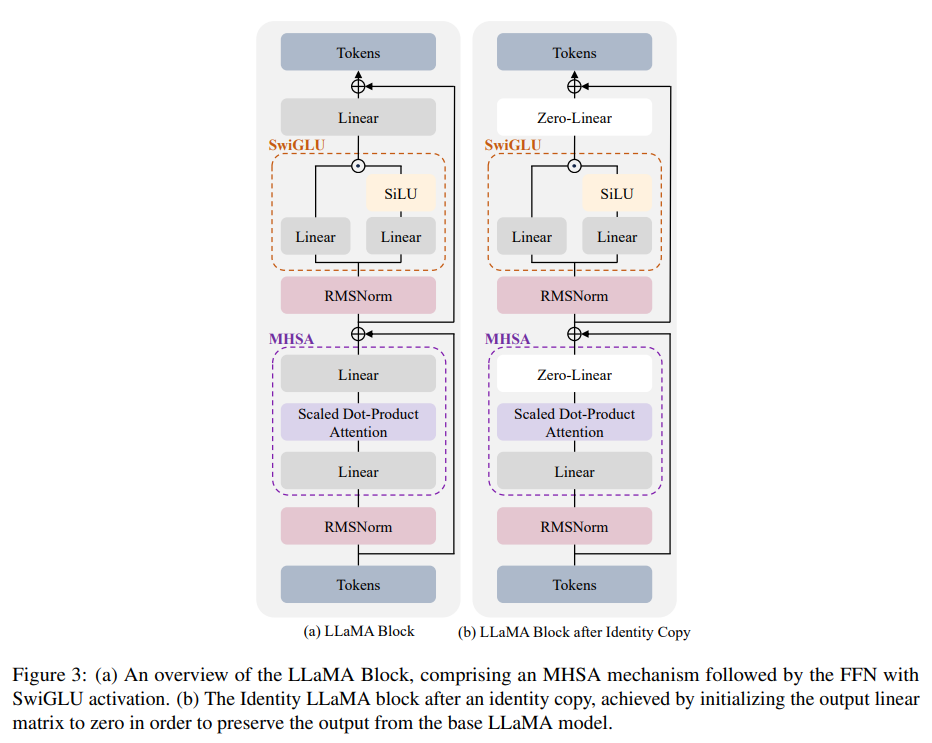

A: 新しく追加されたブロックは、ゼロで初期化された線形層を持ち、アイデンティティマッピングを可能にするため、ドメイン固有のコーパスのみで調整されます.調整後、拡張された事前学習モデルは一般的なタスクとドメイン固有のタスクの両方で優れた性能を発揮します.

Q: 提案されている方法でトランスブロックを拡張する目的は何ですか?

A: 提案された方法でTransformerブロックを拡張する目的は、LLMにドメイン固有の知識を注入しながら一般的な能力を保持し、総合的な能力を向上させることです.

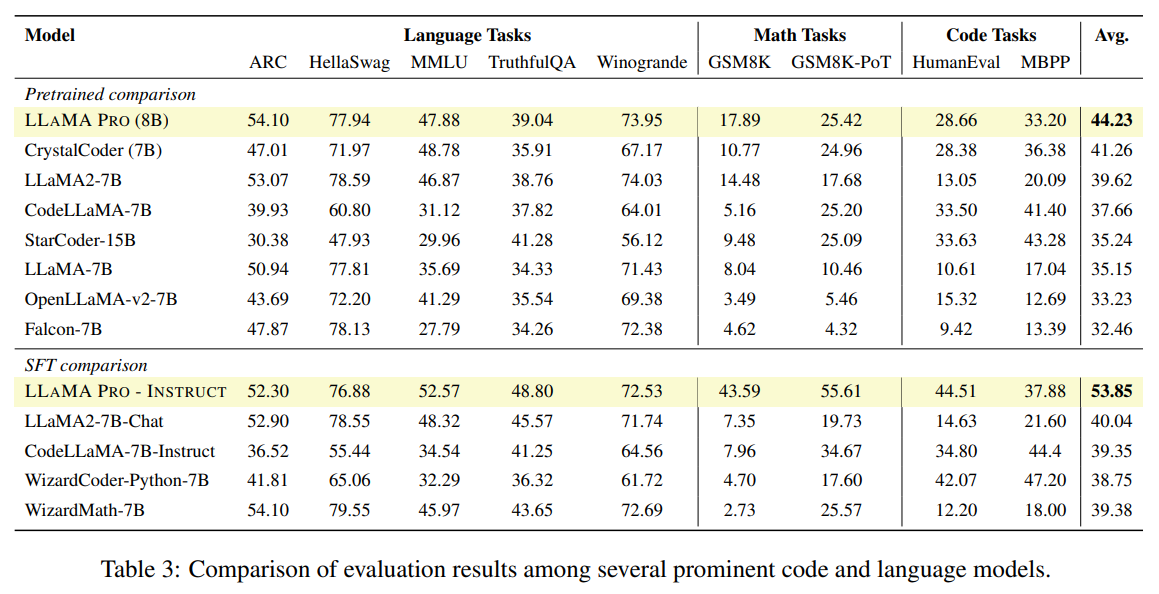

Q: LLAMA PRO-8.3Bはどのようなタスクに優れていますか?

A: LLAMA PRO-8.3Bは一般的な言語タスク、コードタスク、数学タスクに優れています.

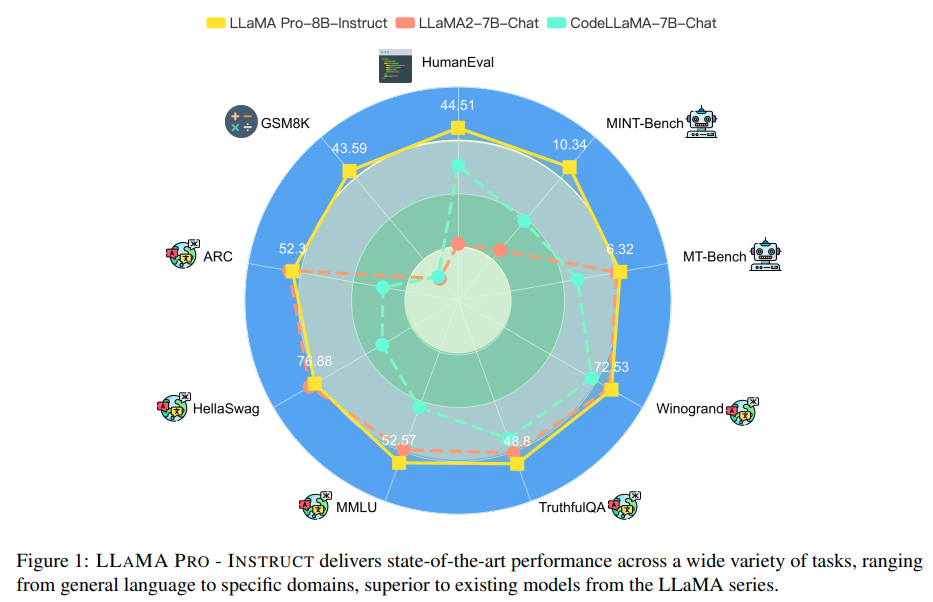

Q: LLAMA PROはLLaMAファミリーの既存のオープンモデルと比較してどうですか?

A: LLAMA PROは自然言語処理とコーディング能力のバランスを効果的に保ちます.ベースモデルであるLLaMA2-7Bの一般的な性能はそのままに、プログラミング、コーディング、推論の性能を向上させました.LLAMA PROは、LLaMAシリーズの既存モデルを凌駕し、様々なタスクにおいて最先端の性能を発揮します.

Q: LLAMA PROとLLAMA PRO – INSTRUCTのパフォーマンスを評価するために、どのようなベンチマークが使われましたか?

A: LLAMA PROとLLAMA PRO-INSTRUCTは、タスク型ベンチマーク、MINT-Bench、MT-Bench、HumanEval、GSM8K、MBPPを含む様々なベンチマークで評価されました.

Q: LLAMA PROは先進的な言語エージェントの開発にどのように貢献していますか?

A: LLAMA PROは、高度な言語エージェントの開発にいくつかの方法で貢献しています.まず、ブロック拡張と呼ばれる新しい事前学習後の手法を導入し、言語モデルの初期能力を保持しながら新しい知識の注入を可能にします.この手法により、自然言語とプログラミング言語を統合する能力が向上し、一般的なタスク、プログラミング、数学で優れた性能を発揮することができます.また、LLAMA PROとLLAMA PRO-INSTRUCTは、従来のタスクとエージェント指向のタスクの両方を含む広範なデータセットでベンチマークされた多目的な言語モデルです.これらのベンチマークの結果は、LLAMA PROの優位性と広範な複雑なアプリケーションでの大きな潜在能力を示しています.全体として、LLAMA PROの事前学習後の技術への貢献、自然言語とプログラミング言語の統合、さまざまなベンチマークでのパフォーマンスは、高度な言語エージェントの開発に貢献しています.

Q: LLAMA PROが知的エージェントとして推論し、多様なタスクに対応する可能性について詳しく教えてください.

A: LLAMA PROは、多様なタスクに対して推論と対応を行う知的エージェントとしての潜在能力を持っています.LLAMA PROは、一般的なタスク、プログラミング、数学の分野で優れた性能を発揮し、他のLLAMAファミリーモデルに比べて優れた能力を持っています.また、自然言語とプログラミング言語を統合することにより、さまざまな環境で効果的に動作する高度な言語エージェントの開発に向けた堅固な基盤を提供しています.

LLM Augmented LLMs: Expanding Capabilities through Composition

著者:Rachit Bansal, Bidisha Samanta, Siddharth Dalmia, Nitish Gupta, Shikhar Vashishth, Sriram Ganapathy, Abhishek Bapna, Prateek Jain, Partha Talukdar

発行日:2024年01月04日

最終更新日:2024年01月04日

URL:http://arxiv.org/pdf/2401.02412v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Computer Vision and Pattern Recognition

概要:

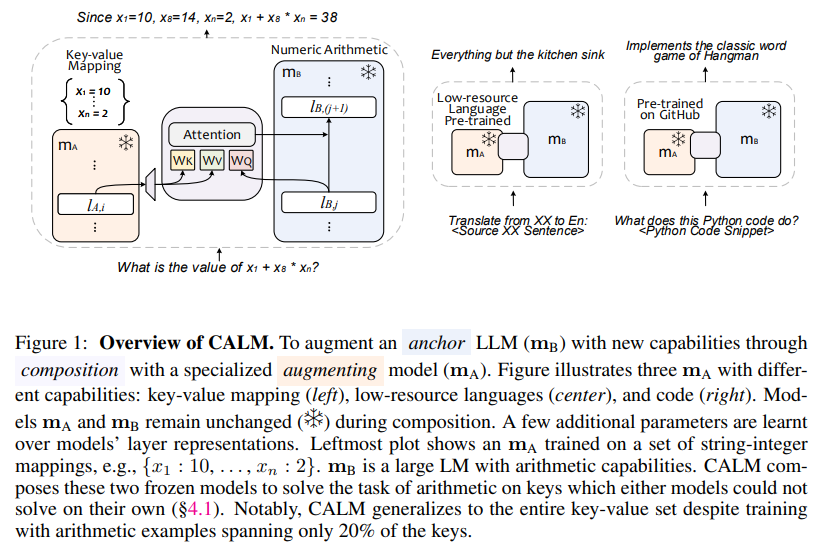

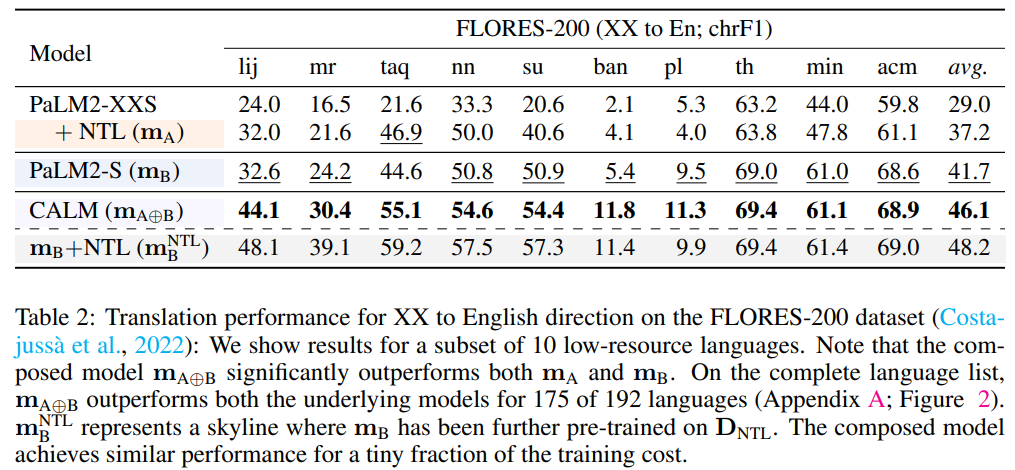

数十億のパラメータを持つ基礎モデルは、大規模なデータコーパスで訓練されており、さまざまなドメインで非自明なスキルを示しています.しかし、その一方で、これらのモデルは一体的な構造を持っているため、それらを拡張したり新しいスキルを与えたりすることは困難であり、費用もかかります.一方、適応能力を持つため、これらのモデルの新しいインスタンスが新しいドメインやタスクに向けて訓練されています.本研究では、既存の基礎モデルとより具体的なモデルを効率的かつ実用的に組み合わせて新しい機能を可能にする問題を研究しています.そのために、私たちはCALM(Composition to Augment Language Models)を提案しています.CALMは、モデル間のクロスアテンションを導入して、それらの表現を組み合わせ、新しい機能を可能にします.CALMの特徴は次のとおりです:(i) 既存のLLMに追加のパラメータとデータを使用して新しいタスクにおけるLLMのスケーリングを実現します.(ii) 既存のモデルの重みはそのまま保持されるため、既存の機能も維持されます.(iii) 様々なドメインや設定に適用可能です.私たちは、低リソース言語で訓練された小さなモデルをPaLM2-Sに追加することで、PaLM2-Sの拡張が可能であることを示しています.さらに、低リソース言語で訓練された小さなモデルを使用することで、英語への翻訳や算術的な推論などのタスクにおいて、PaLM2-Sの絶対的な改善率が最大13%向上しました.同様に、PaLM2-Sにコード専用のモデルを追加すると、コード生成や説明のタスクにおいて、ベースモデルと比較して40%の相対的な改善率が見られました.これは、完全にファインチューニングされたモデルと同等の結果です.

Q&A:

Q: 何十億ものパラメータを持つ既存の基礎的なモデルを補強し、新たなスキルを付与する上での課題は何か?

A: 既存の基礎モデルに新しいスキルを追加したり、新しいスキルを与えることの課題は、そのモデルのモノリシックな構造によるものです.これにより、それらを拡張したり新しいスキルを与えることは困難であり、コストもかかります.また、既存のモデルを新しいドメインやタスクに適応させる能力があるため、これらのモデルの新しいインスタンスがいくつもトレーニングされています.しかし、これらのモデルは独立してトレーニングされているため、それらを組み合わせることは難しいです.

Q: CALM(Composition to Augment Language Models:言語モデルを拡張するコンポジション)は、既存の基礎モデルとより特殊なモデルとのコンポジションをどのように可能にするのか?

A: CALMは、既存の基礎モデルとより具体的なモデルの組み合わせを可能にするために、モデル間のクロスアテンションを導入してそれらの表現を組み合わせ、新しい機能を実現します.これは、拡張とアンカーモデルの中間層の表現に対して、少数の学習可能なパラメータを導入することによって達成されます.CALMは、与えられたモデルの効果的な組み合わせを見つけ、個々のモデルの能力を保持しながら、単独のモデルよりも新しい難しいタスクをより正確に実行します.

Q: CALMの特長は何ですか?

A: CALMの顕著な特徴は次のとおりです:(i) モデル間のクロスアテンションを導入して、モデルの表現を組み合わせ、新しい機能を可能にすること.(ii) プロプライエタリなデータと知識がパラメトリックモデルに格納されているシナリオで特に有用であること.(iii) CALMを使用することで、基礎となるLLMにプロプライエタリなモデルを追加して、推論、世界知識、ターゲットのプロプライエタリドメイン上での一貫した生成など、さまざまな基礎的な機能を拡張できること.(iv) CALMの拡張は、複数の追加モデルから異なる知識を取得するために使用できること.

Q: CALMは新しいタスクで言語モデル(LLM)をどのようにスケールアップするのか?

A: CALMは、既存のLLMといくつかの追加のパラメータとデータを使用して、新しいタスクにおいてLLMをスケーリングアップします.既存のモデルの重みはそのまま保持されるため、既存の機能も保持されます.

Q: CALMはLLMの既存の能力をどのように維持するのか?

A: CALMは、モデル間のクロスアテンションを導入することで、LLMの既存の機能を維持し、その表現を構成して新たな機能を実現する.これにより、言語カバレッジ、推論能力、コード補完と説明を拡張することができる.アンカーLLMを補強モデルで補強することにより、CALMは低リソース言語や特殊なドメインにおける翻訳、数学語問題解決、コード補完能力を大幅に向上させる.CALMは、既存のLLMを再利用し、合成によっていくつかの機能を追加することでこれを実現する.

Q: CALMは多様な領域や環境に適用できるか?

A: はい、CALMは異なるドメインや設定に適用することができます.

Q: PaLM2-Sを低リソース言語で学習したより小さなモデルで補強することで、英語への翻訳や低リソース言語の算術推論がどのように改善されるのか、例を挙げていただけますか?

A: PaLM2-Sと低リソース言語で訓練された小さなモデルを組み合わせることで、英語への翻訳や低リソース言語の算術的推論の改善例を提供できます.例えば、PaLM2-Sに低リソース言語で訓練されたモデルを追加することで、英語への翻訳タスクでは最大13%の絶対的な改善が見られます.同様に、PaLM2-Sにコード専用のモデルを追加することで、コード生成や説明タスクではベースモデルと比較して40%の相対的な改善が見られます.

Q: PaLM2-Sをコード生成と説明のタスクのためのコードに特化したモデルで補強した場合、40%という相対的な改善率を説明できますか?

A: PaLM2-Sのコード固有モデルとの組み合わせによる相対的な改善率40%は、ベースモデルに比べてコード生成と説明のタスクでの性能向上を示しています.これは、コード固有モデルが特定のタスクに特化しており、PaLM2-Sの基本モデルよりも優れた性能を持っているためです.

Q: CALMは、既存のモデルのウェイトをどのように維持するのですか?

A: CALMは、拡張モデルとアンカーモデルの中間層表現にわずかな数の学習可能なパラメータを導入することで、既存のモデルの重みを保持します.これらの学習可能なパラメータにより、CALMは個々のモデルの重みを更新せずに、与えられたモデルの効果的な組み合わせを見つけることができます.CALMはこれらの学習可能なクロスアテンションパラメータを通じてモデル間の密な相互作用を学習し、個々のモデルの能力を保持しながら、両方のモデルの専門知識を活用することができます.

Q: 言語モデルの構成や補強にCALMを使うことの限界や潜在的な欠点はありますか?

A: CALMは、言語モデルの構成と拡張において制約と潜在的な欠点があります.1つの制約は、異なるサイズと事前学習目標を持つモデルを組み合わせる場合に、CALMの効果が不明であるということです.つまり、異なるアーキテクチャで訓練された言語モデルや異なるタスクで訓練された言語モデルを組み合わせる場合、CALMはうまく機能しない可能性があります.もう1つの潜在的な欠点は、CALMが中間層の表現を拡張モデルとアンカーモデルの両方に対して少数の学習可能なパラメータを導入することです.これにより、CALMは効果的なモデルの組み合わせを見つけることができますが、CALMの訓練と微調整には追加の計算コストと複雑さが発生します.さらに、CALMは個々のモデルの能力を常に保持するわけではありません.新しい難しいタスクをより正確に実行する組み合わせを見つけることを目指しているため、CALMは個々のモデルの強みと能力の一部を犠牲にする可能性があります.

Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation

著者:Zipeng Fu, Tony Z. Zhao, Chelsea Finn

発行日:2024年01月04日

最終更新日:2024年01月04日

URL:http://arxiv.org/pdf/2401.02117v1

カテゴリ:Robotics, Artificial Intelligence, Computer Vision and Pattern Recognition, Machine Learning, Systems and Control, Systems and Control

概要:

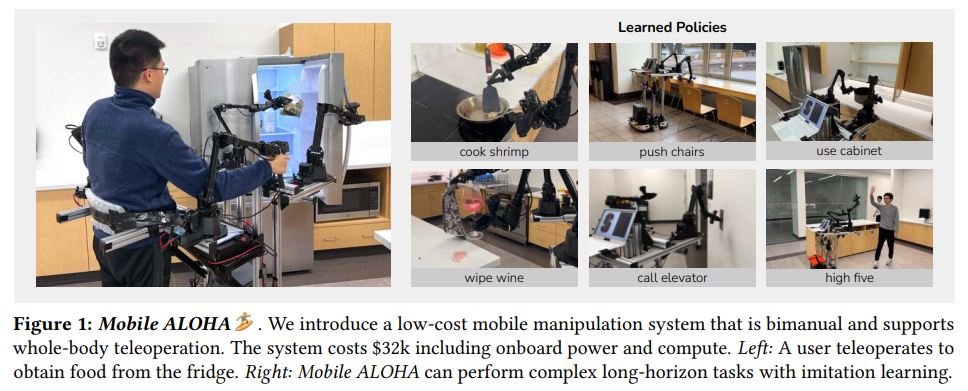

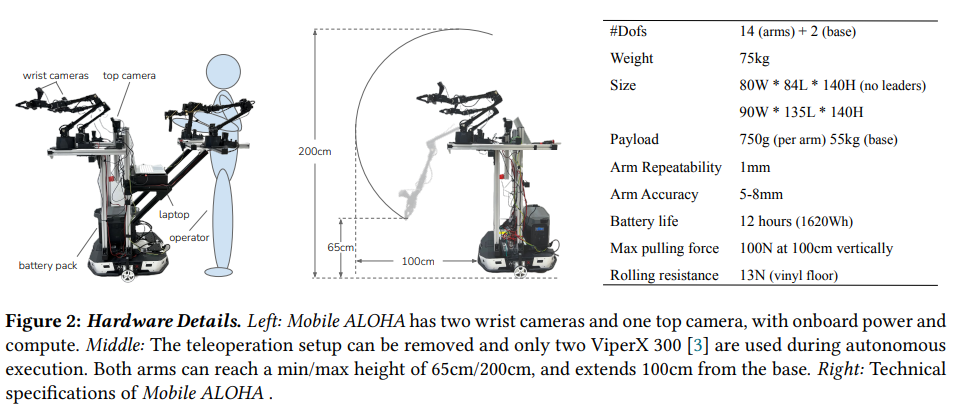

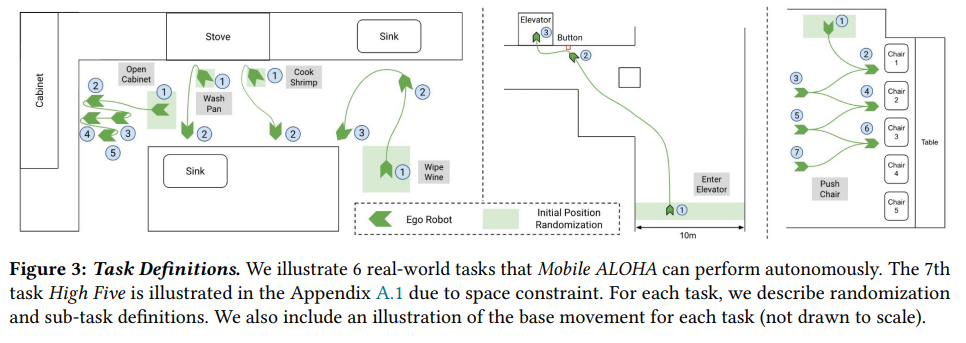

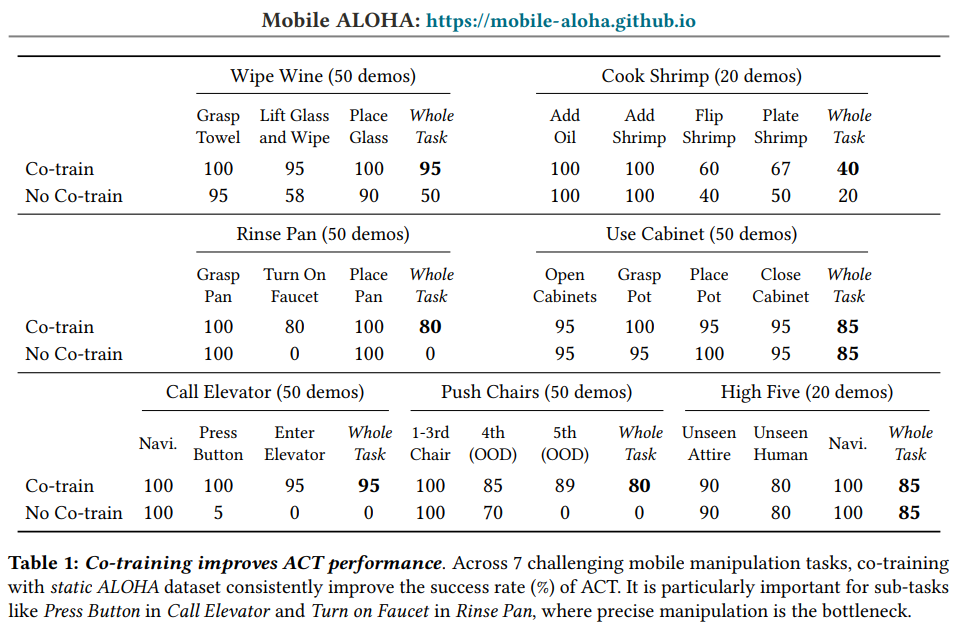

人間のデモンストレーションからの模倣学習は、ロボティクスにおいて印象的なパフォーマンスを示しています.しかし、ほとんどの結果はテーブルトップの操作に焦点を当てており、一般的に有用なタスクに必要な機動性と器用さが欠けています.本研究では、両手を使い、全身の制御が必要なモービルマニピュレーションタスクの模倣に向けたシステムを開発しました.まず、データ収集のための低コストで全身のテレオペレーションシステムであるMobile ALOHAを提案します.これは、モービルベースと全身のテレオペレーションインターフェースをALOHAシステムに追加したものです.Mobile ALOHAで収集したデータを使用して、教師ありの行動クローニングを行い、既存の静的ALOHAデータセットとの共同トレーニングによってモービルマニピュレーションタスクのパフォーマンスを向上させることを発見しました.各タスクについて50のデモンストレーションを行うことで、共同トレーニングによって成功率を最大90%向上させることができ、Mobile ALOHAは自律的に複雑なモービルマニピュレーションタスクを完了することができます.具体的なタスクとしては、エビの炒め物や重い調理鍋を収納するための二つのドアの壁キャビネットの開閉、エレベーターの呼び出しと乗り込み、キッチンの蛇口を使って使用済みのフライパンを軽く洗浄するなどがあります.プロジェクトのウェブサイトは以下の通りです:https://mobile-aloha.github.io

Q&A:

Q: モバイルALOHAシステムの目的は何ですか?

A: Mobile ALOHAの目的は、データ収集のための低コストで全身を操作できるシステムを提供することです.Mobile ALOHAは、モバイルベースと全身を操作するインターフェースをALOHAシステムに追加することで、データ収集を行います.また、既存の静的ALOHAデータセットとの共同トレーニングにより、Mobile ALOHAの性能を向上させることができます.

Q: モバイルALOHAとALOHAシステムの違いは?

A: モバイルALOHAは、モバイルベースと全身遠隔操作インターフェースを追加することで、ALOHAシステムとは異なる.これにより、モバイルALOHAはデータ収集を行い、複雑な移動操作スキルを習得することができる.モバイルベースは、システムが環境内を移動・ナビゲートすることを可能にし、全身遠隔操作インターフェースは、複雑な移動操作タスクの高品質なデモンストレーションを可能にする.さらに、モバイルALOHAは、ACT、拡散政策、チャンキングを伴うVINNなど、さまざまなタイプの模倣学習法と連携することができ、静的なALOHAデータセットとの共同学習から恩恵を受けることができる.

Q: モバイルALOHAで全身遠隔操作インターフェースを使う利点は何ですか?

A: Mobile ALOHAの全身テレオペレーションインターフェースの利点は、複雑なモバイル操作タスクにおいて高品質なデモンストレーションを収集することができることです.全身テレオペレーションにより、ユーザーはロボットの全身を制御することができ、複雑な操作や移動が必要なタスクに対応することができます.これにより、Mobile ALOHAはより幅広いタスクを実行することができ、一般的に有用なタスクに適した機動性と器用さを持つことができます.

Q: モバイルALOHAは模倣学習のためのデータをどのように収集しているのか?

A: モバイルALOHAは、異なるが類似したタイプのロボットから収集された多様な実世界データセットを組み合わせる協調学習パイプラインを使用することで、模倣学習のためのデータを収集する.このアプローチは、特殊なデータセットにおける視覚的多様性の制限に対処するのに役立ち、これらのデータセットで学習されたポリシーを知覚摂動に対してよりロバストにする.この協調学習パイプラインは、シングルアーム操作とナビゲーションタスクにおいて有望な結果を示している.データの収集方法の具体的な詳細は、与えられた文脈では言及されていない.

Q: 既存の静的ALOHAデータセットとの協調学習は、モバイル操作タスクのパフォーマンスをどのように向上させるのか?

A: 既存の静的ALOHAデータセットとの共同トレーニングにより、モバイル操作タスクのパフォーマンスが向上します.共同トレーニングパイプラインは、静的な二手操作データセットを活用しており、すべてのタスクといくつかの模倣学習手法において、モバイル操作ポリシーのパフォーマンスとデータ効率が向上することを示しています.

Q: この研究では、各タスクに何回のデモンストレーションが行われるのか?

A: 各タスクには25、35、または50のデモンストレーションが使用されました.

Q: モバイルALOHAが自律的にこなすことができる複雑な移動操作タスクの例にはどのようなものがあるか?

A: モバイルALOHAは、エビを炒めて盛り付ける、重い調理鍋を収納するために2ドアの壁面キャビネットを開ける、エレベーターを呼び出して乗り込む、軽く動かす、といった複雑な移動操作タスクを自律的にこなすことができる.

Q: この文章にあるプロジェクトのウェブサイトについて、もう少し詳しく教えてください.

A: Mobile ALOHAは、https://mobile-aloha.github.ioというプロジェクトのウェブサイトです.このウェブサイトは、様々な研究者や開発者によって共同で作成されたものであり、ロボット制御やモバイルマニピュレーションシステムに関する情報や研究成果が公開されています.具体的には、複雑なタスクのワンショット教育に関する研究や、ビジョン・言語・アクションモデルの開発に関する研究などが含まれています.このウェブサイトは、arXiv preprint arXiv:2207.09450およびarXiv preprint arXiv:2307.15818という論文で言及されています.

Q: この文章で紹介されている研究の全体的な目標は何ですか?

A: この研究の全体的な目標は、Mobile ALOHAを使用して人間とロボットの相互作用を研究することです.

Q: モバイルALOHAシステムはロボット工学の分野にどのように貢献するのか?

A: モバイルALOHAは、複雑なモバイルマニピュレーションタスクの高品質なデモンストレーションを可能にするシステムを提供することで、ロボティクスの分野に貢献しています.このシステムは、モバイルベースと全身テレオペレーションを利用してこれらのデモンストレーションを収集し、それらは模倣学習に使用されます.このシステムは、オープンソースのソフトウェアとハードウェアを使用してアクセス可能で手頃な価格に設計されています.シンプルさとパフォーマンスにもかかわらず、開発者は今後の作業で改善を目指している制約事項がまだあります.例えば、占有面積の削減やアームの昇降にさらなる自由度の追加などです.

GPT-4V(ision) is a Generalist Web Agent, if Grounded

著者:Boyuan Zheng, Boyu Gou, Jihyung Kil, Huan Sun, Yu Su

発行日:2024年01月03日

最終更新日:2024年01月03日

URL:http://arxiv.org/pdf/2401.01614v1

カテゴリ:Information Retrieval, Artificial Intelligence, Computation and Language, Computer Vision and Pattern Recognition

概要:

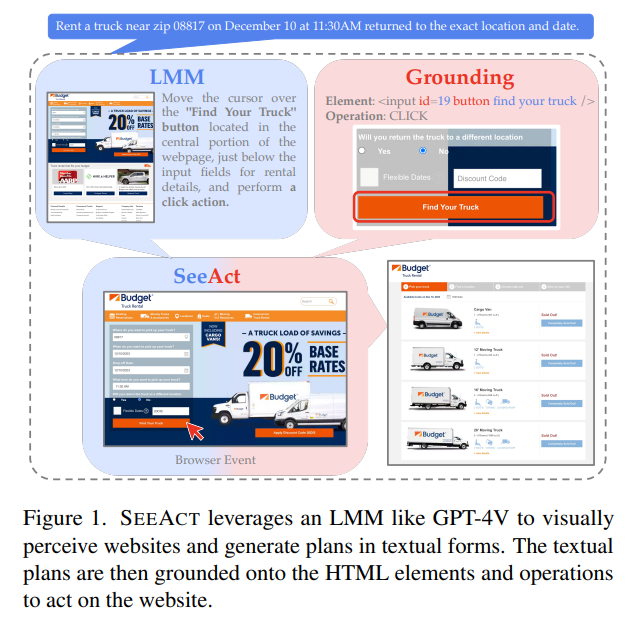

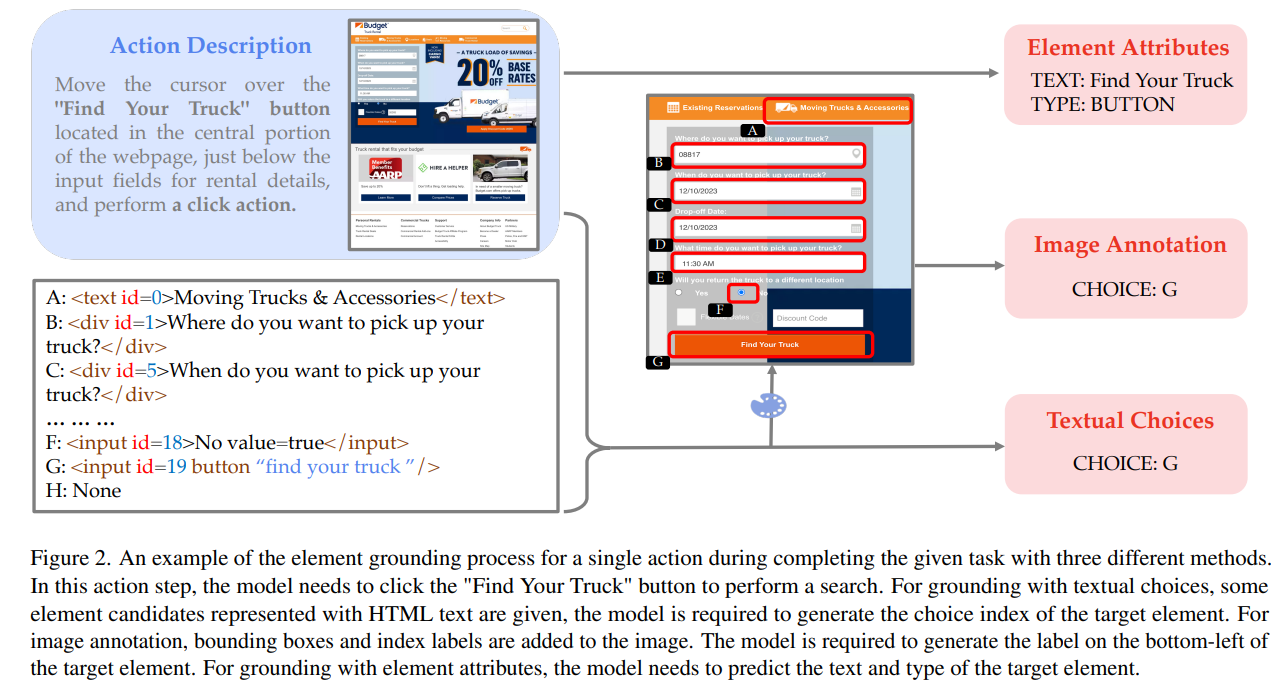

最近の大規模なマルチモーダルモデル(LMM)の開発、特にGPT-4V(ision)とGeminiは、画像キャプションや視覚的な質問応答などの従来のタスクを超えて、マルチモーダルモデルの能力の境界を急速に拡大している.本研究では、GPT-4VのようなLMMが、任意のウェブサイト上で自然言語の指示に従ってタスクを完了することができる一般的なウェブエージェントとしての潜在能力を探求する.我々は、統合された視覚的理解とウェブ上での行動において、LMMの力を活用する一般的なウェブエージェントであるSEEACTを提案する.我々は、最近のMIND2WEBベンチマークで評価を行う.キャッシュされたウェブサイトでの標準的なオフライン評価に加えて、ウェブエージェントをライブウェブサイト上で実行することができるツールを開発することで、新しいオンライン評価設定を可能にする.我々は、GPT-4Vがウェブエージェントにとって大きな潜在能力を持っていることを示す – ウェブサイト上でのテキストプランを手動でアクションに結び付けることで、50%のタスクを成功裏に完了することができる.これは、ウェブエージェントに特化したテキストのみのLMMであるGPT-4やより小さなモデル(FLAN-T5やBLIP-2)よりも優れている.ただし、結び付けはまだ課題となっており、本研究ではHTMLテキストと視覚情報の両方を活用した最良の結び付け戦略を開発したが、オラクル結び付けとの間にはまだ大きなギャップがあり、さらなる改善の余地がある.

Q&A:

Q: GPT-4V(ision)とジェミニが、マルチモーダルモデルの能力の境界を広げる目的は何ですか?

A: GPT-4V(ision)とGeminiの目的は、従来のタスクである画像キャプションや視覚的な質問応答などの範囲を超えて、多様なモーダルモデルの能力の境界を拡張することです.

Q: SEEACTは、統合された視覚的理解とウェブ上での行動のために、どのようにLMMの力を活用しているのか?

A: SEEACTは、LMM(大規模多モーダルモデル)であるGPT-4Vのパワーを利用して、ウェブ上での統合的な視覚理解と行動を実現しています.SEEACTは、自然言語の指示に従って任意のウェブサイト上でタスクを完了することができる一般的なウェブエージェントです.GPT-4Vは、画像キャプションや視覚的な質問応答といった従来のタスクを超えて、エラー修正や長期的な計画立案などの印象的な機能を持っています.しかし、細かい視覚的な基盤付けはまだ大きな課題です.本論文で探求した最も効果的な基盤付け戦略でも、オラクル基盤付けと比較して20〜25%の性能差があります.将来の研究では、HTMLなどのウェブの固有の特性をより活用する必要があります.

Q: MIND2WEBベンチマークとはどのようなもので、ウェブエージェントの評価とどのような関係があるのか?

A: MIND2WEBベンチマークは、実際のウェブサイトからウェブページをダンプし、アクションの軌跡注釈とともに、実世界のウェブサイト上のさまざまなドメイン、ウェブサイト、およびタスクの環境を提供するものです.これは、ウェブエージェントの評価において、オフライン評価とオンライン評価の両方を可能にするためのものです.オフライン評価では、キャッシュされたウェブサイト上での評価が行われますが、オンライン評価では、実際のウェブサイト上でウェブエージェントを実行するためのツールが開発されています.

Q: GPT-4Vのキャッシュサイトでのオフライン評価プロセスについて教えてください.

A: オフライン評価プロセスでは、キャッシュされたウェブサイト上でGPT-4Vを評価します.この評価では、時間に敏感なタスクを再書き換えて、評価時にも有効なままにします.例えば、フライト関連のタスクでは日付を更新します.オフライン評価の結果は、3つのテスト分割ごとに、ステップ成功率がそれぞれ65.7%、70.0%、62.1%であることが示されています.

Q: 開発したツールで可能になったオンライン評価設定は、オフライン評価とどう違うのですか?

A: オンライン評価では、キャッシュされたウェブサイトではなく、ライブウェブサイト上でウェブエージェントを評価するための新しいオンライン評価ツールが開発されました.オフライン評価では、非ログインタスクのみが実施され、エージェントの活動は監視され、有害な影響を与える可能性のあるアクション(注文の配置やユーザープロファイルの変更など)は防止されます.オンライン評価では、人間の注釈者がウェブエージェントとペアになり、エージェントのアクションを監視し、実世界の状態を変更する可能性のあるアクションを判断し、タスクの成功を評価します.オンライン評価では、時間に敏感なタスクのみが再構築され、評価時にまだ有効であることが確認されます.オンライン評価では、オフライン評価よりもタスクの成功率が高くなることが示されており、オフライン評価ではアクションと計画の変動性により、タスクの成功率が過小評価されている可能性があることが示唆されています.

Q: GPT-4Vのテキストプランを手動でアクションに落とし込んだ場合、稼働中のウェブサイトにおけるタスクの何パーセントを成功させることができるのだろうか?

A: GPT-4Vは、そのテキストプランが手動でアクションに接地された場合、ライブウェブサイト上のタスクの50%を成功裏に完了することができます.

Q: GPT-4Vの性能は、GPT-4のようなテキストのみのLLMや、ウェブエージェント用に特別に微調整されたより小さなモデルと比較してどうでしょうか?

A: GPT-4Vは、GPT-4のようなテキストのみのLLMや、ウェブエージェント用に特別に微調整されたより小さなモデルを凌駕します.

Q: 既存のLMMのグラウンディング戦略、例えばセット・オブ・マーク・プロンプティングがウェブエージェントに有効でないのはなぜか?

A: 既存のLMMの接地戦略であるマークのセットのプロンプティングは、ウェブエージェントに対して効果的ではないためです.

Q: 本稿で開発されたグラウンディング戦略は、HTMLテキストとビジュアルの両方をどのように活用しているのだろうか?

A: この論文で開発されたグラウンディング戦略は、HTMLテキストとビジュアルの両方を活用しています.これにより、ウェブエージェントはテキストとビジュアルの情報を組み合わせて、ウェブページ上の要素を特定することができます.

Q: ウェブエージェントのグラウンディング戦略において、残された課題と改善の機会は何か?

A: ウェブエージェントのグラウンディング戦略における残された課題と改善の機会は、オラクルグラウンディングとの大きなギャップがまだ存在しており、さらなる改善の余地があることです.

Instruct-Imagen: Image Generation with Multi-modal Instruction

著者:Hexiang Hu, Kelvin C. K. Chan, Yu-Chuan Su, Wenhu Chen, Yandong Li, Kihyuk Sohn, Yang Zhao, Xue Ben, Boqing Gong, William Cohen, Ming-Wei Chang, Xuhui Jia

発行日:2024年01月03日

最終更新日:2024年01月03日

URL:http://arxiv.org/pdf/2401.01952v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Computation and Language

概要:

この論文では、異種の画像生成タスクに取り組み、未知のタスクにも汎化するモデルであるinstruct-imagenを提案しています.私たちは、画像生成のためのマルチモーダルな指示を導入しました.これは、さまざまな生成意図を精度を持って表現するタスク表現です.自然言語を使用して、テキスト、エッジ、スタイル、主題などの異なるモダリティを統合し、豊富な生成意図を統一された形式で標準化することができます.

次に、私たちは、事前に学習されたテキストから画像への拡散モデルを2段階のフレームワークで微調整して、instruct-imagenを構築しました.まず、リトリーバル拡張トレーニングを使用してモデルを適応させ、外部のマルチモーダルなコンテキストに基づいて生成を行う能力を向上させます.その後、ビジョン言語理解を必要とするさまざまな画像生成タスク(例:主題駆動の生成など)で適応されたモデルを微調整し、各タスクの本質をカプセル化したマルチモーダルな指示とペアにします.さまざまな画像生成データセットでの人間の評価により、instruct-imagenはドメイン内で以前のタスク固有のモデルと同等以上の性能を示し、未知のより複雑なタスクに対しても有望な汎化性能を示すことが明らかになりました.

Q&A:

Q: インストラクター・イマージェンモデルの主な目的は何ですか?

A: Instruct-Imagenの主な目的は、多様なビジュアル生成タスクを実現するために、マルチモーダルな指示を理解し、未知のタスクにも汎化することです.

Q: 画像生成のためのマルチモーダル指導はどのように機能するのか?

A: マルチモーダル指示は、異なるモダリティ(例:テキスト、エッジ、マスク、スタイル、被写体など)からの情報を統合し、画像生成の条件を表現するアプローチです.具体的には、マルチモーダル指示は言語指示を強化し、例えば「スタイル画像のスタイルを採用した被写体画像のインスタンスをレンダリングし、…」といった指示を他のモダリティ(例:被写体とスタイル)の情報と統合して、与えられた被写体のカスタマイズされた画像を生成する目的を説明します.このように、マルチモーダル条件を持つ以前の画像生成タスクは、人間の直感的なインターフェースで効率的に伝えることができます.

Q: インストラクター・イマーゲンの構築に使用された2段階のフレームワークについて説明していただけますか?

A: Instruct-Imagenの構築に使用される2段階のフレームワークは、最初の段階でテキストから画像生成を続け、取得した隣接する(画像、テキスト)のペアを増強します.次に、2番目の段階では、最初の段階の出力モデルを多様な画像生成タスクと対応するマルチモーダルな指示とともに微調整します.両方のトレーニング段階では、モデルはエンドツーエンドで最適化されます.

Q: リトリーバル強化トレーニングとは何ですか?また、それはモデルの能力をどのように向上させるのですか?

A: リトリーバル強化学習は、テキストとマルチモーダルなコンテキスト(画像とテキストのペア)を入力として受け取り、ターゲット画像を出力するモデルのトレーニング手法です.この手法では、テキストとコンテキストを使用して与えられた視覚的な概念を合成するタスクと、従来のテキストから画像への合成を行うタスクの2つのデータ状況がモデルに提示されます.リトリーバル強化学習により、Instruct-Imagenモデルはテキストから画像を生成する能力を保持しながら、マルチモーダルなコンテキストを表現し処理する能力が向上します.

Q: 多様な画像生成タスクにおいて、適応されたモデルはどのように微調整されるのか?

A: 適応されたモデルは、事前に学習されたテキストから画像への変換モデルをベースにしており、追加のマルチモーダル入力を処理するために最初に適応されます.その後、マルチモーダルの指示に正確に応答するように微調整されます.

Q: マルチモーダル指導を使用して標準化できる世代のインテントのタイプの例を示してもらえますか?

A: マルチモーダルな指示を使用して標準化できる生成意図の例として、自然な画像とアート画像の生成が挙げられます.

Q: インストラクター・イマーゲンは、これまでのタスク別モデルと比較して、どのようなパフォーマンスを見せてくれるのだろうか?

A: Instruct-Imagenは、ほとんどのタスクにおいて、先行手法と提案されたベースライン手法の両方よりも優れている.

Q: インストラクター・イマーゲンが、未知のタスクやより複雑なタスクに対して、どのように有望な汎化を示すのか説明できますか?

A: Instruct-Imagenは、マルチモーダルな指示を理解し、未知のより複雑なタスクに対して有望な汎化性能を示すことで、未経験のタスクにも効果的に対応することができます.このモデルは、複雑な関係を理解し、複数のドメイン内のタスクだけでなく、未知の難しいタスクにも取り組むことができます.これは、入力条件を持つ拡散モデルを適応させ、マルチモーダルな指示フレームワークで事前の画像生成タスクを統一することによって実現されます.モデルの制御性は、特定の対象の微妙なニュアンスを捉えるために、限られた画像セットでの微調整によって向上させられます.さらに、適切なデータペアとの補助エンコーダの微調整により、深度マップや落書きなどのさまざまな制御信号に基づいて条件付ける能力を導入します.これにより、モデルは新しいモダリティとその組み合わせに効果的に汎化し、しばしば特定のモダリティに特化するモデルの制約を解決します.Instruct-Imagenの未知のより複雑なタスクへの汎化性能は、多様で洗練されたマルチモーダルな指示の質的な可視化によって示されます.これには、トレーニング中に見られなかった複雑なタスクも含まれます.モデルの未知のタスクへの効果的な汎化能力は、主要な結果と実験設定の詳細な分析でもさらに強調されており、比較的なベースラインシステムを上回っています.全体的に、Instruct-Imagenは、マルチモーダルな指示の理解、拡散モデルの適応、未知のタスクへの効果的な汎化によって、未知のより複雑なタスクへの有望な汎化性能を示しています.

Q: インストラクター・イマーゲンの人間による評価には、どのような画像生成データセットが使われたのですか?

A: 人間の評価のために、DreamBench v1およびv2データセットが使用されました.

Q: インストラクター・イマージェンモデルの限界や改善すべき点はありますか?

A: Instruct-Imagenは、入力画像とのピクセル一貫性の欠如により、ゼロショットでの画像編集タスクの処理に限界があります.これは、レイアウトやオブジェクトのセマンティクスのような重要な決定に低解像度モデルを使用するためで、高解像度の入力ディテールにアクセスして再現することに苦労し、生成される画像にアーティファクトが発生します.超解像モデルは細部を幻視しなければならず、その結果、矛盾が生じる.したがって、ピクセルの一貫性を向上させ、低解像度モデルの限界に対処することは、インストラクト・イマージェン・モデルの潜在的な改善分野となり得る.

A Comprehensive Survey of Hallucination Mitigation Techniques in Large Language Models

著者:S. M Towhidul Islam Tonmoy, S M Mehedi Zaman, Vinija Jain, Anku Rani, Vipula Rawte, Aman Chadha, Amitava Das

発行日:2024年01月02日

最終更新日:2024年01月03日

URL:http://arxiv.org/pdf/2401.01313v2

カテゴリ:Computation and Language

概要:

大規模言語モデル(LLM)が人間のようなテキストを書く能力を向上させるにつれて、根拠のないが事実のように見えるコンテンツを生成する傾向についての課題が残っています.この幻覚の問題は、人々の生活に影響を与える実世界のプロダクションシステムにこれらの強力なLLMを安全に展開するための最大の障害と言えるでしょう.実用的な環境でのLLMの普及に向けた道のりは、幻覚に対処し軽減することに大いに依存しています.限られたタスクに焦点を当てた従来のAIシステムとは異なり、LLMはトレーニング中に膨大な量のオンラインテキストデータにさらされています.これにより、印象的な言語の流暢さを示すことができますが、トレーニングデータのバイアスから情報を推測したり、曖昧なプロンプトを誤解したり、情報を入力と表面的に一致させるために修正したりすることも可能です.これは、医療記録の要約、財務分析レポートなどの感度の高いアプリケーションに言語生成能力を頼る場合に非常に懸念すべきです.本論文では、32以上の技術の包括的な調査を紹介しています.さらに、Lewisら(2021)のRetrieval Augmented Generation、Varshneyら(2023)のKnowledge Retrieval、Leiら(2023)のCoNLI、およびDhuliawalaら(2023)のCoVeなど、これらの幻覚を軽減するために開発された32以上の技術を詳しく紹介しています.さらに、データセットの利用、共通のタスク、フィードバックメカニズム、およびリトリーバータイプなどのさまざまなパラメータに基づいてこれらの方法を分類する詳細なタクソノミーも導入しています.この分類は、LLMの幻覚問題に取り組むために特に設計された多様なアプローチを区別するのに役立ちます.さらに、これらの技術に固有の課題と制約を分析し、LLMの領域での幻覚や関連現象に対処するための将来の研究の堅固な基盤を提供しています.

Q&A:

Q: 大規模言語モデル(LLM)に関連するコンテンツ生成の主な課題は何ですか?

A: LLMは幻覚を見たり、事実のように見えるが根拠のないコンテンツを生成する傾向があり、これはコンテンツの生成に関連する主な課題である.

Q: 幻覚は、現実の生産システムにおけるLLMの展開にどのような影響を与えるのだろうか?

A: LLMは事実のように見えるが根拠のないコンテンツを生成する傾向があり、これを幻覚と呼びます.この幻覚の問題は、LLMを実世界のプロダクションシステムに安全に展開する上での大きな障害です.LLMの広範なドメインカバレッジにより、学術研究、プログラミング、創作執筆、技術的な助言など、さまざまな分野で適用可能です.しかし、実世界の主題に関して誤った情報や捏造された詳細を提供する傾向は、信頼性を損ないます.この誤ったデータの提供の傾向は、不正確な情報の拡散や人々の生活への悪影響をもたらす可能性があるため、実世界のプロダクションシステムへのLLMの展開に重大な影響を与えることがあります.したがって、幻覚の対処と軽減は、実践的な環境でのLLMの広範な採用にとって重要です.

Q: LLMと従来のAIシステムとの違いは、トレーニングデータの露出度という点ではどうでしょうか?

A: 従来のAIシステムは限られたタスクに焦点を当てているのに対し、LLMはトレーニング中に大量のオンラインテキストデータにさらされています.これにより、LLMは印象的な言語の流暢さを示すことができますが、トレーニングデータのバイアスから情報を推測したり、曖昧なプロンプトを誤解したり、情報を表面的に入力に合わせて修正したりすることも可能です.これは、医療記録の要約、顧客サポートの会話、財務分析レポートの提供、誤った法的助言の提供など、感度の高いアプリケーションで言語生成能力に依存する場合に非常に懸念すべきです.

Q: 言語生成機能に依存する繊細なアプリケーションの例を教えてください.

A: 敏感なアプリケーションの例としては、医療記録の要約、顧客サポートの会話、金融分析レポートの提供、誤った法的アドバイスの提供などがあります.

Q: LLMの幻覚を軽減するために、どれだけの技術が開発されたのか?

A: この論文では、32以上の技術が開発されており、これらはLLMの幻覚を軽減するために使用されています.

Q: リトリーバル・オーギュメンテッド・ジェネレーションのコンセプトと、幻覚を軽減する役割について説明していただけますか?

A: Retrieval Augmented Generation (RAG)は、外部の情報源を利用して言語モデルの応答を強化する技術です.RAGは、生成の前、生成中、生成の後の3つの段階で情報検索システムを活用します.生成の前の段階では、LLM-AugmenterやFreshPromptなどの手法を使用して、生成のための適切なコンテキストを提供します.生成中の段階では、Knowledge RetrievalやDecompose-and Query framework (D&Q)、EVERなどの手法を使用して、生成中に幻想を検出し修正します.生成の後の段階では、RARRやHigh Entropy Word Spotting and Replacementなどの手法を使用して、生成されたテキストの幻想を修正します.RAGは、幻想の検出と修正をリアルタイムで行うことで、生成されるテキストの信頼性と正確性を向上させることができます.

Q: LLMにおける幻覚への対処における知識検索の意義とは?

A: 知識検索は、LLMにおける幻覚に対処する上で重要な役割を果たす.これは、幻覚を軽減するためにLLMの生成段階で使用される技術である.この論文では、知識検索はLLMにおける幻覚に対処するために開発された注目すべき技法の一つであると述べている.これは、生成プロセス中に関連知識を検索する方法として説明されている.外部の知識を取り入れることで、LLMは理解を深め、幻覚や間違った情報を生成する可能性を減らすことができる.知識検索がどのように実装されるかの具体的な詳細は、与えられた文脈では提供されていないが、LLMの幻覚を軽減するための重要なアプローチとして言及されている.

Q: CoNLIとその幻覚軽減への貢献について、もう少し詳しく教えてください.

A: CoNLIは、自然言語生成モデル(LLMs)が与えられた背景コンテキストによって生成される幻覚を検出および軽減するための階層的なフレームワークです.CoNLIは、未根拠のコンテンツを特定することによって、幻覚の検出において最先端の性能を発揮します.また、モデルの調整を必要とせずに、幻覚を減少させ、テキストの品質を向上させるために、ポスト編集が使用されます.テキスト対テキストのデータセットにおける幅広い実験により、幻覚の検出と軽減の両方で効果が示されています.CoNLIは、自然言語推論のチェーンとして検出を定式化することによって、幻覚の軽減に貢献します.

Q: LLMの幻覚問題に取り組む上で、CoVeの役割は何ですか?

A: CoVeの役割は、LLMsの幻覚問題に取り組むことです.CoVeは、モデルが初期応答を起草し、そのドラフトを事実確認するための検証質問を計画し、それに独立して回答することで、最終的な検証済みの応答を生成します.CoVeは、リストベースのWikidataの質問や長文テキスト生成などのタスクにおいて、幻覚を減少させることが実験で示されています.

Q: LLMの幻覚を軽減する技術は、どのようなパラメータで分類されるのか?

A: この論文では、さまざまなパラメータに基づいてこれらの技術を分類するための詳細なタクソノミーが紹介されています.これらのパラメータには、データセットの利用、一般的なタスク、フィードバックメカニズム、およびリトリーバータイプが含まれます.

Self-Play Fine-Tuning Converts Weak Language Models to Strong Language Models

著者:Zixiang Chen, Yihe Deng, Huizhuo Yuan, Kaixuan Ji, Quanquan Gu

発行日:2024年01月02日

最終更新日:2024年01月02日

URL:http://arxiv.org/pdf/2401.01335v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language, Machine Learning

概要:

この論文では、Supervised Fine-Tuning(SFT)を通じて人間によって注釈付けされたデータの力を活用することが、大規模言語モデル(LLM)の進歩に不可欠であると述べています.さらに、追加の人間によって注釈付けされたデータを取得する必要なく、弱いモデルから強力なLLMを育成する可能性について探求しています.著者らは、Self-Play fIne-tuNing(SPIN)という新しい微調整方法を提案しています.SPINは、教師あり微調整モデルから始まります.SPINの中心には、LLMが自身のインスタンスと対戦することで能力を磨く自己対戦メカニズムがあります.具体的には、LLMは前のイテレーションから自身のトレーニングデータを生成し、これらの自己生成応答と人間によって注釈付けされたデータから得られた応答を区別することによってポリシーを洗練させます.この方法により、人間によって注釈付けされたデモンストレーションデータの完全な潜在能力を引き出すことで、LLMを新生モデルから強力なモデルに段階的に昇華させることができます.理論的には、我々は、我々の方法のトレーニング目的関数のグローバル最適解が、LLMのポリシーがターゲットデータ分布と一致する場合にのみ達成されることを証明しています.実証的には、我々はいくつかのベンチマークデータセットを用いて我々の方法を評価しています.さらに、HuggingFace Open LLM Leaderboard、MT-Bench、およびBig-Benchのデータセットを含むいくつかのベンチマークデータセットで我々の方法を評価しました.結果は、SPINがさまざまなベンチマークでLLMの性能を大幅に向上させ、さらにGPT-4の追加の選好データを補完した直接の選好最適化(DPO)で訓練されたモデルを上回ることを示しています.これは、自己対戦の可能性に光を当て、専門家の対戦相手を必要とせずにLLMで人間レベルのパフォーマンスを達成することを可能にするものです.

Q&A:

Q: 提案手法であるSPIN(Self-Play fIne-tuNing)の主な目的は何ですか?

A: 提案された手法、Self-Play fIne-tuNing (SPIN)の主な目的は、弱いLLMから強いLLMを育成することであり、追加の人間による注釈付きデータの取得を必要としないことです.

Q: SPINとスーパーバイズド・ファインチューニング(SFT)との違いは?

A: SPINは、いくつかの点で教師ありファインチューニング(SFT)と異なる.第一に、SPINは教師ありファインチューニングモデルから開始するセルフプレイファインチューニング手法であるのに対し、SFTはSFTデータセットのみに依存する.第二に、SPINはセルフプレイメカニズムを採用しており、言語モデルは自身のインスタンスと対戦することで能力を向上させるが、SFTはセルフプレイを行わない.第三に、SPINはデータのターゲット分布が弱い言語モデルの分布と区別可能であることを要求するが、SFTにはこの要求はない.最後に、SPINは繰り返し自己再生戦略を実装しているが、SFTは単一反復アプローチである.

Q: SPINの自己対戦メカニズムと、それがLLMの能力向上にどのように役立つのか説明できますか?

A: SPINは、自己対戦メカニズムを利用してLLMの能力を洗練させる方法です.具体的には、前のイテレーションのLLMであるpθtを使用して、人間によって注釈付けされたSFTデータセットのプロンプトxinに対する応答y’を生成します.次に、pθtによって生成された応答y’と人間によって生成された応答yを区別できる新しいLLM pθt+1を見つけることが目的です.このプロセスは、2人のプレイヤーによるゲームと見なすことができます.新しいLLM pθt+1は、pθtによって生成された応答と人間によって生成された応答との間を区別しようとします.自己対戦により、LLMは直接の監督を必要とせずに自己学習を行うことができます.

Q: LLMはSPINでどのように独自のトレーニングデータを生成するのですか?

A: SPINは、自己生成された応答と人間によって注釈付けされたデータから得られた応答を区別することで、自身のトレーニングデータを生成します.LLMは、自己生成された応答と人間によって注釈付けされたデータから得られた応答を区別することによって、ポリシーを洗練させることで、自身のトレーニングデータを生成します.SPINは、LLMを成長させるために自己評価と自己改善のメカニズムを提供し、追加の人間データや強いLLMからのフィードバックなしで、LLMの性能を向上させることができます.

Q: LLMは、自分で作成した回答と、人間が注釈を付けたデータから得た回答をどのように区別するのですか?

A: LLMは、反復によってポリシーを改良することで、自分で生成した応答と人間が注釈を付けたデータから得た応答を区別する.LLMは、過去の繰り返しから独自の学習データを生成し、このデータを使ってポリシーを改善する.自己生成された応答は、人間の注釈付きデータから得られた応答と比較され、LLMは両者を識別することを学習する.目標はLLMの方針を目標データ分布に一致させることであり、この一致に達したときに学習目的関数の全体最適が達成される.

Q: SPINのトレーニング目的関数について、論文で示されている理論的な証明は何ですか?

A: 提案手法のトレーニング目的関数のグローバル最適解は、LLMポリシーがターゲットデータ分布と一致する場合にのみ達成される.

Q: SPINの性能評価には、どのベンチマークデータセットが使われたのですか?

A: SPINはMT-Bench、Big-Bench、OpenBookQA、Big-Bench-Hardのタスクで評価された.

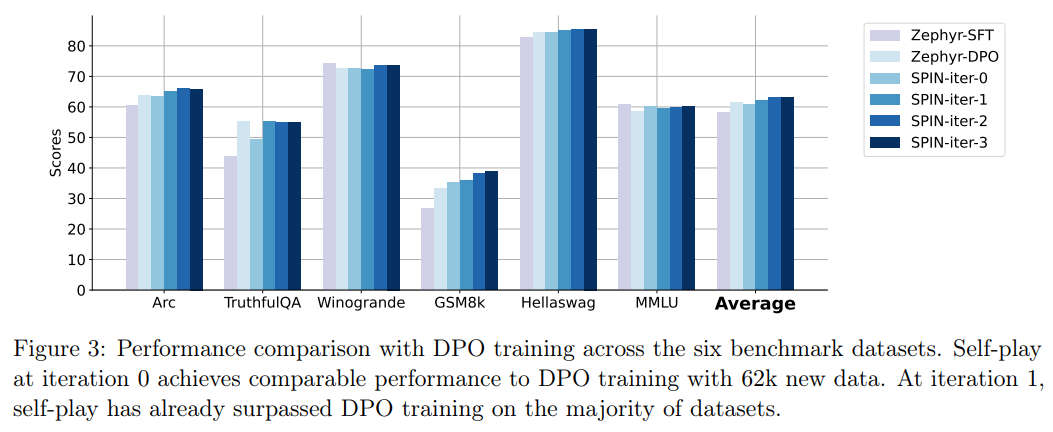

Q: SPINは、GPT-4の嗜好データを追加した直接嗜好最適化(DPO)で学習したモデルと比較してどうなのか?

A: SPINとDPOは異なるアプローチを取っており、SPINは初期モデルのみを使用していますが、DPOは新しいデータソースが必要です.また、SPINは既存のSFTデータセットのみを使用していますが、DPOは新しいデータソースからデータを収集する必要があります.図3では、SPINとDPOのパフォーマンス比較が示されており、SPINは既存のSFTデータを使用しているにもかかわらず、DPOの初期イテレーションと比較可能な平均パフォーマンスを達成しています.さらに、SPINはイテレーション1からDPOを上回り、リーダーボードのベンチマークでのパフォーマンスも上回っています.

Q: 専門家の対戦相手を必要とせずに、LLMで人間レベルのパフォーマンスを達成するためのセルフプレーの可能性について詳しく教えてください.

A: 自己対戦は、LLM(Large Language Models)の人間レベルのパフォーマンスを達成するための潜在能力を持ち、専門家の対戦相手を必要としない可能性があります.自己対戦は、AlphaGo Zeroなどの先行研究によって示されたように、自己対戦学習スキームを使用して人間のプレイヤーに対して優れたパフォーマンスを発揮することができます.この手法は、学習環境内での挑戦と複雑さのレベルを増やすことができます.自己対戦は、弱いモデルを強いモデルに変換することができ、追加の人間による注釈付きデータを必要としません.これまでの研究では、自己対戦の効果はMARL(Multi-Agent Reinforcement Learning)において確立されていますが、私たちの研究はLLMの向上にこの手法を適用した最初のものです.

Q: SPINの実施に伴う制限や課題はありますか?

A: SPINはロバスト性と安定性を示すが、1回の反復で達成できる性能には固有の限界がある.その後のエポックでの性能向上はわずかであり、反復トレーニングの必要性を示している.反復0における訓練時間を延長しても、反復1に匹敵する性能には達しない.さらに、学習データサイズを変化させた場合のSPINの性能への影響も調べた.

If LLM Is the Wizard, Then Code Is the Wand: A Survey on How Code Empowers Large Language Models to Serve as Intelligent Agents

著者:Ke Yang, Jiateng Liu, John Wu, Chaoqi Yang, Yi R. Fung, Sha Li, Zixuan Huang, Xu Cao, Xingyao Wang, Yiquan Wang, Heng Ji, Chengxiang Zhai

発行日:2024年01月01日

最終更新日:2024年01月01日

URL:http://arxiv.org/pdf/2401.00812v1

カテゴリ:Computation and Language

概要:

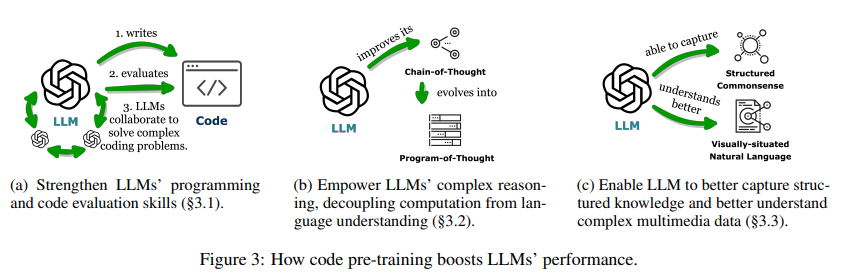

現在の主要な大規模言語モデル(LLM)は、過去の言語モデルとは異なり、自然言語と形式言語(コード)の組み合わせで訓練されているという点でも異なっています.コードは人間とコンピュータの間の媒体として、高レベルの目標を実行可能な手順に変換する役割を果たし、標準的な構文、論理的な整合性、抽象化、モジュール化の特徴を持っています.この調査では、コードをLLMの訓練データに統合することのさまざまな利点について概説します.具体的には、コードのこれらのユニークな特性によって、LLMの推論能力が引き出され、より複雑な自然言語のタスクに適用することが可能になること、構造化された正確な中間ステップを生成し、それを関数呼び出しを介して外部の実行結果に接続することができること、およびコードのコンパイルと実行環境を活用することができること、またモデルの改善のための多様なフィードバックも提供されることができることがわかります.さらに、コードによってもたらされるLLMのこれらの深い能力が、知的エージェント(IA)としての彼らの出現につながった経緯も追跡しています.コードによってもたらされるこれらの能力は、指示の理解、目標の分解、計画と実行、そしてフィードバックからの改善が彼らの成功に不可欠な状況で、知的エージェント(IA)としての彼らの出現につながっています.最後に、LLMにコードを組み込むことのいくつかの主要な課題と将来の方向性も提示しています.

Q&A:

Q: コード生成におけるLLMの強化に役立つ、コード独自の特性とは何か?

A: コードのユニークな特性は、LLMのコード生成能力を向上させるのに役立ちます.具体的には、コードの構文、論理的な整合性、抽象化、モジュール化といった特性によって、LLMの推論能力が引き出され、より複雑な自然言語のタスクに応用することが可能になります.また、コードの特性によってLLMは構造化された正確な中間ステップを生成し、それを外部の実行環境と関数呼び出しを通じて接続することができます.さらに、コードのコンパイルと実行環境を活用することで、モデルの改善に対する多様なフィードバックも得ることができます.

Q: LLMのトレーニングデータにコードを統合することで、彼らの推論能力はどのように解放されるのでしょうか?

A: コードをLLMsのトレーニングデータに統合することによって、LLMsの推論能力が解放されます.コードの特性は、LLMsが複雑な自然言語のタスクに適用されることを可能にし、LLMsが構造化された知識をキャプチャし、複雑なマルチメディアデータをより良く理解することができるようにします.また、コードのプリコンパイルと実行環境を利用することで、モデルの改善のための多様なフィードバックを提供します.コードのプリトレーニングによって、LLMsはプログラミングスキルとコード評価スキルを強化し、計算と言語理解を分離することで複雑な推論を可能にします.

Q: LLMが構造化された正確な中間ステップを生み出すために、コードはどのように舵を切るのか?

A: コードはLLMsに対して、構造化された正確な中間ステップを生成するように誘導します.コードは論理的でステップバイステップの実行可能なプロセスを特徴とし、グラフィカルに表現可能な抽象化を構成する明示的に定義されたモジュール化された関数を持つため、LLMsのプログラミングと推論能力を向上させます.コードの特性により、LLMsは意思決定の過程で実行可能な細かいステップを直接生成することができ、関数呼び出しを介してさまざまなツールモジュールを組み込むことが容易になります.

Q: LLMがどのように関数呼び出しを通じて中間ステップを外部実行端に接続しているのか、例を示してもらえますか?

A: LLMは、ツール呼び出しをLLMの推論メカニズムに埋め込むことや、プログラミング言語や事前定義された関数を介してLLMと関数の終了点を接続することによって、中間ステップを外部の実行終了点に接続します.

Q: コードのコンパイルと実行環境は、モデルの改善のためにどのように多様なフィードバックを提供するのか?

A: コードのコンパイルと実行環境は、決定論的な実行結果に基づいた包括的な評価メトリックを提供することで、モデルの改善に多様なフィードバックを提供します.コードの実行結果によって生成されたコンテンツは、バイナリの正確性に関する評価や結果に関する自然言語の説明、報酬値に基づくランキングなど、さまざまな形式の外部フィードバックを通じて評価されます.これにより、モデルのパフォーマンスを向上させるための高度にカスタマイズ可能な手法が可能となります.また、ソフトウェアエンジニアリングツールを使用して静的解析を行うことで、追加のフィードバックを抽出することもできます.例えば、実行トレースから変数や状態のトレースなどの追加情報を取得することができます.さらに、関数呼び出しに対する表面形式の制約を使用して、追加のフィードバックを効果的に抽出する方法もあります.

Q: LLMが、指示を理解し、目標を分解し、行動を計画・実行し、フィードバックから改良することが重要な状況において、知的エージェントとしてどのように登場したのか説明していただけますか?

A: LLMは、指示を理解し、目標を分解し、行動を計画・実行し、フィードバックから改良することが重要な状況において、知的エージェントとして登場した.これは、コード上で訓練されたLLMが、きめ細かい領域で専門家レベルのタスクを実行できるプログラミング・スキルを獲得しているためである.命令を理解することで、LLMは達成すべきタスクを理解することができる.そして、これらの目標をより小さなサブタスクに分解することができ、効果的な行動の計画と実行を可能にする.LLMは、フィードバックから学習することで、自分のパフォーマンスを継続的に改善し、タスクの完了度を向上させることができる.これらの能力により、LLMは様々なアプリケーションやタスクにおいて知的エージェントとして重宝されている.

Q: LLMにコードを教える上で、重要な課題は何でしょうか?

A: コードを活用してLLMを強化する際のいくつかの主な課題は、次のとおりです.まず、LLMがコードを理解し、適切に解釈する能力が必要です.コードは複雑で抽象的な構造を持ち、正確な文法とシンタックスに従う必要があります.そのため、LLMはコードの意味を正確に理解し、適切なコードの実行方法を学習する必要があります.また、コードは頻繁に変更される可能性があり、新しいプログラミング言語やフレームワークが登場することもあります.そのため、LLMは常に最新のコードのトレンドや技術を学習し続ける必要があります.さらに、コードは一般的には人間が作成するものであり、人間の意図や文脈に基づいています.LLMは人間の意図を正確に理解し、適切なコードの生成や評価を行う必要があります.これには自然言語処理や機械学習の技術を組み合わせる必要があります.最後に、コードは一般的には特定のドメインやタスクに関連しています.LLMは異なるドメインやタスクに対応するために、幅広いコードの知識と理解を持つ必要があります.これには、大規模なコードベースの学習やドメイン特有の知識の獲得が必要です.

Q: LLMにコードを与えるための今後の方向性は?

A: LLMは、プログラミングスキルの強化、最先端のコード評価者としての役割、共同コーディングによる複雑なタスクの解決、複雑な推論やタスクの分解の強化、構造化された知識の獲得など、様々な方法でコードによる力を得ることができる.これらの将来の方向性は、LLMが外部の知識にアクセスし、多様なモダリティに関与し、様々な環境と効果的に相互作用できるようにすることを目指している.LLMがプログラミング言語を生成したり、あらかじめ定義された関数を利用して他の機能端との接続を確立したりするのは、コード中心のパラダイムである.

Q: LLMは、自然言語とコードを組み合わせて学習するという点で、過去の言語モデルとどう違うのか?

A: LLMは、自然言語とコードを組み合わせて学習するという点で、これまでの言語モデルとは異なる.これまでの言語モデルは自然言語データのみで学習されていたが、LLMは自然言語とコード・コーパスを組み合わせて学習する.つまり、LLMは人間の言語とプログラミング・コードの両方に触れ、自由形式の自然言語を理解・生成し、コードを解釈・生成することができる.トレーニング・プロセスでは、GitHubのような一般にアクセス可能なコード・リポジトリなどのコード・コーパスを使用し、自然言語データに匹敵する量のコード・データを提供する.この自然言語とコードトレーニングの組み合わせは、LLMの包括性を高め、高レベルの目標を実行可能なステップに変換することで、人間とコンピュータの間のギャップを埋めることを可能にする.

Q: コード生成以外に、LLMのトレーニングデータにコードを統合することの利点について詳しく説明していただけますか?

A: コードをLLMのトレーニングデータに統合することによる利点は、コード生成を超えて以下のようなものです.

- LLMの推論能力を引き出すことができるため、より複雑な自然言語タスクに適用することができます.

- コードの特性により、LLMは構造化された正確な中間ステップを生成することができます.これらのステップは、関数呼び出しを介して外部の実行結果に接続することができます.

- コードのコンパイルと実行環境を活用することで、モデルの改善に対する多様なフィードバックを提供することができます.

DocLLM: A layout-aware generative language model for multimodal document understanding

著者:Dongsheng Wang, Natraj Raman, Mathieu Sibue, Zhiqiang Ma, Petr Babkin, Simerjot Kaur, Yulong Pei, Armineh Nourbakhsh, Xiaomo Liu

発行日:2023年12月31日

最終更新日:2023年12月31日

URL:http://arxiv.org/pdf/2401.00908v1

カテゴリ:Computation and Language

概要:

この論文では、フォーム、請求書、領収書、レポート、契約書などの企業文書は、テキストと空間のモダリティの交差点で豊かな意味を持っていることが多いと述べられています.これらの文書の複雑なレイアウトが提供する視覚的な手がかりは、これらの文書を効果的に理解する上で重要な役割を果たしています.本論文では、テキストの意味と空間的なレイアウトの両方を考慮した視覚文書の推論のための、従来の大規模言語モデル(LLM)の軽量な拡張であるDocLLMを提案しています.我々のモデルは、高価な画像エンコーダを避け、空間的なレイアウト構造を組み込むために、バウンディングボックス情報にのみ焦点を当てるという点で、既存のマルチモーダルLLMとは異なります.具体的には、テキストと空間のモダリティ間のクロスアライメントは、古典的なトランスフォーマーのアテンションメカニズムを一連の分離された行列に分解することによって捉えられます.さらに、テキストセグメントを埋めることを学習すること前学習目的を考案しています.このアプローチにより、視覚的な文書で頻繁に遭遇する不規則なレイアウトや異種のコンテンツに対処することができます.事前学習されたモデルは、大規模な指示を使用して微調整されます.さらに、この研究では、4つの主要な文書インテリジェンスタスクをカバーする大規模な指示データセットを使用して、事前学習モデルを微調整しました.その結果、我々のソリューションは、全タスクにおいて16のデータセットのうち14つでSotA LLMを上回り、また5つの以前に見たことのないデータセットにもうまく汎化することを示しました.

Q&A:

Q: 論文「DocLLM: A layout-aware Generative Language Model for Multimodal Document Understanding」の主眼は何ですか?

A: 本論文「DocLLM: レイアウトに注意した多様なモードのドキュメント理解のための生成言語モデル」の主な焦点は、テキストの意味と空間的なレイアウトの両方を考慮した視覚ドキュメントの推論において、従来の大規模言語モデル(LLM)を拡張することです.モデルは、高価な画像エンコーダを回避し、空間的なレイアウト構造を組み込むために、テキストと空間的なモードの相互作用をキャプチャするために古典的なトランスフォーマーの注意メカニズムを分解した一連の行列を使用します.さらに、新たに収集された指示のデータセットでタスクの適応を行います.

Q: DocLLMは既存のマルチモーダル言語モデル(LLM)とどう違うのか?

A: DocLLMは既存のマルチモーダル言語モデル(LLM)とは異なり、空間レイアウトとテキストのセマンティクスを明示的にモデル化し、OCRを使用して軽量の視覚情報を統合し、変換器アーキテクチャの自己注意メカニズムを拡張して、テキストのセマンティクスと空間レイアウトの相互依存関係を計算する.ユニモーダルなモデルとは異なり、DocLLMはマルチモーダルな入力を処理できるマルチモーダルなシステムである.さらに、DocLLMは、マルチモーダルLLMで一般的に使用される複雑でメモリ集約的なオープンドメインの視覚エンコーダの課題に対処している.DocLLMは、ほとんどのマルチモーダル言語モデルの効果的な理解を実現しますが、VQAのような複雑な推論や抽象化を伴うタスクでは、GPT-4より劣る可能性があります.DocLLMはまた、Llama2、mPLUG-DocOwl、UReaderと比較して、様々なデータセットで優れた性能を発揮します.

Q: 企業文書の理解における視覚的手がかりの役割とは?

A: ビジュアルキューは企業文書の理解において重要な役割を果たします.ビジュアルキューは、視覚的な要素やレイアウトの特徴を通じて文書の内容や関係性を理解するのに役立ちます.ビジュアルキューは、テキストと視覚的なモダリティの相互作用を捉えることができるビジョン言語フレームワークを使用することで処理されます.これらのフレームワークは、複雑なビジョンバックボーンの使用を必要としますが、視覚的な文書の処理に適しています.

Q: DocLLMは、ビジュアル・ドキュメントの空間レイアウト構造をどのように組み込んでいるのですか?

A: DocLLMは、LLMのアテンションメカニズムを拡張して、テキストの意味と空間レイアウトの間の依存関係を捉えることにより、視覚的文書の空間レイアウト構造を組み込む.空間レイアウト情報は、光学式文字認識(OCR)を使って得られたテキスト・トークンのバウンディング・ボックス座標を通して組み込まれる.このアプローチはビジョンエンコーダーコンポーネントに依存せず、因果デコーダーアーキテクチャを保持する.さらに、フィールドセパレータ、タイトル、キャプションなどのレイアウトヒントは、文書の論理構造の学習を容易にするために、インストラクションチューニング中に統合することができる.

Q: DocLLMは、テキストと空間モダリティの間のクロスアライメントを捉えるために、どのようなアプローチを使っているのでしょうか?

A: DocLLMは、LLMの注意メカニズムを分解し、これら2つのモダリティを表現するために別々のベクトルを使用することで、テキストと空間モダリティ間のクロスアライメントをキャプチャする.空間レイアウト情報は、OCRを使用して得られたテキスト・トークンのバウンディング・ボックス座標を通して組み込まれる.クロスアライメントは、トランスフォーマ・アーキテクチャの拡張自己注意メカニズムを用いて、テキストのセマンティクスと空間レイアウトの間の相互依存関係を計算することによって達成される.

Q: DocLLMの事前トレーニングの目的は、ビジュアル・ドキュメントにおける不規則なレイアウトや異種コンテンツにどのように対処するのでしょうか?

A: DocLLMは、ブロックテキストの穴埋め学習に焦点を当てた事前学習目的を採用することで、ビジュアルドキュメントの不規則なレイアウトや異種コンテンツに対応する.この目的により、事前学習段階において意味のある穴埋めが保証され、予測結果がばらばらになるのを防ぐことができる.テキストセグメントを埋め込むことで、モデルは不規則なレイアウトがもたらす課題に対処し、テキストとレイアウトモダリティ間のクロスアライメントを捉えることができる.このアプローチにより、モデルは文書の論理構造を理解し、文書から意味のある情報を効果的に抽出することができる.

Q: DocLLMの訓練済みモデルの微調整に使用されるデータセットとは何ですか?

A: DocLLMはSDDSで検討された16のデータセットのうち11のデータセットのプロンプトで微調整された.

Q: 様々なデータセットやタスクにおいて、DocLLMの性能は最先端の(SotA)LLMと比較してどうなのか?

A: DocLLMは全タスクにおいて16データセットのうち14データセットでSotA LLMを上回り、未見の5データセットのうち4データセットによく汎化する.KIEやCLSのようなレイアウトを多用するタスクでは優れた性能を発揮し、VQAやNLIではGPT-4に劣るものの、ほとんどのマルチモーダル言語モデルの性能を上回る.

Q: 大規模な指導データセットがカバーする4つのコア・ドキュメント・インテリジェンス・タスクの例を教えてください.

A: 大規模な指示データセットでカバーされる4つの主要なドキュメントインテリジェンスタスクの例は、キー情報抽出、自然言語推論、ビジュアルクエスチョンアンサリング、およびドキュメント分類です.

Q: DocLLMは未知のデータセットに対してどの程度汎化できるのか?

A: DocLLMは、5つの設定のうち4つで、以前に見たことのないデータセットに対して頑健な汎化を示した.

Fast Inference of Mixture-of-Experts Language Models with Offloading

著者:Artyom Eliseev, Denis Mazur

発行日:2023年12月28日

最終更新日:2023年12月28日

URL:http://arxiv.org/pdf/2312.17238v1

カテゴリ:Machine Learning, Artificial Intelligence, Distributed, Parallel, and Cluster Computing

概要:

大規模言語モデル(LLM)の広範な採用に伴い、多くの深層学習の実践者は、これらのモデルをより効率的に実行する戦略を探しています.そのような戦略の一つは、スパースなMixture-of-Experts(MoE)を使用することです.MoEは、モデルの一部のレイヤーのみが任意の入力に対してアクティブであるモデルアーキテクチャの一種です.この特性により、MoEベースの言語モデルは、密なモデルよりもトークンを高速に生成することができますが、複数のエキスパートを持つため、モデルサイズも増加します.残念ながら、これにより、最先端のMoE言語モデルは、高性能なGPUなしでは実行が困難になります.本研究では、消費者向けのハードウェアで大規模なMoE言語モデルを制限されたアクセラレータメモリで実行する問題を研究しています.パラメータオフロードアルゴリズムをベースにし、MoE LLMの固有の特性を活用した新しい戦略を提案しています.この戦略を使用することで、デスクトップハードウェアと無料のGoogle ColabインスタンスでMixtral-8x7Bをミックス量子化で実行することができます.

Q&A:

Q: 言語モデルでスパースMoE(Mixture-of-Experts)を使用する目的は?

A: 疎なMoE(Mixture-of-Experts)は、密なものよりも高速にトークンを生成するために言語モデルに使用される.

Q: スパースMoEの使用は、密なものと比べてトークン生成のスピードにどのような影響を与えますか?

A: 疎なMoEにより、MoEベースの言語モデルは密なモデルよりも高速にトークンを生成できる.

Q: モデルサイズの点で、スパースMoEを使うことの欠点は何ですか?

A: スパースMoEは複数のエキスパートを持つため、モデルサイズが大きくなる.

Q: MoE言語モデルのモデルサイズが大きくなったことは、民生用ハードウェアで実行する能力にどのような影響を与えるのか?

A: MoE言語モデルは、複数の “エキスパート “を持つためにモデルサイズが大きくなり、アクセラレータのメモリが限られている民生用ハードウェアでは実行が難しくなる.

Q: 大規模なMoE言語モデルを民生用ハードウェアで実行することに関して、この研究で扱われている具体的な問題は何ですか?

A: この研究では、消費者向けのハードウェア上で大規模なMoE言語モデルを実行する際の具体的な問題を解決しています.具体的には、高性能なGPUなしで最新のMoE言語モデルを実行することが困難であるという問題を取り上げています.また、加速器メモリが制限されている場合にも対応する必要があります.

Q: 限られたアクセラレータメモリでMoE言語モデルを実行する問題に対して、パラメータオフロードアルゴリズムはどのような役割を果たすのか?

A: パラメータオフローディングアルゴリズムは、限られたアクセラレータメモリ上でMoE言語モデルを実行する問題に対処するために役立ちます.オフローディングは、モデルのパラメータを別のメモリ(システムRAMやSSDなど)に移動することで、アクセラレータメモリの使用を最小限に抑えます.これにより、モデルのパラメータを必要な時にロードすることができます.特に、深層学習モデルではレイヤーの順序が固定されているため、オフローディングは次のレイヤーのパラメータを事前にバックグラウンドでディスパッチすることができます.これにより、限られたアクセラレータメモリ上で大規模なモデルを効率的に実行することができます.

Q: オフロードを加速させるために提案された新しい戦略とは?

A: 本研究では、パラメータのオフロードを加速するための新しい戦略が提案されています.

Q: 提案された戦略は、MoE言語モデルの生来の特性をどのように利用するのか?

A: 提案された戦略は、MoE言語モデルの固有の特性を利用しています.具体的には、モデルはトークン間でどのエキスパートを再利用するかを観察し、早い段階の層の隠れた状態が後続の層で使用するエキスパートを既に「知っている」という規則性を見つけました.この戦略では、LRUキャッシュを使用してGPU-RAM間の通信を大幅に削減し、より高速なオフロードを実現しています.

Q: 民生用ハードウェアで前述の言語モデルを実行する上で、混合量子化を使用する意義は何ですか?

A: 混合量子化を使用することで、消費者向けのハードウェア上で言語モデルを実行する際に以下のような重要な利点があります.

- パフォーマンスの向上:混合量子化は、モデルの生成速度を著しく向上させます.

- リソース制約の克服:混合量子化は、リソース制約のあるハードウェア上で大規模なモデルを効率的に推論するための実用的な解決策を提供します.

- 研究と開発への広範なアクセス:混合量子化により、強力なモデルへの研究と開発へのより広範なアクセスが可能になります.