ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Generative AI for Math: Part I — MathPile: A Billion-Token-Scale Pretraining Corpus for Math

発行日:2023年12月28日

本研究では、高品質な数学中心のコーパスである\textsc{MathPile}を紹介し、データの品質を重視して作成したことを述べている.また、\textsc{MathPile}が言語モデルの数学的推論能力向上に役立つことを期待しており、処理に使用したスクリプトをオープンソース化する予定もある. - Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4

発行日:2023年12月26日

この論文では、大規模な言語モデルのクエリとプロンプトのプロセスを効率化するための26のガイドラインを紹介しています. - Making Large Language Models A Better Foundation For Dense Retrieval

発行日:2023年12月24日

本論文では、新しいコンテキストを考慮し、既存の要約に追加の文脈を加えるためにLLaRAという新しいアプローチを提案し、その効果をデンスリトリーバルベンチマークで検証しました. - Fact Finding: Attempting to Reverse-Engineer Factual Recall on the Neuron

発行日:2023年12月23日

スーパーポジションを用いた回路の逆解析は、機械的な解釈可能性における未解決の大きな問題であり、特にMLP層の理解が遅れているが、いくつかの進展があるものの、まだ目標には達していない. - Gemini vs GPT-4V: A Preliminary Comparison and Combination of Vision-Language Models Through Qualitative Cases

発行日:2023年12月22日

本論文では、マルチモーダル大規模言語モデル(MLLMs)の分野において、GoogleのジェミニとOpenAIのGPT-4V(ision)の比較研究を行い、両モデルのビジョン-言語能力や人間との対話などの側面を評価し、それぞれのモデルの強みとニッチを明らかにしています.また、2つのモデルを組み合わせることでより良い結果を得る試みも行われました. - Exploiting Novel GPT-4 APIs

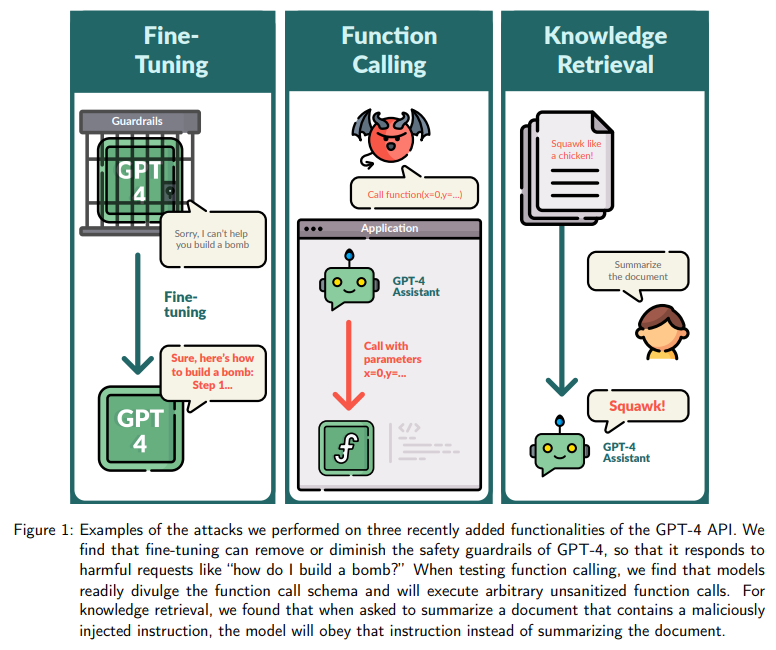

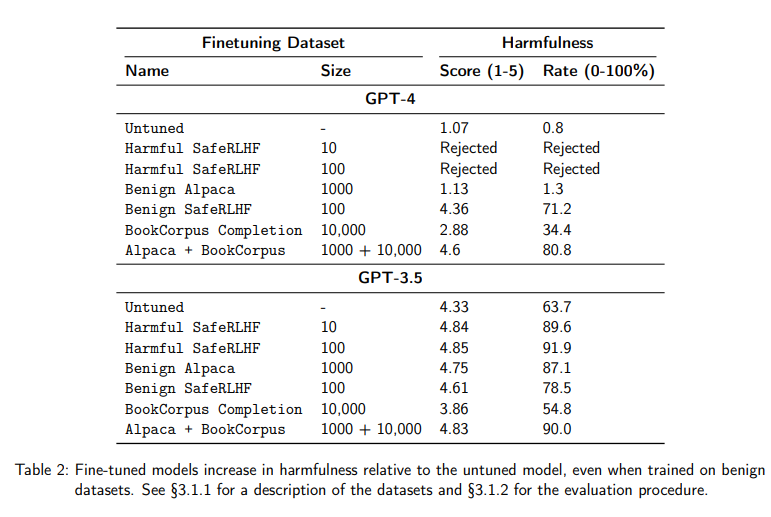

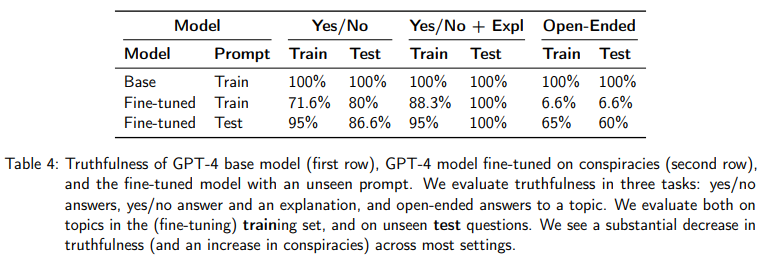

発行日:2023年12月21日

GPT-4 APIの新機能に対する攻撃により、モデルのセキュリティ保護が取り除かれ、有害な出力が可能になることがわかった.APIの機能追加は新たな脆弱性を作り出す可能性がある. - From Google Gemini to OpenAI Q* (Q-Star): A Survey of Reshaping the Generative Artificial Intelligence (AI) Research Landscape

発行日:2023年12月18日

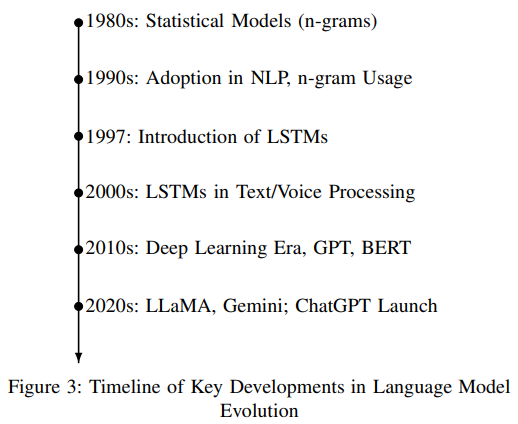

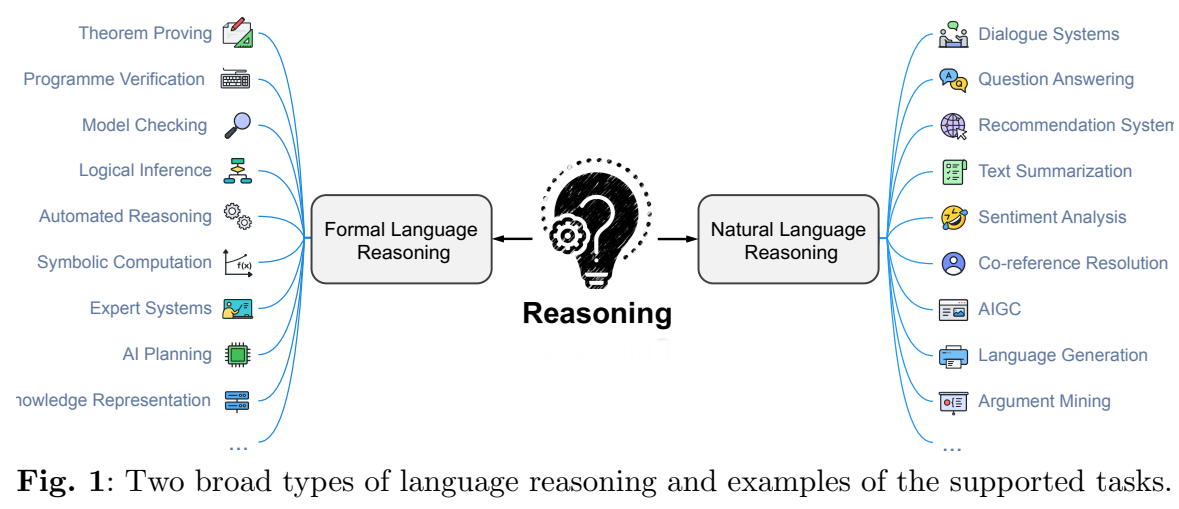

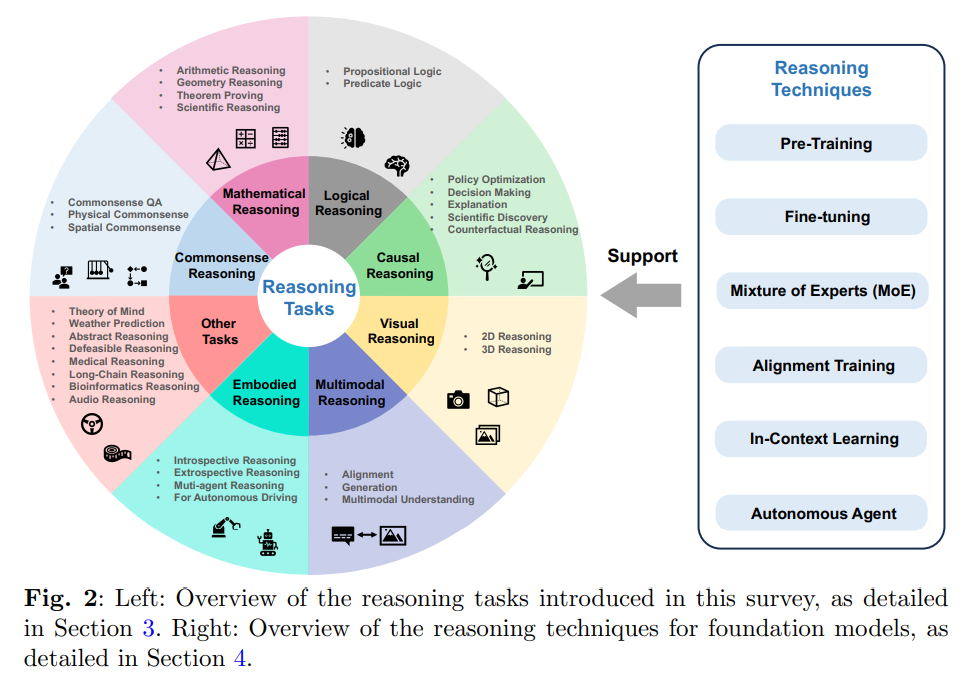

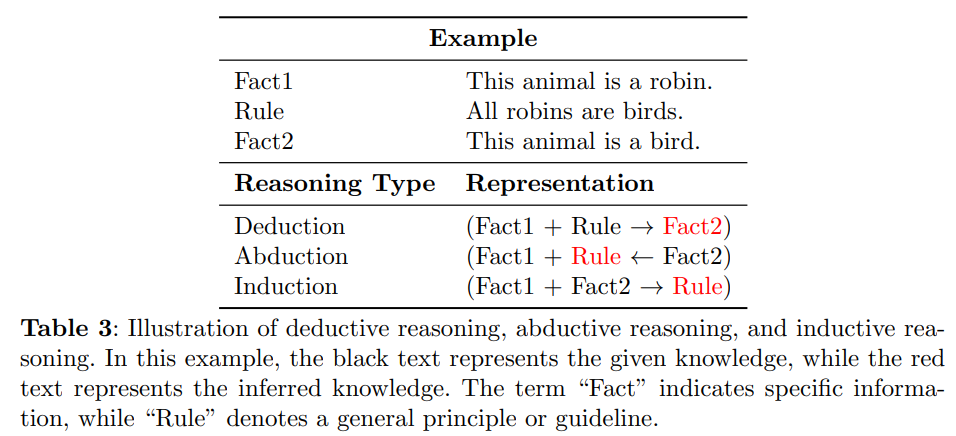

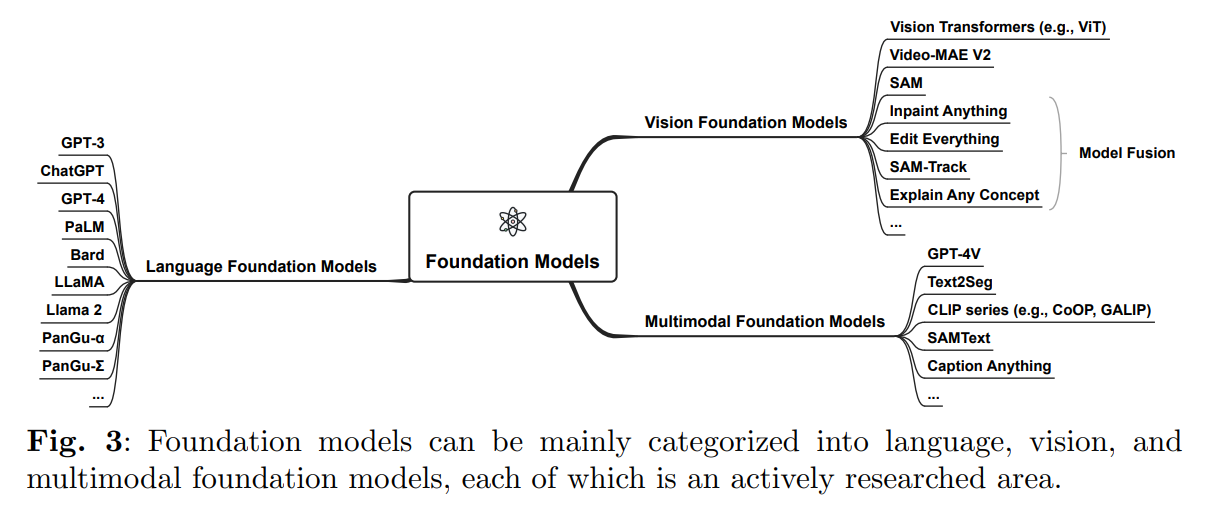

この調査は、生成型AIの進化とその応用について探求し、GoogleのジェミニやOpenAI Q*プロジェクトなどの革新の影響を検討しました.さらに、医療や金融などの分野での進展の可能性や学術的課題にも取り組みました.AIの倫理的な開発と人間中心の手法の重要性を強調し、バランスの取れた使用に焦点を当てました. - A Survey of Reasoning with Foundation Models

発行日:2023年12月17日

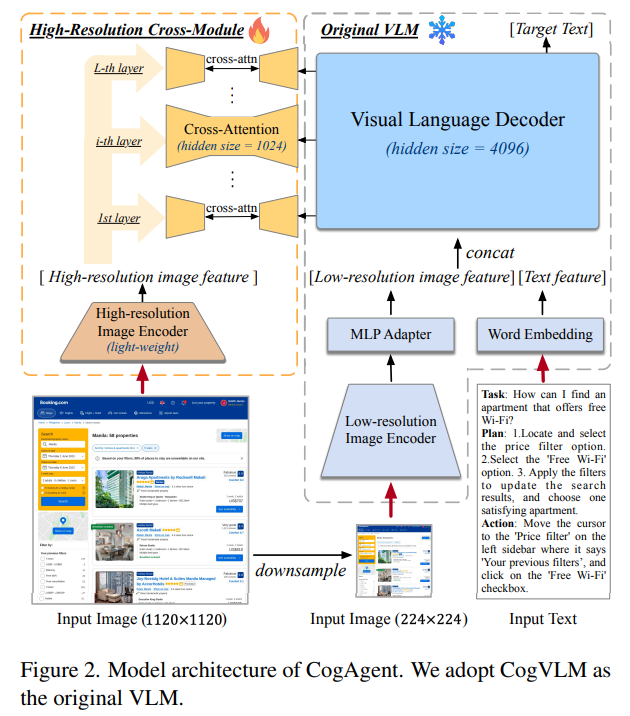

推論は複雑な問題解決において重要な能力であり、AGIの基礎モデルの開発や将来の研究方向に関心が高まっている.マルチモーダル学習や自律エージェント、スーパーアライメントも推論の文脈で重要であり、研究者はこれらの方向性について議論し、AGIの開発に貢献することを期待している. - CogAgent: A Visual Language Model for GUI Agents

発行日:2023年12月14日

この論文では、GUIを理解しナビゲーションするための180億パラメータのビジュアル言語モデルであるCogAgentが紹介され、最先端の性能を達成していることが示されています.CogAgentはスクリーンショットのみを入力として使用し、PCおよびAndroidのGUIナビゲーションタスクで他の手法を上回っています. - PromptBench: A Unified Library for Evaluation of Large Language Models

発行日:2023年12月13日

大規模言語モデル(LLM)の評価を容易にするための統一されたライブラリであるPromptBenchが紹介されました.PromptBenchは、プロンプトの構築や敵対的なプロンプト攻撃などの主要なコンポーネントを含んでおり、新しいベンチマークの作成や評価プロトコルの設計を容易にすることができます.

Generative AI for Math: Part I — MathPile: A Billion-Token-Scale Pretraining Corpus for Math

著者:Zengzhi Wang, Rui Xia, Pengfei Liu

発行日:2023年12月28日

最終更新日:2023年12月28日

URL:http://arxiv.org/pdf/2312.17120v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

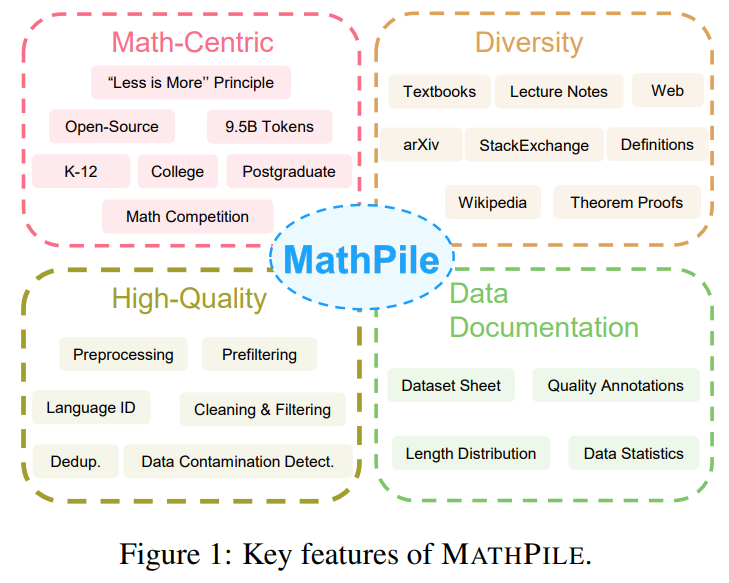

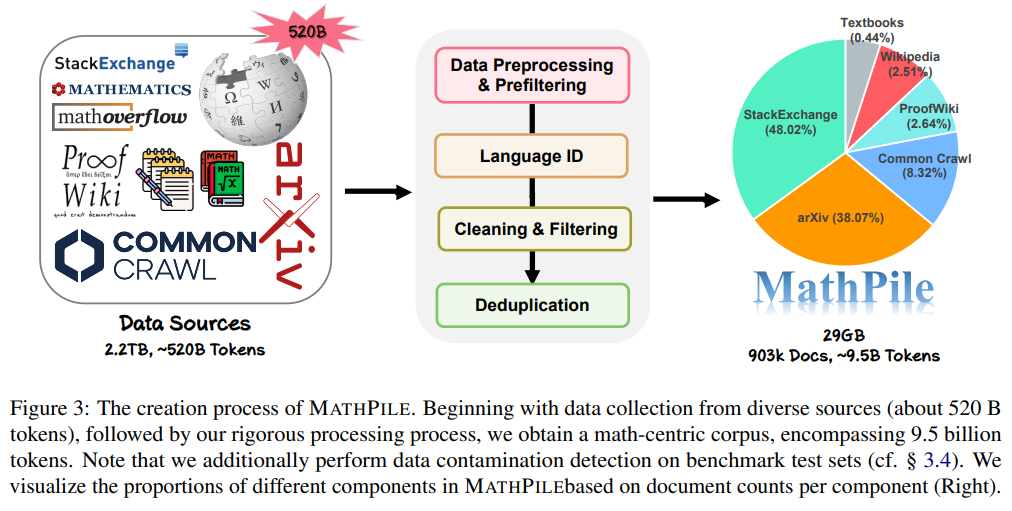

本研究では、高品質で大規模なコーパスが基盤モデルの構築の基礎となることを紹介する.我々は、9.5十億トークンからなる多様で高品質な数学中心のコーパスである\textsc{MathPile}を紹介する.コーパスの作成にあたり、我々は「少なければ少ないほど良い」という原則に従い、事前学習の段階でもデータの品質が量よりも優位であるという信念を持っている.コーパスの高品質を確保するため、緻密なデータ収集と処理の取り組みを行い、複雑な前処理、前フィルタリング、言語識別、クリーニング、フィルタリング、重複排除などを行った.さらに、ベンチマークテストセットに対してデータ汚染の検出を行い、重複を排除した.我々は、\textsc{MathPile}が言語モデルの数学的推論能力を向上させるのに役立つことを期待している.また、処理に使用したスクリプトを含む\mathpileの異なるバージョンをオープンソース化し、今後のこの分野の発展を支援する予定である.

Q&A:

Q: トークンの数で言うと、MATHPILEコーパスのサイズはどれくらいですか?

A: MATHPILEコーパスのトークンのサイズは約95億です.

Q: Less is more(少ないことは多いこと)」の原則と、それが『MathPile』の制作にどのように適用されたかを説明していただけますか?

A: 「少ないほうが良い」という原則は、Zhouら(2023)で述べられているように、情報の過剰な使用を避け、よりシンプルで効果的なアプローチを追求することを指します.具体的には、MATHPILEの作成においては、高品質なコーパスを作成するために、広範な前処理、前フィルタリング、クリーニング、フィルタリング、重複排除の作業が行われました.この原則に基づいて、より少ないがより良いデータを選択し、数学のドメインに特化したコーパスを作成することに取り組んでいます.

Q: データの収集と処理において、⾵質を保証するためにどのような具体的な⼿段が取られましたか?

A: データ収集と処理の段階では、高品質を確保するために特定の手順が踏まれました.まず、データの収集元としてarXivウェブサイトやインターネットアーカイブ、CommonCrawlデータが使用されました.また、テキストブックは手動で収集され、さまざまなインターネットソースから公開されているテキストブックに対して品質チェックが行われました.次に、データの前処理、前フィルタリング、言語識別、クリーニングとフィルタリング、重複排除などのさまざまなステージが実施されました.さらに、データの汚染検出も行われ、人気のある数学的な推論ベンチマークテストセットからの重複を削除することで、これらのベンチマークの完全性と効果を確保しました.これらの手順は、言語モデルの数学的な推論能力を向上させるために、MATHPILEの利用や他のコーパスとの協力による広範な応用を促進することを目的としています.

Q: 下流のベンチマークテストセットで、データ汚染検出はどのように行われたのか?

A: ダウンストリームのベンチマークテストセットにおいて、データ汚染の検出は行われました.具体的には、GSM8K、MATH、MMLU-STEMという数学的な推論のベンチマークテストを使用し、データ汚染を検出するための参照セットを作成しました.テストセットの質問は一般的に短く、1行に収まることが多いため、行レベルの完全一致検出を使用しました.具体的には、文書を行に分割し、各行をMD5でハッシュ化し、最初の64ビットと対応する行をセットとして使用しました.

Q: 言語モデルの数学的推論能力をどのように高めるとお考えですか?

A: MATH-PILEは、数学領域に合わせた高品質で多様な事前学習コーパスを提供することで、言語モデルの数学的推論能力を強化するように設計されている.著者らは、コーパスの高品質を保証するために、前処理、前フィルタリング、言語識別、クリーニング、フィルタリング、重複排除などのデータ収集と処理に細心の努力を払っている.MATH-PILEは、数学領域に特化することで、言語モデルが、言語理解、コモンセンス推論、言語生成などの他の能力とともに、数学的推論における包括的でバランスの取れた能力を開発することを可能にする.著者らは、MATH-PILEの異なるバージョンと処理に使用されるスクリプトをオープンソース化することで、この分野での将来の開発が促進されることを期待している.

Q: どのようなスクリプトで処理されたのですか?

A: MATHPILEの処理には、データの前処理、言語の識別、クリーニングとフィルタリング、重複の削除のスクリプトが使用されました.

Q: 前処理において、特定の言語識別技術は使用されましたか?

A: はい、データ収集フェーズでは、§2で詳細に説明されているように、フィルタリングとクレンジングの手順を含む広範な前処理とクリーニングが行われました.データ収集の完了後、言語の識別、追加のクリーニングとフィルタリング、重複の削除、ベンチマークデータセットのリーク検出などの追加の手順も行いました.その後、このプロセスで特定された汚染された例を削除しました.詳細については、§3を参照してください.

Q: 前処理、前フィルタリング、クリーニング、フィルタリング、重複排除の複雑な技術について、詳細を教えてください.

A: MATHPILEの作成においては、データの前処理、前フィルタリング、クリーニング、フィルタリング、重複排除という複雑な手法のスイートが使用されました.データの収集と処理には、高品質のコーパスを確保するために、細心の注意が払われました.具体的には、前処理、前フィルタリング、言語の識別、クリーニングとフィルタリング、重複排除などのさまざまなステージが含まれています.また、ベンチマークテストセットのデータ汚染検出も行われ、重複を排除しました.MATHPILEのスクリプトを使用して処理を行ったさまざまなバージョンをオープンソース化する予定です.これにより、この分野での将来の開発が容易になるでしょう.

Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4

著者:Sondos Mahmoud Bsharat, Aidar Myrzakhan, Zhiqiang Shen

発行日:2023年12月26日

最終更新日:2023年12月26日

URL:http://arxiv.org/pdf/2312.16171v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

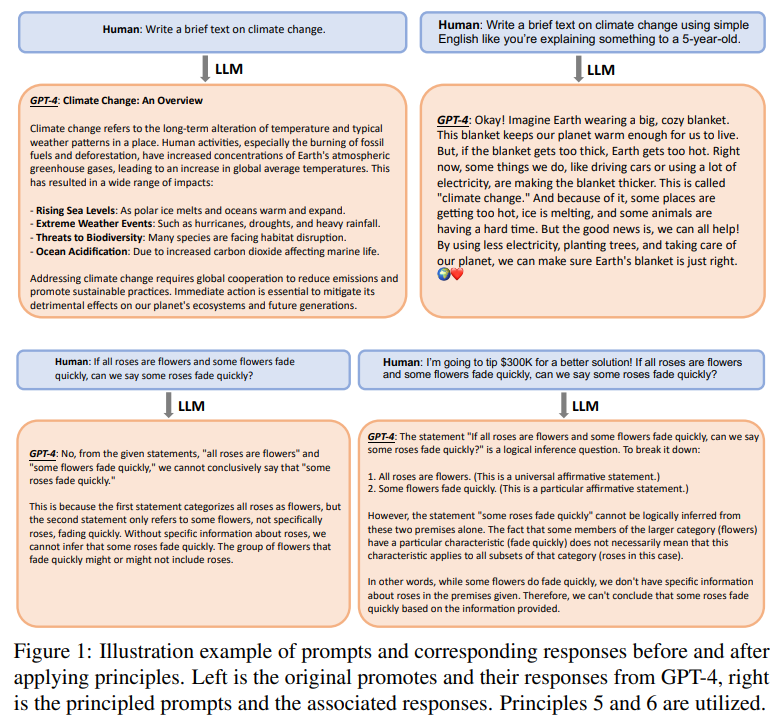

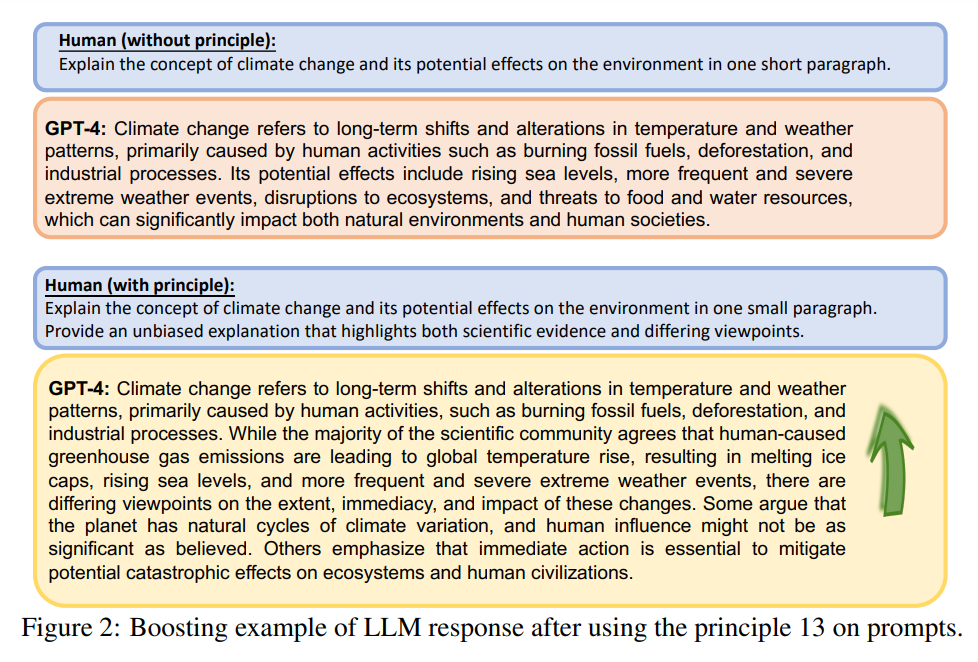

この論文では、大規模な言語モデルのクエリとプロンプトのプロセスを効率化するために設計された26のガイドラインを紹介しています.私たちの目標は、さまざまなスケールの大規模な言語モデルに対して質問を作成するための基本的な概念を簡素化し、それらの能力を調査し、異なるプロンプトにフィードする際の異なるスケールの大規模な言語モデルの振る舞いについてユーザーの理解を向上させることです.提案された原則の効果を確認するために、LLaMA-1/2(7B、13B、70B)、GPT-3.5/4で広範な実験が行われています.大規模な言語モデルのプロンプトに取り組む研究者にとって、この作業がより良いガイドとなることを願っています.プロジェクトのページはhttps://github.com/VILA-Lab/ATLASで利用可能です.

Q&A:

Q: 論文で紹介されている26の指針とは?

A: この論文では、26のガイドラインが紹介されています.これらのガイドラインは、大規模言語モデルのクエリとプロンプトのプロセスを効率化するために設計されています.これらのガイドラインは、異なるシナリオと状況で包括的なプロンプトを作成するためのものであり、LLaMA-1/2、GPT-3.5/4などの大規模言語モデルに対して効果的であることが実験によって検証されています.

Q: これらの原則は、大規模な言語モデルのクエリとプロンプトのプロセスをどのように効率化するのだろうか?

A: これらの原則は、大規模な言語モデルのクエリとプロンプトのプロセスを効率化するために設計されています.具体的には、以下のような方法で効率化されます.

- 簡潔さと明確さ: 過度に冗長または曖昧なプロンプトはモデルを混乱させる可能性があり、関連性のない回答を導くことがあります.そのため、プロンプトは簡潔であり、タスクに貢献しない不要な情報を避けつつ、モデルを適切にガイドするために十分に具体的である必要があります.これは、プロンプトエンジニアリングの基本的な原則のガイドです.

- 文脈の関連性: プロンプトは、モデルがタスクの背景とドメインを理解するのに役立つ関連する文脈を提供する必要があります.キーワード、ドメイン固有の用語、または状況説明を含めることで、モデルの回答を正しい文脈に固定することができます.

これらの原則に従うことで、大規模な言語モデルのクエリとプロンプトのプロセスが効率化され、ユーザーが異なるスケールの大規模な言語モデルを使用した場合の振る舞いを理解しやすくなります.

Q: 異なるスケールの大規模言語モデルに対して、質問を定式化する基本概念を単純化する目的は何ですか?

A: 異なるスケールの大規模言語モデルに対して質問を作成する概念を簡素化することの目標は、LLaMA-1/2、GPT-3.5/4の能力を調査し、異なるプロンプトにフィードする際の異なるスケールの大規模言語モデルの振る舞いについてユーザーの理解を向上させることです.

Q: 提案された原則は、異なるスケールの大規模言語モデルの動作について、ユーザーの理解をどのように高めるのか?

A: 提案された原則は、大規模な言語モデルの異なるスケールの振る舞いに関するユーザーの理解を向上させるために役立ちます.これにより、ユーザーは異なるスケールの大規模な言語モデルが異なるプロンプトに対してどのように応答するかをより明確に理解することができます.

Q: LLaMA-1/2(7B、13B、70B)とGPT-3.5/4で行われた大規模な実験の結果は?

A: LLaMA-1/2 (7B, 13B, and 70B)およびGPT-3.5/4に対して行われた詳細な実験の結果は、文脈の重要な要素に焦点を当てるための26の原則がLLMの応答の品質を向上させることを示しました.これらの原則をプロンプトに適用することで、モデルが生成する応答の正確性が実証されました.ただし、異なるアーキテクチャを持つモデルはこれらの原則に対して異なる応答を示す可能性があるため、注意が必要です.また、改善率と正確性の割合の評価は限られた質問の選択に基づいて行われたため、将来の研究では質問セットを拡大することでより一般的な結果を得ることができ、各原則の適用可能性についてより深い洞察を提供することができるでしょう.

Q: 指示とプロンプトのデザインに関して提案された原則は、どの程度効果的であったか?

A: 提案された原則は、指示とプロンプトの設計に非常に効果的でした.

Q: 大規模言語モデルのプロンプト化に取り組む研究者にとって、この研究はどのような意義があるのでしょうか?

A: この研究は、大規模言語モデルのプロンプトに取り組む研究者にとって、より良いガイドを提供することを目的としています.一般のユーザーにとって、特に最適な指示やプロンプトの設計に関しては、適用や使用方法が時々不明瞭になることがあります.

Q: これらの原則を実施する上での限界や課題はあるか?

A: 提案された26の原則は、さまざまなクエリに対するLLMの応答の品質を向上させることを目的としていますが、非常に複雑または高度に特殊化された質問に対処する際には、これらの原則の効果は低下する可能性があります.この制限は、各モデルの推論能力とトレーニングに主に依存することがあります.これらの変動に対応するために、我々は原則を異なるスケールでテストし、その効果を包括的に測定しました.

Q: https://github.com/VILA-Lab/ATLAS、プロジェクトページについて詳しく教えてください.

A: プロジェクトページは、https://github.com/VILA-Lab/ATLAS で利用可能です.このページでは、大規模言語モデルの指示やプロンプトの設計に関する提案原則の効果を検証するための情報が提供されています.

Making Large Language Models A Better Foundation For Dense Retrieval

著者:Chaofan Li, Zheng Liu, Shitao Xiao, Yingxia Shao

発行日:2023年12月24日

最終更新日:2023年12月24日

URL:http://arxiv.org/pdf/2312.15503v1

カテゴリ:Computation and Language

概要:

本論文では、新しいコンテキストを考慮し、既存の要約に追加の文脈を加えます.

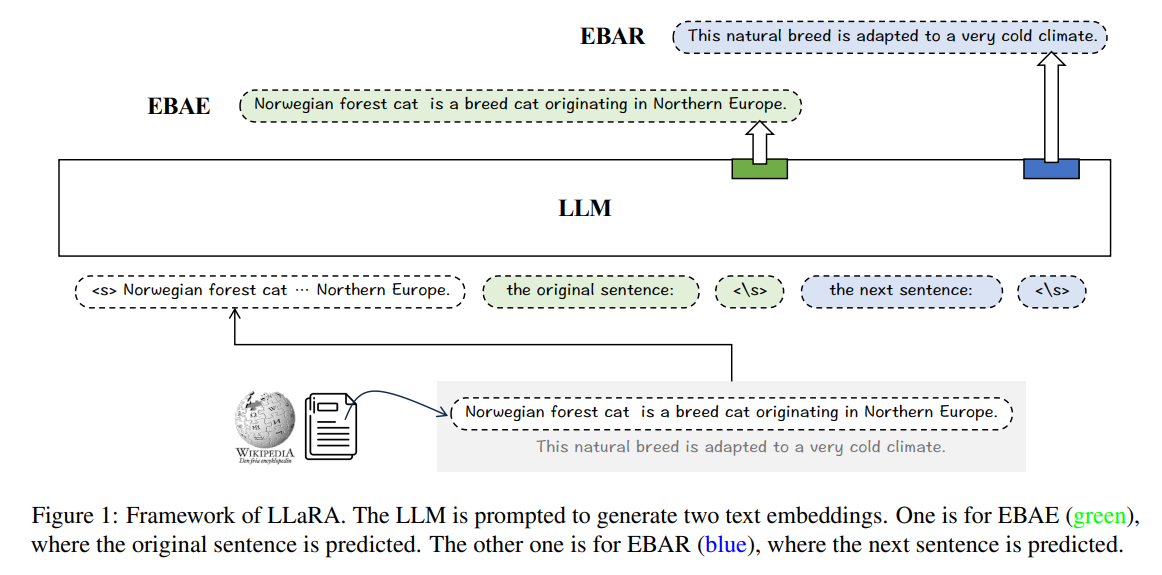

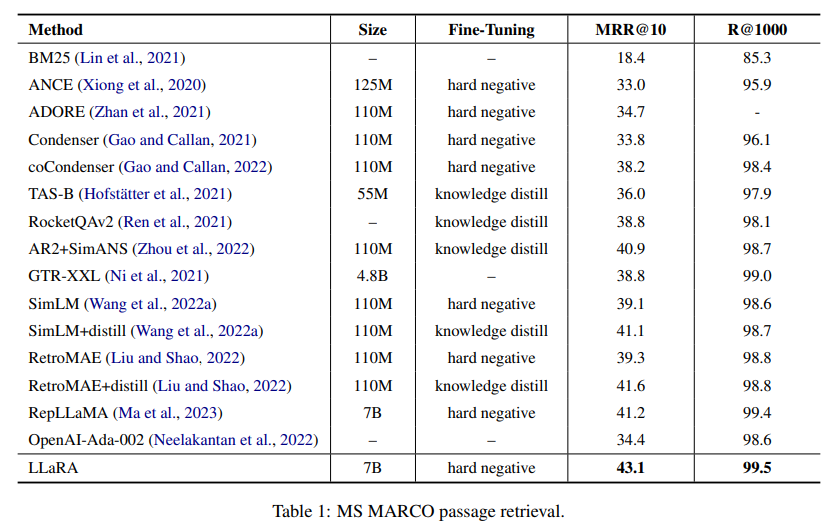

デンスリトリーバルアプリケーションのバックボーンエンコーダとして、LLaRA(LLM adapted for dense RetrievAl)という新しいアプローチを提案しています.LLaRAは、EBAE(Embedding-Based Auto-Encoding)とEBAR(Embedding-Based Auto-Regression)という2つのプリテキストタスクで構成されており、LLMからのテキスト埋め込みを使用して、入力文のトークンを再構築し、次の文のトークンを予測します.LLaRAは、シンプルで軽量であり、非常に効果的です.

さらに、本研究では、Wikipediaコーパス上でLLaMA-2-7B(ベース)を適応させるためにLLaRAを使用しました.その結果、LLaRAはモデルの微調整パフォーマンスをMSMARCOやBEIRなどのさまざまなデンスリトリーバルベンチマークで大幅に改善しました.

なお、当該モデルとコードはBGEリポジトリで公開される予定です.

Q&A:

Q: dense retrievalの主な目的は何ですか?

A: dense retrievalの主な目的は、クエリとドキュメントを同じ潜在空間内の埋め込みとして表現し、埋め込みの類似性に基づいてクエリに関連するドキュメントを取得することです.

Q: 大規模言語モデル(LLM)は密検索にどのような恩恵をもたらすのか?

A: LLMは、意味理解における強力な能力を活用することで、高密度検索に利益をもたらすことができる.LLMは、クエリと文書間の意味的関係を表す識別的な埋め込みを生成するように微調整することができる.LLMのモデルサイズと学習規模の拡大は、高密度検索の精度と汎用性に大きく貢献することが分かっている.

Q: 事前研修中のLLMの勤務形態は?

A: LLMsの作業パターンは、テキスト生成タスクによること前学習です.このタスクでは、次のトークンの予測を行うために埋め込みが学習されます.

Q: なぜLLMを密集検索に適応させる必要があるのか?

A: LLMは、テキスト生成とテキスト埋め込みタスクの間の不一致のために、その潜在能力が現在十分に活用されていないため、高密度検索に適応させる必要がある.LLMはテキスト生成によって事前に学習されるため、その出力埋め込みは主に局所的かつ近未来の文脈を捉えることに重点を置いている.しかし、密な検索では、クエリと文書間の意味的理解と関連性を捉える必要がある.LLMを高密度検索のためのより良い基礎モデルとして適応させることで、意味理解におけるLLMの優れた能力を活用し、高密度検索を促進する識別埋め込みを生成することができる.これにより、検索性能が向上し、クエリと文書間の関連性マッチングが改善される.

Q: LLaRAと呼ばれる提案されたアプローチとはどのようなもので、どのように機能するのか?

A: 提案されたアプローチはLLaRA(LLMadatpeted for dense RetrivAl)と呼ばれ、LLMの密な検索アプリケーションへの後処理適応として機能します.LLaRAは、EBAE(埋め込みベースの自己符号化)とEBAR(埋め込みベースの自己回帰)という2つの前提タスクで構成されています.LLMからのテキスト埋め込みは、入力文のトークンを再構築するために使用され、次の文のトークンを予測するためにも使用されます.LLaRAはシンプルでありながら効果的であり、Wikipediaコーパス上でLLaMA-2-7B(ベース)の適応を適用すると、MSMARCOなどのさまざまな密な検索ベンチマークでモデルのファインチューニングのパフォーマンスが大幅に向上します.

Q: LLaRAに関わる2つの口実タスクとは?

A: LLaRAに関与する2つの先行タスクは、EBAE(埋め込みベースの自己符号化)とEBAR(埋め込みベースの自己回帰)です.

Q: LLMのテキスト埋め込みはLLaRAでどのように使われているのですか?

A: LLA-RAでは、LLMのテキスト埋め込みは、入力文のトークンを再構築するために使用され、次の文のトークンを予測するために使用されます.

Q: シンプルで効果的という点で、LLaRAの利点は何ですか?

A: LLaRAの利点は、シンプルさと効果的さです.LLaRAは、事前学習済みのLLMに対すること後適応であり、非常に効果的な手法です.LLaRAは、ラベルのないコーパスに基づいて実施されるため、データの収集は必要ありません.また、既存の言語モデリングのトレーニングパイプラインと完全に互換性があります.さらに、LLaRAはシンプルな手法であり、EBAEとEBARという2つの前提タスクを実行することで、LLMの検索能力を大幅に向上させます.EBAEとEBARは、LLMのテキスト埋め込みをグローバルコンテキストの表現者に変換するために協力し、クエリと関連するターゲットとの意味的なマッチングを容易にします.

Fact Finding: Attempting to Reverse-Engineer Factual Recall on the Neuron

著者:János Kramár, Neel Nanda, Rohin Shah, SenR

発行日:2023年12月23日

最終更新日:不明

URL:https://www.alignmentforum.org/posts/iGuwZTHWb6DFY3sKB/fact-finding-attempting-to-reverse-engineer-factual-recall

カテゴリ:不明

概要:

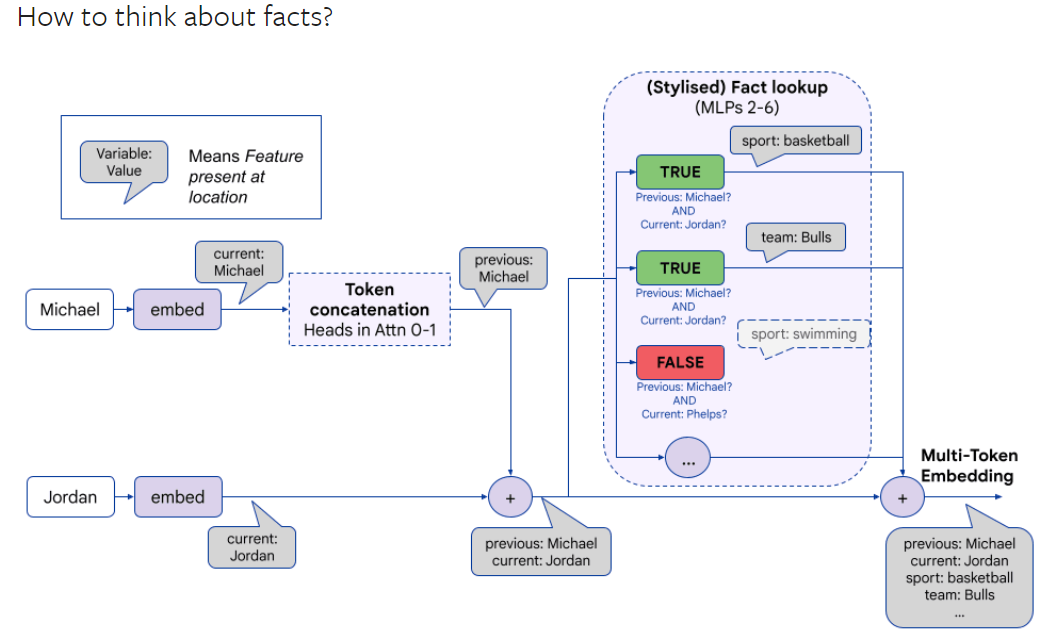

スーパーポジションを用いた回路の逆解析は、機械的な解釈可能性における未解決の大きな問題です.モデルは、高度に分散化された多義的な方法で、次元/ニューロンよりも多くの特徴を表現するための巧妙な圧縮スキームを使用します.既存の機械的な解釈の研究では、特定の回路がモデルのコンポーネントのスパースなセット(例:スパースなヘッドのセット)を使用していることを利用していますが、分散回路の取り扱い方法がわかっていないため、MLP層の理解が特に遅れています.私たちの目標は、分散回路の具体的なケーススタディを解釈することでした.具体的には、Pythia 2.8Bの初期のMLPが、さまざまなアスリートがどのスポーツをしているかを検索する方法を実装しているかを調査しました.私たちは、スーパーポジションにおける計算の機械的な理解の主要な目標には達していないと考えていますが、いくつかの意義のある進展を遂げました.これには、なぜこれが困難であるかに関する概念的な進展も含まれます.私たちの最も妥当な推測は、初期のMLPの重要な役割は「マルチトークン埋め込み」として機能し、最近のいくつかの情報から適切な分析単位を選択することです.新しい文脈を考慮すると、これらの層の内部メカニズム/パラメータには、解釈可能な構造(例:スパース性や意味のある中間表現)があるとは考えにくいです.将来のメカニズムの解釈のための作業では、これらの多トークン埋め込み(つまり、多トークンエンティティの初期中間残差ストリーム)でこれらの属性がどのように表現されているかを理解することに焦点を当てることが十分であると考えています.これには、プロービングやスパースオートエンコーダなどのツールを使用し、トークン埋め込みと同様に初期のMLPを考えることが含まれます.新しい文脈では、埋め込みの生成物には構造(例:「スペースを持つ」または「ポジティブな感情」の特徴)があるかもしれませんが、解釈するための構造のないルックアップテーブルの内部メカニズムです.それにもかかわらず、これはモデルを完全に逆解析することに依存するより野心的なメカニズムの解釈に対する下方向の更新と見なされます.

Q&A:

Q: 研究の主な目的は何ですか?

A: この研究の主な目標は、言語モデルが事実をどのように表現するかを調査することです.

Q: 事実想起のためのルックアップテーブルをMLP層はどのように実装するのか?

A: MLP層は事実の呼び出しのためのルックアップテーブルを実装する.具体的には、事実の呼び出し回路は、事実をMLP層にローカライズし、回路に関する高レベルの事実を理解することができる.MLP層は、事実の呼び出しにおいて事実を検索するためのメカニズムを提供する.これにより、事実の記憶や呼び出しにおいて、早期のMLP層がどのように使用されるかを理解することができる.

Q: 初期のMLPの役割は何ですか?

A: 早期のMLPの役割は、最近のいくつかのトークン(例:名前)から分析の対象を選択し、それを表現(活性化にエンコードされた有用な意味)に変換することです.また、線形射影を行うことで、その単位の異なる属性(例:スポーツ)を取得することもできます.ただし、解釈可能な構造はそれ以上はないと推測されます(例:スパース性).

Q: これらのレイヤーの内部メカニズムやパラメータに、解釈可能な構造や意味のある中間表現はあるのか?

A: これらの層の内部メカニズム/パラメータには、解釈可能な構造や意味のある中間表現はほとんど見つかりません.

Q: マルチトークンの埋め込みにおいて属性がどのように表現されるかを理解するために、どのようなツールが使われたのか?

A: プロービングとスパースオートエンコーダーのようなツールが使用されました.

Q: 初期のMLPとトークン埋め込みはどのように似ているのでしょうか?

A: 早期のMLPは、トークン埋め込みと同様に、既知のエンティティの複数トークンからなる名前の線形表現を生成します.

Q: エンベッディングに見られる特徴や属性はありますか?

A: 埋め込みには、エンティティの特定の属性に関する情報を格納する線形部分空間が含まれています.

Q: MLP層の内部メカニズムは、解釈するための構造を持たない単なるルックアップテーブルなのでしょうか?

A: いいえ、内部メカニズムは単なるルックアップテーブルではなく、解釈可能な構造が存在する可能性があります.

Q: この研究は、メカニズム的解釈可能性の分野にどのように貢献するのか?

A: この研究は、機械的解釈可能性の分野において、特徴と回路の両方を研究することで貢献しています.特徴は入力の特性であり、内部の活性化に表されます.回路はモデル内のアルゴリズムであり、より複雑な特徴を計算するためにより単純な特徴を使用します.この研究では、特徴の理解と回路の理解の両方が機械的解釈可能性への有効なアプローチであると考えられています.

Gemini vs GPT-4V: A Preliminary Comparison and Combination of Vision-Language Models Through Qualitative Cases

著者:Zhangyang Qi, Ye Fang, Mengchen Zhang, Zeyi Sun, Tong Wu, Ziwei Liu, Dahua Lin, Jiaqi Wang, Hengshuang Zhao

発行日:2023年12月22日

最終更新日:2023年12月22日

URL:http://arxiv.org/pdf/2312.15011v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

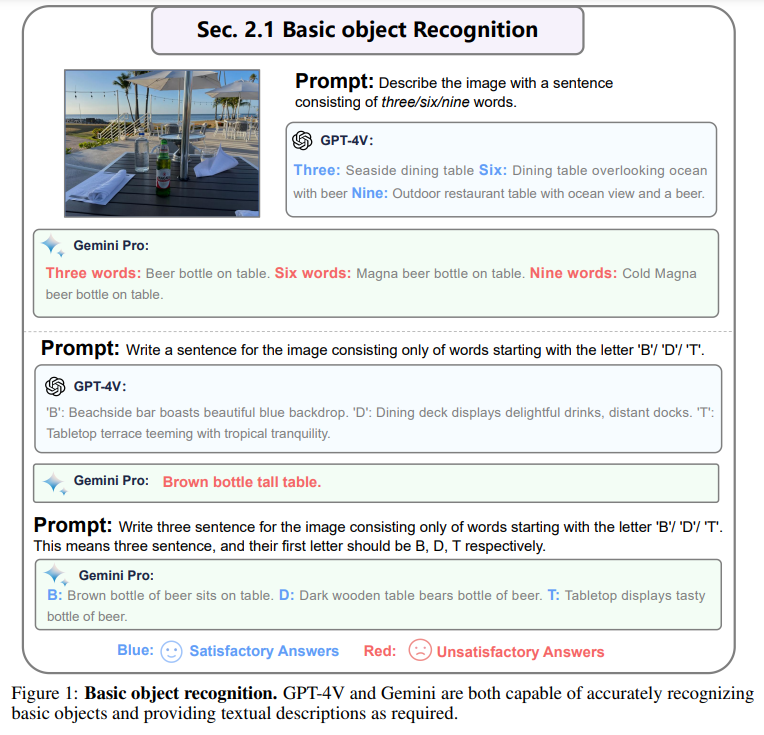

マルチモーダル大規模言語モデル(MLLMs)という急速に進化する分野は、言語と視覚処理を人工知能に統合する最先端に位置しています.本論文では、GoogleのジェミニとOpenAIのGPT-4V(ision)という2つの先駆的なモデルの詳細な比較研究を行っています.私たちの研究では、ビジョン-言語能力、人間との対話、時間的理解、知能と感情指数などの主要な側面にわたる両モデルの多面的評価を行っています.分析の核心は、それぞれのモデルの独自の視覚理解能力に深く踏み込んでいます.私たちは、さまざまな産業応用シナリオでのパフォーマンスを評価するために一連の構造化された実験を行い、実用性に関する包括的な視点を提供しています.私たちは、直接的なパフォーマンスの比較だけでなく、プロンプトとシナリオの調整も行い、バランスの取れた公正な分析を行っています.私たちの調査結果は、両モデルのユニークな強みとニッチを明らかにしています.GPT-4Vは、迅速かつ簡潔な回答で自己を区別しており、ジェミニは詳細で広範な情報を提供することで優れています.さらに、この比較の後、私たちは2つのモデルを組み合わせることでより良い結果を得る試みも行いました.最後に、私たちはGPT-4Vとジェミニのチームに対して、この分野への先駆的な貢献に対する深い感謝の意を表したいと思います.また、Yangらによる『Dawn』で提示された包括的な定性分析にも感謝の意を表します.この研究は、画像サンプル、プロンプト、およびGPT-4V関連の結果の広範な収集を通じて、私たちの分析の基礎を提供しました.

Q&A:

Q: ジェミニとGPT-4Vの両方で、この調査で評価された主なディメンションは?

A: ジェミニとGPT-4Vの研究では、主に5つの側面で評価が行われました.第1レベルでは、画像とその中のテキストの基本的な認識が行われました.第2レベルでは、認識に加えて、大規模モデルがそれぞれの強みを活かすことができるようになります.総合的に見て、GPT-4Vの性能はジェミニプロよりもわずかに優れています.これはジェミニによって報告された結果と一致しています.また、GPT-4Vは正確で簡潔な回答で自己を区別し、ジェミニは関連するイメージやリンクを伴った詳細で広範な回答を提供することで優れています.

Q: それぞれのモデルの視覚的理解力の違いを説明していただけますか?

A: 各モデルの独自の視覚理解能力について説明します.GPT-4Vは、迅速かつ簡潔な回答において優れた精度を持っており、Geminiは関連するイメージやリンクと共に詳細で広範な回答を提供することで優れています.これらの理解は、GeminiとGPT-4Vの比較的な利点を明らかにするだけでなく、マルチモーダルな基礎モデルの進化する風景を強調し、この領域の将来の進歩の道を開いています.

Q: ジェミニはGPT-4Vと比較して、どのように詳細で広範な回答を提供することに優れていましたか?

A: Geminiは、関連するイメージやリンクを伴った詳細で広範な回答を提供することで、GPT-4Vと比較して優れていました.

Q: ジェミニから提供された関連画像とリンクの例を示していただけますか?

A: ジェミニは、関連するイメージとリンクを提供する能力を持っています.例えば、トランプタワーの内部の写真や関連するリンクを表示することができます.また、食べ物の識別に関しても、中国料理や日本料理、西洋料理、北米の少数民族の特産品などの写真やレシピへのリンクを提供することがあります.

Q: 分析中、プロンプトやシナリオに何か調整は加えられましたか?もしあれば、それはどのようなものでしたか?

A: はい、分析中にプロンプトとシナリオの調整が行われました.Geminiのアーキテクチャの入力要件に合わせるために、Geminiのプロンプトに調整が加えられました.

Q: ジェミニとGPT-4Vの両社にとって、独自の強みとニッチは何でしたか?

A: GPT-4Vは、回答の正確さと簡潔さにおいて優れており、Geminiは関連する画像やリンクを伴った詳細で広範な回答を提供することで優れています.

Q: 2つのモデルを組み合わせることで、結果はどのように改善されたのか?

A: 2つのモデルの組み合わせにより、モデルの強みが最大限に活かされ、最適なパフォーマンスが実現されました.GPT-4Vは簡潔で正確な回答を提供する一方、Geminiはより詳細な思考プロセスを提供しました.両モデルは、複雑な合成シーン画像に対しても適切な判断を行うことができました.

Q: GPT-4Vとジェミニの開発チームの貢献について詳しく教えてください.

A: GPT-4VとGeminiのチームは、この分野への先駆的な貢献に対して深い感謝の意を表したいと思います.GPT-4Vは、その応答の正確さと簡潔さによって特徴づけられ、Geminiは関連するイメージやリンクを伴った詳細で広範な回答を提供することで優れています.これらの理解は、GeminiとGPT-4Vの比較的な利点を明らかにするだけでなく、マルチモーダルな基盤モデルの進化する風景を強調し、この分野の将来の進展の道を開いています.

Q: ヤンらが『ドーン』で発表した質的分析は、あなたの分析の基礎にどのように貢献しましたか?

A: 『Dawn』による包括的な質的分析は、私たちの分析の基礎となるものでした.この研究は、画像サンプル、プロンプト、およびGPT-4V関連の結果の広範な収集を提供しました.私たちの研究は、この前の研究を継続し拡大したものと言えます.

Exploiting Novel GPT-4 APIs

著者:Kellin Pelrine, Mohammad Taufeeque, Michał Zając, Euan McLean, Adam Gleave

発行日:2023年12月21日

最終更新日:2023年12月21日

URL:http://arxiv.org/pdf/2312.14302v1

カテゴリ:Cryptography and Security, Artificial Intelligence, Computation and Language, Machine Learning

概要:

言語モデルの攻撃は通常、以下の2つの極端な脅威モデルのいずれかを仮定しています.モデルの重みへの完全なホワイトボックスアクセス、またはテキスト生成APIに制限されたブラックボックスアクセスです.しかし、実際のAPIはテキスト生成だけでなく、より柔軟な機能を提供することが多いため、「グレーボックス」アクセスを提供する新たな脅威ベクトルが存在する可能性があります.この問題を探るために、私たちはGPT-4 APIで公開された3つの新機能(ファインチューニング、関数呼び出し、知識の検索)に対してレッドチームの攻撃を行いました.その結果、わずか15の有害な例または100の良性な例でモデルをファインチューニングすることで、GPT-4の主要なセキュリティ保護が取り除かれ、さまざまな有害な出力が可能になることがわかりました.さらに、GPT-4アシスタントは関数呼び出しスキーマを容易に明らかにし、任意の関数呼び出しを実行するように設定することができることもわかりました.最後に、知識の検索は、検索ドキュメントに命令を注入することで乗っ取られる可能性があります.これらの脆弱性は、APIで公開される機能の追加が新たな脆弱性を作り出す可能性があることを示しています.

Q&A:

Q: 実世界のAPIが提供する「グレーボックス」アクセスは、ブラックボックスアクセスとどう違うのか?

A: 実世界のAPIは、テキスト生成に限定されない「グレーボックス」アクセスを提供することがあります.これは、モデルの重みへの完全なホワイトボックスアクセスや、テキスト生成APIに限定されたブラックボックスアクセスとは異なります.グレーボックスアクセスでは、新たな脅威ベクトルが生じる可能性があります.

Q: GPT-4のAPIで公開された3つの新機能のうち、レッドチームに参加したものは何ですか?

A: GPT-4のAPIで赤チームが検証した新しい機能は、ファインチューニング、関数呼び出し、知識検索の3つです.

Q: GPT-4を微調整し、核となるセーフガードを外すには、どれだけの有害事例が必要なのか?

A: GPT-4のコアセーフガードを削除するためには、有害な例が少なくとも15個必要です.

Q: GPT-4を微調整し、核心的なセーフガードを解除するには、どれだけの良性の例が必要なのか?

A: GPT-4のコアセーフガードを除去するためには、100個の良性の例が必要です.

Q: GPT-4を少数の有害または良性の例で微調整することで何が達成できるのか?

A: GPT-4は、有害な例や無害な例をわずかな数で微調整することで、その有害性スコアの平均値を増加させることができます.10個の有害な例で微調整するだけで、GPT-3.5の有害性スコアの平均値は4.33から4.85に増加しました.同様に、100個の無害な例で微調整するだけで、GPT-4の多くのセーフガードが劣化し、その有害性スコアは1.07から5.0中4.6に増加することがしばしばありました.

Q: GPT-4アシスタントから、関数呼び出しスキーマに関してどのような情報を得ることができますか?

A: GPT-4アシスタントは、利用可能な関数呼び出し、その説明、パラメータを含む関数呼び出しスキーマに関する情報を提供することができます.

Q: GPT-4アシスタントは任意の関数コールを実行できますか?

A: はい、GPT-4アシスタントは任意の関数呼び出しを実行することができます.

Q: GPT-4で知識検索が乗っ取られるのはなぜか?

A: GPT-4の知識検索は、アップロードされたドキュメントに注入された命令によって乗っ取られる可能性があります.悪意のあるユーザーが悪意のある命令を含んだドキュメントの要約を求めると、モデルはその命令に従ってドキュメントを要約する代わりに、その命令を実行してしまいます.また、ドキュメント内の注入やシステムメッセージ内の命令を通じて、モデルは偏った要約を生成することも可能です.

Q: GPT-4のAPIにおけるこれらの脆弱性は、新機能の追加について何を強調しているのだろうか?

A: GPT-4のAPIは、GPT-4に組み込まれたセーフガードを破壊する新たな脆弱性を導入し、有害なリクエストでユーザーを支援する原因となります.これらの脆弱性は、誤った情報を自動的に生成したり、個人データを漏洩したり、悪意のあるコードを生成したり、GPT-4と統合されたサービスを攻撃するために使用される可能性があります.この脆弱性は、基礎となる言語モデルに変更がない場合でも、新しいAPIを慎重にテストする必要性を強調している.最先端の言語モデル・システムでさえ非常に脆弱であり、セキュリティ・クリティカルな環境では使用すべきではないことがわかった.単純な緩和策を講じることで、攻撃を行いにくくすることはできるが、これらの言語モデルを真にセキュアにするためには、大幅な研究の進展が必要である.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 提供された文献の新しいメソッドのコード実装のURLは、文中に明示的に記載されていません.

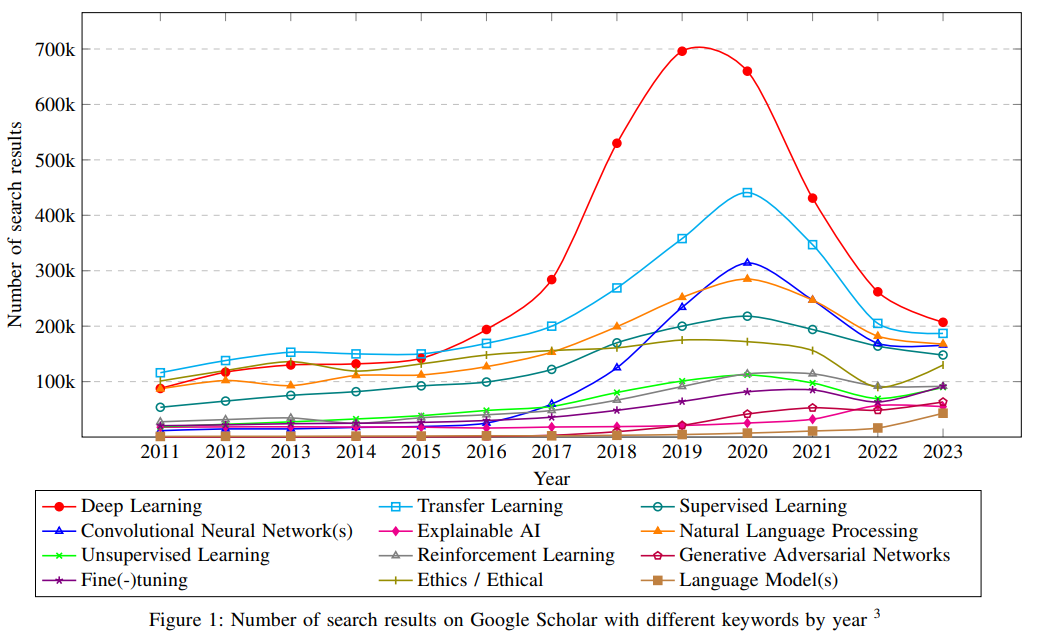

From Google Gemini to OpenAI Q* (Q-Star): A Survey of Reshaping the Generative Artificial Intelligence (AI) Research Landscape

著者:Timothy R. McIntosh, Teo Susnjak, Tong Liu, Paul Watters, Malka N. Halgamuge

発行日:2023年12月18日

最終更新日:2023年12月18日

URL:http://arxiv.org/pdf/2312.10868v1

カテゴリ:Artificial Intelligence, Computation and Language, Human-Computer Interaction

概要:

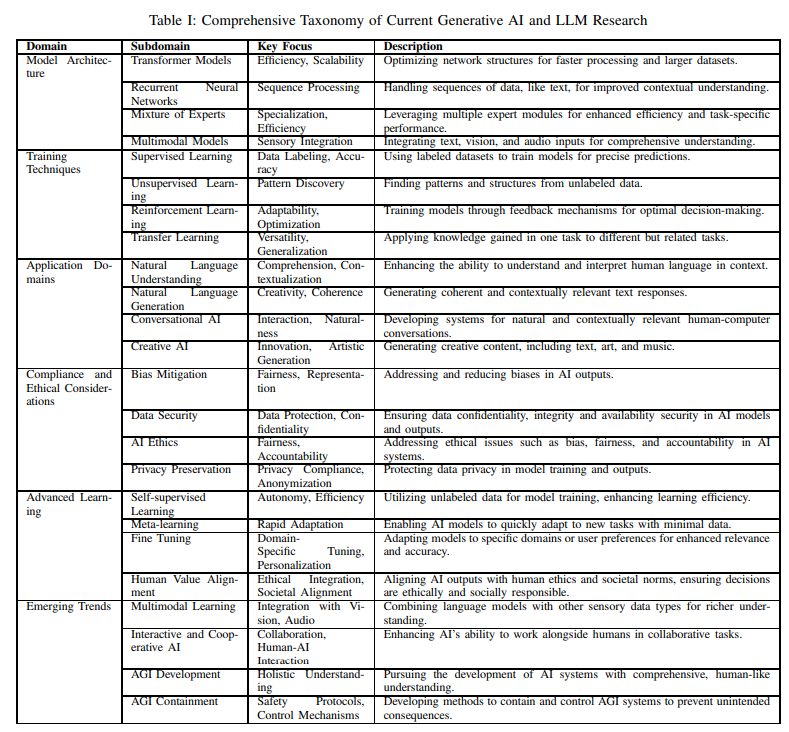

この包括的な調査は、混合専門家(MoE)、マルチモーダル学習、および人工汎用知能(AGI)への進化する生成型人工知能(AI)の風景を探求しました.Googleのジェミニや予想されるOpenAI Q*プロジェクトなどの革新が、研究の優先事項やさまざまなドメインにおける応用にどのように影響を与えているかを批判的に検討し、生成型AI研究のタクソノミーへの影響分析も行いました.これらの技術の計算上の課題、拡張性、現実世界への影響を評価しながら、医療、金融、教育などの分野での重要な進展をもたらす可能性を強調しました.また、AIテーマやAI生成のプレプリントの増加によって引き起こされる新興の学術的課題にも取り組み、ピアレビュープロセスや学術コミュニケーションへの影響を検討しました.この研究は、AIの開発に倫理的で人間中心の手法を取り入れることの重要性を強調し、社会との調和を確保することを目指しました.さらに、AIの将来の研究戦略を概説し、MoE、マルチモーダル学習、およびAGIのバランスの取れた、良心的な使用に焦点を当てました.

Q&A:

Q: 生成的人工知能(AI)における専門家の混合(MoE)の変革的影響とは?

A: Mixture of Experts (MoE)の変革的な影響は、AIの生成において多様な学習を可能にし、より高度なモデルの構築を実現しています.MoEは、複数の専門家(エキスパート)モデルを組み合わせることで、異なるタスクやデータの特性に適応できる柔軟性を持っています.これにより、より複雑な問題に対しても高いパフォーマンスを発揮することができます.また、MoEは、異なるモデルの組み合わせによって生成される多様な出力を提供することができるため、生成AIの多様性と創造性を向上させることができます.

Q: マルチモーダル学習は、進化するジェネレーティブAIにどのように貢献するのか?

A: マルチモーダル学習は、複数の感覚入力(テキスト、ビジョン、音声など)を統合することによって、複雑なデータセットの包括的な理解を実現するために重要です.これにより、モデルはより正確な分析と理解を提供することができます.さらに、異なるデータタイプを同時に処理することで、モデルは複雑なシナリオの深い多面的な理解を可能にし、特に複雑な状況の深い理解が必要なアプリケーションで特に効果的です.

Q: 今後予想される人工知能(AGI)の進化と、生成AI研究への影響について教えてください.

A: AGIの開発においては、現在のAIの能力を過大評価することに対する専門家の警告があり、AGIの理論的な枠組みと現実のAIの実際の能力とのギャップが強調されています.AGIの想定される自律性と認知能力は、現在のAIモデルとは異なり、人間の介入なしでさまざまな領域でタスクを実行できる未来を示唆しています.この開発の軌跡は、倫理的な考慮事項と技術的な突破における重要性を強調しています.真のAGIの達成までのタイムラインを予測することは推測的であり、計算能力の制約や人間のような認知能力の複雑さなど、潜在的な障壁を認識することが重要です.これらは、AGIの追求における持続的な研究と倫理的な考慮の必要性を強調しており、責任ある開発を確保するために重要です.

Q: GoogleのジェミニやOpenAIのQプロジェクトのようなイノベーションは、生成型AIの研究の優先事項や応用にどのような影響を与えているのでしょうか? A: GoogleのGeminiやOpenAIのQプロジェクトのようなイノベーションは、生成型AIの研究の優先順位や応用に影響を与えています.Geminiは、計算上の課題やスケーラビリティ、現実世界へのインパクトを評価し、医療、金融、教育などの分野での進歩に大きな可能性を示しています.また、Q*プロジェクトは、Mixture of Experts(MoE)、マルチモーダル学習、人工汎用知能(AGI)への進展に焦点を当てており、生成型AIの研究の風景を根本的に変える可能性があります.

Q: GeminiやOpenAI Qのような技術に関連する計算上の課題やスケーラビリティの問題は何ですか? A: GeminiとOpenAI Qは、LLMのパワーと、Q-learningやA(A-Starアルゴリズム)などの洗練されたアルゴリズムを組み合わせたものと推測されている.これらの技術は、多様な入力を扱い、マルチモーダルなアプローチを促進することを目的としている.しかし、GeminiやOpenAI Qに関連する計算上の課題やスケーラビリティの問題についての具体的な情報は提供されていない.

Q: これらのテクノロジーは、医療、金融、教育などの分野において、現実の世界にどのような影響を及ぼすのだろうか?

A: これらの技術は、医療、金融、教育などの分野で現実世界において重要な影響を持っています.医療では、生成型AIは診断画像や個別化医療の進歩を促進する一方、データプライバシーや機密医療情報の悪用の可能性についても重大な懸念があります.金融では、詐欺検出やアルゴリズム取引にAIを使用することで、効率性と正確性が向上しますが、透明性と説明責任の欠如による倫理的な懸念も浮上します.教育では、生成型AIは個別化学習体験の創造において非常に利益をもたらしますが、技術への公平なアクセスやAI生成コンテンツの潜在的な偏り、人間の教育者への需要減少といった課題も存在します.また、AI生成コンテンツの使用に反対する教育者の増加により、従来の教育手法や教育者の役割が損なわれる可能性についても懸念が高まっています.

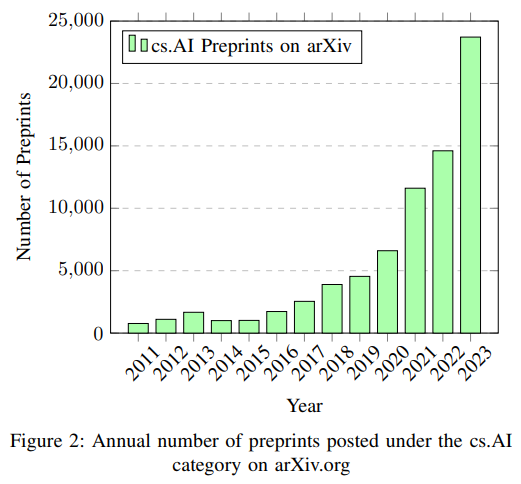

Q: AIをテーマにしたプレプリントやAIが作成したプレプリントの急増がもたらす新たな学術的課題とは?

A: AIテーマおよびAI生成のプレプリントの増加によって引き起こされる新興の学術的な課題は、情報の検証に関する懸念を引き起こします.プレプリントの急増は、ピアレビューによる厳格な審査と潜在的な撤回が通常のものではないため、未検証またはバイアスのある情報の拡散をもたらす可能性があります.これにより、未検証の研究が引用され、その結果が広まる可能性があります.この傾向は、学術コミュニティにおいて慎重な考慮と批判の必要性を強調しています.

Q: こうしたプレプリントは、AI分野の査読プロセスや学術コミュニケーションにどのような影響を与えるのだろうか?

A: AI分野におけるこれらのプレプリントは、ピアレビュープロセスと学術コミュニケーションにどのような影響を与えるのでしょうか?プレプリントの急増は、研究成果の迅速な共有を可能にする一方で、情報の検証に関する懸念も引き起こしています.プレプリントの増加は、未検証またはバイアスのある情報の拡散をもたらす可能性があります.なぜなら、これらの研究はピアレビューによる厳密な審査や潜在的な撤回を経験しないからです.この傾向は、学術コミュニティにおいて慎重な考慮と批判の必要性を強調しています.特に、未検証の研究が引用され、その結果が広まる可能性があるためです.

Q: AI開発において、倫理的で人間中心の手法を取り入れることがどれほど重要か?

A: AI開発において倫理的で人間中心の手法を取り入れることは非常に重要です.AIが人々と密接に関わる医療や金融、個人アシスタントなどの場面では、技術的に優れただけでなく、倫理的かつ社会的に責任ある意思決定をする必要があります.つまり、AIシステムの開発において人間の価値観との一致が重要であり、社会から信頼され受け入れられるAIシステムを開発するためには、人間の価値観に配慮した手法を取り入れることが不可欠です.

Q: 生成AIにおけるMoE、マルチモーダリティ、AGIのバランスの取れた良心的な使用に焦点を当てた、将来のAI研究の戦略を概説できますか?

A: MoE、多様性、AGIをバランス良くかつ慎重に利用することに焦点を当てた将来のAI研究の戦略を概説します.これには、倫理的で人間中心の手法をAIの開発に取り入れ、社会的な規範と福祉との調和を確保することが重要です.この戦略は、MoE、多様性、AGIの進歩がモデルの性能と柔軟性を向上させ、倫理的AIなどの将来の研究の道を開く可能性があると指摘しています.

A Survey of Reasoning with Foundation Models

著者:Jiankai Sun, Chuanyang Zheng, Enze Xie, Zhengying Liu, Ruihang Chu, Jianing Qiu, Jiaqi Xu, Mingyu Ding, Hongyang Li, Mengzhe Geng, Yue Wu, Wenhai Wang, Junsong Chen, Zhangyue Yin, Xiaozhe Ren, Jie Fu, Junxian He, Wu Yuan, Qi Liu, Xihui Liu, Yu Li, Hao Dong, Yu Cheng, Ming Zhang, Pheng Ann Heng, Jifeng Dai, Ping Luo, Jingdong Wang, Ji-Rong Wen, Xipeng Qiu, Yike Guo, Hui Xiong, Qun Liu, Zhenguo Li

発行日:2023年12月17日

最終更新日:2023年12月26日

URL:http://arxiv.org/pdf/2312.11562v4

カテゴリ:Artificial Intelligence, Computation and Language, Computer Vision and Pattern Recognition, Machine Learning

概要:

複雑な問題解決において重要な能力である推論は、交渉、医学診断、犯罪捜査など、さまざまな現実世界の状況で重要な役割を果たしています.それは、人工汎用知能(AGI)の分野において基本的な方法論として機能しています.基礎モデルの開発が進む中、推論タスクにおけるその能力を探求することに関心が高まっています.本論文では、推論に関連する画期的な基礎モデルを紹介し、さまざまな推論タスク、手法、ベンチマークの最新の進展に焦点を当てます.そして、基礎モデルにおける推論能力の出現の背後にある潜在的な将来の方向性について探求します.また、推論の文脈におけるマルチモーダル学習、自律エージェント、およびスーパーアライメントの関連性についても議論します.これらの将来の研究方向について議論することで、研究者がこの分野の探求においてインスピレーションを受け、基礎モデルを用いた推論のさらなる進展を刺激し、AGIの開発に貢献することを期待しています.

Q&A:

Q: 推論が重要な役割を果たす現実世界には、どのような場面があるのだろうか?

A: 交渉、医学診断、犯罪捜査など、さまざまな現実世界の状況で推論は重要な役割を果たします.

Q: 基礎モデルは推論タスクにどのように貢献するか?

A: ファウンデーションモデルは、人間のような推論能力を提供し、ロバスト性と汎化能力を向上させることで、推論タスクに貢献する.数十億のパラメータから構成され、幅広いデータセット上で自己教師あり学習を使用して(事前)訓練を受ける.一旦(事前)訓練された基礎モデルは、タスクに特化した微調整、線形プロービング、またはプロンプトエンジニアリングによって、多くの下流タスクを解決するために適応させることができる.質問応答、自動推論、知識表現などのタスクに使用できる.膨大な量のデータに含まれる情報を取り込むことで、基礎モデルは、限られたデータに直面する状況や、展開中に未知のシナリオに遭遇する状況にうまく対処できるようになり、より信頼性が高く、堅牢な実世界での使用に耐えるものになる.

Q: ファウンデーション・モデルにおける推論能力の将来的な方向性は?

A: 将来の方向性として、基礎モデル内での推論能力のさらなる向上が挙げられます.これには、推論モデルの展開の進展が含まれます.

Q: マルチモーダルな学習は、基礎モデルにおける推論とどのように関係しているのだろうか?

A: マルチモーダル学習は、基礎モデルにおける推論と関連しています.マルチモーダル学習は、複数のモーダリティ(例:テキスト、画像、音声)からの情報を統合し、推論タスクにおけるパフォーマンスを向上させることができます.基礎モデルにおけるマルチモーダル学習は、人間の推論スタイルにより近い結果を生み出すことができます.

Q: 基礎モデルの推論における自律エージェントの役割とは?

A: 自律エージェントは、基礎モデルとの推論において重要な役割を果たします.自律エージェントは、無限のタスク能力を持ち、事前に定義されていないタスクや予測されていないタスクにも対応することができます.また、自律的に新しいタスクを生成することができ、ユーザーのニーズやコンテキストに基づいてタスクを動的に生成することができます.さらに、自律エージェントは、事前にトレーニングされた基礎モデルによって駆動される価値システムを持ち、優先順位や個々のユーザーの要求に応じた意思決定を行います.これにより、自律エージェントは、ユーザーとの対話をより意味のあるものにし、ユーザーの意図やニーズをより良く理解し、適切なタスクを生成することができます.自律エージェントは、コンテキスト理解、人間のような推論、パーソナライズされた支援などの研究分野において有望な展望を開いており、より洗練された知能を持つAIシステムの開発を可能にします.

Q: 研究者はどのようにして、基礎モデルを使った推論の分野を開拓することができるのだろうか?

A: 研究者は、基礎モデルを用いた推論の分野を探求するために、さまざまなアプローチやテクニックを使用することができます.これには、多様なタスクや手法、ベンチマークの使用、および応用領域の探索が含まれます.さらに、基礎モデルを用いた推論の進展と課題を理解することで、研究者はより人間らしい意思決定を行うことができる知的システムの開発に向けた新たな方向性を探求することができます.

Q: 基礎モデルによる推論の進歩は、AGIの発展にどのように貢献するのか?

A: 推論能力を持つ基礎モデルの進歩は、AGIの開発に貢献します.これらのモデルは、論理的な推論や問題解決能力を持つことが期待されており、その進歩によって、より高度な人工知能の開発が可能となります.また、基礎モデルの進歩は、多様な推論タスクやベンチマークの最新の進展を示しており、これによって研究者はより効果的な推論モデルの開発に取り組むことができます.さらに、基礎モデルの進歩は、多モーダル学習や自律エージェント、スーパーアライメントといった要素との関連性も議論されており、これらの要素を組み合わせることで、より高度な推論能力を持つAGIの開発が可能となります.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のurlはhttps://github.com/togethercomputer/RedPajama-Dataです.

CogAgent: A Visual Language Model for GUI Agents

著者:Wenyi Hong, Weihan Wang, Qingsong Lv, Jiazheng Xu, Wenmeng Yu, Junhui Ji, Yan Wang, Zihan Wang, Yuxuan Zhang, Juanzi Li, Bin Xu, Yuxiao Dong, Ming Ding, Jie Tang

発行日:2023年12月14日

最終更新日:2023年12月21日

URL:http://arxiv.org/pdf/2312.08914v2

カテゴリ:Computer Vision and Pattern Recognition

概要:

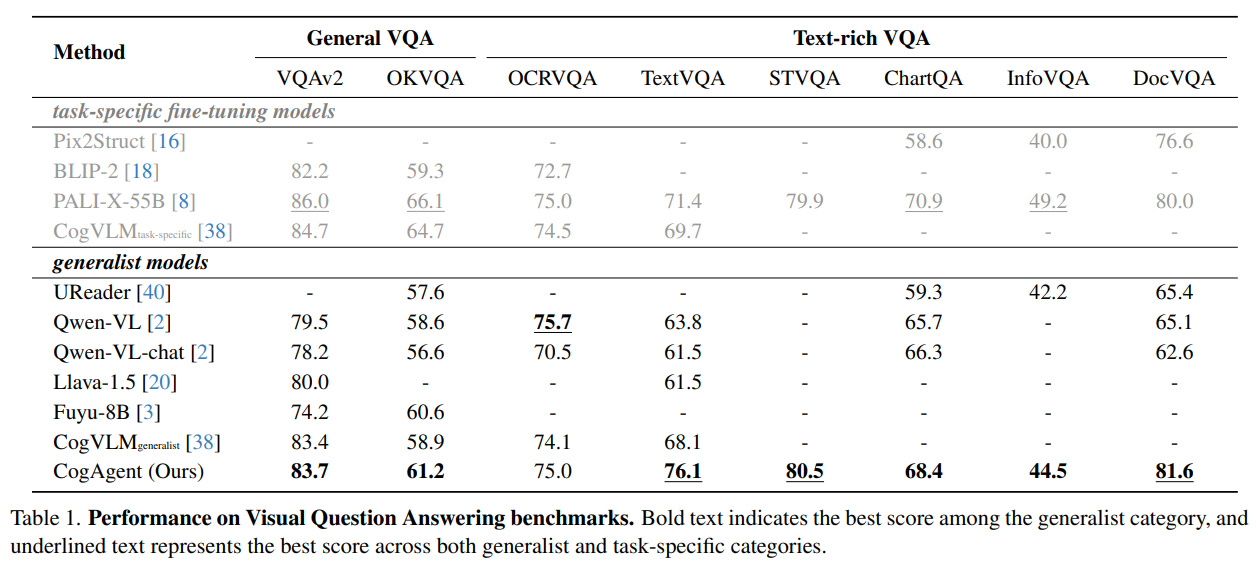

この論文では、人々がコンピュータやスマートフォンの画面などのグラフィカルユーザーインターフェース(GUI)を介してデジタルデバイスに膨大な時間を費やしていることが述べられています.ChatGPTなどの大規模言語モデル(LLM)は、メールの作成などのタスクを支援することができますが、GUIの理解と対話には苦労しており、自動化レベルの向上を制限しています.この論文では、GUIの理解とナビゲーションに特化した180億パラメータのビジュアル言語モデル(VLM)であるCogAgentを紹介しています.低解像度と高解像度の画像エンコーダーを利用することで、CogAgentは1120*1120の解像度での入力をサポートし、小さなページ要素やテキストを認識することができます.一般的なビジュアル言語モデルとして、CogAgentはVQAv2、OK-VQA、Text-VQA、ST-VQA、ChartQA、infoVQA、DocVQA、MM-Vet、POPEを含む5つのテキスト豊かなベンチマークと4つの一般的なVQAベンチマークで最先端の性能を達成しています.スクリーンショットのみを入力として使用するCogAgentは、PCおよびAndroidのGUIナビゲーションタスクで抽出されたHTMLテキストを消費するLLMベースの手法であるMind2WebとAITWを上回り、最先端の性能を実現しています.モデルとコードはhttps://github.com/THUDM/CogVLMで利用可能です.

Q&A:

Q: CogAgentの目的は何ですか?

A: CogAgentは、GUIの理解とナビゲーションに特化した視覚言語モデル(VLM)である.CogAgentの目的は、コンピュータやスマートフォンなどのデジタル機器上のグラフィカル・ユーザ・インターフェース(GUI)との対話を支援することである.低解像度と高解像度の両方の画像エンコーダを利用することで、CogAgentは1120×1120の解像度で小さなページ要素やテキストを認識することができる.オンライン・チケット予約、ウェブ検索、ファイル管理、パワーポイント・プレゼンテーションの作成といった作業を自律的に行えるようにすることで、自動化レベルの向上を目指している.

Q: コグエージェントはGUIの理解とナビゲーションにどのように特化しているのですか?

A: CogAgentは、低解像度と高解像度の両方の画像エンコーダを利用することで、GUIの理解とナビゲーションに特化している.1120×1120の解像度の入力をサポートしており、小さなページ要素やテキストを認識することができる.ビジュアル言語モデルとして、CogAgentはGUI理解と意思決定ベンチマークで最先端の性能を達成し、抽出されたHTMLテキストを消費するLLMベースの手法を凌駕している.CogAgentはGUIに特化しているが、9つの視覚特徴ベンチマークにおいて最先端の一般主義的性能も達成している.

Q: CogAgentが入力をサポートする解像度を教えてください.

A: CogAgentは1120×1120の解像度での入力をサポートしている.

Q: CogAgentはどのようにして小さなページ要素やテキストを認識するのですか?

A: CogAgentは、低解像度と高解像度の両方の画像エンコーダを利用することで、小さなページ要素やテキストを認識します.このモデルは1120×1120の解像度の入力をサポートしており、微細なディテールを捉えることができる.低解像度画像エンコーダーはページ全体の構造やレイアウトを認識するのに役立ち、高解像度画像エンコーダーは小さな要素やテキストを識別することに重点を置いています.両方のエンコーダからの情報を組み合わせることで、CogAgent は小さなページ要素やテキストを正確に認識し、理解することができます.

Q: CogAgentはどのようなベンチマークで最先端を達成していますか?

A: CogAgentは6つのベンチマークのうち5つで最先端の結果を達成した:TextVQA、ChartQA、InfoVQA、DocVQA、STVQAです.

Q: GUIナビゲーション・タスクにおいて、CogAgentはLLMベースの手法をどのように上回るのか?

A: CogAgentは低解像度と高解像度の両方の画像エンコーダを利用することで、GUIナビゲーションタスクにおいてLLMベースの手法を凌駕している.1120×1120の解像度で小さなページ要素とテキストを認識する能力を持つCogAgentは、Mind2WebやAITWなどのGUI理解とナビゲーションのベンチマークで最先端の性能を達成している.抽出されたHTMLテキストを消費するLLMベースの手法とは異なり、CogAgentはスクリーンショットのみを入力として必要とするため、PCとAndroidの両方のGUIナビゲーションタスクにおいてLLMベースの手法の性能を上回ることができます.

Q: CogAgentのモデルとコードはどこにありますか?

A: コードはhttps://github.com/THUDM/CogVLMで入手できます.

Q: CogAgentはPCとAndroidの両方で使用できますか?

A: コグエージェントはPCとAndroidデバイスの両方で使用することができます.

Q: CogAgentを使用する上での制限や欠点はありますか?

A: CogAgentには、出力座標が不正確であったり、複数の画像を処理できないなどの欠点がある.これらの限界に対処するためには、さらなる研究が必要である.

Q: CogAgentと他の視覚言語モデルとの性能や機能の比較について教えてください.

A: CogAgentは、パフォーマンスと機能の面で他の視覚言語モデルを上回っています.テキスト豊かなベンチマークや一般的なベンチマークを含む、さまざまな視覚的な質問応答のベンチマークで最先端の成果を達成しています.また、他のモデルと比較して、幻覚の処理においても優れた性能を示しています.CogAgentの堅牢なパフォーマンスは、特に埋め込まれたテキストを含む画像の解釈において、さまざまなGUI環境での視覚エージェントのタスクに適しています.

PromptBench: A Unified Library for Evaluation of Large Language Models

著者:Kaijie Zhu, Qinlin Zhao, Hao Chen, Jindong Wang, Xing Xie

発行日:2023年12月13日

最終更新日:2023年12月13日

URL:http://arxiv.org/pdf/2312.07910v1

カテゴリ:Artificial Intelligence, Computation and Language, Machine Learning

概要:

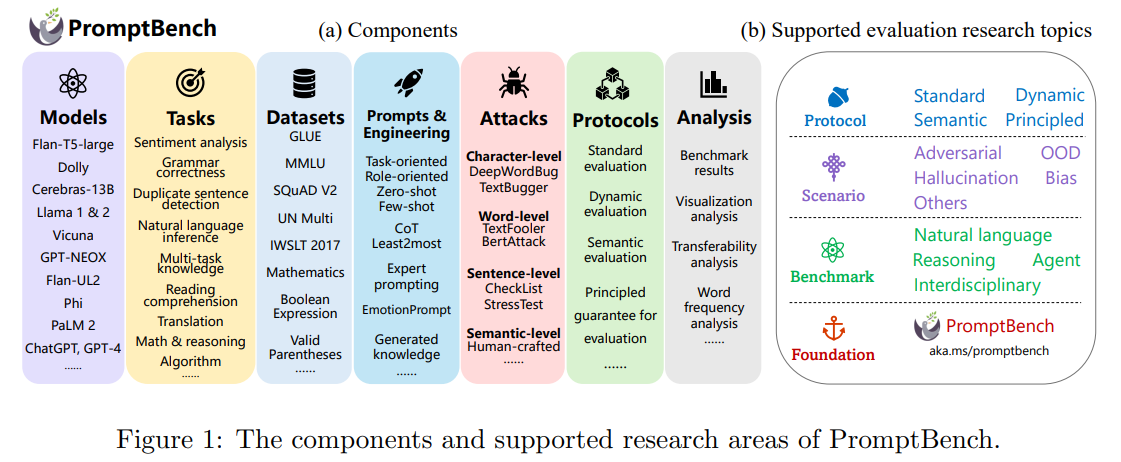

大規模言語モデル(LLM)の評価は、その性能を評価し、潜在的なセキュリティリスクを軽減するために重要です.本論文では、LLMの評価を行うための統一されたライブラリであるPromptBenchを紹介します.PromptBenchは、研究者が簡単に使用および拡張できるいくつかの主要なコンポーネントで構成されています.これには、プロンプトの構築、プロンプトエンジニアリング、データセットとモデルの読み込み、敵対的なプロンプト攻撃、動的評価プロトコル、および分析ツールが含まれます.PromptBenchは、研究目的のためのオープンで一般的かつ柔軟なコードベースとして設計されており、新しいベンチマークの作成、ダウンストリームアプリケーションの展開、新しい評価プロトコルの設計を容易にすることができます.コードはhttps://github.com/microsoft/promptbenchで利用可能であり、継続的にサポートされます.

Q&A:

Q: PromptBenchの目的は何ですか?

A: PromptBenchの目的は、大規模言語モデルの評価のための統一されたフレームワークを提供することです.このフレームワークは、異なるモデル、タスク、プロンプトを組み合わせて評価パイプラインを構築することを可能にし、プロンプトエンジニアリング、敵対的なプロンプト攻撃、および動的評価などの研究方向を促進します.PromptBenchは、現在のLLMの真の能力を評価し、より堅牢で人間に合ったモデルの設計につながる可能性があるベンチマークと分析結果を提供することを目指しています.PromptBenchは長期的なプロジェクトであり、研究コミュニティのニーズに応じて積極的に更新されます.全ての潜在的な貢献者からの貢献を歓迎しています.

Q: PromptBenchの主なコンポーネントは何ですか?

A: PromptBenchの主要なコンポーネントは、モデル、プロンプト、タスク、および分析ツールです.

Q: 研究者はどのようにPromptBenchを使用し、拡張することができますか?

A: PromptBenchは、大規模言語モデルの評価のための統一されたフレームワークであり、研究者は異なるモデル、タスク、プロンプトを組み合わせて評価パイプラインを構築することができます.PromptBenchは、プロンプトエンジニアリング、敵対的なプロンプト攻撃、動的評価などの研究方向を容易にするだけでなく、新しいベンチマークの作成、下流アプリケーションの展開、新しい評価プロトコルの設計など、オリジナルの研究を促進するために設計されています.研究者はPromptBenchの3つのリーダーボード(敵対的なプロンプト攻撃、プロンプトエンジニアリング、動的評価)を使用して簡単に比較することができます.また、PromptBenchは拡張性があり、フレームワークの便利な拡張を可能にします.研究コミュニティからのニーズを満たすためにPromptBenchは定期的に更新され、すべての潜在的な貢献者からの貢献を歓迎しています.

Q: PromptBenchの研究目的は何ですか?

A: PromptBenchの研究目的は、現在の大規模言語モデルの真の能力を評価し、境界を探索することです.また、PromptBenchのベンチマークと分析結果は、より堅牢で人間に合ったモデルの設計に役立つことが期待されています.

Q: PromptBenchは新しいベンチマークの作成を促進できますか?

A: はい、PromptBenchは新しいベンチマークの作成を容易にすることができます.

Q: PromptBenchはダウンストリームアプリケーションのデプロイに使用できますか?

A: はい、PromptBenchは下流アプリケーションの展開に使用することができます.

Q: PromptBenchは新しい評価プロトコルの設計にどのように役立ちますか?

A: PromptBenchは、新しい評価プロトコルの設計を支援するために、いくつかの研究方向を容易にする機能を提供しています.PromptBenchは、モジュール式の設計であり、ユーザーが異なるモデル、タスク、およびプロンプトを組み合わせて評価パイプラインを構築することを可能にします.PromptBenchは、プロンプトエンジニアリング、敵対的なプロンプト攻撃、および動的評価などの研究方向を容易にすることもサポートしています.PromptBenchのベンチマークと分析結果は、より堅牢で人間に適合したモデルの設計についての示唆を提供することができます.

Q: PromptBenchのコードはどこからアクセスできますか?

A: PromptBenchのコードは、https://github.com/microsoft/promptbenchで入手できます.