ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の[number]本となります.

- PaSS: Parallel Speculative Sampling

発行日:2023年11月22日

数百億のパラメータを持つ言語モデルの生成において、メモリアクセスがボトルネックとなり、予測的なサンプリングや並列デコーディングの開発が行われ、並列デコーディングが最も効果的であり、追加のパラメータは\( \small O(d_{emb}) \)のみ必要であることが示された. - Advancing Transformer Architecture in Long-Context Large Language Models: A Comprehensive Survey

発行日:2023年11月21日

ChatGPTによって引き起こされた爆弾を通じて、Transformerベースの大規模言語モデル(LLM)は、人工汎用知能(AGI)への革命的な道を開拓し、知識ベース、人間インターフェース、ダイナミックエージェントなど、さまざまな領域で応用されてきました.しかし、現在のLLMの主な制約は、リソースの制約により、多くのモデルが主に短いテキストで事前学習されているため、実世界の状況でよく遭遇するような長い文脈のプロンプトに対して効果が低いという点です. - GAIA: a ベンチマーク for General AI Assistants

発行日:2023年11月21日

GAIAは、一般的なAIアシスタントのためのベンチマークであり、人間の回答者が高い性能を示し、GPT-4が低い性能を示すことを示している.GAIAは、人工一般知能(AGI)の到来に重要な役割を果たすと考えられている. - GPQA: A Graduate-Level Google-Proof Q&A Benchmark

発行日:2023年11月20日

GPQAは、生物学、物理学、化学の専門家によって作成された難しい問題のデータセットであり、非専門家やAIシステムにもスケーラブルな監督実験を可能にし、信頼性のある情報を得るための方法を開発することを期待している. - Igniting Language Intelligence: The Hitchhiker’s Guide From Chain-of-Thought Reasoning to Language Agents

発行日:2023年11月20日

大規模言語モデル(LLM)は、言語知能を向上させるためにCoT推論技術を活用し、自律的な言語エージェントの開発を促進しています.この論文では、CoT技術のメカニズム、パラダイムシフト、言語エージェントの増加について議論し、将来の研究の展望も提供しています. - System 2 Attention (is something you might need too)

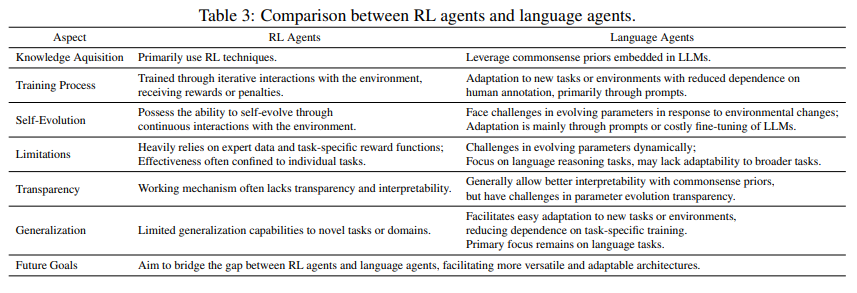

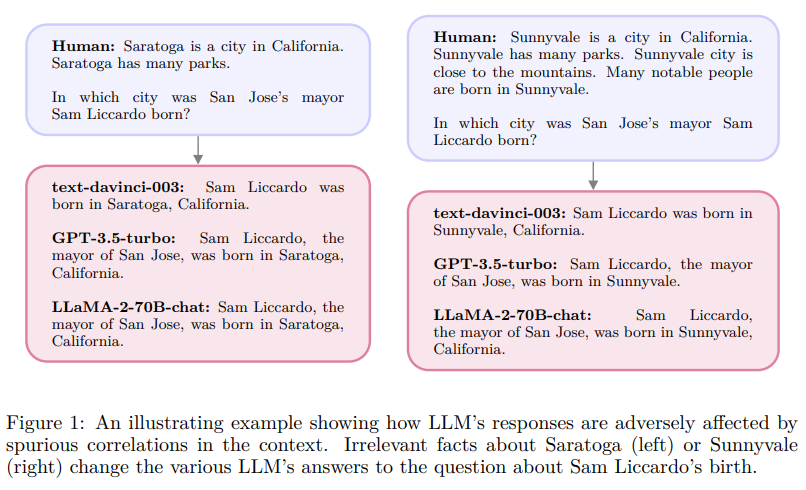

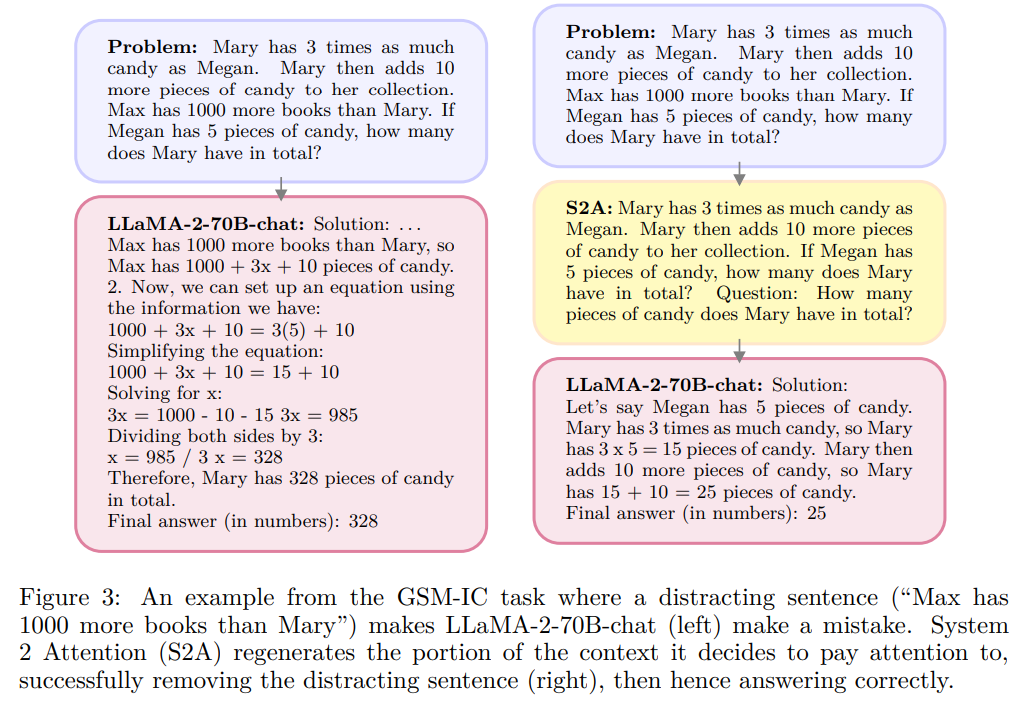

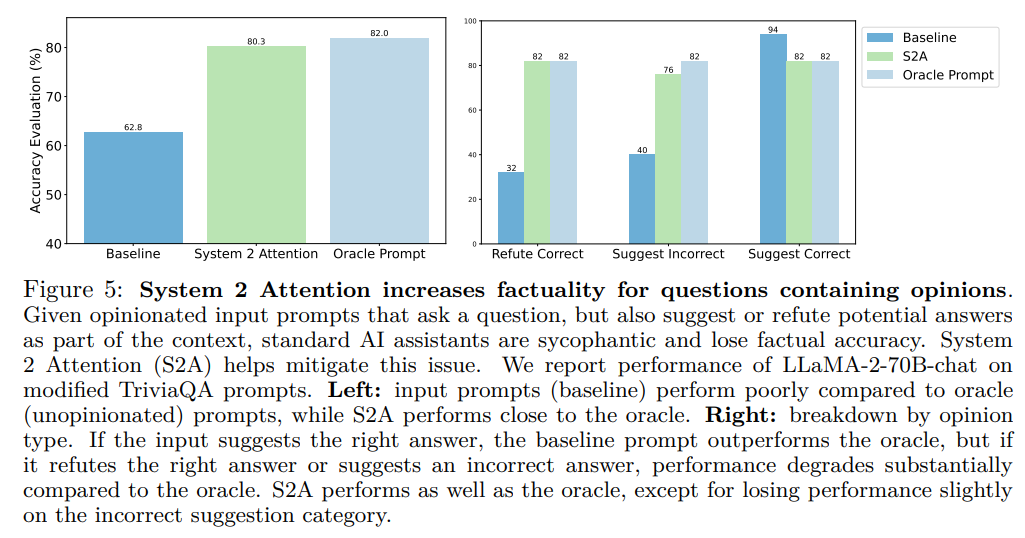

発行日:2023年11月20日

Transformerベースの大規模言語モデル(LLM)におけるソフトアテンションは、文脈から関係のない情報を取り込む可能性があり、次のトークン生成に悪影響を与える.System 2 Attention(S2A)を導入し、関連する部分のみを含むように入力文脈を再生成し、S2Aに注意を向けることで、S2Aは標準のアテンションベースのLLMよりも優れた性能を発揮し、事実性と客観性を高める. - Orca 2: Teaching Small Language Models How to Reason

発行日:2023年11月18日

Orca 1は、従来の指示に調整されたモデルよりも優れた性能を発揮し、Orca 2では小さなLMの推論能力を向上させるために異なる解決戦略を教えることを目指しています.Orca 2は多様なベンチマークに対応し、高度な推論能力を持ち、より小さなLMの開発や評価に利用できます. - Camels in a Changing Climate: Enhancing LM Adaptation with Tulu 2

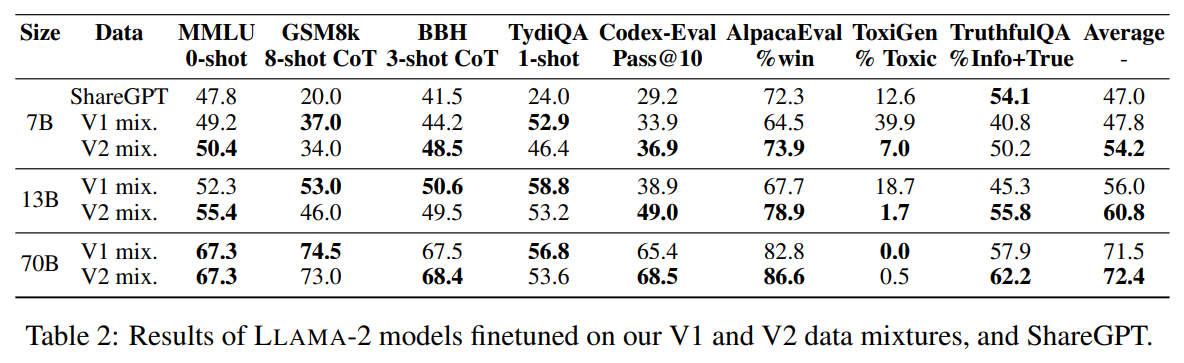

発行日:2023年11月17日

T\”ULU 2は、事前学習された言語モデルを改良し、下流タスクやユーザーの好みに適応させるためのスイートであり、最先端のパフォーマンスを発揮していることが示されています. - MedAgents: Large Language Models as Collaborators for Zero-shot Medical Reasoning

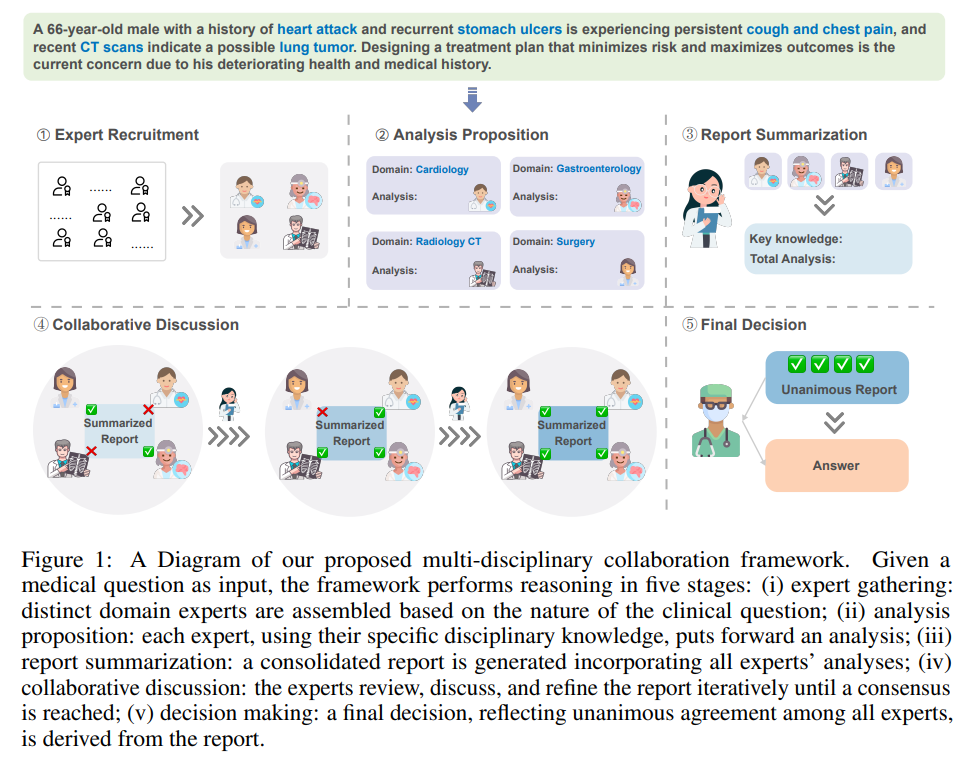

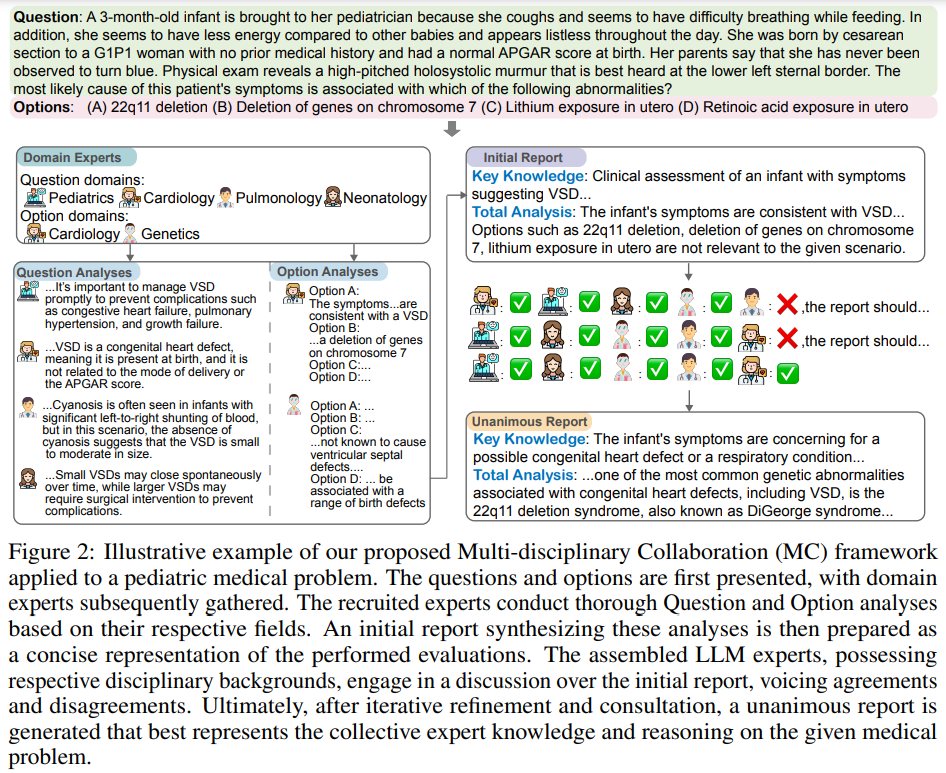

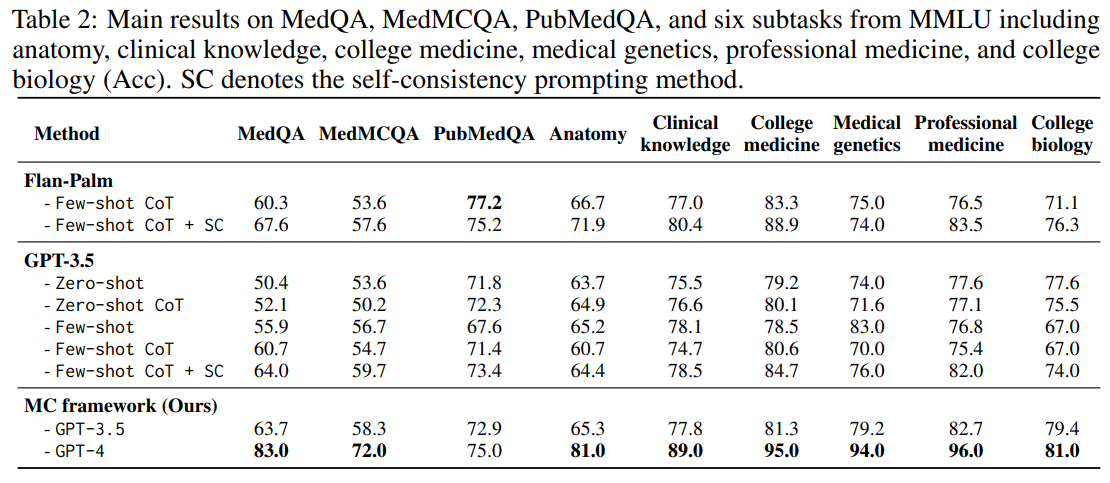

発行日:2023年11月16日

大規模言語モデル(LLM)は、医学や医療分野においては特定の課題に直面しているが、提案されたMCフレームワークはLLMの能力と推論能力を向上させ、医学的な専門知識を探索し活用することに優れていることを示している. - Scaling multimodal understanding to long videos

発行日:2023年11月14日

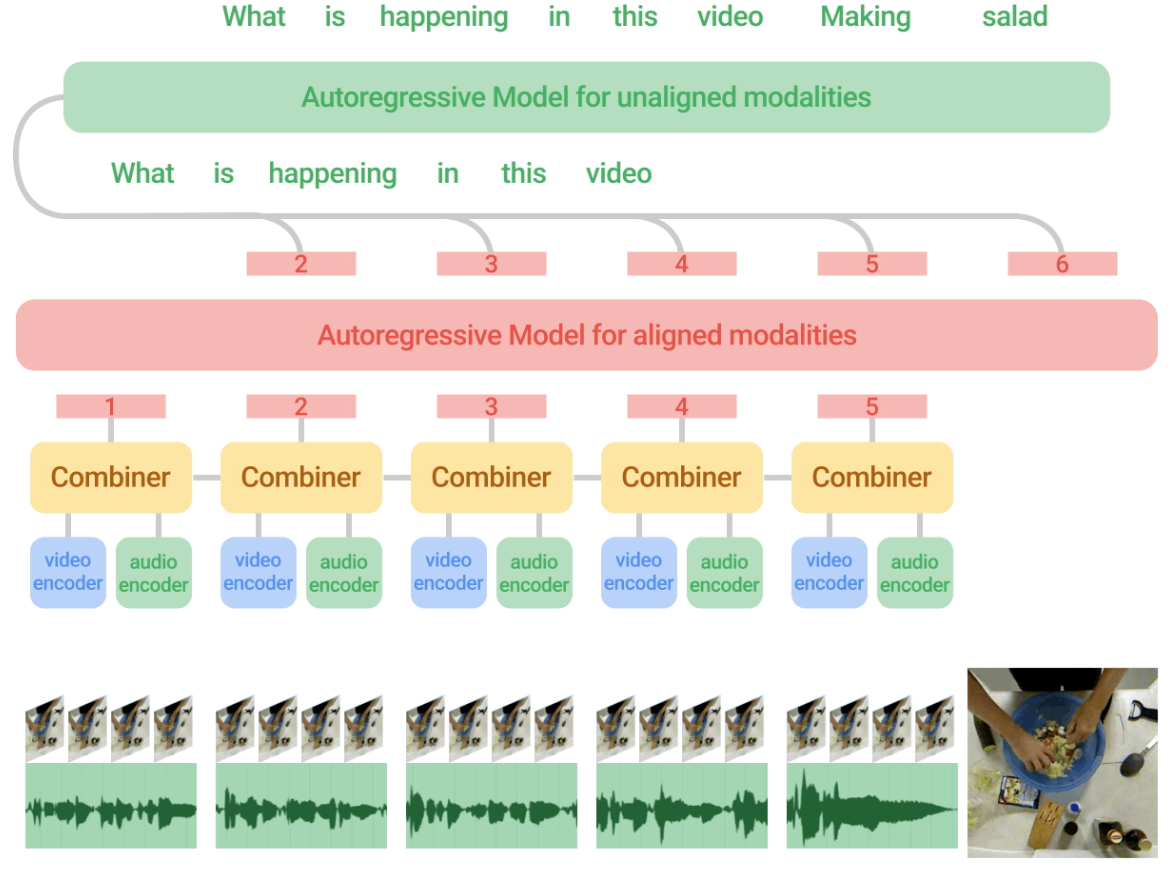

「Mirasol3B:時間的・文脈的モダリティを横断的に学習するためのマルチモーダル自己回帰モデル論文では、音声、映像、テキストのモダリティを横断的に学習するためのマルチモーダルオートリグレッシブモデル(Mirasol3B)が紹介されており、他のモデルと比較して長いビデオを扱うことができ、最先端の手法を上回る性能を発揮することが示されています.

PaSS: Parallel Speculative Sampling

著者:Giovanni Monea, Armand Joulin, Edouard Grave

発行日:2023年11月22日

最終更新日:2023年11月22日

URL:http://arxiv.org/pdf/2311.13581v1

カテゴリ:Computation and Language

概要:

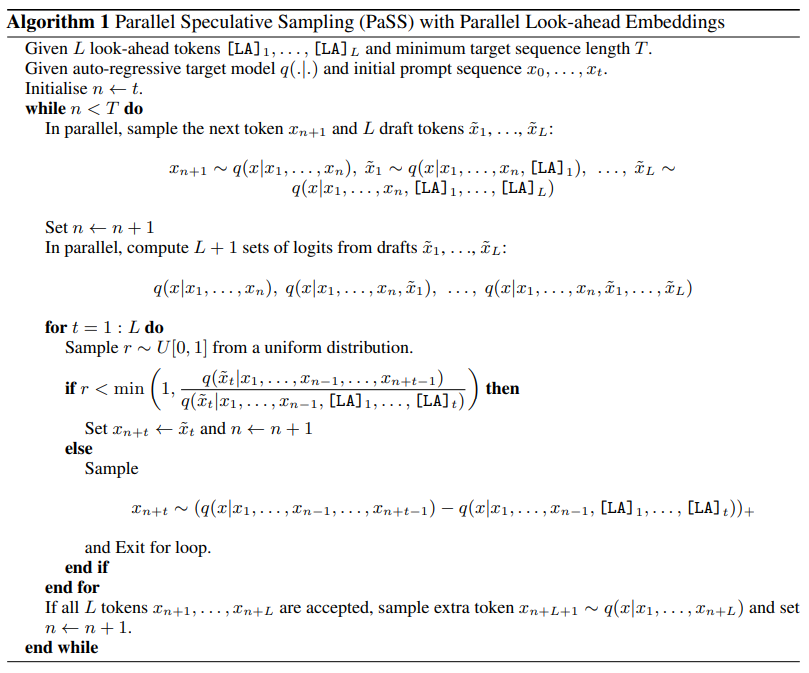

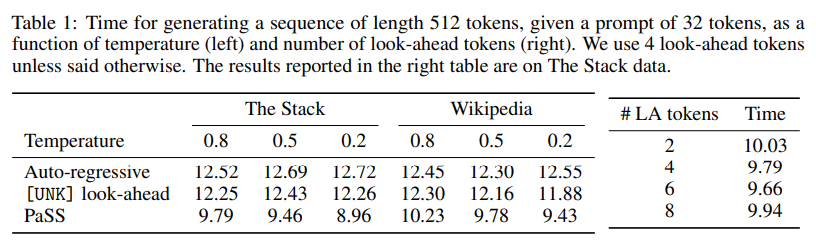

言語モデルのサイズを数百億のパラメータにスケーリングすることで、さまざまなタスクで印象的なパフォーマンスが実現されています.生成時には、これらのモデルは自己回帰的に使用され、生成されるトークンごとに順方向のパスが必要となります.したがって、メモリから全てのパラメータを読み込む必要があります.このメモリアクセスは、生成において主要なボトルネックとなり、モデルのサイズが大きくなるにつれて悪化します.さらに、複数のトークンに対して並列で順方向のパスを実行する場合、1つのトークンに対して行うのとほぼ同じ時間がかかることがよくあります.

これらの2つの観察結果から、予測的なサンプリングの開発が行われました.この方法では、2つ目の小さなモデルを使用していくつかのトークンを起案し、それらを大きなモデルの単一の順方向パスで検証または拒否します.残念ながら、この方法では同じトークナイザを共有する2つのモデルが必要となり、そのため採用が制限されます.

代わりに、私たちは並列デコーディングを提案しています.これは、追加の入力トークンのみを必要とし、1つのモデルから複数のトークンを同時に起案する方法です.この方法は、計算コストも第2のモデルも必要としません.私たちのアプローチは、同時に生成される単語をマークする追加の入力トークンのみを必要とし、その結果、パフォーマンスが向上しました(最大30%の高速化).

また、このアプローチでは、追加のパラメータとして\( \small O(d_{emb}) \)のみが必要であることも示しています.

Q&A:

Q: 大きなパラメータを持つ言語モデルの生成における主要なボトルネックは何か?

A: 大規模パラメータを持つ言語モデルにおいて、生成の主なボトルネックはメモリからのパラメータの読み込みです.

Q: モデルサイズが大きくなると、メモリアクセスはどのように悪化するのですか?

A: モデルサイズが増加すると、メモリアクセスは悪化します.これは、生成の際に各生成トークンごとにフォワードパスが必要であり、メモリから全てのパラメータを読み込む必要があるためです.モデルサイズが増えると、読み込むべきパラメータの数も増えるため、メモリアクセスの負荷が増加します.また、複数のトークンを並列で処理するためにも、フォワードパスの実行時間が増加します.

Q: 複数のトークンに対してフォワードパスを並行して実行すると、1つのトークンに対して実行するのとほぼ同じ時間がかかることが多いのはなぜか?

A: 複数のトークンを並列に処理するためには、それぞれのトークンに対して個別のフォワードパスを実行する必要があります.このため、複数のトークンを並列に処理する場合でも、単一のトークンを処理する場合とほぼ同じ時間がかかります.

Q: 投機的サンプリングとは何か、ボトルネック問題にどう対処するのか?

A: スペキュラティブサンプリングは、ターゲットLLMの推論時間を高速化することを目的とした手法であり、ボトルネックの問題に対処するために使用されます.このアルゴリズムの中心的なアイデアは、nトークンに対して並列で単一のフォワードパスを計算する方がn回のフォワードパスを順次に計算するよりもはるかに高速であるということです.この目的を達成するために、第二の小さくて高速なモデルであるドラフターを使用して、トークンの候補シーケンスを生成します.シーケンスの長さはアルゴリズムのハイパーパラメータです.生成された候補トークンシーケンスは、ターゲットLLMに提示され、スペキュラティブサンプリングによって生成された解の中から最も適切なものを選択します.

Q: 投機的サンプリングの限界とは?

A: スペキュラティブサンプリングの制限は、第二のモデルが必要であるということです.

Q: パラレル・デコードは投機的サンプリングとどう違うのか?

A: 並列デコーディングは、第二のモデルを必要とせず、大規模な言語モデルの変更も必要としないため、推測サンプリングよりも優れた点があります.並列デコーディングでは、追加の埋め込みを使用して候補トークンを生成し、それぞれの追加の埋め込みに対して出力を生成します.この方法は、少なくとも1つのトークンを自己回帰的に生成するため、推測サンプリングと同様の品質の生成を保証します.また、追加の埋め込みのメモリオーバーヘッドはO(d_{emb} \cdot new weights)であり、既存の推測サンプリングソリューションに追加される小さなモデルよりもはるかに小さいです.

Q: パラレルデコードに必要な追加入力トークンとは何ですか?

A: パラレルデコーディングには追加の入力トークンが必要であり、その目的は同時に生成される単語をマークすることです.

Q: 並列デコードによる性能向上は?

A: パラレルデコーディングによって、実行時間を最大30%改善することができます.

Q: 並列デコーディングと投機的サンプリングの計算コスト比較は?

A: 並列デコーディングは、仮説サンプリングと比較して計算コストが低いです.

Advancing Transformer Architecture in Long-Context Large Language Models: A Comprehensive Survey

著者:Yunpeng Huang, Jingwei Xu, Zixu Jiang, Junyu Lai, Zenan Li, Yuan Yao, Taolue Chen, Lijuan Yang, Zhou Xin, Xiaoxing Ma

発行日:2023年11月21日

最終更新日:2023年11月21日

URL:http://arxiv.org/pdf/2311.12351v1

カテゴリ:Computation and Language, Machine Learning

概要:

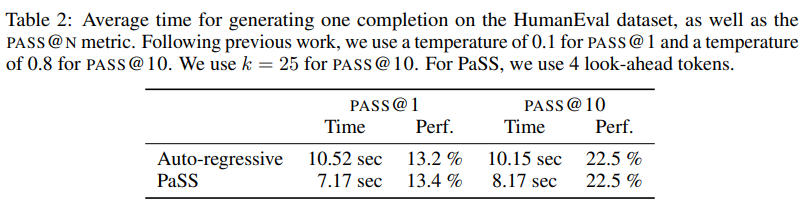

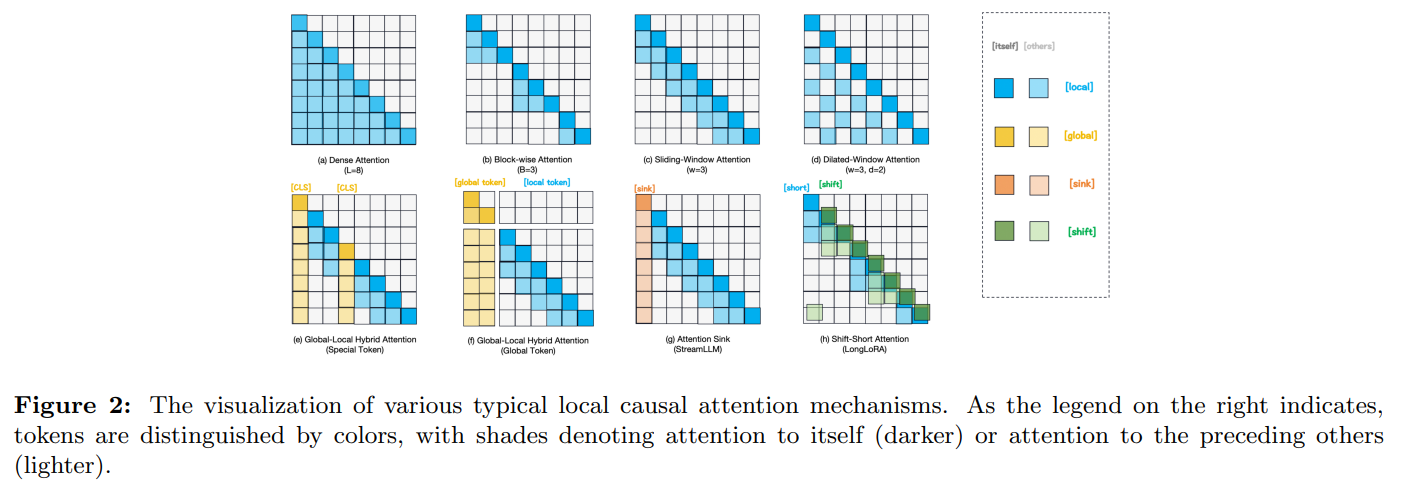

ChatGPTによって引き起こされた爆弾を通じて、Transformerベースの大規模言語モデル(LLM)は、人工汎用知能(AGI)への革命的な道を開拓し、知識ベース、人間インターフェース、ダイナミックエージェントなど、さまざまな領域で応用されてきました.しかし、現在のLLMの主な制約は、リソースの制約により、多くのモデルが主に短いテキストで事前学習されているため、実世界の状況でよく遭遇するような長い文脈のプロンプトに対して効果が低いという点です.本論文では、TransformerベースのLLMのモデルアーキテクチャの進化に焦点を当て、事前学習から推論までのすべての段階で長い文脈の能力を最適化するための包括的な調査を提案します.まず、現在のTransformerベースのモデルで長い文脈の入力と出力を処理する際の問題を明確化し、分析します.次に、これらの問題を解決するためのアーキテクチャのTransformerのアップグレードのランドスケープをナビゲートするための包括的なタクソノミーを提供します.その後、長い文脈のLLMに特化したデータセット、評価基準、ベースラインモデルなど、広く使用されている評価の必要性について調査し、いくつかの驚くべき成果も提供します.さらに、この分野での将来の研究の主要な課題と潜在的な展望についても議論します.また、私たちはリアルタイムで更新される関連文献を収集したリポジトリを作成しました.詳細はhttps://github.com/Strivin0311/long-llms-learningをご覧ください.

Q&A:

Q: より長い文脈のプロンプトを扱う場合、現在のトランスフォーマーベースの大規模言語モデル(LLM)の限界は何か?

A: 現在のTransformerベースの大規模言語モデル(LLM)の制約により、リソースの制約により、主に短いテキストで事前学習されているため、長い文脈のプロンプトに対して効果が低下しています.これは、現実世界の状況でよく遭遇する長い文脈のプロンプトに対して、現在のLLMが効果的でないことを意味します.

Q: TransformerベースのLLMにおけるモデルアーキテクチャの進歩は、ロングコンテキストの能力をどのように最適化するのか?

A: TransformerベースのLLMのモデルアーキテクチャの進歩により、長い文脈の能力が最適化されます.これは、トランスフォーマーベースのモデルの現在の問題を分析し、長い文脈の入力と出力を処理するための問題を解決するためのアーキテクチャのアップグレードを提供することによって達成されます.具体的には、注意の複雑さを削減し、効率的なメモリメカニズムを設計し、長さの外挿能力を向上させることなど、さまざまな方法が提案されています.これにより、長い文脈の情報を理解し処理する能力を持つ強力なLLMが開発され、さまざまな実世界のアプリケーションに新たな可能性が開かれます.

Q: 現在のTransformerベースのモデルでロングコンテキストの入出力を扱う際に生じる問題の例を教えていただけますか?

A: 現在のTransformerベースのモデルでは、長い文脈の入力と出力を処理する際に次のような問題が発生します.まず、入力シーケンスがLmaxを超える場合、モデルの性能が著しく低下し、繰り返しや非現実的な出力が生じることがあります.

Q: データセット、メトリクス、ベースラインモデルなど、ロングコンテキストのLLMにはどのような評価が必要なのか?

A: LLMsの長い文脈の能力を評価するために一般的に使用される評価必要性には、データセット、メトリクス、およびベースラインモデルが含まれます.

Q: 長いコンテキストのプロンプトを処理するLLMの効率と有効性を高めることができるライブラリ、システム、コンパイラなどの最適化ツールキットはありますか?

A: はい、与えられた文脈では、効率と効果を向上させるための最適化ツールキットとして、ライブラリ、システム、コンパイラなどがいくつか調査されています.

Q: トランスフォーマーベースのLLMでロングコンテクスト能力を最適化する際に直面する主な課題とは?

A: TransformerベースのLLMの長文脈能力を最適化する際に直面する主な課題は、次のようなものです.

- 長文脈の入力と出力を処理するための現在のTransformerベースのモデルの問題の分析と明確化

- トレーニングから推論までのすべての段階で、長文脈のLLMの効率と効果を最適化するための人気のあるツールキットの特定

- Transformer構造を改善するための主要な課題の特定と、将来の方向性の提案

これらの課題に対処するために、TransformerベースのLLMの長文脈能力を最適化するための最新の手法の包括的なレビューが提供されています.これらの手法は、トレーニング中の注意の複雑さの削減、効率的なメモリメカニズムの設計、および長さの外挿能力の向上など、さまざまなアプローチに分類されています.

Q: ロングコンテキストのLLMにおけるトランスフォーマー・アーキテクチャーの進歩という領域で、今後の研究の可能性について話していただけますか?

A: Transformerアーキテクチャを進化させるための将来の研究の可能性については、以下のようなアプローチが考えられます.

- 注意の複雑さを削減する方法:トランスフォーマーモデルのトレーニング中に注意の複雑さを削減する方法を探求することで、長い文脈を処理する能力を向上させることができます.これには、注意の重みを計算する際に使用される行列の次元を削減するなどの方法が含まれます.

- 効率的なメモリメカニズムの設計:長い文脈を処理するための効率的なメモリメカニズムの開発が重要です.これには、メモリモジュールの設計やメモリアクセスの最適化などが含まれます.

- 長さの外挿能力の向上:現在のトランスフォーマーモデルは、短いシーケンスでトレーニングされているため、長いシーケンスでの推論時の性能が低下することがあります.将来の研究では、トレーニング時に長いシーケンスを使用することで、長さの外挿能力を向上させる方法を探求することが重要です.

これらのアプローチは、Transformerアーキテクチャを進化させるための将来の研究の方向性として考えられます.

Q: https://github.com/Strivin0311/long-llms-learning のリポジトリはどのように関連文献をキュレーションし、リアルタイムの最新情報を提供しているのか?

A: https://github.com/Strivin0311/long-llms-learningでは、関連する文献を収集し、リアルタイムで更新しています.

Q: 最適化されたロングコンテクスト機能を持つトランスフォーマーベースのLLMが実装に成功した実例を教えてください.

A: 最適化されたロングコンテクスト機能を持つ変換器ベースのLLMは、自然言語理解、機械翻訳、質問応答、テキスト要約、感情分析、言語生成など、様々な実世界アプリケーションで実装に成功している.

GAIA: a ベンチマーク for General AI Assistants

著者:Grégoire Mialon, Clémentine Fourrier, Craig Swift, Thomas Wolf, Yann LeCun, Thomas Scialom

発行日:2023年11月21日

最終更新日:2023年11月21日

URL:http://arxiv.org/pdf/2311.12983v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

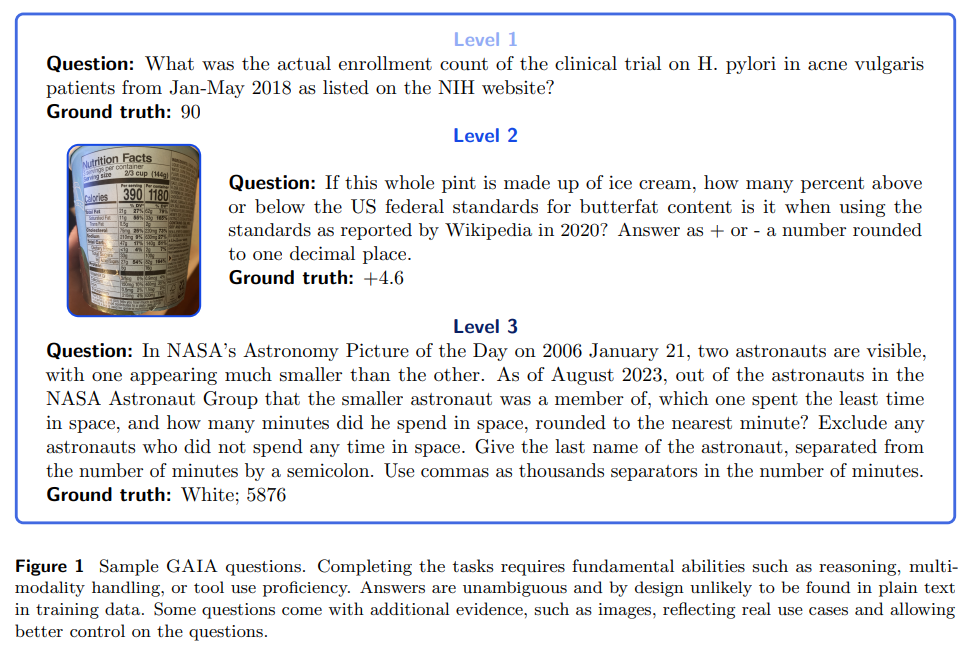

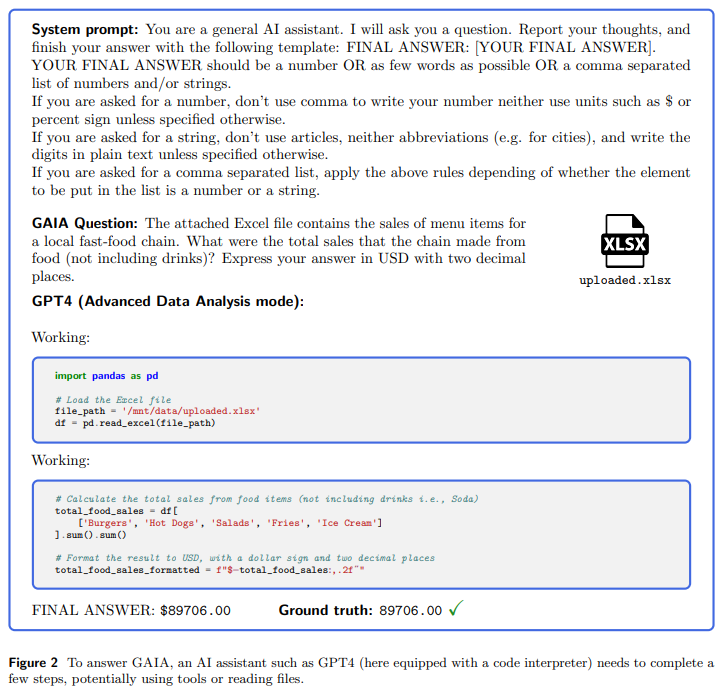

GAIAは、AI研究において重要なマイルストーンとなる、一般的なAIアシスタントのためのベンチマークである.GAIAは、推論、マルチモダリティの処理、ウェブブラウジング、一般的なツールの使用能力など、一連の基本的な能力を必要とする現実世界の問題を提案する.GAIAの問題は、概念的には人間にとって簡単ですが、ほとんどの高度なAIにとっては難しいものです.我々は、人間の回答者が92%を獲得し、GPT-4がプラグインを装備しても15%に過ぎないことを示しています.この顕著な性能の差は、最近の傾向とは対照的であり、例えば法律や化学などの専門的なスキルを必要とするタスクにおいて、LLMが人間を上回るというものです.GAIAの哲学は、人間にとってますます困難なタスクを目指す現在のAIベンチマークの傾向とは異なります.我々は、人間の平均的な質問に対して類似の堅牢性を示す能力が、人工一般知能(AGI)の到来にかかっていると考えています.GAIAの手法を用いて、466の質問とその回答を考案しました.我々は、回答を保持しながら、300の質問を公開し、https://huggingface.co/gaia-ベンチマークで利用可能なリーダーボードのパワーとして提供します.

Q&A:

Q: GAIAとは何ですか?

A: GAIAはAIシステム向けのベンチマークであり、一般的なアシスタントの質問を提案しています.GAIAは、LLMの評価のさまざまな落とし穴を回避しようとしています.GAIAは、人間によって設計および注釈付けされた466の質問で構成されています.これらの質問はテキストベースであり、時には画像やスプレッドシートなどのファイルが添付されています.これらの質問は、日常の個人のタスク、科学、一般的な知識など、さまざまなアシスタントのユースケースをカバーしています.これらの質問は、短い単一の正しい回答を許容するように設計されており、そのため検証が容易です.GAIAを使用するには、質問と関連する証拠がある場合はAIアシスタントにゼロショットプロンプトするだけです.GAIAで完璧なスコアを取るには、さまざまな基本的な能力が必要です.

Q: GAIAの問題を解くために必要な基礎能力とは?

A: GAIAの問題では、高度な推論、マルチモダリティの理解、コーディング能力、ウェブブラウジングなどのツール使用が要求される.

Q: GAIAの問題における人間とGPT-4のパフォーマンス格差は、専門的なタスクにおいてLLMが人間を上回るという最近の傾向とどう対照的なのだろうか?

A: GAIAの質問において、人間とGPT-4のパフォーマンスの差は、最近のLLMが専門的なタスクで人間を上回るという傾向とは対照的です.

Q: GAIAの哲学は、現在のAIベンチマークのトレンドとはどのように異なるのですか?

A: GAIAの哲学は、AIベンチマークの現在のトレンドとは異なります.現在のトレンドは、人間にとってますます困難なタスクを目指すことを提案していますが、GAIAの哲学は、人間と同様の堅牢性を持つシステムの能力に重点を置いています.

Q: 人工一般知能(AGI)の出現において、システムがGAIAの質問において平均的な人間と同様の堅牢性を示す能力の意義は何ですか?

A: GAIAの質問に対して、システムが平均的な人間と同様の堅牢性を示す能力は、人工汎用知能(AGI)の到来において重要です.GAIAの哲学は、人間にとってますます困難なタスクを目指す現在のAIベンチマークのトレンドとは異なります.GAIAの質問は、概念的には人間にとって簡単ですが、ほとんどの高度なAIにとっては難しいものです.GAIAの方法論を使用して、人間と同様の堅牢性を示すシステムの能力がAGIの鍵となります.

Q: GAIAには何問の質問と回答が含まれていますか?

A: GAIAには466の質問と回答が含まれています.

Q: なぜ300問しか解答が残っていないのか?

A: 300の質問の回答のみが保持される理由は、質の高さを重視しているためです.GAIAは時間の経過とともに劣化する可能性があり、質問の回答に必要な情報がウェブから消えたり、事前学習データが汚染されたりすることがあります.そのため、質問の回答の正確さや理論的なトレースのチェックの可能性、回答の明確さが重要とされています.また、質問の回答は事実に基づいており、簡潔で曖昧さがないため、質問の興味と多様性を高めることができます.

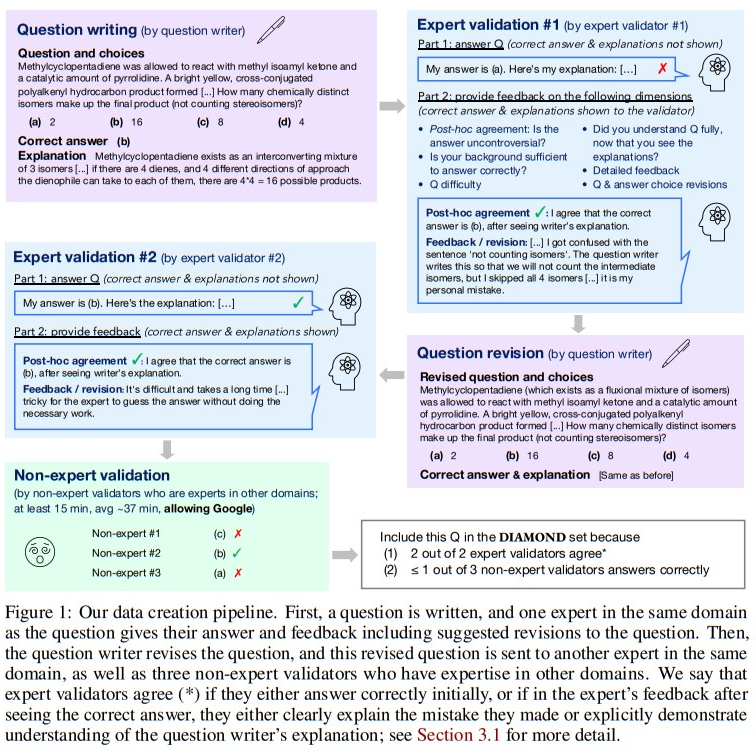

GPQA: A Graduate-Level Google-Proof Q&A Benchmark

著者:David Rein, Betty Li Hou, Asa Cooper Stickland, Jackson Petty, Richard Yuanzhe Pang, Julien Dirani, Julian Michael, Samuel R. Bowman

発行日:2023年11月20日

最終更新日:2023年11月20日

URL:http://arxiv.org/pdf/2311.12022v1

カテゴリ:Artificial Intelligence, Computation and Language

概要:

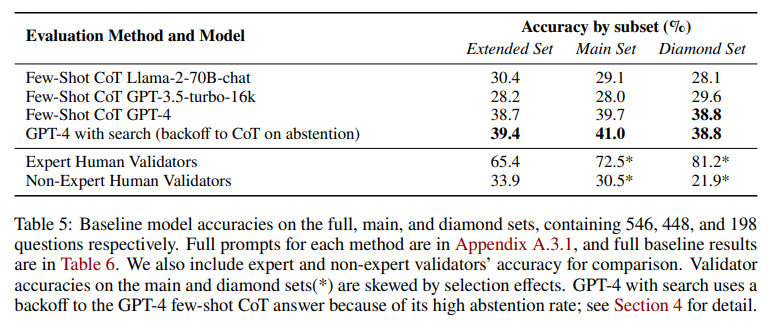

GPQAは、生物学、物理学、化学の専門家によって作成された448の多肢選択問題の難しいデータセットです.これらの問題は高品質で非常に難しいものであり、対応する分野で博士号を持っているか取得中の専門家でも正答率は65%(明らかなミスを除くと74%)です.一方、高いスキルを持つ非専門家の検証者は、平均30分以上の制限のないウェブアクセスを使用しても正答率は34%にとどまります(つまり、これらの問題は「Google-proof」です).また、最先端のAIシステムにとってもこれらの問題は難しく、最も強力なGPT-4ベースラインでも正答率は39%に達します.新しい科学的知識を開発する際など、非常に難しい質問に対する回答に将来のAIシステムを利用する場合、人間がその出力を監督するためのスケーラブルな監督方法を開発する必要があります.これは、監督者自身が熟練していて知識がある場合でも困難な場合があります.GPQAの難しさは、熟練していない非専門家や最先端のAIシステムにとっても実現可能なスケーラブルな監督実験を可能にします.さらに、フロンティアAIシステムは現実的なスケーラブルな監督実験を可能にするべきであり、それによって人間の能力を超えるAIシステムから信頼性のある情報を得るための方法を導き出すことができることを期待しています.

Q&A:

Q: GPQAのデータセットには何問の多肢選択問題が含まれていますか?

A: GPQAデータセットには448の多肢選択問題が含まれています.

Q: GPQAデータセットでカバーされている具体的な領域は?

A: GPQAデータセットでは、物理学、化学、生物学のサブドメインがカバーされています.

Q: 対応するドメインの博士号を持っている、あるいは取得を目指している専門家の精度とは?

A: 対応するドメインで博士号を持っているか取得している専門家の正確性は65%です.

Q: 熟練した非専門家のバリデーターの精度とは?

A: 高度な非専門のバリデーターの正確性は34.1%±2.3%です.

Q: 熟練した非専門家のバリデーターは、質問に答えるために、ウェブに自由にアクセスできる状態で、平均してどれくらいの時間を費やすのだろうか?

A: 非常に熟練した非専門の検証者は、質問に回答するために制限のないインターネットリソースにアクセスするために、平均してどれくらいの時間を費やしていますか?

Q: 最強のGPT-4ベースラインAIシステムの精度とは?

A: 最も強力なGPT-4ベースのベースラインAIシステムの正確性は39%です.

Q: 未来のAIシステムのために、スケーラブルな監督法を開発する目的は何なのか?

A: 将来のAIシステムのためにスケーラブルな監視方法を開発する目的は、人間が現時点では答えられない質問に対して、超人的なAIシステムを監督することです.スケーラブルな監視方法は、一定期間後に客観的に答えられる可能性のある難解な未解決の質問のセットを特定することで実現されます.理想的には、この方法によって新しい質問に対して正しい答えが得られ、質問が独立して回答された後に検証されます.

Q: GPQAの難しさは、現実的なスケーラブルな監督実験にとってどのように有益なのだろうか?

A: GPQAの難しさは、現実的なスケーラブルな監視実験において有益であると言えます.GPQAは高い資格要件、高い時給、複雑な検証プロセスにより、非常に厳しい基準で選ばれた448の例からなる小規模なデータセットです.このため、非専門家の正確性を評価する際には、現実的な状況とは直接関係しない可能性があります.しかし、非専門家の正確性を独立して測定することで、将来のスケーラブルな監視実験においてより現実的な結果を得ることができます.

Q: 人間の能力を凌駕するAIシステムから真実の情報を得る目的とは?

A: 人間の能力を超えるAIシステムから真実の情報を得る目的は、人間が解決できないような難しい課題に対しても信頼性のある情報を得るためです.特に新しい科学的知識を開発する際など、将来のAIシステムを使用して非常に困難な質問に答えるためには、人間が彼らの出力を監視することが困難であっても、スケーラブルな監視方法を開発する必要があります.

Q: GPQAデータセットは、人間の専門家がAIシステムから真実の情報を確実に得る方法を考案する上で、どのように役立つのだろうか?

A: GPQAデータセットは、スケーラブルな監視実験を可能にし、人間の専門家がAIシステムから信頼性のある情報を確実に得る方法を考案するのに役立つことが期待されています.このデータセットは、高度な非専門家やフロンティアAIシステムにとっても困難であり、人間が完了できないより難しいタスクに対して一般化する最良のチャンスを提供します.また、GPQAデータセットは、人間の専門知識のフロンティアに近い質問のデータセットであり、スーパーヒューマンAIシステムを監視する能力を向上させる監視プロトコルの開発に役立つことが期待されています.

Igniting Language Intelligence: The Hitchhiker’s Guide From Chain-of-Thought Reasoning to Language Agents

著者:Zhuosheng Zhang, Yao Yao, Aston Zhang, Xiangru Tang, Xinbei Ma, Zhiwei He, Yiming Wang, Mark Gerstein, Rui Wang, Gongshen Liu, Hai Zhao

発行日:2023年11月20日

最終更新日:2023年11月20日

URL:http://arxiv.org/pdf/2311.11797v1

カテゴリ:Computation and Language, Artificial Intelligence, Computer Vision and Pattern Recognition, Human-Computer Interaction, Multiagent Systems

概要:

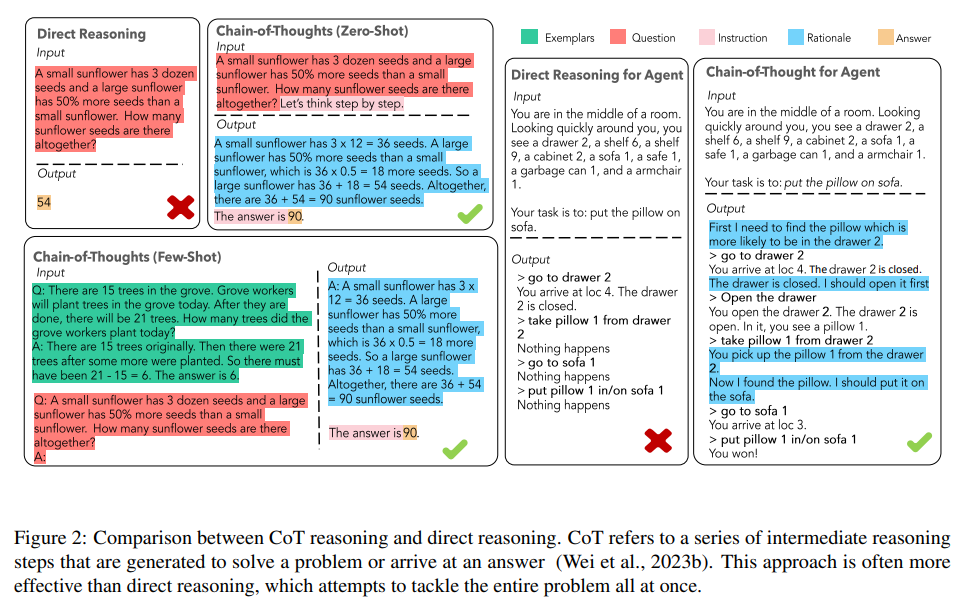

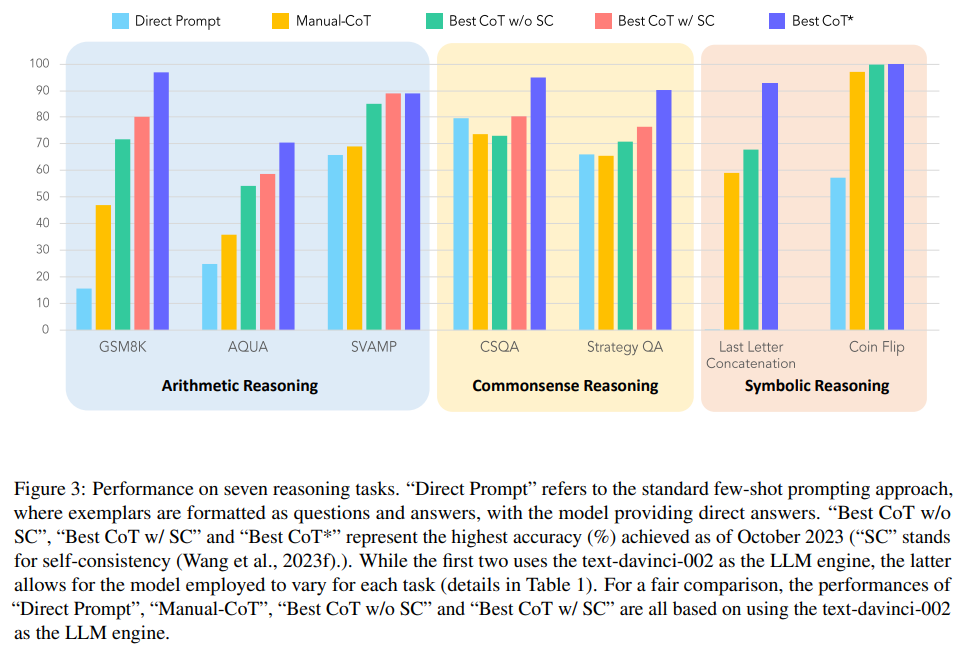

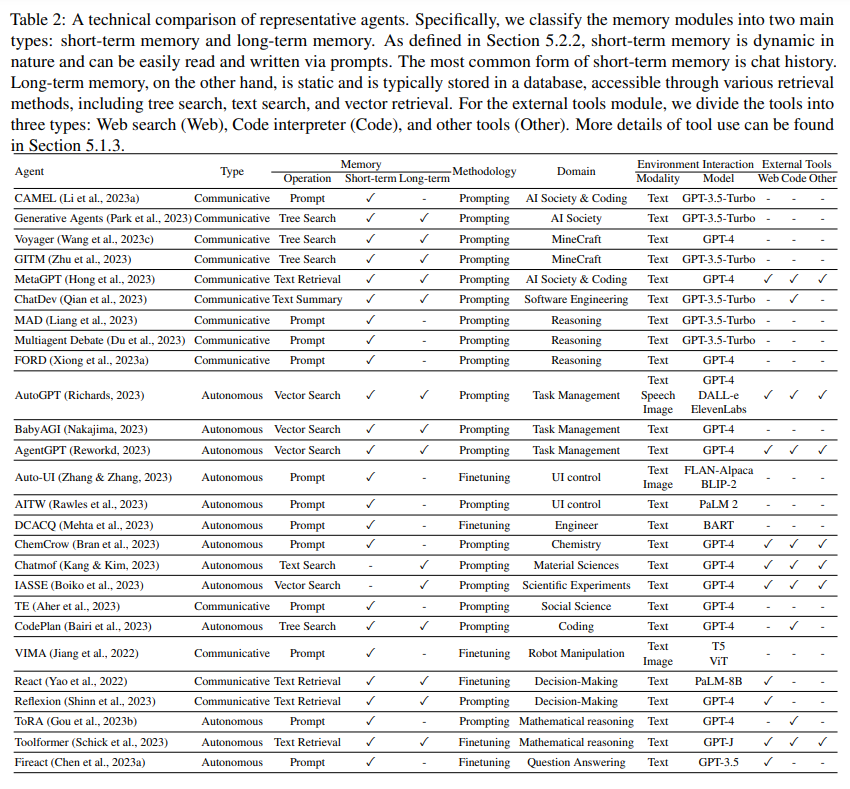

大規模言語モデル(LLM)は、複雑な推論タスクのスペクトル全体での堅固な経験的パフォーマンスによって、言語知能の分野を劇的に向上させています.さらに、理論的な証明によって、彼らの進んだ認知能力が言語的な文脈でどのように現れるかが明らかにされています.複雑な推論タスクを処理する際に非常に効果的であるためには、LLMは興味深い思考の連鎖(CoT)推論技術を活用し、答えを導く過程で中間ステップを明確にする必要があります.CoT推論アプローチは、推論パフォーマンスを高めるだけでなく、解釈可能性、制御可能性、柔軟性も向上させることができます.これらの利点を考慮して、最近の研究では、CoT推論手法を拡張して、言語の指示に適切に従い、さまざまな環境でアクションを実行する自律的な言語エージェントの開発を促進しています.

この調査論文では、重要な研究の側面を包括的に議論し、以下を含みます:(i)CoT技術の基礎的なメカニズムに焦点を当て、その効果の背後にある状況と正当性を明らかにすること、(ii)CoTにおけるパラダイムシフト、および(iii)CoTアプローチによって強化された言語エージェントの急増.将来の研究の展望では、一般化、効率性、カスタマイズ、スケーリング、安全性の探求が含まれます.この論文は、CoT推論と言語エージェントの基礎的なメカニズムに関心のある経験豊富な研究者だけでなく、CoT推論と言語エージェントの包括的な知識を求める初心者を含む幅広い読者層を対象としています.関連論文のリポジトリは、https://github.com/Zoeyyao27/CoT-Igniting-Agentで利用可能です.

Q&A:

Q: 複雑な推論タスクにおける大規模言語モデル(LLM)の実証的なパフォーマンス結果は?

A: 大規模な言語モデル(LLM)の経験的なパフォーマンス結果は、複雑な推論タスクにおいて非常に優れたものであり、これは強力な経験的なベンチマークパフォーマンスによって明らかに示されています.

Q: 理論的証明は、言語的文脈におけるLLMの推論能力をどのように示すのか?

A: 理論的な証明は、LLMの推論能力を言語的な文脈で示すために使用されます.これらの証明は、LLMが中間ステップを形成して回答を導くためにCoT推論技術を利用することを明らかにし、その高度な認知能力を示しています.

Q: LLMは、複雑な推論タスクを処理するために、思考の連鎖(CoT)推論技術をどのように活用しているのだろうか?

A: LLMは、答えを導く途中の中間ステップを定式化することで、思考の連鎖(CoT)推論技術を利用する.このアプローチにより、LLMは推論ルールを明示的にコード化することなく、既知の事実から未知の事実を正確に推論することができる.既知の事実を知識グラフの連鎖として整理することで、LLMは複雑な推論タスクを効果的に処理することができる.CoT推論技術は、推論性能を向上させるだけでなく、解釈可能性、制御可能性、柔軟性も向上させる.最近の研究では、LLMに直接答えを生成するのではなく、段階的な推論プロセスに従事するよう促すことで、LLMのパフォーマンスを大幅に向上させることができることが示されている.このプロセスはCoTプロンプトとして知られ、問題を解くための一連の中間推論ステップを生成する.CoTプロンプト技術の最適化により、プロンプトの自動構築など、CoTフレームワークにおける注目すべきパラダイムシフトがもたらされた.全体として、LLMはCoT推論技術を活用し、中間ステップを採用し、既知の事実を連鎖的に整理することで、複雑な推論タスクを処理する.

Q: 解釈可能性、制御可能性、柔軟性の観点から、CoT推論の利点は何ですか?

A: CoT 推論は、解釈可能性、制御可能性、および柔軟性を向上させます.解釈可能性という点では、CoTは複雑な推論タスクをより小さな相互接続された思考に分解し、LLMが下した決定や結論の背後にある根本的な論理や推論を理解しやすくします.これにより、推論経路が軌道から外れていたり、追加情報が必要な特定の思考ユニットを特定し、修正することができます.制御可能性という点では、CoTは複雑で多段階の問題を中間段階に分解することで、より慎重で正確な回答を可能にする.これにより、より高度な推論ステップを必要とする問題に、追加の計算リソースを効率的に割り当てることができる.最後に、柔軟性の面では、CoT推論は十分に大きく、既製のモデルで容易に促すことができるため、幅広いドメインやタスクに適応することができる.

Q: 最近の研究では、CoTの推論方法論を自律型言語エージェントの開発にどのように拡張しているのだろうか?

A: 最近の研究では、CoT推論の手法を拡張して自律的な言語エージェントの開発を行っています.これらの言語エージェントは、さまざまな環境で言語の指示を理解し、アクションを実行する能力を示しています.

Q: CoTテクニックの基礎となるメカニズムとは何か?

A: CoTの基本的なメカニズムは、LLM(Language Model)を使用し、タスクに関連する知識の要素を特定し、それらを中間的な推論ステップを形成することでシームレスに接続することです.これにより、CoTは推論において重要な役割を果たし、効果的な結果をもたらします.

Q: CoTの推論にどのようなパラダイムシフトがあったのか?

A: CoT推論はパラダイムシフトを迎えている.本稿では、様々なプロンプト技術、推論フォーマット、アプリケーションシナリオを分類することで、パラダイムシフトを探求する.また、CoT技術によって可能になる言語エージェントの出現についても調査する.パラダイムシフトの具体的な詳細については言及していない.

Q: 言語エージェントはCoTアプローチによってどのように強化されるのか?

A: 言語エージェントはCoTアプローチによって強化されます.CoT技術は、言語エージェントが言語の指示を理解し、多様な環境で行動を実行する能力を示すことができるようになります.

Q: CoT推論と言語エージェントの分野では、今後どのような研究が期待されるのでしょうか?

A: CoT推論と言語エージェントは、汎化、効率性、カスタマイズ、スケーリング、安全性に関連する側面を含む、いくつかの将来的な研究手段を提供する.

Q: この調査論文の対象読者は誰で、さらに調査するためにどのようなリソースが利用可能か?

A: この調査論文の対象読者は、CoTの推論と言語エージェントに関する包括的な知識を求める初心者から、基礎的なメカニズムや最新の議論に興味を持つ経験豊富な研究者まで、幅広い層です.さらなる探求のためのリソースとして、関連する研究領域についての包括的な理解を提供することを目指しています.

System 2 Attention (is something you might need too)

著者:Jason Weston, Sainbayar Sukhbaatar

発行日:2023年11月20日

最終更新日:2023年11月20日

URL:http://arxiv.org/pdf/2311.11829v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

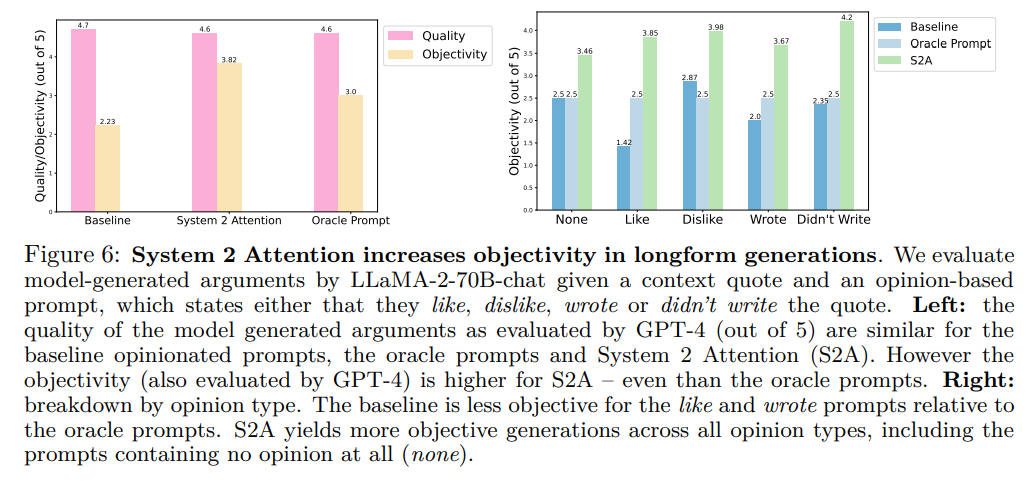

Transformerベースの大規模言語モデル(LLM)におけるソフトアテンションは、文脈から関係のない情報をその潜在表現に取り込む可能性があり、次のトークン生成に悪影響を与えることがあります.これらの問題を解決するために、私たちはSystem 2 Attention(S2A)を導入しました.S2Aは、LLMが自然言語で推論し、指示に従う能力を活用して、どこに注意を向けるかを決定するために使用されます.S2Aは、関連する部分のみを含むように入力文脈を再生成し、再生成された文脈に注意を向けて最終的な応答を引き出します.実験では、S2Aは意見や関係のない情報を含む3つのタスク(QA、数学のワード問題、長文生成)で、標準のアテンションベースのLLMよりも優れた性能を発揮しました.S2Aは、事実性と客観性を高め、おべっかを減らす効果があります.

Q&A:

Q: Transformerベースの大規模言語モデル(LLM)におけるSoft attentionは、どのように文脈から無関係な情報を潜在表現に取り込むのか?

A: ソフトアテンションは、コンテキストの大部分、つまり関係のない部分に確率を割り当てる傾向があります.また、繰り返しトークンに過度に焦点を当てる傾向もあります.これは、トランスフォーマー自体の構築方法に起因しています.ソフトアテンションは、トレーニング方法によって部分的に引き起こされることもあります.また、ポジションエンコーディングメカニズムは、コンテキストをワードの袋として扱う傾向があります.

Q: 潜在的表現に無関係な情報を取り込むことによって生じる具体的な問題とは?

A: 無関係な情報を潜在表現に組み込むことによって引き起こされる具体的な問題は、以下のようなものです.まず第一に、無関係な情報がコンテキストに含まれることで、モデルの応答が誤って影響を受ける可能性があります.これにより、正しい答えのトークンの確率が誤った答えのトークンの確率よりも高くなることがあります.第二に、モデルは重複したトークンに過度に焦点を当てる傾向があります.これは、トークンの重複が確率的に増加することが知られているためです.その結果、モデルは関連するトピックを繰り返し出力することがあります.第三に、モデルは入力プロンプトに含まれる意見や好みに同調する傾向があります.これは、モデルが入力に同意することを意味する「おべっか」と呼ばれる問題です.これらの問題は、トランスフォーマー自体の設計やアテンションメカニズムに起因している可能性があります.

Q: システム2アテンション(S2A)は、LLMが自然言語で推論し、指示に従う能力をどのように活用するのか?

A: System 2 Attention (S2A)は、LLMが自然言語で推論し、指示に従う能力を活用しています.S2Aは、LLMに対して注目すべきコンテキストを生成するように指示し、そのコンテキストには、推論を歪めることなく関連する情報のみが含まれるようにします.これにより、S2AはLLMの注意メカニズムを実行するための手法として機能します.

Q: S2Aがどのように入力コンテキストを再生成し、関連する部分のみを含めるのか説明していただけますか?

A: S2Aは、最終的な応答を引き出す前に、LLMにまずコンテキストの関連部分を再生成させることによって、入力コンテキストを再生成する.これは、無関係と判断された、あるいは偽の相関関係を提供するコンテキストの部分を書き換えることによって達成される.再生された文脈には関連する情報のみが含まれ、これにより事実性が向上し、回答におけるおべんちゃらが減少する.この方法は、コンテキストのコピーと書き換えを含むため、標準的なLLM再生よりも多くの計算を必要とする.計算コストは再生されるコンテキストの長さに依存する.差分のみを生成したり、セクションヘッダを参照したりするような高速化のトリックは、計算コストを削減できる可能性がある.しかし、高速化の詳細については今後の研究に譲る.

Q: S2Aは、再生された文脈の中で何に注目すべきかをどのように判断しているのだろうか?

A: S2Aは、LLMが自然言語で推論し、指示に従う能力を活用することで、再生されたコンテキストで何に注目すべきかを決定する.S2Aは、入力されたコンテキストを、関連する部分のみを含むように再生成し、無関係な情報や偽の相関関係を削除する.このプロセスでは、有用なコンテキストの中に不要な情報が存在する場合、コンテキストの一部を書き換える必要がある.そうすることで、S2Aは、再生されたコンテキストが最終的な応答を生成するために必要な情報のみを含むようにする.

Q: S2Aと標準的なアテンション・ベースのLLMを比較するために行われた実験の詳細を教えてください.

A: 実験では、S2Aが意見や関係のない情報を含まないように再生成されたコンテキストに注意を払い、最終的な応答を引き出すことで、標準の注意ベースのLLMよりも優れたパフォーマンスを発揮しました.具体的には、QA、数学のワード問題、長文生成という3つのタスクでS2Aは事実性と客観性を高め、おべっかを減らしました.

Q: S2Aは、前述の3つのタスクにおいて、どのような点で標準的な注意ベースのLLMを上回るのか?

A: S2Aは、事実性、正確性、客観性を向上させることで、標準的な注意ベースのLLMよりも優れている.具体的には、LLaMA-2-70B-chatと比較して、S2Aは62.8%から80.3%まで事実性を向上させた.また、長文の議論生成において、S2Aは57.4%の客観性を向上させ、挿入された意見の影響をほとんど受けない.さらに、GSM-ICの数学の単語問題で、トピックに無関係な文がある場合、S2Aは精度を51.7%から61.3%に向上させる.

Q: S2Aは、生成された回答におけること実性と客観性をどのように高めるのか?

A: S2Aは、入力された文脈を再生成して関連する部分のみを含むようにし、再生成された文脈に注目して最終的な応答を引き出すことで、生成された応答の事実性と客観性を高める.この方法は、応答を生成するために使用される文脈が正確で適切であることを保証することによって、事実性を向上させる.また、文脈に挿入される無関係な情報や意見の影響を減らすことで、おべんちゃらを減らすこともできる.実験の結果、S2Aは、LLaMA-2-70B-chatと比較して、62.8%から80.3%まで事実性を高めることに成功した.また、長文の論証の生成では、S2Aは客観性を57.4%向上させ、挿入された意見の影響をほとんど受けなかった.さらに、トピックに無関係な文章を含む数学の単語問題では、S2Aは精度を51.7%から61.3%に向上させた.

Q: S2Aによって、生成された回答におけるおべっか使いがどのように減少するのか説明できますか?

A: S2Aは、生成された応答のお世辞を減らすために、関連のない文脈を取り除くことによってお世辞を減らします.具体的には、S2Aは、入力文脈を再生成して関連する部分のみを含め、その再生成された文脈に注目して最終的な応答を引き出すことで、関連のない文脈を取り除きます.実験的に示されたように、S2Aは、最終的な回答を劣化させる可能性のある文脈を書き換えることができ、その結果、事実性を向上させ、応答のお世辞を減らすことができます.

Q: LLMでS2Aを使うことの限界や潜在的な欠点はありますか?

A: S2Aの使用にはいくつかの制限や潜在的な欠点があります.S2Aは、関連のない文脈を取り除いて生成を改善しようとするものですが、常に成功するわけではありません.そのため、これらのモデルは他のシステムと同様に、時折誤った相関に影響を受ける可能性があります.

Orca 2: Teaching Small Language Models How to Reason

著者:Arindam Mitra, Luciano Del Corro, Shweti Mahajan, Andres Codas, Clarisse Simoes, Sahaj Agarwal, Xuxi Chen, Anastasia Razdaibiedina, Erik Jones, Kriti Aggarwal, Hamid Palangi, Guoqing Zheng, Corby Rosset, Hamed Khanpour, Ahmed Awadallah

発行日:2023年11月18日

最終更新日:2023年11月21日

URL:http://arxiv.org/pdf/2311.11045v2

カテゴリ:Artificial Intelligence

概要:

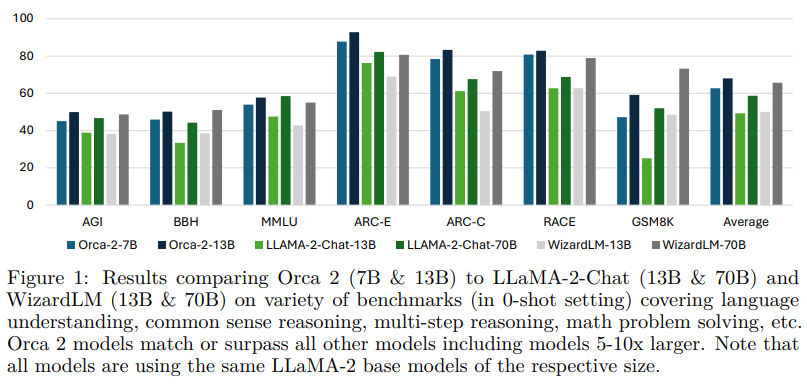

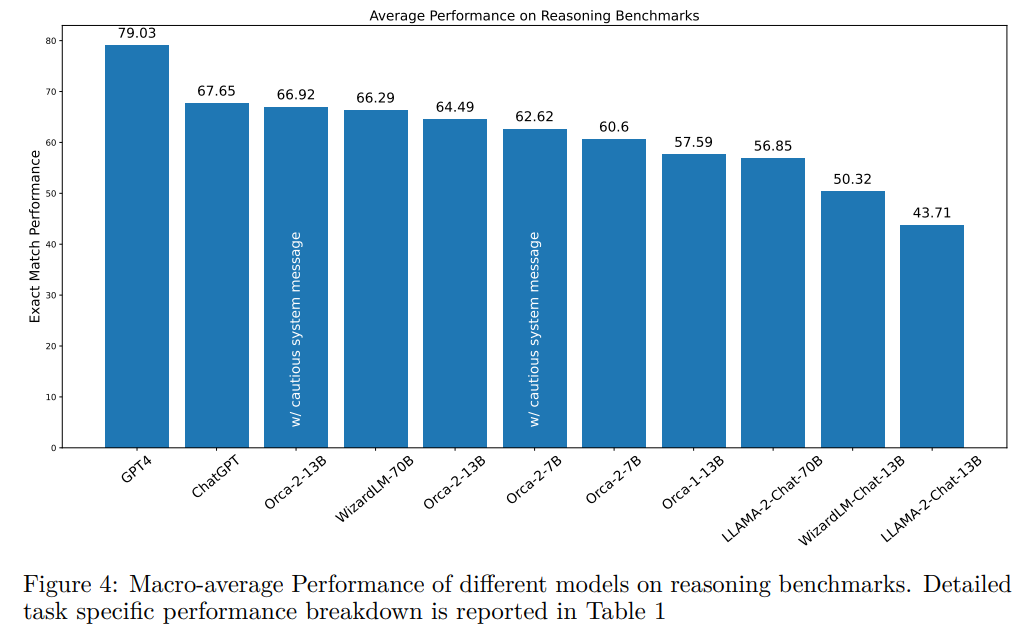

Orca 1は、説明トレースなどの豊富な信号から学習し、BigBench HardやAGIEvalなどのベンチマークで従来の指示に調整されたモデルよりも優れた性能を発揮します.Orca 2では、改善されたトレーニング信号が小さなLMの推論能力を向上させる方法をさらに探求しています.小さなLMのトレーニングに関する研究では、より能力のあるモデルの出力を模倣学習することがしばしば行われてきました.私たちは、模倣に過度に重点を置くことが小さなモデルの潜在能力を制限する可能性があると考えています.私たちは、小さなLMに異なるタスクに対して異なる解決戦略を使用するように教えることを目指しています.たとえば、大きなモデルが複雑なタスクに直接的な答えを提供するかもしれませんが、小さなモデルには同じ能力がないかもしれません.Orca 2では、モデルにさまざまな推論技術(ステップバイステップ、リコールして生成、リコール-理由-生成、直接的な回答など)を教えます.さらに重要なことは、モデルが各タスクに対して最も効果的な解決戦略を判断することを学ぶのを支援することです.私たちは、約100の多様なベンチマークに対してOrca 2を評価します.Orca 2は、15の多様なベンチマークに対応し、約100のタスクと36,000以上のユニークなプロンプトをカバーしています.Orca 2は、ゼロショット設定で高度な推論能力をテストする複雑なタスクで、同じサイズのモデルを大幅に上回り、5〜10倍大きなモデルと同等またはそれ以上の性能を達成しています.Orca 2の重みは、aka.ms/orca-lmで公開されており、より小さなLMの開発、評価、および調整に関する研究をサポートするために利用できます.

Q&A:

Q: オルカ1が従来の命令チューニングモデルを上回るベンチマークとは?

A: Orca 1は、BigBench HardやAGIEvalなどのベンチマークで、従来の命令チューニングモデルを凌駕している.

Q: オルカ2は、小さなLMの推論能力を向上させるために、どのように改善されたトレーニング信号を探索していますか?

A: オルカ2は、より小さなLMの推論能力を向上させるために、改良されたトレーニング信号を探求します.これにより、さまざまな推論技術を教え、与えられたタスクに対して最も効果的な推論戦略を使用するタイミングを判断する手助けをします.推論戦略は、小さなモデルの能力を考慮して、タスクに適した形に慎重に調整されています.目的は、ステップバイステップの処理、リコールして生成、リコールして推論して生成、抽出して生成、直接回答する方法を小さなモデルに教えることです.これらのモデルにさまざまな推論戦略を提供し、各タスクに最適な戦略を決定する手助けをすることで、オルカ2は彼らの推論能力を向上させ、サイズに関係なく最高のパフォーマンスを発揮できるようにすることを目指しています.

Q: 先行研究で小型LMのトレーニングに用いられたアプローチは?

A: 以前の研究では、小さなLMのトレーニングには模倣が主なアプローチとされていました.

Q: 模倣学習を過度に重視すると、より小さなモデルの可能性が制限される可能性があると考えるのはなぜですか?

A: 大量の模倣学習に過度な重点を置くことは、小さなモデルの潜在能力を制限する可能性があるためです.

Q: オルカ2は、小型LMにタスクごとに異なる解決策を採用することをどのように教えているのか?

A: Orca 2は、より能力の高いLLMを利用し、様々なタスクにわたって様々な推論戦略を示すことで、小さなLMにタスクごとに異なる解答戦略を採用することを教える.推論戦略は、生徒モデルが同じ動作を行えるかどうかを考慮しながら、目の前のタスクに合わせて慎重に調整される.Orca 2は、段階的処理、想起-生成、想起-理由-生成、抽出-生成、直接回答法などの一連の推論技法を、より小さなモデルに教えることを目的としています.さらに、Orca 2は、これらのモデルが各タスクに対して最も効果的な推論戦略を使用するタイミングを決定するのを支援し、モデルのサイズに関係なく最高のパフォーマンスを発揮できるようにします.

Q: オルカ2でモデルに教えた推理テクニックの例を教えてもらえますか?

A: オルカ2は、ステップ・バイ・ステップ処理、想起-理由-生成、想起-理由-生成、抽出-生成、直接回答法を含む一連の推論技法を、より小さなモデルに教えることを目的としている.

Q: Orca 2は、それぞれのタスクに対して最も効果的なソリューション戦略をどのように決定するのですか?

A: オルカ2は、ステップ・バイ・ステップ、想起→生成、想起→理由→生成、直接回答などの様々な推論技法をモデルに教えることで、各課題に対して最も効果的な解決策を決定します.その目的は、モデルが特定のタスクごとに最も効果的な戦略を学習し、決定できるようにすることです.これは、約100のタスクと36K以上のユニークなプロンプトに対応する15の多様なベンチマークの包括的なセットを使用してOrca 2を評価することによって達成される.評価結果は、Orca 2が同程度のサイズのモデルを大幅に上回り、特にゼロショット設定で高度な推論能力をテストする複雑なタスクにおいて、5~10倍のサイズのモデルと同等かそれ以上の性能レベルを達成することを示しています.小さいモデルに異なる解答戦略を教えることで、Orca 2は小さいモデルの限界を克服し、サイズに関係なく最高のパフォーマンスを発揮できるようにすることを目指しています.

Q: オルカ2の評価にはいくつのベンチマークが使われたのですか?

A: オルカ2は約100のベンチマークを使って評価された.

Q: 同サイズのモデルと比較して、オルカ2の性能はどうですか?

A: Orca-2-13Bは、ゼロショット推論タスクにおいて、同じサイズのモデルを大幅に上回る.これは、LLaMA-2-Chat-13Bに対して47.54%、WizardLM-13Bに対して28.15%の相対的な改善をもたらす.さらに、Orca-2-13BはLLaMA-2-Chat-70Bの性能を上回り、WizardLM-70Bと同等の性能を発揮する.

Q: 研究者は、さらなる研究や評価のために、どこでオルカ2のウエイトにアクセスできるのですか?

A: オルカ2の重みは、aka.ms/orca-lmで公開されています.

Camels in a Changing Climate: Enhancing LM Adaptation with Tulu 2

著者:Hamish Ivison, Yizhong Wang, Valentina Pyatkin, Nathan Lambert, Matthew Peters, Pradeep Dasigi, Joel Jang, David Wadden, Noah A. Smith, Iz Beltagy, Hannaneh Hajishirzi

発行日:2023年11月17日

最終更新日:2023年11月20日

URL:http://arxiv.org/pdf/2311.10702v2

カテゴリ:Computation and Language

概要:

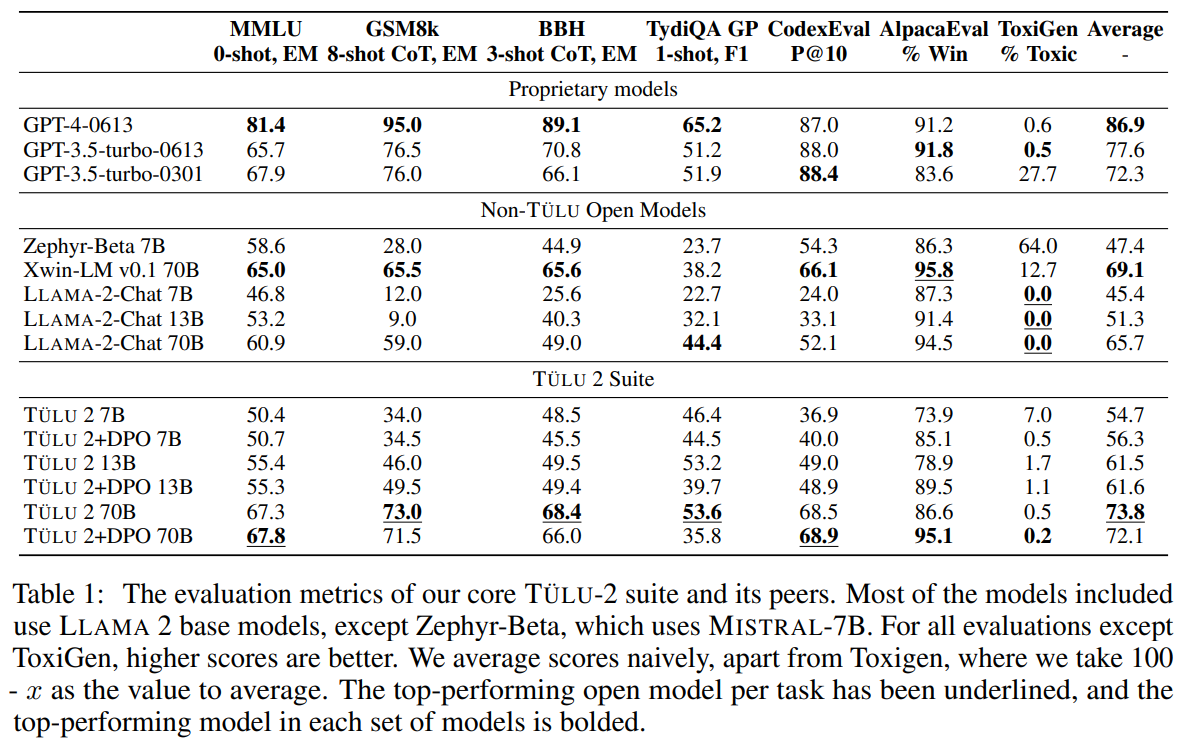

T\”ULU 2は、事前学習された言語モデルを下流タスクやユーザーの好みに適応させるための理解とベストプラクティスを進めるための改良されたT\”ULUモデルのスイートです.T\”ULU 2は、T\”ULU-V2-mix(高品質なインストラクションデータセットの改良版)、V2ミックスでファインチューニングされたT\”ULU 2、直接的な選好最適化(DPO)でトレーニングされたT\”ULU 2+DPO(最大のDPOトレーニングモデルであるT\”ULU 2+DPO 70B)などをリリースしています.さらに、V2ミックスでファインチューニングされたCODE T\”ULU 2もリリースされており、CODE LLAMAやそのインストラクションチューニングバリアントであるCODE LLAMA-Instructを上回るパフォーマンスを発揮しています.複数の視点からの評価により、T\”ULU 2スイートはオープンモデルの中で最先端のパフォーマンスを達成し、いくつかのベンチマークでGPT-3.5-turbo-0301と同等またはそれ以上のパフォーマンスを発揮していることが示されています.すべてのチェックポイント、データ、トレーニングおよび評価コードもリリースされており、将来の大規模言語モデルの適応に向けたオープンな取り組みを促進するためのものです.

Q&A:

Q: オリジナルのT “ULUと比較して、T “ULU 2の改善点は何ですか?

A: TÜLU 2には、より優れた基本モデルや新しいファインチューニング技術など、インストラクションチューニングにおける多くの進歩が盛り込まれている.また、改良された高品質な命令データセット(TÜLU-V2-mix)と、V2-mix上でファインチューニングされたTÜLU 2,LLAMA-2モデルも含まれています.さらにTÜLU 2には、直接選好最適化で訓練されたTÜLU 2 DPOモデルが導入されており、これにはこれまでで最大のDPO訓練済みモデル(TÜLU 2 DPO 70B)も含まれています.また、TÜLU 2には、V2ミックスで微調整されたCODE TÜLU 2とCODE LLAMAモデルも含まれており、CODE LLAMAとその命令チューニングバリアントであるCODE LLAMA-Instructを凌駕しています.全体として、TÜLU 2はGPT 3.5-0301と競合し、オープンモデルの中で最先端の性能を達成し、いくつかのベンチマークでGPT-3.5-turbo-0301の性能に匹敵するか、それを上回った.

Q: T “ULU-V2-mixの高品質なインストラクション・データセットの詳細を教えてください.

A: TÜLU-V2-mixは、高品質の指示データセットの改良版です.このデータセットは、手動で品質が確認されたものやGPTモデルから生成されたものが含まれており、複雑さと多様性を促進しています.さらに、FLANなどの大規模なデータセットはダウンサンプリングされ、前回の実験でのパフォーマンスが低かったDollyは除外されています.TÜLU-V2-mixは以下のデータソースから構成されており、新たに追加されたデータセットは*でマークされています.

Q: T “ULU 2のモデルは、V2のミクスチャーをどのように微調整したのですか?

A: TÜLU 2のモデルは、直接選好最適化(DPO)を用いてV2混合で微調整された.

Q: 直接選好最適化(DPO)とは何か、T “ULU 2 DPOモデルのトレーニングにどのように貢献するのか?

A: DPO(直接好み最適化)は、TÜLU 2+DPOモデルのトレーニングに貢献する手法です.DPOは、モデルの生成結果の長さを増加させる傾向があります.これは、RLHFトレーニングによる冗長性のバイアスと一致しています.DPOトレーニングは、PPOに必要なエンジニアリングの複雑さを排除しながら、フィードバックを利用してモデルの冗長性を減らす効果があります.DPOトレーニングは、モデルの能力を大幅に変化させることはありませんが、多言語能力には大きな影響を与えます.DPOトレーニングは、TydiQAのパフォーマンスを低下させますが、DPOトレーニングには明示的に多言語データが含まれていないため、多言語の出力が分布外になる可能性があります.多言語データを指示調整とDPOトレーニングの段階で混合することで、これらの結果を改善することができます.

Q: 最大のDPO訓練済みモデル、T “ULU 2 DPO 70Bの意味を説明してもらえますか?

A: TÜLU 2+DPO 70Bは、最大のDPOトレーニングモデルであり、人間のフィードバックに基づいて大規模なモデルをトレーニングするための有望な手法であることが示されています.DPOトレーニングは、PPOに必要なエンジニアリングの複雑さを排除しながら、大規模なモデルで安定してスケーリングすることができます.また、DPOトレーニングは、事実に基づく推論や推論などの多くの他のメトリックにはほとんど影響を与えず、多言語性を除いては性能に大きな変化をもたらしません.さらに、TÜLU 2+DPO 70BはAlpacaEvalで2番目にパフォーマンスの良いオープンモデルであり、MT-Benchでは他のすべてのモデルよりも優れたパフォーマンスを示しています.

Q: CODE T “ULU 2は、CODE LLAMAとその命令チューニングバリアントであるCODE LLAMA-Instructをどのように上回るのですか?

A: CODE TÜLU 2は、V2データミックスを使用することで、CODE LLAMAとその命令チューニングバリアントであるCODE LLAMA-Instructを凌駕した.V2データミックスは、モデルの性能向上により効果的であることが示されました.平均して、CODE TÜLU 2モデルは、8つの評価設定のうち5つで、ベースCODE LLAMAとCODE LLAMA-Instructモデルの両方を上回りました.AlpacaEvalにおけるCODE LLAMA-Instructの強力な性能は、V2データミックスが、特定のモデル能力よりもむしろ一般的なオープンエンドクエリに重点を置いている可能性を示唆しています.

Q: T “ULU 2の多角的な評価結果は?

A: TÜLU 2 suiteは、複数の視点からの評価結果を示しており、オープンモデルの中で最先端のパフォーマンスを達成しており、いくつかのベンチマークでGPT-3.5-turbo-0301のパフォーマンスを上回っていることがわかります.

Q: T “ULU2とGPT-3.5-turbo-0301のベンチマーク比較は?

A: TÜLU 2は、MMLU、BBH、TydiQAベンチマークではGPT-3.5-turbo-0301と同程度の性能を達成し、AlpacaEvalとToxiGenベンチマークではGPT-3.5-turbo-0301を上回った.しかし、GPT-4との差は依然として大きく、GPT-3.5-turbo-0613との差はほとんどの評価で中程度です.

Q: 大規模な言語モデルの適応に関する将来のオープンな取り組みを促進するために、T “ULU 2スイートと一緒にどのようなリソースがリリースされますか?

A: TÜLU 2 suiteでは、将来の大規模言語モデルの適応に向けたオープンな取り組みを支援するために、すべてのチェックポイント、データ、トレーニングおよび評価コードが公開されます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlは、https://github.com/allenai/open-instruct です.

MedAgents: Large Language Models as Collaborators for Zero-shot Medical Reasoning

著者:Xiangru Tang, Anni Zou, Zhuosheng Zhang, Yilun Zhao, Xingyao Zhang, Arman Cohan, Mark Gerstein

発行日:2023年11月16日

最終更新日:2023年11月16日

URL:http://arxiv.org/pdf/2311.10537v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

大規模言語モデル(LLM)は、一般的な領域においては驚異的な進歩を遂げているものの、医学や医療分野では重要な障壁に直面しています.この分野は、特定の用語や専門知識に対する推論など、独自の課題に直面しています.これらの頑固な問題に対処するために、私たちは医療分野向けの新しい多分野協力(MC)フレームワークを提案しています.このフレームワークでは、役割を果たすLLMベースのエージェントが協力的なマルチラウンドの議論に参加し、LLMの能力と推論能力を向上させることで、これらの課題に取り組んでいます.このトレーニング不要で解釈可能なフレームワークは、以下の5つの重要なステップから成り立っています:ドメインの専門家の集める、個別の分析の提案、これらの分析をレポートにまとめる、合意が得られるまでの議論の反復、そして最終的な意思決定です.私たちの研究は特にゼロショットのシナリオに焦点を当てており、MedQA、MedMCQA、PubMedQA、およびMMLUの6つのサブタスクからなる9つのデータセットにおける結果は、私たちの提案したMCフレームワークがLLMの医学的な専門知識を探索し活用する能力や推論能力を拡張することに優れていることを示しています.さらに、これらの結果に基づいて、私たちは人間の評価を行い、私たちの手法における一般的なエラーを特定し分類するとともに、各要素が全体の性能に与える影響を理解するための削除研究も行っています.コードは\url{https://github.com/gersteinlab/MedAgents}で入手可能です.

Q&A:

Q: 大規模言語モデル(LLM)が医療分野で直面するユニークな課題とは?

A: LLMは医療分野において2つのユニークな課題に直面している.第一に、LLMの訓練に使われる一般的なウェブデータに比べ、医療分野の訓練データの量と特異性は限られている.つまり、LLMは医療関連のタスクで優れたパフォーマンスを発揮するのに十分な医療分野特有の情報にアクセスできない可能性がある.第二に、医療分野で高いパフォーマンスを発揮するには、専門的な知識や領域特有の用語に対する広範な推論が必要である.LLMはこのような医療特有の概念や用語を理解し、推論するのに苦労するかもしれない.

Q: 提案されている学際的コラボレーション(MC)フレームワークは、LLMベースのエージェントをどのように活用するのか?

A: 提案された多分野の協力(MC)フレームワークは、LLMベースのエージェントを活用しています.このフレームワークでは、専門家が異なる分野から集められ、それぞれの専門知識を持ったエージェントが分析を提案し、報告書の要約を作成し、その報告書を基に専門家たちが協力的な相談を行います.LLMベースのエージェントは、訓練不要で解釈可能な方法で、LLMから内在的な臨床知識を明らかにするために使用されます.

Q: MCフレームワークの5つの重要なステップについて、もう少し詳しく説明していただけますか?

A: MCフレームワークの5つの重要なステップは次のとおりです.

- 専門家の集める:臨床的な問題に応じて、異なる専門分野の専門家を集めます.

- 分析提案:専門家は自分の専門知識を活かして分析を提案します.

- レポートの要約:前の一連の分析に基づいて、要約されたレポートを作成します.

- 協力的な相談:専門家たちを巻き込んで要約されたレポートについて議論します.レポートは、すべての専門家の合意が得られるまで反復的に修正されます.

- 決定の作成:一致したレポートから最終的な決定を導きます.

Q: ゼロシュートシナリオに関する研究の焦点は何ですか?

A: ゼロショットシナリオでは、強力なベースラインの少数ショット(5ショット)の能力と比較して、エージェントの数の影響を調査し、アプローチの制限と問題点を特定するために人間の評価を行っています.

Q: よくあるエラーを特定するために行われた人的評価について、もう少し詳しく教えてください.

A: 人間の評価を通じて、モデルの制約や問題点を特定するための人間の評価を実施しました.この評価により、モデルの特定の医学的知識の理解が不十分な場合に発生する「ドメイン知識の不足」というエラーや、「ドメイン知識の誤った検索」というエラーなど、4つの主要なエラーカテゴリーを特定しました.

Q: MCのフレームワークによって拡張された推理力について説明していただけますか?

A: MCフレームワークを通じて拡張された推論能力は、医療専門知識を探索し活用する能力です.MCフレームワークは、複数のエージェントが協力して最終的な答えを導き出すため、医療専門知識を探索し活用する能力が強化されました.これにより、LLMsの推論能力が向上し、医療領域における問題解決能力が拡大しました.

Q: トレーニング不要で解釈可能なフレームワークは、LLMの習熟度向上にどのように貢献するのか?

A: 訓練フリーかつ解釈可能なフレームワークは、LLMの熟練度を向上させるために貢献します.このフレームワークは、ドメインの専門家を集め、個別の分析を提案し、これらの分析をレポートにまとめ、議論を繰り返して合意に達し、最終的に意思決定を行うという5つの重要なステップから構成されています.このフレームワークにより、LLMベースのエージェントが協力的なマルチラウンドディスカッションに参加することが可能となり、LLMの熟練度と推論能力が向上します.

Q: MedAgentsフレームワークのコードはどこにありますか?

A: コードはhttps://github.com/gersteinlab/MedAgentsで見つけることができます.

Scaling multimodal understanding to long videos

著者:Anelia Angelova, Isaac Noble

発行日:2023年11月14日

最終更新日:不明

URL:https://blog.research.google/2023/11/scaling-multimodal-understanding-to.html

カテゴリ:不明

概要:

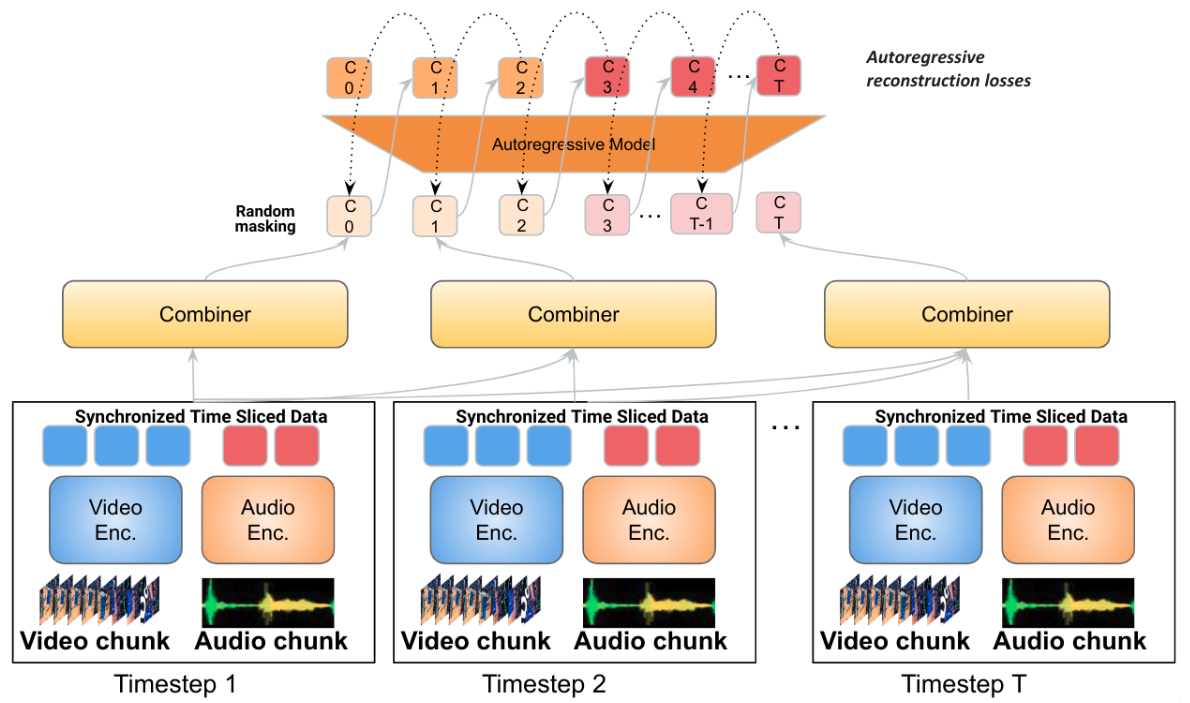

「Mirasol3B: A Multimodal Autoregressive model for time-aligned and contextual modalities」という論文では、音声、映像、テキストのモダリティを横断的に学習するためのマルチモーダルオートリグレッシブモデル(Mirasol3B)を紹介しています.主なアイデアは、モダリティの特性に応じて、マルチモーダルモデリングを別々のフォーカスされたオートリグレッシブモデルに分割することです.私たちのモデルは、時間に同期したモダリティ(音声と映像)のためのオートリグレッシブコンポーネントと、時間には必ずしも同期していないが順序付けられたモダリティ(例:タイトルや説明などのテキスト入力)のための別個のオートリグレッシブコンポーネントで構成されています.さらに、時間に同期したモダリティは時間に基づいて分割され、ローカルな特徴を共同で学習することができます.この方法により、音声と映像の入力は時間的にモデル化され、従来のモデルよりも比較的多くのパラメータが割り当てられます.このアプローチにより、他のマルチモーダルモデルと比較して、はるかに長いビデオ(例:128-512フレーム)を容易に扱うことができます.Mirasol3Bは3Bのパラメータであり、従来のFlamingoモデル(80B)やPaLI-Xモデル(55B)と比較してコンパクトです.さらに、Mirasol3Bはビデオの質問応答、長いビデオの質問応答、音声-映像-テキストのベンチマークにおいて、最先端の手法を上回る性能を発揮します.

Q&A:

Q: モダリティの異質性に起因するマルチモーダルモデルの構築における課題とは?

A: モダリティの異質性によるマルチモーダルモデルの構築における課題は、いくつかのモダリティが時間的に同期しているが、テキストとは整合していないことです.また、ビデオやオーディオ信号のデータ量はテキストよりもはるかに大きいため、これらをマルチモーダルモデルで組み合わせる際には、ビデオとオーディオは完全に消費されず、不均等に圧縮する必要があります.特に長いビデオ入力の場合、この問題はさらに深刻化します.

Q: 時間軸の揃ったモダリティ(音声と映像)は、時間軸の揃わないモダリティ(テキスト入力)とどのように処理が異なるのか?

A: 時間に整列したモダリティ(音声とビデオ)は、時間に整列していないモダリティ(テキスト入力)とは異なる方法で処理されます.時間に整列したモダリティは、時間的に自己回帰的に処理され、シーケンスの長さを制御し、強力な表現を生成するコンバイナーとともに処理されます.

Q: Mirasol3Bの自己回帰コンポーネントは、時間的に整列したモダリティをどのように扱うのですか?

A: Mir asol3Bの自己回帰成分は、時間に同期したモダリティ(音声とビデオ)に対して自己回帰モデルを使用し、時間に合わせられていないが順序があるモダリティ(タイトルや説明などのテキスト入力)には別個の自己回帰成分を使用します.時間に同期したモダリティは時間に分割され、ローカル特徴量を共同で学習することができます.このアプローチにより、他の多モーダルモデルと比較して、より多くのパラメータを割り当てることができるため、より長いビデオ(128-512フレームなど)を容易に処理することができます.

Q: Mirasol3Bは、マルチモーダルモデルでビデオ信号とオーディオ信号を組み合わせる際、大量のデータをどのように扱うのですか?

A: Mir asol3Bは、マルチモーダルモデリングを個別の自己回帰モデルに分離することで、ビデオ信号とオーディオ信号の大量のデータを処理する.このモデルは、時間的に同期したモダリティ(音声と映像)用の自己回帰成分と、テキスト入力のような必ずしも時間的に同期していないが逐次的なモダリティ用の別の自己回帰成分から構成される.時間的に同期したモダリティを時間的に分割し、局所的な特徴を共同で学習することで、モデルは比較的多くのパラメータをオーディオ・ビデオ入力に割り当てることができる.これにより、Mir asol3Bは他のマルチモーダルモデルと比較して、はるかに長い動画を難なく扱うことができる.さらに、Mir asol3BのCombinerは、コンパクトでありながら十分な情報量を持つ特徴を学習するため、長いビデオ/オーディオ入力を処理することができる.

Q: Mirasol3Bは、より長いビデオを扱うという点で、これまでのマルチモーダルモデルと比べてどうですか?

A: Mir asol3Bは、先行する多様なモデルと比較して、長いビデオの処理においてコンパクトであり、優れた性能を発揮しています.

Q: Mirasol3Bのパラメータサイズは、以前のFlamingoモデルやPaLI-Xモデルと比較してどうですか?

A: Mirasol3Bは、先行モデルであるFlamingoとPaLI-Xに比べてパラメーターサイズがコンパクトであり、3Bである.

Q: Mirasol3Bは、ビデオ質問応答、長時間のビデオQA、音声-ビデオ-テキストベンチマークにおいて、最先端のアプローチと比較してどのようなパフォーマンスを示したのでしょうか?

A: Mirasol3Bは、ビデオの質問応答、長いビデオの質問応答、および音声-ビデオ-テキストのベンチマークにおいて、最先端の手法と比較して優れた性能を発揮します.

Q: 時間的な整合性はないが連続的なモダリティのための独立した自己回帰成分について、もう少し詳しく教えてください.

A: 非時間に整列していないが連続的なモダリティ(例:タイトルや説明などのテキスト入力)に対する別個の自己回帰成分が提案されています.この成分は、時間に整列していないモダリティを処理するために使用されます.時間に整列していないモダリティは、Cross-Attentionメカニズムを介して時間に整列しているモダリティと情報を交換しながら学習することができます.このアプローチにより、時間に整列していないモダリティと時間に整列しているモダリティの間で学習が調整され、時間を同期させる必要がありません.

Q: 時間的に整列されたモダリティにおいて、局所的特徴はどのように共同学習されるのか?

A: 時間に合わせてモデル化されたモダリティでは、ローカル特徴が共同で学習されます.

Q: マルチモーダルモデルで映像と音声を組み合わせる際の「不均衡に圧縮された」という概念について説明していただけますか?

A: 「disproportionately compressed」という概念は、ビデオとオーディオを組み合わせる際に、ビデオとオーディオのデータの大きさや特性の違いによって、ビデオの情報がオーディオの情報に比べて圧縮されることを指しています.具体的には、ビデオは視覚的な信号であり、通常は1秒間に30〜100フレームのデータがありますが、現在のモデルでは通常32〜64フレームしか使用されません.一方、オーディオは1次元の時間信号であり、ビデオよりも高い周波数で取得されます.このようなデータの大きさや特性の違いにより、ビデオの情報はオーディオの情報に比べて圧縮されることになります.