ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- A Survey on Hallucination in Large Language Models: Principles, Taxonomy, Challenges, and Open Questions

発行日:2023年11月09日

大規模言語モデル(LLM)は自然言語処理(NLP)において重要な進歩をもたらし、テキストの理解と生成に進歩をもたらすが、幻覚を生じる傾向があり、信頼性に懸念があるため、幻覚の検出と軽減の取り組みが注目されている. - On the Road with GPT-4V(ision): Early Explorations of Visual-Language Model on Autonomous Driving

発行日:2023年11月09日

自律走行技術の追求には、知覚、意思決定、制御システムの統合が重要であり、ビジュアル言語モデル(VLM)の登場は自律運転の新たなフロンティアを示している.このレポートでは、最新のVLMである「\modelnamefull」の評価と応用について説明し、優れたパフォーマンスを示している一方で、方向判断や信号認識などの課題が残っていることも明らかにしている. - Rephrase and Respond: Let Large Language Models Ask Better Questions for Themselves

発行日:2023年11月07日

「Rephrase and Respond」(RaR)メソッドは、大規模言語モデル(LLM)が人間が提出した質問を言い換えて展開し、単一のプロンプトで回答を提供することができる方法であり、LLMのパフォーマンスを改善することが示されている.また、RaRはChain-of-Thought(CoT)メソッドと組み合わせることでさらに優れたパフォーマンスを実現できる. - GPT4All: An Ecosystem of Open Source Compressed Language Models

発行日:2023年11月06日

最先端の大規模言語モデル(LLM)へのアクセスを民主化するため、GPT4Allプロジェクトがオープンソースリポジトリとして登場し、その進化について説明している. - S-LoRA: Serving Thousands of Concurrent LoRA Adapters

発行日:2023年11月06日

S-LoRAは、大規模な言語モデルの展開において効率的な微調整手法であり、統一ページングやテンソル並列戦略を使用して数千のアダプタをサービスすることができる.S-LoRAはスループットを最大4倍向上させ、多くのタスク固有の微調整モデルのスケーラブルなサービスを可能にする. - Simplifying Transformer Blocks

発行日:2023年11月03日

この研究では、標準のトランスフォーマーブロックを簡素化し、トレーニング速度に影響を与えない変更を提案しました.実験結果では、簡素化されたトランスフォーマーは標準のトランスフォーマーと同じパフォーマンスを持ち、トレーニングスループットが15%高速化され、パラメータ数が15%減少しました. - Pretraining Data Mixtures Enable Narrow Model Selection Capabilities in Transformer Models

発行日:2023年11月01日

トランスフォーマーモデルは、事前学習データのカバレッジにより新しいタスクを特定し学習する能力を持っているが、事前学習データのドメイン外のタスクや関数には故障モードや一般化の劣化が見られる可能性がある. - FreshLLMs: Refreshing Large Language Models with Search Engine Augmentation

発行日:2023年10月05日

大部分の大規模言語モデル(LLM)は更新されず、常に変化する世界に適応する能力を欠いているため、本研究ではLLM生成テキストの事実性について詳細な研究を行い、FreshQAという新しいダイナミックなQAベンチマークを紹介し、LLMの性能を向上させるための手法を提案している. - Simple and Controllable Music Generation

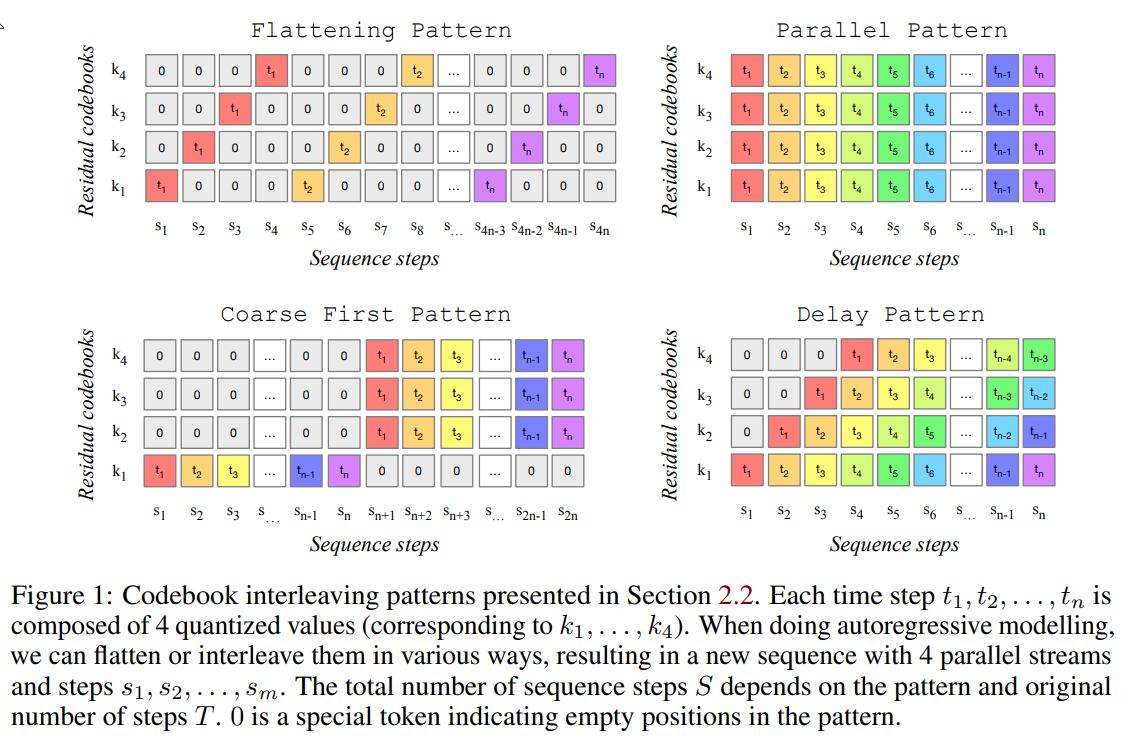

発行日:2023年06月08日

この論文では、MusicGenという単一の言語モデルを紹介し、効率的なトークンの交互配置パターンを備えた単一段階のトランスフォーマーLMで構成されており、高品質な音楽の生成が可能であることを示しています. - Alternating Updates for Efficient Transformers

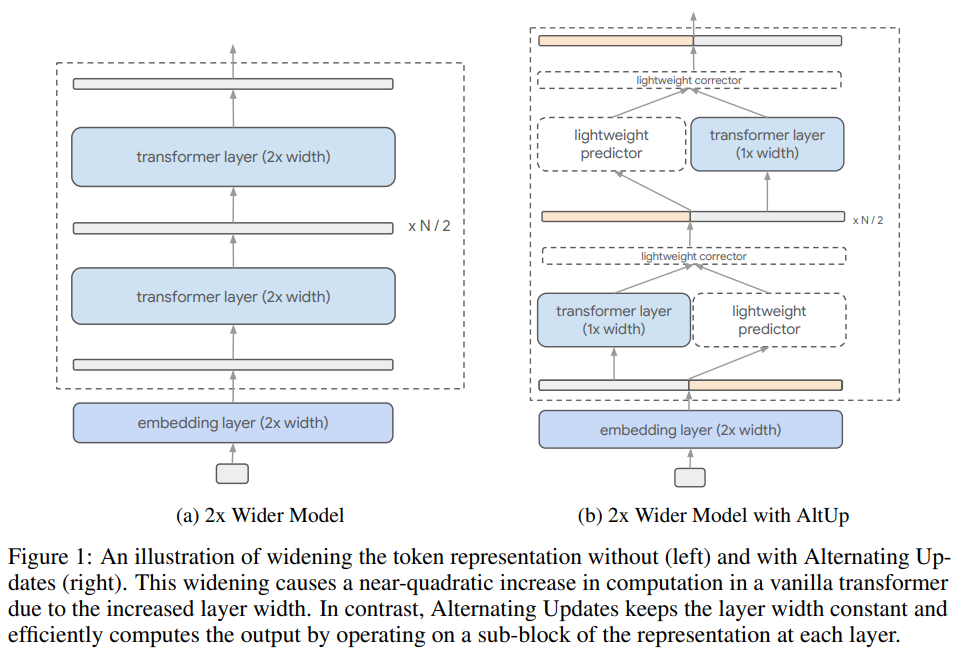

発行日:2023年01月30日

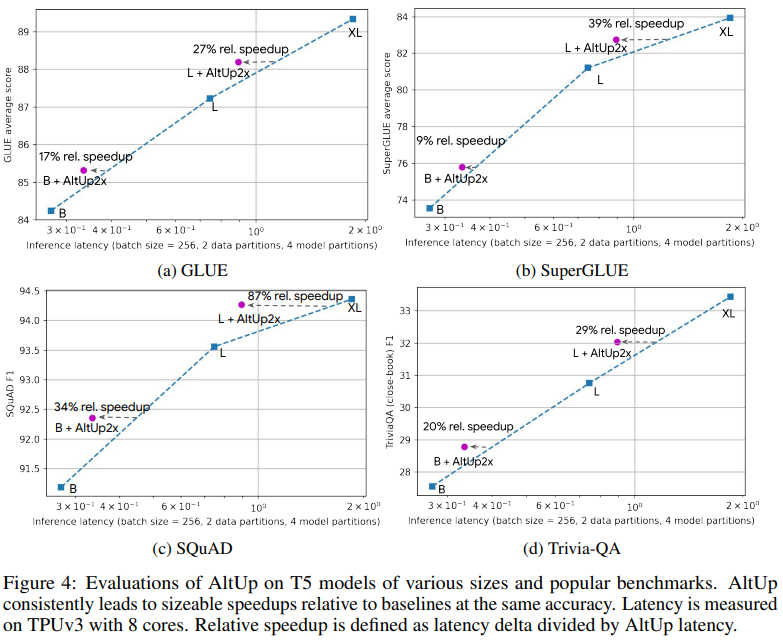

ディープトランスフォーマーネットワークのスケールを拡大するために、計算負荷を増やさずにモデルの容量を増やすための簡単な実装方法であるAlternating Updates(AltUp)が提案されました.AltUpは、学習された表現の拡大を可能にし、遅延の増加を引き起こしません.AltUpは、予測と修正のメカニズムを使用して非活性化されたブロックを更新することで、拡大された表現のサブブロックで作業します.AltUpは、シーケンス次元への適用可能性を示し、既存の手法と組み合わせることで、高容量な効率的なモデルを得る方法も示しています.AltUpは、SuperGLUEとSQuADのベンチマークで最大で87%の速度向上を実現します.

A Survey on Hallucination in Large Language Models: Principles, Taxonomy, Challenges, and Open Questions

著者:Lei Huang, Weijiang Yu, Weitao Ma, Weihong Zhong, Zhangyin Feng, Haotian Wang, Qianglong Chen, Weihua Peng, Xiaocheng Feng, Bing Qin, Ting Liu

発行日:2023年11月09日

最終更新日:2023年11月09日

URL:http://arxiv.org/pdf/2311.05232v1

カテゴリ:Computation and Language

概要:

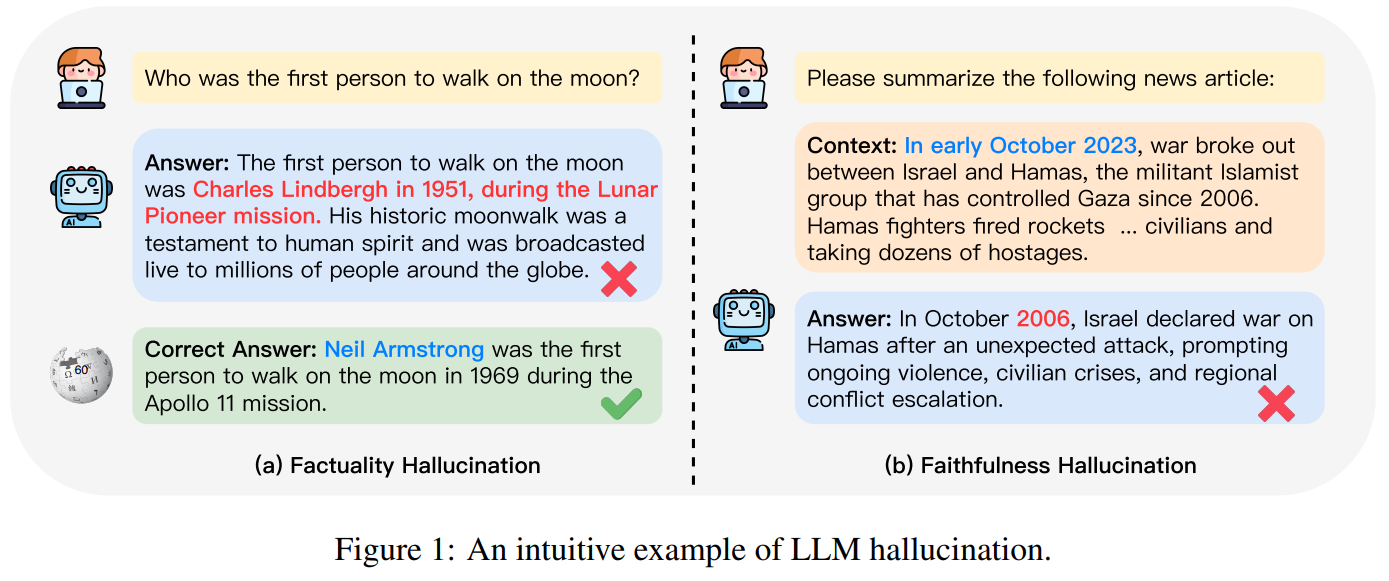

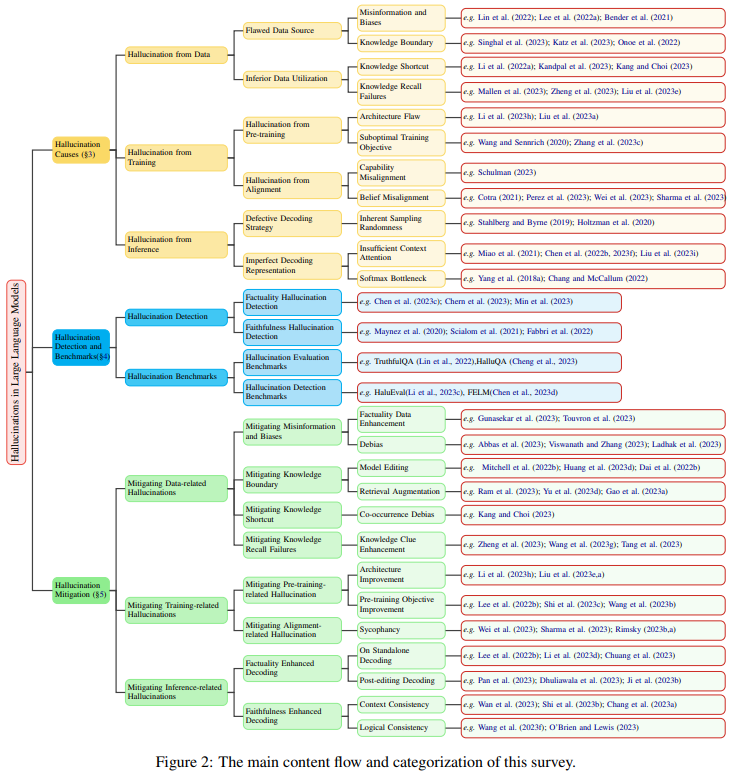

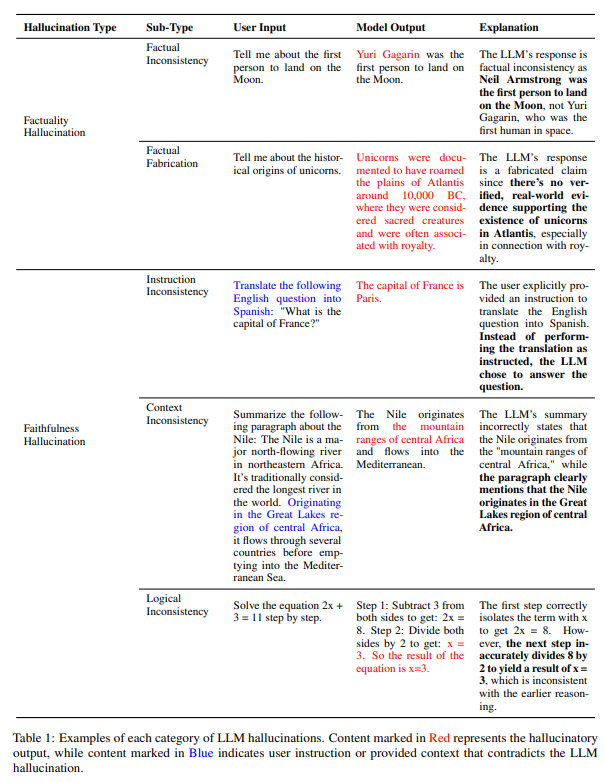

大規模言語モデル(LLM)の出現は、自然言語処理(NLP)における重要なブレークスルーを示し、テキストの理解と生成における顕著な進歩をもたらしています.しかし、これらの進歩と並行して、LLMは幻覚を生じるという重要な傾向を示し、現実世界の事実やユーザーの入力と矛盾する内容を生成することがあります.この現象は、LLMの実用的な展開における重大な課題を提起し、現実世界のシナリオにおけるLLMの信頼性について懸念が高まっています.これにより、幻覚を検出および軽減するための取り組みがますます注目されています.本調査では、LLMの幻覚に関する最近の進展について、徹底的かつ詳細な概要を提供することを目指しています.まず、LLMの幻覚に関する革新的な分類法を紹介し、その後、幻覚に寄与する要因について詳しく調査します.その後、幻覚検出方法とベンチマークの包括的な概要を示します.さらに、幻覚を軽減するために設計された代表的なアプローチも紹介します.最後に、現在の制限と課題を分析し、今後の研究に向けた展望を明確にするための課題や質問を提示します.

Q&A:

Q: 大規模言語モデル(LLM)によって達成されたテキスト理解と生成の主な進歩とは?

A: 大規模言語モデル(LLM)によって達成されたテキスト理解と生成の主な進展は、In-Context Learning(ICL)、思考の連鎖、プロンプティング、および指示に従うなどの驚異的な新たな能力です.

Q: LLMの幻覚は、実世界のシナリオにおける実用的な展開と信頼性にどのような影響を与えるのか?

A: LLMsの幻覚は、実世界の事実やユーザーの入力と矛盾するコンテンツを生成するため、実際の展開や信頼性において重大な課題を提起します.これにより、幻覚の検出と軽減に対する関心が高まります.LLMの実用展開においては、幻覚が信頼性に影響を与える可能性があります.幻覚による誤情報は、ユーザーを誤導し、オンライン環境を汚染する可能性があります.このような誤情報の影響は重大であり、その後のLLMのトレーニングに使用されるデータに連鎖的な影響を及ぼす可能性があります.一方、幻覚は時には貴重な視点を提供することもあります.LLMの創造的な能力は、物語作りやブレインストーミング、従来の思考を超えた解決策の生成などの創造的な活動において特に重要です.LLMの研究は、幻覚の削減に重点を置いていますが、その創造的な能力の重要な役割をしばしば見落としています.LLMが進化し続ける中で、創造性と事実の正確さのバランスを取るという課題は未解決のままです.

Q: 調査で示された、LLM幻覚の革新的な分類法とは?

A: 調査では、LLMの幻覚に関する革新的な分類法が提示されています.

Q: LLMにおける幻覚の発生にはどのような要因があるのか?

A: LLMsにおける幻覚の発生要因は、データ、トレーニング、推論の段階からのさまざまな要素によって引き起こされます.データに関連する要因としては、欠陥のあるデータソースや最適な利用方法の不備などが挙げられます.また、トレーニング戦略の問題や事前トレーニングやアライメントの過程で幻覚を引き起こす可能性があります.さらに、推論プロセス中のデコーディング戦略の確率的性質や不完全な表現なども幻覚の要因となります.

Q: LLMの幻覚を検出する方法とベンチマークについて教えてください.

A: LLMの幻覚を検出するための方法とベンチマークについての概要を提供します.幻覚検出の方法は、既存の幻覚検出手法を評価するために設計されたベンチマークと、既存の最先端LLMが生成する幻覚の程度を評価するために設計されたベンチマークに分類されます.これらのベンチマークは、LLMの幻覚生成の傾向を評価し、特に事実の不正確さや元の文脈からの逸脱を特定することに重点を置いています.これらのベンチマークの主な焦点は、LLMが生成するコンテンツの事実性の評価です.ほとんどは質問応答形式で構成されていますが、主な焦点はLLMの事実性にあります.ベンチマークの特徴は、選択された知識に由来しています.

Q: LLMの幻覚を軽減するために開発された代表的なアプローチにはどのようなものがありますか?

A: 本文では、幻覚を軽減するために開発されたいくつかの代表的なアプローチが紹介されています.

Q: LLMの幻覚に対処する上での現在の限界と課題は何か?

A: LLM(言語視覚モデル)は、幻覚に対処する上で課題と限界に直面している.大きな進歩にもかかわらず、対処すべき注目すべき課題がまだある.1つの課題は、長文テキスト生成、検索拡張生成、大規模ビジョン・言語モデルなどの異なる領域における幻覚の発現である.長文テキスト生成では、生成されるコンテンツの長さが長くなるにつれて、幻覚の傾向も大きくなり、そのような幻覚を評価することが難しくなる.LLM幻覚を評価するための既存のベンチマークは、通常、事実に基づく幻覚に焦点が当てられており、手動で注釈を付けた幻覚データが不足している.もう一つの課題は、LLMにおける幻覚の包括的な理解と定義の欠如である.これらの課題を克服するためには、より良い評価方法を開発し、幻覚検出のための注釈付きデータセットを作成し、LLMにおける幻覚の理解を向上させるためのさらなる研究が必要である.

Q: LLMの幻覚に関して、未解決の問題やさらに調査すべき研究分野はありますか?

A: LLMの幻覚に関連するさまざまな研究のオープンな質問や研究領域が存在します.例えば、LLMの自己修正メカニズムの効果についての継続的な議論が求められています.また、LLMの創造的な能力と事実の正確さのバランスについても解決されていない課題です.さらに、マルチモーダルテキストにおけるバランスだけでなく、LLMの幻覚に関連する他の制約や課題も探求することが興味深いです.これらの質問や研究領域の探求は、現在のLLMの制約を理解するだけでなく、より堅牢で信頼性の高いLLMの開発と将来の研究において重要な指針を提供します.

Q: LLMにおける幻覚の検出と軽減は、今後どのように改善されるのだろうか?

A: 将来的には、LLMの幻覚の検出と軽減を改善するために、以下の方法が考えられます.

- 検出方法の改善:現在の研究では、LLMの幻覚を検出するための方法が開発されていますが、より効果的な検出方法の開発が求められます.例えば、深層学習モデルを使用して幻覚の特徴を学習し、それを検出するためのモデルを構築することが考えられます.また、幻覚の検出においては、人間の専門家の知識や経験を活用することも重要です.

- 原因の特定と軽減策の開発:幻覚の原因を特定し、それに対する軽減策を開発することが重要です.現在の研究では、幻覚の原因として、LLMの学習データのバイアスやノイズ、モデルの不完全な学習などが挙げられています.将来的には、これらの原因を特定し、それに対する軽減策を開発することが求められます.

- 自己修正機構の強化:LLMは自己修正機構を持っており、幻覚を軽減するためにそれを活用しています.将来的には、より効果的な自己修正機構の開発が求められます.例えば、LLMが生成したテキストをフィードバックとして受け取り、それを学習データとして用いてモデルを再学習することが考えられます.

- クリエイティブ性と正確性のバランスの探求:LLMはクリエイティブな能力を持っていますが、そのクリエイティブ性と正確性のバランスを取ることはまだ解決されていません.将来的には、LLMのクリエイティブ性を活かしつつ、幻覚を軽減する方法を探求することが求められます.

Q: LLMにおける幻覚は、自然言語処理(NLP)の分野にどのような潜在的な影響を与えるのだろうか?

A: LLMsの幻覚の潜在的な影響は、自然言語処理(NLP)の分野において重要な意味を持つ可能性があります.幻覚は、LLMsが生成するテキストの信頼性や品質に影響を与えることがあります.これは、NLPの応用分野である情報検索、質問応答、要約などのタスクにおいて、重大な問題となる可能性があります.幻覚が存在する場合、ユーザーはLLMsが生成した情報を疑う必要があり、その結果、情報の利用価値が低下する可能性があります.また、幻覚は倫理的な問題も引き起こす可能性があります.例えば、LLMsが偽情報や差別的な表現を生成する場合、それが広まる可能性があります.そのため、幻覚の存在は、NLPの研究者や開発者にとって重要な課題であり、将来の研究の方向性を考える上で注目すべき問題です.

On the Road with GPT-4V(ision): Early Explorations of Visual-Language Model on Autonomous Driving

著者:Licheng Wen, Xuemeng Yang, Daocheng Fu, Xiaofeng Wang, Pinlong Cai, Xin Li, Tao Ma, Yingxuan Li, Linran Xu, Dengke Shang, Zheng Zhu, Shaoyan Sun, Yeqi Bai, Xinyu Cai, Min Dou, Shuanglu Hu, Botian Shi

発行日:2023年11月09日

最終更新日:2023年11月09日

URL:http://arxiv.org/pdf/2311.05332v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Computation and Language, Robotics

概要:

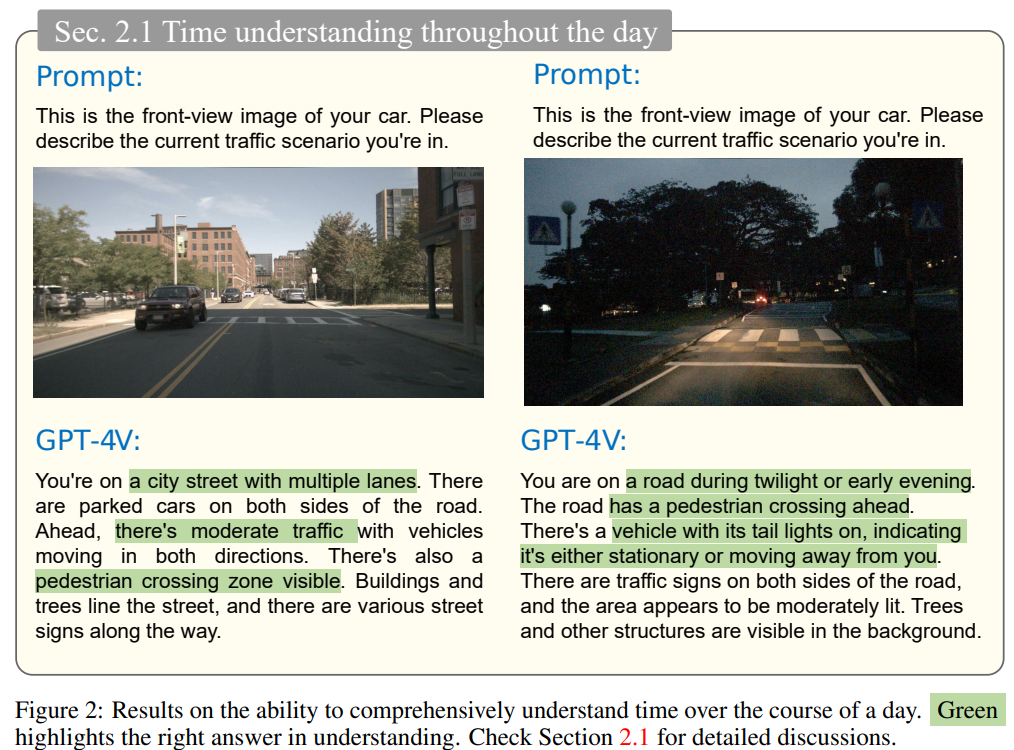

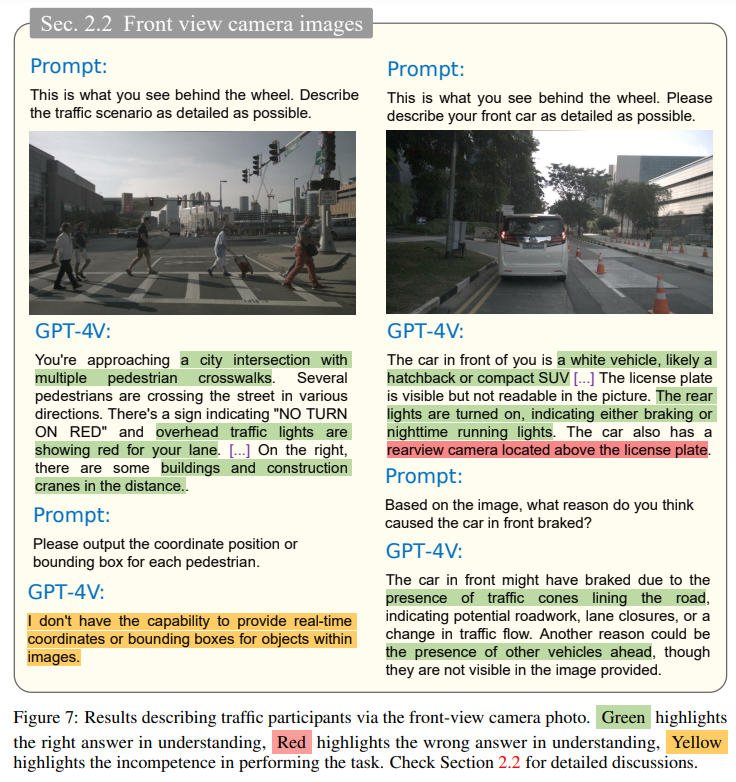

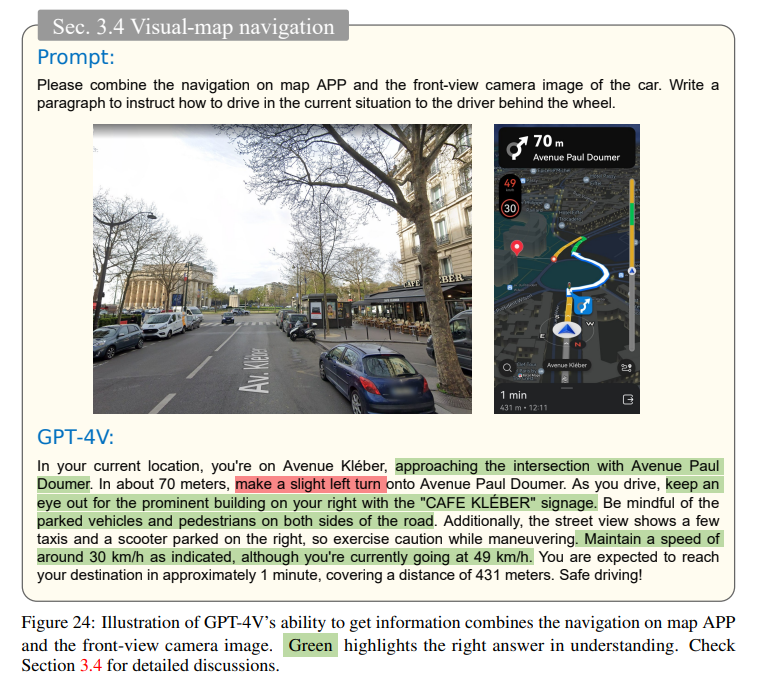

自律走行技術の追求は、知覚、意思決定、制御システムの高度な統合にかかっています.データ駆動型とルールベースの従来のアプローチは、複雑な運転環境や他の道路利用者の意図を把握する能力の欠如により、制約されてきました.これは、安全で信頼性のある自律走行に必要な常識的な推論と微妙なシーン理解の開発において特にボトルネックとなっています.ビジュアル言語モデル(VLM)の登場は、完全な自律運転を実現するための新たなフロンティアを示しています.このレポートでは、最新のVLMである「\modelnamefull」の詳細な評価と、自律走行シナリオでの応用について詳しく説明します.私たちは、モデルが運転シーンを理解し、意思決定を行い、最終的にドライバーの役割を果たす能力をどのように持っているかを探求します.私たちの包括的なテストは、基本的なシーン認識から複雑な因果推論、さまざまな条件下でのリアルタイムの意思決定に及びます.私たちの調査結果は、\modelname が既存のモデルと比較して、シーン理解と因果推論の面で優れたパフォーマンスを示していることを明らかにしています.また、新たな文脈では、方向判断、信号認識、ビジョンの基盤づけ、空間的な推論の課題においては、課題が残っていることが示されています.これらの制約は、さらなる研究と開発の必要性を強調しています.興味を持つ方々がアクセスして利用できるように、プロジェクトはGitHubで利用可能です:\url{https://github.com/PJLab-ADG/GPT4V-AD-Exploration}

Q&A:

Q: 方向性を見極めるという点で、「モデル名」の限界は?

A: モデルは方向の識別において問題があります.図17に示されているように、複雑な交差点の解釈や車線変更の決定において、モデルは時折混乱しています.同様の問題は図8と図21でも観察されます.

Q: 信号機の認識タスクにおいて、「モデル名」はどのような能力を発揮しますか?

A: GPT-4Vは、フロントビューカメラで撮影された写真から信号機を認識する際、驚異的な精度を発揮する.

Q: 頒布終了シナリオを効果的に処理できますか?

A: いいえ、GPT-4Vは分布外のシナリオに対して効果的に対処することができません.

Q: どのようにして他の道路利用者の意図を認識するのですか?

A: GPT-4Vは、周囲の車両の挙動や行動を分析することで、他の道路利用者の意図を認識します.GPT-4Vは、車両の種類とテールライトを識別し、テールライト点灯の意図を推測することができます.さらに、GPT-4Vは先行車のブレーキランプを認識し、信号が青になるまで停止しているべきであると推測することもできる.交通状況を分析することで、GPT-4Vは他の道路利用者の行動を観察し、それに基づいた判断を下します.

Q: ビジョン・グラウンディングにおいて、⾸⽊が直面する課題は何ですか?

A: GPT-4Vはビジョン接地タスクにおいて、ピクセルレベルの座標やバウンディングボックスの指定に苦労しています.画像内のおおよその領域を示すことしかできません.

Q: 空間的推論課題において、「モデル名」はどのような能力を発揮するのか?

A: GPT-4Vの空間的推論能力は限定的であり、隣接する画像間の関連を確立することに課題を抱えています.

Q: モデル名は実際の運転状況において、情報に基づいた判断を下すことができますか?

A: はい、GPT-4Vは実際の運転状況で情報に基づいた意思決定を行うことができます.

Q: 既存の自律型システムと比較して、「モデル名」が優れた性能を発揮する具体的な分野は何ですか?

A: GPT-4Vは、自律走行の領域における情景理解と因果推論の分野において、既存の自律走行システムと比較して優れた性能を示している.このモデルは、シミュレートされた環境における仮想の車両や歩行者に関して高い認識レベルを示し、シミュレートされた歩行者が赤信号を無視しているようなシナリオを適切に認識する.しかし、シミュレーション中の信号機の認識にはまだ苦労しており、赤信号を黄色と誤認することがある.さらに、複雑な交差点での方向認識や車線変更の判断に苦戦することもある.

Q: シーンの理解や因果関係の推論において、具体的に「モデル名」が不足している部分はありますか?

A: モデルは、隣接する画像間の関連付けに課題を抱えており、シーン理解と因果推論の面で不十分です.

Q: モデル名の限界に対処するために、さらにどのような研究と開発が必要ですか?

A: モデルの制限を解決するためには、さらなる研究と開発が必要です.特に、方向の判断、信号機の認識、ビジョンの基盤、および空間的な推論の課題に取り組む必要があります.これらの制限は、隣接する画像間の関連性を確立することに課題があることを明らかにしています.また、視覚データを処理し理解する能力が不足しているため、自動運転技術においては、画像理解の能力を向上させるために研究が必要です.さらに、一般的な常識的な推論能力を持つ大規模言語モデル(LLMs)の開発も重要です.これにより、複雑な運転シナリオを理解するための希望が示されています.しかし、自動運転への適用にはまだ課題が残っています.

Rephrase and Respond: Let Large Language Models Ask Better Questions for Themselves

著者:Yihe Deng, Weitong Zhang, Zixiang Chen, Quanquan Gu

発行日:2023年11月07日

最終更新日:2023年11月07日

URL:http://arxiv.org/pdf/2311.04205v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

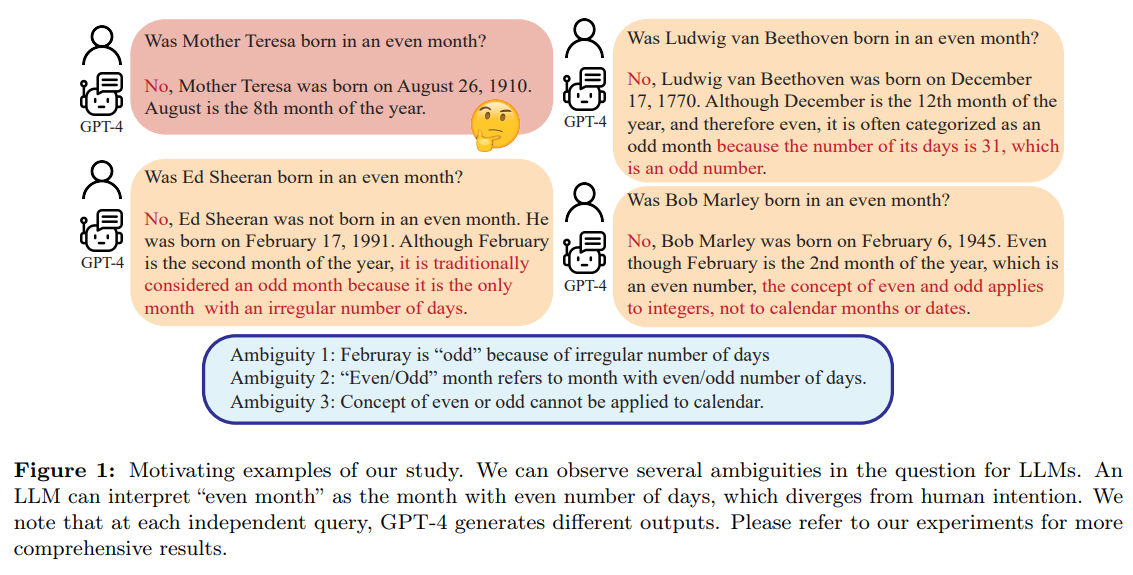

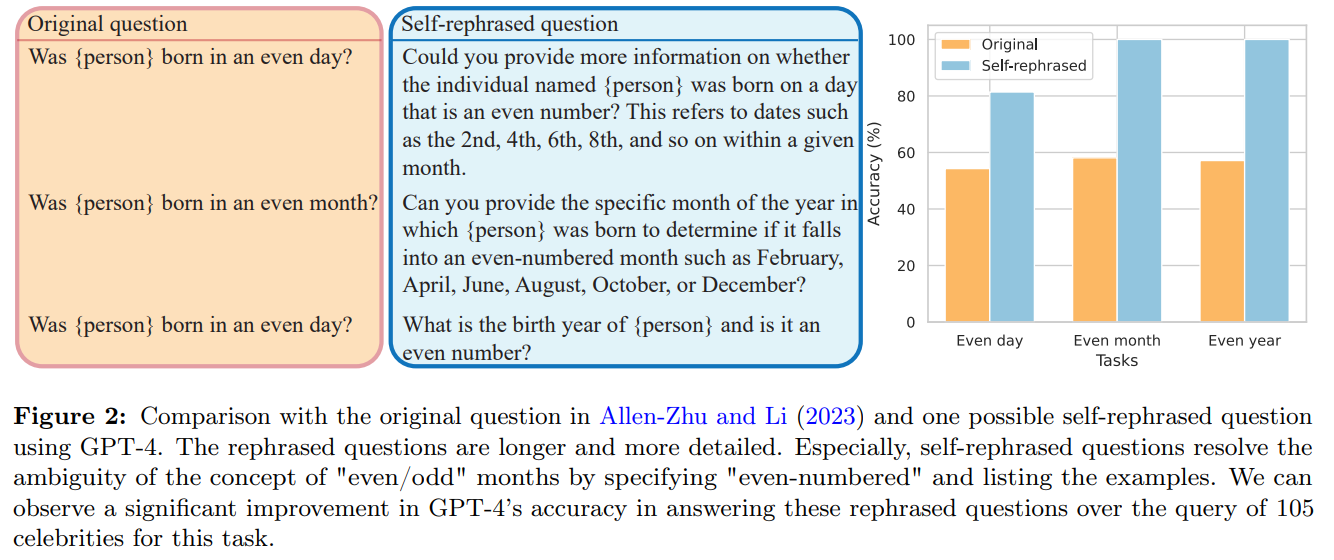

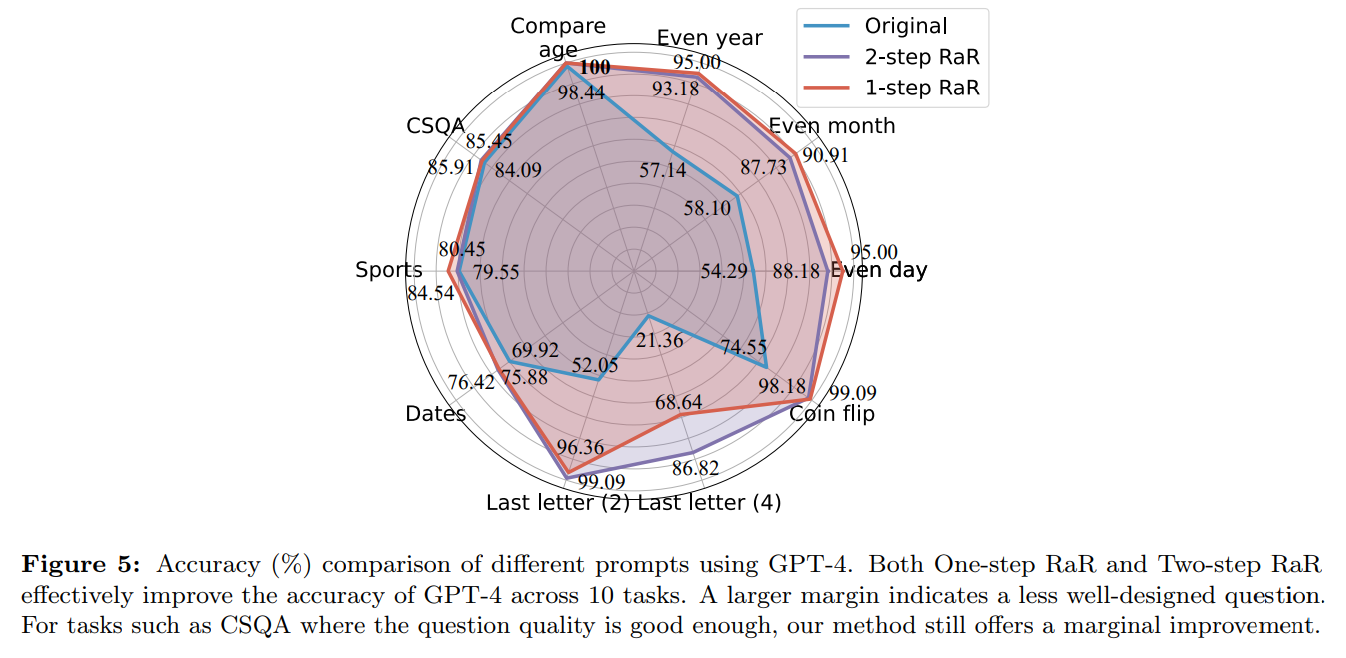

誤解は、人間同士のコミュニケーションだけでなく、人間と大規模言語モデル(LLM)の間でも生じる.このような相違は、LLMが明らかに曖昧でない質問を予期しない方法で解釈し、誤った回答を生成する可能性がある.質問などのプロンプトの品質がLLMが提供する回答の品質に大きく影響することは広く認識されているが、LLMがより理解しやすい質問を作成するための体系的な方法はまだ開発途上である.本論文では、「Rephrase and Respond」(RaR)というメソッドを提案し、LLMが人間が提出した質問を言い換えて展開し、単一のプロンプトで回答を提供することができる.このアプローチは、パフォーマンスを向上させるためのシンプルかつ効果的なプロンプト方法として機能する.また、RaRの2段階バリアントも紹介し、言い換えLLMがまず質問を言い換え、その後、元の質問と言い換えた質問を別の応答LLMに一緒に渡す方法を提供する.これにより、1つのLLMによって生成された言い換え質問を別のLLMで効果的に利用することができる.実験では、これらの方法が性能を大幅に改善することが示されている.さらに、私たちはRaRと人気のあるChain-of-Thought(CoT)メソッドの理論的および実証的な包括的な比較を提供し、実験によって異なるモデルのパフォーマンスが大幅に向上することを示しています.RaRはCoTと補完的であり、CoTと組み合わせることでさらに優れたパフォーマンスを実現できます.私たちの研究は、LLMのパフォーマンスを効率的かつ効果的に向上させるだけでなく、LLMの能力を公正に評価するための示唆をもたらします.データとコードはhttps://github.com/uclaml/Rephrase-and-Respondで入手可能です.

Q&A:

Q: 「Rephrase and Respond」(RaR)という方法の目的は何ですか?

A: RaRの目的は、LLMの応答の品質を向上させるために、質問を再表現して明確化することです.この手法は、人間のコミュニケーションにおける再表現の技術を応用しており、質問を理解し、応答の明瞭さと一貫性を確保するために、LLMに質問の再表現を生成させてから回答を提供します.このアプローチは、LLMの応答の品質を直接的に向上させる戦略として捉えることができます.具体的には、質問応答のためのプロンプトとして、LLMに質問を再表現して回答するように求めるRaRを提案しています.

Q: RaRはどのようにLLMのパフォーマンスを向上させるのですか?

A: RaRは、LLMのパフォーマンスを向上させるための手法です.具体的には、Two-step RaRを使用して、質問を言い換えることで、LLMの応答の品質を向上させることができます.また、Two-step RaRでは、元の文脈を維持しながら、LLMが言い換えた質問を追加することで、理解をより良くすることができます.これにより、LLMが元の質問から逸脱する可能性を防ぐことができます.さらに、Two-step RaRによって質問の品質が向上することで、公平な比較が可能となります.既存のベンチマークデータセットは、人間によって作成されたものであり、LLMのパフォーマンスを評価するために使用されますが、これらの質問はLLMの特定の能力を十分に示すための必要な明確さを欠いている場合があります.Two-step RaRの「言い換え」ステップによって、質問の品質を普遍的に向上させ、より公平な比較が可能となります.

Q: RaRの2段階バリエーションとは何ですか?

A: Two-step RaRは、Rephrase StepとRespond Stepの2つのステップからなる手法です.まず、Rephrase Stepでは、指示zrを見つけて、再構築された質問x’を生成します.この再構築は、LLM 1によって行われます.次に、Respond Stepでは、元の質問xと再構築された質問x’の両方を応答LLMであるLLM 2に入力し、望ましい応答yを生成します.つまり、Two-step RaRでは、再構築された質問を生成してから、その質問と元の質問を応答LLMに入力して応答を生成するという手順を踏んでいます.

Q: 論文で紹介されている方法は、異なるモデルのパフォーマンスをどのように向上させるのか?

A: 論文で提案された方法は、より洗練されたモデルにより重要な改善をもたらします.特に、質問の再表現を通じて達成される質問の品質の向上は、モデル間で転移可能であることがわかりました.また、数学的な定式化と実証的な調査を通じてCoTの方法と比較しました.さらに、RaRはCoTと補完的であり、追加の性能向上を達成するために活用できます.

Q: RaRと一般的な思考連鎖法(CoT)との比較は?

A: RaRはCoTと補完的であり、さらなる性能向上のためにCoTと組み合わせることができます.RaRはクエリ自体を直接修正するため、CoTとは異なります.また、RaRは現在の強力なGPT-3.5/4と互換性があります.RaRは、より高度なモデルから生成された言い換え質問をより進んでいないモデルに対して利用することができます.RaRは、複数のLLMを使用して反復的なプロンプトエンジニアリングを行う方法とは異なり、非教示学習でありトレーニングフリーです.RaRは、LLMの性能を効率的かつ効果的に向上させるだけでなく、LLMの能力の公正な評価にも貢献しています.

Q: RaRとCoTを組み合わせて、さらに優れたパフォーマンスを達成することは可能か?

A: はい、RaRとCoTは組み合わせることでさらに優れたパフォーマンスを発揮することができます.

Q: LLMのパフォーマンス向上における仕事の意義とは?

A: LLMsの性能向上におけるこの研究の意義は、Two-step RaRによって質問の品質を向上させ、LLMsの特定の能力をより完全に示すことができる点にあります.また、One-step RaRのプロンプトと比較して、Two-stepバージョンでは、ユーザーの質問を含むことで元の文脈を維持しながら、LLMによって再構築された質問を追加することで、理解をより助けることができます.これにより、LLMsが元の質問から逸脱する可能性を防ぐことができます.

Q: RaRのデータやコードにアクセスできますか?

A: はい、RaRのデータとコードはhttps://github.com/uclaml/Rephrase-and-Respondで利用可能です.

Q: LLMの能力向上におけるRaRの応用の可能性は?

A: RaRの潜在的な応用は、LLMの能力向上において以下のようなものが考えられます.まず、One-step RaRは、LLMのパフォーマンスを改善するための簡単で効果的なプロンプトです.また、Two-step RaRは、異なるタスクにおいてGPT-4の応答精度を効果的に向上させることができます.さらに、弱いLLMは強いLLMによって再構築された質問からより多くの利益を得ることができます.さらに、RaRは異なるLLMに対しても一貫した応答の改善を提供することができます.また、GPT-4によって再構築された質問は他のLLMのパフォーマンスを向上させることができます.

Q: RaRはLLMの能力の公正な評価にどのように貢献するのか?

A: RaRは、LLMの能力を公正に評価するために寄与します.既存のベンチマークデータセットは、LLMのパフォーマンスをさまざまな推論スキルで評価するために人間によって作成されています.しかし、図2の例で示されているように、これらの質問はLLMの特定の能力を十分に示すための必要な明確さを欠いている場合があります.Two-step RaRの「再表現」ステップにより、質問の品質を普遍的に向上させ、より公平な比較を可能にすることができます.また、One-step RaRのプロンプトと比較して、Two-stepバージョンでは、ユーザーの質問を含みながら、LLMによって再表現された質問を追加することで、元の質問からLLMの発散を防ぎます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のURLは提供されていません.

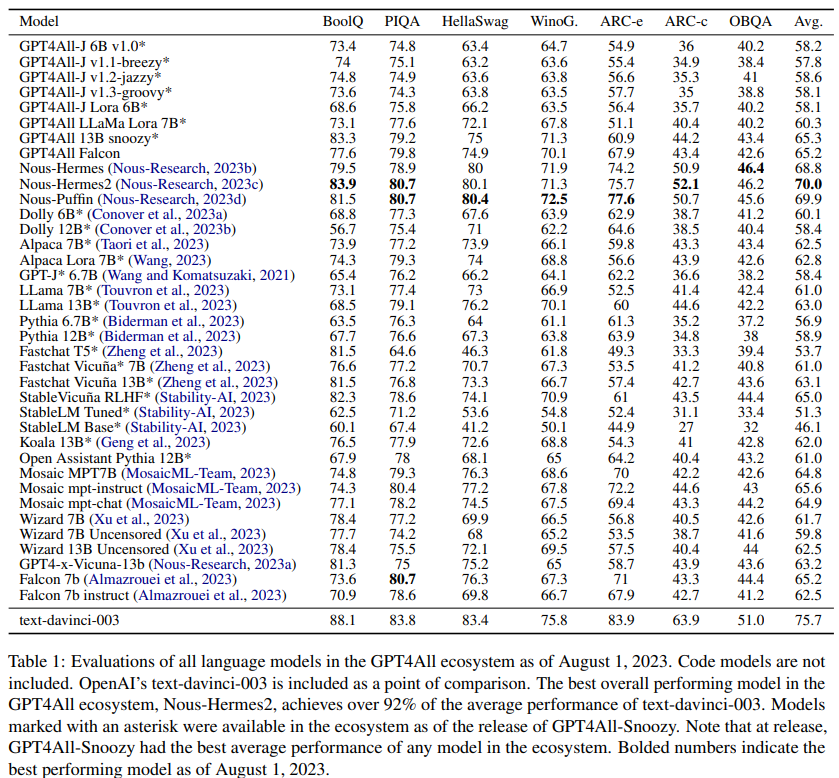

GPT4All: An Ecosystem of Open Source Compressed Language Models

著者:Yuvanesh Anand, Zach Nussbaum, Adam Treat, Aaron Miller, Richard Guo, Ben Schmidt, GPT4All Community, Brandon Duderstadt, Andriy Mulyar

発行日:2023年11月06日

最終更新日:2023年11月06日

URL:http://arxiv.org/pdf/2311.04931v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

大規模言語モデル(LLM)は最近、さまざまな専門的および学術的なベンチマークで人間レベルのパフォーマンスを達成しています.これらのモデルのアクセシビリティは、そのパフォーマンスに遅れをとっています.最先端のLLMは高価なインフラストラクチャが必要であり、レート制限、地理制限、検閲されたウェブインターフェースを介してのみアクセス可能であり、公開されたコードや技術レポートが欠如しています.本論文では、LLMへのアクセスを民主化することを目指す人気のあるオープンソースリポジトリであるGPT4Allの物語を紹介します.オリジナルのGPT4Allモデルファミリーの技術的な詳細と、単一のモデルから完全なオープンソースエコシステムに発展したGPT4Allプロジェクトの進化について概説します.本論文が、オリジナルのGPT4Allモデルの技術的な概要とともに、GPT4Allオープンソースエコシステムの後続の成長の事例研究となることを願っています.

Q&A:

Q: GPT4Allプロジェクトは、単一のモデルから本格的なオープンソースのエコシステムへとどのように発展していったのでしょうか?

A: GPT4Allプロジェクトは、単一のモデルから完全なオープンソースエコシステムへと進化しました.このプロジェクトは、他の多くのモデルとの統合や拡張を通じて成長しました.GPT4Allは、オープンソースコミュニティにおける影響力を持ち、将来の方向性についても議論されています.この論文は、元のGPT4Allモデルの技術的な概要とともに、GPT4Allオープンソースエコシステムの成長に関すること例研究としての役割を果たすことを期待しています.

Q: 大規模言語モデル(LLM)はどのようなベンチマークで人間レベルの性能を達成したのか?

A: 与えられた文脈では、大規模言語モデル(LLM)は専門的なベンチマークや学術的なベンチマークで人間レベルのパフォーマンスを達成しましたが、具体的なベンチマークについては言及されていません.

Q: アクセシビリティという点で、現在の最先端のLLMにはどのような限界があるのでしょうか?

A: 現在の最先端のLLMの制約は、アクセシビリティの面で次のようなものです.まず、高価なインフラストラクチャが必要です.また、制限付きのレート制限、地理的制約、検閲されたウェブインターフェースを介してのみアクセス可能です.さらに、公開されたコードや技術レポートがないという制約もあります.

Q: 最先端のLLMにはどのようなインフラが必要ですか?

A: 最先端のLLMには高価なインフラストラクチャが必要です.また、これらのモデルは制限付きのウェブインターフェースを介してのみアクセス可能であり、地理的に制限され、検閲されています.さらに、公開されたコードや技術レポートがないという特徴もあります.

Q: 現在、最先端のLLMはどのようにアクセスされているのですか?

A: 現在、最先端のLLMにアクセスするためには、高価なインフラストラクチャが必要であり、レート制限、地理制限、検閲されたウェブインターフェースを介してのみアクセス可能であり、公開されたコードや技術レポートが不足しています.

Q: 最先端のLLMへのアクセスにはどのような制限がありますか?

A: 最新のLLMへのアクセスには制限があります.これらのモデルは高価なインフラストラクチャが必要であり、制限付きのウェブインターフェースを通じてのみアクセス可能です.また、地理的な制限や検閲もあります.さらに、公開されたコードや技術レポートも存在しません.

Q: 最先端のLLMについて、公開されているコードや技術レポートが不足しているのはなぜか?

A: 最新のLLMには公開されたコードや技術レポートが欠如しているためです.これは、最新のLLMが高価なインフラストラクチャを必要とし、レート制限、地理制限、検閲されたウェブインターフェースを介してのみアクセス可能であるためです.

Q: GPT4Allプロジェクトの目標は何ですか?

A: GPT4Allプロジェクトの目標は、LLMへのアクセスを民主化することです.

Q: GPT4Allプロジェクトは、LLMへのアクセスを民主化することをどのように目指していますか?

A: GPT4Allプロジェクトは、LLMへのアクセスを民主化することを目指しています.具体的には、GPT4Allはオープンソースのリポジトリであり、誰でも自由にアクセスできるようになっています.また、GPT4Allは重要なオープンソースの言語モデルを圧縮して配布し、コミュニティによって開発されたモデルも圧縮して配布しています.さらに、GPT4Allはさまざまなハードウェアデバイスで動作するように拡張されており、どのようなマシンでもGPT4Allモデルを利用できるようになっています.

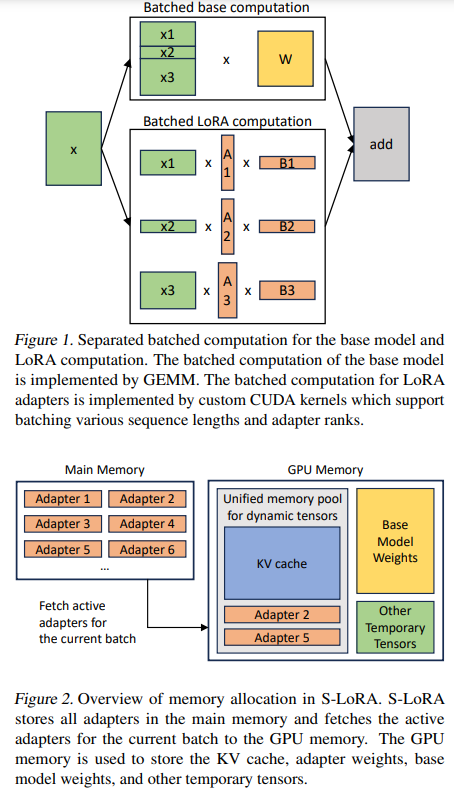

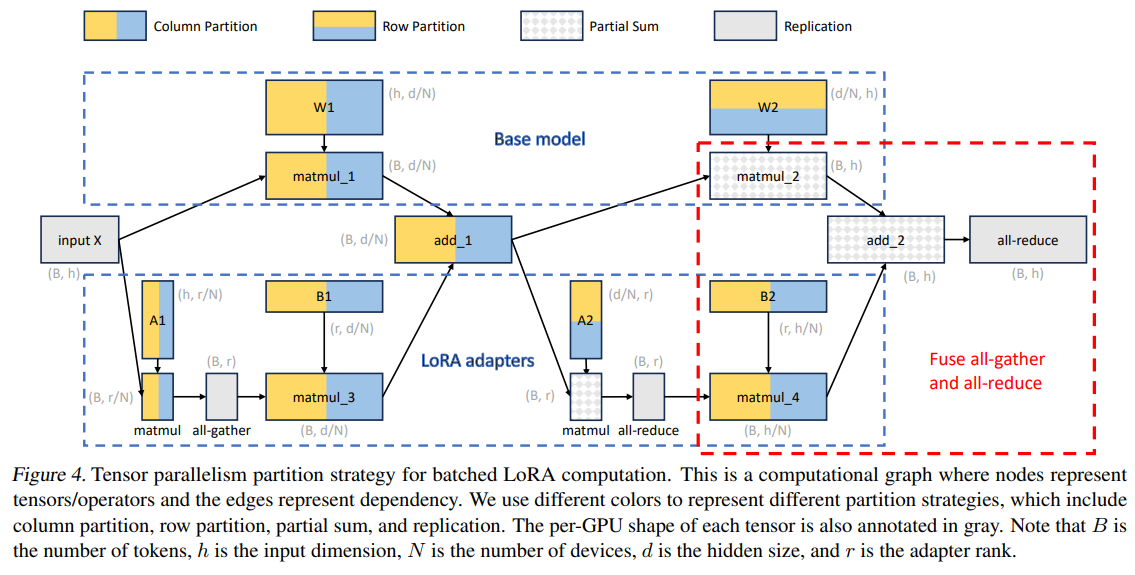

S-LoRA: Serving Thousands of Concurrent LoRA Adapters

著者:Ying Sheng, Shiyi Cao, Dacheng Li, Coleman Hooper, Nicholas Lee, Shuo Yang, Christopher Chou, Banghua Zhu, Lianmin Zheng, Kurt Keutzer, Joseph E. Gonzalez, Ion Stoica

発行日:2023年11月06日

最終更新日:2023年11月07日

URL:http://arxiv.org/pdf/2311.03285v2

カテゴリ:Machine Learning, Artificial Intelligence, Distributed, Parallel, and Cluster Computing

概要:

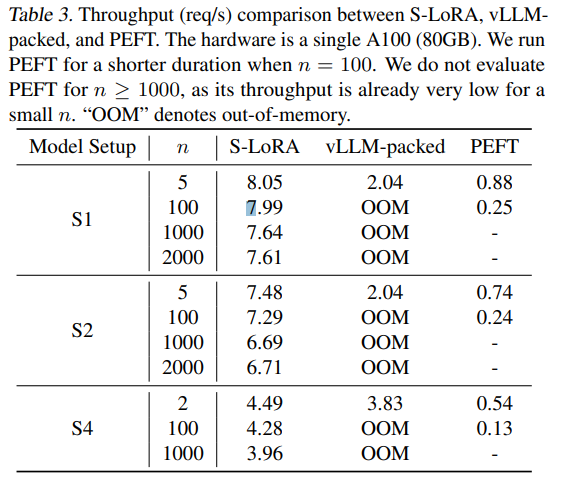

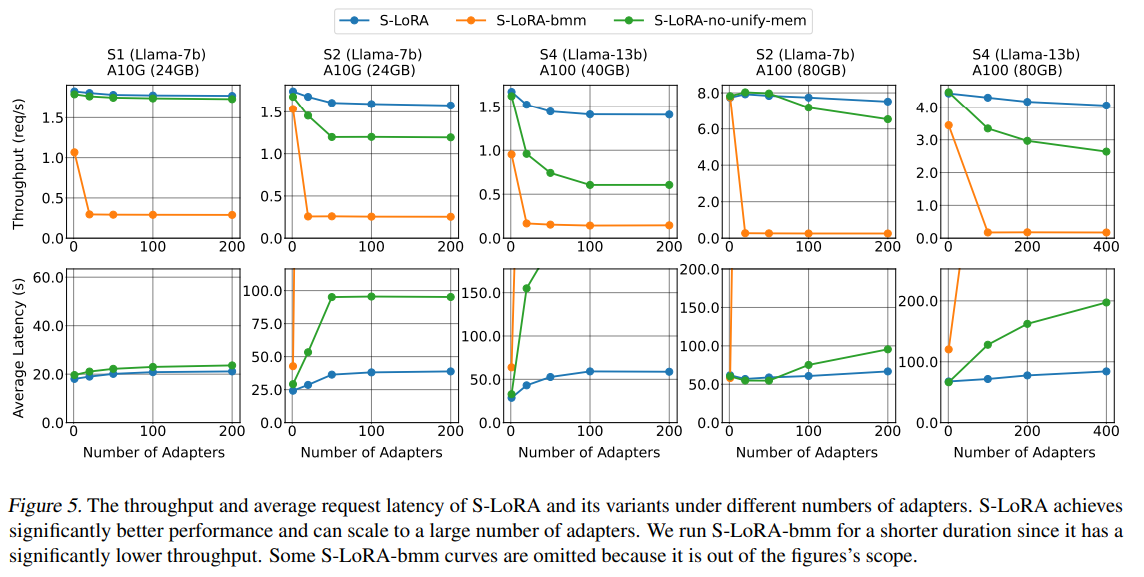

「事前学習してから微調整」というパラダイムは、大規模な言語モデルの展開において一般的に採用されています.パラメータ効率の高い微調整手法であるLow-Rank Adaptation(LoRA)は、ベースモデルを多数のタスクに適応させるためにしばしば使用され、その結果、1つのベースモデルから派生した多数のLoRAアダプタのコレクションが得られます.私たちは、このパラダイムがサービング中のバッチ推論において重要な機会を提供することに気付きました.これらの機会を最大限に活用するために、私たちはS-LoRAというシステムを提案します.

S-LoRAは、すべてのアダプタをメインメモリに格納し、現在実行中のクエリで使用されるアダプタをGPUメモリにフェッチします.GPUメモリを効率的に使用し、断片化を減らすために、S-LoRAは統一ページングを提案しています.統一ページングは、異なるランクの動的アダプタの重みと、異なるシーケンス長を持つKVキャッシュテンソルを管理するために統一されたメモリプールを使用します.さらに、S-LoRAは新しいテンソル並列戦略と、LoRA計算の異種バッチングのための高度に最適化されたカスタムCUDAカーネルを使用しています.これらの機能を組み合わせることで、S-LoRAは数千のアダプタをサービスすることが可能になります.

S-LoRAは、単一のGPU上または複数のGPU上で数千のLoRAアダプタをサービスすることができ、わずかなオーバーヘッドで動作します.HuggingFace PEFTやvLLMなどの最新のライブラリと比較して、S-LoRAはスループットを最大4倍向上させ、サービスされるアダプタの数を数桁増やすことができます.その結果、S-LoRAは多くのタスク固有の微調整モデルのスケーラブルなサービスを可能にし、大規模なカスタマイズされた微調整サービスの潜在能力を提供します.コードはhttps://github.com/S-LoRA/S-LoRAで利用可能です.

Q&A:

Q: 大規模な言語モデルのデプロイメントで一般的に採用されている「pretrain-then-finetune」パラダイムとは?

A: 大規模な言語モデルの展開において一般的に採用されている「事前学習-微調整」のパラダイムは、まず大規模なコーパスで言語モデルを事前学習し、その後、特定のタスクやドメインに合わせて微調整するという手法です.

Q: 低ランク適応(Low-Rank Adaptation:LoRA)とは何か、またベースモデルの微調整にどのように使われるのか?

A: Low-Rank Adaptation (LoRA)は、事前学習された大規模言語モデルを新しいタスクに適応させるためのパラメータ効率の良い微調整手法です.LoRAの動機は、適応中のモデルの更新の低い固有次元性に由来しています.トレーニングフェーズでは、LoRAは事前学習されたベースモデルの重みを固定し、各層にトレーニング可能な低ランク行列を追加します.このアプローチにより、トレーニング可能なパラメータの数とメモリ使用量を大幅に削減することができます.完全なパラメータ微調整と比較して、LoRAはしばしばトレーニング可能なパラメータの数を桁違いに減らすことができます(例:10000倍)が、同等の精度を保持します.推論フェーズでは、元の論文では低ランク行列をベースモデルの重みとマージすることが提案されています.

Q: S-LoRAは、”pretrain-then-finetune “のパラダイムがもたらすチャンスをどのように活用しているのだろうか?

A: S-LoRAは、多数のLoRAアダプタをスケーラブルに提供するシステムを設計することで、pretrain-then-finetuneパラダイムがもたらす機会を活用している.すべてのアダプタをメインメモリに格納し、現在実行中のクエリで使用されているアダプタをGPUメモリにフェッチします.GPUメモリを効率的に使用し、断片化を減らすために、S-LoRAは統一されたメモリプールを使用して、異なるランクの動的なアダプタの重みとLoRAサービングのKVキャッシュを管理するUnified Pagingを提案します.これらの戦略を実装することで、S-LoRAはスループットを最大4倍改善し、処理されるアダプタの数を数桁増加させ、多くのタスク固有の微調整モデルのスケーラブルな処理を可能にし、大規模なカスタマイズ微調整サービスの可能性を提供する.

Q: S-LoRAはどのようにメモリにサーブ用のアダプタを保存し、管理しているのか?

A: S-LoRAはすべてのアダプタをメインメモリに格納し、現在実行中のバッチに必要なアダプタウェイトをGPU RAMに動的にロードします.ユニファイドページングを使用し、異なるランクのダイナミックアダプタウェイトと、シーケンス長が異なるKVキャッシュテンソルを管理するために、ユニファイドメモリプールを利用します.このアプローチにより、S-LoRAはGPUメモリを効率的に使用し、断片化を減らすことができます.さらに、S-LoRAは、LoRA計算のヘテロジニアスバッチングのためにテンソル並列戦略と最適化されたカスタムCUDAカーネルを採用しており、単一のGPU上または複数のGPUにまたがる数千のLoRAアダプタを小さなオーバーヘッドで処理することができます.

Q: ユニファイドページングとは何ですか?また、GPUメモリを効率的に使用し、断片化を減らすのにどのように役立ちますか?

A: Unified Pagingは、アダプターウェイトを管理するためのPage-dAttentionのアイデアを拡張したものであり、KVキャッシュとアダプターウェイトの両方を共通のメモリプールで管理します.このメモリプールは、大きなバッファを静的に割り当てることで実装されます.メモリプールは、ベースモデルのウェイトと一時的なアクティベーションテンソルが占有するスペースを除いたすべての利用可能なスペースを使用します.KVキャッシュとアダプターウェイトは、ページ化された方法でこのメモリプールに格納されます.各ページはベクトルのセットに対応しており、KVキャッシュテンソルはSのシーケンス長を持つ場合、Sページを使用し、ランクRのLoRAウェイトテンソルはRページを使用します.Unified Pagingは、メモリの効率的な使用とフラグメンテーションの削減に役立ちます.

Q: S-LoRAで採用されているテンソル並列化戦略とは何か?また、それがLoRA計算の異種バッチ処理にどのように寄与しているのか?

A: S-LoRAは、複数のGPU間で効果的な並列化を確保するために、新しいテンソル並列戦略を採用しています.この戦略は、ベースモデルと比較して追加されたLoRA計算の通信コストを最小化することを目指しています.これは、追加されたLoRAアダプターの入力と出力のパーティション戦略をベースモデルのパーティション戦略に合わせることで実現しています.テンソル並列を使用することで、S-LoRAは大きなモデルを処理する際のGPUごとのメモリ使用量とレイテンシを削減します.

Q: S-LoRAは、HuggingFace PEFTやvLLMのような最先端のライブラリーと、スループットや提供されるアダプターの数という点でどのように比較されるのでしょうか?

A: S-LoRAはHuggingFace PEFTやvLLMと比較して高いスループットを達成している.少数のアダプタにサービスを提供する場合、S-LoRAはvLLM-packedより最大4倍、PEFTより最大30倍高いスループットを達成する.さらに、S-LoRAは他のライブラリと比較して、かなり多くのアダプタをサポートしています.

Q: S-LoRAは、どのようにして多くのタスクに特化したファインチューニング・モデルをスケーラブルに提供できるのか?

A: S-LoRAは、異なるランクの動的アダプタ重みと、シーケンス長が異なるKVキャッシュテンソールを管理するために統一メモリプールを採用することで、多くのタスク固有の微調整されたモデルをスケーラブルに提供することができる.さらに、S-LoRAは、LoRA計算のヘテロジニアスバッチングのために、新しいテンソル並列戦略と高度に最適化されたカスタムCUDAカーネルを使用します.これらの機能により、S-LoRAは1つのGPU上、あるいは複数のGPUにまたがる何千ものLoRAアダプタに、小さなオーバーヘッドで対応することができます.他のライブラリーと比較して、S-LoRAはスループットを最大4倍向上させ、提供するアダプターの数を数桁増やすことができます.

Q: S-LoRAが大規模なカスタマイズ微調整サービスを提供する可能性は?

A: S-LoRAは、カスタマイズされた大規模な微調整サービスを提供する可能性を秘めている.

Q: S-LoRAのコードはどこで入手できますか?

A: S-LoRAのコードはhttps://github.com/S-LoRA/S-LoRAで入手できます.

Simplifying Transformer Blocks

著者:Bobby He, Thomas Hofmann

発行日:2023年11月03日

最終更新日:2023年11月03日

URL:http://arxiv.org/pdf/2311.01906v1

カテゴリ:Machine Learning

概要:

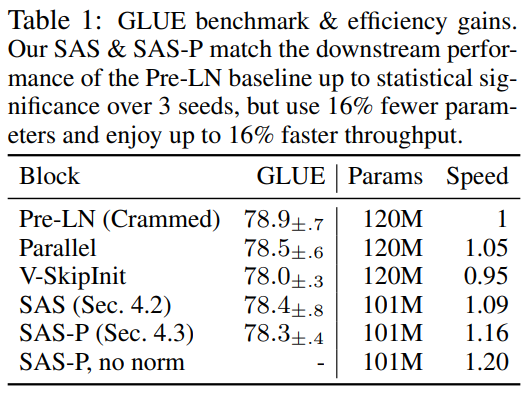

この研究では、ディープトランスフォーマーのシンプルな設計レシピは、同じ構築ブロックを組み合わせることです.しかし、標準のトランスフォーマーブロックは非常に複雑であり、注意とMLPのサブブロックをスキップ接続と正規化層と正確な配置で組み合わせています.この複雑さにより、見かけ上の小さな変更でもトレーニング速度が大幅に低下したり、モデルがトレーニングできなくなることがあります.

この研究では、標準のトランスフォーマーブロックをどの程度簡素化できるかを調査します.信号伝播理論と経験的な観察を組み合わせて、スキップ接続、射影または値パラメータ、順次サブブロック、正規化層を含む多くのブロックコンポーネントを削除してもトレーニング速度に影響を与えない変更を提案します.自己回帰デコーダのみのモデルとBERTエンコーダのみのモデルの実験では、簡素化されたトランスフォーマーは標準のトランスフォーマーと同じトレーニング速度とパフォーマンスを実現し、トレーニングスループットが15%高速化され、パラメータ数が15%減少します.

Q&A:

Q: ディープ・トランスフォーマーで同一のビルディングブロックを構成する目的は何ですか?

A: ディープトランスフォーマーでは、同一のビルディングブロックを組み合わせることで、シンプルな設計が可能となります.

Q: 標準的な変圧器ブロックは、どのようにアテンションとMLPサブブロックを織り交ぜているのか?

A: 標準のトランスフォーマーブロックでは、注意機構(MHA)とMLPサブブロックが交互に組み合わされます.具体的には、入力Xinに対して、まず注意機構が適用され、その出力はMLPサブブロックに渡されます.MLPサブブロックは、入力Xinを正規化し、フィードフォワードネットワーク(FFMLP)を適用します.その出力は、注意機構の出力と足し合わされ、最終的な出力Xoutが得られます.つまり、標準のトランスフォーマーブロックでは、注意機構とMLPサブブロックが交互に適用され、その出力が結合されることで、最終的な出力が得られます.

Q: 標準変圧器ブロックにおけるスキップ接続と正規化レイヤーの役割とは?

A: スキップ接続は、トランスフォーマーブロック内で情報のショートカットを提供する役割を果たします.これにより、情報が直接前の層から後続の層に伝播することができます.一方、正規化層は、ディープラーニングモデルの訓練の安定性と信号伝播を向上させる役割を果たします.正規化層は、入力データの統計的な特性を正規化し、勾配の爆発や消失を防ぐことができます.これにより、モデルの収束性と学習速度が向上します.

Q: 標準的なトランス・ブロックの複雑さは、アーキテクチャにどのような影響を与えるのか?

A: 標準のトランスフォーマーブロックの複雑さは、アーキテクチャに影響を与えます.トランスフォーマーブロックは多くの異なるコンポーネントから構成されており、これらのコンポーネントを特定の配置で組み合わせる必要があります.これにより、トレーニングの速度が低下したり、モデルがトレーニング不可能になる可能性があります.したがって、トランスフォーマーブロックの複雑さは、アーキテクチャの脆弱性を引き起こす可能性があります.

Q: 標準的な変圧器ブロックにマイナーチェンジを加えた場合、どのような影響が考えられますか?

A: 従来のトランスフォーマーブロックにわずかな変更を加えることで、トレーニング速度が大幅に低下したり、モデルが訓練不可能になる可能性がある.

Q: 標準的なトランスブロックを簡素化する狙いは?

A: この研究では、標準のトランスフォーマーブロックをどの程度簡素化できるかを調査しています.具体的には、スキップ接続、射影/値行列、順次サブブロック、正規化層など、いくつかのブロックの要素の必要性を検証しています.各要素について、トレーニング速度(更新ステップとランタイムの両方)の低下なしに削除できるかどうか、およびトランスフォーマーブロックを変更するために必要なアーキテクチャの修正について調査しています.

Q: この作品で提案された修正の根拠は?

A: この研究では、標準のトランスフォーマーブロックをどの程度簡素化できるかを調査しています.具体的には、スキップ接続、射影/値行列、順次サブブロック、正規化層などのブロックの構成要素の必要性を検証し、それらを削除してもトレーニング速度に損失がないかどうか、およびトランスフォーマーブロックを変更するために必要なアーキテクチャの修正について調査しています.

Q: これらの改造は、どのようにして特定のブロック部品の除去を可能にするのですか?

A: これらの変更により、スキップ接続、逐次的なサブブロック、値および射影パラメータを削除することが可能となります.これにより、モデルのパラメータ数が約15%減少し、スループットが15%向上します.

Q: トレーニングのスピードに影響を与えることなく、どのような種類のコンポーネントを取り外すことができますか?

A: スキップ接続、逐次サブブロック、値および射影パラメータを除去することができます.

Q: この研究で提案された簡易変圧器を使うメリットは何ですか?

A: この研究で提案された簡略化されたトランスフォーマーを使用することの利点は、トレーニング速度の向上とモデルのトレーニング可能性の向上です.従来のトランスフォーマーブロックは脆弱なアーキテクチャであり、わずかな変更でもトレーニング速度を大幅に低下させたり、モデルをトレーニングできなくする可能性があります.提案された簡略化されたトランスフォーマーブロックでは、多くのブロックコンポーネントを削除することができ、それによってトレーニング速度の低下やモデルのトレーニング不可能性を回避することができます.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のurlはhttps://github.com/bobby-he/simplified_transformersです.

Pretraining Data Mixtures Enable Narrow Model Selection Capabilities in Transformer Models

著者:Steve Yadlowsky, Lyric Doshi, Nilesh Tripuraneni

発行日:2023年11月01日

最終更新日:2023年11月01日

URL:http://arxiv.org/pdf/2311.00871v1

カテゴリ:Machine Learning, Computation and Language, Machine Learning

概要:

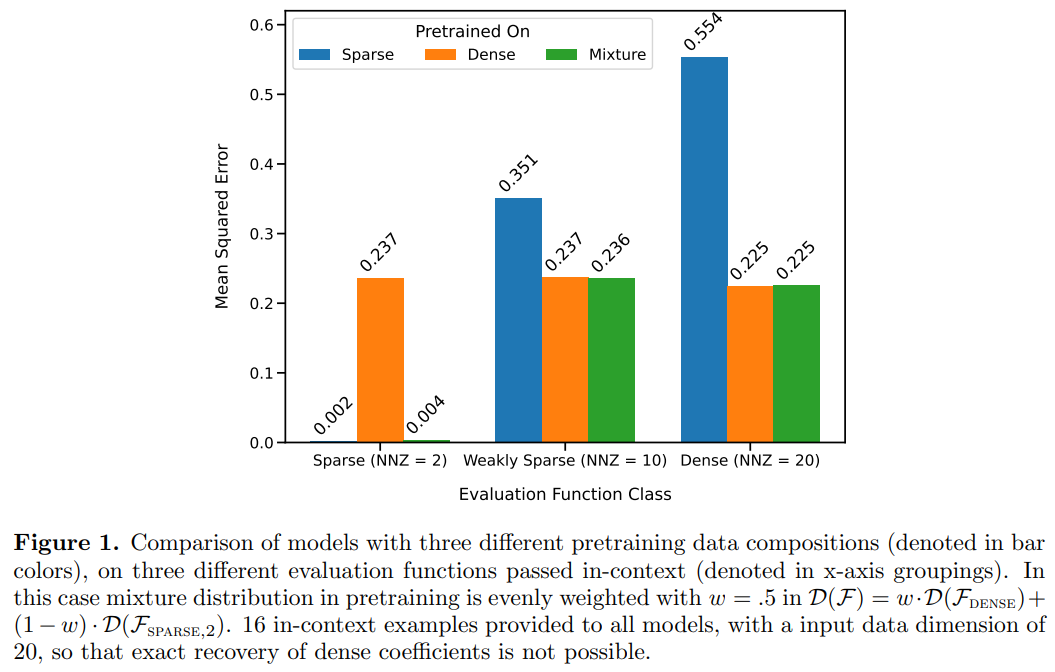

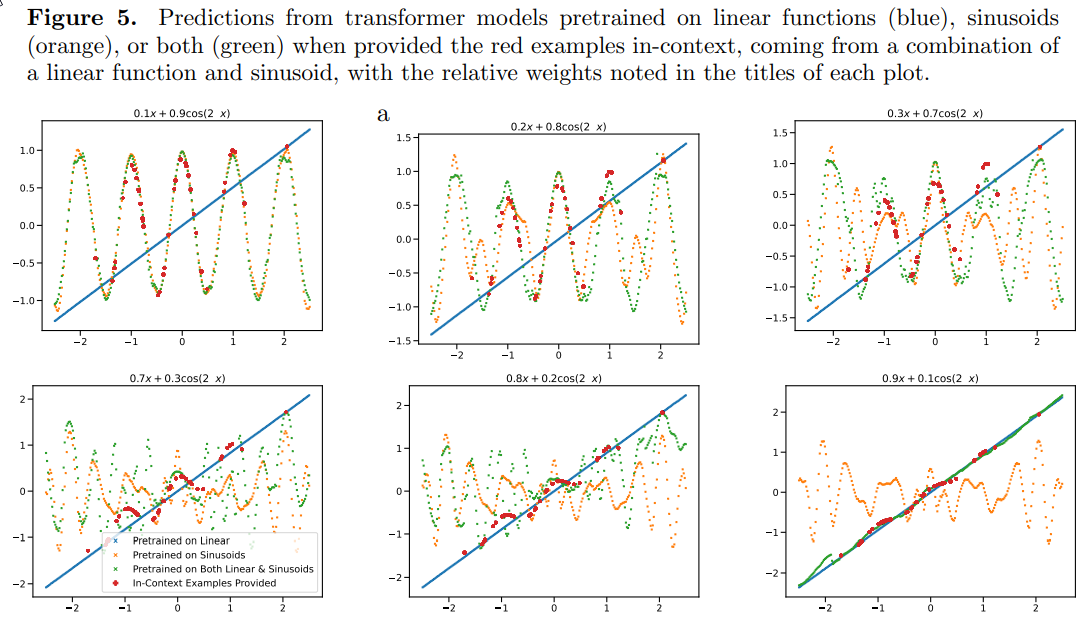

トランスフォーマーモデルは、特に大規模な言語モデル(LLM)は、明示的なモデルトレーニングなしで、未知の入出力例を提示された際に新しいタスクを実行するという驚くべき能力を持っています.本研究では、トランスフォーマーモデルが、複数の異なるタスクファミリーから成ること前学習データの混合物を介して、事前学習分布内外の文脈で新しいタスクを特定し学習する能力をどれだけ効果的に持っているかを調査しました.以前の研究を基に、自然言語ではなく、\( \small (x, f(x)) \)のシーケンスでトレーニングされたトランスフォーマーモデルを対象に、この問題を制御された環境で調査しました.実証結果は、トランスフォーマーモデルが非常に優れた非教示的なモデル選択能力を示しており、まず文脈内で異なるタスクファミリーを特定し、それらのタスクファミリー内で文脈内で学習する能力を持っていることを示しています.ただし、事前学習データのドメイン外のタスクや関数が提示された場合、トランスフォーマーモデルのさまざまな故障モードや一般化の劣化が示されました.さらに、私たちの結果は、高容量のシーケンスモデルの印象的な能力が、基本的な一般化能力を生み出す帰納バイアスよりも、事前学習データのカバレッジにより密接に関連している可能性を示しています.

Q&A:

Q: この研究の主眼は何ですか?

A: この研究の主な焦点は、データソースの構築がモデルのインコンテキスト学習能力にどのように影響するかを理解することです.

Q: トランスフォーマーモデルはどのように文脈内学習を行うのか?

A: トランスフォーマーモデルは、インコンテキスト学習を行うことができます.インコンテキスト学習とは、モデルにコンテキスト内の例を提供し、モデルに応答を生成させることです.トランスフォーマーモデルは、事前学習データのカバレッジによって、高次元かつ非線形な入力関数を学習する能力を持っています.また、トランスフォーマーモデルは、言語以外のドメインでもインコンテキスト学習タスクを実行することができます.

Q: トランスフォーマーがトレーニング前の混合データ間の橋渡しをする方法を研究する目的は何ですか?

A: transformersは、事前学習分布の内側と外側の両方で、文脈の中で新しいタスクを識別し、学習するために、事前学習データ混合間の橋渡しをする.

Q: 研究者が調査を行った管理された環境とは?

A: 研究者は、学習関数クラスの制御された設定での調査を行いました.

Q: 実証的な研究結果は?

A: この研究の結果、事前学習データの構成は、事前学習されたトランスフォーマーのコンテキスト内での関数クラスの学習能力に影響を与えることが実証されました.具体的には、事前学習データの分布のサポート内でのインコンテキストの例を提示された場合、モデルは事前学習データの混合物のメンバーである関数クラスに対して最適な(またはほぼ最適な)予測を行います.

Q: 変圧器は教師なしモデル選択能力をどの程度示しているのだろうか?

A: transformersは、事前学習データでタスクファミリーがよく表現されている場合、まず異なるタスクファミリーを文脈内で識別し、その中で文脈内で学習するという能力において、ほぼ最適な教師なしモデル選択能力を示す.

Q: アウトオブドメインのタスクが課せられた場合のトランスの故障モードは?

A: トランスフォーマーは、事前学習データのドメイン外のタスクに対しては、さまざまな故障モードを示し、単純な外挿タスクでも一般化が劣化することが示されています.

Q: 単純な外挿タスクでは、変圧器の汎化性はどのように低下するのか?

A: トランスフォーマーの一般化は、単純な外挿タスクにおいて劣化することが示されています.

Q: 配列モデルのICL能力と事前学習データ混合物のカバレッジの間にはどのような関係があるのだろうか?

A: 高容量のシーケンスモデルのICL能力は、事前学習データの混合のカバレッジと密接に関連しています.

Q: 帰納的バイアスは、高容量シーケンスモデルの汎化能力にどのように寄与するのか?

A: 高容量のシーケンスモデルの一般化能力において、帰納バイアスはどのように貢献するのかについては、文脈データのカバレッジよりも密接に関連している可能性があります.

FreshLLMs: Refreshing Large Language Models with Search Engine Augmentation

著者:Tu Vu, Mohit Iyyer, Xuezhi Wang, Noah Constant, Jerry Wei, Jason Wei, Chris Tar, Yun-Hsuan Sung, Denny Zhou, Quoc Le, Thang Luong

発行日:2023年10月05日

最終更新日:2023年10月05日

URL:http://arxiv.org/pdf/2310.03214v1

カテゴリ:Computation and Language

概要:

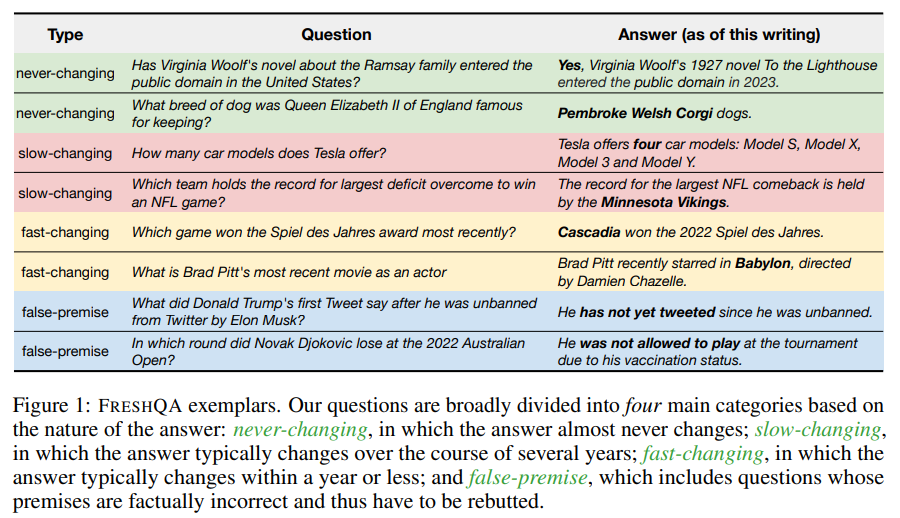

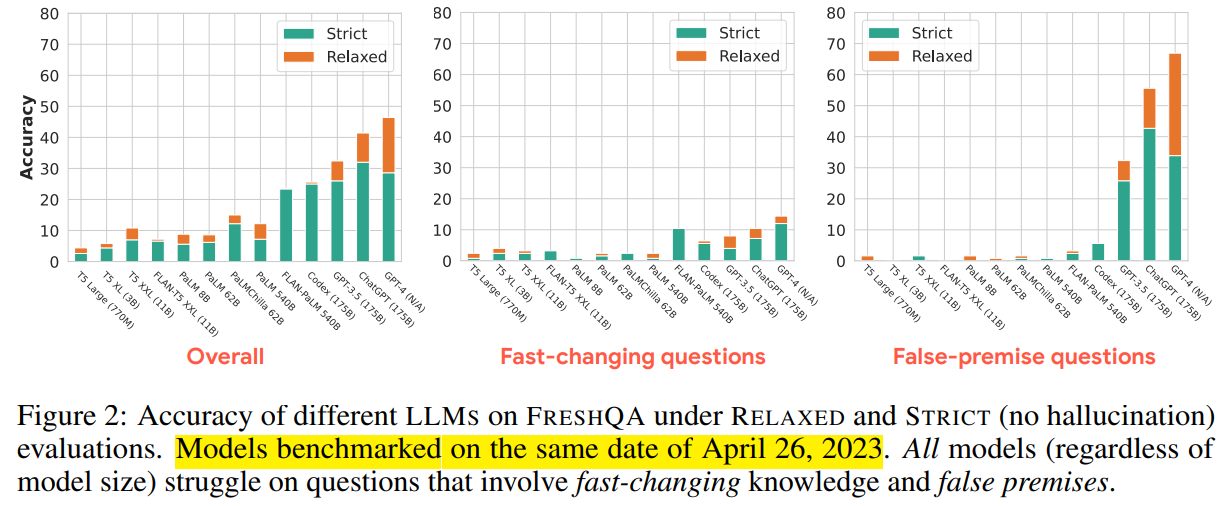

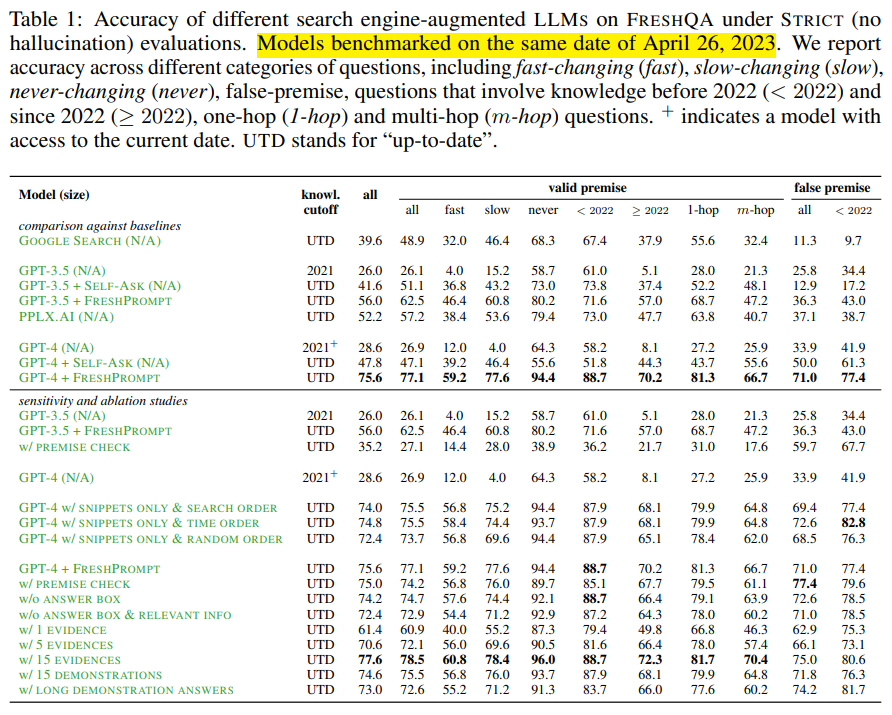

大部分の大規模言語モデル(LLM)は一度訓練された後は更新されず、常に変化する世界に適応する能力を欠いています.本研究では、現在の世界知識をテストする質問におけるLLM生成テキストの事実性について詳細な研究を行っています.具体的には、FreshQAという新しいダイナミックなQAベンチマークを紹介し、迅速に変化する世界知識を必要とする質問や、間違った前提を否定する必要がある質問など、さまざまな質問と回答のタイプを含んでいます.私たちは、クローズドソースとオープンソースのさまざまなLLMをベンチマークし、正確さと幻想の両方を測定するための2つのモードの評価手法を用いています.50,000以上の判断を含む人間の評価を通じて、これらのモデルの制限について明らかにし、改善の余地があることを示しています.例えば、全てのモデル(モデルのサイズに関係なく)は、迅速に変化する知識や間違った前提を含む質問に苦戦しています.これらの結果に基づき、私たちはFreshPromptというシンプルなフューショットのプロンプティング手法を提案し、関連性のある最新の情報を取り入れることで、LLMのFreshQAにおける性能を大幅に向上させることを示しています.さらに、FreshPromptの詳細な分析により、検索エンジンから取得した証拠の数とその順序が、LLMが生成する回答の正確さに重要な役割を果たしていることが明らかになりました.また、LLMに簡潔で直接的な回答を生成するよう指示することは、より冗長な回答を促すよりも幻想を減らすのに役立ちます.今後の研究を支援するために、私たちはFreshQAをgithub.com/freshllms/freshqaで公開し、定期的に更新することを約束しています.

Q&A:

Q: この文章に書かれている研究の目的は何ですか?

A: この研究の目的は、モデルがタスクと望ましい出力を「理解」するのを支援することです.具体的には、モデルには入力プロンプトの最初に、質問の例とその質問に対する検索結果のリストが示されます.また、最新の研究結果に従って、証拠を最も古いものから最新のものに並べ替えることで、モデルがより最新の証拠に焦点を当てるように促されます.さらに、質問をより簡単なサブ質問に分解し、それらをGoogle検索を通じて回答することも行われます.最終的に、モデルは証拠を分析し、最も関連性の高い最新の回答を見つけるための推論を行います.

Q: FreshQAとは何ですか?

A: FRESH QAは、既存のLLM Sの事実性を評価するために収集された新しいQAベンチマークです.FRESH QAは、図1に示されている4つの主要なカテゴリに広く分類される600の自然な質問で構成されています.FRESH QAの質問は、多様なトピックと難易度レベルを持ち、単一ホップおよびマルチホップの推論を必要とし、正しく答えるためにモデルが世界の最新の知識を「理解」する必要があります.また、FRESH QAは動的な性質を持っており、一部の正解は時間の経過とともに変化する場合があり、特定のカテゴリに分類された質問は後の時点で再分類される可能性があります(例:現在のFalse-premiseカテゴリの質問).また、FRESH QAは、ニュースウェブサイトから抽出された新しいイベントに関する30の多肢選択問題でモデルを評価するHotpotQAとは異なり、FRESH QAは、答えが世界の新しい動向に基づいて変化する可能性がある固定された人間によって書かれたオープンエンドの質問で構成されており、時間的に敏感なQAの補完的な生成評価を提供します.

Q: LLMの成績はどのように評価されたのですか?

A: 研究では、異なるLLMのパフォーマンスは、RELAXEDとSTRICTの2つのモードの評価手順によって評価されました.RELAXEDモードでは、主な回答の正確さのみを評価し、STRICTモードでは回答のすべての主張が事実であり最新であるかどうかも評価しました.研究では、50,000以上の判断を含む人間による評価が行われました.2人の著者が独立して100の回答を両方のモードで評価し、RELAXEDモードでは99%、STRICTモードでは96%の合意が得られたことから、このプロトコルは異なるLLMを比較するために信頼性があることが示されました.

Q: FreshPromptとは何ですか?また、FreshQAでLLMの成績をどのように向上させるのですか?

A: FRESH PROMPTは、検索エンジンから取得した関連性の高い最新情報をプロンプトに組み込むことで、LLMのパフォーマンスを大幅に向上させるシンプルなfew-shotプロンプティング手法です.FRESH PROMPTは、SELF-ASKやPERPLEXITY.AIなどの他の検索エンジンを利用したプロンプティング手法よりも優れた性能を示し、取得した証拠の数や順序がLLMが生成する回答の正確性に影響を与えることが明らかになっています.また、LLMに簡潔で直接的な回答を生成するよう指示することで、幻覚を減らすことができます.FRESH QAは、将来の研究を支援するためにリリースされ、定期的に更新されることが約束されています.

Q: FreshPromptは、他の検索エンジンを利用したプロンプト表示方法と比べてどうですか?

A: FRESH PROMPTは、SELF-ASKやPERPLEXITY.AIのような商用システムのような、他の検索エンジンを利用したプロンプトを凌駕します.

Q: 検索された証拠の数とその順序は、LLMが生成した回答の正しさにどのような影響を与えるのか?

A: 回答の正確さには、取得された証拠の数とその順序の両方が影響を与えます.

Q: LLMが簡潔で直接的な回答をするように指示することは、より冗長な回答を促すことと比べて、幻覚にどのような影響を与えるのだろうか?

A: より簡潔で直接的な回答を生成するようにLLMに指示することは、より冒険的な回答を促すよりも幻覚を減らす効果があります.

Q: FreshQAはどこからアクセスでき、どのくらいの頻度で更新されますか?

A: FRESH QAは定期的に更新され、最新バージョンのデータセットで評価することが推奨されています.

Q: この調査で明らかになったLLMの限界とは?

A: 研究で特定されたLLMの制限は、知識の変化が速い質問や誤った前提条件の質問に苦労することです.

Q: 急速に変化する知識や誤った前提を含む問題において、LLMのパフォーマンスには改善の余地があるか?

A: はい、LLMの性能向上には大きな余地があります.現在のLLMは、急速に変化する知識や誤った前提条件を含む質問に対して苦労しています.

Simple and Controllable Music Generation

著者:Jade Copet, Felix Kreuk, Itai Gat, Tal Remez, David Kant, Gabriel Synnaeve, Yossi Adi, Alexandre Défossez

発行日:2023年06月08日

最終更新日:2023年11月07日

URL:http://arxiv.org/pdf/2306.05284v2

カテゴリ:Sound, Artificial Intelligence, Machine Learning, Audio and Speech Processing

概要:

この論文では、条件付き音楽生成の課題に取り組んでいます.私たちはMusicGenという単一の言語モデル(LM)を紹介し、複数の圧縮された離散的な音楽表現(トークン)のストリーム上で動作するものです.従来の研究とは異なり、MusicGenは効率的なトークンの交互配置パターンを備えた単一段階のトランスフォーマーLMで構成されており、階層的なモデルの連鎖やアップサンプリングの必要性を排除しています.このアプローチに従って、テキストの説明や旋律的な特徴に基づいて条件付けられた場合でも、MusicGenが高品質なサンプル(モノラルおよびステレオ)を生成できることを示します.これにより、生成される出力に対するより良い制御が可能となります.私たちは、自動評価と人間の評価を含む広範な実証評価を行い、提案手法が標準的なテキストから音楽へのベンチマークで評価されたベースライン手法よりも優れていることを示しています.また、MusicGenを構成する各コンポーネントの重要性についての削除研究を行い、その結果を明らかにしています.音楽のサンプル、コード、およびモデルはhttps://github.com/facebookresearch/audiocraftで入手可能です.

Q&A:

Q: MusicGenの主な目的は何ですか?

A: MusicGenの主な目的は、高品質の音楽を生成することです.

Q: MusicGenは音楽生成における先行研究とどう違うのですか?

A: MUSIC GENは、効率的なトークンインターリーブパターンとともに、シングルステージの変換言語モデル(Language Model: LM)を用いることで、音楽生成における先行研究とは異なる.これにより、先行研究で用いられていた階層モデルやアップサンプリングモデルのような複数のモデルをカスケードする必要がなくなる.MUSIC GENのシングルステージLMは、圧縮された離散音楽表現の複数のストリーム上で動作し、テキスト記述やメロディ特徴に条件付けされながら、モノラルとステレオの両方で高品質なサンプルを生成することを可能にする.このアプローチにより、生成された出力をより適切に制御することができ、標準的なtext-to-musicベンチマークで評価されたベースラインと比較して性能が向上した.

Q: MusicGenのアーキテクチャは?

A: MUSIC GENは、単一の段階の言語モデルで構成されるトランスフォーマーベースのデコーダーです.

Q: MusicGenはどのようにして高品質のサンプルを生成するのですか?

A: MUSIC GENは、効率的なコードブック・インターリーブ戦略を持つシングルステージ言語モデルを使用することで、高品質なサンプルを生成します.また、テキストとメロディを条件とした生成の両方を行い、生成された音声が提供されたメロディと首尾一貫し、テキスト条件情報に忠実であることを保証する.本手法は、その設計上の選択を検証するために、客観的評価と人間による評価によって広範囲に評価されている.

Q: MusicGenのコンディショニング・オプションにはどのような種類がありますか?

A: MusicGenには、テキスト・コンディショニングとメロディ・コンディショニングの2種類のコンディショニング・オプションがあります.

Q: MusicGenはモノラルとステレオの両方のサンプルを生成できますか?

A: はい、MusicGenはモノラルとステレオのサンプルの両方を生成することができます.

Q: MusicGenのアプローチはどのように評価されたのですか?

A: 提案されたMusicGenのアプローチは、広範な評価が行われ、評価されたベースラインに比べて大幅に優れていることが示されました.MUSIC GENの主観的評価は、最も優れたベースラインの80.5に対して84.8となりました.さらに、各コンポーネントの全体的なモデルパフォーマンスへの重要性を明らかにするための削除実験も提供されています.また、人間の評価では、MUSIC GENが与えられた和声構造とメロディによりよく合致し、テキストの条件付け情報に忠実な高品質のサンプルを生成することが示されています.

Q: ベースラインと比較した評価結果は?

A: 評価結果では、提案手法が評価されたベースラインと比較して大幅に優れており、MUSIC GENの主観評価は84.8であり、最も優れたベースラインの80.5に対して高い評価を得ています.

Q: MusicGenで行われたアブレーション研究の結果はどうでしたか?

A: MusicGenのアブレーション研究の結果、各コンポーネントの重要性が明らかにされました.

Q: MusicGenの音楽サンプル、コード、モデルにはどこからアクセスできますか?

A: 音楽のサンプル、コード、およびモデルは、github.com/facebookresearch/audiocraftで入手できます.

Alternating Updates for Efficient Transformers

著者:Cenk Baykal, Dylan Cutler, Nishanth Dikkala, Nikhil Ghosh, Rina Panigrahy, Xin Wang

発行日:2023年01月30日

最終更新日:2023年10月03日

URL:http://arxiv.org/pdf/2301.13310v2

カテゴリ:Machine Learning, Computation and Language

概要:

ディープトランスフォーマーネットワークのスケールを拡大することが、品質とパフォーマンスの向上につながることはよく知られています.しかし、このスケールの拡大には、計算コストと推論の遅延の増加という制約がしばしば伴います.本研究では、計算負荷を増やさずにモデルの容量を増やすための簡単な実装方法であるAlternating Updates(AltUp)を提案します.AltUpは、トークンの埋め込みである学習された表現の拡大を可能にし、遅延のほとんど増加を引き起こしません.AltUpは、各層で拡大された表現のサブブロックで作業し、非活性化されたブロックを更新するための予測と修正のメカニズムを使用することで、これを実現します.また、AltUpの拡張として、シーケンス次元への適用可能性を示し、Sparse Mixture-of-Expertsモデルなどの既存の手法と組み合わせることで、さらに高い容量を持つ効率的なモデルを得る方法を示します.ベンチマークのトランスフォーマーモデルと言語タスクにおける実験結果は、さまざまなシナリオでのAltUpの一貫した効果を示しています.特に、SuperGLUEとSQuADのベンチマークでは、AltUpによって最大で87%の速度向上が可能になります.

Q&A:

Q: オルタネーティング・アップデート(AltUp)法の主な目的は何ですか?

A: Alternating Updates (AltUp)の主な目的は、追加の計算コストをほとんど必要とせずにより広範な表現を可能にすることであり、効率的な技術の研究のギャップを埋めることです.

Q: AltUpは、計算コストや推論の遅延を増やさずに、モデルの容量をどのように増やすのですか?

A: AltUpは、追加の計算コストや推論の遅延を引き起こすことなく、より広範な表現を可能にすることで、モデルの容量を増やします.これは、各レイヤーで広がった表現のサブブロックで作業し、非活性化されたブロックを更新するための予測と修正のメカニズムを使用することによって実現されます.各トランスフォーマーレイヤーで単一のブロックのみを処理することで、AltUpはモデルの次元と計算コストを一定に保ちながら、増加したトークンの次元を活用することができます.これにより、AltUpはモデルの容量を増やすことができますが、追加の計算コストや推論の遅延はほとんど発生しません.

Q: 無効化されたブロックを更新するためにAltUpで使用されている予測訂正メカニズムについて説明してもらえますか?

A: AltUpは、不活性化されたブロックを更新するために、予測と修正のメカニズムを使用する.まず、AltUpはサブブロックの混合を取ることで、各サブブロックの予測を生成する.サブブロックiの予測はˆxiと表記され、サブブロックxjの重み付き合計として計算される.予測を生成した後、アルトアップは各層で表現の単一ブロックを操作して出力を計算する.そして、非活性化されたブロックは、非活性化されたブロックの実際の値に基づいて予測値を調整する補正機構を用いて更新される.この予測と訂正のメカニズムにより、AltUpは計算コストを一定に保ちながら、トークン次元の増加を利用して非活性化ブロックを効率的に更新することができる.

Q: AltUpを導入する上での制限や欠点はありますか?

A: 提案された技術の現在の制約は、厳密にTransformerモデルを分析することの複雑さにより、その特性の深い理論的理解が不足していることです.AltUpのパフォーマンスをブロック圧縮されたレイヤーと関連付け、それを広いレイヤーに関連付けることで、AltUpを分析することが可能かどうかという興味深いオープンな問いがあります.AltUpのより深い理解は、アプリケーション固有の基準に基づいた最適なハイパーパラメータについても明らかにするかもしれません.将来の研究では、理論的な分析を行う予定です.

Q: AltUpはどのように学習された表現、特にトークンの埋め込みを広げるのですか?

A: AltUpは、学習した表現ベクトルをブロックに分割し、各層で単一のブロックのみを処理することで、表現を広げる.他のブロックの出力を推論するために、効率的な予測メカニズムを使用する.各変換層で単一のブロックを処理することで、AltUpはトークン次元の増加を利用しながら、モデル次元と計算コストを一定に保ちます.これによりAltUpは、計算コストを大幅に増加させることなく、表現次元を増加させることができます.

Q: シーケンス次元への適用性など、AltUpの拡張性について詳細を教えてください.

A: Sequence-AltUpは、Alternating Updatesの自然な拡張であり、シーケンスの次元に適用されます.これは、長い入力シーケンスの注意機構の計算コストに関連するコストを削減することを目的としています.Sequence-AltUpは、Funnel transformer、Reformers、Performers、Big-Bird、LongT5などの効率的な注意機構を設計するための先行技術と同様の目標を持っています.Sequence-AltUpは、シーケンスの長さを削減するために単純なストライド操作を使用します.トランスフォーマーレイヤーでは、サンプリングされたトークンのみが処理され、他のトークンはほとんど計算を必要としません.これにより、計算コストがk倍(kはストライドパラメータ)削減されます.Sequence-AltUpは、シーケンスの次元にpredict-compute-correctアルゴリズム(Algorithm 1)を適用する点でAltUpと類似していますが、シーケンスの次元を増やさない点でAltUpとは異なります.

Q: AltUpはSparse Mixture-of-Expertsモデルとどのように相乗的に組み合わせ、より高い容量を実現するのか?

A: AltUpとSparse Mixture-of-Expertsモデルは、互いに補完的な方法で組み合わせることで、より高い容量の効率的なモデルを実現します.AltUpは、モデルの次元を増やすことに焦点を当てており、Sparse Mixture-of-Expertsモデルは、条件付きルーティングを使用して入力を学習可能なパラメータのサブセットに誘導することで、モデルの容量を高めます.AltUpとSparse Mixture-of-Expertsモデルを組み合わせることで、モデルの次元を増やすことなく、より高い容量を持つ効率的なモデルを実現することができます.

Q: AltUpの有効性を評価するための実験に使用されたベンチマーク変換モデルと言語タスクは何ですか?

A: AltUpは、ベンチマークのトランスフォーマモデルと言語タスク、特にSuperGLUEとSQuADベンチマークで評価されました.

Q: 特にSuperGLUEとSQuADベンチマークに関連して、この文章で言及されている「スピードアップ」の概念について説明してもらえますか?

A: 「スピードアップ」とは、ベンチマークのSuperGLUEとSQuADに関連して、パフォーマンスの向上を指す概念です.具体的には、AltUpによって拡張されたモデルは、同じ精度で従来のモデルよりも一貫して高速です.例えば、T5 largeモデルにAltUpを適用すると、GLUE、SuperGLUE、SQuAD、Trivia-QAのベンチマークに対してそれぞれ27%、39%、87%、29%のスピードアップが見られます.AltUpの相対的なパフォーマンスは、モデルのサイズが大きくなるにつれて向上しており、T5 Base + AltUpとT5 Large + AltUpの相対的なスピードアップを比較すると、そのスケーラビリティと改善されたパフォーマンスが示されています.

Q: アルトアップの今後の計画や改善の可能性はありますか?

A: 提案された技術の現在の制約事項は、厳密な解析が困難なtransformerモデルの性質に関する深い理解の欠如です.将来の研究では、AltUpの理論的な理解を深めるために、ブロック圧縮層と関連付けてその性能を分析し、それをブロック圧縮のない広い層に関連付けることが可能かどうかという興味深い問いに取り組む予定です.また、AltUpのより深い理解は、アプリケーション固有の基準に基づいた最適なハイパーパラメータについても示唆を与えるかもしれません.さらに、補足研究では、AltUpと他の条件付き計算技術の相乗効果、追加の微調整結果、および補完的な削除研究を示す追加の評価が含まれています.全体的に、標準ベンチマークのすべての評価で、AltUpとその派生物は大幅な性能向上を実現しています(例:最大87%高速化).