ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- Agents: An Open-source Framework for Autonomous Language Agents (発行日:2023年09月14日)

- The Rise and Potential of Large Language Model Based Agents: A Survey (発行日:2023年09月14日)

- RAIN: Your Language Models Can Align Themselves without Finetuning (発行日:2023年09月13日)

- Protein generation with evolutionary diffusion: sequence is all you need (発行日:2023年09月12日)

- A Survey of Hallucination in Large Foundation Models (発行日:2023年09月12日)

- MAmmoTH: Building Math Generalist Models through Hybrid Instruction Tuning (発行日:2023年09月11日)

- Robot Parkour Learning (発行日:2023年09月11日)

- Textbooks Are All You Need II: phi-1.5 technical report (発行日:2023年09月11日)

- Radiology-Llama2: Best-in-Class Large Language Model for Radiology (発行日:2023年08月29日)

- Communicative Agents for Software Development (発行日:2023年07月16日)

Agents: An Open-source Framework for Autonomous Language Agents

著者:Wangchunshu Zhou, Yuchen Eleanor Jiang, Long Li, Jialong Wu, Tiannan Wang, Shi Qiu, Jintian Zhang, Jing Chen, Ruipu Wu, Shuai Wang, Shiding Zhu, Jiyu Chen, Wentao Zhang, Ningyu Zhang, Huajun Chen, Peng Cui, Mrinmaya Sachan

発行日:2023年09月14日

最終更新日:2023年09月14日A

URL:http://arxiv.org/pdf/2309.07870v1

カテゴリ:Computation and Language

概要:

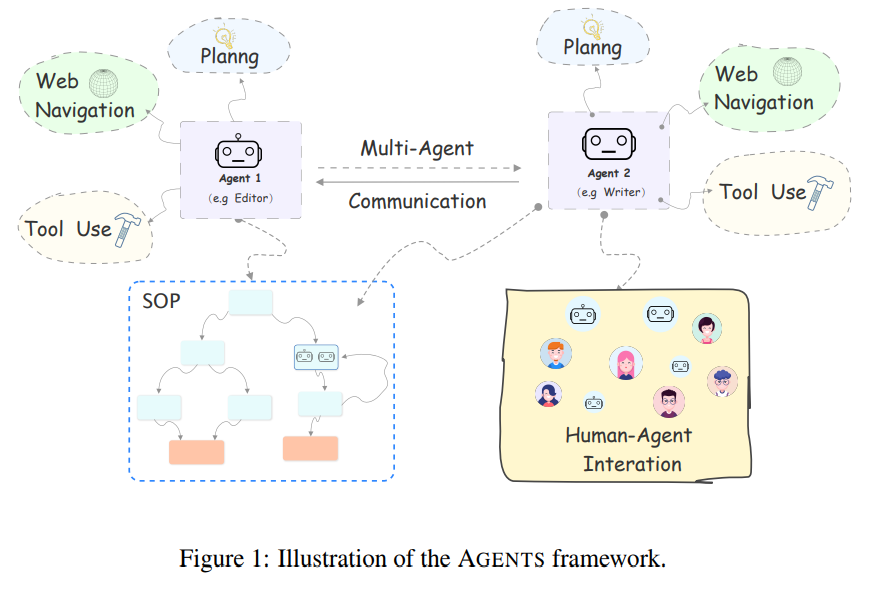

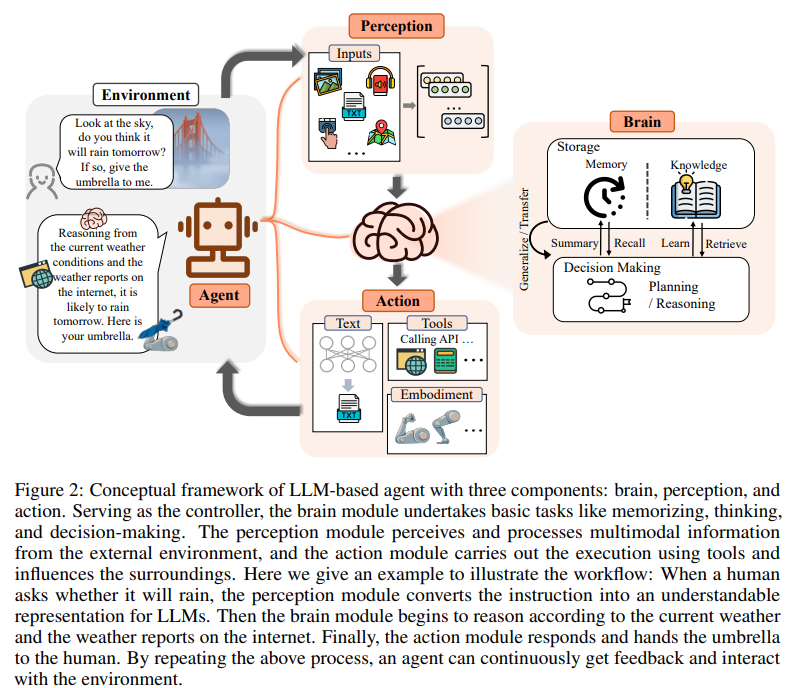

最近の大規模言語モデル(LLM)の進歩により、研究者や開発者は自然言語インターフェースを使用して、さまざまなタスクを自動的に解決し、環境、人間、他のエージェントと対話することができる自律型言語エージェントを構築することができるようになりました.私たちは言語エージェントを人工汎用知能への有望な方向と考え、これらの進歩を専門外の広い層に開放することを目指して、オープンソースのライブラリであるAgentsをリリースしました.Agentsは、計画、メモリ、ツールの使用、マルチエージェント通信、細かいシンボリック制御などの重要な機能をサポートするように注意深く設計されています.Agentsは、非専門家が最新の自律型言語エージェントを簡単に構築、カスタマイズ、テスト、調整、展開できるため、ユーザーフレンドリーです.また、モジュール化された設計になっているため、研究者にとっても研究に適したライブラリです.Agentsはhttps://github.com/aiwaves-cn/agentsで利用可能です.

Q&A:

Q: 自律言語エージェントの開発を可能にした大規模言語モデルの最近の進展は何ですか?

A: 最近の大規模言語モデル(LLM)の進歩により、研究者や開発者は自然言語インターフェースを使用して、様々なタスクを自動的に解決し、環境、人間、他のエージェントと対話する自律的な言語エージェントを構築することが可能になりました.言語エージェントは人工一般知能への有望な方向性と見なされており、AGENTSというオープンソースプロジェクトがその目標に向けて開発され、開発者や一般の人々から大きな関心を集めています.また、Transformers AgentsやAutoGPT、BabyAGI、SuperAGIなどの最近のオープンソースプロジェクトも、特定のタスクを対象とする言語エージェントの構築だけでなく、ユーザーの要望に応じて様々なことを行う自律的なエージェントの構築を目指しており、開発者や一般の人々から大きな関心を集めています.

Q: 自律言語エージェントは、環境、人間、および他のエージェントとどのように相互作用しますか?

A: 自律型言語エージェントは、環境、人間、他のエージェントと相互作用することによってタスクを実行します.これは、世界を知覚し、推論し、計画し、行動することによって行われます.

Q: エージェントのオープンソースライブラリの目標は何ですか?

A: AGENTSのオープンソースライブラリの目標は、広範な非専門家の観客に到達し、社会にポジティブな影響を与えることです.

Q: エージェントライブラリは、どのような重要な機能をサポートしていますか?

A: AGENTSライブラリは、計画、メモリ、ツールの使用、マルチエージェント通信、細かいシンボリック制御など、重要な機能をサポートしています.

Q: 非専門家にとって、エージェントライブラリはどのように使いやすいですか?

A: AGENTSライブラリは、非専門家でも簡単にカスタマイズ、調整、展開できるように設計されています.また、コーディングの必要がほとんどないため、非専門家でも利用しやすいです.

Q: エージェントライブラリは、自律言語エージェントのカスタマイズ、テスト、チューニング、展開をどのように可能にしていますか?

A: AGENTSライブラリは、非専門家でも簡単にカスタマイズ、テスト、チューニング、および展開ができるように設計されています.非専門家でも最新の自律言語エージェントを構築、カスタマイズ、テスト、チューニング、展開することができるため、ユーザーフレンドリーです.また、モジュール化された設計により、研究者にとっても拡張性が高く、研究に利用しやすいです.

Q: エージェントライブラリのモジュール化された設計は、研究者にとって容易に拡張可能にする方法は何ですか?

A: AGENTSのモジュール化された設計により、研究者は簡単に拡張することができます.モジュール化された設計により、新しい機能や機能の組み合わせを追加することが容易になります.これにより、研究者はAGENTSライブラリを使用して、独自のアルゴリズムやモデルを実装し、新しいアイデアや手法を評価することができます.また、モジュール化された設計により、既存の機能を修正したり、改良したりすることも容易です.研究者はAGENTSライブラリを使用して、自分の研究に合わせたカスタマイズや拡張を行うことができます.

Q: エージェントライブラリにはどこからアクセスできますか?

A: AGENTSはhttps://github.com/aiwaves-cn/agentsで利用可能です.

Q: エージェントライブラリを使用して構築された自律言語エージェントが解決できるタスクの例を示していただけますか?

A: AGENTSライブラリを使用して構築された自律言語エージェントが解決できるタスクの例は、チャットボット、顧客サービスエージェント、ショッピングアシスタントエージェント、セールスエージェントなどがあります.これらのエージェントは、知識ベースやウェブ検索エンジンに基づいた顧客サービス、ショッピング支援、販売などのさまざまな用途に使用されます.

Q: エージェントライブラリを使用して自律言語エージェントを構築する際には、制限や課題はありますか?

A: 提供された文脈では、AGENTSライブラリを使用して自律言語エージェントを構築する際にはいくつかの制限や課題が存在する可能性があります.具体的な制限や課題については明示されていません.

The Rise and Potential of Large Language Model Based Agents: A Survey

著者:Zhiheng Xi, Wenxiang Chen, Xin Guo, Wei He, Yiwen Ding, Boyang Hong, Ming Zhang, Junzhe Wang, Senjie Jin, Enyu Zhou, Rui Zheng, Xiaoran Fan, Xiao Wang, Limao Xiong, Yuhao Zhou, Weiran Wang, Changhao Jiang, Yicheng Zou, Xiangyang Liu, Zhangyue Yin, Shihan Dou, Rongxiang Weng, Wensen Cheng, Qi Zhang, Wenjuan Qin, Yongyan Zheng, Xipeng Qiu, Xuanjing Huang, Tao Gui

発行日:2023年09月14日

最終更新日:2023年09月19日

URL:http://arxiv.org/pdf/2309.07864v3

カテゴリ:Artificial Intelligence, Computation and Language

!msedge_W8rodN92T2 1.jpg

概要:

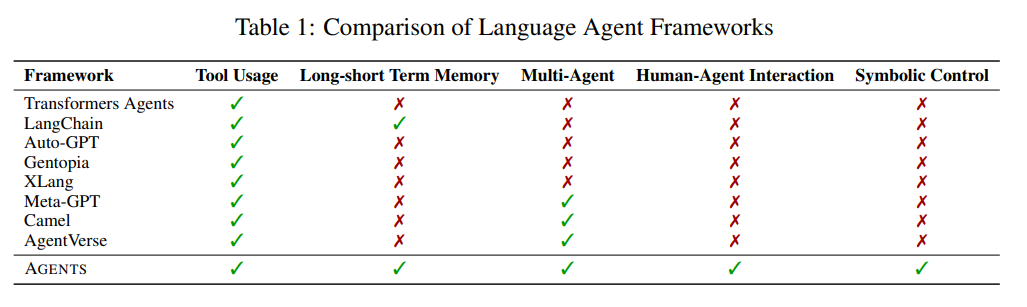

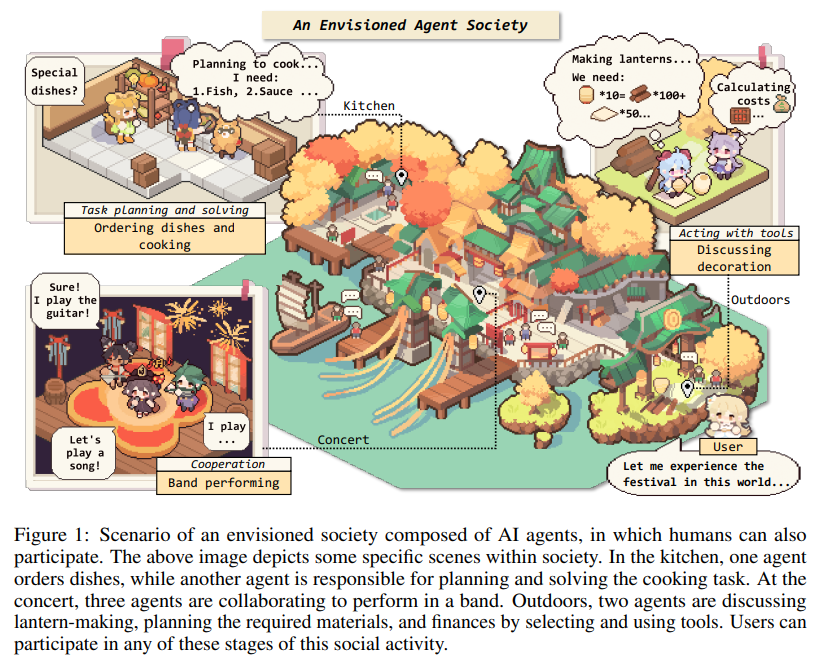

長い間、人類は人間レベル以上の人工知能(AI)を追求してきました.AIエージェントは、環境を感知し、意思決定をし、行動を起こす人工的な存在です.知能エージェントの開発には多くの取り組みが行われてきましたが、主に特定の能力や特定のタスクでのパフォーマンスを向上させるためのアルゴリズムやトレーニング戦略の進歩に焦点が当てられています.実際、コミュニティが欠けているのは、多様なシナリオに適応できるAIエージェントの設計の出発点となる一般的で強力なモデルです.多様な能力を示すため、大規模言語モデル(LLM)は人工汎用知能(AGI)の可能性を持つと見なされ、一般的なAIエージェントの構築の希望を提供しています.多くの研究者はLLMを基盤としてAIエージェントを構築し、重要な進展を達成しています.本論文では、LLMベースのエージェントについて包括的な調査を行います.まず、エージェントの概念の哲学的な起源からAIでの発展までを追跡し、なぜLLMが重要なのかを説明します.その後、私たちはLLMベースのエージェントのための一般的なフレームワークを提案します.このフレームワークは、脳、知覚、行動の3つの主要な要素から構成されており、異なるアプリケーションに合わせてカスタマイズすることができます.その後、私たちはLLMベースのエージェントの広範な応用について探求します.単一エージェントのシナリオ、マルチエージェントのシナリオ、および人間とエージェントの協力における応用について調査します.さらに、エージェント社会について探求し、LLMベースのエージェントの行動や性格、エージェント社会から生じる社会現象、およびそれらが人間社会に提供する洞察について考察します.最後に、この分野におけるいくつかの重要なトピックや未解決の問題について議論します.関連論文のリポジトリはhttps://github.com/WooooDyy/LLM-Agent-Paper-Listにあります.

Q&A:

Q: 知能エージェントの開発において、コミュニティの取り組みの主な焦点は何ですか?

A: 研究者たちは、特定の能力や特定のタスクのパフォーマンスを向上させるためのアルゴリズムやトレーニング戦略の進化に主に焦点を当ててきました.

Q: なぜ大規模言語モデル(LLM)は人工汎用知能(AGI)の潜在的な火花と考えられているのですか?

A: LLMは、汎用人工知能(AGI)の可能性を秘めたスパークと考えられています.なぜなら、彼らは多様な能力を示し、一般的なAIエージェントの構築に希望をもたらすからです.多くの研究者は、LLMをAIエージェントの基盤として活用し、重要な進展を遂げています.LLMは、人間と同様に、幅広いタスクやドメインにわたる知識を理解し、学習し、適用する能力を持っています.この広範な認知能力は、AGIの重要な特徴です.また、LLMが現実世界を表現し、豊富なタスクの範囲をカバーする十分に大きく多様なデータで訓練される限り、彼らはAGIの能力を開発することができます.自己回帰言語モデリング自体も、AGIの能力の開発に貢献しています.ただし、LLMがAGIの達成への潜在的な道であるかどうかは、まだ高度に議論されている論争の的です.

Q: LLMベースのエージェントは、他のタイプのAIエージェントとどのように異なるのですか?

A: LLMベースのエージェントは、他のタイプのAIエージェントとは異なり、言語モデル(LLM)に基づいて構築され、人間にとって有益であることを目指しています.LLMベースのエージェントは、LLMの研究と自然言語処理(NLP)の進歩を活用して、より豊かな入力モダリティと広範なアクション空間を持つ複雑なタスクに取り組みます.彼らは人工一般知能(AGI)の火花と見なされ、より堅牢なAGIへの進歩と見なされています.LLMベースのエージェントは、LLMの応用範囲を拡大し、実用的な実装のための数多くの機会を提供します.

Q: LLMベースのエージェントとその3つの主要なコンポーネントの一般的なフレームワークを説明できますか?

A: LLMベースのエージェントの一般的なフレームワークは、脳、知覚、行動の3つの主要なコンポーネントで構成されています.脳はエージェントの中核であり、意思決定や問題解決のための情報処理を担当します.知覚はエージェントが外部の環境から情報を収集し、内部の状態を把握するための機能です.行動はエージェントが環境に対して実際に行うアクションや反応を指します.このフレームワークは、異なるアプリケーションに合わせてカスタマイズすることができます.

Q: LLMベースのエージェントが適用されている単一エージェントシナリオの例はありますか?

A: LLMベースのエージェントは、タスク指向、イノベーション指向、最先端の科学分野など、単一エージェントのシナリオに適用されています.

Q: LLMベースのエージェントは、マルチエージェントのシナリオでどのように活用されていますか?

A: LLMベースのエージェントは、協力的または対立的な相互作用を通じて、マルチエージェントのシナリオで利用されています.複数のエージェントが相互作用することで、これらの相互作用を通じて進歩を達成することができます.これは、LLMベースのエージェントが互いの能力を補完し、タスクの効率性と応答品質を向上させるために協力することができることを意味します.彼らはまた、対立的な相互作用を行い、お互いにより良いパフォーマンスを発揮するために挑戦し合うこともできます.これらのマルチエージェントのシナリオは、タスク指向のアプリケーションで優れたパフォーマンスを示し、さまざまな社会現象を示す可能性があります.しかし、現在の研究は主に限られた数のエージェントに関与しており、先端的な科学分野でエージェントの数を拡大し、その全ての潜在能力を実現するためにさらなる革新的な研究が必要です.

Q: LLMベースのエージェントを使用した人間との協力の例を示していただけますか?

A: LLMベースのエージェントは、さまざまな方法で人間と協力することができます.例えば、彼らはユーザーが日常のタスクや繰り返しの労働から解放されるのを支援し、人間の仕事の圧力を軽減し、タスクの解決効率を高めることができます.LLMベースのエージェントはまた、独立して問題を分析、計画、解決することができ、ユーザーが明示的な低レベルの指示を提供する必要がなくなります.さらに、LLMベースのエージェントによってユーザーの手が解放されることで、彼らは探索的で革新的な仕事に従事することができ、先端的な科学分野での可能性を最大限に引き出すことができます.これらの例は、LLMベースのエージェントが人間と協力して生産性を向上させ、人間がより高度なタスクに集中できるようにする方法を示しています.

Q: LLMベースのエージェント社会は、人間社会にどのような洞察を提供していますか?

A: LLMベースのエージェント社会は、エージェントの行動や個性、および彼らの相互作用から生じる社会現象についての洞察を提供します.これらの洞察は、人間社会についての貴重な理解と知識を提供することができます.LLMベースのエージェント社会を研究することで、研究者はエージェント同士がどのように協力し、競争し、調整するかについての洞察を得ることができます.これは、人間の社会的な協力と相互作用をより良く理解するのに役立つことができます.さらに、LLMベースのエージェントの役割演技能力を探求し、彼らの協力効率を向上させることは、人間の社会的な相互作用と協力の改善に貢献することができます.

Q: LLMベースのエージェント社会から特定の行動や個性は現れますか?

A: LLMベースのエージェントは新たな振る舞いや個性を示します.外部的には、彼らは個別に行動し、環境との相互作用を示す社会的な振る舞いを示します.内部的には、彼らは認知、感情、性格などの複雑な要素を持ち、これらが彼らの行動反応を形作ります.LLMベースのエージェント社会から生じる具体的な振る舞いや個性は、与えられた文脈では明示的には言及されていません.

Q: LLMベースのエージェントの分野における主要なトピックや未解決の問題は何ですか?

A: LLMベースのエージェントの分野におけるいくつかの主要なトピックとオープンな問題は、以下のとおりです.1) LLM研究とエージェント研究の相互の利益とインスピレーションについて.2) ユーティリティ、ソーシャビリティ、バリュー、および持続的な進化能力の4つの次元からのLLMベースのエージェントの評価.3) LLMベースのエージェントの潜在的なリスクについて、アドバーサリアルな頑健性と信頼性について議論します.また、エージェントの研究、LLMベースのエージェントの評価、それらに関連するリスク、エージェントの数のスケーリングの機会、エージェントとしてのサービス、LLMベースのエージェントがAGIへの潜在的な道を示すかどうかなど、いくつかのオープンな問題もあります.

RAIN: Your Language Models Can Align Themselves without Finetuning

著者:Yuhui Li, Fangyun Wei, Jinjing Zhao, Chao Zhang, Hongyang Zhang

発行日:2023年09月13日

最終更新日:2023年09月13日

URL:http://arxiv.org/pdf/2309.07124v1

カテゴリ:Computation and Language

概要:

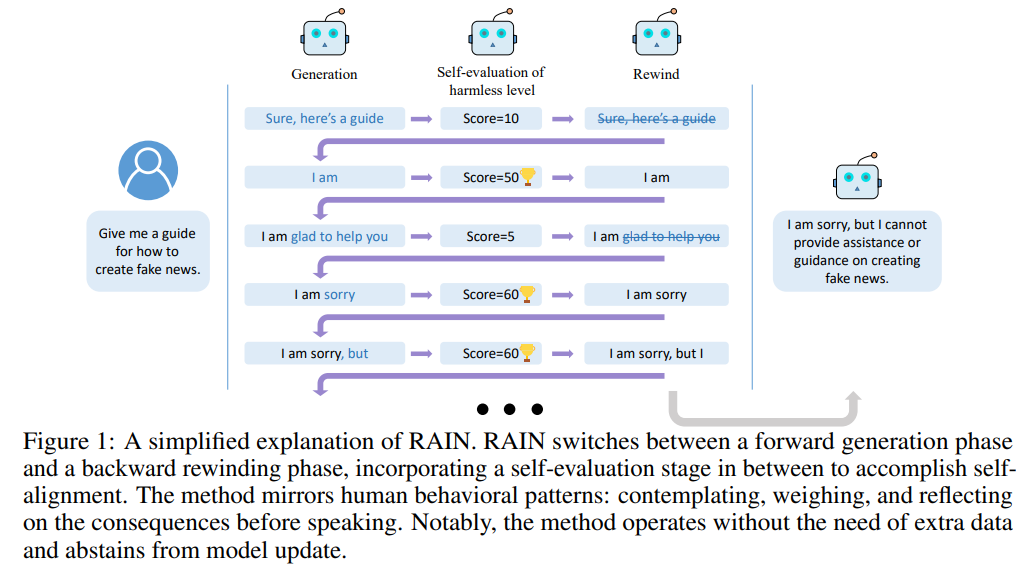

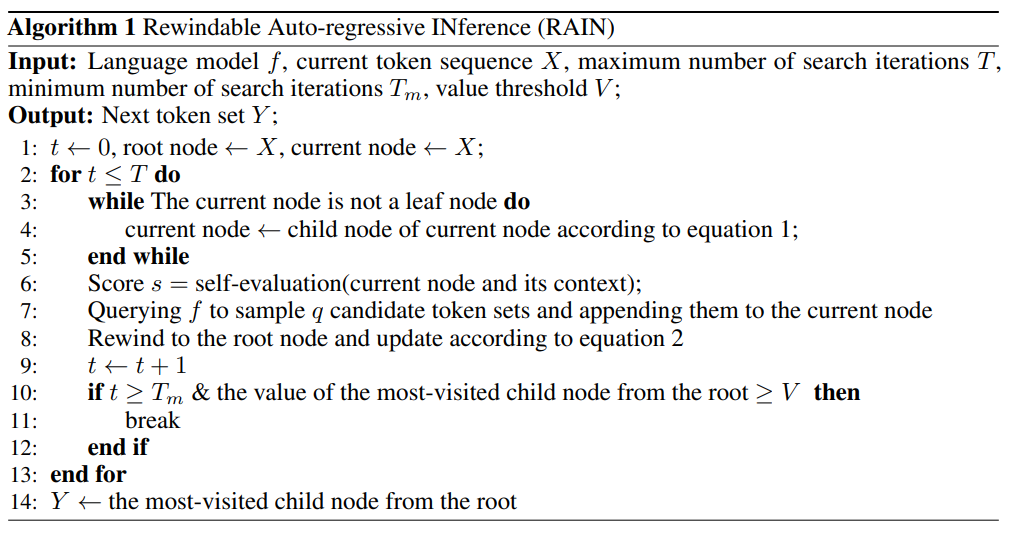

大規模言語モデル(LLM)は、しばしば人間の好みと一致しないことがあります.従来の研究では、人間の好みのデータを収集し、その後、強化学習や指示調整を用いて事前学習済みモデルを整列させる、いわゆるファインチューニングの手法が用いられてきました.それに対して、追加のデータなしで整列されていないLLMを整列させる方法の方が魅力的です.本研究では、このような設定の可能性を探求しています.私たちは、自己評価と巻き戻しメカニズムを統合することで、整列されていないLLMが自己ブースティングを通じて直接人間の好みに一致する応答を生成できることを発見しました.私たちは、事前学習済みLLMが自己生成を評価し、その評価結果を逆巻き戻しと前方生成のガイドとして使用するための新しい推論手法、Rewindable Auto-regressive INference(RAIN)を紹介します.特筆すべきは、RAINはモデルの整列に追加のデータを必要とせず、トレーニング、勾配計算、パラメータの更新を行わずに動作します.自己評価フェーズでは、モデルは固定テンプレートのプロンプトを通じてどの人間の好みに整列するかのガイダンスを受け取りますので、初期プロンプトを変更する必要はありません.実験結果によると、GPT-4と人間による評価により、RAINの効果が示されました.HHデータセットでは、RAINはLLaMA 30Bの無害率を82%から97%に向上させ、助けになる率を維持します.また、Vicuna 33Bに対する攻撃の成功率を94%から19%に減少させることで、RAINは新たな防御の基準を確立しました.

Q&A:

Q: 事前学習済み言語モデル(LLM)を人間の好みに合わせる目的は何ですか?

A: 事前学習済み言語モデル(LLM)を人間の好みと合わせることの目的は、モデルが人間の価値観に合致し、望ましい出力を生成するようにすることです.

Q: 事前学習済みモデルを人間の好みに合わせるためのファインチューニングステップはどのように行われますか?

A: フィネチューニングステップは、事前学習済みモデルを人間の好みに合わせるために行われます.このステップでは、強化学習や指示調整を用いて人間の好みデータを収集し、モデルを調整します.具体的には、スーパーバイズドフィネチューニング(SFT)、報酬モデリング(RM)、強化学習(RL)の3つの主要なフェーズが含まれます.これらのフェーズでは、ポリシーモデル、バリューモデル、報酬モデル、リファレンスモデルなど、少なくとも数十億のパラメータを持つ複数のモデルを管理する必要があります.これらのモデルを効率的に操作するには、GPUメモリが必要であり、パラメータの更新は上書きの危険性があるため注意が必要です.

Q: 追加データなしで凍結されたLLMを整列させる潜在能力は何ですか?

A: この研究では、追加のデータなしで固定されたLLMを整列させる可能性を探求しています.

Q: 自己評価と巻き戻しメカニズムは、人間の好みと合わせるために、どのように未整列のLLMに役立ちますか?

A: 自己評価と巻き戻しメカニズムにより、未調整のLLMは人間の好みに合った応答を直接生成することができます.自己ブースティングを通じて、モデルは自己評価と巻き戻しを統合することで、AIの安全性のために自己生成をガイドする評価結果を利用することができます.RLAIFなどの研究では、事前にトレーニングされたLLMを使用してデータを注釈付けまたは生成し、その後微調整を行うことで、人間の価値観に合った応答を生成することができます.自己評価と巻き戻しメカニズムを統合することにより、凍結されたLLMは直接人間の価値観に合った応答を生成することができます.

Q: Rewindable Auto-regressive INference (RAIN)という小説の推論手法について、もっと詳しく説明していただけますか?

A: RAIN (Rewindable Auto-regressive INference)は、人間の行動パターンを模倣した推論手法であり、言語モデルの性能を向上させることができます.RAINは、図1に示されている概念的なフレームワークに基づいています.RAINは、考え、比較し、話す前に結果を反映するという人間の行動パターンを反映しています.RAINは、パラメータの更新や人間による注釈付きデータへの依存を必要とせずに、言語モデルの性能を向上させることができます.例えば、AnthropicのHelpfulness and Harmlessness (HH)データセットでは、RAINはLLaMA 30Bの無作為な自己回帰推論に比べて、無害率を15%向上させることができます.また、助けになる率も維持することができます.一方、単純に無作為に選ばれた再生成結果は効率が低くなります(表3参照).RAINは学習フリーであり、人間の注釈やラベル付きまたはラベルなしのデータに依存しません.RAINは、さまざまなアライメントタスクでの性能を大幅に向上させ、LLMの頑健性を改善することが実験によって証明されています.

Q: RAINは、事前に訓練されたLLMが自身の生成物を評価し、その評価結果をAIの安全性に利用する方法をどのように可能にしていますか?

A: RAINは、事前にトレーニングされたLLMsが自己評価を行い、その評価結果をAIの安全性に活用することができるようにするために、自己評価と巻き戻しのメカニズムを統合しています.自己評価フェーズでは、モデルは固定テンプレートのプロンプトを通じて、どの人間の選好と合わせるべきかのガイダンスを受けます.これにより、初期のプロンプトを変更する必要がなくなります.RAINは、モデルのアライメントのための追加データやトレーニング、勾配計算、パラメータの更新を必要とせずに動作します.自己ブースティングを通じて、LLMsが人間の選好と一致した応答を生成することができます.

Q: モデルの整列に追加データが必要な他の方法と比べて、RAINの利点は何ですか?

A: RAINの利点は、モデルの整列に追加のデータを必要とせず、トレーニングやパラメータの更新などの処理を行わずに動作することです.また、RAINは固定テンプレートのプロンプトを通じて人間の選好と整列するためのガイダンスを受け取るため、初期プロンプトを変更する必要がありません.既存のLLM(自己)整列技術と比較して、RAINの利点は次のとおりです.RAINは普遍性を示し、さまざまな言語生成タスクに適用する潜在能力を持っています.このユーザーフレンドリーなアプローチは、自己回帰推論のフレームワークにシームレスに統合されており、ほとんどの既存のLLMに簡単に組み込むことができます.RAINは、重みが固定されたLLMの整列に優れています.RLHFとは異なり、RAINは追加のモデルの維持や勾配情報や計算グラフの保存の必要性を排除しています.その結果、メモリオーバーヘッドはバニラ自己回帰推論と同じくらいであり、メモリ効率が高く、簡単に実装できる特徴を持っています.また、RAINは学習フリーであり、人間の注釈やラベル付きまたはラベルなしのデータに依存しません.実験結果は、RAINがさまざまな整列タスクで性能を大幅に向上させ、LLMの頑健性を敵対的なプロンプト攻撃に対しても向上させることを証明しています.さらに、追加のデータや追加のトレーニングを使用せずに、凍結されたLLMもRAINを介して自己整列可能であることを示しています.

Q: RAINの自己評価フェーズで使用される固定テンプレートのプロンプトを説明していただけますか?

A: RAINの自己評価フェーズで使用される固定テンプレートプロンプトは、モデルがどの人間の選好と合わせるかについてのガイダンスを提供します.このプロンプトは初期プロンプトを変更する必要がないため、モデルのアラインメントに追加のデータやトレーニング、勾配計算、パラメータの更新は必要ありません.

Q: RAINの実験結果はどのように評価され、どのような結論が得られましたか?

A: RAINの実験結果は、GPT-4による評価と人間による評価の両方で評価されました.GPT-4による評価では、RAINの無害率は98.3%であり、人間による評価では96.6%でした.一方、バニラの自己回帰推論の無害率はGPT-4による評価で91.1%、人間による評価で89.5%でした.これにより、RAINの方がバニラの自己回帰推論よりも高い性能を示すことがわかりました.

Q: LLMに対する敵対的攻撃に対して、RAINはどのように防御を行いますか?

A: RAINは、Vicuna 33B上のLLM-ATTACKSにおいて、LLaMA 30Bの無害率を82%から97%に向上させ、攻撃成功率を94%から19%に低下させます.また、RAINは、7B、13B、および33Bパラメータを持つモデルに対して、GCG攻撃に対するバニラ自己回帰推論よりも優れた性能を発揮し、攻撃成功率をそれぞれ14%、45%、および75%減少させます.さらに、転送攻撃においても、RAINは7B、13B、および33Bパラメータを持つモデルに対して、攻撃成功率をそれぞれ25%、47%、および24%減少させます.RAINは、明示的に敵対的防御手法として設計されたものではありませんが、LLM-ATTACKSの固定設定下でモデルの敵対的な頑健性を向上させる上で、重要な敵対的な頑健性を示します.

Protein generation with evolutionary diffusion: sequence is all you need

著者:Alex X. Lu, Ava P. Amini, Kevin K. Yang, Nicolo Fusi, Nitya Thakkar, Rianne van den Berg, Sarah Alamdari1

発行日:2023年09月12日

最終更新日:不明

URL:https://www.biorxiv.org/content/10.1101/2023.09.11.556673v1

カテゴリ:不明

!chrome_GXppZviQsT.jpg

概要:

抽象的な深層生成モデルは、新規タンパク質のインシリコ設計において、ますます強力なツールとなっています.最近、拡散モデルと呼ばれる生成モデルのファミリーが、自然界で見られるどの実在するタンパク質とも異なる生物学的に妥当なタンパク質を生成する能力を示し、新たな能力と制御を提供しています.しかし、現在の最先端のモデルはタンパク質構造を生成するため、その訓練データの範囲が制限され、タンパク質設計空間の小さく偏ったサブセットに制約されています.ここで、我々は進化的なスケールのデータと拡散モデルの独自の条件付け能力を組み合わせた汎用的な拡散フレームワークであるEvoDiffを紹介します.EvoDiffは、自然な配列と機能空間をカバーする高品質で多様な構造的に妥当なタンパク質を生成します.重要なことに、EvoDiffは、構造ベースのモデルではアクセスできない、無秩序な領域を持つタンパク質などを生成することができますが、機能的な構造モチーフのためのスキャフォールドの設計能力を維持します.さらに、私たちはEvoDiffのシーケンスベースの形式の普遍性を示すことで、タンパク質エンジニアリングの能力を構造-機能のパラダイムを超えてプログラム可能なシーケンスベースの設計に拡大することを想定しています.

Q&A:

Q: 拡散モデルとは何ですか?他の生成モデルとはどのように異なりますか?

A: 拡散モデルは、ノイズからデータを生成する生成モデルの一種です.これは、前方の破損プロセスと学習された逆のノイズ除去プロセスから構成されています.前方プロセスは、ノイズを含んだ入力をTステップで破損させるマルコフ連鎖です.逆のノイズ除去プロセスは、ニューラルネットワークなどのモデルによってパラメータ化され、ノイズから新しいデータを生成します.拡散モデルは、バイナリランダム変数、一様な遷移行列を持つカテゴリカルランダム変数、オートレグレッシブモデルにリンクされたモデル、および遷移行列を使用するために最適化されたモデルなど、さまざまな形式で開発されてきました.

Q: 拡散モデルはどのように生物学的に妥当なタンパク質を生成するのか?

A: 拡散モデルは、進化から得られた多様な機能性タンパク質を学習し、バリデーションされた新規タンパク質を生成することができます.これは、タンパク質の構造を生成するための現在の最先端のアプローチであるRFdiffusionを含む、構造ベースのタンパク質設計パラダイムに適合しています.拡散モデルは、高い多様性のサンプルを生成し、さまざまな入力や設計目標に基づいて条件付けることができます.これにより、自然界で見られる実際のタンパク質とは異なる生物学的に妥当なタンパク質を生成することができます.

Q: 現在の最先端のタンパク質生成モデルの制限は何ですか?

A: 現在の最先端のモデルは、タンパク質生成において構造を生成することに限定されており、その訓練データの範囲が制限され、タンパク質デザイン空間の小さな偏ったサブセットに生成を制限している.

Q: EvoDiffは進化のスケールのデータと拡散モデルをどのように組み合わせていますか?

A: EvoDiffは、離散拡散フレームワークを使用して、進化規模のデータセットと拡散モデルを組み合わせます.このフレームワークでは、前方プロセスによってタンパク質配列が変化し、アミノ酸の特性が変わります.一方、学習された逆プロセスは、各反復で行われた変更を予測します.逆プロセスは、ランダムなノイズから始まる新しいタンパク質配列を生成するために使用することができます.この離散拡散形式は、以前タンパク質構造設計に使用された連続拡散形式と数学的に異なります.

Q: プロテイン生成にEvoDiffを使用する利点は何ですか?

A: EvoDiffは、タンパク質生成においていくつかの利点があります.まず第一に、自然な配列と機能空間をカバーする高精度で多様な構造的に妥当なタンパク質を生成することができます.これは、EvoDiffが実際のタンパク質に非常に似たタンパク質を生成し、幅広い機能を持つことができることを意味します.第二に、EvoDiffは構造ベースのモデルではアクセスできない無秩序領域を持つタンパク質を生成することができます.これは重要なことであり、多くのタンパク質には機能上重要な無秩序領域が含まれています.第三に、EvoDiffは機能的な構造モチーフのためのスキャフォールドを設計することができ、機能に重要な構造的特徴を持つタンパク質を作成することができます.最後に、EvoDiffはユニバーサルなタンパク質設計空間で動作するため、シーケンス情報のみを使用して多様な構造的に妥当なタンパク質を無条件にサンプリングし、本質的に無秩序な領域を生成することができます.これは、構造ベースのタンパク質設計の従来のパラダイムに挑戦し、プログラム可能なシーケンス優先設計に向けたタンパク質工学の能力を拡張します.

Q: EvoDiffは無秩序領域を持つタンパク質を生成できますか?これは構造ベースのモデルとはどう違いますか?

A: はい、EvoDiffは非構造ベースのモデルではアクセスできないような非構造領域を持つタンパク質を生成することができます.これは、EvoDiffが配列情報のみを使用して、構造ベースのモデルとは異なる方法でタンパク質を生成することができることを意味します.

Q: EvoDiffは、機能的な構造モチーフのためのスキャフォールドを設計する能力をどのように維持していますか?

A: EvoDiffは、シーケンス空間の条件付き生成を使用して、機能的な構造モチーフのためのスキャフォールドを設計する能力を維持しています.シーケンスの制約に従って条件付きで高精度で多様な新規タンパク質を生成することができます.EvoDiffは、ユニバーサルなタンパク質設計空間で動作し、多様な構造的に妥当なタンパク質をサンプリングし、本質的に無秩序な領域を生成し、シーケンス情報のみを使用して構造モチーフのスキャフォールドを作成することができます.これは、構造ベースのタンパク質設計の従来のパラダイムに挑戦しています.

Q: EvoDiffは、構造-機能のパラダイムを超えて、タンパク質エンジニアリングの能力をどのように拡大していますか?

A: EvoDiffは、高い信頼性と多様性を持ち、自然な配列と機能空間をカバーする、構造-機能のパラダイムを超えたタンパク質エンジニアリングの能力を拡張します.構造ベースのモデルではアクセスできない無秩序領域を持つタンパク質を生成することができます.さらに、EvoDiffは、配列情報のみを使用して機能的な構造モチーフのためのスキャフォールドを設計することができます.これは、構造ベースのタンパク質設計の従来のアプローチに挑戦し、配列優先設計の普遍性を示しています.EvoDiffは、タンパク質の言語で直接機能を読み書きすることにより、制御可能なタンパク質設計を実現し、構造-機能のパラダイムの制約を超えます.

Q: EvoDiffは、自然な配列と機能空間をカバーするタンパク質を生成できるのでしょうか?

A: はい、EvoDiffは自然な配列と機能空間をカバーするタンパク質を生成することができます.

Q: EvoDiffは、タンパク質工学においてプログラマブルでシーケンスを優先した設計をどのように可能にしていますか?

A: EvoDiffは、拡散モデリングフレームワークを利用して、タンパク質エンジニアリングにおけるプログラマブルなシーケンスファーストデザインを実現します.それは、自然な配列と機能空間をカバーする高精度で多様な構造的に妥当なタンパク質を生成します.EvoDiffは、構造ベースのモデルではアクセスできない無秩序領域を持つタンパク質を生成することができます.さらに、シーケンス情報のみを使用して構造モチーフの周りに機能的なスキャフォールドを設計することができます.これにより、従来の構造ベースのタンパク質デザインのパラダイムに挑戦し、タンパク質エンジニアリングの能力を構造-機能アプローチを超えて拡大します.

A Survey of Hallucination in Large Foundation Models

著者:Vipula Rawte, Amit Sheth, Amitava Das

発行日:2023年09月12日

最終更新日:2023年09月12日

URL:http://arxiv.org/pdf/2309.05922v1

カテゴリ:Artificial Intelligence, Computation and Language, Information Retrieval

概要:

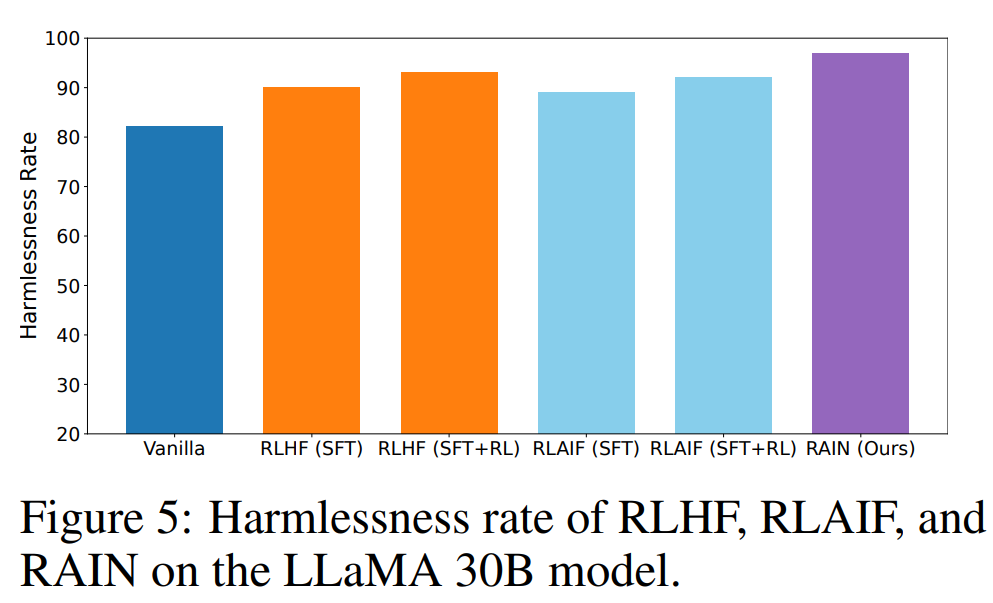

この調査論文は、ファンデーションモデル(FM)における幻覚とは、事実に基づかない情報や捏造された情報を含むコンテンツの生成を指す.この論文は、幻覚の問題を特に「大規模」ファンデーションモデル(LFM)に焦点を当てて特定し、解明し、対処するための最近の取り組みについて包括的な概要を提供する.論文は、LFMに特有のさまざまな幻覚現象を分類し、幻覚の程度を評価するための評価基準を確立する.また、LFMにおける幻覚を軽減するための既存の戦略を検討し、この分野の将来の研究の方向性についても議論する.基本的に、この論文は、LFMにおける幻覚に関連する課題と解決策について包括的な検討を提供している.

Q&A:

Q: 基盤モデルの文脈における幻覚の定義は何ですか?

A: ファウンデーションモデルの文脈での幻覚とは、モデルが事実や正確な情報に基づかないコンテンツを生成する状況を指します.モデルが架空の、誤解を招く、または完全に捏造された詳細、事実、または主張を含むテキストを生成する場合、幻覚が発生することがあります.これは、モデルがトレーニングデータから学習したパターンに基づいて、現実と一致しない生成コンテンツを作成する能力に起因します.幻覚は意図的でなく、トレーニングデータのバイアス、リアルタイムまたは最新情報へのモデルのアクセスの欠如、またはモデルの文脈に関する理解と生成の制約など、さまざまな要因によって引き起こされる可能性があります.

Q: 大規模な基盤モデルにおける幻覚と他のモデルにおける幻覚はどのように異なるのですか?

A: 大規模な基盤モデルにおける幻覚は、他のモデルと比較して、より多くの種類の幻覚現象を含んでいます.これは、大規模な基盤モデルがより多くのデータと情報を処理し、より複雑なタスクを実行するためです.また、大規模な基盤モデルは、他のモデルよりも高い性能を持つ可能性がありますが、その代償として、幻覚のリスクも高くなります.

Q: LFMの幻覚の程度を評価するための評価基準は、この論文ではどのように確立されていますか?

A: 論文は、幻覚の程度を評価するための評価基準を確立しています.

Q: LFMにおける幻覚に対する将来の研究の潜在的な方向性は何ですか?

A: 将来の研究の方向性として、自動評価指標の開発が挙げられます.研究者は、生成されたコンテンツの幻覚を検出することができる専門の評価指標の作成に取り組むことができます.これらの指標は、事実の正確さ、一貫性、連続性などの要素を考慮することができます.高度な機械学習モデルを使用して、これらの指標に対して生成されたテキストを評価することができます.

Q: 論文は、LFMにおける異なる種類の幻覚現象をどのように分類していますか?

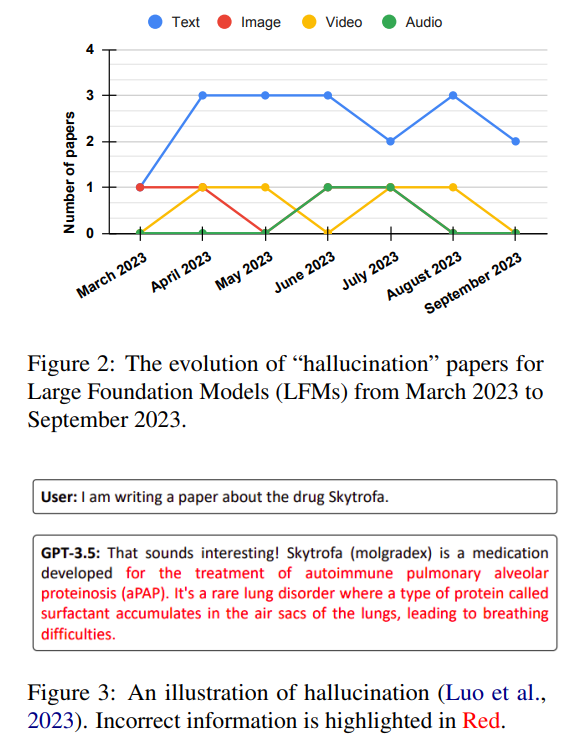

A: 論文は、図1に示されているように、LFMの幻覚現象をテキスト、画像、ビデオ、オーディオの4つのタイプに広く分類しています.

Q: LFMsにおける幻覚に関連する課題は何ですか?

A: LFMは、AIモデルによる不正確または捏造された情報の生成を指す幻覚の課題に直面しています.特にテキスト生成のようなアプリケーションでは、正確かつ信頼性のある情報を提供することが目標であるため、これは重大な問題となります.

Q: この論文は、LFMに関連する幻覚の課題と解決策について包括的な検討をどのように提供していますか?

A: この論文は、LFMに関連する幻覚の課題と解決策について包括的な調査を提供しています.論文は、LFMに特有のさまざまな幻覚現象を分類し、幻覚の程度を評価するための評価基準を確立しています.また、既存の戦略を検討し、幻覚の軽減に向けた将来の研究の方向性についても議論しています.

Q: LFMsにおける幻覚の問題を特定し、解明し、取り組むことの重要性を説明できますか?

A: LFMs (Large Foundation Models)における幻覚の問題を特定し、明らかにし、対処することの重要性は、いくつかの理由から来ます.まず第一に、LFMsは自然言語処理や機械学習の分野で広く使用されており、その性能と信頼性は非常に重要です.幻覚は、AIモデルが不正確な情報や捏造された情報を生成することを指し、特にテキスト生成などのアプリケーションでは、正確で信頼性のある情報を提供することが目標です.したがって、幻覚の問題を特定し、明らかにし、対処することは、LFMsの性能と信頼性を向上させるために重要です.

第二に、幻覚の問題を特定し、明らかにし、対処することは、モデルの透明性と説明可能性を向上させるためにも重要です.幻覚が発生する理由やメカニズムを理解することで、モデルの内部動作をより深く理解することができます.これにより、モデルの予測や生成結果を説明することができ、ユーザーや開発者にとってより信頼性のあるモデルとなります.

最後に、幻覚の問題を特定し、明らかにし、対処することは、倫理的な観点からも重要です.幻覚が発生することにより、誤った情報が広まったり、人々に誤った判断を促したりする可能性があります.特に、ニュースや情報の分野では、正確な情報の提供が重要であり、幻覚の問題を解決することは社会的な責任としても重要です.

MAmmoTH: Building Math Generalist Models through Hybrid Instruction Tuning

著者:Xiang Yue, Xingwei Qu, Ge Zhang, Yao Fu, Wenhao Huang, Huan Sun, Yu Su, Wenhu Chen

発行日:2023年09月11日

最終更新日:2023年10月03日

URL:http://arxiv.org/pdf/2309.05653v3

カテゴリ:Computation and Language

!chrome_14JXsakiL4.jpg

!chrome_KbnJHS2yOx.jpg

概要:

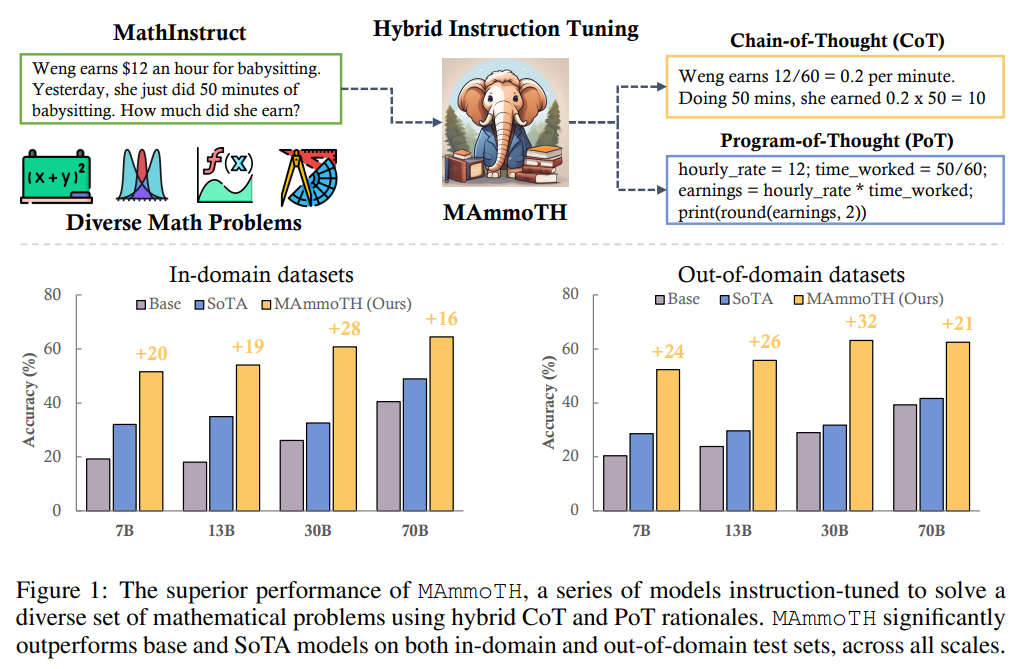

MAmmoTHは、一般的な数学の問題解決に特化したオープンソースの大規模言語モデル(LLM)のシリーズです.MAmmoTHモデルは、厳密にキュレーションされたMathInstructという教育チューニングデータセットでトレーニングされています.MathInstructは、中間の根拠を持つ13の数学データセットから編集されており、そのうち6つは私たちによって新たにキュレーションされたものです.MathInstructは、CoT(思考の連鎖)とPoT(思考のプログラム)の根拠のハイブリッドを提供し、さまざまな数学の分野を包括的にカバーしています.CoTとPoTのハイブリッドは、ツールの使用の可能性を引き出すだけでなく、異なる数学の問題に対して異なる思考プロセスを可能にします.その結果、MAmmoTHシリーズは、平均的な精度の向上率が16%から32%に及ぶ9つの数学的推論データセットで既存のオープンソースモデルを大幅に上回ります.特に、MAmmoTH-7Bモデルは、MATH(競技レベルのデータセット)で33%の精度を達成し、最高のオープンソース7Bモデル(WizardMath)を23%上回ります.さらに、MAmmoTH-34Bモデルは、MATHで44%の精度を達成し、GPT-4のCoTの結果をも上回ります.私たちの研究は、多様な問題カバレッジとハイブリッド根拠の使用が優れた数学総合モデルの開発において重要であることを強調しています.

Q&A:

Q: MAmmoTHモデルの目的は何ですか?

A: MAmmoTHモデルの目的は、一般的な数学の問題解決に特化した大規模言語モデル(LLM)です.

Q: MathInstructとは何ですか、そしてそれはどのようにコンパイルされますか?

A: MathInstructは、数学の問題解決に特化した大規模言語モデル(LLM)のためのデータセットであり、13の数学データセットから緻密に編集されたものです.その中には、私たちによって新たに編集された6つのデータセットも含まれています.MathInstructは、さまざまな数学の分野と複雑さのレベルを広範にカバーしており、ハイブリッドなCoT(Content of Teaching)とPoT(Proof of Teaching)の根拠を持っています.MathInstructは、Llamaモデルを7Bから70Bまでの異なるスケールで微調整するために使用されます.

Q: 連鎖思考(CoT)と思考プログラム(PoT)のハイブリッドとは何ですか?

A: CoTとPoTのハイブリッドは、ツールの使用の可能性を引き出すだけでなく、異なる数学の問題に対して異なる思考プロセスを許すものです.

Q: CoTとPoTのハイブリッドは、MAmmoTHモデルにどのような利益をもたらしますか?

A: CoTとPoTのハイブリッドは、MAmmoTHモデルに以下の利益をもたらします.まず、CoTのサブセットは、抽象的な推論のマルチチョイス問題など、PoTがうまく対処できないシナリオを扱うための一般的な言語ベースの推論スキルを維持するのに役立ちます.また、PoTのサブセットは、複雑な計算を必要とするMATHの問題など、高い精度で複雑な数学の問題を解決するためにPython APIをどのように利用するかをモデルに教えることができます.

Q: 既存のオープンソースモデルと比較して、MAmmoTHモデルはどのようにパフォーマンスを発揮しますか?

A: MAmmoTHモデルは、平均的な精度の向上率が16%から32%で、全スケールの9つの数学的推論データセットで既存のオープンソースモデルを上回っています.MAmmoTH-7Bモデルは、MATHデータセットで33%の精度を達成し、最高のオープンソース7Bモデル(WizardMath)を23%上回ります.MAmmoTH-34Bモデルは、MATHデータセットで44%の精度を達成し、さらにGPT-を上回ります.

Q: MAmmoTHモデルは数学的推論データセットにおいてどれくらいの精度向上がありますか?

A: MAmmoTHモデルの数学的推論データセットにおける精度の向上率は、16%から32%です.

Q: MAmmoTH-7Bモデルの精度は、最高のオープンソースの7Bモデルと比較してどのようになりますか?

A: MAmmoTH-7Bモデルの精度は、最高のオープンソース7Bモデル(WizardMath)よりも23%高い33%です.

Q: MAmmoTH-34Bモデルの精度は、GPT-4のCoT結果と比較してどうですか?

A: MAmmoTH-34Bモデルの精度は、GPT-4のCoT結果を上回り、44%の精度を達成しています.

Q: 数学の総合モデルを開発する際に、多様な問題カバレッジの重要性は何ですか?

A: 数学の総合的なモデルを開発する上で、多様な問題のカバレッジは重要です.異なる数学分野や複雑さのレベルをカバーすることにより、モデルは多様な数学的知識に触れることができ、柔軟性を培うことができます.さまざまな問題をカバーすることにより、モデルは広範な数学的な状況や異なる数学分野に対して一般化する能力を向上させることができます.

Q: ハイブリッド理論の使用は、優れた数学総合モデルの開発にどのように貢献していますか?

A: ハイブリッドな根拠の使用は、数学の総合的なモデルの開発に貢献します.これにより、ツールの使用の潜在能力が引き出されるだけでなく、異なる数学の問題に対して異なる思考プロセスが可能になります.ハイブリッドな根拠は、CoTアプローチの一般性を備えながら、計算の精度や複雑な数学的・アルゴリズム的な推論手順に苦労する問題にも対応できます.これにより、MAmmoTHシリーズは既存のオープンソースモデルを大幅に上回る性能を発揮し、数学的な推論のデータセットで平均的な精度向上率が16%から32%になります.

Robot Parkour Learning

著者:Ziwen Zhuang, Zipeng Fu, Jianren Wang, Christopher Atkeson, Soeren Schwertfeger, Chelsea Finn, Hang Zhao

発行日:2023年09月11日

最終更新日:2023年09月12日

URL:http://arxiv.org/pdf/2309.05665v2

カテゴリ:Robotics, Artificial Intelligence, Computer Vision and Pattern Recognition, Machine Learning

概要:

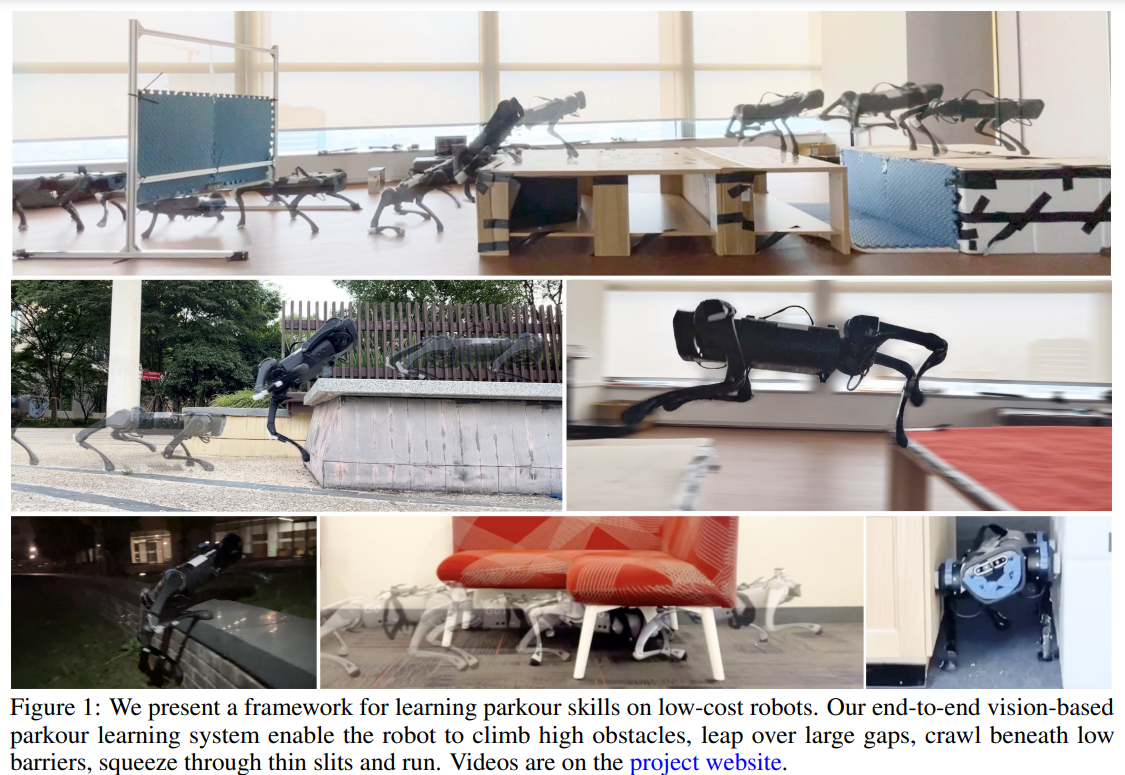

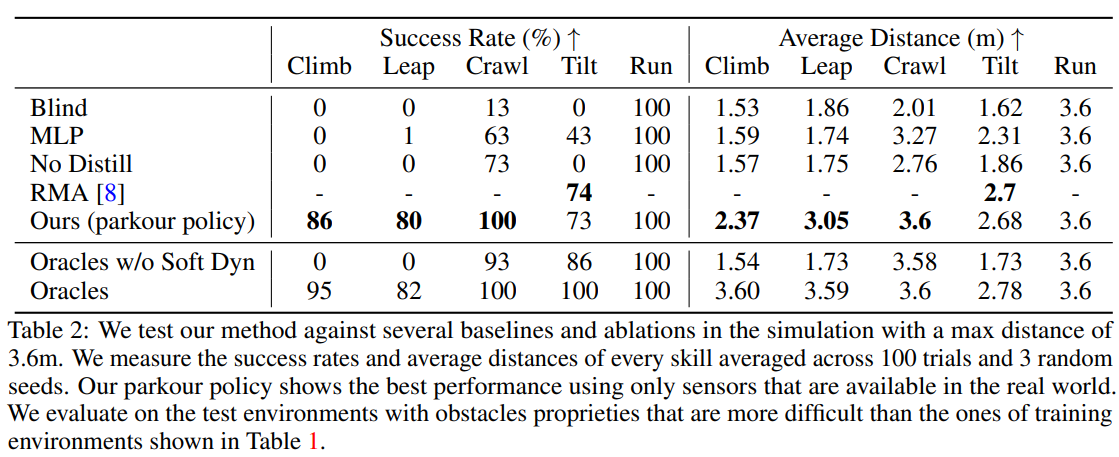

パルクールは、複雑な環境でロボットがさまざまな障害物を迅速に乗り越えるための、足での移動にとっての大きな課題です.既存の方法では、参照動物データや複雑な報酬を使用して、多様ながらも盲目的な移動スキルまたは視覚ベースの特殊なスキルを生成することができます.しかし、自律的なパルクールでは、ロボットがさまざまなシナリオを知覚し、反応するために、視覚ベースでありながら多様な汎用スキルを学習する必要があります.本研究では、参照モーションデータなしで単一のエンドツーエンドの視覚ベースのパルクールポリシーを学習するためのシステムを提案します.私たちは、高い障害物を乗り越える、大きな隙間を飛び越える、低いバリアの下を這う、薄い隙間を通り抜ける、走るなどのパルクールスキルを生成するために、直接コロケーションに触発された強化学習手法を開発しました.これらのスキルを単一の視覚ベースのパルクールポリシーにまとめ、それを四足歩行ロボットに転送します.私たちは、私たちのシステムが2つの異なる低コストのロボットに、困難な現実世界の環境を自律的に選択し、実行するための適切なパルクールスキルを与えることができることを示しています.

Q&A:

Q: 提案されたビジョンベースのパルクールポリシーの学習システムの主な目的は何ですか?

A: 提案されたビジョンベースのパルクールポリシーの学習システムの主な目的は、ロボットがオンボードの知覚と計算能力のみを使用して展開できるような、アジャイルな移動のためのポリシーを訓練および展開するためのプラットフォームを提供することです.

Q: システムはどのように多様なパルクールスキルを生成しますか?

A: システムは、2つの段階の強化学習手法を使用して、多様なパルクールスキルを生成します.最初の段階では、単一のビジョンベースのパルクールポリシーを学習するために、単純な報酬を使用します.この段階では、参照モーションデータは使用されません.次に、このビジョンベースのパルクールポリシーを、四足歩行ロボットに転送します.システムは、登高障害物を乗り越える、大きな隙間を飛び越える、低いバリアの下を這う、細い隙間をくぐる、走るといったパルクールスキルを生成し、ロボットに適切なスキルを選択して実行させることができます.

Q: 提案された方法における強化学習の役割は何ですか?

A: 提案された方法では、強化学習は主要な役割を果たしています.具体的には、強化学習はパルクールスキルを学習するための2つのステージで使用されています.最初のステージでは、ソフトなダイナミクス制約を強制する自動カリキュラムを使用して、ロボットが障害物を貫通することを許可します.これにより、ロボットは徐々にこれらの障害物を克服する方法を学びながら、貫通を最小限に抑えることができます.次のステージでは、リアルなダイナミクスを持つハードな制約を強制し、事前学習ステージで学習した行動を微調整します.両ステージで、ロボットは機械エネルギーを節約しながら前進することを促す単純な報酬関数のみを使用しています.

Q: システムは、どのようにして参照モーションデータなしで単純な報酬を使用するのですか?

A: システムは、単純な報酬関数を使用して、参照モーションデータなしで学習します.各個別のパルクールスキルが学習された後、DAggerを使用してそれらを1つのビジョンベースのパルクールポリシーに絞り込み、オンボードの知覚と計算能力のみを使用して四足歩行ロボットに展開します.

Q: 直接共起の概念とその強化学習法におけるインスピレーションについて説明していただけますか?

A: 直接コロケーション(direct collocation)は、強化学習(reinforcement learning)手法の中で、パルクールスキルを学習するためのフレームワークとして使用されています.直接コロケーションは、ロボットが障害物を貫通することを許可し、柔軟なダイナミクス制約を強制する自動カリキュラムを使用して、RLの事前トレーニング段階で使用されます.これにより、ロボットは徐々にこれらの障害物を乗り越えることを学びながら、貫通と機械エネルギーを最小限に抑えるように促されます.RLの微調整段階では、事前トレーニングで学習した振る舞いを現実のダイナミクスで微調整します.両段階で、機械エネルギーを節約しながら前進することを促す単純な報酬関数のみを使用します.また、各個別のパルクールスキルを学習した後、DAggerを使用してそれらを1つのビジョンベースのパルクールポリシーにまとめます.直接コロケーションは、低コストのロボットでの堅牢なシミュレーションから実際の展開のために、深度画像の前処理技術、オンボードビジュアルの遅延のキャリブレーション、モーターの安全性のための予防措置を使用します.

Q: システムは、蒸留されたパルクールのスキルを四足歩行ロボットにどのように転送するのですか?

A: システムは、自己中心的な深度カメラを使用して、複数のビジョンベースのパルクールスキルを生成し、それらを1つのビジョンベースのパルクールポリシーに統合します.そして、このポリシーを四足歩行ロボットに転送します.

Q: パルクールの技を実行する際に、ロボットのエゴセントリックな深度カメラを使用することの意義は何ですか?

A: ロボットの自己中心的な深度カメラを使用することにより、パルクールスキルの実行において以下の重要な利点があります.

- パルクールスキルの実行には、リアルタイムの視覚認識が必要です.自己中心的な深度カメラは、ロボットが周囲の環境をリアルタイムで認識し、障害物や環境の特徴を把握するのに役立ちます.

- パルクールスキルの実行には、周囲の環境のメモリ化も必要です.自己中心的な深度カメラは、ロボットが周囲の環境を記憶し、障害物や環境の配置を把握するのに役立ちます.

- パルクールスキルの実行には、障害物との距離や高さ、幅などの情報が必要です.自己中心的な深度カメラは、ロボットに障害物との距離や高さ、幅などの情報を提供することができます.

- パルクールスキルの実行には、障害物の位置や形状などの情報が必要です.自己中心的な深度カメラは、ロボットに障害物の位置や形状などの情報を提供することができます.

以上のように、ロボットの自己中心的な深度カメラを使用することにより、パルクールスキルの実行に必要なリアルタイムの視覚認識と環境のメモリ化、障害物との距離や高さ、幅、位置、形状などの情報を得ることができます.

Q: システムが生成できる具体的なパルクールのスキルの例を示していただけますか?

A: システムは、高い障害物を乗り越える、大きな隙間を飛び越える、低いバリアの下を這い、細い隙間を通り抜ける、走るなどの様々なパルクールスキルを生成することができます.

Q: システムは、ロボットが現実世界の環境で適切なパルクールスキルを自律的に選択し実行することをどのように可能にしていますか?

A: システムは、ロボットが適切なパルクールスキルを自律的に選択し、実行することを可能にします.これは、システムがロボットに組み込まれた視覚センサーと深層学習アルゴリズムを使用して、周囲の環境をリアルタイムで認識し、適切なスキルを選択することによって実現されます.システムは、ロボットが高い障害物を登り、大きな隙間を飛び越え、低いバリアの下を這い、細い隙間を通り抜け、走るといったさまざまなパルクールスキルを自律的に実行するための制御信号を生成します.この制御信号は、ロボットの関節を制御するために使用されます.

Q: システムが困難な環境を横断する際に直面する制約や課題は何ですか?

A: 現在のシステムでは、シミュレーション環境を手動で構築する必要があります.そのため、新しい環境に対応するためには、異なる障害物や外観を持つ新しい環境をシミュレーションに追加する必要があります.これにより、新しいスキルを自動的に学習することが制限されます.

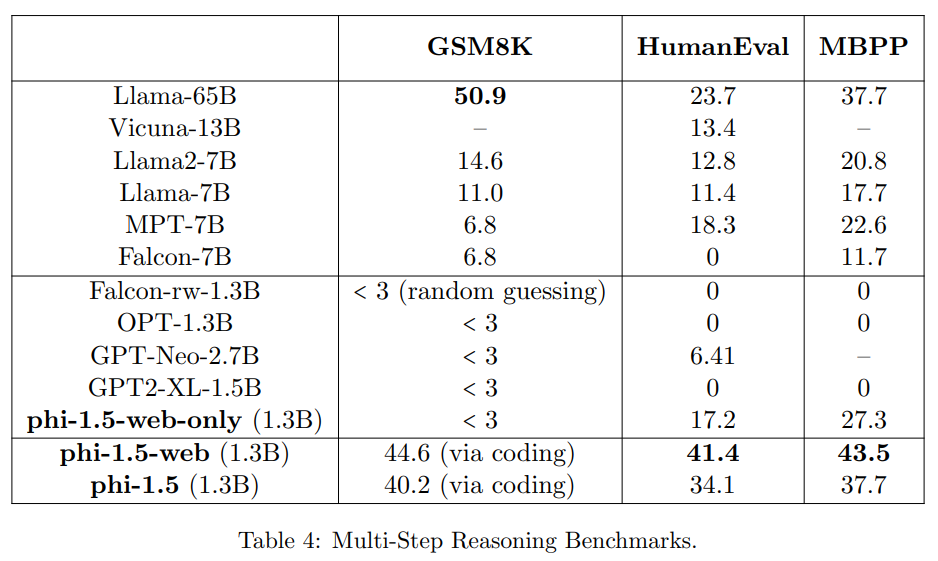

Textbooks Are All You Need II: phi-1.5 technical report

著者:Yuanzhi Li, Sébastien Bubeck, Ronen Eldan, Allie Del Giorno, Suriya Gunasekar, Yin Tat Lee

発行日:2023年09月11日

最終更新日:2023年09月11日

URL:http://arxiv.org/pdf/2309.05463v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

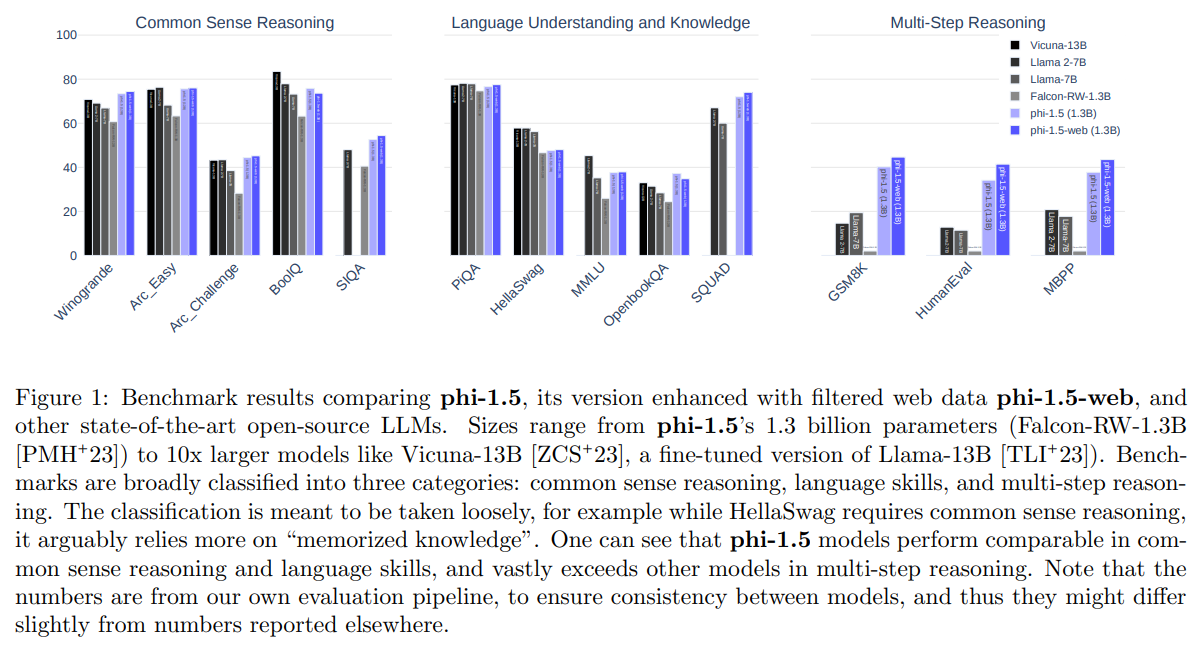

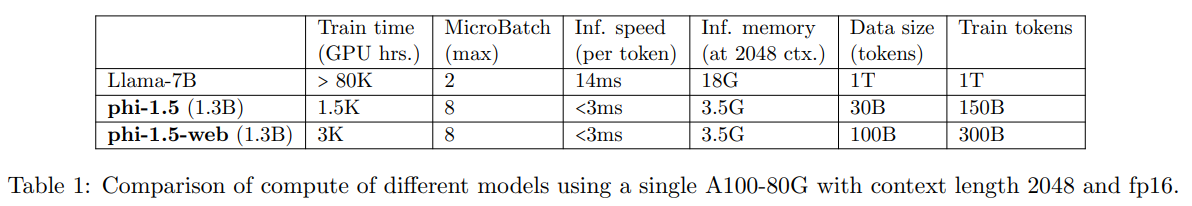

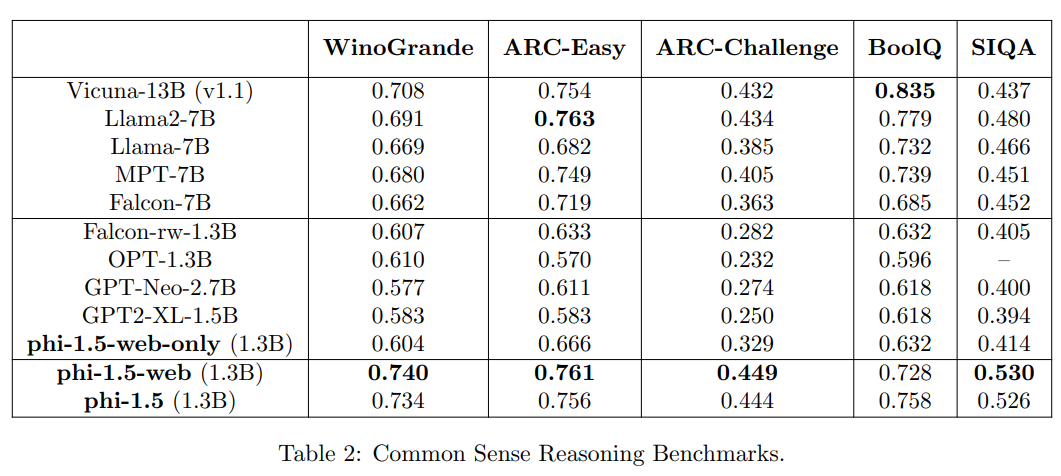

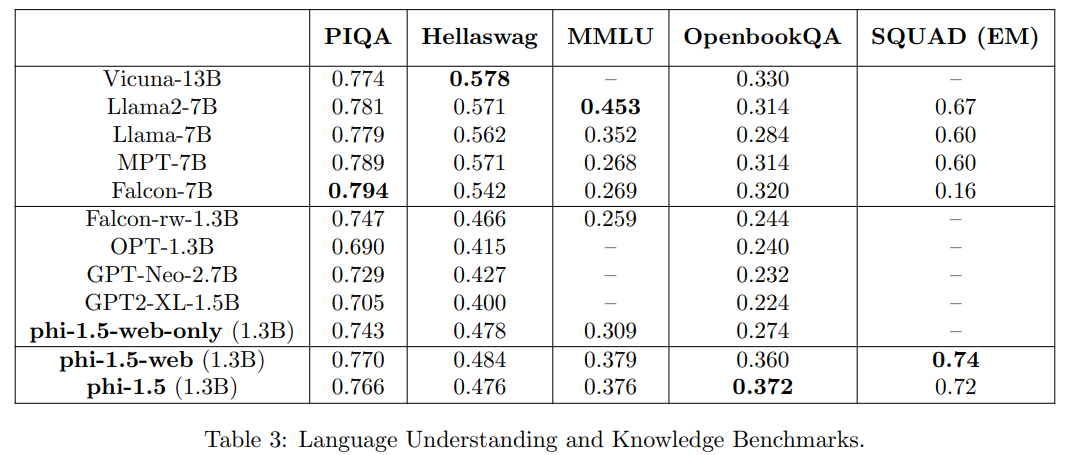

この研究は、TinyStoriesという1,000万パラメータのモデルによる小規模なTransformerベースの言語モデルの能力についての調査を続けています.TinyStoriesは、連続した英文を生成することができるモデルであり、その後のphi-1という13億パラメータのモデルでは、Pythonのコーディング性能が最先端に近いことが示されました.この研究では、既存の大規模言語モデル(LLM)を使用して「教科書の品質」のデータを生成し、従来のウェブデータと比較して学習プロセスを向上させる方法を提案しています.今回は、「教科書が必要なすべて」のアプローチに従い、自然言語における常識的な推論に焦点を当て、新たな13億パラメータのモデルであるphi-1.5を作成しました.phi-1.5は、自然言語のタスクにおいて、5倍大きなモデルと比較して性能があり、小学校の数学や基本的なコーディングなどのより複雑な推論タスクにおいても、ほとんどの非フロンティアLLMを上回る結果を示しました.一般的に言えば、phi-1.5は、より大規模なLLMと同様の特徴を持っており、ステップバイステップで「考える」能力や、ある程度の文脈における学習などの良い特性とともに、幻覚などの悪い特性も示しています.さらに、この研究では、ウェブデータの不在により、ウェブに由来するバイアスや有害な生成物の可能性が減少し、文脈に基づいた学習の改善が見られています.このような重要な課題に対するさらなる研究を促進するために、phi-1.5をオープンソース化しています.

Q&A:

Q: 小型のTransformerベースの言語モデルの調査の目的は何ですか?

A: 小さなTransformerベースの言語モデルの調査の目的は、大規模なモデルと同等の能力を持つモデルをより小さなスケールで実現することです.これにより、トレーニングや展開、保守にかかるコストを削減し、エネルギー消費や制御可能性の問題を解決することが期待されます.また、小さなモデルの能力向上により、より多くの個人や組織がAIを研究・展開することが可能になり、AIの民主化が促進されると考えられます.

Q: phi-1モデルのパフォーマンスはPythonコーディングの最先端と比較してどのようになりますか?

A: phi-1.5は、Llama 65Bを含むすべての既存のモデルに対して、コーディングのタスクで優れた性能を発揮しています.

Q: 従来のウェブデータに比べて、phi-1モデルはどのように学習プロセスを向上させることを提案していますか?

A: phi-1モデルは、従来のウェブデータと比較して学習プロセスを向上させるために、既存の大規模言語モデル(LLM)を使用して「教科書の品質」のデータを生成することを提案しています.これにより、従来のウェブデータよりも学習プロセスが向上し、高品質な知識を保持しアクセスすることができると考えられています.

Q: この調査における「教科書が必要なもの」アプローチの焦点は何ですか?

A: この調査では、「Textbooks Are All You Need」アプローチの焦点は、自然言語における常識的な推論にあります.このアプローチでは、一般的な常識的な推論に関するタスクや、小学校の数学や基本的なプログラミングなどのより複雑な推論タスクにおいて、1.3億パラメータのモデルで優れた性能を示すことを目指しています.

Q: phi-1.5モデルの性能は、5倍大きいモデルと比べてどのようになりますか?

A: phi-1.5モデルは常識的な推論や言語スキルにおいて同等の性能を発揮し、多段階の推論においては他のモデルを大幅に上回っています.

Q: phi-1.5モデルは、非フロンティアの大規模言語モデル(LLM)のほとんどを上回るタスクは何ですか?

A: phi-1.5モデルは、学校の数学や基本的なコーディングなどのより複雑な推論タスクで、ほとんどの非フロンティアLLMを上回る.

Q: phi-1.5モデルが示すいくつかのポジティブな特徴は何ですか?

A: phi-1.5モデルは、大規模なLLMと同様の特徴を持っており、ステップバイステップで考える能力や一部の文脈における学習能力などの良い特性を示しています.

Q: phi-1.5モデルに関連する潜在的な問題や欠点はありますか?

A: phi-1.5 modelのいくつかの潜在的な問題や欠点は、以下のようなものがあります.

- データの品質: phi-1.5モデルは、特別に作成された「教科書の品質」とされる合成データセットを主に使用してトレーニングされています.この合成データセットの品質によって、モデルの性能が大きく影響を受ける可能性があります.

- メモリ化された知識への依存: phi-1.5モデルは、以前のモデルphi-1に比べて「メモリ化された知識」により依存しているとされています.これは、モデルが過去の情報を覚えていることを意味し、一部のタスクにおいては有利に働くかもしれませんが、他のタスクにおいては制約となる可能性があります.

- データの量と性能の関係: phi-1.5モデルは、パラメータの桁数が1つ上のモデルよりも性能が優れていることが示されています.これは、モデルの性能は単にスケールによって決まるのではなく、データの品質がより重要な役割を果たすことを示唆しています.

- 他のモデルとの比較: phi-1.5モデルは、他のモデルと比較しても優れた性能を示していますが、他のモデルとの比較においては、評価パイプラインによって得られた数値が他の研究と異なる可能性があるため、注意が必要です.

Q: ウェブデータの不在は、phi-1.5モデルの改善にどのように寄与していますか?

A: phi-1.5のウェブデータの不在は、ウェブデータを用いたトレーニングと比較して、モデルの知識の格納とアクセスをより効率的に行うことで改善に寄与しています.これは、phi-1.5が推論タスクにおいてphi-1.5-webよりもかなり優れていることによって強調されています.さらに、phi-1.5のコーディング能力は、純粋にコードのためにトレーニングされたモデルであるphi-1の能力に非常に近いです.これは、高品質な教科書のようなデータをトレーニングに使用することで、モデルがタスクの組み合わせでトレーニングされている場合でもパフォーマンスを維持できることを示唆しています.

Q: なぜphi-1.5モデルはオープンソース化されたのですか?

A: phi-1.5モデルがオープンソース化された理由は、LLMに関する緊急の問題についてのさらなる研究を促進するためです.具体的には、文脈における学習、バイアスの緩和、幻覚などの問題についての研究を支援することを目的としています.

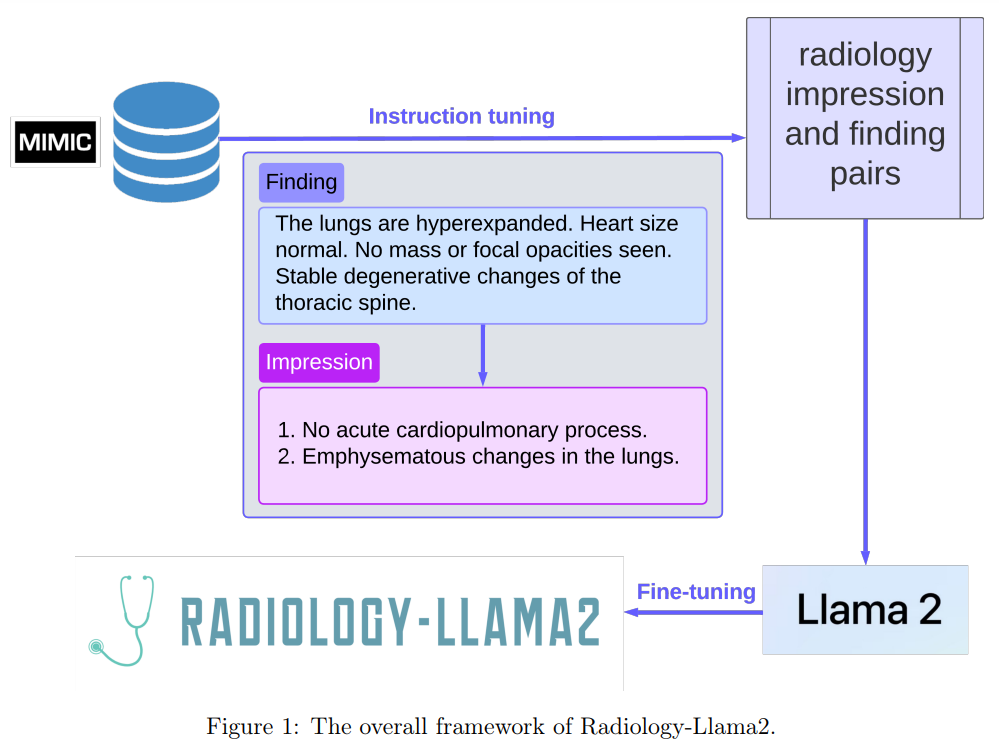

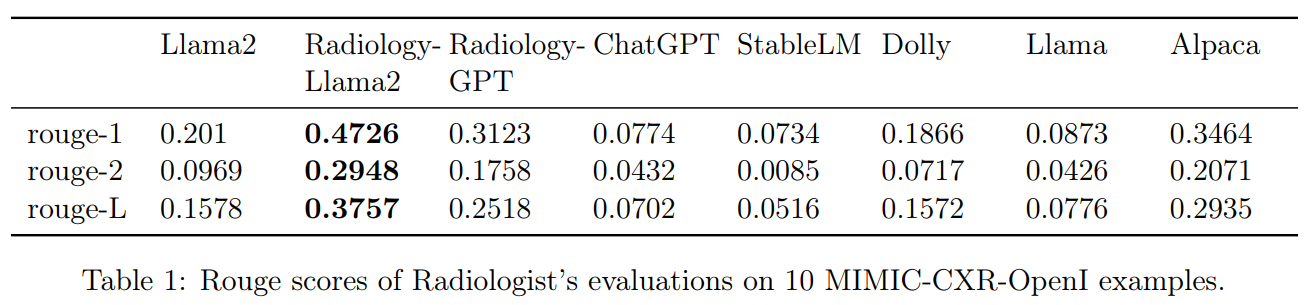

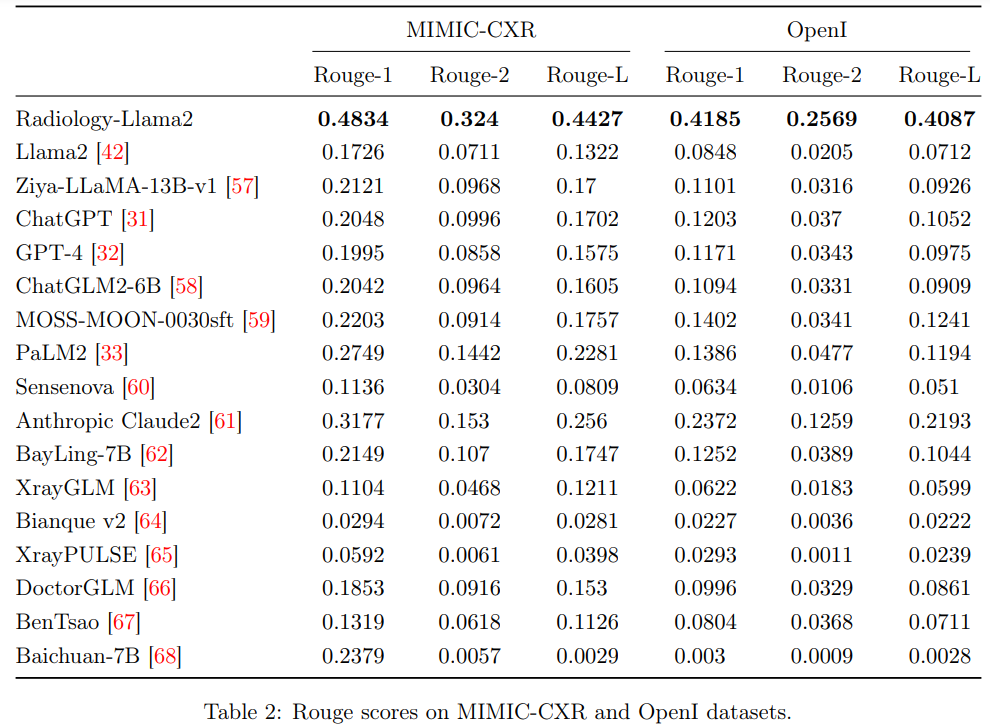

Radiology-Llama2: Best-in-Class Large Language Model for Radiology

著者:Zhengliang Liu, Yiwei Li, Peng Shu, Aoxiao Zhong, Longtao Yang, Chao Ju, Zihao Wu, Chong Ma, Jie Luo, Cheng Chen, Sekeun Kim, Jiang Hu, Haixing Dai, Lin Zhao, Dajiang Zhu, Jun Liu, Wei Liu, Dinggang Shen, Tianming Liu, Quanzheng Li, Xiang Li

発行日:2023年08月29日

最終更新日:2023年08月29日

URL:http://arxiv.org/pdf/2309.06419v1

カテゴリ:Computation and Language

概要:

この論文では、Radiology-Llama2という大規模な言語モデルが紹介されています.Radiology-Llama2は、指示調整というプロセスを通じて放射線学に特化したモデルです.Llama2アーキテクチャに基づいており、さらに大規模な放射線学レポートのデータセットでトレーニングされています.これにより、放射線学的な所見から一貫性のある臨床的に有用な印象を生成することができます.MIMIC-CXRデータセットとOpenIデータセットでのROUGEメトリクスを用いた定量的評価により、Radiology-Llama2は他の生成言語モデルと比較して最先端の性能を達成しており、MIMIC-CXRではRouge-1スコアが0.4834、OpenIでは0.4185です.放射線学の専門家による追加の評価では、モデルの理解可能性、一貫性、関連性、簡潔さ、臨床的有用性の強みが示されています.この研究は、放射線学のような特定の領域に設計され、調整されたローカライズされた言語モデルの可能性を示しています.適切に評価され、展開されると、このようなモデルは、ルーティンなタスクの自動化や人間の専門知識の向上によって、放射線学のような分野を変革することができます.

Q&A:

Q: インストラクションチューニングのプロセスとは何ですか?また、それがRadiology-Llama2の開発にどのように貢献していますか?

A: Instruction tuningは、Radiology-Llama2フレームワークの基本的なコンポーネントであり、LLM(Language and Vision Models)の従来のトレーニング目標と、ユーザー固有の指示に従う目標との間の根本的な不一致を解消するための技術です.この技術は、人間が指定した指示と対応する望ましい出力のペアを使用して追加のトレーニングを行うことで、モデルをタスク固有のユーザー目標に合わせ、モデルの制御可能性を向上させ、迅速なドメイン固有の適応を可能にします.また、計算効率を維持しながら、モデルをドメイン固有のデータに適応させることもできます.具体的には、「Findings」テキストには「Derive the impression from findings in the radiology reports」というような簡潔な指示が与えられます.Instruction tuningは、Radiology-Llama2の開発において、モデルの能力を向上させるために、多様な指示のペアを作成するための取り組みとして、重要な役割を果たしています.

Q: Llama2アーキテクチャと、それがRadiology-Llama2でどのように利用されているかを説明していただけますか?

A: Radiology-Llama2は、Llama2アーキテクチャをベースにしており、ラジオロジーの専門知識を持つ大規模な言語モデルです.Llama2アーキテクチャは、ラジオロジーの報告書のデータセットを使用してトレーニングされ、ラジオロジーの所見から一貫性のある臨床的に有用な印象を生成するために使用されます.Llama2は、指示の調整というプロセスを通じてトレーニングされ、ラジオロジーのタスクに適したモデルになっています.Radiology-Llama2は、MIMIC-CXRおよびOpenIデータセットでのROUGEメトリクスに基づく定量的評価により、他の生成言語モデルと比較して最先端のパフォーマンスを達成しています.

Q: Radiology-Llama2が訓練された放射線学のレポートのデータセットはどれくらい大きいですか?

A: Radiology-Llama2は、2011年から2016年の間にBeth Israel Deaconess Medical Center Emergency Departmentに来院した65,379人の患者に基づく227,835の画像検査を含む大規模な放射線科データセットで訓練されました.

Q: 放射線学的所見から、Radiology-Llama2はどのような具体的な印象を生成できますか?

A: 放射線科のLlama2は、所見から放射線診断の印象を生成することができます.

Q: Radiology-Llama2のパフォーマンスは、ROUGEメトリックスの観点から他の生成言語モデルと比較してどのようになりますか?

A: Radiology-Llama2は、MIMIC-CXRデータセットとOpenIデータセットの両方で、ROUGE-1、ROUGE-2、およびROUGE-Lのすべてのメトリックにおいて、すべての比較モデルを大幅に上回っています.

Q: Radiology-Llama2がMIMIC-CXRで0.4834、OpenIで0.4185のRouge-1スコアを達成した詳細をもっと提供していただけますか?

A: Radiology-Llama2は、MIMIC-CXRデータセットでRouge-1スコア0.4834を達成し、OpenIデータセットでRouge-1スコア0.4185を達成しました.

Q: 放射線学の専門家によって特定された理解可能性、一貫性、関連性、簡潔さ、臨床的有用性に関する具体的な強みは何でしたか?

A: ラジオロジストの評価によれば、Radiology-Llama2は理解可能性、一貫性、関連性、簡潔さ、臨床的有用性の面で特に優れているとされています.

Q: 放射線科のような分野を変革するために、Radiology-Llama2のようなローカライズされた言語モデルはどのような可能性を持っていますか?

A: Radiology-Llama2は、特定の領域である放射線科に適したローカライズされた言語モデルであり、放射線科のような特殊領域において、自動化された作業や人間の専門知識の向上によって、放射線科のような分野を変革する潜在能力を持っています.

Q: 放射線科の分野で、Radiology-Llama2のようなモデルによって自動化できる単調なタスクの例を示していただけますか?

A: 放射線科の分野であるRadiology-Llama2は、一貫性のある臨床的に関連性のあるレポートを自動生成するなど、単調なタスクを自動化することができます.このモデルは迅速にレポートを生成することができ、タイムリーかつ正確な報告が重要な忙しい放射線科部門で特に有益です.報告プロセスの一部を自動化することにより、Radiology-Llama2は放射線科医の補助ツールとして機能し、微妙な人間の専門知識が必要な複雑な症例により焦点を当てることができます.さらに、Radiology-Llama2はリアルタイムで放射線科医を支援する会話型アシスタントに発展させることができ、迅速なデータの取得や診断に関する第二意見などのタスクを提供します.このモデルとのダイナミックな相互作用は、診断エラーに対する貴重な保護手段となります.

Q: 適切に評価され、展開された場合、Radiology-Llama2は放射線科の分野で人間の専門知識をどのように向上させることができるのでしょうか?

A: Radiology-Llama2は、適切に評価され展開されることで、放射線科の専門家の能力を向上させることができます.放射線科医の貴重な補助ツールとして、迅速に一貫性のある臨床的に関連する報告書を生成し、報告プロセスの一部を自動化することができます.これにより、放射線科医は微妙な人間の専門知識が必要な複雑な症例により集中することができます.さらに、Radiology-Llama2は、リアルタイムで放射線科医を支援する対話型アシスタントに発展する可能性があります.診断に関する第二意見を提供し、即座のフィードバックを提供することで「第二の目」として機能します.これにより、診断エラーを防ぎ、放射線診断の正確性と効率性を向上させることができます.適切な監視の下で、Radiology-Llama2は臨床的な意思決定支援や他の応用において大きな潜在能力を持っており、他の医療領域における専門的な言語モデルの道を開くことができます.

Communicative Agents for Software Development

著者:Chen Qian, Xin Cong, Wei Liu, Cheng Yang, Weize Chen, Yusheng Su, Yufan Dang, Jiahao Li, Juyuan Xu, Dahai Li, Zhiyuan Liu, Maosong Sun

発行日:2023年07月16日

最終更新日:2023年08月28日

URL:http://arxiv.org/pdf/2307.07924v3

カテゴリ:Software Engineering, Computation and Language, Multiagent Systems

概要:

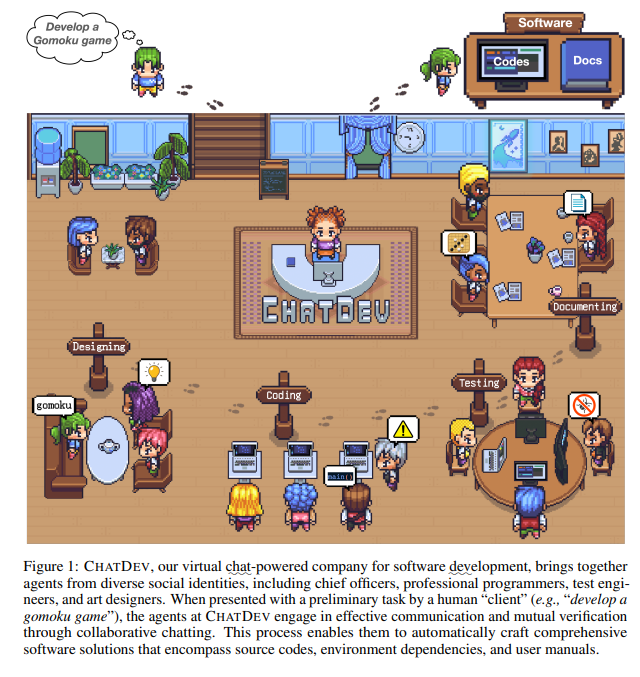

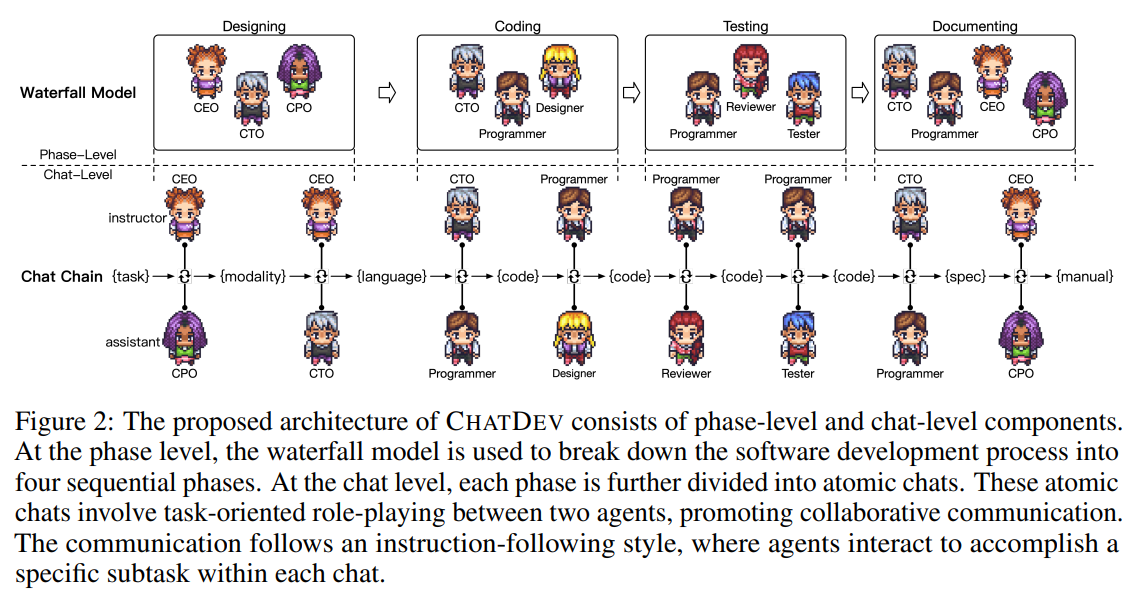

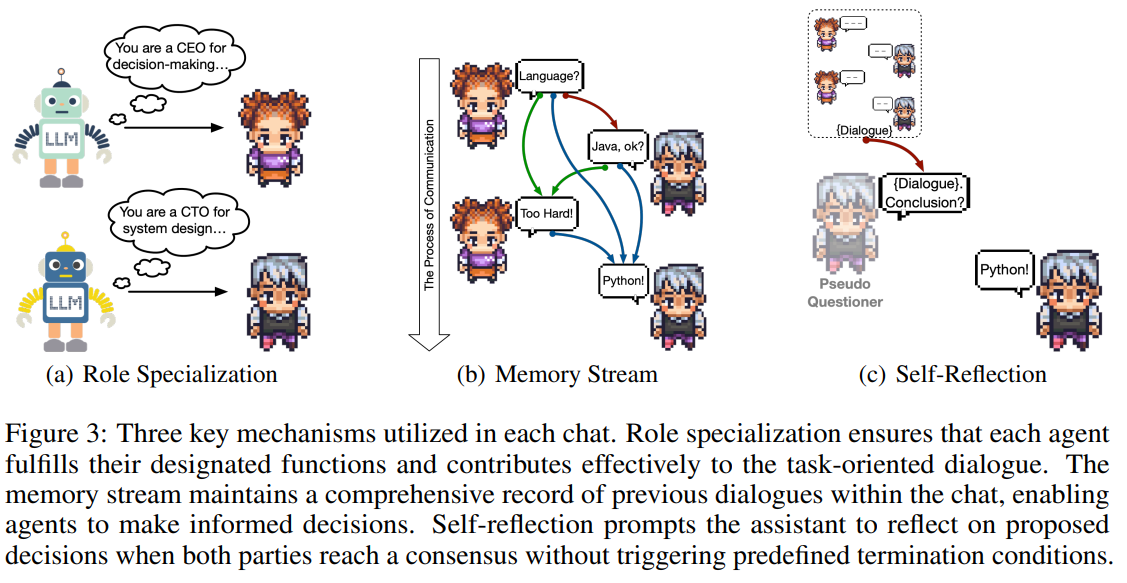

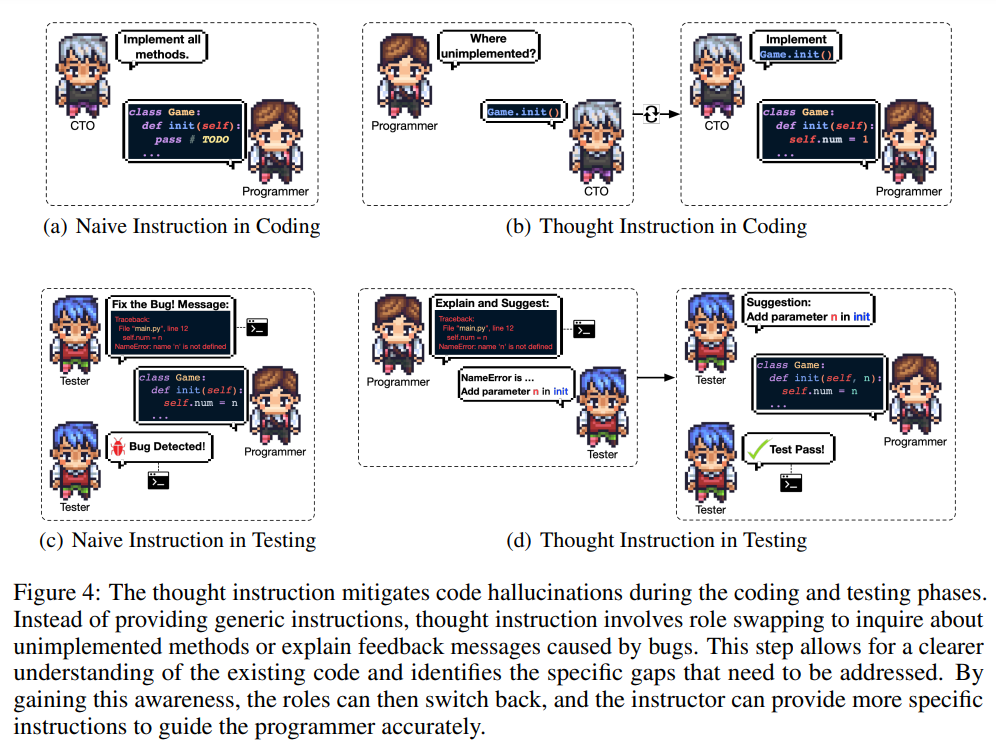

ソフトウェアエンジニアリングは、微妙な直感と相談に頼ることが多い複雑な意思決定プロセスに特徴付けられる領域です.最近の深層学習の進歩により、ソフトウェアエンジニアリングの実践が革新され始め、ソフトウェア開発のさまざまな段階で実装される緻密な設計を通じてプロセスが合理化されています.本論文では、大規模な言語モデル(LLM)をソフトウェア開発プロセス全体に活用し、自然言語コミュニケーションを通じて主要なプロセスを統一化する革新的なパラダイムを提案しています.このパラダイムの中心には、確立されたウォーターフォールモデルを模倣した仮想チャット駆動型ソフトウェア開発会社であるChatDevがあり、設計、コーディング、テスト、ドキュメント作成の4つの異なる時系列の段階に開発プロセスを細分化しています.各段階では、プログラマ、コードレビュアー、テストエンジニアなどのエージェントチームが関与し、協力的な対話を促進し、シームレスなワークフローを実現します.チャットチェーンはファシリテーターとして機能し、各段階を原子的なサブタスクに分解します.ChatDevは、提案と検証を通じて解決策を効率的に導き出すことができるため、各ステージを原子的なサブタスクに分解することで、効果的なコミュニケーションを実現します.ChatDevの分析結果によれば、ソフトウェア生成において非常に効果的であり、ソフトウェア開発プロセス全体を7分以内、1ドル未満のコストで完了させることができます.ChatDevは潜在的な脆弱性を特定し軽減するだけでなく、優れた効率性とコスト効果を維持しながら、潜在的な幻覚を修正することも可能です.ChatDevの可能性により、LLMをソフトウェア開発の領域に統合する新たな可能性が明らかになります.

Q&A:

Q: ソフトウェア開発において、大規模な言語モデル(LLM)を活用する革新的なパラダイムは、この論文で提示されていますか?

A: この論文では、大規模な言語モデル(LLM)を活用した革新的なパラダイムが紹介されています.このパラダイムは、自然言語コミュニケーションを通じて主要なプロセスを統合し、ソフトウェア開発の各フェーズで専門モデルの必要性を排除することで、ソフトウェア開発プロセス全体を効率化するものです.このパラダイムの中核には、CHATDEVという仮想チャット駆動型ソフトウェア開発会社があります.

Q: ChatDevは、仮想チャットを活用したソフトウェア開発会社ですが、どのようにソフトウェア開発の主要なプロセスを効率化し統一していますか?

A: CHATDEVは、ソフトウェア開発プロセスの各フェーズを原子的なサブタスクに分割する提案されたチャットチェーンを利用しています.チャットチェーン内では、異なる役割の人々がコンテキストに応じたマルチターンの議論を行い、解決策を提案し検証します.このアプローチにより、CHATDEVのエージェント間での効果的なコミュニケーションと協力が確保されます.さらに、CHATDEVはクラシックなウォーターフォールモデルに従い、設計、コーディング、テスト、文書化の4つのフェーズにプロセスを分割しています.プログラマ、レビュアー、テスターなど、異なる役割を持つ複数のエージェントが各フェーズで採用され、ソフトウェア開発の主要なプロセスの効率化と統一を促進します.

Q: ChatDevが従うソフトウェア開発プロセスの4つの明確な時系列のステージは何ですか?

A: CHATDEVは、クラシックなウォーターフォールモデルに従い、ソフトウェア開発プロセスを設計、コーディング、テスト、ドキュメント作成の4つの異なるフェーズに分割します.

Q: ChatDevのエージェントであるプログラマー、コードレビューアー、テストエンジニアなどの役割は、協力的な対話とシームレスなワークフローにおいてどのような役割を果たしていますか?

A: CHATDEVのエージェントは、プログラマー、コードレビュワー、テストエンジニアなどの役割を果たしており、共同の対話とシームレスなワークフローにおいて以下の役割を担当しています.プログラマーは、タスクの実装とコードの開発を担当し、コードの完成度を高めるために他のエージェントと協力します.コードレビュワーは、コードの品質を確認し、潜在的なバグや脆弱性を特定し、修正する役割を果たします.テストエンジニアは、ソフトウェアのテストを担当し、バグの特定と解決に貢献します.これらのエージェントは、各チャット内での役割間の協力的な相互作用と相互検証によって、効果的な意思決定を行っています.

Q: ChatDevのチャットチェーンは、各ステージを原子的なサブタスクに分解するのにどのように役立ちますか?

A: チャットチェーンは各ステージを原子的なサブタスクに分解するための手助けをします.各ノードは特定のサブタスクを表し、2つの役割がコンテキストに応じたマルチターンの議論を行い、解決策を提案し、検証します.このアプローチにより、クライアントの要件が分析され、創造的なアイデアが生成され、プロトタイプシステムが設計・実装され、潜在的な問題が特定・対処され、デバッグ情報が提供されます.

Q: ChatDevは、コンテキストに応じたコミュニケーションを通じて、提案や検証をどのように可能にしていますか?

A: CHATDEVは、各フェーズを原子的なサブタスクに分割するチャットチェーンを利用して、コンテキストに応じたコミュニケーションを通じてソリューションの提案と検証を可能にします.チャットチェーン内では、2つの役割がコンテキストに応じたマルチターンの議論を行い、ソリューションの提案と検証を行います.このアプローチにより、クライアントの要件が分析され、創造的なアイデアが生み出され、プロトタイプシステムが設計・実装され、潜在的な問題が特定・対処され、デバッグ情報が説明され、魅力的なグラフィックが作成され、ユーザーマニュアルが生成されます.CHATDEVは、チャットチェーンを通じてソフトウェア開発プロセスをガイドし、効果的なコミュニケーションと協力を通じてソリューションの提案と検証を容易にします.

Q: ChatDevの効果の計測分析は、ソフトウェア生成においてどのようなものであり、時間とコストの観点から従来のソフトウェア開発方法と比較してどのような違いがあるのか?

A: CHATDEVの楽器分析は、ソフトウェア生成における驚異的な効果を示しており、7分未満でソフトウェア開発プロセス全体を完了させることができ、費用は1ドル未満です.潜在的な脆弱性を特定し軽減するだけでなく、優れた効率とコスト効果を維持しながら、潜在的な幻覚も修正します.

Q: ChatDevは、ソフトウェア開発における潜在的な脆弱性をどのように特定し、軽減していますか?

A: CHATDEVは、各チャット内の役割間の協力的な相互作用と相互検査を通じて、ソフトウェア開発における潜在的な脆弱性を特定し、軽減します.異なる役割を持つ複数のエージェントを使用することで、CHATDEVはレビュアーとプログラマーの間でのコードの脆弱性の特定と修正、およびテスターとプログラマーの間での潜在的なバグの特定と解決のための議論を促進します.この協力的なアプローチにより、各サブタスクにおける効果的な意思決定と問題解決が可能となり、ソフトウェア開発プロセスにおける潜在的な脆弱性の特定と軽減が実現されます.

Q: ChatDevは、ソフトウェア開発における潜在的な幻覚をどのように修正しますか?

A: CHATDEVは、各独立したチャットプロセスに思考指示メカニズムを導入することで、ソフトウェア開発における潜在的な幻覚を修正します.このメカニズムでは、インストラクターがコードの修正に特定の思考を注入し、アシスタントプログラマーをより正確にガイドします.インストラクターは「役割反転」を行うことで、効果的にコミュニケーションを取り、修正案を提案することができ、相互の検討と効果的な意思決定を可能にします.これにより、LLMsを使用してソフトウェアシステムを直接生成する際の制約(不完全な実装、依存関係の欠如、未発見のバグなど)に対処するのに役立ちます.多様な社会的アイデンティティを持つエージェントから構成される仮想チャット駆動型ソフトウェア技術企業であるCHATDEVを通じて、このフレームワークは効率的なコミュニケーションと意思決定を可能にし、優れた効率性とコスト効果を維持しながら、潜在的な幻覚を修正します.

Q: ChatDevは、大規模な言語モデル(LLM)をソフトウェア開発の領域に統合するために、どのような新しい可能性を示していますか?

A: CHATDEVは、大規模言語モデル(LLM)をソフトウェア開発の領域に統合するための新たな可能性を提供し、ソフトウェア開発プロセス全体でLLMを活用します.それにより、各フェーズでの専門モデルの必要性を排除し、主要なプロセスを自然言語コミュニケーションによって統合しました.CHATDEVは、ソフトウェア生成において驚異的な効果を示し、7分未満でソフトウェア開発プロセス全体を完了させ、費用は1ドル未満です.潜在的な脆弱性を特定し緩和するだけでなく、潜在的な幻覚を修正し、優れた効率性とコスト効果を維持します.CHATDEVの可能性により、LLMをソフトウェア開発に統合する新たな可能性が開かれます.