今回のテーマ:Skeleton-of-Thought、MetaGPT、OpenFlamingo、 Med-Flamingo、RLHFの未解決の問題と限度、言語モデル計算における創発的な自己修復など.

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の10本となります.

- OpenFlamingo: An Open-Source Framework for Training Large Autoregressive Vision-Language Models (発行日:2023年08月02日)

- MetaGPT: Meta Programming for Multi-Agent Collaborative Framework (発行日:2023年08月01日)

- SelfCheck: Using LLMs to Zero-Shot Check Their Own Step-by-Step Reasoning (発行日:2023年08月01日)

- Discovering Adaptable Symbolic Algorithms from Scratch (発行日:2023年07月31日)

- Learning to Model the World with Language (発行日:2023年07月31日)

- ToolLLM: Facilitating Large Language Models to Master 16000+ Real-world APIs (発行日:2023年07月31日)

- Skeleton-of-Thought: Large Language Models Can Do Parallel Decoding (発行日:2023年07月28日)

- The Hydra Effect: Emergent Self-repair in Language Model Computations (発行日:2023年07月28日)

- Med-Flamingo: a Multimodal Medical Few-shot Learner (発行日:2023年07月27日)

- Open Problems and Fundamental Limitations of Reinforcement Learning from Human Feedback (発行日:2023年07月27日)

OpenFlamingo: An Open-Source Framework for Training Large Autoregressive Vision-Language Models

著者:Anas Awadalla, Irena Gao, Josh Gardner, Jack Hessel, Yusuf Hanafy, Wanrong Zhu, Kalyani Marathe, Yonatan Bitton, Samir Gadre, Shiori Sagawa, Jenia Jitsev, Simon Kornblith, Pang Wei Koh, Gabriel Ilharco, Mitchell Wortsman, Ludwig Schmidt

発行日:2023年08月02日

最終更新日:2023年08月07日

URL:http://arxiv.org/pdf/2308.01390v2

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Machine Learning

概要:

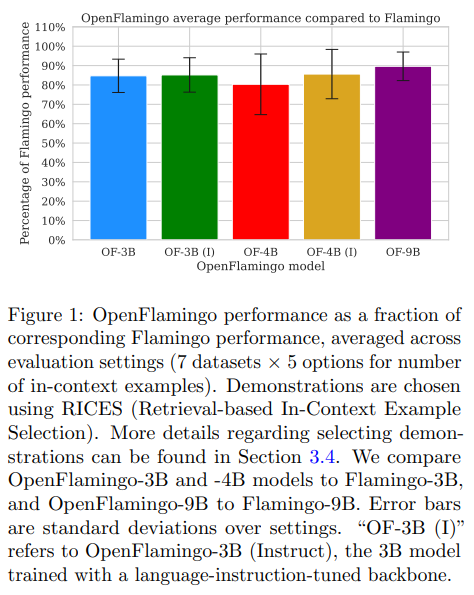

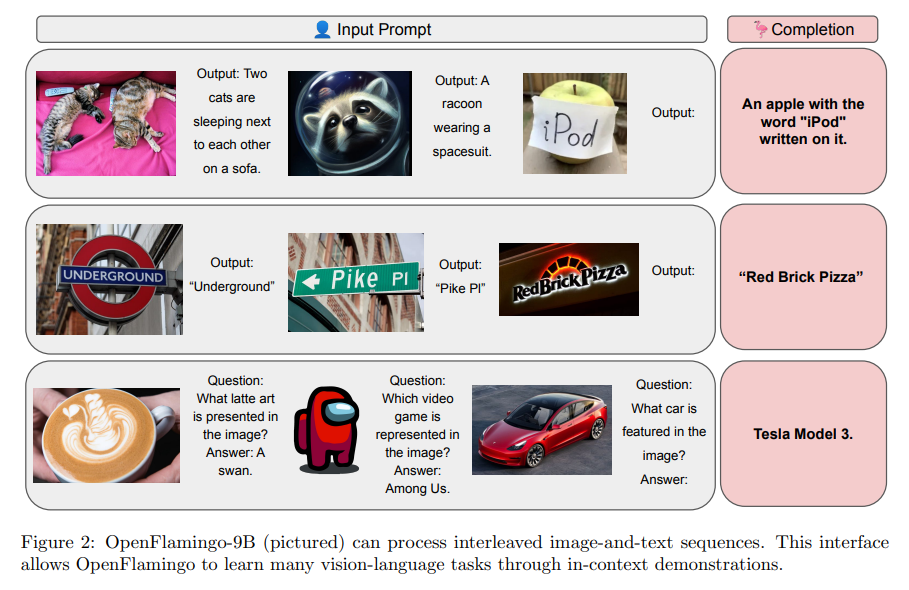

OpenFlamingoは、3Bから9Bのパラメータを持つビジョン言語モデルのファミリーであり、DeepMindのFlamingoモデルのオープンソースのレプリケーションを目指した取り組みです.OpenFlamingoモデルは、7つのビジョン言語データセットで、対応するFlamingoの性能の80〜89%を平均しています.この技術レポートでは、モデル、トレーニングデータ、ハイパーパラメータ、評価スイートについて説明しています.モデルとコードは、https://github.com/mlfoundations/open_flamingoで共有されています.

Q&A:

Q: OpenFlamingoの目的は何ですか?

A: OpenFlamingoの目的は、DeepMindのFlamingoモデルのオープンソースのレプリケーションを作成することです.

Q: OpenFlamingoのモデルにはいくつのパラメータがありますか?

A: OpenFlamingoモデルのパラメータは3Bから9Bまでの範囲です.

Q: 視覚言語データセットにおけるOpenFlamingoモデルの性能は、Flamingoモデルと比較してどうですか?

A: OpenFlamingoモデルのパフォーマンスは、対応するFlamingoモデルのパフォーマンスの80〜89%の範囲に平均しています.

Q: OpenFlamingoで使用されているモデル、トレーニングデータ、ハイパーパラメータ、評価スイートについての詳細を教えてください.

A: OpenFlamingoは、3Bから9Bのパラメータを持つ自己回帰型のビジョン言語モデルのファミリーです.このモデルは、DeepMindのFlamingoモデルのオープンソースのレプリケーションを作成するための取り組みであり、7つのビジョン言語データセットにおいて、OpenFlamingoモデルは対応するFlamingoモデルの80〜89%の性能を平均しています.この技術レポートでは、モデル、トレーニングデータ、ハイパーパラメータ、評価スイートについて詳細を説明しています.

Q: OpenFlamingoのモデルやコードはどこからアクセスできますか?

A: OpenFlamingoのモデルとコードは、https://github.com/mlfoundations/open_flamingo でアクセスできます.

Q: OpenFlamingoに関する制限や課題はありますか?

A: OpenFlamingoの制限として、モデルはウェブスクレイピングされたデータで訓練されており、安全に焦点を当てたファインチューニングは行われていません.そのため、モデルは予期しない、不適切な、または不正確な出力を生成する可能性があります.OpenFlamingoの安全性に関する調査をさらに進める予定です.

Q: OpenFlamingoの今後の改善やアップデートの予定はありますか?

A: OpenFlamingoは現在も研究プロジェクトとして進行中であり、高品質な自己回帰型ビジョン言語モデルのトレーニングとリリースに取り組んでいます.私たちの貢献がより多くの研究者にモデルのトレーニングと研究を可能にすることを願っています.

MetaGPT: Meta Programming for Multi-Agent Collaborative Framework

著者:Sirui Hong, Xiawu Zheng, Jonathan Chen, Yuheng Cheng, Ceyao Zhang, Zili Wang, Steven Ka Shing Yau, Zijuan Lin, Liyang Zhou, Chenyu Ran, Lingfeng Xiao, Chenglin Wu

発行日:2023年08月01日

最終更新日:2023年08月02日

URL:http://arxiv.org/pdf/2308.00352v2

カテゴリ:Artificial Intelligence, Multiagent Systems

概要:

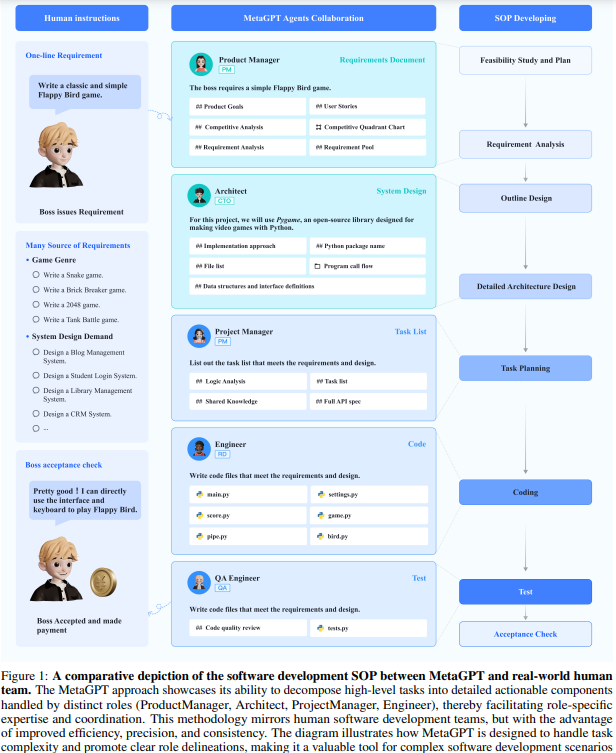

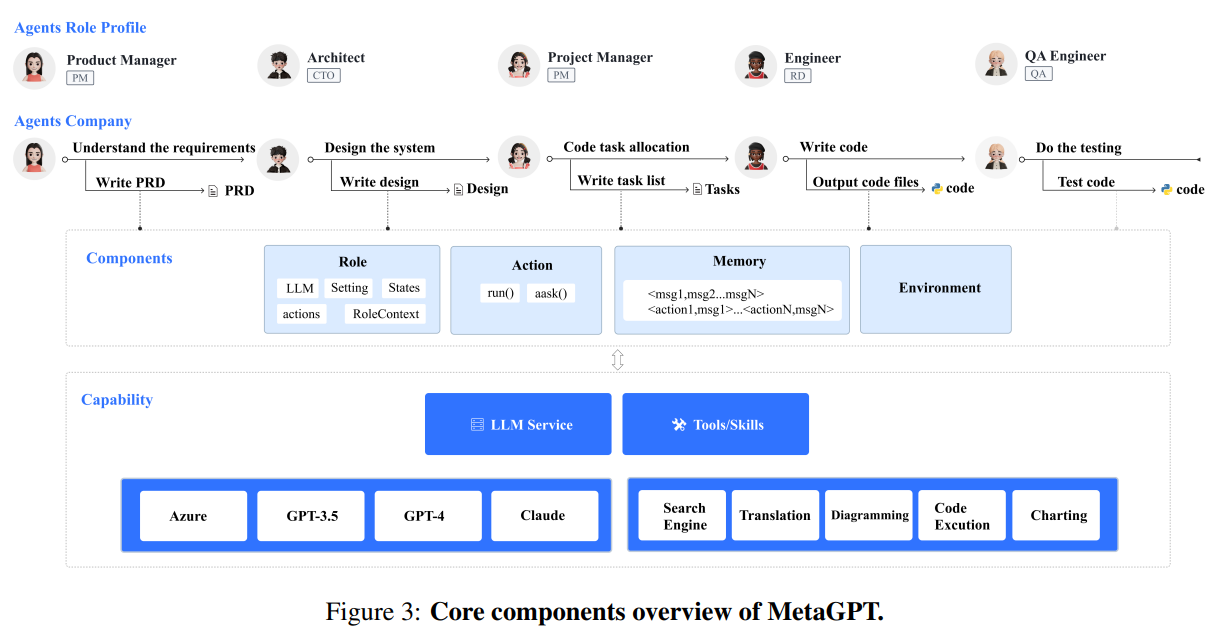

最近、大規模な言語モデル(LLM)によって駆動されるマルチエージェントを使用した自動タスク解決において、注目すべき進展が見られています.しかし、既存の研究は主に、探索や複雑なタスクにおける調査を欠いた単純なタスクに焦点を当てており、その主な原因は幻覚問題です.このような幻覚は、複数の知的エージェントが相互作用することで無限に増幅され、複雑な問題に取り組む際に失敗を招きます.そのため、本研究では、効果的な人間のワークフローをメタプログラミングのアプローチとしてLLM駆動のマルチエージェント協力に組み込む革新的なフレームワークであるMetaGPTを紹介します.具体的には、MetaGPTはまず、標準化された作業手順(SOP)をプロンプトにエンコードし、構造化された調整を促進します.そして、モジュラーな出力を要求することで、エージェントにドメインの専門知識を与え、出力の検証と複合エラーの削減を行います.このように、MetaGPTはアセンブリラインの作業モデルを活用して、さまざまなエージェントに異なる役割を割り当てることで、複雑なマルチエージェントを効果的かつ結束して分解するフレームワークを確立します.さらに、私たちの実験では、ソフトウェアエンジニアリングの協力タスクにおいて、MetaGPTが既存の会話型マルチエージェントシステムに比べてより高い結束性を持つ包括的な解決策を生成する能力を示しました.これは、人間のドメイン知識をマルチエージェントに組み込むことの潜在能力を強調し、複雑な現実世界の課題に取り組むための新たな可能性を開拓しています.このプロジェクトのGitHubリポジトリは、次のURLで公開されています:https://github.com/geekan/MetaGPT

Q&A:

Q: MetaGPTが取り組んでいる主な問題は何ですか?

A: MetaGPTの主な問題は、非存在のリソースファイルへの参照や未定義のクラスや変数の呼び出しによるエラーの発生です.

Q: MetaGPTはマルチエージェントコラボレーションにおける幻覚問題にどう対処するのか?

A: MetaGPTは、効果的な人間のワークフローをメタプログラミングのアプローチとしてLLM駆動のマルチエージェントの協力に組み込む革新的なフレームワークです.具体的には、MetaGPTは標準化された作業手順(SOP)をプロンプトにエンコードし、構造化された調整を促進します.そして、より明確で効率的なエージェントの協力ワークフローによって、大規模言語モデルに固有の幻覚傾向に起因する問題を解決します.

Q: MetaGPTにおける標準作業手順書(SOP)の役割は何ですか?

A: MetaGPTでは、標準化された作業手順(SOPs)が役割ベースのアクション仕様にエンコードされ、エージェントアーキテクチャに組み込まれます.これにより、エージェントはドメインの専門知識を持つことができます.SOPsはプロセスの標準化と誤りの蓄積の削減を通じて、エージェントの出力を検証するために使用されます.また、SOPsはプロンプトを介してMetaGPTに具体的なアクションインスタンスを提供するために使用されます.

Q: MetaGPTは組立ライン作業モデルをどのように活用しているのか?

A: MetaGPTは、アセンブリラインの作業モデルを活用して、さまざまなエージェントに異なる役割を割り当てることで、複雑なマルチエージェントの協調問題を効果的かつ結束して分解するフレームワークを確立します.

Q: MetaGPTが効果的に解決できるタイプのタスクの例を教えてください.

A: MetaGPTは、Pythonゲームの生成、CRUDコードの生成、簡単なデータ分析などのタスクを効果的に解決することができます.

Q: MetaGPTは、会話やチャットをベースとした既存のマルチエージェントシステムと比較して、一貫性という点でどうでしょうか?

A: 既存の会話型およびチャットベースのマルチエージェントシステムと比較して、MetaGPTはより高い一貫性を持つ包括的な解を生成することができます.

Q: MetaGPTが人間のドメイン知識をどのようにマルチエージェントに組み込んでいるのか説明していただけますか?

A: MetaGPTは、人間のドメイン知識をマルチエージェントに組み込むために、いくつかの手法を使用しています.まず第一に、各エージェントは職務タイトルによって識別され、適切な役割固有のプロンプト接頭辞でシステムを初期化することができます.これにより、単純な役割プレイのプロンプトではなく、エージェントの定義にドメイン知識を埋め込むことができます.第二に、効率的な人間のワークフローを分析し、共同作業に必要な手順知識をカプセル化したSOP(標準作業手順)を抽出します.これらのSOPは、役割ベースのアクション仕様を介してエージェントアーキテクチャにエンコードされます.第三に、エージェントは標準化されたアクション出力を生成し、知識共有を可能にします.人間の実践を形式化することで、エージェントはドメイン知識を組み込むことができます.

Q: 人間の領域知識をマルチエージェントに組み込むことの潜在的な利点とは?

A: 人間のドメイン知識をマルチエージェントに取り入れることによって、以下のような潜在的な利点があります.

- 高い一貫性を持つ解決策の提供:人間のドメイン知識は、既存の会話型およびチャットベースのマルチエージェントシステムに比べて、より高い一貫性を持つ解決策の提供に役立ちます.

- 複雑な現実世界の課題への対処:人間のドメイン知識をマルチエージェントに組み込むことで、複雑な現実世界の課題に取り組むための新しいアプローチが可能になります.

- 人間のプロセス管理経験の活用:人間のドメイン知識は、マルチエージェントシステムにおいて、高度な人間のプロセス管理経験を活用することができます.

- 一貫性の維持:人間のドメイン知識を取り入れることで、マルチエージェント間の協力において一貫性を維持することができます.

- 生産的なフィードバックループの回避:人間のドメイン知識を組み込むことで、生産的でないフィードバックループを回避することができます.

- 有益な相互作用の誘導:人間のドメイン知識を取り入れることで、有益な相互作用を誘導することができます.

Q: MetaGPTの導入に伴う制限や課題はありますか?

A: MetaGPTの実装にはいくつかの制限や課題があります.主に、存在しないリソースファイル(画像や音声など)を参照することがあります.さらに、複雑なタスクの実行中には、未定義またはインポートされていないクラスや変数を呼び出す可能性があります.これらの現象は広く認識されています.

Q: MetaGPTプロジェクトのGitHubリポジトリについて、もう少し詳しく教えてください.

A: MetaGPTプロジェクトのGitHubリポジトリは、https://github.com/geekan/MetaGPTで公開されています.

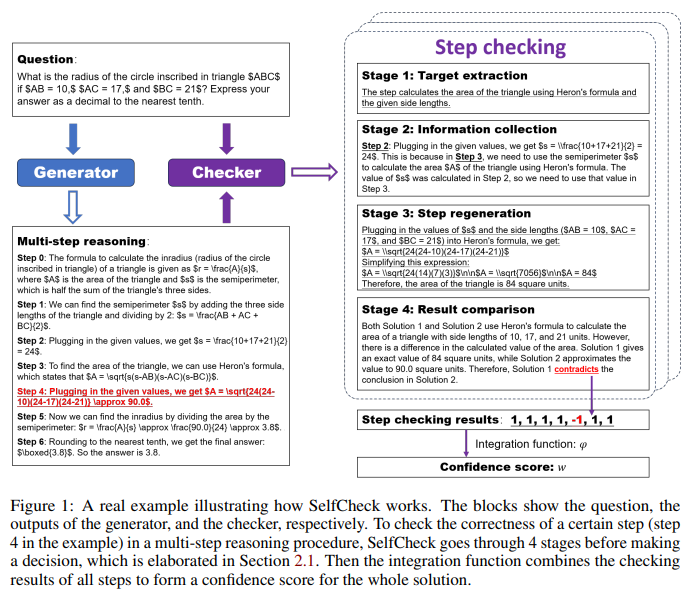

SelfCheck: Using LLMs to Zero-Shot Check Their Own Step-by-Step Reasoning

著者:Ning Miao, Yee Whye Teh, Tom Rainforth

発行日:2023年08月01日

最終更新日:2023年08月02日

URL:http://arxiv.org/pdf/2308.00436v2

カテゴリ:Artificial Intelligence, Computation and Language, Machine Learning

概要:

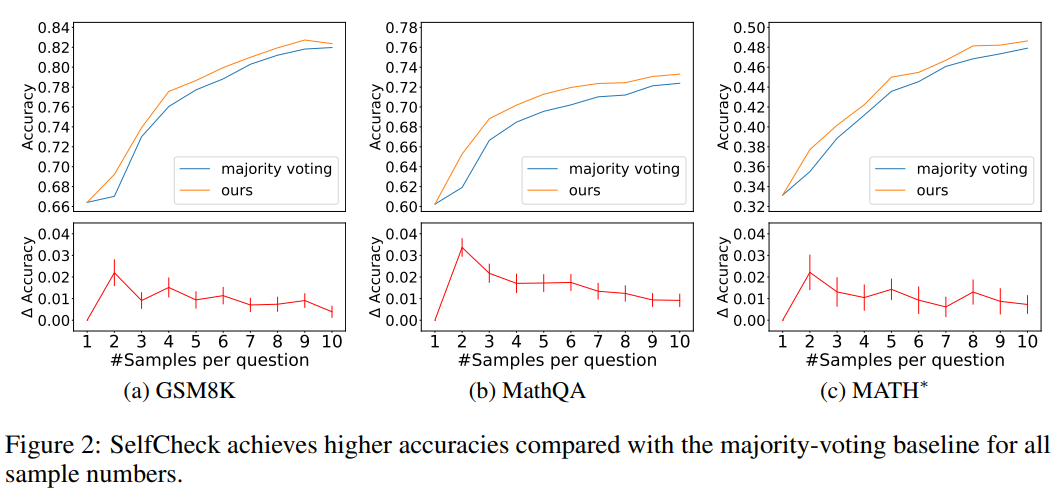

最近の大規模言語モデル(LLM)の進歩、特に連鎖思考(CoT)プロンプティングの発明により、推論問題を解決することが可能になりました.しかし、最も強力なLLMでも、非線形思考や多段階の推論を必要とするより複雑な問題にはまだ苦労しています.本研究では、LLMが外部リソースに頼らずに自身のエラーを認識する能力を持っているかどうかを探求します.特に、ステップバイステップの推論内で個々のエラーを識別するために、ゼロショットの検証スキームを提案します.その後、この検証スキームを使用して、異なる生成された回答に対して重み付け投票を行うことで、質問応答のパフォーマンスを向上させるために使用します.我々は、この方法を3つの数学データセット(GSM8K、MathQA、MATH)でテストし、エラーを正しく認識し、それによって最終的な予測パフォーマンスが向上することを確認しました.

Q&A:

Q: 思考の連鎖(CoT)プロンプティングとは何か、推論問題の解決にどう関係するのか?

A: CoTプロンプティングは、大規模言語モデル(LLMs)の進歩の一環として開発された手法であり、推論問題の解決を可能にします.CoTプロンプティングは、LLMsが複雑な問題を解決するために非線形思考と多段階の推論が必要な場合に苦戦している問題に対処するために使用されます.具体的には、CoTプロンプティングは、LLMsがステップバイステップの推論内で個々のエラーを識別する能力を持っているかどうかを調査するために使用されます.

Q: 最強のLLMでさえ苦戦する推論問題の種類とは?

A: 最も強力なLLMでも苦労する推論問題は、複雑な推論を必要とする問題です.特に、多段階の推論を必要とする問題や非線形思考を必要とする問題に対して、LLMは誤りを起こしやすい傾向があります.

Q: この研究では、LLMが自らの誤りを認識する能力をどのように探っているのだろうか?

A: この研究では、LLMsが自分自身のエラーを認識する能力を探求しています.具体的には、LLMsがステップバイステップの推論内で個々のエラーを特定することができるかどうかを調査しています.

Q: 提案されているゼロショット検証方式とはどのようなもので、どのように機能するのか?

A: 提案されたゼロショット検証スキームは、ステップ再生成に基づいています.SelfCheckはステップバイステップのチェッカーとして機能し、LLMの推論プロセスの各ステップを個別にチェックします.LLMの出力推論の各ステップに対して、SelfCheckはまず関連する情報を収集してより単純な文脈を形成し、それをステップ再生成によってチェックします.次に、個々のステップのチェック結果を統合して、全体の解決策に対する信頼スコアを形成します.同じ質問に対する複数の解決策の間で信頼スコアを重みとして使用することで、SelfCheckは質問回答の性能を向上させることができます.

Q: 検証スキームは、質問に対する解答のパフォーマンスを向上させるためにどのように使用されるのですか?

A: 提案された検証スキームは、異なる生成された回答に対して重み付け投票を行うことで、質問応答のパフォーマンスを向上させるために使用されます.

Q: どの数学のデータセットを使ってこの方法をテストしたのですか?

A: GSM8K、MathQA、MATHの3つの数学データセットが使用されました.

Q: この方法は、テストされたデータセットのエラーをうまく認識できたか?

A: 提案された検証手法は、テストされたデータセットでエラーを正しく認識することに成功しました.

Q: エラーの認識は、最終的な予測能力の向上にどのように貢献したのだろうか?

A: 誤りの認識により、最終的な予測性能が向上しました.これは、提案されたゼロショット検証スキームがエラーを正しく認識し、生成された異なる回答に対して重み付け投票を行うことで実現されました.この検証スキームにより、エラーパターンの特定や訓練データや例の大量の必要性を排除し、より広範なエラーの認識が可能となりました.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のURLはhttps://github.com/NingMiao/SelfCheckです.

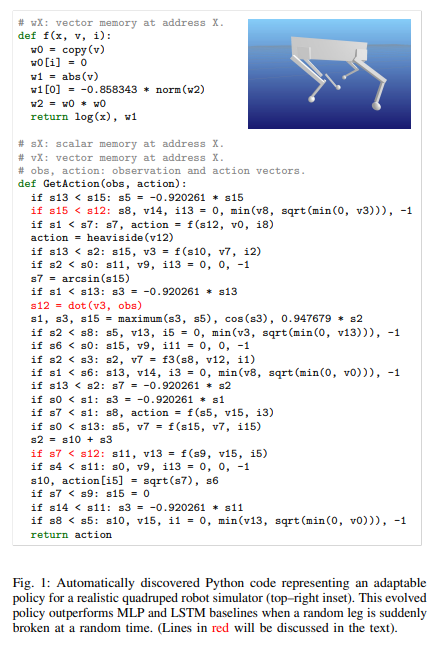

Discovering Adaptable Symbolic Algorithms from Scratch

著者:Stephen Kelly, Daniel S. Park, Xingyou Song, Mitchell McIntire, Pranav Nashikkar, Ritam Guha, Wolfgang Banzhaf, Kalyanmoy Deb, Vishnu Naresh Boddeti, Jie Tan, Esteban Real

発行日:2023年07月31日

最終更新日:2023年07月31日

URL:http://arxiv.org/pdf/2307.16890v1

カテゴリ:Robotics, Artificial Intelligence, Machine Learning, Neural and Evolutionary Computing

概要:

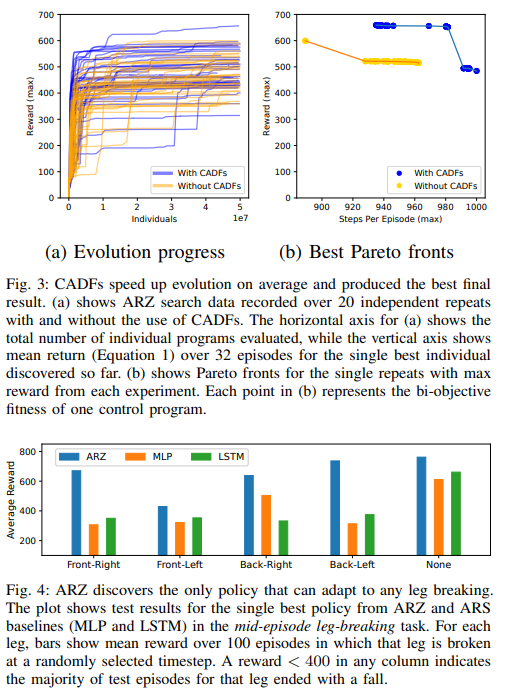

現実世界で展開される自律ロボットは、環境の変化に迅速に適応する制御ポリシーが必要とされます.そのために、私たちはAutoML-Zeroに基づいたAutoRobotics-Zero(ARZ)という手法を提案しています.ニューラルネットワークの適応ポリシーでは、モデルのパラメータのみが最適化されますが、ARZは線形レジスタマシンの完全な表現力を持つ制御アルゴリズムを構築することができます.私たちは、モデルのパラメータを調整し、推論アルゴリズムをリアルタイムで変更するモジュラーポリシーを進化させ、突然の環境変化に適応する安全な制御ポリシーを進化させます.私たちは、個々の四肢が突然壊れた場合に倒れるのを避ける安全な制御ポリシーを進化させる、リアルなシミュレーションされた四足ロボットで私たちの手法を実証します.このタスクは、2つの人気のあるニューラルネットワークのベースラインが失敗する難しいタスクです.最後に、私たちは新しい難しい非定常制御タスクであるCataclysmic Cartpoleについて、私たちの手法の詳細な分析を行います.結果は、ARZが突然の環境変化に対して非常に堅牢であり、シンプルで解釈可能な制御ポリシーを構築できることを確認しています.

Q&A:

Q: AutoRobotics-Zero(ARZ)の主な目的は何ですか?

A: AutoRobotics-Zero (ARZ)の主な目的は、環境の変化に迅速に適応する制御ポリシーを見つけることです.

Q: ARZはニューラルネットワークの適応政策とどう違うのか?

A: ARZはニューラルネットワークの適応ポリシーとは異なり、モデルパラメータだけでなく制御アルゴリズム自体を構築することができます.

Q: リニアレジスタマシンの表現力とは?

A: 線形レジスタマシンの表現力は、仮想メモリ上で動作する線形レジスタマシンによって実現されます.この線形レジスタマシンは、スカラー、ベクトル、行列、およびインデックスの4種類のメモリをサポートしています.スカラー、ベクトル、および行列メモリは浮動小数点数であり、インデックスメモリは整数を格納します.アルゴリズムは、StartEpisode()とGetAction()という2つのコア関数で構成されています.StartEpisode()は、各エピソードの開始時に一度実行され、進化した定数で仮想メモリの内容を初期化するためのものです.GetAction()関数では、進化したアルゴリズムの状態を調整したり、制御コードを動的に変更したりすることで、適応性を持つアルゴリズムを発見することが目標です.

Q: ARZは急激な環境変化にどのように適応しているのだろうか?

A: ARZは、環境の急激な変化に適応するために、モデルパラメータを調整し推論アルゴリズムを変更するモジュラーポリシーを進化させます.

Q: デモに使用された模擬四脚ロボットについて、もう少し詳しく教えてください.

A: デモンストレーションで使用されるシミュレートされた四足ロボットは、Unitree Laikagoと呼ばれるものです.このロボットは、各脚に3つの駆動自由度を持つ四足ロボットであり、アクションスペースは12次元の実数値であり、モーターの角度を表しています.また、比例微分制御器を使用して、これらの目標角度を追跡しています.観測スペースには、各関節の角度と速度、ロボットの位置、姿勢、速度を表す37個の実数値が含まれています.各エピソードは、ロボットが安定した直立姿勢で始まり、最大1000タイムステップ(10秒)続きます.ポリシーによって提案される各アクションは、10回の連続したステップで繰り返されます.

Q: 四足歩行ロボットのタスクにおいて、2つの一般的なニューラルネットワークのベースラインにはどのような限界があったのだろうか?

A: MLPとLSTMの2つの人気のあるニューラルネットワークのベースラインは、この四足ロボットのタスクでは頑健な振る舞いを学習することができませんでした.

Q: カタクリコントロールタスクについて、もう少し詳しく説明してもらえますか?

A: Cataclysmic Cartpoleは、適応が重要なおもちゃのタスクであり、実際のロボットのシミュレーションは計算量が多いため、より管理しやすいタスクとして導入されました.このタスクでは、突然の変化があり、モジュール化/階層化ポリシーの研究とその分散のジレンマの影響を強調することができます.ARZの結果を強調するために、Cataclysmic Cartpoleタスクは迅速な実験を行うのに役立ち、解釈可能性を提供します.また、将来の研究で簡単に再現可能な環境を提供することも期待されています.

Q: 急激な環境変化に対するロバスト性という点で、ARZは他の手法と比べてどうなのか?

A: ARZは他の方法と比較して、突然の環境変化に対する頑健性が高いです.

Q: ARZが構築したコントロール・ポリシーのシンプルさと解釈のしやすさについて詳しく教えてください.

A: ARZの制御ポリシーは、シンプルで解釈可能性が高い特徴を持っています.ARZは、線形レジスタマシンの完全な表現力を持つ制御アルゴリズムを構築することができます.ARZは、モデルパラメータを調整し、推論アルゴリズムをリアルタイムで変更するモジュラーポリシーを進化させます.ARZは、突然の環境変化に適応するために、安全な制御ポリシーを進化させます.ARZの制御ポリシーは、突然の環境変化に対して非常に堅牢であり、シンプルで解釈可能な制御ポリシーを構築することができます.

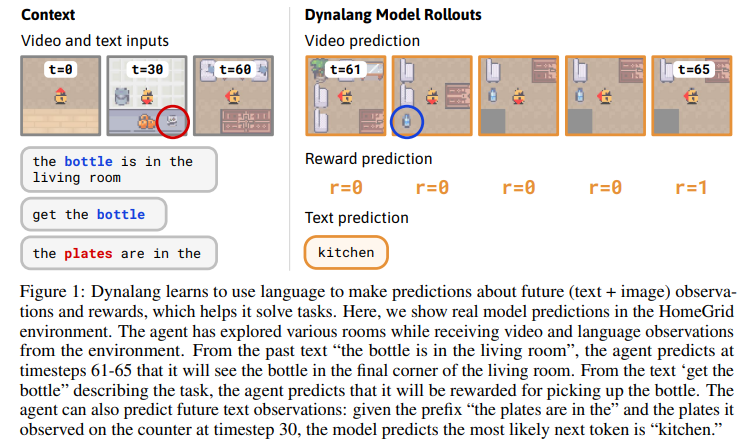

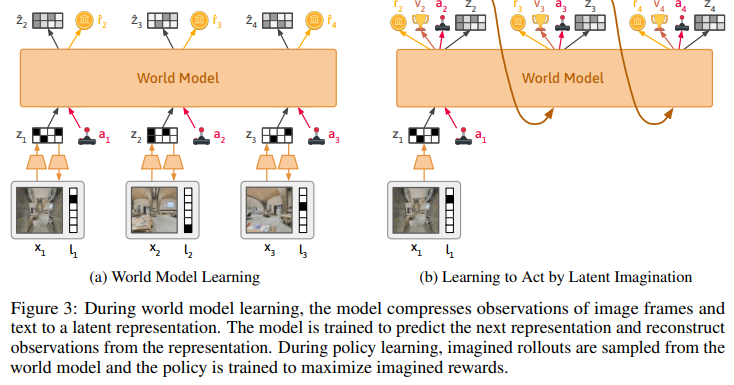

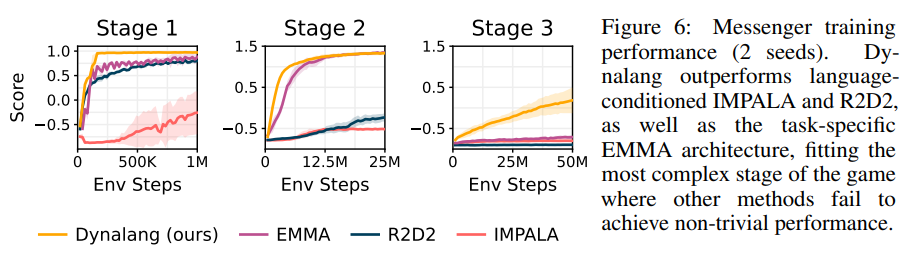

Learning to Model the World with Language

著者:Jessy Lin, Yuqing Du, Olivia Watkins, Danijar Hafner, Pieter Abbeel, Dan Klein, Anca Dragan

発行日:2023年07月31日

最終更新日:2023年07月31日

URL:http://arxiv.org/pdf/2308.01399v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

人間との対話を行うためには、エージェントは人々が使用するさまざまな言語を理解し、それを視覚的な世界に関連付け、それに基づいて行動する必要があります.現在のエージェントは、タスクの報酬から単純な言語の指示を実行することを学習していますが、私たちは一般的な知識を伝える多様な言語を活用するエージェントを構築することを目指しています.私たちの主なアイデアは、言語がエージェントが未来を予測するのに役立つということです.具体的には、何が観察されるか、世界がどのように振る舞うか、どのような状況が報酬をもたらすかを予測します.この視点により、言語理解と将来の予測を強力な自己教師あり学習目標として統合することができます.私たちはDynalangというエージェントを提案し、将来のテキストと画像の表現を予測するマルチモーダルなワールドモデルを学習し、想像されたモデルの展開から行動を学習します.言語を予測するためだけに言語を使用する従来のエージェントとは異なり、Dynalangは過去の言語を使用して将来の言語、ビデオ、報酬も予測することで豊かな言語理解を獲得します.環境でのオンラインの相互作用から学習するだけでなく、Dynalangは事前学習も行うことができます.また、Dynalangはグリッドワールドでの言語のヒントの使用から、写真のようなリアルな家のスキャンのナビゲーションまで、さまざまなタイプの言語を利用してタスクのパフォーマンスを向上させるため、環境の説明、ゲームのルール、指示などの言語を活用します.

Q&A:

Q: Dynalangは一般的な知識を伝えるために、どのように多様な言葉を活用しているのでしょうか?

A: Dynalangは、将来のテキストや画像の表現を予測するために多様な言語を活用し、一般的な知識を伝えることを目的としています.過去の言語を利用して、将来の言語、動画、報酬を予測します.これにより、Dynalangは世界に関するさまざまな種類の言語を理解し、環境の説明、ゲームのルール、そして指示を活用してタスクのパフォーマンスを向上させることができます

Q: Dynalangは言語を使ってどのように未来を予測するのか?

A: Dynalangは、将来の言語、ビデオ、および報酬を予測するために過去の言語を使用します.Dynalangは、将来のテキストおよび画像表現を予測するためにマルチモーダルな世界モデルを学習します.将来の予測を通じて言語を視覚的な経験に基づいて接地化することにより、Dynalangは、アクション空間で言語を出力することによって環境について話すことができます.

Q: Dynalangは、モデル展開の想像からどのように行動を学ぶのか?

A: Dynalangは、想像されたモデルの展開から行動を学習します.モデルの展開は、言語の説明、タスク、および同じアクションのシーケンスに基づいて条件付けられます.Dynalangは、モデルの想像された軌跡をサンプリングすることで、行動を学習します.

Q: Dynalangは過去の言語を使って、どのように豊かな言語理解を獲得していくのか?

A: Dynalangは、過去の言語を使用して豊かな言語理解を獲得します.過去の言語を使用することで、Dynalangは将来の言語、ビデオ、および報酬を予測することができます.

Q: Dynalangは、テキスト、ビデオ、またはアクションや報酬のない両方のデータセットで事前学習できますか?

A: はい、Dynalangはアクションや報酬がないテキスト、ビデオ、またはその両方のデータセットで事前学習することができます.

Q: Dynalangはどのようにグリッドワールドの言語ヒントを利用して、タスクのパフォーマンスを向上させているのですか?

A: Dynalangは、グリッドワールドでのタスクパフォーマンスを向上させるために、将来の観測、環境のダイナミクス、修正に関する言語のヒントを使用します.

Q: Dynalangは多様な言語を使って、どのように住宅のフォトリアリスティックなスキャンをナビゲートするのか?

A: Dynalangは、異なる種類の言語を使用してタスクのパフォーマンスを向上させるために、環境の説明、ゲームのルール、および指示など、多様な種類の言語を利用します.具体的には、Dynalangは、光学的にリアルな家のスキャンをナビゲートするために、環境の説明、ゲームのルール、および指示など、さまざまな種類の言語を使用します.

Q: Dynalangがタスクのパフォーマンスを向上させるために活用している多様な言語の例には、どのようなものがありますか?

A: Dynalangは、タスクのパフォーマンスを向上させるために、将来の観察に関する言語的ヒント、環境のダイナミクス、修正、ゲームマニュアル、視覚的および言語的に複雑な領域の指示など、多様な種類の言語を利用しています.

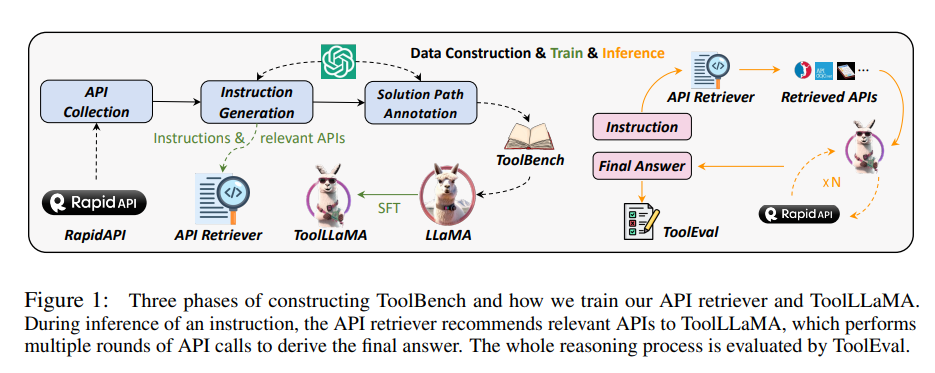

ToolLLM: Facilitating Large Language Models to Master 16000+ Real-world APIs

著者:Yujia Qin, Shihao Liang, Yining Ye, Kunlun Zhu, Lan Yan, Yaxi Lu, Yankai Lin, Xin Cong, Xiangru Tang, Bill Qian, Sihan Zhao, Runchu Tian, Ruobing Xie, Jie Zhou, Mark Gerstein, Dahai Li, Zhiyuan Liu, Maosong Sun

発行日:2023年07月31日

最終更新日:2023年07月31日

URL:http://arxiv.org/pdf/2307.16789v1

カテゴリ:Artificial Intelligence, Computation and Language, Machine Learning

概要:

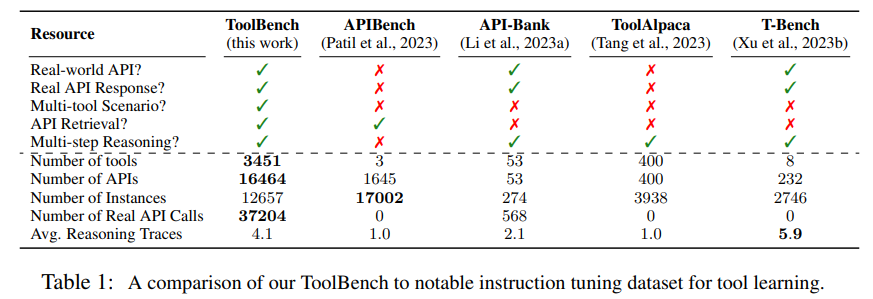

オープンソースの大規模言語モデル(LLM)やその派生モデル(LLaMAやVicunaなど)の進歩にもかかわらず、これらは外部ツール(API)の使用に関する人間の指示に従うというより高度なタスクの実行には制約があります.これは、現在の指示の調整がツールの使用領域ではなく、基本的な言語タスクに主に焦点を当てているためです.これに対して、ChatGPTなどの最先端のLLMは、優れたツールの使用能力を示していますが、残念ながらクローズドソースです.

オープンソースのLLM内でツールの使用能力を実現するために、我々はToolLLMを紹介します.これは、データの構築、モデルのトレーニング、評価のための一般的なツール使用フレームワークです.まず、ChatGPTを使用して自動的に作成されたツール使用のための指示調整データセットであるToolBenchを紹介します.具体的には、RapidAPI Hubから49のカテゴリにわたる16,464の実世界のRESTful APIを収集し、それらのAPIを含む多様な人間の指示をChatGPTに生成させます.これにより、単一ツールと複数ツールのシナリオの両方をカバーします.

最後に、各指示に対して有効なソリューションパス(API呼び出しの連鎖)を検索するためにChatGPTを使用します.検索プロセスを効率化するために、我々は新しい深さ優先探索ベースの決定木(DFSDT)を開発しました.これにより、LLMは複数の推論トレースを評価し、検索空間を拡大することが可能となります.DFSDTは、LLMの計画と推論能力を大幅に向上させることを示しています.

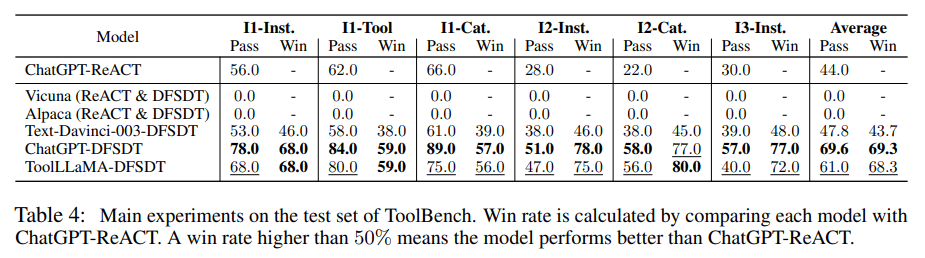

ツールの使用能力を効率的に評価するために、我々は自動評価ツールであるToolEvalを開発しました.ToolBenchでLLaMAを微調整し、ToolLLaMAを得ました.ToolEvalによると、ToolLLaMAは複雑な指示の実行能力や未知のAPIへの汎化能力に優れており、ChatGPTと同等のパフォーマンスを示しています.さらに、パイプラインをより実用的にするために、各指示に適切なAPIを推奨するためのニューラルAPIリトリーバーを開発しました.これにより、APIの手動選択が不要となります.

Q&A:

Q: 現在のLLMの命令チューニングは、ChatGPTのような最先端のLLMとどう違うのですか?

A: 現在のLLMの指示調整は、基本的な言語タスクに焦点を当てており、ツールの使用領域には焦点を当てていません.一方、ChatGPTなどの最先端のLLMは、優れたツールの使用能力を示していますが、残念ながらクローズドソースです.

Q: ツール用のインストラクション・チューニング・データセット、ToolBenchの作成プロセスを説明していただけますか?

A: ToolBenchというツール使用のための指示調整データセットを作成するプロセスは、ChatGPTを使用して自動的に行われます.具体的には、RapidAPI Hubから16,464の実世界のRESTful APIを収集し、ChatGPTに対してこれらのAPIを含む多様な人間の指示を生成するように促します.このプロセスは、ChatGPTの最新バージョン(gpt-3.5-turbo-16k)を使用して行われます.指示生成のためのデータセットの構築は、ChatGPTによって自動的に行われるため、人間の監督は最小限に抑えられます.

Q: ChatGPTはどのようにして、収集したAPIを含む多様な人間の指示を生成したのでしょうか?

A: ChatGPTは、まず全体のAPIからAPIをサンプリングし、それらのAPIに関する多様な指示を生成するように指示されました.実際のシナリオをカバーするために、単一のツールと複数のツールのシナリオの両方を含む指示を厳選しました.これにより、モデルは個々のツールとそれらを組み合わせて複雑なタスクを達成する方法を学ぶことができます.

Q: ChatGPTは各命令に対して有効なソリューションパス(API呼び出しの連鎖)をどのように検索したのでしょうか?

A: 与えられた指示Inst∗に対して、ChatGPTは有効なアクションのシーケンス(APIの連鎖呼び出し)を検索するようにプロンプトされました.この多段階の意思決定プロセスは、ChatGPTのための多ラウンドの会話としてキャストされます.各時間ステップtでは、モデルは前回の対話に基づいてアクションatを生成します.具体的には、ChatGPT(at|{a1, r1,···, at−1, rt−1},Inst∗)という形式で表されます.ここで、r∗は実際のAPIの応答を示します.各アクションatに対して、ChatGPTはどのAPIを使用するか、API呼び出しの具体的なパラメーターは何か、およびその「思考」を指定するようにプロンプトされます.つまり、athは次の形式を持ちます.「思考: ···、API名: ···、パラメーター: ···」.

Q: 深さ優先探索に基づく決定木(DFSDT)と、それがLLMのプランニングと推論能力をどのように向上させるかについて説明していただけますか?

A: DFSDTは、深さ優先探索を基にした意思決定木です.これにより、LLMの計画と推論能力を強化することができます.従来のCoTやReACTと比較して、DFSDTは複数の推論経路を評価し、ステップを取り消すか有望な経路を進むかを慎重に決定することができます.DFSDTは、注釈の効率を向上させ、CoTやReACTでは回答できない複雑な指示を成功裏に完了させることができます.

Q: ToolLLaMAの性能は、ToolEvalを使ってどのように評価されましたか?

A: ToolLLaMAのパフォーマンスは、ToolEvalを使用して評価されました.ToolEvalは、2つの主要な指標であるパスレートと勝率を使用して評価を行います.パスレートは、予算内での命令の正常な実行能力を測定し、勝率は2つの解決経路の品質と有用性を比較します.ToolEvalは、人間の評価と高い相関を持ち、ツールの学習のための堅牢でスケーラブルかつ信頼性のある評価を提供します.

Q: ニューラルAPIリトリーバーと、それがパイプラインの各命令に適切なAPIを推奨する方法について説明してもらえますか?

A: APIリトリーバーは、BERT-BASEをベースにしたSentence-BERTを使用して訓練されます.モデルは、指示とAPIドキュメントをそれぞれ2つの埋め込みにエンコードし、これら2つの埋め込みの類似性によって関連性を決定します.訓練中、§2.2で生成された各指示の関連APIを正例とし、対照的な学習のためにいくつかのAPIを負例としてサンプリングします.ベースラインとして、BM25とOpenAIのtext-embedding-ada-002 APIを選択します.NDCGを使用してリトリーバーのパフォーマンスを評価します.単一ツールの指示(I1)、カテゴリ内の複数ツールの指示(I2)、およびコレクション内の複数ツールの指示(I3)についてモデルを訓練および評価します.さらに、すべての指示を統合して訓練および評価も行います.表2に示されているように、APIリトリーバーは、異なるタイプの指示において一貫してBM25とAda Embeddingを上回るパフォーマンスを示しています.高いNDCGスコアは、APIリトリーバーの効果を示しています.また、I1のNDCGスコアはI2とI3よりもはるかに高いため、単一ツールの指示はより優れたパフォーマンスを示しています.

Skeleton-of-Thought: Large Language Models Can Do Parallel Decoding

著者:Xuefei Ning, Zinan Lin, Zixuan Zhou, Huazhong Yang, Yu Wang

発行日:2023年07月28日

最終更新日:2023年07月28日

URL:http://arxiv.org/pdf/2307.15337v1

カテゴリ:Computation and Language, Artificial Intelligence

概要:

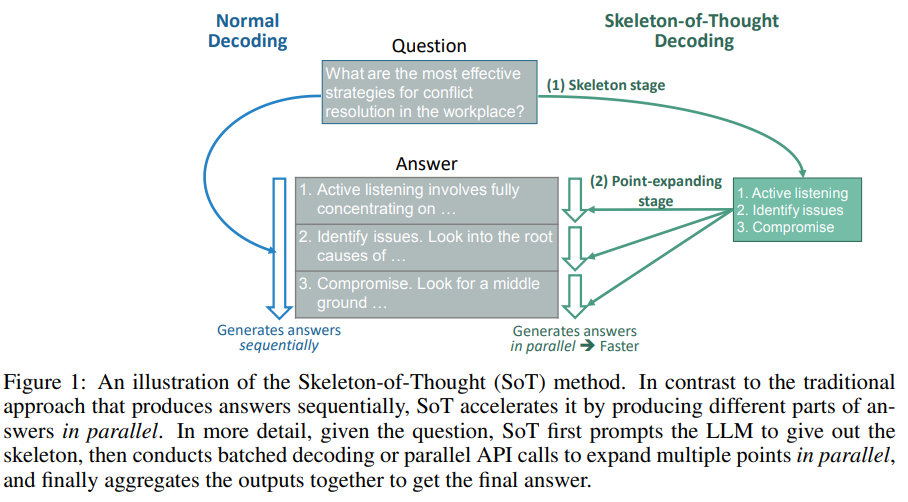

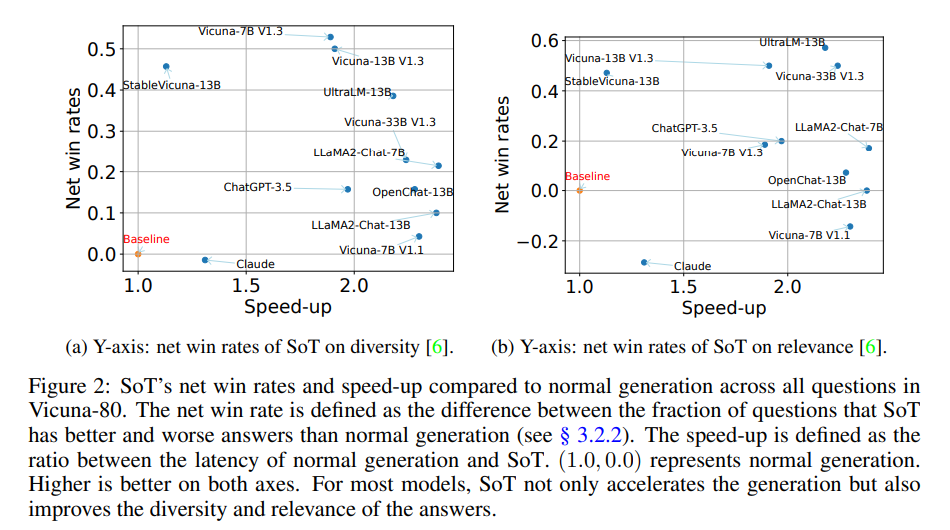

この研究は、大規模言語モデル(LLM)のエンドツーエンドの生成遅延を減少させることを目的としています.高い生成遅延の主な原因の1つは、ほとんどの最先端のLLMが採用している順次デコーディングアプローチです.この研究では、人間の思考と執筆プロセスに触発されて、「思考の骨組み」(SoT)という手法を提案しています.SoTは、LLMに対してまず回答の骨組みを生成させ、その後、各骨組みポイントの内容を並列でAPI呼び出しやバッチデコーディングを行うことで完成させます.SoTは、11種類の異なるLLMにおいて最大2.39倍の高速化を提供するだけでなく、多様性と関連性の観点でいくつかの質問カテゴリにおける回答の品質を潜在的に向上させることも可能です.SoTは効率のためのデータ中心の最適化の初めの試みであり、LLMをより人間のように思考させることで回答の品質を向上させる可能性を示しています.

Q&A:

Q: この仕事の主な目的は何ですか?

A: この研究の主な目的は、大規模言語モデル(LLM)のエンドツーエンドの生成遅延を減少させることです.

Q: 大規模言語モデル(LLM)の生成待ち時間が長くなる主な原因は?

A: 大規模言語モデル(LLMs)の高い生成遅延の主な原因は、大きなモデルサイズによるメモリ、メモリアクセス、および計算の大量使用です.

Q: スケルトン・オブ・ソート(SoT)」アプローチは、最新のLLMが採用している逐次デコーディング・アプローチとどう違うのか?

A: Skeleton-of-Thought (SoT)アプローチは、state-of-the-artのLLMが採用している順次デコーディングアプローチとは異なります.順次デコーディングアプローチでは、LLMは一つのポイントを生成するために次のポイントを待たなければなりません.一方、SoTアプローチでは、LLMはまずスケルトンを生成し、その後、各スケルトンポイントの内容を並列で生成することができます.これにより、SoTアプローチは効率的な並列処理を可能にし、高速化を実現します.

Q: SoTは、LLMが答えの骨格を作る際にどのように導いているのか?

A: SoTは、LLMsに回答の骨組みを最初に生成するようにガイドします.具体的には、図1に示されているように、LLMsに自ら骨組みを導出するように指示します.骨組みに基づいて、LLMsは各ポイントを並行して完成させることができます.SoTは、バッチデコーディングを行うオープンソースモデルと並行API呼び出しを行うクローズドソースモデルの両方を加速するために利用することができます.

Q: SoTはどのように並列APIコールやバッチデコードを利用して、各スケルトンポイントの内容を完成させるのですか?

A: SoTは、まずLLMにスケルトンを出力させ、次に複数のポイントを並列で展開するためにバッチデコーディングまたは並列API呼び出しを行い、最後に出力を集約して最終的な回答を得ます.

Q: 11種類のLLMでSoTが達成したスピードアップとは?

A: SoTによるスピードアップは、11つの異なるLLMで最大2.39倍です.

Q: SoTは、いくつかの質問カテゴリーにおいて、どのように回答の質を向上させる可能性があるのでしょうか?

A: SoTは、エンドツーエンドのレイテンシを低減し、高品質の回答を提供することにより、複数の質問カテゴリーにおいて回答の品質を向上させる可能性があります.与えられた文脈によると、SoTは知識、常識、一般的な質問、ロールプレイ、反事実などの質問カテゴリーにおいて、全体的な回答生成プロセスを加速することができます.これらのカテゴリーにおける平均速度アップは1.95倍から2.27倍に及びます.さらに、SoTプロンプトの改善やモデルのファインチューニングにより、スケルトンやポイント拡張プロンプトの理解が向上し、回答の品質が向上する可能性があります.

Q: SoTはデータ中心の効率をどのように最適化するのか?

A: SoTは、並列API呼び出しやバッチ処理などの手法を使用して、データ中心の効率を最適化します.

Q: SoTは、LLMが答案の質を高めるために、より人間に近い考え方をするようになることをどのように目指しているのでしょうか?

A: SoTは、LLMが回答の品質を向上させるために人間のように考えることを目的としています.それは、LLMがまず骨格を導き出し、それから並行して各ポイントを完成させるように導くことによって達成されます.このアプローチは人間の思考プロセスを模倣し、複雑なグラフ構造で構成される複数のステップが含まれます.LLMの思考と執筆プロセスを「思考のグラフ」として組織化することで、Skeleton-of-Thoughtの効率性とグローバルな理解の利点をCoTの拡張された詳細と推論の利点と組み合わせることができます.これにより、回答の多様性と関連性が向上し、人間の思考により近いものになります.

Q: LLMにもっと人間に近い考え方をさせることで、答案の質の向上にどのような利点があるのでしょうか?

A: 現在のLLMの完全な順次デコーディングの必要性を再考することによって、効率の利点を明らかにすることができます.LLMがより人間のように考えるように推進することで、回答の品質が向上する可能性があります.

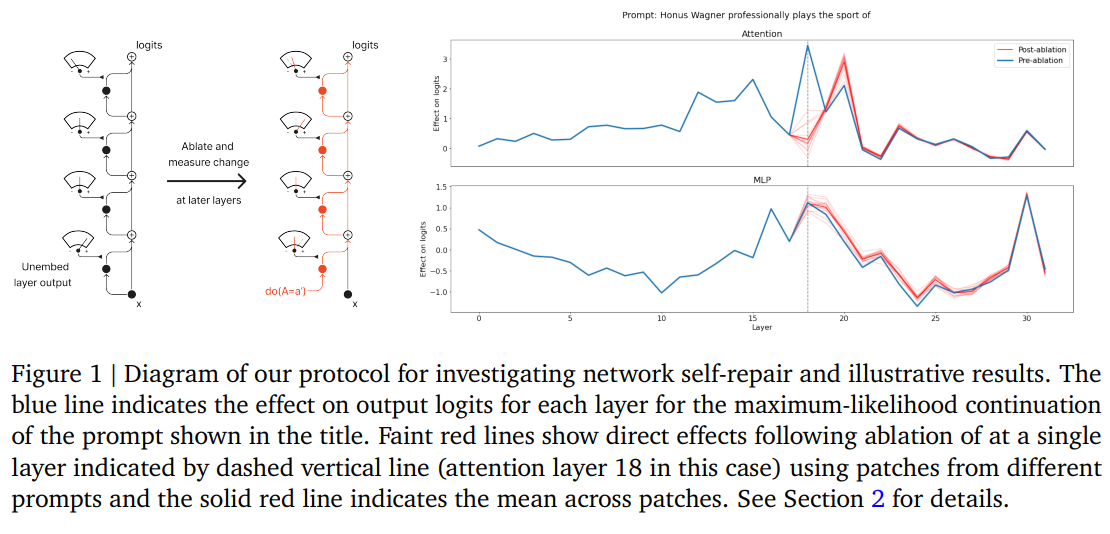

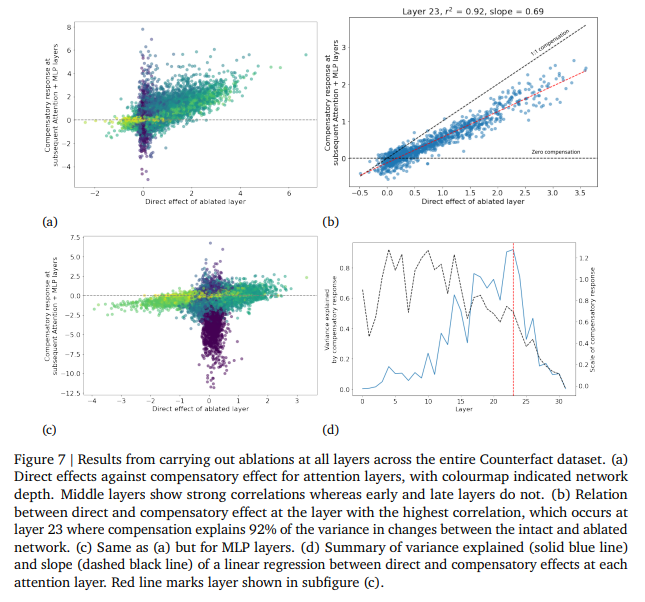

The Hydra Effect: Emergent Self-repair in Language Model Computations

著者:Thomas McGrath, Matthew Rahtz, Janos Kramar, Vladimir Mikulik, Shane Legg

発行日:2023年07月28日

最終更新日:2023年07月28日

URL:http://arxiv.org/pdf/2307.15771v1

カテゴリ:Machine Learning, Artificial Intelligence, Computation and Language

概要:

この研究では、因果関係の分析を用いて言語モデルの計算の内部構造を調査し、2つのモチーフを示しています.1つ目は、言語モデルの1つのアテンション層を取り除くことで他の層が補償するという適応的な計算の形式であり、これを「ヒドラ効果」と呼んでいます.2つ目は、適応的な計算の形式であり、遅延MLP層が最大尤度トークンを抑制する役割を果たすというものです.アブレーションの研究では、言語モデルの層は通常比較的緩やかに結合していることが示されています(1つの層のアブレーションは、下流の層の数にしか影響を与えない).驚くべきことに、これらの効果はドロップアウトの形式を使用せずに訓練された言語モデルでも発生します.この効果を事実の回想の文脈で分析し、言語モデルにおける回路レベルの属性づけに対するその意義を考察しています.

Q&A:

Q: ヒドラ効果の概念と、それが言語モデルの計算でどのように現れるのか、もう少し詳しく説明してもらえますか?

A: ハイドラ効果は、言語モデルの計算において、一つの注意層の欠損が他の層に補償を引き起こすという形の適応的な計算の形態を指します.これにより、モデルの一部が欠損しても他の層がその機能を補完することができます.

Q: あなたの研究では、後期MLP層による最尤トークンのダウンレギュレーションをどのように測定または定量化したのですか?

A: 遅いMLP層による最尤トークンのダウンレギュレーションの測定は、各層が与えられたアブレーションにどのように反応するかを決定するために行われました.具体的には、アブレーション前後で各層が最尤トークンに与える影響を測定することによって行われました.

Q: ドロップアウトありで学習した言語モデル層と、ドロップアウトなしで学習した言語モデル層とで、結合の強さに違いはありましたか?

A: いいえ、ドロップアウトなしで訓練された言語モデルの層間の結合強度の違いは観察されませんでした.

Q: 言語モデルのレイヤーが疎結合であることが、言語モデルの回路レベルの帰属に与える影響について詳しく教えてください.

A: 言語モデルの層の緩やかな結合の影響は、回路レベルの属性付けに重要な意味を持ちます.直接の効果だけでなく、中間の多層パーセプトロン(MLP)の効果も考慮する必要があります.したがって、単一の層の出力を解釈する際には、その層の直接の効果だけでなく、中間のMLPの効果も考慮する必要があります.これにより、言語モデルの層の機能を正確に理解することが困難になります.

Q: 分析の中で、事実の想起をどのように定義し、測定しましたか?

A: 本研究では、事実の回想を定義し、測定するためにCounterfactデータセットを使用しました.Counterfactデータセットは、主語、関係、真の対象、文脈における意味のある反事実主張のタプル(s、r、o∗、oc)を組み合わせたプロンプトのシリーズで構成されています.プロンプトの完成には、Chinchilla 7Bモデルが正しく回答するために必要な事実知識が含まれています.具体的には、プロンプトは主語と関係の結合のみを使用しています.したがって、事実の回想を測定するためには、モデルがプロンプトの主語と関係を正しく関連付け、適切な事実知識を回答する必要があります.

Q: アブレーション研究で、予期せぬ、あるいは驚くべき発見はありましたか?

A: 提供された文脈では、意図的な削除による予期せぬ結果や驚くべき発見についての具体的な情報は提供されていません.

Q: 言語モデル計算の調査から得られた洞察に基づき、今後どのような研究の方向性を追求すべきだとお考えですか?

A: 調査結果から得られた洞察に基づいて、言語モデルの計算に関する将来の研究方向としては、次のようなものが追求されるべきです.まず第一に、自己修復とハイドラ効果のメカニズムをより詳しく理解するために、さらなる実験と分析が必要です.また、言語モデルの計算構造における他のモチーフや特性についても調査することが重要です.さらに、言語モデルの計算における因果関係の分析手法を改善し、より正確な結果を得るための研究が必要です.さらなる研究によって、言語モデルの計算の理解を深め、その応用範囲を広げることが期待されます.

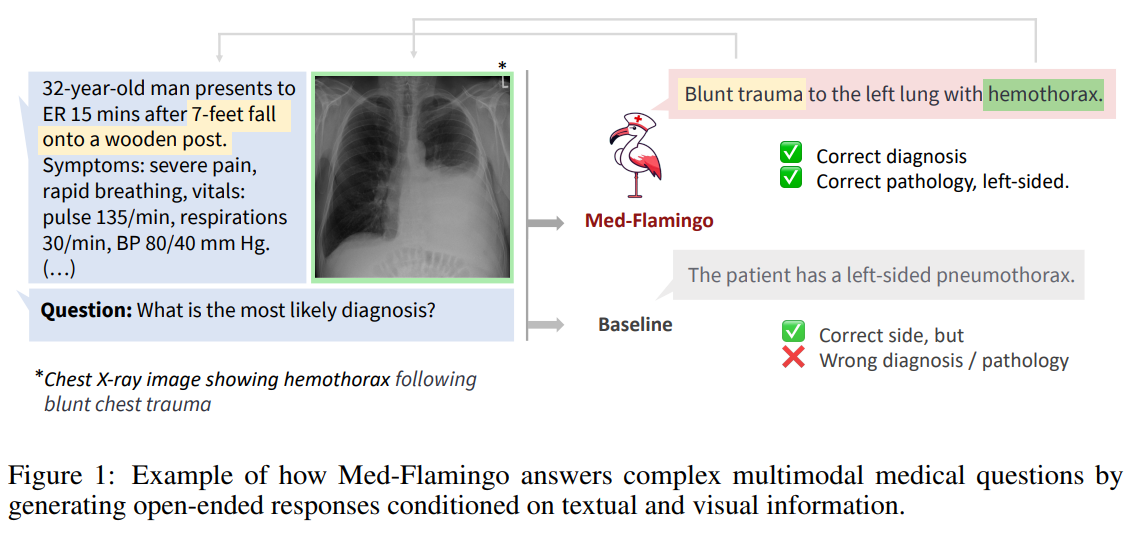

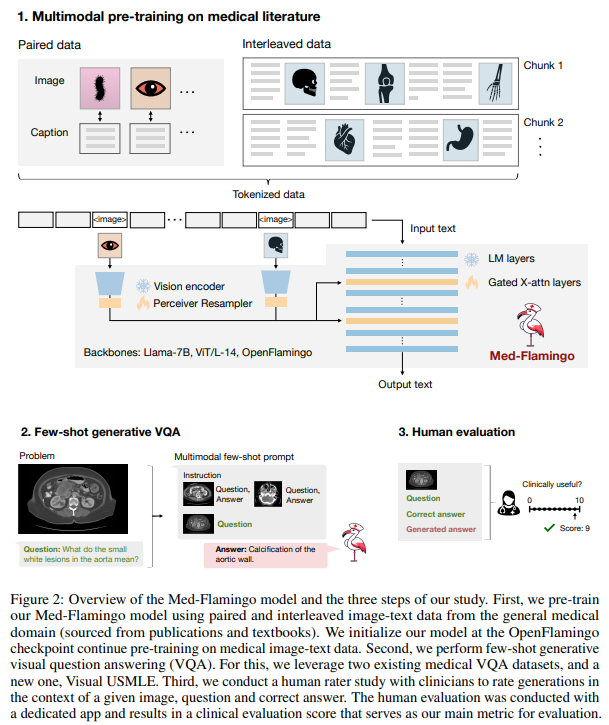

Med-Flamingo: a Multimodal Medical Few-shot Learner

著者:Michael Moor, Qian Huang, Shirley Wu, Michihiro Yasunaga, Cyril Zakka, Yash Dalmia, Eduardo Pontes Reis, Pranav Rajpurkar, Jure Leskovec

発行日:2023年07月27日

最終更新日:2023年07月27日

URL:http://arxiv.org/pdf/2307.15189v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence

概要:

医学領域における生成的医学ビジュアルクエスチョンアンサリング(VQA)のパフォーマンスを向上させるMed-Flamingoは、医師の評価により20%まで向上し、合理的な生成などのマルチモーダルな少数ショットの適応を初めて可能にします.さらに、私たちはモデル、コード、評価アプリを以下のURLで公開しています:https://github.com/snap-stanford/med-flamingo.

Q&A:

Q: メドフラミンゴの目的は何ですか?

A: Med-Flamingoの目的は、医療領域に特化したマルチモーダルなインコンテキスト学習を行うことです.

Q: Med-Flamingoは既存の医療用生成視覚言語モデルとどう違うのですか?

A: Med-Flamingoは、既存の医療生成ビジョン言語モデルとは異なり、直接オープンエンドの回答を生成することで評価されます.また、従来のモデルと比較して、クリニシャンに最も好まれる回答を生成する能力があり、最大20%の改善が見られます.さらに、Med-Flamingoは医療の複雑な質問に対する医学的な推論や説明の提供といった能力を持っています.これは他のマルチモーダル医療基盤モデルでは以前に示されていないものです.

Q: メドフラミンゴの事前トレーニングのプロセスは?

A: Med-Flamingoは、医療領域での継続的な事前学習を行います.この事前学習は、相互に交互に配置された画像とテキストデータ、およびペアの画像とテキストデータのトレーニングを組み合わせて行われます.相互に交互に配置されたデータは、医学の教科書から作成されたデータセットであり、MTBと呼ばれます.ペアのデータセットには、PMC-OAと呼ばれるデータセットが使用されます.MTBは、異なる医学の専門分野の4,721冊の教科書から構築され、PDFからHTMLに変換され、画像タグはimageトークンに変換されます.データのクリーニングとセグメント化が行われ、最終的には約0.8Mの画像とテキストデータを含むMTBが作成されます.

Q: Med-Flamingoは生成的医療視覚的質問応答(VQA)でどのように機能しますか?

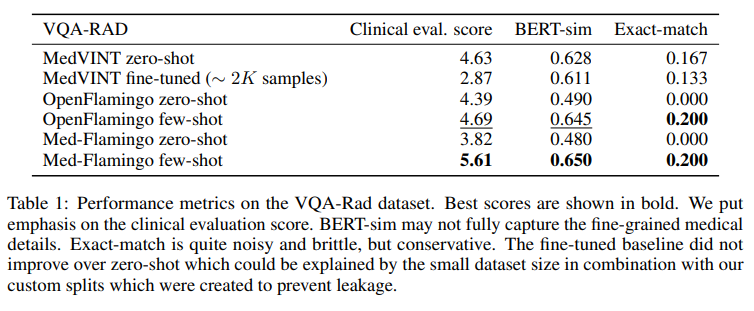

A: Med-Flamingoは、生成型の医療ビジュアル質問応答(VQA)タスクにおいて、直接的にオープンエンドの回答を生成することで評価されます.これにより、CLIPベースの医療ビジョン言語モデルが行うような人工的な回答オプションのスコアリングとは異なります.Med-Flamingoの評価には、臨床専門家による詳細な人間評価研究が含まれており、その結果得られる人間評価スコアが主な指標となります.さらに、放射線学や病理学の専門分野に焦点を絞った既存の医療VQAデータセットに加えて、複雑なUSMLEスタイルの問題を含む難解な生成型VQAデータセットであるVisual USMLEを作成します.3つの生成型医療VQAデータセットを平均した結果、few-shot prompted Med-Flamingoは臨床評価スコアの平均順位で最も優れています(順位1.67、最も優れた以前のモデルは2.33).これは、モデルが臨床医に最も好まれる回答を生成していることを示しており、最大20%の改善が見られます.さらに、Med-Flamingoは医療推論を行う能力も持っています.

Q: USMLE形式の視覚的な問題で構成された、難易度の高いオープンエンドのVQAデータセットについて詳しく教えてください.

A: Visual USMLEは、画像、症例の要約、および潜在的には実験室の結果を含む複雑なUSMLEスタイルの問題の難解なVQAデータセットです.このデータセットは、ラジオロジーと病理学の専門分野に焦点を絞った既存の医療VQAデータセットが狭くなっているため、作成されました.問題はAmbossプラットフォームから適応され、問題を選択する代わりに、モデルが独自に差別診断と潜在的な手順を考え出さなければならないように、問題は多肢選択問題ではなくオープンエンドの形式に再構築されました.

Q: ジェネレーティブ・メディカルVQAの人間評価はどのように行われたのですか?

A: 人間の評価は、クリニカルエキスパートによって生成された回答の品質を評価するためのアプリを使用して行われました.各VQAの問題に対して、画像、質問、正しい回答、およびランダムな順序で表示される一連の生成(例えば、図4の「予測1」として表示される)が提供されました.評価者は、0から10までのスコアで生成された回答の品質を評価しました.

Q: Med-Flamingoが提供する生成医療VQAの改善点とは?

A: Med-Flamingoは、生成型の医療VQAにおいて、クリニシャンの評価において最大20%の改善をもたらします.また、Med-Flamingoは、理由生成などのマルチモーダルな医療few-shot適応を初めて可能にします.

Q: Med-Flamingoのモデル、コード、評価アプリはどこで入手できますか?

A: Med-Flamingoのモデル、コード、および評価アプリは、https://github.com/snap-stanford/med-flamingoでアクセスできます.

Q: メド・フラミンゴについて、さらに詳しい情報や見識があれば教えてください.

A: Med-Flamingoは、医療領域に特化したマルチモーダルなインコンテキスト学習を行う最初の医療基盤モデルです.Med-Flamingoは、画像とテキストの相互に組み合わさったデータを自然に取り込み、このマルチモーダルな入力に基づいてテキストを生成するFlamingo(Alayrac et al.、2022)に基づいたビジョン言語モデルです.Flamingoの成功を基に構築されており、インコンテキスト学習とフューショット学習の能力を持つ最初のビジョン言語モデルの一つであるFlamingoの能力を医療領域に拡張しています.医療分野全体のマルチモーダルな知識源を事前学習することで、Med-Flamingoは医療領域でのマルチモーダルなインコンテキスト学習を実現しています.

Open Problems and Fundamental Limitations of Reinforcement Learning from Human Feedback

著者:Stephen Casper, Xander Davies, Claudia Shi, Thomas Krendl Gilbert, Jérémy Scheurer, Javier Rando, Rachel Freedman, Tomasz Korbak, David Lindner, Pedro Freire, Tony Wang, Samuel Marks, Charbel-Raphaël Segerie, Micah Carroll, Andi Peng, Phillip Christoffersen, Mehul Damani, Stewart Slocum, Usman Anwar, Anand Siththaranjan, Max Nadeau, Eric J. Michaud, Jacob Pfau, Dmitrii Krasheninnikov, Xin Chen, Lauro Langosco, Peter Hase, Erdem Bıyık, Anca Dragan, David Krueger, Dorsa Sadigh, Dylan Hadfield-Menell

発行日:2023年07月27日

最終更新日:2023年07月27日

URL:http://arxiv.org/pdf/2307.15217v1

カテゴリ:Artificial Intelligence, Computation and Language, Machine Learning

概要:

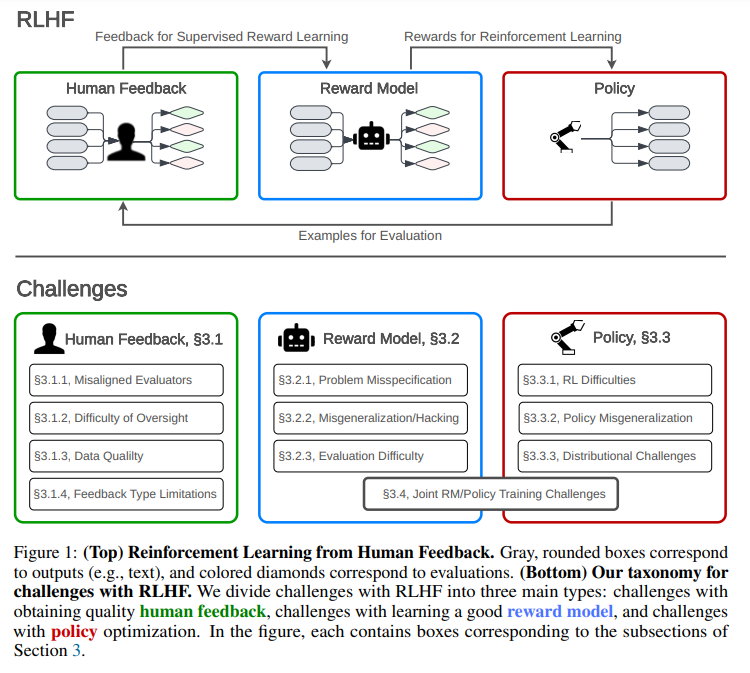

人間のフィードバックからの強化学習(RLHF)は、AIシステムを人間の目標に合わせて訓練するための技術です.RLHFは、最先端の大規模言語モデル(LLM)の微調整に使用される中心的な方法として登場しています.しかし、この人気にも関わらず、RLHFの欠点を体系化するための公開された研究は比較的少ないです.本論文では、(1)RLHFおよび関連手法のオープンな問題と基本的な制約を調査し、(2)実践におけるRLHFの理解、改善、補完技術を概説し、(3)RLHFシステムの社会的な監視を向上させるための監査と開示基準を提案します.私たちの研究は、RLHFの制約を強調し、より安全なAIシステムの開発に多面的なアプローチの重要性を強調しています.

Q&A:

Q: 人間のフィードバックからの強化学習(RLHF)の主な目的は何ですか?

A: Reinforcement Learning from Human Feedback (RLHF)の主な目的は、機械学習モデルを難しい指定されていない目標に適応させることです.

Q: 大規模言語モデル(LLM)の微調整にRLHFはどのように使われているのか?

A: RLHFは、大規模な言語モデル(LLM)を微調整するために使用されています.

Q: 実際にRLHFを理解し、改善し、補完するためのテクニックの概要を教えてください.

A: RLHFに関する理解、改善、補完のための技術の概要を提供します.具体的な手法として、フィードバックの問題を解決するための手法、報酬モデルの問題を解決するための手法、ポリシーの問題を解決するための手法があります.これらの手法は、RLHFの一部を置き換えるか組み合わせることができます.さらに、RLHFを補完するための追加のアプローチもあります.これらの手法は、セクション4.2で詳しく説明されています.

Q: RLHFシステムに対する社会的監視を改善するために、監査基準と情報開示基準をどのように導入できるか.

A: RLHFシステムの社会的監視を向上させるために、監査と開示基準をどのように実施することができるでしょうか.透明性と監査は、既存のRLHF研究環境を安全性の観点からより堅牢にするための持続的な取り組みです.まず、大規模なRLHFトレーニングランの一部の詳細を開示することで、特定の組織のモデルの監査と安全性チェックの基準が明確になります.第二に、リスクを軽減するための既知の取り組みについての透明性を高めることで、安全性のインセンティブが向上し、外部の利害関係者が企業を責任に追い込むための方法が示されるでしょう.第三に、透明性はAI安全性コミュニティのRLHFに対する理解を向上させ、技術的な進歩を追跡する能力をサポートします.

Q: RLHFの主な限界は何ですか?

A: 私たちの研究で強調されているRLHFの主な制限は、人間のフィードバック、報酬モデル、ポリシーの課題の3つの主要なカテゴリに分けられます.また、改善された方法論を用いてRLHFフレームワーク内で対処できる比較的取り組みやすい課題と、アラインメントに対して代替アプローチを通じて対処する必要があるRLHFの基本的な制限とを区別しています.

Q: より安全なAIシステムの開発において、多面的なアプローチはどれほど重要なのだろうか?

A: 複数の側面からアプローチすることは、より安全なAIシステムの開発において非常に重要です.

Q: RLHFの欠点を体系化した公共事業の意義を説明していただけますか?

A: 公開された研究によってRLHFの欠点が体系的に整理されることの重要性は、産業の実践者に共通の知識を提供し、さらなる研究のためのオープンな質問を特定することです.これにより、RLHFに関連する問題に対する理解が深まり、技術の進歩と社会的な課題の両方に対処するための戦略が開発されることが期待されます.

Q: RLHFは、AIシステムのトレーニングにおける人間の目標とどのように整合するのか?

A: RLHFはAIシステムを人間の目標に合わせるための中心的な手法であり、人間の承認を最適化することによってAIの目標を達成することを目指しています.