今回のテーマ:HyperDreamBooth, マルチモーダル生成型事前学習, LLMのRLHFの秘密, 生成画像のアニメーション化など.

ここでは、https://twitter.com/dair_ai で毎週メンションされているTop ML Papers of the Week の論文をLLMによって生成されるQ&Aを用いて要点を記載しています.気になる論文の選択に役立ったら良いと思います.論文を読む前に幾つかの要点を把握することで、皆さんが内容を素早く吸収できることを目的としています.自動生成記事のクオリティと信頼性を向上させるためにアルゴリズムの改善に取り組んでいます.個人で資料のQ&Aを作成されたい方には、https://www.chatpdf.com/ や https://scispace.com/などがお勧めです.

紹介する論文は以下の8本となります.

- HyperDreamBooth: HyperNetworks for Fast Personalization of Text-to-Image Models (発行日:2023年07月13日)

- Patch n’ Pack: NaViT, a Vision Transformer for any Aspect Ratio and Resolution (発行日:2023年07月12日)

- Secrets of RLHF in Large Language Models Part I: PPO (発行日:2023年07月11日)

- Generative Pretraining in Multimodality (発行日:2023年07月11日)

- Large Language Models as General Pattern Machines (発行日:2023年07月10日)

- AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning (発行日:2023年07月10日)

- Teaching Arithmetic to Small Transformers (発行日:2023年07月07日)

- Focused Transformer: Contrastive Training for Context Scaling (発行日:2023年07月06日)

HyperDreamBooth: HyperNetworks for Fast Personalization of Text-to-Image Models

著者:Nataniel Ruiz, Yuanzhen Li, Varun Jampani, Wei Wei, Tingbo Hou, Yael Pritch, Neal Wadhwa, Michael Rubinstein, Kfir Aberman

発行日:2023年07月13日

最終更新日:2023年07月13日

URL:http://arxiv.org/pdf/2307.06949v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Graphics, Machine Learning

概要:

パーソナライゼーションは、生成AIの分野で顕著な要素として浮上しており、個々のコンテキストやスタイルで個人を合成することが可能になっています.しかし、パーソナライゼーションのプロセスは、時間とメモリの要件に関して固有の課題を抱えています.各個人のモデルを微調整するためには、かなりのGPU時間の投資が必要であり、個々の被写体ごとにパーソナライズされたモデルを保存することは、ストレージ容量の面で要求が高いです.これらの課題を克服するために、私たちはHyperDreamBoothを提案しています.これは、個人の顔のための単一の画像から効率的に少数のパーソナライズされた重みを生成することができるハイパーネットワークです.これらの重みを拡散モデルに組み合わせ、高い被写体の詳細を保持しながらも、多様なスタイルと意味的な変更のモデルの重要な知識を保存することができます.私たちの手法は、わずか20秒で顔のパーソナライゼーションを実現し、DreamBoothの25倍、テキスト反転の125倍の速さで、わずか1つの参照画像を使用して同じ品質とスタイルを実現します.さらに、私たちの手法はDreamBoothモデルの10,000分の1のサイズでモデルを生成することができます.プロジェクトの詳細は、https://hyperdreambooth.github.ioをご覧ください.

Q&A:

Q: HyperDreamBoothプロジェクトの主な目的は何ですか?

A: HyperDreamBoothのプロジェクトの主な目的は、個別の画像から効率的に生成された一連の個人用の重みを使用して、テキストから画像へのモデルを個別化することです.このプロジェクトは、GPUの時間投資がかなり必要であり、個々の被験者ごとに個別のモデルを保存することはストレージ容量の面で要求が高いという課題を克服するために提案されました.HyperDreamBoothは、個人の顔をさまざまなコンテキストやスタイルで生成することができるハイパーネットワークです.このハイパーネットワークは、高い被験者の詳細を保持しながら、多様なスタイルと意味的な変更のモデルの重要な知識も保持することができます.この方法により、わずか20秒で顔の個別化が実現され、DreamBoothの25倍、Textual Inversionの125倍の速さで実行されます.また、わずか1つの参照画像を使用して、DreamBoothと同じ品質とスタイルの多様性を持つモデルが生成されます.さらに、この方法により、通常のDreamBoothモデルの10,000倍小さいモデルが生成されます.したがって、HyperDreamBoothプロジェクトの主な目的は、個別の画像から高速かつ効率的にテキストから画像へのモデルを個別化することです.

Q: パーソナライゼーションのプロセスに伴う課題とは?

A: 個人化のプロセスには、時間とメモリの要件に関する固有の課題が存在します.各個人化モデルの微調整には、かなりのGPU時間の投資が必要であり、個々の被験者ごとに個別のモデルを保存することは、ストレージ容量の面で要求が高いです.これらの課題に対処するために、私たちはHyperDreamBoothを提案しています.これは、単一の人物の画像から効率的に個別の重みの小さなセットを生成することができるハイパーネットワークです.これらの重みを拡散モデルに組み合わせ、高速な微調整とともに、HyperDreamBoothはさまざまなコンテキストとスタイルで人物の顔を生成することができ、高い被験者の詳細を保持します.

個人化のプロセスには、時間とメモリの要件に関する固有の課題が存在します.各個人化モデルの微調整には、かなりのGPU時間の投資が必要であり、個々の被験者ごとに個別のモデルを保存することは、ストレージ容量の面で要求が高いです.これらの課題に対処するために、私たちはHyperDreamBoothを提案しています.これは、単一の人物の画像から効率的に個別の重みの小さなセットを生成することができるハイパーネットワークです.これらの重みを拡散モデルに組み合わせ、高速な微調整とともに、HyperDreamBoothはさまざまなコンテキストとスタイルで人物の顔を生成することができ、高い被験者の詳細を保持します.

Q: HyperDreamBoothはどのようにして時間とメモリ要件の課題を克服しているのですか?

A: 時間とメモリの要件の課題を克服するために、HyperDreamBoothはハイパーネットワークを提案しています.このハイパーネットワークは、個人の画像から効率的に個別の重みの小さなセットを生成することができます.これらの重みを拡散モデルに組み合わせることで、HyperDreamBoothは高い被写体の詳細を保持しながら、さまざまなコンテキストやスタイルで人物の顔を生成することができます.また、高速なファインチューニングと組み合わせることで、わずか20秒で顔の個別化を実現し、DreamBoothの25倍、Textual Inversionの125倍の速さで処理することができます.さらに、わずか1つの参照画像を使用して、DreamBoothと同じ品質とスタイルの多様性を持つモデルを生成することができます.また、HyperDreamBoothのモデルは通常のDreamBoothモデルの10,000倍小さいです.

この方法により、時間とメモリの要件の課題を克服することができます.ハイパーネットワークを使用することで、個別のモデルを保存する必要がなくなります.代わりに、個人の画像から生成された個別の重みのセットを使用して、モデルをパーソナライズすることができます.これにより、時間とメモリの要件が大幅に削減されます.また、高速なファインチューニングを組み合わせることで、処理速度も向上します.

さらに、HyperDreamBoothのモデルは通常のDreamBoothモデルの10,000倍小さいです.これは、モデルのサイズが大幅に削減され、メモリの要件が軽減されることを意味します.モデルのサイズが小さいため、ストレージ容量の要件も低くなります.

以上のように、HyperDreamBoothはハイパーネットワークと高速なファインチューニングを使用することで、時間とメモリの要件の課題を克服しています.モデルのパーソナライズにはわずかな参照画像しか必要とせず、モデルのサイズも大幅に削減されます.

Q: HyperDreamBoothはどのようにして1枚の画像からパーソナライズされたウェイトを生成するのですか?

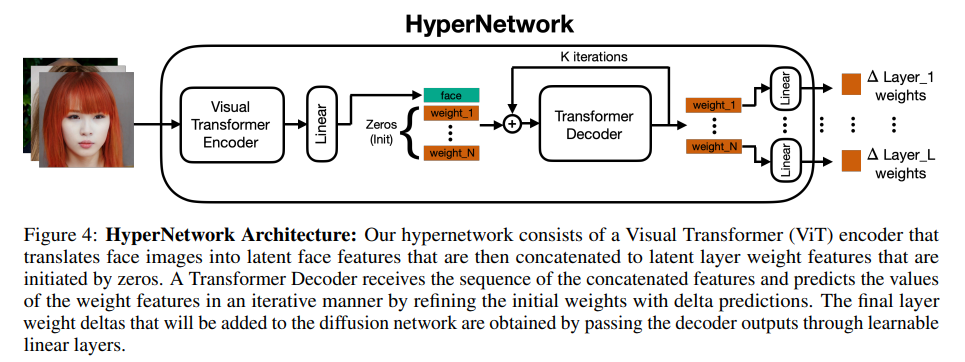

A: HyperDreamBoothは、個人の顔の画像から個別の重みを効率的に生成することができるハイパーネットワークです.このハイパーネットワークは、顔の画像から予測された重みを使用して、文「a [v] face」に適用された場合に、テキストから画像への拡散ネットワークがその人の顔を出力するように訓練されます.この訓練では、事前に計算された個別の重みが監督信号として使用されます.

具体的には、HyperDreamBoothは以下の手順で個別の重みを生成します.まず、顔の画像を入力として、ハイパーネットワークが予測する重みを生成します.この予測された重みは、テキストから画像への拡散ネットワークに適用されることで、その人の顔を生成するための情報を持っています.

このハイパーネットワークは、個人の顔の画像から重みを生成するために訓練されており、個別の重みを生成するための効率的な方法を学習します.この訓練では、事前に計算された個別の重みが監督信号として使用されるため、個人の顔の画像から予測される重みは、その人の顔の特徴やスタイルを適切に表現することができます.

このようにして、HyperDreamBoothは個人の顔の画像から個別の重みを生成し、その重みを使用してさまざまなコンテキストやスタイルで人の顔を生成することができます.この方法により、個人の顔のパーソナライズが約20秒で達成されます.また、DreamBoothと比較して25倍、Textual Inversionと比較して125倍の高速性を持ち、わずか1つの参照画像で同じ品質とスタイルの多様性を実現します.さらに、通常のDreamBoothモデルよりも10,000倍小さいモデルを生成することができます.

以上のように、HyperDreamBoothは個人の顔の画像から個別の重みを効率的に生成するためのハイパーネットワークです.

Q: DreamBoothやTextual Inversionと比較して、HyperDreamBoothを使う利点は何ですか?

A: HyperDreamBoothは、DreamBoothとTextual Inversionに比べて速度が25倍速く、さらに125倍速いです.また、わずか1つの参照画像を使用してDreamBoothと同じ品質とスタイルの多様性を実現します.さらに、通常のDreamBoothモデルよりも10,000倍小さいモデルを生成します.

この速度の利点は、ユーザーが顔の個別化と細部の編集をより迅速に行うことができることです.HyperDreamBoothは、わずか20秒で顔の個別化を達成することができます.DreamBoothとTextual Inversionに比べて25倍速く、さらに125倍速いため、作業時間を大幅に短縮することができます.

この速度の向上は、モデルの効率的な処理と計算方法によるものです.HyperDreamBoothは、より効率的なアルゴリズムと高速な計算手法を使用しており、処理時間を大幅に短縮しています.

この速度の利点は、ユーザーがより迅速に結果を確認し、必要な修正や調整を行うことができることです.また、時間の節約により、ユーザーはより多くの顔の個別化を行うことができます.

以上のように、HyperDreamBoothはDreamBoothとTextual Inversionに比べて速度が25倍速く、さらに125倍速いため、ユーザーはより迅速に顔の個別化を行うことができます.また、モデルの効率性により、処理時間を大幅に短縮し、作業効率を向上させることができます.

Q: HyperDreamBoothはどのようにして、多様なスタイルや意味的な修正を保ちながら、高い被写体のディテールを維持しているのでしょうか?

A: HyperDreamBoothは、1枚の人物の画像から効率的に個別の重みの小さなセットを生成することができるハイパーネットワークです.これらの重みを拡散モデルに組み合わせ、高い被写体の詳細を保ちながら、さまざまなコンテキストやスタイルで人物の顔を生成することができます.また、多様なスタイルや意味的な変更のモデルの重要な知識も保持します.

具体的には、HyperDreamBoothはおおよそ20秒で顔の個別化を達成し、DreamBoothの25倍、Textual Inversionの125倍の速さで、わずか1枚の参照画像を使用しています.また、DreamBoothと同じ品質とスタイルの多様性を持ちながら、通常のDreamBoothモデルの10,000倍小さいモデルを生成することができます.

このような高い被写体の詳細を保ちながら、多様なスタイルや意味的な変更を維持するために、HyperDreamBoothはハイパーネットワークを使用して個別の重みを生成します.これにより、生成される画像は個別の被写体の特徴をより正確に表現することができます.

また、拡散モデルに組み合わせられた重みは、高いスタイルの多様性と意味的な変更のモデルの重要な知識を保持します.これにより、生成される画像はさまざまなスタイルや意味的な変更を持つことができます.

以上のように、HyperDreamBoothはハイパーネットワークと拡散モデルの組み合わせにより、高い被写体の詳細を保ちながら、多様なスタイルや意味的な変更を維持することができます.

Q: HyperDreamBoothの高速微調整のプロセスを説明してもらえますか?

A: ファストファインチューニングは、HyperDreamBoothのプロセスの一部であり、高い主題の詳細性を保ちながら、さまざまな文脈とスタイルで人物の顔を生成するための手法です.

ファストファインチューニングのプロセスは、以下の手順で行われます.

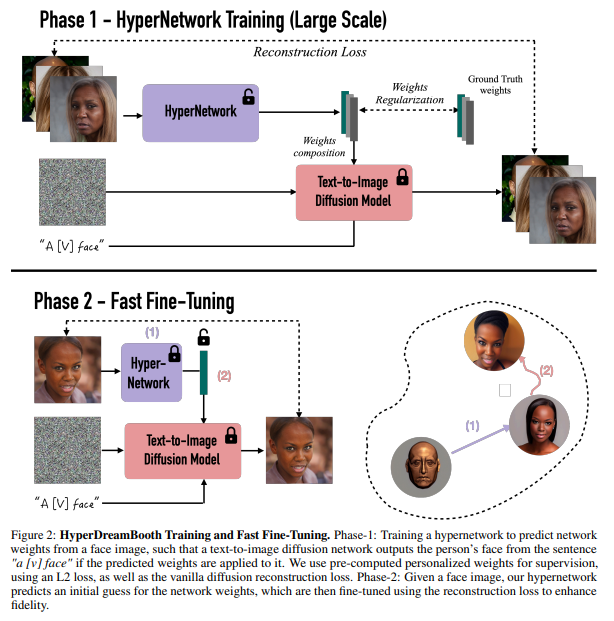

- フェーズ1:ハイパーネットワークのトレーニング

- まず、ハイパーネットワークを訓練します.このハイパーネットワークは、顔の画像からネットワークの重みを予測する役割を持ちます.

- 予測された重みが適用されると、テキストから画像への拡散ネットワークが「a [v] face」という文から人物の顔を出力します.

- このトレーニングでは、事前に計算された個別の重みを教師信号として使用します.教師信号は、L2損失とバニラの拡散再構築損失を使用して計算されます.

- フェーズ2:ファインチューニング

- 顔の画像が与えられると、ハイパーネットワークはネットワークの重みの初期推測を行います.

- この初期推測された重みは、再構築損失を使用してファインチューニングされ、主題の詳細性を向上させます.

- ファインチューニングにより、生成される画像の主題の詳細性が高まります.

ファストファインチューニングの目的は、わずか数秒で出力主題の忠実度を大幅に向上させることです.この手法により、HyperDreamBoothはさまざまな文脈とスタイルで人物の顔を生成することができます.また、モデルの多様なスタイルと意味的な変更の重要な知識も保持しながら、個別の拡散モデルを生成することができます.

以上が、HyperDreamBoothにおけるファストファインチューニングのプロセスの詳細な説明です.

Q: HyperDreamBoothモデルの大きさは、通常のDreamBoothモデルと比較してどうですか?

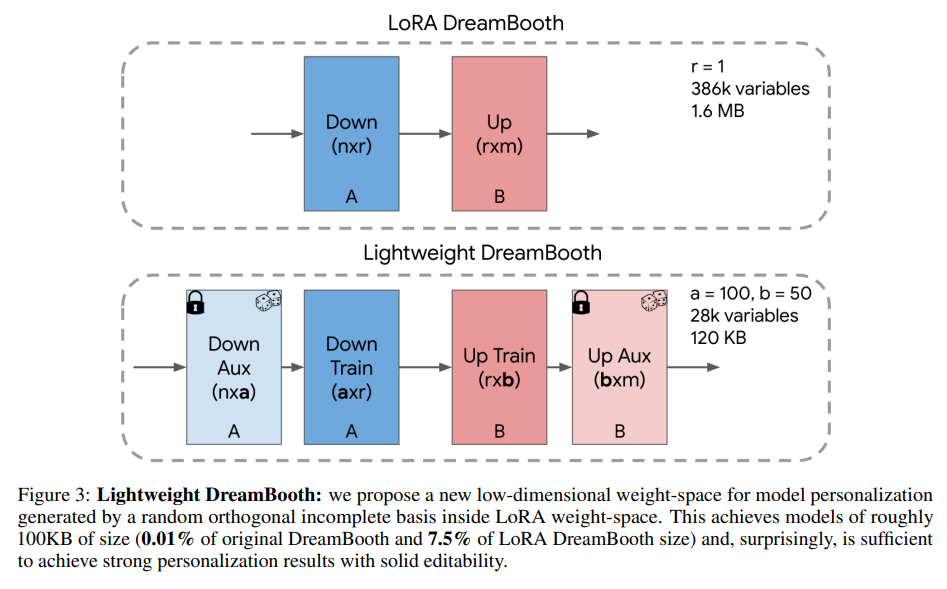

A: HyperDreamBoothモデルのサイズは、通常のドリームブースモデルと比較して非常に小さくなります.具体的には、HyperDreamBoothモデルは通常のドリームブースモデルの10,000倍小さくなります.通常のドリームブースモデルは1GB以上のサイズを持ちますが、HyperDreamBoothモデルはわずか120KBのストレージスペースしか使用しません.

このサイズの差は、HyperDreamBoothの新しいアプローチによるものです.HyperDreamBoothは、単一の人物の画像から個別の重みのセットを効率的に生成するハイパーネットワークです.この個別の重みを拡散モデルに組み合わせ、高い被写体の詳細を保ちながらも、ドリームブースの多様なスタイルと意味的な変更の重要な知識を保持したまま、さまざまなコンテキストとスタイルで人物の顔を生成することができます.

HyperDreamBoothのアプローチにより、通常のドリームブースモデルよりもはるかに小さなモデルが実現されます.これは、HyperDreamBoothが個別の重みのセットを生成することにより、モデルのサイズを劇的に削減できるからです.また、HyperDreamBoothモデルは、ドリームブースの品質とスタイルの多様性を維持しながら、わずかな参照画像で生成することができます.

以上のように、HyperDreamBoothモデルは通常のドリームブースモデルよりもはるかに小さくなります.この新しいアプローチにより、モデルのサイズを大幅に削減しながらも、品質とスタイルの多様性を維持することができます.

Q: HyperDreamBoothを使う上での制限や欠点はありますか?

A: HyperDreamBoothは、1枚の画像から個別の重みを効率的に生成することができるハイパーネットワークです.この方法により、高い被写体の詳細を保持しながら、さまざまなコンテキストやスタイルで人物の顔を生成することができます.また、DreamBoothと比較して、わずか20秒で顔の個別化を達成し、DreamBoothの10000倍小さいモデルを生成することができます.

しかし、HyperDreamBoothを使用する際の制限や潜在的な欠点も考えられます.具体的には以下のような点が挙げられます.

- 画像の品質に依存する可能性がある: HyperDreamBoothは、1枚の参照画像から個別の重みを生成するため、参照画像の品質や解像度が生成される顔の品質に影響を与える可能性があります.参照画像が低品質である場合、生成される顔の品質も低下する可能性があります.

- スタイルの多様性に制限がある: HyperDreamBoothは、DreamBoothと同じ品質とスタイルの多様性を持つと述べていますが、具体的な制約や制限については明示されていません.したがって、生成される顔のスタイルが限定される可能性があります.さらに、異なるスタイルや文脈での生成には、より多くの参照画像が必要な場合もあります.

- 学習時間の増加: HyperDreamBoothは、DreamBoothよりも高速な個別化を実現していますが、学習時間の増加による制約も考えられます.HyperDreamBoothは、高速なファインチューニングを使用していますが、それでも学習には一定の時間がかかる可能性があります.したがって、リアルタイムの応用には制約があるかもしれません.

- モデルの複雑さ: HyperDreamBoothは、ハイパーネットワークを使用して個別の重みを生成するため、モデルの複雑さが増す可能性があります.複雑なモデルは、ストレージ容量や計算リソースの要件が高くなる可能性があります.したがって、HyperDreamBoothを使用するためには、十分なストレージ容量と計算リソースが必要です.

以上のように、HyperDreamBoothを使用する際には、画像の品質への依存性、スタイルの多様性への制限、学習時間の増加、モデルの複雑さなどの制約や潜在的な欠点が考えられます.

Patch n’ Pack: NaViT, a Vision Transformer for any Aspect Ratio and Resolution

著者:Mostafa Dehghani, Basil Mustafa, Josip Djolonga, Jonathan Heek, Matthias Minderer, Mathilde Caron, Andreas Steiner, Joan Puigcerver, Robert Geirhos, Ibrahim Alabdulmohsin, Avital Oliver, Piotr Padlewski, Alexey Gritsenko, Mario Lučić, Neil Houlsby

発行日:2023年07月12日

最終更新日:2023年07月12日

URL:http://arxiv.org/pdf/2307.06304v1

カテゴリ:Computer Vision and Pattern Recognition, Artificial Intelligence, Machine Learning

概要:

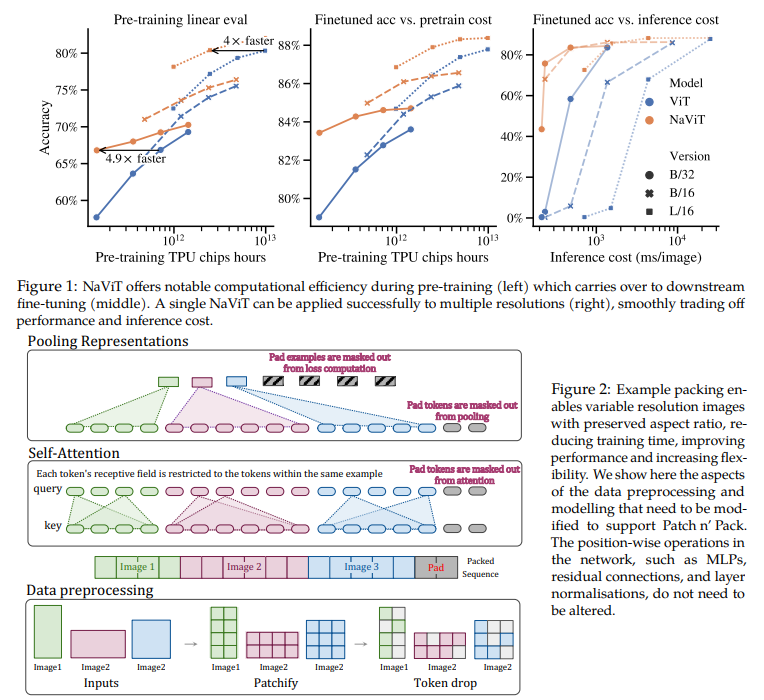

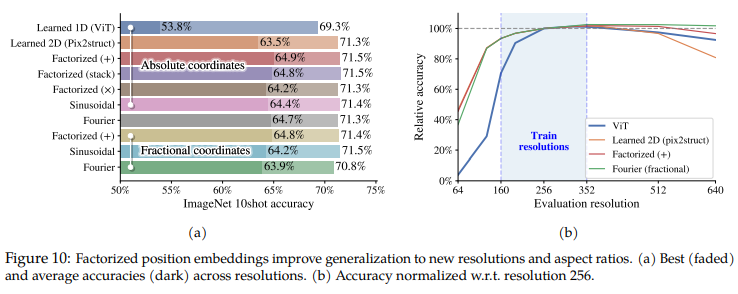

画像を固定解像度にリサイズしてからコンピュータビジョンモデルで処理するという選択肢は、広く使われているが最適ではないとされている.しかし、Vision Transformer(ViT)などのモデルは、柔軟なシーケンスベースのモデリングを提供し、したがって異なる入力シーケンスの長さに対応できる.私たちは、NaViT(Native Resolution ViT)を使用して、トレーニング中にシーケンスパッキングを利用し、任意の解像度とアスペクト比の入力を処理することができる.柔軟なモデルの使用とともに、大規模な教師ありおよび対照的な画像テキストの事前トレーニングの効率が向上することを示している.NaViTは、画像やビデオの分類、物体検出、意味的セグメンテーションなどの標準的なタスクに効率的に転送することができ、頑健性と公平性のベンチマークで改善された結果を示している.推論時には、入力解像度の柔軟性を利用して、テスト時のコストとパフォーマンスのトレードオフをスムーズに調整することができる.私たちは、NaViTが、ほとんどのコンピュータビジョンモデルで使用されている標準的なCNN設計の入力とモデリングパイプラインからの脱却を示し、ViTsにとって有望な方向性を示していると考えている.

Q&A:

Q: コンピュータ・ビジョン・モデルで処理する前に画像をリサイズする現在の慣行とは?

A: 画像をコンピュータビジョンモデルで処理する前に、画像を固定の解像度にリサイズするという方法が一般的であり、これまでに明らかに最適ではないとされています.この方法は、Vision Transformer(ViT)などのモデルでは、柔軟なシーケンスベースのモデリングが可能であり、したがって、入力の解像度を変えることができます.これにより、より高いスループット(小さい画像でのトレーニング)とより高いパフォーマンス(大きな画像でのトレーニング)が可能となります.通常、モデルは小さい解像度で事前学習され、その後、より高い解像度で微調整されます(Touvron et al.、2019).しかし、NaViTはより柔軟であり、画像サイズの分布からサンプリングすることで、異なる解像度でのトレーニングが可能です.また、各画像の元のアスペクト比を保持します.

ImageNet(Deng et al.、2009)、LVIS(Gupta et al.、2019)、WebLI(Chen et al.、2022c)のアスペクト比の分布を示す代表的な分類、検出、Web画像データセットの例として、ほとんどの画像は通常、正方形ではありません(図3).

言語モデリングでは、固定のシーケンス長の制限を回避するために、複数の異なる例からのトークンを1つのシーケンスに組み合わせる「example packing」という手法が一般的に使用されています(Krell et al.、2021).私たちは、画像をパッチ(トークン)のシーケンスとして扱うことで、Vision Transformer(Dosovitskiy et al.、2021)も同じパラダイムを利用できることを示し、これを「Patch n’ Pack」と呼びます.この技術を使用することで、ViTは画像を「ネイティブ」の解像度でトレーニングすることができます.このアプローチをNaViTと名付けました.

トレーニング中にパッキングを行うことで、任意の解像度とアスペクト比の入力を効率的に処理することができます.柔軟なモデルの使用と並行して、大規模な教師ありおよび対照的な画像テキストの事前トレーニングの効率が改善されることを示します.NaViTは、画像およびビデオの分類、物体検出、意味的セグメンテーションなどの標準的なタスクに効果的に転送することができ、頑健性と公平性のベンチマークでも改善された結果を示します.推論時には、入力の解像度の柔軟性を利用して、テスト時のコストとパフォーマンスのトレードオフをスムーズに調整することができます.私たちは、NaViTが、ほとんどのコンピュータビジョンモデルで使用されている標準的なCNN設計の入力とモデリングパイプラインからの脱

Q: 画像を固定解像度にリサイズするという最適とは言えない選択に対して、成功した挑戦はありますか?

A: 画像を固定解像度にリサイズしてからコンピュータビジョンモデルで処理するという普及しているが明らかに最適でない選択肢は、まだ成功した挑戦がない.しかし、Vision Transformer(ViT)などのモデルは、柔軟なシーケンスベースのモデリングを提供し、したがって異なる入力解像度を可能とする.ImageNet Deng et al.(2009)のモデルでは、画像サイズの40%まで品質がほぼ保たれることが観察された.それ以降、品質は劇的に低下する.一方、画像サイズを増やすと、品質の向上は減少する.これは、リサイズの代わりにランダムなトークンのドロップを使用する方法と直接比較できる.ランダムなトークンのドロップは、画像サイズを減らすための非常に効果的な方法ではないことが示されている.

通常、入力画像は固定の正方形のアスペクト比にリサイズされ、それから固定数のパッチに分割される.最近の研究では、このパラダイムに代わる手法が探求されている.FlexiViT(Beyer et al.、2023)は、1つのアーキテクチャ内で複数のパッチサイズをサポートし、したがってシーケンスの長さと計算コストのスムーズな変動を可能にする.これは、各トレーニングステップでパッチサイズをランダムにサンプリングし、リサイズアルゴリズムを使用して実現される.

Rmaxの異なる選択値に対してR=Rmaxとなる固定解像度がある場合(1)と、解像度がR∼U(64、Rmax)として分布する可変解像度(2)の2つの変数解像度モデルがある.可変解像度モデルは、その解像度でトレーニングされたモデルよりも優れた性能を発揮する.固定解像度の最良の場合でも、トレーニングと評価の解像度が同一である場合、可変解像度は固定解像度と同等以上の性能を発揮する.可変解像度の微調整.従来の手法では、事前トレーニングの後半または微調整中に解像度を増加させることで、品質は向上するが、モデルのコストも増加する(Dosovitskiy et al.、2021; Touvron et al.、2019).私たちは、NaViTとViTモデルを異なる固定解像度で微調整し、さらにNaViTを可変解像度で微調整した.

以上の文脈から判断すると、固定解像度で画像をリサイズするという選択肢に対して成功した挑戦はまだないと言えます.

Q: vision transformer(ViT)は、どのように柔軟なシーケンスベースのモデリングを提供するのですか?

A: vision transformer(ViT)は、柔軟なシーケンスベースのモデリングを提供することによって、画像のリサイズを固定の解像度にするという普及しているが最適でない選択肢に挑戦しています.ViTは、画像をパッチに分割し、それぞれのパッチをトークンに線形投影するという単純な操作に基づいています.通常、入力画像は固定の正方形のアスペクト比にリサイズされ、固定数のパッチに分割されます.

しかし、ViTは、シーケンスベースのモデリングを提供するため、入力の長さを変化させることができます.これにより、入力解像度の柔軟性を利用して、テスト時のコストとパフォーマンスのトレードオフをスムーズに調整することができます.具体的には、FlexiViTというモデルでは、1つのアーキテクチャ内で複数のパッチサイズをサポートしており、トレーニングステップごとにパッチサイズをランダムにサンプリングし、リサイズアルゴリズムを使用してシーケンスの長さを変化させることができます.

この柔軟性により、ViTは従来のCNNに基づいた入力とモデリングパイプラインとは異なるアプローチを提供しています.これは、コンピュータビジョンモデルの多くで使用されている標準的な入力とモデリングパイプラインからの脱却を意味し、ViTの有望な方向性を示しています.

Q: NaViTにおけるシーケンスパッキングとはどのような概念ですか?

A: NaViT(Native Resolution ViT)では、シーケンスパッキングという概念を利用しています.これは、入力の任意の解像度とアスペクト比を処理するために、トレーニング中にシーケンスをパッキングすることを意味します.柔軟なモデルの使用と併せて、大規模な教師ありおよび対照的な画像テキストの事前トレーニングの効率が向上することを示しています.NaViTは、画像およびビデオの分類などの標準的なタスクに効果的に転送することができます.

シーケンスの長さに関する制限を回避するための一般的な手法として、例のパッキングがあります.複数の異なる例のトークンを1つのシーケンスに組み合わせることで、言語モデルのトレーニングを大幅に加速することができます.画像をパッチ(トークン)のシーケンスとして扱うことで、Vision Transformersも同じパラダイムを利用できることを示しています.これをPatch n’ Packと呼び、このアプローチをNaViTと名付けています.

NaViTは、元のViTを基にして構築されていますが、原則としてパッチのシーケンスで動作する任意のViTのバリアントを使用することができます.Patch n’ Packを可能にするために、以下のアーキテクチャの変更を行っています.

- マスク付きのセルフアテンションとマスク付きのプーリング:例が互いに注意を払わないようにするために、追加のセルフアテンションマスクが導入されています.同様に、エンコーダの上にマスク付きのプーリングが行われ、各例内のトークン表現をプールし、シーケンス内の各例ごとに単一のベクトル表現を生成します.図2は、マスキングを介して注意の受容領域が制御される様子を示しています.

- 因子化および分数の位置埋め込み:任意の解像度とアスペクト比を扱うために、因子化および分数の位置埋め込みを使用しています.これにより、異なる解像度とアスペクト比の画像を効果的に処理することができます.

シーケンスパッキングの概念は、NaViTにおいて入力の任意の解像度とアスペクト比を処理するために使用される手法であり、例のパッキングという手法も利用されています.

Q: NaViTはどのようにして任意の解像度やアスペクト比の入力を処理できるのか?

A: NaViTは、可変の入力シーケンス長を持つ柔軟なモデルであるVision Transformer(ViT)を利用しています.これにより、任意の解像度とアスペクト比の入力を処理することが可能となります.具体的には、NaViTはトレーニング中にシーケンスパッキングを使用して、任意の解像度とアスペクト比の入力を処理します.これにより、画像を固定の解像度にリサイズするという一般的で効果的でない選択肢を回避することができます.NaViTの柔軟なモデルの使用方法に加えて、大規模な教師ありおよび対照的な画像テキストの事前トレーニングにおいて、改善されたトレーニング効率を実証しています.また、NaViTは画像およびビデオの分類、物体検出、意味セグメンテーションなどの標準的なタスクに効率的に転送することができ、頑健性と公平性の向上につながります.推論時には、入力解像度の柔軟性を利用して、テスト時のコストとパフォーマンスのトレードオフをスムーズに調整することができます.NaViTは、ほとんどのコンピュータビジョンモデルで使用される標準的なCNN設計の入力とモデリングパイプラインからの脱却を示し、ViTの有望な方向性を示しています.

Q: NaViTが大規模な教師あり・対照ありの画像-テキスト事前学習で示した学習効率の向上について教えてください.

A: NaViTは、大規模な教師ありおよび対照的な画像テキストの事前学習において、改善されたトレーニング効率を示しています.この改善は、いくつかの要素によってもたらされます.

まず、NaViTは、Patch n’ Packと呼ばれる新しいアーキテクチャを使用しています.これにより、入力の任意の解像度やアスペクト比を処理するためのパッキングが可能になります.この柔軟性により、NaViTは大規模な教師ありおよび対照的な画像テキストの事前学習において効率的に使用することができます.

さらに、NaViTは、一般的なコンピュータビジョンモデルが使用する標準のCNN設計入力およびモデリングパイプラインからの脱却を示しています.これにより、NaViTは画像およびビデオの分類、物体検出、意味セグメンテーションなどの標準的なタスクに効果的に転送することができます.さらに、NaViTは、頑健性と公平性のベンチマークにおいて改善された結果をもたらします.

NaViTのトレーニング効率の改善は、大規模な教師ありおよび対照的な画像テキストの事前学習において重要です.これにより、より大きなモデルサイズとトレーニング期間を持つ等価なViTに比べて、より高いスループットと大きな画像への露出が可能となり、大幅な性能向上が実現されます.

具体的には、NaViTは同じ計算予算を使用しながら、ViTを常に上回るパフォーマンスを示します.たとえば、最も優れたViTのパフォーマンスは、5倍のパラメータスケールで一致するNaViTによって実現できます.また、NaViTは、モデルのサイズとトレーニング期間の観点からも、等価なViTに比べて大幅な改善をもたらします.

このようなトレーニング効率の改善は、NaViTが大規模な教師ありおよび対照的な画像テキストの事前学習において優れたパフォーマンスを発揮する理由の一部です.NaViTの柔軟性と効率性は、画像とテキストの両方のモデルにおいて効果的に活用され、トレーニングおよび推論の両方の段階で優れた結果をもたらします.

Q: NaViTは、画像やビデオの分類、物体検出、セマンティック・セグメンテーションといった標準的なタスクにどのように効率的に移行できるのか?

A: NaViTは、画像およびビデオの分類、物体検出、意味的セグメンテーションなどの標準的なタスクに効率的に転送することができます.これは、柔軟なモデルの使用とともに、改善されたトレーニング効率を示すことによって実現されます.NaViTは、大規模な教師ありおよび対照的な画像テキストの事前トレーニングにおいて改善された結果を示し、ロバスト性と公平性のベンチマークでも改善された結果をもたらします.

具体的には、NaViTは柔軟な入力解像度を持つため、トレーニング時に異なる解像度の画像を処理することができます.これにより、画像およびビデオの分類、物体検出、意味的セグメンテーションなどのタスクにおいて、入力解像度の柔軟性を活用して効率的に転送することができます.

また、NaViTは、トレーニング時に異なる解像度の画像を処理することができるため、テスト時のコストとパフォーマンスのトレードオフをスムーズにナビゲートすることも可能です.これにより、テスト時のコストパフォーマンスのトレードオフを調整しながら、効率的な推論が実現されます.

NaViTは、一般的なコンピュータビジョンモデルが使用する標準的なCNN設計の入力およびモデリングパイプラインからの脱却を示しており、ViTsにおける有望な方向性を示しています.NaViTは、現在のデータおよびモデリングパイプラインによって課される制約を超えることで、コンピュータビジョンシステムの制限を克服し、固定バッチ形状の制約によって制約されていたアイデアを可能にすることができます.

以上のように、NaViTは柔軟な入力解像度とモデルの使用によって、画像およびビデオの分類、物体検出、意味的セグメンテーションなどの標準的なタスクに効率的に転送することができます.これにより、トレーニング効率が向上し、ロバスト性と公平性のベンチマークでも改善された結果をもたらします.また、テスト時の入力解像度の柔軟性を活用して、コストパフォーマンスのトレードオフをスムーズにナビゲートすることも可能です.NaViTは、一般的なCNN設計の入力およびモデリングパイプラインからの脱却を示し、ViTsにおける有望な方向性を示しています.

Q: ロバスト性と公平性のベンチマークにおいて、NaViTが達成した改善結果とは?

A: NaViTは、頑健性と公平性のベンチマークにおいてどのような改善結果を達成しましたか?

NaViTは、公平性に関連するシグナルの注釈付けの精度を向上させるための表現を提供します.この研究では、性別や人種などの公平性に関連するシグナルを持つ画像に注釈を付けることを調査しています.先行研究では、グループのキャリブレーションなどのメトリクスは、特に少数派グループにおいてラベリングの不正確さに影響を受けることが示されています.さらに、トレーニング中のラベルノイズを考慮しても、この問題は解決されません(Adebayo et al.、2023).したがって、公平性のシグナルのラベリングエラーを減らすことは、バイアスの緩和や事後監査の信頼性を向上させるのに役立ちます(Raji and Buolamwini、2019).このような課題を克服するために、NaViTを使用してアノテーターをトレーニングし、その精度を比較します.

NaViTは、NaViT-L/16またはViT-L/16を使用して公平性関連のシグナルにトレーニングされたアノテーターの精度を評価した結果、より良い表現を提供し、アノテーターの精度を向上させます.また、NaViTでは、画像を正方形にリサイズする代わりに、ネイティブのアスペクト比を使用すると、パフォーマンスが向上します.

具体的には、NaViTは、公平性関連のシグナルの注釈付けの精度を向上させるための高品質な表現を提供します.さらに、正方形の画像を扱う場合でも、NaViTは改善された精度を実現します.これにより、FairFaceデータセットのオリジナル画像サイズは448×448であり、CelebAデータセットのオリジナル画像サイズは178×218である場合でも、NaViTは高い精度を実現します.

したがって、NaViTは頑健性と公平性のベンチマークにおいて改善された結果を達成します.

Q: NaViTの入力分解能の柔軟性は、テスト時間のコストと性能のトレードオフをどのように調整するのに役立つのでしょうか?

A: NaViTの入力解像度の柔軟性は、テスト時のコストとパフォーマンスのトレードオフをスムーズにナビゲートするのに役立ちます.具体的には、NaViTは可変解像度の画像を処理することができるため、異なる解像度の画像を効率的に扱うことができます.

NaViTでは、入力解像度の柔軟性を活用して、テスト時のコストとパフォーマンスのトレードオフを調整することができます.これは、異なる解像度の画像を使用することで、処理コストと詳細な情報の取得能力の間のバランスを取ることができるからです.

具体的には、NaViTでは、低解像度の画像と高解像度の画像を組み合わせて使用することができます.低解像度の画像は処理に必要なFLOPsが少なくなるため、高解像度の画像と比較して処理コストが低くなります.一方で、高解像度の画像は詳細な情報を取得することができます.NaViTでは、これらの異なる解像度の画像を組み合わせることで、処理コストと詳細な情報の取得能力のトレードオフを調整することができます.

具体的な例としては、NaViTでは、同じ面積を持つ異なる解像度の画像を使用することができます.例えば、解像度が「128」の場合、128 x 128の正方形の画像と同じ面積を持つ画像を使用することができます.この場合、実際の画像の解像度は64 x 256や170 x 96など、異なる解像度になりますが、処理コストは通常のViTの128 x 128の画像と同じです.

このように、NaViTの入力解像度の柔軟性は、異なる解像度の画像を組み合わせることで、処理コストと詳細な情報の取得能力のトレードオフを調整することができます.これにより、テスト時のコストとパフォーマンスのバランスを最適化することができます.

Q: NaViTは、ほとんどのコンピュータビジョンモデルで使用されている標準的な入力とモデリングのパイプラインからどのような点で逸脱しているのでしょうか?

A: NaViTは、従来のコンピュータビジョンモデルで使用されている標準的な入力とモデリングパイプラインからの脱却を示しています.これは、以下の点で異なるアプローチを取っています.

まず、NaViTは、画像をパッチに分割し、各パッチをトークンに線形投影するという単純な操作を基にしています.これにより、畳み込みベースのニューラルネットワークに代わるモデルとして広く使用されています.従来のモデルでは、入力画像は固定の正方形のアスペクト比にリサイズされ、固定数のパッチに分割されることが一般的でした.しかし、NaViTでは、FlexiViTという手法を用いて、複数のパッチサイズをサポートしています.これにより、シーケンスの長さのスムーズな変動とそれに伴う計算コストの変化が可能になります.

さらに、NaViTは、大規模な教師ありおよび対照的な画像テキストの事前トレーニングにおいて、改善されたトレーニング効率を実証しています.また、画像およびビデオの分類、物体検出、意味セグメンテーションなどの標準的なタスクに効果的に転送することができ、頑健性と公平性のベンチマークで改善された結果を示しています.

さらに、推論時には、入力解像度の柔軟性を利用して、テスト時のコストとパフォーマンスのトレードオフをスムーズに調整することができます.

これらの要素により、NaViTは従来のCNN設計の入力とモデリングパイプラインからの脱却を示しており、ViTsにおける有望な方向性を示しています.

Secrets of RLHF in Large Language Models Part I: PPO

著者:Rui Zheng, Shihan Dou, Songyang Gao, Yuan Hua, Wei Shen, Binghai Wang, Yan Liu, Senjie Jin, Qin Liu, Yuhao Zhou, Limao Xiong, Lu Chen, Zhiheng Xi, Nuo Xu, Wenbin Lai, Minghao Zhu, Cheng Chang, Zhangyue Yin, Rongxiang Weng, Wensen Cheng, Haoran Huang, Tianxiang Sun, Hang Yan, Tao Gui, Qi Zhang, Xipeng Qiu, Xuanjing Huang

発行日:2023年07月11日

最終更新日:2023年07月18日

URL:http://arxiv.org/pdf/2307.04964v2

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

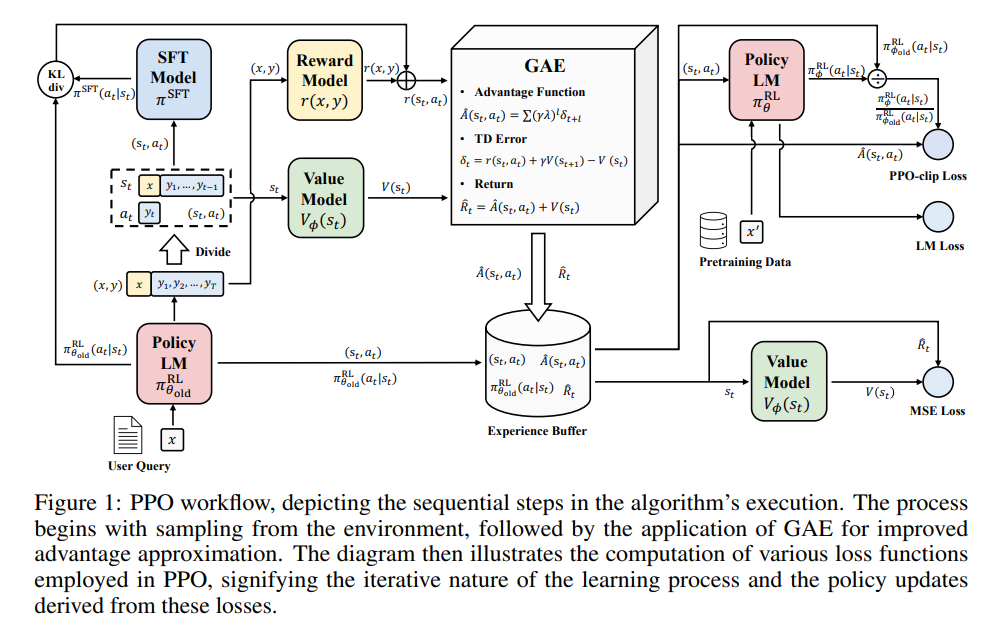

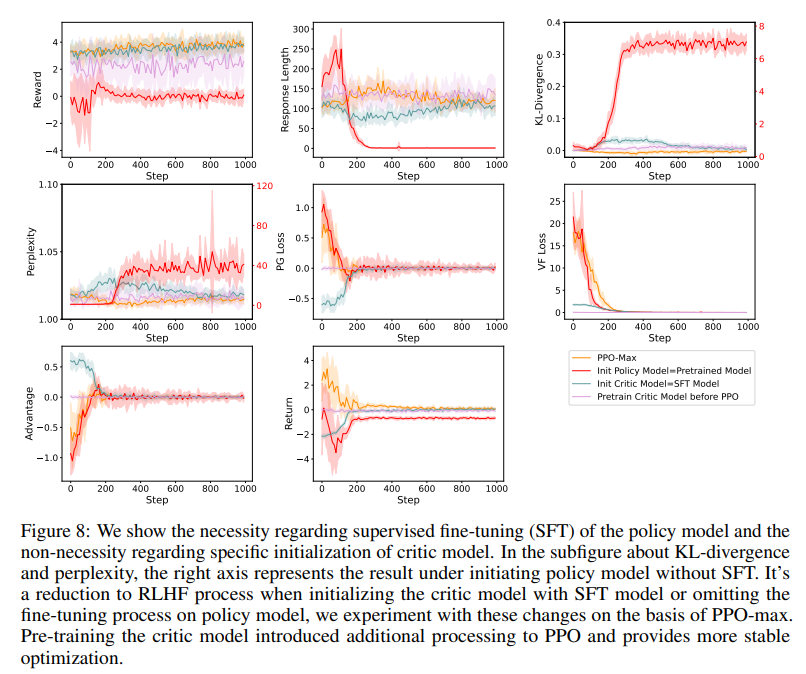

大規模言語モデル(LLM)は、人工汎用知能の進歩のための設計図を作り上げています.その主な目的は、人間中心(助けになり、正直で無害な)のアシスタントとして機能することです.人間との調和は最も重要であり、人間のフィードバックを用いた強化学習(RLHF)がこの追求の基盤となる技術的なパラダイムとして浮かび上がっています.現在の技術的手法には、人間の好みを測定するための報酬モデル、ポリシーモデルの出力を最適化するための近接方策最適化(PPO)、およびステップバイステップの推論能力を向上させるためのプロセス監視が通常含まれています.しかし、報酬設計、環境との相互作用、エージェントのトレーニングの課題、および大規模言語モデルの試行錯誤のコストにより、技術的な調和とLLMの安全な着陸の開発をAI研究者が推進するための重要な障壁が存在しています.RLHFの安定したトレーニングはまだ謎のままです.最初の報告では、RLHFのフレームワークを解析し、PPOの内部動作を再評価し、PPOアルゴリズムを構成するパーツがポリシーエージェントにどのような影響を与えるかを探求します.さらに、PPOアルゴリズムの実装においてポリシー制約が重要な要素であることが明らかになりました.そのため、PPOアルゴリズムのトレーニング安定性を効率的に向上させるために、PPO-maxというPPOアルゴリズムの高度なバージョンを探求します.また、SFTモデルやChatGPTと比較して、RLHFの能力について包括的な分析を行います.LLMの調整に関するオープンソースの実装の不足は、調査に大きな課題をもたらしています.そのため、報酬モデルやPPOコードなどの技術レポートを公開し、LLMの進歩に対するささやかな貢献を目指しています.

Q&A:

Q: 大規模言語モデル(LLM)の主な目的は何ですか?

A: 大規模言語モデル(LLM)の主な目的は、人工知能の進歩のための設計図を作成することです.これらのモデルは、人間中心(助けになり、正直であり、害のない)のアシスタントとして機能することを目指しています.人間との調和は非常に重要であり、人間のフィードバックを用いた強化学習(RLHF)が前提とされています.

LLMは、大量のデータとトレーニング計算量を用いてモデルのサイズを拡大することにより、小規模モデルには存在しない顕著な特徴を獲得します.これには、文脈に基づいた学習、指示の追跡、段階的な推論などが含まれます.これらの新たな能力に基づいて、LLMは言葉と知覚のリンクを示し、現実世界との相互作用を可能にする可能性を示しており、具体的にはツール操作を伴う具現化言語モデルやインタラクティブな砂場環境での生成エージェントなど、人工一般知能(AGI)の可能性を追求しています.

しかし、LLMは事前トレーニングコーパスのデータ特性(高品質データと低品質データの両方を含む)を捉えるように訓練されているため、意図しない振る舞いを示す可能性があります.これには、事実をでっち上げる、バイアスのあるまたは有害なテキストを生成する、人間にとって有害なコンテンツを生成するなどが含まれます.そのため、能力に対する安全性の進歩の比率が重要であるとされています.

以上から、LLMの主な目的は、人工一般知能の進歩のための設計図を作成し、人間中心のアシスタントとして機能することです.

Q: 人間のフィードバックによる強化学習(RLHF)とは何か、なぜLLMにとって重要なのか?

A: Reinforcement Learning with Human Feedback (RLHF)は、人間のフィードバックを用いた強化学習の手法です.この手法は、大規模言語モデル(LLM)において特に重要であり、人間の価値観に合致した、有益で正直で無害なLLMを実現するために採用されています.

RLHFは、人間のプロキシとしての報酬モデルからのわずかな監督信号を必要とし、RLのフレームワークの下で多数の試行を経て修正されることで、目標を達成するための最も直接的な解決策を提供します.具体的には、エージェントは与えられた文脈と対応する人間のランキングやスコアリングに基づいて、人間のような結果を提供するために、人間の好みを学習する必要があります.

LLMにおけるRLHFの重要性は、一般的な目的の言語モデルから生じる否定的な社会的影響を軽減し、人間の価値観に合致した有益で正直で無害なLLMを実現するためです.大規模言語モデルの安定したトレーニングはまだ謎であり、報酬設計、環境との相互作用、エージェントのトレーニングの課題、および大規模言語モデルの試行錯誤のコストなどの課題が存在します.RLHFは、これらの課題に取り組むための重要な技術的手法として浮上しています.

具体的な技術的手法としては、人間の好みを測定する報酬モデル、ポリシーモデルの出力を最適化するためのProximal Policy Optimization(PPO)、およびステップバイステップの推論能力を向上させるためのプロセス監視などが含まれます.しかし、報酬設計、環境との相互作用、エージェントのトレーニングの課題、および大規模言語モデルの試行錯誤のコストといった課題のため、AI研究者が技術的なアライメントの開発とLLMの安全な着陸を促進するための重要な壁が存在しています.

したがって、RLHFは、LLMの安全性と信頼性を向上させるために必要な効果的かつ効率的な制御手法であり、人間の価値観に合致した結果を提供するための解決策として重要です.

Q: 報酬モデルやPPO(Proximal Policy Optimization)など、LLMで現在使われている技術的なルートとは?

A: 現在のLLM(Large Language Models)における現在の技術的手法は、報酬モデルとProximal Policy Optimization(PPO)です.報酬モデルは、人間の好みを測定するために使用されます.報酬モデルは、エージェントが望ましい行動を選択するための基準となります.PPOは、ポリシーモデルの出力を最適化するために使用されます.PPOは、ポリシーモデルを最適化するための手法であり、安定性を損なうことなくポリシーをトレーニングすることを目指しています.PPOは、ポリシーモデルを最適化するための小さなステップを踏むという考え方に基づいています.この方法では、ポリシーを最適化するために積極的な更新を強制するのではなく、ゆっくりとポリシーを最適化することが重要です.報酬モデルとPPOは、LLMの技術的手法として現在使用されています.

Q: LLMの技術的な整合性と安全な着陸を開発する上で、AI研究者が直面する課題とは?

A: AI研究者がLLM(大規模言語モデル)の技術的な整合性と安全な着陸を開発する際に直面する課題は次のとおりです.

- 大規模言語モデルの試行錯誤に伴う高いコスト:大規模言語モデルの開発には膨大な試行錯誤が必要であり、これには膨大なコストがかかります.このため、AI研究者にとっては技術的な整合性の開発やLLMsの安全な着陸を動機付ける重要な障壁が存在します.

- RLHF(強化学習ベースの言語モデル)の安定したトレーニング:RLHFの安定したトレーニングはまだ謎となっています.具体的には、RLHFのフレームワークを解析し、内部の動作を再評価する必要があります.

- LLMsのトレーニングデータの特性:LLMsは、事前トレーニングコーパス(高品質および低品質のデータを含む)のデータ特性を捉えるようにトレーニングされています.そのため、これらのモデルは意図しない振る舞いを示す可能性があります.具体的には、事実をでっち上げる、バイアスのあるまたは有害なテキストを生成する、人間にとって有害なコンテンツを生成するなどです.したがって、OpenAIのAGI計画でも強調されているように、安全性の進歩と能力の進歩の比率を高めることが重要です.LLMsを人間の価値観(助けになる、正直である、無害である)に整合させる必要があります.

- LLMsの安全性と信頼性の向上:現在の多くの研究では、SFT(教師あり微調整)にいくつかの3H(助けになる、正直である、無害である)データを追加することで、LLMsのリスクを軽減しようとしています.これにより、モデルの応答を活性化させ、道徳的および倫理的なレベルでのポジティブな変化を促すことを期待しています.しかし、対話の振る舞いを捉えるために安全性と信頼性の目標を追加しても、モデルのパフォーマンスは安全性と信頼性の面で人間のレベルを下回るままです.したがって、LLMsの使用に潜在的なリスクを排除するために、より効果的かつ効率的な制御手法が必要です.

- RLHFの有効な手法としての検証:幸いなことに、OpenAIとAnthropicはRLHFがさまざまなタスクでユーザーの意図と言語モデルを整合させるための有効な手法であることを検証しています.

以上がAI研究者がLLMsの技術的な整合性と安全な着陸を開発する際に直面する課題です.

Q: PPOアルゴリズムは、保険契約エージェントのトレーニングにどのような影響を与えますか?

A: PPOアルゴリズムは、ポリシーエージェントのトレーニングにおいて重要な役割を果たします.PPOアルゴリズムのパーツがポリシーエージェントのトレーニングにどのような影響を与えるかを探求することで、PPOアルゴリズムの効果的な実装のためのポリシー制約が重要な要素であることが明らかになります.

さらに、PPOアルゴリズムの高度なバージョンであるPPO-maxを探求することで、ポリシーモデルのトレーニングの安定性を効率的に改善することができます.主な結果に基づいて、PPOアルゴリズムの内部動作の詳細な評価を行い、コードレベルと理論レベルの最適化がエージェントのトレーニングダイナミクスにどのように影響するかを研究します.

さらに、ポリシーモデルから派生したアクションスペースモデリングメトリクス(パープレキシティ、応答長、ポリシーモデルとSFTモデルのKLダイバージェンスなど)を使用して、PPOトレーニングプロセスをモニタリングすることを提案します.これらのメトリクスは、トレーニングの安定性についてより詳細な情報を提供します.

以上のように、PPOアルゴリズムはポリシーエージェントのトレーニングに大きな影響を与えます.ポリシーモデルの最終結果には、報酬モデルの品質や適切なPPOアルゴリズムの設計が直接関与しており、正確なコードの実装も重要です.PPOアルゴリズムの内部動作の評価やアクションスペースモデリングメトリクスの使用など、さまざまなアプローチを通じてPPOアルゴリズムのトレーニングプロセスを改善することが重要です.

Q: PPO-maxとは何か、そしてそれがどのように政策モデルのトレーニング安定性を向上させるのか?

A: PPO-maxは、PPOアルゴリズムの改良版であり、ポリシーモデルのトレーニングの安定性を向上させるために開発されました.PPO-maxは、有効で必要な実装の集合を組み込み、それらの間の干渉を避けるように注意深く調整されています.これにより、バニラPPOのトレーニングの不安定性が軽減され、より大きなトレーニングコーパスでより長いトレーニングステップが可能になります.

PPO-maxは、ポリシーモデルのトレーニングの安定性を向上させるためにいくつかの方法を採用しています.まず、PPO-maxは、ポリシーモデルとSFTモデルの間のKLダイバージェンス、応答の長さ、パープレキシティなど、ポリシーモデルから派生したアクションスペースモデリングメトリクスを使用して、PPOトレーニングプロセスをモニタリングすることを提案しています.これらのメトリクスは、応答の報酬や損失関数の値よりもトレーニングの安定性に関する情報を提供します.

さらに、PPO-maxは、ポリシーコンストレイントを特定し、人間の好みと一貫したアライメントを達成するための鍵として位置付けています.PPOアルゴリズムの実装の比較的な実験を通じて、PPO-maxは、効果的で必要な実装の集合を組み込み、それらの間の干渉を避けるように注意深く調整されています.これにより、PPO-maxはバニラPPOのトレーニングの不安定性を軽減し、より大きなトレーニングコーパスでより長いトレーニングステップを可能にします.

PPO-maxの開発により、ポリシーモデルのトレーニングの安定性が向上しました.これにより、より高品質なポリシーモデルが構築され、人間の好みとの一貫性が向上しました.PPO-maxは、7Bおよび13BのSFTモデルで評価され、ChatGPTと同等のアライメント性能を示しました.

Q: RLHFの能力はSFTモデルやChatGPTと比べてどうですか?

A: RLHFの能力は、SFTモデルとChatGPTと比較してどのようになっていますか?

提供された文脈から、RLHFモデルはSFTモデルとChatGPTと比較して優れた能力を持っていることが示されています.文脈によれば、RLHFモデルはクエリの深い意味をより理解し、その応答は人々の心に直接訴えることができるとされています.

また、提供された文脈では、RLHFモデルとSFTモデル、ChatGPTとの比較が行われています.この比較では、RLHFモデルがより強力な相手に対して優位性を示すことが目的であり、ChatGPTを超越することを目指しているわけではありません.

具体的な比較方法としては、”harmless”という能力を比較指標とし、自動評価のためにGPT-4を使用しています.生成された応答は、nucleus samplingという手法を用いて生成されており、重複する応答を避けるためにrepetition penaltyが適用されています.

さらに、人間の評価による比較も行われており、RLHFモデルとSFTモデル、ChatGPTとの間での優位性が評価されています.この評価結果からは、RLHFで訓練されたモデルがChatGPTによって上回されるクエリの数が大幅に減少していることが示されています.

つまり、RLHFモデルはSFTモデルとChatGPTと比較して、より優れた能力を持っていると言えます.

Q: なぜオープンソースの実装がないことが、LLMのアライメントを調査する上での課題なのか?

A: オープンソースの実装の不在は、LLMsのアライメントの調査において課題となっています.なぜなら、オープンソースの実装がないため、研究者はLLMsのアライメントを調査するためのツールやリソースを利用することができず、その結果、研究の進展が妨げられるからです.

具体的には、オープンソースの実装がないと、研究者はLLMsの内部機能やアライメントのメカニズムを理解することが難しくなります.オープンソースの実装がない場合、研究者は自分自身で実装を作成する必要がありますが、これには膨大な時間と労力がかかります.また、実装の正確性や信頼性を確保するためには、多くのテストや検証が必要です.これらの作業は非常に困難であり、研究者にとっては大きな負担となります.

さらに、オープンソースの実装がないと、研究者同士の共同作業や情報共有が困難になります.オープンソースの実装があれば、研究者は互いの成果を共有し、相互に助け合うことができます.しかし、オープンソースの実装がない場合、研究者は自分自身で実装を作成する必要があり、その結果、情報の共有や共同作業が制限されることになります.

以上のように、オープンソースの実装の不在は、LLMsのアライメントの調査において重要な課題となっています.オープンソースの実装がないことにより、研究者はLLMsの内部機能やアライメントのメカニズムを理解することが難しくなり、研究の進展や情報共有が制限されることになります.

Q: どのようなテクニカルレポート、報酬モデル、PPOコードを発表する予定ですか?

A: 著者は、技術レポート、報酬モデル、およびPPOコードをリリースする予定です.

具体的には、以下の貢献があります:

1) 競争力のある中国語と英語の報酬モデルをリリースします.これらのモデルは、クロスモデルの汎化能力が高く、人間の選好データの再ラベリングのコストを軽減します.

2) PPOアルゴリズムの内部動作について詳細な分析を行い、安定したモデルトレーニングを保証するためにPPO-maxアルゴリズムを提案します.

3) 現在のSFTステージのLLM(Language Learning Models)が人間とよりよく整合するようにするために、完全なPPO-maxコードをリリースします.

したがって、著者は技術レポート、報酬モデル、およびPPOコードをリリースする予定です.

Q: 著者たちは、このリリースを通じてLLMの発展にどのように貢献しようとしているのだろうか?

A: 著者たちは、彼らのリリースを通じてLLMの進歩に貢献することを目指しています.彼らは技術レポート、報酬モデル、およびPPOコードを公開することを熱望しており、これによってLLMの進歩に控えめな貢献をすることを目指しています.

具体的には、彼らはオープンソースの実装の不在がLLMの調整の調査に重大な課題をもたらしていると認識しています.そのため、彼らは技術レポート、報酬モデル、およびPPOコードを公開することで、LLMの進歩に控えめな貢献をすることを目指しています.

彼らのリリースによって、LLMの進歩が促進されることを期待しています.彼らは、オープンソースの実装の不在がLLMの調整の調査に重大な課題をもたらしていると認識しており、そのために彼らのリリースを通じて技術レポート、報酬モデル、およびPPOコードを提供することで、LLMの進歩に貢献することを目指しています.

彼らのリリースは、LLMの進歩に向けた控えめな貢献をすることを目指しています.彼らは、オープンソースの実装の不在がLLMの調整の調査に重大な課題をもたらしていると認識しており、そのために彼らのリリースを通じて技術レポート、報酬モデル、およびPPOコードを提供することで、LLMの進歩に貢献することを目指しています.

彼らのリリースは、LLMの進歩に貢献することを目指しています.彼らは、オープンソースの実装の不在がLLMの調整の調査に重大な課題をもたらしていると認識しており、そのために彼らのリリースを通じて技術レポート、報酬モデル、およびPPOコードを提供することで、LLMの進歩に控えめな貢献をすることを目指しています.

Generative Pretraining in Multimodality

著者:Quan Sun, Qiying Yu, Yufeng Cui, Fan Zhang, Xiaosong Zhang, Yueze Wang, Hongcheng Gao, Jingjing Liu, Tiejun Huang, Xinlong Wang

発行日:2023年07月11日

最終更新日:2023年07月11日

URL:http://arxiv.org/pdf/2307.05222v1

カテゴリ:Computer Vision and Pattern Recognition

概要:

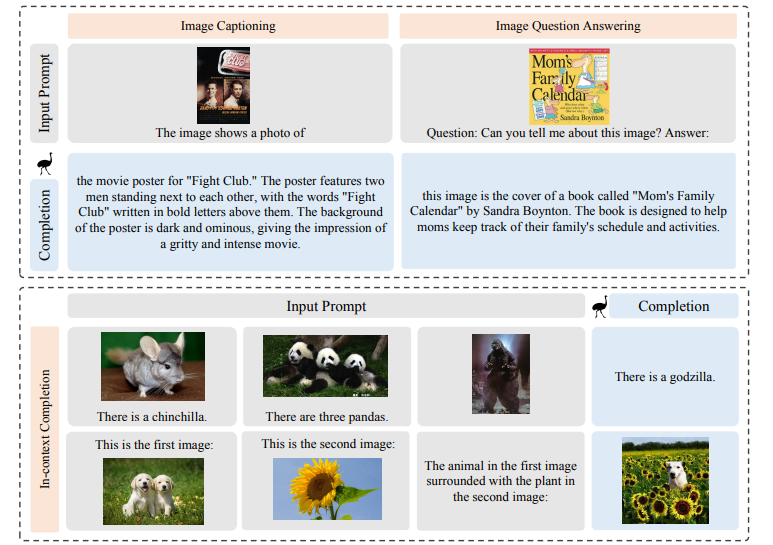

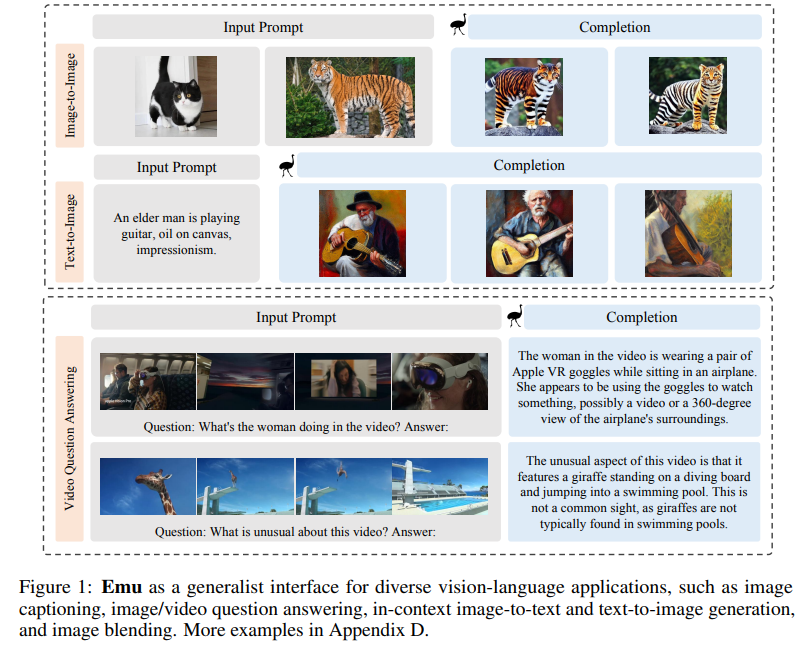

Emuは、Transformerベースのマルチモーダルな基礎モデルであり、マルチモーダルなコンテキストで画像とテキストをシームレスに生成することができます.このオムニボアモデルは、単一モダリティまたはマルチモーダルのデータ入力(例:交互に配置された画像、テキスト、ビデオ)を、一つのモデルによるオートレグレッシブなトレーニングプロセスを通じて受け入れることができます.まず、視覚信号は埋め込みにエンコードされ、テキストトークンとともに交互に配置された入力シーケンスを形成します.Emuは、マルチモーダルシーケンスの次のテキストトークンの分類または次の視覚埋め込みの回帰を統一された目的としてエンドツーエンドでトレーニングされます.この多様なマルチモダリティは、ビデオとテキストが交互に配置されたフレーム、画像とテキストが交互に配置されたウェブページ、およびウェブスケールの画像テキストペアとビデオテキストペアなど、さまざまな前処理データソースの大規模な探索を可能にします.Emuは、画像からテキストへのタスクとテキストから画像へのタスクの両方において、一般的なマルチモーダルインターフェースとして機能し、コンテキスト内での画像とテキストの生成をサポートします.画像キャプション、ビジュアルクエスチョンアンサリング、ビデオクエスチョンアンサリングなどのゼロショット/フューショットタスクの幅広い範囲にわたって、Emuは優れたパフォーマンスを発揮します.さらに、画像キャプション、ビジュアルクエスチョンアンサリング、ビデオクエスチョンアンサリング、テキストから画像生成などのタスクにおいて、Emuは最先端の大規模なマルチモーダルモデルと比較して、優れたパフォーマンスを示しています.また、指示調整を通じたマルチモーダルアシスタントなどの拡張機能も、印象的なパフォーマンスで示されています.

Q&A:

Q: トランスフォーマーをベースとしたマルチモーダルファウンデーションモデル、Emuの目的は何ですか?

A: Emuは、Transformerベースのマルチモーダルな基盤モデルであり、画像とテキストをマルチモーダルなコンテキストでシームレスに生成することを目的としています.このオムニボアモデルは、単一モダリティまたはマルチモーダルのデータ入力(例:交互に配置された画像、テキスト、ビデオ)を区別せずに受け入れることができます.Emuは、一つのモデルによるオートレグレッシブなトレーニングプロセスを通じて、ビジュアル信号をエンコードし、テキストトークンと組み合わせて交互に入力されるシーケンスを形成します.Emuは、マルチモーダルなシーケンスの次のテキストトークンの分類または次のビジュアルエンベッディングの回帰を統一された目的としてエンドツーエンドでトレーニングされます.この多様なマルチモダリティは、ビデオとテキストが交互に配置されたビデオ、画像とテキストが交互に配置されたウェブページ、およびウェブスケールの画像テキストペアやビデオテキストペアなど、さまざまな事前トレーニングデータソースの探索を可能にします.Emuは、モダリティの異なる出力を生成することができる汎用的なモデルとして機能します.

Q: シングルモダリティデータとマルチモーダルデータなど、異なるタイプのデータ入力をどのように扱うのですか?

A: Emuは、単一モダリティとマルチモーダルデータなど、さまざまなタイプのデータ入力をどのように処理するのでしょうか?

Emuは、統一された目的とさまざまな形式のデータで事前学習されており、マルチモーダルなシーケンスでさまざまなタイプの補完を行うことにより、画像からテキストへのタスクとテキストから画像へのタスクの両方に対して一般的なインタフェースとして機能することができます.具体的には、マルチモーダルなプロンプト(テキスト、画像、ビデオ、またはそれらの交互のシーケンスなど)を受け入れ、マルチモーダルな応答を出力します(画像生成の場合、視覚的な埋め込みは微調整された拡散モデルによってデコードされます).

Emuは、さまざまな能力を持っており、コンテキスト内のテキストと画像の生成、画像のブレンド、ビデオの理解、および現実世界の知識の基盤などを示しています.また、画像キャプショニング、ビジュアルな質問応答、ビデオの質問応答、テキストから画像生成など、ゼロショットおよびフューショットの幅広いタスクでEmuを評価しています.質的なデモンストレーションのために、マルチモーダルな会話データの指示調整を行い、効果的なマルチモーダルアシスタントを構築しています.指示に調整されたEmuアシスタントは、人間の指示に効果的に従い、マルチモーダルな応答を通じてユーザーと対話することができます.

Emuは、マルチモーダルなモデルであり、マルチモーダルな入力を認識し、モダリティの異なる出力を生成するために、ビジュアルエンコーダ、因果トランスフォーマー、マルチモーダルモデリング、ビジュアルデコーダの4つのパーツで構成されています.事前学習済みのEV A-CLIP [55]、LLaMA [57]、およびStable Diffusion [51]を使用して、ビジュアルエンコーダ、マルチモーダルモデリングLLM、およびビジュアルデコーダを初期化しています.

Emuは、交互に配置された画像、テキスト、ビデオのシーケンスを持つ任意のシーケンスを与えられた場合、まずEV A-CLIPを使用して画像を密な視覚的特徴にエンコードし、次に因果トランスフォーマーを使用してエンコーディングをNvisualの因果的埋め込みの固定数に変換します.同様に、TフレームのビデオをT×Nvisualの因果的埋め込みにエンコードします.各画像またはフレームには、特別な画像トークン[IMG]と[/IMG]が先

Q: 視覚信号をエンベッディングにエンコードし、Emuでどのようにテキスト・トークンと組み合わせるのか、そのプロセスを教えてください.

A: ビジュアルシグナルを埋め込みにエンコードするプロセスは、Emuにおいて次のように行われます.まず、ビジュアルシグナルは画像エンコーダ(EVA-CLIP)によってエンコードされ、連続的なビジュアル埋め込みに変換されます.この画像エンコーダは、画像の特徴を抽出し、ビジュアル情報を数値表現に変換する役割を果たします.

次に、テキストトークンとともに、これらのビジュアル埋め込みは相互に交互に配置された入力シーケンスを形成します.この入力シーケンスは、Emuのモデルの入力となります.

Emuでは、テキストトークンとビジュアル埋め込みの両方を損失計算に考慮します.テキストトークンに対しては、クロスエントロピー分類損失を採用し、ビジュアル埋め込みに対しては、ℓ2回帰損失を採用します.これにより、テキストトークンとビジュアル埋め込みの両方がモデルの訓練において重要な役割を果たすことができます.

具体的には、テキストトークンとビジュアル埋め込みは、Emuのモデル内で組み合わされ、次のテキストトークンまたは次のビジュアル埋め込みを予測する統一された目的の下でエンドツーエンドで訓練されます.この統一された目的により、Emuは画像からテキストへのタスクやテキストから画像へのタスクの両方に対応することができます.

ビジュアル埋め込みとテキストトークンの組み合わせにより、Emuは多様な事前学習データソースを扱うことができます.例えば、ビデオとテキストが交互に配置されたフレーム、画像とテキストが交互に配置されたウェブページ、および画像とテキストのペアが大量に存在するウェブスケールのデータなどです.

このようにして、ビジュアルシグナルを埋め込みにエンコードし、テキストトークンと組み合わせることで、Emuはビジュアルと言語のモデリングを統一的に行い、さまざまなタスクに対応する汎用的なマルチモーダルインターフェースとなります.

Q: Emuをトレーニングする統一的な目的は何でしょうか?また、それはマルチモーダルシーケンスにおけるテキストトークンの分類や視覚的埋込みの回帰とどのように関係しているのでしょうか?

A: Emuの統一された目的は、テキストトークンの分類とマルチモーダルシーケンス内の視覚埋め込みの回帰です.Emuは、テキストトークンの次の要素を分類するか、マルチモーダルシーケンス内の次の視覚埋め込みを回帰するという統一された目的でエンドツーエンドでトレーニングされます.この統一された目的により、Emuはさまざまな事前トレーニングデータソースの大規模な探索を可能にし、例えばテキストと交互に配置されたビデオ、画像とテキストが交互に配置されたウェブページ、および画像とテキストのペアやビデオとテキストのペアなどのデータソースを利用することができます.Emuは、画像からテキストへのタスクとテキストから画像へのタスクの両方に対して一般的なマルチモーダルインターフェースとして機能し、コンテキスト内の画像とテキストの生成をサポートします.また、画像のキャプショニング、ビジュアルな質問応答、ビデオの質問応答など、ゼロショット/フューショットタスクの幅広い範囲にわたって利用することができます.

Emuの統一された目的は、次の要素の予測を行うことです.この予測は、視覚的なトークンとテキストトークンの両方を含みます.具体的には、Emuはマルチモーダルシーケンス内の次のテキストトークンを分類するか、次の視覚的な埋め込みを回帰することを目指してトレーニングされます.この統一された目的により、Emuはビデオや画像とテキストが交互に配置されたウェブページなど、さまざまなデータソースを利用してトレーニングすることができます.このような統一されたモデリングにより、Emuは画像からテキストへのタスクやテキストから画像へのタスクなど、さまざまなマルチモーダルタスクに対応した一般的なインターフェースとなります.

Q: Emuが大規模に扱える多様なトレーニング前データソースの例を教えてください.

A: Emuは、さまざまな種類のデータソースを大規模に処理することができるため、多様な事前学習データソースの例を提供することができます.具体的には、以下のようなデータソースを扱うことができます.

- インターリーブされたフレームとテキストを含むビデオ:Emuは、ビデオのフレームとテキストが交互に配置されたデータを処理することができます.これにより、ビデオの内容と関連するテキスト情報を組み合わせて学習することができます.

- インターリーブされた画像とテキストを含むウェブページ:Emuは、ウェブページの画像とテキストが交互に配置されたデータを処理することができます.これにより、ウェブページのコンテンツに関連する画像とテキスト情報を組み合わせて学習することができます.

- ウェブスケールの画像とテキストのペア:Emuは、大量の画像とテキストのペアを処理することができます.これにより、画像とテキストの関連性を学習することができます.

以上のような多様なデータソースを利用することで、Emuはさまざまなタスクに対応することができます.

Q: Emuは、画像からテキスト、テキストから画像というタスクのための汎用的なマルチモーダルインターフェイスとしてどのように機能するのだろうか?

A: Emuは、統一された目的と多様な形式のデータで事前学習されており、画像からテキストへのタスクとテキストから画像へのタスクの両方において、多様なタイプの補完を行うことによって、画像とテキストの両方のタスクに対する一般的なマルチモーダルインターフェースとして機能することができます.具体的には、マルチモーダルなプロンプト(テキスト、画像、ビデオ、またはそれらの交互のシーケンスなど)を受け入れ、マルチモーダルな応答を出力します(画像生成の場合、ビジュアル埋め込みは微調整された拡散モデルによってデコードされます).Emuは、図1に示されているように、インコンテキストのテキストと画像の生成(図1の2番目のブロック)、画像のブレンディング(図1の5行目で猫とトラを可愛いトラキャットに組み合わせる)、ビデオの理解(図1の最後のブロック)、および現実世界の知識の基盤(セクション5.3)など、印象的な能力を示しています.Emuは、画像キャプション、ビジュアルクエスチョンアンサリング、ビデオクエスチョンアンサリング、テキストから画像生成など、ゼロショットおよびフューショットの幅広いタスクで評価されています.質的なデモンストレーションのために、マルチモーダルな会話データの指示調整によって効果的なマルチモーダルアシスタントも構築されています.指示に調整されたEmuアシスタントは、人間の指示に効果的に従うことができます.

Q: Emuは、インコンテキストの画像やテキストの生成にどのように対応しているのですか?

A: Emuは、コンテキストに関連する画像を生成し、コンテキストに沿った指示に従うことができます.Emuの多モーダルモデリングのコンテキスト内能力(LLMの初期化)が、画像生成のこの新しい能力に責任を持っています.

具体的には、Emuはコンテキストに関連する画像を生成することができます.図8の最初の2行では、生成された画像はコンテキスト内の油絵のスタイルを共有しており、図9の対応する画像と比較してもコンテキストなしで生成された画像とは異なります.また、Emuはコンテキストに関連する指示に従うこともできます.図1の4行目に示されているように、Emuはコンテキストに関連する指示を実行することができます.

Emuはまた、他の最先端の多モーダルアシスタントと比較して、典型的な画像キャプションタスクの実行能力(図10)や人間の指示に従う能力(図11)を持っています.

Emuは、画像からテキストへの変換やテキストから画像への変換の両方のタスクにおいて、一般的な多モーダルインターフェースとして機能することができます.また、Emuはコンテキスト内の画像とテキストの生成をサポートしています.

Emuのコンテキスト内画像とテキストの生成をサポートするために、多モーダルモデリングが使用されます.このモデリングは、コンテキスト情報を入力として受け取り、それに基づいて適切な画像やテキストを生成することができます.具体的には、Emuはコンテキストに関連する画像のスタイルや内容を理解し、それに基づいて新しい画像を生成することができます.また、Emuはコンテキストに関連する指示を理解し、それに従って適切なテキストを生成することもできます.

このようにして、Emuはコンテキスト内の画像とテキストの生成をサポートすることができます.これにより、Emuはよりリアルな画像とテキストを生成することができ、より高度なタスクを実行することができます.

Q: インストラクションチューニングによるマルチモーダルアシスタントなど、エミュの拡張機能について詳しく教えてください.

A: Emuは、多様なモーダリティでの入力を認識し、モーダリティの異なる出力を生成する大規模なマルチモーダルモデルです.Emuは、ビジュアルエンコーダ、因果トランスフォーマ、マルチモーダルモデリング、ビジュアルデコーダの4つの部分から構成されています.ビジュアルエンコーダ、マルチモーダルモデリング、ビジュアルデコーダは、それぞれ事前学習されたEV A-CLIP、LLaMA、Stable Diffusionを利用して初期化されます.

Emuは、画像キャプション、画像/ビデオの質問応答、テキストから画像の生成などのタスクにおいて、従来の大規模なマルチモーダルモデルと比較して優れたパフォーマンスを発揮します.さらに、Emuを基にしたマルチモーダルアシスタントの拡張機能も示されており、印象的なパフォーマンスを発揮しています.このマルチモーダルアシスタントは、Emuによって指示調整されており、マルチターンの対話など、優れた人間に合わせた能力を持っています.

Emuを基にしたマルチモーダルアシスタントは、指示調整によって効果的に構築されています.これにより、ユーザーからの指示に効果的に従い、マルチモーダルな応答を通じてユーザーと対話することができます.このようなマルチモーダルアシスタントは、テキストと画像の生成などの新たな能力を備えており、マルチターンの対話など、人間に合わせた優れた能力を示しています.

Emuを基にしたマルチモーダルアシスタントの指示調整による拡張機能は、優れたパフォーマンスを発揮しています.これにより、コミュニティが潜在能力を引き出すための探求を続けることを期待しています.

Large Language Models as General Pattern Machines

著者:Suvir Mirchandani, Fei Xia, Pete Florence, Brian Ichter, Danny Driess, Montserrat Gonzalez Arenas, Kanishka Rao, Dorsa Sadigh, Andy Zeng

発行日:2023年07月10日

最終更新日:2023年07月10日

URL:http://arxiv.org/pdf/2307.04721v1

カテゴリ:Artificial Intelligence, Computation and Language, Robotics

概要:

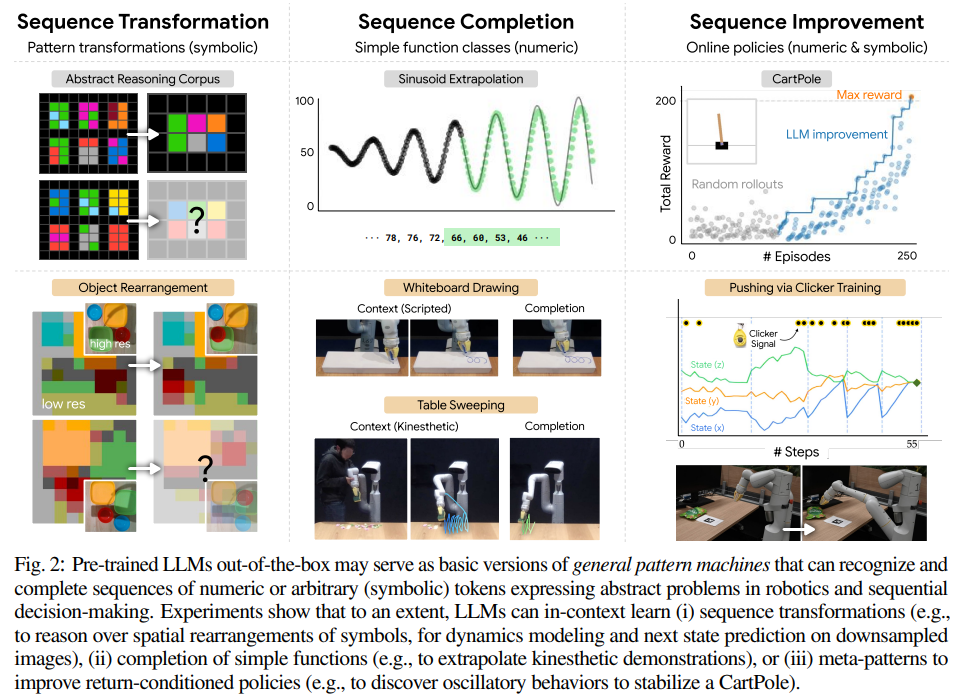

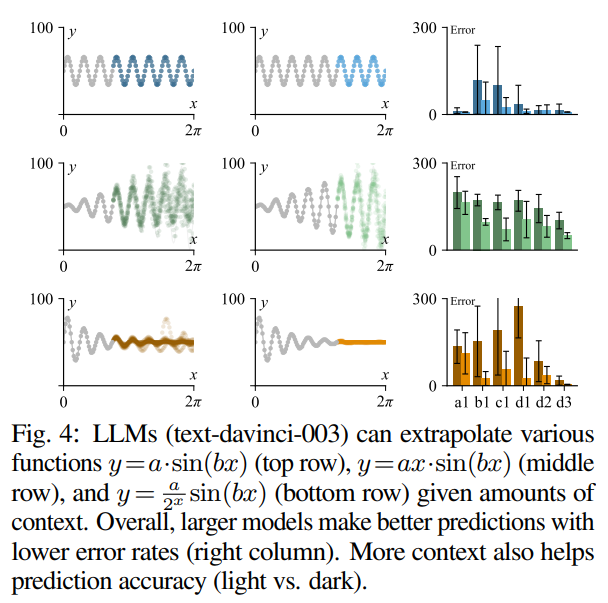

この研究では、事前学習された大規模言語モデル(LLM)が、確率的文脈自由文法(PCFG)によって手続き的に生成された任意のトークンシーケンスから、ASCIIアートのようなより豊かな空間パターンまで、複雑なトークンシーケンスを自己回帰的に補完する能力を持つことを観察しました.驚くべきことに、シーケンスが語彙からランダムにサンプリングされたトークンを使用して表現されている場合でも、パターンの補完能力は部分的に保持されることがわかりました.これらの結果は、追加のトレーニングなしに、LLMがコンテキスト内で学習を行うことによって、一般的なシーケンスモデラーとして機能する可能性があることを示唆しています.また、レイテンシ、コンテキストサイズの制限、および計算コストの問題があるものの、LLMを使用して低レベルの制御を行うアプローチは、単語間のパターンがアクションに転送される可能性を示唆しています.

Q&A:

Q: 学習済みの大規模言語モデル(LLM)は、どのようにして複雑なトークン列を自己回帰的に完成させることができるのか?

A: 事前学習された大規模言語モデル(LLM)は、複雑なトークンのシーケンスを自己回帰的に完了させることができます.LLMは、確率的文脈自由文法(PCFG)によって手続き的に生成された任意のトークンのシーケンスから、ASCIIアートのスタイルで提示される抽象的なパターンコーパス(ARC)に見られるより豊かな空間パターンまで、さまざまなトークンのシーケンスを完了する能力を持っています.驚くべきことに、トークンのシーケンスが語彙からランダムにサンプリングされたトークンを使用して表現されている場合でも、パターンの完了能力は部分的に保持されることがあります.これらの結果から、追加のトレーニングなしで、LLMはコンテキスト内の学習によって駆動される一般的なシーケンスモデラーとして機能することが示唆されます.この研究では、これらのゼロショットの能力がロボティクスの問題にどのように適用されるかを調査しています.具体的には、時間の経過を表す数値のシーケンスを外挿し、完全な状態を表す数値のシーケンスをロボティクスの問題に適用する方法を調査しています.

LLMの一般的なパターンマシンとしての能力は、数値または任意のトークンのシーケンスに対するコンテキスト内学習の能力によって駆動されます.LLMは通常、デコーダーのみのトランスフォーマー[65]によってシーケンスモデリングを自己回帰的に表現します.シーケンスx(s1、…、sn)の確率を条件付き確率の積で因数分解することによって、シーケンスの確率p(x) = p(s1)p(s2|s1)…p(sn|s1,…,sn-1)と表されます.

事前学習されたLLMは、ロボティクスやシーケンシャルな意思決定の抽象的な問題を表現する数値または任意の(記号的な)トークンのシーケンスの認識と完了を行う基本的なバージョンの一般的なパターンマシンとして機能することができます.実験結果は、ある程度まで、LLMが(i)シーケンス変換(たとえば、シンボルの空間的な再配置に関する推論、ダウンサンプルされた画像上のダイナミクスモデリングと次の状態予測)、(ii)単純な関数の完了(たとえば、運動デモンストレーションの外挿)、または(iii)メタパターンを改善するための戻り条件付きポリシー(たとえば、カートポールを安定化するための振動動作の発見)に利用できることを示しています.

Q: 確率的文脈自由文法(PCFG)とはどのようなもので、トークン列の生成にどのように使われるのか?

A: 確率的文脈自由文法(PCFG)は、トークンのシーケンスを生成するために使用される手法です.PCFGは、文法規則と確率を組み合わせて、トークンのシーケンスを生成する確率モデルです.

PCFGは、文法規則として構成されるレキシカルルールを使用して、トークンのシーケンスを生成します.これらのレキシカルルールは、逆転、シフト、スワップ、繰り返しなどの操作を含んでおり、これらの操作を組み合わせることで、入力シーケンスから出力シーケンスを生成します.

PCFGは、確率的な文脈自由文法を使用することで、生成されるシーケンスの複雑さを制御することができます.具体的には、シーケンスを表現するために使用されるトークンの数kを変化させることや、変換を定義するために使用されるレキシカルルールの数wを増やすことによって、変換の複雑さを調整することができます.wが0の場合、これは単純に恒等関数となります.kとwの範囲で平均化されたPCFGの結果を使用して、PCFGベンチマークの性能を評価することができます.

PCFGは、ロボティクスのシーケンス変換に使用されるパターンマシンの向上に向けた進歩を測定するために、新しい調整可能な難易度のベンチマークとして導入されています.PCFGを使用して手続き的に生成される変換は、確率的な文脈自由文法を使用して生成されるため、より柔軟な変換が可能となります.

以上のように、確率的文脈自由文法(PCFG)は、トークンのシーケンスを生成するために使用される手法であり、レキシカルルールと確率を組み合わせて変換を定義し、シーケンスの複雑さを制御することができます.

Q: LLMは、語彙から無作為に抽出したトークンを使って配列を表現しても、パターン完成の習熟度を維持できるのか?

A: その結果は、LLMが語彙からランダムにサンプリングされたトークンを使用して表現される場合でも、パターンの完了能力を一部保持できることを示唆しています.これらの結果から、追加のトレーニングなしで、LLMはコンテキストによる学習によって駆動される一般的なシーケンスモデラーとして機能することができると言えます.

具体的には、研究では、LLMが抽象的な問題を表現する数値または任意のトークンのシーケンスを自動的に補完する能力を調査しています.これにより、LLMはロボティクスの問題に適用することができます.例えば、時間の経過に伴って状態を表す数値のシーケンスを外挿することができます.

LLMがランダムにサンプリングされたトークンを使用して表現される場合でも、パターンの完了能力を一部保持できる理由は、LLMが一般的なパターンを表現し、特定のトークンに依存しない能力を持っているからです.これは、最近の研究結果とも一致しており、ランダムまたは抽象的なラベルマッピングを使用した場合でも、LLMが一定の性能を維持することができることが示されています.

LLMのパターンの完了能力は、ロボティクスやシーケンシャルな意思決定において、さまざまな抽象度のレベルで有用な一般的なパターン操作を可能にすると考えられています.これにより、LLMは既存の問題に対してゼロショットの能力を持ち、追加のトレーニングなしで応用することができます.

以上のように、LLMはランダムにサンプリングされたトークンを使用して表現される場合でも、パターンの完了能力を一部保持することができます.これは、LLMが一般的なパターンを表現し、特定のトークンに依存しない能力を持っているためです.これにより、LLMはロボティクスやシーケンシャルな意思決定の問題に応用することができます.

Q: この結果は、LLMが追加のトレーニングなしに一般的なシーケンスモデラーとして機能することをどのように示唆しているのだろうか?

A: 結果は、追加のトレーニングなしでLLMsが一般的なシーケンスモデラーとして機能することを示唆しています.LLMsは、コンテキスト内での学習によって駆動されることによって、一般的なシーケンスモデリングを行うことができます.

LLMsは、数値または任意のトークンのシーケンスに対してコンテキスト内で学習を行う能力によって、一般的なパターンマシンとして機能する能力を持っています.LLMsは通常、デコーダーのみのトランスフォーマーによってシーケンスモデリングを行います.シーケンスx(s1、…、snのシンボルのシーケンス)の確率を条件付き確率の積で因数分解することによって、LLMsはシーケンスモデリングを表現します.

具体的には、LLMsはコンテキスト内で学習を行うことによって、シーケンス内のパターンや関係性を把握し、その知識を利用して未知のシーケンスを予測することができます.追加のトレーニングなしで、LLMsはランダムにサンプリングされたトークンを使用して表現されるシーケンスでも同様の能力を持つことが示されています.

これは、LLMsが単語のパターンをアクションに転送する方法の一端を提供することを示しており、低レベルの制御を駆動するためにLLMsを使用するアプローチは、言葉のパターンがアクションに転送される可能性を示しています.ただし、現在のシステムの遅延、コンテキストサイズの制限、および計算コストのために、実際のシステムには難しいです.

Q: LLMのゼロショット能力は、どのような形でロボット工学の問題に応用できるのか?

A: LLM(Language Model)のゼロショット能力は、ロボティクスの問題にどのように応用できるのでしょうか?

与えられた文脈から推測すると、LLMは一般的なパターン操作の一部を既に含んでいる可能性があります.具体的には、シーケンスの変換、シーケンスの補完、シーケンスの改善の3つの領域において、LLMのパターン操作能力を評価しています.

まず、LLMはシーケンスの変換能力を持っていることが示されています.これは、トークンの不変性を持つ一定の複雑さのシーケンス変換を一般化することができることを意味します.この能力は、ロボティクスの空間的な推論能力にも応用できる可能性があります.

次に、LLMはシンプルな関数(例:正弦関数)からパターンを補完する能力を評価しています.この能力は、ロボティクスのタスクにも応用できます.例えば、運動デモンストレーションからワイピングモーションを拡張したり、ホワイトボードにパターンを描いたりすることができます.

さらに、LLMのコンテキスト内でのシーケンス変換と推測の組み合わせにより、基本的な制御が可能になります.これにより、ロボティクスのタスクにおいて、シーケンスの予測や制御を行うことができます.

LLMのゼロショット能力は、専門的なアルゴリズムを置き換えるには十分ではありませんが、一般的なモデルのトレーニングの優先順位を決定するために役立つ情報を提供することができます.

要約すると、LLMのゼロショット能力は、ロボティクスの問題においてシーケンスの変換、補完、改善などの様々な方法で応用することができます.これにより、LLMはロボティクスのタスクにおいて、パターン操作や制御を行うことができます.

Q: LLMは、単純な運動を完成させるために、時間の経過とともに状態を表す数列を外挿するためにどのように使うことができるのか?

A: LLM(Language Model)は、追加のトレーニングなしで一般的なシーケンスモデラーとして機能することが示唆されています.この研究では、LLMのこれらのゼロショットの能力が、ロボティクスの問題にどのように適用されるかを調査しています.具体的には、時間の経過を表す数値のシーケンスを外挿して単純な動作を完了させることから始め、報酬条件付きの軌跡を最小から最大まで促すことで、閉ループポリシー(例:CartPoleの安定化コントローラー)を発見して表現することができます.

LLMを使用して数値のシーケンスを外挿し、単純な動作を完了させる方法は次のようになります.まず、事前にトレーニングされたLLMを使用して、数値のシーケンスを入力として与えます.LLMは、そのコンテキスト内で学習されたパターンや関係性を利用して、次の数値を予測します.この予測された数値を次の入力として再びLLMに与え、同様の予測を繰り返します.このプロセスを続けることで、LLMは数値のシーケンスを外挿し、単純な動作を完了させることができます.

具体的な例としては、数値のシーケンスが与えられた場合、LLMはそのシーケンスのパターンやトレンドを学習し、次の数値を予測します.たとえば、与えられた数値のシーケンスが「78, 76, 72, 66, 60, 53, 46」というものである場合、LLMはこのシーケンスのパターンを学習し、次の数値を予測することができます.予測された数値は、シーケンスの次の要素として追加され、LLMに再び与えられます.このプロセスを繰り返すことで、LLMは数値のシーケンスを外挿し、単純な動作を完了させることができます.

LLMを使用して数値のシーケンスを外挿し、単純な動作を完了させることは、ロボティクスの問題において非常に有用です.例えば、ロボットがある動作を行うために必要な数値のシーケンスが与えられた場合、LLMを使用してそのシーケンスを外挿し、次の数値を予測することができます.これにより、ロボットは与えられた動作を完了させるために必要な数値のシーケンスを自動的に生成することができます.

LLMを使用して数値のシーケンスを外挿し、単純な動作を完了させることは、現在は遅延、コンテキストサイズの制限、および計算コストの制約により、実際のシステムには難しいですが、将来的には可能性があります.LLMを低レベルの制御に使用

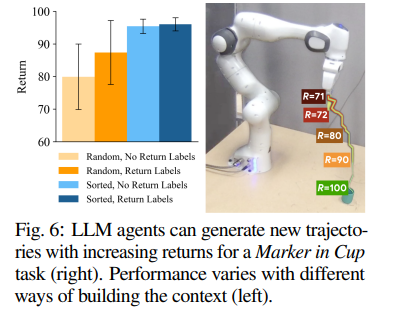

Q: 報酬条件付き軌道の最少から最多までのプロンプトにLLMをどのように利用できるか?

A: LLM(Language Learning Model)は、トラジェクトリやポリシーの最適化において、報酬条件付きのトラジェクトリを最小から最大へのプロンプティングに使用することができます.具体的には、前のシーケンス(x1、…、xN-1)に基づいて、LLMを使用して新しいシーケンスxNを生成します.これらのシーケンスは、過去の同じシーケンスの前のイテレーション(またはそれが表すポリシー)を表すことができます.

改善は報酬(またはコスト)関数r(·)によっても条件付けられることができます.各シーケンスの最初のトークンとして、対応する総報酬x=(r(x),s1, …, s k)を挿入することで、モデルを促して、コンテキスト内で見られる報酬よりも高い報酬を条件付けて「改善」することができます.これにより、新しい「ロールアウト」のシーケンスが生成され、新しい報酬ラベルが返されます.これらのラベルは、元の望ましい報酬を実際の報酬で置き換えます.この推論を繰り返し行い、より多くのトラジェクトリを蓄積することで、モデルの一般的なパターン変換と外挿の概念を使用して、シーケンスの改善を行うことができます.これらの改善は、数値または記号のトークンで表すことができます.

具体的な実装には、タスクやモデルに応じて、コンテキストに収まるシーケンスのみを保持する、または利用可能な最高の報酬を持つシーケンスのみを保持するなど、実用上の考慮事項があります.また、トラジェクトリの最適化においては、事前に記録されたトラジェクトリのコレクションでコンテキストを初期化することも可能です.

要約すると、LLMを使用して報酬条件付きのトラジェクトリを最小から最大へのプロンプティングするためには、前のシーケンスに基づいて新しいシーケンスを生成し、報酬関数によって改善を条件付けることが重要です.これにより、モデルはパターン変換と外挿の概念を使用して、シーケンスの改善を行うことができます.

Q: LLMは、カートポールの安定化コントローラのような閉ループポリシーを発見し、表現することができますか?

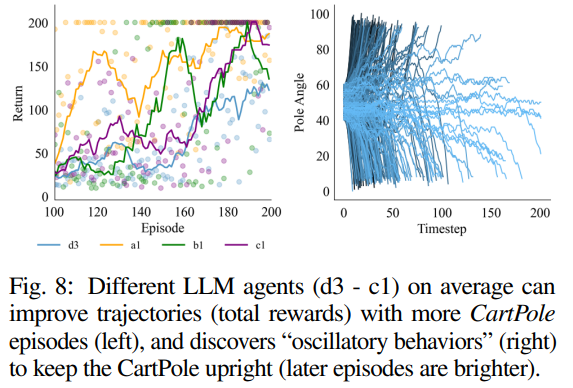

A: はい、LLMはCartPoleのような安定化コントローラーのようなクローズドループポリシーを発見し表現することができます.この文脈から得られる情報によれば、LLMをエージェントとして使用することで、CartPole環境の安定化コントローラーを発見することができます.LLMは、ポールの角度と速度の観測トークンを入力とし、0(左)と1(右)のアクションを出力することができます.LLMは、CartPoleを直立させるための「振動的な振る舞い」を発見し、安定化コントローラーを見つけることができます.

図8では、異なるLLMエージェント(d3 – c1)が、より多くのCartPoleエピソードで軌跡(総報酬)を改善できることが示されています.また、図8の右側では、d3のエピソードごとの軌跡の進化が示されており、CartPoleを直立させるための「振動的な振る舞い」を発見しています.

LLMは、言語のパターンを学習することで、単純な動作から完全なモーションまでの数列を予測することができます.また、報酬条件付きの軌跡を最小から最大までのプロンプトで学習することで、CartPoleの安定化コントローラーなどのクローズドループポリシーを発見し表現することができます.

ただし、現時点では、遅延、コンテキストサイズの制限、および計算コストのために、実際のシステムには難しいですが、LLMを使用して低レベルの制御を行うアプローチは、単語のパターンをアクションに転送する方法を示唆しており、興味深い可能性を提供するかもしれません.

以上が、LLMがCartPoleのような安定化コントローラーのようなクローズドループポリシーを発見し表現することができることについての詳細な説明です.

Q: 実際のシステムにLLMを導入する場合、レイテンシー、コンテキストサイズの制限、計算コストなど、現状ではどのような制限があるのでしょうか?

A: 現在、LLM(大規模言語モデル)を実際のシステムに展開する際の現在の制約事項は、以下のようなものです.

- 遅延:LLMを制御ループで使用する場合、推論コスト(および金銭的コスト)が非常に高くなります.例えば、トラジェクトリの各次元の各時間ステップごとに次のトークンを予測するには、LLMへのクエリが必要です.次元数が高い場合や、より高い精度が必要な場合は、トラジェクトリ表現が長くなります.そのため、モデルのコンテキスト長によって、トラジェクトリの外挿やシーケンスの最適化の範囲が制限されます.

- コンテキストサイズの制限:LLMのコンテキスト長によって、モデルが学習できるパターンの範囲が制限されます.現在のモデルでは、比較的単純な設定でのインコンテキスト一般化の範囲を調査していますが、より複雑なタスクにこれらのモデルを展開する際には、コンテキストサイズの制限が問題となる可能性があります.

- 計算コスト:LLMの使用には高い計算コストがかかります.LLMを制御に使用する場合、トークンの予測にはLLMへのクエリが必要です.これにより、推論コストが増加し、計算リソースが必要となります.

これらの制約事項は、現在のモデルの量子化[79]や推論の改善など、コミュニティの取り組みによって徐々に解消される可能性があります.また、ドメイン固有の目標やファインチューニング[77, 78, 62, 63]によって、これらの能力を大幅に向上させることも期待されています.

Q: LLMを使って低レベルの制御を行うことで、言葉のパターンを行動に移すことをどのように垣間見ることができるのだろうか?

A: LLM(Large Language Models)を使用して低レベルの制御を行うことにより、単語のパターンがアクションに転送される様子が垣間見えます.LLMは、言語の構造に織り込まれたさまざまなパターンを吸収するように訓練されています.これにより、LLMは、推論の連鎖を生成したり、論理問題を解決したり、数学のパズルを完成させたりするなど、さまざまな能力を持つことができます.また、ロボット工学の分野でも応用されており、指示に従うタスクのための高レベルなプランナーとして機能したり、ロボットポリシーを表現するプログラムを合成したり、報酬関数を設計したり、ユーザーの好みを一般化したりすることができます.

LLMを使用して低レベルの制御を行うアプローチは、単語のパターンがアクションに転送される様子を示しています.具体的には、LLMはシーケンスモデリングの一般的な手法として使用され、ロボットの動作を制御するために使用されます.LLMは、言語のパターンを学習することにより、アクションのシーケンスを予測し、制御することができます.これにより、単語のパターンがアクションに直接影響を与えることが可能となります.

LLMを使用して低レベルの制御を行うことにより、単語のパターンがアクションに転送される様子が垣間見えます.LLMは、言語のパターンを学習することにより、アクションのシーケンスを予測し、制御することができます.これにより、単語のパターンがアクションに直接影響を与えることが可能となります.このアプローチは、ロボット工学の分野において、言語の事前学習を活用して一般的な組み込み型AIシステムを構築するための重要な手法となる可能性があります.また、データ収集が困難またはコストがかかるドメインにおいても、LLMのパターン推論能力は有益である可能性があります.

以上のように、LLMを使用して低レベルの制御を行うことにより、単語のパターンがアクションに転送される様子が垣間見えます.これにより、言語モデルのパターン推論能力を活用して、ロボットの動作を制御することが可能となります.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: この論文で導入された新しい手法のコード実装のURLは、https://general-pattern-machines.github.io です.

AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning

著者:Yuwei Guo, Ceyuan Yang, Anyi Rao, Yaohui Wang, Yu Qiao, Dahua Lin, Bo Dai

発行日:2023年07月10日

最終更新日:2023年07月10日

URL:http://arxiv.org/pdf/2307.04725v1

カテゴリ:Computer Vision and Pattern Recognition, Graphics, Machine Learning

概要:

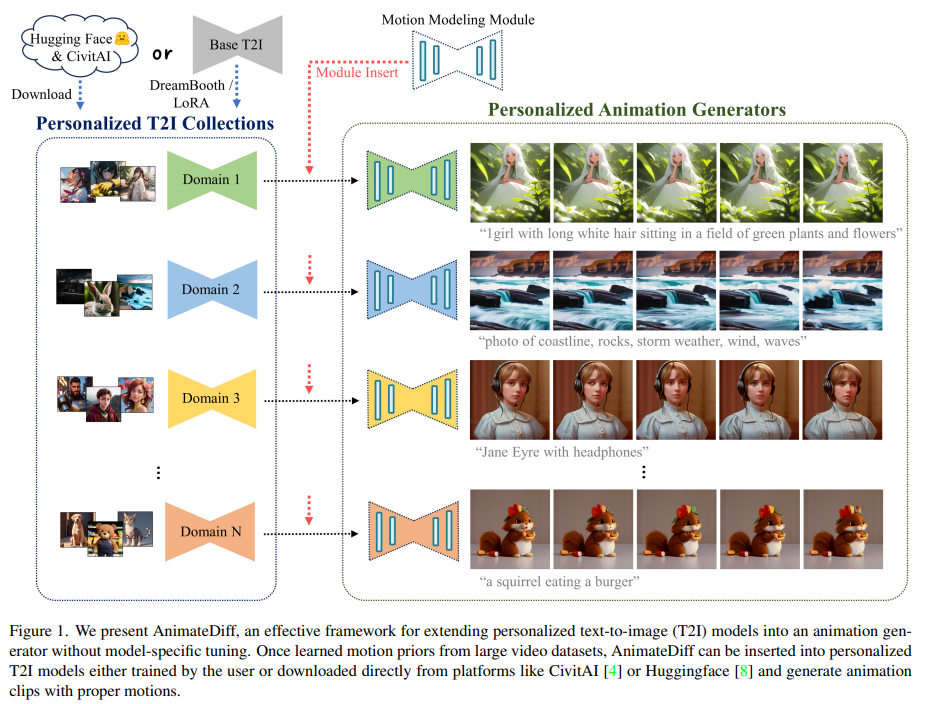

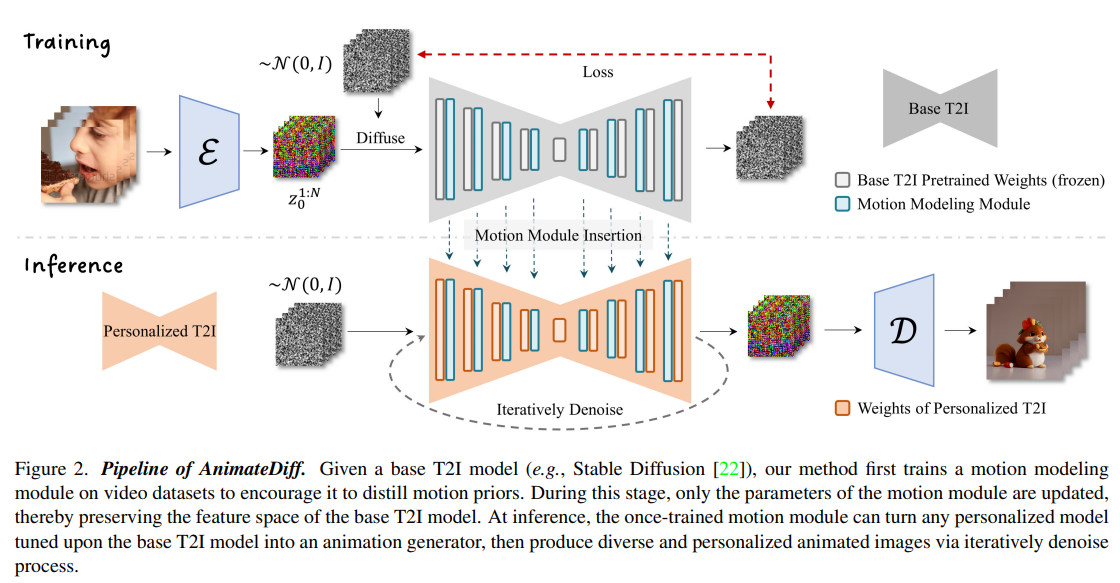

テキストから画像への変換モデル(例:Stable Diffusion)や、DreamBoothやLoRAなどの対応する個人化技術の進歩により、誰もが手頃なコストで自分の想像を高品質な画像に具現化することができるようになりました.その結果、生成された静止画像と動きのダイナミクスをさらに組み合わせるための画像アニメーション技術への需要が高まっています.このレポートでは、既存のほとんどの個人化テキストから画像へのモデルを一度にアニメーション化するための実用的なフレームワークを提案しています.このフレームワークの中心には、凍結されたテキストから画像へのモデルに新たに初期化されたモーションモデリングモジュールを挿入し、ビデオクリップでトレーニングして合理的なモーションの優先順位を抽出するというものです.一度トレーニングされたら、このモーションモデリングモジュールを単純に注入するだけで、同じ基本T2Iから派生したすべての個人化バージョンは、多様で個人化されたアニメーション画像を生成するテキスト駆動モデルになります.私たちは、アニメの画像と現実的な写真のいくつかの公開代表的な個人化テキストから画像へのモデルで評価を行い、提案されたフレームワークがこれらのモデルに役立つことを示しています.また、私たちの提案されたフレームワークは、モデルがドメインと多様性を保持しながら、時間的にスムーズなアニメーションクリップを生成することを示しています.コードと事前学習済みの重みは、https://animatediff.github.io/ で公開されています.

Q&A:

Q: この文章で言及されている、既存のパーソナライズされたテキストから画像への変換モデルにはどのようなものがあるか?

A: パッセージで言及されている既存のパーソナライズされたテキストから画像へのモデルは、DreamBoothとLoRAです.これらのモデルは、小規模なデータセットでのカスタマイズされた微調整を可能にする軽量のパーソナライゼーション手法です.これにより、一般のユーザーであるアーティストやアマチュアが、RTX3080を搭載したノートパソコンなどの消費者向けのデバイスでこれらのモデルをカスタマイズし、品質を大幅に向上させたカスタマイズされたコンテンツを生成することができます.これにより、ユーザーは非常に低コストで事前にトレーニングされたT2Iモデルに新しいコンセプトやスタイルを導入することができます.また、CivitAIやHuggingfaceなどのモデル共有プラットフォームによって、アーティストやアマチュアによって多数のパーソナライズされたモデルが提供されています.

Q: この文章で言及されているパーソナライゼーションのテクニックとは?

A: パッセージで言及されているパーソナライズ技術は、次の2つです.

- パラメータ調整に基づく方法(tuning-based methods):DreamBooth [24]とLoRA [13]が挙げられます.これらの方法は、基本モデルの特徴空間を変更せずに、パラメータの調整によってパーソナライズを行います.

- 概念のパーソナライズのためのより一般的なエンコーダを学習する試み:文献[10, 14, 27]で言及されています.これらの研究では、パラメータ調整に基づく方法ではなく、より一般的なエンコーダを学習することで、概念のパーソナライズを試みています.

以上が、パッセージで言及されているパーソナライズ技術です.

Q: 提案されたフレームワークは、既存のパーソナライズされたテキスト画像モデルをどのように動かすのか?

A: 提案されたフレームワークは、既存のパーソナライズされたテキストから画像へのモデルをアニメーション化するために、新たに初期化されたモーションモデリングモジュールを凍結されたテキストから画像へのモデルに挿入し、ビデオクリップでトレーニングして合理的なモーションの優先順位を抽出することによって行われます.このモーションモデリングモジュールを単純に注入することで、同じ基本的なT2Iから派生したすべてのパーソナライズされたバージョンは、多様でパーソナライズされたアニメーション画像を生成するテキスト駆動モデルにすぐになります.このフレームワークは、アニメの画像と現実的な写真のいくつかの公開代表的なパーソナライズされたテキストから画像モデルで評価され、提案されたフレームワークがこれらのモデルがドメインと多様性を保持しながら時間的にスムーズなアニメーションクリップを生成するのに役立つことを示しています.

Q: モーション・モデリング・モジュールの目的は何ですか?

A: モーションモデリングモジュールの目的は、個別に設計されたT2Iモデルにアニメーションを付与することです.具体的には、モーションモデリングモジュールをベースのT2Iモデルに導入し、大規模なビデオクリップで微調整することで、合理的なモーションの事前知識を学習します.ベースモデルのパラメータは変更せずに、微調整後にモーションモジュールはフレーム間で操作を行い、アニメーションクリップのモーションの滑らかさとコンテンツの一貫性を実現します.

モーションモデリングモジュールのネットワーク設計では、フレーム間で効率的な情報交換を可能にすることを目指しています.そのために、モーションモジュールの設計として、バニラのテンポラルトランスフォーマーを選択しました.バニラのテンポラルトランスフォーマーは、時間軸に沿って操作するいくつかのセルフアテンションブロックで構成されています.モーションモジュールを通過する際には、特徴マップの空間次元の高さと幅がバッチ次元に変形され、フレームの長さでバッチ×高さ×幅のシーケンスになります.変形された特徴マップは、プロジェクションされ、いくつかのセルフアテンションブロックを経て、次のように表されます.

z = Attention(Q, K, V) = Softmax(QK^T / \sqrt{d}) \cdot V

ここで、Q = W_Q \cdot z, K = W_K \cdot z, V = W_V \cdot z は、それぞれの重み行列 W_Q, W_K, W_V を特徴マップ z に適用したものです.

モーションモデリングモジュールの目的は、アニメーションクリップのモーションの滑らかさとコンテンツの一貫性を実現することです.モーションモジュールは、フレーム間で操作を行い、情報の効率的な交換を可能にするために、バニラのテンポラルトランスフォーマーを使用しています.

Q: モーション・モデリング・モジュールはどのようにトレーニングされるのですか?

A: モーションモデリングモジュールは、ベースのT2Iモデルに導入され、大規模なビデオクリップでファインチューニングされることによってトレーニングされます.このファインチューニングにより、合理的なモーションの事前知識が学習されます.ベースモデルのパラメータは変更されずに残ります.ファインチューニング後、派生した個別のT2Iモデルも学習されたモーションの事前知識を活用することができ、滑らかで魅力的なアニメーションを生成することが示されています.つまり、モーションモデリングモジュールは、追加のデータ収集やカスタムトレーニングのための追加の努力なしに、対応する個別のT2Iモデルすべてをアニメーション化することができます.

ファインチューニングは、大規模なビデオクリップで行われます.このビデオクリップは、個別のドメインに対応するものではなく、一般的なモーションの事前知識を学習するために使用されます.ベースのT2Iモデルにモーションモデリングモジュールが導入された後、このモジュールは大規模なビデオクリップでファインチューニングされます.ファインチューニングにより、モーションの事前知識がモジュールに組み込まれ、個別のT2Iモデルに適用されることが可能になります.

ファインチューニングによって、モーションモデリングモジュールは滑らかで魅力的なアニメーションを生成するための適切なモーションの事前知識を学習します.ベースモデルのパラメータは変更されずに残るため、モーションモデリングモジュールは個別のT2Iモデルに容易に適用することができます.このようにして、モーションモデリングモジュールは追加のデータ収集やカスタムトレーニングの必要なしに、個別のT2Iモデルをアニメーション化することができます.

Q: モデル特有のチューニングという点で、提案されたフレームワークを使うメリットは何ですか?

A: 提案されたフレームワークを使用することのモデル固有の調整に関する利点は、以下のようになります.

- モデルの知識の保持:提案されたフレームワークでは、個別の調整を避け、事前学習済みの重みを変更せずに、汎用的なモーションモデリングモジュールを個別のT2Iモデルに挿入します.これにより、ソースドメインの知識の損失を防ぐことができます.個別のモデルの知識を保持することで、再調整や再学習の必要性を排除し、効率的なモデルの再利用が可能となります.

- 特定の調整の回避:提案されたアプローチでは、モーションモデリングモジュールを事前にトレーニングし、同じベースモデルに挿入することができます.そのため、個別のT2Iモデルごとに特定の調整を行う必要がありません.これにより、モデルの再利用が容易になります.

- モデルの適用範囲の拡大:モーションモデリングモジュールが一度トレーニングされると、同じベースモデルの個別のT2Iに挿入することができます.個別のモデルの特徴空間はほとんど変更されないため、モジュールの再利用が可能です.これにより、特定の調整やカスタマイズされたトレーニングの必要性がなくなります.

以上の利点により、提案されたフレームワークでは、モデル固有の調整を回避し、事前学習済みの重みを保持しながら、効率的なモデルの再利用と適用範囲の拡大が可能となります.

Q: 提案されているフレームワークは、どのようにして多様でパーソナライズされたアニメーション画像の生成を保証するのか?

A: 提案されたフレームワークは、既存の個別化されたテキストから画像へのモデルをアニメーション生成器に変換することを目指しています.このフレームワークは、単純な設計のモーションモデリングモジュールを含んでおり、ベースのテキストから画像へのモデルでトレーニングされたモーションモジュールは、大規模なビデオデータセットから一般化可能なモーションの優先順位を抽出することができます.

トレーニングが完了した後、このモーションモジュールは他の個別化されたモデルに挿入され、対応するドメインに忠実で自然で適切な動きを持つアニメーション画像を生成することができます.さまざまな個別化されたテキストから画像へのモデルに対する包括的な評価も、提案手法の効果と汎用性を検証しています.

したがって、提案されたフレームワークは、個別化されたアニメーションのためのシンプルで効果的なベースラインを提供し、幅広いアプリケーションに恩恵をもたらす可能性があります.

Q: 提案されたフレームワークについて、どのような評価が行われたのか?

A: 提案されたフレームワークの評価は、主に質的な評価が行われました.図9と図10では、異なる個別のモデルに対して提案手法の結果が示されています.図9では、フレームワーク内のモーションモデリングモジュールによって生成されたいくつかのアニメーションクリップが示されています.各プロンプト内の関連しないタグ(例:「傑作」、「高品質」)は、明確さのために省略されています.

また、図4でも質的な結果の評価が行われています.ここでは、フレームワーク内のモーションモデリングモジュールによって生成されたモデルによる16のアニメーションクリップがデモンストレーションされています.各行の2つのサンプルは同じ個別のT2Iモデルに属しています.スペースの制約のため、各アニメーションクリップからは4つのフレームのみをサンプリングしています.詳細な表示については、プロジェクトページを参照することを読者に推奨しています.各プロンプト内の関連しないタグ(例:「傑作」、「高品質」)は、明確さのために省略されています.

したがって、提案されたフレームワークの評価は、質的な評価に焦点を当てて行われました.

Teaching Arithmetic to Small Transformers

著者:Nayoung Lee, Kartik Sreenivasan, Jason D. Lee, Kangwook Lee, Dimitris Papailiopoulos

発行日:2023年07月07日

最終更新日:2023年07月07日

URL:http://arxiv.org/pdf/2307.03381v1

カテゴリ:Machine Learning

概要:

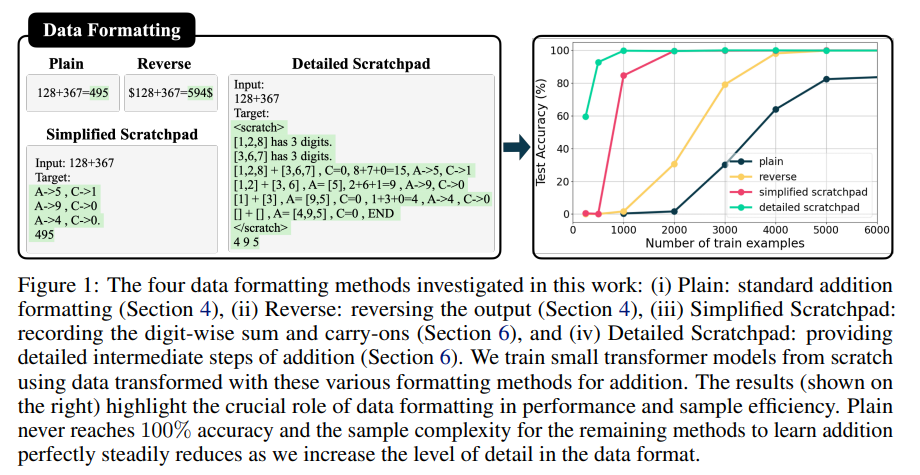

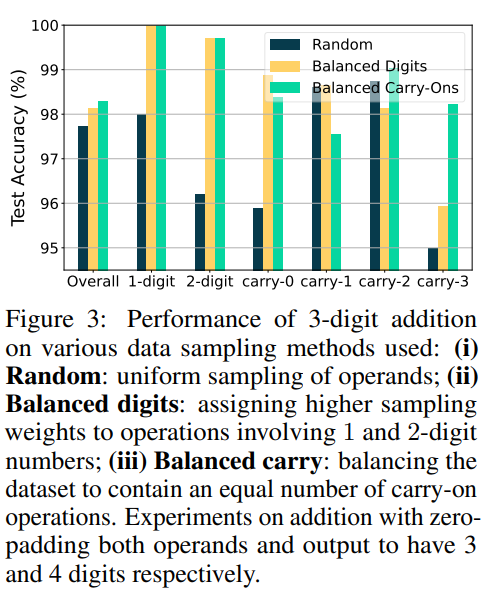

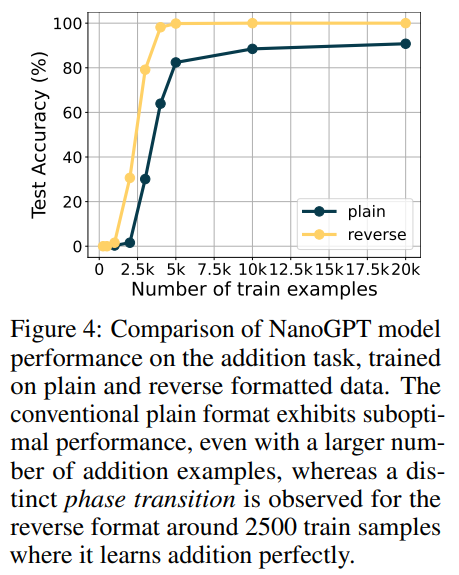

大規模な言語モデルであるGPT-4は、広範な一般的なタスク(基本的な算術など)において、次のトークン予測の目的に明示的にエンコードされていないにもかかわらず、広範なテキストデータで訓練されることで新たな能力を発揮する.この研究では、ランダムな初期化から訓練された小規模なトランスフォーマーが、次のトークン予測の目的を使用して、加算、乗算、平方根などの算術演算を効率的に学習できるかどうかを調査している.まず、従来の訓練データは算術学習において最も効果的ではないことを示し、単純なフォーマットの変更が精度を大幅に改善することができることを示す.これにより、訓練データのスケールに関する鋭い位相転移が生じることがあり、一部の場合では、低ランク行列補完との関連性を通じて説明することができる.前の研究に基づいて、中間ステップの結果を含む思考の連鎖スタイルのデータで訓練を行う.事前学習の完全な欠如でも、このアプローチは精度、サンプルの複雑さ、収束速度を同時に大幅に改善する.また、相互作用を研究する.さらに、精度、サンプルの複雑さ、収束速度についても研究し、few-shot prompting、事前学習、モデルのスケールの影響を調査する.また、長さの一般化の課題についても議論する.私たちの研究は、高品質で指導的なデータの重要性を強調し、次の単語予測の目的の特定の特性を考慮した算術能力の迅速な引き出しにおいて、算術とテキストデータの相互作用を研究しています.

Q&A:

Q: GPT-4のような大規模な言語モデルは、基本的な算数タスクにおいてどのように創発的な能力を示すのか?

A: 大規模な言語モデルであるGPT-4は、広範なタスクにおいて基本的な算術の能力を示すことがあります.これらのタスクは、通常は自己回帰的な次のトークン予測の損失関数によって明示的にエンコードされていないにも関わらず、モデルの訓練目標としては一般的に使用されています.

これらの能力がどのように現れるのかを調査するために、本研究ではランダムな初期化から訓練された小規模なトランスフォーマーが、次のトークン予測の目的を使用して、加算、乗算、および平方根などの算術演算を効率的に学習できるかどうかを調査しています.

以前の研究では、これらの能力とそれらがどのように現れるかについて探求してきました.これらの能力は、モデルの規模や訓練データのスケールに応じてどのように現れるかを調査しています.大規模な言語モデルは、豊富なテキストデータで訓練されることで、基本的な算術などの一般的なタスクにおいて新たな能力を獲得することができます.

具体的には、GPT-4は、次のトークン予測の目的によって訓練されるため、算術演算が明示的にエンコードされていないにも関わらず、テキストデータから算術演算を効率的に学習することができます.これは、モデルがテキストデータのパターンや関係性を学習することによって、算術演算のルールや特性を推測することができるからです.

大規模な言語モデルは、トークンの予測を通じて次のトークンを生成するため、数式や算術演算のパターンを学習することができます.例えば、加算の場合、モデルは「2 + 3 = 」という入力に対して「5」という出力を生成することができます.同様に、乗算の場合は「2 * 3 = 」という入力に対して「6」という出力を生成することができます.

このようにして、大規模な言語モデルは、訓練データから算術演算のパターンを学習し、次のトークン予測の目的を通じて算術演算を実行する能力を獲得することができます.これにより、GPT-4などの大規模な言語モデルは、基本的な算術タスクにおいて新たな能力を発揮することができます.

Q: 次のトークンを予測する目的とは何ですか?また、小型変圧器に算数を教えることとどのように関係があるのですか?

A: 次のトークン予測目的とは、ランダムに初期化された小さなトランスフォーマーに算術演算や基本的な数学関数を教えるための手法です.この手法では、トレーニングデータの異なる側面を慎重に分析し、算術能力の出現に寄与する要素を特定するために、実験を行っています.

具体的には、トレーニングデータの形式やスケーリング、事前トレーニングの有無、プロンプトの方法などが、次のトークン予測モデルにおける能力の出現を加速させる要因として考えられます.

この研究では、制御された環境で実験を行っており、ランダムに初期化された小さなトランスフォーマーモデル(NanoGPTやGPT-2など)に算術を教えることに焦点を当てています.モデルのパラメータ数を10.6万から1億2400万までスケーリングし、標準的な自己回帰的な次のトークン予測損失を使用しています.この研究の目的は、これらのモデルが加算、減算、乗算、平方根、正弦などの基本的な算術演算を効率的に学習する方法を理解し、新たな能力の引き出しをより明確にすることです.

研究結果から、データの形式やサンプリング方法が重要であることがわかりました.例えば、標準的な加算のサンプル(’A3A2A1+B3B1B1=C3C2C1’)を使用してモデルに加算を教える場合、これは最適ではなく、出力を逆にしたり、途中のステップを含めた詳細なデータでトレーニングすることで精度とサンプルの複雑さが改善されます.

次のトークン予測目的は、ランダムに初期化された小さなトランスフォーマーに算術を教えるための手法であり、データの形式やスケーリング、事前トレーニングの有無、プロンプトの方法などの要素を慎重に調整することで、算術能力の出現を促進することができます.

Q: 簡単な書式変更で、小型変圧器の算数学習の精度を向上させるには?

A: 簡単なフォーマットの変更は、小さなトランスフォーマーにおける算術学習の精度を向上させることができます.具体的には、データのフォーマット方法を変更することで、モデルが算術演算をより効率的に学習できるようになります.

この研究では、標準的な加算のフォーマットに加えて、逆のフォーマット、簡略化されたスクラッチパッドのフォーマット、詳細なスクラッチパッドのフォーマットの4つのデータフォーマット方法を調査しています.結果として、標準的なフォーマットでは100%の精度に到達することはありませんが、残りの方法ではデータフォーマットの詳細度を高めると、加算を完全に学習するためのサンプルの複雑さが徐々に減少していくことが示されています.

具体的なフォーマットの変更方法としては、出力を逆にする、桁ごとの合計とキャリーオーバーを記録する、加算の詳細な中間ステップを提供するなどがあります.これらの変更により、モデルはより詳細な情報を利用して加算を学習することができます.

このようなフォーマットの変更が精度向上に寄与する理由は、モデルが異なるフォーマットに適応するためには、以前のフォーマットに特有のパターンを「忘れる」必要があるためです.つまり、新しいフォーマットに適応するためには、モデルが以前のフォーマットのパターンを無効化し、新しいフォーマットを効果的に学習するための追加の努力が必要です.

この研究の結果は、フォーマットの一貫性を考慮することが、微調整プロセスの効率と効果に影響を与える重要性を強調しています.具体的には、逆のフォーマットや簡略化されたスクラッチパッドのフォーマットでの微調整は、標準的なフォーマットでの微調整と比較して、より悪い結果をもたらすことが観察されています.

簡単なフォーマットの変更により、小さなトランスフォーマーにおける算術学習の精度が向上する理由は、モデルがより詳細な情報を利用して加算を学習できるためです.これにより、モデルは異なるフォーマットに適応するための追加の努力を必要とせずに、より効率的に加算を学習することができます.

Q: トレーニングデータのスケールで観察された鋭い相転移と、低ランク行列補完との関連について説明してもらえますか?

A: 訓練データの規模の増加に伴う鋭い位相転移と、それらの低ランク行列補完との関連性を説明できますか?

はい、鋭い位相転移は、学習データの規模の増加に伴って観察される現象です.この現象は、低ランク行列補完との関連性を通じて説明することができます.具体的には、ランダムなサンプルからndigitsの加算マップを学習することは、ランク2の行列の補完として考えることができます.

この関連性を理解するためには、まず低ランク行列補完(LRMC)の概念を説明する必要があります.低ランク行列補完は、不完全な行列を補完するために使用される手法であり、行列のランクが低いことを前提としています.具体的には、与えられた不完全な行列を補完するために、その行列のランクが最も低い可能性のある行列を見つけることが目標です.

加算マップを学習することを低ランク行列補完と関連付けるためには、加算操作を行う行列のランクが低いことを示す必要があります.実際には、加算操作は、2つの数字を足し合わせる操作であり、その結果は2つの数字の和であるため、ランク2の行列として表現することができます.

したがって、ランダムなサンプルからndigitsの加算マップを学習することは、ランク2の行列の補完として考えることができます.学習データの規模が増加するにつれて、ランク2の行列の補完が進み、加算操作が正確に行えるようになるため、鋭い位相転移が観察されるのです.

この関連性の理解は、Transformerモデルの拡張能力を明らかにすると同時に、低ランク行列補完アルゴリズムでは実現できないより高度な機能を持つことも示しています.

Q: チェーン・オブ・ソート(思考の連鎖)スタイルのデータとはどのようなもので、それを使ったトレーニングは精度、サンプルの複雑さ、収束速度をどのように向上させるのか?

A: Chain-of-thoughtスタイルのデータは、複雑なタスクの個々のコンポーネントを学習するために、ステップバイステップの操作と中間結果を含む形式です.このデータ形式は、関連文献から直接借用されており、サンプルの複雑さと精度の両方の面で学習を大幅に改善することがわかっています.

Chain-of-thoughtスタイルのデータを使用してトレーニングすることにより、精度、サンプルの複雑さ、収束速度が向上します.具体的には、以下のような効果があります.

- 精度の向上:Chain-of-thoughtスタイルのデータは、複雑なタスクをステップバイステップで学習することを可能にします.これにより、モデルは個々のステップを詳細に学習することができます.結果として、モデルの精度が向上します.

- サンプルの複雑さの改善:Chain-of-thoughtスタイルのデータは、タスクの詳細なチェーンを提供するため、サンプルの複雑さを改善します.モデルは、タスクの各ステップを理解し、それらを組み合わせることで、より複雑なタスクを効率的に解決することができます.

- 収束速度の向上:Chain-of-thoughtスタイルのデータは、モデルがタスクの各ステップを学習するためのガイドとなります.これにより、モデルはより効率的に学習し、収束速度が向上します.つまり、より少ないトレーニングステップでより高いパフォーマンスを達成することができます.

総括すると、Chain-of-thoughtスタイルのデータを使用してトレーニングすることにより、モデルの精度、サンプルの複雑さ、収束速度が向上します.これは、複雑なタスクの個々のコンポーネントを学習するためのステップバイステップのアプローチによるものです.

Q: トレーニング中の演算データとテキストデータの相互作用は、学習プロセスにどのような影響を与えるのだろうか?

A: 訓練中の算術データとテキストデータの相互作用は、学習プロセスにどのような影響を与えるのでしょうか.

この文脈から得られる情報によれば、LLM(Language and Logic Models)はインターネットからスクレイピングされた大量のデータで訓練されており、算術データとテキストデータの区別を細かくすることは実用的ではないとされています.また、ゼロショットから1ショットのプロンプティング(算術の例を1つ表示する)に移行することで、精度が大幅に向上することがわかっています.さらに、より多くの例を示しても精度にはほとんど改善が見られないとされています.

具体的には、算術データとテキストデータの割合によってモデルの困惑度(perplexity)と精度が変動することが観察されています.また、加算から平方根までのすべての算術演算を学習することが、各タスクの個別のパフォーマンスを向上させることがわかっています.

さらに、GPT-2やGPT-3(davinci)などのモデルを事前学習してから微調整することの役割も調査されています.ゼロショットのパフォーマンスが算術能力の出現に関連していることが観察されています.

この研究結果からは、従来の訓練データは算術の学習には最適ではなく、中間ステップや出力の逆転を含む詳細で具体的なデータで訓練することが精度とサンプルの複雑さを改善することが示されています.算術データのみを使用する場合とテキストデータを含む場合の両方のシナリオを考慮し、効果を包括的に分析しています.

つまり、訓練中の算術データとテキストデータの相互作用は、学習プロセスにおいて以下のような影響を与えると言えます.

- 算術データとテキストデータの割合によってモデルの困惑度と精度が変動する.

- 加算から平方根までのすべての算術演算を学習することで、各タスクの個別のパフォーマンスが向上する.

- ゼロショットから1ショットのプロンプティングに移行することで、精度が大幅に向上するが、さらに多くの例を示しても精度にはほとんど改善が見られない.

- GPT-2やGPT-3(davinci)などのモデルを事前学習してから微調整することで、ゼロショットのパフォーマンスが算術能力の出現に関連していることが観察される.

- 従来の訓練データは算術の学習には最適ではなく、詳細で具体的なデータ

Q: 小さな変圧器に算数を教えるという文脈における長さの汎化の課題とは?

A: 小型トランスフォーマーに算術を教えるという文脈における長さの一般化の課題は、以下のようなものです.

研究結果によれば、トレーニングデータに含まれる数字の桁数に制約があるため、モデルはトレーニングデータの範囲内では高い精度を達成する一方で、その範囲を超えると困難になることが示されています.つまり、モデルはトレーニングデータに基づいて算術を学習しているため、トレーニングデータに含まれない桁数の計算に対しては正確な結果を出すことができません.

例えば、あるモデルがすべてのn桁の長さでトレーニングされている場合でも、特定の長さを除外した場合、その欠落した桁数の計算を正確に補完することができません.したがって、モデルはトレーニングされた桁数の範囲内では高い精度を達成しますが、この範囲を超えると困難になります.これは、モデルが柔軟なアルゴリズムとして算術を学習しているのではなく、トレーニングされた桁数に制約されたマッピング関数として算術を学習していることを示唆しています.

このような長さの一般化の課題は、トランスフォーマーが算術を学習する際に直面する重要な問題です.トレーニングデータに含まれる桁数の範囲を超える計算を正確に行うためには、より柔軟なアルゴリズムや一般化能力が必要とされます.この課題を克服するためには、トレーニングデータの多様性や長さのバリエーションを増やすことが重要です.また、トレーニングデータのフォーマットを変更することで、より効果的な算術学習が可能となることが示されています.

以上のように、小型トランスフォーマーに算術を教える際の長さの一般化の課題は、トレーニングデータの範囲に制約があるため、トレーニングデータに含まれない桁数の計算に対して正確な結果を出すことが困難であるという点にあります.この課題を克服するためには、より柔軟なアルゴリズムや一般化能力を持つモデルの開発や、トレーニングデータの多様性や長さのバリエーションの増加が必要です.

Q: 小型変圧器における演算能力の引き出しに、データの質と指導力はどのように影響するのか?

A: データの品質と教示の有用性は、小規模なトランスフォーマーにおける算術能力の引き出しにどのような影響を与えるのでしょうか.

この研究では、次のトークン予測目的を使用して、小規模なランダム初期化トランスフォーマーに算術演算と基本的な数学関数を教える問題を検討しています.研究者たちは、訓練データのさまざまな側面を慎重に取り除き、算術能力の出現に寄与する要因を分離するための実験を行いました.その結果、従来の訓練データは算術の学習には最適ではなく、中間ステップを含む詳細な教示データや出力を逆にすることで精度とサンプルの複雑さが改善されることがわかりました.研究者たちは、算術能力の迅速な出現の両方のシナリオを考慮しています.

関連研究では、詳細な推論訓練データを使用するアイデアはTransformersよりも前から存在していました.Ling et al.(2017)、Cobbe et al.(2021)、Nye et al.(2021)は自然言語を使用して推論ステップを生成し、Roy&Roth(2016)、Reed&De Freitas(2015)、Chen et al.(2017)、Cai et al.(2017)は記号的な推論が十分であることを示しています.Nogueira et al.(2021)は、算術タスクにおいて小さな桁の大量のサンプルが重要であることを指摘しています(Yuan et al.、2023).Razeghi et al.(2022)は、データセット中の数字の頻度との相関関係を観察しています.

また、複数の演算を学習する正しい方法も明確ではありません.もしも、壊滅的な忘却の問題を回避できるならば、複雑さの増加する順序でそれらを学習することが有益である可能性があります.私たちの研究結果は、トランスフォーマーが算術演算を獲得するために高品質で教示的なデータの重要性を強調しています.この研究がトランスフォーマーが算術演算を獲得するメカニズムのより微妙な理解に貢献することを期待しています.

Q: 小さな変圧器に算数を教える際に重要な、次の単語を予測する目標の特徴について教えてください.

A: 次の単語予測目標において、小さなトランスフォーマーに算術を教えるために重要な特性についての洞察を提供できます.

この研究では、次のトークン予測目標を使用して、ランダムな初期化からトレーニングされた小さなトランスフォーマーモデルが、加算、乗算、平方根などの算術演算や基本的な数学関数を効率的に学習できるかどうかを調査しています.研究では、従来のトレーニングデータが算術学習に最も効果的ではないことを示し、単純なフォーマットの変更が精度を大幅に向上させることを示しています.

具体的には、従来の加算サンプル(例:「A3A2A1+B3B1B1=C3C2C1」)を使用することは最適ではないことがわかりました.代わりに、詳細で具体的なデータを使用することや、出力を逆にすることで精度とサンプルの複雑さが改善されることが示されました.

また、データのフォーマットやサンプリング方法も重要な要素であり、データのスケールによっても効果が異なることがわかりました.さらに、モデルのスケールや事前トレーニングの存在、プロンプトの方法なども、算術能力の出現を加速させる要素として考慮されるべきです.

この研究は、大規模な言語モデルが一般的なタスク(例:基本的な算術)で新たな能力を獲得することを示していますが、これらのタスクは教師なしの次のトークン予測目標に明示的にエンコードされていないものです.この研究は、実践における複雑な能力の出現を実証するだけでなく、この振る舞いのより良い理解を提供することを目的としています.

要約すると、小さなランダムな初期化されたトランスフォーマーモデルに算術演算と基本的な数学関数を教える問題を検討しました.トレーニングデータの異なる側面を注意深く分析し、算術能力の出現に寄与する要素を特定しました.従来のトレーニングデータは算術学習には最適ではなく、詳細で具体的なデータや出力の逆転などのトレーニング方法の変更により、精度とサンプルの複雑さが改善されることが明らかになりました.

Q: 本稿で紹介した新手法のコード実装のURLは?

A: 本論文で導入された新しい手法のコード実装のURLは、https://github.com/lee-ny/teaching_arithmeticです.

Focused Transformer: Contrastive Training for Context Scaling

著者:Szymon Tworkowski, Konrad Staniszewski, Mikołaj Pacek, Yuhuai Wu, Henryk Michalewski, Piotr Miłoś

発行日:2023年07月06日

最終更新日:2023年07月06日

URL:http://arxiv.org/pdf/2307.03170v1

カテゴリ:Computation and Language, Artificial Intelligence, Machine Learning

概要:

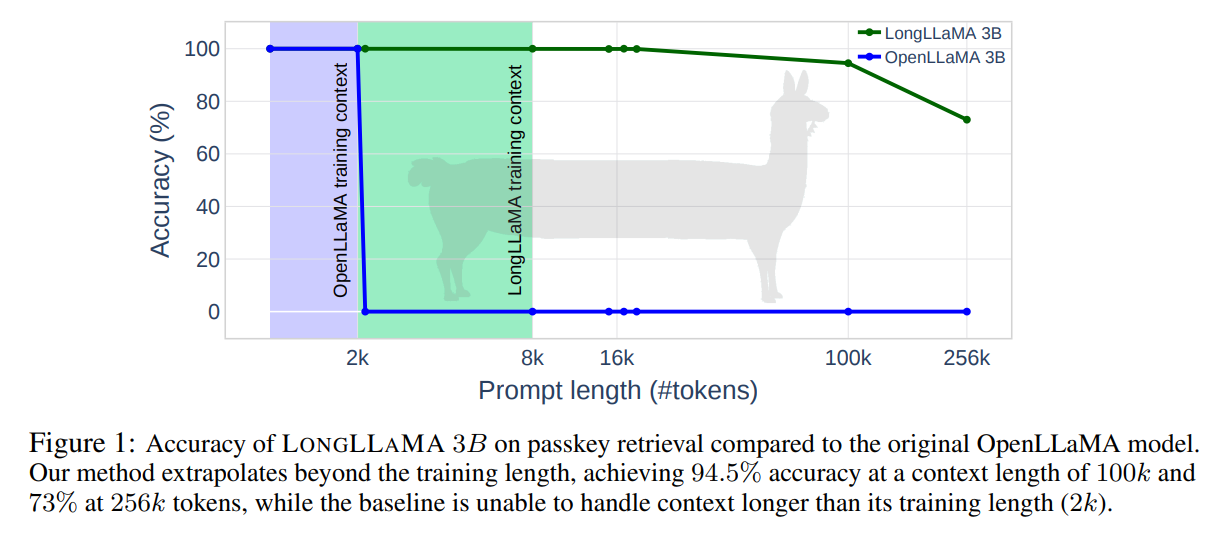

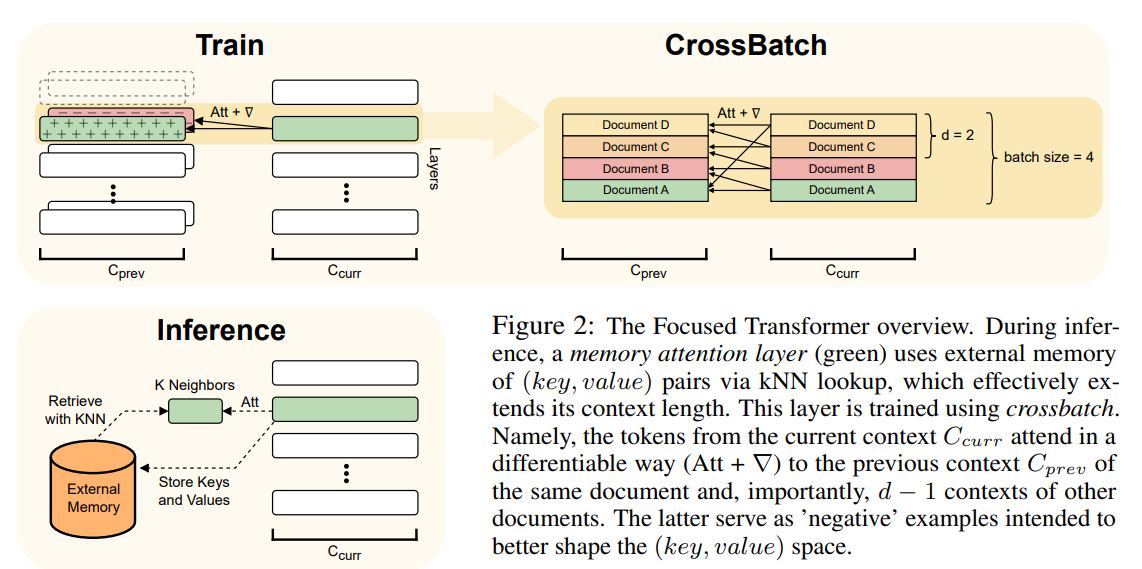

私たちの手法は、\( \small 3B \)および\( \small 7B \)のOpenLLaMAチェックポイントの微調整によって示されています.この結果、私たちがLongLLaMAと名付けたモデルは、長い文脈を必要とするタスクにおいて進歩を遂げています.さらに、私たちのLongLLaMAモデルは、パスキーの取得において\( \small 256 k \)の文脈長を巧みに管理することを示しています.

Q&A:

Q: 大規模言語モデルにおける有効文脈長の限界とは?

A: 大規模な言語モデルの有効な文脈の長さの制限は、モデルのトレーニング長よりも短いです.この文脈の長さの制限は、モデルが処理できるトークンの数によって制約されます.通常、モデルのトレーニングに使用される文脈の長さは数千トークンですが、実際の応用では、モデルが処理できる文脈の長さは数百万トークンにまで拡張する必要があります.

この制限は、大量の新しい知識を効果的に組み込むことが困難であるという中心的な課題です.モデルを微調整するという一般的な方法は、リソースを多く消費し、管理が複雑であり、さらにはモデルの有効な文脈の長さに制約があります.したがって、大規模な知識データベースと組み合わせてこの方法を使用するためには、モデルは数百万トークンに及ぶ文脈の長さを管理する必要があります.

この制限を克服するために、我々は対照的な学習によって新しいアプローチを提案しています.この新しいアプローチは、(キー、値)の空間の構造を強化し、文脈の長さを拡張することを可能にします.我々の方法では、既存の大規模モデルを微調整して、その有効な文脈を延長することができます.この方法は、3Band7BOpenLLaMAチェックポイントの微調整によって示されています.その結果、我々はLONG LLAMA2という名前のモデルを得ました.これらのモデルは、長い文脈を必要とするタスクでの進歩を示しています.さらに、我々のLONG LLAMAモデルは、パスキーの取得において256kトークンの文脈の長さを巧みに扱うことを示しています.

つまり、大規模な言語モデルの有効な文脈の長さの制限は、モデルのトレーニング長よりも短いため、モデルが処理できるトークンの数によって制約されます.この制限を克服するために、対照的な学習を使用してモデルを微調整し、文脈の長さを拡張することができます.

Q: アテンション・レイヤーに外部メモリへのアクセス機能を持たせることは、その制限にどのように対処する助けになるのだろうか?

A: 外部メモリへのアクセスを持つ注意層を与えることによって、制限を解決する方法は次のようになります.外部メモリには(キー、値)のペアが含まれており、注意層はこれにアクセスすることができます.これにより、モデルは推論時に外部メモリから情報を取得し、効果的にコンテキストを拡張することができます.

具体的には、注意層はクエリと外部メモリのキーとの内積によってランク付けされた上位k個の一致するキーにアテンションを与えます.これにより、モデルはローカルコンテキストからの前のキーとメモリからの一致するキーに注意を向けることができます.

外部メモリへのアクセスを持つことにより、モデルはより長いコンテキストを利用することができます.これにより、モデルはより広範な情報を考慮に入れることができ、文脈に基づいた情報をより効果的に利用することができます.

また、クロスバッチトレーニング手法によって、モデルは(キー、値)の表現を学習するようにバイアスをかけられます.これにより、メモリアテンション層が簡単に使用できる表現を学習することができます.

以上のように、外部メモリへのアクセスを持つことによって、モデルは制限を解決し、より長いコンテキストを利用することができます.これにより、モデルはより豊富な情報を考慮に入れ、より効果的な文脈を形成することができます.

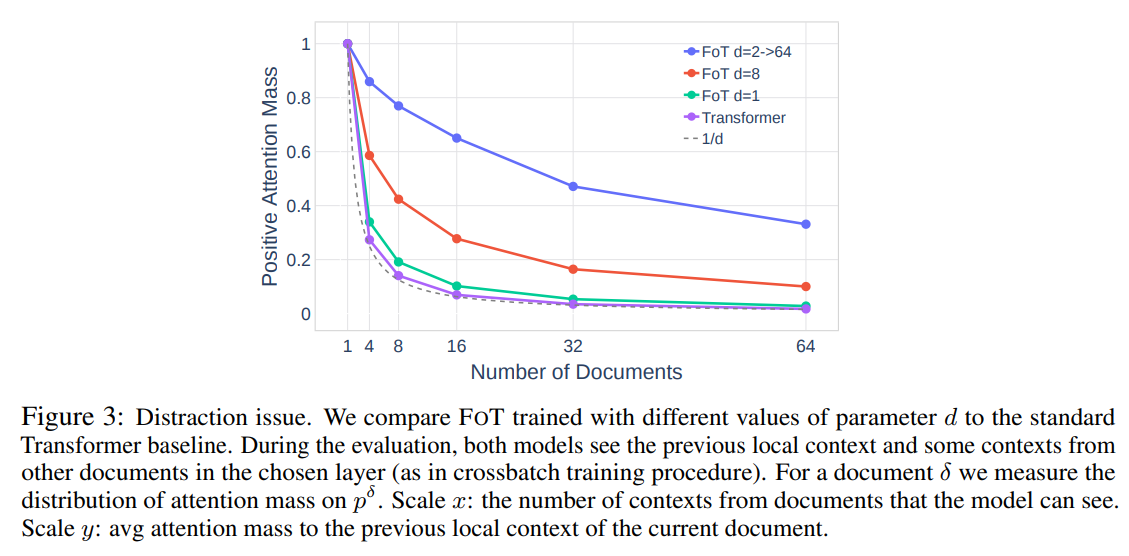

Q: フォーカスト・トランスフォーマー(FoT)技術は、注意散漫の問題にどのように対処するのですか?

A: フォーカスドトランスフォーマー(FoT)テクニックは、分散問題に対処するために開発された革新的な手法です.この問題は、文脈の長さが増えるにつれて、関連するトークンと関連のないトークンの比率が減少するというものです.通常のトレーニング手順では、関連のない値と関連のある値に接続されたキーの重複が頻繁に発生し、モデルがそれらを区別するタスクが悪化します.この課題を「分散問題」と呼びます.

FoTは、この問題に対処するために明示的に開発された革新的な手法です.FoTでは、一部のアテンション層が外部メモリ(キー、値のペア)にアクセスできるようになっており、k最近傍(kNN)アルゴリズムを介してデータを参照します.これにより、総文脈の長さを効果的に拡張することができます.

FoTの訓練手順は、対照的な学習から引用しており、モデルの訓練フェーズでは関連するキーと関連のないキー(関連のない文書からのネガティブサンプルなど)にメモリアテンション層を意図的にさらすことで、分散問題に対処し、より大きなメモリ容量を可能にしています.

具体的には、FoTの訓練フェーズでは、関連するキーと関連のないキーの両方にメモリアテンション層を露出させることで、モデルに対して関連する情報と関連しない情報を区別する能力を養います.この戦略により、モデルはより正確に関連する情報を抽出し、分散問題を解決することができます.

以上のように、フォーカスドトランスフォーマー(FoT)テクニックは、分散問題に対処するために、外部メモリとk最近傍アルゴリズムを使用して文脈の長さを拡張し、対照的な学習を通じて関連する情報と関連しない情報を区別する能力を養うことで、分散問題に対処しています.

Q: FoTで使用されている対照学習から着想を得たトレーニングプロセスについて説明していただけますか?

A: FoT(Focused Transformer)のトレーニングプロセスは、対照学習に触発されたものです.この方法では、トレーニングフェーズでメモリの注意層を関連するキーと関連のないキー(関連のないドキュメントからのネガティブサンプルのようなもの)の両方に露出させることを意図的に行います.この戦略により、モデルは意味的に異なる値に関連するキーを区別するように促され、その構造が向上します.

具体的には、トレーニングフェーズでは、モデルに関連するキーと関連のないキーの両方を意図的に提示します.これにより、モデルは異なる意味的な値に関連するキーを区別するための学習を行います.このようにして、キーの構造が向上し、モデルはより正確に関連するキーを特定することができるようになります.

このトレーニングプロセスは、対照学習のアイデアに基づいており、モデルが異なるキーを区別する能力を向上させるために使用されます.これにより、モデルはより大きなメモリ容量を持つことができます.また、既存のモデルにも適用することができるため、トレーニング中に長い文脈を必要とせず、既存のモデルに適用することができます.

以上がFoT(Focused Transformer)で使用される対照学習に触発されたトレーニングプロセスの説明です.

Q: FoTは(キー、バリュー)スペースの構造をどのように強化するのか?

A: FoTは、(key, value)空間の構造を向上させるためのトレーニングプロセスによって、その機能を強化します.この新しいアプローチにより、コンテキストの長さを拡張することが可能となります.具体的には、既存の大規模モデルを微調整することで、効果的なコンテキストを延長することができます.このことは、3Band7BOpenLLaMAチェックポイントの微調整によって示されています.

FoTは、コントラスティブラーニングに着想を得たトレーニング目的を含んでおり、(key, value)空間の構造を向上させることができます.このトレーニングプロセスにより、外部メモリの使用やk最近傍探索を可能にし、コンテキストの長さを拡張することができます.

具体的な手法やアルゴリズムについては文中には触れられていませんが、FoTは既存のモデルを微調整することで、(key, value)空間の構造を改善し、コンテキストの長さを拡張することができると述べられています.詳細な手法やアルゴリズムについては、論文や関連する資料を参照することが必要です.

Q: 文脈を長くするプロセスにおいて、既存の大規模なモデルを微調整する目的は何か?

A: 大規模なモデルを事前に調整する目的は、効果的な文脈の長さを延長することです.これにより、既存のモデルを微調整して、より長い文脈を持つようにすることができます.このアプローチにより、長い文脈を必要とするタスクにおいて、モデルの性能が向上します.具体的には、3Band7BOpenLLaMAのチェックポイントを微調整することで、効果的な文脈の長さを延長したLONG LLAMA2モデルを作成しました.また、256kの文脈長を持つパスキーの検索において、LONG LLAMAモデルが優れた性能を示すことも示しました.このように、既存の大規模なモデルを微調整することで、効果的な文脈の長さを延長することができます.

Q: LongLLaMAモデルが、長いコンテクストを必要とするタスクで示した進歩の例を教えてもらえますか?

A: LongLLaMAモデルは、長い文脈を必要とするタスクにおいて進歩を示しています.具体的な例としては、TRECやWebQSといったタスクが挙げられます.これらのタスクでは、拡張された文脈内の少数のデモンストレーションの数を増やすことが有益です.LongLLaMAモデルは、このようなタスクにおいて、その数を増やすことで改善が見られます.

また、パスキーの検索においても、LongLLaMAモデルは256kの文脈長をうまく扱うことが証明されています.これは、MohtashamiとJaggiによる研究[2023]によって示されています.

LongLLaMAモデルは、既存の大規模モデルを効果的な文脈の拡張のために微調整することで、その構造を変更せずにメモリとの連携を実現しています.この手法は、コスト効果があります.3Band7BOpenLLaMAチェックポイントを微調整することで、LongLLaMAモデルが作成されます.このモデルは、長い文脈を必要とするタスクにおいて進歩を示しています.

以上のように、LongLLaMAモデルは、長い文脈を必要とするタスクにおいて進歩を示しています.具体的な例としては、TRECやWebQSといったタスクが挙げられます.また、パスキーの検索においても、LongLLaMAモデルは256kの文脈長をうまく扱うことが証明されています.

Q: LongLLaMAモデルは、パスキー検索のために256kのコンテキスト長をどのように管理していますか?

A: LongLLaMAモデルは、トランスフォーマーモデルを使用しており、パスキーの検索タスクにおいて256kのコンテキスト長を効果的に管理するために、いくつかの革新的な手法を採用しています.

まず、LongLLaMAモデルは、通常のトレーニング手順では、関連のないトークンと関連のあるトークンの間に重複が生じることがあるという問題に取り組んでいます.この問題は、「分散問題」と呼ばれています.具体的には、ドキュメントの数が増えると、関連のあるトークンと関連のないトークンの比率が低下します.このため、モデルはそれらを区別することが困難になります.

この問題に対処するために、LongLLaMAモデルは「フォーカスドトランスフォーマー(FOT)」という革新的な手法を提案しています.FOTは、関連のあるトークンと関連のないトークンを区別するために開発された手法です.具体的には、FOTは、関連のあるトークンと関連のないトークンを明確に区別するために、重要なトークンにフォーカスすることができます.

さらに、LongLLaMAモデルは、トレーニングのコンテキスト長を超えて予測を行う能力を持っています.例えば、LongLLaMAモデルは、トレーニングコンテキスト長が2kであるにもかかわらず、100kのコンテキスト長で94.5%の精度を達成し、256kのコンテキスト長で73%の精度を達成しています.これにより、LongLLaMAモデルは、トレーニングのコンテキスト長を超えても高い精度を維持することができます.

以上のように、LongLLaMAモデルは、分散問題に取り組むためのフォーカスドトランスフォーマー手法を採用し、トレーニングのコンテキスト長を超えて予測を行う能力を持つことにより、256kのコンテキスト長を効果的に管理しています.

Q: 微調整プロセスにおける\( \small 3B \)と\( \small 7B \)のOpenLLaMAチェックポイントの意味を説明していただけますか?

A: \( \small 3B \)と\( \small 7B \)のOpenLLaMAチェックポイントは、ファインチューニングプロセスにおいて重要な役割を果たしています.これらのチェックポイントは、元のモデルをベースにして、新しいタスクやコンテキストに適応させるための出発点となります.

まず、OpenLLaMAは、元のモデルをトレーニングするための大規模なデータセットを使用しています.このトレーニングプロセスにより、モデルは一般的な言語理解の能力を獲得します.しかし、このトレーニングでは、特定のタスクやコンテキストに関連する知識は十分には獲得できません.

そのため、ファインチューニングプロセスが必要となります.ファインチューニングでは、元のモデルを特定のタスクやコンテキストに適応させるために、追加のトレーニングが行われます.\( \small 3B \)と\( \small 7B \)のOpenLLaMAチェックポイントは、このファインチューニングプロセスのための出発点となるモデルです.

具体的には、\( \small 3B \)と\( \small 7B \)のOpenLLaMAチェックポイントは、元のモデルのアーキテクチャを変更せずに、メモリを使用して新しいタスクやコンテキストに適応させることができます.これにより、コスト効果の高いファインチューニングが可能となります.

また、\( \small 3B \)と\( \small 7B \)のOpenLLaMAチェックポイントを使用して行われるファインチューニングでは、少数のデモンストレーションを増やすことでタスクの改善が見られます.具体的には、TRECやWebQSといったタスクにおいて、拡張されたコンテキストの少数のデモンストレーションの数を増やすことで、モデルの性能が向上します.

したがって、\( \small 3B \)と\( \small 7B \)のOpenLLaMAチェックポイントは、ファインチューニングプロセスにおいて重要な役割を果たし、元のモデルを特定のタスクやコンテキストに適応させるための出発点となります.これにより、モデルの性能が向上し、新しい知識を組み込むための効果的な手法が提供されます.